- Informationen über dieses Handbuch

- I Einführung zu SUSE Enterprise Storage (SES)

- 1 SES und Ceph

- 2 Hardwareanforderungen und Empfehlungen

- 2.1 Netzwerke im Überblick

- 2.2 Konfigurationen mit mehreren Architekturen

- 2.3 Hardwarekonfiguration

- 2.4 Objektspeicherknoten

- 2.5 Monitorknoten

- 2.6 Object-Gateway-Knoten

- 2.7 Metadata Server-Knoten

- 2.8 Admin-Knoten

- 2.9 iSCSI-Gateway-Knoten

- 2.10 SES und andere SUSE-Produkte

- 2.11 Namensbegrenzungen

- 2.12 Ein einziger Server für OSD und Monitor

- 3 Einrichten des Hochverfügbarkeits-Clusters für den Admin-Knoten

- II Bereitstellen des Ceph-Clusters

- III Upgrade von vorigen Versionen

- 10 Upgrade von SUSE Enterprise Storage 6 auf 7.1

- 10.1 Vor dem Aufrüsten

- 10.2 Upgrade des Salt Masters

- 10.3 Upgrade der MON-, MGR- und OSD-Knoten

- 10.4 Upgrade von Gateway-Knoten

- 10.5 Installieren von

ceph-saltund Anwenden der Cluster-Konfiguration - 10.6 Upgrade und Übernahme des Überwachungs-Stacks

- 10.7 Erneute Bereitstellung des Gateway-Service

- 10.8 Bereinigung nach dem Upgrade

- 11 Upgrade von SUSE Enterprise Storage 7 auf 7.1

- 10 Upgrade von SUSE Enterprise Storage 6 auf 7.1

- A Ceph-Wartungsaktualisierungen auf der Grundlage von vorgeschalteten „Pacific“-Unterversionen

- Glossar

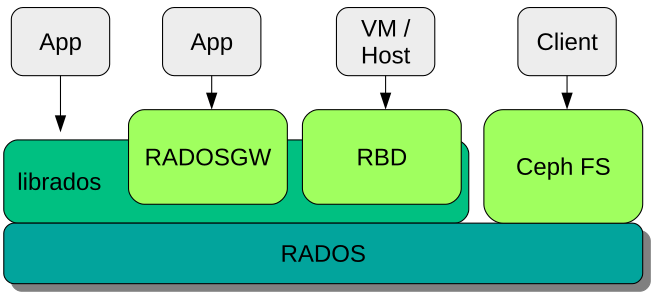

- 1.1 Schnittstellen zum Ceph-Objektspeicher

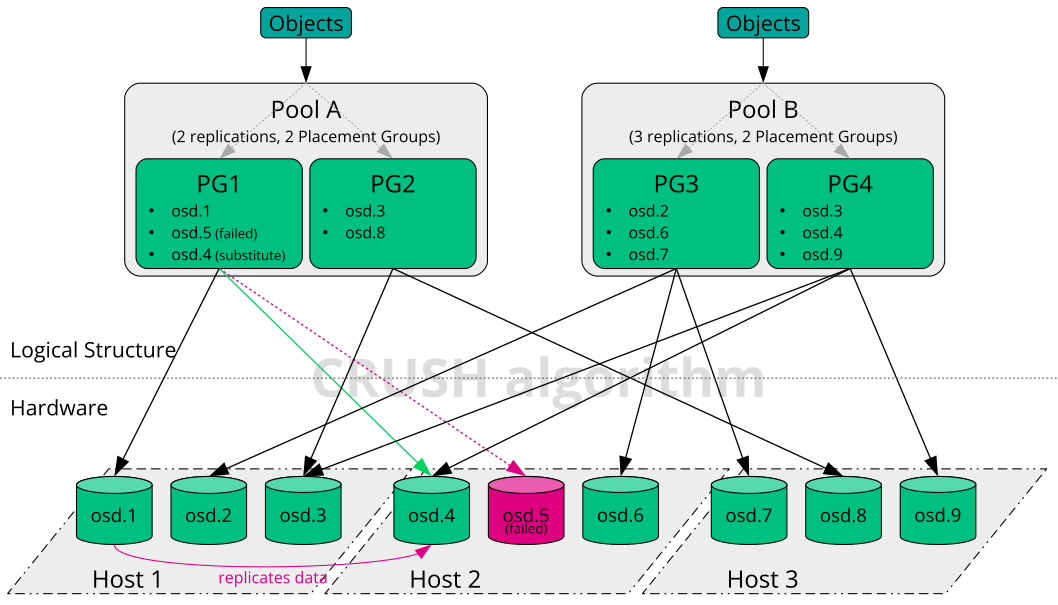

- 1.2 Beispiel eines kleinen Ceph-Speichers

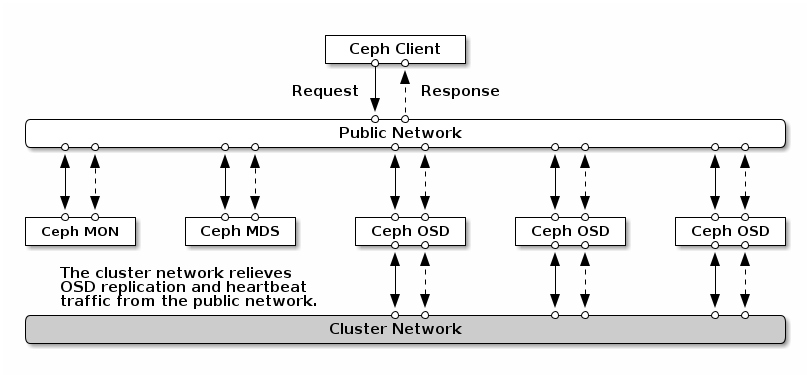

- 2.1 Netzwerke im Überblick

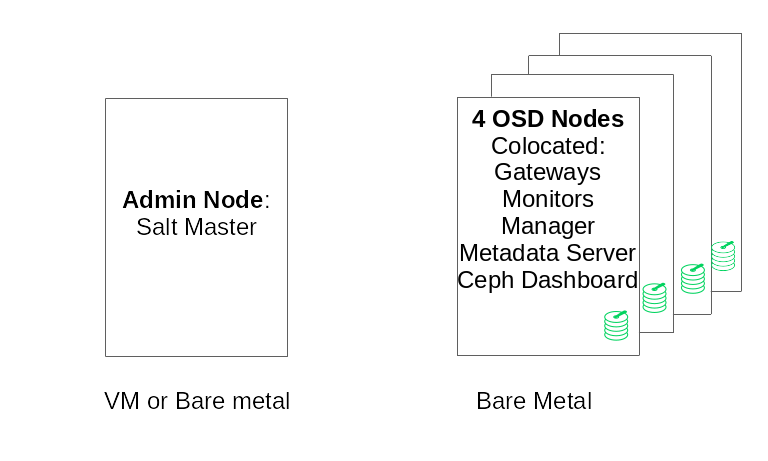

- 2.2 Mindestkonfiguration für den Cluster

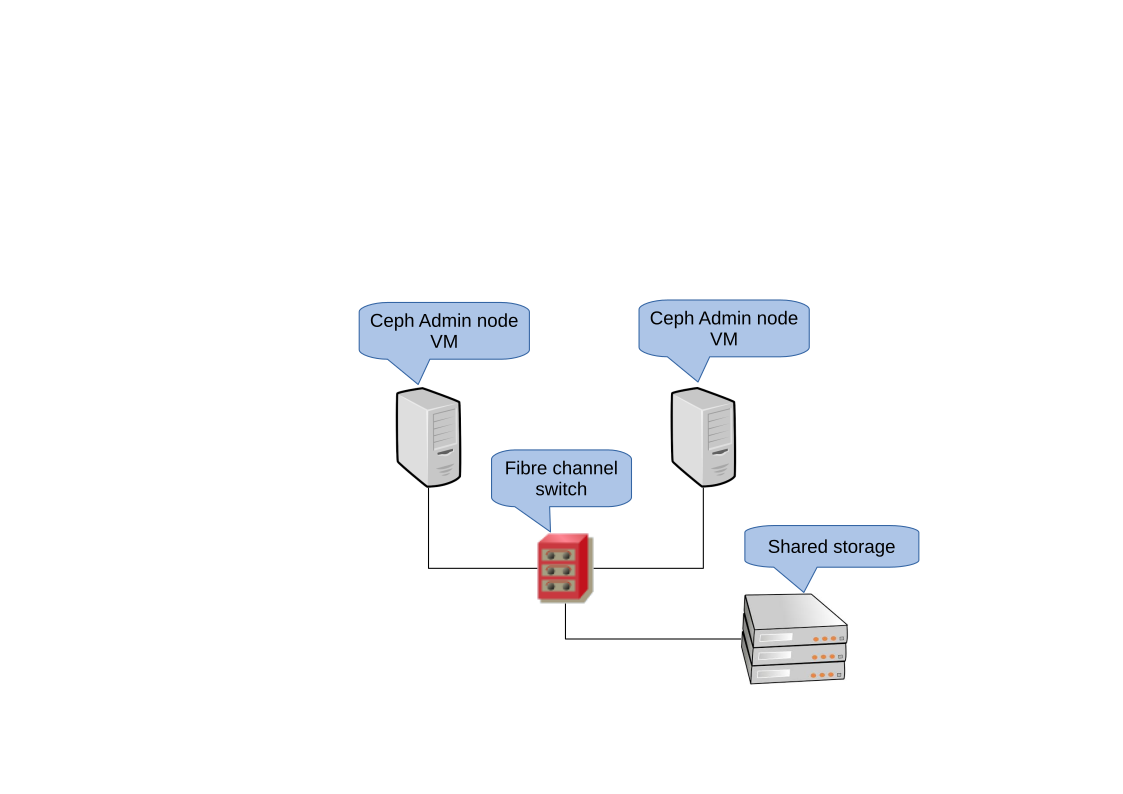

- 3.1 Hochverfügbarkeits-Cluster mit zwei Knoten für den Admin-Knoten

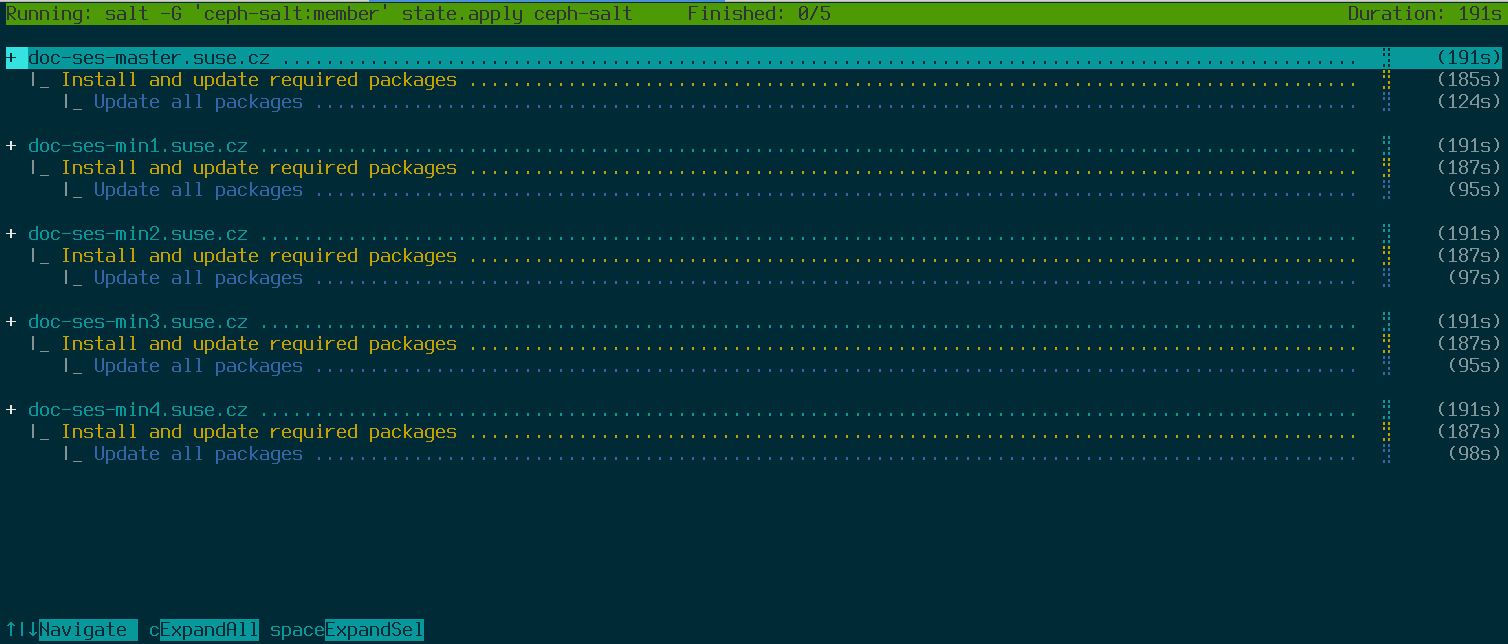

- 7.1 Bereitstellung eines Minimalclusters

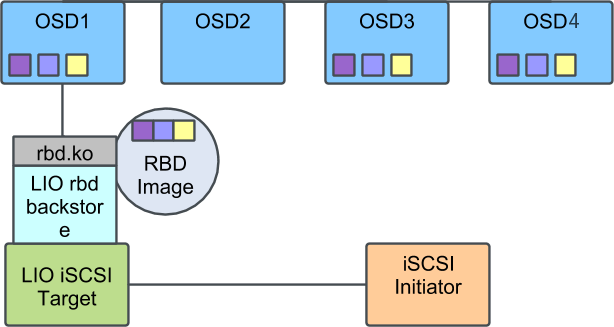

- 9.1 Ceph-Cluster mit einem einzigen iSCSI Gateway

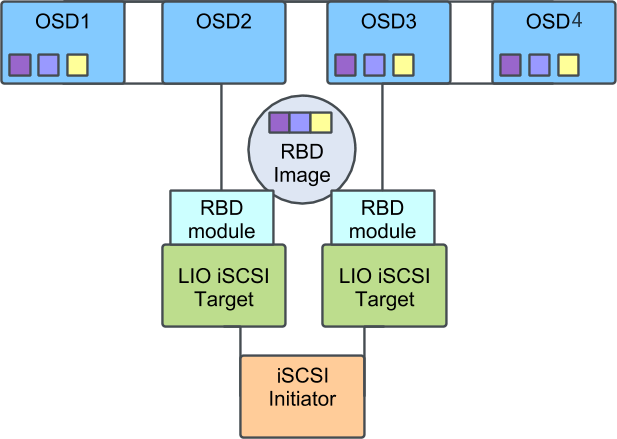

- 9.2 Ceph-Cluster mit mehreren iSCSI Gateways

Copyright © 2020–2025 SUSE LLC und Mitwirkende. Alle Rechte vorbehalten.

Sofern nicht anders angegeben, ist dieses Dokument unter Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0) lizenziert: https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Die SUSE-Marken finden Sie unter http://www.suse.com/company/legal/. Die Rechte für alle Marken von Drittanbietern liegen bei den jeweiligen Eigentümern. Markensymbole (®, ™ usw.) kennzeichnen Marken von SUSE und ihren Tochtergesellschaften. Sternchen (*) kennzeichnen Marken von Drittanbietern.

Alle Informationen in diesem Buch wurden mit größter Sorgfalt zusammengestellt. Auch hierdurch kann jedoch keine hundertprozentige Richtigkeit gewährleistet werden. Weder SUSE LLC, ihre Tochtergesellschaften, die Autoren noch die Übersetzer können für mögliche Fehler und deren Folgen haftbar gemacht werden.

Informationen über dieses Handbuch #

Diese Anleitung konzentriert sich auf die Bereitstellung eines grundlegenden Ceph-Clusters und zusätzlicher Services. Außerdem werden die Schritte für ein Upgrade auf SUSE Enterprise Storage 7.1 von der vorherigen Produktversion beschrieben.

SUSE Enterprise Storage 7.1 ist eine Erweiterung zu SUSE Linux Enterprise Server 15 SP3. Es kombiniert die Funktion des Ceph(http://ceph.com/)-Speicherobjekts mit der Unternehmenstechnik und dem Support von SUSE. Mit SUSE Enterprise Storage 7.1 stellen IT-Organisationen eine dezentrale Speicherarchitektur bereit, die eine Reihe von Anwendungsfällen auf kommerziellen Hardwareplattformen unterstützt.

1 Verfügbare Dokumentation #

Die Dokumentation für unsere Produkte steht unter https://documentation.suse.com bereit. Hier finden Sie außerdem die neuesten Aktualisierungen und können die Dokumentation durchsuchen oder in verschiedenen Formaten herunterladen. Die neuesten Aktualisierungen der Dokumentation finden Sie in der englischen Sprachversion.

Darüber hinaus befindet sich die Dokumentation auf dem installierten System im Verzeichnis /usr/share/doc/manual. Sie ist enthalten in einem RPM-Paket namens ses-manual_LANG_CODE. Installieren Sie es, wenn es nicht bereits auf Ihrem System vorhanden ist. Beispiel:

# zypper install ses-manual_enDie folgende Dokumentation ist für dieses Produkt verfügbar:

- Implementierungsleitfaden

Diese Anleitung konzentriert sich auf die Bereitstellung eines grundlegenden Ceph-Clusters und auf die Bereitstellung zusätzlicher Services. Außerdem werden die Schritte für ein Upgrade auf SUSE Enterprise Storage 7.1 von der vorherigen Produktversion beschrieben.

- Betriebs- und Verwaltungshandbuch

Dieses Handbuch konzentriert sich auf Routineaufgaben, die Sie als Administrator erledigen müssen, nachdem der grundlegende Ceph-Cluster bereitgestellt wurde (Vorgänge ab Tag 2). Außerdem werden alle unterstützten Möglichkeiten zum Zugriff auf die in einem Ceph-Cluster gespeicherten Daten beschrieben.

- Security Hardening Guide (Sicherheitshandbuch)

Diese Anleitung konzentriert sich darauf, wie Sie die Sicherheit Ihres Clusters gewährleisten können.

- Troubleshooting Guide (Handbuch zur Fehlersuche)

In diesem Leitfaden werden verschiedene häufige Probleme bei der Ausführung von SUSE Enterprise Storage 7.1 und andere Fragen zu relevanten Komponenten wie Ceph oder Object Gateway behandelt.

- SUSE Enterprise Storage for Windows Guide (Handbuch zu SUSE Enterprise Storage für Windows)

In diesem Handbuch wird die Integration, Installation und Konfiguration von Microsoft-Windows-Umgebungen und SUSE Enterprise Storage mithilfe des Windows-Treibers beschrieben.

2 Feedback #

Wir freuen uns über Rückmeldungen und Beiträge zu dieser Dokumentation. Hierfür gibt es mehrere Kanäle:

- Serviceanforderungen und Support

Informationen zu Services und Support-Optionen, die für Ihr Produkt verfügbar sind, finden Sie unter http://www.suse.com/support/.

Zum Öffnen einer Service-Anforderung benötigen Sie ein SUSE-Abonnement, das beim SUSE Customer Center registriert ist. Gehen Sie zu https://scc.suse.com/support/requests, melden Sie sich an und klicken Sie auf .

- Fehlerberichte

Melden Sie Probleme mit der Dokumentation unter https://bugzilla.suse.com/. Zum Melden von Problemen ist ein Bugzilla-Konto erforderlich.

Zur Vereinfachung dieses Vorgangs können Sie die Links (Fehler in der Dokumentation melden) neben den Überschriften in der HTML-Version dieses Dokuments verwenden. Dadurch werden das richtige Produkt und die Kategorie in Bugzilla vorab ausgewählt und ein Link zum aktuellen Abschnitt hinzugefügt. Sie können somit sofort mit der Eingabe Ihres Berichts beginnen.

- Beiträge

Verwenden Sie für einen Beitrag zu dieser Dokumentation die Links (Quelle bearbeiten) neben den Überschriften in der HTML-Version dieses Dokuments. Sie führen Sie zum Quellcode auf GitHub, wo Sie eine Pull-Anforderung öffnen können. Für Beiträge ist ein GitHub-Konto erforderlich.

Weitere Informationen zur Dokumentationsumgebung für diese Dokumentation finden Sie in der README des Repositorys unter https://github.com/SUSE/doc-ses.

Alternativ können Sie E-Mails mit Fehlerberichten und Feedback zur Dokumentation an <doc-team@suse.com> senden. Geben Sie den Titel der Dokumentation, die Produktversion und das Datum der Veröffentlichung der Dokumentation an. Geben Sie zudem die entsprechende Abschnittsnummer und den Titel (oder die URL) an und fügen Sie eine kurze Beschreibung des Problems hinzu.

3 Konventionen in der Dokumentation #

In der vorliegenden Dokumentation werden die folgenden Hinweise und typografischen Konventionen verwendet:

/etc/passwd: Verzeichnis- und DateinamenPLATZHALTER: Ersetzen Sie PLATZHALTER durch den tatsächlichen Wert.

PFAD: Eine Umgebungsvariablels,--help: Kommandos, Optionen und Parameteruser: Der Name eines Benutzers oder einer Gruppepackage_name: Der Name eines Softwarepakets

Alt, Alt–F1: Eine zu drückende Taste bzw. Tastenkombination. Tasten werden wie auf einer Tastatur in Großbuchstaben dargestellt.

, › : Menüelemente, Schaltflächen

AMD/Intel Dieser Absatz ist nur für die AMD64-/Intel 64-Architekturen relevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.

IBM Z, POWER Dieser Absatz ist nur für die Architekturen

IBM ZundPOWERrelevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.Kapitel 1, „Beispielkapitel“: Ein Querverweis auf ein anderes Kapitel in diesem Handbuch.

Kommandos, die mit

root-Privilegien ausgeführt werden müssen. Diesen Kommandos kann zur Ausführung als nicht privilegierter Benutzer auch häufig das Präfixsudovorangestellt sein.#command>sudocommandKommandos, die von Benutzern ohne Privilegien ausgeführt werden können.

>commandHinweise

Warnung: WarnhinweisWichtige Informationen, die Sie kennen müssen, bevor Sie fortfahren. Warnt vor Sicherheitsrisiken, potenziellen Datenverlusten, Beschädigung der Hardware oder physischen Gefahren.

Wichtig: Wichtiger HinweisWichtige Informationen, die Sie beachten sollten, bevor Sie den Vorgang fortsetzen.

Anmerkung: AnmerkungErgänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Tipp: TippHilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

Kompaktinfos

Ergänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Hilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

4 Support #

Im Folgenden finden Sie die Supportbestimmung für SUSE Enterprise Storage sowie allgemeine Informationen über Technologievorschauen. Details über den Produktlebenszyklus finden Sie unter https://www.suse.com/lifecycle.

Wenn Sie Anspruch auf Support haben, finden Sie Details zum Sammeln von Informationen für ein Support-Ticket unter https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Erläuterung zum Support für SUSE Enterprise Storage #

Sie benötigen ein entsprechendes Abonnement bei SUSE, um Support zu erhalten. Gehen Sie zur Anzeige der für Sie verfügbaren spezifischen Support-Angebote zu https://www.suse.com/support/ und wählen Sie das betreffende Produkt aus.

Die Support-Stufen sind folgendermaßen definiert:

- L1

Problemermittlung: Technischer Support mit Informationen zur Kompatibilität, Nutzungs-Support, kontinuierliche Wartung, Informationssammlung und einfache Problembehandlung anhand der verfügbaren Dokumentation.

- L2

Problemisolierung: Technischer Support zur Datenanalyse, Reproduktion von Kundenproblemen, Isolierung von Problembereichen und Lösung für Probleme, die in Stufe 1 nicht gelöst wurden, sowie Vorbereitung für Stufe 3.

- L3

Problembehebung: Technischer Support zur Lösung von Problemen durch technische Maßnahmen zur Behebung von Produktfehlern, die durch den Support der Stufe 2 erkannt wurden.

Vertragskunden und Partner erhalten SUSE Enterprise Storage mit L3-Support für alle Pakete, ausgenommen:

Technologievorschauen.

Audio, Grafik, Schriftarten und Artwork.

Pakete, für die ein zusätzlicher Kundenvertrag erforderlich ist.

Einige Pakete, die im Lieferumfang von Modul Workstation Extension enthalten sind, erhalten nur L2-Support.

Pakete mit Namen, die auf -devel enden (die Header-Dateien und ähnliche Entwicklerressourcen enthalten), werden nur zusammen mit ihren Hauptpaketen unterstützt.

SUSE unterstützt nur die Nutzung von Originalpaketen, also unveränderten und nicht kompilierten Paketen.

4.2 Technologievorschauen #

Mit Technologievorschauen sind Pakete, Stacks oder Funktionen gemeint, die SUSE bereitstellt, um einen kurzen Einblick in bevorstehende Innovationen zu geben. Durch Technologievorschauen haben Sie die Möglichkeit, neue Technologien in Ihrer Umgebung zu testen. Über Ihr Feedback würden wir uns sehr freuen. Wenn Sie eine Technologievorschau testen, kontaktieren Sie bitte Ihre Ansprechpartner bei SUSE und teilen Sie ihnen Ihre Erfahrungen und Anwendungsfälle mit. Ihr Input ist für zukünftige Entwicklungen sehr hilfreich.

Technologievorschauen weisen die folgenden Einschränkungen auf:

Technologievorschauen befinden sich noch in Entwicklung. Daher sind die Funktionen möglicherweise unvollständig oder auf andere Weise nicht für die Produktionsnutzung geeignet.

Technologievorschauen werden nicht unterstützt.

Technologievorschauen sind möglicherweise nur für bestimmte Hardwarearchitekturen verfügbar.

Details und Funktionen von Technologievorschauen sind Änderungen unterworfen. Upgrades auf Folgeversionen sind demnach nicht möglich und erfordern eine Neuinstallation.

SUSE kann feststellen, dass eine Vorschau nicht den Kunden- oder Marktanforderungen entspricht oder nicht mit den Unternehmensstandards übereinstimmt. Technologievorschauen können jederzeit aus einem Produkt entfernt werden. SUSE ist nicht verpflichtet, eine unterstützte Version dieser Technologie in der Zukunft bereitzustellen.

Eine Übersicht der Technologievorschauen, die im Lieferumfang Ihres Produkts enthalten sind, finden Sie in den Versionshinweisen unter https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Mitwirkende bei Ceph #

Das Ceph-Projekt und dessen Dokumentation ist das Ergebnis der Arbeit von Hunderten von Mitwirkenden und Organisationen. Weitere Einzelheiten finden Sie unter https://ceph.com/contributors/.

6 Kommandos und Kommandozeilen in diesem Handbuch #

Als Ceph-Cluster-Administrator können Sie das Cluster-Verhalten mit bestimmten Kommandos konfigurieren und anpassen. Hierzu benötigen Sie verschiedene Arten von Kommandos:

6.1 Salt-spezifische Kommandos #

Mit diesen Kommandos können Sie Ceph-Cluster-Knoten bereitstellen, Kommandos auf mehreren (oder allen) Cluster-Knoten gleichzeitig ausführen oder auch Cluster-Knoten hinzufügen oder entfernen. Die am häufigsten verwendeten Kommandos sind ceph-salt und ceph-salt config. Salt-Kommandos müssen auf dem Salt-Master-Knoten als root ausgeführt werden. Diese Kommandos werden in der folgenden Kommandozeile eingegeben:

root@master # Beispiel:

root@master # ceph-salt config ls6.2 Ceph-spezifische Kommandos #

Hierbei handelt es sich um Kommandos auf niedrigerer Ebene, mit denen alle Aspekte des Clusters und seiner Gateways auf der Kommandozeile konfiguriert und feinabgestimmt werden, beispielsweise ceph, cephadm, rbd oder radosgw-admin.

Zum Ausführen von Ceph-spezifischen Kommandos benötigen Sie den Lesezugriff auf einen Ceph-Schlüssel. Die Capabilities des Schlüssels definieren dann Ihre Rechte in der Ceph-Umgebung. Sie können die Ceph-Kommandos als root (oder über sudo) ausführen und den uneingeschränkten Standard-Schlüsselbund „ceph.client.admin.key“ verwenden.

Als sicherere und empfohlene Alternative erstellen Sie je einen stärker eingeschränkten, individuellen Schlüssel für die einzelnen verwaltungsberechtigten Benutzer, den Sie dann in einem Verzeichnis ablegen, in dem die Benutzer ihn lesen können, beispielsweise:

~/.ceph/ceph.client.USERNAME.keyring

Sollen ein benutzerdefinierter verwaltungsberechtigter Benutzer und Schlüsselbund verwendet werden, müssen Sie den Benutzernamen und den Pfad des Schlüssels bei jeder Ausführung des Kommandos ceph mit den Optionen -n client angeben.USER_NAME und --keyring PATH/TO/KEYRING angeben.

Um dies zu vermeiden, nehmen Sie diese Optionen in die Variable CEPH_ARGS in den ~/.bashrc-Dateien der einzelnen Benutzer auf.

Ceph-spezifische Kommandos können auf jedem Cluster-Knoten ausgeführt werden. Es wird jedoch empfohlen, sie ausschließlich auf dem Admin-Knoten auszuführen. In dieser Dokumentation werden die Kommandos mit dem Benutzer cephuser ausgeführt. Die Kommandozeile lautet daher:

cephuser@adm > Beispiel:

cephuser@adm > ceph auth listWenn Sie laut Dokumentation ein Kommando für einen Cluster-Knoten mit einer bestimmten Rolle ausführen sollen, ist dies an der Bezeichnung der Kommandozeile ersichtlich. Beispiel:

cephuser@mon > 6.2.1 Ausführen von ceph-volume #

Ab SUSE Enterprise Storage 7 werden Ceph-Services containerisiert ausgeführt. Wenn Sie ceph-volume auf einem OSD-Knoten ausführen müssen, müssen Sie ihm das Kommando cephadm voranstellen. Beispiel:

cephuser@adm > cephadm ceph-volume simple scan6.3 Allgemeine Linux-Kommandos #

Linux-Kommandos, die nicht Ceph-spezifisch sind, wie mount, cat oder openssl, werden entweder mit der Kommandozeile cephuser@adm > oder # eingeführt. Dies hängt davon ab, welche Rechte für das entsprechende Kommando erforderlich sind.

6.4 Zusätzliche Informationen #

Weitere Informationen zur Ceph-Schlüsselverwaltung finden Sie in Book “Betriebs- und Verwaltungshandbuch”, Chapter 30 “Authentifizierung mit cephx”, Section 30.2 “Schlüsselverwaltungsbereiche”.

Teil I Einführung zu SUSE Enterprise Storage (SES) #

- 1 SES und Ceph

SUSE Enterprise Storage ist ein dezentrales Speichersystem, das auf Skalierbarkeit, Zuverlässigkeit und Leistung ausgelegt ist und auf der Ceph-Technologie basiert. Ein Ceph-Cluster kann auf Standardservern in einem gemeinsamen Netzwerk wie Ethernet ausgeführt werden. Der Cluster lässt sich gut für …

- 2 Hardwareanforderungen und Empfehlungen

Die Hardwareanforderungen für Ceph hängen stark vom E/A-Workload ab. Die folgenden Hardwareanforderungen und Empfehlungen sollten als Ausgangspunkt für die detaillierte Planung betrachtet werden.

- 3 Einrichten des Hochverfügbarkeits-Clusters für den Admin-Knoten

Der Admin-Knoten ist ein Ceph-Cluster-Knoten, in dem der Salt-Master-Service ausgeführt wird. Er verwaltet die restlichen Cluster-Knoten, indem er deren Salt-Minion-Services abfragt und anweist. Er enthält normalerweise auch andere Services, beispielsweise das Grafana Dashboard, das vom Prometheus-Ü…

1 SES und Ceph #

SUSE Enterprise Storage ist ein dezentrales Speichersystem, das auf Skalierbarkeit, Zuverlässigkeit und Leistung ausgelegt ist und auf der Ceph-Technologie basiert. Ein Ceph-Cluster kann auf Standardservern in einem gemeinsamen Netzwerk wie Ethernet ausgeführt werden. Der Cluster lässt sich gut für Tausende von Servern (im Folgenden als Knoten bezeichnet) und im Petabyte-Bereich skalieren. Im Gegensatz zu herkömmlichen Systemen, die Daten über Zuordnungstabellen speichern und abrufen, verwendet Ceph einen deterministischen Algorithmus zum Zuordnen von Speicher für Daten und hat keine zentralisierte Informationsstruktur. Ceph geht davon aus, dass in Speicher-Clustern das Hinzufügen oder Entfernen von Hardware die Regel ist und nicht die Ausnahme. Der Ceph-Cluster automatisiert Verwaltungsaufgaben wie Datenverteilung und -neuverteilung, Datenreproduktion, Ausfallerkennung und Wiederherstellung. Ceph kann sich selbst reparieren und selbst verwalten, was den Verwaltungsaufwand und die Gemeinkosten reduziert.

In diesem Kapitel erhalten Sie einen ersten Überblick über SUSE Enterprise Storage 7.1 und eine kurze Beschreibung der wichtigsten Komponenten.

1.1 Eigenschaften von Ceph #

Die Ceph-Umgebung weist die folgenden Eigenschaften auf:

- Skalierbarkeit

Ceph ermöglicht das Skalieren auf Tausende von Knoten und kann Speicher im Petabyte-Bereich verwalten.

- Kommerzielle Hardware

Zum Ausführen eines Ceph-Clusters ist keine spezielle Hardware erforderlich. Ausführliche Informationen finden Sie unter Kapitel 2, Hardwareanforderungen und Empfehlungen

- Selbstverwaltung

Der Ceph-Cluster verwaltet sich selbst. Wenn Knoten hinzugefügt oder entfernt werden oder ausfallen, verteilt der Cluster die Daten automatisch um. Er erkennt auch überlastete Festplatten.

- Keine Single Points of Failure

Kein Knoten im Cluster speichert wichtige Informationen exklusiv. Die Anzahl der Redundanzen kann konfiguriert werden.

- Open-Source-Software

Ceph ist eine Open-Source-Softwarelösung und unabhängig von spezifischer Hardware oder Anbietern.

1.2 Wichtigste Ceph-Komponenten #

Zur vollen Nutzung aller Funktionen in Ceph ist es erforderlich, einige Basiskomponenten und Konzepte zu verstehen. In diesem Abschnitt werden einige Komponenten von Ceph eingeführt, auf die oft in anderen Kapiteln verwiesen wird.

1.2.1 RADOS #

Die Basiskomponente von Ceph wird RADOS (Reliable Autonomic Distributed Object Store, Zuverlässiger autonomer dezentraler Objektspeicher) genannt. Sie ist für die Verwaltung der im Cluster gespeicherten Daten zuständig. Daten werden in Ceph normalerweise als Objekte gespeichert. Jedes Objekt besteht aus einer Kennung und den Daten.

RADOS bietet die folgenden Methoden für den Zugriff auf gespeicherte Objekte, die viele Anwendungsfälle abdecken:

- Object Gateway

Ein Object Gateway ist ein HTTP REST Gateway für den RADOS-Objektspeicher. Es ermöglicht den Direktzugriff auf Objekte, die im Ceph-Cluster gespeichert sind.

- RADOS-Blockgerät

Der Zugriff auf ein RADOS-Blockgerät (RADOS Block Device, RBD) erfolgt genauso wie der auf andere Blockgeräte. Sie werden beispielsweise für Virtualisierungszwecke in Kombination mit

libvirtverwendet.- CephFS

Das Ceph File System (CephFS) ist ein POSIX-fähiges Dateisystem.

libradoslibradosist eine Bibliothek, die mit vielen Programmiersprachen verwendet werden kann, um eine Anwendung zu erstellen, die direkt mit dem Speicher-Cluster interagiert.

librados wird vom Object Gateway und RBD verwendet, während CephFS direkt mit RADOS (Abbildung 1.1, „Schnittstellen zum Ceph-Objektspeicher“) interagiert.

1.2.2 CRUSH #

Der CRUSH-Algorithmus ist das zentrale Element eines Ceph-Clusters. CRUSH ist das Akronym für Controlled Replication Under Scalable Hashing. CRUSH ist eine Funktion für die Speicherzuordnung und benötigt vergleichsweise wenig Parameter. Es sind also nur wenige Informationen erforderlich, um die Speicherposition eines Objekts zu berechnen. Die Parameter stellen eine aktuelle Zuordnung für den Cluster dar, einschließlich Integrität, einiger vom Administrator definierter Platzierungsregeln und des Namens des Objekts, das gespeichert oder abgerufen werden muss. Mit diesen Informationen können alle Knoten im Ceph-Cluster berechnen, wo ein Objekt und dessen Reproduktionen gespeichert sind. Dies macht das Schreiben und Lesen von Daten sehr effizient. CRUSH versucht, Daten gleichmäßig auf alle Knoten im Cluster zu verteilen.

Die CRUSH-Zuordnung umfasst alle Speicherknoten und vom Administrator definierte Platzierungsregeln zum Speichern von Objekten im Cluster. Sie definiert eine hierarchische Struktur, die normalerweise mit der physischen Struktur des Clusters korrespondiert. Beispielsweise befinden sich Festplatten mit Daten in Hosts, Hosts in Racks, Racks in Reihen und Reihen in Rechenzentren. Diese Struktur wird zur Definition von Fehlerdomänen herangezogen. Ceph stellt dann sicher, dass Reproduktionen in verschiedenen Verzweigungen einer bestimmten Fehlerdomäne gespeichert werden.

Wenn die Fehlerdomäne auf „Rack“ festgelegt ist, werden Reproduktionen von Objekten auf verschiedene Racks verteilt. Dadurch werden Ausfälle entschärft, die durch einen fehlerhaften Schalter in einem Rack verursacht wurden. Wenn eine Stromversorgungseinheit eine Reihe von Racks bereitstellt, kann die Fehlerdomäne auf „Reihe“ festgelegt werden. Wenn die Stromversorgungseinheit ausfällt, sind die Reproduktionsdaten noch in anderen Reihen verfügbar.

1.2.3 Ceph-Knoten und -Daemons #

In Ceph sind Knoten Server, die für den Cluster arbeiten. Sie können verschiedene Typen von Daemons ausführen. Es wird empfohlen, nur einen Typ von Daemon pro Knoten auszuführen, ausgenommen Ceph Manager Daemons, die sich gemeinsam mit Ceph Monitors auf einem Knoten befinden können. Für jeden Client sind mindestens Ceph Monitor, Ceph Manager und Ceph OSD Daemons erforderlich:

- Admin-Knoten

Der Admin-Knoten ist ein Ceph-Cluster-Knoten, von dem aus Sie Befehle zur Verwaltung des Clusters ausführen. Der Admin-Knoten ist das Zentrum des Ceph-Clusters, weil er alle anderen Cluster-Knoten verwaltet, indem er deren Salt Minion Services abfragt und ihnen Anweisungen gibt.

- Ceph Monitor

Ceph-Monitor-Knoten (oft zu MON abgekürzt) pflegen Informationen zur Cluster-Integrität, eine Zuordnung aller Knoten und Datenverteilungsregeln (weitere Informationen hierzu finden Sie in Abschnitt 1.2.2, „CRUSH“).

Wenn Fehler oder Konflikte auftreten, entscheiden die Ceph-Monitor-Knoten im Cluster nach dem Mehrheitsprinzip, welche Informationen korrekt sind. Um eine qualifizierte Mehrheit zu bilden, empfiehlt es sich, eine ungerade Anzahl von Ceph-Monitor-Knoten einzurichten, jedoch mindestens drei davon.

Bei mehreren Standorten sollten die Ceph-Monitor-Knoten auf eine ungerade Anzahl von Standorten verteilt werden. Die Anzahl der Ceph-Monitor-Knoten pro Standort sollte so gewählt werden, dass die Hälfte der Ceph-Monitor-Knoten funktionsfähig bleiben, wenn ein Standort ausfällt.

- Ceph Manager

Der Ceph Manager sammelt die Statusinformationen aus dem gesamten Cluster. Der Ceph-Manager-Daemon wird neben den Ceph-Monitor-Daemons ausgeführt. Er bietet zusätzliche Überwachung und dient als Schnittstelle zwischen der externen Überwachung und den Verwaltungssystemen. Er umfasst auch andere Services. Beispielsweise wird die Weboberfläche des Ceph Dashboards auf demselben Knoten wie der Ceph Manager ausgeführt.

Der Ceph Manager muss nicht weiter konfiguriert werden. Sie müssen nur sicherstellen, dass er ausgeführt wird.

- Ceph OSD

Ein Ceph OSD ist ein Daemon, der Objektspeichergeräte steuert. Dabei handelt es sich um physische oder logische Speichereinheiten (Festplatten oder Partitionen). Objektspeichergeräte können physische Datenträger/Partitionen oder logische Volumes sein. Der Daemon kümmert sich außerdem um die Datenreproduktion und den Ausgleich, falls Knoten hinzugefügt oder entfernt wurden.

Ceph OSD Daemons kommunizieren mit Monitor Daemons und informieren diese über den Zustand der anderen OSD Daemons.

Für CephFS, Object Gateway, NFS Ganesha oder iSCSI Gateway sind zusätzliche Knoten erforderlich:

- Metadata Server (MDS)

CephFS-Metadaten werden in einem eigenen RADOS-Pool gespeichert (weitere Informationen finden Sie unter Abschnitt 1.3.1, „Pools“). Die Metadatenserver fungieren als intelligente Caching-Schicht für die Metadaten und serialisieren den Zugriff bei Bedarf. Dies ermöglicht den gleichzeitigen Zugriff von vielen Clients ohne explizite Synchronisierung.

- Object Gateway

Das Object Gateway ist ein HTTP-REST-Gateway für den RADOS-Objektspeicher. Es ist mit OpenStack Swift und Amazon S3 kompatibel und verfügt über eine eigene Benutzerverwaltung.

- NFS Ganesha

NFS Ganesha bietet NFS-Zugriff auf das Object Gateway oder auf das CephFS. Es wird im Benutzerbereich statt im Kernel-Bereich ausgeführt und interagiert direkt mit dem Object Gateway oder dem CephFS.

- iSCSI Gateway

iSCSI ist ein Speichernetzwerkprotokoll, über das Clients SCSI-Kommandos an SCSI-Speichergeräte (Targets) auf Remote Servern senden können.

- Samba Gateway

Das Samba Gateway bietet Samba-Zugriff auf die Daten, die auf CephFS gespeichert sind.

1.3 Ceph-Speicherstruktur #

1.3.1 Pools #

In einem Ceph-Cluster gespeicherte Objekte werden in Pools abgelegt. Pools stellen logische Partitionen des Clusters zur Außenwelt dar. Für jeden Pool kann ein Regelsatz definiert werden, beispielsweise wie viele Reproduktionen eines jeden Objekts vorhanden sein müssen. Die Standardkonfiguration von Pools wird als reproduzierter Pool bezeichnet.

Pools enthalten normalerweise Objekte, können jedoch auch so konfiguriert werden, dass sie wie ein RAID 5 funktionieren. In dieser Konfiguration werden Objekte in Datenblöcken zusammen mit zusätzlichen Codierungs-Datenblöcken gespeichert. Die Codierungs-Datenblöcke enthalten die redundanten Informationen. Die Anzahl der Daten und Codierungs-Datenblöcke werden vom Administrator definiert. In dieser Konfiguration werden Pools als Pools mit Löschcodierung oder EC-Pools (Erasure Coded Pools, EC) bezeichnet.

1.3.2 Platzierungsgruppen #

Placement Groups (PGs) dienen zur Verteilung von Daten in einem Pool. Beim Erstellen eines Pools wird eine bestimmte Anzahl von Placement Groups festgelegt. Die Placement Groups werden intern zur Gruppierung von Objekten verwendet. Sie sind ein wichtiger Faktor für die Leistung eines Ceph-Clusters. Die PG für ein Objekt wird durch den Namen des Objekts bestimmt.

1.3.3 Beispiel #

In diesem Abschnitt finden Sie ein vereinfachtes Beispiel dafür, wie Ceph Daten verwaltet (Abbildung 1.2, „Beispiel eines kleinen Ceph-Speichers“). Dieses Beispiel stellt keine empfohlene Konfiguration für einen Ceph-Cluster dar. Die Hardwareeinrichtung umfasst drei Speicher-Knoten oder Ceph OSDs (Host 1, Host 2, Host 3). Jeder Knoten hat drei Festplatten, die als OSDs (osd.1 bis osd.9) verwendet werden. In diesem Beispiel sind keine Ceph-Monitor-Knoten berücksichtigt.

Die Begriffe Ceph OSD oder Ceph OSD Daemon beziehen sich auf einen Daemon, der auf einem Knoten ausgeführt wird. Der Begriff OSD dagegen bezieht sich auf einen logischen Datenträger, mit dem der Daemon interagiert.

Der Cluster umfasst zwei Pools, Pool A und Pool B. Während Pool A Objekte nur zweimal reproduziert, ist Ausfallsicherheit für Pool B wichtiger und es gibt daher drei Reproduktionen für jedes Objekt.

Wenn eine Anwendung ein Objekt in einen Pool stellt, beispielsweise über die REST API, dann wird eine Placement Group (PG1 bis PG4) auf Basis des Pools und des Objektnamens ausgewählt. Der CRUSH-Algorithmus berechnet dann, auf welchen OSDs das Objekt gespeichert ist, basierend auf der Placement Group, die das Objekt enthält.

In diesem Beispiel ist die Fehlerdomäne auf Host festgelegt. Dadurch wird sichergestellt, dass die Reproduktionen von Objekten auf verschiedenen Hosts gespeichert sind. Je nach der für einen Pool festgelegten Reproduktionsstufe wird das Objekt auf zwei oder drei OSDs gespeichert, die von der Placement Group verwendet werden.

Eine Anwendung, die ein Objekt schreibt, interagiert nur mit einem Ceph OSD, nämlich dem primären Ceph OSD. Der primäre Ceph OSD führt die Reproduktion aus und bestätigt die Durchführung des Schreibvorgangs, nachdem alle anderen OSDs das Objekt gespeichert haben.

Wenn osd.5 ausfällt, sind alle Objekte in PG1 immer noch auf osd.1 verfügbar. Sobald der Cluster feststellt, dass ein OSD ausgefallen ist, übernimmt ein anderer OSD. In diesem Beispiel wird osd.4 als Ersatz für osd.5 verwendet. Die auf osd.1 gespeicherten Objekte werden dann auf osd.4 reproduziert, um die Reproduktionsstufe wiederherzustellen.

Die Cluster-Zuordnung ändert sich, wenn ein neuer Knoten mit neuen OSDs zum Cluster hinzugefügt wird. Die CRUSH-Funktion gibt dann verschiedene Standorte für Objekte zurück. Objekte, die neue Standorte erhalten, werden verschoben. Durch diesen Vorgang bleiben alle OSDs gleichmäßig ausgelastet.

1.4 BlueStore #

BlueStore ist seit SES 5 ein neues standardmäßiges Speicher-Back-End für Ceph. Seine Leistung ist besser als die von FileStore. Es umfasst vollständige Prüfsummenerstellung für Daten und weist eine integrierte Komprimierung auf.

BlueStore verwaltet ein, zwei oder drei Speichergeräte. Im einfachsten Fall lastet BlueStore ein einzelnes primäres Speichergerät aus. Das Speichergerät ist normalerweise in zwei Abschnitte partitioniert:

Eine kleine Partition namens BlueFS, die Dateisystem-ähnliche Funktionalitäten implementiert, die von RocksDB benötigt werden.

Eine große Partition belegt normalerweise das restliche Gerät. Sie wird direkt von BlueStore verwaltet und enthält alle Ist-Daten. Dieses primäre Gerät ist normalerweise durch eine Blocksymbolverknüpfung im Datenverzeichnis gekennzeichnet.

BlueStore kann auch auf zwei weiteren Geräten bereitgestellt werden:

Ein WAL-Gerät, das für das interne Journal oder Write Ahead-Protokoll von BlueStore verwendet wird. Es ist durch den symbolischen Link block.wal im Datenverzeichnis gekennzeichnet. Ein separates WAL-Gerät ist nur sinnvoll, wenn das Gerät schneller als das primäre Gerät oder das DB-Gerät ist. Beispiel:

Das WAL-Gerät ist ein NVMe, das DB-Gerät ist ein SSD und das Datengerät ist entweder ein SSD oder HDD.

Das WAL-Gerät und das DB-Gerät sind separate SSDs. Das Datengerät ist ein SSD oder HDD.

Ein DB-Gerät kann zum Speichern der internen Metadaten von BlueStore verwendet werden. BlueStore (eigentlich die eingebettete RocksDB) legt zur Leistungsoptimierung so viele Metadaten wie möglich auf dem DB-Gerät ab. Auch hier ist die Bereitstellung eines gemeinsam genutzten DB-Geräts nur sinnvoll, wenn es schneller ist als das primäre Gerät.

Planen Sie sorgfältig eine ausreichende Größe für das DB-Gerät. Wenn das DB-Gerät voll ist, laufen die Metadaten an das primäre Gerät über, was die Leistung des OSD extrem beeinträchtigt.

Mit dem Kommando ceph daemon osd.ID perf dump können Sie prüfen, ob eine WAL/DB-Partition voll wird und überläuft. Der Wert slow_used_bytes gibt die Anzahl der Daten an, die überlaufen:

cephuser@adm > ceph daemon osd.ID perf dump | jq '.bluefs'

"db_total_bytes": 1073741824,

"db_used_bytes": 33554432,

"wal_total_bytes": 0,

"wal_used_bytes": 0,

"slow_total_bytes": 554432,

"slow_used_bytes": 554432,1.5 Zusätzliche Informationen #

Ceph hat als Community-Projekt eine eigene Online-Dokumentation. Weitere Informationen zu Themen, die in diesem Handbuch nicht behandelt werden, finden Sie unter https://docs.ceph.com/en/pacific/.

In der ursprünglichen Veröffentlichung mit dem Titel CRUSH: Controlled, Scalable, Decentralized Placement of Replicated Data von S.A. Weil, S.A. Brandt, E.L. Miller, C. Maltzahn finden Sie nützliche Informationen zu den inneren Abläufen in Ceph. Die Lektüre empfiehlt sich vor allem für die Bereitstellung von Clustern mit großem Volumen. Sie finden die Veröffentlichung unter http://www.ssrc.ucsc.edu/papers/weil-sc06.pdf

SUSE Enterprise Storage kann zusammen mit OpenStack-Distributionen anderer Hersteller verwendet werden. Die Ceph-Clients müssen sich auf einer Ebene befinden, die mit SUSE Enterprise Storage kompatibel sind.

AnmerkungSUSE unterstützt die Serverkomponente der Ceph-Bereitstellung, der Client wird vom Anbieter der OpenStack-Distribution unterstützt.

2 Hardwareanforderungen und Empfehlungen #

Die Hardwareanforderungen für Ceph hängen stark vom E/A-Workload ab. Die folgenden Hardwareanforderungen und Empfehlungen sollten als Ausgangspunkt für die detaillierte Planung betrachtet werden.

Im Allgemeinen sind die Empfehlungen in diesem Abschnitt auf jeweils einen Prozess ausgelegt. Wenn auf dem selben Rechner mehrere Prozesse ablaufen, müssen die CPU-, RAM-, Festplatten- und Netzwerkanforderungen entsprechend erhöht werden.

2.1 Netzwerke im Überblick #

Ceph verfügt über einige logische Netzwerke:

Ein Frontend-Netzwerk namens

öffentliches Netzwerk.Ein vertrauenswürdiges internes Netzwerk, das Back-End-Netzwerk, namens

Clusternetzwerk. Diese Einstellung ist optional.Ein oder mehrere Client-Netzwerke für Gateways. Dies ist optional und würde den Rahmen dieses Kapitels sprengen.

Das öffentliche Netzwerk ist das Netzwerk, über das Ceph-Daemons untereinander und mit ihren Clients kommunizieren. Das bedeutet, dass der gesamte Datenverkehr des Ceph-Clusters über dieses Netzwerk läuft, es sei denn, es ist ein Clusternetzwerk konfiguriert.

Das Clusternetzwerk ist das Back-End-Netzwerk zwischen den OSD-Knoten für Reproduktion, Ausgleich und Wiederherstellung. Ist dieses optionale Netzwerk konfiguriert, würde es im Idealfall die doppelte Bandbreite des öffentlichen Netzwerks mit standardmäßiger Drei-Wege-Reproduktion bieten, da das primäre OSD zwei Kopien an andere OSDs über dieses Netzwerk sendet. Das öffentliche Netzwerk befindet sich zwischen Clients und Gateways auf der einen Seite für die Kommunikation mit Monitoren, Managern, MDS-Knoten und OSD-Knoten. Monitore, Manager und MDS-Knoten nutzen es auch für die Kommunikation mit OSD-Knoten.

2.1.1 Netzwerkempfehlungen #

Wir empfehlen ein einzelnes fehlertolerantes Netzwerk mit ausreichender Bandbreite für Ihre Anforderungen. Für die öffentliche Ceph-Netzwerkumgebung empfehlen wir zwei verbundene 25-GbE-Netzwerkschnittstellen (oder schneller), die über 802.3ad (LACP) verbunden sind. Dies wird als die Mindesteinrichtung für Ceph betrachtet. Wenn Sie zusätzlich ein Clusternetzwerk verwenden, empfehlen wir vier verbundene 25-GbE-Netzwerkschnittstellen. Durch Verbinden von zwei oder mehr Netzwerkschnittstellen verbessern sich der Durchsatz durch Link-Aggregation und, bei redundanten Links und Switches, die Fehlertoleranz und Wartbarkeit.

Sie können auch VLANs erstellen, um verschiedene Arten von Datenverkehr über eine Verbindung zu isolieren. Sie können beispielsweise eine Verbindung erstellen, um zwei VLAN-Schnittstellen bereitzustellen, eine für das öffentliche Netzwerk und die zweite für das Clusternetzwerk. Beim Einrichten des Ceph-Netzwerks ist dies jedoch nicht erforderlich. Details zum Verbinden von Schnittstellen finden Sie unter https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-network.html#sec-network-iface-bonding.

Die Fehlertoleranz kann durch Isolierung der Komponenten in Fehlerdomänen erhöht werden. Zur Erhöhung der Fehlertoleranz des Netzwerks wird durch Verbinden einer Schnittstelle von zwei separaten Netzwerkschnittstellenkarten (NIC) Schutz vor dem Ausfall einer einzelnen NIC erreicht. In ähnlicher Weise schützt das Erstellen einer Verbindung zwischen zwei Switches vor dem Ausfall eines Switches. Wir empfehlen, den Hersteller der Netzwerkgeräte zu konsultieren, um den erforderlichen Grad an Fehlertoleranz zu ermitteln.

Die Einrichtung eines zusätzlichen Verwaltungsnetzwerks, das zum Beispiel die Trennung von SSH-, Salt- oder DNS-Netzwerken ermöglicht, wurde weder getestet, noch wird sie unterstützt.

Wenn Ihre Speicherknoten über DHCP konfiguriert werden, reichen die standardmäßigen Zeitüberschreitungen möglicherweise nicht für eine korrekte Konfiguration des Netzwerks aus, bevor die Ceph Daemons starten. Wenn dies geschieht, werden die Ceph-MONs und -OSDs nicht korrekt gestartet (das Ausführen von systemctl status ceph\* führt zur Fehlermeldung „unable to bind“ (Verbinden nicht möglich)). Zur Vermeidung dieses Problems empfehlen wir, die DHCP-Client-Zeitüberschreitung auf jedem Knoten in Ihrem Speichercluster auf mindestens 30 Sekunden zu erhöhen. Dies wird erreicht durch Ändern der folgenden Einstellungen in jedem Knoten:

Legen Sie in /etc/sysconfig/network/dhcp Folgendes fest:

DHCLIENT_WAIT_AT_BOOT="30"

Legen Sie in /etc/sysconfig/network/config Folgendes fest:

WAIT_FOR_INTERFACES="60"

2.1.1.1 Hinzufügen eines privaten Netzwerks zu einem aktiven Cluster #

Wenn Sie bei der Ceph-Bereitstellung kein Cluster-Netzwerk angeben, dann wird eine einzelne öffentliche Netzwerkumgebung angenommen. Auch wenn Ceph in einem öffentlichen Netzwerk gut funktioniert, wird seine Leistung und Sicherheit durch Festlegen eines zweiten privaten Cluster-Netzwerks erhöht. Zur Unterstützung von zwei Netzwerken muss jeder Ceph-Knoten über mindestens zwei Netzwerkkarten verfügen.

Sie müssen auf jeden Ceph-Knoten die folgenden Änderungen anwenden. Bei einem kleinen Cluster ist dies relativ schnell erledigt, doch bei einem Cluster mit Hunderten oder Tausenden Knoten kann dieser Vorgang sehr zeitaufwändig sein.

Legen Sie das Clusternetzwerk mit folgendem Kommando fest:

#ceph config set global cluster_network MY_NETWORKStarten Sie die OSDs neu, um das angegebene Clusternetzwerk zu binden:

#systemctl restart ceph-*@osd.*.serviceÜberprüfen Sie, ob das private Cluster-Netzwerk auf Betriebssystemebene wie erwartet funktioniert.

2.1.1.2 Überwachungsknoten in verschiedenen Teilnetzen #

Wenn sich die Überwachungsknoten in mehreren Teilnetzen befinden, beispielsweise in verschiedenen Räumen und gesteuert durch verschiedene Schalter, dann müssen Sie ihre öffentliche Netzwerkadresse in der CIDR-Schreibweise entsprechend anpassen:

cephuser@adm > ceph config set mon public_network "MON_NETWORK_1, MON_NETWORK_2, MON_NETWORK_NBeispiel:

cephuser@adm > ceph config set mon public_network "192.168.1.0/24, 10.10.0.0/16"Wenn Sie, wie in diesem Abschnitt beschrieben, mehr als ein Netzwerksegment für das öffentliche Netzwerk (oder für das Clusternetzwerk) angeben, muss jedes dieser Teilnetze zur Weiterleitung zu den anderen Teilnetzen in der Lage sein. Andernfalls können die MONs und andere Ceph-Daemons auf verschiedenen Netzwerksegmenten nicht miteinander kommunizieren, was zu einem geteilten Cluster führen würde. Wenn Sie eine Firewall verwenden, stellen Sie außerdem sicher, dass Sie jede IP-Adresse oder jedes Teilnetz in Ihre iptables einbeziehen und Ports für sie auf allen Knoten öffnen, falls erforderlich.

2.2 Konfigurationen mit mehreren Architekturen #

SUSE Enterprise Storage unterstützt sowohl x86- als auch Arm-Architekturen. Bei der Erwägung der einzelnen Architekturen ist zu beachten, dass es bei den Cores pro OSD, der Frequenz und dem RAM keine gravierenden Unterschiede zwischen den CPU-Architekturen gibt, die sich auf die Größenfestlegung auswirken würden.

Wie bei kleineren x86-Prozessoren (keine Server) bieten weniger leistungsstarke Arm-basierte Cores unter Umständen keine optimalen Arbeitsbedingungen, insbesondere wenn sie für Pools mit Löschcodierung eingesetzt werden.

In der gesamten Dokumentation wird SYSTEM-ARCH anstelle von x86 oder Arm verwendet.

2.3 Hardwarekonfiguration #

Für eine optimale Produkterfahrung empfehlen wir, mit der empfohlenen Cluster-Konfiguration zu beginnen. Für einen Testcluster oder einen Cluster mit geringeren Leistungsanforderungen dokumentieren wir eine minimal unterstützte Cluster-Konfiguration.

2.3.1 Mindestkonfiguration für den Cluster #

Eine Mindestkonfiguration für den Produktcluster besteht aus:

Mindestens vier physikalischen Knoten (OSD-Knoten) mit gemeinsamem Speicherort der Services

Dual-10-Gbit-Ethernet als verbundenes Netzwerk

Einem separaten Admin-Knoten (kann auf einem externen Knoten virtualisiert werden)

Eine detaillierte Konfiguration besteht aus folgenden Komponenten:

Separater Verwaltungsknoten mit 4 GB RAM, vier Cores, 1 TB Kapazität. Dies ist in der Regel der Salt-Master-Knoten. Ceph-Services und -Gateways wie Ceph Monitor, Metadata Server, Ceph OSD, Object Gateway oder NFS Ganesha werden auf dem Admin-Knoten nicht unterstützt, da er die Clusteraktualisierungs- und Upgrade-Prozesse eigenständig orchestrieren muss.

Mindestens vier physische OSD-Knoten mit jeweils acht OSD-Datenträgern. Die Anforderungen finden Sie in Abschnitt 2.4.1, „Mindestanforderungen“.

Die Gesamtkapazität des Clusters sollte so bemessen sein, dass auch bei Ausfall eines Knotens die gesamte genutzte Kapazität (einschließlich Redundanz) 80 % nicht überschreitet.

Drei Ceph Monitor-Instanzen. Monitore müssen aus Latenzgründen von SSD/NVMe-Speicher, nicht von HDDs, betrieben werden.

Monitore, Metadatenserver und Gateways können gemeinsam auf den OSD-Knoten platziert werden. Informationen über die gemeinsame Platzierung finden Sie in Abschnitt 2.12, „Ein einziger Server für OSD und Monitor“. Wenn Sie Services gemeinsam platzieren, müssen die Speicher- und CPU-Anforderungen addiert werden.

iSCSI Gateway, Object Gateway und Metadata Server benötigen mindestens inkrementelle 4 GB RAM und vier Cores.

Wenn Sie CephFS, S3/Swift, iSCSI verwenden, sind für Redundanz und Verfügbarkeit mindestens zwei Instanzen der jeweiligen Rollen (Metadata Server, Object Gateway, iSCSI) erforderlich.

Die Knoten müssen für SUSE Enterprise Storage bestimmt sein und dürfen nicht für andere physische, containerisierte oder virtualisierte Workloads verwendet werden.

Wenn eines der Gateways (iSCSI, Object Gateway, NFS Ganesha, Metadata Server usw.) innerhalb von VMs bereitgestellt wird, dürfen diese VMs nicht auf den physischen Rechnern gehostet werden, die andere Clusterrollen bedienen. (Dies ist nicht notwendig, da sie als verbundene Services unterstützt werden.)

Bei der Bereitstellung von Services als VMs auf Hypervisoren außerhalb des physischen Core-Clusters müssen Ausfalldomänen beachtet werden, um Redundanz zu gewährleisten.

Stellen Sie zum Beispiel nicht mehrere Rollen desselben Typs auf demselben Hypervisor bereit, beispielsweise mehrere MON- oder MDS-Instanzen.

Bei der Bereitstellung innerhalb von VMs ist es besonders wichtig, dass die Knoten über eine starke Netzwerkanbindung und eine gut funktionierende Zeitsynchronisierung verfügen.

Die Hypervisorknoten müssen ausreichend dimensioniert sein, um Störungen durch andere Workloads zu vermeiden, die CPU-, RAM-, Netzwerk- und Speicherressourcen verbrauchen.

2.3.2 Empfohlene Konfiguration für Produktionscluster #

Sobald Sie Ihren Cluster vergrößern, empfehlen wir, Ceph Monitors, Metadatenserver und Gateways auf separate Knoten zu verlagern, um eine bessere Fehlertoleranz zu erreichen.

Sieben Objektspeicher-Knoten

Die einzelnen Knoten dürfen nicht mehr als ca. 15 % des Gesamtspeichers ausmachen.

Die Gesamtkapazität des Clusters sollte so bemessen sein, dass auch bei Ausfall eines Knotens die gesamte genutzte Kapazität (einschließlich Redundanz) 80 % nicht überschreitet.

25 Gb Ethernet oder besser, jeweils verbunden für internes Clusternetzwerk und externes öffentliches Netzwerk.

Mindestens 56 OSDs pro Speicher-Cluster.

In Abschnitt 2.4.1, „Mindestanforderungen“ finden Sie weitere Empfehlungen.

Dedizierte physische Infrastruktur-Knoten.

Drei Ceph-Monitor-Knoten: 4 GB RAM, 4-Core-Prozessor, RAID 1-SSDs als Festplatte.

In Abschnitt 2.5, „Monitorknoten“ finden Sie weitere Empfehlungen.

Object Gateway Knoten: 32 GB RAM, 8-Core-Prozessor, RAID 1-SSDs als Festplatte.

In Abschnitt 2.6, „Object-Gateway-Knoten“ finden Sie weitere Empfehlungen.

iSCSI Gateway Knoten: 16 GB RAM, 8-Core-Prozessor, RAID 1-SSDs als Festplatte.

In Abschnitt 2.9, „iSCSI-Gateway-Knoten“ finden Sie weitere Empfehlungen.

Metadata Server Knoten (einer aktiv, einer unmittelbar betriebsbereit im Standby-Modus): 32 GB RAM, 8-Core-Prozessor, RAID 1-SSDs als Festplatte.

In Abschnitt 2.7, „Metadata Server-Knoten“ finden Sie weitere Empfehlungen.

Ein SES-Admin-Knoten: 4 GB RAM, 4-Core-Prozessor, RAID 1-SSDs als Datenträger.

2.3.3 Multipfadkonfiguration #

Wenn Sie Multipfadhardware verwenden möchten, stellen Sie sicher, dass LVM in der Konfigurationsdatei unter dem Abschnitt Geräte die Einstellung multipath_component_detection = 1 sieht. Dies wird mit dem Kommando lvm config geprüft.

Stellen Sie alternativ sicher, dass LVM die Multipfadkomponenten eines Geräts über die LVM-Filterkonfiguration filtert. Das ist hostspezifisch zu verstehen.

Es wird nicht empfohlen und sollte immer nur dann in Betracht gezogen werden, wenn multipath_component_detection = 1 nicht festgelegt werden kann.

Weitere Informationen zur Multipfadkonfiguration finden Sie unter https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-multipath.html#sec-multipath-lvm.

2.4 Objektspeicherknoten #

2.4.1 Mindestanforderungen #

Die folgenden CPU-Empfehlungen berücksichtigen Geräte unabhängig von der Nutzung durch Ceph:

Ein 2-GHz-CPU-Thread pro rotierendem Datenträger.

Zwei 2-GHz-CPU-Threads pro SSD.

Vier 2-GHz-CPU-Threads pro NVMe.

Separate 10-GbE-Netzwerke (öffentlich, Client und intern), erforderlich 4 × 10 GbE, empfohlen 2 × 25 GbE.

Insgesamt benötigtes RAM = Anzahl der OSDs × (1 GB +

osd_memory_target) + 16 GBWeitere Informationen zu

osd_memory_targetfinden Sie in Book “Betriebs- und Verwaltungshandbuch”, Chapter 28 “Konfiguration des Ceph-Clusters”, Section 28.4.1 “Konfigurieren der automatischen Cache-Größe”.OSD-Datenträger in JBOD-Konfigurationen oder individuelle RAID-0-Konfigurationen.

OSD-Journal darf sich auf der OSD-Festplatte befinden.

OSD-Festplatten sollten exklusiv von SUSE Enterprise Storage verwendet werden.

Dedizierter Datenträger und SSD für das Betriebssystem, vorzugsweise in einer RAID 1-Konfiguration.

Weisen Sie mindestens 4 GB zusätzlichen Arbeitsspeicher zu, wenn dieser OSD-Host einen Teil eines Cache-Pools hostet, der für Cache-Tiering verwendet wird.

Ceph Monitors, Gateway und Metadata Server dürfen in Objektspeicher-Knoten vorhanden sein.

Aus Gründen der Festplattenleistung handelt es sich bei OSD-Knoten um Bare-Metal-Knoten. Auf einem OSD-Knoten sollten keine anderen Workloads ausgeführt werden, es sei denn, es handelt sich um eine Mindesteinrichtung von Ceph Monitors und Ceph Managers.

SSDs für Journal im Verhältnis 6:1 von SSD-Journal zu OSD.

Stellen Sie sicher, dass den OSD-Knoten keine vernetzten Blockgeräte zugeordnet sind, wie zum Beispiel iSCSI- oder RADOS-Blockgeräte-Images.

2.4.2 Mindestgröße für Datenträger #

Zwei Arten von Datenträgerspeicherplatz werden zur Ausführung auf OSD benötigt: der Speicherplatz für das WAL/DB-Gerät sowie der primäre Speicherplatz für die gespeicherten Daten. Der Mindestwert (und Standardwert) für das WAL/DB beträgt 6 GB. Der Mindestspeicherplatz für Daten beträgt 5 GB, da Partitionen, die kleiner als 5 GB sind, das Gewicht 0 zugewiesen wird.

Auch wenn nun der Mindestspeicherplatz für ein OSD 11 GB beträgt, empfehlen wir mindestens 20 GB pro Festplatte, sogar für Testzwecke.

2.4.3 Empfohlene Größe für das WAL- und DB-Gerät von BlueStore #

Weitere Informationen zu BlueStore finden Sie in Abschnitt 1.4, „BlueStore“.

Es wird empfohlen, 4 GB für das WAL-Gerät zu reservieren. Während die DB-Mindestgröße 64 GB für reine RBD-Workloads beträgt, wird für Object Gateway- und CephFS-Workloads eine DB-Größe empfohlen, die 2 % der Kapazität des Hauptgeräts (mindestens jedoch 196 GB) entspricht.

WichtigWir empfehlen größere DB-Volumes für Bereitstellungen mit hoher Auslastung, insbesondere bei hoher RGW- oder CephFS-Nutzung. Reservieren Sie etwas Kapazität (Slots), um bei Bedarf mehr Hardware für mehr DB-Speicherplatz zu installieren.

Falls Sie beabsichtigen, das WAL- und DB-Gerät auf dieselbe Festplatte zu stellen, dann empfehlen wir eine einzelne Partition für beide Geräte statt eine eigene Partition pro Gerät. Dadurch kann Ceph das DB-Gerät auch für WAL-Operationen verwenden. Die Verwaltung des Festplattenspeicherplatzes ist daher effizienter, weil Ceph die DB-Partition für WAL nur dann verwendet, wenn es unbedingt erforderlich ist. Ein weiterer Vorteil besteht darin, dass eine volle Auslastung der WAL-Partition sehr unwahrscheinlich ist und kein Speicherplatz verschwendet wird, da er gegebenenfalls auch für DB-Operationen verwendet werden kann.

Um das DB-Gerät für WAL freizugeben, geben Sie nicht das WAL-Gerät an, sondern nur das DB-Gerät.

Weitere Informationen zum Festlegen eines OSD-Layouts finden Sie im Book “Betriebs- und Verwaltungshandbuch”, Chapter 13 “Betriebsaufgaben”, Section 13.4.3 “Hinzufügen von OSDs mit der DriveGroups-Spezifikation”.

2.4.5 Maximale empfohlene Anzahl von Datenträgern #

Jeder Server kann so viele Festplatten enthalten wie für ihn zulässig sind. Bei der Planung der Anzahl von Festplatten pro Server gibt es einiges zu bedenken:

Netzwerk-Bandbreite. Je mehr Festplatten ein Server enthält, desto mehr Daten müssen für die Schreiboperationen der Festplatte über die Netzwerkkarte(n) übertragen werden.

Arbeitsspeicher. RAM ab 2 GB wird für den BlueStore-Cache herangezogen. Mit dem Standardwert von 4 GB für

osd_memory_targeterhält das System eine angemessene Cache-Anfangsgröße für rotierende Datenträger. Bei SSD oder NVME sollten Sie die Cache-Größe und die RAM-Zuordnung pro OSD erhöhen, damit die höchstmögliche Leistung erzielt wird.Fehlertoleranz. Wenn der Server komplett ausfällt, verliert der Cluster temporär so viele OSDs wie er Festplatten hat. Darüberhinaus müssen Sie alle Daten des ausgefallenen Servers auf die anderen Knoten im Cluster kopieren, damit die Reproduktionsregeln weiterhin ausgeführt werden.

2.5 Monitorknoten #

Mindestens drei MON-Knoten sind erforderlich. Die Anzahl der Monitore sollte immer ungerade sein (1+2n).

4 GB RAM.

Prozessor mit vier logischen Cores.

Ein SSD oder ein anderer ausreichend schneller Speichertyp ist für Monitors sehr zu empfehlen, insbesondere für den Pfad

/var/lib/cephin jedem Monitor-Knoten, da das Quorum bei hohen Festplattenlatenzen möglicherweise instabil ist. Zwei Festplatten in der RAID 1-Konfiguration werden aus Redundanzgründen empfohlen. Es wird empfohlen, dass separate Festplatten oder mindestens separate Festplattenpartitionen für die Überwachungsprozesse zur Verfügung stehen, um den verfügbaren Festplattenspeicherplatz des Monitors vor Ereignissen wie schleichender Protokolldateiausweitung zu schützen.Pro Knoten darf nur ein Überwachungsprozess vorhanden sein.

Die Kombination von OSD-, MON- oder Object-Gateway-Knoten wird nur unterstützt, wenn ausreichend Hardwareressourcen verfügbar sind. Dies bedeutet, dass die Anforderungen für alle Services aufsummiert werden müssen.

Zwei Netzwerkschnittstellen verbunden mit mehreren Schaltern.

2.6 Object-Gateway-Knoten #

Object-Gateway-Knoten sollten über mindestens sechs CPU-Cores und 32 GB RAM verfügen. Wenn sich noch andere Prozesse auf demselben Rechner befinden, müssen deren Anforderungen aufsummiert werden.

2.7 Metadata Server-Knoten #

Die richtige Größe der Metadata Server Knoten hängt vom spezifischen Anwendungsfall ab. Generell gilt, je mehr offene Dateien der Metadata Server verarbeiten muss, desto mehr CPU und RAM benötigt er. Nachfolgend finden Sie die Mindestanforderungen an die

4 GB RAM für jeden Metadatenserver-Daemon.

Gebundene Netzwerkschnittstelle.

2,5 GHz CPU mit mindestens 2 Cores.

2.8 Admin-Knoten #

Mindestens 4 GB RAM und ein CPU mit vier Cores sind erforderlich. Dies umfasst die Ausführung des Salt Masters auf dem Admin-Knoten Für große Cluster mit Hunderten von Knoten werden 6 GB RAM vorgeschlagen.

2.9 iSCSI-Gateway-Knoten #

iSCSI-Gateway-Knoten sollten über mindestens sechs CPU-Cores und 16 GB RAM verfügen.

2.10 SES und andere SUSE-Produkte #

Dieser Abschnitt enthält wichtige Informationen zur Integration von SES in andere SUSE-Produkte.

2.10.1 SUSE Manager #

SUSE Manager und SUSE Enterprise Storage sind nicht integriert. Daher kann SUSE Manager aktuell keinen SES-Cluster verwalten.

2.11 Namensbegrenzungen #

Ceph unterstützt nicht generell Nicht-ASCII-Zeichen in Konfigurationsdateien, Pool-Namen, Benutzernamen und so weiter. Wir empfehlen, beim Konfigurieren eines Ceph-Clusters in allen Ceph-Objekt- bzw. Konfigurationsnamen nur einfache alphanumerische Zeichen (A-Z, a-z, 0-9) und wenige Satzzeichen ('.', '-', '_') zu verwenden.

3 Einrichten des Hochverfügbarkeits-Clusters für den Admin-Knoten #

Der Admin-Knoten ist ein Ceph-Cluster-Knoten, in dem der Salt-Master-Service ausgeführt wird. Er verwaltet die restlichen Cluster-Knoten, indem er deren Salt-Minion-Services abfragt und anweist. Er enthält normalerweise auch andere Services, beispielsweise das Grafana Dashboard, das vom Prometheus-Überwachungs-Toolkit unterstützt wird.

Falls im Admin-Knoten ein Fehler auftritt, müssen Sie normalerweise neue funktionierende Hardware für den Knoten zur Verfügung stellen und den gesamten Konfigurationsstapel des Clusters von einer kürzlich erstellten Sicherung wiederherstellen. Eine derartige Methode ist zeitaufwändig und verursacht den Ausfall des Clusters.

Wir empfehlen einen Hochverfügbarkeits-Cluster für den Ceph Admin-Knoten, um Ausfallzeiten in der Ceph-Cluster-Leistung, die durch Admin-Knoten-Fehler verursacht werden, zu verhindern.

3.1 Überblick zum Hochverfügbarkeits-Cluster für den Admin-Knoten #

Hinter einem Hochverfügbarkeits-Cluster steckt die Überlegung, dass im Fall eines Fehlers im Cluster-Knoten der andere Knoten automatisch dessen Rolle übernimmt, einschließlich des virtualisierten Admin-Knoten. Auf diese Weise bemerken andere Ceph-Cluster-Knoten gar nicht, dass im Admin-Knoten ein Fehler aufgetreten ist.

Für die Mindestlösung eines Hochverfügbarkeits-Clusters für den Admin-Knoten ist die folgende Hardware erforderlich:

Zwei Bare Metal Server, auf denen SUSE Linux Enterprise mit der Hochverfügbarkeitserweiterung ausgeführt und der Admin-Knoten virtualisiert wird.

Mindestens zwei redundante Pfade für die Netzwerkkommunikation, beispielsweise durch Netzwerkgeräte-Bonding.

Gemeinsamer Speicher zum Hosten von Festplatten-Images der virtuellen Maschine des Admin-Knoten. Beide Server müssen auf den gemeinsamen Server zugreifen können. Es kann sich dabei beispielsweise um einen NFS-Export, eine Samba-Freigabe oder ein iSCSI-Ziel handeln.

Weitere detaillierte Informationen zu den Cluster-Anforderungen finden Sie in https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#sec-ha-inst-quick-req.

3.2 Erstellen eines Hochverfügbarkeits-Clusters mit dem Admin-Knoten #

Der folgende Vorgang fasst die wichtigsten Schritte zur Erstellung des Hochverfügbarkeits-Clusters zur Virtualisierung des Admin-Knoten zusammen. Weitere detaillierte Informationen finden Sie unter den angegebenen Links.

Richten Sie einen einfachen Hochverfügbarkeits-Cluster mit zwei Knoten und gemeinsamem Speicher ein. Eine Beschreibung hierzu finden Sie unter https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#art-sleha-install-quick.

Installieren Sie in beiden Cluster-Knoten alle Pakete, die zur Ausführung des KVM-Hypervisors und des

libvirt-Toolkits erforderlich sind. Eine Beschreibung hierzu finden Sie unter https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-vt-installation-kvm.Erstellen Sie im ersten Cluster-Knoten eine neue virtuelle KVM-Maschine und nutzen Sie dazu

libvirt. Eine Beschreibung hierzu finden Sie unter https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-libvirt-inst-virt-install. Speichern Sie die Festplatten-Images der VM im vorkonfigurierten gemeinsamen Speicher.Exportieren Sie nach Abschluss der VM-Einrichtung deren Konfiguration in eine XML-Datei im gemeinsamen Speicher. Verwenden Sie folgende Syntax:

#virsh dumpxml VM_NAME > /path/to/shared/vm_name.xmlErstellen Sie eine Ressource für die VM des Admin-Knoten. Allgemeine Informationen zum Erstellen von Hochverfügbarkeits-Ressourcen finden Sie unter https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-guide/#cha-conf-hawk2. Detaillierte Informationen zum Erstellen einer Ressource für eine virtuelle KVM-Maschine finden Sie unter http://www.linux-ha.org/wiki/VirtualDomain_%28resource_agent%29.

Stellen Sie auf dem neu erstellten VM-Gast den Admin-Knoten einschließlich der dort benötigten weiteren Services bereit. Befolgen Sie die relevanten Anweisungen unter Kapitel 6, Bereitstellen von Salt. Stellen Sie gleichzeitig die restlichen Ceph-Cluster-Knoten auf den Servern ohne Hochverfügbarkeits-Cluster bereit.

Teil II Bereitstellen des Ceph-Clusters #

- 4 Einführung und allgemeine Aufgaben

Ab SUSE Enterprise Storage 7 werden Ceph-Services als Container anstelle von RPM-Paketen bereitgestellt. Der Bereitstellungsprozess umfasst zwei grundlegende Schritte:

- 5 Installieren und Konfigurieren von SUSE Linux Enterprise Server

Installieren und registrieren Sie SUSE Linux Enterprise Server 15 SP3 auf jedem Cluster-Knoten. Während der Installation von SUSE Enterprise Storage ist der Zugriff auf die Aktualisierungs-Repositorys erforderlich, weshalb eine Registrierung obligatorisch ist. Fügen Sie mindestens die folgenden Modu…

- 6 Bereitstellen von Salt

SUSE Enterprise Storage verwendet Salt und ceph-salt für die anfängliche Vorbereitung des Clusters. Mit Salt können Sie Kommandos auf mehreren Cluster-Knoten gleichzeitig von einem dedizierten Host, dem Salt Master, aus konfigurieren und ausführen. Vor dem Bereitstellen von Salt sollten Sie folgende…

- 7 Bereitstellen des Bootstrap-Clusters mit

ceph-salt In diesem Abschnitt werden Sie durch den Prozess der Bereitstellung eines Ceph-Basisclusters geführt. Lesen Sie die folgenden Unterabschnitte sorgfältig durch und führen Sie die enthaltenen Kommandos in der angegebenen Reihenfolge aus.

- 8 Bereitstellen der verbleibenden wichtigsten Services mit cephadm

Nachdem Sie den Ceph-Basiscluster bereitgestellt haben, sollten Sie die wichtigsten Services auf weitere Cluster-Knoten verteilen. Stellen Sie zusätzliche Services bereit, um die Daten des Clusters für Clients zugänglich zu machen.

- 9 Bereitstellung zusätzlicher Services

iSCSI ist ein Storage Area Network (SAN)-Protokoll, das Clients (genannt Initiators) das Senden von SCSI-Kommandos an SCSI-Speichergeräte (Targets) auf Remote Servern ermöglicht. SUSE Enterprise Storage 7.1 umfasst eine Funktion, die die Ceph-Speicherverwaltung für heterogene Clients wie Microsoft W…

4 Einführung und allgemeine Aufgaben #

Ab SUSE Enterprise Storage 7 werden Ceph-Services als Container anstelle von RPM-Paketen bereitgestellt. Der Bereitstellungsprozess umfasst zwei grundlegende Schritte:

- Bereitstellen des Bootstrap-Clusters

Diese Phase wird als Tag 1 der Bereitstellung bezeichnet. Sie umfasst die folgenden Aufgaben: Installieren des zugrunde liegenden Betriebssystems, Konfigurieren der Salt-Infrastruktur und Bereitstellen des Minimalclusters, der aus einem MON- und einem MGR-Service besteht.

Installieren Sie das zugrunde liegende Betriebssystem (SUSE Linux Enterprise Server 15 SP3) auf allen Cluster-Knoten und nehmen Sie die Grundkonfiguration vor.

Stellen Sie die Salt-Infrastruktur auf allen Cluster-Knoten bereit, um die ersten Bereitstellungsvorbereitungen über

ceph-saltdurchzuführen.Konfigurieren Sie die grundlegenden Eigenschaften des Clusters über

ceph-saltund stellen Sie ihn bereit.

- Bereitstellen zusätzlicher Services

An Tag 2 der Bereitstellung werden weitere wichtige und zusätzliche Ceph-Services bereitgestellt, beispielsweise Gateways und ein Überwachungs-Stack.

Beachten Sie, dass in der Ceph-Community-Dokumentation das Kommando cephadm bootstrap bei der Erstinstallation verwendet wird. ceph-salt ruft automatisch das Kommando cephadm bootstrap auf. Das Kommando cephadm bootstrap sollte nicht direkt ausgeführt werden. Eine manuelle Bereitstellung eines Ceph-Clusters mit cephadm bootstrap wird nicht unterstützt.

4.1 Lesen Sie die Versionshinweise #

In den Versionshinweisen finden Sie zusätzliche Informationen zu den Änderungen, die seit der vorigen Version von SUSE Enterprise Storage vorgenommen wurden. Informieren Sie sich in den Versionshinweisen über Folgendes:

Sind bei der Hardware besondere Überlegungen zu beachten?

Wurden erhebliche Änderungen an den verwendeten Software-Paketen vorgenommen?

Gelten besondere Vorsichtsmaßnahmen für die vorliegende Installation?

In den Versionshinweisen finden Sie auch Informationen, die erst nach der Fertigstellung des Handbuchs bekannt wurden. Auch bekannte Probleme werden beschrieben.

Nach Installation des Pakets release-notes-ses finden Sie die Versionshinweise lokal im Verzeichnis /usr/share/doc/release-notes oder online unter https://www.suse.com/releasenotes/.

5 Installieren und Konfigurieren von SUSE Linux Enterprise Server #

Installieren und registrieren Sie SUSE Linux Enterprise Server 15 SP3 auf jedem Cluster-Knoten. Während der Installation von SUSE Enterprise Storage ist der Zugriff auf die Aktualisierungs-Repositorys erforderlich, weshalb eine Registrierung obligatorisch ist. Fügen Sie mindestens die folgenden Module hinzu:

Basesystem Module

Server Applications Module

Weitere Einzelheiten zur Installation von SUSE Linux Enterprise Server finden Sie unter https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-install.html.

Installieren Sie die SUSE Enterprise Storage 7.1-Erweiterung auf jedem Cluster-Knoten.

Tipp: Installation von SUSE Enterprise Storage zusammen mit SUSE Linux Enterprise ServerSie können die SUSE Enterprise Storage 7.1-Erweiterung entweder nach der Installation von SUSE Linux Enterprise Server 15 SP3 separat installieren oder sie während des Installationsvorgangs von SUSE Linux Enterprise Server 15 SP3 hinzufügen.

Weitere Details zur Installation von Erweiterungen finden Sie unter https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-register-sle.html.

Konfigurieren Sie Netzwerkeinstellungen einschließlich der ordnungsgemäßen DNS-Namensauflösung auf jedem Knoten. Weitere Informationen zum Konfigurieren eines Netzwerks finden Sie unter https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#sec-network-yast. Weitere Informationen zum Konfigurieren eines DNS Servers finden Sie unter https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#cha-dns.

6 Bereitstellen von Salt #

SUSE Enterprise Storage verwendet Salt und ceph-salt für die anfängliche Vorbereitung des Clusters. Mit Salt können Sie Kommandos auf mehreren Cluster-Knoten gleichzeitig von einem dedizierten Host, dem Salt Master, aus konfigurieren und ausführen. Vor dem Bereitstellen von Salt sollten Sie folgende wichtige Punkte beachten:

Salt Minions sind die Knoten, die von einem dedizierten Knoten namens Salt Master gesteuert werden.

Wenn der Salt-Master-Host Teil des Ceph-Clusters sein soll, muss er seinen eigenen Salt Minion ausführen, was aber keine Voraussetzung ist.

Tipp: Freigeben mehrerer Rollen pro ServerSie erreichen die optimale Leistung Ihres Ceph-Clusters, wenn jede Rolle in einem separaten Knoten bereitgestellt wird. Manchmal ist es jedoch bei Bereitstellungen erforderlich, einen Knoten für mehrere Rollen freizugeben. Stellen Sie die Ceph OSD-, Metadatenserver- oder Ceph Monitor-Rolle nicht auf dem Admin-Knoten bereit, um Probleme mit der Leistung und dem Upgrade-Vorgang zu vermeiden.

Salt Minions müssen den Hostnamen des Salt Masters im gesamten Netzwerk korrekt auflösen. Standardmäßig suchen sie nach dem Hostnamen

salt. Sie können jedoch auch in der Datei/etc/salt/minionjeden vom Netzwerk erreichbaren Hostnamen angeben.

Installieren Sie

salt-masterauf dem Salt-Master-Knoten:root@master #zypper in salt-masterÜberprüfen Sie, ob der

salt-master-Service aktiviert und gestartet wurde und aktivieren und starten Sie ihn gegebenenfalls:root@master #systemctl enable salt-master.serviceroot@master #systemctl start salt-master.serviceFalls Sie beabsichtigen, die Firewall zu verwenden, überprüfen Sie, ob im Salt-Master-Knoten die Ports 4505 und 4506 für alle Salt-Minion-Knoten offen sind. Wenn die Ports geschlossen sind, können Sie sie mit dem Kommando

yast2 firewallöffnen. Lassen Sie dazu den-Service für die entsprechende Zone zu. Zum BeispielÖffentlich.Installieren Sie das Paket

salt-minionin allen Minion-Knoten.root@minion >zypper in salt-minionBearbeiten Sie

/etc/salt/minionund kommentieren Sie die folgende Zeile aus:#log_level_logfile: warning

Ändern Sie die Protokollstufe

WarnungzuInfo.Anmerkung:log_level_logfileundlog_levelWährend mit

log_levelgesteuert wird, welche Protokollmeldungen auf dem Bildschirm angezeigt werden, wird mitlog_level_logfilegesteuert, welche Protokollmeldungen in/var/log/salt/miniongeschrieben werden.AnmerkungStellen Sie sicher, dass Sie die Protokollebene auf allen Cluster-Knoten (Minions) ändern.

Vergewissern Sie sich, dass der vollqualifizierte Domänenname jedes Knotens von allen anderen Knoten in eine IP-Adresse im öffentlichen Clusternetzwerk aufgelöst werden kann.

Konfigurieren Sie alle Minions für die Verbindung mit dem Master. Wenn Ihr Salt Master mit dem Hostnamen

saltnicht erreichbar ist, bearbeiten Sie die Datei/etc/salt/minionoder erstellen Sie eine neue Datei/etc/salt/minion.d/master.confmit folgendem Inhalt:master: host_name_of_salt_master

Wenn Sie an den oben genannten Konfigurationsdateien Änderungen vorgenommen haben, starten Sie den Salt-Service auf allen entsprechenden Salt Minions neu:

root@minion >systemctl restart salt-minion.serviceÜberprüfen Sie, ob der

salt-minionService in allen Knoten aktiviert und gestartet wurde. Aktivieren und starten Sie ihn, falls erforderlich:#systemctl enable salt-minion.service#systemctl start salt-minion.serviceÜberprüfen Sie den Fingerabdruck der einzelnen Salt Minions und akzeptieren Sie alle Salt-Schlüssel am Salt Master, wenn die Fingerabdrücke übereinstimmen.

AnmerkungWenn ein leerer Fingerabdruck des Salt Minions zurückgegeben wird, prüfen Sie, ob der Salt Minion über eine Salt-Master-Konfiguration verfügt und ob der Minion mit dem Salt Master kommunizieren kann.

Zeigen Sie den Fingerabdruck der einzelnen Minions an:

root@minion >salt-call --local key.finger local: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Nachdem Sie die Fingerabdrücke aller Salt Minions gesammelt haben, listen Sie die Fingerabdrücke aller nicht akzeptierten Minion-Schlüssel am Salt Master auf:

root@master #salt-key -F [...] Unaccepted Keys: minion1: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Wenn die Fingerabdrücke der Minions übereinstimmen, akzeptieren Sie sie:

root@master #salt-key --accept-allVerifizieren Sie, dass die Schlüssel akzeptiert wurden:

root@master #salt-key --list-allTesten Sie, ob alle Salt Minions antworten:

root@master #salt-run manage.status

7 Bereitstellen des Bootstrap-Clusters mit ceph-salt #

In diesem Abschnitt werden Sie durch den Prozess der Bereitstellung eines Ceph-Basisclusters geführt. Lesen Sie die folgenden Unterabschnitte sorgfältig durch und führen Sie die enthaltenen Kommandos in der angegebenen Reihenfolge aus.

7.1 Installieren von ceph-salt #

ceph-salt stellt Werkzeuge zum Bereitstellen von Ceph-Clustern bereit, die von cephadm verwaltet werden. ceph-salt nutzt die Salt-Infrastruktur, um die Verwaltung des Betriebssystems – beispielsweise Softwareaktualisierungen oder Zeitsynchronisierung – durchzuführen und Rollen für Salt Minions zu definieren.

Installieren Sie auf dem Salt Master das Paket ceph-salt:

root@master # zypper install ceph-salt

Das obige Kommando installiert ceph-salt-formula als Abhängigkeit, die die Salt-Master-Konfiguration durch Einfügen zusätzlicher Dateien im Verzeichnis /etc/salt/master.d ändert. Um die Änderungen anzuwenden, starten Sie salt-master.service neu und synchronisieren Sie die Salt-Module:

root@master #systemctl restart salt-master.serviceroot@master #salt \* saltutil.sync_all

7.2 Konfigurieren der Clustereigenschaften #

Konfigurieren Sie mit dem Kommando ceph-salt config die grundlegenden Eigenschaften des Clusters.

Die Datei /etc/ceph/ceph.conf wird von cephadm verwaltet und sollte nicht von Benutzern bearbeitet werden. Die Ceph-Konfigurationsparameter sollten mit dem neuen Kommando ceph config festgelegt werden. Weitere Informationen zu diesem Thema finden Sie unter dem Stichwort Book “Betriebs- und Verwaltungshandbuch”, Chapter 28 “Konfiguration des Ceph-Clusters”, Section 28.2 “Konfigurationsdatenbank”.

7.2.1 Verwenden der ceph-salt-Shell #

Wenn Sie config ohne Pfad oder Unterbefehl ausführen, gelangen Sie in eine interaktive ceph-saltceph-salt-Shell. Die Shell ist praktisch, wenn Sie mehrere Eigenschaften in einem Stapel konfigurieren müssen und nicht die vollständige Kommandosyntax eingeben möchten.

root@master #ceph-salt config/>ls o- / ............................................................... [...] o- ceph_cluster .................................................. [...] | o- minions .............................................. [no minions] | o- roles ....................................................... [...] | o- admin .............................................. [no minions] | o- bootstrap ........................................... [no minion] | o- cephadm ............................................ [no minions] | o- tuned ..................................................... [...] | o- latency .......................................... [no minions] | o- throughput ....................................... [no minions] o- cephadm_bootstrap ............................................. [...] | o- advanced .................................................... [...] | o- ceph_conf ................................................... [...] | o- ceph_image_path .................................. [ no image path] | o- dashboard ................................................... [...] | | o- force_password_update ................................. [enabled] | | o- password ................................................ [admin] | | o- ssl_certificate ....................................... [not set] | | o- ssl_certificate_key ................................... [not set] | | o- username ................................................ [admin] | o- mon_ip .................................................. [not set] o- containers .................................................... [...] | o- registries_conf ......................................... [enabled] | | o- registries .............................................. [empty] | o- registry_auth ............................................... [...] | o- password .............................................. [not set] | o- registry .............................................. [not set] | o- username .............................................. [not set] o- ssh ............................................... [no key pair set] | o- private_key .................................. [no private key set] | o- public_key .................................... [no public key set] o- time_server ........................... [enabled, no server host set] o- external_servers .......................................... [empty] o- servers ................................................... [empty] o- subnet .................................................. [not set]

Wie Sie der Ausgabe des ceph-saltls-Kommandos von entnehmen können, ist die Cluster-Konfiguration in einer Baumstruktur organisiert. Sie haben zwei Möglichkeiten zum Konfigurieren einer bestimmten Eigenschaft des Clusters in der ceph-salt-Shell:

Führen Sie das Kommando von der aktuellen Position aus und geben Sie den absoluten Pfad zur Eigenschaft als erstes Argument ein:

/>/cephadm_bootstrap/dashboard ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username .................................................... [admin]/> /cephadm_bootstrap/dashboard/username set ceph-adminValue set.Wechseln Sie zu dem Pfad, dessen Eigenschaft Sie konfigurieren müssen, und führen Sie das Kommando aus:

/>cd /cephadm_bootstrap/dashboard//ceph_cluster/minions>ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username ................................................[ceph-admin]

Während Sie sich in einer ceph-salt-Shell befinden, können Sie die Funktion der automatischen Vervollständigung ähnlich wie in einer normalen Linux-Shell (Bash) verwenden. Sie vervollständigt Konfigurationspfade, Unterkommandos oder Salt-Minion-Namen. Beim automatischen Vervollständigen eines Konfigurationspfads haben Sie zwei Möglichkeiten:

Drücken Sie zweimal die TAB-Taste →|, damit die Shell einen Pfad relativ zu Ihrer aktuellen Position beendet.

Geben Sie / ein und drücken Sie zweimal die TAB-Taste →|, damit die Shell einen absoluten Pfad beendet.

Wenn Sie cd aus der ceph-salt-Shell heraus ohne Pfad eingeben, wird durch das Kommando eine Baumstruktur der Cluster-Konfiguration ausgegeben, wobei die Zeile des aktuellen Pfads aktiv ist. Mit den Cursortasten nach oben und nach unten navigieren Sie durch die einzelnen Zeilen. Nach dem Bestätigen mit der Eingabetaste Eingabetaste wird der Konfigurationspfad zum letzten aktiven Pfad geändert.

Wir verwenden eine einzige Kommandosyntax ohne Eingabe der ceph-salt-Shell, um die Dokumentation konsistent zu halten. Sie können zum Beispiel den Cluster-Konfigurationsbaum mit folgendem Kommando auflisten:

root@master # ceph-salt config ls7.2.2 Hinzufügen von Salt Minions #

Nehmen Sie alle oder eine Teilmenge der von uns in Kapitel 6, Bereitstellen von Salt bereitgestellten und akzeptierten Salt Minions in die Ceph-Cluster-Konfiguration auf. Sie können die Salt Minions entweder mit ihren vollständigen Namen angeben oder mit einem Globausdruck „*“ und „?“ mehrere Salt Minions gleichzeitig hinzufügen. Verwenden Sie das Unterkommando add unter dem Pfad /ceph_cluster/minions. Mit folgendem Kommando werden alle akzeptierten Salt Minions hinzugefügt:

root@master # ceph-salt config /ceph_cluster/minions add '*'Überprüfen Sie, ob die angegebenen Salt Minions hinzugefügt wurden:

root@master # ceph-salt config /ceph_cluster/minions ls

o- minions ................................................. [Minions: 5]

o- ses-master.example.com .................................. [no roles]

o- ses-min1.example.com .................................... [no roles]

o- ses-min2.example.com .................................... [no roles]

o- ses-min3.example.com .................................... [no roles]

o- ses-min4.example.com .................................... [no roles]7.2.3 Festlegen von Salt Minions, die von cephadm verwaltet werden #

Geben Sie an, welche Knoten zum Ceph-Cluster gehören und von cephadm verwaltet werden sollen. Beziehen Sie alle Knoten ein, die Ceph-Services ausführen, sowie den Admin-Knoten:

root@master # ceph-salt config /ceph_cluster/roles/cephadm add '*'7.2.4 Festlegen des Admin Knoten #

Der Admin-Knoten ist der Knoten, auf dem die Konfigurationsdatei ceph.conf und der Ceph-Admin-Schlüsselbund installiert sind. Normalerweise führen Sie Ceph-spezifische Kommandos auf dem Admin-Knoten aus.

In einer homogenen Umgebung, in der alle oder die meisten Hosts zu SUSE Enterprise Storage gehören, wird empfohlen, dass sich der Admin-Knoten auf demselben Host befindet wie der Salt Master.