Erfahren Sie, wie Sie einzelne oder mehrere Systeme installieren und die Produktfunktionen für eine Bereitstellungsinfrastruktur nutzen. Wählen Sie aus verschiedenen Ansätzen. Von der lokalen Installation über einen Netzwerkinstallationsserver bis zu einer Masseninstallation über eine entfernt gesteuerte, hochgradig angepasste und automatisierte Installationsmethode ist alles möglich.

- Allgemeines zu diesem Handbuch

- 1 Planung für SUSE Linux Enterprise Server

- I Installationsvorbereitung

- II Der Installations-Workflow

- 6 Installation mit YaST

- 6.1 Wahl der Installationsmethode

- 6.2 Systemstart für die Installation

- 6.3 Installationsschritte

- 6.4 Selbstaktualisierung des Installationsprogramms

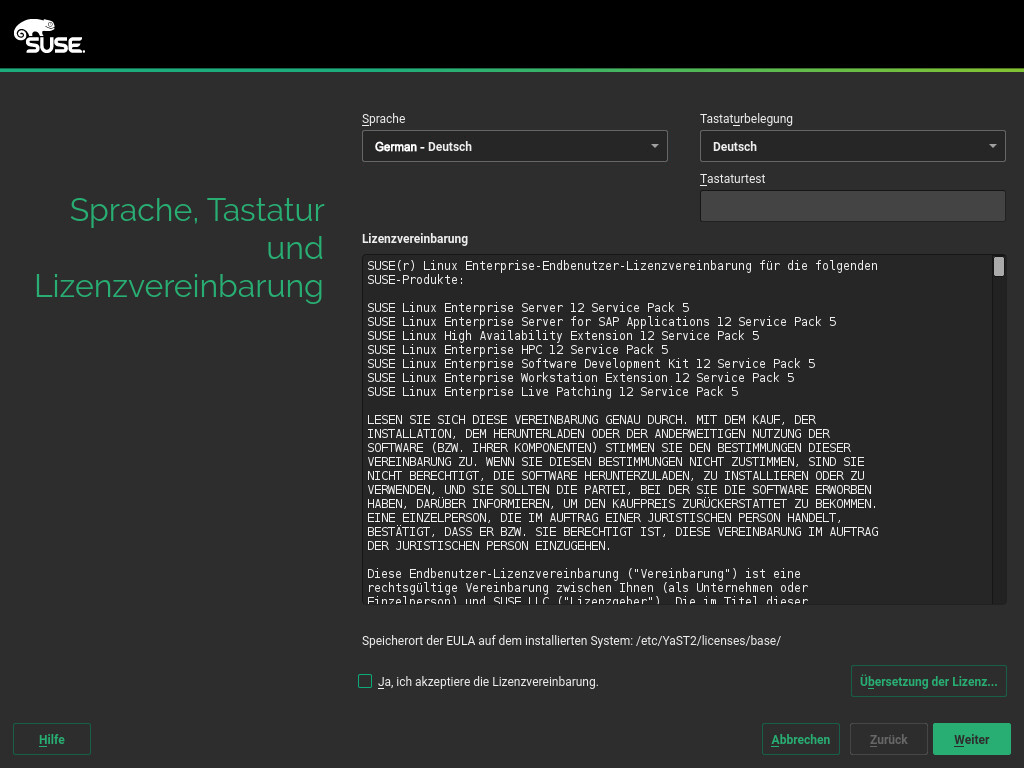

- 6.5 Sprache, Tastatur und Lizenzvereinbarung

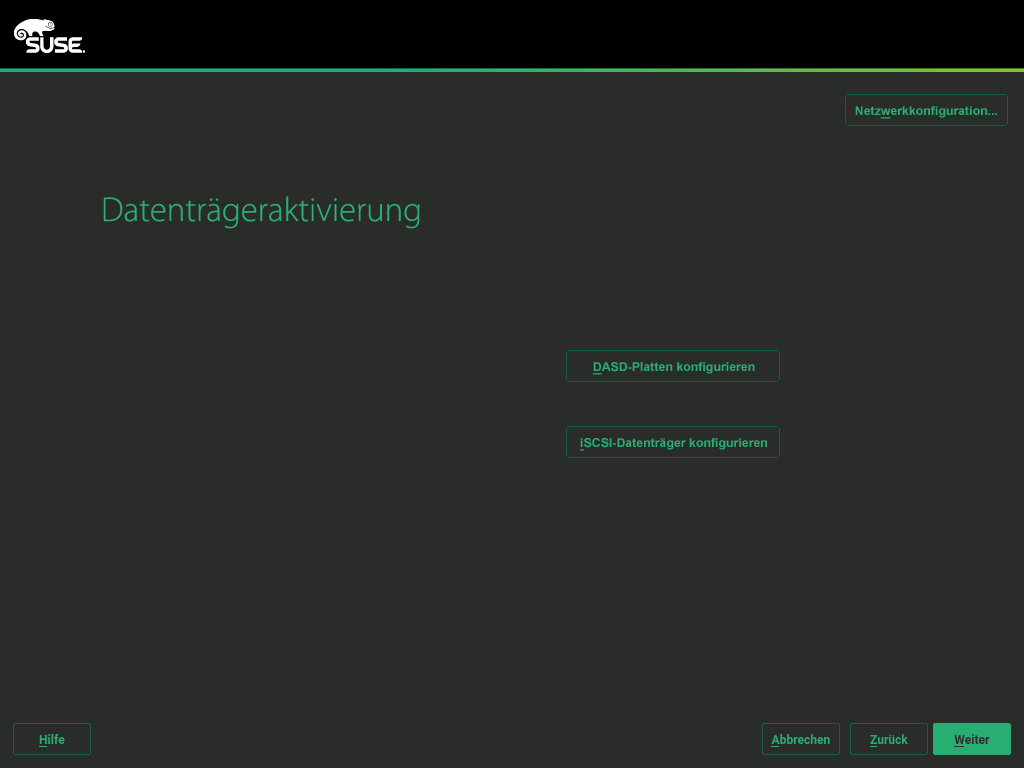

- 6.6 IBM Z: Datenträgeraktivierung

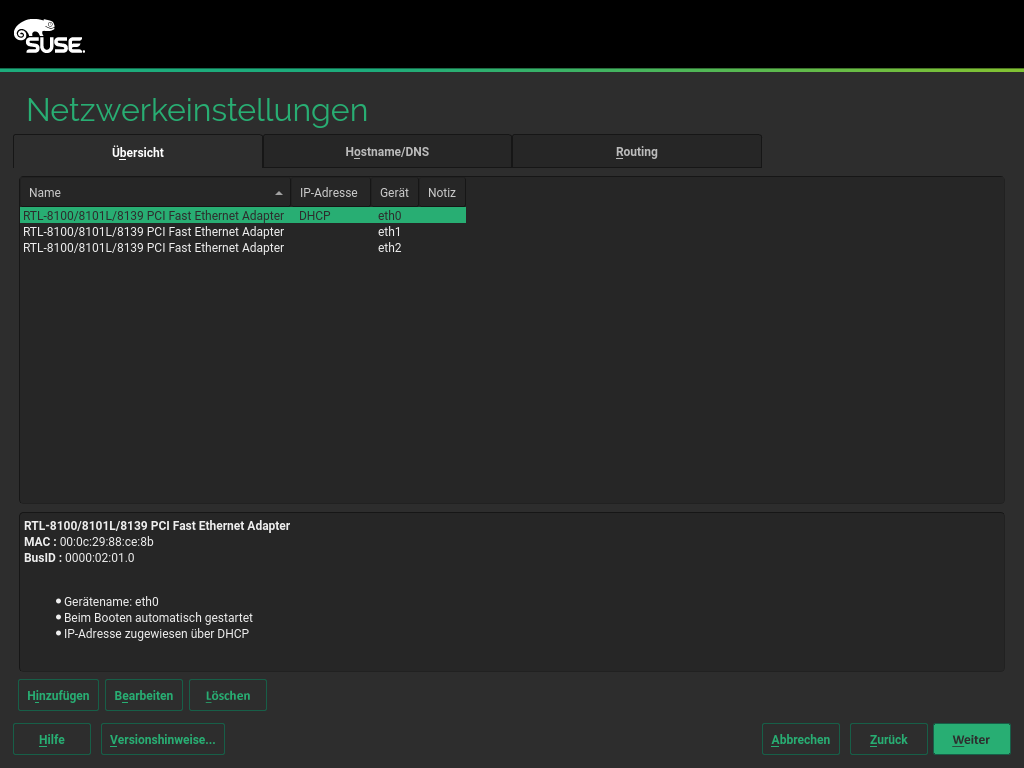

- 6.7 Netzwerkeinstellungen

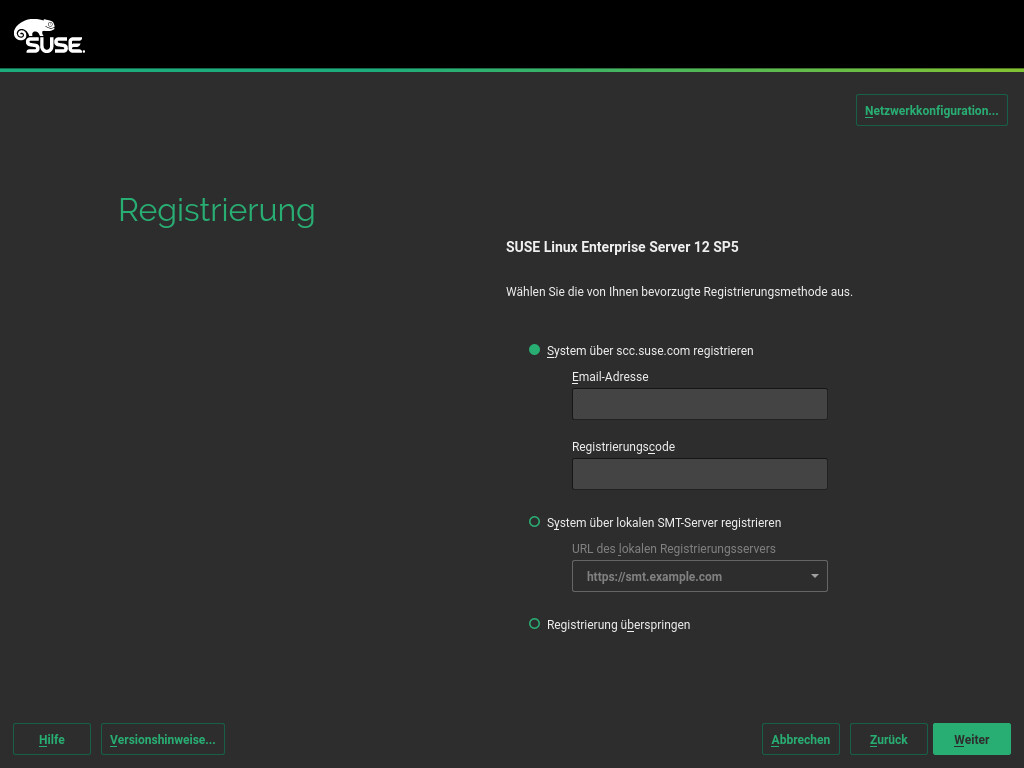

- 6.8 Registrierung beim SUSE Customer Center

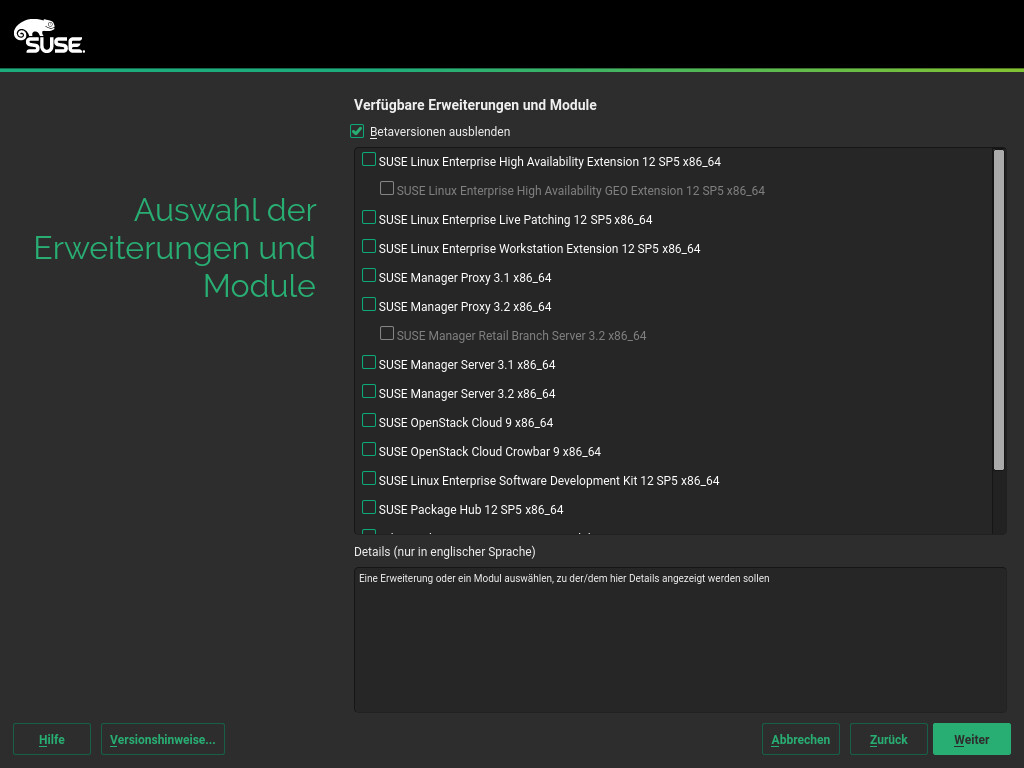

- 6.9 Auswahl der Erweiterungen

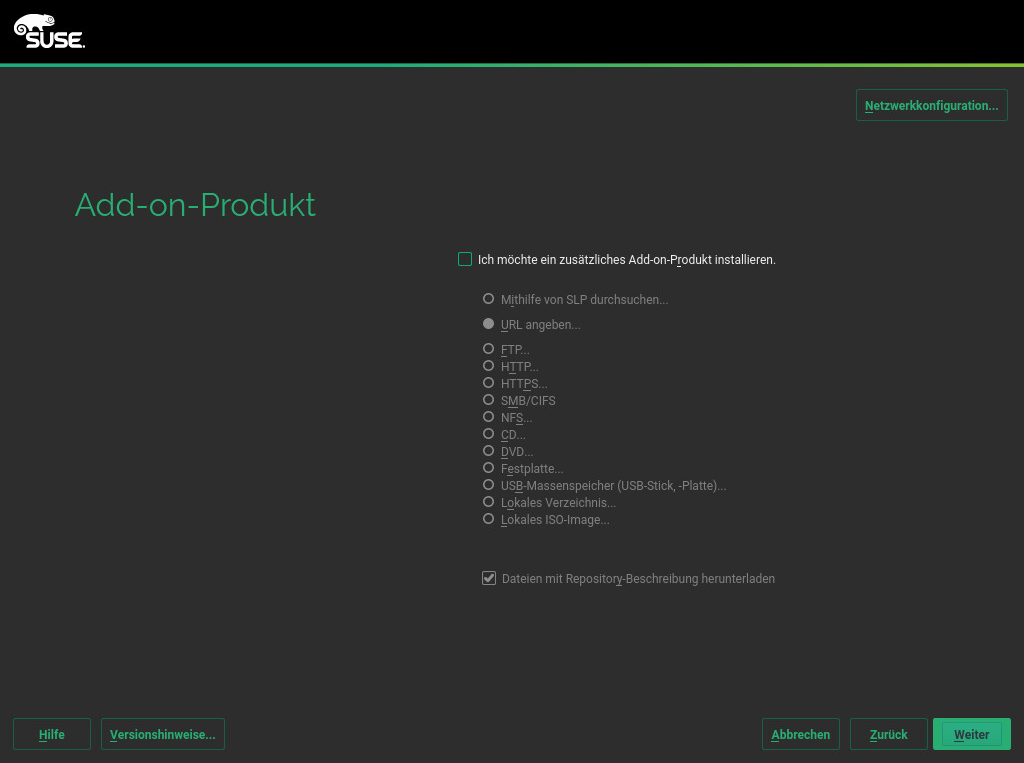

- 6.10 Systemrolle

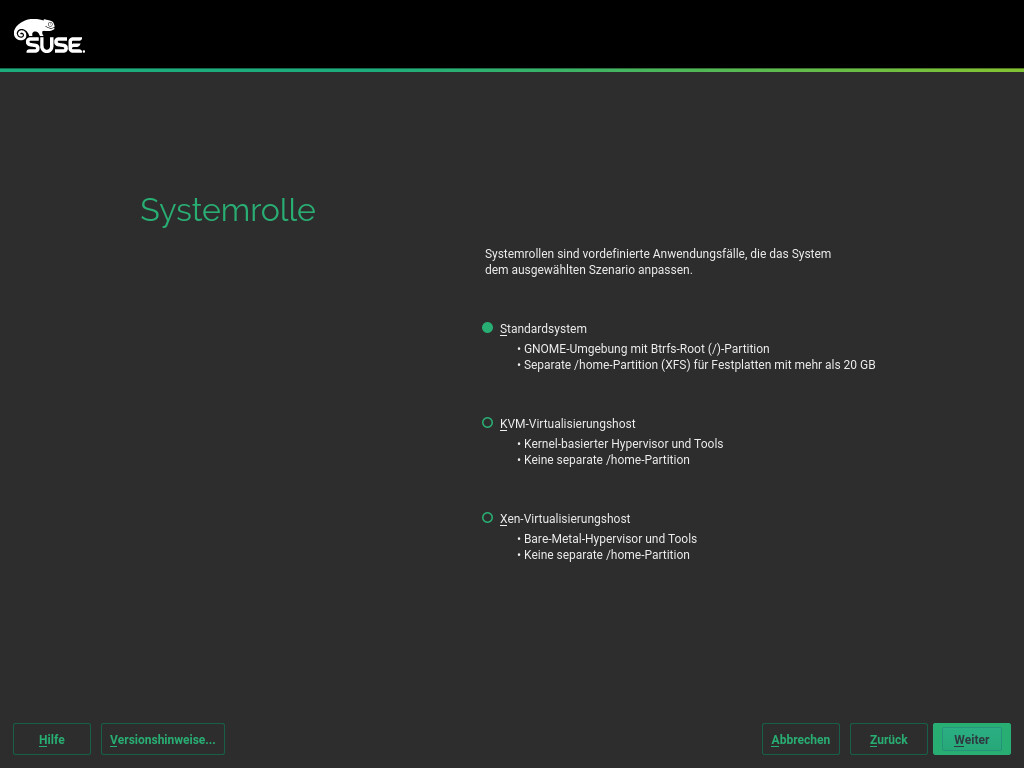

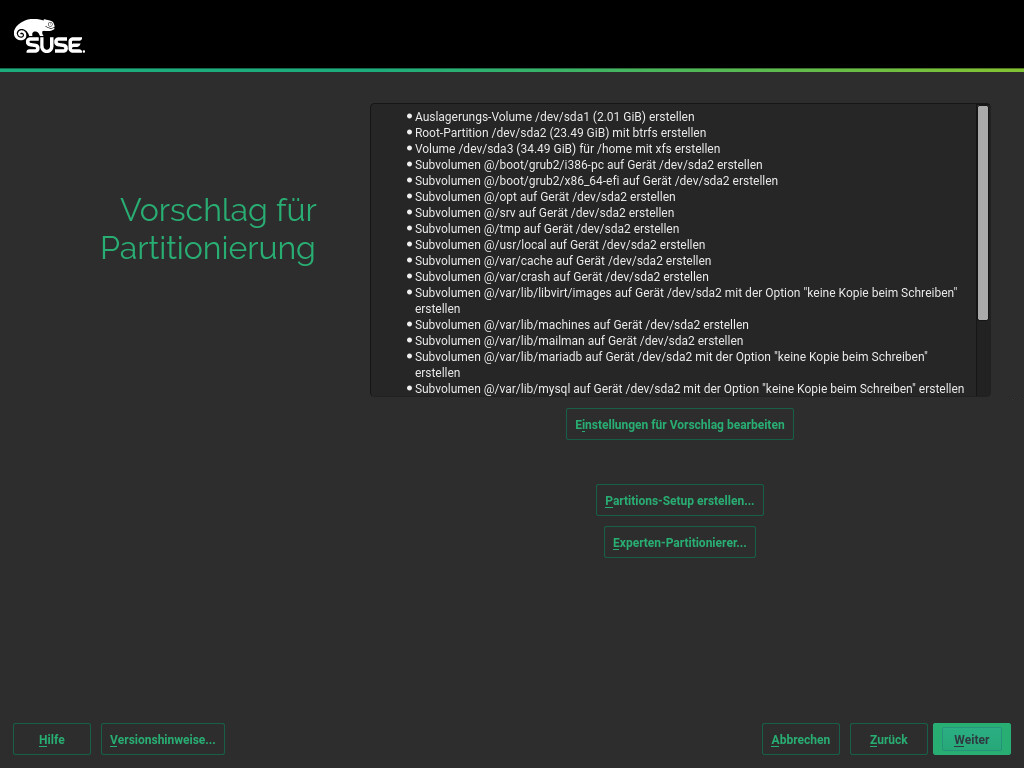

- 6.11 Vorgeschlagene Partitionierung

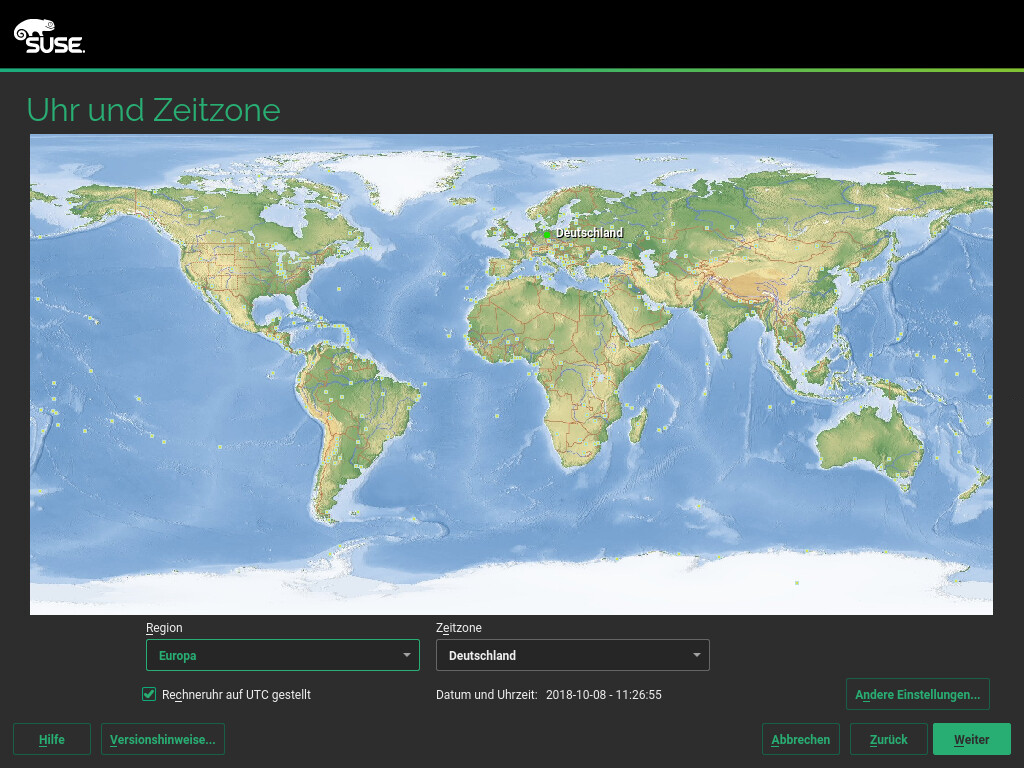

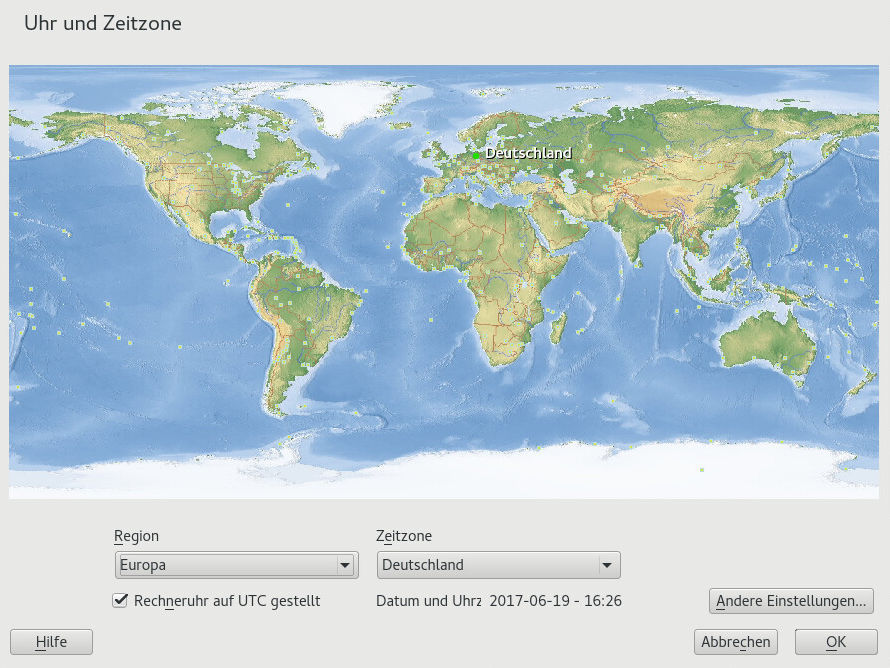

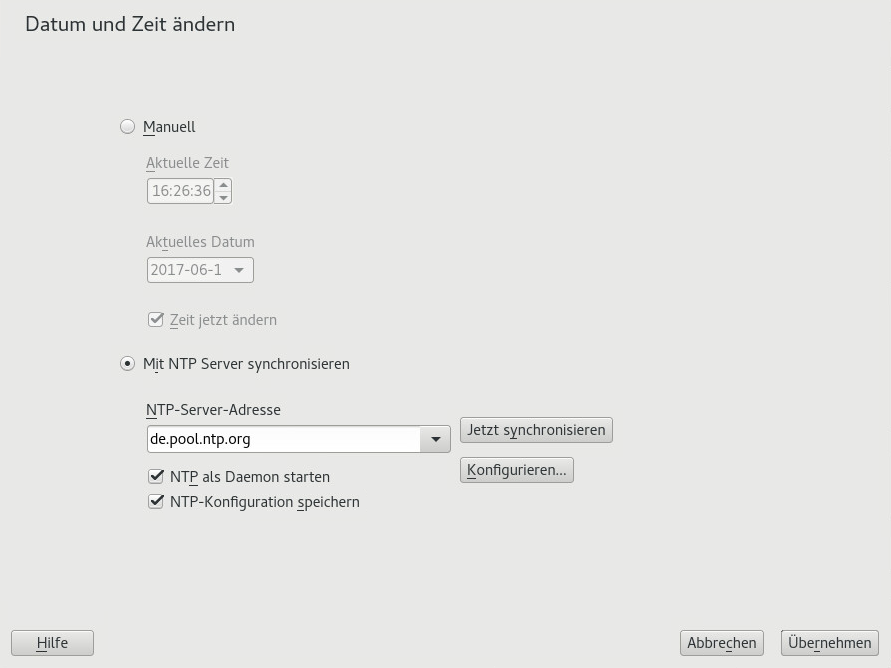

- 6.12 Uhr und Zeitzone

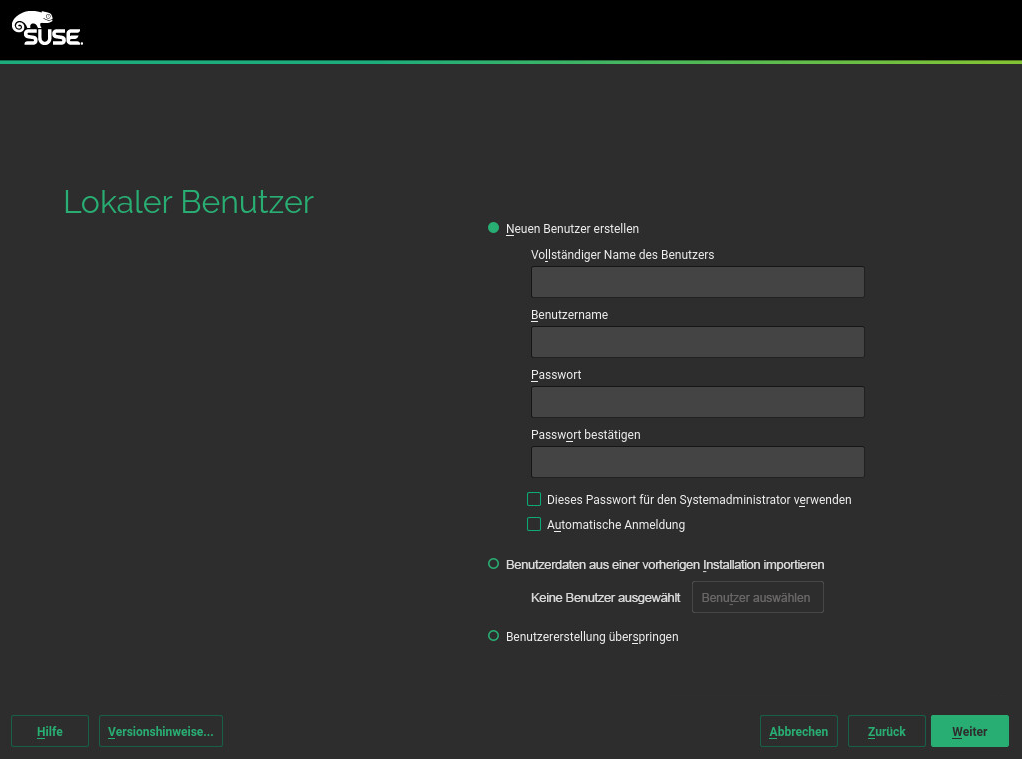

- 6.13 Erstellen von neuen Benutzern

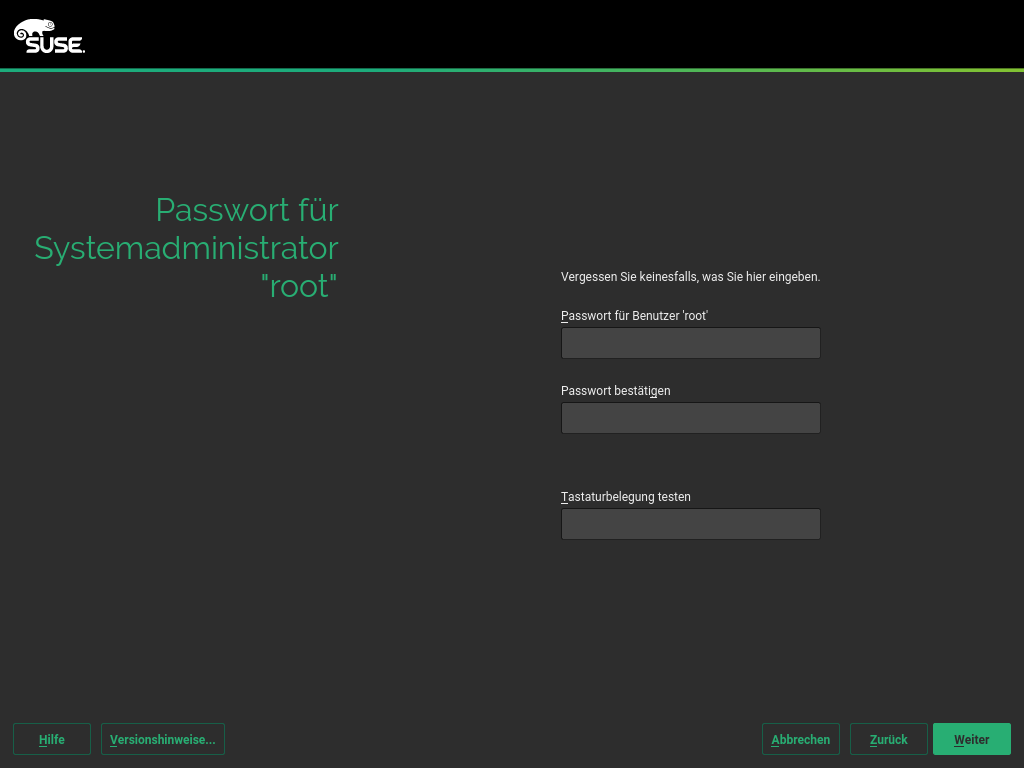

- 6.14 Passwort für den Systemadministrator

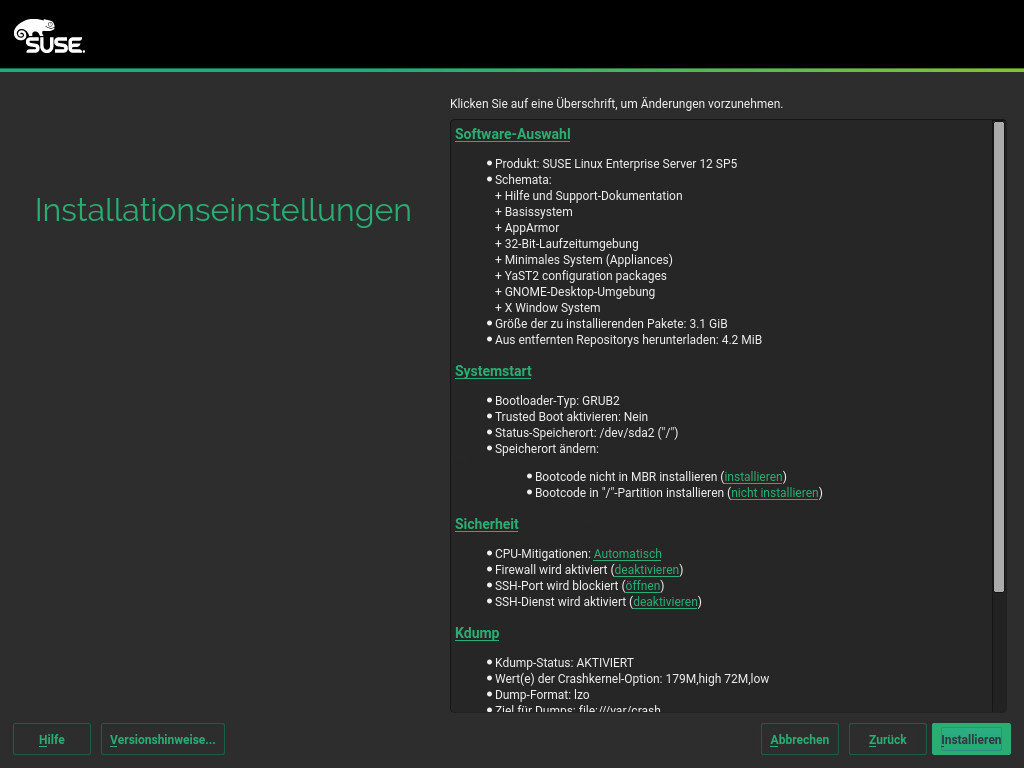

root - 6.15 Installationseinstellungen

- 6.16 Ausführen der Installation

- 7 Klonen von Festplatten-Images

- 6 Installation mit YaST

- III Einrichten eines Installationsservers

- 8 Einrichten des Servers, auf dem sich die Installationsquellen befinden

- 8.1 Einrichten eines Installationsservers mithilfe von YaST

- 8.2 Manuelles Einrichten eines NFS-Repositorys

- 8.3 Manuelles Einrichten eines FTP-Repositorys

- 8.4 Manuelles Einrichten eines HTTP-Repositorys

- 8.5 Verwalten eines SMB-Repositorys

- 8.6 Verwenden von ISO-Images der Installationsmedien auf dem Server

- 9 Vorbereitung des Bootvorgangs für das Zielsystem

- 9.1 Einrichten eines DHCP-Servers

- 9.2 Einrichten eines TFTP-Servers

- 9.3 Installieren von Dateien auf einem TFTP-Server

- 9.4 PXELINUX-Konfigurationsoptionen

- 9.5 Vorbereiten des Zielsystems für PXE-Boot

- 9.6 Vorbereiten des Zielsystems für Wake-on-LAN

- 9.7 Wake-on-LAN

- 9.8 Wake-on-LAN mit YaST

- 9.9 Booten von einer CD oder einem USB-Laufwerk statt über PXE

- 8 Einrichten des Servers, auf dem sich die Installationsquellen befinden

- IV Installationen auf Remote-Systemen

- V Erstkonfiguration des Systems

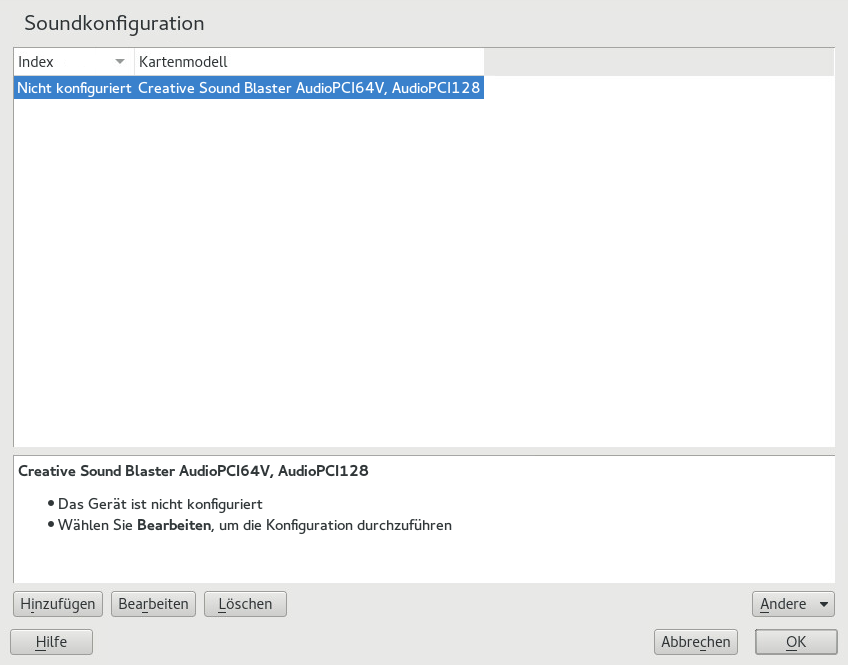

- 11 Einrichten von Hardware-Komponenten mit YaST

- 12 Fortgeschrittene Festplattenkonfiguration

- 13 Installieren bzw. Entfernen von Software

- 14 Installieren von Modulen, Erweiterungen und Add-on-Produkten von Drittanbietern

- 15 Installieren von mehreren Kernel-Versionen

- 16 Verwalten von Benutzern mit YaST

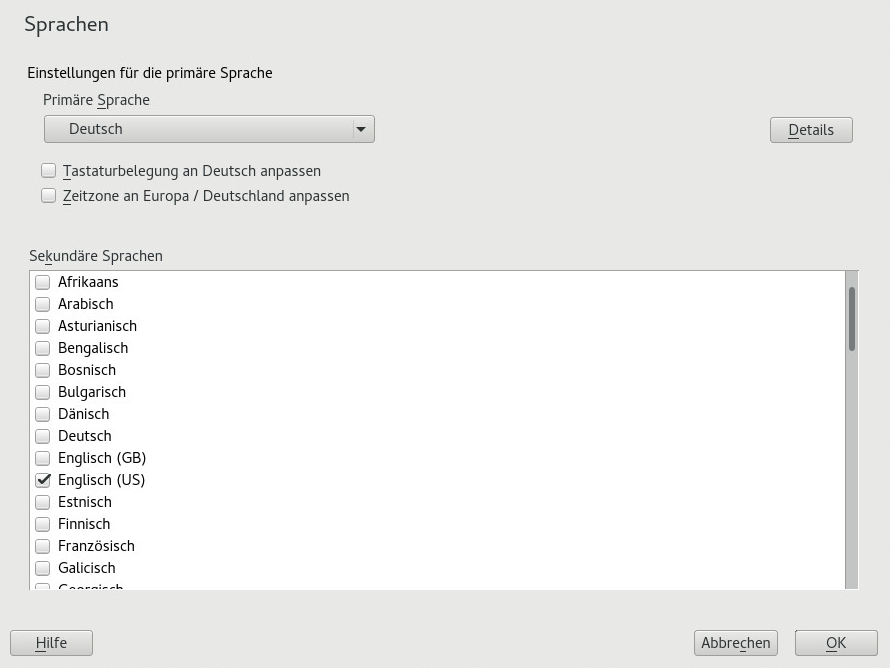

- 17 Ändern der Sprach- und Ländereinstellungen mit YaST

- VI Aktualisieren und Aufrüsten von SUSE Linux Enterprise

- 18 Lebenszyklus und Support

- 19 Upgraden von SUSE Linux Enterprise

- 20 Offline-Upgrade

- 20.1 Konzeptüberblick

- 20.2 Starten der Aufrüstung über ein Installationsmedium

- 20.3 Starten der Aufrüstung über eine Netzwerkquelle

- 20.4 Aktivieren der automatischen Aufrüstung

- 20.5 Upgraden von SUSE Linux Enterprise

- 20.6 Aktualisieren über SUSE Manager

- 20.7 Aktualisieren des Registrierungsstatus nach einem Rollback

- 20.8 Registrieren des Systems

- 21 Online-Upgrade

- 22 Rückportierungs-Quellcode

- A GNU licenses

- 6.1 Der Boot-Bildschirm auf Computern mit herkömmlichem BIOS

- 6.2 Der Boot-Bildschirm auf Computern mit UEFI

- 6.3 Sprache, Tastatur und Lizenzvereinbarung

- 6.4 Datenträgeraktivierung

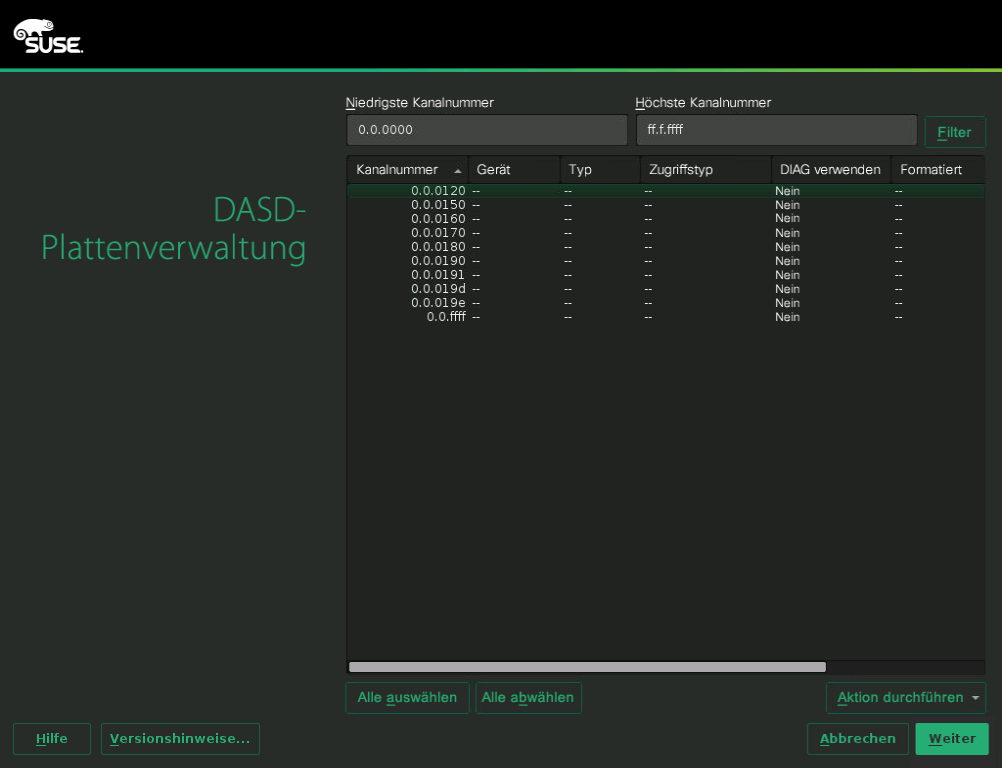

- 6.5 IBM Z: Auswählen eines DASD-Datenträgers

- 6.6 Netzwerkeinstellungen

- 6.7 Registrierung beim SUSE Customer Center

- 6.8 Auswahl der Erweiterungen

- 6.9 Add-on-Produkt

- 6.10 Auswahl der Systemrolle

- 6.11 Partitionierung

- 6.12 Uhr und Zeitzone

- 6.13 Erstellen von neuen Benutzern

- 6.14 Passwort für den Systemadministrator

root - 6.15 Installationseinstellungen

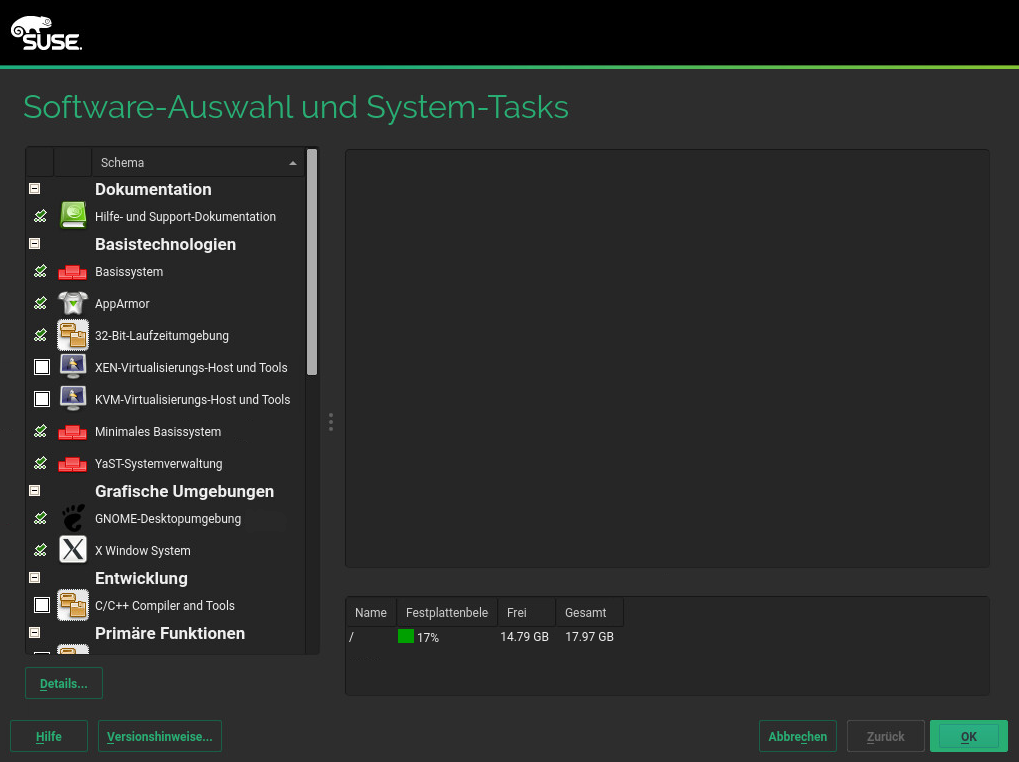

- 6.16 Software-Auswahl und System-Tasks

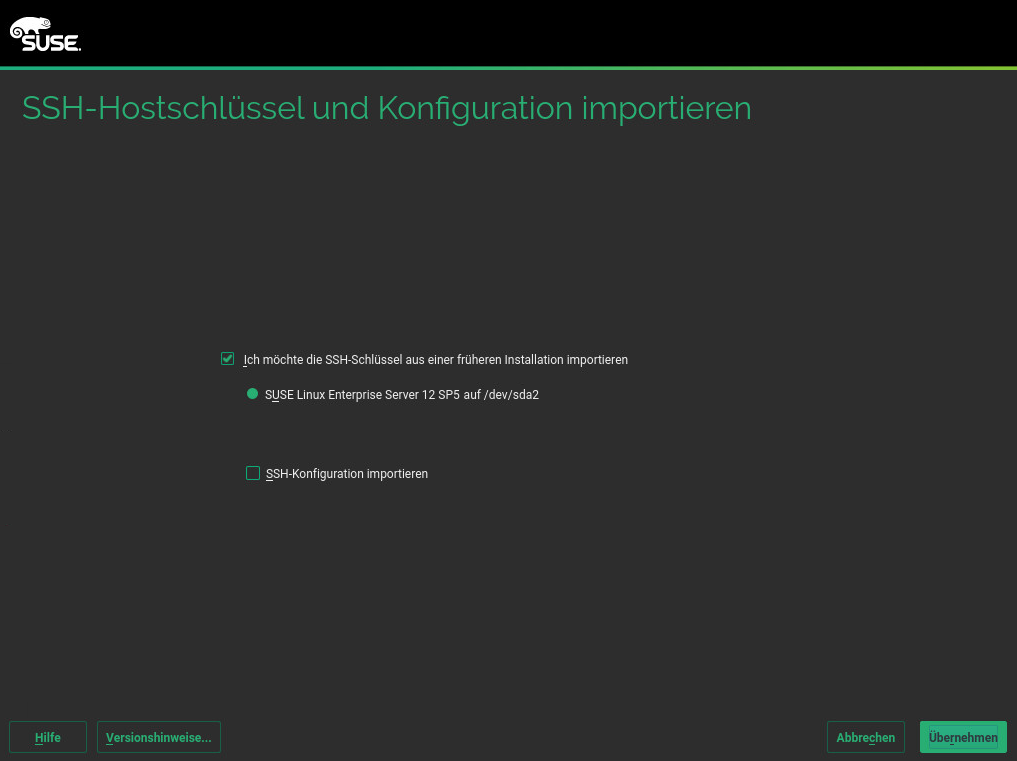

- 6.17 Importieren von SSH-Hostschlüsseln und Konfiguration

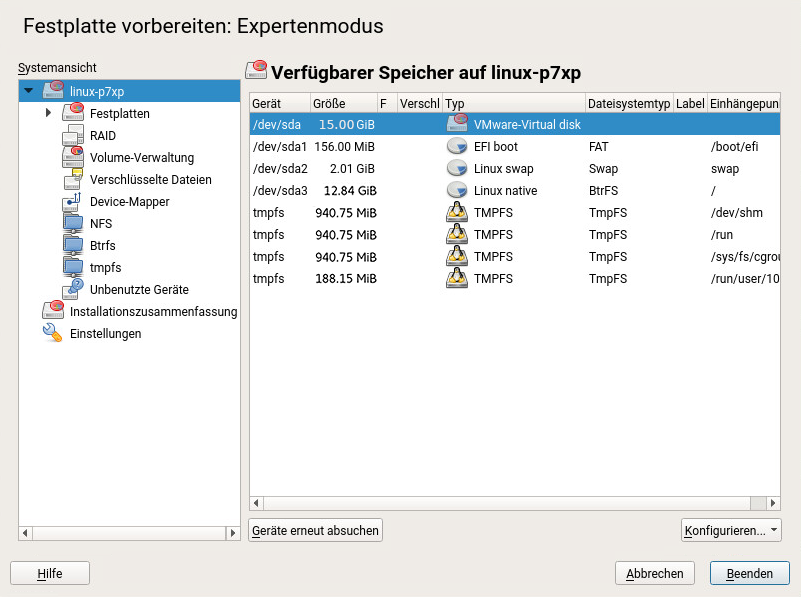

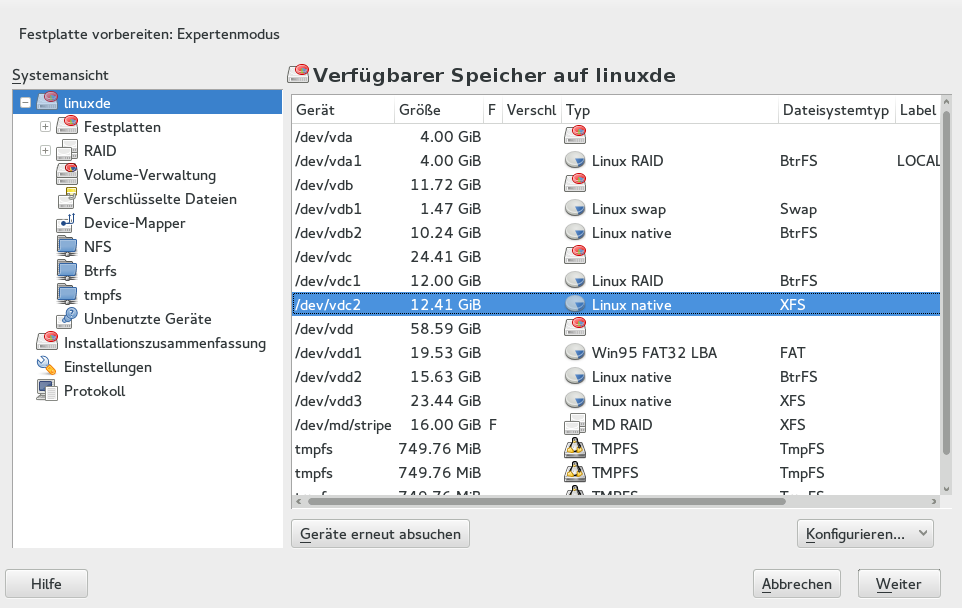

- 12.1 Das YaST-Partitionierungsprogramm

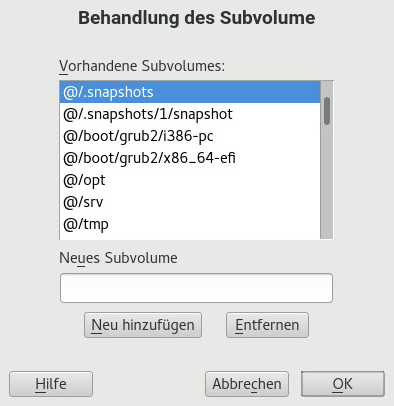

- 12.2 Btrfs-Subvolumes bei der YaST-Partitionierung

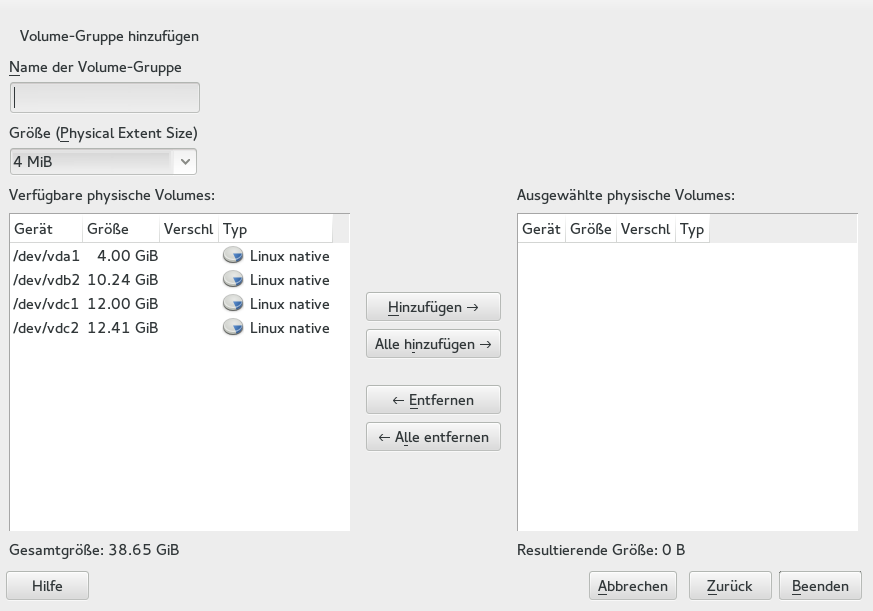

- 12.3 Anlegen einer Volume-Gruppe

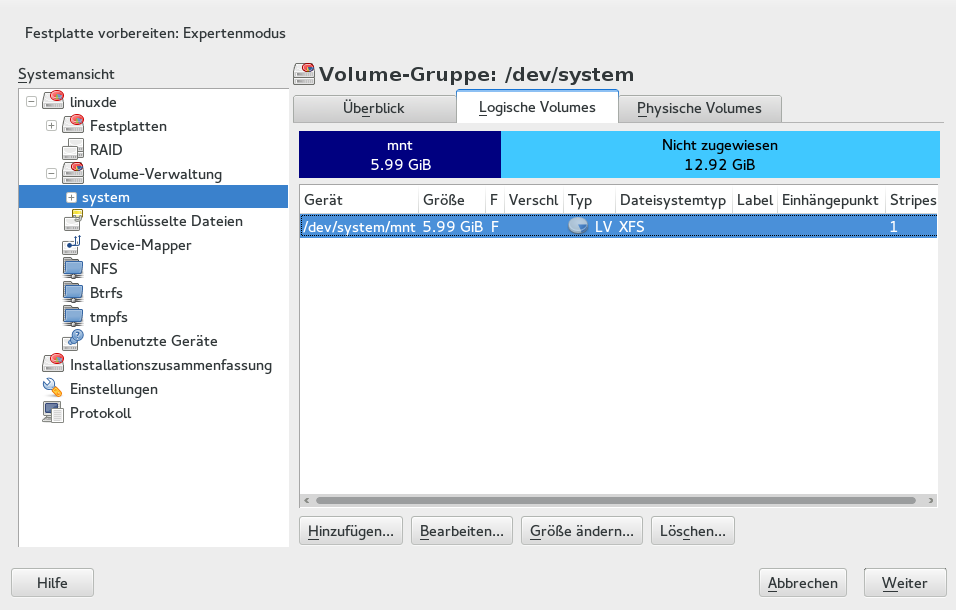

- 12.4 Verwaltung der logischen Volumes

- 12.5 RAID-Partitionen

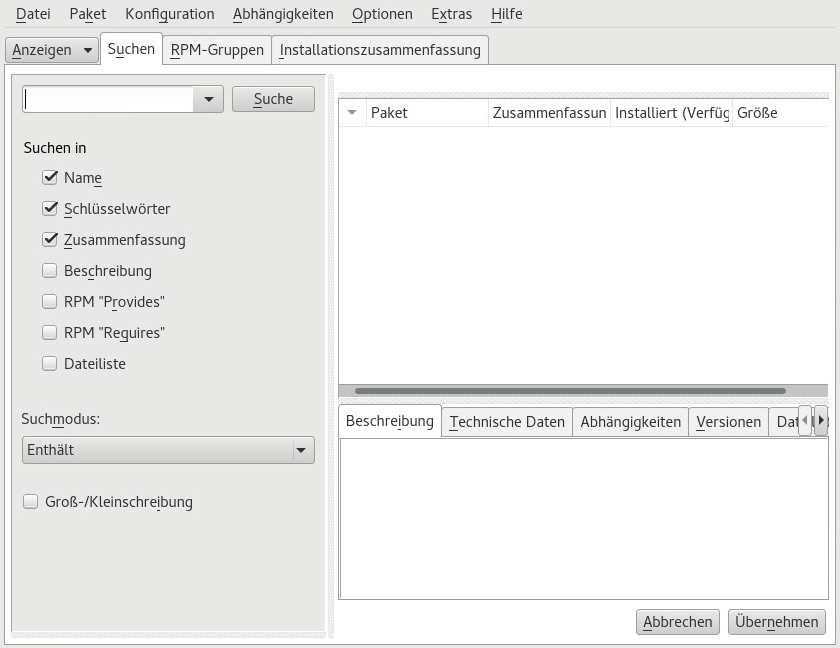

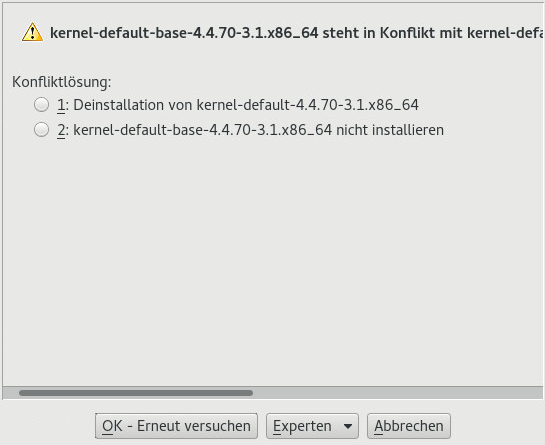

- 13.1 Konfliktverwaltung des Software-Managers

- 13.2 Hinzufügen eines Software-Repositorys

- 13.3 Aktualisierungsbenachrichtigung im GNOME-Sperrbildschirm

- 13.4 Aktualisierungsbenachrichtigung auf dem GNOME-Desktop

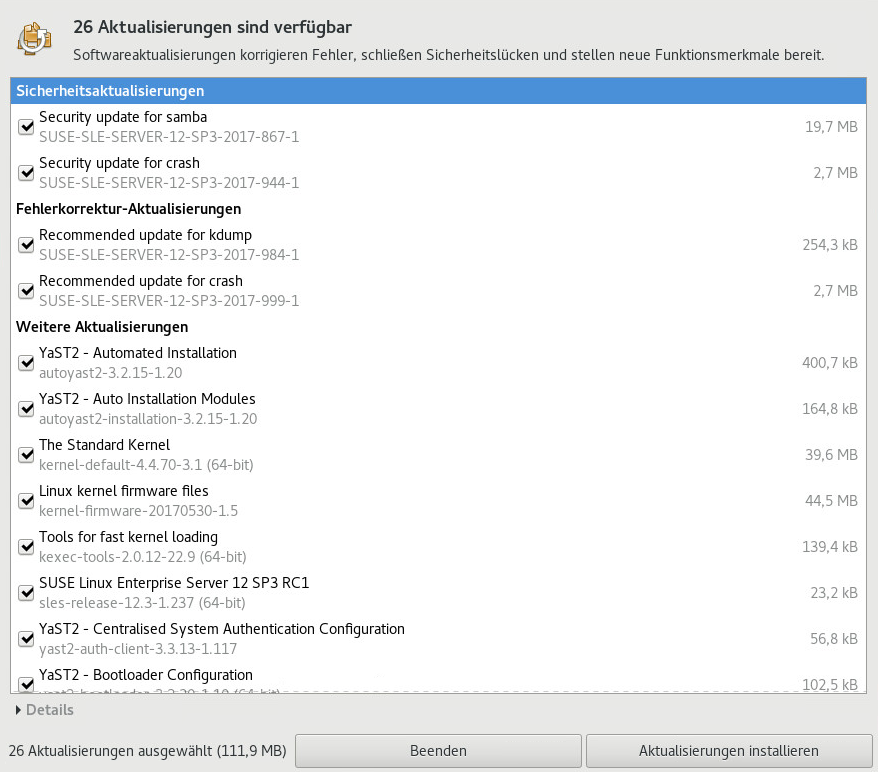

- 13.5 GNOME-Aktualisierungsvorschau

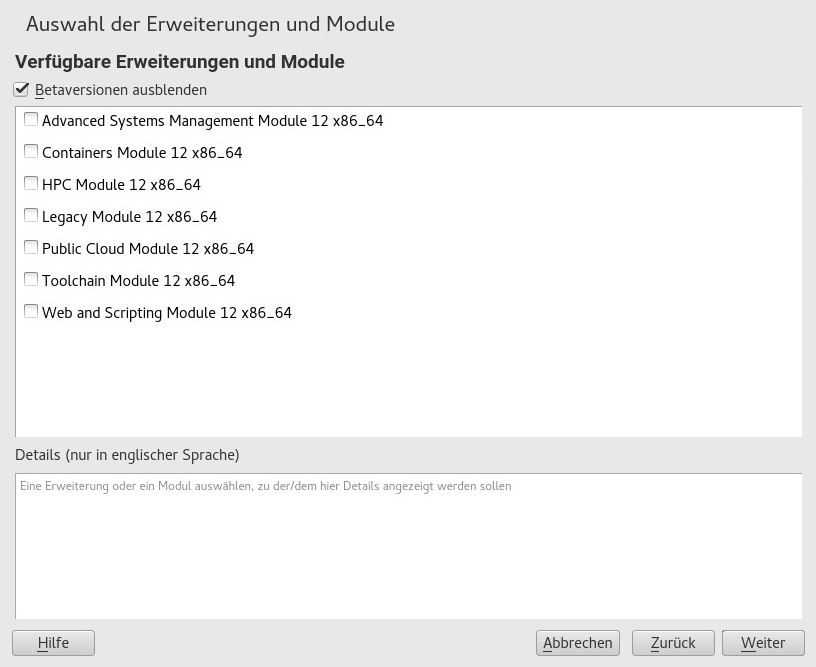

- 14.1 Installation von Systemerweiterungen

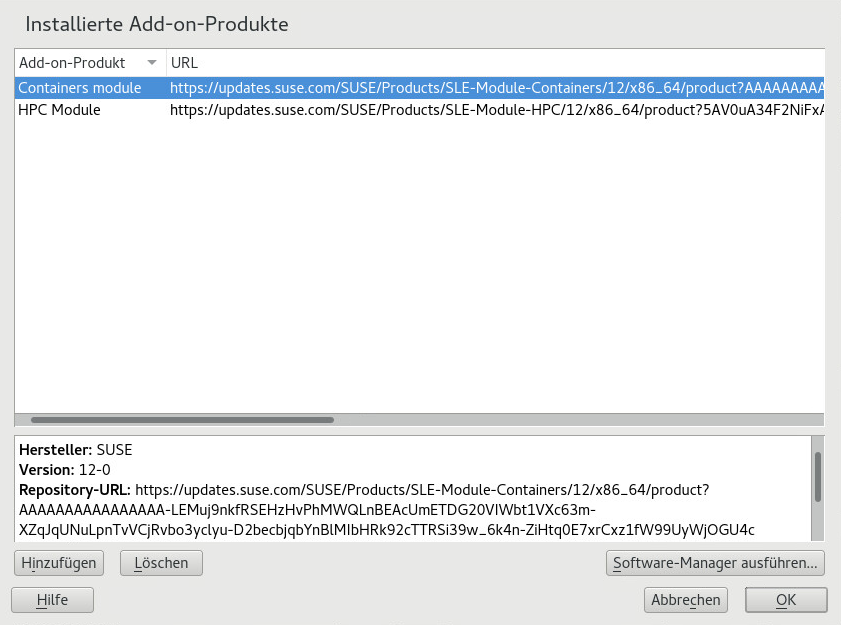

- 14.2 Liste der installierten Add-on-Produkte, Module und Erweiterungen

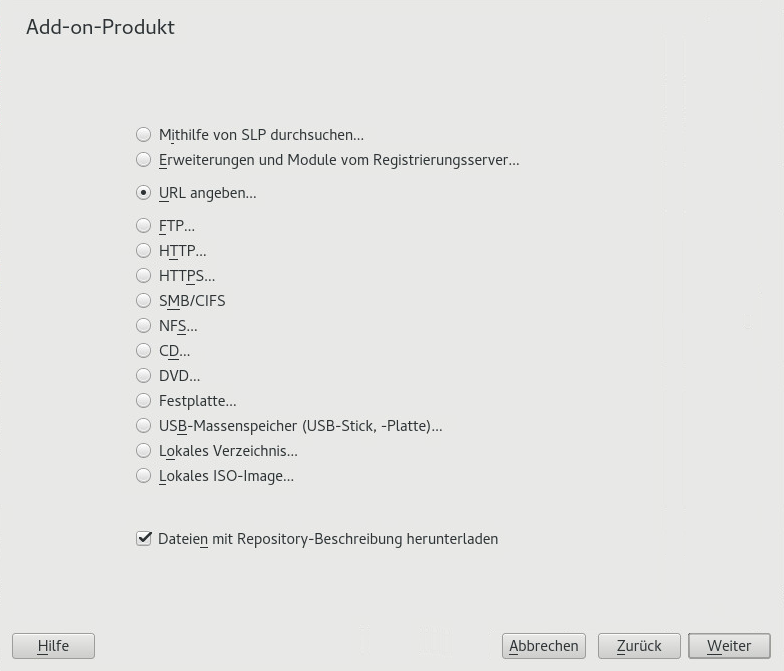

- 14.3 Installation eines Add-on-Produkts oder einer Erweiterung

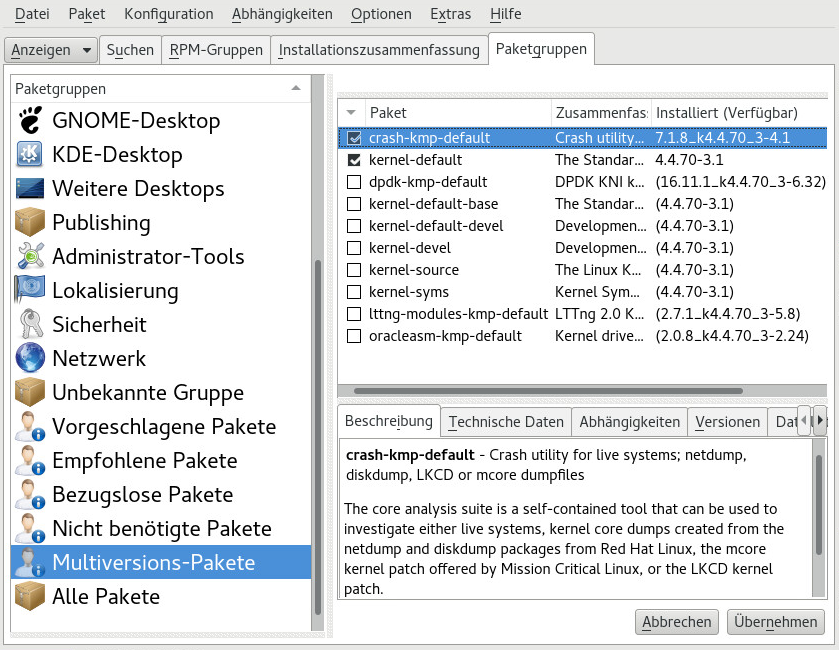

- 15.1 Der YaST-Software-Manager: Multiversionsanzeige

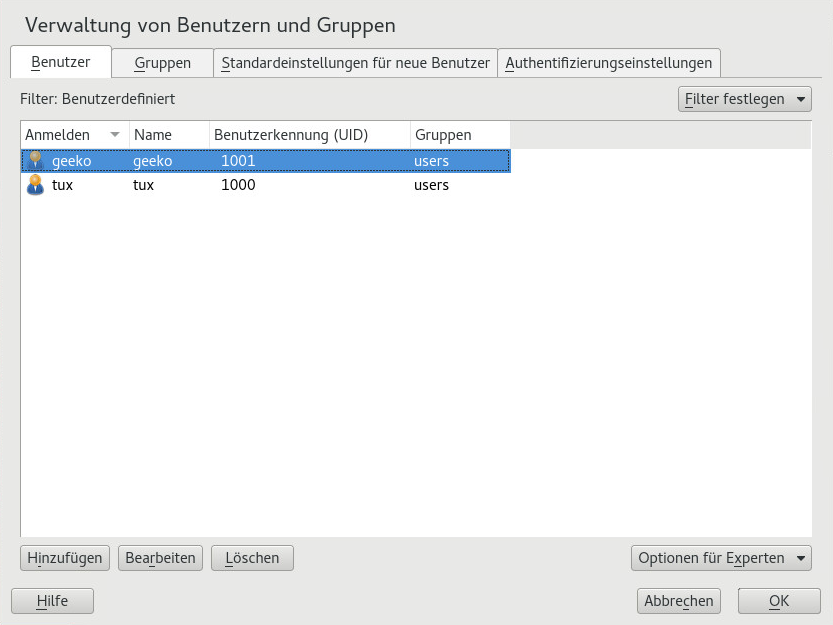

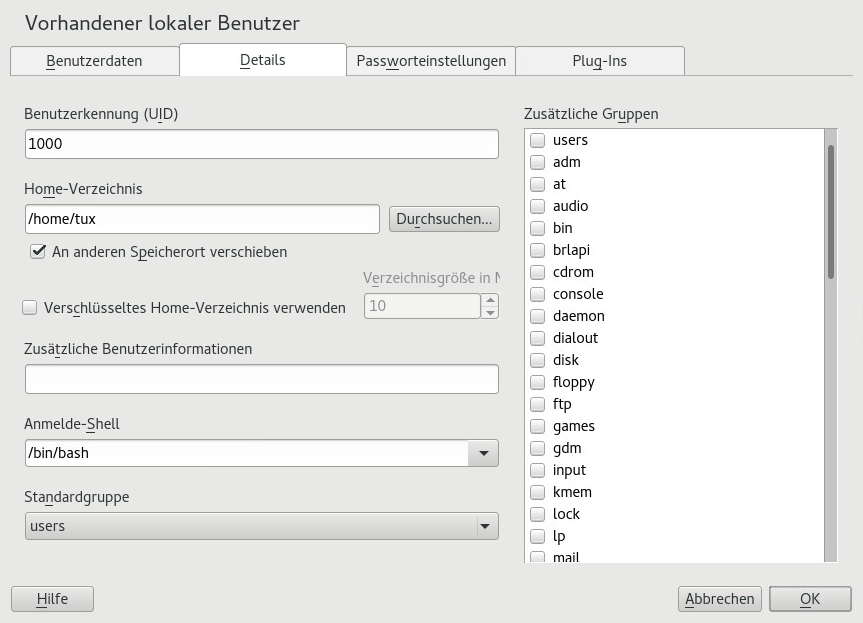

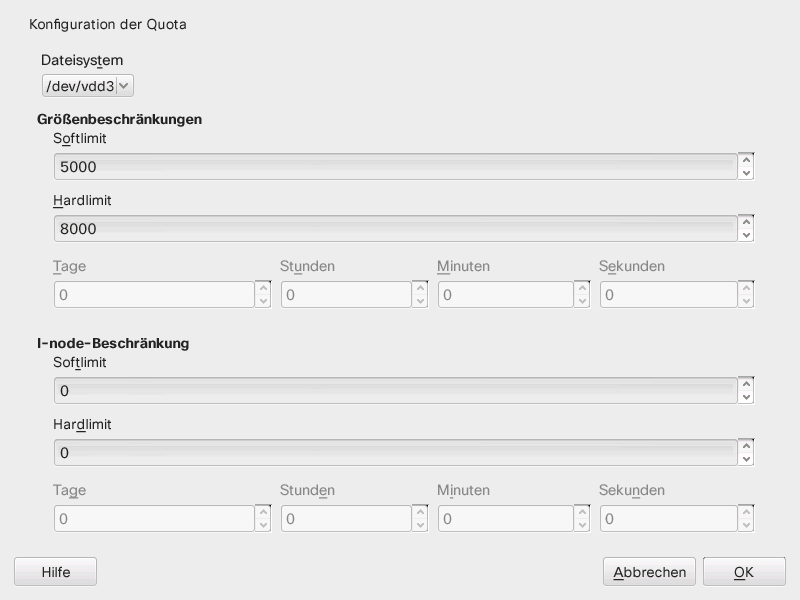

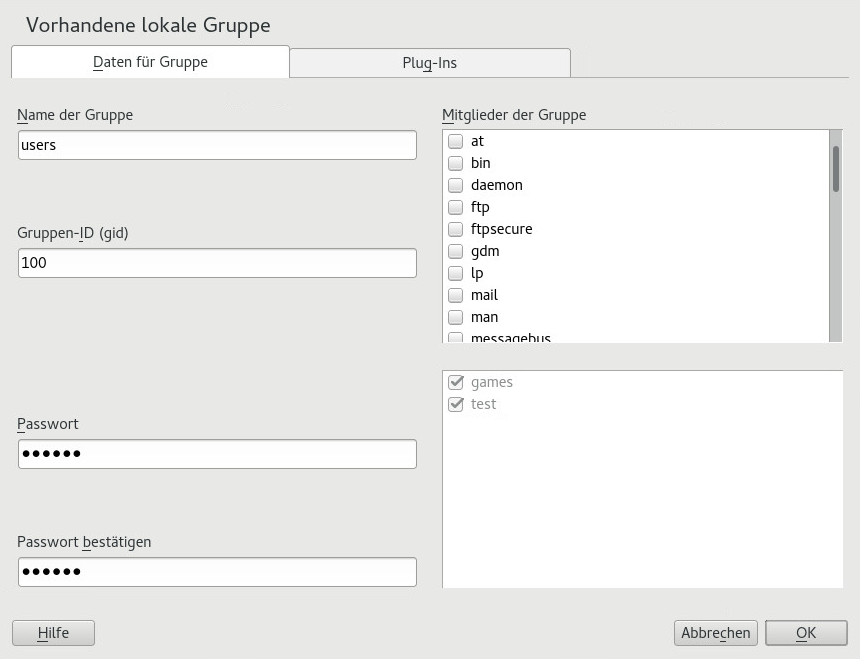

- 16.1 YaST – Verwaltung von Benutzern und Gruppen

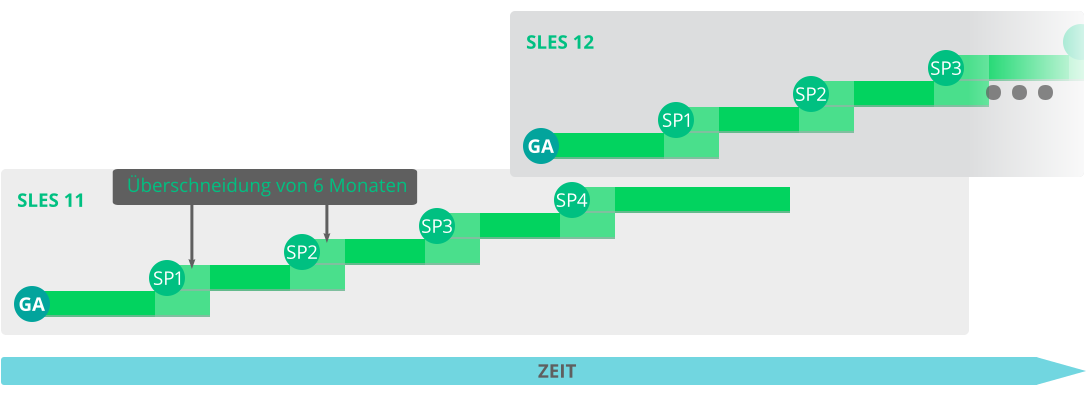

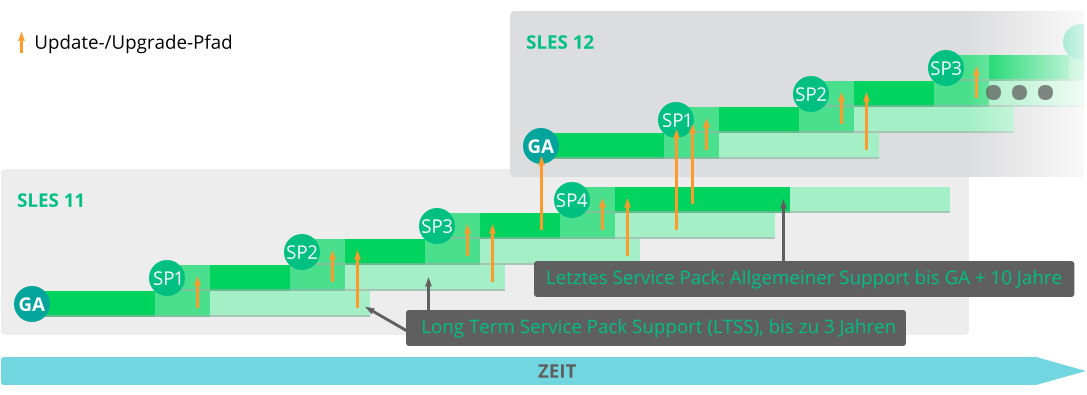

- 18.1 Hauptversionen und Service Packs

- 18.2 Langfristiger Service Pack-Support

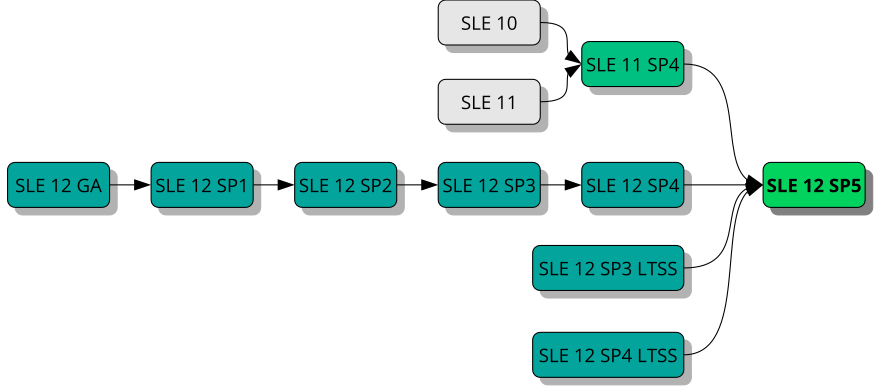

- 19.1 Überblick über die unterstützten Aufrüstungspfade

- 4.1 Konfiguration eines z/VM-Verzeichnisses

- 4.2 Beispiel einer XML-Domänendatei

- 4.3 Übertragen der Binärdateien über FTP

- 4.4 SLES12 EXEC

- 4.5 Unterstützte Netzwerkverbindungstypen und Treiberparameter

- 4.6 Treiberparameter für das Netzwerkgerät

- 4.7 Netzwerkparameter

- 4.8 Parmfile für eine Installation von NFS mit VNC und AutoYaST

- 4.9 Parmfile zur Installation mit NFS, SSH und HSI sowie AutoYaST mit NFS

- 6.1

regcodes.txt - 6.2

regcodes.xml - 19.1 Über

df -hangezeigte Liste

Copyright © 2006–2025 SUSE LLC und Mitwirkende. Alle Rechte vorbehalten.

Es wird die Genehmigung erteilt, dieses Dokument unter den Bedingungen der GNU Free Documentation License, Version 1.2 oder (optional) Version 1.3 zu vervielfältigen, zu verbreiten und/oder zu verändern; die unveränderlichen Abschnitte hierbei sind der Urheberrechtshinweis und die Lizenzbedingungen. Eine Kopie dieser Lizenz (Version 1.2) finden Sie im Abschnitt „GNU Free Documentation License“.

Die SUSE-Marken finden Sie unter http://www.suse.com/company/legal/. Alle anderen Marken von Drittanbietern sind Besitz ihrer jeweiligen Eigentümer. Markensymbole (®, ™ usw.) kennzeichnen Marken von SUSE und der Tochtergesellschaften. Sternchen (*) kennzeichnen Marken von Drittanbietern.

Alle Informationen in diesem Buch wurden mit größter Sorgfalt zusammengestellt. Doch auch dadurch kann hundertprozentige Richtigkeit nicht gewährleistet werden. Weder SUSE LLC noch ihre Tochtergesellschaften noch die Autoren noch die Übersetzer können für mögliche Fehler und deren Folgen haftbar gemacht werden.

Allgemeines zu diesem Handbuch #

Für die Installation von SUSE Linux Enterprise Server stehen verschiedene Verfahren zur Auswahl. Es ist ausgeschlossen, alle Kombinationen von Boot- oder Installationsserver, automatisierten Installationen oder Image-Verwendung zu behandeln. Dieses Handbuch soll Ihnen helfen, die geeignete Implementierungsmethode für Ihre Installation zu wählen.

- Teil I, „Installationsvorbereitung“

Die Anleitungen für die Standardimplementierung unterscheiden sich abhängig von der verwendeten Architektur. Unterschiede und Anforderungen hinsichtlich der Architektur finden Sie in diesem Abschnitt.

- Teil II, „Der Installations-Workflow“

Die meisten Aufgaben, die bei der Installation erforderlich sind, werden hier beschrieben. Dies umfasst auch die manuelle Einrichtung Ihres Computers und die Installation weiterer Software.

- Teil III, „Einrichten eines Installationsservers“

Für die Installation von SUSE Linux Enterprise Server stehen zahlreiche Verfahren zur Auswahl. Abgesehen von der üblichen Medieninstallation können Sie verschiedene netzwerkbasierte Methoden wählen. In diesem Teil wird die Einrichtung eines Installationsservers beschrieben. Außerdem wird erläutert, wie Sie den Bootvorgang des Zielsystems auf die Installation vorbereiten können.

- Teil IV, „Installationen auf Remote-Systemen“

In diesem Teil werden die gängigsten Szenarien für Installationen auf Remote-Systemen beschrieben. Bei manchen sind nach wie vor Eingriffe durch den Benutzer oder bis zu einem gewissen Grad physischer Zugriff auf das Zielsystem erforderlich, während andere vollständig automatisiert sind und keinerlei Interaktionen erfordern. Hier können Sie sich informieren, welches Verfahren für Ihr Szenario am besten geeignet ist.

- Teil V, „Erstkonfiguration des Systems“

Hier wird die Konfiguration Ihres Systems nach der Installation beschrieben. Dieser Teil befasst sich mit gängigen Aufgaben, zu denen beispielsweise die Einrichtung von Hardwarekomponenten, die Installation oder Entfernung von Software, die Benutzerverwaltung oder die Änderung von Einstellungen mit YaST zählen.

- Teil VI, „Aktualisieren und Aufrüsten von SUSE Linux Enterprise“

In diesem Teil erhalten Sie Hintergrundinformationen zu Terminologie, SUSE-Produktlebenszyklen und Service Pack-Releases sowie zu empfohlenen Richtlinien für Upgrades.

1 Erforderliche Hintergrundkenntnisse #

Um den Umfang dieser Richtlinien einzuschränken, wird von bestimmten technischen Voraussetzungen ausgegangen:

Sie verfügen über Erfahrung im Umgang mit Computern und Ihnen sind die gängigen technischen Fachbegriffe bekannt.

Sie sind mit der Dokumentation für Ihr System und mit dem Netzwerk, in dem es ausgeführt wird, vertraut.

Sie verfügen über Grundkenntnisse in Linux-Systemen.

2 Verfügbare Dokumentation #

Die Dokumentation für unsere Produkte steht unter https://documentation.suse.com/ bereit. Hier finden Sie außerdem die neuesten Aktualisierungen und Sie können die Dokumentation durchsuchen oder in verschiedenen Formaten herunterladen.

Darüber hinaus befindet sich die Dokumentation in der Regel auf dem installierten System im Verzeichnis /usr/share/doc/manual.

Die folgende Dokumentation ist für dieses Produkt verfügbar:

- Article “Schnelleinführung zur Installation”

Die Systemanforderungen werden aufgelistet, und Sie werden schrittweise durch die Installation von SUSE Linux Enterprise Server von DVD oder einem ISO-Abbild geführt.

- Book “Bereitstellungshandbuch”

Erfahren Sie, wie Sie einzelne oder mehrere Systeme installieren und die Produktfunktionen für eine Bereitstellungsinfrastruktur nutzen. Wählen Sie aus verschiedenen Ansätzen. Von der lokalen Installation über einen Netzwerkinstallationsserver bis zu einer Masseninstallation über eine entfernt gesteuerte, hochgradig angepasste und automatisierte Installationsmethode ist alles möglich.

- Book “Administrationshandbuch”

Es behandelt Systemverwaltungsaufgaben wie Wartung, Überwachung und Anpassung eines neu installierten Systems.

- Book “Virtualization Guide”

Hier wird die Virtualisierungstechnologie im Allgemeinen beschrieben, die vereinheitlichte Schnittstelle libvirt für die Virtualisierung wird vorgestellt und Sie finden ausführliche Informationen zu bestimmten Hypervisoren.

- Book “Storage Administration Guide”

Hier finden Sie Informationen zum Verwalten von Speichergeräten auf einem SUSE Linux Enterprise-Server.

- Book “AutoYaST”

AutoYaST ist ein System für die unbeaufsichtigte Massenbereitstellung von SUSE Linux Enterprise Server-Systemen über ein AutoYaST-Profil, in dem sich Installations- und Konfigurationsdaten befinden. Das Handbuch führt Sie durch die grundlegenden Schritte der automatischen Installation: Vorbereitung, Installation und Konfiguration.

- Book “Security and Hardening Guide”

Zudem werden grundlegende Konzepte der Systemsicherheit vorgestellt, die sowohl lokale als auch netzwerkbezogene Aspekte abdecken. Es wird erläutert, wie Sie die in das Produkt eingegliederte Sicherheitssoftware wie AppArmor oder das Prüfsystem nutzen, mit dem zuverlässig Informationen zu allen sicherheitsspezifischen Ereignissen gesammelt werden.

- Book “Hardening Guide”

Hier finden Sie detaillierte Informationen zum Installieren und Einrichten eines sicheren SUSE Linux Enterprise-Servers sowie zu weiteren Verfahren, die nach dem Installieren anfallen und die Sicherheit und Stabilität der Installation erhöhen. Der Administrator wird bei sicherheitsrelevanten Auswahlmöglichkeiten und Entscheidungen unterstützt.

- Book “System Analysis and Tuning Guide”

Ein Administratorhandbuch zur Problemsuche, Fehlerbehebung und Optimierung. Erfahren Sie, wie Sie Ihr System mithilfe von Überwachungswerkzeugen prüfen und optimieren können und wie Sie Ihre Ressourcen effizient verwalten. Es enthält zudem einen Überblick über häufige Probleme und Lösungen sowie weitere Hilfequellen und Dokumentationsressourcen.

- Book “Subscription Management Tool Guide”

Ein Administratorhandbuch zum Subscription Management Tool. Dabei handelt es sich um ein Proxy-System für das SUSE Customer Center mit Repository und Registrierungszielen. Erfahren Sie, wie Sie einen lokalen SMT-Server installieren und konfigurieren, Repositorys spiegeln und verwalten, Client-Computer verwalten und Clients für die Verwendung von SMT konfigurieren.

- Book “GNOME-Benutzerhandbuch”

Einführung in den GNOME-Desktop von SUSE Linux Enterprise Server. Das Handbuch begleitet Sie bei der Verwendung und Konfiguration des Desktops und hilft Ihnen, wichtige Aufgaben zu erledigen. Dies richtet sich in erster Linie an Endbenutzer, die GNOME als ihren Standard-Desktop nutzen möchten.

3 Rückmeldungen #

Für Rückmeldungen stehen mehrere Kanäle zur Verfügung:

- Fehler und Verbesserungsanforderungen

Informationen zu Diensten und Support-Optionen, die für Ihr Produkt verfügbar sind, finden Sie unter http://www.suse.com/support/.

Die Community bietet Hilfe für openSUSE. Weitere Informationen finden Sie unter https://en.opensuse.org/Portal:Support.

Zum Melden von Fehlern in einer Produktkomponente gehen Sie zu https://scc.suse.com/support/requests, melden Sie sich an und klicken Sie auf .

- Anregungen und Kritik unserer Leser

Wir freuen uns über Ihre Kommentare und Vorschläge zu diesem Handbuch und den anderen Teilen der Dokumentation dieses Produkts. Mit dem Link „Report Bug“ neben den einzelnen Überschriften geben Sie Feedback über SUSE Bugzilla.

Für Feedback zur Dokumentation dieses Produkts können Sie auch eine Email an

doc-team@suse.desenden. Geben Sie auf jeden Fall auch den Titel der Dokumentation, die Produktversion und das Datum der Veröffentlichung der Dokumentation an. Geben Sie eine genaue Beschreibung des Problems an und beziehen Sie sich auf die entsprechende Abschnittsnummer und Seite (oder URL), wenn Sie Fehler melden oder Verbesserungen vorschlagen.

4 Konventionen in der Dokumentation #

In der vorliegenden Dokumentation werden die folgenden Hinweise und typografischen Konventionen verwendet:

/etc/passwd: Verzeichnis- und DateinamenPLATZHALTER: Ersetzen Sie PLATZHALTER durch den tatsächlichen Wert.

PATH: die Umgebungsvariable PATHls,--help: Kommandos, Optionen und ParameterBenutzer: Benutzer oder GruppenPaketname: Name eines Pakets

Alt, Alt–F1: Eine Taste oder Tastenkombination. Tastennamen werden wie auf der Tastatur in Großbuchstaben dargestellt.

, › : Menüelemente, Schaltflächen

AMD/Intel Dieser Absatz ist nur für die AMD64-/Intel-64-Architektur relevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.

IBM Z, POWER Dieser Absatz ist nur für die IBM-Architekturen

ZundPOWERrelevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.Tanzende Pinguine (Kapitel Pinguine, ↑Zusätzliches Handbuch): Dies ist ein Verweis auf ein Kapitel in einem anderen Handbuch.

Kommandos, die mit

root-Privilegien ausgeführt werden müssen. Diesen Befehlen kann zur Ausführung als nicht privilegierter Benutzer auch häufig das Präfixsudovorangestellt sein.root #commandtux >sudo commandKommandos, die von Benutzern ohne Privilegien ausgeführt werden können.

tux >commandHinweise

Warnung: WarnhinweisWichtige Informationen, die Sie kennen müssen, bevor Sie fortfahren. Warnt vor Sicherheitsrisiken, potenziellen Datenverlusten, Beschädigung der Hardware oder physischen Gefahren.

Wichtig: Wichtiger HinweisWichtige Informationen, die Sie beachten sollten, bevor Sie den Vorgang fortsetzen.

Anmerkung: AnmerkungErgänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Tipp: TippHilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

1 Planung für SUSE Linux Enterprise Server #

1.1 Überlegungen für die Bereitstellung von SUSE Linux Enterprise Server #

Die Bereitstellung eines Betriebssystems muss sowohl in einer bestehenden IT-Umgebung als auch in einer völlig neuen Implementierung sorgfältig vorbereitet werden. Zu Beginn Ihrer Planung sollten Sie die Projektziele und die benötigten Funktionen festlegen. Diese Überlegungen werden bei jedem Projekt anders aussehen. Immer sollten Sie sich jedoch die folgenden Fragen stellen:

Wie viele Installationen sind erforderlich? Von dieser Überlegung hängt die optimale Bereitstellungsmethode ab.

Wird das System als physischer Host oder als virtueller Computer ausgeführt?

Befindet sich das System in einer feindseligen Umgebung? In Book “Security and Hardening Guide”, Chapter 1 “Security and Confidentiality” finden Sie einen Überblick über die daraus folgenden Konsequenzen.

Wie erhalten Sie reguläre Updates? Alle Patches stehen registrierten Benutzern online zur Verfügung. Die Registrierungs- und Patch-Support-Datenbank finden Sie unter http://download.suse.com/.

Benötigen Sie für die lokale Installation Hilfe? SUSE bietet Schulungen, Support und Beratung für alle Fragen im Zusammenhang mit SUSE Linux Enterprise Server. Weitere Informationen hierzu finden Sie unter https://www.suse.com/products/server/.

Benötigen Sie Produkte von Drittanbietern? Vergewissern Sie sich, dass das benötigte Produkt von der gewünschten Plattform unterstützt wird. Bei Bedarf bietet SUSE auch Unterstützung für Software auf anderen Plattformen an.

1.2 Bereitstellung von SUSE Linux Enterprise Server #

Um sicherzustellen, dass Ihr System fehlerlos läuft, sollten Sie nur zertifizierte Hardware verwenden. Unsere Datenbank der zertifizierten Geräte wird regelmäßig aktualisiert. Ein Suchformular für zertifizierte Hardware finden Sie unter http://www.suse.com/yessearch/Search.jsp.

Abhängig von der Anzahl der gewünschten Installationen empfehlen sich eventuell Installationsserver oder sogar völlig automatische Installationen. Wenn Sie Xen- oder KVM-Virtualisierungstechnologien verwenden möchten, empfehlen sich eventuell Netzwerk-Root-Dateisysteme oder Netzwerkspeicherlösungen wie iSCSI.

SUSE Linux Enterprise Server umfasst eine Vielzahl an verschiedensten Services. Einen Überblick über die Dokumentation zu diesen Diensten finden Sie in diesem Handbuch in Book “Administrationshandbuch”, Preface “Allgemeines zu diesem Handbuch”. Die meisten Konfigurationen lassen sich in YaST, dem Konfigurationsprogramm von SUSE, vornehmen. Darüber hinaus sind aber auch zahlreiche manuelle Konfigurationen möglich, die in den betreffenden Kapiteln beschrieben werden.

Über die Installation der Software hinaus sollten Sie in der Planung auch die Schulung der System-Endbenutzer sowie die Schulung Ihrer Helpdesk-Mitarbeiter berücksichtigen.

1.3 Ausführung von SUSE Linux Enterprise Server #

Das Betriebssystem SUSE Linux Enterprise Server ist bewährt und stabil. Dennoch lassen sich Hardware-Ausfälle oder andere Ursachen für Ausfallzeiten und Datenverluste nicht gänzlich vermeiden. Sie sollten daher für jede wichtige Arbeit, bei der es zu einem Datenverlust kommen kann, regelmäßig Sicherungskopien anfertigen.

Aus Sicherheitsgründen und zum Schutz Ihrer Daten sollten Sie alle verwendeten Systeme regelmäßig aktualisieren. Wenn es um einen unternehmenswichtigen Server geht, sollten Sie einen zweiten, identischen Computer (außerhalb der Produktionsumgebung) ausführen und alle Änderungen darauf testen. Bei Hardware-Ausfällen steht Ihnen so auch ein redundantes System zur Verfügung, zu dem Sie jederzeit wechseln können.

1.4 Registrieren von SUSE Linux Enterprise Server #

Um technischen Support und Produktaktualisierungen zu erhalten, müssen Sie Ihr SUSE-Produkt beim SUSE Customer Center registrieren und aktivieren. Es wird empfohlen, die Registrierung während der Installation vorzunehmen, da Sie so in der Lage sind, das System mit den neuesten verfügbaren Aktualisierungen und Patches zu installieren. Falls Sie gerade offline sind oder die Registrierung Schritt überspringen möchten, können Sie die Registrierung jederzeit später aus dem installierten System heraus nachholen.

Falls Ihr Unternehmen keinen lokalen Registrierungsserver anbietet, benötigen Sie für die Registrierung von SUSE Linux ein SUSE-Konto. Falls Sie noch kein SUSE-Konto besitzen, wechseln Sie zur SUSE Customer Center-Startseite (https://scc.suse.com/), und erstellen Sie dort ein Konto.

Bei der Installation werden Sie aufgefordert, Ihren Registrierungscode einzugeben. Weitere Informationen finden Sie in Abschnitt 6.8, „Registrierung beim SUSE Customer Center“.

Wenn Sie die Instanzen automatisch mit AutoYaST bereitstellen, können Sie das System während der Installation registrieren. Geben Sie hierzu die entsprechenden Informationen in der AutoYaST-Steuerungsdatei an. Weitere Informationen finden Sie im Book “AutoYaST”, Chapter 4 “Configuration and Installation Options”, Section 4.3 “System Registration and Extension Selection”.

Weitere Informationen zum Registrieren eines bereits installierten Systems finden Sie unter Abschnitt 13.2, „Registrieren eines installierten Systems“.

Teil I Installationsvorbereitung #

- 2 Installation auf AMD64 und Intel 64

In diesem Kapitel werden die nötigen Schritte für die Vorbereitung der Installation von SUSE Linux Enterprise Server auf AMD64- und Intel-64-Rechnern beschrieben. Es beschreibt die für die Vorbereitung der verschiedenen Installationsmethoden erforderlichen Schritte. Die Liste der Hardware-Anforderungen bietet einen Überblick über die von SUSE Linux Enterprise Server unterstützten Systeme. Sie erhalten Informationen über verfügbare Installationsmethoden und mehrere bekannte Probleme. Sie lernen, wie Sie die Installation steuern, Installationsmedien zur Verfügung stelln und mit normalen Methoden booten können.

- 3 Installation auf IBM POWER

In diesem Kapitel wird beschrieben, wie Sie die Installation von SUSE Linux Enterprise Server auf IBM POWER-Systemen vorbereiten.

- 4 Installation auf IBM Z

In diesem Kapitel wird die Vorbereitung der Installation von SUSE® Linux Enterprise Server auf IBM Z beschrieben. Hier finden Sie alle erforderlichen Informationen, mit denen Sie die Installation auf LPAR- und z/VM-Seite vorbereiten.

- 5 Installation in der ARM AArch64-Architektur

In diesem Kapitel werden die erforderlichen Schritte für die Vorbereitung der Installation von SUSE Linux Enterprise Server auf ARM AArch64-Computern beschrieben. Es beschreibt die für die Vorbereitung der verschiedenen Installationsmethoden erforderlichen Schritte. Die Liste der Hardware-Anforderungen bietet einen Überblick über die von SUSE Linux Enterprise Server unterstützten Systeme. Sie erhalten Informationen über verfügbare Installationsmethoden und mehrere bekannte Probleme. Sie lernen, wie Sie die Installation steuern, Installationsmedien zur Verfügung stelln und mit normalen Methoden booten können.

2 Installation auf AMD64 und Intel 64 #

In diesem Kapitel werden die nötigen Schritte für die Vorbereitung der Installation von SUSE Linux Enterprise Server auf AMD64- und Intel-64-Rechnern beschrieben. Es beschreibt die für die Vorbereitung der verschiedenen Installationsmethoden erforderlichen Schritte. Die Liste der Hardware-Anforderungen bietet einen Überblick über die von SUSE Linux Enterprise Server unterstützten Systeme. Sie erhalten Informationen über verfügbare Installationsmethoden und mehrere bekannte Probleme. Sie lernen, wie Sie die Installation steuern, Installationsmedien zur Verfügung stelln und mit normalen Methoden booten können.

2.1 Systemvoraussetzungen für den Betrieb von Linux #

Das Betriebssystem SUSE® Linux Enterprise Server eignet sich für die verschiedensten Hardware-Geräte. Es ist unmöglich, alle denkbaren Hardware-Kombinationen aufzuführen, die von SUSE Linux Enterprise Server unterstützt werden. Um Ihnen für die Planungsphase eine Richtlinie zur Verfügung zu stellen, werden hier die Mindestanforderungen dargestellt.

Wenn Sie ganz sichergehen möchten, dass eine bestimmte Computerkonfiguration funktioniert, erkundigen Sie sich, welche Plattformen von SUSE zertifiziert wurden. Eine Liste finden Sie unter https://www.suse.com/yessearch/.

2.1.1 Hardware für Intel 64 und AMD64 #

Die Intel-64- und AMD64-Architekturen unterstützen die einfache Migration von x86-Software auf 64 Bit. Wie die x86-Architektur stellen auch sie eine kostengünstige Alternative dar.

- Prozessor

Alle aktuell erhältlichen CPUs werden unterstützt.

- Maximale Anzahl an CPUs

Gemäß dem Software-Design unterstützen Intel 64 und AMD64 maximal 8192 CPUs. Wenn Sie ein so großes System nutzen möchten, informieren Sie sich auf unserer Webseite zur Hardware-Systemzertifizierung über die unterstützten Geräte (siehe https://www.suse.com/yessearch/).

- Arbeitsspeicheranforderungen

Für eine Minimalinstallation sind mindestens 512 MB Arbeitsspeicher erforderlich. Es werden jedoch mindestens 1024 MB bzw. 512 MB pro CPU auf Multiprozessorcomputern empfohlen. Bei einer Remote-Installation über HTTP oder FTP sind weitere 150 MB einzurechnen. Diese Werte gelten ausschließlich für die Installation des Betriebssystems. Der tatsächliche Arbeitsspeicherbedarf in der Produktion ist abhängig von der Auslastung des Systems.

- Anforderungen an die Festplatte

Die Anforderungen an die Festplatte sind im Wesentlichen abhängig von der ausgewählten Installation und von der geplanten Nutzung des Computers. Mindestanforderungen für verschiedene Optionen:

System

Anforderungen an die Festplatte

Minimalinstallation

800 MB bis 1 GB

Minimales X Window-System

1,4 GB

GNOME-Desktop

3,5 GB

Alle Schemata

8,5 GB

Verwenden von Snapshots für die Virtualisierung

min. 8 GB

- Boot-Methoden

Der Computer kann von einer CD oder über das Netzwerk gestartet werden. Zum Starten über das Netzwerk ist ein spezieller Boot-Server erforderlich. Die Einrichtung kann mit SUSE Linux Enterprise Server erfolgen.

2.2 Überlegungen zur Installation #

Dieser Abschnitt umfasst zahlreiche Faktoren, die vor der Installation von SUSE Linux Enterprise Server auf AMD64- und Intel-64-Hardware zu berücksichtigen sind.

2.2.1 Installationstyp #

SUSE Linux Enterprise Server wird in der Regel als unabhängiges Betriebssystem installiert. Seit der Einführung der Virtualisierung ist es auch möglich, mehrere Instanzen von SUSE Linux Enterprise Server auf derselben Hardware auszuführen. Die Installation des VM-Host-Servers erfolgt jedoch wie eine typische Installation mit einigen zusätzlichen Paketen. Die Installation von virtuellen Gästen wird in Book “Virtualization Guide”, Chapter 9 “Guest Installation” beschrieben.

2.2.2 Boot-Methoden #

Je nachdem, welche Hardware Sie verwenden, sind folgende Boot-Methoden für den ersten Boot-Vorgang vor der Installation von SUSE Linux Enterprise Server verfügbar:

|

Boot-Option |

Verwenden Sie |

|---|---|

|

CD- oder DVD-Laufwerk |

Die einfachste Boot-Methode. Hierfür benötigt das System ein lokal verfügbares CD-ROM- oder DVD-ROM-Laufwerk. |

|

Flash-Laufwerke |

Suchen Sie die für die Erstellung von Boot-Disketten erforderlichen Images auf der ersten CD oder DVD im Verzeichnis |

|

PXE oder bootp |

Muss vom BIOS oder von der Firmware des verwendeten Systems unterstützt werden. Für diese Option ist ein Boot-Server im Netzwerk erforderlich. Diese Aufgabe kann auch von einem anderen SUSE Linux Enterprise-Server übernommen werden. |

|

Festplatte |

SUSE Linux Enterprise Server kann auch von der Festplatte gebootet werden. Kopieren Sie hierfür den Kernel ( |

2.2.3 Installationsquelle #

Bei der Installation von SUSE Linux Enterprise Server müssen die tatsächlichen Installationsdaten im Netzwerk, auf einer Festplattenpartition oder auf einer lokalen DVD verfügbar sein. Zur Ausführung der Installation über das Netzwerk benötigen Sie einen Installationsserver. Richten Sie einen Computer in einer Unix- oder Linux-Umgebung als NFS-, HTTP-, SMB- oder FTP-Server ein, um die Installationsdaten zur Verfügung zu stellen. Um die Installationsdaten über einen Windows-Computer bereitzustellen, geben Sie die Daten mit SMB frei.

Die Installationsquelle kann besonders leicht ausgewählt werden, wenn Sie einen SLP-Server im lokalen Netzwerk konfigurieren. Weitere Informationen finden Sie unter Kapitel 8, Einrichten des Servers, auf dem sich die Installationsquellen befinden.

2.2.4 Installationsziel #

Die meisten Installationen erfolgen auf der lokalen Festplatte. Daher müssen die Festplatten-Controller für das Installationssystem nicht zur Verfügung stehen. Wenn ein bestimmter Controller (z. B. ein RAID-Controller) ein zusätzliches Kernel-Modul benötigt, stellen Sie für das Installationssystem eine Aktualisierungsdiskette für das Kernel-Modul bereit.

Sonstige Installationsziele können verschiedene Arten von Block-Geräten sein, die ausreichenden Speicherplatz und eine entsprechende Geschwindigkeit zum Ausführen eines Betriebssystems bieten. Dies beinhaltet auch Netzwerk-Block-Geräte, wie iSCSI oder SAN. Die Installation kann auch auf Netzwerk-Dateisystemen mit den standardmäßigen Unix-Berechtigungen ausgeführt werden. Beim Starten dieser Systeme können jedoch Probleme auftreten, da sie von initramfs unterstützt werden müssen, damit das eigentliche System gestartet werden kann. Diese Installationen sind insbesondere dann von Nutzen, wenn Sie dasselbe System an verschiedenen Standorten starten müssen oder den Einsatz von Virtualisierungsfunktionen planen (z. B. Domänenmigration).

2.2.5 Verschiedene Installationsmethoden #

SUSE Linux Enterprise Server bietet verschiedene Methoden zum Steuern der Installation:

Installation über die Konsole

Installation über die serielle Konsole

Installation mit AutoYaST

Installation mit KIWI-Images

Installation über SSH

Installation mit VNC

Standardmäßig wird die grafische Konsole verwendet. Wenn die Installation auf mehreren Computern mit ähnlichen Voraussetzungen erfolgen soll, ist es ratsam, eine AutoYaST-Konfigurationsdatei oder ein KIWI-Preload-Image zu erstellen und diese(s) für den Installationsprozess bereitzustellen. Weitere Informationen hierzu finden Sie in der Dokumentation zu AutoYaST unter Book “AutoYaST” bzw. in der Dokumentation zu KIWI unter http://doc.opensuse.org/projects/kiwi/doc/.

2.3 Boot- und Installationsmedien #

Beim Installieren des Systems können sich die Medien für das Booten und die Systeminstallation unterscheiden. Alle Kombinationen unterstützter Medien für Booten und Installieren können verwendet werden.

2.3.1 Boot-Medien #

Das Booten eines Computers hängt von den Möglichkeiten der verwendeten Hardware und der Verfügbarkeit von Medien für die entsprechende Boot-Option ab.

- Booten von DVD

Dies ist die häufigste Möglichkeit zum Booten eines Systems. Sie ist für die meisten Computerbenutzer einfach, erfordert aber eine Menge von Interaktion für jeden Installationsvorgang.

- Booten von einer USB-Festplatte

Abhängig von der verwendeten Hardware ist es möglich, von einer USB-Festplatte zu booten. Das entsprechende Medium muss gemäß den Anweisungen unter Abschnitt 6.2.2, „PC (AMD64/Intel 64/ARM AArch64): Systemstart“ erstellt werden.

- Booten vom Netzwerk

Sie können einen Computer nur direkt vom Netzwerk aus starten, wenn dies in der Firmware oder im BIOS des Computers unterstützt wird. Diese Bootmethode erfordert einen Boot-Server, der die erforderlichen Boot-Images über das Netzwerk bereitstellt. Das exakte Protokoll hängt von Ihrer Hardware ab. In der Regel benötigen Sie mehrere Dienste, wie TFTP und DHCP oder PXE-Boot. Wenn Sie einen Boot-Server benötigen, lesen Sie auch Abschnitt 10.1.3, „Installation auf entfernten Systemen über VNC – PXE-Boot und Wake-on-LAN“.

2.3.2 Installationsmedien #

Die Installationsmedien enthalten alle erforderlichen Pakete und Metadaten für die Installation von SUSE Linux Enterprise Server. Diese müssen dem Installationssystem nach dem Booten für die Installation zur Verfügung stehen. Die Installationsmedien für SUSE Linux Enterprise Server können dem System mit verschiedenen Methoden zur Verfügung gestellt werden.

- Installation von DVD

Alle erforderlichen Daten werden auf den Bootmedien geliefert. Abhängig von der gewählten Installation können eine Netzwerkverbindung oder Add-on-Medien erforderlich sein.

- Installation über das Netzwerk

Wenn Sie die Installation von mehreren Systemen planen, vereinfacht die Bereitstellung der Installationsmedien über das Netzwerk vieles. Die Installation von vielen gängigen Protokollen ist möglich, z. B. NFS, HTTP, FTP oder SMB. Weitere Informationen zur Ausführung einer solchen Installation finden Sie unter Kapitel 10, Installationen auf Remote-Systemen.

2.4 Installationsvorgang #

In diesem Abschnitt erhalten Sie einen Überblick über die für den Abschluss der SUSE® Linux Enterprise Server-Installation erforderlichen Schritte im entsprechenden Modus. Teil II, „Der Installations-Workflow“ enthält eine vollständige Beschreibung der Installation und Konfiguration des Systems mit YaST.

2.4.1 Starten von einem lokalen Wechsellaufwerk #

Bei der Installation können Sie DVD-ROM- und USB-Speichergeräte nutzen. Passen Sie den Computer an Ihre Anforderungen an:

Vergewissern Sie sich, dass das Laufwerk als bootfähiges Laufwerk im BIOS eingegeben ist.

Legen Sie das Boot-Medium in das Laufwerk ein und starten Sie den Boot-Vorgang.

Das Installations-Bootmenü SUSE Linux Enterprise Server ermöglicht das Übertragen verschiedener Parameter an das Installationssystem. Siehe auch Abschnitt 10.2.2, „Benutzerdefinierte Boot-Optionen“. Wenn die Installation über das Netzwerk ausgeführt werden soll, geben Sie hier die Installationsquelle an.

Falls während der Installation unerwartete Probleme auftreten, starten Sie im abgesicherten Modus.

2.4.2 Installation über das Netzwerk #

Zum Durchführen der Installation über eine Netzwerkquelle ist ein Installationsserver erforderlich. Der Installationsvorgang für diesen Server wird in Kapitel 8, Einrichten des Servers, auf dem sich die Installationsquellen befinden beschrieben.

Wenn Sie über einen SLP-Server verfügen, wählen Sie im ersten Boot-Bildschirm SLP als Installationsquelle aus. Wählen Sie während des Boot-Vorgangs aus, welche der verfügbaren Installationsquellen verwendet werden soll.

Wenn die DVD im Netzwerk verfügbar ist, verwenden Sie sie als Installationsquelle. Geben Sie in diesem Fall an der Boot-Eingabeaufforderung den Parameter install=<URL> mit den entsprechenden Werten ein. Eine detailliertere Beschreibung dieses Parameters finden Sie in Abschnitt 10.2.2, „Benutzerdefinierte Boot-Optionen“.

2.5 Steuern der Installation #

Die Installation lässt sich auf verschiedene Arten steuern. Am häufigsten erfolgt die Installation von SUSE® Linux Enterprise Server über die Computerkonsole. Für andere Situationen stehen weitere Optionen zur Verfügung.

2.5.1 Installation über die Computerkonsole #

Am einfachsten wird SUSE Linux Enterprise Server über die Computerkonsole installiert. Bei dieser Methode werden Sie von einem grafischen Installationsprogramm durch den Installationsvorgang geführt. Diese Installationsmethode wird ausführlich in Kapitel 6, Installation mit YaST behandelt.

Die Installation kann auch ohne Grafikmodus über die Konsole ausgeführt werden. Im textbasierten Installationsprogramm stehen dieselben Funktionen zur Verfügung wie in der grafischen Version. Einige Tipps zur Navigation in diesem Modus erhalten Sie in Book “Administrationshandbuch”, Chapter 5 “YaST im Textmodus”, Section 5.1 “Navigation in Modulen”.

2.5.2 Installation über eine serielle Konsole #

Für diese Installationsmethode ist ein zweiter Computer erforderlich, der über ein Null-Modem-Kabel mit dem Computer verbunden ist, auf dem SUSE Linux Enterprise Server installiert werden soll. Je nach Hardware kann sogar die Firmware oder das BIOS des Computers für die serielle Konsole zugreifbar sein. Wenn dies möglich ist, können Sie die gesamte Installation mit dieser Methode ausführen. Möchten Sie die serielle Konsoleninstallation aktivieren, geben Sie den zusätzlichen Parameter console=ttyS0 im Boot-Befehl an. Der richtige Zeitpunkt hierfür ist nach Abschluss des Boot-Vorgangs und vor Start des Installationssystems.

Die meisten Computer verfügen über zwei serielle Schnittstellen, ttyS0 und ttyS1. Für die Installation benötigen Sie ein Terminalprogramm, wie minicom oder screen. Initiieren Sie die serielle Verbindung, indem Sie das screen-Programm in einer lokalen Konsole durch die Eingabe des folgenden Kommandos starten:

screen /dev/ttyS0 9600

Das bedeutet, dass screen den ersten seriellen Port mit einer Baudrate von 9600 überwacht. Von nun an fährt die Installation ähnlich der textbasierten Installation über dieses Terminal fort.

2.5.3 Installation mit SSH #

Sollten Sie nicht über Direktzugriff auf den Computer verfügen und wurde die Installation über eine Managementkonsole gestartet, können Sie das gesamte Installationsverfahren über das Netzwerk steuern. Geben Sie hierzu am Bootprompt die Parameter ssh=1 und ssh.password=SECRET ein. Anschließend wird ein SSH-Daemon im System gestartet und Sie können sich als Benutzer root mit dem Passwort SECRET anmelden.

Stellen Sie mit ssh -X eine Verbindung her. Wenn ein lokaler X-Server verfügbar ist, wird X-Forwarding über SSH unterstützt. Andernfalls stellt YaST über ncurses eine Textschnittstelle zur Verfügung. Anschließend werden Sie von YaST durch den Installationsvorgang geführt. Eine genauere Erläuterung dieses Vorgangs finden Sie in Abschnitt 10.1.5, „Einfache entfernte Installation über SSH – Dynamische Netzwerkkonfiguration“.

Wenn in Ihrem lokalen Netzwerk kein DHCP-Server verfügbar ist, weisen Sie dem Installationssystem manuell eine IP-Adresse zu. Geben Sie hierzu am Bootprompt die Option HostIP=IPADDR ein.

2.5.4 Installation über VNC #

Wenn Sie über keinen direkten Zugriff auf das System verfügen, aber eine grafische Installation wünschen, installieren Sie SUSE Linux Enterprise Server über VNC. Diese Methode wird ausführlich in Abschnitt 10.3.1, „VNC-Installation“ beschrieben.

Da geeignete VNC-Clients auch für andere Betriebssysteme wie Microsoft Windows und mac OS verfügbar sind, kann die Installation auch von Computern aus gesteuert werden, auf denen diese Betriebssysteme ausgeführt werden.

2.5.5 Installation mit AutoYaST #

Wenn SUSE Linux Enterprise Server auf mehreren Computern mit ähnlicher Hardware installiert werden muss, empfiehlt es sich, die Installationen mit AutoYaST durchzuführen. Installieren Sie in diesem Fall zuerst eine Instanz von SUSE Linux Enterprise Server und erstellen Sie hierüber die erforderlichen AutoYaST-Konfigurationsdateien.

Für AutoYaST finden Sie eine umfangreiche Dokumentation in Book “AutoYaST” .

2.6 Behandlung von Start- und Installationsproblemen #

Vor der Bereitstellung wird SUSE® Linux Enterprise Server umfangreichen Tests unterzogen. Dennoch treten gelegentlich Probleme beim Start oder bei der Installation auf.

2.6.1 Probleme beim Starten #

Startprobleme können das YaST-Installationsprogramm daran hindern, Ihr System zu starten. Ein weiteres Symptom ist, dass Ihr System nicht startet, nachdem die Installation abgeschlossen wurde.

- Das installierte System startet, aber nicht die Medien.

Ändern Sie die Firmware oder das BIOS Ihres Computers, sodass die richtige Startsequenz eingestellt ist. Ziehen Sie hierzu die Dokumentation zu Ihrer Hardware zurate.

- Der Computer bleibt hängen.

Ändern Sie die Konsole auf Ihrem Computer, sodass die Kernel-Ausgabe sichtbar wird. Überprüfen Sie die letzten Ausgaben. In der Regel erfolgt dies durch Drücken der Taste Strg–Alt–F10. Falls Sie das Problem nicht beheben können, wenden Sie sich an die SUSE Linux Enterprise Server-Supportmitarbeiter. Um alle Systemmeldungen zum Startzeitpunkt zu protokollieren, verwenden Sie eine serielle Verbindung, wie in Abschnitt 2.5, „Steuern der Installation“ beschrieben.

- Boot-Disk

Die Boot-Disk ist eine nützliche Übergangslösung, falls Probleme bei der Festlegung der anderen Konfigurationen auftreten oder Sie die Entscheidung bezüglich des endgültigen Startmechanismus noch aufschieben möchten. Weitere Details über das Erstellen von Boot-Disks finden Sie unter Book “Administrationshandbuch”, Chapter 12 “Der Bootloader GRUB 2” grub2-mkrescue.

- Viruswarnung nach der Installation

In einigen BIOS-Varianten wird die Struktur des Bootsektors (MBR) überprüft und nach der Installation von GRUB 2 wird fälschlicherweise eine Virenwarnung angezeigt. Dieses Problem lässt sich lösen, indem Sie das BIOS aufrufen, nach den entsprechenden Einstellungen suchen und diese bearbeiten. Deaktivieren Sie beispielsweise . Sie können diese Option später wieder aktivieren. Wenn als einziges Betriebssystem Linux verwendet wird, ist dies jedoch nicht erforderlich.

2.6.2 Probleme bei der Installation #

Wenn während der Installation ein unerwartetes Problem auftritt, sind Informationen zum Ermitteln der Ursache erforderlich. Die folgenden Anweisungen helfen Ihnen bei der Fehlersuche:

Überprüfen Sie die Ausgaben der verschiedenen Konsolen. Sie können die Konsole mit der Tastenkombination Strg–Alt– Fn wechseln. Rufen Sie beispielsweise eine Shell zum Ausführen verschiedener Befehle auf, indem Sie Strg–Alt– F2 drücken.

Versuchen Sie, die Installation mit „sicheren Einstellungen“ zu starten. (Drücken Sie im Installationsbildschirm die Taste F5 und wählen Sie .) Wenn die Installation in diesem Fall problemlos funktioniert, besteht eine Inkompatibilität, die zu einem Fehler in

ACPIoderAPICführt. In einigen Fällen kann eine BIOS- oder Firmware-Aktualisierung dieses Problem beheben.Überprüfen Sie die Systemmeldungen in der Konsole des Installationssystems durch Eingabe des Befehls

dmesg -T.

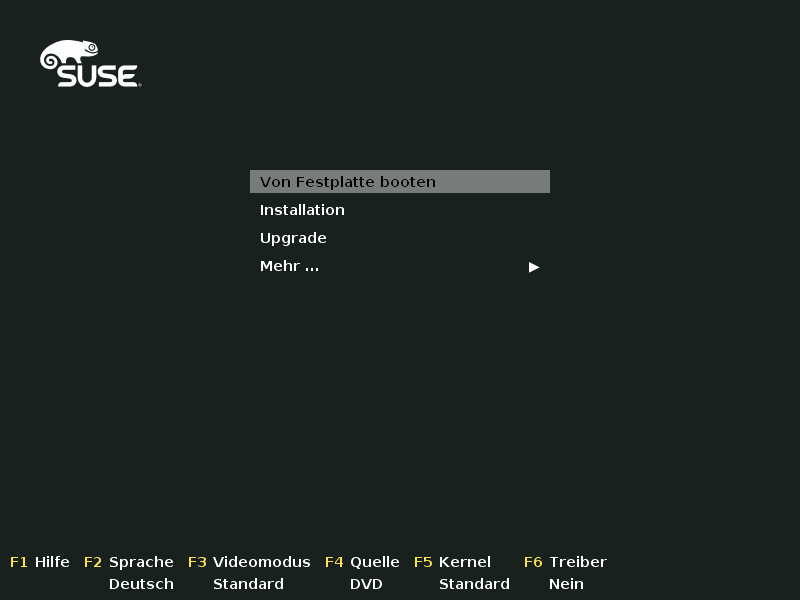

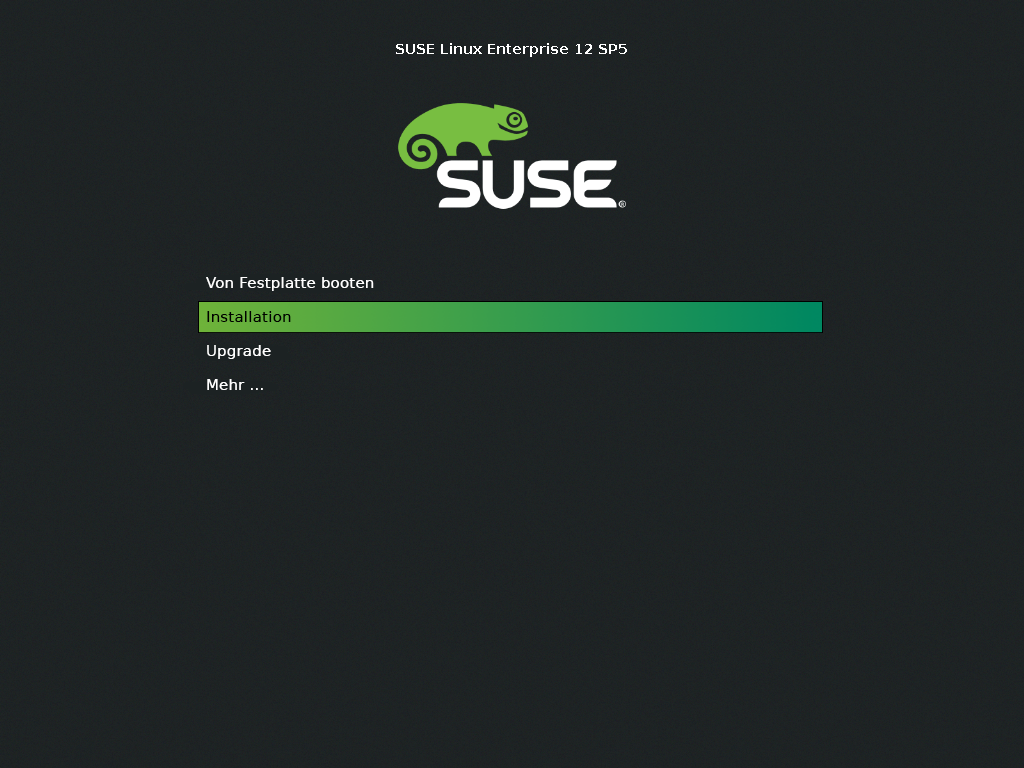

2.6.3 Ändern der Boot-Quelle zur Boot-DVD #

Um den Installationsprozess zu erleichtern und Installationsfehler zu vermeiden, wird das System gemäß der Standardeinstellung der SUSE Linux Enterprise Server-Installations-DVD von der ersten Festplatte gestartet. Zu diesem Zeitpunkt übernimmt in der Regel ein installierter Bootloader die Steuerung des Systems. Das bedeutet, dass die Start-DVD während einer Installation im Laufwerk bleiben kann. Wählen Sie zum Start der Installation eine der Installationsmöglichkeiten im Bootmenü des Mediums aus.

3 Installation auf IBM POWER #

In diesem Kapitel wird beschrieben, wie Sie die Installation von SUSE Linux Enterprise Server auf IBM POWER-Systemen vorbereiten.

3.1 Anforderungen #

Die Standardinstallation erfordert mindestens 512 MB RAM. Für die Installation eines Standardsystems mit dem GNOME-Desktop werden mindestens 3,5 GB freier Festplattenspeicher benötigt; für eine vollständige Installation sind ca. 8,5 GB erforderlich.

3.1.1 Hardwareanforderungen #

Das Betriebssystem SUSE Linux Enterprise Server kann auf IBM POWER8-Servern ausgeführt werden. Um Ihnen für die Planungsphase eine Richtlinie zur Verfügung zu stellen, werden hier die Mindestanforderungen dargestellt.

Wenn Sie sichergehen möchten, dass eine bestimmte Computerkonfiguration funktioniert, schlagen Sie in der Datenbank der von SUSE zertifizierten Hardware nach. Eine Liste der zertifizierten Hardware finden Sie unter http://www.suse.com/yessearch/Search.jsp.

SUSE Linux Enterprise Server unterstützt möglicherweise weitere IBM POWER-Systeme, die im Folgenden nicht aufgeführt sind. Aktuelle Informationen finden Sie im IBM Information Center für Linux unter http://www.ibm.com/support/knowledgecenter/linuxonibm/liaam/liaamdistros.htm.

Die aktuelle Firmware finden Sie bei IBM FixCentral (http://www.ibm.com/support/fixcentral/). Wählen Sie das System in der Liste der Produktgruppen aus. Im IBM PowerLinux Tools Repository steht weitere Software zur Verfügung. Das IBM Tools Repository wird auch als Yum-Repository bezeichnet. Unter https://ibm.biz/Bdxn3N finden Sie weitere Informationen zur Verwendung des IBM PowerLinux Tools Repository.

3.1.1.1 Server mit IBM POWER8-Prozessor #

Alle PowerKVM-fähigen POWER8-Server werden unterstützt.

8247-21L (IBM Power®-System S120L)

8247-22L (IBM Power-System S220L)

8284-22A (IBM Power-System S2200)

8286-41A (IBM Power-System S1400)

8286-42A (IBM Power-System S2400)

3.2 Vorbereitung #

In diesem Abschnitt werden die Schritte beschrieben, die zur Vorbereitung vor der eigentlichen Installation von SUSE Linux Enterprise Server anfallen. Das Installationsverfahren richtet sich nach dem verwendeten System. Folgende Methoden werden unterstützt:

Wenn SUSE Linux Enterprise Server auf mehreren Systemen oder Partitionen installiert werden soll, empfiehlt sich die Erstellung einer Netzwerkinstallationsquelle. Die Installationsquelle kann für die gleichzeitige Installation auf mehreren Partitionen oder Systemen verwendet werden. Informationen zur Konfiguration einer Netzwerkinstallationsquelle finden Sie in Abschnitt 8.1, „Einrichten eines Installationsservers mithilfe von YaST“.

3.2.1 Installation auf IBM PowerKVM-Servern mithilfe von Kimchi #

Dieser Abschnitt befasst sich mit der Vorbereitung der Installation auf IBM PowerLinux-Systemen mit PowerKVM. Hier wird die Installation von einem ISO-Image über die Kimchi-Web-Schnittstelle erläutert. Kimchi ist ein Werkzeug für die Administration von IBM PowerKVM.

In diesem Abschnitt wird vorausgesetzt, dass PowerKVM auf dem IBM PowerLinux-Server ausgeführt wird. Falls PowerKVM nicht vorinstalliert ist, befolgen Sie die Anweisungen zum Installieren und Einrichten von PowerKVM im Abschnitt „Configuring IBM PowerKVM on Power Systems“ (Konfigurieren von IBM PowerKVM auf Power-Systemen) unter http://www.ibm.com/support/knowledgecenter/linuxonibm/liabp/liabpkickoff.htm.

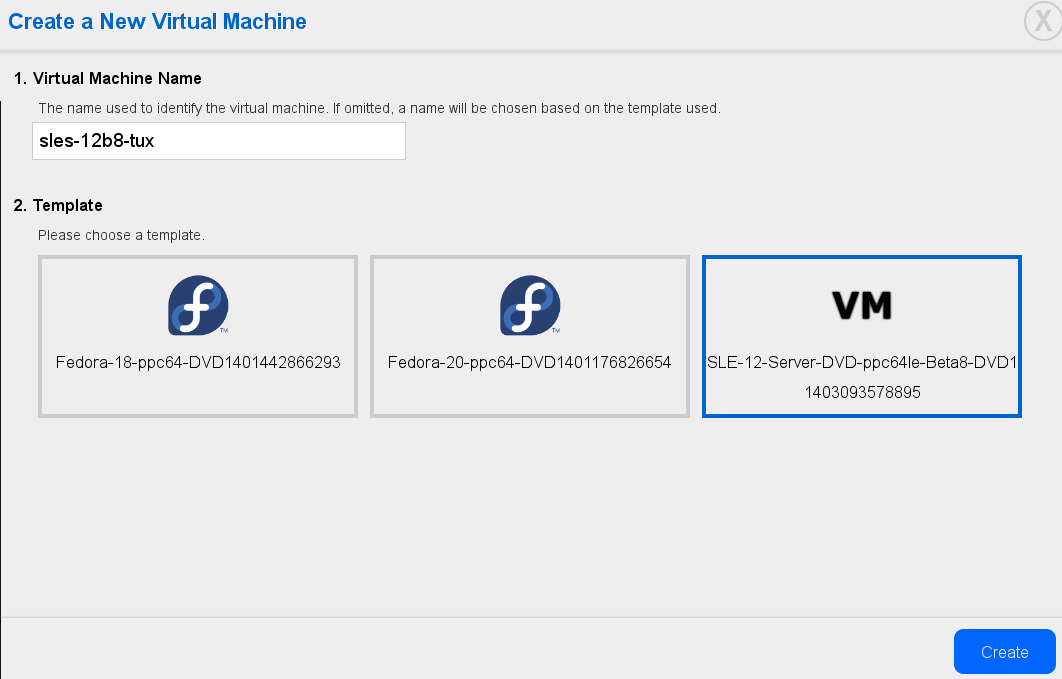

3.2.1.1 Erstellen einer SUSE Linux Enterprise Server-Schablone mit Kimchi #

Schablonen fungieren als Installationsquelle für PowerKVM-Gäste. Sie können eine Schablone erstellen, eine bereits vorhandene Schablone bearbeiten oder eine Schablone klonen. Wenn Sie eine Schablone auf Basis eines bestehenden Gasts klonen möchten, muss der betreffende Gast deaktiviert werden.

Geben Sie im Webbrowser die URL des PowerLinux-Servers ein, auf dem PowerKVM ausgeführt wird, beispielsweise

https://POWERLINUX_IP:8001(ersetzen Sie POWERLINUX_IP durch die IP-Adresse Ihres Systems).Klicken Sie auf den Karteireiter (Schablonen). Die Seite (Schablonen) wird geöffnet.

Zum Erstellen der SUSE Linux Enterprise Server-Schablone klicken Sie auf das grüne Pluszeichen ().

Wählen Sie im Dialogfeld (Schablone hinzufügen) eine der folgenden Optionen aus:

Wählen Sie diese Option aus, wenn Sie Speicherpools nach auf dem System verfügbaren ISO-Installationsimages durchsuchen möchten.

- (Lokale Imagedatei)

Wählen Sie diese Option aus, wenn Sie einen Pfad zu einer lokalen Imagedatei angeben möchten.

- (Remote-ISO-Datei)

Wählen Sie diese Option aus, wenn Sie einen entfernten Ort für ein ISO-Installationsimage angeben möchten.

Wählen Sie die gewünschte ISO-Datei für die Erstellung eines Gasts aus und klicken Sie auf (Schablonen aus ausgewählter ISO erstellen).

Zum Konfigurieren der soeben erstellten Schablone klicken Sie auf › , und ändern Sie die Werte gemäß Ihren Anforderungen.

Weitere Informationen finden Sie im Abschnitt „Setting up a template using Kimchi“ (Einrichten einer Schablone mit Kimchi) unter http://www.ibm.com/support/knowledgecenter/linuxonibm/liabp/liabpkimchitemplate.htm.

3.2.1.2 Installieren von SUSE Linux Enterprise Server als Gast mit Kimchi #

Geben Sie im Webbrowser die URL des PowerLinux-Servers ein, auf dem PowerKVM ausgeführt wird, beispielsweise

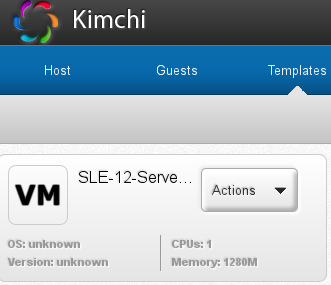

https://POWERLINUX_IP:8001(ersetzen Sie POWERLINUX_IP durch die IP-Adresse Ihres Systems).Klicken Sie auf den Karteireiter (Gäste). Die Seite (Gäste) wird geöffnet.

Zum Erstellen des SUSE Linux Enterprise Server-Gastes klicken Sie auf das grüne Pluszeichen ().

Geben Sie unter (Name des virtuellen Computers) einen Namen für den SUSE Linux Enterprise Server-Gast ein.

Wählen Sie die SUSE Linux Enterprise Server-Schablone aus, die Sie in Abschnitt 3.2.1.1, „Erstellen einer SUSE Linux Enterprise Server-Schablone mit Kimchi“ erstellt haben, und klicken Sie auf .

Nach seiner Erstellung kann der Gast gestartet werden. Zum Starten des SUSE Linux Enterprise Server-Gastes klicken Sie auf den roten Ein-/Aus-Schalter. Sie können jedoch auch › auswählen.

Klicken Sie auf › , und verbinden Sie den VNC-Viewer mit dem Installationsprogramm (siehe Abschnitt 10.3.1.2, „Herstellen der Verbindung mit dem Installationsprogramm“).

Wenn Sie mehrere Gäste eines ähnlichen Typs erstellen möchten, wählen Sie (Klonen) im Menü (Aktionen) eines bestehenden Gasts aus.

Nun können Sie die Standardinstallation über VNC wie in Abschnitt 6.3, „Installationsschritte“ beschrieben fortsetzen.

3.2.2

Installation auf IBM PowerKVM-Servern mit virt-install

#

Alternativ zu einer Installation mit Kimchi können Sie auch das Kommandozeilenwerkzeug virt-install für eine Installation auf Servern mit IBM PowerKVM verwenden. Dies ist vor allem dann sinnvoll, wenn Sie mehrere virtuelle Maschinen auf IBM PowerLinux Server-Systemen installieren müssen. virt-install unterstützt zahlreiche Installationsszenarien. Im Folgenden wird die Installation im Fernverfahren mit VNC und PXE-Boot erläutert. Weitere Informationen zu virt-install finden Sie in Book “Virtualization Guide”, Chapter 9 “Guest Installation”, Section 9.2 “Installing from the Command Line with virt-install”.

Bereiten Sie ein Repository mit den Installationsquellen und einem PXE-Boot-fähigen Zielsystem vor (siehe Abschnitt 10.1.3, „Installation auf entfernten Systemen über VNC – PXE-Boot und Wake-on-LAN“).

Geben Sie Folgendes in die Kommandozeile ein (passen Sie dabei die Option gemäß Ihren Anforderungen und der Hardware an):

virt-install --name server_sle12 --memory 4096 --vcpus=2 --pxe \ --graphics vnc --os-variant sles11 \ --disk pool=default,size=3000,format=qcow2,allocation=1G,bus=virtio \ -w mac=MAC_ADDRESS,model=spapr-vlan

Hierbei wird die grafische VNC-Oberfläche verwendet, und der grafische Client wird automatisch gestartet. Führen Sie die Installation wie in Abschnitt 6.3, „Installationsschritte“ beschrieben aus.

3.2.3 Installation in einer Partition mit IVM #

Diese Anleitung enthält hilfreiche Informationen für die Installation von SUSE Linux Enterprise Server in einer Power Systems-Serverpartition mit der Weboberfläche Integrated Virtualization Manager (IVM). Vor Installationsbeginn müssen folgende Voraussetzungen erfüllt sein:

Das Linux on Power-System wurde eingeschaltet.

Der virtuelle E/A-Server (Virtual I/O Server, VIOS) wurde installiert.

Die IVM-Erstkonfiguration wurde durchgeführt.

Öffnen Sie ein Webbrowserfenster und stellen Sie mit dem HTTP- oder HTTPS-Protokoll eine Verbindung zu der IP-Adresse her, die dem IVM während des Installationsprozesses zugewiesen wurde (zum Beispiel https://IP-ADRESSE). Das Begrüßungsfenster wird angezeigt.

Melden Sie sich als Benutzer

padminan und geben Sie das Passwort ein, das Sie während des Installationsprozesses definiert haben. Die IVM-Oberfläche wird angezeigt.Wählen Sie (Virtuelles Ethernet anzeigen/ändern) aus.

Klicken Sie auf (Virtuelles Ethernet initialisieren), um eine Ethernet-Konnektivität zwischen den Partitionen bereitzustellen.

Sobald das virtuelle Ethernet initialisiert wurde, klicken Sie auf Apply (Anwenden).

Wenn Ihre Installation externes Networking erfordert, erstellen Sie eine virtuelle Ethernet-Bridge.

Wählen Sie den Karteireiter (Virtuelle Ethernet-Bridge) aus.

Wählen Sie den physischen Adapter für die Bridge aus und fahren Sie mit der Option (Anwenden) fort.

Erstellen Sie jetzt mit folgenden Schritten eine Partition:

Klicken Sie in der IVM-Weboberfläche auf › (Partition änzeigen/ändern > Partition erstellen).

Geben Sie einen Namen für die Partition ein. Um mit dem nächsten Schritt fortzufahren, klicken Sie in diesem und in den folgenden Schritten jeweils auf (Weiter).

Geben Sie den Arbeitsspeicher für Ihre Partition an. Falls Sie einen gemeinsam genutzten Arbeitsspeicherpool erstellt haben, können Ihre Partitionen Arbeitsspeicher gemeinsam nutzen. Wählen Sie andernfalls (Dediziert) aus.

Geben Sie die Anzahl der Prozessoren und den Verarbeitungsmodus für die Partition an.

Geben Sie ein virtuelles Ethernet für die Partition an. Wenn Sie keinen Adapter konfigurieren möchten, wählen Sie (Keiner) für das virtuelle Ethernet aus.

Erstellen Sie einen neuen virtuellen Datenträger oder weisen Sie bereits vorhandene virtuelle Datenträger und physische Volumes zu, die zurzeit keiner Partition zugewiesen sind.

Überprüfen Sie die Angaben in (Name des virtuellen Datenträgers) und (Name des Speicherpools) für Ihre Platte und geben Sie in (Größe des virtuellen Datenträgers) die gewünschte Größe an.

Konfigurieren Sie optische Einheiten für Ihre Partition, indem Sie die Einträge (Physische optische Einheiten) und (Virtuelle optische Einheiten) einblenden und die Einheit(en) auswählen, die Sie der Partition zuweisen möchten.

Überprüfen Sie die Konfigurationseinstellungen für Ihre Partition und klicken Sie auf (Beenden). Die Partition wird erstellt und ist danach in der Liste (Partitionen anzeigen/ändern) verfügbar.

Aktivieren Sie nun die soeben erstellte Partition:

Klicken Sie in der IVM-Weboberfläche auf (Partition anzeigen/ändern) und wählen Sie das Feld neben der Partition aus, die Sie aktivieren möchten.

Wählen Sie (Weitere Aufgaben) aus.

Wählen Sie (Terminalfenster öffnen) aus.

Klicken Sie neben der Partition auf (Aktivieren).

Geben Sie im Terminalfenster 1 ein, um die System Management Services (SMS) zu starten.

Der Rechner ist jetzt eingerichtet und Sie können in die Installation booten:

Geben Sie im Fenster (Bootauswahl) 1 ein, um das auszuwählen. Geben Sie 1 ein, bevor der Bildschirm für das Booten der Firmware vollständig in der Anzeige zu sehen ist, da der Bildschirm ausgeblendet wird, sobald er vollständig ist. Falls Sie den Bildschirm versäumt haben, booten Sie das System neu.

Sie können jetzt den Mediendatenträger für den virtuellen E/A-Server (Virtual I/O Server, VIOS) in das Laufwerk einlegen.

Geben Sie 2 ein, um im Menü (Sprachauswahl) mit der Eingabe des Passworts fortzufahren. Geben Sie das Passwort für die Admin-ID ein.

Geben Sie im SMS-Hauptmenü 5 ein, um (Bootoptionen auswählen) zu wählen.

Geben Sie 1 ein, um (Installations-/Bootgerät) auszuwählen.

Geben Sie 7 ein, um alle verfügbaren Bootgeräte anzuzeigen.

Geben Sie die Nummer des gewünschten Geräts ein. Falls Ihr Gerät nicht aufgelistet wird, geben Sie N ein, damit weitere Geräte angezeigt werden.

Geben Sie 2 ein, damit das Booten mit der Option (Booten im normalen Modus) erfolgt.

Geben Sie 1, um das SMS-Menü zu verlassen und den Bootvorgang zu starten.

Geben Sie am Bootprompt des Installationsprogramms Folgendes ein:

install vnc=1 vncpassword=VNC_PASSWORD

Ersetzen Sie VNC_PASSWORD durch ein Passwort Ihrer Wahl (die Mindestlänge beträgt acht Zeichen) und drücken Sie Eingabetaste, um die Installation von SUSE Linux Enterprise Server zu starten. Das Laden des Kernels beginnt.

Sobald das Laden des Kernels begonnen hat, benötigt das Installationsprogramm einige Informationen vom System, um eine VNC-Sitzung einrichten zu können. Damit VNC genutzt werden kann, wird ein gültiger TCP/IP-Stack benötigt. Verwenden Sie entweder DHCP oder definieren Sie Ihre Informationen zum Networking manuell mithilfe der Anweisungen des Installationsprogramms.

Wählen Sie im Fenster (Netzwerkgerät) als Netzwerkgerät aus. Wählen Sie aus und drücken Sie Eingabetaste.

Testen Sie die Installationsmedien. Wenn Sie den Vorgang ohne Test fortsetzen möchten, wählen Sie (Überspringen) aus.

Sobald das System den VNC-Server gestartet hat, wird eine Nachricht bezüglich der Verbindung Ihres VNC-Clients gefolgt von einer IP-Adresse angezeigt. Notieren Sie sich diese IP-Adresse.

Starten Sie einen VNC-Client auf Ihrem Notebook oder PC. Geben Sie die IP-Adresse aus dem vorherigen Schritt und danach

:1ein. Beispiel: 192.168.2.103:1.Führen Sie die Installation wie in Abschnitt 6.3, „Installationsschritte“ beschrieben aus.

3.2.4 Installation auf Servern ohne Open Power Abstraction Layer #

Mithilfe der folgenden Informationen können Sie Linux über eine serielle Konsole oder mit einem Monitor und einer Tastatur auf einem Power Systems-Server installieren. Bei dieser Installation wird ein nicht verwaltetes (eigenständiges) System vorausgesetzt, das umgehend gebootet werden kann.

Schalten Sie Ihr System ein, indem Sie (Einschalten) im Menü (System ein-/ausschalten) auswählen. Wenn Sie gefragt werden, ob Sie mit der Konsole fortfahren möchten, geben Sie 0 ein. In diesem Fall wird die Konsole genutzt.

Legen Sie das Installationsmedium von SUSE Linux Enterprise Server in das Laufwerk ein.

Geben Sie im Fenster (Sprache auswählen) 2 ein, um mit dem Bootvorgang fortzufahren.

Geben Sie 1 ein, um die Lizenzvereinbarung zu akzeptieren.

Geben Sie im Fenster (Bootauswahl) 1 ein, um das auszuwählen. Geben Sie 1 ein, bevor der Bildschirm für das Booten der Firmware vollständig in der Anzeige zu sehen ist, da der Bildschirm ausgeblendet wird, sobald er vollständig ist. Falls Sie den Bildschirm versäumt haben, booten Sie das System neu.

Geben Sie 2 ein, um im Menü (Sprachauswahl) mit der Eingabe des Passworts fortzufahren. Geben Sie das Passwort für die Admin-ID ein.

Geben Sie im SMS-Hauptmenü 5 ein, um (Bootoptionen auswählen) zu wählen.

Geben Sie 7 ein, um alle verfügbaren Bootgeräte anzuzeigen.

Geben Sie die Nummer des gewünschten Geräts ein. Falls Ihr Gerät nicht aufgelistet wird, geben Sie N ein, damit weitere Geräte angezeigt werden.

Geben Sie 2 ein, damit das Booten mit der Option (Booten im normalen Modus) erfolgt.

Geben Sie 1, um das SMS-Menü zu verlassen und den Bootvorgang zu starten.

Geben Sie am Bootprompt des Installationsprogramms Folgendes ein:

install vnc=1 vncpassword=VNC_PASSWORD

Ersetzen Sie VNC_PASSWORD durch ein Passwort Ihrer Wahl (die Mindestlänge beträgt acht Zeichen) und drücken Sie Eingabetaste, um die Installation von SUSE Linux Enterprise Server zu starten. Das Laden des Kernels beginnt.

Sobald das Laden des Kernels begonnen hat, benötigt das Installationsprogramm einige Informationen vom System, um eine VNC-Sitzung einrichten zu können. Damit VNC genutzt werden kann, wird ein gültiger TCP/IP-Stack benötigt. Verwenden Sie entweder DHCP oder definieren Sie Ihre Informationen zum Networking manuell mithilfe der Anweisungen des Installationsprogramms.

Wählen Sie im Fenster (Netzwerkgerät) als Netzwerkgerät aus. Wählen Sie aus und drücken Sie Eingabetaste.

Testen Sie die Installationsmedien. Wenn Sie den Vorgang ohne Test fortsetzen möchten, wählen Sie (Überspringen) aus.

Sobald das System den VNC-Server gestartet hat, wird eine Nachricht bezüglich der Verbindung Ihres VNC-Clients gefolgt von einer IP-Adresse angezeigt. Notieren Sie sich diese IP-Adresse.

Starten Sie einen VNC-Client auf Ihrem Notebook oder PC. Geben Sie die IP-Adresse aus dem vorherigen Schritt und danach

:1ein. Beispiel: 192.168.2.103:1.Führen Sie die Installation wie in Abschnitt 6.3, „Installationsschritte“ beschrieben aus.

3.3 Weiterführende Informationen #

Sie erhalten weitere Informationen zu IBM PowerLinux von SUSE und IBM:

Die SUSE Support Knowledge Base unter https://www.suse.com/support/kb/ stellt eine sehr hilfreiche Informationsquelle dar, die Kunden bei der Lösung von Problemen unterstützt. Durchsuchen Sie die Knowledge Base zu SUSE Linux Enterprise Server mithilfe von Stichwörtern wie POWER oder PowerKVM.

Sicherheitswarnungen finden Sie unter https://www.suse.com/support/security/. Darüber hinaus bietet SUSE zwei sicherheitsrelevante Mailinglisten an, die jeder abonnieren kann.

suse-security: Eine allgemeine Diskussion von Sicherheitsfragen zu Linux und SUSE. Alle Sicherheitswarnungen für SUSE Linux Enterprise Server werden an diese Liste gesendet.suse-security-announce: Eine SUSE-Mailingliste speziell für Sicherheitswarnungen.

Prüfen Sie bei Hardwarefehlern, ob in der Kontrollleiste entsprechende Codes angezeigt werden. Sie können die angezeigten Codes im IBM Power Systems Hardware Information Center unter https://ibm.biz/Bdxn3T nachschlagen.

Im Abschnitt „IBM PowerLinux FAQ“ des Information Center unter https://ibm.biz/Bdxn35 finden Sie Tipps zur Fehlerbehebung.

Um sich in die linuxppc-dev-Mailingliste einzutragen, melden Sie sich über die Formulare unter http://lists.ozlabs.org/listinfo/linuxppc-dev/ an.

4 Installation auf IBM Z #

In diesem Kapitel wird die Vorbereitung der Installation von SUSE® Linux Enterprise Server auf IBM Z beschrieben. Hier finden Sie alle erforderlichen Informationen, mit denen Sie die Installation auf LPAR- und z/VM-Seite vorbereiten.

4.1 Allgemeine Informationen und Anforderungen #

Dieser Abschnitt gibt grundlegende Informationen zu den Systemvoraussetzungen (z. B. zur unterstützten Hardware), zur MicroCode-Ebene und zur Software. Außerdem werden die verschiedenen Installationstypen vorgestellt, und es wird erläutert, wie Sie einen IPL-Vorgang bei der ersten Installation ausführen. Ausführliche technische Informationen zu IBM Z unter SUSE Linux Enterprise Server finden Sie unter http://www.ibm.com/developerworks/linux/linux390/documentation_suse.html.

4.1.1 Systemanforderungen #

Dieser Abschnitt enthält eine Liste der Hardwarekomponenten für IBM Z, die von SUSE Linux Enterprise Server unterstützt werden. Als Nächstes wird die MicroCode-Ebene (MCL) erläutert, die in Ihrem System mit IBM Z verwendet wird. Diese ist äußerst wichtig für die Installation. Zusätzliche Software, die installiert werden und für die Installation genutzt werden kann, wird am Ende dieses Abschnitts aufgeführt.

4.1.1.1 Hardware #

SUSE Linux Enterprise Server läuft problemlos auf den folgenden Plattformen:

IBM zEnterprise System z196 (2817)

IBM zEnterprise System z114 (2818)

IBM zEnterprise EC12 (zEC12) (2827)

IBM zEnterprise BC12 (zBC12) (2828)

IBM z Systems z13 (2964)

IBM z Systems z13s (2965)

IBM LinuxONE Emperor (2964)

IBM LinuxONE Rockhopper (2965)

4.1.1.1.1 Arbeitsspeicheranforderungen #

Für verschiedene Installationsmethoden gelten bei der Installation unterschiedliche Speicheranforderungen. Nach Abschluss der Installation kann der Systemadministrator den Arbeitsspeicher auf die gewünschte Größe reduzieren. SUSE empfiehlt die Verwendung von:

|

1 GB |

Für die Installation unter z/VM. |

|

1 GB |

Für die Installation unter LPAR. |

|

1 GB |

Für die Installation unter KVM. |

Für die Installation von NFS-, FTP- oder SMB-Installationsquellen oder bei der Verwendung von VNC sind mindestens 512 MB Arbeitsspeicher erforderlich. Andernfalls schlägt der Installationsversuch wahrscheinlich fehl. Beachten Sie außerdem, dass die Anzahl der für den z/VM-Gast oder das LPAR-Image sichtbaren Geräte die Speicheranforderungen beeinflusst. Die Installation mit buchstäblich Hunderten von zugänglichen Geräten (selbst wenn sie für die Installation nicht verwendet werden) kann mehr Speicher erfordern.

4.1.1.1.2 Speicherplatzanforderungen #

Die Anforderungen an die Festplatte hängen im Wesentlichen von der Installation ab. Gewöhnlich benötigen Sie mehr Speicherplatz als die Installationssoftware alleine, damit ein System ordnungsgemäß arbeitet. Mindestanforderungen für verschiedene Optionen:

|

800 MB |

Minimalinstallation |

|

1,4 GB |

Minimalinstallation + Basissystem |

|

2,6 GB |

Standardinstallation |

|

3,6 GB+ |

Empfohlen (mit grafischem Desktop, Entwicklungspaketen und JAVA). |

4.1.1.1.3 Netzwerkverbindung #

Für die Kommunikation mit dem SUSE Linux Enterprise Server-System wird eine Netzwerkverbindung benötigt. Dabei kann es sich um eine oder mehrere der folgenden Verbindungen oder Netzwerkkarten handeln:

OSA Express Ethernet (einschließlich Fast und Gigabit Ethernet)

HiperSockets oder Gast-LAN

10 GBE, VSWITCH

RoCE (RDMA over Converged Ethernet)

Folgende Schnittstellen sind noch enthalten, werden aber nicht mehr unterstützt:

CTC (oder virtuelles CTC)

ESCON

IP-Netzwerkschnittstelle für IUCV

Für Installationen unter KVM müssen die folgenden Anforderungen erfüllt sein, damit dem VM-Gast (VM Guest) ein transparenter Zugang zum Netzwerk ermöglicht wird:

Die virtuelle Netzwerkschnittstelle muss mit einer Host-Netzwerkschnittstelle verbunden sein.

Die Host-Netzwerkschnittstelle muss mit einem Netzwerk verbunden sein, in das der virtuelle Server integriert ist.

Wenn für den Host durch die Gruppierung von zwei unabhängigen OSA-Netzwerkports in einer gebündelten Netzwerkschnittstelle (Bonding) eine redundante Netzwerkverbindung konfiguriert wurde, lautet die Kennung für die gebündelte Netzwerkschnittstelle

bond0(bzw. bei mehreren gebündelten Schnittstellenbond1,bond2usw.).Wenn die Host-Netzwerkverbindung nicht als redundante Verbindung eingerichtet wurde, muss die Kennung der alleinigen Netzwerkschnittstelle verwendet werden. Sie wird in der Form enccw0.0.NNNN angegeben. Dabei steht NNNN für die Gerätenummer der gewünschten Netzwerkschnittstelle.

4.1.1.2 MicroCode-Ebene, APARs und Korrekturen #

Eine Dokumentation zu den Einschränkungen und Anforderungen für diese Version von SUSE Linux Enterprise Server finden Sie bei IBM developerWorks unter http://www.ibm.com/developerworks/linux/linux390/documentation_suse.html. Es wird empfohlen, immer den höchsten verfügbaren Service-Level zu verwenden. Erfragen Sie die Mindestanforderungen bei Ihrem IBM-Support.

4.1.1.2.1 z/VM #

z/VM 5.4

z/VM 6.2

z/VM 6.3– Sie sollten zur Verbesserung der qclib-Ausgabe unbedingt APAR VM65419 (oder höher) installieren.

Besprechen Sie die Installationsreihenfolge mit Ihrem IBM-Support, da es eventuell erforderlich ist, die VM APARs vor der Installation der neuen MicroCode-Levels zu aktivieren.

4.1.1.3 Software #

Beim Installieren von SUSE Linux Enterprise Server über nicht-Linux-gestütztes NFS oder FTP können Probleme mit der NFS- oder FTP-Serversoftware auftreten. Der Windows-Standard-FTP-Server kann Fehler verursachen, daher wird auf diesen Rechnern generell eine Installation über SMB empfohlen.

Zum Herstellen einer Verbindung mit dem SUSE Linux Enterprise Server-Installationssystem ist eine der folgenden Methoden erforderlich (SSH oder VNC wird empfohlen):

- SSH mit Terminalemulation (xterm-kompatibel)

SSH ist ein Unix-Standardwerkzeug, das auf jedem Unix- oder Linux-System vorhanden sein sollte. Für Windows gibt es einen SSH-Client mit dem Namen Putty. Es ist frei benutzbar und verfügbar unter http://www.chiark.greenend.org.uk/~sgtatham/putty/.

- VNC-Client

Für Linux ist der VNC-Client vncviewer in SUSE Linux Enterprise Server als Teil des

tightvnc-Pakets inbegriffen. Für Windows ist TightVNC ebenfalls erhältlich. Laden Sie es von http://www.tightvnc.com/ herunter.- X-Server

Suchen Sie eine geeignete X-Server-Implementierung auf jedem beliebigen Linux- oder Unix-Arbeitsplatzrechner. Für Windows und macOS sind zahlreiche kommerzielle X-Window-Systemumgebungen erhältlich. Einige davon können als kostenlose Testversionen heruntergeladen werden. Eine Testversion von Mocha X Server von MochaSoft kann unter http://www.mochasoft.dk/freeware/x11.htm bezogen werden.

Lesen Sie die README im Stammverzeichnis auf der DVD 1 von SUSE Linux Enterprise Server, bevor Sie SUSE Linux Enterprise Server auf IBM Z installieren. Diese Datei ergänzt diese Dokumentation.

4.1.2 Installationstypen #

In diesem Abschnitt finden Sie einen Überblick über die verschiedenen Installationstypen für SUSE Linux Enterprise Server auf IBM Z:

- LPAR

Installation von SUSE Linux Enterprise Server anhand einer logischen Partition (LPAR).

- z/VM

Installation von SUSE Linux Enterprise Server als Gastbetriebssystem in z/VM.

- KVM

Installation von SUSE Linux Enterprise Server als Gastbetriebssystem in KVM.

Abhängig vom Modus der Installation (LPAR oder z/VM) gibt es verschiedene Möglichkeiten zum Start des Installationsvorgangs und Ausführen eines IPL-Vorgangs für das installierte System.

4.1.2.1 LPAR #

Wenn Sie SUSE Linux Enterprise Server für IBM Z in eine logische Partition (LPAR) installieren, weisen Sie der Instanz die nötigen Arbeitsspeicher- und Prozessorressourcen zu. Installation in LPAR wird für stark belastete Produktionscomputer empfohlen. Durch die Ausführung in einer LPAR stehen außerdem höhere Sicherheitsstandards zur Verfügung. Netzwerkverbindungen zwischen LPARs werden über externe Schnittstellen oder Hipersockets ermöglicht. Wenn Sie die Installation für die Virtualisierung mit KVM einsetzen möchten, wird die Installation in einer LPAR dringend empfohlen.

4.1.2.2 z/VM #

Die Ausführung von SUSE Linux Enterprise Server für IBM Z in z/VM bedeutet, dass SUSE Linux Enterprise Server als Gastsystem in z/VM fungiert. Ein Vorteil dieses Modus ist, dass Sie von z/VM die volle Kontrolle über SUSE Linux Enterprise Server haben. Dies ist sehr nützlich für Kernel-Entwicklung oder Kernel-basierte Fehlersuche. Es ist auch sehr einfach, Hardware zu Linux-Gästen hinzuzufügen oder von ihnen zu entfernen. Das Anlegen von SUSE Linux Enterprise Server-Gästen ist unkompliziert und Sie können Hunderte von Linux-Instanzen gleichzeitig ausführen.

4.1.2.3 KVM-Gast #

Damit SUSE Linux Enterprise Server für IBM Z als KVM-Gast installiert werden kann, muss eine Instanz des KVM-Hostservers in der logischen Partition (LPAR) installiert sein. Weitere Informationen zur Installation von Gästen finden Sie in Prozedur 4.3, „Überblick über die Installation eines KVM-Gasts“.

4.1.3 IPL-Optionen #

Dieser Abschnitt bietet die Informationen, die Sie zur Ausführung eines IPL für die erste Installation benötigen. Abhängig von der Art der Installation müssen unterschiedliche Optionen verwendet werden. Es werden der VM-Reader, das Laden von CD-ROM oder von einem Server sowie das Laden von einer per SCSI verbundenen DVD-ROM vorgestellt. Die Installation der Softwarepakete, die über das Netzwerk erfolgt, benötigt das IPL-Medium nicht.

4.1.3.1 VM Reader #

Übertragen Sie für die Ausführung des IPL von einem VM-Reader zunächst die erforderlichen Dateien in den Reader. Zur Vereinfachung der Administration wird empfohlen, den Benutzer linuxmnt anzulegen, der eine Minidisk mit den Dateien und Skripten besitzt, die für IPL benötigt werden. Auf diese Minidisk greifen dann die Linux-Gäste im Nur-Lese-Modus zu.

4.1.3.2 Laden von einem Wechselmedium oder einem Server #

Für den IPL-Vorgang auf eine LPAR kann das Kernel-Image entweder direkt vom CD/DVD-ROM-Gerät der SE oder HMC geladen werden oder von jedem fernen System, das über FTP zugänglich ist. Diese Funktion kann von der HMC ausgeführt werden. Für die Installation ist eine Datei mit einer Zuordnung des Speicherorts der Installationsdaten im Dateisystem sowie den Arbeitsspeicherpositionen erforderlich, an die die Daten kopiert werden sollen.

Für SUSE Linux Enterprise Server gibt es zwei Dateien. Beide Dateien befinden sich im Stammverzeichnis des Dateisystems von DVD 1:

suse.ins: Damit diese Datei funktioniert, müssen Sie den Netzwerkzugriff in Linuxrc einrichten, bevor Sie die Installation starten.susehmc.ins: Hiermit können Sie die Installation ohne Netzwerkzugriff ausführen.

Erweitern Sie im linken Navigationsbereich der HMC den Eintrag › , und wählen Sie das Mainframe-System aus, mit dem Sie arbeiten möchten. Wählen Sie die LPAR, in der SUSE Linux Enterprise Server gebootet werden soll, in der Tabelle der LPARs aus, und wählen Sie (Von Wechselmedium oder Server laden).

Wählen Sie (CD-ROM/DVD der HMC) oder (FTP-Quelle) aus. Bei Auswahl der letzteren Option müssen Sie die Adresse oder den Namen des Servers und Ihren Berechtigungsnachweis eingeben. Falls sich die entsprechende .ins-Datei nicht im Root-Verzeichnis des Servers befindet, müssen Sie den Pfad dieser Datei angeben. Navigieren Sie zum Menü (Zu ladende Software auswählen) und wählen Sie dort den Eintrag für die entsprechende .ins-Datei aus. Starten Sie die Installation mit .

4.1.3.3 Laden von einer per SCSI verbundenen DVD #

Zur Ausführung von IPL von einer SCSI-DVD benötigen Sie Zugriff auf einen FCP-Adapter, der mit einem DVD-Laufwerk verbunden ist. Darüber hinaus benötigen Sie Werte wie die WWPN und die LUN vom SCSI-Laufwerk. Weitere Informationen finden Sie unter Abschnitt 4.2.4.1.2, „IPL von per FCP angeschlossener SCSI-DVD“.

4.1.3.4 Laden vom Netzwerk mit zPXE #

Zur Ausführung von IPL vom Netzwerk mit zPXE ist ein Cobbler-Server mit Kernel, RAM-Datenträger und parmfile erforderlich. Es wird durch Ausführung des ZPXE EXEC-Skripts initiiert. Weitere Informationen finden Sie in Abschnitt 4.2.1.3, „Verwenden eines Cobbler-Servers für zPXE“. zPXE ist nur auf z/VM verfügbar.

4.2 Vorbereitung der Installation #

Erfahren Sie, wie Sie die Daten zur Installation bereitstellen, SUSE Linux Enterprise Server mit verschiedenen Methoden installieren und den IPL-Vorgang des SUSE Linux Enterprise Server-Installationssystems vorbereiten und ausführen. Darüber hinaus erhalten Sie Informationen zur Konfiguration der Netzwerkinstallation.

4.2.1 Bereitstellen der Installationsdaten #

In diesem Abschnitt finden Sie ausführliche Informationen dazu, wie Sie die Installationsdaten für SUSE Linux Enterprise Server auf IBM Z zur Installation bereitstellen. Je nach Computer- und Systemumgebung treffen Sie eine Auswahl zwischen der NFS- oder FTP-Installation. Wenn Sie in Ihrer Umgebung Microsoft Windows-Arbeitsstationen ausführen, können Sie auch das Windows-Netzwerk einschließlich des SMB-Protokolls für die Installation von SUSE Linux Enterprise Server auf dem IBM Z-System verwenden.

Ab Service Pack 1 von SUSE Linux Enterprise Server Version 10 kann IPL über die DVD ausgeführt und die DVD als Installationsmedium verwendet werden. Dies ist besonders praktisch, wenn Beschränkungen für das Einrichten eines Installationsservers bestehen, der Installationsmedien über das Netzwerk bereitstellt. Voraussetzung ist ein per FCP angeschlossenes SCSI-DVD-Laufwerk.

Es ist nicht möglich, von einer Festplatte zu installieren, indem der Inhalt der DVD auf eine Partition auf einem DASD kopiert wird.

4.2.1.1 Verwenden einer DVD für Linux Workstation oder SUSE Linux Enterprise Server #

Wenn Sie in Ihrer Rechnerumgebung einen Linux-Arbeitsplatzrechner ausführen, stellen Sie hierüber die Installationsdaten für den Installationsvorgang für IBM Z mit NFS oder FTP bereit. Wenn der Linux-Arbeitsplatzrechner unter SUSE Linux Enterprise Server ausgeführt wird, können Sie einen Installationsserver (NFS oder FTP) über das YaST-Modul einrichten, wie unter Abschnitt 8.1, „Einrichten eines Installationsservers mithilfe von YaST“ beschrieben.

4.2.1.1.1 Über NFS #

Die Installationsmedien werden über NFS (Network File System) verfügbar gemacht.

Durch das Exportieren des Dateisystem-Root (/) werden eingehängte Geräte (z. B. DVD) nicht automatisch exportiert. Der Einhängepunkt muss in /etc/exports explizit angegeben werden:

/media/dvd *(ro)

Starten Sie nach dem Ändern dieser Datei den NFS-Server mit dem Befehl sudo systemctl restart nfsserver neu.

4.2.1.1.2 Über FTP #

Die Einrichtung eines FTP-Servers auf einem Linux-System umfasst die Installation und Konfiguration der Serversoftware, beispielsweise vsftpd,. Wenn Sie SUSE Linux Enterprise Server verwenden, lesen Sie die Installationsanweisungen im Book “Administrationshandbuch”, Chapter 33 “Einrichten eines FTP-Servers mit YaST”. Da ein Download der Installationsdaten über eine anonyme Anmeldung nicht unterstützt wird, müssen Sie den FTP-Server für die Unterstützung der Benutzerauthentifizierung konfigurieren.

4.2.1.1.3 SUSE Linux Enterprise Server auf DVD #

DVD 1 für SUSE Linux Enterprise Server für IBM Z enthält ein bootfähiges Linux-Image für Intel-gestützte Arbeitsplatzrechner sowie ein Image für IBM Z.

Booten Sie für Intel-basierte Arbeitsplatzrechner von dieser DVD, beantworten Sie die Fragen hinsichtlich bevorzugter Sprache und Tastaturbelegung und wählen Sie dann (Rettungssystem starten) aus. Hierfür sind mindestens 64 MB RAM erforderlich. Festplattenspeicher wird nicht benötigt, da sich das gesamte Rettungssystem im RAM (Random Accesss Memory) des Arbeitsplatzrechners befindet. Dieser Ansatz setzt ausreichend Erfahrung mit Linux und Netzwerken voraus, da die Netzwerkfunktionen des Arbeitsplatzrechners manuell eingerichtet werden müssen.

Führen Sie für IBM Z für Ihre LPAR/Ihren VM-Gast IPL von dieser DVD aus, wie in Abschnitt 4.2.4.1.2, „IPL von per FCP angeschlossener SCSI-DVD“ beschrieben. Nach der Eingabe Ihrer Netzwerkparameter behandelt das Installationssystem die DVD als Quelle der Installationsdaten. Da an IBM Z kein X11-fähiges Terminal direkt angeschlossen werden kann, wählen Sie zwischen VNC- und SSH-Installation. SSH bietet auch eine grafische Installation durch Tunneling der X-Verbindung über SSH mit ssh -X.

4.2.1.2 Mit einer Microsoft Windows-Arbeitsstation #