Dieses Handbuch behandelt Systemverwaltungsaufgaben wie Wartung, Überwachung und Anpassung eines neu installierten Systems.

- Vorwort

- I Häufige Tasks

- 1 Bash-Shell und Bash-Skripte

- 2 Grundlegende Infos zu

sudo - 3 Verwenden von YaST

- 4 YaST im Textmodus

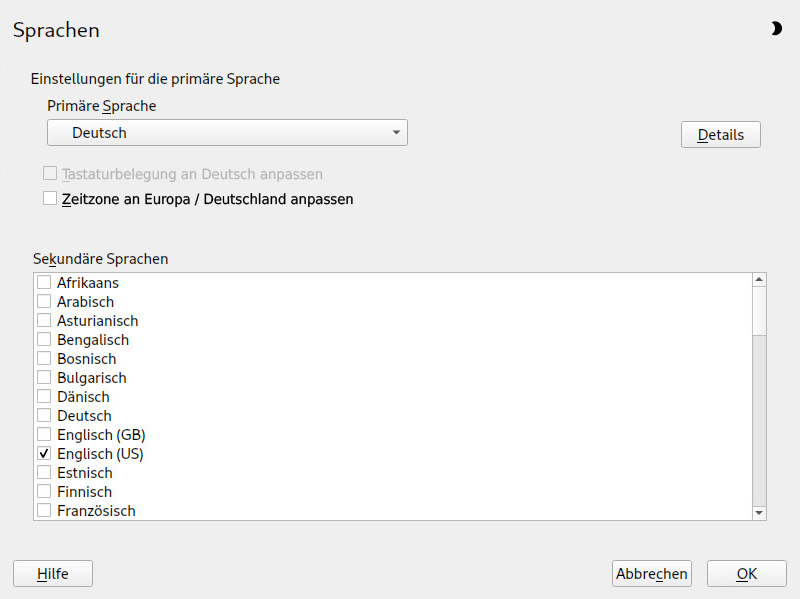

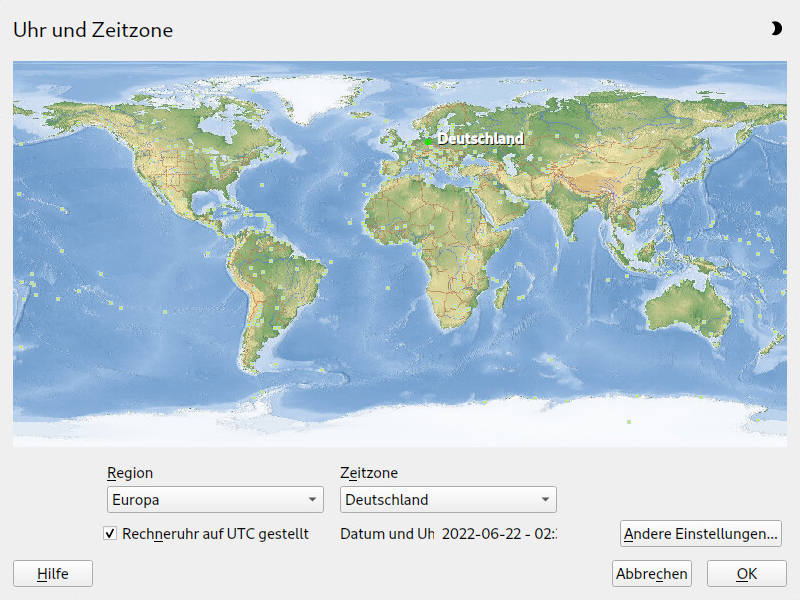

- 5 Ändern der Sprach- und Ländereinstellungen mit YaST

- 6 Verwalten von Benutzern mit YaST

- 6.1 Dialogfeld „Verwaltung von Benutzern und Gruppen“

- 6.2 Verwalten von Benutzerkonten

- 6.3 Weitere Optionen für Benutzerkonten

- 6.4 Ändern der Standardeinstellungen für lokale Benutzer

- 6.5 Zuweisen von Benutzern zu Gruppen

- 6.6 Gruppen verwalten

- 6.7 Ändern der Methode zur Benutzerauthentifizierung

- 6.8 Standard-Systembenutzer

- 7 YaST-Online-Aktualisierung

- 8 Installieren bzw. Entfernen von Software

- 9 Verwalten von Software mit Kommandozeilenwerkzeugen

- 10 Systemwiederherstellung und Snapshot-Verwaltung mit Snapper

- 10.1 Standardeinrichtung

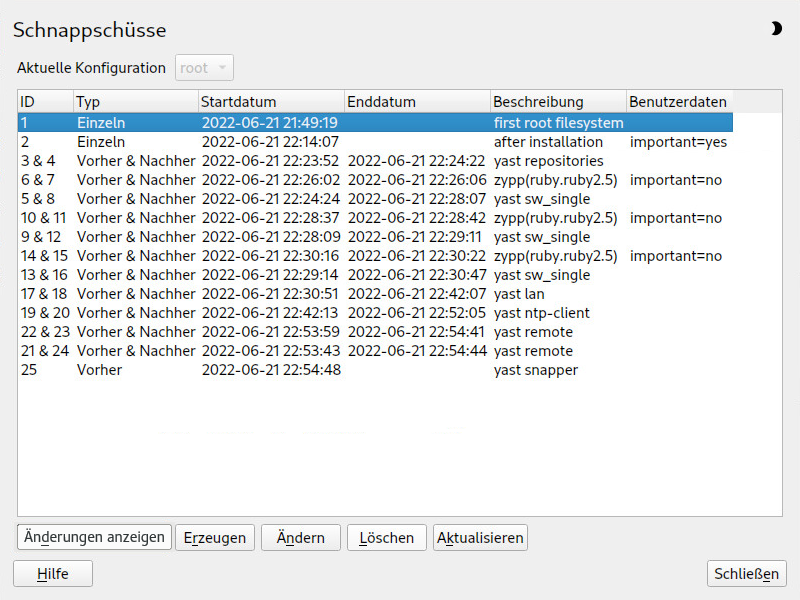

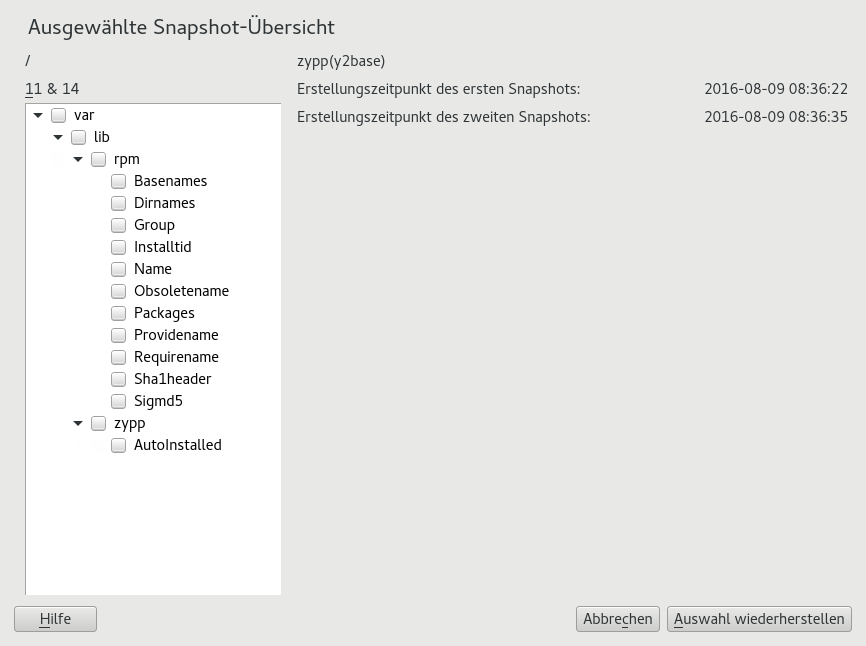

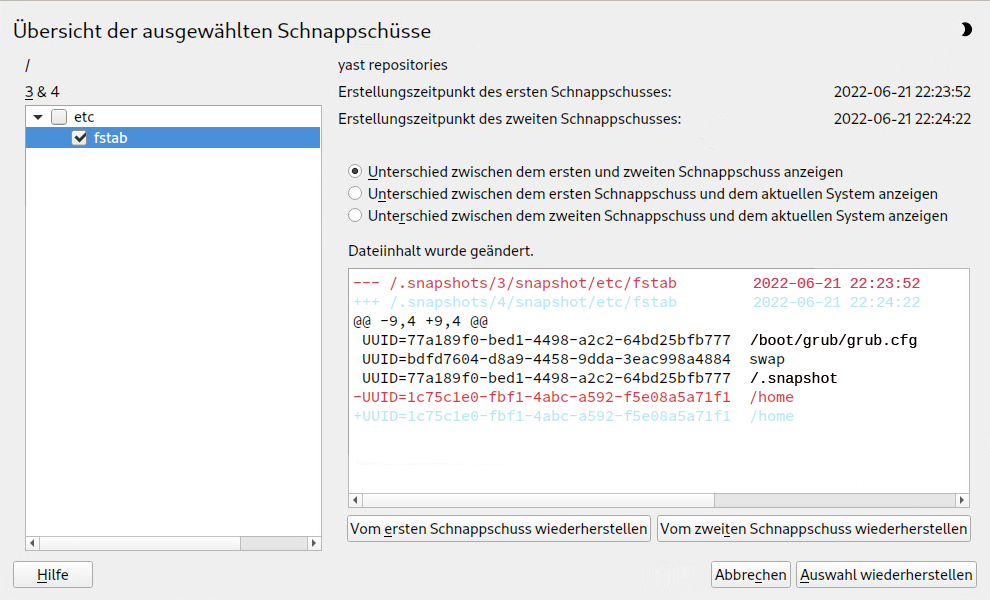

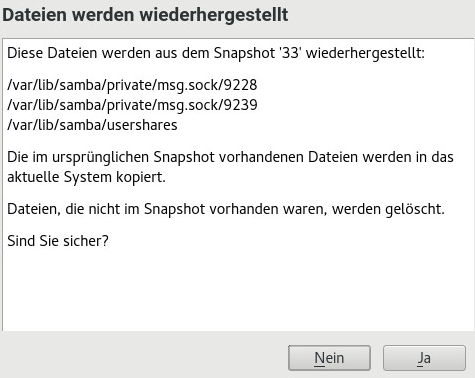

- 10.2 Rückgängigmachen von Änderungen mit Snapper

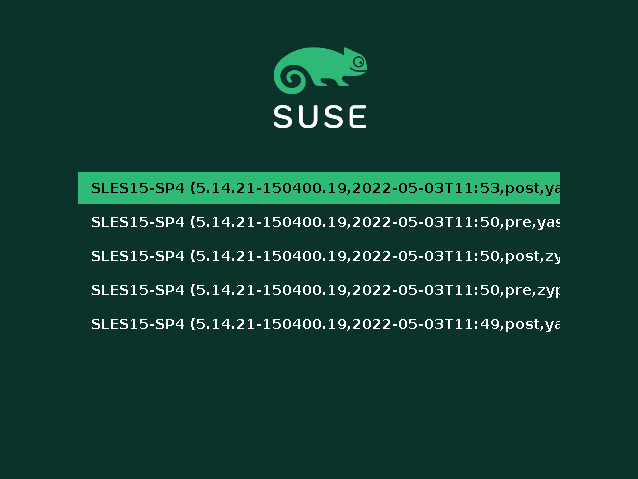

- 10.3 System-Rollback durch Booten aus Snapshots

- 10.4 Aktivieren von Snapper in Benutzer-Startverzeichnissen

- 10.5 Erstellen und Bearbeiten von Snapper-Konfigurationen

- 10.6 Manuelles Erstellen und Verwalten von Snapshots

- 10.7 Automatisches Bereinigen von Snapshots

- 10.8 Anzeigen von exklusiv für Snapshots verwendetem Festplattenspeicherplatz

- 10.9 Häufig gestellte Fragen

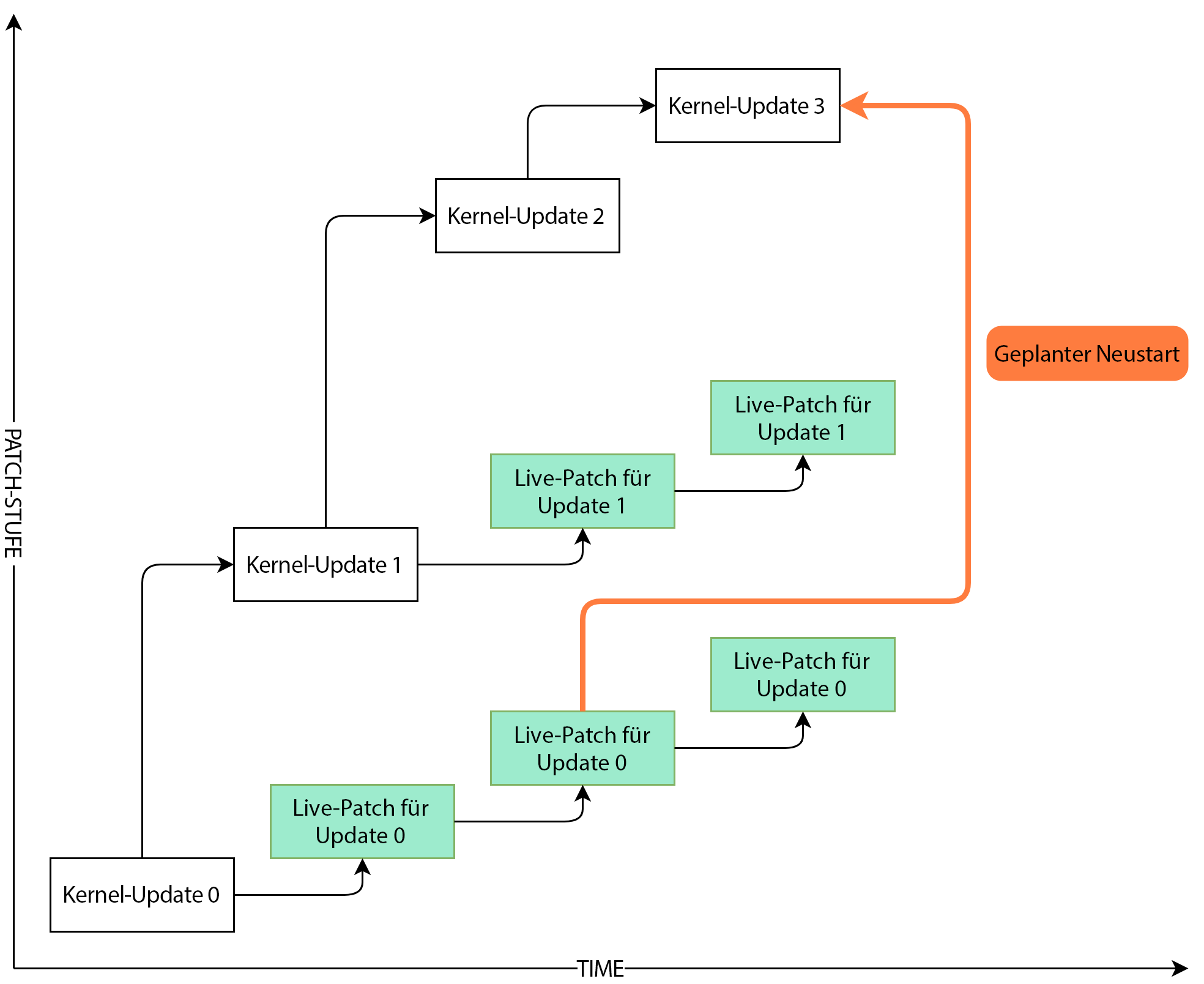

- 11 Live-Kernel-Patching mit KLP

- 12 Userspace-Live-Patching

- 13 Transaktionsaktualisierungen

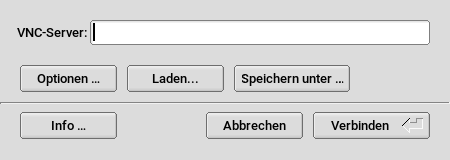

- 14 Remote-Grafiksitzungen mit VNC

- 15 Kopieren von Dateien mit RSync

- II Booten eines Linux-Systems

- III System

- 20 32-Bit- und 64-Bit-Anwendungen in einer 64-Bit-Systemumgebung

- 21

journalctl: Abfragen dessystemd-Journals - 22

update-alternatives: Verwalten mehrerer Kommando- und Dateiversionen - 23 Grundlegendes zu Netzwerken

- 23.1 IP-Adressen und Routing

- 23.2 IPv6 – das Internet der nächsten Generation

- 23.3 Namensauflösung

- 23.4 Konfigurieren von Netzwerkverbindungen mit YaST

- 23.5 Manuelle Netzwerkkonfiguration

- 23.6 Grundlegende Routereinrichtung

- 23.7 Einrichten von Bonding-Geräten

- 23.8 Einrichten von Team-Geräten für Netzwerk-Teaming

- 23.9 Softwaredefiniertes Networking mit Open vSwitch

- 24 Druckerbetrieb

- 25 Über die grafische Benutzeroberfläche

- 26 Zugriff auf Dateisysteme mit FUSE

- 27 Installieren von mehreren Kernel-Versionen

- 28 Verwalten von Kernelmodulen

- 29 Gerätemanagement über dynamischen Kernel mithilfe von

udev- 29.1 Das

/dev-Verzeichnis - 29.2 Kernel

ueventsundudev - 29.3 Treiber, Kernel-Module und Geräte

- 29.4 Booten und erstes Einrichten des Geräts

- 29.5 Überwachen des aktiven

udev-Daemons - 29.6 Einflussnahme auf die Behandlung von Geräteereignissen durch den Kernel mithilfe von

udev-Regeln - 29.7 Dauerhafte Benennung von Geräten

- 29.8 Von

udevverwendete Dateien - 29.9 Weitere Informationen

- 29.1 Das

- 30 Spezielle Systemfunktionen

- 31 Verwendung von NetworkManager

- IV Hardwarekonfiguration

- V Services

- 37 Serviceverwaltung mit YaST

- 38 Zeitsynchronisierung mit NTP

- 38.1 Konfigurieren eines NTP-Clients mit YaST

- 38.2 Manuelle Konfiguration von NTP im Netzwerk

- 38.3 Konfigurieren von

chronydzur Laufzeit mitchronyc - 38.4 Dynamische Zeitsynchronisierung während der Laufzeit

- 38.5 Einrichten einer lokalen Referenzuhr

- 38.6 Uhrensynchronisierung mit einer externen Zeitreferenz (ETR)

- 39 Domain Name System (DNS)

- 40 DHCP

- 41 SLP

- 42 Der HTTP-Server Apache

- 42.1 Schnelleinführung

- 42.2 Konfigurieren von Apache

- 42.3 Starten und Beenden von Apache

- 42.4 Installieren, Aktivieren und Konfigurieren von Modulen

- 42.5 Aktivieren von CGI-Skripten

- 42.6 Einrichten eines sicheren Webservers mit SSL

- 42.7 Ausführen mehrerer Apache-Instanzen auf demselben Server

- 42.8 Vermeiden von Sicherheitsproblemen

- 42.9 Fehlersuche

- 42.10 Weitere Informationen

- 43 Einrichten eines FTP-Servers mit YaST

- 44 Caching-Proxyserver Squid

- 44.1 Einige Tatsachen zu Proxyservern

- 44.2 Systemanforderungen

- 44.3 Grundlegende Verwendung von Squid

- 44.4 Das YaST-Squid-Modul

- 44.5 Die Squid-Konfigurationsdatei

- 44.6 Konfigurieren eines transparenten Proxys

- 44.7 Verwenden der Cache-Manager-CGI von Squid (

cachemgr.cgi) - 44.8 Erstellung von Cache-Berichten mit Calamaris

- 44.9 Weitere Informationen

- 45 Web Based Enterprise Management mit SFCB

- VI Fehlersuche

- 46 Hilfe und Dokumentation

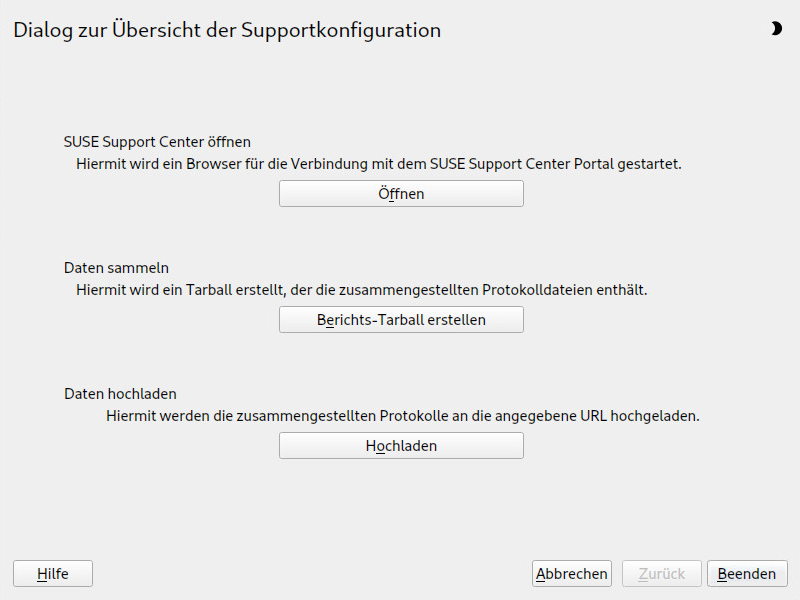

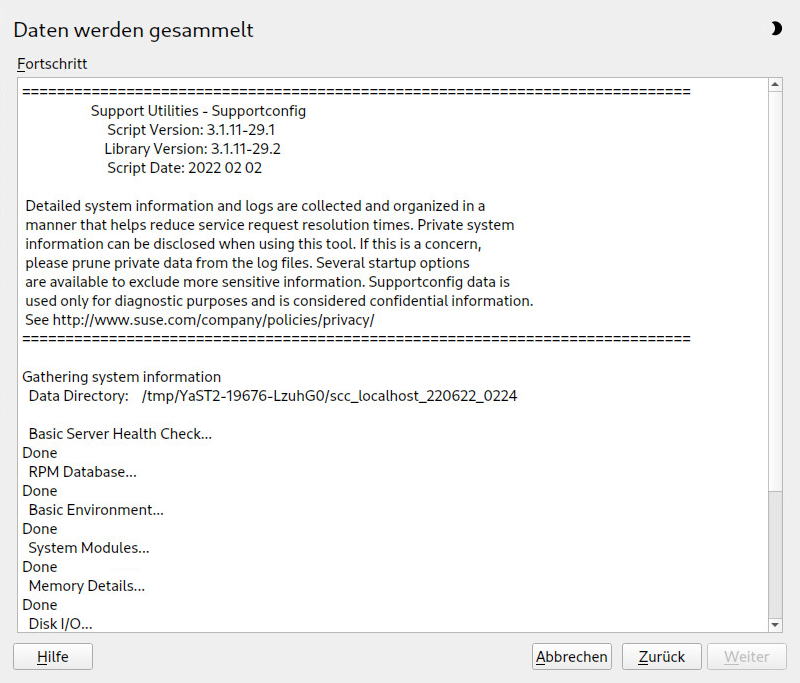

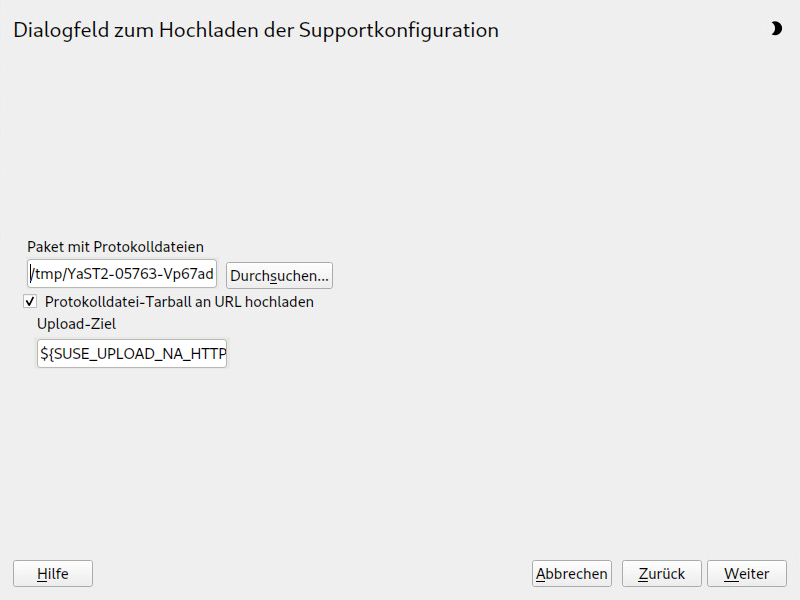

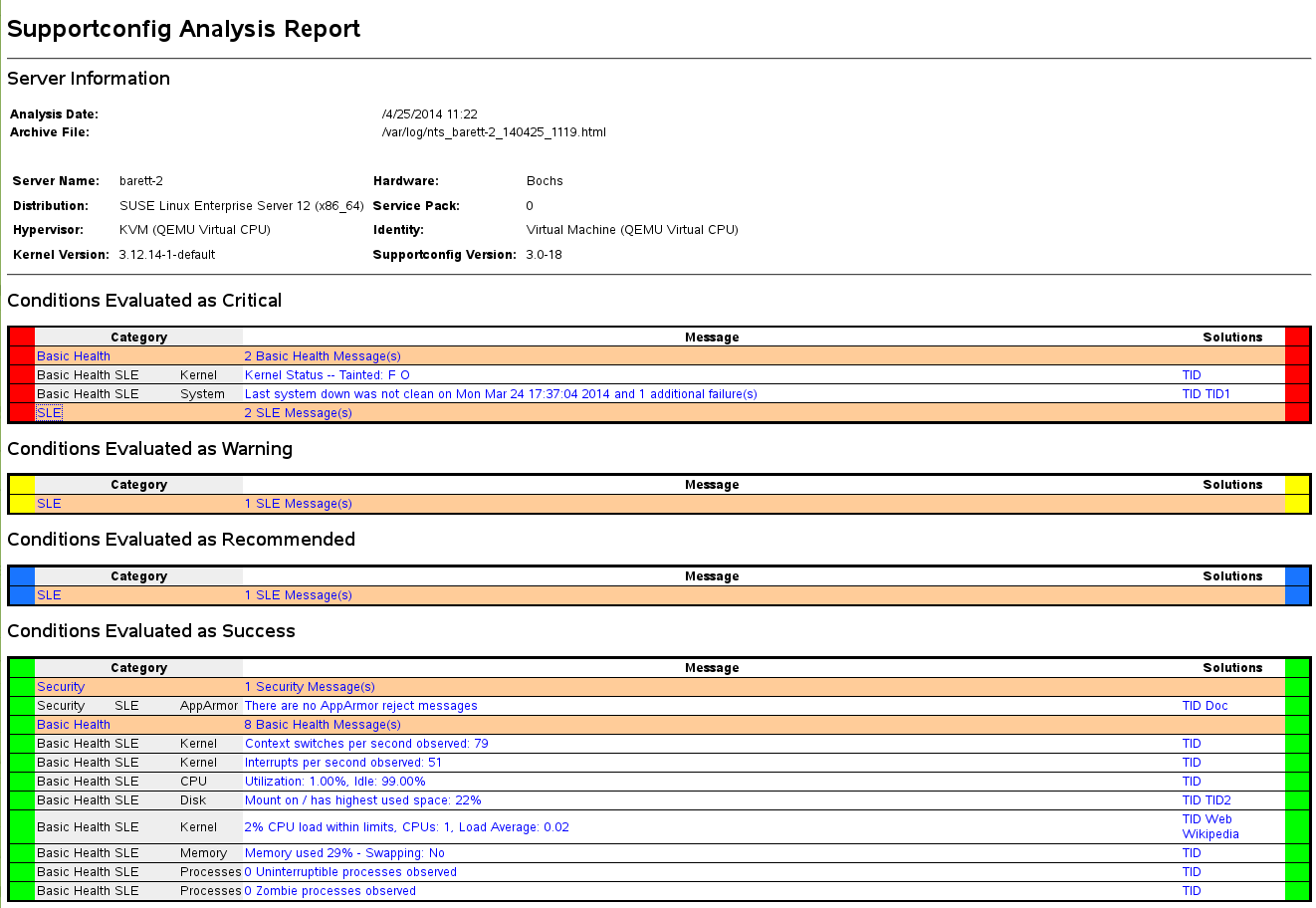

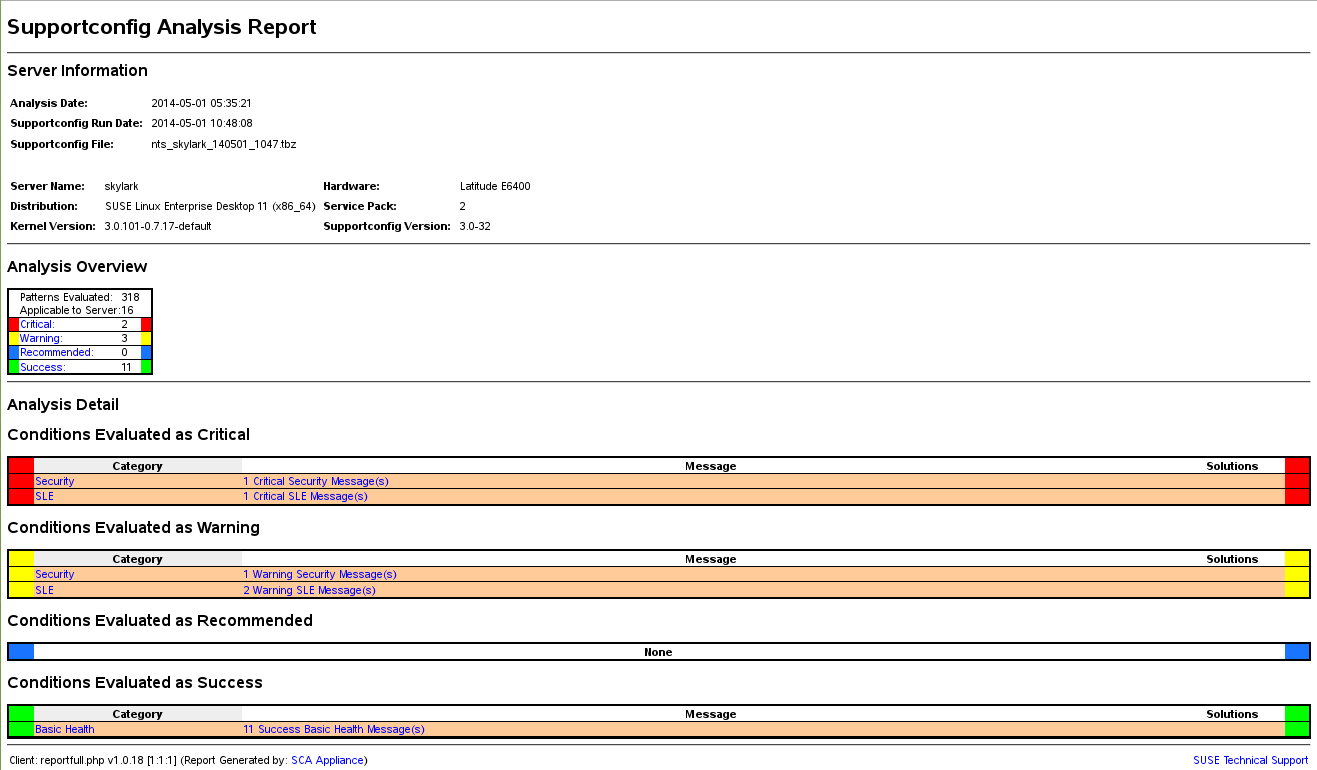

- 47 Erfassen der Systeminformationen für den Support

- 47.1 Anzeigen aktueller Systeminformationen

- 47.2 Erfassen von Systeminformationen mit supportconfig

- 47.3 Übertragen von Informationen an den globalen technischen Support

- 47.4 Analysieren von Systeminformationen

- 47.5 Sammeln von Informationen bei der Installation

- 47.6 Unterstützung für Kernelmodule

- 47.7 Weitere Informationen

- 48 Häufige Probleme und deren Lösung

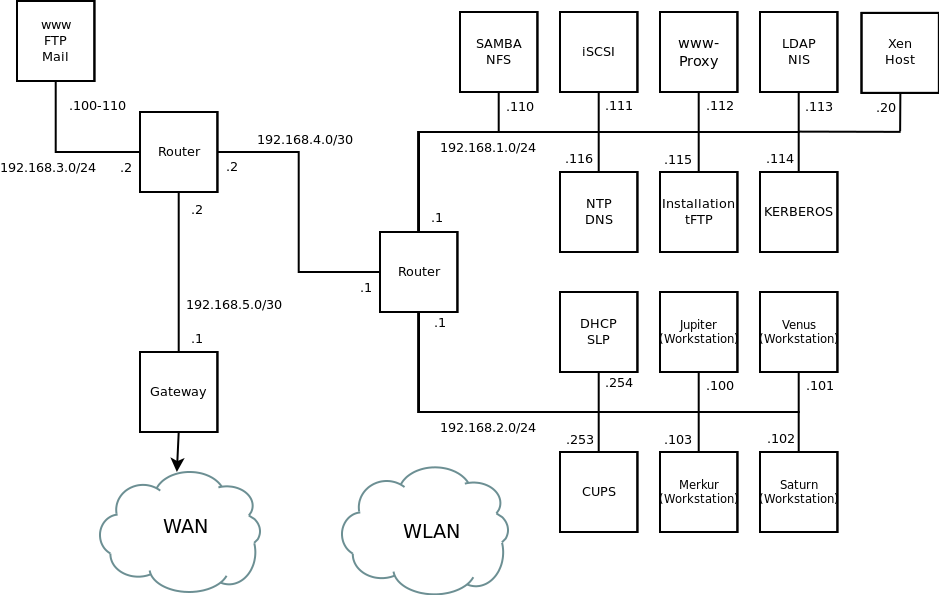

- A Ein Beispielnetzwerk

- B GNU licenses

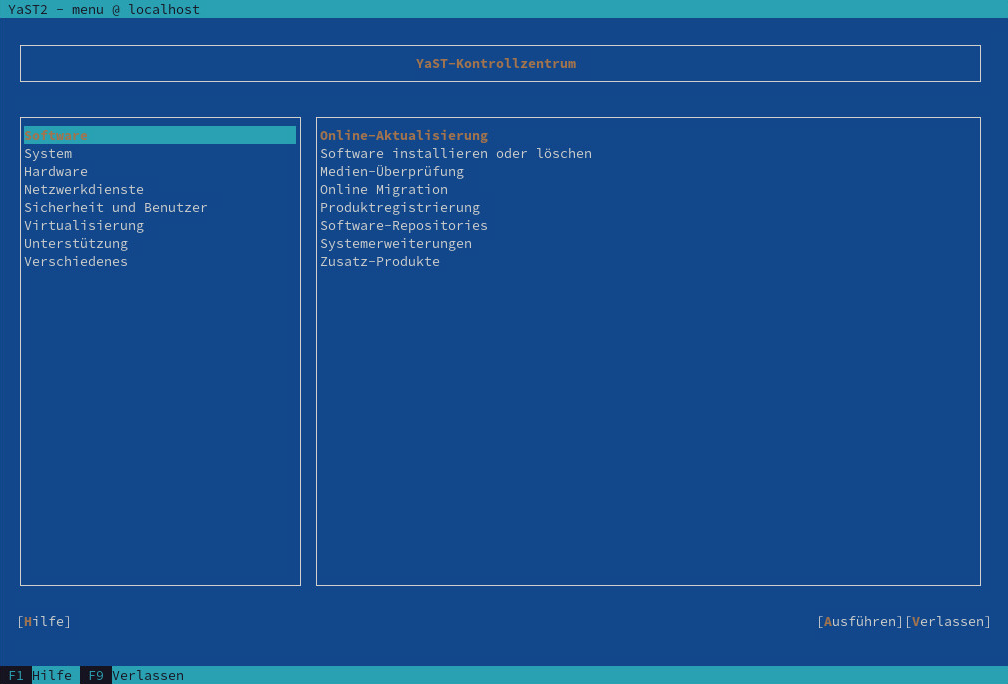

- 4.1 Hauptfenster von YaST im Textmodus

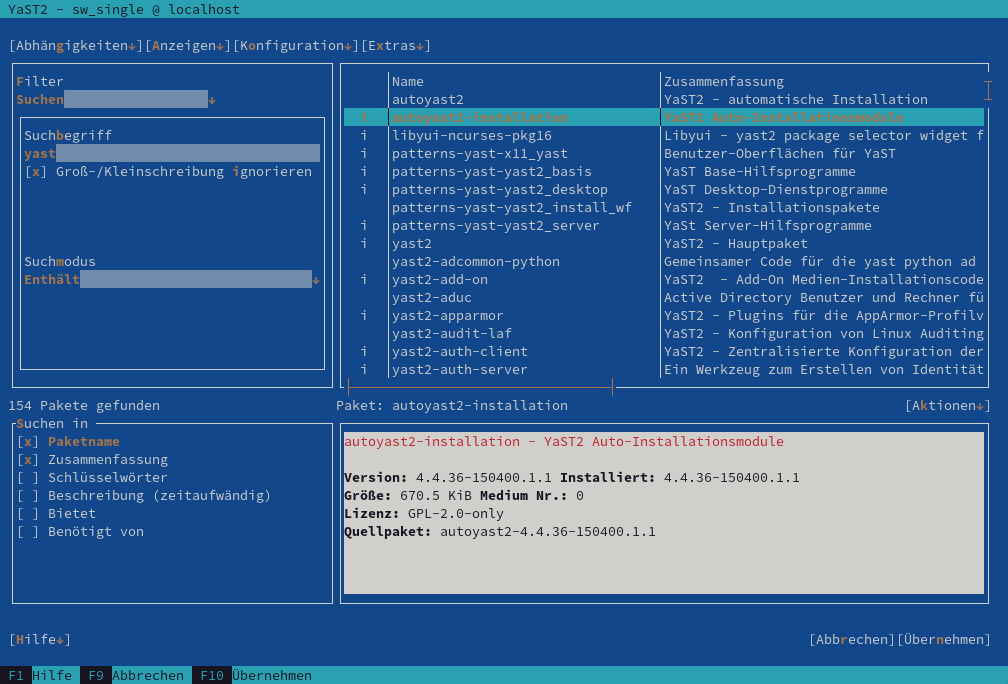

- 4.2 Das Software-Installationsmodul

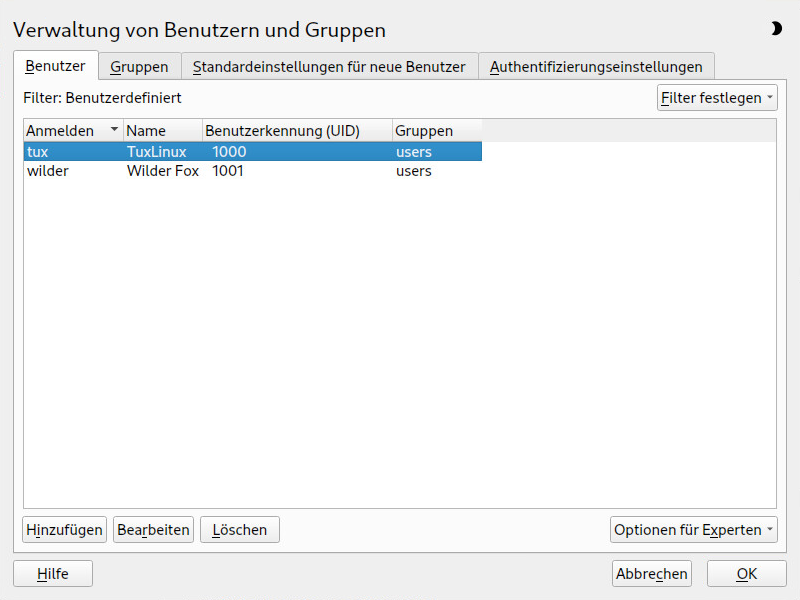

- 6.1 YaST – Verwaltung von Benutzern und Gruppen

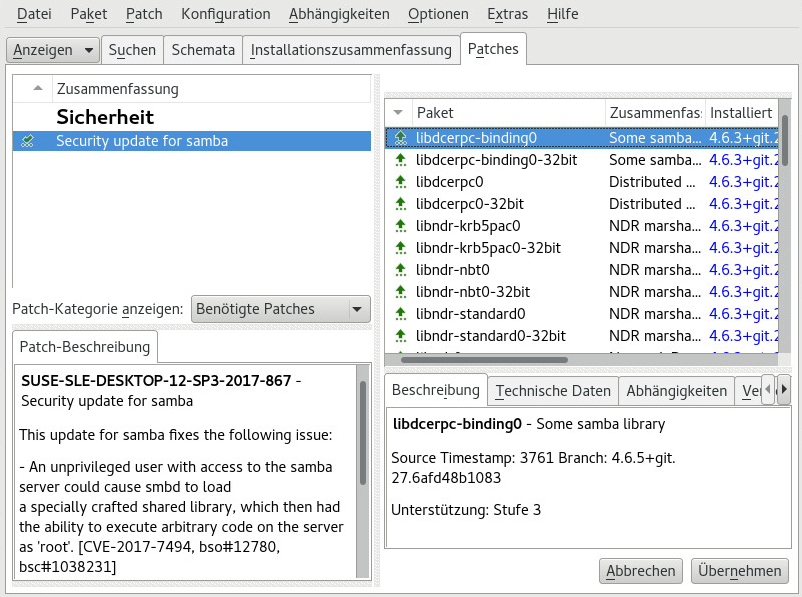

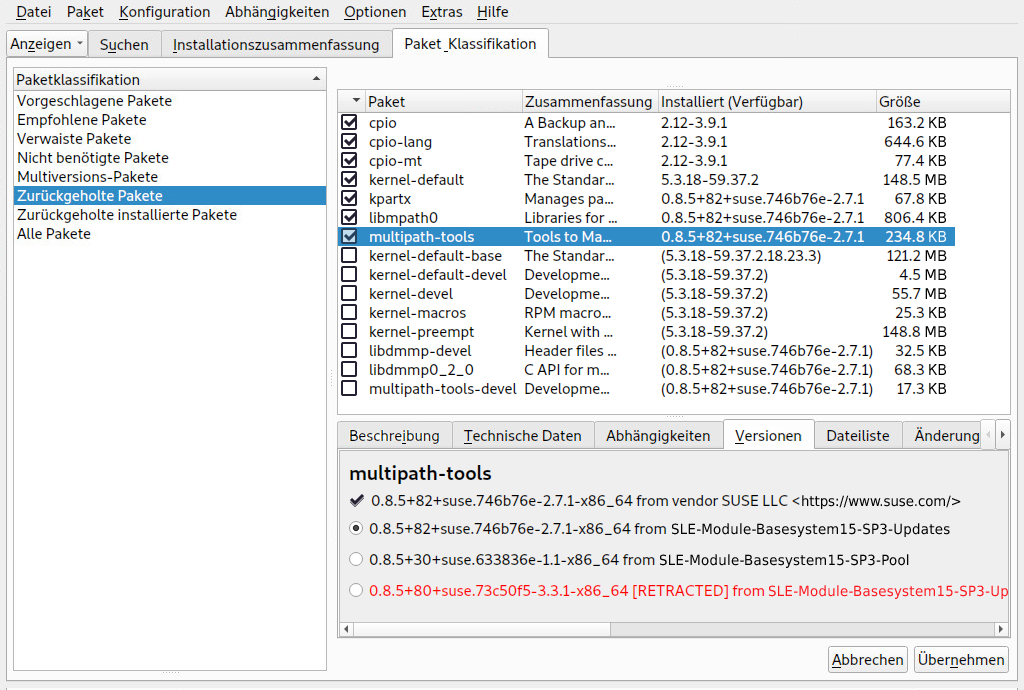

- 7.1 YaST-Online-Aktualisierung

- 7.2 Anzeigen von zurückgezogenen Patches und ihres Verlaufs

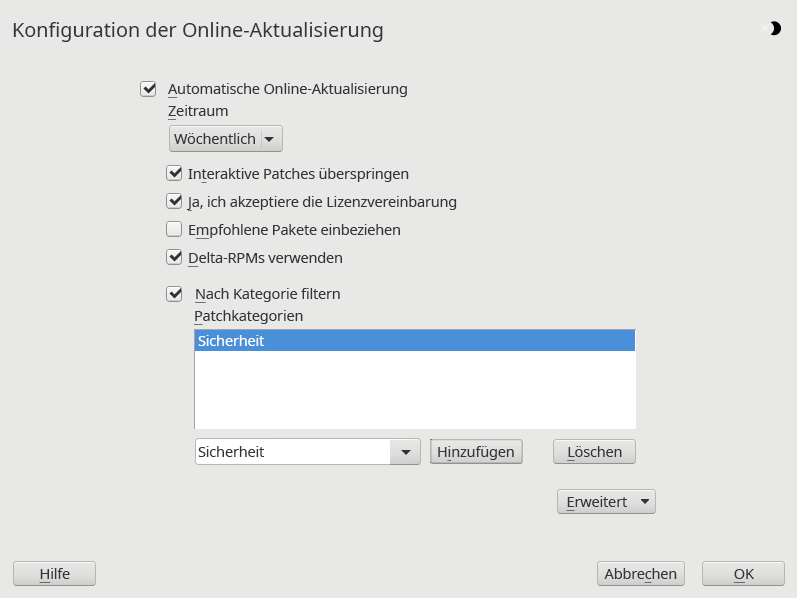

- 7.3 Konfiguration der YaST-Online-Aktualisierung

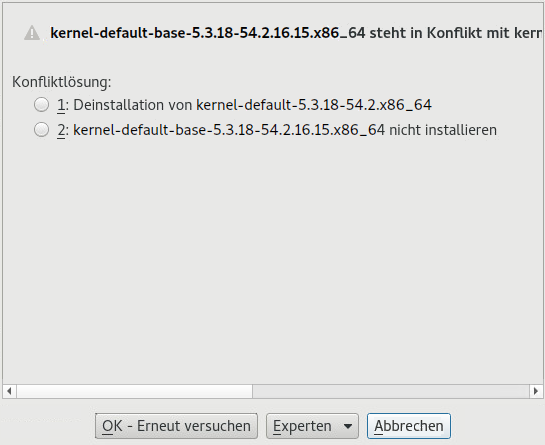

- 8.1 Konfliktverwaltung des Software-Managers

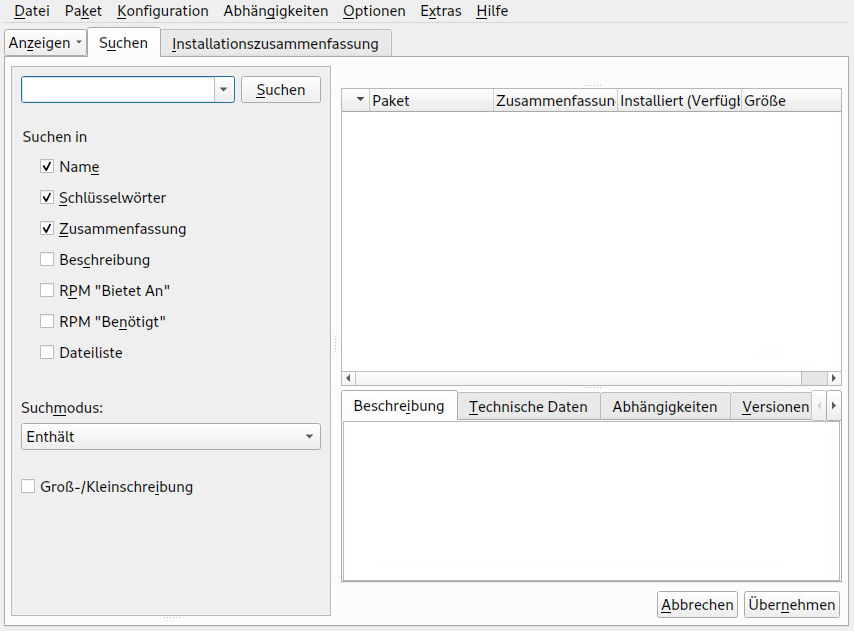

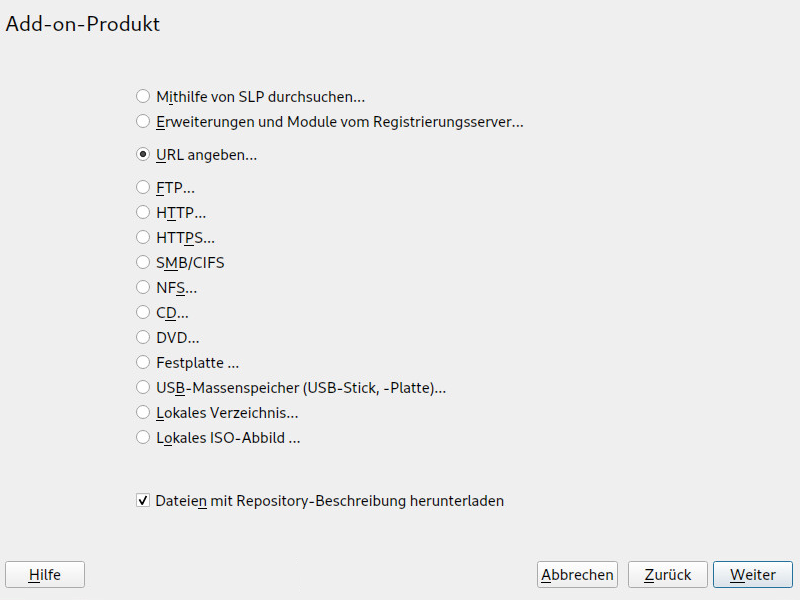

- 8.2 Hinzufügen eines Software-Repositorys

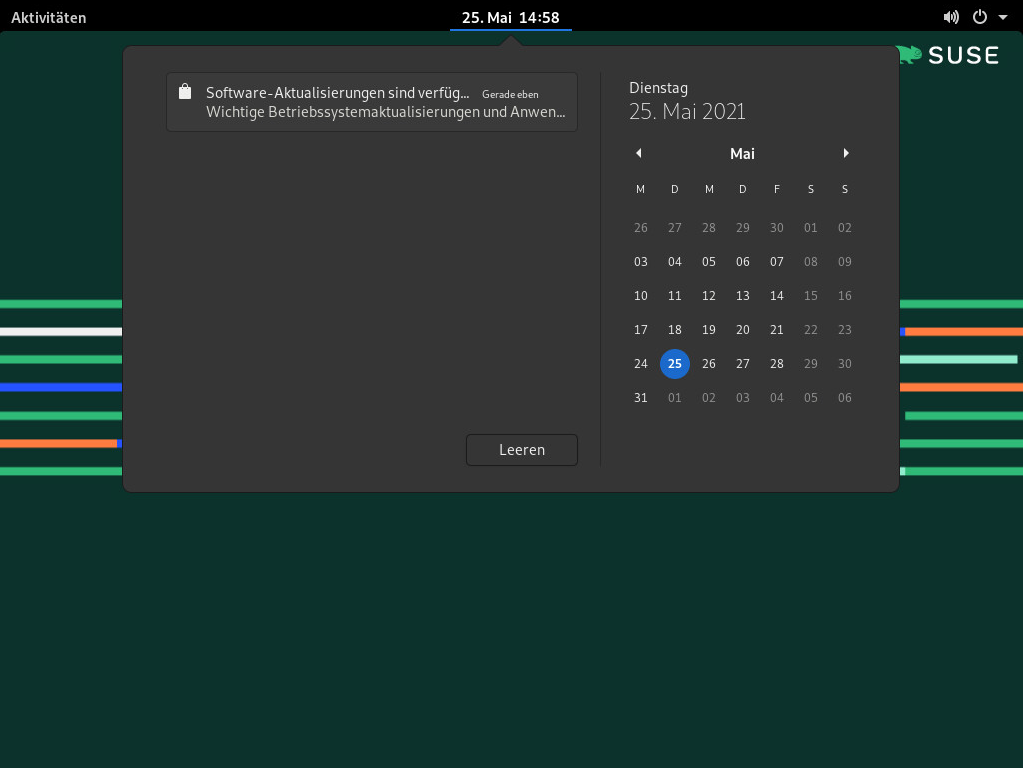

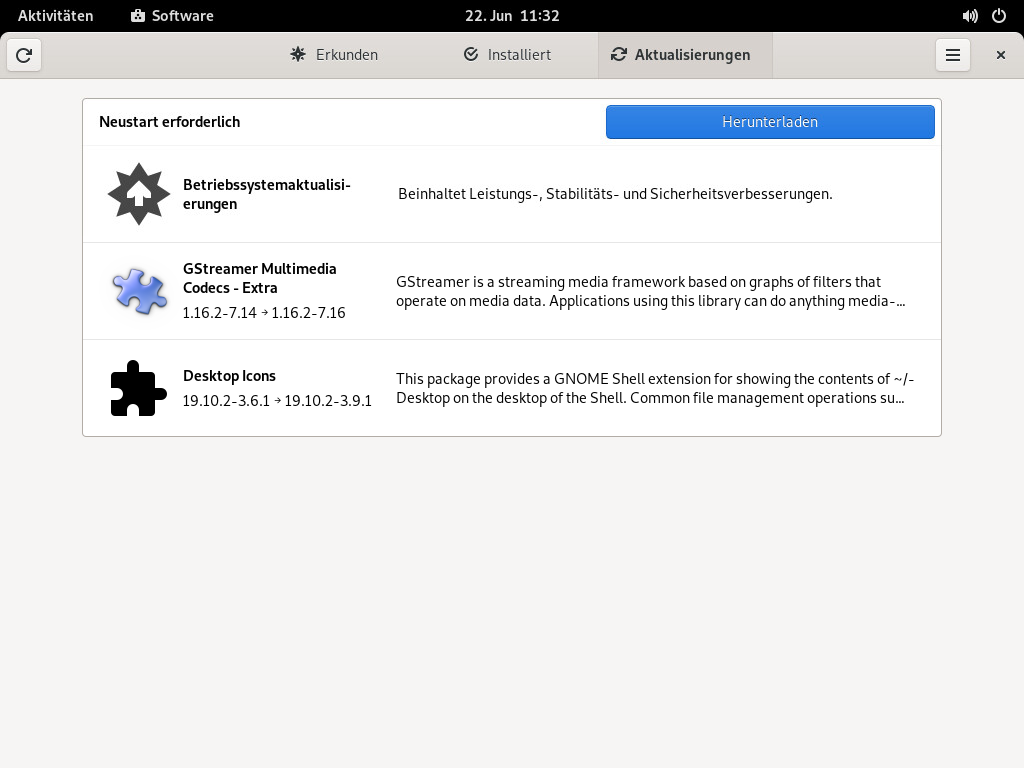

- 8.3 Aktualisierungsbenachrichtigung auf dem GNOME-Desktop

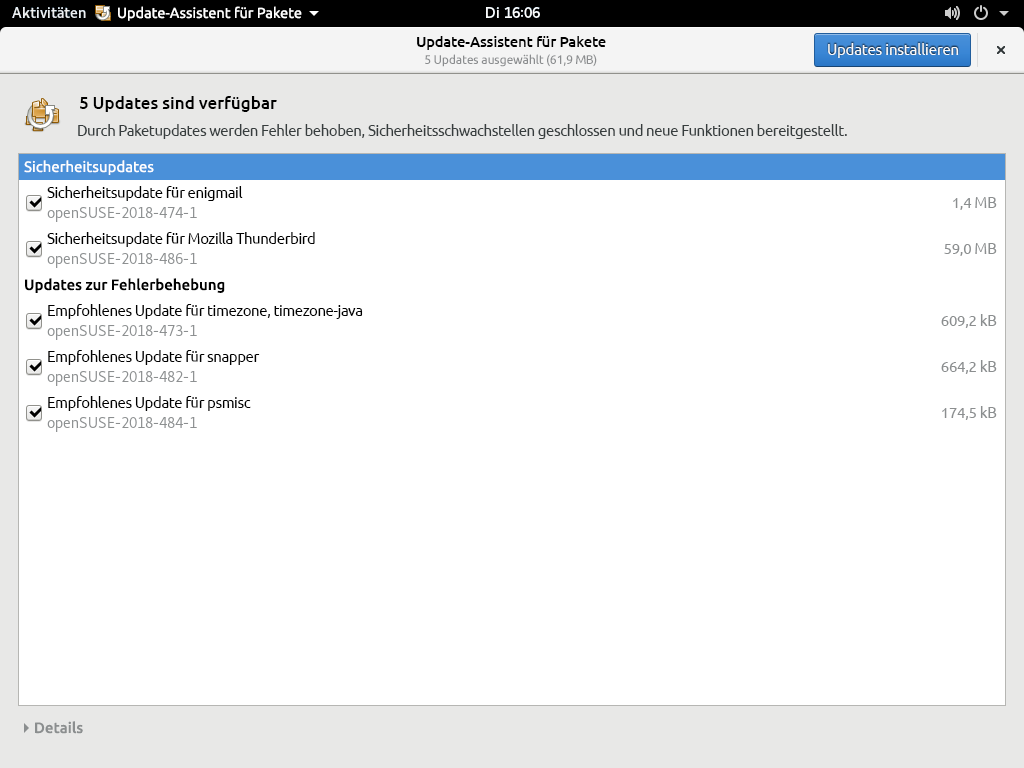

- 8.4 – Ansicht

- 10.1 Bootloader: Snapshots

- 14.1 vncviewer

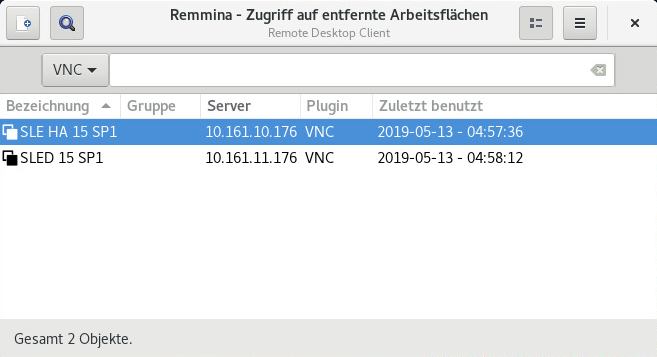

- 14.2 Hauptfenster von Remmina

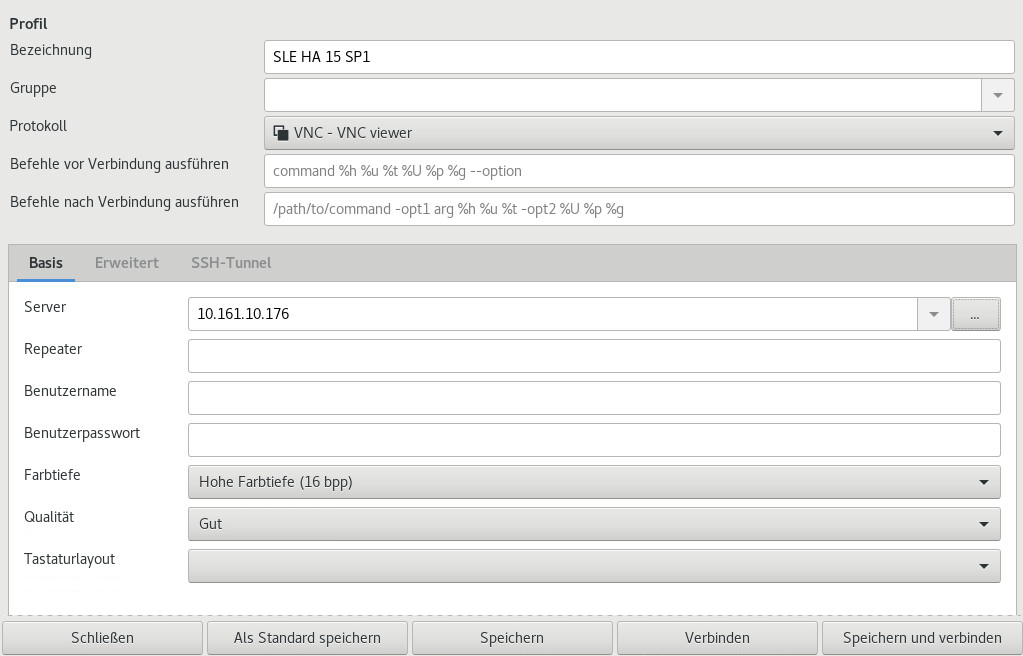

- 14.3 Remote Desktop Preference

- 14.4 Schnellstart

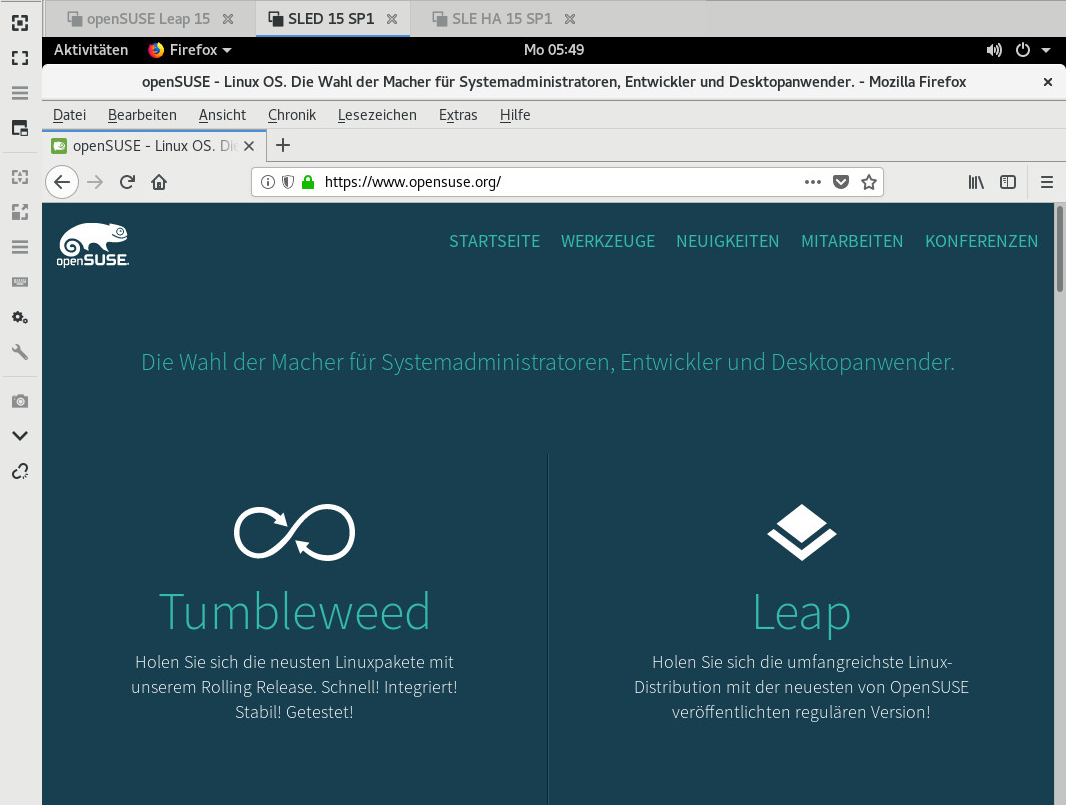

- 14.5 Remmina-Remote-Sitzung mit Anzeige

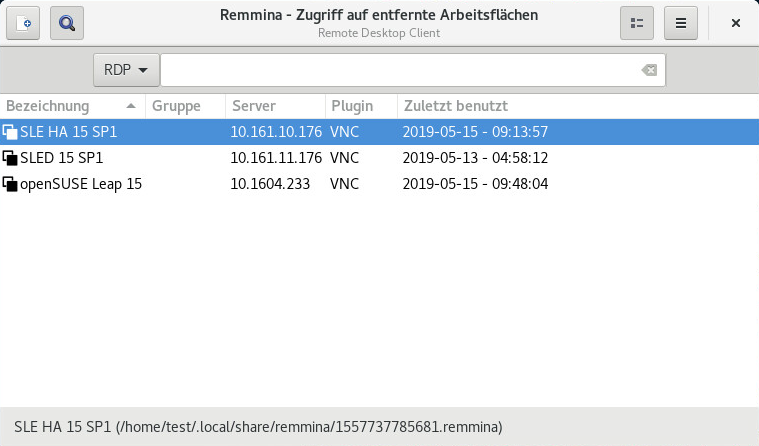

- 14.6 Pfad zur Profildatei

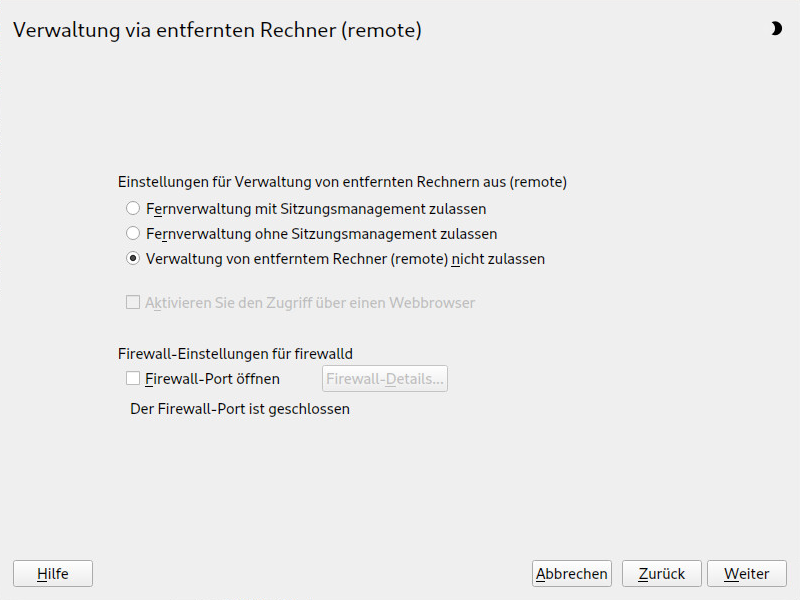

- 14.7 Fernverwaltung

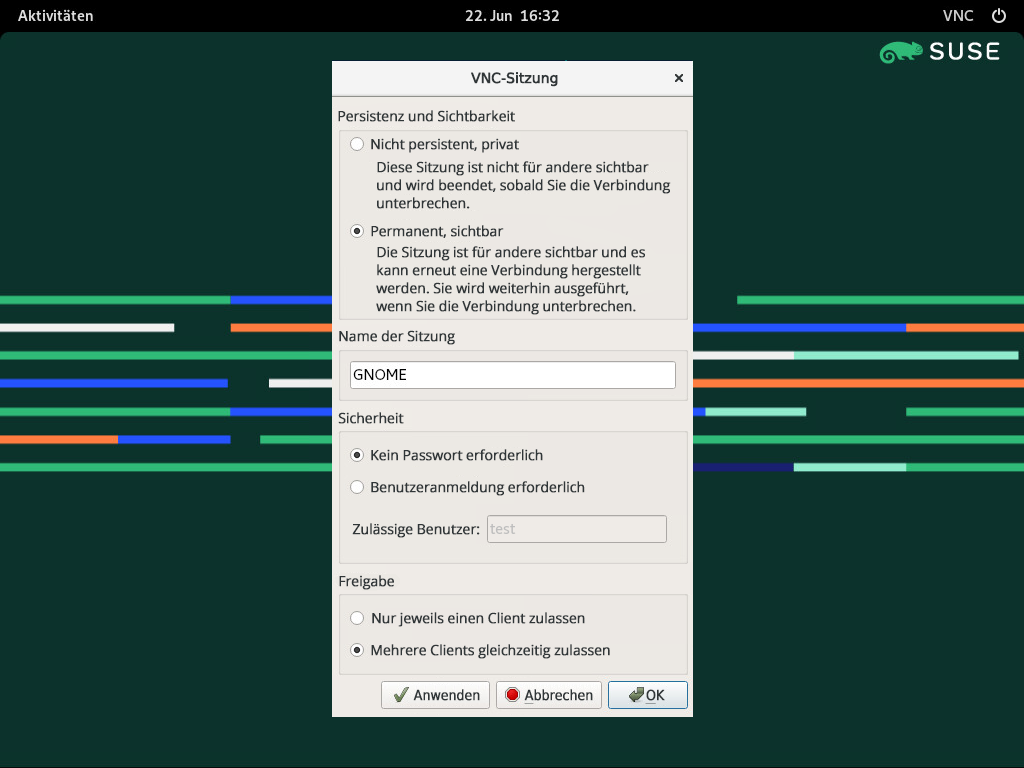

- 14.8 VNC-Sitzungseinstellungen

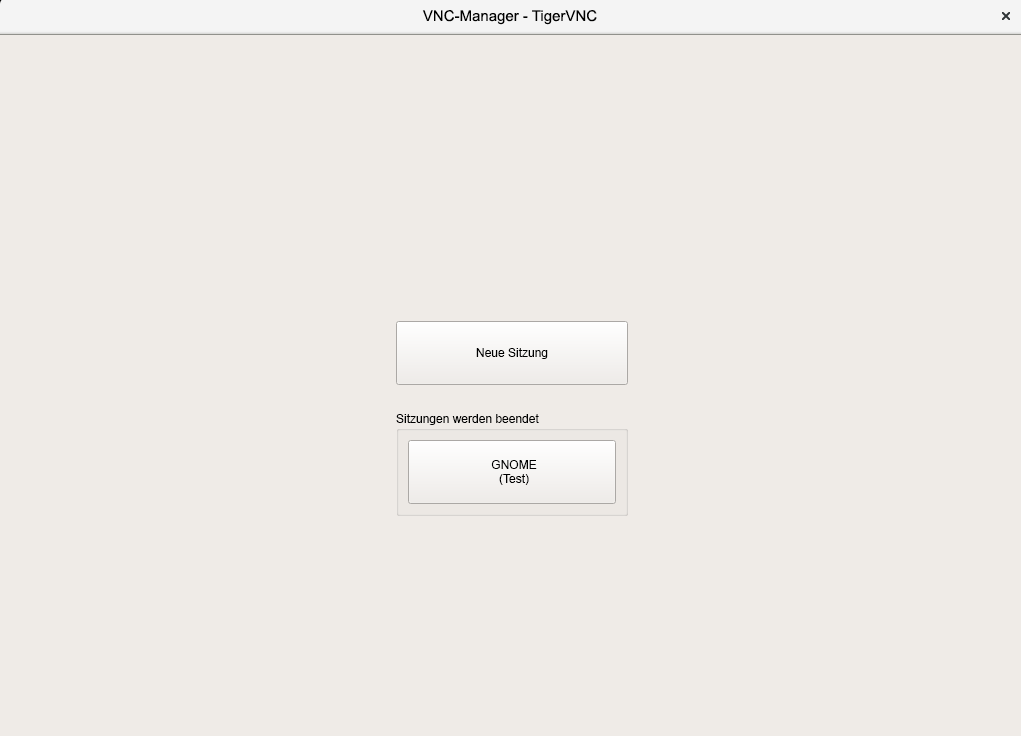

- 14.9 Beitreten zu einer permanenten VNC-Sitzung

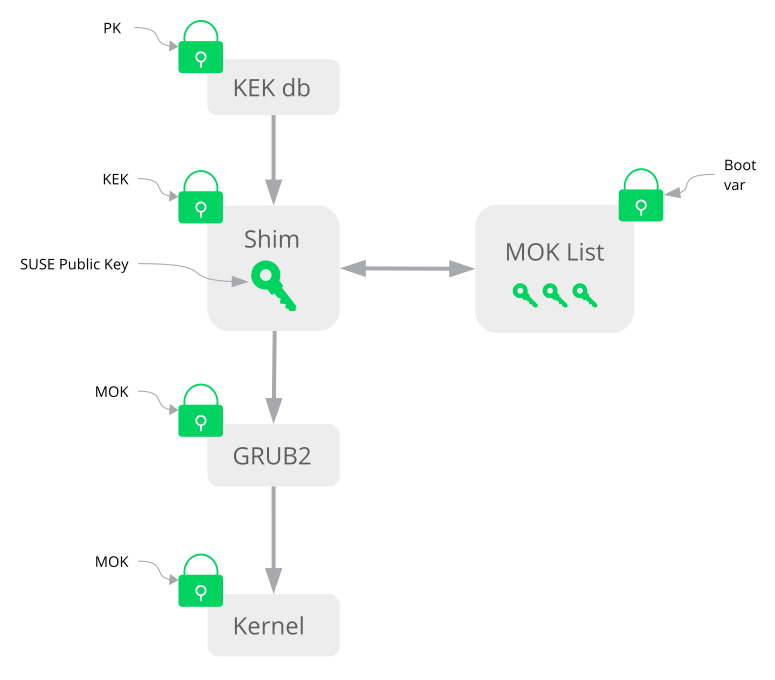

- 17.1 Secure Boot-Unterstützung

- 17.2 UEFI: Secure Boot-Vorgang

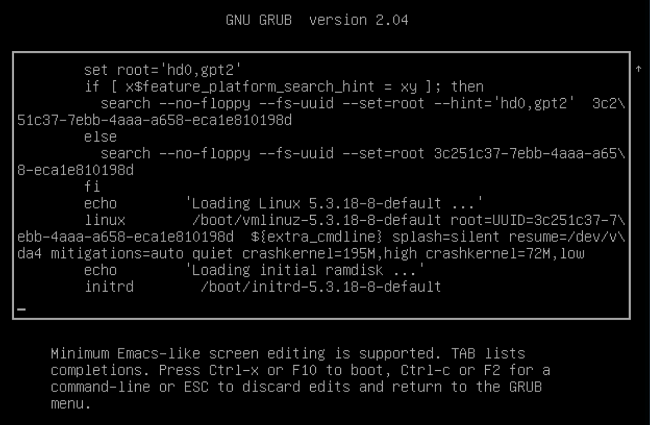

- 18.1 Booteditor in GRUB 2

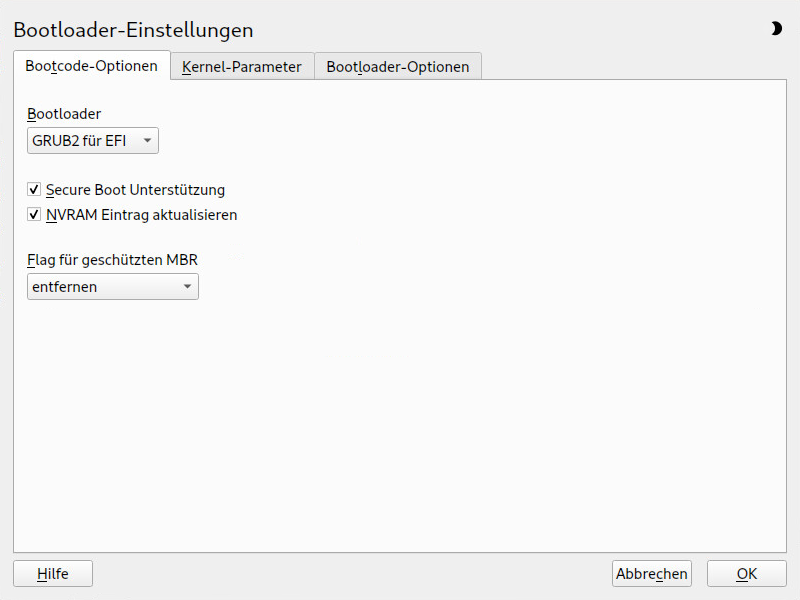

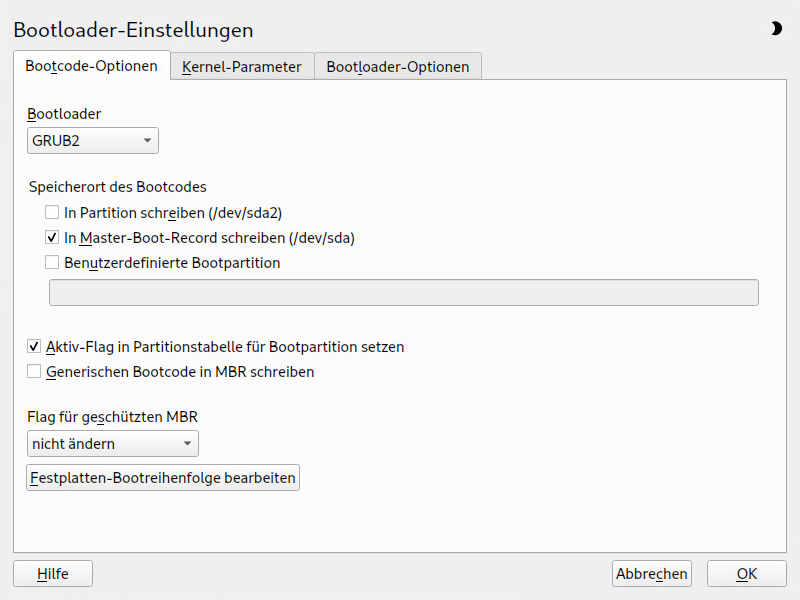

- 18.2 Bootcode-Optionen

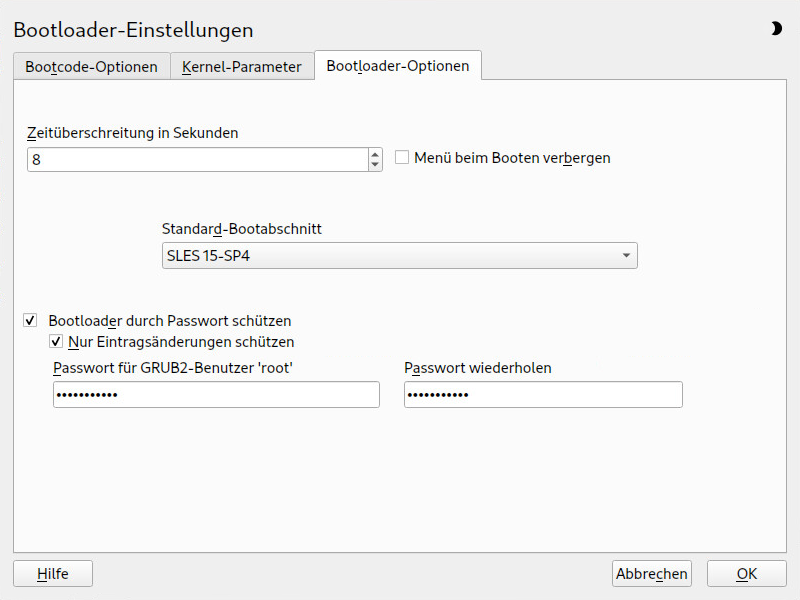

- 18.3 Bootloader-Optionen

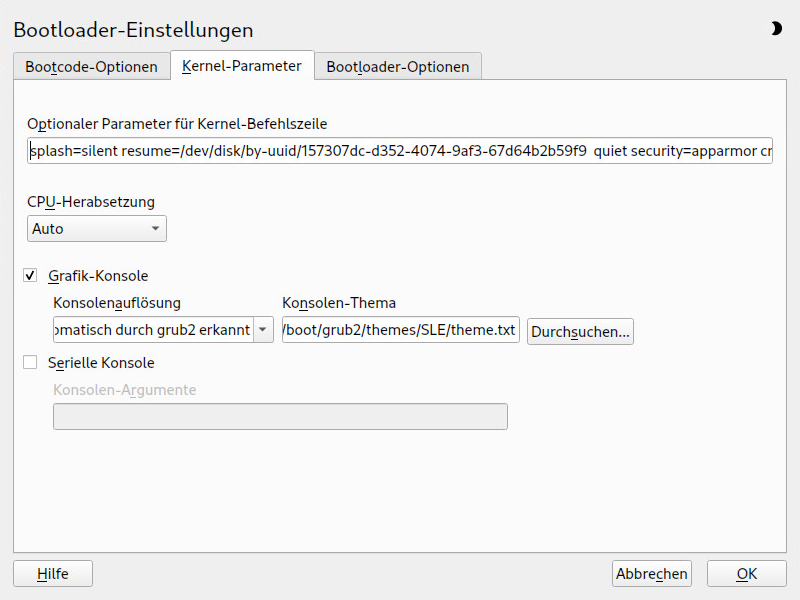

- 18.4 Kernel-Parameter

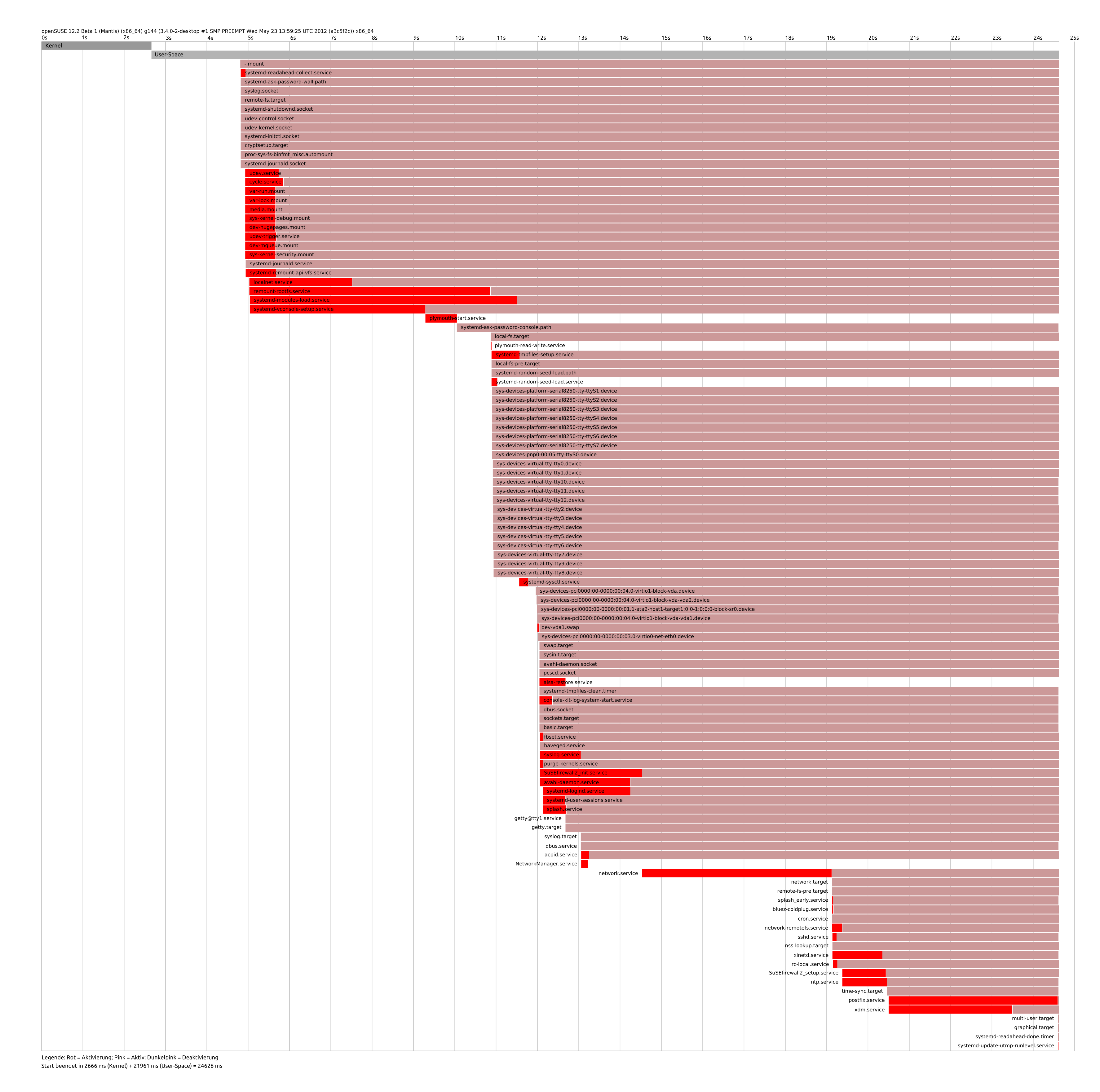

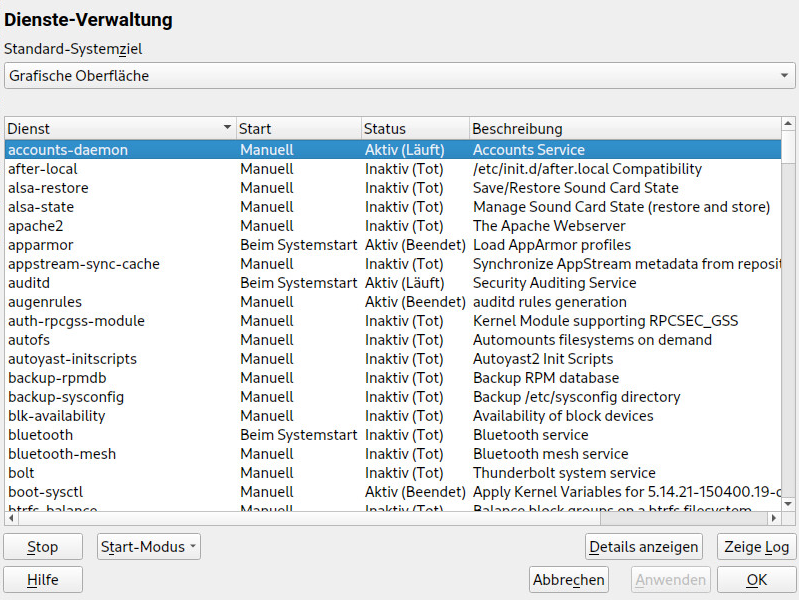

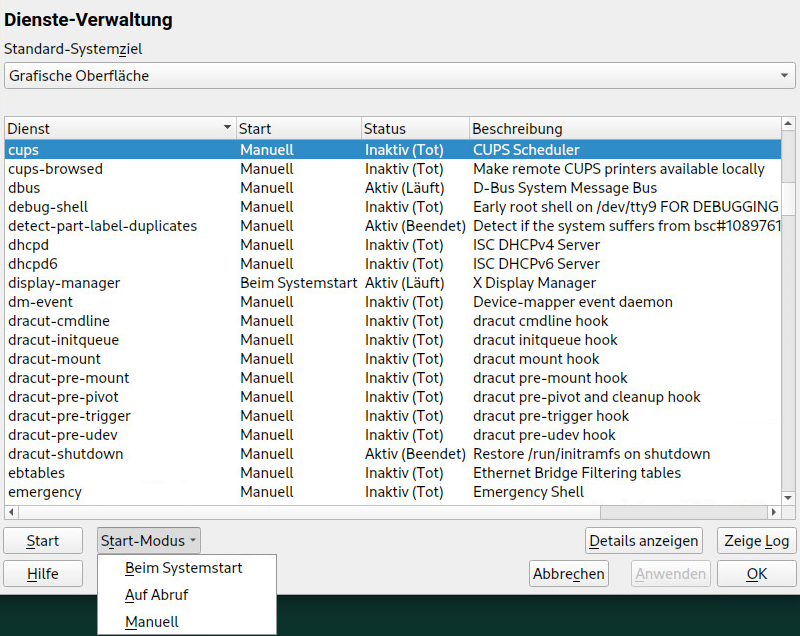

- 19.1 Services Manager

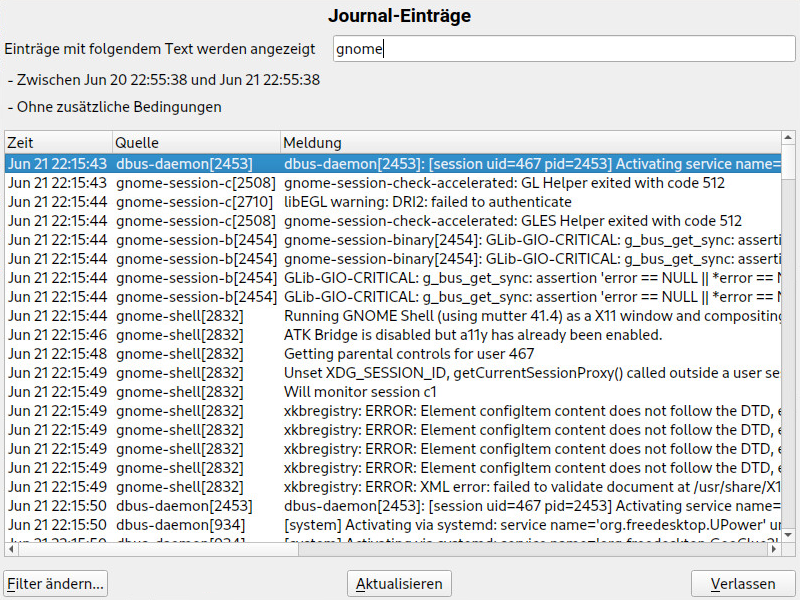

- 21.1 YaST-systemd-Journal

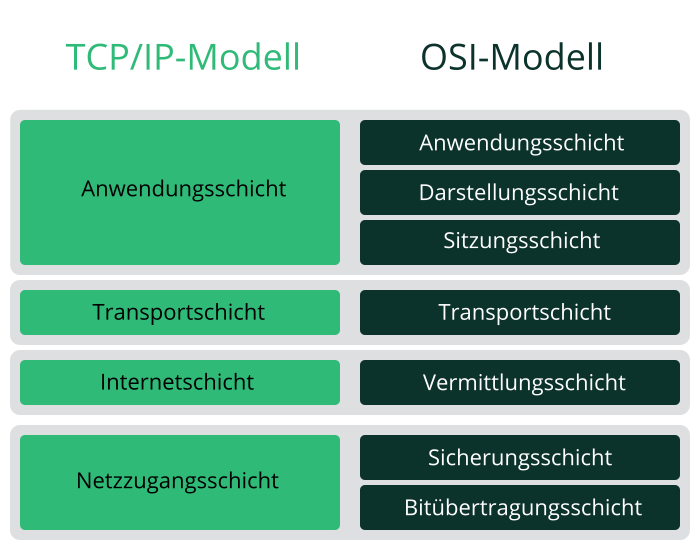

- 23.1 Vereinfachtes Schichtmodell für TCP/IP

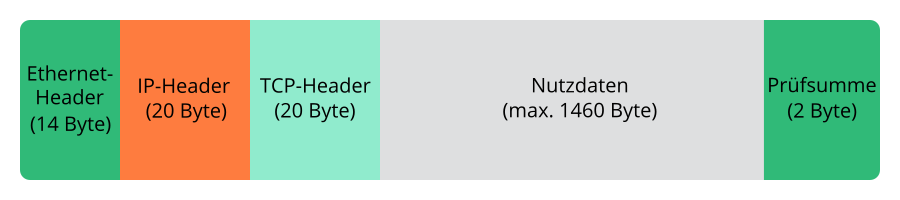

- 23.2 TCP/IP-Ethernet-Paket

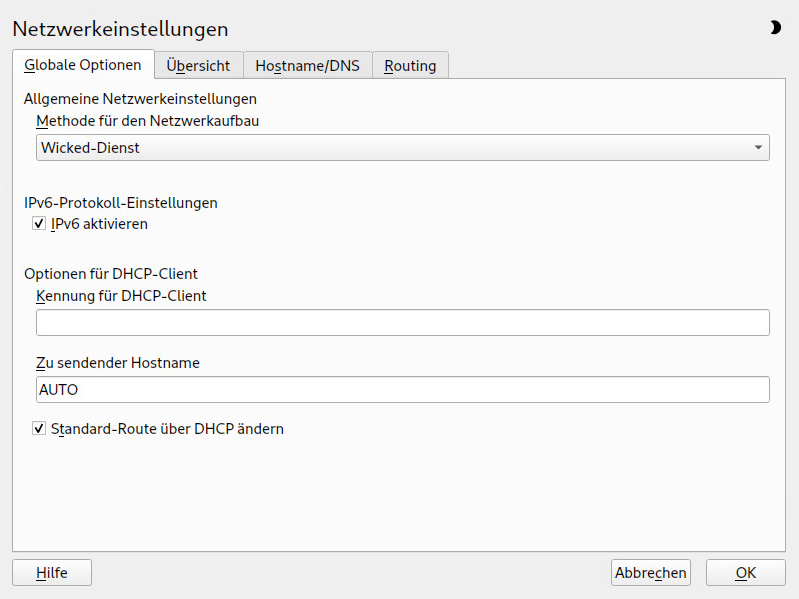

- 23.3 Konfigurieren der Netzwerkeinstellungen

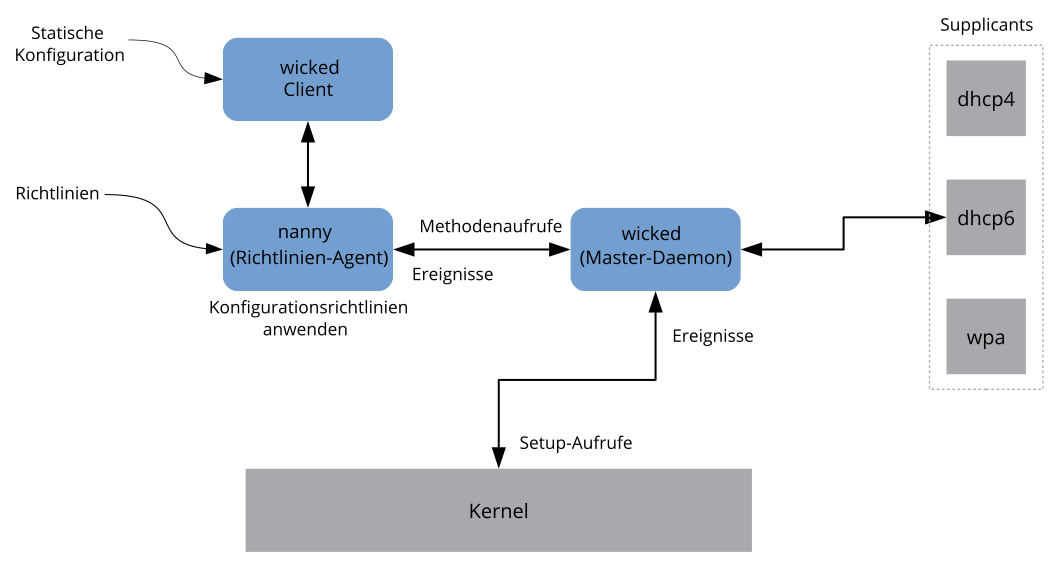

- 23.4

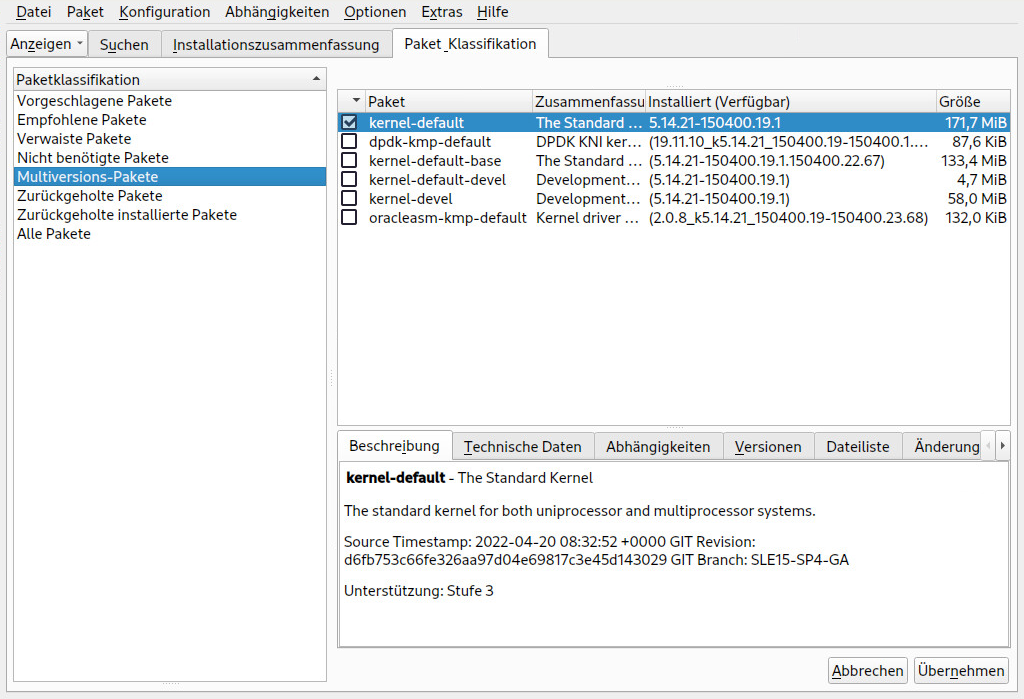

wicked-Architektur - 27.1 Der YaST-Software-Manager: Multiversionsanzeige

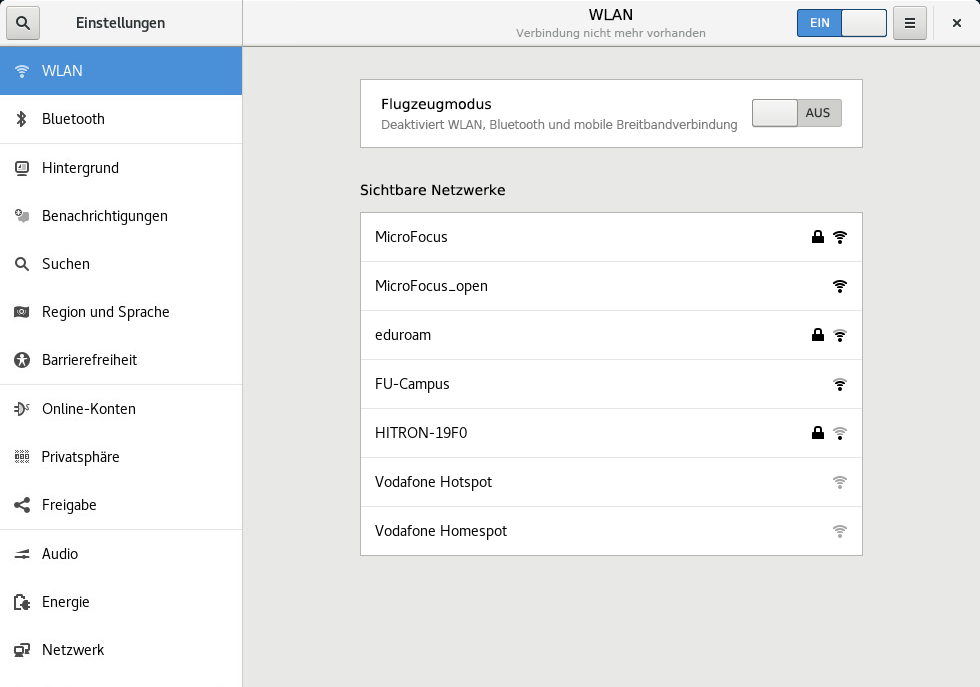

- 31.1 Dialogfeld „Netzwerkverbindungen“ in GNOME

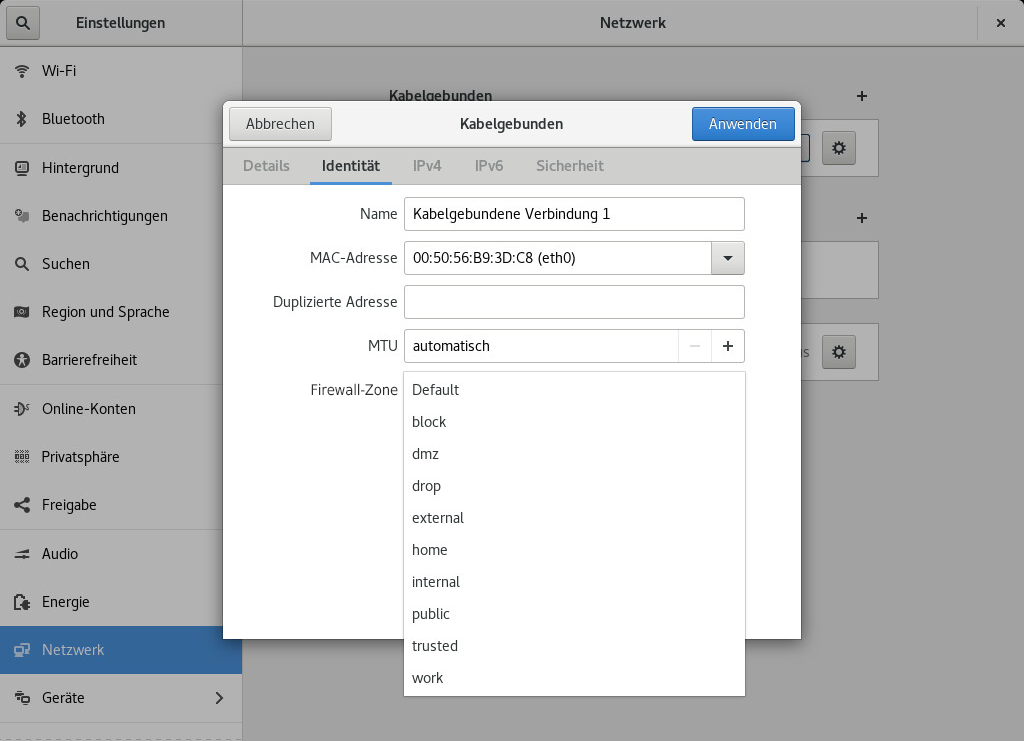

- 31.2

firewalld-Zonen in NetworkManager - 37.1 YaST Service-Manager

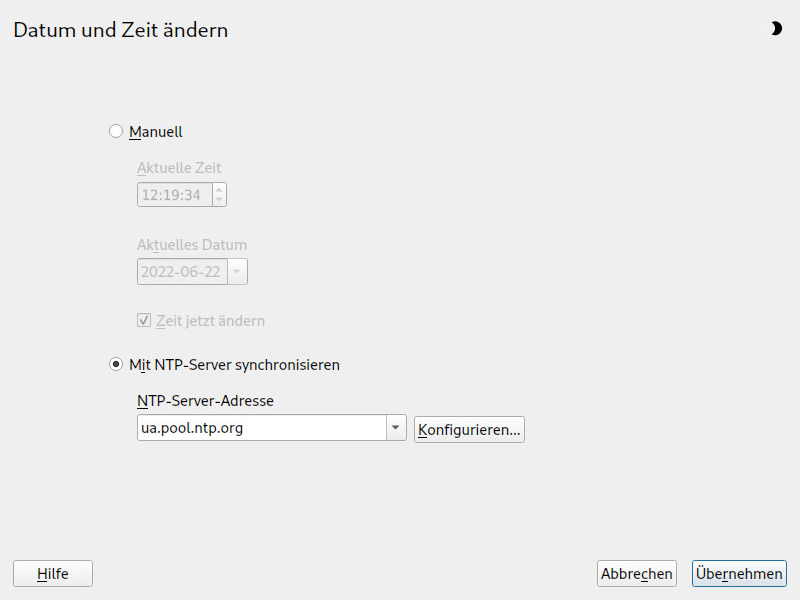

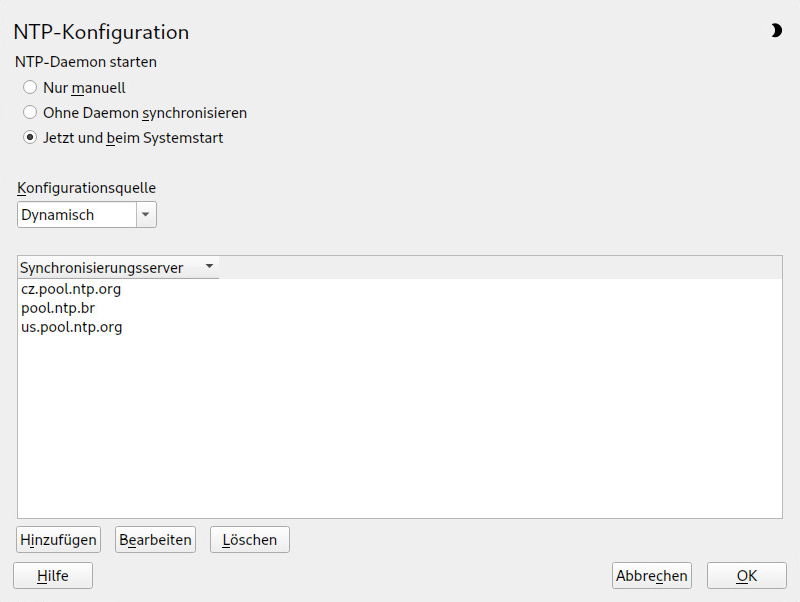

- 38.1 Fenster „NTP-Konfiguration“

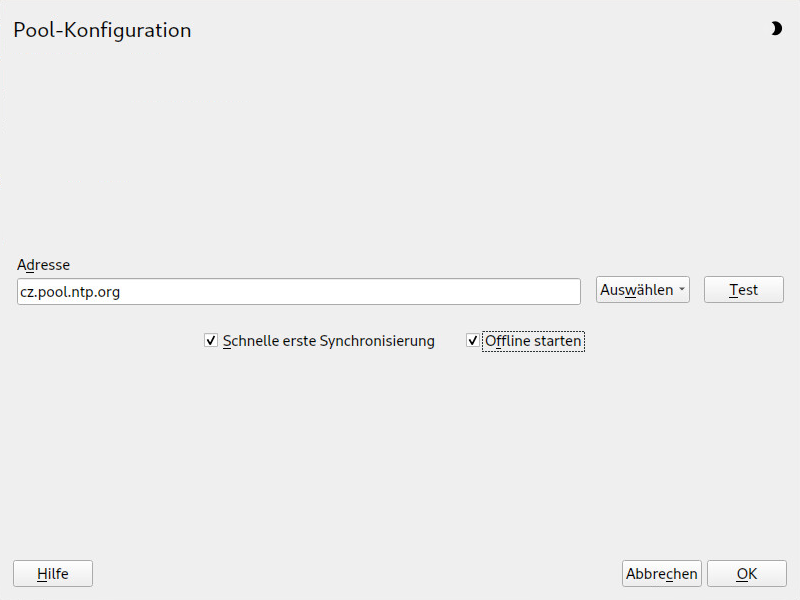

- 38.2 Hinzufügen eines Zeitservers

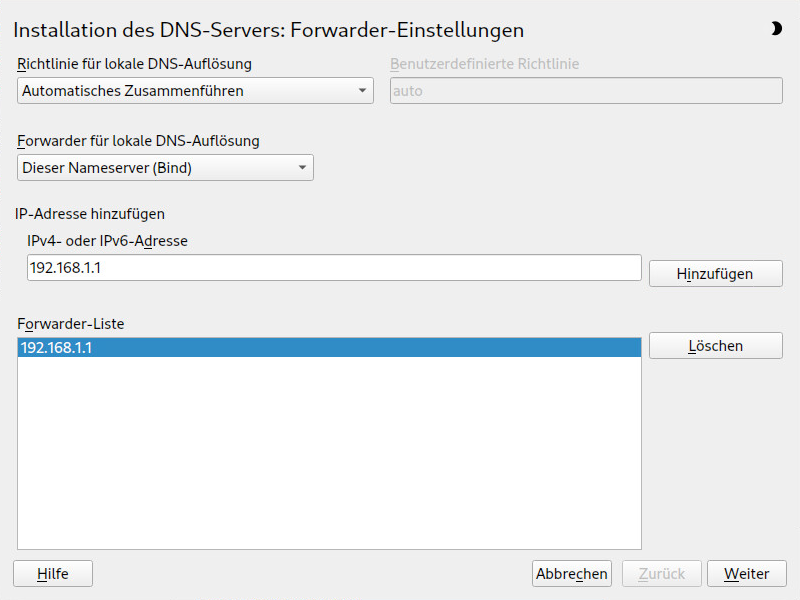

- 39.1 DNS-Server-Installation: Forwarder-Einstellungen

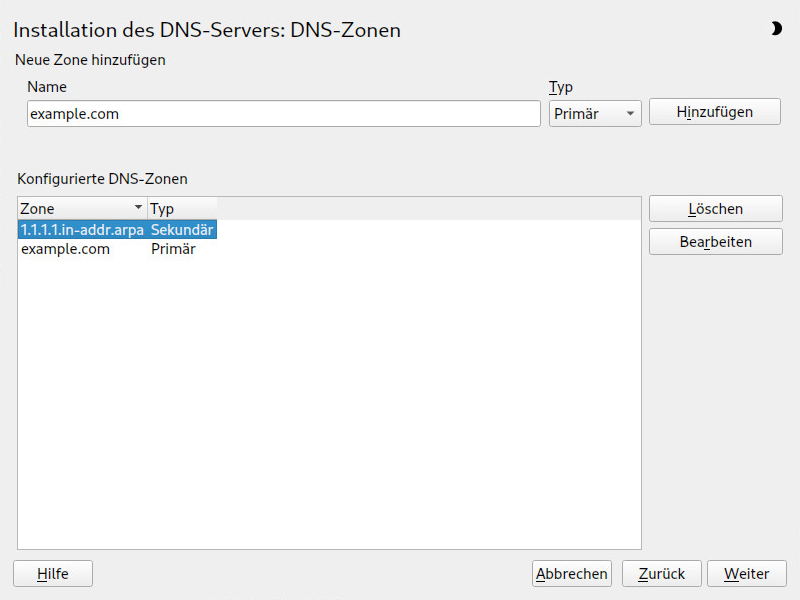

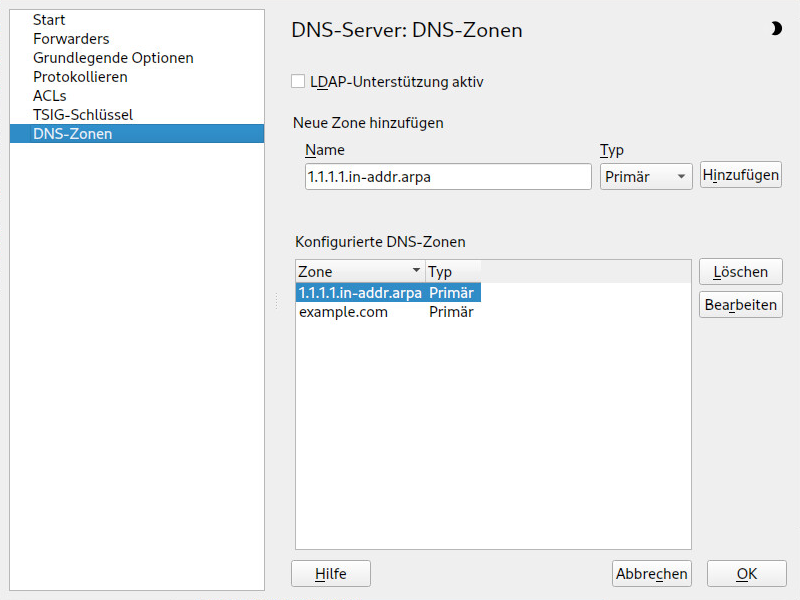

- 39.2 DNS-Server-Installation: DNS-Zonen

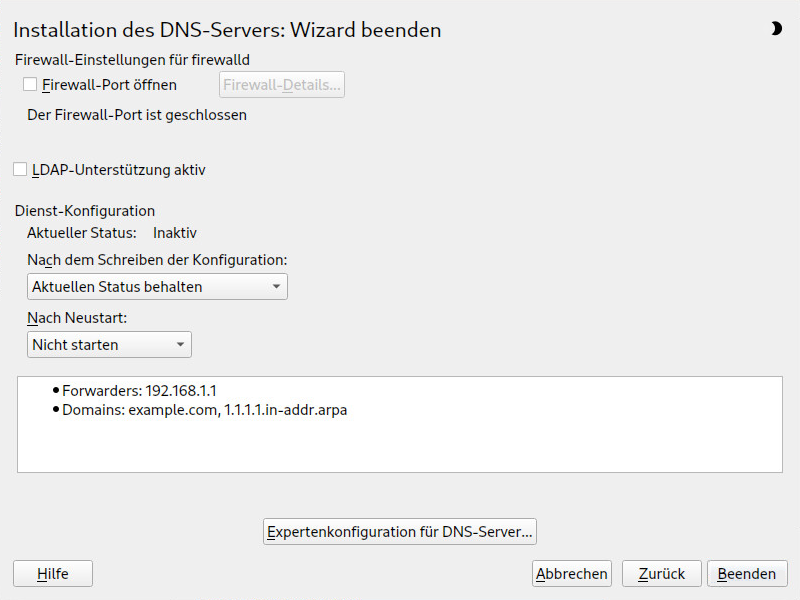

- 39.3 DNS-Server-Installation: Wizard beenden

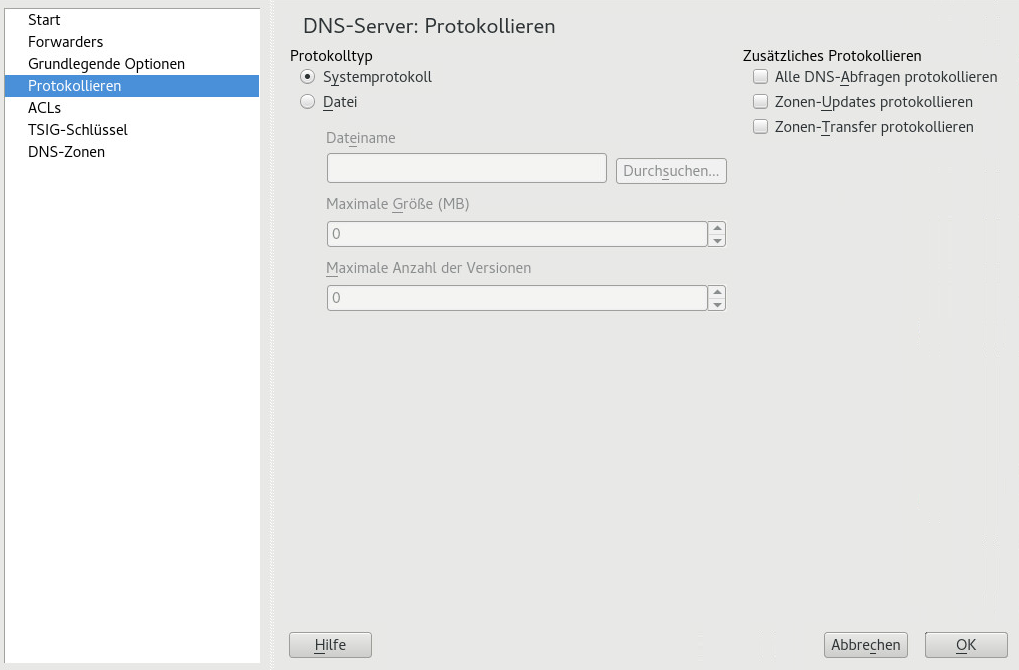

- 39.4 DNS-Server: Protokollieren

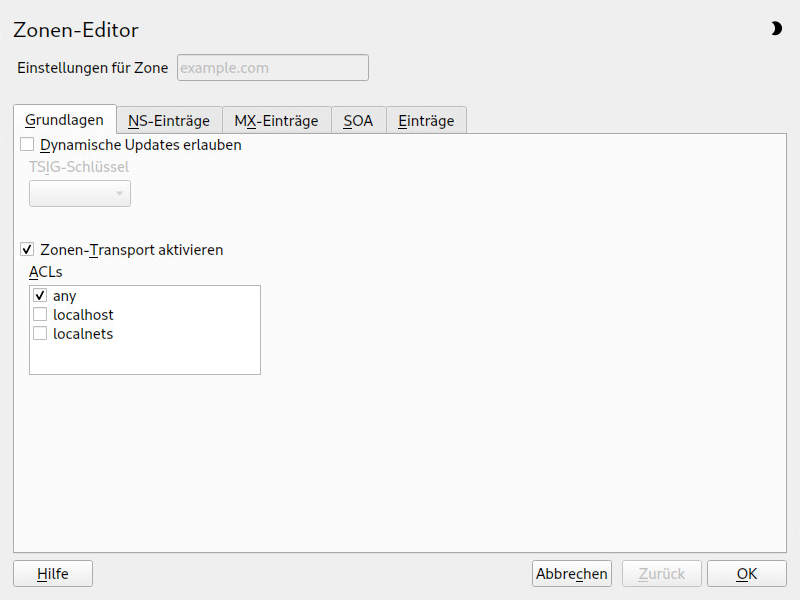

- 39.5 DNS-Server: Zonen-Editor (Grundlagen)

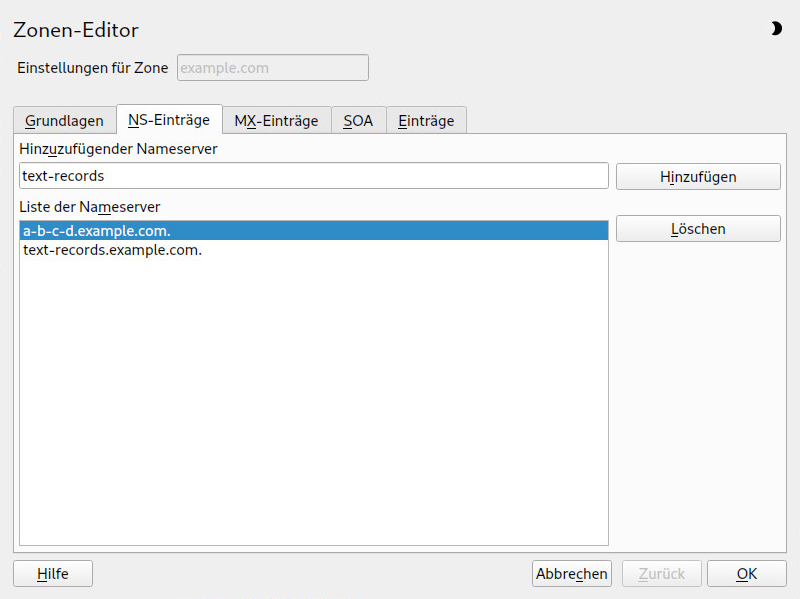

- 39.6 DNS-Server: Zonen-Editor (NS-Einträge)

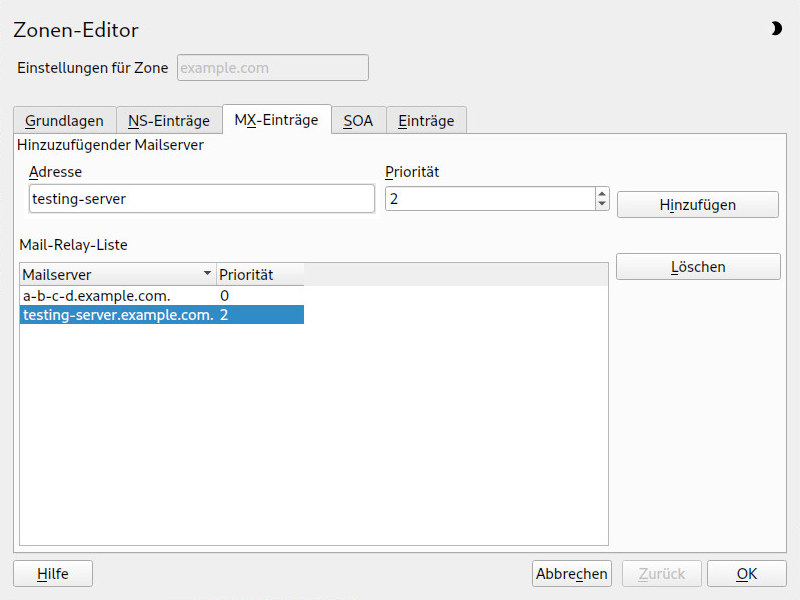

- 39.7 DNS-Server: Zonen-Editor (MX-Einträge)

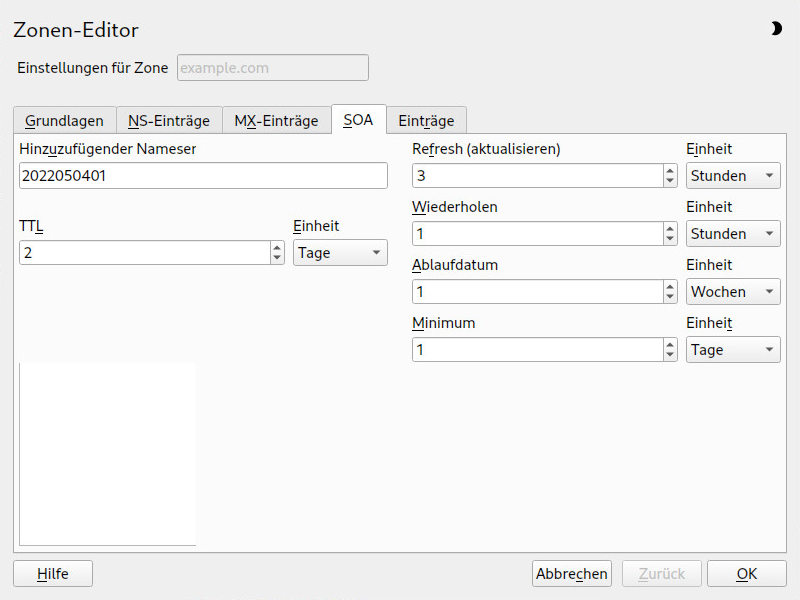

- 39.8 DNS-Server: Zonen-Editor (SOA)

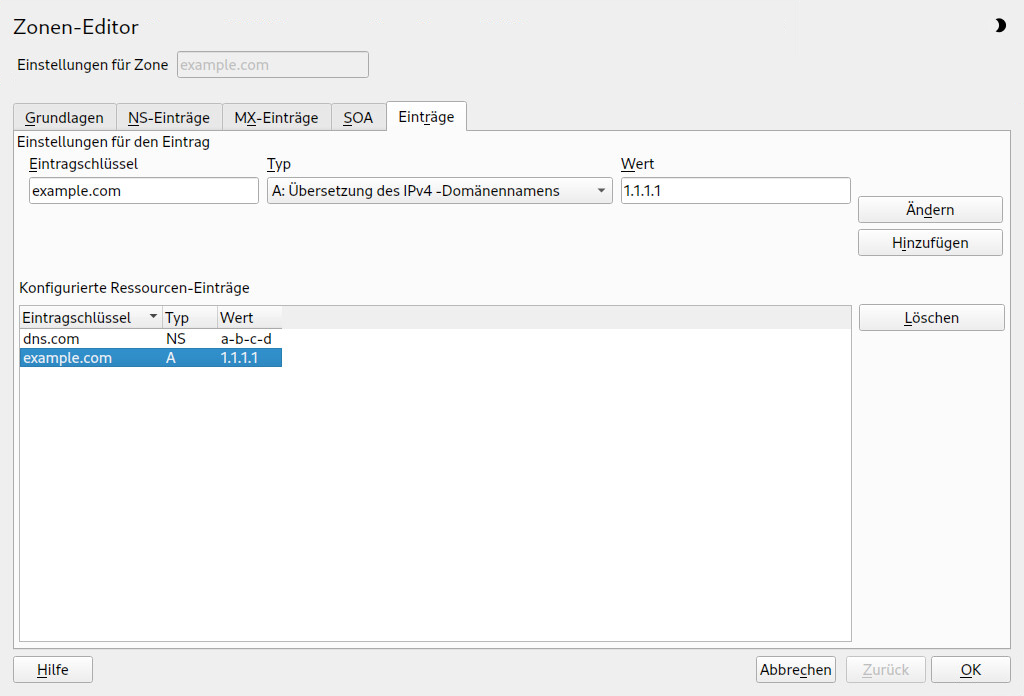

- 39.9 Hinzufügen eines Eintrags für eine primäre Zone

- 39.10 Hinzufügen einer Reverse Zone

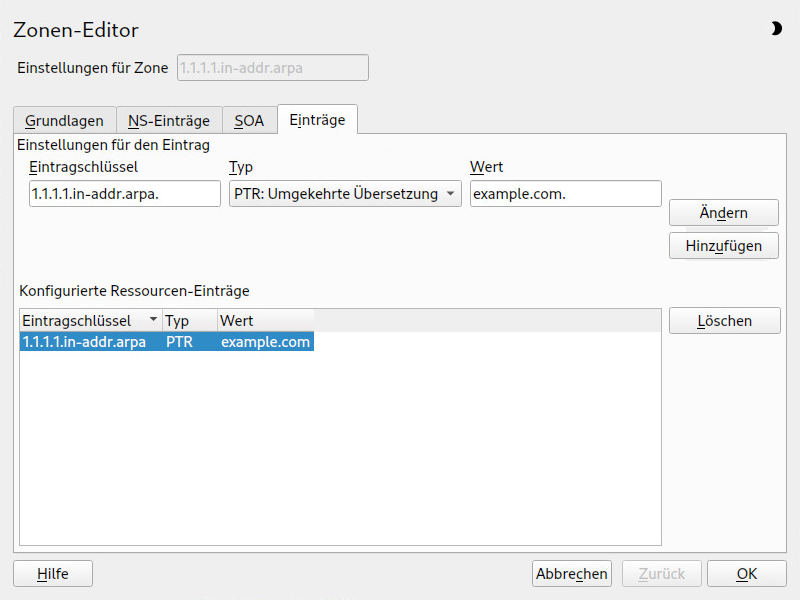

- 39.11 Hinzufügen eines Reverse-Eintrags

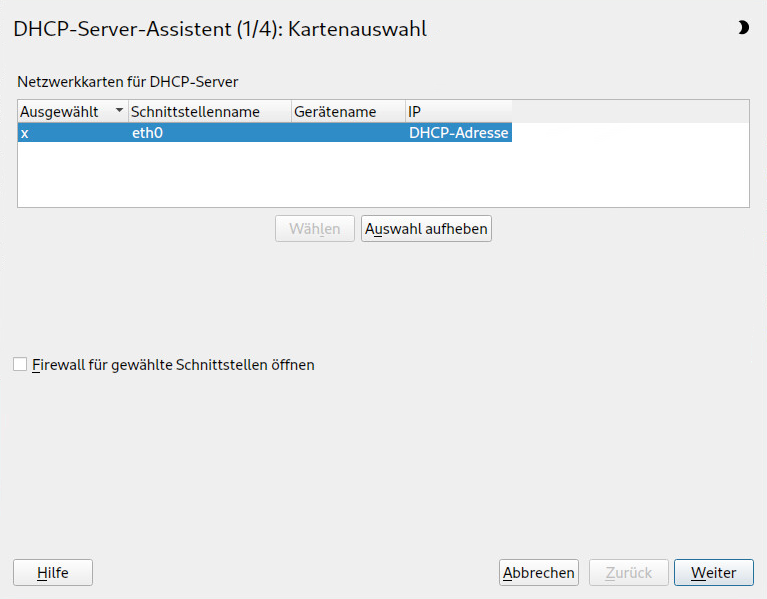

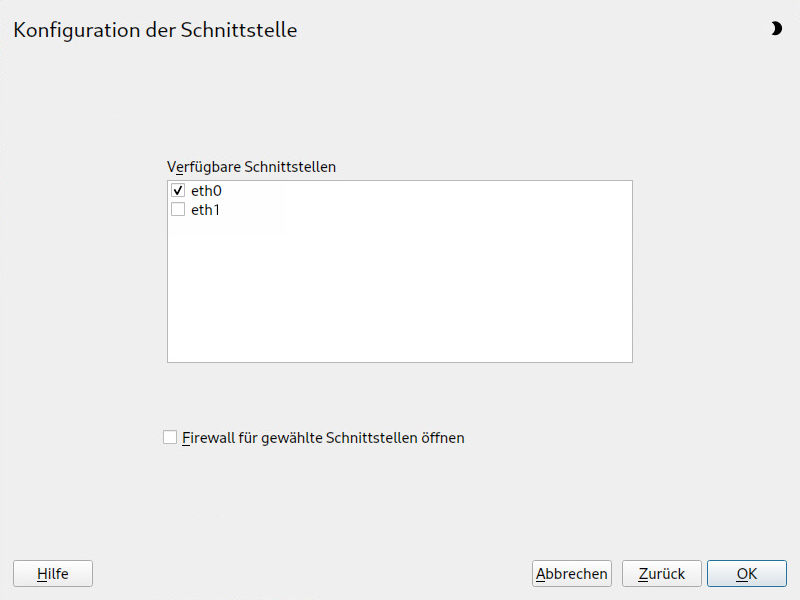

- 40.1 DHCP-Server: Kartenauswahl

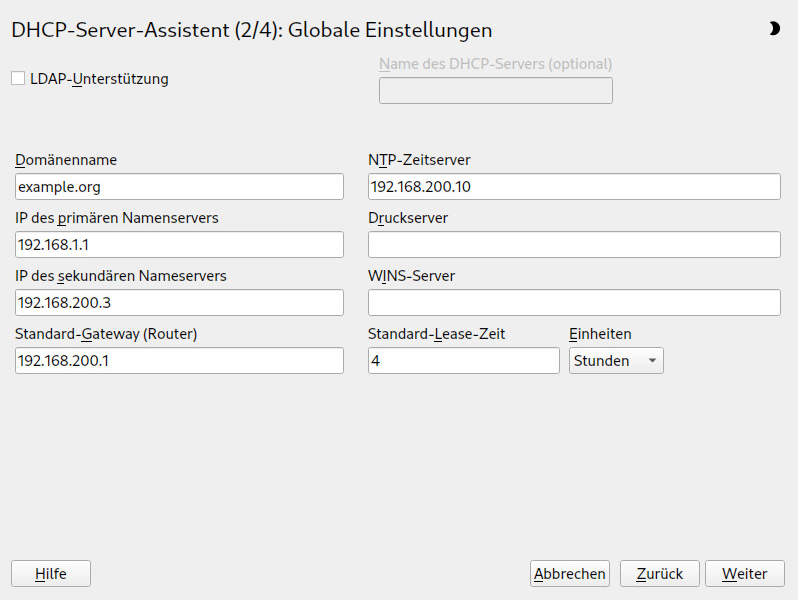

- 40.2 DHCP-Server: globale Einstellungen

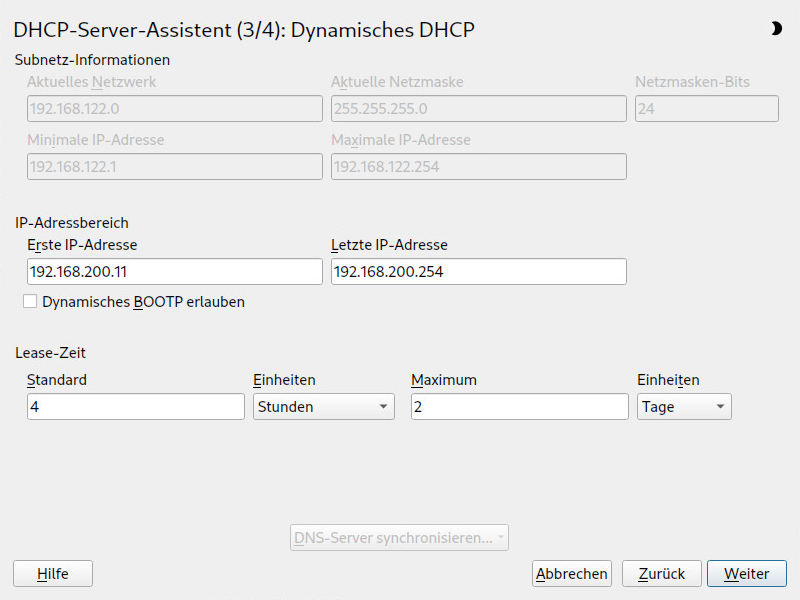

- 40.3 DHCP-Server: dynamisches DHCP

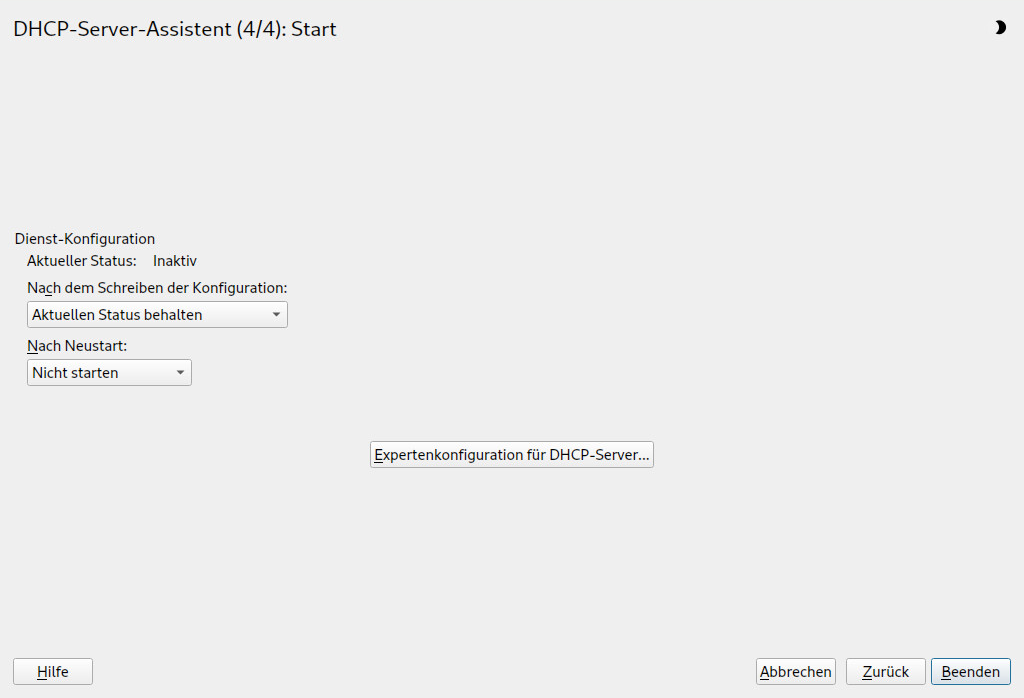

- 40.4 DHCP-Server: Start

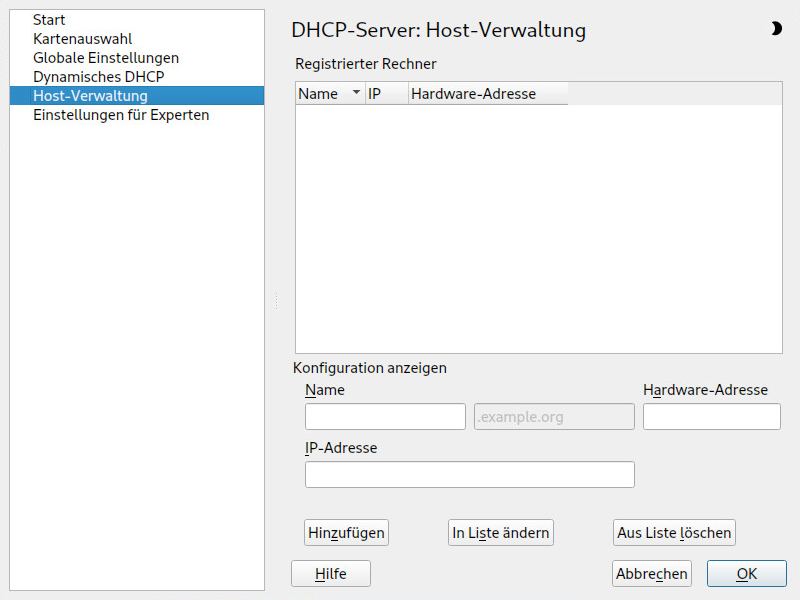

- 40.5 DHCP-Server: Host-Verwaltung

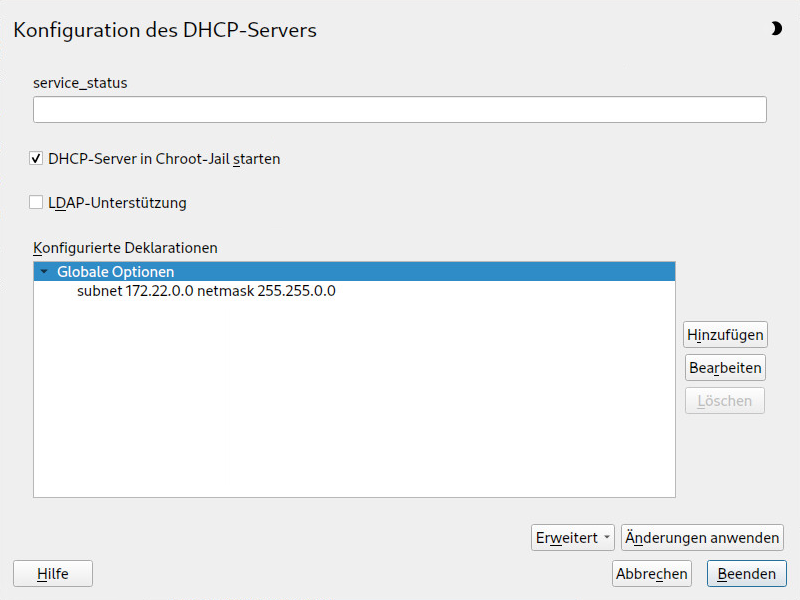

- 40.6 DHCP-Server: Chroot Jail und Deklarationen

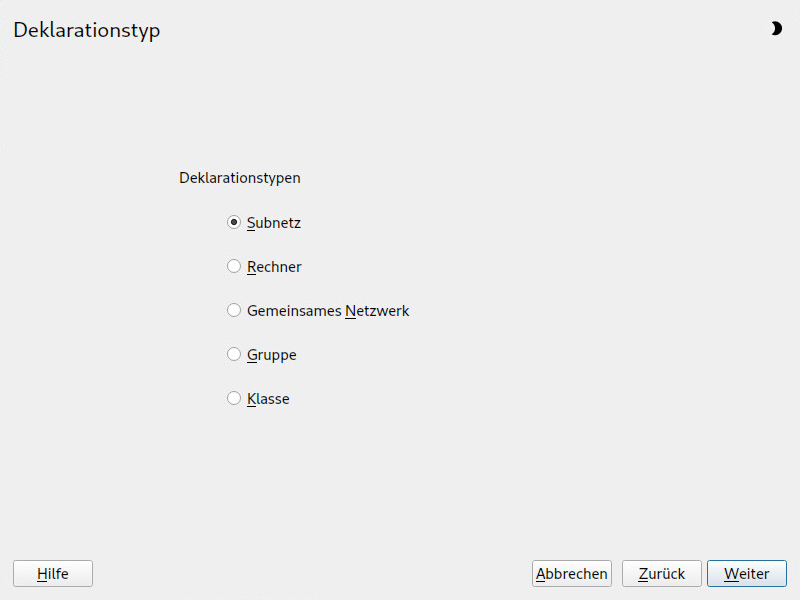

- 40.7 DHCP-Server: Auswählen eines Deklarationstyps

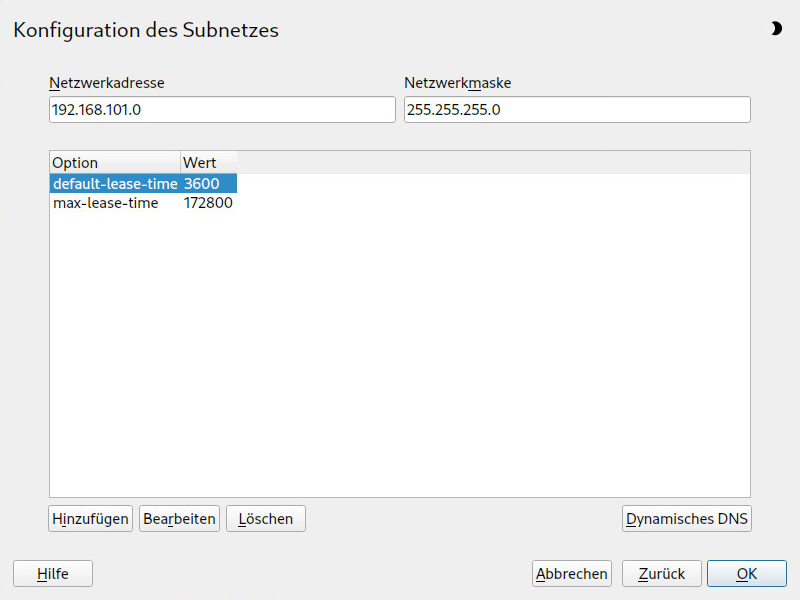

- 40.8 DHCP-Server: Konfigurieren von Subnetzen

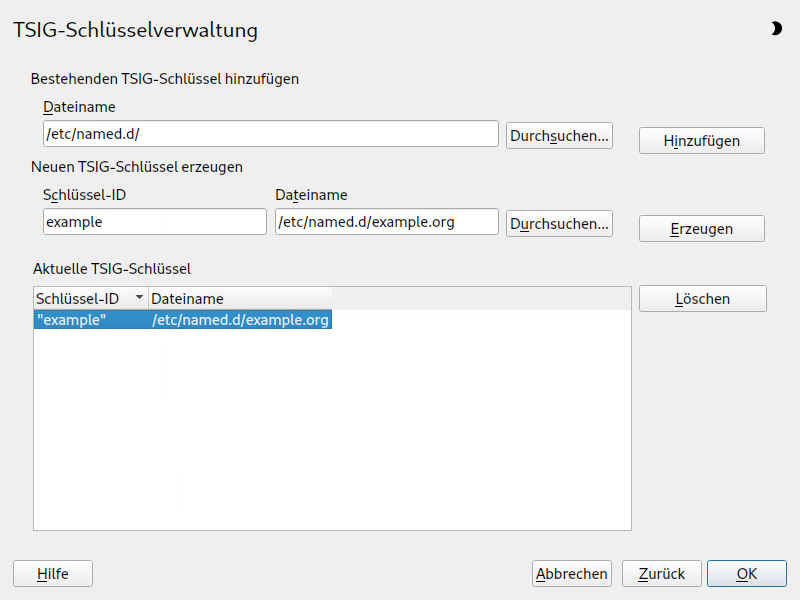

- 40.9 DHCP-Server: TSIG-Konfiguration

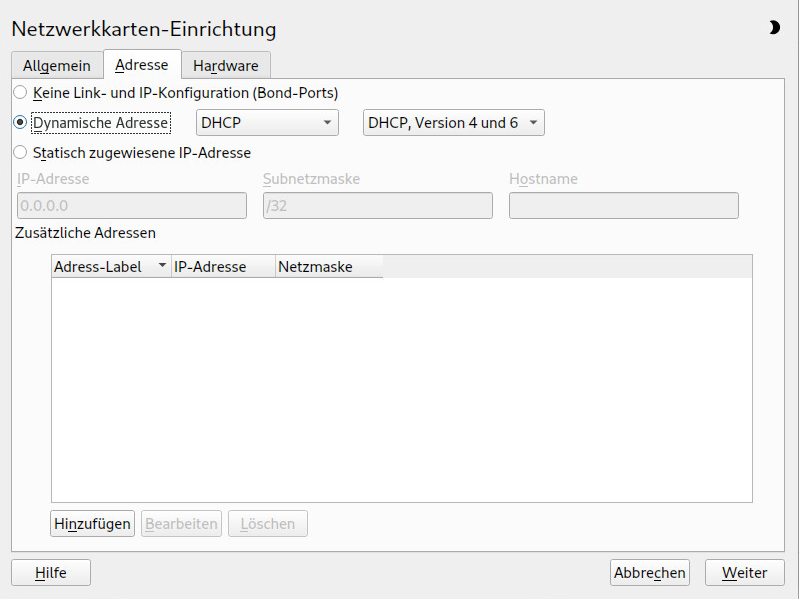

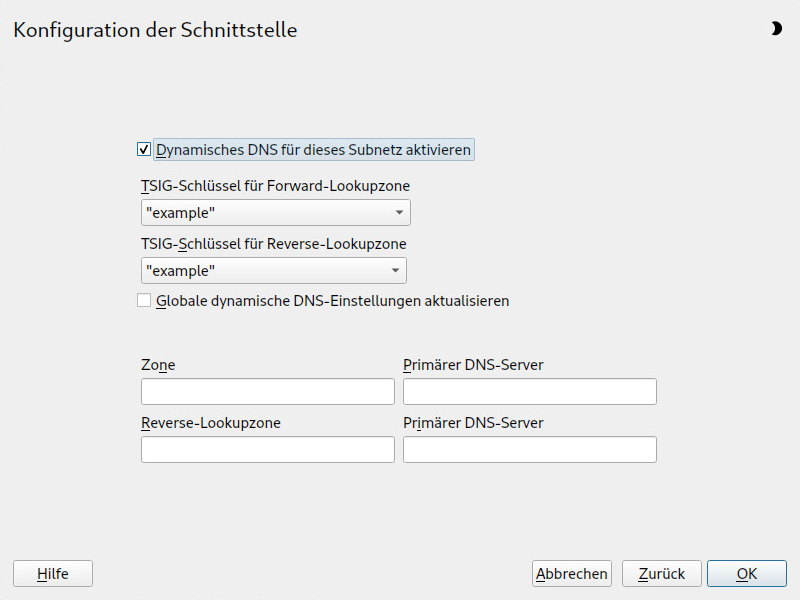

- 40.10 DHCP-Server: Schnittstellenkonfiguration für dynamisches DNS

- 40.11 DHCP-Server: Netzwerkschnittstelle und Firewall

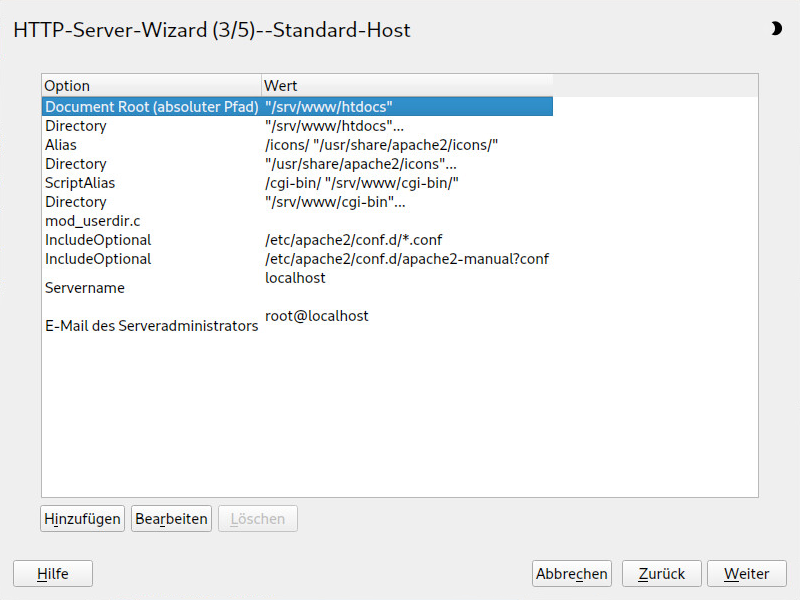

- 42.1 HTTP-Server-Assistent: Standardhost

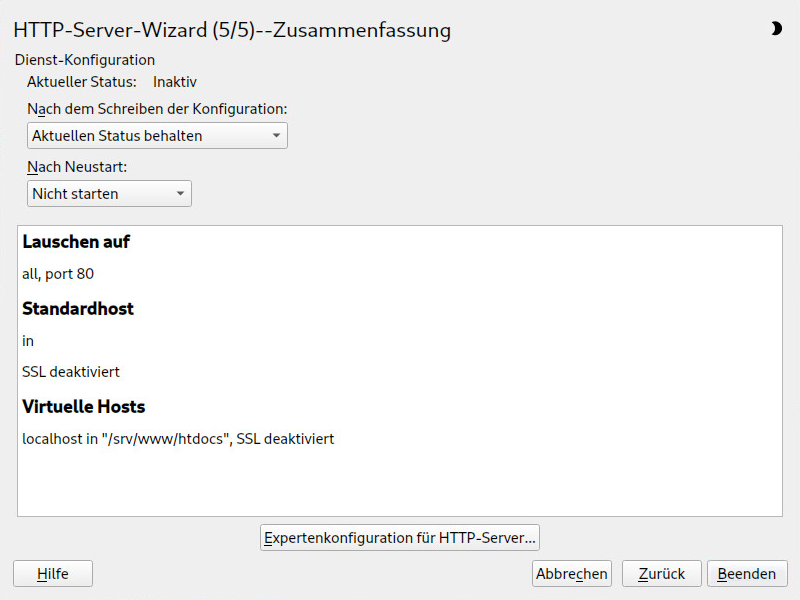

- 42.2 HTTP-Server-Assistent: Zusammenfassung

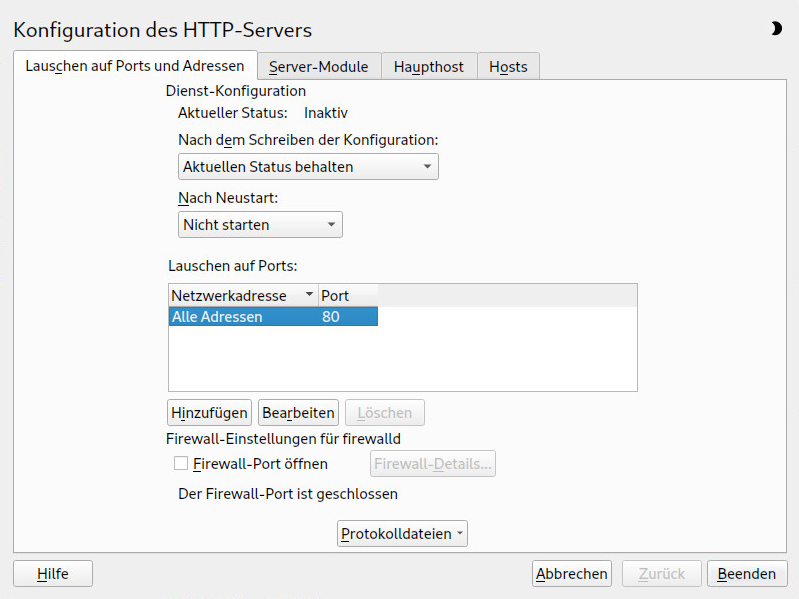

- 42.3 Konfiguration des HTTP-Servers: Überwachen von Ports und Adressen

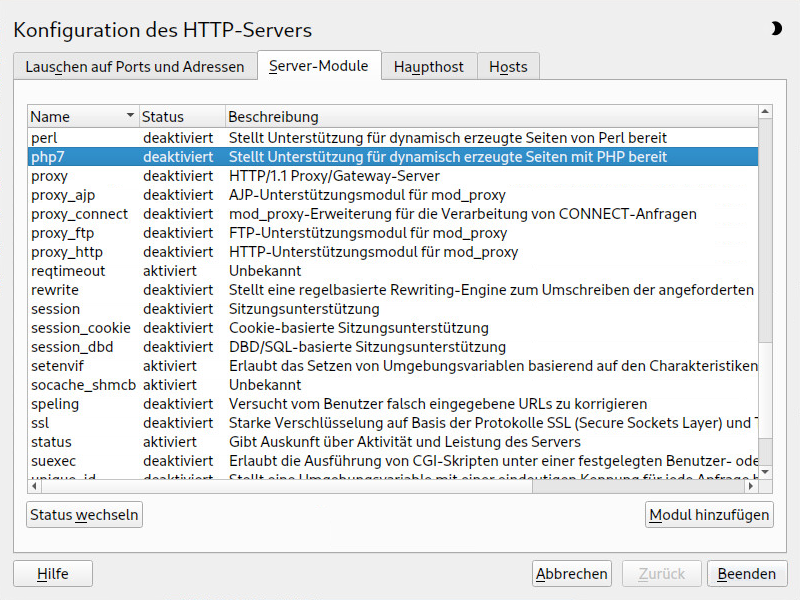

- 42.4 Konfiguration des HTTP-Servers: Server-Module

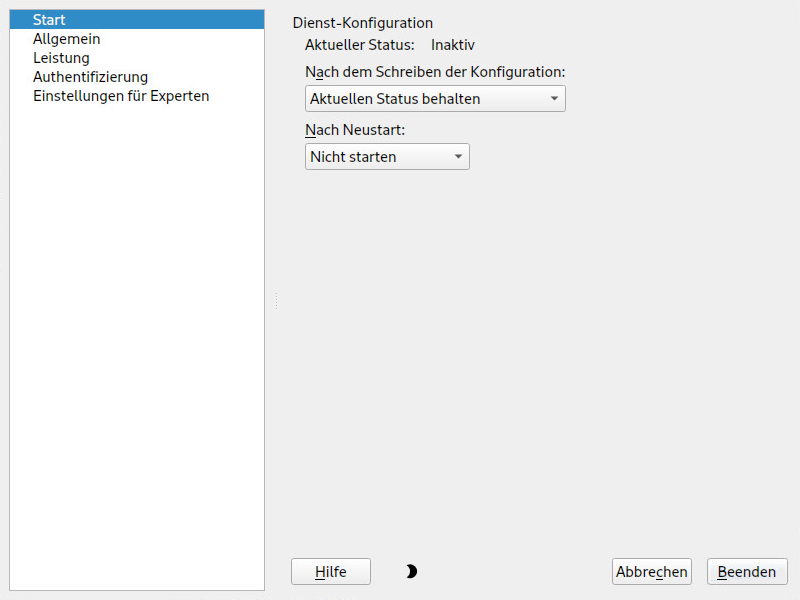

- 43.1 FTP-Serverkonfiguration – Start

- 47.1 Mit dem SCA-Werkzeug erstellter HTML-Bericht

- 47.2 Mit dem SCA-Werkzeug erstellter HTML-Bericht

- 1.1 Bash-Konfigurationsdateien für Login-Shells

- 1.2 Bash-Konfigurationsdateien für Nicht-Login-Shells

- 1.3 Besondere Dateien für die Bash-Shell

- 1.4 Überblick über eine Standardverzeichnisstruktur

- 1.5 Nützliche Umgebungsvariablen

- 9.1 Wichtige Optionen für RPM-Abfragen

- 9.2 RPM-Überprüfungsoptionen

- 19.1 Kommandos zur Dienstverwaltung

- 19.2 Kommandos zum Aktivieren und Deaktivieren von Diensten

- 19.3 System V-Runlevels und

systemd-Ziel-Units - 23.1 Private IP-Adressdomänen

- 23.2 Parameter für /etc/host.conf

- 23.3 Über /etc/nsswitch.conf verfügbare Datenbanken

- 23.4 Konfigurationsoptionen für NSS-„Datenbanken“

- 23.5 Funktionsvergleich zwischen Bonding und Team

- 25.1 Erzeugen einer PFL aus Fontconfig-Regeln

- 25.2 Ergebnisse beim Erzeugen der PFL aus Fontconfig-Regeln mit anderer Reihenfolge

- 25.3 Ergebnisse beim Erzeugen einer PFL aus Fontconfig-Regeln

- 30.1

ulimit: Einstellen von Ressourcen für Benutzer - 45.1 Kommandos zur Verwaltung von sfcbd

- 46.1 man-Seiten – Kategorien und Beschreibungen

- 47.1 Vergleich der Funktionen und Dateinamen im TAR-Archiv

- 48.1 Protokolldateien

- 48.2 Systeminformationen mit dem

/proc-Dateisystem - 48.3 Systeminformationen mit dem

/sys-Dateisystem

- 1.1 Ein Shell-Skript, das einen Text druckt

- 9.1 Zypper – Liste der bekannten Repositorys

- 9.2

rpm -q -i wget - 9.3 Skript für die Suche nach Paketen

- 10.1 Beispiel für eine Zeitleisten-Konfiguration

- 18.1 Verwendung von grub2-mkconfig

- 18.2 Verwendung von grub2-mkrescue

- 18.3 Verwendung von grub2-script-check

- 18.4 Verwendung von grub2-once

- 19.1 Liste der aktiven Dienste

- 19.2 Liste der fehlerhaften Dienste

- 19.3 Auflisten aller Prozesse, die zu einem Dienst gehören

- 22.1 Alternativen-System für den Befehl

java - 23.1 IP-Adressen schreiben

- 23.2 Verknüpfung von IP-Adressen mit der Netzmaske

- 23.3 Beispiel einer IPv6-Adresse

- 23.4 IPv6-Adressen mit Angabe der Präfix-Länge

- 23.5 Gebräuchliche Netzwerkschnittstellen und Beispiele für statische Routen

- 23.6

/var/run/netconfig/resolv.conf - 23.7

/etc/hosts - 23.8

/etc/networks - 23.9

/etc/host.conf - 23.10

/etc/nsswitch.conf - 23.11 Ausgabe des ping-Befehls

- 23.12 Konfiguration für Lastausgleich bei Netzwerk-Teaming

- 23.13 Konfiguration für DHCP-Netzwerk-Teaming-Gerät

- 24.1 Fehlermeldung von

lpd - 24.2 Broadcast vom CUPS-Netzwerkserver

- 25.1 Festlegen von Rendering-Algorithmen

- 25.2 Aliasse und Ersetzungen von Familiennamen

- 25.3 Aliase und Ersetzungen von Familiennamen

- 25.4 Aliasse und Ersetzungen von Familiennamen

- 29.1

udev-Beispielregeln - 30.1 Eintrag in /etc/crontab

- 30.2 /etc/crontab: Entfernen der Zeitstempeldateien

- 30.3

ulimit: Einstellungen in~/.bashrc - 39.1 Weiterleitungsoptionen in named.conf

- 39.2 Eine Grundversion von /etc/named.conf

- 39.3 Eintrag zur Deaktivierung der Protokollierung

- 39.4 Zoneneintrag für „example.com“

- 39.5 Zoneneintrag für „example.net“

- 39.6 Die Datei /var/lib/named/example.com.zone

- 39.7 Reverse-Lookup

- 40.1 Die Konfigurationsdatei /etc/dhcpd.conf

- 40.2 Ergänzungen zur Konfigurationsdatei

- 42.1 Einfache Beispiele für namensbasierte

VirtualHost-Einträge - 42.2 Namensbasierte

VirtualHost-Direktiven - 42.3 IP-basierte

VirtualHost-Direktiven - 42.4 Grundlegende

VirtualHost-Konfiguration - 42.5 CGI-Konfiguration für virtuelle Hosts

- 44.1 Eine Anforderung mit

squidclient - 44.2 Definieren von ACL-Regeln

- 47.1 Ausgabe von

hostinfobeim Anmelden alsroot

Copyright © 2006–2025 SUSE LLC und Mitwirkende. Alle Rechte vorbehalten.

Es wird die Genehmigung erteilt, dieses Dokument unter den Bedingungen der GNU Free Documentation License, Version 1.2 oder (optional) Version 1.3 zu vervielfältigen, zu verbreiten und/oder zu verändern; die unveränderlichen Abschnitte hierbei sind der Urheberrechtshinweis und die Lizenzbedingungen. Eine Kopie dieser Lizenz (Version 1.2) finden Sie im Abschnitt „GNU Free Documentation License“.

Die SUSE-Marken finden Sie unter https://www.suse.com/company/legal/. Alle anderen Marken von Drittanbietern sind Besitz ihrer jeweiligen Eigentümer. Markensymbole (®, ™ usw.) kennzeichnen Marken von SUSE und ihren Tochtergesellschaften. Sternchen (*) kennzeichnen Marken von Drittanbietern.

Alle Informationen in diesem Buch wurden mit größter Sorgfalt zusammengestellt. Auch hierdurch kann jedoch keine hundertprozentige Richtigkeit gewährleistet werden. Weder SUSE LLC, ihre Tochtergesellschaften, die Autoren noch die Übersetzer können für mögliche Fehler und deren Folgen haftbar gemacht werden.

Vorwort #

1 Verfügbare Dokumentation #

- Online-Dokumentation

Die Online-Dokumentation zu diesem Produkt ist unter https://documentation.suse.com/#sles verfügbar. Durchsuchen Sie die Dokumentation oder laden Sie sie in verschiedenen Formaten herunter.

Die Online-Dokumentation für andere Produkte finden Sie unter https://documentation.suse.com/.

Anmerkung: Neueste AktualisierungenDie neuesten Aktualisierungen der Dokumentation sind normalerweise in der englischen Version der Dokumentation verfügbar.

- Versionshinweise

Die Versionshinweise finden Sie unter https://www.suse.com/releasenotes/.

- In Ihrem System

Für die Offline-Nutzung finden Sie die Dokumentation in Ihrem installierten System unter

/usr/share/doc. Viele Kommandos sind auch detailliert auf den Handbuchseiten beschrieben. Führen Sie zu deren Anzeigemangefolgt von einem bestimmten Kommandonamen aus. Sollte dasman-Kommando nicht auf Ihrem System installiert sein, müssen Sie es mitsudo zypper install maninstallieren.

2 Verbessern der Dokumentation #

Ihr Feedback und Ihre Beiträge zu dieser Dokumentation sind willkommen. Für Feedback stehen die folgenden Kanäle zur Verfügung:

- Serviceanforderungen und Support

Informationen zu Services und Support-Optionen, die für Ihr Produkt verfügbar sind, finden Sie unter https://www.suse.com/support/.

Zum Öffnen einer Service-Anforderung benötigen Sie ein SUSE-Abonnement, das beim SUSE Customer Center registriert ist. Gehen Sie zu https://scc.suse.com/support/requests, melden Sie sich an und klicken Sie auf .

- Fehlerberichte

Melden Sie Probleme mit der Dokumentation unter https://bugzilla.suse.com/. Sie können diesen Vorgang vereinfachen, indem Sie den Link in der HTML-Version dieses Dokuments verwenden. Positionieren Sie den Cursor im betroffenen Satz und klicken Sie im Abschnitt im rechten Navigationsbereich auf . Dadurch werden das richtige Produkt und die Kategorie in Bugzilla vorab ausgewählt und ein Link zum aktuellen Abschnitt hinzugefügt. Sie können somit sofort mit der Eingabe Ihres Berichts beginnen. Ein Bugzilla-Konto ist erforderlich.

- Beiträge

Verwenden Sie für einen Beitrag zu dieser Dokumentation den Link in der HTML-Version dieses Dokuments. Positionieren Sie den Cursor im betroffenen Satz und klicken Sie im Abschnitt im rechten Navigationsbereich auf (Quelldokument bearbeiten). So gelangen Sie zum Quellcode auf GitHub, wo Sie eine Pull-Anforderung öffnen können. Ein GitHub-Konto ist erforderlich.

Anmerkung: (Quelldokument bearbeiten) nur auf Englisch verfügbarDie Links für (Quelldokument bearbeiten) sind nur in der englischen Version jedes Dokuments verfügbar. Verwenden Sie für alle anderen Sprachen den Link wie oben beschrieben.

Weitere Informationen zur Dokumentationsumgebung für diese Dokumentation finden Sie in der README des Repositorys unter https://github.com/SUSE/doc-sle/blob/main/README.adoc

Alternativ können Sie E-Mails mit Fehlerberichten und Feedback zur Dokumentation an <doc-team@suse.com> senden. Geben Sie den Titel der Dokumentation, die Produktversion und das Datum der Veröffentlichung der Dokumentation an. Geben Sie zudem die entsprechende Abschnittsnummer und den Titel (oder die URL) an und fügen Sie eine kurze Beschreibung des Problems hinzu.

3 Konventionen in der Dokumentation #

In der vorliegenden Dokumentation werden die folgenden Hinweise und typografischen Konventionen verwendet:

/etc/passwd: Verzeichnis- und DateinamenPLATZHALTER: Ersetzen Sie PLATZHALTER durch den tatsächlichen Wert.

PATH: die Umgebungsvariable PATHls,--help: Kommandos, Optionen und Parameteruser: Benutzer oder Gruppenpackage name: Name eines Pakets

Alt, Alt–F1: Eine Taste oder Tastenkombination; Tastennamen werden wie auf der Tastatur in Großbuchstaben dargestellt.

, › : Menüelemente, Schaltflächen

AMD/Intel Dieser Absatz ist nur für die AMD64-/Intel-64-Architektur relevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.

IBM Z, POWER Dieser Absatz ist nur für die Architekturen

IBM ZundPOWERrelevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.Tanzende Pinguine (Kapitel Pinguine, ↑Zusätzliches Handbuch): Dies ist ein Verweis auf ein Kapitel in einem anderen Handbuch.

Kommandos, die mit

root-Privilegien ausgeführt werden müssen. Diesen Kommandos kann zur Ausführung als nicht privilegierter Benutzer auch häufig das Präfixsudovorangestellt sein.#command>sudocommandKommandos, die von Benutzern ohne Privilegien ausgeführt werden können.

>commandHinweise

Warnung: WarnhinweisWichtige Informationen, die Sie kennen müssen, bevor Sie fortfahren. Warnt vor Sicherheitsrisiken, potenziellen Datenverlusten, Beschädigung der Hardware oder physischen Gefahren.

Wichtig: Wichtiger HinweisWichtige Informationen, die Sie beachten sollten, bevor Sie den Vorgang fortsetzen.

Anmerkung: AnmerkungErgänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Tipp: TippHilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

4 Support #

Im Folgenden finden Sie die Supportbestimmung für SUSE Linux Enterprise Server sowie allgemeine Informationen über Technologievorschauen. Details über den Produktlebenszyklus finden Sie im Book “Upgradehandbuch”, Chapter 2 “Lebenszyklus und Support”.

Wenn Sie Anspruch auf Support haben, finden Sie Details zum Sammeln von Informationen für ein Support-Ticket im Kapitel 47, Erfassen der Systeminformationen für den Support.

4.1 Supportbestimmung für SUSE Linux Enterprise Server #

Sie benötigen ein entsprechendes Abonnement bei SUSE, um Support zu erhalten. Gehen Sie zur Anzeige der für Sie verfügbaren spezifischen Support-Angebote zu https://www.suse.com/support/ und wählen Sie das betreffende Produkt aus.

Die Support-Level sind folgendermaßen definiert:

- L1

Problemermittlung: Technischer Support mit Informationen zur Kompatibilität, Nutzungs-Support, kontinuierliche Wartung, Informationssammlung und einfache Problembehandlung anhand der verfügbaren Dokumentation.

- L2

Problemisolierung: Technischer Support zur Datenanalyse, Reproduktion von Kundenproblemen, Isolierung von Problembereichen und Lösung für Probleme, die in Stufe 1 nicht gelöst wurden, sowie Vorbereitung für Stufe 3.

- L3

Problembehebung: Technischer Support zur Lösung von Problemen durch technische Maßnahmen zur Behebung von Produktfehlern, die durch den Support der Stufe 2 erkannt wurden.

Vertragskunden und Partner erhalten SUSE Linux Enterprise Server mit L3-Support für alle Pakete, ausgenommen:

Technologievorschauen

Audio, Grafik, Schriftarten und Artwork

Pakete, für die ein zusätzlicher Kundenvertrag erforderlich ist

Einige Pakete, die im Lieferumfang von Modul Workstation Extension enthalten sind, erhalten nur L2-Support.

Pakete mit Namen, die auf -devel enden (die Header-Dateien und ähnliche Entwicklerressourcen enthalten), werden nur zusammen mit ihren Hauptpaketen unterstützt.

SUSE unterstützt nur die Nutzung von Originalpaketen, also unveränderten und nicht kompilierten Paketen.

4.2 Technologievorschauen #

Mit Technologievorschauen sind Pakete, Stacks oder Funktionen gemeint, die SUSE bereitstellt, um einen kurzen Einblick in bevorstehende Innovationen zu geben. Durch die Vorschauen haben Sie die Möglichkeit, neue Technologien in Ihrer Umgebung zu testen. Über Ihr Feedback würden wir uns sehr freuen. Wenn Sie eine Technologievorschau testen, kontaktieren Sie Ihre Ansprechpartner bei SUSE und teilen Sie ihnen Ihre Erfahrungen und Anwendungsfälle mit. Ihr Input ist für zukünftige Entwicklungen sehr hilfreich.

Technologievorschauen haben jedoch die folgenden Einschränkungen:

Technologievorschauen befinden sich noch in Entwicklung. Daher sind die Funktionen möglicherweise unvollständig oder auf andere Weise nicht für die Produktionsnutzung geeignet.

Technologievorschauen werden nicht unterstützt.

Technologievorschauen sind möglicherweise nur für bestimmte Hardwarearchitekturen verfügbar.

Details und Funktionen von Technologievorschauen sind Änderungen unterworfen. Upgrades auf Folgeversionen sind demnach nicht möglich und erfordern eine Neuinstallation.

Technologievorschauen können jederzeit verworfen werden. Zum Beispiel wenn SUSE erkennt, dass eine Vorschau nicht den Kunden- oder Marktanforderungen entspricht oder nachweislich nicht den Unternehmensstandards entspricht. SUSE ist nicht verpflichtet, eine unterstützte Version dieser Technologie in der Zukunft bereitzustellen.

Eine Übersicht der Technologievorschauen, die im Lieferumfang Ihres Produkts enthalten sind, finden Sie in den Versionshinweisen unter https://www.suse.com/releasenotes/.

Teil I Häufige Tasks #

- 1 Bash-Shell und Bash-Skripte

Heutzutage werden zunehmend Computer mit einer grafischen Bedienoberfläche (GUI) wie GNOME verwendet. GUIs bieten zwar viele Funktionen, kommen jedoch an ihre Grenzen, wenn automatische Aufgaben ausgeführt werden sollen. Shells sind eine gute Ergänzung für GUIs. In diesem Kapitel erhalten Sie einen Überblick über einige Aspekte von Shells, in diesem Fall Bash-Shells.

- 2 Grundlegende Infos zu

sudo Für bestimmte Kommandos sind root-Berechtigungen erforderlich. Die Anmeldung als

rootist aus Sicherheitsgründen und zur Vermeidung von Fehlern jedoch nicht zu empfehlen. Es ist sicherer, sich als normaler Benutzer anzumelden und dann mitsudoKommandos mit höheren Rechten auszuführen.- 3 Verwenden von YaST

YaST ist ein SUSE Linux Enterprise Server-Tool mit einer grafischen Oberfläche für alle wesentlichen Installations- und Systemkonfigurationsaufgaben. Ob Sie Pakete aktualisieren, einen Drucker konfigurieren, Firewall-Einstellungen bearbeiten, einen FTP-Server einrichten oder eine Festplatte partitio…

- 4 YaST im Textmodus

Die ncurses-basierte pseudo-grafische YaST-Oberfläche sollte vor allem Systemadministratoren bei der Verwaltung von Systemen ohne X-Server unterstützen. Die Oberfläche bietet einige Vorteile im Vergleich zu herkömmlichen grafischen Benutzeroberflächen. Die Navigation auf der ncurses-Oberfläche erfol…

- 5 Ändern der Sprach- und Ländereinstellungen mit YaST

In diesem Kapitel wird die Konfiguration der Sprach- und Ländereinstellungen erläutert. Sie können die Sprache global für das gesamte System, individuell für bestimmte Benutzer oder Desktops oder auch vorübergehend für einzelne Anwendungen ändern. Darüber hinaus können Sie sekundäre Sprachen konfigurieren und die Datums- und Ländereinstellungen anpassen.

- 6 Verwalten von Benutzern mit YaST

Während der Installation haben Sie möglicherweise einen lokalen Benutzer für Ihr System erstellt. Mit dem YaST-Modul Benutzer- und Gruppenverwaltung können Sie Benutzer hinzufügen und vorhandene Benutzer bearbeiten. Darüber hinaus können Sie das System für die Authentifizierung von Benutzern über ei…

- 7 YaST-Online-Aktualisierung

SUSE stellt fortlaufend Sicherheitsaktualisierungen für Ihr Softwareprodukt bereit. Standardmäßig stellt das Miniprogramm für die Aktualisierung sicher, dass Ihr System stets auf dem neuesten Stand ist. Weitere Informationen zu diesem Miniprogramm finden Sie im Abschnitt 8.5, „Der GNOME Package Upda…

- 8 Installieren bzw. Entfernen von Software

Suchen Sie mit dem Softwareverwaltungswerkzeug von YaST nach Softwarekomponenten, die Sie hinzufügen oder entfernen möchten. YaST löst alle Abhängigkeiten für Sie. Zum Installieren von Paketen, die nicht auf den Installationsmedien vorliegen, fügen Sie Ihrer Einrichtung Software-Repositorys hinzu, und lassen Sie diese mit YaST verwalten. Mit dem Aktualisierungs-Miniprogramm können Sie Softwareaktualisierungen verwalten und Ihr System so auf dem neuesten Stand halten.

- 9 Verwalten von Software mit Kommandozeilenwerkzeugen

Dieses Kapitel behandelt zypper und RPM, zwei Kommandozeilen-Tools zum Verwalten von Software. Eine Definition der in diesem Kontext verwendeten Terminologie (beispielsweise

Repository,PatchoderUpdate) finden Sie unter Abschnitt 8.1, „Definition der Begriffe“.- 10 Systemwiederherstellung und Snapshot-Verwaltung mit Snapper

Mit Snapper werden Dateisystem-Snapshots erstellt und verwaltet. Durch Dateisystem-Snapshots kann eine Kopie des Zustands eines Dateisystems zu einem bestimmten Zeitpunkt beibehalten werden. Die Standardeinrichtung von Snapper lässt ein Rollback von Systemänderungen zu. Sie können es jedoch auch zum Erstellen von Sicherungen der Benutzerdaten auf Wechseldatenträgern verwenden. Als Basis für diese Funktion verwendet Snapper das Btrfs-Dateisystem oder LVM-Volumes mit Thin Provisioning mit einem XFS- oder Ext4-Dateisystem.

- 11 Live-Kernel-Patching mit KLP

In diesem Dokument werden die Grundlagen der Kernel Live Patching-Technologie (KLP) erläutert und Sie finden hier Richtlinien für den SLE Live Patching-Dienst.

- 12 Userspace-Live-Patching

In diesem Dokument werden die Grundlagen und die Verwendung des Userspace-Live-Patchings erläutert.

- 13 Transaktionsaktualisierungen

Transaktionsaktualisierungen sind in SUSE Linux Enterprise Server als Technologievorschau für die Aktualisierung von SLES verfügbar, wenn das root-Dateisystem schreibgeschützt ist. Transaktionsaktualisierungen sind atomar (alle Aktualisierungen werden nur angewendet, wenn alle Aktualisierungen erfolgreich sind) und unterstützen Rollbacks. Es ist kein laufendes System betroffen, da Änderungen erst aktiviert werden, nachdem das System neu gebootet wurde. Da Reboots eine Störung darstellen, muss der Administrator entscheiden, ob ein Reboot kostspieliger ist als die Störung laufender Services. Wenn Reboots zu kostspielig sind, sollten Sie keine Transaktionsaktualisierungen verwenden.

Transaktionsaktualisierungen werden täglich vom Skript

transactional-updateausgeführt. Das Skript prüft auf verfügbare Aktualisierungen. Falls Aktualisierungen vorhanden sind, erstellt es im Hintergrund einen neuen Snapshot des root-Dateisystems. Danach ruft es die Aktualisierungen von den Versionskanälen ab. Sobald der neue Snapshot vollständig aktualisiert ist, wird er als aktiv gekennzeichnet und wird nach dem nächsten Reboot des Systems zum neuen standardmäßigen root-Dateisystem. Wenntransactional-updateautomatisch ausgeführt wird (das Standardverhalten), wird das System auch neu gebootet. Sowohl die Zeitdauer für den Aktualisierungsvorgang als auch das Wartungsfenster für den Reboot sind konfigurierbar.Es können nur Pakete aktualisiert werden, die Teil des Snapshots des root-Dateisystems sind. Sollten die Pakete Dateien enthalten, die nicht Teil des Snapshots sind, dann könnte die Aktualisierung fehlschlagen oder das System beschädigen.

RPMs, die eine Lizenz benötigen, um akzeptiert zu werden, können nicht aktualisiert werden.

- 14 Remote-Grafiksitzungen mit VNC

Über VNC (Virtual Network Computing) haben Sie über einen Grafik-Desktop Zugriff auf einen Remote-Rechner und können Remote-Grafikanwendungen ausführen. VNC ist plattformunabhängig und greift auf den Remote-Rechner über ein beliebiges Betriebssystem zu. In diesem Kapitel wird beschrieben, wie mit den Desktop-Clients vncviewer und Remmina eine Verbindung zu einem VNC-Server hergestellt und wie ein VNC-Server betrieben wird.

SUSE Linux Enterprise Server unterstützt zwei verschiedene Arten von VNC-Sitzungen: einmalige Sitzungen, die so lange „aktiv“ sind, wie die VNC-Verbindung zum Client besteht, und permanente Sitzungen, die so lange „aktiv“ sind, bis sie explizit beendet werden.

Ein VNC-Server kann beide Sitzungen gleichzeitig auf verschiedenen Ports bieten, eine geöffnete Sitzung kann jedoch nicht von einem Typ in den anderen konvertiert werden.

- 15 Kopieren von Dateien mit RSync

Viele moderne Benutzer arbeiten heutzutage gleich mit mehreren Computern: Computer daheim und am Arbeitsplatz, Laptop, Smartphone oder Tablet. Damit wird die Synchronisierung von Dateien und Dokumenten über mehrere Geräte wichtiger als je zuvor.

1 Bash-Shell und Bash-Skripte #

Heutzutage werden zunehmend Computer mit einer grafischen Bedienoberfläche (GUI) wie GNOME verwendet. GUIs bieten zwar viele Funktionen, kommen jedoch an ihre Grenzen, wenn automatische Aufgaben ausgeführt werden sollen. Shells sind eine gute Ergänzung für GUIs. In diesem Kapitel erhalten Sie einen Überblick über einige Aspekte von Shells, in diesem Fall Bash-Shells.

1.1 Was ist „die Shell“? #

Traditionell handelt es sich bei der Linux-Shell um Bash (Bourne again Shell). Wenn in diesem Kapitel die Rede von „der Shell“ ist, ist die Bash-Shell gemeint. Außer Bash sind noch weitere Shells verfügbar (ash, csh, ksh, zsh und viele mehr), von denen jede unterschiedliche Funktionen und Merkmale aufweist. Wenn Sie weitere Informationen über andere Shells wünschen, suchen Sie in YaST nach shell.

1.1.1 Bash-Konfigurationsdateien #

Eine Shell lässt sich aufrufen als:

Interaktive Login-Shell. Diese wird zum Anmelden bei einem Computer durch den Aufruf von Bash mit der Option

--loginverwendet oder beim Anmelden an einem entfernten Computer mit SSH.„Gewöhnliche“ interaktive Shell. Dies ist normalerweise beim Starten von xterm, konsole, gnome-terminal oder ähnlichen Kommandozeilenschnittstellen-Tools (CLI-Tools) der Fall.

Nicht interaktive Shell. Dies wird beim Aufrufen eines Shell-Skripts in der Kommandozeile verwendet.

Abhängig vom verwendeten Shell-Typ werden unterschiedliche Konfigurationsdateien gelesen. Die folgenden Tabellen zeigen die Login- und Nicht-Login-Shell-Konfigurationsdateien.

|

Datei |

Beschreibung |

|---|---|

|

|

Bearbeiten Sie diese Datei nicht, andernfalls werden Ihre Änderungen beim nächsten Update möglicherweise zerstört. |

|

|

Verwenden Sie diese Datei, wenn Sie |

|

|

Enthält systemweite Konfigurationsdateien für bestimmte Programme |

|

|

Fügen Sie hier benutzerspezifische Konfigurationsdaten für Login-Shells ein. |

Die Login-Shell greift außerdem auf die unter Tabelle 1.2, „Bash-Konfigurationsdateien für Nicht-Login-Shells“ aufgeführten Konfigurationsdateien zu.

|

|

Bearbeiten Sie diese Datei nicht, andernfalls werden Ihre Änderungen beim nächsten Update möglicherweise zerstört. |

|

|

Verwenden Sie diese Datei, um Ihre systemweiten Änderungen nur für die Bash-Shell einzufügen. |

|

|

Fügen Sie hier benutzerspezifische Konfigurationsdaten ein. |

Daneben verwendet die Bash-Shell einige weitere Dateien:

|

Datei |

Beschreibung |

|---|---|

|

|

Enthält eine Liste aller Kommandos, die Sie eingegeben haben. |

|

|

Wird beim Abmelden ausgeführt. |

|

|

Benutzerdefinierte Aliase für häufig verwendete Kommandos. Weitere Details zum Definieren von Aliasen finden Sie unter |

Shells zur Verhinderung der Anmeldung#

Bestimmte Shells verhindern die Anmeldung von Benutzern im System: /bin/false und /sbin/nologin. Beide geben bei Anmeldeversuchen von Benutzern im System automatisch einen Fehler aus. Diese Methode war als Sicherheitsmaßnahme für Systembenutzer gedacht. Moderne Linux-Betriebssysteme kontrollieren den Systemzugriff jedoch inzwischen mit effektiveren Tools wie PAM und AppArmor.

Standardmäßig ist bei SUSE Linux Enterprise Server die Shell /bin/bash menschlichen Benutzern zugewiesen und die Shell /bin/false oder /sbin/nologin Systembenutzern. Dem Benutzer nobody ist aus historischen Gründen /bin/bash zugewiesen. Es handelt sich dabei um einen Benutzer mit minimalen Rechten, der standardmäßig als Systembenutzer verwendet wurde. Jegliche Sicherheit, die durch den Benutzer nobody erreicht wird, geht jedoch verloren, wenn er von mehreren Systembenutzern verwendet wird. Es sollte möglich sein, ihn in /sbin/nologin zu ändern. Am schnellsten lässt sich dies testen, wenn Sie die Änderung vornehmen und sehen, ob dadurch Dienste oder Anwendungen beschädigt werden.

Mit folgendem Kommando wird unter /etc/passwdaufgelistet, welche Shells allen Benutzern, Systembenutzern und menschlichen Benutzern zugewiesen sind. Die Ausgabe unterscheidet sich je nach Services und Benutzer in Ihrem System:

> sort -t: -k 7 /etc/passwd | awk -F: '{print $1"\t" $7}' | column -t

tux /bin/bash

nobody /bin/bash

root /bin/bash

avahi /bin/false

chrony /bin/false

dhcpd /bin/false

dnsmasq /bin/false

ftpsecure /bin/false

lightdm /bin/false

mysql /bin/false

postfix /bin/false

rtkit /bin/false

sshd /bin/false

tftp /bin/false

unbound /bin/false

bin /sbin/nologin

daemon /sbin/nologin

ftp /sbin/nologin

lp /sbin/nologin

mail /sbin/nologin

man /sbin/nologin

nscd /sbin/nologin

polkitd /sbin/nologin

pulse /sbin/nologin

qemu /sbin/nologin

radvd /sbin/nologin

rpc /sbin/nologin

statd /sbin/nologin

svn /sbin/nologin

systemd-coredump /sbin/nologin

systemd-network /sbin/nologin

systemd-timesync /sbin/nologin

usbmux /sbin/nologin

vnc /sbin/nologin

wwwrun /sbin/nologin

messagebus /usr/bin/false

scard /usr/sbin/nologin1.1.2 Die Verzeichnisstruktur #

Die folgende Tabelle bietet eine kurze Übersicht über die wichtigsten Verzeichnisse der höheren Ebene auf einem Linux-System. Ausführlichere Informationen über die Verzeichnisse und wichtige Unterverzeichnisse erhalten Sie in der folgenden Liste.

|

Verzeichnis |

Inhalt |

|---|---|

|

|

root-Verzeichnis – Startpunkt der Verzeichnisstruktur. |

|

|

Grundlegende binäre Dateien, z. B. Kommandos, die der Systemadministrator und normale Benutzer brauchen. Enthält gewöhnlich auch die Shells, z. B. Bash. |

|

|

Statische Dateien des Bootloaders. |

|

|

Erforderliche Dateien für den Zugriff auf Host-spezifische Geräte. |

|

|

Host-spezifische Systemkonfigurationsdateien. |

|

|

Enthält die Home-Verzeichnisse aller Benutzer mit einem Konto im System. Das Home-Verzeichnis von |

|

|

Grundlegende freigegebene Bibliotheken und Kernel-Module. |

|

|

Einhängepunkte für Wechselmedien. |

|

|

Einhängepunkt für das temporäre Einhängen eines Dateisystems. |

|

|

Add-On-Anwendungssoftwarepakete. |

|

|

Home-Verzeichnis für den Superuser |

|

|

Grundlegende Systembinärdateien. |

|

|

Daten für Dienste, die das System bereitstellt. |

|

|

Temporäre Dateien. |

|

|

Sekundäre Hierarchie mit Nur-Lese-Daten. |

|

|

Variable Daten wie Protokolldateien. |

|

|

Nur verfügbar, wenn sowohl Microsoft Windows* als auch Linux auf Ihrem System installiert ist. Enthält die Windows-Daten. |

Die folgende Liste bietet detailliertere Informationen und einige Beispiele für die Dateien und Unterverzeichnisse, die in den Verzeichnissen verfügbar sind:

/binEnthält die grundlegenden Shell-Befehle, die

rootund andere Benutzer verwenden können. Zu diesen Kommandos gehörenls,mkdir,cp,mv,rmundrmdir./binumfasst außerdem Bash, die Standard-Shell in SUSE Linux Enterprise Server./bootEnthält Daten, die zum Booten erforderlich sind, wie zum Beispiel den Bootloader, den Kernel und andere Daten, die verwendet werden, bevor der Kernel mit der Ausführung von Programmen im Benutzermodus beginnt.

/devEnthält Gerätedateien, die Hardware-Komponenten darstellen.

/etcEnthält lokale Konfigurationsdateien, die den Betrieb von Programmen wie das X Window System steuern können. Das Unterverzeichnis

/etc/init.denthält LSB-init-Skripte, die während des Bootvorgangs ausgeführt werden können./home/BENUTZERNAMEEnthält die privaten Daten aller Benutzer, die ein Konto auf dem System haben. Die Dateien, die hier gespeichert sind, können nur durch den Besitzer oder den Systemadministrator geändert werden. Standardmäßig befinden sich hier Ihr Email-Verzeichnis und Ihre persönliche Desktopkonfiguration in Form von verborgenen Dateien und Verzeichnissen, z. B.

.gconf/und.config.Anmerkung: Home-Verzeichnis in einer NetzwerkumgebungWenn Sie in einer Netzwerkumgebung arbeiten, kann Ihr Home-Verzeichnis einem von

/homeabweichenden Verzeichnis zugeordnet sein./libEnthält die grundlegenden freigegebenen Bibliotheken, die zum Booten des Systems und zur Ausführung der Kommandos im root-Dateisystem erforderlich sind. Freigegebene Bibliotheken entsprechen in Windows DLL-Dateien.

/mediaEnthält Einhängepunkte für Wechselmedien, z. B. CD-ROMs, Flash-Laufwerke und Digitalkameras (sofern sie USB verwenden). Unter

/mediasind beliebige Laufwerktypen gespeichert, mit Ausnahme der Festplatte Ihres Systems. Wenn Ihr Wechselmedium eingelegt bzw. mit dem System verbunden und eingehängt wurde, können Sie von hier darauf zugreifen./mntDieses Verzeichnis bietet einen Einhängepunkt für ein vorübergehend eingehängtes Dateisystem.

rootkann hier Dateisysteme einhängen./optReserviert für die Installation von Drittanbieter-Software. Hier finden Sie optionale Softwareprogramme und größere Add-On-Programmpakete.

/rootHome-Verzeichnis für den Benutzer

root. Hier befinden sich die persönlichen Daten vonroot./ausführenEin tmpfs-Verzeichnis, das von

systemdund verschiedenen Komponenten genutzt wird./var/runstellt einen symbolischen Link zu/rundar./sbinWie durch das

sangegeben, enthält dieses Verzeichnis Dienstprogramme für den Superuser./sbinenthält die Binärdateien, die zusätzlich zu den Binärdateien in/binzum Booten und Wiederherstellen des Systems unbedingt erforderlich sind./srvEnhält Daten für Dienste, die das System bereitstellt, z. B. FTP und HTTP.

/tmpDieses Verzeichnis wird von Programmen benutzt, die eine temporäre Speicherung von Dateien verlangen.

Wichtig: Bereinigen des temporären Verzeichnisses/tmpbei SystemstartIm Verzeichnis

/tmpgespeicherte Daten werden nicht zwingend bei einem Neustart des Systems beibehalten. Dies ist beispielsweise von den Einstellungen in/etc/tmpfiles.d/tmp.confabhängig./usr/usrhat nichts mit Benutzern („user“) zu tun, sondern ist das Akronym für UNIX-Systemressourcen. Die Daten in/usrsind statische, schreibgeschützte Daten, die auf verschiedenen Hosts freigegeben sein können, die denFilesystem Hierarchy Standard(FHS) einhalten. Dieses Verzeichnis enthält alle Anwendungsprogramme (auch die grafischen Desktops wie GNOME) und bildet eine zweite Hierarchie im Dateisystem./usrenthält mehrere Unterverzeichnisse, z. B./usr/bin,/usr/sbin,/usr/localund/usr/share/doc./usr/binEnthält Programme, die für den allgemeinen Zugriff verfügbar sind.

/usr/sbinEnthält Programme, die für den Systemadministrator reserviert sind, z. B. Reparaturfunktionen.

/usr/localIn diesem Verzeichnis kann der Systemadministrator lokale, verteilungsunabhängige Erweiterungen installieren.

/usr/share/docEnthält verschiedene Dokumentationsdateien und die Versionshinweise für Ihr System. Im Unterverzeichnis

Handbuchbefindet sich eine Online-Version dieses Handbuchs. Wenn mehrere Sprachen installiert sind, kann dieses Verzeichnis die Handbücher für verschiedene Sprachen enthalten.Im Verzeichnis

packagesfinden Sie die Dokumentation zu den auf Ihrem System installierten Software-Paketen. Für jedes Paket wird ein Unterverzeichnis/usr/share/doc/packages/PAKETNAMEangelegt, das häufig README-Dateien für das Paket und manchmal Beispiele, Konfigurationsdateien oder zusätzliche Skripten umfasst.Wenn HOWTOs (Verfahrensbeschreibungen) auf Ihrem System installiert sind, enhält

/usr/share/docauch das Unterverzeichnishowtomit zusätzlicher Dokumentation zu vielen Aufgaben im Zusammenhang mit der Einrichtung und Ausführung von Linux-Software./varWährend

/usrstatische, schreibgeschützte Daten enthält, ist/varfür Daten, die während des Systembetriebs geschrieben werden und daher variabel sind, z. B. Protokolldateien oder Spooling-Daten. Eine Übersicht über die wichtigsten Protokolldateien finden Sie unter/var/log/. Weitere Informationen stehen unter Tabelle 48.1, „Protokolldateien“ zur Verfügung.

1.2 Schreiben von Shell-Skripten #

Shell-Skripte bieten eine bequeme Möglichkeit, die verschiedensten Aufgaben zu erledigen: Erfassen von Daten, Suche nach einem Wort oder Begriff in einem Text und andere nützliche Dinge. Das folgende Beispiel zeigt ein kleines Shell-Skript, das einen Text druckt:

#!/bin/sh 1 # Output the following line: 2 echo "Hello World" 3

Die erste Zeile beginnt mit den Shebang-Zeichen ( | |

Die zweite Zeile ist ein Kommentar, der mit dem Hash-Zeichen beginnt. Wir empfehlen Ihnen, schwierige Zeilen zu kommentieren. Richtiges Kommentieren erinnert Sie an den Zweck und die Funktion der Zeile. Ihr Skript wird zudem hoffentlich auch von anderen Lesern verstanden. Das Kommentieren wird in der Entwickler-Community als gute Vorgehensweise angesehen. | |

Die dritte Zeile verwendet das integrierte Kommando |

Vor Ausführung dieses Skripts sind einige Voraussetzungen zu erfüllen:

Jedes Skript muss eine Shebang-Zeile enthalten (wie im obigen Beispiel). Falls die Zeile fehlt, müssen Sie den Interpreter manuell aufrufen.

Sie können das Skript an beliebiger Stelle speichern. Jedoch empfiehlt es sich, es in einem Verzeichnis zu speichern, in dem die Shell es finden kann. Der Suchpfad in einer Shell wird durch die Umgebungsvariable

PATHbestimmt. In der Regel verfügt ein normaler Benutzer über keinen Schreibzugriff auf/usr/bin. Daher sollten Sie Ihre Skripten im Benutzerverzeichnis~/bin/speichern. Das obige Beispiel erhält den Namenhello.sh.Das Skript muss zum Ausführen von Dateien berechtigt sein. Stellen Sie die Berechtigungen mit dem folgenden Kommando ein:

>chmod +x ~/bin/hello.sh

Wenn Sie alle oben genannten Voraussetzungen erfüllt haben, können Sie das Skript mithilfe der folgenden Methoden ausführen:

Als absoluten Pfad. Das Skript kann mit einem absoluten Pfad ausgeführt werden. In unserem Fall lautet er

~/bin/hello.sh.Überall. Wenn die Umgebungsvariable

PATHdas Verzeichnis enthält, in dem sich das Skript befindet, können Sie das Skript mithello.shausführen.

1.3 Umlenken von Kommandoereignissen #

Jedes Kommando kann drei Kanäle für Eingabe oder Ausgabe verwenden:

Standardausgabe. Dies ist der Standardausgabe-Kanal. Immer wenn ein Kommando eine Ausgabe erzeugt, verwendet es den Standardausgabe-Kanal.

Standardeingabe. Wenn ein Kommando Eingaben von Benutzern oder anderen Kommandos benötigt, verwendet es diesen Kanal.

Standardfehler. Kommandos verwenden diesen Kanal zum Melden von Fehlern.

Zum Umlenken dieser Kanäle bestehen folgende Möglichkeiten:

Kommando > DateiSpeichert die Ausgabe des Kommandos in eine Datei; eine etwaige bestehende Datei wird gelöscht. Beispielsweise schreibt das Kommando

lsseine Ausgabe in die Dateilisting.txt:>ls > listing.txtKommando >> DateiHängt die Ausgabe des Kommandos an eine Datei an. Beispielsweise hängt das Kommando

lsseine Ausgabe an die Dateilisting.txtan:>ls >> listing.txtKommando < DateiLiest die Datei als Eingabe für das angegebene Kommando. Beispielsweise liest das Kommando

readden Inhalt der Datei in die Variable ein:>read a < fooKommando1 | Kommando2Leitet die Ausgabe des linken Kommandos als Eingabe für das rechte Kommando um. Beispiel: Das Kommando

catgibt den Inhalt der Datei/proc/cpuinfoaus. Diese Ausgabe wird vongrepverwendet, um nur diejenigen Zeilen herauszufiltern, diecpuenthalten:>cat /proc/cpuinfo | grep cpu

Jeder Kanal verfügt über einen Dateideskriptor: 0 (Null) für Standardeingabe, 1 für Standardausgabe und 2 für Standardfehler. Es ist zulässig, diesen Dateideskriptor vor einem <- oder >-Zeichen einzufügen. Beispielsweise sucht die folgende Zeile nach einer Datei, die mit foo beginnt, aber seine Fehlermeldungen durch Umlenkung zu /dev/null unterdrückt:

> find / -name "foo*" 2>/dev/null1.4 Verwenden von Aliassen #

Ein Alias ist ein Definitionskürzel für einen oder mehrere Kommandos. Die Syntax für einen Alias lautet:

alias NAME=DEFINITION

Beispielsweise definiert die folgende Zeile den Alias lt, der eine lange Liste ausgibt (Option -l), sie nach Änderungszeit sortiert (-t) und sie in umgekehrter Reihenfolge sortiert ausgibt (-r):

> alias lt='ls -ltr'

Zur Anzeige aller Aliasdefinitionen verwenden Sie alias. Entfernen Sie den Alias mit unalias und dem entsprechenden Aliasnamen.

1.5 Verwenden von Variablen in der Bash-Shell #

Eine Shell-Variable kann global oder lokal sein. Auf globale Variablen, z. B. Umgebungsvariablen, kann in allen Shells zugegriffen werden. Lokale Variablen sind hingegen nur in der aktuellen Shell sichtbar.

Verwenden Sie zur Anzeige von allen Umgebungsvariablen das Kommando printenv. Wenn Sie den Wert einer Variable kennen müssen, fügen Sie den Namen Ihrer Variablen als ein Argument ein:

> printenv PATH

Eine Variable (global oder lokal) kann auch mit echo angezeigt werden:

> echo $PATHVerwenden Sie zum Festlegen einer lokalen Variablen einen Variablennamen, gefolgt vom Gleichheitszeichen und dem Wert für den Namen:

> PROJECT="SLED"

Geben Sie keine Leerzeichen um das Gleichheitszeichen ein, sonst erhalten Sie einen Fehler. Verwenden Sie zum Setzen einer Umgebungsvariablen export:

> export NAME="tux"

Zum Entfernen einer Variable verwenden Sie unset:

> unset NAMEDie folgende Tabelle enthält einige häufige Umgebungsvariablen, die Sie in Ihren Shell-Skripten verwenden können:

|

|

Home-Verzeichnis des aktuellen Benutzers |

|

|

Aktueller Hostname |

|

|

Wenn ein Werkzeug lokalisiert wird, verwendet es die Sprache aus dieser Umgebungsvariablen. Englisch kann auch auf |

|

|

Suchpfad der Shell, eine Liste von Verzeichnissen, die durch Doppelpunkte getrennt sind |

|

|

Gibt die normale Eingabeaufforderung an, die vor jedem Kommando angezeigt wird |

|

|

Gibt die sekundäre Eingabeaufforderung an, die beim Ausführen eines mehrzeiligen Kommandos angezeigt wird |

|

|

Aktuelles Arbeitsverzeichnis |

|

|

Aktueller Benutzer |

1.5.1 Verwenden von Argumentvariablen #

Wenn Sie beispielsweise über das Skript foo.sh verfügen, können Sie es wie folgt ausführen:

> foo.sh "Tux Penguin" 2000

Für den Zugriff auf alle Argumente, die an Ihr Skript übergeben werden, benötigen Sie Positionsparameter. Diese sind $1 für das erste Argument, $2 für das zweite usw. Sie können bis zu neun Parameter verwenden. Verwenden Sie $0 zum Abrufen des Skriptnamens.

Das folgende Skript foo.sh gibt alle Argumente von 1 bis 4 aus:

#!/bin/sh echo \"$1\" \"$2\" \"$3\" \"$4\"

Wenn Sie das Skript mit den obigen Argumenten ausführen, erhalten Sie Folgendes:

"Tux Penguin" "2000" "" ""

1.5.2 Verwenden der Variablenersetzung #

Variablenersetzungen wenden beginnend von links oder rechts ein Schema auf den Inhalt einer Variable an. Die folgende Liste enthält die möglichen Syntaxformen:

${VAR#schema}entfernt die kürzeste mögliche Übereinstimmung von links:

>file=/home/tux/book/book.tar.bz2>echo ${file#*/} home/tux/book/book.tar.bz2${VAR##schema}entfernt die längste mögliche Übereinstimmung von links:

>file=/home/tux/book/book.tar.bz2>echo ${file##*/} book.tar.bz2${VAR%schema}entfernt die kürzeste mögliche Übereinstimmung von rechts:

>file=/home/tux/book/book.tar.bz2>echo ${file%.*} /home/tux/book/book.tar${VAR%%schema}entfernt die längste mögliche Übereinstimmung von rechts:

>file=/home/tux/book/book.tar.bz2>echo ${file%%.*} /home/tux/book/book${VAR/pattern_1/pattern_2}ersetzt den Inhalt von VAR von PATTERN_1 durch PATTERN_2:

>file=/home/tux/book/book.tar.bz2>echo ${file/tux/wilber} /home/wilber/book/book.tar.bz2

1.6 Gruppieren und Kombinieren von Kommandos #

In Shells können Sie Kommandos für die bedingte Ausführung verketten und gruppieren. Jedes Kommando übergibt einen Endcode, der den Erfolg oder Misserfolg seiner Ausführung bestimmt. Wenn er 0 (Null) lautet, war das Kommando erfolgreich, alle anderen Codes bezeichnen einen Fehler, der spezifisch für das Kommando ist.

Die folgende Liste zeigt, wie sich Kommandos gruppieren lassen:

Kommando1 ; Kommando2führt die Kommandos in sequenzieller Reihenfolge aus. Der Endcode wird nicht geprüft. Die folgende Zeile zeigt den Inhalt der Datei mit

catan und gibt deren Dateieigenschaften unabhängig von deren Endcodes mitlsaus:>cat filelist.txt ; ls -l filelist.txtKommando1 && Kommando2führt das rechte Kommando aus, wenn das linke Kommando erfolgreich war (logisches UND). Die folgende Zeile zeigt den Inahlt der Datei an und gibt deren Dateieigenschaften nur aus, wenn das vorherige Kommando erfolgreich war (vgl. mit dem vorherigen Eintrag in dieser Liste):

>cat filelist.txt && ls -l filelist.txtKommando1 || Kommando2führt das rechte Kommando aus, wenn das linke Kommando fehlgeschlagen ist (logisches ODER). Die folgende Zeile legt nur ein Verzeichnis in

/home/wilber/baran, wenn die Erstellung des Verzeichnisses in/home/tux/foofehlgeschlagen ist:>mkdir /home/tux/foo || mkdir /home/wilber/barfuncname(){ ... }erstellt eine Shell-Funktion. Sie können mithilfe der Positionsparameter auf ihre Argumente zugreifen. Die folgende Zeile definiert die Funktion

hellofür die Ausgabe einer kurzen Meldung:>hello() { echo "Hello $1"; }Sie können diese Funktion wie folgt aufrufen:

>hello TuxDie Ausgabe sieht wie folgt aus:

Hello Tux

1.7 Arbeiten mit häufigen Ablaufkonstrukten #

Zur Steuerung des Ablaufs Ihres Skripts verfügt eine Shell über while-, if-, for- und case-Konstrukte.

1.7.1 Das Steuerungskommando „if“ #

Das Kommando if wird verwendet, um Ausdrücke zu prüfen. Beispielsweise testet der folgende Code, ob es sich beim aktuellen Benutzer um Tux handelt:

if test $USER = "tux"; then echo "Hello Tux." else echo "You are not Tux." fi

Der Testausdruck kann so komplex oder einfach wie möglich sein. Der folgende Ausdruck prüft, ob die Datei foo.txt existiert:

if test -e /tmp/foo.txt ; then echo "Found foo.txt" fi

Der Testausdruck kann auch in eckigen Klammern abgekürzt werden:

if [ -e /tmp/foo.txt ] ; then echo "Found foo.txt" fi

Weitere nützliche Ausdrücke finden Sie unter https://bash.cyberciti.biz/guide/If..else..fi.

1.7.2 Erstellen von Schleifen mit dem Kommando for #

Mithilfe der for-Schleife können Sie Kommandos an einer Liste von Einträgen ausführen. Beispielsweise gibt der folgende Code einige Informationen über PNG-Dateien im aktuellen Verzeichnis aus:

for i in *.png; do ls -l $i done

1.8 Weitere Informationen #

Wichtige Informationen über die Bash-Shell finden Sie auf den man-Seiten zu man bash. Für weitere Informationen zu diesem Thema siehe die folgende Liste:

http://tldp.org/LDP/Bash-Beginners-Guide/html/index.html – Bash-Anleitungen für Anfänger

http://tldp.org/HOWTO/Bash-Prog-Intro-HOWTO.html – BASH-Programmierung – Einführende schrittweise Anleitungen

http://tldp.org/LDP/abs/html/index.html – Anleitung für erweiterte Bash-Skripts

http://www.grymoire.com/Unix/Sh.html – Sh - the Bourne Shell (Sh – die Bourne-Shell)

2 Grundlegende Infos zu sudo #

Für bestimmte Kommandos sind root-Berechtigungen erforderlich. Die Anmeldung als root ist aus Sicherheitsgründen und zur Vermeidung von Fehlern jedoch nicht zu empfehlen. Es ist sicherer, sich als normaler Benutzer anzumelden und dann mit sudo Kommandos mit höheren Rechten auszuführen.

Auf SUSE Linux Enterprise Server ist sudo standardmäßig auf eine ähnliche Funktionsweise wie su konfiguriert. sudo ist jedoch eine flexible Methode, mit der Benutzer Kommandos mit den Rechten eines beliebigen anderen Benutzers ausführen können. Dies kann dazu genutzt werden, Rollen mit bestimmten Berechtigungen bestimmten Benutzern und Gruppen zuzuweisen. Es ist beispielsweise möglich, Mitgliedern der Gruppe users das Ausführen eines Kommandos mit den Berechtigungen des Benutzers wilber zu erlauben. Der Zugriff auf das Kommando wird weiter eingeschränkt, wenn Kommandooptionen nicht zugelassen werden. Während „su“ immer das root-Passwort für die Authentifizierung mit PAM erfordert, kann sudo für die Authentifizierung mit Ihren eigenen Berechtigungsnachweisen konfiguriert werden. Benutzer müssen folglich ihr root-Passwort nicht bekanntgeben, was die Sicherheit erhöht.

2.1 Grundlegende Verwendung von sudo #

Im folgenden Kapitel wird die grundlegende Verwendung von sudo vorgestellt.

2.1.1 Ausführung eines einzelnen Kommandos #

Als normaler Benutzer können Sie alle Kommandos als root ausführen, indem Sie sudo vor das Kommando setzen. Dadurch werden Sie aufgefordert, das root-Passwort anzugeben. Bei erfolgreicher Authentifizierung wird daraufhin das Kommando als root ausgeführt:

>id -un1 tux>sudoid -unroot's password:2 root>id -untux3>sudoid -un4 root

Das Kommando | |

Das Passwort wird bei der Eingabe weder als Klartext noch durch maskierende Zeichen angezeigt. | |

Nur Kommandos, die mit | |

Die erhöhten Rechte bleiben für bestimmte Zeit erhalten, sodass Sie das |

Die E/A-Umleitung funktioniert nicht mit sudo:

>sudoecho s > /proc/sysrq-trigger bash: /proc/sysrq-trigger: Permission denied>sudocat < /proc/1/maps bash: /proc/1/maps: Permission denied

Im oben genannten Beispiel werden nur die Kommandos echo und cat mit erhöhten Rechten ausgeführt. Die Umleitung wird von der Shell des Benutzers mit Benutzerrechten ausgeführt. Für eine Umleitung mit erhöhten Rechten müssen Sie eine Shell starten wie in Abschnitt 2.1.2, „Starten einer Shell“ beschrieben oder das dd-Dienstprogramm verwenden:

echo s | sudo dd of=/proc/sysrq-trigger sudo dd if=/proc/1/maps | cat

2.1.2 Starten einer Shell #

Es ist nicht immer praktisch, sudo jedes mal zur Ausführung eines Kommandos mit erhöhten Rechten zu verwenden. Sie können zwar das Kommando sudo bash verwenden, doch zum Starten einer Shell empfiehlt sich die Verwendung einer der integrierten Methoden:

sudo -s (<Kommando>)Startet eine von der Umgebungsvariablen

SHELLangegebene Shell oder die Standard-Shell des Zielbenutzers. Falls ein Kommando angegeben ist, wird es (mit der Option-c) an die Shell übergeben. Andernfalls wird die Shell im interaktiven Modus ausgeführt.tux:~ >sudo -s root's password:root:/home/tux #exittux:~ >sudo -i (<Kommando>)Ähnlich wie

-s, doch die Shell wird als Anmeldungs-Shell gestartet. Das bedeutet, dass die Startdateien der Shell (.profileusw.) verarbeitet werden und das aktuelle Arbeitsverzeichnis auf das Home-Verzeichnis des Zielbenutzers festgelegt wird.tux:~ >sudo -i root's password:root:~ #exittux:~ >

Standardmäßig gibt sudo keine Umgebungsvariablen weiter. Dieses Verhalten kann mit der Option env_reset geändert werden (weitere Informationen finden Sie unter Hilfreiche Flags und Optionen).

2.2 Konfigurieren von sudo #

sudo umfasst eine breite Palette an konfigurierbaren Optionen.

Wenn Sie sich versehentlich aus sudo ausgesperrt haben, starten Sie mit su - und dem root-Passwort eine root-Shell. Beheben Sie den Fehler mit visudo.

2.2.1 Bearbeiten der Konfigurationsdateien #

Die Hauptkonfigurationsdatei mit den Richtlinien für sudo ist /etc/sudoers. Da es möglich ist, sich selbst aus dem System auszusperren, wenn die Datei nicht gut erstellt ist, wird dringend empfohlen, visudo zum Bearbeiten zu verwenden. Es verhindert Bearbeitungskonflikte und prüft auf Syntaxfehler, bevor die Änderungen gespeichert werden.

Sie können statt visudo auch einen anderen Editor verwenden. Legen Sie dazu die Umgebungsvariable EDITOR fest, wie zum Beispiel:

sudo EDITOR=/usr/bin/nano visudo

Denken Sie daran, dass die Datei /etc/sudoers von den Systempaketen bereitgestellt wird und direkt in der Datei vorgenommene Änderungen möglicherweise Aktualisierungen beschädigen. Daher wird empfohlen, benutzerdefinierte Konfigurationen in Dateien im Verzeichnis /etc/sudoers.d/ abzulegen. Erstellen oder bearbeiten Sie eine Datei mit folgendem Kommando:

sudo visudo -f /etc/sudoers.d/NAME

Mit folgendem Kommando wird die Datei geöffnet und ein anderer Editor verwendet (in diesem Fall nano):

sudo EDITOR=/usr/bin/nano visudo -f /etc/sudoers.d/NAME

/etc/sudoers.d

Die Anweisung #includedir in /etc/sudoers ignoriert Dateien, die auf das Zeichen ~ (Tilde) enden oder das Zeichen. (Punkt) enthalten.

Führen Sie man 8 visudo aus, um weitere Informationen zum Kommando visudo zu erhalten.

2.2.2 Basiskonfigurationssyntax von sudoers #

Die sudoers-Konfigurationsdateien enthalten zwei Optionstypen: Zeichenketten und Flags. Zeichenketten können beliebige Werte enthalten, Flags hingegen können nur aktiviert (ON) oder deaktiviert (OFF) werden. Die wichtigsten Syntaxkonstrukte für sudoers-Konfigurationsdateien sind:

# Everything on a line after # is ignored 1 Defaults !insults # Disable the insults flag 2 Defaults env_keep += "DISPLAY HOME" # Add DISPLAY and HOME to env_keep tux ALL = NOPASSWD: /usr/bin/frobnicate, PASSWD: /usr/bin/journalctl 3

Es gibt zwei Ausnahmen: | |

Entfernen Sie das Ausrufezeichen ( | |

-

targetpw Dieses Flag steuert, ob der aufrufende Benutzer das Passwort des Zielbenutzers (ON) (beispielsweise

root) oder des aufrufenden Benutzers (OFF) eingeben muss.Defaults targetpw # Turn targetpw flag ON

-

rootpw Bei diesem Flag fordert

sudozur Eingabe desroot-Passworts auf. Die Standardeinstellung ist “OFF”.Defaults !rootpw # Turn rootpw flag OFF

-

env_reset Bei diesem Flag konstruiert

sudoeine minimale Umgebung mitTERM,PATH,HOME,MAIL,SHELL,LOGNAME,USER,USERNAMEundSUDO_*. Zusätzlich werden Variablen, die inenv_keepaufgelistet sind, aus der aufrufenden Umgebung importiert. Standardmäßig ist ON festgelegt.Defaults env_reset # Turn env_reset flag ON

-

env_keep Eine Liste der Umgebungsvariablen, die beizubehalten sind, wenn für das Flag

env_resetON festgelegt ist.# Set env_keep to contain EDITOR and PROMPT Defaults env_keep = "EDITOR PROMPT" Defaults env_keep += "JRE_HOME" # Add JRE_HOME Defaults env_keep -= "JRE_HOME" # Remove JRE_HOME

-

env_delete Eine Liste der Umgebungsvariablen, die zu löschen sind, wenn für das Flag

env_resetOFF festgelegt ist.# Set env_delete to contain EDITOR and PROMPT Defaults env_delete = "EDITOR PROMPT" Defaults env_delete += "JRE_HOME" # Add JRE_HOME Defaults env_delete -= "JRE_HOME" # Remove JRE_HOME

Das Token Defaults kann auch zum Erstellen von Aliassen für eine Sammlung von Benutzern, Hosts oder Kommandos verwendet werden. Außerdem ist es möglich, eine Option anzuwenden, die nur für eine bestimmte Reihe von Benutzern gültig ist.

Genauere Informationen zur Konfigurationsdatei /etc/sudoers erhalten Sie mit dem Kommando man 5 sudoers.

2.2.3 Grundlegende sudoers-Regeln #

Jede Regel befolgt folgendes Schema ([] markiert optionale Teile):

#Who Where As whom Tag What User_List Host_List = [(User_List)] [NOPASSWD:|PASSWD:] Cmnd_List

User_ListEine oder mehrere (durch Komma getrennte) Kennungen: Entweder ein Benutzername, eine Gruppe im Format

%GROUPNAMEoder eine Benutzer-ID im Format#UID. Eine Negierung wird mit dem Präfix!Präfix.Host_ListEine oder mehrere (durch Komma getrennte) Kennungen: Entweder ein (vollständig qualifizierter) Hostname oder eine IP-Adresse. Eine Negierung wird mit dem Präfix

!Präfix.ALList eine häufige Wahl fürHost_List.NOPASSWD:|PASSWD:Der Benutzer wird nicht aufgefordert, ein Passwort einzugeben, wenn Kommandos ausgeführt werden, die

Cmd_ListnachNOPASSWD:entsprechen.PASSWDist der Standard. Es muss nur angegeben werden, wenn sich sowohlPASSWDals auchNOPASSWDauf derselben Zeile befinden:tux ALL = PASSWD: /usr/bin/foo, NOPASSWD: /usr/bin/bar

Cmnd_ListEiner oder mehrere (durch Komma getrennte) Bezeichner: Ein Pfad zu einer ausführbaren Datei, gefolgt von einem optionalen zulässigen Argument.

/usr/bin/foo # Anything allowed /usr/bin/foo bar # Only "/usr/bin/foo bar" allowed /usr/bin/foo "" # No arguments allowed

ALL kann als User_List, Host_List und Cmnd_List verwendet werden.

Eine Regel, die es tux erlaubt, alle Kommandos als „root“ ohne Eingabe des Passworts auszuführen:

tux ALL = NOPASSWD: ALL

Eine Regel, die es tux erlaubt, systemctl restart apache2 auszuführen:

tux ALL = /usr/bin/systemctl restart apache2

Eine Regel, die es tux erlaubt, wall als admin ohne Argumente auszuführen:

tux ALL = (admin) /usr/bin/wall ""

Verwenden Sie keine Regeln wie ALL ALL = ALL ohne Defaults targetpw. Andernfalls kann jeder Benutzer Kommandos als root ausführen.

Wenn Sie den Gruppennamen in der Datei sudoers angeben, verwenden Sie den NetBIOS-Domänennamen statt des Bereichs, beispielsweise:

%DOMAIN\\GROUP_NAME ALL = (ALL) ALL

Denken Sie bei winbindd daran, dass das Format auch von der Option winbind separator in der Datei smb.conf abhängt. Die Standardeinstellung ist \. Wird sie beispielsweise in + geändert, muss das Kontoformat in der Datei sudoers entsprechend DOMAIN+GROUP_NAME lauten.

2.3 sudo-Anwendungsfälle #

Die Standardkonfiguration funktioniert bei standardmäßigen Verwendungsszenarien, lässt sich jedoch für spezifische Bedürfnisse anpassen.

2.3.1 Verwenden von sudo ohne root-Passwort #

Grundsätzlich können Mitglieder der Gruppe wheel alle Kommandos mit sudo als „root“ ausführen. In der folgenden Vorgehensweise wird erklärt, wie ein Benutzerkonto zur Gruppe wheel hinzugefügt wird.

Fügen Sie Ihr Benutzerkonto zur Gruppe

wheelhinzu.Falls Ihr Benutzerkonto nicht bereits Mitglied der Gruppe

wheelist, fügen Sie es mit dem Kommandosudo usermod -a -G wheel USERNAMEhinzu. Melden Sie sich ab und wieder an, um die Änderung zu aktivieren. Überprüfen Sie, ob die Änderung erfolgreich war, indem Sie das Kommandogroups BENUTZERNAMEausführen.Authentifizieren Sie sich mit dem normalen Passwort des Benutzerkontos.

Erstellen Sie die Datei

/etc/sudoers.d/userpwmit dem Kommandovisudo(siehe Abschnitt 2.2.1, „Bearbeiten der Konfigurationsdateien“) und fügen Sie Folgendes hinzu:Defaults !targetpw

Wählen Sie eine neue Standardregel aus.

Falls Sie möchten, dass Benutzer ihre Passwörter erneut eingeben oder nicht, entfernen Sie das Kommentarzeichen in der entsprechenden Zeile in

/etc/sudoersund kommentieren Sie die Standardregel aus.## Uncomment to allow members of group wheel to execute any command # %wheel ALL=(ALL) ALL ## Same thing without a password # %wheel ALL=(ALL) NOPASSWD: ALL

Gestalten Sie die Standardregel restriktiver.

Kommentieren Sie die Regel, die alles erlaubt, in

/etc/sudoersaus oder löschen Sie sie:ALL ALL=(ALL) ALL # WARNING! Only use this together with 'Defaults targetpw'!

Warnung: Gefährliche Regel in sudoersÜberspringen Sie diesen Schritt nicht. Andernfalls kann jeder beliebige Benutzer jedes beliebige Kommando als

rootausführen.Testen Sie die Konfiguration.

Führen Sie

sudoals Mitglied und Nicht-Mitglied vonwheelaus.tux:~ >groups users wheeltux:~ >sudo id -un tux's password: rootwilber:~ >groups userswilber:~ >sudo id -un wilber is not in the sudoers file. This incident will be reported.

2.3.2 Verwenden von sudo mit X.Org-Anwendungen #

Werden grafische Anwendungen mit sudo gestartet, führt dies normalerweise zu folgendem Fehler:

>sudoxterm xterm: Xt error: Can't open display: %s xterm: DISPLAY is not set

Eine einfache Behelfslösung ist xhost. Damit wird dem root-Benutzer vorübergehend der Zugriff auf die X-Sitzung des lokalen Benutzers gestattet. Dies erfolgt mit folgendem Kommando:

xhost si:localuser:root

Folgendes Kommando entfernt den gewährten Zugriff:

xhost -si:localuser:root

Die Ausführung grafischer Anwendungen mit root-Rechten beeinträchtigt die Sicherheit. Es wird empfohlen, den root-Zugriff für eine grafische Anwendung nur in Ausnahmefällen zu aktivieren. Außerdem sollte der gewährte root-Zugriff sofort nach Schließen der grafischen Anwendung entzogen werden.

2.4 Weitere Informationen #

Das Kommando sudo --help gibt einen kurzen Überblick über die verfügbaren Kommandozeilenoptionen und das Kommando man sudoers detaillierte Informationen über sudoers und dessen Konfiguration.

3 Verwenden von YaST #

YaST ist ein SUSE Linux Enterprise Server-Tool mit einer grafischen Oberfläche für alle wesentlichen Installations- und Systemkonfigurationsaufgaben. Ob Sie Pakete aktualisieren, einen Drucker konfigurieren, Firewall-Einstellungen bearbeiten, einen FTP-Server einrichten oder eine Festplatte partitionieren müssen – mit YaST ist dies alles möglich. YaST ist in Ruby geschrieben und weist eine erweiterbare Architektur auf, die es ermöglicht, neue Funktionen über Module hinzuzufügen.

Weitere Informationen zu YaST sind auf der offiziellen Website des Projekts verfügbar unter https://yast.opensuse.org/.

3.1 YaST-Oberfläche im Überblick #

YaST verfügt über zwei grafische Oberflächen. Die eine wird für grafische Desktop-Umgebungen wie KDE und GNOME verwendet. Die andere ist eine ncurses-basierte pseudo-grafische Oberfläche für Systeme ohne X-Server (weitere Informationen hierzu finden Sie in Kapitel 4, YaST im Textmodus).

In der grafischen Version von YaST sind alle Module in YaST nach Kategorie gruppiert. Über die Navigationsleiste erhalten Sie schnell Zugriff auf die Module in der gewünschten Kategorie. Im Suchfeld am oberen Rand lassen sich Module nach Namen suchen. Geben Sie zur Suche nach einem bestimmten Modul dessen Namen im Suchfeld ein. Danach sollten Sie beim Tippen die Module sehen, die der eingegebenen Zeichenfolge entsprechen.

3.2 Nützliche Tastenkombinationen #

Die grafische Version von YaST unterstützt Tastenkombinationen.

- Bildschirminhalt drucken

Erstellt und speichert ein Bildschirmfoto. In bestimmten Desktop-Umgebungen funktioniert diese Kombination womöglich nicht.

- Umschalttaste–F4

Aktiviert und deaktiviert die Farbpalette für Benutzer mit Sehbehinderungen.

- Umschalttaste–F7

Aktiviert/Deaktiviert die Protokollierung von Fehlermeldungen (Debugging).

- Umschalttaste–F8

Öffnet einen Dateidialog, über den Sie die Protokolldateien in einem benutzerdefinierten Speicherort speichern können.

- Strg–Umschalttaste–Alt–D

Sendet ein Fehlerereignis (Debugging). YaST-Module können darauf mit der Ausführung spezieller Debugging-Aktionen reagieren. Das Ergebnis ist abhängig vom jeweiligen YaST-Modul.

- Strg–Umschalttaste–Alt–M

Startet und stoppt den Makro-Rekorder.

- Strg–Umschalttaste–Alt–P

Gibt ein Makro wieder.

- Strg–Umschalttaste–Alt–S

Öffnet den Layoutdatei-Editor.

- Strg–Umschalttaste–Alt–T

Speichert den Miniprogramm-Baum in der Protokolldatei.

- Strg–Umschalttaste–Alt–X

Öffnet ein Konsolenfenster (xterm). Nützlich für VNC-Installationen.

- Strg–Umschalttaste–Alt–Y

Öffnet den Miniprogramm-Baum-Browser.

4 YaST im Textmodus #

Die ncurses-basierte pseudo-grafische YaST-Oberfläche sollte vor allem Systemadministratoren bei der Verwaltung von Systemen ohne X-Server unterstützen. Die Oberfläche bietet einige Vorteile im Vergleich zu herkömmlichen grafischen Benutzeroberflächen. Die Navigation auf der ncurses-Oberfläche erfolgt über die Tastatur. Für praktisch alle Oberflächenelemente stehen Tastenkombinationen zur Verfügung. Die ncurses-Oberfläche benötigt nur wenige Ressourcen und wird selbst auf langsamer Hardware schnell ausgeführt. Die ncurses-basierte Version von YaST lässt sich über eine SSH-Verbindung ausführen, damit Sie Remote-Systeme verwalten können. Denken Sie daran, dass die minimale unterstützte Größe des Terminal-Emulators, in dem Sie YaST ausführen, 80 x 25 Zeichen beträgt.

Öffnen Sie zum Starten der ncurses-basierten Version von YaST das Terminal und führen Sie das Kommando sudo yast2 aus. Navigieren Sie anhand der →|- oder Pfeiltasten durch die Oberflächenelemente wie Menüelemente, Felder und Schaltflächen. Auf alle Menüelemente und Schaltflächen in YaST wird über die entsprechenden Funktionstasten oder Tastenkombinationen zugegriffen. Beispielsweise brechen Sie den aktuellen Vorgang durch Drücken der F9-Taste ab. Mit der F10-Taste übernehmen Sie Änderungen. Bei jedem Menüelement und jeder Schaltfläche auf der ncurses-basierten Oberfläche von YaST ist in der Bezeichnung ein Buchstabe hervorgehoben. Dieser Buchstabe ist Teil der Tastenkombination, die dem Oberflächenelement zugewiesen wurde. Beispielsweise ist der Buchstabe B auf der Schaltfläche hervorgehoben. Das bedeutet, dass Sie die Schaltfläche durch Drücken von Alt–Alt+Q aktivieren können.

Wenn ein YaST-Dialogfeld verzerrt oder unleserlich wird (z. B. beim Ändern der Fenstergröße), drücken Sie Strg–L. Damit wird das Fenster aktualisiert, und der Fensterinhalt wird wiederhergestellt.

4.2 Erweiterte Tastenkombinationen #

Die ncurses-basierte Version von YaST bietet einige erweiterte Tastenkombinationen.

- Umschalttaste–F1

Zeigt eine Liste der erweiterten Tastenfunktionen.

- Umschalttaste–F4

Ändert das Farbschema.

- Strg–Q

Beendet die Anwendung.

- Strg–L

Aktualisiert den Bildschirm.

- Strg–DF1

Zeigt eine Liste der erweiterten Tastenfunktionen.

- Strg–DUmschalttaste–D

Speichert das Dialogfeld als Bildschirmfoto in der Protokolldatei.

- Strg–DUmschalttaste–Y

Öffnet YDialogSpy mit der Widget-Hierarchie.

4.3 Einschränkung der Tastenkombinationen #

Wenn der Fenster-Manager globale Alt-Kombinationen verwendet, funktionieren die Alt-Kombinationen in YaST möglicherweise nicht. Tasten wie Alt oder Umschalttaste können auch durch die Einstellungen des Terminals belegt sein.

- Verwenden von Alt statt Esc

Tastenkombinationen mit Alt können auch mit Esc anstelle von Alt ausgeführt werden. Esc–H ersetzt beispielsweise Alt–H. (Drücken Sie Esc, und drücken Sie dann H.)

- Navigation vor und zurück mit Strg–F und Strg–B

Wenn die Kombinationen mit Alt und Umschalttaste vom Fenster-Manager oder dem Terminal belegt sind, verwenden Sie stattdessen die Kombinationen Strg–F (forward=vor) und Strg–B (backward=zurück).

- Einschränkung der Funktionstasten

Die Funktionstasten (F1 bis F12) werden auch für Funktionen herangezogen. Bestimmte Funktionstasten können vom Terminal übernommen werden und stehen eventuell für YaST nicht zur Verfügung. Auf einer reinen Textkonsole sollten die Tastenkombinationen mit Alt und die Funktionstasten jedoch stets vollständig zur Verfügung stehen.

4.4 YaST-Kommandozeilenoptionen #

Neben der Schnittstelle im Textmodus bietet YaST auch eine Kommandozeilenschnittstelle. Rufen Sie eine Liste der YaST-Kommandozeilenoptionen mit folgendem Kommando ab:

>sudoyast -h

4.4.1 Installieren von Paketen über die Kommandozeile #

Wenn Sie den Namen des Pakets kennen und das Paket von einem aktiven Installations-Repository bereitgestellt wird, können Sie das Paket mithilfe der Kommandozeilenoption -i installieren:

>sudoyast -i package_name

oder

>sudoyast --install -i package_name

package_name kann ein einzelner kurzer Paketname sein (beispielsweise gvim, solche Pakete werden mit Abhängigkeitsüberprüfung installiert) oder der vollständige Pfad zu einem RPM-Paket, das ohne Abhängigkeitsüberprüfung installiert wird.

YaST bietet grundlegende Funktionen zur Verwaltung von Software von der Kommandozeile aus. Für anspruchsvollere Paketverwaltungsaufgaben sollten Sie Zypper verwenden. Weitere Informationen zu Zypper finden Sie in Abschnitt 9.1, „Verwenden von zypper“

4.4.2 Arbeiten mit einzelnen Modulen #

Um Zeit zu sparen, können Sie einzelne YaST-Module mit folgendem Kommando starten:

>sudoyast module_name

Eine Liste aller auf Ihrem System verfügbaren Module können Sie mit yast -l oder yast --list anzeigen.

4.4.3 Kommandozeilenparameter der YaST-Module #

Um die Verwendung von YaST-Funktionen in Skripts zu ermöglichen, bietet YaST Kommandozeilenunterstützung für einzelne Module. Die Kommandozeilenunterstützung steht jedoch nicht für alle Module zur Verfügung. Die verfügbaren Optionen eines Moduls zeigen Sie mit folgendem Kommando an:

>sudoyast module_name help

Wenn ein Modul keine Kommandozeilenunterstützung bietet, wird es im Textmodus gestartet und es wird folgende Meldung angezeigt:

This YaST module does not support the command line interface.

In den nachfolgenden Abschnitten werden alle YaST-Module mit Kommandozeilenunterstützung beschrieben, und es werden alle zugehörigen Kommandos und die verfügbaren Optionen kurz erläutert.

4.4.3.1 Häufige Kommandos in YaST-Modulen #

Alle YaST-Module unterstützen die folgenden Kommandos:

- help

Zeigt eine Liste der unterstützten Kommandos des Moduls mit einer Beschreibung an:

>sudoyast lan help- longhelp

Wie

help, zeigt jedoch zusätzlich eine detaillierte Liste der Optionen aller Kommandos mit einer Beschreibung an:>sudoyast lan longhelp- xmlhelp

Wie

longhelp; die Ausgabe ist jedoch als XML-Dokument strukturiert und wird in eine Datei umgeleitet:>sudoyast lan xmlhelp xmlfile=/tmp/yast_lan.xml- interactive

Gibt den Modus Interaktiv ein. Damit führen Sie die Kommandos des Moduls aus, ohne das Präfix

sudo yastangeben zu müssen. MitBeendenverlassen Sie den Interaktiv-Modus.

4.4.3.2 yast add-on #

Fügt ein neues Add-on-Produkt aus dem angegebenen Pfad ein:

>sudoyast add-on http://server.name/directory/Lang-AddOn-CD1/

Sie können den Quellpfad mit den folgenden Protokollen angeben: http:// ftp:// nfs:// disk:// cd:// oder dvd://.

4.4.3.3 yast audit-laf #

Öffnet und konfiguriert das Linux Audit Framework. Weitere Informationen finden Sie im Book “Security and Hardening Guide”. yast audit-laf akzeptiert die folgenden Kommandos:

- set

Legt eine Option fest:

>sudoyast audit-laf set log_file=/tmp/audit.logMit

yast audit-laf set helperhalten Sie eine vollständige Liste der Optionen.- show

Zeigt die Einstellungen für eine Option an:

>sudoyast audit-laf show diskspace space_left: 75 space_left_action: SYSLOG admin_space_left: 50 admin_space_left_action: SUSPEND action_mail_acct: root disk_full_action: SUSPEND disk_error_action: SUSPENDMit

yast audit-laf show helperhalten Sie eine vollständige Liste der Optionen.

4.4.3.4 yast dhcp-server #

Verwaltet den DHCP-Server und konfiguriert dessen Einstellung. yast dhcp-server akzeptiert die folgenden Kommandos:

- Deaktivieren

Deaktiviert den DHCP-Serverdienst.

- enable

Aktiviert den DHCP-Serverdienst.

- Host

Konfiguriert Einstellungen für einzelne Hosts.

- interface

Gibt an, welche Netzwerkschnittstelle überwacht werden soll:

>sudoyast dhcp-server interface current Selected Interfaces: eth0 Other Interfaces: bond0, pbu, eth1Mit

yast dhcp-server interface helperhalten Sie eine vollständige Liste der Optionen.- Optionen

Verwaltet globale DHCP-Optionen. Mit

yast dhcp-server options helperhalten Sie eine vollständige Liste der Optionen.- status

Gibt den Status des DHCP-Dienstes aus.

- subnet

Verwaltet die DHCP-Subnetzoptionen. Mit

yast dhcp-server subnet helperhalten Sie eine vollständige Liste der Optionen.

4.4.3.5 yast dns-server #

Verwaltet die DNS-Serverkonfiguration. yast dns-server akzeptiert die folgenden Kommandos:

- acls

Zeigt die Einstellungen für die Zugriffssteuerungsliste an:

>sudoyast dns-server acls show ACLs: ----- Name Type Value ---------------------------- any Predefined localips Predefined localnets Predefined none Predefined- dnsrecord

Konfiguriert Zonenressourcen-Datensätze:

>sudoyast dnsrecord add zone=example.org query=office.example.org type=NS value=ns3Mit

yast dns-server dnsrecord helperhalten Sie eine vollständige Liste der Optionen.- forwarders

Konfiguriert DNS-Forwarder:

>sudoyast dns-server forwarders add ip=10.0.0.100>sudoyast dns-server forwarders show [...] Forwarder IP ------------ 10.0.0.100Mit

yast dns-server forwarders helperhalten Sie eine vollständige Liste der Optionen.- Host

Verarbeitet gleichzeitig „A“ und den zugehörigen „PTR“-Eintrag:

>sudoyast dns-server host show zone=example.orgMit

yast dns-server host helperhalten Sie eine vollständige Liste der Optionen.- logging

Konfiguriert die Protokollierungseinstellungen:

>sudoyast dns-server logging set updates=no transfers=yesMit

yast dns-server logging helperhalten Sie eine vollständige Liste der Optionen.- mailserver

Konfiguriert die Zonen-Mailserver:

>sudoyast dns-server mailserver add zone=example.org mx=mx1 priority=100Mit

yast dns-server mailserver helperhalten Sie eine vollständige Liste der Optionen.- nameserver

Konfiguriert die Zonen-Nameserver:

>sudoyast dns-server nameserver add zone=example.com ns=ns1Mit

yast dns-server nameserver helperhalten Sie eine vollständige Liste der Optionen.- soa

Konfiguriert den SOA-Datensatz (Start of Authority):