- Acerca de esta guía

- I Presentación de SUSE Enterprise Storage (SES)

- 1 SES y Ceph

- 2 Requisitos y recomendaciones de hardware

- 2.1 Descripción general de la red

- 2.2 Configuraciones de varias arquitecturas

- 2.3 Configuración del hardware

- 2.4 Nodos de almacenamiento de objetos

- 2.5 Nodos de monitor

- 2.6 Nodos de Object Gateway

- 2.7 Nodos de servidor de metadatos

- 2.8 Nodo de administración

- 2.9 Nodos de iSCSI Gateway

- 2.10 SES y otros productos SUSE

- 2.11 Limitaciones de nombres

- 2.12 Servidor compartido por varios OSD y monitores

- 3 Configuración de alta disponibilidad del nodo de administración

- II Distribución del clúster de Ceph

- III Actualización desde versiones anteriores

- 10 Actualización desde SUSE Enterprise Storage 6 a la versión 7.1

- 10.1 Antes de actualizar

- 10.2 Actualización del master de Salt

- 10.3 Actualización de los nodos de MON, MGR y OSD

- 10.4 Actualización de nodos de pasarela

- 10.5 Instalación de

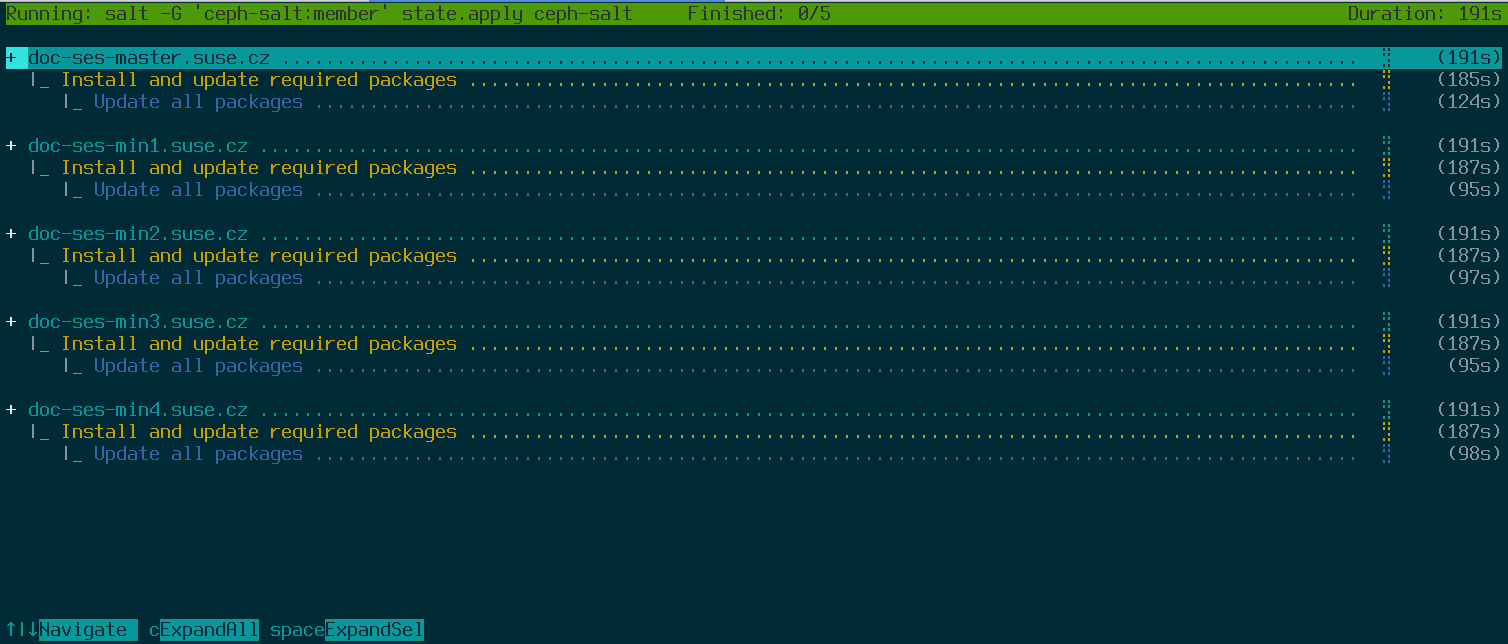

ceph-salty aplicación de la configuración del clúster - 10.6 Actualización y adopción de la pila de supervisión

- 10.7 Redistribución del servicio de pasarela

- 10.8 Limpieza posterior a la actualización

- 11 Actualización desde SUSE Enterprise Storage 7 a la versión 7.1

- 11.1 Antes de actualizar

- 11.2 Migración de SUSE Linux Enterprise Server en cada nodo del clúster a la versión SUSE Linux Enterprise Server 15 SP3

- 11.3 Actualización de los paquetes relacionados con SUSE Enterprise Storage en cada nodo del clúster

- 11.4 Actualización de los servicios de clúster de Ceph existentes

- 10 Actualización desde SUSE Enterprise Storage 6 a la versión 7.1

- A Actualizaciones de mantenimiento de Ceph basadas en versiones secundarias superiores de Pacific

- Glosario

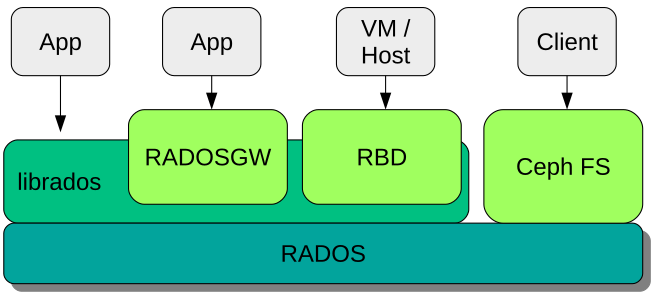

- 1.1 Interfaces con el almacén de objetos de Ceph

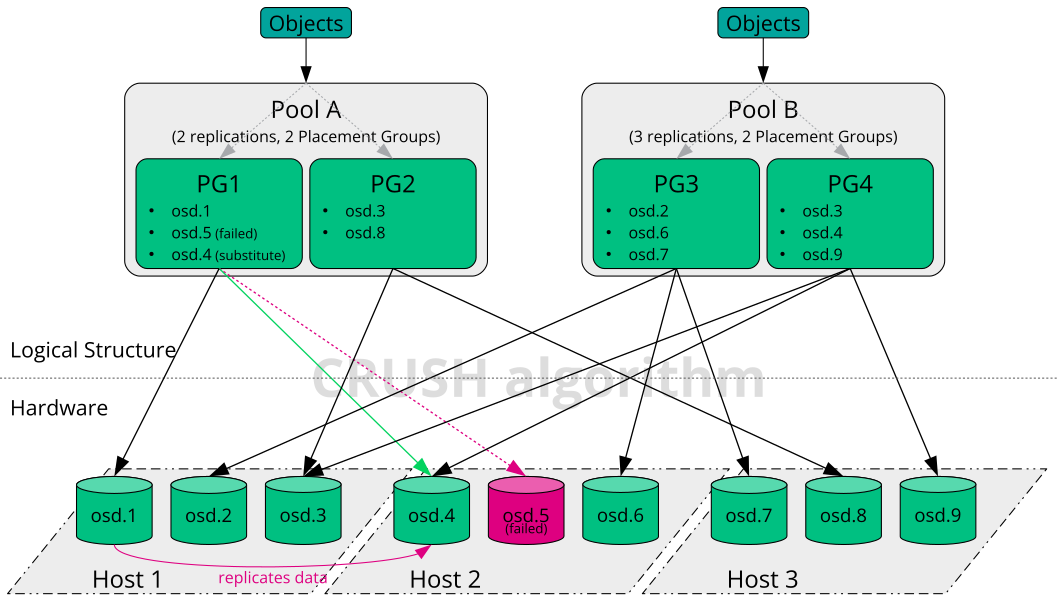

- 1.2 Ejemplo de Ceph a pequeña escala

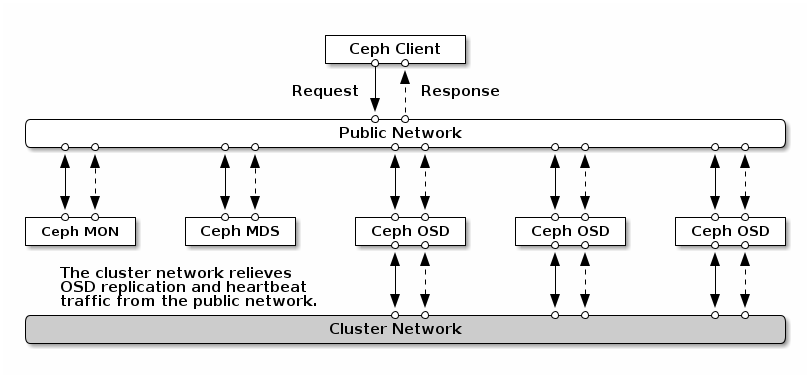

- 2.1 Descripción general de la red

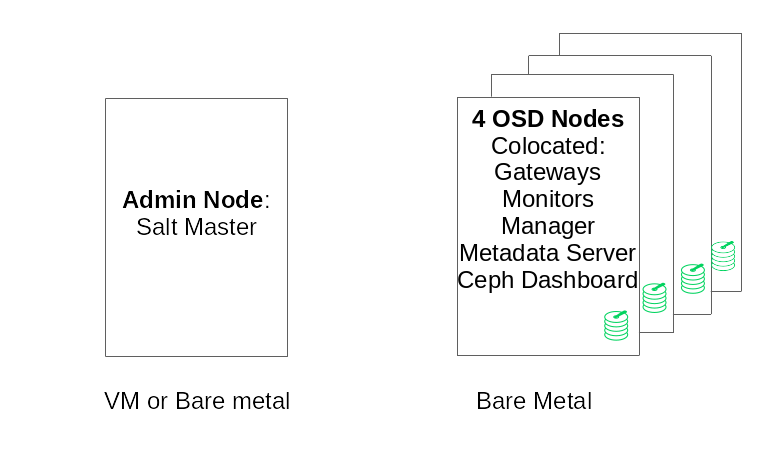

- 2.2 Configuración de clúster mínima

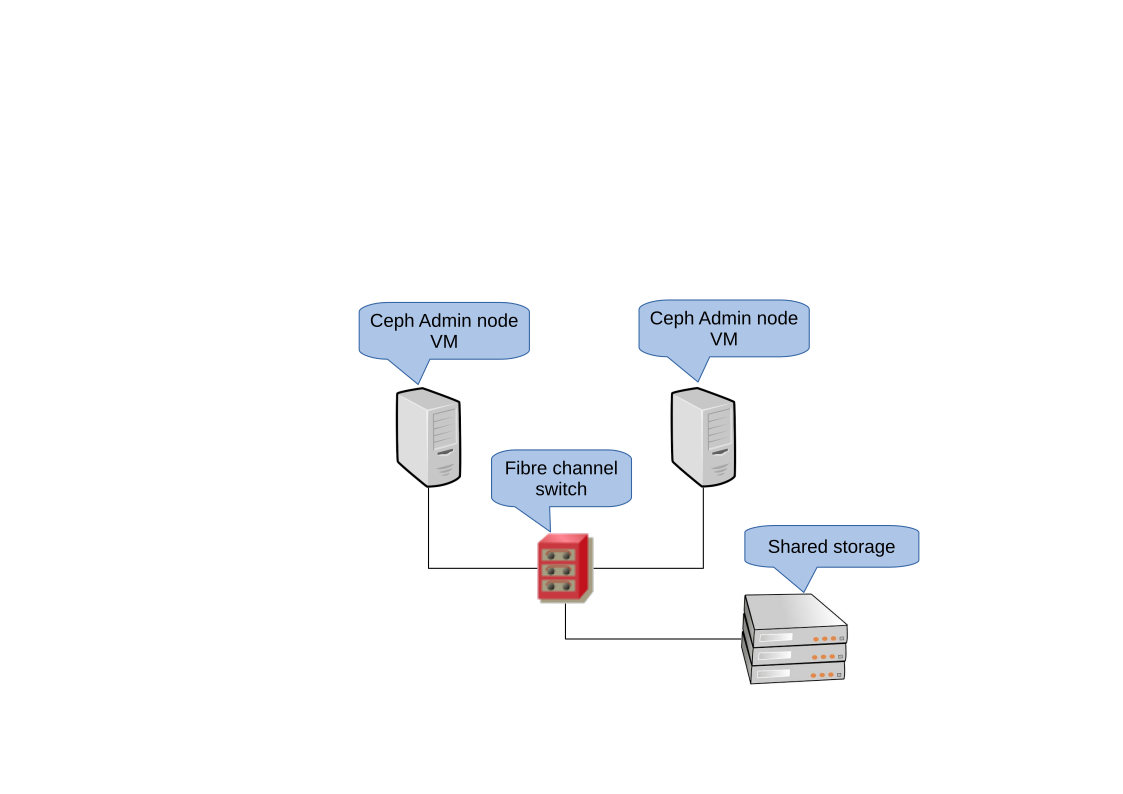

- 3.1 Clúster de alta disponibilidad de 2 nodos para el nodo de administración

- 7.1 Distribución de un clúster mínimo

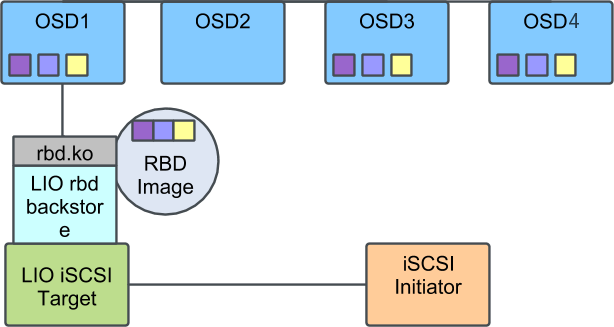

- 9.1 Clúster de Ceph con una sola instancia de iSCSI Gateway

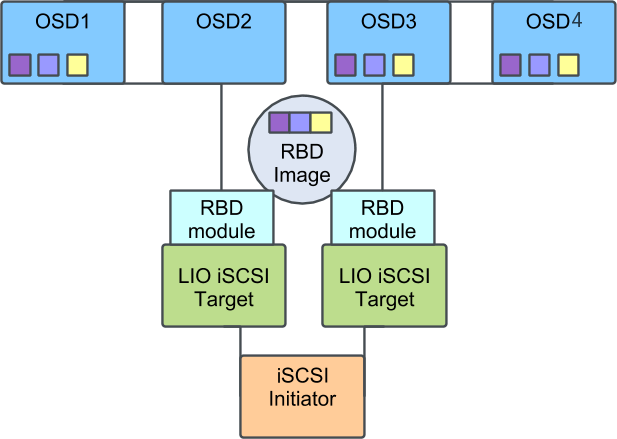

- 9.2 Clúster de Ceph con varias instancias de iSCSI Gateway

Copyright © 2020–2025 SUSE LLC y colaboradores. Reservados todos los derechos.

Salvo que se indique lo contrario, este documento está sujeto a la licencia Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Para obtener información sobre las marcas comerciales de SUSE, consulte http://www.suse.com/company/legal/. Todas las marcas comerciales de otros fabricantes son propiedad de sus propietarios respectivos. Los símbolos de marcas comerciales (®, ™, etc.) indican marcas comerciales de SUSE y sus afiliados. Los asteriscos (*) indican marcas comerciales de otros fabricantes.

Toda la información recogida en esta publicación se ha compilado prestando toda la atención posible al más mínimo detalle. Sin embargo, esto no garantiza una precisión total. Ni SUSE LLC, ni sus filiales, ni los autores o traductores serán responsables de los posibles errores o las consecuencias que de ellos pudieran derivarse.

Acerca de esta guía #

Esta guía se centra en la distribución de un clúster de Ceph básico y en cómo distribuir servicios adicionales. También se describen los pasos necesarios para actualizar a SUSE Enterprise Storage 7.1 desde la versión anterior del producto.

SUSE Enterprise Storage 7.1 es una extensión para SUSE Linux Enterprise Server 15 SP3. Combina las funciones del proyecto de almacenamiento Ceph (http://ceph.com/) con la ingeniería empresarial y la asistencia de SUSE. SUSE Enterprise Storage 7.1 proporciona a las organizaciones de TI la capacidad de distribuir una arquitectura de almacenamiento distribuida que admite varios casos de uso mediante plataformas de hardware básicas.

1 Documentación disponible #

La documentación de nuestros productos está disponible en https://documentation.suse.com, donde también encontrará las actualizaciones más recientes y podrá explorar o descargar la documentación en diferentes formatos. Las últimas actualizaciones de la documentación se pueden encontrar en la versión en inglés.

Además, la documentación del producto también estará disponible en el sistema instalado, en la vía /usr/share/doc/manual. Se incluye en un paquete de RPM denominado ses-manual_LANG_CODE. Instálelo si aún no está en el sistema, por ejemplo:

# zypper install ses-manual_enLa documentación disponible para este producto es la siguiente:

- Guía de distribución

Esta guía se centra en la distribución de un clúster de Ceph básico y en cómo distribuir servicios adicionales. También se describen los pasos necesarios para actualizar a SUSE Enterprise Storage 7.1 desde la versión anterior del producto.

- Guía de administración y operaciones

Esta guía se centra en las tareas rutinarias de las que usted, como administrador, debe ocuparse después de que se haya distribuido el clúster de Ceph básico (operaciones del día 2). También describe todas las formas admitidas para acceder a los datos almacenados en un clúster de Ceph.

- Guía de protección de la seguridad

Esta guía se centra en cómo garantizar la seguridad del clúster.

- Guía de resolución de problemas

Esta guía describe varios problemas comunes al ejecutar SUSE Enterprise Storage 7.1 y otros problemas relacionados con los componentes relevantes, como Ceph u Object Gateway.

- Guía de SUSE Enterprise Storage para Windows

Esta guía describe la integración, instalación y configuración de entornos Microsoft Windows y SUSE Enterprise Storage mediante el controlador de Windows.

2 Proporcionar comentarios #

Agradecemos sus comentarios y contribuciones sobre esta documentación. Existen varios canales para enviarlos:

- Peticiones de servicio y asistencia técnica

Para obtener más información sobre los servicios y las opciones de asistencia técnica disponibles para el producto, consulte http://www.suse.com/support/.

Para abrir una petición de servicio, necesita una suscripción de SUSE registrada en el Centro de servicios al cliente de SUSE. Diríjase a https://scc.suse.com/support/requests, entre a la sesión y haga clic en (Crear nueva).

- Informes de errores

Puede informar sobre errores de la documentación en https://bugzilla.suse.com/. Para informar sobre errores, se requiere una cuenta de Bugzilla.

Para simplificar el proceso, puede utilizar los enlaces (Informar sobre errores de la documentación) que aparecen junto a los titulares de la versión HTML de este documento. De esta forma, se preseleccionan el producto y la categoría correctos en Bugzilla y se añade un enlace a la sección actual. Así, podrá empezar a escribir directamente el informe.

- Contribuciones

Para contribuir a esta documentación, utilice los enlaces (Editar origen) situados junto a los titulares de la versión HTML de este documento. Llevan al código fuente de GitHub, donde puede abrir una petición de extracción. Para contribuir, se requiere una cuenta de GitHub.

Para obtener más información sobre el entorno utilizado en esta documentación, consulte el archivo README (Léame) en https://github.com/SUSE/doc-ses.

- Correo

También puede informar sobre errores y enviar comentarios sobre la documentación a <doc-team@suse.com>. Por favor, incluya el título del documento, la versión del producto y la fecha de publicación de la documentación. También puede incluir el número de sección y título correspondientes (o proporcionar la URL), así como una descripción concisa del problema.

3 Convenciones de la documentación #

En este documento se utilizan los siguientes avisos y convenciones tipográficas:

/etc/passwd: nombres de directorio y nombres de archivos.ESPACIO RESERVADO: sustituya ESPACIO RESERVADO con el valor real.

VÍA: una variable de entorno.ls,‑‑help: comandos, opciones y parámetros.user: el nombre del usuario o grupo.package_name: el nombre de un paquete de software.

Alt, Alt–F1: tecla o combinación de teclas que pulsar. Las teclas se muestran en mayúsculas como en un teclado.

, › : elementos de menú, botones.

AMD/Intel Este párrafo solo es relevante para las arquitecturas AMD64/Intel 64. Las flechas marcan el principio y el final del bloque de texto.

IBM Z, POWER Este párrafo solo es relevante para las arquitecturas

IBM ZyPOWER. Las flechas marcan el principio y el final del bloque de texto.Capítulo 1, “capítulo de ejemplo”: referencia cruzada a otro capítulo de esta guía.

Comandos que se deben ejecutar con privilegios de usuario

root. A menudo, también es posible añadir estos comandos como prefijos con el comandosudopara que un usuario sin privilegios los pueda ejecutar.#command>sudocommandComandos que pueden ejecutar los usuarios sin privilegios.

>commandNotificaciones

Aviso: aviso de advertenciaInformación vital que debe tener en cuenta antes de continuar. Advierte acerca de problemas de seguridad, pérdida de datos potenciales, daños del hardware o peligros físicos.

Importante: aviso importanteInformación importante que debe tener en cuenta antes de continuar.

Nota: aviso de notaInformación adicional, por ejemplo sobre las diferencias en las versiones de software.

Sugerencia: aviso de sugerenciaInformación útil, como una directriz o un consejo práctico.

Avisos compactos

Información adicional, por ejemplo sobre las diferencias en las versiones de software.

Información útil, como una directriz o un consejo práctico.

4 Asistencia #

A continuación, encontrará la declaración de asistencia técnica de SUSE Enterprise Storage e información general sobre tecnología en fase preliminar. Para obtener más información sobre el ciclo de vida del producto, consulte https://www.suse.com/lifecycle.

Si tiene derecho a recibir asistencia técnica, encontrará detalles sobre cómo recopilar información para un ticket de asistencia en https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Declaración de asistencia técnica para SUSE Enterprise Storage #

Para recibir asistencia técnica, necesita disponer de una suscripción adecuada de SUSE. Para ver las ofertas de asistencia técnica específicas que tiene a su disposición, diríjase a https://www.suse.com/support/ y seleccione su producto.

Los niveles de asistencia se definen así:

- L1

Determinación de problemas; lo que significa que se ofrece asistencia técnica diseñada para proporcionar información de compatibilidad, asistencia sobre el uso, mantenimiento continuo, recopilación de información y resolución de problemas básicos con la documentación disponible.

- L2

Aislamiento de problemas; lo que significa que se ofrece asistencia técnica diseñada para analizar datos, reproducir los problemas del cliente, aislar el área del problema y proporcionar una resolución a los problemas que no se pueden resolver en el nivel 1 (L1) ni preparar para el nivel 3 (L3).

- L3

Resolución de problemas; lo que significa que se ofrece asistencia técnica diseñada para resolver los problemas mediante ingeniería y resolver los defectos que se han identificado en la asistencia de nivel 2 (L2).

En el caso de los clientes y socios con contrato, SUSE Enterprise Storage se suministra con asistencia L3 para todos los paquetes, excepto en los siguientes casos:

Tecnología en fase preliminar.

Sonido, gráficos, fuentes y material gráfico.

Paquetes que precisan de un contrato de clientes adicional.

Algunos paquetes incluidos como parte del módulo de extensión de estación de trabajo solo admiten asistencia L2.

Los paquetes con nombres que terminan en -devel (que contienen archivos de encabezado y recursos similares para desarrolladores) solo incluyen asistencia si van acompañados de sus paquetes principales.

SUSE solo admite el uso de paquetes originales. Es decir, paquetes que no hayan sido modificados ni recompilados.

4.2 Tecnología en fase preliminar #

Se considera como "tecnología en fase preliminar" cualquier paquete, pila o función proporcionada por SUSE para ofrecer un adelanto de las próximas innovaciones. Estos elementos se incluyen para ofrecer la oportunidad de probar nuevas tecnologías en su entorno. Le agradeceremos mucho sus comentarios. Si se dispone a probar una tecnología en fase preliminar, póngase en contacto con su representante de SUSE e infórmele de su experiencia y sus casos de uso. Sus comentarios nos resultarán útiles para desarrollar el producto.

Las tecnologías en fase preliminar tienen las limitaciones siguientes:

Están aún en proceso de desarrollo. En consecuencia, sus funciones pueden estar incompletas, ser inestables o no ser adecuadas de alguna otra forma para su uso en producción.

No se ofrece asistencia técnica para ellas.

Es posible que solo estén disponibles para arquitecturas de hardware específicas.

Sus detalles y funciones están sujetos a cambios. Como resultado, quizás no sea posible actualizar estas tecnologías en las versiones posteriores o que sea necesario realizar una instalación nueva.

SUSE puede descubrir que una tecnología en fase preliminar no cumple las necesidades del cliente o del mercado, o que no cumple con los estándares empresariales. Las tecnologías en fase preliminar se pueden eliminar de un producto en cualquier momento. SUSE no se compromete a facilitar una versión con asistencia técnica de dichas tecnologías en el futuro.

Para ver una descripción general de las tecnologías en fase preliminar incluidas con el producto, consulte la notas de la versión en https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Colaboradores de Ceph #

El proyecto Ceph y su documentación son el resultado del trabajo de cientos de colaboradores y organizaciones. Consulte https://ceph.com/contributors/ para obtener más información.

6 Comandos e indicadores de comandos utilizados en esta guía #

Como administrador de clústeres de Ceph, va a configurar y ajustar el comportamiento del clúster ejecutando comandos específicos. Necesitará varios tipos de comandos:

6.1 Comandos relacionados con Salt #

Estos comandos ayudan a distribuir los nodos de clúster de Ceph, a ejecutar comandos en varios nodos de clúster al mismo tiempo (o en todos ellos) o a ayudarle a añadir o quitar nodos de clúster. Los comandos más utilizados son ceph-salt y ceph-salt config. Los comandos de Salt se deben ejecutar en el nodo master de Salt como usuario root. Estos comandos se introducen con el siguiente símbolo del sistema:

root@master # Por ejemplo:

root@master # ceph-salt config ls6.2 Comandos relacionados con Ceph #

Se trata de comandos de nivel inferior para configurar y ajustar todos los aspectos del clúster y sus pasarelas en la línea de comandos; por ejemplo, ceph, cephadm, rbd o radosgw-admin.

Para ejecutar comandos relacionados con Ceph, debe tener acceso de lectura a una clave de Ceph. Los privilegios que tiene en el entorno Ceph se definen en las capacidades de la clave. Una opción es ejecutar comandos de Ceph como usuario root (o mediante sudo) y utilizar el anillo de claves sin restricciones por defecto "ceph.client.admin.key".

La opción más segura y recomendada es crear una clave individual más restrictiva para cada usuario administrador y colocarla en un directorio donde los usuarios puedan leerla, por ejemplo:

~/.ceph/ceph.client.USERNAME.keyring

Para utilizar un usuario administrador y un anillo de claves personalizados, debe especificar el nombre de usuario y la vía a la clave cada vez que ejecute el comando ceph mediante las opciones -n client.NOMBRE_USUARIO y ‑‑keyring VÍA/A/ANILLO/DE/CLAVES.

Para evitarlo, incluya estas opciones en la variable CEPH_ARGS en los archivos ~/.bashrc de los usuarios individuales.

Aunque puede ejecutar comandos relacionados con Ceph en cualquier nodo de clúster, se recomienda hacerlo en el nodo de administración. Esta documentación utiliza al usuario cephuser para ejecutar los comandos, por lo tanto, se introducen con el siguiente símbolo del sistema:

cephuser@adm > Por ejemplo:

cephuser@adm > ceph auth listSi la documentación indica que ejecute un comando en un nodo de clúster con una función específica, el símbolo del sistema se encargará. Por ejemplo:

cephuser@mon > 6.2.1 Ejecución de ceph-volume #

A partir de SUSE Enterprise Storage 7, los servicios de Ceph se ejecutan en contenedores. Si necesita ejecutar ceph-volume en un nodo de OSD, debe anteponer el comando cephadm, por ejemplo:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandos generales de Linux #

Los comandos de Linux no relacionados con Ceph, como mount, cat o openssl se introducen con los símbolos del sistema cephuser@adm > o #, dependiendo de los privilegios que requiera el comando relacionado.

6.4 Información adicional #

Para obtener más información sobre la gestión de claves de Ceph, consulte el Book “Guía de administración y operaciones”, Chapter 30 “Autenticación con cephx”, Section 30.2 “Áreas clave de gestión”.

Parte I Presentación de SUSE Enterprise Storage (SES) #

- 1 SES y Ceph

SUSE Enterprise Storage es un sistema de almacenamiento distribuido basado en la tecnología Ceph diseñado para que tenga capacidad de ampliación, sea fiable y aporte alto rendimiento. Los clústeres de Ceph se pueden ejecutar en servidores básicos en una red común como Ethernet. Es posible ampliar fá…

- 2 Requisitos y recomendaciones de hardware

Los requisitos de hardware de Ceph dependen en gran medida de la carga de trabajo de E/S. Se deben tener en cuenta los requisitos y recomendaciones de hardware siguientes como punto de partida para realizar una planificación detallada.

- 3 Configuración de alta disponibilidad del nodo de administración

El nodo de administración es un nodo de clúster de Ceph donde se ejecuta el servicio master de Salt. Gestiona el resto de los nodos del clúster consultando y dando instrucciones a sus servicios de minion de Salt. Normalmente también incluye otros servicios; por ejemplo, la consola Grafana respaldada…

1 SES y Ceph #

SUSE Enterprise Storage es un sistema de almacenamiento distribuido basado en la tecnología Ceph diseñado para que tenga capacidad de ampliación, sea fiable y aporte alto rendimiento. Los clústeres de Ceph se pueden ejecutar en servidores básicos en una red común como Ethernet. Es posible ampliar fácilmente el clúster hasta miles de servidores (a partir de ahora denominados nodos) y almacenar petabytes de información. A diferencia de los sistemas convencionales que cuentan con tablas de asignación para almacenar y recuperar datos, Ceph utiliza un algoritmo determinista para asignar el almacenamiento de datos y no tiene ninguna estructura de información centralizada. Ceph entiende que en los clústeres de almacenamiento la adición o eliminación de hardware es la norma, no la excepción. El clúster de Ceph automatiza las tareas de gestión, como la distribución, redistribución y réplica de datos; la detección de fallos y la recuperación. Ceph se autorrepara y se autoadministra, con lo que se consigue una reducción de las tareas administrativas y del presupuesto necesario.

Este capítulo proporciona una visión general de SUSE Enterprise Storage 7.1 y describe brevemente los componentes más importantes.

1.1 Características de Ceph #

El entorno Ceph incluye las siguientes características:

- Capacidad de ampliación

Ceph puede ampliarse a miles de nodos y gestionar petabytes de almacenamiento.

- Hardware básico

Para ejecutar un clúster de Ceph no se requiere ningún hardware especial. Para obtener información, consulte el Capítulo 2, Requisitos y recomendaciones de hardware

- Autoadministración

El clúster de Ceph se gestiona automáticamente. Cuando se añaden o se eliminan nodos, o cuando estos fallan, el clúster redistribuye los datos automáticamente. También es consciente de los discos sobrecargados.

- Sin un punto único de error

Ningún nodo de un clúster almacena información importante por sí solo. El número de redundancias se puede configurar.

- Software de código abierto

Ceph es una solución de software de código abierto e independiente de hardware o proveedores específicos.

1.2 Componentes principales de Ceph #

Para aprovechar al máximo las ventajas de Ceph, es necesario comprender algunos de sus componentes y conceptos básicos. Esta sección presenta algunas partes de Ceph a las que se hace referencia con frecuencia en otros capítulos.

1.2.1 RADOS #

El componente básico de Ceph se denomina RADOS (Reliable Autonomic Distributed Object Store, almacén de objetos distribuido autónomo fiable). Es el encargado de gestionar los datos almacenados en el clúster. Los datos de Ceph se almacenan normalmente como objetos. Cada objeto se compone de un identificador y datos.

RADOS proporciona los siguientes métodos de acceso para los objetos almacenados que abarcan muchos casos de uso:

- Object Gateway

Object Gateway es una pasarela REST HTTP para el almacén de objetos RADOS. Permite el acceso directo a los objetos almacenados en el clúster de Ceph.

- Dispositivo de bloques RADOS

Es posible acceder al dispositivo de bloques RADOS (RBD) igual que a cualquier otro dispositivo de bloques. Por ejemplo, se pueden usar en combinación con

libvirtcon fines de virtualización.- CephFS

El sistema de archivos de Ceph tiene conformidad con POSIX.

libradoslibradoses una biblioteca que se puede utilizar con varios lenguajes de programación a fin de crear una aplicación capaz de interactuar directamente con el clúster de almacenamiento.

librados se utiliza en Object Gateway y RBD, mientras que CephFS interactúa directamente con RADOS (Figura 1.1, “Interfaces con el almacén de objetos de Ceph”).

1.2.2 CRUSH #

En el núcleo de un clúster de Ceph se encuentra el algoritmo CRUSH. CRUSH es el acrónimo de Controlled Replication Under Scalable Hashing (réplica controlada bajo hash escalable). Es una función que gestiona la asignación del almacenamiento y, en comparación con otros algoritmos, necesita pocos parámetros. Es decir, que solo necesita una pequeña cantidad de información para calcular la posición de almacenamiento de un objeto. Los parámetros son un mapa actual del clúster, incluido el estado de actividad, algunas reglas de colocación definidas por el administrador y el nombre del objeto que se va a almacenar o recuperar. Con esta información, todos los nodos del clúster de Ceph pueden calcular dónde está almacenado un objeto y sus réplicas. De esta forma, la escritura o lectura de los datos se realiza de forma muy eficaz. CRUSH intenta distribuir homogéneamente los datos por todos los nodos del clúster.

El mapa de CRUSH contiene todos los nodos de almacenamiento y las reglas de colocación definidas por el administrador para almacenar los objetos en el clúster. Define una estructura jerárquica que se suele corresponder con la estructura física del clúster. Por ejemplo, los discos que contienen los datos están en hosts, los hosts están en bastidores, los bastidores en filas y las filas en centros de datos. Esta estructura se puede utilizar para definir dominios de fallo. Ceph se asegura de que las réplicas se almacenan en diferentes ramas de un dominio de fallo concreto.

Si el dominio de fallo se define en el bastidor, las réplicas de los objetos se distribuyen en distintos bastidores. Esto puede mitigar las interrupciones causadas por un conmutador que falle en un bastidor. Si una unidad de distribución de alimentación da energía a una fila de bastidores, el dominio de fallo se puede definir en la fila. Cuando se produce un fallo en la unidad de distribución de alimentación, los datos replicados siguen disponibles en las demás filas.

1.2.3 Nodos y daemons de Ceph #

En Ceph, los nodos son servidores que trabajan para el clúster. Pueden ejecutar distintos tipos de daemons. Se recomienda ejecutar solo un tipo de daemon en cada nodo, excepto los daemons de Ceph Manager, que se pueden colocar junto con monitores Ceph Monitor. Cada clúster requiere al menos los daemons de Ceph Monitor, Ceph Manager y Ceph OSD:

- Nodo de administración

El nodo de administración es un nodo de clúster de Ceph desde el que se ejecutan comandos para gestionar el clúster. El nodo de administración es un punto central del clúster de Ceph porque gestiona el resto de los nodos del clúster consultando y dando instrucciones a los servicios minion de Salt.

- Ceph Monitor

Los nodos de Ceph Monitor (a menudo abreviado como MON) guardan información sobre el estado de la actividad del clúster: un mapa de todos los nodos y las reglas de distribución de los datos (consulte la Sección 1.2.2, “CRUSH”).

Si se producen fallos o conflictos, los nodos de Ceph Monitor del clúster deciden por mayoría qué información es la correcta. Para formar una mayoría cualificada, se recomienda tener un número impar de nodos de Ceph Monitor, y tres como mínimo.

Si se utiliza más de un sitio, los nodos de Ceph Monitor deben distribuirse en un número impar de sitios. El número de nodos de Ceph Monitor por sitio debe ser superior al 50 % de los nodos de Ceph Monitor que permanecen operativos si se produce un fallo en un sitio.

- Ceph Manager

Ceph Manager recopila la información de estado de todo el clúster. El daemon de Ceph Manager se ejecuta junto con los daemons de Ceph Monitor. Proporciona supervisión adicional y sirve de interfaz entre los sistemas de supervisión y gestión externos. También incluye otros servicios. Por ejemplo, la interfaz de usuario Web de Ceph Dashboard se ejecuta en el mismo nodo que Ceph Manager.

Ceph Manager no requiere configuración adicional, aparte de asegurarse de que está en ejecución.

- Ceph OSD

Un Ceph OSD es un daemon que gestiona dispositivos de almacenamiento de objetos, que son unidades de almacenamiento físicas o lógicas (discos duros o particiones). Los dispositivos de almacenamiento de objetos pueden ser discos físicos/particiones o volúmenes lógicos. El daemon se encarga también de la réplica de datos y del reequilibrio de la carga en caso de que se añadan o se eliminen nodos.

Los daemons Ceph OSD se comunican con los daemons de monitor y les proporcionan el estado de los demás daemons de OSD.

Para utilizar CephFS, Object Gateway, NFS Ganesha o iSCSI Gateway se necesitan nodos adicionales:

- Servidor de metadatos (MDS)

Los metadatos de CephFS se almacenan en su propio repositorio RADOS (consulte la Sección 1.3.1, “Repositorios”). Los servidores de metadatos actúan como una capa de almacenamiento en caché inteligente para los metadatos y serializan el acceso cuando es necesario. Esto permite el acceso simultáneo desde muchos clientes sin sincronización explícita.

- Object Gateway

Object Gateway es una pasarela REST HTTP para el almacén de objetos RADOS. Es compatible con OpenStack Swift y Amazon S3 y tiene su propia de gestión de usuarios.

- NFS Ganesha

NFS Ganesha proporciona acceso NFS para Object Gateway o CephFS. Se ejecuta en el espacio del usuario, en lugar de en el espacio del kernel, e interactúa directamente con Object Gateway o CephFS.

- iSCSI Gateway

iSCSI es un protocolo de red de almacenamiento que permite a los clientes enviar comandos SCSI a dispositivos de almacenamiento SCSI (destinos) en servidores remotos.

- Samba Gateway

Samba Gateway proporciona un acceso Samba a los datos almacenados en CephFS.

1.3 Estructura de almacenamiento de Ceph #

1.3.1 Repositorios #

Los objetos que se almacenan en un clúster de Ceph se colocan en repositorios. Los repositorios representan particiones lógicas del clúster hacia el mundo exterior. Por cada repositorio, es posible definir un conjunto de reglas; por ejemplo, cuántas réplicas de cada objeto deben existir. La configuración estándar de los repositorios se denomina repositorio replicado.

Los repositorios suelen contener objetos, pero también pueden configurarse para actuar como si fueran un sistema RAID 5. En esta configuración, los objetos se almacenan en porciones junto con porciones de código adicionales. Las porciones de código contienen información redundante. El administrador puede definir el número de datos y de porciones de código. En esta configuración, los repositorios se denominan repositorios codificados de borrado o repositorios EC.

1.3.2 Grupos de colocación #

Los grupos de colocación (PG) se utilizan para la distribución de datos dentro de un repositorio. Cuando se crea un repositorio, se define un número determinado de grupos de colocación. Los grupos de colocación se utilizan de modo interno para agrupar objetos y son un factor importante para el rendimiento de un clúster de Ceph. El grupo de colocación para un objeto se determina según el nombre del objeto.

1.3.3 Ejemplo #

Esta sección proporciona un ejemplo de cómo gestiona Ceph los datos (consulte la Figura 1.2, “Ejemplo de Ceph a pequeña escala”). El ejemplo no representa una configuración recomendada de un clúster de Ceph. El hardware está formado por tres nodos de almacenamiento o tres Ceph OSD (Host 1, Host 2 y Host 3). Cada nodo tiene tres discos duros que se utilizan como OSD (osd.1 a osd.9). Los nodos de Ceph Monitor no se tratan en este ejemplo.

Ceph OSD o daemon Ceph OSD hace referencia a un daemon que se ejecuta en un nodo, mientras que el término OSD hace referencia al disco lógico con el que interactúa el daemon.

El clúster tiene dos repositorios, Repositorio A y Repositorio B. Mientras Repositorio A replica objetos solo dos veces, la capacidad de recuperación de Repositorio B es más importante y tiene tres réplicas para cada objeto.

Cuando una aplicación coloca un objeto en un repositorio, por ejemplo, mediante la API REST, se selecciona un grupo de colocación (PG1 a PG4) según el repositorio y el nombre del objeto. El algoritmo CRUSH calcula en qué OSD se almacena el objeto, según el grupo de colocación que contiene el objeto.

En este ejemplo, el dominio de fallo está definido en el host. Esto garantiza que las réplicas de los objetos se almacenan en distintos hosts. Según el nivel de réplica que se defina para un repositorio, el objeto se almacenará en dos o en tres de los OSD que usa el grupo de colocación.

Una aplicación que escribe un objeto solo interactúa con un Ceph OSD: el Ceph OSD primario. El Ceph OSD primario se encarga de la réplica y confirma que el proceso de escritura ha terminado después de que todos los demás OSD hayan almacenado el objeto.

Si falla osd.5, todos los objetos de PG1 siguen estando disponibles en osd.1. En cuanto el clúster reconoce que un OSD ha fallado, otro OSD toma su lugar. En este ejemplo, osd.4 se utiliza como sustituto de osd.5. Los objetos almacenados en osd.1 se replican a osd.4 para restaurar el nivel de réplica.

Si se añade un nuevo nodo con nuevos OSD al clúster, el mapa del clúster cambia. La función CRUSH devuelve ubicaciones diferentes para los objetos. los objetos que reciben las nuevas ubicaciones se reubican. Este proceso da como resultado un uso equilibrado de todos los OSD.

1.4 BlueStore #

BlueStore es el procesador final de almacenamiento por defecto para Ceph desde SES 5. Su rendimiento es mejor que el de FireStore y cuenta con suma de comprobación de los datos completos y compresión integrada.

BlueStore puede gestionar uno, dos o tres dispositivos de almacenamiento. En el caso más sencillo, BlueStore consume un único dispositivo de almacenamiento primario. Normalmente, el dispositivo de almacenamiento se divide en dos partes:

Una pequeña partición denominada BlueFS que implementa las funciones de sistema de archivos requeridas por RocksDB.

El resto del dispositivo suele estar ocupado por una partición de gran tamaño. Se gestiona directamente mediante BlueStore y contiene todos los datos reales. Este dispositivo primario normalmente se identifica mediante un enlace simbólico de bloque en el directorio de datos.

También es posible distribuir BlueStore en dos dispositivos adicionales:

Un dispositivo WAL que se puede usar para el diario interno o el registro de escritura anticipada de BlueStore. Se identifica mediante el enlace simbólico block.wal en el directorio de datos. Solo resulta útil emplear un dispositivo WAL independiente si el dispositivo es más rápido que el dispositivo primario o que el dispositivo DB, por ejemplo en estos casos:

Si el dispositivo WAL es un NVMe, el dispositivo DB es una unidad SSD y el dispositivo de datos es una unidad SSD o un disco duro.

Los dispositivos WAL y DB están en unidades SSD independientes, y el dispositivo de datos está en un SSD o un disco duro.

Es posible utilizar un dispositivo DB para almacenar los metadatos internos de BlueStore. BlueStore (o en su lugar, la instancia incrustada de RocksDB) colocará todos los metadatos que pueda en el dispositivo DB para mejorar el rendimiento. De nuevo, provisionar un dispositivo DB compartido solo resulta útil si es más rápido que el dispositivo primario.

Debe realizar una planificación exhaustiva para garantizar un tamaño suficiente al dispositivo DB. Si el dispositivo DB se llena, los metadatos se diseminarán por todo el dispositivo primario, lo que afectará muy negativamente al rendimiento del OSD.

Puede comprobar si una partición WAL/BD se está llenando y desbordándose con el comando ceph daemon osd.ID perf dump. El valor slow_used_bytes muestra la cantidad de datos que se han desbordado:

cephuser@adm > ceph daemon osd.ID perf dump | jq '.bluefs'

"db_total_bytes": 1073741824,

"db_used_bytes": 33554432,

"wal_total_bytes": 0,

"wal_used_bytes": 0,

"slow_total_bytes": 554432,

"slow_used_bytes": 554432,1.5 Información adicional #

Ceph es un proyecto comunitario que cuenta con su propia documentación en línea completa. Para obtener información sobre temas que no encuentre en este manual, consulte https://docs.ceph.com/en/pacific/.

La publicación original CRUSH: Controlled, Scalable, Decentralized Placement of Replicated Data (CRUSH: colocación controlada, ampliable y descentralizada de datos replicados) de S.A. Weil, S.A. Brandt, E.L. Miller y C. Maltzahn proporciona información útil sobre el funcionamiento interno de Ceph. Se recomienda su lectura sobre todo al distribuir clústeres a gran escala. Encontrará la publicación en http://www.ssrc.ucsc.edu/papers/weil-sc06.pdf.

SUSE Enterprise Storage se puede utilizar con distribuciones OpenStack que no sean de SUSE. Los clientes de Ceph deben estar en un nivel que sea compatible con SUSE Enterprise Storage.

NotaSUSE admite el componente de servidor de la distribución de Ceph y el proveedor de distribución de OpenStack debe admitir el cliente.

2 Requisitos y recomendaciones de hardware #

Los requisitos de hardware de Ceph dependen en gran medida de la carga de trabajo de E/S. Se deben tener en cuenta los requisitos y recomendaciones de hardware siguientes como punto de partida para realizar una planificación detallada.

En general, las recomendaciones proporcionadas en esta sección dependerán de los procesos que haya activos. Si hay varios procesos en el mismo equipo, los requisitos de CPU, RAM, espacio en disco y red deben sumarse.

2.1 Descripción general de la red #

Ceph tiene varias redes lógicas:

Una red de procesador frontal denominada

red pública.Una red interna de confianza, la red de procesador final, denominada

red de clúster. Este campo es opcional.Una o varias redes cliente para las pasarelas. Esto es opcional y queda fuera del alcance de este capítulo.

La red pública es la red a través de la cual los daemons de Ceph se comunican entre sí y con sus clientes. Esto significa que todo el tráfico del clúster de Ceph pasa por esta red, excepto en el caso de que se configure una red de clúster.

La red de clúster es la red de procesador final entre los nodos de OSD para la réplica, el reequilibrado y la recuperación. Si se configura, esta red opcional proporcionaría, idealmente, el doble del ancho de banda que la red pública, con réplica de tres vías por defecto, ya que el OSD primario envía dos copias a otros OSD a través de esta red. La red pública se encuentra entre los clientes y las pasarelas por un lado para comunicarse con los monitores, los gestores, los nodos de MDS y los nodos de OSD. También la utilizan los monitores, los gestores y los nodos MDS para comunicarse con los nodos de OSD.

2.1.1 Recomendaciones de red #

Se recomienda tener una única red tolerante a fallos con suficiente ancho de banda para satisfacer sus necesidades. Para el entorno de red pública de Ceph, se recomiendan dos interfaces de red de 25 GbE (o más rápidas) asociadas mediante 802.3ad (LACP). Esto se considera la configuración mínima para Ceph. Si también utiliza una red de clúster, se recomiendan cuatro interfaces de red de 25 GbE asociadas. La asociación de dos o más interfaces de red proporciona un mejor rendimiento mediante la agregación de enlaces y, mediante enlaces y conmutadores redundantes, mejora la tolerancia a fallos y la facilidad de mantenimiento.

También puede crear VLAN para aislar diferentes tipos de tráfico a través de una asociación. Por ejemplo, puede crear una asociación para proporcionar dos interfaces VLAN, una para la red pública y la segunda para la red de clúster. Sin embargo, esto no es necesario al configurar la red de Ceph. Encontrará información detallada sobre la asociación de las interfaces en https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-network.html#sec-network-iface-bonding.

La tolerancia a fallos se puede mejorar aislando los componentes en dominios de fallo. Para mejorar la tolerancia a fallos de la red, la asociación de una interfaz desde dos tarjetas de interfaz de red (NIC) independientes ofrece protección contra fallos de una sola NIC. Del mismo modo, la creación de una asociación entre dos conmutadores protege contra el fallo de un conmutador. Se recomienda consultar con el proveedor del equipo de red para determinar el nivel de tolerancia a fallos necesario.

La configuración de red de administración adicional (que permite, por ejemplo, separar las redes SSH, Salt o DNS) no se ha probado ni se admite.

Si los nodos de almacenamiento se configuran a través de DHCP, es posible que los tiempos límite por defecto no sean suficientes para que la red se configure de forma correcta antes de que se inicien los daemons de Ceph. Si esto ocurre, los MON y los OSD de Ceph no se iniciarán correctamente (al ejecutar systemctl status ceph\* se producirán errores de tipo "no se puede asociar"). Para evitar este problema, se recomienda aumentar el tiempo límite del cliente DHCP a al menos 30 segundos en cada nodo del clúster de almacenamiento. Para hacerlo, hay que cambiar los valores siguientes en cada nodo:

En /etc/sysconfig/network/dhcp, defina

DHCLIENT_WAIT_AT_BOOT="30"

En /etc/sysconfig/network/config, defina

WAIT_FOR_INTERFACES="60"

2.1.1.1 Adición de una red privada a un clúster en ejecución #

Si no especifica una red de clúster durante la distribución de Ceph, se considera que se trata de un único entorno de redes público. Aunque Ceph funciona correctamente con una red pública, su rendimiento y la seguridad mejoran si se establece una segunda red de clúster privada. Para que admitan dos redes, cada nodo de Ceph debe tener al menos dos tarjetas de red.

Debe aplicar los cambios siguientes a cada nodo de Ceph. Hacerlo en un clúster pequeño es relativamente rápido, pero si el clúster está formado por cientos o miles de nodos, puede tardarse mucho tiempo.

Defina la red del clúster mediante el comando siguiente:

#ceph config set global cluster_network MY_NETWORKReinicie los OSD para asociarlos a la red de clúster especificada:

#systemctl restart ceph-*@osd.*.serviceCompruebe que la red de clúster privada funciona según lo previsto en el nivel de sistema operativo.

2.1.1.2 Nodos de monitor en subredes diferentes #

Si los nodos de monitor se encuentran en varias subredes, por ejemplo, se encuentran en distintas salas y emplean conmutadores distintos, es necesario especificar la dirección de la red pública con notación CIDR.

cephuser@adm > ceph config set mon public_network "MON_NETWORK_1, MON_NETWORK_2, MON_NETWORK_NPor ejemplo:

cephuser@adm > ceph config set mon public_network "192.168.1.0/24, 10.10.0.0/16"Si especifica más de un segmento de red para la red pública (o de clúster) como se describe en esta sección, cada una de estas subredes debe ser capaz de encaminarse a todas las demás; de lo contrario, los MON y otros daemons de Ceph en diferentes segmentos de la red no podrán comunicarse entre sí y se producirá una situación de clústeres malinformados. Además, si está utilizando un cortafuegos, asegúrese de incluir cada dirección IP o subred en sus iptables y abrir puertos para ellos en todos los nodos según sea necesario.

2.2 Configuraciones de varias arquitecturas #

SUSE Enterprise Storage admite arquitecturas x86 y Arm. Al considerar cada arquitectura, es importante tener en cuenta que desde la perspectiva de los núcleos por OSD, la frecuencia y la RAM, no hay diferencia real entre las arquitecturas de CPU en lo que respecta al tamaño.

como ocurre con los procesadores x86 más pequeños (que no son de servidor), los núcleos basados en Arm de menor rendimiento podrían no proporcionar una experiencia óptima, especialmente si se utilizan para repositorios codificados de borrado.

En toda la documentación se utiliza SYSTEM-ARCH en lugar de x86 o Arm.

2.3 Configuración del hardware #

Para obtener el mejor resultado del producto, se recomienda comenzar con la configuración de clúster recomendada. Para un clúster de prueba o uno con menos requisitos de rendimiento, se indica una configuración de clúster mínima compatible.

2.3.1 Configuración de clúster mínima #

Una configuración de clúster mínima para el producto consta de:

Al menos cuatro nodos físicos (nodos de OSD) con coubicación de servicios

Ethernet dual de 10 Gb como red asociada

Un nodo de administración independiente (se puede virtualizar en un nodo externo)

Una configuración detallada está formada por:

Un nodo de administración independiente con 4 GB de RAM, cuatro núcleos y 1 TB de capacidad de almacenamiento. Normalmente, se trata del nodo master de Salt. Los servicios y pasarelas de Ceph, como Ceph Monitor, el servidor de metadatos, Ceph OSD, Object Gateway o NFS Ganesha no se admiten en el nodo de administración, ya que necesita organizar los procesos de actualización del clúster de forma independiente.

Al menos cuatro nodos de OSD físicos, con ocho discos de OSD cada uno, consulte los requisitos en la Sección 2.4.1, “Requisitos mínimos”.

La capacidad total del clúster debe ajustarse de modo que, incluso si un nodo no está disponible, la capacidad total utilizada (incluida la redundancia) no supere el 80 %.

Tres instancias de Ceph Monitor. Por motivos de latencia, los monitores deben ejecutarse desde el almacenamiento SSD/NVMe, no desde los discos duros.

Los monitores, el servidor de metadatos y las pasarelas se pueden coubicar en los nodos de OSD; encontrará más información sobre la coubicación de monitores en la Sección 2.12, “Servidor compartido por varios OSD y monitores”. Si tiene servicios coubicados, es necesario sumar los requisitos de memoria y CPU.

iSCSI Gateway, Object Gateway y el servidor de metadatos requieren al menos 4 GB de RAM y cuatro núcleos.

Si utiliza CephFS, S3/Swift o iSCSI, se requieren al menos dos instancias de las funciones respectivas (servidor de metadatos, Object Gateway e iSCSI) para la redundancia y la disponibilidad.

Los nodos deben estar dedicados a SUSE Enterprise Storage y no deben utilizarse para ninguna otra carga de trabajo física, ni en contenedores ni virtualizada.

Si alguna de las pasarelas (iSCSI, Object Gateway, NFS Ganesha, servidor de metadatos, etc.) se distribuye dentro de máquinas virtuales, estas no deben estar alojadas en equipos físicos que dan servicio a otras funciones del clúster. (Esto no es necesario, ya que se admiten como servicios coubicados).

Al distribuir servicios como máquinas virtuales en hipervisores fuera del clúster físico central, se deben respetar los dominios de fallo para garantizar la redundancia.

Por ejemplo, no distribuya varias funciones del mismo tipo en el mismo hipervisor, como varias instancias de MON o MDS.

Al distribuir dentro de máquinas virtuales, es fundamental asegurarse de que los nodos cuentan con una conectividad de red sólida y una sincronización del tiempo de trabajo adecuada.

Los nodos del hipervisor deben tener el tamaño adecuado para evitar la interferencia de otras cargas de trabajo que consumen recursos de CPU, RAM, red y almacenamiento.

2.3.2 Configuración recomendada para clúster de producción #

Si el tamaño del clúster ha aumentado, se recomienda reubicar los monitores Ceph Monitor, los servidores de metadatos y las pasarelas en nodos independientes para mejorar la tolerancia a fallos.

Siete nodos de almacenamiento de objeto

Ningún nodo individual debe superar aproximadamente el 15 % del almacenamiento total.

La capacidad total del clúster debe ajustarse de modo que, incluso si un nodo no está disponible, la capacidad total utilizada (incluida la redundancia) no supere el 80 %.

Ethernet de 25 Gb o superior, asociados para el clúster interno y la red pública externa cada uno.

Más de 56 OSD por clúster de almacenamiento.

Consulte la Sección 2.4.1, “Requisitos mínimos” para obtener más recomendaciones.

Nodos de infraestructura física dedicados.

Tres nodos de Ceph Monitor: 4 GB de RAM, procesador de 4 núcleos, SSD RAID 1 para el disco.

Consulte la Sección 2.5, “Nodos de monitor” para obtener más recomendaciones.

Nodos de Object Gateway: 32 GB de RAM, procesador de 8 núcleos, SSD para el disco.

Consulte la Sección 2.6, “Nodos de Object Gateway” para obtener más recomendaciones.

Nodos de iSCSI Gateway: 16 GB de RAM, procesador de 8 núcleos, SSD para el disco.

Consulte la Sección 2.9, “Nodos de iSCSI Gateway” para obtener más recomendaciones.

Nodos de servidor de metadatos (uno activo y uno en hot standby): 32 GB de RAM, procesador de 8 núcleos, SSD RAID 1 para el disco.

Consulte la Sección 2.7, “Nodos de servidor de metadatos” para obtener más recomendaciones.

Un nodo de administración de SES: 4 GB de RAM, procesador de 4 núcleos, SSD RAID 1 para el disco.

2.3.3 Configuración de múltiples rutas #

Si desea utilizar hardware de múltiples rutas, asegúrese de que LVM puede acceder a multipath_component_detection = 1 en el archivo de configuración en la sección devices (dispositivos). Esto se puede comprobar mediante el comando lvm config.

Como alternativa, asegúrese de que LVM filtre los componentes de múltiples rutas de un dispositivo mediante la configuración de filtro de LVM. Esto será específico para cada host.

Esta configuración no se recomienda y solo debe plantearse si no es posible definir multipath_component_detection = 1.

Para obtener más información acerca de la configuración de múltiples rutas, consulte https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-multipath.html#sec-multipath-lvm.

2.4 Nodos de almacenamiento de objetos #

2.4.1 Requisitos mínimos #

Las siguientes recomendaciones de CPU sirven para los dispositivos, independientemente del uso por parte de Ceph:

1 subproceso de CPU de 2 GHz por disco giratorio.

2 subprocesos de CPU de 2 GHz por SSD.

4 subprocesos de CPU de 2 GHz por NVMe.

Redes 10 GbE separadas (pública/cliente e interna): se requieren 4 de 10 GbE; se recomiendan 2 de 25 GbE.

Total de RAM requerida = número de OSD x (1 GB +

osd_memory_target) + 16 GBConsulte el Book “Guía de administración y operaciones”, Chapter 28 “Configuración del clúster de Ceph”, Section 28.4.1 “Configuración del tamaño automático del caché” para obtener más detalles sobre el valor de

osd_memory_target.Discos OSD en configuraciones JBOD o configuraciones RAID-0 individuales.

El diario del OSD puede encontrarse en el disco del OSD.

Los discos OSD deben utilizarse exclusivamente para SUSE Enterprise Storage.

Disco o unidad SSD dedicados para el sistema operativo, preferiblemente en una configuración de RAID 1.

Asigne al menos 4 GB adicionales de RAM si este host OSD va a alojar parte de un repositorio de caché utilizado para la organización en niveles del caché.

Los monitores Ceph Monitor, la pasarela y los servidores de metadatos pueden encontrarse en los nodos de almacenamiento de objeto.

Por motivos de rendimiento del disco, los nodos de OSD son nodos de hardware. Ninguna otra carga de trabajo debe ejecutarse en un nodo de OSD a menos que sea una configuración mínima de Ceph Monitors y gestores Ceph Managers.

Discos SSD para el diario con una proporción de 6:1 entre el diario de SSD y los OSD.

Asegúrese de que los nodos de OSD no tienen asignados dispositivos de bloques en red, como iSCSI o imágenes de dispositivos de bloques RADOS.

2.4.2 Tamaño mínimo de disco #

Existen dos tipos de espacio de disco necesarios para ejecutarse en OSD: el espacio para el dispositivo WAL/DB, y el espacio principal para los datos almacenados. El valor mínimo (y por defecto) para WAL/DB es de 6 GB. El espacio mínimo para los datos es de 5 GB, ya que a las particiones de menos de 5 GB se les asigna automáticamente un peso de 0.

Por lo tanto, aunque el espacio mínimo de disco para un OSD es de 11 GB, no se recomienda usar discos de menos de 20 GB, ni siquiera con fines de prueba.

2.4.3 Tamaño recomendado para el dispositivo WAL y DB de BlueStore #

Consulte la Sección 1.4, “BlueStore” para obtener más información sobre BlueStore.

Se recomienda reservar 4 GB para el dispositivo WAL. Aunque el tamaño mínimo de la base de datos es de 64 GB para las cargas de trabajo de solo RBD, el tamaño de base de datos recomendado para las cargas de trabajo de Object Gateway y CephFS es del 2 % de la capacidad del dispositivo principal (pero al menos de 196 GB).

ImportanteSe recomiendan volúmenes de base de datos más grandes para las distribuciones de alta carga, especialmente si hay un uso elevado de RGW o CephFS. Reserve parte de la capacidad (ranuras) para instalar más hardware y disponer de más espacio en la base de datos si es necesario.

Si tiene previsto colocar el dispositivo WAL y el dispositivo DB en el mismo disco, se recomienda usar una partición única para ambos dispositivos, en lugar de tener una partición independiente para cada uno. Esto permite a Ceph utilizar también el dispositivo DB para el funcionamiento de WAL. Por lo tanto, la gestión del espacio de disco es más eficaz, ya que Ceph utiliza la partición de DB para WAL solo si es necesario. Otra ventaja es que la probabilidad de que la partición WAL se llene es muy pequeña, y si no se utiliza por completo, su espacio no se desperdicia, sino que se usa para el funcionamiento del dispositivo DB.

Para compartir el dispositivo DB con el dispositivo WAL, no especifique el dispositivo WAL: especifique solo el dispositivo DB.

Encontrará más información sobre cómo especificar un diseño de OSD en el Book “Guía de administración y operaciones”, Chapter 13 “Tareas operativas”, Section 13.4.3 “Adición de OSD mediante la especificación DriveGroups”.

2.4.5 Número máximo de discos recomendado #

Puede tener tantos discos como permita un servidor. Pero existen algunos asuntos que debe tener en cuenta a la hora de planificar el número de discos por servidor:

Ancho de banda de red. Cuantos más discos haya en un servidor, más datos deben transferirse a través de las tarjetas de red para las operaciones de escritura del disco.

Memoria. La RAM que supere los 2 GB se utiliza para el caché de BlueStore. Con el valor por defecto de

osd_memory_targetde 4 GB, el sistema tiene un tamaño de caché inicial razonable para los medios giratorios. Si utiliza SSD o NVME, plantéese la posibilidad de aumentar el tamaño de la memoria caché y la asignación de RAM por OSD para maximizar el rendimiento.Tolerancia a fallos. Si el servidor falla por completo, cuantos más discos tenga, más OSD perderá temporalmente el clúster. Además, para mantener las reglas de réplica en ejecución, necesita copiar todos los datos desde el servidor que ha fallado a los demás nodos del clúster.

2.5 Nodos de monitor #

Se necesitan al menos tres nodos de MON. El número de monitores debe ser siempre impar (1+2n).

4 GB de RAM.

Procesador con cuatro núcleos lógicos.

Se recomienda un disco SSD u otro tipo de almacenamiento suficientemente rápido para los monitores, específicamente para la vía

/var/lib/cephde cada nodo de monitor, ya que el quórum puede ser inestable con latencias elevadas de disco. Se recomiendan dos discos con configuración RAID 1 para aportar redundancia. Se recomienda utilizar discos distintos, o al menos particiones de disco independientes para los procesos de monitor a fin de proteger el espacio disponible en el monitor frente a estados como la ralentización del archivo de registro.Solo debe haber un proceso de monitor por nodo.

La mezcla de nodos de OSD, MON y Object Gateway solo se admite si los recursos de hardware disponibles son suficientes. Esto significa que deberán sumarse los requisitos de todos los servicios.

Dos interfaces de red vinculadas a varios conmutadores.

2.6 Nodos de Object Gateway #

Los nodos de Object Gateway deben tener al menos seis núcleos de CPU y 32 GB de RAM. Si hay otros procesos ubicados en el mismo equipo, deben sumarse sus requisitos.

2.7 Nodos de servidor de metadatos #

El tamaño correcto de los nodos del servidor de metadatos depende del caso de uso específico. Por lo general, cuantos más archivos abiertos deba gestionar el servidor de metadatos, más CPU y RAM se necesitará. Los requisitos mínimos de son los descritos a continuación:

4 GB de RAM para cada daemon de servidor de metadatos.

Interfaz de red vinculada.

2,5 GHz de CPU con un mínimo de 2 núcleos.

2.8 Nodo de administración #

Se requieren al menos 4 GB de RAM y una CPU de cuatro núcleos. Esto incluye la ejecución del master de Salt en el nodo de administración. Para clústeres de gran tamaño con cientos de nodos, se recomiendan 6 GB de RAM.

2.9 Nodos de iSCSI Gateway #

Los nodos de iSCSI Gateway deben tener al menos seis núcleos de CPU y 16 GB de RAM.

2.10 SES y otros productos SUSE #

Esta sección contiene información importante acerca de la integración de SES con otros productos SUSE.

2.10.1 SUSE Manager #

SUSE Manager y SUSE Enterprise Storage no están integrados; por lo tanto, SUSE Manager no puede gestionar actualmente un clúster de SES.

2.11 Limitaciones de nombres #

En general, Ceph no admite caracteres no ASCII en los archivos de configuración, los nombres de repositorio, los nombres de usuario, etc. Cuando configure un clúster de Ceph, se recomienda utilizar solo caracteres alfanuméricos sencillos (A-z, a-z, 0-9) y la puntuación mínima (".", "-" o "_") en todos los nombres de objeto y configuración de Ceph.

3 Configuración de alta disponibilidad del nodo de administración #

El nodo de administración es un nodo de clúster de Ceph donde se ejecuta el servicio master de Salt. Gestiona el resto de los nodos del clúster consultando y dando instrucciones a sus servicios de minion de Salt. Normalmente también incluye otros servicios; por ejemplo, la consola Grafana respaldada por el kit de herramientas de supervisión Prometheus.

En caso de que el nodo de administración falle, lo habitual es que deba proporcionar un nuevo hardware que funcione para el nodo y que tenga que restaurar la pila de configuración del clúster completa a partir de una copia de seguridad reciente. Este método lleva bastante tiempo y provoca interrupciones del clúster.

Para evitar tiempos de inactividad del clúster de Ceph debido a fallos en el nodo de administración, se recomienda usar un clúster de alta disponibilidad (HA) para el nodo de administración de Ceph.

3.1 Esquema del clúster de alta disponibilidad para el nodo de administración #

La idea de un clúster de alta disponibilidad consiste en que, en caso de fallo del nodo del clúster, el otro nodo se haga cargo automáticamente de su función, incluido el nodo de administración virtualizado. De este modo, los otros nodos del clúster no notan que el nodo de administración de Ceph ha fallado.

La solución de alta disponibilidad mínima para el nodo de administración requiere el siguiente hardware:

Dos servidores instalados desde cero donde se pueda ejecutar SUSE Linux Enterprise con la extensión de alta disponibilidad y donde se pueda virtualizar el nodo de administración.

Dos o más vías de comunicación de red redundantes; por ejemplo, mediante vínculos de dispositivos de red.

Almacenamiento compartido para alojar las imágenes de disco de la máquina virtual del nodo de administración. Debe ser posible acceder al almacenamiento compartido desde ambos servidores. Puede ser, por ejemplo, una exportación NFS, un recurso compartido Samba o el destino iSCSI.

Encontrará más información sobre los requisitos del clúster en https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#sec-ha-inst-quick-req.

3.2 Creación de un clúster de alta disponibilidad con un nodo de administración #

El procedimiento siguiente resume los pasos más importantes a la hora de crear el clúster de alta disponibilidad para la virtualización del nodo de administración. Para obtener más detalles, consulte los enlaces indicados.

Configure un clúster de alta disponibilidad básico de 2 nodos con almacenamiento compartido, como se describe en https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#art-sleha-install-quick.

En ambos nodos del clúster, instale todos los paquetes necesarios para ejecutar el hipervisor KVM y el kit de herramientas

libvirt, como se describe en https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-vt-installation-kvm.En el primer nodo del clúster, cree una máquina virtual KVM nueva mediante

libvirt, como se describe en https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-libvirt-inst-virt-install. Utilice el almacenamiento compartido preconfigurado para almacenar las imágenes de disco de la máquina virtual.Después de que se haya completado la configuración de la máquina virtual, exporte su configuración a un archivo XML en el almacenamiento compartido. Utilice la siguiente sintaxis:

#virsh dumpxml VM_NAME > /path/to/shared/vm_name.xmlCree un recurso para la máquina virtual del nodo de administración. Consulte https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-guide/#cha-conf-hawk2 para obtener información general sobre cómo crear recursos de alta disponibilidad. Encontrará información detallada sobre cómo crear recursos para una máquina virtual KVM en http://www.linux-ha.org/wiki/VirtualDomain_%28resource_agent%29.

En la máquina virtual invitada que acaba de crear, distribuya el nodo de administración, incluidos los servicios adicionales que necesite allí. Siga los pasos relevantes del Capítulo 6, Distribución de Salt. Al mismo tiempo, distribuya los demás nodos del clúster de Ceph en los servidores del clúster que no sean de alta disponibilidad.

Parte II Distribución del clúster de Ceph #

- 4 Introducción y tareas comunes

Desde SUSE Enterprise Storage 7, los servicios de Ceph se distribuyen como contenedores en lugar de como paquetes RPM. El proceso de distribución consta de dos pasos básicos:

- 5 Instalación y configuración de SUSE Linux Enterprise Server

Instale y registre SUSE Linux Enterprise Server 15 SP3 en cada nodo del clúster. Durante la instalación de SUSE Enterprise Storage, se requiere acceso a los repositorios de actualización, por lo que el registro es obligatorio. Incluya al menos los siguientes módulos:

- 6 Distribución de Salt

SUSE Enterprise Storage utiliza Salt y ceph-salt para la preparación inicial del clúster. Salt le ayuda a configurar y ejecutar comandos en varios nodos de clúster de forma simultánea desde un host dedicado llamado máster de Salt. Antes de distribuir Salt, tenga en cuenta los siguientes puntos impor…

- 7 Distribución del clúster de bootstrap mediante

ceph-salt Esta sección le guía por el proceso de distribuir un clúster de Ceph básico. Lea atentamente las subsecciones y ejecute los comandos incluidos en el orden indicado.

- 8 Distribución de los servicios principales restantes mediante cephadm

Después de distribuir el clúster de Ceph básico, distribuya los servicios principales a más nodos del clúster. Para que los clientes puedan acceder a los datos del clúster, distribuya también servicios adicionales.

- 9 Distribución de servicios adicionales

iSCSI es un protocolo de red de área de almacenamiento (SAN) que permite a los clientes (denominados iniciadores) enviar comandos SCSI a dispositivos de almacenamiento SCSI (destinos) en servidores remotos. SUSE Enterprise Storage 7.1 incluye una utilidad que permite gestionar el almacenamiento de C…

4 Introducción y tareas comunes #

Desde SUSE Enterprise Storage 7, los servicios de Ceph se distribuyen como contenedores en lugar de como paquetes RPM. El proceso de distribución consta de dos pasos básicos:

- Distribución del clúster de bootstrap

Esta fase se denomina distribución del día 1 y consta de las siguientes tareas: incluye la instalación del sistema operativo subyacente, la configuración de la infraestructura de Salt y la distribución del clúster mínimo que consta de un servicio MON y un servicio MGR.

Instale y realice la configuración básica del sistema operativo subyacente (SUSE Linux Enterprise Server 15 SP3) en todos los nodos del clúster.

Distribuya la infraestructura de Salt en todos los nodos del clúster para realizar los preparativos de la distribución inicial mediante

ceph-salt.Configure las propiedades básicas del clúster mediante

ceph-salte impleméntelo.

- Distribución de servicios adicionales

Durante la distribución del día 2, se distribuyen los servicios principales y no principales de Ceph; por ejemplo, pasarelas y la pila de supervisión.

Tenga en cuenta que la documentación de la comunidad de Ceph utiliza el comando cephadm bootstrap durante la distribución inicial. ceph-salt llama automáticamente al comando cephadm bootstrap. El comando cephadm bootstrap no debe ejecutarse directamente. No se admitirá ninguna distribución manual del clúster de Ceph mediante bootstrap cephadm.

4.1 Lectura de las notas de la versión #

En las notas de la versión puede encontrar información adicional sobre los cambios realizados desde la versión previa de SUSE Enterprise Storage. Consulte las notas de versión para comprobar lo siguiente:

si el hardware necesita consideraciones especiales,

si los paquetes de software usados han cambiado de forma significativa,

si es necesario tomar precauciones especiales para la instalación.

Las notas de la versión también proporcionan información que no pudo publicarse en el manual a tiempo y notas acerca de problemas conocidos.

Después de instalar el paquete release-notes-ses, encontrará las notas de la versión en el directorio /usr/share/doc/release-notes o en línea en https://www.suse.com/releasenotes/.

5 Instalación y configuración de SUSE Linux Enterprise Server #

Instale y registre SUSE Linux Enterprise Server 15 SP3 en cada nodo del clúster. Durante la instalación de SUSE Enterprise Storage, se requiere acceso a los repositorios de actualización, por lo que el registro es obligatorio. Incluya al menos los siguientes módulos:

Módulo de sistema base

Módulo de aplicaciones de servidor

Obtenga más información sobre cómo instalar SUSE Linux Enterprise Server en https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-install.html.

Instale la extensión de SUSE Enterprise Storage 7.1 en cada nodo del clúster.

Sugerencia: instalación de SUSE Enterprise Storage junto con SUSE Linux Enterprise ServerPuede instalar la extensión de SUSE Enterprise Storage 7.1 por separado después de instalar SUSE Linux Enterprise Server 15 SP3, o bien añadirla durante el procedimiento de instalación de SUSE Linux Enterprise Server 15 SP3.

Encontrará más información sobre cómo instalar extensiones en https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-register-sle.html.

Configure los ajustes de red, incluida la resolución de nombre DNS adecuada en cada nodo. Para obtener más información acerca de cómo configurar una red, consulte https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#sec-network-yast. Para obtener más información sobre cómo configurar un servidor DNS, consulte https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#cha-dns.

6 Distribución de Salt #

SUSE Enterprise Storage utiliza Salt y ceph-salt para la preparación inicial del clúster. Salt le ayuda a configurar y ejecutar comandos en varios nodos de clúster de forma simultánea desde un host dedicado llamado máster de Salt. Antes de distribuir Salt, tenga en cuenta los siguientes puntos importantes:

Los minions de Salt son los nodos que se controlan mediante un nodo dedicado denominado master de Salt.

Si el host del master de Salt debe formar parte del clúster de Ceph, debe ejecutar su propio minion de Salt, pero esto no es un requisito.

Sugerencia: uso compartido de varias funciones por servidorConseguirá el mejor rendimiento del clúster de Ceph si cada función se distribuye en un nodo independiente. Pero las distribuciones reales requieren en ocasiones que se comparta un nodo para varias funciones. Para evitar problemas de rendimiento y en el procedimiento de actualización, no distribuya las funciones de Ceph OSD, el servidor de metadatos ni Ceph Monitor al nodo de administración.

Los minions de Salt deben resolver correctamente el nombre de host del master de Salt en la red. Por defecto, buscan el nombre de host

salt, pero puede especificar cualquier otro nombre de host al que se pueda acceder por la red en el archivo/etc/salt/minion.

Instale

salt-masteren el nodo master de Salt:root@master #zypper in salt-masterCompruebe que el servicio

salt-masteresté habilitado y se haya iniciado, y si no lo estuviera, habilítelo e inícielo:root@master #systemctl enable salt-master.serviceroot@master #systemctl start salt-master.serviceSi va a utilizar un cortafuegos, asegúrese de que el nodo master de Salt tiene los puertos 4505 y 4506 abiertos para todos los nodos minion de Salt. Si los puertos están cerrados, puede abrirlos con el comando

yast2 firewallpermitiendo el servicio para la zona oportuna. Por ejemplo,public.Instale el paquete

salt-minionen todos los nodos minion.root@minion >zypper in salt-minionEdite

/etc/salt/miniony elimine el comentario de la siguiente línea:#log_level_logfile: warning

Cambie el nivel de registro de

warningainfo.Nota:log_level_logfileylog_levelMientras que

log_levelcontrola qué mensajes de registro se mostrarán en la pantalla,log_level_logfilecontrola qué mensajes de registro se escribirán en/var/log/salt/minion.NotaAsegúrese de cambiar el nivel de registro en todos los nodos del clúster (minions).

Asegúrese de que todos los demás nodos pueden resolver el nombre de dominio completo de cada nodo en una dirección IP en la red pública del clúster.

Configure todos los minions para que se conecten con el master. Si el host denominado

saltno puede acceder al master de Salt, edite el archivo/etc/salt/miniono cree un archivo nuevo/etc/salt/minion.d/master.confcon el siguiente contenido:master: host_name_of_salt_master

Si ha realizado cambios en los archivos de configuración mencionados anteriormente, reinicie el servicio Salt en todos los minions de Salt:

root@minion >systemctl restart salt-minion.serviceCompruebe que el servicio

salt-minionestá habilitado e iniciado en todos los nodos. Habilítelo e inícielo si fuera necesario:#systemctl enable salt-minion.service#systemctl start salt-minion.serviceVerifique la huella digital de cada minion de Salt y acepte todas las claves salt del master de Salt si las huellas coinciden.

NotaSi la huella digital del minion de Salt vuelve vacía, asegúrese de que el minion de Salt tenga una configuración de master de Salt y que pueda comunicarse con el master de Salt.

Para ver la huella digital de cada minion:

root@minion >salt-call --local key.finger local: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Después de recopilar las huellas digitales de todos los minions de Salt, muestre las huellas de todas las claves de minion no aceptadas del master de Salt:

root@master #salt-key -F [...] Unaccepted Keys: minion1: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Si las huellas digitales de los minions coinciden, acéptelas:

root@master #salt-key --accept-allVerifique que las claves se han aceptado:

root@master #salt-key --list-allCompruebe si todos los minions de Salt responden:

root@master #salt-run manage.status

7 Distribución del clúster de bootstrap mediante ceph-salt #

Esta sección le guía por el proceso de distribuir un clúster de Ceph básico. Lea atentamente las subsecciones y ejecute los comandos incluidos en el orden indicado.

7.1 Instalación ceph-salt #

ceph-salt proporciona herramientas para distribuir clústeres de Ceph gestionados por cephadm. ceph-salt utiliza la infraestructura de Salt para realizar la gestión del sistema operativo (por ejemplo, las actualizaciones de software o la sincronización horaria) y para definir funciones para los minions de Salt.

En el master de Salt, instale el paquete ceph-salt:

root@master # zypper install ceph-salt

El comando anterior instaló ceph-salt-formula como una dependencia que modifica la configuración del master de Salt insertando archivos adicionales en el directorio /etc/salt/master.d. Para aplicar los cambios, reinicie salt-master.service y sincronice los módulos de Salt:

root@master #systemctl restart salt-master.serviceroot@master #salt \* saltutil.sync_all

7.2 Configuración de las propiedades del clúster #

Utilice el comando ceph-salt config para configurar las propiedades básicas del clúster.

El archivo /etc/ceph/ceph.conf se gestiona mediante cephadm y los usuarios no deben editarlo. Los parámetros de configuración de Ceph deben definirse mediante el nuevo comando ceph config. Consulte el Book “Guía de administración y operaciones”, Chapter 28 “Configuración del clúster de Ceph”, Section 28.2 “Base de datos de configuración” para obtener más información.

7.2.1 Uso de la shell ceph-salt #

Si ejecuta config sin ninguna vía o subcomando, deberá introducir una shell ceph-saltceph-salt interactiva. La shell es útil si necesita configurar varias propiedades en un lote y no desea escribir la sintaxis completa del comando.

root@master #ceph-salt config/>ls o- / ............................................................... [...] o- ceph_cluster .................................................. [...] | o- minions .............................................. [no minions] | o- roles ....................................................... [...] | o- admin .............................................. [no minions] | o- bootstrap ........................................... [no minion] | o- cephadm ............................................ [no minions] | o- tuned ..................................................... [...] | o- latency .......................................... [no minions] | o- throughput ....................................... [no minions] o- cephadm_bootstrap ............................................. [...] | o- advanced .................................................... [...] | o- ceph_conf ................................................... [...] | o- ceph_image_path .................................. [ no image path] | o- dashboard ................................................... [...] | | o- force_password_update ................................. [enabled] | | o- password ................................................ [admin] | | o- ssl_certificate ....................................... [not set] | | o- ssl_certificate_key ................................... [not set] | | o- username ................................................ [admin] | o- mon_ip .................................................. [not set] o- containers .................................................... [...] | o- registries_conf ......................................... [enabled] | | o- registries .............................................. [empty] | o- registry_auth ............................................... [...] | o- password .............................................. [not set] | o- registry .............................................. [not set] | o- username .............................................. [not set] o- ssh ............................................... [no key pair set] | o- private_key .................................. [no private key set] | o- public_key .................................... [no public key set] o- time_server ........................... [enabled, no server host set] o- external_servers .......................................... [empty] o- servers ................................................... [empty] o- subnet .................................................. [not set]

Como puede ver en el resultado del comando ceph-saltls de , la configuración del clúster está organizada en una estructura de árbol. Para configurar una propiedad específica del clúster en la shell ceph-salt, tiene dos opciones:

Ejecute el comando desde la posición actual e introduzca la vía absoluta a la propiedad como primer argumento:

/>/cephadm_bootstrap/dashboard ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username .................................................... [admin]/> /cephadm_bootstrap/dashboard/username set ceph-adminValue set.Cambie a la vía cuya propiedad necesite configurar y ejecute el comando:

/>cd /cephadm_bootstrap/dashboard//ceph_cluster/minions>ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username ................................................[ceph-admin]

En una shell ceph-salt, puede utilizar la función de autocompletado de forma similar a la de una shell de Linux normal (Bash). Completa vías de configuración, subcomandos o nombres de minions de Salt. Para autocompletar una vía de configuración, tiene dos opciones:

Para permitir que la shell termine una vía relativa a su posición actual, pulse la tecla TAB →| dos veces.

Para permitir que la shell termine una vía absoluta, introduzca / y pulse la tecla TAB →| dos veces.

Si escribe cd desde la shell ceph-salt sin ninguna vía, el comando producirá una estructura de árbol de la configuración del clúster con la línea de la vía actual activa. Puede utilizar las teclas de cursor arriba y abajo para desplazarse por cada línea. Después de confirmar con Intro, la vía de configuración cambiará a la última activa.

Para mantener la coherencia de la documentación, se utilizará una sintaxis de comando única sin entrar en la shell ceph-salt. Por ejemplo, puede mostrar el árbol de configuración del clúster mediante el comando siguiente:

root@master # ceph-salt config ls7.2.2 Adición de minions de Salt #

Incluya todos los minions de Salt que se han distribuido y aceptado en la Capítulo 6, Distribución de Salt, o un subconjunto de ellos, en la configuración del clúster de Ceph. Puede especificar los minions de Salt por sus nombres completos o utilizar las expresiones globales "*" y "?" para incluir varios minions de Salt a la vez. Utilice el subcomando add en la vía /ceph_cluster/minions. El comando siguiente incluye todos los minions de Salt aceptados:

root@master # ceph-salt config /ceph_cluster/minions add '*'Compruebe que se han añadido los minions de Salt especificados:

root@master # ceph-salt config /ceph_cluster/minions ls

o- minions ................................................. [Minions: 5]

o- ses-master.example.com .................................. [no roles]

o- ses-min1.example.com .................................... [no roles]

o- ses-min2.example.com .................................... [no roles]

o- ses-min3.example.com .................................... [no roles]

o- ses-min4.example.com .................................... [no roles]7.2.3 Especificación de minions de Salt gestionados por cephadm #

Especifique qué nodos pertenecerán al clúster de Ceph y se gestionarán mediante cephadm. Incluya todos los nodos que ejecutarán servicios de Ceph, así como el nodo de administración:

root@master # ceph-salt config /ceph_cluster/roles/cephadm add '*'7.2.4 Especificación del nodo de administración #

El nodo de administración es el nodo en el que se instalan el archivo de configuración ceph.conf y el anillo de claves de administración de Ceph. Normalmente, los comandos relacionados con Ceph se ejecutan en el nodo de administración.

En un entorno homogéneo en el que todos o la mayoría de los hosts pertenezcan a SUSE Enterprise Storage, se recomienda tener el nodo de administración en el mismo host que el master de Salt.