Inicio rápido de instalación y configuración #

Este documento sirve como guía para la instalación de un clúster muy básico de dos nodos mediante los guiones de bootstrap proporcionados por la shell crm. Esto incluye la configuración de una dirección IP virtual como recurso de clúster y el uso del SBD (del inglés Split Brain Detector, detector de inteligencia dividida) en el almacenamiento compartido como mecanismo de “fencing” de nodo.

Copyright © 2006–2025 SUSE LLC y colaboradores. Reservados todos los derechos.

Está permitido copiar, distribuir y modificar este documento según los términos de la licencia de documentación gratuita GNU, versión 1.2 o (según su criterio) versión 1.3. Este aviso de copyright y licencia deberán permanecer inalterados. En la sección titulada “GNU Free Documentation License” (Licencia de documentación gratuita GNU) se incluye una copia de la versión 1.2 de la licencia.

Para obtener información sobre las marcas comerciales de SUSE, consulte https://www.suse.com/company/legal/. Todas las marcas comerciales de otros fabricantes son propiedad de sus propietarios respectivos. Los símbolos de marcas comerciales (®, ™, etc.) indican marcas comerciales de SUSE y sus filiales. Los asteriscos (*) indican marcas comerciales de otros fabricantes.

Toda la información recogida en esta publicación se ha compilado prestando toda la atención posible al más mínimo detalle. Sin embargo, esto no garantiza una precisión total. Ni SUSE LLC, ni sus filiales, ni los autores o traductores serán responsables de los posibles errores o las consecuencias que de ellos pudieran derivarse.

1 Ejemplo de uso #

Los procedimientos descritos en este documento sirven para realizar una instalación mínima de un clúster de dos nodos con las siguientes propiedades:

Dos nodos:

alice(IP:192.168.1.1) ybob(IP:192.168.1.2), conectados entre sí a través de la red.Una dirección IP virtual flotante (

192.168.1.10) que permite a los clientes conectarse al servicio independientemente del nodo en el que se esté ejecutando. Esta dirección IP se utiliza para conectarse a la herramienta de gestión gráfica Hawk2.Un dispositivo de almacenamiento compartido, que se utiliza como mecanismo de “fencing” del SBD. Esto evita que haya nodos malinformados (split brain).

Failover (relevo de funciones multinodo) de recursos de un nodo a otro si el host activo se interrumpe (instalación activa/pasiva).

Puede utilizar el clúster de dos nodos con fines de prueba o como configuración de clúster mínima que puede ampliar más adelante. Antes de utilizar el clúster en un entorno de producción, consulte el Book “Administration Guide” para modificar el clúster según sus necesidades.

2 Requisitos del sistema #

En esta sección se informa sobre los principales requisitos del sistema para la situación descrita en la Sección 1. Para ajustar el clúster a fin de usarlo en un entorno de producción, consulte la lista completa en el Book “Administration Guide”, Chapter 2 “System requirements and recommendations”.

2.1 Requisitos de hardware #

- Servidores

Dos servidores con el software especificado en la Sección 2.2, “Requisitos de software”.

Los servidores pueden ser equipos desde cero o máquinas virtuales. No es necesario que el hardware sea idéntico (memoria, espacio de disco, etc.), pero debe tener la misma arquitectura. No se admiten clústeres de distintas plataformas.

- Canales de comunicación

Se necesitan al menos dos medios de comunicación TCP/IP por nodo del clúster. El equipo de red debe ser compatible con los medios de comunicación que desee utilizar para las comunicaciones del clúster: multidifusión o difusión unidireccional. Los medios de comunicación deben admitir una velocidad de datos de 100 Mbit/s o superior. Para que la instalación del clúster sea compatible, se requieren dos o más vías de comunicación redundantes. Esto puede realizarse de las siguientes formas:

Con un vínculo de dispositivos de red (opción preferida)

Con un segundo canal de comunicación en Corosync

- “Fencing” de nodo o STONITH

Un dispositivo de "fencing" (o delimitación) de nodos (STONITH) para evitar que se produzcan nodos malinformados. Puede ser un dispositivo físico (un conmutador de alimentación) o un mecanismo como un SBD (STONITH por disco), en combinación con un watchdog (o vigilante). El SBD se puede utilizar con almacenamiento compartido o en modo sin disco. Este documento describe el uso del SBD con almacenamiento compartido. Se deben cumplir los siguientes requisitos:

Un dispositivo de almacenamiento compartido. Para obtener información sobre la configuración del almacenamiento compartido, consulte Storage Administration Guide for SUSE Linux Enterprise Server. Si solo necesita almacenamiento compartido básico para realizar pruebas, consulte el Apéndice A, Almacenamiento iSCSI básico para el SBD.

La vía al dispositivo de almacenamiento compartido debe ser persistente y coherente en todos los nodos del clúster. Utilice nombres de dispositivo estables, como

/dev/disk/by-id/dm-uuid-part1-mpath-abcedf12345.El dispositivo SBD no debe utilizar RAID, LVM ni DRBD * basados en host.

Para obtener más información sobre STONITH, consulte el Book “Administration Guide”, Chapter 12 “Fencing and STONITH”. Para obtener más información sobre el SBD, consulte el Book “Administration Guide”, Chapter 13 “Storage protection and SBD”.

2.2 Requisitos de software #

Todos los nodos necesitan al menos los siguientes módulos y extensiones:

Módulo de sistema base 15 SP6

Módulo de aplicaciones de servidor 15 SP6

SUSE Linux Enterprise High Availability 15 SP6

2.3 Otros requisitos y recomendaciones #

- Sincronización horaria

Los nodos del clúster deben sincronizarse con un servidor NTP externo al clúster. Desde SUSE Linux Enterprise High Availability 15, la implementación por defecto de NTP es chrony. Si desea información adicional, consulte Administration Guide for SUSE Linux Enterprise Server 15 SP6.

Es posible que el clúster no funcione correctamente si los nodos no están sincronizados, o incluso si están sincronizados pero tienen distintas zonas horarias configuradas. Asimismo, los archivos de registro y los informes del clúster son muy difíciles de analizar sin la sincronización. Si utiliza guiones de bootstrap, el sistema le avisará si NTP no está aún configurado.

- Nombre del host y dirección IP

Utilice direcciones IP estáticas.

Solo se admite la dirección IP principal.

Muestre todos los nodos del clúster en el archivo

/etc/hostscon su nombre de host completo y su nombre de host abreviado. Es esencial que los miembros del clúster puedan encontrarse unos a otros por su nombre. Si los nombres no están disponibles, se producirá un error de comunicación interna del clúster.

- SSH

Todos los nodos del clúster deben ser capaces de acceder a los demás mediante SSH. Herramientas como

crm report(para resolver problemas) y el de Hawk2 requieren acceso SSH sin contraseña entre los nodos; si no se proporciona, solo podrán recopilar datos del nodo actual.Si utiliza guiones de bootstrap para configurar el clúster, las claves SSH se crean y se copian automáticamente.

3 Descripción general de los guiones de bootstrap #

Los comandos siguientes ejecutan guiones de bootstrap que requieren solo un mínimo de tiempo y de intervención manual.

Con

crm cluster initpuede definir los parámetros básicos necesarios para la comunicación del clúster. Esto le deja con un clúster de un nodo en ejecución.Con

crm cluster joinpuede añadir más nodos al clúster.Con

crm cluster removepuede eliminar nodos del clúster.

Las opciones definidas por los guiones de bootstrap pueden no ser las mismas que los ajustes por defecto de Pacemaker. Puede comprobar qué ajustes han cambiado los guiones de bootstrap en /var/log/crmsh/crmsh.log. Todas las opciones que se establecen durante el proceso de bootstrap se pueden modificar más adelante con el módulo de clúster de YaST. Consulte el Book “Administration Guide”, Chapter 4 “Using the YaST cluster module” para obtener más información.

El guion de bootstrap crm cluster init comprueba y configura los siguientes componentes:

- NTP

Comprueba si NTP está configurado para iniciarse en el momento del arranque. Si no es así, aparece un mensaje.

- SSH

Crea claves SSH para el inicio de sesión sin contraseña entre los nodos del clúster.

- Csync2

Configura Csync2 para replicar los archivos de configuración en todos los nodos de un clúster.

- Corosync

Configura el sistema de comunicación del clúster.

- SBD/watchdog

Comprueba si existe un watchdog y se le pregunta si desea configurar el SBD como mecanismo de “fencing” de nodo.

- IP virtual flotante

Le pregunta si desea configurar una dirección IP virtual para la administración del clúster con Hawk2.

- Cortafuegos

Abre los puertos del cortafuegos necesarios para la comunicación del clúster.

- Nombre del clúster

Define un nombre para el clúster, que es, por defecto,

hacluster. Este componente es opcional y resulta útil sobre todo para los clústeres geográficos. Normalmente, el nombre del clúster refleja la ubicación geográfica y permite que sea más fácil distinguir un sitio dentro de un clúster geográfico.- QDevice/QNetd

Le pregunta si desea configurar QDevice/QNetd para participar en las decisiones de quórum. Se recomienda utilizar QDevice y QNetd para clústeres con un número par de nodos, y especialmente para clústeres de dos nodos.

Esta configuración no se trata aquí, pero puede configurarla más adelante como se describe en el Book “Administration Guide”, Chapter 14 “QDevice and QNetd”.

El guión crm cluster init detecta el entorno del sistema (por ejemplo, Microsoft Azure) y ajusta determinados valores de clúster en función del perfil de ese entorno. Si desea información adicional, consulte el archivo /etc/crm/profiles.yml.

4 Instalación de los paquetes de Alta disponibilidad #

Los paquetes para configurar y gestionar un clúster se incluyen en el patrón de instalación High Availability. Este patrón solo está disponible después de instalar SUSE Linux Enterprise High Availability.

Puede registrarse en el Centro de servicios al cliente de SUSE e instalar SUSE Linux Enterprise High Availability mientras instala SUSE Linux Enterprise Server o después de la instalación. Para obtener más información, consulte Deployment Guide para SUSE Linux Enterprise Server.

Instale el patrón Alta disponibilidad desde la línea de comandos:

#zypper install -t pattern ha_slesInstale el patrón Alta disponibilidad en todos los equipos que vayan a formar parte del clúster.

Nota: instalación de paquetes de software en todos los nodosPara realizar una instalación automática de SUSE Linux Enterprise Server 15 SP6 y SUSE Linux Enterprise High Availability 15 SP6, utilice AutoYaST para clonar los nodos existentes. Para obtener más información, consulte el Book “Administration Guide”, Chapter 3 “Installing SUSE Linux Enterprise High Availability”, Section 3.2 “Mass installation and deployment with AutoYaST”.

5 Uso del SBD para el "fencing" de nodos #

Antes de poder configurar el SBD con el guion de bootstrap, debe habilitar un watchdog en cada nodo. SUSE Linux Enterprise Server incluye varios módulos del kernel que proporcionan controladores de watchdog específicos del hardware. SUSE Linux Enterprise High Availability usa el daemon de SBD como componente de software que “alimenta” al watchdog.

En el procedimiento siguiente se utiliza el watchdog softdog.

El controlador softdog presupone que sigue habiendo al menos una CPU en ejecución. Si todas las CPU están bloqueadas, el código del controlador softdog que debe rearrancar el sistema no se ejecuta nunca. Por el contrario, los watchdogs de hardware siguen en funcionamiento aunque todas las CPU estén bloqueadas.

Antes de utilizar el clúster en un entorno de producción, se recomienda encarecidamente sustituir el módulo softdog por el módulo de hardware que mejor se adapte al hardware existente.

Sin embargo, si ningún watchdog coincide con el hardware, se puede usar softdog como módulo de watchdog del kernel.

En cada nodo, habilite el watchdog softdog:

#echo softdog > /etc/modules-load.d/watchdog.conf#systemctl restart systemd-modules-loadCompruebe que el módulo softdog está correctamente cargado:

#lsmod | grep dogsoftdog 16384 1

6 Configuración del primer nodo #

Configure el primer nodo con el guion crm cluster init. Esto requiere solo un mínimo de tiempo y de intervención manual.

alice) con crm cluster init #Inicie sesión en el primer nodo del clúster como

rooto como usuario con privilegios desudo.Importante: acceso mediante clave SSHEl clúster utiliza el acceso SSH sin contraseña para la comunicación entre los nodos. El guión

crm cluster initcomprueba las claves SSH y las genera si aún no existen.En la mayoría de los casos, las claves SSH del usuario

rootosudodeben existir (o haberse generado) en el nodo.Como alternativa, las claves SSH de un usuario

sudopueden existir en un equipo local y pasarse al nodo reenviando el agente SSH. Esto requiere una configuración adicional que no se describe para esta configuración mínima. Para obtener más información, consulte el Book “Administration Guide”, Chapter 5 “Configuration and administration basics”, Section 5.5.1 “Logging in”.Inicie el guion de bootstrap:

#crm cluster init --name CLUSTERNAMESustituya el marcador de posición CLUSTERNAME por un nombre descriptivo, como la ubicación geográfica del clúster (por ejemplo,

amsterdam). Esto resulta especialmente útil para crear un clúster geográfico más adelante, ya que simplifica la identificación de un sitio.Si necesita utilizar multidifusión en lugar de unidifusión (valor por defecto) para la comunicación del clúster, utilice la opción

--multicast(o-U).El guion comprueba la configuración de NTP y si existe un servicio de watchdog de hardware. Si se necesita, genera las claves SSH pública y privada usadas para el acceso SSH y la sincronización Csync2 e inicia los servicios respectivos.

Configure el nivel de comunicación del clúster (Corosync):

Introduzca la dirección de red con la que se debe enlazar. Por defecto, el guion propone la dirección de red

eth0. Si lo prefiere, especifique una dirección de red distinta; por ejemplo,bond0.Acepte el puerto propuesto (

5405) o introduzca uno diferente.

Configure el SBD como mecanismo de "fencing" de nodo:

Confirme con

yque desea utilizar el SBD.Introduzca una vía persistente para la partición del dispositivo de bloques que desea utilizar para el SBD. La vía debe ser coherente en todos los nodos del clúster.

El guion crea una pequeña partición en el dispositivo que se utilizará para el SBD.

Configure una dirección IP virtual para la administración del clúster con Hawk2:

Confirme con

yque desea configurar una dirección IP virtual.Introduzca una dirección IP no utilizada que desee usar como IP de administración para Hawk2:

192.168.1.10.En lugar de iniciar sesión en un nodo de clúster individual con Hawk2, puede conectarse a la dirección IP virtual.

Elija si desea configurar QDevice y Qnetd. Si desea optar por la instalación mínima descrita en este documento, rechace su configuración por ahora con

n. Puede configurar QDevice y QNetd más adelante, como se describe en el Book “Administration Guide”, Chapter 14 “QDevice and QNetd”.

Por último, el guion inicia los servicios de clúster para conectar el clúster y habilitar Hawk2. La URL que se utilizará para Hawk2 se muestra en la pantalla.

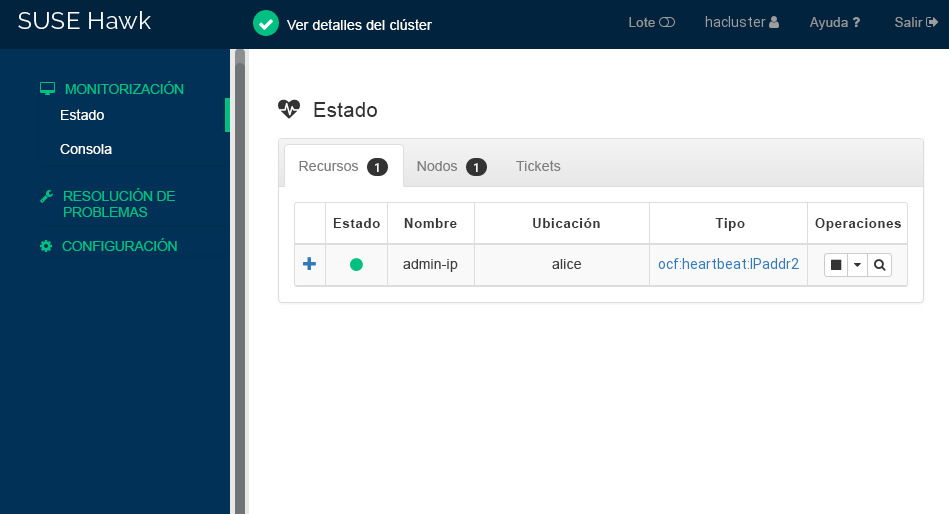

Ahora dispone de un clúster de un nodo en ejecución. Para ver su estado, haga lo siguiente:

En cualquier equipo, inicie un navegador Web y asegúrese de que las cookies y JavaScript están habilitados.

Como URL, introduzca la dirección IP virtual que ha configurado con el guion de bootstrap:

https://192.168.1.10:7630/

Nota: advertencia de certificadoSi aparece una advertencia de certificado cuando intenta acceder a la URL por primera vez, se debe a que se está usando un certificado autofirmado. Los certificados autofirmados no se consideran de confianza por defecto.

Consulte a su operador de clúster los detalles del certificado para verificarlo.

Si desea continuar de todas formas, puede añadir una excepción en el navegador para omitir la advertencia.

En la pantalla de inicio de sesión de Hawk2, escriba el y la del usuario que creó el guion de bootstrap (usuario

haclustery contraseñalinux).Importante: contraseña seguraSustituya la contraseña por defecto por una segura tan pronto como sea posible:

#passwd haclusterHaga clic en . La interfaz Web de Hawk2 muestra por defecto la pantalla Estado:

Figura 1: estado del clúster de un nodo en Hawk2 #

7 Adición del segundo nodo #

Añada un segundo nodo al clúster con el guion de bootstrap crm cluster join. El guion solo necesita acceso a un nodo de clúster existente y finaliza automáticamente la configuración básica en el equipo actual.

Si desea información adicional, consulte el comando crm cluster join --help.

bob) con crm cluster join #Inicie sesión en el segundo nodo del clúster como

rooto como usuario con privilegios desudo.Inicie el guion de bootstrap:

Si configura el primer nodo como

root, puede ejecutar este comando sin parámetros adicionales:#crm cluster joinSi configura el primer nodo como usuario

sudo, debe especificar ese usuario con la opción-c:>sudo crm cluster join -c USER@aliceSi NTP no se ha configurado para iniciarse durante el arranque, aparece un mensaje. El guion también comprueba si hay un dispositivo de watchdog de hardware. Recibirá una advertencia si no hay ninguno presente.

Si aún no ha especificado

alicecon-c, se le solicita la dirección IP del primer nodo.Si aún no ha configurado el acceso SSH sin contraseña entre ambos equipos, se le pide la contraseña del primer nodo.

Después de iniciar sesión en el nodo especificado, el guión copia la configuración de Corosync, configura SSH y Csync2, pone en línea el equipo actual como un nuevo nodo de clúster e inicia el servicio necesario para Hawk2.

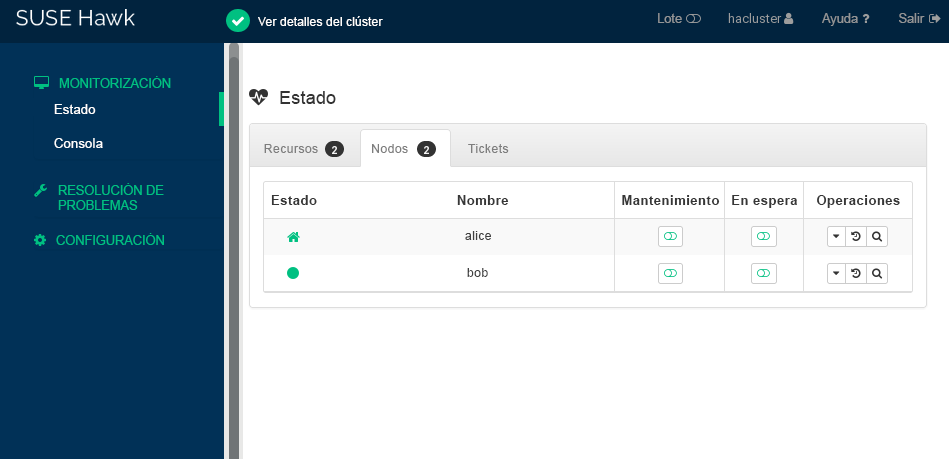

Compruebe el estado del clúster en Hawk2. En › deberían aparecer dos nodos con estado verde:

8 Comprobación del clúster #

Las siguientes pruebas pueden ayudarle a identificar problemas con la configuración del clúster. Sin embargo, una prueba realista implica casos de uso y escenarios específicos. Antes de utilizar el clúster en un entorno de producción, pruébelo exhaustivamente en consonancia con sus casos de uso.

El comando

sbd -d DEVICE_NAME listmuestra todos los nodos que son visibles para el SBD. Para la configuración descrita en este documento, el resultado debe mostrar tantoalicecomobob.La Sección 8.1, “Prueba de failover de recursos” es una sencilla prueba para comprobar si el clúster mueve la dirección IP virtual al otro nodo en caso de que el nodo que está ejecutando actualmente el recurso pase a modo

standby.La Sección 8.2, “Pruebas con el comando

crm cluster crash_test” simula fallos de clúster e informa de los resultados.

8.1 Prueba de failover de recursos #

Como prueba rápida, el siguiente procedimiento comprueba el failover de los recursos:

Abra un terminal y ejecute un ping a

192.168.1.10, la dirección IP virtual:#ping 192.168.1.10Inicie sesión en Hawk2.

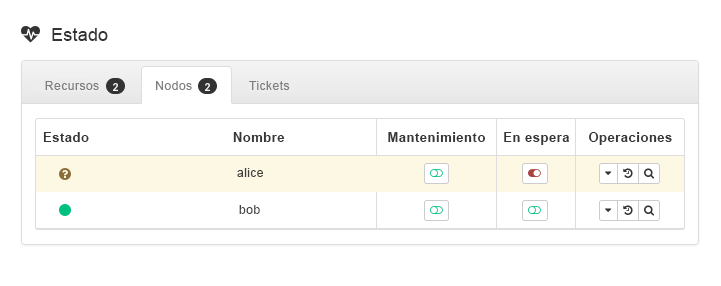

En la opción › , marque el nodo en el que se está ejecutando la dirección IP virtual (recurso

admin_addr). Este procedimiento interpreta que el recurso se está ejecutando enalice.Ponga

aliceen modo :Figura 3: nodoaliceen modo En espera #Haga clic en › . El recurso

admin_addrse ha migrado abob.

Durante la migración, se mostrará un flujo ininterrumpido de pings a la dirección IP virtual. Esto muestra que la configuración del clúster y la dirección IP flotante funcionan correctamente. Cancele el comando ping con Control–C.

8.2 Pruebas con el comando crm cluster crash_test #

El comando crm cluster crash_test activa los errores del clúster para buscar posibles problemas. Antes de utilizar el clúster en el entorno de producción, se recomienda utilizar este comando para asegurarse de que todo funciona correctamente.

El comando admite las siguientes comprobaciones:

--split-brain-iptablesSimula una situación de clústeres con nodos malinformados mediante el bloqueo del puerto de Corosync. Comprueba si un nodo se puede aislar en la medida de lo esperado.

--kill-sbd/--kill-corosync/--kill-pacemakerdInterrumpe los daemons de SBD, Corosync y Pacemaker. Después de ejecutar una de estas pruebas, encontrará un informe en el directorio

/var/lib/crmsh/crash_test/. El informe incluye una descripción del caso de prueba, un registro de acciones y una explicación de los posibles resultados.--fence-node NODEDelimita el nodo concreto que se ha pasado desde la línea de comandos.

Para obtener más información, consulte el crm cluster crash_test --help.

#crm_mon -1Stack: corosync Current DC: alice (version ...) - partition with quorum Last updated: Fri Mar 03 14:40:21 2020 Last change: Fri Mar 03 14:35:07 2020 by root via cibadmin on alice 2 nodes configured 1 resource configured Online: [ alice bob ] Active resources: stonith-sbd (stonith:external/sbd): Started alice#crm cluster crash_test--fence-node bob============================================== Testcase: Fence node bob Fence action: reboot Fence timeout: 60 !!! WARNING WARNING WARNING !!! THIS CASE MAY LEAD TO NODE BE FENCED. TYPE Yes TO CONTINUE, OTHER INPUTS WILL CANCEL THIS CASE [Yes/No](No):YesINFO: Trying to fence node "bob" INFO: Waiting 60s for node "bob" reboot... INFO: Node "bob" will be fenced by "alice"! INFO: Node "bob" was successfully fenced by "alice"

Para observar el cambio de estado de bob durante la prueba, inicie sesión en Hawk2 y acceda a › .

9 Pasos siguientes #

Los guiones de bootstrap proporcionan una forma rápida de configurar un clúster de Alta disponibilidad básico que puede utilizarse con fines de prueba. Sin embargo, para expandir este clúster a un clúster de Alta disponibilidad en funcionamiento que se pueda usar en entornos de producción, se recomiendan más pasos.

- Adición de más nodos

Añada más nodos al clúster mediante uno de los siguientes métodos:

Para los nodos individuales, utilice el guion

crm cluster joincomo se describe en la Sección 7, “Adición del segundo nodo”.Para la instalación masiva de varios nodos, utilice AutoYaST como se describe en el Book “Administration Guide”, Chapter 3 “Installing SUSE Linux Enterprise High Availability”, Section 3.2 “Mass installation and deployment with AutoYaST”.

Un clúster normal puede contener hasta 32 nodos. Con el servicio

pacemaker_remote, los clústeres de Alta disponibilidad se pueden ampliar para incluir nodos adicionales más allá de este límite. Consulte el Article “Pacemaker Remote Quick Start” para obtener más información.- Configuración de QDevice

Si el clúster tiene un número par de nodos, configure QDevice y QNetd para participar en las decisiones de quórum. QDevice proporciona un número configurable de votos, lo que permite que un clúster mantenga más fallos de nodo de los que permiten las reglas de quórum estándar. Para obtener información, consulte el Book “Administration Guide”, Chapter 14 “QDevice and QNetd”.

- Habilitación de un watchdog de hardware

Antes de utilizar el clúster en un entorno de producción, sustituya el módulo

softdogpor el módulo de hardware que mejor se adapte al hardware existente. Para obtener información, consulte el Book “Administration Guide”, Chapter 13 “Storage protection and SBD”, Section 13.6 “Setting up the watchdog”.

10 Para más información #

Hay disponible más documentación sobre este producto en https://documentation.suse.com/sle-ha/. Para consultar otras tareas de configuración y administración, consulte la completa Administration Guide.

A Almacenamiento iSCSI básico para el SBD #

Utilice los siguientes procedimientos para configurar el almacenamiento iSCSI básico para utilizarlo con el SBD. Estos procedimientos solo se recomiendan con fines de prueba. Antes de usar iSCSI en un entorno de producción, consulte Storage Administration Guide for SUSE Linux Enterprise Server.

Una máquina virtual de SUSE Linux Enterprise Server para actuar como destino iSCSI. Esta máquina virtual no debe formar parte del clúster.

Dos dispositivos de almacenamiento virtual en la máquina virtual: un dispositivo de 20 GB para el sistema y un dispositivo de 1 GB para el SBD.

Dos nodos de SUSE Linux Enterprise Server que aún no se hayan añadido a un clúster de Alta disponibilidad.

En primer lugar, configure un destino iSCSI en la máquina virtual:

Instale el paquete yast2-iscsi-lio-server:

#zypper install yast2-iscsi-lio-serverInicie el módulo

iscsi-lio-serveren YaST:#yast2 iscsi-lio-serverEn la pestaña , en , seleccione .

Active .

En la pestaña , active .

En , introduzca un valor en y en .

En , introduzca un valor en y en . Esta contraseña debe ser diferente de la que ha indicado en .

En la pestaña , seleccione .

Cambie el nombre de sustituyendo

.com.example.Añada la del servidor.

Seleccione .

En la ventana , introduzca en la vía al dispositivo de almacenamiento de 1 GB (por ejemplo,

/dev/vbd).Seleccione .

Seleccione .

Seleccione para cerrar YaST.

Para comprobar la configuración del destino, cambie a la interfaz de línea de comandos del destino:

#targetcliMuestre la configuración:

/>ls

A continuación, configure los iniciadores iSCSI en los nodos. Repita este procedimiento en ambos nodos:

Instale el paquete yast2-iscsi-client:

#zypper install yast2-iscsi-clientInicie el servicio

iscsid:#systemctl start iscsidAbra el módulo

iscsi-clienten YaST:#yast2 iscsi-clientEn la pestaña , seleccione .

Introduzca la dirección IP del destino iSCSI.

Desactive .

En , introduzca el y la del iniciador.

En , introduzca el y la del destino.

Seleccione .

Cuando YaST descubra el destino iSCSI, seleccione .

En seleccione .

Seleccione .

Seleccione para cerrar YaST.

Compruebe el iniciador iSCSI:

#lsscsi[0:0:1:0] cd/dvd QEMU QEMU DVD-ROM 2.5+ /dev/sr0 [2:0:0:0] disk LIO-ORG IBLOCK 4.0 /dev/sdaBusque una línea con

IBLOCK. En este ejemplo, el dispositivo iSCSI es/dev/sda.Compruebe el estado del servicio

iscsid:#systemctl status iscsid

Encontrará el nombre del dispositivo estable en /dev/disk/by-id/. Normalmente, un dispositivo iSCSI comienza con scsi-SLIO-ORG_IBLOCK.

Si tiene varios discos, puede ejecutar el comando lsblk -o name,serial para confirmar qué nombre de dispositivo estable corresponde a qué nombre corto (por ejemplo, /dev/sda).

Cuando configure el clúster, especifique el nombre del dispositivo estable mediante uno de estos métodos:

Cuando se ejecute

crm cluster init, introduzca el nombre del dispositivo estable cuando se le solicite.Antes de ejecutar

crm cluster init, añada el nombre del dispositivo estable a/etc/sysconfig/sbd:SBD_DEVICE=/dev/disk/by-id/scsi-SLIO-ORG_IBLOCK_DEVICE_ID_STRING

Cuando ejecute

crm cluster init, respondana esta pregunta:SBD is already configured to use /dev/disk/by-id/scsi-SLIO-ORG_IBLOCK_... - overwrite (y/n)?

This appendix contains the GNU Free Documentation License version 1.2.

GNU Free Documentation License #

Copyright (C) 2000, 2001, 2002 Free Software Foundation, Inc. 51 Franklin St, Fifth Floor, Boston, MA 02110-1301 USA. Everyone is permitted to copy and distribute verbatim copies of this license document, but changing it is not allowed.

0. PREAMBLE #

The purpose of this License is to make a manual, textbook, or other functional and useful document "free" in the sense of freedom: to assure everyone the effective freedom to copy and redistribute it, with or without modifying it, either commercially or non-commercially. Secondarily, this License preserves for the author and publisher a way to get credit for their work, while not being considered responsible for modifications made by others.

This License is a kind of "copyleft", which means that derivative works of the document must themselves be free in the same sense. It complements the GNU General Public License, which is a copyleft license designed for free software.

We have designed this License to use it for manuals for free software, because free software needs free documentation: a free program should come with manuals providing the same freedoms that the software does. But this License is not limited to software manuals; it can be used for any textual work, regardless of subject matter or whether it is published as a printed book. We recommend this License principally for works whose purpose is instruction or reference.

1. APPLICABILITY AND DEFINITIONS #

This License applies to any manual or other work, in any medium, that contains a notice placed by the copyright holder saying it can be distributed under the terms of this License. Such a notice grants a world-wide, royalty-free license, unlimited in duration, to use that work under the conditions stated herein. The "Document", below, refers to any such manual or work. Any member of the public is a licensee, and is addressed as "you". You accept the license if you copy, modify or distribute the work in a way requiring permission under copyright law.

A "Modified Version" of the Document means any work containing the Document or a portion of it, either copied verbatim, or with modifications and/or translated into another language.

A "Secondary Section" is a named appendix or a front-matter section of the Document that deals exclusively with the relationship of the publishers or authors of the Document to the Document's overall subject (or to related matters) and contains nothing that could fall directly within that overall subject. (Thus, if the Document is in part a textbook of mathematics, a Secondary Section may not explain any mathematics.) The relationship could be a matter of historical connection with the subject or with related matters, or of legal, commercial, philosophical, ethical or political position regarding them.

The "Invariant Sections" are certain Secondary Sections whose titles are designated, as being those of Invariant Sections, in the notice that says that the Document is released under this License. If a section does not fit the above definition of Secondary then it is not allowed to be designated as Invariant. The Document may contain zero Invariant Sections. If the Document does not identify any Invariant Sections then there are none.

The "Cover Texts" are certain short passages of text that are listed, as Front-Cover Texts or Back-Cover Texts, in the notice that says that the Document is released under this License. A Front-Cover Text may be at most 5 words, and a Back-Cover Text may be at most 25 words.

A "Transparent" copy of the Document means a machine-readable copy, represented in a format whose specification is available to the general public, that is suitable for revising the document straightforwardly with generic text editors or (for images composed of pixels) generic paint programs or (for drawings) some widely available drawing editor, and that is suitable for input to text formatters or for automatic translation to a variety of formats suitable for input to text formatters. A copy made in an otherwise Transparent file format whose markup, or absence of markup, has been arranged to thwart or discourage subsequent modification by readers is not Transparent. An image format is not Transparent if used for any substantial amount of text. A copy that is not "Transparent" is called "Opaque".

Examples of suitable formats for Transparent copies include plain ASCII without markup, Texinfo input format, LaTeX input format, SGML or XML using a publicly available DTD, and standard-conforming simple HTML, PostScript or PDF designed for human modification. Examples of transparent image formats include PNG, XCF and JPG. Opaque formats include proprietary formats that can be read and edited only by proprietary word processors, SGML or XML for which the DTD and/or processing tools are not generally available, and the machine-generated HTML, PostScript or PDF produced by some word processors for output purposes only.

The "Title Page" means, for a printed book, the title page itself, plus such following pages as are needed to hold, legibly, the material this License requires to appear in the title page. For works in formats which do not have any title page as such, "Title Page" means the text near the most prominent appearance of the work's title, preceding the beginning of the body of the text.

A section "Entitled XYZ" means a named subunit of the Document whose title either is precisely XYZ or contains XYZ in parentheses following text that translates XYZ in another language. (Here XYZ stands for a specific section name mentioned below, such as "Acknowledgements", "Dedications", "Endorsements", or "History".) To "Preserve the Title" of such a section when you modify the Document means that it remains a section "Entitled XYZ" according to this definition.

The Document may include Warranty Disclaimers next to the notice which states that this License applies to the Document. These Warranty Disclaimers are considered to be included by reference in this License, but only as regards disclaiming warranties: any other implication that these Warranty Disclaimers may have is void and has no effect on the meaning of this License.

2. VERBATIM COPYING #

You may copy and distribute the Document in any medium, either commercially or non-commercially, provided that this License, the copyright notices, and the license notice saying this License applies to the Document are reproduced in all copies, and that you add no other conditions whatsoever to those of this License. You may not use technical measures to obstruct or control the reading or further copying of the copies you make or distribute. However, you may accept compensation in exchange for copies. If you distribute a large enough number of copies you must also follow the conditions in section 3.

You may also lend copies, under the same conditions stated above, and you may publicly display copies.

3. COPYING IN QUANTITY #

If you publish printed copies (or copies in media that commonly have printed covers) of the Document, numbering more than 100, and the Document's license notice requires Cover Texts, you must enclose the copies in covers that carry, clearly and legibly, all these Cover Texts: Front-Cover Texts on the front cover, and Back-Cover Texts on the back cover. Both covers must also clearly and legibly identify you as the publisher of these copies. The front cover must present the full title with all words of the title equally prominent and visible. You may add other material on the covers in addition. Copying with changes limited to the covers, as long as they preserve the title of the Document and satisfy these conditions, can be treated as verbatim copying in other respects.

If the required texts for either cover are too voluminous to fit legibly, you should put the first ones listed (as many as fit reasonably) on the actual cover, and continue the rest onto adjacent pages.

If you publish or distribute Opaque copies of the Document numbering more than 100, you must either include a machine-readable Transparent copy along with each Opaque copy, or state in or with each Opaque copy a computer-network location from which the general network-using public has access to download using public-standard network protocols a complete Transparent copy of the Document, free of added material. If you use the latter option, you must take reasonably prudent steps, when you begin distribution of Opaque copies in quantity, to ensure that this Transparent copy will remain thus accessible at the stated location until at least one year after the last time you distribute an Opaque copy (directly or through your agents or retailers) of that edition to the public.

It is requested, but not required, that you contact the authors of the Document well before redistributing any large number of copies, to give them a chance to provide you with an updated version of the Document.

4. MODIFICATIONS #

You may copy and distribute a Modified Version of the Document under the conditions of sections 2 and 3 above, provided that you release the Modified Version under precisely this License, with the Modified Version filling the role of the Document, thus licensing distribution and modification of the Modified Version to whoever possesses a copy of it. In addition, you must do these things in the Modified Version:

Use in the Title Page (and on the covers, if any) a title distinct from that of the Document, and from those of previous versions (which should, if there were any, be listed in the History section of the Document). You may use the same title as a previous version if the original publisher of that version gives permission.

List on the Title Page, as authors, one or more persons or entities responsible for authorship of the modifications in the Modified Version, together with at least five of the principal authors of the Document (all of its principal authors, if it has fewer than five), unless they release you from this requirement.

State on the Title page the name of the publisher of the Modified Version, as the publisher.

Preserve all the copyright notices of the Document.

Add an appropriate copyright notice for your modifications adjacent to the other copyright notices.

Include, immediately after the copyright notices, a license notice giving the public permission to use the Modified Version under the terms of this License, in the form shown in the Addendum below.

Preserve in that license notice the full lists of Invariant Sections and required Cover Texts given in the Document's license notice.

Include an unaltered copy of this License.

Preserve the section Entitled "History", Preserve its Title, and add to it an item stating at least the title, year, new authors, and publisher of the Modified Version as given on the Title Page. If there is no section Entitled "History" in the Document, create one stating the title, year, authors, and publisher of the Document as given on its Title Page, then add an item describing the Modified Version as stated in the previous sentence.

Preserve the network location, if any, given in the Document for public access to a Transparent copy of the Document, and likewise the network locations given in the Document for previous versions it was based on. These may be placed in the "History" section. You may omit a network location for a work that was published at least four years before the Document itself, or if the original publisher of the version it refers to gives permission.

For any section Entitled "Acknowledgements" or "Dedications", Preserve the Title of the section, and preserve in the section all the substance and tone of each of the contributor acknowledgements and/or dedications given therein.

Preserve all the Invariant Sections of the Document, unaltered in their text and in their titles. Section numbers or the equivalent are not considered part of the section titles.

Delete any section Entitled "Endorsements". Such a section may not be included in the Modified Version.

Do not retitle any existing section to be Entitled "Endorsements" or to conflict in title with any Invariant Section.

Preserve any Warranty Disclaimers.

If the Modified Version includes new front-matter sections or appendices that qualify as Secondary Sections and contain no material copied from the Document, you may at your option designate some or all of these sections as invariant. To do this, add their titles to the list of Invariant Sections in the Modified Version's license notice. These titles must be distinct from any other section titles.

You may add a section Entitled "Endorsements", provided it contains nothing but endorsements of your Modified Version by various parties--for example, statements of peer review or that the text has been approved by an organization as the authoritative definition of a standard.

You may add a passage of up to five words as a Front-Cover Text, and a passage of up to 25 words as a Back-Cover Text, to the end of the list of Cover Texts in the Modified Version. Only one passage of Front-Cover Text and one of Back-Cover Text may be added by (or through arrangements made by) any one entity. If the Document already includes a cover text for the same cover, previously added by you or by arrangement made by the same entity you are acting on behalf of, you may not add another; but you may replace the old one, on explicit permission from the previous publisher that added the old one.

The author(s) and publisher(s) of the Document do not by this License give permission to use their names for publicity for or to assert or imply endorsement of any Modified Version.

5. COMBINING DOCUMENTS #

You may combine the Document with other documents released under this License, under the terms defined in section 4 above for modified versions, provided that you include in the combination all of the Invariant Sections of all of the original documents, unmodified, and list them all as Invariant Sections of your combined work in its license notice, and that you preserve all their Warranty Disclaimers.

The combined work need only contain one copy of this License, and multiple identical Invariant Sections may be replaced with a single copy. If there are multiple Invariant Sections with the same name but different contents, make the title of each such section unique by adding at the end of it, in parentheses, the name of the original author or publisher of that section if known, or else a unique number. Make the same adjustment to the section titles in the list of Invariant Sections in the license notice of the combined work.

In the combination, you must combine any sections Entitled "History" in the various original documents, forming one section Entitled "History"; likewise combine any sections Entitled "Acknowledgements", and any sections Entitled "Dedications". You must delete all sections Entitled "Endorsements".

6. COLLECTIONS OF DOCUMENTS #

You may make a collection consisting of the Document and other documents released under this License, and replace the individual copies of this License in the various documents with a single copy that is included in the collection, provided that you follow the rules of this License for verbatim copying of each of the documents in all other respects.

You may extract a single document from such a collection, and distribute it individually under this License, provided you insert a copy of this License into the extracted document, and follow this License in all other respects regarding verbatim copying of that document.

7. AGGREGATION WITH INDEPENDENT WORKS #

A compilation of the Document or its derivatives with other separate and independent documents or works, in or on a volume of a storage or distribution medium, is called an "aggregate" if the copyright resulting from the compilation is not used to limit the legal rights of the compilation's users beyond what the individual works permit. When the Document is included in an aggregate, this License does not apply to the other works in the aggregate which are not themselves derivative works of the Document.

If the Cover Text requirement of section 3 is applicable to these copies of the Document, then if the Document is less than one half of the entire aggregate, the Document's Cover Texts may be placed on covers that bracket the Document within the aggregate, or the electronic equivalent of covers if the Document is in electronic form. Otherwise they must appear on printed covers that bracket the whole aggregate.

8. TRANSLATION #

Translation is considered a kind of modification, so you may distribute translations of the Document under the terms of section 4. Replacing Invariant Sections with translations requires special permission from their copyright holders, but you may include translations of some or all Invariant Sections in addition to the original versions of these Invariant Sections. You may include a translation of this License, and all the license notices in the Document, and any Warranty Disclaimers, provided that you also include the original English version of this License and the original versions of those notices and disclaimers. In case of a disagreement between the translation and the original version of this License or a notice or disclaimer, the original version will prevail.

If a section in the Document is Entitled "Acknowledgements", "Dedications", or "History", the requirement (section 4) to Preserve its Title (section 1) will typically require changing the actual title.

9. TERMINATION #

You may not copy, modify, sublicense, or distribute the Document except as expressly provided for under this License. Any other attempt to copy, modify, sublicense or distribute the Document is void, and will automatically terminate your rights under this License. However, parties who have received copies, or rights, from you under this License will not have their licenses terminated so long as such parties remain in full compliance.

10. FUTURE REVISIONS OF THIS LICENSE #

The Free Software Foundation may publish new, revised versions of the GNU Free Documentation License from time to time. Such new versions will be similar in spirit to the present version, but may differ in detail to address new problems or concerns. See https://www.gnu.org/copyleft/.

Each version of the License is given a distinguishing version number. If the Document specifies that a particular numbered version of this License "or any later version" applies to it, you have the option of following the terms and conditions either of that specified version or of any later version that has been published (not as a draft) by the Free Software Foundation. If the Document does not specify a version number of this License, you may choose any version ever published (not as a draft) by the Free Software Foundation.

ADDENDUM: How to use this License for your documents #

Copyright (c) YEAR YOUR NAME. Permission is granted to copy, distribute and/or modify this document under the terms of the GNU Free Documentation License, Version 1.2 or any later version published by the Free Software Foundation; with no Invariant Sections, no Front-Cover Texts, and no Back-Cover Texts. A copy of the license is included in the section entitled “GNU Free Documentation License”.

If you have Invariant Sections, Front-Cover Texts and Back-Cover Texts, replace the “with...Texts.” line with this:

with the Invariant Sections being LIST THEIR TITLES, with the Front-Cover Texts being LIST, and with the Back-Cover Texts being LIST.

If you have Invariant Sections without Cover Texts, or some other combination of the three, merge those two alternatives to suit the situation.

If your document contains nontrivial examples of program code, we recommend releasing these examples in parallel under your choice of free software license, such as the GNU General Public License, to permit their use in free software.