- À propos de ce guide

- I Ceph Dashboard

- 1 À propos de Ceph Dashboard

- 2 Interface utilisateur Web du tableau de bord

- 3 Gestion des utilisateurs et des rôles Ceph Dashboard

- 4 Affichage des éléments internes de la grappe

- 4.1 Affichage des noeuds de grappe

- 4.2 Accès à l'inventaire de la grappe

- 4.3 Affichage des instances Ceph Monitor

- 4.4 Affichage des services

- 4.5 Affichage des OSD Ceph

- 4.6 Affichage de la configuration de la grappe

- 4.7 Affichage de la carte CRUSH

- 4.8 Affichage des modules Manager

- 4.9 Affichage des journaux

- 4.10 Affichage de la surveillance

- 5 Gestion des réserves

- 6 Gestion du périphérique de traitement par blocs RADOS (RBD)

- 7 Gestion de NFS Ganesha

- 8 Gestion de CephFS

- 9 Gestion de la passerelle Object Gateway

- 10 Configuration manuelle

- 11 Gestion des utilisateurs et des rôles via la ligne de commande

- II Opération de grappe

- 12 Détermination de l'état d'une grappe

- 12.1 Vérification de l'état d'une grappe

- 12.2 Vérification de l'état de santé de la grappe

- 12.3 Vérification des statistiques d'utilisation d'une grappe

- 12.4 Vérification de l'état des OSD

- 12.5 Contrôle des OSD pleins

- 12.6 Vérification de l'état des instances Monitor

- 12.7 Vérification des états des groupes de placement

- 12.8 Capacité de stockage

- 12.9 Surveillance des OSD et des groupes de placement

- 13 Tâches opérationnelles

- 13.1 Modification de la configuration d'une grappe

- 13.2 Ajout de noeuds

- 13.3 Suppression de noeuds

- 13.4 Gestion des OSD

- 13.5 Déplacement du Salt Master vers un nouveau noeud

- 13.6 Mise à jour des noeuds de grappe

- 13.7 Mise à jour de Ceph

- 13.8 Arrêt ou redémarrage de la grappe

- 13.9 Suppression d'une grappe Ceph entière

- 14 Exécution des services Ceph

- 15 Sauvegarde et restauration

- 16 Surveillance et alertes

- 12 Détermination de l'état d'une grappe

- III Stockage de données dans une grappe

- 17 Gestion des données stockées

- 18 Gestion des réserves de stockage

- 19 Réserves codées à effacement

- 20 Périphérique de bloc RADOS

- 20.1 Commandes de périphériques de bloc

- 20.2 Montage et démontage

- 20.3 Images instantanées

- 20.4 Miroirs d'image RBD

- 20.5 Paramètres de cache

- 20.6 Paramètres QoS

- 20.7 Paramètres de la lecture anticipée

- 20.8 Fonctions avancées

- 20.9 Assignation RBD à l'aide d'anciens clients de kernel

- 20.10 Activation des périphériques de bloc et de Kubernetes

- IV Accès aux données de la grappe

- 21 Ceph Object Gateway

- 21.1 Restrictions d'Object Gateway et règles de dénomination

- 21.2 Déploiement de la passerelle Object Gateway

- 21.3 Exploitation du service Object Gateway

- 21.4 Options de configuration

- 21.5 Gestion des accès à la passerelle Object Gateway

- 21.6 Interfaces clients HTTP

- 21.7 Activation de HTTPS/SSL pour les passerelles Object Gateway

- 21.8 Modules de synchronisation

- 21.9 authentification LDAP

- 21.10 Partitionnement d'index de compartiment

- 21.11 Intégration à OpenStack Keystone

- 21.12 Placement de réserve et classes de stockage

- 21.13 Passerelles Object Gateway multisites

- 22 Passerelle Ceph iSCSI

- 23 Système de fichiers en grappe

- 24 Exportation des données Ceph via Samba

- 25 NFS Ganesha

- 21 Ceph Object Gateway

- V Intégration des outils de virtualisation

- VI Configuration d'une grappe

- A Mises à jour de la maintenance de Ceph basées sur les versions intermédiaires de « Pacific » en amont

- Glossaire

- 2.1 Écran de connexion à Ceph Dashboard

- 2.2 Notification concernant une nouvelle version de SUSE Enterprise Storage

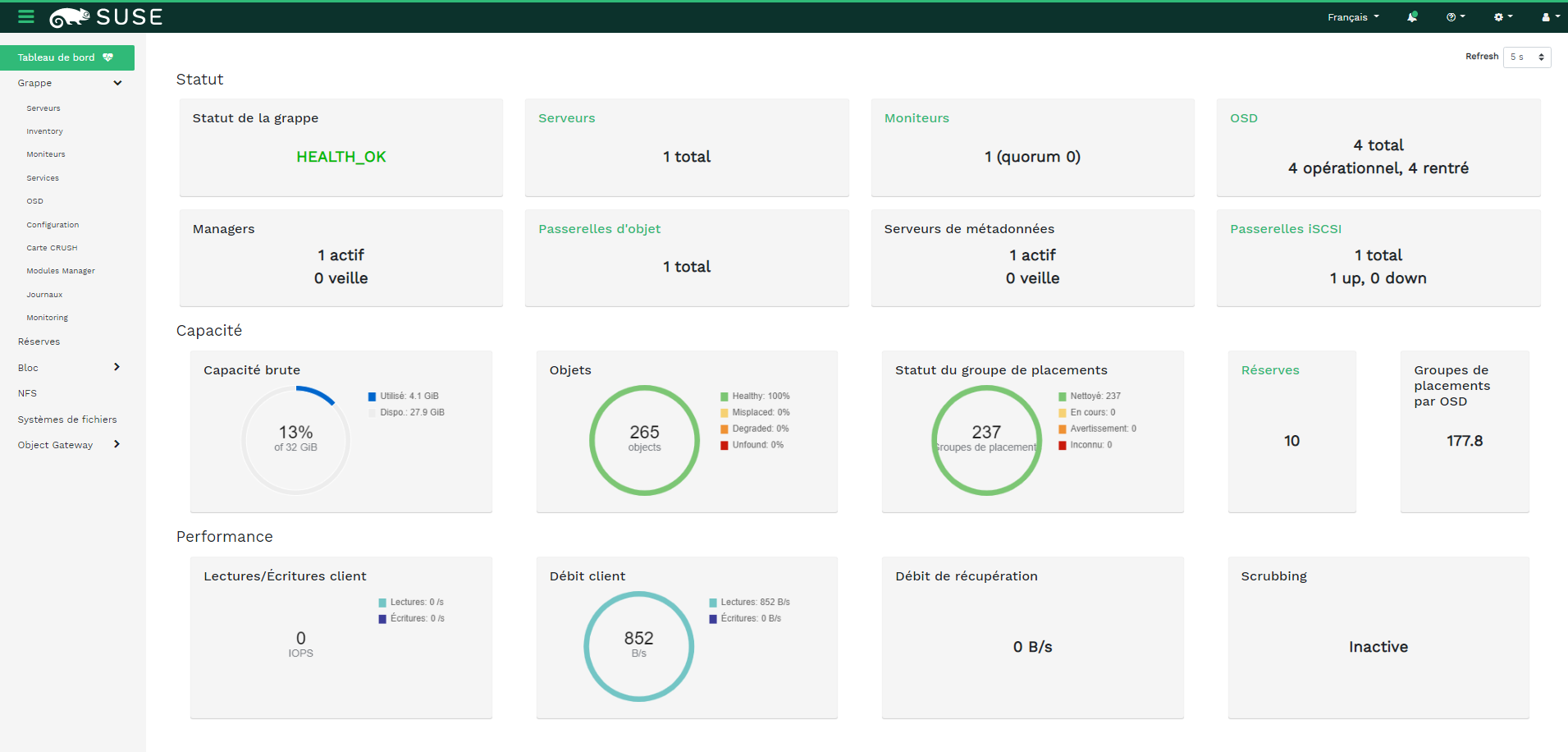

- 2.3 Page d'accueil de Ceph Dashboard

- 2.4 Widgets de statut

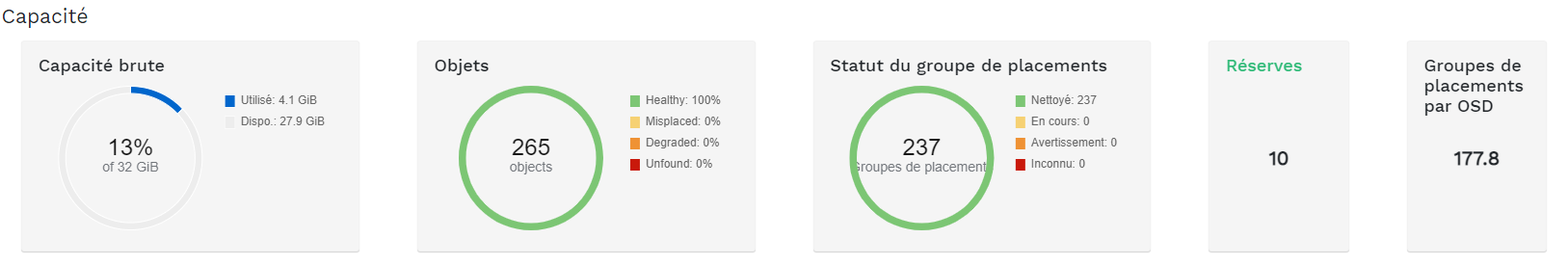

- 2.5 Widgets de capacité

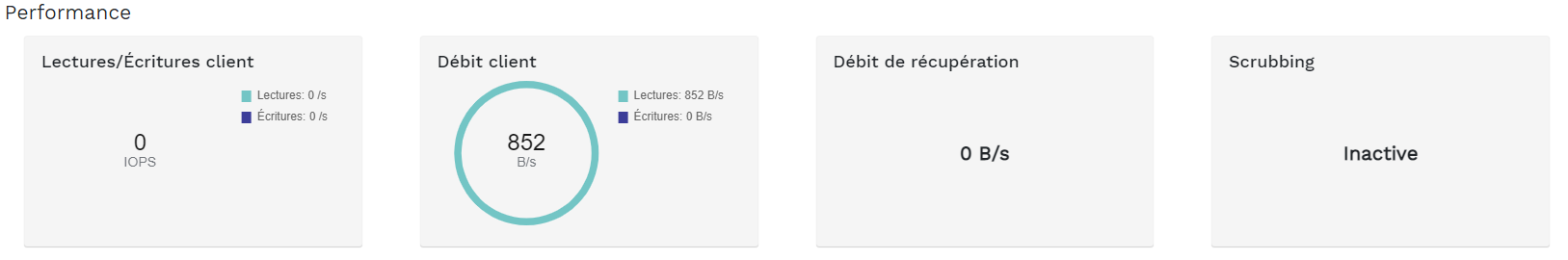

- 2.6 Widgets de performance

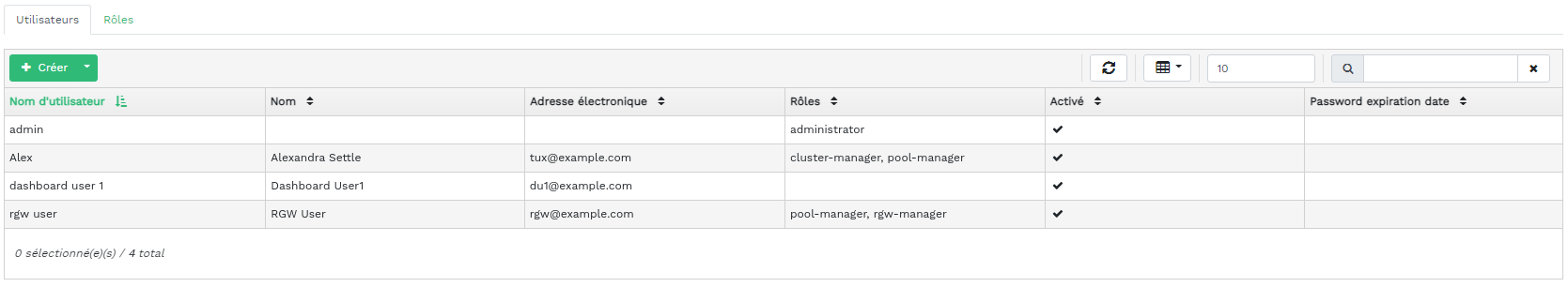

- 3.1 Gestion des utilisateurs

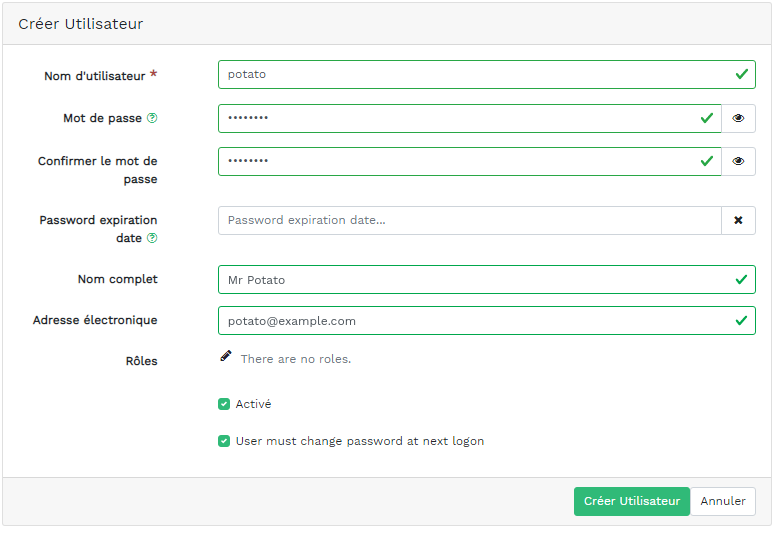

- 3.2 Ajout d'un utilisateur

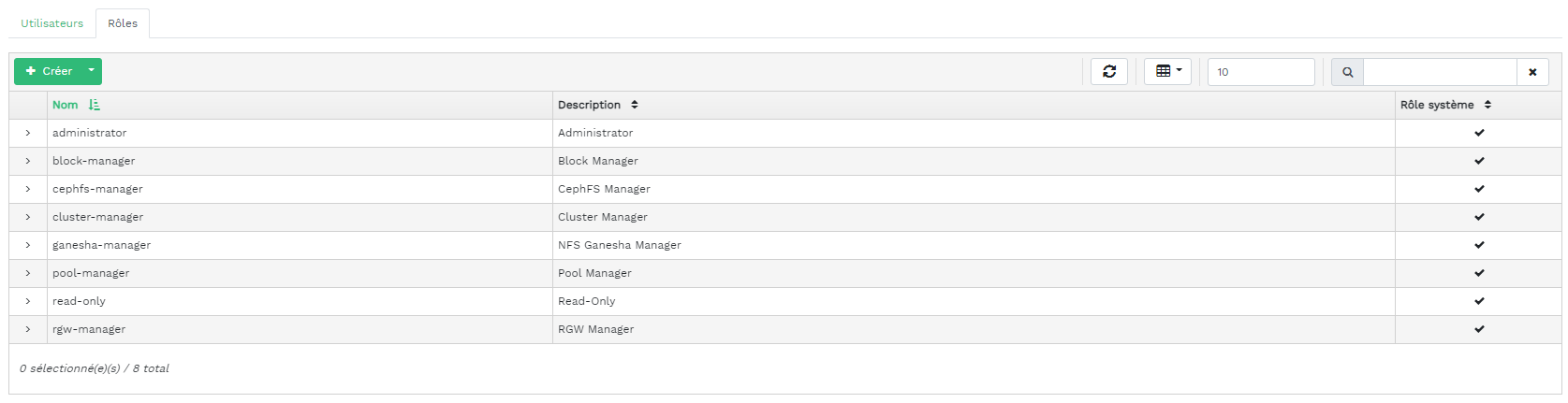

- 3.3 Rôles utilisateur

- 3.4 Ajout d'un rôle

- 4.1 Hôtes

- 4.2 Services

- 4.3 Ceph Monitor

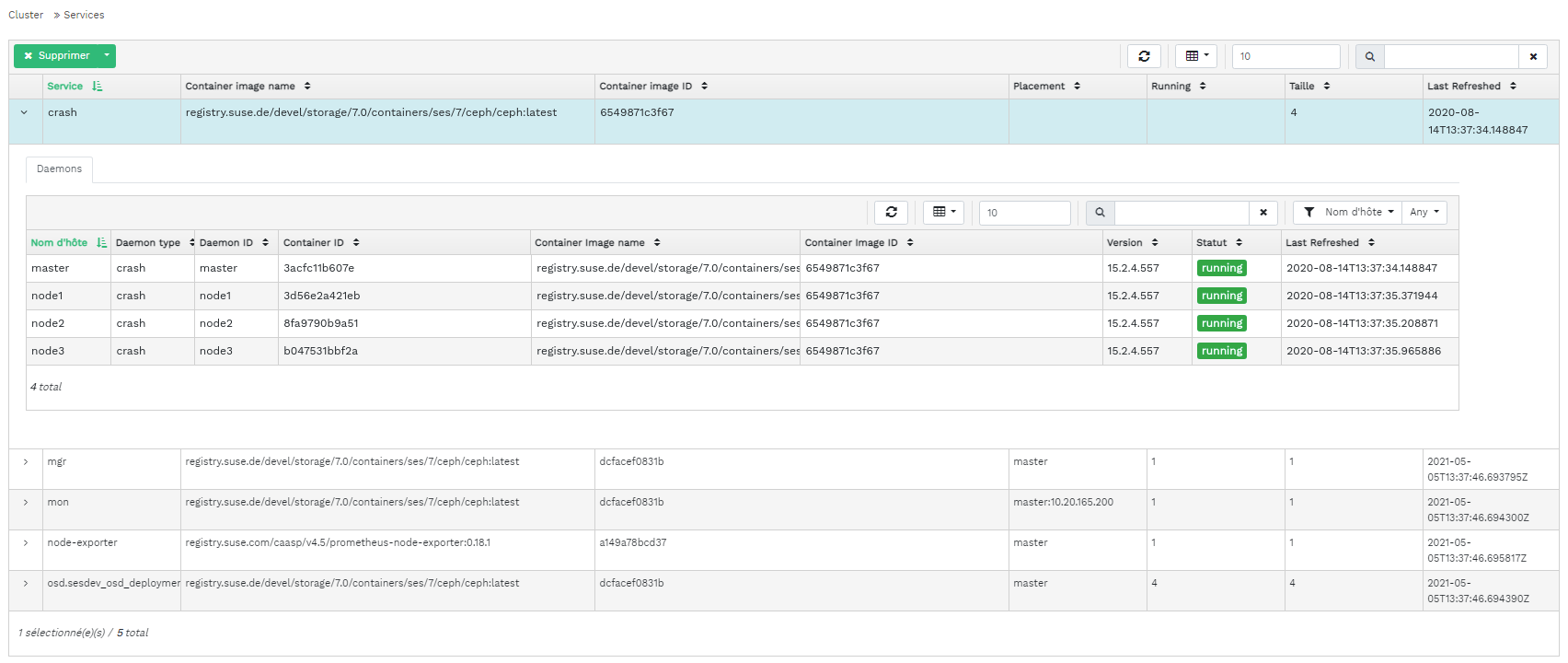

- 4.4 Services

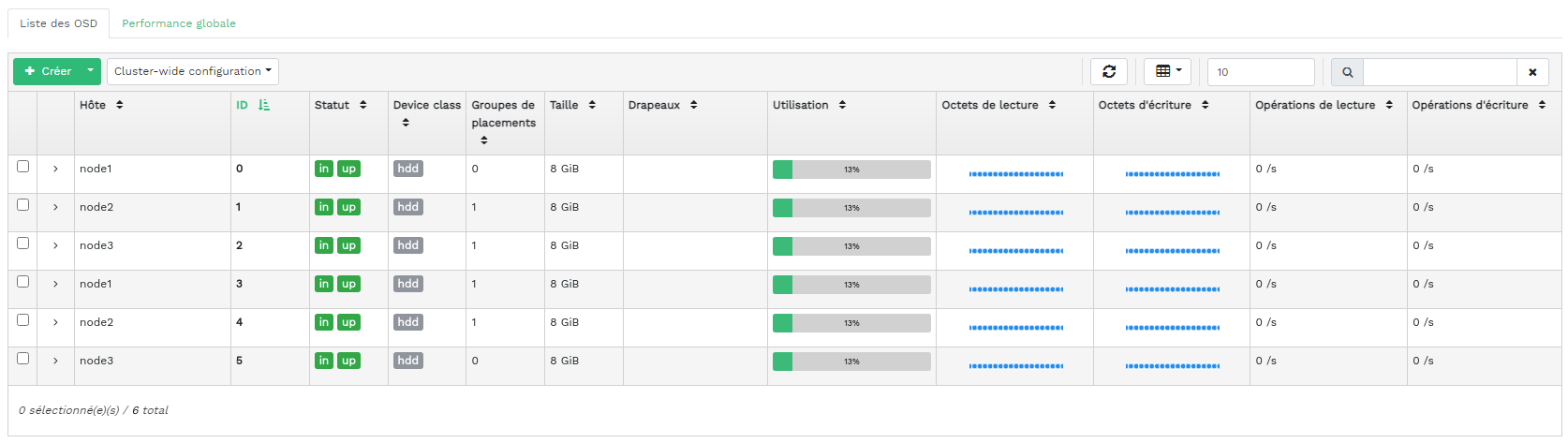

- 4.5 Instances Ceph OSD

- 4.6 Drapeaux OSD

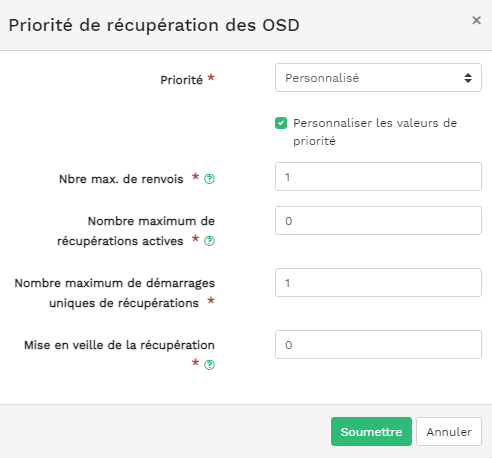

- 4.7 Priorité de récupération des OSD

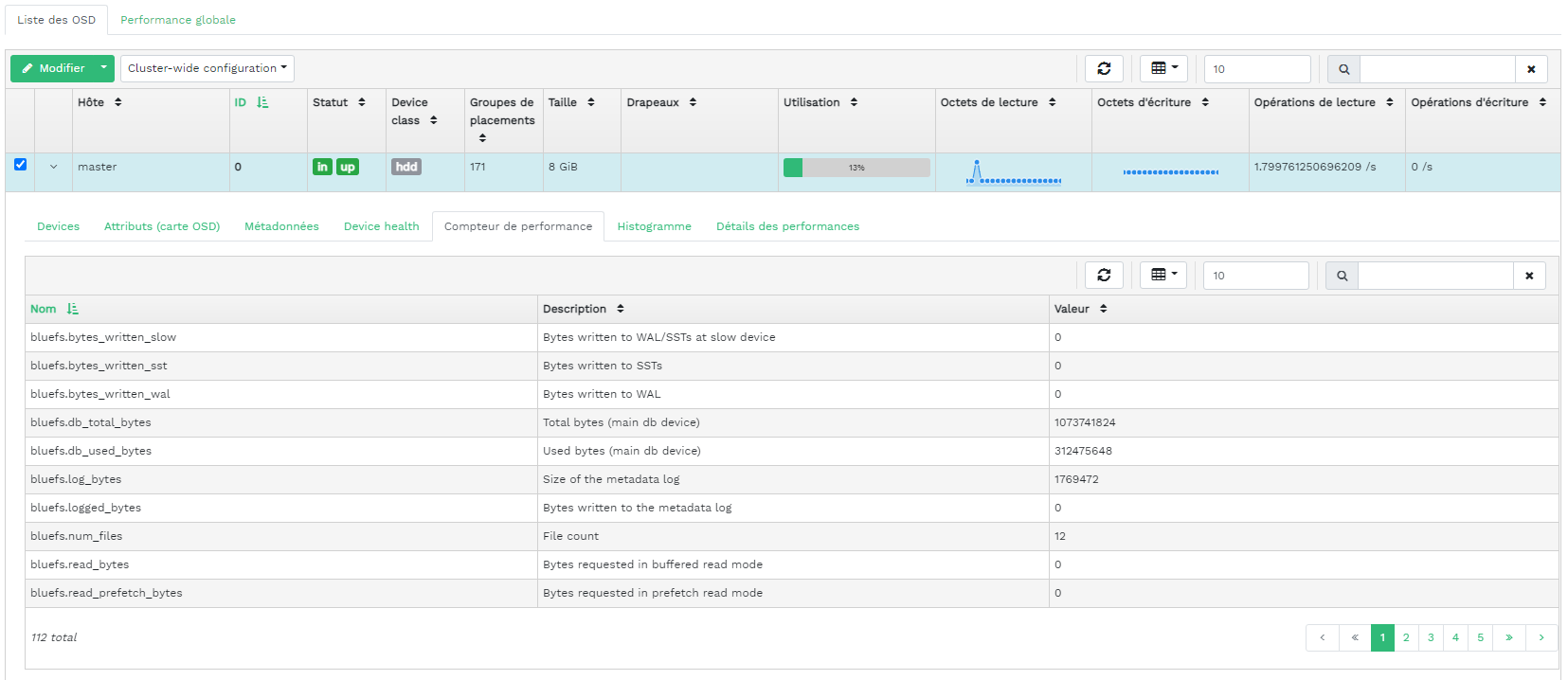

- 4.8 Détails des OSD

- 4.9 Créer des OSD

- 4.10 Ajout de périphériques principaux

- 4.11 Création d'OSD avec des périphériques principaux ajoutés

- 4.12

- 4.13 OSD nouvellement ajoutés

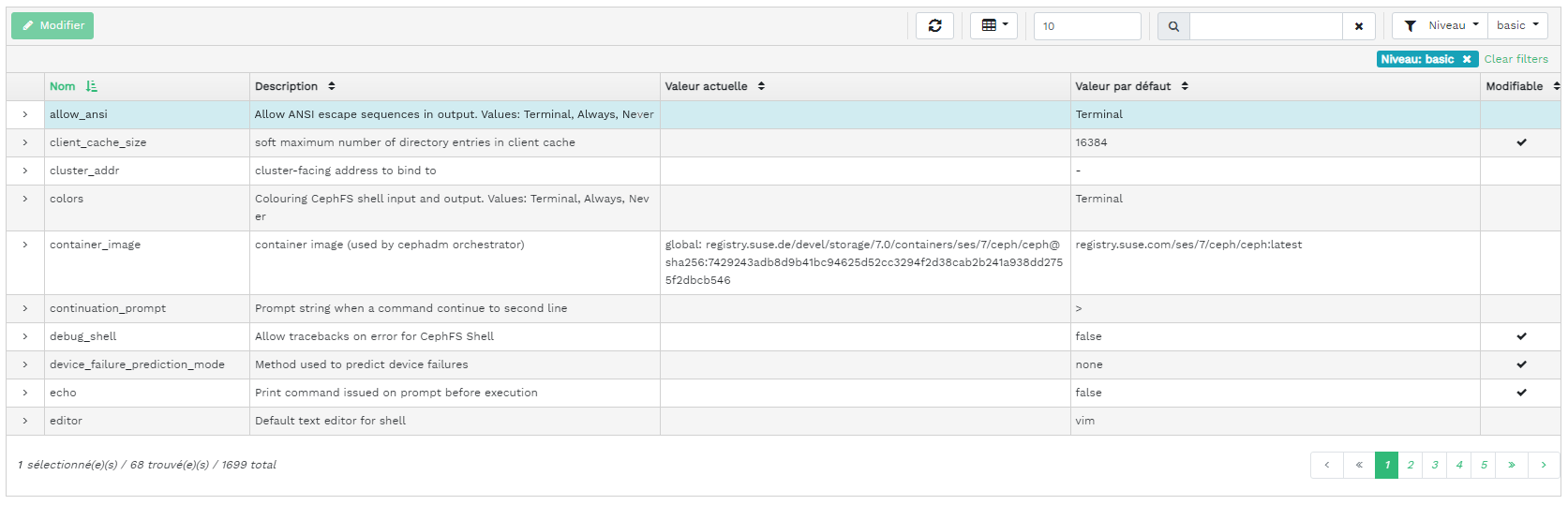

- 4.14 Configuration de la grappe

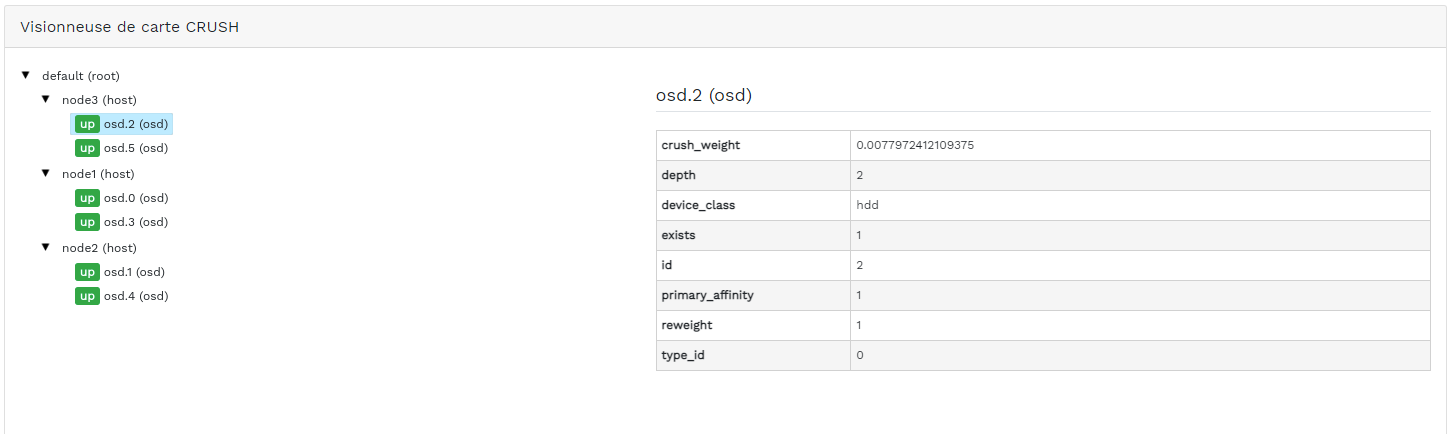

- 4.15 Carte CRUSH

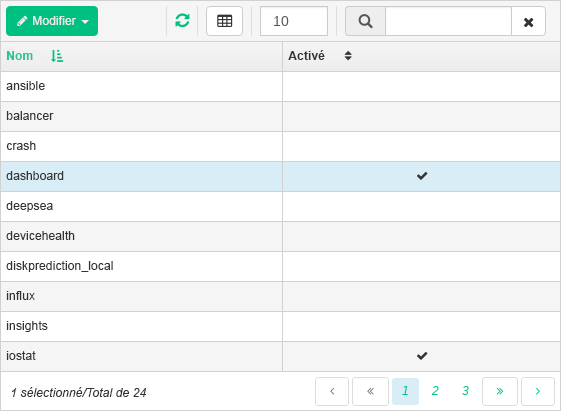

- 4.16 Modules Manager

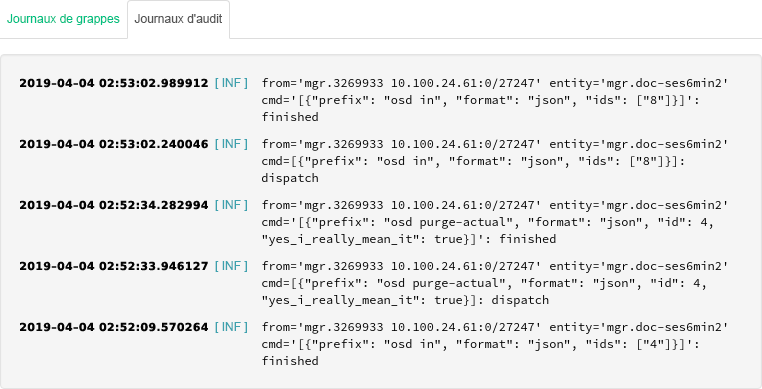

- 4.17 Journaux

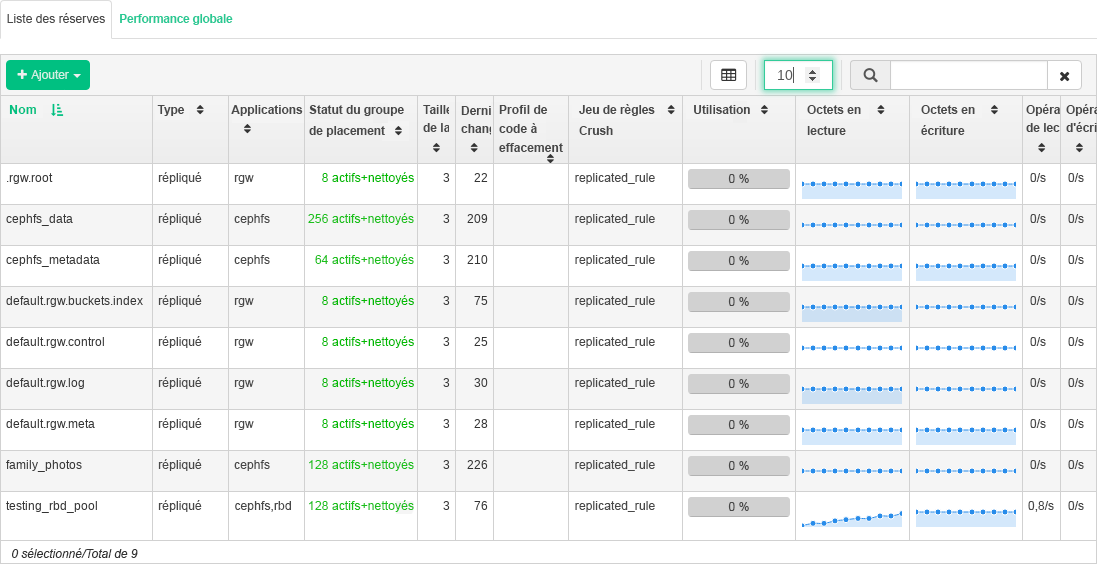

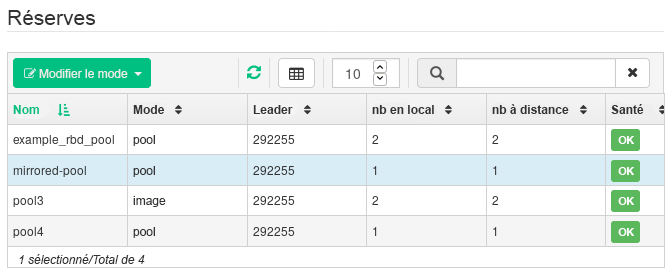

- 5.1 Liste des réserves

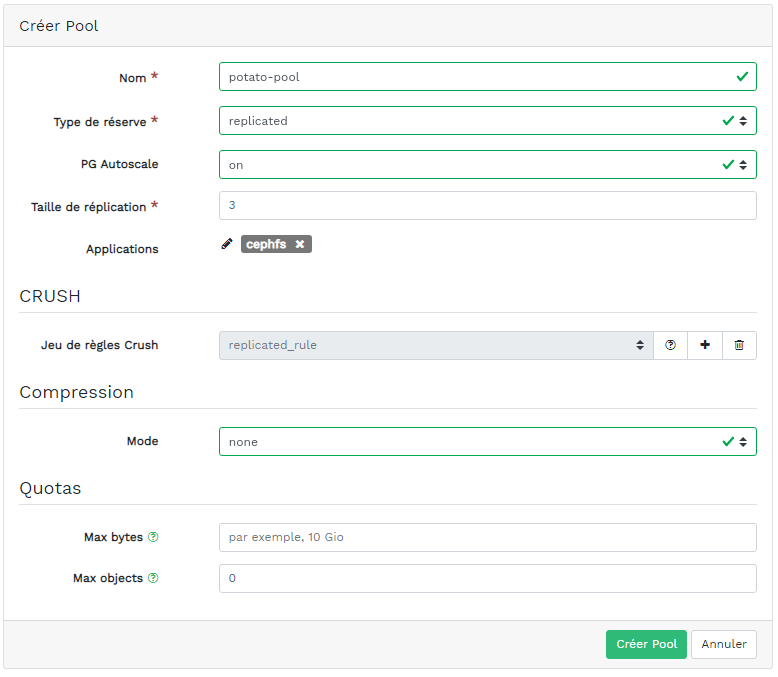

- 5.2 Ajout d'une nouvelle réserve

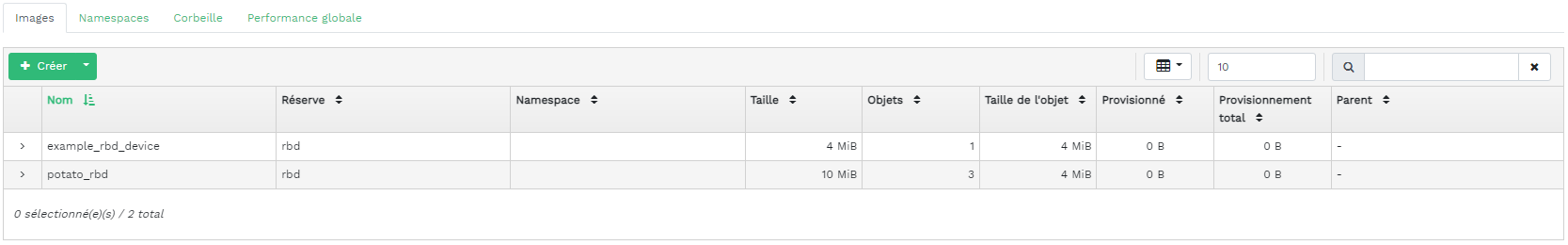

- 6.1 Liste des images RBD

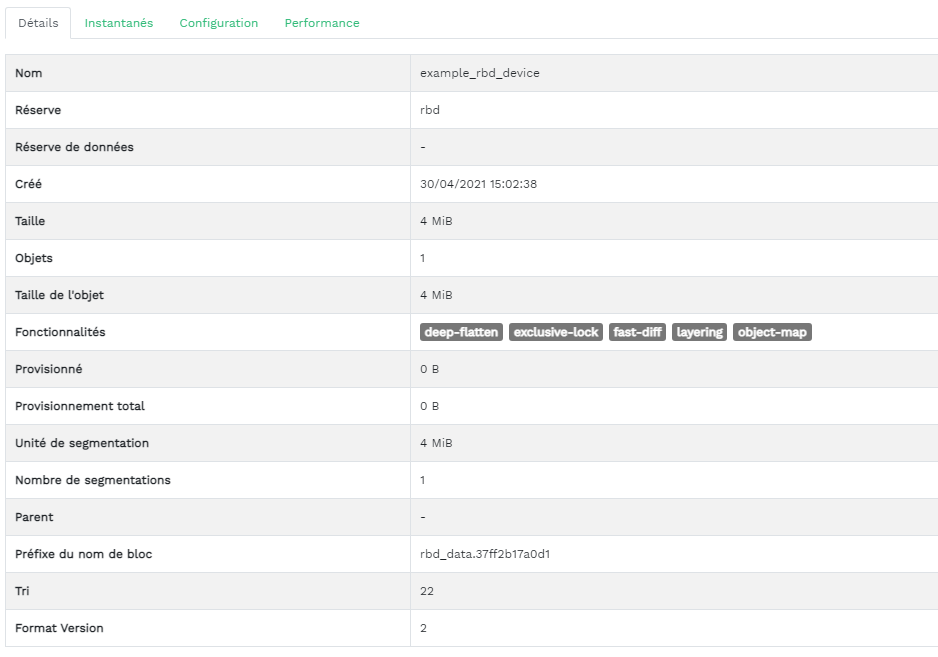

- 6.2 Détails des RBD

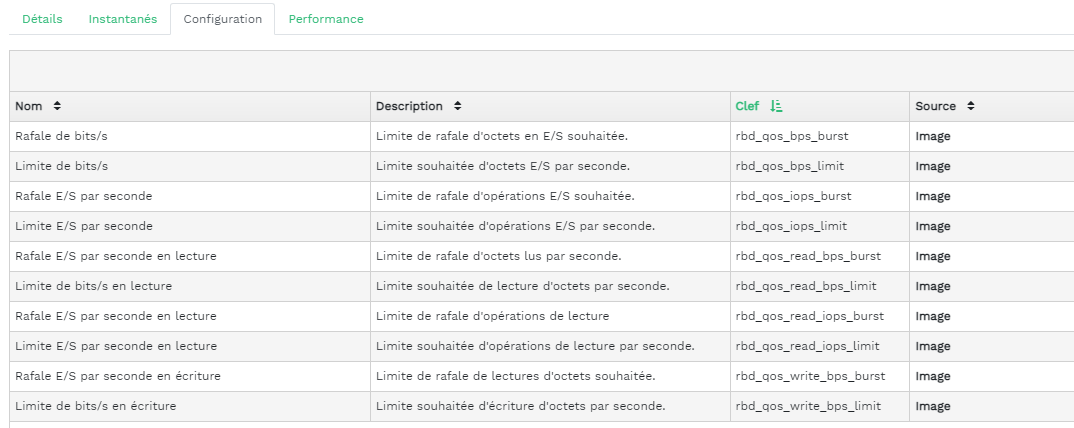

- 6.3 Configuration d'un RBD

- 6.4 Ajout d'un nouveau RBD

- 6.5 Instantanés de RBD

- 6.6 Exécution de daemons

rbd-mirror - 6.7 Création d'une réserve avec l'application RBD

- 6.8 Configuration du mode de réplication

- 6.9 Ajout des informations d'identification de l'homologue

- 6.10 Liste des réserves répliquées

- 6.11 Nouvelle image RBD

- 6.12 Nouvelle image RBD synchronisée

- 6.13 Statut de la réplication des images RBD

- 6.14 Liste des cibles iSCSI

- 6.15 Détails d'une cible ISCSI

- 6.16 Ajout d'une nouvelle cible

- 7.1 Liste des exportations NFS

- 7.2 Détails de l'exportation NFS

- 7.3 Ajout d'une nouvelle exportation NFS

- 7.4 Modification d'une exportation NFS

- 8.1 Détails CephFS

- 8.2 Détails CephFS

- 9.1 Détails de la passerelle

- 9.2 Utilisateurs de la passerelle

- 9.3 Ajout d'un nouvel utilisateur de la passerelle

- 9.4 Détails d'un compartiment de passerelle

- 9.5 Modification des détails du compartiment

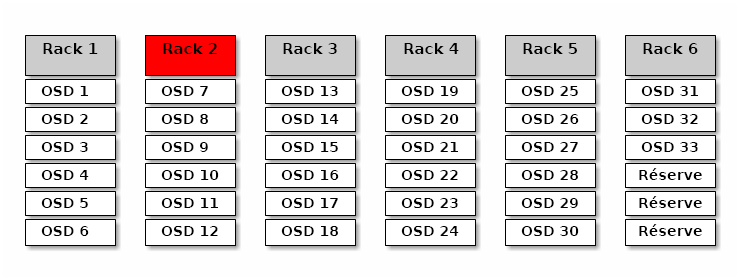

- 12.1 grappe Ceph

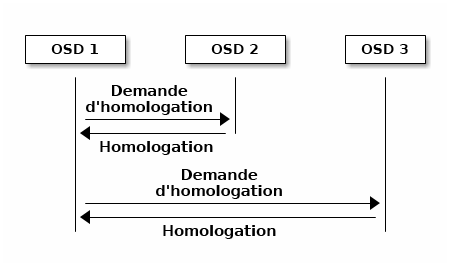

- 12.2 Schéma d'homologation

- 12.3 État des groupes de placement

- 17.1 OSD avec classes de périphériques mixtes

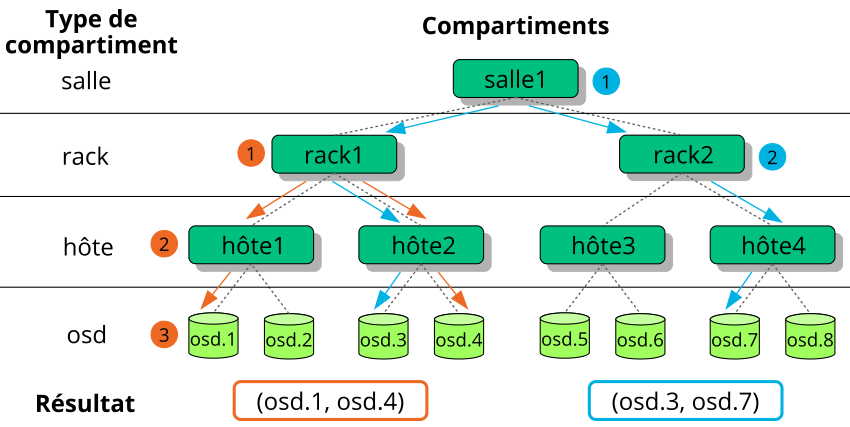

- 17.2 Exemple d'arborescence

- 17.3 Méthodes de remplacement de noeud

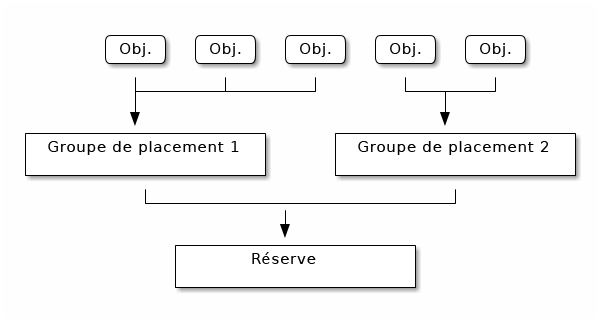

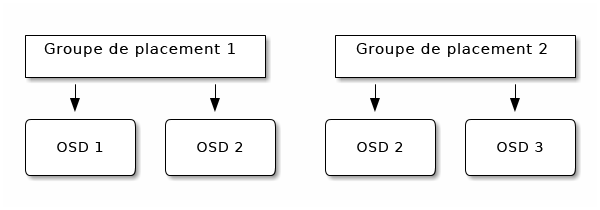

- 17.4 Groupes de placement d'une réserve

- 17.5 Groupes de placement et OSD

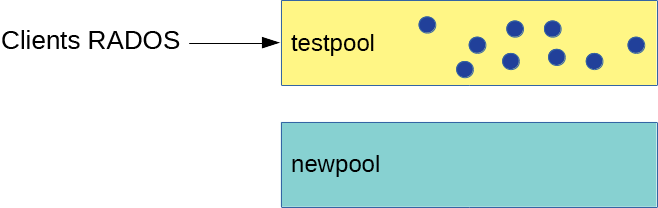

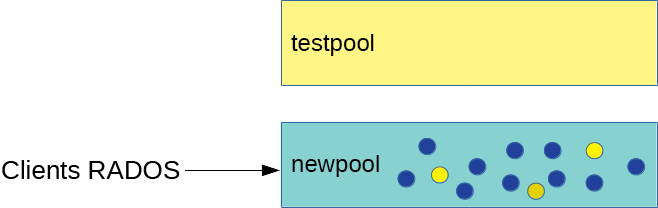

- 18.1 Réserves avant migration

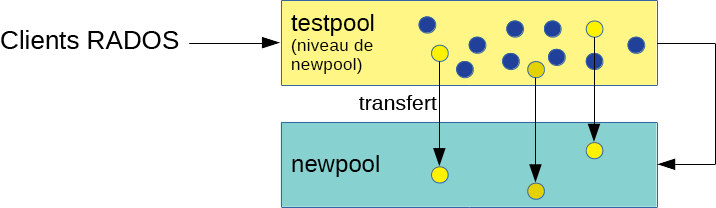

- 18.2 Configuration du niveau de cache

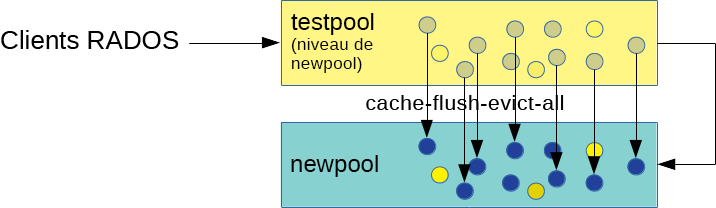

- 18.3 Vidage des données

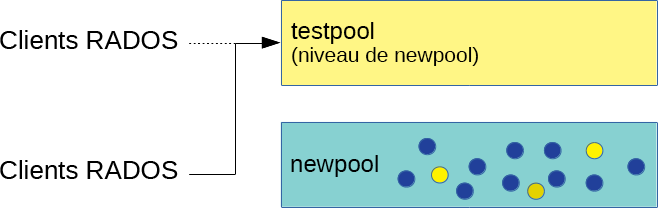

- 18.4 Définition de la superposition

- 18.5 Migration effectuée

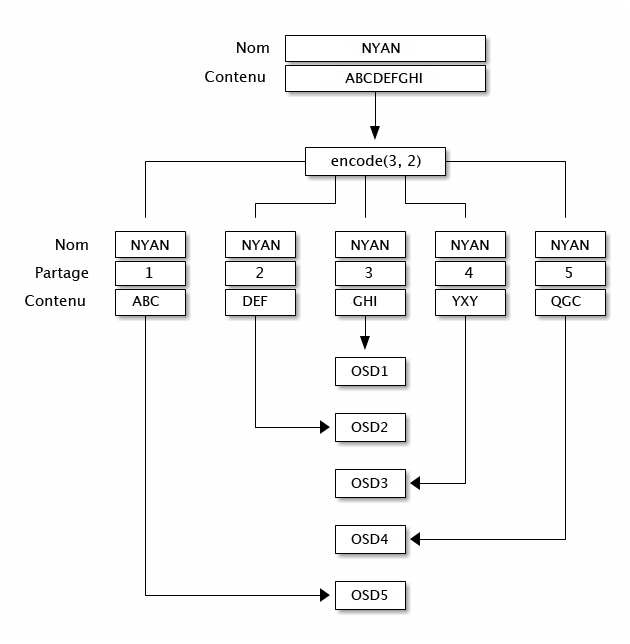

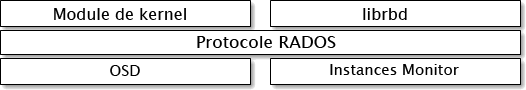

- 20.1 Protocole RADOS

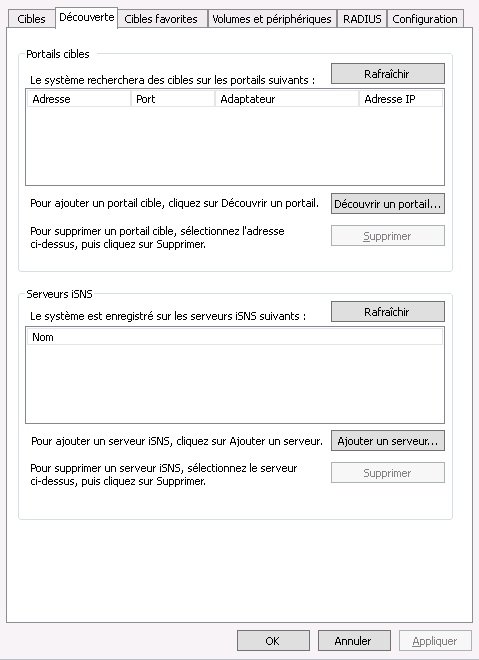

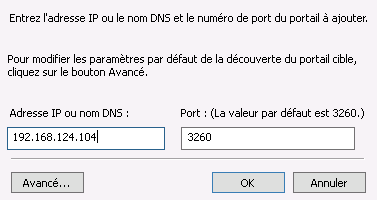

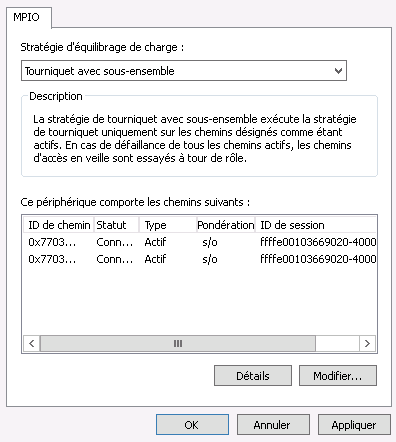

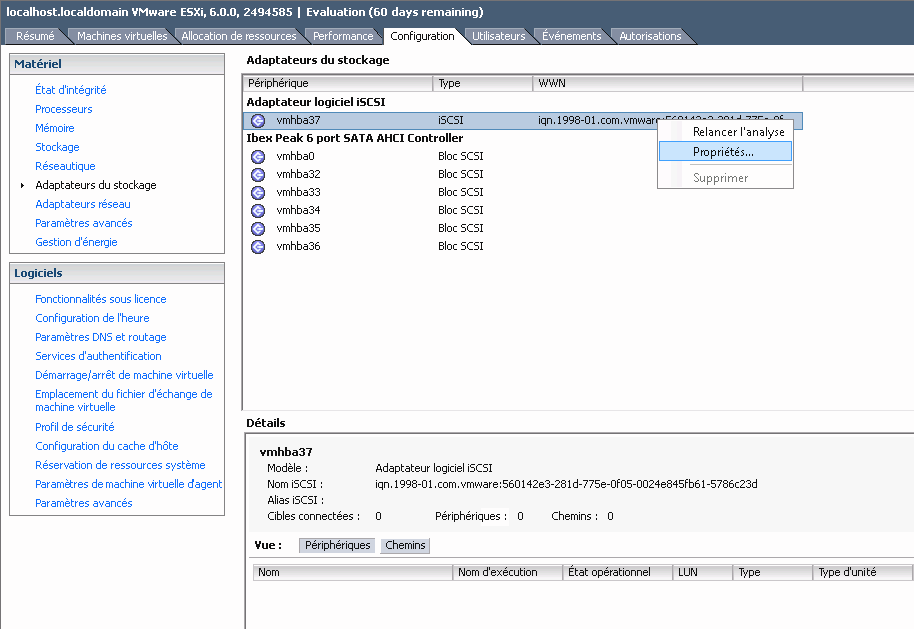

- 22.1 propriétés de l'initiateur iSCSI

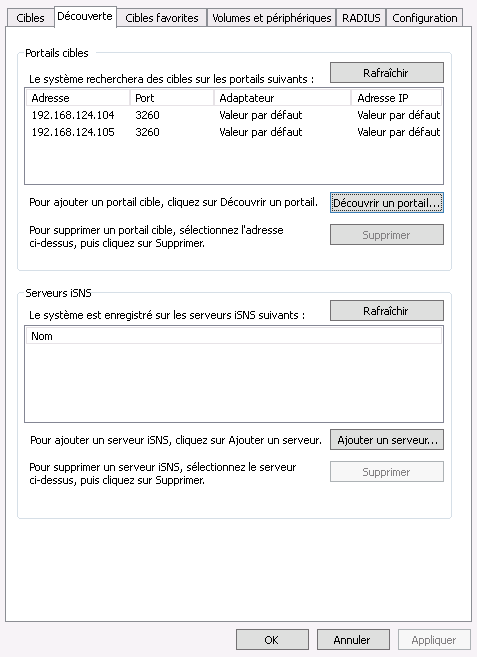

- 22.2 découverte du portail cible

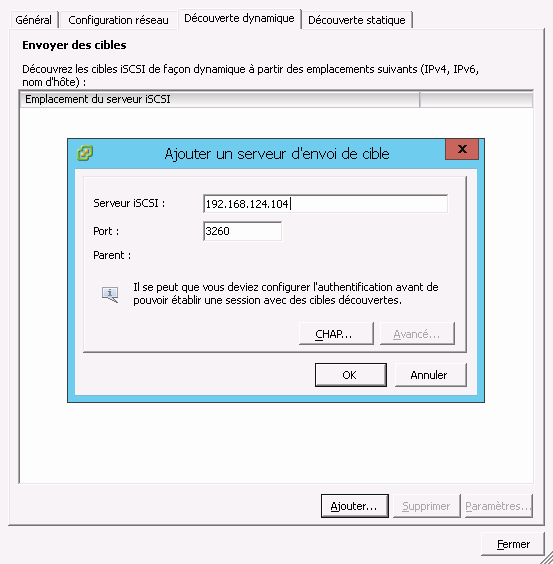

- 22.3 portails cibles

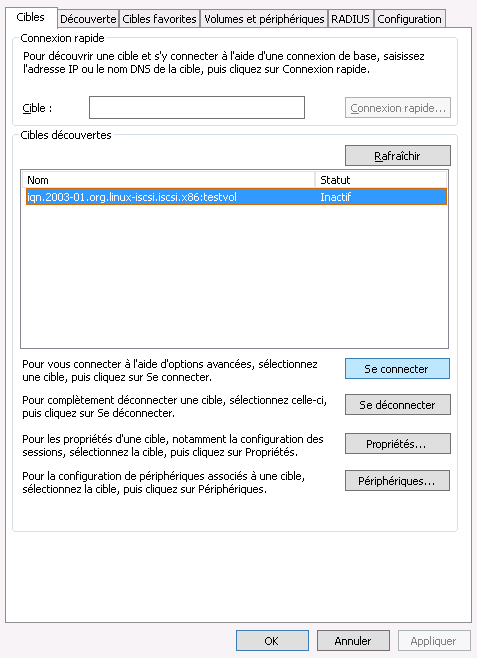

- 22.4 Cibles

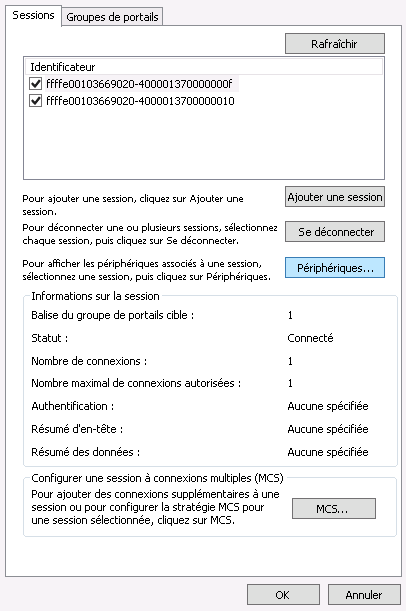

- 22.5 propriétés de la cible iSCSI

- 22.6 détails du périphérique

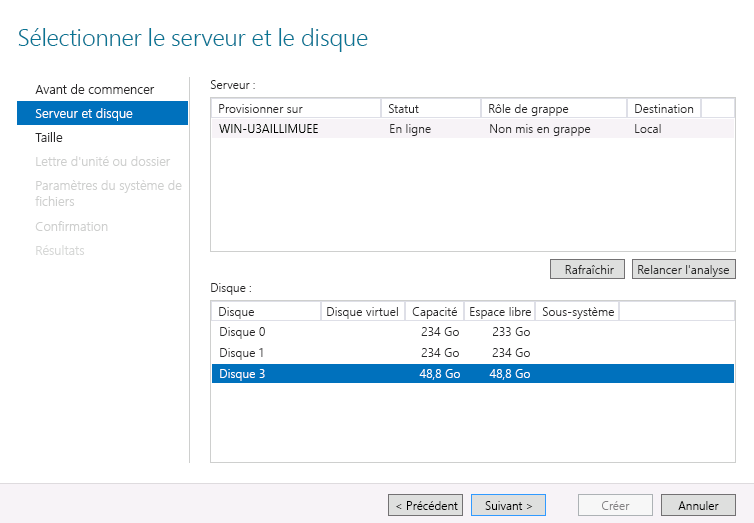

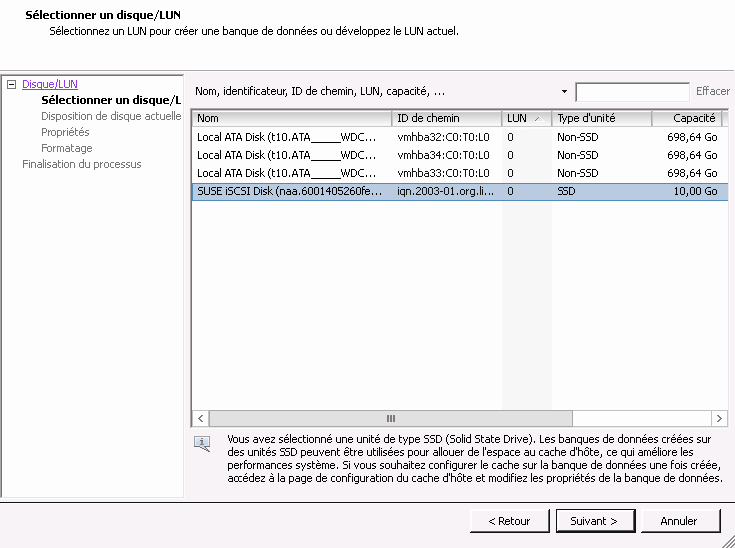

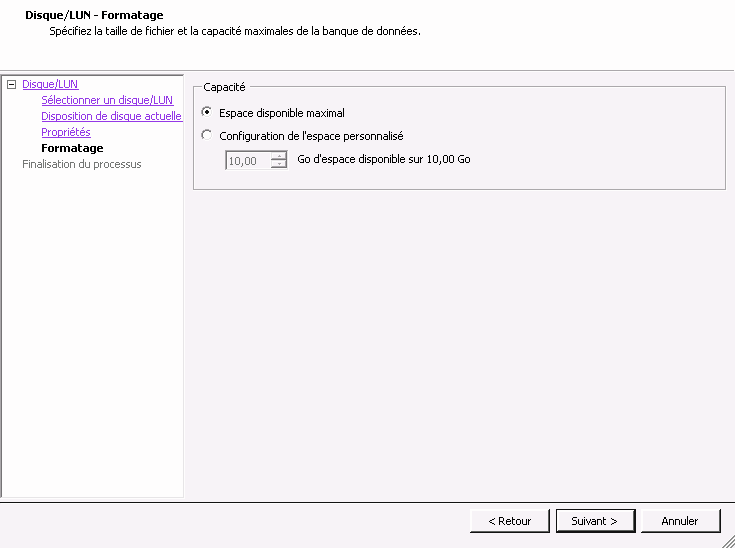

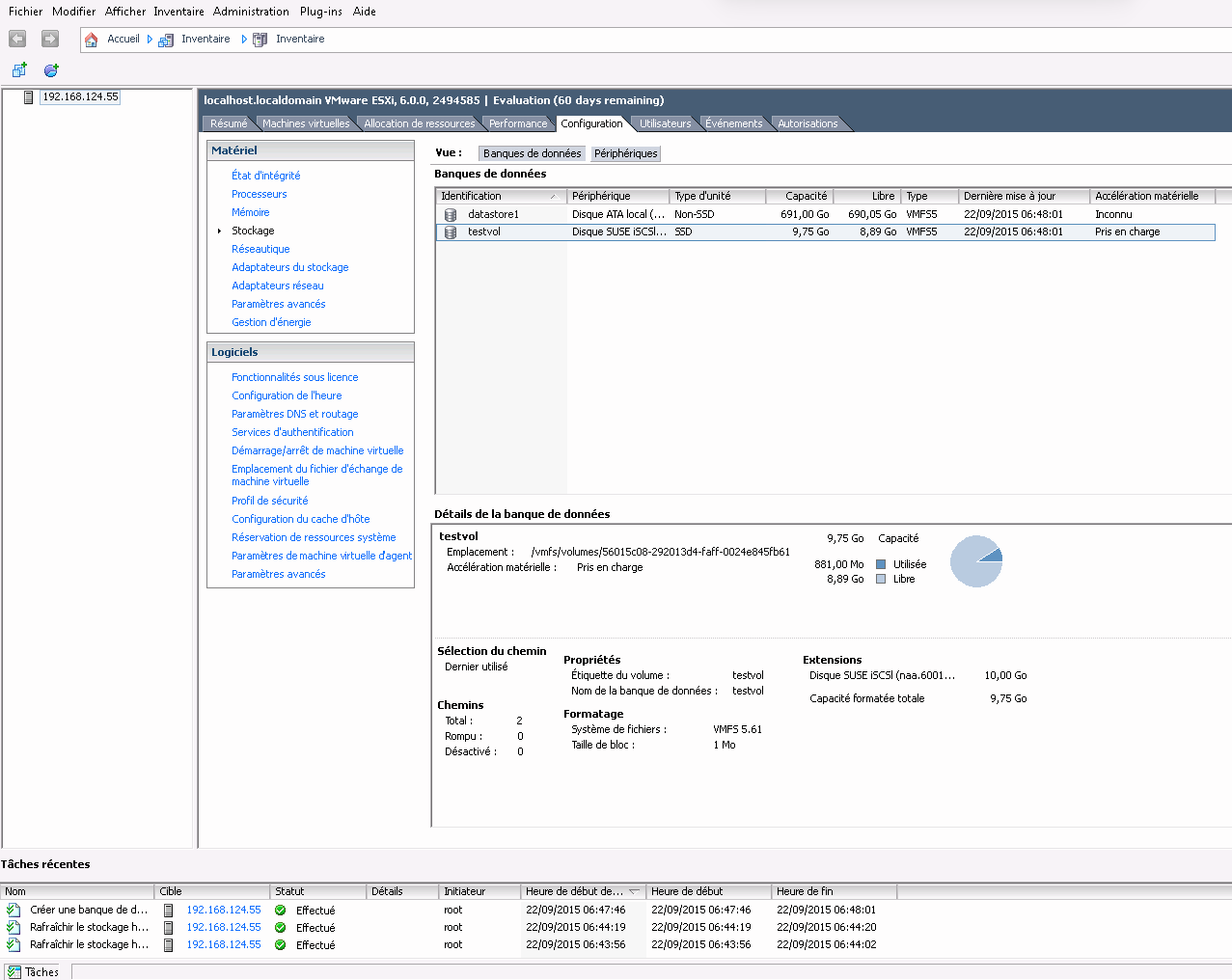

- 22.7 assistant Nouveau Volume

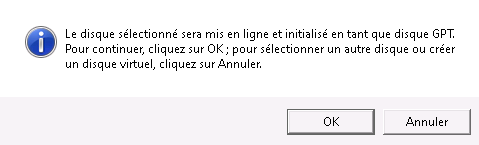

- 22.8 invite de disque hors ligne

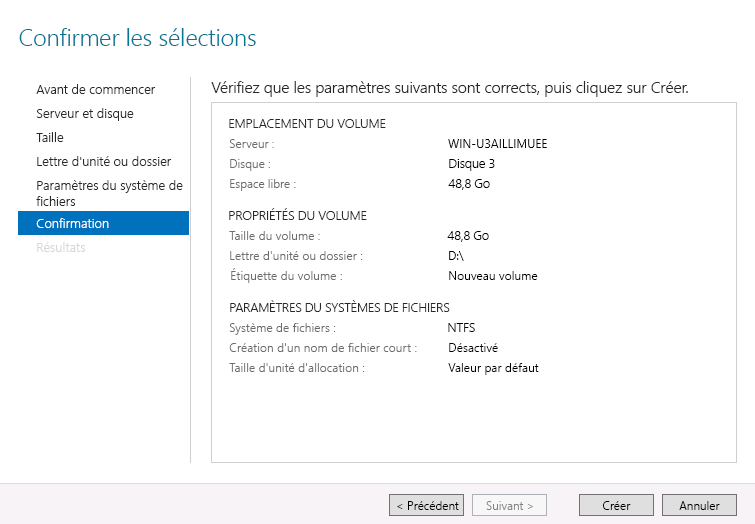

- 22.9 confirmation des sélections de volume

- 22.10 propriétés de l'initiateur iSCSI

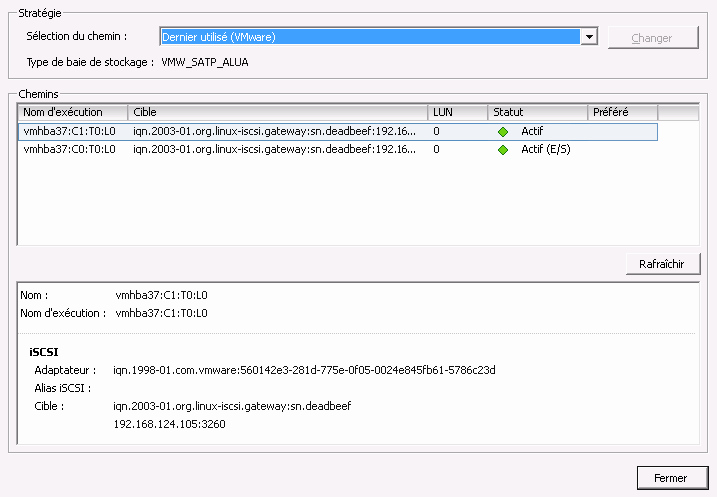

- 22.11 ajout d'un serveur cible

- 22.12 gestion des périphériques multipath

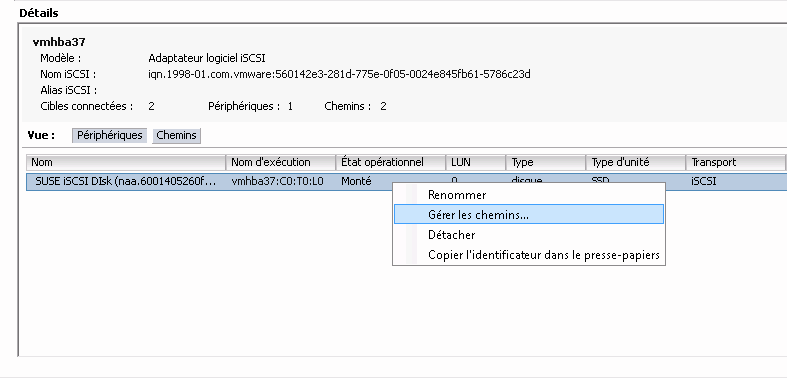

- 22.13 liste des chemins pour multipath

- 22.14 boîte de dialogue Ajouter un stockage

- 22.15 configuration de l'espace personnalisé

- 22.16 présentation de la banque de données iSCSI

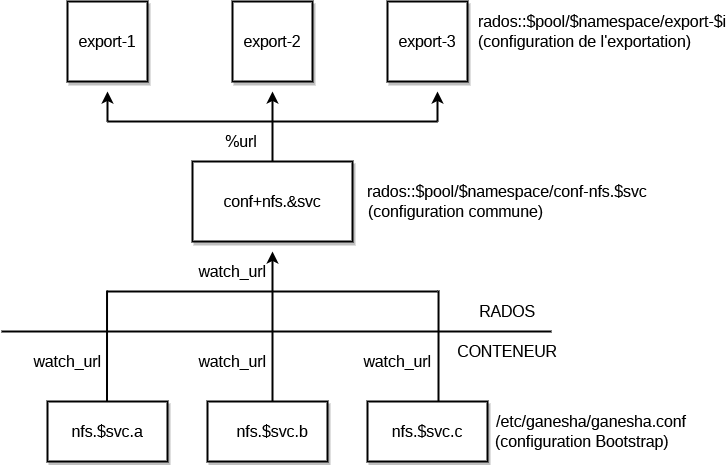

- 25.1 Structure de NFS Ganesha

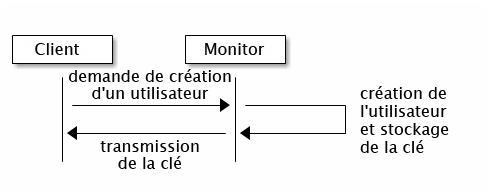

- 30.1 authentification

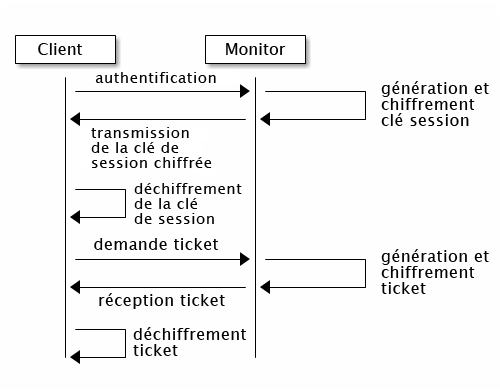

cephxde base - 30.2

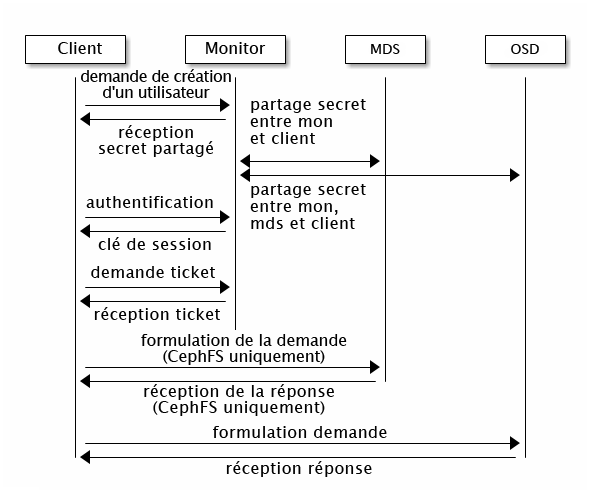

cephxd'authentification - 30.3 authentification

cephx- MDS et OSD

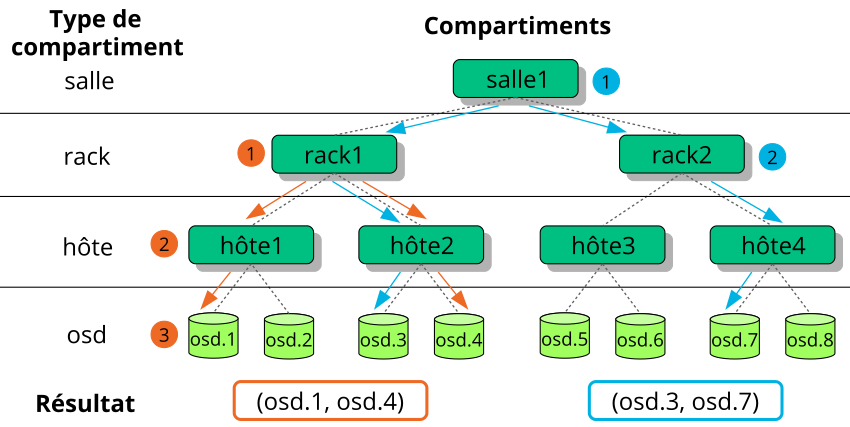

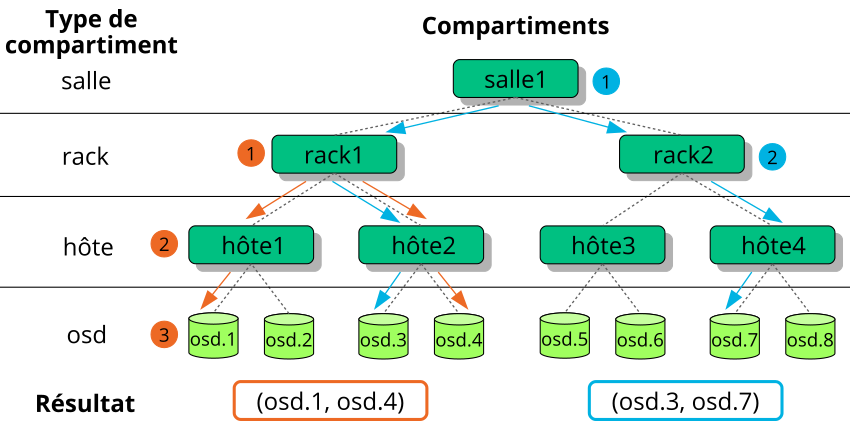

- 12.1 localisation d'un objet

- 13.1 Correspondance par taille de disque

- 13.2 Configuration simple

- 13.3 Configuration avancée

- 13.4 Configuration avancée avec des noeuds non uniformes

- 13.5 Configuration experte

- 13.6 Configuration complexe (et peu probable)

- 17.1

crushtool --reclassify-root - 17.2

crushtool --reclassify-bucket - 21.1 configuration générique

- 21.2 configuration non générique

- 28.1 Exemple de configuration Beast

- 28.2 Exemple de configuration CivetWeb dans

/etc/ceph/ceph.conf

Copyright © 2020–2025 SUSE LLC et contributeurs. Tous droits réservés.

Sauf indication contraire, ce document est concédé sous licence Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0) : https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Pour les marques commerciales SUSE, consultez le site Web http://www.suse.com/company/legal/. Toutes les marques commerciales de fabricants tiers appartiennent à leur propriétaire respectif. Les symboles de marque commerciale (®, ™, etc.) désignent des marques de SUSE et de ses sociétés affiliées. Des astérisques (*) désignent des marques commerciales de fabricants tiers.

Toutes les informations de cet ouvrage ont été regroupées avec le plus grand soin. Cela ne garantit cependant pas sa complète exactitude. Ni SUSE LLC, ni les sociétés affiliées, ni les auteurs, ni les traducteurs ne peuvent être tenus responsables des erreurs possibles ou des conséquences qu'elles peuvent entraîner.

À propos de ce guide #

Ce guide est axé sur les tâches de routine que vous devez effectuer en tant qu'administrateur après le déploiement de la grappe Ceph de base (opérations au quotidien). Il décrit également toutes les méthodes prises en charge pour accéder aux données stockées dans une grappe Ceph.

SUSE Enterprise Storage 7.1 est une extension de SUSE Linux Enterprise Server 15 SP3. Il réunit les fonctionnalités du projet de stockage Ceph (http://ceph.com/), l'ingénierie d'entreprise et le support de SUSE. SUSE Enterprise Storage 7.1 permet aux organisations informatiques de déployer une architecture de stockage distribuée capable de prendre en charge un certain nombre de cas d'utilisation à l'aide de plates-formes matérielles courantes.

1 Documentation disponible #

La documentation relative à nos produits est disponible à la page https://documentation.suse.com, où vous pouvez également rechercher les dernières mises à jour et parcourir ou télécharger la documentation dans différents formats. Les dernières mises à jour de la documentation sont disponibles dans la version en anglais.

En outre, la documentation sur le produit est disponible dans votre système sous /usr/share/doc/manual. Elle est incluse dans un paquetage RPM nommé ses-manual_LANG_CODE. S'il ne se trouve pas déjà sur votre système, installez-le. Par exemple :

# zypper install ses-manual_enLa documentation suivante est disponible pour ce produit :

- Guide de déploiement

Ce guide est axé sur le déploiement d'une grappe Ceph de base et sur la manière de déployer des services supplémentaires. Il couvre également les étapes de mise à niveau vers SUSE Enterprise Storage 7.1 à partir de la version précédente du produit.

- Guide d'opérations et d'administration

Ce guide est axé sur les tâches de routine que vous devez effectuer en tant qu'administrateur après le déploiement de la grappe Ceph de base (opérations au quotidien). Il décrit également toutes les méthodes prises en charge pour accéder aux données stockées dans une grappe Ceph.

- Guide de renforcement de la sécurité

Ce guide explique comment garantir la sécurité de votre grappe.

- Guide de dépannage

Ce guide passe en revue divers problèmes courants lors de l'exécution de SUSE Enterprise Storage 7.1, ainsi que d'autres problèmes liés aux composants pertinents tels que Ceph ou Object Gateway.

- Guide de SUSE Enterprise Storage pour Windows

Ce guide décrit l'intégration, l'installation et la configuration des environnements Microsoft Windows et de SUSE Enterprise Storage à l'aide du pilote Windows.

2 Commentaires #

Vos commentaires et contributions concernant cette documentation sont les bienvenus. Pour nous en faire part, plusieurs canaux sont à votre disposition :

- Requêtes de service et support

Pour connaître les services et les options de support disponibles pour votre produit, visitez le site http://www.suse.com/support/.

Pour ouvrir une requête de service, vous devez disposer d'un abonnement SUSE enregistré auprès du SUSE Customer Center. Accédez à https://scc.suse.com/support/requests, connectez-vous, puis cliquez sur .

- Signalement d'erreurs

Signalez les problèmes liés à la documentation à l'adresse https://bugzilla.suse.com/. Pour signaler des problèmes, vous avez besoin d'un compte Bugzilla.

Pour simplifier ce processus, vous pouvez utiliser les liens (Signaler une erreur dans la documentation) en regard des titres dans la version HTML de ce document. Ces liens présélectionnent le produit et la catégorie appropriés dans Bugzilla et ajoutent un lien vers la section actuelle. Vous pouvez directement commencer à signaler le bogue.

- Contributions

Pour contribuer à cette documentation, utilisez les liens (Modifier la source), en regard des titres dans la version HTML de ce document. Ils vous permettent d'accéder au code source sur GitHub, où vous pouvez ouvrir une demande d'ajout (Pull request). Pour apporter votre contribution, vous avez besoin d'un compte GitHub.

Pour plus d'informations sur l'environnement de documentation utilisé pour cette documentation, reportez-vous au fichier lisezmoi de l'espace de stockage à l'adresse https://github.com/SUSE/doc-ses.

- Messagerie

Vous pouvez également signaler des erreurs et envoyer vos commentaires concernant la documentation à l'adresse <doc-team@suse.com>. Veillez à inclure le titre du document, la version du produit et la date de publication du document. Mentionnez également le numéro et le titre de la section concernée (ou incluez l'URL), et décrivez brièvement le problème.

3 Conventions relatives à la documentation #

Les conventions typographiques et mentions suivantes sont utilisées dans cette documentation :

/etc/passwd: noms de répertoires et de fichiersMARQUE_RÉSERVATION : l'élément MARQUE_RÉSERVATION doit être remplacé par la valeur réelle

CHEMIN: variable d'environnementls,--help: commandes, options et paramètresuser: nom de l'utilisateur ou du groupepackage_name : nom d'un paquetage logiciel

Alt, Alt–F1 : touche ou combinaison de touches sur lesquelles appuyer. Les touches sont affichées en majuscules comme sur un clavier.

, › : options de menu, boutons

AMD/Intel Ce paragraphe n'est utile que pour les architectures AMD64/Intel 64. Les flèches marquent le début et la fin du bloc de texte.

IBM Z, POWER Ce paragraphe ne s'applique qu'aux architectures

IBM ZetPOWER. Les flèches marquent le début et la fin du bloc de texte.Chapitre 1, “Exemple de chapitre” : renvoi à un autre chapitre de ce guide.

Commandes à exécuter avec les privilèges

root. Souvent, vous pouvez également leur ajouter en préfixe la commandesudopour les exécuter sans privilèges.#command>sudocommandCommandes pouvant être exécutées par des utilisateurs non privilégiés.

>commandAvis

Warning: note d'avertissementInformation essentielle dont vous devez prendre connaissance avant de continuer. Met en garde contre des problèmes de sécurité ou des risques de perte de données, de détérioration matérielle ou de blessure physique.

Important: note importanteInformation importante dont vous devez prendre connaissance avant de continuer.

Note: note de remarqueInformation supplémentaire, par exemple sur les différences dans les versions des logiciels.

Tip: note indiquant une astuceInformation utile, telle qu'un conseil ou un renseignement pratique.

Notes compactes

Information supplémentaire, par exemple sur les différences dans les versions des logiciels.

Information utile, telle qu'un conseil ou un renseignement pratique.

4 Support #

Vous trouverez ci-dessous la déclaration de support pour SUSE Enterprise Storage et des informations générales sur les avant-premières technologiques. Pour plus d'informations sur le cycle de vie du produit, reportez-vous au site https://www.suse.com/lifecycle.

Si vous avez droit au support, vous trouverez des instructions détaillées sur la collecte d'informations pour un ticket de support sur le site https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Déclaration de support pour SUSE Enterprise Storage #

Pour bénéficier d'un support, vous devez disposer d'un abonnement adéquat auprès de SUSE. Pour connaître les offres de support spécifiques auxquelles vous pouvez accéder, rendez-vous sur la page https://www.suse.com/support/ et sélectionnez votre produit.

Les niveaux de support sont définis comme suit :

- N1

Identification du problème : support technique conçu pour fournir des informations de compatibilité, un support pour l'utilisation, une maintenance continue, la collecte d'informations et le dépannage de base à l'aide de la documentation disponible.

- N2

Isolement du problème : support technique conçu pour analyser des données, reproduire des problèmes clients, isoler la zone problématique et fournir une solution aux problèmes qui ne sont pas résolus au niveau 1 ou préparer le niveau 3.

- N3

Résolution des problèmes : support technique conçu pour résoudre les problèmes en impliquant des ingénieurs afin de corriger des défauts produit identifiés par le support de niveau 2.

Pour les clients et partenaires sous contrat, SUSE Enterprise Storage est fourni avec un support de niveau 3 pour tous les paquetages, excepté les suivants :

Avant-premières technologiques.

Son, graphiques, polices et illustrations.

Paquetages nécessitant un contrat de client supplémentaire.

Certains paquetages fournis avec le module Workstation Extension (Extension de poste de travail), qui bénéficient uniquement d'un support de niveau 2

Paquetages dont les noms se terminent par -devel (contenant les fichiers d'en-tête et les ressources développeurs similaires) ne bénéficient d'un support que dans le cadre de leurs paquetages principaux.

SUSE offre un support uniquement pour l'utilisation de paquetages d'origine, autrement dit les paquetages qui ne sont pas modifiés ni recompilés.

4.2 Avant-premières technologiques #

Les avant-premières technologiques sont des paquetages, des piles ou des fonctions fournis par SUSE pour donner un aperçu des innovations à venir. Ces avant-premières technologiques sont fournies pour vous permettre de tester de nouvelles technologies au sein de votre environnement. Tous vos commentaires sont les bienvenus ! Si vous testez une avant-première technologique, veuillez contacter votre représentant SUSE et l'informer de votre expérience et de vos cas d'utilisation. Vos remarques sont utiles pour un développement futur.

Les avant-premières technologiques présentent les limites suivantes :

Les avant-premières technologiques sont toujours en cours de développement. Ainsi, elles peuvent être incomplètes ou instables, ou non adaptées à une utilisation en production.

Les avant-premières technologiques ne bénéficient pas du support technique.

Les avant-premières technologiques peuvent être disponibles uniquement pour des architectures matérielles spécifiques.

Les détails et fonctionnalités des avant-premières technologiques sont susceptibles d'être modifiés. Il en résulte que la mise à niveau vers des versions ultérieures d'une avant-première technologique peut être impossible et nécessiter une nouvelle installation.

SUSE peut découvrir qu'une avant-première ne répond pas aux besoins des clients ou du marché, ou n'est pas conforme aux normes de l'entreprise. Les avant-premières technologiques peuvent être supprimées d'un produit à tout moment. SUSE ne s'engage pas à fournir à l'avenir une version prise en charge de ces technologies.

Pour obtenir un aperçu des avant-premières technologiques fournies avec votre produit, reportez-vous aux notes de version à l'adresse https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Contributeurs Ceph #

Le projet Ceph et sa documentation sont le résultat du travail de centaines de contributeurs et d'organisations. Pour plus d'informations, consultez la page https://ceph.com/contributors/.

6 Commandes et invites de commande utilisées dans ce guide #

En tant qu'administrateur de grappe Ceph, vous configurez et ajustez le comportement de la grappe en exécutant des commandes spécifiques. Il existe plusieurs types de commandes dont vous avez besoin :

6.1 Commandes associées à Salt #

Ces commandes vous aident à déployer des noeuds de grappe Ceph, à exécuter des commandes simultanément sur plusieurs noeuds de la grappe (ou tous), ou à ajouter ou supprimer des noeuds de la grappe. Les commandes les plus fréquemment utilisées sont ceph-salt et ceph-salt config. Vous devez exécuter les commandes Salt sur le noeud Salt Master en tant qu'utilisateur root. Ces commandes sont introduites avec l'invite suivante :

root@master # Par exemple :

root@master # ceph-salt config ls6.2 Commandes associées à Ceph #

Il s'agit de commandes de niveau inférieur permettant de configurer et d'affiner tous les aspects de la grappe et de ses passerelles sur la ligne de commande, par exemple ceph, cephadm, rbd ou radosgw-admin.

Pour exécuter les commandes associées à Ceph, vous devez disposé d'un accès en lecture à une clé Ceph. Les fonctionnalités de la clé définissent alors vos privilèges au sein de l'environnement Ceph. Une option consiste à exécuter les commandes Ceph en tant qu'utilisateur root (ou via sudo) et à employer le trousseau de clés par défaut sans restriction « ceph.client.admin.key ».

L'option plus sûre et recommandée consiste à créer une clé individuelle plus restrictive pour chaque administrateur et à la placer dans un répertoire où les utilisateurs peuvent la lire, par exemple :

~/.ceph/ceph.client.USERNAME.keyring

Pour utiliser un administrateur et un trousseau de clés personnalisés, vous devez spécifier le nom d'utilisateur et le chemin d'accès à la clé chaque fois que vous exécutez la commande ceph à l'aide des options -n client.NOM_UTILISATEUR et --keyring CHEMIN/VERS/TROUSSEAU.

Pour éviter cela, incluez ces options dans la variable CEPH_ARGS des fichiers ~/.bashrc des différents utilisateurs.

Bien que vous puissiez exécuter les commandes associées à Ceph sur n'importe quel noeud de la grappe, nous vous recommandons de les lancer sur le noeud Admin. Dans cette documentation, nous employons l'utilisateur cephuser pour exécuter les commandes. Elles sont donc introduites avec l'invite suivante :

cephuser@adm > Par exemple :

cephuser@adm > ceph auth listSi la documentation vous demande d'exécuter une commande sur un noeud de la grappe avec un rôle spécifique, cela sera réglé par l'invite. Par exemple :

cephuser@mon > 6.2.1 Exécution de ceph-volume #

À partir de SUSE Enterprise Storage 7, les services Ceph s'exécutent de manière conteneurisée. Si vous devez exécuter ceph-volume sur un noeud OSD, vous devez l'ajouter au début de la commande cephadm, par exemple :

cephuser@adm > cephadm ceph-volume simple scan6.3 Commandes Linux générales #

Les commandes Linux non associées à Ceph, telles que mount, cat ou openssl, sont introduites avec les invites cephuser@adm > ou #, selon les privilèges que la commande concernée nécessite.

6.4 Informations supplémentaires #

Pour plus d'informations sur la gestion des clés Ceph, reportez-vous à la Section 30.2, « Les zones de gestion principales ».

Partie I Ceph Dashboard #

- 1 À propos de Ceph Dashboard

Ceph Dashboard est une application Web intégrée de gestion et de surveillance Ceph qui permet de gérer divers aspects et objets de la grappe. Le tableau de bord est automatiquement activé après le déploiement de la grappe de base, comme décrit dans le Book “Guide de déploiement”, Chapter 7 “Déploiem…

- 2 Interface utilisateur Web du tableau de bord

Pour vous connecter à Ceph Dashboard, faites pointer votre navigateur vers son URL, y compris le numéro de port. Exécutez la commande suivante pour rechercher l'adresse :

- 3 Gestion des utilisateurs et des rôles Ceph Dashboard

La gestion des utilisateurs du tableau de bord effectuée à l'aide de commandes Ceph sur la ligne de commande a déjà été présentée au Chapitre 11, Gestion des utilisateurs et des rôles via la ligne de commande.

- 4 Affichage des éléments internes de la grappe

L'élément de menu permet d'afficher des informations détaillées sur les hôtes de la grappe Ceph, l'inventaire, les instances Ceph Monitor, les services, les OSD, la configuration, la carte CRUSH, Ceph Manager, les journaux et les fichiers de surveillance.

- 5 Gestion des réserves

Pour plus d'informations générales sur les réserves Ceph, reportez-vous au Chapitre 18, Gestion des réserves de stockage. Pour des informations spécifiques sur les réserves codées à effacement, reportez-vous au Chapitre 19, Réserves codées à effacement.

- 6 Gestion du périphérique de traitement par blocs RADOS (RBD)

Pour répertorier tous les périphériques de bloc RADOS (RADOS Block Device, RBD) disponibles, cliquez sur › dans le menu principal.

- 7 Gestion de NFS Ganesha

NFS Ganesha prend en charge les versions 4.1 et ultérieures de NFS. Il ne prend pas en charge la version 3 de NFS.

- 8 Gestion de CephFS

Pour trouver des informations détaillées sur CephFS, reportez-vous au Chapitre 23, Système de fichiers en grappe.

- 9 Gestion de la passerelle Object Gateway

Avant de commencer, il se peut que vous rencontriez la notification suivante lorsque vous tentez d'accéder à l'interface client Object Gateway sur Ceph Dashboard :

- 10 Configuration manuelle

Cette section présente des informations avancées pour les utilisateurs qui préfèrent configurer manuellement les paramètres du tableau de bord via la ligne de commande.

- 11 Gestion des utilisateurs et des rôles via la ligne de commande

Cette section explique comment gérer les comptes utilisateur employés par Ceph Dashboard. Elle vous aide à créer ou modifier des comptes utilisateur, ainsi qu'à définir des rôles et autorisations appropriés pour les utilisateurs.

1 À propos de Ceph Dashboard #

Ceph Dashboard est une application Web intégrée de gestion et de surveillance Ceph qui permet de gérer divers aspects et objets de la grappe. Le tableau de bord est automatiquement activé après le déploiement de la grappe de base, comme décrit dans le Book “Guide de déploiement”, Chapter 7 “Déploiement de la grappe Bootstrap à l'aide de ceph-salt”.

Ceph Dashboard pour SUSE Enterprise Storage 7.1 ajoute à Ceph Manager davantage de fonctionnalités de gestion Web pour faciliter l'administration de Ceph, notamment la surveillance et l'administration des applications. Vous n'avez plus besoin de connaître les commandes complexes relatives à Ceph pour gérer et surveiller votre grappe Ceph. Vous pouvez utiliser l'interface intuitive de Ceph Dashboard ou son API REST intégrée.

Le module Ceph Dashboard permet de visualiser des informations et des statistiques relatives à la grappe Ceph à l'aide d'un serveur Web hébergé par ceph-mgr. Pour plus d'informations sur Ceph Manager, reportez-vous au Book “Guide de déploiement”, Chapter 1 “SES et Ceph”, Section 1.2.3 “Noeuds et daemons Ceph”.

2 Interface utilisateur Web du tableau de bord #

2.1 Connexion #

Pour vous connecter à Ceph Dashboard, faites pointer votre navigateur vers son URL, y compris le numéro de port. Exécutez la commande suivante pour rechercher l'adresse :

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",La commande renvoie l'URL où se trouve Ceph Dashboard. Si vous rencontrez des problèmes avec cette commande, reportez-vous au Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”.

Connectez-vous à l'aide des informations d'identification créées lors du déploiement de la grappe (voir Book “Guide de déploiement”, Chapter 7 “Déploiement de la grappe Bootstrap à l'aide de ceph-salt”, Section 7.2.9 “Configuration des informations d'identification de connexion de Ceph Dashboard”).

Si vous ne souhaitez pas utiliser le compte admin par défaut pour accéder à Ceph Dashboard, créez un compte utilisateur personnalisé avec des privilèges d'administrateur. Pour plus d'informations, reportez-vous au Chapitre 11, Gestion des utilisateurs et des rôles via la ligne de commande.

Dès qu'une mise à niveau vers une nouvelle version majeure de Ceph (nom de code : Pacific) est disponible, le tableau de bord Ceph affiche un message approprié en haut de la zone de notification. Pour effectuer la mise à niveau, suivez les instructions du Book “Guide de déploiement”, Chapter 11 “Mise à niveau de SUSE Enterprise Storage 7 vers la version 7.1”.

L'interface utilisateur du tableau de bord est divisée en plusieurs blocs : le menu utilitaire dans la partie supérieure droite de l'écran, le menu principal à gauche et le volet de contenu principal.

2.4 Volet de contenu #

Le volet de contenu occupe la partie principale de l'écran du tableau de bord. La page d'accueil du tableau de bord présente de nombreux widgets utiles pour vous informer brièvement sur l'état actuel de la grappe, la capacité et les performances.

2.5 Fonctionnalités courantes de l'interface utilisateur Web #

Dans Ceph Dashboard, la plupart des opérations s'effectuent à l'aide de listes, par exemple, des listes de réserves, de noeuds OSD ou de périphériques RBD. Par défaut, toutes les listes se rafraîchissent automatiquement toutes les cinq secondes. Les widgets communs suivants vous aident à gérer ou à ajuster ces listes :

Cliquez sur ![]() pour déclencher un rafraîchissement manuel de la liste.

pour déclencher un rafraîchissement manuel de la liste.

Cliquez sur ![]() pour afficher ou masquer des colonnes de table individuelles.

pour afficher ou masquer des colonnes de table individuelles.

Cliquez sur ![]() et entrez (ou sélectionnez) le nombre de lignes à afficher sur une seule page.

et entrez (ou sélectionnez) le nombre de lignes à afficher sur une seule page.

Cliquez à l'intérieur de  et filtrez les lignes en saisissant la chaîne à rechercher.

et filtrez les lignes en saisissant la chaîne à rechercher.

Utilisation  pour modifier la page affichée si la liste s'étend sur plusieurs pages.

pour modifier la page affichée si la liste s'étend sur plusieurs pages.

2.6 Widgets du tableau de bord #

Chaque widget du tableau de bord affiche des informations d'état spécifiques liées à un aspect particulier d'une grappe Ceph en cours d'exécution. Certains widgets sont des liens actifs. Si vous cliquez sur ces derniers, ils vous redirigent vers une page détaillée associée au sujet qu'ils représentent.

Certains widgets graphiques vous montrent plus de détails lorsque vous passez le pointeur de la souris sur eux.

2.6.1 Widgets de statut #

Les widgets vous donnent un bref aperçu du statut actuel de la grappe.

Présente des informations de base sur l'état de santé de la grappe.

Affiche le nombre total de noeuds de la grappe.

Affiche le nombre de moniteurs en cours d'exécution et leur quorum.

Affiche le nombre total d'OSD, ainsi que le nombre d'OSD démarrés et rentrés.

Affiche le nombre de daemons Ceph Manager actifs et en veille.

Affiche le nombre d'instances Object Gateway en cours d'exécution.

Affiche le nombre de serveurs de métadonnées.

Affiche le nombre de passerelles iSCSI configurées.

2.6.2 Widgets de capacité #

Les widgets affichent de brèves informations sur la capacité de stockage.

Affiche le rapport entre la capacité de stockage brute utilisée et celle disponible.

Affiche le nombre d'objets de données stockés dans la grappe.

Affiche une représentation graphique des groupes de placements en fonction de leur statut.

Affiche le nombre de réserve dans la grappe.

Affiche le nombre moyen de groupes de placements par OSD.

2.6.3 Widgets de performance #

Les widgets font référence aux données de performance de base des clients Ceph.

Quantité d'opérations de lecture et d'écriture des clients par seconde.

Quantité de données transférées vers et depuis les clients Ceph, en octets par seconde.

Débit de données récupérées par seconde.

Affiche le statut du nettoyage (voir Section 17.4.9, « Nettoyage d'un groupe de placement »), à savoir

Inactif,ActivéouActif.

3 Gestion des utilisateurs et des rôles Ceph Dashboard #

La gestion des utilisateurs du tableau de bord effectuée à l'aide de commandes Ceph sur la ligne de commande a déjà été présentée au Chapitre 11, Gestion des utilisateurs et des rôles via la ligne de commande.

Cette section décrit comment gérer les comptes utilisateur à l'aide de l'interface utilisateur Web du tableau de bord.

3.1 Liste des utilisateurs #

Cliquez sur ![]() dans le menu de l'utilitaire, puis sélectionnez .

dans le menu de l'utilitaire, puis sélectionnez .

La liste contient le nom d'utilisateur de chaque utilisateur, son nom complet, son adresse électronique, la liste des rôles assignés, l'état d'activation du rôle et la date d'expiration du mot de passe.

3.2 Ajout de nouveaux utilisateurs #

Cliquez sur en haut à gauche de l'en-tête de tableau pour ajouter un nouvel utilisateur. Entrez son nom d'utilisateur, son mot de passe et éventuellement un nom complet et une adresse électronique.

Cliquez sur la petite icône de crayon pour assigner des rôles prédéfinis à l'utilisateur. Confirmez en cliquant sur le bouton .

3.3 Modification des utilisateurs #

Dans le tableau, cliquez sur la ligne d'un utilisateur pour la mettre en surbrillance, puis sélectionnez pour éditer les détails de l'utilisateur. Confirmez en cliquant sur le bouton .

3.4 Suppression d'utilisateurs #

Cliquez sur la ligne d'un utilisateur dans le tableau pour la mettre en surbrillance, puis sélectionnez la zone de liste déroulante en regard de et sélectionnez dans la liste pour supprimer le compte utilisateur. Cochez la case et confirmez avec le bouton .

3.5 Liste des rôles des utilisateurs #

Cliquez sur ![]() dans le menu de l'utilitaire, puis sélectionnez . Cliquez ensuite sur l'onglet .

dans le menu de l'utilitaire, puis sélectionnez . Cliquez ensuite sur l'onglet .

La liste contient le nom et la description de chaque rôle, et indique s'il s'agit d'un rôle système.

3.6 Ajout de rôles personnalisés #

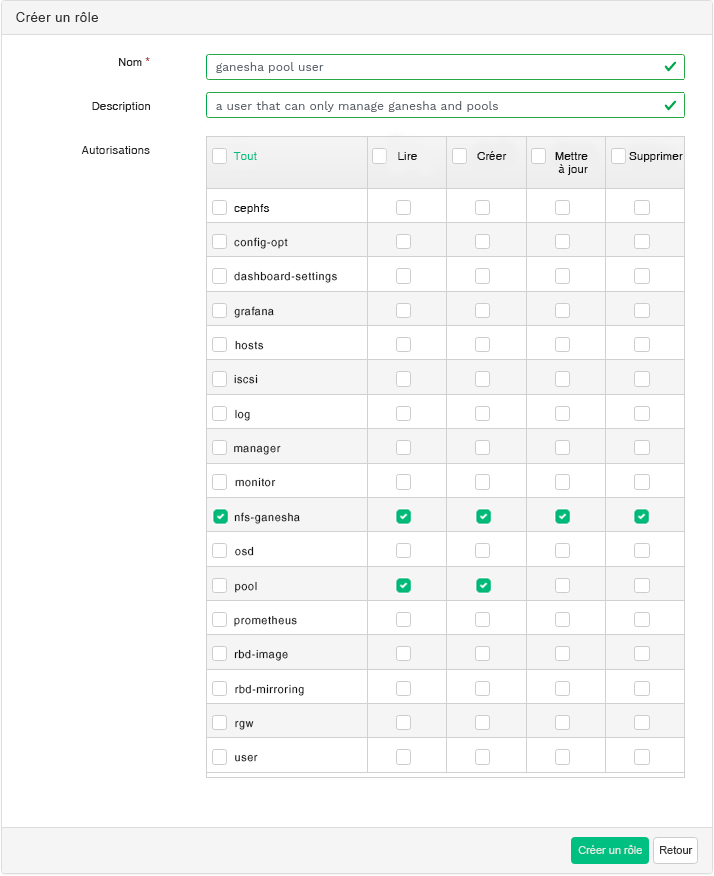

Cliquez sur en haut à gauche de l'en-tête de tableau pour ajouter un nouveau rôle personnalisé. Entrez le et la , puis en regard de , sélectionnez les autorisations appropriées.

Si vous créez des rôles utilisateur personnalisés et avez l'intention de supprimer ultérieurement la grappe Ceph à l'aide de la commande ceph-salt purge, vous devez d'abord purger les rôles personnalisés. Pour plus de détails, reportez-vous à la Section 13.9, « Suppression d'une grappe Ceph entière ».

Si vous cochez la case qui précède le nom du périmètre, vous activez toutes les autorisations pour ce périmètre. Si vous cochez la case , vous activez toutes les autorisations pour tous les périmètres.

Confirmez en cliquant sur le bouton .

3.7 Modification des rôles personnalisés #

Cliquez sur la ligne d'un utilisateur dans le tableau pour la mettre en surbrillance, puis sélectionnez en haut à gauche de l'en-tête du tableau pour éditer la description et les autorisations du rôle personnalisé. Confirmez en cliquant sur le bouton (Modifier le rôle).

3.8 Suppression des rôles personnalisés #

Cliquez sur la ligne d'un rôle dans le tableau pour la mettre en surbrillance, puis sélectionnez la zone de liste déroulante en regard de et sélectionnez dans la liste pour supprimer le rôle. Cochez la case et confirmez avec le bouton .

4 Affichage des éléments internes de la grappe #

L'élément de menu permet d'afficher des informations détaillées sur les hôtes de la grappe Ceph, l'inventaire, les instances Ceph Monitor, les services, les OSD, la configuration, la carte CRUSH, Ceph Manager, les journaux et les fichiers de surveillance.

4.1 Affichage des noeuds de grappe #

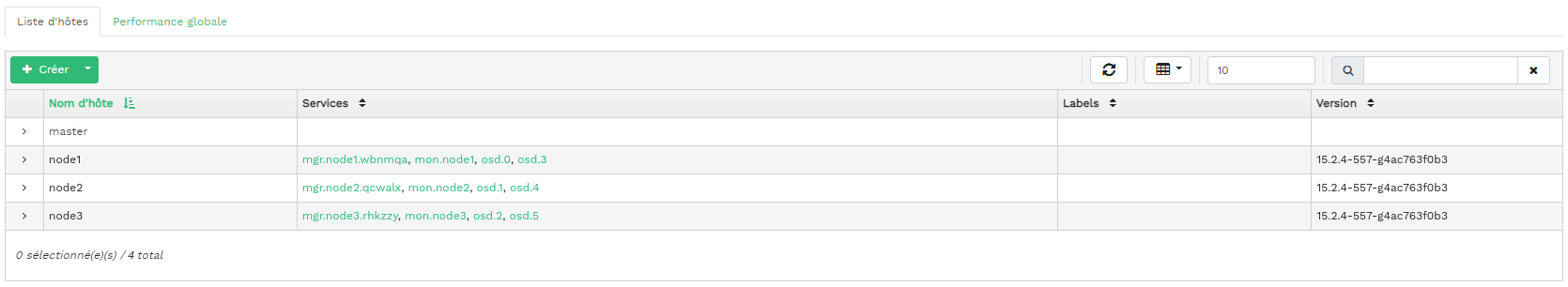

Cliquez sur › pour afficher la liste des noeuds de la grappe.

Cliquez sur la flèche de liste déroulante en regard d'un nom de noeud dans la colonne pour afficher les détails des performances du noeud.

La colonne répertorie tous les daemons qui s'exécutent sur chaque noeud associé. Cliquez sur un nom de daemon pour afficher sa configuration détaillée.

4.2 Accès à l'inventaire de la grappe #

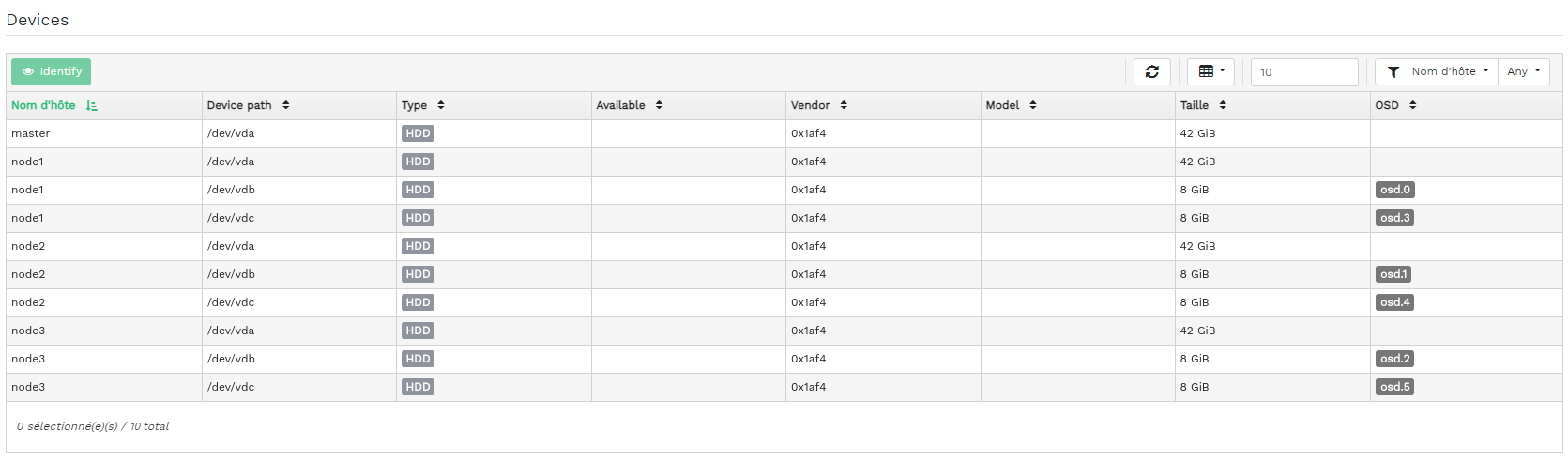

Cliquez sur › pour afficher la liste des périphériques. La liste inclut le chemin, le type, la disponibilité, le fournisseur, le modèle, la taille et les OSD du périphérique.

Cliquez pour sélectionner un nom de noeud dans la colonne . Une fois le nom sélectionné, cliquez sur pour identifier le périphérique sur lequel l'hôte s'exécute. Cela indique au périphérique de faire clignoter ses voyants. Sélectionnez la durée de cette opération entre 1, 2, 5, 10 et 15 minutes. Cliquez sur .

4.3 Affichage des instances Ceph Monitor #

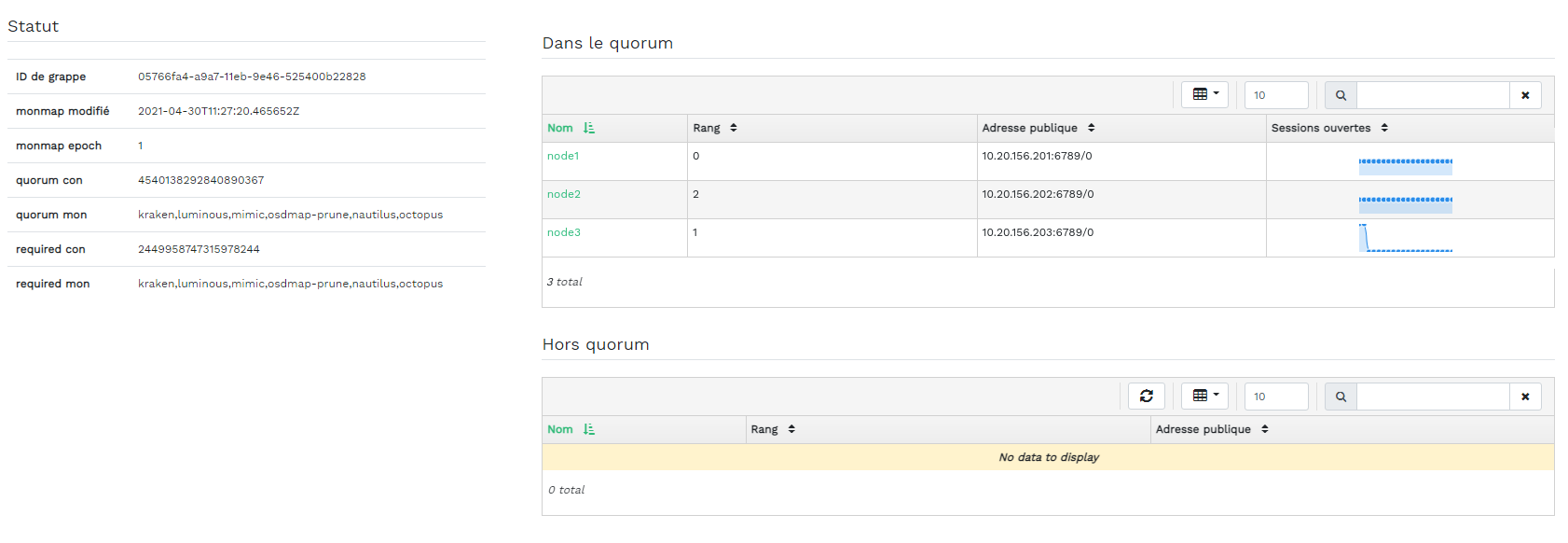

Cliquez sur › pour afficher la liste des noeuds de la grappe hébergeant des moniteurs Ceph en cours d'exécution. Le volet de contenu est divisé en deux vues : Statut et Dans le quorum ou Hors quorum.

Le tableau affiche des statistiques générales sur les instances Ceph Monitor en cours d'exécution, notamment les informations suivantes :

ID de grappe

monmap modifié

monmap epoch

quorum con

quorum mon

required con

required mon

Les volets Dans le quorum et Hors quorum incluent le nom de chaque moniteur, son numéro de rang, son adresse IP publique et le nombre de sessions ouvertes.

Cliquez sur un nom de noeud dans la colonne pour afficher la configuration Ceph Monitor associée.

4.4 Affichage des services #

Cliquez sur › pour afficher les détails de chacun des services disponibles : crash, Ceph Manager et les instances Ceph Monitor. La liste inclut le nom et l'ID de l'image du conteneur, le statut de ce qui est en cours d'exécution, la taille et la date du dernier rafraîchissement.

Cliquez sur la flèche de liste déroulante en regard d'un nom de service dans la colonne pour afficher les détails du daemon. La liste détaillée inclut le nom d'hôte, le type et l'ID du daemon, l'ID du conteneur, le nom et l'ID de l'image du conteneur, le numéro de version, le statut et la date du dernier rafraîchissement.

4.5 Affichage des OSD Ceph #

Cliquez sur › pour afficher la liste des noeuds hébergeant des daemons OSD en cours d'exécution. La liste comprend, pour chaque noeud, le nom, l'ID, le statut, la classe de périphérique, le nombre de groupes de placements, la taille, l'utilisation, un graphique des octets de lecture/d'écriture dans le temps, ainsi que le taux d'opérations de lecture/écriture par seconde.

Sélectionnez dans le menu déroulant de dans l'en-tête du tableau pour ouvrir une fenêtre contextuelle. Elle contient une liste des drapeaux qui s'appliquent à l'ensemble de la grappe. Vous pouvez activer ou désactiver des drapeaux individuels et confirmer avec le bouton .

Sélectionnez dans le menu déroulant de dans l'en-tête du tableau pour ouvrir une fenêtre contextuelle. Elle contient une liste des priorité de récupération des OSD qui s'appliquent à l'ensemble de la grappe. Vous pouvez activer le profil de priorité préféré et affiner les différentes valeurs ci-dessous. Confirmez en cliquant sur .

Cliquez sur la flèche de liste déroulante en regard d'un nom de noeud dans la colonne pour afficher un tableau étendu avec des détails sur les paramètres et les performances des périphériques. En parcourant plusieurs onglets, vous pouvez voir les listes , , , , ainsi qu'un graphique des opérations de lecture et d'écriture et les .

Une fois que vous avez cliqué sur un nom de noeud OSD, la ligne du tableau est mise en surbrillance. Cela signifie que vous pouvez désormais effectuer une tâche sur le noeud. Vous pouvez choisir d'effectuer l'une des opérations suivantes : , , , , , , , , , , ou .

Cliquez sur la flèche vers le bas en haut à gauche de l'en-tête du tableau à côté du bouton et sélectionnez la tâche à effectuer.

4.5.1 Ajout d'OSD #

Pour ajouter de nouveaux OSD, procédez comme suit :

Vérifiez que certains noeuds de la grappe disposent de périphériques de stockage dont le statut est

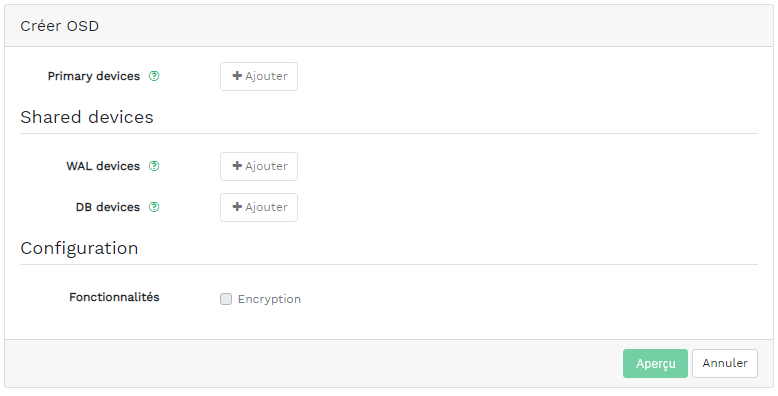

Disponible. Cliquez ensuite sur la flèche vers le bas en haut à gauche de l'en-tête du tableau et sélectionnez . Cela ouvre la fenêtre .Figure 4.9 : Créer des OSD #Pour ajouter des périphériques de stockage principaux pour les OSD, cliquez sur . Avant de pouvoir ajouter des périphériques de stockage, vous devez spécifier des critères de filtrage en haut à droite du tableau , par exemple . Cliquez sur pour confirmer.

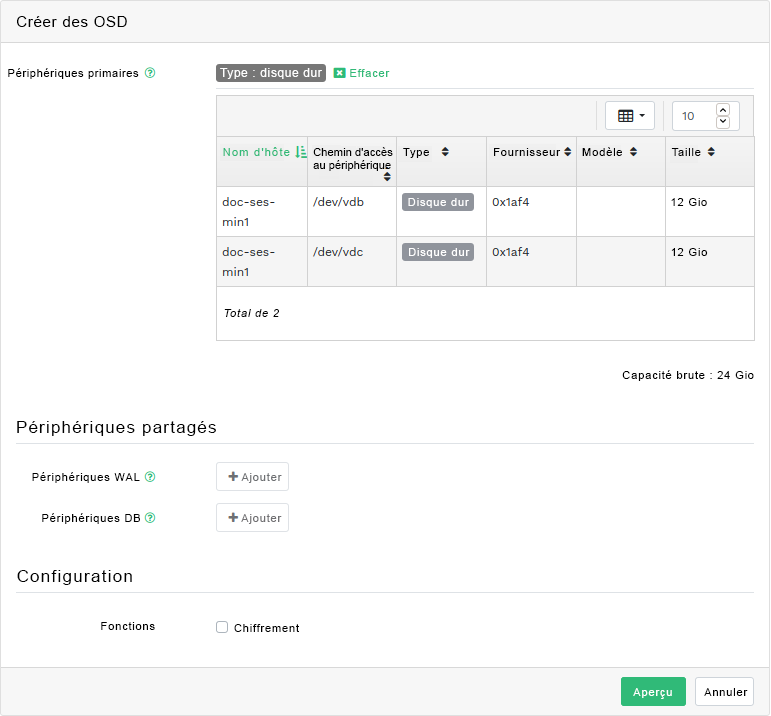

Figure 4.10 : Ajout de périphériques principaux #Dans la fenêtre mise à jour, ajoutez éventuellement des périphériques WAL et BD partagés, ou activez le chiffrement des périphériques.

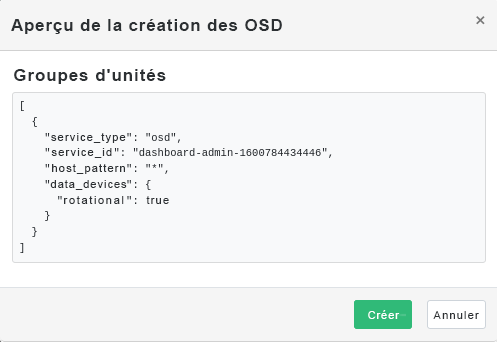

Figure 4.11 : Création d'OSD avec des périphériques principaux ajoutés #Cliquez sur pour afficher l'aperçu des spécifications DriveGroups pour les périphériques ajoutés précédemment. Confirmez en cliquant sur .

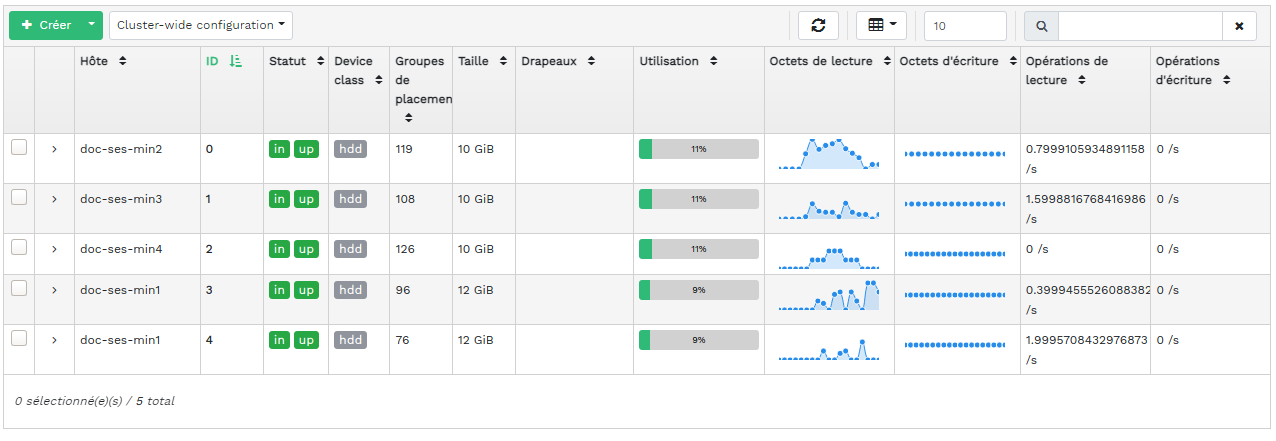

Figure 4.12 : #Les nouveaux périphériques seront ajoutés à la liste des OSD.

Figure 4.13 : OSD nouvellement ajoutés #RemarqueIl n'y a pas de visualisation de la progression du processus de création des OSD. Leur création prend un certain temps. Les OSD apparaissent dans la liste lorsqu'ils ont été déployés. Si vous souhaitez vérifier le statut du déploiement, affichez les journaux en cliquant sur › .

4.6 Affichage de la configuration de la grappe #

Cliquez sur › pour afficher une liste complète des options de configuration de la grappe Ceph. La liste contient le nom de l'option, sa brève description et ses valeurs actuelles et par défaut, et indique si l'option est modifiable.

Cliquez sur la flèche de liste déroulante en regard d'une option de configuration dans la colonne pour afficher un tableau étendu avec des informations détaillées sur l'option, telles que son type de valeur, les valeurs minimales et maximales autorisées, si elle peut être mise à jour au moment de l'exécution, etc.

Lorsqu'une option spécifique est mise en surbrillance, vous pouvez éditer sa ou ses valeurs en cliquant sur le bouton en haut à gauche de l'en-tête du tableau. Confirmez les modifications en cliquant sur .

4.7 Affichage de la carte CRUSH #

Cliquez sur › pour afficher une carte CRUSH de la grappe. Pour plus d'informations générales sur les cartes CRUSH, reportez-vous à la Section 17.5, « Manipulation de la carte CRUSH ».

Cliquez sur la racine, les noeuds ou des OSD spécifiques pour afficher des informations plus détaillées, telles que la pondération CRUSH, la profondeur dans l'arborescence de la carte, la classe de périphérique de l'OSD, etc.

4.8 Affichage des modules Manager #

Cliquez sur › pour afficher une liste des modules Ceph Manager disponibles. Chaque ligne reprend un nom de module et indique s'il est actuellement activé ou non.

Cliquez sur la flèche de liste déroulante en regard d'un module dans la colonne pour afficher un tableau étendu avec des paramètres détaillés dans le tableau ci-dessous. Pour les éditer, cliquez sur en haut à gauche de l'en-tête du tableau. Confirmez les modification en cliquant sur .

Cliquez sur la flèche de la liste déroulante en regard du bouton en haut à gauche de l'en-tête du tableau pour ou un module.

4.9 Affichage des journaux #

Cliquez sur › pour afficher une liste des entrées de journal récentes de la grappe. Chaque ligne comprend un tampon horaire, le type de l'entrée de journal et le message consigné.

Cliquez sur l'onglet pour afficher les entrées de journal du sous-système d'audit. Reportez-vous à la Section 11.5, « Audit des requêtes API » pour connaître les commandes permettant d'activer ou de désactiver les audits.

4.10 Affichage de la surveillance #

Cliquez sur › pour gérer et afficher les détails des alertes Prometheus.

Si Prometheus est actif, dans ce volet de contenu, vous pouvez afficher des informations détaillées sur les , ou les .

Si Prometheus n'est pas déployé, une bannière d'information apparaît avec un lien vers la documentation appropriée.

5 Gestion des réserves #

Pour plus d'informations générales sur les réserves Ceph, reportez-vous au Chapitre 18, Gestion des réserves de stockage. Pour des informations spécifiques sur les réserves codées à effacement, reportez-vous au Chapitre 19, Réserves codées à effacement.

Pour répertorier toutes les réserves disponibles, cliquez sur (Réserves) dans le menu principal.

La liste affiche, pour chaque réserve, le nom, le type, l'application associée, le statut du groupe de placements, la taille des répliques, la dernière modification, le profil de code à effacement, l'ensemble de règles crush, l'utilisation et les statistiques de lecture/écriture.

Cliquez sur la flèche de liste déroulante en regard d'un nom de réserve dans la colonne pour afficher une table étendue contenant des informations détaillées sur la réserve, telles que les détails généraux, les détails de performances et la configuration.

5.1 Ajout d'une nouvelle réserve #

Pour ajouter une nouvelle réserve, cliquez sur en haut à gauche du tableau des réserves. Dans le formulaire de la réserve, vous pouvez entrer le nom de la réserve, son type, ses applications, son mode de compression et ses quotas, y compris le nombre maximal d'octets et d'objets. Le formulaire de la réserve calcule lui-même le nombre de groupes de placements qui convient le mieux à cette réserve. Le calcul est basé sur la quantité d'OSD dans la grappe et le type de réserve sélectionné avec ses paramètres spécifiques. Dès qu'un nombre de groupes de placements est défini manuellement, il est remplacé par un nombre calculé. Confirmez en cliquant sur le bouton (Créer une réserve).

5.2 Suppression de réserves #

Pour supprimer une réserve, sélectionnez-la dans la ligne du tableau. Cliquez sur la flèche de liste déroulante en regard du bouton , puis sur .

5.3 Modification des options d'une réserve #

Pour modifier les options d'une réserve, sélectionnez la réserve dans la ligne du tableau, puis cliquez sur en haut à gauche du tableau des réserves.

Vous pouvez modifier le nom de la réserve, augmenter le nombre de groupes de placements et éditer la liste des applications et les paramètres de compression. Confirmez en cliquant sur le bouton (Modifier une réserve).

6 Gestion du périphérique de traitement par blocs RADOS (RBD) #

Pour répertorier tous les périphériques de bloc RADOS (RADOS Block Device, RBD) disponibles, cliquez sur › dans le menu principal.

La liste affiche de brèves informations sur le périphérique, telles que son nom, le nom de la réserve associée, l'espace de noms, la taille du périphérique, le nombre et la taille des objets sur le périphérique, des informations sur le provisioning des détails et le parent.

6.1 Affichage des détails sur les RBD #

Pour afficher des informations plus détaillées sur un périphérique, cliquez sur sa ligne dans le tableau :

6.2 Affichage de la configuration d'un RBD #

Pour afficher la configuration détaillée d'un périphérique, cliquez sur sa ligne dans le tableau, puis sur l'onglet dans le tableau inférieur :

6.3 Création de RBD #

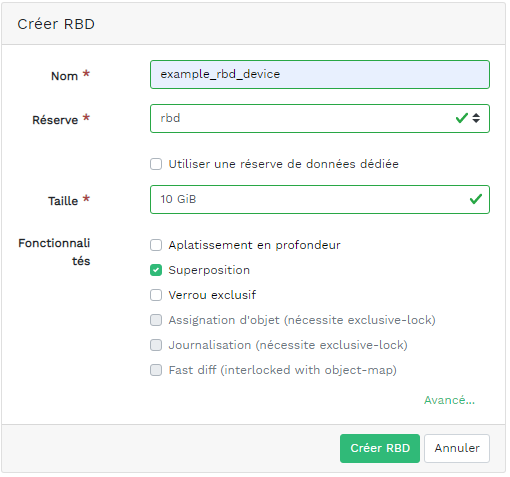

Pour ajouter un nouveau périphérique, cliquez sur en haut à gauche de l'en-tête du tableau, puis procédez comme suit dans l'écran :

Entrez le nom du nouveau périphérique. Reportez-vous au Book “Guide de déploiement”, Chapter 2 “Configuration matérielle requise et recommandations”, Section 2.11 “Limitations concernant les noms” pour plus d'informations sur les règles de dénomination.

Sélectionnez la réserve à laquelle est assignée l'application

rbdà partir de laquelle le nouveau périphérique RBD va être créé.Spécifiez la taille du nouveau périphérique.

Spécifiez des options supplémentaires pour le périphérique. Pour affiner les paramètres de l'appareil, cliquez sur et entrez des valeurs pour la taille d'objet, l'unité de segmentation ou le nombre de segments. Pour spécifier les limites de la qualité de service (Quality of Service, QoS), cliquez sur et indiquez les valeurs.

Confirmez en cliquant sur le bouton .

6.4 Suppression de RBD #

Pour supprimer un périphérique, sélectionnez-le dans la ligne du tableau. Cliquez sur la flèche de liste déroulante en regard du bouton , puis sur . Confirmez la suppression en cliquant sur (Supprimer le RBD).

La suppression d'un RDB est une opération irréversible. En revanche, vous permet de restaurer ultérieurement le périphérique en le sélectionnant sur l'onglet du principal tableau et en cliquant sur en haut à gauche de l'en-tête du tableau.

6.5 Création d'instantanés de périphériques de traitement par blocs RADOS (RBD) #

Pour créer un instantané de périphérique de traitement par blocs RADOS, sélectionnez le périphérique dans la ligne du tableau. Le volet de contenu de configuration détaillé apparaît. Sélectionnez l'onglet et cliquez sur en haut à gauche de l'en-tête du tableau. Entrez le nom de l'instantané et confirmez en cliquant sur (Créer un instantané de RBD).

Après avoir sélectionné un instantané, vous pouvez effectuer des opérations supplémentaires sur le périphérique, telles que renommer, protéger, cloner, copier ou supprimer. restaure l'état de l'appareil à partir de l'instantané actuel.

6.6 Mise en miroir de RBD #

Les images RBD peuvent être mises en miroir de manière asynchrone entre deux grappes Ceph. Vous pouvez utiliser Ceph Dashboard pour configurer la réplication d'images RBD entre plusieurs grappes. Cette fonctionnalité est disponible en deux modes :

- Mode basé sur un journal

Ce mode utilise la fonctionnalité de journalisation de l'image RBD afin de garantir une réplication ponctuelle, cohérente entre les grappes en cas de panne.

- Mode basé sur des instantanés

Ce mode utilise des instantanés en miroir d'image RBD planifiés régulièrement ou créés manuellement pour répliquer des images RBD cohérentes entre les grappes en cas de panne.

La mise en miroir est configurée réserve par réserve au sein des grappes homologues et peut être configurée sur un sous-ensemble spécifique d'images dans la réserve ou configurée pour mettre en miroir automatiquement toutes les images d'une réserve lorsque vous utilisez la mise en miroir basée sur le journal uniquement.

La mise en miroir est configurée à l'aide de la commande rbd , qui est installée par défaut dans SUSE Enterprise Storage 7.1. Le daemon rbd-mirror est chargé d'extraire les mises à jour d'image de la grappe homologue distante et de les appliquer à l'image au sein de la grappe locale. Reportez-vous à la Section 6.6.2, « Activation du daemon rbd-mirror » pour plus d'informations sur l'activation du daemon rbd-mirror.

Selon les besoins de réplication, la mise en miroir RBD peut être configurée pour une réplication unidirectionnelle ou bidirectionnelle :

- Réplication unidirectionnelle

Lorsque les données sont mises en miroir uniquement à partir d'une grappe primaire vers une grappe secondaire, le daemon

rbd-mirrors'exécute uniquement sur la grappe secondaire.- Réplication bidirectionnelle

Lorsque les données sont mises en miroir à partir des images primaires sur une grappe vers des images non primaires sur une autre grappe (et inversement), le daemon

rbd-mirrors'exécute sur les deux grappes.

Chaque instance du daemon rbd-mirror doit pouvoir se connecter simultanément aux grappes Ceph locales et distantes, par exemple tous les hôtes de moniteur et OSD. En outre, le réseau doit disposer de suffisamment de bande passante entre les deux centres de données pour gérer le workload en miroir.

Pour des informations générales et l'approche de ligne de commande pour la mise en miroir de périphérique de bloc RADOS, reportez-vous à la Section 20.4, « Miroirs d'image RBD ».

6.6.1 Configuration de grappes primaires et secondaires #

Une grappe primaire est celle sur laquelle la réserve d'origine avec les images est créée. Une grappe secondaire est celle sur laquelle la réserve ou les images sont répliquées à partir de la grappe primaire.

Les termes primaire et secondaire peuvent être relatifs dans le contexte de la réplication, étant donné qu'ils se rapportent davantage aux réserves individuelles qu'aux grappes. Par exemple, dans la réplication bidirectionnelle, une réserve peut être mise en miroir de la grappe primaire vers la grappe secondaire, tandis qu'une autre réserve peut être mise en miroir de la grappe secondaire vers la grappe primaire.

6.6.2 Activation du daemon rbd-mirror #

Les procédures suivantes montrent comment effectuer les tâches d'administration de base pour configurer la mise en miroir à l'aide de la commande rbd. La mise en miroir est configurée réserve par réserve au sein des grappes Ceph.

Les étapes de configuration d'une réserve doivent être effectuées sur les deux grappes homologues. Ces procédures supposent que deux grappes, nommées « primary » (primaire) et « secondary » (secondaire), sont accessibles depuis un seul hôte pour plus de clarté.

Le daemon rbd-mirror effectue la réplication réelle des données de grappe.

Renommez

ceph.confet les fichiers de trousseau de clés et copiez-les de l'hôte primaire vers l'hôte secondaire :cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringPour activer la mise en miroir sur une réserve avec

rbd, indiquezmirror pool enable, le nom de la réserve et le mode de mise en miroir :cephuser@adm >rbd mirror pool enable POOL_NAME MODERemarqueLe mode de mise en miroir peut être

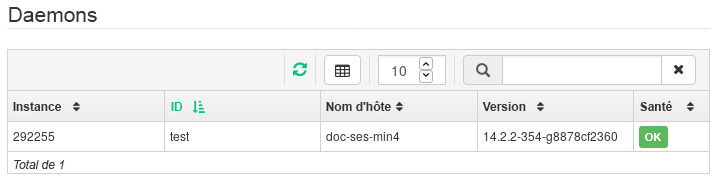

imageoupool. Par exemple :cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageDans Ceph Dashboard, accédez à › . Le tableau à gauche montre les daemons

rbd-mirroren cours d'exécution et leur état de santé.Figure 6.6 : Exécution de daemonsrbd-mirror#

6.6.3 Désactivation de la mise en miroir #

Pour désactiver la mise en miroir sur une réserve avec rbd, spécifiez la commande mirror pool disable et le nom de la réserve :

cephuser@adm > rbd mirror pool disable POOL_NAMELorsque la mise en miroir est désactivée sur une réserve de cette manière, la mise en miroir est également désactivée sur toutes les images (dans la réserve) pour lesquelles la mise en miroir a été explicitement activée.

6.6.4 Démarrage des homologues #

Pour que rbd-mirror découvre sa grappe homologue, l'homologue doit être enregistré dans la réserve et un compte utilisateur doit être créé. Ce processus peut être automatisé avec rbd et les commandes mirror pool peer bootstrap create ainsi que mirror pool peer bootstrap import.

Pour créer manuellement un nouveau jeton Bootstrap avec rbd, spécifiez la commande mirror pool peer bootstrap create, un nom de réserve, ainsi qu'un nom de site facultatif pour décrire la grappe locale :

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

La sortie de la commande mirror pool peer bootstrap create sera un jeton qui doit être fourni à la commande mirror pool peer bootstrap import. Par exemple, sur la grappe primaire :

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \

joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

Pour importer manuellement le jeton Bootstrap créé par une autre grappe à l'aide de la commande rbd, spécifiez la commande mirror pool peer bootstrap import, le nom de la réserve, un chemin d'accès au jeton créé (ou « - » pour lire à partir de l'entrée standard), ainsi qu'un nom de site facultatif pour décrire la grappe locale et une direction de mise en miroir (par défaut, rx-tx pour la mise en miroir bidirectionnelle, mais cela peut également être défini sur rx-only pour la mise en miroir unidirectionnelle) :

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathPar exemple, sur la grappe secondaire :

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW1pcn \ Jvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \ joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 Suppression d'un homologue de grappe #

Pour supprimer une grappe Ceph homologue de mise en miroir avec la commande rbd, indiquez la commande mirror pool peer remove, le nom de la réserve et l'UUID de l'homologue (disponible dans le résultat de la commande rbd mirror pool info) :

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Configuration de la réplication de réserve dans Ceph Dashboard #

Le daemon rbd-mirror doit avoir accès à la grappe primaire pour pouvoir mettre en miroir des images RBD. Veillez à avoir suivi les étapes de la Section 6.6.4, « Démarrage des homologues » avant de poursuivre.

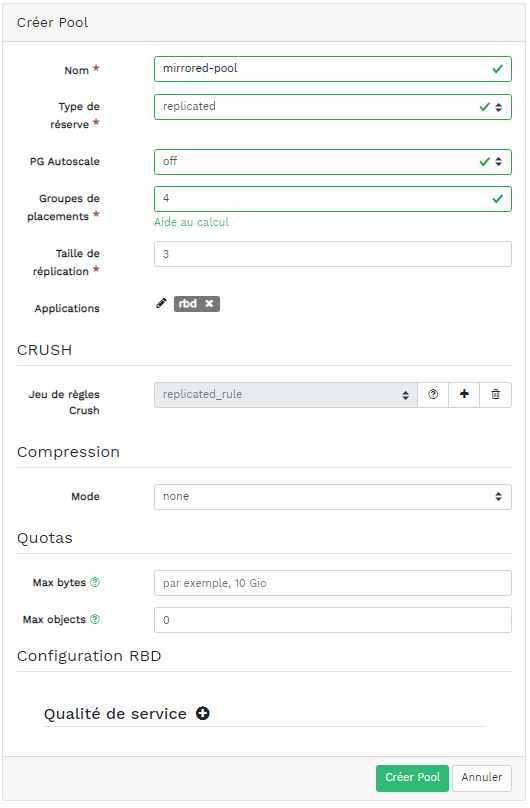

Sur les grappes primaire et secondaire, créez une réserve portant le même nom et assignez-lui l'application

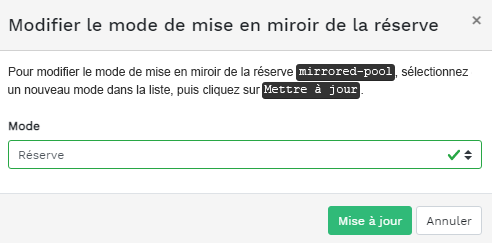

rbd. Reportez-vous à la Section 5.1, « Ajout d'une nouvelle réserve » pour plus de détails sur la création d'une réserve.Figure 6.7 : Création d'une réserve avec l'application RBD #Sur les tableaux de bord des grappes primaire et secondaire, accédez à › . Dans le tableau à droite, cliquez sur le nom de la réserve à répliquer et, après avoir cliqué sur , sélectionnez le mode de réplication. Dans cet exemple, nous travaillerons avec un mode de réplication réserve, ce qui signifie que toutes les images d'une réserve donnée seront répliquées. Confirmez en cliquant sur .

Figure 6.8 : Configuration du mode de réplication #Important : erreur ou avertissement sur la grappe primaireAprès la mise à jour du mode de réplication, un drapeau d'erreur ou d'avertissement apparaît dans la colonne de droite correspondante. Cela est dû au fait que la réserve n'a encore aucun utilisateur homologue qui lui est assigné pour la réplication. Ignorez ce drapeau pour la grappe primaire étant donné que nous assignons un utilisateur homologue à la grappe secondaire uniquement.

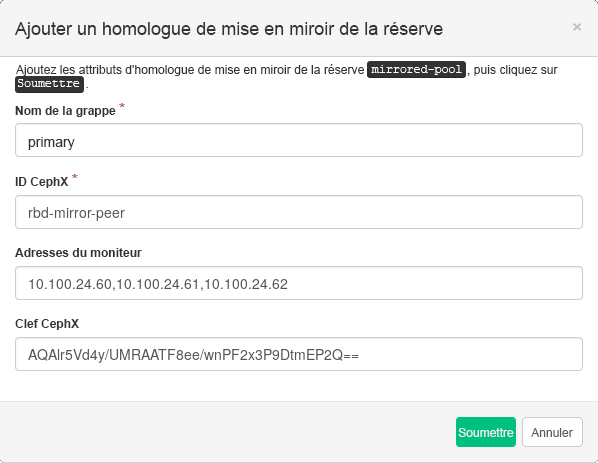

Sur le tableau de bord de la grappe secondaire, accédez à › . Ajoutez l'homologue de miroir de réserve en sélectionnant . Spécifiez les détails de la grappe primaire :

Figure 6.9 : Ajout des informations d'identification de l'homologue #Chaîne unique arbitraire qui identifie la grappe primaire (par exemple « primaire »). Le nom de la grappe doit être différent de celui de la grappe secondaire réel.

ID utilisateur Ceph que vous avez créé en tant qu'homologue de mise en miroir. Dans cet exemple, il s'agit de « rbd-mirror-peer ».

Liste des adresses IP des noeuds Ceph Monitor de la grappe principale, séparées par des virgules.

Clé liée à l'ID utilisateur homologue. Vous pouvez la récupérer en exécutant l'exemple de commande suivant sur la grappe primaire :

cephuser@adm >ceph auth print_key pool-mirror-peer-name

Confirmez en cliquant sur .

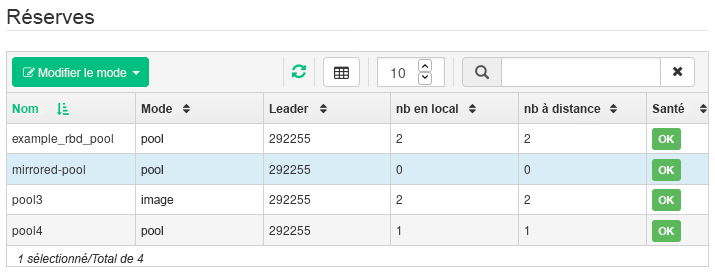

Figure 6.10 : Liste des réserves répliquées #

6.6.7 Vérification du fonctionnement de la réplication d'image RBD #

Lorsque le daemon rbd-mirror est en cours d'exécution et que la réplication d'image RBD est configurée sur Ceph Dashboard, il est temps de vérifier si la réplication fonctionne réellement :

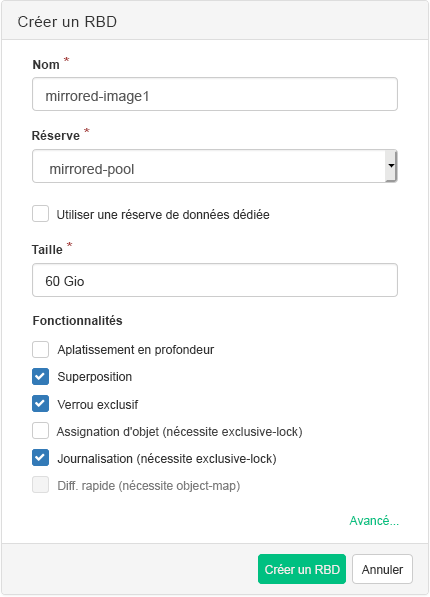

Sur l'instance Ceph Dashboard de la grappe primaire, créez une image RBD de sorte que sa réserve parent soit la réserve que vous avez déjà créée à des fins de réplication. Activez les fonctionnalités

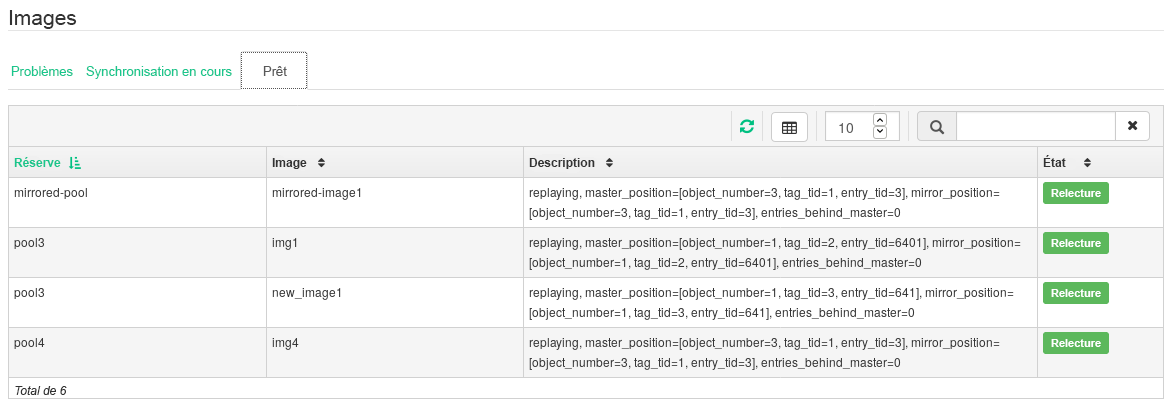

Verrou exclusifetJournalisationpour l'image. Reportez-vous à la Section 6.3, « Création de RBD » pour plus de détails sur la création d'images RBD.Figure 6.11 : Nouvelle image RBD #Après avoir créé l'image que vous souhaitez répliquer, ouvrez l'instance Ceph Dashboard de la grappe secondaire et accédez à › . Le tableau sur la droite rend compte du changement du et synchronise le .

Figure 6.12 : Nouvelle image RBD synchronisée #Astuce : progression de la réplicationLe tableau en bas de la page affiche le statut de la réplication des images RBD. L'onglet inclut les éventuels problèmes, l'onglet affiche la progression de la réplication des images et l'onglet répertorie toutes les images dont la réplication a réussi.

Figure 6.13 : Statut de la réplication des images RBD #Sur la grappe primaire, écrivez des données dans l'image RBD. Sur l'instance Ceph Dashboard de la grappe secondaire, accédez à › et surveillez si la taille de l'image correspondante augmente au fur et à mesure que des données sont inscrites sur la grappe primaire.

6.7 Gestion des passerelles iSCSI #

Pour plus d'informations sur les passerelles iSCSI, reportez-vous au Chapitre 22, Passerelle Ceph iSCSI.

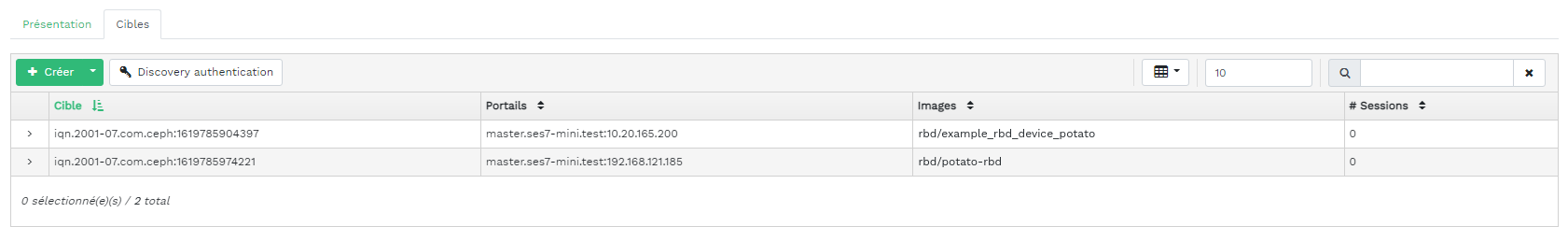

Pour répertorier toutes les passerelles disponibles et les images assignées, cliquez sur › dans le menu principal. Un onglet s'ouvre et répertorie les passerelles iSCSI actuellement configurées et les images RBD assignées.

Le tableau répertorie l'état de chaque passerelle, le nombre de cibles iSCSI et le nombre de sessions. Le tableau répertorie le nom de chaque image assignée, le type de backstore du nom de la réserve associée et d'autres détails statistiques.

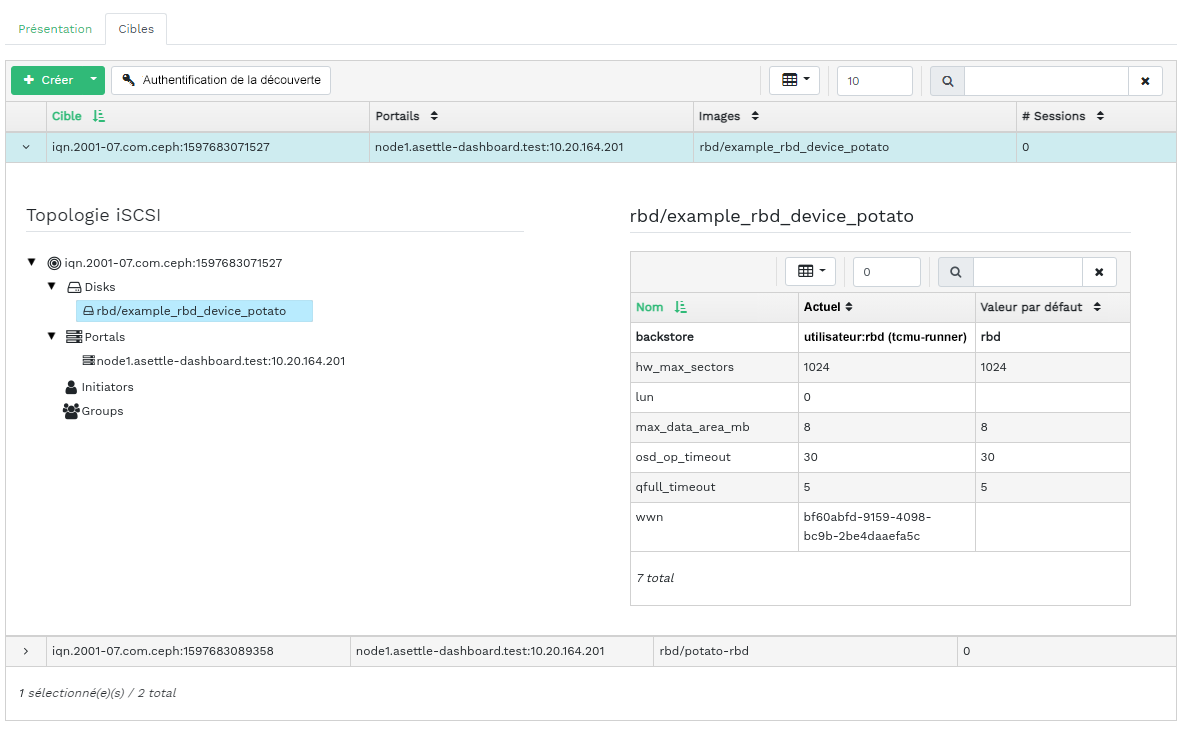

L'onglet répertorie les cibles iSCSI actuellement configurées.

Pour afficher des informations plus détaillées sur une cible, cliquez sur la flèche de liste déroulante sur la ligne cible du tableau. Un schéma structuré en arborescence s'ouvre et liste les disques, les portails, les initiateurs et les groupes. Cliquez sur un élément pour le développer et afficher son contenu détaillé, éventuellement avec une configuration associée dans le tableau sur la droite.

6.7.1 Ajout de cibles iSCSI #

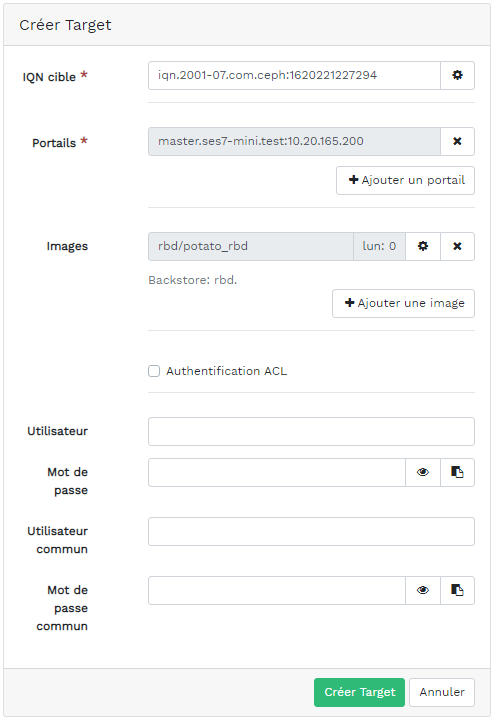

Pour ajouter une nouvelle cible iSCSI, cliquez sur en haut à gauche dans le tableau , puis entrez les informations requises.

Entrez l'adresse cible de la nouvelle passerelle.

Cliquez sur (Ajouter un portail) et sélectionnez un ou plusieurs portails iSCSI dans la liste.

Cliquez sur (Ajouter une image) et sélectionnez une ou plusieurs images RBD pour la passerelle.

Si vous devez utiliser l'authentification pour accéder à la passerelle, sélectionnez la case à cocher , puis entrez les informations d'identification. Vous pouvez trouver des options d'authentification plus avancées après avoir activé et l'.

Confirmez en cliquant sur le bouton (Créer une cible).

6.7.2 Modification des cibles iSCSI #

Pour modifier une cible iSCSI existante, cliquez sur sa ligne dans le tableau , puis cliquez sur en haut à gauche du tableau.

Vous pouvez ensuite modifier la cible iSCSI, ajouter ou supprimer des portails et ajouter ou supprimer des images RBD associées. Vous pouvez également ajuster les informations d'authentification pour la passerelle.

6.7.3 Suppression de cibles iSCSI #

Pour supprimer une cible iSCSI, sélectionnez la ligne du tableau, puis cliquez sur la flèche déroulante en regard du bouton , puis sélectionnez . Cochez la case et confirmez avec le bouton (Supprimer la cible iSCSI).

6.8 Qualité de service (QoS) RBD #

Pour plus d'informations générales et une description des options de configuration QoS RBD, reportez-vous à la Section 20.6, « Paramètres QoS ».

Les options QoS peuvent être configurées à différents niveaux.

Globalement

Par réserve

Par image

La configuration globale est en haut de la liste et sera utilisée pour toutes les images RBD récemment créées et pour les images qui ne remplacent pas ces valeurs au niveau de la couche image RBD ou réserve. Une valeur d'option spécifiée globalement peut être remplacée par réserve ou par image. Les options spécifiées sur une réserve seront appliquées à toutes les images RBD de cette réserve, excepté si elles sont remplacées par une option de configuration définie sur une image. Les options spécifiées sur une image remplaceront les options spécifiées sur une réserve et celles définies globalement.

De cette façon, il est possible de définir des valeurs par défaut de manière globale, de les adapter pour toutes les images RBD d'une réserve spécifique et de remplacer la configuration de la réserve pour des images RBD individuelles.

6.8.1 Configuration globale des options #

Pour configurer globalement les options de périphérique de traitement par blocs RADOS (RBD), sélectionnez › dans le menu principal.

Pour lister toutes les options de configuration globale disponibles, en regard de , choisissez dans le menu déroulant.

Filtrez ensuite les résultats du tableau en entrant

rbd_qosdans le champ de recherche. Cela liste toutes les options de configuration disponibles pour QoS.Pour modifier une valeur, cliquez sur sa ligne dans le tableau, puis sélectionnez en haut à gauche du tableau. La boîte de dialogue contient six champs différents pour spécifier les valeurs. Les valeurs d'option de configuration RBD sont requises dans la zone de texte

RemarqueContrairement aux autres boîtes de dialogue, celle-ci ne vous permet pas de spécifier la valeur dans des unités pratiques. Vous devez définir ces valeurs en octets ou en entrées/sorties par seconde (IOPS), en fonction de l'option que vous modifiez.

6.8.2 Configuration des options d'une nouvelle réserve #

Pour créer une réserve et configurer ses options de configuration RBD, cliquez sur › . Sélectionnez (répliqué) comme type de réserve. Vous devez ensuite ajouter la balise d'application rbd à la réserve pour être en mesure de configurer les options QoS RBD.

Il n'est pas possible de définir les options de configuration RBD QoS sur une réserve codée à effacement. Pour configurer les options QoS RBD pour les réserves codées à effacement, vous devez modifier la réserve de métadonnées répliquée d'une image RBD. La configuration sera ensuite appliquée à la réserve de données codée à effacement de cette image.

6.8.3 Configuration des options d'une réserve existante #

Pour configurer les options QoS RBD sur une réserve existante, cliquez sur , puis sur la ligne de la réserve dans le tableau, et sélectionnez en haut à gauche du tableau.

Dans la boîte de dialogue, vous devriez voir la section suivie d'une section .

Si aucune d'elles n'apparaît, vous êtes probablement occupé à modifier une réserve codée à effacement, qui ne permet pas de définir des options de configuration RBD, ou la réserve n'est pas configurée pour être utilisée par des images RBD. Dans ce dernier cas, assignez la balise d'application à la réserve et les sections de configuration correspondantes s'afficheront.

6.8.4 Options de configuration #

Cliquez sur pour développer les options de configuration. Une liste de toutes les options disponibles s'affiche. Les unités des options de configuration sont déjà affichées dans les zones de texte. En cas d'option d'octets par seconde, vous pouvez utiliser des raccourcis tels que « 1M » ou « 5G ». Ils seront automatiquement convertis en « 1 Mo/s » et « 5 Go/s » respectivement.

Si vous cliquez sur le bouton de réinitialisation à droite de chaque zone de texte, toute valeur éventuelle définie pour la réserve est supprimée. En revanche, cela ne supprime pas les valeurs de configuration des options configurées globalement ou au niveau d'une image RBD.

6.8.5 Création d'options QoS RBD avec une nouvelle image RBD #

Pour créer une image RBD avec des options QoS RBD définies sur cette image, sélectionnez › , puis cliquez sur . Cliquez sur pour développer la section de configuration avancée. Cliquez sur pour ouvrir toutes les options de configuration disponibles.

6.8.6 Modification des options QoS RBD sur les images existantes #

Pour modifier les options QoS RBD pour une image existante, sélectionnez › et cliquez sur la ligne du tableau de la réserve, puis sur . La boîte de dialogue de modification s'affiche. Cliquez sur pour développer la section de configuration avancée. Cliquez sur pour ouvrir toutes les options de configuration disponibles.

6.8.7 Modification des options de configuration lors de la copie ou du clonage d'images #

Si une image RBD est clonée ou copiée, par défaut, les valeurs définies sur cette image particulière sont également copiées. Si vous le souhaitez, vous pouvez les modifier lors de la copie ou du clonage en spécifiant les valeurs de configuration mises à jour dans la boîte de dialogue de copie/clonage, de la même manière que lors de la création ou de l'édition d'une image RBD. De cette façon, seules les valeurs de l'image RBD copiée ou clonée sont définies (ou réinitialisées). Cette opération ne modifie ni la configuration d'image RBD source, ni la configuration globale.

Si vous choisissez de réinitialiser la valeur d'option lors de la copie/du clonage, aucune valeur ne sera définie pour cette option sur cette image. Cela signifie que toute valeur de cette option spécifiée pour la réserve parent sera utilisée si elle est configurée pour la réserve parent. Dans le cas contraire, le système appliquera la valeur par défaut globale.

7 Gestion de NFS Ganesha #

NFS Ganesha prend en charge les versions 4.1 et ultérieures de NFS. Il ne prend pas en charge la version 3 de NFS.

Pour plus d'informations générales sur NFS Ganesha, reportez-vous au Chapitre 25, NFS Ganesha.

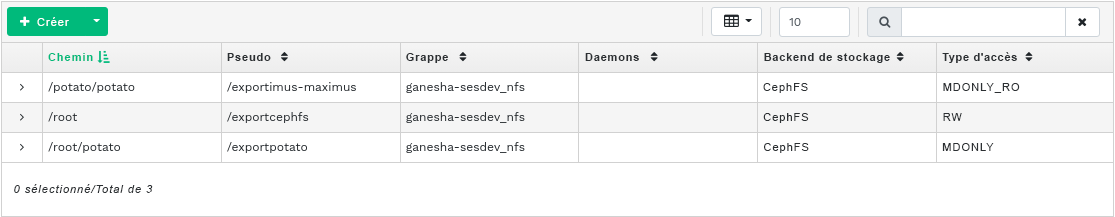

Pour répertorier toutes les exportations NFS disponibles, cliquez sur dans le menu principal.

La liste affiche le répertoire de chaque exportation, le nom d'hôte du daemon, le type d'interface dorsale de stockage et son type d'accès.

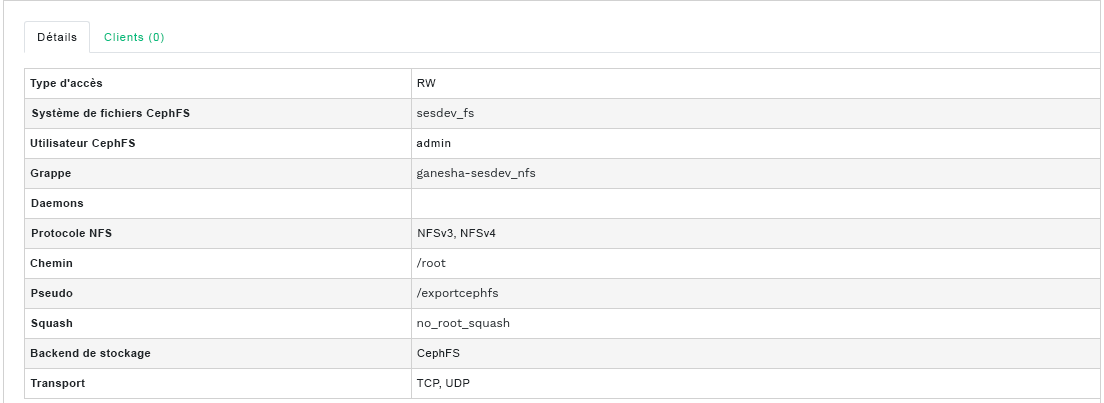

Pour afficher des informations plus détaillées sur une exportation NFS, cliquez sur sa ligne dans le tableau.

7.1 Création d'exportations NFS #

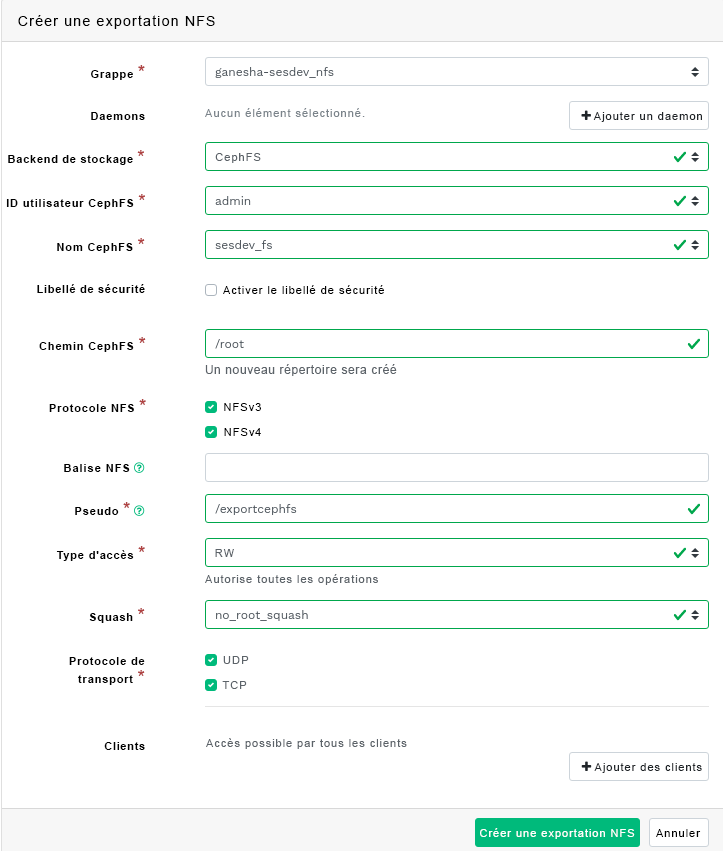

Pour ajouter un nouvelle exportation NFS, cliquez sur en haut à gauche du tableau des exportations, puis entrez les informations requises.

Sélectionnez un ou plusieurs daemons NFS Ganesha qui exécuteront l'exportation.

Sélectionnez une interface dorsale de stockage.

ImportantÀ l'heure actuelle, seules les exportations NFS soutenues par CephFS sont prises en charge.

Sélectionnez un ID utilisateur et d'autres options associées à l'interface dorsale.

Entrez le chemin de répertoire pour l'exportation NFS. Si le répertoire n'existe pas sur le serveur, il est alors créé.

Indiquez d'autres options liées à NFS, telles que la version du protocole NFS prise en charge, le pseudo, le type d'accès, l'action squash ou le protocole de transport.

Si vous devez limiter l'accès à des clients spécifiques, cliquez sur (Ajouter des clients) et ajoutez leurs adresses IP, ainsi que le type d'accès et les options d'action squash.

Confirmez en cliquant sur .

7.2 Suppression des exportations NFS #

Pour supprimer une exportation, sélectionnez-la et mettez-la en surbrillance dans la ligne du tableau. Cliquez sur la flèche de liste déroulante en regard du bouton et sélectionnez . Cochez la case et confirmez avec le bouton .

7.3 Modification d'exportations NFS #

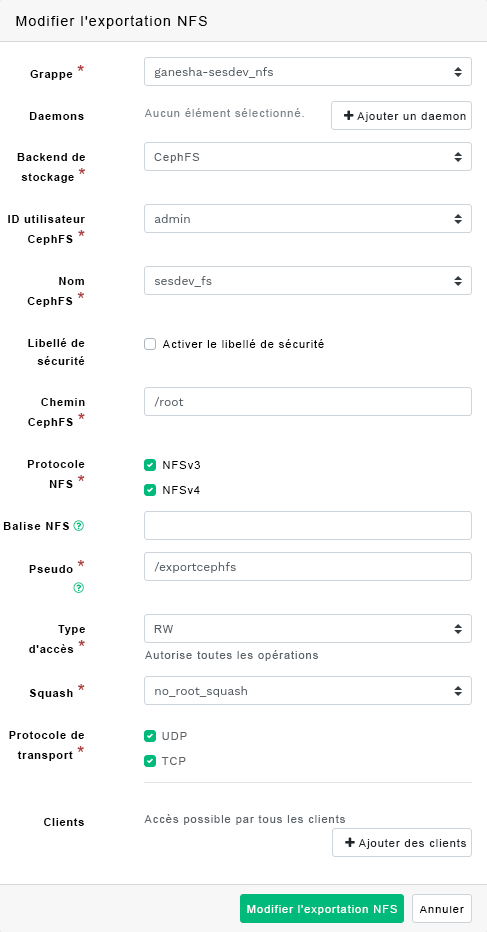

Pour modifier une exportation existante, sélectionnez-la et mettez-la en surbrillance dans la ligne du tableau, puis cliquez sur en haut à gauche du tableau des exportations.

Vous pouvez ensuite régler tous les détails de l'exportation NFS.

8 Gestion de CephFS #

Pour trouver des informations détaillées sur CephFS, reportez-vous au Chapitre 23, Système de fichiers en grappe.

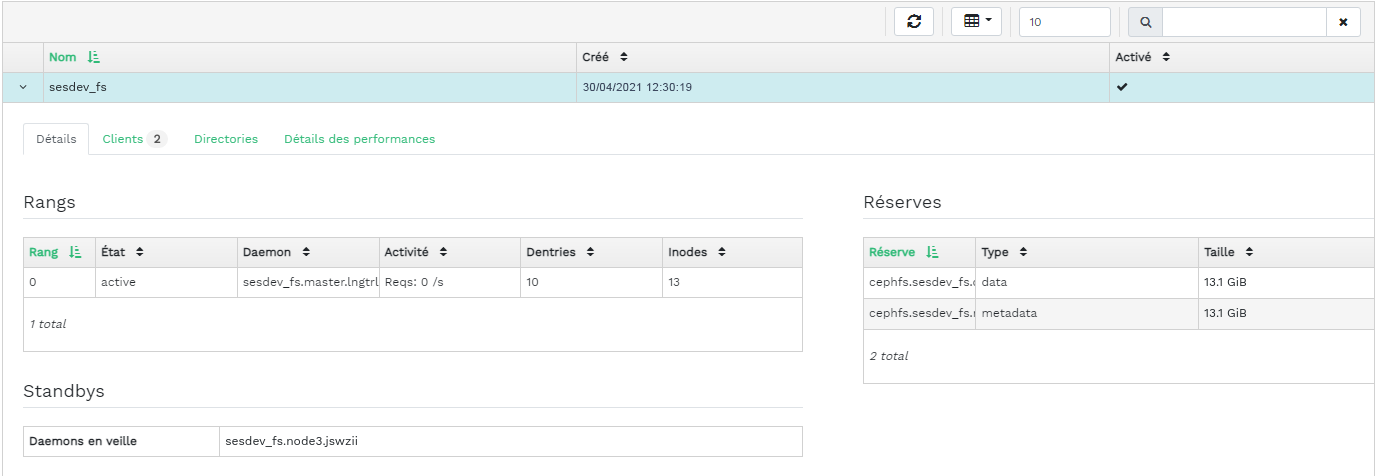

8.1 Affichage de l'aperçu CephFS #

Cliquez sur dans le menu principal pour afficher la vue d'ensemble des systèmes de fichiers configurés. Le tableau principal affiche le nom de chaque système de fichiers, sa date de création et s'il est activé ou non.

Vous pouvez cliquer sur la ligne d'un système de fichiers dans le tableau afin de découvrir des détails sur son rang et sur les réserves ajoutées au système de fichiers.

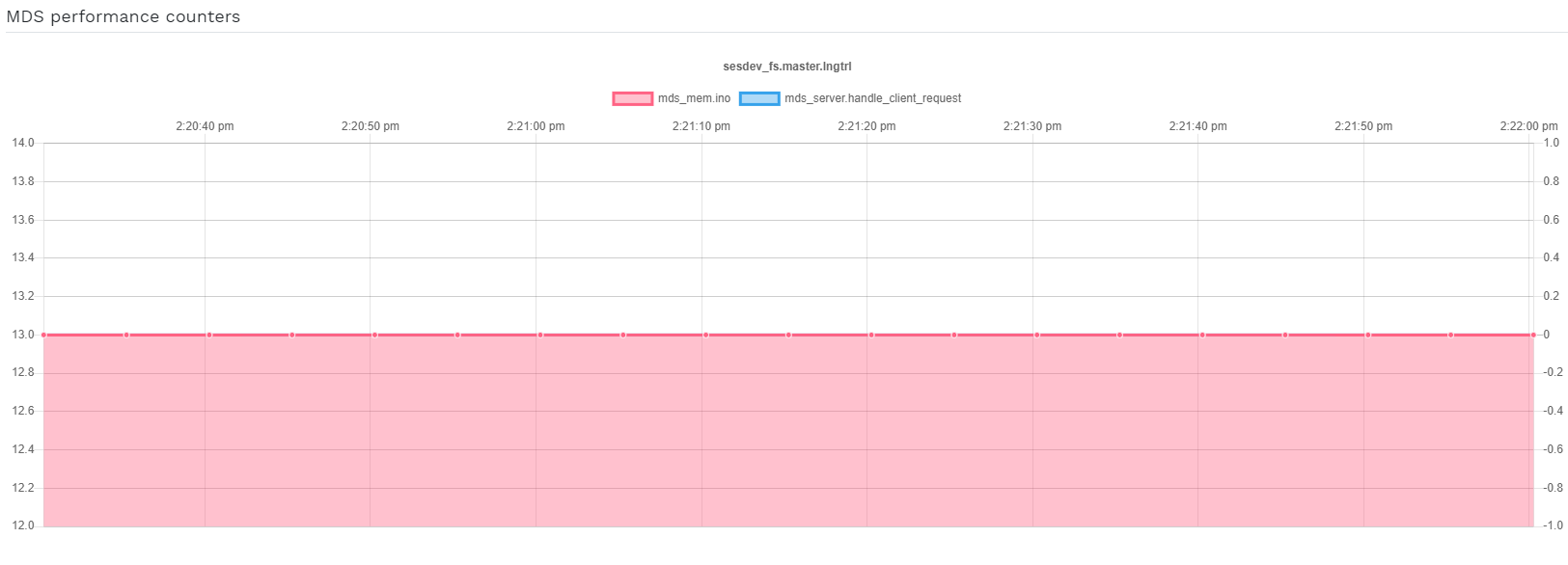

Au bas de l'écran, vous pouvez voir des statistiques comptant le nombre d'inodes MDS connexes et les demandes des clients, recueillies en temps réel.

9 Gestion de la passerelle Object Gateway #

Avant de commencer, il se peut que vous rencontriez la notification suivante lorsque vous tentez d'accéder à l'interface client Object Gateway sur Ceph Dashboard :

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

Cela est dû au fait que la passerelle Object Gateway n'a pas été configurée automatiquement par cephadm pour Ceph Dashboard. Si vous rencontrez cette notification, suivez les instructions de la Section 10.4, « Activation de l'interface client de gestion d'Object Gateway » pour activer manuellement l'interface client Object Gateway pour Ceph Dashboard.

Pour plus d'informations générales sur Object Gateway, reportez-vous au Chapitre 21, Ceph Object Gateway.

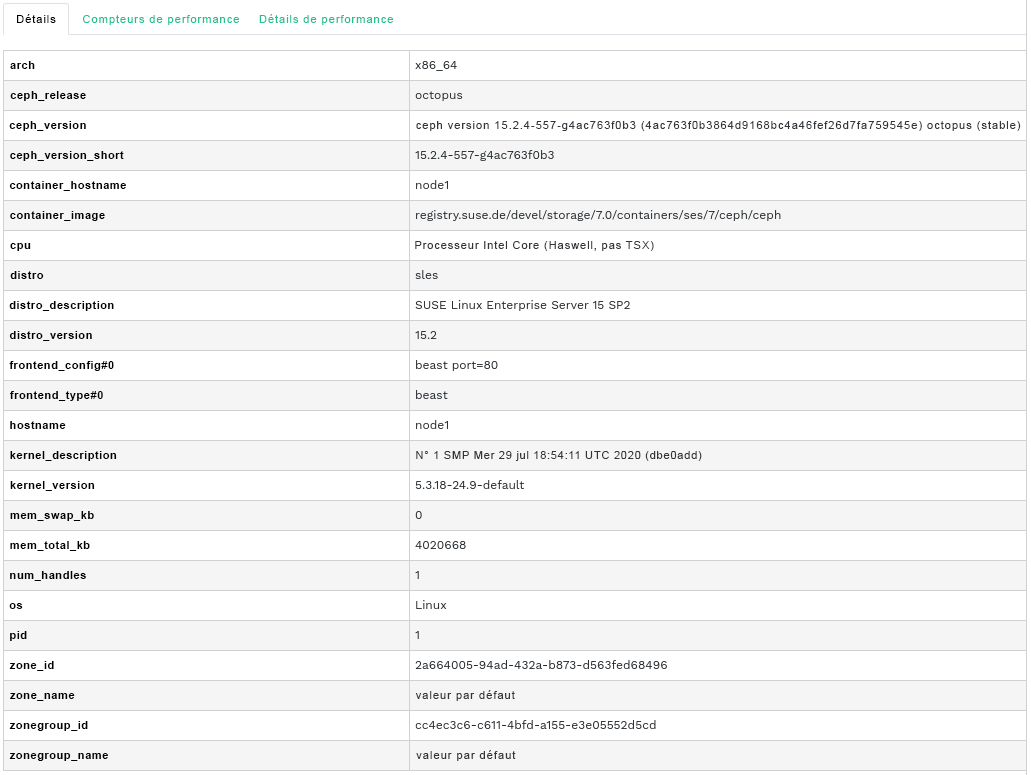

9.1 Affichage des instances Object Gateway #

Pour afficher une liste des passerelles Object Gateway configurées, cliquez sur › . La liste comprend l'ID de la passerelle, le nom de l'hôte du noeud de grappe sur lequel le daemon de la passerelle est en cours d'exécution et le numéro de version de la passerelle.

Cliquez sur la flèche de liste déroulante en regard du nom de la passerelle pour afficher des informations détaillées sur cette dernière. L'onglet affiche les détails des opérations de lecture/d'écriture et les statistiques de cache.

9.2 Gestion des utilisateurs Object Gateway #

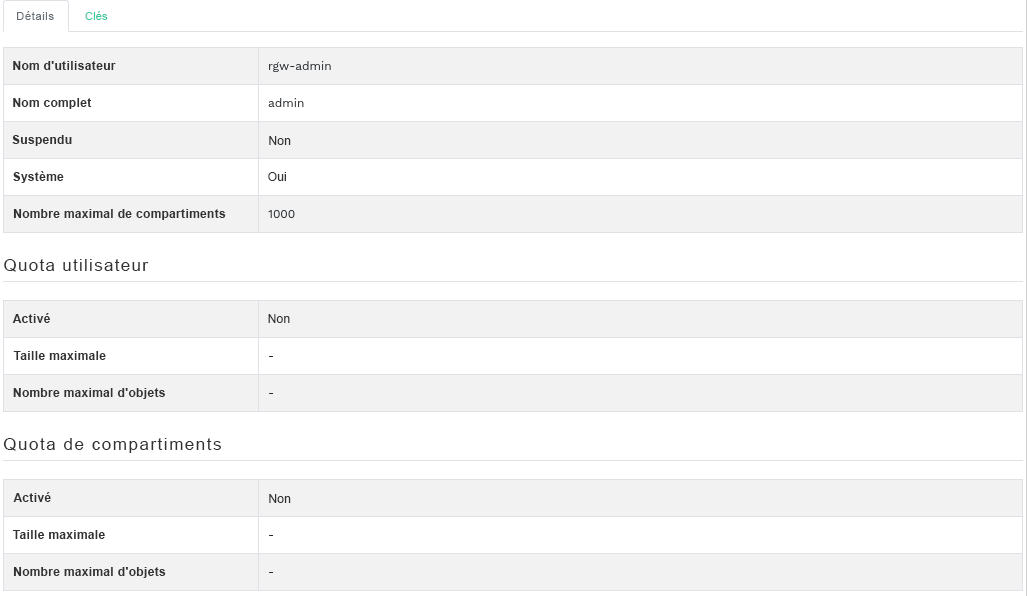

Cliquez sur › pour afficher une liste des utilisateurs Object Gateway existants.

Cliquez sur la flèche de liste déroulante en regard du nom d'utilisateur pour afficher des détails sur le compte utilisateur, tels que les informations de statut ou les détails de quota utilisateur et de compartiments.

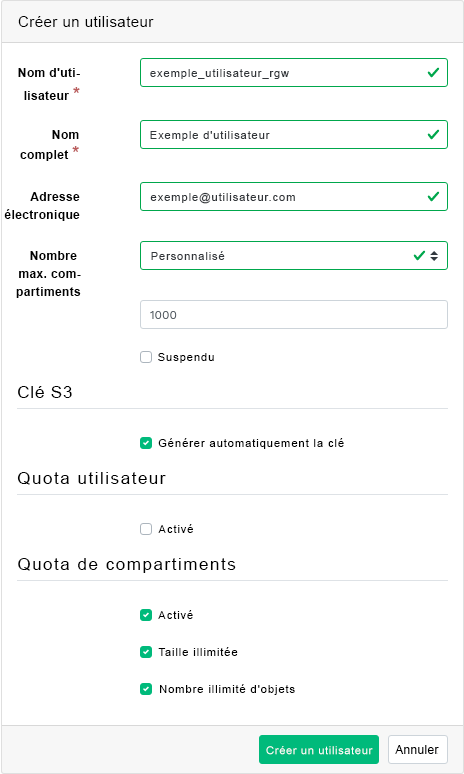

9.2.1 Ajout d'un nouvel utilisateur de la passerelle #

Pour ajouter un nouvel utilisateur de la passerelle, cliquez sur en haut à gauche de l'en-tête du tableau. Remplissez les informations d'identification, les détails sur la clé S3 et les quotas utilisateur et de compartiments, puis confirmez en cliquant sur .

9.2.2 Suppression d'utilisateurs de la passerelle #

Pour supprimer un utilisateur de la passerelle, sélectionnez-le et mettez-le en surbrillance. Cliquez sur le bouton de liste déroulante en regard de et sélectionnez dans la liste pour supprimer le compte utilisateur. Cochez la case et confirmez avec le bouton .

9.2.3 Modification des détails des utilisateurs de la passerelle #

Pour modifier les détails d'un utilisateur de la passerelle, sélectionnez-le et mettez-le en surbrillance. Cliquez sur en haut à gauche de l'en-tête du tableau.

Modifiez les informations utilisateur de base ou supplémentaires, telles que les fonctions, clés, utilisateurs secondaires et les détails de quota. Confirmez en cliquant sur le bouton .

L'onglet comprend une liste en lecture seule des utilisateurs de la passerelle et de leurs clés secrète et d'accès. Pour afficher les clés, cliquez sur un nom d'utilisateur dans la liste, puis sélectionnez en haut à gauche de l'en-tête du tableau. Dans la boîte de dialogue , cliquez sur l'icône en forme d'oeil pour dévoiler les clés, ou cliquez sur l'icône du presse-papiers pour copier la clé associée dans le presse-papiers.

9.3 Gestion des compartiments Object Gateway #

Les compartiments Object Gateway (OGW) implémentent la fonctionnalité des conteneurs OpenStack Swift. Ils servent de conteneurs pour le stockage des objets de données.

Cliquez sur › pour afficher une liste des compartiments Object Gateway.

9.3.1 Ajout d'un nouveau compartiment #

Pour ajouter un nouvel compartiment Object Gateway, cliquez sur en haut à gauche de l'en-tête du tableau. Entrez le nom du compartiment, sélectionnez le propriétaire et définissez la cible de placement. Confirmez en cliquant sur le bouton (Créer un compartiment).

À ce stade, vous pouvez également activer le verrouillage en sélectionnant . Cela peut toutefois être configuré après la création. Pour plus d'informations, reportez-vous à la Section 9.3.3, « Modification du compartiment ».

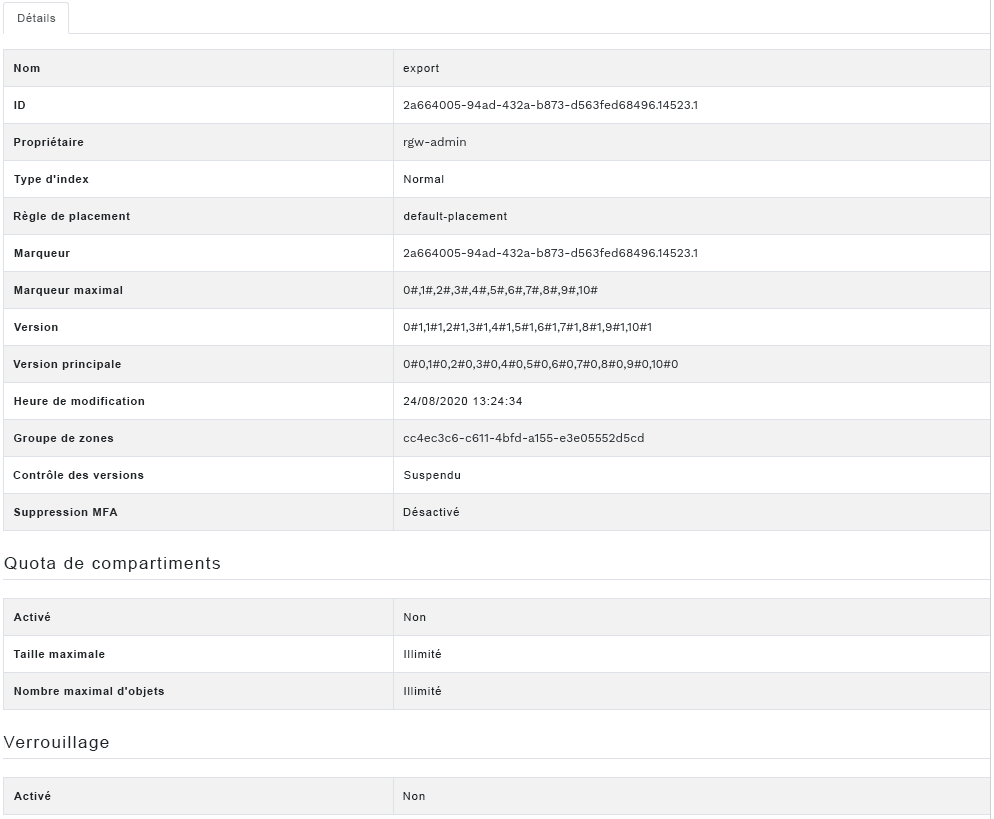

9.3.2 Affichage des détails d'un compartiment #

Pour afficher des informations détaillées sur un compartiment Object Gateway, cliquez sur la flèche de liste déroulante en regard du nom du compartiment.

Sous le tableau , vous pouvez trouver des détails sur les paramètres de quota de compartiments et de verrouillage.

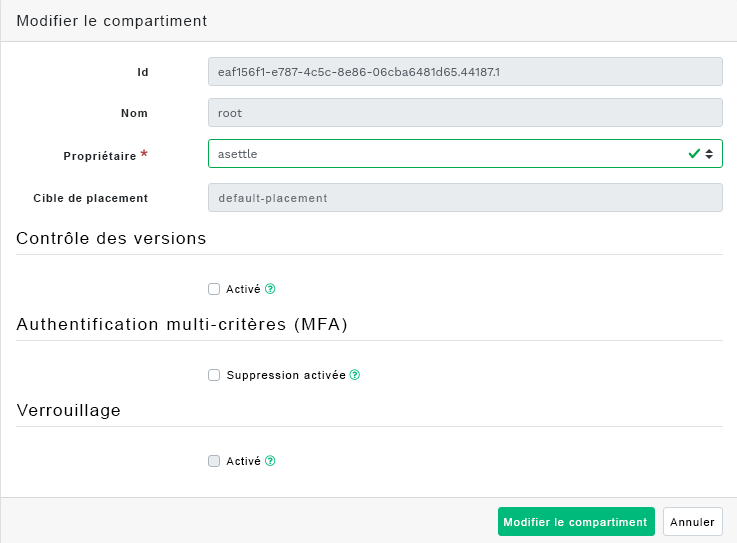

9.3.3 Modification du compartiment #

Sélectionnez et mettez en surbrillance un compartiment, puis cliquez sur en haut à gauche de l'en-tête du tableau.

Vous pouvez mettre à jour le propriétaire du compartiment ou activer le contrôle des versions, l'authentification multi-critères ou le verrouillage. Cliquez sur pour confirmer les modifications.

9.3.4 Suppression d'un compartiment #

Pour supprimer un compartiment Object Gateway, sélectionnez-le et mettez-le en surbrillance. Cliquez sur le bouton de liste déroulante en regard de et sélectionnez dans la liste pour supprimer le compartiment. Cochez la case et confirmez avec le bouton (Supprimer le compartiment).

10 Configuration manuelle #

Cette section présente des informations avancées pour les utilisateurs qui préfèrent configurer manuellement les paramètres du tableau de bord via la ligne de commande.

10.1 Configuration de la prise en charge de TLS/SSL #

Par défaut, toutes les connexions HTTP vers le tableau de bord sont sécurisées via TLS/SSL. Une connexion sécurisée nécessite un certificat SSL. Vous pouvez soit utiliser un certificat auto-signé, soit générer un certificat à faire signer par une autorité de certification bien connue.

Vous pouvez souhaiter désactiver le support SSL pour une raison spécifique, par exemple, si le tableau de bord s'exécute derrière un proxy qui ne prend pas en charge SSL.