- À propos de ce guide

- I Présentation de SUSE Enterprise Storage (SES)

- 1 SES et Ceph

- 2 Configuration matérielle requise et recommandations

- 2.1 Aperçu du réseau

- 2.2 Configurations d'architecture multiples

- 2.3 Configuration du matériel

- 2.4 Noeuds de stockage des objets

- 2.5 Noeuds de moniteur

- 2.6 Noeuds Object Gateway

- 2.7 Noeuds de serveur de métadonnées

- 2.8 Noeud Admin

- 2.9 Noeuds de passerelle iSCSI

- 2.10 SES et autres produits SUSE

- 2.11 Limitations concernant les noms

- 2.12 OSD et Monitor partageant un même serveur

- 3 Configuration haute disponibilité du noeud Admin

- II Déploiement de la grappe Ceph

- III Mise à niveau à partir de versions précédentes

- 10 Mise à niveau de SUSE Enterprise Storage 6 vers la version 7.1

- 10.1 Avant la mise à niveau

- 10.2 Mise à niveau de Salt Master

- 10.3 Mise à niveau des noeuds MON, MGR et OSD

- 10.4 Mise à niveau des noeuds de passerelle

- 10.5 Installation de

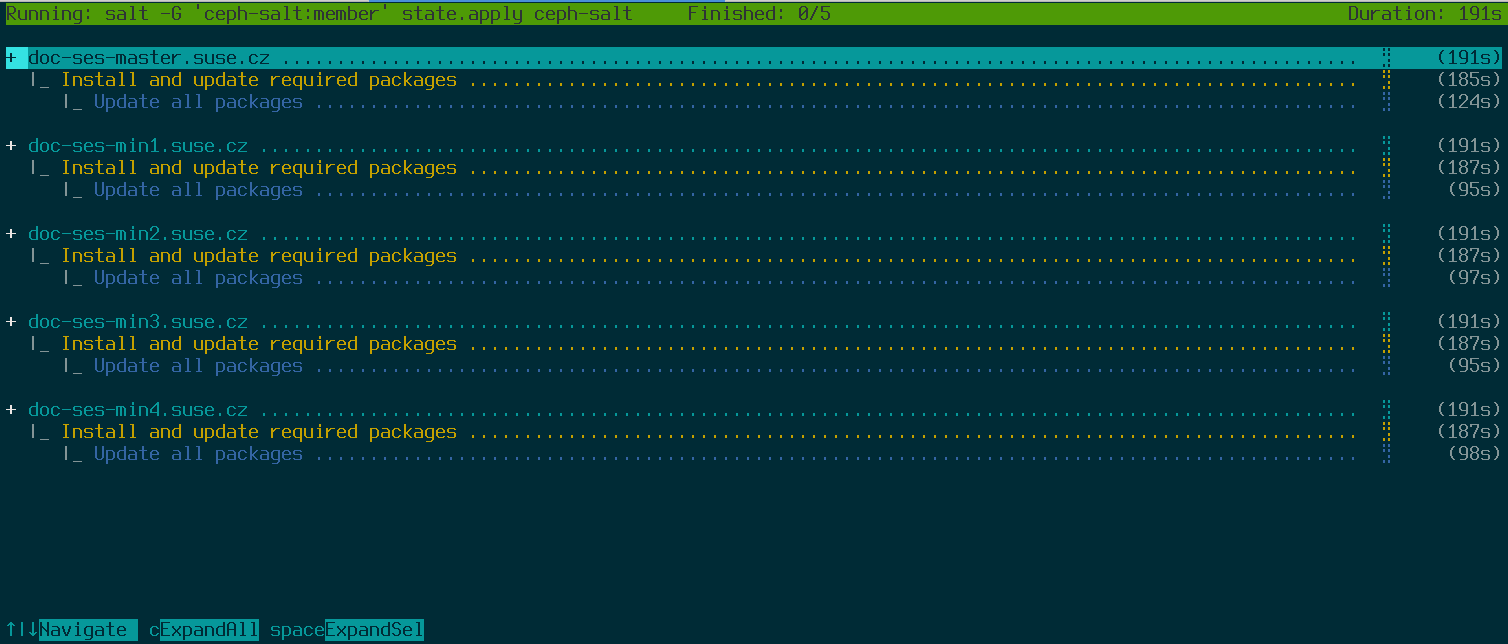

ceph-saltet application de la configuration de la grappe - 10.6 Mise à niveau et adoption de la pile de surveillance

- 10.7 Redéploiement du service de passerelle

- 10.8 Nettoyage après mise à niveau

- 11 Mise à niveau de SUSE Enterprise Storage 7 vers la version 7.1

- 11.1 Avant la mise à niveau

- 11.2 Migration de SUSE Linux Enterprise Server sur chaque noeud de grappe vers la version SUSE Linux Enterprise Server 15 SP3

- 11.3 Mise à jour des paquetages associés à SUSE Enterprise Storage sur chaque noeud de grappe

- 11.4 Mise à niveau des services de grappe Ceph existants

- 10 Mise à niveau de SUSE Enterprise Storage 6 vers la version 7.1

- A Mises à jour de la maintenance de Ceph basées sur les versions intermédiaires de « Pacific » en amont

- Glossaire

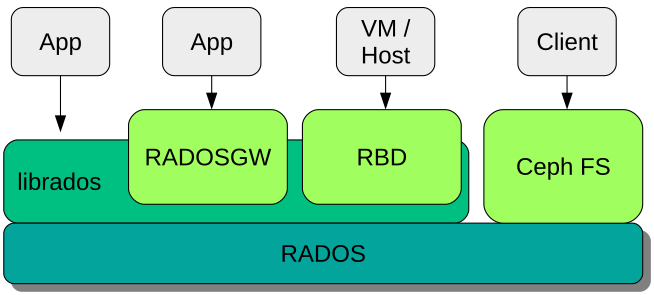

- 1.1 Interfaces avec la zone de stockage des objets Ceph

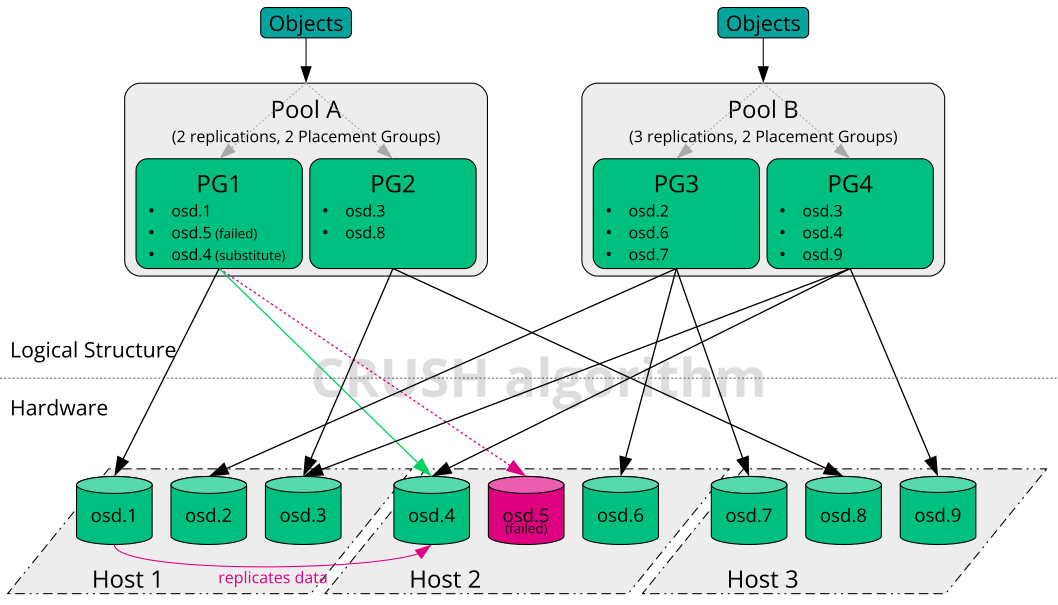

- 1.2 Exemple de Ceph à petite échelle

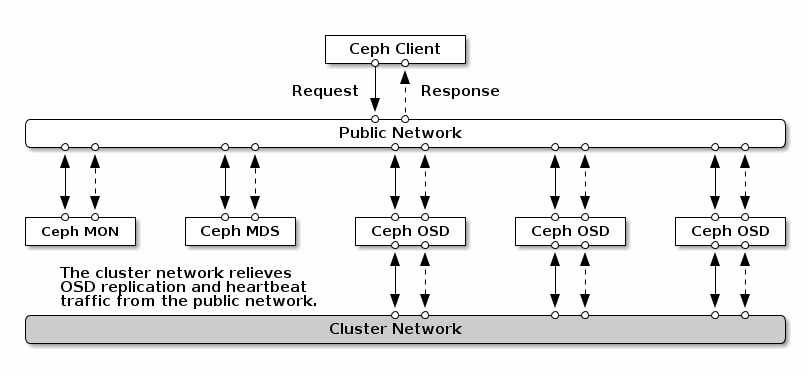

- 2.1 Aperçu du réseau

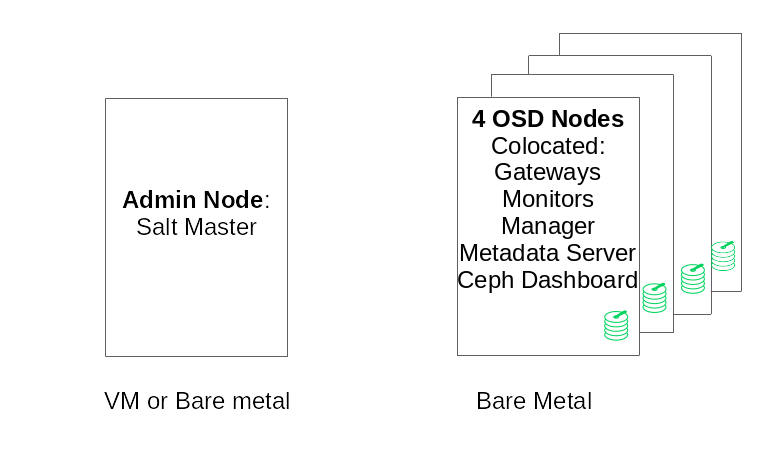

- 2.2 Configuration minimale de la grappe

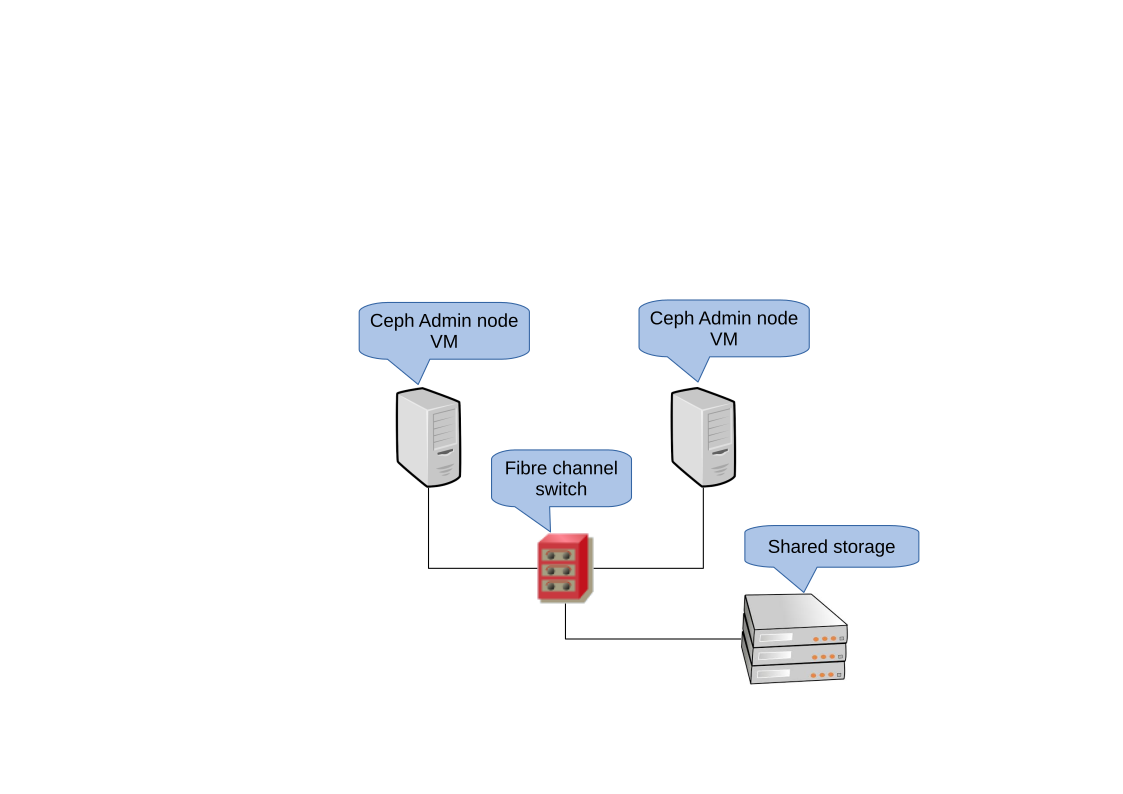

- 3.1 Grappe haute disponibilité à 2 noeuds pour le noeud Admin

- 7.1 Déploiement d'une grappe minimale

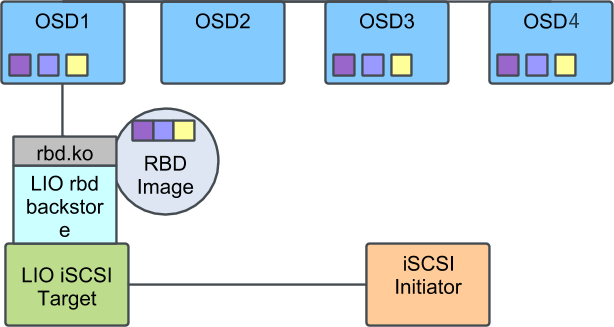

- 9.1 grappe Ceph avec une passerelle iSCSI unique

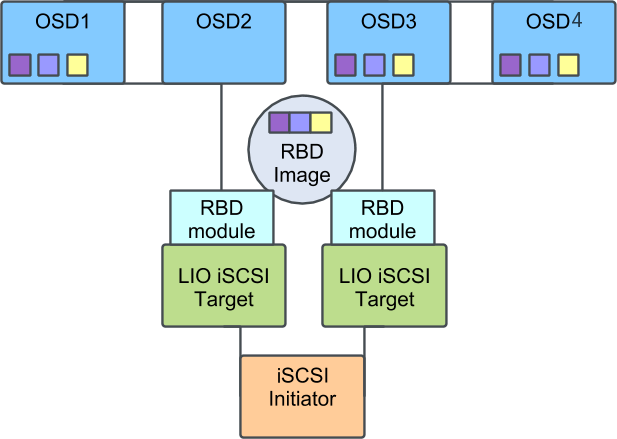

- 9.2 Grappe Ceph avec plusieurs passerelles iSCSI

Copyright © 2020–2025 SUSE LLC et contributeurs. Tous droits réservés.

Sauf indication contraire, ce document est concédé sous licence Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0) : https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Pour les marques commerciales SUSE, consultez le site Web http://www.suse.com/company/legal/. Toutes les marques commerciales de fabricants tiers appartiennent à leur propriétaire respectif. Les symboles de marque commerciale (®, ™, etc.) désignent des marques de SUSE et de ses sociétés affiliées. Des astérisques (*) désignent des marques commerciales de fabricants tiers.

Toutes les informations de cet ouvrage ont été regroupées avec le plus grand soin. Cela ne garantit cependant pas sa complète exactitude. Ni SUSE LLC, ni les sociétés affiliées, ni les auteurs, ni les traducteurs ne peuvent être tenus responsables des erreurs possibles ou des conséquences qu'elles peuvent entraîner.

À propos de ce guide #

Ce guide est axé sur le déploiement d'une grappe Ceph de base et sur la manière de déployer des services supplémentaires. Il couvre également les étapes de mise à niveau vers SUSE Enterprise Storage 7.1 à partir de la version précédente du produit.

SUSE Enterprise Storage 7.1 est une extension de SUSE Linux Enterprise Server 15 SP3. Il réunit les fonctionnalités du projet de stockage Ceph (http://ceph.com/), l'ingénierie d'entreprise et le support de SUSE. SUSE Enterprise Storage 7.1 permet aux organisations informatiques de déployer une architecture de stockage distribuée capable de prendre en charge un certain nombre de cas d'utilisation à l'aide de plates-formes matérielles courantes.

1 Documentation disponible #

La documentation relative à nos produits est disponible à la page https://documentation.suse.com, où vous pouvez également rechercher les dernières mises à jour et parcourir ou télécharger la documentation dans différents formats. Les dernières mises à jour de la documentation sont disponibles dans la version en anglais.

En outre, la documentation sur le produit est disponible dans votre système sous /usr/share/doc/manual. Elle est incluse dans un paquetage RPM nommé ses-manual_LANG_CODE. S'il ne se trouve pas déjà sur votre système, installez-le. Par exemple :

# zypper install ses-manual_enLa documentation suivante est disponible pour ce produit :

- Guide de déploiement

Ce guide est axé sur le déploiement d'une grappe Ceph de base et sur la manière de déployer des services supplémentaires. Il couvre également les étapes de mise à niveau vers SUSE Enterprise Storage 7.1 à partir de la version précédente du produit.

- Guide d'opérations et d'administration

Ce guide est axé sur les tâches de routine que vous devez effectuer en tant qu'administrateur après le déploiement de la grappe Ceph de base (opérations au quotidien). Il décrit également toutes les méthodes prises en charge pour accéder aux données stockées dans une grappe Ceph.

- Guide de renforcement de la sécurité

Ce guide explique comment garantir la sécurité de votre grappe.

- Guide de dépannage

Ce guide passe en revue divers problèmes courants lors de l'exécution de SUSE Enterprise Storage 7.1, ainsi que d'autres problèmes liés aux composants pertinents tels que Ceph ou Object Gateway.

- Guide de SUSE Enterprise Storage pour Windows

Ce guide décrit l'intégration, l'installation et la configuration des environnements Microsoft Windows et de SUSE Enterprise Storage à l'aide du pilote Windows.

2 Commentaires #

Vos commentaires et contributions concernant cette documentation sont les bienvenus. Pour nous en faire part, plusieurs canaux sont à votre disposition :

- Requêtes de service et support

Pour connaître les services et les options de support disponibles pour votre produit, visitez le site http://www.suse.com/support/.

Pour ouvrir une requête de service, vous devez disposer d'un abonnement SUSE enregistré auprès du SUSE Customer Center. Accédez à https://scc.suse.com/support/requests, connectez-vous, puis cliquez sur .

- Signalement d'erreurs

Signalez les problèmes liés à la documentation à l'adresse https://bugzilla.suse.com/. Pour signaler des problèmes, vous avez besoin d'un compte Bugzilla.

Pour simplifier ce processus, vous pouvez utiliser les liens (Signaler une erreur dans la documentation) en regard des titres dans la version HTML de ce document. Ces liens présélectionnent le produit et la catégorie appropriés dans Bugzilla et ajoutent un lien vers la section actuelle. Vous pouvez directement commencer à signaler le bogue.

- Contributions

Pour contribuer à cette documentation, utilisez les liens (Modifier la source), en regard des titres dans la version HTML de ce document. Ils vous permettent d'accéder au code source sur GitHub, où vous pouvez ouvrir une demande d'ajout (Pull request). Pour apporter votre contribution, vous avez besoin d'un compte GitHub.

Pour plus d'informations sur l'environnement de documentation utilisé pour cette documentation, reportez-vous au fichier lisezmoi de l'espace de stockage à l'adresse https://github.com/SUSE/doc-ses.

- Messagerie

Vous pouvez également signaler des erreurs et envoyer vos commentaires concernant la documentation à l'adresse <doc-team@suse.com>. Veillez à inclure le titre du document, la version du produit et la date de publication du document. Mentionnez également le numéro et le titre de la section concernée (ou incluez l'URL), et décrivez brièvement le problème.

3 Conventions relatives à la documentation #

Les conventions typographiques et mentions suivantes sont utilisées dans cette documentation :

/etc/passwd: noms de répertoires et de fichiersMARQUE_RÉSERVATION : l'élément MARQUE_RÉSERVATION doit être remplacé par la valeur réelle

CHEMIN: variable d'environnementls,--help: commandes, options et paramètresuser: nom de l'utilisateur ou du groupepackage_name : nom d'un paquetage logiciel

Alt, Alt–F1 : touche ou combinaison de touches sur lesquelles appuyer. Les touches sont affichées en majuscules comme sur un clavier.

, › : options de menu, boutons

AMD/Intel Ce paragraphe n'est utile que pour les architectures AMD64/Intel 64. Les flèches marquent le début et la fin du bloc de texte.

IBM Z, POWER Ce paragraphe ne s'applique qu'aux architectures

IBM ZetPOWER. Les flèches marquent le début et la fin du bloc de texte.Chapitre 1, “Exemple de chapitre” : renvoi à un autre chapitre de ce guide.

Commandes à exécuter avec les privilèges

root. Souvent, vous pouvez également leur ajouter en préfixe la commandesudopour les exécuter sans privilèges.#command>sudocommandCommandes pouvant être exécutées par des utilisateurs non privilégiés.

>commandAvis

Warning: note d'avertissementInformation essentielle dont vous devez prendre connaissance avant de continuer. Met en garde contre des problèmes de sécurité ou des risques de perte de données, de détérioration matérielle ou de blessure physique.

Important: note importanteInformation importante dont vous devez prendre connaissance avant de continuer.

Note: note de remarqueInformation supplémentaire, par exemple sur les différences dans les versions des logiciels.

Tip: note indiquant une astuceInformation utile, telle qu'un conseil ou un renseignement pratique.

Notes compactes

Information supplémentaire, par exemple sur les différences dans les versions des logiciels.

Information utile, telle qu'un conseil ou un renseignement pratique.

4 Support #

Vous trouverez ci-dessous la déclaration de support pour SUSE Enterprise Storage et des informations générales sur les avant-premières technologiques. Pour plus d'informations sur le cycle de vie du produit, reportez-vous au site https://www.suse.com/lifecycle.

Si vous avez droit au support, vous trouverez des instructions détaillées sur la collecte d'informations pour un ticket de support sur le site https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Déclaration de support pour SUSE Enterprise Storage #

Pour bénéficier d'un support, vous devez disposer d'un abonnement adéquat auprès de SUSE. Pour connaître les offres de support spécifiques auxquelles vous pouvez accéder, rendez-vous sur la page https://www.suse.com/support/ et sélectionnez votre produit.

Les niveaux de support sont définis comme suit :

- N1

Identification du problème : support technique conçu pour fournir des informations de compatibilité, un support pour l'utilisation, une maintenance continue, la collecte d'informations et le dépannage de base à l'aide de la documentation disponible.

- N2

Isolement du problème : support technique conçu pour analyser des données, reproduire des problèmes clients, isoler la zone problématique et fournir une solution aux problèmes qui ne sont pas résolus au niveau 1 ou préparer le niveau 3.

- N3

Résolution des problèmes : support technique conçu pour résoudre les problèmes en impliquant des ingénieurs afin de corriger des défauts produit identifiés par le support de niveau 2.

Pour les clients et partenaires sous contrat, SUSE Enterprise Storage est fourni avec un support de niveau 3 pour tous les paquetages, excepté les suivants :

Avant-premières technologiques.

Son, graphiques, polices et illustrations.

Paquetages nécessitant un contrat de client supplémentaire.

Certains paquetages fournis avec le module Workstation Extension (Extension de poste de travail), qui bénéficient uniquement d'un support de niveau 2

Paquetages dont les noms se terminent par -devel (contenant les fichiers d'en-tête et les ressources développeurs similaires) ne bénéficient d'un support que dans le cadre de leurs paquetages principaux.

SUSE offre un support uniquement pour l'utilisation de paquetages d'origine, autrement dit les paquetages qui ne sont pas modifiés ni recompilés.

4.2 Avant-premières technologiques #

Les avant-premières technologiques sont des paquetages, des piles ou des fonctions fournis par SUSE pour donner un aperçu des innovations à venir. Ces avant-premières technologiques sont fournies pour vous permettre de tester de nouvelles technologies au sein de votre environnement. Tous vos commentaires sont les bienvenus ! Si vous testez une avant-première technologique, veuillez contacter votre représentant SUSE et l'informer de votre expérience et de vos cas d'utilisation. Vos remarques sont utiles pour un développement futur.

Les avant-premières technologiques présentent les limites suivantes :

Les avant-premières technologiques sont toujours en cours de développement. Ainsi, elles peuvent être incomplètes ou instables, ou non adaptées à une utilisation en production.

Les avant-premières technologiques ne bénéficient pas du support technique.

Les avant-premières technologiques peuvent être disponibles uniquement pour des architectures matérielles spécifiques.

Les détails et fonctionnalités des avant-premières technologiques sont susceptibles d'être modifiés. Il en résulte que la mise à niveau vers des versions ultérieures d'une avant-première technologique peut être impossible et nécessiter une nouvelle installation.

SUSE peut découvrir qu'une avant-première ne répond pas aux besoins des clients ou du marché, ou n'est pas conforme aux normes de l'entreprise. Les avant-premières technologiques peuvent être supprimées d'un produit à tout moment. SUSE ne s'engage pas à fournir à l'avenir une version prise en charge de ces technologies.

Pour obtenir un aperçu des avant-premières technologiques fournies avec votre produit, reportez-vous aux notes de version à l'adresse https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Contributeurs Ceph #

Le projet Ceph et sa documentation sont le résultat du travail de centaines de contributeurs et d'organisations. Pour plus d'informations, consultez la page https://ceph.com/contributors/.

6 Commandes et invites de commande utilisées dans ce guide #

En tant qu'administrateur de grappe Ceph, vous configurez et ajustez le comportement de la grappe en exécutant des commandes spécifiques. Il existe plusieurs types de commandes dont vous avez besoin :

6.1 Commandes associées à Salt #

Ces commandes vous aident à déployer des noeuds de grappe Ceph, à exécuter des commandes simultanément sur plusieurs noeuds de la grappe (ou tous), ou à ajouter ou supprimer des noeuds de la grappe. Les commandes les plus fréquemment utilisées sont ceph-salt et ceph-salt config. Vous devez exécuter les commandes Salt sur le noeud Salt Master en tant qu'utilisateur root. Ces commandes sont introduites avec l'invite suivante :

root@master # Par exemple :

root@master # ceph-salt config ls6.2 Commandes associées à Ceph #

Il s'agit de commandes de niveau inférieur permettant de configurer et d'affiner tous les aspects de la grappe et de ses passerelles sur la ligne de commande, par exemple ceph, cephadm, rbd ou radosgw-admin.

Pour exécuter les commandes associées à Ceph, vous devez disposé d'un accès en lecture à une clé Ceph. Les fonctionnalités de la clé définissent alors vos privilèges au sein de l'environnement Ceph. Une option consiste à exécuter les commandes Ceph en tant qu'utilisateur root (ou via sudo) et à employer le trousseau de clés par défaut sans restriction « ceph.client.admin.key ».

L'option plus sûre et recommandée consiste à créer une clé individuelle plus restrictive pour chaque administrateur et à la placer dans un répertoire où les utilisateurs peuvent la lire, par exemple :

~/.ceph/ceph.client.USERNAME.keyring

Pour utiliser un administrateur et un trousseau de clés personnalisés, vous devez spécifier le nom d'utilisateur et le chemin d'accès à la clé chaque fois que vous exécutez la commande ceph à l'aide des options -n client.NOM_UTILISATEUR et --keyring CHEMIN/VERS/TROUSSEAU.

Pour éviter cela, incluez ces options dans la variable CEPH_ARGS des fichiers ~/.bashrc des différents utilisateurs.

Bien que vous puissiez exécuter les commandes associées à Ceph sur n'importe quel noeud de la grappe, nous vous recommandons de les lancer sur le noeud Admin. Dans cette documentation, nous employons l'utilisateur cephuser pour exécuter les commandes. Elles sont donc introduites avec l'invite suivante :

cephuser@adm > Par exemple :

cephuser@adm > ceph auth listSi la documentation vous demande d'exécuter une commande sur un noeud de la grappe avec un rôle spécifique, cela sera réglé par l'invite. Par exemple :

cephuser@mon > 6.2.1 Exécution de ceph-volume #

À partir de SUSE Enterprise Storage 7, les services Ceph s'exécutent de manière conteneurisée. Si vous devez exécuter ceph-volume sur un noeud OSD, vous devez l'ajouter au début de la commande cephadm, par exemple :

cephuser@adm > cephadm ceph-volume simple scan6.3 Commandes Linux générales #

Les commandes Linux non associées à Ceph, telles que mount, cat ou openssl, sont introduites avec les invites cephuser@adm > ou #, selon les privilèges que la commande concernée nécessite.

6.4 Informations supplémentaires #

Pour plus d'informations sur la gestion des clés Ceph, reportez-vous à la Book “Guide d'opérations et d'administration”, Chapter 30 “Authentification avec cephx”, Section 30.2 “Les zones de gestion principales”.

Partie I Présentation de SUSE Enterprise Storage (SES) #

- 1 SES et Ceph

SUSE Enterprise Storage (SES) est un système de stockage distribué conçu pour l'évolutivité, la fiabilité et les performances, et basé sur la technologie Ceph. Une grappe Ceph peut être exécutée sur des serveurs courants dans un réseau standard comme Ethernet. La grappe évolue facilement vers des mi…

- 2 Configuration matérielle requise et recommandations

La configuration matérielle requise de Ceph dépend fortement du workload des E/S. La configuration matérielle requise et les recommandations suivantes doivent être considérées comme un point de départ de la planification détaillée.

- 3 Configuration haute disponibilité du noeud Admin

Le noeud Admin est un noeud de la grappe Ceph sur lequel le service Salt Master s'exécute. Il gère le reste des noeuds de la grappe en interrogeant et en indiquant leurs services de minion Salt. En général, il inclut également d'autres services, par exemple, le tableau de bord Grafana soutenu par le…

1 SES et Ceph #

SUSE Enterprise Storage (SES) est un système de stockage distribué conçu pour l'évolutivité, la fiabilité et les performances, et basé sur la technologie Ceph. Une grappe Ceph peut être exécutée sur des serveurs courants dans un réseau standard comme Ethernet. La grappe évolue facilement vers des milliers de serveurs (appelés plus tard noeuds) et dans la plage de pétaoctets. Contrairement aux systèmes conventionnels qui possèdent des tables d'allocation pour stocker et récupérer des données, Ceph utilise un algorithme déterministe pour allouer du stockage des données et ne dispose d'aucune structure centralisée des informations. Ceph suppose que, dans les grappes de stockage, l'ajout ou la suppression de matériel est la règle, et non l'exception. La grappe Ceph automatise les tâches de gestion telles que la distribution et la redistribution des données, la réplication des données, la détection des échecs et la récupération. Ceph peut à la fois s'autoréparer et s'autogérer, ce qui se traduit par une réduction des frais administratifs et budgétaires.

Ce chapitre fournit un aperçu global de SUSE Enterprise Storage 7.1 et décrit brièvement les éléments les plus importants.

1.1 Fonctions de Ceph #

L'environnement Ceph possède les fonctions suivantes :

- Évolutivité

Ceph peut s'adapter à des milliers de noeuds et gérer le stockage dans la plage de pétaoctets.

- Matériel courant

Aucun matériel spécial n'est requis pour exécuter une grappe Ceph. Pour plus de détails, reportez-vous au Chapitre 2, Configuration matérielle requise et recommandations

- Autogestion

La grappe Ceph est autogérée. Lorsque des noeuds sont ajoutés ou supprimés ou échouent, la grappe redistribue automatiquement les données. Elle a également connaissance des disques surchargés.

- Aucun point d'échec unique

Aucun noeud d'une grappe ne stocke les informations importantes de manière isolée. Vous pouvez configurer le nombre de redondances.

- Logiciels Open Source

Ceph est une solution logicielle Open Source et indépendante du matériel ou de fournisseurs spécifiques.

1.2 Composants de base de Ceph #

Pour tirer pleinement parti de la puissance de Ceph, il est nécessaire de comprendre certains des composants et concepts de base. Cette section présente certaines parties de Ceph qui sont souvent référencées dans d'autres chapitres.

1.2.1 RADOS #

Le composant de base de Ceph est appelé RADOS (Reliable Autonomic Distributed Object Store) (Zone de stockage des objets distribués autonome fiable). Il est chargé de gérer les données stockées dans la grappe. Les données de Ceph sont généralement stockées en tant qu'objets. Chaque objet se compose d'un identificateur et des données.

RADOS fournit les méthodes d'accès suivantes aux objets stockés qui couvrent de nombreux cas d'utilisation :

- Object Gateway

Object Gateway est une passerelle HTTP REST pour la zone de stockage des objets RADOS. Elle permet un accès direct aux objets stockés dans la grappe Ceph.

- Périphérique de bloc RADOS

Les périphériques de bloc RADOS (RADOS Block Devices, RBD) sont accessibles comme n'importe quel autre périphérique de bloc. Ils peuvent être utilisés, par exemple, en combinaison avec

libvirtà des fins de virtualisation.- CephFS

Le système de fichiers Ceph est un système de fichiers compatible POSIX.

libradoslibradosest une bibliothèque pouvant être utilisée avec de nombreux langages de programmation pour créer une application capable d'interagir directement avec la grappe de stockage.

librados est utilisé par Object Gateway et les RBD alors que CephFS s'interface directement avec RADOS (Figure 1.1, « Interfaces avec la zone de stockage des objets Ceph »).

1.2.2 CRUSH #

Au coeur d'une grappe Ceph se trouve l'algorithme CRUSH. CRUSH est l'acronyme de Controlled Replication Under Scalable Hashing (Réplication contrôlée sous hachage évolutif). CRUSH est une fonction qui gère l'allocation de stockage et nécessite relativement peu de paramètres. Cela signifie que seule une petite quantité d'informations est nécessaire pour calculer la position de stockage d'un objet. Les paramètres sont une carte actuelle de la grappe, comprenant l'état de santé, certaines règles de placement définies par l'administrateur et le nom de l'objet qui doit être stocké ou récupéré. Avec ces informations, tous les noeuds de la grappe Ceph sont en mesure de calculer l'emplacement auquel un objet et ses répliques sont stockés. Cela rend l'écriture ou la lecture des données très efficace. CRUSH tente de distribuer équitablement les données sur tous les noeuds de la grappe.

La carte CRUSH contient tous les noeuds de stockage et les règles de placement définies par l'administrateur pour le stockage des objets dans la grappe. Elle définit une structure hiérarchique qui correspond généralement à la structure physique de la grappe. Par exemple, les disques contenant des données sont dans des hôtes, les hôtes sont dans des racks, les racks dans des rangées et les rangées dans des centres de données. Cette structure peut être utilisée pour définir des domaines de défaillance. Ceph s'assure ensuite que les réplications sont stockées sur différentes branches d'un domaine de défaillance spécifique.

Si le domaine de défaillance est défini sur le niveau rack, les réplications d'objets sont réparties sur différents racks. Cela peut limiter les interruptions de service provoquées par un commutateur défaillant sur un rack. Si une unité de distribution de l'alimentation dessert une rangée de racks, le domaine de défaillance peut être défini sur rangée. En cas de défaillance de l'unité de distribution de l'alimentation, les données répliquées sont toujours disponibles sur les autres rangées.

1.2.3 Noeuds et daemons Ceph #

Dans Ceph, les noeuds sont des serveurs fonctionnant pour la grappe. Ils peuvent exécuter divers types de daemons. Nous recommandons de n'exécuter qu'un seul type de daemon sur chaque noeud, à l'exception des daemons Ceph Manager qui peuvent se trouver au même emplacement que ceux de Ceph Monitor. Chaque grappe nécessite au moins des daemons Ceph Monitor, Ceph Manager, et Ceph OSD :

- Noeud Admin

Le noeud Admin est un noeud de grappe Ceph à partir duquel vous exécutez des commandes pour gérer la grappe. Le noeud Admin est un point central de la grappe Ceph, car il gère les autres noeuds de la grappe en interrogeant et en instruisant leurs services de Minion Salt.

- Ceph Monitor

Les noeuds Ceph Monitor (souvent abrégés en MON) gèrent des informations sur l'état de santé de la grappe, une carte de tous les noeuds et des règles de distribution des données (reportez-vous à la Section 1.2.2, « CRUSH »).

En cas de défaillance ou de conflit, les noeuds Ceph Monitor de la grappe décident, à la majorité, des informations qui sont correctes. Pour former une majorité admissible, il est recommandé de disposer d'un nombre impair de noeuds Ceph Monitor et au minimum de trois d'entre eux.

Si plusieurs sites sont utilisés, les noeuds Ceph Monitor doivent être distribués sur un nombre impair de sites. Le nombre de noeuds Ceph Monitor par site doit être tel que plus de 50 % des noeuds Ceph Monitor restent fonctionnels en cas de défaillance d'un site.

- Ceph Manager

Ceph Manager collecte les informations d'état de l'ensemble de la grappe. Le daemon Ceph Manager s'exécute parallèlement aux daemons Ceph Monitor. Il fournit une surveillance supplémentaire et assure l'interface avec les systèmes de surveillance et de gestion externes. Il comprend également d'autres services. Par exemple, l'interface utilisateur Web de Ceph Dashboard s'exécute sur le même noeud que Ceph Manager.

Ceph Manager ne requiert aucune configuration supplémentaire : il suffit de s'assurer qu'il s'exécute.

- Ceph OSD

Ceph OSD est un daemon qui gère des périphériques de stockage d'objets (Object Storage Devices, OSD) qui sont des unités de stockage physiques ou logiques (disques durs ou partitions). Les périphériques de stockage d'objets peuvent être des disques/partitions physiques ou des volumes logiques. Le daemon prend également en charge la réplication et le rééquilibrage des données en cas d'ajout ou de suppression de noeuds.

Les daemons Ceph OSD communiquent avec les daemons Ceph Monitor et leur fournissent l'état des autres daemons OSD.

Pour utiliser CephFS, Object Gateway, NFS Ganesha ou la passerelle iSCSI, des noeuds supplémentaires sont requis :

- Serveur de métadonnées (MDS)

Les métadonnées CephFS sont stockées dans sa propre réserve RADOS (voir Section 1.3.1, « Réserves »). Les serveurs de métadonnées agissent comme une couche de mise en cache intelligente pour les métadonnées et sérialisent l'accès en cas de besoin. Cela permet un accès simultané à partir de nombreux clients sans synchronisation explicite.

- Object Gateway

Object Gateway est une passerelle HTTP REST pour la zone de stockage des objets RADOS. Elle est compatible avec OpenStack Swift et Amazon S3, et possède sa propre gestion des utilisateurs.

- NFS Ganesha

NFS Ganesha fournit un accès NFS à Object Gateway ou à CephFS. NFS Ganesha s'exécute dans l'espace utilisateur au lieu de l'espace kernel, et interagit directement avec Object Gateway ou CephFS.

- Passerelle iSCSI

iSCSI est un protocole de réseau de stockage qui permet aux clients d'envoyer des commandes SCSI à des périphériques de stockage SCSI (cibles) sur des serveurs distants.

- Passerelle Samba

La passerelle Samba offre un accès Samba aux données stockées sur CephFS.

1.3 Structure de stockage Ceph #

1.3.1 Réserves #

Les objets qui sont stockés dans une grappe Ceph sont placés dans des réserves. Les réserves représentent les partitions logiques de la grappe vers le monde extérieur. Pour chaque réserve, un ensemble de règles peut être défini, par exemple, combien de réplications de chaque objet doivent exister. La configuration standard des réserves est appelée réserve répliquée.

Les réserves contiennent généralement des objets, mais peuvent également être configurées pour agir de la même manière qu'un RAID 5. Dans cette configuration, les objets sont stockés sous forme de tranches avec d'autres tranches de codage. Les tranches de codage contiennent les informations redondantes. Le nombre de données et les tranches de codage peuvent être définis par l'administrateur. Dans cette configuration, les réserves sont appelées réserves codées à effacement ou réserves EC.

1.3.2 Groupes de placement #

Les groupes de placement (PG) sont utilisés pour la distribution des données au sein d'une réserve. Lorsque vous créez une réserve, un certain nombre de groupes de placement sont définis. Les groupes de placement sont utilisés en interne pour grouper des objets et sont un facteur important en termes de performances d'une grappe Ceph. Le groupe de placement d'un objet est déterminé par le nom de l'objet.

1.3.3 Exemple #

Cette section fournit un exemple simplifié de la façon dont Ceph gère les données (reportez-vous à la Figure 1.2, « Exemple de Ceph à petite échelle »). Cet exemple ne représente pas une configuration recommandée pour une grappe Ceph. La configuration matérielle comprend trois noeuds de stockage ou noeuds Ceph OSD (Hôte 1, Hôte 2, Hôte 3). Chaque noeud comporte trois disques durs qui sont utilisés comme OSD (osd.1 à osd.9). Les noeuds Ceph Monitor sont ignorés dans cet exemple.

Alors que Ceph OSD ou daemon Ceph OSD fait référence à un daemon exécuté sur un noeud, le terme OSD fait référence au disque logique avec lequel le daemon interagit.

La grappe comporte deux réserves, Réserve A et Réserve B. Alors que Réserve A ne réplique les objets que deux fois, la résilience pour Réserve B est plus importante et comporte trois réplications pour chaque objet.

Lorsqu'une application place un objet dans une réserve, par exemple via l'API REST, un groupe de placement (PG1 à PG4) est sélectionné en fonction de la réserve et du nom de l'objet. L'algorithme CRUSH calcule ensuite les OSD sur lesquels l'objet est stocké, en fonction du groupe de placement qui contient l'objet.

Dans cet exemple, le domaine de défaillance est défini sur le niveau hôte. Cela garantit que les réplications d'objets sont stockées sur des hôtes différents. En fonction du niveau de réplication défini pour une réserve, l'objet est stocké sur deux ou trois OSD utilisés par le groupe de placement.

Une application qui écrit un objet interagit uniquement avec un Ceph OSD, le Ceph OSD primaire. Le Ceph OSD primaire se charge de la réplication et confirme l'achèvement du processus d'écriture une fois que tous les autres OSD ont stocké l'objet.

Si osd.5 échoue, tous les objets du PG1 sont toujours disponibles sur osd.1. Dès que la grappe identifie un échec d'OSD, un autre OSD prend le relais. Dans cet exemple osd.4 est utilisé en remplacement d'osd.5. Les objets stockés sur osd.1 sont ensuite répliqués sur osd.4 pour restaurer le niveau de la réplication.

Si un nouveau noeud avec de nouveaux OSD est ajouté à la grappe, la carte de la grappe va changer. La fonction CRUSH renvoie alors des emplacements différents pour les objets. Les objets qui reçoivent de nouveaux emplacements seront déplacés. Ce processus aboutit à une utilisation équilibrée de tous les OSD.

1.4 BlueStore #

BlueStore est une nouvelle interface dorsale de stockage par défaut pour Ceph depuis la version 5 de SES. Il offre de meilleures performances que FileStore, une somme de contrôle de données complète et une compression intégrée.

BlueStore gère un, deux ou trois périphériques de stockage. Dans le cas le plus simple, BlueStore utilise un seul périphérique de stockage primaire. Le périphérique de stockage est normalement partitionné en deux parties :

Une petite partition nommée BlueFS qui met en oeuvre des fonctionnalités de type système de fichiers requises par RocksDB.

Le reste du périphérique est généralement une grande partition occupant le reste du périphérique. Il est géré directement par BlueStore et contient toutes les données réelles. Ce périphérique primaire est normalement identifié par un lien symbolique de bloc dans le répertoire de données.

Il est également possible de déployer BlueStore sur deux périphériques supplémentaires :

Un périphérique WAL peut être utilisé pour le journal interne ou le journal d'écriture anticipée de BlueStore. Il est identifié par le lien symbolique block.wal dans le répertoire de données. Il n'est utile d'utiliser un périphérique WAL distinct que si le périphérique est plus rapide que le périphérique primaire ou le périphérique DB, par exemple dans les cas suivants :

Le périphérique WAL est une interface NVMe, le périphérique DB est un disque SSD et le périphérique de données est un disque SSD ou un disque HDD.

Les périphériques WAL et DB sont des disques SSD distincts et le périphérique de données est un disque SSD ou un disque HDD.

Un périphérique DB peut être utilisé pour stocker les métadonnées internes de BlueStore. BlueStore (ou plutôt, la base de données RocksDB intégrée) mettra autant de métadonnées que possible sur le périphérique DB pour améliorer les performances. Encore une fois, il n'est utile de déployer un périphérique DB partagé que s'il est plus rapide que le périphérique primaire.

Planifiez minutieusement la taille du périphérique DB pour qu'elle soit suffisante. Si le périphérique DB sature, les métadonnées débordent sur le périphérique primaire, ce qui dégrade considérablement les performances de l'OSD.

Vous pouvez vérifier si une partition WAL/DB est pleine et déborde avec la commande ceph daemon osd.ID perf dump. La valeur slow_used_bytes indique la quantité de données qui déborde :

cephuser@adm > ceph daemon osd.ID perf dump | jq '.bluefs'

"db_total_bytes": 1073741824,

"db_used_bytes": 33554432,

"wal_total_bytes": 0,

"wal_used_bytes": 0,

"slow_total_bytes": 554432,

"slow_used_bytes": 554432,1.5 Informations supplémentaires #

Ceph, en tant que projet communautaire, dispose de sa propre documentation en ligne. Pour les rubriques non trouvées dans ce manuel, reportez-vous au site https://docs.ceph.com/en/pacific/.

La publication d'origine CRUSH: Controlled, Scalable, Decentralized Placement of Replicated Data (CRUSH : placement contrôlé, évolutif et décentralisé des données répliquées) par S.A. Weil, S.A. Brandt, E.L. Miller, C. Maltzahn fournit des informations utiles sur le fonctionnement interne de Ceph. Il est surtout recommandé de le lire lors du déploiement de grappes à grande échelle. La publication peut être consultée à l'adresse http://www.ssrc.ucsc.edu/papers/weil-sc06.pdf.

SUSE Enterprise Storage peut être utilisé avec des distributions non-SUSE OpenStack. Les clients Ceph doivent être à un niveau compatible avec SUSE Enterprise Storage.

RemarqueSUSE prend en charge le composant serveur du déploiement Ceph et le client est pris en charge par le fournisseur de la distribution OpenStack.

2 Configuration matérielle requise et recommandations #

La configuration matérielle requise de Ceph dépend fortement du workload des E/S. La configuration matérielle requise et les recommandations suivantes doivent être considérées comme un point de départ de la planification détaillée.

En général, les recommandations données dans cette section dépendent du processus. Si plusieurs processus sont situés sur la même machine, les besoins en UC, RAM, disque et réseau doivent être additionnés.

2.1 Aperçu du réseau #

Ceph compte plusieurs réseaux logiques :

Un réseau d'interface client appelé

réseau public.Un réseau interne approuvé, le réseau back-end, appelé

réseau de grappes. Cette option est facultative.Un ou plusieurs réseaux client pour les passerelles. Ceci est facultatif et sort du cadre de ce chapitre.

Le réseau public est le réseau sur lequel les daemons Ceph communiquent entre eux et avec leurs clients. Cela signifie que tout le trafic de la grappe Ceph passe par ce réseau, sauf dans le cas où un réseau de grappe est configuré.

Le réseau de grappe est le réseau back-end entre les noeuds OSD, pour la réplication, le rééquilibrage et la récupération. Lorsqu'il est configuré, ce réseau facultatif devrait idéalement fournir deux fois la bande passante du réseau public avec la réplication tripartite par défaut, étant donné que l'OSD primaire envoie deux copies aux autres OSD par le biais de ce réseau. Le réseau public est situé entre les clients et les passerelles d'un côté pour communiquer avec les moniteurs, les gestionnaires ainsi qu'avec les noeuds MDS et OSD. Il est également utilisé par les moniteurs, les gestionnaires et les noeuds MDS pour communiquer avec les noeuds OSD.

2.1.1 Recommandations concernant le réseau #

Nous vous recommandons d'utiliser un seul réseau tolérant aux pannes avec une bande passante suffisante pour répondre à vos besoins. Pour l'environnement de réseau public Ceph, nous recommandons deux interfaces réseau 25 GbE (ou plus rapides) liées à l'aide de 802.3ad (LACP). Cette recommandation est considérée comme la configuration minimale pour Ceph. Si vous utilisez également un réseau en grappe, nous recommandons quatre interfaces réseau 25 GbE liées. La liaison de deux ou plusieurs interfaces réseau offre un meilleur débit grâce à l'agrégation de liens et, compte tenu des liens et commutateurs redondants, une meilleure tolérance aux pannes et une meilleure maintenabilité.

Vous pouvez également créer des VLAN pour isoler différents types de trafic sur une liaison. Par exemple, vous pouvez créer une liaison pour fournir deux interfaces VLAN, l'une pour le réseau public et l'autre pour le réseau en grappe. Ce n'est toutefois pas nécessaire lors de la configuration du réseau Ceph. Vous trouverez des détails sur la liaison des interfaces sur le site https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-network.html#sec-network-iface-bonding.

La tolérance aux pannes peut être améliorée en isolant les composants dans des domaines de défaillance. Pour améliorer la tolérance aux pannes du réseau, la liaison d'une interface à partir de deux cartes d'interface réseau (NIC) distinctes offre une protection contre la défaillance d'une seule carte réseau. De même, la création d'une liaison entre deux commutateurs protège contre la défaillance d'un commutateur. Nous vous recommandons de vous adresser au fournisseur de l'équipement réseau afin de définir le niveau de tolérance aux pannes requis.

La configuration réseau d'administration supplémentaire (qui permet, par exemple, de séparer les réseaux SSH, Salt ou DNS) n'est ni testée ni prise en charge.

Si les noeuds de stockage sont configurés via DHCP, les timeouts par défaut peuvent ne pas être suffisants pour que le réseau soit configuré correctement avant le démarrage des différents daemons Ceph. Si cela se produit, les instances MON et OSD de Ceph ne démarreront pas correctement (l'exécution de systemctl status ceph\* entraînera des erreurs de type « unable to bind » [liaison impossible]). Pour éviter ce problème, nous vous recommandons d'augmenter le timeout du client DHCP sur au moins 30 secondes pour chaque noeud de votre grappe de stockage. Pour ce faire, vous pouvez modifier les paramètres suivants sur chaque noeud :

Dans /etc/sysconfig/network/dhcp, définissez

DHCLIENT_WAIT_AT_BOOT="30"

Dans /etc/sysconfig/network/config, définissez

WAIT_FOR_INTERFACES="60"

2.1.1.1 Ajout d'un réseau privé à une grappe en cours d'exécution #

Si vous ne spécifiez pas de réseau pour la grappe lors du déploiement de Ceph, il suppose un environnement de réseau public unique. Bien que Ceph fonctionne parfaitement avec un réseau public, ses performances et sa sécurité s'améliorent lorsque vous définissez un second réseau de grappe privé. Pour prendre en charge deux réseaux, chaque noeud Ceph doit disposer d'au moins deux cartes réseau.

Vous devez apporter les modifications suivantes à chaque noeud Ceph. Ces modifications sont relativement rapides à apporter à une petite grappe, mais peuvent prendre beaucoup de temps si votre grappe est composée de centaines ou de milliers de noeuds.

Définissez le réseau de la grappe à l'aide de la commande suivante :

#ceph config set global cluster_network MY_NETWORKRedémarrez les OSD pour qu'ils se lient au réseau de grappe spécifié :

#systemctl restart ceph-*@osd.*.serviceVérifiez que le réseau privé de la grappe fonctionne comme prévu au niveau du système d'exploitation.

2.1.1.2 Noeuds de moniteur sur des sous-réseaux distincts #

Si les noeuds de moniteur se trouvent sur plusieurs sous-réseaux, par exemple s'ils se trouvent dans des pièces différentes et sont desservis par différents commutateurs, vous devez spécifier leur adresse de réseau public en notation CIDR :

cephuser@adm > ceph config set mon public_network "MON_NETWORK_1, MON_NETWORK_2, MON_NETWORK_NPar exemple :

cephuser@adm > ceph config set mon public_network "192.168.1.0/24, 10.10.0.0/16"Si vous spécifiez plusieurs segments de réseau pour le réseau public (ou en grappe) comme décrit dans cette section, chacun de ces sous-réseaux doit pouvoir être routé vers tous les autres. Dans le cas contraire, les daemons MON et les autres daemons Ceph sur différents segments de réseau ne peuvent pas communiquer et il en résulte une grappe divisée. De plus, si vous utilisez un pare-feu, veillez à inclure chaque sous-réseau ou adresse IP dans vos iptables et ouvrez leur les ports nécessaires sur tous les noeuds.

2.2 Configurations d'architecture multiples #

SUSE Enterprise Storage prend en charge les architectures x86 et Arm. Si nous considérons chaque architecture, il est important de noter que d'un point de vue du nombre de coeurs par OSD, de la fréquence et de la mémoire RAM, il n'y a pas de différence réelle entre les architectures de processeurs en termes de dimensionnement.

Comme pour les processeurs x86 plus petits (non-serveurs), les coeurs basés sur Arm moins performants peuvent ne pas fournir une expérience optimale, en particulier lorsqu'ils sont utilisés pour des réserves codées à effacement.

Dans toute la documentation, SYSTEM-ARCH est utilisé à la place de x86 ou Arm.

2.3 Configuration du matériel #

Pour bénéficier d'une expérience optimale avec le produit, nous vous recommandons de commencer par configurer la grappe recommandée. Pour une grappe de test ou une grappe ne nécessitant pas de performances très importantes, nous documentons une configuration minimale prise en charge pour la grappe.

2.3.1 Configuration minimale de la grappe #

Une configuration de grappe minimale pour le produit se compose des éléments suivants :

Au moins quatre noeuds physiques (noeuds OSD) avec cohabitation des services

Ethernet Dual-10 Go en tant que réseau lié

Un noeud Admin distinct (peut être virtualisé sur un noeud externe)

Une configuration détaillée est la suivante :

Un noeud Admin distinct avec 4 Go de RAM, quatre coeurs et 1 To de capacité de stockage. Il s'agit généralement du noeud Salt Master. Les passerelles et services Ceph et de passerelles, tels que Ceph Monitor, Metadata Server, Ceph OSD, Object Gateway ou NFS Ganesha ne sont pas pris en charge sur le noeud Admin, car il doit orchestrer indépendamment les processus de mise à jour et de mise à niveau de la grappe.

Au moins quatre noeuds OSD physiques, avec huit disques OSD chacun, reportez-vous à la Section 2.4.1, « Configuration minimale requise » pour consulter la configuration requise.

La capacité totale de la grappe doit être dimensionnée de sorte que, même si un noeud est indisponible, la capacité totale utilisée (y compris la redondance) ne dépasse pas 80 %.

Trois instances de Ceph Monitor. Pour des raisons de latence, les moniteurs doivent être exécutés à partir d'un espace de stockage SSD/NVMe et non à partir de disques durs.

Les moniteurs, le serveur de métadonnées et les passerelles peuvent cohabiter sur les noeuds OSD. Reportez-vous à la Section 2.12, « OSD et Monitor partageant un même serveur » concernant la cohabitation des moniteurs. Si vous faites cohabiter des services, les exigences de mémoire et d'UC doivent être additionnées.

La passerelle iSCSI, Object Gateway et le serveur de métadonnées ont au minimum besoin de 4 Go de RAM incrémentielle et de quatre coeurs.

Si vous utilisez CephFS, S3/Swift, iSCSI, au moins deux instances des rôles respectifs (serveur de métadonnées, Object Gateway, iSCSI) sont requises à des fins de redondance et de disponibilité.

Les noeuds doivent être dédiés à SUSE Enterprise Storage et ne doivent pas être utilisés pour d'autres workloads physiques, conteneurisés ou virtualisés.

Si l'une des passerelles (iSCSI, Object Gateway, NFS Ganesha, serveur de métadonnées, etc.) est déployée au sein de machines virtuelles, ces dernières ne doivent pas être hébergées sur les machines physiques servant d'autres rôles de grappe. (Ce n'est pas nécessaire puisqu'elles sont prises en charge en tant que services cohabitants.)

Lors du déploiement de services en tant que machines virtuelles sur des hyperviseurs en dehors de la grappe physique principale, les domaines de défaillance doivent être respectés afin de garantir la redondance.

Par exemple, ne déployez pas plusieurs rôles du même type sur le même hyperviseur, tels que plusieurs instances MON ou MDS.

Lors d'un déploiement sur des machines virtuelles, il est particulièrement important de s'assurer que les noeuds disposent d'une solide connectivité réseau et d'une synchronisation horaire fonctionnant convenablement.

Les noeuds d'hyperviseur doivent avoir la bonne taille pour éviter les interférences occasionnées par d'autres workloads consommant des ressources de processeur, de RAM, de réseau et de stockage.

2.3.2 Configuration recommandée pour une grappe en production #

Une fois votre grappe développée, nous vous recommandons de déplacer les instances Ceph Monitor, les serveurs de métadonnées et les passerelles vers des noeuds distincts afin d'améliorer la tolérance aux pannes.

Sept noeuds de stockage des objets

Aucun noeud n'excède environ 15 % du stockage total.

La capacité totale de la grappe doit être dimensionnée de sorte que, même si un noeud est indisponible, la capacité totale utilisée (y compris la redondance) ne dépasse pas 80 %.

Ethernet de 25 Go ou plus chacun lié à la grappe interne et au réseau public externe.

Plus de 56 OSD par grappe de stockage.

Reportez-vous à la Section 2.4.1, « Configuration minimale requise » pour d'autres recommandations.

Noeuds d'infrastructure physique dédiés.

Trois noeuds de moniteur Ceph : 4 Go de RAM, processeur à 4 coeurs, disques SSD RAID 1.

Reportez-vous à la Section 2.5, « Noeuds de moniteur » pour d'autres recommandations.

Noeuds Object Gateway : 32 Go de RAM, processeur à 8 coeurs, disques SSD RAID 1.

Reportez-vous à la Section 2.6, « Noeuds Object Gateway » pour d'autres recommandations.

Noeuds Passerelle iSCSI : 16 Go de RAM, processeur à 8 coeurs, disques SSD RAID 1.

Reportez-vous à la Section 2.9, « Noeuds de passerelle iSCSI » pour d'autres recommandations.

Noeuds MDS (un actif/un de secours) : 32 Go de RAM, processeur à 8 coeurs, disques SSD RAID 1.

Reportez-vous à la Section 2.7, « Noeuds de serveur de métadonnées » pour d'autres recommandations.

Un noeud Admin SES : 4 Go de RAM, processeur à 4 coeurs, disques SSD RAID 1.

2.3.3 Configuration multipath #

Si vous souhaitez utiliser du matériel multipath, assurez-vous que LVM voit multipath_component_detection = 1 dans le fichier de configuration sous la section devices. Vous pouvez vérifier à l'aide de la commande lvm config.

Vous pouvez également vous assurer que LVM filtre les composants mpath d'un périphérique via la configuration du filtre LVM. Cela dépendra de l'hôte.

Ce n'est pas recommandé et ne doit être envisagé que si multipath_component_detection = 1 ne peut pas être défini.

Pour plus d'informations sur la configuration multipath, consultez l'adresse https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-multipath.html#sec-multipath-lvm.

2.4 Noeuds de stockage des objets #

2.4.1 Configuration minimale requise #

Les recommandations d'UC suivantes tiennent compte des périphériques indépendamment de l'utilisation par Ceph :

1x thread d'UC 2 GHz par disque rotatif.

2x threads d'UC 2 GHz par disque SSD.

4x threads d'UC 2 GHz par disque NVMe.

Réseaux 10 GbE séparés (public/client et interne), 4x 10 GbE requis, 2x 25 GbE recommandés.

Mémoire RAM totale requise = nombre d'OSD x (1 Go +

osd_memory_target) + 16 GoReportez-vous au Book “Guide d'opérations et d'administration”, Chapter 28 “Configuration de la grappe Ceph”, Section 28.4.1 “Configuration du dimensionnement automatique du cache” pour plus de détails sur

osd_memory_target.Disques OSD dans les configurations JBOD ou les configurations RAID-0 individuelles.

Le journal OSD peut résider sur le disque OSD.

Les disques OSD doivent être exclusivement utilisés par SUSE Enterprise Storage.

Disque et SSD dédiés au système d'exploitation, de préférence dans une configuration RAID 1.

Allouez au moins 4 Go de RAM supplémentaires si cet hôte OSD doit héberger une partie d'une réserve en cache utilisée pour la hiérarchisation du cache.

Les moniteurs Ceph, la passerelle et les serveurs de métadonnées peuvent résider sur les noeuds de stockage des objets.

Pour des raisons de performances de disque, les noeuds OSD sont des noeuds sans système d'exploitation. Aucun autre workload ne doit s'exécuter sur un noeud OSD, sauf s'il s'agit d'une configuration minimale d'instances Ceph Monitor et Ceph Manager.

Disques SSD pour journal avec un ratio journal SSD à OSD de 6:1.

Assurez-vous qu'aucun périphérique de bloc en réseau n'est assigné aux noeuds OSD, tels que des images de périphérique de bloc RADOS ou iSCSI.

2.4.2 Taille minimale du disque #

Deux types d'espace disque sont nécessaires pour l'exécution sur un OSD : l'espace pour le périphérique WAL/DB et l'espace primaire pour les données stockées. La valeur minimale (et par défaut) pour le périphérique WAL/DB est de 6 Go. L'espace minimum pour les données est de 5 Go, car les partitions inférieures à 5 Go sont automatiquement assignées à une pondération de 0.

Ainsi, bien que l'espace disque minimal pour un OSD soit de 11 Go, il est recommandé de ne pas utiliser un disque inférieur à 20 Go, même à des fins de test.

2.4.3 Taille recommandée pour les périphériques WAL et DB de BlueStore #

Reportez-vous à la Section 1.4, « BlueStore » pour plus d'informations sur BlueStore.

Nous vous recommandons de réserver 4 Go pour le périphérique WAL. Alors que la taille minimale de la base de données est de 64 Go pour les workloads RBD uniquement, la taille recommandée pour les workloads Object Gateway et CephFS est de 2 % de la capacité du périphérique principal (mais au moins 196 Go).

ImportantNous recommandons des volumes de base de données plus importants pour les déploiements à charge élevée, en particulier si l'utilisation de RGW ou de CephFS est importante. Réservez une certaine capacité (emplacements) pour installer plus de matériel et plus d'espace DB si nécessaire.

Si vous envisagez de placer les périphériques WAL et DB sur le même disque, il est recommandé d'utiliser une partition unique pour les deux périphériques, plutôt que d'utiliser une partition distincte pour chacun. Cela permet à Ceph d'utiliser également le périphérique DB pour les opérations WAL. La gestion de l'espace disque est donc plus efficace, car Ceph n'utilise la partition DB pour le WAL qu'en cas de nécessité. Un autre avantage est que la probabilité que la partition WAL soit pleine est très faible, et lorsqu'elle n'est pas entièrement utilisée, son espace n'est pas gaspillé, mais utilisé pour les opérations de DB.

Pour partager le périphérique DB avec le WAL, ne spécifiez pas le périphérique WAL et indiquez uniquement le périphérique DB.

Pour plus d'informations sur la spécification d'une disposition OSD, reportez-vous au Book “Guide d'opérations et d'administration”, Chapter 13 “Tâches opérationnelles”, Section 13.4.3 “Ajout d'OSD à l'aide de la spécification DriveGroups”.

2.4.5 Nombre maximal recommandé de disques #

Vous pouvez avoir autant de disques sur un serveur que ce dernier l'autorise. Il existe quelques aspects à considérer lorsque vous planifiez le nombre de disques par serveur :

Bande passante du réseau. Plus vous avez de disques sur un serveur, plus il y a de données à transférer via la ou les cartes réseau pour les opérations d'écriture sur disque.

Mémoire. Plus de 2 Go de RAM sont utilisés pour le cache BlueStore. Avec la valeur par défaut de l'option

osd_memory_target, à savoir 4 Go, le système dispose d'une taille de cache de départ raisonnable pour les supports rotatifs. Si vous utilisez des disques SSD ou NVMe, pensez à augmenter la taille du cache et l'allocation de RAM par OSD afin d'optimiser les performances.Tolérance aux pannes. Si le serveur complet tombe en panne, plus il comporte de disques, plus le nombre d'OSD perdus temporairement par la grappe est important. En outre, pour maintenir les règles de réplication en cours d'exécution, vous devez copier toutes les données du serveur en panne vers les autres noeuds de la grappe.

2.5 Noeuds de moniteur #

Au moins trois noeuds MON sont requis. Le nombre de moniteurs doit toujours être impair (1+2n).

4 Go de RAM.

Processeur à quatre coeurs logiques.

Un SSD ou un autre type de support de stockage suffisamment rapide est vivement recommandé pour les moniteurs, en particulier pour le chemin

/var/lib/cephsur chaque noeud de moniteur, car le quorum peut être instable avec des latences de disque élevées. Deux disques en configuration RAID 1 sont recommandés pour la redondance. Il est recommandé d'utiliser des disques distincts ou au moins des partitions de disque distinctes pour les processus Monitor, afin de protéger l'espace disque disponible du moniteur contre des phénomènes tels que le grossissement excessif du fichier journal.Il ne doit y avoir qu'un seul processus Monitor par noeud.

La combinaison des noeuds OSD, Monitor ou Object Gateway n'est prise en charge que s'il y a suffisamment de ressources matérielles disponibles. Cela signifie que les besoins de tous les services doivent être additionnés.

Deux interfaces réseau liées à plusieurs commutateurs.

2.6 Noeuds Object Gateway #

Les noeuds Object Gateway doivent avoir au moins six coeurs de processeur et 32 Go de RAM. Lorsque d'autres processus sont colocalisés sur la même machine, leurs besoins doivent être additionnés.

2.7 Noeuds de serveur de métadonnées #

Le dimensionnement approprié des noeuds MDS (Metadata Server, Serveur de métadonnées) dépend du cas d'utilisation spécifique. En règle générale, plus le nombre de fichiers ouverts que le serveur de métadonnées doit traiter est important, plus l'UC et la RAM requises sont importantes. La configuration minimale requise est la suivante :

4 Go de RAM pour chaque daemon MDS.

Interface réseau liée.

2,5 GHz d'UC avec au moins 2 coeurs.

2.8 Noeud Admin #

Au moins 4 Go de RAM et une UC quadruple coeur sont requis. Cela inclut l'exécution de Salt Master sur le noeud Admin. Pour les grappes de grande taille avec des centaines de noeuds, 6 Go de RAM sont conseillés.

2.9 Noeuds de passerelle iSCSI #

Les noeuds de passerelle iSCSI doivent avoir au moins six coeurs de processeur et 16 Go de RAM.

2.10 SES et autres produits SUSE #

Cette section contient des informations importantes concernant l'intégration de SES avec d'autres produits SUSE.

2.10.1 SUSE Manager #

SUSE Manager et SUSE Enterprise Storage n'étant pas intégrés, SUSE Manager ne peut actuellement pas gérer une grappe SES.

2.11 Limitations concernant les noms #

Ceph ne prend généralement pas en charge les caractères non-ASCII dans les fichiers de configuration, les noms de réserve, les noms d'utilisateur, etc. Lors de la configuration d'une grappe Ceph, il est recommandé d'utiliser uniquement des caractères alphanumériques simples (A-Z, a-z, 0-9) et des ponctuations minimales (« . », « - », « _ ») dans tous les noms d'objet/de configuration Ceph.

3 Configuration haute disponibilité du noeud Admin #

Le noeud Admin est un noeud de la grappe Ceph sur lequel le service Salt Master s'exécute. Il gère le reste des noeuds de la grappe en interrogeant et en indiquant leurs services de minion Salt. En général, il inclut également d'autres services, par exemple, le tableau de bord Grafana soutenu par le toolkit de surveillance Prometheus.

En cas de défaillance du noeud Admin, vous devez généralement fournir un nouveau matériel pour le noeud et restaurer la pile de configuration complète de la grappe à partir d'une sauvegarde récente. Cette méthode prend énormément de temps et provoque l'interruption de la grappe.

Pour éviter le temps hors service de la grappe Ceph causé par la défaillance du noeud Admin, il est recommandé d'utiliser une grappe haute disponibilité (High Availability, HA) pour le noeud Admin Ceph.

3.1 Aperçu de la grappe HA pour le noeud Admin #

Le principe d'une grappe HA est qu'en cas de défaillance d'un noeud de la grappe, un autre noeud prend automatiquement en charge son rôle, y compris le noeud Admin virtualisé. De cette façon, les autres noeuds de la grappe Ceph ne remarquent pas la défaillance du noeud Admin.

La solution HA minimale pour le noeud Admin requiert le matériel suivant :

Deux serveurs sans système d'exploitation en mesure d'exécuter SUSE Linux Enterprise avec l'extension haute disponibilité et de virtualiser le noeud Admin.

Deux ou plusieurs chemins de communication réseau redondants, par exemple via la liaison de périphérique réseau.

Un stockage partagé pour héberger les images de disque de la machine virtuelle du noeud Admin. Le stockage partagé doit être accessible depuis les deux serveurs. Il peut s'agir, par exemple, d'une exportation NFS, d'un partage Samba ou d'une cible iSCSI.

Pour plus de détails sur les conditions requises de la grappe, reportez-vous à la page https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#sec-ha-inst-quick-req.

3.2 Création d'une grappe haute disponibilité avec le noeud Admin #

La procédure suivante résume les étapes les plus importantes de la création d'une grappe haute disponibilité pour la virtualisation du noeud Admin. Pour plus d'informations, reportez-vous aux liens indiqués.

Configurez une grappe haute disponibilité à 2 noeuds de base avec un stockage partagé comme décrit dans le manuel https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#art-sleha-install-quick.

Sur les deux noeuds de la grappe, installez tous les paquetages requis pour l'exécution de l'hyperviseur KVM et du toolkit

libvirtcomme décrit dans le manuel https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-vt-installation-kvm.Sur le premier noeud de la grappe, créez une machine virtuelle KVM en utilisant

libvirtcomme décrit dans le manuel https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-libvirt-inst-virt-install. Utilisez le stockage partagé préconfiguré pour stocker les images de disque de la machine virtuelle.Une fois la configuration de la machine virtuelle terminée, exportez sa configuration dans un fichier XML sur le stockage partagé. Utilisez la syntaxe suivante.

#virsh dumpxml VM_NAME > /path/to/shared/vm_name.xmlCréez une ressource pour la machine virtuelle du noeud Admin. Reportez-vous à l'adresse https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-guide/#cha-conf-hawk2 pour des informations générales sur la création de ressources haute disponibilité. Des informations détaillées sur la création de ressources pour une machine virtuelle KVM sont décrites à l'adresse http://www.linux-ha.org/wiki/VirtualDomain_%28resource_agent%29.

Sur l'invité de la machine virtuelle qui vient d'être créé, déployez le noeud Admin, y compris les services supplémentaires dont vous avez besoin. Suivez les étapes appropriées du Chapitre 6, Déploiement de Salt. En même temps, déployez les noeuds de la grappe Ceph restants sur les serveurs de grappe non-HA.

Partie II Déploiement de la grappe Ceph #

- 4 Introduction et tâches courantes

Depuis SUSE Enterprise Storage 7, les services Ceph sont déployés en tant que conteneurs au lieu des paquetages RPM. Le processus de déploiement comporte deux étapes de base :

- 5 Installation et configuration de SUSE Linux Enterprise Server

Installez et enregistrez SUSE Linux Enterprise Server 15 SP3 sur chaque noeud de la grappe. Lors de l'installation de SUSE Enterprise Storage, vous devrez pouvoir accéder aux dépôts de mise à jour. L'enregistrement est donc obligatoire. Incluez au moins les modules suivants :

- 6 Déploiement de Salt

SUSE Enterprise Storage utilise Salt et ceph-salt pour la préparation initiale de la grappe. Salt vous aide à configurer et à exécuter des commandes sur plusieurs noeuds de grappe simultanément à partir d'un hôte dédié appelé Salt Master. Avant de déployer Salt, tenez compte des points importants su…

- 7 Déploiement de la grappe Bootstrap à l'aide de

ceph-salt Cette section vous guide tout au long du processus de déploiement d'une grappe Ceph de base. Lisez attentivement les sous-sections suivantes et exécutez les commandes incluses dans l'ordre indiqué.

- 8 Déploiement des services essentiels restants à l'aide de cephadm

Après avoir déployé la grappe Ceph de base, déployez les services principaux sur d'autres noeuds de la grappe. Pour que les clients puissent accéder aux données de la grappe, déployez aussi des services supplémentaires.

- 9 Déploiement de services supplémentaires

iSCSI est un protocole SAN (Storage area network) qui permet aux clients (appelés initiateurs) d'envoyer des commandes SCSI aux périphériques de stockage SCSI (cibles) sur des serveurs distants. SUSE Enterprise Storage 7.1 comprend une interface qui ouvre la gestion du stockage Ceph aux clients hété…

4 Introduction et tâches courantes #

Depuis SUSE Enterprise Storage 7, les services Ceph sont déployés en tant que conteneurs au lieu des paquetages RPM. Le processus de déploiement comporte deux étapes de base :

- Déploiement d'une grappe Bootstrap

Cette phase est appelée Déploiement du jour 1 et comprend les tâches suivantes : elle comprend l'installation du système d'exploitation sous-jacent, la configuration de l'infrastructure Salt et le déploiement de la grappe minimale qui se compose d'un service MON et d'un service MGR.

Installez et effectuez la configuration de base du système d'exploitation sous-jacent (SUSE Linux Enterprise Server 15 SP3) sur tous les noeuds de la grappe.

Déployez l'infrastructure Salt sur tous les noeuds de la grappe pour préparer le déploiement initial via

ceph-salt.Configurez les propriétés de base de la grappe via

ceph-saltet déployez-la.

- Déploiement de services supplémentaires

Dans le cadre du Déploiement du jour 2, des services Ceph essentiels et non essentiels, par exemple des passerelles et une pile de surveillance, sont déployés.

Notez que la documentation de la communauté Ceph utilise la commande de démarrage cephadm bootstrap lors du déploiement initial. ceph-salt invoque automatiquement la commande cephadm bootstrap. La commande cephadm bootstrap ne doit pas être exécutée directement. Tout déploiement manuel de grappes Ceph à l'aide de l'outil de cephdm bootstrap ne sera pas pris en charge.

4.1 Lisez les notes de version #

Les notes de version contiennent des informations supplémentaires sur les modifications apportées depuis la version précédente de SUSE Enterprise Storage. Consultez les notes de version pour vérifier les aspects suivants :

Votre matériel doit tenir compte de certaines considérations spéciales.

Les paquetages logiciels utilisés ont été considérablement modifiés.

Des précautions spéciales sont nécessaires pour votre installation.

Les notes de version incluent également des informations de dernière minute qui, faute de temps, n'ont pas pu être intégrées au manuel. Elles contiennent également des notes concernant les problèmes connus.

Une fois le paquetage release-notes-ses installé, vous trouverez les notes de version en local dans le répertoire /usr/share/doc/release-notes ou en ligne à l'adresse https://www.suse.com/releasenotes/.

5 Installation et configuration de SUSE Linux Enterprise Server #

Installez et enregistrez SUSE Linux Enterprise Server 15 SP3 sur chaque noeud de la grappe. Lors de l'installation de SUSE Enterprise Storage, vous devrez pouvoir accéder aux dépôts de mise à jour. L'enregistrement est donc obligatoire. Incluez au moins les modules suivants :

Module Basesystem (Système de base)

Module Server Applications (Applications serveur)

Pour plus de détails sur l'installation de SUSE Linux Enterprise Server, reportez-vous à la documentation https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-install.html.

Installez l'extension SUSE Enterprise Storage 7.1 sur chaque noeud de la grappe.

Astuce : installez SUSE Enterprise Storage en même temps que SUSE Linux Enterprise ServerVous pouvez installer l'extension SUSE Enterprise Storage 7.1 séparément après avoir installé SUSE Linux Enterprise Server 15 SP3 ou l'ajouter au cours de la procédure d'installation de SUSE Linux Enterprise Server 15 SP3.

Pour plus de détails sur l'installation des extensions, reportez-vous à la documentation https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-register-sle.html.

Configurez les paramètres réseau, y compris la résolution de nom DNS appropriée sur chaque noeud. Pour plus d'informations sur la configuration d'un réseau, reportez-vous à l'adresse https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#sec-network-yast. Pour plus d'informations sur la configuration d'un serveur DNS, reportez-vous à l'adresse https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#cha-dns.

6 Déploiement de Salt #

SUSE Enterprise Storage utilise Salt et ceph-salt pour la préparation initiale de la grappe. Salt vous aide à configurer et à exécuter des commandes sur plusieurs noeuds de grappe simultanément à partir d'un hôte dédié appelé Salt Master. Avant de déployer Salt, tenez compte des points importants suivants :

Les minions Salt sont les noeuds contrôlés par un noeud dédié appelé Salt Master.

Si l'hôte Salt Master doit faire partie de la grappe Ceph, il doit exécuter son propre minion Salt, mais ce n'est pas obligatoire.

Astuce : partage de plusieurs rôles par serveurVous obtiendrez les meilleures performances de votre grappe Ceph lorsque chaque rôle est déployé sur un noeud distinct. Toutefois, les déploiements réels nécessitent parfois le partage d'un noeud entre plusieurs rôles. Pour éviter les problèmes liés aux performances et à la procédure de mise à niveau, ne déployez pas le rôle Ceph OSD, Serveur de métadonnées ou Ceph Monitor sur le noeud Admin.

Les minions Salt doivent résoudre correctement le nom d'hôte de Salt Master sur le réseau. Par défaut, ils recherchent le nom d'hôte

salt, mais vous pouvez spécifier tout autre nom d'hôte accessible par le réseau dans le fichier/etc/salt/minion.

Installez

salt-mastersur le noeud Salt Master :root@master #zypper in salt-masterVérifiez si le service

salt-masterest activé et démarré, puis activez-le et démarrez-le, le cas échéant :root@master #systemctl enable salt-master.serviceroot@master #systemctl start salt-master.serviceSi vous envisagez d'utiliser le pare-feu, vérifiez si les ports 4505 et 4506 du noeud Salt Master sont ouverts pour tous les noeuds minions Salt. Si les ports sont fermés, vous pouvez les ouvrir à l'aide de la commande

yast2 firewallen autorisant le service à accéder à la zone appropriée. Par exemple,public.Installez le paquetage

salt-minionsur tous les noeuds des minions.root@minion >zypper in salt-minionModifiez

/etc/salt/minionet supprimez les commentaires de la ligne suivante :#log_level_logfile: warning

Remplacez le niveau de consignation

warningparinfo.Remarque :log_level_logfileetlog_levelTandis que

log_levelcontrôle quels messages du journal seront affichés à l'écran,log_level_logfilecontrôle quels messages du journal seront écrits dans/var/log/salt/minion.RemarqueVeillez à modifier le niveau de consignation sur tous les noeuds de grappe (minion).

Assurez-vous que le nom de domaine complet de chaque noeud peut être résolu sur une adresse IP du réseau de grappes public par tous les autres noeuds.

Configurez tous les minions pour qu'ils se connectent au maître. Si le nom d'hôte

saltne parvient pas à joindre votre Salt Master, modifiez le fichier/etc/salt/minionou créez un fichier/etc/salt/minion.d/master.confavec le contenu suivant :master: host_name_of_salt_master

Si vous avez apporté des modifications aux fichiers de configuration mentionnés ci-dessus, redémarrez le service Salt sur tous les minions Salt qui y sont associés :

root@minion >systemctl restart salt-minion.serviceVérifiez que le service

salt-minionest activé et démarré sur tous les noeuds. Activez et démarrez-le, le cas échéant :#systemctl enable salt-minion.service#systemctl start salt-minion.serviceVérifiez l'empreinte digitale de chaque minion Salt et acceptez toutes les clés Salt sur Salt Master si les empreintes digitales correspondent.

RemarqueSi l'empreinte de minion Salt revient vide, vérifiez que le minion Salt a une configuration Salt Master et qu'il peut communiquer avec Salt Master.

Affichez l'empreinte digitale de chaque minion :

root@minion >salt-call --local key.finger local: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Après avoir collecté les empreintes digitales de tous les minions Salt, répertoriez les empreintes de toutes les clés de minions non acceptées sur Salt Master :

root@master #salt-key -F [...] Unaccepted Keys: minion1: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Si les empreintes des minions correspondent, acceptez-les :

root@master #salt-key --accept-allVérifiez que les clés ont été acceptées :

root@master #salt-key --list-allTestez si tous les minions Salt répondent :

root@master #salt-run manage.status

7 Déploiement de la grappe Bootstrap à l'aide de ceph-salt #

Cette section vous guide tout au long du processus de déploiement d'une grappe Ceph de base. Lisez attentivement les sous-sections suivantes et exécutez les commandes incluses dans l'ordre indiqué.

7.1 Installation ceph-salt #

ceph-salt fournit des outils pour le déploiement de grappes Ceph gérées par cephdm. ceph-salt utilise l'infrastructure Salt pour gérer le système d'exploitation (par exemple, les mises à jour logicielles ou la synchronisation horaire) et définir les rôles pour les minions Salt.

Sur Salt Master, installez le paquetage ceph-salt :

root@master # zypper install ceph-salt

La commande ci-dessus a installé ceph-salt-formula en tant que dépendance ayant modifié la configuration de Salt Master en insérant des fichiers supplémentaires dans le répertoire /etc/salt/master.d. Pour appliquer les modifications, redémarrez salt-master.service et synchronisez les modules Salt :

root@master #systemctl restart salt-master.serviceroot@master #salt \* saltutil.sync_all

7.2 Configuration des propriétés de grappe #

Utilisez la commande ceph-salt config pour configurer les propriétés de base de la grappe.

Le fichier /etc/ceph/ceph.conf est géré par cephadm et les utilisateurs ne doivent pas le modifier. Les paramètres de configuration Ceph doivent être définis à l'aide de la nouvelle commande ceph config. Pour plus d'informations, reportez-vous au Book “Guide d'opérations et d'administration”, Chapter 28 “Configuration de la grappe Ceph”, Section 28.2 “Base de données de configuration”.

7.2.1 Utilisation du shell ceph-salt #

Si vous exécutez config sans chemin ni sous-commande, vous accédez à un shell ceph-saltceph-salt interactif. Le shell est pratique si vous devez configurer plusieurs propriétés dans un seul lot sans devoir saisir la syntaxe complète de la commande.

root@master #ceph-salt config/>ls o- / ............................................................... [...] o- ceph_cluster .................................................. [...] | o- minions .............................................. [no minions] | o- roles ....................................................... [...] | o- admin .............................................. [no minions] | o- bootstrap ........................................... [no minion] | o- cephadm ............................................ [no minions] | o- tuned ..................................................... [...] | o- latency .......................................... [no minions] | o- throughput ....................................... [no minions] o- cephadm_bootstrap ............................................. [...] | o- advanced .................................................... [...] | o- ceph_conf ................................................... [...] | o- ceph_image_path .................................. [ no image path] | o- dashboard ................................................... [...] | | o- force_password_update ................................. [enabled] | | o- password ................................................ [admin] | | o- ssl_certificate ....................................... [not set] | | o- ssl_certificate_key ................................... [not set] | | o- username ................................................ [admin] | o- mon_ip .................................................. [not set] o- containers .................................................... [...] | o- registries_conf ......................................... [enabled] | | o- registries .............................................. [empty] | o- registry_auth ............................................... [...] | o- password .............................................. [not set] | o- registry .............................................. [not set] | o- username .............................................. [not set] o- ssh ............................................... [no key pair set] | o- private_key .................................. [no private key set] | o- public_key .................................... [no public key set] o- time_server ........................... [enabled, no server host set] o- external_servers .......................................... [empty] o- servers ................................................... [empty] o- subnet .................................................. [not set]

Comme vous pouvez le constater dans la sortie de la commande ceph-saltls de , la configuration de la grappe est organisée en arborescence. Pour configurer une propriété spécifique de la grappe dans le shell ceph-salt, deux options s'offrent à vous :

Exécutez la commande à partir de la position actuelle et entrez le chemin absolu de la propriété comme premier argument :

/>/cephadm_bootstrap/dashboard ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username .................................................... [admin]/> /cephadm_bootstrap/dashboard/username set ceph-adminValue set.Accédez au chemin dont vous devez configurer la propriété et exécutez la commande :

/>cd /cephadm_bootstrap/dashboard//ceph_cluster/minions>ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username ................................................[ceph-admin]

Lorsque vous êtes dans un shell ceph-salt, vous pouvez utiliser la fonction de saisie semi-automatique similaire à celle d'un shell Linux normal (bash). Il complète les chemins de configuration, les sous-commandes ou les noms des minions Salt. Lors de la saisie semi-automatique d'un chemin de configuration, deux options s'offrent à vous :

Pour laisser le shell terminer un chemin par rapport à votre position actuelle, appuyez deux fois sur la touche TAB →|.

Pour laisser le shell terminer un chemin absolu, entrez / et appuyez deux fois sur la touche TAB →|.

Si vous entrez cd à partir du shell ceph-salt sans aucun chemin, la commande imprime une structure d'arborescence de la configuration de grappe avec la ligne du chemin actuellement actif. Vous pouvez utiliser les flèches Haut et Bas pour parcourir les différentes lignes. Après avoir confirmé avec la touche Entrée, le chemin de configuration est remplacé par le dernier chemin actif.

Pour assurer la cohérence de la documentation, nous utiliserons une syntaxe de commande unique sans accéder au shell ceph-salt. Par exemple, vous pouvez répertorier l'arborescence de configuration de la grappe à l'aide de la commande suivante :