Indique comment installer un ou plusieurs systèmes et exploiter les fonctionnalités inhérentes au produit pour une infrastructure de déploiement. Vous pouvez choisir entre différentes approches qui vont d'une installation locale ou d'un serveur d'installation réseau au déploiement en masse à l'aide d'une technique d'installation automatisée, commandée à distance et hautement personnalisée.

- À propos de ce guide

- 1 Planification pour SUSE Linux Enterprise Server

- I Préparation de l'installation

- II Workflow d'installation

- 6 Installation avec YaST

- 6.1 Choix de la méthode d'installation

- 6.2 Démarrage du système pour l'installation

- 6.3 Étapes de l'installation

- 6.4 Mise à jour automatique du programme d'installation

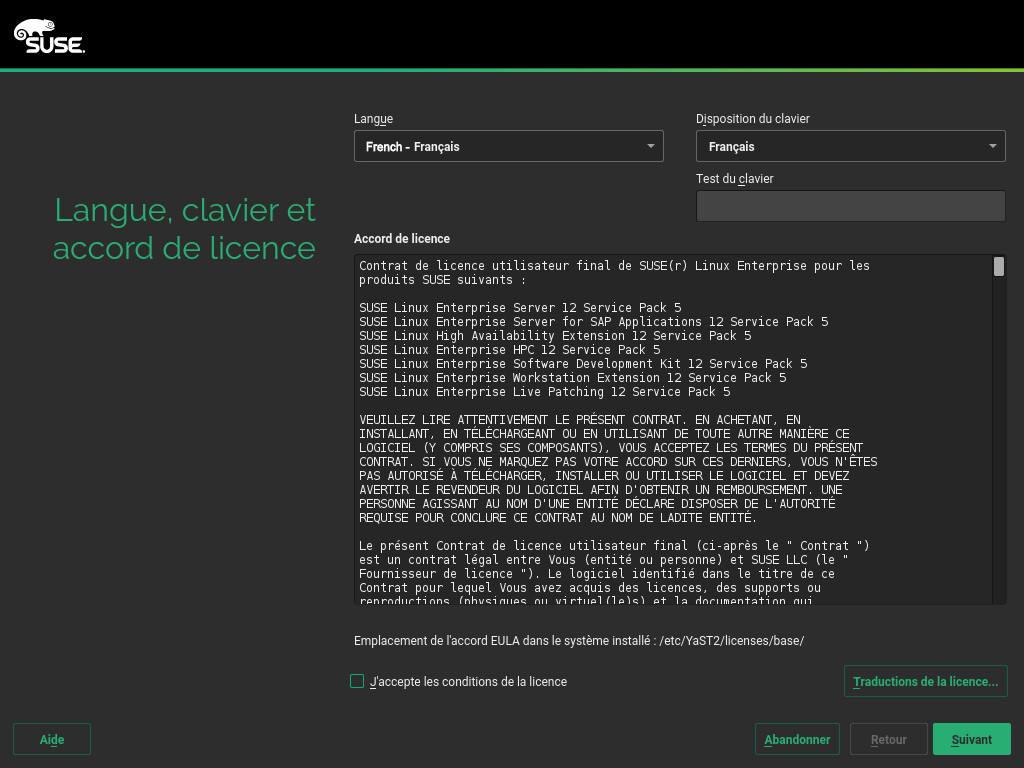

- 6.5 Langue, clavier et accord de licence

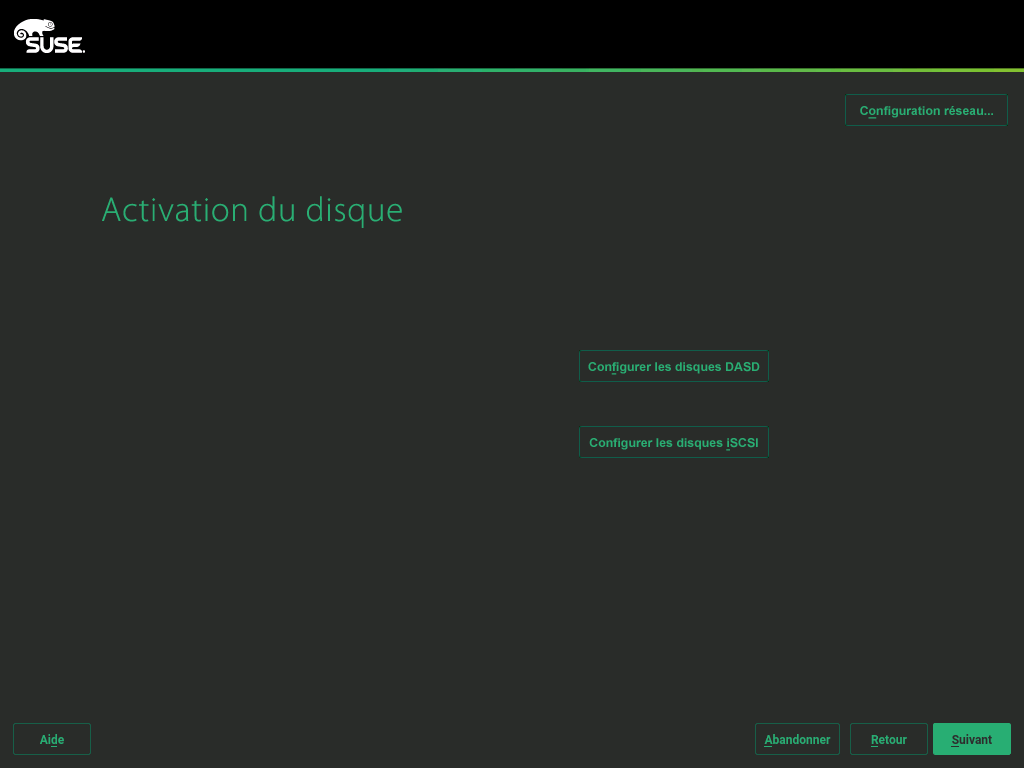

- 6.6 IBM Z : activation du disque

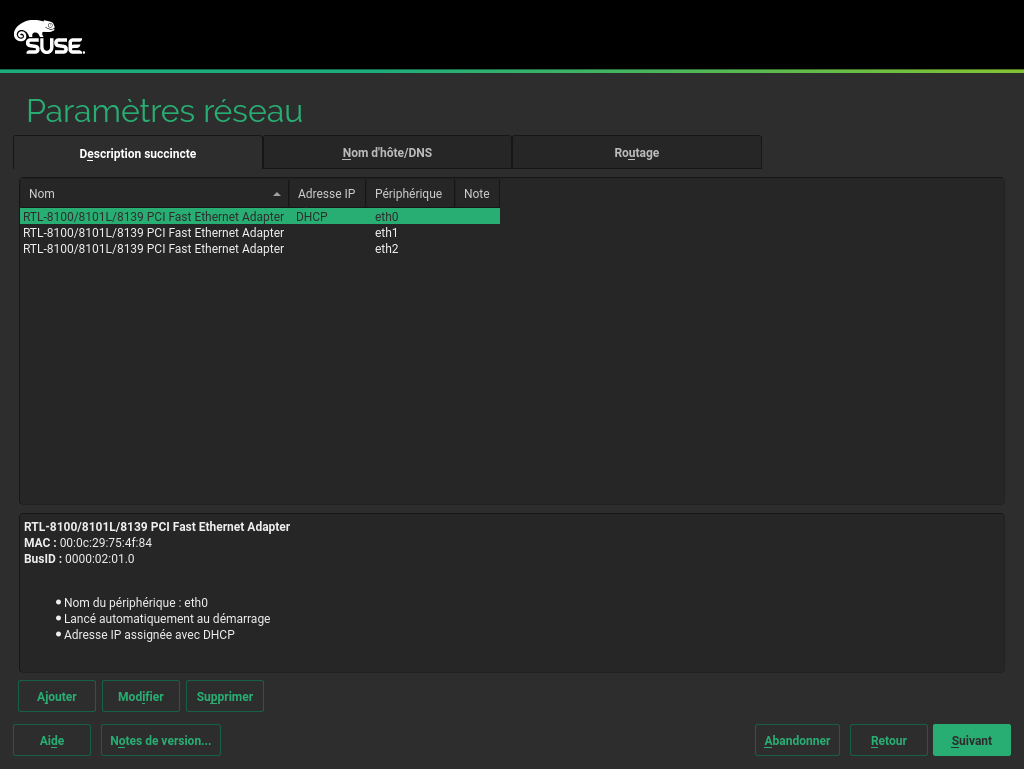

- 6.7 Paramètres réseau

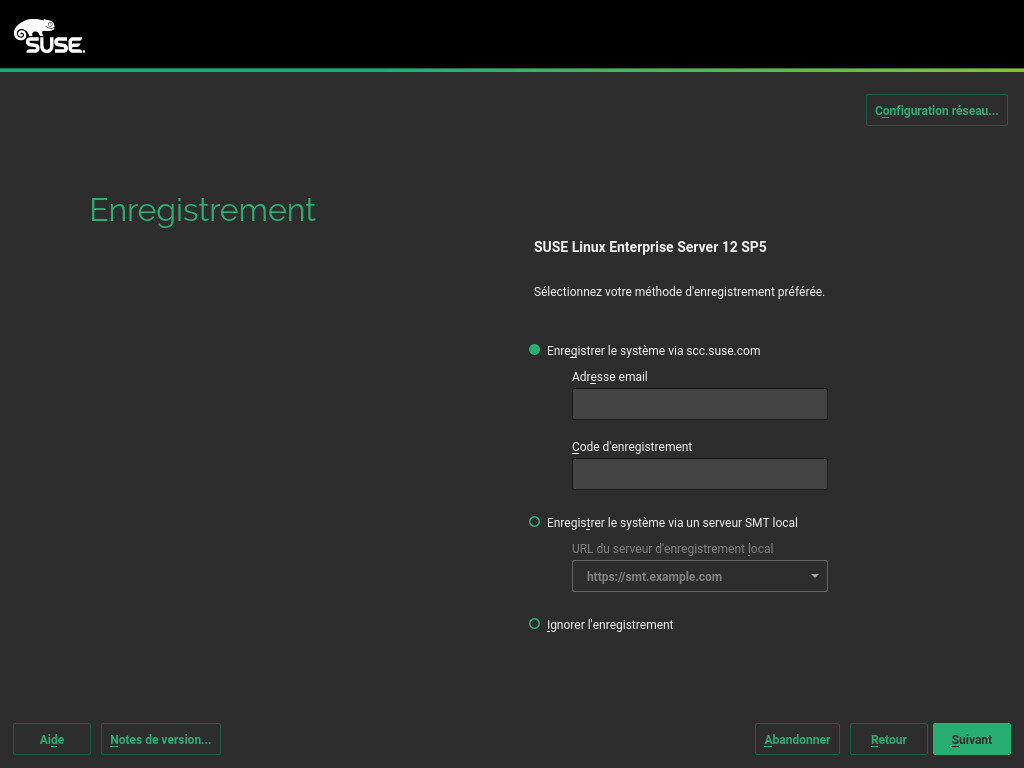

- 6.8 Enregistrement auprès du SUSE Customer Center

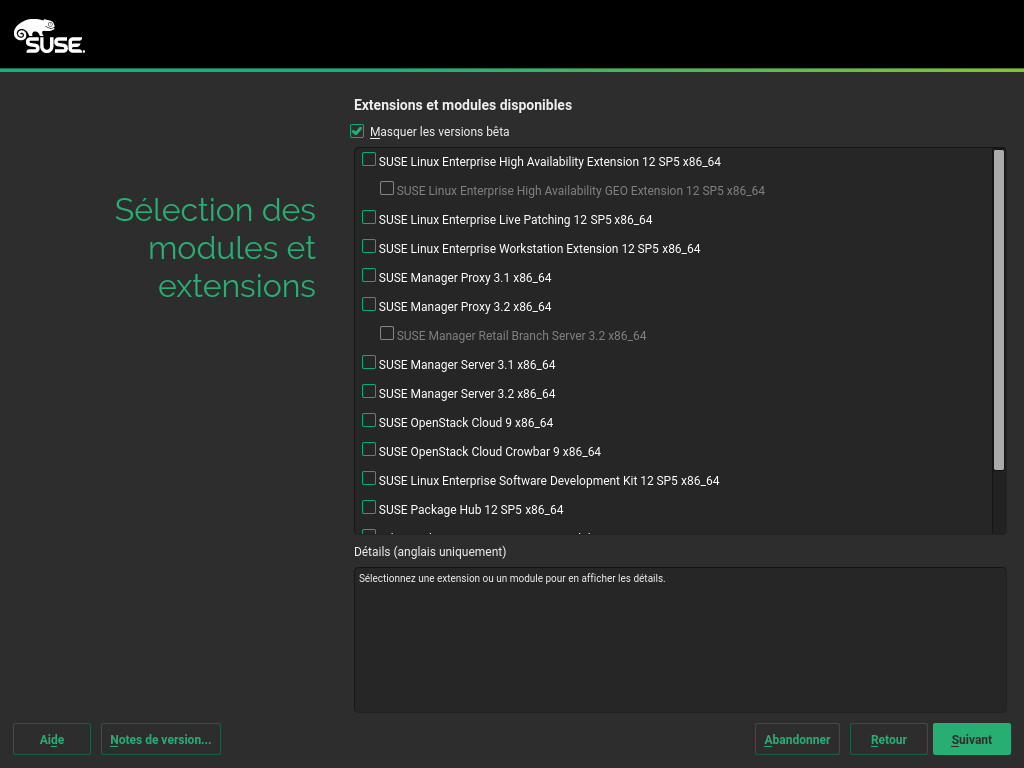

- 6.9 Sélection d'extensions

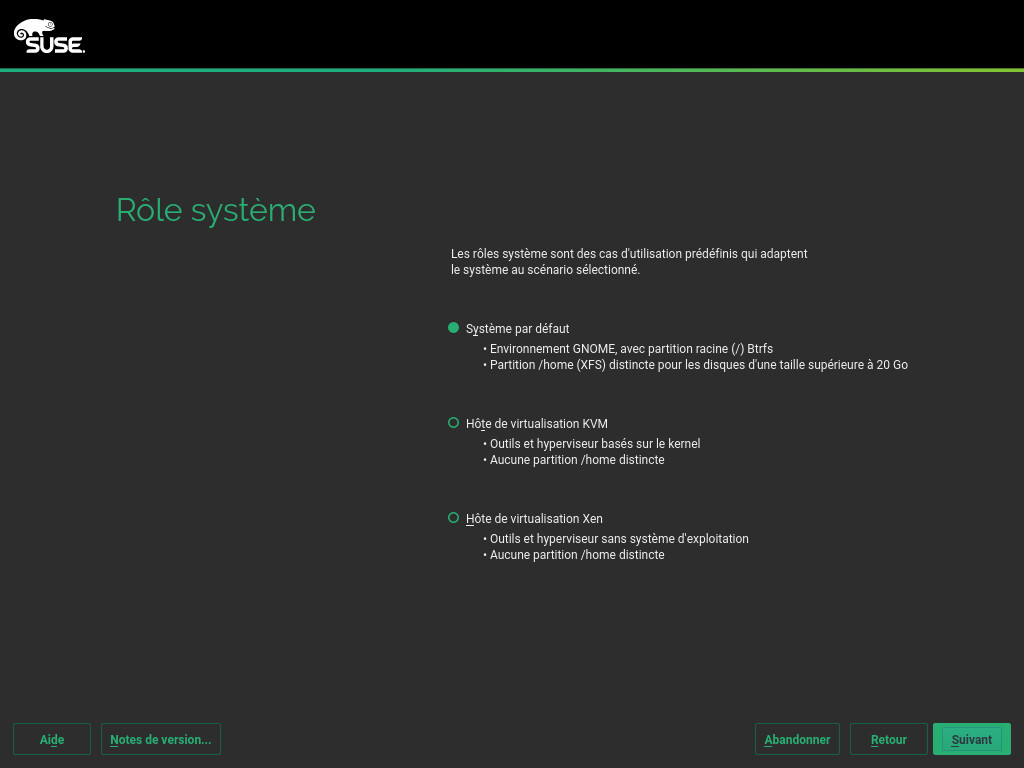

- 6.10 Rôle système

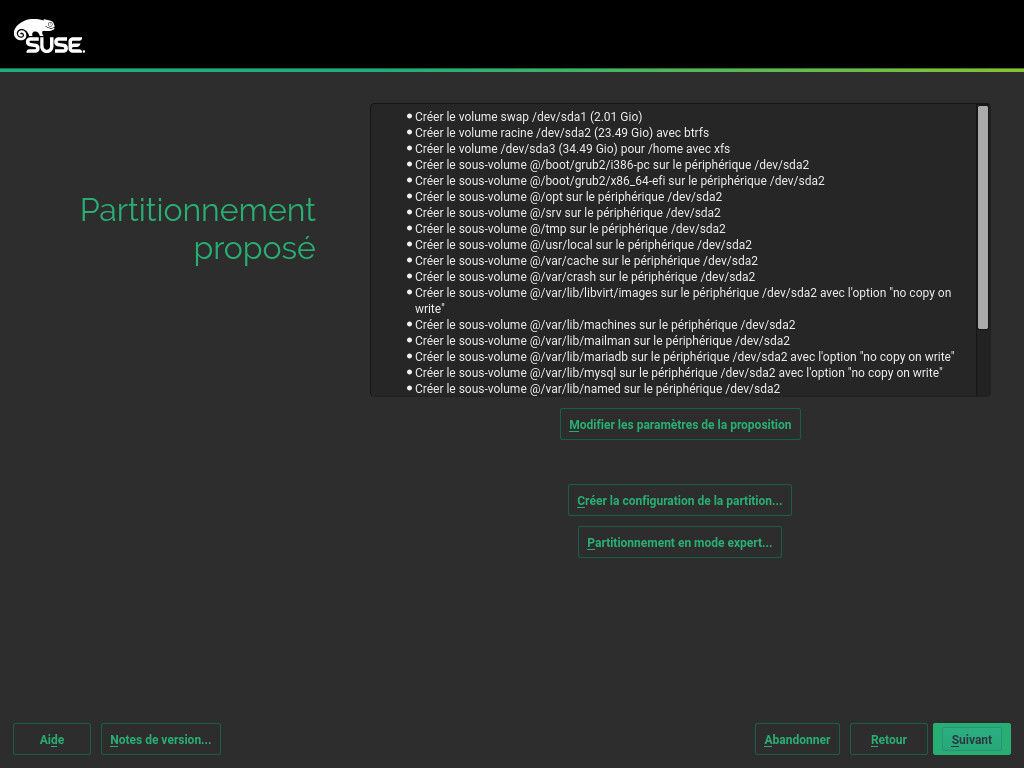

- 6.11 Partitionnement proposé

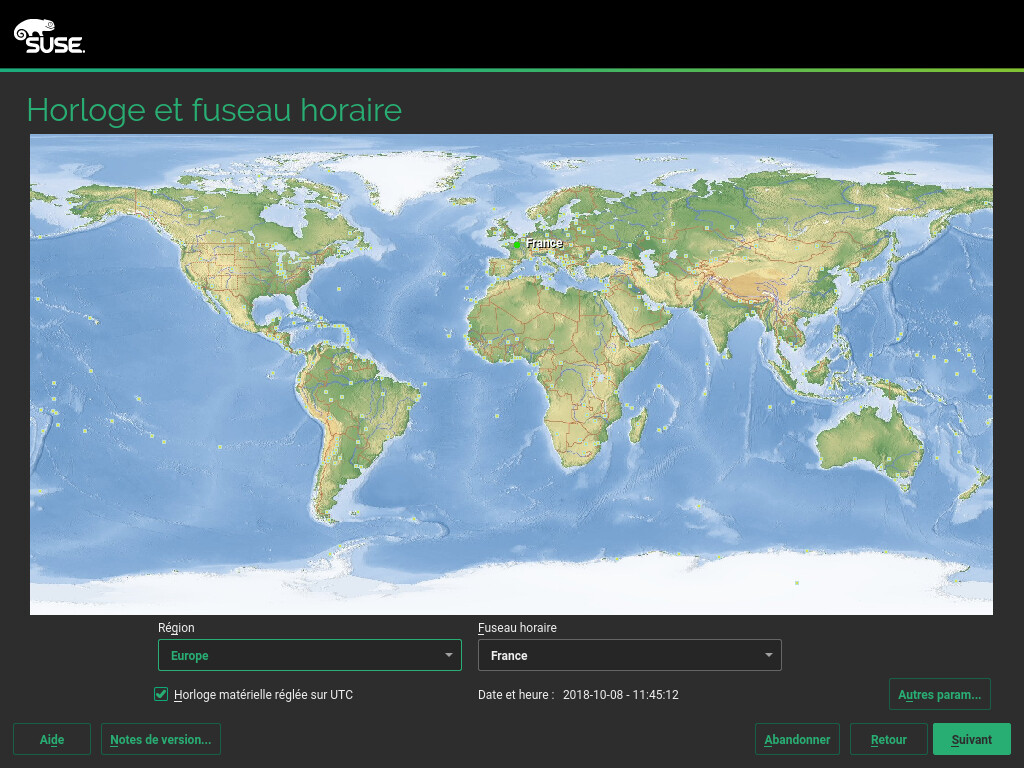

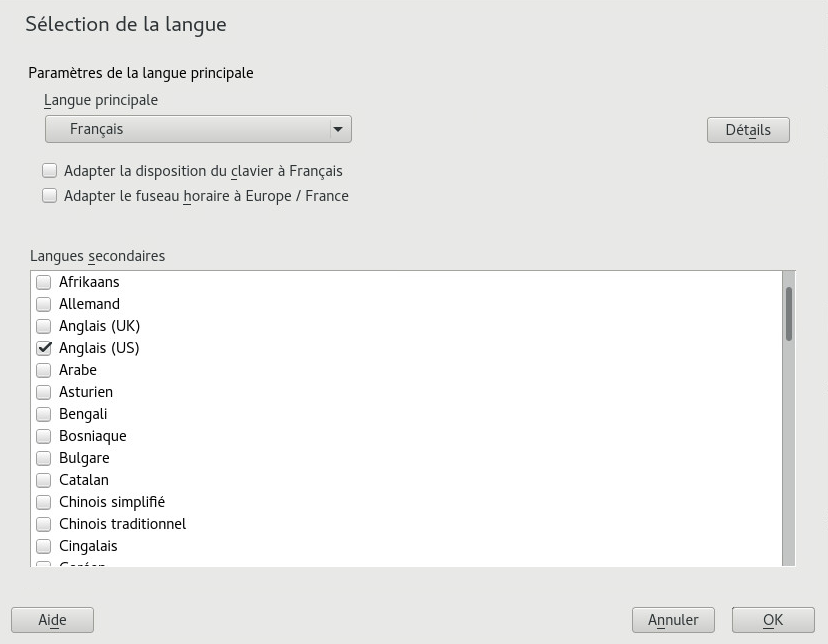

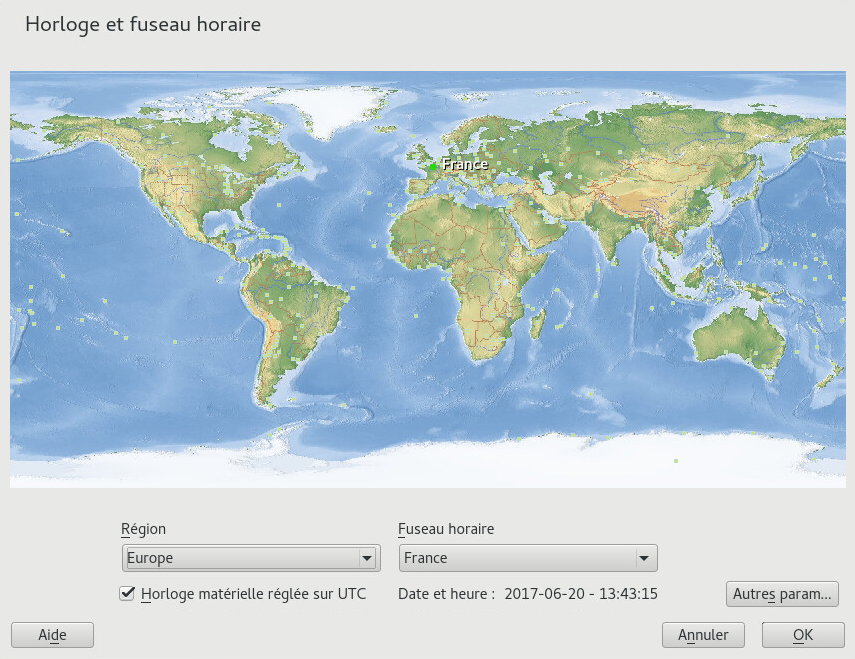

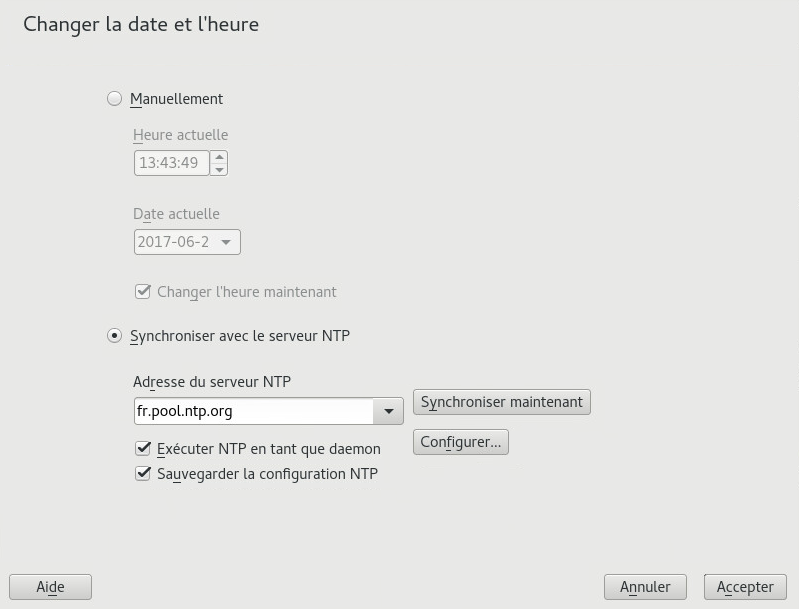

- 6.12 Horloge et fuseau horaire

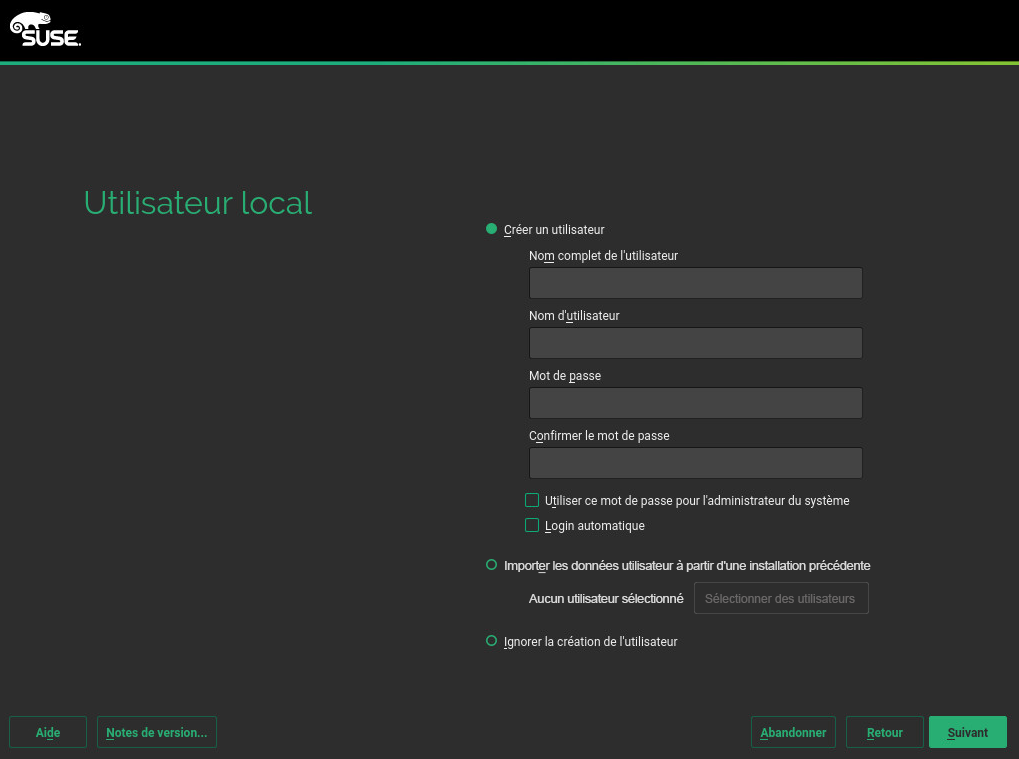

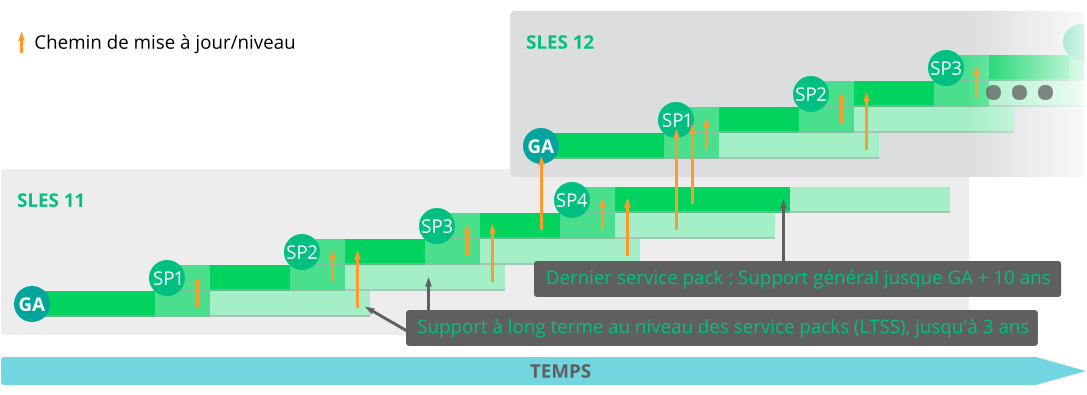

- 6.13 Création d'un utilisateur

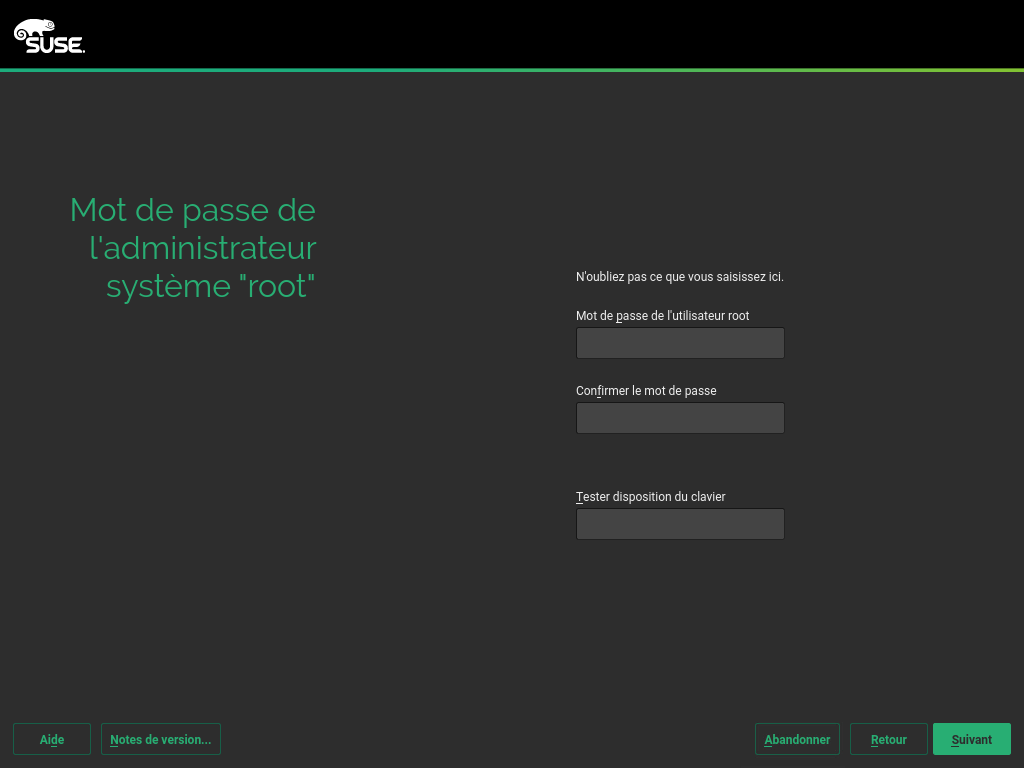

- 6.14 Mot de passe de l'administrateur système

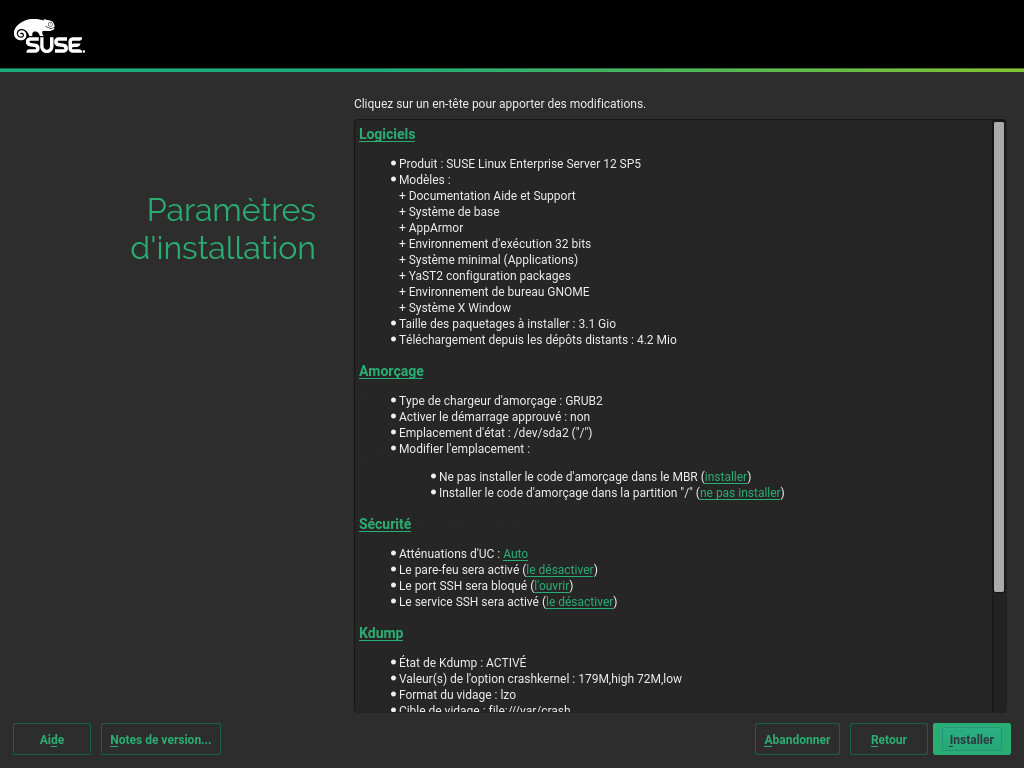

root - 6.15 Paramètres d'installation

- 6.16 Réalisation de l'installation

- 7 Clonage d'images de disque

- 6 Installation avec YaST

- III Configuration d'un serveur d'installation

- 8 Configuration du serveur qui contient les sources d'installation

- 9 Préparation du démarrage du système cible

- 9.1 Configuration d'un serveur DHCP

- 9.2 Configuration d'un serveur TFTP

- 9.3 Installation des fichiers sur le serveur TFTP

- 9.4 Options de configuration PXELINUX

- 9.5 Préparation du système cible pour le démarrage PXE

- 9.6 Préparation du système cible pour la fonction Wake on LAN (réveil à distance)

- 9.7 Wake on LAN

- 9.8 Wake on LAN (réveil à distance) avec YaST

- 9.9 Démarrage à partir du CD ou d'une clé USB au lieu de PXE

- IV Installation à distance

- V Configuration initiale du système

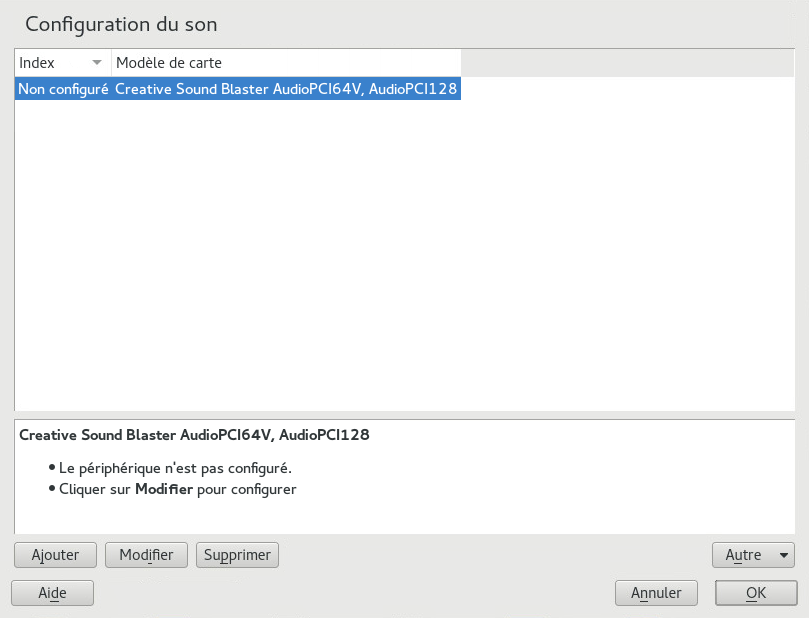

- 11 Configuration des composants matériels avec YaST

- 12 Configuration avancée des disques

- 13 Installation et suppression de logiciels

- 14 Installation de modules, extensions et produits complémentaires tiers

- 15 Installation de plusieurs versions du kernel

- 16 Gestion des utilisateurs avec YaST

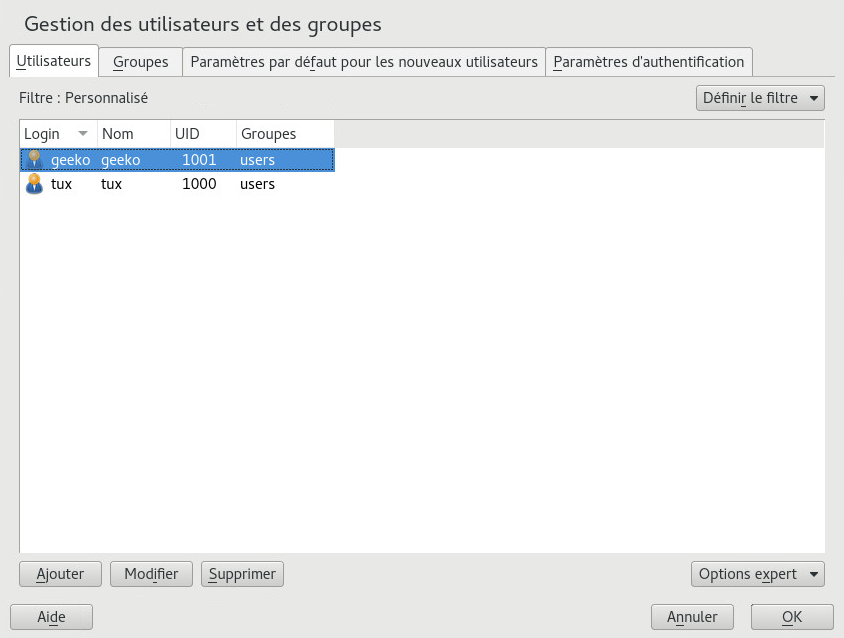

- 16.1 Boîte de dialogue Gestion des utilisateurs et des groupes

- 16.2 Gestion des comptes utilisateur

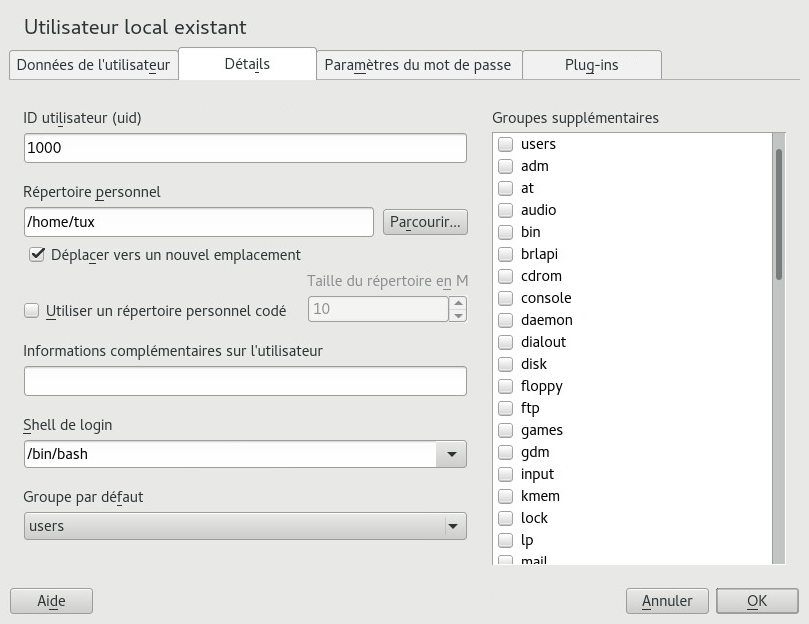

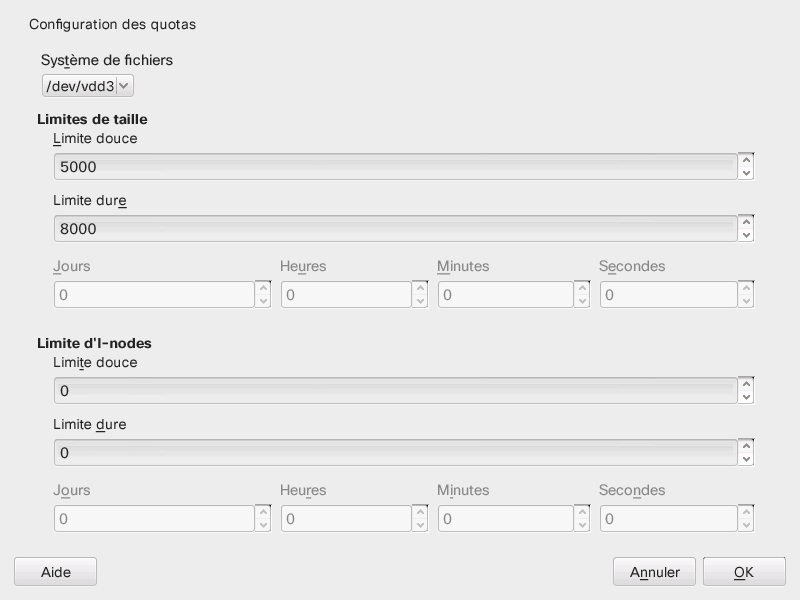

- 16.3 Options supplémentaires des comptes utilisateur

- 16.4 Modification des paramètres par défaut des utilisateurs locaux

- 16.5 Affectation des utilisateurs à des groupes

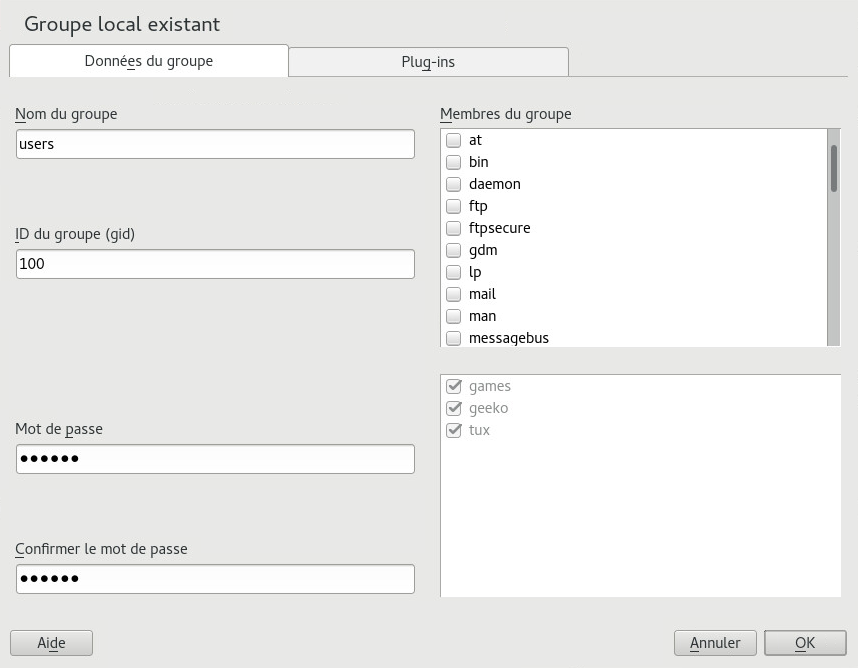

- 16.6 Gestion des groupes

- 16.7 Modification de la méthode d'authentification des utilisateurs

- 17 Modification des paramètres de langue et de pays avec YaST

- VI Mise à jour et mise à niveau de SUSE Linux Enterprise

- 18 Cycle de vie et support

- 19 Mise à niveau de SUSE Linux Enterprise

- 20 Mise à niveau en mode hors ligne

- 20.1 Présentation conceptuelle

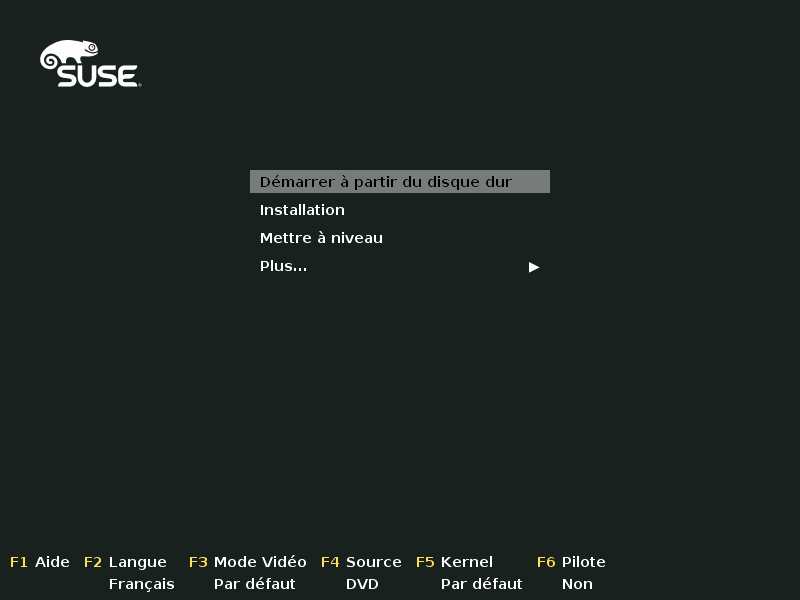

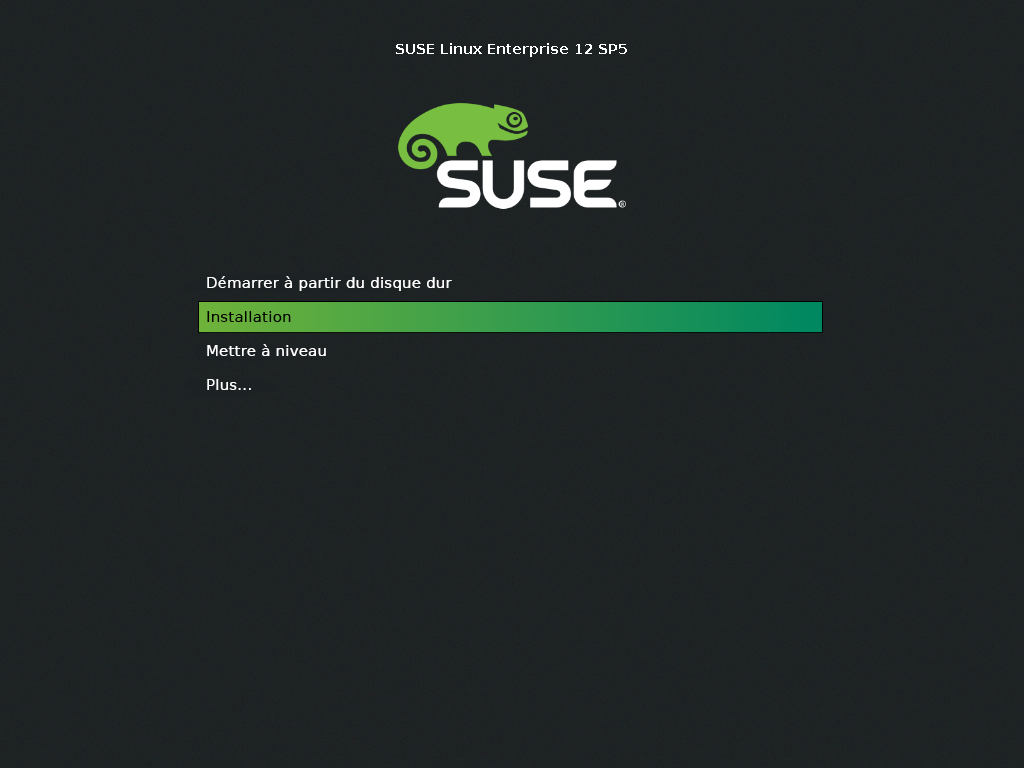

- 20.2 Démarrage de la mise à niveau à partir d'un support d'installation

- 20.3 Démarrage de la mise à niveau à partir d'une source réseau

- 20.4 Activation de la mise à niveau automatique

- 20.5 Mise à niveau de SUSE Linux Enterprise

- 20.6 Mise à jour via SUSE Manager

- 20.7 Mise à jour de l'état d'enregistrement après un retour à l'état initial

- 20.8 Enregistrement de votre système

- 21 Mise à niveau en ligne

- 21.1 Présentation conceptuelle

- 21.2 Déroulement de la migration des Service Packs

- 21.3 Annulation de la migration d'un Service Pack

- 21.4 Mise à niveau à l'aide de l'outil de migration en ligne (YaST)

- 21.5 Mise à niveau avec zypper

- 21.6 Mise à niveau à l'aide de Plain Zypper

- 21.7 Restauration de l'état initial d'un Service Pack

- 22 Code source du rétroportage

- A GNU licenses

- 6.1 Écran de démarrage sur les ordinateurs équipés d'un BIOS traditionnel

- 6.2 Écran de démarrage sur les machines équipées de l'interface EUFI

- 6.3 Langue, clavier et accord de licence

- 6.4 Activation du disque

- 6.5 IBM Z : sélection d'un DASD

- 6.6 Paramètres réseau

- 6.7 Enregistrement auprès du SUSE Customer Center

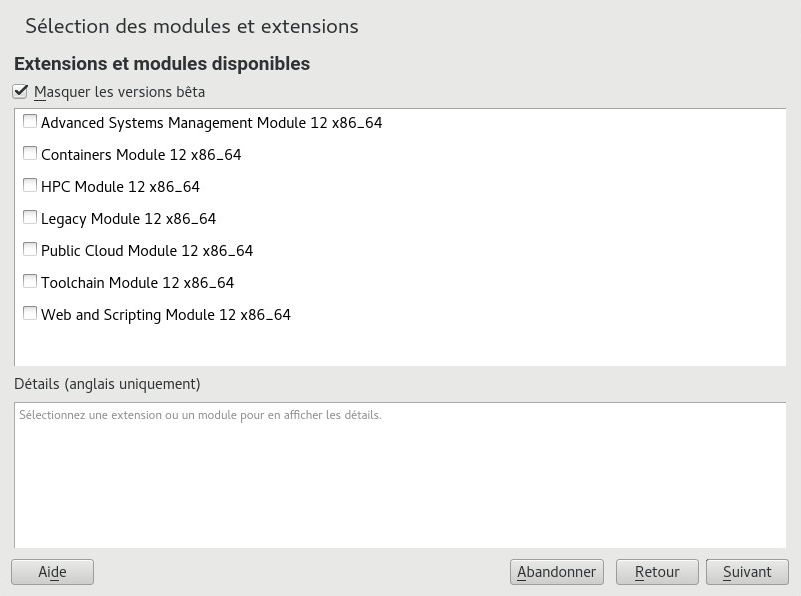

- 6.8 Sélection d'extensions

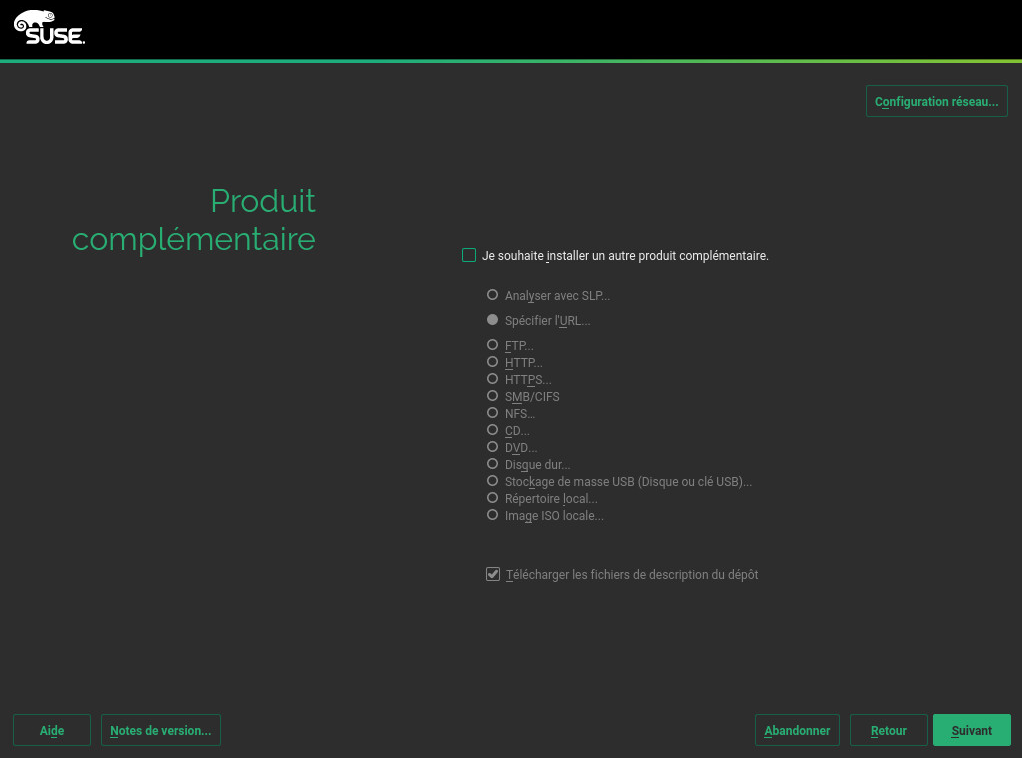

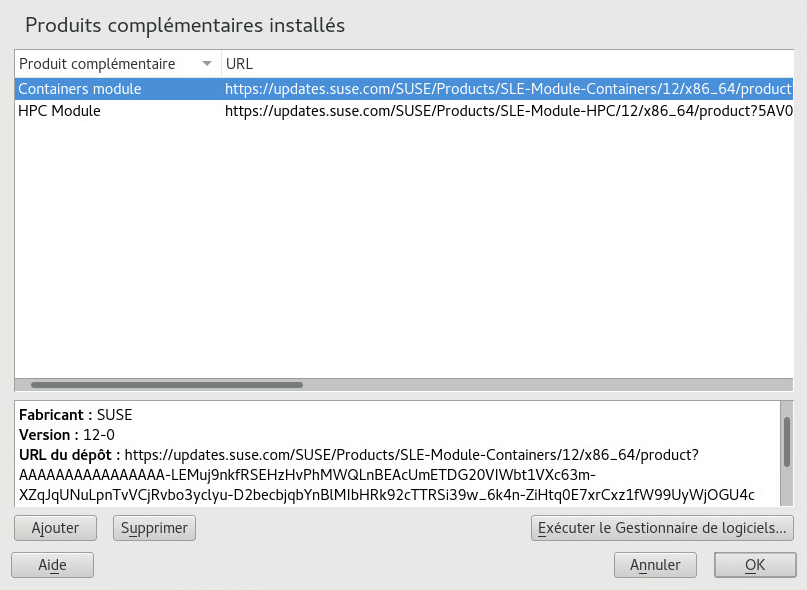

- 6.9 Produit complémentaire

- 6.10 Sélection d'un rôle système

- 6.11 Partitioning (Partitionnement)

- 6.12 Horloge et fuseau horaire

- 6.13 Création d'un utilisateur

- 6.14 Mot de passe de l'administrateur système

root - 6.15 Paramètres d'installation

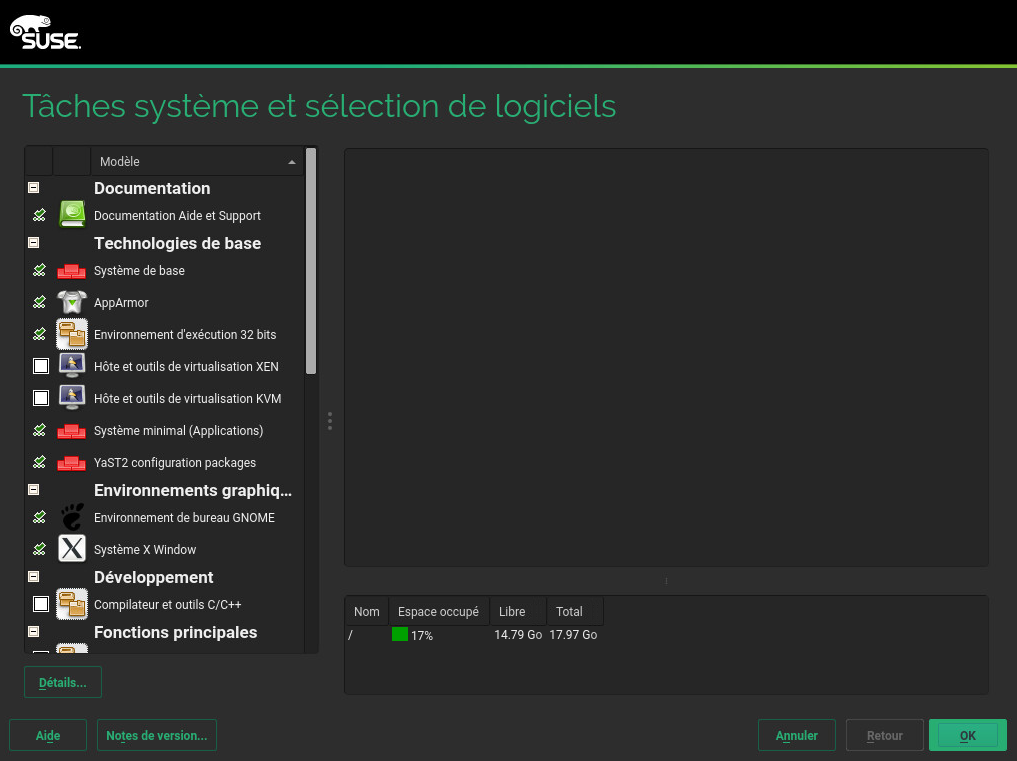

- 6.16 Tâches système et sélection de logiciels

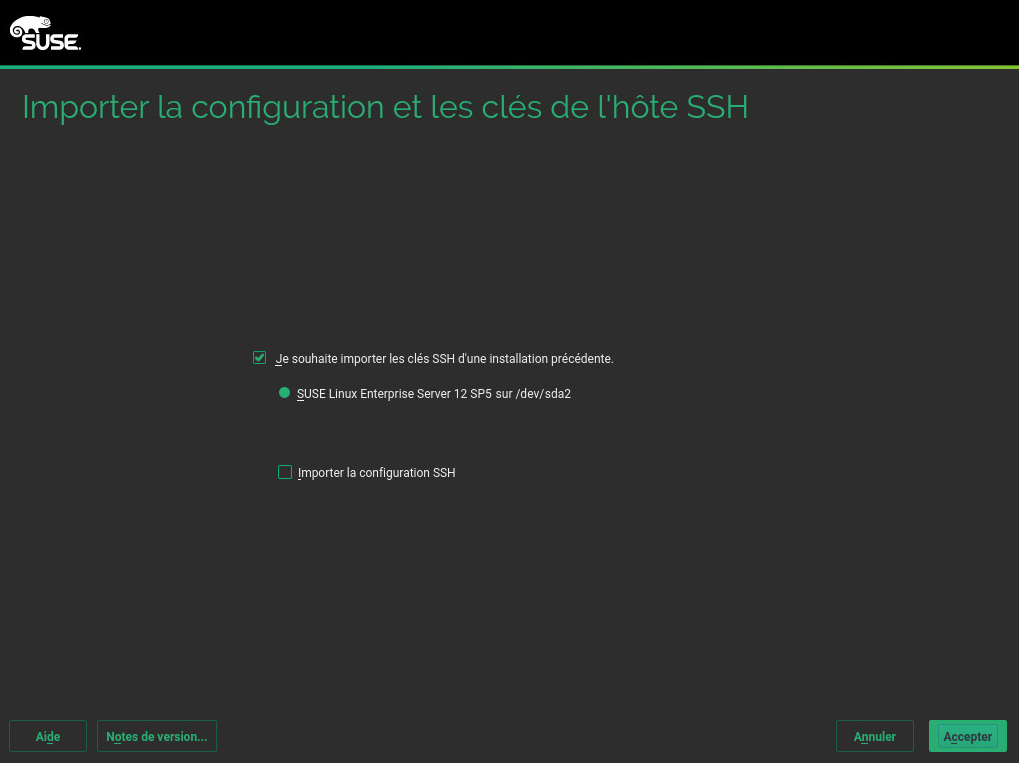

- 6.17 Importation des clés d'hôte SSH et de la configuration

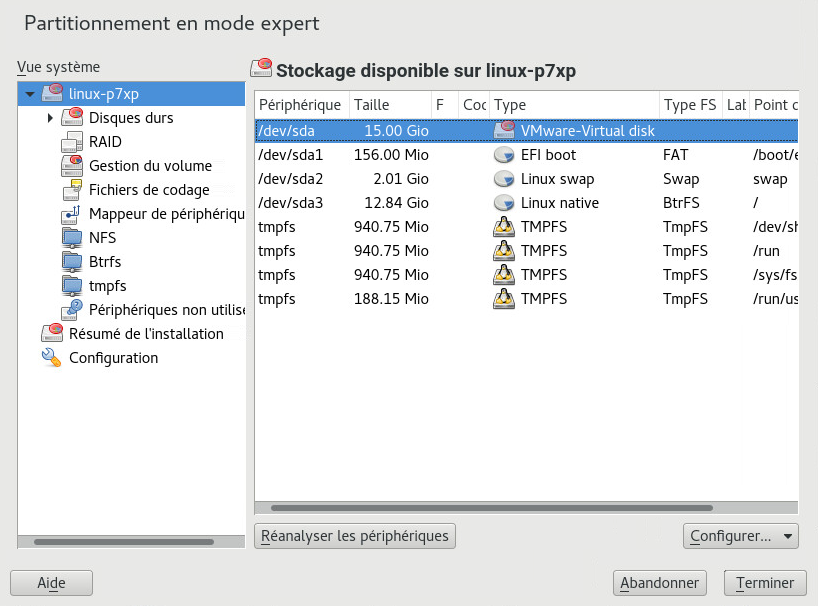

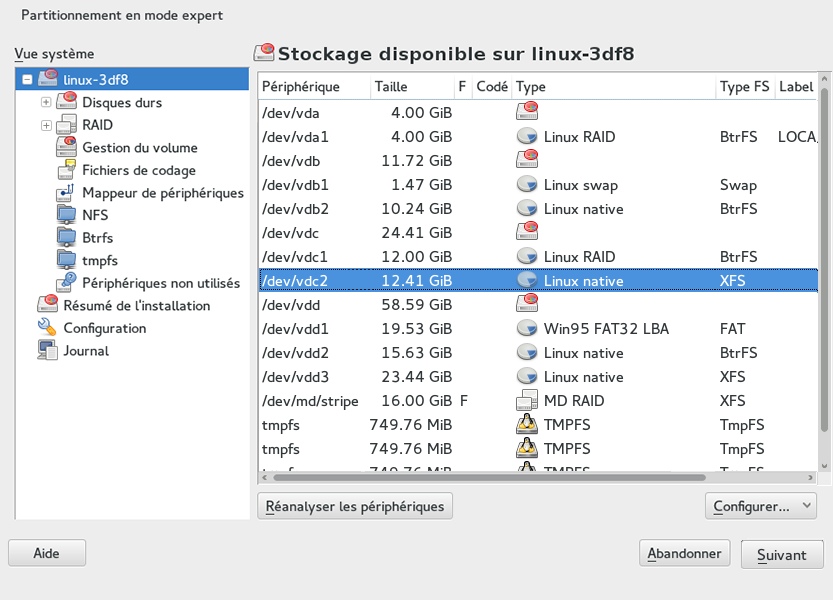

- 12.1 Outil de partitionnement de YaST

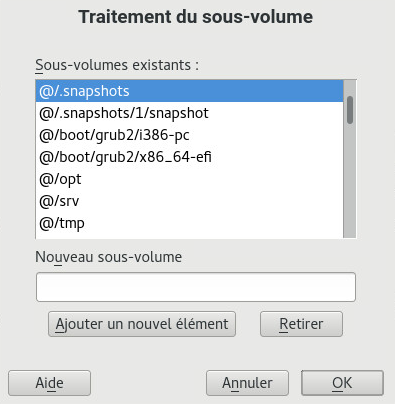

- 12.2 Sous-volumes Btrfs dans le partitionneur YaST

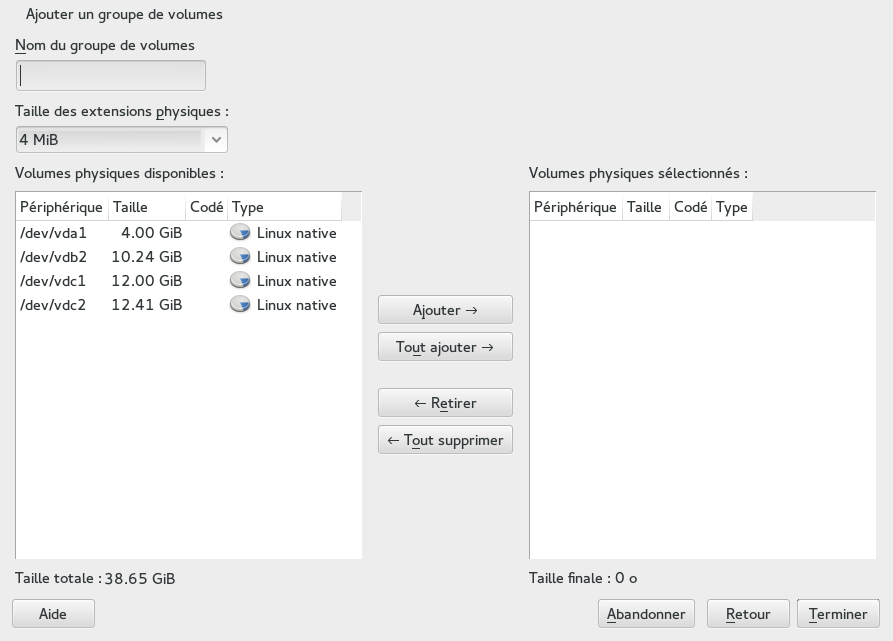

- 12.3 Création d'un groupe de volumes

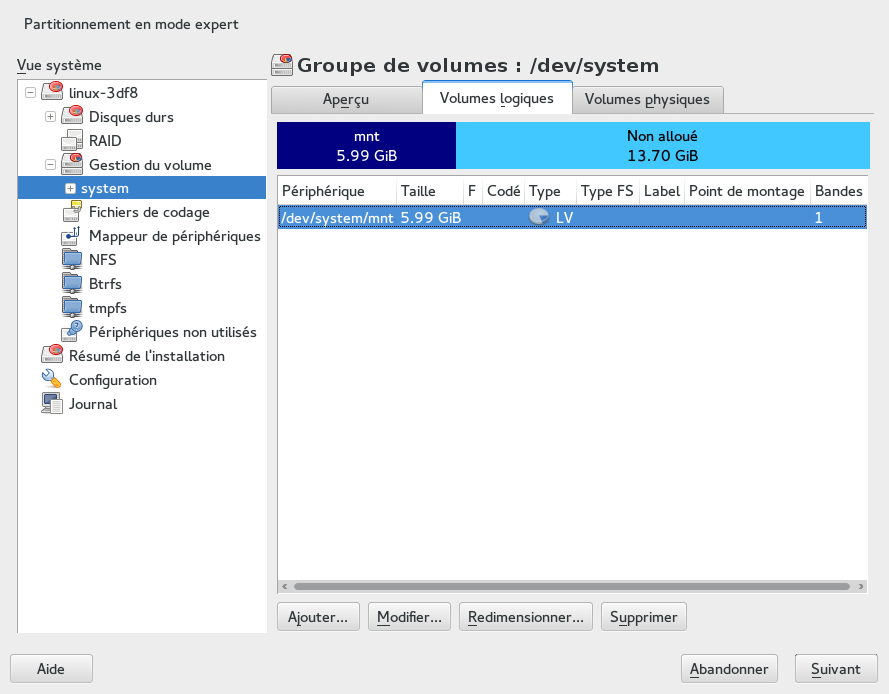

- 12.4 Gestion des volumes logiques

- 12.5 Partitions RAID

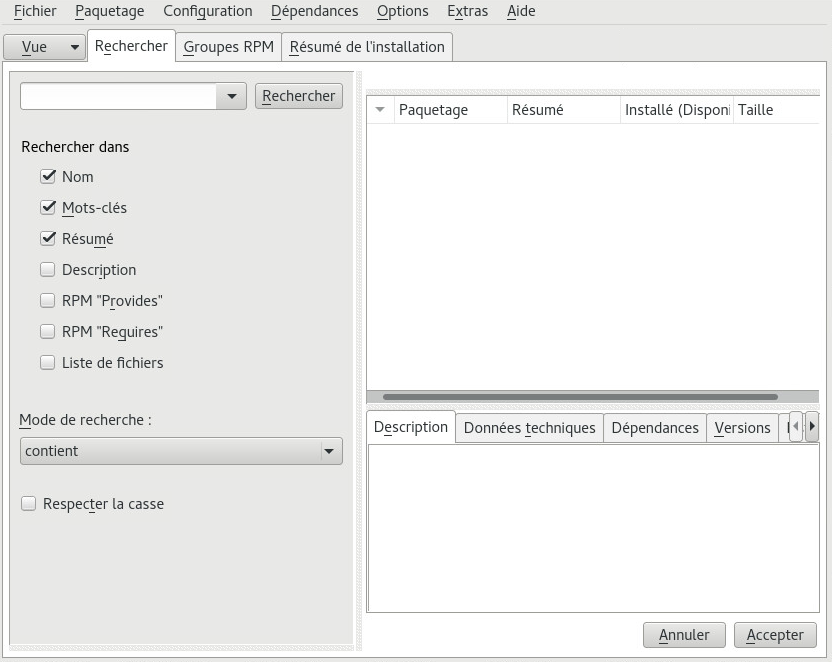

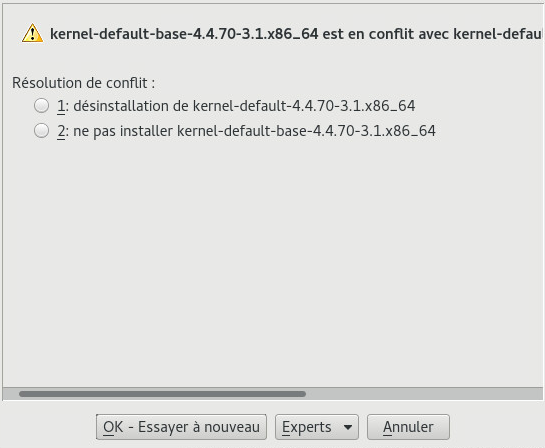

- 13.1 Gestion d'un conflit dans le gestionnaire de logiciels

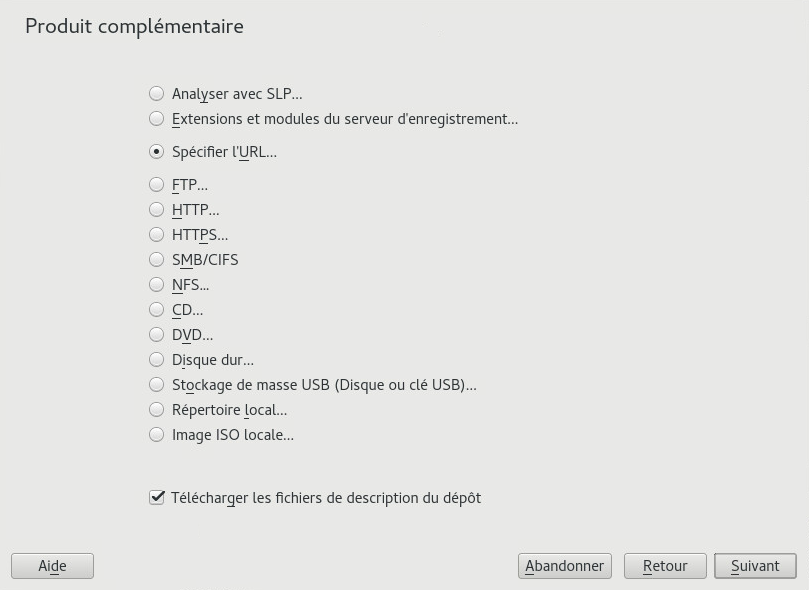

- 13.2 Ajout d'un dépôt de logiciels

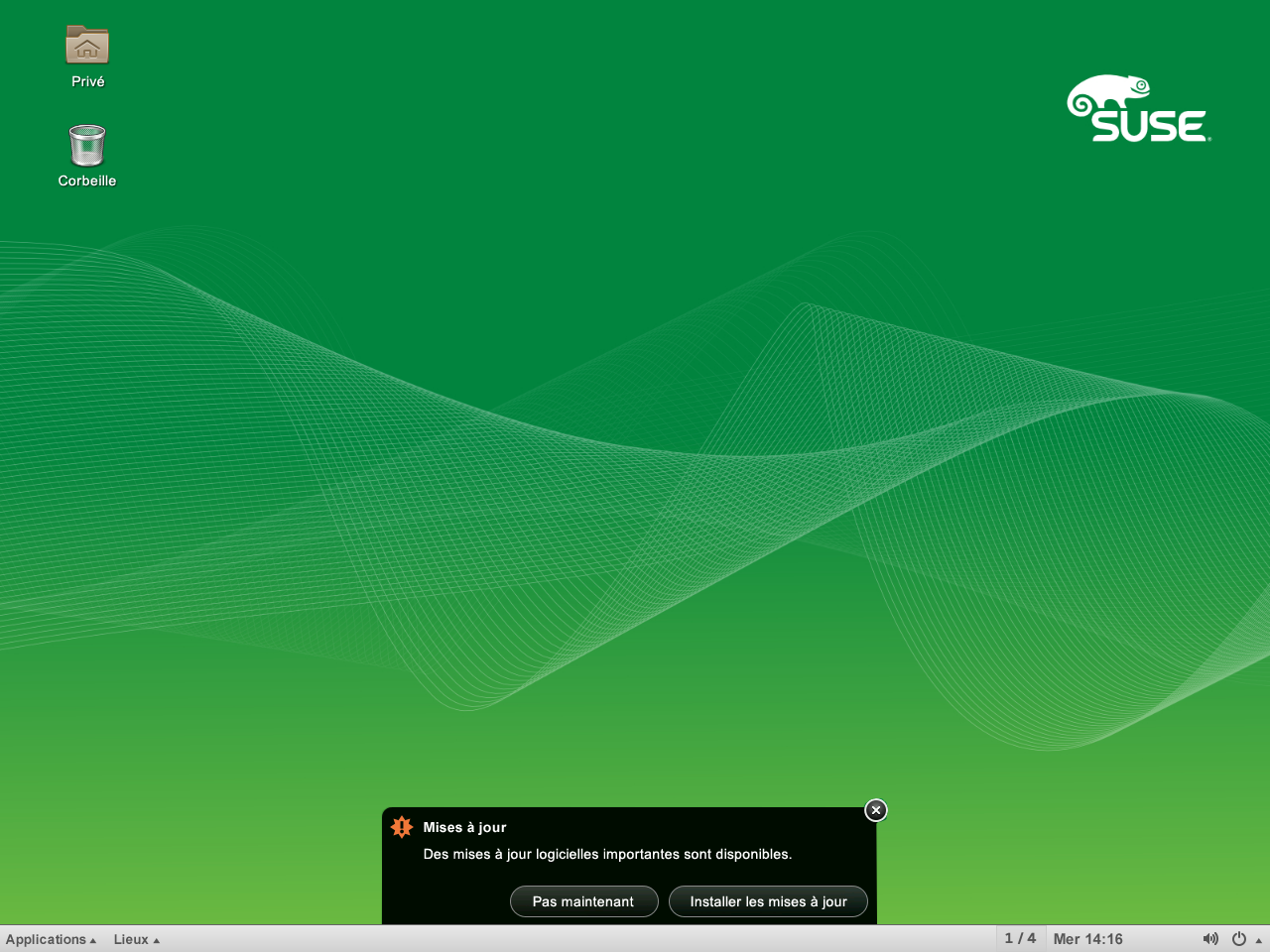

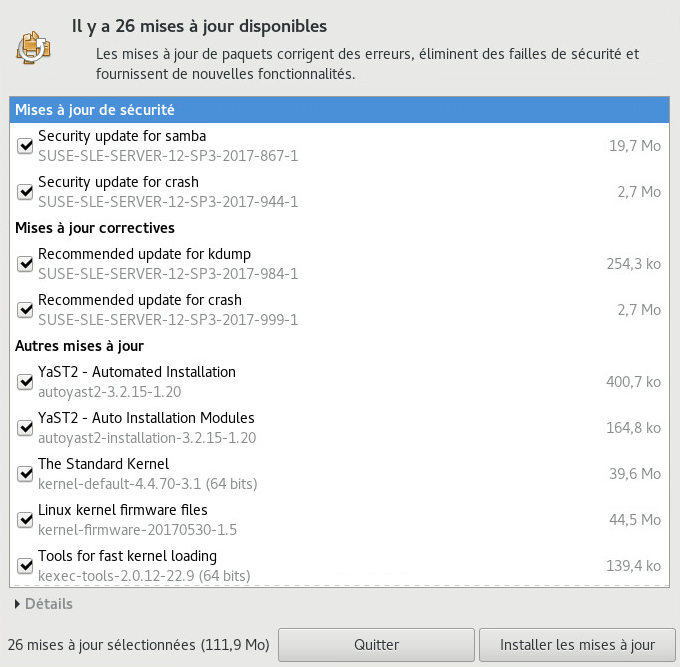

- 13.3 Notification de mise à jour sur l'écran de verrouillage de GNOME

- 13.4 Notification de mise à jour sur le bureau de GNOME

- 13.5 Visionneuse de mise à jour de GNOME

- 14.1 Installation des extensions de système

- 14.2 Liste des produits complémentaires, modules et extensions installés

- 14.3 Installation d'un produit complémentaire ou d'une extension

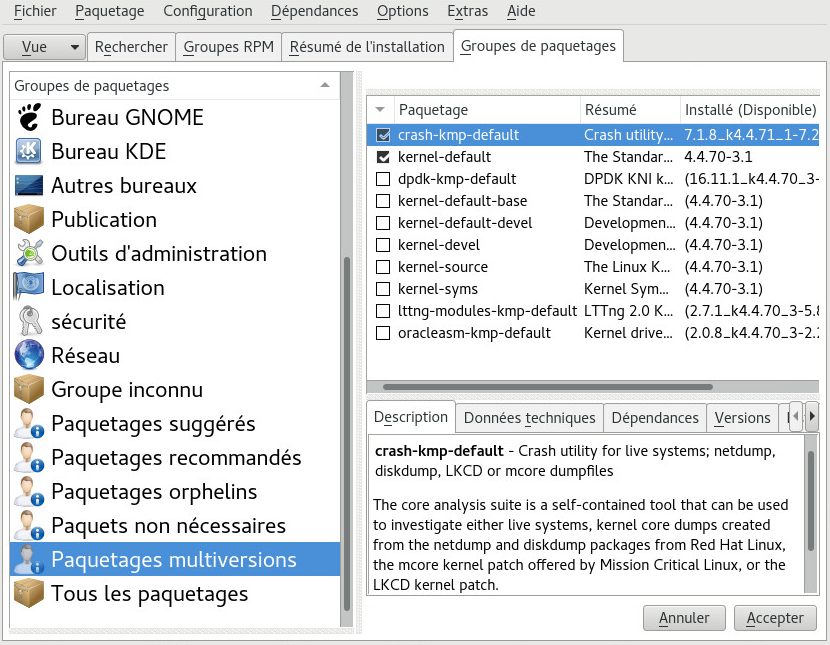

- 15.1 Gestionnaire de logiciels : affichage multiversion

- 16.1 Gestion des utilisateurs et des groupes YaST

- 18.1 Versions majeures et Service Packs

- 18.2 Support à long terme au niveau des service packs

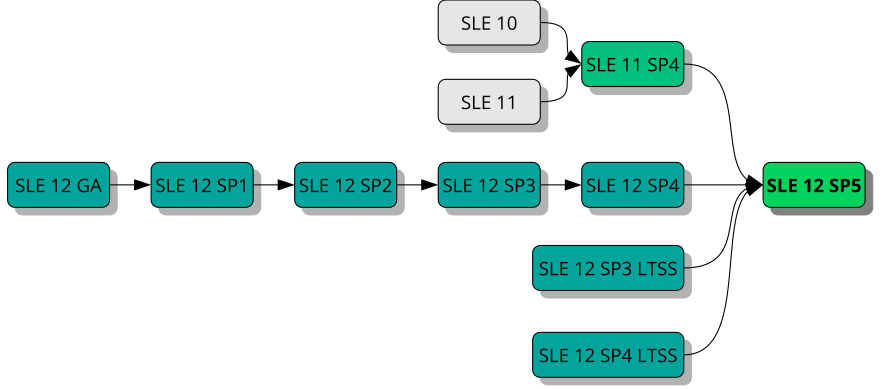

- 19.1 Aperçu des chemins de mise à niveau pris en charge

- 4.1 Configuration d'un répertoire z/VM

- 4.2 Exemple de fichier XML de domaine

- 4.3 Transfert de fichiers binaires via le serveur FTP

- 4.4 SLES12 EXEC

- 4.5 Types de connexion réseau pris en charge et paramètres des pilotes

- 4.6 Paramètres du pilote de périphérique réseau

- 4.7 Paramètres réseau

- 4.8 Fichier parmfile pour une installation à partir de NFS avec VNC et AutoYaST

- 4.9 Fichier parmfile pour une installation avec NFS, SSH et HSI et AutoYaST avec NFS

- 6.1

regcodes.txt - 6.2

regcodes.xml - 19.1 List with

df -h

Copyright © 2006– 2025 SUSE LLC et contributeurs. Tous droits réservés.

Il est autorisé de copier, distribuer et/ou modifier ce document conformément aux conditions de la licence de documentation libre GNU version 1.2 ou (à votre discrétion) 1.3, avec la section permanente qu'est cette mention de copyright et la licence. Une copie de la version de licence 1.2 est incluse dans la section intitulée « Licence de documentation libre GNU ».

Pour les marques commerciales SUSE, consultez le site Web http://www.suse.com/company/legal/. Toutes les autres marques de fabricants tiers sont la propriété de leur détenteur respectif. Les symboles de marque commerciale (®,™, etc.) indiquent des marques commerciales de SUSE et de ses filiales. Des astérisques (*) désignent des marques commerciales de fabricants tiers.

Toutes les informations de cet ouvrage ont été regroupées avec le plus grand soin. Cela ne garantit cependant pas sa complète exactitude. Ni SUSE LLC, ni les sociétés affiliées, ni les auteurs, ni les traducteurs ne peuvent être tenus responsables des erreurs possibles ou des conséquences qu'elles peuvent entraîner.

À propos de ce guide #

Il existe plusieurs façons d'installer SUSE Linux Enterprise Server. Il est impossible d'évoquer toutes les combinaisons de démarrage, du serveur d'installation, d'installations automatisées ou de déploiement d'images. Ce manuel doit vous aider à choisir la méthode la plus appropriée pour déployer votre installation.

- Partie I, « Préparation de l'installation »

Les instructions de déploiement standard diffèrent selon l'architecture utilisée. Pour connaître les différences et les conditions relatives à l'architecture, reportez-vous à cette section.

- Partie II, « Workflow d'installation »

La plupart des tâches requises au cours des installations sont décrites ici. Il est notamment question de la configuration manuelle de votre ordinateur et de l'installation de logiciels supplémentaires.

- Partie III, « Configuration d'un serveur d'installation »

SUSE® Linux Enterprise Server peut être installé de différentes manières. Outre l'installation classique à partir d'un support, vous avez le choix entre plusieurs approches réseau. Cette section décrit la procédure de configuration d'un serveur d'installation et la préparation du démarrage du système cible pour l'installation.

- Partie IV, « Installation à distance »

Cette section présente les scénarios d'installation à distance les plus courants. Tandis que certaines nécessitent une intervention de l'utilisateur ou un certain degré d'accès physique au système cible, d'autres sont totalement automatisées et ne requièrent aucune intervention. Découvrez quelle approche convient le mieux à votre scénario.

- Partie V, « Configuration initiale du système »

Apprenez à configurer votre système après l'installation. Cette section traite des tâches courantes telles que la configuration des composants matériels, l'installation ou la suppression de logiciels, la gestion des utilisateurs ou la modification des paramètres avec YaST.

- Partie VI, « Mise à jour et mise à niveau de SUSE Linux Enterprise »

Cette section fournit des informations générales sur la terminologie, les versions de Service Pack et les cycles de vie des produits SUSE, ainsi que sur les stratégies de mise à niveau recommandées.

1 Exigences requises #

Pour que ces instructions restent gérables, certaines hypothèses techniques ont été faites:

avoir une certaine expérience en matière informatique et connaître le vocabulaire technique de base ;

connaître la documentation de votre système et le réseau sur lequel il s'exécute ;

avoir une connaissance de base des systèmes Linux.

2 Documentation disponible #

La documentation relative à nos produits est disponible à la page https://documentation.suse.com/, où vous pouvez également rechercher les dernières mises à jour et parcourir ou télécharger la documentation dans différents formats.

En outre, la documentation sur le produit est généralement disponible dans votre système sous /usr/share/doc/manual.

La documentation suivante est disponible pour ce produit :

- Article “Démarrage rapide de l'installation”

Répertorie les configurations système requises et indique comment installer SUSE Linux Enterprise Server depuis un DVD ou une image ISO.

- Book “Guide de déploiement”

Indique comment installer un ou plusieurs systèmes et exploiter les fonctionnalités inhérentes au produit pour une infrastructure de déploiement. Vous pouvez choisir entre différentes approches qui vont d'une installation locale ou d'un serveur d'installation réseau au déploiement en masse à l'aide d'une technique d'installation automatisée, commandée à distance et hautement personnalisée.

- Book “Administration Guide”

Présente les tâches d'administration système telles que la maintenance, la surveillance et la personnalisation d'un système initialement installé.

- Book “Virtualization Guide”

Décrit la technologie de virtualisation dans les grandes lignes et présente libvirt, l'interface unifiée de virtualisation, ainsi que des informations détaillées sur des hyperviseurs spécifiques.

- Book “Storage Administration Guide”

Fournit des informations à propos de la gestion des périphériques de stockage sous SUSE Linux Enterprise Server.

- Book “AutoYaST”

AutoYaST est un système pour le déploiement de masse sans surveillance des systèmes SUSE Linux Enterprise Server (SLES) utilisant un profil AutoYaST contenant les données d'installation et de configuration. Ce manuel vous guide pendant les étapes de base de l'installation automatique : préparation, installation et configuration.

- Book “Security and Hardening Guide”

Présente les concepts de base de la sécurité système, couvrant les aspects de la sécurité locale et réseau. Explique comment utiliser les logiciels de sécurité inhérents au produit, tels que AppArmor ou le système d'audit qui collecte, de manière fiable, des informations sur tout événement ayant trait à la sécurité.

- Book “Hardening Guide”

Traite en détail des procédures d'installation et de configuration d'une solution SUSE Linux Enterprise Server sécurisée, ainsi que des autres processus nécessaires après l'installation pour renforcer la sécurité de cette installation. Assiste l'administrateur dans les choix et décisions en matière de sécurité.

- Book “System Analysis and Tuning Guide”

Guide d'administrateur pour la détection, la résolution des problèmes et l'optimisation du système. Indique comment inspecter et optimiser votre système à l'aide d'outils de surveillance et comment gérer efficacement les ressources. Contient également un aperçu des problèmes courants et de leurs solutions, de l'aide supplémentaire et des ressources de documentation.

- Book “Subscription Management Tool Guide”

Guide de l'administrateur pour l'outil de gestion des abonnements, un système proxy pour SUSE Customer Center avec des cibles de dépôt et d'enregistrement. Découvrez comment installer et configurer un serveur SMT local, mettre en miroir et gérer les dépôts, gérer les machines clientes et configurer des clients pour utiliser SMT.

- Book “GNOME User Guide”

Présente le bureau GNOME de SUSE Linux Enterprise Server. Ce manuel vous guide tout au long de l'utilisation et de la configuration du bureau, et vous aide à réaliser des tâches essentielles. Il s'adresse essentiellement aux utilisateurs finaux qui souhaitent utiliser efficacement GNOME comme bureau par défaut.

3 Commentaires #

Pour soumettre vos commentaires, vous disposez de plusieurs options :

- Bogues et demandes d'amélioration

Pour connaître les services et les options de support disponibles pour votre produit, visitez le site http://www.suse.com/support/.

L'aide sur openSUSE est fournie par la communauté. Reportez-vous au site https://en.opensuse.org/Portal:Support pour plus d'informations.

Pour signaler les bogues relatifs à un composant produit, rendez-vous sur le site https://scc.suse.com/support/requests, connectez-vous et cliquez sur .

- Commentaires utilisateur

Nous sommes à l'écoute de vos commentaires et suggestions concernant ce manuel et les autres documentations fournies avec ce produit. Utilisez le lien « Report Bug » (Signaler un bogue) à côté de chaque titre pour fournir des commentaires via SUSE Bugzilla.

- Messagerie

Pour formuler des commentaires sur la documentation de ce produit, vous pouvez également envoyer un message électronique à l'adresse

doc-team@suse.com. Veillez à inclure le titre du document, la version du produit et la date de publication de la documentation. Pour signaler des erreurs ou proposer des améliorations, veuillez fournir une brève description du problème et mentionner le numéro de section et la page (ou URL) correspondants.

4 Conventions relatives à la documentation #

Les conventions typographiques et mentions suivantes sont utilisées dans cette documentation :

/etc/passwd: noms de répertoires et de fichiersMARQUE_RÉSERVATION: l'élément MARQUE_RÉSERVATION doit être remplacé par la valeur réelle

PATH: variable d'environnement PATHls,--help: commandes, options et paramètresuser: utilisateurs ou groupesnom_paquetage : nom d'un paquetage

Alt, Alt–F1 : touche ou combinaison de touches sur lesquelles appuyer ; les touches apparaissent en majuscules comme sur un clavier

, › : options de menu, boutons

AMD/Intel Ce paragraphe concerne uniquement l'architecture AMD64/Intel 64. Les flèches marquent le début et la fin du bloc de texte.

IBM Z, POWER Ce paragraphe ne s'applique qu'aux architectures IBM

ZetPOWER. Les flèches marquent le début et la fin du bloc de texte.Pingouins qui dansent (chapitre Pingouins, ↑Autre manuel) : référence au chapitre d'un autre manuel.

Commandes à exécuter avec les privilèges

root. Souvent, vous pouvez également leur ajouter en préfixe la commandesudopour les exécuter sans privilèges.root #commandtux >sudo commandCommandes pouvant être exécutées par des utilisateurs non privilégiés.

tux >commandAvis

Avertissement : note d'avertissementInformation essentielle dont vous devez prendre connaissance avant de continuer. Met en garde contre des problèmes de sécurité ou des risques de perte de données, de détérioration matérielle ou de blessure physique.

Important : note importanteInformation importante dont vous devez prendre connaissance avant de continuer.

Remarque : note de remarqueInformation supplémentaire, par exemple sur les différences dans les versions des logiciels.

Astuce : note indiquant une astuceInformation utile, telle qu'un conseil ou un renseignement pratique.

1 Planification pour SUSE Linux Enterprise Server #

1.1 Considérations relatives au déploiement d'un serveur SUSE Linux Enterprise Server #

La mise en œuvre d'un système d'exploitation est une opération qui doit être préparée avec soin, qu'elle se produise dans un environnement informatique existant ou créé de toutes pièces. Au début de la phase de planification, vous devez tenter de définir les objectifs du projet et les fonctions requises. Cette étape doit être répétée pour chaque projet. Vous devrez chaque fois répondre aux questions suivantes :

Combien d'installations va-t-il falloir effectuer ? Les méthodes de déploiement les mieux adaptées varient en fonction de cette réponse.

Le système sera-t-il exécuté en tant qu'hôte physique ou en tant que machine virtuelle ?

Le système se situera-t-il dans un environnement hostile ? Pour obtenir une vue d'ensemble des conséquences possibles, reportez-vous au Book “Security and Hardening Guide”, Chapter 1 “Security and Confidentiality”.

Comment allez-vous obtenir les mises à jour régulières ? Tous les correctifs sont fournis en ligne pour les utilisateurs enregistrés. Pour l'enregistrement et les correctifs, reportez-vous à la base de données de l'assistance technique (http://download.suse.com/).

Avez-vous besoin d'aide pour votre installation locale ? SUSE propose des formations, une assistance technique et des services de conseil pour tout ce qui a trait à SUSE Linux Enterprise Server. Pour plus d'informations, reportez-vous au site https://www.suse.com/products/server/.

Avez-vous besoin de produits tiers ? Vérifiez que le produit requis est également pris en charge par la plate-forme choisie. SUSE peut vous aider à prendre en charge des logiciels sur d'autres plates-formes, au besoin.

1.2 Déploiement de SUSE Linux Enterprise Server #

Pour garantir le parfait fonctionnement de votre système, essayez d'utiliser systématiquement un matériel certifié. Le processus de certification du matériel est continuel. La base de données des matériels certifiés est régulièrement mise à jour. Vous trouverez le formulaire de recherche des matériels certifiés à la page http://www.suse.com/yessearch/Search.jsp.

En fonction du nombre d'installations souhaitées, il peut être avantageux de recourir à des serveurs d'installation, voire de complètement automatiser les installations. Avec les technologies de virtualisation Xen ou KVM, il est conseillé d'envisager le recours aux systèmes de fichiers racines réseau ou aux solutions de stockage réseau (iSCSI, par exemple).

SUSE Linux Enterprise Server vous propose tout un éventail de services. Pour obtenir la vue d'ensemble des informations documentées dans le présent ouvrage, reportez-vous au Book “Administration Guide”, Preface “About This Guide”. La plupart des configurations requises peuvent être réalisées avec YaST, l'utilitaire de configuration de SUSE. En outre, de nombreuses configurations manuelles sont décrites dans les sections correspondantes.

En plus de l'installation logicielle de base, il est conseillé d'étudier la possibilité de former les utilisateurs finals des systèmes, ainsi que le personnel de votre service d'assistance.

1.3 Exécution de SUSE Linux Enterprise Server #

Le système d'exploitation de SUSE Linux Enterprise Server est stable et éprouvé. Malheureusement, cela n'empêche pas les pannes matérielles ou autres, qui risquent de bloquer le système ou de faire perdre des données. Pour toute tâche informatique sérieuse présentant des risques de perte de données, il est vivement recommandé de procéder à une sauvegarde régulière.

Pour une sécurité optimale, notamment en ce qui concerne les données, vous devez régulièrement effectuer des mises à jour de toutes les machines utilisées. Si vous avez un serveur d'importance stratégique, vous devez exécuter une seconde machine identique (pré-production) qui permet de tester toutes les modifications. De plus, vous aurez également la possibilité de changer de machine en cas de panne matérielle.

1.4 Enregistrement de SUSE Linux Enterprise Server #

Pour obtenir un support technique et les mises à jour des produits, vous devez enregistrer et activer vos produits SUSE auprès du SUSE Customer Center. Nous vous recommandons de vous enregistrer pendant l'installation, car cela vous permettra d'installer le système avec les mises à jour et les correctifs les plus récents. Toutefois, si vous êtes hors ligne ou que vous souhaitez ignorer l'étape d'enregistrement, vous pouvez vous enregistrer à tout moment ultérieurement sur le système installé.

Si votre entreprise ne fournit pas de serveur d'enregistrement local, l'inscription de SUSE Linux nécessite un compte SUSE Si vous ne disposez pas encore de compte SUSE, rendez-vous sur la page d'accueil du SUSE Customer Center (https://scc.suse.com/) pour en créer un.

Pendant l'installation, il vous sera demandé d'entrer votre code d'enregistrement. Pour plus de détails, reportez-vous à la Section 6.8, « Enregistrement auprès du SUSE Customer Center ».

Si vous déployez vos instances automatiquement à l'aide d'AutoYaST, vous pouvez enregistrer le système pendant l'installation en fournissant les informations correspondantes dans le fichier de contrôle AutoYaST. Pour plus de détails, reportez-vous au Book “AutoYaST”, Chapter 4 “Configuration and Installation Options”, Section 4.3 “System Registration and Extension Selection”.

Pour l'enregistrement d'un système déjà installé, reportez-vous à la Section 13.2, « Enregistrement d'un système installé ».

Partie I Préparation de l'installation #

- 2 Installation sur AMD64 et Intel 64

Ce chapitre décrit les étapes nécessaires pour préparer l'installation de SUSE Linux Enterprise Server sur des ordinateurs AMD64 et Intel 64. Cette section présente les étapes nécessaires pour préparer les différentes méthodes d'installation. La liste des configurations matérielles requises donne un aperçu des systèmes pris en charge par SUSE Linux Enterprise Server. Vous trouverez ici des informations sur les méthodes d'installation possibles et sur plusieurs problèmes connus fréquents. Vous apprendrez également comment contrôler l'installation, fournir des supports d'installation et démarrer par les méthodes habituelles.

- 3 Installation sur IBM POWER

Ce chapitre décrit la procédure pour préparer l'installation de SUSE® Linux Enterprise Server sur les systèmes IBM POWER.

- 4 Installation sur IBM Z

Ce chapitre décrit la procédure pour préparer l'installation de SUSE® Linux Enterprise Server sur les systèmes IBM Z. Il fournit toutes les informations nécessaires pour préparer l'installation du côté LPAR et z/VM.

- 5 Installation sur ARM AArch64

Ce chapitre décrit les étapes nécessaires pour préparer l'installation de SUSE Linux Enterprise Server sur des ordinateurs ARM AArch64. Cette section présente les étapes nécessaires pour préparer les différentes méthodes d'installation. La liste des configurations matérielles requises donne un aperçu des systèmes pris en charge par SUSE Linux Enterprise Server. Vous trouverez ici des informations sur les méthodes d'installation possibles et sur plusieurs problèmes connus fréquents. Vous apprendrez également comment contrôler l'installation, fournir des supports d'installation et démarrer par les méthodes habituelles.

2 Installation sur AMD64 et Intel 64 #

Ce chapitre décrit les étapes nécessaires pour préparer l'installation de SUSE Linux Enterprise Server sur des ordinateurs AMD64 et Intel 64. Cette section présente les étapes nécessaires pour préparer les différentes méthodes d'installation. La liste des configurations matérielles requises donne un aperçu des systèmes pris en charge par SUSE Linux Enterprise Server. Vous trouverez ici des informations sur les méthodes d'installation possibles et sur plusieurs problèmes connus fréquents. Vous apprendrez également comment contrôler l'installation, fournir des supports d'installation et démarrer par les méthodes habituelles.

2.1 Configuration système pour Linux #

Le système d'exploitation SUSE® Linux Enterprise Server peut être déployé sur une vaste gamme d'équipements matériels. Il est impossible de répertorier toutes les combinaisons de supports SUSE Linux Enterprise Server matériels. Cependant, vous trouverez ci-dessous des informations sur la configuration minimale requise pour vous aider lors de la phase de planification.

Pour garantir le bon fonctionnement d'une configuration d'ordinateur donnée, recherchez les plates-formes certifiées par SUSE. Pour consulter la liste, consultez le site https://www.suse.com/yessearch/.

2.1.1 Matériel pour Intel 64 et AMD64 #

Les architectures Intel 64 et AMD64 permettent une migration simple des logiciels x86 vers leur version 64 bits. Tout comme l'architecture x86, elles représentent une alternative rentable.

- UC

Toutes les unités centrales disponibles sur le marché à ce jour sont prises en charge.

- Nombre maximum d'unités centrales

Le nombre maximal d'UC prises en charge de par la conception du logiciel est de 8 192 pour Intel 64 et AMD64. Si vous avez l'intention d'utiliser un système de cette capacité, vérifiez sur notre page Web (https://www.suse.com/yessearch/) que les périphériques sont conformes à la certification système du matériel.

- Configuration requise pour la mémoire

Un minimum de 512 Mo de mémoire est requis pour une installation minimale. Cependant, la configuration système minimale recommandée est de 1024 ou de 512 Mo par unité centrale sur les ordinateurs multiprocesseurs. Ajoutez 150 Mo pour une installation à distance via HTTP ou FTP. Notez que ces valeurs ne sont valables que pour l'installation du système d'exploitation. La quantité de mémoire réelle en production dépend de la charge de travail système.

- Configuration requise pour le disque dur

La configuration requise pour le disque dépend en grande partie de l'installation sélectionnée et de votre utilisation de la machine. La configuration minimale des différents éléments est la suivante :

Système

Configuration requise pour le disque dur

Minimum

800 Mo - 1 Go

Interface X Window System minimale

1,4 Go

Bureau GNOME

3,5 Go

Tous les modèles

8,5 Go

Utilisation d'instantanés pour la virtualisation

min. 8 Go

- Méthodes de démarrage

L'ordinateur peut être démarré depuis un CD ou un réseau. Un serveur de démarrage spécifique est requis pour un démarrage sur le réseau. Il peut également être configuré avec SUSE Linux Enterprise Server.

2.2 Considérations relatives à l'installation #

Cette section aborde plusieurs facteurs à prendre en compte avant d'installer SUSE Linux Enterprise Server sur un matériel AMD64 et Intel 64.

2.2.1 Type d'installation #

SUSE Linux Enterprise Server est normalement installé en tant que système d'exploitation indépendant. Depuis l'introduction de la virtualisation, il est également possible d'exécuter plusieurs instances de SUSE Linux Enterprise Server sur le même matériel. Toutefois, l'installation du serveur hôte de machine virtuelle s'effectue comme une installation classique en y ajoutant des paquetages supplémentaires. L'installation des invités virtuels est décrite dans le Book “Virtualization Guide”, Chapter 9 “Guest Installation”.

2.2.2 Méthodes de démarrage #

Selon le matériel utilisé, les méthodes de démarrage suivantes sont disponibles pour la première procédure de démarrage (avant l'installation de SUSE Linux Enterprise Server).

|

Option de démarrage |

Utilisation |

|---|---|

|

Un lecteur de CD ou de DVD |

Il s'agit de la méthode de démarrage la plus simple. Le système requiert un lecteur de CD ou de DVD disponible en local. |

|

Disques flash |

Les images requises pour créer des disques de démarrage se trouvent sur le premier CD ou DVD dans le répertoire |

|

PXE ou bootp |

Doit être pris en charge par le BIOS ou le microprogramme du système utilisé. Cette option nécessite qu'un serveur de démarrage soit installé sur le réseau. Cette tâche peut être assurée par un serveur SLES distinct. |

|

Disque dur |

SUSE Linux Enterprise Server peut également être lancé à partir d'un disque dur. Pour ce faire, copiez le kernel ( |

2.2.3 Source d'installation #

Lors de l'installation de SUSE Linux Enterprise Server, les données d'installation effectives doivent être accessibles sur le réseau, sur une partition du disque dur ou sur un DVD local. Pour effectuer une installation depuis le réseau, vous avez besoin d'un serveur d'installation. Pour mettre les données d'installation à disposition, configurez un ordinateur dans un environnement Unix ou Linux en tant que serveur NFS, HTTP, SMB ou FTP. Pour rendre les données d'installation disponibles depuis un ordinateur Windows, libérez les données avec SMB.

La source d'installation est particulièrement facile à sélectionner si vous configurez un serveur SLP sur le réseau local. Pour plus d'informations, reportez-vous au Chapitre 8, Configuration du serveur qui contient les sources d'installation.

2.2.4 Cible d'installation #

La plupart des installations sont effectuées sur un disque dur local. Par conséquent, il est nécessaire que les contrôleurs du disque dur soient accessibles au système d'installation. Si un contrôleur spécifique (comme un contrôleur RAID) requiert un module de kernel supplémentaire, fournissez un disque de mise à jour du module de kernel au système d'installation.

Tous les types de périphériques de bloc peuvent servir de cibles d'installation, à condition qu'ils offrent un espace disque et une vitesse suffisants pour exécuter un système d'exploitation. Il peut s'agir de périphériques de bloc réseau comme iSCSI ou SAN. Il est également possible d'effectuer des installations sur des systèmes de fichiers réseau offrant des autorisations Unix standard. Cependant, il peut être difficile de démarrer ces systèmes de fichiers, qui doivent être pris en charge par initramfs avant que le système ne démarre. Ce type d'installation peut être utile lorsque vous devez démarrer le même système à des endroits différents ou que vous prévoyez d'utiliser des fonctionnalités de virtualisation telles que la migration de domaine.

2.2.5 Autres méthodes d'installation #

SUSE Linux Enterprise Server propose plusieurs méthodes de contrôle de l'installation :

Installation sur la console

Installation avec une console série

Installation avec AutoYaST

Installation avec des images KIWI

Installation avec SSH

Installation avec VNC

Par défaut, la console graphique est utilisée. Si vous devez installer un grand nombre d'ordinateurs similaires, il est recommandé de créer un fichier de configuration AutoYaST ou une image KIWI préchargée et de le/la rendre accessible au processus d'installation. Reportez-vous également à la documentation d'AutoYaST sur le site Book “AutoYaST” et de KIWI à l'adresse http://doc.opensuse.org/projects/kiwi/doc/.

2.3 Support de démarrage et d'installation #

Lors de l'installation du système, le support de démarrage peut être différent du support d'installation du système. Toutes les combinaisons de supports pris en charge pour le démarrage et l'installation peuvent être utilisées.

2.3.1 Support de démarrage #

Le démarrage d'un ordinateur dépend des performances du matériel utilisé et de la disponibilité du support pour l'option de démarrage correspondante.

- Démarrage à partir d'un DVD

Il s'agit de la méthode la plus courante pour démarrer un système. Très simple pour la plupart des utilisateurs d'ordinateurs, elle requiert néanmoins un grand nombre d'interactions pour chaque processus d'installation.

- Démarrage à partir d'un disque dur USB

En fonction du matériel utilisé, il est possible de démarrer le système à partir d'un disque dur USB. Le support correspondant doit être créé en suivant la procédure décrite à la Section 6.2.2, « PC (AMD64/Intel 64/ARM AArch64) : démarrage du système ».

- Démarrage à partir d'un réseau

Vous ne pouvez démarrer un ordinateur directement depuis le réseau que s'il est pris en charge par le BIOS ou le microprogramme de l'ordinateur. Cette méthode de démarrage nécessite qu'un serveur de démarrage fournisse les images de démarrage requises sur le réseau. Le protocole exact dépend de votre matériel. Plusieurs services, tels que TFTP et DHCP ou le démarrage PXE, sont généralement nécessaires. Si vous avez besoin d'un serveur de démarrage, consultez également la Section 10.1.3, « Installation à distance via VNC : démarrage PXE et fonction Wake on LAN (réveil à distance) ».

2.3.2 Support d'installation #

Le support d'installation contient tous les paquetages et méta-informations nécessaires pour installer une instance SUSE Linux Enterprise Server. Le système d'installation doit pouvoir y accéder après le démarrage en vue de l'installation. SUSE Linux Enterprise Server permet de fournir le support d'installation au système de différentes manières.

- Installation à partir d'un DVD

Toutes les données nécessaires sont fournies sur le support de démarrage. En fonction de l'installation sélectionnée, une connexion réseau ou des supports supplémentaires peuvent être nécessaires.

- Installation réseau

Si vous envisagez d'installer plusieurs systèmes, il est plus facile de fournir les supports d'installation via le réseau. Il est possible d'effectuer l'installation via plusieurs protocoles courants, comme NFS, HTTP, FTP ou SMB. Pour plus d'informations sur l'exécution d'une telle installation, reportez-vous au Chapitre 10, Installation à distance.

2.4 Procédure d'installation #

Cette section présente les étapes requises pour effectuer une installation complète de SUSE® Linux Enterprise Server dans le mode requis. La Partie II, « Workflow d'installation » contient une description complète de la procédure d'installation et de configuration du système avec &yast.

2.4.1 Démarrage depuis une unité locale interchangeable #

Vous pouvez utiliser un lecteur de DVD-ROM et des périphériques de stockage USB pour procéder à une installation. Réglez votre ordinateur en fonction de vos besoins :

Assurez-vous que le lecteur est entré comme lecteur amorçable dans le BIOS.

Insérez le support de démarrage dans le lecteur et lancez la procédure de démarrage.

Le menu de démarrage de l'installation de SUSE Linux Enterprise Server permet de transférer différents paramètres vers le système d'installation. Reportez-vous également à la Section 10.2.2, « Utilisation des options de démarrage personnalisées ». Si vous souhaitez effectuer l'installation sur le réseau, indiquez à cet endroit la source d'installation.

Si vous rencontrez des problèmes au cours de l'installation, utilisez les paramètres sans échec pour le démarrage.

2.4.2 Installation via le réseau #

Un serveur d'installation est requis pour effectuer l'installation via une source réseau. La procédure d'installation du serveur est décrite au Chapitre 8, Configuration du serveur qui contient les sources d'installation.

Si vous avez un serveur SLP, sélectionnez SLP comme source d'installation dans le premier écran de démarrage. Lors de la procédure de démarrage, sélectionnez les sources d'installation disponibles à utiliser.

Si le DVD est disponible sur le réseau, utilisez-le comme source d'installation. Dans ce cas, spécifiez le paramètre install=<URL> avec des valeurs appropriées à l'invite de démarrage. Pour plus d'informations sur ce paramètre, reportez-vous à la Section 10.2.2, « Utilisation des options de démarrage personnalisées ».

2.5 Contrôle de l'installation #

Vous pouvez contrôler l'installation de différentes manières. La méthode la plus souvent utilisée consiste à installer SUSE® Linux Enterprise Server à partir de la console de l'ordinateur. D'autres options sont disponibles pour différentes situations.

2.5.1 Installation sur la console de l'ordinateur #

La méthode la plus simple pour installer SUSE Linux Enterprise Server est d'utiliser la console de l'ordinateur. Avec cette méthode, un programme d'installation graphique vous guide tout au long du processus d'installation. Cette méthode d'installation est décrite en détail au Chapitre 6, Installation avec YaST.

Vous pouvez tout de même effectuer l'installation sur la console sans mode graphique établi. Le programme d'installation textuel offre la même fonctionnalité que la version graphique. Pour quelques conseils sur la navigation dans ce mode, reportez-vous au Book “Administration Guide”, Chapter 5 “YaST in Text Mode”, Section 5.1 “Navigation in Modules”.

2.5.2 Installation à l'aide d'une console série #

Pour cette méthode d'installation, vous avez besoin d'un deuxième ordinateur, connecté par un câble modem nul à l'ordinateur sur lequel vous installez SUSE Linux Enterprise Server. Selon le matériel, la console série est parfois déjà en mesure d'accéder au microprogramme ou au BIOS de l'ordinateur. Si cela est possible, vous pouvez effectuer toute l'installation avec cette méthode. Pour activer l'installation de la console série, spécifiez le paramètre supplémentaire console=ttyS0 à l'invite d'amorçage. Cela doit se faire une fois le processus d'amorçage terminé, mais avant le démarrage du système d'installation.

Sur la plupart des ordinateurs, il y a deux interfaces série : ttyS0 et ttyS1. Pour l'installation, vous avez besoin d'un programme de terminal tel que minicom ou screen. Pour initialiser la connexion série, lancez l'application Screen (Écran) dans une console locale en entrant la commande suivante :

screen /dev/ttyS0 9600

Cela signifie que l'écran reçoit les données du premier port série avec un débit en bauds de 9 600. À partir de maintenant, l'installation est semblable à l'installation en mode texte sur ce terminal.

2.5.3 Installation avec le protocole SSH #

Si vous n'avez pas d'accès direct à la machine et si l'installation est lancée depuis une console de gestion, vous pouvez contrôler tout le processus d'installation via le réseau. Pour ce faire, saisissez les paramètres ssh=1 et ssh.password=SECRET à l'invite de démarrage. Un daemon SSH est ensuite lancé sur le système. Vous pouvez alors vous connecter en tant qu'utilisateur root avec le mot de passe SECRET.

Pour vous connecter, utilisez ssh -X. Le transfert X via SSH est pris en charge, pour autant que vous disposiez d'un serveur X local. Dans le cas contraire, YaST fournit une interface texte via ncurses. YaST vous guide ensuite tout au long du processus d'installation. Cette procédure est décrite en détail à la Section 10.1.5, « Installation simple à distance via SSH : configuration réseau dynamique ».

Si votre réseau local ne comporte aucun serveur DHCP disponible, affectez manuellement une adresse IP au système d'installation. Pour ce faire, saisissez l'option HostIP=IPADDR à l'invite de démarrage.

2.5.4 Installation via VNC #

Si vous ne pouvez pas accéder directement au système, mais que vous souhaitez effectuer une installation graphique, installez SUSE Linux Enterprise Server via VNC. Cette méthode est décrite en détail à la Section 10.3.1, « Installation VNC ».

Étant donné que des clients VNC appropriés sont également disponibles pour d'autres systèmes d'exploitation tels que Microsoft Windows et Mac OS, l'installation peut également être contrôlée depuis des ordinateurs exécutant ces systèmes d'exploitation.

2.5.5 Installation avec AutoYaST #

Si vous devez installer SUSE Linux Enterprise Server sur plusieurs ordinateurs présentant une configuration matérielle similaire, il est recommandé d'effectuer les installations avec AutoYaST. Dans ce cas, installez une instance de SUSE Linux Enterprise Server, puis utilisez-la pour créer les fichiers de configuration AutoYaST nécessaires.

AutoYaST est décrit en détail au Book “AutoYaST” .

2.6 Gestion des problèmes de démarrage et d'installation #

Avant la livraison, SUSE® Linux Enterprise Server est soumis à un programme de test approfondi. Malgré cela, des problèmes peuvent survenir lors du démarrage ou de l'installation.

2.6.1 Problèmes liés au démarrage #

Des problèmes de démarrage peuvent empêcher le lancement du programme d'installation de YaST sur votre système. Il peut aussi arriver que votre système ne démarre pas une fois l'installation terminée.

- Le système installé démarre, mais pas le support

Modifiez le microprogramme ou le BIOS de l'ordinateur pour corriger la séquence de démarrage. Pour ce faire, reportez-vous au manuel du matériel.

- L'ordinateur se bloque

Modifiez la console de votre ordinateur pour rendre les sorties du kernel visibles. Assurez-vous de vérifier les dernières sorties. Pour ce faire, appuyez sur la touche Ctrl–Alt–F10. Si vous ne parvenez pas à résoudre le problème, consultez le service de support de SUSE Linux Enterprise Server. Pour consigner tous les messages système au démarrage, utilisez une connexion série, comme décrit dans la Section 2.5, « Contrôle de l'installation ».

- Disquette de démarrage

La disquette de démarrage est une solution provisoire utile si vous rencontrez des difficultés lors de la configuration d'autres options ou si vous souhaitez reporter la décision concernant le mécanisme de démarrage final. Pour plus d'informations sur la création des disquettes de démarrage, reportez-vous au Book “Administration Guide”, Chapter 13 “The Boot Loader GRUB 2” grub2-mkrescue.

- Avertissement de virus après l'installation

Des variantes BIOS vérifient la structure du secteur de démarrage (MBR) et affichent de manière erronée un avertissement de virus après l'installation de GRUB 2. Pour résoudre ce problème, entrez dans le BIOS et recherchez les paramètres ajustables correspondants. Par exemple, désactivez la . Vous pourrez réactiver cette option ultérieurement. Cependant, cela n'est pas nécessaire si Linux est le seul système d'exploitation utilisé.

2.6.2 Problèmes liés à l'installation #

Si un problème inattendu survient pendant l'installation, des informations sont nécessaires pour en déterminer la cause. Suivez les instructions ci-après pour résoudre le problème :

Vérifiez les sorties sur les différentes consoles. Vous pouvez passer d'une console à l'autre en employant la combinaison de touches Ctrl–Alt–Fn. Par exemple, pour obtenir un shell dans lequel éxécuter différentes commandes, appuyez sur Ctrl–Alt–F2.

Essayez de lancer l'installation avec les « Paramètres sécurisés » (appuyez sur la touche F5 dans l'écran d'installation et sélectionnez ). Si l'installation fonctionne normalement, il existe une incompatibilité qui entraîne l'échec d'

ACPIou d'APIC. Dans certains cas, une mise à jour du BIOS ou du microprogramme résout ce problème.Saisissez la commande

dmesg -Tpour vérifier les messages système sur une console sur le système d'installation.

2.6.3 Redirection de la source de démarrage vers le DVD de démarrage #

Pour simplifier le processus d'installation et éviter des installations accidentelles, votre système est paramétré par défaut pour un démarrage à partir du premier disque dur sur le DVD d'installation de SUSE Linux Enterprise Server. À ce stade, un chargeur de démarrage installé prend généralement le contrôle du système. Cela signifie que le DVD de démarrage peut rester dans le lecteur lors d'une installation. Pour démarrer l'installation, choisissez une option d'installation dans le menu de démarrage du support.

3 Installation sur IBM POWER #

Ce chapitre décrit la procédure pour préparer l'installation de SUSE® Linux Enterprise Server sur les systèmes IBM POWER.

3.1 Configuration requise #

Une installation standard requiert au moins 512 Mo de RAM. L'installation d'un système standard avec le bureau GNOME requiert au moins 3,5 Go d'espace disque dur disponible ; une installation complète nécessite environ 8,5 Go.

3.1.1 Configuration matérielle requise #

Le système d'exploitation SUSE® Linux Enterprise Server peut fonctionner sur des serveurs IBM POWER8. Vous trouverez ci-dessous des informations sur la configuration minimale requise pour vous aider lors de la phase de planification.

Pour garantir le bon fonctionnement d'une configuration d'ordinateur donnée, consultez la base de données des matériels certifiés par SUSE. La liste des matériels certifiés est disponible à l'adresse http://www.suse.com/yessearch/Search.jsp.

SUSE Linux Enterprise Server peut prendre en charge d'autres systèmes IBM POWER non répertoriés ci-dessous. Pour obtenir les informations les plus récentes, rendez-vous sur le Centre d'informations IBM pour Linux à l'adresse http://www.ibm.com/support/knowledgecenter/linuxonibm/liaam/liaamdistros.htm.

Vous trouverez des informations à jour sur IBM FixCentral (http://www.ibm.com/support/fixcentral/). Sélectionnez votre système dans la liste Groupe de produits. Des logiciels supplémentaires sont disponibles à partir du dépôt d'outils IBM PowerLinux. Le dépôt d'outils IBM est également appelé dépôt Yum. Pour plus d'informations sur l'utilisation du dépôt d'outils IBM PowerLinux, consultez l'adresse https://ibm.biz/Bdxn3N.

3.1.1.1 Serveurs équipés d'un processeur IBM POWER8 #

Tous les serveurs POWER8 pris en charge sont compatibles avec PowerKVM.

8247-21L (IBM Power® System S120L)

8247-22L (IBM Power System S220L)

8284-22A (IBM Power System S2200)

8286-41A (IBM Power System S1400)

8286-42A (IBM Power System S2400)

3.2 Préparation #

Ce chapitre décrit les étapes de préparation requises avant de procéder effectivement à l'installation de SUSE Linux Enterprise Server. La procédure d'installation dépend du système utilisé. Les méthodes suivantes sont prises en charge :

Si SUSE® Linux Enterprise Server doit être installé sur plusieurs systèmes ou partitions, il est recommandé de créer une source d'installation réseau. Vous pouvez utiliser la même source pour procéder à des installations simultanées sur plusieurs partitions ou systèmes. Pour plus d'informations sur la configuration d'une source d'installation réseau, reportez-vous à la Section 8.1, « Configuration d'un serveur d'installation à l'aide de YaST ».

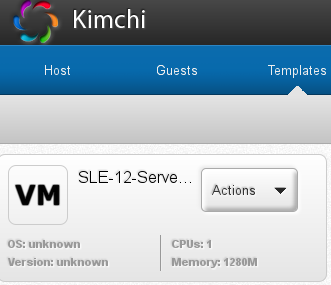

3.2.1 Installation sur des serveurs avec IBM PowerKVM à l'aide de Kimchi #

Cette section décrit les étapes préparatoires à l'installation sur des systèmes IBM PowerLinux avec PowerKVM. Vous y apprendrez comment effectuer l'installation à partir d'une image ISO avec l'interface utilisateur Kimchi. Kimchi est un outil destiné à l'administration d'IBM PowerKVM.

Dans cette section, nous partons du principe que PowerKVM s'exécute sur votre serveur IBM PowerLinux. Si PowerKVM n'est pas préinstallé, consultez l'article « Configuring IBM PowerKVM on Power Systems » (Configuration d'IBM PowerKVM sur des systèmes Power) sur le site http://www.ibm.com/support/knowledgecenter/linuxonibm/liabp/liabpkickoff.htm pour installer et configurer PowerKVM.

3.2.1.1 Création d'un modèle SUSE Linux Enterprise Server avec Kimchi #

Les modèles constituent la source d'installation pour les invités PowerKVM. Vous pouvez créer un modèle, le cloner ou le modifier. Pour cloner un modèle à partir d'un invité existant, ce dernier doit être désactivé.

Entrez l'URL du serveur PowerLinux sur lequel PowerKVM s'exécute dans la barre d'adresse du navigateur Web ;

https://POWERLINUX_IP:8001, par exemple (remplacez POWERLINUX_IP [ADRESSE_IP_POWERLINUX] par l'adresse IP de votre système).Cliquez sur l'onglet pour activer la page .

Cliquez sur le signe plus () vert pour créer le modèle SUSE Linux Enterprise Server.

Dans la boîte de dialogue (Ajouter un modèle), effectuez une sélection parmi les options suivantes :

- (Image ISO locale)

Sélectionnez cette option pour analyser les réserves de stockage à la recherche des images ISO d'installation disponibles sur le système.

- (Fichier image local)

Sélectionnez cette option pour spécifier un chemin d'accès à un fichier image local.

- (Fichier ISO distant)

Sélectionnez cette option pour spécifier un emplacement distant d'une image ISO d'installation.

Sélectionnez le fichier ISO à utiliser pour créer un invité et cliquez sur (Créer des modèles à partir du fichier ISO sélectionné).

Pour configurer le nouveau modèle, cliquez sur › et modifiez ensuite les valeurs par défaut conformément à votre workload.

Pour plus d'informations, consultez l'article « Setting up a template using Kimchi » (Configuration d'un modèle à l'aide de Kimchi) à l'adresse http://www.ibm.com/support/knowledgecenter/linuxonibm/liabp/liabpkimchitemplate.htm.

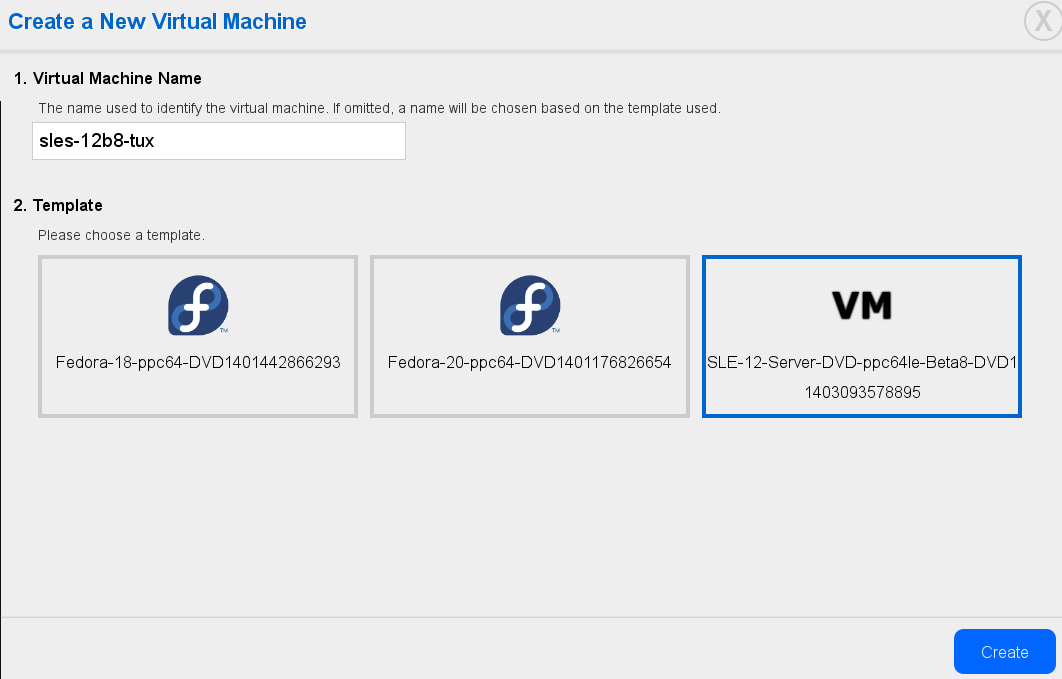

3.2.1.2 Installation de SUSE Linux Enterprise Server en tant qu'invité avec Kimchi #

Entrez l'URL du serveur PowerLinux sur lequel PowerKVM s'exécute dans la barre d'adresse du navigateur Web ;

https://POWERLINUX_IP:8001, par exemple (remplacez POWERLINUX_IP [ADRESSE_IP_POWERLINUX] par l'adresse IP de votre système).Cliquez sur l'onglet pour activer la page .

Cliquez sur le signe plus () vert pour créer l'invité SUSE Linux Enterprise Server.

Attribuez un à l'invité SUSE Linux Enterprise Server.

Sélectionnez le modèle SUSE Linux Enterprise Server créé à la Section 3.2.1.1, « Création d'un modèle SUSE Linux Enterprise Server avec Kimchi », puis cliquez sur .

Une fois que l'invité est créé, il est prêt à être démarré. Cliquez sur le bouton marche/arrêt de couleur rouge pour démarrer l'invité SUSE Linux Enterprise Server. Vous pouvez également sélectionner › .

Cliquez sur › , puis connectez votre visionneuse VNC au processus d'installation selon la procédure décrite à la Section 10.3.1.2, « Connexion au programme d'installation ».

Pour créer plusieurs invités d'un type similaire, sélectionnez dans le menu d'un invité existant.

Vous pouvez à présent poursuivre l'installation par défaut via VNC, comme décrit à la Section 6.3, « Étapes de l'installation ».

3.2.2

Installation sur des serveurs avec IBM PowerKVM à l'aide de virt-install

#

Au lieu d'effectuer une installation avec Kimchi, vous pouvez utiliser l'outil de ligne de commande Virt-install qui permet de réaliser l'installation sur des serveurs avec IBM PowerKVM. Cette méthode est particulièrement utile si vous devez installer plusieurs machines virtuelles sur des systèmes IBM PowerLinux Server. virt-install prend en charge de nombreux scénarios d'installation ; un scénario d'installation à distance via un démarrage PXE et VNC est présenté à la section suivante. Pour plus d'informations sur virt-install, reportez-vous au Book “Virtualization Guide”, Chapter 9 “Guest Installation”, Section 9.2 “Installing from the Command Line with virt-install”.

Préparez un dépôt avec les sources d'installation et le système cible compatible avec le démarrage PXE, comme décrit à la Section 10.1.3, « Installation à distance via VNC : démarrage PXE et fonction Wake on LAN (réveil à distance) ».

Entrez une commande semblable à ceci sur la ligne de commande (réglez les options en fonction de vos besoins et de votre matériel) :

virt-install --name server_sle12 --memory 4096 --vcpus=2 --pxe \ --graphics vnc --os-variant sles11 \ --disk pool=default,size=3000,format=qcow2,allocation=1G,bus=virtio \ -w mac=MAC_ADDRESS,model=spapr-vlan

Cette commande utilise le graphique VNC et le client graphique est démarré automatiquement. Effectuez l'installation comme décrit à la Section 6.3, « Étapes de l'installation ».

3.2.3 Installation sur une partition à l'aide d'IVM #

Ce guide vous aide à installer SUSE Linux Enterprise Server sur une partition de serveur Power Systems à l'aide de l'interface Web Integrated Virtualization Manager (IVM). Avant de commencer l'installation, assurez-vous que les conditions suivantes soient remplies :

Le système Linux on Power est sous tension.

Le serveur E/S virtuel est installé.

IVM est bien configuré.

Ouvrez une fenêtre de navigateur Web et connectez-vous, via le protocole HTTP ou HTTPS, à l'adresse IP qui a été assignée à IVM au cours du processus d'installation (par exemple, https://ADRESSE_IP). La fenêtre de bienvenue s'affiche.

Connectez-vous en tant qu'utilisateur

padminet spécifiez le mot de passe défini au cours du processus d'installation. L'interface IVM s'affiche.Sélectionnez (Afficher/modifier l'Ethernet virtuel).

Cliquez sur (Initialiser l'Ethernet virtuel) pour permettre une connectivité Ethernet entre les partitions.

Lorsque l'Ethernet virtuel est initialisé, cliquez sur Apply (Appliquer).

Si votre installation requiert une mise en réseau externe, créez un pont Ethernet virtuel.

Sélectionnez l'onglet (Pont Ethernet virtuel).

Sélectionnez l'adaptateur physique pour le pont, puis .

Ensuite, créez une partition en procédant comme suit :

Dans l'interface Web IVM, cliquez sur (Afficher/modifier la partition) (Créer une partition).

Entrez le nom de la partition. Pour passer à l'étape suivante, cliquez sur (Suivant) dans cet écran et au cours des étapes suivantes.

Spécifiez la mémoire de votre partition. Si vous avez créé une réserve de mémoire partagée, vos partitions peuvent partager de la mémoire. Dans le cas contraire, sélectionnez (Dédiée).

Spécifiez le nombre de processeurs et le mode de traitement de la partition.

Spécifiez un Ethernet virtuel pour la partition. Si vous ne souhaitez pas configurer un adaptateur, sélectionnez (Aucun) pour l'Ethernet virtuel.

Créez un nouveau disque virtuel ou assignez des disques virtuels et des volumes physiques existants qui ne sont actuellement assignés à aucune partition.

Vérifiez le et le de votre disque, et spécifiez une .

Configurez les périphériques optiques de votre partition en développant les sections (Périphériques optiques physiques) et (Périphériques optiques virtuels) pour ensuite sélectionner le ou les périphériques à assigner à la partition.

Vérifiez les paramètres de configuration de votre partition, puis cliquez sur (Terminer). La partition est créée et disponible à partir de la liste (Afficher/modifier les partitions).

À présent, activez la partition créée :

Dans l'interface Web IVM, cliquez sur (Afficher/modifier la partition) et sélectionnez la zone en regard de la partition à activer.

Sélectionnez (Plus de tâches).

Sélectionnez (Ouvrir une fenêtre de terminal).

Cliquez sur (Activer) en regard de la partition.

Dans la fenêtre de terminal, entrez 1 pour démarrer les services de gestion du système (SMS).

La machine est maintenant configurée. Vous pouvez démarrer l'installation :

Dans la fenêtre (Sélection de démarrage), entrez1 pour sélectionner le menu . Entrez 1 avant que l'écran de démarrage du microprogramme soit complètement affiché, car il disparaît une fois l'opération terminée. Si vous manquez l'écran, redémarrez le système.

À ce stade, vous pouvez insérer le disque de support du serveur E/S virtuel (VIOS) dans l'unité de disque.

Entrez 2 pour passer à la saisie du mot de passe dans le menu de . Entrez le mot de passe de l'ID d'administrateur.

Dans le menu SMS principal, entrez 5 pour choisir l'option (Sélectionner les options de démarrage).

Entrez 1 pour sélectionner (Installer/démarrer un périphérique).

Entrez 7 pour afficher tous les périphériques de démarrage disponibles.

Entrez le numéro correspondant au périphérique à utiliser. Si votre périphérique n'est pas répertorié, entrez N pour en afficher d'autres.

Entrez 2 pour effectuer un démarrage de type (Démarrage en mode normal).

Entrez 1 pour quitter le menu SMS et lancer le processus de démarrage.

À l'invite de démarrage du programme d'installation, tapez :

install vnc=1 vncpassword=VNC_PASSWORD

Remplacez VNC_PASSWORD (MOT_DE_PASSE_VNC par un mot de passe de votre choix (la longueur minimale est de huit caractères) et appuyez sur Entrée pour lancer l'installation de SUSE Linux Enterprise Server. Le kernel commence à se charger.

Une fois que le kernel a commencé à se charger, le programme d'installation a besoin de certaines informations de la part du système afin de configurer une session VNC. Vous devez disposer d'une pile TCP/IP valide pour pouvoir utiliser VNC. Utilisez DHCP ou définissez manuellement vos informations réseau à l'aide des instructions fournies par le programme d'installation.

Dans la fenêtre , sélectionnez en tant que périphérique réseau. Sélectionnez et appuyez sur Entrée.

Testez le support d'installation. Vous pouvez également poursuivre sans effectuer le test. Pour ce faire, sélectionnez .

Une fois le serveur VNC démarré par le système, un message vous invite à connecter votre client VNC et fournit une adresse IP. Prenez note de cette adresse IP.

Démarrez un client VNC sur votre ordinateur portable ou votre PC. Entrez l'adresse IP obtenue à l'étape précédente, suivie de

:1, par exemple 192.168.2.103:1.Effectuez l'installation comme décrit au Section 6.3, « Étapes de l'installation ».

3.2.4 Installation sur des serveurs sans couche d'abstraction OpenPower #

Ces informations permettent d'installer Linux à l'aide d'une console série ou d'un écran et d'un clavier sur un serveur Power Systems. Cette installation suppose que vous disposiez d'un système non géré (autonome) prêt à démarrer.

Mettez votre système sous tension en sélectionnant (Allumer) dans le menu (Allumer/éteindre le système). Lorsque le système vous demande si vous souhaitez continuer à l'aide de la console, entrez 0 pour poursuivre.

Insérez le support d'installation de SUSE Linux Enterprise Server dans l'unité de disque.

Dans la fenêtre (Sélectionner la langue), entrez 2 pour continuer le démarrage.

Entrez 1 pour accepter le contrat de licence.

Dans la fenêtre (Sélection de démarrage), entrez1 pour sélectionner le menu . Entrez 1 avant que l'écran de démarrage du microprogramme soit complètement affiché, car il disparaît une fois l'opération terminée. Si vous manquez l'écran, redémarrez le système.

Entrez 2 pour passer à la saisie du mot de passe dans le menu de . Entrez le mot de passe de l'ID d'administrateur.

Dans le menu SMS principal, entrez 5 pour choisir l'option (Sélectionner les options de démarrage).

Entrez 7 pour afficher tous les périphériques de démarrage disponibles.

Entrez le numéro correspondant au périphérique à utiliser. Si votre périphérique n'est pas répertorié, entrez N pour en afficher d'autres.

Entrez 2 pour effectuer un démarrage de type (Démarrage en mode normal).

Entrez 1 pour quitter le menu SMS et lancer le processus de démarrage.

À l'invite de démarrage du programme d'installation, tapez :

install vnc=1 vncpassword=VNC_PASSWORD

Remplacez VNC_PASSWORD (MOT_DE_PASSE_VNC par un mot de passe de votre choix (la longueur minimale est de huit caractères) et appuyez sur Entrée pour lancer l'installation de SUSE Linux Enterprise Server. Le kernel commence à se charger.

Une fois que le kernel a commencé à se charger, le programme d'installation a besoin de certaines informations de la part du système afin de configurer une session VNC. Vous devez disposer d'une pile TCP/IP valide pour pouvoir utiliser VNC. Utilisez DHCP ou définissez manuellement vos informations réseau à l'aide des instructions fournies par le programme d'installation.

Dans la fenêtre , sélectionnez en tant que périphérique réseau. Sélectionnez et appuyez sur Entrée.

Testez le support d'installation. Vous pouvez également poursuivre sans effectuer le test. Pour ce faire, sélectionnez .

Une fois le serveur VNC démarré par le système, un message vous invite à connecter votre client VNC et fournit une adresse IP. Prenez note de cette adresse IP.

Démarrez un client VNC sur votre ordinateur portable ou votre PC. Entrez l'adresse IP obtenue à l'étape précédente, suivie de

:1, par exemple 192.168.2.103:1.Effectuez l'installation comme décrit au Section 6.3, « Étapes de l'installation ».

3.3 Pour plus d'informations #

Pour plus d'informations sur IBM PowerLinux, consultez les sources SUSE et IBM :

La base de connaissances du support SUSE à l'adresse https://www.suse.com/support/kb/ est un outil efficace pour aider les clients à résoudre leurs problèmes. Effectuez des recherches dans la base de connaissances sur SUSE Linux Enterprise Server à l'aide de mots clés tels que POWER ou PowerKVM.

Recherchez les alertes de sécurité à l'adresse suivante : https://www.suse.com/support/security/. SUSE tient également à jour deux listes de diffusion, auxquelles toute personne peut s'abonner, en relation avec la sécurité.

suse-security: discussion d'ordre général concernant la sécurité pour Linux et SUSE. Toutes les alertes de sécurité pour SUSE Linux Enterprise Server sont envoyées à cette liste.suse-security-announce: la liste de diffusion de SUSE signale exclusivement les alertes de sécurité.

En cas d'erreurs matérielles, vérifiez sur le Panneau de configuration tout code susceptible d'être affiché. Vous pouvez rechercher tous les codes affichés dans le centre d'informations IBM Power Systems Hardware Information Center à l'adresse https://ibm.biz/Bdxn3T.

Pour des conseils de dépannage, reportez-vous à la rubrique IBM PowerLinux FAQ dans le centre d'informations à l'adresse https://ibm.biz/Bdxn35.

Pour faire partie de la liste de diffusion linuxppc-dev, enregistrez-vous à l'aide des formulaires disponibles à l'adresse http://lists.ozlabs.org/listinfo/linuxppc-dev/.

4 Installation sur IBM Z #

Ce chapitre décrit la procédure pour préparer l'installation de SUSE® Linux Enterprise Server sur les systèmes IBM Z. Il fournit toutes les informations nécessaires pour préparer l'installation du côté LPAR et z/VM.

4.1 Informations générales et spécifications #

Cette section fournit des informations de base sur la configuration système requise (telle que le matériel pris en charge), le niveau MicroCode et le logiciel. Elle traite également des différents types d'installation et de la manière d'exécuter un IPL pour la première installation. Pour obtenir des informations techniques détaillées concernant IBM Z sous SUSE Linux Enterprise Server, consultez le site http://www.ibm.com/developerworks/linux/linux390/documentation_suse.html.

4.1.1 Configuration système requise #

Cette section fournit une liste du matériel pour IBM Z pris en charge par SUSE Linux Enterprise Server. Elle traite ensuite du niveau MicroCode (MCL) utilisé sur votre système IBM Z pour l'installation. Vous trouverez des informations sur les autres logiciels à installer et à utiliser pour l'installation à la fin de cette section.

4.1.1.1 Matériel #

SUSE Linux Enterprise Server s'exécute correctement sur les plates-formes suivantes :

IBM zEnterprise System z196 (2817)

IBM zEnterprise System z114 (2818)

IBM zEnterprise EC12 (zEC12) (2827)

IBM zEnterprise BC12 (zBC12) (2828)

IBM z Systems z13 (2964)

IBM z Systems z13s (2965)

IBM LinuxONE Emperor (2964)

IBM LinuxONE Rockhopper (2965)

4.1.1.1.1 Prérequis système liés à la mémoire #

Des méthodes d'installation différentes ont des prérequis système liés à la mémoire différents lors de l'installation. Une fois l'installation terminée, l'administrateur système peut réduire la mémoire pour obtenir la taille souhaitée. SUSE recommande :

|

1 Go |

Pour une installation sous z/VM. |

|

1 Go |

Pour une installation sous LPAR. |

|

1 Go |

Pour une installation sous KVM. |

Pour une installation à partir de sources d'installation NFS, FTP ou SMB ou chaque fois que VNC est utilisé, au moins 512 Mo de mémoire sont requis. Dans le cas contraire, la tentative d'installation risque d'échouer. Souvenez-vous que le nombre de périphériques visibles par un invité z/VM ou une image LPAR affecte la configuration de mémoire requise. Une installation avec des centaines de périphériques accessibles peut nécessiter plus de mémoire (même si ces périphériques ne sont pas utilisés pour l'installation).

4.1.1.1.2 Espace disque requis #

La configuration du disque dur requise dépend fortement de l'installation. En règle générale, pour que le système fonctionne correctement, vous devez avoir plus d'espace disque que n'en nécessite le logiciel d'installation. La configuration minimale des différents éléments est la suivante :

|

800 Mo |

Installation minimale |

|

1,4 Go |

Installation minimale + système de base |

|

2,6 Go |

Installation par défaut |

|

3,6 Go+ |

Recommandée (avec bureau graphique, paquetages de développement et Java). |

4.1.1.1.3 Connexion réseau #

Une connexion réseau est requise pour communiquer avec votre système SUSE Linux Enterprise Server. Il peut s'agir d'une ou de plusieurs des connexions ou des cartes réseau suivantes :

OSA Express Ethernet (y compris Fast et Gigabit Ethernet)

HiperSockets ou Guest LAN

10 GBE, VSWITCH

RoCE (RDMA over Converged Ethernet)

Les interfaces suivantes sont toujours incluses mais ne sont plus prises en charge :

CTC (ou CTC virtuel)

ESCON

Interface réseau IP pour IUCV

Pour les installations sous KVM, assurez-vous que les conditions suivantes sont réunies pour permettre à l'invité de machine virtuelle d'accéder en toute transparence au réseau :

L'interface réseau virtuelle est connectée à une interface réseau hôte.

L'interface réseau hôte est connectée à un réseau auquel le serveur virtuel participera.

Si l'hôte est configuré pour utiliser une connexion réseau redondante en regroupant deux ports réseau OSA indépendants dans une interface réseau liée, l'identificateur de cette dernière est

bond0(ou, s'il existe plusieurs interfaces liées,bond1,bond2, etc.).Si la connexion réseau hôte n'a pas été configurée de façon redondante, il faut utiliser l'identificateur de l'interface réseau unique. Celui-ci se présente sous la forme enccw0.0.NNNN, où NNNN est le numéro de périphérique de l'interface réseau de votre choix.

4.1.1.2 Niveau MicroCode, APAR et correctifs #

Vous trouverez la documentation relative aux restrictions et exigences de cette version de SUSE Linux Enterprise Server sur IBM developerWorks à l'adresse http://www.ibm.com/developerworks/linux/linux390/documentation_suse.html. Il est recommandé de toujours utiliser le niveau de service le plus élevé. Contactez l'assistance technique IBM pour connaître la configuration minimale requise.

4.1.1.2.1 z/VM #

z/VM 5.4

z/VM 6.2

z/VM 6.3. Il est vivement recommandé d'installer APAR VM65419 (ou version ultérieure) afin d'améliorer la sortie de qclib.

Négociez l'ordre d'installation avec votre support IBM, car il peut être nécessaire d'activer les APAR VM avant d'installer les nouveaux niveaux MicroCode.

4.1.1.3 Logiciel #

Si vous installez SUSE Linux Enterprise Server via un protocole NFS ou FTP non-Linux, vous risquez de rencontrer des problèmes avec les logiciels serveur NFS ou FTP. Le serveur FTP standard de Windows* peut générer des erreurs. L'installation via SMB sur ces machines est donc généralement recommandée.

Pour vous connecter au système d'installation de SUSE Linux Enterprise Server, utilisez l'une des méthodes suivantes (l'utilisation de SSH or VNC est recommandée) :

- SSH avec émulation de terminal (compatible xterm)

SSH est un outil Unix standard qui doit être présent sur tout système Unix ou Linux. Pour Windows, il existe un client SSH appelé Putty. Il est gratuit et disponible sur le site http://www.chiark.greenend.org.uk/~sgtatham/putty/.

- Client VNC

Pour Linux, un client VNC nommé vncviewer est inclus dans SUSE Linux Enterprise Server en tant que partie du paquetage

tightvnc. Pour Windows, TightVNC est également disponible. Vous pouvez le télécharger sur le site http://www.tightvnc.com/.- Serveur X

Vous trouverez une mise en oeuvre du serveur X adaptée sur tous les postes de travail Linux ou Unix. Il existe de nombreux environnements commerciaux de systèmes X Window pour Windows et Mac OS*. Certains peuvent être téléchargés sous la forme de versions d'essai gratuites. Vous pouvez obtenir une version d'essai du serveur Mocha X Server de MochaSoft sur le site http://www.mochasoft.dk/freeware/x11.htm.

Consultez le fichier README situé dans le répertoire racine du DVD 1 de votre instance SUSE Linux Enterprise Server avant d'installer SUSE Linux Enterprise Server sur IBM Z. Ce fichier complète la documentation présentée dans ce manuel.

4.1.2 Types d'installation #

Cette section présente les différents types d'installation possibles avec SUSE Linux Enterprise Server pour IBM Z :

- LPAR

Installation de SUSE Linux Enterprise Server à l'aide d'une partition logique (LPAR).

- z/VM

Installation de SUSE Linux Enterprise Server en tant que système d'exploitation invité dans z/VM.

- KVM

Installation de SUSE Linux Enterprise Server en tant que système d'exploitation invité dans KVM.

Selon le mode d'installation (LPAR ou z/VM), il existe plusieurs manières de démarrer le processus d'installation et d'exécuter un IPL sur le système installé.

4.1.2.1 LPAR #

Si vous installez SUSE Linux Enterprise Server for IBM Z sur une partition logique (LPAR), assignez de la mémoire et des processeurs à l'instance. L'installation dans une partition logique est recommandée si les machines de production sont très chargées. L'exécution en mode LPAR permet également de bénéficier de normes de sécurité plus strictes. La mise en réseau entre les partitions logiques est possible sur des interfaces externes ou Hipersockets. Si vous prévoyez d'utiliser votre installation à des fins de virtualisation avec KVM, une installation dans une partition logique est vivement conseillée.

4.1.2.2 z/VM #

L'exécution de SUSE Linux Enterprise Server for IBM Z dans z/VM implique que SUSE Linux Enterprise Server est un système invité au sein de z/VM. Un avantage de ce mode est que vous contrôlez totalement SUSE Linux Enterprise Server à partir de z/VM. Cela s'avère très utile pour le développement du kernel ou le débogage basé sur le kernel. Il est également très facile d'ajouter ou de supprimer du matériel vers et depuis les invités Linux. La création d'invités SUSE Linux Enterprise Server supplémentaires est une opération particulièrement simple. Vous pouvez, en outre, exécuter des centaines d'instances Linux simultanément.

4.1.2.3 Invité KVM #

Afin d'installer SUSE Linux Enterprise Server for IBM Z en tant qu'invité KVM, une instance de serveur hôte KVM doit être installée sur la partition logique. Pour plus de détails sur l'installation de l'invité, reportez-vous à la Procédure 4.3, « Présentation d'une installation invité KVM ».

4.1.3 Options IPL #

Cette section fournit les informations nécessaires pour exécuter un IPL pour la première installation. Selon le type d'installation, différentes options doivent être utilisées. Les options Lecteur VM, Charger depuis un CD-ROM ou un serveur et Chargement depuis un DVD associé à SCSI sont traitées dans cette section. L'installation des paquetages logiciels, via le réseau, ne requiert pas de support IPL.

4.1.3.1 Lecteur VM #

Pour exécuter un IPL depuis un lecteur VM, transférez tout d'abord les fichiers nécessaires vers le lecteur. Pour une meilleure administration, il est recommandé de créer un utilisateur linuxmnt qui détient un minidisque avec les fichiers et les scripts requis pour IPL. Les invités Linux peuvent ensuite accéder à ce minidisque en lecture seule.

4.1.3.2 Chargement à partir d'un support amovible ou un serveur #

Pour exécuter un IPL dans une partition LPAR, vous pouvez charger directement l'image du kernel à partir du lecteur de CD/DVD-ROM de la console HMC ou de l'ordinateur SE, ou à partir de tout système distant accessible via FTP. Vous pouvez exécuter cette fonction depuis HMC. Le processus d'installation requiert un fichier avec une assignation de l'emplacement des données d'installation sur le système de fichiers et les emplacements de la mémoire où les données doivent être copiées.

Pour SUSE Linux Enterprise Server, il existe deux fichiers de ce type. Les deux se trouvent dans le répertoire racine du système de fichiers du DVD1 :

Suse.insqui nécessitera, pour pouvoir être utilisé, de configurer l'accès réseau dans Linuxrc avant de commencer l'installation.susehmc.insqui permet d'effectuer l'installation sans le moindre accès au réseau.

Dans le volet de navigation gauche de HMC, développez › (Gestion des systèmes) et sélectionnez le macroordinateur que vous voulez utiliser. Choisissez la partition logique (LPAR) dans laquelle vous souhaitez démarrer SUSE Linux Enterprise Server dans la table de partitions logiques et sélectionnez ensuite .

Sélectionnez maintenant ou . Si vous avez choisi la seconde option, fournissez l'adresse ou le nom du serveur, ainsi que vos informations d'identification. Si le fichier .ins approprié ne se trouve pas dans le répertoire racine du serveur, indiquez le chemin d'accès à ce fichier. Accédez au menu (Sélectionner le logiciel à charger) et sélectionnez l'entrée .ins appropriée. Cliquez sur pour démarrer l'installation.

4.1.3.3 Chargement depuis un DVD associé à SCSI #

Pour exécuter un IPL à partir d'un DVD SCSI, vous devez avoir accès à un adaptateur FCP connecté à un lecteur de DVD. Vous devez récupérer les valeurs pour WWPN et LUN sur l'unité SCSI. Pour plus de détails, reportez-vous à la Section 4.2.4.1.2, « Exécution d'un IPL à partir d'un DVD SCSI associé FCP ».

4.1.3.4 Chargement depuis le réseau à l'aide de zPXE #

Pour effectuer un chargement IPL à partir du réseau avec zPXE, un serveur Cobbler fournissant le kernel, le disque RAM et un fichier parmfile est nécessaire. Il est initié en exécutant le script ZPXE EXEC. Reportez-vous à la Section 4.2.1.3, « Utilisation d'un serveur Cobbler pour zPXE » pour plus d'informations. zPXE est uniquement disponible sur z/VM.

4.2 Préparation de l'installation #

Découvrez comment rendre les données accessibles pour l'installation, installer SUSE Linux Enterprise Server selon différentes méthodes ainsi que préparer et utiliser l'IPL du système d'installation de SUSE Linux Enterprise Server. Vous trouverez également des informations sur la configuration et l'installation réseau.

4.2.1 Mise à disposition des données d'installation #

Cette section fournit des informations détaillées pour rendre accessibles les données d'installation de SUSE Linux Enterprise Server for IBM Z. Selon l'ordinateur que vous utilisez et l'environnement système, choisissez une installation NFS ou FTP. Si vous exécutez des postes de travail Microsoft Windows dans votre environnement, vous pouvez utiliser le réseau Windows (y compris le protocole SMB) pour installer SUSE Linux Enterprise Server sur votre système IBM Z.

Depuis le Service Pack 1 de SUSE Linux Enterprise Server Version 10, il est possible d'exécuter un IPL depuis un DVD et d'utiliser ce dernier comme support d'installation. Cela peut s'avérer très pratique si vous êtes confronté à des restrictions concernant la configuration d'un serveur d'installation fournissant un support d'installation sur votre réseau. Vous devez disposer d'un lecteur de DVD SCSI associé à un protocole FCP.

Il est impossible de procéder à une installation depuis le disque dur en plaçant le contenu du DVD sur une partition sur un DASD.

4.2.1.1 Utilisation d'un poste de travail Linux ou d'un DVD SUSE Linux Enterprise Server #

Si votre poste de travail Linux s'exécute dans votre environnement informatique, utilisez le poste de travail pour fournir les données d'installation au processus d'installation IBM Z via NFS ou FTP. Si le poste de travail Linux s'exécute sous SUSE Linux Enterprise Server, vous pouvez configurer un serveur d'installation (NFS ou FTP) à l'aide du module YaST , comme décrit à la Section 8.1, « Configuration d'un serveur d'installation à l'aide de YaST ».

4.2.1.1.1 Avec un serveur NFS #

Utilisez le serveur NFS (network file system - système de fichiers réseau) pour mettre à disposition le support d'installation.

Exporter la racine du système de fichiers (/) n'entraîne pas l'exportation des périphériques installés, comme un DVD. Désignez explicitement le point d'installation dans /etc/exports :

/media/dvd *(ro)

Une fois ce fichier modifié, redémarrez le serveur NFS en exécutant la commande sudo systemctl restart nfsserver.

4.2.1.1.2 Avec un serveur FTP #

La configuration d'un serveur FTP sur un système Linux implique d'installer et de configurer un logiciel serveur, tel que vsftpd. Si vous utilisez SUSE Linux Enterprise Server, reportez-vous au Book “Administration Guide”, Chapter 34 “Setting Up an FTP Server with YaST” pour obtenir des instructions d'installation. Le téléchargement des données d'installation via une connexion anonyme n'est pas pris en charge. Par conséquent, vous devez configurer le serveur FTP pour assurer l'authentification utilisateur.

4.2.1.1.3 SUSE Linux Enterprise Server sur DVD #

Le DVD 1 de SUSE Linux Enterprise Server for IBM Z contient une image Linux de démarrage pour les postes de travail Intel et une image pour IBM Z.