- Informazioni su questa guida

- I Presentazione di SUSE Enterprise Storage (SES)

- 1 SES e Ceph

- 2 Requisiti hardware e raccomandazioni

- 2.1 Panoramica sulla rete

- 2.2 Configurazioni ad architettura multipla

- 2.3 Configurazione hardware

- 2.4 Nodi storage oggetto

- 2.5 Nodi monitor

- 2.6 Nodi Object Gateway

- 2.7 Nodi Metadata Server

- 2.8 Nodo admin

- 2.9 Nodi iSCSI Gateway

- 2.10 SES e altri prodotti SUSE

- 2.11 Limitazioni di denominazione

- 2.12 Condivisione di un server da parte di OSD e monitor

- 3 Configurazione ad elevata disponibilità del nodo admin

- II Distribuzione del cluster Ceph

- III Upgrade dalle release precedenti

- 10 Upgrade da SUSE Enterprise Storage 6 a 7.1

- 10.1 Attività preparatorie all'upgrade

- 10.2 Esecuzione dell'upgrade del Salt Master

- 10.3 Esecuzione dell'upgrade dei nodi MON, MGR e OSD

- 10.4 Esecuzione dell'upgrade dei nodi del gateway

- 10.5 Installazione di

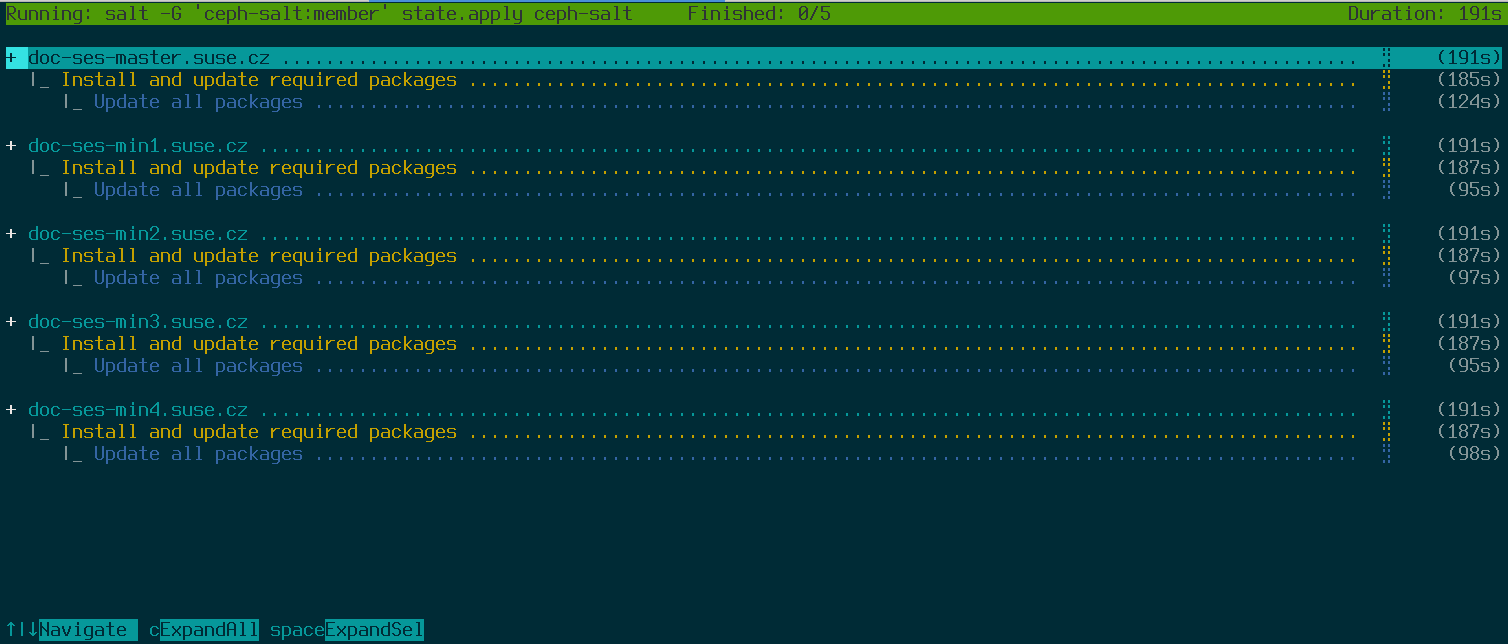

ceph-salte applicazione della configurazione del cluster - 10.6 Esecuzione dell'upgrade e adozione dello stack di monitoraggio

- 10.7 Ridistribuzione del servizio del gateway

- 10.8 Pulizia successiva all'upgrade

- 11 Upgrade da SUSE Enterprise Storage 7 a 7.1

- 11.1 Attività preparatorie all'upgrade

- 11.2 Migrazione di SUSE Linux Enterprise Server su ciascun nodo del cluster alla versione SUSE Linux Enterprise Server 15 SP3

- 11.3 Aggiornamento dei pacchetti relativi a SUSE Enterprise Storage su ciascun nodo del cluster

- 11.4 Upgrade dei servizi esistenti del cluster Ceph

- 10 Upgrade da SUSE Enterprise Storage 6 a 7.1

- A Aggiornamenti alla manutenzione di Ceph basati sulle release intermedie upstream "Pacific"

- Glossario

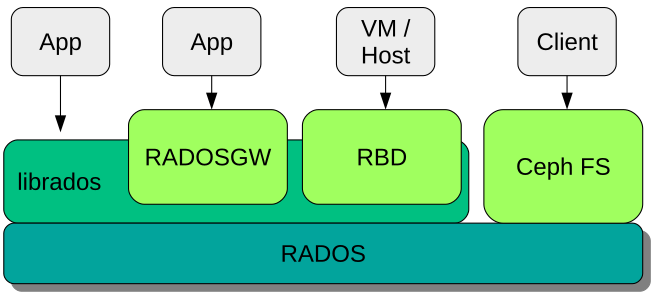

- 1.1 Interfacce con l'archivio dati Ceph

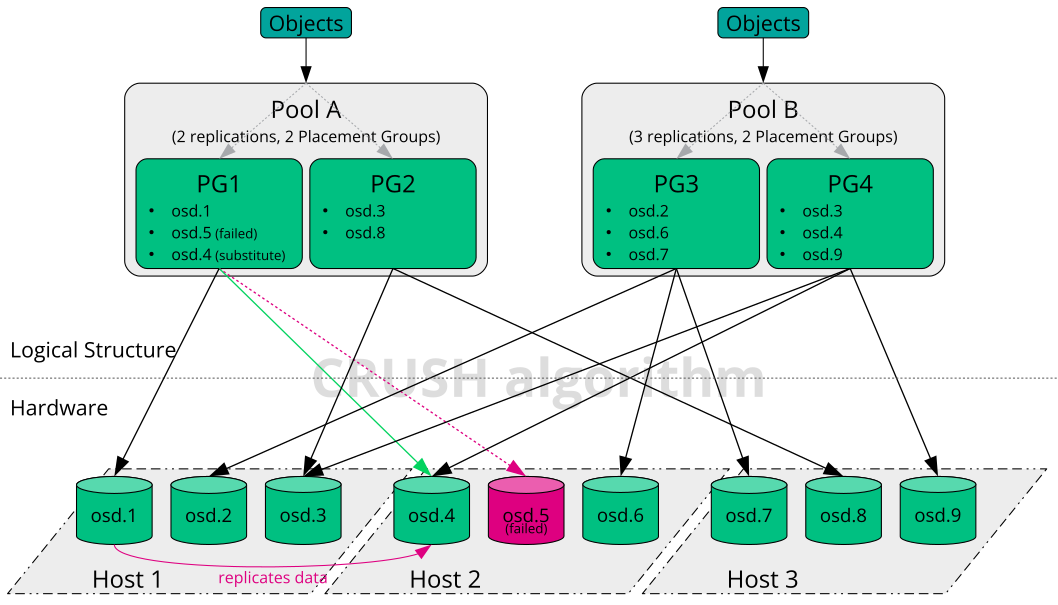

- 1.2 Esempio di Ceph su piccola scala

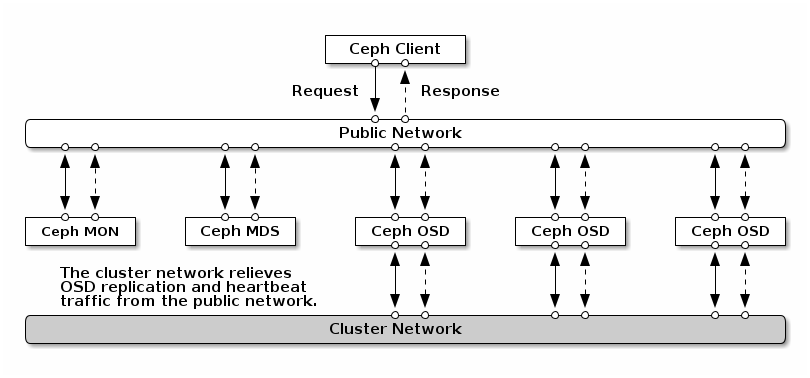

- 2.1 Panoramica sulla rete

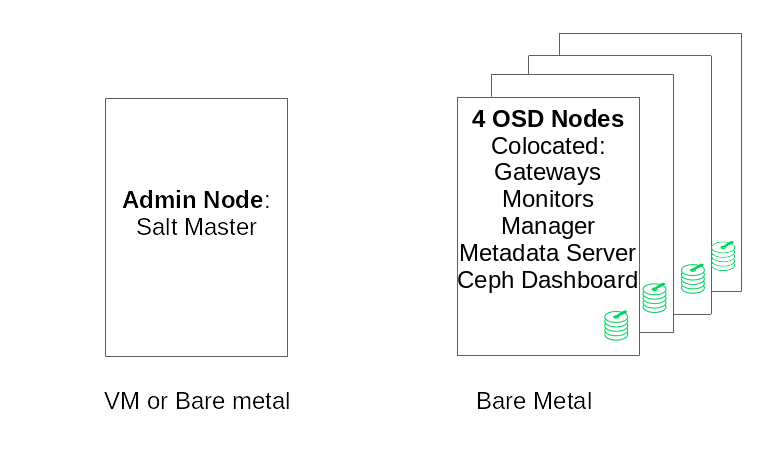

- 2.2 Configurazione minima del cluster

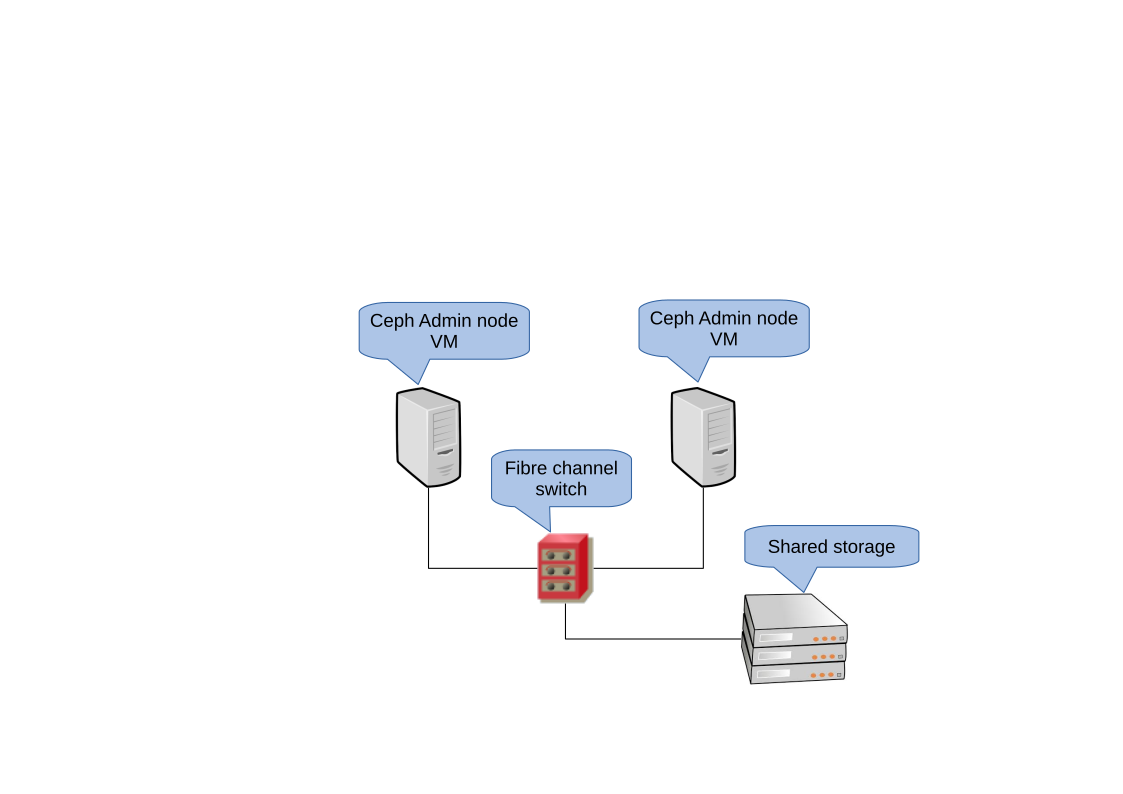

- 3.1 Cluster ad elevata disponibilità a 2 nodi per il nodo admin

- 7.1 Distribuzione di un cluster minimo

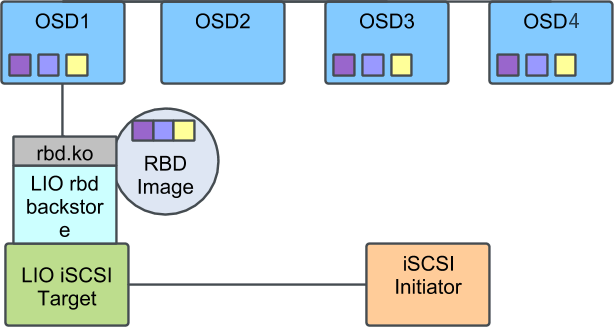

- 9.1 Cluster Ceph con un singolo iSCSI Gateway

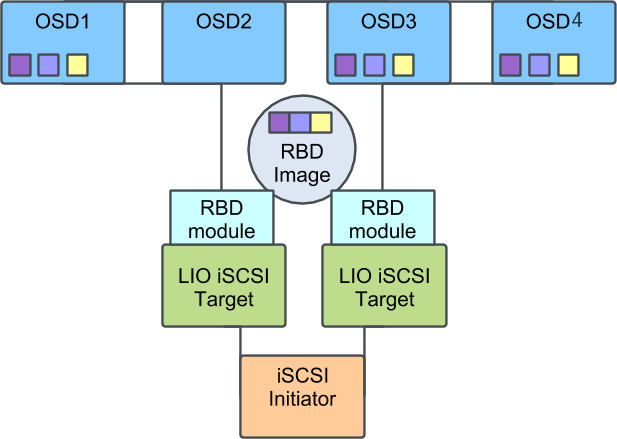

- 9.2 Cluster Ceph con più iSCSI Gateway

Copyright © 2020–2024 SUSE LLC e collaboratori. Tutti i diritti riservati.

Tranne laddove diversamente specificato, il presente documento è fornito con licenza Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode

Per i marchi di fabbrica SUSE vedere http://www.suse.com/company/legal/. Tutti i marchi di fabbrica di terze parti appartengono ai rispettivi proprietari. I simboli dei marchi di fabbrica (®, ™, ecc.) indicano i marchi di fabbrica di SUSE e delle sue affiliate. Gli asterischi (*) indicano i marchi di fabbrica di terze parti.

Tutte le informazioni presenti nella presente pubblicazione sono state compilate con la massima attenzione ai dettagli. Ciò, tuttavia, non garantisce una precisione assoluta. SUSE LLC, le rispettive affiliate, gli autori e i traduttori non potranno essere ritenuti responsabili di eventuali errori o delle relative conseguenze.

Informazioni su questa guida #

Questa guida è incentrata sulla distribuzione di un cluster Ceph di base e di servizi aggiuntivi. Illustra inoltre le procedure da completare per eseguire l'upgrade a SUSE Enterprise Storage 7.1 dalla versione precedente.

SUSE Enterprise Storage 7.1 è un'estensione per SUSE Linux Enterprise Server 15 SP3 che combina le funzionalità del progetto di storage Ceph (http://ceph.com/) con il supporto e l'ingegneria aziendale di SUSE. SUSE Enterprise Storage 7.1 fornisce alle organizzazioni IT la possibilità di installare un'architettura di storage distribuita in grado di supportare numerosi casi di utilizzo mediante piattaforme hardware commodity.

1 Documentazione disponibile #

La documentazione relativa ai nostri prodotti è disponibile all'indirizzo https://documentation.suse.com, dove sono disponibili anche gli ultimi aggiornamenti ed è possibile sfogliare ed effettuare il download della documentazione in vari formati. Gli ultimi aggiornamenti della documentazione sono disponibili in lingua inglese.

Inoltre, la documentazione dei prodotti è disponibile nel sistema installato in /usr/share/doc/manual. È inclusa in un pacchetto RPM denominato ses-manual_LANG_CODE. Installarlo se non è già presente nel sistema, ad esempio:

# zypper install ses-manual_enPer questo prodotto è disponibile la seguente documentazione:

- Guida all'installazione

Questa guida è incentrata sulla distribuzione di un cluster Ceph di base e di servizi aggiuntivi. Illustra inoltre le procedure da completare per eseguire l'upgrade a SUSE Enterprise Storage 7.1 dalla versione precedente.

- Guida all'amministrazione e alle operazioni

Questa guida è incentrata sui task di routine che gli amministratori devono completare in seguito alla distribuzione del cluster Ceph di base (operazioni giorno 2). Descrive inoltre tutti i metodi supportati per l'accesso ai dati memorizzati in un cluster Ceph.

- Guida alla sicurezza avanzata

Questa guida descrive le procedure per verificare la protezione del cluster.

- Guida alla soluzione dei problemi

Questa guida descrive diversi problemi comuni correlati all'esecuzione di SUSE Enterprise Storage 7.1 e altri problemi relativi ai componenti pertinenti, come Ceph oppure Object Gateway.

- Guida di SUSE Enterprise Storage per Windows

Questa guida descrive le procedure di integrazione, installazione e configurazione degli ambienti Microsoft Windows e SUSE Enterprise Storage tramite il driver di Windows.

2 Invio di feedback #

Qualsiasi feedback e contributo alla presente documentazione è ben accetto. È possibile lasciare il proprio feedback tramite tanti canali diversi:

- Richieste di servizio e supporto

Per verificare i servizi e le opzioni di supporto disponibili per il proprio prodotto, visitare http://www.suse.com/support/.

Per aprire una richiesta di servizio, è necessario l'abbonamento al SUSE Customer Center. Andare a https://scc.suse.com/support/requests, eseguire il login e fare clic su .

- Segnalazioni di bug

Segnalare i problemi relativi alla documentazione all'indirizzo https://bugzilla.suse.com/. Per la segnalazione dei problemi, è necessario un account Bugzilla.

Per semplificare il processo, è possibile utilizzare i collegamenti per la , accanto ai titoli nella versione HTML del presente documento, che preselezionano la categoria e il prodotto corretti in Bugzilla e indirizzano alla sezione corrente. È possibile iniziare a digitare subito la segnalazione di bug.

- Contributi

Per contribuire alla presente documentazione, utilizzare i collegamenti , accanto ai titoli nella versione HTML del documento, che indirizzano al codice sorgente su GitHub, dove è possibile aprire una richiesta pull. Per inviare un contributo, è necessario un account GitHub.

Per ulteriori informazioni sull'ambiente di documentazione utilizzato, vedere il file README dell'archivio all'indirizzo https://github.com/SUSE/doc-ses.

- Posta

È inoltre possibile segnalare errori e inviare feedback sulla documentazione scrivendo all'indirizzo <doc-team@suse.com>. Includere il titolo del documento, la versione del prodotto e la data di pubblicazione del documento. Inoltre, includere il titolo e il numero della sezione pertinente (o specificare l'URL) e fornire una breve descrizione del problema.

3 Convenzioni utilizzate nella documentazione #

Nel presente documento vengono utilizzati gli avvisi e le convenzioni tipografiche illustrati di seguito:

/etc/passwd: nomi di directory e fileSEGNAPOSTO: sostituire SEGNAPOSTO con il valore effettivo

PATH: variabile di ambientels,--help: comandi, opzioni e parametriuser: nome dell'utente o del gruppopackage_name: nome di un pacchetto software

Alt, Alt–F1: tasto da premere o combinazione di tasti. I tasti sono visualizzati in maiuscolo come se fossero sulla tastiera.

, › (Salva con nome): voci di menu, pulsanti

AMD/Intel Questo paragrafo si riferisce esclusivamente alle architetture AMD64/Intel 64. Le frecce contrassegnano l'inizio e la fine del blocco di testo.

IBM Z, POWER Questo paragrafo si riferisce esclusivamente alle architetture

IBM ZePOWER. Le frecce contrassegnano l'inizio e la fine del blocco di testo.Capitolo 1, «Capitolo di esempio»: riferimento incrociato a un altro capitolo della presente guida.

Comandi che devono essere eseguiti con privilegi di

root. Per eseguire tali comandi come utente senza privilegi, è spesso possibile anteporvi il prefissosudo.#command>sudocommandComandi che possono essere eseguiti anche da utenti senza privilegi.

>commandAvvisi

Avvertimento: avvertenzaInformazioni essenziali che è indispensabile conoscere prima di procedere. Segnala problemi di sicurezza, potenziali perdite di dati, danni hardware o pericoli fisici.

Importante: avviso importanteInformazioni importanti che è consigliabile leggere prima di procedere.

Nota: notaInformazioni aggiuntive, che illustrano ad esempio le differenze tra le varie versioni del software.

Suggerimento: suggerimentoInformazioni utili, come linee guida o consigli pratici.

Avvisi compatti

Informazioni aggiuntive, che illustrano ad esempio le differenze tra le varie versioni del software.

Informazioni utili, come linee guida o consigli pratici.

4 Supporto #

Di seguito sono riportate l'Informativa sul supporto per SUSE Enterprise Storage e informazioni generali sulle anteprime della tecnologia. Per i dettagli sul ciclo di vita del prodotto, vedere il https://www.suse.com/lifecycle.

Se si ha diritto al supporto, ulteriori dettagli su come raccogliere informazioni per un ticket di supporto sono disponibili all'indirizzo https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Informativa sul supporto per SUSE Enterprise Storage #

Per ricevere supporto, occorre una sottoscrizione idonea a SUSE. Per visualizzare le offerte di supporto specifiche disponibili, andare a https://www.suse.com/support/ e selezionare il prodotto in uso.

Di seguito sono riportate le definizioni dei livelli di supporto:

- L1

Individuazione del problema, ovvero supporto tecnico pensato per fornire informazioni di compatibilità, assistenza per l'utilizzo, operazioni di manutenzione, raccolta di informazioni e risoluzione dei problemi di base tramite la documentazione disponibile.

- L2

Isolamento del problema, ovvero supporto tecnico pensato per l'analisi dei dati, la riproduzione dei problemi dei clienti, l'isolamento dell'area del problema e la proposta di una risoluzione dei problemi non risolti al livello 1 o la loro preparazione per il livello 3.

- L3

Risoluzione del problema, ovvero supporto tecnico pensato per la risoluzione dei difetti del prodotto identificati al livello di supporto 2.

Per i clienti e i partner con contratto, SUSE Enterprise Storage è fornito con supporto L3 per tutti i pacchetti, a eccezione di quanto segue:

Anteprime della tecnologia.

Suoni, grafiche, tipi di carattere e oggetti grafici.

Pacchetti che richiedono un contratto con il cliente aggiuntivo.

Alcuni pacchetti rilasciati come parte del modulo Workstation Extension dispongono soltanto del supporto L2.

I pacchetti con nomi che terminano con -devel (contenenti file di intestazione e simili risorse per sviluppatori) sono supportati soltanto insieme ai relativi pacchetti principali.

SUSE supporterà soltanto l'utilizzo dei pacchetti originali. Vale a dire, i pacchetti non modificati e non ricompilati.

4.2 Anteprime della tecnologia #

Le anteprime della tecnologia sono pacchetti, stack o funzioni forniti da SUSE come anticipazioni sulle future innovazioni. Tramite le anteprime della tecnologia, i clienti hanno la possibilità di testare le nuove tecnologie all'interno del proprio ambiente. I feedback degli utenti sono bene accetti. Se si esegue il test di un'anteprima della tecnologia, contattare il proprio rappresentante SUSE per informarlo della propria esperienza utente e dei casi d'uso. I suggerimenti degli utenti sono molto utili per lo sviluppo futuro.

Le anteprime della tecnologia presentano le seguenti limitazioni:

Le anteprime della tecnologia sono ancora in fase di sviluppo. Di conseguenza, potrebbero essere incomplete a livello di funzioni, instabili o in altri modi non adatte per l'utilizzo nell'ambiente di produzione.

Le anteprime della tecnologia non dispongono di alcun supporto.

Le anteprime della tecnologia potrebbero essere disponibili soltanto per architetture hardware specifiche.

I dettagli e le funzionalità delle anteprime della tecnologia sono soggetti a modifica. Di conseguenza, potrebbe non essere possibile eseguire l'upgrade alle successive release di un'anteprima della tecnologia e potrebbe essere necessario eseguire una nuova installazione.

SUSE potrebbe rilevare che un'anteprima non soddisfa le esigenze dei clienti o del mercato o che non è confacente agli standard aziendali. Le anteprime della tecnologia possono essere rimosse da un prodotto in qualsiasi momento. SUSE non si impegna a fornire una versione supportata di tali tecnologie in futuro.

Per una panoramica delle anteprime della tecnologia fornite con il prodotto, vedere le note di rilascio all'indirizzo https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Collaboratori di Ceph #

Il progetto Ceph e la relativa documentazione sono il risultato del lavoro di centinaia di collaboratori e organizzazioni. Per ulteriori dettagli, consultare la pagina all'indirizzo https://ceph.com/contributors/.

6 Comandi e prompt dei comandi utilizzati nella presente guida #

Gli amministratori del cluster Ceph si occupano della configurazione e della modifica del comportamento del cluster tramite l'esecuzione di comandi specifici. Saranno necessari diversi tipi di comandi:

6.1 Comandi correlati a Salt #

Questi comandi consentono di distribuire i nodi del cluster Ceph, di eseguire comandi contemporaneamente su più (o su tutti i) nodi del cluster e semplificano l'aggiunta o la rimozione dei nodi del cluster. I comandi utilizzati più di frequente sono ceph-salt e ceph-salt config. È necessario eseguire i comandi Salt sul nodo del Salt Master come root. Questi comandi sono introdotti dal prompt seguente:

root@master # Esempio:

root@master # ceph-salt config ls6.2 Comandi correlati a Ceph #

Si tratta di comandi di livello inferiore per la configurazione e l'ottimizzazione di tutti gli aspetti del cluster e dei relativi gateway sulla riga di comando, ad esempio ceph, cephadm, rbd o radosgw-admin.

Per eseguire i comandi correlati a Ceph, è necessario disporre dell'accesso in lettura a una chiave Ceph. Le capacità della chiave definiscono i privilegi dell'utente all'interno dell'ambiente Ceph. Un'opzione consiste nell'eseguire i comandi di Ceph come root (o tramite sudo) e utilizzare il portachiavi di default senza restrizioni "ceph.client.admin.key".

L'opzione consigliata e più sicura consiste nel creare una chiave individuale più restrittiva per ogni utente amministratore e inserirla in una directory in cui gli utenti possano leggerla, ad esempio:

~/.ceph/ceph.client.USERNAME.keyring

Per utilizzare un utente amministratore e un portachiavi personalizzati, è necessario specificare il nome utente e il percorso della chiave ogni volta che si esegue il comando ceph tramite le opzioni -n client.USER_NAME e --keyring PATH/TO/KEYRING.

Per evitarlo, includere queste opzioni nella variabile CEPH_ARGS nei file ~/.bashrc dei singoli utenti.

I comandi correlati a Ceph possono essere eseguiti su qualsiasi nodo del cluster, ma è consigliabile eseguirli sul nodo admin. In questa documentazione, l'utente cephuser esegue i comandi, pertanto questi vengono introdotti dal prompt seguente:

cephuser@adm > Esempio:

cephuser@adm > ceph auth listSe nella documentazione è indicato di eseguire un comando su un nodo del cluster con un ruolo specifico, questo verrà indirizzato dal prompt. Esempio:

cephuser@mon > 6.2.1 Esecuzione di ceph-volume #

A partire da SUSE Enterprise Storage 7, i servizi Ceph vengono eseguiti in container. Se è necessario eseguire ceph-volume su un nodo OSD, occorre anteporlo con il comando cephadm, ad esempio:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandi Linux generali #

I comandi Linux non correlati a Ceph, come mount, cat o openssl, sono introdotti con i prompt cephuser@adm > o # , a seconda dei privilegi richiesti dal comando correlato.

6.4 Informazioni aggiuntive #

Per ulteriori informazioni sulla gestione della chiave Ceph, fare riferimento a Book “Guida all'amministrazione e alle operazioni”, Chapter 30 “Autenticazione con cephx”, Section 30.2 “Gestione delle chiavi”.

Parte I Presentazione di SUSE Enterprise Storage (SES) #

- 1 SES e Ceph

SUSE Enterprise Storage è un sistema di storage distribuito progettato per scalabilità, affidabilità e prestazioni basato sulla tecnologia Ceph. È possibile eseguire un cluster Ceph su server generici in una rete comune come Ethernet. Il cluster può scalare inoltre fino a migliaia di server (più ava…

- 2 Requisiti hardware e raccomandazioni

I requisiti hardware di Ceph dipendono strettamente dal carico di lavoro degli IO. Tenere presente i seguenti requisiti hardware e raccomandazioni come base di partenza per una pianificazione dettagliata.

- 3 Configurazione ad elevata disponibilità del nodo admin

Il nodo admin è un nodo del cluster Ceph dove è in esecuzione il servizio Salt Master. Gestisce il resto dei nodi del cluster tramite l'invio di interrogazioni e istruzioni ai rispettivi servizi Salt Minion. Comprende in genere anche altri servizi, ad esempio il dashboard Grafana supportato dal kit …

1 SES e Ceph #

SUSE Enterprise Storage è un sistema di storage distribuito progettato per scalabilità, affidabilità e prestazioni basato sulla tecnologia Ceph. È possibile eseguire un cluster Ceph su server generici in una rete comune come Ethernet. Il cluster può scalare inoltre fino a migliaia di server (più avanti denominati nodi) e nel campo dei petabyte. Rispetto ai sistemi convenzionali che dispongono di tabelle di allocazione per memorizzare e recuperare i dati, Ceph utilizza un algoritmo deterministico per allocare lo storage per i dati e non dispone di alcuna struttura informativa centralizzata. Ceph suppone che nei cluster di storage l'aggiunta o la rimozione dell'hardware sia la normalità, non l'eccezione. Il cluster Ceph automatizza i task di gestione come distribuzione e ridistribuzione dei dati, replica dei dati, rilevamento e ripristino degli errori. Ceph sfrutta capacità di autoregolazione e autogestione, determinando la riduzione delle spese amministrative e sforamenti di bilancio.

Questo capitolo contiene una panoramica di alto livello di SUSE Enterprise Storage 7.1 e una breve descrizione dei componenti più importanti.

1.1 Funzioni di Ceph #

L'ambiente Ceph presenta le seguenti caratteristiche:

- Scalabilità

Ceph è in grado di scalare a migliaia di nodi e gestire lo storage nel campo dei petabyte.

- Hardware

Per eseguire il cluster Ceph, non sono richiesti hardware speciali. Per i dettagli, vedere Capitolo 2, Requisiti hardware e raccomandazioni

- Autogestione

Il cluster Ceph è in grado di autogestirsi. Quando si aggiungono o rimuovono nodi o in caso di guasto, il cluster ridistribuisce automaticamente i dati. È inoltre in grado di riconoscere i dischi sovraccarichi.

- Nessun Single point of failure

Nessun nodo in un cluster memorizza da solo dati importanti. È possibile configurare il numero di ridondanze.

- Software open source

Ceph è una soluzione software open source e indipendente da hardware o fornitori specifici.

1.2 Componenti di base di Ceph #

Per utilizzare pienamente la potenza di Ceph, è necessario comprendere alcuni dei componenti e concetti di base. Questa sezione presenta alcune parti di Ceph a cui si fa spesso riferimento in altri capitoli.

1.2.1 RADOS #

Il componente base di Ceph è denominato RADOS (Reliable Autonomic Distributed Object Store), responsabile per la gestione dei dati memorizzati nel cluster. I dati in Ceph vengono in genere memorizzati come oggetti. Ciascun oggetto consiste di un identificativo e dai dati.

RADOS fornisce i seguenti metodi di accesso agli oggetti memorizzati che riguardano molti casi d'uso:

- Object Gateway

Object Gateway è un gateway HTTP REST per lo store di oggetti RADOS che consente l'accesso diretto agli oggetti memorizzati nel cluster Ceph.

- Dispositivo di blocco RADOS (RADOS Block Device, RBD)

È possibile accedere ai RADOS Block Device (RBD) seguendo la stessa procedura degli altri dispositivi di blocco e utilizzarli ad esempio insieme con

libvirtper scopi di virtualizzazione.- CephFS

Il file system di Ceph è di tipo POSIX-compatibile.

libradoslibradosè una libreria utilizzabile con molti linguaggi di programmazione per creare un'applicazione in grado di interagire direttamente con il cluster di storage.

librados è utilizzata da Object Gateway e RBD mentre CephFS si interfaccia direttamente con RADOS Figura 1.1, «Interfacce con l'archivio dati Ceph».

1.2.2 CRUSH #

Il core del cluster Ceph è l'algoritmo CRUSH. CRUSH è l'acronimo di Controlled Replication Under Scalable Hashing. CRUSH è una funzione che gestisce l'allocazione dello storage e richiede comparabilmente pochi parametri. Ciò significa che è necessaria solo una piccola quantità di dati per calcolare la posizione di storage di un oggetto. I parametri sono una mappa corrente del cluster comprendente lo stato, alcune regole di posizionamento definite dall'amministratore e il nome dell'oggetto che deve essere memorizzato o recuperato. Con questi dati, tutti i nodi nel cluster Ceph sono in grado di calcolare dove si trova un oggetto e le sue repliche. Ciò rende la scrittura o la lettura dei dati molto efficace. CRUSH tenta di distribuire in modo uniforme i dati tra tutti i nodi nel cluster.

La mappa CRUSH contiene tutti i nodi di storage e le regole di posizionamento definite dall'amministratore per la memorizzazione degli oggetti nel cluster e definisce una struttura gerarchica che di solito corrisponde alla struttura fisica del cluster. Ad esempio, i dischi contenenti i dati sono negli host, gli host sono nei rack, i rack in righe e le righe nei data center. È possibile utilizzare questa struttura per definire i domini di guasto. Ceph quindi garantisce che le repliche vengano memorizzate su diverse diramazioni di uno specifico dominio di guasto.

Se il dominio di guasto è configurato su un rack, le repliche degli oggetti sono distribuite su diversi rack. Ciò può ridurre le perdite provocate da un errore di commutazione in un rack. Se un'unità di distribuzione alimentazione alimenta una riga di rack, il dominio di guasto può essere configurato su una riga. In caso di errore dell'unità di distribuzione di alimentazione, i dati replicati sono sempre disponibili su altre righe.

1.2.3 Daemon e nodi Ceph #

In Ceph, i nodi sono server che lavorano per il cluster e possono eseguire diversi tipi di daemon. Si consiglia di eseguire solo un tipo di daemon in ogni nodo, tranne per i daemon Ceph Manager che possono essere co-ubicati con i Ceph Monitor. Per ogni cluster sono necessari almeno i daemon Ceph Monitor, Ceph Manager e Ceph OSD:

- Nodo admin

Il nodo admin è un nodo del cluster Ceph da cui si eseguono i comandi per la gestione del cluster. Il nodo admin è un punto centrale del cluster Ceph perché gestisce i nodi residui del cluster tramite interrogazione e istruendo i relativi servizi Salt Minion.

- Ceph Monitor

I nodi Ceph Monitor (spesso abbreviato con MON) mantengono le informazioni sullo stato del cluster, una mappa di tutti i nodi e regole di distribuzione dati (vedere Sezione 1.2.2, «CRUSH»).

Se si verificano errori o conflitti, i nodi Ceph Monitor nel cluster decidono a maggioranza quali dati sono corretti. Per formare una maggioranza qualificata, si consiglia un numero dispari di nodi Ceph Monitor e almeno tre.

Se si utilizzano più siti, i nodi Ceph Monitor devono essere distribuiti su un numero dispari di siti. Il numero di nodi Ceph Monitor per sito deve essere tale che oltre il 50% dei nodi Ceph Monitor resti funzionale in caso di errore di un sito.

- Ceph Manager

Ceph Manager raccoglie le informazioni di stato dall'intero cluster. Il daemon Ceph Manager viene eseguito insieme con i daemon Ceph Monitor, fornisce ulteriore monitoraggio e si interfaccia con i sistemi di gestione e monitoraggio esterni. Include anche altri servizi. Ad esempio, l'interfaccia utente Web del Ceph Dashboard viene eseguita sullo stesso nodo del Ceph Manager.

Per Ceph Manager non è necessaria una configurazione aggiuntiva; è sufficiente verificare che sia in esecuzione.

- Ceph OSD

Ceph OSD è un daemon che gestisce gli Object Storage Device che sono unità di storage logiche o fisiche (dischi rigidi o partizioni). Gli Object Storage Device possono essere dischi fisici/partizioni o volumi logici. Il daemon si occupa inoltre della replica dei dati e del ribilanciamento in caso di nodi aggiunti o rimossi.

I daemon Ceph OSD comunicano con i daemon monitor e forniscono loro lo stato degli altri daemon OSD.

Per utilizzare CephFS, Object Gateway, NFS Ganesha o iSCSI Gateway, sono richiesti nodi aggiuntivi:

- Metadata Server (MDS)

I metadati di CephFS vengono archiviati sul relativo pool RADOS (vedere la Sezione 1.3.1, «Pool»). I Metadata Server agiscono come strato di memorizzazione nella cache smart per i metadati e serializzano l'accesso quando necessario. In questo modo, è possibile consentire l'accesso simultaneo da diversi client senza sincronizzazione esplicita.

- Object Gateway

Object Gateway è un gateway HTTP REST per l'archivio dati RADOS. È compatibile con OpenStack Swift e Amazon S3 e dispone di propria gestione utente.

- NFS Ganesha

NFS Ganesha fornisce un accesso NFS all'Object Gateway o a CephFS. Viene eseguito nell'utente invece che nello spazio kernel e interagisce direttamente con l'Object Gateway o CephFS.

- iSCSI Gateway

iSCSI è un protocollo di rete di storage che consente ai client di inviare comandi SCSI ai dispositivi di storage SCSI (destinazioni) su server remoti.

- Gateway Samba

Il gateway Samba fornisce accesso Samba ai dati memorizzati su CephFS.

1.3 Struttura di memorizzazione di Ceph #

1.3.1 Pool #

Gli oggetti memorizzati in un cluster Ceph vengono posti nei pool. I pool rappresentano le partizioni logiche del cluster per l'esterno. Per ogni pool è possibile definire un set di regole, ad esempio quante repliche di ogni oggetto devono esistere. La configurazione standard dei pool è denominata pool replicato.

I pool in genere contengono oggetti, ma è possibile configurarli anche per funzionare come RAID 5. In questa configurazione, gli oggetti vengono memorizzati in chunk insieme con i chunk di codifica aggiuntivi. I chunk di codifica contengono i dati ridondanti. Il numero di dati e chunk di codifica può essere definito dall'amministratore. In questa configurazione, i pool sono denominati pool con codice di cancellazione o pool EC.

1.3.2 Gruppi di posizionamento #

I gruppi di posizionamento (PG) sono utilizzati per la distribuzione dei dati in un pool. Quando si crea un pool, viene impostato un determinato numero di gruppi di posizionamento. I gruppi di posizionamento sono utilizzati internamente per raggruppare gli oggetti e sono un fattore importante per le prestazioni di un cluster Ceph. Il PG di un oggetto è determinato dal nome dell'oggetto.

1.3.3 Esempio #

Questa sezione fornisce un esempio semplificato della gestione dati di Ceph (vedere Figura 1.2, «Esempio di Ceph su piccola scala»). Questo esempio non rappresenta una configurazione consigliata per un cluster Ceph. La configurazione hardware consiste di tre nodi di storage Ceph OSD (Host 1, Host 2, Host 3). Ogni nodo ha tre dischi rigidi utilizzati come OSD (da osd.1 a osd.9). In questo esempio, vengono tralasciati i nodi Ceph Monitor.

Mentre Ceph OSD o daemon Ceph OSD si riferisce a un daemon eseguito su un nodo, il termine OSD si riferisce al disco logico con cui interagisce il daemon.

Il cluster ha due pool, Pool A e Pool B. Mentre il Pool A replica gli oggetti solo due volte, la resilienza per Pool B è più importante e ha tre repliche per ogni oggetto.

Quando un'applicazione mette un oggetto in un pool, ad esempio tramite la API REST, un Gruppo di posizionamento (da PG1 a PG4) viene selezionato in base a pool e nome oggetto. L'algoritmo CRUSH calcola quindi su quali OSD viene memorizzato l'oggetto, in base al Gruppo di posizionamento contenente l'oggetto.

In questo esempio, il dominio di guasto è impostato sull'host. Ciò garantisce che le repliche degli oggetti siano memorizzate su diversi host. In base al livello di replica impostato per un pool, l'oggetto viene memorizzato su due o tre OSD utilizzati dal Gruppo di posizionamento.

Un'applicazione che scrive un oggetto interagisce solo con un Ceph OSD, il Ceph OSD primario. Il Ceph OSD primario si occupa della replica e conferma il completamento del processo di scrittura dopo che tutti gli altri OSD hanno memorizzato l'oggetto.

In caso di errore di osd.5, tutti gli oggetti in PG1 sono ancora disponibili su osd.1. Non appena il cluster riconosce l'errore di un OSD, un altro OSD lo sostituisce. In questo esempio osd.4 viene utilizzato come sostituzione per osd.5. Gli oggetti memorizzati su osd.1 vengono quindi replicati su osd.4 per ripristinare il livello di replica.

Se si aggiunge al cluster un nuovo nodo con nuovi OSD, la mappa del cluster cambia. La funzione CRUSH restituisce quindi diverse ubicazioni per gli oggetti. Gli oggetti che ricevono nuove ubicazioni vengono riposizionati. Questo processo determina un uso bilanciato di tutti gli OSD.

1.4 BlueStore #

BlueStore è un nuovo back-end di storage di default per Ceph di SES 5. Offre migliori prestazioni di FileStore, check-sum dei dati completo e compressione integrata.

BlueStore gestisce uno, due o tre dispositivi di storage. Nel caso più semplice, BlueStore consuma un singolo dispositivo di storage primario. Il dispositivo di storage è di solito partizionato in due parti:

Una piccola partizione denominata BlueFS che implementa funzionalità di tipo file system richieste da RocksDB.

Il resto del dispositivo è in genere una grande partizione che occupa tutto lo spazio residuo del dispositivo. È gestito direttamente da BlueStore e contiene tutti i dati effettivi. Tale dispositivo primario è in genere identificato da un collegamento simbolico di blocco nella directory dei dati.

È inoltre possibile distribuire BlueStore su due dispositivi aggiuntivi:

Un dispositivo WAL può essere utilizzato per il giornale di registrazione interno di BlueStore o il log di scrittura. È identificato dal collegamento simbolico block.wal nella directory dei dati e serve solo per utilizzare un dispositivo WAL separato se il dispositivo è più veloce del dispositivo primario o del dispositivo DB, ad esempio quando:

il dispositivo WAL è un NVMe e il dispositivo DB è una SSD e il dispositivo dati è un'unità SSD o HDD.

Entrambi i dispositivi WAL e DB sono SSD separate e il dispositivo dati è un'unità SSD o HDD.

È possibile utilizzare un dispositivo DB per memorizzare i metadati interni di BlueStore. BlueStore (o piuttosto il RocksDB integrato) trasferisce tutti i metadati possibili sul dispositivo DB per migliorare le prestazioni. Di nuovo, è utile solo per il provisioning di un dispositivo DB condiviso se è più veloce del dispositivo primario.

Pianificarla attentamente per assicurarsi che il dispositivo DB sia delle dimensioni sufficienti. Se il dispositivo DB è pieno, i metadati si riverseranno sul dispositivo primario che degraderà notevolmente le prestazioni dell'OSD.

È possibile verificare se una partizione WAL/DB si sta riempiendo e trasferendo i dati con il comando ceph daemon osd.ID perf dump. Il valore slow_used_bytes mostra la quantità di dati in uscita:

cephuser@adm > ceph daemon osd.ID perf dump | jq '.bluefs'

"db_total_bytes": 1073741824,

"db_used_bytes": 33554432,

"wal_total_bytes": 0,

"wal_used_bytes": 0,

"slow_total_bytes": 554432,

"slow_used_bytes": 554432,1.5 Informazioni aggiuntive #

Ceph è un progetto di community che dispone di una propria documentazione completa online. Per argomenti non trovati nel presente manuale, consultare https://docs.ceph.com/en/pacific/.

La pubblicazione originale CRUSH: Controlled, Scalable, Decentralized Placement of Replicated Data di S.A. Weil, S.A. Brandt, E.L. Miller, C. Maltzahn fornisce spunti utili nelle opere interne di Ceph. Se ne consiglia la lettura soprattutto per la distribuzione di cluster in grande scala. La pubblicazione è disponibile al seguente collegamento http://www.ssrc.ucsc.edu/papers/weil-sc06.pdf.

SUSE Enterprise Storage può essere utilizzato con le distribuzioni OpenStack non SUSE. I client Ceph devono trovarsi a un livello compatibile con SUSE Enterprise Storage.

NotaSUSE supporta il componente server della distribuzione Ceph, mentre il client è supportato dal fornitore della distribuzione OpenStack.

2 Requisiti hardware e raccomandazioni #

I requisiti hardware di Ceph dipendono strettamente dal carico di lavoro degli IO. Tenere presente i seguenti requisiti hardware e raccomandazioni come base di partenza per una pianificazione dettagliata.

In generale, le raccomandazioni date sono riferite a un processo. Se sullo stesso computer sono ubicati più processi, occorre sommare i requisiti di CPU, RAM, disco e rete.

2.1 Panoramica sulla rete #

Ceph dispone di diverse reti logiche:

Una rete di front-end, la

rete pubblica.Una rete interna affidabile, ovvero la rete di back-end o

rete di cluster. Si tratta di una procedura opzionale.Una o più reti client per i gateway. Si tratta di reti facoltative che non rientrano nell'ambito del presente capitolo.

La rete pubblica è la rete su cui i daemon Ceph comunicano tra di loro e con i client, ciò significa che tutto il traffico del cluster Ceph passa su questa rete, tranne nel caso in cui sia configurata una rete di cluster.

La rete di cluster è la rete di back-end tra i nodi OSD per la replica, il ribilanciamento e il recupero. Se adeguatamente configurata, questa rete facoltativa può fornire fino al doppio della larghezza di banda della rete pubblica con la replica a tre vie di default, dal momento che viene utilizzata dall'OSD primario per inviare due copie agli altri OSD. La rete pubblica consente a client e gateway di comunicare con monitor, manager, nodi MDS e nodi OSD. È inoltre utilizzata da monitor, manager e nodi MDS per la comunicazione con i nodi OSD.

2.1.1 Raccomandazioni di rete #

Si consiglia di utilizzare una singola rete a tolleranza di errore con larghezza di banda sufficiente per soddisfare i propri requisiti. Per l'ambiente di rete pubblica Ceph, si consigliano due interfacce di rete associate da 25 GbE (o più veloci) associate tramite 802.3ad (LACP). Questa è considerata come la configurazione di base di Ceph. Se si utilizza anche una rete di cluster, si consigliano quattro interfacce di rete associate da 25 GbE. L'associazione di due o più interfacce di rete offre migliore velocità effettiva tramite l'aggregazione dei collegamenti e, in caso di collegamenti e switch ridondanti, maggiore tolleranza agli errori e gestibilità.

È possibile inoltre creare VLAN per isolare diversi tipi di traffico su un'associazione. Ad esempio, è possibile creare un'associazione per fornire due interfacce VLAN, una per la rete pubblica e una per la rete di cluster. Tuttavia, ciò non è necessario durante la configurazione delle reti Ceph. All'indirizzo https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-network.html#sec-network-iface-bonding sono disponibili ulteriori dettagli sull'associazione delle interfacce.

Isolando i componenti nei domini di errore, si aumenta la tolleranza agli errori. Per ottenere una maggiore tolleranza agli errori della rete, è possibile associare un'interfaccia a due NIC (Network Interface Card) separate, qualora si verificasse un errore su una. Analogamente, associare due switch diversi fornisce maggiore protezione, nel caso si verificasse un errore su uno. Rivolgersi al fornitore delle apparecchiature di rete per impostare il livello adeguato di tolleranza agli errori.

La configurazione della rete di amministrazione aggiuntiva, che consente ad esempio la separazione delle reti SSH, Salt o DNS, non è né testata né supportata.

Se i nodi di storage sono configurati tramite DHCP, i timeout default possono non essere sufficienti per configurare correttamente la rete prima dell'avvio dei vari daemon Ceph. Se ciò avviene, i Ceph MON e OSD non si avvieranno in modo corretto (l'esecuzione di systemctl status ceph\* genererà errori di associazione). Per evitare questo problema, si consiglia di aumentare il timeout del client DHCP ad almeno 30 secondi su ciascun nodo nel cluster di memorizzazione. È possibile fare questo modificando le impostazioni seguenti su ogni nodo:

In /etc/sysconfig/network/dhcp, impostare

DHCLIENT_WAIT_AT_BOOT="30"

In /etc/sysconfig/network/config, impostare

WAIT_FOR_INTERFACES="60"

2.1.1.1 Aggiunta di una rete privata a un cluster in esecuzione #

Se non si specifica una rete di cluster durante la distribuzione, Ceph presume un ambiente di rete pubblica singola. Mentre Ceph funziona bene con una rete pubblica, le sue prestazioni e sicurezza aumentano quando si imposta una seconda rete di cluster privata. Per supportare due reti, ogni nodo Ceph deve avere almeno due schede di rete.

Occorre applicare le seguenti modifiche a ogni nodo Ceph. È relativamente rapido farlo con un piccolo cluster, ma può essere necessario molto tempo in caso di cluster contenente centinaia o migliaia di nodi.

Impostare la rete di cluster utilizzando il comando seguente:

#ceph config set global cluster_network MY_NETWORKRiavviare gli OSD per eseguire l'associazione alla rete di cluster specificata:

#systemctl restart ceph-*@osd.*.serviceVerificare che la rete di cluster privata funzioni come previsto al livello del SO.

2.1.1.2 Nodi di monitoraggio su sottoreti diverse #

Se i nodi monitor sono su sottoreti diverse, ad esempio si trovano in stanze diverse e sono serviti da switch differenti, occorre specificare l'indirizzo di rete pubblica nella notazione CIDR:

cephuser@adm > ceph config set mon public_network "MON_NETWORK_1, MON_NETWORK_2, MON_NETWORK_NEsempio:

cephuser@adm > ceph config set mon public_network "192.168.1.0/24, 10.10.0.0/16"Se si specifica più di un segmento di rete per la rete pubblica (o di cluster) come descritto in questa sezione, ciascuna di queste sottoreti deve essere in grado di eseguire l'instradamento a tutte le altre, altrimenti i MON e gli altri daemon Ceph su segmenti di rete diversi non potranno comunicare e verrà generato un cluster suddiviso. Inoltre, se si utilizza un firewall, assicurarsi di includere ogni indirizzo IP o sottorete nelle iptables e aprire le porte per questi ultimi su tutti i nodi in base alle esigenze.

2.2 Configurazioni ad architettura multipla #

SUSE Enterprise Storage supporta le architetture x86 e Arm. Durante la valutazione di ciascuna architettura, è importante osservare che dalla prospettiva dei core per OSD, frequenza e RAM, non esistono reali differenze tra le architetture CPU in termini di ridimensionamento.

Come per i processori x86 (non-server) di dimensioni più piccole, i core basati su Arm a prestazioni ridotte potrebbero non fornire un'esperienza ottimale, soprattutto se utilizzati per i pool con codice di cancellazione.

Nella documentazione, SYSTEM-ARCH è utilizzato al posto di x86 o Arm.

2.3 Configurazione hardware #

La configurazione del cluster consigliata garantisce la migliore esperienza utente con il prodotto. Per i cluster di test o con requisiti di prestazioni inferiori, è descritta la configurazione minima supportata.

2.3.1 Configurazione minima del cluster #

La configurazione minima del cluster è costituita da:

Almeno quattro nodi fisici (nodi OSD) con la co-location dei servizi;

Ethernet Dual-10 Gb come rete associata;

Un nodo admin separato (può essere virtualizzato su un nodo esterno).

La configurazione dettagliata prevede:

Nodo admin separato con 4 GB di RAM, quattro core, capacità di memorizzazione di 1 TB. In genere questo è il nodo Salt Master. I servizi e i gateway Ceph, come Ceph Monitor, Metadata Server, Ceph OSD, Object Gateway o NFS Ganesha non sono supportati sul nodo admin poiché quest'ultimo deve coordinare i processi di upgrade e aggiornamento del cluster in modo indipendente.

Almeno quattro nodi OSD fisici, con otto dischi OSD ciascuno; vedere la Sezione 2.4.1, «Requisiti minimi» per i requisiti.

La capacità complessiva del cluster deve essere ridimensionata per fare in modo che, anche nel caso di mancata disponibilità di un nodo, la capacità complessiva in uso (inclusa la ridondanza) non superi l'80%.

Tre istanze di Ceph Monitor. Per ragioni di latenza, i monitor devono essere eseguiti dallo storage SSD/NVMe e non da HDD.

Monitor, Metadata Server e gateway possono trovarsi in co-location sui nodi OSD; vedere la Sezione 2.12, «Condivisione di un server da parte di OSD e monitor» per informazioni sulla co-location dei monitor. In caso di co-location dei servizi, occorre aggiungere i requisiti di memoria e CPU.

iSCSI Gateway, Object Gateway e Metadata Server richiedono almeno 4 GB di RAM incrementale e quattro core.

Se si utilizzano CephFS, S3/Swift e iSCSI, per garantire ridondanza e disponibilità sono necessarie almeno due istanze dei rispettivi ruoli (Metadata Server, Object Gateway, iSCSI).

I nodi devono essere dedicati a SUSE Enterprise Storage e non devono essere utilizzati per altri workload fisici, in container o virtualizzati.

Se i gateway (iSCSI, Object Gateway, NFS Ganesha, Metadata Server ecc.) sono distribuiti all'interno di macchine virtuali, queste ultime non devono essere ospitate sulle macchine fisiche che servono altri ruoli del cluster (ciò non è necessario, poiché sono supportati come servizi in co-location).

Se si esegue la distribuzione dei servizi come macchine virtuali su Hypervisor all'esterno del cluster fisico principale, occorre rispettare i domini di errore per assicurare la ridondanza.

Ad esempio, non distribuire più ruoli dello stesso tipo sullo stesso Hypervisor (come più istanze MDS o MON).

Se si esegue la distribuzione all'interno delle macchine virtuali, è particolarmente importante verificare che la connettività di rete dei nodi sia ottimale e che l'orario venga sincronizzato correttamente.

I nodi dell'Hypervisor devono avere dimensioni adeguate per evitare interferenze provenienti da altri workload che consumano risorse di CPU, RAM, rete e storage.

2.3.2 Configurazione del cluster di produzione consigliata #

Con la crescita del cluster, si consiglia di ricollocare i Ceph Monitor, i Metadata Server e i gateway per separare i nodi e ottenere una maggiore tolleranza agli errori.

Sette nodi Storage oggetto

Nessun singolo nodo eccede ~15% dello storage totale.

La capacità complessiva del cluster deve essere ridimensionata per fare in modo che, anche nel caso di mancata disponibilità di un nodo, la capacità complessiva in uso (inclusa la ridondanza) non superi l'80%.

Ethernet da 25 Gb o superiore, con associazione per la rete pubblica esterna e di cluster interna.

56+ OSD per cluster di storage.

Vedere la Sezione 2.4.1, «Requisiti minimi» per ulteriori raccomandazioni.

Nodi infrastruttura fisica dedicata.

Tre nodi Ceph Monitor: 4 GB RAM, processore a 4 core, SSD RAID 1 per disco.

Vedere la Sezione 2.5, «Nodi monitor» per ulteriori raccomandazioni.

Nodi Object Gateway: 32 GB RAM, processore 8 core, SSD RAID 1 per disco.

Vedere la Sezione 2.6, «Nodi Object Gateway» per ulteriori raccomandazioni.

Nodi iSCSI Gateway: 16 GB RAM, processore 8 core, SSD RAID 1 per disco.

Vedere la Sezione 2.9, «Nodi iSCSI Gateway» per ulteriori raccomandazioni.

Nodi Metadata Server (uno attivo/uno hot standby): 32 GB RAM, processore 8 core, SSD RAID 1 per disco.

Vedere la Sezione 2.7, «Nodi Metadata Server» per ulteriori raccomandazioni.

Un nodo admin SES: 4 GB di RAM, processore 4 core, SSD RAID 1 per disco.

2.3.3 Configurazione multipath #

Se si desidera utilizzare l'hardware multipath, assicurarsi che LVM visualizzi multipath_component_detection = 1 nella sezione devices del file di configurazione. È possibile verificare questa istruzione tramite il comando lvm config.

In alternativa, assicurarsi che LVM filtri i componenti mpath di un dispositivo tramite la configurazione di filtro LVM. Si tratta di un'impostazione specifica per l'host.

Questa procedura non è consigliata e deve essere presa in considerazione soltanto se non è possibile impostare multipath_component_detection = 1.

Per ulteriori informazioni sulla configurazione multipath, vedere https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-multipath.html#sec-multipath-lvm.

2.4 Nodi storage oggetto #

2.4.1 Requisiti minimi #

Le seguenti raccomandazioni sulla CPU si applicano ai dispositivi indipendentemente dall'utilizzo di Ceph:

1 thread CPU da 2 GHz per unità a rotazione.

2 thread CPU da 2 GHz per SSD.

4 thread CPU da 2 GHz per NVMe.

Reti 10 GbE (pubbliche/client e interne) separate: 4 da 10 GbE obbligatorie, 2 da 25 GbE consigliate.

RAM totale richiesta = numero di OSD x (1 GB +

osd_memory_target) + 16 GBPer ulteriori dettagli su

osd_memory_target, consultare questo riferimento: Book “Guida all'amministrazione e alle operazioni”, Chapter 28 “Configurazione del cluster Ceph”, Section 28.4.1 “Configurazione del ridimensionamento automatico della cache”.Dischi OSD nelle configurazioni JBOD o configurazioni RAID-0 individuali.

Il giornale di registrazione OSD può risiedere sul disco OSD.

I dischi OSD devono essere utilizzati esclusivamente da SUSE Enterprise Storage.

SSD e disco dedicato per il sistema operativo, preferibilmente in una configurazione RAID 1.

Allocare almeno altri 4 GB di RAM se questo host OSD ospiterà parte di un pool di cache utilizzato per la suddivisione in livelli della cache.

Monitor Ceph, gateway e Metadata Server possono risiedere sui nodi storage oggetto.

Per motivi legati alle prestazioni del disco, i nodi OSD sono nodi bare metal. Nessun altro workload deve essere eseguito su un nodo OSD a meno che non si tratti di una configurazione minima di Ceph Monitor e Ceph Manager.

SSD per giornale di registrazione con rapporto 6:1 tra giornale SSD e OSD.

Assicurarsi che i nodi OSD non dispongano di dispositivi di blocco di rete mappati, come immagini iSCSI o dispositivi di blocco RADOS (RADOS Block Device, RBD).

2.4.2 Dimensioni minime del disco #

Vi sono due tipi di spazi su disco necessari per l'esecuzione su OSD: lo spazio per il dispositivo WAL/DB e lo spazio primario per i dati memorizzati. Il valore minimo (e di default) per il dispositivo WAL/DB è 6 GB. Lo spazio minimo per i dati è pari a 5 GB, in quanto a partizioni più piccole di 5 GB viene assegnato automaticamente il peso di 0.

Perciò, sebbene lo spazio minimo su disco per un OSD sia 11 GB, si sconsigliano dischi inferiori a 20 GB, anche per scopi di test.

2.4.3 Dimensioni consigliate per il dispositivo DB e WAL di BlueStore #

Per ulteriori informazioni su BlueStore, consultare Sezione 1.4, «BlueStore».

Si consiglia di riservare 4 GB per il dispositivo WAL. Sebbene la dimensione minima del DB sia 64 GB per i workload solo RBD, quella consigliata per i workload di Object Gateway e CephFS è il 2% della capacità del dispositivo principale (ma almeno 196 GB).

ImportantePer le distribuzioni a carico elevato, soprattutto in caso di elevato utilizzo di RGW o CephFS, si consigliano volumi di database maggiori. Riservare una parte di capacità (slot) per l'installazione di altro hardware per disporre di ulteriore spazio sul database, se necessario.

Se si intende mettere il dispositivo WAL e DB sullo stesso disco, si consiglia di utilizzare una singola partizione per entrambi i dispositivi, invece di avere una partizione separata per ciascuno. Ciò consente a Ceph di utilizzare il dispositivo DB anche per il funzionamento di WAL. La gestione dello spazio del disco è quindi più efficace in quanto Ceph utilizza la partizione DB per WAL solo se serve. Un altro vantaggio è che le probabilità che la partizione WAL si riempia sono molto basse e, quando questa non è utilizzata completamente, il suo spazio non viene sprecato ma utilizzato per le operazioni del dispositivo DB.

Per condividere il dispositivo DB con WAL, non specificare il dispositivo WAL e specificare solo il dispositivo DB.

Nel Book “Guida all'amministrazione e alle operazioni”, Chapter 13 “Task operativi”, Section 13.4.3 “Aggiunta di OSD tramite la specifica dei DriveGroups” è possibile trovare ulteriori informazioni su come specificare un layout OSD.

2.4.5 Numero massimo di dischi consigliato #

Il server può contenere tutti i dischi consentiti. Quando si pianifica il numero di dischi per server, vi sono alcuni elementi da tenere presente:

Ampiezza della banda di rete. Più dischi sono presenti in un server, più dati occorre trasferire tramite scheda di rete per le operazioni di scrittura sul disco.

Memoria. Viene utilizzata una RAM superiore a 2 GB per la cache BlueStore. Con l'opzione

osd_memory_targetdi default di 4 GB, il sistema dispone di dimensioni iniziali della cache ragionevoli per i supporti a rotazione. Se si utilizzano SSD o NVME, prendere in considerazione di aumentare le dimensioni della cache e l'allocazione della RAM per ogni OSD per ottimizzare le prestazioni.Tolleranza agli errori. In caso di guasto del server completo, più dischi sono presenti, più OSD vengono persi temporaneamente dal cluster. Inoltre, per mantenere in esecuzione le regole di replicazione, occorre copiare tutti i dati dal server guasto negli altri nodi nel cluster.

2.5 Nodi monitor #

Sono richiesti almeno tre nodi MON. Il numero di monitor deve sempre essere dispari (1+2n).

4 GB di RAM.

Processore con quattro core logici.

Si consiglia un'unità SSD o altro tipo di storage sufficientemente veloce per i monitor, in particolare per il percorso

/var/lib/cephsu ogni nodo monitor, in quanto il quorum potrebbe essere instabile con alte latenze del disco. Si consigliano due dischi in configurazione RAID 1 per ridondanza. Si consiglia di utilizzare dischi separati o almeno partizioni del disco separate per i processi monitor per proteggere lo spazio su disco disponibile del monitor da elementi come file di registro che diventano troppo grandi.Deve essere presente solo un processo monitor per nodo.

È possibile combinare nodi OSD, MON oppure Object Gateway solo se sono disponibili sufficienti risorse hardware. Ciò significa che si devono sommare i requisiti per tutti i servizi.

Due interfacce di rete associate a più switch.

2.6 Nodi Object Gateway #

I nodi Object Gateway devono disporre di almeno sei core CPU e 32 GB di RAM. Se nello stesso computer sono co-ubicati altri processi, occorre sommare i loro requisiti.

2.7 Nodi Metadata Server #

Il corretto dimensionamento dei nodi Metadata Server dipende dal caso d'uso specifico. In genere, il numero di file aperti che deve gestire il Metadata Server è proporzionale alla quantità di CPU e RAM richiesta. Di seguito sono riportati i requisiti minimi:

4 GB di RAM per ogni daemon del server di metadati.

Interfaccia di rete vincolata.

CPU da 2,5 GHz con almeno 2 core.

2.8 Nodo admin #

Richiesti almeno 4 GB di RAM e una CPU quad-core. Ciò include l'esecuzione del Salt Master sul nodo admin. Per i grandi cluster con centinaia di nodi, consigliati 6 GB di RAM.

2.9 Nodi iSCSI Gateway #

I nodi iSCSI Gateway devono disporre di almeno sei core CPU e 16 GB di RAM.

2.10 SES e altri prodotti SUSE #

Questa sezione contiene informazioni importanti sull'integrazione di SES con altri prodotti SUSE.

2.10.1 SUSE Manager #

SUSE Manager e SUSE Enterprise Storage non sono integrati, perciò SUSE Manager non è in grado attualmente di gestire un cluster SES.

2.11 Limitazioni di denominazione #

Ceph non supporta in genere i caratteri non ASCII nei file di configurazione, nei nomi di pool, nomi utente e così via. Quando si configura un cluster Ceph, si consiglia di utilizzare solo caratteri alfanumerici semplici (A-Z, a-z, 0-9) e punteggiatura minima (".", "-", "_") in tutti i nomi di configurazione/oggetto Ceph.

3 Configurazione ad elevata disponibilità del nodo admin #

Il nodo admin è un nodo del cluster Ceph dove è in esecuzione il servizio Salt Master. Gestisce il resto dei nodi del cluster tramite l'invio di interrogazioni e istruzioni ai rispettivi servizi Salt Minion. Comprende in genere anche altri servizi, ad esempio il dashboard Grafana supportato dal kit di strumenti di monitoraggio Prometheus.

In caso di errore del nodo admin, occorre di solito fornire un nuovo hardware funzionante per il nodo e ripristinare lo stack di configurazione cluster completo da un backup recente. Tale metodo richiede tempo e determina l'indisponibilità del cluster.

Per evitare il tempo di fermo delle prestazioni del cluster Ceph provocati dall'errore del nodo admin, si consiglia di utilizzare il cluster ad elevata disponibilità (High Availability, HA) per il nodo admin Ceph.

3.1 Profilo del cluster ad elevata disponibilità per il nodo admin #

Il concetto di un cluster HA prevede che in caso di errore di un nodo del cluster, l'altro nodo subentri automaticamente nel ruolo, compreso il nodo admin virtualizzato. In questo modo, gli altri nodi del cluster Ceph non avvertono l'errore del nodo admin Ceph.

La soluzione HA minima per il nodo admin richiede il seguente hardware:

Due server bare metal in grado di eseguire SUSE Linux Enterprise con l'estensione High Availability e virtualizzare il nodo admin.

Due o più percorsi di comunicazione di rete ridondanti, ad esempio tramite Network Device Bonding.

Storage condiviso per ospitare le immagini dei dischi della macchina virtuale del nodo admin. Lo storage condiviso deve essere accessibile da entrambi i server. Può essere ad esempio un'esportazione NFS, una condivisione Samba o una destinazione iSCSI.

Ulteriori dettagli sui requisiti del cluster sono disponibili all'indirizzo https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#sec-ha-inst-quick-req.

3.2 Costruzione del cluster ad elevata disponibilità con il nodo admin #

La procedura seguente riepiloga i passaggi più importanti di costruzione del cluster HA per virtualizzare il nodo admin. Per i dettagli, consultare i collegamenti indicati.

Configurare un cluster HA di base a 2 nodi con storage condiviso come descritto in https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#art-sleha-install-quick.

Su entrambi i nodi cluster, installare tutti i pacchetti richiesti per eseguire l'ipervisore KVM e il toolkit

libvirtcome descritto in https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-vt-installation-kvm.Sul primo nodo del cluster, creare una nuova macchina virtuale (VM) KVM utilizzando

libvirtcome descritto in https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-libvirt-inst-virt-install. Utilizzare lo storage condiviso preconfigurato per memorizzare le immagini del disco della VM.Al termine della configurazione della VM, esportarne la configurazione su un file XML sullo storage condiviso. Usare la seguente sintassi:

#virsh dumpxml VM_NAME > /path/to/shared/vm_name.xmlCreare una risorsa per la VM del nodo admin. Per informazioni generali sulla creazione di risorse HA, consultare https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-guide/#cha-conf-hawk2. All'indirizzo http://www.linux-ha.org/wiki/VirtualDomain_%28resource_agent%29 sono disponibili informazioni dettagliate sulla creazione di risorse per una macchina virtuale KVM.

Sul guest VM appena creato, distribuire il nodo admin compresi i servizi aggiuntivi necessari. Seguire la procedura pertinente indicata nella Capitolo 6, Distribuzione Salt. Contemporaneamente, distribuire i restanti nodi del cluster Ceph sui server del cluster non HA.

Parte II Distribuzione del cluster Ceph #

- 4 Introduzione e task comuni

A partire da SUSE Enterprise Storage 7, i servizi Ceph vengono distribuiti sotto forma di container in sostituzione dei pacchetti RPM. Il processo di distribuzione prevede due passaggi fondamentali:

- 5 Installazione e configurazione di SUSE Linux Enterprise Server

Installare e registrare SUSE Linux Enterprise Server 15 SP3 su ciascun nodo del cluster. Durante l'installazione di SUSE Enterprise Storage, è necessario eseguire la registrazione poiché l'accesso agli archivi di aggiornamento è obbligatorio. Includere almeno i moduli seguenti:

- 6 Distribuzione Salt

SUSE Enterprise Storage utilizza Salt e

ceph-saltper la preparazione iniziale del cluster. Salt consente di configurare ed eseguire contemporaneamente i comandi su più nodi del cluster da un host dedicato denominato Salt Master. Prima della distribuzione Salt, esaminare quanto segue:- 7 Distribuzione del cluster di bootstrap mediante

ceph-salt Questa sezione illustra il processo di distribuzione di un cluster Ceph di base. Leggere con attenzione le sottosezioni seguenti ed eseguire i comandi inclusi nell'ordine dato.

- 8 Distribuzione dei rimanenti servizi di base mediante cephadm

In seguito alla distribuzione del cluster Ceph di base, distribuire i servizi di base su altri nodi del cluster. Per rendere i dati del cluster accessibili ai client, distribuire anche dei servizi aggiuntivi.

- 9 Distribuzione di servizi aggiuntivi

iSCSI è un protocollo di rete dell'area di storage (SAN) che consente ai client (denominati iniziatori) di inviare comandi SCSI ai dispositivi di storage SCSI (destinazioni) su server remoti. SUSE Enterprise Storage 7.1 include una struttura che apre la gestione dello storage Ceph a client eterogene…

4 Introduzione e task comuni #

A partire da SUSE Enterprise Storage 7, i servizi Ceph vengono distribuiti sotto forma di container in sostituzione dei pacchetti RPM. Il processo di distribuzione prevede due passaggi fondamentali:

- Distribuzione del cluster di bootstrap

Questa fase è denominata Distribuzione giorno 1 e include le seguenti attività: installazione del sistema operativo sottostante, configurazione dell'infrastruttura Salt e distribuzione del cluster minimo che consiste in un servizio MON e un servizio MGR.

Installare ed eseguire le attività di configurazione di base del sistema operativo sottostante (SUSE Linux Enterprise Server 15 SP3) su tutti i nodi del cluster.

Distribuire l'infrastruttura Salt su tutti i nodi del cluster per eseguire le preparazioni di distribuzione iniziali tramite

ceph-salt.Configurare le proprietà di base del cluster tramite

ceph-salte distribuirlo.

- Distribuzione di servizi aggiuntivi

Durante la Distribuzione giorno 2, vengono distribuiti servizi Ceph aggiuntivi, sia di base che non fondamentali, ad esempio gateway e stack di monitoraggio.

Tenere presente che nella documentazione della community Ceph viene utilizzato il comando cephadm bootstrap durante la distribuzione iniziale. ceph-salt richiama automaticamente il comando cephadm bootstrap. Il comando cephadm bootstrap non deve essere eseguito direttamente. Le distribuzioni dei cluster Ceph in cui è utilizzato in modo manuale il comando cephadm bootstrap non saranno supportate.

4.1 Lettura delle note di rilascio #

Nelle note di rilascio è possibile trovare informazioni aggiuntive sulle modifiche apportate rispetto alla release precedente di SUSE Enterprise Storage. Controllare le note di rilascio per vedere se:

l'hardware necessita di considerazioni speciali;

i pacchetti software utilizzati hanno subito modifiche significative;

è necessario adottare precauzioni speciali per l'installazione.

Le note di rilascio forniscono inoltre informazioni che non si è fatto in tempo a riportare nel manuale. Contengono anche alcune note su problemi noti.

Dopo aver installato il pacchetto release-notes-ses, individuare localmente le note di rilascio nella directory /usr/share/doc/release-notes oppure online all'indirizzo https://www.suse.com/releasenotes/.

5 Installazione e configurazione di SUSE Linux Enterprise Server #

Installare e registrare SUSE Linux Enterprise Server 15 SP3 su ciascun nodo del cluster. Durante l'installazione di SUSE Enterprise Storage, è necessario eseguire la registrazione poiché l'accesso agli archivi di aggiornamento è obbligatorio. Includere almeno i moduli seguenti:

Basesystem Module

Server Applications Module

All'indirizzo https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-install.html è possibile trovare ulteriori dettagli su come installare SUSE Linux Enterprise Server.

Installare l'estensione SUSE Enterprise Storage 7.1 su ogni nodo del cluster.

Suggerimento: installazione di SUSE Enterprise Storage insieme a SUSE Linux Enterprise ServerÈ possibile installare l'estensione SUSE Enterprise Storage 7.1 separatamente dopo aver installato SUSE Linux Enterprise Server 15 SP3 oppure è possibile aggiungerla durante la procedura di installazione di SUSE Linux Enterprise Server 15 SP3.

All'indirizzo https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-register-sle.html è possibile trovare ulteriori dettagli su come installare le estensioni.

Configurare le impostazioni di rete compresa la risoluzione del nome DNS corretto su ogni nodo. Per ulteriori informazioni sulla configurazione di una rete, vedere https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#sec-network-yast. Per ulteriori informazioni sulla configurazione di un server DNS, vedere https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#cha-dns.

6 Distribuzione Salt #

SUSE Enterprise Storage utilizza Salt e ceph-salt per la preparazione iniziale del cluster. Salt consente di configurare ed eseguire contemporaneamente i comandi su più nodi del cluster da un host dedicato denominato Salt Master. Prima della distribuzione Salt, esaminare quanto segue:

I Salt Minion sono i nodi controllati da un nodo dedicato denominato Salt Master.

Se l'host Salt Master deve fare parte del cluster Ceph, deve eseguire il proprio Salt Minion, anche se non si tratta di un requisito obbligatorio.

Suggerimento: condivisione di più ruoli per serverÈ possibile ottenere le prestazioni migliori dal cluster Ceph quando ogni ruolo viene distribuito su un nodo separato. Le installazioni reali, tuttavia, a volte richiedono la condivisione di un nodo per più ruoli. Per evitare problemi di prestazioni e con la procedura di upgrade, non distribuire il ruolo Ceph OSD, del server di metadati o Ceph Monitor sul nodo admin.

I Salt Minion devono risolvere correttamente il nome host del Salt Master in rete. Per default, cercano il nome host

salt, ma è possibile specificare altri nomi host individuabili in rete nel file/etc/salt/minion.

Installare il

salt-mastersul nodo Salt Master:root@master #zypper in salt-masterVerificare che il servizio

salt-mastersia abilitato e avviato, se necessario abilitarlo e avviarlo:root@master #systemctl enable salt-master.serviceroot@master #systemctl start salt-master.serviceSe si intende utilizzare il firewall, verificare che il nodo Salt Master abbia le porte 4505 e 4506 aperte per tutti i nodi Salt Minion. Se le porte sono chiuse, è possibile aprirle con il comando

yast2 firewallconsentendo il servizio per la zona appropriata. Ad esempio,public.Installare il pacchetto

salt-minionsu tutti i nodi minion.root@minion >zypper in salt-minionModificare

/etc/salt/minione rimuovere i commenti dalla riga seguente:#log_level_logfile: warning

Modificare il livello di log da

warningainfo.Nota:log_level_logfileelog_levelMentre

log_levelcontrolla i messaggi di log che verranno visualizzati sulla schermata,log_level_logfilecontrolla i messaggi di log che verranno scritti su/var/log/salt/minion.NotaAssicurarsi di impostare il livello di log su tutti i nodi del cluster (minion).

Assicurarsi che il nome di dominio completo di ogni nodo possa essere risolto in un indirizzo IP sulla rete di cluster pubblica da tutti gli altri nodi.

Configurare tutti i minion sulla connessione al master. Se il Salt Master non è raggiungibile dal nome host

salt, modificare il file/etc/salt/minionoppure creare un nuovo file/etc/salt/minion.d/master.confcon il contenuto seguente:master: host_name_of_salt_master

Se sono state apportate modifiche ai file di configurazione menzionati sopra, riavviare il servizio Salt su tutti i Salt Minion correlati:

root@minion >systemctl restart salt-minion.serviceVerificare che il servizio

salt-minionsia abilitato e avviato su tutti i nodi. Abilitarlo e avviarlo se necessario:#systemctl enable salt-minion.service#systemctl start salt-minion.serviceVerificare ogni impronta digitale del Salt Minion e accettare tutte le chiavi salt sul Salt Master se le impronte digitali corrispondono.

NotaSe l'impronta digitale del Salt Minion viene restituita vuota, assicurarsi che il Salt Minion disponga di una configurazione Salt Master e che sia in grado di comunicare con quest'ultimo.

Visualizzare l'impronta di ogni minion:

root@minion >salt-call --local key.finger local: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Dopo aver raccolto le impronte digitali di tutti i Salt Minion, elencare le impronte di tutte le chiavi minion non accettate sul Salt Master:

root@master #salt-key -F [...] Unaccepted Keys: minion1: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Se le impronte digitali dei minion corrispondono, accettarle:

root@master #salt-key --accept-allVerificare che le chiavi siano state accettate:

root@master #salt-key --list-allVerificare se tutti i Salt Minion rispondono:

root@master #salt-run manage.status

7 Distribuzione del cluster di bootstrap mediante ceph-salt #

Questa sezione illustra il processo di distribuzione di un cluster Ceph di base. Leggere con attenzione le sottosezioni seguenti ed eseguire i comandi inclusi nell'ordine dato.

7.1 Installazione ceph-salt #

ceph-salt fornisce strumenti per la distribuzione dei cluster Ceph gestiti da cephadm. ceph-salt utilizza l'infrastruttura Salt per la gestione del sistema operativo, ad esempio gli aggiornamenti del software o la sincronizzazione dell'orario, e per la definizione dei ruoli dei Salt Minion.

Sul Salt Master, installare il pacchetto ceph-salt:

root@master # zypper install ceph-salt

Il comando precedente installa ceph-salt-formula come dipendenza che modifica la configurazione del Salt Master inserendo file aggiuntivi nella directory /etc/salt/master.d. Per applicare le modifiche, riavviare salt-master.service e sincronizzare i moduli Salt:

root@master #systemctl restart salt-master.serviceroot@master #salt \* saltutil.sync_all

7.2 Configurazione delle proprietà del cluster #

Utilizzare il comando ceph-salt config per configurare le proprietà di base del cluster.

Il file /etc/ceph/ceph.conf è gestito da cephadm e gli utenti non devono modificarlo. Impostare i parametri di configurazione Ceph con il nuovo comando ceph config. Consultare Book “Guida all'amministrazione e alle operazioni”, Chapter 28 “Configurazione del cluster Ceph”, Section 28.2 “Database di configurazione” per maggiori informazioni.

7.2.1 Utilizzo della shell ceph-salt #

Se si esegue config senza alcun percorso o sottocomando, viene creata una shell ceph-saltceph-salt interattiva. La shell è utile se è necessario configurare contemporaneamente più proprietà o se non si desidera digitare l'intera sintassi del comando.

root@master #ceph-salt config/>ls o- / ............................................................... [...] o- ceph_cluster .................................................. [...] | o- minions .............................................. [no minions] | o- roles ....................................................... [...] | o- admin .............................................. [no minions] | o- bootstrap ........................................... [no minion] | o- cephadm ............................................ [no minions] | o- tuned ..................................................... [...] | o- latency .......................................... [no minions] | o- throughput ....................................... [no minions] o- cephadm_bootstrap ............................................. [...] | o- advanced .................................................... [...] | o- ceph_conf ................................................... [...] | o- ceph_image_path .................................. [ no image path] | o- dashboard ................................................... [...] | | o- force_password_update ................................. [enabled] | | o- password ................................................ [admin] | | o- ssl_certificate ....................................... [not set] | | o- ssl_certificate_key ................................... [not set] | | o- username ................................................ [admin] | o- mon_ip .................................................. [not set] o- containers .................................................... [...] | o- registries_conf ......................................... [enabled] | | o- registries .............................................. [empty] | o- registry_auth ............................................... [...] | o- password .............................................. [not set] | o- registry .............................................. [not set] | o- username .............................................. [not set] o- ssh ............................................... [no key pair set] | o- private_key .................................. [no private key set] | o- public_key .................................... [no public key set] o- time_server ........................... [enabled, no server host set] o- external_servers .......................................... [empty] o- servers ................................................... [empty] o- subnet .................................................. [not set]

Come è possibile vedere dall'output del comando ceph-saltls di , la configurazione del cluster presenta una struttura ad albero. Sono disponibili due opzioni per configurare una proprietà specifica del cluster nella shell ceph-salt:

Eseguire il comando dalla posizione corrente e immettere il percorso assoluto alla proprietà come primo argomento:

/>/cephadm_bootstrap/dashboard ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username .................................................... [admin]/> /cephadm_bootstrap/dashboard/username set ceph-adminValue set.Modificare inserendo il percorso di cui occorre configurare la proprietà ed eseguire il comando:

/>cd /cephadm_bootstrap/dashboard//ceph_cluster/minions>ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username ................................................[ceph-admin]

Dalla shell ceph-salt, è possibile utilizzare la funzione di completamento automatico in modo simile a come la si utilizza in una normale shell Linux (Bash). Tale funzione consente di completare i percorsi di configurazione, i sottocomandi o i nomi dei Salt Minion. Durante il completamento automatico di un percorso di configurazione, sono disponibili due opzioni:

Per fare in modo che la shell termini un percorso relativo sulla posizione corrente, premere due volte il tasto TAB →|.

Per fare in modo che la shell termini un percorso assoluto, immettere / e premere due volte il tasto TAB →|.

Se si immette cd dalla shell ceph-salt senza specificare alcun percorso, il comando stamperà una struttura ad albero della configurazione del cluster con la riga dell'attuale percorso attivo. È possibile utilizzare i tasti su è giù del cursore per spostarsi tra le singole righe. Dopo aver confermato con Enter, il percorso di configurazione verrà modificato sull'ultimo percorso attivo.

Per assicurare la coerenza della documentazione, viene utilizzata la sintassi di un singolo comando senza immettere la shell ceph-salt. Ad esempio, è possibile elencare l'albero di configurazione del cluster con il comando seguente:

root@master # ceph-salt config ls7.2.2 Aggiunta di Salt Minion #

Includere nella configurazione del cluster Ceph tutti o un sottoinsieme di Salt Minion distribuiti e accettati nella Capitolo 6, Distribuzione Salt. È possibile specificare i Salt Minion utilizzando il loro nome intero oppure le espressioni glob "*" e "?" per includere contemporaneamente più Salt Minion. Utilizzare il sottocomando add nel percorso /ceph_cluster/minions. Il comando seguente include tutti i Salt Minion accettati:

root@master # ceph-salt config /ceph_cluster/minions add '*'Verificare che i Salt Minion specificati siano stati aggiunti:

root@master # ceph-salt config /ceph_cluster/minions ls

o- minions ................................................. [Minions: 5]

o- ses-master.example.com .................................. [no roles]

o- ses-min1.example.com .................................... [no roles]

o- ses-min2.example.com .................................... [no roles]

o- ses-min3.example.com .................................... [no roles]

o- ses-min4.example.com .................................... [no roles]7.2.3 Specifica dei Salt Minion gestiti da cephadm #

Specificare i nodi che apparterranno al cluster Ceph e che saranno gestiti da cephadm. Includere tutti i nodi che eseguiranno i servizi Ceph, oltre al nodo admin:

root@master # ceph-salt config /ceph_cluster/roles/cephadm add '*'7.2.4 Specifica del nodo admin #

Il nodo admin è il nodo in cui sono installati il file di configurazione ceph.conf e il portachiavi di amministrazione Ceph. In genere, i comandi correlati a Ceph vengono eseguiti sul nodo admin.

Negli ambienti eterogenei, dove tutti o quasi tutti gli host appartengono a SUSE Enterprise Storage, si consiglia di posizionare il nodo admin sullo stesso host del Salt Master.

Negli ambienti eterogenei dove un'infrastruttura Salt ospita più di un cluster, ad esempio SUSE Enterprise Storage insieme a SUSE Manager, non posizionare il nodo admin sullo stesso host del Salt Master.

Per specificare il nodo admin, eseguire il comando seguente:

root@master #ceph-salt config /ceph_cluster/roles/admin add ses-master.example.com 1 minion added.root@master #ceph-salt config /ceph_cluster/roles/admin ls o- admin ................................................... [Minions: 1] o- ses-master.example.com ...................... [Other roles: cephadm]

ceph.conf e del portachiavi di amministrazione su più nodiÈ possibile installare il file di configurazione e il portachiavi di amministrazione Ceph su più nodi, se richiesto dalla distribuzione. Per motivi di sicurezza, evitare di installarli su tutti i nodi del cluster.

7.2.5 Specifica del primo nodo MON/MGR #

È necessario specificare quale Salt Minion del cluster eseguirà il bootstrap del cluster. Questo minion diventerà il primo a eseguire i servizi Ceph Monitor e Ceph Manager.

root@master #ceph-salt config /ceph_cluster/roles/bootstrap set ses-min1.example.com Value set.root@master #ceph-salt config /ceph_cluster/roles/bootstrap ls o- bootstrap ..................................... [ses-min1.example.com]

Inoltre, è necessario specificare l'indirizzo IP del MON di bootstrap sulla rete pubblica per assicurarsi che il parametro public_network sia impostato correttamente, ad esempio:

root@master # ceph-salt config /cephadm_bootstrap/mon_ip set 192.168.10.207.2.6 Specifica dei profili ottimizzati #

È necessario specificare quali minion del cluster dispongono di profili ottimizzati attivamente. A questo scopo, aggiungere questi ruoli esplicitamente con i comandi seguenti:

Un minion non può ricoprire sia il ruolo latency che il ruolo throughput.

root@master #ceph-salt config /ceph_cluster/roles/tuned/latency add ses-min1.example.com Adding ses-min1.example.com... 1 minion added.root@master #ceph-salt config /ceph_cluster/roles/tuned/throughput add ses-min2.example.com Adding ses-min2.example.com... 1 minion added.

7.2.7 Generazione di una coppia di chiavi SSH #

cephadm utilizza il protocollo SSH per comunicare con i nodi del cluster. L'account utente denominato cephadm viene creato automaticamente e utilizzato per la comunicazione SSH.

È necessario generare la parte privata e pubblica della coppia di chiavi SSH: