- このガイドについて

- I Cephダッシュボード

- II クラスタの運用

- III クラスタへのデータ保存

- IV クラスタデータへのアクセス

- V 仮想化ツールとの統合

- VI クラスタの設定

- A アップストリーム「Pacific」ポイントリリースに基づくCeph保守更新

- 用語集

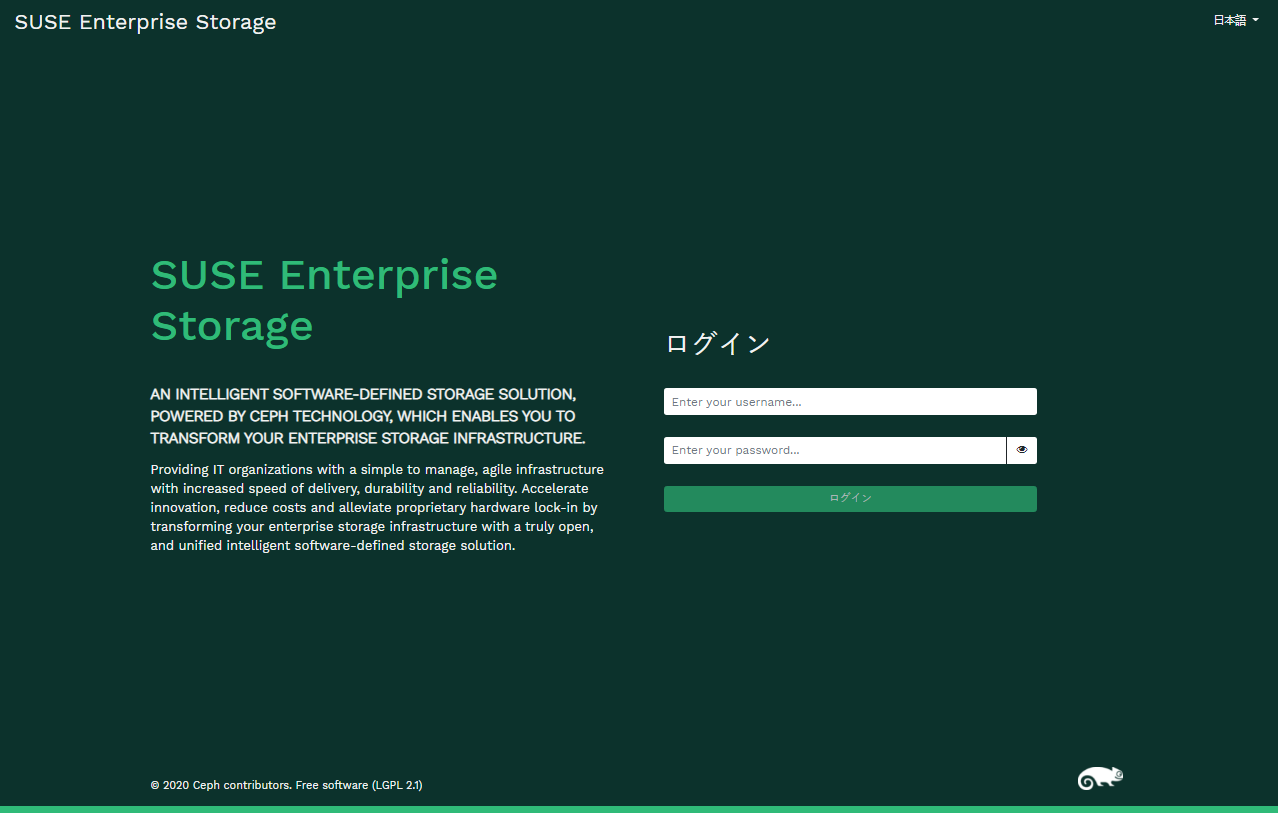

- 2.1 Cephダッシュボードのログイン画面

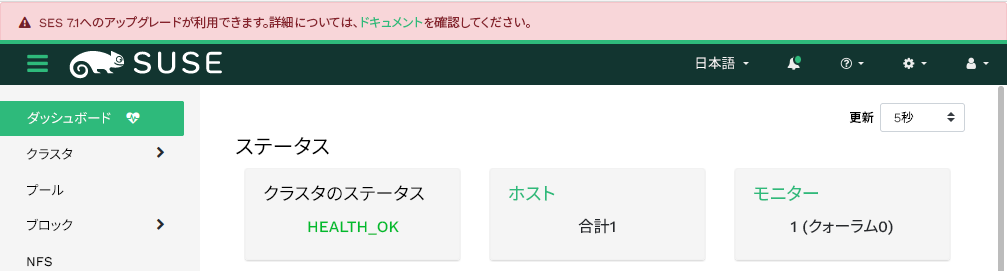

- 2.2 新しいSUSE Enterprise Storageリリースに関する通知

- 2.3 Cephダッシュボードのホームページ

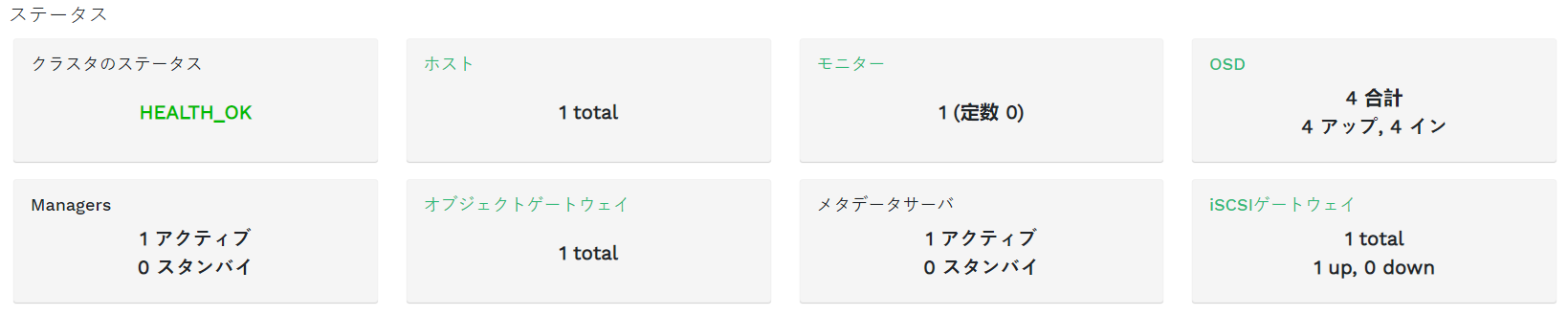

- 2.4 ステータスウィジェット

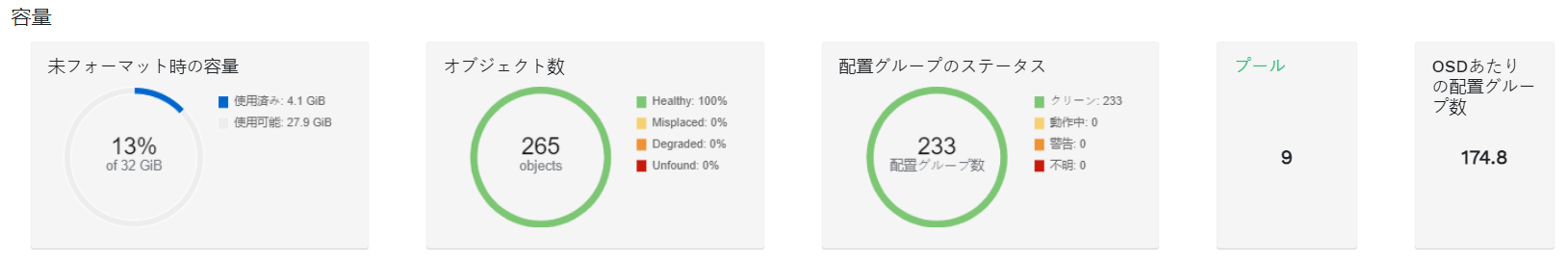

- 2.5 容量のウィジェット

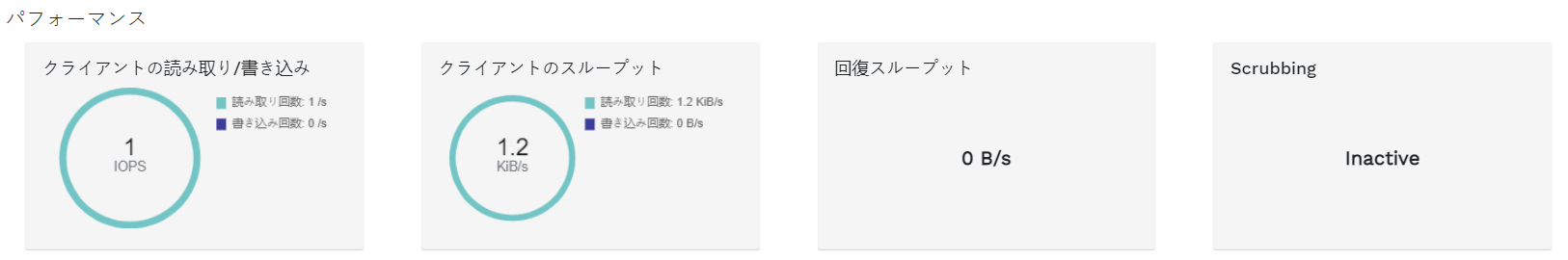

- 2.6 パフォーマンスウィジェット

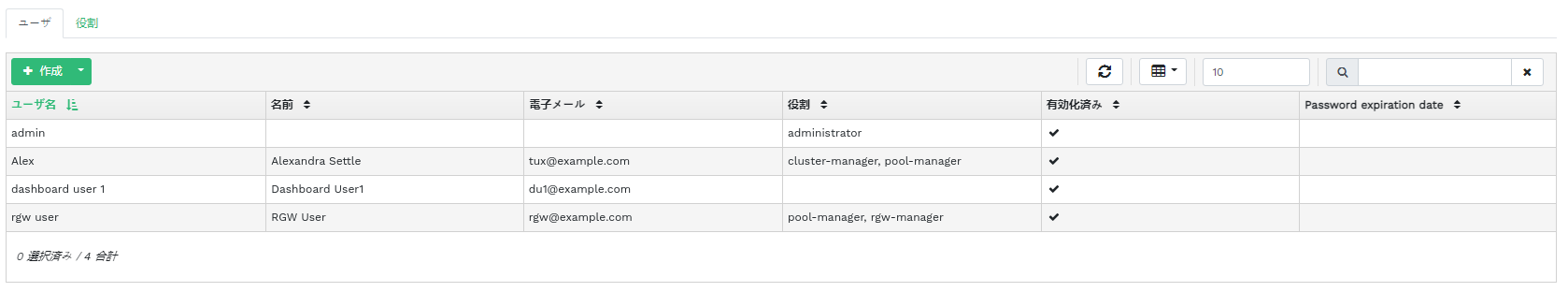

- 3.1 ユーザの管理

- 3.2 ユーザの追加

- 3.3 ユーザの役割

- 3.4 役割の追加

- 4.1 ホスト

- 4.2 サービス

- 4.3 Ceph Monitor

- 4.4 サービス

- 4.5 Ceph OSD

- 4.6 OSDフラグ

- 4.7 OSD回復優先度

- 4.8 OSDの詳細

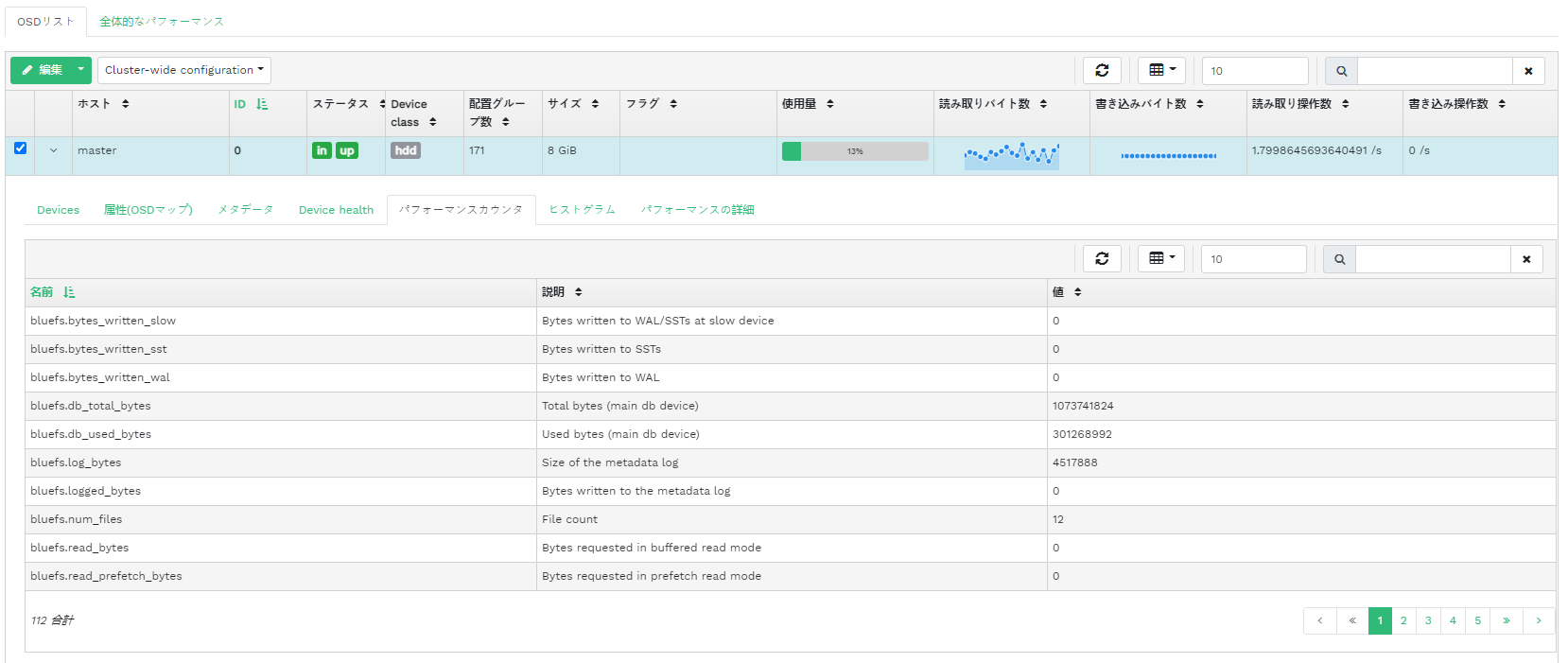

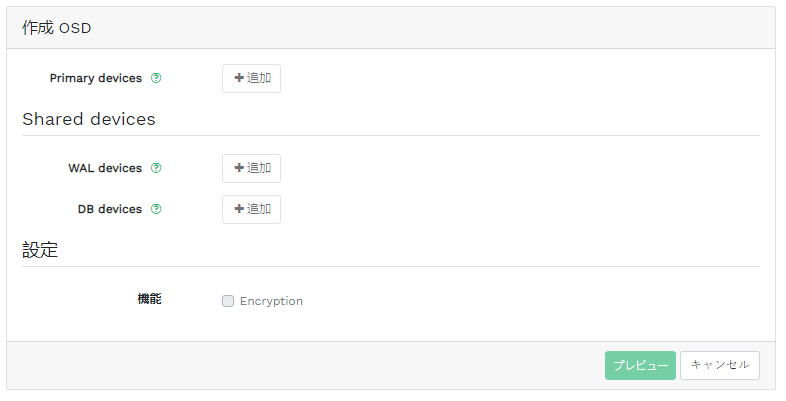

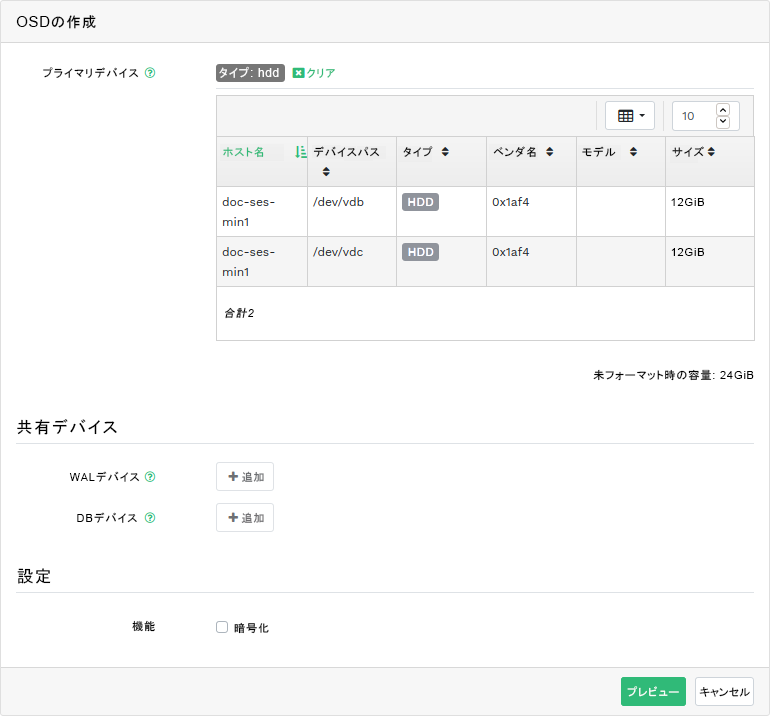

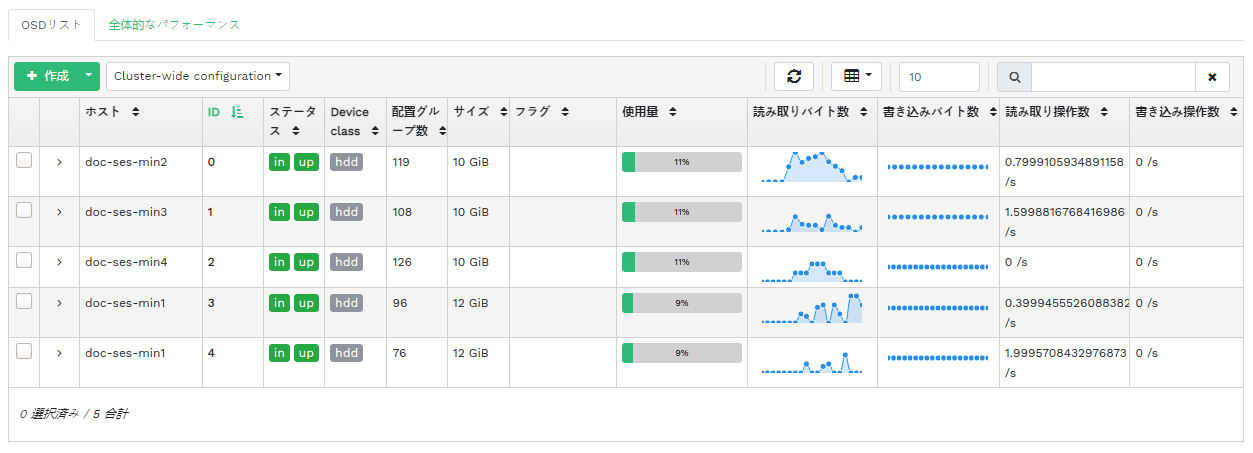

- 4.9 OSDの作成

- 4.10 プライマリデバイスの追加

- 4.11 プライマリデバイスを追加したOSDの作成

- 4.12

- 4.13 新しく追加されたOSD

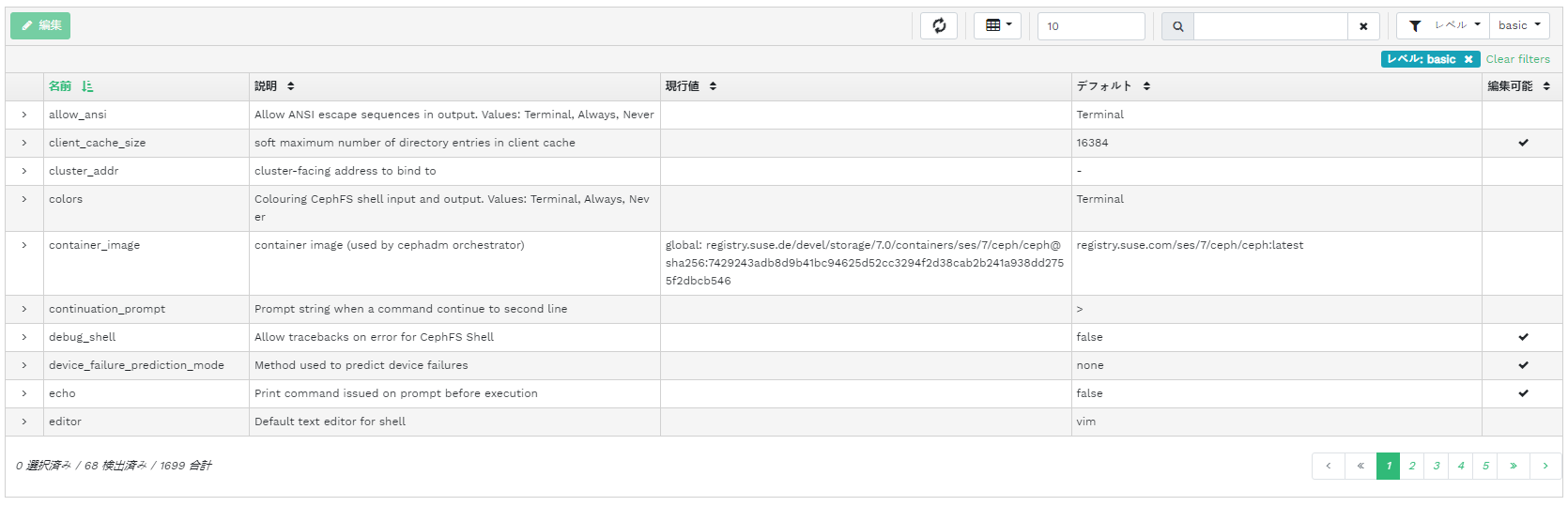

- 4.14 クラスタの設定

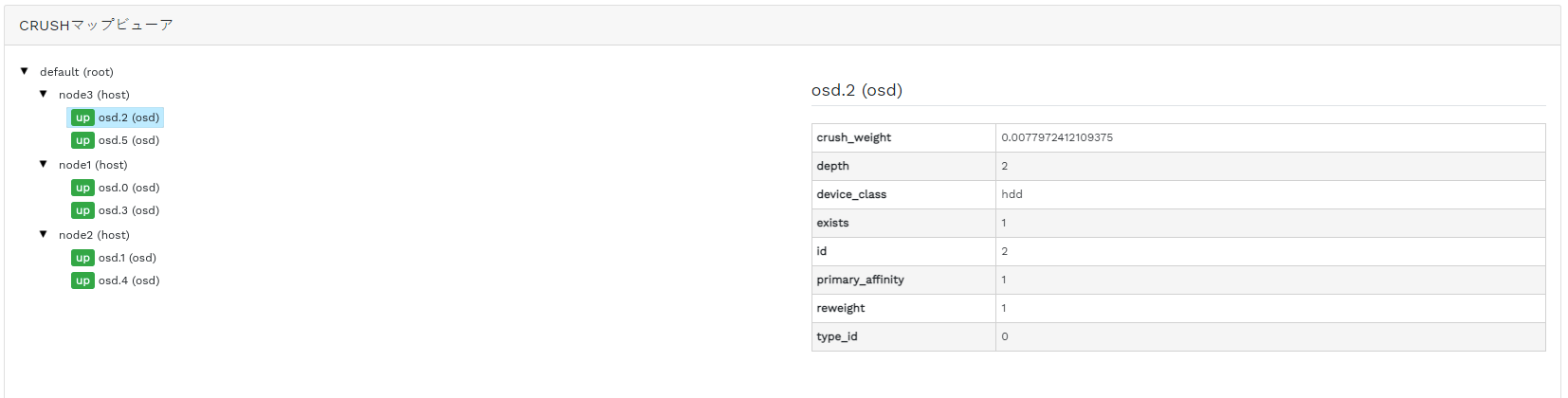

- 4.15 CRUSHマップ

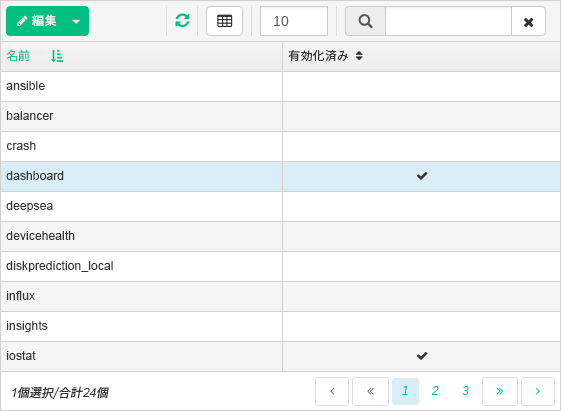

- 4.16 マネージャモジュール

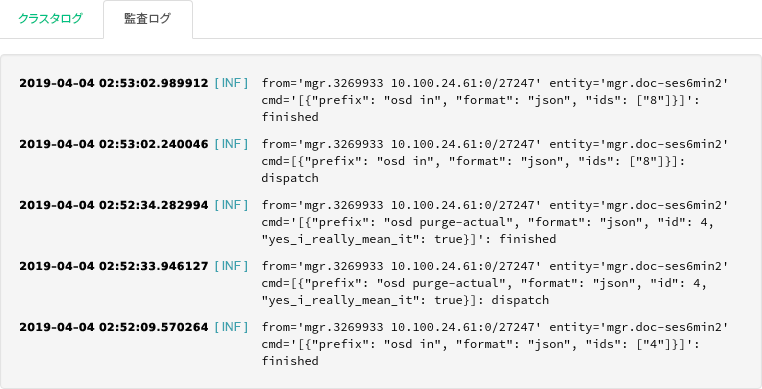

- 4.17 ログ

- 5.1 プールのリスト

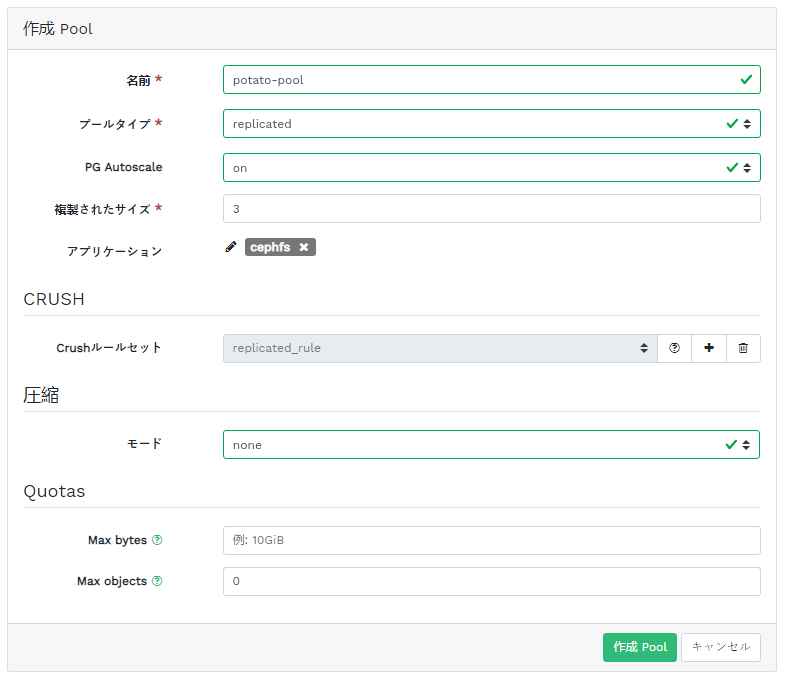

- 5.2 新しいプールの追加

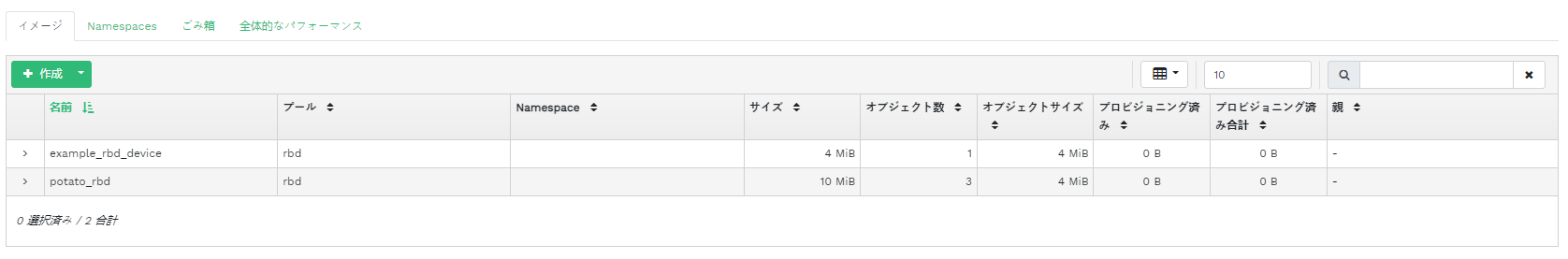

- 6.1 RBDイメージのリスト

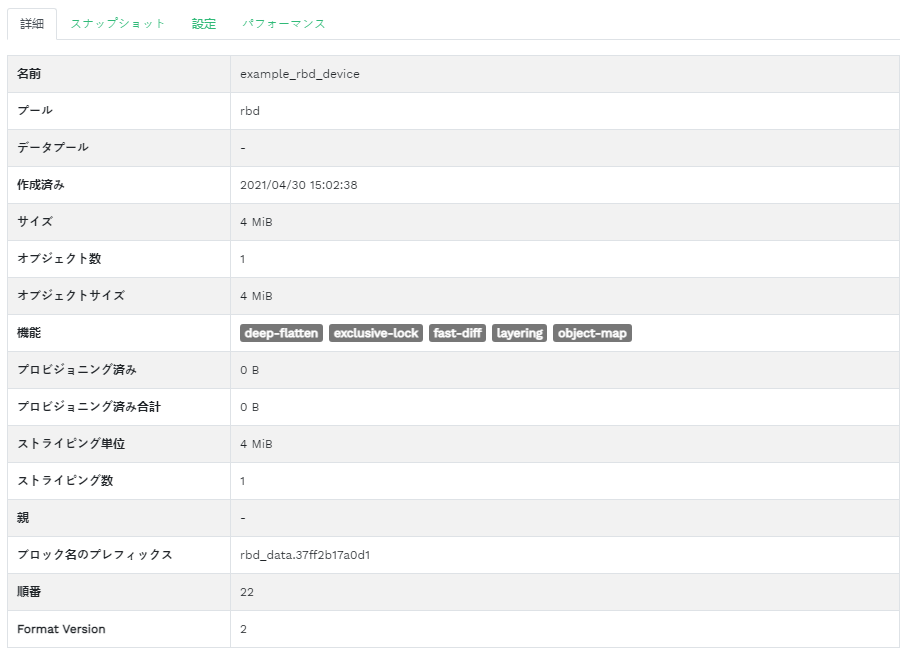

- 6.2 RBDの詳細

- 6.3 RBD設定

- 6.4 新しいRBDの追加

- 6.5 RBDのスナップショット

- 6.6

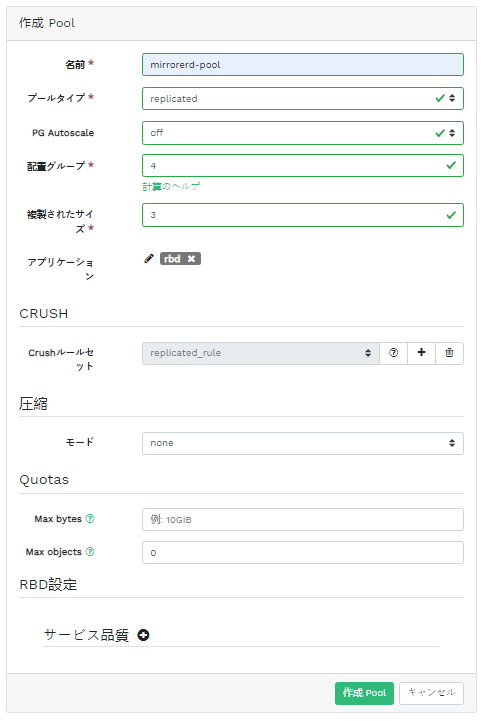

rbd-mirrorデーモンの実行 - 6.7 RBDアプリケーションを使用したプールの作成

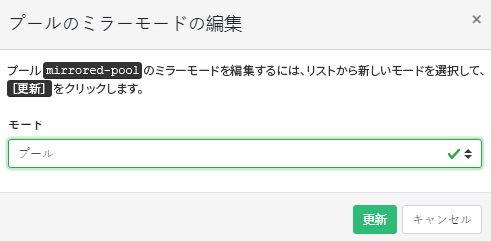

- 6.8 レプリケーションモードの設定

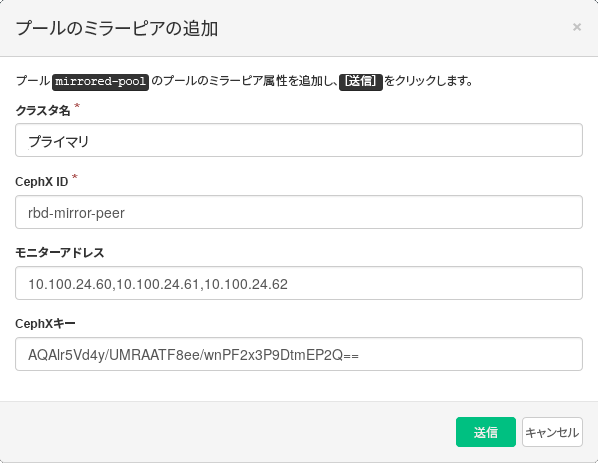

- 6.9 ピア資格情報の追加

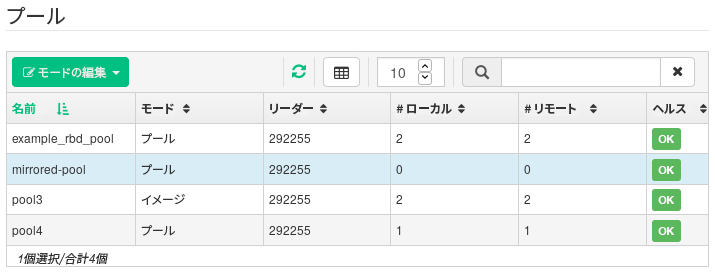

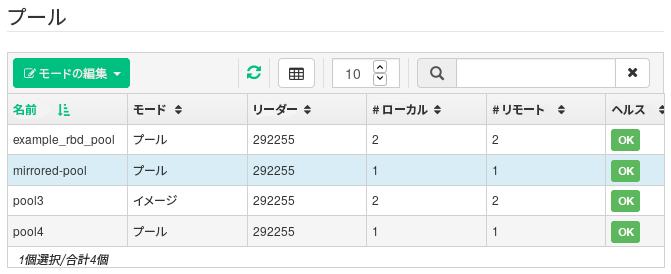

- 6.10 複製されたプールのリスト

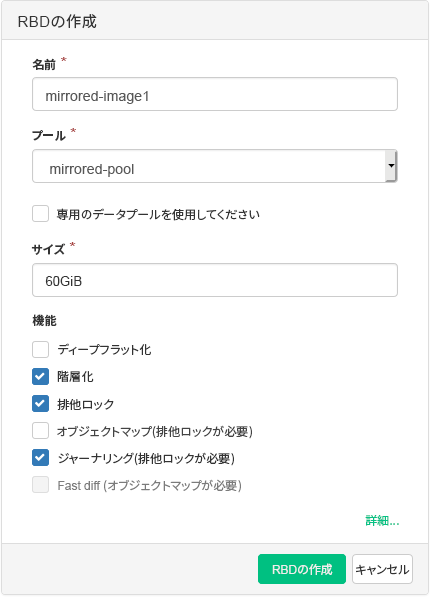

- 6.11 新しいRBDイメージ

- 6.12 新しいRBDイメージの同期

- 6.13 RBDイメージのレプリケーションステータス

- 6.14 iSCSIターゲットのリスト

- 6.15 iSCSIターゲット詳細

- 6.16 新しいターゲットの追加

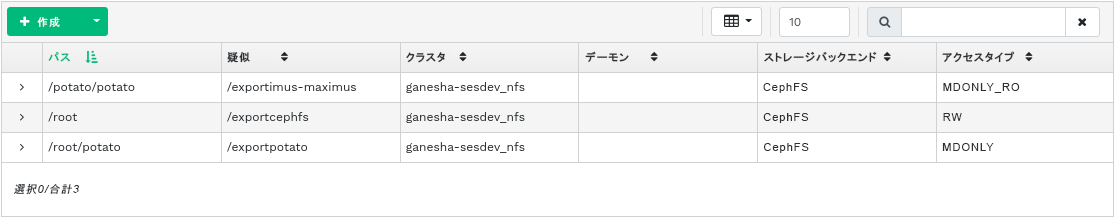

- 7.1 NFSエクスポートのリスト

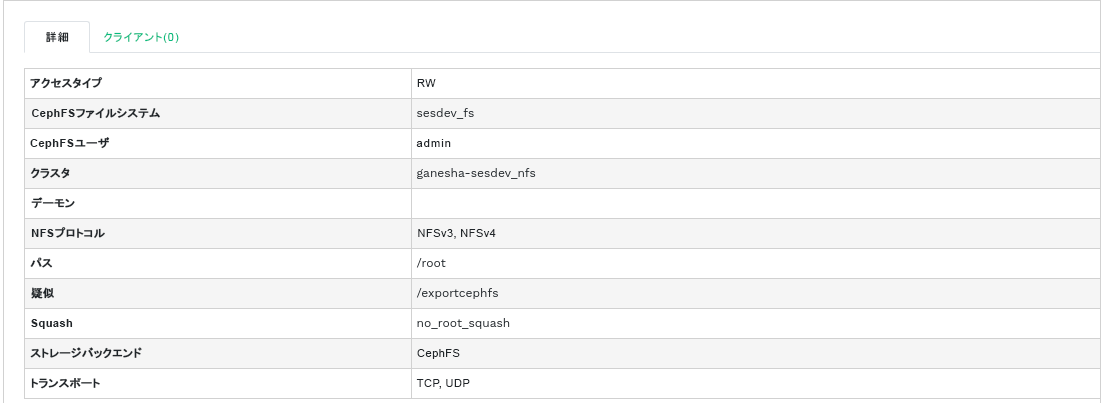

- 7.2 NFSエクスポートの詳細

- 7.3 新しいNFSエクスポートの追加

- 7.4 NFSエクスポートの編集

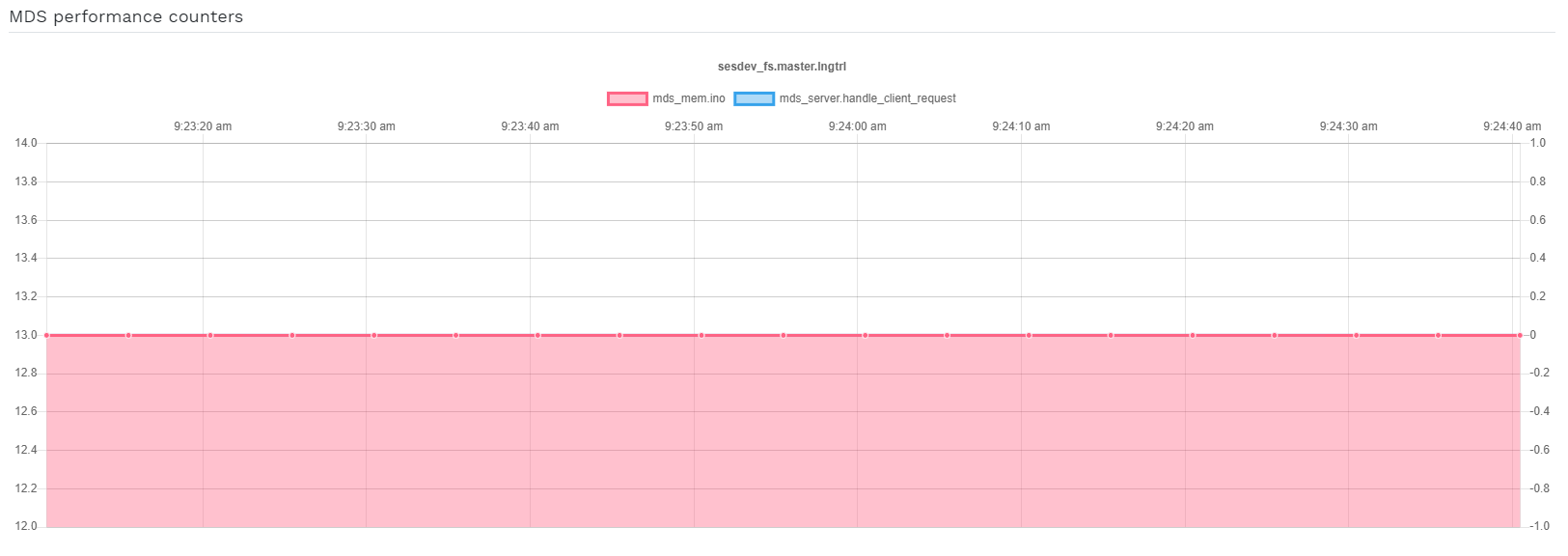

- 8.1 CephFSの詳細

- 8.2 CephFSの詳細

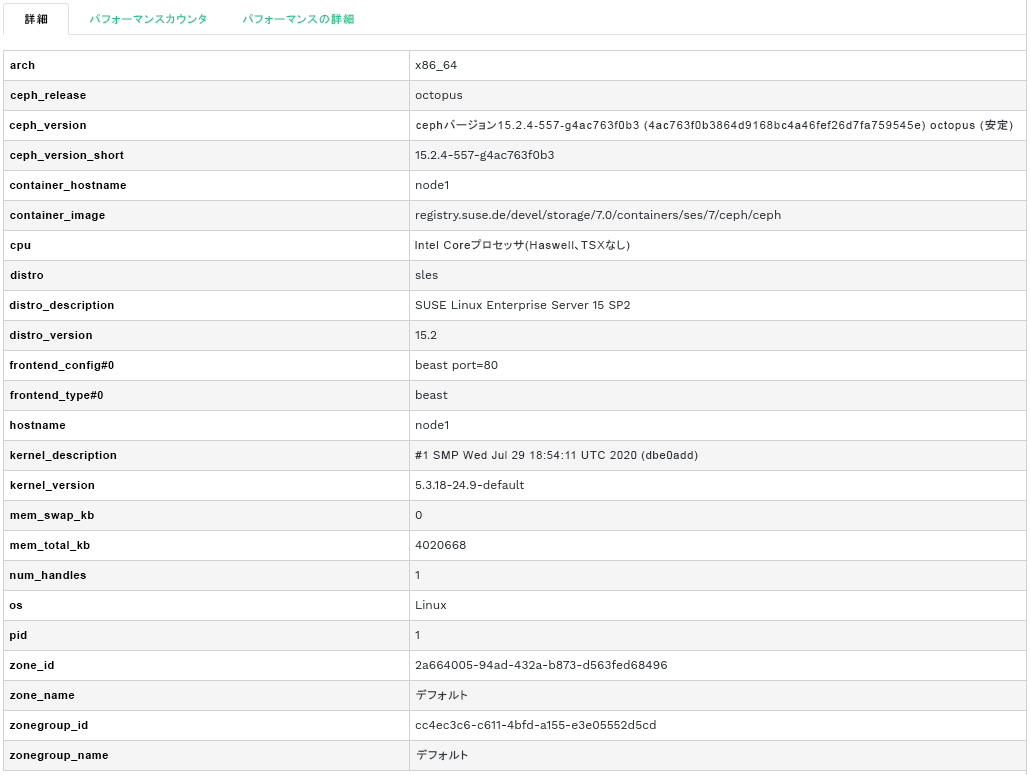

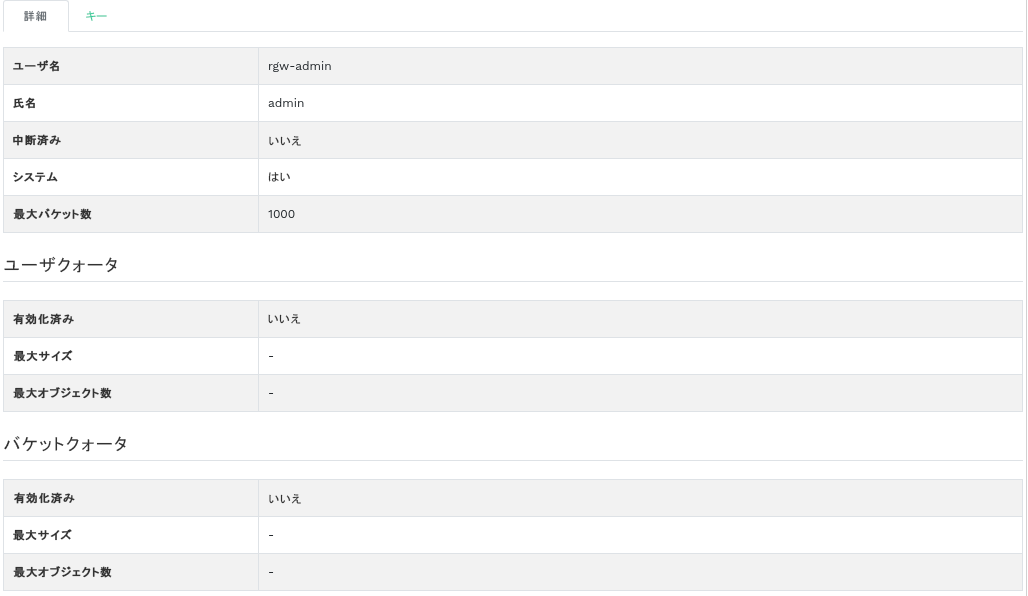

- 9.1 ゲートウェイの詳細

- 9.2 ゲートウェイユーザ

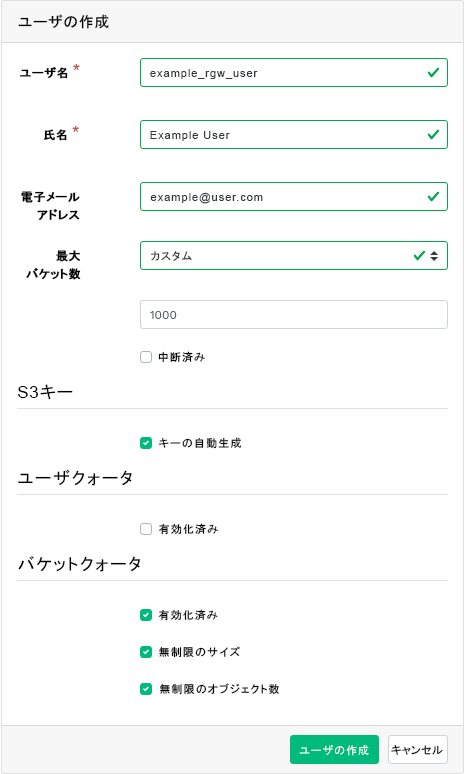

- 9.3 新しいゲートウェイユーザの追加

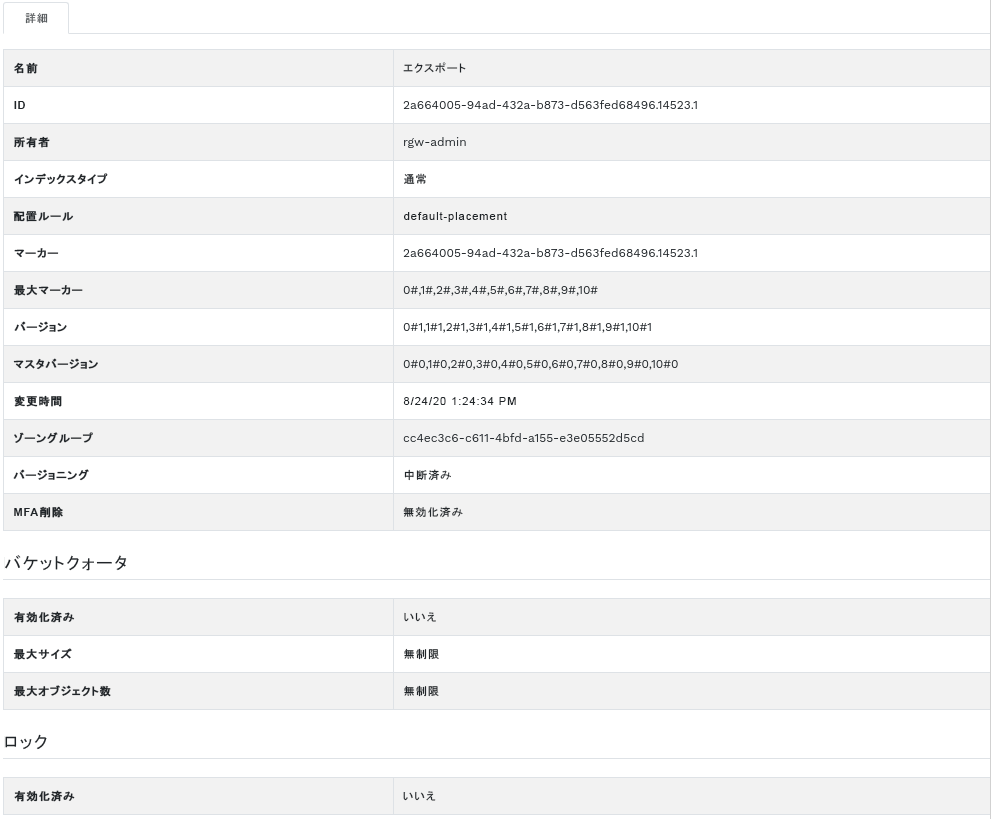

- 9.4 ゲートウェイバケットの詳細

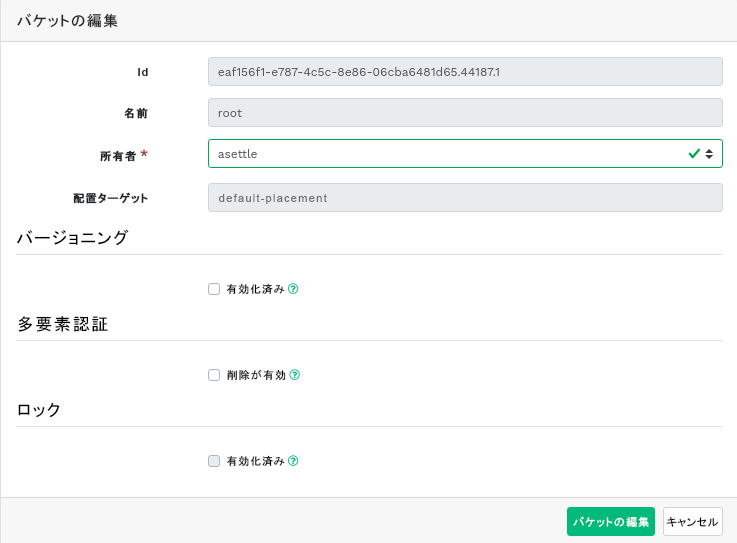

- 9.5 バケットの詳細の編集

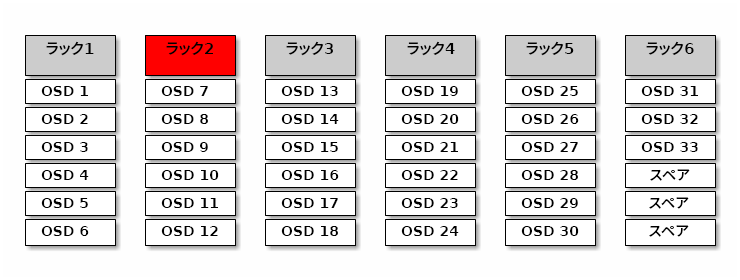

- 12.1 Cephクラスタ

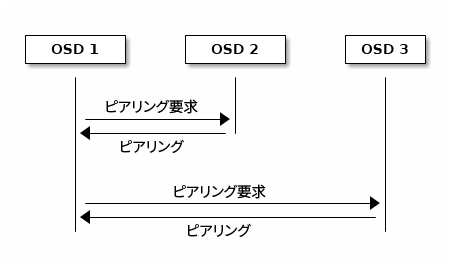

- 12.2 ピアリングスキーマ

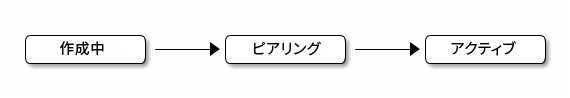

- 12.3 配置グループのステータス

- 17.1 複数のデバイスクラスが混在するOSD

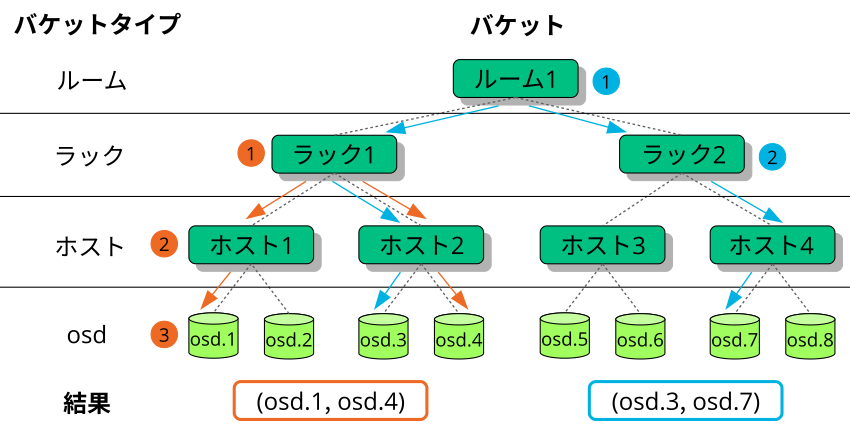

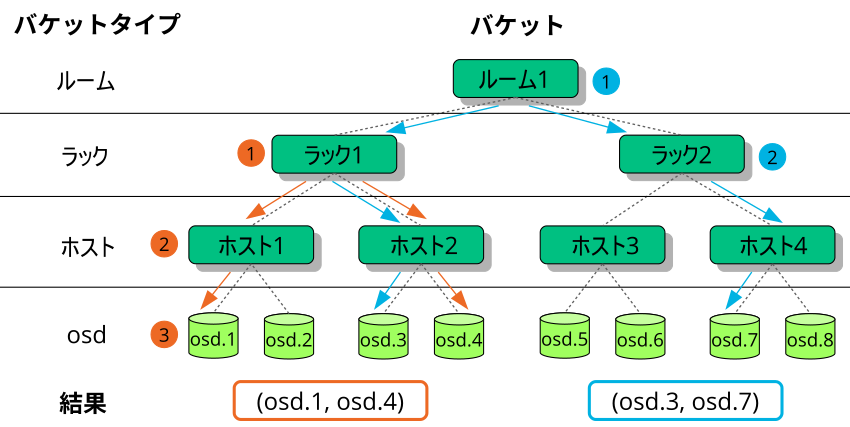

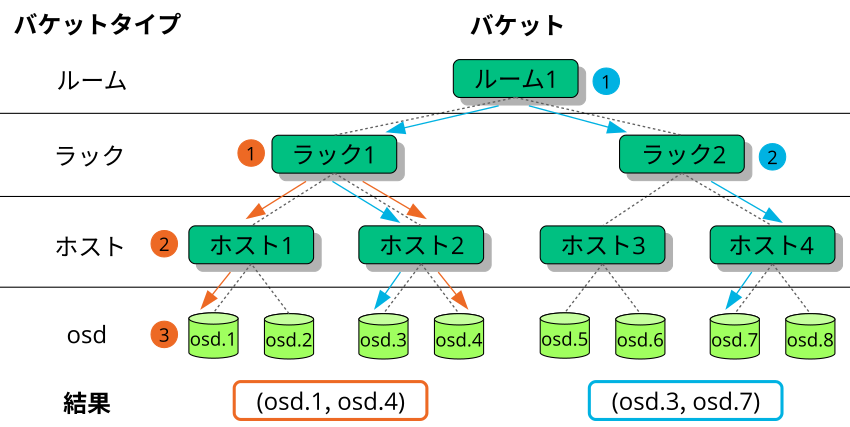

- 17.2 ツリーの例

- 17.3 ノードの置換方法

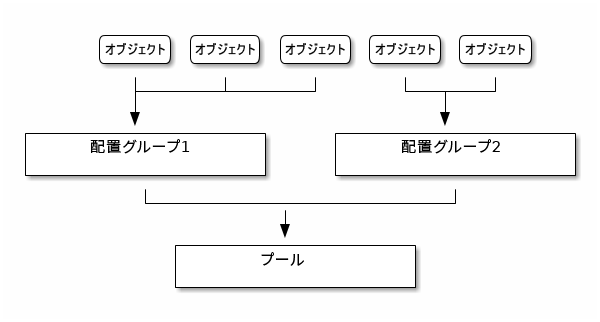

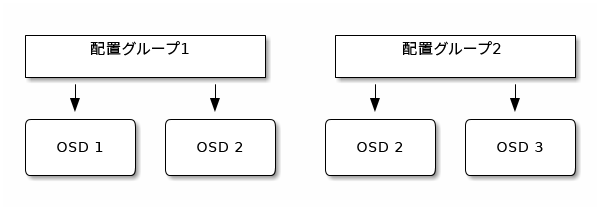

- 17.4 プール内の配置グループ

- 17.5 配置グループとOSD

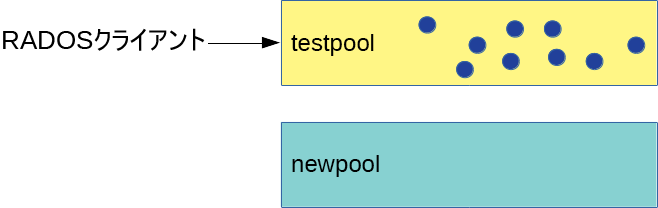

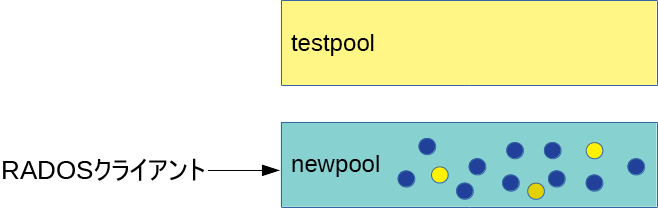

- 18.1 マイグレーション前のプール

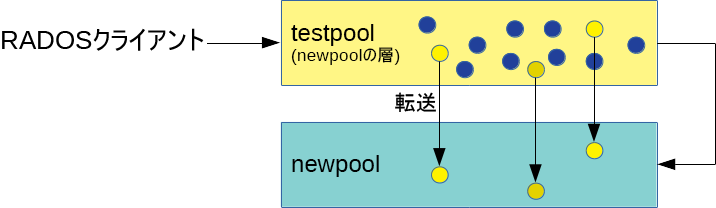

- 18.2 キャッシュ層のセットアップ

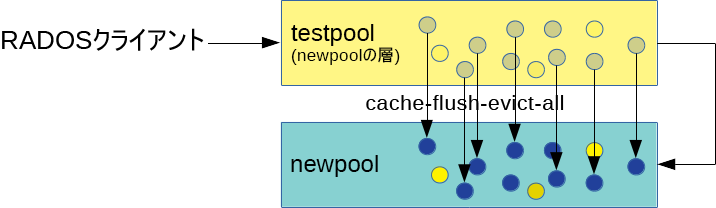

- 18.3 データのフラッシュ

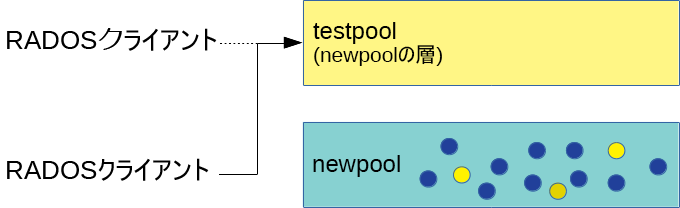

- 18.4 オーバーレイの設定

- 18.5 マイグレーションの完了

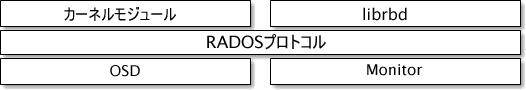

- 20.1 RADOSプロトコル

- 22.1 iSCSIイニシエータのプロパティ

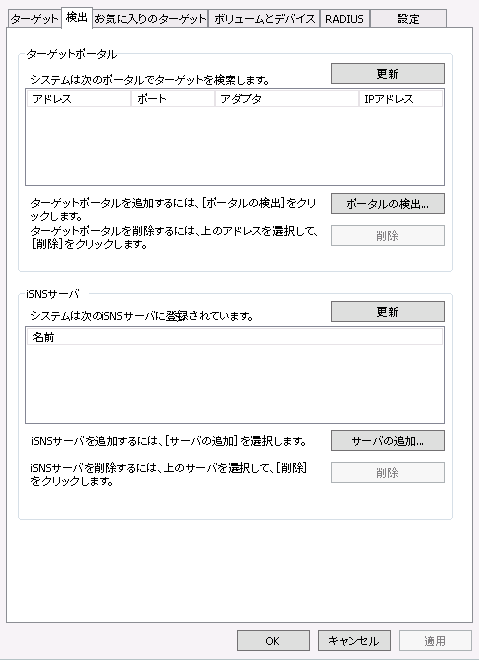

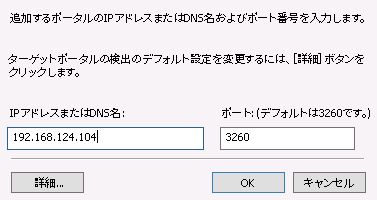

- 22.2 ターゲットポータルの探索

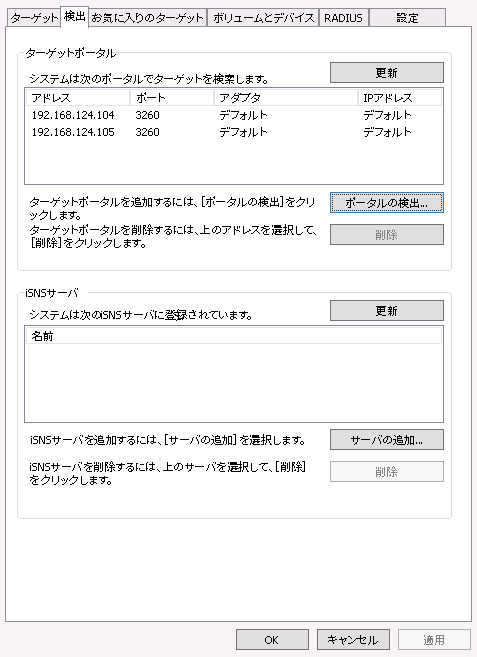

- 22.3 ターゲットポータル

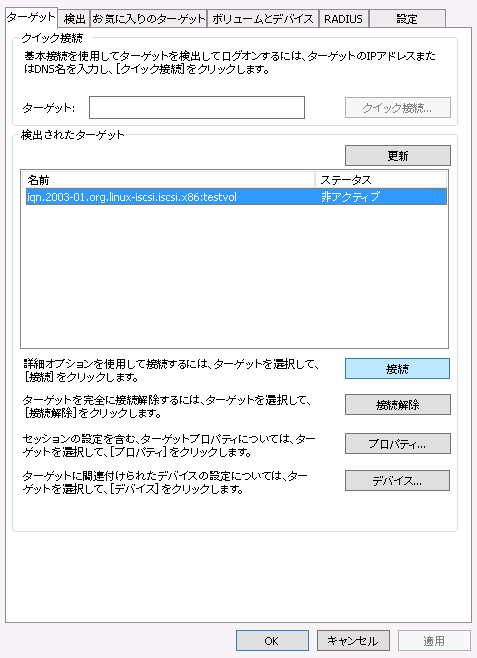

- 22.4 ターゲット

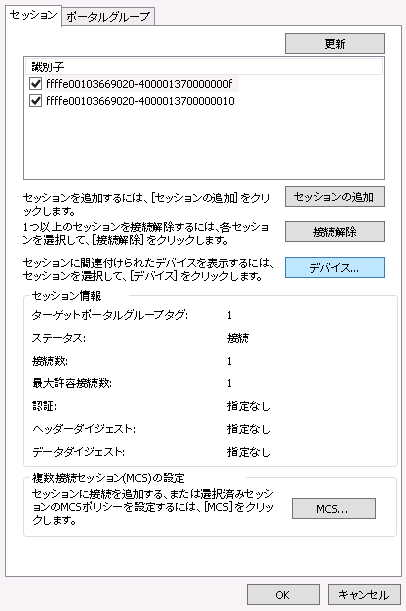

- 22.5 iSCSIターゲットのプロパティ

- 22.6 デバイスの詳細

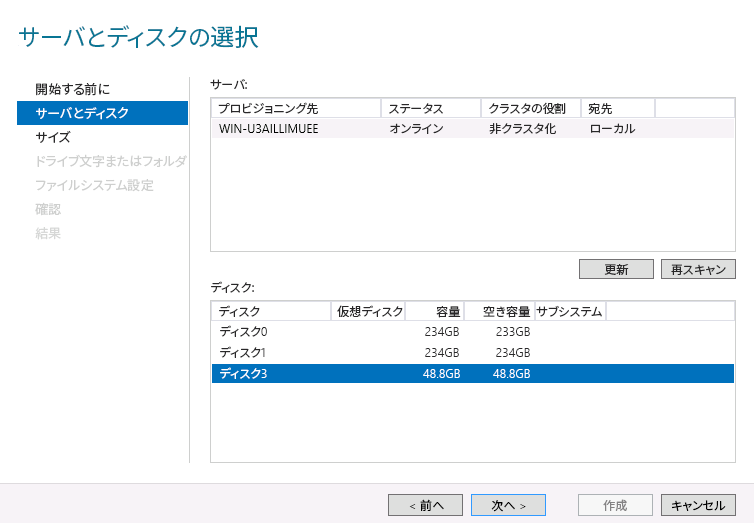

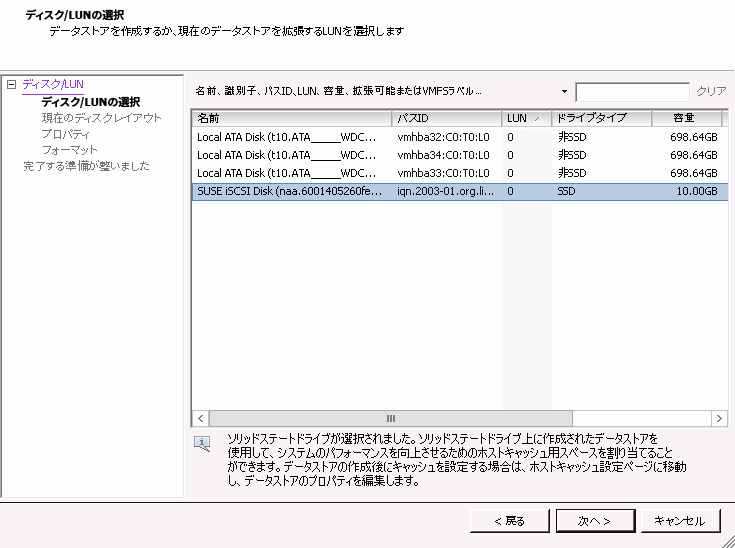

- 22.7 新しいボリュームウィザード

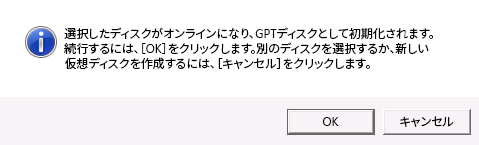

- 22.8 オフラインディスクのプロンプト

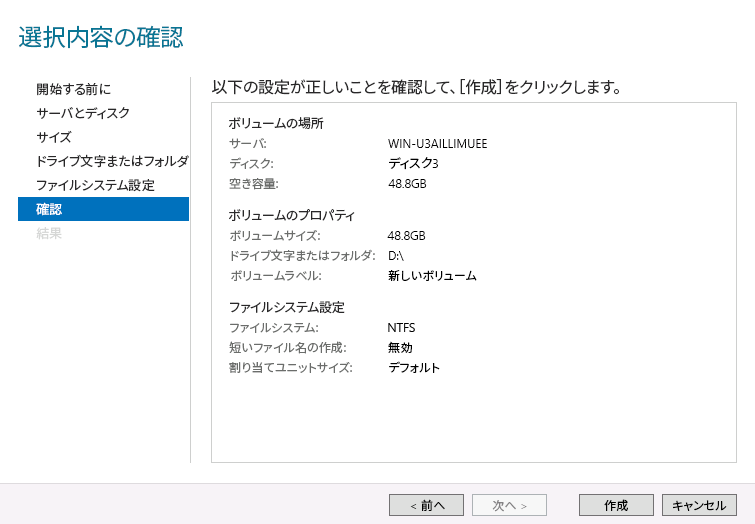

- 22.9 ボリュームの選択内容の確認

- 22.10 iSCSIイニシエータのプロパティ

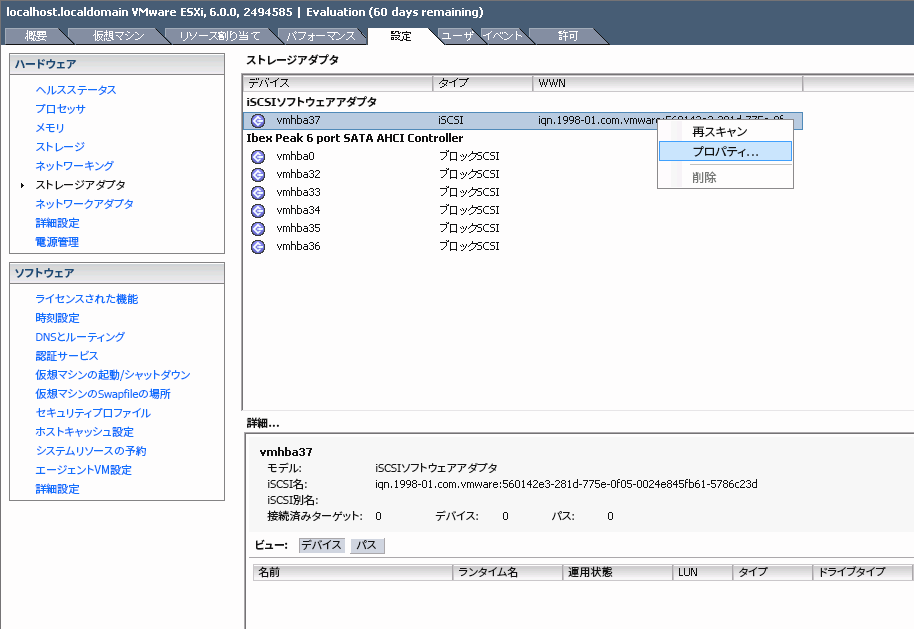

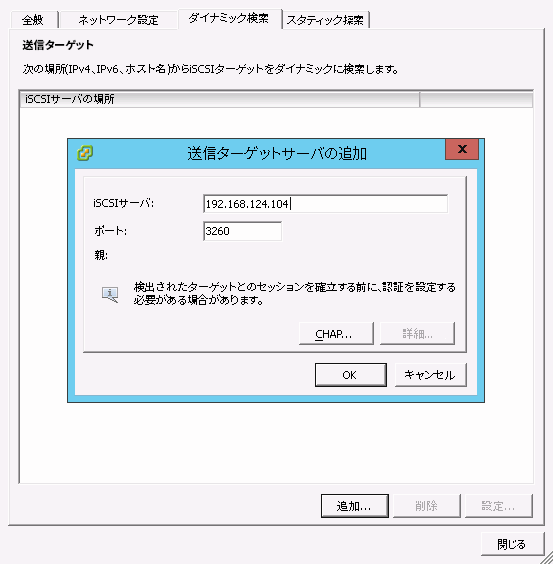

- 22.11 ターゲットサーバの追加

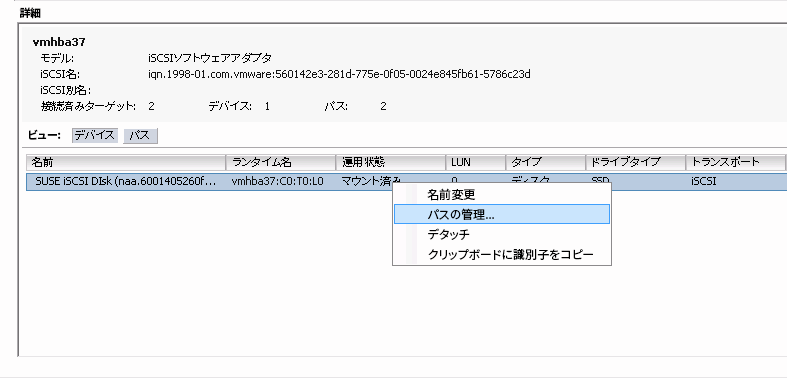

- 22.12 マルチパスデバイスの管理

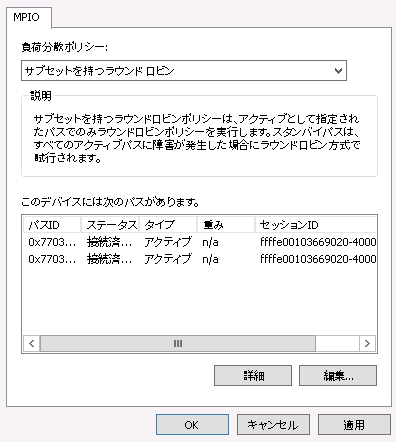

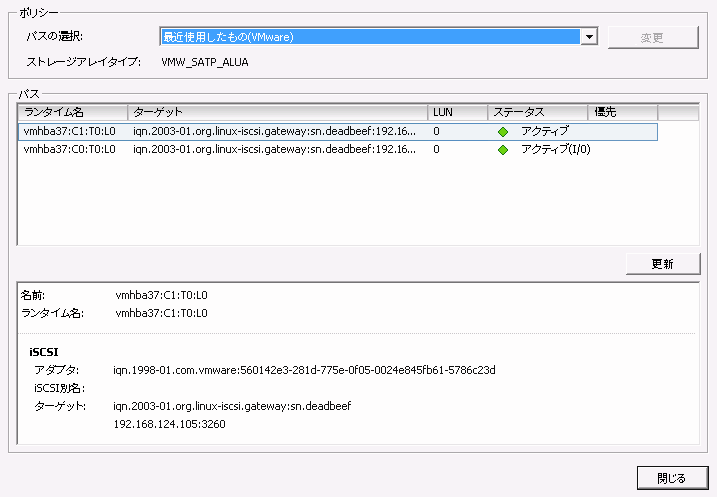

- 22.13 マルチパスのパスの一覧

- 22.14 ストレージの追加ダイアログ

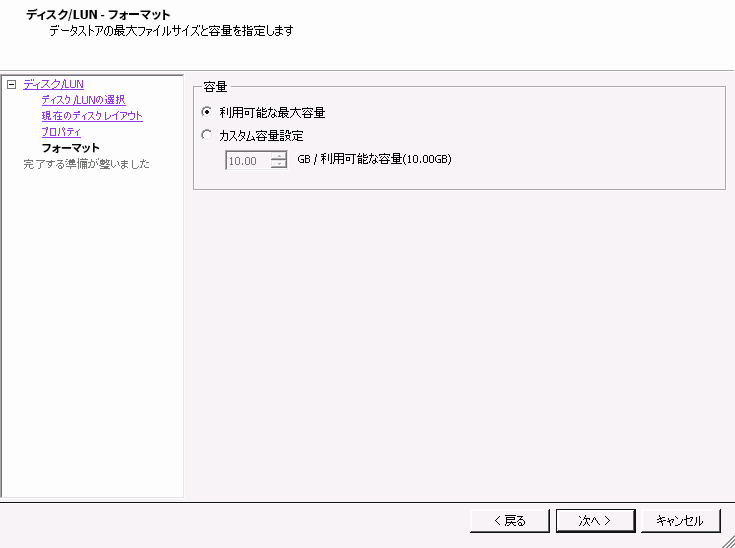

- 22.15 カスタム領域設定

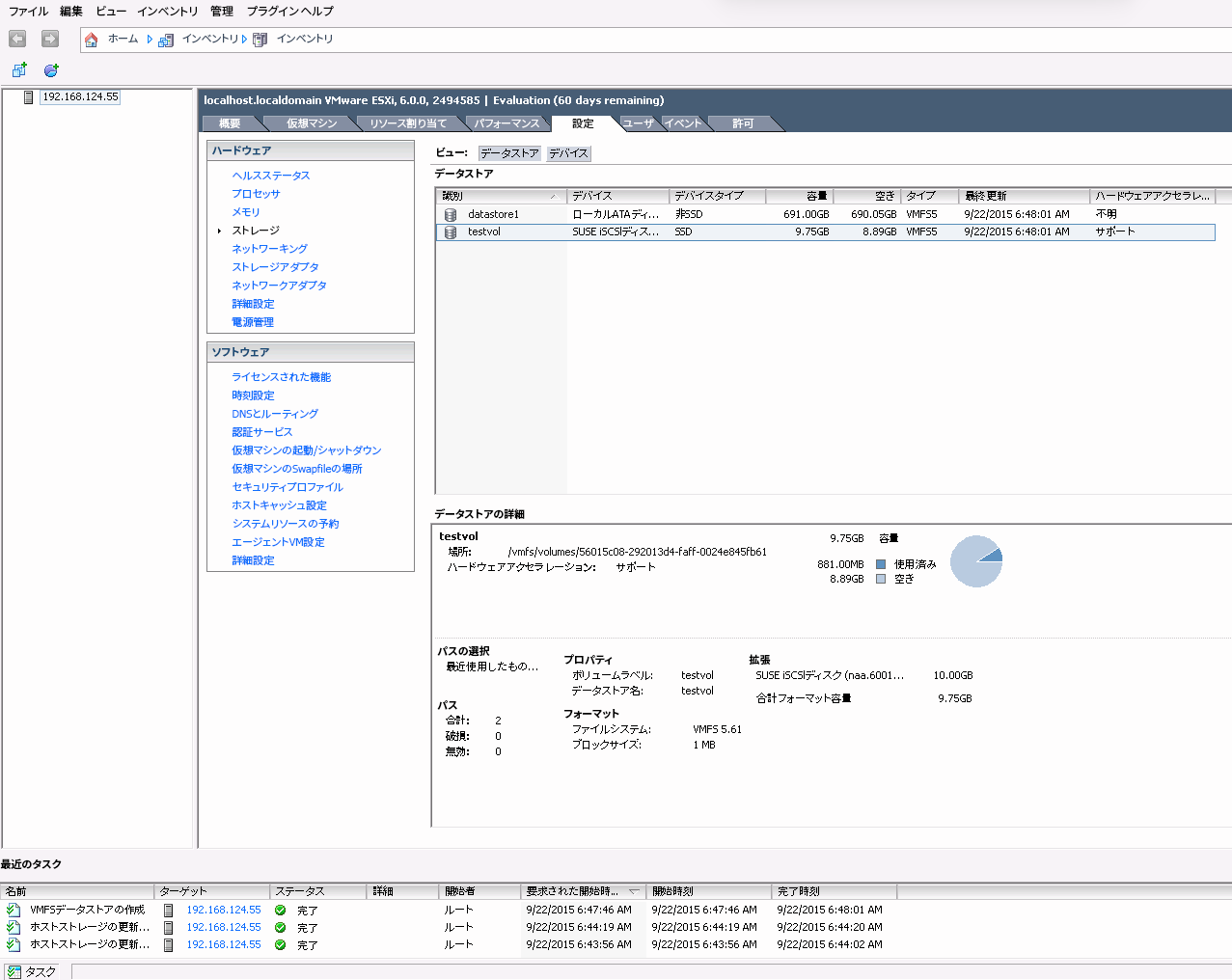

- 22.16 iSCSIデータストアの概要

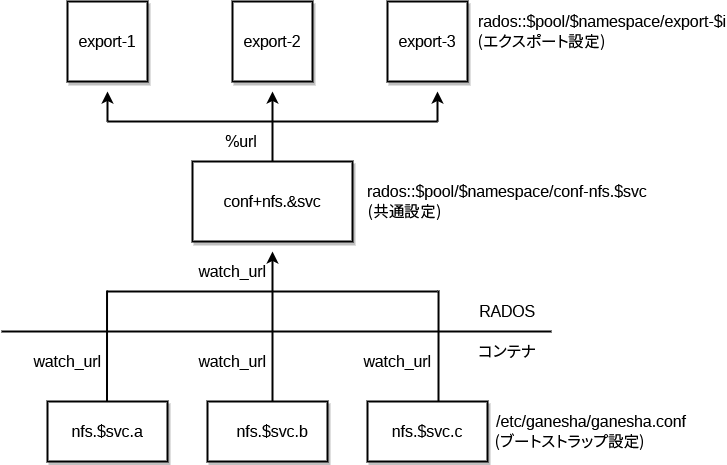

- 25.1 NFS Ganeshaの構造

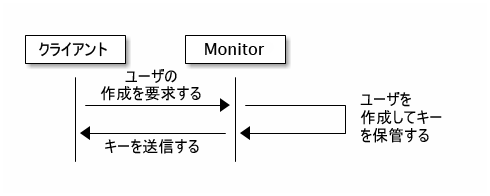

- 30.1

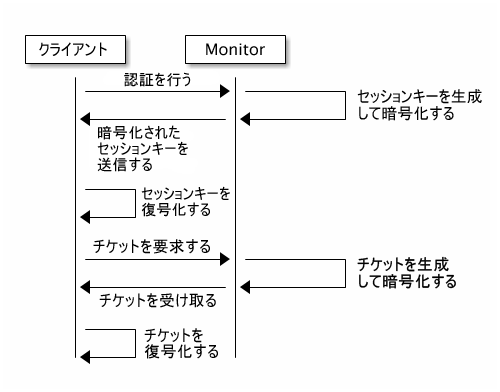

cephx基本認証 - 30.2

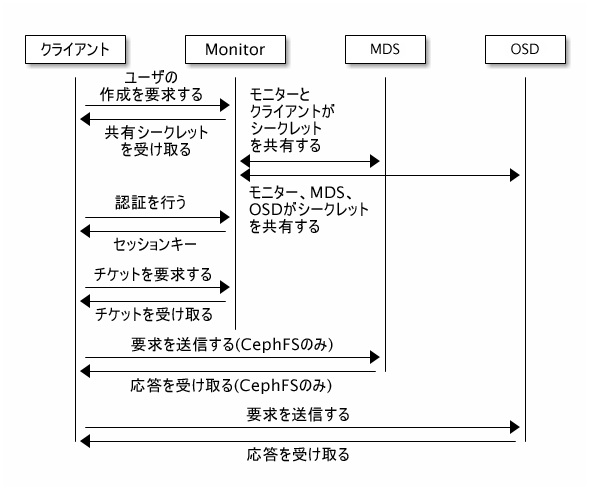

cephx認証 - 30.3

cephx認証 - MDSとOSD

Copyright © 2020–2025 SUSE LLC and contributors.All rights reserved.

特に明記されている場合を除き、本書はクリエイティブ・コモンズ表示-継承4.0国際(CC-BY-SA 4.0)に基づいてライセンスされています。https://creativecommons.org/licenses/by-sa/4.0/legalcodeを参照してください。

SUSEの商標については、http://www.suse.com/company/legal/を参照してください。サードパーティ各社とその製品の商標は、所有者であるそれぞれの会社に所属します。商標記号(®、 ™など)は、SUSEおよび関連会社の商標を示します。アスタリスク(*)は、第三者の商標を示します。

本書のすべての情報は、細心の注意を払って編集されています。しかし、このことは絶対に正確であることを保証するものではありません。SUSE LLC、その関係者、著者、翻訳者のいずれも誤りまたはその結果に対して一切責任を負いかねます。

このガイドについて #

このガイドでは、基本的なCephクラスタを展開した後に、管理者として実行する必要があるルーチンタスク(日常的な管理)に焦点を当てて説明しています。また、サポートされている、Cephクラスタに保存されたデータにアクセスする方法をすべて説明しています。

SUSE Enterprise Storage 7.1はSUSE Linux Enterprise Server 15 SP3の拡張機能です。Ceph (http://ceph.com/)ストレージプロジェクトの機能に、SUSEのエンタープライズエンジニアリングとサポートが組み合わされています。SUSE Enterprise Storage 7.1により、IT組織は、コモディティハードウェアプラットフォームを使用して多様な使用事例に対応できる分散ストレージアーキテクチャを展開できます。

1 利用可能なマニュアル #

製品に関するマニュアルは、https://documentation.suse.comからご利用いただけます。最新のアップデートもご利用いただけるほか、マニュアルをさまざまな形式でブラウズおよびダウンロードすることができます。最新のマニュアルアップデートは英語版で検索できます。

また、製品マニュアルは、/usr/share/doc/manualの下にあるインストール済みシステムから入手できます。製品マニュアルは ses-manual_LANG_CODE.システム上にマニュアルが存在しない場合は、たとえば次のコマンドを使用してインストールしてください。

# zypper install ses-manual_enこの製品の次のマニュアルを入手できます。

- 導入ガイド

このガイドでは基本的なCephクラスタの展開方法と、追加のサービスの展開方法に焦点を当てて説明しています。また、旧バージョンの製品をSUSE Enterprise Storage 7.1にアップグレードする手順についても説明しています。

- 運用と管理ガイド

このガイドでは、基本的なCephクラスタを展開した後に、管理者として実行する必要があるルーチンタスク(日常的な管理)に焦点を当てて説明しています。また、サポートされている、Cephクラスタに保存されたデータにアクセスする方法をすべて説明しています。

- Security Hardening Guide

このガイドでは、クラスタのセキュリティを確保する方法に焦点を当てて説明しています。

- トラブルシューティングガイド

このガイドでは、SUSE Enterprise Storage 7.1を実行する際のさまざまな一般的な問題と、CephやObject Gatewayのような関連コンポーネントに関する問題について説明しています。

- SUSE Enterprise Storage for Windows Guide

このガイドでは、Windowsドライバを使用したMicrosoft Windows環境とSUSE Enterprise Storageの統合、インストール、および設定について説明しています。

2 フィードバックの提供 #

このドキュメントに対するフィードバックや貢献を歓迎します。次のチャネルがあります。

- サービス要求およびサポート

ご使用の製品に利用できるサービスとサポートのオプションについては、http://www.suse.com/support/を参照してください。

サービス要求を提出するには、SUSE Customer Centerに登録済みのSUSEサブスクリプションが必要です。https://scc.suse.com/support/requestsからログインしてをクリックしてください。

- バグレポート

https://bugzilla.suse.com/から入手できるドキュメントを使用して、問題を報告してください。問題を報告するには、Bugzillaアカウントが必要です。

このプロセスを簡略化するために、このドキュメントのHTMLバージョンの見出しの横にあるリンクを使用できます。リンクを使用すると、Bugzillaで適切な製品とカテゴリが事前に選択され、現在のセクションへのリンクが追加されます。バグレポートの入力を直ちに開始できます。

- ドキュメントの編集に貢献

このドキュメントに貢献するには、このドキュメントのHTMLバージョンの見出しの横にあるリンクを使用してください。GitHubのソースコードに移動し、そこからプル要求を提出できます。貢献にはGitHubアカウントが必要です。

このドキュメントの編集に使用する環境の詳細は、https://github.com/SUSE/doc-sesにあるリポジトリのREADMEを参照してください。

- メール

ドキュメントに関するエラーの報告やフィードバックは<doc-team@suse.com>宛に送信してもかまいません。ドキュメントのタイトル、製品のバージョン、およびドキュメントの発行日を記載してください。また、関連するセクション番号とタイトル(またはURL)、問題の簡潔な説明も記載してください。

3 マニュアルの表記規則 #

このマニュアルでは、次の通知と表記規則が使用されています。

/etc/passwd: ディレクトリ名とファイル名PLACEHOLDER: PLACEHOLDERは、実際の値で置き換えられます。

PATH: 環境変数ls、--help: コマンド、オプション、およびパラメータuser: ユーザまたはグループの名前package_name: ソフトウェアパッケージの名前

Alt、Alt–F1: 押すキーまたはキーの組み合わせ。キーはキーボードのように大文字で表示されます。

、 › : メニュー項目、ボタン

AMD/Intel この説明は、AMD64/Intel 64アーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。

IBM Z, POWER この説明は、

IBM ZおよびPOWERの各アーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。第1章、「章の例」: このガイドの別の章への相互参照。

root特権で実行する必要のあるコマンド。多くの場合、これらのコマンドの先頭にsudoコマンドを置いて、特権のないユーザとしてコマンドを実行することもできます。#command>sudocommand特権のないユーザでも実行できるコマンド。

>command通知

警告: 警告の通知続行する前に知っておくべき、無視できない情報。セキュリティ上の問題、データ損失の可能性、ハードウェアの損傷、または物理的な危険について警告します。

重要: 重要な通知続行する前に知っておくべき重要な情報です。

注記: メモの通知追加情報。たとえば、ソフトウェアバージョンの違いに関する情報です。

ヒント: ヒントの通知ガイドラインや実際的なアドバイスなどの役に立つ情報です。

コンパクトな通知

追加情報。たとえば、ソフトウェアバージョンの違いに関する情報です。

ガイドラインや実際的なアドバイスなどの役に立つ情報です。

4 サポート #

SUSE Enterprise Storageのサポートステートメントと、技術プレビューに関する概要を以下に示します。製品ライフサイクルの詳細については、https://www.suse.com/lifecycleを参照してください。

サポート資格をお持ちの場合、https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.htmlを参照して、サポートチケットの情報を収集する方法の詳細を確認してください。

4.1 SUSE Enterprise Storageのサポートステートメント #

サポートを受けるには、SUSEの適切な購読が必要です。利用可能なサポートサービスを具体的に確認するには、https://www.suse.com/support/にアクセスして製品を選択してください。

サポートレベルは次のように定義されます。

- L1

問題の判別。互換性情報、使用サポート、継続的な保守、情報収集、および利用可能なドキュメントを使用した基本的なトラブルシューティングを提供するように設計されたテクニカルサポートを意味します。

- L2

問題の切り分け。データの分析、お客様の問題の再現、問題領域の特定、レベル1で解決できない問題の解決、またはレベル3の準備を行うように設計されたテクニカルサポートを意味します。

- L3

問題解決。レベル2サポートで特定された製品の欠陥を解決するようにエンジニアリングに依頼して問題を解決するように設計されたテクニカルサポートを意味します。

契約されているお客様およびパートナーの場合、SUSE Enterprise Storageでは、次のものを除くすべてのパッケージに対してL3サポートを提供します。

技術プレビュー.

サウンド、グラフィック、フォント、およびアートワーク。

追加の顧客契約が必要なパッケージ.

モジュール「Workstation Extension」の一部として出荷される一部のパッケージは、L2サポートのみです。

メインのパッケージと共にのみサポートが提供される、名前が-develで終わるパッケージ(ヘッダファイルや同様の開発者用のリソースを含む)。

SUSEは、元のパッケージの使用のみをサポートします。つまり、変更も、再コンパイルもされないパッケージをサポートします。

4.2 技術プレビュー #

技術プレビューとは、今後のイノベーションを垣間見ていただくための、SUSEによって提供されるパッケージ、スタック、または機能を意味します。技術プレビューは、ご利用中の環境で新しい技術をテストする機会を参考までに提供する目的で収録されています。私たちはフィードバックを歓迎しています。技術プレビューをテストする場合は、SUSEの担当者に連絡して、経験や使用例をお知らせください。ご入力いただいた内容は今後の開発のために役立たせていただきます。

技術プレビューには、次の制限があります。

技術プレビューはまだ開発中です。したがって、機能が不完全であったり、不安定であったり、何らかの理由で運用環境での使用には適していなかったりする場合があります。

技術プレビューにはサポートが提供されません。

技術プレビューは、特定のハードウェアアーキテクチャでしか利用できないことがあります。

技術プレビューの詳細および機能は、変更される場合があります。そのため、今後リリースされる技術プレビューへのアップグレードができない場合や、再インストールが必要となる場合があります。

SUSEで、プレビューがお客様や市場のニーズを満たしていない、またはエンタープライズ標準に準拠していないことを発見する場合があります。技術プレビューは製品から予告なく削除される可能性があります。SUSEでは、このようなテクノロジーのサポートされるバージョンを将来的に提供できない場合があります。

ご使用の製品に付属している技術プレビューの概要については、https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1にあるリリースノートを参照してください。

5 Cephの貢献者 #

Cephプロジェクトとそのドキュメントは、数百人の貢献者と組織の作業の結果です。詳しくは「https://ceph.com/contributors/」を参照してください。

6 このガイドで使用されるコマンドとコマンドプロンプト #

Cephクラスタ管理者は、特定のコマンドを実行して、クラスタの動作を設定および調整します。必要になるコマンドには、次のようにいくつかの種類があります。

6.1 Salt関連のコマンド #

これらのコマンドは、Cephクラスタノードを展開する場合や、クラスタノードの一部(または全部)で同時にコマンドを実行する場合、クラスタノードを追加または削除する場合に役立ちます。最も頻繁に使用されるコマンドはceph-saltとceph-salt configです。Salt Masterノードでは、Saltコマンドはrootとして実行する必要があります。これらのコマンドは、次のプロンプトで示されます。

root@master # 例:

root@master # ceph-salt config ls6.2 Ceph関連のコマンド #

これらは、ceph、cephadm、rbd、またはradosgw-adminなど、コマンドラインでクラスタとそのゲートウェイのすべての側面を設定および微調整するための下位レベルのコマンドです。

Ceph関連のコマンドを実行するには、Cephキーの読み取りアクセス権が必要です。このキーの機能により、Ceph環境内におけるユーザの特権が定義されます。1つのオプションは、rootとして(またはsudoを使用して)Cephコマンドを実行し、制限のないデフォルトのキーリング「ceph.client.admin.key」を使用します。

より安全な推奨オプションは、各管理者ユーザに対してより制限の厳しい個別のキーを作成し、そのキーを、各ユーザが読み取ることができるディレクトリに保存することです。次に例を示します。

~/.ceph/ceph.client.USERNAME.keyring

カスタムの管理者ユーザとキーリングを使用するには、cephコマンドを実行するたびに、-n client.USER_NAMEオプションと--keyring PATH/TO/KEYRINGオプションを使用して、ユーザ名とプールのパスを指定する必要があります。

これを回避するには、個々のユーザの~/.bashrcファイルでCEPH_ARGS変数にこれらのオプションを含めてください。

Ceph関連のコマンドは任意のクラスタノードで実行できますが、管理ノードで実行することをお勧めします。このドキュメントでは、cephuserユーザを使用してコマンドを実行するので、コマンドは次のプロンプトが表示されます。

cephuser@adm > 例:

cephuser@adm > ceph auth listクラスタノードに対して特定の役割でコマンドを実行するようドキュメントで指示されている場合は、プロンプトによって示されます。以下に例を示します。

cephuser@mon > 6.2.1 ceph-volumeの実行 #

SUSE Enterprise Storage 7から、Cephサービスはコンテナ化された状態で実行されます。OSDノード上でceph-volumeを実行する必要がある場合は、cephadmコマンドに付加する必要があります。たとえば、次のようになります。

cephuser@adm > cephadm ceph-volume simple scan6.3 一般的なLinuxコマンド #

mount、cat、またはopensslなど、Cephに関連しないLinuxコマンドは、関連するコマンドに必要な特権に応じて、cephuser@adm >または#のいずれかで導入されます。

6.4 追加情報 #

Cephのキー管理の詳細については、30.2項 「キー管理」を参照してください。

パート I Cephダッシュボード #

- 1 Cephダッシュボードについて

CephダッシュボードはWebベースのCeph管理/監視用ビルトインアプリケーションで、クラスタの様々な側面とオブジェクトを管理します。Book “導入ガイド”, Chapter 7 “

ceph-saltを使用したブートストラップクラスタの展開”で基本的なクラスタが展開されると、ダッシュボードは自動的に有効化されます。- 2 ダッシュボードのWebユーザインタフェース

Cephダッシュボードにログインするには、ポート番号を含むCephダッシュボードのURLをブラウザに与えます。アドレスを確認するには、次のコマンドを実行します。

- 3 Cephダッシュボードユーザと役割の管理

コマンドラインでCephコマンドを使用して実行するダッシュボードユーザ管理については、第11章 「コマンドラインによるユーザと役割の管理」ですでに紹介しています。

- 4 クラスタの内部情報の表示

メニュー項目を使用すると、Cephクラスタホスト、インベントリ、Ceph Monitor、サービス、OSD、設定、CRUSHマップ、Ceph Manager、ログ、および監視ファイルに関する詳細情報を表示できます。

- 5 プールの管理

Cephのプールの全般的な情報については、第18章 「ストレージプールの管理」を参照してください。イレージャコーディングプールに固有の情報については、第19章 「イレージャコーディングプール」を参照してください。

- 6 RADOS Block Deviceの管理

利用可能なすべてのRBD (RADOS Block Devices)を一覧にするには、メインメニューから › をクリックします。

- 7 NFS Ganeshaの管理

NFS Ganeshaは、NFSバージョン4.1以降をサポートしています。NFSバージョン3はサポートしていません。

- 8 CephFSの管理

CephFSの詳細情報については、第23章 「クラスタファイルシステム」を参照してください。

- 9 Object Gatewayの管理

Cephダッシュボード上でObject Gatewayのフロントエンドにアクセスしようとすると、次の通知が表示される場合があります。

- 10 手動設定

このセクションでは、コマンドラインでダッシュボードを手動で設定したいユーザ向けの詳細情報を紹介します。

- 11 コマンドラインによるユーザと役割の管理

このセクションでは、Cephダッシュボードによって使用されるユーザアカウントを管理する方法について説明します。これは、ユーザアカウントを作成または変更する場合や、適切なユーザ役割と許可を設定する場合に役立ちます。

1 Cephダッシュボードについて #

CephダッシュボードはWebベースのCeph管理/監視用ビルトインアプリケーションで、クラスタの様々な側面とオブジェクトを管理します。Book “導入ガイド”, Chapter 7 “ceph-saltを使用したブートストラップクラスタの展開”で基本的なクラスタが展開されると、ダッシュボードは自動的に有効化されます。

SUSE Enterprise Storage 7.1用のCephダッシュボードには、Webベースの管理機能が追加され、Ceph Managerの監視やアプリケーション管理などのCephの管理が容易になりました。Ceph関連の複雑なコマンドを知らなくても、Cephクラスタを管理および監視できるようになりました。Cephダッシュボードの直感的なインタフェース、またはその組み込みREST APIのいずれかを使用できます。

Cephダッシュボードモジュールは、ceph-mgrがホストされたWebサーバを使用して、Cephクラスタに関する情報と統計を視覚化します。Ceph Managerの詳細については、Book “導入ガイド”, Chapter 1 “SESとCeph”, Section 1.2.3 “Cephのノードとデーモン”を参照してください。

2 ダッシュボードのWebユーザインタフェース #

2.1 ログイン #

Cephダッシュボードにログインするには、ポート番号を含むCephダッシュボードのURLをブラウザに与えます。アドレスを確認するには、次のコマンドを実行します。

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",このコマンドはCephダッシュボードが置かれている場所のURLを返します。このコマンドの使用に関して問題が生じた場合、Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”を参照してください。

クラスタの展開時に作成した資格情報を使用してログインします(Book “導入ガイド”, Chapter 7 “ceph-saltを使用したブートストラップクラスタの展開”, Section 7.2.9 “Cephダッシュボードログインアカウント情報の設定”を参照してください)。

Cephダッシュボードへアクセスするのにデフォルトの「admin」アカウントを使用しない場合は、管理者特権を持つカスタムユーザアカウントを作成します。詳細については、第11章 「コマンドラインによるユーザと役割の管理」を参照してください。

新しいCephメジャーリリース(コードネーム: Pacific)へのアップグレードが利用可能になるとすぐに、Cephダッシュボードの上部の通知領域に関連するメッセージが表示されます。アップグレードを実行するには、Book “導入ガイド”, Chapter 11 “SUSE Enterprise Storage 7から7.1へのアップグレード”の手順に従ってください。

ダッシュボードのユーザインタフェースはいくつかの「ブロック」に別れています。すなわち、画面右上の「ユーティリティメニュー」、画面左側の「メインメニュー」、そして、中央の「コンテンツペイン」です。

2.4 コンテンツペイン #

コンテンツペインは、ダッシュボードの画面のメイン部分を占めます。ダッシュボードのホームページには、多数の便利なウィジェットが表示されており、クラスタの現在のステータス、容量、およびパフォーマンス情報について簡潔に通知します。

2.5 Web UIの共通機能 #

Cephダッシュボードでは、プールのリスト、OSDノードのリスト、RBDデバイスのリストなど、「リスト」を操作することがよくあります。すべてのリストは、デフォルトでは5秒ごとに自動更新されます。次の共通ウィジェットは、これらのリストを管理または調整する場合に役立ちます。

ページの右上隅にある[ユーザ管理![]() をクリックして、リストの手動更新をトリガします。

をクリックして、リストの手動更新をトリガします。

ページの右上隅にある[ユーザ管理![]() をクリックして、個々のテーブル列を表示または非表示にします。

をクリックして、個々のテーブル列を表示または非表示にします。

ページの右上隅にある[ユーザ管理![]() をクリックして、1ページに表示する行数を入力(または選択)します。

をクリックして、1ページに表示する行数を入力(または選択)します。

2.6 ダッシュボードウィジェット #

各ダッシュボードウィジェットには、実行中のCephクラスタの特定の側面に関連する特定のステータス情報が表示されます。一部のウィジェットはアクティブなリンクになっており、クリックすると、そのウィジェットが表すトピックに関連する詳細ページにリダイレクトされます。

一部のグラフィカルウィジェットでは、マウスポインタを合わせると詳細が表示されます。

2.6.1 ステータスウィジェット #

ウィジェットは、クラスタの現在のステータスに関する簡単な概要を提供します。

クラスタのヘルスに関する基本的な情報が示されます。

クラスタノードの合計数が表示されます。

実行中のモニターとその定数の数が表示されます。

OSDの合計数と、「up」および「in」のOSDの数が表示されます。

アクティブおよびスタンバイ状態のCeph Managerデーモンの数が表示されます。

実行中のObject Gatewayの数が表示されます。

メタデータサーバの数が表示されます。

設定されているiSCSI Gatewayの数が表示されます。

2.6.2 容量のウィジェット #

ウィジェットには、ストレージ容量に関する簡単な情報が表示されます。

使用済みの容量と使用可能な未フォーマット時のストレージ容量の比率が表示されます。

クラスタに保存されているデータオブジェクトの数が表示されます。

配置グループのチャートがステータスに従って表示されます。

クラスタのプールの数が表示されます。

OSDあたりの配置グループの平均数が表示されます。

2.6.3 パフォーマンスウィジェット #

ウィジェットは、Cephクライアントの基本的なパフォーマンスを参照します。

1秒あたりのクライアントの読み取り/書き込み操作の量。

1秒あたりのCephクライアントとの間で転送されるデータ量(バイト単位)。

1秒あたりに回復されるデータのスループット。

スクラビング(17.4.9項 「配置グループのスクラブ」を参照してください)のステータスを表示します。ステータスは

非アクティブ、有効化済み、アクティブのいずれかです。

3 Cephダッシュボードユーザと役割の管理 #

コマンドラインでCephコマンドを使用して実行するダッシュボードユーザ管理については、第11章 「コマンドラインによるユーザと役割の管理」ですでに紹介しています。

このセクションでは、ダッシュボードWebユーザインタフェースを使用してユーザアカウントを管理する方法について説明します。

3.1 ユーザの一覧 #

ページの右上隅にある[ユーザ管理![]() ユーティリティメニューのをクリックし、を選択します。

ユーティリティメニューのをクリックし、を選択します。

リストに含まれる情報は、各ユーザのユーザ名、フルネーム、メールアドレス、割り当てられた役割の一覧、役割が有効化どうか、および、パスワード失効日です。

3.2 新しいユーザの追加 #

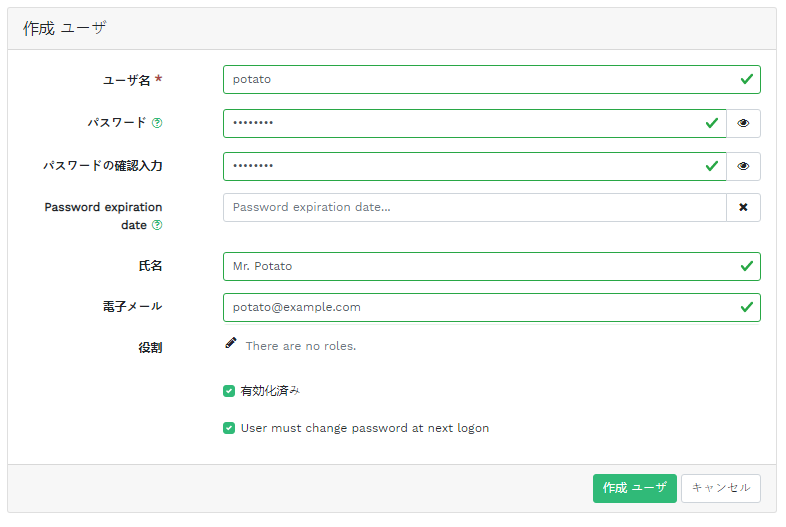

新しいユーザを追加するには、テーブル見出しの左上のをクリックします。ユーザ名、パスワード、およびオプションで氏名と電子メールを入力します。

事前定義された役割をユーザに割り当てるには、小さいペンのアイコンをクリックします。をクリックして確認します。

3.3 ユーザの編集 #

ユーザのテーブル行をクリックして選択を強調表示します。を選択して、ユーザに関する詳細を編集します。をクリックして確認します。

3.4 ユーザの削除 #

ユーザのテーブル行をクリックして選択を強調表示してから、の横にあるドロップダウンボックスを選択します。リストからを選択してユーザアカウントを削除します。チェックボックスをオンにし、をクリックして確認します。

3.5 ユーザの役割の一覧 #

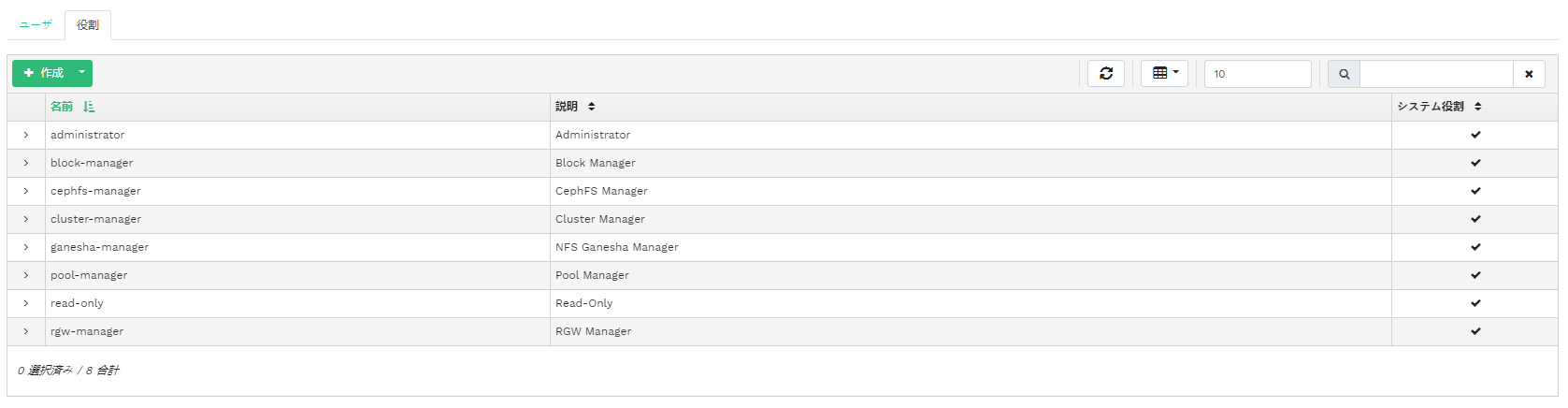

ページの右上隅にある[ユーザ管理![]() ユーティリティメニューのをクリックし、を選択します。続いて、タブをクリックします。

ユーティリティメニューのをクリックし、を選択します。続いて、タブをクリックします。

このリストには、各役割の名前、説明、およびシステム役割であるかどうかが含まれます。

3.6 カスタム役割の追加 #

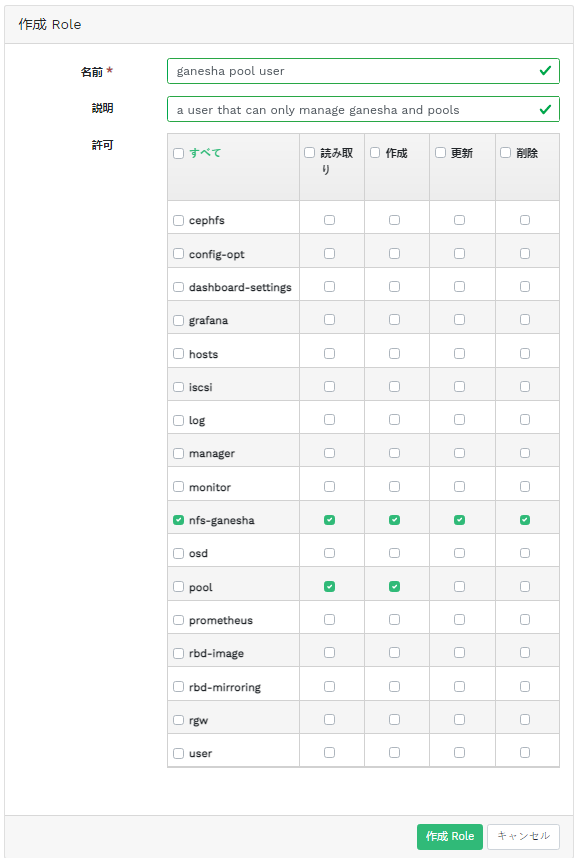

新しいカスタム役割を追加するには、テーブル見出しの左上のをクリックします。とを入力し、の横で、適切な許可を選択します。

カスタムユーザ役割を作成し、後でceph-salt purgeコマンドを使ってCephクラスタを削除する場合、まずカスタム役割を消去する必要があります。詳細については、13.9項 「Cephクラスタ全体の削除」を参照してください。

トピック名の前にあるチェックボックスをオンにすると、そのトピックの許可がすべて有効になります。チェックボックスをオンにすると、すべてのトピックの許可がすべて有効になります。

をクリックして確認します。

3.7 カスタム役割の編集 #

カスタムの役割の説明と許可を編集するには、ユーザのテーブル行をクリックして選択を強調表示し、テーブル見出しの左上のを選択します。をクリックして確認します。

3.8 カスタム役割の削除 #

役割のテーブル行をクリックして選択を強調表示してから、の横にあるドロップダウンボックスを選択します。リストからを選択して役割を削除します。チェックボックスをオンにし、をクリックして確認します。

4 クラスタの内部情報の表示 #

メニュー項目を使用すると、Cephクラスタホスト、インベントリ、Ceph Monitor、サービス、OSD、設定、CRUSHマップ、Ceph Manager、ログ、および監視ファイルに関する詳細情報を表示できます。

4.1 クラスタノードの表示 #

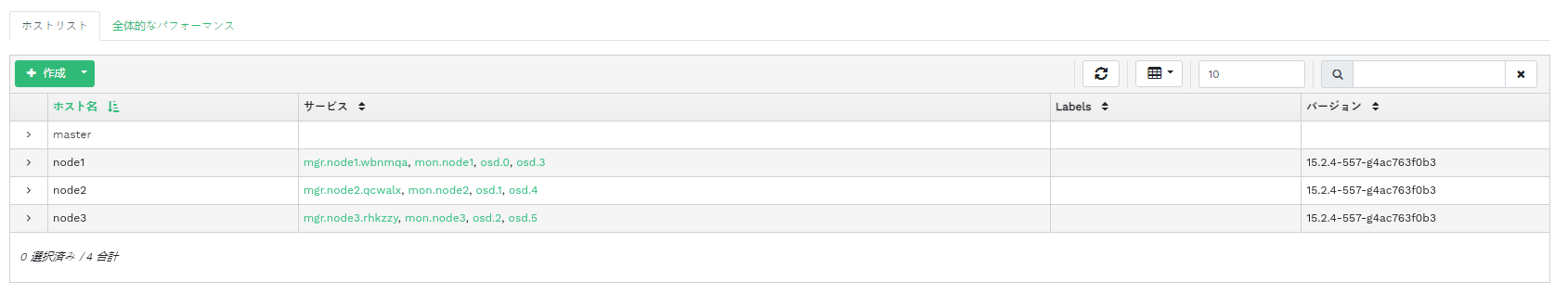

クラスタノードのリストを表示するには、 › をクリックします。

ノードのパフォーマンスの詳細を表示するには、列のノード名の横にあるドロップダウン矢印をクリックします。

列には、関連する各ノードで実行されているすべてのデーモンが一覧にされます。デーモン名をクリックすると、その詳細な設定が表示されます。

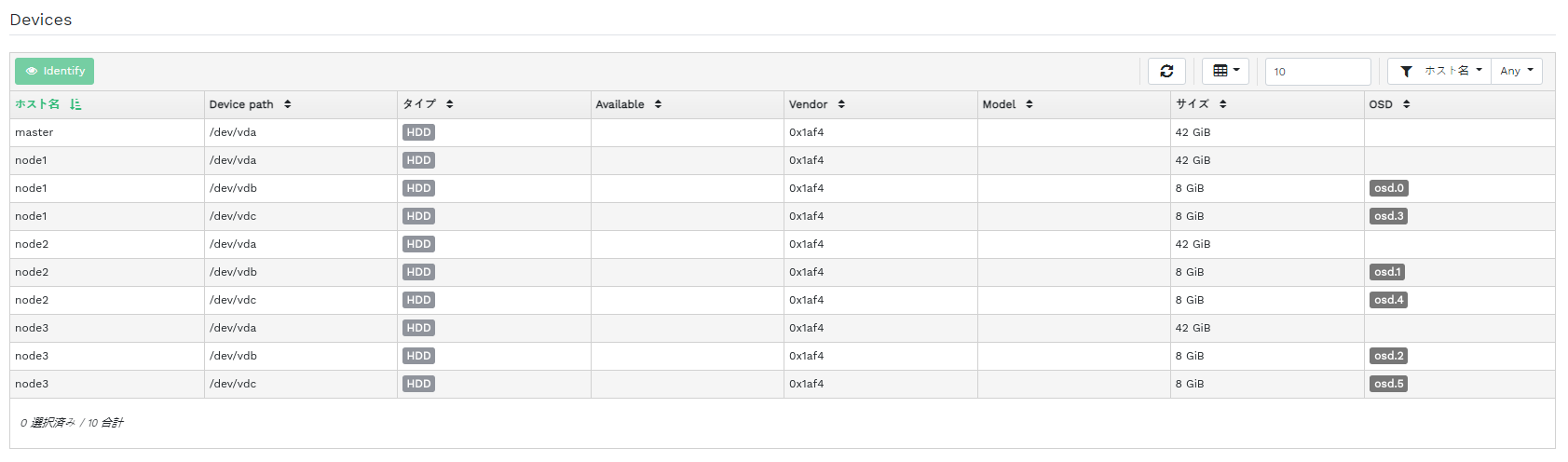

4.2 クラスタのインベントリへのアクセス #

デバイスのリストを表示するには、 › をクリックします。リストにはデバイスのパス、種類、利用可能かどうか、ベンダー、モデル、サイズ、OSDが含まれます。

列のノード名をクリックして選択します。選択した状態で、をクリックすると、そのホストを実行しているデバイスが特定されます。このとき、デバイスにLEDを点滅させるよう指示されます。このアクションの時間は、1、2、5、10、15分から選択します。をクリックします。

4.3 Ceph Monitorの表示 #

実行中のCeph Monitorが存在するクラスタノードのリストを表示するには、 › をクリックします。コンテンツペインは2つのビューに分割されます。1つはステータスビューで、もう1つは定数内と非定数内のビューです。

テーブルには、実行中のCeph Monitorに関する一般的な統計情報が表示されます。内容は次の通りです。

クラスタID

monmapが変更されました

monmapエポック

定数con

定数mon

必須のcon

必須のmon

定数内と非定数内のペインには、各Monitorの名前、ランク数、パブリックIPアドレス、開いているセッション数が含まれます。

関連するCeph Monitorの設定を表示するには、列のノード名をクリックします。

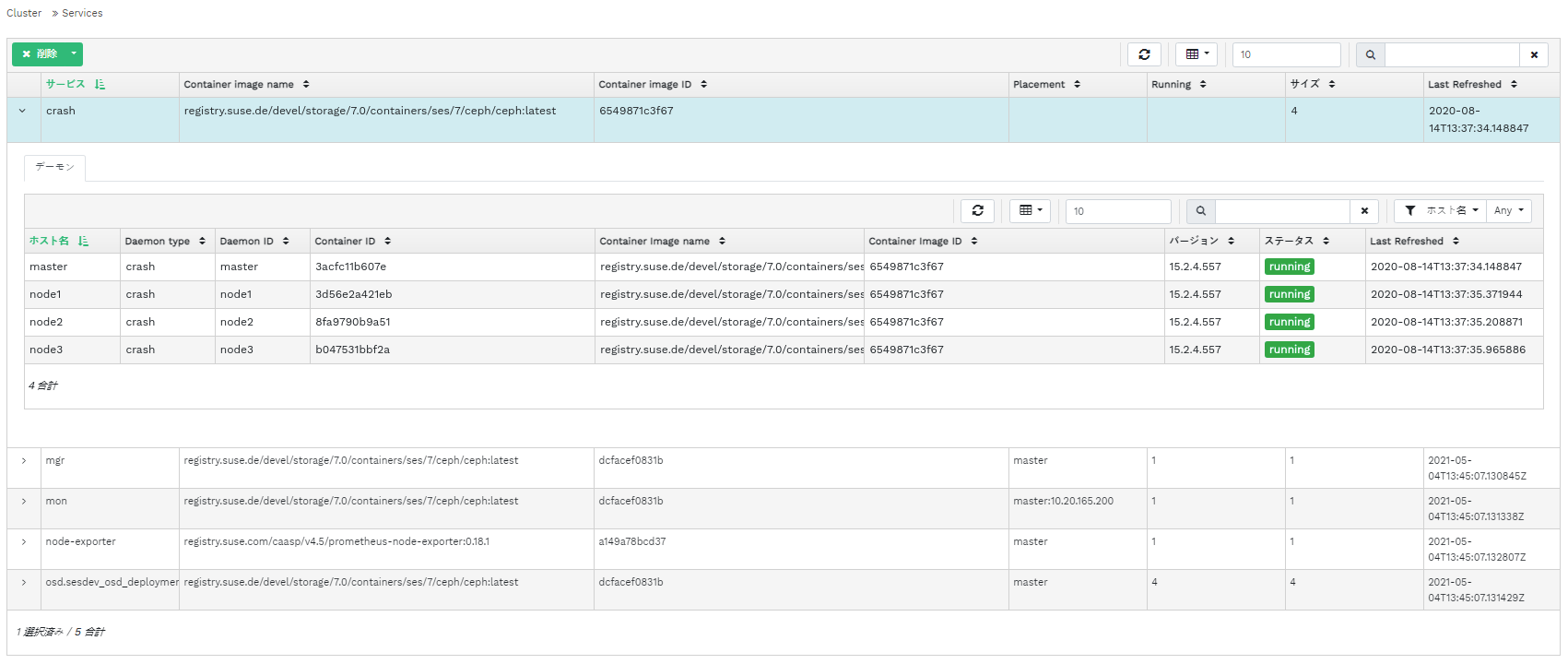

4.4 サービスの表示 #

利用可能な各サービスの詳細を表示するには、 › をクリックします。サービスの例としては、crash、Ceph Manager、Ceph Monitorなどがあります。リストにはコンテナイメージの名前、コンテナイメージのID、実行中の内容のステータス、サイズ、最後に更新された日時が含まれます。

デーモンの詳細を表示するには、列のサービス名の横にあるドロップダウン矢印をクリックします。詳細リストには、ホスト名、デーモンの種類、デーモンID、コンテナID、コンテナイメージ名、コンテナイメージID、バージョン番号、ステータス、最後に更新された日時が含まれます。

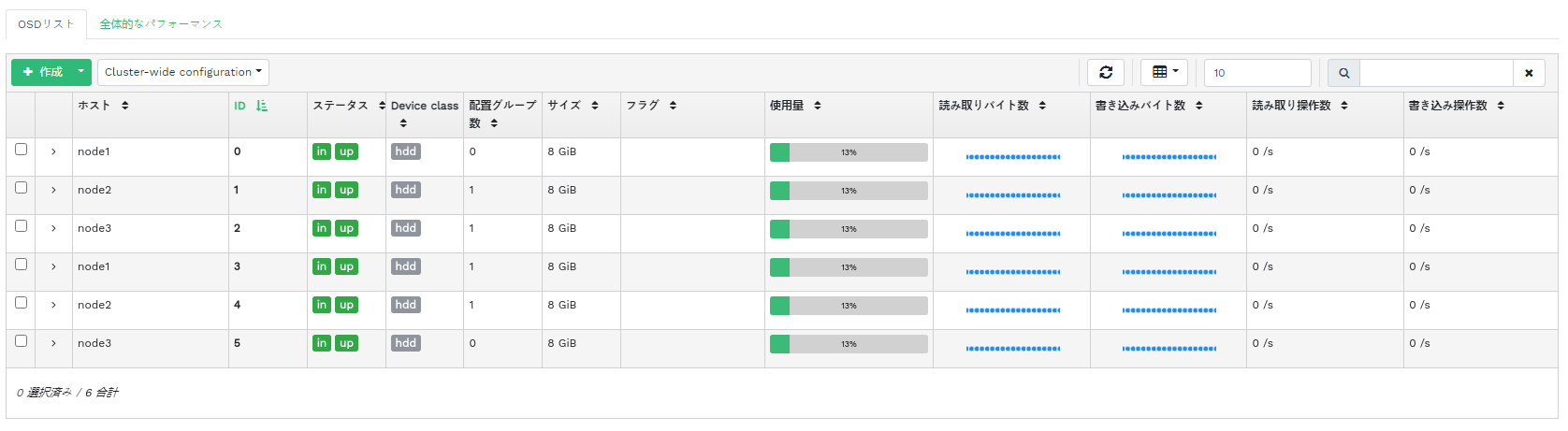

4.5 Ceph OSDの表示 #

実行中のOSDデーモンが存在するノードのリストを表示するには、 › をクリックします。このリストには、各ノードの名前、ID、ステータス、デバイスクラス、配置グループの数、サイズ、使用状況、時間内の読み込み/書き込みチャート、および1秒あたりの読み込み/書き込み操作の速度が含まれます。

ポップアップウィンドウを開くには、テーブル見出しのドロップダウンメニューから、を選択します。このウィンドウにはクラスタ全体に適用されるフラグの一覧が表示されます。個々のフラグを有効または無効にし、をクリックして確認できます。

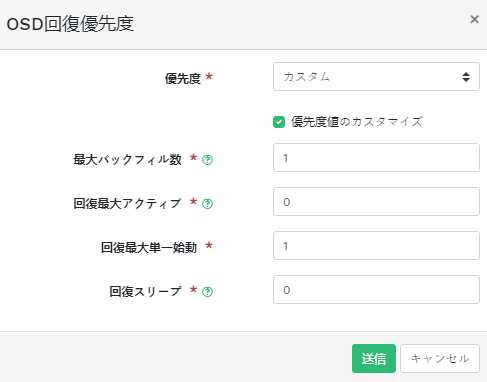

ポップアップウィンドウを開くには、テーブル見出しのドロップダウンメニューから、を選択します。このウィンドウにはクラスタ全体に適用されるOSDの回復優先度の一覧が表示されます。希望する優先度プロファイルを有効にし、その下の個々の値を微調整できます。をクリックして確認します。

デバイスの設定とパフォーマンスに関する詳細が含まれる拡張テーブルを表示するには、列のノード名の横にあるドロップダウン矢印をクリックします。複数のタブを参照すると、、、、、読み込みと書き込みをグラフィカルに表示する、およびの各リストを確認できます。

OSDノード名をクリックすると、テーブルの行が強調表示されます。これは、そのノードでタスクを実行できることを表すものです。以下のアクションのいずれかを選択して実行できます。、、、、、、、、、、、。

ボタン隣のテーブル見出しの左上にある下矢印をクリックし、実行したいタスクを選択します。

4.5.1 OSDの追加 #

新しいOSDを追加するには、次の手順に従います。

ステータスが

使用可能のストレージデバイスを持つクラスタノードが存在することを確認します。テーブル見出しの左上にある下矢印をクリックして、を選択します。これにより、ウィンドウが開きます。図 4.9: OSDの作成 #OSDにプライマリストレージデバイスを追加するには、 をクリックします。ストレージデバイスを追加する前に、テーブルの右上でフィルタ条件を指定する必要があります。たとえば、 など。をクリックして確認します。

図 4.10: プライマリデバイスの追加 #更新されたウィンドウで、必要に応じて共有WALとBDデバイスを追加したり、デバイスの暗号化を有効化したりします。

図 4.11: プライマリデバイスを追加したOSDの作成 #以前追加したデバイスのDriveGroup仕様のプレビューを表示するには、をクリックします。をクリックして確認します。

図 4.12: #OSDのリストに新しいデバイスが追加されます。

図 4.13: 新しく追加されたOSD #注記OSD作成プロセスの進捗を視覚化する機能はありません。実際に作成されるまでには、多少の時間がかかります。OSDは展開が完了すると、リストに表示されます。展開のステータスを確認したい場合は、 › をクリックして、ログを表示します。

4.6 クラスタ設定の表示 #

Cephクラスタ設定オプションの完全なリストを表示するには、 › をクリックします。リストにはオプション名、簡単な説明、現在値とデフォルト値、およびオプションを編集可能かどうかが含まれます。

オプションに関する詳細情報が含まれる拡張テーブルを表示するには、列の設定オプションの隣にあるドロップダウン矢印をクリックします。詳細情報としては、値の種類、最小許容値と最大許容値、実行中に更新可能か、などが含まれます。

特定のオプションを強調表示した後で、テーブル見出しの左上のボタンをクリックして、その値を編集できます。をクリックして変更を確定します。

4.7 CRUSHマップの表示 #

クラスタのCRUSHマップを表示するには、 › をクリックします。CRUSHマップの全般的な情報については、17.5項 「CRUSHマップの操作」を参照してください。

ルート、ノード、または個々のOSDをクリックすると、CRUSHの重み、マップツリー内での深さ、OSDのデバイスクラスなどの詳細情報が表示されます。

4.8 マネージャモジュールの表示 #

使用可能なCeph Managerモジュールのリストを表示するには、 › をクリックします。各行は、モジュール名と、そのモジュールが現在有効かどうかに関する情報で構成されます。

詳細設定を含む拡張テーブルを、下のテーブルに表示するには、列のモジュールの隣にあるドロップダウン矢印をクリックします。設定を編集するには、テーブル見出しの左上のボタンをクリックします。をクリックして変更を確定します。

モジュールをまたはするには、テーブル見出しの左上にあるボタンの隣のドロップダウン矢印をクリックします。

4.9 ログの表示 #

クラスタの最近のログエントリのリストを表示するには、 › をクリックします。各行は、タイムスタンプ、ログエントリのタイプ、およびログに記録されたメッセージ自体で構成されます。

監査サブシステムのログエントリを表示するには、タブをクリックします。監査を有効または無効にするためのコマンドについては、11.5項 「API要求の監査」を参照してください。

4.10 監視の表示 #

Prometheusアラートの詳細の管理と表示を行うには、 › をクリックします。

アクティブなPrometheusが存在するなら、このコンテンツペインの、、またはから詳細な情報を表示できます。

Prometheusが展開されていない場合、表示される情報バナーから関連するドキュメントを表示できます。

5 プールの管理 #

Cephのプールの全般的な情報については、第18章 「ストレージプールの管理」を参照してください。イレージャコーディングプールに固有の情報については、第19章 「イレージャコーディングプール」を参照してください。

利用可能なすべてのプールを一覧にするには、メインメニューからをクリックします。

このリストには、各プールの名前、タイプ、関連するアプリケーション、配置グループのステータス、レプリカサイズ、最後の変更、イレージャコード化済みプロファイル、使用量、Crushルールセット、および読み書きの統計情報が表示されます。

列のプール名の隣にあるドロップダウン矢印をクリックして、プールの詳細情報が含まれる拡張テーブルを表示してください。たとえば、一般的な詳細、パフォーマンスの詳細、設定などが表示されます。

5.1 新しいプールの追加 #

新しいプールを追加するには、プールテーブルの左上のをクリックします。プールフォームには、プール名、タイプ、アプリケーション、圧縮モード、最大バイト数と最大オブジェクト数のクオータを入力できます。この特定のプールに最適な配置グループの数は、プールのフォームそのものによって事前に計算されます。この計算は、クラスタ内のOSDの量、および選択したプールタイプとその特定の設定に基づきます。配置グループ数を手動で設定すると、すぐに計算された数に置き換えられます。をクリックして確認します。

5.2 プールの削除 #

プールを削除するには、そのテーブル行のプールを選択します。ボタンの横にあるドロップダウン矢印をクリックして、をクリックします。

5.3 プールのオプションの編集 #

プールのオプションを編集するには、そのテーブル行を選択してプールテーブルの左上のをクリックします。

プールの名前を変更したり、配置グループの数を増やしたり、プールのアプリケーションのリストや圧縮設定を変更したりできます。をクリックして確認します。

6 RADOS Block Deviceの管理 #

利用可能なすべてのRBD (RADOS Block Devices)を一覧にするには、メインメニューから › をクリックします。

このリストにはデバイスの概要が含まれます。たとえば、デバイス名、関連するプール名、ネームスペース、デバイスのサイズ、デバイスのオブジェクト数とオブジェクトサイズ、デバイスのプロビジョニングの詳細、親などです。

6.1 RBDに関する詳細の表示 #

デバイスに関する詳細情報を表示するには、テーブルでそのデバイスの行をクリックします。

6.2 RBDの設定の表示 #

デバイスの詳細な設定を表示するには、テーブルでそのデバイスの行をクリックし、続いてその下のテーブルでタブをクリックします。

6.3 RBDの作成 #

新しいデバイスを追加するには、テーブル見出しの左上のをクリックして、画面で次の操作を行います。

新しいデバイスの名前を入力します。命名の制限については、Book “導入ガイド”, Chapter 2 “ハードウェア要件と推奨事項”, Section 2.11 “名前の制限”を参照してください。

新しいRBDデバイスの作成元となる、

rbdアプリケーションが割り当てられたプールを選択します。新しいデバイスのサイズを指定します。

デバイスの追加オプションを指定します。デバイスのパラメータを微調整するには、をクリックし、オブジェクトサイズ、ストライプユニット、またはストライプ数の値を入力します。QoS (サービス品質)の制限を入力するには、をクリックし、制限値を入力します。

をクリックして確認します。

6.4 RBDの削除 #

デバイスを削除するには、そのテーブル行を選択します。ボタンの横にあるドロップダウン矢印をクリックして、をクリックします。をクリックして削除を確認します。

RBDの削除は元に戻せないアクションです。代わりにを実行すると、後でメインテーブルのタブでデバイスを選択し、テーブル見出しの左上のをクリックしてデバイスを復元できます。

6.5 RADOS Block Deviceのスナップショットの作成 #

RADOS Block Deviceのスナップショットを作成するには、そのテーブル行を選択してください。設定内容ペインが表示されます。タブを選択し、テーブル見出しの左上にあるをクリックします。スナップショットの名前を入力し、をクリックして確認します。

スナップショットを選択した後で、デバイスの名前の変更、保護、複製、コピー、削除などの追加のアクションを実行できます。は、現在のスナップショットからデバイスの状態を復元します。

6.6 RBDミラーリング #

RADOS Block Deviceイメージを2つのCephクラスタ間で非同期にミラーリングできます。Cephダッシュボードを使用して、2つ以上のクラスタ間でRBDイメージを複製するよう設定できます。この機能には2つのモードがあります。

- ジャーナルベース

このモードは、RBDイメージのジャーナリング機能を使用して、クラスタ間でクラッシュコンシステントなレプリケーションを保証します。

- スナップショットベース

このモードでは、RBDイメージのミラースナップショットを使用して、クラッシュコンシステントなRBDイメージをクラスタ間で複製します。ミラースナップショットはスケジュールに沿って定期的に作成するか、手動で作成します。

ジャーナルベースのミラーリングだけを使用している場合、ミラーリングはピアクラスタ内のプールごとに設定されます。また、プール内の特定のイメージサブセットに設定することや、プール内のすべてのイメージを自動的にミラーリングするように設定することもできます。

ミラーリングは、SUSE Enterprise Storage 7.1にデフォルトでインストールされているrbdコマンドを使用して設定されます。rbd-mirrorデーモンは、リモートのピアクラスタからイメージの更新をプルし、ローカルクラスタ内のイメージに適用します。6.6.2項 「rbd-mirrorデーモンの有効化」デーモンの有効化の詳細については、rbd-mirrorを参照してください。

レプリケーションに対する要望に応じて、RADOS Block Deviceのミラーリングは単方向レプリケーション用または双方向レプリケーション用に設定できます。

- 単方向レプリケーション

データがプライマリクラスタからセカンダリクラスタにミラーリングされるだけであれば、

rbd-mirrorデーモンはセカンダリクラスタ上でのみ実行されます。- 双方向レプリケーション

データが、あるクラスタのプライマリイメージから別のクラスタの非プライマリイメージにミラーリングされる場合(逆も同様)、

rbd-mirrorデーモンは両方のクラスタで実行されます。

rbd-mirrorデーモンの各インスタンスは、ローカルとリモート両方のCephクラスタを同時に接続できなければなりません。たとえば、すべてのMonitorホストとOSDホストを接続できる必要があります。さらに、ミラーリングのワークロードを扱うため、ネットワークの2つのデータセンター間には十分な帯域幅が必要です。

6.6.1 プライマリクラスタとセカンダリクラスタの設定 #

「プライマリ」クラスタは、イメージを含む元のプールが作成される場所です。「セカンダリ」クラスタは、「プライマリ」クラスタからプールやイメージが複製される場所です。

「プライマリ」および「セカンダリ」という用語は、クラスタよりも個々のプールとの関連性が高いため、レプリケーションのコンテキストでは相対的に使用できます。たとえば、双方向レプリケーションにおいて、あるプールを「プライマリ」クラスタから「セカンダリ」クラスタにミラーリングし、別のプールを「セカンダリ」クラスタから「プライマリ」クラスタにミラーリングできます。

6.6.2 rbd-mirrorデーモンの有効化 #

次の手順では、rbdコマンドを使用してミラーリングを設定するための基本的な管理タスクを実行する方法を説明します。ミラーリングは、Cephクラスタ内のプールごとに設定します。

プールの設定手順は、両方のピアクラスタで行う必要があります。これから説明する手順では、わかりやすくするため「プライマリ」および「セカンダリ」という名前の2つのクラスタが1つのホストからアクセス可能であることを想定しています。

rbd-mirrorデーモンは、クラスタデータの実際のレプリケーションを実行します。

ceph.confとキーリングファイルの名前を変更し、プライマリホストからセカンダリホストにコピーします。cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringrbdを使用してプールのミラーリングを有効にするには、mirror pool enable、プール名、ミラーリングモードを指定します。cephuser@adm >rbd mirror pool enable POOL_NAME MODE注記ミラーリングモードは

imageまたはpoolを指定できます。以下に例を示します。cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageCephダッシュボードで › に移動します。左側のテーブルに、アクティブに実行されている

rbd-mirrorデーモンとそのヘルスが表示されます。図 6.6:rbd-mirrorデーモンの実行 #

6.6.3 ミラーリングの無効化 #

rbdを使用してプールのミラーリングを無効化するには、mirror pool disableコマンドとプール名を指定します。

cephuser@adm > rbd mirror pool disable POOL_NAMEこの方法でプールのミラーリングを無効にした場合、ミラーリングを明示的に有効にしたイメージ(プール内)のミラーリングも無効になります。

6.6.4 ピアのブートストラップ処理 #

rbd-mirrorがピアクラスタを発見するためには、ピアをプールに登録し、ユーザアカウントを作成する必要があります。このプロセスはrbdコマンドとともにmirror pool peer bootstrap createコマンドとmirror pool peer bootstrap importコマンドを使用することで自動化できます。

rbdを使用して新しいブートストラップトークンを手動で作成するには、mirror pool peer bootstrap createコマンドとプール名に加えて、ローカルクラスタを記述するためにオプションのサイト名を指定します。

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

mirror pool peer bootstrap createコマンドの出力はトークンです。このトークンをmirror pool peer bootstrap importコマンドに提供する必要があります。たとえば、プライマリクラスタで次のコマンドを実行します。

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \

joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

rbdコマンドを使用して別のクラスタが作成したブートストラップトークンを手動でインポートするには、次の項目を指定します。mirror pool peer bootstrap importコマンド、プール名、作成されたトークンへのファイルパス(標準入力から読み込む場合は「-」)、および、オプションでローカルクラスタとミラーリング方向を記述するサイト名(デフォルトでは双方向ミラーリングを表すrx-txに設定されていますが、単方向ミラーリングを表すrx-onlyにも設定できます)。

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathたとえば、セカンダリクラスタで次のコマンドを実行します。

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW1pcn \ Jvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \ joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 クラスタピアの削除 #

rbdコマンドを使用して、ミラーリングピアCephクラスタを削除するには、mirror pool peer removeコマンド、プール名、ピアのUUIDを指定します(UUIDはrbd mirror pool infoコマンドにより取得できます)。

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Cephダッシュボードによるプールのレプリケーション設定 #

RBDイメージをミラーリングできるようにするには、rbd-mirrorデーモンがプライマリクラスタへのアクセス権を持っている必要があります。作業を始める前に、6.6.4項 「ピアのブートストラップ処理」の手順に従って設定したかを確認してください。

「プライマリ」および「セカンダリ」クラスタの両方で同じ名前のプールを作成し、プールに

rbdアプリケーションを割り当てます。新しいプールの作成の詳細については、5.1項 「新しいプールの追加」を参照してください。図 6.7: RBDアプリケーションを使用したプールの作成 #「プライマリ」および「セカンダリ」クラスタの両方のダッシュボードで、 › に移動します。右側のテーブルで、複製するプールの名前をクリックし、をクリックした後で、レプリケーションモードを選択します。この例では、「プール」レプリケーションモードを使用します。つまり、指定したプール内のすべてのイメージが複製されます。をクリックして確認します。

図 6.8: レプリケーションモードの設定 #重要: プライマリクラスタでのエラーまたは警告レプリケーションモードを更新すると、対応する右側の列にエラーまたは警告フラグが表示されます。これは、まだプールにレプリケーション用のピアユーザが割り当てられていないためです。ピアユーザは「セカンダリ」クラスタにのみ割り当てるので、「プライマリ」クラスタではこのフラグは無視してください。

「セカンダリ」クラスタのダッシュボードで、 › に移動します。を選択してプールミラーピアを追加します。「プライマリ」クラスタの詳細を指定します。

図 6.9: ピア資格情報の追加 #プライマリクラスタを識別する任意の固有の文字列(「primary」など)。このクラスタ名は、実際のセカンダリクラスタの名前とは異なる必要があります。

ミラーリングピアとして作成したCephユーザID。この例では、「rbd-mirror-peer」です。

プライマリクラスタのCeph MonitorノードのIPアドレスをカンマ区切りリスト。

ピアユーザIDに関連したキー。このキーを取得するには、プライマリクラスタで次のサンプルコマンドを実行します。

cephuser@adm >ceph auth print_key pool-mirror-peer-name

をクリックして確認します。

図 6.10: 複製されたプールのリスト #

6.6.7 RBDイメージレプリケーションが機能することの確認 #

rbd-mirrorデーモンが実行されていて、CephダッシュボードでRBDイメージレプリケーションが設定されている場合、ここで、レプリケーションが実際に機能するかどうかを確認します。

「プライマリ」クラスタのCephダッシュボードで、RBDイメージを作成し、その親プールが、レプリケーション用にすでに作成済みのプールになるようにします。イメージに対して[

排他ロック]機能と[ジャーナリング]機能を有効にします。RBDイメージの作成方法の詳細については、6.3項 「RBDの作成」を参照してください。図 6.11: 新しいRBDイメージ #複製するイメージを作成した後で、「セカンダリ」クラスタのCephダッシュボードを開き、 › に移動します。右側のテーブルは、イメージの数の変更を反映し、イメージの数を同期します。

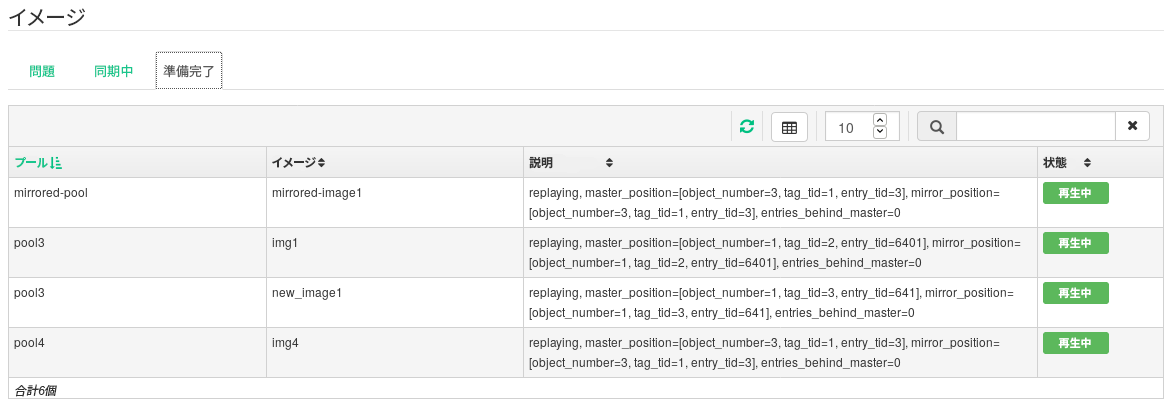

図 6.12: 新しいRBDイメージの同期 #ヒント: レプリケーションの進行状況ページ下部のテーブルには、RBDイメージのレプリケーションのステータスが表示されます。タブには、考えられる問題が含まれており、タブには、イメージのレプリケーションの進行状況が表示され、タブには、レプリケーションが正常に完了したすべてのイメージが一覧にされます。

図 6.13: RBDイメージのレプリケーションステータス #「プライマリ」クラスタで、データをRBDイメージに書き込みます。「セカンダリ」クラスタのCephダッシュボードで、 › に移動して、プライマリクラスタのデータが書き込まれるにつれて、対応するイメージのサイズが大きくなっているかどうかを監視します。

6.7 iSCSI Gatewayの管理 #

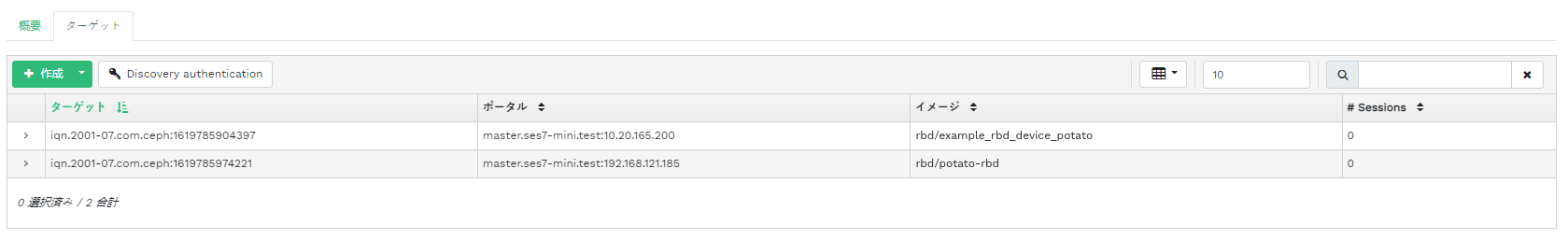

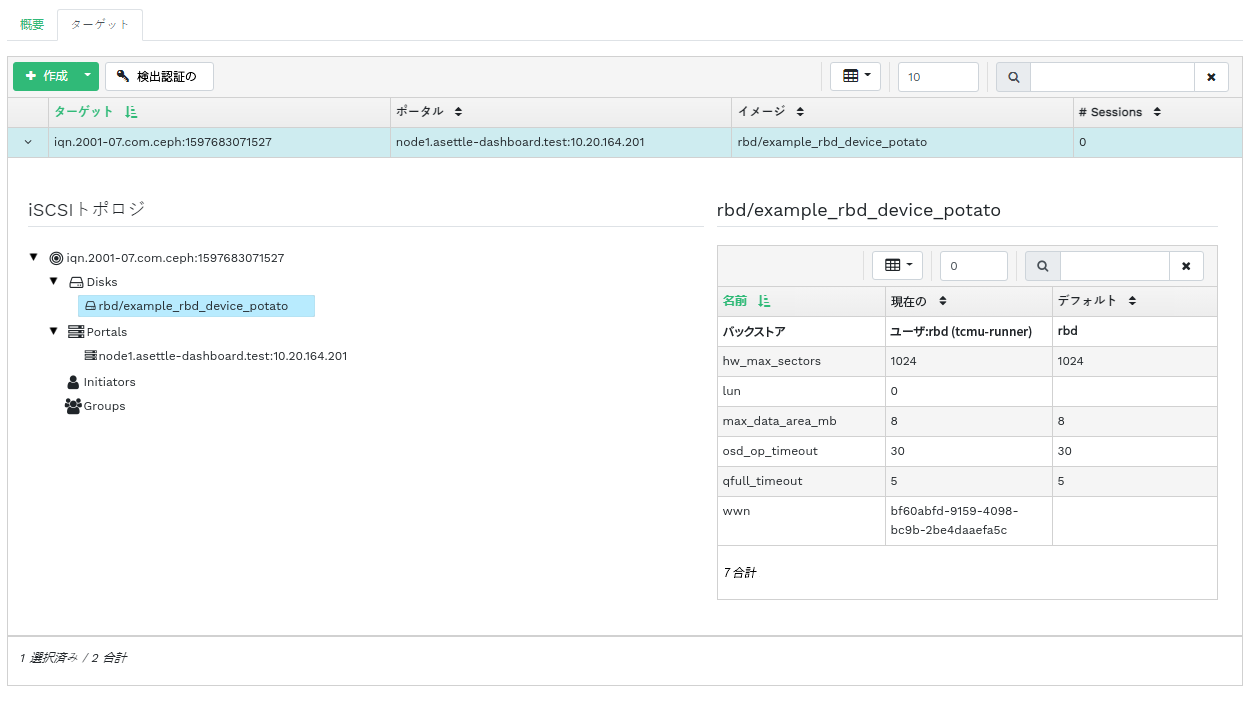

利用可能なすべてのゲートウェイとマップ済みイメージを一覧にするには、メインメニューから › をクリックします。タブを開くと、現在設定されているiSCSI Gatewayとマップ済みのRBDイメージが一覧にされます。

テーブルには、各ゲートウェイの状態、iSCSIターゲットの数、およびセッションの数が一覧にされます。テーブルには、各マップ済みイメージの名前、関連するプール名のバックストアタイプ、および他の統計情報の詳細が一覧にされます。

タブには、現在設定されているiSCSIターゲットが一覧にされます。

ターゲットのより詳細な情報を表示するには、そのテーブル行のドロップダウン矢印をクリックしてください。ツリー構造のスキーマが開き、ディスク、ポータル、イニシエータ、およびグループが一覧にされます。項目をクリックして展開し、その詳細コンテンツを表示します。オプションで右側の表に関連する設定が表示されます。

6.7.1 iSCSIターゲットの追加 #

新しいiSCSIターゲットを追加するには、テーブルの左上のをクリックして、必要な情報を入力します。

新しいゲートウェイのターゲットアドレスを入力します。

をクリックして、リストから1つまたは複数のiSCSIポータルを選択します。

をクリックして、ゲートウェイのRBDイメージを1つまたは複数選択します。

認証を使用してゲートウェイにアクセスする必要がある場合は、チェックボックスをオンにして資格情報を入力します。およびを有効にすると、より高度な認証オプションが表示されます。

をクリックして確認します。

6.7.2 iSCSIターゲットの編集 #

既存のiSCSIターゲットを編集するには、テーブルでその行をクリックし、テーブルの左上のをクリックします。

その後、iSCSIターゲットの追加、ポータルの追加または削除、および関連するRBDイメージの追加または削除を行うことができます。ゲートウェイの認証情報を調整することもできます。

6.7.3 iSCSIターゲットの削除 #

iSCSIターゲットを削除するには、テーブル行を選択してからボタンの隣にあるドロップダウン矢印をクリックして、を選択します。を有効にして、をクリックして確認します。

6.8 RBD QoS (サービス品質) #

QoSオプションは次の複数のレベルで設定できます。

グローバル

プールごと

イメージごと

「グローバル」の設定はリストの一番上にあり、新しく作成されたすべてのRBDイメージと、プールまたはRBDイメージ層でこれらの値を上書きしないイメージに使用されます。グローバルに指定されたオプション値をプールごとまたはイメージごとに上書きできます。プールに対して指定されたオプションは、そのプールのすべてのRBDイメージに適用されます。ただし、イメージに対して設定された設定オプションが優先される場合を除きます。イメージに対して指定されたオプションは、プールに対して指定されたオプションを上書きし、グローバルに指定されたオプションを上書きします。

このようにして、デフォルトをグローバルに定義して、特定のプールのすべてのRBDイメージに適合させ、個々のRBDイメージのプール設定を上書きできます。

6.8.1 オプションのグローバルな設定 #

RADOS Block Deviceをグローバルに設定するには、メインメニューから › を選択してください。

の横に、すべての利用可能なグローバル設定オプションを一覧にするには、ドロップダウンメニューからを選択します。

検索フィールドで

rbd_qosをフィルタリングして、テーブルの結果をフィルタします。これにより、QoSで使用可能なすべての設定オプションが一覧にされます。値を変更するには、テーブルでその行をクリックし、テーブルの左上のを選択します。ダイアログには、値を指定するための6つの異なるフィールドが含まれます。テキストボックスには、RBD設定オプションの値を入力する必要があります。

注記他のダイアログとは異なり、このダイアログでは接頭辞付きの単位で値を指定できません。編集するオプションによっては、バイトまたはIOPSのいずれかでこれらの値を設定する必要があります。

6.8.2 新しいプールでのオプションの設定 #

新しいプールを作成し、そのプールにRBD設定オプションを設定するには、 › をクリックします。プールタイプとしてを選択します。RBD QoSオプションを設定できるようにするには、プールにrbdアプリケーションタグを追加する必要があります。

イレージャコーディングプールにRBD QoS設定オプションを設定することはできません。イレージャコーディングプールにRBD QoSオプションを設定するには、RBDイメージの複製されたメタデータプールを編集する必要があります。これにより、そのイメージのイレージャコーディングデータプールに設定が適用されます。

6.8.3 既存のプールでのオプションの設定 #

既存のプールにRBD QoSオプションを設定するには、をクリックし、プールのテーブル行をクリックして、テーブルの左上のを選択します。

ダイアログにセクションが表示され、その後にセクションが表示されます。

セクションもセクションも表示されない場合は、RBD設定オプションの設定に使用できない「イレージャコーディング」プールを編集しているか、RBDイメージで使用するようにプールが設定されていない可能性があります。後者の場合は、アプリケーションタグをプールに割り当てます。これにより、対応する設定セクションが表示されます。

6.8.4 設定オプション #

設定オプションを展開するには、をクリックします。使用可能なすべてのオプションのリストが表示されます。設定オプションの単位は、テキストボックスにすでに表示されています。BPS (1秒あたりのバイト数)オプションの場合は、「1M」や「5G」などのショートカットを自由に使用できます。これらはそれぞれ自動的に「1 MB/秒」と「5 GB/秒」に変換されます。

各テキストボックスの右にあるリセットボタンをクリックすると、プールに設定されている値が削除されます。グローバルに設定されたオプションやRBDイメージに設定されたオプションの設定値は削除されません。

6.8.5 新しいRBDイメージを使用したRBD QoSオプションの作成 #

イメージにRBD QoSオプションが設定された状態でRBDイメージを作成するには、 › を選択し、をクリックします。詳細設定セクションを展開するには、をクリックします。使用可能なすべての設定オプションを開くには、をクリックします。

6.8.6 既存のイメージでのRBD QoSの編集 #

既存のイメージでRBD QoSオプションを編集するには、 › を選択し、プールのテーブル行をクリックして、最後にをクリックします。編集ダイアログが表示されます。詳細設定セクションを展開するには、をクリックします。使用可能なすべての設定オプションを開くには、をクリックします。

6.8.7 イメージをコピーまたは複製する際の設定オプションの変更 #

RBDイメージを複製またはコピーする場合、デフォルトでは、その特定のイメージに設定された値もコピーされます。コピーまたは複製時にRBDイメージを変更する場合は、RBDイメージを作成または編集する場合と同様に、コピー/複製ダイアログで、更新された設定値を指定できます。この場合、コピーまたは複製するRBDイメージの値のみが設定(またはリセット)されます。この操作では、ソースRBDイメージの設定もグローバル設定も変更されません。

コピー/複製時にオプションの値をリセットすることを選択した場合、そのオプションの値は、そのイメージに設定されません。つまり、親プールに値が設定されている場合、親プールに指定されたそのオプションの値が使用されます。親プールに値が設定されていない場合は、グローバルなデフォルトが使用されます。

7 NFS Ganeshaの管理 #

NFS Ganeshaは、NFSバージョン4.1以降をサポートしています。NFSバージョン3はサポートしていません。

利用可能なすべてのNFSエクスポートを一覧にするには、メインメニューからをクリックします。

各エクスポートのディレクトリ、デーモンのホスト名、ストレージバックエンドのタイプ、およびアクセスタイプがリストに表示されます。

NFSエクスポートの詳細情報を表示するには、そのテーブル行をクリックします。

7.1 NFSエクスポートの作成 #

新しいNFSエクスポートを追加するには、エクスポートテーブルの左上にあるをクリックして、必要な情報を入力します。

エクスポートを実行するNFS Ganeshaデーモンを1つ以上選択します。

ストレージのバックエンドを選択します。

重要現時点でサポートされているのは、CephFSにより支援されているNFSエクスポートだけです。

ユーザIDと、その他のバックエンド関連オプションを選択します。

NFSエクスポートのディレクトリパスを入力します。指定したディレクトリがサーバ上に存在しない場合、新しく作成されます。

他のNFS関連オプションを指定します。たとえば、サポートされるNFSプロトコルのバージョン、疑似、アクセスタイプ、スカッシュ、トランスポートプロトコルなどです。

アクセスを特定のクライアントだけに制限する必要がある場合、をクリックして、クライアントのIPアドレスと共に、アクセスタイプと(ルート権限無効化オプションを指定します。

をクリックして確認します。

7.2 NFSエクスポートの削除 #

エクスポートを削除するには、そのテーブル行でエクスポートを選択して強調表示します。ボタンの横にあるドロップダウン矢印をクリックして、を選択します。チェックボックスをオンにし、をクリックして確認します。

7.3 NFSエクスポートの編集 #

既存のエクスポートを編集するには、そのテーブル行でエクスポートを選択して強調表示し、エクスポートテーブルの左上にあるをクリックします。

その後、NFSエクスポートのすべての詳細を調整できます。

8 CephFSの管理 #

8.1 CephFSの概要の表示 #

設定されているファイルシステムの概要を表示するには、メインメニューからをクリックします。メインテーブルには、各ファイルシステムの名前、作成日、および有効かどうか表示されます。

ファイルシステムのテーブル行をクリックすると、そのランクと、ファイルシステムに追加されたプールの詳細が表示されます。

画面の下部に、関連するMDS iノードとクライアント要求の数をリアルタイムで収集した統計情報カウントが表示されます。

9 Object Gatewayの管理 #

Cephダッシュボード上でObject Gatewayのフロントエンドにアクセスしようとすると、次の通知が表示される場合があります。

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

これは、cephadmによるObject GatewayのCephダッシュボード向け自動設定が行われていないためです。この通知が表示された場合、10.4項 「Object Gateway管理フロントエンドの有効化」の手順に従って、Object GatewayのCephダッシュボード用フロントエンドを手動で有効化してください。

9.1 Object Gatewayの表示 #

設定されているObject Gatewayのリストを表示するには、 › をクリックします。このリストには、ゲートウェイのID、ゲートウェイデーモンが実行されているクラスタノードのホスト名、およびゲートウェイのバージョン番号が含まれます。

ゲートウェイの詳細情報を表示するには、ゲートウェイ名の横にあるドロップダウン矢印をクリックします。タブには、読み込み/書き込み操作とキャッシュ統計情報の詳細が表示されます。

9.2 Object Gatewayユーザの管理 #

既存のObject Gatewayユーザのリストを表示するには、 › をクリックします。

ユーザアカウントの詳細を表示するには、ユーザ名の横にあるドロップダウン矢印をクリックします。表示される情報は、ステータス情報やユーザとバケットクォータの詳細などです。

9.2.1 新しいゲートウェイユーザの追加 #

新しいゲートウェイユーザを追加するには、テーブル見出しの左上のをクリックします。資格情報、S3キー、ユーザとバケットクォータの詳細を入力し、をクリックして確認します。

9.2.2 ゲートウェイユーザの削除 #

ゲートウェイユーザを削除するには、ユーザを選択して強調表示します。の横のドロップダウンボタンをクリックし、リストからを選択してユーザアカウントを削除します。チェックボックスをオンにし、をクリックして確認します。

9.2.3 ゲートウェイユーザの詳細の編集 #

ゲートウェイユーザの詳細を変更するには、ユーザを選択して強調表示します。テーブル見出しの左上にあるをクリックします。

機能、キー、サブユーザ、クォータ情報など、基本または追加のユーザ情報を変更します。をクリックして確認します。

タブには、ゲートウェイユーザ、およびそのアクセスキーと秘密鍵の読み込み専用リストが含まれます。キーを表示するには、リストでユーザ名をクリックし、テーブル見出しの左上のを選択します。ダイアログで、「目」のアイコンをクリックしてキーを表示するか、クリップボードアイコンをクリックして関連するキーをクリップボードにコピーします。

9.3 Object Gatewayバケットの管理 #

OGW (Object Gateway)バケットは、OpenStack Swiftコンテナの機能を実装しています。Object Gatewayバケットは、データオブジェクトを保存するためのコンテナとして機能します。

› をクリックして、オブジェクトゲートウェイバケットのリストを表示します。

9.3.1 新しいバケットの追加 #

新しいオブジェクトゲートウェイバケットを追加するには、テーブル見出しの左上のをクリックします。バケット名を入力し、所有者を選択し、配置ターゲットを設定します。をクリックして確認します。

9.3.2 バケットの詳細の表示 #

Object Gatewayバケットの詳細情報を表示するには、バケット名の隣にあるドロップダウン矢印をクリックします。

テーブルの下で、バケットクォータとロック設定の詳細を確認できます。

9.3.3 バケットの編集 #

バケットを選択して強調表示してから、テーブル見出しの左上にあるをクリックします。

バケットの所有者の更新と、バージョニング、多要素認証、ロックの有効化ができます。変更後、をクリックして確認します。

9.3.4 バケットの削除 #

Object Gatewayバケットを削除するには、バケットを選択して強調表示します。の横のドロップダウンボタンをクリックし、リストからを選択してバケットを削除します。チェックボックスをオンにし、をクリックして確認します。

10 手動設定 #

このセクションでは、コマンドラインでダッシュボードを手動で設定したいユーザ向けの詳細情報を紹介します。

10.1 TLS/SSLサポートの設定 #

ダッシュボードとのすべてのHTTP接続は、デフォルトでTLS/SSLによって保護されています。セキュア接続にはSSL証明書が必要です。自己署名証明書を使用することも、証明書を生成して既知のCA (認証局)で署名することもできます。

特定の理由がある場合、SSLのサポートを無効にできます。たとえば、SSLをサポートしないプロキシの後方でダッシュボードを実行する場合などです。

SSLを無効にする場合は注意してください。「ユーザ名とパスワード」は「暗号化されずに」ダッシュボードに送信されます。

SSLを無効にするには、次のコマンドを実行します。

cephuser@adm > ceph config set mgr mgr/dashboard/ssl falseSSL証明書とキーを変更した後で、Ceph Managerプロセスを手動で再起動する必要があります。このためには、次のコマンドを実行します。

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAMEまたは、ダッシュボードモジュールを無効化して再度有効化することもできます。この場合、マネージャが自身を再起動します。

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 自己署名証明書の作成 #

セキュア通信用の自己署名証明書の作成は簡単です。これにより、ダッシュボードの実行を高速化できます。

ほとんどのWebブラウザでは、自己署名証明書を使用すると警告が表示され、ダッシュボードへのセキュアな接続を確立するには明示的に確認する必要があります。

自己署名証明書を生成してインストールするには、次の組み込みコマンドを使用します。

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 CA署名証明書の使用 #

ダッシュボードへの接続を適切に保護し、Webブラウザで自己署名証明書に関する警告が表示されないようにするため、CAによって署名された証明書を使用することをお勧めします。

次のようなコマンドを使用して証明書キーペアを生成できます。

# openssl req -new -nodes -x509 \

-subj "/O=IT/CN=ceph-mgr-dashboard" -days 3650 \

-keyout dashboard.key -out dashboard.crt -extensions v3_ca

上のコマンドは、dashboard.keyファイルとdashboard.crtファイルを出力します。dashboard.crtファイルがCAによって署名されたら、次のコマンドを実行して、すべてのCeph Managerインスタンスに対してその証明書を有効にします。

cephuser@adm >ceph dashboard set-ssl-certificate -i dashboard.crtcephuser@adm >ceph dashboard set-ssl-certificate-key -i dashboard.key

Ceph Managerの各インスタンスに対して異なる証明書が必要な場合は、次のようにコマンドを変更してインスタンスの名前を含めます。NAMEは、Ceph Managerインスタンスの名前(通常は関連するホスト名)で置き換えます。

cephuser@adm >ceph dashboard set-ssl-certificate NAME -i dashboard.crtcephuser@adm >ceph dashboard set-ssl-certificate-key NAME -i dashboard.key

10.2 ホスト名とポート番号の変更 #

Cephダッシュボードは特定のTCP/IPアドレスとTCPポートにバインドされます。デフォルトでは、ダッシュボードをホストする現在アクティブなCeph Managerは、TCPポート8443 (SSLが無効な場合は8080)にバインドされます。

Ceph Manager(および、Cephダッシュボード)を実行しているホストでファイアウォールが有効化されている場合、ポートにアクセスできるように設定変更が必要な場合があります。Ceph向けファイアウォール設定の詳細については、Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”を参照してください。

Cephダッシュボードは、デフォルトで「::」にバインドされます。これは、使用可能なすべてのIPv4およびIPv6アドレスに対応します。次のコマンドを使用すると、すべてのCeph Managerインスタンスに適用されるようにWebアプリケーションのIPアドレスとポート番号を変更できます。

cephuser@adm >ceph config set mgr mgr/dashboard/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/server_port PORT_NUMBER

各ceph-mgrデーモンは専用のダッシュボードインスタンスをホストするため、インスタンスを個別に設定しなければならない場合があります。次のコマンドを使用して、特定のマネージャインスタンスのIPアドレスとポート番号を変更します(NAMEをceph-mgrのIDで置き換えます)。

cephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_port PORT_NUMBER

ceph mgr servicesコマンドは、現在設定されているすべてのエンドポイントを表示します。dashboardキーを検索して、ダッシュボードにアクセスするためのURLを取得します。

10.3 ユーザ名とパスワードの調整 #

デフォルトの管理者アカウントを使用しない場合は、別のユーザアカウントを作成して、それを少なくとも1つの役割に関連付けます。事前定義済みの一連のシステム役割が用意されており、これらの役割を使用できます。詳細については、第11章 「コマンドラインによるユーザと役割の管理」を参照してください。

管理者特権を持つユーザを作成するには、次のコマンドを使用します。

cephuser@adm > ceph dashboard ac-user-create USER_NAME PASSWORD administrator10.4 Object Gateway管理フロントエンドの有効化 #

ダッシュボードのObject Gateway管理機能を使用するには、systemフラグが有効なユーザのログインアカウント情報を指定する必要があります。

systemフラグが設定されたユーザがいない場合は、作成します。cephuser@adm >radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --systemコマンドが出力するaccess_keyとsecret_keyを記録します。

radosgw-adminコマンドを使用して、既存のユーザの資格情報を取得することもできます。cephuser@adm >radosgw-admin user info --uid=USER_ID受信した資格情報を別のファイルでダッシュボードに提供します。

cephuser@adm >ceph dashboard set-rgw-api-access-key ACCESS_KEY_FILEcephuser@adm >ceph dashboard set-rgw-api-secret-key SECRET_KEY_FILE

SUSE Linux Enterprise Server 15 SP3では、デフォルトでファイアウォールが有効です。ファイアウォール設定の詳細については、Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”を参照してください。

考慮すべき点がいくつかあります。

Object Gatewayのホスト名とポート番号は自動的に決定されます。

複数のゾーンを使用している場合、マスタゾーングループとマスタゾーン内のホストは自動的に決定されます。ほとんどのセットアップではこれで十分ですが、状況によってはホスト名とポートを手動で設定したい場合があります。

cephuser@adm >ceph dashboard set-rgw-api-host HOSTcephuser@adm >ceph dashboard set-rgw-api-port PORT次の追加設定が必要になる場合があります。

cephuser@adm >ceph dashboard set-rgw-api-scheme SCHEME # http or httpscephuser@adm >ceph dashboard set-rgw-api-admin-resource ADMIN_RESOURCEcephuser@adm >ceph dashboard set-rgw-api-user-id USER_IDObject Gatewayのセットアップで自己署名証明書(10.1項 「TLS/SSLサポートの設定」)を使用している場合は、不明なCAによって署名された証明書、またはホスト名が一致しないことによって接続が拒否されないようにするため、ダッシュボードで証明書の検証を無効にします。

cephuser@adm >ceph dashboard set-rgw-api-ssl-verify FalseObject Gatewayで要求の処理に時間がかかりすぎて、ダッシュボードがタイムアウトする場合は、タイムアウト値を調整できます(デフォルトは45秒)。

cephuser@adm >ceph dashboard set-rest-requests-timeout SECONDS

10.5 iSCSI管理の有効化 #

Cephダッシュボードは、iSCSIターゲットを管理します。これには、Ceph iSCSIゲートウェイのrbd-target-apiサービスが提供するREST APIを使用します。REST APIがインストール済みで、iSCSIゲートウェイ上で有効化されていることを確認します。

CephダッシュボードのiSCSI管理機能は、ceph-iscsiプロジェクトの最新版であるバージョン3に依存しています。使用しているオペレーティングシステムが適切なバージョンであることを確認してください。さもなければ、CephダッシュボードはiSCSI管理機能を使用できません。

ceph-iscsi REST APIがHTTPSモードに設定されており、自己署名証明書を使用している場合、ceph-iscsi APIにアクセスした際のSSL証明書の検証を回避するようにダッシュボードを設定します。

API SSL検証を無効化します。

cephuser@adm > ceph dashboard set-iscsi-api-ssl-verification false利用可能なiSCSIゲートウェイを定義します。

cephuser@adm >ceph dashboard iscsi-gateway-listcephuser@adm >ceph dashboard iscsi-gateway-add scheme://username:password@host[:port]cephuser@adm >ceph dashboard iscsi-gateway-rm gateway_name

10.6 Single Sign-Onを有効にする #

SSO (「シングルサインオン」)は、ユーザが複数のアプリケーションに1つのIDとパスワードで同時にログインできるアクセス制御方法です。

Cephダッシュボードは、SAML 2.0プロトコルを介したユーザの外部認証をサポートしています。「権限付与」は引き続きダッシュボードによって実行されるため、まずユーザアカウントを作成し、それを目的の役割に関連付ける必要があります。ただし、「認証」プロセスは、既存のIdP (「Identity Provider」)によって実行できます。

シングルサインオンを設定するには、次のコマンドを使用します。

cephuser@adm > ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL \

IDP_METADATA IDP_USERNAME_ATTRIBUTE \

IDP_ENTITY_ID SP_X_509_CERT \

SP_PRIVATE_KEYパラメータは次の通りです。

- CEPH_DASHBOARD_BASE_URL

Cephダッシュボードにアクセス可能なベースURL(たとえば、「https://cephdashboard.local」)。

- IDP_METADATA

IdPメタデータXMLのURL、ファイルパス、または内容(たとえば、「https://myidp/metadata」)。

- IDP_USERNAME_ATTRIBUTE

オプション。認証応答からユーザ名を取得するために使用される属性。デフォルトは「uid」。

- IDP_ENTITY_ID

オプション。IdPメタデータに複数のエンティティIDが存在する場合に使用します。

- SP_X_509_CERT / SP_PRIVATE_KEY

オプション。署名と暗号化のためにCephダッシュボード(サービスプロバイダ)によって使用される証明書のファイルパスまたは内容。これらのファイルパスは、アクティブなCeph Managerインスタンスからアクセスできる必要があります。

SAML要求の発行者の値は次のパターンに従います。

CEPH_DASHBOARD_BASE_URL/auth/saml2/metadata

SAML 2.0の現在の設定を表示するには、次のコマンドを実行します。

cephuser@adm > ceph dashboard sso show saml2シングルサインオンを無効にするには、次のコマンドを実行します。

cephuser@adm > ceph dashboard sso disableSSOが有効かどうかを確認するには、次のコマンドを実行します。

cephuser@adm > ceph dashboard sso statusSSOを有効にするには、次のコマンドを実行します。

cephuser@adm > ceph dashboard sso enable saml211 コマンドラインによるユーザと役割の管理 #

このセクションでは、Cephダッシュボードによって使用されるユーザアカウントを管理する方法について説明します。これは、ユーザアカウントを作成または変更する場合や、適切なユーザ役割と許可を設定する場合に役立ちます。

11.1 パスワードポリシーの管理 #

デフォルトでは、次のチェックを含むパスワードポリシー機能が有効になっています。

パスワードはN文字より長いか。

古いパスワードと新しいパスワードは同じか。

次のコマンドにより、パスワードポリシー機能全体をON/OFFに切り替えることができます。

cephuser@adm > ceph dashboard set-pwd-policy-enabled true|false次のチェック項目を個別にON/OFFに切り替えることも可能です。

cephuser@adm >ceph dashboard set-pwd-policy-check-length-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-oldpwd-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-username-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-exclusion-list-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-complexity-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-sequential-chars-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-repetitive-chars-enabled true|false

また、パスワードポリシーの動作設定に次のオプションを利用できます。

最小のパスワード長(デフォルトは8文字)。

cephuser@adm >ceph dashboard set-pwd-policy-min-length N最低限のパスワードの複雑さ(デフォルトは10)。

cephuser@adm >ceph dashboard set-pwd-policy-min-complexity Nパスワードの複雑さは、パスワードに含まれる各文字を分類することで算出されます。

パスワードに使用できない単語をカンマで区切ったリスト。

cephuser@adm >ceph dashboard set-pwd-policy-exclusion-list word[,...]

11.2 ユーザアカウントの管理 #

Cephダッシュボードは、複数のユーザアカウントの管理をサポートしています。各ユーザアカウントは、ユーザ名、パスワード(bcryptを使用して暗号化された形式で保存)、オプションの名前、およびオプションの電子メールアドレスで構成されます。

ユーザアカウントはCeph Monitorの設定データベースに保存され、すべてのCeph Managerインスタンス間でグローバルに共有されます。

ユーザアカウントを管理するには、次のコマンドを使用します。

- 既存のユーザの表示

cephuser@adm >ceph dashboard ac-user-show [USERNAME]- 新しいユーザの作成

cephuser@adm >ceph dashboard ac-user-create USERNAME -i [PASSWORD_FILE] [ROLENAME] [NAME] [EMAIL]- ユーザの削除

cephuser@adm >ceph dashboard ac-user-delete USERNAME- ユーザのパスワードの変更

cephuser@adm >ceph dashboard ac-user-set-password USERNAME -i PASSWORD_FILE- ユーザの名前と電子メールの変更

cephuser@adm >ceph dashboard ac-user-set-info USERNAME NAME EMAIL- ユーザの無効化

cephuser@adm >ceph dashboard ac-user-disable USERNAME- ユーザの有効化

cephuser@adm >ceph dashboard ac-user-enable USERNAME

11.3 ユーザの役割と許可 #

このセクションでは、ユーザの役割に割り当てることができるセキュリティスコープ、ユーザの役割を管理する方法、およびユーザの役割をユーザアカウントに割り当てる方法について説明します。

11.3.1 セキュリティスコープの定義 #

ユーザアカウントは、ユーザがダッシュボードのどの部分にアクセスできるかを定義する一連の役割に関連付けられます。ダッシュボードの各部分は、「セキュリティ」スコープ内でグループ化されます。セキュリティスコープは事前定義されていて静的です。現在のところ、次のセキュリティスコープを使用できます。

- hosts

メニューエントリに関連するすべての機能が含まれます。

- config-opt

Ceph設定オプションの管理に関連するすべての機能が含まれます。

- pool

プールの管理に関連するすべての機能が含まれます。

- osd

Ceph OSDの管理に関連するすべての機能が含まれます。

- monitor

Ceph Monitorの管理に関連するすべての機能が含まれます。

- rbd-image

RADOS Block Deviceイメージの管理に関連するすべての機能が含まれます。

- rbd-mirroring

RADOS Block Deviceのミラーリングの管理に関連するすべての機能が含まれます。

- iscsi

iSCSIの管理に関連するすべての機能が含まれます。

- rgw

Object Gatewayの管理に関連するすべての機能が含まれます。

- cephfs

CephFSの管理に関連するすべての機能が含まれます。

- manager (マネージャ)

Ceph Managerの管理に関連するすべての機能が含まれます。

- log

Cephのログの管理に関連するすべての機能が含まれます。

- grafana

Grafanaプロキシに関連するすべての機能が含まれます。

- prometheus

Prometheusアラート管理に関連するすべての機能が含まれます。

- dashboard-settings

ダッシュボードの設定を変更できます。

11.3.2 ユーザの役割の指定 #

「役割」は、「セキュリティスコープ」と一連の「許可」との間の一連のマッピングを指定するものです。許可には、「read」、「create」、「update」、および「delete」の4つのタイプがあります。

次の例では、ユーザがプールの管理に関連する機能に対して「read」許可と「create」許可を持ち、RBDイメージの管理に関連する機能に対して完全な許可を持つ役割を指定します。

{

'role': 'my_new_role',

'description': 'My new role',

'scopes_permissions': {

'pool': ['read', 'create'],

'rbd-image': ['read', 'create', 'update', 'delete']

}

}ダッシュボードには、「システム役割」と呼ばれる、事前定義済みの一連の役割があらかじめ用意されています。これらの役割は、Cephダッシュボードを新規インストールした後ですぐに使用できます。

- 管理者

すべてのセキュリティスコープに対する完全な許可を提供します。

- 読み込み専用

ダッシュボード設定を除くすべてのセキュリティスコープの読み込み許可を提供します。

- block-manager

「rbd-image」、「rbd-mirroring」、および「iscsi」のスコープに対する完全な許可を提供します。

- rgw-manager

「rgw」スコープに対する完全な許可を提供します。

- cluster-manager

「hosts」、「osd」、「monitor」、「manager」、および「config-opt」のスコープに対する完全な許可を提供します。

- pool-manager

「pool」スコープに対する完全な許可を提供します。

- cephfs-manager

「cephfs」スコープに対する完全な許可を提供します。

11.3.2.1 カスタム役割の管理 #

次のコマンドを使用して、新しいユーザの役割を作成できます。

- 新規ロール(役割)を作成します:

cephuser@adm >ceph dashboard ac-role-create ROLENAME [DESCRIPTION]- 役割の削除:

cephuser@adm >ceph dashboard ac-role-delete ROLENAME- 役割へのスコープ許可の追加

cephuser@adm >ceph dashboard ac-role-add-scope-perms ROLENAME SCOPENAME PERMISSION [PERMISSION...]- 役割からのスコープ許可の削除

cephuser@adm >ceph dashboard ac-role-del-perms ROLENAME SCOPENAME

11.3.2.2 ユーザアカウントへの役割の割り当て #

役割をユーザに割り当てるには、次のコマンドを使用します。

- ユーザの役割の設定

cephuser@adm >ceph dashboard ac-user-set-roles USERNAME ROLENAME [ROLENAME ...]- ユーザへの追加の役割の追加

cephuser@adm >ceph dashboard ac-user-add-roles USERNAME ROLENAME [ROLENAME ...]- ユーザからの役割の削除

cephuser@adm >ceph dashboard ac-user-del-roles USERNAME ROLENAME [ROLENAME ...]

カスタム役割を作成し、後でceph.purgeランナを使ってCephクラスタを削除する場合、まずカスタム役割を消去する必要があります。詳細については、13.9項 「Cephクラスタ全体の削除」を参照してください。

11.3.2.3 例: ユーザとカスタム役割の作成 #

このセクションでは、RBDイメージの管理、Cephプールの表示と作成、および他のスコープへの読み込み専用アクセスを行うことができるユーザアカウントの作成手順について説明します。

tuxという名前の新しいユーザを作成します。cephuser@adm >ceph dashboard ac-user-create tux PASSWORD役割を作成し、スコープ許可を指定します。

cephuser@adm >ceph dashboard ac-role-create rbd/pool-managercephuser@adm >ceph dashboard ac-role-add-scope-perms rbd/pool-manager \ rbd-image read create update deletecephuser@adm >ceph dashboard ac-role-add-scope-perms rbd/pool-manager pool read create役割を

tuxユーザに関連付けます。cephuser@adm >ceph dashboard ac-user-set-roles tux rbd/pool-manager read-only

11.4 プロキシ設定 #

Cephダッシュボードへの固定URLを定めたい場合や、管理ノードへの直接接続を許可したくない場合は、プロキシを設定できます。このプロキシは受け取った要求現在をアクティブなceph-mgrインスタンスへ自動的に転送します。

11.4.1 リバースプロキシによるダッシュボードへのアクセス #

リバースプロキシ設定を使用してダッシュボードにアクセスしている場合は、URLプレフィックスを使用してダッシュボードを提供しなければならないことがあります。ダッシュボードがプレフィックスを含むハイパーリンクを使用できるようにするには、url_prefix設定を設定できます。

cephuser@adm > ceph config set mgr mgr/dashboard/url_prefix URL_PREFIX

これにより、http://HOST_NAME:PORT_NUMBER/URL_PREFIX/でダッシュボードにアクセスできます。

11.4.2 リダイレクションの無効化 #

CephダッシュボードがHAProxyのようなロードバランシングプロキシの背後にある場合、リダイレクション動作を無効化することで、内部URL(解決できないURL)がフロントエンドのクライアントに公開されないようにします。次のコマンドを使用することで、ダッシュボードがアクティブなダッシュボードへリダイレクトするのではなく、HTTPエラー(デフォルトでは500)を返すようになります。

cephuser@adm > ceph config set mgr mgr/dashboard/standby_behaviour "error"デフォルトのリダイレクション動作に設定をリセットするには、次のコマンドを使用します。

cephuser@adm > ceph config set mgr mgr/dashboard/standby_behaviour "redirect"11.4.3 エラーステータスコードの設定 #

リダイレクション動作を無効化する場合、スタンバイダッシュボードのHTTPステータスコードをカスタマイズする必要があります。そのためには、次のコマンドを実行します。

cephuser@adm > ceph config set mgr mgr/dashboard/standby_error_status_code 50311.4.4 HAProxyの設定例 #

以下に示す設定は、HAProxyを使用したTLS/SSLパススルーの例です。

この設定が効果を発揮する状況は次の通りです。ダッシュボードがフェールオーバーした際に、フロントエンドのクライアントはHTTPリダイレクト応答(303)を受け取る可能性があります。この場合、クライアントは解決不能ホストにリダイレクトされてしまいます。

このような状況は、HAProxyの2つのヘルスチェック中にフェールオーバーが発生した場合に生じます。これは、それまでアクティブだったダッシュボードが、新しいアクティブノードをリダイレクト先とする303エラーで応答してしまうためです。このような状況を避けるため、スタンバイノードのリダイレクション動作を無効化することを検討する必要があります。

defaults

log global

option log-health-checks

timeout connect 5s

timeout client 50s

timeout server 450s

frontend dashboard_front

mode http

bind *:80

option httplog

redirect scheme https code 301 if !{ ssl_fc }

frontend dashboard_front_ssl

mode tcp

bind *:443

option tcplog

default_backend dashboard_back_ssl

backend dashboard_back_ssl

mode tcp

option httpchk GET /

http-check expect status 200

server x HOST:PORT ssl check verify none

server y HOST:PORT ssl check verify none

server z HOST:PORT ssl check verify none11.5 API要求の監査 #

CephダッシュボードのREST APIは、PUT、POST、およびDELETEの各要求をCeph監査ログに記録できます。ログはデフォルトでは無効ですが、次のコマンドで有効にできます。

cephuser@adm > ceph dashboard set-audit-api-enabled trueログが有効な場合、要求ごとに次のパラメータがログに記録されます。

- from

「https://[::1]:44410」などの要求の発信元。

- path

/api/authなどのREST APIパス。- method

「PUT」、「POST」、または「DELETE」。

- user

ユーザの名前(または「None」)。

次に、ログエントリの例を示します。

2019-02-06 10:33:01.302514 mgr.x [INF] [DASHBOARD] \

from='https://[::ffff:127.0.0.1]:37022' path='/api/rgw/user/exu' method='PUT' \

user='admin' params='{"max_buckets": "1000", "display_name": "Example User", "uid": "exu", "suspended": "0", "email": "user@example.com"}'要求ペイロード(引数とその値のリスト)のログは、デフォルトで有効になっています。これは、次のコマンドを使用して無効にできます。

cephuser@adm > ceph dashboard set-audit-api-log-payload false11.6 CephダッシュボードによるNFS Ganeshaの設定 #

Cephダッシュボードは、CephFSまたはObject Gatewayをバックストアとして使用するNFS Ganeshaエクスポートを管理できます。ダッシュボードはCephFSクラスタのRADOSオブジェクトに保存されたNFS Ganeshaの設定ファイルを管理します。NFS Ganeshaは設定の一部をCephクラスタに保存する必要があります。

NFS Ganeshaの設定オブジェクトの場所を設定するには、次のコマンドを実行します。

cephuser@adm > ceph dashboard set-ganesha-clusters-rados-pool-namespace pool_name[/namespace]これで、Cephダッシュボードを使用してNFS Ganeshaのエクスポートを管理できます。

11.6.1 複数のNFS Ganeshaクラスタの設定 #

Cephダッシュボードは、異なるNFS Ganeshaクラスタに属するNFS Ganeshaエクスポートの管理をサポートしています。各NFS Ganeshaクラスタの設定オブジェクトを異なるRADOSプール/ネームスペースに保存することをお勧めします。これは、設定を互いに分離するためです。

各NFS Ganeshaクラスタの設定の場所を指定するには、次のコマンドを使用します。

cephuser@adm > ceph dashboard set-ganesha-clusters-rados-pool-namespace cluster_id:pool_name[/namespace](,cluster_id:pool_name[/namespace])*Cluster_idは任意の文字列で、NFS Ganeshaクラスタを一意に識別します。

Cephダッシュボードと複数のNFS Ganeshaクラスタを設定した場合、エクスポートがどのクラスタに属しているかをWeb UIによって自動的に選択できるようになります。

11.7 デバッグ用プラグイン #

Cephダッシュボードのプラグインはダッシュボードの機能を拡張します。デバッグプラグインを使用すると、デバッグモードによってダッシュボードの動作をカスタマイズできるようになります。次のコマンドによって、デバッグモードの有効化、無効化、確認ができます。

cephuser@adm >ceph dashboard debug status Debug: 'disabled'cephuser@adm >ceph dashboard debug enable Debug: 'enabled'cephuser@adm >dashboard debug disable Debug: 'disabled'

デフォルトでは、この機能は無効です。このモードは運用環境の展開に推奨される設定です。必要に応じて、再起動せずにデバッグモードを有効化できます。

パート II クラスタの運用 #

- 12 クラスタの状態の判断

実行中のクラスタがある場合、

cephツールを使用して監視できます。一般的に、クラスタの状態の判断には、Ceph OSD、Ceph Monitor、配置グループ、およびメタデータサーバのステータスを確認します。- 13 運用タスク

既存のCephクラスタの設定を変更するには、次の手順に従います。

- 14 Cephサービスの運用

Cephサービスは、デーモンレベル、ノードレベル、またはクラスタレベルで運用できます。必要なアプローチに応じて、cephadmか

systemctlコマンドを使用してください。- 15 バックアップおよび復元

この章では、Cephクラスタの機能を復元できるようにするには、クラスタのどの部分をバックアップする必要があるかについて説明します。

- 16 監視とアラート

SUSE Enterprise Storage 7.1では、cephadmが監視スタックとアラートスタックを展開します。ユーザはcephadmを使用して展開したいサービス(Prometheus、Alertmanager、Grafanaなど)をYAML設定ファイルで指定する必要がありますが、CLIを使用してサービスを展開することもできます。同じ種類のサービスが複数展開される場合は、高可用性セットアップが展開されます。ノードエクスポータはこのルールの例外です。

12 クラスタの状態の判断 #

実行中のクラスタがある場合、cephツールを使用して監視できます。一般的に、クラスタの状態の判断には、Ceph OSD、Ceph Monitor、配置グループ、およびメタデータサーバのステータスを確認します。

cephツールをインタラクティブモードで実行するには、コマンドラインで引数を付けずに「ceph」と入力します。インタラクティブモードは、1行に多くのcephコマンドを入力する場合に便利です。例:

cephuser@adm > ceph

ceph> health

ceph> status

ceph> quorum_status

ceph> mon stat12.1 クラスタの状態の確認 #

ceph statusかceph -sを使用して、クラスタの直近の状態を確認できます。

cephuser@adm > ceph -s

cluster:

id: b4b30c6e-9681-11ea-ac39-525400d7702d

health: HEALTH_OK

services:

mon: 5 daemons, quorum ses-min1,ses-master,ses-min2,ses-min4,ses-min3 (age 2m)

mgr: ses-min1.gpijpm(active, since 3d), standbys: ses-min2.oopvyh

mds: my_cephfs:1 {0=my_cephfs.ses-min1.oterul=up:active}

osd: 3 osds: 3 up (since 3d), 3 in (since 11d)

rgw: 2 daemons active (myrealm.myzone.ses-min1.kwwazo, myrealm.myzone.ses-min2.jngabw)

task status:

scrub status:

mds.my_cephfs.ses-min1.oterul: idle

data:

pools: 7 pools, 169 pgs

objects: 250 objects, 10 KiB

usage: 3.1 GiB used, 27 GiB / 30 GiB avail

pgs: 169 active+clean出力に表示される情報は、次のとおりです。

クラスタID

クラスタのヘルス状態

Monitorマップのエポック、およびMonitor定数の状態

Monitorマップのエポック、およびOSDの状態

Ceph Managerのステータス

Object Gatewayのステータス

配置グループのマップバージョン

配置グループとプールの数

保存データの「名目上」の量と、保存オブジェクトの数

保存データの合計量

usedの値は、未加工ストレージの実際の使用量を反映します。xxx GB / xxx GBの値は、クラスタの全体的なストレージ容量の利用可能な量(より少ない数)を意味します。名目上の数は、複製、クローン作成、またはスナップショット作成前の保存データのサイズを反映します。したがって、実際の保存データの量は名目上の量より大きくなるのが一般的です。Cephは、データのレプリカを作成し、クローンやスナップショットの作成にもストレージ容量を使用することがあるためです。

直近の状態を表示するその他のコマンドは次のとおりです。

ceph pg statceph osd pool statsceph dfceph df detail

リアルタイムに更新された情報を取得するには、次のコマンドのいずれか(ceph -sを含む)をwatchコマンドの引数として実行します。

# watch -n 10 'ceph -s'監視を終了する場合は、Ctrl–Cキーを押します。

12.2 クラスタのヘルスの確認 #

クラスタの起動後、データの読み込みや書き込みを開始する前に、クラスタのヘルスを確認します。

cephuser@adm > ceph health

HEALTH_WARN 10 pgs degraded; 100 pgs stuck unclean; 1 mons down, quorum 0,2 \

node-1,node-2,node-3設定またはキーリングにデフォルト以外の場所を指定した場合、その場所を指定できます。

cephuser@adm > ceph -c /path/to/conf -k /path/to/keyring healthCephクラスタは、次のいずれかのヘルスコードを返します。

- OSD_DOWN

1つ以上のOSDにダウン状態を示すマークが付いています。OSDデーモンが停止されているか、ピアOSDがネットワーク経由でOSDに接続できない可能性があります。一般的な原因として、デーモンの停止またはクラッシュ、ホストのダウン、ネットワークの停止などがあります。

ホストが正常である場合、デーモンは起動していて、ネットワークは機能しています。デーモンがクラッシュした場合は、そのデーモンのログファイル(

/var/log/ceph/ceph-osd.*)にデバッグ情報が記述されていることがあります。- OSD_crush type_DOWN (例: OSD_HOST_DOWN)

特定のCRUSHサブツリー内のすべてのOSD (たとえば、特定のホスト上のすべてのOSD)にダウン状態を示すマークが付いています。

- OSD_ORPHAN

OSDがCRUSHマップ階層で参照されていますが、存在しません。次のコマンドを使用して、OSDをCRUSH階層から削除できます。

cephuser@adm >ceph osd crush rm osd.ID- OSD_OUT_OF_ORDER_FULL

「backfillfull」(デフォルトは0.90)、「nearfull」(デフォルトは0.85)、「full」(デフォルトは0.95)、または「failsafe_full」、あるいはこれらすべての使用量のしきい値が昇順になっていません。特に、backfillfull < nearfull、nearfull < full、full < failsafe_fullとなっている必要があります。

現在の値を読み込むには、次のコマンドを実行します。

cephuser@adm >ceph health detail HEALTH_ERR 1 full osd(s); 1 backfillfull osd(s); 1 nearfull osd(s) osd.3 is full at 97% osd.4 is backfill full at 91% osd.2 is near full at 87%次のコマンドを使用してしきい値を調整できます。

cephuser@adm >ceph osd set-backfillfull-ratio ratiocephuser@adm >ceph osd set-nearfull-ratio ratiocephuser@adm >ceph osd set-full-ratio ratio- OSD_FULL

1つ以上のOSDがfullのしきい値を超えており、クラスタは書き込みを実行できません。次のコマンドを使用して、プールごとの使用量を確認できます。

cephuser@adm >ceph df次のコマンドを使用して、現在定義されているfullの比率を確認できます。

cephuser@adm >ceph osd dump | grep full_ratio書き込み可用性を復元するための短期的な回避策は、fullのしきい値を少し高くすることです。

cephuser@adm >ceph osd set-full-ratio ratioさらにOSDを展開してクラスタに新しいストレージを追加するか、既存のデータを削除して領域を解放します。

- OSD_BACKFILLFULL

1つ以上のOSDがbackfillfullのしきい値を超えており、データをこのデバイスにリバランスできません。これは、リバランスを完了できないこと、およびクラスタが満杯に近付いていることを示す早期警告です。次のコマンドを使用して、プールごとの使用量を確認できます。

cephuser@adm >ceph df- OSD_NEARFULL

1つ以上のOSDがnearfullのしきい値を超えています。これは、クラスタが満杯に近付いていることを示す早期警告です。次のコマンドを使用して、プールごとの使用量を確認できます。

cephuser@adm >ceph df- OSDMAP_FLAGS

関心のあるクラスタフラグが1つ以上設定されています。「full」を除き、これらのフラグは次のコマンドを使用して設定またはクリアできます。

cephuser@adm >ceph osd set flagcephuser@adm >ceph osd unset flag次のようなフラグがあります。

- full

クラスタにfullのフラグが付いており、書き込みを実行できません。

- pauserd、pausewr

読み込みまたは書き込みを一時停止しました。

- noup

OSDの起動が許可されていません。

- nodown

OSD障害レポートが無視されているため、MonitorはOSDに「down」のマークを付けません。

- noin

以前に「out」のマークが付けられているOSDには、起動時に「in」のマークは付けられません。

- noout

設定した間隔が経過した後、「down」状態のOSDに自動的に「out」のマークは付けられません。

- nobackfill、norecover、norebalance

回復またはデータリバランスは中断されます。

- noscrub、nodeep_scrub

スクラブ(17.6項 「配置グループのスクラブ」を参照)は無効化されます。

- notieragent

キャッシュ階層化アクティビティは中断されます。

- OSD_FLAGS

1つ以上のOSDに、関心のあるOSDごとのフラグが付いています。次のようなフラグがあります。

- noup

OSDの起動が許可されていません。

- nodown

このOSD障害レポートは無視されます。

- noin

障害後に、このOSDにすでに自動的に「out」のマークが付けられている場合、起動時に「in」のマークは付けられません。

- noout

このOSDがダウンしている場合、設定した間隔が経過した後に自動的に「out」のマークは付けられません。

次のコマンドを使用して、OSDごとのフラグを設定およびクリアできます。

cephuser@adm >ceph osd add-flag osd-IDcephuser@adm >ceph osd rm-flag osd-ID- OLD_CRUSH_TUNABLES

CRUSHマップは非常に古い設定を使用しており、更新する必要があります。このヘルス警告をトリガさせることなく使用できる最も古い調整可能パラメータ(すなわち、クラスタに接続できる最も古いクライアントバージョン)は、

mon_crush_min_required_version設定オプションで指定します。- OLD_CRUSH_STRAW_CALC_VERSION

CRUSHマップは、strawバケットの中間重み値の計算に、最適ではない古い手法を使用しています。新しい手法を使用するようCRUSHマップを更新する必要があります(

straw_calc_version=1)。- CACHE_POOL_NO_HIT_SET

使用量を追跡するためのヒットセットが1つ以上のキャッシュプールに設定されておらず、階層化エージェントはキャッシュからフラッシュまたは削除するコールドオブジェクトを識別できません。次のコマンドを使用して、キャッシュプールにヒットセットを設定できます。

cephuser@adm >ceph osd pool set poolname hit_set_type typecephuser@adm >ceph osd pool set poolname hit_set_period period-in-secondscephuser@adm >ceph osd pool set poolname hit_set_count number-of-hitsetscephuser@adm >ceph osd pool set poolname hit_set_fpp target-false-positive-rate- OSD_NO_SORTBITWISE

Luminous v12より前のOSDは実行されていませんが、

sortbitwiseフラグが付いていません。Luminous v12以上のOSDを起動する前に、sortbitwiseフラグを設定する必要があります。cephuser@adm >ceph osd set sortbitwise- POOL_FULL

1つ以上のプールがクォータに達しており、書き込みをこれ以上許可していません。次のコマンドを使用して、プールのクォータと使用量を設定できます。

cephuser@adm >ceph df detail次のコマンドを使用して、プールのクォータを増加できます。

cephuser@adm >ceph osd pool set-quota poolname max_objects num-objectscephuser@adm >ceph osd pool set-quota poolname max_bytes num-bytesまたは、既存のデータを削除して使用量を削減できます。

- PG_AVAILABILITY

データ可用性が低下しています。つまり、クラスタは、クラスタ内の一部のデータに対する潜在的な読み込みまたは書き込み要求を実行できません。具体的には、1つ以上のPGがI/O要求の実行を許可していない状態です。問題があるPGの状態には、「peering」、「stale」、「incomplete」、および「active」の欠如などがあります(これらの状態がすぐにはクリアされない場合)。影響を受けるPGについての詳しい情報は、次のコマンドを使用して参照できます。

cephuser@adm >ceph health detailほとんどの場合、根本原因は、現在1つ以上のOSDがダウンしていることです。次のコマンドを使用して、問題がある特定のPGの状態を問い合わせることができます。

cephuser@adm >ceph tell pgid query- PG_DEGRADED

一部のデータのデータ冗長性が低下しています。つまり、一部のデータについて必要な数のレプリカがクラスタにないか(複製プールの場合)、イレージャコードのフラグメントがクラスタにありません(イレージャコーディングプールの場合)。具体的には、1つ以上のPGに「degraded」または「undersized」のフラグが付いているか(クラスタ内にその配置グループの十分なインスタンスがありません)、またはしばらくの間「clean」フラグが付いていません。影響を受けるPGについての詳しい情報は、次のコマンドを使用して参照できます。

cephuser@adm >ceph health detailほとんどの場合、根本原因は、現在1つ以上のOSDがダウンしていることです。次のコマンドを使用して、問題がある特定のPGの状態を問い合わせることができます。

cephuser@adm >ceph tell pgid query- PG_DEGRADED_FULL

クラスタに空き領域がないため、一部のデータのデータ冗長性が低下しているか、危険な状態である可能性があります。具体的には、1つ以上のPGに「backfill_toofull」または「recovery_toofull」のフラグが付いています。つまり、1つ以上のOSDがbackfillfullのしきい値を超えているため、クラスタはデータを移行または回復できません。

- PG_DAMAGED

データスクラブ(17.6項 「配置グループのスクラブ」を参照)によってクラスタのデータ整合性に問題が検出されました。具体的には、1つ以上のPGに「inconsistent」または「snaptrim_error」のフラグが付いています。これは、前のスクラブ操作で問題が見つかったか、「repair」フラグが設定されていることを示しており、現在その不整合の修復が進行中であることを意味します。

- OSD_SCRUB_ERRORS

最近のOSDスクラブで不整合が発見されました。

- CACHE_POOL_NEAR_FULL

キャッシュ層プールがほぼ満杯です。このコンテキストにおける「満杯」は、キャッシュプールの「target_max_bytes」および「target_max_objects」のプロパティによって判断されます。プールがターゲットしきい値に達した場合、データがキャッシュからフラッシュまたは削除される間、プールへの書き込み要求がブロックされることがあり、通常はレイテンシが非常に高くなり、パフォーマンスが低下する状態になります。次のコマンドを使用して、キャッシュプールのターゲットサイズを調整できます。

cephuser@adm >ceph osd pool set cache-pool-name target_max_bytes bytescephuser@adm >ceph osd pool set cache-pool-name target_max_objects objects通常のキャッシュフラッシュおよび削除アクティビティは、基本層の可用性またはパフォーマンスの低下、あるいはクラスタ全体の負荷によっても低速になることがあります。

- TOO_FEW_PGS

使用中のPGの数が、設定可能なしきい値である、OSDあたりの

mon_pg_warn_min_per_osdのPG数未満です。このため、クラスタ内のOSDへのデータの分散とバランスが最適ではなくなり、全体的なパフォーマンスが低下します。- TOO_MANY_PGS

使用中のPGの数が、設定可能なしきい値である、OSDあたりの

mon_pg_warn_max_per_osdのPG数を超えています。このため、OSDデーモンのメモリ使用量が増加する、クラスタの状態が変化(たとえば、OSDの再起動、追加、削除)した後にピアリングの速度が低下する、Ceph ManagerとCeph Monitorの負荷が増加するなどの可能性があります。既存のプールの

pg_num値を減らすことはできませんが、pgp_num値を減らすことは可能です。これによって、同じOSDセットの複数のPGを効果的に一緒に配置して、前に説明した悪影響を多少緩和できます。次のコマンドを使用して、pgp_numの値を調整できます。cephuser@adm >ceph osd pool set pool pgp_num value- SMALLER_PGP_NUM

1つ以上のプールの

pgp_numの値がpg_num未満です。これは通常、配置動作を同時に増やさずにPG数を増やしたことを示します。通常は、次のコマンドを使用して、pgp_numをpg_numに一致するよう設定し、データマイグレーションをトリガすることによって解決します。cephuser@adm >ceph osd pool set pool pgp_num pg_num_value- MANY_OBJECTS_PER_PG

1つ以上のプールで、PGあたりの平均オブジェクト数がクラスタの全体の平均を大幅に超過しています。具体的なしきい値は、

mon_pg_warn_max_object_skewの設定値で制御します。これは通常、クラスタ内のほとんどのデータを含むプールのPGが少なすぎるか、それほど多くのデータを含まない他のプールのPGが多すぎるか、またはその両方であることを示します。Monitorのmon_pg_warn_max_object_skew設定オプションを調整することによって、しきい値を上げてヘルス警告を停止できます。- POOL_APP_NOT_ENABLED

1つ以上のオブジェクトが含まれるプールが存在しますが、特定のアプリケーション用のタグが付けられていません。この警告を解決するには、プールにアプリケーション用のラベルを付けます。たとえば、プールがRBDによって使用される場合は、次のコマンドを実行します。

cephuser@adm >rbd pool init pool_nameプールがカスタムアプリケーション「foo」によって使用されている場合、次の低レベルのコマンドを使用してラベルを付けることもできます。

cephuser@adm >ceph osd pool application enable foo- POOL_FULL

1つ以上のプールがクォータに達しています(またはクォータに非常に近付いています)。このエラー条件をトリガするためのしきい値は、

mon_pool_quota_crit_threshold設定オプションで制御します。次のコマンドを使用して、プールクォータを増減(または削除)できます。cephuser@adm >ceph osd pool set-quota pool max_bytes bytescephuser@adm >ceph osd pool set-quota pool max_objects objectsクォータの値を0に設定すると、クォータは無効になります。

- POOL_NEAR_FULL

1つ以上のプールがクォータに近付いています。この警告条件をトリガするためのしきい値は、

mon_pool_quota_warn_threshold設定オプションで制御します。次のコマンドを使用して、プールクォータを増減(または削除)できます。cephuser@adm >ceph osd osd pool set-quota pool max_bytes bytescephuser@adm >ceph osd osd pool set-quota pool max_objects objectsクォータの値を0に設定すると、クォータは無効になります。

- OBJECT_MISPLACED

クラスタ内の1つ以上のオブジェクトが、クラスタで保存場所に指定されているノードに保存されていません。これは、クラスタに最近加えられた変更によって発生したデータマイグレーションがまだ完了していないことを示します。データの誤配置そのものは危険な状態ではありません。データ整合性は危険な状態ではなく、必要な数の新しいコピーが(必要な場所に)存在する限り、オブジェクトの古いコピーが削除されることはありません。

- OBJECT_UNFOUND

クラスタ内の1つ以上のオブジェクトが見つかりません。具体的には、OSDはオブジェクトの新しいコピーまたは更新されたコピーが存在していることを認識していますが、現在動作しているOSD上にオブジェクトのそのバージョンのコピーが見つかりません。「見つからない」オブジェクトに対する読み込みまたは書き込み要求はブロックされます。検出されなかったオブジェクトの最新のコピーがある、ダウンしているOSDを稼働状態に戻すのが理想的です。見つからないオブジェクトを受け持っているPGのピアリング状態から、候補のOSDを特定できます。

cephuser@adm >ceph tell pgid query- REQUEST_SLOW

OSDの1つ以上の要求の処理に長い時間がかかっています。これは、極端な負荷、低速なストレージデバイス、またはソフトウェアのバグを示している可能性があります。OSDホストから次のコマンドを実行して、対象のOSDの要求キューを問い合わせることができます。

cephuser@adm >cephadm enter --name osd.ID -- ceph daemon osd.ID ops最も低速な最近の要求のサマリが表示されます。

cephuser@adm >cephadm enter --name osd.ID -- ceph daemon osd.ID dump_historic_ops次のコマンドを使用して、OSDの場所を特定できます。

cephuser@adm >ceph osd find osd.id- REQUEST_STUCK

1つ以上のOSD要求が比較的長時間ブロックされています(たとえば、4096秒)。これは、クラスタが長時間にわたって正常でないか(たとえば、十分な数のOSDが実行されていないか、PGが非アクティブ)、OSDに何らかの内部的な問題があることを示します。

- PG_NOT_SCRUBBED

最近、1つ以上のPGがスクラブ(17.6項 「配置グループのスクラブ」を参照)されていません。PGは通常、

mon_scrub_intervalの秒数ごとにスクラブされ、スクラブなしにmon_warn_not_scrubbedの間隔が経過した場合、この警告がトリガされます。cleanフラグが付いていない場合、PGはスクラブされません。これは、PGが誤配置されているか機能が低下している場合に発生することがあります(前のPG_AVAILABILITYおよびPG_DEGRADEDを参照してください)。次のコマンドを使用して、クリーンなPGのスクラブを手動で開始できます。cephuser@adm >ceph pg scrub pgid- PG_NOT_DEEP_SCRUBBED

最近、1つ以上のPGが詳細スクラブ(17.6項 「配置グループのスクラブ」を参照)されていません。PGは通常、

osd_deep_mon_scrub_intervalの秒数ごとにスクラブされ、スクラブなしにmon_warn_not_deep_scrubbed秒が経過した場合、この警告がトリガされます。cleanフラグが付いていない場合、PGは詳細スクラブされません。これは、PGが誤配置されているか機能が低下している場合に発生することがあります(前のPG_AVAILABILITYおよびPG_DEGRADEDを参照してください)。次のコマンドを使用して、クリーンなPGのスクラブを手動で開始できます。cephuser@adm >ceph pg deep-scrub pgid

設定またはキーリングにデフォルト以外の場所を指定した場合、その場所を指定できます。

# ceph -c /path/to/conf -k /path/to/keyring health12.3 クラスタの使用量統計の確認 #

クラスタのデータ使用量とプール間での分散を確認するには、ceph dfコマンドを使用します。詳細を取得するには、ceph df detailを使用します。

cephuser@adm > ceph df

--- RAW STORAGE ---

CLASS SIZE AVAIL USED RAW USED %RAW USED

hdd 30 GiB 27 GiB 121 MiB 3.1 GiB 10.40

TOTAL 30 GiB 27 GiB 121 MiB 3.1 GiB 10.40

--- POOLS ---

POOL ID STORED OBJECTS USED %USED MAX AVAIL

device_health_metrics 1 0 B 0 0 B 0 8.5 GiB

cephfs.my_cephfs.meta 2 1.0 MiB 22 4.5 MiB 0.02 8.5 GiB

cephfs.my_cephfs.data 3 0 B 0 0 B 0 8.5 GiB

.rgw.root 4 1.9 KiB 13 2.2 MiB 0 8.5 GiB

myzone.rgw.log 5 3.4 KiB 207 6 MiB 0.02 8.5 GiB

myzone.rgw.control 6 0 B 8 0 B 0 8.5 GiB

myzone.rgw.meta 7 0 B 0 0 B 0 8.5 GiB

出力のRAW STORAGEセクションには、クラスタがデータに使用しているストレージの量の概要が表示されます。

CLASS: デバイスのストレージクラス。デバイスクラスの詳細については、17.1.1項 「デバイスクラス」を参照してください。SIZE: クラスタの全体的なストレージ容量。AVAIL: クラスタで利用可能な空き領域の量。USED: ブロックデバイスに保持されている、純粋にデータオブジェクト用として割り当てられている領域(すべてのOSDの累積)。RAW USED: 「USED」領域と、Ceph用としてブロックデバイスで割り当て/予約されている領域(BlueStoreのBlueFSの部分など)。% RAW USED: 使用済みの未加工ストレージの割合。この数字をfull ratioおよびnear full ratioと組み合わせて使用して、クラスタの容量に達していないことを確認します。詳細については、12.8項 「ストレージの容量」を参照してください。注記: クラスタの充足レベル未加工ストレージの充足レベルが100%に近付いている場合は、クラスタに新しいストレージを追加する必要があります。使用量がさらに多くなると、1つのOSDが満杯になり、クラスタのヘルスに問題が発生することがあります。

すべてのOSDの充足レベルを一覧にするには、コマンド

ceph osd df treeを使用します。

出力のPOOLSセクションには、プールのリストと各プールの名目上の使用量が表示されます。このセクションの出力には、レプリカ、クローン、またはスナップショットは反映されて「いません」。たとえば、1MBのデータを持つオブジェクトを保存した場合、名目上の使用量は1MBですが、実際の使用量は、レプリカ、クローン、およびスナップショットの数によっては2MB以上になることがあります。

POOL: プールの名前。ID: プールのID。STORED: ユーザが保存したデータの量。OBJECTS: プールごとの保存オブジェクトの名目上の数。USED: すべてのOSDノードによって純粋にデータ用として割り当てられている領域の量(KB単位)。%USED: プールごとの使用済みストレージの名目上の割合。MAX AVAIL: 特定のプールで利用可能な最大領域。

POOLSセクションの数字は名目上の数字です。レプリカ、スナップショット、またはクローンの数は含まれません。そのため、USEDの量や%USEDの量を合計しても、出力のRAW STORAGEセクションのRAW USEDの量や%RAW USEDの量にはなりません。

12.4 OSDの状態の確認 #

次のコマンドを実行して、OSDが動作中であることを確認します。

cephuser@adm > ceph osd statあるいは、

cephuser@adm > ceph osd dumpCRUSHマップ内での位置に従ってOSDを表示することもできます。

ceph osd treeコマンドを実行すると、CRUSHツリーと共に、ホスト、そのOSD、動作中かどうか、および重みが出力されます。

cephuser@adm > ceph osd tree

ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 3 0.02939 root default

-3 3 0.00980 rack mainrack

-2 3 0.00980 host osd-host

0 1 0.00980 osd.0 up 1.00000 1.00000

1 1 0.00980 osd.1 up 1.00000 1.00000

2 1 0.00980 osd.2 up 1.00000 1.0000012.5 満杯のOSDの確認 #

Cephでは、データが失われないようにするため、満杯のOSDに書き込むことはできません。運用クラスタでは、クラスタが満杯率に近付くと警告が表示されます。mon osd full ratioのデフォルトは0.95です。すなわち、容量の95%に達すると、クライアントによるデータの書き込みが停止されます。mon osd nearfull ratioのデフォルトは0.85です。すなわち、容量の85%に達するとヘルス警告が生成されます。

満杯のOSDノードはceph healthでレポートされます。

cephuser@adm > ceph health

HEALTH_WARN 1 nearfull osds

osd.2 is near full at 85%あるいは、

cephuser@adm > ceph health

HEALTH_ERR 1 nearfull osds, 1 full osds

osd.2 is near full at 85%

osd.3 is full at 97%満杯のクラスタへの最適な対応方法は、新しいOSDホスト/ディスクを追加して、クラスタが新しく利用可能になったストレージにデータを再分散できるようにする方法です。

OSDが満杯になると(ディスク領域の100%を使用すると)、通常は警告なしにすぐにクラッシュします。次に、OSDノードを管理する際に覚えておくべきヒントをいくつか示します。

各OSDのディスク領域(通常は

/var/lib/ceph/osd/osd-{1,2..}にマウント)は、基礎となる専用のディスクまたはパーティションに配置する必要があります。Ceph設定ファイルを確認して、CephがOSD専用のディスク/パーティションにログファイルを保存しないようにします。

他のプロセスがOSD専用のディスク/パーティションに書き込まないようにします。

12.6 Monitorの状態の確認 #

クラスタの起動後、最初にデータを読み書きする前に、Ceph Monitorの定数のステータスを確認します。クラスタがすでに要求を処理している場合は、Ceph Monitorのステータスを定期的に確認して、それらが実行されていることを確認します。

Monitorマップを表示するには、次のコマンドを実行します。

cephuser@adm > ceph mon statあるいは、

cephuser@adm > ceph mon dumpMonitorクラスタの定数の状態を確認するには、次のコマンドを実行します。

cephuser@adm > ceph quorum_status定数の状態が返されます。たとえば、3つのMonitorで構成されるCephクラスタは、次の状態を返す場合があります。

{ "election_epoch": 10,

"quorum": [

0,

1,

2],

"monmap": { "epoch": 1,

"fsid": "444b489c-4f16-4b75-83f0-cb8097468898",

"modified": "2011-12-12 13:28:27.505520",

"created": "2011-12-12 13:28:27.505520",

"mons": [

{ "rank": 0,

"name": "a",

"addr": "192.168.1.10:6789\/0"},

{ "rank": 1,

"name": "b",

"addr": "192.168.1.11:6789\/0"},

{ "rank": 2,

"name": "c",

"addr": "192.168.1.12:6789\/0"}

]

}

}12.7 配置グループの状態の確認 #

配置グループはオブジェクトをOSDにマップします。配置グループを監視する場合、配置グループがactiveおよびcleanである必要があります。詳細については、12.9項 「OSDと配置グループの監視」を参照してください。

12.8 ストレージの容量 #

Cephストレージクラスタがその最大容量に近付くと、Cephは、データ損失を防止するための安全対策として、Ceph OSDに対して書き込みや読み込みを行えないようにします。したがって、運用クラスタをその満杯率に近付けることは、高可用性が犠牲になるため、適切な方法ではありません。デフォルトの満杯率は0.95、つまり容量の95%に設定されています。これは、OSDの数が少ないテストクラスタでは非常に積極的な設定です。

クラスタを監視する際には、nearfullの比率に関連する警告に注意してください。これは、1つ以上のOSDに障害が発生している場合に、複数のOSDに障害が発生すると、サービスが一時的に中断する可能性があることを意味します。OSDを追加してストレージ容量を増やすことを検討してください。

テストクラスタの一般的なシナリオには、システム管理者がCephストレージクラスタからCeph OSDを1つ削除して、クラスタの再バランスを監視することが含まれます。次に、別のCeph OSDを削除し、最終的にクラスタが満杯率に達してロックするまで削除を続けます。テストクラスタでも、何らかの容量計画を立てることをお勧めします。計画を立てることにより、高可用性を維持するために必要なスペア容量を見積もることができます。理想的には、Ceph OSDに一連の障害が発生した場合に、これらのCeph OSDをすぐに交換しなくてもクラスタがactive + cleanの状態に回復できるような計画を立てます。active + degradedの状態でクラスタを実行することはできますが、これは通常の動作条件には適しません。

次の図は、ホストあたり1つのCeph OSDが存在する33個のCephノードで構成されるシンプルなCephストレージクラスタを表していて、各ノードは3TBドライブに対して読み書きを行います。この例で使用するクラスタの実際の最大容量は99TBです。mon osd full ratioオプションは0.95に設定されています。クラスタの残り容量が5TBまで低下すると、クライアントはデータを読み書きできなくなります。したがって、このストレージクラスタの動作容量は、99TBではなく95TBです。

このようなクラスタで、1つまたは2つのOSDに障害が発生することはよくあります。それほど頻繁ではないものの妥当なシナリオとして、ラックのルータまたは電源装置に障害が発生して、同時に複数のOSD (OSD 7~12など)がダウンする状況があります。このようなシナリオでは、たとえ数台のホストと追加のOSDを早急に追加することになるとしても、稼働状態を維持してactive + clean状態を達成できるクラスタを目指す必要があります。容量使用率が高すぎても、データが失われることはありません。ただし、クラスタの容量使用率が満杯率を超える場合は、障害ドメイン内の停止を解決しても、データ可用性が犠牲になる可能性が依然としてあります。この理由のため、少なくとも大まかな容量計画を立てることをお勧めします。

クラスタの次の2つ数量を特定します。

OSDの数。

クラスタの合計容量。

クラスタの合計容量をクラスタのOSDの数で割ると、クラスタ内のOSDの平均容量がわかります。この平均容量に、通常の操作時に同時に障害が発生すると予想するODSの数(比較的少数)を掛けることを検討してください。最後に、クラスタの容量に満杯率を掛ると、最大動作容量が得られます。次に、妥当な満杯率に達しないと予想されるOSDのデータの量を引きます。OSD障害(OSDのラック)の数を増やして上の手順を繰り返し、ほぼ満杯率に近い妥当な数を得ます。

次の設定はクラスタの作成時にのみ適用され、その後OSDマップに保存されます。

[global] mon osd full ratio = .80 mon osd backfillfull ratio = .75 mon osd nearfull ratio = .70

これらの設定はクラスタの作成中にのみ適用されます。後で、ceph osd set-nearfull-ratioコマンドとceph osd set-full-ratioコマンドを使用して、OSDマップで変更する必要があります。

- mon osd full ratio

OSDを

fullと見なす使用済みディスク容量の割合。デフォルトは0.95です。- mon osd backfillfull ratio

OSDが過剰に

fullであるためバックフィルできないと見なす使用済みディスク容量の割合。デフォルトは0.90です。- mon osd nearfull ratio

OSDを

nearfullと見なす使用済みディスク容量の割合。デフォルトは0.85です。

一部のOSDはnearfullであるのに他のOSDには十分な容量がある場合、nearfullのOSDのCRUSHの重みに問題がある可能性があります。

12.9 OSDと配置グループの監視 #

高可用性と高信頼性を実現するには、ハードウェアとソフトウェアの問題を管理する耐障害性を持つアプローチが必要です。Cephには単一障害点がなく、データに対する要求を「degraded」モードで処理できます。Cephのデータ配置には、データが特定のOSDアドレスに直接バインドされないようにする間接層が導入されています。つまり、システム障害を追跡するには、問題の根本にある配置グループとその基礎となるOSDを見つける必要があります。

クラスタの一部に障害が発生すると、特定のオブジェクトにアクセスできなくなる場合があります。これは、他のオブジェクトにアクセスできないという意味ではありません。障害が発生したら、OSDおよび配置グループを監視するための手順に従います。次にトラブルシューティングを開始します。

Cephは通常、自己修復します。ただし、問題が続く場合は、OSDと配置グループを監視すると問題を特定するのに役立ちます。

12.9.1 OSDの監視 #

OSDのステータスは、「クラスタ内」(「in」)または「クラスタ外」(「out」)のいずれかです。それと同時に、「稼働中」(「up」)または「ダウンしていて実行中でない」(「down」)のいずれかにもなります。OSDが「up」の場合、クラスタ内(データを読み書きできる)またはクラスタ外のいずれかの可能性があります。OSDがクラスタ内に存在していて、最近クラスタ外に移動した場合、Cephは配置グループを他のOSDに移行します。OSDがクラスタ外の場合、CRUSHは配置グループをOSDに割り当てません。OSDは、「down」の場合、「out」にもなります。

OSDが「down」で「in」の場合は問題があり、クラスタは正常な状態ではありません。

ceph health、ceph -s、ceph -wなどのコマンドを実行する場合、クラスタは常にHEALTH OKをエコーバックするわけではないことに気付くことがあります。OSDに関しては、次の状況ではクラスタがHEALTH OKをエコーしないことを予期する必要があります。

まだクラスタを起動していない(クラスタは応答しない)。

クラスタを起動または再起動したが、配置グループは作成中で、OSDはピアリングプロセス中であるため、まだ準備ができていない。

OSDを追加または削除した。

クラスタマップを変更した。

OSDの監視の重要な側面は、クラスタが稼働中であるときに、クラスタ内のすべてのOSDも稼働中であることを確認することです。すべてのOSDが実行中であるかどうかを確認するには、次のコマンドを実行します。

# ceph osd stat

x osds: y up, z in; epoch: eNNNN

この結果から、OSDの合計数(x)、「up」のOSDの数(y)、「in」のOSDの数(z)、およびマップのエポック(eNNNN)がわかります。クラスタ内にある「in」のOSDの数が「up」であるOSDの数より多い場合は、次のコマンドを実行して、実行中でないceph-osdデーモンを特定します。

# ceph osd tree

#ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 2.00000 pool openstack

-3 2.00000 rack dell-2950-rack-A

-2 2.00000 host dell-2950-A1

0 ssd 1.00000 osd.0 up 1.00000 1.00000

1 ssd 1.00000 osd.1 down 1.00000 1.00000たとえば、IDが1のOSDがdownしている場合は、次のコマンドを実行して起動します。

cephuser@osd > sudo systemctl start ceph-CLUSTER_ID@osd.0.service停止しているOSDや再起動しないOSDに関連する問題については、Book “Troubleshooting Guide”, Chapter 4 “Troubleshooting OSDs”, Section 4.3 “OSDs not running”を参照してください。

12.9.2 配置グループセットの割り当て #

CRUSHが配置グループをOSDに割り当てる場合、CRUSHはプールのレプリカの数を確認し、配置グループの各レプリカが異なるOSDに割り当てられるように配置グループをOSDに割り当てます。たとえば、プールに配置グループのレプリカが3つ必要な場合、CRUSHはこれらをそれぞれosd.1、osd.2、osd.3に割り当てることがあります。CRUSHは実際には、CRUSHマップで設定した障害ドメインを考慮した擬似的にランダムな配置にしようとします。そのため、大規模なクラスタで複数の配置グループが最も近隣にあるOSDに割り当てられることはほとんどありません。特定の配置グループのレプリカを含む必要があるOSDのセットを「動作セット」と呼びます。動作セットのOSDがダウンしているか、または他の理由で配置グループのオブジェクトの要求を処理できない場合があります。このような状況が生じた場合は、次のシナリオの1つに一致する可能性があります。

OSDを追加または削除した。これにより、CRUSHが配置グループを他のOSDに再割り当てしたため、「動作セット」の構成が変更され、「バックフィル」プロセスによってデータのマイグレーションが実行された。

OSDが「down」状態であったため再起動され、現在回復中である。

「動作セット」のOSDが「down」状態であるか、要求を処理できないため、別のOSDが一時的にその権限を引き継いだ。

Cephは、要求を実際に処理するOSDのセットである「アップセット」を使用してクライアント要求を処理します。ほとんどの場合、「アップセット」と「動作セット」は事実上同一です。これらが同一ではない場合、Cephがデータを移行中であるか、OSDが回復中であるか、または問題があることを示している場合があります(たとえば、このようなシナリオでは、Cephでは通常

HEALTH WARN状態と「stuck stale」メッセージをエコーします)。

配置グループのリストを取得するには、次のコマンドを実行します。

cephuser@adm > ceph pg dump指定した配置グループの「動作セット」または「アップセット」内にあるOSDを表示するには、次のコマンドを実行します。

cephuser@adm > ceph pg map PG_NUM

osdmap eNNN pg RAW_PG_NUM (PG_NUM) -> up [0,1,2] acting [0,1,2]この結果から、osdmapエポック(eNNN)、配置グループの数(PG_NUM)、「アップセット」(「up」)のOSD、および「動作セット」(「acting」)のOSDがわかります。

「アップセット」と「動作セット」が一致しない場合、これはクラスタの再バランスそのものか、クラスタの潜在的な問題の指標である可能性があります。

12.9.3 ピアリング #

配置グループにデータを書き込む場合、データの状態はactiveでなければならず、さらにclean状態である必要があります。Cephが配置グループの現在の状態を判断するために、配置グループのプライマリOSD (「動作セット」の最初のOSD)は、セカンダリおよび3番目のOSDとピアリングして、配置グループの現在の状態に関する合意を確立します(PGの3つのレプリカがプールにあることを想定)。

12.9.4 配置グループの状態の監視 #

ceph health、ceph -s、ceph -wなどのコマンドを実行する場合、クラスタは常にHEALTH OKメッセージをエコーバックするわけでないことに気付くことがあります。OSDが実行中であるかどうかを確認した後で、配置グループの状態も確認する必要があります。

配置グループのピアリングに関係する次のような多くの状況では、クラスタはHEALTH OKをエコー「しない」ことを予期してください。

プールを作成したが、配置グループはまだピアリングされていない。

配置グループが回復中である。

クラスタにOSDを追加したか、クラスタからOSDを削除した。

CRUSHマップを変更したが、配置グループは移行中である。

配置グループの異なるレプリカに整合性のないデータがある。

Cephが配置グループのレプリカをスクラブしている。

Cephにバックフィル操作を完了するための十分なストレージ容量がない。

上のいずれかの状況でCephがHEALTH WARNをエコーしても慌てないでください。多くの場合、クラスタは単独で回復します。場合によっては、対処が必要です。配置グループの監視の重要な側面は、クラスタが稼働しているときに、すべての配置グループが「active」であり、できれば「clean」状態であることを確認することです。すべての配置グループのステータスを確認するには、次のコマンドを実行します。

cephuser@adm > ceph pg stat

x pgs: y active+clean; z bytes data, aa MB used, bb GB / cc GB availこの結果から、配置グループの合計数(x)、特定の状態(「active+clean」など)である配置グループの数(y)、および保存データの量(z)がわかります。

配置グループの状態に加えて、Cephでは、使用済みのストレージ容量(aa)、残りのストレージ容量(bb)、および配置グループの合計ストレージ容量もエコーバックされます。次のようないくつかのケースでは、これらの数値が重要になる可能性があります。

near full ratioまたはfull ratioに達しつつある。CRUSH設定のエラーのため、データがクラスタ間で分散されている。

配置グループIDは、プール番号(プール名ではない)、それに続くピリオド(.)、および配置グループID (16進数)で構成されます。プール番号とプールの名前は、ceph osd lspoolsの出力で参照できます。たとえば、デフォルトのプールrbdはプール番号0に対応します。完全修飾形式の配置グループIDは次の形式です。

POOL_NUM.PG_ID

これは通常、次のようになります。

0.1f

配置グループのリストを取得するには、次のコマンドを実行します。

cephuser@adm > ceph pg dump出力をJSON形式でフォーマットしてファイルに保存することもできます。

cephuser@adm > ceph pg dump -o FILE_NAME --format=json特定の配置グループに対してクエリを実行するには、次のコマンドを実行します。

cephuser@adm > ceph pg POOL_NUM.PG_ID query次のリストでは、配置グループの一般的な状態について詳しく説明します。

- 作成中

プールを作成すると、指定した数の配置グループが作成されます。Cephは、1つ以上の配置グループを作成している場合に「creating」をエコーします。配置グループが作成されると、その配置グループの「動作セット」に属するOSDがピアリングされます。ピアリングが完了したら、配置グループのステータスは「active+clean」になります。これは、Cephクライアントがその配置グループへの書き込みを開始できることを意味します。

図 12.3: 配置グループのステータス #- ピアリング

Cephは、配置グループのピアリング中に、配置グループのレプリカを保存するOSDを、その配置グループ内にあるオブジェクトとメタデータの状態について合意状態にします。つまり、Cephがピアリングを完了すると、その配置グループを保存するOSDは配置グループの現在の状態に関して合意したことになります。ただし、ピアリングプロセスが完了しても、各レプリカの内容が最新であるという意味には「なりません」。

注記: 信頼できる履歴Cephでは、「動作セット」のすべてのOSDが書き込み操作を永続化するまで、クライアントへの書き込み操作を確認「しません」。この動作により、ピアリング操作が最後に正常に完了した後に確認されたすべての書き込み操作のレコードが、「動作セット」の少なくとも1つのメンバーに確実に存在するようになります。

確認された書き込み操作それぞれの正確なレコードにより、Cephは、配置グループの信頼できる新しい履歴を構築および拡張できます。この履歴には、一連の操作の順序が完全かつ全面的に記録されているため、この履歴を実行すれば、配置グループのOSDのコピーを最新の状態にすることができます。

- アクティブ

Cephがピアリングプロセスを完了すると、配置グループは

activeになります。active状態とは、プライマリ配置グループとレプリカで配置グループのデータを読み込み操作と書き込み操作に一般的に使用できることを意味します。- クリーン

配置グループが

clean状態である場合、プライマリOSDとレプリカOSDは正常にピアリングされていて、その配置グループに未処理のレプリカは存在しません。配置グループ内のすべてのオブジェクトは、Cephによって正確な回数複製されています。- DEGRADED

クライアントがプライマリOSDにオブジェクトを書き込む場合、プライマリOSDが、レプリカをレプリカOSDに書き込む責任を持ちます。プライマリOSDがオブジェクトをストレージに書き込んだ後も、配置グループは「degraded」状態のままです。この状態は、Cephがレプリカオブジェクトを正常に作成したという確認をプライマリOSDがレプリカOSDから受け取るまで続きます。

配置グループが「active+degraded」になる可能性がある理由は、OSDにまだオブジェクトがすべて格納されていなくてもOSDが「active」になる可能性があるためです。OSDがダウンした場合、CephはそのOSDに割り当てられた各配置グループを「degraded」としてマークします。OSDが稼働状態に戻ったら、OSDをもう一度ピアリングする必要があります。ただし、「degraded」状態の配置グループが「active」であれば、クライアントは引き続きその配置グループに新しいオブジェクトを書き込むことができます。

OSDが「down」で、「degraded」状態が解決しない場合、Cephは、ダウンしているOSをクラスタの「out」としてマークし、「down」状態のOSDから別のOSDにデータを再マップします。「down」とマークされてから「out」とマークされるまでの時間は、

mon osd down out intervalオプションで制御します。デフォルトでは600秒に設定されています。配置グループに含める必要がある1つ以上のオブジェクトをCephが見つけることができないという理由で、配置グループが「degraded」状態になる可能性もあります。見つからないオブジェクトに対して読み書きを行うことはできませんが、「degraded」状態の配置グループ内にある他のすべてのオブジェクトには今までどおりアクセスできます。

- 回復中