このガイドは、SUSE® Linux Enterprise High Availabilityを使用してクラスタを設定、構成、および管理する必要がある管理者を対象にしています。構成と管理を素早く効率的に行うため、この製品にはグラフィカルユーザインタフェースとコマンドラインインタフェース(CLI)の両方が備わっています。重要なタスクを実行するために、このガイドには両方のアプローチが説明されています。これにより、ニーズを満たす適切なツールを選択できるようになります。

- 序文

- I インストールおよびセットアップ

- II 設定および管理

- III ストレージとデータレプリケーション

- IV 保守とアップグレード

- V 付録

- 用語集

- E GNU licenses

- 1.1 3サーバクラスタ

- 1.2 1台のサーバに障害が発生した後の3サーバクラスタ

- 1.3 一般的なファイバチャネルクラスタの設定

- 1.4 一般的なiSCSIクラスタの設定

- 1.5 共有ストレージなしの一般的なクラスタ設定

- 1.6 アーキテクチャ

- 4.1 YaST - マルチキャスト設定

- 4.2 YaST - ユニキャスト設定

- 4.3 YaST - セキュリティ

- 4.4 YaST —

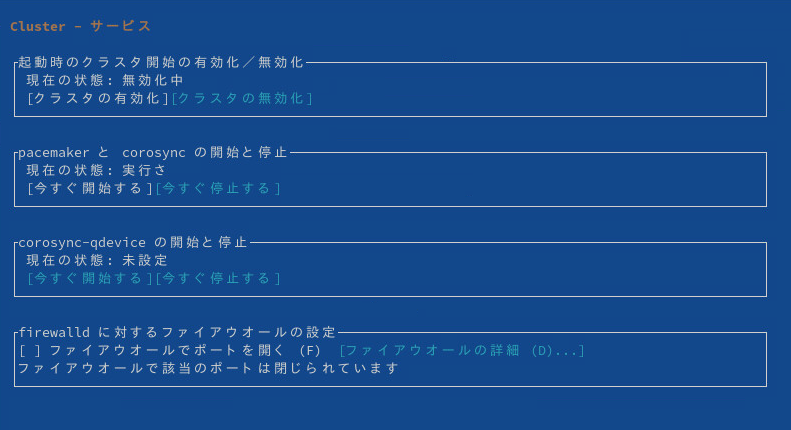

conntrackd - 4.5 YaST - サービス

- 4.6 YaST - Csync2

- 5.1 Hawk2 - クラスタの設定

- 5.2 Hawk2 - Apache Webサーバ用のウィザード

- 5.3 Hawk2バッチモードが有効

- 5.4 Hawk2のバッチモード—注入されたイベントと設定の変更

- 6.1 Hawk2 - プリミティブリソース

- 6.2 グループリソース

- 6.3 Hawk2 - リソースグループ

- 6.4 Hawk2 - クローンリソース

- 6.5 Hawk2 - STONITHリソース

- 6.6 操作値

- 6.7 Hawk2 - リソース詳細

- 7.1 Hawk2 - 場所制約

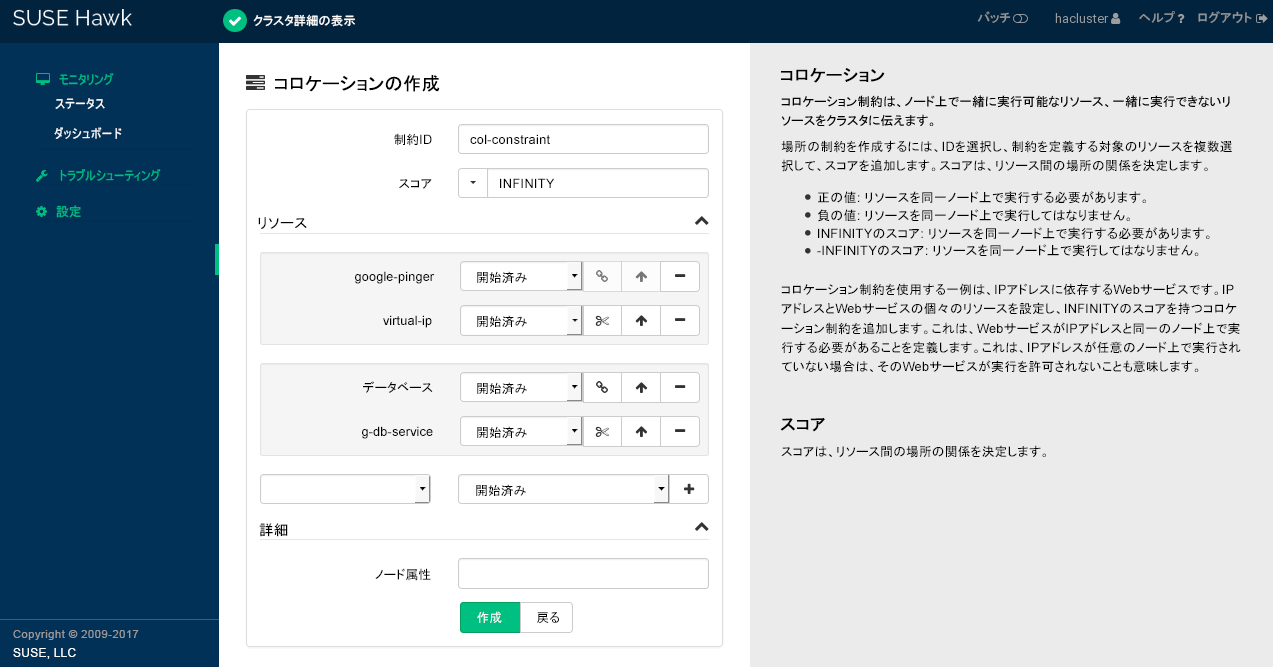

- 7.2 Hawk2 - コロケーション制約

- 7.3 Hawk2 - 順序制約

- 7.4 Hawk2 - コロケーション制約の2つのリソースセット

- 7.5 Hawk2: リソースフェールオーバーのメタ属性

- 7.6 Hawk2: リソースフェールバックのメタ属性

- 7.7 Hawk2: ノード使用属性の編集

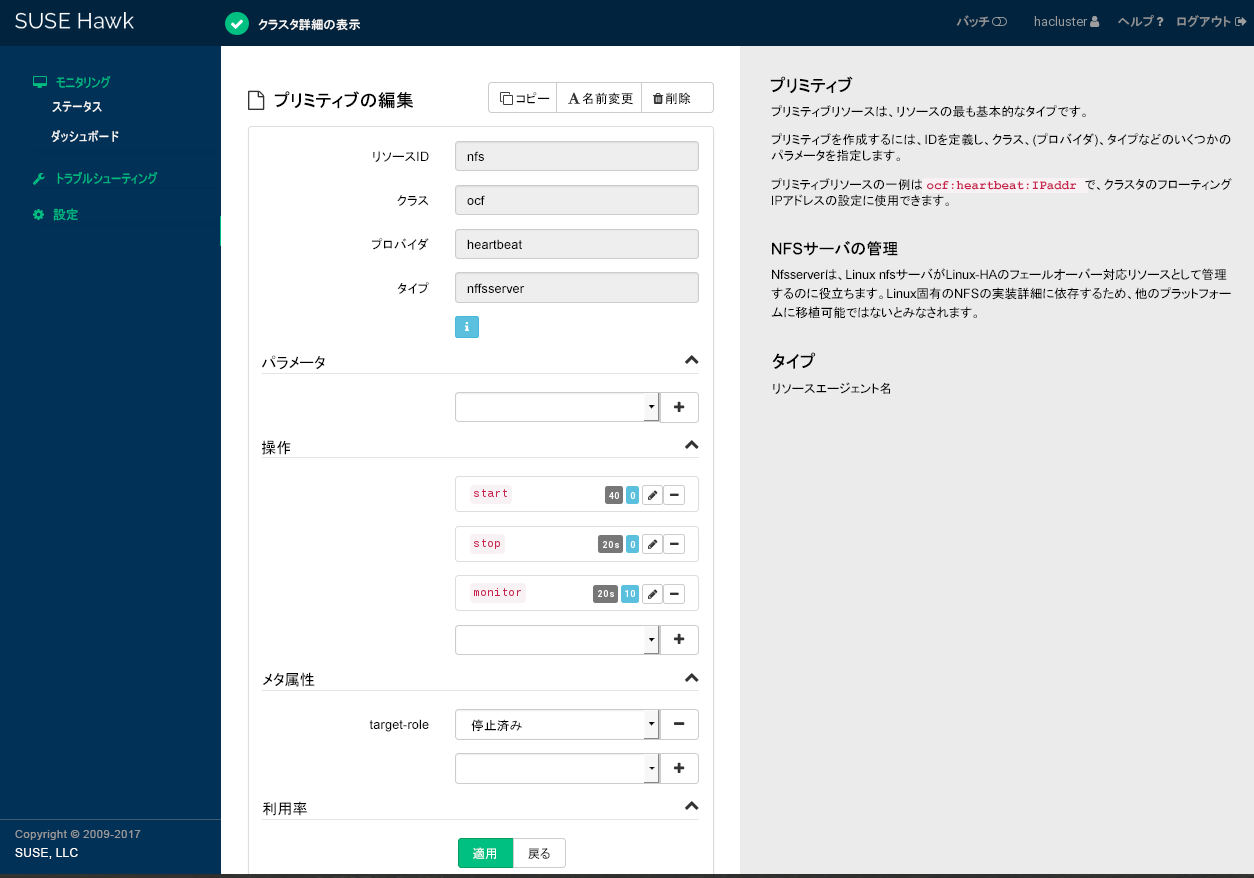

- 8.1 Hawk2 - プリミティブリソースの編集

- 8.2 Hawk2 - タグ

- 11.1 Hawk2 - クラスタの状態

- 11.2 1つのクラスタサイト(

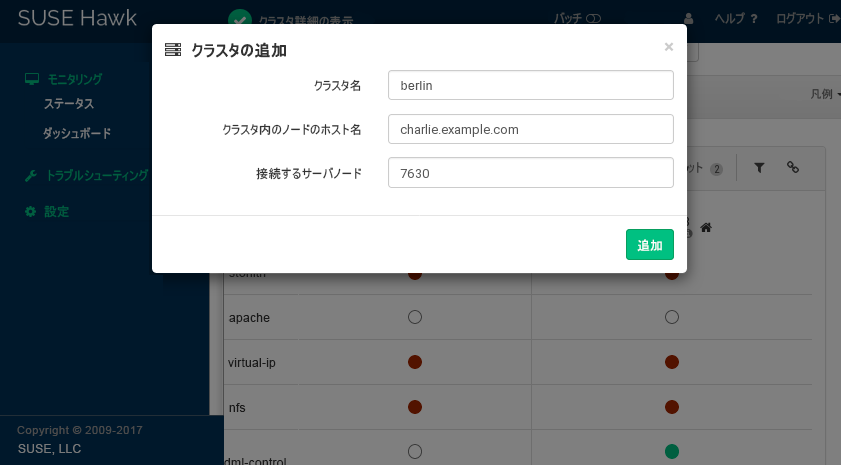

amsterdam)を表示するHawk2ダッシュボード - 11.3 Hawk2がクラスタの詳細を追加する

- 11.4 最新イベントテーブル

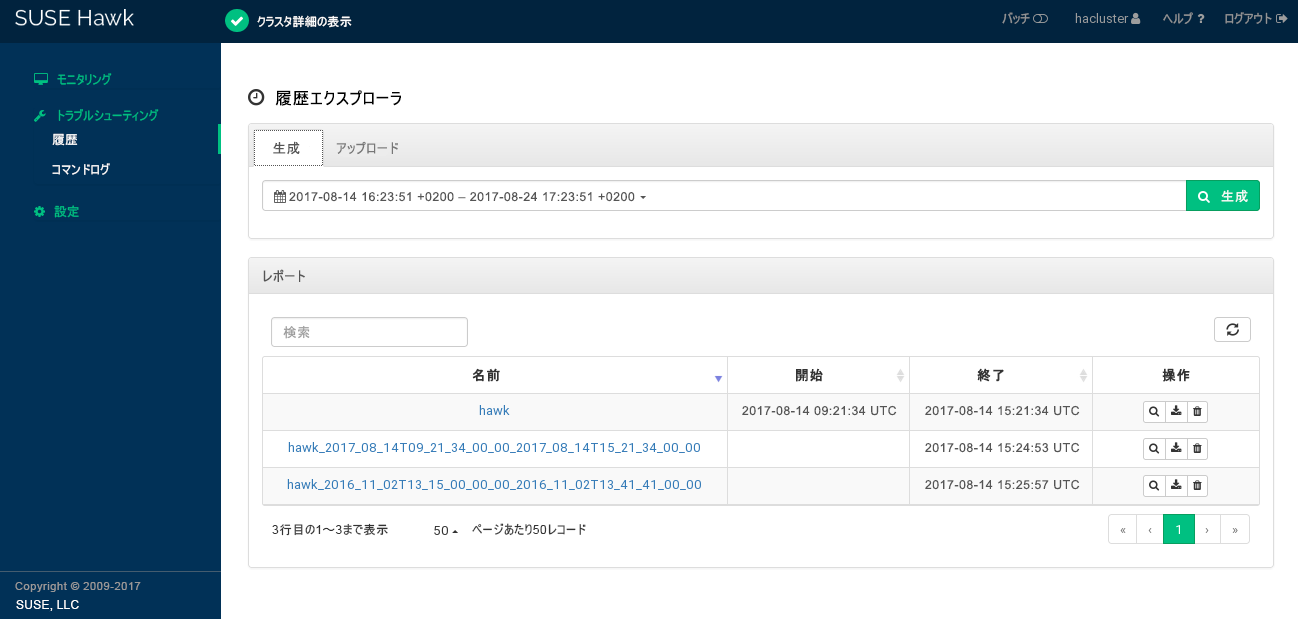

- 11.5 Hawk2 - 履歴エクスプローラーのメインビュー

- 11.6 Hawk2レポートの詳細

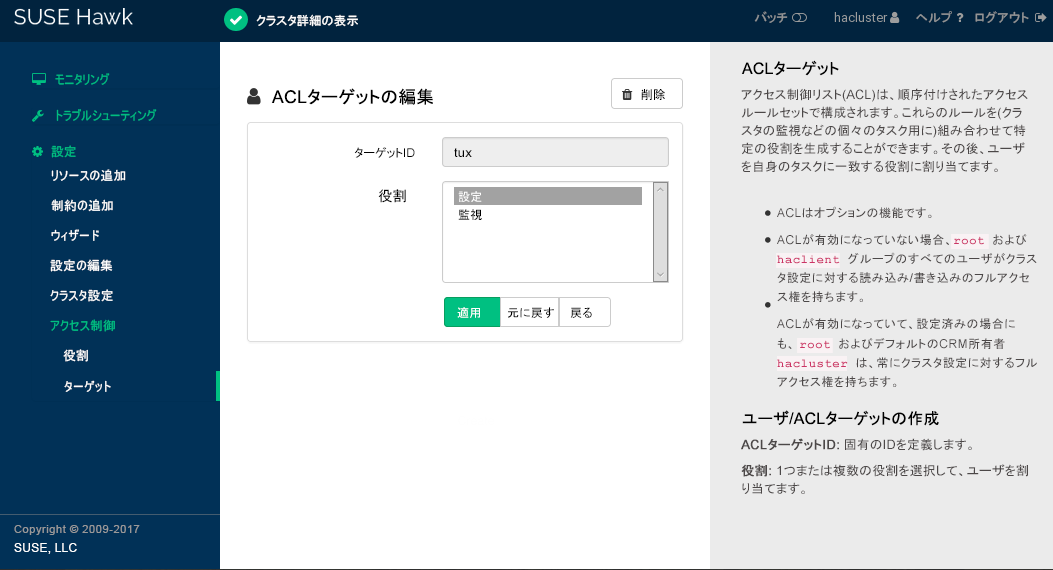

- 15.1 Hawk2の役割作成

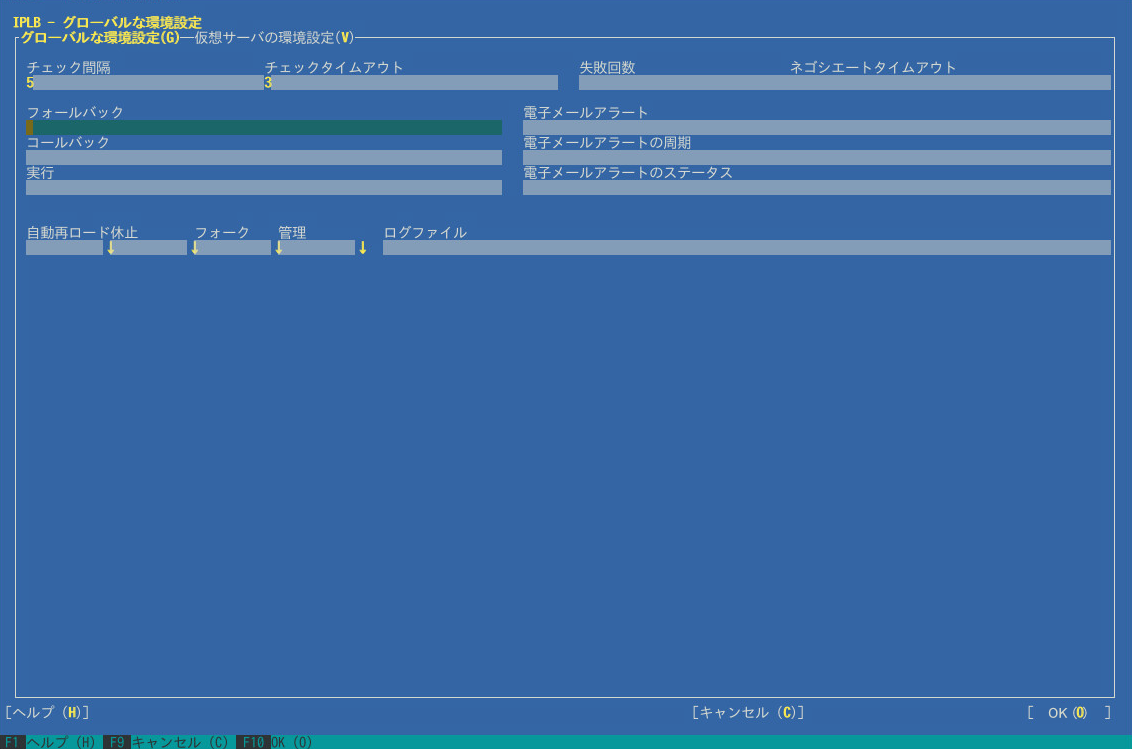

- 17.1 YaST IP負荷分散 - グローバルパラメータ

- 17.2 YaST IP負荷分散 - 仮想サービス

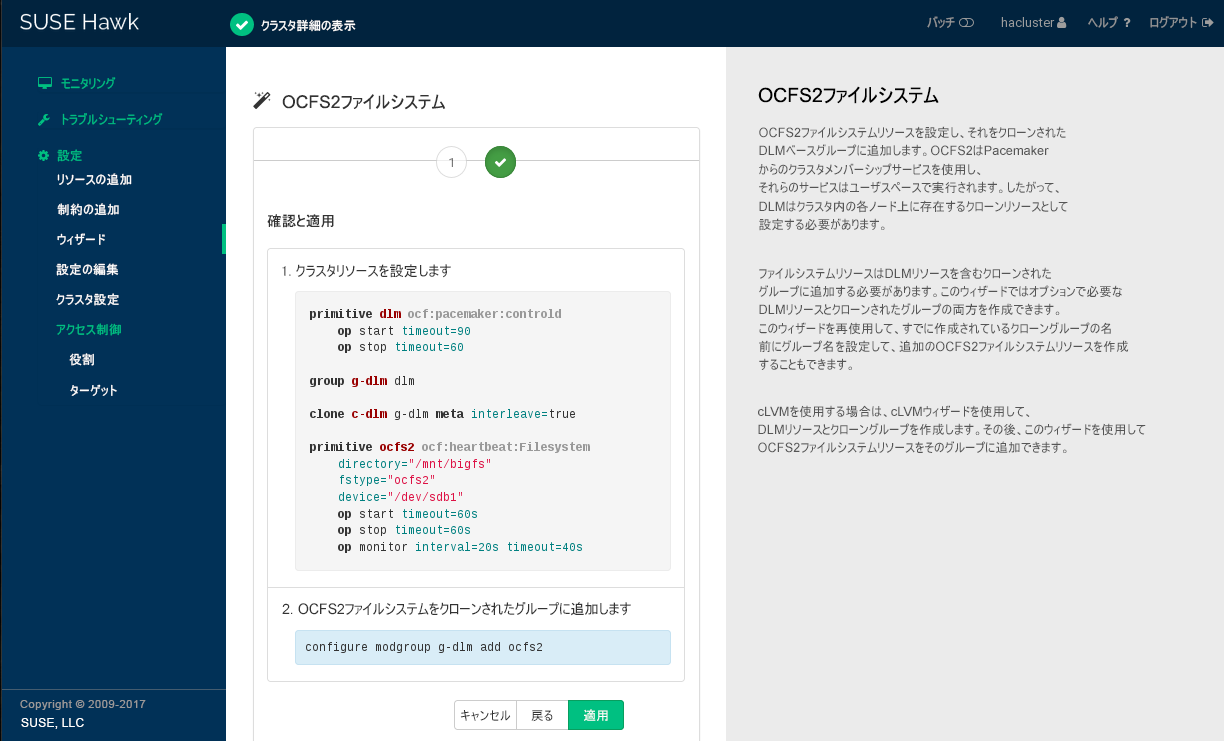

- 21.1 OCFS2 CIBの変更のHawk2まとめ画面

- 23.1 Linux内でのDRBDの位置

- 23.2 リソースの環境設定

- 23.3 リソースのスタッキング

- 23.4

drbdmonが示す正常な接続 - 23.5

drbdmonが示す異常な接続 - 24.1 Cluster LVMを使用した共有ディスクのセットアップ

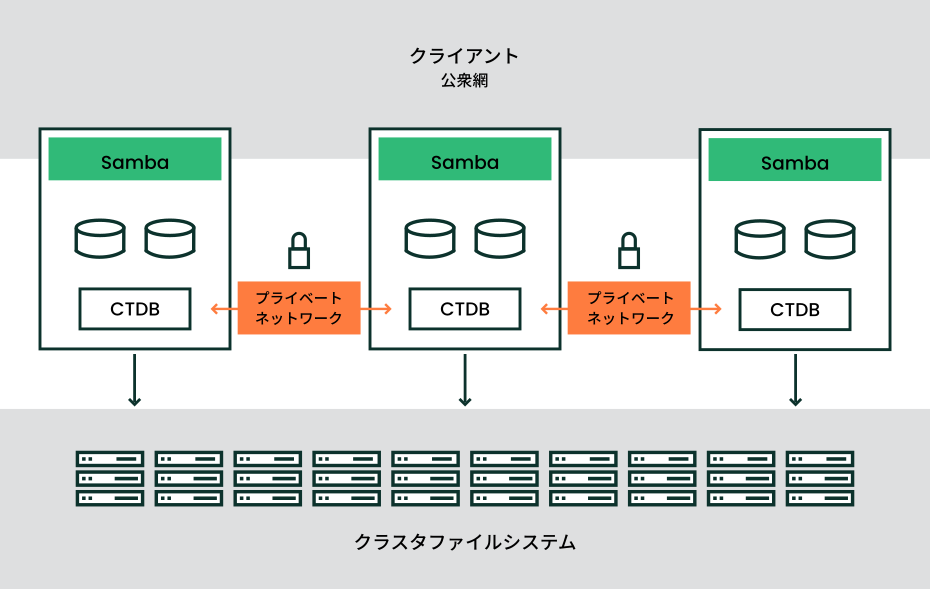

- 26.1 CTDBクラスタの構造

- 5.1 2ノードクラスタのCorosync設定の例

- 5.2 NノードクラスタのCorosync設定の例

- 5.3 単純なcrmshシェルスクリプト

- 6.1 Webサーバのリソースグループ

- 7.1 場所制約のリソースセット

- 7.2 コロケートされたリソースのチェーン

- 7.3 順序付けされたリソースのチェーン

- 7.4 リソースセットとして表される順序付けされたリソースのチェーン

- 7.5 マイグレーションしきい値 - プロセスフロー

- 7.6

hv_memoryを無効にしてKVM用のリソースエージェントを作成する - 7.7

host_memoryを無効にしてXen用のリソースエージェントを作成する - 9.1 監視プラグインのリソースの設定

- 12.1 IBM RSAライトアウトデバイスの設定

- 12.2 UPSフェンシングデバイスの設定

- 12.3 Kdumpデバイスの設定

- 13.1 タイムアウト計算の式

- 14.1 QDeviceのステータス

- 14.2 QNetdサーバのステータス

- 15.1 XML内のクラスタ設定の例

- 17.1 単純なldirectord設定

- 23.1 3ノードのスタックされたDRBDリソースの設定

- 23.2 クラスタ情報ベース(CIB)を使用したリソースレベルのフェンシングを含むDRBDの設定

- 27.1 NFSサーバを使用したファイルバックアップの保存

- 27.2 サードパーティのバックアップツール(EMC NetWorkerなど)の使用

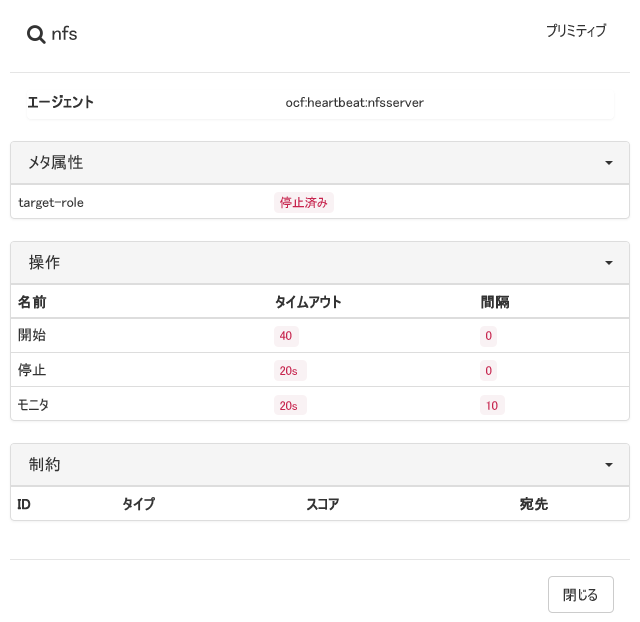

- A1 停止されたリソース

Copyright © 2006–2025 SUSE LLC and contributors.All rights reserved.

この文書は、GNUフリー文書ライセンスのバージョン1.2または(オプションとして)バージョン1.3の条項に従って、複製、頒布、および/または改変が許可されています。ただし、この著作権表示およびライセンスは変更せずに記載すること。ライセンスバージョン1.2のコピーは、「GNUフリー文書ライセンス」セクションに含まれています。

SUSEの商標については、https://www.suse.com/company/legal/を参照してください。サードパーティ各社とその製品の商標は、所有者であるそれぞれの会社に所属します。商標記号(®、™など)は、SUSEおよびその関連会社の商標を示します。アスタリスク(*)は、第三者の商標を示します。

本書のすべての情報は、細心の注意を払って編集されています。しかし、このことは絶対に正確であることを保証するものではありません。SUSE LLC、その関係者、著者、翻訳者のいずれも誤りまたはその結果に対して一切責任を負いかねます。

序文 #

1 利用可能なマニュアル #

- オンラインマニュアル

オンラインマニュアルはhttps://documentation.suse.comにあります。さまざまな形式のマニュアルをブラウズまたはダウンロードできます。

注記: 最新のアップデート最新のアップデートは、通常、英語版マニュアルで入手できます。

- SUSE Knowledgebase

問題が発生した場合は、https://www.suse.com/support/kb/でオンラインで入手できる技術情報文書(TID)を確認してください。SUSE Knowledgebaseを検索して、お客様のニーズに応じた既知のソリューションを見つけます。

- リリースノート

リリースノートはhttps://www.suse.com/releasenotes/を参照してください。

- ご使用のシステムで

オフラインで使用するために、リリースノートはシステム上の

/usr/share/doc/release-notesでも入手できます。個々のパッケージのマニュアルは、/usr/share/doc/packagesで入手できます。「マニュアルページ」には、多くのコマンドについても説明されています。説明を表示するには、

manコマンドに確認したいコマンドの名前を付加して実行してください。システムにmanコマンドがインストールされていない場合は、sudo zypper install manコマンドでインストールします。

2 ドキュメントの改善 #

このドキュメントに対するフィードバックや貢献を歓迎します。フィードバックを提供するための次のチャネルが利用可能です。

- サービス要求およびサポート

ご使用の製品に利用できるサービスとサポートのオプションについては、https://www.suse.com/support/を参照してください。

サービス要求を提出するには、SUSE Customer Centerに登録済みのSUSEサブスクリプションが必要です。https://scc.suse.com/support/requestsに移動して、ログインし、をクリックします。

- バグレポート

https://bugzilla.suse.com/から入手できるドキュメントを使用して、問題を報告してください。

このプロセスを容易にするには、このドキュメントのHTMLバージョンの見出しの横にあるアイコンをクリックしてください。これにより、Bugzillaで適切な製品とカテゴリが事前に選択され、現在のセクションへのリンクが追加されます。バグレポートの入力を直ちに開始できます。

Bugzillaアカウントが必要です。

- ドキュメントの編集に貢献

このドキュメントに貢献するには、このドキュメントのHTMLバージョンの見出しの横にあるアイコンをクリックしてください。GitHubのソースコードに移動し、そこからプルリクエストをオープンできます。

GitHubアカウントが必要です。

注記: は英語でのみ利用可能アイコンは、各ドキュメントの英語版でのみ使用できます。その他の言語では、代わりにアイコンを使用してください。

このドキュメントに使用されるドキュメント環境に関する詳細については、リポジトリのREADMEを参照してください。

- メール

ドキュメントに関するエラーの報告やフィードバックは<doc-team@suse.com>宛に送信していただいても構いません。ドキュメントのタイトル、製品のバージョン、およびドキュメントの発行日を記載してください。また、関連するセクション番号とタイトル(またはURL)、問題の簡潔な説明も記載してください。

3 マニュアルの表記規則 #

このマニュアルでは、次の通知と表記規則が使用されています。

/etc/passwd: ディレクトリ名とファイル名PLACEHOLDER: PLACEHOLDERは、実際の値で置き換えられます。

PATH: 環境変数ls、--help: コマンド、オプションおよびパラメータuser: ユーザまたはグループの名前package_name: ソフトウェアパッケージの名前

Alt、Alt–F1: 押すキーまたはキーの組み合わせ。キーはキーボードのように大文字で表示されます。

、 › : メニュー項目、ボタン

AMD/Intel この説明は、AMD64/Intel 64アーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。

IBM Z, POWER この説明は、

IBM ZおよびPOWERアーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。Chapter 1, 「Example chapter」: このガイドの別の章への相互参照。

root特権で実行する必要のあるコマンド。これらのコマンドの先頭にsudoコマンドを置いて、特権のないユーザとしてコマンドを実行することもできます。#command>sudocommand特権のないユーザでも実行できるコマンド:

>commandコマンドは、行末のバックスラッシュ文字(

\)で2行または複数行に分割できます。バックスラッシュは、コマンドの呼び出しが行末以降も続くことをシェルに知らせます。>echoa b \ c dコマンド(プロンプトで始まる)と、シェルによって返される各出力の両方を示すコード ブロック:

>commandoutput対話型crmシェルで実行されるコマンド。

crm(live)#通知

警告: 警告の通知続行する前に知っておくべき、無視できない情報。セキュリティ上の問題、データ損失の可能性、ハードウェアの損傷、または物理的な危険について警告します。

重要: 重要な通知続行する前に知っておくべき重要な情報です。

注記: メモの通知追加情報。たとえば、ソフトウェアバージョンの違いに関する情報です。

ヒント: ヒントの通知ガイドラインや実際的なアドバイスなどの役に立つ情報です。

コンパクトな通知

追加情報。たとえば、ソフトウェアバージョンの違いに関する情報です。

ガイドラインや実際的なアドバイスなどの役に立つ情報です。

クラスタノードと名前、リソース、およびに制約に関する命名規則の概要については、付録B 命名規則を参照してください。

4 サポート #

SUSE Linux Enterprise High Availabilityのサポートステートメントと、技術プレビューに関する一般情報を以下に示します。製品ライフサイクルの詳細については、https://www.suse.com/lifecycleを参照してください。

サポート資格をお持ちの場合、https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.htmlを参照して、サポートチケットの情報を収集する方法の詳細を確認してください。

4.1 SUSE Linux Enterprise High Availabilityのサポートステートメント #

サポートを受けるには、SUSEの適切な購読が必要です。利用可能な特定のサポートサービスを確認するには、https://www.suse.com/support/にアクセスして製品を選択してください。

サポートレベルは次のように定義されます。

- L1

問題の判別。互換性情報、使用サポート、継続的な保守、情報収集、および利用可能なドキュメントを使用した基本的なトラブルシューティングを提供するように設計されたテクニカルサポートを意味します。

- L2

問題の切り分け。データの分析、お客様の問題の再現、問題領域の特定、レベル1で解決できない問題の解決、またはレベル3の準備を行うように設計されたテクニカルサポートを意味します。

- L3

問題解決。レベル2サポートで特定された製品の欠陥を解決するようにエンジニアリングに依頼して問題を解決するように設計されたテクニカルサポートを意味します。

契約されているお客様およびパートナーの場合、SUSE Linux Enterprise High Availabilityでは、次のものを除くすべてのパッケージに対してL3サポートを提供します。

技術プレビュー。

サウンド、グラフィック、フォント、およびアートワーク。

追加の顧客契約が必要なパッケージ。

モジュール「Workstation Extension」の一部として出荷される一部のパッケージは、L2サポートのみです。

名前が-develで終わるパッケージ(ヘッダファイルや開発者用のリソースを含む)に対しては、メインのパッケージとともにサポートが提供されます。

SUSEは、元のパッケージの使用のみをサポートします。つまり、変更も、再コンパイルもされないパッケージをサポートします。

4.2 技術プレビュー #

技術プレビューとは、今後のイノベーションを垣間見ていただくための、SUSEによって提供されるパッケージ、スタック、または機能を意味します。技術プレビューは、ご利用中の環境で新しい技術をテストする機会を参考までに提供する目的で収録されています。私たちはフィードバックを歓迎しています。技術プレビューをテストする場合は、SUSEの担当者に連絡して、経験や使用例をお知らせください。ご入力いただいた内容は今後の開発のために役立たせていただきます。

技術プレビューには、次の制限があります。

技術プレビューはまだ開発中です。したがって、機能が不完全であったり、不安定であったり、運用環境での使用には適していなかったりする場合があります。

技術プレビューにはサポートが提供されません。

技術プレビューは、特定のハードウェアアーキテクチャでしか利用できないことがあります。

技術プレビューの詳細および機能は、変更される場合があります。その結果、技術プレビューのその後のリリースへのアップグレードは不可能になり、再インストールが必要な場合があります。

SUSEで、プレビューがお客様や市場のニーズを満たしていない、またはエンタープライズ標準に準拠していないことを発見する場合があります。技術プレビューは製品から予告なく削除される可能性があります。SUSEでは、このようなテクノロジーのサポートされるバージョンを将来的に提供できない場合があります。

ご使用の製品に付属している技術プレビューの概要については、https://www.suse.com/releasenotesにあるリリースノートを参照してください。

パート I インストールおよびセットアップ #

- 1 製品の概要

SUSE® Linux Enterprise High Availabilityは、オープンソースクラスタリング技術の統合スイートです。これにより、高可用性の物理および仮想Linuxクラスタを実装し、シングルポイント障害を排除することができます。データ、アプリケーション、サービスなどの重要なネットワークリソースの高度な可用性と管理のしやすさを実現します。その結果、ミッションクリティカルなLinuxワークロードに対してビジネスの継続性維持、データ整合性の保護、予期せぬダウンタイムの削減を行います。

基本的な監視、メッセージング、およびクラスタリソース管理の機能を標準装備し、個々の管理対象クラスタリソースのフェールオーバー、フェールバック、およびマイグレーション(負荷分散)をサポートします。

この章では、製品の主な機能およびSUSE Linux Enterprise High Availabilityの利点を紹介します。ここには、いくつかのクラスタ例が記載されており、クラスタを設定するコンポーネントについて学ぶことができます。最後のセクションでは、アーキテクチャの概要を示し、クラスタ内の個々のアーキテクチャ層とプロセスについて説明します。

High Availabilityクラスタのコンテキストでよく使用される用語については、用語集を参照してください。

- 2 システム要件と推奨事項

次のセクションでは、SUSE® Linux Enterprise High Availabilityのシステム要件と前提条件について説明します。また、クラスタセットアップの推奨事項についても説明します。

- 3 SUSE Linux Enterprise High Availabilityのインストール

初めてSUSE® Linux Enterprise High Availabilityを使用して高可用性クラスタを設定する場合、最も簡単な方法は、基本的な2ノードクラスタで開始することです。2ノードクラスタを使用して、一部のテストを実行することもできます。後で、AutoYaSTを使用して既存のクラスタノードのクローンを作成することにより、さらにノードを追加できます。クローンを作成したノードには、元のノードと同じパッケージがインストールされ、クローンノードは同じシステム設定を持つことになります。

前のバージョンのSUSE Linux Enterprise High Availabilityを実行する既存のクラスタをアップグレードする場合は、第29章 「クラスタアップグレードとソフトウェアパッケージの更新」を参照してください。

- 4 YaSTクラスタモジュールの使用

YaSTクラスタモジュールでは、クラスタを手動で(最初から)設定するか、既存のクラスタのオプションを変更することができます。

ただし、クラスタの設定に自動化された方法を選ぶ場合は、Article “インストールとセットアップクイックスタート”を参照してください。このマニュアルでは、必要なパッケージのインストール方法と、crmによって提供されているブートストラップスクリプトを使用して基本的な2ノードクラスタを設定する手順を説明しています。

たとえば、1つのノードをYaSTクラスタで設定してから、ブートストラップスクリプトの1つを使用して他のノードを統合させる(またはその逆も可能)など、両方のセットアップ方法を組み合わせることもできます。

1 製品の概要 #

SUSE® Linux Enterprise High Availabilityは、オープンソースクラスタリング技術の統合スイートです。これにより、高可用性の物理および仮想Linuxクラスタを実装し、シングルポイント障害を排除することができます。データ、アプリケーション、サービスなどの重要なネットワークリソースの高度な可用性と管理のしやすさを実現します。その結果、ミッションクリティカルなLinuxワークロードに対してビジネスの継続性維持、データ整合性の保護、予期せぬダウンタイムの削減を行います。

基本的な監視、メッセージング、およびクラスタリソース管理の機能を標準装備し、個々の管理対象クラスタリソースのフェールオーバー、フェールバック、およびマイグレーション(負荷分散)をサポートします。

この章では、製品の主な機能およびSUSE Linux Enterprise High Availabilityの利点を紹介します。ここには、いくつかのクラスタ例が記載されており、クラスタを設定するコンポーネントについて学ぶことができます。最後のセクションでは、アーキテクチャの概要を示し、クラスタ内の個々のアーキテクチャ層とプロセスについて説明します。

High Availabilityクラスタのコンテキストでよく使用される用語については、用語集を参照してください。

1.1 モジュールとしてまたは拡張機能として使用可能 #

高可用性は、複数の製品でモジュールとしてまたは拡張機能として使用できます。詳細については、https://documentation.suse.com/sles/html/SLES-all/article-modules.html#art-modules-high-availabilityを参照してください。

1.2 主な特長 #

SUSE® Linux Enterprise High Availabilityでは、ネットワークリソースの可用性を確保し、管理することができます。以降のセクションでは、いくつかの主要機能に焦点を合わせて説明します。

1.2.1 広範なクラスタリングシナリオ #

SUSE Linux Enterprise High Availabilityは次のシナリオをサポートします。

アクティブ/アクティブ設定

アクティブ/パッシブ設定: N+1、N+M、Nから1、NからM

ハイブリッド物理仮想クラスタ。仮想サーバを物理サーバとともにクラスタ化できます。これによって、サービスの可用性とリソースの使用状況が向上します。

ローカルクラスタ

メトロクラスタ(「ストレッチされた」ローカルクラスタ)

Geoクラスタ(地理的に離れたクラスタ)

クラスタに属するすべてのノードは、同じプロセッサプラットフォーム(x86、IBM Z、またはPOWER)を備えている必要があります。混在アーキテクチャのクラスタはサポートされて「いません」。

クラスタには、最大32のLinuxサーバを含めることができます。pacemaker_remoteを使用すると、この制限を超えて追加のLinuxサーバを含めるようにクラスタを拡張できます。クラスタ内のどのサーバも、クラスタ内の障害が発生したサーバのリソース(アプリケーション、サービス、IPアドレス、およびファイルシステム)を再起動することができます。

1.2.2 柔軟性 #

SUSE Linux Enterprise High Availabilityには、Corosyncメッセージングおよびメンバーシップ層のほか、Pacemakerクラスタリソースマネージャが標準装備されています。管理者は、Pacemakerを使用して、リソースのヘルスと状態を継続的に監視し、依存関係を管理することができます。高度に設定可能なルールとポリシーに基づいて、サービスを自動的に停止および開始することができます。SUSE Linux Enterprise High Availabilityでは、ユーザの組織に適した特定のアプリケーションおよびハードウェアインフラストラクチャに合わせて、クラスタのカスタマイズが可能です。時間依存設定を使用して、サービスを特定の時刻に修復済みのノードに自動的にフェールバック(マイグレート)させることができます。

1.2.3 ストレージとデータレプリケーション #

SUSE Linux Enterprise High Availabilityでは必要に応じてサーバストレージを動的に割り当ておよび再割り当てできます。ファイバチャネルまたはiSCSIストレージエリアネットワーク(SAN)をサポートしています。共有ディスクもサポートされていますが、必要要件ではありません。SUSE Linux Enterprise High Availabilityには、クラスタ対応のファイルシステム(OCFS2)とCluster Logical Volume Manager (Cluster LVM)も含まれています。データをレプリケーションする場合は、DRBD*を使用して、High Availabilityサービスのデータをクラスタのアクティブノードからスタンバイノードへミラーリングします。さらに、SUSE Linux Enterprise High Availabilityでは、Sambaクラスタリング技術であるCTDB (Cluster Trivial Database)もサポートしています。

1.2.4 仮想化環境のサポート #

SUSE Linux Enterprise High Availabilityは、物理Linuxサーバと仮想Linuxサーバの混合クラスタリングをサポートしています。SUSE Linux Enterprise Server 15 SP6には、オープンソースの仮想化ハイパーバイザであるXenと、KVM (カーネルベースの仮想マシン)が付属しています。KVMは、ハードウェア仮想化の拡張機能に基づいた、Linux用の仮想化ソフトウェアです。SUSE Linux Enterprise High Availability内のクラスタリソースマネージャは、仮想サーバ内で実行中のサービスと物理サーバ内で実行中のサービスを認識、監視、および管理できます。ゲストシステムは、クラスタにサービスとして管理されます。

アクティブクラスタでノードのライブマイグレーションを実行するときには注意してください。クラスタスタックは、ライブマイグレーションプロセスに起因するオペレーティングシステムのフリーズに耐えることができない場合があり、結果として、ノードがフェンシングされる可能性があります。

次のいずれかのアクションを実行してライブマイグレーション中のノードのフェンシングを回避することをお勧めします。

CorosyncトークンのタイムアウトおよびSBDウォッチドッグのタイムアウトを増やし、その他の関連設定を調整します。適切な値は個別の設定によって異なります。詳細については、13.5項 「タイムアウトの計算」を参照してください。

ライブマイグレーションを実行する前に、ノードまたはクラスタ全体のいずれかでクラスタサービスを停止します。詳細については、28.2項 「保守タスクのためのさまざまなオプション」を参照してください。

運用環境でライブマイグレーションを試す前に、この設定を十分にテストする必要があります。

1.2.5 ローカル、メトロ、およびGeoクラスタのサポート #

SUSE Linux Enterprise High Availabilityは、地理的に分散したクラスタ(Geoクラスタ)を含むさまざまな地理的シナリオをサポートします。

- ローカルクラスタ

1つのロケーション内の単一のクラスタ(たとえば、すべてのノードが1つのデータセンターにある)。クラスタはノード間の通信にマルチキャストまたはユニキャストを使用し、フェールオーバーを内部で管理します。ネットワークの遅延時間は無視できます。ストレージは通常、すべてのノードに同時にアクセスされます。

- メトロクラスタ

すべてのサイトがファイバチャネルで接続された、複数の建物またはデータセンターにわたってストレッチできる単一のクラスタ。クラスタはノード間の通信にマルチキャストまたはユニキャストを使用し、フェールオーバーを内部で管理します。ネットワークの遅延時間は通常は短くなります(約20マイルの距離で5ms未満)。ネットワークのレイテンシは通常は短くなります(約20マイルの距離で<5ms)。ストレージは頻繁にレプリケートされます(ミラーリングまたは同期レプリケーション)

- Geoクラスタ(マルチサイトクラスタ)

それぞれにローカルクラスタを持つ、複数の地理的に離れたサイト。サイトはIPによって交信します。サイト全体のフェールオーバーはより高いレベルのエンティティによって調整されます。Geoクラスタは限られたネットワーク帯域幅および高レイテンシに対応する必要があります。ストレージは同期的にレプリケートされます。

注記: GeoクラスタリングおよびSAPワークロード現在、Geoクラスタは、SAP HANAのシステムレプリケーションもSAP S/4HANAおよびSAP NetWeaverのエンキューレプリケーション設定もサポートしていません。

個々のクラスタノード間の地理的距離が大きいほど、クラスタが提供するサービスの高可用性を妨げる可能性のある要因が多くなります。ネットワークの遅延時間、限られた帯域幅およびストレージへのアクセス が長距離クラスタの課題として残ります。

1.2.6 リソースエージェント #

SUSE Linux Enterprise High Availabilityには、Apache、IPv4、IPv6、その他多数のリソースを管理するための多数のリソースエージェントが含まれています。またIBM WebSphere Application Serverなどの一般的なサードパーティアプリケーション用のリソースエージェントも含まれています。ご利用の製品に含まれているOpen Cluster Framework (OCF)リソースエージェントの概要は、crm

raで説明される5.5.4項 「OCFリソースエージェントに関する情報の表示」コマンドを使用してください。

1.2.7 ユーザフレンドリな管理ツール #

SUSE Linux Enterprise High Availabilityには、強力なツールセットが付属しています。クラスタの基本的なインストールとセットアップ、および効果的な設定と管理のためにこれらのツールを使用してください。

- YaST

一般的なシステムインストールおよび管理用グラフィカルユーザインタフェース。『インストールとセットアップクイックスタート』で説明されているように、YaSTを使用して、SUSE Linux Enterprise High AvailabilityをSUSE Linux Enterprise Server上にインストールします。YaSTでは、クラスタまたは個々のコンポーネントの設定に役立つように、High Availabilityカテゴリ内の次のモジュールも提供しています。

クラスタ: 基本的なクラスタセットアップ。詳細については、第4章 「YaSTクラスタモジュールの使用」を参照してください。

DRBD: Distributed Replicated Block Deviceの設定。

IP負荷分散: Linux仮想サーバまたはHAProxyによる負荷分散の設定。詳細については、第17章 「負荷分散」を参照してください。

- Hawk2

High AvailabilityクラスタをLinuxまたは非Linuxマシンから同様に監視および管理することができる、ユーザフレンドリなWebベースのインタフェース。Hawk2には、(グラフィカルな)Webブラウザを使用して、クラスタの内部または外部の任意のマシンからアクセスできます。したがって、使用しているシステムが最小限のグラフィカルユーザインタフェースしか提供していない場合でも、理想的なソリューションとなります。詳細については、5.4項 「Hawk2の概要」を参照してください。

crmシェルリソースを設定し、すべての監視または管理作業を実行する、統合されたパワフルなコマンドラインインタフェースです。詳細については、5.5項 「crmshの概要」を参照してください。

1.3 利点 #

SUSE Linux Enterprise High Availabilityを使用すると、最大32台のLinuxサーバを高可用性クラスタ(HAクラスタ)に設定できます。リソースを動的に切り替えたり、クラスタ内の任意のノードに移動することができます。ノード障害発生時のリソースの自動マイグレーションの設定ができます。また、ハードウェアのトラブルシューティングやワークロードのバランスをとるために、リソースを手動で移動することもできます。

SUSE Linux Enterprise High Availabilityは、一般的なコンポーネントを利用して高可用性を提供します。アプリケーションと操作をクラスタに統合することによって、運用コストを削減できます。SUSE Linux Enterprise High Availabilityを使用すると、クラスタ全体を一元的に管理することも可能です。変化するワークロード要件に合わせてリソースを調整する(つまり、手動でクラスタを「負荷分散」する)ことができます。3ノード以上でクラスタを設定すると、複数のノードが「ホットスペア」を共用できて無駄がありません。

その他にも重要な利点として、予測できないサービス停止を削減したり、ソフトウェアおよびハードウェアの保守やアップグレードのための計画的なサービス停止を削減できる点が挙げられます。

次に、クラスタによるメリットについて説明します。

可用性の向上

パフォーマンスの改善

運用コストの低減

拡張性

障害回復

データの保護

サーバの集約

ストレージの集約

共有ディスクサブシステムにRAID を導入することによって、共有ディスクの耐障害性を強化できます。

次のシナリオは、SUSE Linux Enterprise High Availabilityが提供可能な利点を示しています。

クラスタシナリオ例#

ノード3台でクラスタが設定され、それぞれのノードにWebサーバをインストールしたと仮定します。クラスタ内の各ノードが、2つのWebサイトをホストしています。各Webサイトのすべてのデータ、グラフィックス、Webページコンテンツは、クラスタ内の各ノードに接続された、共有ディスクサブシステムに保存されています。次の図は、このクラスタのセットアップを示しています。

通常のクラスタ操作では、クラスタ内の各ノードが他のノードと常に交信し、すべての登録済みリソースを定期的にポーリングして、障害を検出します。

Webサーバ1でハードウェアまたはソフトウェアの障害が発生したため、このサーバを利用してインターネットアクセス、電子メール、および情報収集を行っているユーザの接続が切断されたとします。次の図は、Webサーバ1で障害が発生した場合のリソースの移動を表したものです。

WebサイトAがWebサーバ2に、WebサイトBがWebサーバ3に移動します。IPアドレスと証明書もWebサーバ2とWebサーバ3に移動します。

クラスタを設定するときに、それぞれのWebサーバがホストしているWebサイトについて、障害発生時の移動先を指定します。先に説明した例では、WebサイトAの移動先としてWebサーバ2が、WebサイトBの移動先としてWebサーバ3が指定されています。このようにして、Webサーバ 1によって処理されていたワークロードが、残りのクラスタメンバーに均等に分散され、可用性を維持できます。

Webサーバ1で障害が発生したとき、High Availabilityソフトウェアは次の処理を実行しました。

障害を検出し、Webサーバ 1が本当に機能しなくなっていることをSTONITHを使用して検証。STONITHは「Shoot The Other Node In The Head」の略です。これは、動作異常のノードを停止することでクラスタに問題を発生させないようにする手段です。

Webサーバ1にマウントされていた共有データディレクトリを、Webサーバ2およびWebサーバ3に再マウント。

Webサーバ1で動作していたアプリケーションを、Webサーバ2およびWebサーバ3で再起動。

IPアドレスをWebサーバ2およびWebサーバ3に移動。

この例では、フェールオーバープロセスが迅速に実行され、ユーザはWebサイトの情報へのアクセスを数秒程度で回復できます。通常、再度ログインする必要はありません。

ここで、Webサーバ1で発生した問題が解決し、通常に操作できる状態に戻ったと仮定します。WebサイトAおよびWebサイトBは、Webサーバ1に自動的にフェールバック(復帰)することも、そのままの状態を維持することもできます。これは、リソースの設定方法によって決まります。サービスをWebサーバ1に戻すと、ある程度のダウンタイムが生じます。このため、SUSE Linux Enterprise High Availabilityでは、サービスの中断がほとんどまたはまったく発生しなくなるまで、マイグレーションを延期することもできます。いずれの場合でも利点と欠点があります。

SUSE Linux Enterprise High Availabilityには、リソースマイグレーション機能も用意されています。システム管理の必要に応じて、アプリケーション、Webサイトなどをクラスタ内の他のサーバに移動できます。

たとえば、WebサイトAまたはWebサイトBをWebサーバ1からクラスタ内の他のサーバに手動で移動することができます。これは、Webサーバ1のアップグレードや定期メンテナンスを実施する場合、また、Webサイトのパフォーマンスやアクセスを向上させる場合に有効な機能です。

1.4 クラスタ設定: ストレージ #

SUSE Linux Enterprise High Availabilityでのクラスタ設定には、共有ディスクサブシステムが含まれる場合と含まれない場合があります。共有ディスクサブシステムの接続には、高速ファイバチャネルカード、ケーブル、およびスイッチを使用でき、また設定にはiSCSIを使用することができます。ノードの障害時には、クラスタ内の別の指定されたノードが、障害の発生したノードにマウントされていた共有ディスクディレクトリを自動的にマウントします。この機能によって、ネットワークユーザは、共有ディスクサブシステム上のディレクトリに対するアクセスを中断することなく実行できます。

共有ディスクサブシステムをLVMと使用する場合、クラスタ内の、アクセスが必要なすべてのサーバにそのサブシステムを接続する必要があります。

一般的なリソースの例としては、データ、アプリケーション、およびサービスなどがあります。次の図は、一般的なファイバチャネルクラスタの設定を表したものです。緑色の線は、Ethernet電源スイッチへの接続を示しています。このようなデバイスは、ネットワークを介して制御することが可能であり、ping要求が失敗したときにノードを再起動することができます。

ファイバチャネルは最も高いパフォーマンスを提供しますが、iSCSIを利用するようにクラスタを設定することもできます。iSCSIは低コストなストレージエリアネットワーク(SAN)を作成するための方法として、ファイバチャネルの代わりに使用できます。次の図は、一般的なiSCSIクラスタの設定を表したものです。

ほとんどのクラスタには共有ディスクサブシステムが含まれていますが、共有ディスクサブシステムなしのクラスタを作成することもできます。次の図は、共有ディスクサブシステムなしのクラスタを表したものです。

1.5 アーキテクチャ #

このセクションでは、SUSE Linux Enterprise High Availabilityのアーキテクチャの概要について簡単に説明します。アーキテクチャコンポーネントと、その相互運用方法について説明します。

1.5.1 アーキテクチャ層 #

SUSE Linux Enterprise High Availabilityでは、アーキテクチャが階層化されています。図1.6「アーキテクチャ」に異なる層と関連するコンポーネントを示します。

1.5.1.1 メンバーシップとメッセージング層(Corosync) #

このコンポーネントは、クラスタのメッセージング、メンバーシップ、クォーラムに関する信頼性の高い情報を提供します。具体的には、グループ通信システムであるCorosyncクラスタエンジンがその処理を担っています。

1.5.1.2 クラスタリソースマネージャ(Pacemaker) #

クラスタリソースマネージャであるPacemakerは、クラスタ内で発生したイベントへの対応を司る「頭脳」です。これは、あらゆるアクションを統括するpacemaker-controldクラスタコントローラとして実装されます。イベントとは、クラスタにおけるノードの加入と離脱、リソースでの障害発生、保守などの計画的なアクティビティのことを指します。

- ローカルリソースマネージャ

ローカルリソースマネージャは、各ノードのPacemaker層とリソース層の間に存在し、

pacemaker-execdデーモンとして実装されます。このデーモンにより、Pacemakerでのリソースの起動、停止、監視が可能になります。- CIB (クラスタ情報データベース)

Pacemakerは、ノードごとにCIBを保持しています。CIBとは、クラスタ設定のXML表現のことで、クラスタの各オプション、ノード、リソース、制約、個々の要素間の関係性などが記述されています。CIBには、現在のクラスタのステータスも反映されます。各クラスタノードにはCIBレプリカが配置され、クラスタ全体との同期が取られます。クラスタの設定とステータスの読み書きは、

pacemaker-basedデーモンが行います。- DC (指定コーディネータ)

DCは、クラスタ内にあるすべてのノードの中から選択されます。この操作は、DCがまだ指定されていない場合や、現在のDCが何らかの理由でクラスタを離脱した場合に行われます。DCは、ノードのフェンシングやリソースの移動など、クラスタ全体に及ぶ変更が必要かどうかを判断できる、クラスタ内で唯一のエンティティです。その他すべてのノードは、現在のDCから設定とリソース割り当て情報を取得します。

- ポリシーエンジン

ポリシーエンジンはすべてのノードで実行できますが、DC上にあるものだけがアクティブになります。このエンジンは

pacemaker-schedulerdデーモンとして実装されます。クラスタ遷移が必要になると、pacemaker-schedulerdはクラスタの現在の状態と設定を基に、クラスタの次の状態を計算します。また、次の状態を達成するためにどんなアクションを行う必要があるかも決定します。

1.5.1.3 リソースおよびリソースエージェント #

高可用性を備えたクラスタでは、高い可用性を維持し続ける必要があるサービスのことを「リソース」と呼びます。RA (リソースエージェント)とは、これらのクラスタリソースの起動、停止、監視に使用されるスクリプトのことです。

1.5.2 プロセスフロー #

pacemakerdデーモンは、その他のあらゆる関連デーモンの起動と監視を行います。pacemaker-controldデーモンはすべてのアクションを統括し、自身のインスタンスを各クラスタノードに配置します。Pacemakerは、プライマリとして動作するインスタンスを1つ選択することにより、クラスタのすべての意思決定を一元化します。選択したpacemaker-controldデーモンで障害が発生する場合は、新たなプライマリがマスターになります。

クラスタ内で実行するアクションの多くは、クラスタ全体に及ぶ変更を伴います。これらのアクションにはクラスタリソースの追加や削除、リソース制約の変更などがあります。このようなアクションを実行する場合は、クラスタ内でどのような変化が発生するのかを理解することが重要です。

たとえば、クラスタIPアドレスリソースを追加するとします。そのためには、crmシェルかWebインタフェースを使用してCIBを変更できます。DCでアクションを実行する必要はありません。クラスタ内の任意のノードでいずれかのツールを使用でき、その使用情報がDCに伝達されます。そして、DCがすべてのクラスタノードにCIBの変更を複製します。

pacemaker-schedulerdは、CIBの情報に基づいて、クラスタの理想的な状態とその達成方法を計算します。命令のリストをDCにフィードします。DCはメッセージング/インフラストラクチャ層を介してコマンドを送信し、他のノードのpacemaker-controldピアがこれらのコマンドを受信します。それぞれのピアは、ローカルでリソースエージェントエグゼキュータ(pacemaker-execd)を使用してリソースに変更を加えます。pacemaker-execdはクラスタに対応しておらず、リソースエージェントと直接通信します。

すべてのピアノードは操作結果をDCに返送します。DCが、すべての必要な操作がクラスタ内で成功したことを確認すると、クラスタはアイドル状態に戻り、次のイベントを待機します。予定どおり実行されなかった操作があれば、CIBに記録された新しい情報を基に、pacemaker-schedulerdを再度呼び出します。

場合によっては、共有データの保護や完全なリソース復旧のためにノードの電源を切らなければならないことがあります。Pacemakerクラスタにおけるノードレベルフェンシングの実装は、STONITHです。このPacemakerにはフェンシングサブシステムpacemaker-fencedが内蔵されています。STONITHデバイスは、(特定のフェンシングエージェントを使用する)クラスタリソースとして設定する必要があります。これにより、フェンシングデバイスの監視が可能になるからです。クライアントは障害を検出すると、pacemaker-fencedへ要求を送信します。このデーモンはフェンシングエージェントを実行することにより、ノードを停止します。

2 システム要件と推奨事項 #

次のセクションでは、SUSE® Linux Enterprise High Availabilityのシステム要件と前提条件について説明します。また、クラスタセットアップの推奨事項についても説明します。

2.1 ハードウェア要件 #

次のリストは、SUSE® Linux Enterprise High Availabilityに基づくクラスタのハードウェア要件を指定しています。これらの要件は、最低のハードウェア設定を表しています。クラスタの使用方法によっては、ハードウェアを追加しなければならないこともあります。

- サーバ

2.2項 「ソフトウェアの必要条件」に指定されたソフトウェアを搭載した1~32台のLinuxサーバ。

サーバはベアメタルでも仮想マシンでも構いません。各サーバが同一のハードウェア設定(メモリ、ディスクスペースなど)になっている必要はありませんが、アーキテクチャは同じである必要があります。クロスプラットフォームのクラスタはサポートされていません。

pacemaker_remoteを使用すると、32ノード制限を超えて追加のLinuxサーバを含めるようにクラスタを拡張できます。- 通信チャネル

クラスタノードあたり、少なくとも2つのTCP/IP通信メディア。ネットワーク機器は、クラスタ通信に使用する通信手段(マルチキャストまたはユニキャスト)をサポートする必要があります。通信メディアは100Mbit/s以上のデータレートをサポートする必要があります。サポートされるクラスタセットアップでは、2つ以上の冗長通信パスが必要です。これは次のように実行できます。

ネットワークデバイスボンディング(推奨)

Corosync内の2つ目の通信チャネル。

詳細については、第16章 「ネットワークデバイスボンディング」と手順4.3「冗長通信チャネルの定義」をそれぞれ参照してください。

- ノードフェンシング/STONITH

「スプリットブレイン」シナリオを回避するため、クラスタにはノードフェンシングメカニズムが必要です。スプリットブレインシナリオでは、クラスタノードは、お互いを認識していない2つ以上のグループに分割されます(ハードウェアまたはソフトウェアの障害か、ネットワーク接続の切断による)。フェンシングメカニズムにより、問題のあるノードを分離します(通常はノードをリセットするか、ノードの電源をオフにすることによって分離します)。これをSTONITH (「Shoot the other node in the head」)と呼びます。ノードフェンシングメカニズムは、物理デバイス(電源スイッチ)でも、SBD (ディスクによるSTONITH)のようなメカニズムとウォッチドッグを組み合わせたものでも構いません。SBDを使用するには共有ストレージが必要です。

SBDが使用される場合を除き、High Availabilityクラスタの各ノードには少なくとも1つのSTONITHデバイスが必要です。ノードごとに複数のSTONITHデバイスを使用することを強くお勧めします。

重要: STONITHがない場合はサポートなしクラスタにはノードフェンシングメカニズムが必要です。

グローバルクラスタオプション

stonith-enabledおよびstartup-fencingはtrueに設定する必要があります。これらを変更するとサポートされなくなります。

2.2 ソフトウェアの必要条件 #

すべてのノードは、少なくとも次のモジュールおよび拡張機能が必要です。

Basesystem Module 15 SP6

Server Applications Module 15 SP6

SUSE Linux Enterprise High Availability 15 SP6

インストール中に選択したシステムの役割に応じて、デフォルトで次のソフトウェアパターンがインストールされます。

- HAノードシステムの役割

高可用性 (

sles_ha)強化された基本システム (

enhanced_base)- HA GEOノードシステムの役割

Geo Clustering for High Availability (

ha_geo)強化された基本システム (

enhanced_base)

これらのシステムの役割を介してインストールすると、最小限のインストールにのみ抑えられます。必要に応じて、パッケージを手動で追加しなければならない場合があります。

最初に別のシステムの役割が割り当てられていたマシンの場合、sles_haパターンまたはha_geoパターンとその他の必要なパッケージを手動でインストールする必要があります。

2.3 ストレージ要件 #

一部のサービスでは、共有ストレージが必要です。外部NFS共有を使用する場合は、冗長通信パスを介してすべてのクラスタノードから確実にアクセスできる必要があります。

クラスタでデータの可用性を高めたい場合は、共有ディスクシステム(SAN: Storage Area Network)の利用をお勧めします。共有ディスクシステムを使用する場合は、次の要件を満たしていることを確認してください。

メーカーの指示のに従い、共有ディスクシステムが適切に設定され、正しく動作していることを確認します。

共有ディスクシステム中のディスクを、ミラーリングまたはRAIDを使用して耐障害性が高められるように設定してください。

共有ディスクシステムのアクセスにiSCSIを使用している場合、iSCSIイニシエータとターゲットを正しく設定していることを確認します。

2台のマシンにデータを配分するミラーリングRAIDシステムを実装するためにDRBD*を使用する際、DRBDに提供されるデバイスにのみアクセスし、決してバッキングデバイスにはアクセスしないようにします。冗長性を確保するために、クラスタの残りの部分と同一のNICを利用できます。

SBDをSTONITHメカニズムとして使用する場合は、共有ストレージに対して追加の要件が適用されます。詳細については、13.3項 「要件と制約」を参照してください。

2.4 その他の要件と推奨事項 #

サポートされていて、役に立つHigh Availabilityセットアップについては、次の推奨事項を検討してください。

- クラスタノード数

3つ以上のノードを持つクラスタに対して、奇数のクラスタノードを使用してクォーラムを持つようにすることを強くお勧めします。クォーラムの詳細については、5.2項 「クォーラムの判断」を参照してください。通常のクラスタには最大32ノードを含めることができます。

pacemaker_remoteサービスを使用すると、高可用性クラスタを拡張して、この制限を超えて追加のノードを含めることができます。詳細については、『Pacemaker Remote Quick Start』を参照してください。- 時刻同期

クラスタノードはクラスタ外のNTPサーバに同期する必要があります。SUSE Linux Enterprise High Availability 15以降、Chronyは、NTPでデフォルトで実装されるようになりました。詳細については、 Administration Guide for SUSE Linux Enterprise Server 15 SP6を参照してください。

ノードが同期されていない場合、または同期されていても異なるタイムゾーンが設定されている場合、クラスタが正しく動作しない場合があります。また、同期が行われていないと、ログファイルとクラスタレポートの分析が非常に困難になります。ブートストラップスクリプトを使用するときにNTPがまだ設定されていない場合、警告が表示されます。

- ネットワークインタフェースカード(NIC)名

すべてのノード上で同一である必要があります。

- ホスト名およびIPアドレス

静的IPアドレスを使用します。

プライマリIPアドレスのみがサポートされます。

ファイル

/etc/hostsにあるすべてのクラスタノードを、完全修飾ホスト名およびショートホスト名で一覧表示します。クラスタのメンバーが名前で互いを見つけられることが重要です。名前を使用できない場合、内部クラスタ通信は失敗します。Pacemakerがノード名を取得する方法の詳細については、https://clusterlabs.org/doc/en-US/Pacemaker/1.1/html/Pacemaker_Explained/s-node-name.htmlも参照してください。

- SSH

すべてのクラスタノードはSSHによって互いにアクセスできる必要があります。

crm report(トラブルシューティング用)などのツールおよびHawk2のは、ノード間でパスワード不要のSSHアクセスを必要とします。それがない場合、現在のノードからしかデータを収集できません。ブートストラップスクリプトを使用してクラスタを設定した場合、SSHキーは自動的に作成され、コピーされます。YaSTクラスタモジュールを使用してクラスタを設定した場合、SSHキーを自分自身で設定する必要があります。

注記: 規定要件デフォルトでは、クラスタは

rootユーザとして操作を実行します。パスワード不要のrootSSHアクセスが規定要件に準拠していない場合、代わりにsudo特権を持つユーザとしてクラスタを設定できます。このユーザは、crm reportなどのクラスタ操作を実行できます。また、SSHキーをノードに直接保存できない場合、5.5.1項 「ログイン」で説明されているように、代わりにSSHエージェントを転送してローカルSSHキーを使用できます。

さらに厳密なセキュリティポリシーが必要な場合、D1項 「非rootユーザに限定的な

sudo特権を設定する」で説明されているように、crm reportに特化した限定的なsudo特権のみを持つ非rootユーザを設定できます。については、現在のところ、パスワード不要のログインに代わる方法はありません。

3 SUSE Linux Enterprise High Availabilityのインストール #

初めてSUSE® Linux Enterprise High Availabilityを使用して高可用性クラスタを設定する場合、最も簡単な方法は、基本的な2ノードクラスタで開始することです。2ノードクラスタを使用して、一部のテストを実行することもできます。後で、AutoYaSTを使用して既存のクラスタノードのクローンを作成することにより、さらにノードを追加できます。クローンを作成したノードには、元のノードと同じパッケージがインストールされ、クローンノードは同じシステム設定を持つことになります。

前のバージョンのSUSE Linux Enterprise High Availabilityを実行する既存のクラスタをアップグレードする場合は、第29章 「クラスタアップグレードとソフトウェアパッケージの更新」を参照してください。

3.1 手動インストール #

高可用性用のパッケージの手動インストールについては、Article “インストールとセットアップクイックスタート”を参照してください。このマニュアルでは、基本的な2ノードクラスタをセットアップする手順を説明しています。

3.2 AutoYaSTによる大量インストールと展開 #

2ノードクラスタをインストールしてセットアップした後で、AutoYaSTを使用して既存のノードのクローンを作成し、クラスタにそのクローンを追加することによりクラスタを拡張できます。

AutoYaSTでは、インストールおよび設定データを含むプロファイルを使用します。このプロファイルによって、インストールする対象と、インストールしたシステムが最終的に使用準備が整ったシステムになるように設定する方法がAutoYaSTに指示されます。そこでこのプロファイルはさまざまな方法による大量配備に使用できます(たとえば、既存のクラスタノードのクローンなど)。

さまざまなシナリオでAutoYaSTを使用する方法の詳細については、 AutoYaST Guide for SUSE Linux Enterprise Server 15 SP6を参照してください 。

手順3.1「AutoYaSTによるクラスタノードのクローン作成」では、同じハードウェア設定を持つ一群のマシンにSUSE Linux Enterprise High Availability SP6を展開していることを前提としています。

同じではないハードウェア上にクラスタノードを展開する必要がある場合は、『SUSE Linux Enterprise Server 15 SP6展開ガイド』、「Automated Installation」の章の「Rule-Based Autoinstallation」セクションを参照してください。

クローンを作成するノードが正しくインストールされ、設定されていることを確認します。詳細については、『インストールとセットアップクイックスタート』または『第4章 「YaSTクラスタモジュールの使用」』を参照してください。

単純な大量インストールについては、『SUSE Linux Enterprise 15 SP6展開ガイド』の説明に従ってください。これには、次の基本ステップがあります。

AutoYaSTプロファイルの作成AutoYaST GUIを使用して、既存のシステム設定を基にプロファイルを作成し、変更します。AutoYaSTでは、モジュールを選択し、ボタンをクリックします。必要な場合は、他のモジュールの設定を調整し、その結果のコントロールファイルをXMLとして保存します。

DRBDを設定した場合、AutoYaST GUIでこのモジュールを選択してクローンを作成することもできます。

AutoYaSTプロファイルのソースと、他のノードのインストールルーチンに渡すパラメータを決定します。

SUSE Linux Enterprise ServerのソースとSUSE Linux Enterprise High Availabilityインストールデータを決定します。

自動インストールのブートシナリオを決定し、設定します。

パラメータを手動で追加するか、または

infoファイルを作成することにより、インストールルーチンにコマンド行を渡します。自動インストールプロセスを開始および監視します。

クローンのインストールに成功したら、次の手順を実行して、クローンノードをクラスタに加えます。

4.7項 「すべてのノードへの設定の転送」の説明に従って、Csync2を使用して、設定済みのノードからクローンノードへ重要な設定ファイルを転送します。

ノードをオンラインにするには、4.8項 「クラスタをオンラインにする」の説明のとおり、クローンノード上でクラスタサービスを開始します。

これで、/etc/corosync/corosync.confファイルがCsync2を介してクローンノードに適用されたので、クローンノードがクラスタに加わります。CIBは、クラスタノード間で自動的に同期されます。

4 YaSTクラスタモジュールの使用 #

YaSTクラスタモジュールでは、クラスタを手動で(最初から)設定するか、既存のクラスタのオプションを変更することができます。

ただし、クラスタの設定に自動化された方法を選ぶ場合は、Article “インストールとセットアップクイックスタート”を参照してください。このマニュアルでは、必要なパッケージのインストール方法と、crmによって提供されているブートストラップスクリプトを使用して基本的な2ノードクラスタを設定する手順を説明しています。

たとえば、1つのノードをYaSTクラスタで設定してから、ブートストラップスクリプトの1つを使用して他のノードを統合させる(またはその逆も可能)など、両方のセットアップ方法を組み合わせることもできます。

4.1 用語の定義 #

YaSTクラスタモジュールおよびこの章で使用されているいくつかの主要な用語を以下に定義します。

- バインドネットワークアドレス(

bindnetaddr) Corosyncエグゼクティブのバインド先のネットワークアドレス。クラスタ間の設定ファイルの共有を簡素化するため、Corosyncはネットワークインタフェースネットマスクを使用して、ネットワークのルーティングに使用されるアドレスビットのみをマスクします。たとえば、ローカルインタフェースが

192.168.5.92でネットマスクが255.255.255.0の場合、bindnetaddrは192.168.5.0に設定します。ローカルインタフェースが192.168.5.92でネットマスクが255.255.255.192の場合は、bindnetaddrを192.168.5.64に設定します。ringX_addrを含むnodelistが/etc/corosync/corosync.confで明示的に設定されている場合、bindnetaddrは厳密には必要ありません。注記: すべてのノードのネットワークアドレスすべてのノード上で同じCorosync設定が使用されるため、ネットワークアドレスは、特定のネットワークインタフェースのアドレスではなく、

bindnetaddrとして使用します。conntrackツールカーネル内の接続トラッキングシステムとやり取りできるようにして、iptablesでのステートフルなパケット検査を可能にします。SUSE Linux Enterprise High Availabilityによって使用され、クラスタノード間の接続ステータスを同期します。詳細については、https://conntrack-tools.netfilter.org/を参照してください。

- Csync2

クラスタ内のすべてのノード、およびGeoクラスタ全体に設定ファイルを複製するために使用できる同期ツールです。Csync2は、同期グループ別にソートされた任意の数のホストを操作できます。各同期グループは、メンバーホストの独自のリストとその包含/除外パターン(同期グループ内でどのファイルを同期するか定義するパターン)を持っています。グループ、各グループに属するホスト名、および各グループの包含/除外ルールは、Csync2設定ファイル

/etc/csync2/csync2.cfgで指定されます。Csync2は、認証には、同期グループ内でIPアドレスと事前共有キーを使用します。管理者は、同期グループごとに1つのキーファイルを生成し、そのファイルをすべてのグループメンバーにコピーする必要があります。

Csync2の詳細については、https://oss.linbit.com/csync2/paper.pdfを参照してください。

- 既存のクラスタ

「既存のクラスタ」という用語は、1つ以上のノードで構成されるクラスタを指すものとして使用されます。既存のクラスタは、通信チャネルを定義する基本的なCorosync設定を持ちますが、必ずしもリソース設定を持つとは限りません。

- マルチキャスト

ネットワーク内で一対多数の通信に使用される技術で、クラスタ通信に使用できます。Corosyncはマルチキャストとユニキャストの両方をサポートしています。

注記: スイッチとマルチキャストクラスタ通信にマルチキャストを使用するには、ご使用のスイッチがマルチキャストをサポートしていることを確認します。

- マルチキャストアドレス (

mcastaddr) Corosyncエグゼクティブによるマルチキャストに使用されるIPアドレス。このIPアドレスはIPv4またはIPv6のいずれかに設定できます。IPv6ネットワークを使用する場合は、ノードのIDを指定する必要があります。プライベートネットワークでは、どのようなマルチキャストアドレスでも使用できます。

- マルチキャストポート(

mcastport) クラスタ通信に使用されるポート。Corosyncでは、マルチキャストの受信用に指定する

mcastportと、マルチキャストの送信用のmcastport -1の、2つのポートを使用します。- 冗長リングプロトコル(RRP)

ネットワーク障害の一部または全体に対する災害耐性のために、複数の冗長ローカルエリアネットワークが使用できるようになります。この方法では、1つのネットワークが作動中である限り、クラスタ通信を維持できます。Corosyncはトーテム冗長リングプロトコルをサポートします。信頼できるソートされた方式でメッセージを配信するために、論理トークンパスリングがすべての参加ノードに課せられます。ノードがメッセージをブロードキャストできるのは、トークンを保持している場合のみです。

Corosyncに定義済みの冗長通信チャネルを持つ場合、RRPを使用してこれらのインタフェースの使用方法をクラスタに伝えます。RRPでは次の3つのモードを使用できます(

rrp_mode)。activeに設定した場合、Corosyncは両方のインタフェースをアクティブに使用します。ただし、このモードは非推奨の機能です。passiveに設定した場合、Corosyncは代わりに使用可能なネットワークを介してメッセージを送信します。noneに設定した場合、RRPは無効になります。

- ユニキャスト

1つのあて先ネットワークにメッセージを送信する技術Corosyncはマルチキャストとユニキャストの両方をサポートしています。Corosyncでは、ユニキャストはUDP-unicast (UDPU)として実装されます。

4.2 YaSTモジュール #

YaSTを起動して、 › を選択します。または、コマンドラインでモジュールを開始します。

sudo yast2 cluster

次のリストは、YaSTクラスタモジュールで使用可能な画面の概要を示しています。この画面には、クラスタセットアップの成功に必要なパラメータが含まれているかどうか、またはそのパラメータがオプションであるかどうかも説明されています。

- 通信チャネル(必須)

クラスタノード間の通信に1つまたは2つの通信チャネルを定義できます。転送プロトコルとして、マルチキャスト(UDP)またはユニキャスト(UDPU)のいずれかを使用します。詳細については、4.3項 「通信チャネルの定義」を参照してください。

重要: 冗長通信パスサポートされるクラスタセットアップでは、2つ以上の冗長通信パスが必要です。推奨される方法は、第16章 「ネットワークデバイスボンディング」で説明されるように、ネットワークデバイスボンディングを使用することです。

使用できない場合は、Corosync内にの2つ目の通信チャネルを定義する必要があります。

- セキュリティ(オプションだが推奨)

クラスタの認証設定を定義できます。共有シークレットが必要なHMAC/SHA1認証を使用して、メッセージを保護し、認証することができます。詳細については、4.4項 「認証設定の定義」を参照してください。

- Csync2の設定(オプションだが推奨)

Csync2では、設定変更を追跡して、クラスタノード間でファイルの同期を取ることができます。詳細については、4.7項 「すべてのノードへの設定の転送」を参照してください。

- conntrackdの設定(オプション)

ユーザスペース

conntrackdを設定できます。iptablesでの「ステートフルな」パケット検査のためにconntrackツールを使用します。詳細については、4.5項 「クラスタノード間の接続ステータスの同期」を参照してください。- サービス(必須)

クラスタノードをオンラインにするためにサービスを設定できます。ブート時にクラスタサービスを開始するかどうか、およびノード間の通信に必要なポートをファイアウォールで開くかどうかを定義します。詳細については、4.6項 「サービスの設定」を参照してください。

初めてクラスタモジュールを起動した場合は、モジュールが、ウィザードのように、基本設定に必要なすべてのステップをガイドします。そうでない場合は、左パネルのカテゴリをクリックして、ステップごとに設定オプションにアクセスします。

YaSTクラスタモジュール内の特定の設定は、現在のノードにのみ適用されます。他の設定はCsync2を使用してすべてのノードに自動的に転送できます。これについての詳しい情報は次のセクションを参照してください。

4.3 通信チャネルの定義 #

クラスタノード間で正常な通信を行うには、少なくとも1つの通信チャネルを定義します。手順 4.1または手順 4.2のそれぞれで説明されるように、転送プロトコルとしてマルチキャスト(UDP)またはユニキャスト(UDPU)のいずれかを使用します。2番目の冗長チャネル(手順 4.3)を定義する場合は、両方の通信チャネルで「同じ」プロトコルを使用する必要があります。

SUSE Linux Enterprise High Availabilityをパブリッククラウドプラットフォームに展開する場合は、ユニキャストで通信してください。クラウドプラットフォームでは、一般的にマルチキャストでの通信がサポートされていません。

YaST画面で定義されるすべての設定は、/etc/corosync/corosync.confに書き込まれます。マルチキャストとユニキャストの設定のサンプルファイルは/usr/share/doc/packages/corosync/にあります。

IPv4アドレスを使用する場合、ノードIDはオプションです。IPv6アドレスを使用する場合、ノードIDは必須です。各ノードにIDを手動で指定する代わりに、YaSTクラスタモジュールには、クラスタノードごとに固有のIDを自動的に生成するオプションが含まれています。

マルチキャストを使用する場合、すべてのクラスタノードに同じbindnetaddr、mcastaddr、およびmcastportが使用されます。クラスタ内のすべてのノードは同じマルチキャストアドレスを使用することで互いを認識します。別のクラスタは、別のマルチキャストアドレスを使用します。

YaSTクラスタモジュールを起動して、カテゴリに切り替えます。

プロトコルを

Multicastに設定します。を定義します。クラスタマルチキャストに使用するサブネットに値を設定します。

を定義します。

を定義します。

クラスタノードごとに一意のIDを自動的に生成するには、を有効にしたままにします。

を定義します。

の数を入力します。これは、パーティションされたクラスタでCorosyncがクォーラムを計算する場合に重要です。デフォルトでは、各ノードには

1票が割り当てられています。の数は、クラスタ内のノード数と一致する必要があります。変更内容を確認します。

必要な場合は、手順4.3「冗長通信チャネルの定義」で説明するように、Corosyncで冗長な通信チャネルを定義します。

クラスタ通信にマルチキャストではなくユニキャストを使用する場合は、次の手順に従います。

YaSTクラスタモジュールを起動して、カテゴリに切り替えます。

プロトコルを

Unicastに設定します。を定義します。

ユニキャスト通信では、Corosyncはクラスタ内のすべてのノードのIPアドレスを認識する必要があります。各ノードで、をクリックし、次の詳細情報を入力します。

(Corosyncで2つ目の通信チャネルを使用する場合にのみ必要)

(オプションが無効になっている場合にのみ必要)

クラスタメンバーのアドレスを変更または削除するには、またはボタンを使用します。

クラスタノードごとに一意のIDを自動的に生成するには、を有効にしたままにします。

を定義します。

の数を入力します。これは、パーティションされたクラスタでCorosyncがクォーラムを計算する場合に重要です。デフォルトでは、各ノードには

1票が割り当てられています。の数は、クラスタ内のノード数と一致する必要があります。変更内容を確認します。

必要な場合は、手順4.3「冗長通信チャネルの定義」で説明するように、Corosyncで冗長な通信チャネルを定義します。

ネットワークデバイスボンディングが何らかの理由で使用できない場合、第2の選択は、Corosyncに冗長通信チャネル(2つ目のリング)を定義することです。この方法では、2つの物理的に分かれたネットワークが通信に使用できます。1つのネットワークが失敗しても、クラスタノードは、もう一方のネットワークを介して通信できます。

Corosync内の追加の通信チャネルは2つ目のトークンパスリングを形成します。/etc/corosync/corosync.confでは、設定した最初のチャネルはプライマリリングで、リング番号0を取得します。2つ目のリング(冗長チャネル)はリング番号1を取得します。

Corosyncに定義済みの冗長通信チャネルを持つ場合、RRPを使用してこれらのインタフェースの使用方法をクラスタに伝えます。RRPでは、2つの物理的に別個のネットワークが通信に使用されます。1つのネットワークが失敗しても、クラスタノードは、もう一方のネットワークを介して通信できます。

RRPでは次の3つのモードを使用できます。

activeに設定した場合、Corosyncは両方のインタフェースをアクティブに使用します。ただし、このモードは非推奨の機能です。passiveに設定した場合、Corosyncは代わりに使用可能なネットワークを介してメッセージを送信します。noneに設定した場合、RRPは無効になります。

/etc/hosts Corosync内で複数のリングが設定されている場合、各ノードが複数のIPアドレスを持つことができます。これはすべてのノードの/etc/hostsに反映する必要があります。

YaSTクラスタモジュールを起動して、カテゴリに切り替えます。

を有効にします。冗長チャネルは、定義した最初の通信チャネルと同じプロトコルを使用する必要があります。

マルチキャストを使用する場合は冗長チャネル用に次のパラメータを入力します: 使用する、、および。

ユニキャストを使用する場合は次のパラメータを定義します: 使用する、および。クラスタに参加するすべてのノードのIPアドレスを入力します。

Corosyncに、異なるチャネルを使用する方法とタイミングを伝えるには、使用するを選択します。

通信チャネルが1つだけ定義されている場合、が自動的に無効化されます(値

none)。activeに設定した場合、Corosyncは両方のインタフェースをアクティブに使用します。ただし、このモードは非推奨の機能です。passiveに設定した場合、Corosyncは代わりに使用可能なネットワークを介してメッセージを送信します。

RRPの使用時に、SUSE Linux Enterprise High Availabilityは現在のリングの状態を監視し、障害発生後に冗長リングを自動的に再度有効化します。

または、

corosync-cfgtoolを使用してリングの状態を手動で確認します。使用可能なオプションは-hで参照できます。変更内容を確認します。

4.4 認証設定の定義 #

クラスタの認証設定を定義するには、HMAC/SHA1認証を使用できます。共有シークレットが必要なHMAC/SHA認証を使用して、メッセージを保護し、認証する必要があります。指定した認証キー(パスワード)が、クラスタ中のすべてのノードで使用されます。

YaSTクラスタモジュールを起動し、カテゴリに切り替えます。

をオンにします。

新しく作成したクラスタの場合は、をクリックします。認証キーが作成され、

/etc/corosync/authkeyに書き込まれます。ご使用のマシンを既存のクラスタに参加させたい場合、新しいキーファイルは生成しないでください。代わりに、いずれかのノードから

/etc/corosync/authkeyを(手動またはCsync2によって)ご使用のマシンにコピーします。変更内容を確認します。YaSTが設定を

/etc/corosync/corosync.confに書き込みます。

4.5 クラスタノード間の接続ステータスの同期 #

iptablesに対してステートフルなパケット検査ができるようにするには、conntrackツールを設定して使用します。これには、次の基本手順を必要とします。

conntrackdの設定 #

YaSTクラスタモジュールを使用して、ユーザスペースconntrackdを設定します(図4.4「YaST — conntrackd」を参照してください)。これには、その他の通信チャネルに使用されていない専用のネットワークインタフェースが必要です。デーモンは後でリソースエージェントによって起動できます。

YaSTクラスタモジュールを起動して、カテゴリに切り替えます。

接続ステータスの同期に使用するを定義します。

で、接続ステータスを同期させるグループのID番号を定義します。

をクリックして、

conntrackdの設定ファイルを作成します。既存のクラスタでオプションを変更した場合、変更を確認して、クラスタモジュールを終了します。

クラスタ設定を先に進めるには、をクリックして、4.6項 「サービスの設定」で続行します。

を選択して、接続ステータスを同期します。選択したインタフェースのIPv4アドレスが自動的に検出され、YaSTに表示されます。これはすでに設定済みで、マルチキャストをサポートしている必要があります。

conntrackd #conntrackツールを設定したら、これをLinux Virtual Serverで使用できます(負荷分散を参照してください)。

4.6 サービスの設定 #

YaSTクラスタモジュールは、ブート時にノード上で一定のサービスを開始するかどうか定義します。サービスを手動で開始または停止するためにモジュールを使用することもできます。クラスタノードをオンラインにし、クラスタリソースマネージャを起動するには、Pacemakerをサービスとして実行する必要があります。

YaSTクラスタモジュール内で、カテゴリに切り替えます。

このクラスタノードがブートするたびにクラスタサービスを開始するには、グループで該当するオプションを選択します。グループで、を選択する場合は、このノードがブートするたびに手動でクラスタサービスを開始する必要があります。クラスタサービスを手動で開始するには、次のコマンドを使用します:

#crm cluster startクラスタサービスを直ちに開始または停止するには、それぞれのボタンをクリックします。

現在のマシン上でのクラスタ通信に必要なポートをファイアウォールで開くには、をアクティブにします。

変更内容を確認します。この設定は、すべてのクラスタノードではなく、ご使用のマシンにのみ適用されることにご注意ください。

4.7 すべてのノードへの設定の転送 #

結果として生成された設定ファイルをすべてのノードに手動でコピーする代わりに、csync2ツールを使用して、クラスタ内のすべてのノードにレプリケートします。

これには、次の基本手順を必要とします。

YaSTによるCsync2の設定ボタンをクリックします。

Csync2による設定ファイルの同期ボタンをクリックします。

Csync2では、設定変更を追跡して、クラスタノード間でファイルの同期を取ることができます。

操作に対して重要なファイルのリストを定義できます。

(他のクラスタノードに対して)これらのファイルの変更を表示できます。

1つのコマンドで複数の設定済みファイルの同期を取ることができます。

~/.bash_logoutの単純なシェルスクリプトを使用して、システムからログアウトする前に、同期化されていない変更について通知できます。

Csync2の詳細については、https://oss.linbit.com/csync2/とhttps://oss.linbit.com/csync2/paper.pdfにアクセスしてください。

4.7.1 YaSTによるCsync2の設定 #

YaSTクラスタモジュールを起動して、カテゴリに切り替えます。

同期グループを指定するには、グループでをクリックし、クラスタ内のすべてのノードのローカルホスト名を入力します。ノードごとに、

hostnameコマンドから返された文字列を正確に使用する必要があります。ヒント: ホスト名解決ホスト名解決がネットワークで正しく機能しない場合は、各クラスタノードのホスト名とIPアドレスの組み合わせを指定することもできます。この指定には、HOSTNAME@IP文字列(たとえば、

alice@192.168.2.100)を使用します。Csync2は、接続時にIPアドレスを使用します。をクリックして、同期グループのキーファイルを生成します。キーファイルは、

/etc/csync2/key_hagroupに書き込まれます。このファイルは、作成後に、クラスタのすべてのメンバーに手動でコピーする必要があります。すべてのノード間で、通常、同期される必要のあるファイルをリストに入れるには、をクリックします。

同期するファイルのリストからファイルを、、またはするには、該当する各ボタンを使用します。ファイルごとに絶対パス名を入力する必要があります。

をクリックして、Csync2をアクティブにします。これによって次のコマンドが実行され、ブート時にCsync2が自動的に起動します。

#systemctl enable csync2.socketをクリックします。YaSTがCsync2の設定内容を

/etc/csync2/csync2.cfgに書き込みます。

4.7.2 Csync2を使用した変更内容の同期 #

Csync2を初めて実行する前に、次の準備をする必要があります。

ファイル

/etc/csync2/csync2.cfgを、4.7.1項 「YaSTによるCsync2の設定」で説明されるとおりに設定した後、すべてのノードに手動でコピーします。4.7.1項のステップ 3の1つのノードで作成した

/etc/csync2/key_hagroupファイルを、クラスタ内の「すべての」ノードにコピーしてください。このファイルは、Csync2による認証で必要になります。ただし、すべてのノードで同じファイルでなければならないので、他のノードではファイルを再生成しないでください。すべてのノード上で次のコマンドを実行して、Csync2サービスを今すぐ開始します。

#systemctl start csync2.socket

最初にすべてのファイルを一度同期させるには、設定の「コピー元」であるマシン上で次のコマンドを実行します。

#csync2 -xvこれによって、すべてのファイルをその他のノードにプッシュすることで、一度に同期を行います。すべてのファイルが正常に同期されると、Csync2がエラーなしで終了します。

同期対象の1つ以上のファイルが(現在のノードだけでなく)他のノード上で変更されている場合は、Csync2から、以下のものと同様の出力との衝突が報告されます。

While syncing file /etc/corosync/corosync.conf: ERROR from peer hex-14: File is also marked dirty here! Finished with 1 errors.

現在のノードのファイルバージョンが「最良」だと確信する場合は、そのファイルを強制して再同期を行い、競合を解決できます。

#csync2 -f /etc/corosync/corosync.conf#csync2 -x

Csync2オプションの詳細については、次のコマンドを実行してください

#csync2 -help

Csync2は変更のみをプッシュします。Csync2はマシン間でファイルを絶えず同期しているわけではありません。

同期が必要なファイルを更新する際はいつも、変更を加えたマシン上でcsync2

-xvを実行することで、変更をその他のマシンにプッシュする必要があります。変更されていないファイルが配置された他のマシン上でこのコマンドを実行しても、何も起こりません。

4.8 クラスタをオンラインにする #

最初のクラスタ設定が完了した後、すべてのクラスタノード上でクラスタサービスを開始し、スタックをオンラインにします。

既存のノードにログインします。

すべてのクラスタノード上でクラスタサービスを開始します。

#crm cluster start --allこのコマンドにはノード間のパスワード不要のSSHが必要です。パスワード不要のSSHが設定されていない場合、各ノードに個別にログインし、

crm cluster startを実行する必要があります。クラスタのステータスを

crm statusコマンドで確認します。すべてのノードがオンラインの場合、出力は次のようになります。#crm status Cluster Summary: * Stack: corosync * Current DC: alice (version ...) - partition with quorum * Last updated: ... * Last change: ... by hacluster via crmd on bob * 2 nodes configured * 1 resource instance configured Node List: * Online: [ alice bob ] ...この出力は、クラスタリソースマネージャが起動し、リソースを管理できる状態にあることを示しています。

基本設定を完了し、ノードがオンラインになったら、クラスタリソースの設定を開始できます。crmシェル(crmsh)やHawk2などのクラスタ管理ツールのいずれかを使用します。詳細については、5.5項 「crmshの概要」または5.4項 「Hawk2の概要」を参照してください。

パート II 設定および管理 #

- 5 設定および管理の基本事項

HAクラスタの主な目的はユーザサービスの管理です。ユーザサービスの典型的な例は、Apache Webサーバまたはデータベースです。サービスとは、ユーザの観点からすると、指示に基づいて特別な何かを行うことを意味していますが、クラスタにとっては開始や停止できるリソースにすぎません。サービスの性質はクラスタには無関係なのです。

この章では、クラスタを管理するときに知っておく必要があるいくつかの基本的な概念について説明します。後続の各章では、SUSE Linux Enterprise High Availabilityが提供する各管理ツールを使用して、主要な設定および管理タスクを行う方法を説明します。

- 6 クラスタリソースの設定

クラスタの管理者は、クラスタ内のサーバ上の各リソースや、サーバ上で実行する各アプリケーションに対してクラスタリソースを作成する必要があります。クラスタリソースには、Webサイト、メールサーバ、データベース、ファイルシステム、仮想マシン、およびユーザが常時使用できるその他のサーバベースのアプリケーションまたはサービスなどが含まれます。

- 7 リソース制約の設定

すべてのリソースを設定する以外にも、多くの作業が必要です。クラスタが必要なすべてのリソースを認識しても、正しく処理できるとは限りません。リソースの制約を指定して、リソースを実行可能なクラスタノード、リソースのロード順序、特定のリソースが依存している他のリソースを指定することができます。

- 8 クラスタリソースの管理

クラスタ内でリソースを設定したら、クラスタ管理ツールを使用して、リソースを起動、停止、クリーンアップ、削除、または移行します。この章では、リソース管理タスクにHawk2またはcrmshを使用する方法について説明します。

- 9 リモートホストでのサービスの管理

リモートホストでサービスを監視および管理できることが、ここ数年の間にますます重要になってきています。SUSE Linux Enterprise High Availability 11 SP3では、監視プラグインを介したリモートホストでのサービスの詳細な監視機能を提供してきました。SUSE Linux Enterprise High Availability 15 SP6では、最近追加された

pacemaker_remoteサービスを使用すると、リモートマシンにクラスタスタックをインストールしていなくても、実際のクラスタノードと同様にリモートホストでリソースを全面的に管理および監視できます。- 10 リソースエージェントの追加または変更

クラスタによる管理が必要なすべての作業は、リソースとして使用できなければなりません。主要なグループとして、リソースエージェントとSTONITHエージェントの2つがあります。両方のカテゴリで、エージェントの追加や所有が可能で、クラスタ機能を各自のニーズに合わせて拡張することができます。

- 11 クラスタの監視

この章では、クラスタのヘルスを監視し、その履歴を表示する方法について説明します。

- 12 フェンシングとSTONITH

フェンシングはHA (High Availability)向けコンピュータクラスタにおいて重要なコンセプトです。クラスタがノードの1つの誤動作を検出し、そのノードの削除が必要となることがあります。これをフェンシングと呼び、一般にSTONITHリソースで実行されます。フェンシングは、HAクラスタを既知の状態にするための方法として定義できます。

クラスタのすべてのリソースには、それぞれ状態が関連付けられています。たとえば、「リソースr1はaliceで起動されている」などです。HAクラスタでは、このような状態は「リソースr1はalice以外のすべてのノードで停止している」ことを示します。クラスタは各リソースが1つのノードでのみ起動されるようにするためです。各ノードはリソースに生じた変更を報告する必要があります。つまり、クラスタの状態は、リソースの状態とノードの状態の集まりです。

ノードまたはリソースの状態を十分に確定することができない場合には、フェンシングが発生します。クラスタが所定のノードで起こっていることを認識しない場合でも、フェンシングによって、そのノードが重要なリソースを実行しないようにできます。

- 13 ストレージ保護とSBD

SBD (STONITH Block Device)は、共有ブロックストレージ(SAN、iSCSI、FCoEなど)を介したメッセージの交換を通じて、Pacemakerベースのクラスタのノードフェンシングメカニズムを提供します。これにより、フェンシングメカニズムが、ファームウェアバージョンの変更や特定のファームウェアコントローラへの依存から切り離されます。動作異常のノードが本当に停止したかどうかを確認するために、各ノードではウォッチドッグが必要です。特定の条件下では、ディスクレスモードで実行することにより、共有ストレージなしでSBDを使用することもできます。

クラスタブートストラップスクリプトは、フェンシングメカニズムとしてSBDを使用するオプションを使用してクラスタを設定する自動化された方法を提供します。詳細については、Article “インストールとセットアップクイックスタート”を参照してください。ただし、SBDを手動で設定する場合、個々の設定に関するオプションが増えます。

この章では、SBDの背後にある概念について説明します。スプリットブレインシナリオの場合に潜在的なデータ破損からクラスタを保護するために、SBDが必要とするコンポーネントを設定する手順を説明します。

ノードレベルのフェンシングに加えて、LVM排他アクティブ化やOCFS2ファイルロックのサポート(リソースレベルのフェンシング)など、ストレージ保護のための追加のメカニズムを使用することができます。これにより、管理上またはアプリケーション上の障害からシステムが保護されます。

- 14 QDeviceおよびQNetd

QDeviceおよびQNetdはクォーラムの決定に参加します。アービトレータ

corosync-qnetdからの支援により、corosync-qdeviceは設定可能な投票数を提供するため、クラスタは標準のクォーラムルールで許可されているよりも多くのノード障害に耐えることができます。ノード数が偶数であるクラスタ、特に2ノードクラスタについては、corosync-qnetdおよびcorosync-qdeviceの展開をお勧めします。- 15 アクセス制御リスト

crmシェル(crmsh)またはHawk2などのクラスタ管理ツールは、

rootユーザまたはhaclientグループ内のユーザが使用できます。デフォルトで、これらのユーザは完全な読み込み/書き込みのアクセス権を持ちます。アクセスを制限するか、または詳細なアクセス権を割り当てるには、「アクセス制御リスト」(ACL)を使用できます。アクセス制御リストは、順序付けされたアクセスルールセットで構成されています。各ルールにより、クラスタ設定の一部への読み込みまたは書き込みアクセスの許可、またはアクセスの拒否が行われます。ルールは通常、組み合わせて特定の役割を生成し、ユーザを自分のタスクに一致する役割に割り当てることができます。

- 16 ネットワークデバイスボンディング

多くのシステムで、通常のEthernetデバイスの標準のデータセキュリティ/可用性の要件を超えるネットワーク接続の実装が望ましいことがあります。その場合、数台のEthernetデバイスを集めて1つのボンディングデバイスを設定できます。

- 17 負荷分散

「負荷分散」によって、外部のクライアントからは、サーバのクラスタが1つの大きな高速サーバであるかのように見えます。この単一サーバのように見えるサーバは、仮想サーバと呼ばれます。このサーバは、着信要求をディスパッチする1つ以上のロードバランサと実際のサービスを実行しているいくつかの実際のサーバで構成されます。SUSE Linux Enterprise High Availabilityの負荷分散設定によって、高度にスケーラブルで可用性の高いネットワークサービス(Web、キャッシュ、メール、FTP、メディア、VoIPなど)を構築できます。

- 18 仮想化のための高可用性

この章では、仮想マシンを可用性の高いクラスタリソースとして設定する方法を説明します。

- 19 Geoクラスタ(マルチサイトクラスタ)

SUSE® Linux Enterprise High Availability 15 SP6は、ローカルクラスタとメトロエリアクラスタのほかに、地理的に離れたクラスタ(Geoクラスタ。マルチサイトクラスタとも呼ばれます)もサポートしています。これは、それぞれ1つのローカルクラスタで持った複数の地理的に離れたサイトを持てることを意味します。これらクラスタ間のフェールオーバーは、より高いレベルのエンティティである

boothによって管理されます。Geoクラスタの使用方法と設定方法の詳細については、Article “Geoクラスタリングのクイックスタート”とBook “Geo Clustering Guide”を参照してください。

5 設定および管理の基本事項 #

HAクラスタの主な目的はユーザサービスの管理です。ユーザサービスの典型的な例は、Apache Webサーバまたはデータベースです。サービスとは、ユーザの観点からすると、指示に基づいて特別な何かを行うことを意味していますが、クラスタにとっては開始や停止できるリソースにすぎません。サービスの性質はクラスタには無関係なのです。

この章では、クラスタを管理するときに知っておく必要があるいくつかの基本的な概念について説明します。後続の各章では、SUSE Linux Enterprise High Availabilityが提供する各管理ツールを使用して、主要な設定および管理タスクを行う方法を説明します。

5.1 ユースケースのシナリオ #

通常、クラスタのカテゴリは次のいずれかです。

2ノードクラスタ

2ノードより多いクラスタ。これは通常、奇数のノード数を意味します。

異なるトポロジを追加して、異なるユースケースを生成することもできます。次のユースケースは最も一般的です。

- 1つの場所の2ノードクラスタ

設定:FC SANまたは同様の共有ストレージ、レイヤ2ネットワーク。

使用シナリオ:サービスの高可用性、およびデータレプリケーションのデータ冗長性なしに焦点を当てた埋め込みクラスタ。このようなセットアップは無線ステーションや組立てラインコントローラなどに使用されます。

- 2つの場所の2ノードクラスタ(最も広く使用されている)

設定:対称的なストレッチクラスタ、FC SAN、およびレイヤ2ネットワークのすべてが2つの場所に及ぶ。

使用シナリオ:サービスの高可用性、およびローカルデータの冗長性に焦点を当てた従来のストレッチクラスタ。データベースおよびエンタープライズリソース計画に適しており、最も一般的な設定の1つです。

- 3つの場所の奇数のノード数

設定:2×N+1ノード、FC SANが2つの主な場所に及ぶ。FC SANを使用しない補助的な3番目のサイト、過半数メーカーとして機能する。レイヤ2ネットワーク、少なくとも2つの主な場所に及ぶ。

使用シナリオ:サービスの高可用性、およびデータの冗長性に焦点を当てた従来のストレッチクラスタ。たとえば、データベース、エンタープライズリソースプランニング。

5.2 クォーラムの判断 #

1つ以上のノードとその他のクラスタ間で通信が失敗した場合は、常にクラスタパーティションが発生します。ノードは同じパーティション内の他のノードのみと通信可能で、切り離されたノードは認識しません。クラスタパーティションは、ノード(投票)の過半数を保有する場合、クォーラムを持つ(「定足数に達している」)と定義されます。これを実現する方法は「クォーラム計算」によって実行されます。クォーラムはフェンシングの要件です。

クォーラムはPacemakerによって計算または決定されません。Corosyncは、Pacemaker設定を変更することなく、2ノードクラスタのクォーラムを直接処理できます。

クォーラムの計算方法は、次のような要因によって影響されます。

- クラスタノード数

実行中のサービスを継続させるため、2ノードを超えるクラスタはクラスタパーティションの解決においてクォーラム(過半数)に依存します。次の数式に基づき、クラスタが機能するために必要な動作ノードの最少数を計算できます。

N ≥ C/2 + 1 N = minimum number of operational nodes C = number of cluster nodes

たとえば、5ノードクラスタでは、最低3つの動作ノード(または障害が発生する可能性のある2ノード)が必要です。

2ノードクラスタまたは奇数のクラスタノードのいずれかを使用することを強くお勧めします。2ノードクラスタは、2サイト間のストレッチセットアップで重要です。奇数のノード数を持つクラスタは、1つのシングルサイトで構築するか、または3つのサイト間で分散させることができます。

- Corosyncの設定

Corosyncはメッセージングおよびメンバーシップ層です。5.2.1項 「2ノードクラスタのCorosync設定」および5.2.2項 「NノードクラスタのCorosync設定」を参照してください。

5.2.1 2ノードクラスタのCorosync設定 #

ブートストラップスクリプトを使用する場合、Corosync設定には次のオプションを持つquorumセクションがあります。

quorum {

# Enable and configure quorum subsystem (default: off)

# see also corosync.conf.5 and votequorum.5

provider: corosync_votequorum

expected_votes: 2

two_node: 1

}

デフォルトで、two_node: 1が設定されている場合、wait_for_allオプションが自動的に有効になります。wait_for_allが有効でない場合、クラスタは両方のノードでパラレルに開始される必要があります。または、最初のノードが、見つからない2番目のノードで起動フェンシングを実行します。

5.2.2 NノードクラスタのCorosync設定 #

2ノードクラスタを使用しない場合、Nノードクラスタに奇数のノードを使用することを強くお勧めします。クォーラム設定の場合、次のオプションがあります。

crm cluster joinコマンドを使用したノードの追加、またはCorosync設定の手動調整。

/etc/corosync/corosync.confを手動で調整する場合、次の設定を使用します。

quorum {

provider: corosync_votequorum 1

expected_votes: N 2

wait_for_all: 1 3

}Corosyncからのクォーラムサービスの使用 | |

予想される投票数。このパラメータは | |

wait for all (WFA)機能を有効にします。WFAが有効な場合、クラスタはすべてのノードが認識可能になった後でのみ定足数に達します。一部の起動時の競合状態を回避するために、 |

5.3 グローバルクラスタオプション #

グローバルクラスタオプションは、一定の状況下でのクラスタの動作を制御します。それらは、セットにグループ化され、Hawk2やcrmシェルなどのクラスタ管理ツールで表示したり、変更したりできます。

事前に定義されている値は、通常は、そのまま保持できます。ただし、クラスタの主要機能を想定どおりに機能させるには、クラスタの基本的なセットアップ後に、次のパラメータを調整する必要がある場合があります。

5.3.1 グローバルオプションno-quorum-policy #

このグローバルオプションは、クラスタパーティションにクォーラムがない(ノードの過半数がパーティションに含まれない)場合どうするかを定義します。

次の値を使用できます。

ignoreno-quorum-policyをignoreに設定すると、クラスタパーティションは、クォーラムがない場合でも、クォーラムがあるように動作します。このクラスタパーティションは、フェンシングを発行し、リソース管理を継続できます。SLES 11では、この値が2ノードのクラスタ用の推奨設定でした。SLES 12以降、値

ignoreは廃止されます。使用しないでください。設定と条件に基づいて、Corosyncはクラスタノードまたは単一ノードに「クォーラム」を与えます。または与えません。2ノードのクラスタの場合、ノードが失われた場合の唯一の意味のある動作は、常に反応することです。最初のステップとして、クォーラムを失ったノードのフェンシングを試行してください。

freezeクォーラムが失われた場合は、クラスタパーティションがフリーズします。リソース管理は続行されます。実行中のリソースは停止されません(ただし、イベントの監視に対応して再起動される可能性があります)。ただし、影響を受けたパーティション内では、以後のリソースが開始されません。

一定のリソースが他のノードとの通信に依存しているクラスタの場合(たとえば、OCFS2マウントなど)は、この設定が推奨されます。この場合、デフォルト設定

no-quorum-policy=stopは、次のようなシナリオになるので有効でありません。つまり、ピアノードが到達不能な間はそれらのリソースを停止できなくなります。その代わり、停止の試行は最終的にタイムアウトし、stop failureになり、エスカレートされた復元とフェンシングを引き起こします。stop(デフォルト値)クォーラムが失われると、影響を受けるクラスタパーティション内のすべてのリソースが整然と停止します。

suicideクォーラムが失われると、影響を受けるクラスタパーティション内のすべてのノードがフェンシングされます。このオプションは、SBDと組み合わせる場合にのみ機能します。第13章 「ストレージ保護とSBD」を参照してください。

5.3.2 グローバルオプションstonith-enabled #

このグローバルオプションは、フェンシングを適用して、STONITHデバイスによる、障害ノードや停止できないリソースを持つノードのダウンを許可するかどうか定義します。通常のクラスタ操作には、STONITHデバイスの使用が必要なので、このグローバルオプションは、デフォルトでtrueに設定されています。デフォルト値では、クラスタは、STONITHリソースが定義されていない場合にはリソースの開始を拒否します。

何らかの理由でフェンシングを無効にする必要がある場合は、stonith-enabledをfalseに設定しますが、これはご使用の製品のサポートステータスに影響を及ぼすことに注意してください。また、stonith-enabled="false"を指定すると、Distributed Lock Manager (DLM)のようなリソースやDLMによるすべてのサービス(lvmlockd、GFS2、OCFS2など)は開始できません。

STONITHがないクラスタはサポートされません。

5.4 Hawk2の概要 #

クラスタリソースを設定および管理する場合、Hawk2、またはcrmシェル(crmsh)コマンドラインユーティリティのいずれかを使用します。

Hawk2のユーザフレンドリなWebインタフェースを使用すると、High AvailabilityクラスタをLinuxまたは非Linuxマシンから同様に監視および管理することができます。Hawk2には、(グラフィカルな)Webブラウザを使用して、クラスタの内部または外部の任意のマシンからアクセスできます。

5.4.1 Hawk2の要件 #

Hawk2にログインするには、次の要件を満たす必要があります。

- hawk2 [Package]

Hawk2で接続するすべてのクラスタノードにhawk2パッケージをインストールする必要があります。

- Webブラウザ

Hawk2を使用してクラスタノードにアクセスするマシンに必要なものは、JavaScriptとクッキーを有効にして接続を確立できるグラフィカルなWebブラウザです。

- Hawk2サービス

Hawk2を使用するには、このWebインタフェースで接続するノード上で、それぞれのWebサービスが開始されている必要があります。手順5.1「Hawk2サービスの開始」を参照してください。

crmシェルで提供されているブートストラップスクリプトを使用してクラスタを設定した場合、Hawk2サービスはすでに有効になっています。

- 各クラスタノードのユーザ名、グループおよびパスワード

Hawk2ユーザは

haclientグループのメンバーである必要があります。インストール時にhaclusterという名前のLinuxユーザが作成されますが、このユーザがhaclientグループに追加されます。セットアップ用に

crm cluster initスクリプトを使用している場合は、haclusterユーザに対してデフォルトパスワードが設定されます。Hawk2を起動する前に、安全なパスワードに変更してください。crm cluster initスクリプトを使用しなかった場合は、最初にhaclusterのパスワードを設定するか、またはhaclientグループのメンバーである新しいユーザを作成します。Hawk2を使用して接続する各ノードでこれを実行します。- ワイルドカード証明書の処理

ワイルドカード証明書は、複数のサブドメインに対して有効な公開鍵証明書です。たとえば、

*.example.comのワイルドカード証明書は、ドメインwww.example.com、login.example.comなどを保護します。Hawk2はワイルドカード証明書と従来の証明書をサポートします。

/srv/www/hawk/bin/generate-ssl-certによって、デフォルトの自己署名秘密鍵および証明書が生成されます。独自の証明書(従来型またはワイルドカード)を使用するには、

/etc/ssl/certs/hawk.pemで生成された証明書を独自の証明書に置き換えます。

接続先にするノードで、シェルを開き、

rootとしてログインします。次のように入力して、サービスのステータスをチェックします。

#systemctl status hawkサービスが実行されていない場合は、次のコマンドでサービスを開始します。

#systemctl start hawkブート時にHawk2を自動的に起動したい場合は、次のコマンドを実行します。

#systemctl enable hawk

5.4.2 ログイン #

Hawk2 Webインタフェースは、HTTPSプロトコルとポート7630を使用します。

Hawkを使用して個々のクラスタノードにログインする代わりに、浮動、仮想IPアドレス(IPaddrまたはIPaddr22)をクラスタリソースとして設定できます。そのための特別な設定は不要です。サービスがどの物理ノードで実行されていても、クライアントはHawkサービスに接続できます。

クラスタをcrmシェルで提供されているブートストラップスクリプトを使用して設定する際には、クラスタ管理用に仮想IPを設定するかどうかを尋ねられます。

いずれかのマシンでWebブラウザを起動し、次のURLを入力します。

https://HAWKSERVER:7630/

HAWKSERVERの部分は、Hawk Webサービスを実行するクラスタノードのIPアドレスまたはホスト名で置き換えます。Hawk2でクラスタ管理用に仮想IPアドレスを設定した場合、その仮想IPアドレスでHAWKSERVERを置き換えます。

注記: 証明書の警告初めてURLにアクセスしようとするときに証明書の警告が表示される場合は、自己署名証明書が使用されています。自己署名証明書は、デフォルトでは信頼されません。

証明書を検証するには、クラスタオペレータに証明書の詳細を求めます。

続行するには、ブラウザに例外を追加して警告をバイパスします。

自己署名証明書を公式認証局によって署名された証明書で置き換える方法の詳細については、自己署名証明書の置き換えを参照してください。

Hawk2ログイン画面で、

haclusterユーザ(または、haclientグループのメンバーである他の任意のユーザ)のとを入力します。をクリックします。

5.4.3 Hawk2の概要: 主な構成要素 #

Hawk2にログインすると、左側にはナビゲーションバー、右側には複数のリンクが含まれる最上位の行が表示されます。

デフォルトでは、rootまたはhaclusterとしてログインしたユーザは、すべてのクラスタ設定作業への、完全な読み込み/書き込みのアクセス権を持ちます。ただし、アクセス制御リスト(ACL)を使用すれば、より詳細なアクセス権限を定義することができます。

CRMでACLが有効になっている場合、Hawk2で利用できる機能は、ユーザ役割と割り当てられたアクセスパーミッションごとに異なります。Hawk2のは、ユーザhaclusterのみが実行できます。

5.4.3.2 最上位の行 #

Hawk2の最上位の行には、次のエントリが表示されます。

: クリックすると、バッチモードに切り替わります。これにより、変更をシミュレートしてステージングし、それらの変更を単一のトランザクションとして適用できます。詳細については、5.4.7項 「バッチモードの使用」を参照してください。

: Hawk2用の設定ができます(たとえば、Webインタフェースの言語の設定やSTONITHを無効にした場合に警告を表示するかなどの設定)。

: SUSE Linux Enterprise High Availabilityドキュメントにアクセスしたり、リリースノートを参照したり、バグを報告したりします。

: クリックするとログアウトします。

5.4.4 グローバルクラスタオプションの設定 #

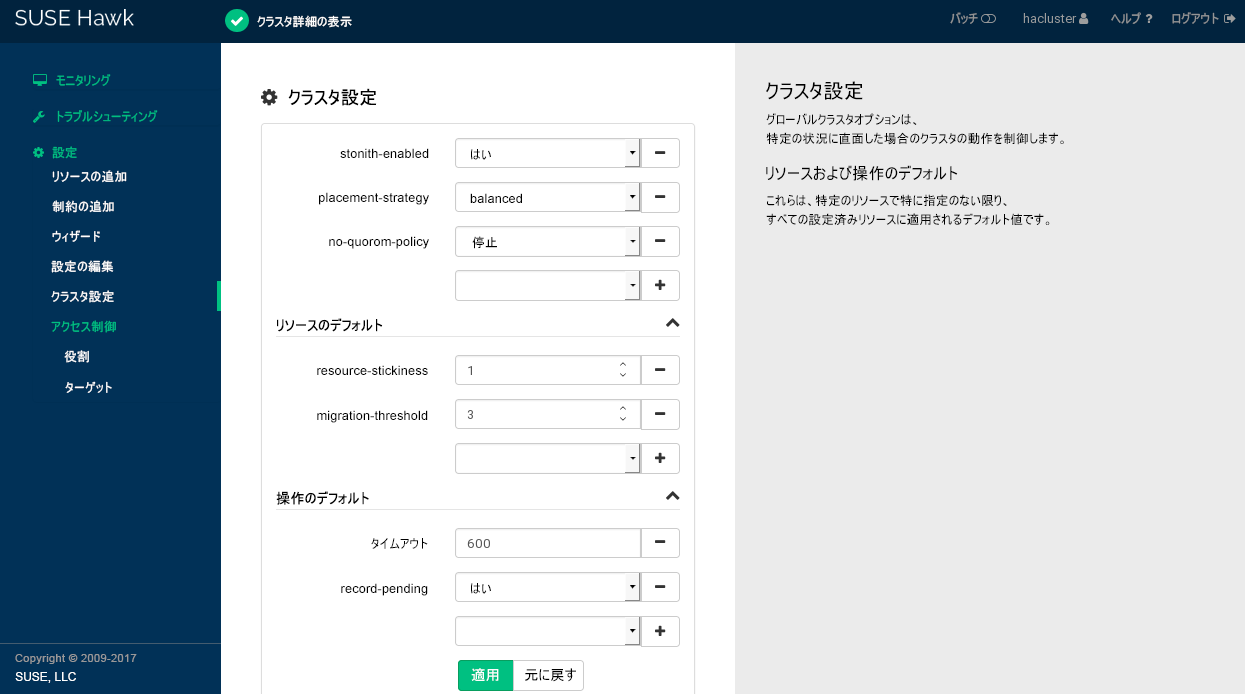

グローバルクラスタオプションは、一定の状況下でのクラスタの動作を制御します。これらは、セットにグループ化され、Hawk2、crmshなどのクラスタ管理ツールで表示し、変更することができます。事前に定義されている値は、通常は、そのまま保持できます。ただし、クラスタの主要機能を正しく機能させるには、クラスタの基本的なセットアップ後に、次のパラメータを調整する必要があります。

Hawk2にログインします。

https://HAWKSERVER:7630/

左のナビゲーションバーから、 › を選択します。

画面が開きます。グローバルクラスタオプションとその現在の値が表示されます。

画面の右側にパラメータの簡単な説明を表示するには、マウスポインタをパラメータに合わせます。

図 5.1: Hawk2 - クラスタの設定 #およびの値を確認し、必要に応じて調整します。

を適切な値に設定します。詳しくは「5.3.1項 「グローバルオプション

no-quorum-policy」」を参照してください。何らかの理由でフェンシングを無効にする必要がある場合は、を

noに設定します。通常のクラスタ操作にはSTONITHデバイスの使用が必要なため、デフォルトでは、trueに設定されています。デフォルト値では、クラスタは、STONITHリソースが設定されていない場合にはリソースの開始を拒否します。重要: STONITHがない場合はサポートなしクラスタにはノードフェンシングメカニズムが必要です。

グローバルクラスタオプション

stonith-enabledおよびstartup-fencingはtrueに設定する必要があります。これらを変更するとサポートされなくなります。

クラスタ設定からパラメータを削除するには、パラメータの横のアイコンをクリックします。パラメータを削除すると、クラスタはそのパラメータがデフォルト値に設定されている場合と同様に動作します。

クラスタ設定に新たなパラメータを追加するには、ドロップダウンボックスから選択します。

またはを変更する必要がある場合は、次のような処理を実行します。

値を調整するには、ドロップダウンボックスから別の値を選択するか、値を直接編集します。

新しいリソースのデフォルトまたは操作のデフォルトを追加するには、空のドロップダウンボックスから1つ選択し、値を入力します。デフォルト値が存在する場合は、Hawk2から自動的に提示されます。

パラメータを削除するには、その横のアイコンをクリックします。とに値が指定されていない場合、クラスタは6.12項 「リソースオプション(メタ属性)」および6.14項 「リソース操作」にドキュメントされているデフォルト値を使用します。

変更内容を確認します。

5.4.5 現在のクラスタ設定の表示(CIB) #

クラスタ管理者はクラスタ設定を知る必要がある場合があります。Hawk2は、現在の設定をcrmシェル構文で、XMLとして、およびグラフとして表示できます。クラスタ設定をcrmシェル構文で表示するには、左ナビゲーションバーから、 › を選択し、をクリックします。代わりに設定をraw XMLで表示するには、をクリックします。CIBで設定されたノードとリソースのグラフィカルな表現を示すには、をクリックします。リソース間の関係も表示されます。

5.4.6 ウィザードを使用したリソースの追加 #

Hawk2ウィザードは、仮想IPアドレスやSDB STONITHリソースなどの単純なリソースを設定する場合に便利です。また、DRBDブロックデバイスやApache Webサーバのリソース設定などの、複数リソースを含む複雑な設定においても役立ちます。設定手順をウィザードに従って進めることができ、入力が必要なパラメータについては情報が提供されます。

Hawk2にログインします。

https://HAWKSERVER:7630/

左のナビゲーションバーから、 › の順に選択します。

ウィザードの横にある下矢印アイコンをクリックして個々のカテゴリを展開し、目的のウィザードを選択します。

画面の指示に従います。最後の設定手順が完了したら、を選択して、入力した値を検証します。

Hawk2が実行するアクションと、設定の内容が表示されます。設定によっては、を選択して設定を適用する前に、

rootパスワードの入力を求めるプロンプトが表示されることがあります。

詳細については、第6章 「クラスタリソースの設定」を参照してください。

5.4.7 バッチモードの使用 #

Hawk2は、「クラスタシミュレータ」を含むを提供します。これは次の操作に使用できます。

各変更を直ちに反映させるのではなく、クラスタに変更をステージングして、それらの変更を単一トランザクションとして適用する。

たとえば、潜在的な障害シナリオを調べるため、変更やクラスタイベントをシミュレートする。

たとえば、互いに依存するリソースのグループを作成する場合にバッチモードを使用できます。バッチモードを使用すると、クラスタに中間的なまたは不完全な設定を適用することを回避できます。

バッチモードが有効な間は、リソースや制約を追加したり編集したり、クラスタ設定を変更できます。ノードのオンラインまたはオフライン化、リソース操作およびチケットの許可または取り消しなど、クラスタのイベントをシミュレートすることもできます。詳細については手順5.6「ノード、リソース、またはチケットイベントの挿入」を参照してください。

「クラスタシミュレータ」は、すべての変更後に自動的に実行され、ユーザインタフェースに予想される結果を表示します。たとえば、次のような場合もあります。バッチモードの最中にリソースを止めると、実際リソースはまだ実行中であるにも関わらず、ユーザインタフェースにはリソースが停止したと表示されます。

一部のウィザードには単なるクラスタ設定を超えるアクションが含まれます。これらのウィザードをバッチモードで使用する場合、クラスタ設定を超えるすべての変更がライブシステムに直ちに適用されます。

したがって、root許可が必要なウィザードはバッチモードでは実行できません。

Hawk2にログインします。

https://HAWKSERVER:7630/

バッチモードを有効にするには、最上位の行からを選択します。

最上位の行の下に追加のバーが表示されます。これは、バッチモードがアクティブであることを示し、バッチモードで実行可能なアクションへのリンクが含まれます。

図 5.3: Hawk2バッチモードが有効 #バッチモードがアクティブなときに、リソースや制約の追加または編集、あるいはクラスタ設定の編集など、クラスタに対する変更を実行します。

変更はシミュレートされ、すべての画面に表示されます。

行った変更の詳細を表示するには、バッチモードバーからを選択します。ウィンドウが開きます。

設定の変更について、ライブ状態とシミュレートされた変更間の相違がcrmsh構文で表示されます。

-文字で開始される行は、現在の状態を表し、+で開始される行は、提案される状態を示します。イベントを注入したり、さらに詳細を表示する場合は、手順 5.6を参照してください。または、をクリックしてウィンドウを閉じます。

シミュレートした変更をまたはするかのいずれかを選択し、選択内容を確認します。これによりバッチモードが無効になり、通常のモードに戻ります。

バッチモードで実行中に、Hawk2ではとを注入することもできます。

ノードの状態を変更できます。使用可能な状態は、、、およびです

リソースの一部のプロパティを変更できます。たとえば、操作(

start、stop、monitorなど)、その操作を適用するノード、およびシミュレートされる予想される結果を設定できます。(Geoクラスタにおける)チケットの許可と取り消しの影響をテストできます。

Hawk2にログインします。

https://HAWKSERVER:7630/

バッチモードがまだアクティブでない場合、最上位の行でをクリックして、バッチモードに切り替えます。

バッチモードバーで、をクリックして、ウィンドウを開きます。

ノードのステータスの変更をシミュレートするには

› を順にクリックします。

操作するを選択し、そのターゲットを選択します。

変更内容を確認します。イベントはダイアログに一覧表示されるイベントのキューに追加されます。

リソースの操作をシミュレートするには

› を順にクリックします。

操作するを選択し、シミュレートするを選択します。

必要に応じて、を定義します。

操作を実行するを選択し、ターゲットとするを選択します。イベントはダイアログに一覧表示されるイベントのキューに追加されます。

変更内容を確認します。

チケットアクションをシミュレートするには

› を順にクリックします。

操作するを選択し、シミュレートするを選択します。

変更内容を確認します。イベントはダイアログに一覧表示されるイベントのキューに追加されます。

ダイアログ(図 5.4)で、注入されたイベントごとに新しい行が表示されます。ここに一覧表示されるイベントは、直ちにシミュレートされ、画面に反映されます。

設定の変更も行った場合は、ライブ状態とシミュレートされた変更の間の相違が注入されたイベントの下に表示されます。

図 5.4: Hawk2のバッチモード—注入されたイベントと設定の変更 #注入されたイベントを削除するには、その隣のアイコンをクリックします。Hawk2では、それに従って画面が更新されます。

実行されたシミュレーションに関する詳細を表示するには、をクリックして、次のいずれかを選択します。

詳細な概要を表示します。

- /

では、初期のCIB状態を示します。では、遷移後のCIBの状態を示します。

遷移のグラフィカルな表現を示します。

遷移のXML表示を示します。

シミュレートされた変更を確認したら、ウィンドウを閉じます。

バッチモードを終了するには、シミュレートされた変更をするか、するかのいずれかを選択します。

5.5 crmshの概要 #

クラスタリソースを設定および管理するには、コマンドラインユーティリティであるcrmシェル(crmsh)またはWebベースのユーザインタフェースであるHawk2のいずれかを使用します。

このセクションでは、コマンドラインツールcrmを紹介します。crmコマンドには、リソース、CIB、ノード、リソースエージェントなどを管理するサブコマンドがあります。このコマンドには、例を組み込んだ詳細なヘルプシステムが用意されています。すべての例は、付録Bで説明される命名規則に従います。

イベントは/var/log/crmsh/crmsh.logにログを記録します。

crmを引数なしで(または1つのサブレベルのみを引数として)使用することにより、crmシェルは対話モードになります。このモードは、次のプロンプトで示されます。

crm(live/HOSTNAME)読みやすくするために、このマニュアルでは対話型crmのプロンプトでホスト名を省略します。次の例のように、aliceなどの特定のノードで対話型シェルを実行する必要がある場合にのみホスト名を含めます。

crm(live/alice)5.5.1 ログイン #

クラスタを管理するには、十分な権限が必要です。次のユーザは、crmコマンドおよびそのサブコマンドを実行できます。

rootユーザまたはsudo特権を持つユーザ。これらのユーザは、SSHを使用してcrm cluster init、crm cluster join、crm reportなどのcrmsh操作を行うことにより、すべてのクラスタノードに対して完全な権限を持っています。リソースや制約の追加など、CIBの変更も実行できます。CRM所有者ユーザ(通常、ユーザ

hacluster、クラスタインストール時にデフォルトで作成される)。このユーザは、CIBを変更できますが、SSHを使用する操作(crm reportなど)については限定的な権限しかありません。ヒント: 権限のないユーザuserオプションを使用することで、crmとそのサブコマンドを一般(権限のない)ユーザとして実行し、必要な場合はsudoを使用してIDを変更できます。たとえば、次のコマンドは、権限のあるユーザIDとしてhaclusterを設定します。#crm options user haclustersudoがパスワードを要求しないように/etc/sudoersを設定する必要があります。

SSHを使用する操作の場合、クラスタは、ノード間の通信にパスワード不要のSSHアクセスを使用します。crm cluster initを使用してクラスタを設定した場合、スクリプトは、SSHキーがあるかどうかを確認し、ない場合には生成します。YaSTクラスタモジュールを使用してクラスタを設定した場合、SSHキーを自分自身で設定する必要があります。

ほとんどの場合、rootユーザのSSHキーまたはsudoユーザのSSHキーがノードに存在している(または生成されている)はずです。または、sudoユーザのSSHキーがローカルマシンにあり、SSHエージェントの転送によってノードに渡すことができます。これは、ノードにSSHキーを保存しないようにする必要がある場合に便利ですが、追加の設定が必要です。

ローカルマシンでSSHエージェントを起動し、そこにキーを追加します。SUSE Linux Enterprise Serverの詳細については、『Security and Hardening Guide』で「 Automated public key logins with ssh-agent」を参照してください。

sudo特権を持つユーザとして最初のクラスタノードにログインし、-Aオプションを使用してSSHエージェントの転送を有効にします。user@local >ssh -A USER@NODE1crm cluster initスクリプトを使用してクラスタを初期化します。user@node1 >sudo --preserve-env=SSH_AUTH_SOCK \1crm cluster init --use-ssh-agent2初期設定が完了したら、最初のノードを終了し、

-Aオプションを使用して2つ目のノードにログインします。crm cluster joinスクリプトを使用して、クラスタに2つ目のノードを追加します。-cオプションを使用して、クラスタを初期化したユーザおよびノードを指定します。user@node2 >sudo --preserve-env=SSH_AUTH_SOCK \ crm cluster join --use-ssh-agent -c USER@NODE1

ブートストラップスクリプトを使用する代わりにYaSTを使用してクラスタを設定した場合、SSHキーは、自動生成されません。SSHキーを設定してSSHエージェントの転送を有効にするために、ブートストラップスクリプトのsshステージを単独で使用できます。YaSTでクラスタを設定した後、クラスタをオンラインにする前にこれらのコマンドを実行します。

最初のノード上で次のコマンドを実行します。

user@node1 >sudo --preserve-env=SSH_AUTH_SOCK \ crm cluster init ssh --use-ssh-agent

他のすべてのノード上で次のコマンドを実行します。

user@node2 >sudo --preserve-env=SSH_AUTH_SOCK \ crm cluster join ssh --use-ssh-agent -c USER@NODE1

5.5.2 ヘルプの表示 #

ヘルプには複数の方法でアクセスできます。

crmとそのコマンドラインオプションの使用方法を出力するには:#crm --help使用可能なすべてのコマンドの一覧を表示するには:

#crm helpコマンドの参照情報だけでなく、他のヘルプセクションにアクセスするには:

#crm help topicsconfigureサブコマンドの詳細なヘルプテキストを表示するには:#crm configure helpconfigureのgroupサブコマンドの構文、使用方法、例を出力するには:#crm configure help groupこれも同様です:

#crm help configure group

helpサブコマンド(--helpオプションと混同しないこと)のほとんどすべての出力によって、テキストビューアが開きます。このテキストビューアは上下にスクロール可能で、ヘルプテキストが読みやすくなっています。テキストビューアを閉じるには、Qキーを押します。

crmshは、対話型シェルに対してだけではなく、バッシュでの直接的で完全なタブ補完機能をサポートしています。たとえば、crm help

config<Tab>を入力すると、対話型シェルのように単語が補完されます。

5.5.3 crmshのサブコマンドの実行 #

crmコマンドそのものは、次のように使用できます。

直接: すべてのサブコマンドを

crmに続け、Enterを押すと、直ちにその出力が表示されます。たとえば、crm help raを入力すると、raサブコマンド(リソースエージェント)に関する情報を取得できます。サブコマンドは、その短縮形が固有である限り短縮できます。たとえば、

statusをstに短縮しても、crmshはこれを認識できます。パラメータを短縮する機能もあります。通常、パラメータは

paramsキーワードを使用して追加します。paramsセクションが最初のセクションでほかにセクションがない場合、このセクションを省略できます。たとえば、次のような行があるとします。#crm primitive ipaddr IPaddr2 params ip=192.168.0.55これは次の行と同等です。

#crm primitive ipaddr IPaddr2 ip=192.168.0.55crmシェルスクリプトとして使用: シェルスクリプトには

crmcrmのサブコマンドが含まれます。詳細については、5.5.5項 「crmshのシェルスクリプトの使用」を参照してください。crmshクラスタスクリプトとして使用:これらは、メタデータ、RPMパッケージへの参照、設定ファイル、およびcrmshサブコマンドを1つのわかりやすい名前でバンドルしてまとめたものです。

crm scriptコマンドを使用して管理します。これらをcrmshシェルスクリプトと混同しないでください。両方に共通する目的はいくつかありますが、crmシェルスクリプトにはサブコマンドのみが含まれるのに対し、クラスタスクリプトにはコマンドの単純なエミュレーション以上の処理が組み込まれています。詳細については、5.5.6項 「crmshのクラスタスクリプトの使用」を参照してください。

内部シェルとして対話式に使用: 「

crm」とタイプして、内部シェルに入ります。プロンプトがcrm(live)に変化します。helpを使用すると、利用可能なサブコマンドの概要を取得できます。内部シェルにはさまざまなサブコマンドレベルがあり、1つのサブコマンドをタイプしてEnterを押すことで、そのサブコマンドのレベルに「入る」ことができます。たとえば、「

resource」とタイプすると、リソース管理レベルに入ります。プロンプトはcrm(live)resource##に変わります。内部シェルを終了するには、コマンドquitを使用します。1レベル戻る場合は、back、up、end、またはcdを使用します。crm、そしてオプションを付けずにサブコマンドを入力してEnterを押すと、そのレベルに直接入ることができます。内部シェルは、サブコマンドとリソースのタブによる完了もサポートします。コマンドの冒頭をタイプして<Tab>を押すと、

crmがそのオブジェクトを表示します。

crmshは、同期のコマンドの実行もサポートしています。これを有効にするには、-wオプションを使用します。crmを-wなしで起動した場合でも、後ほどユーザ初期設定のwaitをyes (options

wait yes)に設定すれば、有効にすることができます。このオプションが有効化される場合、crmは遷移が終了するまで待機します。処理が開始すると毎回、進行状況を示すための点が印刷されます。同期コマンドの実行はresource

startなどのコマンドにのみ適用できます。

crmツールには、管理機能(サブコマンドresourceおよびnode)があり、設定(cib、configure)に使用できます。

以降のサブセクションでは、crmツールの重要な側面について、その概要を示します。

5.5.4 OCFリソースエージェントに関する情報の表示 #

リソースエージェントはクラスタ設定で常に操作する必要があるため、crmツールには、raコマンドが含まれています。このコマンドを使用して、リソースエージェントの情報を表示し、リソースエージェントを管理します(詳細は6.2項 「サポートされるリソースエージェントクラス」も参照)。

#crm racrm(live)ra#

コマンドclassesは、すべてのクラスとプロバイダを一覧表示します。

crm(live)ra#classeslsb ocf / heartbeat linbit lvm2 ocfs2 pacemaker service stonith systemd

クラス(およびプロバイダ)に使用できるすべてのリソースエージェントの概要を取得するには、listコマンドを使用します。

crm(live)ra#list ocfAoEtarget AudibleAlarm CTDB ClusterMon Delay Dummy EvmsSCC Evmsd Filesystem HealthCPU HealthSMART ICP IPaddr IPaddr2 IPsrcaddr IPv6addr LVM LinuxSCSI MailTo ManageRAID ManageVE Pure-FTPd Raid1 Route SAPDatabase SAPInstance SendArp ServeRAID ...

リソースエージェントの概要は、infoで表示できます。

crm(live)ra#info ocf:linbit:drbdThis resource agent manages a DRBD* resource as a master/slave resource. DRBD is a shared-nothing replicated storage device. (ocf:linbit:drbd) Master/Slave OCF Resource Agent for DRBD Parameters (* denotes required, [] the default): drbd_resource* (string): drbd resource name The name of the drbd resource from the drbd.conf file. drbdconf (string, [/etc/drbd.conf]): Path to drbd.conf Full path to the drbd.conf file. Operations' defaults (advisory minimum): start timeout=240 promote timeout=90 demote timeout=90 notify timeout=90 stop timeout=100 monitor_Slave_0 interval=20 timeout=20 start-delay=1m monitor_Master_0 interval=10 timeout=20 start-delay=1m

ビューアは、「Q」を押すと終了できます。

crmを直接使用する

前の例では、crmコマンドの内部シェルを使用しました。ただし、必ずしも、それを使用する必要はありません。該当するサブコマンドをcrmに追加すれば、同じ結果が得られます。たとえば、すべてのOCFリソースエージェントを一覧するには、シェルに「crm ra list ocf」を入力すれば済みます。

5.5.5 crmshのシェルスクリプトの使用 #

crmshシェルスクリプトは、crmshサブコマンドをファイル内に列挙する便利な方法を提供します。これにより、特定の行をコメントしたり、これらのコメントを後で再生したりするのが簡単になります。crmshシェルスクリプトには「crmshサブコマンドのみ」を含めることができることに注意してください。他のコマンドは許可されていません。

crmshシェルスクリプトを使用するには、その前に特定のコマンドを使用してファイルを作成してください。たとえば、次のファイルにはクラスタのステータスが出力され、すべてのノードのリストが提供されます。

# A small example file with some crm subcommandsstatusnode list

ハッシュ記号(#)で始まる行はコメントなので、無視されます。行が長すぎる場合は、行末にバックスラッシュ(\)を挿入し、次の行に続けます。読みやすさを向上させるために、特定のサブコマンドに属する行をインデントすることをお勧めします。

このスクリプトを使用するには、次の方法のいずれかを使用します。

#crm -f example.cli#crm < example.cli

5.5.6 crmshのクラスタスクリプトの使用 #

すべてのクラスタノードから情報を収集して変更をすべて展開することは、鍵となるクラスタ管理タスクです。複数のノードで同じ手順を手動で実行するのはミスを起こしがちであるため、代わりにcrmshクラスタスクリプトを使用できます。

これらを「crmshシェルスクリプト」と混同しないでください(5.5.5項 「crmshのシェルスクリプトの使用」で説明)。

crmshシェルスクリプトとは対照的に、クラスタスクリプトでは次のような追加のタスクを実行します。

特定のタスクに必要なソフトウェアをインストールする。

設定ファイルを作成または変更する。

情報を収集し、クラスタの潜在的な問題をレポートする。

変更をすべてのノードに展開する。

crmshクラスタスクリプトは、他のクラスタ管理ツールを置き換えるものではなく、クラスタ全体に対して統合化された方法でこれらのタスクを実行できるようにします。詳細については、https://crmsh.github.io/scripts/を参照してください。

5.5.6.1 使用方法 #

利用可能なすべてのクラスタのリストを取得するには、次のコマンドを実行します。

#crm script list

スクリプトのコンポーネントを表示するには、showコマンドと、クラスタスクリプトの名前を使用します。次に例を示します。

#crm script show mailtomailto (Basic) MailTo This is a resource agent for MailTo. It sends email to a sysadmin whenever a takeover occurs. 1. Notifies recipients by email in the event of resource takeover id (required) (unique) Identifier for the cluster resource email (required) Email address subject Subject

showの出力には、タイトル、短い説明、および手順が含まれます。各手順は一連のステップに分かれており、これらのステップを指定された順序で実行します。

各ステップには、必須パラメータとオプションパラメータのリスト、および短い説明とそのデフォルト値が含まれます。

各クラスタスクリプトは、一連の共通パラメータを認識します。これらのパラメータは任意のスクリプトに渡すことができます。

| パラメータ | 引数 | 説明 |

|---|---|---|

| action | INDEX | 設定した場合、1つのアクションのみを実行します(verifyによって返されたインデックス)。 |

| dry_run | BOOL | 設定した場合、実行のシミュレートのみを行います(デフォルト: no)。 |

| nodes | LIST | スクリプト実行対象のノードのリスト。 |

| port | NUMBER | 接続先のポート。 |

| statefile | FILE | シングルステップ実行の場合に、指定したファイルに状態を保存します。 |

| sudo | BOOL | 設定した場合、sudoパスワードを入力するようcrmによってプロンプトが表示され、必要に応じてsudoが使用されます(デフォルト: no)。 |

| timeout | NUMBER | 秒単位での実行タイムアウト(デフォルト: 600)。 |

| user | USER | 指定したユーザとしてスクリプトを実行します。 |

5.5.6.2 クラスタスクリプトの検証と実行 #

問題を避けるため、クラスタスクリプトを実行する前に、実行するアクションを確認してパラメータを検証します。クラスタスクリプトは一連のアクションを実行でき、さまざまな理由で失敗する可能性があります。そのため、実行前にパラメータを検証すると、問題の回避に役立ちます。

たとえば、mailtoリソースエージェントでは、固有の識別子と電子メールアドレスが必要です。これらのパラメータを検証するには、以下を実行します。

#crm script verify mailto id=sysadmin email=tux@example.org1. Ensure mail package is installed mailx 2. Configure cluster resources primitive sysadmin MailTo email="tux@example.org" op start timeout="10" op stop timeout="10" op monitor interval="10" timeout="10" clone c-sysadmin sysadmin

verifyコマンドは各ステップを出力し、指定したパラメータでプレースホルダを置き換えます。verifyで問題が見つかった場合は報告します。問題がなければ、verifyコマンドをrunに置き換えます。

#crm script run mailto id=sysadmin email=tux@example.orgINFO: MailTo INFO: Nodes: alice, bob OK: Ensure mail package is installed OK: Configure cluster resources

crm statusを使用して、リソースがクラスタに統合されているかどうかを確認します。

#crm status[...] Clone Set: c-sysadmin [sysadmin] Started: [ alice bob ]

5.5.7 設定テンプレートの使用 #

設定テンプレートの使用は非推奨で、今後削除される予定です。設定テンプレートはクラスタスクリプトに置き換えられます。5.5.6項 「crmshのクラスタスクリプトの使用」を参照してください。

設定テンプレートは、crmsh用の既成のクラスタ設定です。リソーステンプレート(6.8.2項 「crmshを使用したリソーステンプレートの作成」の説明を参照)と混同しないでください。これらはクラスタ用のテンプレートで、crmシェル用ではありません。

設定テンプレートは、最小限の操作で、特定ユーザのニーズに合わせて調整できます。テンプレートで設定を作成する際には、警告メッセージでヒントが与えられます。これは、後から編集することができ、さらにカスタマイズできます。

次の手順は、簡単ですが機能的なApache設定を作成する方法を示しています。

rootとしてログインし、crm対話型シェルを開始します。#crm configure設定テンプレートから新しい設定を作成します。

templateサブコマンドに切り替えます。crm(live)configure#template使用可能な設定テンプレートを一覧します。

crm(live)configure template#list templatesgfs2-base filesystem virtual-ip apache clvm ocfs2 gfs2必要な設定テンプレートを決めます。Apache設定が必要なので、

apacheテンプレートを選択し、g-intranetと名付けます。crm(live)configure template#new g-intranet apacheINFO: pulling in template apache INFO: pulling in template virtual-ip

パラメータを定義します。

作成した設定を一覧表示します。

crm(live)configure template#listg-intranet入力を必要とする最小限の変更項目を表示します。

crm(live)configure template#showERROR: 23: required parameter ip not set ERROR: 61: required parameter id not set ERROR: 65: required parameter configfile not set好みのテキストエディタを起動し、ステップ 3.bでエラーとして表示されたすべての行に入力します。

crm(live)configure template#edit

設定を表示し、設定が有効かどうか確認します(太字のテキストは、ステップ 3.cで入力した設定によって異なります)。

crm(live)configure template#showprimitive virtual-ip ocf:heartbeat:IPaddr \ params ip="192.168.1.101" primitive apache apache \ params configfile="/etc/apache2/httpd.conf" monitor apache 120s:60s group g-intranet \ apache virtual-ip設定を適用します。

crm(live)configure template#applycrm(live)configure#cd ..crm(live)configure#show変更内容をCIBに送信します。

crm(live)configure#commit

詳細がわかっていれば、コマンドをさらに簡素化できます。次のコマンドをシェルで使用して、上記の手順を要約できます。

#crm configure template \ new g-intranet apache params \ configfile="/etc/apache2/httpd.conf" ip="192.168.1.101"

内部crmシェルに入っている場合は、次のコマンドを使用します。

crm(live)configure template#new intranet apache params \ configfile="/etc/apache2/httpd.conf" ip="192.168.1.101"

ただし、このコマンドは、設定テンプレートから設定を作成するだけです。設定をCIBに適用したり、コミットすることはありません。

5.5.8 シャドウ設定のテスト #

シャドウ設定は、異なる構成シナリオのテストに使用されます。複数のシャドウ設定を作成した場合は、1つ1つテストして変更を加えた影響を確認できます。

通常の処理は次のようになります。

rootとしてログインし、crm対話型シェルを開始します。#crm configure新しいシャドウ設定を作成します。

crm(live)configure#cib new myNewConfigINFO: myNewConfig shadow CIB createdシャドウCIBの名前を省略する場合は、一時名の

@tmp@が作成されます。現在のライブ設定をシャドウ設定にコピーするには、次のコマンドを使用します。コピーしない場合は、このステップをスキップします。

crm(myNewConfig)#

cib reset myNewConfigこのコマンドを使用すると、既存のリソースを後から編集する場合に、簡単に編集できます。

通常どおり変更を行います。シャドウ設定の作成後は、すべての変更がシャドウ設定に適用されます。すべての変更を保存するには、次のコマンドを使用します。

crm(myNewConfig)#

commitライブクラスタ設定が再び必要な場合は、次のコマンドでライブ設定に戻ります。

crm(myNewConfig)configure#

cib use livecrm(live)#

5.5.9 設定の変更のデバッグ #

設定の変更をクラスタにロードする前に、変更内容をptestでレビューすることを推奨します。ptestコマンドを指定すると、変更のコミットによって生じるアクションのダイアグラムを表示できます。ダイアグラムを表示するには、graphvizパッケージが必要です。次の例は監視操作を追加するスクリプトです。

#crm configurecrm(live)configure#show fence-bobprimitive fence-bob stonith:apcsmart \ params hostlist="bob"crm(live)configure#monitor fence-bob 120m:60scrm(live)configure#show changedprimitive fence-bob stonith:apcsmart \ params hostlist="bob" \ op monitor interval="120m" timeout="60s"crm(live)configure#ptestcrm(live)configure#commit

5.5.10 クラスタダイアグラム #

クラスタダイアグラムを出力するには、コマンドcrm configure graphを使用します。これにより現在の設定が現在のウィンドウに表示されるので、X11が必要になります。

SVG (Scalable Vector Graphics)を使用する場合は、次のコマンドを使用します。

#crm configure graph dot config.svg svg

5.5.11 Corosync設定の管理 #

Corosyncは、ほとんどのHAクラスタの下層にあるメッセージング層です。corosyncサブコマンドは、Corosync設定を編集および管理するためのコマンドを提供します。

たとえば、クラスタのステータスを一覧表示するには、statusを使用します。

#crm corosync statusPrinting ring status. Local node ID 175704363 RING ID 0 id = 10.121.9.43 status = ring 0 active with no faults Quorum information ------------------ Date: Thu May 8 16:41:56 2014 Quorum provider: corosync_votequorum Nodes: 2 Node ID: 175704363 Ring ID: 4032 Quorate: Yes Votequorum information ---------------------- Expected votes: 2 Highest expected: 2 Total votes: 2 Quorum: 2 Flags: Quorate Membership information ---------------------- Nodeid Votes Name 175704363 1 alice.example.com (local) 175704619 1 bob.example.com

diffコマンドは、(特に指示がない限り)すべてのノード上のCorosync設定を比較し、相違点を出力します。

#crm corosync diff--- bob +++ alice @@ -46,2 +46,2 @@ - expected_votes: 2 - two_node: 1 + expected_votes: 1 + two_node: 0

詳細については、https://crmsh.nongnu.org/crm.8.html#cmdhelp_corosyncを参照してください。

5.5.12 cib.xmlから独立したパスワードの設定 #

クラスタ設定にパスワードなどの機密の情報が含まれている場合、それらをローカルファイルに保存する必要があります。こうしておけば、これらのパラメータがログに記録されたり、サポートレポートに漏洩することはありません。

secretを使用する前に、すべてのリソースの概要を確認するため、showコマンドを実行します。

#crm configure showprimitive mydb mysql \ params replication_user=admin ...

上記のmydbリソースに対してパスワードを設定するには、次のコマンドを使用します。

#crm resource secret mydb set passwd linuxINFO: syncing /var/lib/heartbeat/lrm/secrets/mydb/passwd to [your node list]

次のように、保存されたパスワードが返されます。

#crm resource secret mydb show passwdlinux

パラメータはノード間で同期する必要があります。crm resource secretコマンドがそれを処理します。秘密のパラメータを管理する場合には、このコマンドのみを使用することを強く推奨します。

5.6 詳細の参照先 #

- https://crmsh.github.io/

crmシェル(crmsh)、High Availabilityクラスタ管理用の高度なコマンドラインインタフェースのホームページ。

- https://crmsh.github.io/documentation

crmshを使用した基本的なクラスタ設定の『Getting Started』チュートリアルとcrmシェルの包括的なManualを含む、crmシェルに関するいくつかのドキュメントが含まれています。マニュアルはhttps://crmsh.github.io/man-2.0/で入手できます。チュートリアルはhttps://crmsh.github.io/start-guide/に用意されています。

- https://clusterlabs.org/

Pacemakerのホームページ、SUSE Linux Enterprise High Availabilityに付属のクラスタリソースマネージャ。

- https://www.clusterlabs.org/pacemaker/doc/

いくつかの包括的なマニュアルと一般的な概念を説明するより簡潔なドキュメントが含まれています。例:

Pacemaker Explained: 参照用に包括的で詳細な情報が含まれています。

Colocation Explained

Ordering Explained

6 クラスタリソースの設定 #

クラスタの管理者は、クラスタ内のサーバ上の各リソースや、サーバ上で実行する各アプリケーションに対してクラスタリソースを作成する必要があります。クラスタリソースには、Webサイト、メールサーバ、データベース、ファイルシステム、仮想マシン、およびユーザが常時使用できるその他のサーバベースのアプリケーションまたはサービスなどが含まれます。

6.1 リソースのタイプ #

次のリソースタイプを作成できます。

- プリミティブ

プリミティブリソースは、リソースの中で最も基本的なタイプです。

- グループ

グループには、一緒の場所で見つけ、連続して開始し、逆の順序で停止する必要のあるリソースセットが含まれます。

- クローン

クローンは、複数のホスト上でアクティブにできるリソースです。対応するリソースエージェントがサポートしていれば、どのようなリソースもクローン化できます。

プロモータブルクローン(マルチステートリソースとも呼ばれていました)は、昇格できる特別なタイプのクローンリソースです。

6.2 サポートされるリソースエージェントクラス #

追加するクラスタリソースごとに、リソースエージェントが準拠する基準を定義する必要があります。リソースエージェントは、提供するサービスを抽象化して正確なステータスをクラスタに渡すので、クラスタは管理するリソースについてコミットする必要がありません。クラスタは、リソースエージェントに依存して、start、stop、またはmonitorのコマンドの発行に適宜対応します。

通常、リソースエージェントはシェルスクリプトの形式で配布されます。SUSE Linux Enterprise High Availabilityは次のリソースエージェントクラスをサポートします。

- Open Cluster Framework (OCF)リソースエージェント

OCF RAエージェントは、High Availabilityでの使用に最適であり、特に、プロモータブルクローンリソースまたは特殊なモニタリング機能を必要とする場合に適しています。それらのエージェントは、通常、

/usr/lib/ocf/resource.d/provider/にあります。この機能はLSBスクリプトの機能と同様です。ただし、環境設定では、常に、パラメータの受け入れと処理を容易にする環境変数が使用されます。OCF仕様ではアクションによってどの出口コードが返されるか、厳密な定義があります。10.3項 「OCF戻りコードと障害回復」を参照してください。クラスタは、それらの仕様に正確に準拠します。すべてのOCFリソースエージェントは少なくとも

start、stop、status、monitorおよびmeta-dataの各アクションが必要です。meta-dataアクションは、エージェントの設定方法についての情報を取得します。たとえば、プロバイダIPaddrでheartbeatエージェントの詳細を知るには、次のコマンドを使用します。OCF_ROOT=/usr/lib/ocf /usr/lib/ocf/resource.d/heartbeat/IPaddr meta-data

出力は、XML形式の情報であり、いくつかのセクションを含みます(一般説明、利用可能なパラメータ、エージェント用の利用可能なアクション)。

または、crmshを使用して、OCFリソースエージェントに関する情報を表示します。詳細については、5.5.4項 「OCFリソースエージェントに関する情報の表示」を参照してください。

- Linux Standards Base (LSB)スクリプト

LSBリソースエージェントは一般にオペレーティングシステム/配布パッケージによって提供され、

/etc/init.dにあります。リソースエージェントをクラスタで使用するには、それらのエージェントがLSB iniスクリプトの仕様に準拠している必要があります。たとえば、エージェントには複数のアクションが実装されている必要があります。少なくともstart、stop、restart、reload、force-reloadおよびstatusが実装されている必要があります。詳細については、https://refspecs.linuxbase.org/LSB_4.1.0/LSB-Core-generic/LSB-Core-generic/iniscrptact.htmlを参照してください。これらのサービスの構成は標準化されていません。High AvailabilityでLSBスクリプトを使用する場合は、該当のスクリプトの設定方法を理解する必要があります。これに関する情報は、多くの場合、

/usr/share/doc/packages/PACKAGENAME内の該当パッケージのマニュアルに記載されています。- systemd

Pacemakerは、systemdサービスが存在する場合は、それを管理できます。initスクリプトの代わりに、systemdはユニットファイルを持ちます。一般的に、サービス(またはユニットファイル)は、オペレーティングシステムによって提供されます。既存のinitスクリプトを変換する場合は、https://0pointer.de/blog/projects/systemd-for-admins-3.htmlで詳細情報を検索してください。

- サービス

現在、並列に存在するタイプのシステムサービスが多数あります:

LSB(System V initに属する)、systemd、および(一部のディストリビューションでは)upstart。そのため、Pacemakerは、どれが指定のクラスタノードに適用されるのかを理解する特殊なエイリアスをサポートします。これは、クラスタにsystemd、upstart、およびLSBサービスが混在する場合には特に役立ちます。Pacemakerは、次の順番で指定されたサービスを検索しようとします: LSB (SYS-V) initスクリプト、systemdユニットファイル、またはUpstartジョブ。- Nagios

モニタリングプラグイン(かつてはNagiosプラグインと呼ばれていた)により、リモートホスト上のサービスを監視できます。Pacemakerは、モニタリングプラグインが存在する場合は、これを使用してリモートモニタリングを実行できます。詳細については、9.1項 「監視プラグインを使用したリモートホストでのサービスの監視」を参照してください。

- STONITH(フェンシング)リソースエージェント

このクラスは、フェンシング関係のリソース専用に使用されます。詳細については、第12章 「フェンシングとSTONITH」を参照してください。

SUSE Linux Enterprise High Availabilityによって提供されるエージェントは、OCFの仕様に基づいて開発されています。

6.3 タイムアウト値 #

リソースのタイムアウト値は次の3つのパラメータの影響を受けることがあります。

op_defaults(操作用のグローバルタイムアウト)リソーステンプレートに対して定義された特定のタイムアウト値

リソースに対して定義された特定のタイムアウト値

リソースに対して「特定の」値が定義される場合、グローバルデフォルトより優先されます。また、リソースに対して定義された特定の値は、リソーステンプレートで定義された値より優先されます。

タイムアウト値を適切に設定することは非常に重要です。これらの値を短くしすぎると、次のような理由で、多数の(不必要な)フェンシング処理が発生します。

リソースでタイムアウトが発生すると、リソースは失敗し、クラスタはリソースを停止しようとします。

リソースの停止も失敗した場合(たとえば、停止用タイムアウトの設定が低すぎるため)、クラスタはノードをフェンシングします。これが制御不能になるノードを考慮します。

操作に対するグローバルデフォルトを調整し、crmshおよびHawk2の両方で特定のタイムアウト値を設定できます。タイムアウト値の決定および設定のベストプラクティスは次のとおりです。

負荷の下でリソースが開始および停止するためにかかる時間を確認します。

必要な場合、パラメータ

op_defaultsを追加し、それに応じて(デフォルトの)タイムアウト値を設定します。たとえば、

op_defaultsを60秒に設定します。crm(live)configure#op_defaults timeout=60さらに長い時間を必要とするリソースについては、個別の値を定義します。

あるリソースに対して操作を設定する場合には、個別の

start操作およびstop操作を追加します。Hawk2を使用して設定する場合、これらの操作に適したタイムアウト値候補が表示されます。

6.4 プリミティブリソースの作成 #

リソースは、クラスタで使用する前にセットアップする必要があります。たとえば、Apacheサーバをクラスタリソースとして使用するには、まず、Apacheサーバをセットアップし、Apacheの環境設定を完了してから、クラスタで個々のリソースを起動します。

リソースに特定の環境要件がある場合は、それらの要件がすべてのクラスタノードに存在し、同一であることを確認してください。SUSE Linux Enterprise High Availabilityはこの種の設定は管理しません。これは、管理者自身が行う必要があります。

Hawk2またはcrmshのいずれかを使用してプリミティブリソースを作成できます。

SUSE Linux Enterprise High Availabilityでリソースを管理しているときに、同じリソースを他の方法(クラスタ外で、たとえば、手動、ブート、再起動など)で開始したり、停止してはいけません。High Availabilityソフトウェアが、すべてのサービスの開始または停止アクションを実行します。

サービスがクラスタ制御下ですでに実行された後にテストまたは保守タスクを実行する必要がある場合は、リソース、ノード、またはクラスタ全体を保守モードに設定してから、これらのいずれかに手動でタッチしてください。詳細については、28.2項 「保守タスクのためのさまざまなオプション」を参照してください。

クラスタリソースとクラスタノードは異なる名前にする必要があります。同じ名前にするとHawk2で障害が発生します。

6.4.1 Hawk2を使用したプリミティブリソースの作成 #

最も基本的なタイプのリソースを作成するには、次の手順に従います。

Hawk2にログインします。

https://HAWKSERVER:7630/

左のナビゲーションバーから、 › › の順に選択します。

固有のを入力します。

リソース設定の基にするリソーステンプレートが存在する場合は、で目的のテンプレートを選択します。

で、使用するリソースエージェントのクラスを選択します。

lsb、ocf、service、stonith、またはsystemdから選択できます。詳細については、6.2項 「サポートされるリソースエージェントクラス」を参照してください。ocfをクラスとして選択した場合、OCFリソースエージェントのを指定します。OCFの指定によって、複数のベンダが同じリソースエージェントを提供できるようになります。リストから、使用するリソースエージェントを選択します(たとえばまたは)。このリソースエージェントの簡単な説明が表示されます。

注記リストに表示される選択肢は、選択した(OCFリソースの場合は、も)によって異なります。

図 6.1: Hawk2 - プリミティブリソース #リソースの基本を指定すると、Hawk2には次のカテゴリが表示されます。Hawk2の提案に従ってこれらのカテゴリを保持するか、必要に応じて編集します。

- パラメータ(インスタンス属性)

リソースが制御するサービスのインスタンスを決定します。リソースを作成する際、Hawk2は必要なパラメータを自動的に表示します。これらを編集して、有効なリソースの設定を取得します。

詳細については、6.13項 「インスタンス属性(パラメータ)」を参照してください。

- 操作

リソース監視に必要です。リソースを作成する際、Hawk2は、最も重要なリソース操作(

monitor、startおよびstop)を表示します。詳細については、6.14項 「リソース操作」を参照してください。

- メタ属性

特定のリソースの処理方法をCRMに指示します。リソースを作成する際、Hawk2はそのリソースの重要なメタ属性を自動的にリストにします(たとえばリソースの初期状態を定義する

target-role属性です。デフォルトではStoppedに設定されているため、リソースはすぐには始動しません)。詳細については、6.12項 「リソースオプション(メタ属性)」を参照してください。

- 使用率

特定のリソースがノードから要求する容量をCRMに指示します。

詳細については、7.10.1項 「Hawk2を使用した負荷インパクトに基づくリソースの配置」を参照してください。

をクリックして、設定を完了します。画面上部に、アクションが成功したかどうかを示すメッセージが表示されます。

6.4.2 crmshを使用したプリミティブリソースの作成 #

rootとしてログインし、crmツールを開始します。#crm configureプリミティブIPアドレスを設定します。

crm(live)configure#primitive myIP IPaddr \ params ip=127.0.0.99 op monitor interval=60s前のコマンドは「プリミティブ」に名前

myIPを設定します。クラス(ここではocf)、プロバイダ(heartbeat)、およびタイプ(IPaddr)を選択する必要がありますさらに、このプリミティブでは、IPアドレスなどのパラメータが必要です。自分の設定に合わせてアドレスを変更してください。行った変更を表示して確認します。

crm(live)configure#show変更をコミットして反映させます。