インストールとセットアップクイックスタート #

このマニュアルでは、crmシェルで提供されているブートストラップスクリプトを使用して、非常に基本的な2ノードクラスタをセットアップする手順を説明します。仮想IPアドレスをクラスタリソースとして設定する手順や、共有ストレージ上でSBDをノードフェンシングメカニズムとして使用する手順も記載されています。

Copyright © 2006–2025 SUSE LLC and contributors.All rights reserved.

この文書は、GNUフリー文書ライセンスのバージョン1.2または(オプションとして)バージョン1.3の条項に従って、複製、頒布、および/または改変が許可されています。ただし、この著作権表示およびライセンスは変更せずに記載すること。ライセンスバージョン1.2のコピーは、「GNUフリー文書ライセンス」セクションに含まれています。

SUSEの商標については、https://www.suse.com/company/legal/を参照してください。サードパーティ各社とその製品の商標は、所有者であるそれぞれの会社に所属します。商標記号(®、™など)は、SUSEおよびその関連会社の商標を示します。アスタリスク(*)は、第三者の商標を示します。

本書のすべての情報は、細心の注意を払って編集されています。しかし、このことは絶対に正確であることを保証するものではありません。SUSE LLC、その関係者、著者、翻訳者のいずれも誤りまたはその結果に対して一切責任を負いかねます。

1 使用シナリオ #

このマニュアルに記載されている手順に従うと、次のプロパティを持つ2ノードクラスタの最小セットアップになります。

ネットワーク経由で相互に接続された2つのノード:

alice(IP:192.168.1.1)およびbob(IP:192.168.1.2)。実行しているノードがどれであれ、クライアントからの該当サービスへの接続を可能にする浮動仮想IPアドレス(

192.168.1.10)。このIPアドレスは、グラフィカル管理ツールHawk2への接続に使用します。SBDフェンシングメカニズムとして使用される共有ストレージデバイス。これによりスプリットブレインシナリオが回避されます。

アクティブなホストが停止した場合における、一方のノードから他方のノードへのリソースのフェールオーバー(「アクティブ/パッシブ」セットアップ)。

この2ノードクラスタは、テスト目的で使用することも、後で拡張可能な最小クラスタ設定として使用することもできます。運用環境でクラスタを使用する前に、Book “管理ガイド”を参照して、ご自分の要件に従ってクラスタを変更してください。

2 システム要件 #

この項では、1項で説明されているシナリオの重要なシステム要件について説明します。運用環境で使用するためにクラスタを調整する方法については、Book “管理ガイド”, Chapter 2 “システム要件と推奨事項”の一覧を参照してください。

2.1 ハードウェア要件 #

- サーバ

2.2項 「ソフトウェアの必要条件」で指定されているソフトウェアがインストールされた2台のサーバ。

サーバはベアメタルでも仮想マシンでも構いません。各サーバが同一のハードウェア設定(メモリ、ディスクスペースなど)になっている必要はありませんが、アーキテクチャは同じである必要があります。クロスプラットフォームのクラスタはサポートされていません。

- 通信チャネル

クラスタノードあたり、少なくとも2つのTCP/IP通信メディア。ネットワーク機器は、クラスタ通信に使用する通信手段(マルチキャストまたはユニキャスト)をサポートする必要があります。通信メディアは100Mbit/s以上のデータレートをサポートする必要があります。サポートされるクラスタセットアップでは、2つ以上の冗長通信パスが必要です。これは次のように実行できます。

ネットワークデバイスボンディング(推奨)

Corosync内の2つ目の通信チャネル。

- ノードフェンシング/STONITH

スプリットブレインシナリオを回避するためのノードフェンシング(STONITH)デバイス。これは、物理デバイス(電源スイッチ)でも、SBD (ディスクによるSTONITH)のようなメカニズムとウォッチドッグを組み合わせたものでも構いません。SBDは、共有ストレージまたはディスクレスモードのいずれかで使用できます。このドキュメントでは、SBDを共有ストレージで使用する方法について説明します。次の要件を満たす必要があります。

共有ストレージデバイス。共有ストレージの設定については、Storage Administration Guide for SUSE Linux Enterprise Serverを参照してください。テスト目的で基本的な共有ストレージのみが必要な場合は、付録A SBDの基本的なiSCSIストレージを参照してください。

共有ストレージデバイスのパスが永続的で、クラスタ内のすべてのノードで一致している必要があります。

/dev/disk/by-id/dm-uuid-part1-mpath-abcedf12345などの固定デバイス名を使用してください。SBDデバイスが、ホストベースのRAID、LVM、またはDRBD*を使用してはいけません。

STONITHの詳細については、Book “管理ガイド”, Chapter 12 “フェンシングとSTONITH”を参照してください。SBDの詳細については、Book “管理ガイド”, Chapter 13 “ストレージ保護とSBD”を参照してください。

2.2 ソフトウェアの必要条件 #

すべてのノードは、少なくとも次のモジュールおよび拡張機能が必要です。

Basesystem Module 15 SP6

Server Applications Module 15 SP6

SUSE Linux Enterprise High Availability 15 SP6

2.3 その他の要件と推奨事項 #

- 時刻同期

クラスタノードはクラスタ外のNTPサーバに同期する必要があります。SUSE Linux Enterprise High Availability 15以降、Chronyは、NTPでデフォルトで実装されるようになりました。詳細については、Administration Guide for SUSE Linux Enterprise Server 15 SP6を参照してください。

ノードが同期されていない場合、または同期されていても異なるタイムゾーンが設定されている場合、クラスタが正しく動作しない場合があります。また、同期が行われていないと、ログファイルとクラスタレポートの分析が非常に困難になります。ブートストラップスクリプトを使用するときにNTPがまだ設定されていない場合、警告が表示されます。

- ホスト名およびIPアドレス

静的IPアドレスを使用します。

プライマリIPアドレスのみがサポートされます。

/etc/hostsファイルにあるすべてのクラスタノードを、完全修飾ホスト名およびショートホスト名で一覧表示します。クラスタのメンバーが名前で互いを見つけられることが重要です。名前を使用できない場合、内部クラスタ通信は失敗します。

- SSH

すべてのクラスタノードはSSHによって互いにアクセスできる必要があります。

crm report(トラブルシューティング用)などのツールおよびHawk2のは、ノード間でパスワード不要のSSHアクセスを必要とします。それがない場合、現在のノードからしかデータを収集できません。クラスタのセットアップにブートストラップスクリプトを使用した場合、SSHキーは自動的に作成されてコピーされます。

3 ブートストラップスクリプトの概要 #

次のコマンドは、最低限の時間と手動操作しか必要のないブートストラップスクリプトを実行します。

crm cluster initを使用して、クラスタ通信に必要な基本パラメータを定義します。これによって1ノードクラスタの実行が可能になります。crm cluster joinで、他のノードをクラスタに追加します。crm cluster removeで、クラスタからノードを削除します。

ブートストラップスクリプトによって設定されるオプションは、Pacemakerのデフォルト設定と同じではない場合があります。ブートストラップスクリプトが変更した設定は/var/log/crmsh/crmsh.logで確認できます。ブートストラッププロセス中に設定されたオプションは、YaSTクラスタモジュールで後で変更できます。詳細についてはBook “管理ガイド”, Chapter 4 “YaSTクラスタモジュールの使用”を参照してください。

ブートストラップスクリプトcrm cluster initが確認および設定するコンポーネントは、次のとおりです。

- NTP

NTPがブート時に開始するように設定されているかどうかをチェックします。設定されていない場合は、メッセージが表示されます。

- SSH

クラスタノード間でパスワード不要のログインを行うためのSSHキーを作成します。

- Csync2

クラスタ内のすべてのノードで設定ファイルを複製するようにCsync2を設定します。

- Corosync

クラスタ通信システムを設定します。

- SBD/ウォッチドッグ

ウォッチドッグが存在するかどうかをチェックし、SBDをノードフェンシングメカニズムとして設定するかどうか確認メッセージを表示します。

- 仮想浮動IP

Hawk2でのクラスタ管理用の仮想IPアドレスを設定するかどうか確認メッセージを表示します。

- ファイアウォール

クラスタ通信に必要なポートをファイアウォールで開きます。

- クラスタ名

クラスタの名前を定義します。デフォルトでは

haclusterです。これはオプションで、主にGeoクラスタで役立ちます。通常、クラスタ名は地理的な場所を反映し、Geoクラスタ内のサイトを識別しやすくします。- QDevice/QNetd

QDevice/QNetdを設定してクォーラムの決定に参加するかどうか確認メッセージを表示します。ノード数が偶数であるクラスタ、特に2ノードクラスタについては、QDeviceおよびQNetdの使用をお勧めします。

この設定についてはここでは説明しませんが、Book “管理ガイド”, Chapter 14 “QDeviceおよびQNetd”で説明されているように後で設定できます。

crm cluster initスクリプトは、システム環境(Microsoft Azureなど)を検出し、その環境のプロファイルに基づいて特定のクラスタ設定を調整します。詳細については、ファイル/etc/crm/profiles.ymlを参照してください。

4 High Availabilityパッケージのインストール #

クラスタを設定および管理するためのパッケージは、High Availabilityインストールパターンに含まれています。このパターンは、SUSE Linux Enterprise High Availabilityのインストール後にのみ使用できます。

SUSE Customer Centerに登録して、SUSE Linux Enterprise Serverのインストール中またはインストール後にSUSE Linux Enterprise High Availabilityをインストールできます。SUSE Linux Enterprise Serverの詳細については、Deployment Guideを参照してください。

コマンドラインからHigh Availabilityパターンをインストールします。

#zypper install -t pattern ha_slesクラスタの一部になるすべてのマシンにHigh Availabilityパターンをインストールします。

注記: すべてのノードへのソフトウェアパッケージのインストールSUSE Linux Enterprise Server 15 SP6およびSUSE Linux Enterprise High Availability Extension 15 SP6を自動インストールする場合は、AutoYaSTを使用して既存のノードをクローンします。詳細については、Book “管理ガイド”, Chapter 3 “SUSE Linux Enterprise High Availabilityのインストール”, Section 3.2 “AutoYaSTによる大量インストールと展開”を参照してください。

5 ノードフェンシングにSBDを使用する #

ブートストラップスクリプトでSBDを設定する前に、各ノードでウォッチドッグを有効にする必要があります。SUSE Linux Enterprise Serverには、ハードウェア固有のウォッチドッグドライバを提供する、いくつかのカーネルモジュールが付属しています。SUSE Linux Enterprise High Availabilityはウォッチドッグに「フィード」するソフトウェアコンポーネントとしてSBDデーモンを使用します。

次の手順では、softdogウォッチドッグを使用します。

softdogドライバはCPUが最低1つは動作中であることを前提とします。すべてのCPUが固まっている場合、システムを再起動させるsoftdogドライバのコードは実行されません。これに対して、ハードウェアウォッチドッグはすべてのCPUが固まっていても動作し続けます。

運用環境でクラスタを使用する前に、softdogモジュールを、ご使用のハードウェアに最適なハードウェアモジュールに置き換えることを強くお勧めします。

ただし、ハードウェアに適合するウォッチドッグがない場合、カーネルウォッチドッグモジュールとしてsoftdogを使用することができます。

各ノードで、softdogウォッチドッグを有効にします。

#echo softdog > /etc/modules-load.d/watchdog.conf#systemctl restart systemd-modules-loadsoftdogモジュールが正しくロードされているかどうかをテストします。

#lsmod | grep dogsoftdog 16384 1

6 最初のノードの設定 #

crm cluster initスクリプトを使用して最初のノードを設定します。ここでは最小限の時間と手動介入しか必要ありません。

aliceを使用して最初のノード(crm cluster init)を設定する #最初のクラスタノードに

rootとして、またはsudo特権を持つユーザとしてログインします。重要: SSHキーアクセスクラスタは、ノード間の通信にパスワードなしのSSHアクセスを使用します。

crm cluster initスクリプトは、SSHキーがあるかどうかを確認し、ない場合には生成します。ほとんどの場合、

rootユーザのSSHキーまたはsudoユーザのSSHキーがノードに存在している(または生成されている)必要があります。または、

sudoユーザのSSHキーがローカルマシンにあり、SSHエージェントの転送によってノードに渡すことができます。このためには、この最小セットアップでは説明していない追加の設定が必要です。詳細については、Book “管理ガイド”, Chapter 5 “設定および管理の基本事項”, Section 5.5.1 “ログイン”を参照してください。ブートストラップスクリプトを起動します。

#crm cluster init --name CLUSTERNAMECLUSTERNAMEプレースホルダを、クラスタの地理的な場所のような、意味のある名前で置き換えます(たとえば、

amsterdam)。これによってサイトを識別しやすくなるため、後でGeoクラスタを作成する場合に特に役立ちます。クラスタ通信にユニキャスト(デフォルト)の代わりにマルチキャストを使用する必要がある場合は、オプション

--multicast(または-U)を使用します。このスクリプトは、NTP設定とハードウェアウォッチドッグサービスを確認します。必要な場合、SSHアクセスとCsync2の同期に使用される公開SSHキーおよび秘密SSHキーが生成され、それぞれのサービスが起動されます。

クラスタ通信層(Corosync)を設定します。

バインドするネットワークアドレスを入力します。デフォルトでは、スクリプトは

eth0のネットワークアドレスを提案します。または、たとえばbond0のアドレスなど、別のネットワークアドレスを入力します。提案されたポート(

5405)を受け入れるか、別のポートを入力します。

SBDをノードフェンシングメカニズムとして設定します。

<

y>キーを押して、SBDを使用することを確認します。SBDに使用するブロックデバイスのパーティションの永続的なパスを入力します。パスはクラスタ内のすべてのノード全体で一致している必要があります。

このスクリプトは、SBDに使用するデバイスに小さなパーティションを作成します。

Hawk2でクラスタを管理するための仮想IPアドレスを設定します。

<

y>キーを押して、仮想IPアドレスを設定することを確認します。Hawk2の管理IPとして使用する、未使用のIPアドレス(

192.168.1.10)を入力します。Hawk2で個々のクラスタノードにログインする代わりに、その仮想IPアドレスに接続できるようになります。

QDeviceおよびQNetdを設定するかどうかを選択します。このドキュメントで説明されている最小限のセットアップについては、今のところ

nで拒否してください。Book “管理ガイド”, Chapter 14 “QDeviceおよびQNetd”で説明しているように、QDeviceおよびQNetdは後で設定できます。

最後に、スクリプトはクラスタサービスを開始し、クラスタをオンラインにして、Hawk2を有効にします。Hawk2に使用するURLが画面に表示されます。

1ノードクラスタが実行するようになります。状態を表示するには、次の手順に従います。

任意のコンピュータで、Webブラウザを起動し、JavaScriptとクッキーが有効なことを確認します。

URLとして、ブートストラップスクリプトで設定した仮想IPアドレスを入力します。

https://192.168.1.10:7630/

注記: 証明書の警告初めてURLにアクセスしようとするときに証明書の警告が表示される場合は、自己署名証明書が使用されています。自己署名証明書は、デフォルトでは信頼されません。

証明書を検証するための詳細情報については、クラスタのオペレータに問い合わせてください。

続行するには、ブラウザに例外を追加して警告をバイパスします。

Hawk2のログイン画面で、ブートストラップスクリプトで作成されたユーザのとを入力します(ユーザ

hacluster、パスワードlinux)。重要: セキュリティ保護されたパスワードデフォルトのパスワードはできるだけ早くセキュリティ保護されたパスワードに変更します。

#passwd haclusterをクリックします。Hawk2 Webインタフェースには、デフォルトで状態画面が表示されます。

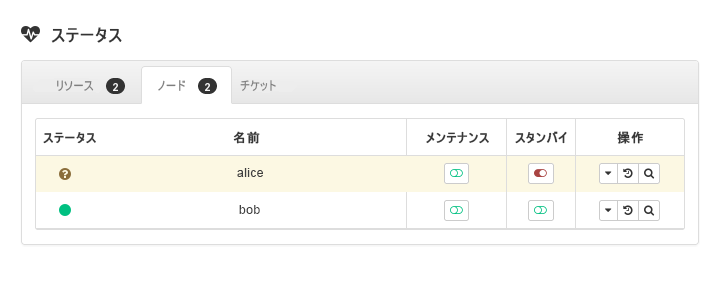

図 1: Hawk2の1ノードクラスタの状態 #

7 2つ目のノードの追加 #

crm cluster joinブートストラップスクリプトを使用して、クラスタに2つ目のノードを追加します。スクリプトは既存のクラスタノードへのアクセスのみが必要で、ご使用のマシンで自動的に基本セットアップを完了します。

詳細については、crm cluster join --helpコマンドを参照してください。

bobを使用して2つ目のノード(crm cluster join)を追加する #2つ目のノードに

rootとして、またはsudo特権を持つユーザとしてログインします。ブートストラップスクリプトを起動します。

最初のノードを

rootとして設定する場合は、追加のパラメータなしで次のコマンドを実行できます。#crm cluster join最初のノードを

sudoユーザとして設定する場合は、-cオプションでそのユーザを指定する必要があります。>sudo crm cluster join -c USER@aliceNTPがブート時に開始するよう設定されていない場合、メッセージが表示されます。スクリプトは、ハードウェアウォッチドッグデバイスもチェックします。デバイスがないときは警告が表示されます。

-cでまだaliceを指定していない場合は、最初のノードのIPアドレスが求められます。両方のマシン間にパスワードなしのSSHアクセスを設定していない場合、最初のノードのパスワードが求められます。

指定したノードへのログイン後、スクリプトは、Corosync設定をコピーし、SSHおよびCsync2を設定し、現在のマシンを新しいクラスタノードとしてオンラインにし、Hawk2に必要なサービスを起動します。

Hawk2でクラスタの状態を確認します。 › に、2つのノードが緑色の状態で表示されます。

8 クラスタのテスト #

次のテストは、クラスタのセットアップに関する問題を特定するのに役立ちます。ただし、現実的なテストには、具体的なユースケースやシナリオが含まれます。運用環境でクラスタを使用する前に、ご自分のユースケースに従ってクラスタを十分にテストしてください。

sbd -d DEVICE_NAME listコマンドは、SBDに表示されるすべてのノードを一覧表示します。このドキュメントで説明されているセットアップでは、出力結果は、aliceとbobの両方を示すはずです。8.1項 「リソースフェールオーバーのテスト」は、現在リソースを実行しているノードを

standbyに設定した場合に、クラスタによって仮想IPアドレスが他方のノードに移動されるかどうかを確認する簡単なテストです。8.2項 「

crm cluster crash_testコマンドを使用したテスト」は、クラスタの障害をシミュレートし、結果を報告します。

8.1 リソースフェールオーバーのテスト #

簡単なテストとして、次の手順でリソースフェールオーバーを確認します。

ターミナルを開き、使用している仮想IPアドレス

192.168.1.10に対してpingを実行します。#ping 192.168.1.10Hawk2にログインします。

› で、仮想IPアドレス(リソース

admin_addr)がどのノードで実行されているかを確認します。この手順では、リソースがaliceで実行されていることを前提としています。aliceをモードにします。図 3: スタンバイモードのノードalice#› の順にクリックします。リソース

admin_addrはbobにマイグレートされました。

マイグレーション中は、仮想IPアドレスに対して連続してpingが実行されます。これは、クラスタセットアップと浮動IPが正常に機能していることを示します。pingCCtrl–を押してコマンドをキャンセルします。

8.2 crm cluster crash_testコマンドを使用したテスト #

crm cluster crash_testコマンドは、クラスタの障害をトリガして問題を見つけます。クラスタを運用環境で使用する前に、このコマンドを使用して、すべてが予期するように動作しているか確認することをお勧めします。

このコマンドは以下のチェックをサポートします。

--split-brain-iptablesCorosyncポートをブロックすることにより、スプリットブレインシナリオをシミュレートします。1つのノードが予期されるようにフェンシングできるかどうかをチェックします。

--kill-sbd/--kill-corosync/--kill-pacemakerdSBD、Corosync、およびPacemakerのデーモンを終了します。これらのテストのいずれかを実行すると、

/var/lib/crmsh/crash_test/ディレクトリにレポートが表示されます。レポートには、テストケースの説明、アクションのログ、考え得る結果の説明が含まれます。--fence-node NODEコマンドラインから渡される特定のノードをフェンスします。

詳細については、crm cluster crash_test --helpを参照してください。

#crm_mon -1Stack: corosync Current DC: alice (version ...) - partition with quorum Last updated: Fri Mar 03 14:40:21 2020 Last change: Fri Mar 03 14:35:07 2020 by root via cibadmin on alice 2 nodes configured 1 resource configured Online: [ alice bob ] Active resources: stonith-sbd (stonith:external/sbd): Started alice#crm cluster crash_test--fence-node bob============================================== Testcase: Fence node bob Fence action: reboot Fence timeout: 60 !!! WARNING WARNING WARNING !!! THIS CASE MAY LEAD TO NODE BE FENCED. TYPE Yes TO CONTINUE, OTHER INPUTS WILL CANCEL THIS CASE [Yes/No](No):YesINFO: Trying to fence node "bob" INFO: Waiting 60s for node "bob" reboot... INFO: Node "bob" will be fenced by "alice"! INFO: Node "bob" was successfully fenced by "alice"

テスト中のbobの変更ステータスを表示するには、Hawk2にログインし、 › に移動します。

9 次のステップ #

ブートストラップスクリプトを使用すると、テスト目的で使用可能な基本的な高可用性クラスタを迅速に設定できます。ただし、このクラスタを、運用環境で使用可能な機能する高可用性クラスタに拡張するには、さらなるステップを実行することをお勧めします。

- ノードの追加

次のいずれかの方法を使用して、クラスタにノードを追加します。

個々のノードの場合は、7項 「2つ目のノードの追加」の説明に従って

crm cluster joinスクリプトを使用します。複数のノードの大量インストールの場合は、Book “管理ガイド”, Chapter 3 “SUSE Linux Enterprise High Availabilityのインストール”, Section 3.2 “AutoYaSTによる大量インストールと展開”の説明に従ってAutoYaSTを使用します。

通常のクラスタには最大32ノードを含めることができます。

pacemaker_remoteサービスを使用すると、高可用性クラスタを拡張して、この制限を超えて追加のノードを含めることができます。詳しく詳細については「Article “Pacemaker Remote Quick Start”」を参照してください。- QDeviceの設定

クラスタのノード数が偶数の場合、QDeviceおよびQNetdを設定し、クォーラムの決定に参加します。QDeviceは設定可能な投票数を提供するため、クラスタは標準のクォーラムルールで許可されているよりも多くのノード障害に耐えることができます。詳細については、Book “管理ガイド”, Chapter 14 “QDeviceおよびQNetd”を参照してください。

- ハードウェアウォッチドッグの有効化

運用環境でクラスタを使用する前に、

softdogモジュールを、ご使用のハードウェアに最適なハードウェアモジュールに置き換えてください。詳細については、Book “管理ガイド”, Chapter 13 “ストレージ保護とSBD”, Section 13.6 “ウォッチドッグのセットアップ”を参照してください。

10 詳細の参照先 #

本製品の他のマニュアルは、https://documentation.suse.com/sle-ha/で入手できます。設定および管理タスクの詳細については、包括的な『Administration Guide』を参照してください。

A SBDの基本的なiSCSIストレージ #

以下の手順を使用して、SBDで使用する基本的なiSCSIストレージを設定します。これらの手順は、テスト目的でのみ推奨されます。運用環境でiSCSIを使用する前に、 Storage Administration Guide for SUSE Linux Enterprise Serverを参照してください。

iSCSIターゲットとして機能するSUSE Linux Enterprise Server仮想マシン。このVMはクラスタの一部ではありません。

Vmに2つの仮想ストレージデバイスがある(システム用に20 GBデバイス、SBD用に1 GBデバイス)。

高可用性クラスタにまだ追加されていない2つのSUSE Linux Enterprise Serverノード。

最初に、仮想マシンにiSCSIターゲットを設定します。

パッケージyast2-iscsi-lio-serverをインストールします:。

#zypper install yast2-iscsi-lio-serverYaSTで

iscsi-lio-serverモジュールを起動します:。#yast2 iscsi-lio-serverタブので、を選択します。

を有効にします。

タブで、を有効にします。

に、とを入力します。

に、とを入力します。このパスワードは、のパスワードとは異なる必要があります。

タブで、を選択します。

.com.exampleを置き換えて、名を変更します。サーバのを追加します。

を選択します。

ウィンドウで、1GBストレージデバイスへのを入力します(例:

/dev/vbd)。を選択します。

を選択します。

を選択して、YaSTを閉じます。

ターゲットのセットアップを確認するには、ターゲットCLIに切り替えます。

#targetcli設定を表示します。

/>ls

次に、ノードにiSCSIイニシエータを設定します。両方のノードでこの手順を繰り返します。

パッケージyast2-iscsi-clientをインストールします:。

#zypper install yast2-iscsi-clientiscsidサービスを開始します。#systemctl start iscsidYaSTで

iscsi-clientモジュールを開きます。#yast2 iscsi-clientタブで、を選択します。

iSCSIターゲットのIPアドレスを入力します。

をクリアします。

に、イニシエータのとを入力します。

に、ターゲットのとを入力します。

を選択します。

YaSTがiSCSIターゲットを検出したら、を選択します。

で、を選択します。

を選択します。

を選択して、YaSTを閉じます。

iSCSIイニシエータを確認します。

#lsscsi[0:0:1:0] cd/dvd QEMU QEMU DVD-ROM 2.5+ /dev/sr0 [2:0:0:0] disk LIO-ORG IBLOCK 4.0 /dev/sdaIBLOCKを含む行を探します。この例では、iSCSIデバイスは/dev/sdaです。iscsidサービスの状態を確認します。#systemctl status iscsid

/dev/disk/by-id/で固定デバイス名を見つけることができます。通常、iSCSIデバイスはscsi-SLIO-ORG_IBLOCKで開始します。

複数のディスクがある場合、コマンドlsblk -o name,serialを実行して、どの固定デバイス名がどの短縮名(例: /dev/sda)に対応するかを確認します。

クラスタを設定する際には、次のいずれかの方法を使用して固定デバイス名を指定します。

crm cluster initを実行する場合は、プロンプトが表示されたら、固定デバイス名を入力します。crm cluster initを実行する前に、/etc/sysconfig/sbdに固定デバイス名を追加します。SBD_DEVICE=/dev/disk/by-id/scsi-SLIO-ORG_IBLOCK_DEVICE_ID_STRING

crm cluster initを実行する場合は、次の質問にnと答えます。SBD is already configured to use /dev/disk/by-id/scsi-SLIO-ORG_IBLOCK_... - overwrite (y/n)?

B GNU licenses #

This appendix contains the GNU Free Documentation License version 1.2.

GNU Free Documentation License #

Copyright (C) 2000, 2001, 2002 Free Software Foundation, Inc. 51 Franklin St, Fifth Floor, Boston, MA 02110-1301 USA. Everyone is permitted to copy and distribute verbatim copies of this license document, but changing it is not allowed.

0. PREAMBLE #

The purpose of this License is to make a manual, textbook, or other functional and useful document "free" in the sense of freedom: to assure everyone the effective freedom to copy and redistribute it, with or without modifying it, either commercially or non-commercially. Secondarily, this License preserves for the author and publisher a way to get credit for their work, while not being considered responsible for modifications made by others.

This License is a kind of "copyleft", which means that derivative works of the document must themselves be free in the same sense. It complements the GNU General Public License, which is a copyleft license designed for free software.

We have designed this License to use it for manuals for free software, because free software needs free documentation: a free program should come with manuals providing the same freedoms that the software does. But this License is not limited to software manuals; it can be used for any textual work, regardless of subject matter or whether it is published as a printed book. We recommend this License principally for works whose purpose is instruction or reference.

1. APPLICABILITY AND DEFINITIONS #

This License applies to any manual or other work, in any medium, that contains a notice placed by the copyright holder saying it can be distributed under the terms of this License. Such a notice grants a world-wide, royalty-free license, unlimited in duration, to use that work under the conditions stated herein. The "Document", below, refers to any such manual or work. Any member of the public is a licensee, and is addressed as "you". You accept the license if you copy, modify or distribute the work in a way requiring permission under copyright law.

A "Modified Version" of the Document means any work containing the Document or a portion of it, either copied verbatim, or with modifications and/or translated into another language.

A "Secondary Section" is a named appendix or a front-matter section of the Document that deals exclusively with the relationship of the publishers or authors of the Document to the Document's overall subject (or to related matters) and contains nothing that could fall directly within that overall subject. (Thus, if the Document is in part a textbook of mathematics, a Secondary Section may not explain any mathematics.) The relationship could be a matter of historical connection with the subject or with related matters, or of legal, commercial, philosophical, ethical or political position regarding them.

The "Invariant Sections" are certain Secondary Sections whose titles are designated, as being those of Invariant Sections, in the notice that says that the Document is released under this License. If a section does not fit the above definition of Secondary then it is not allowed to be designated as Invariant. The Document may contain zero Invariant Sections. If the Document does not identify any Invariant Sections then there are none.

The "Cover Texts" are certain short passages of text that are listed, as Front-Cover Texts or Back-Cover Texts, in the notice that says that the Document is released under this License. A Front-Cover Text may be at most 5 words, and a Back-Cover Text may be at most 25 words.

A "Transparent" copy of the Document means a machine-readable copy, represented in a format whose specification is available to the general public, that is suitable for revising the document straightforwardly with generic text editors or (for images composed of pixels) generic paint programs or (for drawings) some widely available drawing editor, and that is suitable for input to text formatters or for automatic translation to a variety of formats suitable for input to text formatters. A copy made in an otherwise Transparent file format whose markup, or absence of markup, has been arranged to thwart or discourage subsequent modification by readers is not Transparent. An image format is not Transparent if used for any substantial amount of text. A copy that is not "Transparent" is called "Opaque".

Examples of suitable formats for Transparent copies include plain ASCII without markup, Texinfo input format, LaTeX input format, SGML or XML using a publicly available DTD, and standard-conforming simple HTML, PostScript or PDF designed for human modification. Examples of transparent image formats include PNG, XCF and JPG. Opaque formats include proprietary formats that can be read and edited only by proprietary word processors, SGML or XML for which the DTD and/or processing tools are not generally available, and the machine-generated HTML, PostScript or PDF produced by some word processors for output purposes only.

The "Title Page" means, for a printed book, the title page itself, plus such following pages as are needed to hold, legibly, the material this License requires to appear in the title page. For works in formats which do not have any title page as such, "Title Page" means the text near the most prominent appearance of the work's title, preceding the beginning of the body of the text.

A section "Entitled XYZ" means a named subunit of the Document whose title either is precisely XYZ or contains XYZ in parentheses following text that translates XYZ in another language. (Here XYZ stands for a specific section name mentioned below, such as "Acknowledgements", "Dedications", "Endorsements", or "History".) To "Preserve the Title" of such a section when you modify the Document means that it remains a section "Entitled XYZ" according to this definition.

The Document may include Warranty Disclaimers next to the notice which states that this License applies to the Document. These Warranty Disclaimers are considered to be included by reference in this License, but only as regards disclaiming warranties: any other implication that these Warranty Disclaimers may have is void and has no effect on the meaning of this License.

2. VERBATIM COPYING #

You may copy and distribute the Document in any medium, either commercially or non-commercially, provided that this License, the copyright notices, and the license notice saying this License applies to the Document are reproduced in all copies, and that you add no other conditions whatsoever to those of this License. You may not use technical measures to obstruct or control the reading or further copying of the copies you make or distribute. However, you may accept compensation in exchange for copies. If you distribute a large enough number of copies you must also follow the conditions in section 3.

You may also lend copies, under the same conditions stated above, and you may publicly display copies.

3. COPYING IN QUANTITY #

If you publish printed copies (or copies in media that commonly have printed covers) of the Document, numbering more than 100, and the Document's license notice requires Cover Texts, you must enclose the copies in covers that carry, clearly and legibly, all these Cover Texts: Front-Cover Texts on the front cover, and Back-Cover Texts on the back cover. Both covers must also clearly and legibly identify you as the publisher of these copies. The front cover must present the full title with all words of the title equally prominent and visible. You may add other material on the covers in addition. Copying with changes limited to the covers, as long as they preserve the title of the Document and satisfy these conditions, can be treated as verbatim copying in other respects.

If the required texts for either cover are too voluminous to fit legibly, you should put the first ones listed (as many as fit reasonably) on the actual cover, and continue the rest onto adjacent pages.

If you publish or distribute Opaque copies of the Document numbering more than 100, you must either include a machine-readable Transparent copy along with each Opaque copy, or state in or with each Opaque copy a computer-network location from which the general network-using public has access to download using public-standard network protocols a complete Transparent copy of the Document, free of added material. If you use the latter option, you must take reasonably prudent steps, when you begin distribution of Opaque copies in quantity, to ensure that this Transparent copy will remain thus accessible at the stated location until at least one year after the last time you distribute an Opaque copy (directly or through your agents or retailers) of that edition to the public.

It is requested, but not required, that you contact the authors of the Document well before redistributing any large number of copies, to give them a chance to provide you with an updated version of the Document.

4. MODIFICATIONS #

You may copy and distribute a Modified Version of the Document under the conditions of sections 2 and 3 above, provided that you release the Modified Version under precisely this License, with the Modified Version filling the role of the Document, thus licensing distribution and modification of the Modified Version to whoever possesses a copy of it. In addition, you must do these things in the Modified Version:

Use in the Title Page (and on the covers, if any) a title distinct from that of the Document, and from those of previous versions (which should, if there were any, be listed in the History section of the Document). You may use the same title as a previous version if the original publisher of that version gives permission.

List on the Title Page, as authors, one or more persons or entities responsible for authorship of the modifications in the Modified Version, together with at least five of the principal authors of the Document (all of its principal authors, if it has fewer than five), unless they release you from this requirement.

State on the Title page the name of the publisher of the Modified Version, as the publisher.

Preserve all the copyright notices of the Document.

Add an appropriate copyright notice for your modifications adjacent to the other copyright notices.

Include, immediately after the copyright notices, a license notice giving the public permission to use the Modified Version under the terms of this License, in the form shown in the Addendum below.

Preserve in that license notice the full lists of Invariant Sections and required Cover Texts given in the Document's license notice.

Include an unaltered copy of this License.

Preserve the section Entitled "History", Preserve its Title, and add to it an item stating at least the title, year, new authors, and publisher of the Modified Version as given on the Title Page. If there is no section Entitled "History" in the Document, create one stating the title, year, authors, and publisher of the Document as given on its Title Page, then add an item describing the Modified Version as stated in the previous sentence.

Preserve the network location, if any, given in the Document for public access to a Transparent copy of the Document, and likewise the network locations given in the Document for previous versions it was based on. These may be placed in the "History" section. You may omit a network location for a work that was published at least four years before the Document itself, or if the original publisher of the version it refers to gives permission.

For any section Entitled "Acknowledgements" or "Dedications", Preserve the Title of the section, and preserve in the section all the substance and tone of each of the contributor acknowledgements and/or dedications given therein.

Preserve all the Invariant Sections of the Document, unaltered in their text and in their titles. Section numbers or the equivalent are not considered part of the section titles.

Delete any section Entitled "Endorsements". Such a section may not be included in the Modified Version.

Do not retitle any existing section to be Entitled "Endorsements" or to conflict in title with any Invariant Section.

Preserve any Warranty Disclaimers.

If the Modified Version includes new front-matter sections or appendices that qualify as Secondary Sections and contain no material copied from the Document, you may at your option designate some or all of these sections as invariant. To do this, add their titles to the list of Invariant Sections in the Modified Version's license notice. These titles must be distinct from any other section titles.

You may add a section Entitled "Endorsements", provided it contains nothing but endorsements of your Modified Version by various parties--for example, statements of peer review or that the text has been approved by an organization as the authoritative definition of a standard.

You may add a passage of up to five words as a Front-Cover Text, and a passage of up to 25 words as a Back-Cover Text, to the end of the list of Cover Texts in the Modified Version. Only one passage of Front-Cover Text and one of Back-Cover Text may be added by (or through arrangements made by) any one entity. If the Document already includes a cover text for the same cover, previously added by you or by arrangement made by the same entity you are acting on behalf of, you may not add another; but you may replace the old one, on explicit permission from the previous publisher that added the old one.

The author(s) and publisher(s) of the Document do not by this License give permission to use their names for publicity for or to assert or imply endorsement of any Modified Version.

5. COMBINING DOCUMENTS #

You may combine the Document with other documents released under this License, under the terms defined in section 4 above for modified versions, provided that you include in the combination all of the Invariant Sections of all of the original documents, unmodified, and list them all as Invariant Sections of your combined work in its license notice, and that you preserve all their Warranty Disclaimers.

The combined work need only contain one copy of this License, and multiple identical Invariant Sections may be replaced with a single copy. If there are multiple Invariant Sections with the same name but different contents, make the title of each such section unique by adding at the end of it, in parentheses, the name of the original author or publisher of that section if known, or else a unique number. Make the same adjustment to the section titles in the list of Invariant Sections in the license notice of the combined work.

In the combination, you must combine any sections Entitled "History" in the various original documents, forming one section Entitled "History"; likewise combine any sections Entitled "Acknowledgements", and any sections Entitled "Dedications". You must delete all sections Entitled "Endorsements".

6. COLLECTIONS OF DOCUMENTS #

You may make a collection consisting of the Document and other documents released under this License, and replace the individual copies of this License in the various documents with a single copy that is included in the collection, provided that you follow the rules of this License for verbatim copying of each of the documents in all other respects.

You may extract a single document from such a collection, and distribute it individually under this License, provided you insert a copy of this License into the extracted document, and follow this License in all other respects regarding verbatim copying of that document.

7. AGGREGATION WITH INDEPENDENT WORKS #

A compilation of the Document or its derivatives with other separate and independent documents or works, in or on a volume of a storage or distribution medium, is called an "aggregate" if the copyright resulting from the compilation is not used to limit the legal rights of the compilation's users beyond what the individual works permit. When the Document is included in an aggregate, this License does not apply to the other works in the aggregate which are not themselves derivative works of the Document.

If the Cover Text requirement of section 3 is applicable to these copies of the Document, then if the Document is less than one half of the entire aggregate, the Document's Cover Texts may be placed on covers that bracket the Document within the aggregate, or the electronic equivalent of covers if the Document is in electronic form. Otherwise they must appear on printed covers that bracket the whole aggregate.

8. TRANSLATION #

Translation is considered a kind of modification, so you may distribute translations of the Document under the terms of section 4. Replacing Invariant Sections with translations requires special permission from their copyright holders, but you may include translations of some or all Invariant Sections in addition to the original versions of these Invariant Sections. You may include a translation of this License, and all the license notices in the Document, and any Warranty Disclaimers, provided that you also include the original English version of this License and the original versions of those notices and disclaimers. In case of a disagreement between the translation and the original version of this License or a notice or disclaimer, the original version will prevail.

If a section in the Document is Entitled "Acknowledgements", "Dedications", or "History", the requirement (section 4) to Preserve its Title (section 1) will typically require changing the actual title.

9. TERMINATION #

You may not copy, modify, sublicense, or distribute the Document except as expressly provided for under this License. Any other attempt to copy, modify, sublicense or distribute the Document is void, and will automatically terminate your rights under this License. However, parties who have received copies, or rights, from you under this License will not have their licenses terminated so long as such parties remain in full compliance.

10. FUTURE REVISIONS OF THIS LICENSE #

The Free Software Foundation may publish new, revised versions of the GNU Free Documentation License from time to time. Such new versions will be similar in spirit to the present version, but may differ in detail to address new problems or concerns. See https://www.gnu.org/copyleft/.

Each version of the License is given a distinguishing version number. If the Document specifies that a particular numbered version of this License "or any later version" applies to it, you have the option of following the terms and conditions either of that specified version or of any later version that has been published (not as a draft) by the Free Software Foundation. If the Document does not specify a version number of this License, you may choose any version ever published (not as a draft) by the Free Software Foundation.

ADDENDUM: How to use this License for your documents #

Copyright (c) YEAR YOUR NAME. Permission is granted to copy, distribute and/or modify this document under the terms of the GNU Free Documentation License, Version 1.2 or any later version published by the Free Software Foundation; with no Invariant Sections, no Front-Cover Texts, and no Back-Cover Texts. A copy of the license is included in the section entitled “GNU Free Documentation License”.

If you have Invariant Sections, Front-Cover Texts and Back-Cover Texts, replace the “with...Texts.” line with this:

with the Invariant Sections being LIST THEIR TITLES, with the Front-Cover Texts being LIST, and with the Back-Cover Texts being LIST.

If you have Invariant Sections without Cover Texts, or some other combination of the three, merge those two alternatives to suit the situation.

If your document contains nontrivial examples of program code, we recommend releasing these examples in parallel under your choice of free software license, such as the GNU General Public License, to permit their use in free software.