このガイドでは、SUSE Linux Enterprise Serverでストレージデバイスを管理する方法について説明します。

- 序文

- I ファイルシステムとマウント

- II 論理ボリューム(LVM)

- III ソフトウェアRAID

- IV ネットワークストレージ

- 14 Linux用iSNS

- 15 IPネットワークの大容量記憶域: iSCSI

- 16 Fibre Channel Storage over Ethernet Networks: FCoE

- 17 NVMe over Fabric

- 18 デバイスのマルチパスI/Oの管理

- 18.1 マルチパスI/Oの理解

- 18.2 ハードウェアサポート

- 18.3 マルチパス処理のプラニング

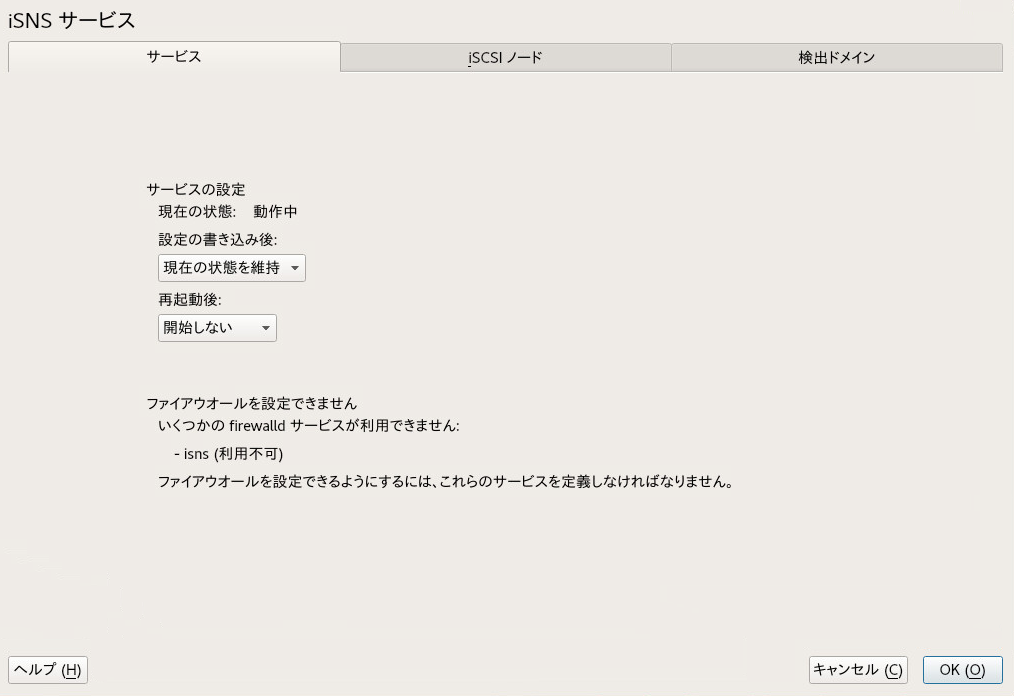

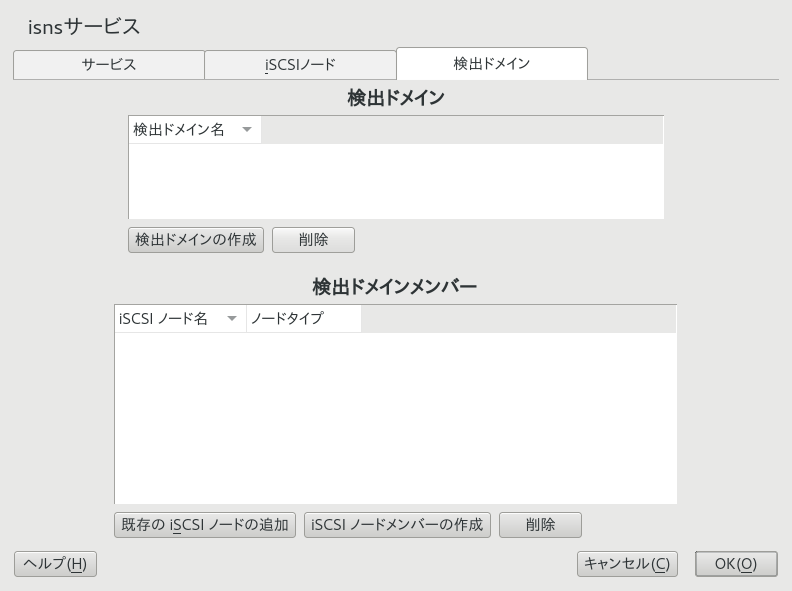

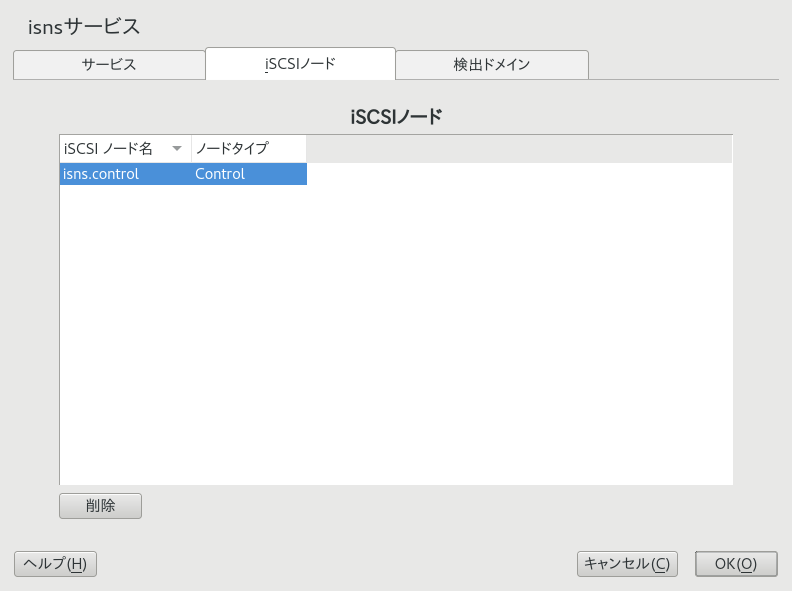

- 18.4 マルチパス管理ツール

- 18.5 マルチパス処理用システムの設定

- 18.6 マルチパス設定

- 18.7 ポーリング、待ち行列、およびフェールバック用のポリシーの設定

- 18.8 非マルチパスデバイスのブラックリスト化

- 18.9 ユーザフレンドリ名または別名の設定

- 18.10 パスフェールオーバーのポリシーと優先度の設定

- 18.11 ルートデバイスのマルチパスI/Oの設定

- 18.12 既存ソフトウェアRAID用マルチパスI/Oの設定

- 18.13 マルチパスデバイスでのLVM2の使用

- 18.14 ベストプラクティス

- 18.15 MPIOのトラブルシューティング

- 19 NFS共有ファイルシステム

- 20 Samba

- 21 autofsによるオンデマンドマウント

- A GNU licenses

- 1.1 Btrfsクオータの有効化

- 1.2 サブボリュームのクォータの設定

- 1.3 デバイスのサブボリュームのリスト

- 5.1 物理パーティショニング対LVM

- 5.2 DATAという名前のボリュームグループ内の物理ボリューム

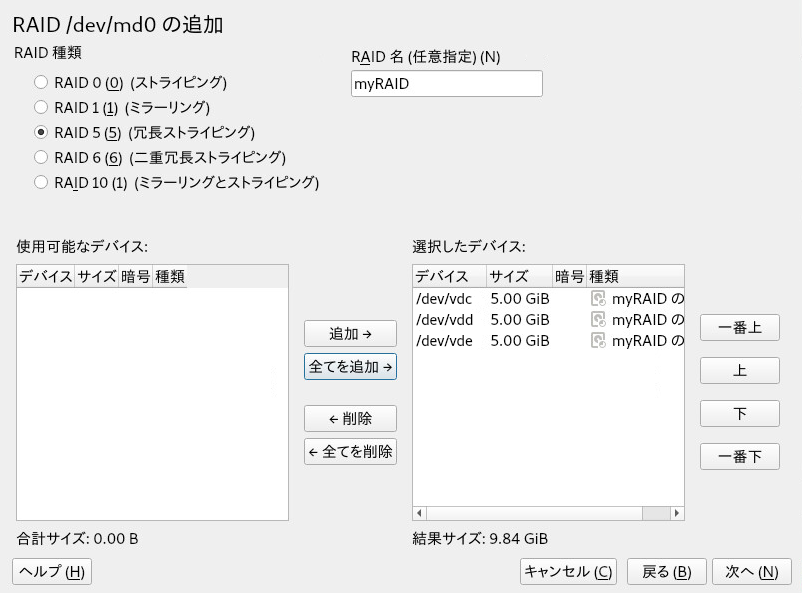

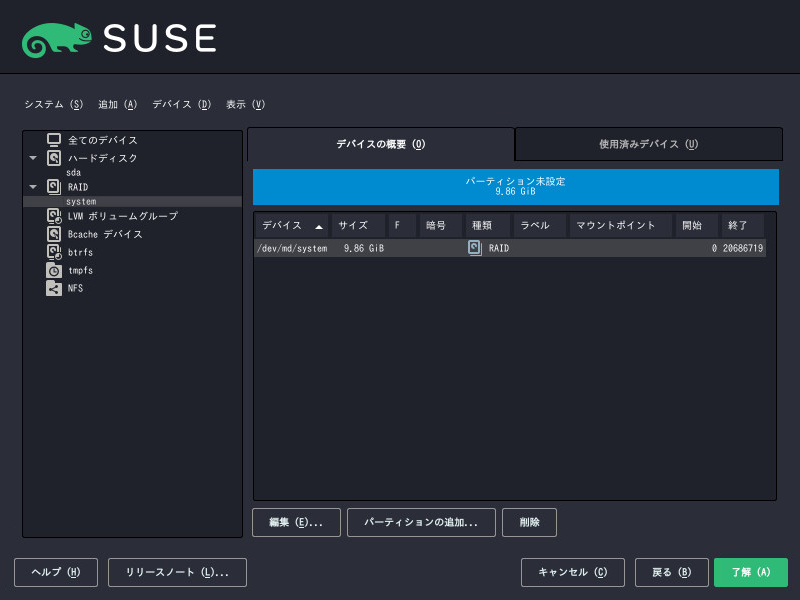

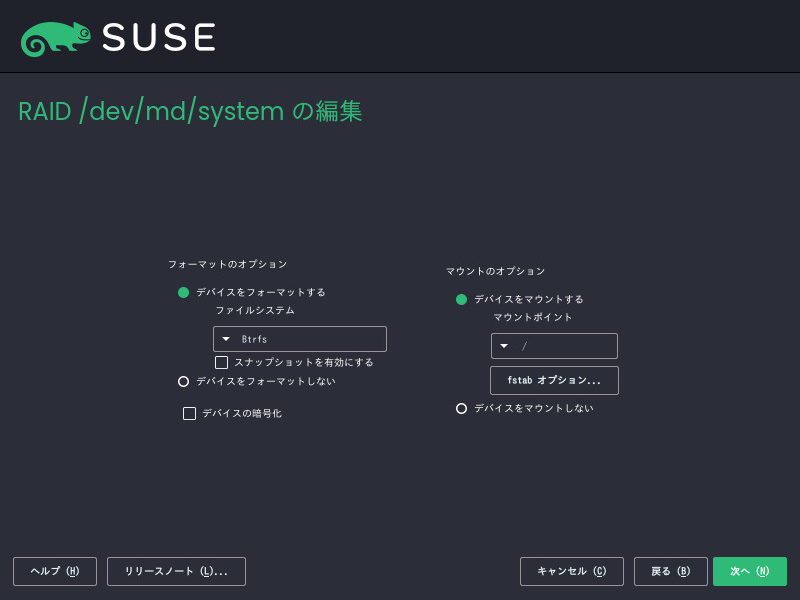

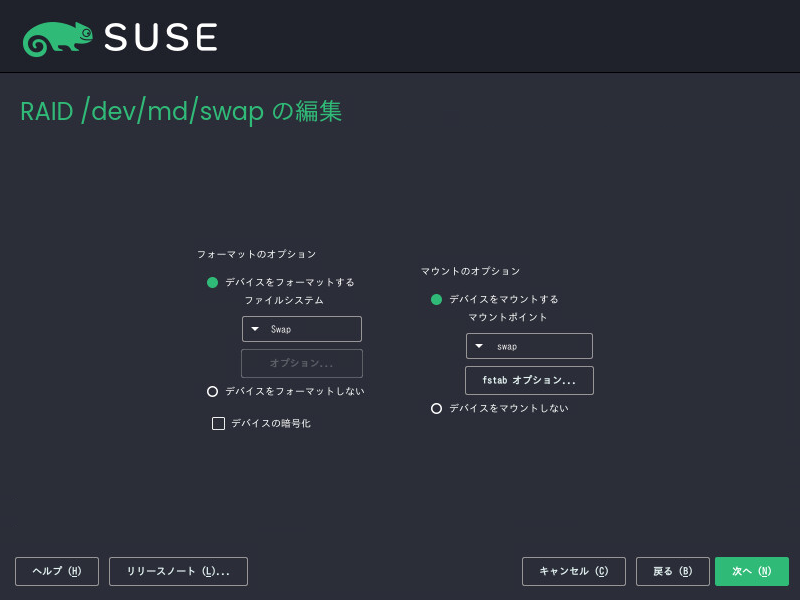

- 7.1 RAID 5設定の例

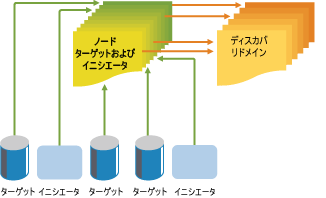

- 14.1 iSNS検出ドメイン

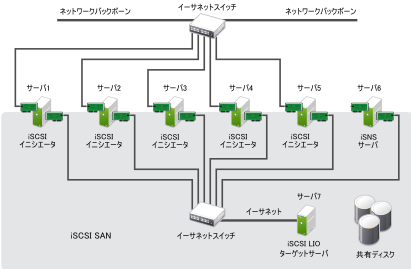

- 15.1 iSNSサーバによるiSCSI SAN

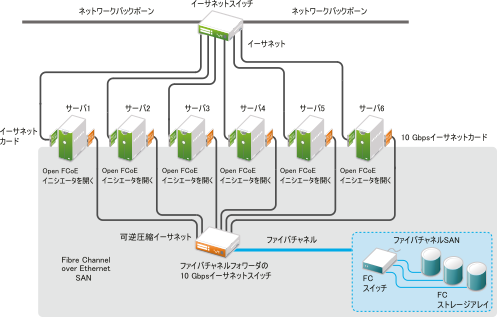

- 16.1 Open Fibre Channel over Ethernet SAN

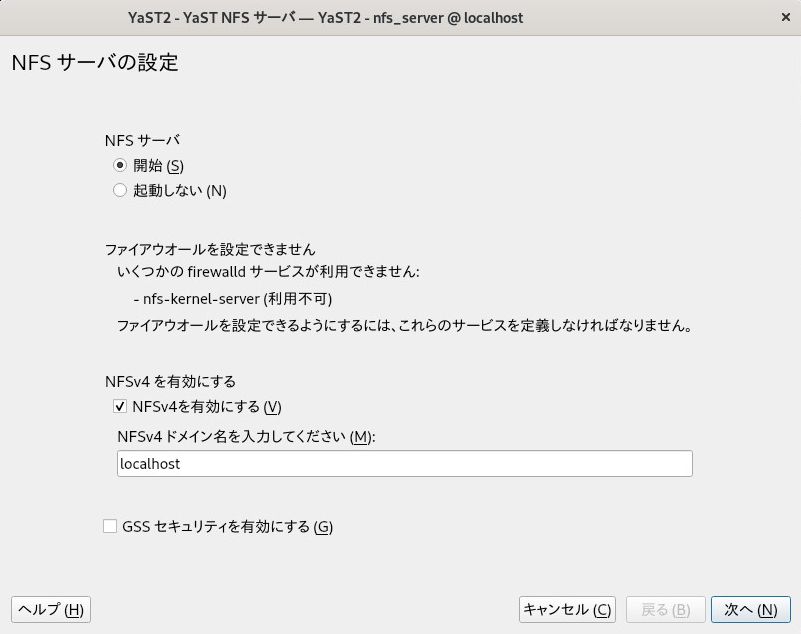

- 19.1 NFSサーバ設定ツール

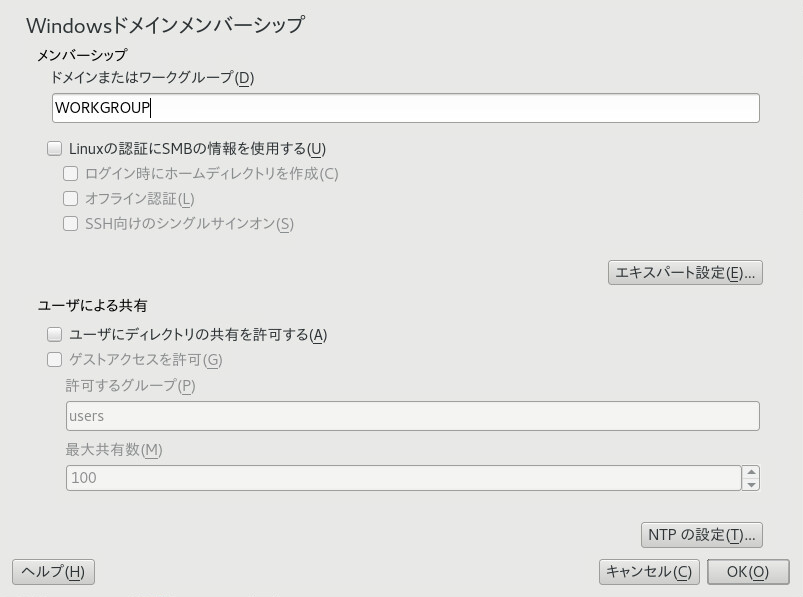

- 20.1 Windowsドメインメンバーシップの決定

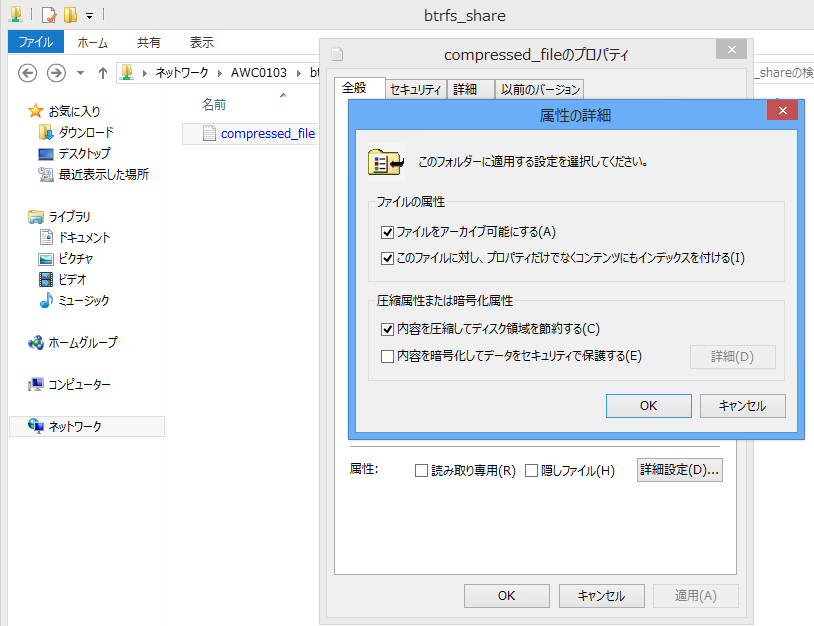

- 20.2 Windowsエクスプローラのダイアログ

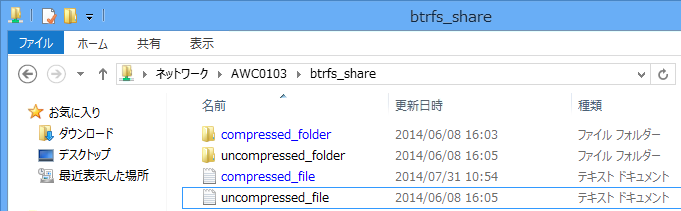

- 20.3 Windowsエクスプローラでの圧縮ファイルのディレクトリリスト

- 20.4 スナップショットが有効な新しいSamba共有の追加

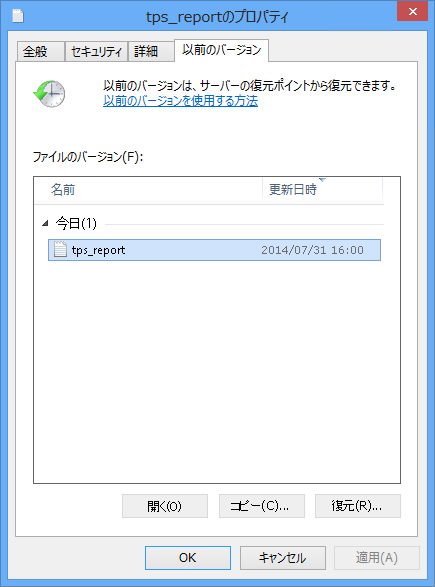

- 20.5 Windowsエクスプローラのタブ

- 1.1 Linux環境でのファイルシステムのタイプ

- 1.2 ファイルおよびファイルシステムの最大サイズ(オンディスクフォーマット、4KiBブロックサイズ)

- 1.3 ストレージの制限

- 2.1 ファイルシステムサイズ変更のサポート

- 7.1 RAID 5とRAID 6の比較

- 9.1 ネストしたRAIDレベル

- 9.2 ネスティングでRAID 10 (1+0)を作成するシナリオ

- 9.3 ネスティングでRAID 10 (0+1)を作成するシナリオ

- 9.4 複雑なRAID 10とネストしたRAID 10の比較

- 9.5 mdadmでRAID 10を作成するシナリオ

- 11.1 RAIDのサイズ変更に必要なタスク

- 11.2 コンポーネントパーティションのサイズを増加するシナリオ

- 12.1 非SES-2パターンとSES-2パターン間での変換

- 18.1 マルチパスデバイス名のタイプの比較

- 18.2 multipath -pコマンドのグループポリシーオプション

Copyright © 2006–2025 SUSE LLC and contributors. All rights reserved.

この文書は、GNUフリー文書ライセンスのバージョン1.2または(オプションとして)バージョン1.3の条項に従って、複製、配布、および/または改変が許可されています。ただし、この著作権表示およびライセンスは変更せずに記載すること。ライセンスバージョン1.2のコピーは、「GNUフリー文書ライセンス」セクションに含まれています。

SUSEの商標については、https://www.suse.com/company/legal/を参照してください。その他の第三者のすべての商標は、各社の所有に帰属します。商標記号(®、 ™など)は、SUSEおよび関連会社の商標を示します。アスタリスク(*)は、第三者の商標を示します。

本書のすべての情報は、細心の注意を払って編集されています。しかし、このことは絶対に正確であることを保証するものではありません。SUSE LLC、その関係者、著者、翻訳者のいずれも誤りまたはその結果に対して一切責任を負いかねます。

序文 #

1 利用可能なマニュアル #

- オンラインマニュアル

本製品のオンラインマニュアルは、https://documentation.suse.com/#slesで入手できます。様々な形式のマニュアルをブラウズまたはダウンロードできます。

他の製品のオンラインマニュアルは、https://documentation.suse.com/で検索してください。

注記: 最新のアップデート最新のマニュアルアップデートは、通常、英語版マニュアルで入手できます。

- リリースノート

リリースノートはhttps://www.suse.com/releasenotes/を参照してください。

- ご使用のシステムで

オフラインで利用するには、システムの

/usr/share/docにインストールされたマニュアルを確認してください。「マニュアルページ」には、多くのコマンドについても詳しく説明されています。説明を表示するには、manコマンドに確認したいコマンドの名前を付加して実行してください。システムにmanコマンドがインストールされていない場合は、sudo zypper install manコマンドでインストールします。

2 ドキュメントの改善 #

このドキュメントに対するフィードバックや貢献を歓迎します。フィードバックを提供するための次のチャネルが利用可能です。

- サービス要求およびサポート

ご使用の製品に利用できるサービスとサポートのオプションについては、https://www.suse.com/support/を参照してください。

サービス要求を提出するには、SUSE Customer Centerに登録済みのSUSEサブスクリプションが必要です。https://scc.suse.com/support/requestsからログインしてをクリックしてください。

- バグレポート

https://bugzilla.suse.com/から入手できるドキュメントを使用して、問題を報告してください。このプロセスを簡素化するために、このドキュメントのHTMLバージョンでリンクを使用できます。該当する文にカーソルを合わせ、右側ナビゲーションパネルのセクションでをクリックします。リンクを使用すると、Bugzillaで適切な製品とカテゴリが事前に選択され、現在のセクションへのリンクが追加されます。バグレポートの入力をただちに開始できます。Bugzillaアカウントが必要です。

- ドキュメントの編集に貢献

このドキュメントに貢献するには、このドキュメントのHTMLバージョンで(ソースドキュメントの編集)リンクを使用してください。該当する文にカーソルを合わせ、右側ナビゲーションパネルのセクションで(ソースドキュメントの編集)をクリックします。GitHubのソースコードに移動し、そこからプル要求を提出できます。GitHubアカウントが必要です。

注記: (ソースドキュメントの編集)は英語でのみ利用可能(ソースドキュメントの編集)リンクは、各ドキュメントの英語版でのみ使用できます。その他の言語では、上記のリンクを使用してください。

このドキュメントに使用されるドキュメント環境に関する詳細については、https://github.com/SUSE/doc-sle/blob/main/README.adocにあるリポジトリのREADMEを参照してください。

- メール

ドキュメントに関するエラーの報告やフィードバックは<doc-team@suse.com>宛に送信してもかまいません。ドキュメントのタイトル、製品のバージョン、およびドキュメントの発行日を記載してください。また、関連するセクション番号とタイトル(またはURL)、問題の簡潔な説明も記載してください。

3 マニュアルの表記規則 #

このマニュアルでは、次の通知と表記規則が使用されています。

/etc/passwd: ディレクトリ名とファイル名PLACEHOLDER: PLACEHOLDERは、実際の値で置き換えられます

PATH: 環境変数PATHls、--help: コマンド、オプション、およびパラメータuser: ユーザまたはグループpackage name: パッケージの名前

Alt、Alt–F1 :使用するキーまたはキーの組み合わせ、キーはキーボード上と同様、大文字で表示されます

、 › : メニュー項目、ボタン

AMD/Intel この説明は、AMD64/Intel 64アーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。

IBM Z, POWER この説明は、

IBM ZおよびPOWERの各アーキテクチャにのみ当てはまります。矢印は、テキストブロックの先頭と終わりを示します。Dancing Penguins (「Penguins」の章、↑他のマニュアル):他のマニュアルの章への参照です。

root特権で実行する必要のあるコマンド。多くの場合、これらのコマンドの先頭にsudoコマンドを置いて、特権のないユーザとしてコマンドを実行することもできます。#command>sudocommand特権のないユーザでも実行できるコマンド。

>command通知

警告: 警告の通知続行する前に知っておくべき、無視できない情報。セキュリティ上の問題、データ損失の可能性、ハードウェアの損傷、または物理的な危険について警告します。

重要: 重要な通知続行する前に知っておくべき重要な情報です。

注記: メモの通知追加情報。たとえば、ソフトウェアバージョンの違いに関する情報です。

ヒント: ヒントの通知ガイドラインや実際的なアドバイスなどの役に立つ情報です。

4 サポート #

SUSE Linux Enterprise Serverのサポートステートメントと、技術プレビューに関する概要を以下に示します。製品ライフサイクルの詳細については、Book “アップグレードガイド”, Chapter 2 “ライフサイクルとサポート”を参照してください。

サポート資格をお持ちの場合、Book “管理ガイド”, Chapter 47 “サポート用システム情報の収集”を参照して、サポートチケットの情報を収集する方法の詳細を確認してください。

4.1 SUSE Linux Enterprise Serverのサポートステートメント #

サポートを受けるには、SUSEの適切な購読が必要です。利用可能なサポートサービスを具体的に確認するには、https://www.suse.com/support/にアクセスして製品を選択してください。

サポートレベルは次のように定義されます。

- L1

問題の判別。互換性情報、使用サポート、継続的な保守、情報収集、および利用可能なドキュメントを使用した基本的なトラブルシューティングを提供するように設計されたテクニカルサポートを意味します。

- L2

問題の切り分け。データの分析、お客様の問題の再現、問題領域の特定、レベル1で解決できない問題の解決、またはレベル3の準備を行うように設計されたテクニカルサポートを意味します。

- L3

問題解決。レベル2サポートで特定された製品の欠陥を解決するようにエンジニアリングに依頼して問題を解決するように設計されたテクニカルサポートを意味します。

契約されているお客様およびパートナーの場合、SUSE Linux Enterprise Serverでは、次のものを除くすべてのパッケージに対してL3サポートを提供します。

技術プレビュー。

サウンド、グラフィック、フォント、およびアートワーク。

追加の顧客契約が必要なパッケージ。

モジュール「Workstation Extension」の一部として出荷される一部のパッケージは、L2サポートのみです。

メインのパッケージと共にのみサポートが提供される、名前が-develで終わるパッケージ (ヘッダファイルや同様の開発者用のリソースを含む)。

SUSEは、元のパッケージの使用のみをサポートします。つまり、変更も、再コンパイルもされないパッケージをサポートします。

4.2 技術プレビュー #

技術プレビューとは、今後のイノベーションを垣間見ていただくための、SUSEによって提供されるパッケージ、スタック、または機能を意味します。プレビューは、使用中の環境内で新しいテクノロジーをテストする際の利便性のために用意されています。私たちはフィードバックを歓迎しています。技術プレビューをテストする場合は、SUSEの担当者に連絡して、経験や使用例をお知らせください。お客様からの情報を、今後の開発に役立てさせていただきます。

ただし、技術プレビューには、次の制限事項があります。

技術プレビューはまだ開発中です。したがって、機能が不完全であったり、不安定であったり、何らかの理由で運用環境での使用には適していなかったりする場合があります。

技術プレビューにはサポートが提供されません。

技術プレビューは、特定のハードウェアアーキテクチャでしか利用できないことがあります。

技術プレビューの詳細および機能は、変更される場合があります。そのため、今後リリースされる技術プレビューへのアップグレードができない場合や、再インストールが必要となる場合があります。

技術プレビューは、任意の時点で終了する可能性があります。たとえば、SUSEでプレビューがお客様または市場のニーズを満たしていない、またはエンタープライズ基準に準拠していないことが判明した場合などです。SUSEでは、このようなテクノロジーのサポートされるバージョンを将来的に提供できない場合があります。

ご使用の製品に付属している技術プレビューの概要については、https://www.suse.com/releasenotes/にあるリリースノートを参照してください。

パート I ファイルシステムとマウント #

- 1 Linuxファイルシステムの概要

SUSE Linux Enterprise Serverにはいくつかの異なるファイルシステム(Btrfs、Ext4、Ext3、Ext2、XFSなど)が付属しており、そのいずれかを選択することができます。各ファイルシステムには、それぞれ独自の利点と欠点があります。SUSE Linux Enterprise Serverにおける主要ファイルシステムの機能の対照比較については、https://www.suse.com/releasenotes/x86_64/SUSE-SLES/15-SP3/#file-system-comparison(「Comparison of supported file systems (サポートされるファイルシステムの比較)」)を参照してください。この章では、それらのファイルシステムの機能および利点の概要を説明します。

- 2 ファイルシステムのサイズ変更

ファイルシステムのサイズ変更(パーティションまたはボリュームのサイズ変更と混同しないでください)を使用して、物理ボリュームの使用可能な容量を増やしたり、物理ボリュームで増やした使用可能な容量を使用したりできます。

- 3 ストレージデバイスのマウント

このセクションでは、デバイスのマウント中に使用されるデバイス識別子の概要および、ネットワークストレージのマウントに関する詳細について説明します。

- 4 ブロックデバイス操作の多層キャッシング

多層キャッシュは、2つ以上の層で構成される複製/分散キャッシュです。1つは低速であるものの安価な回転方式のブロックデバイス(ハードディスク)に代表され、もう1つは高価であるもののデータ操作を高速に実行します(SSDフラッシュディスクなど)。

1 Linuxファイルシステムの概要 #

SUSE Linux Enterprise Serverにはいくつかの異なるファイルシステム(Btrfs、Ext4、Ext3、Ext2、XFSなど)が付属しており、そのいずれかを選択することができます。各ファイルシステムには、それぞれ独自の利点と欠点があります。SUSE Linux Enterprise Serverにおける主要ファイルシステムの機能の対照比較については、https://www.suse.com/releasenotes/x86_64/SUSE-SLES/15-SP3/#file-system-comparison(「Comparison of supported file systems (サポートされるファイルシステムの比較)」)を参照してください。この章では、それらのファイルシステムの機能および利点の概要を説明します。

SUSE Linux Enterprise 12では、オペレーティングシステム用のデフォルトファイルシステムはBtrfsであり、他はすべてXFSがデフォルトです。また、Extファイルシステムファミリ、およびOCFS2も引き続きサポートします。デフォルトでは、Btrfsファイルシステムは複数のサブボリュームと共に設定されます。ルートファイルシステムでは、Snapperインフラストラクチャを使用して、スナップショットが自動的に有効になります。Snapperの詳細については、Book “管理ガイド”, Chapter 10 “Snapperを使用したシステムの回復とスナップショット管理”を参照してください。

プロ級のハイパフォーマンスのセットアップには、可用性の高いストレージシステムが必要なことがあります。ハイパフォーマンスのクラスタリングシナリオの要件を満たすため、SUSE Linux Enterprise Serverでは、High Availability ExtensionアドオンにOCFS2 (Oracle Cluster File System 2)とDRBD (Distributed Replicated Block Device)を組み込んでいます。これらの高度なストレージシステムは、本書では扱いません。詳細については、SUSE Linux Enterprise High Availability Extensionの『 管理ガイド』を参照してください。

ただし、すべてのアプリケーションに最適なファイルシステムは存在しません。各ファイルシステムには特定の利点と欠点があり、それらを考慮する必要があります。最も高度なファイルシステムを選択する場合でも、適切なバックアップ戦略が必要です。

本項で使用されるデータの完全性およびデータの一貫性という用語は、ユーザスペースデータ(ユーザが使用するアプリケーションによりファイルに書き込まれるデータ)の一貫性を指す言葉ではありません。ユーザスペースのデータが一貫しているかどうかは、アプリケーション自体が管理する必要があります。

本項で特に指定のない限り、パーティションおよびファイルシステムの設定または変更に必要なすべての手順は、YaSTパーティショナを使用して実行できます(そうすることをお勧めします)。詳細については、「Book “導入ガイド”, Chapter 10 “”」を参照してください。

1.1 用語集 #

- metadata

ファイルシステムが内包するデータ構造です。これにより、すべてのオンディスクデータが正しく構成され、アクセス可能になります。です。ほとんどすべてのファイルシステムに独自のメタデータ構造があり、それが各ファイルシステムに異なるパフォーマンス特性が存在する理由の1つになっています。メタデータが破損しないよう維持するのは、非常に重要なことです。もし破損した場合、ファイルシステム内にあるすべてのデータがアクセス不\'94\'5cになる可\'94\'5c性があるからです。

- inode

サイズ、リンク数、ファイルの内容を実際に格納しているディスクブロックへのポインタ、作成日時、変更日時、アクセス日時など、ファイルに関する各種の情報を含むファイルシステムのデータ構造。

- ジャーナル(journal)

ファイルシステムのジャーナルは、ファイルシステムがそのメタデータ内で行う変更を特定のログに記録するオンディスク構造です。ジャーナル機能は、システム起動時にファイルシステム全体をチェックする長時間の検索プロセスが不要なため、ファイルシステムの回復時間を大幅に短縮します。ただし、それはジャーナルが再現できる場合に限定されます。

1.2 Btrfs #

Btrfsは、Chris Masonが開発したCOW(コピーオンライト)ファイルシステムです。このシステムは、Ohad Rodehが開発したCOWフレンドリなBツリーに基づいています。Btrfsは、ロギングスタイルのファイルシステムです。このシステムでは、ブロックの変更をジャーナリングする代わりに、それらの変更を新しい場所に書き込んで、リンクインします。新しい変更は、最後の書き込みまで確定されません。

1.2.1 主な特長 #

Btrfsは、次のような耐障害性、修復、容易な管理機能を提供します。

書き込み可能なスナップショット。更新適用後に必要に応じてシステムを容易にロールバックしたり、ファイルをバックアップできます。

サブボリュームのサポート: BtrFSでは、割り当てられたスペースのプールにデフォルトのサブボリュームが作成されます。BtrFSでは、同じスペースプール内で個々のファイルシステムとして機能する追加サブボリュームを作成できます。サブボリュームの数は、プールに割り当てられたスペースによってのみ制限されます。

scrubを使用したオンラインでのチェックと修復の機能が、Btrfsのコマンドラインツールの一部として利用できます。ツリー構造が正しいことを前提として、データとメタデータの完全性を検証します。マウントしたファイルシステム上で、scrubを定期的に実行することができます。これは、通常の操作中にバックグラウンドプロセスとして実行されます。メタデータとユーザデータ用のさまざまなRAIDレベル。

メタデータとユーザデータ用のさまざまなチェックサム。エラー検出が向上します。

Linux LVM (Logical Volume Manager)ストレージオブジェクトとの統合。

SUSE Linux Enterprise Server上でのYaSTパーティショナおよびAutoYaSTとの統合。その際、MD (複数デバイス)およびDM (デバイスマッパー)の各ストレージ設定ではBtrfsファイルシステムの作成も行われます。

既存のExt2、Ext3、およびExt4ファイルシステムからの、オフラインのマイグレーション。

/bootのブートローダサポート。Btrfsパーティションからの起動を可能にします。マルチボリュームBtrfsは、SUSE Linux Enterprise Server 15 SP4では、RAID0、RAID1、およびRAID10プロファイルでサポートされます。それより高いレベルのRAIDは現時点サポートされませんが、将来のサービスパックでサポートされる可能性があります。

Btrfsのコマンドを使用して、透過圧縮を設定します。

1.2.2 SUSE Linux Enterprise Server上のルートファイルシステム設定 #

SUSE Linux Enterprise Serverのルートパーティションは、デフォルトでBtrfsとスナップショットを使用して設定されます。スナップショットを使用すると、更新適用後に必要に応じてシステムを容易にロールバックしたり、ファイルをバックアップしたりできます。スナップショットは、Book “管理ガイド”, Chapter 10 “Snapperを使用したシステムの回復とスナップショット管理”で説明するSUSE Snapperインフラストラクチャを使用して簡単に管理できます。SUSEのSnapperプロジェクトの一般情報については、OpenSUSE.orgにあるSnapper Portal wiki (http://snapper.io)を参照してください。

スナップショットを使用してシステムをロールバックする場合、ユーザのホームディレクトリ、WebサーバとFTPサーバのコンテンツ、ログファイルなどのデータがロールバック中に失われたり、上書きされたりしないようにする必要があります。それには、ルートファイルシステムでBtrfsサブボリュームを使用します。サブボリュームは、スナップショットから除外できます。インストール時にYaSTによって提示されるSUSE Linux Enterprise Serverのルートファイルシステムのデフォルト設定には、次のサブボリュームが含まれます。これらがスナップショットから除外される理由を次に示します。

/boot/grub2/i386-pc、/boot/grub2/x86_64-efi、/boot/grub2/powerpc-ieee1275、/boot/grub2/s390x-emuブートローダ設定のロールバックはサポートされていません。これらのディレクトリは、アーキテクチャ固有です。最初の2つのディレクトリはAMD64/Intel 64マシン上に存在し、その後の2つのディレクトリはそれぞれIBM POWERとIBM Z上に存在します。

/home/homeが独立したパーティションに存在していない場合、ロールバック時にデータが失われのを避けるために除外されます。/optサードパーティ製品は通常、

/optにインストールされます。ロールバック時にこれらのアプリケーションがアンインストールされるのを避けるために除外されます。/srvWebおよびFTPサーバ用のデータが含まれています。ロールバック時にデータが失われるのを避けるために除外されます。

/tmpスナップショットから除外される一時ファイルとキャッシュを含むすべてのディレクトリ。

/usr/localこのディレクトリは、ソフトウェアの手動インストール時に使用します。ロールバック時にこれらのインストール済みソフトウェアがアンインストールされるのを避けるために除外されます。

/varこのディレクトリには、ログ、一時キャッシュ、

/var/optのサードパーティ製品など、多くのバリアブルファイルが含まれており、仮想マシンのイメージとデータベースのデフォルトの場所です。したがって、このサブボリュームはスナップショットからすべてのこのバリアブルデータを除外するように作成され、コピーオンライトが無効になっています。

SUSEがロールバックをサポートするのは、事前設定されているサブボリュームがまったく削除されていない場合のみです。ただし、YaSTパーティショナを使用して、サブボリュームを追加することはできます。

1.2.2.1 圧縮されたBtrfsファイルシステムのマウント #

Btrfsファイルシステムは透過的な圧縮をサポートしています。有効にすると、Btrfsは書き込み時にファイルデータを圧縮し、読み込み時にファイルデータを解凍します。

compressまたはcompress-forceマウントオプションを使用し、圧縮アルゴリズム(zstd、lzo、またはzlib)を選択します(zlibがデフォルト値です)。zlib圧縮は、より圧縮率が高く、一方lzo圧縮はより高速でCPU負荷が低くなります。zstdアルゴリズムは、lzoに近いパフォーマンスと、zlibと類似の圧縮率を備えた最新の妥協案を提供します。

例:

# mount -o compress=zstd /dev/sdx /mnt

ファイルを作成し、そのファイルに書き込む場合で、圧縮された結果のサイズが未圧縮サイズよりも大きいか等しい場合、Btrfsはこのファイルに以後も書き込みができるように圧縮をスキップします。この動作が必要ない場合、compress-forceオプションを使用します。最初の圧縮できないデータを含むファイルには有効です。

圧縮は、新規ファイルのみに効果があることに注意してください。圧縮なしで書き込まれたファイルは、ファイルシステムがcompressオプションまたはcompress-forceオプションを使用してマウントされたときに圧縮されません。また、nodatacow属性を持つファイルのエクステントは圧縮されません。

#chattr+C FILE#mount-o nodatacow /dev/sdx /mnt

暗号化は、圧縮処理とは関係のない独立した処理です。このパーティションにデータを書き込んだら、詳細を印刷してください。

# btrfs filesystem show /mnt

btrfs filesystem show /mnt

Label: 'Test-Btrfs' uuid: 62f0c378-e93e-4aa1-9532-93c6b780749d

Total devices 1 FS bytes used 3.22MiB

devid 1 size 2.00GiB used 240.62MiB path /dev/sdb1

永続的に設定したい場合、compressオプションまたはcompress-forceオプションを/etc/fstab設定ファイルに追加します。例:

UUID=1a2b3c4d /home btrfs subvol=@/home,compress 0 01.2.2.2 サブボリュームのマウント #

SUSE Linux Enterprise Server上のスナップショットからシステムをロールバックするには、まずスナップショットからブートします。これにより、ロールバックを実行する前に、スナップショットを実行しながらチェックできます。スナップショットからブートできるようにするには、サブボリュームをマウントします(通常は不要な操作です)。

1.2.2項 「SUSE Linux Enterprise Server上のルートファイルシステム設定」の一覧に示されているサブボリューム以外に、@という名前のボリュームが存在します。これは、ルートパーティション(/)としてマウントされるデフォルトサブボリュームです。それ以外のサブボリュームは、このボリュームにマウントされます。

スナップショットからブートすると、@サブボリュームではなく、スナップショットが使用されます。スナップショットに含まれるファイルシステムの部分は、/として読み込み専用でマウントされます。それ以外のサブボリュームは、スナップショットに書き込み可能でマウントされます。この状態は、デフォルトでは一時的なものです。次回の再起動により、前の設定が復元されます。これを永久的なものにするには、snapper rollbackコマンドを実行します。これにより、今回のブートに使用したスナップショットが新しいデフォルトのサブボリュームになり、再起動後はこのサブボリュームが使用されます。

1.2.2.3 空き領域の確認 #

通常、ファイルシステムの使用量はdfコマンドで確認します。Btrfsファイルシステムでは、dfの出力は誤解を招く可能性があります。生データが割り当てる領域とは別に、Btrfsファイルシステムもメタデータ用の領域を割り当てて使用するからです。

その結果、まだ大量の領域を使用できるように見えても、Btrfsファイルシステムによって領域不足がレポートされることがあります。その場合、メタデータ用に割り当てられた領域はすべて使用されています。Btrfsファイルシステム上の使用済みの領域と使用可能な領域を確認するには、次のコマンドを使用します。

btrfs filesystem show>sudobtrfs filesystem show / Label: 'ROOT' uuid: 52011c5e-5711-42d8-8c50-718a005ec4b3 Total devices 1 FS bytes used 10.02GiB devid 1 size 20.02GiB used 13.78GiB path /dev/sda3ファイルシステムの合計サイズとその使用量を表示します。最後の行のこれら2つの値が一致する場合、ファイルシステム上の領域はすべて割り当て済みです。

btrfs filesystem df>sudobtrfs filesystem df / Data, single: total=13.00GiB, used=9.61GiB System, single: total=32.00MiB, used=16.00KiB Metadata, single: total=768.00MiB, used=421.36MiB GlobalReserve, single: total=144.00MiB, used=0.00Bファイルシステムの割り当て済みの領域(

total)および使用済みの領域の値を表示します。メタデータのtotalおよびusedの値がほぼ等しい場合、メタデータ用の領域はすべて割り当て済みです。btrfs filesystem usage>sudobtrfs filesystem usage / Overall: Device size: 20.02GiB Device allocated: 13.78GiB Device unallocated: 6.24GiB Device missing: 0.00B Used: 10.02GiB Free (estimated): 9.63GiB (min: 9.63GiB) Data ratio: 1.00 Metadata ratio: 1.00 Global reserve: 144.00MiB (used: 0.00B) Data Metadata System Id Path single single single Unallocated -- --------- -------- --------- -------- ----------- 1 /dev/sda3 13.00GiB 768.00MiB 32.00MiB 6.24GiB -- --------- -------- --------- -------- ----------- Total 13.00GiB 768.00MiB 32.00MiB 6.24GiB Used 9.61GiB 421.36MiB 16.00KiB前の2つのコマンドを組み合わせたのと同様のデータを表示します。

詳細については、man 8 btrfs-filesystemおよびhttps://btrfs.wiki.kernel.org/index.php/FAQを参照してください。

1.2.3 ReiserFSおよびExtの各ファイルシステムからBtrfsへのマイグレーション #

btrfs-convertツールを使用して、既存のReiserFSまたはExt (Ext2、Ext3、またはExt4)からBtrfsファイルシステムにデータボリュームをマイグレートすることができます。これにより、アンマウントされた(オフライン)ファイルシステムのインプレース変換を実行できます。これにはbtrfs-convertツールとともにブート可能なインストールメディアが必要な場合があります。このツールは元のファイルシステムの空き領域内にBtrfsファイルシステムを構築し、それに含まれているデータに直接リンクします。メタデータを作成するにはデバイスに十分な空き領域が必要です。さもないと変換に失敗します。元のファイルシステムはそのままとなり、Btrfsファイルシステムによって空き領域が占有されることはありません。必要なスペースの量はファイルシステムのコンテンツによって決まりますが、そこに含まれるファイルシステムオブジェクト(ファイル、ディレクトリ、拡張属性)の数によって左右される場合があります。データは直接参照されるため、ファイルシステム上のデータ量は変換に必要なスペースに影響を与えません。ただし、テールパッキングを使用するファイルや2KiBを超えるサイズのファイルは除きます。

ルートファイルシステムをBtrfsに変換する操作はサポートも推奨もされません。さまざまなステップをそれぞれのセットアップに合わせる必要があるため、このような変換の自動化は不可能です。このプロセスには、適切なロールバックを実行するために複雑な設定を行う必要があり、/bootがルートファイルシステム上にある必要があり、システムに専用のサブボリュームが存在する必要があるなどの要件があります。そのため、既存のファイルシステムを保持するか、新たにシステム全体を再インストールしてください。

元のファイルシステムをBtrfsファイルシステムに変換するには、次のコマンドを実行します。

# btrfs-convert /path/to/device/etc/fstabの確認

変換後は、/etc/fstabに記載されている元のファイルシステムへのすべての参照で、デバイスにBtrfsファイルシステムがあることが示されるように調整されていることを確認する必要があります。

変換時には、Btrfsファイルシステムのコンテンツにソースファイルシステムのコンテンツが反映されます。ソースファイルシステムは、fs_root/reiserfs_saved/imageで作成された関連する読み込み専用イメージを削除するまで保持されます。イメージファイルの実態は、変換前におけるReiserFSファイルシステムの「スナップショット」であり、Btrfsファイルシステムが変更されても変わりません。イメージファイルを削除するには、reiserfs_savedサブボリュームを削除します。

# btrfs subvolume delete fs_root/reiserfs_savedファイルシステムを元に戻すには、次のコマンドを使用します。

# btrfs-convert -r /path/to/deviceBtrfsファイルシステムとしてマウントされているファイルシステムへの変更はすべて失われます。マウント中には負荷分散操作を実行しないでください。さもないと、ファイルシステムが正しく復元されなくなります。

1.2.4 Btrfsの管理 #

Btrfsは、YaSTパーティショナおよびAutoYaST内に統合されています。これはインストール時に利用可能で、ルートファイルシステム用のソリューションを設定することができます。インストール後に、YaSTパーティショナを使用して、Btrfsのボリュームの参照と管理を行うことができます。

Btrfsの管理ツールは、btrfsprogsパッケージ内に用意されています。Btrfsコマンドの使用については、man 8 btrfs、man 8 btrfsck、およびman 8 mkfs.btrfsの各コマンドを参照してください。Btrfsの機能については、Btrfs wiki (http://btrfs.wiki.kernel.org)を参照してください。

1.2.5 サブボリュームに対するBtrfsクォータのサポート #

Btrfsルートファイルシステムのサブボリューム(/var/log、/var/crashまたは/var/cacheなど)が、通常の操作時に利用可能なディスクスペースのすべてを使用でき、システムに不具合が発生します。この状況を回避するため、SUSE Linux Enterprise ServerではBtrfsサブボリュームに対するクォータのサポートを提供するようになりました。YaSTの提案からルートファイルシステムを設定すると、サブボリュームのクォータを有効にして設定する準備が整います。

1.2.5.1 YaSTを使用したBtrfsクォータの設定 #

YaSTを使用してルートファイルシステムのサブボリュームにクォータを設定するには、次の手順に従います。

YaSTを起動し、 › を選択して、で警告を確認します。

左側のペインで、をクリックします。

メインウィンドウで、サブボリュームクォータを有効にするデバイスを選択して、下部にあるをクリックします。

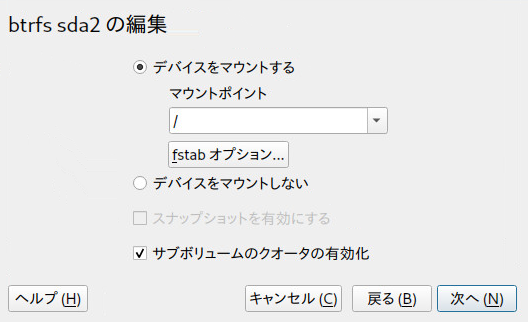

ウィンドウで、チェックボックスを有効にし、で確定します。

図 1.1: Btrfsクオータの有効化 #既存のサブボリュームのリストから、クォータでサイズを制限するサブボリュームをクリックし、下部にあるをクリックします。

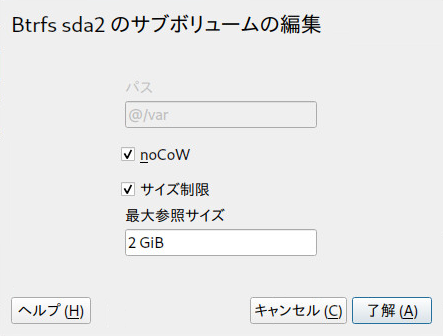

ウィンドウで、を有効にし、参照される最大サイズを指定します。をクリックして確認します。

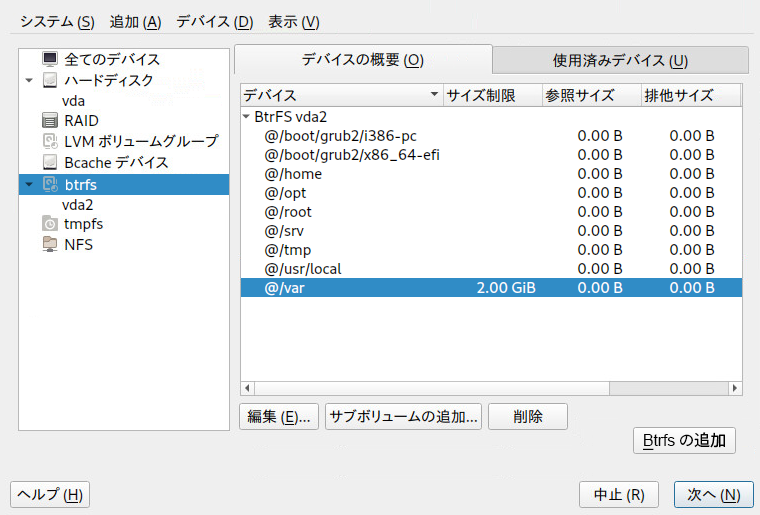

図 1.2: サブボリュームのクォータの設定 #サブボリューム名の横に新しいサイズ制限が表示されます。

図 1.3: デバイスのサブボリュームのリスト #で変更を適用します。

1.2.5.2 コマンドラインでのBtrfsクォータの設定 #

コマンドラインでルートファイルシステムのサブボリュームにクォータを設定するには、次の手順に従います。

クォータサポートを有効にします。

>sudobtrfs quota enable /サブボリュームのリストを取得します。

>sudobtrfs subvolume list /クォータは既存のサブボリュームにのみ設定できます。

前の手順で表示されたサブボリュームの1つにクォータを設定します。サブボリュームは、パス(

/var/tmpなど)または0/SUBVOLUME ID(0/272など)のどちらかによって識別できます。次に、/var/tmpに5GBのクォータを設定する例を示します。>sudobtrfs qgroup limit 5G /var/tmpサイズは、バイト(5000000000)、キロバイト(5000000K)、メガバイト(5000M)、またはギガバイト(5G)のいずれかの単位で指定できます。結果として得られるサイズは多少異なります。これは、1024バイト=1KiB、1024KiB=1MiBなどだからです。

既存のクォータを一覧にするには、次のコマンドを使用します。

max_rfer列に、クォータがバイト単位で表示されます。>sudobtrfs qgroup show -r /

既存のクォータを無効にする場合、クォータサイズをnoneに設定します。

>sudobtrfs qgroup limit none /var/tmp

特定のパーティションとそのすべてのサブボリュームのクォータサポートを無効にするには、btrfs quota disableを使用します。

>sudobtrfs quota disable /

1.2.5.3 詳細情報 #

詳細については、man 8 btrfs-qgroupおよびman 8 btrfs-quotaを参照してください。Btrfs wiki (https://btrfs.wiki.kernel.org/index.php/UseCases)のUseCasesページにも詳細情報が記載されています。

1.2.6 Btrfsでのスワッピング #

有効なスワップファイルがソースサブボリュームに含まれている場合、スナップショットを作成できません。

SLESでは、結果のスワップファイルに関連する次の条件が満たされている場合、Btrfsファイルシステム上のファイルへのスワッピングをサポートしています。

スワップファイルには

NODATACOWおよびNODATASUMマウントオプションが必要です。スワップファイルは圧縮できません -

NODATACOWおよびNODATASUMマウントオプションを設定することで、これを確認できます。両方のオプションにより、スワップファイルの圧縮が無効になります。スワップファイルは、デバイスのサイズ変更、追加、削除、置換などの排他的な操作の実行中、またはバランシング操作の実行中は有効にできません。

スワップファイルはスパースにすることはできません。

スワップファイルはインラインファイルにすることはできません。

スワップファイルは

単一の割り当てプロファイルファイルシステム上にある必要があります。

1.2.7 Btrfs send/receive #

Btrfsでは、ファイルシステムの状態をキャプチャするためのスナップショットを作成できます。Snapperでは、たとえばこの機能を使用してシステムの変更前後のスナップショットを作成することで、ロールバックを可能にしています。ただし、send/receive機能とスナップショットを併用すると、リモートの場所にファイルシステムのコピーを作成して管理することもできます。たとえば、この機能を使用してインクリメンタルバックアップを実行できます。

btrfs send操作は、同じサブボリュームの2つの読み込み専用スナップショットの差分を計算して、それをファイルまたはSTDOUTに送信します。Btrfs receive操作は、sendコマンドの結果を取得して、それをスナップショットに適用します。

1.2.7.1 前提条件 #

send/receive機能を使用するには、次の要件を満たす必要があります。

ソース側(

send)とターゲット側(receive)にBtrfsファイルシステムが必要です。Btrfs send/receiveはスナップショットを操作するため、それぞれのデータがBtrfsサブボリュームに存在する必要があります。

ソース側のスナップショットは読み込み専用である必要があります。

SUSE Linux Enterprise 12 SP2以上。それより古いバージョンのSUSE Linux Enterpriseはsend/receiveをサポートしていません。

1.2.7.2 インクリメンタルバックアップ #

次の手順では、/data(ソース側)のインクリメンタルバックアップを/backup/data(ターゲット側)に作成する場合を例にして、Btrfs send/receiveの基本的な使用方法を示します。/dataはサブボリュームである必要があります。

ソース側に初期スナップショット(この例では

snapshot_0という名前)を作成し、それがディスクに書き込まれていることを確認します。>sudobtrfs subvolume snapshot -r /data /data/bkp_data sync新しいサブボリューム

/data/bkp_dataが作成されます。これは次のインクリメンタルバックアップの基として使用されるので、参照用に保持しておく必要があります。初期スナップショットをターゲット側に送信します。これは初期のsend/receive操作であるため、完全なスナップショットを送信する必要があります。

>sudobash -c 'btrfs send /data/bkp_data | btrfs receive /backup'ターゲット側に新しいサブボリューム

/backup/bkp_dataが作成されます。

初期セットアップが完了したら、インクリメンタルバックアップを作成して、現在のスナップショットと以前のスナップショットの差分をターゲット側に送信できます。手順は常に同じです。

ソース側に新しいスナップショットを作成します。

差分をターゲット側に送信します。

オプション: 両側のスナップショットの名前変更またはクリーンアップ、あるいはその両方を行います。

ソース側に新しいスナップショットを作成し、それがディスクに書き込まれていることを確認します。次の例では、スナップショットにbkp_data_CURRENT_DATEという名前が付いています。

>sudobtrfs subvolume snapshot -r /data /data/bkp_data_$(date +%F) sync新しいサブボリューム(たとえば、

/data/bkp_data_2016-07-07)が作成されます。以前のスナップショットと新たに作成したスナップショットの差分をターゲット側に送信します。そのためには、オプション

-p SNAPSHOTを使用して、以前のスナップショットを指定します。>sudobash -c 'btrfs send -p /data/bkp_data /data/bkp_data_2016-07-07 \ | btrfs receive /backup'新しいサブボリューム

/backup/bkp_data_2016-07-07が作成されます。その結果、それぞれの側に2つずつ、合計4つのスナップショットが存在することになります。

/data/bkp_data/data/bkp_data_2016-07-07/backup/bkp_data/backup/bkp_data_2016-07-07続行するには、次の3つのオプションがあります。

両方の側のすべてのスナップショットを保持する。このオプションの場合、両方の側のどのスナップショットにもロールバックすることが可能であると同時に、すべてのデータの複製を保持していることになります。これ以上のアクションは必要ありません。次回のインクリメンタルバックアップを実行するときには、最後から2番目のスナップショットをsend操作の親として使用することに注意してください。

ソース側には最新のスナップショットのみを保持し、ターゲット側にはすべてのスナップショットを保持する。この場合も、両方の側のどのスナップショットにもロールバックできます。ソース側で特定のスナップショットへのロールバックを実行するには、ターゲット側からソース側に、完全なスナップショットのsend/receive操作を実行します。ソース側で削除/移動操作を実行します。

両方の側に最新のスナップショットのみを保持する。この方法では、ソース側で作成された最新のスナップショットと同じ状態のバックアップがターゲット側にあります。ほかのスナップショットにロールバックすることはできません。ソース側とターゲット側で削除/移動操作を実行します。

ソース側に最新のスナップショットのみを保持するには、次のコマンドを実行します。

>sudobtrfs subvolume delete /data/bkp_data>sudomv /data/bkp_data_2016-07-07 /data/bkp_data最初のコマンドで以前のスナップショットを削除し、2番目のコマンドで現在のスナップショットの名前を

/data/bkp_dataに変更します。これにより、バックアップされた最新のスナップショットは常に/data/bkp_dataという名前になります。その結果、常にこのサブボリューム名をインクリメンタルsend操作の親として使用できます。ターゲット側に最新のスナップショットのみを保持するには、次のコマンドを実行します。

>sudobtrfs subvolume delete /backup/bkp_data>sudomv /backup/bkp_data_2016-07-07 /backup/bkp_data最初のコマンドで以前のバックアップスナップショットを削除し、2番目のコマンドで現在のスナップショットの名前を

/backup/bkp_dataに変更します。これにより、最新のバックアップスナップショットは常に/backup/bkp_dataという名前になります。

スナップショットをリモートマシンに送信するには、SSHを使用します。

> btrfs send /data/bkp_data | ssh root@jupiter.example.com 'btrfs receive /backup'1.2.8 データ重複排除のサポート #

Btrfsはデータ重複排除をサポートします。そのための方法として、ファイルシステム内の複数の同一ブロックを、共通ストレージロケーションにある、そのブロックの1つのコピーを指す論理リンクで置き換えます。SUSE Linux Enterprise Serverでは、ファイルシステムをスキャンして同一ブロックをチェックするduperemoveツールを提供しています。Btrfsファイルシステムで使用される場合、これらのブロックを重複排除して、ファイルシステムのスペースを節約することもできます。duperemoveはデフォルトではインストールされません。使用できるようにするには、パッケージduperemoveをインストールします。

大量のファイルを重複排除する場合は、--hashfileオプションを使用します。

>sudoduperemove--hashfile HASH_FILEfile1 file2 file3

--hashfileオプションは、すべての指定されたファイルのハッシュをRAMではなくHASH_FILEに保存して、使い果たされるのを防ぎます。HASH_FILEは再利用可能です。ベースラインハッシュファイルを生成した最初の実行後、大量のデータセットへの変更を非常に迅速に重複排除できます。

duperemoveは、ファイルのリストを処理することも、ディレクトリを再帰的にスキャンすることもできます。

>sudoduperemove OPTIONS file1 file2 file3>sudoduperemove -r OPTIONS directory

動作モードには、読み込み専用と重複排除の2つがあります。読み込み専用モードで実行した場合(-dスイッチを指定しない)、指定されたファイルまたはディレクトリをスキャンして重複ブロックをチェックし、出力します。これは、どのファイルシステムでも機能します。

重複排除モードでのduperemoveの実行は、Btrfsファイルシステムでのみサポートされています。指定されたファイルまたはディレクトリをスキャンした後、重複しているブロックは重複排除用に送信されます。

詳細については、man 8 duperemoveを参照してください。

1.2.9 ルートファイルシステムからのサブボリュームの削除 #

特定の目的のためにルートファイルシステムからデフォルトのBtrfsサブボリュームの1つを削除する必要がある場合があります。それらの1つはサブボリューム、たとえば@/homeまたは@/srvを別のデバイスのファイルシステムに変換します。次の手順は、Btrfsサブボリュームを削除する方法を示しています。

削除する必要のあるサブボリュームを特定します(たとえば、

@/opt)。ルートパスのサブボリュームIDが常に「5」であることに注意してください。>sudobtrfs subvolume list / ID 256 gen 30 top level 5 path @ ID 258 gen 887 top level 256 path @/var ID 259 gen 872 top level 256 path @/usr/local ID 260 gen 886 top level 256 path @/tmp ID 261 gen 60 top level 256 path @/srv ID 262 gen 886 top level 256 path @/root ID 263 gen 39 top level 256 path @/opt [...]ルートパーティションをホストするデバイス名を見つけます:。

>sudobtrfs device usage / /dev/sda1, ID: 1 Device size: 23.00GiB Device slack: 0.00B Data,single: 7.01GiB Metadata,DUP: 1.00GiB System,DUP: 16.00MiB Unallocated: 14.98GiBルートファイルシステム(ID 5のサブボリューム)を別のマウントポイント(たとえば

/mnt)上にマウントします:。>sudomount -o subvolid=5 /dev/sda1 /mntマウントされたルートファイルシステムから

@/optパーティションを削除します:。>sudobtrfs subvolume delete /mnt/@/opt以前にマウントされたルートファイルシステムをアンマウントします:。

>sudoumount /mnt

1.3 XFS #

本来は、IRIX OS用のファイルシステムを意図してSGIがXFSの開発を開始したのは、1990年代初期です。XFSの開発動機は、ハイパフォーマンスの64ビットジャーナルファイルシステムの作成により、非常に厳しいコンピューティングの課題に対応することでした。XFSは大規模なファイルを操作する点で非常に優れていて、ハイエンドのハードウェアを適切に活用します。XFSは、SUSE Linux Enterprise Serverのデータパーティション用のデフォルトファイルシステムです。

ただし、XFSの主要機能を一見すれば、XFSが、ハイエンドコンピューティングの分野で、他のジャーナリングファイルシステムの強力な競合相手となっている理由がわかります。

- 高いスケーラビリティ

XFSはアロケーショングループを使用して高いスケーラビリティを実現する

XFSファイルシステムの作成時に、ファイルシステムの基にあるブロックデバイスは、等しいサイズをもつ8つ以上の線形の領域に分割されます。これらを「アロケーショングループ」と呼びます。各アロケーショングループは、独自のinodeと空きディスクスペースを管理します。実用的には、アロケーショングループを、1つのファイルシステムの中にある複数のファイルシステムと見なすこともできます。アロケーショングループは互いに独立しているものではないため、複数のアロケーショングループをカーネルから同時にアドレス指定できるという特徴があります。この機能は、XFSの高いスケーラビリティに大きく貢献しています。独立性の高いアロケーショングループは、性質上、\'83\'7dルチプロセッサシステムのニーズに適しています。

- 高いパフォーマンス

XFSはディスクスペースの効率的な管理によって高いパフォーマンスを実現する

空きスペースとinodeは、各アロケーショングループ内のB+-Treeによって処理されます。B+ツリーの採用は、XFSのパフォーマンスとスケーラビリティを大きく向上させています。XFSでは、プロセスを2分割して割り当てを処理する遅延割り当てを使用します。保留されているトランザクションはRAMの中に保存され、適切な量のスペースが確保されます。XFSは、この時点では、データを正確にはどこに(ファイルシステムのどのブロックに)格納するか決定していません。決定可能な最後の瞬間まで、この決定は遅延(先送り)されます。暫定的に使用される一時データは、ディスクに書き込まれません。XFSがデータの実際の保存場所を決定するまでに、その役割を終えているからです。このように、XFSは、書き込みのパフォーマンスを向上させ、ファイルシステムのフラグメンテーションを減少させます。遅延アロケーションは、他のファイルシステムより書き込みイベントの頻度を下げる結果をもたらすので、書き込み中にクラッシュが発生した場合、データ損失が深刻になる可\'94\'5c性が高くなります。

- 事前割り当てによるファイルシステムの断片化の回避

データをファイルシステムに書き込む前に、XFSはファイルが必要とする空きスペースを予約(プリアロケート、事前割り当て)します。したがって、ファイルシステムの断片化は大幅に減少します。ファイルの内容がファイルシステム全体に分散することがないので、パフォーマンスが向上します。

1.3.1 XFSフォーマット #

SUSE Linux Enterprise Serverは、XFSファイルシステムの「オンディスクフォーマット」(v5)をサポートしています。このフォーマットの主な利点には、全XFSメタデータの自動チェックサム、ファイルタイプのサポート、および1つのファイルに対する大量のアクセス制御リストのサポートがあります。

このフォーマットは、SUSE Linux Enterpriseカーネルの3.12より古いバージョン、xfsprogsの3.2.0より古いバージョン、およびSUSE Linux Enterprise 12より前にリリースされたバージョンのGRUB 2ではサポートされていません。

XFSではV4フォーマットのファイルシステムが非推奨になっています。このファイルシステムフォーマットは次のコマンドで作成されました。

mkfs.xfs -m crc=0 DEVICE

このフォーマットはSLE 11以前のリリースで使用されましたが、現在このフォーマットを使用するとdmesgによって次の警告メッセージが表示されます。

Deprecated V4 format (crc=0) will not be supported after September 2030

dmesgコマンドの出力に上記のメッセージが表示されたら、ファイルシステムをV5フォーマットに更新することをお勧めします。

データを別のデバイスにバックアップします。

そのデバイスにファイルシステムを作成します。

mkfs.xfs -m crc=1 DEVICE

更新したデバイスにバックアップからデータを復元します。

1.4 Ext2 #

Ext2の起源は、Linuxの歴史の初期にさかのぼります。その前身であったExtended File Systemは、1992年4月に実装され、Linux 0.96cに統合されました。Extended File Systemにはさまざまな変更が加えられてきました。そして、Ext2はLinuxファイルシステムとして数年にわたり非常に高い人気を得ています。その後、ジャーナルファイルシステムが作成され、回復時間が非常に短くなったため、Ext2の重要性は低下しました。

Ext2の利点に関する短い要約を読むと、かつて幅広く好まれ、そして今でも一部の分野で多くのLinuxユーザから好まれるLinuxファイルシステムである理由を理解するのに役立ちます。

- 堅実性と速度

「古くからある標準」であるExt2は、さまざまな改良が加えられ、入念なテストが実施されてきました。だからこそ、Ext2は非常に信頼性が高いとの評価を得ることが多いのでしょう。ファイルシステムが正常にアンマウントできず、システムが機能停止した場合、e2fsckはファイルシステムのデータの分析を開始します。メタデータは一貫した状態に戻り、保留されていたファイルとデータブロックは、指定のディレクトリ(

lost+found)に書き込まれます。ジャーナルファイルシステムとは対照的に、e2fsckは、最近変更されたわずかなメタデータだけではなく、ファイルシステム全体を分析します。この結果、ジャーナルファイルシステムがログデータだけをチェックするのに比べて、かなり長い時間を要します。ファイルシステムのサイズにもよりますが、この手順は30分またはそれ以上を要することがあります。したがって、高可用性を必要とするどのようなサーバでも、Ext2を選択することは望ましくありません。ただし、Ext2はジャーナルを維持せず、わずかなメモリを使用するだけなので、他のファイルシステムより高速なことがあります。- 容易なアップグレード性

Ext3は、Ext2のコードをベースとし、Ext2のオンディスクフォーマットとメタデータフォーマットも共用するので、Ext2からExt3へのアップグレードは非常に容易です。

1.5 Ext3 #

Ext3は、Stephen Tweedieによって設計されました。他のすべての次世代ファイルシステムとは異なり、Ext3は完全に新しい設計理念に基づいているわけではありません。Ext3は、Ext2をベースとしています。これら2つのファイルシステムは、非常に似ています。Ext3ファイルシステムを、Ext2ファイルシステムの上に構築することも容易です。Ext2とExt3の最も重要な違いは、Ext3がジャーナルをサポートしていることです。要約すると、Ext3には、次の3つの主要な利点があります。

1.5.1 Ext2からの容易で信頼性の高いアップグレード #

Ext2のコードは、Ext3が次世代ファイルシステムであることを明確に主張するための強力な土台になりました。Ext3では、Ext2の信頼性および堅実性がExt3で採用されたジャーナルファイルシステムの利点とうまく統合されています。XFSのような他のジャーナリングファイルシステムへの移行はかなり手間がかかります(ファイルシステム全体のバックアップを作成し、移行先ファイルシステムを新規に作成する必要があります)が、それとは異なり、Ext3への移行は数分で完了します。ファイルシステム全体を新たに作成し直しても、それが完璧に動作するとは限らないので、Ext3への移行は非常に安全でもあります。ジャーナルファイルシステムへのアップグレードを必要とする既存のExt2システムの数を考慮に入れると、多くのシステム管理者にとってExt3が重要な選択肢となり得る理由が容易にわかります。Ext3からExt2へのダウングレードも、アップグレードと同じほど容易です。Ext3ファイルシステムのアンマウントを正常に行い、Ext2ファイルシステムとして再マウントします。

1.5.2 Ext2ファイルシステムからExt3への変換 #

Ext2ファイルシステムをExt3に変換するには、次の手順に従います。

Ext3ジャーナルの作成には、

tune2fs -jをrootユーザとして実行します。この結果、デフォルトのパラメータを使用してExt3ジャーナルが作成されます。

ジャーナルのサイズおよびジャーナルを常駐させるデバイスを指定するには、

tune2fs-Jとともに適切なジャーナルオプションsize=およびdevice=を指定して、実行します。tune2fsプログラムの詳細については、tune2fsのマニュアルページを参照してください。ファイル

/etc/fstabをrootユーザとして編集して、該当するパーティションに指定されているファイルシステムタイプをext2からext3に変更し、その変更内容を保存します。これにより、Ext3ファイルシステムが認識されるようになります。この変更結果は、次回の再起動後に有効になります。

Ext3パーティションとしてセットアップされたルートファイルシステムをブートするには、

ext3とjbdの各モジュールをinitrdに追加します。それには、次を実行します。/etc/dracut.conf.d/-filesystem.confを開くか作成し、次の行を追加します(行頭空白に注意してください):force_drivers+=" ext3 jbd"

dracut-fコマンドを実行します。

システムを再起動します。

1.6 Ext4 #

2006年に、Ext4はExt3の後継として登場しました。これは、拡張ファイルシステムバージョンの最新ファイルシステムです。当初、最大1エクスビバイトのサイズのボリューム、最大16テビバイトのサイズのファイルおよび無制限の数のサブディレクトリをサポートすることによってストレージサイズを拡大するために、Ext4は設計されました。Ext4では、従来の直接ブロックポインタおよび間接ブロックポインタの代わりにエクステントを使用してファイルの内容をマップします。エクステントの使用によって、ディスクにおけるデータ格納とデータ取得の両方が改善されています。

同時に、遅延ブロック割り当て、ファイルシステムチェックルーチンの大幅な高速化など、さまざまなパフォーマンス強化も図られています。また、Ext4は、ジャーナルチェックサムのサポートおよびナノ秒単位でのタイムスタンプの提供により、信頼性を高めています。Ext4には、Ext2およびExt3との完全な後方互換性があり、どちらのファイルシステムもExt4としてマウントできます。

Ext3の機能は、Ext4カーネルモジュールのExt4ドライバによって完全にサポートされます。

1.6.1 信頼性とパフォー\'83\'7dンス #

他のジャーナルファイルシステムは、「メタデータのみ」のジャーナルアプローチに従っています。つまり、メタデータは常に一貫した状態に保持されますが、ファイルシステムのデータ自体については、一貫性が自動的に保証されるわけではありません。Ext4は、メタデータとデータの両方に注意するよう設計されています。「注意」の度合いはカスタマイズできます。data=journalモードでExt4をマウントすると、最大の保護(データの完全性)が実現されますが、メタデータとデータの両方がジャーナル化されるので、システムの動作が遅くなります。別のアプローチは、data=orderedモードを使用することです。これは、データとメタデータ両方の完全性を保証しますが、ジャーナルを適用するのはメタデータのみです。ファイルシステムドライバは、1つのメタデータの更新に対応するすべてのデータブロックを収集します。これらのブロックは、メタデータの更新前にディスクに書き込まれます。その結果、パフォーマンスを犠牲にすることなく、メタデータとデータの両方に関する一貫性を達成できます。3番目のマウントオプションは、data=writebackを使用することです。これは、対応するメタデータをジャーナルにコミットした後で、データをメインファイルシステムに書き込むことを可能にします。多くの場合、このオプションは、パフォーマンスの点で最善と考えられています。しかし、内部のファイルシステムの完全性が維持される一方で、クラッシュと回復を実施した後では、古いデータがファイル内に再登場させてしまう可能性があります。Ext4では、デフォルトとして、data=orderedオプションを使用します。

1.6.2 Ext4ファイルシステムのinodeサイズとinode数 #

inodeには、ファイルシステム内のファイルとそのブロック位置に関する情報が格納されます。拡張された属性およびACL用にinodeのスペースを確保するために、デフォルトのinodeサイズが256バイトに拡大されました。

新規のExt4ファイルシステムを作成する際、inodeテーブル内のスペースは、作成可能なinodeの総数に対して事前に割り当てられています。バイト数/inode数の比率と、ファイルシステムのサイズによって、inode数の上限が決まります。ファイルシステムが作成されると、バイト数/inode数のバイト数の各スペースに対して、1つのinodeが作成されます。

number of inodes = total size of the file system divided by the number of bytes per inode

inodeの数によって、ファイルシステム内に保有できるファイルの数が決まります。つまり、各ファイルにつき1つのinodeです。

inodeの割り当て後は、inodeサイズやバイト数/inode数の比率の設定を変えることはできません。異なる設定のファイルシステムを再度作成するか、ファイルシステムを拡張しない限り、新規のinodeは設定できません。inodeの最大数を超えると、ファイルをいくつか削除するまで、ファイルシステム上に新規のファイルを作成することはできません。

新規のExt4ファイルシステムを作成する際に、inodeのスペース使用をコントロールするためのinodeサイズとバイト数/inode数の比率、およびファイルシステム上のファイル数の上限を指定することができます。ブロックサイズ、inodeサイズ、およびバイト数/inode数の比率が指定されない場合は、/etc/mked2fs.confファイル内のデフォルト値が適用されます。詳細については、mke2fs.conf(5)マニュアルページを参照してください。

次のガイドラインを使用します。

inodeサイズ. デフォルトのinodeサイズは256バイトです。2の累乗で、ブロックサイズ以下の128以上のバイト数の値を指定します(128、256、512など)。Ext4ファイルシステムで拡張属性またはACLを使用しない場合は、128バイトのみを使用してください。

バイト数/inode数の比率: デフォルトのバイト数/inode数の比率は、16384バイトです。有効なバイト数/inode数の比率は、2の累乗で1024バイト以上(1024、2048、4096、8192、16384、32768など)です。この値は、ファイルシステムのブロックサイズより小さくはできません。なぜなら、ブロックサイズは、データを格納するために使用するスペースの最小チャンクだからです。Ext4ファイルシステムのデフォルトのブロックサイズは、4KiBです。

また、格納する必要があるファイルの数とサイズを検討してください。たとえば、ファイルシステムに多数の小さなファイルを持つことになる場合は、バイト数/inode数の比率を小さめに指定すれば、inodeの数を増やすことができます。ファイルシステムに非常に大きなファイルを入れる場合は、バイト数/inode数の比率を大きめに指定できますが、それによって許容されるinodeの数は減ります。

一般的に、inodeの数は、足りなくなるよりは多すぎる方が得策です。inodeの数が少な過ぎてファイルも非常に小さい場合、実際には空であってもディスク上のファイルの最大数に到達してしまいます。inodeの数が多すぎて、ファイルが非常に大きい場合は、空き領域があることが表示されたとしても、それを使うことができません。なぜなら、inode用に確保されたスペースに新規のファイルを作成することはできないからです。

inodeサイズとバイト数/inode数の比率を設定するには、次のいずれかの方法を使用します。

すべての新規Ext4ファイルシステムのデフォルト設定を変更する: テキストエディタで、

/etc/mke2fs.confファイルのdefaultsセクションを変更して、inode_sizeおよびinode_ratioを、希望するデフォルト値に設定します。その値が、すべての新規のExt4ファイルシステムに適用されます。例:blocksize = 4096 inode_size = 128 inode_ratio = 8192

コマンドラインで: Ext4ファイルシステムを作成する際に、inodeサイズ(

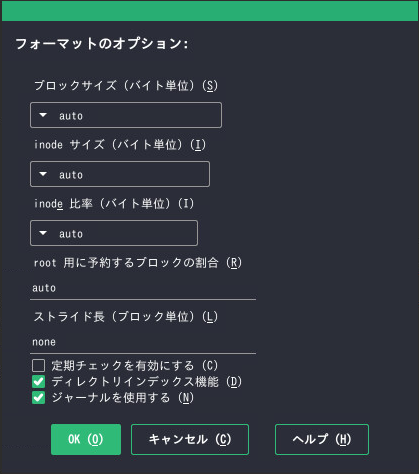

-I 128)およびバイト数/inode数の比率(-i 8192)を、mkfs.ext4(8)コマンドまたはmke2fs(8)コマンドに渡します。たとえば、次のコマンドのいずれかを使用します:。>sudomkfs.ext4 -b 4096 -i 8092 -I 128 /dev/sda2>sudomke2fs -t ext4 -b 4096 -i 8192 -I 128 /dev/sda2YaSTを使用したインストール時に: インストール時に新規のExt4ファイルシステムを作成する際に、inodeサイズとバイト数/inode数の比率を渡します。で、パーティションを選択して、をクリックします。で、を選択し、をクリックします。ダイアログで、、、およびドロップダウンボックスから、希望の値を選択します。

たとえば、ドロップダウンボックスから4096を選択しドロップダウンボックスから8192を選択し、ドロップダウンボックスから128を選択して、をクリックします。

1.6.3 Ext4へのアップグレード #

ファイルシステムの更新を実行する前に、ファイルシステムにあるすべてのデータをバックアップします。

Ext2またはExt3からアップグレードするには、以下を有効にする必要があります。

Ext4で必要な機能 #- エクステント

各ファイルを近くに保持して断片化を防ぐために使用されるハードディスク上の連続ブロック

- unint_bg

遅延inodeテーブルの初期化

- dir_index

大きいディレクトリ用のハッシュされたbツリー検索

- Ext2:

as_journal Ext2ファイルシステムでジャーナリングを有効にします。

これらの機能を有効にするには、次のコマンドを実行します。

Ext3:

#tune2fs -O extents,uninit_bg,dir_index DEVICE_NAMEExt2:

#tune2fs -O extents,uninit_bg,dir_index,has_journal DEVICE_NAME

rootによって/etc/fstabファイルが編集されるとき、ext3またはext2のレコードをext4に変更します。この変更結果は、次回の再起動後に有効になります。Ext4パーティションでセットアップされたファイルシステムをブートするには、

ext4とjbdの各モジュールをinitramfsに追加します。/etc/dracut.conf.d/filesystem.confを開くか作成し、次の行を追加します。force_drivers+=" ext4 jbd"

既存のdracut

initramfsを上書きする必要があります。そのためには、次のコマンドを実行します。dracut -f

システムを再起動します。

1.7 ReiserFS #

ReiserFSのサポートは、SUSE Linux Enterprise Server 15で廃止されました。既存のパーティションをBtrfsにマイグレートするには、1.2.3項 「ReiserFSおよびExtの各ファイルシステムからBtrfsへのマイグレーション」を参照してください。

1.8 OpenZFSとZFS #

OpenZFSファイルシステムもZFSファイルシステムもSUSEではサポートされていません。ZFSは閉じられたソースファイルシステムであるため、SUSEでは使用できません。OpenZFSは、GPLライセンスと互換性のないCDDLライセンスの下にあります。ただし、BtrfsにはOpenZFS respのすばらしい代替品があります。ZFSはSUSEによって完全にサポートされています。

1.9 サポートされている他のファイルシステム #

表1.1「Linux環境でのファイルシステムのタイプ」は、Linuxがサポートしている他のいくつかのファイルシステムを要約したものです。これらは主に、他の種類のメディアや外部オペレーティングシステムとの互換性およびデータの相互交換を保証することを目的としてサポートされています。

|

ファイルシステムのタイプ |

説明 |

|---|---|

|

|

CD-ROMの標準ファイルシステム。 |

|

|

|

|

|

Network File System (ネットワークファイルシステム) :ネットワーク内の任意のコンピュータにデータを格納でき、ネットワーク経由でアクセスを付与できます。 |

|

|

Windows NT file system (NTファイルシステム) :読み取り専用です。 |

|

|

USBフラッシュドライブやSDカードなど、フラッシュメモリで使用するために最適化されたファイルシステムです。 |

|

|

Server Message Block (サーバメッセージブロック): Windowsのような製品が、ネットワーク経由でのファイルアクセスを可能にする目的で採用しています。 |

|

|

BSD、SunOS、およびNextStepで使用されています。読み取り専用モードでサポートされています。 |

|

|

UNIX on MS-DOS(MS-DOS上のUNIX) - 標準 |

|

|

Virtual FAT: |

1.10 ブロックされるファイルシステム #

セキュリティ上の理由によって、自動マウントからブロックされるファイルシステムがあります。これらのファイルシステムは通常維持されなくなり、一般的に使用されません。ただし、このファイルシステムのカーネルモジュールをロードできます。これは、カーネル内のAPIの互換性が保たれているためです。ユーザがマウントできるファイルシステムとファイルシステムの自動マウントを取り外し可能デバイスで組み合わせると、特権のないユーザがカーネルモジュールの自動ロードをトリガする状況が発生し、悪意のあるデータが取り外し可能デバイスに格納される危険性があります。

自動マウントが許可されていないファイルシステムのリストを取得するには、次のコマンドを実行します。

>sudorpm -ql suse-module-tools | sed -nE 's/.*blacklist_fs-(.*)\.conf/\1/p'

mountコマンドを使用してブロックされるファイルシステムでデバイスをマウントしようとすると、このコマンドはエラーメッセージを出力します。次に例を示します。

mount: /mnt/mx: unknown filesystem type 'minix' (hint: possibly blacklisted, see mount(8)).

ファイルシステムのマウントを有効にするには、ブロックリストからそのファイルシステムを削除する必要があります。ブロックされるファイルシステムそれぞれに独自の設定ファイルがあります。たとえば、efsでは/lib/modules.d/60-blacklist_fs-efs.confです。ただし、suse-module-toolsパッケージが更新されると、これらのファイルは必ず上書きされるため、編集しないでください。ブロックされるファイルシステムの自動マウントを許可するには、次の方法があります。

/dev/nullへのシンボリックリンクを作成します。たとえば、efsファイルシステムの場合には次のようにします。>sudoln -s /dev/null /etc/modules.d/60-blacklist_fs-efs.conf設定ファイルを

/etc/modprobe.dにコピーします。>sudocp /lib/modules.d/60-blacklist_fs-efs.conf /etc/modprobe.d/60-blacklist_fs-efs.conf設定ファイルの次のステートメントをコメントにします。

# blacklist omfs

ファイルシステムを自動マウントできない場合でも、modprobeを直接使用して、そのファイルシステムの対応するカーネルモジュールをロードできます。

>sudomodprobe FILESYSTEM

たとえば、cramfsファイルシステムの場合、出力は次のようになります。

unblacklist: loading cramfs file system module unblacklist: Do you want to un-blacklist cramfs permanently (<y>es/<n>o/n<e>ver)? y unblacklist: cramfs un-blacklisted by creating /etc/modprobe.d/60-blacklist_fs-cramfs.conf

yesを選択すると、modprobeコマンドは、指定したファイルシステムの設定ファイルからシンボリックリンクを作成するスクリプトを/dev/nullに呼び出します。したがって、このファイルシステムはブロックリストから削除されます。

1.11 Linux環境での大規模ファイルサポート #

当初、Linuxは、最大ファイルサイズとして 2GiB (231バイト)をサポートしていました。また、ファイルシステムに大規模ファイルサポートが付いていない限り、32ビットシステム上での最大ファイルサイズは2GiBです。

現在、弊社のすべての標準ファイルシステムでは、LFS (大規模ファイルサポート)を提供しています。LFSは、理論的には、263バイトの最大ファイルサイズをサポートします。表1.2「ファイルおよびファイルシステムの最大サイズ(オンディスクフォーマット、4KiBブロックサイズ)」では、Linuxのファイルとファイルシステムの、現行のオンディスクフォーマットの制限事項を概説しています。表内の数字は、ファイルシステムで使用しているブロックサイズが、共通規格である4KiBであることを前提としています。異なるブロックサイズを使用すると結果は異なります。スパースブロックを使用している場合、表1.2「ファイルおよびファイルシステムの最大サイズ(オンディスクフォーマット、4KiBブロックサイズ)」に記載の最大ファイルサイズは、ファイルシステムの実際のサイズより大きいことがあります。

このマニュアルでの換算式: 1024バイト = 1KiB、1024KiB = 1MiB、1024MiB = 1GiB、1024GiB = 1TiB、1024TiB = 1PiB、1024PiB = 1EiB(「NIST: Prefixes for Binary Multiples」も参照してください)。

|

ファイルシステム(4KiBブロックサイズ) |

ファイルシステムの最大サイズ |

ファイルの最大サイズ |

|---|---|---|

|

Btrfs |

16EiB |

16EiB |

|

Ext3 |

16TiB |

2TiB |

|

Ext4 |

1EiB |

16TiB |

|

OCFS2 (High Availability Extensionで使用可能な、クラスタ認識のファイルシステム) |

16TiB |

1EiB |

|

XFS |

16EiB |

8EiB |

|

NFSv2 (クライアント側) |

8EiB |

2GiB |

|

NFSv3/NFSv4 (クライアント側) |

8EiB |

8EiB |

表1.2「ファイルおよびファイルシステムの最大サイズ(オンディスクフォーマット、4KiBブロックサイズ)」は、ディスクフォーマット時の制限について説明しています。Linuxカーネルは、操作するファイルとファイルシステムのサイズについて、独自の制限を課しています。管理の初期設定には、次のオプションがあります。

- ファイルサイズ

32ビットシステムでは、ファイルサイズが2TiB (241バイト)を超えることはできません。

- ファイルシステムのサイズ

ファイルシステムのサイズは、最大273バイトまで可能です。しかし、この制限は、現在使用可能なハードウェアが到達可能な範囲を上回っています。

1.12 Linuxのカーネルにおけるストレージの制限 #

表1.3「ストレージの制限」に、SUSE Linux Enterprise Serverに関連したストレージに関するカーネルの制限をまとめています。

|

ストレージの機能 |

制限 |

|---|---|

|

サポートされるLUNの最大数 |

ターゲットあたり16384 LUN。 |

|

単一LUNあたりのパスの最大数 |

デフォルトで無制限。それぞれのパスが、通常のLUNとして扱われます。 実際の制限は、ターゲットあたりのLUNの数と、HBAあたりのターゲットの数(ファイバチャネルHBAの場合は16777215)により決まります。 |

|

HBAの最大数 |

無制限.実際の制限は、システムのPCIスロットの量で決まります。 |

|

オペレーティングシステムあたりの、デバイスマッパーマルチパス付きパスの最大数(合計) |

約1024。実際の数は、各マルチパスデバイスのデバイス番号文字列の長さによって異なります。これはマルチパスツール内のコンパイル時変数であり、この制限が問題となる場合は増やすこともできます。 |

|

最大サイズ(ブロックデバイスごと) |

最大8EiB。 |

1.13 未使用のファイルシステムブロックの解放 #

SSD(Solid-State Drive)およびシンプロビジョニングされたボリュームでは、ファイルシステムによって使用されていないブロックに対してTrimを実行すると効果的です。SUSE Linux Enterprise Serverは、unmapおよびTRIMの操作をサポートするすべてのファイルシステムで、これらの操作を完全にサポートします。

2つのタイプの一般的に使用されるTRIM(オンラインTRIMと定期TRIM)があります。デバイスをトリムする最も適切な方法は使用例によって異なります。一般的に、定期TRIMの使用をお勧めします(特に、デバイスに十分な未使用ブロックがある場合)。デバイスの容量が一杯に近くなることが多い場合はオンラインTRIMをお勧めします。

TRIMのサポート

TRIMを使用する前に、デバイスがこの操作をサポートしていることを必ず確認してください。確認を怠ると、そのデバイスのデータが喪失する危険性があります。TRIMのサポートを確認するには、次のコマンドを実行します。

>sudolsblk --discard

このコマンドを実行すると、使用可能なすべてのブロックデバイスに関する情報が出力されます。DISC-GRAN列およびDISC-MAX列の値がゼロ以外の場合、デバイスはTRIM操作をサポートしています。

1.13.1 定期TRIM #

定期TRIMは、定期的にsystemdによって呼び出されるfstrimコマンドによって処理されます。コマンドを手動で実行することもできます。

定期TRIMをスケジュールするには、次のようにfstrim.timerを有効にします。

>sudosystemctl enable fstrim.timer

systemdは/usr/lib/systemd/systemにユニットファイルを作成します。デフォルトでは、このサービスは1週間に1回実行されます。通常はこれで十分です。ただし、OnCalendarオプションを目的の値に設定することによって頻度を変更できます。

fstrimのデフォルト動作は、ファイルシステムですべてのブロックを破棄することです。コマンドを呼び出すときにオプションを使用してこの動作を変更できます。たとえば、offsetオプションを渡してトリミング手順の開始地点を定義できます。詳細については、man fstrimを参照してください。

fstrimコマンドを実行すると、/etc/fstabファイルに保存されているすべてのデバイスでトリミングを実行できます。これはTRIM操作をサポートしています。この目的でコマンドを呼び出すときには-Aオプションを使用します。

特定のデバイスのトリミングを無効にするには、次のようにX-fstrim.notrimオプションを/etc/fstabファイルに追加します。

UID=83df497d-bd6d-48a3-9275-37c0e3c8dc74 / btrfs defaults,X-fstrim.notrim 0 0

1.13.2 オンラインTRIM #

デバイスのオンラインTRIMは、デバイスにデータを書き込むたびに実行されます。

デバイスのオンラインTRIMを有効にするには、次のようにdiscardオプションを/etc/fstabファイルに追加します。

UID=83df497d-bd6d-48a3-9275-37c0e3c8dc74 / btrfs defaults,discard

また、Ext4ファイルシステムでtune2fsコマンドを使用して/etc/fstabにdiscardオプションを設定します。

>sudotune2fs -o discard DEVICE

discardオプションを指定してmountによってデバイスがマウントされた場合も、discardオプションは/etc/fstabに追加されます。

>sudomount -o discard DEVICE

discardオプションを使用すると、一部の低品質SSDデバイスの寿命が短くなる場合があります。オンラインTRIMによってデバイスのパフォーマンスに悪影響が及ぶ場合もあります(大量のデータが削除される場合など)。この状況では、消去ブロックが再割り当てされ、そのすぐ後に同じ消去ブロックが未使用として再度マークされる場合があります。

1.14 ファイルシステムのトラブルシューティング #

本項では、ファイルシステムに関するいくつかの既知の問題と、考えられる解決手段について説明します。

1.14.1 Btrfsエラー: デバイスに空き領域がない #

Btrfsファイルシステムを使用しているルート(/)パーティションにデータを書き込めなくなります。「No space left on device」というエラーが表示されます。

考えられる原因とこの問題の回避策については、この後の各項を参照してください。

1.14.1.1 Snapperスナップショットによるディスク容量の使用 #

BtrfsファイルシステムでSnapperが動作している場合、「No space left on device」が表示される問題は、通常は、システム上にスナップショットとして保存されているデータが多すぎるために発生します。

Snapperからいくつかのスナップショットを削除することはできますが、スナップショットはすぐには削除されないので、必要な容量が解放されない可能性があります。

Snapperからファイルを削除するには:

端末コンソールを開きます。

コマンドプロンプトで、たとえば「

btrfs filesystem show」と入力します。>sudobtrfs filesystem show Label: none uuid: 40123456-cb2c-4678-8b3d-d014d1c78c78 Total devices 1 FS bytes used 20.00GB devid 1 size 20.00GB used 20.00GB path /dev/sda3以下を入力してください。

>sudobtrfs fi balance start MOUNTPOINT -dusage=5このコマンドは、データを空またはほぼ空のデータチャンクに再配置して、その容量を回収し、メタデータに再割り当てしようとします。この処理にはしばらくかかります(1 TBで数時間)が、処理中もシステムは使用可能です。

Snapperのスナップショットを一覧にします。以下を入力してください。

>sudosnapper -c root listSnapperから1つ以上のスナップショットを削除します。以下を入力してください。

>sudosnapper -c root delete SNAPSHOT_NUMBER(S)必ず最も古いスナップショットを最初に削除してください。古いスナップショットほど、多くの容量を使用します。

この問題が発生しないように、Snapperのクリーンアップアルゴリズムを変更できます。詳細についてはBook “管理ガイド”, Chapter 10 “Snapperを使用したシステムの回復とスナップショット管理”, Section 10.6.1.2 “クリーンアップアルゴリズム”を参照してください。スナップショットクリーンアップを制御する設定値は、EMPTY_*、NUMBER_*、およびTIMELINE_*です。

ファイルシステムディスクでBtrfsとSnapperを使用する場合、標準のストレージ案の2倍のディスク容量を確保しておくことが推奨されます。YaSTパーティショナは、ルートファイルシステムでBtrfsを使用する場合のストレージ案として、自動的に標準の2倍のディスク容量を提案します。

1.14.1.2 ログ、クラッシュ、およびキャッシュのファイルによるディスク容量の使用 #

システムディスクがデータでいっぱいになりつつある場合、/var/log、/var/crash、/var/lib/systemd/coredump、および/var/cacheからファイルを削除する方法があります。

Btrfs rootファイルシステムのサブボリューム/var/log、/var/crashおよび/var/cacheが、通常の操作時に利用可能なディスクスペースのすべてを使用でき、システムに不具合が発生します。この状況を回避するため、SUSE Linux Enterprise Serverではサブボリュームに対するBtrfsクォータのサポートを提供するようになりました。詳細については1.2.5項 「サブボリュームに対するBtrfsクォータのサポート」を参照してください。

テストおよび開発用のマシンでは、特にアプリケーションが頻繁にクラッシュする場合、コアダンプが保存されている/var/lib/systemd/coredumpを確認することもできます。

1.14.2 Btrfs: デバイス間でデータのバランスを取る #

btrfs balanceコマンドは、btrfs-progsパッケージの一部です。次の状況例では、Btrfsファイルシステムのブロックグループのバランスを取ります。

600GBをデータで使用される1TBのドライブがあり、さらに1TBドライブを追加するとします。バランスを取ることで、理論的には、各ドライブに300GBの使用済みスペースができます。

デバイスには空に近い多数のチャンクがあります。バランスを取ることによりこれらのチャンクがクリアされるまで、それらのスペースは利用できません。

使用率に基づいて半分空のブロックグループを圧縮する必要があります。次のコマンドは、使用率が5%以下のブロックグループのバランスを取ります。

>sudobtrfs balance start -dusage=5 /ヒント/usr/lib/systemd/system/btrfs-balance.timerタイマーによって、未使用ブロックグループが毎月クリーンアップされます。ブロックデバイスのフルでない部分をクリアし、データをより均等に分散する必要があります。

異なるRAIDタイプ間でデータを移行する必要があります。たとえば、一連のディスク上のデータをRAID1からRAID5に変換するには、次のコマンドを実行します。

>sudobtrfs balance start -dprofiles=raid1,convert=raid5 /

Btrfsファイルシステム上のデータのバランスを取るデフォルトの動作(たとえば、バランスを取る頻度やマウントポイント)を微調整するには、/etc/sysconfig/btrfsmaintenanceを検査してカスタマイズします。関連するオプションは、BTRFS_BALANCE_で開始されます。

btrfs balanceコマンドの使用に関する詳細については、そのマニュアルページ(man 8 btrfs-balance)を参照してください。

1.14.3 SSDでデフラグメンテーションしない #

Linuxファイルシステムには、データフラグメンテーションを回避するメカニズムがあり、通常はデフラグメントする必要はありません。ただし、データフラグメンテーションを回避できない場合、およびハードディスクのデフラグメンテーションによってパフォーマンスが大幅に向上する場合に使用するケースがあります。

これは従来のハードディスクにのみ適用されます。フラッシュメモリを使用してデータを保存するソリッドステートディスク(SSD)では、ファームウェアによってデータを書き込むチップを判断するアルゴリズムが提供されます。データは通常、ドライブ全体に分散されます。したがって、SSDのデフラグメンテーションは望ましい効果がなく、不要なデータを書き込むことにより、SSDの製品寿命を縮めます。

この理由のため、SUSEではSSDでデフラグメントしないことを明示的にお勧めします。一部のベンダーも、ソリッドステートディスクをデフラグメントすることについて警告しています。これには、次のものが含まれますが、これに限定されません。

HPE 3PAR StoreServオールフラッシュ

HPE 3PAR StoreServコンバージドフラッシュ

1.15 詳細情報 #

ここまでに説明した各ファイルシステムのプロジェクトには、独自のWebページがあります。そこで詳しいドキュメントとFAQ、さらにメーリングリストを参照することができます。

Kernel.orgのBtrfs Wiki: https://btrfs.wiki.kernel.org/

E2fsprogs: Ext2/3/4 File System Utilities: http://e2fsprogs.sourceforge.net/

OCFS2プロジェクト: https://oss.oracle.com/projects/ocfs2/

ファイルシステム(Linuxファイルシステムに限らない)の詳しい比較については、Wikipediaプロジェクトの「Comparison of file systems」(http://en.wikipedia.org/wiki/Comparison_of_file_systems#Comparison)を参照してください。

2 ファイルシステムのサイズ変更 #

ファイルシステムのサイズ変更(パーティションまたはボリュームのサイズ変更と混同しないでください)を使用して、物理ボリュームの使用可能な容量を増やしたり、物理ボリュームで増やした使用可能な容量を使用したりできます。

2.1 使用例 #

パーティションまたは論理ボリュームのサイズ変更には、YaSTパーティショナを使用することをお勧めします。その際、ファイルシステムは自動的にパーティションまたはボリュームの新しいサイズに合わせて調整されます。ただし、YaSTではファイルシステムのサイズ変更はサポートされていないので、次のようなケースでは手動でサイズを変更する必要があります。

VM Guestの仮想ディスクのサイズを変更した後。

NAS (Network Attached Storage)のボリュームのサイズを変更した後。

手動でパーティションのサイズを変更した後(たとえば、

fdiskまたはpartedを使用)、または論理ボリュームのサイズを変更した後(たとえば、lvresizeを使用)。Btrfsファイルシステムを縮小する場合(SUSE Linux Enterprise Server 12の時点ではYaSTはBtrfsファイルシステムの拡大のみをサポートしています)。

2.2 サイズ変更のガイドライン #

ファイルシステムのサイズ変更には、データを失う可能性をはらむリスクが伴います。

データの喪失を避けるには、データを必ずバックアップしてから、サイズ変更タスクを開始します。

ファイルシステムのサイズを変更する場合は、次のガイドラインに従ってください。

2.2.1 サイズ変更をサポートしているファイルシステム #

ボリュームに使用可能な容量を増やせるようにするには、ファイルシステムがサイズ変更をサポートしている必要があります。SUSE® Linux Enterprise Serverでは、ファイルシステムExt2、Ext3、およびExt4に対して、ファイルシステムのサイズ変更ユーティリティを使用できます。このユーティリティは、次のようにサイズの増減をサポートします。

|

ファイルシステム |

ユーティリティ |

サイズの増加(拡大) |

サイズの削減(縮小) |

|---|---|---|---|

|

Btrfs |

|

オンライン |

オンライン |

|

XFS |

|

オンライン |

サポートされていません。 |

|

Ext2 |

|

オンラインまたはオフライン |

オフラインのみ |

|

Ext3 |

|

オンラインまたはオフライン |

オフラインのみ |

|

Ext4 |

|

オンラインまたはオフライン |

オフラインのみ |

2.2.2 ファイルシステムのサイズの増加 #

デバイス上で使用可能な最大容量までファイルシステムを拡大することも、正確なサイズを指定することもできます。ファイルシステムのサイズを拡大する前に、必ずデバイス、または論理ボリュームのサイズを拡大しておいてください。

ファイルシステムに正確なサイズを指定する場合は、その新しいサイズが次の条件を満たすかどうかを必ず確認してください。

新しいサイズは、既存データのサイズより大きくなければなりません。さもないと、データが失われます。

ファイルシステムのサイズは使用可能な容量より大きくできないので、新しいサイズは、現在のデバイスサイズ以下でなければなりません。

2.2.3 ファイルシステムのサイズの削減 #

デバイス上のファイルシステムのサイズを削減する際には、新しいサイズが次の条件を満たすかどうかを必ず確認してください。

新しいサイズは、既存データのサイズより大きくなければなりません。さもないと、データが失われます。

ファイルシステムのサイズは使用可能な容量より大きくできないので、新しいサイズは、現在のデバイスサイズ以下でなければなりません。

ファイルシステムが保存されている論理ボリュームのサイズを削減する場合は、デバイス、または論理ボリュームのサイズを削減しようとする前に、必ずファイルシステムのサイズを削減しておきます。

XFSでフォーマットされたファイルシステムのサイズを縮小することはできません。XFSではそのような機能がサポートされていないためです。

2.3 Btrfsファイルシステムのサイズの変更 #

Btrfsファイルシステムのサイズは、ファイルシステムがマウントされているときに、btrfs filesystem resizeコマンドを使用して変更できます。ファイルシステムのマウント中にサイズの増加と縮小の両方を実行できます。

端末コンソールを開きます。

変更するファイルシステムがマウントされていることを確認します。

次のどちらかの方法で

btrfs filesystem resizeコマンドを使用して、ファイルシステムのサイズを変更します。ファイルシステムのサイズをデバイスの使用可能な最大サイズまで拡張するには、次のように入力します。

>sudobtrfs filesystem resize max /mntファイルシステムを特定のサイズに拡張するには、次のコマンドを入力します。

>sudobtrfs filesystem resize SIZE /mntSIZEを目的のサイズ(バイト単位)で置き換えます。50000K(キロバイト)、250M(メガバイト)、2G (ギガバイト)など、値の単位を指定することもできます。または、プラス(

+)記号またはマイナス(-)記号を値の前に付けることにより、現在のサイズに対する増減を指定することもできます。>sudobtrfs filesystem resize +SIZE /mnt sudo btrfs filesystem resize -SIZE /mnt

次のように入力して、マウントされたファイルシステムに対するサイズ変更の効果をチェックします。

>df -hディスクフリー(

df)コマンドは、ディスクの合計サイズ、使用されたブロック数、およびファイルシステム上の使用可能なブロック数を表示します。-hオプションは、読みやすい形式でサイズを出力します(1K、234M、2Gなど)。

2.4 XFSファイルシステムのサイズの変更 #

XFSファイルシステムのサイズは、ファイルシステムがマウントされているときに、xfs_growfsコマンドを使用して増加できます。XFSファイルシステムのサイズを縮小することはできません。

端末コンソールを開きます。

変更するファイルシステムがマウントされていることを確認します。

xfs_growfsコマンドを使用して、ファイルシステムのサイズを増やします。次に、ファイルシステムのサイズを、利用可能な最大値まで増やす例を示します。他のオプションについては、man 8 xfs_growfsを参照してください。>sudoxfs_growfs -d /mnt次のように入力して、マウントされたファイルシステムに対するサイズ変更の効果をチェックします。

>df -hディスクフリー(

df)コマンドは、ディスクの合計サイズ、使用されたブロック数、およびファイルシステム上の使用可能なブロック数を表示します。-hオプションは、読みやすい形式でサイズを出力します(1K、234M、2Gなど)。

2.5 Ext2、Ext3、またはExt4の各ファイルシステムのサイズの変更 #

Ext2、Ext3、およびExt4ファイルシステムのサイズは、各パーティションがマウントされているかどうかにかかわらず、resize2fsコマンドを使用して増加できます。Extファイルシステムのサイズを減らすには、ファイルシステムをアンマウントする必要があります。

端末コンソールを開きます。

ファイルシステムのサイズを減らす必要がある場合は、アンマウントします。

次のどちらかの方法で、ファイルシステムのサイズを変更します。

ファイルシステムのサイズを

/dev/sda1と呼ばれるデバイスの、利用可能な最大サイズまで拡大するには、次のように入力します。>sudoresize2fs /dev/sda1sizeパラメータを指定しない場合、サイズはパーティションのサイズにデフォルト設定されます。

ファイルシステムを特定のサイズに変更するには、次のコマンドを入力します。

>sudoresize2fs /dev/sda1 SIZESIZEパラメータは、要求されたファイルシステムの新サイズを指定します。単位を指定しない場合のsizeパラメータの単位は、ファイルシステムのブロックサイズです。オプションとして、sizeパラメータの後ろに、次の単位指定子の1つを付けることができます。

sは512バイトのセクタ、Kはキロバイト(1キロバイトは1024バイト)、Mはメガバイト、Gはギガバイトを表します。

サイズ変更が完了するまで待って、続行します。

ファイルシステムがマウントされていない場合は、この時点で、ファイルシステムをマウントします。

次のように入力して、マウントされたファイルシステムに対するサイズ変更の効果をチェックします。

>df -hディスクフリー(

df)コマンドは、ディスクの合計サイズ、使用されたブロック数、およびファイルシステム上の使用可能なブロック数を表示します。-hオプションは、読みやすい形式でサイズを出力します(1K、234M、2Gなど)。

3 ストレージデバイスのマウント #

このセクションでは、デバイスのマウント中に使用されるデバイス識別子の概要および、ネットワークストレージのマウントに関する詳細について説明します。

3.1 UUIDの理解 #

UUID (Universally Unique Identifier)は、ファイルシステムの128ビットの番号であり、ローカルシステムと他のシステム全体に渡る固有な識別子です。UUIDは、システムハードウェア情報とタイムスタンプをそのシードの一部として、ランダムに生成されます。UUIDは、通常、デバイスに固有なタグを付けるために使用されます。

非永続的な「従来の」デバイス名(/dev/sda1など)を使用すると、ストレージを追加したときに、システムがブートできなくなる可能性があります。たとえば、root (/)が/dev/sda1に割り当てられている場合、SANを接続した後またはシステムにハードディスクを追加した後に、/dev/sdg1に再割り当てされる可能性があります。この場合、ブートローダ設定と/etc/fstabファイルを調整する必要があり、そうしないとシステムは起動できなくなります。

デフォルトでは、UUIDは、ブートデバイスのブートローダおよび/etc/fstabファイルで使用されます。UUIDは、ファイルシステムのプロパティであり、ドライブを再フォーマットすれば変更できます。デバイス名のUUIDを使用することの代替案として、IDまたはラベルでデバイスを識別する方法があります。

UUIDは、ソフトウェアRAIDデバイスのアセンブルと起動の基準としても使用できます。RAIDが作成されると、mdドライバは、デバイスのUUIDを生成し、その値をmdスーパーブロックに保存します。

どのブロックデバイスのUUIDも、/dev/disk/by-uuidディレクトリ内で見つけることができます。たとえば、UUIDエントリは次のようになります。

> ls -og /dev/disk/by-uuid/

lrwxrwxrwx 1 10 Dec 5 07:48 e014e482-1c2d-4d09-84ec-61b3aefde77a -> ../../sda13.2 udevによる永続的なデバイス名 #

Linuxカーネル2.6以降、udevによって、永続的なデバイス名を使用した動的な/devディレクトリのユーザスペースソリューションが提供されます。システムに対してデバイスを追加または削除する場合は、ホットプラグシステムの一部としてudevが実行されます。

ルールのリストが特定デバイス属性との比較に使用されます。udevルールのインフラストラクチャ(/etc/udev/rules.dディレクトリで定義)は、すべてのディスクデバイスに、それらの認識順序や当該デバイスに使用される接続に関わらず、安定した名前を提供します。udevツールは、カーネルが作成するすべての該当ブロックデバイスを調べ、一定のバス、ドライブタイプ、またはファイルシステムに基づいて、ネーミングルールを適用します。udev用の独自ルールを定義する方法については、「Writing udev Rules」を参照してください。

動的なカーネル提供のデバイスノード名に加えて、udevは、/dev/diskディレクトリ内のデバイスをポイントする永続的なシンボリックリンクのクラスを保持します。このディレクトリは、さらに、by-id、by-label、by-path、およびby-uuidの各サブディレクトリに分類されます。

udev以外のプログラム(LVMやmdなど)も、UUIDを生成することがありますが、それらのUUIDは/dev/diskにリストされません。

udevによるデバイス管理の詳細については、Book “管理ガイド”, Chapter 29 “udevによる動的カーネルデバイス管理”を参照してください。

udevコマンドの詳細については、man 7 udevを参照してください。

3.3 ネットワークストレージデバイスのマウント #

ストレージデバイスの一部のタイプでは、systemd.mountを開始してデバイスをマウントする前に、ネットワークを設定して使用可能にする必要があります。これらのタイプのデバイスのマウントを延期するには、該当するそれぞれのネットワークストレージデバイスの/etc/fstabファイルに_netdevオプションを追加します。次に例を示します。

mars.example.org:/nfsexport /shared nfs defaults,_netdev 0 0

4 ブロックデバイス操作の多層キャッシング #

多層キャッシュは、2つ以上の層で構成される複製/分散キャッシュです。1つは低速であるものの安価な回転方式のブロックデバイス(ハードディスク)に代表され、もう1つは高価であるもののデータ操作を高速に実行します(SSDフラッシュディスクなど)。

SUSE Linux Enterprise Serverは、フラッシュデバイスと回転方式のデバイスとの間のキャッシング用に、それぞれbcacheおよびlvmcacheという2つの異なるソリューションを実装しています。

4.1 一般的な用語 #

本項では、キャッシュ関連機能の説明でよく使用されるいくつかの用語について説明します。

- マイグレーション

論理ブロックの主コピーをデバイス間で移動すること。

- 昇格

低速なデバイスから高速なデバイスへのマイグレーション。

- 降格

高速なデバイスから低速なデバイスへのマイグレーション。

- 起点デバイス

大容量で低速なブロックデバイス。古いか、キャッシュデバイス上のコピーとの同期が保たれている(ポリシーによります)、論理ブロックのコピーが常に含まれます。

- キャッシュデバイス

小容量で高速なブロックデバイス。

- メタデータデバイス

キャッシュに入っているブロック、ダーティブロック、およびポリシーオブジェクトが使用する追加のヒントを記録する小容量のデバイス。この情報はキャッシュデバイスに配置することもできますが、別個に保持することにより、ボリュームマネージャで異なった設定にすることができます。たとえば、堅牢性を強化するためのミラーとして設定できます。メタデータデバイスを使用できるキャッシュデバイスは1つだけです。

- ダーティブロック

何らかのプロセスがキャッシュに配置されたデータブロックに書き込みを行う場合、そのキャッシュされているブロックは、キャッシュ内で上書きされていて、元のデバイスにもう一度書き込む必要があるため、「ダーティ」とマークされます。

- キャッシュミス

I/O操作の要求は、まず、キャッシュされたデバイスのキャッシュを参照します。要求された値が見つからなかった場合、デバイス自体を検索しますが、これは低速です。これを「キャッシュミス」と呼びます。

- キャッシュヒット

要求された値がキャッシュされたデバイスのキャッシュ内で見つかった場合、その値は高速に提供されます。これを「キャッシュヒット」と呼びます。

- コールドキャッシュ

値が格納されていない(空の)キャッシュのことで、「キャッシュミス」を引き起こします。キャッシュされたブロックデバイスの操作が進むにつれて、キャッシュはデータで満たされていき、「ウォーム」になります。

- ウォームキャッシュ

すでに何らかの値が格納されていて、「キャッシュヒット」になる確立が高いキャッシュ。

4.2 キャッシングモード #

多層キャッシュで使用される基本的なキャッシングモードは、「ライトバック」、「ライトスルー」、「ライトアラウンド」、および「パススルー」です。

- ライトバック

キャッシュされているブロックに書き込まれたデータは、キャッシュにのみ書き込まれ、そのブロックはダーティとマークされます。これはデフォルトのキャッシングモードです。

- ライトスルー

キャッシュされているブロックへの書き込みは、起点デバイスとキャッシュデバイスの両方にヒットするまで完了しません。「ライトスルー」キャッシュでは、クリーンブロックはクリーンな状態のままです。

- ライトアラウンド

ライトスルーキャッシュと同様の手法ですが、書き込みI/Oは、キャッシュをバイパスして永続ストレージに直接書き込まれます。この手法では、直後に再読み込みされない書き込みI/Oによってキャッシュがいっぱいになるのを防ぐことができますが、最近書き込まれたデータの読み込み要求で「キャッシュミス」が発生し、低速なバルクストレージからの読み込みが必要になり、レイテンシが増加するという欠点があります。

- パススルー

「パススルー」モードを有効にするには、キャッシュがクリーンである必要があります。読み込みは、キャッシュをバイパスして起点デバイスから実行されます。書き込みは起点デバイスに転送され、キャッシュブロックは「無効化」されます。「パススルー」では、データ整合性が維持されるため、データ整合性を気にすることなくキャッシュデバイスをアクティブ化できます。書き込みが実行されるにつれて、キャッシュは徐々にコールドになります。後でキャッシュの整合性を検証できる場合、または

invalidate_cblocksメッセージを使用して整合性を保証できる場合は、キャッシュデバイスがまだウォームである間に、デバイスを「ライトスルー」または「ライトバック」モードに切り替えることができます。それ以外の場合は、目的のキャッシングモードに切り替える前に、キャッシュの内容を破棄できます。

4.3 bcache #

bcacheはLinuxカーネルブロック層のキャッシュです。1台以上の高速なディスクドライブ(SSDなど)を1台以上の低速なハードディスクのキャッシュとして動作させることができます。bcacheは、ライトスルーとライトバックをサポートし、使用するファイルシステムから独立しています。デフォルトでは、SSDの強みである、ランダム読み込みとランダム書き込みのみのキャッシュを実行します。デスクトップやサーバのほか、ハイエンドのストレージアレイにも適しています。

4.3.1 主な特徴 #

1つのキャッシュデバイスを使用して、任意の数のバッキングデバイスをキャッシュできます。バッキングデバイスは、マウント中および使用中のランタイムに接続および切断できます。

不正なシャットダウンから回復します。キャッシュがバッキングデバイスと整合性があるようになるまで、書き込みは完了しません。

輻輳する場合、SSDへのトラフィックを制限します。

非常に効率的なライトバック実装。ダーティデータは常にソートされた順序で書き込まれます。

運用環境での使用における安定性と信頼性。

4.3.2 bcacheデバイスのセットアップ #

この項では、bcacheデバイスのセットアップと管理の手順を説明します。

bcache-toolsパッケージをインストールします。>sudozypper in bcache-toolsバッキングデバイスを作成します(通常は機械式ドライブ)。デバイス全体、パーティション、またはその他の標準ブロックデバイスをバッキングデバイスにすることができます。

>sudomake-bcache -B /dev/sdbキャッシュデバイスを作成します(通常はSSDディスク)。

>sudomake-bcache -C /dev/sdcこの例では、デフォルトのブロックサイズとバケットサイズである512Bと128KBを使用しています。ブロックサイズはバッキングデバイスのセクタサイズ(通常は512または4k)と一致している必要があります。バケットサイズは、書き込みの増大を防ぐために、キャッシングデバイスの消去ブロックサイズと一している必要があります。たとえば、セクタが4kのハードディスクと消去ブロックサイズが2MBのSSDを使用する場合、このコマンドは次のようになります。

sudo make-bcache --block 4k --bucket 2M -C /dev/sdc

ヒント: 複数デバイスのサポートmake-bcacheは、複数のバッキングデバイスとキャッシュデバイスを同時に準備および登録できます。この場合、後から手動でキャッシュデバイスをバッキングデバイスに接続する必要はありません。>sudomake-bcache -B /dev/sda /dev/sdb -C /dev/sdcbcacheデバイスは次のように表示されます。/dev/bcacheN

さらに、次のようにも表示されます。

/dev/bcache/by-uuid/UUID /dev/bcache/by-label/LABEL

bcacheデバイスは通常の方法で正常にフォーマットおよびマウントできます。>sudomkfs.ext4 /dev/bcache0>sudomount /dev/bcache0 /mntbcacheデバイスは、/sys/block/bcacheN/bcacheにあるsysfsによって制御できます。キャッシュデバイスとバッキングデバイスの両方を登録した後、バッキングデバイスを関連キャッシュセットに接続して、キャッシュを有効にする必要があります。

>echo CACHE_SET_UUID > /sys/block/bcache0/bcache/attachCACHE_SET_UUIDは

/sys/fs/bcacheで確認できます。デフォルトでは、

bcacheはパススルーキャッシングモードを使用します。たとえば、これをライトバックに変更するには、次のコマンドを実行します。>echo writeback > /sys/block/bcache0/bcache/cache_mode

4.3.3 sysfsを使用するbcacheの設定 #

bcacheデバイスは、sysfsインタフェースを使用してランタイム設定値を保存します。このようにして、bcacheバッキングディスクとキャッシュディスクの動作を変更したり、使用状況の統計を表示したりできます。

bcache sysfs の全パラメータのリストについては、/usr/src/linux/Documentation/bcache.txtファイルの説明を参照してください。主に、SYSFS - BACKING DEVICE、SYSFS - BACKING DEVICE STATS、およびSYSFS - CACHE DEVICEの各セクションで扱っています。

4.4 lvmcache #

lvmcacheは、論理ボリューム(LV)で構成されるキャッシングメカニズムです。dm-cacheカーネルドライバを使用し、ライトスルー(デフォルト)およびライトバックのキャッシングモードをサポートします。lvmcacheは、データの一部をより高速で小容量のLVに動的に移行することによって、大容量で低速なLVのパフォーマンスを向上させます。LVMの詳細については、パートII「論理ボリューム(LVM)」を参照してください。

LVMでは、この小容量で高速なLVを「キャッシュプールLV」と呼びます。一方、大容量で低速なLVを「起点LV」と呼びます。dm-cacheの要件があるため、LVMは、キャッシュプールLVをさらに「キャッシュデータLV」と「キャッシュメタデータLV」という2つのデバイスに分割します。キャッシュデータLVは、速度の向上を目的として、起点LVからのデータブロックのコピーが保持される場所です。キャッシュメタデータLVには、データブロックが保存されている場所を指定するアカウンティング情報が格納されます。

4.4.1 lvmcacheの構成 #

この項では、LVMベースのキャッシングの作成と設定の手順を説明します。

起点LVを作成します。新しいLVを作成するか既存のLVを使用して、起点LVにします。

>sudolvcreate -n ORIGIN_LV -L 100G vg /dev/SLOW_DEVキャッシュデータLVを作成します。このLVには、起点LVからのデータブロックが格納されます。このLVのサイズがキャッシュのサイズになり、キャッシュプールLVのサイズとして報告されます。

>sudolvcreate -n CACHE_DATA_LV -L 10G vg /dev/FASTキャッシュメタデータLVを作成します。このLVには、キャッシュプールメタデータが格納されます。このLVのサイズは、キャッシュデータLVの約1000分の1にする必要があります。最小サイズは8MBです。

>sudolvcreate -n CACHE_METADATA_LV -L 12M vg /dev/FASTこれまでに作成したボリュームの一覧を表示します。

>sudolvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg -wi-a----- 10.00g cache_metadata_lv vg -wi-a----- 12.00m origin_lv vg -wi-a----- 100.00gキャッシュプールLVを作成します。データLVとメタデータLVをキャッシュプールLVに結合します。同時にキャッシュプールLVの動作を設定できます。

CACHE_POOL_LVは、CACHE_DATA_LVの名前を引き継ぎます。

CACHE_DATA_LVは、CACHE_DATA_LV_cdataという名前に変更されて、非表示になります。

CACHE_META_LVは、CACHE_DATA_LV_cmetaという名前に変更されて、非表示になります。

>sudolvconvert --type cache-pool \ --poolmetadata vg/cache_metadata_lv vg/cache_data_lv>sudolvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg Cwi---C--- 10.00g [cache_data_lv_cdata] vg Cwi------- 10.00g [cache_data_lv_cmeta] vg ewi------- 12.00m origin_lv vg -wi-a----- 100.00gキャッシュLVを作成します。キャッシュプールLVを起点LVにリンクして、キャッシュLVを作成します。

ユーザがアクセス可能なキャッシュLVは起点LVの名前を引き継ぎ、起点LVは非表示LVになってORIGIN_LV_corigという名前に変更されます。

キャッシュLVは、ORIGIN_LVの名前を引き継ぎます。

ORIGIN_LVは、ORIGIN_LV_corigという名前に変更されて、非表示になります。

>sudolvconvert --type cache --cachepool vg/cache_data_lv vg/origin_lv>sudolvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg Cwi---C--- 10.00g [cache_data_lv_cdata] vg Cwi-ao---- 10.00g [cache_data_lv_cmeta] vg ewi-ao---- 12.00m origin_lv vg Cwi-a-C--- 100.00g cache_data_lv [origin_lv_corig] [origin_lv_corig] vg -wi-ao---- 100.00g

4.4.2 キャッシュプールの削除 #

LVキャッシュをオフにする方法はいくつかあります。

4.4.2.1 キャッシュLVからキャッシュプールLVを切断 #

キャッシュプールLVをキャッシュLVから接続解除して、未使用キャッシュプールLVとキャッシュされていない起点LVを残すことができます。データは、必要に応じてキャッシュプールから起点LVに書き戻されます。

>sudolvconvert --splitcache vg/origin_lv

4.4.2.2 起点LVを削除せずにキャッシュプールLVを削除 #

この方法では、必要に応じてキャッシュプールから起点LVにデータを書き戻してから、キャッシュプールLVを削除し、キャッシュされていない起点LVを残します。

>sudolvremove vg/cache_data_lv

次に示す別のコマンドでも、キャッシュLVからキャッシュプールを接続解除し、キャッシュプールを削除します。

>sudolvconvert --uncache vg/origin_lv

4.4.2.3 起点LVとキャッシュプールLVの両方を削除 #

キャッシュLVを削除すると、起点LVとリンクされたキャッシュプールLVの両方が削除されます。

>sudolvremove vg/origin_lv

4.4.2.4 詳細情報 #

サポートされるキャッシュモード、冗長なサブ論理ボリューム、キャッシュポリシー、既存のLVからキャッシュタイプへの変換など、lvmcacheに関連するその他のトピックは、lvmcacheのマニュアルページ(man 7 lvmcache)で参照できます。

パート II 論理ボリューム(LVM) #

- 5 LVMの設定

この章では、LVM (Logical Volume Manager)の原理と多くの状況で役立つ基本機能を説明します。YaST LVMの設定は、YaST Expert Partitionerからアクセスできます。このパーティショニングツールにより、既存のパーティションを編集、および削除できます。また、LVMで使用する新規パーティションを作成することもできます。

- 6 LVMボリュームスナップショット

LVM (Logical Volume Manager)論理ボリュームスナップショットはコピーオンライト技術の1つで、既存のボリュームのデータブロックに対する変更を監視し、いずれかのブロックに書き込みが行われると、スナップショット時のブロックの値がスナップショットボリュームにコピーされます。こうすることで、スナップショットボリュームが削除されるまで、データのその時点のコピーが保存されます。

5 LVMの設定 #

この章では、LVM (Logical Volume Manager)の原理と多くの状況で役立つ基本機能を説明します。YaST LVMの設定は、YaST Expert Partitionerからアクセスできます。このパーティショニングツールにより、既存のパーティションを編集、および削除できます。また、LVMで使用する新規パーティションを作成することもできます。

LVMを使用することでデータ損失などの危険性が増加する恐れがあります。この危険性にはアプリケーションのクラッシュ、電源障害、誤ったコマンドなども含まれます。LVMまたはボリュームの再設定を実施する前にデータを保存してください。バックアップなしでは作業を実行しないでください。

5.1 論理ボリュームマネージャ(LVM)の理解 #

LVMは、複数の物理ボリューム(ハードディスク、パーティション、LUN)にハードディスクスペースを柔軟に分散することができます。LVMが開発された理由は、インストール中に初期パーティショニングが終了した後でのみ、ハードディスクスペースのセグメンテーションを変更するニーズが発生する可能性があるためです。実行中のシステムでパーティションを変更することは困難なので、LVMは必要に応じて論理ボリューム(LV)を作成できるストレージスペースの仮想プール(ボリュームグループ(VG))を提供します。オペレーティングシステムは物理パーティションの代わりにこれらのLVにアクセスします。ボリュームグループは2つ以上のディスクにまたがることができます。したがって、複数のディスクまたはそれらの一部で1つのVGを構成できます。この方法で、LVMは物理ディスクスペースから一種の抽象化を行います。この抽象化により、物理パーティショニングを使用する場合よりはるかに簡単で安全な方法でセグメンテーションを変更できます。

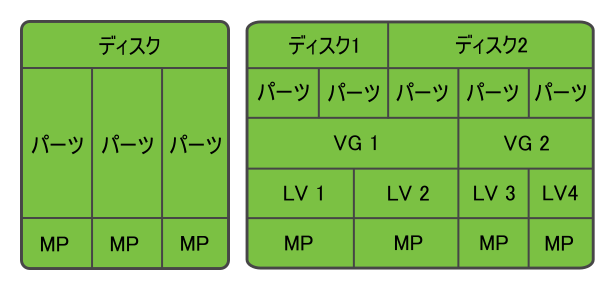

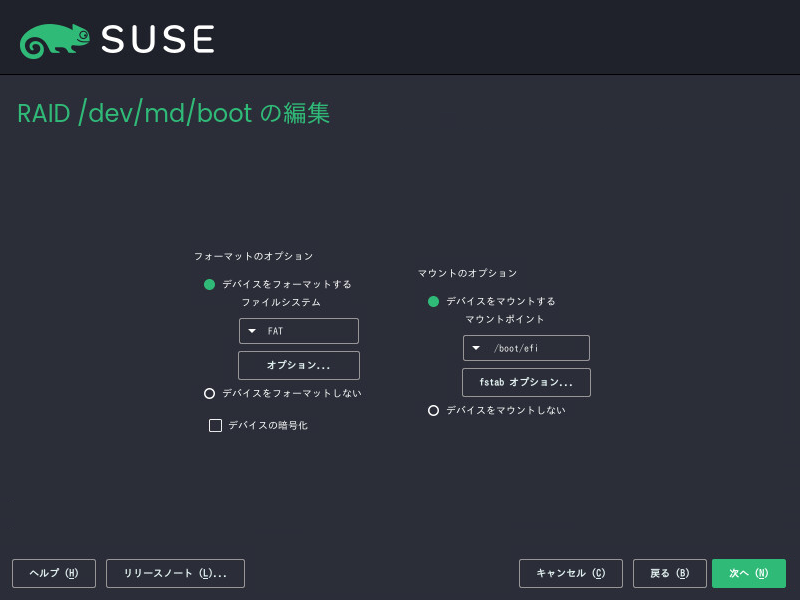

図5.1「物理パーティショニング対LVM」では物理パーティショニング(左)とLVM区分(右)を比較しています。左側は、1つのディスクが割り当てられたマウントポイント(MP)をもつ3つの物理パーティション(PART)に分かれています。これによりオペレーティングシステムはそれぞれのパーティションにアクセスできます。右側では2つのディスクがそれぞれ3つの物理パーティションに分かれています。2つのLVMボリュームグループ(VG 1およびVG 2)が定義されています。VG 1には、ディスク1の2つのパーティションとディスク2の1つのパーティションが含まれています。VG 2には、ディスク2の残りの2つのパーティションが含まれています。

LVMでは、ボリュームグループに組み込まれた物理ディスクをPV (物理ボリューム)と呼びます。図5.1「物理パーティショニング対LVM」のボリュームグループ内には、4つの論理ボリューム(LV 1からLV 4)が定義されています。これらのボリュームは、関連付けられたマウントポイント(MP)を介してオペレーティングシステムに使用されます。別の論理ボリュームとの境界とパーティションの境界を並べることはできません。この例ではLV 1およびLV 2の間に境界があります。

LVMの機\'94\'5c:

複数のハードディスクまたはパーティションを大きな論理ボリュームにまとめることができます。

提供された設定が適切であれば、LV(

/usrなど)は空きスペースがなくなったときに拡張することができます。LVMを使用することで、実行中のシステムにハードディスクまたはLVを追加できます。ただし、そのためには、ディスクやLVを追加することのできるホットプラグ可能なハードウェアが必要になります。

複数の物理ボリューム上に論理ボリュームのデータストリームを割り当てるストライピングモードを有効にすることもできます。これらの物理ボリュームが別のディスクに存在する場合、RAID 0と同様に読み込みおよび書き込みのパフォーマンスを向上できます。

スナップショット機能は稼動中のシステムで一貫性のある(特にサーバ)バックアップを取得できます。

LVMはRAIDレベル0、1、4、5、および6もサポートしていますが、mdraidを使用することをお勧めします(第7章 「ソフトウェアRAIDの設定」を参照)。ただし、LVMはRAID 0および1では適切に動作します。これは、RAID 0は一般的な論理ボリューム管理と同様である(個々の論理ブロックが物理デバイス上のブロックにマップされる)ためです。RAID 1上でLVMを使用した場合は、ミラーの同期を追跡して同期プロセスを完全に管理することができます。それより高いRAIDレベルでは、接続されたディスクの状態を監視するほか、ディスクアレイで問題が発生した場合に管理者に通知することのできる、管理デーモンが必要になります。LVMにはこのようなデーモンが組み込まれていますが、デバイス障害などの例外的な状況では、このデーモンは正しく機能しません。

LVMまたはソフトウェアRAIDアレイでルートファイルシステムを使用してシステムを設定する場合、/bootを別個の非LVMまたは非RAIDパーティションに配置する必要があります。そうしないと、システムは起動しません。このパーティションの推奨サイズは500MBで、推奨ファイルシステムはExt4です。

これらの機能とともにLVMを使用することは、頻繁に使用されるホームPCや小規模サーバではそれだけでも意義があります。データベース、音楽アーカイブ、またはユーザディレクトリのように増え続けるデータストックがある場合は、LVMが特に役に立ちます。LVMを使用すると、物理ハードディスクより大きなファイルシステムの作成が可能になります。ただし、LVMでの作業は従来のパーティションでの作業とは異なることに留意してください。

YaSTパーティショナの使用によって、新規および既存のLVMストレージオブジェクトを管理できます。LVMの設定に関する指示や詳細情報については、公式のLVM HOWTOを参照してください。

5.2 ボリュームグループの作成 #

LVMボリュームグループ(VG)は、Linux LVMパーティションをスペースの論理プールにします。グループ内の使用可能なスペースから論理ボリュームを作成できます。グループ内のLinux LVMパーティションは、同じディスクに存在することも、さまざまなディスクに存在することも可能です。パーティションまたはディスク全体を追加することにより、グループのサイズを拡張できます。

ディスク全体を使用する場合、そのディスクにパーティションを含めることはできません。パーティションを使用した場合、それらをマウントしないでください。YaSTは、パーティションをVGに追加する際に自動的にパーティションタイプを0x8E Linux LVMに変更します。

YaSTを起動してを開きます。

既存のパーティショニングセットアップを再設定する必要がある場合は、次の手順に従います。詳細については、Book “導入ガイド”, Chapter 10 “”, Section 10.1 “の使用”を参照してください。未使用のディスクまたはパーティションを使用したいだけの場合は、この手順をスキップしてください。

警告: パーティションされていないディスクの物理ボリュームパーティションされていないディスクがオペレーティングシステムのインストール先(ブート元)ではない場合、そのディスクを物理ボリューム(PV)として使用することができます。

パーティションされていないディスクはシステムレベルで「未使用」として表示されるため、上書きされてしまったり、間違ってアクセスされたりする可能性があります。

既にパーティションが含まれているハードディスク全体を使用するには、そのディスク上にあるパーティションをすべて削除します。

現在マウントされているパーティションを使用するには、そのパーティションをアンマウントします。

左のパネルで、を選択します。

既存のボリュームグループのリストが右のパネルに表示されます。

[ボリューム管理]ページの左下で、をクリックします。

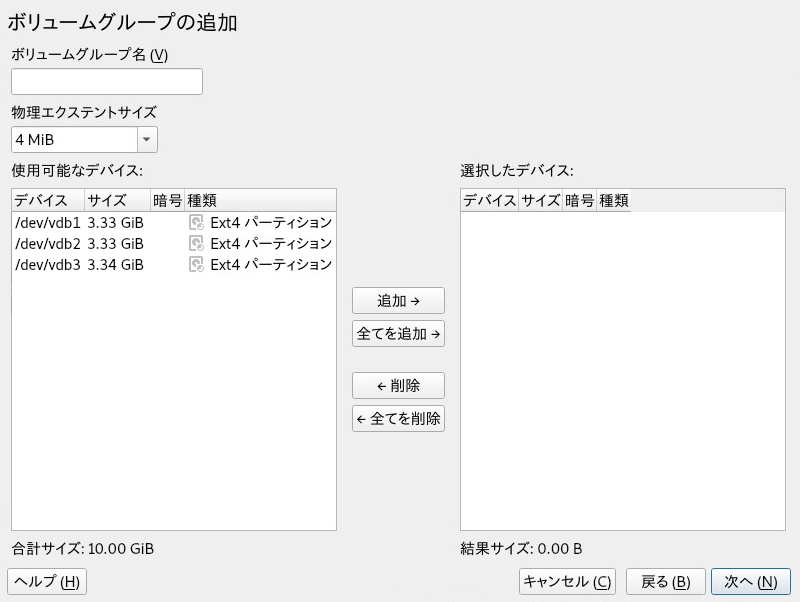

ボリュームグループは次のように定義します。

を指定します。

インストール時にボリュームグループを作成している場合は、SUSE Linux Enterprise Serverのシステムファイルを含むボリュームグループに対して

systemという名前が示唆されます。を指定します。

は、ボリュームグループの物理ブロックのサイズを定義します。ボリュームグループにある全ディスクスペースはこの物理ブロックサイズ内で使用されます。値の範囲は、2の累乗で1KBから16GBまでです。通常、この値は4MBに設定されます。

LVM1では、LVごとに65534エクステントまでしかサポートしないので、4MBの物理エクステントで最大LVサイズとして256GBが可能でした。SUSE Linux Enterprise Serverで使用されるLVM2では、物理エクステントの数に制限はありません。エクステントが多くても、論理ボリュームに対するI/Oパフォーマンスには影響しませんが、LVMツールの動作が遅くなります。

重要: 物理エクステントサイズ1つのボリュームグループに異なるサイズの物理エクステントを混在させないでください。初期設定後はエクステントを変更しないでください。

リストで、このボリュームグループに含めたいLinux LVMパーティションを選択し、をクリックして、それらのパーティションをリストに移動します。

をクリックします。

リストに新しいグループが表示されます。

[ボリューム管理]ページで、をクリックし、新しいグループが一覧されることを確認してから、をクリックします。

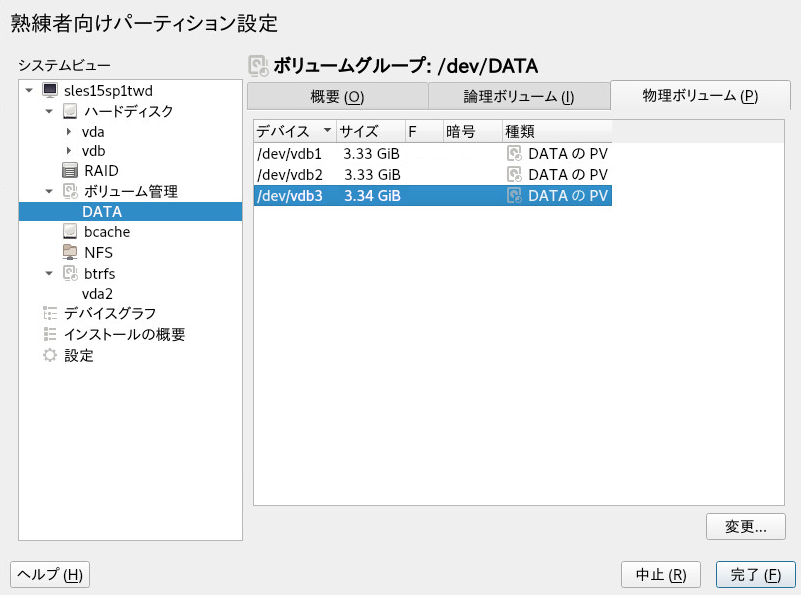

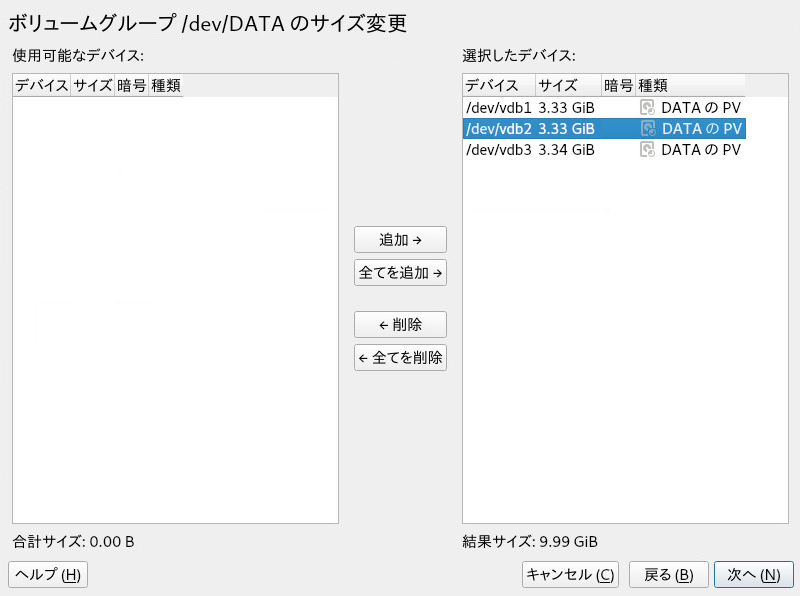

ボリュームグループを構成している物理デバイスを確認するため、稼働中のシステムでYaSTパーティショナを開き、 › › の順にクリックします。をクリックしてこの画面を閉じます。

図 5.2: DATAという名前のボリュームグループ内の物理ボリューム #

5.3 論理ボリュームの作成 #

論理ボリュームは、ハードディスクと同様に領域のプールを提供します。この領域を使用可能にするには、論理ボリュームを定義する必要があります。論理ボリュームは通常のパーティションに似ており、フォーマットやマウントが可能です。

YaSTパーティショナを使用して、既存のボリュームグループから論理ボリュームを作成します。各ボリュームグループに少なくとも1つの論理ボリュームを割り当ててください。ボリュームグループ内の空き領域を使い果たすまで、必要に応じて新しい論理ボリュームを作成できます。LVM論理ボリュームをオプションでシンプロビジョニングすることによって、使用可能な空き領域を超えるサイズで論理ボリュームを作成することもできます(詳しくは5.3.1項 「シンプロビジョニング論理ボリューム」を参照)。

通常のボリューム: (デフォルト)ボリュームの領域は直ちに割り当てられます。

シンプール: この論理ボリュームは、シンボリューム用に予約された領域のプールです。シンボリュームでは、必要な領域をそのプールからオンデマンドで割り当てることができます。

シンボリューム: ボリュームは疎ボリュームとして作成されます。このボリュームでは、必要な領域はシンプールからオンデマンドで割り当てられます。

ミラーリングされたボリューム: このボリュームは、定義した数のミラーで作成されます。

YaSTを起動してを開きます。

左のパネルで、を選択します。既存のボリュームグループのリストが右のパネルに表示されます。

ボリュームを作成するボリュームグループを選択して、 › の順に選択します。

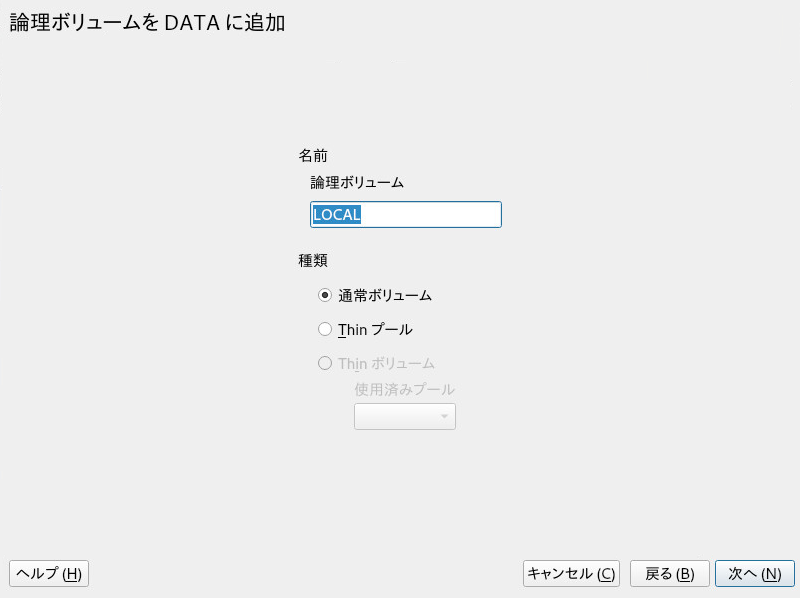

にボリューム名を入力し、を選択します(シンプロビジョニングボリュームの設定については、5.3.1項 「シンプロビジョニング論理ボリューム」を参照してください)。で続行します。

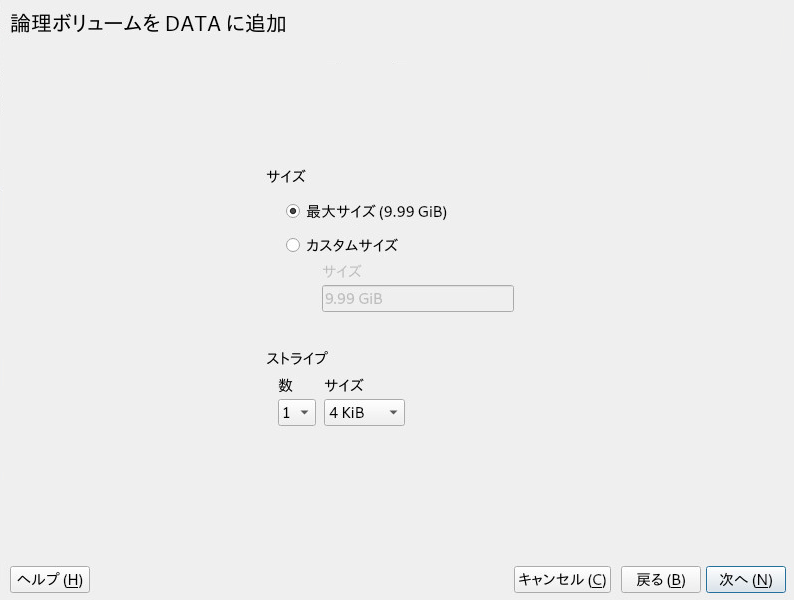

ボリュームのサイズと、複数ストライプを使用するかどうかを指定します。

ストライプボリュームを使用すると、データは複数の物理ボリュームに分散されます。これらの物理ボリュームが別のハードディスクに存在する場合、この性質により、読み込みおよび書込みのパフォーマンスが向上します(RAID 0など)。利用可能な最大ストライプ数は、物理ボリュームの数と同じです。デフォルト(

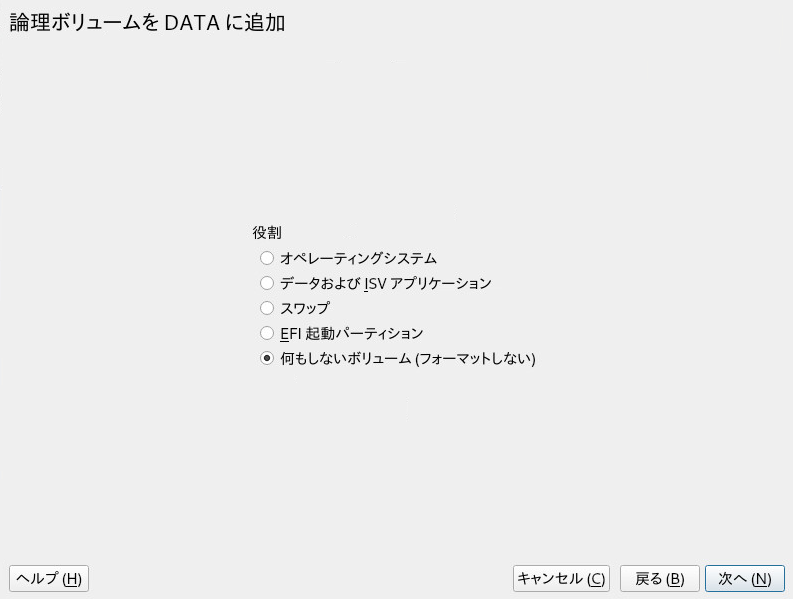

1)は、複数のストライプを使用しない設定です。でボリュームの役割を選択します。ここで選択した内容は、次のダイアログのデフォルト値にのみ影響します。値は次の手順で変更可能です。わからない場合は、を選択します。

で、を選択し、を選択します。メニューの内容は、ファイルシステムによって異なります。通常は、デフォルト値を変更する必要はありません。

の下で、を選択してから、マウントポイントを選択します。をクリックして、このボリュームの特別なマウントオプションを追加します。

をクリックします。

をクリックし、変更が一覧されることを確認してから、をクリックします。

5.3.1 シンプロビジョニング論理ボリューム #

LVM論理ボリュームはシンプロビジョニング可能です(オプション)。シンプロビジョニングを使用すると、利用可能な空き領域を超えるサイズの論理ボリュームを作成できます。任意の数のシンボリューム用に予約した未使用領域が含まれるシンプールを作成します。シンボリュームは疎ボリュームとして作成され、必要に応じてシンプールから領域が割り当てられます。ストレージ領域をコスト効果の高い方法で割り当てなければならなくなった場合、シンプールを動的に拡張できます。シンプロビジョニングボリュームは、Snapperで管理可能なスナップショットもサポートします。詳細については、Book “管理ガイド”, Chapter 10 “Snapperを使用したシステムの回復とスナップショット管理”を参照してください。

シンプロビジョニング論理ボリュームを設定するには、手順5.1「論理ボリュームの設定」の説明に従って作業を進めます。ボリュームタイプを選択する手順になったら、を選択せずに、またはを選択します。

この論理ボリュームは、シンボリューム用に予約された領域のプールです。シンボリュームでは、必要な領域をそのプールからオンデマンドで割り当てることができます。

ボリュームは疎ボリュームとして作成されます。このボリュームでは、必要な領域はシンプールからオンデマンドで割り当てられます。

クラスタでシンプロビジョニングボリュームを使用するには、クラスタを使用するシンプールとシンボリュームを1つのクラスタリソースで管理する必要があります。これにより、シンボリュームとシンプールを常に同じノードに排他的にマウントできます。

5.3.2 ミラーリングされたボリュームの作成 #

複数のミラーを使用して1つの論理ボリュームを作成できます。LVMは、下層の物理ボリュームに書き込まれたデータが別の物理ボリュームに確実にミラーリングされるようにします。そのため、1つの物理ボリュームがクラッシュしても、論理ボリューム上のデータにアクセスできます。LVMは、同期プロセスを管理するためのログファイルも保持します。このログには、現在ミラーとの同期を実行中のボリューム領域についての情報が含まれます。デフォルトでは、ログはディスク(可能であればミラーとは別のディスク)に保存されます。ただし、揮発性メモリなどの別の場所をログに指定できます。

現在のところ、使用可能なミラー実装のタイプには、「通常」(非RAID)のmirror論理ボリュームと、raid1論理ボリュームがあります。

ミラーリングされた論理ボリュームを作成したら、ミラーリングされた論理ボリュームで、アクティブ化、拡張、削除などの標準の操作を実行できます。

5.3.2.1 ミラーリングされた非RAID論理ボリュームの設定 #

ミラーリングされたボリュームを作成するには、lvcreateコマンドを使用します。次の例では、ボリュームグループ「vg1」を使用する、「lv1」という名前の2つのミラーを使用して、500GBの論理ボリュームを作成しています。

>sudolvcreate -L 500G -m 2 -n lv1 vg1

このような論理ボリュームは、ファイルシステムのコピーを3つ提供するリニアボリューム(ストライピングなし)です。mオプションは、ミラーの数を指定します。Lオプションは、論理ボリュームのサイズを指定します。

論理ボリュームは、デフォルトサイズである512KBの領域に分割されます。異なるサイズの領域が必要な場合は、-Rオプションを使用します。このオプションの後に、目的の領域サイズをメガバイト単位で指定してください。または、lvm.confファイルのmirror_region_sizeオプションを編集して、好みの領域サイズを設定することもできます。

5.3.2.2 raid1論理ボリュームの設定 #

LVMはRAIDをサポートしているため、RAID1を使用してミラーリングを実装できます。このような実装には、非RAIDミラーと比較して次のような利点があります。

LVMは、各ミラーイメージに対して完全に冗長なビットマップ領域を維持しており、これによって障害対応能力が向上する。

ミラーイメージを一時的にアレイから分離し、マージして元に戻すことができる。

一時的な障害にアレイで対応できる。

LVMのRAID 1実装はスナップショットをサポートする。

一方、このタイプのミラーリング実装では、クラスタ化されたボリュームグループ内に論理ボリュームを作成することはできません。

RAIDを使用してミラーボリュームを作成するには、次のコマンドを発行します。

>sudolvcreate --type raid1 -m 1 -L 1G -n lv1 vg1

各オプション/パラメータには次のような意味があります。

--type-raid1を指定する必要があります。指定しないと、暗黙のセグメントタイプmirrorが使用され、非RAIDミラーが作成されます。-m- ミラーの数を指定します。-L- 論理ボリュームのサイズを指定します。-n- このオプションを使用して、論理ボリュームの名前を指定します。vg1- 論理ボリュームで使用されるボリュームグループの名前です。

LVMは、アレイ内の各データボリュームに対して、1つのエクステントサイズの論理ボリュームを作成します。ミラーリングされたボリュームが2つある場合、LVMは、メタデータを保存する別のボリュームを2つ作成します。

RAID論理ボリュームを作成したら、一般的な論理ボリュームと同じ方法でそのボリュームを使用できます。アクティブ化、拡張などを行うことができます。

5.4 非ルートLVMボリュームグループの自動アクティブ化 #

非ルートLVMボリュームグループのアクティブ化の動作は、/etc/lvm/lvm.confファイルおよびauto_activation_volume_listパラメータで制御します。デフォルトでは、このパラメータは空で、すべてのボリュームがアクティブ化されます。一部のボリュームグループのみをアクティブ化するには、その名前を引用符で囲んで追加し、カンマで区切ります。次に例を示します。

auto_activation_volume_list = [ "vg1", "vg2/lvol1", "@tag1", "@*" ]

リストをauto_activation_volume_listパラメータで定義した場合、次のように処理されます。

各論理ボリュームは、最初にこのリストに照らして確認されます。

一致しない場合、論理ボリュームはアクティブ化されません。

デフォルトでは、非ルートLVMボリュームグループは、システムの再起動時にdracutによって自動的にアクティブ化されます。このパラメータにより、システムの再起動時にすべてのボリュームグループをアクティブにすることも、または指定した非ルートLVMボリュームグループのみをアクティブにすることもできます。

5.5 既存のボリュームグループのサイズ変更 #

ボリュームグループによって提供される領域は、物理ボリュームを追加することによっていつでも拡張できます。これは、システムの稼働中であっても、サービスを中断することなく実行できます。これにより、グループに論理ボリュームを追加したり、既存のボリュームのサイズを拡張したりできます。5.6項 「論理ボリュームのサイズ変更」を参照してください。

また、物理ボリュームを削除してボリュームグループのサイズを縮小することもできます。YaSTで削除できる物理ボリュームは、現在未使用の物理ボリュームだけです。現在使用中の物理ボリュームを確認するには、次のコマンドを実行します。PE Ranges列に表示されているパーティション(物理ボリューム)が使用中のものです。

>sudopvs -o vg_name,lv_name,pv_name,seg_pe_ranges root's password: VG LV PV PE Ranges /dev/sda1 DATA DEVEL /dev/sda5 /dev/sda5:0-3839 DATA /dev/sda5 DATA LOCAL /dev/sda6 /dev/sda6:0-2559 DATA /dev/sda7 DATA /dev/sdb1 DATA /dev/sdc1

YaSTを起動してを開きます。

左のパネルで、を選択します。既存のボリュームグループのリストが右のパネルに表示されます。

変更するボリュームグループを選択し、タブを有効にして、をクリックします。

次のいずれかの操作を行います。

追加: 1つまたは複数の物理ボリューム(LVMパーティション)をリストからリストに移動することにより、ボリュームグループのサイズを拡張します。

削除: 1つまたは複数の物理ボリューム(LVMパーティション)をリストからリストに移動することにより、ボリュームグループのサイズを縮小します。

をクリックします。

をクリックし、変更が一覧されることを確認してから、をクリックします。

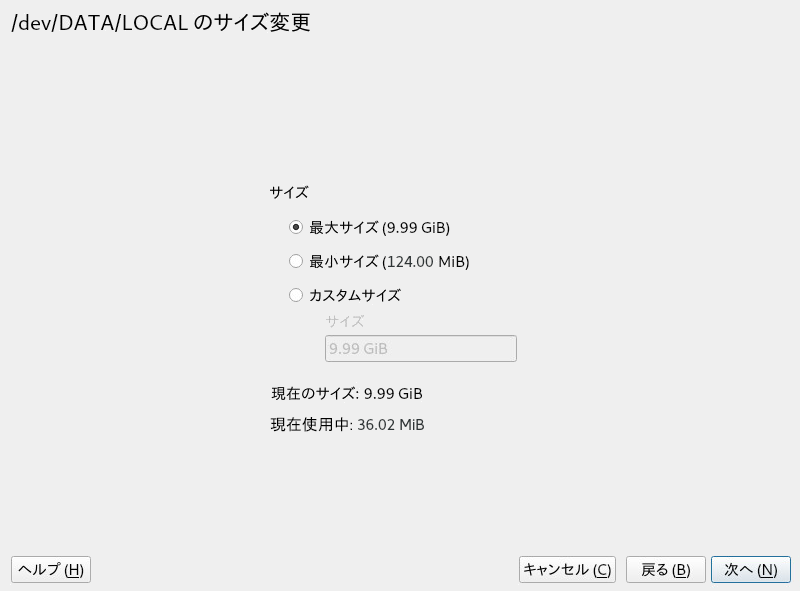

5.6 論理ボリュームのサイズ変更 #

ボリュームグループ内に利用可能な未使用の空き領域がある場合、論理ボリュームを拡張して使用可能な領域を増やすことができます。また、ボリュームのサイズを縮小してボリュームグループの領域を解放し、他の論理ボリュームで使用できるようにすることもできます。

ボリュームのサイズを縮小すると、そのファイルシステムのサイズもYaSTによって自動的に縮小されます。現在マウントされているボリュームのサイズを「オンライン」で(つまりマウント中に)変更できるかどうかは、ファイルシステムによって異なります。オンライン拡張をサポートするファイルシステムは、Btrfs、XFS、Ext3、およびExt4です。

オンライン縮小をサポートするファイルシステムは、Btrfsのみです。Ext2/3/4ファイルシステムを縮小するには、アンマウントする必要があります。XFSはファイルシステムの縮小をサポートしないため、XFSでフォーマットされたボリュームは縮小できません。

YaSTを起動してを開きます。

左のパネルで、を選択します。既存のボリュームグループのリストが右のパネルに表示されます。

変更する論理ボリュームを選択し、をクリックします。

次のオプションの1つを使用して目的のサイズを設定します。

最大サイズ. 論理ボリュームのサイズを、ボリュームグループの残り領域をすべて使用するよう拡張します。

最小サイズ. 論理ボリュームのサイズを、データおよびファイルシステムメタデータによって使用されているサイズまで縮小します。

カスタムサイズ. ボリュームの新しいサイズを指定します。上に表示されている最小値から最大値までの範囲内の値を指定する必要があります。キロバイトにはK、メガバイトにはM、ギガバイトにはG、テラバイトにはTをそれぞれ使用します(たとえば

20G)。

をクリックします。

をクリックし、変更が一覧されることを確認してから、をクリックします。

5.7 ボリュームグループまたは論理ボリュームの削除 #

ボリュームグループを削除すると、グループの各メンバーパーティションに含まれているデータがすべて破棄されます。論理ボリュームを削除すると、そのボリュームに保存されているデータがすべて破棄されます。

YaSTを起動してを開きます。

左のパネルで、を選択します。既存のボリュームグループのリストが右のパネルに表示されます。

削除するボリュームグループまたは論理ボリュームを選択して、をクリックします。

選択した内容に応じて警告ダイアログが表示されます。を選択して確認します。

をクリックして、削除されたボリュームグループが一覧表示されていることを確認します。削除は赤色フォントで示されます。をクリックします。

5.8 LVMコマンドの使用 #

LVMコマンドの使用の詳細については、次の表で説明されている各コマンドのマニュアルページを参照してください。すべてのコマンドはroot特権で実行する必要があります。sudo

COMMANDを使用するか(推奨)、直接rootとして実行します。

pvcreate DEVICELVMで物理ボリュームとして使用できるようにデバイス(

/dev/sdb1など)を初期化します。指定したデバイス上にファイルシステムが存在する場合、警告が表示されます。blkidがインストールされている場合にのみ(デフォルトでインストールされています)、pvcreateにより既存のファイルシステムの有無が確認されることを覚えておいてください。blkidが使用可能でない場合、pvcreateによって何も警告が生成されず、警告なしにファイルシステムが失われる場合があります。pvdisplay DEVICELVM物理ボリュームに関する情報(現在、論理ボリュームで使用中かどうかなど)を表示します。

-

vgcreate -c y VG_NAME DEV1 [DEV2...] 指定した1つ以上のデバイスでクラスタ化ボリュームグループを作成します。

-

vgcreate --activationmode ACTIVATION_MODE VG_NAME ボリュームグループのアクティブ化のモードを設定します。次のいずれかの値を指定できます。

complete- 欠落している物理ボリュームの影響を受けない論理ボリュームのみをアクティブ化できます。特定の論理ボリュームでそのような障害が許容される場合も、同様の処理が実行されます。degraded- デフォルトのアクティブ化モードです。論理ボリュームをアクティブ化するための十分なレベルの冗長性がある場合、一部の物理ボリュームが欠落していても、その論理ボリュームをアクティブ化できます。partial- LVMは、一部の物理ボリュームが欠落していても、ボリュームグループのアクティブ化を試みます。非冗長論理ボリュームから重要な物理ボリュームが欠落している場合、通常、その論理ボリュームはアクティブ化できず、エラーターゲットとして扱われます。

-

vgchange -a [ey|n] VG_NAME ボリュームグループおよびその論理ボリュームを入出力用にアクティブ(

-a ey)または非アクティブ(-a n)にします。クラスタ内のボリュームをアクティブ化する場合は、必ず

eyオプションを使用してください。ロードスクリプトではこのオプションがデフォルトで使用されます。vgremove VG_NAMEボリュームグループを削除します。このコマンドを使用する前に、論理ボリュームを削除してボリュームグループを非アクティブにしてください。

-

vgdisplay VG_NAME 指定したボリュームグループに関する情報を表示します。

ボリュームグループの合計物理エクステントを確認するには、次のように入力します。

>vgdisplay VG_NAME | grep "Total PE"-

lvcreate -L SIZE -n LV_NAME VG_NAME 指定したサイズの論理ボリュームを作成します。

-

lvcreate -L SIZE --thinpool POOL_NAME VG_NAME ボリュームグループ

VG_NAMEから、指定したサイズのシンプールmyPoolを作成します。次の例では、ボリュームグループ

LOCALから5GBのサイズのシンプールを作成します。>sudolvcreate -L 5G --thinpool myPool LOCAL-

lvcreate -T VG_NAME/POOL_NAME -V SIZE -n LV_NAME プールPOOL_NAME内にシン論理ボリュームを作成します。次の例では、ボリュームグループ

LOCAL上のプールmyPoolから1GBのシンボリュームmyThin1を作成します。>sudolvcreate -T LOCAL/myPool -V 1G -n myThin1-

lvcreate -T VG_NAME/POOL_NAME -V SIZE -L SIZE -n LV_NAME シンプールの作成とシン論理ボリュームの作成を1つのコマンドに結合することもできます。

>sudolvcreate -T LOCAL/myPool -V 1G -L 5G -n myThin1-

lvcreate --activationmode ACTIVATION_MODE LV_NAME 論理ボリュームのアクティブ化のモードを設定します。次のいずれかの値を指定できます。

complete- 論理ボリュームは、そのすべての物理ボリュームがアクティブな場合にのみアクティブ化できます。degraded- デフォルトのアクティブ化モードです。論理ボリュームをアクティブ化するための十分なレベルの冗長性がある場合、一部の物理ボリュームが欠落していても、その論理ボリュームをアクティブ化できます。partial- LVMは、一部の物理ボリュームが欠落していても、ボリュームのアクティブ化を試みます。この場合、論理ボリュームの一部が使用できなくなり、データが消失することがあります。このオプションは通常は使用しませんが、データを復元する場合に役立つことがあります。

activation_mode設定オプションの上記いずれかの値を指定することによって、/etc/lvm/lvm.confでアクティブ化モードを指定することもできます。-

lvcreate -s [-L SIZE] -n SNAP_VOLUME SOURCE_VOLUME_PATH VG_NAME 指定した論理ボリュームに対してスナップショットボリュームを作成します。サイズオプション(

-Lまたは--size)を指定しなかった場合、スナップショットはシンスナップショットとして作成されます。-

lvremove /dev/VG_NAME/LV_NAME 論理ボリュームを削除します。

このコマンドを使用する前に、論理ボリュームを

umountコマンドでアンマウントして閉じてください。-

lvremove SNAP_VOLUME_PATH スナップショットボリュームを削除します。

-

lvconvert --merge SNAP_VOLUME_PATH 論理ボリュームをスナップショットのバージョンに戻します。

-

vgextend VG_NAME DEVICE 指定したデバイス(物理ボリューム)を既存のボリュームグループに追加します。

-

vgreduce VG_NAME DEVICE 指定した物理ボリュームを既存のボリュームグループから削除します。

物理ボリュームが論理ボリュームによって使用中でないことを確認してください。使用中の場合は、

pvmoveコマンドを使用してデータを別の物理ボリュームに移動する必要があります。-

lvextend -L SIZE /dev/VG_NAME/LV_NAME 指定した論理ボリュームのサイズを拡張します。その後、新たに使用可能になった領域を使用するため、ファイルシステムを拡張する必要もあります。詳細については第2章 「ファイルシステムのサイズ変更」を参照してください。

-

lvreduce -L SIZE /dev/VG_NAME/LV_NAME 指定した論理ボリュームのサイズを縮小します。

ボリュームを縮小する前に、まずファイルシステムのサイズを縮小してください。そうしないと、データを失うリスクがあります。詳細については第2章 「ファイルシステムのサイズ変更」を参照してください。

-

lvrename /dev/VG_NAME/LV_NAME /dev/VG_NAME/NEW_LV_NAME 既存のLVM論理ボリュームの名前を変更します。ボリュームグループの名前は変更されません。

udevルールではなくLVMを使用してLVデバイスノードとシンボリックリンクを管理する場合は、次のいずれかの方法でudevからの通知を無効にすることによって可能になります。

/etc/lvm/lvm.confでactivation/udev_rules = 0およびactivation/udev_sync = 0を設定する。lvcreateコマンドで--nodevsyncを指定しても、activation/udev_sync = 0と同じ結果になります。この場合も、activation/udev_rules = 0の設定が必要です。環境変数

DM_DISABLE_UDEVを設定する。export DM_DISABLE_UDEV=1

この方法でも、udevからの通知が無効になります。さらに、

/etc/lvm/lvm.confのudev関連の設定はすべて無視されます。

5.8.1 コマンドによる論理ボリュームのサイズ変更 #

論理ボリュームのサイズ変更には、コマンドlvresize、lvextend、およびlvreduceが使用されます。構文とオプションについては、これらの各コマンドのマニュアルページを参照してください。LVを拡大するには、VG上に十分な未使用スペースがなければなりません。

論理ボリュームを拡大または縮小する場合、YaSTパーティショナを使用することをお勧めします。YaSTを使用すると、そのボリュームのファイルシステムのサイズも自動的に調整されます。

LVは使用中に手動で拡大または縮小できますが、LV上のファイルシステムについてはこれが不可能な場合があります。LVを拡大、縮小しても、そのボリューム内のファイルシステムのサイズは自動的に変更されません。後でファイルシステムを拡大するには、別のコマンドを使用する必要があります。ファイルシステムのサイズ変更の詳細については、第2章 「ファイルシステムのサイズ変更」を参照してください。

手動でLVのサイズを変更する場合は、次に示すように正しい順序に従ってください。

LVを拡大する場合は、ファイルシステムを拡大する前にLVを拡大する必要があります。

LVを縮小する場合は、LVを縮小する前にファイルシステムを縮小する必要があります。

論理ボリュームのサイズを拡張するには:

端末コンソールを開きます。

論理ボリュームにExt2またはExt4ファイルシステム(オンライン拡張がサポートされていません)が含まれる場合、マウント解除します。仮想マシン(Xen VMなど)用に提供されているファイルシステムが含まれている場合は、最初にVMをシャットダウンします。

端末コンソールのプロンプトに対して、次のコマンドを入力し、論理ボリュームのサイズを拡大します。

>sudolvextend -L +SIZE /dev/VG_NAME/LV_NAMESIZEの場合は、10GBのように、論理ボリュームに追加したい容量を指定してください。

/dev/VG_NAME/LV_NAMEを、/dev/LOCAL/DATAなどの論理ボリュームへのLinuxパスに入れ替えます。例:>sudolvextend -L +10GB /dev/vg1/v1ファイルシステムのサイズを調整します。詳細については第2章 「ファイルシステムのサイズ変更」を参照してください。

ファイルシステムをマウント解除した場合は、再びマウントします。

たとえば、LVをLV上の(マウント済みでアクティブな) Btrfsで10GB拡張するには:

>sudolvextend −L +10G /dev/LOCAL/DATA>sudobtrfs filesystem resize +10G /dev/LOCAL/DATA

論理ボリュームのサイズを縮小するには:

端末コンソールを開きます。

論理ボリュームにBtrfsファイルが含まれていない場合は、論理ボリュームをマウント解除します。仮想マシン(Xen VMなど)用に提供されているファイルシステムが含まれている場合は、最初にVMをシャットダウンします。XFSファイルシステムを使用しているボリュームのサイズは縮小できません。

ファイルシステムのサイズを調整します。詳細については第2章 「ファイルシステムのサイズ変更」を参照してください。

端末コンソールのプロンプトに対して、次のコマンドを入力し、論理ボリュームのサイズをファイルシステムのサイズまで縮小します。

>sudolvreduce /dev/VG_NAME/LV_NAMEファイルシステムをアンマウントしてあった場合は、再びマウントします。

たとえば、LVをLV上のBtrfsで5GB縮小するには:

>sudobtrfs filesystem resize -size 5G /dev/LOCAL/DATA sudo lvreduce /dev/LOCAL/DATA

SUSE Linux Enterprise Server 12 SP1から、lvextend、lvresize、およびlvreduceで--resizefsオプションがサポートされるようになりました。このオプションは、ボリュームのサイズを変更するだけでなく、ファイルシステムのサイズも変更します。したがって、上に示すlvextendおよびlvreduceの例は、次のように実行することもできます。

>sudolvextend --resizefs −L +10G /dev/LOCAL/DATA>sudolvreduce --resizefs -L -5G /dev/LOCAL/DATA

--resizefsは、ext2/3/4、Btrfs、およびXFSの各ファイルシステムでサポートされます。このオプションを使用したBtrfsのサイズ変更は、まだ上流では許可されていないため、SUSE Linux Enterprise Serverでのみ可能です。

5.8.2 LVMキャッシュボリュームの使用 #

LVMでは、大容量の低速なブロックデバイスに対して、高速なブロックデバイス(SSDデバイスなど)をライトバックキャッシュまたはライトスルーキャッシュとして使用できます。キャッシュ論理ボリュームタイプは、小容量の高速なLVを使用して、大容量の低速なLVのパフォーマンスを向上させます。

LVMキャッシングを設定するには、キャッシングデバイス上に2つの論理ボリュームを作成する必要があります。大容量の論理ボリュームはキャッシング自体に使用され、小容量のボリュームはキャッシングメタデータの保存に使用されます。これら2つのボリュームは、元のボリュームと同じボリュームグループに属している必要があります。これらのボリュームを作成したら、キャッシュプールに変換して元のボリュームに接続する必要があります。

元のボリュームがまだ存在しない場合は(低速なデバイス上に)作成します。

物理ボリュームを(高速なデバイスから)元のボリュームが属するボリュームグループに追加して、物理ボリューム上にキャッシュデータボリュームを作成します。

キャッシュメタデータボリュームを作成します。サイズは、キャッシュデータボリュームの1/1000にする必要があります。最小サイズは8MBです。

キャッシュデータボリュームとメタデータボリュームをキャッシュプールボリュームに結合します。

>sudolvconvert --type cache-pool --poolmetadata VOLUME_GROUP/METADATA_VOLUME VOLUME_GROUP/CACHING_VOLUMEキャッシュプールを元のボリュームに接続します。

>sudolvconvert --type cache --cachepool VOLUME_GROUP/CACHING_VOLUME VOLUME_GROUP/ORIGINAL_VOLUME

LVMキャッシングの詳細については、lvmcache(7)のマニュアルページを参照してください。

5.9 LVM2ストレージオブジェクトへのタグ付け #

タグは、ストレージオブジェクトのメタデータに割り当てられる順序付けのないキーワードまたは用語です。タグを使用すると、順序付けのないタグのリストをLVMストレージオブジェクトのメタデータに添付することによって、それらのオブジェクトのコレクションを有用になるように分類できます。

5.9.1 LVM2タグの使用 #

LVM2ストレージオブジェクトにタグを付けたら、それらのタグをコマンドで使用して、次のタスクを達成できます。

特定のタグの有無に応じて、処理するLVMオブジェクトを選択します。

設定ファイル内でタグを使用することにより、サーバ上でアクティブにするボリュームグループと論理ボリュームを制御します。