- SUSE Edge 3.4ドキュメント

- I クイックスタート

- II コンポーネント

- 5 Rancher

- 6 Rancher Dashboard拡張機能

- 7 Rancher Turtles

- 8 Fleet

- 9 SUSE Linux Micro

- 10 Metal3

- 11 Edge Image Builder

- 12 Edgeネットワーキング

- 13 Elemental

- 14 K3s

- 15 RKE2

- 16 SUSE Storage

- 17 SUSE Security

- 18 MetalLB

- 19 Endpoint Copier Operator

- 20 Edge Virtualization

- 21 System Upgrade Controller

- 22 Upgrade Controller

- 23 SUSE Multi-Linux Manager

- III ハウツーガイド

- IV ヒントとコツ

- V サードパーティの統合

- VI Day 2操作

- VII SUSE Telco Cloudのドキュメント

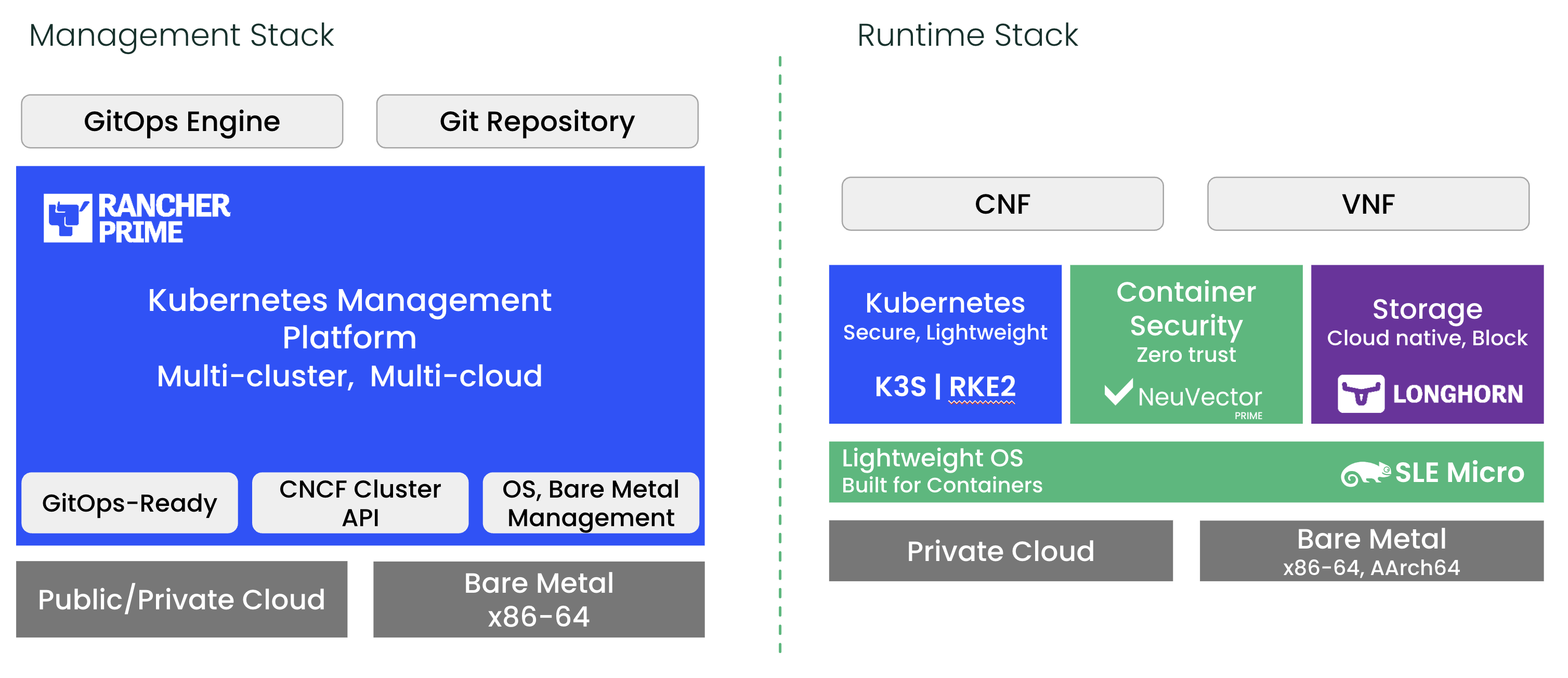

- 37 SUSE Telco Cloud

- 38 コンセプトとアーキテクチャ

- 39 要件と前提

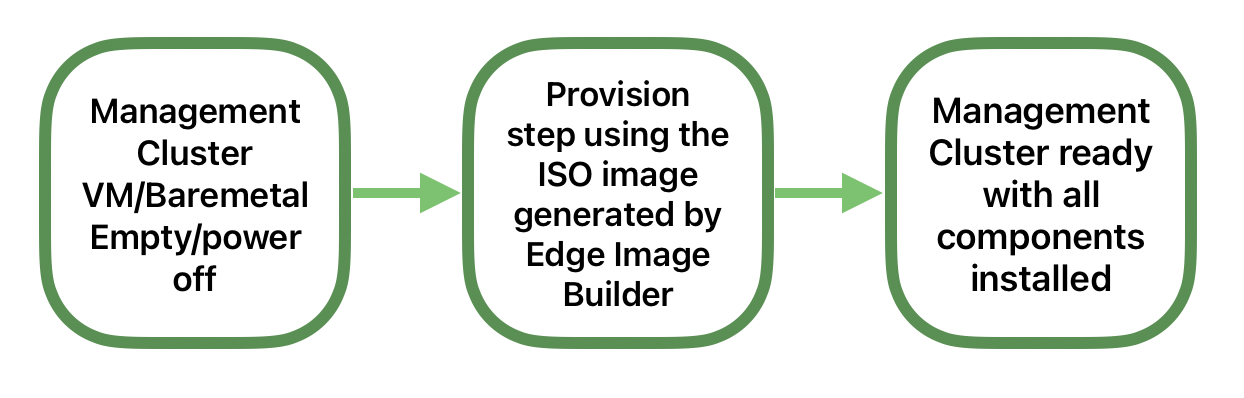

- 40 管理クラスタの設定

- 41 通信機能の設定

- 42 完全に自動化されたダイレクトネットワークプロビジョニング

- 42.1 はじめに

- 42.2 接続シナリオのダウンストリームクラスタイメージの準備

- 42.3 エアギャップシナリオ用のダウンストリームクラスタイメージの準備

- 42.4 ダイレクトネットワークプロビジョニングを使用したダウンストリームクラスタのプロビジョニング(シングルノード)

- 42.5 ダイレクトネットワークプロビジョニングを使用したダウンストリームクラスタのプロビジョニング(マルチノード)

- 42.6 高度なネットワーク設定

- 42.7 通信機能(DPDK、SR-IOV、CPUの分離、Huge Page、NUMAなど)

- 42.8 プライベートレジストリ

- 42.9 エアギャップシナリオでのダウンストリームクラスタのプロビジョニング

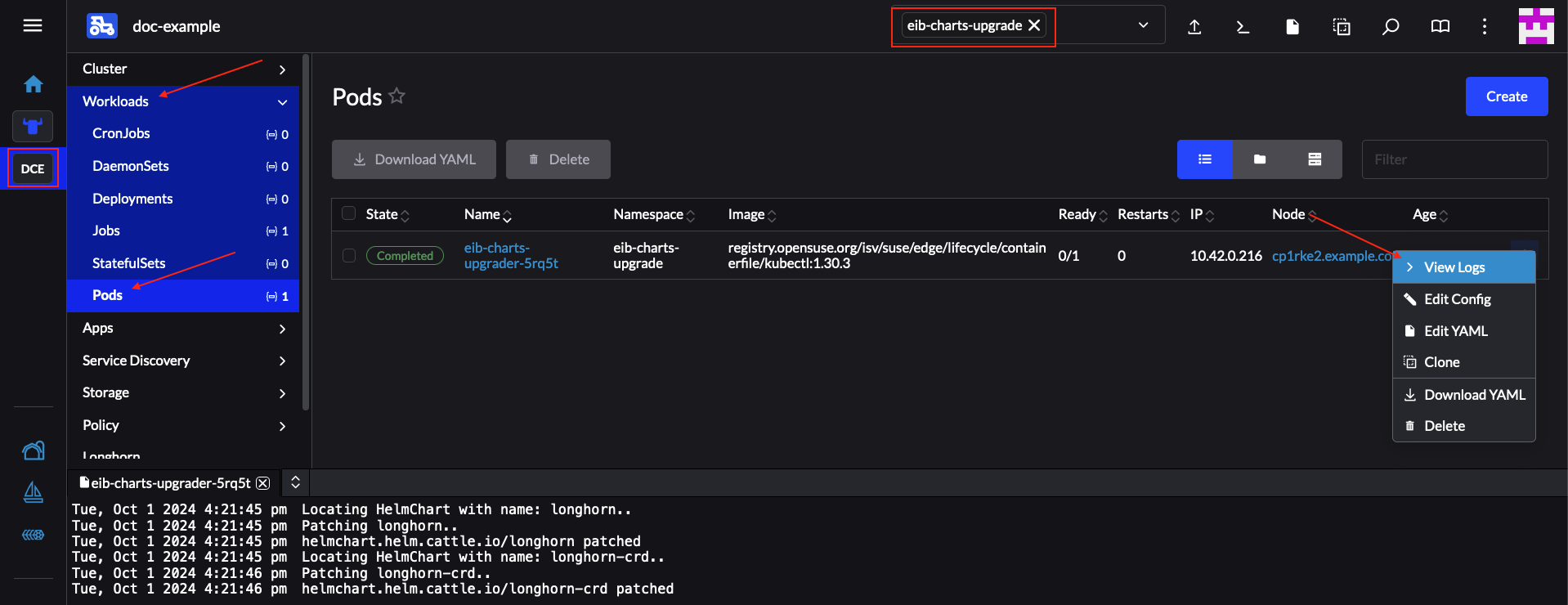

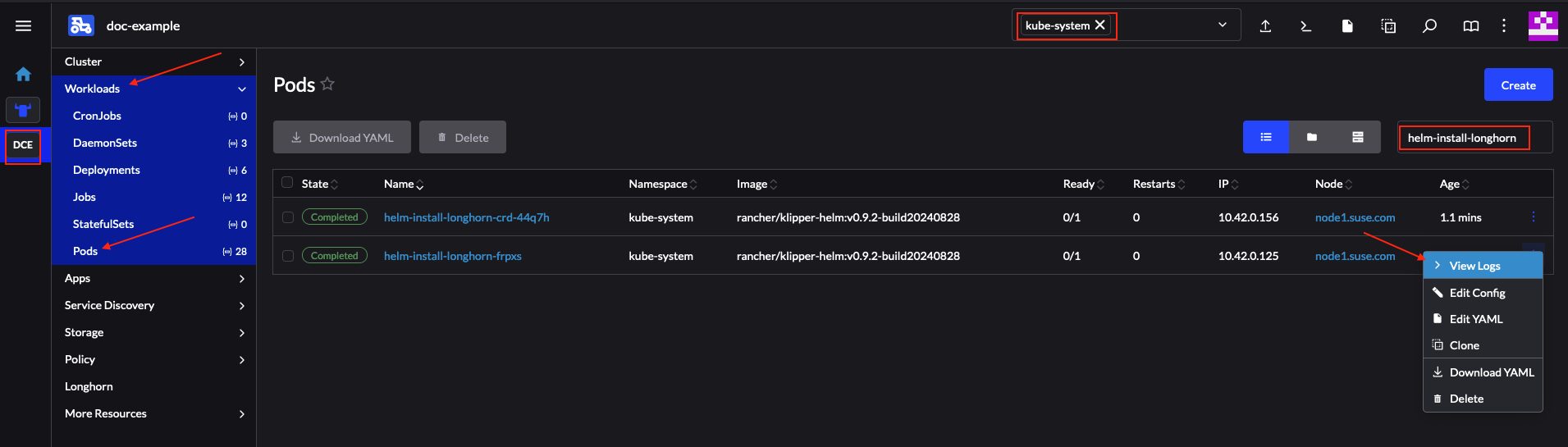

- 43 ライフサイクルのアクション

- VIII トラブルシューティング

- IX 付録

SUSE Edge 3.4ドキュメント #

『SUSE Edgeドキュメント』をお読みいただきありがとうございます。このドキュメントには、高レベルアーキテクチャの概要、クイックスタートガイド、検証済みの設計、コンポーネントの使用に関するガイダンス、サードパーティ統合、エッジコンピューティングインフラストラクチャとワークロードを管理するためのベストプラクティスが記載されています。

1 SUSE Edgeとは #

SUSE Edgeは、インフラストラクチャとクラウドネイティブなアプリケーションをエッジにデプロイするという独自の課題に対処することに特化した、緊密に統合されて包括的に検証されたエンドツーエンドのソリューションです。SUSE Edgeが重点を置いているのは、独創的でありながら高い柔軟性とスケーラビリティを持つセキュアなプラットフォームを提供し、初期デプロイメントイメージの構築からノードのプロビジョニングとオンボーディング、アプリケーションのデプロイメント、可観測性、ライフサイクル全体の運用にまで対応することです。このプラットフォームは、最良のオープンソースソフトウェアに基づいてゼロから構築されており、SUSEが持つ、30年にわたってセキュアで安定した定評あるSUSE Linuxプラットフォームを提供してきた歴史と、Rancherポートフォリオによって拡張性に優れ機能豊富なKubernetes管理を提供してきた経験の両方に合致するものです。SUSE Edgeは、これらの機能の上に構築されており、小売、医療、輸送、物流、通信、スマート製造、産業用IoTなど、さまざまな市場セグメントに対応できる機能を提供します。

2 設計理念 #

このソリューションは、顧客の要件や期待はさまざまであるため「万能」なエッジプラットフォームは存在しないという考え方に基づいて設計されています。エッジデプロイメントにより、実に困難な問題を解決し、継続的に進化させることが要求されます。たとえば、大規模なスケーラビリティ、ネットワークの可用性の制限、物理的なスペースの制約、新たなセキュリティの脅威と攻撃ベクトル、ハードウェアアーキテクチャとシステムリソースのバリエーション、レガシインフラストラクチャやレガシアプリケーションのデプロイとインタフェースの要件、耐用年数を延長している顧客ソリューションといった課題があります。こうした課題の多くは、従来の考え方(たとえば、データセンター内やパブリッククラウドへのインフラストラクチャやアプリケーションのデプロイメント)とは異なるため、はるかに細かく設計を検討し、一般的な前提の多くを再検討する必要があります。

たとえば、SUSEはミニマリズム、モジュール性、操作のしやすさに価値を見出しています。システムは複雑化するほど故障しやすくなるため、エッジ環境ではミニマリズムが重要です。数百、数十万カ所に及ぶとなると、複雑なシステムは複雑な故障が発生します。また、SUSEのソリューションはモジュール性を備えているため、ユーザの選択肢を増やしながら、デプロイしたプラットフォームが不必要に複雑になることを解消できます。さらに、ミニマリズムおよびモジュール性と、操作のしやすさとのバランスを取ることも必要です。人間はプロセスを何千回も繰り返すとミスを犯す可能性があるため、プラットフォーム側で潜在的なミスを確実に回復し、技術者が現場に出向かなくても済むようにすると同時に、一貫性と標準化を実現するよう努める必要もあります。

3 高レベルアーキテクチャ #

SUSE Edgeの高レベルシステムアーキテクチャは、「管理」クラスタと「ダウンストリーム」クラスタの2つのコアカテゴリに分けられます。管理クラスタは1つまたは複数のダウンストリームクラスタのリモート管理を担当しますが、特定の状況下では、ダウンストリームクラスタはリモート管理なしで動作する必要があります。たとえば、エッジサイトに外部接続がない場合や独立して動作する必要がある場合などです。SUSE Edgeでは、管理クラスタとダウンストリームクラスタの両方の動作に利用される技術コンポーネントは大部分が共通していますが、システム仕様と最上位に位置するアプリケーションが異なる場合があります。すなわち管理クラスタはシステム管理とライフサイクル操作を有効にするアプリケーションを実行しますが、ダウンストリームクラスタはユーザアプリケーションを提供するための要件を満たします。

3.1 SUSE Edgeで使用されるコンポーネント #

SUSE Edgeは、既存のSUSEとRancherのコンポーネントと、エッジコンピューティングに必要な制約や複雑さに対応できるようにEdgeチームが構築した追加機能とコンポーネントで構成されています。管理クラスタとダウンストリームクラスタの両方で使用されるコンポーネントは、高レベルなアーキテクチャ図とともに以下に説明しますが、これは網羅的なリストではないことに注意してください。

3.1.1 管理クラスタ #

管理: これは、接続されたダウンストリームクラスタのプロビジョニングとライフサイクルの管理に使用されるSUSE Edgeの中核です。管理クラスタには通常、以下のコンポーネントが含まれます。

Rancher Prime (第5章 「Rancher」)によるマルチクラスタ管理により、ダウンストリームクラスタのオンボーディングとインフラストラクチャおよびアプリケーションの継続的なライフサイクル管理のための共通ダッシュボードが可能になり、包括的なテナント分離と

IDP(アイデンティティプロバイダ)統合、サードパーティの統合および拡張のための大規模なマーケットプレイス、ベンダニュートラルなAPIも提供されます。SUSE Multi-Linux Managerを使用したLinuxシステム管理により、ダウンストリームクラスタ上で実行される基礎となるLinuxオペレーティングシステム(*SUSE Linux Micro (第9章 「SUSE Linux Micro」))の自動的なLinuxパッチおよび設定管理が可能になります。このコンポーネントはコンテナ化されていますが、現時点では他の管理コンポーネントとは別のシステムで実行する必要があるため、上の図では「Linux管理」とラベル付けされています。

特定のSUSE Edgeリリースへの管理クラスタコンポーネントのアップグレードを処理する専用のライフサイクル管理(第22章 「Upgrade Controller」)コントローラ。

Elemental (第13章 「Elemental」)を使用したRancher Primeへのリモートシステムのオンボーディングにより、接続されたエッジノードを目的のKubernetesクラスタに遅延バインディングしたり、GitOps経由でアプリケーションをデプロイメントしたりできます。

Metal3 (第10章 「Metal3」)、MetalLB (第18章 「MetalLB」)、および

CAPI(Cluster API)インフラストラクチャプロバイダによるオプションの完全なベアメタルライフサイクルおよび管理サポートにより、リモート管理機能を備えたベアメタルシステムの完全なエンドツーエンドのプロビジョニングが可能になります。ダウンストリームクラスタとそれらに存在するアプリケーションのプロビジョニングとライフサイクルの管理のためのFleet (第8章 「Fleet」)と呼ばれるオプションのGitOpsエンジン。

管理クラスタ自体を支えるのは、ベースオペレーティングシステムとしてのSUSE Linux Micro (第9章 「SUSE Linux Micro」)と、管理クラスタアプリケーションをサポートするKubernetesディストリビューションとしてのRKE2 (第15章 「RKE2」)です。

3.1.2 ダウンストリームクラスタ #

ダウンストリーム: これは、エッジでユーザワークロードを実行するために使用されるSUSE Edgeの分散部分です。つまり、エッジの場所自体で実行されるソフトウェアであり、通常は次のコンポーネントで構成されます。

K3s (第14章 「K3s」)やRKE2 (第15章 「RKE2」)などのセキュアで軽量なディストリビューションを含む、Kubernetesディストリビューションの選択肢(

RKE2は、政府機関や規制産業での使用に耐えるように強化、認定、最適化されています)。SUSE Security (第17章 「SUSE Security」)を使用するとイメージ脆弱性スキャン、ディープパケットインスペクション、リアルタイム脅威および脆弱性保護のようなセキュリティ機能が有効になります。

SUSE Storage (第16章 「SUSE Storage」)によるソフトウェアブロックストレージにより、軽量で永続的、弾力性があり、拡張可能なブロックストレージが可能になります。

SUSE Linux Micro (第9章 「SUSE Linux Micro」)を搭載した、軽量でコンテナに最適化された堅牢なLinuxオペレーティングシステムで、エッジでのコンテナや仮想マシンの実行に不変で耐障害性に優れたOSを提供します。SUSE Linux Microは、AArch64およびAMD64/Intel 64アーキテクチャの両方で使用でき、レイテンシの影響を受けやすいアプリケーション(通信事業者のユースケースなど)向けの

リアルタイムカーネルもサポートしています。接続されたクラスタ(つまり、管理クラスタに接続しているクラスタ)には、Rancher Primeへの接続を管理するためのRancher System Agentと、SUSE Multi-Linux Managerからの指示を受けてLinuxソフトウェアの更新を適用するためのvenv-salt-minionの2つのエージェントがデプロイされます。これらのエージェントは、切断されたクラスタの管理には必要ありません。

3.2 接続 #

上記のイメージは、接続されたダウンストリームクラスタと、それらの管理クラスタへの接続に関する高レベルアーキテクチャの概要を示しています。管理クラスタは、ダウンストリームクラスタとターゲット管理クラスタとの間のネットワーキングの可用性に応じて、オンプレミスとクラウドの両方の容量で、さまざまな基礎となるインフラストラクチャプラットフォーム上にデプロイできます。これが機能するための唯一の要件は、ダウンストリームクラスタノードを管理インフラストラクチャに接続するネットワークでアクセス可能なAPIとコールバックURLです。

この接続が確立されるメカニズムは、ダウンストリームクラスタのデプロイメントのメカニズムとは異なるものであることを認識することが重要です。この詳細については、次のセクションでさらに詳しく説明しますが、基本的な理解を深めるために、接続されたダウンストリームクラスタが「管理」クラスタとして確立される主なメカニズムは3つあります。

ダウンストリームクラスタはまず「切断された」容量でデプロイされ(Edge Image Builder (第11章 「Edge Image Builder」)経由)、接続が許可されると、管理クラスタにインポートされます。

ダウンストリームクラスタは、組み込みオンボーディングメカニズム(たとえばElemental (第13章 「Elemental」)経由)を使用するように設定され、初回ブート時に管理クラスタに自動的に登録されるため、クラスタ設定の遅延バインディングが許可されます。

ダウンストリームクラスタにはベアメタル管理機能(CAPI + Metal3)がプロビジョニングされており、クラスタがデプロイされ、設定されると(Rancher Turtlesオペレータ経由)管理クラスタに自動的にインポートされます。

大規模なデプロイメントの規模に対応し、地理的に分散した環境における帯域幅とレイテンシの問題を最適化し、停止時や管理クラスタのアップグレード時の混乱を最小限に抑えるために、複数の管理クラスタを実装することが推奨されます。現在の管理クラスタのスケーラビリティの限界とシステム要件については、こちらをご覧ください。

4 一般的なEdgeデプロイメントパターン #

動作環境とライフサイクル要件はさまざまであるため、SUSEでは、SUSE Edgeを運用する市場セグメントやユースケースに大まかに一致する別個のデプロイメントパターンを多数サポートしています。また、これらの各デプロイメントパターンに対応するクイックスタートガイドを作成し、ユーザのニーズに基づいてSUSE Edgeプラットフォームに習熟できるようにしています。以下に、現在サポートされている3つのデプロイメントパターンを、各クイックスタートページへのリンクとともに説明します。

4.1 ダイレクトネットワークプロビジョニング #

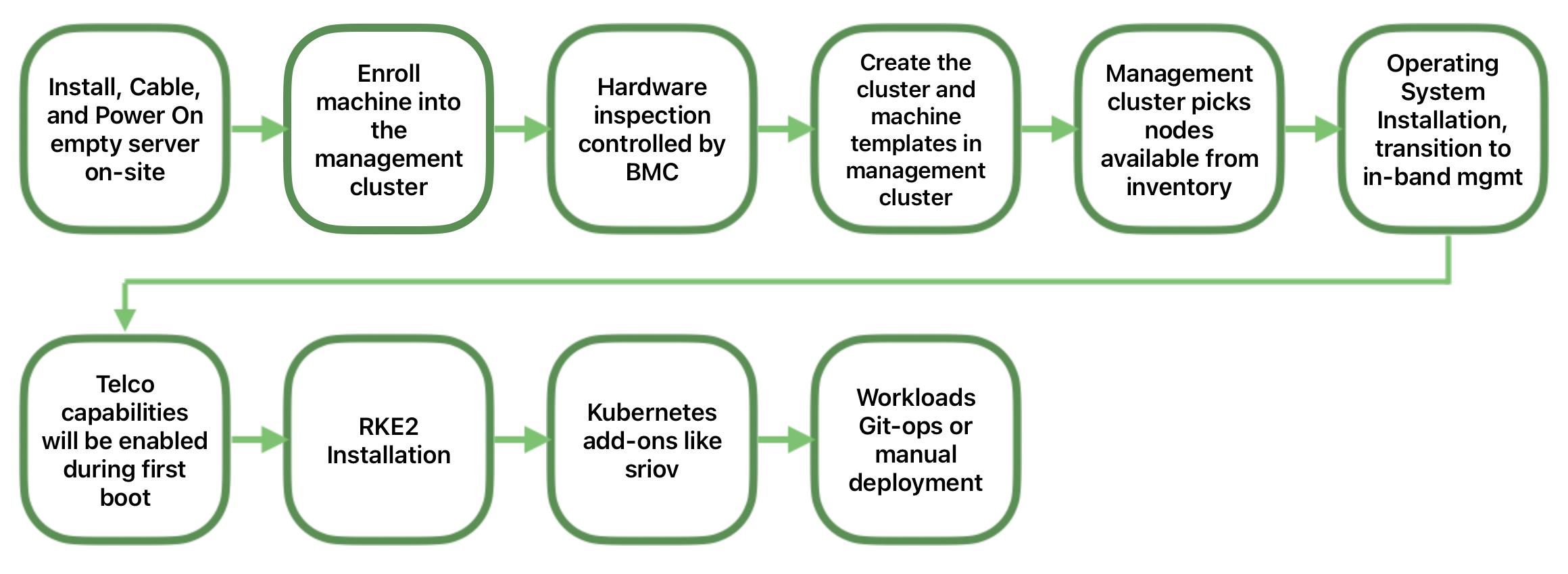

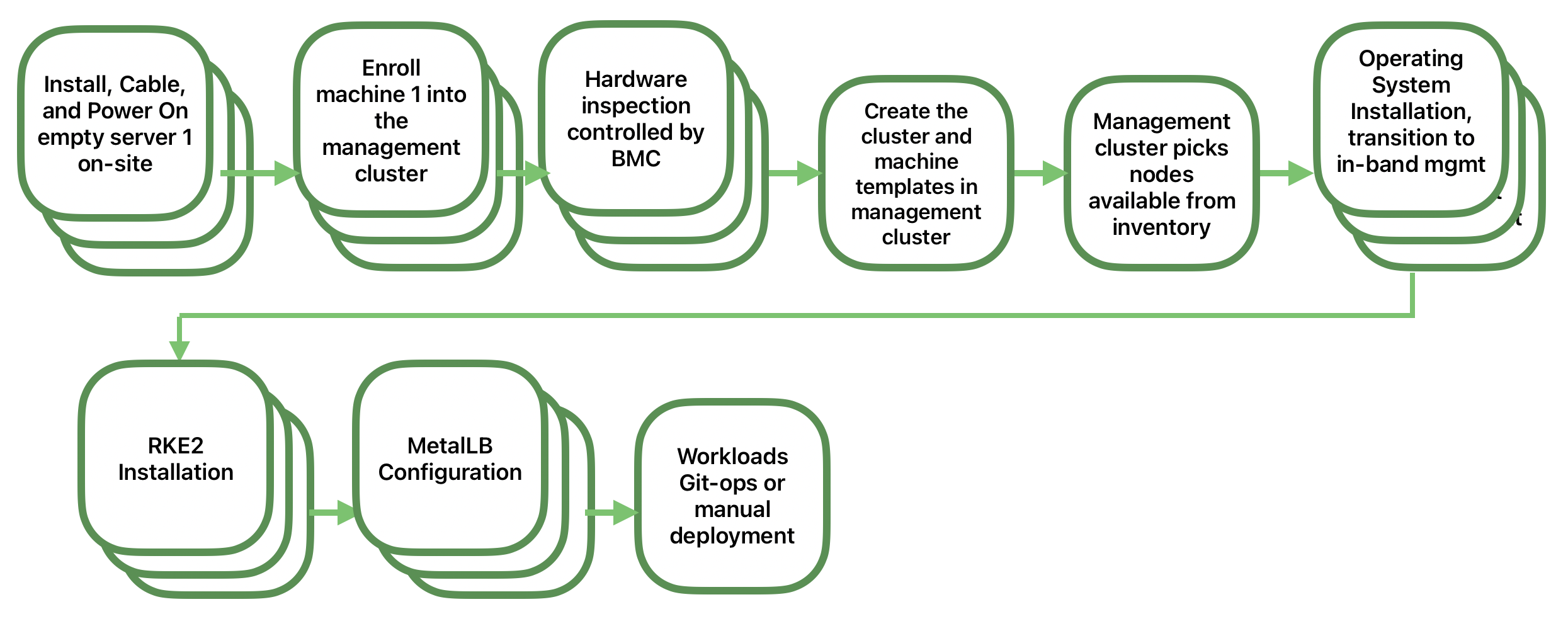

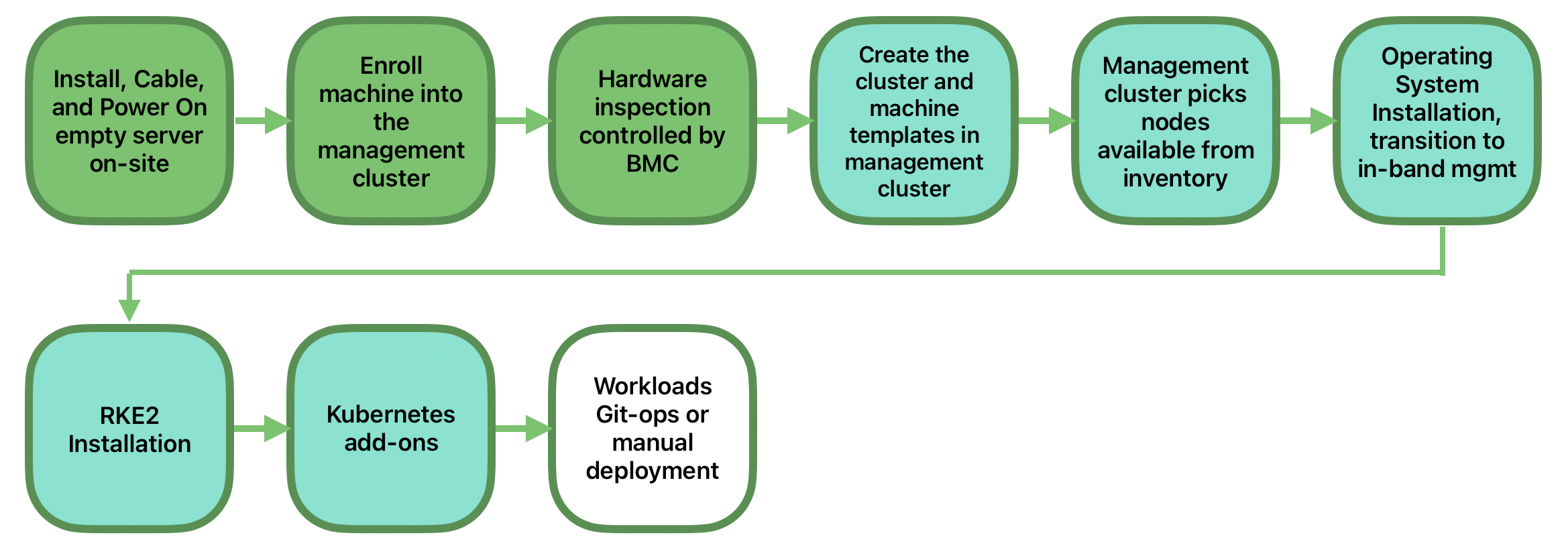

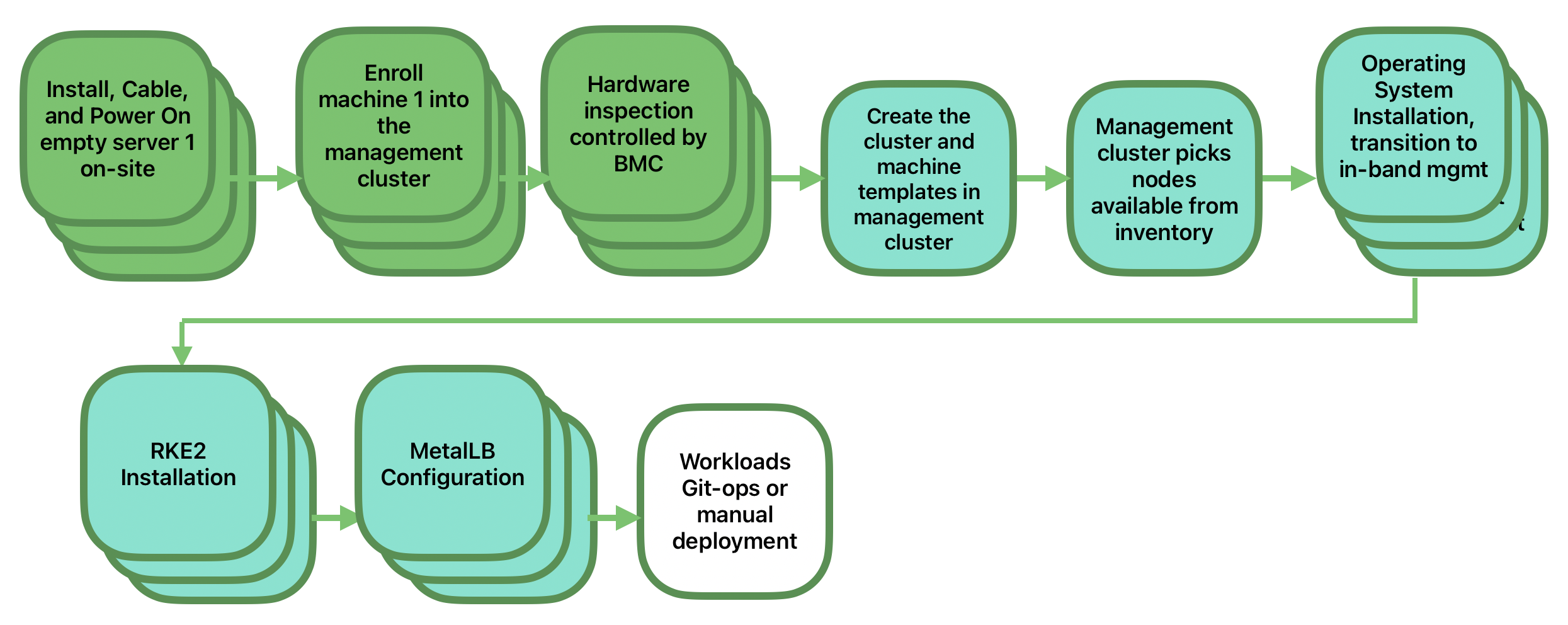

ダイレクトネットワークプロビジョニングでは、デプロイ先のハードウェアの詳細がわかっている場合に、アウトオブバンド管理インタフェースに直接アクセスして、プロビジョニングプロセス全体をオーケストレーションして自動化します。このシナリオで顧客が期待するソリューションとは、エッジサイトを一元的な場所から完全に自動化してプロビジョニングすることができ、ブートイメージの作成をはるかに上回る機能を備えていて、エッジロケーションでの手動操作を最小限に抑えられるソリューションです。つまり、ラックに搭載して電源をオンにし、必要なネットワークを物理ハードウェアに接続するだけで、自動化プロセスによってアウトオブバンド管理(Redfish APIなど)を介してマシンの電源が投入され、ユーザの介入なしにインフラストラクチャのプロビジョニング、オンボーディング、デプロイメントが処理されるソリューションです。これが機能するための鍵は、管理者がシステムを把握している、つまりどのハードウェアがどこにあるかを管理者が把握していることと、デプロイメントが中央で処理されることが想定されていることです。

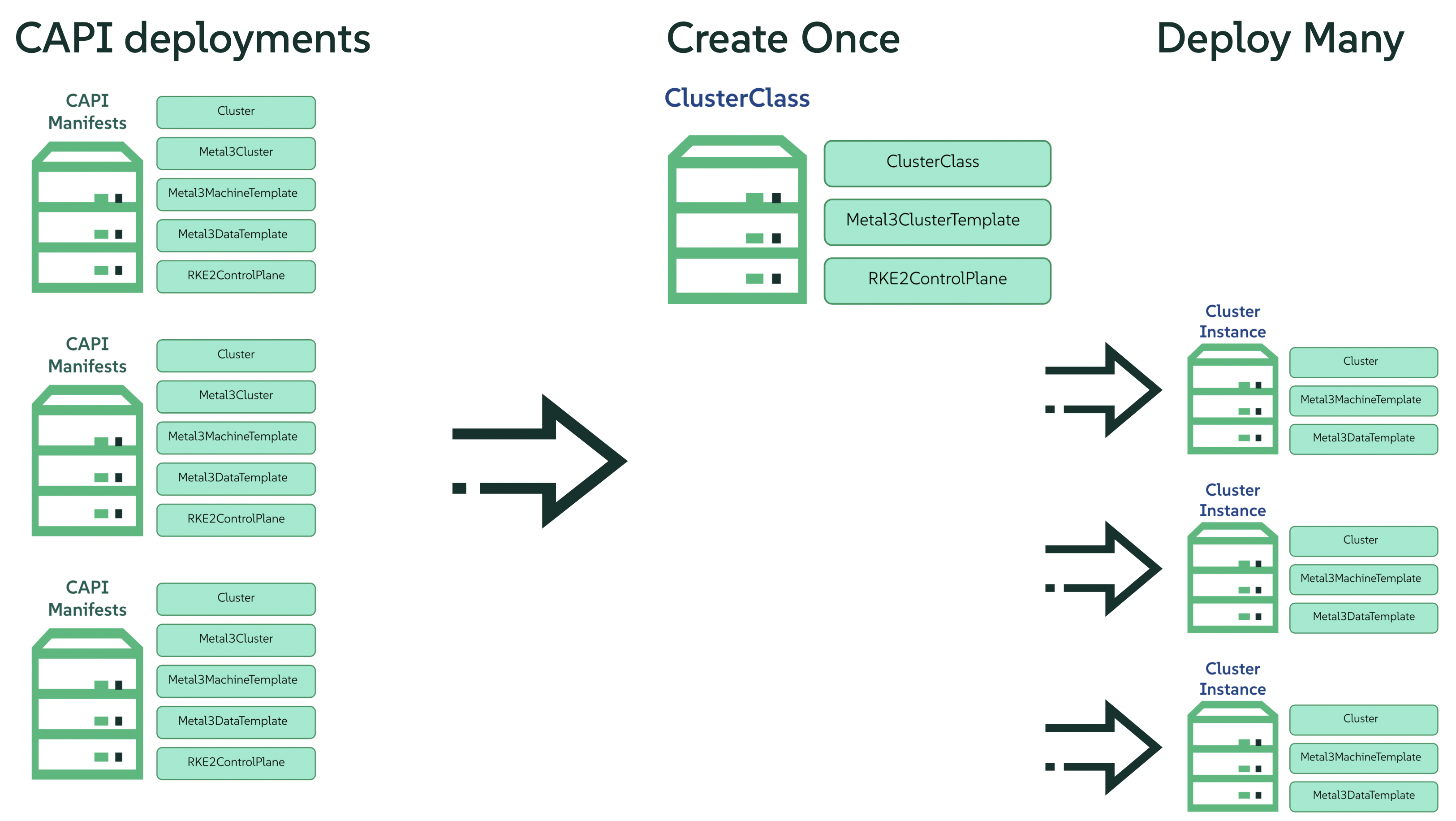

このソリューションは最も堅牢です。管理者がハードウェアの管理インタフェースを直接操作して既知のハードウェアを扱うことに加え、ネットワークの利用可否に対する制約が少ないためです。機能面では、このソリューションは、Cluster APIとMetal3を広範に使用して、ベアメタルからオペレーティングシステム、Kubernetes、階層化アプリケーションまでを自動プロビジョニングし、デプロイメント後にSUSE Edgeの他の一般的なライフサイクル管理機能にリンクする機能を提供します。このソリューションのクイックスタートについては、第1章 「Metal3を使用したBMCの自動デプロイメント」を参照してください。

4.2 「Phone Home」ネットワークプロビジョニング #

場合によっては、中央管理クラスタでハードウェアを直接管理できない環境で運用することがあります(たとえば、リモートネットワークがファイアウォールの背後にある場合や、アウトオブバンド管理インタフェースがない場合などがあり、エッジでよく見られる「PC」タイプのハードウェアで一般的です)。このシナリオの場合のために、SUSEでは、ハードウェアのブートストラップ時にその配置先がわかっていなくても、クラスタとそのワークロードをリモートでプロビジョニングできるツールを提供しています。エッジコンピューティングについて考える場合、ほとんどの人はこう考えます。エッジコンピューティングとは、不明な部分がある数千あるいは数万台のシステムがエッジロケーションで起動し、安全にPhone Home通信を行い、そのシステムの身元を検証し、実行すべき処理についての指示を受信することです。ここで要件として期待されるのは、工場でマシンを事前イメージングしたり、USBなどでブートイメージをアタッチしたりする以外には、ユーザがほとんど介入しなくてもプロビジョニングとライフサイクル管理ができることです。この領域での主な課題は、こうしたデバイスの規模、一貫性、セキュリティ、ライフサイクルに対処することです。

このソリューションでは、非常に柔軟で一貫性のある方法でシステムをプロビジョニングおよびオンボーディングできます。システムの場所、タイプや仕様、初回電源投入日時などは問いません。SUSE Edgeでは、Edge Image Builderを使用してシステムを非常に柔軟にカスタマイズできます。また、ノードのオンボーディングとKubernetesのプロビジョニングにはRancherのElementalが提供する登録機能を活用するとともに、オペレーティングシステムへのパッチの適用にはSUSE Multi-Linux Managerを活用します。このソリューションのクイックスタートについては、第2章 「Elementalを使用したリモートホストのオンボーディング」を参照してください。

4.3 イメージベースのプロビジョニング #

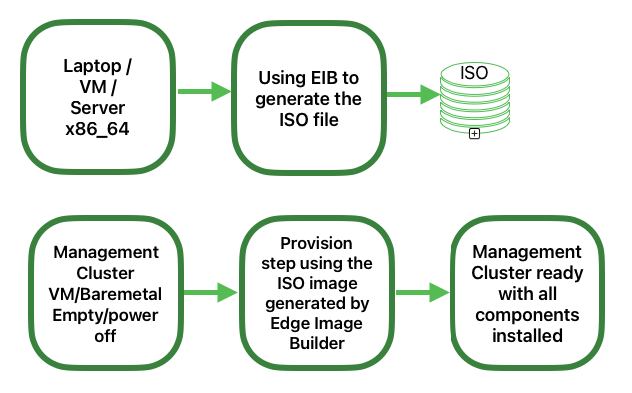

スタンドアロン環境、エアギャップ環境、またはネットワークが制限された環境で運用する必要があるお客様向けに、SUSE Edgeでは、必要なデプロイメントアーティファクトがすべて含まれる、完全にカスタマイズされたインストールメディアを生成できるソリューションを提供しています。これにより、シングルノードとマルチノード両方の高可用性Kubernetesクラスタを、必要なワークロードと追加の階層化コンポーネントを含めてエッジに設定できます。これはすべて、外部とのネットワーク接続や集中管理プラットフォームの介入なしに行うことができます。ユーザエクスペリエンスは、インストールメディアをターゲットシステムに提供するという点では「Phone Home」ソリューションによく似ていますが、このソリューションは「インプレースでブートストラップ」する点が異なります。このシナリオでは、生成されたクラスタをRancherに接続して継続的に管理する(つまり、大幅な再設定や再デプロイメントなしに、「非接続」動作モードから「接続」動作モードに移行する)ことも、分離した状態のまま動作を続行することもできます。どちらの場合も、一貫した同じメカニズムを適用してライフサイクル操作を自動化できることに注意してください。

さらに、このソリューションを使用すると、「ダイレクトネットワークプロビジョニング」モデルと「Phone Homeネットワークプロビジョニング」モデルの両方をサポートする集中型インフラストラクチャをホストできる管理クラスタを迅速に作成することもできます。この方法では、あらゆるタイプのエッジインフラストラクチャを最も迅速・簡単にプロビジョニングできます。このソリューションでは、SUSE Edge Image Builderの機能を多用して、完全にカスタマイズされた無人インストールメディアを作成します。クイックスタートについては、第3章 「Edge Image Builderを使用したスタンドアロンクラスタ」を参照してください。

5 SUSE Edge Stack Validation #

すべてのSUSE Edgeリリースは、緊密に統合され、徹底的に検証されたコンポーネントで構成されており、1 つのバージョンとして管理されています。コンポーネント間の統合をテストするだけでなく、強制的な障害シナリオ下でシステムが期待どおりに動作することを保証する継続的な統合とスタック検証の一環として、SUSE Edgeチームはすべてのテスト実行と結果を公開しています。結果とすべての入力パラメータはci.edge.suse.comでご確認いただけます。

6 コンポーネントの全リスト #

コンポーネントの全リストと、各コンポーネントの概要説明へのリンク、およびSUSE Edgeでの使用方法については、以下をご覧ください。

Rancher (第5章 「Rancher」)

Rancher Dashboard拡張機能(第6章 「Rancher Dashboard拡張機能」)

Rancher Turtles (第7章 「Rancher Turtles」)

SUSE Multi-Linux Manager

Fleet (第8章 「Fleet」)

SUSE Linux Micro (第9章 「SUSE Linux Micro」)

Metal³ (第10章 「Metal3」)

Edge Image Builder (第11章 「Edge Image Builder」)

NetworkManager Configurator (第12章 「Edgeネットワーキング」)

Elemental (第13章 「Elemental」)

K3s (第14章 「K3s」)

RKE2 (第15章 「RKE2」)

SUSE Storage (第16章 「SUSE Storage」)

SUSE Security (第17章 「SUSE Security」)

MetalLB (第18章 「MetalLB」)

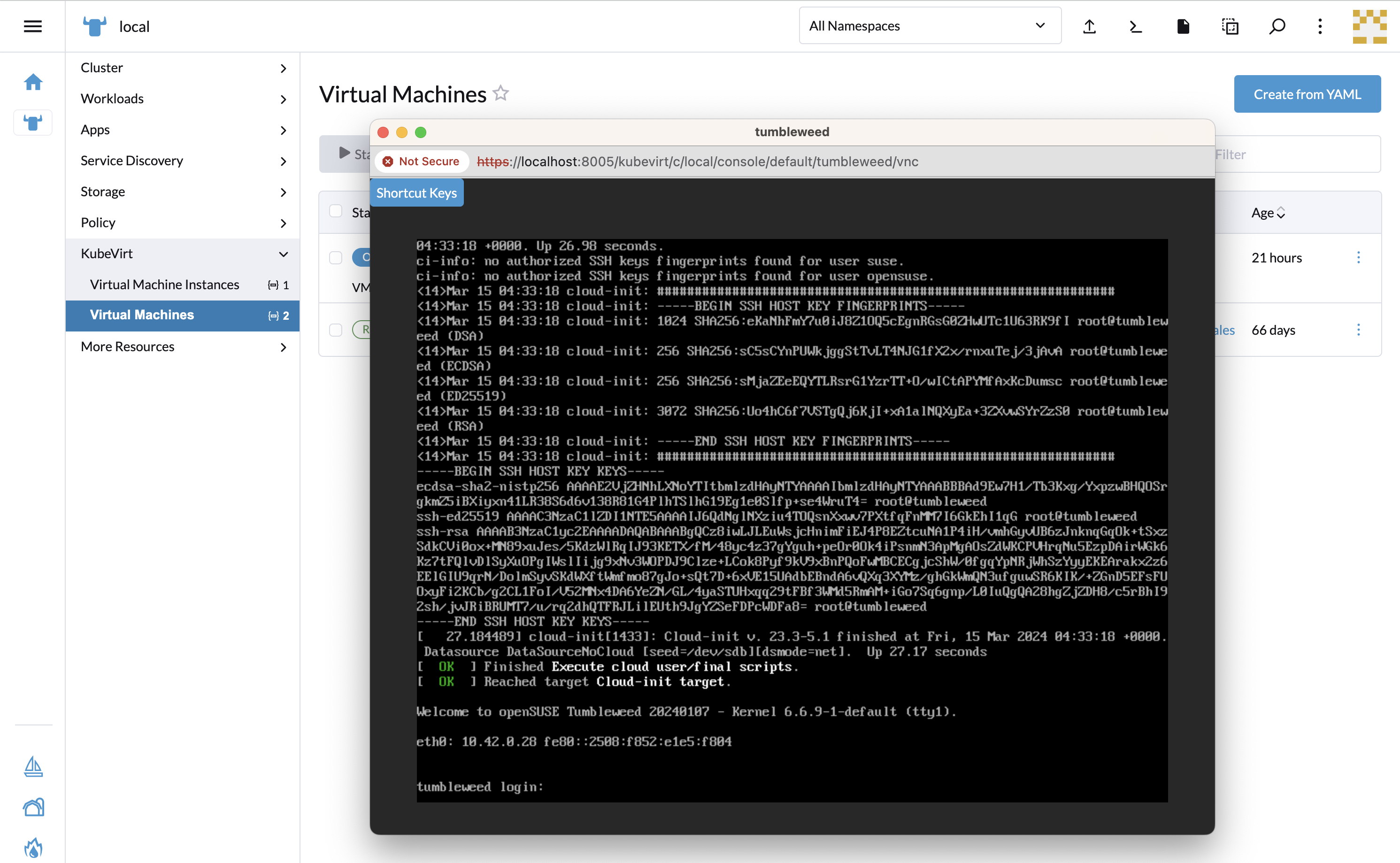

KubeVirt (第20章 「Edge Virtualization」)

System Upgrade Controller (第21章 「System Upgrade Controller」)

Upgrade Controller (第22章 「Upgrade Controller」)

パート I クイックスタート #

クイックスタートはこちら

- 1 Metal3を使用したBMCの自動デプロイメント

Metal3は、Kubernetesにベアメタルインフラストラクチャ管理機能を提供するCNCFプロジェクトです。

- 2 Elementalを使用したリモートホストのオンボーディング

このセクションでは、SUSE Edgeの一部としての「Phone Homeネットワークプロビジョニング」ソリューションについて説明します。このソリューションは、Elementalを使用してノードのオンボーディングを支援します。Elementalは、Kubernetesを使用してリモートホスト登録と一元化された完全なクラウドネイティブOS管理を可能にするソフトウェアスタックです。SUSE Edgeスタックでは、Elementalの登録機能を使用して、リモートホストをRancherにオンボーディングできます。これにより、ホストを集中管理プラットフォームに統合し、そこからKubernetesクラスタ…

- 3 Edge Image Builderを使用したスタンドアロンクラスタ

Edge Image Builder (EIB)は、完全なエアギャップシナリオでもマシンをブートストラップできるCustomized, Ready-to-Boot (CRB)ディスクイメージの生成プロセスを効率化するツールです。EIBを使用すると、SUSE Edgeの3つのデプロイメントフットプリントすべてで使用するデプロイメントイメージを作成できます。これは、EIBが十分に柔軟であり、最小限のカスタマイズ(例: ユーザの追加やタイムゾーンの設定)から、あらゆる設定を網羅したイメージ(例: 複雑なネットワーク設定を行い、マルチノードKubernetesクラスタをデプロイして、顧客ワークロードを…

- 4 SUSE Multi-Linux Manager

SUSE Multi-Linux ManagerはSUSE Edgeに含まれており、エッジデプロイメントのすべてのノードでSUSE Linux Microを基盤となるオペレーティングシステムとして常に最新の状態に保つための自動化と制御を提供します。また、エッジノード上のKubernetesとKubernetes上にデプロイされたアプリケーションの管理にも使用できます。

1 Metal3を使用したBMCの自動デプロイメント #

Metal3は、Kubernetesにベアメタルインフラストラクチャ管理機能を提供するCNCFプロジェクトです。

Metal3は、Redfishなどのアウトオブバンドプロトコルを介した管理をサポートするベアメタルサーバのライフサイクルを管理するためのKubernetesネイティブリソースを提供します。

また、Cluster API (CAPI)も十分にサポートされており、広く採用されているベンダニュートラルなAPIを使用して、複数のインフラストラクチャプロバイダにわたってインフラストラクチャリソースを管理できます。

1.1 この方法を使用する理由 #

この方法は、ターゲットハードウェアがアウトオブバンド管理をサポートしていて、完全に自動化されたインフラストラクチャ管理フローが望まれるシナリオで役立ちます。

管理クラスタは宣言型APIを提供するように設定されており、このAPIによってダウンストリームクラスタのベアメタルサーバのインベントリと状態を管理できます。これには、自動検査、クリーニング、プロビジョニング/プロビジョニング解除も含まれます。

1.2 高レベルアーキテクチャ #

1.3 前提条件 #

ダウンストリームクラスタのサーバハードウェアとネットワーキングに関連する固有の制約がいくつかあります。

管理クラスタ

ターゲットサーバ管理/BMC APIへのネットワーク接続が必要

ターゲットサーバのコントロールプレーンネットワークへのネットワーク接続が必要

マルチノード管理クラスタの場合、追加の予約済みIPアドレスが必要

制御対象ホスト

Redfish、iDRAC、またはiLOのインタフェースを介したアウトオブバンド管理のサポートが必要

仮想メディアを使用したデプロイメントのサポートが必要(PXEは現在サポートされていない)

Metal3プロビジョニングAPIにアクセスするために管理クラスタへのネットワーク接続が必要

ツールがいくつか必要です。ツールは管理クラスタにインストールするか、管理クラスタにアクセス可能なホストにインストールできます。

PodmanやRancher Desktopなどのコンテナランタイム

SL-Micro.x86_64-6.1-Base-GM.raw OSイメージファイルはSUSE Customer CenterまたはSUSEダウンロードページからダウンロードする必要があります。

1.4 デプロイメント #

1.4.1 管理クラスタのセットアップ #

管理クラスタをインストールし、Metal3を使用する基本的な手順は次のとおりです。

RKE2管理クラスタをインストールします。

Rancherのインストール

ストレージプロバイダをインストールします(オプション)。

Metal3の依存関係をインストールします。

Rancher Turtles経由でCAPIの依存関係をインストールします。

ダウンストリームクラスタホスト用のSLEMicro OSイメージを構築します。

BareMetalHost CRを登録し、ベアメタルのインベントリを定義します。

CAPIリソースを定義して、ダウンストリームクラスタを作成します。

このガイドでは、既存のRKE2クラスタとRancher (cert-managerを含む)が、たとえばEdge Image Builder (第11章 「Edge Image Builder」)を使用してインストールされていることを前提としています。

1.4.2 Metal3の依存関係のインストール #

cert-managerがまだRancherのインストールの一部としてインストールされていない場合は、cert-managerをインストールして実行する必要があります。

永続ストレージプロバイダをインストールする必要があります。SUSE

Storageを推奨しますが、開発/PoC環境ではlocal-path-provisionerを使用することもできます。以下の手順は、StorageClassがデフォルトとしてマークされていることを前提としています。マークされていない場合は、Metal3チャートに追加の設定が必要です。

追加のIPが必要です。このIPはMetalLBによって管理され、Metal3管理サービスに一貫したエンドポイントを提供します。このIPは、コントロールプレーンサブネットに属していて、静的設定用に予約されている必要があります(どのDHCPプールにも属していてはなりません)。

まず、MetalLBをインストールします。

helm install \ metallb oci://registry.suse.com/edge/charts/metallb \ --namespace metallb-system \ --create-namespace続いて、次のように、

STATIC_IRONIC_IPとして定義された予約済みIPを使用して 、IPAddressPoolとL2Advertisementを定義します。export STATIC_IRONIC_IP=<STATIC_IRONIC_IP> cat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: ironic-ip-pool namespace: metallb-system spec: addresses: - ${STATIC_IRONIC_IP}/32 serviceAllocation: priority: 100 serviceSelectors: - matchExpressions: - {key: app.kubernetes.io/name, operator: In, values: [metal3-ironic]} EOFcat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: ironic-ip-pool-l2-adv namespace: metallb-system spec: ipAddressPools: - ironic-ip-pool EOFこれでMetal3をインストールできます。

helm install \ metal3 oci://registry.suse.com/edge/charts/metal3 \ --namespace metal3-system \ --create-namespace \ --set global.ironicIP="$STATIC_IRONIC_IP"initコンテナがこのデプロイメントで実行されるまで約2分かかる場合があるため、続行する前にPodがすべて実行されていることを確認します。

kubectl get pods -n metal3-system NAME READY STATUS RESTARTS AGE baremetal-operator-controller-manager-85756794b-fz98d 2/2 Running 0 15m metal3-metal3-ironic-677bc5c8cc-55shd 4/4 Running 0 15m metal3-metal3-mariadb-7c7d6fdbd8-64c7l 1/1 Running 0 15m

metal3-systemネームスペースのすべてのPodが実行されるまで、以下の手順に進まないでください。

1.4.3 Cluster APIの依存関係のインストール #

Cluster APIの依存関係は、Rancher Turtles Helmチャートで管理されます。

cat > values.yaml <<EOF

rancherTurtles:

features:

embedded-capi:

disabled: true

rancher-webhook:

cleanup: true

EOF

helm install \

rancher-turtles oci://registry.suse.com/edge/charts/rancher-turtles \

--namespace rancher-turtles-system \

--create-namespace \

-f values.yamlしばらくすると、コントローラPodがcapi-system、capm3-system、rke2-bootstrap-system、およびrke2-control-plane-systemの各ネームスペースで実行されているはずです。

1.4.4 ダウンストリームクラスタイメージの準備 #

Kiwi (第28章 「Kiwiを使用したSUSE Linux Microの更新イメージの構築」)とEdge Image Builder (第11章 「Edge Image Builder」)を使用して、ダウンストリームクラスタホスト上にプロビジョニングされる、変更されたSLEMicroゴールデンイメージを準備します。

このガイドではダウンストリームクラスタをデプロイするために必要な最小限の設定について説明します。

1.4.4.1 イメージの設定 #

Edge Image Builderを実行すると、そのホストからディレクトリがマウントされるため、ターゲットイメージの定義に使用する設定ファイルを保存するディレクトリ構造を作成する必要があります。

downstream-cluster-config.yamlはイメージ定義ファイルです。詳細については、第3章 「Edge Image Builderを使用したスタンドアロンクラスタ」を参照してください。ダウンロードされたゴールデンイメージは

xzで圧縮されているので、unxzで展開し、base-imagesフォルダの下にコピー/移動する必要があります。networkフォルダはオプションです。詳細については、1.4.5.1.1項 「静的ネットワーク設定用の追加スクリプト」を参照してください。custom/scriptsディレクトリには、初回ブート時に実行するスクリプトが含まれます。現在、デプロイメントのOSルートパーティションのサイズを変更するには、

01-fix-growfs.shスクリプトが必要です。

├── downstream-cluster-config.yaml

├── base-images/

│ └ SL-Micro.x86_64-6.1-Base-GM.raw

├── network/

| └ configure-network.sh

└── custom/

└ scripts/

└ 01-fix-growfs.sh1.4.4.1.1 ダウンストリームクラスタイメージ定義ファイル #

downstream-cluster-config.yamlファイルは、ダウンストリームクラスタイメージの主要な設定ファイルです。次に、Metal3を介したデプロイメントの最小例を示します。

apiVersion: 1.3

image:

imageType: raw

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-GM.raw

outputImageName: SLE-Micro-eib-output.raw

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

kernelArgs:

- ignition.platform.id=openstack

- net.ifnames=1

systemd:

disable:

- rebootmgr

- transactional-update.timer

- transactional-update-cleanup.timer

users:

- username: root

encryptedPassword: $ROOT_PASSWORD

sshKeys:

- $USERKEY1

packages:

packageList:

- jq

sccRegistrationCode: $SCC_REGISTRATION_CODEここで、$SCC_REGISTRATION_CODEはSUSE Customer

Centerからコピーした登録コードで、パッケージリストには必要なjqが含まれています。

$ROOT_PASSWORDはルートユーザの暗号化パスワードで、テスト/デバッグに役立ちます。このパスワードは、openssl

passwd -6 PASSWORDコマンドで生成できます。

運用環境では、$USERKEY1を実際のSSHキーに置き換えて、usersブロックに追加できるSSHキーを使用することをお勧めします。

net.ifnames=1は、Predictable

Network Interface Namingを有効にします。

これはMetal3チャートのデフォルト設定と一致しますが、この設定は、設定されたチャートのpredictableNicNamesの値と一致する必要があります。

また、ignition.platform.id=openstackは必須であり、この引数がないと、Metal3の自動化フローでIgnitionによるSUSE

Linux Microの設定が失敗することにも注意してください。

time

セクションはオプションですが、証明書とクロックスキューに関する潜在的な問題を回避するように設定することを強くお勧めします。この例で指定されている値は説明のみを目的としています。ご自身の特定の要件に合わせて調整してください。

1.4.4.1.2 Growfsスクリプト #

現在、プロビジョニング後の初回ブート時にディスクサイズに合わせてファイルシステムを拡張するには、カスタムスクリプト(custom/scripts/01-fix-growfs.sh)が必要です。01-fix-growfs.shスクリプトには次の情報が含まれます。

#!/bin/bash

growfs() {

mnt="$1"

dev="$(findmnt --fstab --target ${mnt} --evaluate --real --output SOURCE --noheadings)"

# /dev/sda3 -> /dev/sda, /dev/nvme0n1p3 -> /dev/nvme0n1

parent_dev="/dev/$(lsblk --nodeps -rno PKNAME "${dev}")"

# Last number in the device name: /dev/nvme0n1p42 -> 42

partnum="$(echo "${dev}" | sed 's/^.*[^0-9]\([0-9]\+\)$/\1/')"

ret=0

growpart "$parent_dev" "$partnum" || ret=$?

[ $ret -eq 0 ] || [ $ret -eq 1 ] || exit 1

/usr/lib/systemd/systemd-growfs "$mnt"

}

growfs /同じアプローチを使用して、プロビジョニングプロセス中に実行する独自のカスタムスクリプトを追加します。詳細については、第3章 「Edge Image Builderを使用したスタンドアロンクラスタ」を参照してください。

1.4.4.2 イメージの作成 #

これまでのセクションに従ってディレクトリ構造を準備したら、次のコマンドを実行してイメージを構築します。

podman run --rm --privileged -it -v $PWD:/eib \

registry.suse.com/edge/3.4/edge-image-builder:1.3.0 \

build --definition-file downstream-cluster-config.yamlこれにより、上記の定義に基づいて、SLE-Micro-eib-output.rawという名前の出力イメージファイルが作成されます。

その後、この出力イメージをWebサーバ経由で利用できるようにする必要があります。その際、Metal3チャートを使用して有効にしたメディアサーバコンテナ(注記)か、ローカルにアクセス可能な他のサーバのいずれかを使用します。以下の例では、このサーバをimagecache.local:8080として参照します。

EIBイメージをダウンストリームクラスタにデプロイする際は、Metal3MachineTemplateオブジェクトにイメージのSHA256ハッシュ値を含める必要があります。これは次のように生成できます:

sha256sum <image_file> > <image_file>.sha256

# On this example:

sha256sum SLE-Micro-eib-output.raw > SLE-Micro-eib-output.raw.sha2561.4.5 BareMetalHostインベントリの追加 #

自動デプロイメント用にベアメタルサーバを登録するには、リソースを2つ作成する必要があります。BMCアクセス資格情報を保存するシークレットと、BMC接続とその他の詳細を定義するMetal3 BareMetalHostリソースです。

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-credentials

type: Opaque

data:

username: YWRtaW4=

password: cGFzc3dvcmQ=

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

architecture: x86_64

online: true

bootMACAddress: "00:f3:65:8a:a3:b0"

bmc:

address: redfish-virtualmedia://192.168.125.1:8000/redfish/v1/Systems/68bd0fb6-d124-4d17-a904-cdf33efe83ab

disableCertificateVerification: true

credentialsName: controlplane-0-credentials次の点に注意してください。

シークレットのユーザ名/パスワードはbase64でエンコードされている必要があります。また、末尾に改行を含めないでください(たとえば、単なる

echoではなく、echo ‑nを使用してください)。cluster-roleラベルは、この時点で設定することも、後でクラスタの作成時に設定することもできます。以下の例では、control-planeまたはworkerを想定しています。bootMACAddressは、ホストのコントロールプレーンNICに一致する有効なMACである必要があります。bmcのアドレスはBMC管理APIへの接続です。次のアドレスがサポートされています。redfish-virtualmedia://<IP ADDRESS>/redfish/v1/Systems/<SYSTEM ID>: Redfish仮想メディア(たとえば、SuperMicro)idrac-virtualmedia://<IP ADDRESS>/redfish/v1/Systems/System.Embedded.1: Dell iDRAC

BareMetalHost APIの詳細については、アップストリームのAPIドキュメントを参照してください。

1.4.5.1 静的IPの設定 #

上記のBareMetalHostの例では、DHCPでコントロールプレーンネットワークの設定を提供することを想定していますが、静的IPなどの手動設定が必要なシナリオでは、以下に説明するように追加の設定を指定できます。

1.4.5.1.1 静的ネットワーク設定用の追加スクリプト #

Edge Image

Builderでゴールデンイメージを作成する際には、networkフォルダ内に次のconfigure-network.shファイルを作成します。

このファイルにより、初回ブート時に設定ドライブのデータを使用して、NM Configuratorツールを使ってホストネットワーキングを設定します。

#!/bin/bash

set -eux

# Attempt to statically configure a NIC in the case where we find a network_data.json

# In a configuration drive

CONFIG_DRIVE=$(blkid --label config-2 || true)

if [ -z "${CONFIG_DRIVE}" ]; then

echo "No config-2 device found, skipping network configuration"

exit 0

fi

mount -o ro $CONFIG_DRIVE /mnt

NETWORK_DATA_FILE="/mnt/openstack/latest/network_data.json"

if [ ! -f "${NETWORK_DATA_FILE}" ]; then

umount /mnt

echo "No network_data.json found, skipping network configuration"

exit 0

fi

DESIRED_HOSTNAME=$(cat /mnt/openstack/latest/meta_data.json | tr ',{}' '\n' | grep '\"metal3-name\"' | sed 's/.*\"metal3-name\": \"\(.*\)\"/\1/')

echo "${DESIRED_HOSTNAME}" > /etc/hostname

mkdir -p /tmp/nmc/{desired,generated}

cp ${NETWORK_DATA_FILE} /tmp/nmc/desired/_all.yaml

umount /mnt

./nmc generate --config-dir /tmp/nmc/desired --output-dir /tmp/nmc/generated

./nmc apply --config-dir /tmp/nmc/generated1.4.5.1.2 ホストネットワーク設定の追加シークレット #

NM Configurator (第12章 「Edgeネットワーキング」)でサポートされているnmstate形式のデータを含む追加シークレットをホストごとに定義できます。

その後、このシークレットは、BareMetalHostリソースでpreprovisioningNetworkDataNameの指定フィールドを使用して参照されます。

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-networkdata

type: Opaque

stringData:

networkData: |

interfaces:

- name: enp1s0

type: ethernet

state: up

mac-address: "00:f3:65:8a:a3:b0"

ipv4:

address:

- ip: 192.168.125.200

prefix-length: 24

enabled: true

dhcp: false

dns-resolver:

config:

server:

- 192.168.125.1

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.125.1

next-hop-interface: enp1s0

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

preprovisioningNetworkDataName: controlplane-0-networkdata

# Remaining content as in previous example1.4.5.2 BareMetalHostの準備 #

上記の説明に従ってBareMetalHostリソースと関連するシークレットを作成すると、次のようにホスト準備ワークフローがトリガされます。

ターゲットホストのBMCに接続された仮想メディアによってramdiskイメージがブートされる

ramdiskがハードウェア詳細を検査し、ホストをプロビジョニング用に準備する(たとえば、ディスクから以前のデータを消去する)

このプロセスが完了すると、BareMetalHostの

status.hardwareフィールドのハードウェア詳細が更新され、検証可能になる

このプロセスには数分かかる場合がありますが、完了すると、BareMetalHostの状態がavailableになります。

% kubectl get baremetalhost

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available true 9m44s

worker-0 available true 9m44s1.4.6 ダウンストリームクラスタの作成 #

続いて、ダウンストリームクラスタを定義するCluster APIリソースと、BareMetalHostリソースをプロビジョニングしてからブートストラップを実行してRKE2クラスタを形成するマシンリソースを作成します。

1.4.7 コントロールプレーンのデプロイメント #

コントロールプレーンをデプロイするために、以下のリソースを含む次のようなyamlマニフェストを定義します。

クラスタリソースでは、クラスタ名、ネットワーク、およびコントロールプレーン/インフラストラクチャプロバイダのタイプ(この場合はRKE2/Metal3)を定義します。

Metal3Clusterでは、コントロールプレーンのエンドポイント(シングルノードの場合はホストIP、マルチノードの場合はLoadBalancerエンドポイント。この例ではシングルノードを想定)を定義します。

RKE2ControlPlaneでは、RKE2のバージョンと、クラスタのブートストラップ時に必要な追加設定を定義します。

Metal3MachineTemplateではBareMetalHostリソースに適用するOSイメージを定義し、hostSelectorでは使用するBareMetalHostを定義します。

Metal3DataTemplateでは、BareMetalHostに渡す追加のメタデータを定義します(networkDataは現在のところEdgeソリューションではサポートされていないことに注意してください)。

簡潔にするため、この例では、BareMetalHostのIPアドレスが192.168.125.200で設定されている単一ノードのコントロールプレーンを想定しています。より高度なマルチノードの例については、第42章 「完全に自動化されたダイレクトネットワークプロビジョニング」を参照してください。

apiVersion: cluster.x-k8s.io/v1beta1

kind: Cluster

metadata:

name: sample-cluster

namespace: default

spec:

clusterNetwork:

pods:

cidrBlocks:

- 192.168.0.0/18

services:

cidrBlocks:

- 10.96.0.0/12

controlPlaneRef:

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

name: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

name: sample-cluster

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

metadata:

name: sample-cluster

namespace: default

spec:

controlPlaneEndpoint:

host: 192.168.125.200

port: 6443

noCloudProvider: true

---

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

metadata:

name: sample-cluster

namespace: default

spec:

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-controlplane

replicas: 1

version: v1.33.3+rke2r1

rolloutStrategy:

type: "RollingUpdate"

rollingUpdate:

maxSurge: 0

agentConfig:

format: ignition

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-controlplane

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-controlplane-template

hostSelector:

matchLabels:

cluster-role: control-plane

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-controlplane-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machine自身の環境に合わせて調整したら、kubectlを使用して例を適用し、その後

clusterctlを使用してクラスタのステータスを監視できます。

% kubectl apply -f rke2-control-plane.yaml

# Wait for the cluster to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 22m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 27m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 22m

│ └─Machine/sample-cluster-chflc True 23m1.4.8 ワーカー/コンピュートのデプロイメント #

コントロールプレーンのデプロイメントと同様に、次のリソースを含むYAMLマニフェストを定義します。

MachineDeploymentでは、レプリカ(ホスト)の数とブートストラップ/インフラストラクチャプロバイダ(この場合はRKE2/Metal3)を定義します。

RKE2ConfigTemplateでは、エージェントホストのブートストラップ用のRKE2のバージョンと初回ブート設定を記述します。

Metal3MachineTemplateではBareMetalHostリソースに適用するOSイメージを定義し、hostSelectorでは使用するBareMetalHostを定義します。

Metal3DataTemplateでは、BareMetalHostに渡す追加のメタデータを定義します(

networkDataは現在サポートされていないことに注意してください)。

apiVersion: cluster.x-k8s.io/v1beta1

kind: MachineDeployment

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

name: sample-cluster

namespace: default

spec:

clusterName: sample-cluster

replicas: 1

selector:

matchLabels:

cluster.x-k8s.io/cluster-name: sample-cluster

template:

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

spec:

bootstrap:

configRef:

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

name: sample-cluster-workers

clusterName: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-workers

nodeDrainTimeout: 0s

version: v1.33.3+rke2r1

---

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

agentConfig:

format: ignition

version: v1.33.3+rke2r1

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-workers-template

hostSelector:

matchLabels:

cluster-role: worker

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-workers-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machine上記の例をコピーし、自身の環境に合わせて調整したら、kubectlを使用して適用し、clusterctlでクラスタのステータスを監視できます。

% kubectl apply -f rke2-agent.yaml

# Wait for the worker nodes to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 25m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 30m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 25m

│ └─Machine/sample-cluster-chflc True 27m

└─Workers

└─MachineDeployment/sample-cluster True 22m

└─Machine/sample-cluster-56df5b4499-zfljj True 23m1.4.9 クラスタのプロビジョニング解除 #

ダウンストリームクラスタをプロビジョニング解除するには、上記の作成手順で適用したリソースを削除します。

% kubectl delete -f rke2-agent.yaml

% kubectl delete -f rke2-control-plane.yamlこれにより、BareMetalHostリソースのプロビジョニング解除がトリガされます。これには数分かかることがあり、その後リソースは再び利用可能な状態になります。

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 deprovisioning sample-cluster-controlplane-vlrt6 false 10m

worker-0 deprovisioning sample-cluster-workers-785x5 false 10m

...

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available false 15m

worker-0 available false 15m1.5 既知の問題 #

現在、アップストリームのIPアドレス管理コントローラはサポートされていません。このコントローラには、SLEMicroで選択されているネットワーク設定ツールと初回ブートツールチェーンとの互換性がまだないためです。

関連して、 IPAMリソースと、Metal3DataTemplateのnetworkDataフィールドは現在のところサポートされていません。

redfish-virtualmediaを介したデプロイメントのみが現在サポートされています。

Ironic Python Agent (IPA)とターゲットオペレーティングシステム(SL Micro 6.0/6.1)の間で、特に、デバイスに予測可能な名前を設定しようとする際に、ネットワークデバイス名の不整合が発生する可能性があります。

これが発生するのは、Ironic Python Agent (IPA)のカーネルが現在、ターゲットオペレーティングシステム(SL Micro 6.0/6.1)のカーネルと整合していないためです。これにより、ネットワークドライバに不整合が生じ、SL Microが想定する命名パターンとは異なる命名パターンでIPAがネットワークデバイスを検出できるようになります。

当面の回避策として、以下の2つの異なるアプローチが利用可能です。*

ネットワーク設定で2つの異なるシークレットを作成します。1つはIPAが検出するデバイス名を使用したIPAで使用されるシークレットで、BareMetalHost定義のpreprovisioningNetworkDataNameとして使用します。もう1つはSL

Microが検出するデバイス名を使用したシークレットで、BareMetalHost定義のnetworkData.nameとして使用します。*

代わりに、生成されたnmconnectionファイル上の他のインタフェースを参照するためにUUIDを使用します。詳細は、ヒントとコツセクションを参照してください。

1.6 予定されている変更 #

networkDataフィールドを使用した、IPAMリソースと設定のサポートの有効化

1.7 追加のリソース #

SUSE Telco Cloudドキュメント(第37章 「SUSE Telco Cloud」)には、通信事業者のユースケースにおけるMetal3のより高度な使用例が記載されています。

1.7.1 シングルノード設定 #

管理クラスタがシングルノードであるテスト/PoC環境では、MetalLBを介して管理されるフローティングIPを追加する必要はありません。

このモードでは、管理クラスタAPIのエンドポイントが管理クラスタのIPになるため、DHCPを使用している場合はそのIPを予約するか、管理クラスタのIPが変更されないように静的に設定する必要があります(以下では<MANAGEMENT_CLUSTER_IP>と表記しています)。

このシナリオを有効にするために必要なMetal3チャートの値は次のとおりです。

global:

ironicIP: <MANAGEMENT_CLUSTER_IP>

metal3-ironic:

service:

type: NodePort1.7.2 仮想メディアISOをアタッチするためのTLSの無効化 #

一部のサーバベンダは、仮想メディアISOイメージをBMCにアタッチする際にSSL接続を検証しますが、Metal3のデプロイメント用に生成された証明書は自己署名されているため、問題が発生する可能性があります。この問題を回避するには、次のようなMetal3チャートの値を使用して、仮想メディアディスクをアタッチする場合にのみTLSを無効にすることができます。

global:

enable_vmedia_tls: false別の解決策は、CA証明書を使用してBMCを設定することです。この場合、kubectlを使用してクラスタから証明書を読み込むことができます。

kubectl get secret -n metal3-system ironic-vmedia-cert -o yamlこれにより、証明書をサーバのBMCコンソールで設定できますが、そのプロセスはベンダ固有です(すべてのベンダで可能というわけではなく、可能でない場合はenable_vmedia_tlsフラグが必要なことがあります)。

1.7.3 ストレージ設定 #

管理クラスタがシングルノードであるテスト/PoC環境では、永続ストレージは不要ですが、運用ユースケースでは管理クラスタにSUSE Storage (Longhorn)をインストールすることをお勧めします。これによりPodの再起動/再スケジュール時にMetal3に関連するイメージを保持できます。

この永続ストレージを有効にするために必要なMetal3チャート値は次のとおりです。

metal3-ironic:

persistence:

ironic:

size: "5Gi"SUSE Telco Cloud管理クラスタのドキュメント(第40章 「管理クラスタの設定」)には、永続ストレージを使用した管理クラスタの設定方法に関する詳細が記載されています。

2 Elementalを使用したリモートホストのオンボーディング #

このセクションでは、SUSE Edgeの一部としての「Phone Homeネットワークプロビジョニング」ソリューションについて説明します。このソリューションは、Elementalを使用してノードのオンボーディングを支援します。Elementalは、Kubernetesを使用してリモートホスト登録と一元化された完全なクラウドネイティブOS管理を可能にするソフトウェアスタックです。SUSE Edgeスタックでは、Elementalの登録機能を使用して、リモートホストをRancherにオンボーディングできます。これにより、ホストを集中管理プラットフォームに統合し、そこからKubernetesクラスタに加えて、階層化コンポーネント、アプリケーション、およびそのライフサイクルをすべて共通の場所からデプロイおよび管理できるようになります。

このアプローチが役立つシナリオとしては、制御するデバイスが管理クラスタと同じネットワーク上にないか、アウトオブバンド管理コントローラが搭載されておらず、より直接的に制御できない場合や、さまざまな「不明」なシステムをエッジで多数ブートしており、それらを安全にオンボーディングして大規模に管理する必要がある場合が考えられます。これは、小売や産業用IoTなど、デバイスが設置されるネットワークをほとんど制御できない分野のユースケースによく見られるシナリオです。

2.1 高レベルアーキテクチャ #

2.2 必要なリソース #

このクイックスタートを実行するためのシステムと環境の最小要件を次に示します。

集中管理クラスタ(RancherとElementalをホストするクラスタ)用のホスト:

開発またはテスト用の場合、最小8GBのRAMと20GBのディスク容量(運用環境での使用についてはこちらを参照)

プロビジョニングするターゲットノード、すなわちエッジデバイス(デモまたはテストの場合は仮想マシンを使用可能)

最小4GBのRAM、2 CPUコア、20GBのディスク

管理クラスタの解決可能なホスト名、またはsslip.ioなどのサービスで使用する静的IPアドレス

Edge Image Builderでインストールメディアを構築するためのホスト

ブート用のUSBフラッシュドライブ(物理ハードウェアを使用する場合)

最新のSUSE Linux Micro 6.1 SelfInstall ISOイメージのダウンロードコピー(こちらから入手可能です)

ターゲットマシンにある既存のデータはこのプロセスの一環として上書きされます。ターゲットデプロイメントノードに接続されているUSBストレージデバイスやディスク上のデータは、必ずバックアップしてください。

このガイドは、アップストリームクラスタをホストするためにDigital Oceanドロップレットを使用し、ダウンストリームデバイスとしてIntel NUCを使用して作成されています。インストールメディアの構築には、SUSE Linux Enterprise Serverを使用しています。

2.3 ブートストラップクラスタの構築 #

まず、RancherとElementalをホストできるクラスタを作成します。このクラスタは、ダウンストリームノードが接続されているネットワークからルーティングできる必要があります。

2.3.1 Kubernetesクラスタの作成 #

ハイパースケーラ(Azure、AWS、Google Cloudなど)を使用している場合、クラスタを設定する最も簡単な方法は、ハイパースケーラのビルトインツールを使用することです。このガイドでは、簡潔にするために、これらの各オプションのプロセスについては詳述しません。

ベアメタルや別のホスティングサービスにインストールしようとしていて、Kubernetesディストリビューションそのものも用意する必要がある場合は、RKE2を使用することをお勧めします。

2.3.2 DNSの設定 #

続行する前に、クラスタへのアクセスを設定する必要があります。クラスタ自体のセットアップと同様に、DNSの設定方法は、クラスタがホストされている場所によって異なります。

DNSレコードの設定を扱わない場合(たとえば、これが一時的なテストサーバである場合)、代わりにsslip.ioなどのサービスを使用できます。このサービスを使用すると、<address>.sslip.ioを使用して任意のIPアドレスを解決できます。

2.4 Rancherのインストール #

Rancherをインストールするには、作成したクラスタのKubernetes APIにアクセスする必要があります。これは、使用しているKubernetesのディストリビューションによって異なります。

RKE2の場合、kubeconfigファイルは/etc/rancher/rke2/rke2.yamlに書き込まれます。このファイルをローカルシステムに~/.kube/configとして保存します。このファイルを編集して、外部にルーティング可能な正しいIPアドレスまたはホスト名を含めなければならない場合があります。

Rancherのドキュメントに記載されているコマンドを使用して、Rancherを簡単にインストールできます。

cert-managerをインストールします。

helm repo add jetstack https://charts.jetstack.io

helm repo update

helm install cert-manager jetstack/cert-manager \

--namespace cert-manager \

--create-namespace \

--set crds.enabled=true次に、Rancher自体をインストールします。

helm repo add rancher-prime https://charts.rancher.com/server-charts/prime

helm repo update

helm install rancher rancher-prime/rancher \

--namespace cattle-system \

--create-namespace \

--set hostname=<DNS or sslip from above> \

--set replicas=1 \

--set bootstrapPassword=<PASSWORD_FOR_RANCHER_ADMIN> \

--version 2.12.1これを運用システムにする予定の場合は、cert-managerを使用して、実際の証明書(Let's Encryptの証明書など)を設定してください。

設定したホスト名をブラウズし、使用したbootstrapPasswordでRancherにログインします。ガイドに従って簡単なセットアッププロセスを完了します。

2.5 Elementalのインストール #

Rancherをインストールしたら、続いてElementalのオペレータと必要なCRDをインストールできます。Elemental用のHelmチャートはOCIアーティファクトとして公開されているため、インストールは他のチャートよりも若干シンプルです。Rancherのインストールに使用したものと同じシェルからインストールすることも、ブラウザでRancherのシェル内からインストールすることもできます。

helm install --create-namespace -n cattle-elemental-system \

elemental-operator-crds \

oci://registry.suse.com/rancher/elemental-operator-crds-chart \

--version 1.7.3

helm install -n cattle-elemental-system \

elemental-operator \

oci://registry.suse.com/rancher/elemental-operator-chart \

--version 1.7.32.5.1 (オプション) Elemental UI拡張機能のインストール #

2.6 Elementalの設定 #

シンプルにするために、変数$ELEMを、設定ディレクトリを配置する場所のフルパスに設定することをお勧めします。

export ELEM=$HOME/elemental

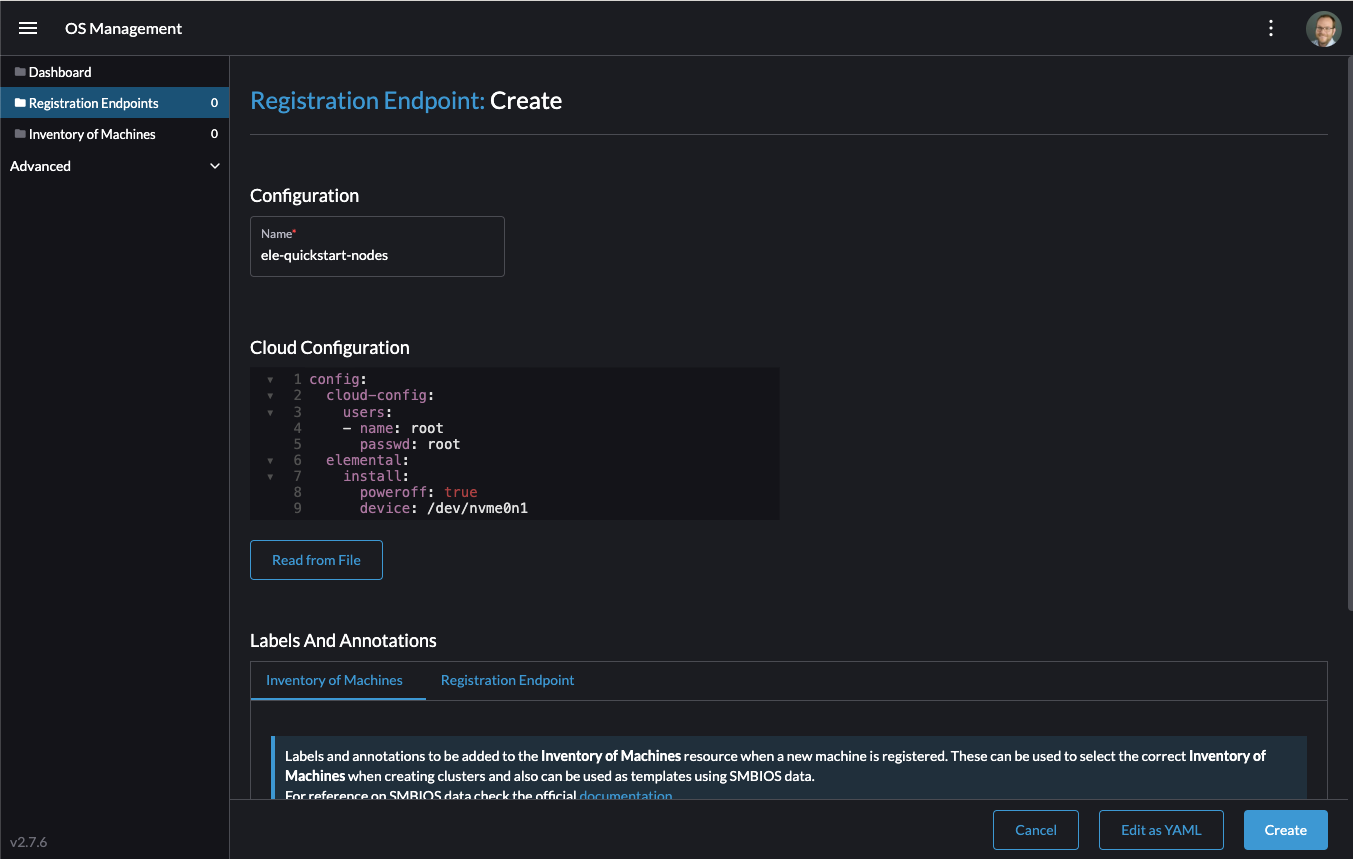

mkdir -p $ELEMマシンがElementalに登録できるようにするために、fleet-defaultネームスペースにMachineRegistrationオブジェクトを作成する必要があります。

このオブジェクトの基本的なバージョンを作成してみましょう。

cat << EOF > $ELEM/registration.yaml

apiVersion: elemental.cattle.io/v1beta1

kind: MachineRegistration

metadata:

name: ele-quickstart-nodes

namespace: fleet-default

spec:

machineName: "\${System Information/Manufacturer}-\${System Information/UUID}"

machineInventoryLabels:

manufacturer: "\${System Information/Manufacturer}"

productName: "\${System Information/Product Name}"

EOF

kubectl apply -f $ELEM/registration.yamlこのcatコマンドでは、各$をバックスラッシュ(\)でエスケープしています。このため、バッシュではテンプレート化されていません。手動でコピーする場合は、バックスラッシュを削除してください。

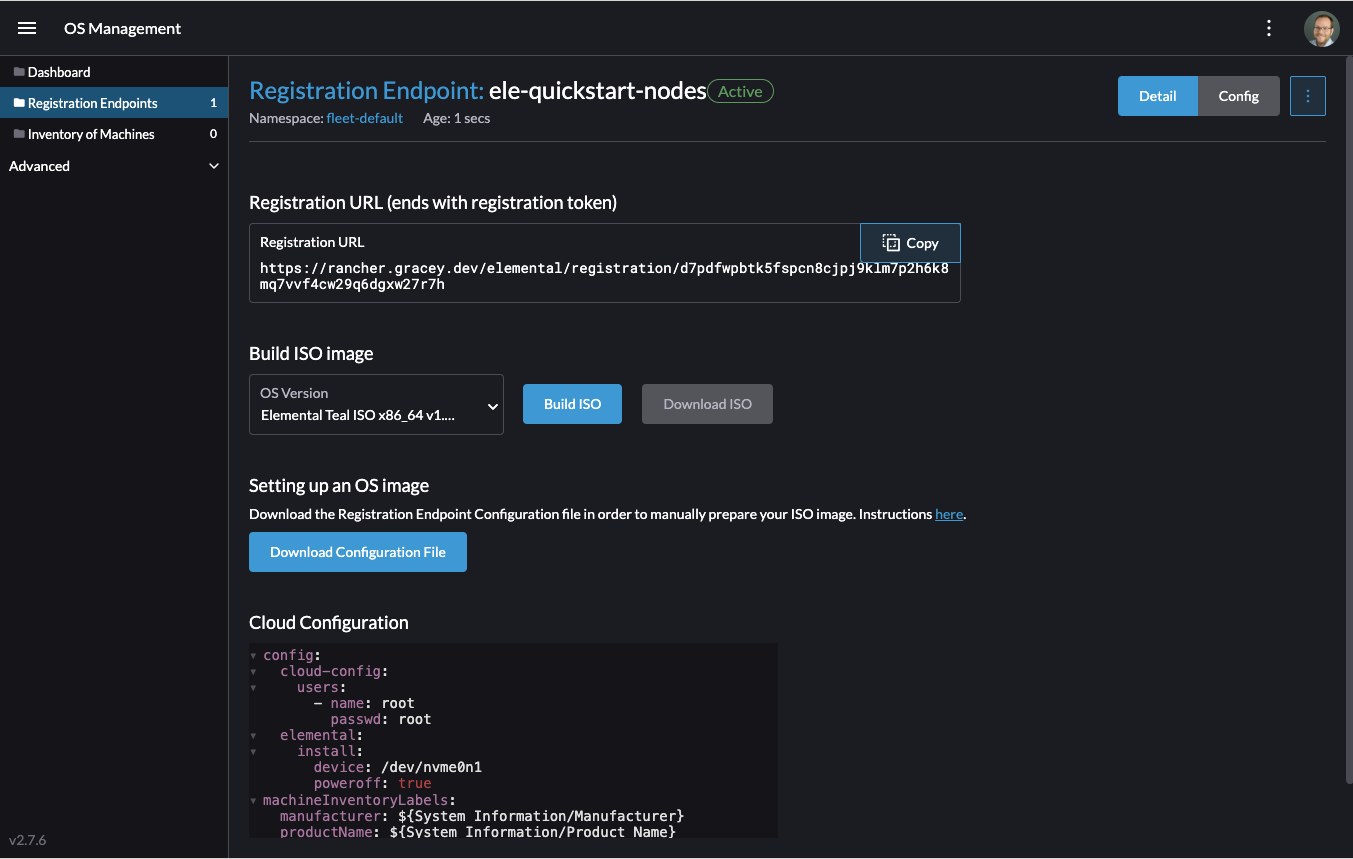

オブジェクトが作成されたら、割り当てられるエンドポイントを見つけてメモを取ります。

REGISURL=$(kubectl get machineregistration ele-quickstart-nodes -n fleet-default -o jsonpath='{.status.registrationURL}')または、UIからこの操作を実行することもできます。

- UI拡張機能

[OS Management extension (OS管理拡張機能)]から[Create Registration Endpoint (登録エンドポイントの作成) ]をクリックします。

この設定に名前を付けます。

注記[Cloud Configuration (クラウドの設定)]フィールドは無視して構いません。ここのデータは、Edge Image Builderを使用した次の手順で上書きされるためです。

次に、下にスクロールして、マシンの登録時に作成されるリソースに付ける各ラベルに対して[Add Label (ラベルの追加)]をクリックします。これはマシンを区別するのに役立ちます。

[Create (作成)]をクリックして、設定を保存します。

登録が作成されると、登録URLが表示され、[Copy (コピー)] をクリックしてアドレスをコピーできます。

ヒントクリックしてその画面から移動してしまった場合は、左側のメニューの[Registration Endpoints (登録エンドポイント)]をクリックし、先ほど作成したエンドポイント名をクリックできます。

このURLは次の手順で使用します。

2.7 イメージの構築 #

Elementalの現在のバージョンには独自のインストールメディアを構築する方法が用意されていますが、SUSE Edge 3.4では代わりにKiwiとEdge Image Builderでインストールメディアを構築します。したがって、生成されるシステムは、SUSE Linux Microをベースオペレーティングシステムとして構築されます。

Kiwiの詳細については、まずKiwi Image Builderプロセス(第28章 「Kiwiを使用したSUSE Linux Microの更新イメージの構築」)に従って、新しいイメージを構築してください。また、Edge Image Builderについては、Edge Image Builder導入ガイド(第3章 「Edge Image Builderを使用したスタンドアロンクラスタ」)のほかに、コンポーネントのドキュメント(第11章 「Edge Image Builder」)も参照してください。

PodmanをインストールしたLinuxシステムで、ディレクトリを作成し、Kiwiによって構築されるゴールデンイメージを配置します。

mkdir -p $ELEM/eib_quickstart/base-images

cp /path/to/{micro-base-image-iso} $ELEM/eib_quickstart/base-images/

mkdir -p $ELEM/eib_quickstart/elementalcurl $REGISURL -o $ELEM/eib_quickstart/elemental/elemental_config.yamlcat << EOF > $ELEM/eib_quickstart/eib-config.yaml

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso

outputImageName: elemental-image.iso

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

isoConfiguration:

installDevice: /dev/vda

users:

- username: root

encryptedPassword: \$6\$jHugJNNd3HElGsUZ\$eodjVe4te5ps44SVcWshdfWizrP.xAyd71CVEXazBJ/.v799/WRCBXxfYmunlBO2yp1hm/zb4r8EmnrrNCF.P/

packages:

sccRegistrationCode: XXX

EOFtimeセクションはオプションですが、証明書とクロックスキューに関する潜在的な問題を回避するように設定することを強くお勧めします。この例で指定されている値は説明のみを目的としています。ご自身の特定の要件に合わせて調整してください。エンコードされていないパスワードは

eibです。sccRegistrationCodeは、公式なソースから必要なRPMをダウンロードしてインストールするために必要です(または、代わりにelemental-registerおよびelemental-system-agentのRPMを手動でサイドロードすることもできます)。この

catコマンドでは、各$をバックスラッシュ(\)でエスケープしています。このため、バッシュではテンプレート化されていません。手動でコピーする場合は、バックスラッシュを削除してください。インストールデバイスは、インストール中に消去されます。

podman run --privileged --rm -it -v $ELEM/eib_quickstart/:/eib \

registry.suse.com/edge/3.4/edge-image-builder:1.3.0 \

build --definition-file eib-config.yaml物理デバイスをブートする場合は、イメージをUSBフラッシュ ドライブに書き込む必要があります。これは、次のコマンドで実行できます。

sudo dd if=/eib_quickstart/elemental-image.iso of=/dev/<PATH_TO_DISK_DEVICE> status=progress2.8 ダウンストリームノードのブート #

インストールメディアを作成したので、それを使用してダウンストリームノードをブートできます。

Elementalで制御するシステムごとに、インストールメディアを追加してデバイスをブートします。インストールが完了すると、デバイスは再起動して自身を登録します。

UI拡張機能を使用している場合は、[Inventory of Machines (マシンのインベントリ)]にノードが表示されます。

ログインプロンプトが表示されるまでインストールメディアを取り外さないでください。初回ブート時には、USBスティック上のファイルにアクセスしたままになります。

2.9 ダウンストリームクラスタの作成 #

Elementalを使用して新しいクラスタをプロビジョニングする際に作成する必要があるオブジェクトが2つあります。

- Linux

- UI拡張機能

最初のオブジェクトはMachineInventorySelectorTemplateです。このオブジェクトにより、クラスタとインベントリ内のマシン間のマッピングを指定できます。

インベントリ内のマシンをラベルに一致させるセレクタを作成します。

cat << EOF > $ELEM/selector.yaml apiVersion: elemental.cattle.io/v1beta1 kind: MachineInventorySelectorTemplate metadata: name: location-123-selector namespace: fleet-default spec: template: spec: selector: matchLabels: locationID: '123' EOFリソースをクラスタに適用します。

kubectl apply -f $ELEM/selector.yamlマシンの名前を取得し、一致するラベルを追加します。

MACHINENAME=$(kubectl get MachineInventory -n fleet-default | awk 'NR>1 {print $1}') kubectl label MachineInventory -n fleet-default \ $MACHINENAME locationID=123シンプルなシングルノードK3sクラスタリソースを作成し、クラスタに適用します。

cat << EOF > $ELEM/cluster.yaml apiVersion: provisioning.cattle.io/v1 kind: Cluster metadata: name: location-123 namespace: fleet-default spec: kubernetesVersion: v1.33.3+k3s1 rkeConfig: machinePools: - name: pool1 quantity: 1 etcdRole: true controlPlaneRole: true workerRole: true machineConfigRef: kind: MachineInventorySelectorTemplate name: location-123-selector apiVersion: elemental.cattle.io/v1beta1 EOF kubectl apply -f $ELEM/cluster.yaml

これらのオブジェクトを作成したら、先ほどインストールした新しいノードを使用して新しいKubernetesクラスタがスピンアップするはずです。

2.10 ノードリセット(オプション) #

SUSE Rancher Elementalは、「ノードリセット」を実行する機能をサポートしています。ノードリセットは、Rancherからクラスタ全体が削除されたとき、クラスタからシングルノードが削除されたとき、またはマシンインベントリからノードが手動で削除されたときに任意でトリガできます。これは、孤立したリソースをリセットしてクリーンアップし、クリーンアップされたノードを自動的にマシンインベントリに戻して再利用可能にする場合に役立ちます。ノードリセットはデフォルトでは有効になっていないため、削除されたシステムはクリーンアップされず(つまり、データは削除されず、Kubernetesクラスタリソースはダウンストリームクラスタで動作し続けます)、データを消去してマシンをElemental経由でRancherに再登録するには手動操作が必要となります。

この機能をデフォルトで有効にするには、MachineRegistrationにconfig.elemental.reset.enabled:

trueを追加して明示的に有効にする必要があります。例:

config:

elemental:

registration:

auth: tpm

reset:

enabled: trueその後、このMachineRegistrationに登録されているすべてのシステムが自動的にelemental.cattle.io/resettable:'true'のアノテーションを受け取って設定に反映します。既存のMachineInventoryにこのアノテーションがない場合や、すでにノードをデプロイ済みである場合などに、個々のノードで手動でこの操作を実行する場合は、MachineInventoryを変更し、resettable設定を追加します。例:

apiVersion: elemental.cattle.io/v1beta1

kind: MachineInventory

metadata:

annotations:

elemental.cattle.io/os.unmanaged: 'true'

elemental.cattle.io/resettable: 'true'SUSE Edge 3.1では、Elemental

Operatorによってオペレーティングシステム上にマーカが配置され、これによってクリーンアッププロセスが自動的にトリガされます。クリーンアッププロセスは、すべてのKubernetesサービスを停止して永続データをすべて削除し、すべてのKubernetesサービスをアンインストールして、残っているKubernetes/Rancherディレクトリをクリーンアップし、元のElemental

MachineRegistration設定を使用して強制的にRancherに再登録します。これは自動的に行われるため、手動での操作は必要ありません。呼び出されるスクリプトは/opt/edge/elemental_node_cleanup.shにあり、マーカが配置されるとすぐにsystemd.pathを介してトリガされるため、直ちに実行されます。

resettable機能を使用する場合、Rancherからノード/クラスタを削除する際の望ましい動作は、データを消去して再登録を強制することであると想定されています。この状況ではデータが確実に失われるため、この機能は、自動リセットを実行することがわかっている場合にのみ使用してください。

2.11 次の手順 #

このガイドの使用後に調べるべき推奨リソースを次に示します。

第8章 「Fleet」のエンドツーエンドの自動化

第12章 「Edgeネットワーキング」の追加のネットワーク設定オプション

3 Edge Image Builderを使用したスタンドアロンクラスタ #

Edge Image Builder (EIB)は、完全なエアギャップシナリオでもマシンをブートストラップできるCustomized, Ready-to-Boot (CRB)ディスクイメージの生成プロセスを効率化するツールです。EIBを使用すると、SUSE Edgeの3つのデプロイメントフットプリントすべてで使用するデプロイメントイメージを作成できます。これは、EIBが十分に柔軟であり、最小限のカスタマイズ(例: ユーザの追加やタイムゾーンの設定)から、あらゆる設定を網羅したイメージ(例: 複雑なネットワーク設定を行い、マルチノードKubernetesクラスタをデプロイして、顧客ワークロードをデプロイし、Rancher/ElementalとSUSE Multi-Linux Managerを介して集中管理プラットフォームに登録するイメージ)までを提供できるためです。EIBはコンテナイメージ内で動作するため、プラットフォーム間できわめて容易に移植可能です。さらに、必要な依存関係をすべて備えた自己完結型であるため、EIBツールの操作に使用するシステムにインストールされているパッケージに及ぼす影響が最小限に抑えられます。

マルチノードシナリオの場合、同じ構築されたイメージを使用してプロビジョニングされたホストが Kubernetesクラスタに自動的に参加できるように、EIBははMetalLBとEndpoint Copier Operatorを自動的にデプロイします。

詳細については、Edge Image Builderの紹介(第11章 「Edge Image Builder」)を参照してください。

Edge Image Builder 1.3.0は、SUSE Linux Micro 6.1イメージのカスタマイズをサポートしています。SUSE Linux Enterprise Micro 5.5や6.0などの古いバージョンはサポートされていません。

3.1 前提条件 #

SLES 15 SP6を実行しているAMD64/Intel 64ビルドホストマシン(物理または仮想)

Podmanコンテナエンジン

Kiwi Builder手順を使用して作成されたSUSE Linux Micro 6.1 SelfInstall ISOイメージ(第28章 「Kiwiを使用したSUSE Linux Microの更新イメージの構築」)

非運用目的の場合は、openSUSE Leap 15.6、またはopenSUSE Tumbleweedをビルドホストマシンとして使用できます。互換性のあるコンテナランタイムが利用できれば、その他のオペレーティングシステムでも機能します。

3.1.1 EIBイメージの取得 #

EIBのコンテナイメージは一般に公開されており、イメージ構築ホストで次のコマンドを実行することでSUSE Edgeレジストリからダウンロードできます。

podman pull registry.suse.com/edge/3.4/edge-image-builder:1.3.03.2 イメージ設定ディレクトリの作成 #

EIBはコンテナ内で動作するため、ホストから設定ディレク トリをマウントして、必要な設定を指定できるようにする必要があります。ビルドプロセス中に、EIBは必要な入力ファイルやサポートアーティファクトすべてにアクセスできます。このディレクトリは、特定の構造に従う必要があります。このディレクトリがホームディレクトリに存在し、「eib」という名前であると仮定して、ディレクトリを作成してみましょう。

export CONFIG_DIR=$HOME/eib

mkdir -p $CONFIG_DIR/base-images前の手順でSUSE Linux Micro 6.1入力イメージをホストする「base-images」ディレクトリを作成しました。このイメージが設定ディレクトリにコピーされていることを確認しましょう。

cp /path/to/SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso $CONFIG_DIR/base-images/slemicro.isoEIBの実行中に元のゴールデンイメージは変更されません。EIBの設定ディレクトリのルートに、目的の設定でカスタマイズされた新しいバージョンが作成されます。

この時点では、設定ディレクトリは次のようになっているはずです。

└── base-images/

└── slemicro.iso3.3 イメージ定義ファイルの作成 #

定義ファイルには、Edge Image Builderがサポートする設定可能なオプションの大部分が記述されています。オプションの完全な例については、こちらを参照してください。以下で説明する例よりも広範な例については、アップストリームのイメージ構築ガイドを参照することをお勧めします。まずは、OSイメージの非常に基本的な定義ファイルから始めましょう。

cat << EOF > $CONFIG_DIR/iso-definition.yaml

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

EOFこの定義では、AMD64/Intel

64ベースのシステム用の出力イメージを生成するように指定しています。さらに変更を加えるためのベースとして使用するイメージは、slemicro.isoという名前のisoイメージであり、$CONFIG_DIR/base-images/slemicro.isoにあることが想定されています。また、EIBがイメージの変更を完了すると、出力イメージはeib-image.isoという名前になり、デフォルトでは$CONFIG_DIRに存在することも記述されています。

これで、ディレクトリ構造は次のようになります。

├── iso-definition.yaml

└── base-images/

└── slemicro.iso以降のセクションでは、一般的な操作の例をいくつか紹介していきます。

3.3.1 OSユーザの設定 #

EIBを使用すると、パスワードやSSHキーなどのログイン情報を事前にユーザに設定できます(固定されたルートパスワードの設定も含む)。この例の一部として、ルートパスワードを修正します。最初の手順は、OpenSSLを使用して一方向暗号化パスワードを作成することです。

openssl passwd -6 SecurePasswordこれは次のような出力になります。

$6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1次に、定義ファイルにoperatingSystemというセクションを追加し、その中にusers配列を含めます。作成したファイルは次のようになります。

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1ユーザの追加、ホームディレクトリの作成、ユーザIDの設定、ssh-key認証の追加、グループ情報の変更も行うことができます。他の例については、アップストリームのイメージ構築ガイドを参照してください。

3.3.2 OSの時刻の設定 #

timeセクションはオプションですが、証明書とクロックスキューに関する潜在的な問題を避けるために、設定することを強くお勧めします。EIBは、chronydと/etc/localtimeをここのパラメータに応じて設定します。

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2timezoneでは、タイムゾーンを「地域/都市」(例: 「Europe/London」)の形式で指定します。完全なリストを確認するには、Linuxシステム上でtimedatectl list-timezonesを実行します。ntp - NTPの設定(chronydを使用)に関連する属性を定義します。

forceWait - 他のサービスを開始する前にchronydが時刻ソースの同期を試行するよう要求します。タイムアウトは180秒です。

pools - chronydがデータソースとして使用するプールのリストを指定します(

iburstを使用すると、最初の同期にかかる時間を短縮できます)。servers - chronydがデータソースとして使用するサーバのリストを指定します(

iburstを使用すると、最初の同期にかかる時間を短縮できます)。

この例で指定されている値は説明のみを目的としています。ご自身の特定の要件に合わせて調整してください。

3.3.3 証明書の追加 #

certificatesディレクトリに保存された拡張子「.pem」または「.crt」の証明書ファイルは、ノードのシステム全体の証明書ストアにインストールされます。

.

├── definition.yaml

└── certificates

├── my-ca.pem

└── my-ca.crt詳細については、「Securing Communication with TLS Certificate (TLS証明書による通信のセキュリティ保護)」ガイドを参照してください。

3.3.4 RPMパッケージの設定 #

EIBの主な特徴の1つは、イメージにソフトウェアパッケージを追加するメカニズムを備えていることです。このため、インストールが完了した時点で、システムはインストールされたパッケージをすぐに利用できます。EIBでは、ユーザは以下を行うことができます。

イメージ定義のリスト内の名前でパッケージを指定する

これらのパッケージを検索するネットワークリポジトリを指定する

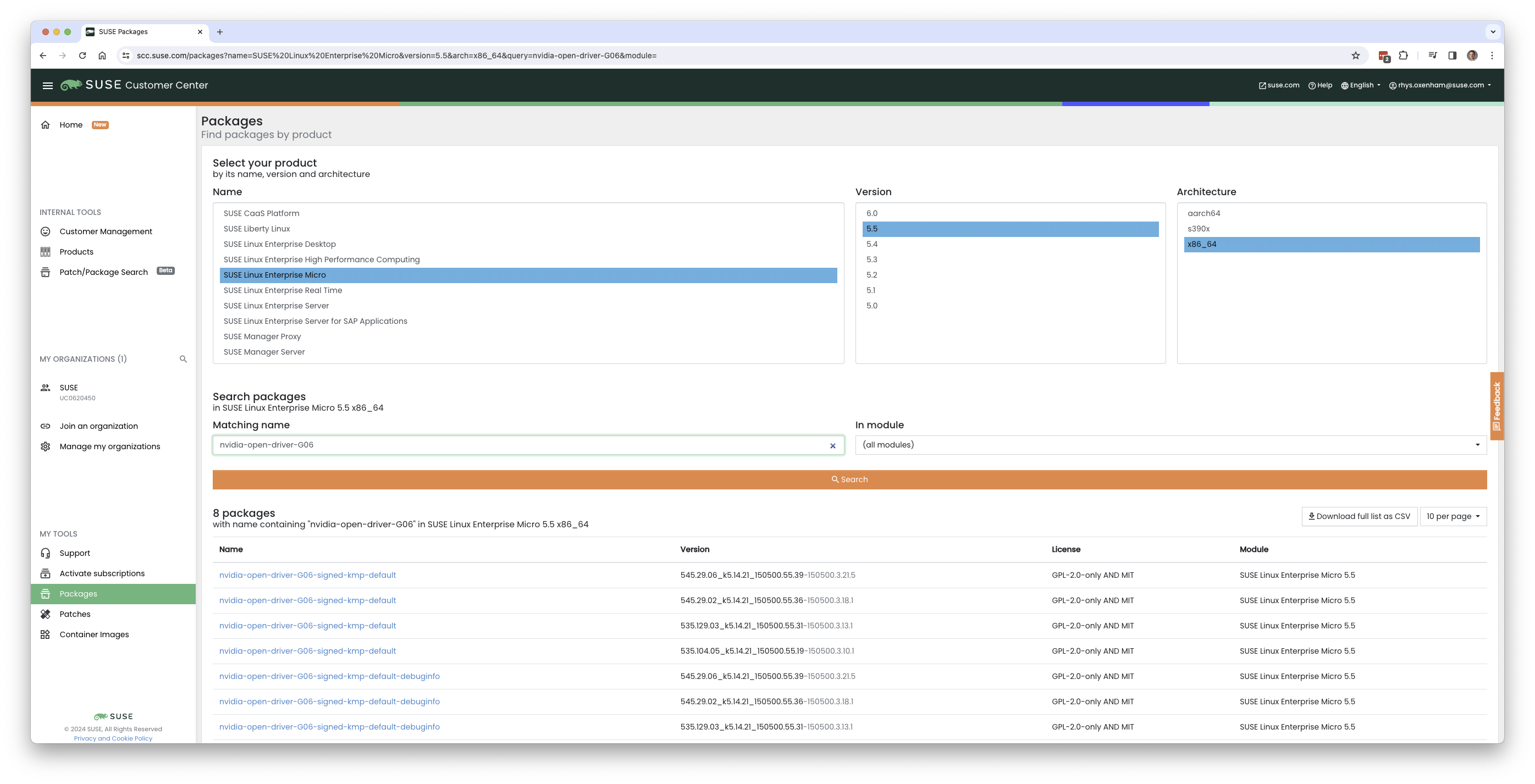

一覧にされたパッケージをSUSEの公式リポジトリで検索するためのSUSE Customer Center (SCC)資格情報を指定する

$CONFIG_DIR/rpmsディレクトリ経由で、ネットワークリポジトリに存在しないカスタムRPMをサイドロードする同じディレクトリ(

$CONFIG_DIR/rpms/gpg-keys)経由で、サードパーティ製パッケージの検証を有効にするためにGPGキーを指定する

これにより、EIBは、イメージの構築時にパッケージ解決プロセスを実行し、ゴールデンイメージを入力として受け取り、提供されているパッケージ(リストで指定されているか、ローカルで提供されているパッケージ)をすべてプルしてインストールしようと試みます。EIBは、依存関係を含むすべてのパッケージを出力イメージ内に存在するリポジトリにダウンロードし、そのパッケージを初回ブートプロセス中にインストールするようにシステムに指示します。イメージの構築中にこのプロセスを実行することで、初回ブート時にパッケージが目的のプラットフォーム(エッジのノードなど)に正常にインストールされることが保証されます。これは、操作時に追加パッケージをネットワーク経由でプルするのではなく、イメージに事前に書き込んでおきたい環境でも便利です。たとえば、エアギャップ環境や、ネットワークが制限された環境です。

これを示すシンプルな例として、サードパーティベンダがサポートするNVIDIAリポジトリにあるnvidia-container-toolkit

RPMパッケージをインストールします。

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64生成される定義ファイルは次のようになります。

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64上記はシンプルな例ですが、完全を期するために、イメージ生成を実行する前にNVIDIAパッケージ署名キーをダウンロードしてください。

$ mkdir -p $CONFIG_DIR/rpms/gpg-keys

$ curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey > $CONFIG_DIR/rpms/gpg-keys/nvidia.gpgこの方法でRPMを追加することは、サポートされているサードパーティコンポーネント、またはユーザが提供(および保守)するパッケージを追加することを目的としています。このメカニズムは、通常ではSUSE Linux Microでサポートされないパッケージを追加する目的では使用しないでください。このメカニズムを使用して、openSUSEのリポジトリから新しいリリースやサービスパックなどのコンポーネントを追加した場合(この操作はサポートされません)、最終的にサポート対象外の設定になるおそれがあります。特に、依存関係の解決によってオペレーティングシステムのコア部分が置き換えられる場合は、作成されたシステムが期待どおりに機能しているように見えても注意が必要です。確信が持てない場合は、SUSEの担当者に連絡してサポートを依頼し、目的の設定がサポート可能かどうかを判断してください。

3.3.5 Kubernetesクラスタとユーザワークロードの設定 #

EIBのもう1つの特徴は、EIBを使用すると、「インプレースでブートストラップ」する(つまり調整のためにどのような形態の集中管理インフラストラクチャも必要としない)シングルノードとマルチノード両方の高可用性Kubernetesクラスタのデプロイメントを自動化できることです。このアプローチは主にエアギャップデプロイメント、すなわちネットワークが制限された環境のためのものですが、ネットワークに制限なく完全にアクセスできる場合であっても、スタンドアロンクラスタを迅速にブートストラップする方法として役立ちます。

この方法を使用すると、カスタマイズされたオペレーティングシステムをデプロイできるだけでなく、Kubernetesの設定を指定したり、Helmチャートを介して追加の階層化コンポーネントを指定したり、指定したKubernetesマニフェストを介してユーザワークロードを指定したりすることもできます。ただしこの方法を使用する場合、その背景にある設計理念として、ユーザがエアギャップ化を望んでいるとデフォルトで想定します。したがって、イメージ定義で指定されているすべての項目を、ユーザが指定したワークロードを含めてイメージにプルします。その際に、EIBは、定義で要求されている検出済みイメージをすべてローカルにコピーし、作成されたデプロイ済みシステムの組み込みのイメージレジストリで提供します。

次の例では、既存のイメージ定義を使用してKubernetesの設定を指定します(この例では、複数のシステムとその役割が一覧にされていないため、デフォルトでシングルノードを想定します)。この設定により、シングルノードのRKE2 KubernetesクラスタをプロビジョニングするようにEIBに指示します。ユーザが指定したワークロード(マニフェストを使用)と階層化コンポーネント(Helmを使用)の両方のデプロイメントの自動化を説明するために、SUSE EdgeのHelmチャートを使用してKubeVirtをインストールし、Kubernetesマニフェストを使用してNGINXをインストールします。既存のイメージ定義に追加する必要がある設定は次のとおりです。

kubernetes:

version: v1.33.3+rke2r1

manifests:

urls:

- https://k8s.io/examples/application/nginx-app.yaml

helm:

charts:

- name: kubevirt

version: 304.0.1+up0.6.0

repositoryName: suse-edge

repositories:

- name: suse-edge

url: oci://registry.suse.com/edge/charts作成された完全な定義ファイルは次のようになります。

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64

kubernetes:

version: v1.33.3+k3s1

manifests:

urls:

- https://k8s.io/examples/application/nginx-app.yaml

helm:

charts:

- name: kubevirt

version: 304.0.1+up0.6.0

repositoryName: suse-edge

repositories:

- name: suse-edge

url: oci://registry.suse.com/edge/charts3.3.6 ネットワークの設定 #

このクイックスタートの最後の例では、EIBで生成したイメージを使ってシステムをプロビジョニングした場合に作成されるネットワークを設定しましょう。ネットワーク設定を指定しない限り、ブート時に検出されたすべてのインタフェースでDHCPが使用されるのがデフォルトのモデルであることを理解することが重要です。ただし、これが常に望ましい設定であるとは限りません。これは特に、DHCPが利用できず静的な設定を指定する必要がある場合や、より複雑なネットワーキング構造(ボンド、LACP、VLANなど)を設定する必要がある場合、特定のパラメータ(ホスト名、DNSサーバ、ルートなど)を上書きする必要がある場合に該当します。

EIBでは、ノードごとの設定を指定することも(対象のシステムをMACアドレスで一意に識別します)、上書きによって各マシンに同一の設定を指定することもできます(システムのMACアドレスが不明な場合に便利です)。またEIBでは、Network

Manager Configurator (nmc)というツールも追加で使用されます。Network

Manager ConfiguratorはSUSE Edgeチームによって構築されたツールであり、nmstate.ioの宣言型ネットワークスキーマに基づいてカスタムネットワーキング設定を適用できるようにします。また、ブートしているノードをブート時に識別し、必要なネットワーク設定をサービス開始前に適用します。

ここでは、1つのインタフェースを持つシステムに静的ネットワーク設定を適用します。そのために、ネットワークの望ましい状態を、必要なnetworkディレクトリ内にある(目的のホスト名に基づく)ノード固有のファイルに記述します。

mkdir $CONFIG_DIR/network

cat << EOF > $CONFIG_DIR/network/host1.local.yaml

routes:

config:

- destination: 0.0.0.0/0

metric: 100

next-hop-address: 192.168.122.1

next-hop-interface: eth0

table-id: 254

- destination: 192.168.122.0/24

metric: 100

next-hop-address:

next-hop-interface: eth0

table-id: 254

dns-resolver:

config:

server:

- 192.168.122.1

- 8.8.8.8

interfaces:

- name: eth0

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E7

ipv4:

address:

- ip: 192.168.122.50

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

EOF上記の例は、テストを仮想マシン上で実行すると仮定して、デフォルトの192.168.122.0/24サブネット用に設定されています。ご使用の環境に合わせて、MACアドレスも忘れずに変更してください。同じイメージを使用して複数のノードをプロビジョニングできるため、

EIBで(nmcを介して)設定されたネットワーキングは、各ノードをMACアドレスで一意に識別できるかどうかに依存しており、その後、ブート中にnmcは正しいネットワーキング設定を各マシンに適用します。つまり、インストール先のシステムのMACアドレスを把握する必要があります。また、デフォルトの動作ではDHCPに依存しますが、configure-network.shフックを利用して、すべてのノードに共通の設定を適用することもできます。詳細については、ネットワーキングのガイド(第12章 「Edgeネットワーキング」)を参照してください。

作成されるファイル構造は、次のようになります。

├── iso-definition.yaml

├── base-images/

│ └── slemicro.iso

└── network/

└── host1.local.yaml作成したネットワーク設定が解析され、必要なNetworkManager接続ファイルが自動的に生成されて、EIBが作成する新しいインストールイメージに挿入されます。これらのファイルはホストのプロビジョニング中に適用され、完全なネットワーク設定が生成されます。

3.4 イメージの構築 #

EIBで使用するゴールデンイメージとイメージ定義ができたので、イメージを構築してみましょう。これには、podmanを使用し、定義ファイルを指定して「build」コマンドでEIBコンテナを呼び出すだけです。

podman run --rm -it --privileged -v $CONFIG_DIR:/eib \

registry.suse.com/edge/3.4/edge-image-builder:1.3.0 \

build --definition-file iso-definition.yamlコマンドの出力は次のようになります。

Setting up Podman API listener...

Downloading file: dl-manifest-1.yaml 100% (498/498 B, 9.5 MB/s)

Pulling selected Helm charts... 100% (1/1, 43 it/min)

Generating image customization components...

Identifier ................... [SUCCESS]

Custom Files ................. [SKIPPED]

Time ......................... [SKIPPED]

Network ...................... [SUCCESS]

Groups ....................... [SKIPPED]

Users ........................ [SUCCESS]

Proxy ........................ [SKIPPED]

Resolving package dependencies...

Rpm .......................... [SUCCESS]

Os Files ..................... [SKIPPED]

Systemd ...................... [SKIPPED]

Fips ......................... [SKIPPED]

Elemental .................... [SKIPPED]

Suma ......................... [SKIPPED]

Populating Embedded Artifact Registry... 100% (3/3, 10 it/min)

Embedded Artifact Registry ... [SUCCESS]

Keymap ....................... [SUCCESS]

Configuring Kubernetes component...

The Kubernetes CNI is not explicitly set, defaulting to 'cilium'.

Downloading file: rke2_installer.sh

Downloading file: rke2-images-core.linux-amd64.tar.zst 100% (657/657 MB, 48 MB/s)

Downloading file: rke2-images-cilium.linux-amd64.tar.zst 100% (368/368 MB, 48 MB/s)

Downloading file: rke2.linux-amd64.tar.gz 100% (35/35 MB, 50 MB/s)

Downloading file: sha256sum-amd64.txt 100% (4.3/4.3 kB, 6.2 MB/s)

Kubernetes ................... [SUCCESS]

Certificates ................. [SKIPPED]

Cleanup ...................... [SKIPPED]

Building ISO image...

Kernel Params ................ [SKIPPED]

Build complete, the image can be found at: eib-image.iso構築されたISOイメージは$CONFIG_DIR/eib-image.isoに保存されます。

├── iso-definition.yaml

├── eib-image.iso

├── _build

│ └── cache/

│ └── ...

│ └── build-<timestamp>/

│ └── ...

├── base-images/

│ └── slemicro.iso

└── network/

└── host1.local.yamlビルドごとに、$CONFIG_DIR/_build/内にタイムスタンプ付きのフォルダが作成されます。このフォルダには、ビルドのログ、ビルド中に使用されたアーティファクト、およびCRBイメージに追加されたすべてのスクリプトとアーティファクトを含むcombustionディレクトリとartefactsディレクトリが含まれます。

このディレクトリの内容は次のようになります。

├── build-<timestamp>/

│ │── combustion/

│ │ ├── 05-configure-network.sh

│ │ ├── 10-rpm-install.sh

│ │ ├── 12-keymap-setup.sh

│ │ ├── 13b-add-users.sh

│ │ ├── 20-k8s-install.sh

│ │ ├── 26-embedded-registry.sh

│ │ ├── 48-message.sh

│ │ ├── network/

│ │ │ ├── host1.local/

│ │ │ │ └── eth0.nmconnection

│ │ │ └── host_config.yaml

│ │ ├── nmc

│ │ └── script

│ │── artefacts/

│ │ │── registry/

│ │ │ ├── hauler

│ │ │ ├── nginx:<version>-registry.tar.zst

│ │ │ ├── rancher_kubectl:<version>-registry.tar.zst

│ │ │ └── registry.suse.com_suse_sles_15.6_virt-operator:<version>-registry.tar.zst

│ │ │── rpms/

│ │ │ └── rpm-repo

│ │ │ ├── addrepo0

│ │ │ │ ├── nvidia-container-toolkit-<version>.rpm

│ │ │ │ ├── nvidia-container-toolkit-base-<version>.rpm

│ │ │ │ ├── libnvidia-container1-<version>.rpm

│ │ │ │ └── libnvidia-container-tools-<version>.rpm

│ │ │ ├── repodata

│ │ │ │ ├── ...

│ │ │ └── zypper-success

│ │ └── kubernetes/

│ │ ├── rke2_installer.sh

│ │ ├── registries.yaml

│ │ ├── server.yaml

│ │ ├── images/

│ │ │ ├── rke2-images-cilium.linux-amd64.tar.zst

│ │ │ └── rke2-images-core.linux-amd64.tar.zst

│ │ ├── install/

│ │ │ ├── rke2.linux-amd64.tar.gz

│ │ │ └── sha256sum-amd64.txt

│ │ └── manifests/

│ │ ├── dl-manifest-1.yaml

│ │ └── kubevirt.yaml

│ ├── createrepo.log

│ ├── eib-build.log

│ ├── embedded-registry.log

│ ├── helm

│ │ └── kubevirt

│ │ └── kubevirt-0.4.0.tgz

│ ├── helm-pull.log

│ ├── helm-template.log

│ ├── iso-build.log

│ ├── iso-build.sh

│ ├── iso-extract

│ │ └── ...

│ ├── iso-extract.log

│ ├── iso-extract.sh

│ ├── modify-raw-image.sh

│ ├── network-config.log

│ ├── podman-image-build.log

│ ├── podman-system-service.log

│ ├── prepare-resolver-base-tarball-image.log

│ ├── prepare-resolver-base-tarball-image.sh

│ ├── raw-build.log

│ ├── raw-extract

│ │ └── ...

│ └── resolver-image-build

│ └──...

└── cache

└── ...ビルドが失敗した場合、情報が含まれる最初のログはeib-build.logです。そこから、失敗したコンポーネントに移動してデバッグを行います。

この時点で、以下を行う、すぐに使用できるイメージができているはずです。

SUSE Linux Micro 6.1をデプロイする

ルートパスワードを設定する

nvidia-container-toolkitパッケージをインストールするコンテンツをローカルに提供する組み込みのコンテナレジストリを設定する

シングルノードRKE2をインストールする

静的ネットワーキングを設定する

KubeVirtをインストールする

ユーザが指定したマニフェストをデプロイする

3.5 イメージ構築プロセスのデバッグ #

イメージ構築プロセスが失敗する場合は、アップストリームのデバッグガイドを参照してください。

3.6 新しく構築されたイメージのテスト #

新しく構築されたCRBイメージをテストする方法については、アップストリームのイメージテストガイドを参照してください。

4 SUSE Multi-Linux Manager #

SUSE Multi-Linux ManagerはSUSE Edgeに含まれており、エッジデプロイメントのすべてのノードでSUSE Linux Microを基盤となるオペレーティングシステムとして常に最新の状態に保つための自動化と制御を提供します。また、エッジノード上のKubernetesとKubernetes上にデプロイされたアプリケーションの管理にも使用できます。

このクイックスタートガイドは、エッジノードにオペレーティングシステムの更新を提供することを目的として、SUSE Multi-Linux Managerをできるだけ早く使いこなすためのものです。このクイックスタートガイドでは、ストレージのサイズ設定、ステージング目的の追加ソフトウェアチャンネルの作成と管理、大規模なデプロイメントのためのユーザ、システムグループ、組織の管理などのトピックについては説明しません。運用環境で使用する場合は、包括的なSUSE Multi-Linux Manager のドキュメントを参照することを強くお勧めします。

SUSE Multi-Linux Managerを効果的に使用するためにSUSE Edgeを準備するには、次の手順が必要です。

SUSE Multi-Linux Manager Serverのデプロイと設定

SUSE Linux Microパッケージリポジトリの同期

システムグループの作成

アクティベーションキーの作成

Edge Image Builderを使用したSUSE Multi-Linux Manager登録用インストールメディアの準備

4.1 SUSE Multi-Linux Manager Serverのデプロイ #

SUSE Multi-Linux Manager 5.0.5のインスタンスをすでに実行している場合は、この手順をスキップできます。

SUSE Multi-Linux Manager Serverは、専用の物理サーバ、自身のハードウェア上の仮想マシン、またはクラウドで実行できます。SUSE Multi-Linux Serverの事前に設定された仮想マシンイメージはサポートされているパブリッククラウド用に提供されています。

このクイックスタートでは、AMD64/Intel

64用の「qcow2」イメージSUSE-Manager-Server.x86_64-5.0.4-Qcow-5.0-2025-04.qcow2を使用しています。このイメージは、https://www.suse.com/download/suse-manager/またはSUSE

Customer

Centerで入手できます。このイメージは、KVMなどのハイパーバイザー上の仮想マシンとして機能します。イメージの最新バージョンを常に確認して、新しいインストールに使用してください。

SUSE Multi-Linux Manager Serverを他のサポートされているハードウェアアーキテクチャにもインストールできます。その場合は、ハードウェアアーキテクチャに合ったイメージを選択してください。

イメージをダウンロードしたら、次の最小ハードウェア仕様を満たす仮想マシンを作成します。

16GB RAM

4つの物理コアまたは仮想コア

最低100GBの追加のブロックデバイス

qcow2イメージでは、オペレーティングシステムをインストールする必要はありません。イメージをルートパーティションとして直接アタッチできます。

後でエッジノードが完全修飾ドメイン名(「FQDN」)を含むホスト名でSUSE Multi-Linux Manager Serverにアクセスできるように、ネットワークを設定する必要があります。

SUSE Multi-Linux Managerを初めてブートする際には、いくつかの初期設定を実行する必要があります。

キーボードレイアウトの選択

ライセンス契約の同意

タイムゾーンの選択

オペレーティングシステムのルートパスワードの入力

次の各手順は「ルート」ユーザとして実行する必要があります。

次の手順では、SUSE Customer Centerで入手可能なSUSE Multi-Linux Manager Extensionの登録コードが必要です。同じコードを使用して、SUSE Linux MicroとSUSE Multi-Linux Managerの両方を登録できます。

SUSE Linux Microを登録します。

transactional-update register -r <REGCODE> -e <your_email>SUSE Multi-Linux Managerを登録します。

transactional-update register -p SUSE-Manager-Server/5.0/x86_64 -r <REGCODE>製品文字列は、ハードウェアアーキテクチャによって異なります。たとえば、64ビットArmシステムでSUSE Multi-Linux Managerを使用している場合、文字列は「SUSE-Manager-Server/5.0/aarch64」になります。

再起動します。

システムを更新します。

transactional-update変更がなければ、再起動して更新を適用します。

SUSE Multi-Linux

Managerは、Podmanによって管理されるコンテナを介して提供されます。mgradmコマンドがセットアップと設定を自動的に行います。

SUSE Multi-Linux Manager Serverのホスト名が、管理対象のエッジノードがネットワークで適切に解決できる完全修飾ドメイン名(「FQDN」)で設定されていることが非常に重要です。

SUSE Multi-Linux Manager

Serverコンテナをインストールして設定する前に、以前に追加した追加のブロックデバイスを準備しておく必要があります。そのためには、仮想マシンがそのデバイスに付けた名前を知っている必要があります。たとえば、ブロックデバイスが

/dev/vdbの場合、次のコマンドを使用して、SUSE Multi-Linux

Managerで使用するように設定できます。

mgr-storage-server /dev/vdbSUSE Multi-Linux Managerをデプロイします。

mgradm install podman <FQDN>CA証明書のパスワードを入力します。このパスワードはログインパスワードとは異なる必要があります。通常は後で入力する必要はありませんが、メモしておいてください。

「admin」ユーザのパスワードを入力します。これは、SUSE Multi-Linux Managerにログインするための初期ユーザです。後で完全な権利または制限された権利を持つ追加のユーザを作成できます。

4.2 SUSE Multi-Linux Managerの設定 #

デプロイメントが完了したら、先ほど指定したホスト名を使用して、SUSE Multi-Linux Manager Web UIにログインできます。初期ユーザは「admin」です。前の手順で指定したパスワードを使用します。

次の手順では、SUSE Customer Centerの組織の「ユーザ」タブの2番目のサブタブにある組織の資格情報が必要です。これらの資格情報を使用して、SUSE Multi-Linux Managerはサブスクリプションを持つすべての製品を同期できます。

[管理] > [セットアップウィザード]を選択します。

組織の資格情報タブで、SUSE Customer

Centerにあるユーザ名とパスワードを使用して新しい資格情報を作成します。

次のタブ[SUSE製品]に移動します。SUSE Customer

Centerとの最初のデータ同期が完了するまで待つ必要があります。

リストが入力されたら、フィルタを使用して「Micro

6.1」のみを表示します。エッジノードが実行されるハードウェアアーキテクチャ(x86_64またはaarch64)に対応するSUSE

Linux Micro 6.1のチェックボックスをオンにします。

[製品の追加]をクリックします。これにより、SUSE Linux

Microのメインパッケージリポジトリ(「チャンネル」)が追加され、SUSE

Managerクライアントツールのチャンネルがサブチャンネルとして自動的に追加されます。

インターネット接続によっては、最初の同期にしばらく時間がかかります。次の手順からすぐに開始できます。

[システム]

>[システムグループ]で、システムがオンボード時に自動的に参加するグループを少なくとも1つ作成します。グループはシステムを分類する重要な方法であり、設定やアクションをシステムセット全体に一度に適用できます。概念的には、Kubernetesのラベルに似ています。

[+グループの作成]をクリックします。

短い名前(「エッジノード 」など)と長い説明を入力します。

[システム]

>[アクティベーションキー]で、少なくとも1つのアクティベーションキーを作成します。アクティベーションキーは、システムが

SUSE Multi-Linux

Managerにオンボードされたときに自動的に適用される設定プロファイルと考えることができます。特定のエッジノードを異なるグループに追加したり、異なる設定を使用したりする場合は、それら用に個別のアクティベーションキーを作成し、後でEdge

Image Builderでカスタマイズしたインストールメディアを作成する際に使用できます。

アクティベーションキーの典型的な高度なユースケースは、テストクラスタを最新の更新を含むソフトウェアチャンネルに割り当て、運用クラスタを、テストクラスタでテストした後にのみ最新の更新を取得するソフトウェアチャンネルに割り当てることです。

[+キーの作成]をクリックします。

短い説明を選択します(「エッジノード」など)。キーを識別する一意の名前を指定します(AMD64/Intel 64ハードウェアアーキテクチャを備えたエッジノードの場合は 「edge-x86_64 」など)。番号のプレフィックスが自動的にキーに追加されます。デフォルトの組織の場合、番号は常に「1」です。SUSE Multi-Linux Managerで追加の組織を作成し、これらの組織のキーを作成する場合、この番号は異なる可能性があります。

クローンソフトウェアチャンネルを作成していない場合は、ベースチャンネルの設定を「SUSE Managerの既定値」のままにしておくことができます。これにより、エッジノードに正しいSUSE更新リポジトリが自動的に割り当てられます。

「子チャンネル」として、アクティベーションキーが使用されているハードウェアアーキテクチャの[推奨を含める]スライダを選択します。これにより、「SUSE-Manager-Tools-For-SL-Micro-6.1」チャンネルが追加されます。

[グループ]タブで、以前に作成したグループを追加します。このアクティベーションキーを使用してオンボードされたすべてのノードがそのグループに自動的に追加されます。

4.3 Edge Image Builderを使用したカスタマイズされたインストールイメージの作成 #

Edge Image Builderを使用するには、PodmanでLinuxベースのコンテナを起動できる環境のみが必要です。

最小限のラボのセットアップでは、SUSE Multi-Linux Manager Serverが実行しているのと同じ仮想マシンを実際に使用できます。仮想マシンに十分なディスク容量があることを確認してください。これは運用環境での使用には推奨されないセットアップです。Edge Image Builderをテストしたホストオペレーティングシステムについては、 3.1項 「前提条件」を参照してください。

SUSE Multi-Linux Managerサーバホストにrootとしてログインします。

Edge Image Builderコンテナをプルします。

podman pull registry.suse.com/edge/3.4/edge-image-builder:1.3.0ディレクトリ/opt/eibとサブディレクトリbase-imagesを作成します。

mkdir -p /opt/eib/base-imagesこのクイックスタートでは、SUSE Linux Microイメージの「セルフインストール」フレーバーを使用しています。このイメージは、後で物理USBメモリに書き込んで、物理サーバにインストールするために使用できます。ご使用のサーバにBMC (ベースボード管理コントローラ)経由でインストールISOをリモートアタッチするオプションがある場合は、その方法も使用できます。また、このイメージはほとんどの仮想化ツールでも使用できます。

イメージを物理ノードに直接プリロードする場合、またはVMから直接起動する場合は、「生」イメージフレーバーを使用することもできます。

これらのイメージはSUSE Customer Centerまたはhttps://www.suse.com/download/sle-micro/にあります。

イメージ

SL-Micro.x86_64-6.1-Default-SelfInstall-GM.install.isoをbase-imagesディレクトリにダウンロードまたはコピーして、「slemicro.iso」という名前を付けます。

Armベースの構築ホスト上でのAArch64イメージの構築は、SUSE Edge 3.4の技術プレビュー対象です。おそらく動作しますが、まだサポートされていません。お試しいただく場合は、64ビットのArmマシンでPodmanを実行し、すべての例とコードスニペットの「x86_64」を「aarch64」に置き換える必要があります。

/opt/eibに、iso-definition.yamlというファイルを作成します。これはEdge

Image Builderのビルド定義です。

ここでは、SL Micro 6.1をインストールし、ルートパスワードとキーマップを設定して、CockpitグラフィカルUIを起動し、ノードをSUSE Multi-Linux Managerに登録するシンプルな例を示します。

apiVersion: 1.3

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

createHomeDir: true

encryptedPassword: $6$aaBTHyqDRUMY1HAp$pmBY7.qLtoVlCGj32XR/Ogei4cngc3f4OX7fwBD/gw7HWyuNBOKYbBWnJ4pvrYwH2WUtJLKMbinVtBhMDHQIY0

keymap: de

systemd:

enable:

- cockpit.socket

packages:

noGPGCheck: true

suma:

host: ${fully qualified hostname of your SUSE Multi-Linux Manager Server}

activationKey: 1-edge-x86_64Edge Image Builderは、ネットワークを設定し、ノードにKubernetesを自動的にインストールして、Helmチャート経由でアプリケーションをデプロイすることもできます。より包括的な例については、第3章 「Edge Image Builderを使用したスタンドアロンクラスタ」を参照してください。

baseImageには、使用するbase-imagesディレクトリ内のISOの実際の名前を指定します。

この例では、ルートパスワードは「root」になります。使用する安全なパスワードのパスワードハッシュを作成する方法については、3.3.1項 「OSユーザの設定」を参照してください。

キーマップを、インストール後にシステムが使用する実際のキーボードレイアウトに設定します。

SUSEではRPMパッケージのチェックにGPGキーを提供しないため、オプションnoGPGCheck:

trueを使用しています。運用環境での使用に推奨するより安全なセットアップに関する包括的なガイドについては、アップストリームのパッケージインストールガイドを参照してください。

何度か言及したように、SUSE Multi-Linux Managerホストには、エッジノードがブートするネットワークで解決できる完全修飾ホスト名が必要です。

activationKeyの値は、SUSE Multi-Linux

Managerで作成したキーと一致する必要があります。

インストール後にエッジノードをSUSE Multi-Linux Managerに自動的に登録するインストールイメージを構築するには、次の2つのアーティファクトを準備する必要もあります。

SUSE Multi-Linux Managerの管理エージェントをインストールするSalt minionパッケージ

SUSE Multi-Linux ManagerサーバのCA証明書

4.3.1 venv-salt-minionパッケージのダウンロード #

/opt/eibに、サブディレクトリrpmsを作成します。

SUSE Multi-Linux

Managerサーバからそのディレクトリにパッケージvenv-salt-minionをダウンロードします。Web

UIから取得する場合は、[ソフトウェア]

>[チャンネル一覧]にあるパッケージを見つけてSUSE-Manager-Tools

…チャンネルからダウンロードするか、SUSE Multi-Linux

Managerの「ブートストラップリポジトリ」からcurlなどのツールを使用してダウンロードします。

curl -O http://${HOSTNAME_OF_SUSE_MANAGER}/pub/repositories/slmicro/6/1/bootstrap/x86_64/venv-salt-minion-3006.0-8.1.x86_64.rpm実際のパッケージ名は、新しいリリースがすでにリリースされている場合は異なる場合があります。複数のパッケージから選択できる場合は、必ず最新のパッケージを選択してください。

SUSE Multi-Linux Managerのリリースノートに記載されている問題を回避するには、最新バージョンのビルドキーパッケージをrpmsディレクトリ(このドキュメントの作成時点ではsuse-build-key-12.0-slfo.1.1_3.1.noarch.rpm)に配置する必要があります。このパッケージは、SL

MicroのPoolチャンネルのPackagesタブ経由で、SUSE Multi-Linux

Managerの[ソフトウェア]セクションにあります。[詳細]ビューには[ダウンロード]ボタンがあります。

4.4 SUSE Multi-Linux Manager CA証明書のダウンロード #

/opt/eibに、サブディレクトリcertificatesを作成します。

SUSE Multi-Linux ManagerからそのディレクトリにCA証明書をダウンロードします。

curl -O http://${HOSTNAME_OF_SUSE_MANAGER}/pub/RHN-ORG-TRUSTED-SSL-CERT証明書の名前をRHN-ORG-TRUSTED-SSL-CERT.crtに変更する必要があります。その後、Edge

Image Builderは、インストール時に証明書がエッジノードにインストールされ、アクティブ化されていることを確認します。

これでEdge Image Builderを実行できます。

cd /opt/eib

podman run --rm -it --privileged -v /opt/eib:/eib \

registry.suse.com/edge/3.4/edge-image-builder:1.3.0 \

build --definition-file iso-definition.yamlYAML定義ファイルに別の名前を使用している場合や別のバージョンのEdge Image Builderを使用する場合は、それに応じてコマンドを調整する必要があります。

ビルドが完了したら、

/opt/eibディレクトリにインストールISOがeib-image.isoとして保存されます。

このイメージは、SUSE Multi-Linux Managerに登録しようとするノードをデプロイするために使用できます。

ノードのインストールが完了すると、SUSE Multi-Linux

Managerの[Salt/キー]セクションにノードのキーが保留中として表示されます。キーを受け入れると、ノードはSUSE

Multi-Linux

Managerに自動的にオンボードされ、そのプロセスが完了すると[システム]リストに表示されます。ノードには、アクティベーションキーで指定したシステムグループが割り当てられます。

その後、追加の設定を適用する前に再起動をスケジュールする必要があります。

キーの受け入れは、こちらで説明されているように、ホワイトリストを使用して完全に自動化できることに注意してください。

パート II コンポーネント #

Edgeのコンポーネントのリスト

- 5 Rancher

https://ranchermanager.docs.rancher.com/v2.12にあるRancherのドキュメントを参照してください。

- 6 Rancher Dashboard拡張機能

拡張機能により、ユーザ、開発者、パートナー、および顧客はRancher UIを拡張および強化できます。SUSE Edgeでは、KubeVirtとAkriのダッシュボード拡張機能を提供しています。

- 7 Rancher Turtles

https://documentation.suse.com/cloudnative/cluster-api/にあるRancher Turtlesのドキュメントを参照してください。

- 8 Fleet

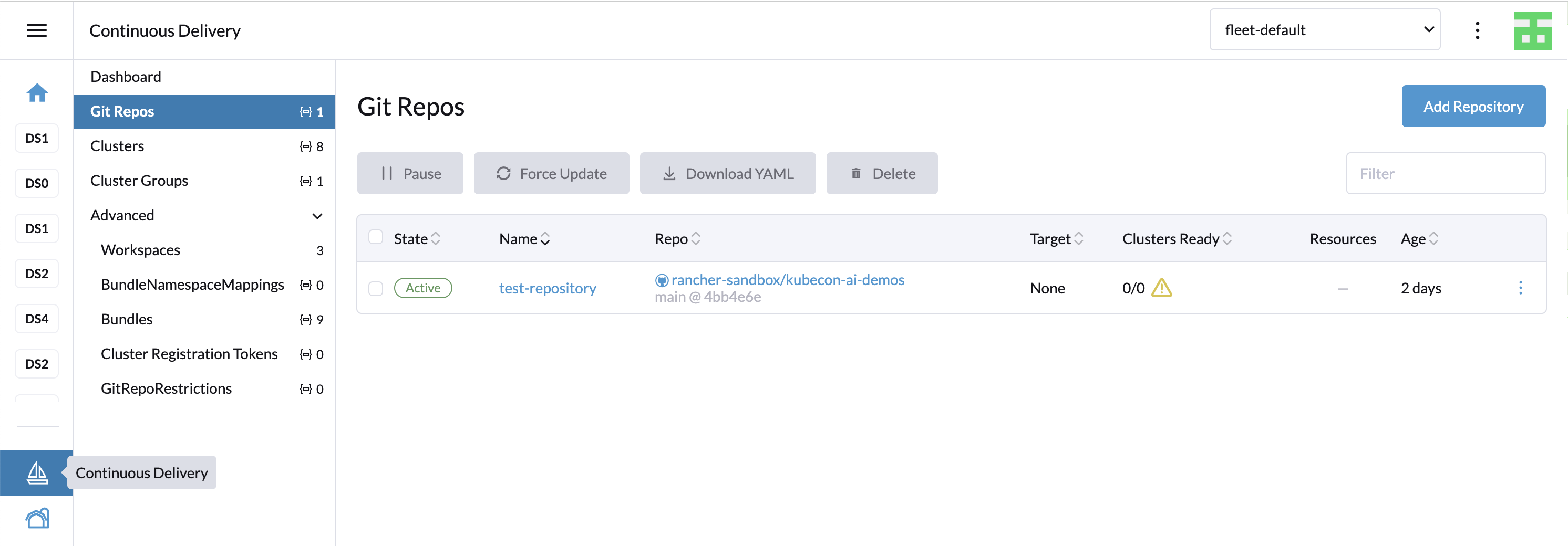

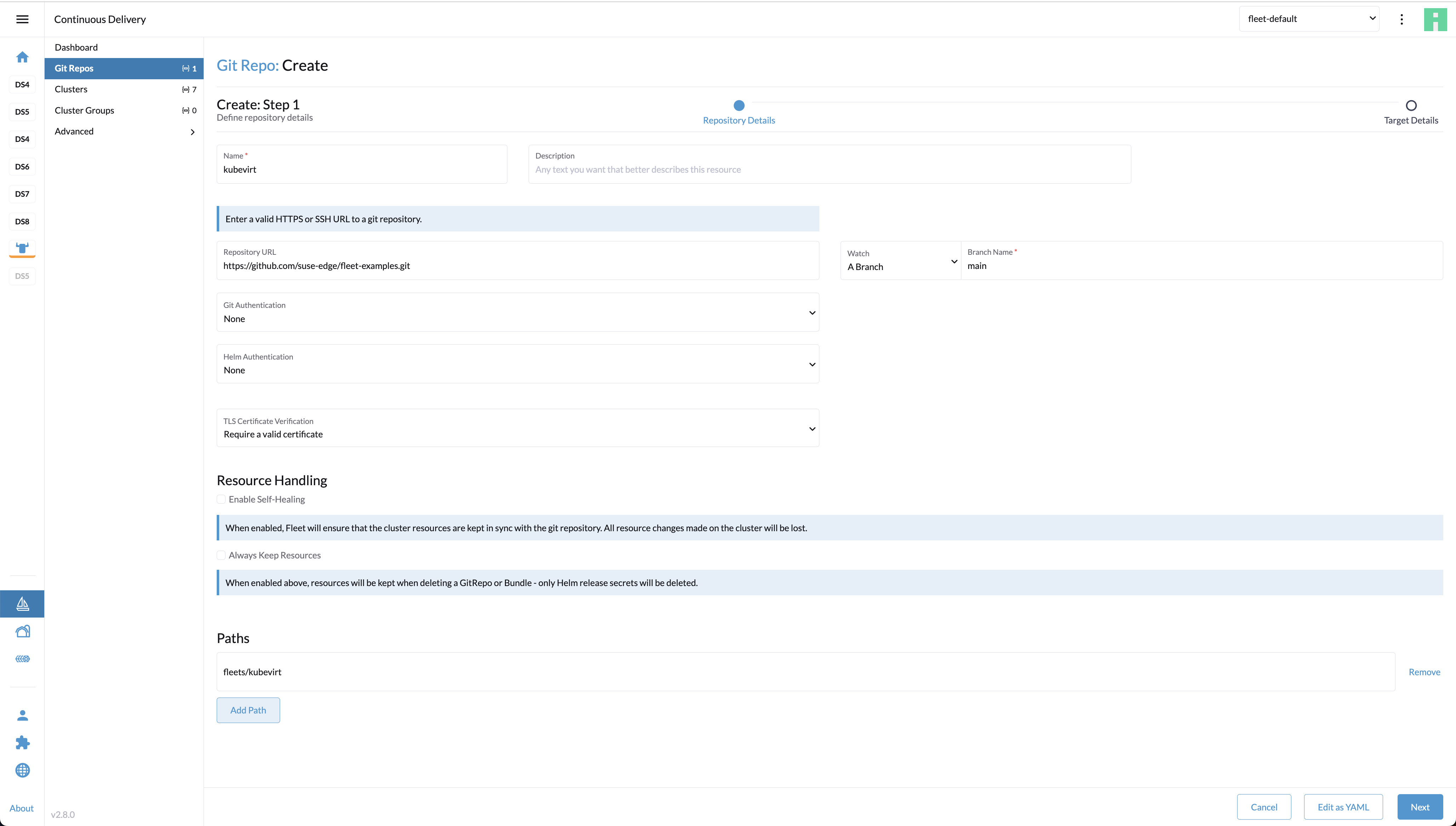

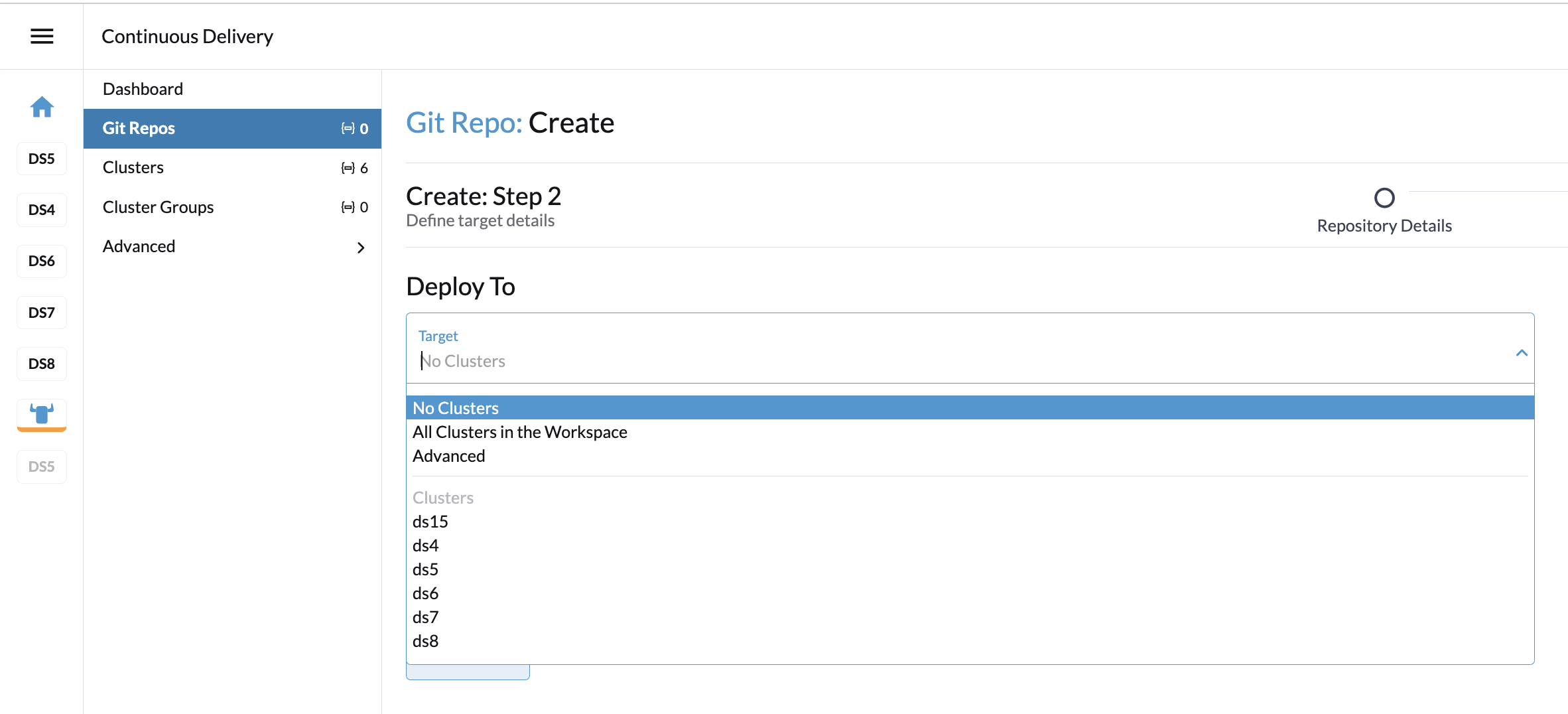

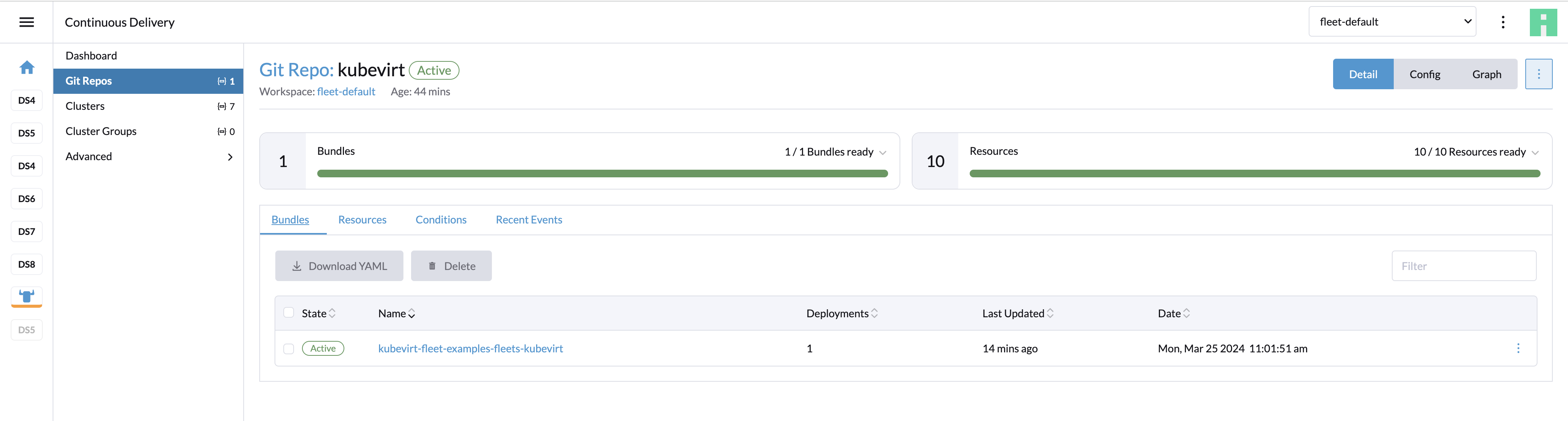

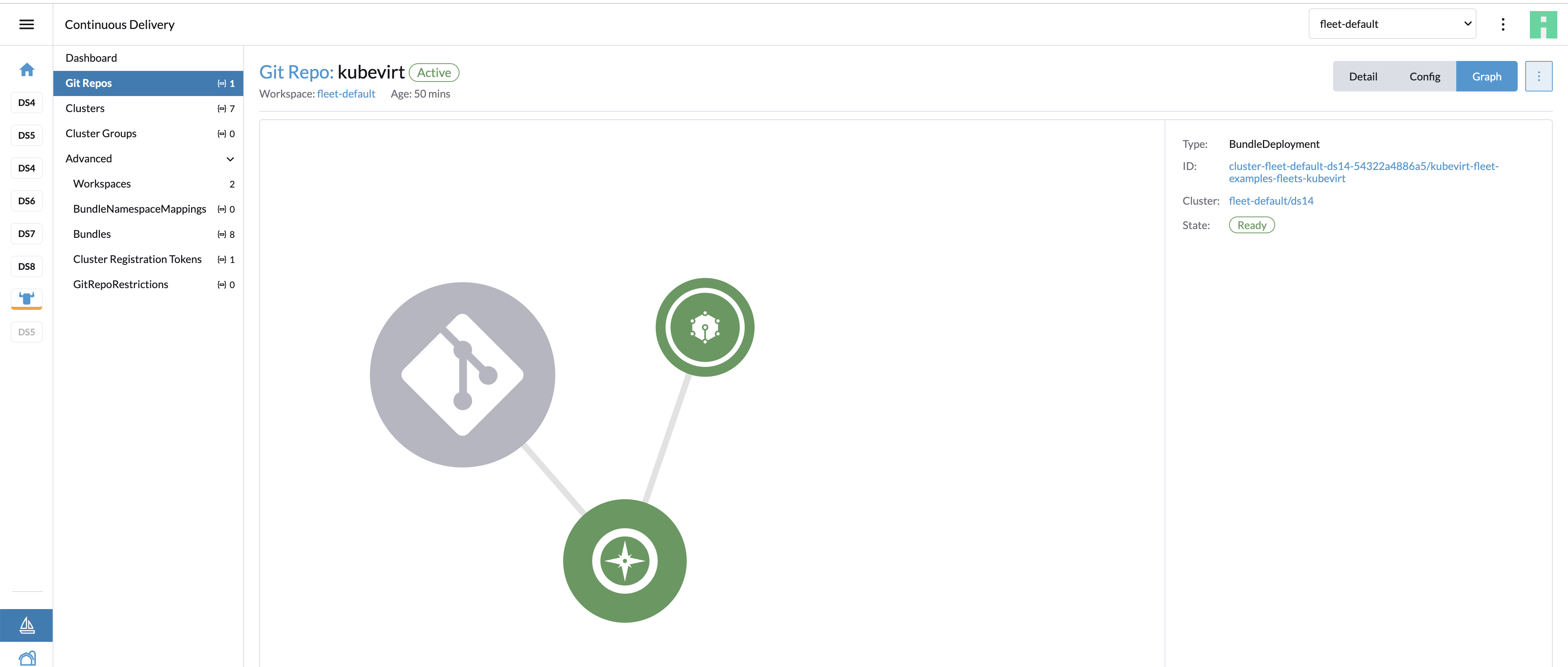

Fleetは、ユーザがローカルクラスタをより細かく制御できるようにするとともに、GitOpsを通じて常時監視を行えるようにすることを目的に設計されたコンテナ管理およびデプロイメントエンジンです。Fleetはスケール能力に重点を置いているだけでなく、クラスタに何がインストールされているかを正確に監視するための高度な制御と可視性もユーザに提供します。

- 9 SUSE Linux Micro

SUSE Linux Micro公式ドキュメントを参照してください。

- 10 Metal3

Metal3は、Kubernetesにベアメタルインフラストラクチャ管理機能を提供するCNCFプロジェクトです。

- 11 Edge Image Builder

公式リポジトリを参照してください。

- 12 Edgeネットワーキング

このセクションでは、SUSE Edgeソリューションにおけるネットワーク設定へのアプローチについて説明します。宣言的な方法でSUSE Linux Micro上でNetworkManagerを設定する方法を示し、関連ツールの統合方法について説明します。

- 13 Elemental

Elementalは、Kubernetesを使用した完全にクラウドネイティブな集中型のOS管理を可能にするソフトウェアスタックです。Elementalスタックは、Rancher自体またはエッジノード上に存在する多数のコンポーネントで構成されます。中核となるコンポーネントは次のとおりです。

- 14 K3s

K3sは、リソースに制約のあるリモートの無人の場所やIoTアプライアンス内の運用ワークロード向けに設計された、高可用性のKubernetes認定ディストリビューションです。

- 15 RKE2

RKE2の公式ドキュメントを参照してください。

- 16 SUSE Storage

SUSE Storageは、Kubernetes向けに設計された、信頼性が高くユーザフレンドリな軽量の分散ブロックストレージシステムです。当初はRancher Labsによって開発され、現在はCNCFの下でインキュベートされているオープンソースプロジェクトであるLonghornをベースにした製品です。

- 17 SUSE Security

SUSE SecurityはKubernetes向けのセキュリティソリューションであり、L7ネットワークセキュリティ、ランタイムセキュリティ、サプライチェーンセキュリティ、およびコンプライアンスチェックを1つの統合パッケージで提供します。

- 18 MetalLB

MetalLBの公式ドキュメントを参照してください。

- 19 Endpoint Copier Operator

Endpoint Copier Operatorは、Kubernetesサービスとエンドポイントのコピーを作成し、同期を維持することを目的としたKubernetesオペレータです。

- 20 Edge Virtualization

このセクションでは、Edge Virtualizationを使用してエッジノードで仮想マシンを実行する方法について説明します。Edge Virtualizationは、軽量な仮想化ユースケース向けに設計されており、仮想化およびコンテナ化されたアプリケーションのデプロイメントと管理に共通のワークフローが利用されることが想定されています。

- 21 System Upgrade Controller

System Upgrade Controllerのドキュメントを参照してください。

- 22 Upgrade Controller

次のSUSE Edgeプラットフォームコンポーネントに対してアップグレードを実行できるKubernetesコントローラ:

- 23 SUSE Multi-Linux Manager

SUSE Multi-Linux ManagerはSUSE Edgeに含まれており、エッジデプロイメントのすべてのノードでSUSE Linux Microを基盤となるオペレーティングシステムとして常に最新の状態に保つための自動化と制御を提供します。

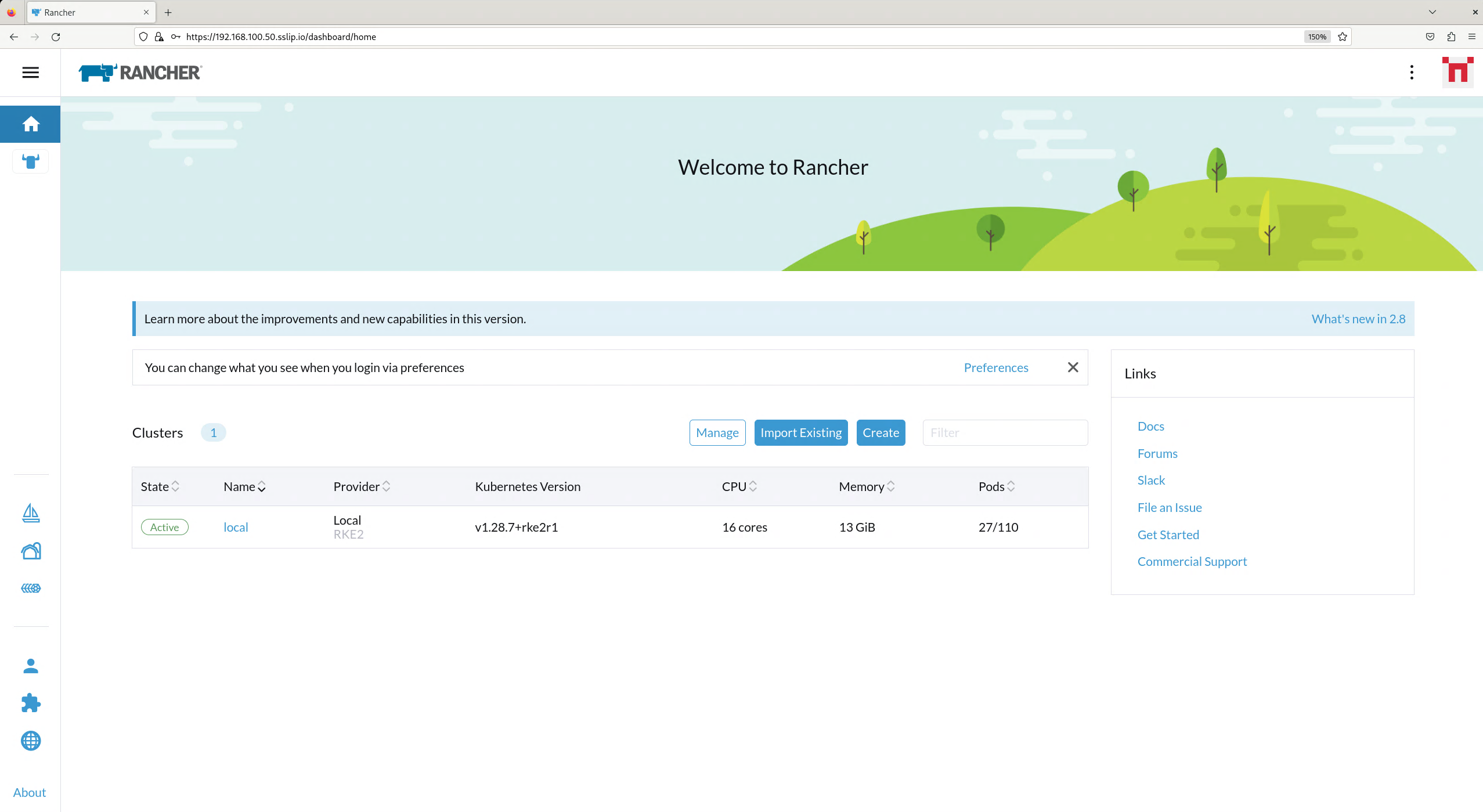

5 Rancher #

https://ranchermanager.docs.rancher.com/v2.12にあるRancherのドキュメントを参照してください。

Rancherは、オープンソースの強力なKubernetes管理プラットフォームであり、複数の環境にまたがるKubernetesクラスタのデプロイメント、運用、および監視を効率化します。オンプレミス、クラウド、エッジのいずれのクラスタを管理する場合でも、Rancherは、Kubernetesに関するあらゆるニーズに対応する、統合された中央プラットフォームを提供します。

5.1 Rancherの主な機能 #

マルチクラスタ管理: Rancherの直感的なインタフェースを使用して、パブリッククラウド、プライベートデータセンター、エッジロケーションのどこからでもKubernetesクラスタを管理できます。

セキュリティとコンプライアンス: Rancherでは、Kubernetes環境全体にセキュリティポリシー、ロールベースのアクセス制御(RBAC)、およびコンプライアンス標準が適用されます。

クラスタ操作のシンプル化: Rancherはクラスタのプロビジョニング、アップグレード、トラブルシューティングを自動化し、あらゆる規模のチームでKubernetesの操作をシンプル化します。

中央型のアプリケーションカタログ: Rancherアプリケーションカタログは、多種多様なHelmチャートとKubernetes Operatorを提供し、コンテナ化アプリケーションのデプロイと管理を容易にします。

継続的デリバリ: RancherはGitOpsと継続的インテグレーション/継続的デリバリパイプラインをサポートしており、自動化および効率化されたアプリケーションデリバリプロセスを実現します。

5.2 SUSE EdgeでのRancherの使用 #

Rancherは、SUSE Edgeスタックに複数のコア機能を提供します。

5.2.1 Kubernetesの集中管理 #

大量の分散クラスタが存在する一般的なエッジデプロイメントでは、Rancherは、これらのKubernetesクラスタを管理するための中央コントロールプレーンとして機能します。プロビジョニング、アップグレード、監視、およびトラブルシューティングのための統合インタフェースを提供し、操作をシンプル化し、一貫性を確保します。

5.2.2 クラスタデプロイメントのシンプル化 #

Rancherは、軽量なSUSE Linux Microオペレーティングシステム上でのKubernetesクラスタの作成を効率化し、Kubernetesの堅牢な機能を備えたエッジインフラストラクチャの展開を容易にします。

5.2.3 アプリケーションのデプロイメントと管理 #

統合されたRancherアプリケーションカタログは、SUSE Edgeクラスタ全体でのコンテナ化アプリケーションのデプロイと管理をシンプル化し、エッジワークロードのシームレスなデプロイメントを可能にします。

5.2.4 セキュリティとポリシーの適用 #

Rancherは、ポリシーベースのガバナンスツール、ロールベースのアクセス制御(RBAC)を備えているほか、外部の認証プロバイダと統合できます。これにより、SUSE Edgeのデプロイメントは、分散環境において重要なセキュリティとコンプライアンスを維持できます。

5.3 ベストプラクティス #

5.3.1 GitOps #

RancherにはビルトインコンポーネントとしてFleetが含まれており、Gitに保存されたコードでクラスタ設定やアプリケーションのデプロイメントを管理できます。

5.3.2 可観測性 #

Rancherには、PrometheusやGrafanaなどのビルトインのモニタリングおよびログツールが含まれており、クラスタのヘルスとパフォーマンスについて包括的な洞察を得ることができます。

5.4 Edge Image Builderを使用したインストール #

SUSE Edgeは、SUSE Linux Micro OSのゴールデンイメージをカスタマイズするために第11章 「Edge Image Builder」を使用しています。EIBでプロビジョニングしたKubernetesクラスタ上にRancherをエアギャップインストールするには、27.6項 「Rancherのインストール」に従ってください。

5.5 追加リソース #

6 Rancher Dashboard拡張機能 #

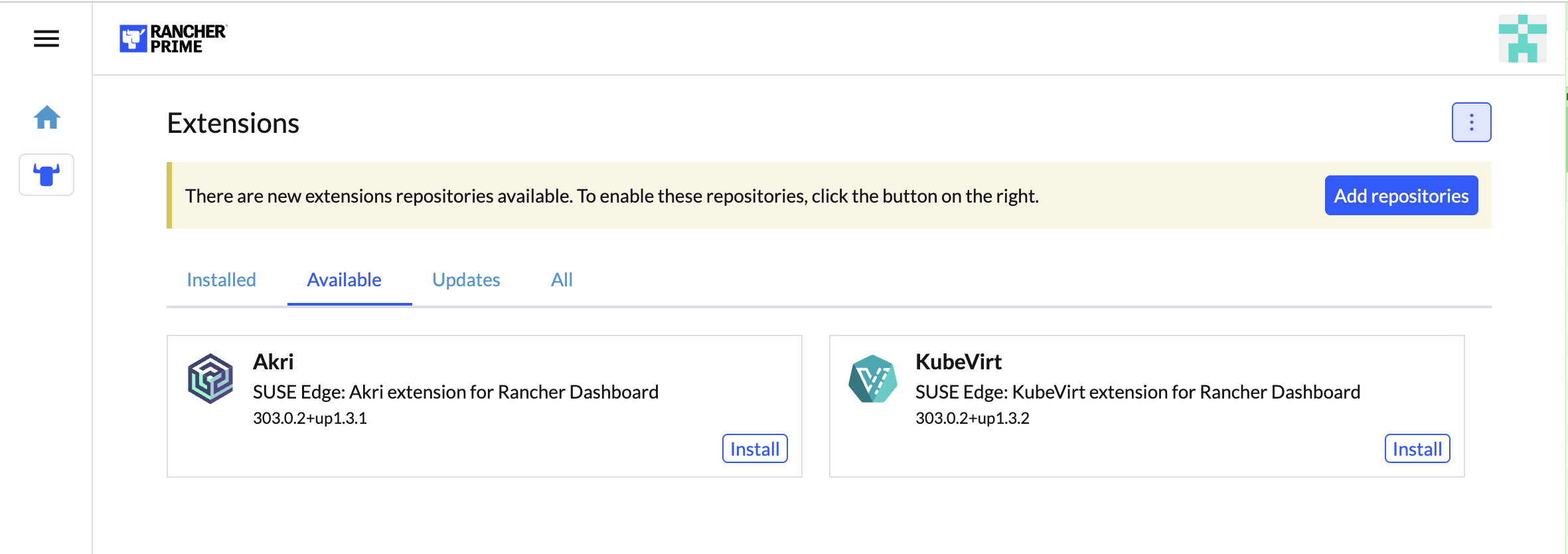

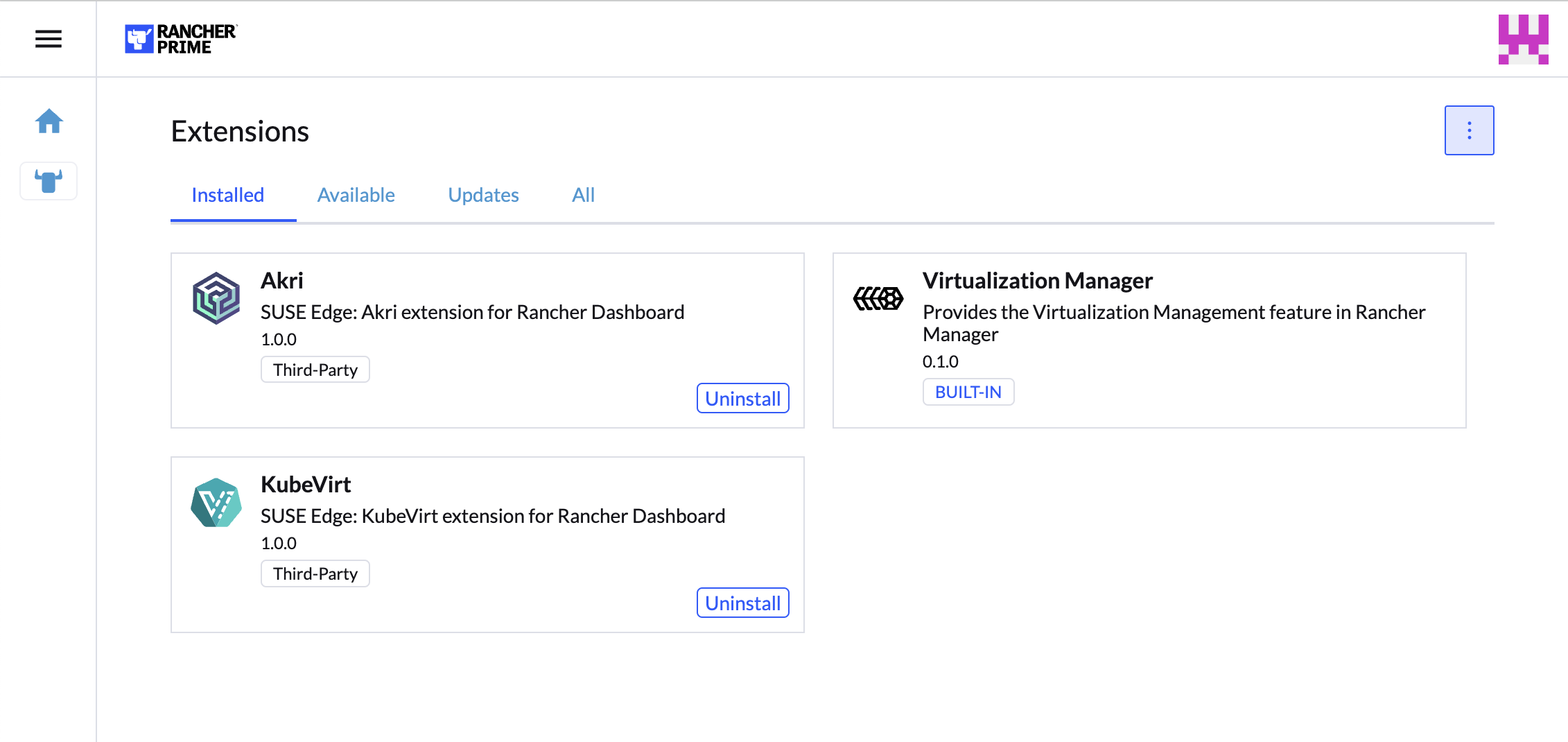

拡張機能により、ユーザ、開発者、パートナー、および顧客はRancher UIを拡張および強化できます。SUSE Edgeでは、KubeVirtとAkriのダッシュボード拡張機能を提供しています。

Rancher Dashboard拡張機能の一般的な情報については、Rancherのドキュメントを参照してください。

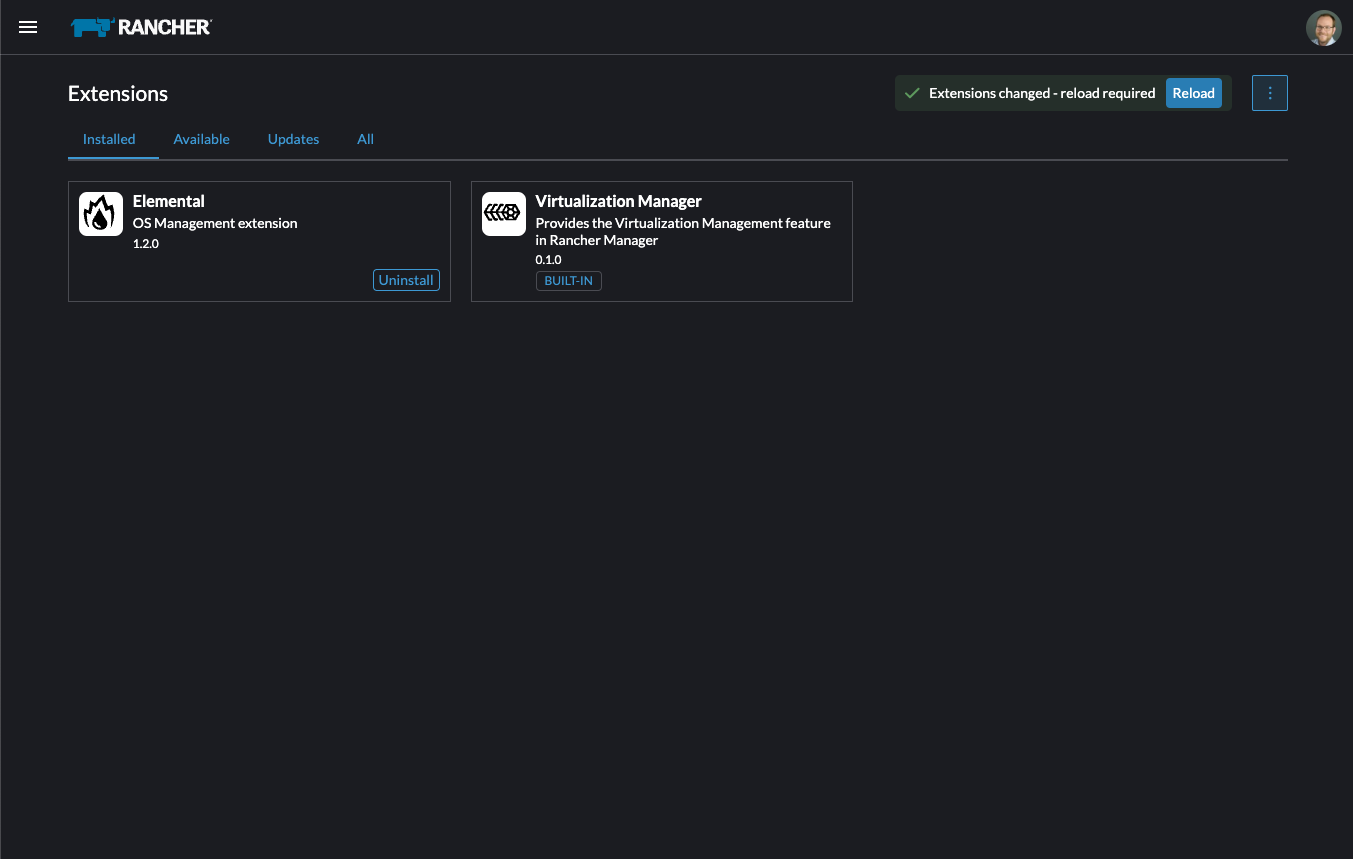

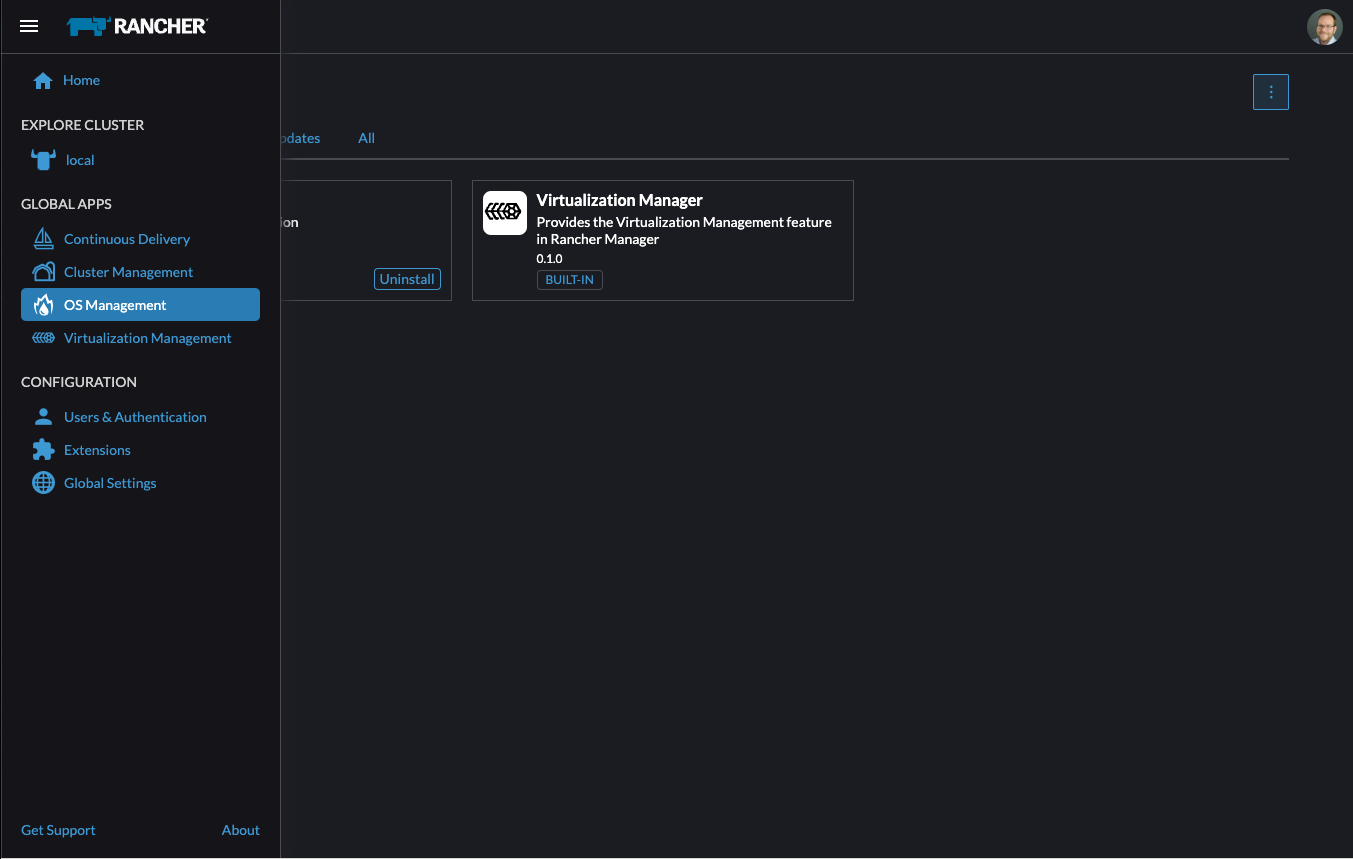

6.1 インストール #

ダッシュボード拡張機能を含むすべてのSUSE Edge 3.4コンポーネントは、OCIアーティファクトとして配布されます。SUSE Edge拡張機能をインストールするには、Rancher Dashboard UI、Helm、またはFleetを使用できます。

6.1.1 Rancher Dashboard UIを使用したインストール #

ナビゲーションサイドバーの[ Configuration (設定)]セクションで、[Extensions (拡張機能)]をクリックします。

[Extensions (拡張機能)]ページで、右上にある3つのドットメニューをクリックし、[Manage Repositories (リポジトリの管理)]を選択します。

各拡張機能は、独自のOCIアーティファクトで配布されます。これらはSUSE Edge Helmチャートリポジトリから入手できます。

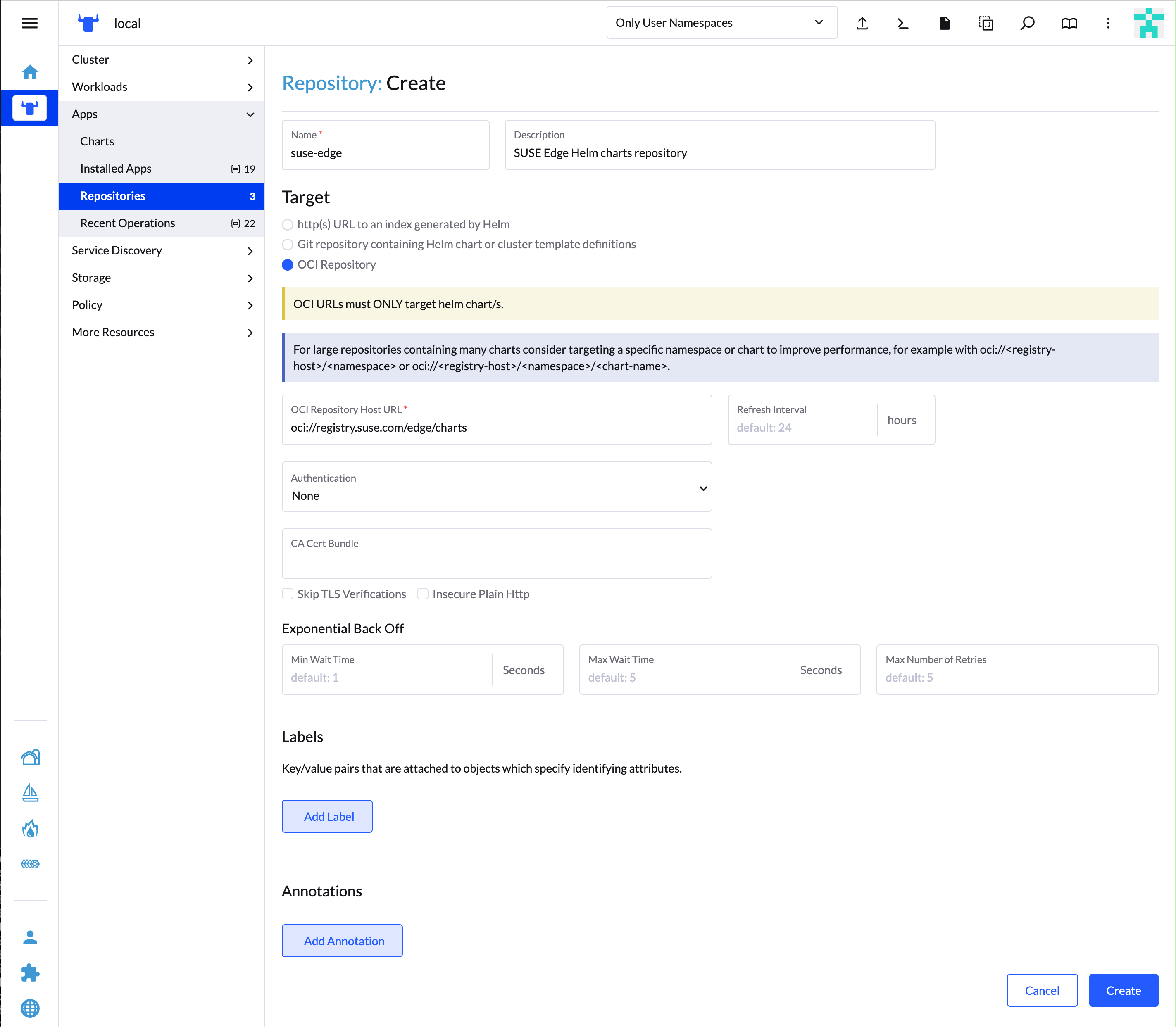

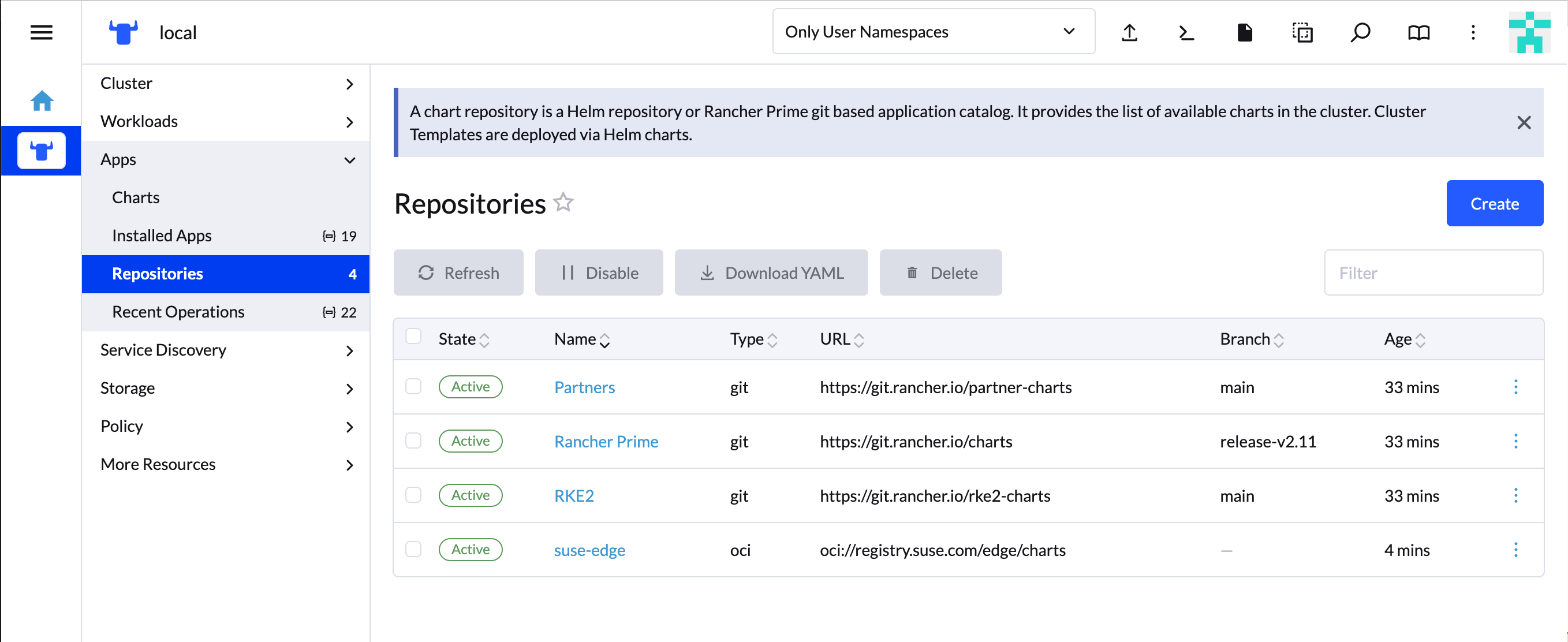

[Repositories (リポジトリ)]ページで、[

Create (作成)]をクリックします。フォームにリポジトリ名とURLを指定して、[

Create (作成)]をクリックします。SUSE Edge HelmチャートリポジトリURL:

oci://registry.suse.com/edge/charts拡張機能リポジトリがリストに追加され、[

Active (アクティブ)]状態であることがわかります。ナビゲーションサイドバーの [Configuration (設定)]セクションの [Extensions (拡張機能)]に戻ります。

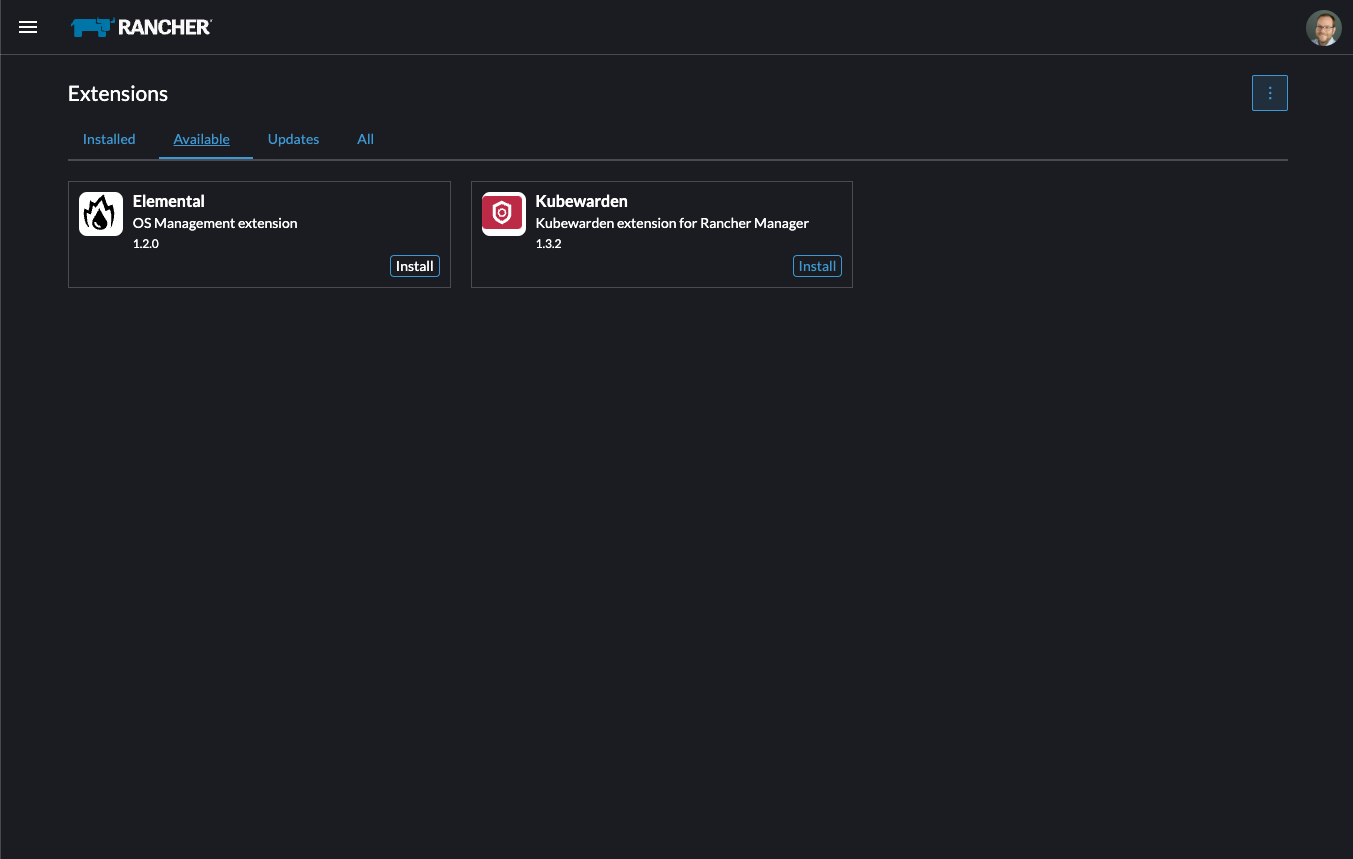

[Available (利用可能)]タブで、インストール可能な拡張機能を確認できます。

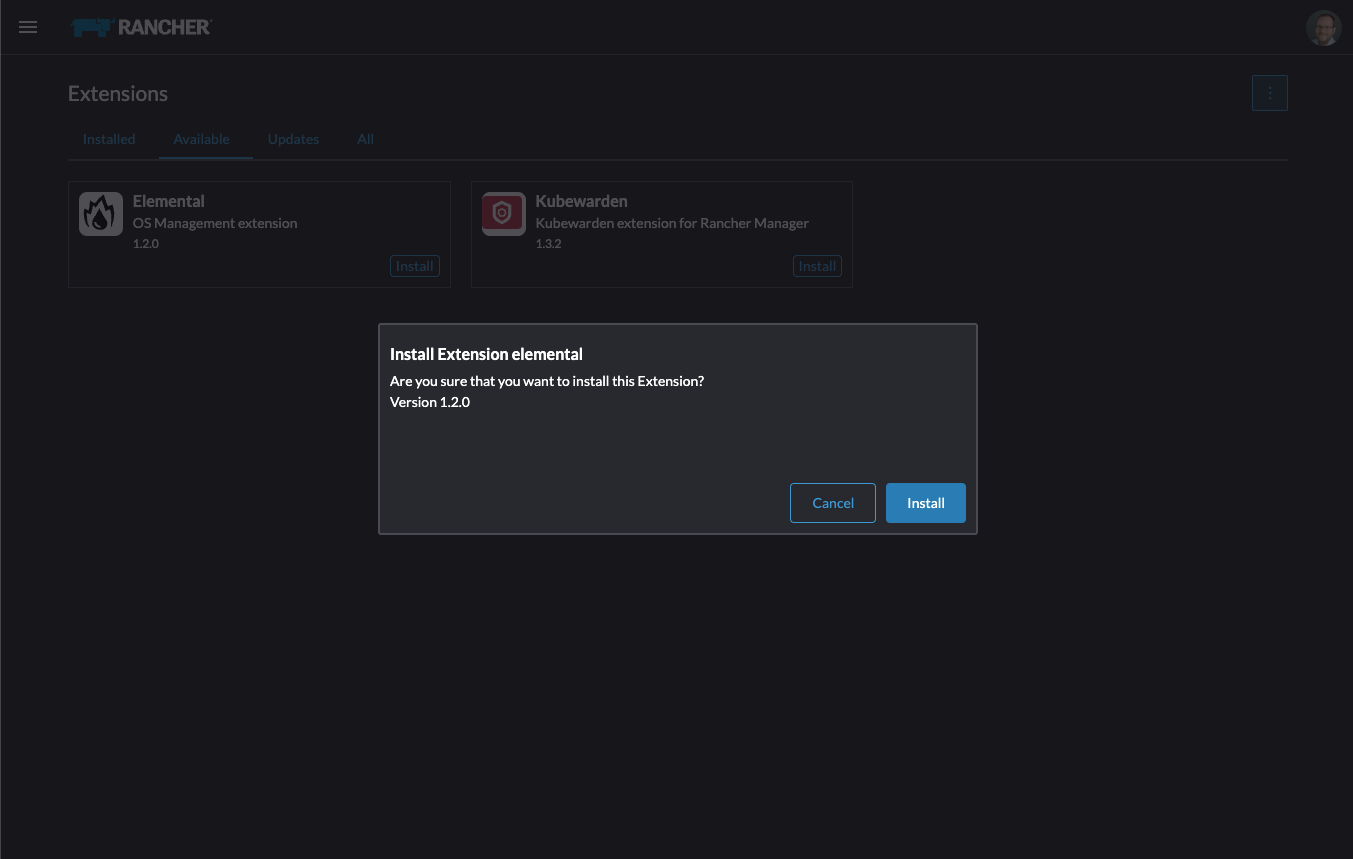

拡張機能カードで、[

Install (インストール)]をクリックし、インストールを確認します。拡張機能がインストールされると、Rancher UIによってページの再ロードが促されます。

拡張機能のインストールのRancherドキュメントページを参照してください。

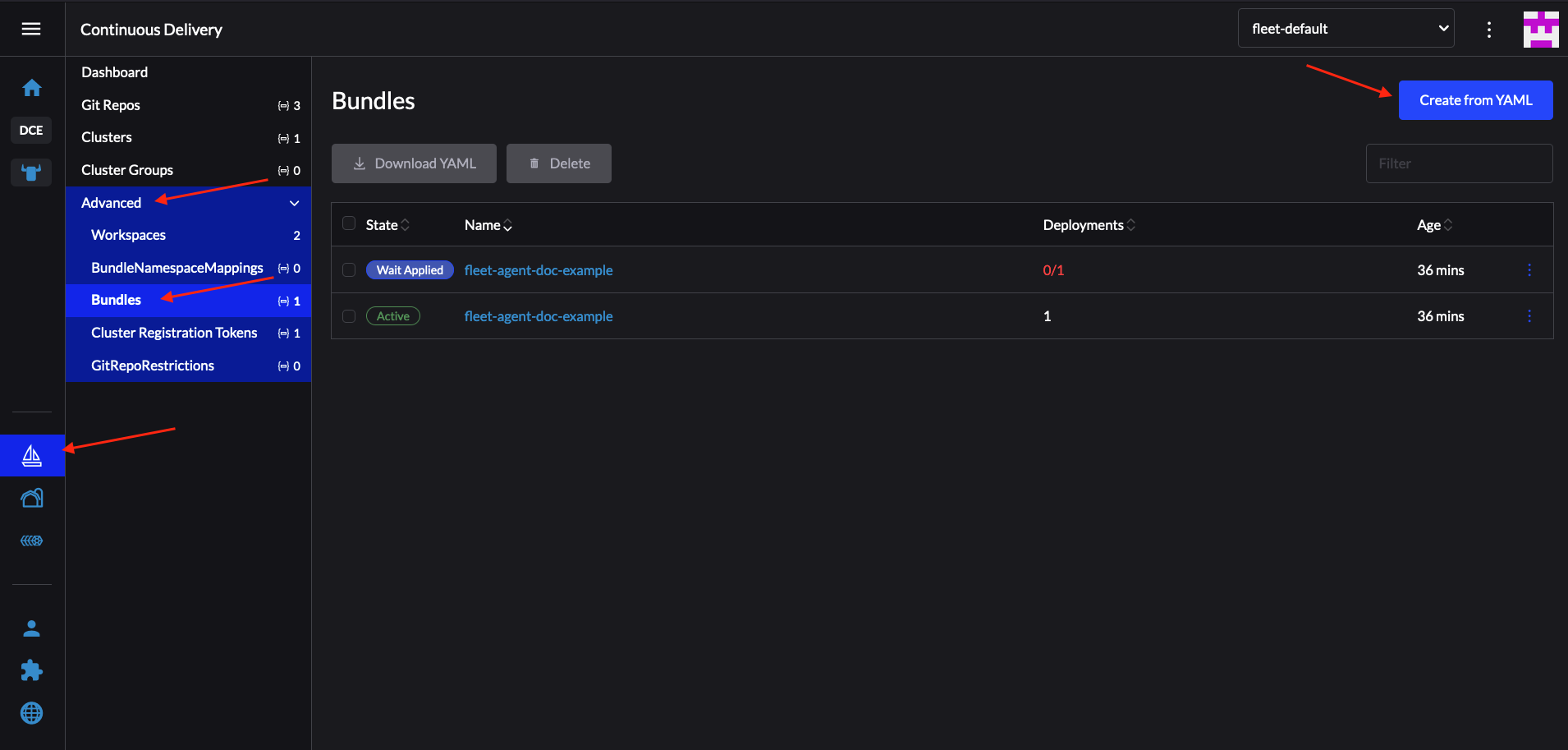

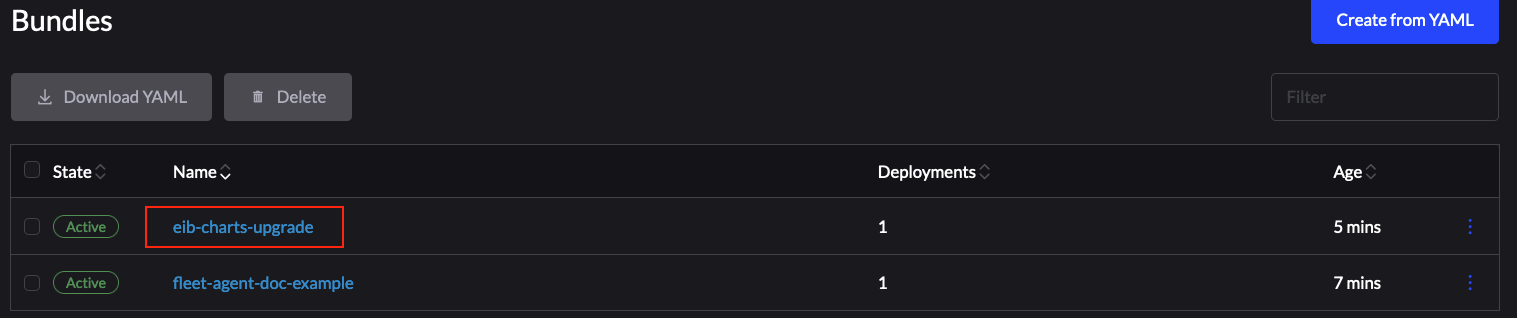

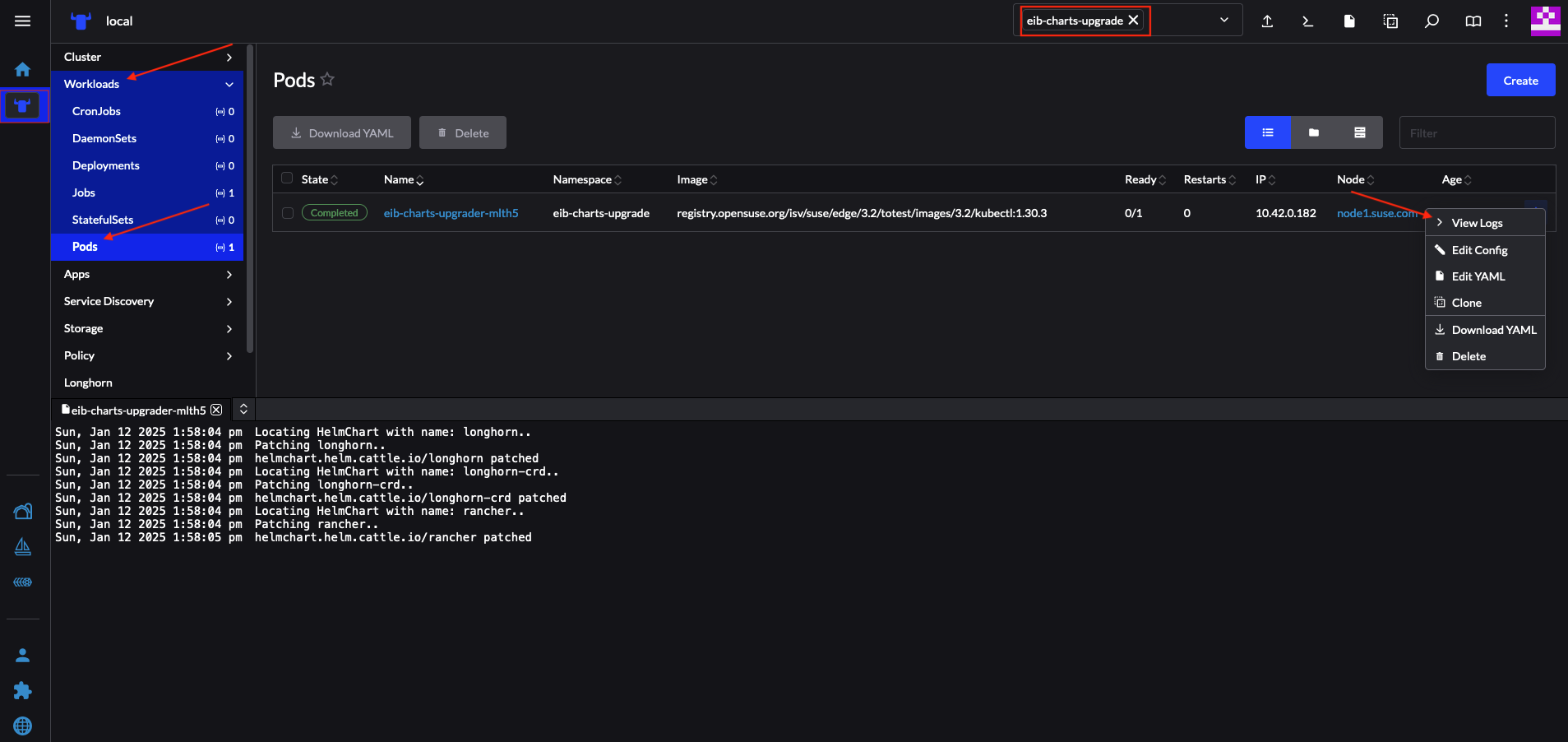

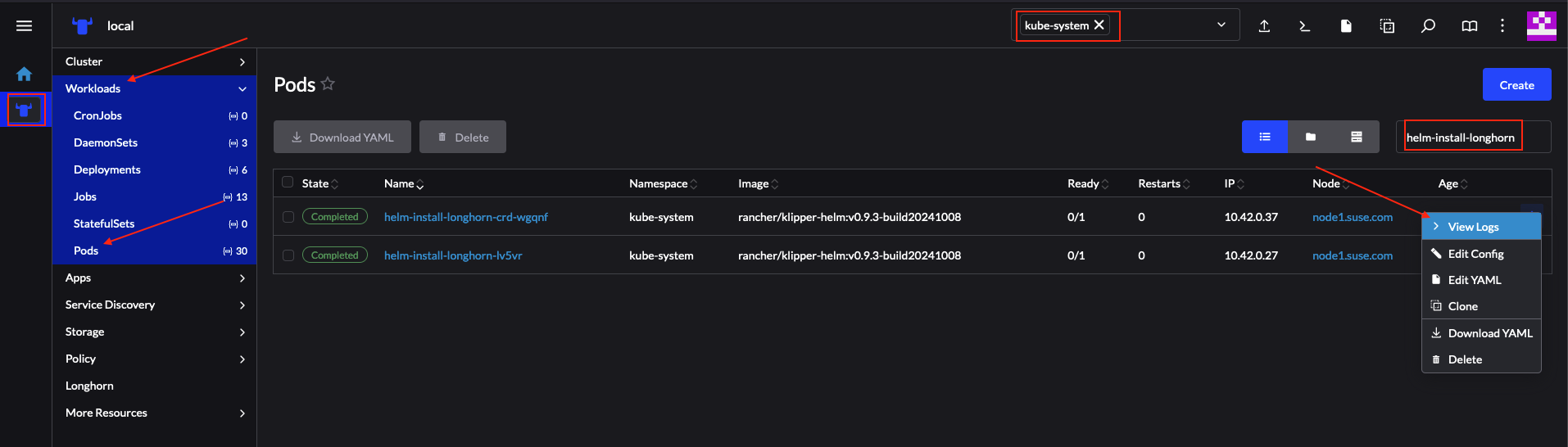

6.1.2 Helmを使用したインストール #