- Sobre este guia

- I Apresentando o SUSE Enterprise Storage (SES)

- 1 SES e Ceph

- 2 Requisitos e recomendações de hardware

- 2.1 Visão geral da rede

- 2.2 Configurações de várias arquiteturas

- 2.3 Configuração de hardware

- 2.4 Nós de armazenamento de objetos

- 2.5 Nós do monitor

- 2.6 Nós do Gateway de Objetos

- 2.7 Nós do servidor de metadados

- 2.8 Nó de Admin

- 2.9 Nós do Gateway iSCSI

- 2.10 SES e outros produtos da SUSE

- 2.11 Limitações de nome

- 2.12 OSD e monitor que compartilham um servidor

- 3 Configuração de alta disponibilidade do nó de admin

- II Implantando o cluster do Ceph

- III Fazendo upgrade de versões anteriores

- 10 Upgrade do SUSE Enterprise Storage 6 para 7.1

- 10.1 Antes de fazer upgrade

- 10.2 Fazendo upgrade do Master Salt

- 10.3 Fazendo upgrade dos nós MON, MGR e OSD

- 10.4 Fazendo upgrade de nós de gateway

- 10.5 Instalando o

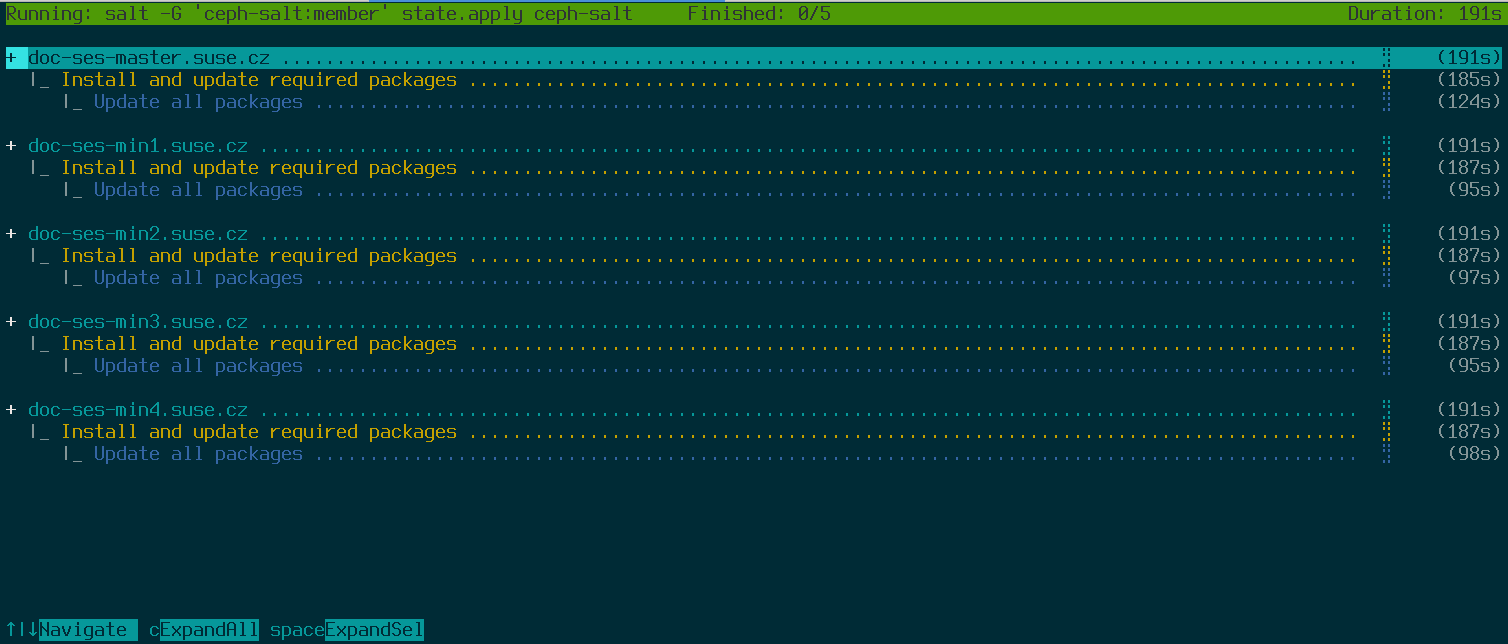

ceph-salte aplicando a configuração do cluster - 10.6 Fazendo upgrade e adotando a pilha de monitoramento

- 10.7 Reimplantação do serviço de gateway

- 10.8 Limpeza após o upgrade

- 11 Upgrade do SUSE Enterprise Storage 7 para 7.1

- 10 Upgrade do SUSE Enterprise Storage 6 para 7.1

- A Atualizações de manutenção do Ceph baseadas nos point releases de upstream do “Pacific”

- Glossário

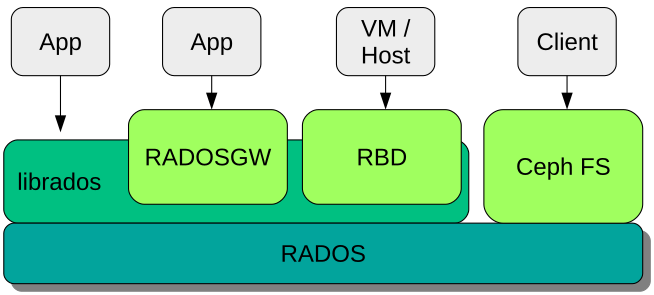

- 1.1 Interfaces com o armazenamento de objetos do Ceph

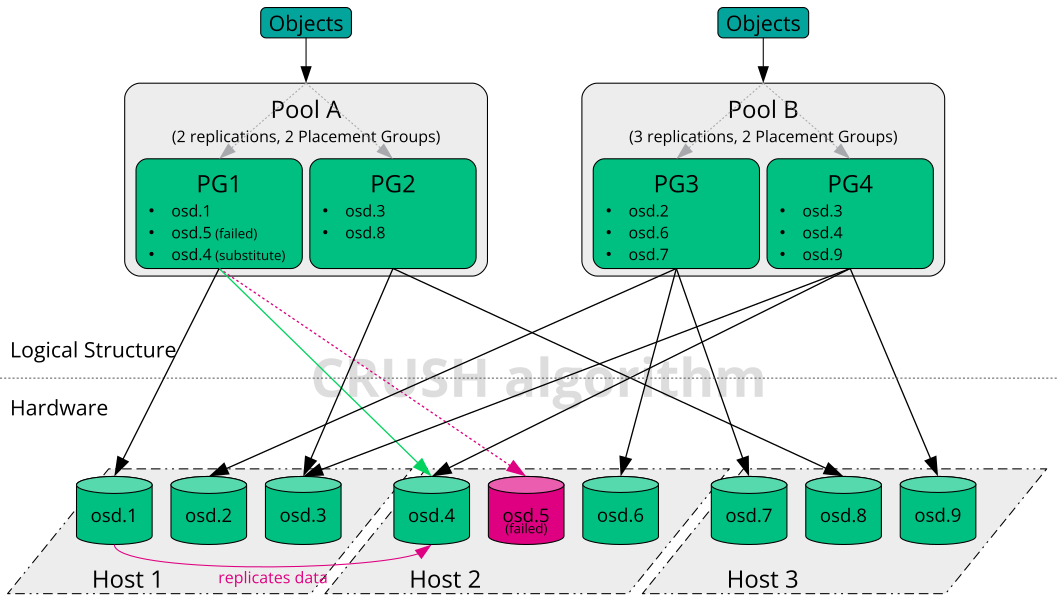

- 1.2 Exemplo de Ceph de pouco dimensionamento

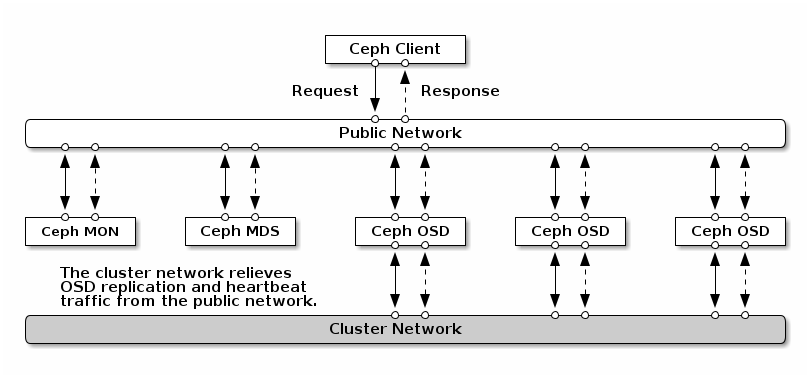

- 2.1 Visão geral da rede

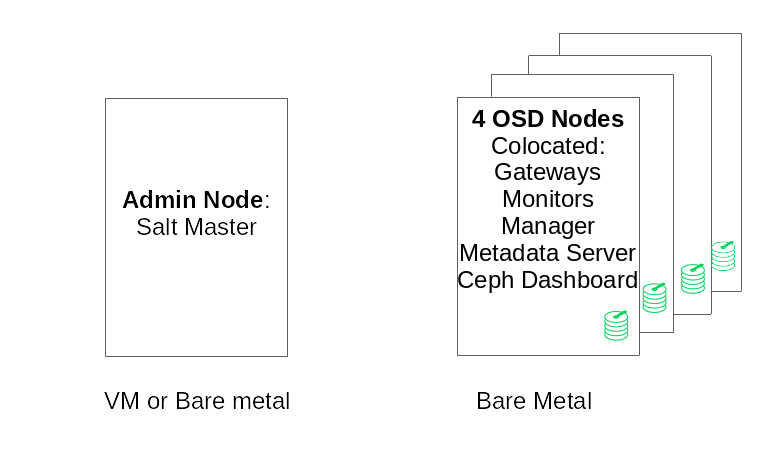

- 2.2 Configuração de cluster mínima

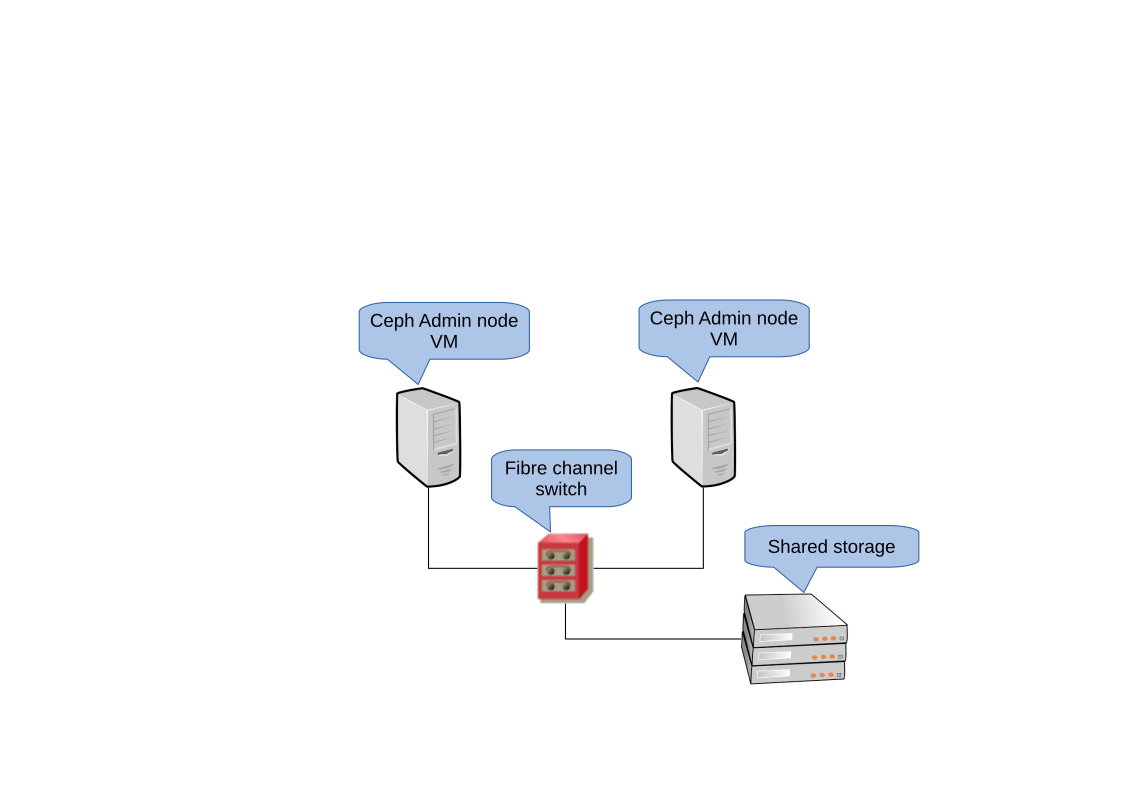

- 3.1 Cluster de HA de 2 nós para o Nó de Admin

- 7.1 Implantação de um cluster mínimo

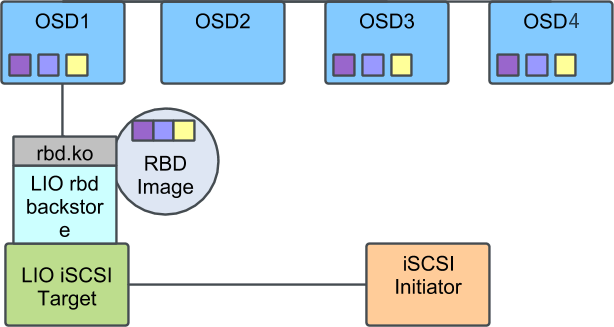

- 9.1 Cluster do Ceph com único iSCSI Gateway

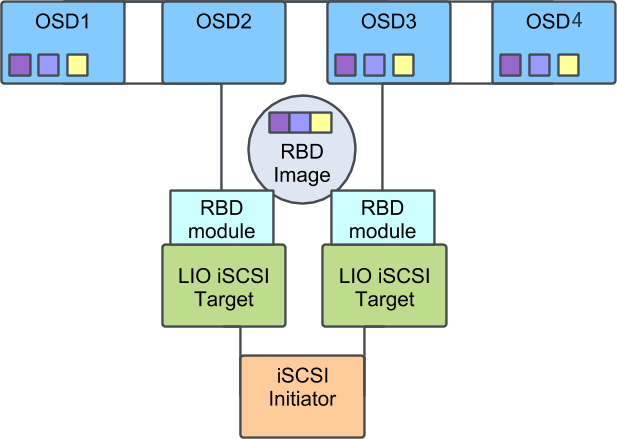

- 9.2 Cluster do Ceph com vários gateways iSCSI

Copyright © 2020–2025 SUSE LLC e colaboradores. Todos os direitos reservados.

Exceto quando especificado de outra forma, este documento está licenciado nos termos da Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Para ver as marcas registradas da SUSE, visite http://www.suse.com/company/legal/. Todas as marcas registradas de terceiros pertencem aos seus respectivos proprietários. Os símbolos de marca registrada (®, ™ etc.) indicam as marcas registradas da SUSE e de suas afiliadas. Os asteriscos (*) indicam marcas registradas de terceiros.

Todas as informações deste manual foram compiladas com a maior atenção possível aos detalhes. Entretanto, isso não garante uma precisão absoluta. A SUSE LLC, suas afiliadas, os autores ou tradutores não serão responsáveis por possíveis erros nem pelas consequências resultantes de tais erros.

Sobre este guia #

O foco deste guia é a implantação de um cluster básico do Ceph e de serviços adicionais. Ele também abrange as etapas de upgrade da versão anterior do produto para o SUSE Enterprise Storage 7.1.

SUSE Enterprise Storage 7.1 é uma extensão do SUSE Linux Enterprise Server 15 SP3. Ele combina os recursos do projeto de armazenamento do Ceph (http://ceph.com/) com a engenharia corporativa e o suporte da SUSE. O SUSE Enterprise Storage 7.1 oferece às organizações de TI o recurso para implantar uma arquitetura de armazenamento distribuído capaz de suportar inúmeros casos de uso por meio de plataformas de hardware convencional.

1 Documentação disponível #

A documentação para nossos produtos está disponível no site https://documentation.suse.com, onde você também pode encontrar as atualizações mais recentes e procurar ou fazer download da documentação em vários formatos. As atualizações mais recentes da documentação estão disponíveis em inglês.

Além disso, a documentação do produto está disponível no seu sistema instalado em /usr/share/doc/manual. Ela está incluída em um pacote RPM chamado ses-manual_LANG_CODE. Instale esse pacote caso ainda não esteja em seu sistema, por exemplo:

# zypper install ses-manual_enA seguinte documentação está disponível para este produto:

- Guia de Implantação

O foco deste guia é a implantação de um cluster básico do Ceph e de serviços adicionais. Ele também abrange as etapas de upgrade para o SUSE Enterprise Storage 7.1 a partir da versão anterior do produto.

- Guia de Administração e Operações

O foco deste guia são as tarefas de rotina que você, como administrador, precisa realizar após a implantação do cluster básico do Ceph (operações do dia 2). Ele também descreve todos os meios possíveis para acessar os dados armazenados em um cluster do Ceph.

- Guia de Reforço da Segurança

O foco deste guia é a garantia da segurança do cluster.

- Troubleshooting Guide (Guia de Solução de Problemas)

Este guia aborda os vários problemas comuns durante a execução do SUSE Enterprise Storage 7.1 e outras questões relacionadas a componentes relevantes, como o Ceph ou o Gateway de Objetos.

- Guia do SUSE Enterprise Storage para Windows

Este guia descreve a integração, a instalação e a configuração dos ambientes Microsoft Windows e SUSE Enterprise Storage que usam o Driver do Windows.

2 Inserindo comentários #

Ficamos satisfeitos com seus comentários e contribuições para esta documentação. E você pode contribuir por meio de vários canais:

- Solicitações de serviço e suporte

Para conhecer os serviços e as opções de suporte disponíveis para o seu produto, consulte http://www.suse.com/support/.

Para abrir uma solicitação de serviço, você precisa de uma assinatura do SUSE registrada no SUSE Customer Center. Vá para https://scc.suse.com/support/requests, efetue login e clique em .

- Relatórios de bugs

Relate os problemas com a documentação em https://bugzilla.suse.com/. A geração de relatórios de problemas requer uma conta do Bugzilla.

Para simplificar esse processo, você pode usar os links ao lado dos cabeçalhos na versão HTML deste documento. Isso pré-seleciona o produto e a categoria certos no Bugzilla e adiciona um link à seção atual. Você pode começar a digitar o relatório do bug imediatamente.

- Contribuições

Para contribuir com esta documentação, use os links ao lado dos cabeçalhos na versão HTML deste documento. Eles levarão você até o código-fonte no GitHub, onde é possível abrir uma solicitação pull. A contribuição requer uma conta do GitHub.

Para obter mais informações sobre o ambiente da documentação usado para este documento, consulte o README do repositório em https://github.com/SUSE/doc-ses.

É possível também relatar erros e enviar comentários sobre a documentação para <doc-team@suse.com>. Inclua o título do documento, a versão do produto e a data de publicação do documento. Mencione também o número e o título da seção relevante (ou inclua o URL) e insira uma breve descrição do problema.

3 Convenções da documentação #

Os seguintes avisos e convenções tipográficas são usados nesta documentação:

/etc/passwd: Nomes de diretório e arquivoPLACEHOLDER: Substitua PLACEHOLDER pelo valor real

PATH: Uma variável de ambientels,--help: Comandos, opções e parâmetrosuser: O nome do usuário ou grupopackage_name: O nome de um pacote de software

Alt, Alt–F1: Uma tecla para pressionar ou uma combinação de teclas. As teclas são mostradas em maiúsculas como no teclado.

, › : itens de menu, botões

AMD/Intel Este parágrafo é relevante apenas para as arquiteturas AMD64/Intel 64. As setas marcam o início e o fim do bloco de texto.

IBM Z, POWER Este parágrafo é relevante apenas para as arquiteturas

IBM ZePOWER. As setas marcam o início e o fim do bloco de texto.Capítulo 1, “Capítulo de exemplo”: Uma referência cruzada a outro capítulo deste guia.

Comandos que devem ser executados com privilégios

root. Geralmente, você também pode usar o comandosudocomo prefixo nesses comandos para executá-los como usuário não privilegiado.#command>sudocommandComandos que podem ser executados por usuários sem privilégios.

>commandAvisos

Atenção: Mensagem de avisoInformações vitais que você deve saber antes de continuar. Avisa sobre problemas de segurança, potencial perda de dados, danos no hardware ou perigos físicos.

Importante: Aviso importanteInformações importantes que você deve saber antes de continuar.

Nota: NotaInformações adicionais, por exemplo, sobre diferenças nas versões do software.

Dica: Aviso de dicaInformações úteis, como uma diretriz ou informação prática.

Avisos compactos

Informações adicionais, por exemplo, sobre diferenças nas versões do software.

Informações úteis, como uma diretriz ou informação prática.

4 Suporte #

Encontre a declaração de suporte do SUSE Enterprise Storage e as informações gerais sobre as prévias de tecnologia a seguir. Para obter detalhes sobre o ciclo de vida do produto, consulte https://www.suse.com/lifecycle.

Se você tiver direito a suporte, encontre os detalhes de como coletar informações para um ticket de suporte em https://documentation.suse.com/sles-15/html/SLES-all/cha-adm-support.html.

4.1 Declaração de suporte do SUSE Enterprise Storage #

Para receber suporte, você precisa de uma inscrição apropriada na SUSE. Para ver as ofertas de suporte específicas que estão disponíveis para você, acesse https://www.suse.com/support/ e selecione seu produto.

Os níveis de suporte são definidos da seguinte forma:

- L1

Determinação do problema, que significa suporte técnico designado para fornecer informações de compatibilidade, suporte ao uso, manutenção contínua, coleta de informações e solução básica de problemas usando a documentação disponível.

- L2

Isolamento do problema, que significa suporte técnico designado para analisar os dados, reproduzir os problemas dos clientes, isolar a área problemática e resolver os problemas não resolvidos no Nível 1 ou preparar-se para o Nível 3.

- L3

Resolução do problema, que significa suporte técnico designado para resolver os problemas com a participação da engenharia para solucionar defeitos nos produtos que foram identificados pelo Suporte de Nível 2.

Para clientes e parceiros contratados, o SUSE Enterprise Storage é entregue com suporte L3 para todos os pacotes, com as seguintes exceções:

Prévias de tecnologia.

Som, gráficos, fontes e arte.

Pacotes que requerem um contrato de cliente adicional.

Alguns pacotes enviados como parte do módulo Workstation Extension contam apenas com o suporte L2.

Os pacotes com nomes que terminam em -devel (contendo arquivos de cabeçalho e recursos de desenvolvedor semelhantes) serão suportados apenas junto com seus pacotes principais.

A SUSE apenas oferecerá suporte ao uso dos pacotes originals. Isto é, pacotes que não foram modificados nem recompilados.

4.2 Prévias de tecnologia #

As Prévias de tecnologia são pacotes, pilhas ou recursos fornecidos pela SUSE como amostras de inovações futuras. As prévias de tecnologia foram incluídas para sua conveniência e para que você possa testar as novas tecnologias em seu ambiente. Agradecemos seus comentários! Se você testar uma prévia de tecnologia, contate seu representante SUSE e conte sobre sua experiência e seus casos de uso. Suas informações são úteis para o desenvolvimento futuro.

As prévias de tecnologia têm as seguintes limitações:

As prévias de tecnologia ainda estão em desenvolvimento. Portanto, elas podem ter funcionalidades incompletas, instáveis ou, de alguma outra maneira, inadequadas para uso em produção.

As prévias de tecnologia não contam com suporte.

As prévias de tecnologia talvez estejam disponíveis apenas para arquiteturas de hardware específicas.

Os detalhes e as funcionalidades das prévias de tecnologia estão sujeitos a mudanças. Consequentemente, o upgrade para as versões subsequentes de uma prévia de tecnologia pode ser impossível e exigir uma instalação nova.

A SUSE pode descobrir que uma prévia não atende às necessidades do cliente ou do mercado, ou não está em conformidade com os padrões da empresa. As prévias de tecnologia podem ser removidas de um produto a qualquer momento. A SUSE não se compromete em oferecer uma versão com suporte desse tipo de tecnologia no futuro.

Para obter uma visão geral das prévias de tecnologia fornecidas com seu produto, consulte as notas de lançamento em https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.1.

5 Colaboradores do Ceph #

O projeto do Ceph e a respectiva documentação são resultados do trabalho de centenas de colaboradores e organizações. Visite https://ceph.com/contributors/ para obter mais detalhes.

6 Comandos e prompts de comando usados neste guia #

Como administrador de cluster do Ceph, você configura e ajusta o comportamento do cluster executando comandos específicos. Há vários tipos de comandos que serão necessários:

6.1 Comandos relacionados ao Salt #

Esses comandos ajudam você a implantar nós do cluster do Ceph, executar comandos em vários (ou todos) nós do cluster ao mesmo tempo ou a adicionar ou remover nós do cluster. Os comandos usados com mais frequência são ceph-salt e ceph-salt config. Você precisa executar os comandos do Salt no nó do Master Salt como root. Esses comandos são introduzidos com o seguinte prompt:

root@master # Por exemplo:

root@master # ceph-salt config ls6.2 Comandos relacionados ao Ceph #

Esses são comandos de nível inferior para configurar e ajustar todos os aspectos do cluster e seus gateways na linha de comando, por exemplo, ceph, cephadm, rbd ou radosgw-admin.

Para executar os comandos relacionados ao Ceph, você precisa ter acesso de leitura a uma chave do Ceph. Os recursos da chave definem seus privilégios no ambiente do Ceph. Uma opção é executar os comandos do Ceph como root (ou por meio do sudo) e usar o chaveiro padrão irrestrito “ceph.client.admin.key”.

A opção mais segura e recomendada é criar uma chave individual mais restritiva para cada usuário administrador e colocá-la em um diretório onde os usuários possam lê-la, por exemplo:

~/.ceph/ceph.client.USERNAME.keyring

Para utilizar um usuário admin e um chaveiro personalizados, você precisa especificar o nome de usuário e o caminho para a chave toda vez que executar o comando ceph com as opções -n client.USER_NAME e --keyring PATH/TO/KEYRING.

Para evitar isso, inclua essas opções na variável CEPH_ARGS nos arquivos ~/.bashrc dos usuários individuais.

É possível executar os comandos relacionados ao Ceph em qualquer nó do cluster, mas a recomendação é executá-los no Nó de Admin. Esta documentação utiliza o usuário cephuser para executar os comandos, portanto, eles são introduzidos com o seguinte prompt:

cephuser@adm > Por exemplo:

cephuser@adm > ceph auth listSe a documentação orientar você a executar um comando em um nó do cluster com uma função específica, isso será processado pelo prompt. Por exemplo:

cephuser@mon > 6.2.1 Executando o ceph-volume #

A partir do SUSE Enterprise Storage 7, os serviços do Ceph são executados em containers. Se você precisar executar o ceph-volume em um nó OSD, anteceda-o com o comando cephadm, por exemplo:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandos gerais do Linux #

Os comandos do Linux não relacionados ao Ceph, como mount, cat ou openssl, são introduzidos com os prompts cephuser@adm > ou #, dependendo dos privilégios exigidos pelo comando relacionado.

6.4 Informações adicionais #

Para obter mais informações sobre o gerenciamento de chaves do Ceph, consulte o Book “Guia de Administração e Operações”, Chapter 30 “Autenticação com cephx”, Section 30.2 “As principais áreas de”.

Parte I Apresentando o SUSE Enterprise Storage (SES) #

- 1 SES e Ceph

O SUSE Enterprise Storage é um sistema de armazenamento distribuído projetado para escalabilidade, confiabilidade e desempenho que usa a tecnologia Ceph. É possível executar um cluster do Ceph em servidores convencionais em uma rede comum, como Ethernet. O cluster tem capacidade de dimensionamento p…

- 2 Requisitos e recomendações de hardware

Os requisitos de hardware do Ceph dependem bastante da carga de trabalho de E/S. Os requisitos e as recomendações de hardware a seguir devem ser considerados um ponto de partida para o planejamento detalhado.

- 3 Configuração de alta disponibilidade do nó de admin

O Nó de Admin é um nó de cluster do Ceph em que o serviço do Master Salt é executado. Ele gerencia o restante dos nós do cluster consultando e instruindo os serviços do Minion Salt. Normalmente, ele também inclui outros serviços, por exemplo, o painel de controle do Grafana com suporte do kit de fer…

1 SES e Ceph #

O SUSE Enterprise Storage é um sistema de armazenamento distribuído projetado para escalabilidade, confiabilidade e desempenho que usa a tecnologia Ceph. É possível executar um cluster do Ceph em servidores convencionais em uma rede comum, como Ethernet. O cluster tem capacidade de dimensionamento para milhares de servidores (posteriormente mencionados como nós) e dentro da faixa de petabytes. Ao contrário dos sistemas convencionais que têm tabelas de alocação para armazenar e buscar dados, o Ceph usa um algoritmo determinístico para alocar armazenamento de dados e não tem nenhuma estrutura centralizada de informações. Nos clusters de armazenamento, o Ceph considera a adição ou remoção de hardware a regra, e não a exceção. O cluster do Ceph automatiza as tarefas de gerenciamento, como distribuição e redistribuição de dados, replicação de dados, detecção de falhas e recuperação. O Ceph é autorreparável e autogerenciável, o que resulta na redução de overhead administrativo e orçamentário.

Este capítulo apresenta uma visão geral resumida do SUSE Enterprise Storage 7.1 e descreve brevemente os componentes mais importantes.

1.1 Recursos do Ceph #

O ambiente do Ceph tem os seguintes recursos:

- Escalabilidade

O Ceph pode ser dimensionado para milhares de nós e pode gerenciar o armazenamento na faixa de petabytes.

- Hardware convencional

Não há necessidade de hardware especial para executar um cluster do Ceph. Para obter os detalhes, consulte a Capítulo 2, Requisitos e recomendações de hardware

- Autogerenciável

O cluster do Ceph é autogerenciável. Quando os nós são adicionados, removidos ou falham, o cluster redistribui os dados automaticamente. Ele também reconhece discos sobrecarregados.

- Sem Ponto Único de Falha

Nenhum nó em um cluster armazena informações importantes separadamente. É possível configurar o número de redundâncias.

- Software de código-fonte aberto

O Ceph é uma solução de software de código-fonte aberto e independente de hardware ou de fornecedores específicos.

1.2 Componentes básicos do Ceph #

Para aproveitar todas as vantagens do Ceph, é necessário conhecer alguns dos componentes e conceitos básicos. Esta seção apresenta algumas partes do Ceph que são mencionadas com mais frequência em outros capítulos.

1.2.1 RADOS #

O componente básico de Ceph é denominado RADOS (Reliable Autonomic Distributed Object Store). Ele é responsável por gerenciar os dados armazenados no cluster. Normalmente, os dados no Ceph são armazenados como objetos. Cada objeto consiste em um identificador e nos dados.

O RADOS oferece os seguintes métodos de acesso aos objetos armazenados que envolvem diversos casos de uso:

- Gateway de Objetos

O Gateway de Objetos é um gateway HTTP REST para armazenamento de objetos RADOS. Ele permite acesso direto aos objetos armazenados no cluster do Ceph.

- Dispositivo de blocos RADOS

É possível acessar o Dispositivo de Blocos RADOS (RBD, RADOS Block Device) como qualquer outro dispositivo de blocos. Eles podem ser usados em combinação com o

libvirtpara fins de virtualização, por exemplo.- CephFS

O Sistema de Arquivos Ceph é compatível com POSIX.

libradoslibradosé uma biblioteca que pode ser usada com várias linguagens de programação para criar um aplicativo capaz de interagir diretamente com o cluster de armazenamento.

O Gateway de Objetos e o RBD usam a librados, enquanto o CephFS estabelece interface direta com o RADOS (Figura 1.1, “Interfaces com o armazenamento de objetos do Ceph”).

1.2.2 CRUSH #

No centro de um cluster do Ceph está o algoritmo CRUSH. CRUSH é o acrônimo de Controlled Replication Under Scalable Hashing. Trata-se de uma função que processa a alocação de armazenamento e precisa de poucos parâmetros equivalentes. Isso significa que apenas uma pequena quantidade de informações é necessária para calcular a posição de armazenamento de um objeto. Os parâmetros são um mapa atual do cluster, incluindo o estado de saúde, algumas regras de posicionamento definidas pelo administrador e o nome do objeto que precisa ser armazenado ou recuperado. Com essas informações, todos os nós no cluster do Ceph são capazes de calcular onde um objeto e suas réplicas serão armazenados. Isso dificulta a gravação e a leitura de dados muito eficientes. O CRUSH tenta distribuir igualmente os dados a todos os nós do cluster.

O Mapa CRUSH contém todos os nós de armazenamento e as regras de posicionamento definidas pelo administrador para armazenar objetos no cluster. Ele define uma estrutura hierárquica que costuma corresponder à estrutura física do cluster. Por exemplo, os discos com dados estão em hosts, os hosts estão em racks, os racks estão em linhas e as linhas estão em data centers. É possível usar essa estrutura para definir domínios de falha. Em seguida, o Ceph garante que as replicações sejam armazenadas em ramificações diferentes de um domínio de falha específico.

Se o domínio de falha for definido como rack, as replicações dos objetos serão distribuídas para racks diferentes. Isso pode reduzir as interrupções causadas por um switch com falha em um rack. Se uma unidade de distribuição de energia fornece uma linha de racks, o domínio de falha pode ser definido como linha. Quando a unidade de distribuição de energia falha, os dados replicados ainda ficam disponíveis em outras linhas.

1.2.3 Nós e daemons do Ceph #

No Ceph, os nós são servidores que trabalham para o cluster. Eles podem executar vários tipos de daemons. Recomendamos executar apenas um tipo de daemon em cada nó, exceto os daemons do Ceph Manager, que podem ser combinados com Ceph Monitors. Cada cluster requer pelo menos os daemons do Ceph Monitor, Ceph Manager e Ceph OSD:

- Nó de Admin

O Nó de Admin é um nó de cluster do Ceph do qual você executa comandos para gerenciar o cluster. O Nó de Admin é um ponto central do cluster do Ceph porque ele gerencia o restante dos nós do cluster, consultando e instruindo os serviços do Minion Salt.

- Ceph Monitor

Os nós do Ceph Monitor (geralmente abreviado como MON) mantêm informações sobre o estado de saúde do cluster, um mapa de todos os nós e as regras de distribuição de dados (consulte a Seção 1.2.2, “CRUSH”).

Em caso de falhas ou conflitos, os nós do Ceph Monitor no cluster decidem, por maioria, quais informações estão corretas. Para formar uma maioria qualificada, é recomendável ter um número ímpar de nós do Ceph Monitor e, pelo menos, três deles.

Se for usado mais de um site, os nós do Ceph Monitor deverão ser distribuídos para um número ímpar de sites. O número de nós do Ceph Monitor por site deve ser suficiente para que mais do que 50% dos nós do Ceph Monitor continuem funcionando em caso de falha de um site.

- Ceph Manager

O Ceph Manager coleta as informações de estado do cluster inteiro. O daemon do Ceph Manager é executado com os daemons do Ceph Monitor. Ele fornece monitoramento adicional e estabelece interface com os sistemas externos de monitoramento e gerenciamento. Ele também inclui outros serviços. Por exemplo, a IU da Web do Ceph Dashboard é executada no mesmo nó que o Ceph Manager.

O Ceph Manager não requer configuração adicional, além de garantir que esteja em execução.

- Ceph OSD

O Ceph OSD é um daemon que processa Dispositivos de Armazenamento de Objetos, que são unidades físicas ou lógicas de armazenamento (discos rígidos ou partições). Os Dispositivos de Armazenamento de Objetos podem ser discos/partições físicos ou volumes lógicos. O daemon também se encarrega da replicação e redistribuição de dados em caso de nós adicionados ou removidos.

Os daemons Ceph OSD comunicam-se com os daemons do monitor e informam a eles o estado dos outros daemons OSD.

Para usar o CephFS, o Gateway de Objetos, o NFS Ganesha ou o iSCSI Gateway, são necessários outros nós:

- MDS (Metadata Server – Servidor de Metadados)

Os metadados do CephFS são armazenados em seu próprio pool RADOS (consulte a Seção 1.3.1, “Pools”). Os Servidores de Metadados atuam como uma camada de cache inteligente para os metadados e serializam o acesso quando necessário. Isso permite acesso simultâneo de vários clientes sem sincronização explícita.

- Gateway de Objetos

O Gateway de Objetos é um gateway HTTP REST para armazenamento de objetos RADOS. Ele é compatível com o OpenStack Swift e o Amazon S3 e tem seu próprio gerenciamento de usuários.

- NFS Ganesha

O NFS Ganesha concede acesso de NFS ao Gateway de Objetos ou CephFS. Ele é executado no espaço do usuário, em vez do kernel, e interage diretamente com o Gateway de Objetos ou o CephFS.

- iSCSI Gateway

iSCSI é um protocolo de rede de armazenamento que permite aos clientes enviar comandos SCSI para dispositivos de armazenamento SCSI (destinos) em servidores remotos.

- Gateway do Samba

O Gateway do Samba concede ao Samba acesso aos dados armazenados no CephFS.

1.3 Estrutura de armazenamento do Ceph #

1.3.1 Pools #

Os objetos armazenados em um cluster do Ceph são agrupados em pools. Os pools representam as partições lógicas do cluster para o mundo externo. É possível definir um conjunto de regras para cada pool. Por exemplo, o número necessário de replicações de cada objeto. A configuração padrão dos pools chama-se pool replicado.

Normalmente, os pools contêm objetos, mas também podem ser configurados para agir como um RAID 5. Nessa configuração, os objetos são armazenados em pacotes com outros pacotes de codificação. Os pacotes de codificação contêm as informações redundantes. O número de dados e de pacotes de codificação pode ser definido pelo administrador. Nessa configuração, os pools são denominados pools codificados para eliminação ou pools EC.

1.3.2 Grupos de posicionamento #

Os PGs (Placement Groups – Grupos de Posicionamento) são usados para distribuição de dados em um pool. Ao criar um pool, determinado número de grupos de posicionamento é definido. Os grupos de posicionamento são usados internamente para agrupar objetos e são um fator importante para o desempenho de um cluster do Ceph. O PG de um objeto é determinado pelo nome do objeto.

1.3.3 Exemplo #

Esta seção mostra um exemplo simplificado de como o Ceph gerencia os dados (consulte a Figura 1.2, “Exemplo de Ceph de pouco dimensionamento”). Esse exemplo não representa uma configuração recomendada para um cluster do Ceph. A configuração de hardware consiste em três nós de armazenamento ou Ceph OSDs (Host 1, Host 2, Host 3). Cada nó tem três discos rígidos que são usados como OSDs (osd.1 a osd.9). Os nós do Ceph Monitor são ignorados neste exemplo.

Enquanto Ceph OSD ou daemon Ceph OSD refere-se a um daemon executado em um nó, a palavra OSD refere-se ao disco lógico com o qual o daemon interage.

O cluster tem dois pools: Pool A e Pool B. Enquanto o Pool A replica os objetos apenas duas vezes, a resiliência do Pool B é mais importante e efetua três replicações de cada objeto.

Quando um aplicativo coloca um objeto em um pool (por exemplo, pela API REST), um Grupo de Posicionamento (PG1 a PG4) é selecionado com base no nome do pool e do objeto. Em seguida, o algoritmo CRUSH calcula em quais OSDs o objeto é armazenado, com base no Grupo de Posicionamento que contém o objeto.

Neste exemplo, o domínio de falha foi definido como host. Isso garante que as replicações dos objetos sejam armazenadas em hosts diferentes. Dependendo do nível de replicação definido para um pool, o objeto é armazenado em dois ou três OSDs, que são usados pelo Grupo de Posicionamento.

Um aplicativo que grava um objeto interage apenas com um Ceph OSD: o principal. O Ceph OSD principal efetua a replicação e confirma a conclusão do processo de gravação depois que todos os outros OSDs armazenaram o objeto.

Em caso de falha no osd.5, todos os objetos no PG1 ainda estarão disponíveis no osd.1. Logo que o cluster reconhece a falha em um OSD, outro OSD entra em ação. Neste exemplo, o osd.4 é usado como substituto do osd.5. Os objetos armazenados no osd.1 são replicados para o osd.4 para restaurar o nível de replicação.

Se um novo nó com novos OSDs for adicionado ao cluster, o mapa do cluster será modificado. Na sequência, a função CRUSH retorna locais diferentes para os objetos. Os objetos que recebem os novos locais serão realocados. Esse processo resulta no uso equilibrado de todos os OSDs.

1.4 BlueStore #

BlueStore é um novo back end de armazenamento padrão para Ceph a partir do SES 5. Ele apresenta melhor desempenho do que o FileStore, checksum completo de dados e compactação incorporada.

O BlueStore gerencia um, dois ou três dispositivos de armazenamento. No caso mais simples, o BlueStore consome um único dispositivo de armazenamento principal. Normalmente, o dispositivo de armazenamento é particionado em duas partes:

Uma pequena partição denominada BlueFS que implementa funcionalidades do tipo do sistema de arquivos que o RocksDB exige.

Normalmente, o restante do dispositivo é ocupado por uma partição grande. Ele é gerenciado diretamente pelo BlueStore e contém todos os dados reais. Normalmente, esse dispositivo principal é identificado por um link simbólico de bloco no diretório de dados.

É possível também implantar o BlueStore em dois dispositivos adicionais:

É possível usar o dispositivo WAL para o diário interno ou o registro write-ahead do BlueStore. Ele é identificado pelo link simbólico block.wal no diretório de dados. O uso de um dispositivo WAL separado será útil apenas se ele for mais rápido do que o dispositivo principal ou o dispositivo de BD. Por exemplo, quando:

O dispositivo WAL é um NVMe, o dispositivo de BD é uma SSD e o dispositivo de dados é uma SSD ou HDD.

Ambos os dispositivos WAL e de BD são SSDs separadas, e o dispositivo de dados é uma SSD ou HDD.

É possível usar um dispositivo de BD para armazenar metadados internos do BlueStore. O BlueStore (ou, em vez dele, o RocksDB incorporado) colocará o máximo de metadados que puder no dispositivo de BD para melhorar o desempenho. Mais uma vez, apenas será útil provisionar um dispositivo de BD compartilhado se ele for mais rápido do que o dispositivo principal.

Planeje com cuidado para garantir o tamanho suficiente do dispositivo de BD. Se o dispositivo de BD ficar cheio, os metadados serão despejados no dispositivo principal, o que prejudica bastante o desempenho do OSD.

Você pode verificar se uma partição WAL/BD está ficando lotada e sendo despejada ao executar o comando ceph daemon osd.ID perf dump. O valor slow_used_bytes mostra a quantidade de dados que está sendo despejada:

cephuser@adm > ceph daemon osd.ID perf dump | jq '.bluefs'

"db_total_bytes": 1073741824,

"db_used_bytes": 33554432,

"wal_total_bytes": 0,

"wal_used_bytes": 0,

"slow_total_bytes": 554432,

"slow_used_bytes": 554432,1.5 Informações adicionais #

Como um projeto comunitário, o Ceph tem sua própria documentação online completa. Para os tópicos não encontrados neste manual, visite https://docs.ceph.com/en/pacific/.

A publicação original CRUSH: Controlled, Scalable, Decentralized Placement of Replicated Data por S.A. Weil, S.A. Brandt, E.L. Miller, C. Maltzahn apresenta informações úteis sobre o funcionamento interno do Ceph. Principalmente na implantação de clusters em grande escala, trata-se de uma leitura recomendada. Você encontra essa publicação em http://www.ssrc.ucsc.edu/papers/weil-sc06.pdf.

É possível usar o SUSE Enterprise Storage com distribuições que não são do SUSE OpenStack. Os clientes Ceph precisam estar em um nível que seja compatível com o SUSE Enterprise Storage.

NotaA SUSE suporta o componente de servidor da implantação do Ceph, e o cliente é suportado pelo fornecedor de distribuição do OpenStack.

2 Requisitos e recomendações de hardware #

Os requisitos de hardware do Ceph dependem bastante da carga de trabalho de E/S. Os requisitos e as recomendações de hardware a seguir devem ser considerados um ponto de partida para o planejamento detalhado.

Em geral, as recomendações apresentadas nesta seção são baseadas em cada processo. Se houver vários processos localizados na mesma máquina, os requisitos de CPU, RAM, disco e rede deverão ser incrementados.

2.1 Visão geral da rede #

O Ceph tem várias redes lógicas:

Uma rede de front end chamada

public network.Uma rede interna confiável, a rede de back end, chamada

cluster network. Isso é opcional.Uma ou mais redes de cliente para gateways. Isso é opcional e está fora do escopo deste capítulo.

A rede pública é a rede pela qual os daemons do Ceph se comunicam entre si e com seus clientes. Isso significa que todo o tráfego de cluster do Ceph passa por essa rede, exceto quando há uma rede de cluster configurada.

A rede de cluster é a rede de back end entre os nós OSD para replicação, reequilíbrio e recuperação. Se configurada, essa rede opcional deve oferecer o dobro da largura de banda da rede pública com replicação de três vias padrão, já que o OSD primário envia duas cópias para outros OSDs por meio dessa rede. A rede pública está em um lado entre os clientes e os gateways para se comunicar com monitores, gerenciadores, nós MDS e nós OSD. Ela também é usada por monitores, gerenciadores e nós MDS para se comunicar com os nós OSD.

2.1.1 Recomendações de rede #

Recomendamos uma única rede tolerante a falhas com largura de banda suficiente para atender aos seus requisitos. Para o ambiente de rede pública do Ceph, recomendamos duas interfaces de rede de 25 GbE (ou mais rápidas) vinculadas por meio de 802.3ad (LACP). Essa é considerada a configuração mínima do Ceph. Se você também usa uma rede de cluster, recomendamos quatro interfaces de rede de 25 GbE vinculadas. A vinculação de duas ou mais interfaces de rede proporciona melhor throughput por meio da agregação de links e, considerando os links e switches redundantes, melhora a tolerância a falhas e a capacidade de manutenção.

Você também pode criar VLANs para isolar diferentes tipos de tráfego em uma vinculação. Por exemplo, você pode criar uma vinculação para fornecer duas interfaces VLAN: uma para a rede pública e a segunda para a rede de cluster. No entanto, isso não é necessário ao configurar o projeto de rede do Ceph. Os detalhes sobre a vinculação das interfaces estão disponíveis em https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-network.html#sec-network-iface-bonding.

É possível aprimorar a tolerância a falhas por meio do isolamento dos componentes em domínios de falha. Para melhorar a tolerância a falhas da rede, a vinculação de uma interface de duas Placas de Interface de Rede (NIC, Network Interface Cards) separadas oferece proteção contra falhas de uma única NIC. Da mesma forma, criar uma vinculação entre dois switches protege contra falhas de um switch. Recomendamos consultar o fornecedor do equipamento de rede para projetar o nível de tolerância a falhas necessário.

A configuração de rede de administração adicional, que permite, por exemplo, separar projetos de rede SSH, Salt ou DNS, não foi testada nem é suportada.

Se os nós de armazenamento foram configurados por DHCP, os tempos de espera padrão talvez não sejam suficientes para que a rede seja configurada corretamente antes que os vários daemons do Ceph sejam iniciados. Se isso acontecer, os Ceph MONs e OSDs não serão iniciados corretamente (a execução do systemctl status ceph\* resultará em erros do tipo “impossível vincular”). Para evitar esse problema, recomendamos aumentar o tempo de espera do cliente DHCP para pelo menos 30 segundos em cada nó no cluster de armazenamento. Para fazer isso, mude as seguintes configurações em cada nó:

Em /etc/sysconfig/network/dhcp, defina

DHCLIENT_WAIT_AT_BOOT="30"

Em /etc/sysconfig/network/config, defina

WAIT_FOR_INTERFACES="60"

2.1.1.1 Adicionando uma rede privada a um cluster em execução #

Se você não especificar uma rede de cluster durante a implantação do Ceph, ele assumirá um ambiente de rede pública única. Enquanto o Ceph funciona bem com uma rede pública, seu desempenho e segurança melhoram quando você define uma segunda rede privada de cluster. Para suportar duas redes, cada nó do Ceph precisa ter pelo menos duas placas de rede.

Você precisará aplicar as mudanças a seguir a cada nó do Ceph. É relativamente rápido fazer isso em um cluster pequeno, mas pode ser muito demorado se você tem um cluster com centenas ou milhares de nós.

Defina a rede de cluster usando o seguinte comando:

#ceph config set global cluster_network MY_NETWORKReinicie os OSDs para vinculação à rede de cluster especificada:

#systemctl restart ceph-*@osd.*.serviceVerifique se a rede privada de cluster funciona conforme esperado no nível do OS.

2.1.1.2 Nós de monitoramento em sub-redes diferentes #

Se os nós do monitor estiverem em várias sub-redes, por exemplo, localizados em salas distintas e processados por switches diferentes, você precisará especificar o endereço da rede pública na notação CIDR:

cephuser@adm > ceph config set mon public_network "MON_NETWORK_1, MON_NETWORK_2, MON_NETWORK_NPor exemplo:

cephuser@adm > ceph config set mon public_network "192.168.1.0/24, 10.10.0.0/16"Se você especificar mais de um segmento de rede para a rede pública (ou cluster), conforme descrito nesta seção, cada uma dessas sub-redes deverá ser capaz de rotear para todas as outras. Do contrário, os MONs e outros daemons do Ceph em diferentes segmentos de rede não poderão se comunicar, e o resultado será um cluster dividido. Além disso, se você usa um firewall, certifique-se de incluir cada endereço IP ou sub-rede em seu iptables e abrir as portas para eles em todos os nós, conforme necessário.

2.2 Configurações de várias arquiteturas #

O SUSE Enterprise Storage suporta as arquiteturas x86 e Arm. Ao considerar cada arquitetura, é importante notar que, de uma perspectiva de núcleo por OSD, frequência e RAM, não há diferença real entre as arquiteturas de CPU quanto ao dimensionamento.

Assim como nos processadores x86 menores (sem servidor), os núcleos de desempenho mais baixo com base em Arm podem não oferecer uma experiência ideal, principalmente quando usados para pools codificados para eliminação.

Em toda a documentação, SYSTEM-ARCH é usado no lugar de x86 ou Arm.

2.3 Configuração de hardware #

Para obter a melhor experiência do produto, recomendamos começar com a configuração de cluster recomendada. Para um cluster de teste ou um cluster com menos requisitos de desempenho, documentamos uma configuração de cluster mínima suportada.

2.3.1 Configuração de cluster mínima #

Uma configuração de cluster mínima do produto consiste em:

Pelo menos quatro nós físicos (nós OSD) com colocation de serviços

Ethernet dupla de 10 Gb como rede vinculada

Um Nó de Admin separado (pode ser virtualizado em um nó externo)

Veja abaixo uma configuração detalhada:

Nó de Admin separado com 4 GB de RAM, quatro núcleos, capacidade de armazenamento de 1 TB. Normalmente, esse é o nó do Master Salt. Os serviços e gateways do Ceph, como Ceph Monitor, Servidor de Metadados, Ceph OSD, Gateway de Objetos ou NFS Ganesha, não são suportados no Nó de Admin, pois ele precisa orquestrar os processos de atualização e upgrade do cluster de forma independente.

Pelo menos quatro nós OSD físicos, com oito discos OSD cada. Consulte a Seção 2.4.1, “Requisitos mínimos” para obter os requisitos.

A capacidade total do cluster deve ser dimensionada de modo que, mesmo com um nó indisponível, a capacidade total usada (incluindo redundância) não exceda 80%.

Três instâncias do Ceph Monitor. Os monitores precisam ser executados do armazenamento SSD/NVMe, não de HDDs, por motivos de latência.

É possível fazer colocation dos monitores, do Servidor de Metadados e dos gateways nos nós OSD. Consulte a Seção 2.12, “OSD e monitor que compartilham um servidor” para saber sobre colocation do monitor. Se você fizer colocation dos serviços, os requisitos de memória e CPU precisarão ser somados.

O iSCSI Gateway, o Gateway de Objetos e o Servidor de Metadados exigem pelo menos 4 GB de RAM incremental e quatro núcleos.

Se você usa CephFS, S3/Swift ou iSCSI, serão necessárias pelo menos duas instâncias das respectivas funções (Servidor de Metadados, Gateway de Objetos, iSCSI) para redundância e disponibilidade.

Os nós devem ser dedicados ao SUSE Enterprise Storage e não devem ser usados para nenhuma outra carga de trabalho física, em containers ou virtualizada.

Se qualquer um dos gateways (iSCSI, Gateway de Objetos, NFS Ganesha, Servidor de Metadados etc.) for implantado em VMs, essas VMs não deverão ser hospedadas em máquinas físicas que processam outras funções do cluster. (Isso é desnecessário, pois eles são suportados como serviços com colocation.)

Ao implantar serviços como VMs em hipervisores fora do cluster físico principal, os domínios de falha devem ser respeitados para garantir a redundância.

Por exemplo, não implante várias funções do mesmo tipo no mesmo hypervisor, como várias instâncias de MONs ou MDSs.

Na implantação em VMs, é importante principalmente garantir que os nós tenham uma forte conectividade de rede e uma boa sincronização de horário.

Os nós do hipervisor devem ser dimensionados adequadamente para evitar a interferência de outras cargas de trabalho que consomem recursos de CPU, RAM, rede e armazenamento.

2.3.2 Configuração recomendada do cluster de produção #

Depois que você aumentar o cluster, recomendamos realocar os Ceph Monitors, os Servidores de Metadados e os Gateways para nós separados para melhorar a tolerância a falhas.

Sete Nós de Armazenamento de Objetos

Nenhum nó único excede ~ 15% do total de armazenamento.

A capacidade total do cluster deve ser dimensionada de modo que, mesmo com um nó indisponível, a capacidade total usada (incluindo redundância) não exceda 80%.

Ethernet de 25 Gb ou superior, cada uma vinculada ao cluster interno e à rede pública externa.

Mais de 56 OSDs por cluster de armazenamento.

Consulte a Seção 2.4.1, “Requisitos mínimos” para ver outras recomendações.

Nós dedicados de infraestrutura física.

Três nós do Ceph Monitor: 4 GB de RAM, processador de 4 núcleos, SSDs RAID 1 para disco.

Consulte a Seção 2.5, “Nós do monitor” para ver outras recomendações.

Nós do Gateway de Objetos: 32 GB de RAM, processador de 8 núcleos, SSDs RAID 1 para disco.

Consulte a Seção 2.6, “Nós do Gateway de Objetos” para ver outras recomendações.

Nós do iSCSI Gateway: 16 GB de RAM, processador de 8 núcleos, SSDs RAID 1 para disco.

Consulte a Seção 2.9, “Nós do Gateway iSCSI” para ver outras recomendações.

Nós do Servidor de Metadados (um ativo/um standby ativo): 32 GB de RAM, processador de 8 núcleos, SSDs RAID 1 para disco.

Consulte a Seção 2.7, “Nós do servidor de metadados” para ver outras recomendações.

Um Nó de Admin do SES: 4 GB de RAM, processador de 4 núcleos, SSDs RAID 1 para disco.

2.3.3 Configuração de múltiplos caminhos #

Para usar um hardware de múltiplos caminhos, verifique se o LVM vê multipath_component_detection = 1 no arquivo de configuração na seção devices. É possível executar o comando lvm config para verificar isso.

Se preferir, verifique se o LVM filtra os componentes mpath de um dispositivo por meio da configuração do filtro do LVM. Esse procedimento será específico do host.

Ele não é recomendado e deverá ser considerado apenas se multipath_component_detection = 1 não puder ser definido.

Para obter informações sobre configuração de múltiplos caminhos, consulte https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-multipath.html#sec-multipath-lvm.

2.4 Nós de armazenamento de objetos #

2.4.1 Requisitos mínimos #

As seguintes recomendações de CPU consideram os dispositivos independentemente do uso pelo Ceph:

1x Thread de CPU de 2 GHz por spinner.

2x Threads de CPU de 2 GHz por SSD.

4x Threads de CPU de 2 GHz por NVMe.

Redes separadas de 10 GbE (pública/cliente e interna), 4x 10 GbE necessário, 2x 25 GbE recomendado.

RAM total necessária = número de OSDs x (1 GB +

osd_memory_target) + 16 GB.Consulte o Book “Guia de Administração e Operações”, Chapter 28 “Configuração do cluster do Ceph”, Section 28.4.1 “Configurando o dimensionamento automático do cache” para obter mais detalhes sobre

osd_memory_target.Discos OSD nas configurações de JBOD ou nas configurações individuais de RAID-0.

Diário OSD pode residir no disco OSD.

Os discos OSD devem ser usados exclusivamente pelo SUSE Enterprise Storage.

Disco e SSD dedicados para o sistema operacional, preferencialmente em uma configuração de RAID 1.

Aloque pelo menos 4 GB de RAM adicional se esse host OSD for hospedar parte de um pool de cache usado para camadas de cache.

Ceph Monitors, Ceph Gateway e Servidores de Metadados podem residir em Nós de Armazenamento de Objetos.

Por motivos de desempenho do disco, os nós OSD estão completamente vazios. Nenhuma outra carga de trabalho deve ser executada em um nó OSD, a menos que seja uma configuração mínima de Ceph Monitors e Ceph Managers.

SSDs para Diário com o diário de SSD de proporção 6:1 para OSD.

Verifique se os nós OSD não têm dispositivos de blocos em rede mapeados, como iSCSI ou imagens de Dispositivo de Blocos RADOS.

2.4.2 Tamanho mínimo do disco #

Há dois tipos de espaço em disco necessários para execução no OSD: o espaço para o dispositivo WAL/BD e o espaço principal para os dados armazenados. O valor mínimo (e padrão) para o WAL/BD é de 6 GB. O espaço mínimo para os dados é de 5 GB, pois as partições menores do que 5 GB recebem automaticamente o peso de 0.

Portanto, embora o espaço mínimo em disco para um OSD seja de 11 GB, não é recomendável um disco menor do que 20 GB, mesmo para fins de teste.

2.4.3 Tamanho recomendado para o dispositivo WAL e BD do BlueStore #

Consulte a Seção 1.4, “BlueStore” para obter mais informações sobre o BlueStore.

Recomendamos reservar 4 GB para o dispositivo WAL. O tamanho mínimo do BD é 64 GB para cargas de trabalho apenas RBD, mas o tamanho recomendado do BD para cargas de trabalho do Gateway de Objetos e do CephFS é 2% da capacidade do dispositivo principal (sendo no mínimo 196 GB).

ImportanteRecomendamos volumes de BD maiores para implantações de alta carga, principalmente se houver uso elevado do RGW ou CephFS. Reserve parte da capacidade (slots) para instalar mais hardware e ter mais espaço no banco de dados, se necessário.

Se você pretende colocar o dispositivo WAL e BD no mesmo disco, recomendamos usar uma única partição para ambos os dispositivos, em vez de ter uma partição separada para cada um. Dessa forma, o Ceph pode usar o dispositivo BD também para operação de WAL. Portanto, o gerenciamento do espaço em disco é mais eficaz, pois o Ceph usa a partição BD para o WAL apenas quando há necessidade dela. Outra vantagem é que há pouca probabilidade de a partição WAL ficar cheia, e quando ela não é totalmente usada, o espaço dela não é desperdiçado, mas usado para operação do BD.

Para compartilhar o dispositivo BD com o WAL, não especifique o dispositivo WAL, mas apenas o dispositivo BD.

Encontre mais informações sobre como especificar um layout de OSD no Book “Guia de Administração e Operações”, Chapter 13 “Tarefas operacionais”, Section 13.4.3 “Adicionando OSDs por meio da especificação DriveGroups”.

2.4.5 Número máximo recomendado de discos #

Você poderá ter quantos discos forem permitidos em um servidor. Há algumas coisas que devem ser consideradas na hora de planejar o número de discos por servidor:

Largura de banda de rede. Quanto mais discos você tiver em um servidor, mais dados deverão ser transferidos por placa(s) de rede para as operações de gravação em disco.

Memória. RAM acima de 2 GB é usada para o cache do BlueStore. Com o

osd_memory_targetpadrão de 4 GB, o sistema tem um tamanho de cache inicial razoável para mídia giratória. Se você usa SSD ou NVME, considere aumentar o tamanho do cache e a alocação de RAM por OSD para maximizar o desempenho.Tolerância a falhas. Em caso de falha no servidor inteiro, quanto mais discos ele tiver, mais OSDs o cluster perderá temporariamente. Além disso, para manter as regras de replicação em execução, você precisa copiar todos os dados do servidor com falha para os outros nós no cluster.

2.5 Nós do monitor #

Pelo menos três nós MON são necessários. O número de monitores deve ser sempre ímpar (1+2n).

4 GB de RAM.

Processador com quatro núcleos lógicos.

Uma SSD ou outro tipo de armazenamento rápido o bastante é altamente recomendado para monitores, principalmente para o caminho

/var/lib/cephem cada nó do monitor, pois o quorum pode ficar instável com altas latências de disco. É recomendada a configuração de dois discos no RAID 1 para redundância. É recomendável o uso de discos separados ou, pelo menos, de partições de disco separadas para que os processos do monitor protejam o espaço em disco disponível do monitor contra eventos como arquivo de registro muito grande.Deve haver apenas um processo do monitor por nó.

A combinação de nós OSD, MON ou do Gateway de Objetos apenas será suportada se houver recursos de hardware suficientes disponíveis. Isso significa que os requisitos para todos os serviços precisam ser incrementados.

Duas interfaces de rede vinculadas a vários switches.

2.6 Nós do Gateway de Objetos #

Os nós do Gateway de Objetos devem ter pelo menos seis núcleos de CPU e 32 GB de RAM. Quando outros processos são colocalizados na mesma máquina, os requisitos precisam ser incrementados.

2.7 Nós do servidor de metadados #

O dimensionamento apropriado dos nós do Servidor de Metadados depende do caso de uso específico. Em geral, quanto mais arquivos abertos o Servidor de Metadados tiver que processar, mais CPU e RAM serão necessárias. Veja a seguir os requisitos mínimos:

4 GB de RAM para cada daemon do Servidor de Metadados.

Interface de rede vinculada.

CPU de 2.5 GHz com, no mínimo, 2 núcleos.

2.8 Nó de Admin #

Pelo menos 4 GB de RAM e uma CPU quad-core são necessárias. Isso inclui a execução do Master Salt no Nó de Admin. Para clusters grandes com centenas de nós, 6 GB de RAM é a sugestão.

2.9 Nós do Gateway iSCSI #

Os nós do Gateway iSCSI devem ter pelo menos seis núcleos de CPU e 16 GB de RAM.

2.10 SES e outros produtos da SUSE #

Esta seção contém informações importantes sobre a integração do SES com outros produtos da SUSE.

2.10.1 SUSE Manager #

O SUSE Manager e o SUSE Enterprise Storage não estão integrados, portanto, o SUSE Manager não pode gerenciar um cluster do SES neste momento.

2.11 Limitações de nome #

Em geral, o Ceph não suporta caracteres não ASCII em arquivos de configuração, nomes de pool, nomes de usuário, etc. Ao configurar um cluster do Ceph, é recomendável usar apenas caracteres alfanuméricos simples (A-Z, a-z, 0-9) e pontuação mínima ('.', '-', '_’) em todos os nomes de objeto/configuração do Ceph.

3 Configuração de alta disponibilidade do nó de admin #

O Nó de Admin é um nó de cluster do Ceph em que o serviço do Master Salt é executado. Ele gerencia o restante dos nós do cluster consultando e instruindo os serviços do Minion Salt. Normalmente, ele também inclui outros serviços, por exemplo, o painel de controle do Grafana com suporte do kit de ferramentas de monitoramento do Prometheus.

Em caso de falha no Nó de Admin, geralmente você precisa fornecer um novo hardware ativo para o nó e restaurar a pilha completa de configuração do cluster de um backup recente. Esse é um método demorado e provoca interrupção no cluster.

Para evitar o tempo de espera no desempenho do cluster do Ceph causado pela falha no Nó de Admin, é recomendável usar o cluster de Alta Disponibilidade (HA, High Availability) para o Nó de Admin do Ceph.

3.1 Estrutura do cluster de HA para o nó de admin #

A ideia de um cluster de HA é que, em caso de falha em um nó do cluster, o outro nó assume automaticamente a função dele, incluindo o Nó de Admin virtualizado. Dessa forma, os outros nós do cluster do Ceph não percebem a falha no Nó de Admin.

A solução de HA mínima para o Nó de Admin requer o seguinte hardware:

Dois servidores completamente vazios capazes de executar o SUSE Linux Enterprise com a extensão de Alta Disponibilidade e de virtualizar o Nó de Admin.

Dois ou mais caminhos de comunicação de rede redundantes. Por exemplo, via Ligação de Dispositivo de Rede.

Armazenamento compartilhado para hospedar a(s) imagem(ns) de disco da máquina virtual do Nó de Admin. O armazenamento compartilhado precisa ser acessível aos dois servidores. Por exemplo, ele pode ser uma exportação NFS, um compartilhamento do Samba ou um destino iSCSI.

Encontre mais detalhes sobre os requisitos de cluster no site https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#sec-ha-inst-quick-req.

3.2 Criando um cluster de HA com o nó de admin #

O procedimento a seguir resume as etapas mais importantes de criação do cluster de HA para virtualização do Nó de Admin. Para obter detalhes, consulte os links indicados.

Configure um cluster de HA básico de 2 nós com armazenamento compartilhado, conforme descrito em https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-install-quick/#art-sleha-install-quick.

Em ambos os nós do cluster, instale todos os pacotes necessários para executar o hipervisor KVM e o kit de ferramentas

libvirt, conforme descrito em https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-vt-installation-kvm.No primeiro nó do cluster, crie uma nova VM (Virtual Machine – Máquina Virtual) KVM usando o

libvirt, conforme descrito em https://documentation.suse.com/sles/15-SP3/single-html/SLES-virtualization/#sec-libvirt-inst-virt-install. Use o armazenamento compartilhado pré-configurado para armazenar as imagens de disco da VM.Após o término da configuração da VM, exporte sua configuração para um arquivo XML no armazenamento compartilhado. Use a seguinte sintaxe:

#virsh dumpxml VM_NAME > /path/to/shared/vm_name.xmlCrie um recurso para a VM do Nó de Admin. Consulte https://documentation.suse.com/sle-ha/15-SP3/single-html/SLE-HA-guide/#cha-conf-hawk2 para obter informações gerais sobre a criação de recursos de HA. Há informações detalhadas sobre a criação de recursos para uma máquina virtual KVM descritas em http://www.linux-ha.org/wiki/VirtualDomain_%28resource_agent%29.

No convidado da VM recém-criado, implante o Nó de Admin, incluindo os serviços adicionais necessários nele. Siga as etapas relevantes na Capítulo 6, Implantando o Salt. Ao mesmo tempo, implante os nós de cluster do Ceph restantes nos servidores de cluster não HA.

Parte II Implantando o cluster do Ceph #

- 4 Introdução e tarefas comuns

Desde o SUSE Enterprise Storage 7, os serviços do Ceph são implantados como containers, em vez de pacotes RPM. O processo de implantação tem duas etapas básicas:

- 5 Instalando e configurando o SUSE Linux Enterprise Server

Instale e registre o SUSE Linux Enterprise Server 15 SP3 em cada nó do cluster. Durante a instalação do SUSE Enterprise Storage, é necessário ter acesso aos repositórios de atualização, portanto, o registro é obrigatório. Inclua pelo menos os seguintes módulos:

- 6 Implantando o Salt

O SUSE Enterprise Storage usa o Salt e o

ceph-saltpara a preparação inicial do cluster. O Salt ajuda você a configurar e executar comandos em vários nós do cluster simultaneamente, de um host dedicado chamado Master Salt. Antes de implantar o Salt, considere os seguintes pontos importantes:- 7 Implantando o cluster de boot usando

ceph-salt Esta seção orienta você pelo processo de implantação de um cluster básico do Ceph. Leia as subseções a seguir com atenção e execute os comandos incluídos na ordem indicada.

- 8 Implantando os serviços principais restantes com o cephadm

Após implantar o cluster básico do Ceph, implante os serviços principais em mais nós do cluster. Para tornar os dados do cluster acessíveis aos clientes, implante também mais serviços.

- 9 Implantação de serviços adicionais

iSCSI é um protocolo SAN (Storage Area Network) que permite aos clientes (denominados iniciadores) enviar comandos SCSI para dispositivos de armazenamento SCSI (destinos) em servidores remotos. O SUSE Enterprise Storage 7.1 inclui um recurso que abre o gerenciamento de armazenamento do Ceph para cli…

4 Introdução e tarefas comuns #

Desde o SUSE Enterprise Storage 7, os serviços do Ceph são implantados como containers, em vez de pacotes RPM. O processo de implantação tem duas etapas básicas:

- Implantando o cluster de boot

Essa fase é chamada de Implantação do dia 1 e consiste nas seguintes tarefas: Ela inclui a instalação do sistema operacional de base, a configuração da infraestrutura do Salt e a implantação do cluster mínimo, que é composto de um serviço MON e de um serviço MGR.

Instale e faça a configuração básica do sistema operacional subjacente, SUSE Linux Enterprise Server 15 SP3, em todos os nós do cluster.

Implante a infraestrutura do Salt em todos os nós do cluster para executar as preparações iniciais de implantação por meio do

ceph-salt.Configure as propriedades básicas do cluster por meio do

ceph-salte implante-o.

- Implantando serviços adicionais

Durante a Implantação do dia 2, os outros serviços essenciais e não essenciais do Ceph, por exemplo, gateways e pilha de monitoramento, são implantados.

Observe que a documentação da comunidade do Ceph usa o comando cephadm bootstrap durante a implantação inicial. O ceph-salt chama o comando cephadm bootstrap automaticamente. O comando cephadm bootstrap não deve ser executado diretamente. Qualquer implantação manual de cluster do Ceph que use o cephadm bootstrap não será suportada.

4.1 Ler os detalhes da versão #

Nos detalhes da versão, você encontra mais informações sobre o que mudou desde a versão anterior do SUSE Enterprise Storage. Consulte os detalhes da versão para verificar se:

seu hardware precisa de considerações especiais.

qualquer pacote de software usado foi significativamente modificado.

são necessárias precauções especiais para a instalação.

Os detalhes da versão também apresentam informações que não puderam ser incluídas a tempo no manual. Eles também incluem notas sobre problemas conhecidos.

Após a instalação do pacote release-notes-ses, encontre os detalhes da versão no diretório local /usr/share/doc/release-notes ou online em https://www.suse.com/releasenotes/.

5 Instalando e configurando o SUSE Linux Enterprise Server #

Instale e registre o SUSE Linux Enterprise Server 15 SP3 em cada nó do cluster. Durante a instalação do SUSE Enterprise Storage, é necessário ter acesso aos repositórios de atualização, portanto, o registro é obrigatório. Inclua pelo menos os seguintes módulos:

Basesystem Module

Server Applications Module

Encontre mais detalhes sobre como instalar o SUSE Linux Enterprise Server em https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-install.html.

Instale a extensão do SUSE Enterprise Storage 7.1 em cada nó do cluster.

Dica: Instalar o SUSE Enterprise Storage junto com o SUSE Linux Enterprise ServerVocê poderá instalar a extensão do SUSE Enterprise Storage 7.1 separadamente após instalar o SUSE Linux Enterprise Server 15 SP3 ou adicioná-la durante o procedimento de instalação do SUSE Linux Enterprise Server 15 SP3.

Encontre mais detalhes sobre como instalar extensões em https://documentation.suse.com/sles/15-SP3/html/SLES-all/cha-register-sle.html.

Defina as configurações de rede incluindo a resolução de nome DNS em cada nó. Para obter mais informações sobre como configurar uma rede, consulte https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#sec-network-yast. Para obter mais informações sobre como configurar um servidor DNS, consulte https://documentation.suse.com/sles/15-SP3/single-html/SLES-admin/#cha-dns.

6 Implantando o Salt #

O SUSE Enterprise Storage usa o Salt e o ceph-salt para a preparação inicial do cluster. O Salt ajuda você a configurar e executar comandos em vários nós do cluster simultaneamente, de um host dedicado chamado Master Salt. Antes de implantar o Salt, considere os seguintes pontos importantes:

Os Minions Salt são os nós controlados por um nó dedicado denominado Master Salt.

Se o host Master Salt fizer parte do cluster do Ceph, ele precisará executar seu próprio Minion Salt, mas isso não é um requisito.

Dica: Compartilhando várias funções por servidorO desempenho do cluster do Ceph é melhor quando cada função é implantada em um nó separado. Porém, as implantações reais às vezes exigem que um nó seja compartilhado com várias funções. Para evitar problema de desempenho e de procedimento de upgrade, não implante a função Ceph OSD, Servidor de Metadados ou Ceph Monitor no Nó de Admin.

Os Minions Salt precisam resolver corretamente o nome de host do Master Salt na rede. Por padrão, eles procuram o nome de host

salt, mas você pode especificar qualquer outro nome de host acessível por rede no arquivo/etc/salt/minion.

Instale o

salt-masterno nó do Master Salt:root@master #zypper in salt-masterVerifique se o serviço

salt-masterestá habilitado e foi iniciado. Se necessário, habilite-o e inicie-o:root@master #systemctl enable salt-master.serviceroot@master #systemctl start salt-master.serviceSe você pretende usar o firewall, verifique se o nó do Master Salt tem as portas 4505 e 4506 abertas para todos os nós do Minion Salt. Se as portas estiverem fechadas, você poderá abri-las usando o comando

yast2 firewalle permitindo o serviço para a zona apropriada. Por exemplo,public.Instale o pacote

salt-minionem todos os nós do minion.root@minion >zypper in salt-minionEdite o

/etc/salt/minione remova o comentário da seguinte linha:#log_level_logfile: warning

Mude o nível de registro de

warningparainfo.Nota:log_level_logfileelog_levellog_levelcontrola quais mensagens de registro serão exibidas na tela, elog_level_logfilecontrola quais mensagens de registro serão gravadas no/var/log/salt/minion.NotaVerifique se você mudou o nível de registro em todos os nós do cluster (minion).

Verifique se o nome de domínio completo e qualificado de cada nó pode ser resolvido para um endereço IP na rede pública do cluster por todos os outros nós.

Configure todos os minions para se conectarem ao master. Se o Master Salt não puder ser acessado pelo nome de host

salt, edite o arquivo/etc/salt/minionou crie um novo arquivo/etc/salt/minion.d/master.confcom o seguinte conteúdo:master: host_name_of_salt_master

Se você efetuou quaisquer mudanças nos arquivos de configuração mencionados acima, reinicie o serviço Salt em todos os Minions Salt relacionados:

root@minion >systemctl restart salt-minion.serviceVerifique se o serviço

salt-minionestá habilitado e foi iniciado em todos os nós. Se necessário, habilite-o e inicie-o:#systemctl enable salt-minion.service#systemctl start salt-minion.serviceVerifique a impressão digital de cada Minion Salt e aceite todas as chaves do Salt no Master Salt, se as impressões digitais forem correspondentes.

NotaSe a impressão digital do Minion Salt retornar vazia, verifique se o Minion Salt tem uma configuração do Master Salt e pode se comunicar com o Master Salt.

Ver a impressão digital de cada minion:

root@minion >salt-call --local key.finger local: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Após coletar as impressões digitais de todos os Minions Salt, liste as impressões digitais de todas as chaves de minion não aceitas no Master Salt:

root@master #salt-key -F [...] Unaccepted Keys: minion1: 3f:a3:2f:3f:b4:d3:d9:24:49:ca:6b:2c:e1:6c:3f:c3:83:37:f0:aa:87:42:e8:ff...Se houver correspondência de impressões digitais dos minions, aceite-as:

root@master #salt-key --accept-allVerifique se as chaves foram aceitas:

root@master #salt-key --list-allFaça o teste para verificar se todos os Minions Salt respondem:

root@master #salt-run manage.status

7 Implantando o cluster de boot usando ceph-salt #

Esta seção orienta você pelo processo de implantação de um cluster básico do Ceph. Leia as subseções a seguir com atenção e execute os comandos incluídos na ordem indicada.

7.1 Instalando ceph-salt #

O ceph-salt inclui ferramentas para implantar clusters do Ceph gerenciados pelo cephadm. O ceph-salt usa a infraestrutura do Salt para executar o gerenciamento de OS; por exemplo, atualizações de software ou sincronização de horário, e definir funções para os Minions Salt.

No Master Salt, instale o pacote ceph-salt:

root@master # zypper install ceph-salt

O comando acima instalou ceph-salt-formula como uma dependência que modificou a configuração do Master Salt inserindo arquivos adicionais no diretório /etc/salt/master.d. Para aplicar as mudanças, reinicie o salt-master.service e sincronize os módulos do Salt:

root@master #systemctl restart salt-master.serviceroot@master #salt \* saltutil.sync_all

7.2 Configurando as propriedades do cluster #

Use o comando ceph-salt config para configurar as propriedades básicas do cluster.

O arquivo /etc/ceph/ceph.conf é gerenciado pelo cephadm e os usuários não devem editá-lo. Os parâmetros de configuração do Ceph devem ser definidos usando o novo comando ceph config. Consulte o Book “Guia de Administração e Operações”, Chapter 28 “Configuração do cluster do Ceph”, Section 28.2 “Banco de dados de configuração” para obter mais informações.

7.2.1 Usando o shell do ceph-salt #

Se você executar o config sem nenhum caminho ou subcomando, digitará um shell interativo do ceph-saltceph-salt. O shell é prático se você precisa configurar várias propriedades em um lote e não deseja digitar a sintaxe completa do comando.

root@master #ceph-salt config/>ls o- / ............................................................... [...] o- ceph_cluster .................................................. [...] | o- minions .............................................. [no minions] | o- roles ....................................................... [...] | o- admin .............................................. [no minions] | o- bootstrap ........................................... [no minion] | o- cephadm ............................................ [no minions] | o- tuned ..................................................... [...] | o- latency .......................................... [no minions] | o- throughput ....................................... [no minions] o- cephadm_bootstrap ............................................. [...] | o- advanced .................................................... [...] | o- ceph_conf ................................................... [...] | o- ceph_image_path .................................. [ no image path] | o- dashboard ................................................... [...] | | o- force_password_update ................................. [enabled] | | o- password ................................................ [admin] | | o- ssl_certificate ....................................... [not set] | | o- ssl_certificate_key ................................... [not set] | | o- username ................................................ [admin] | o- mon_ip .................................................. [not set] o- containers .................................................... [...] | o- registries_conf ......................................... [enabled] | | o- registries .............................................. [empty] | o- registry_auth ............................................... [...] | o- password .............................................. [not set] | o- registry .............................................. [not set] | o- username .............................................. [not set] o- ssh ............................................... [no key pair set] | o- private_key .................................. [no private key set] | o- public_key .................................... [no public key set] o- time_server ........................... [enabled, no server host set] o- external_servers .......................................... [empty] o- servers ................................................... [empty] o- subnet .................................................. [not set]

Como você pode ver na saída do comando ceph-saltls do , a configuração do cluster está organizada em uma estrutura de árvore. Para configurar uma propriedade específica do cluster no shell do ceph-salt, você tem duas opções:

Execute o comando a partir da posição atual e digite o caminho absoluto para a propriedade como o primeiro argumento:

/>/cephadm_bootstrap/dashboard ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username .................................................... [admin]/> /cephadm_bootstrap/dashboard/username set ceph-adminValue set.Mude para o caminho com a propriedade que você precisa configurar e execute o comando:

/>cd /cephadm_bootstrap/dashboard//ceph_cluster/minions>ls o- dashboard ....................................................... [...] o- force_password_update ..................................... [enabled] o- password .................................................... [admin] o- ssl_certificate ........................................... [not set] o- ssl_certificate_key ....................................... [not set] o- username ................................................[ceph-admin]

Enquanto estiver em um shell do ceph-salt, você poderá usar o recurso de preenchimento automático semelhante ao do shell normal do Linux (Bash). Ele preenche os caminhos de configuração, subcomandos ou nomes de Minion Salt. Ao preencher automaticamente um caminho de configuração, você tem duas opções:

Para permitir que o shell termine um caminho relativo à sua posição atual, pressione a tecla TAB →| duas vezes.

Para permitir que o shell termine um caminho absoluto, digite / e pressione a tecla TAB →| duas vezes.

Se você digitar cd no shell do ceph-salt sem nenhum caminho, o comando imprimirá uma estrutura de árvore da configuração do cluster com a linha do caminho atual ativo. Você pode usar as teclas do cursor para cima e para baixo para navegar pelas linhas individuais. Depois de confirmar com Enter, o caminho de configuração mudará para o último caminho ativo.

Para manter a documentação consistente, usaremos uma única sintaxe de comando sem inserir o shell do ceph-salt. Por exemplo, você pode listar a árvore de configuração do cluster usando o seguinte comando:

root@master # ceph-salt config ls7.2.2 Adicionando minions Salt #

Inclua todos ou um subconjunto de Minions Salt que implantamos e aceitamos na Capítulo 6, Implantando o Salt na configuração do cluster do Ceph. Você pode especificar os Minions Salt usando os nomes completos ou as expressões glob “*” e “?” para incluir vários Minions Salt de uma vez. Use o subcomando add no caminho /ceph_cluster/minions. O seguinte comando inclui todos os Minions Salt aceitos:

root@master # ceph-salt config /ceph_cluster/minions add '*'Verifique se os Minions Salt especificados foram adicionados:

root@master # ceph-salt config /ceph_cluster/minions ls

o- minions ................................................. [Minions: 5]

o- ses-master.example.com .................................. [no roles]

o- ses-min1.example.com .................................... [no roles]

o- ses-min2.example.com .................................... [no roles]

o- ses-min3.example.com .................................... [no roles]

o- ses-min4.example.com .................................... [no roles]7.2.3 Especificando minions Salt gerenciados pelo cephadm #

Especifique os nós que pertencerão ao cluster do Ceph e serão gerenciados pelo cephadm. Inclua todos os nós que executarão os serviços do Ceph e também o Nó de Admin:

root@master # ceph-salt config /ceph_cluster/roles/cephadm add '*'7.2.4 Especificando o nó de admin #

O Nó de Admin é o nó em que o arquivo de configuração ceph.conf e o chaveiro admin do Ceph estão instalados. Geralmente, você executa os comandos relacionados ao Ceph no Nó de Admin.

Em um ambiente homogêneo onde todos ou a maioria dos hosts pertencem ao SUSE Enterprise Storage, recomendamos manter o Nó de Admin no mesmo host que o Master Salt.

Em um ambiente heterogêneo onde uma infraestrutura do Salt hospeda mais de um cluster, por exemplo, o SUSE Enterprise Storage junto com o SUSE Manager, não coloque o Nó de Admin no mesmo host que o Master Salt.

Para especificar o Nó de Admin, execute o seguinte comando:

root@master #ceph-salt config /ceph_cluster/roles/admin add ses-master.example.com 1 minion added.root@master #ceph-salt config /ceph_cluster/roles/admin ls o- admin ................................................... [Minions: 1] o- ses-master.example.com ...................... [Other roles: cephadm]

ceph.conf e o chaveiro admin em vários nósVocê pode instalar o arquivo de configuração do Ceph e o chaveiro admin em vários nós, se sua implantação exigir isso. Por motivos de segurança, evite instalá-los em todos os nós do cluster.

7.2.5 Especificando o primeiro nó MON/MGR #

Você precisa especificar qual dos Minions Salt do cluster inicializará o cluster. Esse minion será o primeiro a executar os serviços Ceph Monitor e Ceph Manager.

root@master #ceph-salt config /ceph_cluster/roles/bootstrap set ses-min1.example.com Value set.root@master #ceph-salt config /ceph_cluster/roles/bootstrap ls o- bootstrap ..................................... [ses-min1.example.com]

Além disso, você precisa especificar o endereço IP do MON de boot na rede pública para garantir que o parâmetro public_network seja definido corretamente, por exemplo:

root@master # ceph-salt config /cephadm_bootstrap/mon_ip set 192.168.10.207.2.6 Especificando perfis ajustados #

Você precisa especificar quais dos minions do cluster têm os perfis ajustados ativamente. Para fazer isso, adicione estas funções explicitamente com os seguintes comandos:

Um minion não pode ter as duas funções latency e throughput.

root@master #ceph-salt config /ceph_cluster/roles/tuned/latency add ses-min1.example.com Adding ses-min1.example.com... 1 minion added.root@master #ceph-salt config /ceph_cluster/roles/tuned/throughput add ses-min2.example.com Adding ses-min2.example.com... 1 minion added.

7.2.7 Gerando um par de chaves SSH #

O cephadm usa o protocolo SSH para se comunicar com os nós do cluster. Uma conta do usuário chamada cephadm é criada automaticamente e usada para comunicação por SSH.

Você precisa gerar a parte particular e a pública do par de chaves SSH:

root@master #ceph-salt config /ssh generate Key pair generated.root@master #ceph-salt config /ssh ls o- ssh .................................................. [Key Pair set] o- private_key ..... [53:b1:eb:65:d2:3a:ff:51:6c:e2:1b:ca:84:8e:0e:83] o- public_key ...... [53:b1:eb:65:d2:3a:ff:51:6c:e2:1b:ca:84:8e:0e:83]

7.2.8 Configurando o servidor de horário #

Todos os nós do cluster precisam ter o horário sincronizado com uma fonte de horário confiável. Há vários cenários para realizar a sincronização de horário:

Se todos os nós do cluster já estiverem configurados para sincronizar o horário usando um serviço NTP de sua escolha, desabilite completamente o processamento do servidor de horário:

root@master #ceph-salt config /time_server disableSe o seu site já tiver uma fonte de horário única, especifique o nome de host dessa fonte:

root@master #ceph-salt config /time_server/servers add time-server.example.comSe preferir, o

ceph-saltpode configurar um dos Minions Salt para agir como o servidor de horário para o restante do cluster. Esse recurso às vezes é chamado de “servidor de horário interno”. Nesse cenário, oceph-saltconfigura o servidor de horário interno (que deve ser um dos Minions Salt) para sincronizar seu horário com um servidor de horário externo, comopool.ntp.org, e configura todos os outros minions para obter o horário do servidor de horário interno. Isso pode ser feito da seguinte maneira:root@master #ceph-salt config /time_server/servers add ses-master.example.comroot@master #ceph-salt config /time_server/external_servers add pool.ntp.orgA opção

/time_server/subnetespecifica a sub-rede da qual os clientes NTP têm permissão para acessar o servidor NTP. Ela é definida automaticamente quando você especifica/time_server/servers. Se você precisar mudá-la ou especificá-la manualmente, execute:root@master #ceph-salt config /time_server/subnet set 10.20.6.0/24

Verifique as configurações do servidor de horário:

root@master # ceph-salt config /time_server ls

o- time_server ................................................ [enabled]

o- external_servers ............................................... [1]

| o- pool.ntp.org ............................................... [...]

o- servers ........................................................ [1]

| o- ses-master.example.com ..................................... [...]