SUSE Linux Enterprise High Availability Extension 12 SP5

管理指南

摘要#

本指南适用于需要使用 SUSE® Linux Enterprise High Availability Extension 设置、配置和维护群集的管理员。为了快速有效地进行配置和管理,High Availability Extension 包含一个图形用户界面 (GUI) 和一个命令行界面 (CLI),本指南详细介绍了如何通过 GUI 和 CLI 这两种方法执行关键任务。因此,管理员可以根据其需要选择适当的工具。

- 关于本指南

- I 安装、设置和升级

- II 配置和管理

- III 储存和数据复制

- IV 附录

- 术语表

- E GNU Licenses

- 1.1 三台服务器的群集

- 1.2 三台服务器的群集(其中一台服务器出现故障后)

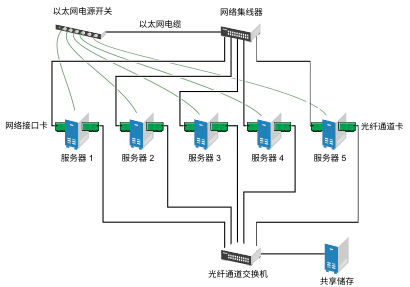

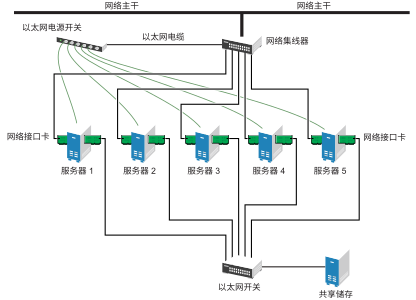

- 1.3 典型的光纤通道群集配置

- 1.4 典型的 iSCSI 群集配置

- 1.5 典型的不含共享储存的群集配置

- 1.6 体系结构

- 4.1 YaST 群集 - 多路广播配置

- 4.2 YaST 群集 - 单路广播配置

- 4.3 YaST 群集 - 安全性

- 4.4 YaST 群集 - Csync2

- 4.5 YaST 群集 -

conntrackd - 4.6 YaST 群集 - 服务

- 6.1 组资源

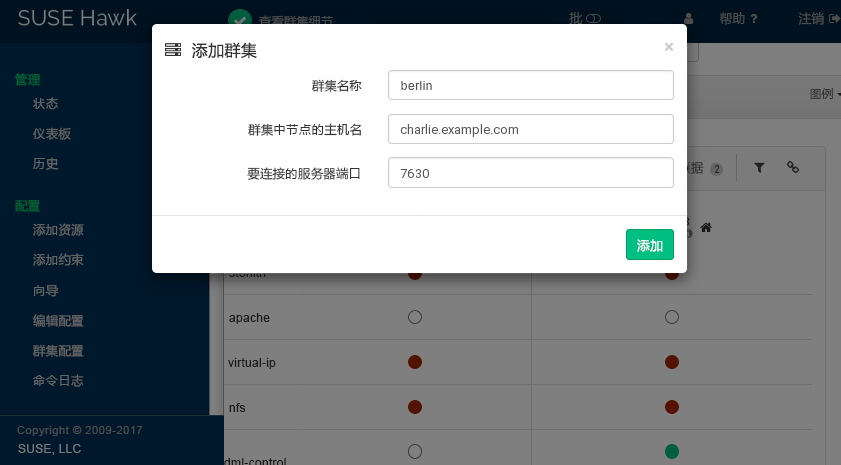

- 7.1 Hawk2 - 群集配置

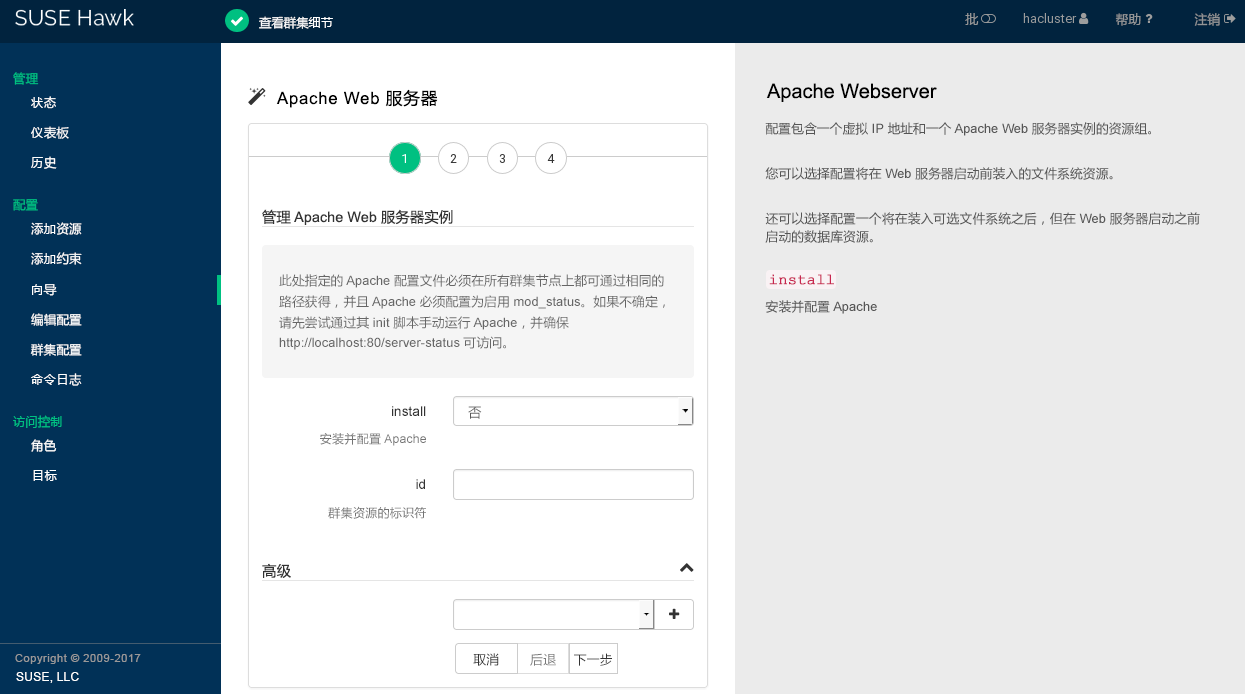

- 7.2 Hawk2 - 用于 Apache Web 服务器的向导

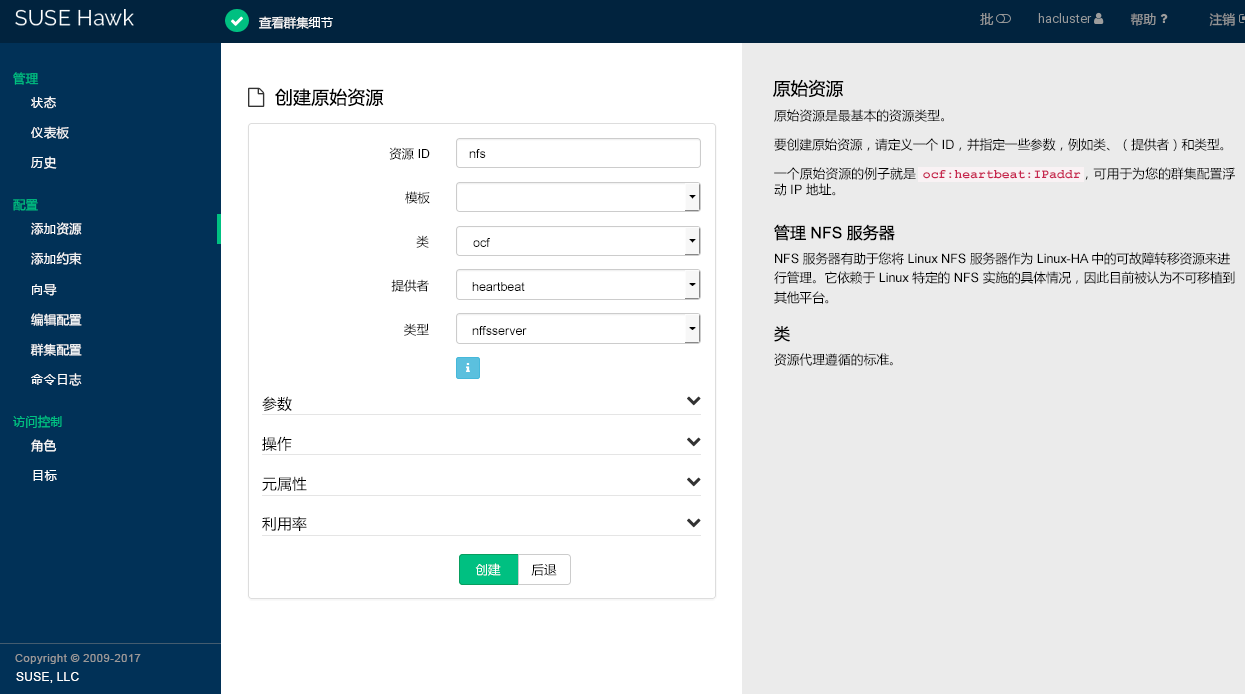

- 7.3 Hawk2 - 原始资源

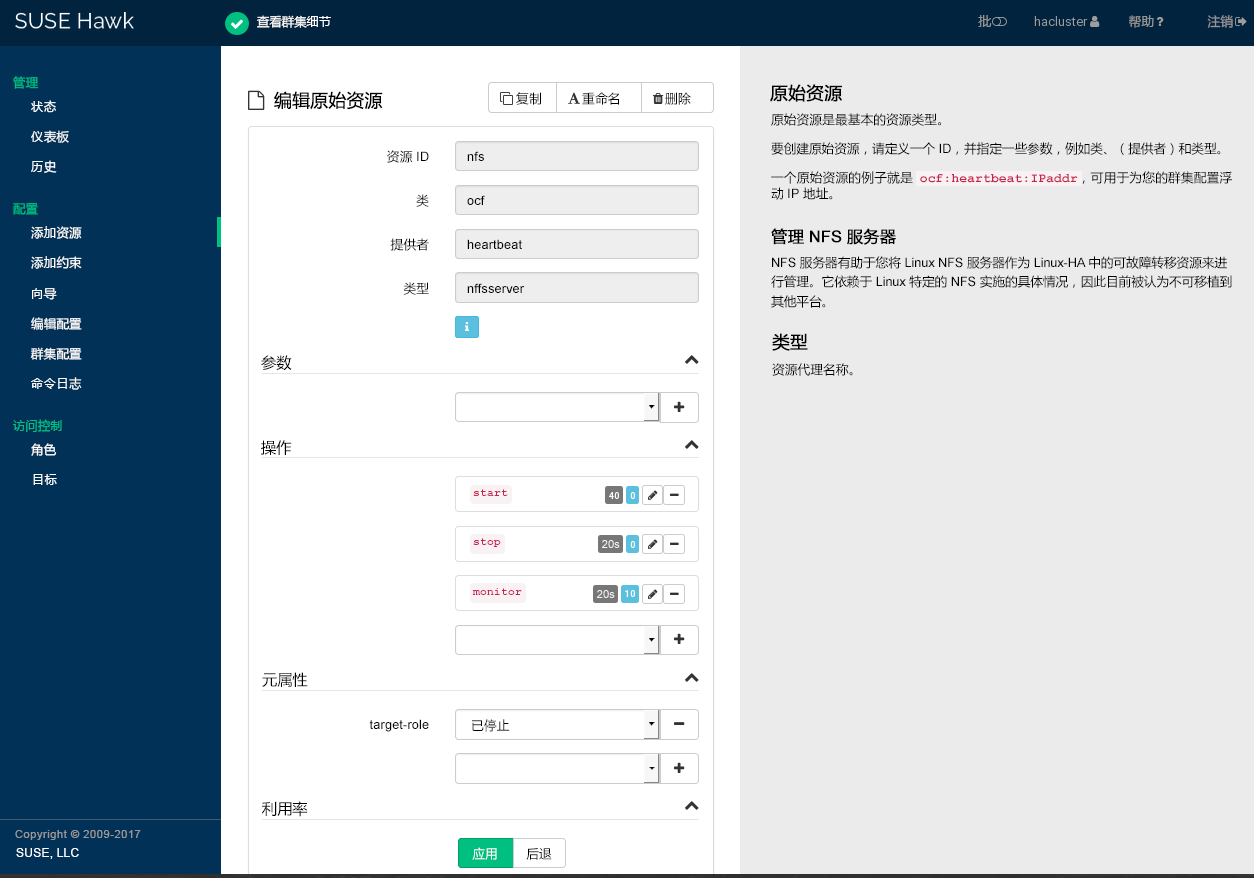

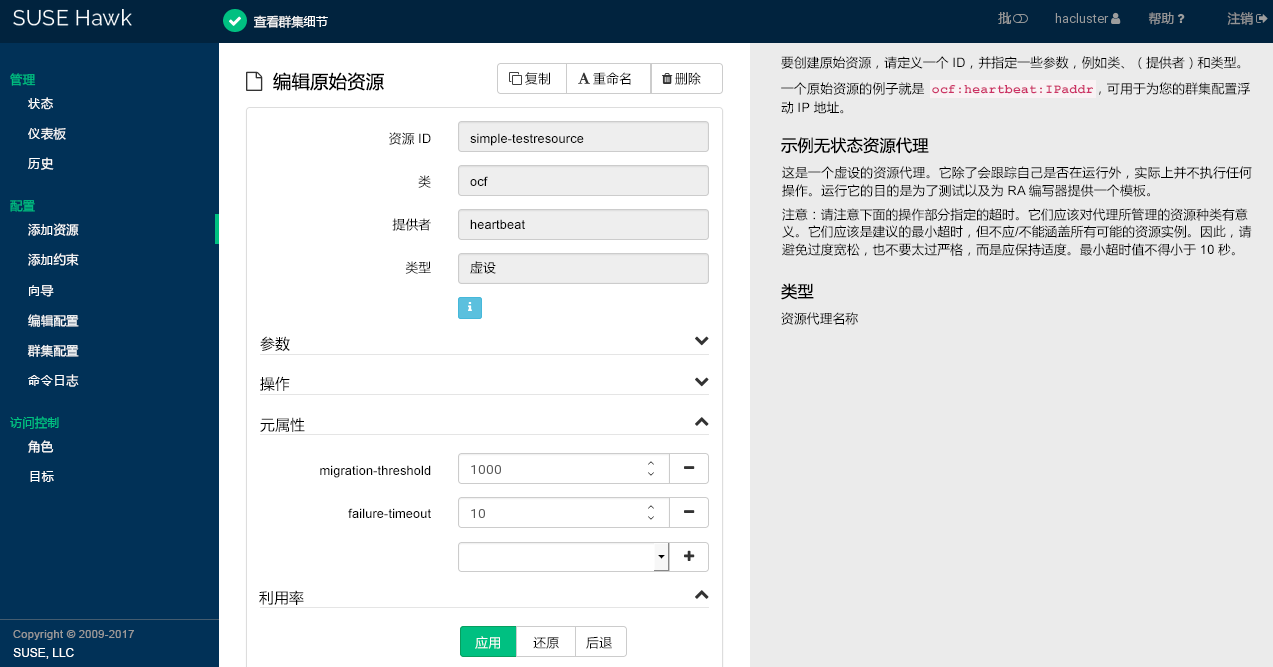

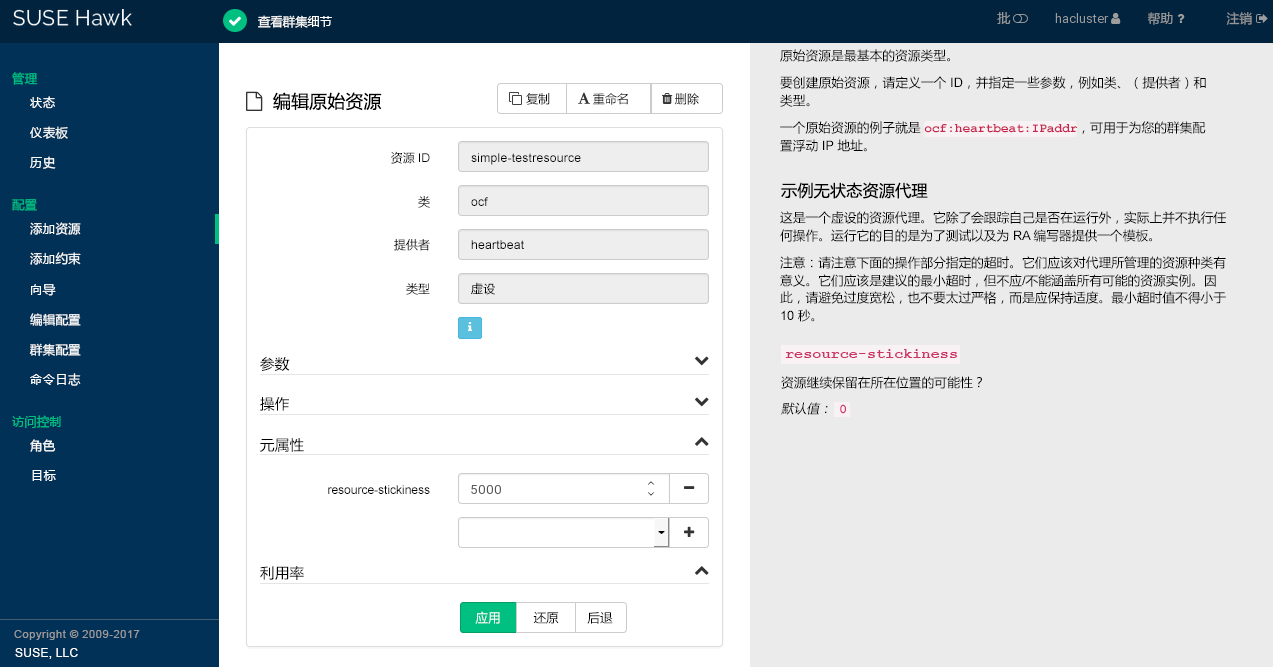

- 7.4 Hawk2 - 编辑原始资源

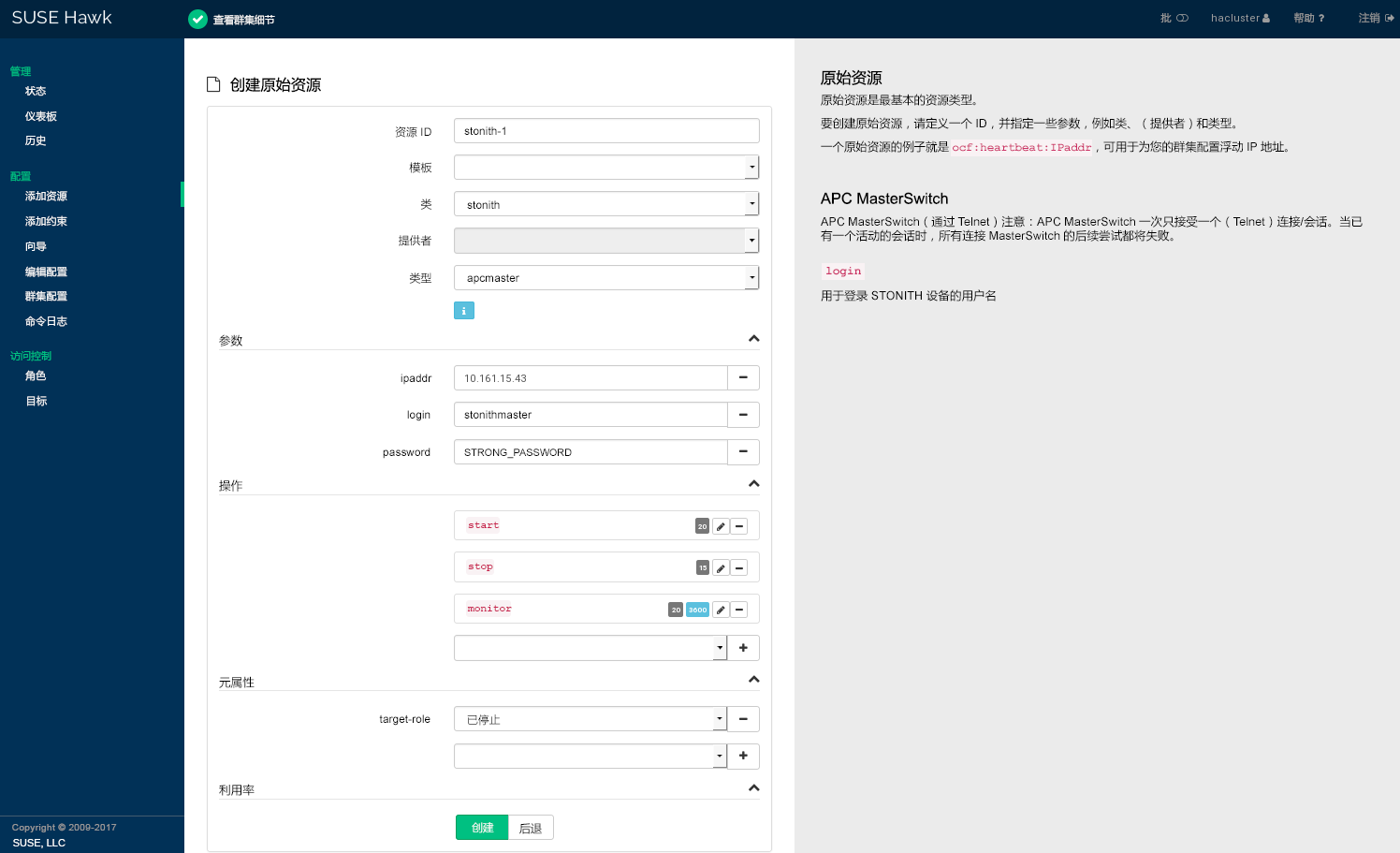

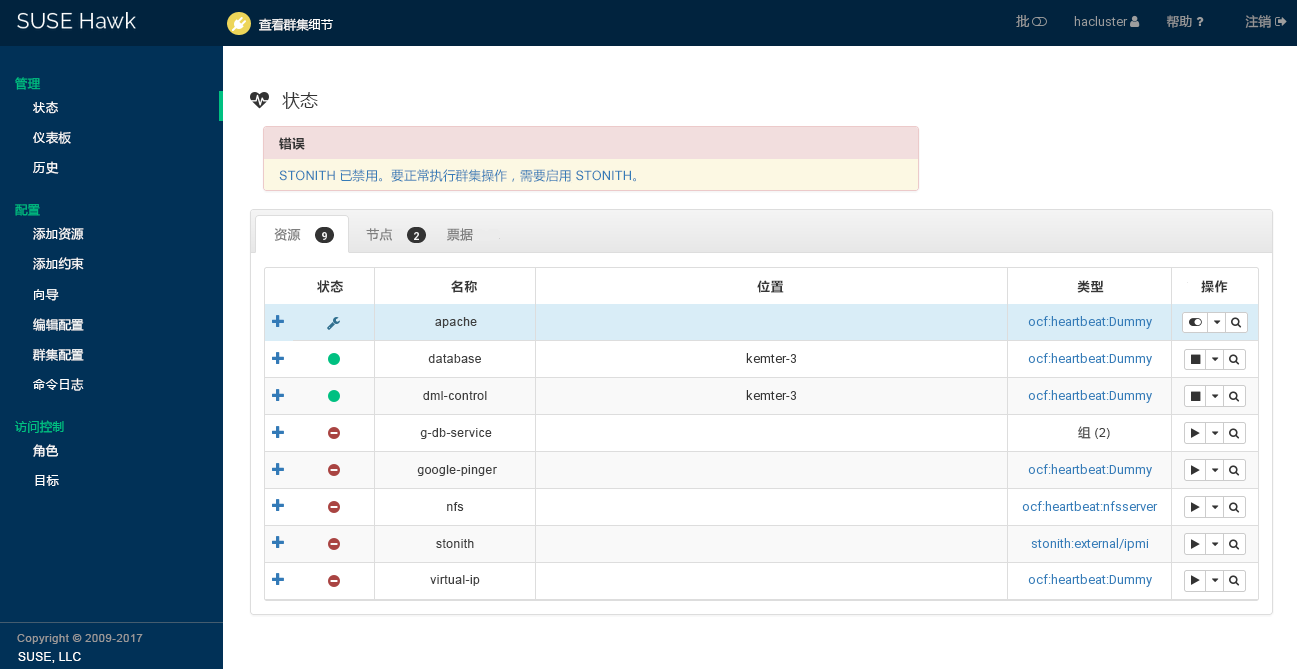

- 7.5 Hawk2 - STONITH 资源

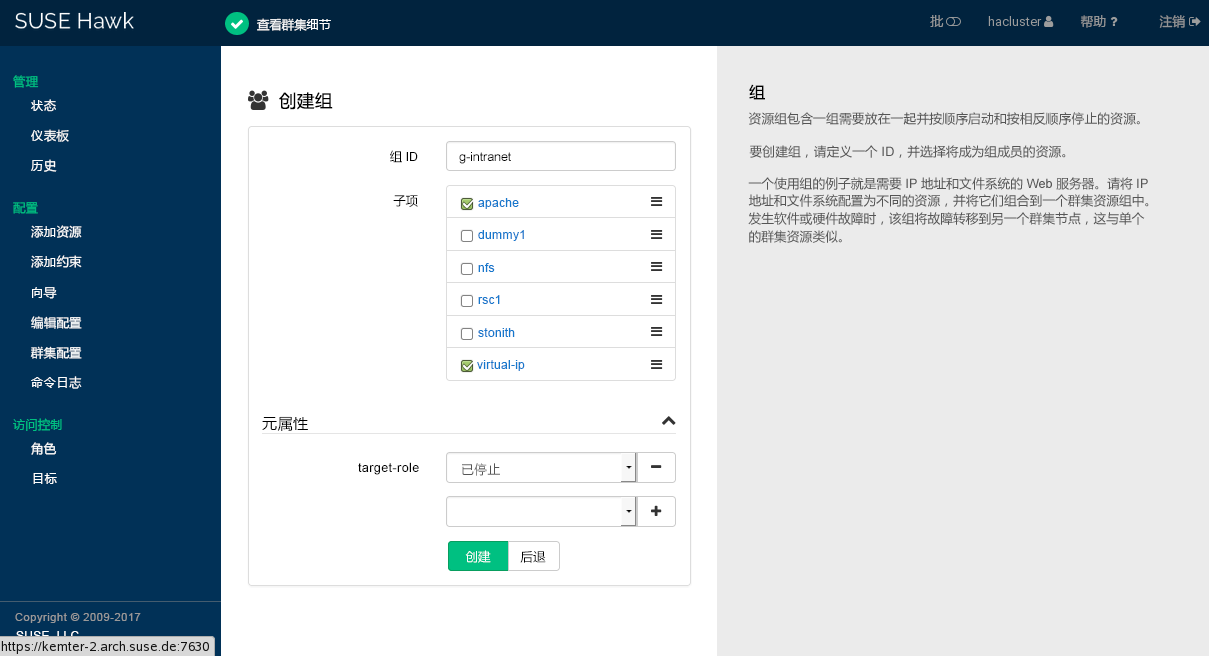

- 7.6 Hawk2 - 资源组

- 7.7 Hawk2 - 克隆资源

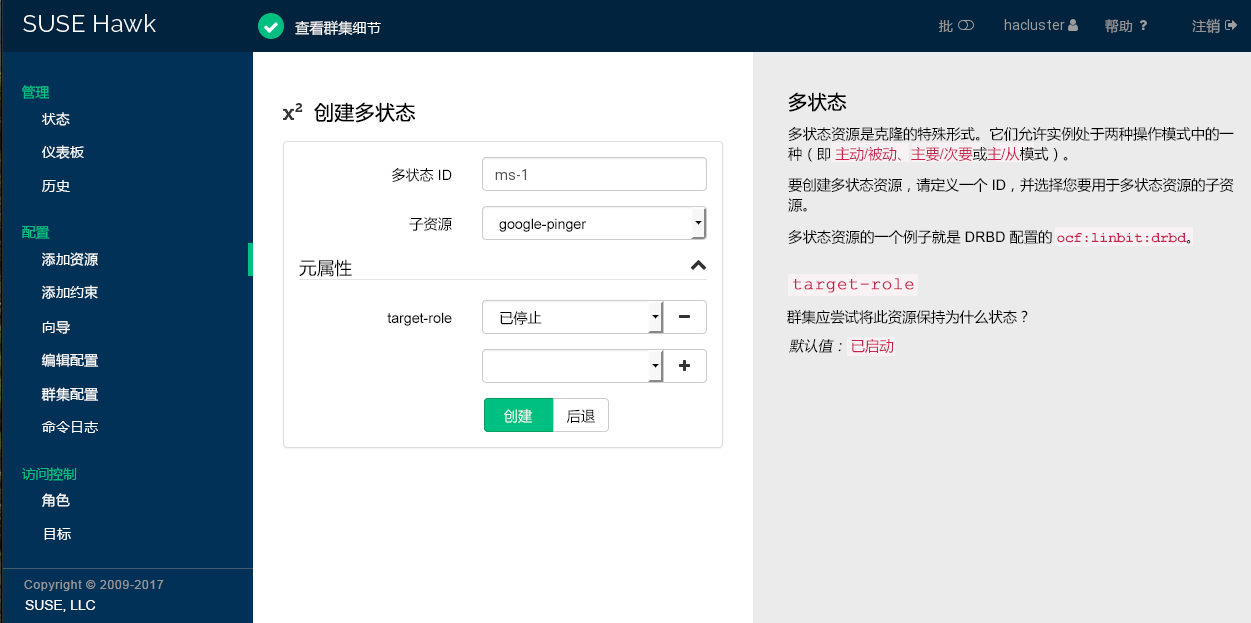

- 7.8 Hawk2 - 多状态资源

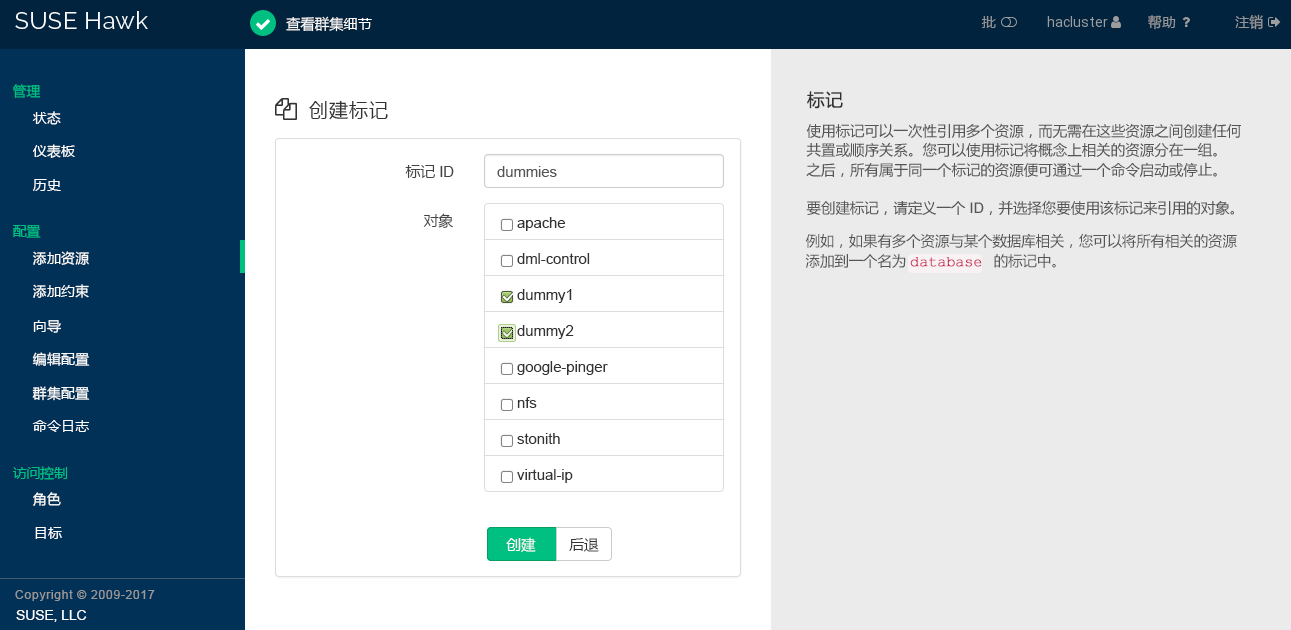

- 7.9 Hawk2 - 标记

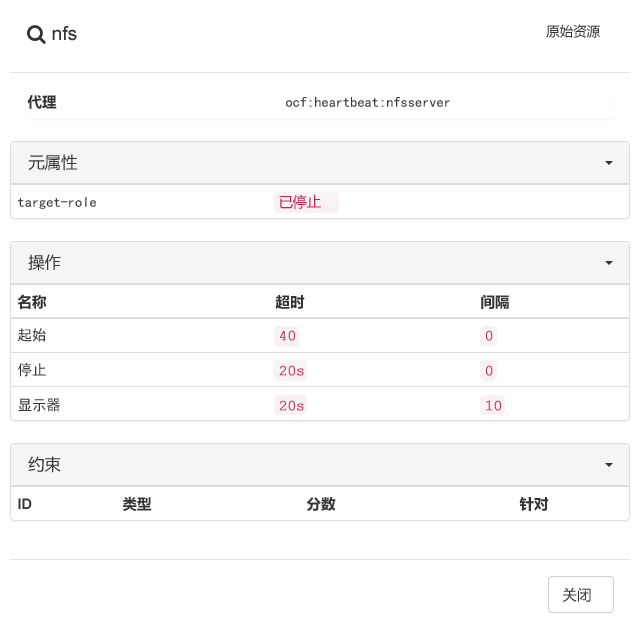

- 7.10 Hawk2 - 资源细节

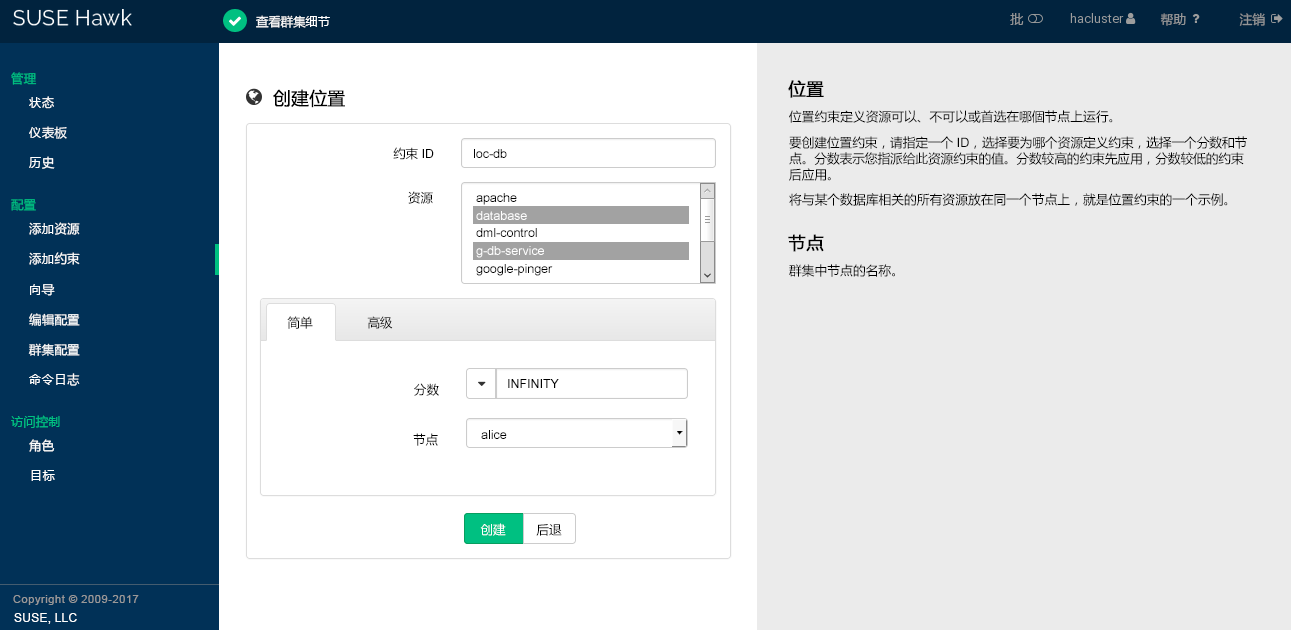

- 7.11 Hawk2 - 位置约束

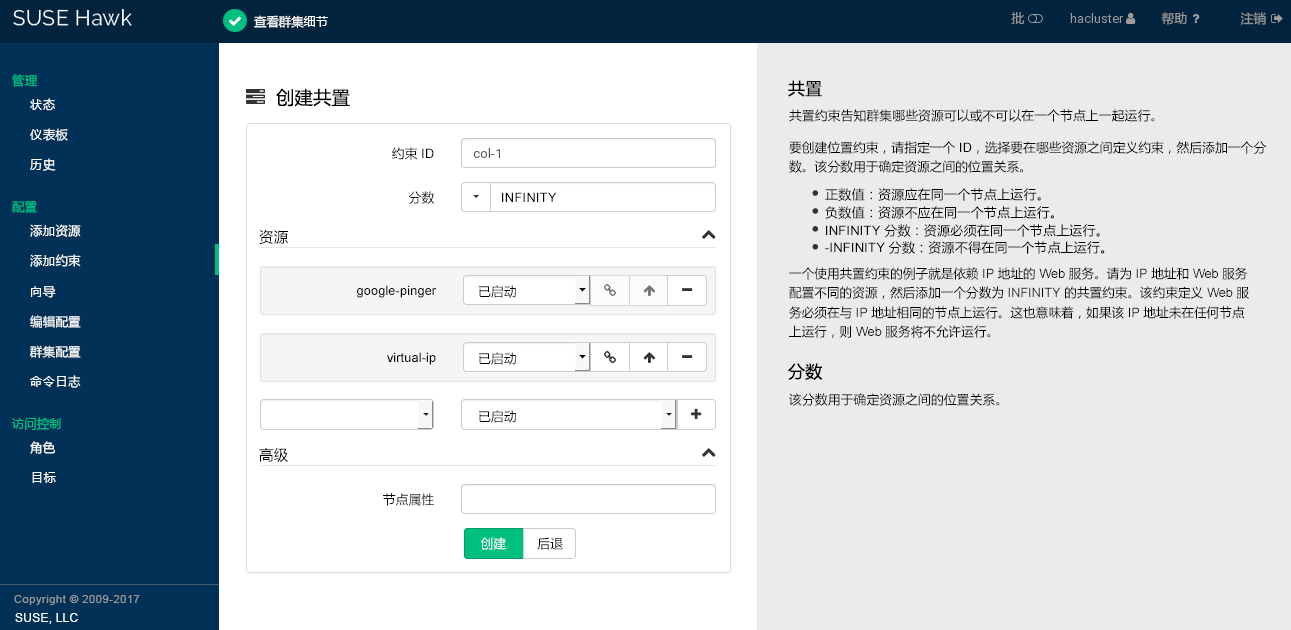

- 7.12 Hawk2 - 共置约束

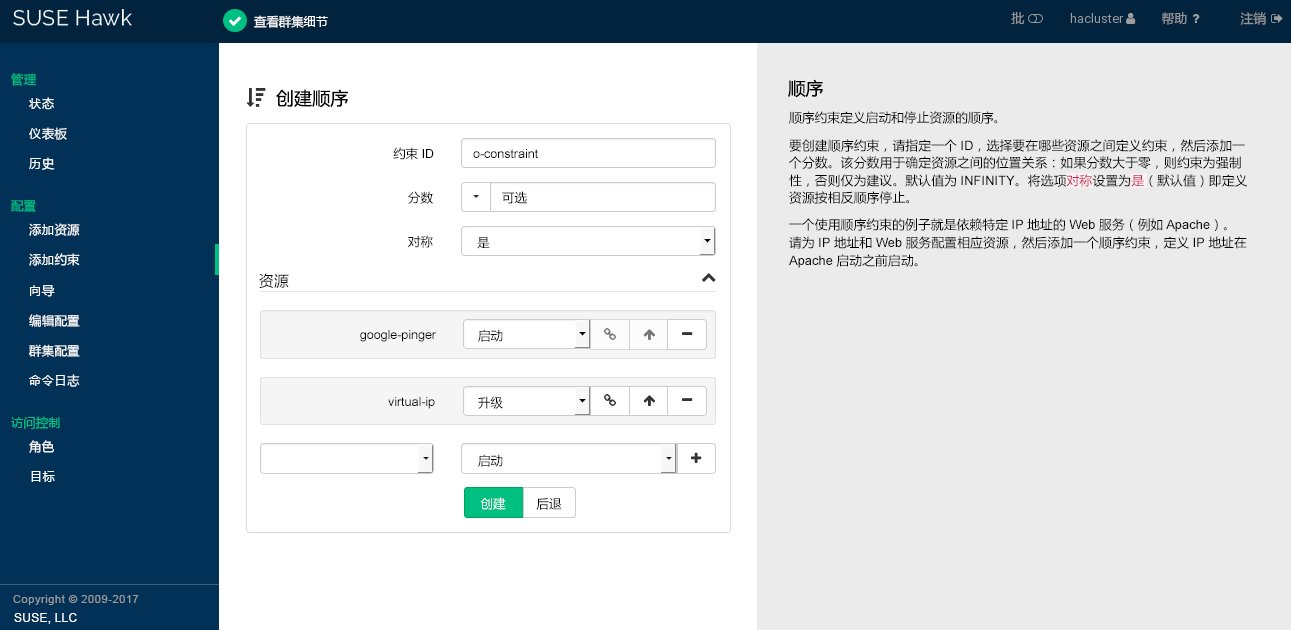

- 7.13 Hawk2 - 顺序约束

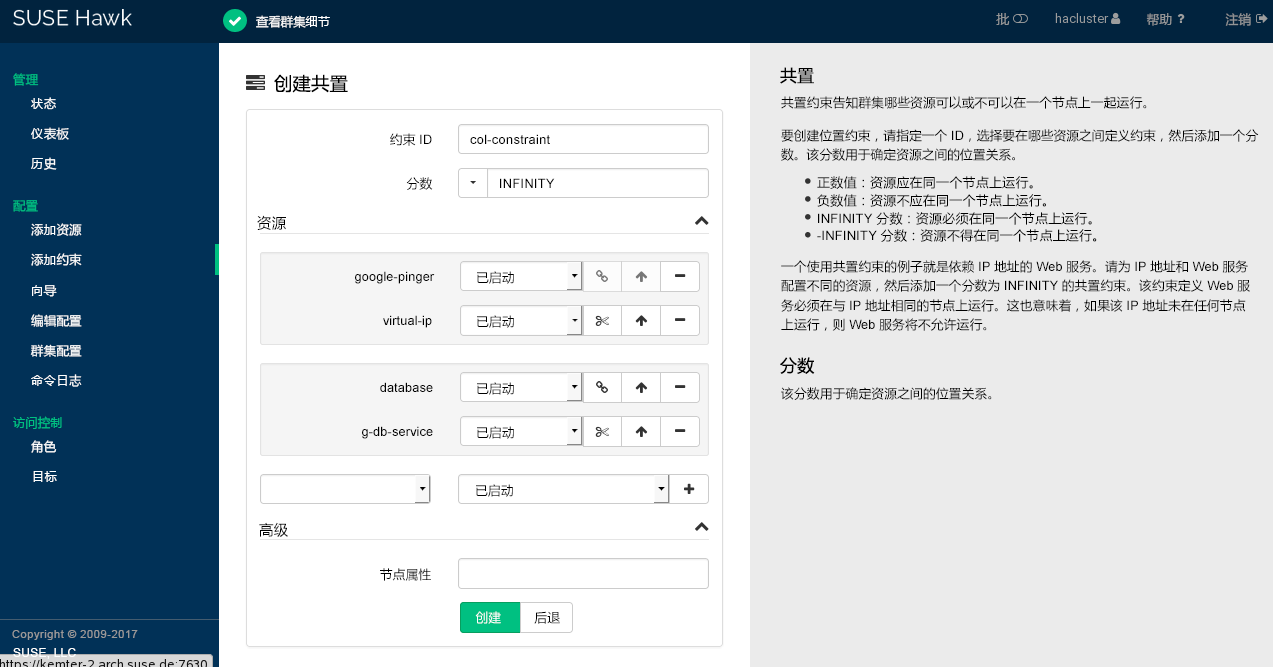

- 7.14 Hawk2 - 一个共置约束中的两个资源集

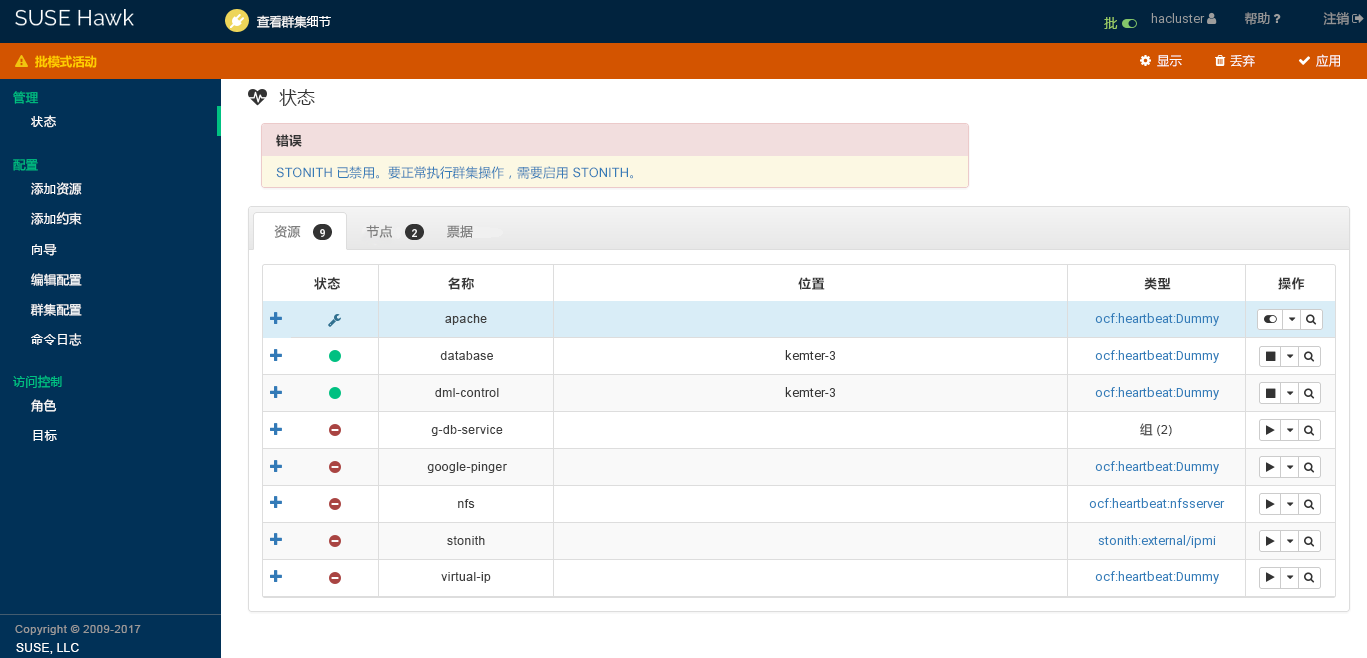

- 7.15 Hawk2 - 群集状态

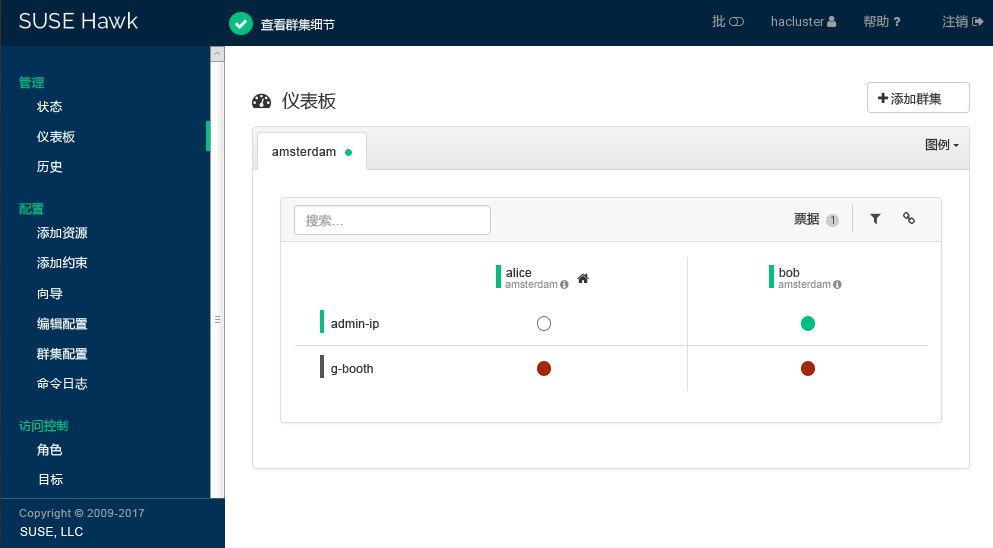

- 7.16 包含一个群集站点 (

amsterdam) 的 Hawk2 仪表板 - 7.17 Hawk2 批模式已激活

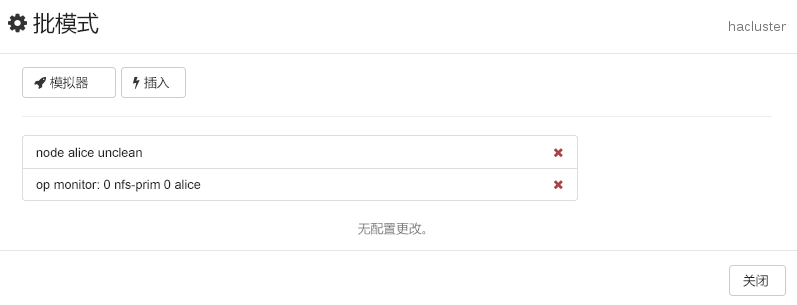

- 7.18 Hawk2 批模式 - 插入的事件和配置更改

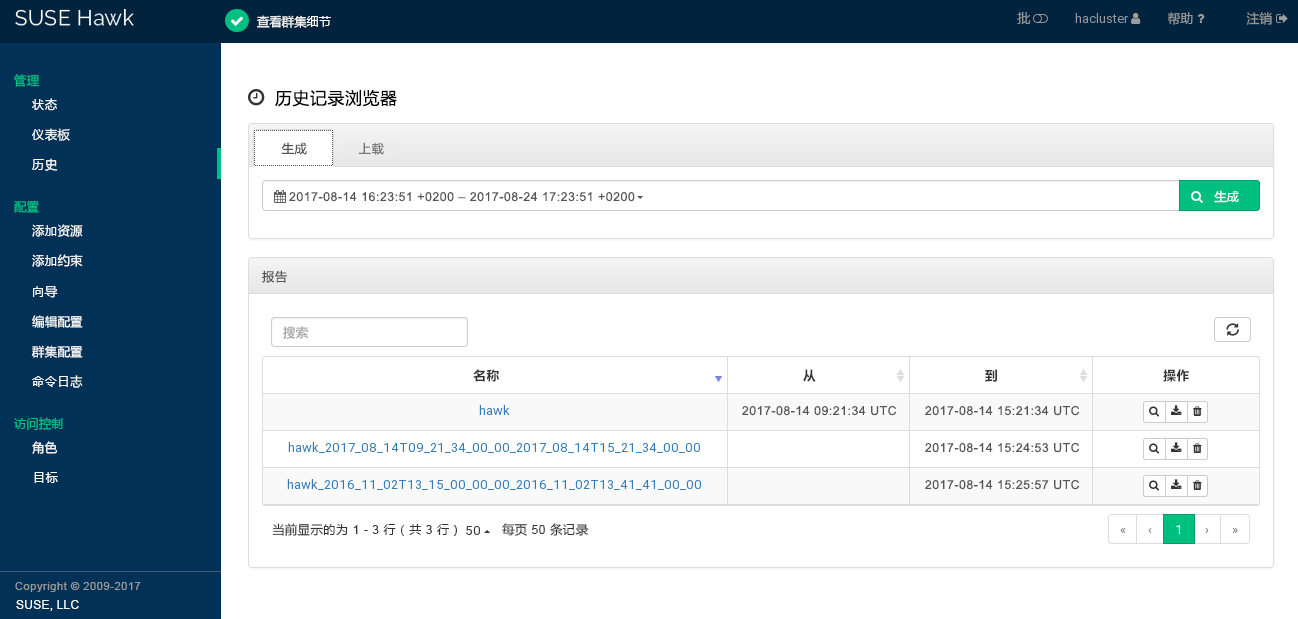

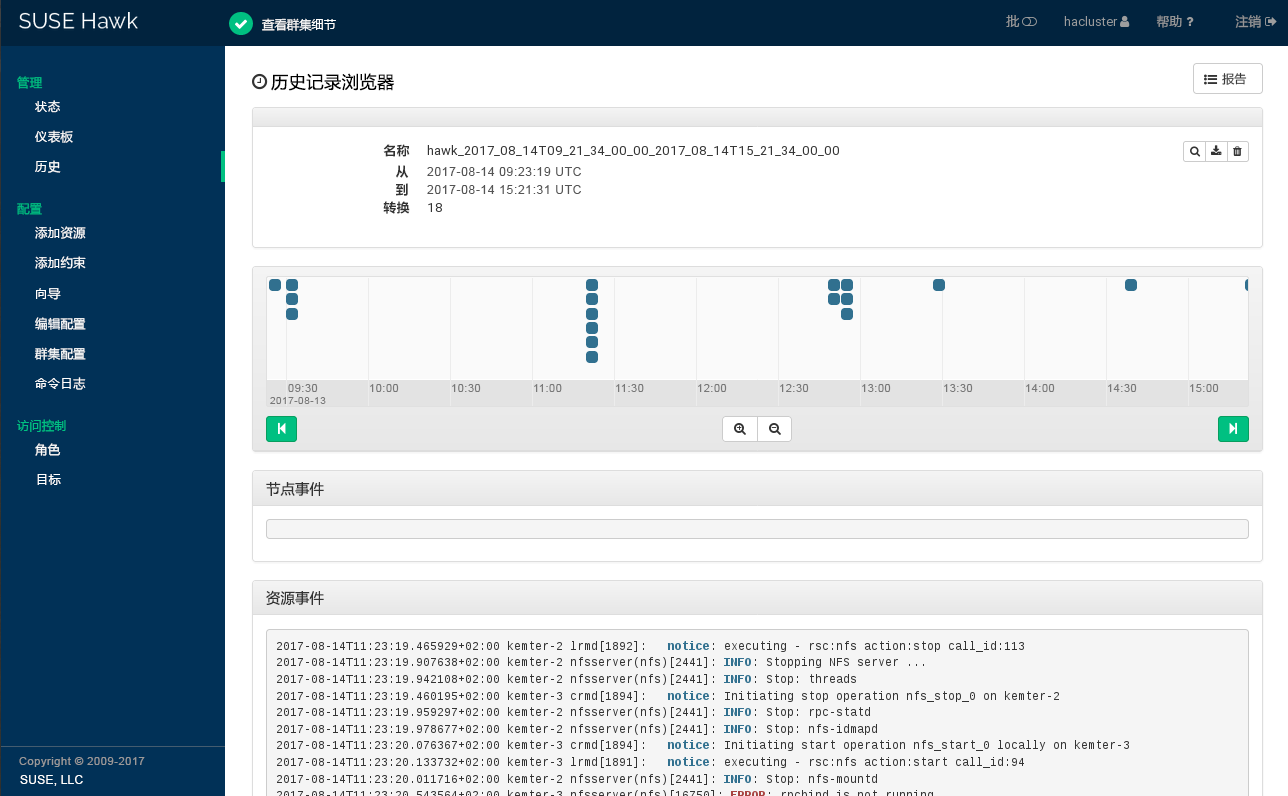

- 7.19 Hawk2 - 历史记录浏览器主视图

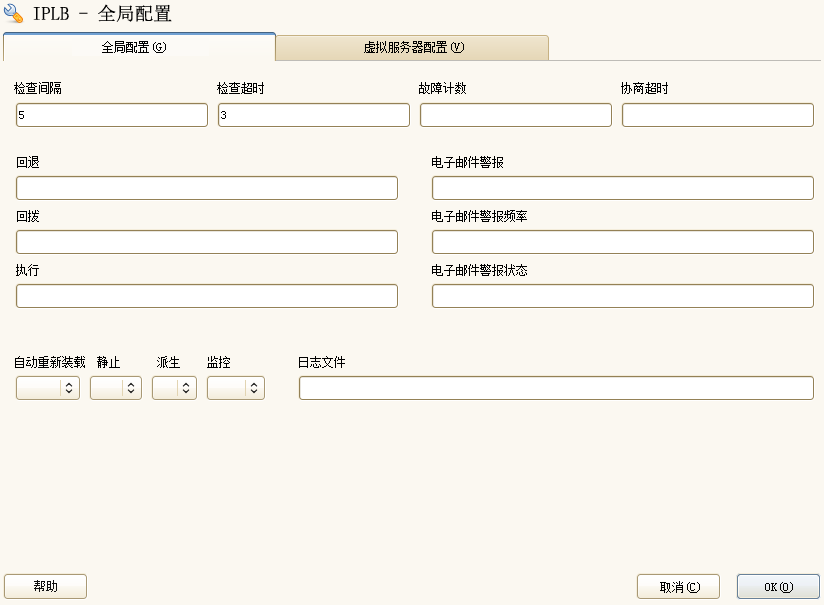

- 14.1 YaST IP 负载平衡 - 全局参数

- 14.2 YaST IP 负载平衡 - 虚拟服务

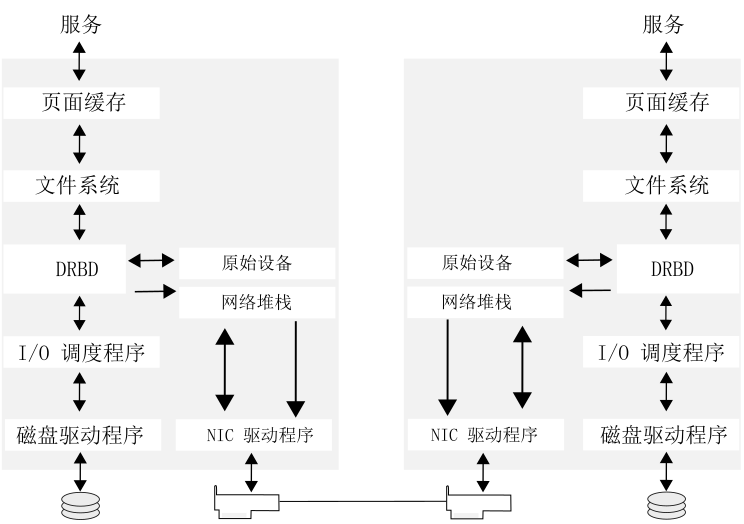

- 20.1 DRBD 在 Linux 中的位置

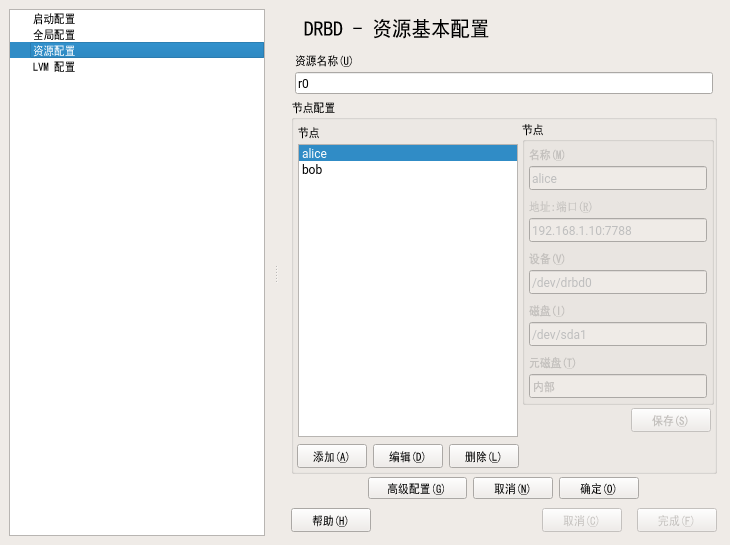

- 20.2 资源配置

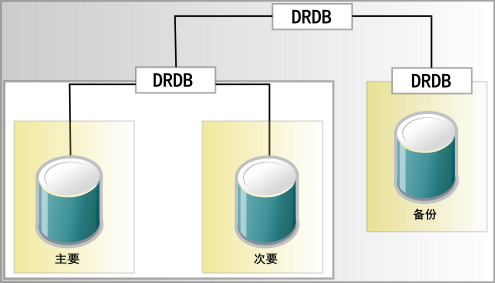

- 20.3 资源堆叠

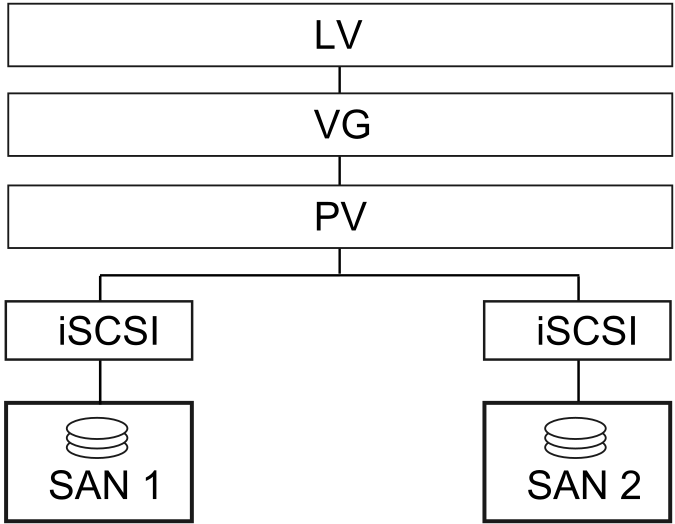

- 21.1 设置使用 cLVM 的 iSCSI

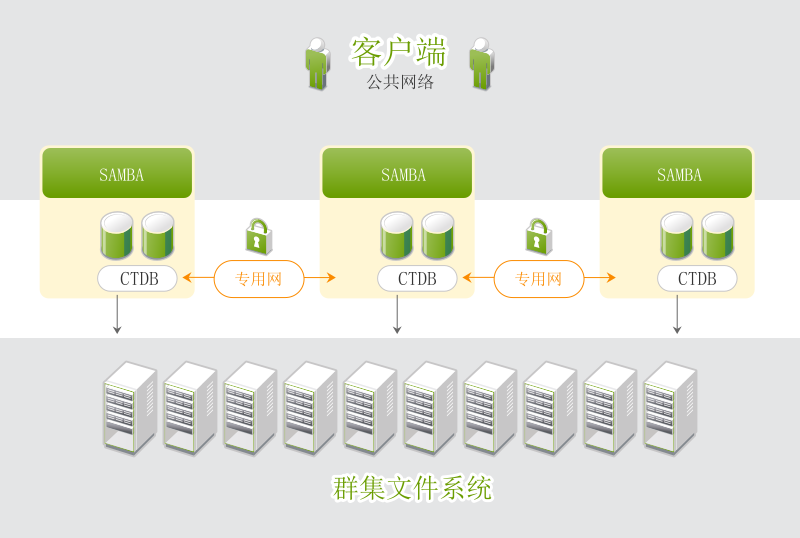

- 23.1 CTDB 群集的结构

- 6.1 双节点群集的 Corosync 配置摘录

- 6.2 N 节点群集的 Corosync 配置摘录

- 6.3 Web 服务器的资源组

- 6.4 用于位置约束的资源集

- 6.5 共置资源链

- 6.6 有序资源链

- 6.7 以资源集表示的有序资源链

- 6.8 迁移阈值 - 流程

- 6.9 负载平衡放置配置示例

- 6.10 为监视插件配置资源

- 8.1 简单 crmsh 外壳脚本

- 10.1 IBM RSA 无人值守设备的配置

- 10.2 UPS 屏蔽设备的配置

- 10.3 Kdump 设备的配置

- 11.1 超时计算公式

- 12.1 XML 格式群集配置摘录

- 14.1 简单的 ldirectord 配置

- 20.1 三节点堆叠 DRBD 资源的配置

- 20.2 使用群集信息库 (CIB) 启用资源级屏蔽的 DRBD 配置

- 24.1 使用 NFS 服务器储存文件备份

- 24.2 使用 EMC NetWorker 等第三方备份工具

- A.1 已停止的资源

版权所有 © 2006–2025 SUSE LLC 和贡献者。保留所有权利。

根据 GNU 自由文档许可证 (GNU Free Documentation License) 版本 1.2 或(根据您的选择)版本 1.3 中的条款,在此授予您复制、分发和/或修改本文档的许可权限;本版权声明和许可证附带不可变部分。许可证版本 1.2 的副本包含在题为“GNU 自由文档许可证”的部分。

有关 SUSE 商标,请参见 http://www.suse.com/company/legal/。所有其它第三方商标是其各自所有者的财产。商标符号(®、™ 等)代表 SUSE 及其附属公司的商标。星号 (*) 代表第三方商标。

本指南力求涵盖所有详细信息。但这并不确保本指南准确无误。SUSE LLC 及其附属公司、作者和译者对于可能出现的错误或由此造成的后果皆不承担责任。

本指南分为以下部分:

- 安装、设置和升级

开始安装和配置群集之前,先熟悉群集的基础知识和体系结构,了解其关键功能和优点的概况。执行下一步之前,要先了解必须满足哪些软硬件要求以及做好哪些准备工作。使用 YaST 安装 HA 群集并进行基本设置。了解如何将群集升级到最新的发行版,或如何更新各个包。

- 配置和管理

使用 Web 界面 (Hawk2) 或命令行界面 (crmsh) 添加、配置和管理群集资源。为避免未授权访问群集配置,请定义角色并为角色指派一些用户,以细化访问控制。了解如何使用负载平衡和屏蔽。如果您考虑编写自己的资源代理或修改现有的资源代理,请了解一些有关如何创建不同类型的资源代理的背景信息。

- 储存和数据复制

SUSE Linux Enterprise High Availability Extension 随附了群集感知文件系统 OCFS2 和 GFS2,以及群集式逻辑卷管理器 (cLVM)。要复制数据,可以使用 DRBD*。该工具可让您将高可用性服务的数据从群集的活动节点镜像到其备用节点。此外,群集 Samba 服务器还可为异构环境提供 High Availability 解决方案。

- 附录

包含常见问题及其解决方案的概述。提供本文档中使用的有关群集、资源和约束的命名约定。包含 HA 特定术语的词汇表。

本手册中的许多章节包含了系统或因特网上提供的其他文档资源的链接。

1 可用文档 #

注意:在线文档和最新更新

我们的产品文档可从 https://documentation.suse.com 获取,您也可以在此处找到最新更新,以及浏览或下载各种格式的文档。最新的文档更新通常以英语版本提供。

针对本产品提供的文档如下:

- 《安装和设置快速入门》

本文档会指导您使用

ha-cluster-bootstrap包提供的引导脚本完成最基本的双节点群集的设置。其中包括将虚拟 IP 地址配置为群集资源,以及使用共享存储上的 SBD 作为屏蔽机制。- 《管理指南》

本指南适用于需要使用 SUSE® Linux Enterprise High Availability Extension 设置、配置和维护群集的管理员。为了快速有效地进行配置和管理,High Availability Extension 包含一个图形用户界面 (GUI) 和一个命令行界面 (CLI),本指南详细介绍了如何通过 GUI 和 CLI 这两种方法执行关键任务。因此,管理员可以根据其需要选择适当的工具。

- 《Geo 群集快速入门》

使用 Geo 群集,您可以拥有多个地理位置分散的站点并且在每个站点部署一个本地群集。这些群集之间的故障转移由更高级别的实体进行协调,即投票间群集票据管理器。

- 《Geo 群集指南》

使用 Geo 群集,您可以拥有多个地理位置分散的站点并且在每个站点部署一个本地群集。这些群集之间的故障转移由更高级别的实体进行协调,即投票间群集票据管理器。本文档详细介绍了 booth 的设置选项和参数、Geo 群集的 Csync2 设置、如何配置群集资源,以及当发生变化时,如何将这些资源转移到其他群集站点。文档中还讲述了如何通过指令行和 Hawk 管理 Geo 群集,以及如何将群集升级到产品的最新版本。

- 《使用 DRBD 和 Pacemaker 的高度可用 NFS 储存》

此文档介绍了如何使用 SUSE Linux Enterprise High Availability Extension 12 SP5 的以下组件在双节点群集中设置高度可用的 NFS 储存:DRBD*(Distributed Replicated Block Device,分布式复制块设备)、LVM(Logical Volume Manager,逻辑卷管理器)和群集资源管理框架 Pacemaker。

- 《Pacemaker 远程快速入门》

本文档将指导您完成具有远程节点或 Guest 节点的高可用性群集设置,这些节点由 Pacemaker 和

pacemaker_remote管理。pacemaker_remote中的 remote 一词并不是指物理距离,而是表示“不属于”群集。

2 反馈 #

提供了多种反馈渠道:

- 服务与支持

有关产品可用的服务和支持选项,请参见 http://www.suse.com/support/。

要报告产品组件的 Bug,请访问 https://scc.suse.com/support/requests 并登录,然后单击。

- Bug 报告

如果您有 SUSE Bugzilla 帐户,请单击 HTML 版的本文档中标题旁边的 链接。您即会转到 Bugzilla,可以在该处开启 Bug 报告。

- 邮件

如有对本产品文档的反馈,也可以发送邮件至

doc-team@suse.com。请确保反馈中含有文档标题、产品版本和文档发布日期。要报告错误或给出增强建议,请提供问题的简要说明并指出相应章节编号和页码(或 URL)。

3 文档约定 #

本文档中使用了以下通知和排版约定:

tux >command可由任何用户(包括

root用户)运行的命令。root #command必须使用

root特权运行的命令。您往往还可以在这些命令前加上sudo命令来运行它们。crm(live)在交互式 crm 外壳中执行的命令。有关细节,请参见第 8 章 “配置和管理群集资源(命令行)”。

/etc/passwd:目录名称和文件名PLACEHOLDER:PLACEHOLDER 将会替换为实际的值

PATH:环境变量 PATHls、--help:命令、选项和参数user:用户和组packagename:包名称

Alt、Alt–F1:按键或组合键;这些键以大写形式显示,如在键盘上一样

、 › :菜单项,按钮

amd64, em64t, ipf 本段仅与体系结构

amd64、em64t和ipf相关。箭头标记文本块的开始位置和结束位置。跳舞的企鹅(企鹅一章,↑其他手册):此内容参见自其他手册中的一章。

注意

警告

在继续操作之前,您必须了解的不可或缺的信息。向您指出有关安全问题、潜在数据丢失、硬件损害或物理危害的警告。

重要

在继续操作之前,您必须了解的重要信息。

注意

额外信息,例如有关软件版本差异的信息。

提示

有用信息,例如指导方针或实用性建议。

有关群集节点和名称、资源与约束的命名约定概述,请参见附录 B “命名约定”。

4 关于本文档的制作 #

本文档用 SUSEDoc(DocBook 5 的子集)编写而成。XML 源文件用 jing(请参见 https://code.google.com/p/jing-trang/)加以验证、用 xsltproc 进行处理,并用 Norman Walsh 的样式表的自定义版本转换为 XSL-FO。最终的 PDF 通过 Apache Software Foundation 的 FOP 排版。用于制作本文档的开放源代码工具和环境由 DocBook Authoring and Publishing Suite (DAPS) 提供。项目的主页可以在 https://github.com/openSUSE/daps 中找到。

本文档的 XML 源代码可以在 https://github.com/SUSE/doc-sleha 中找到。

第 I 部分 安装、设置和升级 #

- 1 产品概述

SUSE® Linux Enterprise High Availability Extension 是一个开放源代码群集技术的集成套件,可让您实现高度可用的物理和虚拟 Linux 群集,并排除单一故障点。它可确保关键资源的高可用性和可管理性,这些资源包括数据、应用程序和服务。因此,它有助于维持业务连续性、保护数据完整性及减少 Linux 关键任务工作负荷的计划外停机时间。

它随附提供必需的监视、消息交换和群集资源管理功能(支持对独立管理的群集资源进行故障转移、故障回复和迁移(负载平衡))。

本章介绍 High Availability Extension 的主要产品功能和优点。您将在本章中找到多个示例群集并了解组成群集的组件。最后一节概述了体系结构,描述了群集内的各体系结构层和进程。

有关 High Availability 群集环境中使用的一些通用术语的解释,请参见术语表。

- 2 系统要求和建议

下面的小节说明了系统要求以及 SUSE® Linux Enterprise High Availability Extension 的一些先决条件。此外,还提供了有关群集设置的建议。

- 3 安装 High Availability Extension

如果您是首次使用 SUSE® Linux Enterprise High Availability Extension 设置高可用性群集,最简单的方法就是从基本的双节点群集开始设置。您也可以使用双节点群集来运行一些测试。之后,您便可使用 AutoYaST 克隆现有的群集节点来添加更多节点。克隆的节点上会安装相同的包,并具有与原始节点相同的系统配置。

如果要升级运行较低版 SUSE Linux Enterprise High Availability Extension 的现有群集,请参见第 5 章 “升级群集和更新软件包”。

- 4 使用 YaST 群集模块

YaST 群集模块可让您手动从头开始设置群集,或修改现有群集的选项。

不过,如果您希望采用自动方式设置群集,请参见Article “安装和设置快速入门”。该指南介绍了如何安装所需的包并会引导您创建基本的双节点群集,该群集是使用

ha-cluster-bootstrap脚本设置的。您还可结合使用这两种设置方法,例如,使用 YaST 群集设置一个节点,然后使用其中一个引导脚本集成更多节点(或反之)。

- 5 升级群集和更新软件包

本章介绍两种不同方案:将群集升级为 SUSE Linux Enterprise High Availability Extension 的另一个版本(主要版本或服务包),以及更新群集节点上的单个包。请参见第 5.2 节 “将群集升级到最新产品版本”与第 5.3 节 “更新群集节点上的软件包”。

如果您要升级群集,请在开始升级之前查看第 5.2.1 节 “SLE HA 和 SLE HA Geo 支持的升级路径”和第 5.2.2 节 “升级前必须满足的先决条件”。

1 产品概述 #

摘要#

SUSE® Linux Enterprise High Availability Extension 是一个开放源代码群集技术的集成套件,可让您实现高度可用的物理和虚拟 Linux 群集,并排除单一故障点。它可确保关键资源的高可用性和可管理性,这些资源包括数据、应用程序和服务。因此,它有助于维持业务连续性、保护数据完整性及减少 Linux 关键任务工作负荷的计划外停机时间。

它随附提供必需的监视、消息交换和群集资源管理功能(支持对独立管理的群集资源进行故障转移、故障回复和迁移(负载平衡))。

本章介绍 High Availability Extension 的主要产品功能和优点。您将在本章中找到多个示例群集并了解组成群集的组件。最后一节概述了体系结构,描述了群集内的各体系结构层和进程。

有关 High Availability 群集环境中使用的一些通用术语的解释,请参见术语表。

1.1 作为扩展提供 #

High Availability Extension 是以 SUSE Linux Enterprise Server 12 SP5 的扩展的形式提供的。对于地理位置分散的群集(Geo 群集)的支持将作为 High Availability Extension 的独立扩展提供,即 Geo Clustering for SUSE Linux Enterprise High Availability Extension。

1.2 主要特征 #

SUSE® Linux Enterprise High Availability Extension 可帮助您保障和管理网络资源的可用性。以下各节重点说明一些关键功能:

1.2.1 各种群集方案 #

High Availability Extension 支持下列方案:

主动/主动配置

主动/被动配置:N+1、N+M、N 到 1 和 N 到 M

混合物理和虚拟群集,支持将虚拟服务器和物理服务器群集在一起。这可提高服务可用性和资源利用率。

本地群集

城域群集(“延伸的”本地群集)

Geo 群集(地理位置分散的群集)受附加 Geo 扩展的支持,具体请参见第 1.2.5 节 “支持本地、城域和 Geo 群集”。

群集最多可包含 32 个 Linux 服务器。使用 pacemaker_remote 可扩展群集使之突破此限制,包含更多的 Linux 服务器。如果群集内的一台服务器发生故障,则群集内的任何其他服务器均可重启动此服务器上的资源(应用程序、服务、IP 地址和文件系统)。

1.2.2 灵活性 #

High Availability Extension 附带了 Corosync 讯息交换和成员资格层以及 Pacemaker 群集资源管理器。使用 Pacemaker,管理员可以持续监视其资源的运行状况和状态、管理依赖性以及根据高度可配置的规则和策略自动停止和启动服务。High Availability Extension 允许您根据适合您组织的特定应用程序和硬件基础体系结构对群集进行定制。基于时间的配置使服务可以在特定时间自动迁移回已修复的节点。

1.2.3 储存和数据复制 #

借助 High Availability Extension,您可以根据需要动态地指派和重指派服务器储存。它支持光纤通道储存区域网络 (SAN) 和网络中的 iSCSI 储存。因此也支持共享磁盘系统,但此类系统不是必需的。SUSE Linux Enterprise High Availability Extension 还附带有群集感知文件系统、卷管理器 (OCFS2) 和群集式逻辑卷管理器 (cLVM)。如需复制数据,可使用 DRBD* 将高可用性服务的数据从群集的活动节点镜像到其备用节点。此外,SUSE Linux Enterprise High Availability Extension 还支持 CTDB(Clustered Trivial Database,群集普通数据库),这是一种 Samba 群集技术。

1.2.4 支持虚拟环境 #

SUSE Linux Enterprise High Availability Extension 支持包含物理和虚拟 Linux 服务器的群集,也支持混用这两种类型的服务器。SUSE Linux Enterprise Server 12 SP5 随附 Xen 和 KVM(基于内核的虚拟机)。两者都是开放源代码虚拟化超级管理程序。群集可将虚拟化 guest 系统(也称为 VM)作为服务来管理。

1.2.5 支持本地、城域和 Geo 群集 #

SUSE Linux Enterprise High Availability Extension 已扩展,可以支持下列不同的地理方案。对于地理位置分散的群集(Geo 群集)的支持将作为 High Availability Extension 的独立扩展提供,即 Geo Clustering for SUSE Linux Enterprise High Availability Extension。

- 本地群集

一个位置的单个群集(例如,位于一个数据中心内的所有节点)。该群集使用多路广播或单路广播实现节点之间的通讯,并在内部管理故障转移。网络延迟可以忽略。储存通常由所有节点同步访问。

- 城域群集

可涵盖多个建筑物或数据中心的单个群集。该群集通常使用单路广播实现节点之间的通讯,并在内部管理故障转移。网络延迟通常很低(在大约 20 英里的距离内小于 5 毫秒)。最好是通过光纤通道连接储存。数据复制由储存在内部执行,或者由基于主机的镜像在群集的控制下执行。

- Geo 群集(多站点群集)

多个地理位置分散的站点,每个站点一个本地群集。站点通过 IP 通讯。站点间的故障转移由更高级别实体协调。Geo 群集需要应对有限网络带宽和高延迟问题。储存异步复制。

各个群集节点之间的地理距离越大,可能影响群集所提供服务的高可用性的因素就越多。网络延迟、有限带宽以及对储存的访问权是远距离群集面临的主要难题。

1.2.6 资源代理 #

SUSE Linux Enterprise High Availability Extension 包含大量资源代理来管理资源,如 Apache、IPv4 和 IPv6 等。它还为通用的第三方应用程序(例如 IBM WebSphere Application Server)提供了资源代理。如需产品随附的 Open Cluster Framework (OCF) 资源代理的概述,请根据第 8.1.3 节 “显示有关 OCF 资源代理的信息”中所述使用 crm ra 命令。

1.2.7 用户友好的管理工具 #

High Availability Extension 附带了一组功能强大的工具,可用于对群集进行基本的安装和设置,以及有效地执行配置和管理任务:

- YaST

常规系统安装和管理的图形用户界面。使用此用户界面,可按《安装和设置快速入门》中所述在 SUSE Linux Enterprise Server 的基础上安装 High Availability Extension。YaST 在 High Availability 类别中还提供以下模块,可帮助您配置群集或各个组件:

群集:基本群集设置。有关详细信息,请参见第 4 章 “使用 YaST 群集模块”。

DRBD:配置分布式复制块设备。

IP 负载平衡:使用 Linux 虚拟服务器或 HAProxy 配置负载平衡。有关详细信息,请参见第 14 章 “负载平衡”。

- HA Web Konsole (Hawk2)

基于 Web 的用户界面,使用此界面可从非 Linux 计算机管理 Linux 群集。如果系统未提供图形用户界面,它还是理想的解决方案。指引您完成资源的创建和配置,并可用于执行启动、停止或迁移资源之类的管理任务。有关详细信息,请参见第 7 章 “使用 Hawk2 配置和管理群集资源”。

crm外壳强大的统一命令行界面,用于配置资源和执行所有监视或管理任务。有关详细信息,请参见第 8 章 “配置和管理群集资源(命令行)”。

1.3 优势 #

High Availability Extension 允许您将最多 32 台 Linux 服务器配置为一个高度可用的群集(HA 群集),在群集中可以将资源动态地切换或移动到任何服务器上。可以将资源配置为在发生服务器故障时自动进行迁移,或手动移动资源以对硬件查错或平衡工作负载。

High Availability Extension 通过商品组件提供高可用性。通过将应用程序和操作合并到群集中降低了成本。High Availability Extension 还可让您集中管理整个群集并调整资源以满足不断变化的工作负载要求(这样就手动地实现了群集的“负载平衡”)。允许群集的多个(两个以上)节点共享一个“热备份”也节约了成本。

一个同样重要的好处是潜在地减少了计划外服务中断及用于软件和硬件维护和升级的计划内中断。

实施群集的理由包括:

提高可用性

改善性能

降低操作成本

可伸缩性

灾难恢复

数据保护

服务器合并

储存合并

通过在共享磁盘子系统上实施 RAID 可获得共享磁盘容错。

以下方案说明了 High Availability Extension 具备的一些优点。

示例群集方案#

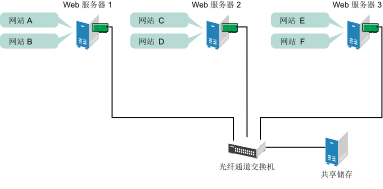

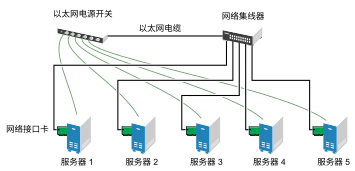

假设您配置了一个包含三台服务器的群集,并在群集内的每台服务器上安装了 Web 服务器。群集内的每台服务器都主管两个网站。每个网站的全部数据、图形和 Web 页面内容都储存在一个连接到群集中每台服务器的共享磁盘子系统上。下图说明了该系统的结构。

图 1.1︰ 三台服务器的群集 #

在群集的正常工作状态下,每台服务器都与群集内的其他服务器持续通讯,并对所有已注册的资源进行定期巡回检测以检测故障。

假设 Web 服务器 1 出现硬件或软件故障,而依赖此 Web 服务器访问因特网、收发电子邮件和获取信息的用户失去了连接。下图说明了当 Web 服务器 1 出现故障时,资源的移动情况。

图 1.2︰ 三台服务器的群集(其中一台服务器出现故障后) #

网站 A 移至 Web 服务器 2,网站 B 移至 Web 服务器 3。IP 地址和证书也移至 Web 服务器 2 和 Web 服务器 3。

在配置群集时,您决定了在出现故障的情况下,每台 Web 服务器上的网站将移至哪里。在上例中,您已配置将网站 A 移至 Web 服务器 2,将网站 B 移至 Web 服务器 3。这样,曾由 Web 服务器 1 处理的工作负荷继续存在且平均分配给剩余的群集成员。

如果 Web 服务器 1 发生故障,则 High Availability Extension 软件会执行下列操作:

检测到故障,并与 STONITH 确认 Web 服务器 1 确实已出现故障。STONITH 是“Shoot The Other Node In The Head”(关闭其他节点)的首字母缩写,它是一种关闭行为异常节点的方式,可防止这些节点在群集中引发问题。

将以前安装在 Web 服务器 1 上的共享数据目录重新安装在 Web 服务器 2 和 Web 服务器 3 上。

在 Web 服务器 2 和 Web 服务器 3 上重启动以前运行于 Web 服务器 1 上的应用程序。

将 IP 地址传送到 Web 服务器 2 和 Web 服务器 3。

在此示例中,故障转移过程迅速完成,用户在几秒钟之内就可以重新访问 Web 站点信息,而且通常无需重新登录。

现在,假设 Web 服务器 1 的故障已解决,它已恢复到正常工作状态。网站 A 和网站 B 可以自动故障回复(移回)至 Web 服务器 1,或者留在当前所在的服务器上。这取决于您是如何配置它们的资源的。将服务迁移回 Web 服务器 1 将导致一段时间的中断,因此 High Availability Extension 也允许您将迁移推迟到某个将极少或不会造成服务中断的时段。这两种选择都各有优缺点。

High Availability Extension 还提供资源迁移功能。可以根据系统管理的需要将应用程序、网站等资源移动到群集中的其他服务器。

例如,您可以手动将网站 A 或网站 B 从 Web 服务器 1 移至群集内的其他任何一台服务器。此操作的用例包括,对 Web 服务器 1 进行升级或定期维护,或者提高网站的性能或可访问性。

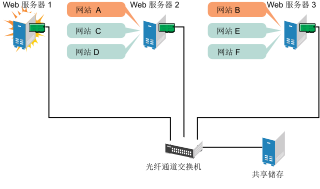

1.4 群集配置:储存 #

High Availability Extension 的群集配置可能包括共享磁盘子系统,也可能并不包括。共享磁盘子系统可通过高速光纤通道卡、电缆和交换机连接,也可配置为使用 iSCSI。如果服务器出现故障,群集中的另一个指定服务器将自动装入之前在故障服务器上装入的共享磁盘目录。这样,网络用户就能继续访问共享磁盘子系统上的目录。

典型的资源包括数据、应用程序和服务。下图显示了一个典型的光纤通道群集配置的结构。

图 1.3︰ 典型的光纤通道群集配置 #

虽然光纤通道提供的性能最佳,但也可以将群集配置为使用 iSCSI。iSCSI 是除光纤通道外的另一种选择,可用于创建低成本的储存区域网络 (SAN)。下图显示了一个典型的 iSCSI 群集配置。

图 1.4︰ 典型的 iSCSI 群集配置 #

虽然大多数群集都包括共享磁盘子系统,但也可以创建不含共享磁盘子系统的群集。下图显示了一个不含共享磁盘子系统的群集。

图 1.5︰ 典型的不含共享储存的群集配置 #

1.5 体系结构 #

本节简要介绍 High Availability Extension 的体系结构。它提供了有关体系结构组件的信息,并描述了这些组件是如何协同工作的。

1.5.1 体系结构层 #

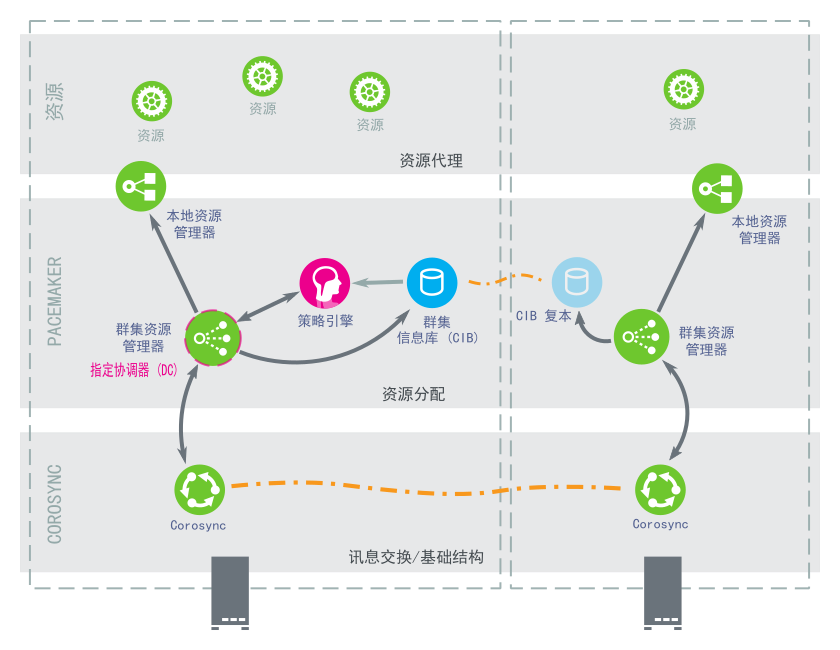

High Availability Extension 采用分层式体系结构。图 1.6 “体系结构”说明了不同的层及其相关的组件。

图 1.6︰ 体系结构 #

1.5.1.1 消息交换和基础结构层 #

主层或第一层是讯息交换/基础结构层,也称为 Corosync 层。此层包含了发出含有“I am alive”(我在线)信号及其他信息的讯息的组件。

1.5.1.2 资源分配层 #

下一层是资源分配层。此层最复杂,它包含以下组件:

- 群集资源管理器 (CRM)

在资源分配层中执行的每个操作都要经过群集资源管理器。如果资源分配层的其他组件(或更高层中的组件)需要通讯,则它们通过本地 CRM 进行。在每个节点上,CRM 都会维护群集信息库 (CIB)。

- 群集信息库 (CIB)

群集信息库是整个群集配置和当前状态在内存中的 XML 表示。它包含所有群集选项、节点、资源、约束及其之间的关系的定义。CIB 还将更新同步到所有群集节点。群集中有一个主 CIB,由指定协调器 (DC)进行维护。所有其他节点都包含 CIB 复本。

- 指定协调器 (DC)

群集中的一个 CRM 会选为 DC。DC 是群集中唯一可以决定需要在整个群集执行更改(例如节点屏蔽或资源移动)的实体。DC 同时也是用于保存 CIB 主副本的节点。所有其他节点都从当前 DC 获取他们的配置和资源分配信息。DC 是在成员资格更改后从群集的所有节点中选出的。

- 策略引擎 (PE)

只要指定协调程序需要进行群集范围的更改(对新 CIB 作出反应),策略引擎就会根据群集的当前状态和配置计算其下一个状态。PE 还生成一个转换图,包含用于达到下一个群集状态的(资源)操作和依赖项的列表。PE 始终在 DC 上运行。

- 本地资源管理器 (LRM)

LRM 代表 CRM 调用本地资源代理(请参见第 1.5.1.3 节 “资源层”)。因此它可以执行启动/停止/监视操作并将结果报告给 CRM。LRM 是其本地节点上所有资源相关信息的权威来源。

1.5.1.3 资源层 #

最高层是资源层。资源层包括一个或多个资源代理 (RA)。资源代理是已写入的用来启动、停止和监视某种服务(资源)的程序(通常是外壳脚本)。资源代理仅由 LRM 调用。第三方可将他们自己的代理放在文件系统中定义的位置,这样就为各自的软件提供了现成群集集成。

1.5.2 处理流程 #

SUSE Linux Enterprise High Availability Extension 使用 Pacemaker 作为 CRM。CRM 作为守护程序执行 (crmd),它在每个群集节点上都有一个实例。Pacemaker 通过选出一个 crmd 实例来充当主实例,实现所有群集决策制定的集中化。如果选定的 crmd 过程(或它所在的节点)出现故障,则将建立一个新的过程。

在每个节点上保留了一个 CIB,它反映了群集的配置和群集中所有资源的当前状态。CIB 的内容会在整个群集中自动保持同步。

群集中执行的许多操作都将导致整个群集的更改。这些操作包括添加或删除群集资源、更改资源约束等等。了解执行这样的操作时群集中会发生的状况是很重要的。

例如,假设您要添加一个群集 IP 地址资源。为此,您可以使用一种命令行工具或 Web 界面来修改 CIB。您不必在 DC 上执行此操作,可以使用群集中任何节点上的任何工具,此操作会被传送到 DC 上。然后 DC 将把此 CIB 更改复制到所有群集节点。

根据 CIB 中的信息,PE 便计算群集的理想状态及如何达到此状态,并将指令列表传递给 DC。DC 通过消息交换/基础结构层发送命令,这些命令将由其他节点上的 crmd 对等体接收。每个 crmd 使用它的 LRM(作为 lrmd 实现)执行资源修改。lrmd 不是群集感知的,它直接与资源代理(脚本)交互。

所有同级节点将操作的结果报告给 DC。一旦 DC 得出所有必需操作在群集中都已成功执行的结论,群集将回到空闲状态并等待后续事件。如果有操作未按计划执行,则会再次调用 PE,CIB 中将记录新信息。

在某些情况下,可能需要关闭节点以保护共享数据或完成资源恢复。为此,Pacemaker 附带了一个屏蔽子系统,stonithd。STONITH 是“Shoot The Other Node In The Head”(关闭其他节点)的首字母缩写。它通常是使用 STONITH 共享块设备、远程管理板或远程电源开关实现的。为了方便使用 STONITH 设备,在 Pacemaker 中将它们模型化为资源(并在 CIB 中进行配置)。但是,stonithd 会负责了解 STONITH 拓扑,让其客户端请求屏蔽某个节点,而自身则执行其余的工作。

2.1 硬件要求 #

以下列表指出了基于 SUSE® Linux Enterprise High Availability Extension 的群集的硬件要求。这些要求表示最低硬件配置。根据群集的用途,可能会需要其他硬件。

- 服务器

安装了第 2.2 节 “软件要求”中指定的软件的 1 到 32 台 Linux 服务器。

服务器可以是裸机,也可以是虚拟机。两者不要求有相同的硬件(内存、磁盘空间等),但们必须具有相同的体系结构。不支持跨平台群集。

使用

pacemaker_remote可扩展群集使之突破 32 个节点的限制,包含更多的 Linux 服务器。- 通讯通道

每个群集节点至少有两个 TCP/IP 通讯媒体。网络设备必须支持您要用于群集通讯的通讯方式:多路广播或单路广播。通讯媒体应支持 100 Mbit/s 或更高的数据传送速度。对于受支持的群集设置,要求有两个或更多冗余通讯路径。这可通过以下方式实现:

网络设备绑定(首选)。

Corosync 中的另一个通讯通道。

基础架构层(例如超级管理程序)中的网络容错。

有关细节,请分别参见第 13 章 “网络设备绑定”和过程 4.3 “定义冗余通讯通道”。

- 节点屏蔽/STONITH

为了避免发生“节点分裂”的情况,群集需要有节点屏蔽机制。在节点分裂的情况下,群集节点会由于硬件或软件故障或者网络连接断开而分成两个或更多互不相识的组。而屏蔽机制会隔离存在问题的节点(通常的做法是重设置该节点或关闭其电源)。这也称为 STONITH(“Shoot the other node in the head”,关闭其他节点)。节点屏蔽机制可以是物理设备(电源开关),也可以是 SBD(按磁盘 STONITH)等机制再结合检查包。使用 SBD 需要有共享存储。

除非使用了 SBD,否则高可用性群集中的每个节点都必须至少有一个 STONITH 设备。强烈建议每个节点上有多个 STONITH 设备。

重要:不支持无 STONITH 的配置

您必须为群集配置节点屏蔽机制。

全局群集选项

stonith-enabled和startup-fencing必须设置为true。如果您更改这些选项,将会失去支持。

2.2 软件要求 #

在将组成群集的所有节点上,都必须安装以下软件。

SUSE® Linux Enterprise Server 12 SP5(含所有可用的联机更新)

SUSE Linux Enterprise High Availability Extension 12 SP5(含所有可用的联机更新)

(可选)对于 Geo 群集:Geo Clustering for SUSE Linux Enterprise High Availability Extension 12 SP5(含所有可用联机更新)

2.3 储存要求 #

有些服务需要使用共享储存。如果使用外部 NFS 共享,必须能够从所有群集节点通过冗余通讯路径可靠地访问该共享。

为确保数据的高可用性,我们建议您为群集设置共享磁盘系统(储存区域网络,简称 SAN)。如果使用共享磁盘子系统,请确保符合以下要求:

根据制造商的说明正确设置共享磁盘系统并且共享磁盘系统可正确运行。

共享磁盘系统中包含的磁盘应配置为使用镜像或 RAID,来为共享磁盘系统增加容错性。

如果准备对共享磁盘系统访问使用 iSCSI,则请确保正确配置了 iSCSI 启动器和目标。

使用 DRBD* 实施在两台计算机间分发数据的镜像 RAID 系统时,请确保只访问 DRBD 提供的设备,切勿访问备份设备。使用绑定的 NIC。要利用冗余,可以使用群集剩余组件中所用的相同 NIC。

如果使用 SBD 作为 STONITH 机制,则共享储存还需要满足其他要求。有关细节,请参见第 11.3 节 “要求”。

2.4 其他要求和建议 #

为了实现受支持且有用的高可用性设置,请考虑以下建议:

- 群集节点数

对于包含两个以上节点的群集,强烈建议使用奇数数目的群集节点,以便具有仲裁。有关仲裁的详细信息,请参见第 6.2 节 “仲裁判定”。

- 时间同步

群集节点必须同步到群集外的 NTP 服务器。有关详细信息,请参见 https://documentation.suse.com/sles-12/html/SLES-all/cha-netz-xntp.html。

如果节点未同步,群集可能无法正常运作。此外,日志文件和群集报告在不进行同步的情况下也很难进行分析。如果使用引导脚本,而 NTP 尚未配置,则系统会提出警告。

- 网络接口卡 (NIC) 名称

必须在所有节点上都相同。

- 主机名和 IP 地址

使用静态 IP 地址。

在

/etc/hosts文件中列出了所有群集节点,包括其完全限定的主机名和简短主机名。群集成员必须能够按名称找到彼此。如果名称不可用,则将无法进行群集内部通讯。有关 Pacemaker 如何获取节点名称的细节,请参见 http://clusterlabs.org/doc/en-US/Pacemaker/1.1/html/Pacemaker_Explained/s-node-name.html。

- SSH

所有群集节点都必须能通过 SSH 相互访问。

crm report(用于查错)等工具和 Hawk2 的要求节点之间采用无口令 SSH 访问方式,否则它们只能从当前节点收集数据。注意:合规要求

如果无口令 SSH 访问不符合法规要求,您可以使用附录 D “在没有

root访问权的情况下运行群集报告”中所述的变通方法来运行crm report。对于,目前还没有其他方式可替代无口令登录。

3 安装 High Availability Extension #

摘要#

如果您是首次使用 SUSE® Linux Enterprise High Availability Extension 设置高可用性群集,最简单的方法就是从基本的双节点群集开始设置。您也可以使用双节点群集来运行一些测试。之后,您便可使用 AutoYaST 克隆现有的群集节点来添加更多节点。克隆的节点上会安装相同的包,并具有与原始节点相同的系统配置。

如果要升级运行较低版 SUSE Linux Enterprise High Availability Extension 的现有群集,请参见第 5 章 “升级群集和更新软件包”。

3.1 手动安装 #

Article “安装和设置快速入门”中介绍了手动安装 High Availability Extension 包的过程。

3.2 使用 AutoYaST 进行批量安装和部署 #

安装并设置双节点群集后,您可以使用 AutoYaST 克隆现有节点并将克隆节点添加到群集,以便扩展群集。

AutoYaST 使用包含安装和配置数据的配置文件。配置文件会告知 AutoYaST 要安装的内容以及如何配置已安装系统,以最终获得一个现成可用的系统。然后可使用此配置文件以各种方式(例如,克隆现有群集节点)进行大批量部署。

重要:相同硬件

过程 3.1 “使用 AutoYaST 克隆群集节点”假设您要将 SUSE Linux Enterprise High Availability Extension 12 SP5 部署到硬件配置完全相同的一组计算机上。

如果您需要在配置不同的硬件上部署群集节点,请参见《SUSE Linux Enterprise 12 SP5 部署指南》“自动安装”一章中的“基于规则的自动安装”一节。

过程 3.1︰ 使用 AutoYaST 克隆群集节点 #

确保已正确安装和配置要克隆的节点。有关细节,请参见《SUSE Linux Enterprise High Availability Extension 安装和设置快速入门》或第 4 章 “使用 YaST 群集模块”。

按照《SUSE Linux Enterprise 12 SP5 部署指南》中的概要说明进行简单的大批量安装。其中包括以下基本步骤:

创建 AutoYaST 配置文件。使用 AutoYaST GUI 基于现有系统配置创建和修改配置文件。在 AutoYaST 中选择 模块并单击按钮。如果需要,调整其他模块中的配置,并将生成的控制文件另存为 XML 格式的文件。

如果您已配置 DRBD,也可以在 AutoYaST GUI 中选择并克隆此模块。

确定 AutoYaST 配置文件的来源以及要传递到其他节点的安装例程的参数。

确定 SUSE Linux Enterprise Server 和 SUSE Linux Enterprise High Availability Extension 安装数据的来源。

确定并设置自动安装的引导方案。

通过手动添加参数或创建

info文件,将命令行传递到安装例程。启动并监视自动安装进程。

成功安装克隆节点后,执行以下步骤将克隆节点加入群集中:

过程 3.2︰ 使克隆节点处于联机状态 #

按第 4.5 节 “将配置传送到所有节点”中所述使用 Csync2 将密钥配置文件从已配置的节点传送到克隆节点。

要使节点联机,请按第 4.8 节 “使群集联机”中所述在克隆的节点上启动 Pacemaker 服务。

现在克隆节点将加入群集,因为 /etc/corosync/corosync.conf 文件已通过 Csync2 应用到克隆节点。CIB 将在群集节点间自动同步。

4.1 术语定义 #

下面定义了 YaST 群集模块和本章中使用的多个关键术语。

- 绑定网络地址 (

bindnetaddr) Corosync 管理器应绑定的网络地址。为方便在群集间共享配置文件,Corosync 使用网络接口网络掩码来仅屏蔽用于路由网络的地址位。例如,如果本地接口是

192.168.5.92并且网络掩码是255.255.255.0,则bindnetaddr将设置为192.168.5.0。例如,如果本地接口是192.168.5.92并且网络掩码是255.255.255.192,则bindnetaddr将设置为192.168.5.64。注意:所有节点的网络地址

由于所有节点将使用相同的 Corosync 配置,请务必使用

bindnetaddr之类的网络地址,而不是特定网络接口地址。conntrack 工具可与内核内连接跟踪系统交互,以便对 iptables 启用有状态包检测。High Availability Extension 使用此工具来同步群集节点之间的连接状态。有关详细信息,请参见 http://conntrack-tools.netfilter.org/。

- Csync2

可用于在群集中的所有节点间(甚至在 Geo 群集间)复制配置文件的同步工具。Csync2 可处理排入同步组的任意数量的主机。每个同步组都有自己的成员主机列表及其包含/排除模式,包含/排除模式定义了在同步组中应同步哪些文件。同步组、属于每个组的主机名以及每个组的包含/排除规则均在 Csync2 配置文件

/etc/csync2/csync2.cfg中指定。对于身份验证,Csync2 使用 IP 地址和同步组中的预共享密钥。需要为每个同步组生成一个密钥文件,并将其复制到所有组成员。

有关 Csync2 的更多信息,请参见 http://oss.linbit.com/csync2/paper.pdf。

- 现有群集

术语“现有群集”指的是任何包括至少一个节点的群集。现有群集具有定义通讯通道的基本 Corosync 配置,但它们不一定已有资源配置。

- 多路广播

一种用于网络内一对多通讯的技术,可用于群集通讯。Corosync 支持多路广播和单路广播。如果多路广播不符合公司 IT 策略,则改为使用单路广播。

注意:交换机和多路广播

要使用多路广播进行群集通讯,请确保交换机支持多路广播。

- 多路广播地址 (

mcastaddr) Corosync 管理器使用 IP 地址进行多路广播。IP 地址可以为 IPv4 或 IPv6。如果使用 IPv6 网络,则必须指定节点 ID。可以使用专用网内的任何多路广播地址。

- 多路广播端口 (

mcastport) 用于群集通讯的端口。Corosync 使用两个端口:一个用于接收多路广播的指定

mcastport和一个用于发送多路广播的mcastport -1。- Redundant Ring Protocol (RRP)

该协议支持使用多个冗余局域网来从部分或整体网络故障中恢复。这样,只要一个网络运行正常,群集通讯就仍可继续。Corosync 支持 Totem Redundant Ring Protocol。所有参与节点上都强制实施逻辑令牌传递环以确保可靠且有序地传递消息。只有拥有令牌的节点才允许广播消息。

在 Corosync 中定义了冗余通讯通道后,使用 RRP 告知群集如何使用这些接口。RRP 可具有三种模式 (

rrp_mode):如果设置为

active,则 Corosync 将主动使用这两个接口。但是,此模式已弃用。如果设置为

passive,Corosync 将选择性地通过可用网络发送消息。如果设置为

none,将会禁用 RRP。

- 单路广播

一种将消息发送到单个网络目标的技术。Corosync 支持多路广播和单路广播。在 Corosync 中,单路广播作为 UDP 单路广播 (UDPU) 实施。

4.2 YaST 群集模块 #

启动 YaST 并选择 › 。也可以从命令行启动模块:

sudo yast2 cluster

下面的列表显示了 YaST 群集模块中可用屏幕的概述。它还指出了屏幕是否包含成功设置群集必需的参数,或其参数是否可选。

- 通讯通道(必需)

允许您定义用于在群集节点之间进行通讯的一个或两个通讯通道。对于传输协议,请使用多路广播 (UDP) 或单路广播 (UDPU)。有关细节,请参见第 4.3 节 “定义通讯通道”。

- 安全性(可选但建议使用)

允许您定义群集的身份验证设置。HMAC/SHA1 身份验证需要使用共享机密来保护和验证讯息。有关细节,请参见第 4.4 节 “定义身份验证设置”。

- 配置 Csync2(可选但建议使用)

Csync2 将帮助您跟踪配置更改,并在群集节点之间保持文件同步。有关细节,请参见第 4.5 节 “将配置传送到所有节点”。

- 配置 conntrackd(可选)

可让您配置用户空间

conntrackd。使用 conntrack 工具为 iptables 进行有状态包检测。有关细节,请参见第 4.6 节 “同步群集节点间的连接状态”。- 服务(必需)

允许您配置服务以使群集节点联机。定义是否在引导时启动 Pacemaker 服务,以及是否在防火墙中打开节点间通讯所需的端口。有关细节,请参见第 4.7 节 “配置服务”。

如果是首次启动群集模块,它会显示为向导,引导您完成进行基本设置所需的所有步骤。否则,请单击左侧面板上的类别,以访问每个步骤的配置选项。

注意:YaST 群集模块中的设置

YaST 群集模块中的一些设置仅适用于当前节点。其他设置可以通过 Csync2 自动传送到所有节点。可在以下各部分中找到有关此配置的详细信息。

4.3 定义通讯通道 #

为实现群集节点间的成功通讯,请定义至少一个通讯通道。对于传输协议,请分别按过程 4.1 或过程 4.2 中所述使用多路广播 (UDP) 或单路广播 (UDPU)。如果要定义另一个冗余通道(过程 4.3),则这两个通讯通道必须使用相同的协议。

YaST 屏幕中定义的所有设置都会写入到 /etc/corosync/corosync.conf 中。/usr/share/doc/packages/corosync/ 中提供了一些多路广播和单路广播设置的示例文件。

如果您使用的是 IPv4 地址,则节点 ID 可以选填。如果使用的是 IPv6 地址,则必须填写节点 ID。YaST 群集模块提供了一个自动为每个群集节点生成唯一 ID 的选项,用户无需手动为每个节点指定 ID。

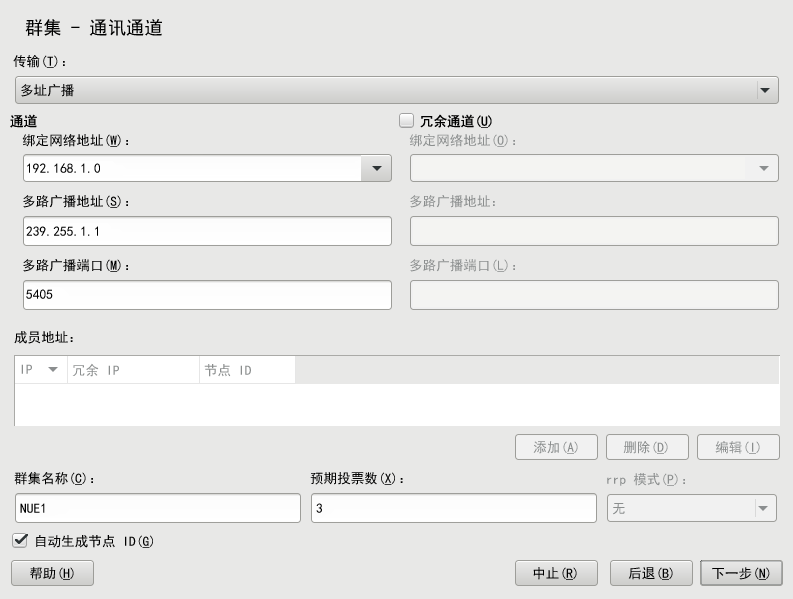

过程 4.1︰ 定义第一个通讯通道(多路广播) #

使用多路广播时,将对所有群集节点使用相同的 bindnetaddr、mcastaddr 和 mcastport。通过使用相同的多路广播地址,群集中的所有节点都将知晓彼此。对于不同的群集,请使用不同的多路广播地址。

启动 YaST 群集模块,然后切换到类别。

将协议设为

多路广播。定义。将此值设置为要用于群集多路广播的子网。

定义。

定义。

要为每个群集节点自动生成唯一的 ID,请将 保留为启用状态。

定义。

输入。此值非常重要,Corosync 将使用它来为分区的群集计算法定票数。默认情况下,每个节点有

1张投票。必须与群集中的节点数匹配。确认更改。

如果需要,请按过程 4.3 “定义冗余通讯通道”中所述在 Corosync 中定义冗余通讯通道。

图 4.1︰ YaST 群集 - 多路广播配置 #

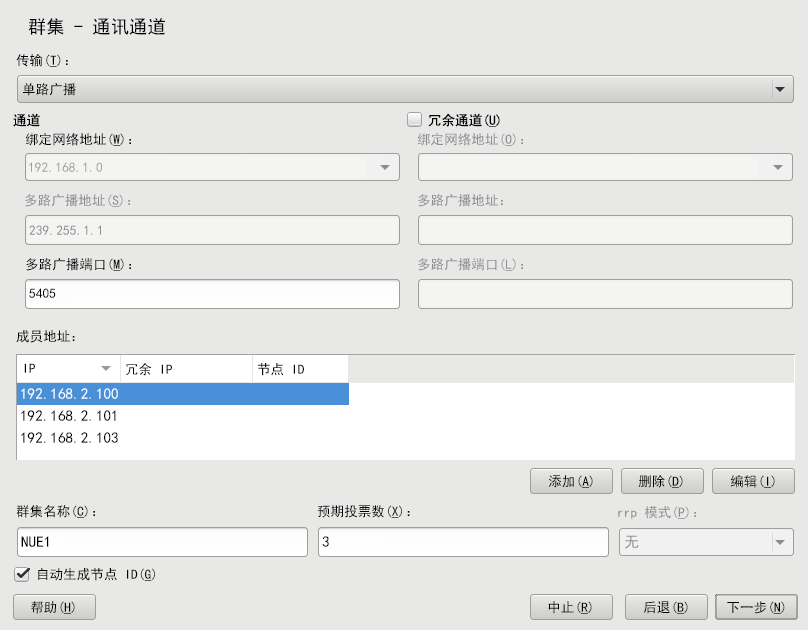

如果要使用单路广播(而非多路广播)进行群集通讯,请按如下所述继续操作。

过程 4.2︰ 定义第一个通讯通道(单路广播) #

启动 YaST 群集模块,然后切换到类别。

将协议设为

单路广播。定义。

对于单路广播通讯,Corosync 需要知道群集中所有节点的 IP 地址。对于将要加入群集的每个节点,单击并输入以下细节:

(仅当在 Corosync 中使用了第二个通讯通道时才需要指定)

(仅当禁用了 选项时才需要指定)

要修改或删除群集成员的任何地址,请使用或按钮。

要为每个群集节点自动生成唯一的 ID,请将 保留为启用状态。

定义。

输入。此值非常重要,Corosync 将使用它来为分区的群集计算法定票数。默认情况下,每个节点有

1张投票。必须与群集中的节点数匹配。确认更改。

如果需要,请按过程 4.3 “定义冗余通讯通道”中所述在 Corosync 中定义冗余通讯通道。

图 4.2︰ YaST 群集 - 单路广播配置 #

如果由于任何原因不能使用网络设备绑定,第二个最佳选择就是在 Corosync 中定义冗余通讯通道(次环)。这样就可使用两个物理上分隔的网络进行通讯。如果一个网络发生故障,群集节点仍可通过另一个网络进行通讯。

Corosync 中的另一个通讯通道将会形成另一个令牌传递环。在 /etc/corosync/corosync.conf 中,您配置的第一个通道就是主环,其环编号为 0。第二个环(冗余通道)的环编号为 1。

在 Corosync 中定义了冗余通讯通道后,使用 RRP 告知群集如何使用这些接口。有了 RRP,就可以使用两个物理位置分开的网络进行通讯。如果一个网络发生故障,群集节点仍可通过另一个网络进行通讯。

RRP 可以有三种模式:

如果设置为

active,则 Corosync 将主动使用这两个接口。但是,此模式已弃用。如果设置为

passive,Corosync 将选择性地通过可用网络发送消息。如果设置为

none,将会禁用 RRP。

过程 4.3︰ 定义冗余通讯通道 #

重要:冗余环和 /etc/hosts

如果 Corosync 中配置了多个环,则每个节点都可具有多个 IP 地址。这需要在所有节点的 /etc/hosts 文件中反映出来。

启动 YaST 群集模块,然后切换到类别。

请激活。冗余通道必须使用与所定义的第一个通讯通道相同的协议。

如果使用多路广播,请输入以下参数:要使用的,冗余通道的和。

如果使用单路广播,请定义以下参数:要使用的及。输入将加入群集的所有节点的 IP 地址。

要告知 Corosync 如何以及何时使用其他通道,请选择要使用的 :

如果只定义了一个通讯通道, 将自动禁用(值

none)。如果设置为

active,则 Corosync 将主动使用这两个接口。但是,此模式已弃用。如果设置为

passive,Corosync 将选择性地通过可用网络发送消息。

使用 RRP 时,High Availability Extension 会监视当前环的状态,并在发生故障后自动重新启用冗余环。

或者,使用

corosync-cfgtool手动检查环状态。使用-h查看可用选项。确认更改。

4.4 定义身份验证设置 #

要定义群集的身份验证设置,您可以使用 HMAC/SHA1 身份验证。此方式需要使用共享机密来保护和验证讯息。指定的身份验证密钥(密码)将用于群集中的所有节点。

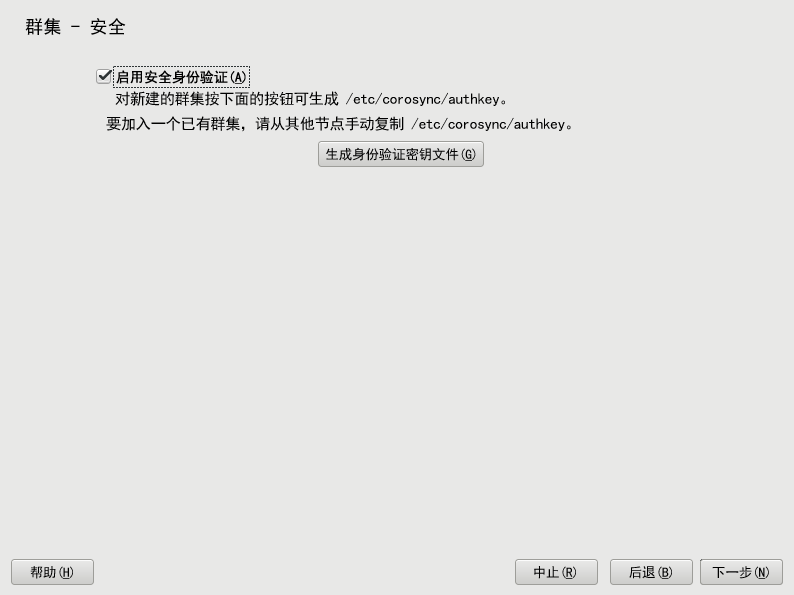

过程 4.4︰ 启用安全性身份验证 #

启动 YaST 群集模块,然后切换到类别。

激活。

对于新创建的群集,请单击。将创建身份验证密钥并将其写入

/etc/corosync/authkey。如果希望当前计算机加入现有群集,则不用生成新的密钥文件。而是将

/etc/corosync/authkey从一个节点复制到当前计算机(手动或使用 Csync2 皆可)。确认更改。YaST 会将此配置写入

/etc/corosync/corosync.conf。

图 4.3︰ YaST 群集 - 安全性 #

4.5 将配置传送到所有节点 #

如果不想将生成的配置文件手动复制到所有节点,可使用 csync2 工具在群集中的所有节点间进行复制。

这需要以下基本步骤:

Csync2 将帮助您跟踪配置更改,并在群集节点之间保持文件同步。

可以定义对操作至关重要的文件列表。

可以显示这些文件的更改(对于其他群集节点)。

可以使用单个命令同步配置的文件。

使用

~/.bash_logout中的一个简单外壳脚本,您可以在从系统注销之前获得更改未同步的提醒。

http://oss.linbit.com/csync2/ 和 http://oss.linbit.com/csync2/paper.pdf 上提供了有关 Csync2 的详细信息。

4.5.1 使用 YaST 配置 Csync2 #

启动 YaST 群集模块,然后切换到 类别。

要指定同步组,请在组中单击,然后输入群集中所有节点的本地主机名。对于每个节点,必须使用

hostname命令返回的确切字符串。提示:主机名解析

如果您的网络中无法正常进行主机名解析,您也可以为每个群集节点指定主机名与 IP 地址的组合。为此,请使用字符串 HOSTNAME@IP,例如

alice@192.168.2.100。这样,Csync2 将在连接时使用 IP 地址。单击以创建同步组的密钥文件。密钥文件将写入

/etc/csync2/key_hagroup。创建后,必须将其手动复制到群集的所有成员。要使用通常需要在所有节点间同步的文件填充列表,请单击。

如果要从待同步的文件列表、或文件,请使用相应按钮。必须为每个文件输入绝对路径名。

通过单击 激活 Csync2。随后会执行以下命令,以在引导时自动启动 Csync2:

root #systemctlenable csync2.socket确认更改。YaST 会将 Csync2 配置写入

/etc/csync2/csync2.cfg。要立即启动同步过程,请继续第 4.5.2 节 “使用 Csync2 同步更改”。

图 4.4︰ YaST 群集 - Csync2 #

4.5.2 使用 Csync2 同步更改 #

要成功使用 Csync2 同步文件,必须满足以下要求:

同一 Csync2 配置在所有群集节点上均可用。

同一 Csync2 身份验证密钥在所有群集节点上均可用。

所有群集节点上都必须正在运行 Csync2。

因此,在首次运行 Csync2 之前,需要做好以下准备:

过程 4.5︰ 使用 Csync2 准备初始同步 #

如

所述配置后,将文件/etc/csync2/csync2.cfg第 4.5.1 节 “使用 YaST 配置 Csync2” 手动复制到所有节点。将执行第 4.5.1 节 的步骤 3 时在一个节点上生成的

/etc/csync2/key_hagroup文件复制到群集中的所有节点。它是 Csync2 在进行身份验证时需要使用的文件。但请勿在其他节点上重新生成该文件,因为所有节点上的文件都必须相同。在所有节点上执行以下命令,以便立即启动服务:

root #systemctlstart csync2.socket

过程 4.6︰ 使用 Csync2 同步配置文件 #

要对所有文件执行一次初始同步,请在要从中复制配置的计算机上执行以下命令:

root #csync2-xv这会将文件推送到其他节点,从而一次同步所有文件。如果所有文件都成功同步,则 Csync2 将完成,不会报错。

如果在其他节点(不仅在当前节点)上对要同步的一个或多个文件进行了修改,则 Csync2 会报告冲突。您将得到类似以下内容的输出:

While syncing file /etc/corosync/corosync.conf: ERROR from peer hex-14: File is also marked dirty here! Finished with 1 errors.

如果确信当前节点上的文件版本是“最佳”版本,可以通过强制使用此文件并重新同步来解决冲突:

root #csync2-f/etc/corosync/corosync.confroot #csync2-x

有关 Csync2 选项的更多信息,请运行

csync2 -help

注意:在任何更改后推送同步

Csync2 仅推送更改。它不会在计算机之间连续同步文件。

每次更新需要同步的文件时,都必须将更改推送到其他计算机:在您进行了更改的计算机上运行 csync2

-xv。如果对未更改文件的任何其他计算机运行此命令,则不会执行任何操作。

4.6 同步群集节点间的连接状态 #

要对 iptables 启用有状态包检测,请配置并使用 conntrack 工具。这需要以下基本步骤:

为

conntrackd配置一个资源(类:ocf,提供程序:heartbeat)。如果使用 Hawk2 添加资源,请使用 Hawk2 推荐的默认值。

配置 conntrack 工具后,可对 Linux 虚拟服务器使用这些工具,请参见负载平衡。

过程 4.7︰ 使用 YaST 配置 conntrackd #

使用 YaST 群集模块配置用户空间 conntrackd。这需要未用于其他通讯通道的专用网络接口。守护程序可随后通过资源代理启动。

启动 YaST 群集模块,然后切换到 类别。

选择来同步连接状态。会自动检测所选接口的 IPv4 地址并显示在 YaST 中。该地址必须已经配置并且必须支持多路广播。

定义要用于同步连接状态的。

在中,定义要将连接状态同步到其中的组的数字 ID。

单击 来创建

conntrackd的配置文件。如果修改了现有群集的任何选项,请确认更改并关闭群集模块。

有关进一步群集配置,请单击并继续第 4.7 节 “配置服务”。

图 4.5︰ YaST 群集 - conntrackd #

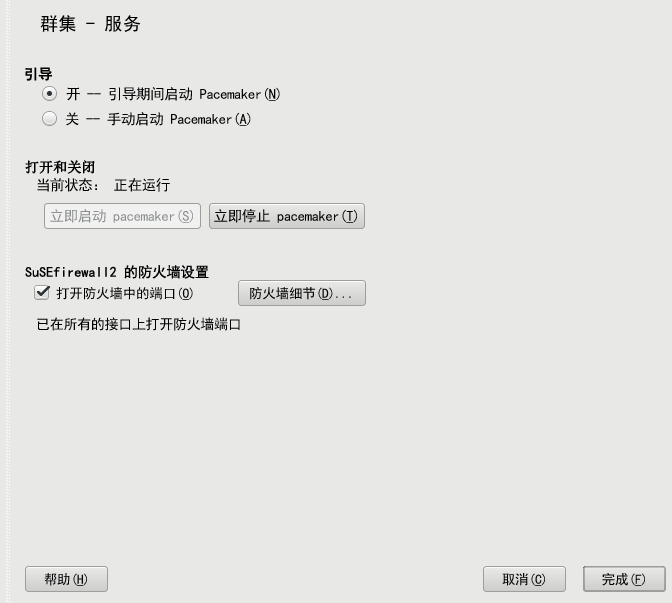

4.7 配置服务 #

在 YaST 群集模块中,定义是否在引导节点时启动其上的特定服务。也可使用模块手动启动和停止服务。为使群集节点联机并启动群集资源管理器,Pacemaker 必须作为服务运行。

过程 4.8︰ 启用 Pacemaker #

在 YaST 群集模块中,切换到类别。

要在每次引导此群集节点时启动 Pacemaker,请在组中选择相应选项。如果在组中选择,则必须在每次引导此节点时手动启动 Pacemaker。要手动启动 Pacemaker,请使用以下命令:

root #systemctlstart pacemaker要立即启动或停止 Pacemaker,请单击相应按钮。

要在防火墙中打开所需的端口以在当前计算机上进行群集通讯,请激活。该配置将写入

/etc/sysconfig/SuSEfirewall2.d/services/cluster。确认更改。请注意,该配置仅应用于当前计算机,而不是所有群集节点。

图 4.6︰ YaST 群集 - 服务 #

4.8 使群集联机 #

完成初始群集配置后,在每个群集节点上启动 Pacemaker 服务,以使堆栈联机:

过程 4.9︰ 启动 Pacemaker 并检查状态 #

登录到现有节点。

检查服务是否已在运行。

root #systemctlstatus pacemaker如果尚未启动,立即启动 Pacemaker:

root #systemctlstart pacemaker对每个群集节点重复上述步骤。

在某个节点上,使用

crm status命令检查群集状态。如果所有节点都联机,则输出应类似于如下内容:root #crm status Last updated: Thu Jul 3 11:07:10 2014 Last change: Thu Jul 3 10:58:43 2014 Current DC: alice (175704363) - partition with quorum 2 Nodes configured 0 Resources configured Online: [ alice bob ]此输出表示群集资源管理器已启动,可以管理资源了。

完成基本配置并使节点处于联机状态后,可以开始配置群集资源。使用某种群集管理工具,例如 crm 外壳 (crmsh) 或 HA Web Konsole。有关更多信息,请参见第 7 章 “使用 Hawk2 配置和管理群集资源”或第 8 章 “配置和管理群集资源(命令行)”。

5 升级群集和更新软件包 #

摘要#

本章介绍两种不同方案:将群集升级为 SUSE Linux Enterprise High Availability Extension 的另一个版本(主要版本或服务包),以及更新群集节点上的单个包。请参见第 5.2 节 “将群集升级到最新产品版本”与第 5.3 节 “更新群集节点上的软件包”。

如果您要升级群集,请在开始升级之前查看第 5.2.1 节 “SLE HA 和 SLE HA Geo 支持的升级路径”和第 5.2.2 节 “升级前必须满足的先决条件”。

5.1 术语 #

下面介绍本章中使用的最重要术语的定义:

- 主要版本, 正式发布 (GA) 版本

SUSE Linux Enterprise(或任何软件产品)的主要版本是一个新版本,其中会引入一些新功能和工具,去除之前弃用的组件,并进行一些不向后兼容的更改。

- 脱机迁移

如果新的产品版本包含不向后兼容的重大更改,则需要通过脱机迁移来升级群集:您需要将所有节点脱机,升级整个群集,然后才能将所有节点重新联机。

- 滚动升级

在滚动升级过程中,每次会升级一个群集节点,其余的群集节点将保持运行状态:您需要将第一个节点脱机,将它升级,再将它重新联机以加入群集。然后,需要逐个对其余节点重复上述过程,直到所有群集节点都升级为主要版本。

- 服务包 (SP)

将几个增补程序合并到便于安装或部署的一个组织体中。服务包是有编号的并通常包含安全性修复、更新、升级或程序增强。

- 更新

安装包的更新次要版本。

- 升级

5.2 将群集升级到最新产品版本 #

至于支持哪种升级路径以及如何执行升级,取决于当前产品版本,以及您要迁移到的目标版本。

采用滚动升级方式,只能从产品版本 GA 滚动升级到下一个服务包,以及从一个服务包滚动升级到下一个服务包。

从一个主要版本升级到下一个主要版本(例如,从 SLE HA 11 升级到 SLE HA 12),或者从属于一个主要版本的服务包升级到下一个主要版本(例如,从 SLE HA 11 SP3 升级到 SLE HA 12),需要执行脱机迁移。

有关升级基础系统 (SUSE Linux Enterprise Server) 的信息,请参见您要升级到的目标版本的《SUSE Linux Enterprise Server 部署指南》。https://documentation.suse.com/#sles/ 上提供了该指南。

第 5.2.1 节概述了 SLE HA (Geo) 支持的升级路径,并提供了其他文档供您参考。

重要:升级后不支持混合群集和逆转

不支持在 SUSE Linux Enterprise High Availability Extension 11/SUSE Linux Enterprise High Availability Extension 12 上运行混合群集。

完成到产品版本 12 的升级过程后,不支持再还原到产品版本 11。

5.2.1 SLE HA 和 SLE HA Geo 支持的升级路径 #

|

升级前版本和目标版本 |

升级路径 |

有关细节请参见 |

|---|---|---|

|

从 SLE HA 11 SP3 升级到 SLE HA (Geo) 12 |

脱机迁移 |

|

|

从 SLE HA (Geo) 11 SP4 升级到 SLE HA (Geo) 12 SP1 |

脱机迁移 |

|

|

从 SLE HA (Geo) 12 升级到 SLE HA (Geo) 12 SP1 |

滚动升级 |

|

|

从 SLE HA (Geo) 12 SP1 升级到 SLE HA (Geo) 12 SP2 |

滚动升级 |

|

|

从 SLE HA (Geo) 12 SP2 升级到 SLE HA (Geo) 12 SP3 |

滚动升级 |

|

|

从 SLE HA (Geo) 12 SP3 升级到 SLE HA (Geo) 12 SP4 |

滚动升级 |

|

|

从 SLE HA (Geo) 12 SP4 升级到 SLE HA (Geo) 12 SP5 |

滚动升级 |

|

https://documentation.suse.com 上提供了有关细节请参见列中所列的全部文档。

5.2.2 升级前必须满足的先决条件 #

- 备份

确保系统备份为最新的且可恢复。

- 测试

请先在群集设置的临时实例上测试升级过程,然后再在生产环境中执行该过程。

这样,您便可以估算出维护期所需的时间段。这还有助于检测和解决可能会出现的任何意外问题。

5.2.3 脱机迁移 #

本节内容适用于以下方案:

从 SLE HA 11 SP3 升级到 SLE HA 12

从 SLE HA 11 SP4 升级到 SLE HA 12 SP1

如果您的群集仍旧基于早期的产品版本而不是上面所列的版本,请先将它升级到 SUSE Linux Enterprise Server 和 SUSE Linux Enterprise High Availability Extension 的某个版本,该版本必须可用作升级到所需目标版本的源。

High Availability Extension 12 群集堆栈的各个组件包含了重大更改(例如 /etc/corosync/corosync.conf、OCFS2 的磁盘格式)。因此,不能从任何 SUSE Linux Enterprise High Availability Extension 11 版本滚动升级到该版本。必须将所有群集节点脱机,并根据过程 5.1 “执行群集范围的脱机迁移”中所述迁移整个群集。

过程 5.1︰ 执行群集范围的脱机迁移 #

登录到每个群集节点,并使用以下命令停止群集堆栈:

root #rcopenaisstop将每个群集节点都升级到 SUSE Linux Enterprise Server 和 SUSE Linux Enterprise High Availability Extension 的所需目标版本。如果您有现有的 Geo 群集设置且想升级它,请参见《Geo Clustering for SUSE Linux Enterprise High Availability Extension Geo 群集快速入门》中的附加指导。要了解各个升级过程的细节,请参见第 5.2.1 节 “SLE HA 和 SLE HA Geo 支持的升级路径”。

完成升级过程后,请重引导装有 SUSE Linux Enterprise Server 和 SUSE Linux Enterprise High Availability Extension 升级版的每个节点。

如果在群集设置中使用了 OCFS2,请执行以下命令以更新设备上的结构:

root #o2cluster--update PATH_TO_DEVICE该命令会向磁盘添加附加的参数,SUSE Linux Enterprise High Availability Extension 12 和 12 SPx 随附的 OCFS12 更新版本需要这些参数。

要更新 Corosync 2 的

/etc/corosync/corosync.conf,请执行以下操作:登录到某个节点,然后启动 YaST 群集模块。

切换到类别并输入以下新参数的值:和。有关细节,请分别参见过程 4.1 “定义第一个通讯通道(多路广播)”或过程 4.2 “定义第一个通讯通道(单路广播)”。

如果 YaST 检测到对 Corosync 2 无效或缺失的任何其他选项,它会提示您进行更改。

确认在 YaST 中所做更改。YaST 会将配置写入

/etc/corosync/corosync.conf。如果为群集配置了 Csync2,请使用以下命令将更新的 Corosync 配置推送到其他群集节点:

root #csync2-xv有关 Csync2 的细节,请参见第 4.5 节 “将配置传送到所有节点”。

或者,也可以通过将

/etc/corosync/corosync.conf手动复制到所有群集节点,来同步更新的 Corosync 配置。

登录到每个节点,并使用以下命令启动群集堆栈:

root #systemctlstart pacemaker使用

crm status或 Hawk2 检查群集状态。将以下服务配置为在引导时启动:

root #systemctl enable pacemakerroot #systemctl enable hawkroot #systemctl enable sbd

注意:升级 CIB 语法版本

标记(用于对资源分组)和某些 ACL 功能仅适用于 pacemaker-2.0 或更高的 CIB 语法版本(要检查版本,请使用 cibadmin -Q |grep validate-with 命令)。如果您是从 SUSE Linux Enterprise High Availability Extension 11 SPx 升级的,CIB 版本默认不会升级。要手动升级到最新的 CIB 版本,请使用以下命令之一:

root #cibadmin--upgrade --force

或者

root #crmconfigure upgrade force

5.2.4 滚动升级 #

本节内容适用于以下方案:

从 SLE HA 12 升级到 SLE HA 12 SP1

从 SLE HA 12 SP1 升级到 SLE HA 12 SP2

从 SLE HA (Geo) 12 SP2 升级到 SLE HA (Geo) 12 SP3

从 SLE HA (Geo) 12 SP3 升级到 SLE HA (Geo) 12 SP4

从 SLE HA (Geo) 12 SP4 升级到 SLE HA (Geo) 12 SP5

警告:活动的群集堆栈

在开始升级某个节点之前,请停止该节点上的群集堆栈。

如果在软件更新期间,群集资源管理器所在节点处于活动状态,可能会导致不可预料的结果,例如活动的节点被屏蔽。

过程 5.2︰ 执行群集范围的滚动升级 #

以

root用户身份登录要升级的节点,并停止群集堆栈:root #systemctlstop pacemaker升级到 SUSE Linux Enterprise Server 和 SUSE Linux Enterprise High Availability Extension 的所需目标版本。要了解各个升级过程的细节,请参见第 5.2.1 节 “SLE HA 和 SLE HA Geo 支持的升级路径”。

在升级后的节点上重启动群集堆栈,使该节点重新加入群集:

root #systemctlstart pacemaker使下一个节点处于脱机状态,并对此节点重复上述过程。

使用

crm status或 Hawk2 检查群集状态。

重要:滚动升级的时间限制

只有在将所有群集节点都升级到最新产品版本之后,最新产品版本提供的新功能才可用。对于采用混合版本的群集,其在滚动升级期间受支持的时间非常短暂。请在一周内完成滚动升级。

如果检测到您的群集节点有不同的 CRM 版本,Hawk2 屏幕还会显示一条警告。

5.3 更新群集节点上的软件包 #

警告:活动的群集堆栈

启动某节点的更新之前,请停止该节点上的群集堆栈,或将该节点置于维护模式,具体取决于群集堆栈是否受影响。有关详细信息,请参见步骤 1。

如果在软件更新期间,群集资源管理器所在节点处于活动状态,可能会导致不可预料的结果,例如活动的节点被屏蔽。

在节点上安装任何包更新之前,请先确认以下问题:

这种更新是否会影响属于 SUSE Linux Enterprise High Availability Extension 或 Geo Clustering Extension 的任何包?如果

是,请先在节点上停止群集堆栈,然后再开始软件更新:root #systemctlstop pacemaker包更新操作是否需要重引导计算机?如果

是,请先在节点上停止群集堆栈,然后再开始软件更新:root #systemctlstop pacemaker如果不属于上述任何一种情况,则不需要停止群集堆栈。在这种情况下,请先将节点置于维护模式,然后再开始软件更新:

root #crmnode maintenance NODE_NAME有关维护模式的更多细节,请参见第 16.2 节 “用于维护任务的不同选项”。

使用 YaST 或 Zypper 来安装包更新。

在成功安装更新后:

启动相应节点上的群集堆栈(如果在执行步骤 1 时已将它停止):

root #systemctlstart pacemaker或者去除维护标志,使节点恢复正常模式:

root #crmnode ready NODE_NAME

使用

crm status或 Hawk2 检查群集状态。

5.4 更多信息 #

有关您要升级到的产品的任何更改和新功能的详细信息,请参见其发行说明,所在网址为 https://www.suse.com/releasenotes/。

第 II 部分 配置和管理 #

- 6 配置和管理基础

HA 群集的主要目的是管理用户服务。Apache Web 服务器或数据库便是一种典型的用户服务。从用户角度来看,服务就是在客户的要求下执行某些操作。但对群集来说,服务只是可以启动或停止的资源,其本质与群集无关。

在本章中,我们将介绍一些配置资源和管理群集时需要了解的基本概念。以下章节介绍如何使用 High Availability Extension 提供的每种管理工具执行主配置和管理任务。

- 7 使用 Hawk2 配置和管理群集资源

要配置和管理群集资源,请使用 HA Web Konsole (Hawk2) 或 crm 外壳 (crmsh) 命令行实用程序。如果您从安装了 Hawk 的较低版 SUSE® Linux Enterprise High Availability Extension 升级,该包将替换为最新版本 Hawk2。

Hawk2 的 Web 用户界面可用于从非 Linux 计算机监视和管理 Linux 群集。另外,如果系统仅提供很小的图形用户界面,它也会是个理想的解决方案。

- 8 配置和管理群集资源(命令行)

要配置和管理群集资源,可以使用 crm 外壳 (crmsh) 命令行实用程序或基于 Web 的用户界面 HA Web Konsole (Hawk2)。

本章介绍了命令行工具

crm,并包含此工具的概述以及如何使用模板,主要介绍如何配置和管理群集资源:创建基本和高级类型的资源(组和克隆资源)、配置约束、指定故障转移节点和故障回复节点、配置资源监视以及手动启动、清理、删除和迁移资源。- 9 添加或修改资源代理

需由群集管理的所有任务都必须可用作资源。在此处需要考虑两个主要组:资源代理和 STONITH 代理。对于这两个类别,您都可以添加自己的代理,根据需要扩展群集的功能。

- 10 屏障和 STONITH

屏蔽在 HA(高可用性)计算机群集中是一个非常重要的概念。群集有时会检测到某个节点行为异常,需要删除此节点。这称为屏蔽,通常使用 STONITH 资源实现。屏蔽可以定义为一种使 HA 群集具有已知状态的方法。

群集中的每个资源均带有状态。例如:“资源 r1 已在 alice 上启动”。在 HA 群集中,这种状态暗示了“资源 r1 在除 alice 外的所有节点上都处于停止状态”,因为群集必须确保每个资源只能在一个节点上启动。每个节点都必须报告资源发生的每个更改。这样群集状态就是资源状态和节点状态的集合。

当节点或资源的状态无法十分肯定地确立时,将进行屏蔽。即使在群集未感知到给定节点上发生的事件时,屏蔽也可确保此节点不会运行任何重要资源。

- 11 储存保护和 SBD

SBD(STONITH 块设备)通过经由共享块储存(SAN、iSCSI、FCoE 等)交换讯息来为基于 Pacemaker 的群集提供节点屏蔽机制。此方法可以将屏蔽机制隔离开来,使其不受固件版本更改的影响或不依赖于特定固件控制器。SBD 需要在每个节点上安装一个检查包,以确保能确实停止行为异常的节点。在某些情况下,还可以通过无磁盘模式运行 SBD,以便使用不含共享储存的 SBD。

此 ha-cluster-bootstrap 脚本提供了一种自动设置群集的方式,并可选择使用 SBD 作为屏蔽机制。有关细节,请参见《安装和设置快速入门》。但是,手动设置 SBD 可为您提供个别设置的更多选项。

本章介绍 SBD 背后的概念。它将指导您完成 SBD 所需的组件配置,以保护您的群集防止在发生节点分裂情况下出现可能的数据损坏。

除了节点级别屏蔽,您还可以使用额外的储存保护机制,例如 LVM2 排它激活或 OCFS2 文件锁定支持(资源级别屏蔽)。它们可以保护您的系统,以防出现管理或应用程序故障。

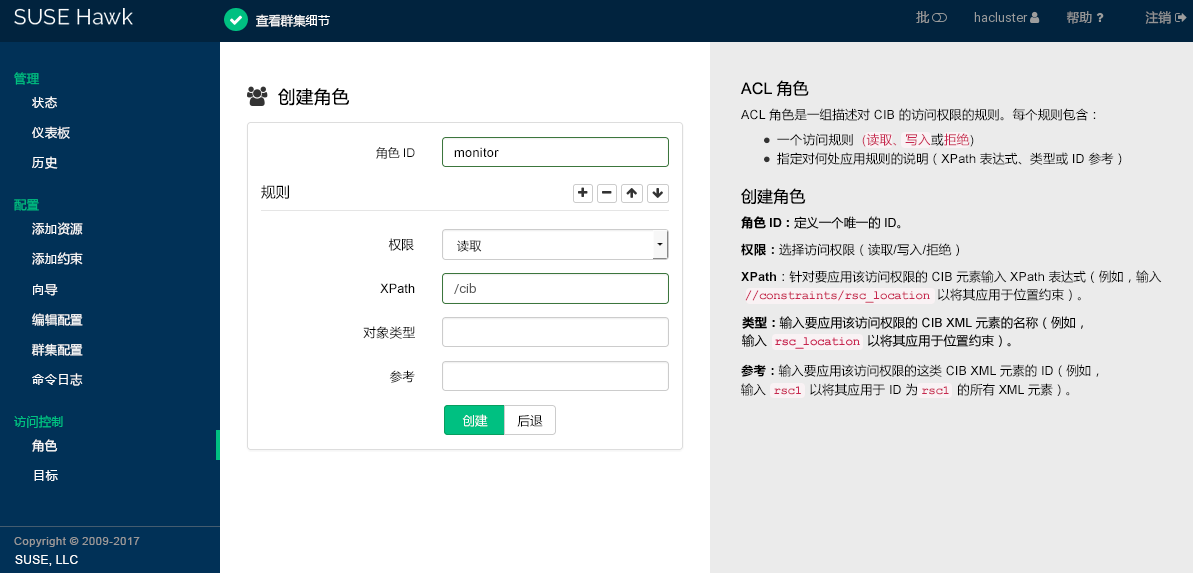

- 12 访问控制列表

crm 外壳 (crmsh) 或 Hawk2 等群集管理工具可由

root用户或haclient组内的任何用户使用。默认情况下,这些用户具有完全读/写访问权。要限制访问权或指派更加细化的访问权限,可以使用访问控制列表 (ACL)。访问控制列表由一组有序的访问规则构成。每个规则针对一部分群集配置赋予用户读取或写入访问权限,或拒绝其访问。规则通常会组合在一起产生特定角色,然后可以为用户指派与其任务匹配的角色。

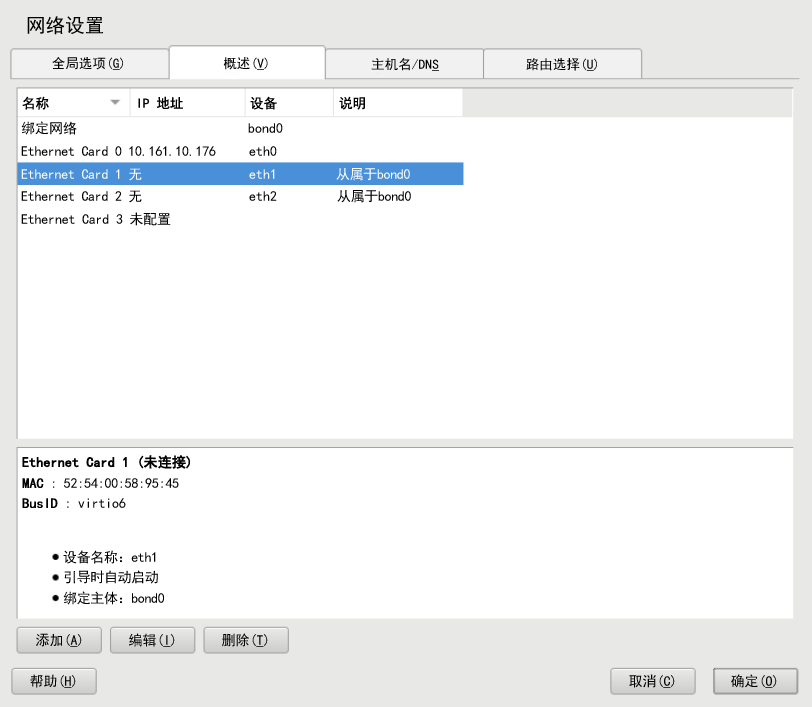

- 13 网络设备绑定

对于许多系统,需要实施高于典型以太网设备的标准数据安全性或可用性要求的网络连接。在这些情况下,可以将多个以太网设备聚合到单个绑定设备。

- 14 负载平衡

在负载平衡的情况下,服务器群集对于外部客户端而言就如同是一台大型的快速服务器。这种看上去像是单台服务器的服务器被称为虚拟服务器。它包括一个或多个用于调度进来的请求的负载平衡器,以及若干台运行实际服务的真实服务器。完成 High Availability Extension 的负载平衡设置后,您就可以构建高度可缩放且高度可用的网络服务,例如 Web、超速缓存、邮件、FTP、媒体和 VoIP 服务。

- 15 Geo 群集(多站点群集)

除本地群集和城域群集外,SUSE® Linux Enterprise High Availability Extension 12 SP5 还支持地理位置分散的群集(Geo 群集,有时也称为多站点群集)。这意味着,每个本地群集可以有多个地域分散的站点。这些群集之间的故障转移由更高级的实体、所谓的

投票间进行协调。对 Geo 群集的支持是作为 Geo Clustering for SUSE Linux Enterprise High Availability Extension 的一个独立扩展提供。有关如何使用和设置 Geo 群集的详细信息,请参见Article “Geo 群集快速入门”或Book “Geo Clustering Guide”。- 16 执行维护任务

要在群集节点上执行维护任务,可能需要停止该节点上运行的资源、移动这些资源,或者关闭或重引导该节点。此外,可能还需要暂时接管群集中资源的控制权,甚至需要在资源仍在运行时停止群集服务。

本章介绍如何在不产生负面影响的情况下手动关闭群集节点。此外,本章将会概述群集堆栈提供的用于执行维护任务的不同选项。

6.1 用例方案 #

群集一般分为以下两种类别:

双节点群集

包含两个以上节点的群集。这通常表示节点数是奇数。

添加不同的拓扑可以衍生不同的用例。下面是最常见的用例:

- 位于一个位置的双节点群集

配置:: FC SAN 或类似的共享储存,第 2 层网络。

使用方案:: 嵌入式群集,注重服务的高可用性,而不是实现数据冗余来进行数据复制。例如,此类设置可用于无线电台或装配生产线控制器。

- 位于两个位置的双节点群集(使用最广泛)

配置:: 对称的延伸群集,FC SAN,以及跨两个位置的第 2 层网络。

使用方案:: 典型的延伸群集,注重服务的高可用性和本地数据冗余。用于数据库和企业资源规划。过去数年来最流行的设置之一。

- 位于三个位置的奇数数目的节点

配置:: 2×N+1 个节点,FC SAN 跨两个主要位置第三个辅助站点不部署 FC SAN,而是充当多数仲裁者。第 2 层网络至少跨两个主要位置。

使用方案:: 典型的延伸群集,注重服务的高可用性和数据冗余。例如数据库和企业资源规划。

6.2 仲裁判定 #

当一个或多个节点与群集的剩余节点之间的通讯失败时,即会发生群集分区。这些节点只能与同一分区中的其他节点通讯,并不知道被隔开的节点的存在。如果群集分区具有多数节点(或投票),则将其定义为具有仲裁(是“具有法定票数的”)。通过仲裁计算来获得此结果。要实现屏蔽,就必须具有仲裁。

SUSE Linux Enterprise High Availability Extension 11 与 SUSE Linux Enterprise High Availability Extension 12 的仲裁计算方式有所不同。在 SUSE Linux Enterprise High Availability Extension 11 中,仲裁由 Pacemaker 计算。从 SUSE Linux Enterprise High Availability Extension 12 开始,Corosync 可以直接处理双节点群集的仲裁,而无需更改 Pacemaker 配置。

仲裁计算方式受以下因素的影响:

- 群集节点数

为使服务保持运行状态,包含两个以上节点的群集依赖法定票数(多数票决)来解决群集分区。根据以下公式,您可以计算群集正常运行所需的最小工作节点数目:

N ≥ C/2 + 1 N = minimum number of operational nodes C = number of cluster nodes

例如,五节点群集至少需要三个工作节点(或两个可以故障转移的节点)。

我们强烈建议使用双节点群集或奇数数目的群集节点。双节点群集适合跨两个站点的延伸设置。所含节点数为奇数的群集可以构建于单个站点上,也可以分散在三个站点之间。

- Corosync 配置

Corosync 是一个讯息交换和成员资格层,具体请参见第 6.2.4 节 “双节点群集的 Corosync 配置”和第 6.2.5 节 “N 节点群集的 Corosync 配置”。

6.2.1 全局群集选项 #

全局群集选项控制群集在遇到特定情况时的行为方式。它们被分成若干组,可通过 Hawk2 和 crm 外壳之类的群集管理工具来查看和修改。

通常可保留预定义值。但为了使群集的关键功能正常工作,需要在进行基本群集设置后调整以下参数:

6.2.2 全局选项 no-quorum-policy #

此全局选项定义在群集分区不具有法定票数(分区不具有多数节点投票)时应执行的操作。

允许的值有:

ignore将

no-quorum-policy设置为ignore可使群集的行为如同它具有仲裁一样。它仍会进行资源管理。在 SLES 11 中,建议对双节点群集使用此设置。此选项从 SLES 12 开始已过时。Corosync 依据配置和条件为群集节点或单个节点提供“仲裁” — 或者不提供仲裁。

对于双节点群集,唯一有意义的行为就是始终像失去仲裁一样来做出反应。第一个步骤始终应该是尝试屏蔽丢失的节点。

freeze如果失去法定票数,群集分区将会冻结。继续进行资源管理:正在运行的资源不会停止(但可能重启动以响应监视事件),但不会启动受影响分区中的任何其他资源。

如果群集中的某些资源依赖于与其他节点的通讯(例如,OCFS2 装入),建议对此类群集使用此设置。在这种情况下,默认设置

no-quorum-policy=stop没有任何作用,因为它将导致以下情况:在对等节点不可到达时将无法停止这些资源。反之,尝试停止这些资源最终将超时并导致stop failure,进而触发升级恢复和屏蔽。stop(默认值)如果失去法定票数,受影响群集分区中的所有资源都将以一种有序的方式停止。

suicide如果失去法定票数,受影响群集分区中的所有节点都将被屏蔽。此选项只能与 SBD 结合使用,具体请参见第 11 章 “储存保护和 SBD”。

6.2.3 全局选项 stonith-enabled #

此全局选项定义是否要应用屏蔽,以允许 STONITH 设备关闭发生故障的节点以及无法停止其资源的节点。默认情况下,此全局选项设置为 true,因为对于常规的群集操作,有必要使用 STONITH 设备。根据默认值,如果未定义 STONITH 资源,则群集将拒绝启动任何资源。

如果出于任何原因而需要禁用屏蔽,请将 stonith-enabled 设置为 false,但请注意,这会影响产品的支持状态。此外,在 stonith-enabled="false" 的情况下,分布式锁管理器 (DLM) 等资源以及依赖于 DLM 的所有服务(例如 cLVM、GFS2 和 OCFS2)都将无法启动。

重要:不支持无 STONITH 的配置

不支持无 STONITH 资源的群集。

6.2.4 双节点群集的 Corosync 配置 #

使用引导脚本时,Corosync 配置包含一个 quorum 段落,其中包含以下选项:

例 6.1︰ 双节点群集的 Corosync 配置摘录 #

quorum {

# Enable and configure quorum subsystem (default: off)

# see also corosync.conf.5 and votequorum.5

provider: corosync_votequorum

expected_votes: 2

two_node: 1

}

与 SUSE Linux Enterprise 11 相比,SUSE Linux Enterprise 12 中的 votequorum 子系统基于 Corosync 版本 2.x。这表示不得使用 no-quorum-policy=ignore 选项。

当设置了 two_node: 1 时,默认会自动启用 wait_for_all 选项。如果未启用 wait_for_all,则群集应在两个节点上并行启动。否则,第一个节点将对缺失的第二个节点执行启动屏蔽。

6.3 群集资源 #

作为群集管理员,您需要在群集中为服务器上运行的每个资源或应用程序创建群集资源。群集资源可以包括网站、电子邮件服务器、数据库、文件系统、虚拟机和任何其他基于服务器的应用程序或在任意时间对用户都可用的服务。

6.3.1 资源管理 #

必须先设置群集中的资源,然后才能使用它。例如,要使用 Apache 服务器作为群集资源,请先设置 Apache 服务器并完成 Apache 配置,然后才能在群集中启动相应的资源。

如果资源有特定环境要求,请确保这些要求已得到满足并且在所有群集节点上均相同。这种配置不由 High Availability Extension 管理。您必须自行管理。

注意:不要处理由群集管理的服务

使用 High Availability Extension 管理资源时,不得以其他方式(在群集外,例如手动或在引导时或重引导时)启动或停止同一资源。High Availability Extension 软件负责所有服务的启动或停止操作。

如果当服务已在群集控制下运行后您需要执行测试或维护任务,请确保先将资源、节点或整个群集置于维护模式,然后再进行手动处理。有关细节,请参见第 16.2 节 “用于维护任务的不同选项”。

配置群集中的资源后,请使用群集管理工具手动启动、停止、清理、删除或迁移资源。有关如何使用首选群集管理工具执行此操作的细节:

crmsh:第 8 章 “配置和管理群集资源(命令行)”

6.3.2 支持的资源代理类 #

对于添加的每个群集资源,需要定义资源代理需遵守的标准。资源代理提取它们提供的服务并显示群集的确切状态,以使群集对其管理的资源不作确答。群集依赖于资源代理在收到启动、停止或监视命令时作出相应反应。

通常,资源代理的形式为外壳脚本。High Availability Extension 支持以下类别的资源代理:

- Open Cluster Framework (OCF) 资源代理

OCF RA 代理最适合用于高可用性,特别是当您需要多状态资源或特殊监视功能时。这些代理通常位于

/usr/lib/ocf/resource.d/provider/中。其功能与 LSB 脚本的功能相似。但是,始终使用环境变量进行配置,这样可轻松接受和处理参数。OCF 规范(由于它与资源代理相关)可在 https://github.com/ClusterLabs/OCF-spec/blob/master/ra/1.0/resource-agent-api.md 中找到。OCF 规范有严格的定义,其中包括操作必须返回退出码,请参见第 9.3 节 “OCF 返回码和故障恢复”。群集严格遵循这些规范。要求所有 OCF 资源代理至少包含操作

start、stop、status、monitor和meta-data。meta-data操作可检索有关如何配置代理的信息。例如,如果要了解提供程序heartbeat的IPaddr代理的更多信息,请使用以下命令:OCF_ROOT=/usr/lib/ocf /usr/lib/ocf/resource.d/heartbeat/IPaddr meta-data

输出是 XML 格式的信息,包括多个部分(代理的常规描述、可用参数和可用操作)。

或者,也可以使用 crmsh 来查看有关 OCF 资源代理的信息。有关细节,请参见第 8.1.3 节 “显示有关 OCF 资源代理的信息”。

- Linux Standards Base (LSB) 脚本

LSB 资源代理一般由操作系统/分发包提供,并可在

/etc/init.d中找到。要用于群集,它们必须遵守 LSB init 脚本规范。例如,它们必须实施了多个操作,至少包括start、stop、restart、reload、force-reload和status。有关详细信息,请参见 http://refspecs.linuxbase.org/LSB_4.1.0/LSB-Core-generic/LSB-Core-generic/iniscrptact.html。这些服务的配置没有标准化。如果要将 LSB 脚本用于 High Availability,请确保您了解如何配置相关脚本。通常,您可以在

/usr/share/doc/packages/PACKAGENAME中的相关包文档中找到配置此类脚本的信息。- Systemd

从 SUSE Linux Enterprise 12 起,systemd 取代了常用的 System V init 守护程序。Pacemaker 可以管理 systemd 服务(如果有)。systemd 不使用 init 脚本,而是使用单元文件。通常,服务(或单元文件)由操作系统提供。如果您要转换现有的 init 脚本,可访问 http://0pointer.de/blog/projects/systemd-for-admins-3.html 找到更多信息。

- 服务

当前同时存在许多“通用”类型的系统服务:

LSB(属于 System V init)、systemd和(在某些分发版中提供的)upstart。因此,Pacemaker 支持使用特殊别名,这样可智能识别要将哪个服务应用到给定的群集节点。当群集中混合使用 systemd、upstart 和 LSB 服务时,此功能尤其有用。Pacemaker 将尝试按以下顺序查找指定服务:LSB (SYS-V) init 脚本、Systemd 单元文件或 Upstart 作业。- Nagios

使用监视插件(以前称为 Nagios 插件)可以监视远程主机上的服务。Pacemaker 可以使用监视插件(如果有)来执行远程监视。有关详细信息,请参见第 6.6.1 节 “使用监视插件监视远程主机上的服务”。

- STONITH(屏蔽)资源代理

此类仅用于与屏蔽相关的资源。有关详细信息,参见第 10 章 “屏障和 STONITH”。

随 High Availability Extension 提供的代理已写入 OCF 规范。

6.3.3 资源类型 #

可创建以下类型的资源:

- 原始资源

基元资源是最基本的资源类型。

了解如何使用首选群集管理工具创建原始资源:

Hawk2:过程 7.5 “添加原始资源”

crmsh:第 8.4.2 节 “创建群集资源”

- 组

组包含一组需要放在一起、按顺序启动和按相反顺序停止的资源。有关更多信息,请参见第 6.3.5.1 节 “组”。

- 克隆资源

克隆是可以在多个主机上处于活动状态的资源。如果各个资源代理支持,则任何资源均可克隆。有关更多信息,请参见第 6.3.5.2 节 “克隆资源”。

- 多状态资源(以前称为主/从资源)

多状态资源是一种特殊类型的克隆资源,它们可具有多个模式。有关更多信息,请参见第 6.3.5.3 节 “多状态资源”。

6.3.4 资源模板 #

如果希望创建具有类似配置的多个资源,则定义资源模板是最简单的方式。定义后,就可以在基元资源或特定类型的约束中引用该模板,请参见第 6.5.3 节 “资源模板和约束”。

如果在原始资源中引用了模板,则该原始资源将继承在模板中定义的所有操作、实例属性(参数)、元属性和利用率属性。此外,还可以为原始资源定义特定的操作或属性。如果在模板和原始资源中都定义了以上内容,则原始资源中定义的值将优先于模板中定义的值。

了解如何使用首选群集配置工具定义资源模板:

Hawk2:过程 7.6 “添加资源模板”

crmsh:第 8.4.3 节 “创建资源模板”

6.3.5 高级资源类型 #

基元资源是最简单的一种资源,易于配置,不过对于群集配置,您可能还需要更多高级资源类型,如组、克隆资源或多状态资源。

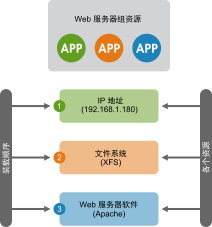

6.3.5.1 组 #

某些群集资源依赖于其他组件或资源,它们要求每个组件或资源都按特定顺序启动并在同一服务器上与它所依赖的资源一起运行。要简化此配置,可以使用群集资源组。

例 6.3︰ Web 服务器的资源组 #

资源组示例可以是需要 IP 地址和文件系统的 Web 服务器。在本例中,每个组件都是组成群集资源组的一个单独资源。资源组将在一台或多台服务器上运行。在发生软件或硬件故障时,资源组会将故障转移到群集中的另一台服务器,这一点与单个群集资源类似。

图 6.1︰ 组资源 #

组具有以下属性:

- 启动和停止

资源按其显示顺序启动并按相反顺序停止。

- 相关性

如果组中某个资源在某处无法运行,则该组中位于其之后的任何资源都不允许运行。

- 内容

组可能仅包含一些原始群集资源。组必须包含至少一个资源,否则配置无效。要引用组资源的子级,请使用子级 ID 而不是组 ID。

- 限制

尽管在约束中可以引用组的子代,但通常倾向于使用组的名称。

- 粘性

粘性在组中可以累加。每个活动的组成员可以将其粘性值累加到组的总分中。因此,如果

resource-stickiness的默认值是100,且组中有 7 个成员(其中 5 个成员处于活动状态),那么整个组首选其当前位置(分数为500)。- 资源监视

要为组启用资源监视,必须为组中每个要监视的资源分别配置监视。

了解如何使用首选群集管理工具创建组:

Hawk2:过程 7.9 “添加资源组”

crmsh:第 8.4.10 节 “配置群集资源组”

6.3.5.2 克隆资源 #

您可能希望某些资源在群集的多个节点上同时运行。为此,必须将资源配置为克隆资源。可以配置为克隆的资源示例包括群集文件系统(如 OCFS2)。可以克隆提供的任何资源。资源的资源代理支持此操作。克隆资源的配置甚至也有不同,具体取决于资源驻留的节点。

资源克隆有三种类型:

- 匿名克隆

这是最简单的克隆类型。这种克隆类型在所有位置上的运行方式都相同。因此,每台计算机上只能有一个匿名克隆实例是活动的。

- 全局唯一克隆

这些资源各不相同。一个节点上运行的克隆实例与另一个节点上运行的实例不同,同一个节点上运行的任何两个实例也不同。

- 状态克隆(多状态资源)

这些资源的活动实例分为两种状态:主动和被动。有时也称为主要和辅助,或主和从。状态克隆可以是匿名克隆也可以是全局唯一克隆。另请参见第 6.3.5.3 节 “多状态资源”。

克隆资源必须正好包含一组或一个常规资源。

配置资源监视或约束时,克隆资源与简单资源具有不同的要求。有关细节,请参见 http://www.clusterlabs.org/doc/ 上的《Pacemaker Explained》(Pacemaker 配置说明)。请参见“Clones - Resources That Get Active on Multiple Hosts”(克隆资源 - 在多个主机上处于活动状态的资源)一节。

了解如何使用首选群集管理工具创建克隆资源:

Hawk2:过程 7.10 “添加克隆资源”

crmsh:第 8.4.11 节 “配置克隆资源”。

6.3.5.3 多状态资源 #

多状态资源是克隆的特殊形式。它们允许实例处于两种操作模式中的一种(即 master 或 slave,不过您也可以按照自己的想法来命名这些模式)。多状态资源只能包含一个组或一个常规资源。

配置资源监视或约束时,多状态资源与简单资源具有不同的要求。有关细节,请参见 http://www.clusterlabs.org/doc/ 上的《Pacemaker Explained》(Pacemaker 配置说明)。请参见“Multi-state - Resources That Have Multiple Modes”(多状态 - 具有多个节点的资源)一节。

6.3.6 资源选项(元属性) #

您可以为添加的每个资源定义选项。群集使用这些选项来决定资源的行为方式,它们会告知 CRM 如何对待特定的资源。可以使用 crm_resource --meta 命令或者按过程 7.5 “添加原始资源”中所述使用 Hawk2 来设置资源选项。

表 6.1︰ 原始资源选项 #

|

选项 |

描述 |

默认值 |

|---|---|---|

|

|

如果不允许所有的资源都处于活动状态,群集会停止优先级较低的资源以便让优先级较高的资源处于活动状态。 |

|

|

|

群集应在哪种状态下尝试保留此资源?允许的值有: |

|

|

|

是否允许群集启动和停止资源?允许的值: |

|

|

|

是否可以手动处理资源?允许的值: |

|

|

|

资源留在所处位置的自愿程度如何? |

calculated |

|

|

节点上的此资源应发生多少故障后才能确定该节点没有资格主管此资源? |

|

|

|

如果群集发现资源在多个节点上处于活动状态,应执行什么操作?允许的值: |

|

|

|

在恢复为如同未发生故障一样正常工作(并允许资源返回它发生故障的节点)之前,需要等待几秒钟? |

|

|

|

允许对支持 |

|

|

|

此资源定义的远程节点的名称。这会将资源作为远程节点启用,同时定义唯一的名称用于标识该远程节点。如果未设置其他参数,则此值还会被假定为要在

警告:使用唯一 ID此值不得与任何现有资源 ID 或节点 ID 重复。 |

none(已禁用) |

|

|

guest 与 pacemaker_remote 建立连接时使用的自定义端口。 |

|

|

|

当远程节点的名称不是 guest 的主机名时要连接到的 IP 地址或主机名。 |

|

|

|

待发 guest 连接在超时之前的等待时间。 |

|

6.3.7 实例属性(参数) #

可为所有资源类的脚本指定参数,这些参数可确定脚本的行为方式和所控制的服务实例。如果资源代理支持参数,则可使用 crm_resource 命令或按过程 7.5 “添加原始资源”中所述使用 Hawk2 来添加这些参数。在 crm 命令行实用程序和 Hawk2 中,实例属性分别称为 params 和 Parameter。通过以 root 身份执行以下命令,可找到 OCF 脚本支持的实例属性列表:

root #crmra info [class:[provider:]]resource_agent

或(无可选部分):

root #crmra info resource_agent

输出列出了所有支持的属性及其用途和默认值。

例如,命令

root #crmra info IPaddr

返回以下输出:

Manages virtual IPv4 addresses (portable version) (ocf:heartbeat:IPaddr)

This script manages IP alias IP addresses

It can add an IP alias, or remove one.

Parameters (* denotes required, [] the default):

ip* (string): IPv4 address

The IPv4 address to be configured in dotted quad notation, for example

"192.168.1.1".

nic (string, [eth0]): Network interface

The base network interface on which the IP address will be brought

online.

If left empty, the script will try and determine this from the

routing table.

Do NOT specify an alias interface in the form eth0:1 or anything here;

rather, specify the base interface only.

cidr_netmask (string): Netmask

The netmask for the interface in CIDR format. (ie, 24), or in

dotted quad notation 255.255.255.0).

If unspecified, the script will also try to determine this from the

routing table.

broadcast (string): Broadcast address

Broadcast address associated with the IP. If left empty, the script will

determine this from the netmask.

iflabel (string): Interface label

You can specify an additional label for your IP address here.

lvs_support (boolean, [false]): Enable support for LVS DR

Enable support for LVS Direct Routing configurations. In case a IP

address is stopped, only move it to the loopback device to allow the

local node to continue to service requests, but no longer advertise it

on the network.

local_stop_script (string):

Script called when the IP is released

local_start_script (string):

Script called when the IP is added

ARP_INTERVAL_MS (integer, [500]): milliseconds between gratuitous ARPs

milliseconds between ARPs

ARP_REPEAT (integer, [10]): repeat count

How many gratuitous ARPs to send out when bringing up a new address

ARP_BACKGROUND (boolean, [yes]): run in background

run in background (no longer any reason to do this)

ARP_NETMASK (string, [ffffffffffff]): netmask for ARP

netmask for ARP - in nonstandard hexadecimal format.

Operations' defaults (advisory minimum):

start timeout=90

stop timeout=100

monitor_0 interval=5s timeout=20s注意:组、克隆或多状态资源的实例属性

请注意,组、克隆和多状态资源没有实例属性。但是,任何实例属性集都将由组、克隆或多状态资源的子级继承。

6.3.8 资源操作 #

默认情况下,群集将不会确保您的资源一直正常。要指示群集执行此操作,需要将监视操作添加到资源定义中。可为所有类或资源代理添加监视操作。有关更多信息,请参见第 6.4 节 “资源监视”。

表 6.2︰ 资源操作属性 #

|

操作 |

描述 |

|---|---|

|

|

您的操作名称。必须是唯一的。(不会显示 ID)。 |

|

|

要执行的操作。常见值: |

|

|

执行操作的频率。单位:秒 |

|

|

需要等待多久才能声明操作失败。 |

|

|

需要满足哪些条件才会发生此操作。允许的值: |

|

|

此操作失败时执行的操作。允许的值:

|

|

|

如果值为 |

|

|

仅当资源具有此角色时才运行操作。 |

|

|

可全局设置或为单独资源设置。使 CIB 反映资源上“正在进行中的”操作的状态。 |

|

|

操作描述。 |

6.3.9 超时值 #

资源的超时值会受以下参数的影响:

op_defaults(操作的全局超时),在资源模板中定义的特定超时值,

为资源定义的特定超时值。

注意:值的优先级

如果为资源定义了特定值,则该值优先于全局默认值。资源的特定值也优先于在资源模板中定义的值。

获取超时值权限非常重要。将它们设置得太小会导致大量(不必要的)屏蔽操作,原因如下:

如果资源运行超时,它将失败,群集将尝试停止它。

如果停止资源也失败(例如,由于停止超时值设置得太小),群集将屏蔽该节点。发生此状况时所在的节点将被视为已失去控制。

您可以使用 crmsh 和 Hawk2 调整操作的全局默认值并设置任何特定的超时值。确定和设置超时值的最佳实践如下所示:

过程 6.1︰ 确定超时值 #

检查资源启动和停止(在负载状况下)所需的时间。

如果需要,请添加

op_defaults参数并相应地设置(默认)超时值:例如,将

default-action-timeout设置为60秒:crm(live)configure#op_defaults timeout=60对于需要更长时间期限的资源,则定义单独的超时值。

为资源配置操作时,添加单独的

start和stop操作。使用 Hawk2 配置操作时,它会针对这些操作提供有用的超时建议。

6.4 资源监视 #

如果要确保资源正在运行,必须为其配置资源监视。

如果资源监视程序检测到故障,将发生以下情况:

根据

/etc/corosync/corosync.conf中logging部分指定的配置生成日志文件消息。故障会在群集管理工具(Hawk2、

crm status)中和 CIB 状态部分反映出来。群集将启动重要的恢复操作,可包括停止资源以修复故障状态以及在本地或在其他节点上重启动资源。资源也可能不会重启动,具体取决于配置和群集状态。

如果不配置资源监视,则不会告知成功启动的资源故障,且群集始终显示资源状况正常。

- 监视已停止的资源

通常,只要资源在运行,就仅受群集监视。但是,为了检测并发违例,还需为停止的资源配置监视。例如:

primitive dummy1 ocf:heartbeat:Dummy \ op monitor interval="300s" role="Stopped" timeout="10s" \ op monitor interval="30s" timeout="10s"当资源

dummy1处于role="Stopped"状态时,此配置就会每300秒触发一次对该资源的监视操作。在运行时,针对它的监视间隔为30秒。- 检测

CRM 会对每个节点上的各个资源执行初始监视,也称为

探测。清理资源之后也会执行探测。如果为资源定义了多项监视操作,则 CRM 将选择间隔时间最小的一项操作,并会使用其超时值作为探测的默认超时值。如果未配置任何监视操作,则将应用整个群集的默认值。默认值为20秒(如果未通过配置op_defaults参数来指定其他默认值)。如果您不想依赖自动计算或op_defaults值,请为此资源的探测定义具体的监视操作。为此,可以添加一个监视操作并将interval设置为0,例如:crm(live)configure#primitiversc1 ocf:pacemaker:Dummy \ op monitor interval="0" timeout="60"rsc1的探测将在60 秒后超时,而不管op_defaults中定义的全局超时或者配置的任何其他操作超时如何。如果未设置interval="0"以指定相应资源的探测,CRM 将自动检查是否为该资源定义了任何其他监视操作,并按如上所述计算探测的超时值。

了解如何使用首选群集管理工具添加对资源的监视操作:

Hawk2:过程 7.13 “添加和修改操作”

crmsh:第 8.4.9 节 “配置资源监视”

6.5 资源约束 #

配置好所有资源只是完成了该任务的一部分。即便群集熟悉所有必需资源,它可能还无法进行正确处理。资源约束允许您指定在哪些群集节点上运行资源、以何种顺序装载资源,以及特定资源依赖于哪些其他资源。

6.5.1 约束类型 #

提供三种不同的约束:

- 资源位置

位置约束定义资源可以、不可以或首选在哪些节点上运行。

- 资源共置

共置约束告知群集哪些资源可以或不可以在一个节点上一起运行。

- 资源顺序

顺序约束定义操作的顺序。

重要:约束与特定资源类型的限制

不要为资源组的成员创建共置约束,而是应该创建指向整个资源组的共置约束。其他所有类型的约束可安全地用于资源组的成员。

不要对包含克隆资源或者应用了多状态资源的资源使用任何约束。约束必须应用于克隆资源或多状态资源,不能应用于子资源。

6.5.1.1 资源集 #

6.5.1.1.1 使用资源集定义约束 #

可以使用资源集作为定义位置、共置或顺序约束的备用格式,在资源集中,基元资源已被全部分组到一个集合中。以前,为了实现此目的,用户可以定义一个资源组(不一定总能准确表达设计意图),也可以将每种关系定义为单个约束。随着资源和组合数目的增加,后面这种做法会导致约束过度膨胀。通过资源集进行配置并不一定会减少复杂程度,但更易于理解和维护,如以下示例中所示。

例 6.4︰ 用于位置约束的资源集 #

例如,可以在 crmsh 中使用资源集 (loc-alice) 的以下配置,将两个虚拟 IP(vip1 和 vip2)置于同一个节点 alice:

crm(live)configure#primitivevip1 ocf:heartbeat:IPaddr2 params ip=192.168.1.5crm(live)configure#primitivevip1 ocf:heartbeat:IPaddr2 params ip=192.168.1.6crm(live)configure#locationloc-alice { vip1 vip2 } inf: alice

要使用资源集来替换共置约束的配置,请考虑以下两个示例:

例 6.5︰ 共置资源链 #

<constraints>

<rsc_colocation id="coloc-1" rsc="B" with-rsc="A" score="INFINITY"/>

<rsc_colocation id="coloc-2" rsc="C" with-rsc="B" score="INFINITY"/>

<rsc_colocation id="coloc-3" rsc="D" with-rsc="C" score="INFINITY"/>

</constraints>由资源集表示的相同配置:

<constraints>

<rsc_colocation id="coloc-1" score="INFINITY" >

<resource_set id="colocated-set-example" sequential="true">

<resource_ref id="A"/>

<resource_ref id="B"/>

<resource_ref id="C"/>

<resource_ref id="D"/>

</resource_set>

</rsc_colocation>

</constraints>如果想使用资源集来替换顺序约束的配置,请考虑以下两个示例:

例 6.6︰ 有序资源链 #

<constraints>

<rsc_order id="order-1" first="A" then="B" />

<rsc_order id="order-2" first="B" then="C" />

<rsc_order id="order-3" first="C" then="D" />

</constraints>可以使用包含有序资源的资源集来实现相同的目的:

例 6.7︰ 以资源集表示的有序资源链 #

<constraints>

<rsc_order id="order-1">

<resource_set id="ordered-set-example" sequential="true">

<resource_ref id="A"/>

<resource_ref id="B"/>

<resource_ref id="C"/>

<resource_ref id="D"/>

</resource_set>

</rsc_order>

</constraints>

资源集可以是有序的 (sequential=true),也可以是无序的 (sequential=false)。此外,可以使用 require-all 属性在 AND 与 OR 逻辑之间切换。

6.5.1.1.2 不带依赖项的共置约束的资源集 #

有时,将一组资源放置在同一个节点上(定义共置约束)会很有用,但前提是这些资源之间不存在硬依赖性。例如,您想要在同一个节点上放置两个资源,但不希望群集在其中一个资源发生故障时重启动另一个资源。可以在 crm 外壳中使用 weak bond 命令实现此目的。

了解如何使用首选群集管理工具设置这些“弱绑定”:

6.5.1.2 更多信息 #

了解如何使用首选群集管理工具添加各种约束:

Hawk2:第 7.6 节 “配置约束”

crmsh:第 8.4.5 节 “配置资源约束”

有关配置约束的更多信息以及顺序和共置基本概念的详细背景信息,请参见以下文档。可以从 http://www.clusterlabs.org/doc/ 访问这些文档:

《Pacemaker Explained》(Pacemaker 配置说明),“Resource Constraints”(资源约束)一章

《Colocation Explained》(共置说明)

《Ordering Explained》(顺序说明)

6.5.2 分数和无限值 #

定义约束时,还需要指定分数。各种分数是群集工作方式的重要组成部分。其实,从迁移资源到决定在已降级群集中停止哪些资源的整个过程是通过以某种方式操纵分数来实现的。分数按每个资源来计算,资源分数为负的任何节点都无法运行该资源。计算资源的分数后,群集会选择分数最高的节点。

INFINITY(无穷大)目前定义为 1,000,000。提高或降低分数需遵循以下三个基本规则:

任何值 + 无穷大 = 无穷大

任何值 - 无穷大 = -无穷大

无穷大 - 无穷大 = -无穷大

定义资源约束时,需为每个约束指定一个分数。分数表示您指派给此资源约束的值。分数较高的约束先应用,分数较低的约束后应用。通过使用不同的分数为既定资源创建更多位置约束,可以指定资源要故障转移至的目标节点的顺序。

6.5.3 资源模板和约束 #

如果定义了资源模板(请参见第 6.3.4 节 “资源模板”),则可在以下类型的约束中引用该模板:

顺序约束

共置约束

rsc_ticket 约束(用于 Geo 群集)。

但是,共置约束不得包含多个对模板的引用。资源集不得包含对模板的引用。

在约束中引用的资源模板代表派生自该模板的所有原始资源。这意味着,约束将应用于引用资源模板的所有原始资源。在约束中引用资源模板是资源集的备用方式,它可以显著简化群集配置。有关资源集的细节,请参见过程 7.17 “为约束使用资源集”。

6.5.4 故障转移节点 #

资源在出现故障时会自动重启动。如果在当前节点上无法实现此操作,或者此操作在当前节点上失败了 N 次,它将尝试故障转移到其他节点。每次资源失败时,其失败计数都会增加。您可以多次定义资源的故障次数(migration-threshold),在该值之后资源会迁移到新节点。如果群集中存在两个以上的节点,则特定资源故障转移的节点由 High Availability 软件选择。

但可以通过为资源配置一个或多个位置约束和一个 migration-threshold 来指定此资源将故障转移到的节点。

了解如何使用首选群集管理工具指定故障转移节点:

Hawk2:第 7.6.6 节 “指定资源故障转移节点”

crmsh:第 8.4.6 节 “指定资源故障转移节点”

例 6.8︰ 迁移阈值 - 流程 #

例如,假设您已经为 rsc1 资源配制了一个首选在 alice 节点上运行的位置约束。如果那里失败了,系统会检查 migration-threshold 并与故障计数进行比较。如果故障计数 >= migration-threshold,会将资源迁移到下一个自选节点。

一旦达到阈值,节点将不再能运行失败资源,直到重设置资源的 failcount 为止。这可以由群集管理员手动执行或通过设置资源的 failure-timeout 选项执行。

例如,设置 migration-threshold=2 和 failure-timeout=60s 会导致资源在发生两次故障后迁移到新节点。允许该资源在一分钟后移回(具体取决于粘性和约束分数)。

迁移阈值概念有两个异常,发生在资源启动失败或停止失败时:

启动失败将失败计数设置为

INFINITY,因此总是会导致立即迁移。停止故障会导致屏蔽(

stonith-enabled设置为true时,这是默认设置)。如果不定义 STONITH 资源(或

stonith-enabled设置为false),则该资源不会迁移。

有关配合首选群集管理工具使用迁移阈值和重置故障计数的详细信息,请参见:

Hawk2:第 7.6.6 节 “指定资源故障转移节点”

crmsh:第 8.4.6 节 “指定资源故障转移节点”

6.5.5 故障回复节点 #

当原始节点恢复联机并位于群集中时,资源可能会故障回复到该节点。为防止资源故障回复到之前运行它的节点,或者要指定让该资源故障回复到其他节点,请更改其资源粘性值。可以在创建资源时或之后指定资源粘性。

指定资源粘性值时请考虑以下含义:

- 值为

0: 这是默认选项。资源放置在系统中的最适合位置。这意味着当负载能力“较好”或较差的节点变得可用时才转移资源。此选项的作用几乎等同于自动故障回复,只是资源可能会转移到非之前活动的节点上。

- 值大于

0: 资源更愿意留在当前位置,但是如果有更合适的节点可用时会移动。值越高表示资源越愿意留在当前位置。

- 值小于

0: 资源更愿意移离当前位置。绝对值越高表示资源越愿意离开当前位置。

- 值为

INFINITY: 如果不是因节点不适合运行资源(节点关机、节点待机、达到

migration-threshold或配置更改)而强制资源转移,资源总是留在当前位置。此选项的作用几乎等同于完全禁用自动故障回复。- 值为

-INFINITY: 资源总是移离当前位置。

6.5.6 根据资源负载影响放置资源 #

并非所有资源都相等。某些资源(如 Xen guest)需要托管它们的节点满足其容量要求。如果所放置资源的总需求超过了提供的容量,则资源性能将降低(或甚至失败)。

要考虑此情况,可使用 High Availability Extension 指定以下参数:

特定节点提供的容量。

特定资源需要的容量。

资源放置整体策略。

了解如何使用首选群集管理工具配置这些设置:

Hawk2:第 7.6.8 节 “根据负载影响配置资源放置”

crmsh:第 8.4.8 节 “根据负载影响配置资源放置”

如果节点有充足的可用容量来满足资源要求,则此节点将被视为此资源的有效节点。容量的性质对 High Availability Extension 而言完全无关紧要;它只是确保在将资源移到节点上之前满足资源的所有容量要求。

要手动配置资源要求和节点提供的容量,请使用利用率属性。可根据个人喜好命名利用率属性,并根据配置需要定义多个名称/值对。但是,属性值必须是整数。

如果将具有利用率属性的多个资源组合或设置共置约束,则 High Availability Extension 会考虑此情况。如有可能,资源将被放置到可以满足所有容量要求的节点上。

注意:组的利用率属性

无法直接为资源组设置利用率属性。但是,为了简化组的配置,可以使用组中所有资源所需的总容量添加利用率属性。

High Availability Extension 还提供了方法来自动检测和配置节点容量和资源要求:

NodeUtilization 资源代理检查节点的容量(与 CPU 和 RAM 有关)。要配置自动检测,请创建类、提供程序和类型如下的克隆资源:ocf:pacemaker:NodeUtilization。每个节点上应都有一个克隆实例在运行。实例启动后,利用率部分将添加到节点的 CIB 配置中。

为了自动检测资源的最低要求(与 RAM 和 CPU 有关),Xen 资源代理已得到改善。启动 Xen 资源后,它将反映 RAM 和 CPU 的使用情况。利用率属性将自动添加到资源配置中。

注意:适用于 Xen 和 libvirt 的不同资源代理

ocf:heartbeat:Xen 资源代理不应与 libvirt 搭配使用,因为 libvirt 需要能够修改计算机说明文件。

对于 libvirt,请使用 ocf:heartbeat:VirtualDomain 资源代理。

除了检测最低要求外,High Availability Extension 还允许通过 VirtualDomain 资源代理监视当前的利用率。它检测虚拟机的 CPU 和 RAM 使用情况。要使用此功能,请配置类、提供程序和类型如下的资源:ocf:heartbeat:VirtualDomain。可以使用以下实例属性: autoset_utilization_cpu 和

autoset_utilization_hv_memory。两者都默认为 true。这将在每个监视周期中更新 CIB 中的利用率值。

与手动或自动配置容量和要求无关,放置策略必须使用 placement-strategy 属性(在全局群集选项中)指定。可用值如下:

default(默认值)不考虑利用率值。根据位置得分分配资源。如果分数相等,资源将均匀分布在节点中。

utilization在确定节点是否有足够的可用容量来满足资源要求时考虑利用率值。但仍会根据分配给节点的资源数执行负载平衡。

minimal在确定节点是否有足够的可用容量来满足资源要求时考虑利用率值。尝试将资源集中到尽可能少的节点上(以节省其余节点上的能耗)。

balanced在确定节点是否有足够的可用容量来满足资源要求时考虑利用率值。尝试均匀分布资源,从而优化资源性能。

注意:配置资源优先级

可用的放置策略是最佳方法 - 它们不使用复杂的启发式解析程序即可始终实现最佳分配结果。确保正确设置资源优先级,以便首选调度最重要的资源。

例 6.9︰ 负载平衡放置配置示例 #

以下示例演示了配有四台虚拟机、节点数相等的三节点群集。

node alice utilization memory="4000"

node bob utilization memory="4000"

node charlie utilization memory="4000"

primitive xenA ocf:heartbeat:Xen utilization hv_memory="3500" \

params xmfile="/etc/xen/shared-vm/vm1"

meta priority="10"

primitive xenB ocf:heartbeat:Xen utilization hv_memory="2000" \

params xmfile="/etc/xen/shared-vm/vm2"

meta priority="1"

primitive xenC ocf:heartbeat:Xen utilization hv_memory="2000" \

params xmfile="/etc/xen/shared-vm/vm3"

meta priority="1"

primitive xenD ocf:heartbeat:Xen utilization hv_memory="1000" \

params xmfile="/etc/xen/shared-vm/vm4"

meta priority="5"

property placement-strategy="minimal"

如果三个节点都处于正常状态,那么资源 xenA 将首先放置到一个节点上,然后是 xenD。xenB 和 xenC 将分配在一起或者其中一个与 xenD 分配在一起。

如果一个节点出现故障,可用的总内存将不足以托管所有资源。将确保分配 xenA,xenD 同样如此。但是,只能再放置剩余资源 xenB 和 xenC 中的一个。由于它们的优先级相同,结果未定。要解决这种不确定性,需要为其中一个资源设置更高的优先级。

6.5.7 使用标记分组资源 #

标记是 Pacemaker 中最近新增的功能。使用标记可以一次性引用多个资源,而无需在这些资源之间创建任何共置或顺序关系。此功能十分适用于对概念上相关的资源进行分组。例如,如果有多个资源与某个数据库相关,您可以创建一个名为 databases 的标记,并将与该数据库相关的所有资源都添加到此标记。这样,只需使用一条命令就能停止或启动所有这些资源。

标记也可以用于约束。例如,loc-db-prefer 位置约束将应用到标记了 databases 的一组资源:

location loc-db-prefer databases 100: alice

了解如何使用首选群集管理工具创建标记:

Hawk2:过程 7.12 “添加标记”

crmsh:第 8.5.6 节 “分组/标记资源”

6.6 管理远程主机上的服务 #

在最近几年中,是否能够监视和管理远程主机上的服务已变得越来越重要。SUSE Linux Enterprise High Availability Extension 11 SP3 可让用户通过监视插件来密切监视远程主机上的服务。最近添加的 pacemaker_remote 服务现在允许 SUSE Linux Enterprise High Availability Extension

12 SP5 全面管理和监视远程主机上的资源,就如同这些资源是真实的群集节点一样,并且无需用户在远程计算机上安装群集堆栈。

6.6.1 使用监视插件监视远程主机上的服务 #

虚拟机的监视可以通过 VM 代理来完成(只有在超级管理程序中出现 guest 时才可选择 VM 代理),或者通过从 VirtualDomain 或 Xen 代理调用外部脚本来完成。直到现在为止,仍只有通过在虚拟机中对高可用性堆栈进行完全设置才能实现更细化的监视。

通过提供对监视插件(以前称为 Nagios 插件)的支持,High Availability Extension 现在还可让您监视远程主机上的服务。您可以收集 guest 上的外部状态,而无需修改 guest 映像。例如,VM guest 可能会运行需要能够访问的 Web 服务或简单的网络资源。现在,有了 Nagios 资源代理,您就可以监视 guest 上的 Web 服务或网络资源。如果这些服务再也无法访问,High Availability Extension 将触发相应 guest 的重启或迁移操作。

如果您的 guest 依赖于某项服务(例如,guest 要使用 NFS 服务器),则这项服务可以是由群集管理的普通资源,也可以是使用 Nagios 资源进行监视的外部服务。

要配置 Nagios 资源,必须在主机上安装以下包:

monitoring-pluginsmonitoring-plugins-metadata

必要时,YaST 或 Zypper 将解决对后续包的任何依赖性问题。

将监视插件配置为属于资源容器(通常是 VM)的资源便是其中一个典型用例。如果容器中有任何资源发生故障,则将重启该容器。有关配置示例,请参见例 6.10 “为监视插件配置资源”。或者,如果想使用 Nagios 资源代理通过网络监视主机或服务,还可将这些代理配置为普通资源。

例 6.10︰ 为监视插件配置资源 #

primitive vm1 ocf:heartbeat:VirtualDomain \

params hypervisor="qemu:///system" config="/etc/libvirt/qemu/vm1.xml" \

op start interval="0" timeout="90" \

op stop interval="0" timeout="90" \

op monitor interval="10" timeout="30"

primitive vm1-sshd nagios:check_tcp \

params hostname="vm1" port="22" \ 1

op start interval="0" timeout="120" \ 2

op monitor interval="10"

group g-vm1-and-services vm1 vm1-sshd \

meta container="vm1" 3

支持的参数与监视插件的长选项相同。监视插件通过参数 | |

因为启动 guest 操作系统并让其服务运行需要一段时间,所以必须设置足够长的监视资源启动超时。 | |

|

以上示例仅包含适用于 check_tcp 插件的一个 资源,但也可以针对不同的插件类型配置多个 资源(例如 check_http 或 check_udp)。

如果服务的主机名相同,还可以为组指定 hostname 参数,而无需为各个基元资源一一添加该参数。例如:

group g-vm1-and-services vm1 vm1-sshd vm1-httpd \

meta container="vm1" \

params hostname="vm1"

如果监视插件监视的任何服务在 VM 中发生故障,则群集会检测到该情况并重启容器资源 (VM)。可以通过指定服务监视操作的 on-fail 属性来配置在这种情况下要执行的操作。默认值为 restart-container。

在考虑 VM 的 migration-threshold 时,会将服务的故障计数考虑在内。

6.6.2 使用 pacemaker_remote 管理远程节点上的服务 #

使用 pacemaker_remote 服务可将高可用性群集扩展到虚拟节点或远程裸机计算机。这些虚拟节点或远程裸机无需运行群集堆栈就能成为群集的成员。

High Availability Extension 现在可以起动虚拟环境(KVM 和 LXC)以及驻留在这些虚拟环境中的资源,而无需虚拟环境运行 Pacemaker 或 Corosync。

对于同时要管理用作群集资源的虚拟机以及 VM 中驻留的资源的用例,您现在可以使用以下设置:

“常规”(裸机)群集节点运行 High Availability Extension。

虚拟机运行

pacemaker_remote服务(几乎不需要在 VM 端进行任何配置)。“常规”群集节点上的群集堆栈会起动 VM 并连接到 VM 上运行的

pacemaker_remote服务,以将 VM 作为远程节点集成到群集中。

由于远程节点上未安装群集堆栈,因此这意味着:

远程节点不参与仲裁。

远程节点无法成为 DC。

远程节点不受可伸缩性限制(Corosync 将成员数限制为 32 个节点)的约束。

您可以在 http://www.clusterlabs.org/doc/ 上的《Pacemaker Remote—Extending High Availability into Virtual Nodes》(Pacemaker 远程 - 将高可用性扩展到虚拟节点)中找到有关 remote_pacemaker 服务的更多信息,包括多个用例和详细的设置说明。

6.7 监视系统运行状况 #

为避免节点耗尽磁盘空间而使得系统无法管理已分配给该节点的任何资源,High Availability Extension 提供了一个资源代理 ocf:pacemaker:SysInfo。使用此代理可监视节点在磁盘分区的状况。SysInfo RA 会创建一个名为 #health_disk 的节点属性,如果任何受监视磁盘的可用空间低于指定限制,就会将其设置为 red。

要定义 CRM 在节点状况到达临界状态时应如何反应,请使用全局群集选项 node-health-strategy。

过程 6.2︰ 配置系统运行状况监视 #

要在某个节点耗尽磁盘空间时从该节点自动移除资源,请执行以下操作:

配置

ocf:pacemaker:SysInfo资源:primitive sysinfo ocf:pacemaker:SysInfo \ params disks="/tmp /var"1 min_disk_free="100M"2 disk_unit="M"3 \ op monitor interval="15s"要完成资源配置,请创建

ocf:pacemaker:SysInfo的克隆并在每个群集节点上启动此克隆。将

node-health-strategy设置为migrate-on-red:property node-health-strategy="migrate-on-red"

如果

#health_disk属性设置为red,则策略引擎会将-INF添加到该节点的资源分数中。此时将从此节点移除所有资源。STONITH 资源将是最后一个被停止的资源,但即使 STONITH 资源不再运行,仍可屏蔽该节点。屏蔽对 CIB 有直接访问权且将继续起作用。

当节点状况变成 red 状态后,解决会导致问题的状况。然后清除 red 状态,使节点能够再次运行资源。登录到群集节点并使用下列其中一种方法:

执行以下命令:

root #crmnode status-attr NODE delete #health_disk在该节点上重启动 Pacemaker。

重引导该节点。

该节点将恢复服务并可再次运行资源。

6.8 更多信息 #

- http://crmsh.github.io/

用于高可用性群集管理的高级命令行界面 crm 外壳 (crmsh) 的主页。

- http://crmsh.github.io/documentation

提供有关 crm 外壳的多份文档,包括使用 crmsh 完成基本群集设置的入门教程,以及 crm 外壳的综合性手册。后者可在 http://crmsh.github.io/man-2.0/ 上访问。http://crmsh.github.io/start-guide/ 上提供了相关教程。

- http://clusterlabs.org/

Pacemaker 主页,随 High Availability Extension 提供的群集资源管理器。

- http://www.clusterlabs.org/doc/

提供数个综合性手册,以及一些解释一般概念的简短文档。例如:

《Pacemaker Explained》(Pacemaker 说明):包含全面、详尽的参考信息。

《Configuring Fencing with crmsh》(使用 crmsh 配置屏蔽):如何配置和使用 STONITH 设备。

《Colocation Explained》(共置说明)

《Ordering Explained》(顺序说明)

- https://clusterlabs.org

高可用性 Linux 项目的主页。

7.1 Hawk2 要求 #

仅当系统满足以下要求后,用户才能登录 Hawk2:

Hawk2包必须安装在要使用 Hawk2 连接的所有群集节点上。在要使用 Hawk2 访问群集节点的计算机上,需要安装启用了 JavaScript 和 Cookie 的(图形)Web 浏览器才能建立连接。

要使用 Hawk2,必须在要通过 Web 界面连接到的节点上启动相应的 Web 服务。请参见过程 7.1 “启动 Hawk2 服务”。

如果您是使用

ha-cluster-bootstrap包中的脚本设置群集的,则此时 Hawk2 服务已启用。Hawk2 用户必须是

haclient组的成员。安装程序将创建名为hacluster的 Linux 用户,该用户将添加到haclient组中。使用ha-cluster-init脚本进行设置时,将为hacluster用户设置默认口令。在启动 Hawk2 之前,请设置或更改

hacluster用户的口令。或者,创建属于haclient组的新用户。请在要使用 Hawk2 连接的所有节点上执行此操作。

过程 7.1︰ 启动 Hawk2 服务 #

在要连接到的节点上,打开外壳并以

root用户身份登录。通过输入以下命令,检查服务的状态

root #systemctlstatus hawk如果服务未在运行,请使用以下命令启动服务

root #systemctlstart hawk如果希望 Hawk2 在引导时自动启动,请执行以下命令:

root #systemctlenable hawk

7.2 登录 #

Hawk2 Web 界面使用 HTTPS 协议和端口 7630。

您无需使用 Hawk2 登录个别群集节点,而是可以将一个浮动的虚拟 IP 地址(IPaddr 或 IPaddr2)配置为群集资源。该地址无需任何特殊配置。如此,无论 Hawk 服务在哪个物理节点上运行,客户端都可以连接到该服务。

在使用 ha-cluster-bootstrap 脚本设置群集时,系统会询问您是否配置虚拟 IP 以用于群集管理。

过程 7.2︰ 登录 Hawk2 Web 界面 #

在任一台计算机上,启动 Web 浏览器并输入以下 URL:

https://HAWKSERVER:7630/

使用运行 Hawk Web 服务的任何群集节点的 IP 地址或主机名替换 HAWKSERVER。如果已配置虚拟 IP 地址以使用 Hawk2 进行群集管理,请使用该虚拟 IP 地址替换 HAWKSERVER。

注意:证书警告

当您首次尝试访问 URL 时如果显示证书警告,则表示使用了自我签名证书。默认情况下,自我签名证书不被视为可信证书。

要校验证书,请联系群集操作员获取证书细节。

要继续,可在浏览器中添加例外,以绕过警告。

有关如何将自我签名证书替换为官方证书颁发机构签名的证书的信息,请参见替换自签名证书。

在 Hawk2 登录屏幕上,输入 用户(或属于 组的任何其他用户)的

用户名和口令。单击。

7.3 Hawk2 概述:主要元素 #

登录 Hawk2 后,左侧会显示一个导航栏,右侧会显示一个顶层行,其中包含若干链接。

注意:Hawk2 中的可用功能

默认情况下,以 root 或 hacluster 身份登录的用户对所有群集配置任务具有完全读写访问权。不过,使用访问控制列表 (ACL) 可以定义细化的访问权限。

如果在 CRM 中启用了 ACL,Hawk2 中的可用功能取决于用户角色和指派给这些角色的访问权限。Hawk2 中的只能由用户 hacluster 来执行。

7.3.2 顶层行 #

Hawk2 的顶层行显示以下条目:

:单击可切换到批模式。可用于模拟和分阶段进行更改并通过单次事务应用这些更改。有关细节,请参见第 7.9 节 “使用批模式”。

:可用于设置 Hawk2 的首选项(例如,Web 界面的语言,或者是否在 STONITH 处于禁用状态时显示警告)。

:访问 SUSE Linux Enterprise High Availability Extension 文档、阅读发行说明或报告 Bug。

:单击可注销。

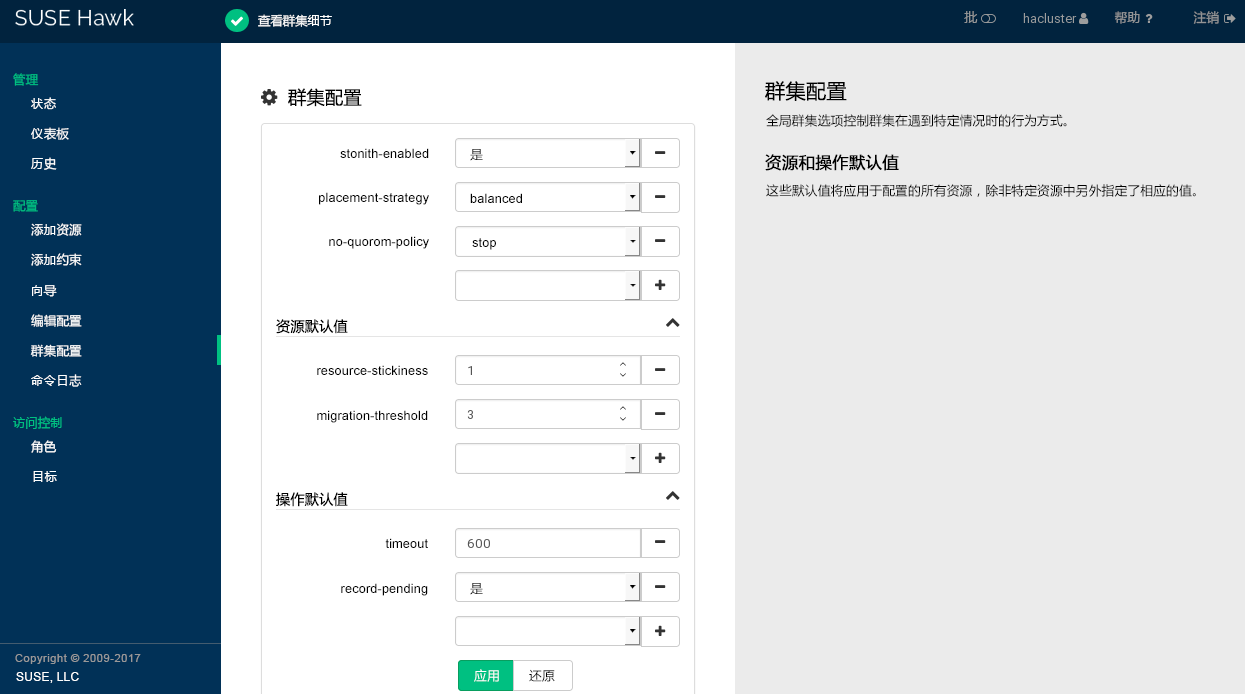

7.4 配置全局群集选项 #

全局群集选项控制群集在遇到特定情况时的行为方式。它们被分成若干组,可通过 Hawk2 和 crmsh 之类的群集管理工具来查看和修改。通常可保留预定义值。但为了确保群集的关键功能正常工作,需要在进行基本群集设置后调整以下参数:

过程 7.3︰ 修改全局群集选项 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择。

屏幕即会打开。屏幕中显示全局群集选项及其当前值。

要在屏幕右侧显示某个参数的简要描述,请将鼠标悬停在该参数上方。

图 7.1︰ Hawk2 - 群集配置 #

检查 和 的值并根据需要进行调整。

将 设置为合适的值。有关详细信息,请参见第 6.2.2 节 “全局选项

no-quorum-policy”。如果出于某些原因需要禁用屏蔽,请将 设置为

no。默认情况下,该参数设置为true,因为执行常规的群集操作必须要使用 STONITH 设备。根据默认值,如果未配置 STONITH 资源,群集将拒绝启动任何资源。重要:不支持无 STONITH 的配置

您必须为群集配置节点屏蔽机制。

全局群集选项

stonith-enabled和startup-fencing必须设置为true。如果您更改这些选项,将会失去支持。

要从群集配置中去除某个参数,请单击该参数旁边的图标。如果删除了某个参数,则群集的表现方式就像该参数采用默认值一样。

要向群集配置添加新参数,请从下拉框中选择一个参数。

如果您需要更改或,请执行以下步骤:

要调整某个值,请从下拉框中选择一个不同的值,或直接编辑该值。

要添加新的资源默认值或操作默认值,请从空下拉框中选择一项,然后输入值。如果有默认值,Hawk2 会自动建议这些值。

要去除某个参数,请单击该参数旁边的图标。如果没有为和指定值,群集会使用第 6.3.6 节 “资源选项(元属性)”和第 6.3.8 节 “资源操作”中所述的默认值。

确认更改。

7.5 配置群集资源 #

群集管理员需要为群集中服务器上运行的每个资源或应用程序创建群集资源。群集资源可包括网站、邮件服务器、数据库、文件系统、虚拟机和任何其他基于服务器的应用程序或对用户随时都可用的服务。

有关可创建的资源类型的概述,请参见第 6.3.3 节 “资源类型”。当您指定资源基本信息(ID、类、提供程序和类型)后,Hawk2 会显示以下类别:

- 参数(实例属性)

确定资源控制的服务实例。有关更多信息,请参见第 6.3.7 节 “实例属性(参数)”。

创建资源时,Hawk2 会自动显示所有必要的参数。对这些参数进行编辑,以便拥有有效的资源配置。

- 操作

为监视资源所需。有关更多信息,请参见第 6.3.8 节 “资源操作”。

创建资源时,Hawk2 会显示最重要的资源操作(

monitor、start和stop)。- 元属性

告知 CRM 如何处理特定资源。有关更多信息,请参见第 6.3.6 节 “资源选项(元属性)”。

创建资源时,Hawk2 会自动列出该资源的重要元属性,例如,定义资源初始状态的

target-role属性。默认情况下,该属性设置为Stopped,因此资源不会立即启动。- 利用率

告知 CRM 某个资源需从节点获取的容量。有关更多信息,请参见第 7.6.8 节 “根据负载影响配置资源放置”。

您可以在创建资源期间或之后调整这些类别中的项和值。

7.5.1 显示当前群集配置 (CIB) #

群集管理员有时需要知道群集配置。Hawk2 可以 crm 外壳语法、XML 和图表形式显示当前配置。要查看 crm 外壳语法形式的群集配置,请在左侧导航栏中选择并单击。要改为以原始 XML 显示配置,请单击 。单击会以图表显示 CIB 中配置的节点和资源。它还会显示各资源之间的关系。

7.5.2 使用向导添加资源 #

Hawk2 向导是设置简单资源(如虚拟 IP 地址或 SBD STONITH 资源)的便捷方式。对于包含多个资源的复杂配置(例如 DRBD 块设备或 Apache Web 服务器的资源配置)而言,这种方法也十分有用。向导会引导您完成所有配置步骤,并提供您需要输入的参数的相关信息。

过程 7.4︰ 使用资源向导 #

登录 Hawk2:

https://HAWKSERVER:7630/

在左侧导航栏中,选择。

单击各个类别旁边的向下箭头图标将其展开,然后选择所需的向导。

按照屏幕指导执行操作。完成最后的配置步骤后,您所输入的值。

Hawk2 会显示它将执行的操作以及配置的最终成果。根据配置,您可能会收到提示要求输入

root口令才能配置。

图 7.2︰ Hawk2 - 用于 Apache Web 服务器的向导 #

7.5.3 添加简单资源 #

要创建最基本类型的资源,请执行以下操作:

过程 7.5︰ 添加原始资源 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

如果存在您要在其基础上设置资源配置的资源模板,请选择相应的。有关配置模板的细节,请参见过程 7.6 “添加资源模板”。

选择要使用的资源代理:

lsb、ocf、service、stonith或systemd。有关详细信息,请参见第 6.3.2 节 “支持的资源代理类”。如果选择了

ocf作为类,则指定 OCF 资源代理的。OCF 规范允许多个供应商供应相同的资源代理。从列表中,选择要使用的资源代理(例如 或 )。将显示该资源代理的简短描述。

如此,资源基本信息即指定完成。

注意

列表中提供的选项取决于您选择的(对于 OCF 资源还取决于中选择的内容)。

图 7.3︰ Hawk2 - 原始资源 #

要保留 Hawk2 建议的、和,请单击完成配置。如果操作成功,屏幕顶部会显示一条讯息。

要调整参数、操作或元属性,请参见第 7.5.5 节 “修改资源”。要配置资源的属性,请参见过程 7.21 “配置资源所需的容量”。

7.5.4 添加资源模板 #

要创建大量具有类似配置的资源,定义资源模板是最简单的方式。定义后,便可在基元或特定类型的约束中引用它。有关功能及使用资源模板的详细信息,请参见第 6.5.3 节 “资源模板和约束”。

过程 7.6︰ 添加资源模板 #

配置资源模板就如同配置原始资源一样。

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

按照过程 7.5 “添加原始资源”中的指导从步骤 5 开始。

7.5.5 修改资源 #

如果您之前创建了一个资源,可以随时根据需要调整参数、操作或元属性来编辑其配置。

7.5.6 添加 STONITH 资源 #

重要:不支持无 STONITH 的配置

您必须为群集配置节点屏蔽机制。

全局群集选项

stonith-enabled和startup-fencing必须设置为true。如果您更改这些选项,将会失去支持。

默认情况下,全局群集选项 stonith-enabled 设置为 true。如果未定义任何 STONITH 资源,群集将拒绝启动任何资源。配置一个或多个 STONITH 资源以完成 STONITH 设置。要为 SBD、libvirt (KVM/Xen) 或 vCenter/ESX 服务器添加 STONITH 资源,最简单的方式就是使用 Hawk2 向导(请参见第 7.5.2 节 “使用向导添加资源”)。虽然 STONITH 资源的配置过程与其他资源类似,但它们的行为在某些方面有所不同。有关细节,请参见第 10.3 节 “STONITH 资源和配置”。

过程 7.8︰ 添加 STONITH 资源 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

从列表,选择资源代理类 。

从列表中,选择用于控制 STONITH 设备的 STONITH 插件。该插件的简短描述即会显示。

Hawk2 会自动显示该资源必需的。为每个参数输入值。

Hawk2 会显示最重要的资源并建议默认值。如果在此处不修改任何设置,Hawk2 会在您确认后立即添加建议的操作及其默认值。

如无更改必要,请保留默认的设置。

图 7.5︰ Hawk2 - STONITH 资源 #

确认更改以创建 STONITH 资源。

如果操作成功,屏幕顶部会显示一条讯息。

要完成屏蔽配置,请添加约束。有关详细信息,请参见第 10 章 “屏障和 STONITH”。

7.5.7 添加群集资源组 #

某些群集资源依赖于其他组件或资源,这些资源要求每个组件或资源按特定顺序启动,并在同一服务器上运行。为简化此配置,SUSE Linux Enterprise High Availability Extension 支持使用组。

资源组包含一组需要放在一起并按顺序启动和按相反顺序停止的资源。有关资源组的示例以及组及其属性的更多信息,请参见第 6.3.5.1 节 “组”。

过程 7.9︰ 添加资源组 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

要定义组成员,请选择列表中的一项或多项。通过使用右侧的“手柄”图标将组成员拖放为需要的顺序对其进行重新排序。

根据需要修改或添加。

单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.6︰ Hawk2 - 资源组 #

7.5.8 添加克隆资源 #

如果希望特定资源同时在群集中的多个节点上运行,请将这些资源配置为克隆。一个可配置为克隆的资源的例子就是要作为克隆使用的 OCFS2 之类群集文件系统的 ocf:pacemaker:controld任何普通的资源或资源组均可克隆。克隆资源的实例的行为方式可能一样。但其配置也可能有所不同,具体取决于克隆资源所在的节点。

有关可用类型的资源克隆的概述,请参见第 6.3.5.2 节 “克隆资源”。

注意:克隆资源的子资源

克隆资源可以包含原始资源或组作为子资源。在 Hawk2 中,创建克隆资源时不能创建或修改子资源。添加克隆资源之前,先创建子资源并根据需要配置它们。有关细节,请参见第 7.5.3 节 “添加简单资源”或第 7.5.7 节 “添加群集资源组”。

过程 7.10︰ 添加克隆资源 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

从列表中,选择原始资源或组作为克隆资源的子资源。

根据需要修改或添加。

单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.7︰ Hawk2 - 克隆资源 #

7.5.9 添加多状态资源 #

多状态资源是克隆的特殊形式。它们允许实例处于两种运行模式中的其中一种模式(称为主动/被动、主要/次要、主/从)。多状态资源只能包含一个组或一个常规资源。

配置资源监视或约束时,多状态资源与简单资源具有不同的要求。有关细节,请参见 http://www.clusterlabs.org/doc/ 上的《Pacemaker Explained》(Pacemaker 配置说明)。请参见“Multi-state - Resources That Have Multiple Modes”(多状态 - 具有多个节点的资源)一节。

注意:多状态资源的子资源

多状态资源可以包含原始资源或组作为子资源。在 Hawk2 中,在创建多状态资源时不能创建或修改子资源。添加多状态资源之前,先创建子资源并根据需要配置它们。有关细节,请参见第 7.5.3 节 “添加简单资源”或第 7.5.7 节 “添加群集资源组”。

过程 7.11︰ 添加多状态资源 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

从列表中,选择原始资源或组作为多状态资源的子资源。

根据需要修改或添加。

单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.8︰ Hawk2 - 多状态资源 #

7.5.10 使用标记分组资源 #

使用标记可以一次性引用多个资源,而无需在这些资源之间创建任何共置或顺序关系。您可以使用标记对概念上相关的资源分组。例如,如果您有多个资源与某个数据库相关,可以将所有相关的资源添加到名为数据库的标记中。

属于一个标记的所有资源都可通过一个命令启动或停止。

过程 7.12︰ 添加标记 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

从列表中,选择要使用标记引用的资源。

单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.9︰ Hawk2 - 标记 #

7.5.11 配置资源监视 #

High Availability Extension 不仅会检测到节点故障,还会检测到节点上各资源的失败情况。如果要确保资源正在运行,则为其配置资源监视。通常,资源仅会在运行时受到群集的监视。但是,为了检测并发违例,还需为停止的资源配置监视。要进行资源监视,请指定超时和/或启动延迟值及间隔。间隔告诉 CRM 检查资源状态的频率。您还可以设置特定参数,如为 start 或 stop 操作设置 timeout。

过程 7.13︰ 添加和修改操作 #

登录 Hawk2:

https://HAWKSERVER:7630/

按过程 7.5 “添加原始资源”中所述添加资源,或选择要编辑的现有原始资源。

Hawk2 会自动显示最重要的(

start、stop、monitor)并建议默认值。要查看属于每个建议值的属性,请将鼠标悬停在相应的值上。

要更改针对

start或stop操作建议的timeout值,请执行以下操作:单击操作旁边的钢笔图标。

在打开的对话框中,为

timeout参数输入不同的值,例如10,然后确认您的更改。

要更改针对

monitor操作建议的值,请执行以下操作:单击操作旁边的钢笔图标。

在打开的对话框中,为监控

interval输入不同的值。要配置资源停止时针对资源的监视,请执行以下操作:

从下面的空下拉框中选择

role这一项。从

角色下拉框中,选择已停止。单击确认更改并关闭操作对话框。

在资源配置屏幕中确认更改。如果操作成功,屏幕顶部会显示一条讯息。

有关在资源监视程序检测到故障时将发生的流程,请参见第 6.4 节 “资源监视”。

要查看资源故障,请切换到 Hawk2 中的屏幕,然后选择您感兴趣的资源。在列中,单击向下箭头图标并选择。随后打开的对话框会列出对资源执行的最近操作。失败事件显示为红色。要查看资源细节,请单击列中的放大镜图标。

图 7.10︰ Hawk2 - 资源细节 #

7.6 配置约束 #

配置所有资源后,指定群集应如何正确地处理它们。使用资源约束可指定资源可以在哪些群集节点上运行、以何顺序装载资源,以及特定资源依赖于其他哪些资源。

有关约束的可用类型的概述,请参见第 6.5.1 节 “约束类型”。定义约束时,还需要指定分数。有关分数及其在群集中的含义的更多信息,请参见第 6.5.2 节 “分数和无限值”。

7.6.1 添加位置约束 #

位置约束决定资源可在哪个节点上运行、优先在哪个节点上运行,或者不能在哪个节点上运行。将与某个数据库相关的所有资源存放在同一个节点上,就是位置约束的一个示例。

过程 7.14︰ 添加位置约束 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

从列表中,选择要为其定义约束的一个或多个资源。

输入一个。分数表示您指派给此资源约束的值。正值表示资源可以在下一步中指定的上运行。负值表示它不应在该节点上运行。分数较高的约束先应用,分数较低的约束后应用。

也可以通过下拉框设置某些常用值:

要强制资源在该节点上运行,请单击箭头图标并选择

始终。如此会将分数设置为INFINITY。如果不想让资源在该节点上运行,请单击箭头图标并选择

从不。如此会将分数设置为-INFINITY,表示资源不得在该节点上运行。要将分数设置为

0,请单击箭头图标并选择建议。这样便会禁用约束。如果您要设置资源发现,但又不想约束资源,便可使用此方法。

选择一个。

单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.11︰ Hawk2 - 位置约束 #

7.6.2 添加共置约束 #

共置约束告知群集哪些资源可以或不可以在一个节点上一起运行。由于共置约束定义了资源之间的依赖性,因此您至少需要两个资源才能创建共置约束。

过程 7.15︰ 添加共置约束 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

输入一个。分数决定资源之间的位置关系。正值表示多个资源应在同一个节点上运行。负值表示多个资源不应在同一个节点上运行。分数将与其他因数结合使用,以确定放置资源的位置。

也可以通过下拉框设置某些常用值:

如果要强制多个资源在同一个节点上运行,请单击箭头图标并选择

始终。如此会将分数设置为INFINITY。如果不想让多个资源在同一个节点上运行,请单击箭头图标并选择

从不。如此会将分数设置为-INFINITY,表示资源不得在同一个节点上运行。

要为约束定义资源,请执行以下步骤:

从类别的下拉框中,选择某个资源(或模板)。

系统即会添加该资源,并且下面会出现一个新的空下拉框。

重复此步骤添加更多资源。

由于最上面的资源依赖于下一个资源,依此类推,因此群集将首先决定最后一个资源的放置位置,然后再根据该决定放置依赖的资源。如果无法满足约束,群集可能不允许运行依赖资源。

要交换共置约束中资源的顺序,请单击一个资源旁边的向上箭头图标,将其与上方的项目加以交换。

如果需要,请指定每个资源的更多参数(例如

Started、Stopped、Master、Slave、Promote、Demote):单击资源旁边的空下拉框并选择所需项。单击以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.12︰ Hawk2 - 共置约束 #

7.6.3 添加顺序约束 #

顺序约束定义启动和停止资源的顺序。由于顺序约束定义了资源之间的依赖性,因此您至少需要两个资源才能创建顺序约束。

过程 7.16︰ 添加顺序约束 #

登录 Hawk2:

https://HAWKSERVER:7630/

从左侧导航栏中,选择 › 。

输入唯一的。

输入一个。如果分数大于零,则顺序约束为强制性的,否则为选择性的。

也可以通过下拉框设置某些常用值:

要将顺序约束设为强制性,请单击箭头图标并选择

强制。如果只想将顺序约束作为建议,请单击箭头图标并选择

可选。序列化:要确保不会同时对资源执行两个停止/启动操作,请单击箭头图标并选择序列化。如此可确保一个资源完成启动操作后,另一个资源方可启动。典型的使用案例是启动期间在主机上产生高负载的资源。

对于顺序约束,通常可将选项保持为启用状态。这指定了资源以相反顺序停止。

要为约束定义资源,请执行以下步骤:

从类别的下拉框中,选择某个资源(或模板)。

系统即会添加该资源,并且下面会出现一个新的空下拉框。

重复此步骤添加更多资源。

排在最前面的资源最先启动,然后是排在第二的资源,以此类推。通常资源将以相反顺序停止。

要交换顺序约束中资源的顺序,请单击一个资源旁边的向上箭头图标,将其与上方的项目加以交换。

如果需要,请指定每个资源的更多参数(例如

Started、Stopped、Master、Slave、Promote、Demote):单击资源旁边的空下拉框并选择所需项。确认更改以完成配置。如果操作成功,屏幕顶部会显示一条讯息。

图 7.13︰ Hawk2 - 顺序约束 #

7.6.4 在约束中使用资源集 #

可以使用资源集作为定义约束的备用形式。它们有与组相同的排序语义。

过程 7.17︰ 为约束使用资源集 #

要在位置约束中使用资源集,请执行以下操作:

按过程 7.14 “添加位置约束”中所述操作,但步骤 4 除外:不要选择单个资源,而是按住 Ctrl 或 Shift 同时单击鼠标选择多个资源。这样便会在位置约束中创建一个资源集。

要从位置约束中去除某个资源,请按住 Ctrl 并再次单击该资源,以将其取消选中。

要在共置或顺序约束中使用资源集,请执行以下操作:

按过程 7.15 “添加共置约束”或过程 7.16 “添加顺序约束”中所述操作,但为约束定义资源的步骤(步骤 5.a 或步骤 6.a)除外:

添加多个资源。

要创建资源集,请单击某个资源旁边的链形图标将其与上方的资源链接起来。资源集通过属于集合的资源周围的框架显现。

您可以在一个资源集中组合多个资源,或创建多个资源集。

图 7.14︰ Hawk2 - 一个共置约束中的两个资源集 #

要将某个资源与其上方的资源解除链接,请单击该资源旁边的剪刀图标。

确认更改以完成约束配置。

7.6.5 更多信息 #

有关配置约束的更多信息以及顺序和共置基本概念的详细背景信息,请参见 http://www.clusterlabs.org/doc/ 上提供的文档:

《Pacemaker Explained》(Pacemaker 配置说明)中的“Resource Constraints”(资源约束)一章

《Colocation Explained》(共置说明)

《Ordering Explained》(顺序说明)

7.6.6 指定资源故障转移节点 #

资源在出现故障时会自动重启动。如果在当前节点上无法实现此操作,或者此操作在当前节点上失败了 N 次,它将尝试故障转移到其他节点。您可以定义资源的故障次数(migration-threshold),在该值之后资源会迁移到新节点。如果群集中存在两个以上的节点,则由 High Availability 软件选择特定资源故障转移的节点。

可按照以下步骤指定资源将故障转移到的特定节点:

过程 7.18︰ 指定故障转移节点 #

登录 Hawk2:

https://HAWKSERVER:7630/

按过程 7.14 “添加位置约束”中所述,为资源配置位置约束。

按过程 7.7: 修改资源的参数、操作或元属性中的步骤 4 所述为资源添加