提供有关如何在 SUSE Linux Enterprise Server 上管理储存设备的信息。

- 关于本指南

- I 文件系统与装入

- II 逻辑卷 (LVM)

- III 软件 RAID

- IV 网络储存

- A GNU licenses

- 1.1 Linux 中的文件系统类型

- 1.2 文件和文件系统的最大大小(磁盘格式,4 KiB 块大小)

- 1.3 储存限制

- 2.1 文件系统对调整大小的支持

- 7.1 RAID 5 和 RAID 6 的比较

- 9.1 嵌套的 RAID 级别

- 9.2 通过嵌套创建 RAID 10 (1+0) 的情形

- 9.3 通过嵌套创建 RAID 10 (0+1) 的情形

- 9.4 复杂 RAID 10 与嵌套 RAID 10 的比较

- 9.5 使用 mdadm 创建 RAID 10 的情况

- 11.1 调整 RAID 大小中涉及的任务

- 11.2 增加组件分区的大小的情形

- 12.1 非 SES-2 模式与 SES-2 模式之间的转换

- 17.1 储存阵列的多路径 I/O 功能

- 17.2 multipath-tools 包中的工具

- 17.3 multipath -p 命令的组策略选项

- 17.4 多路径设备名称类型比较

- 17.5 multipath -p 命令的组策略选项

版权所有 © 2006– 2025 SUSE LLC 和贡献者。保留所有权利。

根据 GNU 自由文档许可证 (GNU Free Documentation License) 版本 1.2 或(根据您的选择)版本 1.3 中的条款,在此授予您复制、分发和/或修改本文档的许可权限;本版权声明和许可证附带不可变部分。许可证版本 1.2 的副本包含在题为“GNU 自由文档许可证”的部分。

有关 SUSE 商标,请参见 http://www.suse.com/company/legal/。所有其它第三方商标是其各自所有者的财产。商标符号(®、™ 等)代表 SUSE 及其附属公司的商标。星号 (*) 代表第三方商标。

本指南力求涵盖所有详细信息。但这并不确保本指南准确无误。SUSE LLC 及其附属公司、作者和译者对于可能出现的错误或由此造成的后果皆不承担责任。

关于本指南 #

本指南提供关于如何管理 SUSE Linux Enterprise Server 12 SP5 上的储存设备的信息。有关分区和管理设备的信息,请参见Book “部署指南”, Chapter 12 “高级磁盘设置”。本指南适用于系统管理员。

1 可用文档 #

此外,您安装的系统的 /usr/share/doc/manual 下通常会提供产品文档。

针对本产品提供的文档如下:

- Article “安装快速入门”

列出系统要求,并指导您从 DVD 或 ISO 映像逐步安装 SUSE Linux Enterprise Server。

- Book “部署指南”

显示如何安装单个或多个系统,以及如何利用产品继承功能建立部署基础结构。有各种方法可供选择,可以选择使用本地安装或网络安装服务器,也可以选择使用远程控制、高度自定义的自动安装技术进行大规模部署。

- Book “管理指南”

讲述系统管理任务,如维护、监视和自定义初始安装的系统。

- Book “Virtualization Guide”

概述虚拟化技术,并介绍虚拟化的统一接口 libvirt,以及有关特定超级管理程序的详细信息。

- Book “储存管理指南”

提供有关如何在 SUSE Linux Enterprise Server 上管理储存设备的信息。

- Book “AutoYaST”

AutoYaST 系统使用包含安装和配置数据的 AutoYaST 配置文件,让您以无人照管方式批量部署 SUSE Linux Enterprise Server 系统。该手册将引导您完成自动安装的基本步骤,包括准备、安装和配置。

- Book “Security and Hardening Guide”

介绍系统安全的基本概念,包括本地安全方面和网络安全方面。说明如何使用产品固有的安全软件(例如 AppArmor),或者能够可靠收集有关任何安全相关事件的信息的审核系统。

- Book “Hardening Guide”

处理安装和设置安全 SUSE Linux Enterprise Server 的特定事项以及进一步确保和强化安装所需的额外安装后步骤。支持管理员选择与安全相关的选项并做出决策。

- Book “System Analysis and Tuning Guide”

关于问题检测、解决和优化的管理员指南。了解如何使用监视工具检查和优化系统以及如何有效管理资源。还包含常见问题和解决方法的概述以及其他帮助和文档资源。

- Book “Subscription Management Tool Guide”

订阅管理工具管理员指南。订阅管理工具是用于 SUSE Customer Center 并包含储存库和注册目标的代理系统。了解如何安装和配置本地 SMT 服务器、镜像和管理储存库、管理客户端计算机,以及配置客户端以使用 SMT。

- Book “GNOME 用户指南”

介绍 SUSE Linux Enterprise Server 的 GNOME 桌面。指导您使用和配置桌面并帮助您执行关键任务。它主要面向想要有效使用 GNOME 作为其默认桌面的最终用户。

2 反馈 #

提供了多种反馈渠道:

- 错误和增强请求

有关产品可用的服务和支持选项,请参见 http://www.suse.com/support/。

有关 openSUSE 的帮助由社区提供。有关更多信息,请参考https://en.opensuse.org/Portal:Support。

要报告产品组件的 Bug,请访问 https://scc.suse.com/support/requests 并登录,然后单击。

- 用户意见

我们希望收到您对本手册和本产品中包含的其他文档的意见和建议。请使用每个标题旁的“报告问题”链接通过 SUSE Bugzilla 提供反馈。

- 邮件

如有对本产品文档的反馈,也可以发送邮件至

doc-team@suse.com。请确保反馈中含有文档标题、产品版本和文档发布日期。要报告错误或给出增强建议,请提供问题的简要说明并指出相应章节编号和页码(或 URL)。

3 文档约定 #

本文档中使用了以下通知和排版约定:

/etc/passwd:目录名称和文件名PLACEHOLDER:PLACEHOLDER 将会替换为实际的值

PATH:环境变量 PATHls、--help:命令、选项和参数user:用户和组package name :包名称

Alt、Alt–F1:按键或组合键;这些键以大写形式显示,如在键盘上一样

、 › :菜单项,按钮

AMD/Intel 本段内容仅与 AMD64/Intel 64 体系结构相关。箭头标记文本块的开始位置和结束位置。

IBM Z, POWER 本段内容仅与 IBM 体系结构

Z和POWER相关。箭头标记文本块的开始位置和结束位置。跳舞的企鹅(企鹅一章,↑其他手册):此内容参见自其他手册中的一章。

必须使用

root特权运行的命令。您往往还可以在这些命令前加上sudo命令,以非特权用户身份来运行它们。root #commandtux >sudo command可以由非特权用户运行的命令。

tux >command注意

警告:警告通知在继续操作之前,您必须了解的不可或缺的信息。向您指出有关安全问题、潜在数据丢失、硬件损害或物理危害的警告。

重要:重要通知在继续操作之前,您必须了解的重要信息。

注意:注意通知额外信息,例如有关软件版本差异的信息。

提示:提示通知有用信息,例如指导方针或实用性建议。

第 I 部分 文件系统与装入 #

- 1 Linux 中的文件系统的概述

SUSE Linux Enterprise Server 随附了不同的文件系统供您选择,包括 Btrfs、Ext4、Ext3、Ext2、ReiserFS 和 XFS。每个文件系统都有各自的优点和缺点。有关 SUSE Linux Enterprise Server 中主要文件系统的并排功能比较,请参见 http://www.suse.com/products/server/technical-information/#FileSystem(文件系统支持和大小)。本章概述了这些文件系统的工作原理以及它们的优点。

- 2 调整文件系统大小

调整文件系统大小(不要与调整分区或卷大小混淆)可用于将物理卷上的空间变为可用状态,或使用物理卷上可用的其他空间。

- 3 使用 UUID 装入设备

本章介绍使用 UUIDs(全局唯一标识符)而不是设备名称(例如

/dev/sda1)来识别文件系统设备。从 SUSE Linux Enterprise Server 12 开始,默认在引导加载程序文件和/etc/fstab文件中使用 UUID。- 4 用于块设备操作的多层超速缓存

多层超速缓存是一种复制的/分布式超速缓存,它至少包括两个层:一个层由速度较慢但较为廉价的旋转块设备(硬盘)表示,另一个层成本更高,但执行数据操作的速度更快(例如,SSD 闪存盘)。

1 Linux 中的文件系统的概述 #

SUSE Linux Enterprise Server 随附了不同的文件系统供您选择,包括 Btrfs、Ext4、Ext3、Ext2、ReiserFS 和 XFS。每个文件系统都有各自的优点和缺点。有关 SUSE Linux Enterprise Server 中主要文件系统的并排功能比较,请参见 http://www.suse.com/products/server/technical-information/#FileSystem(文件系统支持和大小)。本章概述了这些文件系统的工作原理以及它们的优点。

在 SUSE Linux Enterprise 12 中,Btrfs 是操作系统的默认文件系统,XFS 是所有其他使用案例的默认文件系统。此外,SUSE 仍继续支持 Ext 系列的文件系统、ReiserFS 和 OCFS2。根据默认设置,Btrfs 文件系统将设置为使用子卷。对于使用 snapper 基础结构的根文件系统,将会自动启用快照。有关 snapper 的详细信息,请参见Book “管理指南”, Chapter 7 “通过 Snapper 进行系统恢复和快照管理”。

专业的高性能设置可能需要高可用性的储存系统。为符合高性能群集案例的要求,SUSE Linux Enterprise Server 在 High Availability Extension 附加产品中加入了 OCFS2(Oracle Cluster File System 2) 与 Distributed Replicated Block Device (DRBD)。本指南中不涉及这些高级储存系统的内容。有关详细信息,请参见《SUSE Linux Enterprise High Availability Extension 管理指南》,网址为:http://www.suse.com/doc。

记住一点很重要:没有任何一种文件系统适合所有种类的应用。每个文件系统都有各自的特定优点和缺点,必须将这些因素考虑在内。此外,即使是最复杂的文件系统也不能替代合理的备份策略。

本节中使用的术语数据完整性和数据一致性并不是指用户空间数据(您的应用程序写入其文件的数据)的一致性。此数据是否一致必须由应用程序本身控制。

除非本节特别指明,否则设置或更改分区以及文件系统所需的一切步骤,都可以使用 YaST 分区程序(强烈推荐使用)来执行。有关信息,请参见Book “部署指南”, Chapter 12 “高级磁盘设置”。

1.1 术语 #

- 元数据

文件系统内部的一种数据结构。它可确保磁盘上的所有数据都有条不紊,并且可供访问。从本质上讲,它是“有关数据的数据”。几乎每一种文件系统都有自己的元数据结构,这也是文件系统展现出不同性能特性的原因所在。维护元数据的完整性非常重要,因为如果不这样,则可能无法访问文件系统中的所有数据。

- inode

文件系统的数据结构包含文件的各种信息,包括大小、链接数量、实际储存文件内容的磁盘块的指针、创建、修改和访问的日期与时间。

- 日记

在提及文件系统时,日记是包含某种日志的磁盘上结构,文件系统将要对文件系统的元数据进行的更改储存在此日志中。日记可大大降低文件系统的恢复时间,因为有了它就不需要在系统启动时执行文件系统全面检查这一冗长的搜索程序。而只是重放日记。

1.2 Btrfs #

Brtfs 是由 Chris Mason 开发的一种写时复制 (COW) 文件系统。它基于 Ohad Rodeh 开发的适用于 COW 的 B 树。Btrfs 是日志记录样式的文件系统。它不记录块更改,而是将块更改写入新位置,然后链接上更改。新更改在上一次写后才提交。

1.2.1 主要特征 #

Btrfs 提供容错、修复和易于管理的功能,比如:

可写快照,允许应用更新后按需轻松回滚系统或允许备份文件。

子卷支持:Btrfs 会在为其指派的空间池中创建默认子卷。它允许您在相同空间池中创建更多的子卷,作为不同的文件系统。子卷的数目仅受分配给池的空间所限。

Btrfs 命令行工具中提供了在线检查和修复功能

scrub。它会在假设树状结构没有问题的前提下,验证数据和元数据的完整性。您可以在安装的文件系统上定期运行 scrub;正常操作期间,它将在后台运行。不同 RAID 级别,适用于元数据和用户数据。

用于元数据和用户数据的不同校验和,可改进错误检测。

与 Linux 逻辑卷管理器 (LVM) 储存对象集成。

与 SUSE Linux Enterprise Server 上的 YaST 分区程序及 AutoYaST 整合。这还包括在多个设备 (MD) 和设备映射程序 (DM) 储存配置上创建 Btrfs 文件系统。

从现有的 Ext2、Ext3 以及 Ext4 文件系统进行脱机迁移。

/boot的引导加载程序支持,允许从 Btrfs 分区引导。SUSE Linux Enterprise Server }12 SP5 中的 RAID0、RAID1 和 RAID10 配置文件支持多卷 Btrfs。更高的 RAID 级别尚不受支持,但安装将来发布的服务包后可能会支持。

使用 Btrfs 命令设置透明压缩。

1.2.2 SUSE Linux Enterprise Server 上的根文件系统设置 #

SUSE Linux Enterprise Server 默认设置为对根分区使用 Btrfs 和快照。快照可让您在应用更新之后有需要时轻松地回滚系统,也可让您备份文件。快照可通过 SUSE Snapper 基础结构轻松管理,如Book “管理指南”, Chapter 7 “通过 Snapper 进行系统恢复和快照管理”所述。有关 SUSE Snapper 项目的一般信息,请参见 OpenSUSE.org (http://snapper.io) 上的 Snapper 门户网站 Wiki。

使用快照回滚系统时,必须确保在回滚期间,数据(例如用户的主目录、Web 和 FTP 服务器内容或日志文件)不会遗失或被重写。这一点通过使用根文件系统上的 Btrfs 子卷实现。子卷可从快照中排除。安装期间,根据 YaST 建议,SUSE Linux Enterprise Server 上的默认根文件系统设置包含下列子卷。由于以下原因,它们会从快照中排除。

/boot/grub2/i386-pc、/boot/grub2/x86_64-efi、/boot/grub2/powerpc-ieee1275、/boot/grub2/s390x-emu不能回滚引导加载程序配置。上面列出的目录是架构专属目录。前两个目录位于 AMD64/Intel 64 计算机上,后两个目录分别位于 IBM POWER 和 IBM Z 上。

/home如果独立的分区中没有

/home,便会将该目录排除以免在回滚时发生数据丢失。/opt、/var/opt第三方产品通常安装到

/opt下。排除此目录是为了防止在回滚时卸装这些应用程序。/srv包含 Web 和 FTP 服务器的数据。排除此目录是为了防止在回滚时发生数据丢失。

/tmp、/var/tmp、/var/cache、/var/crash包含临时文件和超速缓存的所有目录都会排除在快照范围之外。

/usr/local在手动安装软件时会用到此目录。系统会将该目录排除以免在回滚时卸载这些安装的软件。

/var/lib/libvirt/images使用 libvirt 管理的虚拟机映像的默认位置。为确保回滚期间虚拟机映像不会替换为旧版本而被排除。默认情况下,此子卷是使用

写入时不复制选项创建的。/var/lib/mailman、/var/spool包含邮件或邮件队列的目录会排除,以免在回滚后造成邮件丢失。

/var/lib/bind包含 DNS 服务器的区域数据。排除该目录是为了确保回滚后名称服务器仍能运作。

/var/lib/mariadb、/var/lib/mysql、/var/lib/pgqsl这些目录包含数据库数据。默认情况下,这些子卷是使用

写入时不复制选项创建的。/var/log日志文件所在的位置。排除该目录是为了在对受损的系统进行回滚后能够对日志文件进行分析。

/var/log默认会设置 NoCOW 属性,禁止写入时复制,从而改进了性能并减少了重复的块数量。使用lsattr进行校验:tux >lsattr -l /var/ /var/log No_COW

仅当您未去除任何预先设置的子卷时,SUSE 支持才支持回滚。不过,您可以使用 YaST 分区程序添加其他子卷。

1.2.2.1 装入压缩的 Btrfs 文件系统 #

GRUB 2 无法读取 lzo 压缩根目录。如果要使用压缩,您需要创建单独的 /boot 分区。

从 SLE12 SP1 开始,支持压缩 Btrfs 文件系统。使用 compress 或 compress-force 选项,并选择压缩算法 lzo 或 zlib(默认)。zlib 压缩的压缩率更高,而 lzo 的压缩速度更快,并且所需的 CPU 负载更小。

例如:

root # mount -o compress /dev/sdx /mnt

如果您创建了一个文件并在其中写入数据,而压缩后的结果大于或等于未压缩时的大小,则将来针对此文件执行写入操作后,Btrfs 会始终跳过压缩。如果您不希望有这种行为,请使用 compress-force 选项。对于包含一些初始未压缩数据的文件而言,此选项可能很有用。

请注意,压缩只会作用于新文件。如果使用 compress 或 compress-force 选项装入文件系统,则在未压缩的情况下写入的文件将不会压缩。此外,包含 nodatacow 属性的文件的内容永远不会压缩:

root #chattr+C FILEroot #mount-o nodatacow /dev/sdx /mnt

加密与任何压缩操作均无关。在此分区中写入一些数据后,请打印细节:

root # btrfs filesystem show /mnt

btrfs filesystem show /mnt

Label: 'Test-Btrfs' uuid: 62f0c378-e93e-4aa1-9532-93c6b780749d

Total devices 1 FS bytes used 3.22MiB

devid 1 size 2.00GiB used 240.62MiB path /dev/sdb1

如果您希望此设置是永久性的,请在 /etc/fstab 配置文件中添加 compress 或 compress-force 选项。例如:

UUID=1a2b3c4d /home btrfs subvol=@/home,compress 0 01.2.2.2 装入子卷 #

在 SUSE Linux Enterprise Server 上,从快照进行系统回滚的程序通过先从快照引导来执行。这样一来,您便可以在运行回滚之前,在运行的同时检查快照。只要装入子卷,就可以实现从快照引导(通常没必要)。

除了第 1.2.2 节 “SUSE Linux Enterprise Server 上的根文件系统设置”中列出的子卷之外,系统中还存在一个名为 @ 的卷。这是默认的子卷,将作为根分区 (/) 装入。其他子卷将装入到此卷中。

从快照引导时,使用的不是 @ 子卷,而是快照。快照中包括的文件系统部分将以只读方式装入为 /。其他子卷将以可写入方式装入到快照中。此状态默认为临时状态,下次重引导时将还原先前的配置。若要使它成为永久状态,请执行 snapper rollback 命令。这将使目前引导的快照成为新的默认子卷,在重引导之后将会使用它。

1.2.2.3 检查可用空间 #

通常可通过运行 df 命令来检查文件系统的用量。在 Btrfs 文件系统上,df 的输出可能有误导性,因为除了原始数据分配的空间以外,Btrfs 文件系统还会为元数据分配并使用空间。

因此,即使看上去仍有大量的可用空间,Btrfs 文件系统也可能会报告空间不足。发生这种情况时,为元数据分配的全部空间都已用尽。使用以下命令可检查 Btrfs 文件系统上已用和可用的空间:

btrfs filesystem showtux >sudo btrfs filesystem show / Label: 'ROOT' uuid: 52011c5e-5711-42d8-8c50-718a005ec4b3 Total devices 1 FS bytes used 10.02GiB devid 1 size 20.02GiB used 13.78GiB path /dev/sda3显示文件系统的总大小及其用量。如果最后一行中的这两个值匹配,则表示文件系统上的全部空间都已分配出去。

btrfs filesystem dftux >sudo btrfs filesystem df / Data, single: total=13.00GiB, used=9.61GiB System, single: total=32.00MiB, used=16.00KiB Metadata, single: total=768.00MiB, used=421.36MiB GlobalReserve, single: total=144.00MiB, used=0.00B显示文件系统的已分配 (

total) 空间和已用空间值。如果元数据的total和used值基本上相等,则表示元数据的全部空间都已分配出去。btrfs filesystem usagetux >sudo btrfs filesystem usage / Overall: Device size: 20.02GiB Device allocated: 13.78GiB Device unallocated: 6.24GiB Device missing: 0.00B Used: 10.02GiB Free (estimated): 9.63GiB (min: 9.63GiB) Data ratio: 1.00 Metadata ratio: 1.00 Global reserve: 144.00MiB (used: 0.00B) Data Metadata System Id Path single single single Unallocated -- --------- -------- --------- -------- ----------- 1 /dev/sda3 13.00GiB 768.00MiB 32.00MiB 6.24GiB -- --------- -------- --------- -------- ----------- Total 13.00GiB 768.00MiB 32.00MiB 6.24GiB Used 9.61GiB 421.36MiB 16.00KiB显示类似于前两个命令输出合并所得的数据。

有关详细信息,请参见 man 8 btrfs-filesystem 和 https://btrfs.wiki.kernel.org/index.php/FAQ。

1.2.3 从 Ext 和 ReiserFS 文件系统迁移至 Btrfs #

您可以将数据卷从现有 Ext(Ext2、Ext3 或 Ext4)或 ReiserFS 文件系统迁移至 Btrfs 文件系统。转换过程将在该设备的适当位置以脱机方式进行。文件系统至少需要使用设备上 15% 的可用空间。

要将 文件系统转换为 Btrfs 文件系统,请将文件系统脱机,然后输入:

sudo btrfs-convert DEVICE

要将迁移回滚到原先的 文件系统,请将文件系统脱机,然后输入:

sudo btrfs-convert -r DEVICE

不支持将根文件系统转换为 Btrfs。请保留现有的文件系统,或者从头开始重新安装整个系统。

回滚到原先的 文件系统时,将丢失所有在转换为 Btrfs 文件系统后添加的数据。也就是说,只有原始数据会重新转换为先前的文件系统。

1.2.4 Btrfs 管理 #

Btrfs 与 YaST 分区程序和 AutoYaST 集成。您可以在安装期间使用它来为根文件系统建立解决方案。安装之后,您可以使用 YaST 分区程序来查看和管理 Btrfs 卷。

btrfsprogs 包中提供了 Btrfs 管理工具。有关使用 Btrfs 命令的信息,请参见 man 8 btrfs、man 8 btrfsck 和 man 8 mkfs.btrfs 命令。有关 Btrfs 功能的信息,请参见 Btrfs Wiki,网址为 http://btrfs.wiki.kernel.org。

1.2.5 Btrfs 子卷定额支持 #

Btrfs 根文件系统子卷 /var/log、/var/crash 和 /var/cache 在正常运作情况下可能会使用所有可用的磁盘空间,此时将导致系统故障。为避免出现此状况,SUSE Linux Enterprise Server 现在提供了 Btrfs 子卷配额支持。如果您按照相应的 YaST 建议设置根文件系统,系统会为根文件系统进行相应的准备:所有子卷的配额组 (qgroup) 均已设置。若要设置根文件系统中子卷的配额,请执行下列步骤:

启用配额支持:

sudo btrfs quota enable /

取得子卷列表:

sudo btrfs subvolume list /

只能为现有子卷设置配额。

为上一步中所列的其中一个子卷设置配额。子卷可以用路径识别(例如

/var/tmp),也可以用0/子卷 ID识别(例如0/272)。下面的范围为/var/tmp设置了 5 GB 的配额。sudo btrfs qgroup limit 5G /var/tmp

大小单位可以是字节 (5000000000)、KB (5000000K)、MB (5000M) 或 GB (5G)。以字节为单位产生的值略有不同,因为 1024 字节 = 1 KB,1024 KB = 1 MB 等。

若要列出现有配额,请使用以下命令。

max_rfer列以字节为单位显示配额。sudo btrfs qgroup show -r /

如果您要取消现有定额,请将定额大小设置为 none:

sudo btrfs qgroup limit none /var/tmp

若要禁用某个分区及其所有子卷的配额支持,请使用 btrfs quota disable:

sudo btrfs quota disable /

有关细节,请参见 man 8 btrfs-qgroup 和 man 8 btrfs-quota。Btrfs Wiki (https://btrfs.wiki.kernel.org/index.php/UseCases) 上的 UseCases 页面也提供了更多信息。

1.2.6 Btrfs 发送/接收 #

Btrfs 允许生成快照来捕获文件系统的状态。例如,Snapper 可使用此功能在系统更改之前及之后创建快照,以便允许回滚。不过,将快照与发送/接收功能结合使用还可以在远程位置创建和维护文件系统的副本。例如,此功能可用于执行增量备份。

btrfs send 操作可计算同一子卷中两个只读快照之间的差异,并将差异发送到某个文件或 STDOUT。Btrfs receive 操作接收发送命令的结果,并将其应用到快照。

1.2.6.1 先决条件 #

要使用 Btrfs 的发送/接收功能,需要满足以下要求:

源端(

发送)和目标端(接收)各有一个 Btrfs 文件系统。Btrfs 发送/接收是对快照执行的,因此,相应的数据需要驻留在 Btrfs 子卷中。

源端中的快照必须为只读模式。

SUSE Linux Enterprise 12 SP2 或更高版本。早期版本的 SUSE Linux Enterprise 不支持发送/接收。

1.2.6.2 增量备份 #

以下过程展示了 Btrfs 发送/接收操作的基本用法,其中示范了如何在 /backup/data(目标端)中创建 /data(源端)的增量备份。/data 必须是一个子卷。

在源端创建初始快照(在本示例中名为

snapshot_0),并确保将它写入该磁盘:sudo btrfs subvolume snapshot -r /data /data/bkp_data sync

即会创建一个新子卷

/data/bkp_data。该子卷将用作后续增量备份的基础,应将它保留为参照。将初始快照发送到目标端。由于这是初始的发送/接收操作,因此需要发送整个快照:

sudo bash -c 'btrfs send /data/bkp_data | btrfs receive /backup'

目标端上即会创建一个新子卷

/backup/bkp_data。

完成初始设置后,可以创建增量备份,并将当前快照与先前快照之间的差异发送到目标端。操作过程始终是相同的:

在源端创建新快照。

将差异发送到目标端。

可选:重命名和/或清理两端中的快照。

在源端创建新快照,并确保将它写入该磁盘。在下面的示例中,快照命名为 bkp_data_当前日期:

sudo btrfs subvolume snapshot -r /data /data/bkp_data_$(date +%F) sync

创建新子卷,例如

/data/bkp_data_2016-07-07。将先前快照与您创建的快照之间的差异发送到目标端。为此,可以使用选项

-p SNAPSHOT指定先前的快照。sudo bash -c 'btrfs send -p /data/bkp_data /data/bkp_data_2016-07-07 \ | btrfs receive /backup'

即会创建一个新子卷

/backup/bkp_data_2016-07-07。如此我们有了四个快照,每端各有两个:

/data/bkp_data/data/bkp_data_2016-07-07/backup/bkp_data/backup/bkp_data_2016-07-07现在,关于如何继续,您有三种选择:

保留两端中的所有快照。如果采用这种选择,您可以回滚到两端中的任一快照,同时会复制所有数据。不需要执行额外操作。执行后续增量备份时,请记得使用倒数第二个快照作为发送操作的父项。

仅保留源端中的最后一个快照,保留目标端中的所有快照。此外,允许回滚到两端中的任一快照 - 要回滚到源端中的特定快照,请对整个快照执行从目标端到源端的发送/接收操作。在源端执行删除/移动操作。

仅保留两端中的最后一个快照。采用这种方法,您会在目标端创建一个备份,该备份代表源端中生成的最后一个快照的状态。系统无法回滚到其他快照。在源端和目标端执行删除/移动操作。

如果只想保留源端中的最后一个快照,请执行以下命令:

sudo btrfs subvolume delete /data/bkp_data sudo mv /data/bkp_data_2016-07-07 /data/bkp_data

第一条命令将删除先前的快照,第二条命令将当前快照重命名为

/data/bkp_data。这可确保备份的最后一个快照始终命名为/data/bkp_data。因此,您也可以始终使用此子卷名称作为增量发送操作的父项。如果只想保留目标端中的最后一个快照,请执行以下命令:

sudo btrfs subvolume delete /backup/bkp_data sudo mv /backup/bkp_data_2016-07-07 /backup/bkp_data

第一条命令将删除先前的备份快照,第二条命令将当前备份快照重命名为

/backup/bkp_data。这可确保最新的备份快照始终命名为/backup/bkp_data。

要将快照发送到远程计算机,请使用 SSH:

btrfs send /data/bkp_data | ssh root@jupiter.example.com 'btrfs receive /backup'

1.2.7 重复数据删除支持 #

Btrfs 支持重复数据删除功能,具体办法是以指向通用储存位置中的块单一副本的逻辑链接替换文件系统中完全相同的块。SUSE Linux Enterprise Server 提供 duperemove 工具来扫描文件系统中有没有完全相同的块。在 Btrfs 文件系统上使用时,它也可以用来对这些块执行重复数据删除。系统上默认不会安装 duperemove。要使此功能可用,请安装包

duperemove

。

从 SUSE Linux Enterprise Server 12 SP5 开始,duperemove 不再适用于对整个文件系统执行重复数据删除。它主要用于对 10 到 50 个为一组的大型文件执行重复数据删除操作(这些文件可能具有许多通用块,例如虚拟机映像)。

duperemove 可以针对一系列文件操作,也可以以递归方式扫描某个目录:

sudo duperemove OPTIONS file1 file2 file3 sudo duperemove -r OPTIONS directory

它有两种操作模式:只读和重复数据删除。以只读模式运行时(即不使用 -d 开关),它会扫描给定文件或目录中的重复块,并将其打印出来。此模式适用于所有文件系统。

以重复数据删除模式执行 duperemove 仅在 Btrfs 文件系统上受支持。扫描给定文件或目录之后,将会提交重复的块以进行重复数据删除。

有关详细信息,请参见 man 8 duperemove。

1.3 XFS #

SGI 在 20 世纪 90 年代初开始开发 XFS,最初计划将 XFS 作为 IRIX OS 的文件系统。开发 XFS 的目的是创建一个高性能的 64 位日记文件系统来满足对计算能力的极高要求。XFS 适合操纵大型文件,在高端硬件上表现优异。XFS 是 SUSE Linux Enterprise Server 中数据分区的默认文件系统。

快速回顾 XFS 的关键功能可解释为什么此文件系统经证明在高端计算方面是其他日记文件系统的强大竞争对手。

1.3.1 使用分配组实现高可伸缩性 #

在创建 XFS 文件系统时,文件系统底层的块设备被分成 8 个或 8 个以上相同大小的线性区域。这些区域称为分配组。每个分配组管理自己的 inode 和可用空间。实际上,可以将分配组看作文件系统中的文件系统。因为分配组相互独立,所以内核可同时对多个分配组进行寻址。此功能是 XFS 优异的可伸缩性关键之所在。独立分配组的概念自然适合多处理器系统的需要。

1.3.2 通过有效管理磁盘空间获得高性能 #

可用空间和 inode 是由分配组内的 B+ 树处理的。使用 B+ 树将大大增强 XFS 的性能和可伸缩性。XFS 使用延迟分配,它可以通过将进程分为两部分而处理分配。将挂起事务储存在 RAM 中并保留适当数量的空间。XFS 仍不决定应储存数据的准确位置(即不指出文件系统块)。此决定将被延迟到最后的时刻。某些生存期很短的临时数据可能永远不会被储存到磁盘上,这是因为在 XFS 决定保存它们的实际位置时,这些数据可能已经过时了。以这种方式,XFS 增强了写性能并减少了文件系统分段。因为延迟分配引起写事件的频率比其他文件系统引起写事件的频率要低,所以如果写操作期间发生系统崩溃,则数据丢失可能会更加严重。

1.3.3 进行预分配以避免文件系统碎片 #

在将数据写入文件系统前,XFS 保留(预分配)文件所需的可用空间。这样会大大减少文件系统碎片的数目。因为文件的内容不会分散在整个文件系统中,所以性能得以提高。

从 12 版开始,SUSE Linux Enterprise Server 支持 XFS 文件系统的新“磁盘格式” (v5)。由 YaST 创建的 XFS 文件系统将使用这种新格式。这种格式的主要优点包括,所有 XFS 元数据的自动检查总数、文件类型支持以及支持文件更多数量的访问控制列表。

请注意,低于 3.12 版的 SUSE Linux Enterprise 内核、低于 3.2.0 版的 xfsprogs,以及在 SUSE Linux Enterprise 12 之前发布的 GRUB 2 版本均不支持这种格式。如果同时还要从不符合上述先决条件的系统中使用该文件系统,就会出现问题。

如果您需要在较旧 SUSE 系统或其他 Linux 发行套件与 XFS 文件系统之间实现互操作性,请使用 mkfs.xfs 命令手动格式化文件系统。这将创建一个采用旧格式的 XFS 文件系统(除非您使用 -m crc=1 选项)。

1.4 Ext2 #

Ext2 的原身可以追溯到 Linux 历史的早期。其前身是“扩展文件系统”,于 1992 年 4 月实施,集成在 Linux 0.96c 中。扩展文件系统经历了数次修改,后来才称为 Ext2,曾经是多年来最受欢迎的 Linux 文件系统。但随着日记文件系统的创建以及其恢复时间的缩短,Ext2 的重要性逐渐降低。

简要总结 Ext2 的优点有助于您了解为什么它以前是(在某些领域现在仍是)许多 Linux 用户最喜欢使用的 Linux 文件系统。

- 可靠性和速度

Ext2 是一个“老古董”,它经历了许多改进和频繁的测试。这可能是人们经常称之为坚如磐石的文件系统的原因。在系统中断后,如果无法彻底卸装文件系统,则 e2fsck 将开始分析文件系统数据。系统使元数据恢复一致的状态,并将挂起的文件或数据块写入指定的目录(名为

lost+found)。与日记文件系统相比,e2fsck 会分析整个文件系统,而不仅仅是元数据中最近修改的位。这种操作所花的时间要远远超过检查日记文件系统的日志数据所花的时间。根据文件系统的大小,此过程可能需要半小时或更长时间。因此,对于任何要求高可用性的服务器,不要选择 Ext2。但是,因为 Ext2 不维护日记且使用的内存也更少,所以其速度往往快于其他文件系统。- 可方便地升级

因为 Ext3 以 Ext2 代码为基础并且共享 Ext2 的磁盘上格式和元数据格式,所以从 Ext2 升级到 Ext3 非常容易。

1.5 Ext3 #

Ext3 由 Stephen Tweedie 设计。与所有其他下一代文件系统不同,Ext3 并没有采用全新的设计原则。它是在 Ext2 的基础上设计的。这两个文件系统密切关联。可以方便地在 Ext2 文件系统上建立 Ext3 文件系统。Ext2 和 Ext3 最重要的区别是 Ext3 支持日记。总之,Ext3 有三个主要优点:

1.5.1 方便并高度可靠地从 Ext2 升级 #

Ext2 的代码为 Ext3 奠定了坚实的基础,使后者成为受到高度评价的下一代文件系统。在 Ext3 中,它的可靠性和稳定性与日记文件系统的优点完美地结合在一起。不像转换至其他日记文件系统(例如 ReiserFS 或 XFS)那么冗长乏味(备份整个文件系统,然后从头开始重新创建),转换至 Ext3 只是数分钟的事。升级到 Ext3 还很安全,因为从头重新创建整个文件系统可能会出现问题。考虑到等待升级到日记文件系统的现有 Ext2 系统的数量,就很容易明白为什么 Ext3 对许多系统管理员来说如此重要。从 Ext3 降级到 Ext2 与升级一样简单。将 Ext3 文件系统完全卸载,然后重新装入成 Ext2 文件系统即可。

1.5.2 可靠性和性能 #

某些其他日记文件系统采用“仅元数据”的日记方法。这意味着元数据始终保持一致的状态,但无法自动保证文件系统数据本身一致。Ext3 的设计既可以照顾到元数据,又可以照顾到数据。“照顾”的程度可以自定义。在 data=journal 方式中启用 Ext3 可以提供最大的安全性(数据完整性),但因为要将元数据和数据都记入日记,所以可能会降低系统的速度。一个相对较新的方法是采用 data=ordered 方式,这种方式确保了数据和元数据的完整性,但只对元数据使用日记。文件系统驱动程序收集与一次元数据更新对应的所有数据块。这些数据块在更新元数据之前被写入磁盘中。这样,在不牺牲性能的情况下,元数据和数据的一致性得以实现。第三个要使用的选项是 data=writeback,允许数据在其元数据已经提交至日记后再写入主要文件系统。在性能方面,此选项常被认为是最佳选项。但它在维护内部文件系统完整性的同时,允许以前的数据在系统崩溃并恢复后再次出现在文件中。Ext3 使用 data=ordered 选项作为默认值。

1.5.3 将 Ext2 文件系统转换为 Ext3 #

要将 Ext2 文件系统转换为 Ext3:

作为

root用户运行tune2fs -j来创建 Ext3 日记。此命令将用默认参数创建 Ext3 日记。

要指定日记的大小和所驻留的设备,请改为运行

tune2fs-J,同时使用所需的日记选项size=和device=。tune2fs手册页中有关于tune2fs程序的更多信息。作为

root用户编辑文件/etc/fstab,以将为相应分区指定的文件系统类型从ext2更改为ext3,然后保存更改。这确保可以正确识别出 Ext3 文件系统。此更改将在下次重引导后生效。

若引导已设置为 Ext3 分区的根文件系统,请在

initrd中添加模块ext3和jbd。操作步骤如下:打开或创建

/etc/dracut.conf.d/10-filesystem.conf并添加以下行(请注意前导空格):force_drivers+=" ext3 jbd"

然后运行

dracut-f命令。

重引导系统。

1.5.4 Ext3 文件系统 inode 大小及 inode 数量 #

inode 用于存储文件的相关信息及其在文件系统中的块位置。为了让 inode 有空间可以容纳扩展属性以及 ACL,Ext3 的默认 inode 大小从 SLES 10 上的 128 字节增加到了 SLES 11 上的 256 字节。与 SLES 10 相比,当您在 SLES 11 上创建新的 Ext3 文件系统时,为相同数量的 Inode 预先分配的默认空间容量会增加一倍,文件系统中文件的可用空间则会减少相应的容量。因此,要容纳与 SLES 10 上的 Ext3 文件系统中数量相同的 inode 和文件,您必须使用更大的分区。

当您创建新的 Ext3 文件系统时,系统将根据可创建的 Inode 总数预先分配 Inode 表格中的空间。每 inode 的字节数比率以及文件系统的大小决定了可以创建的 inode 数量。建立文件系统时,将根据每 inode 字节数的单位空间创建 inode:

number of inodes = total size of the file system divided by the number of bytes per inode

inode 的数量控制着文件系统中可容纳的文件数:一个文件对应一个 inode。为解决 inode 大小增加而使可用空间变少的问题,每 inode 的字节数比率的默认值由 SLES 10 上的 8192 字节增加到了 SLES 11 上的 16384 字节。比率翻倍意味着可以创建的文件数量将只有 SLES 10 上 Ext3 文件系统中可容纳文件数量的一半。

inode 分配完毕后,将无法更改 inode 大小的设置或每 inode 的字节数比率。如果不使用其他设置重新创建文件系统,或不扩展文件系统,则无法添加 Inode。超过 inode 最大数量时,只有删除部分文件才能在文件系统上创建新文件。

新建 Ext3 文件系统时,您可以指定 inode 大小和每 inode 的字节数比率,以控制文件系统上可容纳 inode 空间占用量以及文件数量。如果未指定块大小、inode 大小以及每 inode 的字节数比率值,则将应用 /etc/mked2fs.conf 中的默认值。有关信息,请参见 mke2fs.conf(5) 手册页。

使用以下指标:

inode 大小: 默认的 inode 大小为 256 字节。指定字节值,即介于 128 字节(含)到块大小(含)之间的 2 的乘方值,如 128、256、512,以此类推。只有当 Ext3 文件系统上不使用扩展属性或 ACL 时才可使用 128 字节。

每 inode 的字节数比率: 默认的每 inode 的字节数比率为 16384 字节。有效的每 inode 的字节数比率值必须是大于等于 1024 字节的 2 的乘方值,如 1024、2048、4096、8192、16384、32768,以此类推。该值不应小于文件系统的块大小,因为块大小是用于存储数据的最小空间大块。Ext3 文件系统默认的块大小为 4 KB。

此外,您还应考虑文件的数量以及需要存储的文件大小。例如,如果您的文件系统上将会有许多小文件,则可以指定一个较小的每 inode 的字节数比率,这样会增加 inode 的数量。如果文件系统将储存超大型文件,您可以指定一个较大的每 Inode 的字节数比率,这样可减少可能的 Inode 数。

通常情况下,最好要保证有足够多的 inode 可供使用。如果 inode 数量过少且文件很小,则可能当磁盘上的文件数量已达最大值时实际上磁盘却还很空。如果 inode 过多且文件很大,则可能虽然报告仍有可用空间,但却无法使用,这是因为您无法在为 inode 预留的空间中新建文件。

如果您在 Ext3 文件系统上不使用扩展属性或 ACL,则在创建文件系统时可通过将 inode 大小指定为 128 字节,并将每 inode 的字节数比率指定为 8192 字节,来恢复到 SLES 10 行为。使用以下任何一种方法设置 inode 大小以及每 inode 的字节数比率:

更改所有新的 Ext3 文件的默认设置: 在文本编辑器中,修改

/etc/mke2fs.conf文件的defaults部分,以为inode_size和inode_ratio设置所需的默认值。这些值将应用到所有新的 Ext3 文件系统。例如:blocksize = 4096 inode_size = 128 inode_ratio = 8192

在命令行处: 新建 Ext3 文件系统时,将 inode 大小 (

-I 128) 以及每 inode 的字节数比率 (-i 8192) 传递给mkfs.ext3(8)命令或mke2fs(8)命令。例如,使用以下任一命令:sudo mkfs.ext3 -b 4096 -i 8092 -I 128 /dev/sda2 sudo mke2fs -t ext3 -b 4096 -i 8192 -I 128 /dev/sda2

在使用 YaST 安装期间: 在安装期间,新建 Ext3 文件系统时要传递 inode 大小和每 inode 的字节数比率值。在下的页面的 YaST 分区程序中,选择,然后单击。从对话框中的、以及 下拉框中,选择所需的值。

例如,在 下拉框中选择 4096、在下拉框中选择 8192、在 下拉框中选择 128,然后单击。

在使用 AutoYaST 安装期间: 在 AutoYaST 配置文件中,您可以使用

fs_options标记来设置opt_bytes_per_inode比率值(-i 为 8192)以及opt_inode_density值(-I 为 128):<partitioning config:type="list"> <drive> <device>/dev/sda</device> <initialize config:type="boolean">true</initialize> <partitions config:type="list"> <partition> <filesystem config:type="symbol">ext3</filesystem> <format config:type="boolean">true</format> <fs_options> <opt_bytes_per_inode> <option_str>-i</option_str> <option_value>8192</option_value> </opt_bytes_per_inode> <opt_inode_density> <option_str>-I</option_str> <option_value>128</option_value> </opt_inode_density> </fs_options> <mount>/</mount> <partition_id config:type="integer">131</partition_id> <partition_type>primary</partition_type> <size>25G</size> </partition> </partitions> </drive> <partitioning>

有关相关信息,请参见 http://www.suse.com/support/kb/doc.php?id=7009075(SLES11 ext3 分区只能储存 SLES10 上可储存的文件数的 50% [技术信息文档 7009075])。

1.6 Ext4 #

2006 年,Ext4 做为 Ext3 的传承面市。它支持最大大小为 1 EiB 的卷、最大大小为 16 TiB 的文件和无限个子目录,消除了 Ext3 在储存上的一些局限。它还引入了多项性能增强功能,例如延迟块分配和速度大幅加快的文件系统检查例程。Ext4 还支持日记校验和,并可提供以纳秒度量的时间戳,因而更加可靠。Ext4 完全反向兼容于 Ext2 和 Ext3,后两个文件系统都可以作为 Ext4 装入。

1.7 ReiserFS #

作为 2.4 内核版本的正式的重要功能之一,ReiserFS 作为 2.2.x SUSE 内核的内核增补程序提供,因为版本 6.4 的 ReiserFS 是由 Hans Reiser 和 Namesys 开发团队设计的。ReiserFS 已证明它自己是 Ext2 功能强大的替代系统。其重要优点是通过数据日记实现的更合理的磁盘空间使用、更佳的磁盘访问性能、更快的崩溃恢复能力以及可靠性。

现有 ReiserFS 分区在 SUSE Linux Enterprise Server 12 的有效期间均受支持,专用于迁移。从 SUSE Linux Enterprise Server 12 开始,去除了创建新 ReiserFS 文件系统的支持。

1.8 支持的其他文件系统 #

表 1.1 “Linux 中的文件系统类型”对 linux 支持的其他一些文件系统进行了总结。支持这些文件系统主要是为了确保与不同类型的媒体或异操作系统实现兼容和数据交换。

|

文件系统类型 |

描述 |

|---|---|

|

|

压缩的 ROM 文件系统:一种经压缩的只读 ROM 文件系统。 |

|

|

高性能文件系统:IBM OS/2 标准文件系统。只在只读模式下支持。 |

|

|

CD-ROM 上的标准文件系统。 |

|

|

此文件系统源自有关操作系统的学术项目,是在 Linux 中使用的第一个文件系统。目前,它被用作软盘的文件系统。 |

|

|

|

|

|

网络文件系统:在此文件系统中,可以将数据储存在网络中的任何计算机上,并可以通过网络授予访问权限。 |

|

|

Windows NT 文件系统;只读。 |

|

|

Windows 等产品使用服务器消息块来支持通过网络启用文件访问。 |

|

|

在 SCO Unix、Xenix 和 Coherent(用于 PC 的商用 Unix 系统)上使用。 |

|

|

供 BSD、SunOS 和 NextStep 使用。只在只读方式下支持此文件系统。 |

|

|

MS-DOS 上的 Unix:在标准 |

|

|

虚拟 FAT: |

1.9 Linux 中对大型文件的支持 #

最初,Linux 支持的最大文件大小为 2 GiB(231 字节)。除非文件系统支持大型文件,否则 32 位系统上的最大文件大小为 2 GiB。

目前,所有标准文件系统都具有 LFS(大型文件支持)功能,理论上可支持的最大文件大小为 263 字节。表 1.2 “文件和文件系统的最大大小(磁盘格式,4 KiB 块大小)”概述了 Linux 文件和文件系统的当前磁盘上格式的限制。表中的数字基于文件系统使用 4 KiB 块大小的假设得出,这是通用的标准。使用不同的块大小,结果也就不同。使用较稀疏的块时,表 1.2 “文件和文件系统的最大大小(磁盘格式,4 KiB 块大小)”中的最大文件大小可能会大于文件系统的实际大小。

在此文档中:1024 字节 = 1 KiB;1024 KiB = 1 MiB;1024 MiB = 1 GiB;1024 GiB = 1 TiB;1024 TiB = 1 PiB;1024 PiB = 1 EiB(另请参见 NIST:二进制倍数的前缀)。

|

文件系统(4 KiB 块大小) |

最大文件系统大小 |

最大文件大小 |

|---|---|---|

|

Btrfs |

16 EiB |

16 EiB |

|

Ext3 |

16 TiB |

2 TiB |

|

Ext4 |

1 EiB |

16 TiB |

|

OCFS2(高可用性扩展中可使用的集群感知文件系统) |

16 TiB |

1 EiB |

|

ReiserFS v3.6 |

16 TiB |

1 EiB |

|

XFS |

8 EiB |

8 EiB |

|

NFSv2(客户端) |

8 EiB |

2 GiB |

|

NFSv3/NFSv4(客户端) |

8 EiB |

8 EiB |

表 1.2 “文件和文件系统的最大大小(磁盘格式,4 KiB 块大小)”介绍了有关磁盘上格式的限制。 Linux 内核自身的大小限制同样适用于其处理的文件和文件系统大小。下面介绍了这些限制:

- 文件大小

在 32 位系统上,文件不能超过 2 TiB(241 字节)。

- 文件系统大小

文件系统最大可以为 273 个字节。但是,目前可用的硬件尚不会超出这一限制。

1.10 Linux 内核储存的限制 #

表 1.3 “储存限制” 总结了与 SUSE Linux Enterprise Server 相关联的储存的内核限制。

|

储存功能 |

限制 |

|---|---|

|

支持的 LUN 最大数量 |

每个目标 16384 个 LUN。 |

|

每一个单独 LUN 的最大路径数量 |

默认情况下没有限制。每个路径视作一个常规 LUN。 每个目标的 LUN 数量以及每个 HBA 的目标数量决定了实际的限制(光纤通道 HBA 为 16777215)。 |

|

HBA 的最大数量 |

不限。实际限制取决于系统的 PCI 槽的数量。 |

|

每个操作系统使用 device-mapper-multipath 的最大路径数量(总计) |

大约为 1024。实际数量取决于每个多路径设备的设备号字符串长度。它是 multipath-tools 中的一个编译时间变量,如果此限制会导致问题,则可提高其值。 |

|

每一个块设备的最大大小 |

最多 8 EiB。 |

1.11 文件系统疑难解答 #

本节说明文件系统的一些已知问题和可能的解决方案。

1.11.1 Btrfs 错误:设备上没有剩余空间 #

使用 Btrfs 文件系统的根 (/) 分区停止接受数据。您收到错误“设备上没有剩余空间”。

请参见下列各部分,了解有关此问题的可能原因和预防措施的信息。

1.11.1.1 Snapper 快照使用的磁盘空间 #

如果 Snapper 是针对 Btrfs 文件系统运行的,则“设备上没有剩余空间”问题通常是由于系统上做为快照储存的数据过多所致。

您可以从 Snapper 中去除一些快照,不过,快照不会立即删除,可能不能释放您需要的空间容量。

若要从 Snapper 中删除文件:

打开一个终端控制台。

在命令提示符处,输入

btrfs filesystem show,例如:tux >sudo btrfs filesystem show Label: none uuid: 40123456-cb2c-4678-8b3d-d014d1c78c78 Total devices 1 FS bytes used 20.00GB devid 1 size 20.00GB used 20.00GB path /dev/sda3输入

sudo btrfs fi balance start MOUNTPOINT -dusage=5

此命令会尝试将数据重新放置在空的或接近空的数据块中,从而允许收回空间并将其重新指派给元数据。此操作可能需要一些时间(1 TB 数据可能需要很多小时),不过,在此期间系统仍可以使用。

列出 Snapper 中的快照。输入

sudo snapper -c root list

从 Snapper 中删除一或多个快照。输入

sudo snapper -c root delete SNAPSHOT_NUMBER(S)

务必先删除最旧的快照。快照生成的时间越长,其占用的空间就越大。

为了避免此问题发生,您可以更改 Snapper 清理算法。有关细节,请参见Book “管理指南”, Chapter 7 “通过 Snapper 进行系统恢复和快照管理”, Section 7.6.1.2 “清理算法”。控制快照清理的配置值为 EMPTY_*、NUMBER_* 和 TIMELINE_*。

如果在文件系统磁盘上搭配使用 Snapper 和 Btrfs,建议您保留两倍于标准储存建议的磁盘空间容量。YaST 分区程序会自动在 Btrfs 储存建议中为根文件系统建议标准磁盘空间的两倍容量。

1.11.1.2 日志、崩溃和缓存文件使用的磁盘空间 #

如果系统磁盘填满了数据,您可以尝试从 /var/log、/var/crash、/var/lib/systemd/coredump 和 /var/cache 中删除文件。

Btrfs 根文件系统子卷 /var/log、/var/crash 和 /var/cache 在正常运作情况下可能会使用所有可用的磁盘空间,此时将导致系统故障。为避免出现此状况,SUSE Linux Enterprise Server 提供了 Btrfs 子卷配额支持。有关详细信息,请参见第 1.2.5 节 “Btrfs 子卷定额支持”。

在测试和开发计算机上,尤其是当应用程序频繁崩溃时,您也可能想查看 /var/lib/systemd/coredump,内核转储就储存在其中。

1.11.2 释放未使用的文件系统块 #

在固态硬盘 (SSD) 和精简配置的卷中,释放未被文件系统使用的块会很有用。SUSE Linux Enterprise Server 完全支持在支持取消映射或释放方法的所有文件系统上执行这些操作。

建议通过运行 /sbin/wiper.sh,来释放 SUSE Linux Enterprise Server 上支持的文件系统(Btrfs 除外)。在运行此脚本之前,请务必阅读 /usr/share/doc/packages/hdparm/README.wiper。对于大多数桌面和服务器系统,每周释放一次便已足够。使用 -o discard 装入文件系统会降低性能,并可能对 SSD 的寿命造成负面影响,因此不建议使用此选项。

wiper.sh

wiper.sh 脚本会释放装入的读写 ext4 或 XFS 文件系统以及装入/未装入的只读 ext2、ext3、ext4 和 XFS 文件系统的数据块。请勿在 Btrfs 文件系统上使用 wiper.sh,否则可能会损坏数据。应该使用 btrfsmaintenance 包中的 /usr/share/btrfsmaintenance/btrfs-trim.sh。

1.12 其他信息 #

上面介绍的每个文件系统项目都有自己的主页,可以在其中找到邮件列表信息、更多文档和常见问题:

Kernel.org 上的 Btrfs Wiki:https://btrfs.wiki.kernel.org/

E2fsprogs: Ext2/3/4 File System Utilities: http://e2fsprogs.sourceforge.net/

Introducing Ext3: http://www.ibm.com/developerworks/linux/library/l-fs7/

OCFS2 Project(OCFS2 项目):http://oss.oracle.com/projects/ocfs2/

有关 Linux 文件系统的多部份全面教学课程,请参见 IBM developerWork 中的《Advanced File System Implementor’s Guide》(高级文件系统实施指南,网址:https://www.ibm.com/developerworks/linux/library/l-fs/)。

Wikipedia 项目上的“Comparison of File Systems”(文件系统比较,网址:http://en.wikipedia.org/wiki/Comparison_of_file_systems#Comparison)中提供了对各种文件系统(不仅仅是 Linux 文件系统)更深入的比较。

2 调整文件系统大小 #

调整文件系统大小(不要与调整分区或卷大小混淆)可用于将物理卷上的空间变为可用状态,或使用物理卷上可用的其他空间。

2.1 使用案例 #

强烈建议您使用 YaST 分区程序来调整分区或逻辑卷的大小。这样一来,文件系统将自动调整为分区或卷的新大小。不过,在某些情况下,您需要手动调整文件系统的大小,因为 YaST 不支持它们:

调整虚拟机 Guest 的虚拟磁盘大小之后。

调整网络附加储存中的卷大小之后。

手动调整分区(例如通过使用

fdisk或parted)或逻辑卷(例如通过使用lvresize)的大小之后。要缩小 Btrfs 文件系统的大小时(从 SUSE Linux Enterprise Server 12 开始,YaST 仅支持增大 Btrfs 文件系统)。

2.2 调整大小指导原则 #

调整任何文件系统的大小都存在一定的风险,可能会造成数据遗失。

为了避免数据丢失,请确保在开始任何调整大小任务之前备份您的数据。

计划调整文件系统大小时,请考虑以下指导原则。

2.2.1 支持调整大小的文件系统 #

文件系统必须支持调整大小才能利用卷可用空间增加功能。SUSE Linux Enterprise Server 中提供了适用于文件系统 Ext2、Ext3、Ext4 及 ReiserFS 的文件系统重设置大小实用程序。这些实用程序支持如下增加和减小大小:

|

文件系统 |

实用程序 |

增大大小(增大) |

减小大小(收缩) |

|---|---|---|---|

|

Btrfs |

|

联机 |

联机 |

|

XFS |

|

联机 |

不支持 |

|

Ext2 |

|

联机或脱机 |

仅限脱机 |

|

Ext3 |

|

联机或脱机 |

仅限脱机 |

|

Ext4 |

|

联机或脱机 |

仅限脱机 |

|

ReiserFS |

|

联机或脱机 |

仅限脱机 |

2.2.2 增加文件系统的大小 #

您可以将文件系统增大到设备上的最大可用空间,或指定一个准确大小。请确保在尝试增加文件系统的大小之前先增加设备或逻辑卷的大小。

为文件系统指定精确大小时,请确保新大小满足以下条件:

新大小必须大于现有数据的大小;否则会发生数据丢失。

新大小必须等于或小于当前设备大小,因为文件系统大小不能超出可用空间。

2.2.3 减小文件系统的大小 #

当减小设备上的文件系统的大小时,请确保新的大小满足以下条件:

新大小必须大于现有数据的大小;否则会发生数据丢失。

新大小必须等于或小于当前设备大小,因为文件系统大小不能超出可用空间。

如果还计划减小用于保存文件系统的逻辑卷的大小,请确保在尝试减小设备或逻辑卷的大小之前先减小文件系统的大小。

XFS 格式文件系统的大小无法减少,因为 XFS 不支持此功能。

2.3 更改 Btrfs 文件系统的大小 #

装入 Btrfs 文件系统后,您可以使用 btrfs filesystem resize 命令来更改该文件系统的大小。装入了文件系统时,增加和缩小大小均受支持。

打开一个终端控制台。

确定您要更改的文件系统已装入。

使用

btrfs filesystem resize命令通过下列其中一种方法更改文件系统的大小:要将文件系统大小扩展为设备的最大可用大小,请输入

sudo btrfs filesystem resize max /mnt

要将文件系统扩展为指定大小,请输入

sudo btrfs filesystem resize SIZE /mnt

将 SIZE 替换为所需大小(以字节为单位)。您还可以为值指定单位,例如 50000K (KB)、250M (MB) 或 2G (GB)。您也可以在值前面加上加号 (

+) 或减号 (-),分别指定增加或缩小至目前的大小:sudo btrfs filesystem resize +SIZE /mnt sudo btrfs filesystem resize -SIZE /mnt

通过输入以下命令,检查已装入文件系统的调整大小的结果

df -h

磁盘可用 (

df) 命令显示磁盘的总大小、使用的块数以及文件系统上可用的块数。-h 选项会以可辨识的格式列印大小,如 1K、234M 或 2G。

2.4 更改 XFS 文件系统的大小 #

装入 XFS 文件系统后,您可以使用 xfs_growfs 命令来增加该文件系统的大小。XFS 文件系统的大小无法减少。

打开一个终端控制台。

确定您要更改的文件系统已装入。

使用

xfs_growfs命令增加文件系统的大小。下面的示例会将文件系统的大小扩充为最大可用值。请参见man 8 xfs_growfs了解更多选项。sudo xfs_growfs -d /mnt

通过输入以下命令,检查已装入文件系统的调整大小的结果

df -h

磁盘可用 (

df) 命令显示磁盘的总大小、使用的块数以及文件系统上可用的块数。-h 选项会以可辨识的格式列印大小,如 1K、234M 或 2G。

2.5 更改 Ext2、Ext3 或 Ext4 文件系统的大小 #

不管是否装入了相应的分区,都可以使用 resize2fs 命令增加 Ext2、Ext3 和 Ext4 文件系统的大小。若要减少 Ext 文件系统的大小,需要将其卸载。

打开一个终端控制台。

如果应减少文件系统的大小,请将它卸载。

使用下列方法之一更改文件系统的大小:

要将文件系统大小扩展为名为

/dev/sda1的设备的最大可用大小,请输入sudo resize2fs /dev/sda1

如果未指定大小参数,大小将默认为该分区的大小。

若要将文件系统更改为特定大小,请输入

sudo resize2fs /dev/sda1 SIZE

SIZE 参数指定为文件系统请求的新大小。如果不指定任何单位,则大小参数的单位是文件系统的块大小。也可以选择在大小参数后面加上下列其中一种单位指示项:

s表示 512 字节扇区;K表示 KB(1 KB 为 1024 字节);M表示 MB;G表示 GB。

等到调整大小完成再继续。

如果未装入该文件系统,则现在装入它。

通过输入以下命令,检查已装入文件系统的调整大小的结果

df -h

磁盘可用 (

df) 命令显示磁盘的总大小、使用的块数以及文件系统上可用的块数。-h 选项会以可辨识的格式列印大小,如 1K、234M 或 2G。

2.6 更改 Reiser 文件系统的大小 #

ReiserFS 文件系统在装入或卸载时可增加大小。若要减少其大小,则需要将其卸载。

打开一个终端控制台。

如果您要减少文件系统的大小,而文件系统已装入,请将其卸除。

使用以下其中一种方法,更改名为

/dev/sda2的设备上文件系统的大小:要将文件系统大小扩展为设备的最大可用大小,请输入

sudo resize_reiserfs /dev/sda2

不指定大小时,这会将卷增加到分区的完整大小。

要将文件系统扩展为指定大小,请输入

sudo resize_reiserfs -s SIZE /dev/sda2

将 SIZE 替换为所需大小(以字节为单位)。您还可以为值指定单位,例如 50000K (KB)、250M (MB) 或 2G (GB)。您也可以在值前面加上加号 (

+) 或减号 (-),分别指定增加或缩小至目前的大小:sudo resize_reiserfs -s +SIZE /dev/sda2 sudo resize_reiserfs -s -SIZE /dev/sda2

等到调整大小完成再继续。

如果未装入该文件系统,则现在装入它。

通过输入以下命令,检查已装入文件系统的调整大小的结果

df -h

磁盘可用 (

df) 命令显示磁盘的总大小、使用的块数以及文件系统上可用的块数。-h 选项会以可辨识的格式列印大小,如 1K、234M 或 2G。

3 使用 UUID 装入设备 #

本章介绍使用 UUIDs(全局唯一标识符)而不是设备名称(例如 /dev/sda1)来识别文件系统设备。从 SUSE Linux Enterprise Server 12 开始,默认在引导加载程序文件和 /etc/fstab 文件中使用 UUID。

3.1 具有 udev 的永久性设备名称 #

从 Linux 内核 2.6 开始,udev 使用永久性设备命名方式,为动态的 /dev 目录提供了一种用户空间解决方案。作为热插拔系统的一部分,在系统中添加或删除设备时会执行 udev。

使用一个规则列表来针对特定设备属性进行匹配。udev 规则基础设施(在 /etc/udev/rules.d 目录中定义)为所有磁盘设备提供了稳定的名称,无论它们的识别顺序或该设备使用的连接如何。udev 工具检查内核创建的用来根据特定总线、驱动器类型或文件系统应用命名规则的每个相应块设备。有关如何为 udev 定义您自己的规则的信息,请参见 Writing udev Rules(编写 udev 规则)。

和动态的内核提供的设备节点名一起,udev 还在 /dev/disk 目录中维护有指向该设备的永久符号链接的类,该目录进一步按 by-id、by-label、by-path 和 by-uuid 子目录分类。

除了 udev 之外的其他程序(如 LVM 或 md)也可生成 UUID,但它们不在 /dev/disk 中列出。

3.2 了解 UUID #

UUID(全球唯一标识符)是表示文件系统的 128 位数字,在本地系统和其他系统中都是唯一的。它根据系统硬件信息和时戳(做为其种子的一部分)随机生成。UUID 通常用于唯一性标记设备。

使用非永久性的“传统”设备名称(例如 /dev/sda1)可能在添加储存时导致系统出现无法引导的情况。例如,如果将根 (/) 指派给 /dev/sda1,则在挂接 SAN 或将其他硬盘加入系统后,系统可能会将它重新指派给 /dev/sdg1。在此情况下,需要调整启动加载程序配置和 /etc/fstab 文件,否则系统将无法引导。

避免此问题的一个方法是在引导加载程序和引导设备的 /etc/fstab 文件中使用 UUID。这是自第 12 版以来 SUSE Linux Enterprise 中的默认设置。UUID 是文件系统的一个属性,如果重新格式化驱动器,UUID 会更改。如果不想使用设备名称的 UUID,另一种替代方法是使用 ID 或标签识别设备。

您还可以将 UUID 用做组装与激活软件 RAID 设备的准则。当创建 RAID 时,md 驱动程序会为该设备生成一个 UUID,并将该值储存在 md 超块中。

您可以在 /dev/disk/by-uuid 目录中找到任何块设备的 UUID。UUID 项目示例如下所示:

tux > ls -og /dev/disk/by-uuid/

lrwxrwxrwx 1 10 Dec 5 07:48 e014e482-1c2d-4d09-84ec-61b3aefde77a -> ../../sda13.3 其他信息 #

有关使用 udev 来管理设备的详细信息,请参见Book “管理指南”, Chapter 21 “使用 udev 进行动态内核设备管理”。

有关 udev 命令的详细信息,请参见 man 7 udev。

4 用于块设备操作的多层超速缓存 #

多层超速缓存是一种复制的/分布式超速缓存,它至少包括两个层:一个层由速度较慢但较为廉价的旋转块设备(硬盘)表示,另一个层成本更高,但执行数据操作的速度更快(例如,SSD 闪存盘)。

SUSE Linux Enterprise Server 为闪存设备与旋转设备的超速缓存实施两种不同的解决方案:bcache 和 lvmcache。

4.1 一般术语 #

本节对在介绍超速缓存相关功能时经常用到的几个术语进行了解释:

- 迁移

将逻辑块的主副本从一个设备移到另一个设备。

- 升级

从慢速设备迁移到快速设备。

- 降级

从快速设备迁移到慢速设备。

- 源设备

大型慢速块设备。它始终包含逻辑块的副本,该副本可能已过时或者与超速缓存设备上的副本保持同步(取决于策略)。

- 超速缓存设备

小型高速块设备。

- 元数据设备

一个小型设备,用于记录哪些块在超速缓存中、哪些块是脏的,以及供策略对象使用的附加提示。此信息可放在超速缓存设备上,但将它隔离可让卷管理器对它进行不同的配置,例如,配置为镜像以提高稳定性。元数据设备只能由单个超速缓存设备使用。

- 脏块

如果某个进程将信息写入超速缓存中的某个数据块,则该超速缓存的块将被标记为脏块,因为该块在超速缓存中已被覆盖,需要写回到原始设备。

- 超速缓存未命中

I/O 操作请求会先指向已超速缓存设备的超速缓存。如果找不到请求的值,则会在设备本身中查找,因此速度会变慢。这称为超速缓存未命中。

- 超速缓存命中

如果在已超速缓存设备的超速缓存中找到请求的值,则可以快速提供该值。这称为超速缓存命中。

- 冷超速缓存

不保存任何值(为空)且导致超速缓存未命中的超速缓存。在执行已超速缓存块设备的操作过程中,冷超速缓存中会填充数据,从而变为暖超速缓存。

- 暖超速缓存

已保存了一些值并且可能会导致超速缓存命中的超速缓存。

4.2 超速缓存模式 #

下面是多层超速缓存使用的基本超速缓存模式:写回、直写、绕写和直通。

- 写回

写入已超速缓存块的数据只会存入超速缓存,并且该块将标记为脏块。这是默认的超速缓存模式。

- 直写

只有在同时命中源设备和超速缓存设备之后,向已超速缓存块的写入才会完成。在直写超速缓存中,干净块将保持干净状态。

- 绕写

类似于直写超速缓存的一种技术,不过,写 I/O 将直接写入永久性储存,并绕过超速缓存。这可以防止超速缓存因写 I/O 而填满,导致以后不可重新读取,不过,缺点是对最近写入数据的读取请求会造成“超速缓存未命中”,因而需要从慢速大容量储存中读取这些数据,致使发生较高延迟。

- 直通

要启用直通模式,超速缓存必须是干净的。将绕过超速缓存,从源设备为读取请求提供服务。写请求将转到源设备,使超速缓存块“失效”。直通允许您激活超速缓存设备时不必考虑数据一致性,而这是可以维护的。随着写操作的不断进行,超速缓存将逐渐变为冷状态。如果您以后可以校验超速缓存的一致性,或者可以使用

invalidate_cblocks讯息来建立这种一致性,则可以在超速缓存设备仍处于暖状态时,将它切换到直写或写回模式。或者,可以在切换到所需的超速缓存模式之前,先丢弃超速缓存内容。

4.3 bcache #

bcache 是一个 Linux 内核块层超速缓存。它允许使用一个或多个高速磁盘驱动器(例如 SSD)作为一个或多个速度低得多的硬盘的超速缓存。bcache 支持直写和写回,不受所用文件系统的约束。默认情况下,它只超速缓存随机读取和写入,这也是 SSD 的强项。它还适合用于台式机、服务器和高端储存阵列。

4.3.1 主要功能 #

可以使用单个超速缓存设备来超速缓存任意数量的后备设备。在运行时可以挂接和分离已装入及使用中的后备设备。

在非正常关机后恢复 - 只有在超速缓存与后备设备一致后才完成写入。

SSD 拥塞时限制传至 SSD 的流量。

高效的写回实施方案。脏数据始终按排序顺序写出。

稳定可靠,可在生产环境中使用。

4.3.2 设置 bcache 设备 #

本节介绍设置和管理 bcache 设备的步骤。

安装

bcache-tools包:sudo zypper in bcache-tools

创建后备设备(通常是一个机械驱动器)。后备设备可以是整个设备、一个分区或任何其他标准块设备。

sudo make-bcache -B /dev/sdb

创建超速缓存设备(通常是一个 SSD 磁盘)。

sudo make-bcache -C /dev/sdc

本示例使用了默认的块大小和储存桶大小,分别为 512 B 和 128 KB。块大小应与后备设备的扇区大小(通常为 512 或 4k)匹配。储存桶大小应与超速缓存设备的擦除块大小匹配,以便减少写入放大现象。例如,如果使用具有 4k 扇区的硬盘和具有 2 MB 擦除块大小的 SSD,则此命令将如下所示:

sudo make-bcache --block 4k --bucket 2M -C /dev/sdc

提示:多设备支持make-bcache可同时准备和注册多个后备设备与一个超速缓存设备。在这种情况下,以后您不需要将超速缓存设备手动挂接到后备设备:sudo make-bcache -B /dev/sda /dev/sdb -C /dev/sdc

bcache设备将显示为/dev/bcacheN

和

/dev/bcache/by-uuid/UUID /dev/bcache/by-label/LABEL

您可以像平时一样正常格式化和装入

bcache设备:mkfs.ext4 /dev/bcache0 mount /dev/bcache0 /mnt

您可以在

/sys/block/bcacheN/bcache中通过sysfs控制bcache设备。注册超速缓存设备和后备设备后,需要将后备设备挂接到相关的超速缓存集才能启用超速缓存:

echo CACHE_SET_UUID > /sys/block/bcache0/bcache/attach

其中,CACHE_SET_UUID 可在

/sys/fs/bcache中找到。默认情况下,

bcache使用直通超速缓存模式。要更改模式,例如,更改为写回模式,请运行echo writeback > /sys/block/bcache0/bcache/cache_mode

4.3.3 使用 sysfs 的 bcache 配置 #

bcache 设备使用 sysfs 接口来储存其运行时配置值。这样,您便可以更改 bcache 后备设备和超速缓存磁盘的行为,或查看其使用统计数字。

有关 bcache sysfs 参数的完整列表,请查看 /usr/src/linux/Documentation/bcache.txt 文件的内容,主要查看 SYSFS - BACKING DEVICE、SYSFS - BACKING DEVICE STATS 和 SYSFS - CACHE DEVICE 部分。

4.4 lvmcache #

lvmcache 是由逻辑卷 (LV) 组成的超速缓存机制。它使用 dm-cache 内核驱动程序,支持直写(默认)和写回超速缓存模式。lvmcache 可将大型慢速 LV 的部分数据动态迁移到更快、更小的 LV,从而提高其性能。有关 LVM 的详细信息,请参见第 II 部分 “逻辑卷 (LVM)”。

LVM 将小型快速 LV 称为超速缓存池 LV。大型慢速 LV 称为源 LV。由于 dm-cache 的要求,LVM 进一步将超速缓存池 LV 分割成两个设备:超速缓存数据 LV 和超速缓存元数据 LV。来自源 LV 的数据块副本保存在超速缓存数据 LV 中,以提高速度。超速缓存元数据 LV 保存记帐信息,这些信息指定数据块的储存位置。

4.4.1 配置 lvmcache #

本节介绍创建和配置基于 LVM 的超速缓存的步骤。

创建源 LV。创建新 LV,或使用现有 LV 作为源 LV:

lvcreate -n ORIGIN_LV -L 100G vg /dev/SLOW_DEV

创建超速缓存数据 LV。此 LV 将保存来自源 LV 的数据块。此 LV 的大小是超速缓存的大小,将报告为超速缓存池 LV 的大小。

lvcreate -n CACHE_DATA_LV -L 10G vg /dev/FAST

创建超速缓存元数据 LV。此 LV 将保存超速缓存池元数据。此 LV 的大小应该比超速缓存数据 LV 大约小 1000 倍,其最小大小为 8MB。

lvcreate -n CACHE_METADATA_LV -L 12M vg /dev/FAST

列出您目前为止所创建的卷:

lvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg -wi-a----- 10.00g cache_metadata_lv vg -wi-a----- 12.00m origin_lv vg -wi-a----- 100.00g

创建超速缓存池 LV。将数据 LV 和元数据 LV 组合成一个超速缓存池 LV。同时还可以设置超速缓存池 LV 的行为。

CACHE_POOL_LV 与 CACHE_DATA_LV 同名。

CACHE_DATA_LV 重命名为 CACHE_DATA_LV_cdata,并且会隐藏起来。

CACHE_META_LV 重命名为 CACHE_DATA_LV_cmeta,并且会隐藏起来。

lvconvert --type cache-pool \ --poolmetadata vg/cache_metadata_lv vg/cache_data_lv

lvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg Cwi---C--- 10.00g [cache_data_lv_cdata] vg Cwi------- 10.00g [cache_data_lv_cmeta] vg ewi------- 12.00m origin_lv vg -wi-a----- 100.00g

创建超速缓存 LV。通过将超速缓存池 LV 链接到源 LV 来创建超速缓存 LV。

用户可访问的超速缓存 LV 与源 LV 同名,源 LV 将变成重命名为 ORIGIN_LV_corig 的隐藏 LV。

CacheLV 与 ORIGIN_LV 同名。

ORIGIN_LV 重命名为 ORIGIN_LV_corig,并且会隐藏起来。

lvconvert --type cache --cachepool vg/cache_data_lv vg/origin_lv

lvs -a vg LV VG Attr LSize Pool Origin cache_data_lv vg Cwi---C--- 10.00g [cache_data_lv_cdata] vg Cwi-ao---- 10.00g [cache_data_lv_cmeta] vg ewi-ao---- 12.00m origin_lv vg Cwi-a-C--- 100.00g cache_data_lv [origin_lv_corig] [origin_lv_corig] vg -wi-ao---- 100.00g

4.4.2 去除超速缓存池 #

可通过多种方法关闭 LV 超速缓存。

4.4.2.1 从超速缓存 LV 分离超速缓存池 LV #

您可以从超速缓存 LV 断开与超速缓存池 LV 的连接,留下一个未使用的超速缓存池 LV 和一个未超速缓存的源 LV。数据将根据需要从超速缓存池写回到源 LV。

lvconvert --splitcache vg/origin_lv

4.4.2.2 去除超速缓存池 LV 但不去除其源 LV #

以下命令会根据需要将数据从超速缓存池写回到源 LV,然后去除超速缓存池 LV,留下未超速缓存的源 LV。

lvremove vg/cache_data_lv

也可以使用以下替代命令从超速缓存 LV 断开与超速缓存池的连接,并删除超速缓存池:

lvconvert --uncache vg/origin_lv

4.4.2.3 去除源 LV 和超速缓存池 LV #

去除超速缓存 LV 会同时去除源 LV 和链接的超速缓存池 LV。

lvremove vg/origin_lv

4.4.2.4 更多信息 #

可以在 lvmcache 手册页 (man 7 lvmcache) 中找到有关 lvmcache 的更多主题,例如支持的超速缓存模式、冗余的子逻辑卷、超速缓存策略,或者将现有 LV 转换为超速缓存类型。

第 II 部分 逻辑卷 (LVM) #

5 LVM 配置 #

本章介绍逻辑卷管理器 (LVM) 的原理,以及令其在许多情况下都能发挥效用的基本功能。YaST LVM 配置可以通过 YaST 专家分区程序完成。此分区工具用于编辑和删除现有分区并创建用于 LVM 的新分区。

使用 LVM 可能会增加一些风险,例如数据丢失。这些风险还包括应用程序崩溃、电源故障及有问题的命令。在实施 LVM 或重配置卷前,请保存数据。决不要在没有备份的情况下工作。

5.1 了解逻辑卷管理器 #

LVM 支持在多个物理卷(硬盘、分区、LUN)之间弹性分配硬盘空间。开发逻辑卷管理器是因为可能只有在安装期间初始分区完成后才需要更改硬盘空间的分段。因为在正在运行的系统中修改分区比较困难,LVM 提供了储存空间的虚拟池(卷组或 VG),如果需要,可以从中生成逻辑卷 (LV)。操作系统访问这些逻辑卷而不是物理分区。卷组可以跨多个磁盘,这样多个磁盘或部分磁盘可以构成一个 VG。LVM 以这种方式提供了一种对物理磁盘空间的抽象,从而能够以比物理分区更方便、更安全的方式更改硬盘空间的分段。

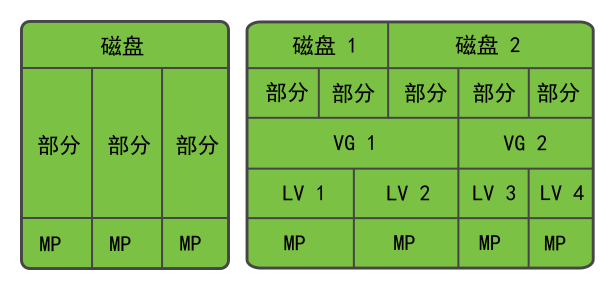

图 5.1 “物理分区与 LVM”比较物理分区(左)和 lvm 分段(右)。在左侧,将一个磁盘分成 3 个物理分区 (PART),每个分区指派了一个安装点 (MP),以便操作系统可以访问它们。在右侧,有两个磁盘,一个磁盘分为 2 个物理分区,另一个磁盘分为 3 个物理分区。定义了两个 LVM 卷组(VG1 和 VG2)。VG 1 包含 DISK 1 中的两个分区和 DISK 2 中的一个分区。VG 2 包含 DISK 2 中的其余两个分区。

在 LVM 中,合并到卷组的物理磁盘分区称为物理卷 (PV)。在图 5.1 “物理分区与 LVM”的卷组中,定义了四个逻辑卷(LV 1 至 LV 4),操作系统可以通过关联的安装点 (MP) 来使用这些逻辑卷。不同逻辑卷之间的边界不一定是任何分区边界。请参见本示例中 LV 1 和 LV 2 之间的边界。

LVM 功能:

可以将多块硬盘或多个分区合并为一个较大的逻辑卷。

如果配置合适,当可用空间用完后,可以扩大 LV(例如

/usr)。通过使用 LVM,可以在正在运行的系统中添加硬盘或 LV。但这需要支持此类操作的可热插拔的硬件。

可激活分段方式,此方式将通过若干物理卷来分发逻辑卷的数据流。如果这些物理卷位于不同的磁盘上,则可提高读写性能(类似于 RAID 0)。

使用快照功能可以在正在运行的系统中执行一致的备份(尤其适合服务器)。

尽管 LVM 也支持 0/1/4/5/6 级别的 RAID,但建议使用 MD RAID(请参见第 7 章 “软件 RAID 配置”)。不过,LVM 可以与 RAID 0 和 1 搭配使用,因为 RAID 0 类似于通用逻辑卷管理(各个逻辑块将映射到物理设备上的块)。在 RAID 1 基础上使用的 LVM 可以跟踪镜像同步,并完全能够管理同步过程。使用更高的 RAID 级别时,需要借助一个管理守护程序来监视挂接的磁盘的状态,并在磁盘阵列出现问题时通知管理员。LVM 包含这种守护程序,但在异常情况下(例如设备故障),该守护程序无法正常工作。

如果您将系统的根文件系统配置在 LVM 或软件 RAID 阵列中,则必须将 /boot 置于单独的非 LVM 或非 RAID 分区上,否则系统将无法引导。此类分区的建议大小为 500 MB,建议的文件系统为 Ext4。

通过这些功能,使用 LVM 还对频繁使用的家用 PC 或小型服务器有用。如果您的数据储存量(如数据库、音乐存档或用户目录)不断增长,则 LVM 尤其有用。它支持您使用大于物理硬盘的文件系统。但是,请记住,使用 LVM 与使用传统的分区截然不同。

您可以使用 YaST 分区程序管理新的或现有的 LVM 储存对象。有关配置 LVM 的指示及详细信息,请参见官方的 LVM HOWTO。

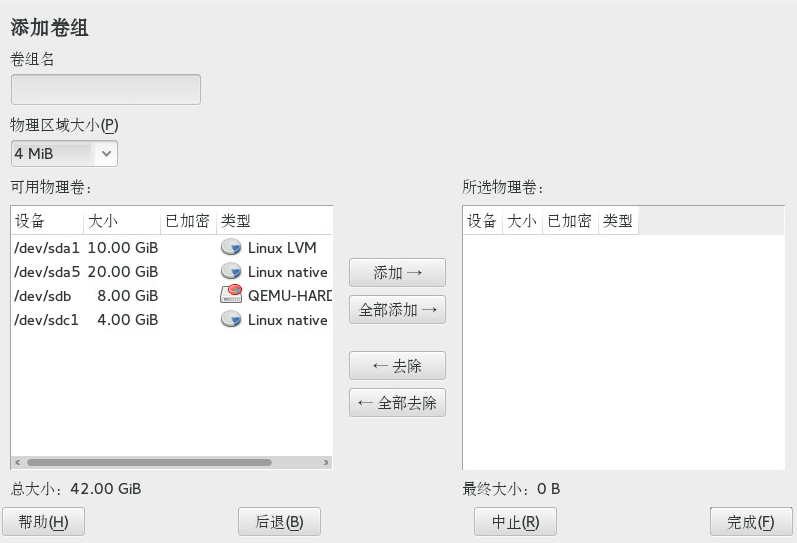

5.2 创建卷组 #

LVM 卷组 (VG) 会将 Linux LVM 分区组织到一个逻辑空间池中。您可以从组的可用空间中划分出逻辑卷。组中的 Linux LVM 分区可以在相同或不同磁盘上。您可以添加分区或整个磁盘来扩大组的大小。

要使用整个磁盘,该磁盘不得包含任何分区。使用分区时,不得装入分区。在将分区添加到 VG 时,YaST 会自动将它们的分区类型更改为 0x8E Linux LVM。

起动 YaST 并打开。

如果您需要重新配置现有分区设置,请执行下面操作。有关细节,请参见Book “部署指南”, Chapter 12 “高级磁盘设置”, Section 12.1 “使用 YaST 分区程序”。如果您只想使用未使用的磁盘或已存在的分区,请跳过此步骤。

警告:未分区磁盘上的物理卷可以使用某个未分区的磁盘作为物理卷 (PV),前提是该磁盘不是安装操作系统的磁盘,也不是操作系统从中引导的磁盘。

由于未分区的磁盘在系统级别显示为未使用,因此很容易被覆盖或被不正确地访问。

要使用已包含分区的整个硬盘,请删除该磁盘上的所有分区。

要使用当前已装入的分区,请将其卸载。

在左侧面板中,选择。

右侧面板中即会打开现有卷组的列表。

在“卷管理”页面左下方,单击 › 。

按如下所示定义卷组︰

指定。

如果在安装时创建卷组,建议对将包含 SUSE Linux Enterprise Server 文件系统的卷组采用名称

system。指定。

定义卷组中物理块的大小。卷组中的所有磁盘空间都是按此大小的区块来处理的。值可以是 1 KB 到 16 GB(2 的幂数形式)。通常将此值设置为 4 MB。

在 LVM1 中,4 MB 物理区域允许的最大 LV 大小为 256 GB,因为它仅支持每个 LV 最多 65534 个区域。SUSE Linux Enterprise Server 上使用的 LVM2 不会限制物理区域的数量。区域数过多不会影响逻辑卷的 I/O 性能,但会降低 LVM 工具的速度。

重要:物理区域大小单个 VG 中不应混合有不同的物理区域大小。区域在初始设置后不应修改。

在列表中,选择要成为此卷组一部分的 Linux LVM 分区,然后单击将它们移动到列表。

单击。

新组将出现在列表中。

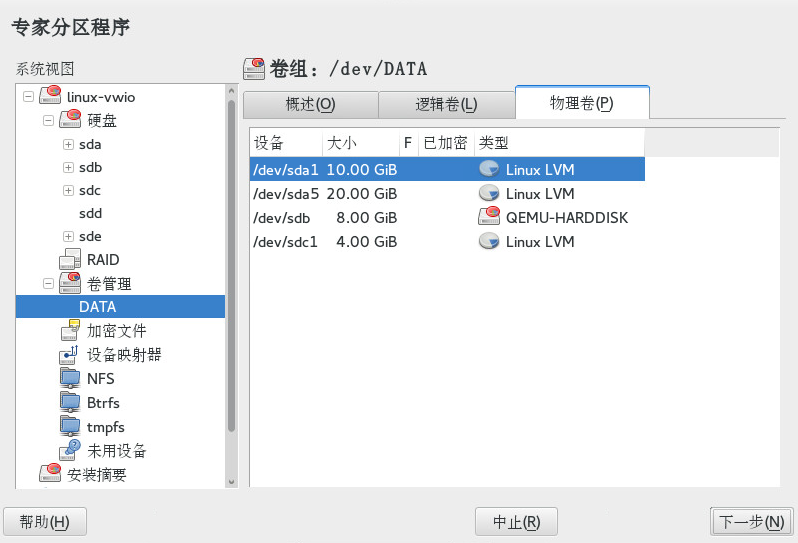

在“卷管理”页上,单击,验证是否列出了新卷组,然后单击。

要检查哪些物理设备属于卷组的一部分,可随时在运行的系统中打开 YaST 分区程序,然后单击 › › 。单击离开此屏幕。

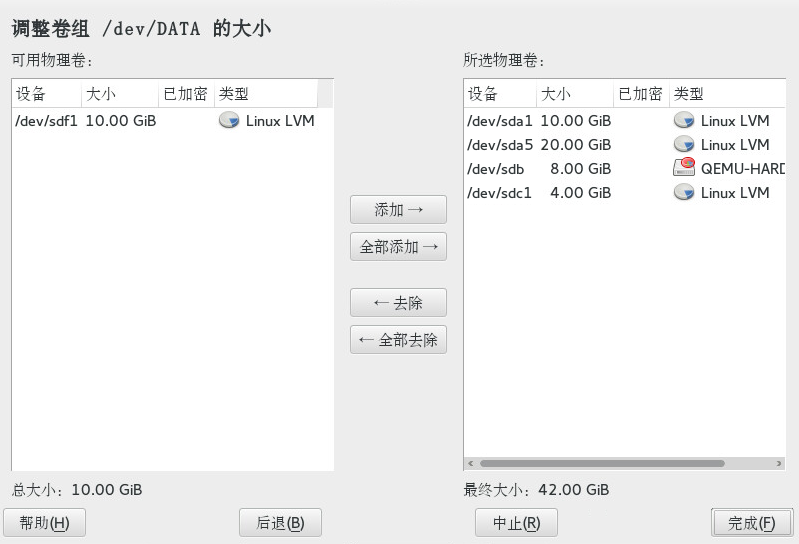

图 5.2︰ 名为 DATA 的卷组中的物理卷 #

5.3 创建逻辑卷 #

逻辑卷提供一个空间池,此空间池与硬盘提供的空间池类似。要让此空间可用,需要定义逻辑卷。逻辑卷类似于一个普通分区 - 您可以进行格式化并将其装入系统。

使用 YaST 分区程序从现有卷组创建逻辑卷。请为每个卷组至少指派一个逻辑卷。您可以根据需要创建新的逻辑卷,直到卷组中的所有可用空间都用完为止。可以选择性地精简配置一个 LVM 逻辑卷,以便创建大小超出可用空间的逻辑卷(有关详细信息,请参见第 5.3.1 节 “精简配置的逻辑卷”)。

普通卷: (默认)系统会立即分配卷的空间。

瘦池: 逻辑卷是预留供瘦卷使用的空间池。瘦卷可以按需从瘦池分配它们所需的空间。

瘦卷: 该卷会被创建为稀疏卷。瘦卷会按需从瘦池分配所需的空间。

镜像卷: 创建的卷中包含定义数目的镜像。

起动 YaST 并打开。

在左侧面板中,选择。右侧面板中即会打开现有卷组的列表。

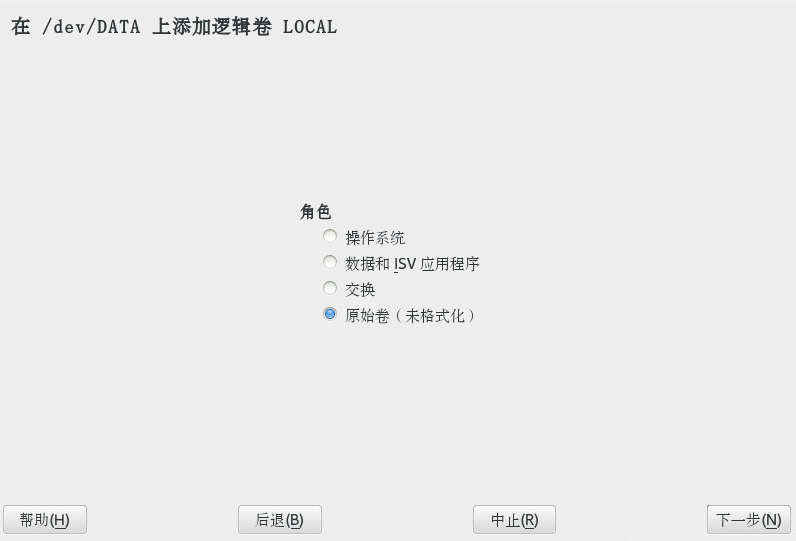

选择要在其中创建卷的卷组,然后选择 › 。

提供卷的,然后选择(有关设置精简配置卷的相关信息,请参见第 5.3.1 节 “精简配置的逻辑卷”)。单击继续。

指定卷的大小和是否使用多个分段。

使用带区卷时,将在多个物理卷之间分配数据。如果这些物理卷驻留在不同的硬盘上,则通常会提高读写性能(与 RAID 0 类似)。可用带区卷的最大数量为物理卷的数量。默认值 (

1) 表示不使用多个带区卷。选择卷的。您在此处所做选择只会影响将要打开的对话框的默认值。这些值可在下一个步骤中更改。如果不确定,请选择。

在下,选择,然后选择。菜单的内容取决于文件系统。通常不需要更改默认值。

在下,选择,然后选择安装点。单击 ,为卷添加特殊装入选项。

单击。

单击,验证是否列出了所做的更改,然后单击。

5.3.1 精简配置的逻辑卷 #

LVM 逻辑卷可选择进行精简配置。精简配置可让您创建大小超出可用空间的逻辑卷。您创建包含未使用空间(预留供任意数目的瘦卷使用)的瘦池。瘦卷会被创建为稀疏卷,并会根据需要从瘦池分配空间。瘦池可以根据需要动态扩大,以实现储存空间的高效分配。精简配置的卷还支持快照(可以使用 Snapper 进行管理)— 有关详细信息,请参见Book “管理指南”, Chapter 7 “通过 Snapper 进行系统恢复和快照管理”。

要设置精简配置的逻辑卷,请按过程 5.1 “设置逻辑卷”中所述步骤操作。选择卷类型时,不要选择,而要选择或。

逻辑卷是预留供瘦卷使用的空间池。瘦卷可以按需从瘦池分配它们所需的空间。

该卷会被创建为稀疏卷。瘦卷会按需从瘦池分配所需的空间。

要使用群集中的精简配置卷,使用它的瘦池和瘦卷必须在单个群集资源中管理。如此可使瘦卷和瘦池始终在同一个节点上以独占方式装入。

5.3.2 创建镜像卷 #

可以创建包含多个镜像的逻辑卷。LVM 会确保将写入底层物理卷的数据镜像到不同的物理卷。因此,即使某个物理卷崩溃,您仍可访问逻辑卷上的数据。LVM 还会保留一个日志文件用于管理同步过程。日志中包含有关哪些卷区域当前正在与镜像同步的信息。默认情况下,日志储存在磁盘上,当情况允许时,会储存在与镜像不同的磁盘上。不过,您可以为日志指定一个不同的位置,例如,指定易失性内存。

目前可以使用两种类型的镜像实施:“正常”的(非 raid)镜像逻辑卷和 raid1 逻辑卷。

创建镜像逻辑卷后,可对这些卷执行标准操作,例如激活、扩展和去除。

5.3.2.1 设置镜像非 raid 逻辑卷 #

要创建镜像卷,请使用 lvcreate 命令。下面的示例将创建一个 500 GB 大小使用卷组 vg1 的逻辑卷,其中包含两个名为 lv1 的镜像。

lvcreate -L 500G -m 2 -n lv1 vg1

此类逻辑卷是一种线性卷(无分段),可提供文件系统的三个副本。m 选项指定镜像的计数。L 选项指定逻辑卷的大小。

逻辑卷会划分为几个默认大小为 512 KB 的区域。如果需要不同大小的区域,请使用 -R 选项并后接所需的区域大小(以 MB 为单位)。或者,可以在 lvm.conf 文件中编辑 mirror_region_size 选项来配置首选的区域大小。

5.3.2.2 设置 raid1 逻辑卷 #

由于 LVM 支持 RAID,您可以使用 RAID1 来实施镜像。与非 raid 镜像相比,这种实施具有以下优点:

LVM 会为每个镜像映像维护一个完全冗余的位图区,从而提高了其故障处理能力。

可以暂时从阵列中分割出镜像映像,然后将它们重新合并。

阵列可以处理暂时性故障。

LVM RAID 1 实施支持快照。

但在另一方面,这种类型的镜像实施不允许在群集卷组中创建逻辑卷。

要使用 RAID 创建镜像卷,请发出以下命令:

lvcreate --type raid1 -m 1 -L 1G -n lv1 vg1

其中的各选项/参数的含义如下:

--type- 需要指定raid1,否则该命令将使用隐式分段类型mirror并创建非 raid 镜像。-m- 指定镜像的计数。-L- 指定逻辑卷的大小。-n- 使用此选项指定逻辑卷的名称。vg1- 逻辑卷使用的卷组的名称。

LVM 将为阵列中的每个数据卷创建一个区域大小的逻辑卷。如果您有两个镜像卷,LVM 将另外创建两个卷用于储存元数据。

创建 RAID 逻辑卷后,您可以像使用普通的逻辑卷一样使用该卷。您可以将它激活、扩展,等等。

5.4 自动激活非 root LVM 卷组 #

非根 LVM 卷组的激活行为由 /etc/lvm/lvm.conf 文件中的

auto_activation_volume_list 参数控制。默认情况下,该参数为空,也就是说,会激活所有卷。如果只想激活某些卷组,请将名称括在引号中,并用逗号分隔各名称,例如:

auto_activation_volume_list = [ "vg1", "vg2/lvol1", "@tag1", "@*" ]

如果在 auto_activation_volume_list 参数中定义了列表,将发生以下情况:

首先会根据此列表检查每个逻辑卷。

如果两者不匹配,则不激活该逻辑卷。

默认情况下,在 Dracut 重启动系统时,非根 LVM 卷组会自动激活。您可以使用此参数在系统重启时激活所有卷组,或仅激活指定的非根 LVM 卷组。

5.5 调整现有卷组的大小 #

在运行的系统中卷组提供的空间可随时扩大,而不需要添加更多物理卷导致服务中断。这可让您将逻辑卷添加到组中,或如第 5.6 节 “调整逻辑卷的大小”中所述扩大现有卷的大小。

还可以通过删除物理卷来缩小卷组的大小。YaST 只允许删除当前未使用的物理卷。要了解哪些物理卷当前正在使用,请运行下列命令。PE Ranges 列中列出的分区(物理卷)即是使用中的分区︰

tux > sudo pvs -o vg_name,lv_name,pv_name,seg_pe_ranges

root's password:

VG LV PV PE Ranges

/dev/sda1

DATA DEVEL /dev/sda5 /dev/sda5:0-3839

DATA /dev/sda5

DATA LOCAL /dev/sda6 /dev/sda6:0-2559

DATA /dev/sda7

DATA /dev/sdb1

DATA /dev/sdc15.6 调整逻辑卷的大小 #

如果卷组中有未使用的可用空间,则您可以增大逻辑卷以提供更多可用空间。您还可以将卷的大小减少为其他逻辑卷可使用的卷组的可用空间。

减少卷的大小时,YaST 会同时自动调整其文件系统的大小。当前已装入的卷是否可以“联机”(即保持已装入状态)调整大小取决于其文件系统。Btrfs、XFS、Ext3 和 ReiserFS 支持联机增大文件系统。

仅 Btrfs 支持联机缩小文件系统。要缩小 XFS、Ext2/3/4 和 ReiserFS 卷,您需要将它们卸载。无法缩小以 XFS 格式化的卷,因为 XFS 不支持文件系统缩小。

5.7 删除卷组或逻辑卷 #

删除卷组会清空其每个成员分区中的所有数据。删除逻辑卷会损坏该卷上储存的所有数据。

起动 YaST 并打开。

在左侧面板中,选择。右侧面板中即会打开现有卷组的列表。

选择要删除的卷组或逻辑卷,然后单击。

根据您的选择,系统会显示警告对话框。单击以确认对话框。

单击,校验是否列出了删除的卷组(用红色字体表示删除),然后单击。

5.8 使用 LVM 命令 #

有关使用 LVM 命令的信息,请参见下表中所述的命令的手册页。所有命令都需要拥有 root 权限才能执行。请使用 sudo

COMMAND(建议采用此方式),或者直接以 root 身份执行这些命令。

pvcreate 设备初始化设备(例如

/dev/sdb1)以作为物理卷供 LVLM 使用。如果指定的设备上有任何文件系统,将出现警告。请记住,仅当已安装blkid时(默认已安装),pvcreate才会检查现有文件系统。如果blkid不可用,pvcreate不会生成任何警告,因此您可能会丢失文件系统却看不到任何警告。pvdisplay 设备显示 LVM 物理卷的相关信息,例如当前它是否正在逻辑卷中使用。

-

vgcreate -c y VG_NAME DEV1 [DEV2...] 使用一个或多个指定的设备创建群集卷组。

-

vgcreate --activationmode ACTIVATION_MODE VG_NAME 配置卷组激活模式。可以指定下列值之一:

complete- 只能激活不受缺失物理卷影响的逻辑卷,即使特定的逻辑卷能够容许这种故障也如此。degraded- 默认的激活模式。如果有足够的冗余级别来激活某个逻辑卷,则即使缺少某些物理卷,也能激活该逻辑卷。partial- 即使缺少某些物理卷,LVM 也会尝试激活卷组。如果某个非冗余逻辑卷缺少重要的物理卷,则通常无法激活该逻辑卷,并会将它作为错误目标进行处理。

-

vgchange -a [ey|n] 卷组名称 激活 (

-a ey) 或停用 (-a n) 卷组及其逻辑卷的输入/输出。激活群集中的某个卷时,请务必使用

ey选项。此选项默认在装载脚本中使用。vgremove 卷组名称删除卷组。请在使用此命令之前删除逻辑卷,然后停用卷组。

-

vgdisplay 卷组名称 显示指定卷组的相关信息。

要了解卷组的物理区域总大小,请输入

vgdisplay VG_NAME | grep "Total PE"

-

lvcreate -L SIZE -n LV_NAME VG_NAME 创建具有指定大小的逻辑卷。

-

lvcreate -L SIZE --thinpool POOL_NAME VG_NAME 基于卷组 VG_NAME 创建具有指定大小的瘦池

myPool。下面的示例会从卷组

LOCAL创建大小为 5 GB 的瘦池:lvcreate -L 5G --thinpool myPool LOCAL

-

lvcreate -T VG_NAME/POOL_NAME -V SIZE -n LV_NAME 在池 POOL_NAME 中创建瘦逻辑卷。下面的示例会从卷组

LOCAL上的池myPool创建名为myThin1的 1GB 瘦卷:lvcreate -T LOCAL/myPool -V 1G -n myThin1

-

lvcreate -T VG_NAME/POOL_NAME -V SIZE -L SIZE -n LV_NAME 还可以通过一条命令同时创建瘦池和瘦逻辑卷:

lvcreate -T LOCAL/myPool -V 1G -L 5G -n myThin1

-

lvcreate --activationmode ACTIVATION_MODE LV_NAME 配置逻辑卷激活模式。可以指定下列值之一:

complete- 仅当逻辑卷的所有物理卷都处于活动状态时才能激活该逻辑卷。degraded- 默认的激活模式。如果有足够的冗余级别来激活某个逻辑卷,则即使缺少某些物理卷,也能激活该逻辑卷。partial- 即使缺少某些物理卷,LVM 也会尝试激活卷。如果逻辑卷有一部分不可用,使用此选项可能会导致数据丢失。通常不使用此选项,但在恢复数据时,它可能会有用。

您可以通过在

/etc/lvm/lvm.conf中指定activation_mode配置选项的上述值之一,来指定激活模式。-

lvcreate -s [-L SIZE] -n SNAP_VOLUME SOURCE_VOLUME_PATH VG_NAME 创建指定逻辑卷的快照卷。如果未包含大小选项(

-L或--size),则快照会被创建为瘦快照。-

lvremove /dev/VG_NAME/LV_NAME 删除逻辑卷。

使用此命令之前,请先使用

umount命令卸载逻辑卷以将其关闭。-

lvremove SNAP_VOLUME_PATH 删除快照卷。

-

lvconvert --merge SNAP_VOLUME_PATH 将逻辑卷还原为快照的版本。

-

vgextend VG_NAME DEVICE 将指定的设备(物理卷)添加到现有卷组。

-

vgreduce VG_NAME DEVICE 从现有卷组中删除指定的物理卷。

确保物理卷当前未被逻辑卷使用。如果正在使用中,则必须使用

pvmove命令将数据移至另一个物理卷。-

lvextend -L SIZE /dev/VG_NAME/LV_NAME 扩大指定逻辑卷的大小。随后,您还必须相应地扩大文件系统以充分利用新扩充的空间。有关详细信息,请参见第 2 章 “调整文件系统大小”。

-

lvreduce -L SIZE /dev/VG_NAME/LV_NAME 减少指定逻辑卷的大小。

在缩小卷之前,请确保先减少文件系统的大小,否则可能会丢失数据。有关详细信息,请参见第 2 章 “调整文件系统大小”。

-

lvrename /dev/VG_NAME/LV_NAME /dev/VG_NAME/NEW_LV_NAME 重命名现有 LVM 逻辑卷。此操作不会更改卷组名。

如果您想使用 LVM 而不是 udev 规则来管理 LV 设备节点和符号链接,可以使用下列方法之一来禁止 udev 发出通知:

在

/etc/lvm/lvm.conf中配置activation/udev_rules = 0和activation/udev_sync = 0。请注意,结合

lvcreate命令指定--nodevsync的效果与设置activation/udev_sync = 0相同;仍需设置activation/udev_rules = 0。设置环境变量

DM_DISABLE_UDEV:export DM_DISABLE_UDEV=1

这样也会禁止 udev 发出通知。此外,

/etc/lvm/lvm.conf中所有 udev 相关设置将被忽略。

5.8.1 用命令调整逻辑卷大小 #

lvresize、lvextend 和 lvreduce 命令用于调整逻辑卷大小。有关语法和选项信息,请参见每个命令的手册页。要扩展 LV,VG 上必须有足够的可用未分配空间。

建议使用 YaST 分区程序来增大或缩小逻辑卷。使用 YaST 时,卷中文件系统的大小也会相应进行自动调整。

LV 可以在使用中状态下进行手动增大或缩小,但是其上的文件系统无法随之调整。扩展或收缩 LV 不会自动修改卷中文件系统的大小。随后必须使用其他命令增大文件系统。有关调整文件系统大小的信息,请参见第 2 章 “调整文件系统大小”。

手动调整 LV 大小时,请确保使用正确的顺序︰

如果扩展逻辑卷,则必须在试图增大文件系统之前扩展逻辑卷。

如果缩小逻辑卷,则必须在试图缩小逻辑卷之前缩小文件系统。

扩展逻辑卷的大小:

打开一个终端控制台。

如果逻辑卷包含 Ext2 或 Ext4 文件系统,则不支持联机增大,请将其卸下。如果它包含为虚拟机(例如 Xen VM)托管的文件系统,请先关闭该 VM。

在终端控制台提示时,输入以下命令以增加逻辑卷大小:

sudo lvextend -L +SIZE /dev/VG_NAME/LV_NAME

对于 SIZE,请指定要添加到逻辑卷的空间容量,例如 10 GB。将

/dev/VG_NAME/LV_NAME替换为逻辑卷的 Linux 路径,例如/dev/LOCAL/DATA。例如:sudo lvextend -L +10GB /dev/vg1/v1

调整文件系统的大小。有关详细信息,请参见第 2 章 “调整文件系统大小”。

如果卸下了文件系统,请将其重新装入。

例如,将带有(已装入并激活)Btrfs 的 LV 扩大 10GB:

sudo lvextend −L +10G /dev/LOCAL/DATA sudo btrfs filesystem resize +10G /dev/LOCAL/DATA

要缩小逻辑卷的大小,请执行以下操作:

打开一个终端控制台。

如果逻辑卷不包含 Btrfs 文件系统,请将其卸下。如果它包含为虚拟机(例如 Xen VM)托管的文件系统,请先关闭该 VM。请注意,带有 XFS 文件系统的卷不能减少大小。

调整文件系统的大小。有关详细信息,请参见第 2 章 “调整文件系统大小”。

在终端控制台提示符中,输入下列命令以将逻辑卷的大小缩小为文件系统的大小︰

sudo lvreduce /dev/VG_NAME/LV_NAME

如果卸载了文件系统,请将其重新装入。

例如,将带有 Btrfs 的 LV 缩减 5GB:

sudo btrfs filesystem resize -size 5G /dev/LOCAL/DATA sudo lvreduce /dev/LOCAL/DATA

从 SUSE Linux Enterprise Server 12 SP1 开始,lvextend、lvresize 和 lvreduce 支持 --resizefs 选项,该选项不仅可以更改卷的大小,而且还能调整文件系统的大小。因此,上面所示的 lvextend 和 lvreduce 示例也可以改编为:

sudo lvextend --resizefs −L +10G /dev/LOCAL/DATA sudo lvreduce --resizefs -L -5G /dev/LOCAL/DATA

请注意,以下文件系统支持 --resizefs:ext2/3/4、reiserfs、Btrfs 和 XFS。目前只能在 SUSE Linux Enterprise Server 上使用此选项调整 Btrfs 的大小,因为上游尚未接受此选项。

5.8.2 通过 lvmetad 动态汇总 LVM 元数据 #

大部分 LVM 命令都需要准确查看储存在系统的磁盘设备上的 LVM 元数据。对于当前的 LVM 设计,如果此信息不可用,则 LVM 必须扫描系统中的所有物理磁盘设备。在具有许多磁盘的系统中,这需要大量的 I/O 操作。如果磁盘无法响应,LVM 命令可能是在等待磁盘时发生超时。

通过 lvmetad 动态汇总 LVM 元数据可解决此问题。lvmetad 守护程序通过在每次设备状态更改时动态汇总元数据信息,来减少此扫描的需要。这些事件通过 udev 规则向 lvmetad 发出信号。如果守护程序未运行,则 LVM 会如常执行扫描。

默认情况下会启用此选项。如果该选项已在您的系统上已禁用,可执行以下操作来启用它:

打开一个终端控制台。

停止

lvmetad守护程序︰sudo systemctl stop lvm2-lvmetad

编辑

/etc/lvm/lvm.conf并将use_lvmetad设置为1︰use_lvmetad = 1

重启动

lvmetad守护程序︰sudo systemctl start lvm2-lvmetad

5.8.3 使用 LVM 超速缓存卷 #

LVM 支持使用高速块设备(例如 SSD 设备)作为较低速大型块设备的写回或直写超速缓存。该超速缓存逻辑卷类型使用小型高速 LV 来提高大型慢速 LV 的性能。

要设置 LVM 超速缓存,需在超速缓存设备上创建两个逻辑卷。较大的卷用于超速缓存本身,较小的卷用于储存超速缓存元数据。这两个卷需属于原始卷所在的同一个卷组。创建这些卷后,需要将其转换为超速缓存池,并将该池挂接到原始卷:

在慢速设备上创建原始卷(如果尚不存在)。

将物理卷(从快速设备)添加到原始卷所属的同一个卷组,然后在物理卷上创建超速缓存数据卷。

创建超速缓存元数据卷。该卷的大小应为超速缓存数据卷大小的 1/1000,最小大小为 8 MB。

将超速缓存数据卷和元数据卷组合成一个超速缓存池卷:

lvconvert --type cache-pool --poolmetadata VOLUME_GROUP/METADATA_VOLUME VOLUME_GROUP/CACHING_VOLUME

将超速缓存池挂接到原始卷:

lvconvert --type cache --cachepool VOLUME_GROUP/CACHING_VOLUME VOLUME_GROUP/ORIGINAL_VOLUME

有关 LVM 超速缓存的详细信息,请参见 lvmcache(7) 手册页。

5.9 标记 LVM2 储存对象 #

标记是无序的关键字或指派给储存对象元数据的术语。使用标记功能可以采用您认为有用的方式将无序的标记列表附加到 LVM 储存对象元数据,从而对储存对象集合进行分类。

5.9.1 使用 LVM2 标记 #

标记 LVM2 储存对象后,可以在命令中使用标记来完成以下任务:

根据有或无特定标记选择要处理的 LVM 对象。

使用配置文件中的标记,控制在服务器上激活哪些卷组和逻辑卷。

通过在命令中指定标记,覆盖全局配置中的设置。

可以使用标记代替接受以下项的任何命令行 LVM 对象参考:

对象列表

单个对象,只要标记扩展到单个对象

目前,在任何位置都不支持将对象名称替换为标记。扩展自变量后,列表中的重复自变量将通过删除重复自变量而保留每个自变量的第一个实例来解决。

只要是自变量类型可能不明确的位置,都必须在标记前面加上商业性 (@) 字符,比如 @mytag。在其他位置是否使用 “@” 前缀是可选的。

5.9.2 创建 LVM2 标记的要求 #

对 LVM 使用标记时,请注意以下要求:

- 支持的字符

LVM 标记单词可以包含 ASCII 大写字符 A 到 Z、小写字符 a 到 z、数字 0 到 9、下划线 (_)、加号 (+)、连字符 (-) 和句点 (.)。单词不能以连字符开头。最大长度为 128 个字符。

- 支持的储存对象

可以标记 LVM2 物理卷、卷组、逻辑卷和逻辑卷分段。PV 标记将储存在其卷组的元数据中。删除卷组时也删除孤立的物理卷中的标记。快照不能标记,但快照源可以标记。

LVM1 对象不能标记,因为磁盘格式不支持此功能。

5.9.3 命令行标记语法 #

--addtag标记信息将标记添加到(或标记)LVM2 储存对象。示例:

sudo vgchange --addtag @db1 vg1

--deltag标记信息删除(或取消标记)LVM2 储存对象中的标记。示例:

sudo vgchange --deltag @db1 vg1

--tag标记信息指定用于缩小要激活或停用的卷组列表或逻辑卷的标记。

如果卷的标记与提供的标记匹配,则输入以下命令将其激活(示例):

sudo lvchange -ay --tag @db1 vg1/vol2

5.9.4 配置文件语法 #

以下几节显示了特定用例的示例配置。

5.9.4.1 在 lvm.conf 文件中启用主机名标记 #

将下面的代码添加到 /etc/lvm/lvm.conf 文件中,以启用主机上 /etc/lvm/lvm_<HOSTNAME>.conf 文件中单独定义的主机标记。

tags {

# Enable hostname tags

hosttags = 1

}

您将激活代码置于主机上的 /etc/lvm/lvm_<HOSTNAME>.conf 文件中。请参见 第 5.9.4.3 节 “定义激活”。

5.9.4.2 在 lvm.conf 文件中为主机名定义标记 #

tags {

tag1 { }

# Tag does not require a match to be set.

tag2 {

# If no exact match, tag is not set.

host_list = [ "hostname1", "hostname2" ]

}

}5.9.4.3 定义激活 #

您可以修改 /etc/lvm/lvm.conf 文件,以根据标记激活 LVM 逻辑卷。

在文本编辑器中,将以下代码添加到文件中:

activation {

volume_list = [ "vg1/lvol0", "@database" ]

}

用您的标记替换 @database。使用 "@*" 根据主机上设置的任何标记匹配此标记。

激活命令会匹配卷组和逻辑卷的元数据中设置的 VGNAME、VGNAME/LVNAME 或 @TAG。只有元数据标记匹配时,才激活卷组或逻辑卷。默认情况下,如果不匹配则不会激活。

如果 volume_list 不存在,且主机上已定义标记,则只有主机标记与元数据标记匹配时,才会激活卷组或逻辑卷。

如果 volume_list 已定义但为空,并且主机上未定义任何标记,则不会激活。

如果未定义 volume_list,则不会施加任何 LV 激活限制(允许所有情况)。

5.9.4.4 在多个主机名配置文件中定义激活 #

在 lvm.conf 文件中启用主机标记后,便可在主机配置文件 (/etc/lvm/lvm_<HOST_TAG>.conf) 中使用激活代码。例如,一个服务器在 /etc/lvm/ 目录中有两个配置文件:

lvm.conf

|

lvm_<HOST_TAG>.conf

|

启动时,会装载 /etc/lvm/lvm.conf 文件,并处理该文件中的任何标记设置。如果定义了任何主机标记,它会装载相关的 /etc/lvm/lvm_<HOST_TAG>.conf 文件。搜索特定配置文件项目时,将会先搜索主机标记文件,然后搜索 lvm.conf 文件,并在找到第一个匹配项时停止搜索。在 lvm_<HOST_TAG>.conf 文件中,使用与所设标记顺序相反的顺序。这样就可以先搜索最后设置标记的文件。主机标记文件中设置的新标记将会触发额外的配置文件装载。

5.9.5 将标记用于群集中的简单激活控制 #

您可以通过在 /etc/lvm/lvm.conf 文件中启用 hostname_tags 选项来设置简单主机名激活控制。将相同文件用于群集中的每一台计算机上,以便建立全局设置。

在文本编辑器中,将以下代码添加到

/etc/lvm/lvm.conf文件中:tags { hostname_tags = 1 }将文件复制到群集中的所有主机上。

从群集中的任何计算机上,将

db1添加到将激活vg1/lvol2的计算机列表中:sudo lvchange --addtag @db1 vg1/lvol2

在

db1服务器上,输入以下内容以激活它:sudo lvchange -ay vg1/vol2

5.9.6 使用标记激活群集中首选主机上的卷组 #

本部分中的示例展示了完成以下任务的两种方法:

仅激活数据库主机

db1和db2上的卷组vg1。仅激活文件服务器主机

fs1上的卷组vg2。最初在文件服务器备份主机

fsb1上不激活任何卷组,但对其进行准备以从文件服务器主机fs1接管卷组。

5.9.6.1 选项 1:集中化管理和主机间静态配置复制 #

在以下解决方案中,单个配置文件复制到多台主机中。

将

@database标记添加到卷组vg1的元数据中。在终端控制台上,输入sudo vgchange --addtag @database vg1

将

@fileserver标记添加到卷组vg2的元数据中。在终端控制台上,输入sudo vgchange --addtag @fileserver vg2

在文本编辑器中,用以下代码修改

/etc/lvm/lvm.conf文件,以定义@database、@fileserver和@fileserverbackup标记。tags { database { host_list = [ "db1", "db2" ] } fileserver { host_list = [ "fs1" ] } fileserverbackup { host_list = [ "fsb1" ] } } activation { # Activate only if host has a tag that matches a metadata tag volume_list = [ "@*" ] }将修改后的

/etc/lvm/lvm.conf文件复制到四台主机中:db1、db2、fs1和fsb1。如果文件服务器主机出现故障,则在终端控制台的任何节点上输入以下命令即可在

fsb1上启动vg2:sudo vgchange --addtag @fileserverbackup vg2 sudo vgchange -ay vg2

5.9.6.2 选项 2: 本地化管理和配置 #

在以下解决方案中,每台主机在本地保存有关激活哪些类别的卷的信息。

将

@database标记添加到卷组vg1的元数据中。在终端控制台上,输入sudo vgchange --addtag @database vg1

将

@fileserver标记添加到卷组vg2的元数据中。在终端控制台上,输入sudo vgchange --addtag @fileserver vg2

在

/etc/lvm/lvm.conf文件中启用主机标记:在文本编辑器中,用以下代码修改

/etc/lvm/lvm.conf文件,以启用主机标记配置文件。tags { hosttags = 1 }将修改后的

/etc/lvm/lvm.conf文件复制到四台主机上:db1、db2、fs1和fsb1。

在主机

db1上,创建数据库主机db1的激活配置文件。在文本编辑器中,创建/etc/lvm/lvm_db1.conf文件并添加以下代码:activation { volume_list = [ "@database" ] }在主机

db2上,创建数据库主机db2的激活配置文件。在文本编辑器中,创建/etc/lvm/lvm_db2.conf文件并添加以下代码:activation { volume_list = [ "@database" ] }在主机 fs1 上,创建文件服务器主机

fs1的激活配置文件。在文本编辑器中,创建/etc/lvm/lvm_fs1.conf文件并添加以下代码:activation { volume_list = [ "@fileserver" ] }如果文件服务器主机

fs1出现故障,要启动备用文件服务器主机 fsb1 作为文件服务器:在主机

fsb1上,创建主机fsb1的激活配置文件。在文本编辑器中,创建/etc/lvm/lvm_fsb1.conf文件并添加以下代码:activation { volume_list = [ "@fileserver" ] }在终端控制台上,输入以下命令之一:

sudo vgchange -ay vg2 sudo vgchange -ay @fileserver

6 LVM 卷快照 #

逻辑卷管理器 (LVM) 逻辑卷快照是一种写入时复制技术,它会监控现有卷数据块的更改,以便在对其中一个块执行写入操作时,将进行快照时块的值复制到快照卷。这样,便可保留数据的时间点副本,直到快照卷删除为止。

6.1 了解卷快照 #

文件系统快照包含有关自身的元数据以及在生成快照后更改过的源逻辑卷的数据块。通过快照访问数据时,您会看到复制来源逻辑卷的时间点。不需要从备份媒体恢复数据或重写更改过的数据。

在快照有效期内,必须先装入快照,然后才能装入其来源逻辑卷。

LVM 卷快照可用于从文件系统的时间点视图创建备份。快照是即时创建并永久保留的,直到您将其删除为止。您可以从快照备份文件系统,而卷本身仍可继续供用户使用。快照最初包含自身相关的一些元数据,但不包含来源逻辑卷的实际数据。快照使用写时复制技术在原始数据块中的数据发生更改时进行检测。当对快照卷中的块捕获快照时,它会复制所包含的值,然后允许在来源块中储存新的数据。随着来源逻辑卷上有更多块更改其原始值,快照大小将会增大。

调整快照大小时,请考虑来源逻辑卷中要更改的数据量,以及要保留快照的时间。您为快照卷分配的空间量因以下因素而异:来源逻辑卷的大小、计划保留快照的时间,以及在快照有效期中预期会更改的数据块数。快照卷创建后不能调整大小。从原则上说,应创建一个约占原始逻辑卷大小 10% 的快照卷。如果您预测在删除快照前,来源逻辑卷中的每个块都会至少更改一次,则快照的容量至少应相当于来源逻辑卷的容量加上部份额外空间,其中后者用于储存快照卷的相关元数据。如果数据更改不那么频繁或如果预期的有效期足够短,则需要的空间较少。

在 LVM2 中,快照默认为读/写。直接将数据写入快照时,该块在例外表格中标示为使用,不会从来源逻辑卷中复制。您可以装载快照卷,并通过直接将数据写入快照卷来测试应用更改。您可以通过卸载快照、去除快照,然后重新装载来源逻辑卷,轻松丢弃更改。

在虚拟 Guest 环境中,您可以使用快照功能用于在服务器的磁盘上创建的 LVM 逻辑卷,就如在物理服务器上一样。

在虚拟主机环境中,您可以使用快照功能来备份虚拟机的储存后端,或测试对虚拟机映像(例如用于修补程序或升级)进行的更改,而不必修改来源逻辑卷。虚拟机必须将 LVM 逻辑卷用做其储存后端,以免使用虚拟磁盘文件。您可以装载 LVM 逻辑卷,并将它用做文件型磁盘来储存虚拟机映像;也可以指派 LVM 逻辑卷做为物理磁盘,以便将其视为块设备进行写入操作。

从 SLES 11 SP3 开始,LVM 逻辑卷快照可以瘦配置。如果您创建没有指定大小的快照,则会使用瘦配置。创建为瘦卷的快照在需要时使用瘦池中的空间。快照瘦卷的特性与任何其他瘦卷相同。您可以独立地激活卷、扩展卷、重命名卷、去除卷,甚至可以创建卷的快照。

若要使用群集中瘦配置的快照,来源逻辑卷及其快照必须在单个群集资源中管理。这允许卷及其快照在同一个节点上始终独占性地装载。

当用完快照后,一定要将其从系统中删除。随着来源逻辑卷上数据块的不断更改,快照终将完全填满。填满时就会处于禁用状态,导致您无法重新装载来源逻辑卷。

如果您为一个来源逻辑卷创建多个快照,在去除最后创建快照之前,请先删除较旧的快照。

6.2 使用 LVM 创建 Linux 快照 #

可以使用逻辑卷管理器 (LVM) 创建文件系统的快照。

打开终端控制台,然后输入

sudo lvcreate -s [-L <size>] -n SNAP_VOLUME SOURCE_VOLUME_PATH

如果不指定大小,快照会创建为瘦快照。

例如:

sudo lvcreate -s -L 1G -n linux01-snap /dev/lvm/linux01

快照将被创建为 /dev/lvm/linux01-snap 卷。

6.3 监视快照 #

打开终端控制台,然后输入

sudo lvdisplay SNAP_VOLUME

例如:

tux > sudo lvdisplay /dev/vg01/linux01-snap

--- Logical volume ---

LV Name /dev/lvm/linux01

VG Name vg01

LV UUID QHVJYh-PR3s-A4SG-s4Aa-MyWN-Ra7a-HL47KL

LV Write Access read/write

LV snapshot status active destination for /dev/lvm/linux01

LV Status available

# open 0

LV Size 80.00 GB

Current LE 1024

COW-table size 8.00 GB

COW-table LE 512

Allocated to snapshot 30%

Snapshot chunk size 8.00 KB

Segments 1

Allocation inherit

Read ahead sectors 0

Block device 254:56.4 删除 Linux 快照 #

打开终端控制台,然后输入

sudo lvremove SNAP_VOLUME_PATH

例如:

sudo lvremove /dev/lvmvg/linux01-snap

6.5 在虚拟主机上使用虚拟机的快照 #

如果将 LVM 逻辑卷用做虚拟机的后端储存,可以让系统灵活地管理基础设备,例如更轻松地移动储存对象、创建快照和备份数据。您可以装载 LVM 逻辑卷,并将它用做文件型磁盘来储存虚拟机映像;也可以指派 LVM 逻辑卷做为物理磁盘,以便将其视为块设备进行写入操作。您可以在 LVM 逻辑卷上创建虚拟磁盘映像,然后创建 LVM 快照。

您可以利用快照的读/写功能创建虚拟机的不同实例,并在这些实例中更改特定虚拟机实例的快照。您也可以在 LVM 逻辑卷上创建虚拟磁盘映像、创建来源逻辑卷的快照以及修改特定虚拟机实例的快照。您还可以创建来源逻辑卷的另一个快照,并修改该快照以取得不同虚拟机实例。不同虚拟机实例的大部分数据与映像一起储存在来源逻辑卷上。

在 Guest 环境中,您还可以利用快照的读/写功能保留虚拟磁盘映像,同时测试修补程序或升级。您创建包含映像的 LVM 卷的快照,然后在快照位置运行虚拟机。来源逻辑卷保持不变,对机器的所有更改均写入快照。为了恢复到虚拟机映像的来源逻辑卷,您需要关闭虚拟机,然后从来源逻辑卷中去除快照。若要重新开始,请重新创建快照、装载快照,然后在快照映像上重启动虚拟机。

下列程序使用文件型虚拟磁盘映像和 Xen 超级管理程序。对于在 SUSE Linux Enterprise 平台上运行的其他超级管理程序(例如 KVM),您可以调整本节中的过程。若要从快照卷中运行文件型虚拟机映像,请运行下列步骤:

确保已装入包含文件型虚拟机映像的来源逻辑卷,例如在安装点

/var/lib/xen/images/<IMAGE_NAME>装入。创建具有足够空间来储存预期差别的 LVM 逻辑卷快照。

sudo lvcreate -s -L 20G -n myvm-snap /dev/lvmvg/myvm

如果不指定大小,快照会创建为瘦快照。

创建安装点,用于装入快照卷。

sudo mkdir -p /mnt/xen/vm/myvm-snap

在所创建的安装点装入快照卷。

sudo mount -t auto /dev/lvmvg/myvm-snap /mnt/xen/vm/myvm-snap

在文本编辑器中,复制来源虚拟机的配置文件,修改指向装入快照卷上的文件型图像文件的路径,然后储存文件,例如

/etc/xen/myvm-snap.cfg。使用虚拟机的已装入快照卷启动虚拟机。

sudo xm create -c /etc/xen/myvm-snap.cfg

(可选)去除快照,然后在来源逻辑卷使用未更改的虚拟机映像。

sudo unmount /mnt/xenvms/myvm-snap sudo lvremove -f /dev/lvmvg/mylvm-snap

(可选)根据需要重复此程序。

6.6 将快照与来源逻辑卷合并以还原更改或回滚至先前的状态 #

如果您需要将卷上的数据回滚或还原至先前的状态,快照可能非常有用。例如,如果因管理员失误,或是因包安装或升级出故障或没必要,导致数据出现更改,您可能需要予以还原。

您可以使用 lvconvert --merge 命令还原对 LVM 逻辑卷的更改。合并按如下所示开始:

如果来源逻辑卷和快照卷均未打开,合并将立即开始。

如果来源逻辑卷或快照卷已打开,合并将在来源逻辑卷或快照卷第一次启动和同时关闭时开始。

如果来源逻辑卷不能关闭(例如根文件系统),系统会推迟到下一次服务器重引导并激活来源逻辑卷的时候再合并。

如果来源逻辑卷包含虚拟机映像,您必须关闭虚拟机,停用来源逻辑卷和快照卷(也就是依次卸下这些卷),然后发出合并命令。因为来源逻辑卷会自动重新装入,而且合并完成时会删除快照卷,所以在合并完成之前请勿重启动虚拟机。合并完成之后,您可以将生成的逻辑卷用于虚拟机。

合并开始之后,系统将在服务器重启动之后继续合并,直到合并完成。在合并期间,无法为来源逻辑卷创建新快照。

合并期间,系统对来源逻辑卷的读取或写入操作会透明地重定向到正在合并的快照,因此用户能够立即查看和访问数据,就像当时创建快照时一样,不必等到合并完成。

合并完成后,来源逻辑卷会包含与创建快照时相同的数据,加上合并开始后对数据的任何更改。生成的逻辑卷沿用了来源逻辑卷的名称、次要编号和 UUID。系统会自动重新装入来源逻辑卷,并去除快照卷。

打开终端控制台,然后输入

sudo lvconvert --merge [-b] [-i SECONDS] [SNAP_VOLUME_PATH[...snapN]|@VOLUME_TAG]

您可以在命令行上指定一或多个快照;也可以使用相同卷标记来标记多个来源逻辑卷,然后在命令行上指定

@<VOLUME_TAG>。标记过的卷的快照会合并到其各自的来源逻辑卷中。有关标记逻辑卷的的相关信息,请参见第 5.9 节 “标记 LVM2 储存对象”。选项包括:

- -b, --background

在背景中执行守护程序,这样可以并行合并多个指定的快照。

- -i, --interval <SECONDS>

以固定的间隔以百分比形式报告进度。指定的间隔以秒为单位。

有关此命令的详细信息,请参见

lvconvert(8)man 页面。例如:

sudo lvconvert --merge /dev/lvmvg/linux01-snap

此命令将

/dev/lvmvg/linux01-snap合并到其来源逻辑卷中。sudo lvconvert --merge @mytag

如果

lvol1、lvol2和lvol3全都以mytag标记,每个快照卷将依序与其各自的来源逻辑卷合并;即先lvol1,再lvol2,然后lvol3。如果指定了--background选项,相应标记过的逻辑卷的快照将并行同时合并。(可选)如果来源逻辑卷和快照卷均已打开且可以关闭,则您可以手动停用然后激活来源逻辑卷,以便让合并立即开始。

sudo umount ORIGINAL_VOLUME sudo lvchange -an ORIGINAL_VOLUME sudo lvchange -ay ORIGINAL_VOLUME sudo mount ORIGINAL_VOLUME MOUNT_POINT

例如:

sudo umount /dev/lvmvg/lvol01 sudo lvchange -an /dev/lvmvg/lvol01 sudo lvchange -ay /dev/lvmvg/lvol01 sudo mount /dev/lvmvg/lvol01 /mnt/lvol01

(可选)如果来源逻辑卷和快照卷均已打开且来源逻辑卷不能关闭(例如

根文件系统),则您可以重启动服务器并装入来源逻辑卷,以让合并在重启动之后立即开始。

第 III 部分 软件 RAID #

- 7 软件 RAID 配置

RAID(独立磁盘冗余阵列)的用途是将多个硬盘分区合并成一个大的虚拟硬盘,以便优化性能和/或数据安全性。大多数 RAID 控制器使用 SCSI 协议,因为对大量硬盘,它可用比 IDE 协议更高效的方式寻址,更适于命令的并行处理。还有一些支持 IDE 或 SATA 硬盘的 RAID 控制器。软件 RAID 具有 RAID 系统的优势,同时没有硬件 RAID 控制器的额外成本。但是这需要一些 CPU 时间以及内存,所以不适用于真正高性能的计算机。

- 8 为根分区配置软件 RAID

在 SUSE Linux Enterprise Server 中,设备映射程序 RAID 工具已集成到 YaST 分区程序中。安装时可以使用此分区程序为包含根 (

/) 分区的系统设备创建软件 RAID。不能将/boot分区储存在除 RAID 1 以外的 RAID 分区上。- 9 创建软件 RAID 10 设备

本章说明如何设置嵌套和复杂 RAID 10 设备。RAID 10 设备包含嵌套 RAID 1(镜像)和 RAID 0(分段)阵列。嵌套 RAID 可以设置为条带化镜像 (RAID 1+0) 或镜像化条带 (RAID 0+1)。复杂 RAID 10 设置支持更高的数据冗余级别,因此镜像与分段兼得,并且拥有更多的数据安全措施。

- 10 创建降级 RAID 阵列

降级阵列是缺少某些设备的阵列。仅对 RAID 1、RAID 4、RAID 5 和 RAID 6 支持降级阵列。这些 RAID 类型被设计为作为容错功能的一部分,容忍缺少一些设备。通常,当一个设备失败时,会发生降级阵列。可以故意创建一个降级阵列。

- 11 使用 mdadm 调整软件 RAID 阵列的大小

本章描述如何使用多设备管理 (

mdadm(8)) 工具增加或减小软件 RAID 1、4、5 或 6 设备的大小。- 12 适用于 MD 软件 RAID 的储存机箱 LED 实用程序

储存机箱 LED 监视实用程序 (

ledmon) 和 LED 控件 (ledctl) 实用程序属于 Linux 用户空间应用程序,它们使用多种接口和协议来控制储存机箱 LED。主要用途是视觉化显示使用 mdadm 实用程序创建的 Linux MD 软件 RAID 设备的状态。ledmon守护程序会监视驱动器阵列的状态,然后相应更新驱动器 LED 的状态。您可以使用ledctl实用程序为指定的设备设置 LED 模式。

7 软件 RAID 配置 #

RAID(独立磁盘冗余阵列)的用途是将多个硬盘分区合并成一个大的虚拟硬盘,以便优化性能和/或数据安全性。大多数 RAID 控制器使用 SCSI 协议,因为对大量硬盘,它可用比 IDE 协议更高效的方式寻址,更适于命令的并行处理。还有一些支持 IDE 或 SATA 硬盘的 RAID 控制器。软件 RAID 具有 RAID 系统的优势,同时没有硬件 RAID 控制器的额外成本。但是这需要一些 CPU 时间以及内存,所以不适用于真正高性能的计算机。

需要使用群集多设备(群集 MD)来设置群集文件系统下的软件 RAID。请参考 https://documentation.suse.com/sle-ha-12/html/SLE-HA-all/cha-ha-cluster-md.html 上的 High Availability Extension 文档。

SUSE Linux Enterprise 提供了将若干硬盘组合为一个软 RAID 系统的选项。RAID 暗示将多块硬盘合成一个 RAID 系统的多种策略,这些策略的目标、优点及特点各不相同。这些变化形式通常称作 RAID 级别。

7.1 了解 RAID 级别 #

本节描述常见的 RAID 级别 0、1、2、3、4、5 和嵌套的 RAID 级别。

7.1.1 RAID 0 #

此级别通过将每个文件按块分放到多个磁盘上,提高了数据访问性能。这实际上并不是真正的 RAID,因为它未提供数据备份,但 RAID 0 已成为这种类型的系统的标准名称。使用 RAID 0,可以将两块或多块硬盘组合在一起。这样性能固然很好,但如果有任何一块硬盘出现故障,都将损坏 RAID 系统并丢失数据。

7.1.2 RAID 1 #

此级别为数据提供了充分的安全性,因为它将数据按 1:1 复制到另一块硬盘上。这种方法称为硬盘镜像。如果一块磁盘损坏,则可以使用另一块镜像磁盘上的内容副本。在所有这些硬盘中,只要有一块硬盘没有损坏,您的数据就不会丢失。但是,如果没有检测到损坏,损坏的数据可能会镜像到正确的磁盘,并以这种方式损坏其数据。与使用单个磁盘访问时相比,写性能在复制过程中稍有损失(慢 10% 到 20%),但读访问的速度要大大快于任何一块普通物理硬盘,原因是对数据进行了复制,从而可以并行扫描它们。RAID 1 通常提供几乎为单个磁盘读事务速率两倍的速率,写事务速率与单个磁盘几乎相同。

7.1.3 RAID 2 和 RAID 3 #

这些不是典型的 RAID 实现。级别 2 在位一级而不是块一级对数据进行分段。级别 3 则利用专用的校验磁盘在字节一级进行分段,但不能同时处理多个请求。这两种级别都极少使用。

7.1.4 RAID 4 #

级别 4 与级别 0 一样,也是在块一级进行分段,但结合使用了专用的校验磁盘。如果一块数据磁盘失败,将使用奇偶校验数据创建替换磁盘。不过,这块奇偶校验磁盘可能造成写访问的瓶颈。尽管如此,有时仍使用级别 4。

7.1.5 RAID 5 #

RAID 5 是级别 0 和级别 1 在性能和冗余方面经优化后的折衷方案。硬盘空间等于使用的磁盘数减 1。数据分布在这些硬盘上,这一点与 RAID 0 相同。但出于安全原因,在其中一个分区上创建了奇偶校验块。这些块通过 XOR 互相链接,并在系统出现故障时,通过启用相应的校验块重构建内容。对于 RAID 5,在同一时间只能有一块硬盘出现故障。如果一块硬盘出现故障,则必须在情况允许时将其更换,以防止丢失数据。

7.1.6 RAID 6 #

RAID 6 实际上是 RAID 5 的扩展,通过允许第二种独立分布式奇偶校验模式(双重奇偶校验),允许更多容错功能。即使在数据恢复过程中两个硬盘出现故障,系统仍将继续运行,数据不会丢失。

RAID 6 可承受多个并行驱动器故障,从而提供非常高的数据容错性能。它处理任何两个设备的丢失而不会丢失数据。此外,它还需要 N+2 个驱动器来储存相当于 N 个驱动器的数据。它至少需要四个设备。

RAID 6 的性能稍微低一些,但在正常模式和单磁盘故障模式下可以与 RAID 5 媲美。它在双磁盘故障模式下非常慢。RAID 6 配置需要占用相当多的 CPU 时间和内存,用于写入操作。

|

功能 |

RAID 5 |

RAID 6 |

|---|---|---|

|

设备数 |

N+1,至少 3 个 |

N+2,至少 4 个 |

|

奇偶校验 |

分布式,单 |

分布式,双 |

|

性能 |

在写和重构建方面有中度影响 |

比 RAID 5 在串行写方面影响大 |

|

容错 |

一个组件设备的故障 |

两个组件设备的故障 |

7.1.7 嵌套和复杂 RAID 级别 #

现在已开发出了其他 RAID 级别,例如 RAIDn、RAID 10、RAID 0+1、RAID 30 和 RAID 50。有些是硬件供应商创建的专用实施。创建 RAID 10 配置的示例可在第 9 章 “创建软件 RAID 10 设备”中找到。

7.2 使用 YaST 配置软 RAID #

可以通过 YaST 专家分区程序访问 YaST 软 RAID 配置。此分区工具还用于编辑和删除现有分区,并创建用于软 RAID 的新分区。下列说明在设置 RAID 级别 0、1、5 和 6 时适用。设置 RAID 10 配置的方法如第 9 章 “创建软件 RAID 10 设备”所述。

起动 YaST 并打开。

如果需要,请创建应该与 RAID 配置搭配使用的分区。请勿将它们格式化,并将分区类型设置为 。使用现有分区时,不需要更改它们的分区类型 — YaST 会自动更改。有关详细信息,请参见Book “部署指南”, Chapter 12 “高级磁盘设置”, Section 12.1 “使用 YaST 分区程序”。

强烈建议您使用储存在其他硬盘上的分区,以便降低当其中一个硬盘损坏时(RAID 1 和 5)遗失数据的风险,并优化 RAID 0 的性能。

对于 RAID 0,至少需要两个分区。RAID 1 只需要两个分区,而 RAID 5 至少需要三个分区。RAID 6 设置至少需要四个分区。建议仅使用大小相同的分区,因为每个段仅可将相同的空间量作为最小大小的分区。

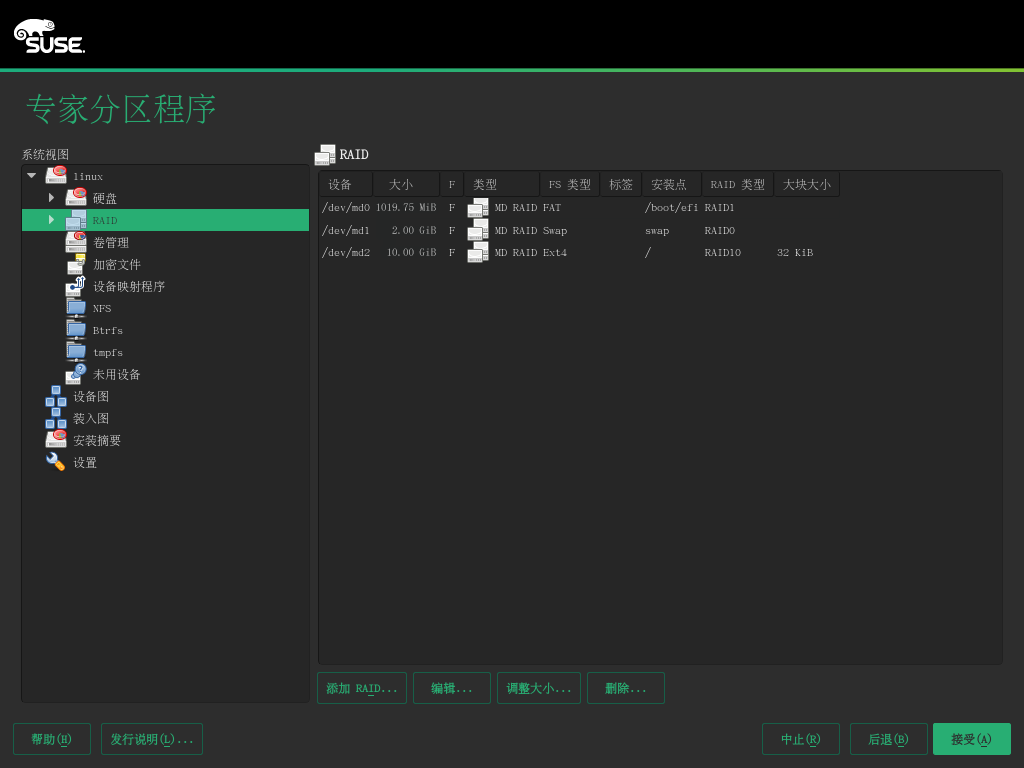

在左侧面板中,选择 。

右侧面板中即会打开现有 RAID 配置的列表。

在 RAID 页面的左下方,单击 。

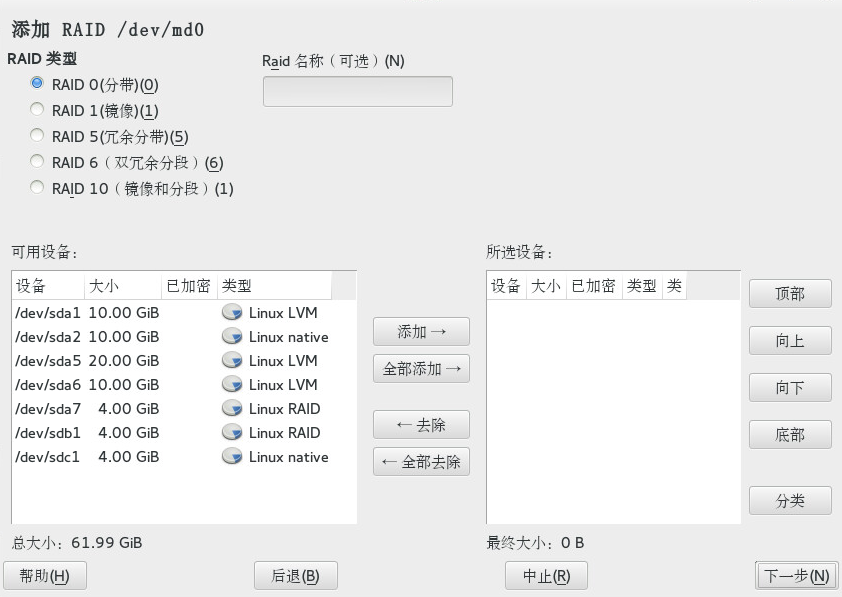

选择并从对话框中适当数目的分区。

您可以选择性地为 RAID 指派一个 。这样,RAID 的名称将是

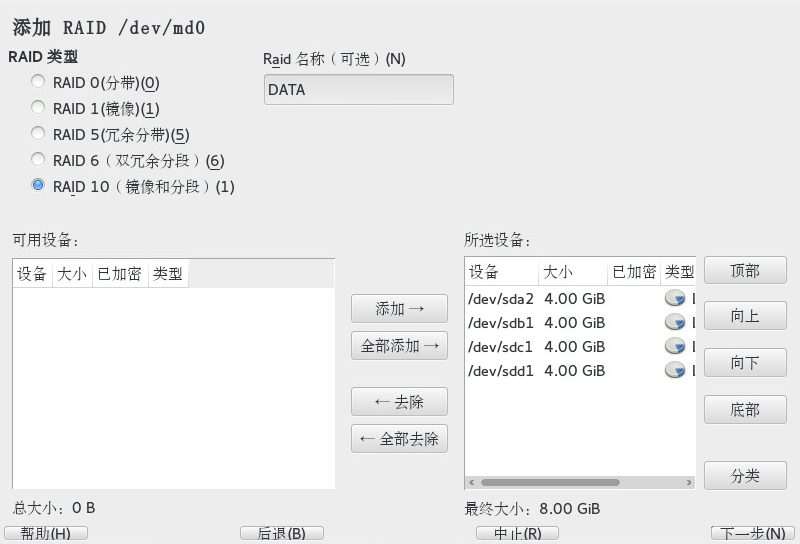

/dev/md/NAME。有关详细信息,请参见第 7.2.1 节 “RAID 名称”。图 7.1︰ RAID 5 配置示例 #单击继续。

选择,如果适用,同时选择。最佳的大块大小视数据的类型和 RAID 的类型而定。有关详细信息,请参见 https://raid.wiki.kernel.org/index.php/RAID_setup#Chunk_sizes。有关奇偶校验算法的详细信息,请在搜索

--layout选项时加上man 8 mdadm。如果不确定,请接受默认值。选择卷的。您在此处所做选择只会影响将要打开的对话框的默认值。这些值可在下一个步骤中更改。如果不确定,请选择。

在下,选择,然后选择。菜单的内容取决于文件系统。通常不需要更改默认值。

在下,选择,然后选择安装点。单击 ,为卷添加特殊装入选项。

单击。

单击,验证是否列出了所做的更改,然后单击。

7.2.1 RAID 名称 #

软件 RAID 设备默认带有 mdN 模式的数值名称,其中 N 是数字。因此,以 md127 为例,它可以按 /dev/md127 这样的方式进行访问,并且在 /proc/mdstat 和 /proc/partitions 中会列出为 md127。但这些名称不方便使用,为此,SUSE Linux Enterprise Server 提供了两种解决方法:

- 提供指向设备的具名链接

当您使用 YaST 或在命令行上使用

mdadm --create '/dev/md/NAME' 创建 RAID 设备时,可以选择为 RAID 设备指定一个名称。设备名称仍然是mdN,但系统会创建一个链接/dev/md/NAME:tux >ls -og /dev/md total 0 lrwxrwxrwx 1 8 Dec 9 15:11 myRAID -> ../md127设备在

/proc下仍显示为md127。- 提供具名设备

在设置时,如果指向设备的具名链接仍然不够方便,请运行下列命令将 CREATE names=yes 行添加至

/etc/mdadm.conf:sudo echo "CREATE names=yes" >> /etc/mdadm.conf

它会让系统将

myRAID之类的名称用做“真实”的设备名称。设备不但可以在/dev/myRAID中访问,而且也会在/proc下列为myRAID。请注意,只有在更改配置文件之后,此项才适用于 RAID。工作中的 RAID 将继续使用mdN名称,直到这些 RAID 停止并重新组装为止。警告:不兼容的工具不是所有工具都可以支持具名 RAID 设备。如果工具认为一个 RAID 设备是命名为

mdN,它将无法识别该设备。

7.3 软件 RAID 疑难解答 #

查看 /proc/mdstats 文件以确定 RAID 分区是否受损。如果磁盘出现故障,请关闭 Linux 系统并用以同样方式分区的新硬盘替换出现问题的硬盘。然后重启动您的系统并输入命令 mdadm /dev/mdX --add /dev/sdX。将 X 替换为您的特定设备标识符。这会自动将硬盘整合到 RAID 系统中并完全重新构造(适用于除 RAID 0 以外的所有 RAID 级别)。

尽管可以在重构建期间访问所有数据,但在 RAID 完全重构建之前,仍然可能遇到一些性能问题。

7.3.1 修复故障磁盘之后进行恢复 #

RAID 阵列中的磁盘可能会出于多种原因而发生故障。下面列出了最常见的原因:

磁盘媒体出现问题。

磁盘驱动器控制器发生故障。

与磁盘的连接断开。

在发生磁盘媒体或控制器故障时,需要更换或修复设备。如果未在 RAID 中配置热备件,则需要手动干预。

对于后一种情况,可以在修复连接(可能会自动修复)之后,使用 mdadm 命令自动重新添加发生故障的设备。

由于 md/mdadm 不能可靠地判断磁盘发生故障的原因,因此会臆测发生了严重的磁盘错误,并一直将任何发生操作失败的设备视为有故障,直到明确被告知该设备可靠为止。

在某些情况下(例如,储存设备包含内部 RAID 阵列),连接问题往往是设备发生故障的原因。在这种情况下,您可以告知 mdadm,在设备出现后,可以放心地使用 --re-add 自动重新添加该设备。为此,您可以将下面一行添加到 /etc/mdadm.conf 中:

POLICY action=re-add

请注意,仅当 udev 规则导致 mdadm -I DISK_DEVICE_NAME 在自发出现的任何设备上运行(默认行为),并且已配置 write-intent 位图(默认会配置)时,才会在设备重新出现之后自动重新添加该设备。

如果您希望此策略仅应用到某些设备而不应用到其余设备,可以将 path= 选项添加到 /etc/mdadm.conf 中的 POLICY 一行,以将非默认操作限制为只对选定的设备执行。可以使用通配符来识别设备组。有关详细信息,请参见 man 5 mdadm.conf。

7.4 更多信息 #

位于下列位置的操作指南中提供了软 RAID 的配置说明和更多细节:

Linux RAID wiki:https://raid.wiki.kernel.org/

/usr/share/doc/packages/mdadm/Software-RAID.HOWTO.html文件中的软件 RAID HOWTO

此外还提供了 Linux RAID 邮件列表,例如 linux-raid (http://marc.info/?l=linux-raid)。

8 为根分区配置软件 RAID #

在 SUSE Linux Enterprise Server 中,设备映射程序 RAID 工具已集成到 YaST 分区程序中。安装时可以使用此分区程序为包含根 (/) 分区的系统设备创建软件 RAID。不能将 /boot 分区储存在除 RAID 1 以外的 RAID 分区上。

8.1 针对根分区使用软件 RAID 设备的先决条件 #

请确保配置满足以下要求:

创建 RAID 1 镜像设备需要有两块硬盘。这两块硬盘的大小应相近。RAID 使用较小驱动器大小。块储存设备可以是本地设备(计算机中或直接挂接到计算机)、光纤通道储存子系统或 iSCSI 储存子系统的任意组合。

如果在 MBR 中安装引导加载程序,则不需要为

/boot创建独立分区。如果无法在 MBR 中安装引导加载程序,则/boot需要驻留在单独的分区上。对于 UEFI 计算机,需要设置专用的

/boot/efi分区。该分区需要格式化为 VFAT,可以驻留在 RAID 1 设备上,以防包含/boot/efi的物理磁盘发生故障时出现引导问题。如果要使用硬件 RAID 设备,请不要在其上尝试运行软件 RAID。

如果要使用 iSCSI 目标设备,需要在创建 RAID 设备之前启用对 iSCSI 发起端的支持。

如果储存子系统在服务器和其直接挂接的本地设备、光纤通道设备或要在软件 RAID 中使用的 iSCSI 设备之间提供多个 I/O 路径,则在创建 RAID 设备之前需要启用多路径支持。

8.2

为根 (/) 分区设置具有软件 RAID 设备的系统

#

使用 YaST 启动安装,并按照Book “部署指南”, Chapter 6 “使用 YaST 进行安装”中的说明继续操作,直到达到步骤为止。

单击以打开自定义分区程序。

(可选)如果有要使用的 iSCSI 目标设备,则需要从屏幕右下方的部分中选择 › ,启用 iSCSI 发起端软件。有关更多细节,请参见第 14 章 “经由 IP 网络的大容量储存:iSCSI”。

(可选)如果要对设备使用多个 I/O 路径,则需要通过从屏幕右下方的部分中选择 › › ,启用多路径支持。

(可选)如果您既未配置 iSCSI 又未设置多路径,则会显示默认的建议设置。单击以删除它们。

为要用于软件 RAID 的每个设备设置 格式。应该为

/、/boot/efi或交换分区使用 RAID。在左侧面板中,选择 并选择要使用的设备,然后单击。

在下,选择,然后单击。

在下,指定要使用的大小,然后单击。

在下,选择。

选择,并将设置为 。

单击,并对第二个分区重复这些步骤。

为

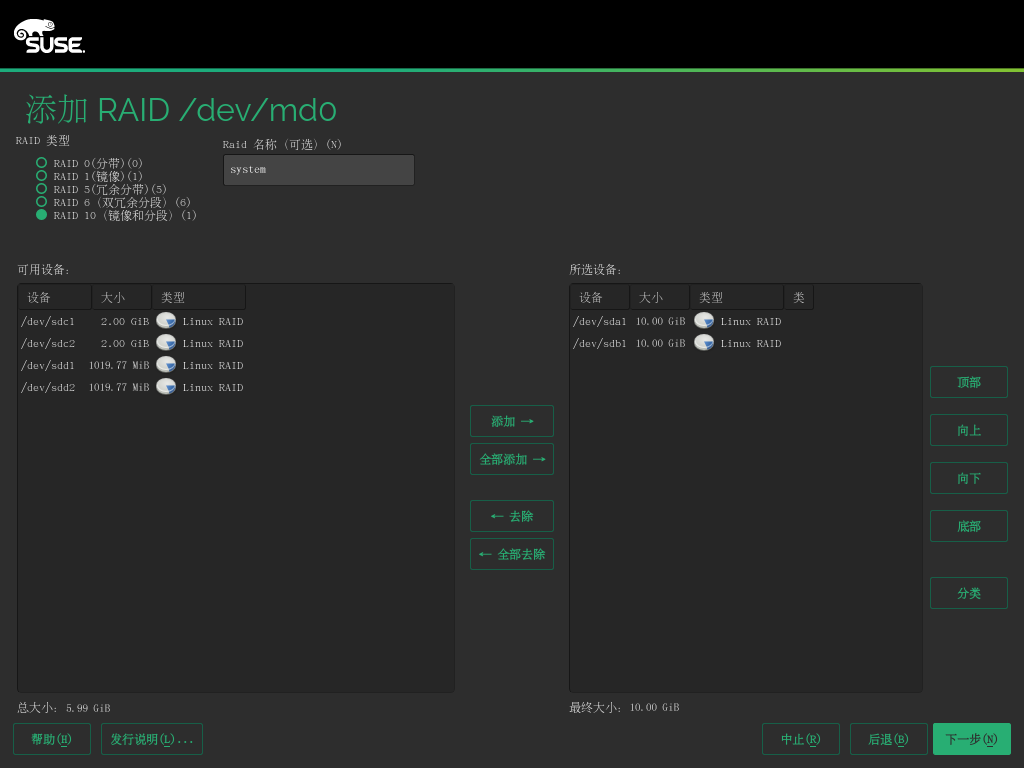

/分区创建 RAID 设备。在左侧面板中,选择,然后选择。

为

/分区设置所需的 ,并将 设置为system。从部分中选择您在上一步中准备好的两个 RAID 设备并它们。

单击继续。

在 下,从下拉框中选择大块大小。保留默认设置是安全的做法。

在下选择,然后单击继续。

选择并将安装点设置为

/。单击完成退出该对话框。

软件 RAID 设备便会受设备映射程序的管理,并会在

/dev/md/system路径下创建一个设备。(可选)对于 UEFI 计算机,使用类似的步骤来创建

/boot/efi装入分区。请记住,/boot/efi仅支持 RAID 1,需要使用 FAT 文件系统来格式化该分区。图 8.1︰ RAID 上的 、 和交换分区 #单击结束分区程序。

页面上会显示新的建议。

继续安装。对于包含独立

/boot/efi分区的 UEFI 计算机,请在屏幕上单击,然后将设置为 。检查选项是否已激活。只要重引导服务器,设备映射程序就会在引导时启动,以便自动识别软件 RAID,并可在根 (/) 分区上启动操作系统。

9 创建软件 RAID 10 设备 #

本章说明如何设置嵌套和复杂 RAID 10 设备。RAID 10 设备包含嵌套 RAID 1(镜像)和 RAID 0(分段)阵列。嵌套 RAID 可以设置为条带化镜像 (RAID 1+0) 或镜像化条带 (RAID 0+1)。复杂 RAID 10 设置支持更高的数据冗余级别,因此镜像与分段兼得,并且拥有更多的数据安全措施。

9.1 使用 mdadm 创建嵌套 RAID 10 设备 #

嵌套的 RAID 设备由使用另一个 RAID 阵列(而不是物理磁盘)作为其基本元素的 RAID 阵列组成。此配置的目标是提高 RAID 的性能和容错能力。YaST 不支持设置嵌套 RAID 级别,但可以通过 mdadm 命令行工具实现。

根据嵌套的顺序,可以设置两个不同的嵌套 RAID。本文使用了下列术语:

RAID 1+0: 先构建 RAID 1(镜像)阵列,然后组合形成 RAID 0(条带化)阵列。

RAID 0+1: 先构建 RAID 0(条带化)阵列,然后组合形成 RAID 1(镜像)阵列。

下表描述嵌套为 1+0 和 0+1 的 RAID 10 的优点和缺点。假定您使用的储存对象驻留在不同的磁盘上,每个都有专用的 I/O 功能。

|

RAID 级别 |

描述 |

性能和容错 |

|---|---|---|

|

10 (1+0) |

使用 RAID 1(镜像)阵列构建的 RAID 0(条带化) |

RAID 1+0 提供高级别的 I/O 性能、数据冗余、和磁盘容错。因为 RAID 0 中的每个成员设备都分别镜像,因此可以容忍多个磁盘故障,并且只要失败的磁盘在不同的镜像中,数据仍然可用。 您可以选择为每个底层的镜像阵列配置一个备用设备,或配置一个备用设备充当服务于所有镜像的备用组。 |

|

10 (0+1) |

使用 RAID 0(条带化)阵列构建的 RAID 1(镜像) |

RAID 0+1 提供高级别的 I/O 性能和数据冗余,但比 1+0 的容错稍差。如果在镜像的一端多个磁盘失败,则另一个镜像可用。但是,如果在镜像的两端同时丢失磁盘,则所有数据会丢失。 这种解决方案比 1+0 解决方案磁盘容错差,但是如果需要在不同的站点执行维护或维护镜像,则可以使镜像的整个一端脱机,并仍可以有完全正常的储存设备。同时,如果丢失两个站点之间的连接,每个站点会彼此独立地运行。如果条带化镜像分段,则不是这种情况,因为这些镜像在较低级别进行管理。 如果一个设备失败,该端的镜像则会失败,因为 RAID 1 不容错。创建新的 RAID 0 以替换失败的一端,然后重新同步这两个镜像。 |

9.1.1 使用 mdadm 创建嵌套的 RAID 10 (1+0) #

嵌套的 RAID 1+0 的构建方法是,创建两个或更多 RAID 1(镜像),然后使用它们作为 RAID 0 中的组件设备。

本节中的过程使用下表中显示的设备名。确保使用您自己的设备名称修改这些设备名称。

|

原始设备 |

RAID 1(镜像) |

RAID 1+0(条带化镜像) | ||

|---|---|---|---|---|

|

|

| ||

|

|

打开一个终端控制台。

如果需要,使用 parted 等磁盘分区程序创建四个大小相同的 0xFD Linux RAID 分区。

创建两个软件 RAID 1 设备,为每个 RAID 设备使用两个不同的设备。在命令提示符处,输入以下两个命令:

sudo mdadm --create /dev/md0 --run --level=1 --raid-devices=2 /dev/sdb1 /dev/sdc1 sudo mdadm --create /dev/md1 --run --level=1 --raid-devices=2 /dev/sdd1 /dev/sde1

创建嵌套的 RAID 1+0 设备。在命令提示符处,使用您在上一步中创建的软件 RAID 1 设备输入以下命令:

sudo mdadm --create /dev/md2 --run --level=0 --chunk=64 \ --raid-devices=2 /dev/md0 /dev/md1

默认大块大小为 64 KB。

在 RAID 1+0 设备

/dev/md2上创建文件系统,例如 XFS 文件系统:sudo mkfs.xfs /dev/md2

要使用其他文件系统,请修改该命令。

编辑

/etc/mdadm.conf文件,如果它不存在,则创建该文件(例如通过运行sudo vi /etc/mdadm.conf)。添加下列行(如果该文件存在,则第一行很可能也已经存在)。DEVICE containers partitions ARRAY /dev/md0 UUID=UUID ARRAY /dev/md1 UUID=UUID ARRAY /dev/md2 UUID=UUID

每个设备的 UUID 可以使用以下命令检索:

sudo mdadm -D /dev/DEVICE | grep UUID

编辑

/etc/fstab文件以添加 RAID 1+0 设备/dev/md2的项。下列示例显示了采用 XFS 文件系统并以/data做为安装点的 RAID 设备的项。/dev/md2 /data xfs defaults 1 2

装入 RAID 设备:

sudo mount /data

9.1.2 使用 mdadm 创建嵌套的 RAID 10 (0+1) #

嵌套的 RAID 0+1 的构建方法是,创建两个到四个 RAID 0(分段)设备,然后将它们镜像为 RAID 1 中的组件设备。

在此配置中,不能为底层的 RAID 0 设备指定备用设备,因为 RAID 0 不能容忍设备丢失。如果在镜像的一端一个设备失败,则必须创建一个替换 RAID 0 设备,然后将其添加到镜像。

本节中的过程使用下表中显示的设备名。确保使用您自己的设备名称修改这些设备名称。

|

原始设备 |

RAID 0(条带化) |

RAID 0+1(镜像条带化) | ||

|---|---|---|---|---|

|

|

| ||

|

|

打开一个终端控制台。

如果需要,使用 parted 等磁盘分区程序创建四个大小相同的 0xFD Linux RAID 分区。

创建两个软件 RAID 0 设备,为每个 RAID 0 设备使用两个不同的设备。在命令提示符处,输入以下两个命令:

sudo mdadm --create /dev/md0 --run --level=0 --chunk=64 \ --raid-devices=2 /dev/sdb1 /dev/sdc1 sudo mdadm --create /dev/md1 --run --level=0 --chunk=64 \ --raid-devices=2 /dev/sdd1 /dev/sde1

默认大块大小为 64 KB。

创建嵌套的 RAID 0+1 设备。在命令提示符处,使用您在上一步中创建的软件 RAID 0 设备输入以下命令:

sudo mdadm --create /dev/md2 --run --level=1 --raid-devices=2 /dev/md0 /dev/md1

在 RAID 1+0 设备

/dev/md2上创建文件系统,例如 XFS 文件系统:sudo mkfs.xfs /dev/md2

要使用其他文件系统,请修改该命令。

编辑

/etc/mdadm.conf文件,如果它不存在,则创建该文件(例如通过运行sudo vi /etc/mdadm.conf)。添加下列行(如果该文件存在,第一行很可能也已经存在)。DEVICE containers partitions ARRAY /dev/md0 UUID=UUID ARRAY /dev/md1 UUID=UUID ARRAY /dev/md2 UUID=UUID

每个设备的 UUID 可以使用以下命令检索:

sudo mdadm -D /dev/DEVICE | grep UUID

编辑

/etc/fstab文件以添加 RAID 1+0 设备/dev/md2的项。下列示例显示了采用 XFS 文件系统并以/data做为安装点的 RAID 设备的项。/dev/md2 /data xfs defaults 1 2

装入 RAID 设备:

sudo mount /data

9.2 创建复杂 RAID 10 #

YaST(以及带 --level=10 选项的 mdadm)可创建单一复杂软件 RAID 10,它结合了 RAID 0(分段)与 RAID 1(镜像)的功能。所有数据块的多个副本遵循一个分段准则在多个驱动器上排列。组件设备应大小相同。

复杂 RAID 10 与嵌套 RAID 10 (1+0) 的目的类似,但在以下方面不同:

|

特性 |

复杂 RAID 10 |

嵌套 RAID 10 (1+0) |

|---|---|---|

|

设备数 |

允许组件设备数为奇数或偶数 |

要求组件设备数为偶数 |

|

组件设备 |

作为单个 RAID 设备管理 |

作为嵌套 RAID 设备管理 |

|

分段 |

在组件设备的近布局或远布局中发生分段。 远布局提供根据驱动器数(而不是 RAID 1 对数)缩放的串行读吞吐量。 |

在组件设备之间连续发生分段 |

|

数据的多个副本 |

两个或更多副本,最多为阵列中的设备数 |

每个镜像段上的副本 |

|

热备用设备 |

单个备用设备可以服务于所有组件设备 |

为每个底层的镜像阵列配置一个备用设备,或配置一个备用设备充当服务于所有镜像的备用组。 |

9.2.1 复杂 RAID 10 中的设备和复本数 #

配置复杂 RAID 10 阵列时,必须指定需要的每个数据块的复本数。默认复本数是 2,但该值可以是 2 到阵列中设备数之间的任何数字。

必须至少使用指定的复本数的组件设备。但是,RAID 10 阵列中的组件设备数不必是每个数据块的复本数的倍数。有效储存大小是设备数除以复本数。

例如,如果为使用 5 个组件设备创建的阵列指定 2 个复本,则每个块的副本储存在两个不同的设备上。所有数据的一个副本的有效储存大小是 5/2 或 2.5 乘以组件设备的大小。

9.2.2 布局 #

复杂 RAID 10 设置支持 3 种不同的布局,这些布局定义了在磁盘上排列数据块的方式。可用布局有近(默认值)、远和偏移。它们的性能特性各不相同,因此您必须选择适合自己工作负载的布局。

9.2.2.1 近布局 #

使用近布局,数据块的副本会在不同的组件设备上彼此邻近地条带化。即,一个数据块的多个副本在不同设备中的偏移类似。近布局是 RAID 10 的默认布局。例如,如果使用奇数个组件设备以及数据的两个副本,则一些副本可能在设备的一个大块中。

在半数的驱动器上,复杂 RAID 10 的近布局在读写性能上与 RAID 0 类似。

具有偶数个磁盘和两个复本的近布局:

sda1 sdb1 sdc1 sde1 0 0 1 1 2 2 3 3 4 4 5 5 6 6 7 7 8 8 9 9

具有奇数个磁盘和两个复本的近布局:

sda1 sdb1 sdc1 sde1 sdf1 0 0 1 1 2 2 3 3 4 4 5 5 6 6 7 7 8 8 9 9 10 10 11 11 12

9.2.2.2 远布局 #

远布局在所有驱动器的前面部分条带化数据,然后在所有驱动器的后面部分条带化数据的另一份副本,以确保块的所有副本在不同的驱动器上。第二个值集合在组件驱动器的中间开始。

使用远布局,复杂 RAID 10 的读取性能类似于所有驱动器上的 RAID 0,但写入速度比 RAID 0 慢得多,因为前者需要更多地搜寻驱动器头。适用于读密集性操作,例如只读文件服务器。

RAID 10 的写入速度类似于其他镜像 RAID 类型(例如使用近布局的 RAID 1 和 RAID 10),因为该文件系统的电梯式操作会以最佳方式而不是原始写入方式调度写入。使用远布局的 RAID 10 最适合镜像写入应用程序。

具有偶数个磁盘和两个复本的远布局:

sda1 sdb1 sdc1 sde1 0 1 2 3 4 5 6 7 . . . 3 0 1 2 7 4 5 6

具有奇数个磁盘和两个复本的远布局:

sda1 sdb1 sdc1 sde1 sdf1 0 1 2 3 4 5 6 7 8 9 . . . 4 0 1 2 3 9 5 6 7 8

9.2.2.3 偏移布局 #

偏移布局会复制分段,从而使指定大块的多个副本在连续的驱动器上以连续偏移进行布局。事实上,会复制每个分段且副本会按每个设备进行偏移。如果使用适当较大的大块大小且不超过写入的寻道大小,则此方式会赋予远布局类似的读特征。

具有偶数个磁盘和两个复本的偏移布局:

sda1 sdb1 sdc1 sde1 0 1 2 3 3 0 1 2 4 5 6 7 7 4 5 6 8 9 10 11 11 8 9 10

具有奇数个磁盘和两个复本的偏移布局:

sda1 sdb1 sdc1 sde1 sdf1 0 1 2 3 4 4 0 1 2 3 5 6 7 8 9 9 5 6 7 8 10 11 12 13 14 14 10 11 12 13

9.2.2.4 使用 YaST 和 mdadm 指定复本数和布局 #

复本数和布局在 YaST 中或使用 mdadm 的 --layout 参数指定为。接受的值如下:

nN对近布局指定

n,并用复本数替换 N。n2是默认值,在未设置布局和复本数时使用。fN对远布局指定

f,并用复本数替换 N。oN对偏移布局指定

o,并用复本数替换 N。

YaST 自动为参数的所有可能的值提供了选择。

9.2.3 使用 YaST 分区程序创建复杂 RAID 10 #

起动 YaST 并打开分区程序。

如果需要,请创建应该与 RAID 配置搭配使用的分区。请勿将它们格式化,并将分区类型设置为 。使用现有分区时,不需要更改它们的分区类型 — YaST 会自动更改。有关详细信息,请参见Book “部署指南”, Chapter 12 “高级磁盘设置”, Section 12.1 “使用 YaST 分区程序”。

对于 RAID 10,至少需要四个分区。强烈建议您使用储存在不同硬盘上的分区,以降低当其中一个损坏时遗失数据的风险。建议仅使用大小相同的分区,因为每个段仅可将相同的空间量作为最小大小的分区。

在左侧面板中,选择 。

右侧面板中即会打开现有 RAID 配置的列表。

在 RAID 页面的左下方,单击 。

在 下,选择 。