- Informationen über dieses Handbuch

- I Ceph Dashboard

- 1 Infos zum Ceph Dashboard

- 2 Dashboard-Webbenutzeroberfläche

- 3 Verwalten von Ceph-Dashboard-Benutzern und -Rollen

- 4 Anzeigen von Cluster-internen Elementen

- 4.1 Anzeigen von Cluster-Knoten

- 4.2 Zugreifen auf das Clusterinventar

- 4.3 Anzeigen von Ceph Monitors

- 4.4 Anzeigen von Services

- 4.5 Anzeigen von Ceph OSDs

- 4.6 Anzeigen der Cluster-Konfiguration

- 4.7 Anzeigen der CRUSH Map

- 4.8 Anzeigen von Manager-Modulen

- 4.9 Anzeigen von Protokollen

- 4.10 Anzeigen der Überwachung

- 5 Verwalten von Pools

- 6 Verwalten von RADOS-Blockgeräten

- 7 Verwalten von NFS Ganesha

- 8 Verwalten von CephFS

- 9 Verwalten des Object Gateways

- 10 Manuelle Konfiguration

- 11 Verwalten von Benutzern und Rollen über die Kommandozeile

- II Clustervorgang

- 12 Ermitteln des Clusterzustands

- 12.1 Überprüfen des Status eines Clusters

- 12.2 Überprüfen der Clusterintegrität

- 12.3 Überprüfen der Nutzungsstatistik eines Clusters

- 12.4 Überprüfen des OSD-Status

- 12.5 Suchen nach vollen OSDs

- 12.6 Prüfen des Monitorstatus

- 12.7 Überprüfen des Zustands von Platzierungsgruppen

- 12.8 Speicherkapazität

- 12.9 Überwachen der OSDs und Platzierungsgruppen

- 13 Betriebsaufgaben

- 13.1 Ändern der Cluster-Konfiguration

- 13.2 Hinzufügen von Knoten

- 13.3 Entfernen von Knoten

- 13.4 OSD-Verwaltung

- 13.5 Verschieben des Salt Masters auf einen neuen Knoten

- 13.6 Aktualisieren der Cluster-Knoten

- 13.7 Aktualisieren von Ceph

- 13.8 Anhalten oder Neustarten des Clusters

- 13.9 Vollständiges Entfernen eines Ceph-Clusters

- 14 Betrieb von Ceph-Services

- 15 Sichern und Wiederherstellen

- 16 Überwachung und Warnungen

- 12 Ermitteln des Clusterzustands

- III Speichern von Daten in einem Cluster

- IV Zugreifen auf Cluster-Daten

- 21 Ceph Object Gateway

- 21.1 Object-Gateway-Beschränkungen und Benennungseinschränkungen

- 21.2 Bereitstellen des Object Gateways

- 21.3 Betrieb des Object Gateway Service

- 21.4 Konfigurationsoptionen

- 21.5 Verwalten des Zugriffs auf Object Gateway

- 21.6 HTTP-Frontends

- 21.7 Aktivieren von HTTPS/SSL für Object Gateways

- 21.8 Synchronisierungsmodule

- 21.9 LDAP-Authentifizierung

- 21.10 Bucket-Index-Sharding

- 21.11 Integration von OpenStack Keystone

- 21.12 Pool-Platzierung und Speicherklassen

- 21.13 Object Gateways an mehreren Standorten

- 22 Ceph iSCSI Gateway

- 23 Cluster-Dateisystem

- 24 Exportieren von Ceph-Daten mit Samba

- 25 NFS Ganesha

- 21 Ceph Object Gateway

- V Integration in Virtualisierungstools

- VI Konfigurieren eines Clusters

- A Ceph-Wartungsaktualisierungen auf der Grundlage von vorgeschalteten „Octopus“-Unterversionen

- B Aktualisierungen für die Dokumentation

- Glossar

- 2.1 Ceph-Dashboard-Anmeldebildschirm

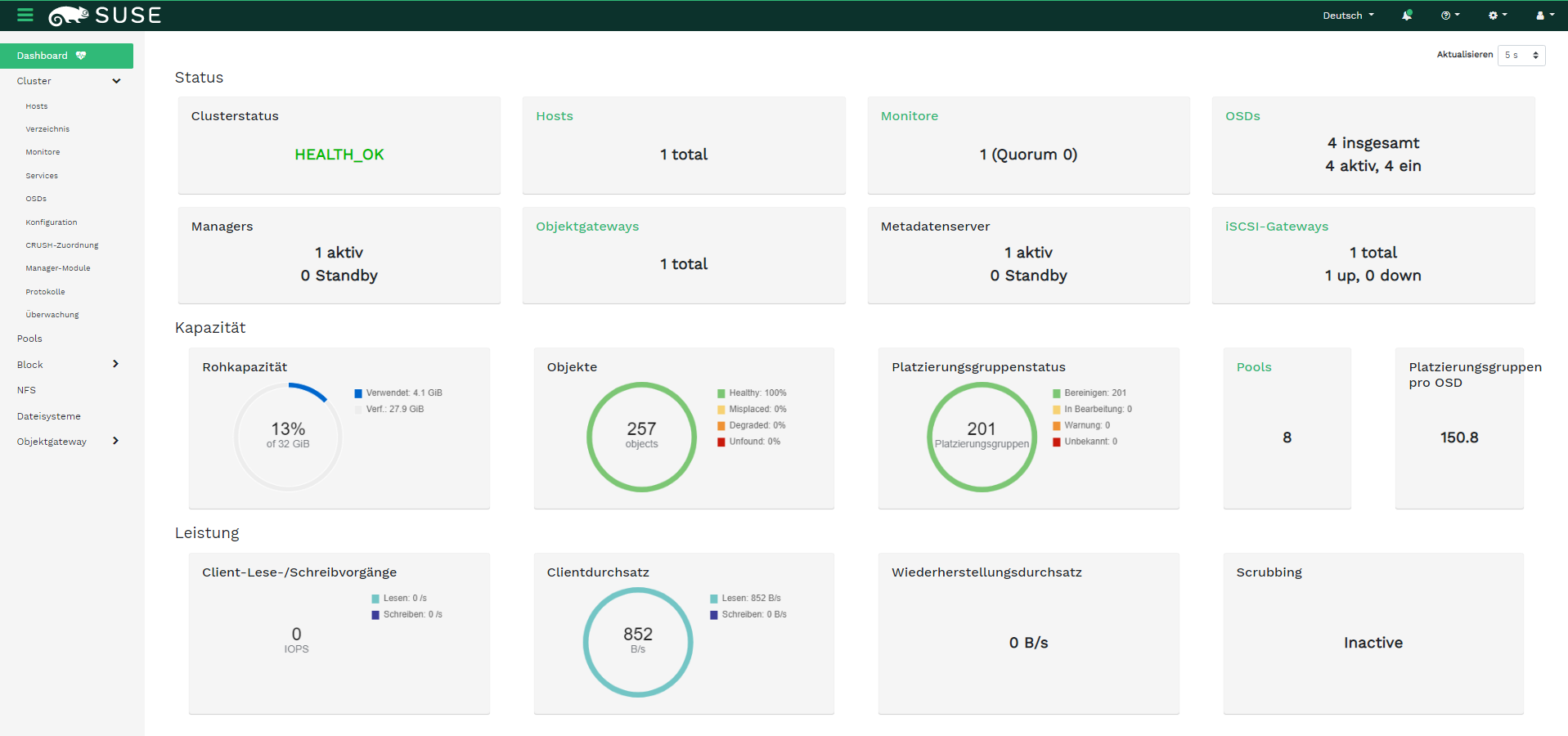

- 2.2 Ceph-Dashboard-Startseite

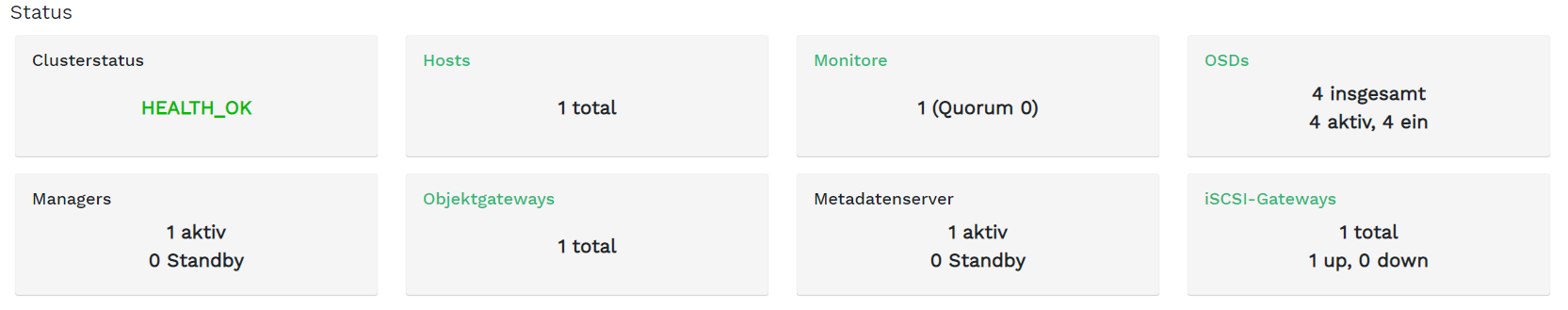

- 2.3 Status-Widgets

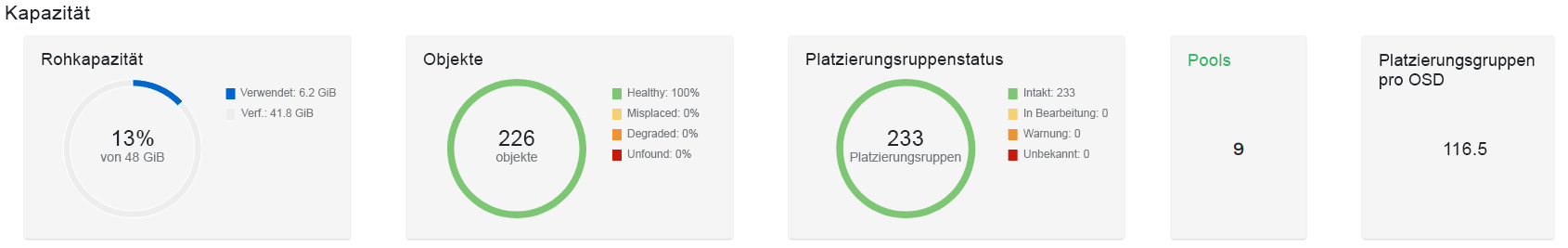

- 2.4 Kapazitäts-Widgets

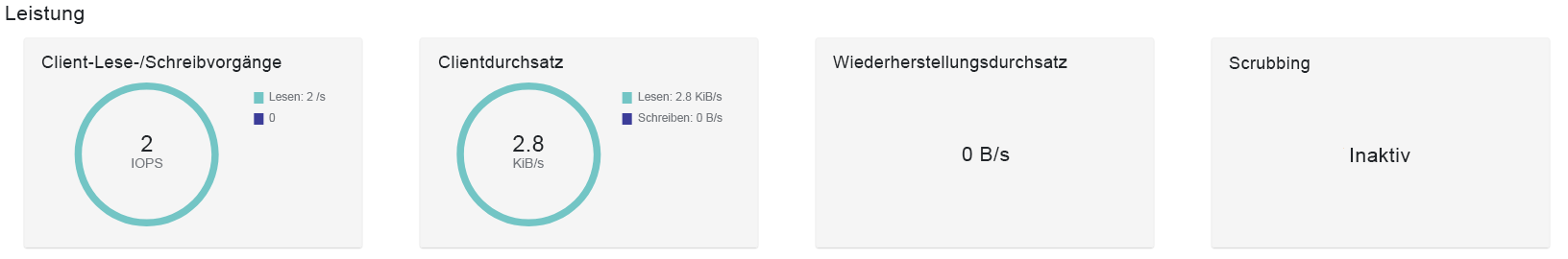

- 2.5 Leistungs-Widgets

- 3.1 Benutzerverwaltung

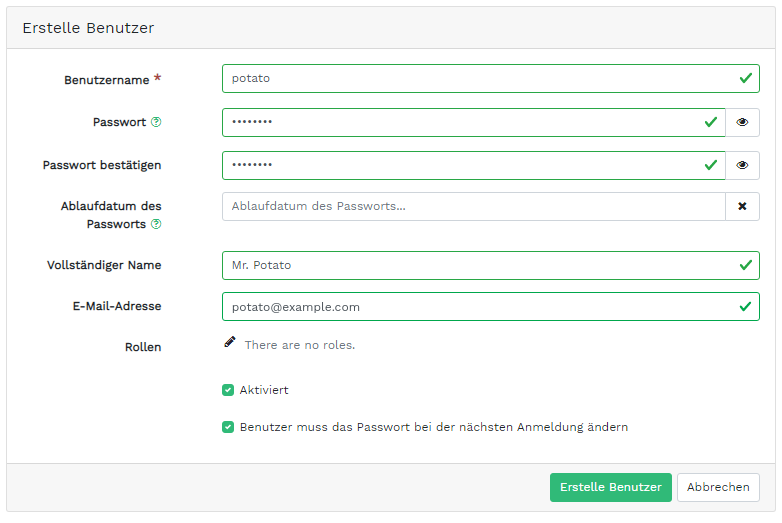

- 3.2 Hinzufügen eines Benutzers

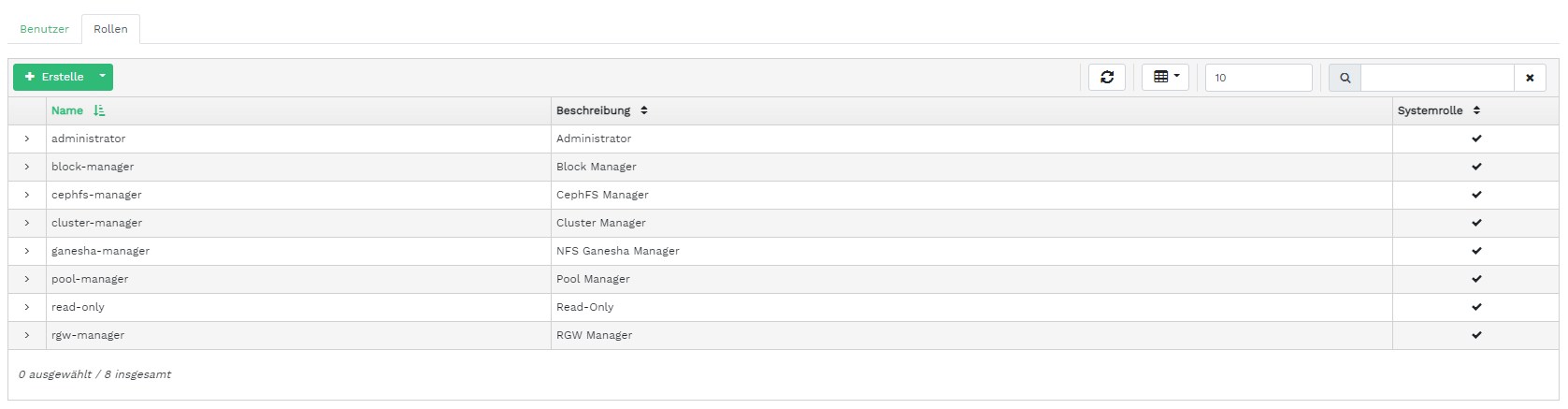

- 3.3 Benutzerrollen

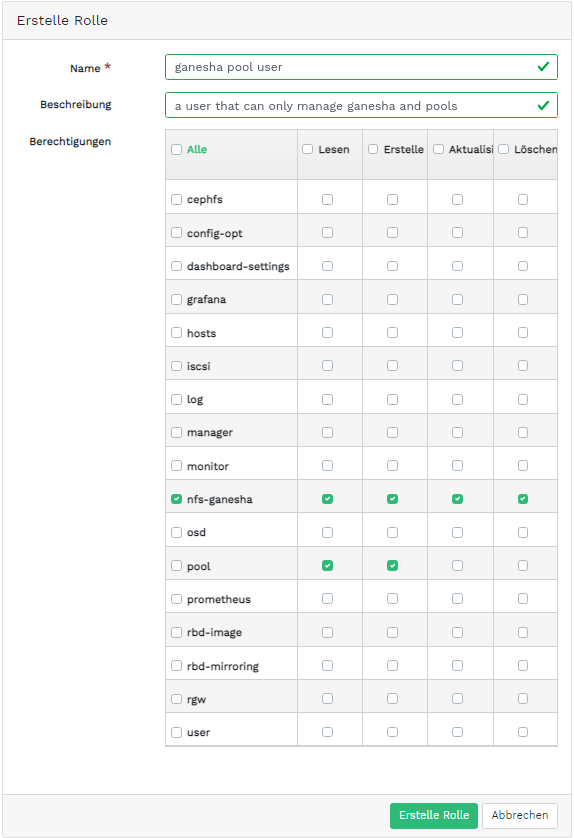

- 3.4 Hinzufügen einer Rolle

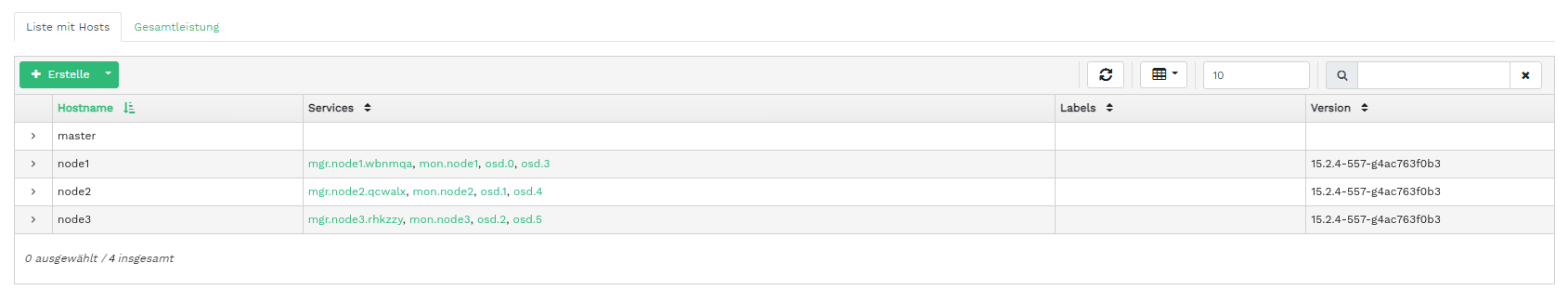

- 4.1 Hosts

- 4.2 Services

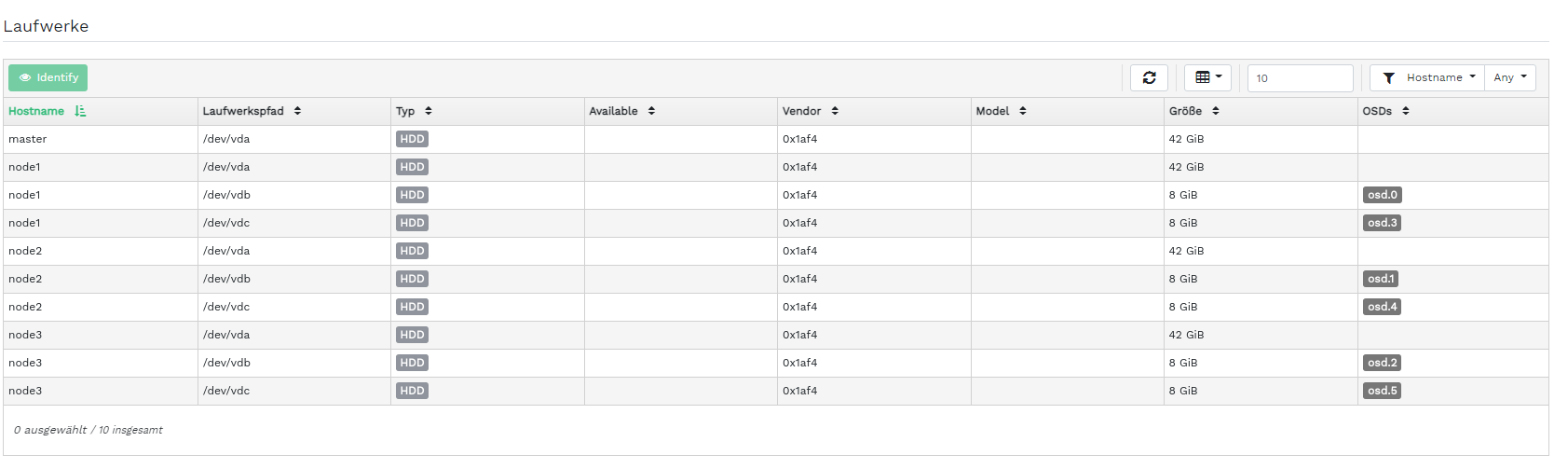

- 4.3 Ceph Monitors

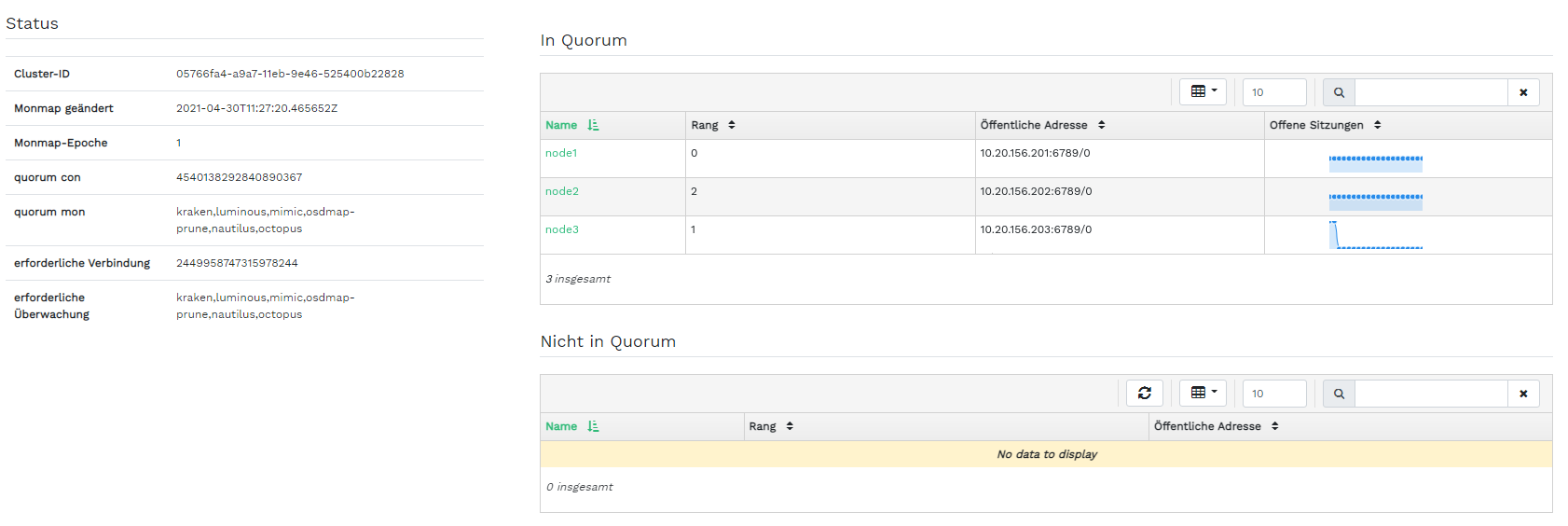

- 4.4 Services

- 4.5 Ceph OSDs

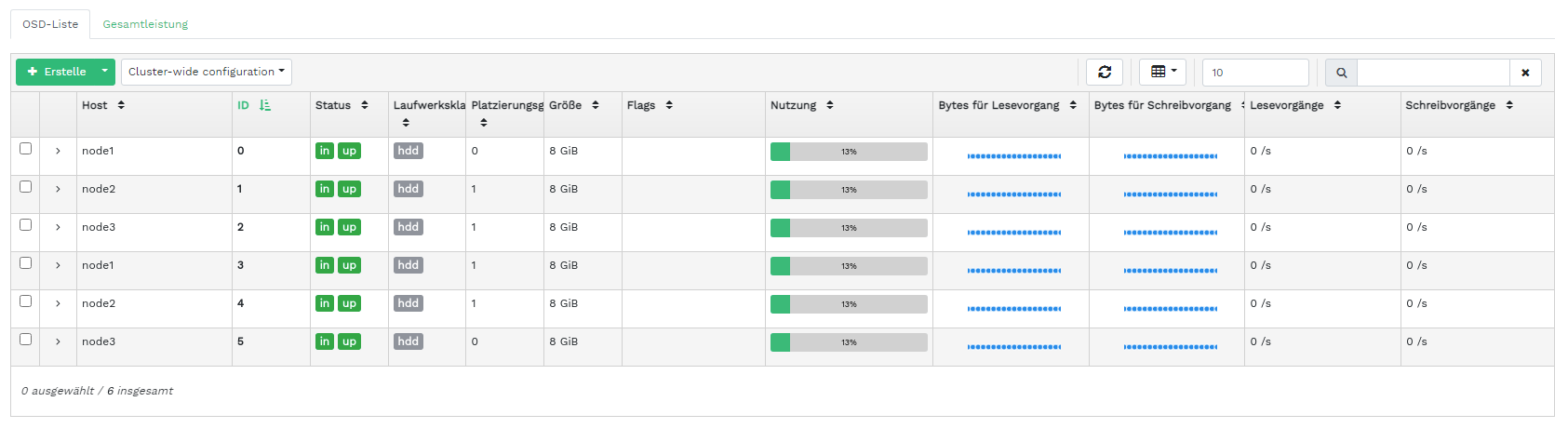

- 4.6 OSD-Flags

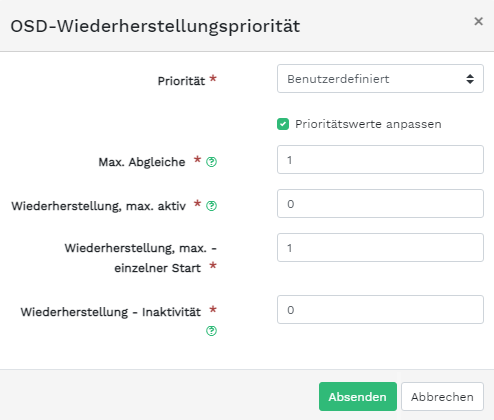

- 4.7 OSD-Wiederherstellungspriorität

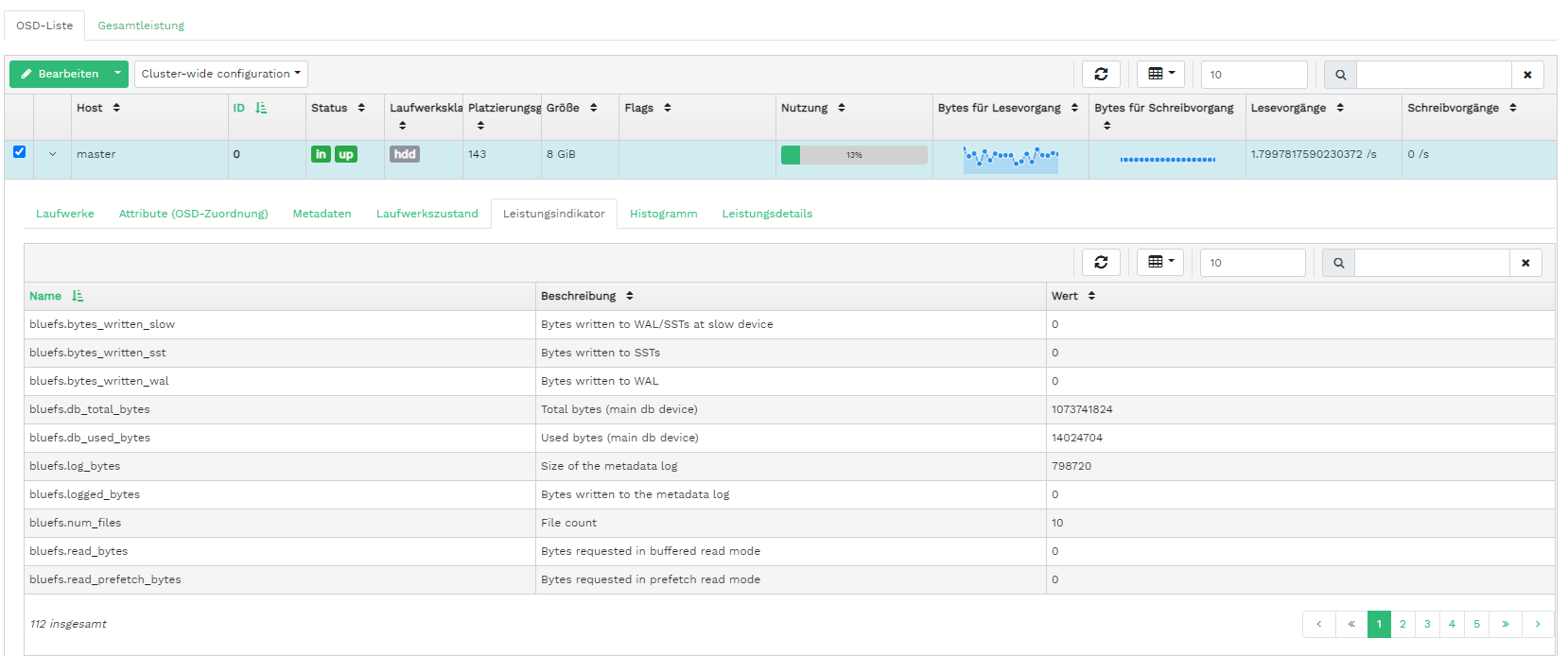

- 4.8 OSD-Details

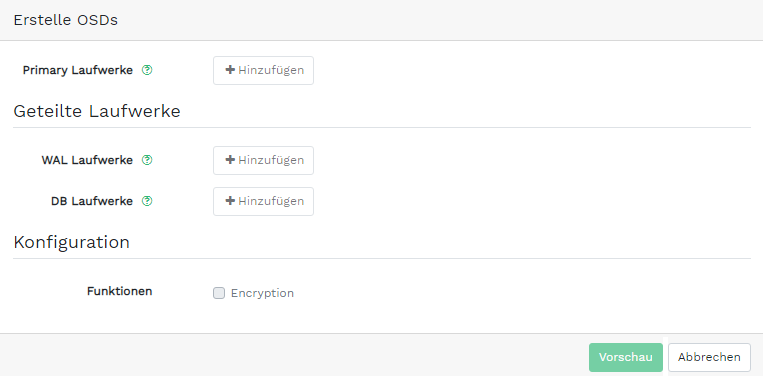

- 4.9 OSDs erstellen

- 4.10 Hinzufügen von primären Geräten

- 4.11 OSDs mit hinzugefügten primären Geräten erstellen

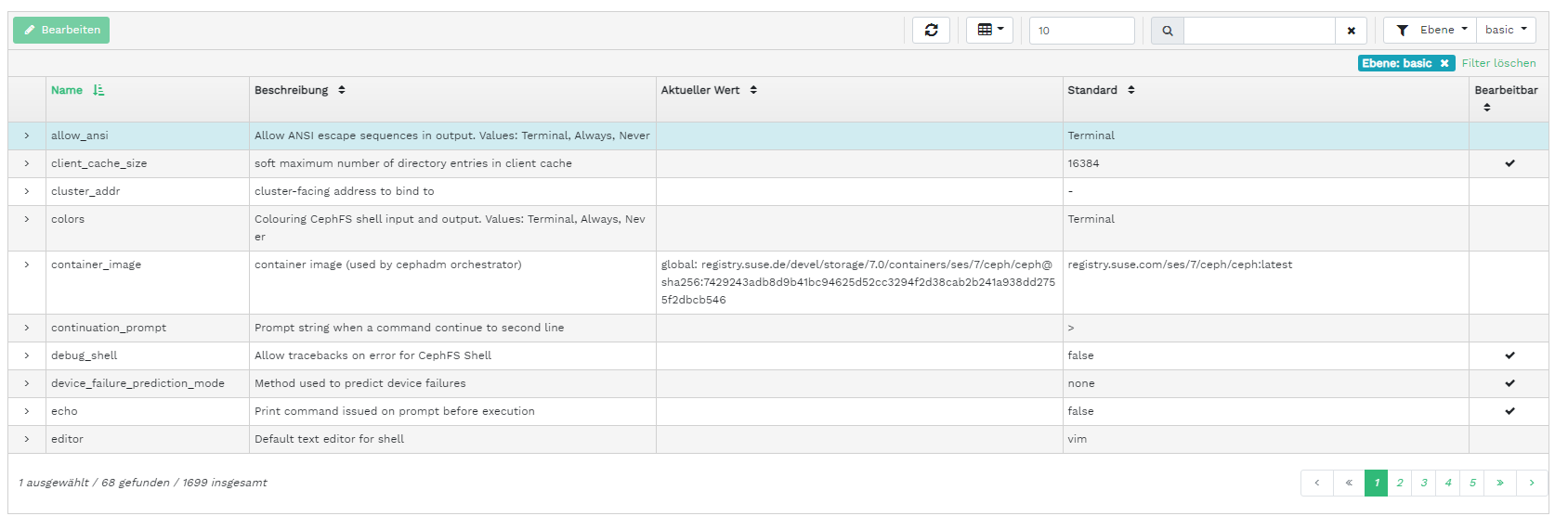

- 4.12

- 4.13 Neu hinzugefügte OSDs

- 4.14 Cluster-Konfiguration

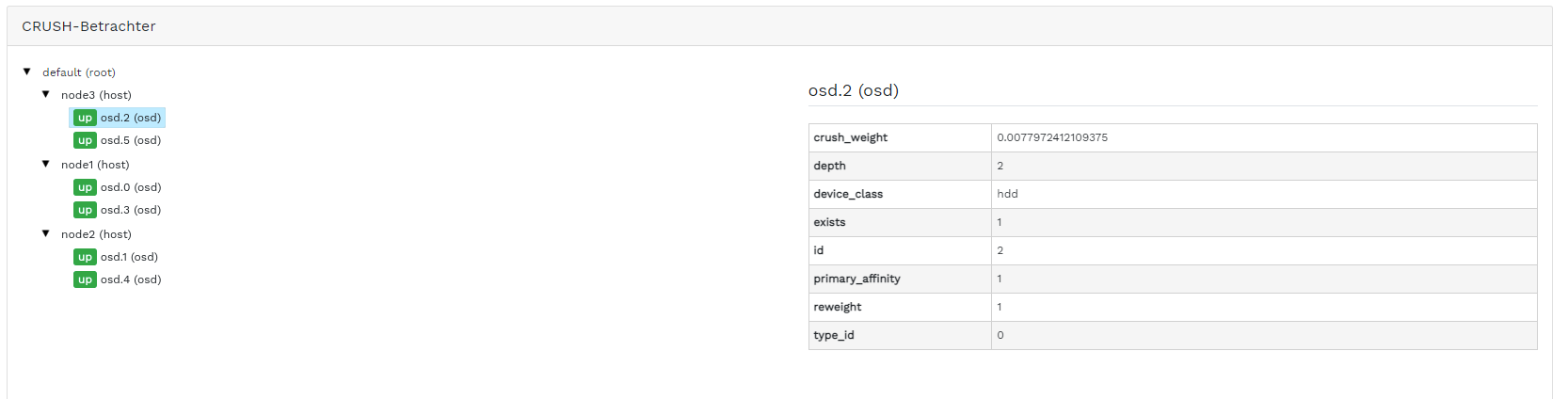

- 4.15 CRUSH Map

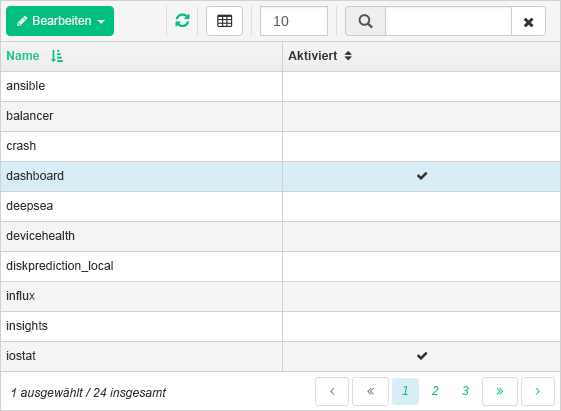

- 4.16 Manager-Module

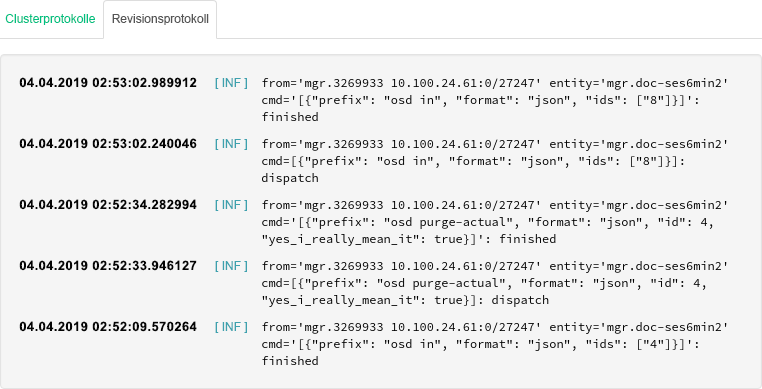

- 4.17 Protokolle

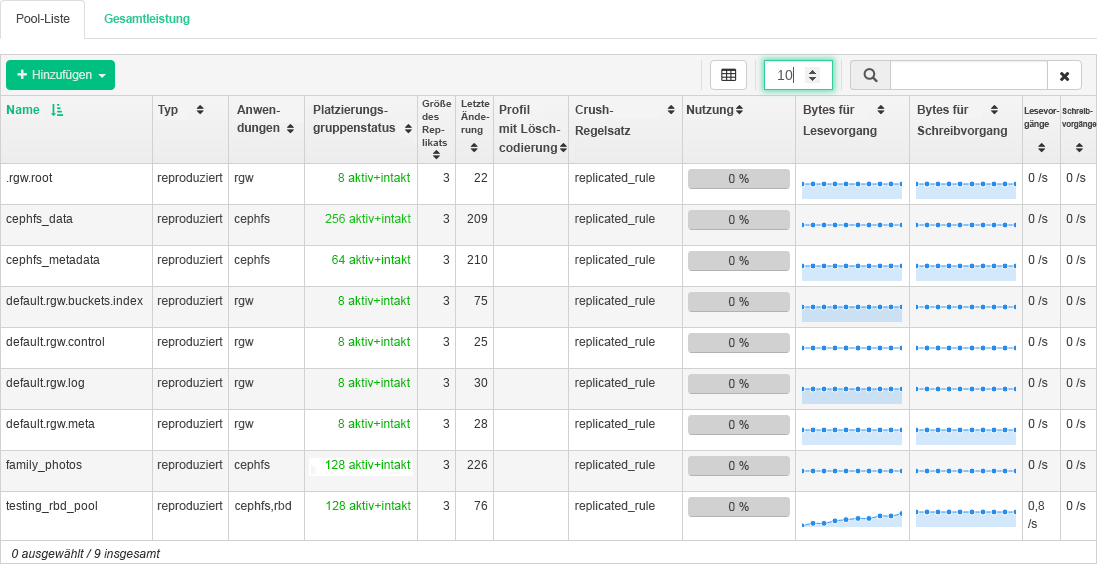

- 5.1 Liste der Pools

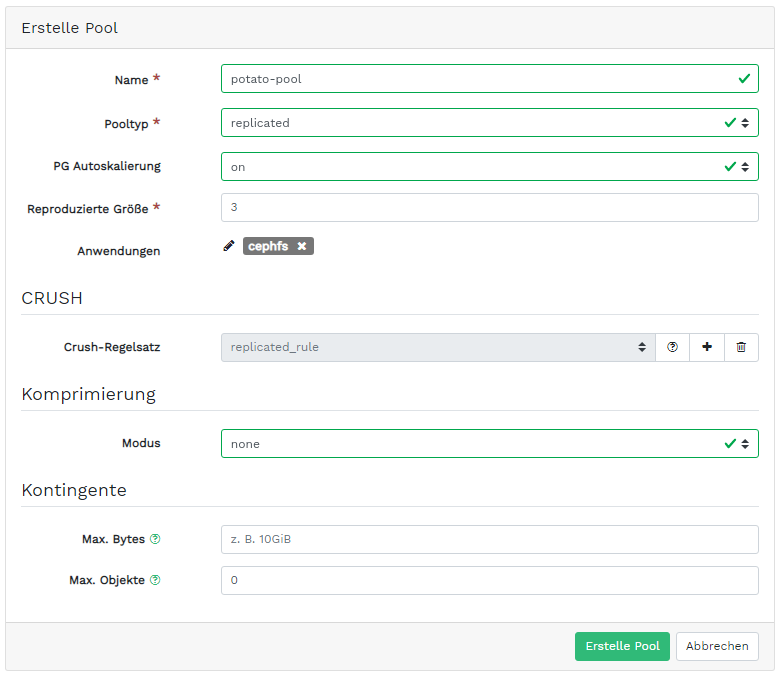

- 5.2 Hinzufügen eines neuen Pools

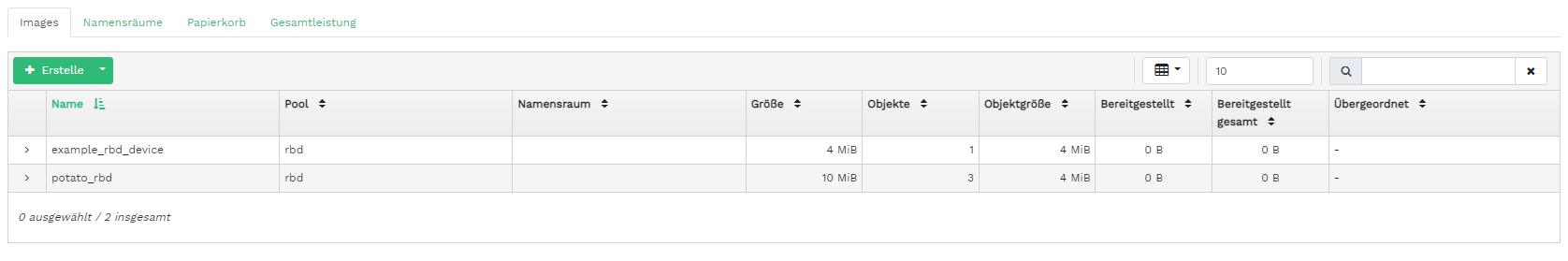

- 6.1 Liste der RBD-Images

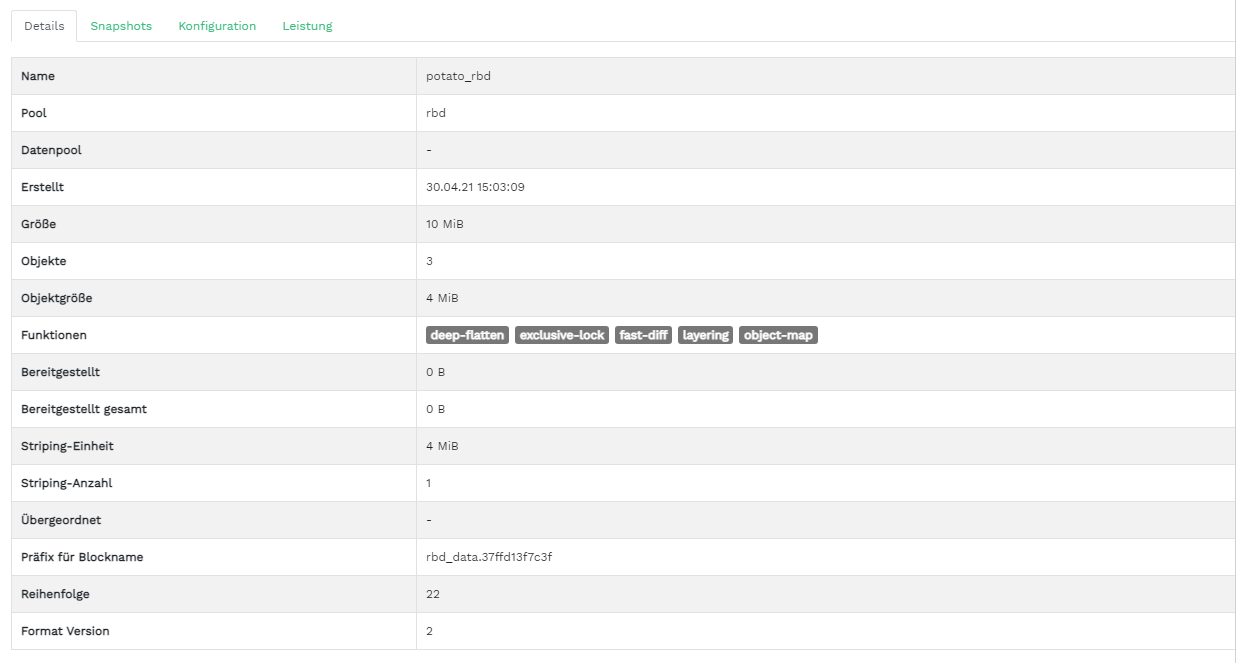

- 6.2 RBD-Details

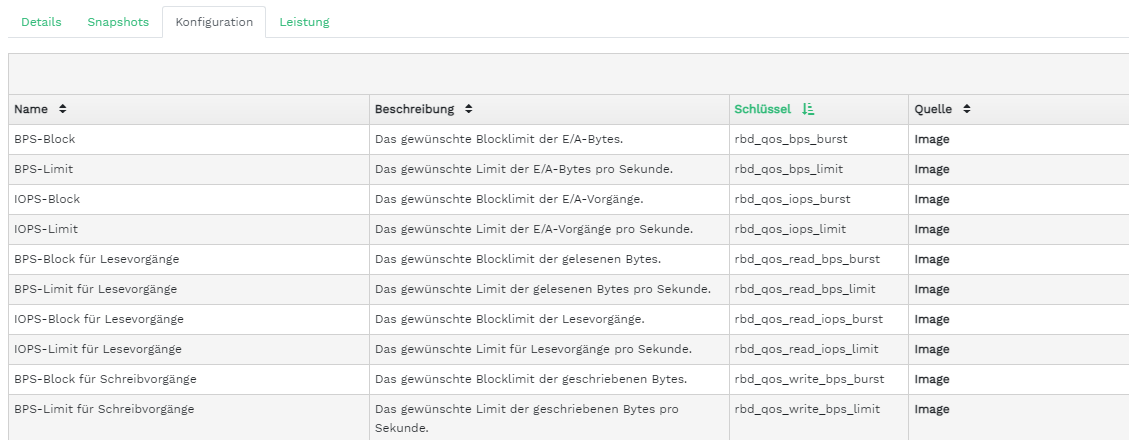

- 6.3 RBD-Konfiguration

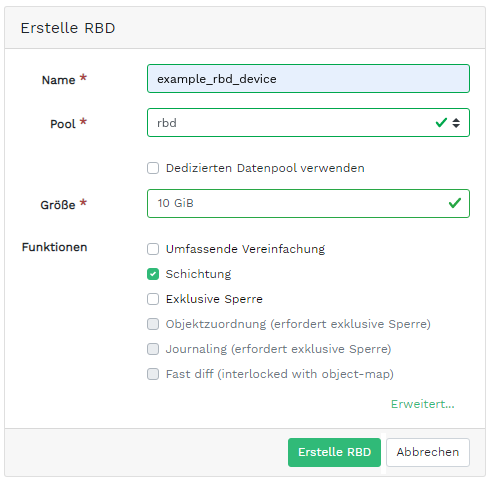

- 6.4 Hinzufügen eines neuen RBD

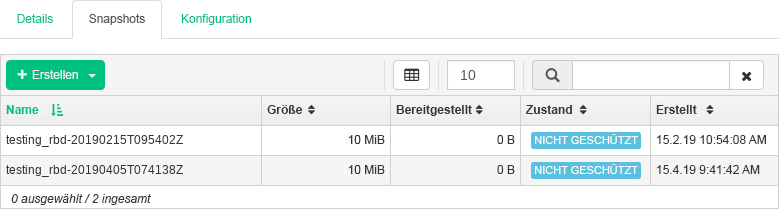

- 6.5 RBD-Snapshots

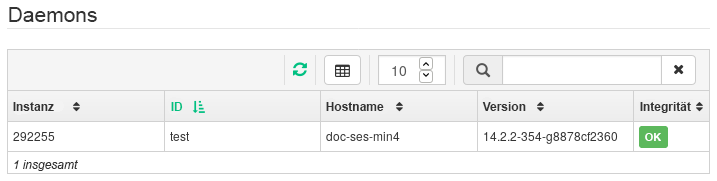

- 6.6 Ausführen von

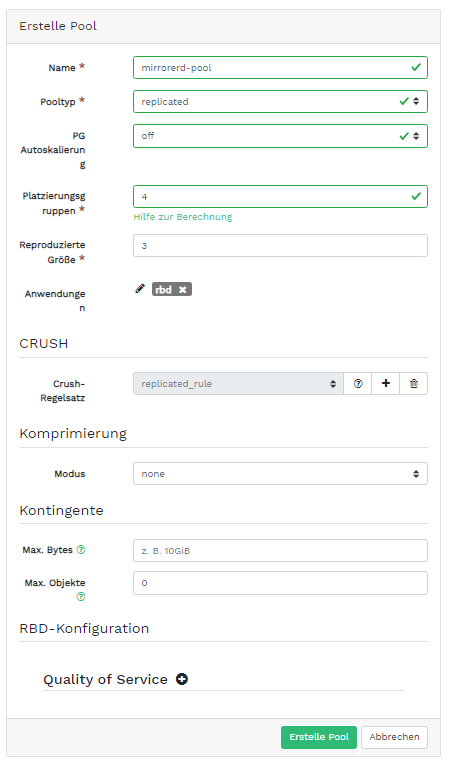

rbd-mirror-Daemons - 6.7 Erstellen eines Pools mit der RBD-Anwendung

- 6.8 Konfigurieren des Reproduktionsmodus

- 6.9 Hinzufügen des Peer-Berechtigungsnachweises

- 6.10 Liste der reproduzierten Pools

- 6.11 Neues RBD-Image

- 6.12 Synchronisiertes neues RBD-Image

- 6.13 Reproduktionsstatus der RBD-Images

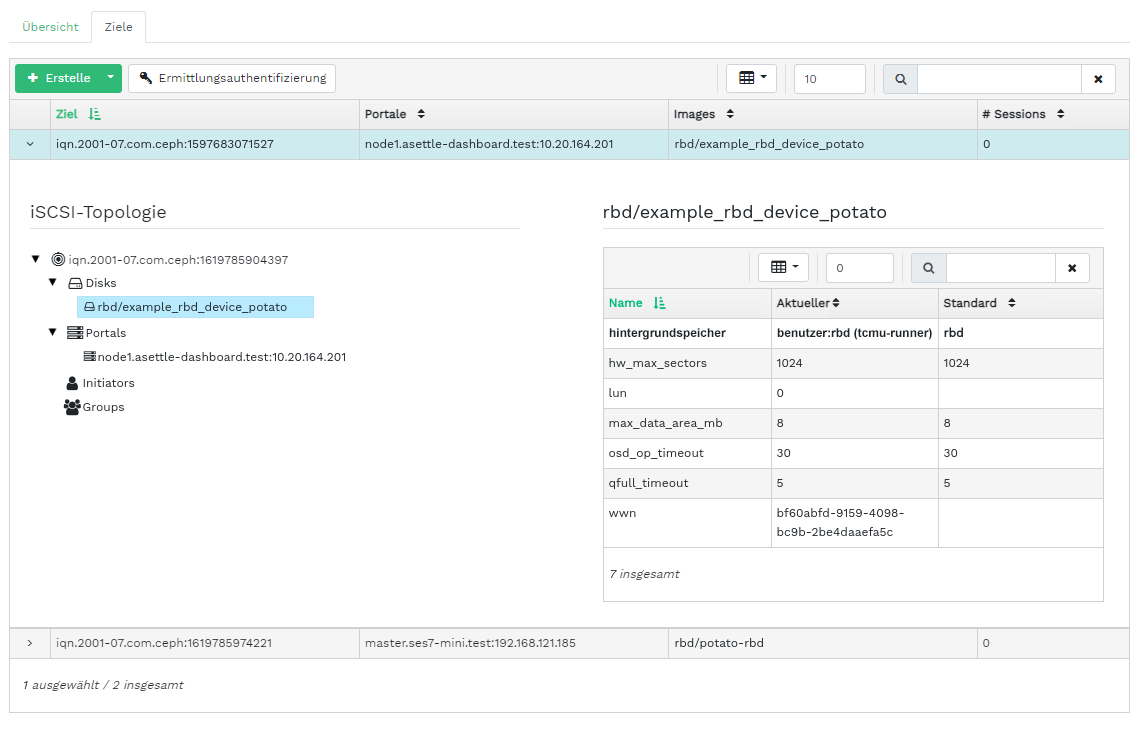

- 6.14 Liste der iSCSI-Ziele

- 6.15 Details zu iSCSI-Zielen

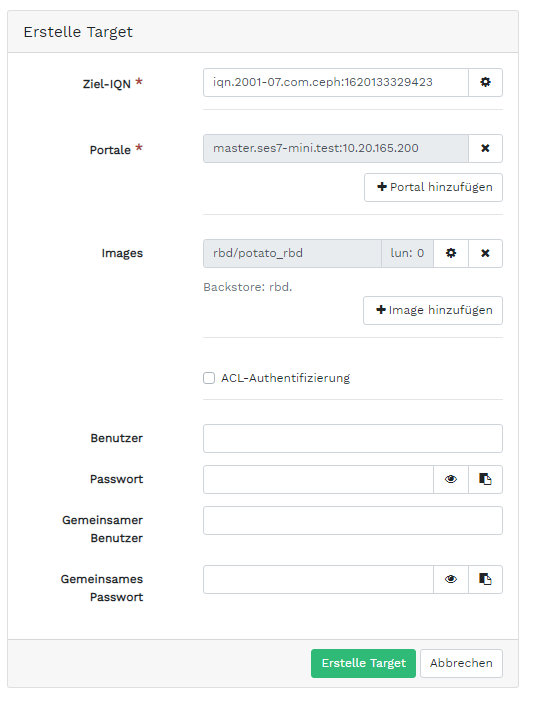

- 6.16 Hinzufügen eines neuen Ziels

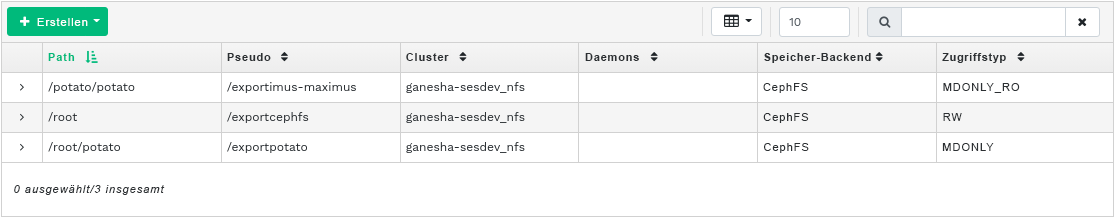

- 7.1 Liste der NFS-Exporte

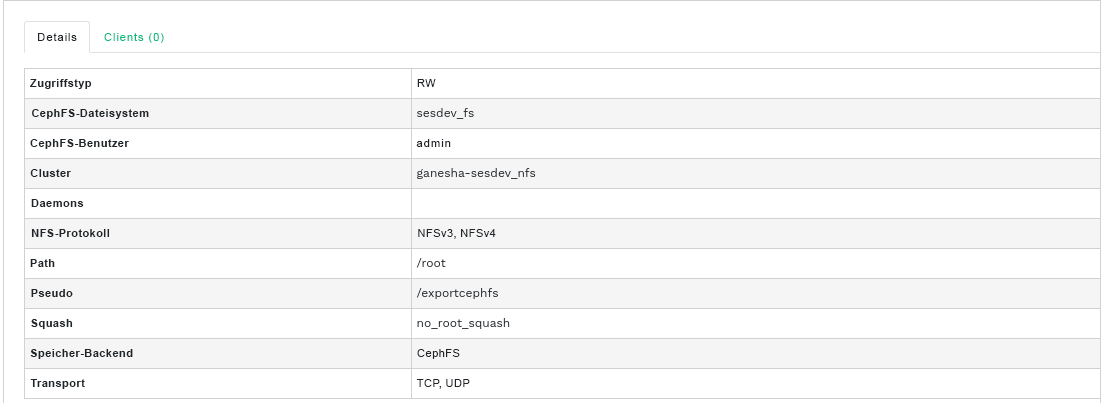

- 7.2 Details zu NFS-Exporten

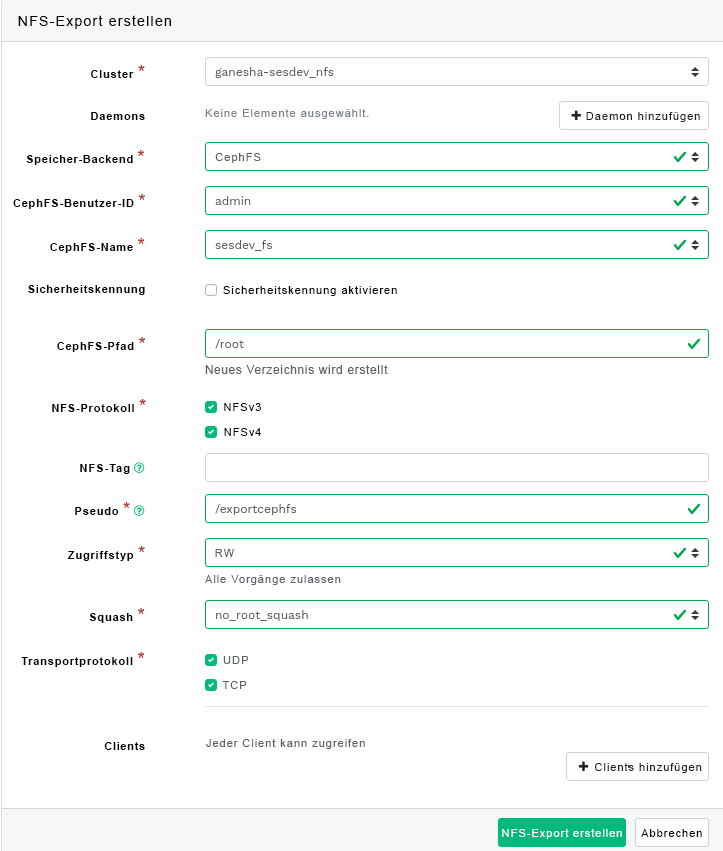

- 7.3 Hinzufügen eines neuen NFS-Exports

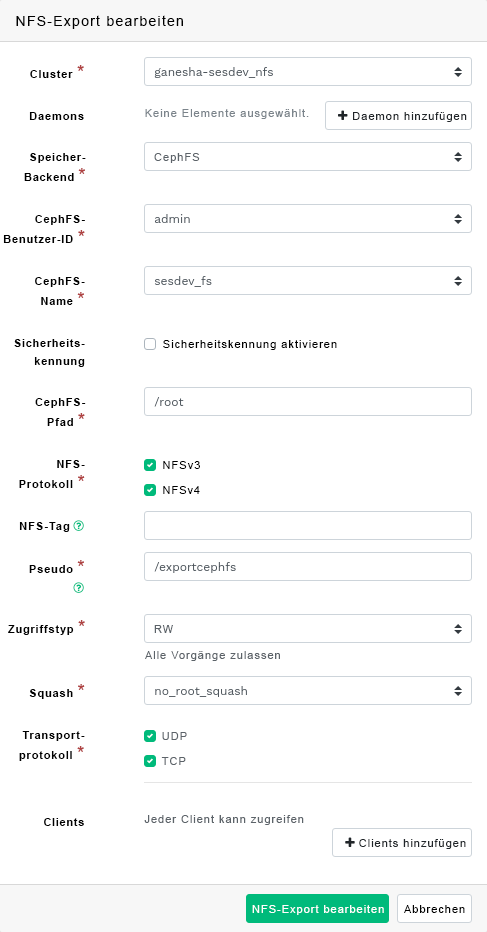

- 7.4 Bearbeiten eines NFS-Exports

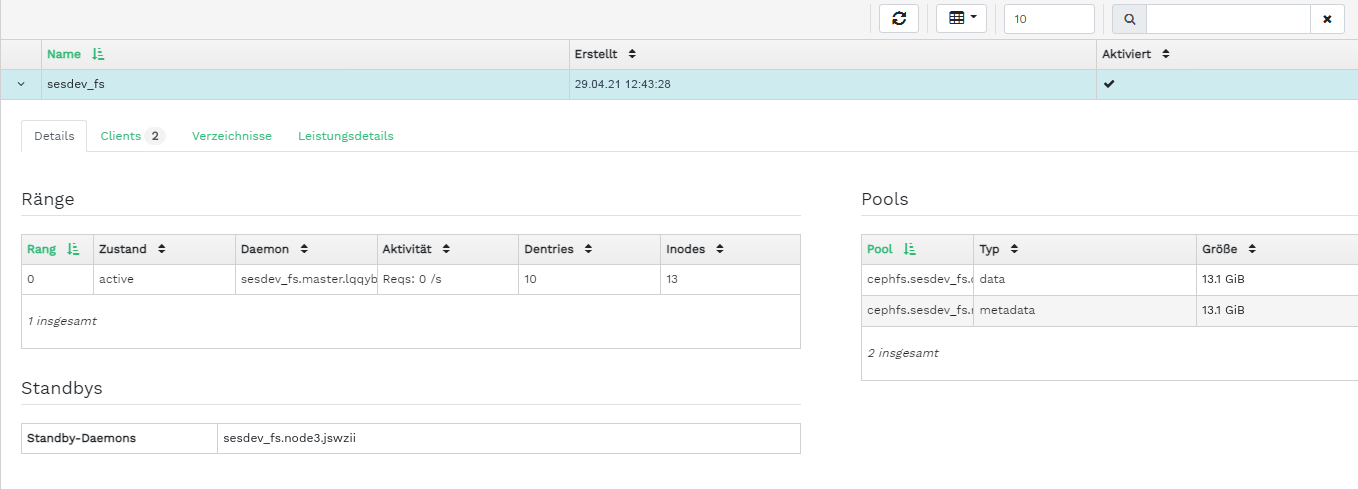

- 8.1 CephFS-Details

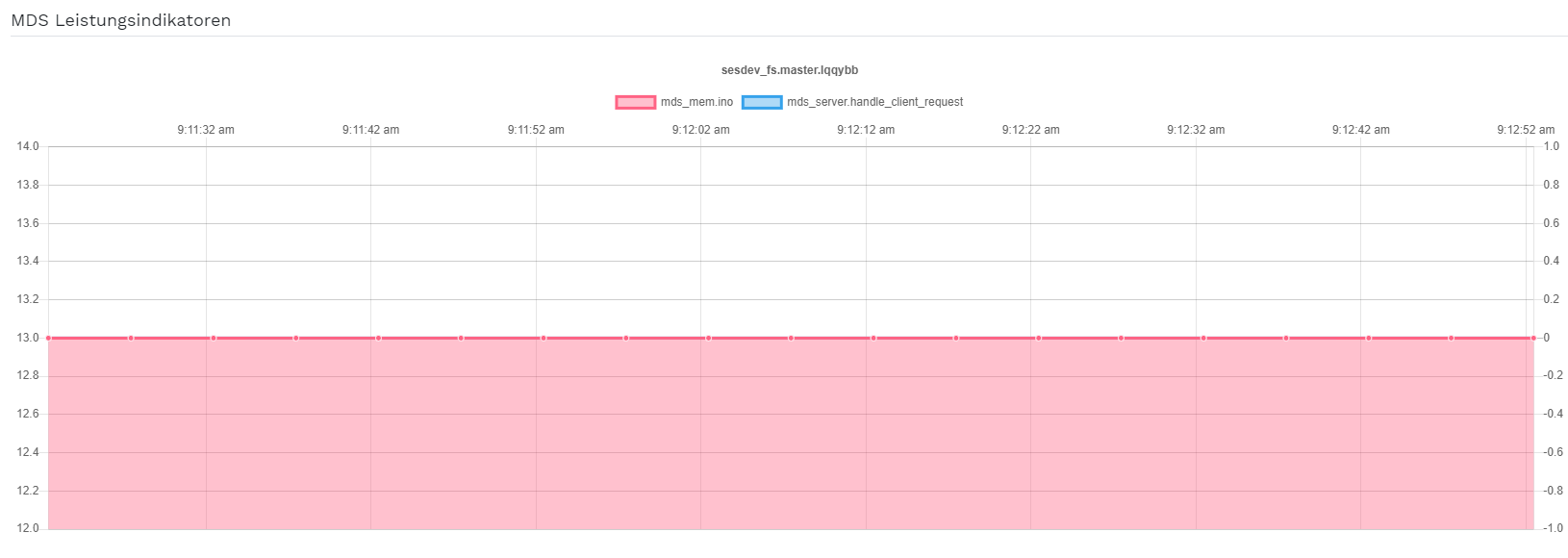

- 8.2 CephFS-Details

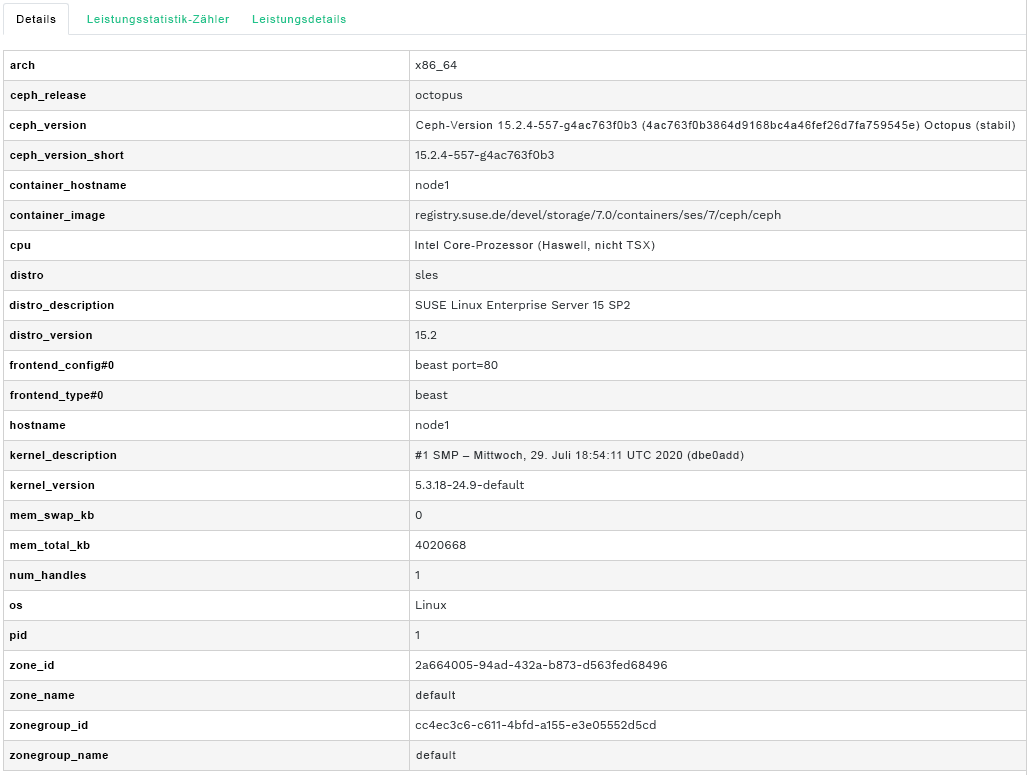

- 9.1 Gateway-Details

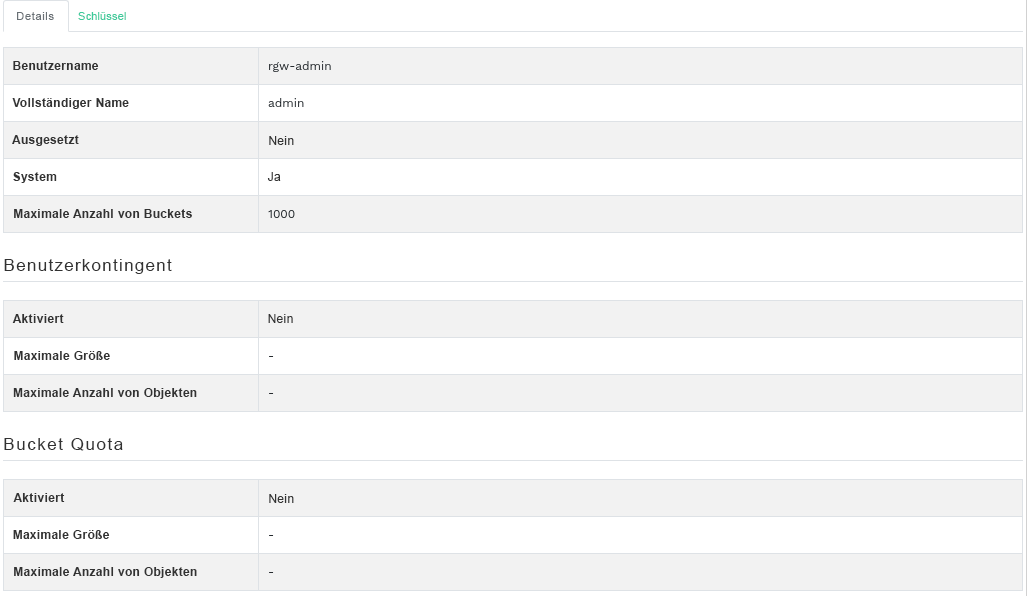

- 9.2 Gateway-Benutzer

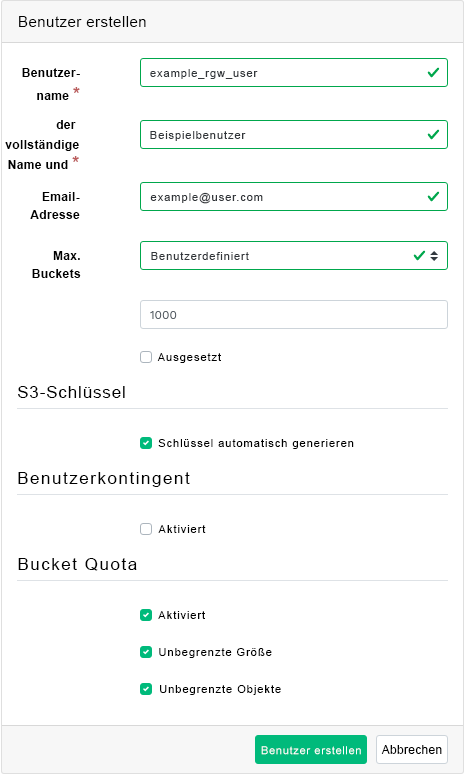

- 9.3 Hinzufügen eines neuen Gateway-Benutzers

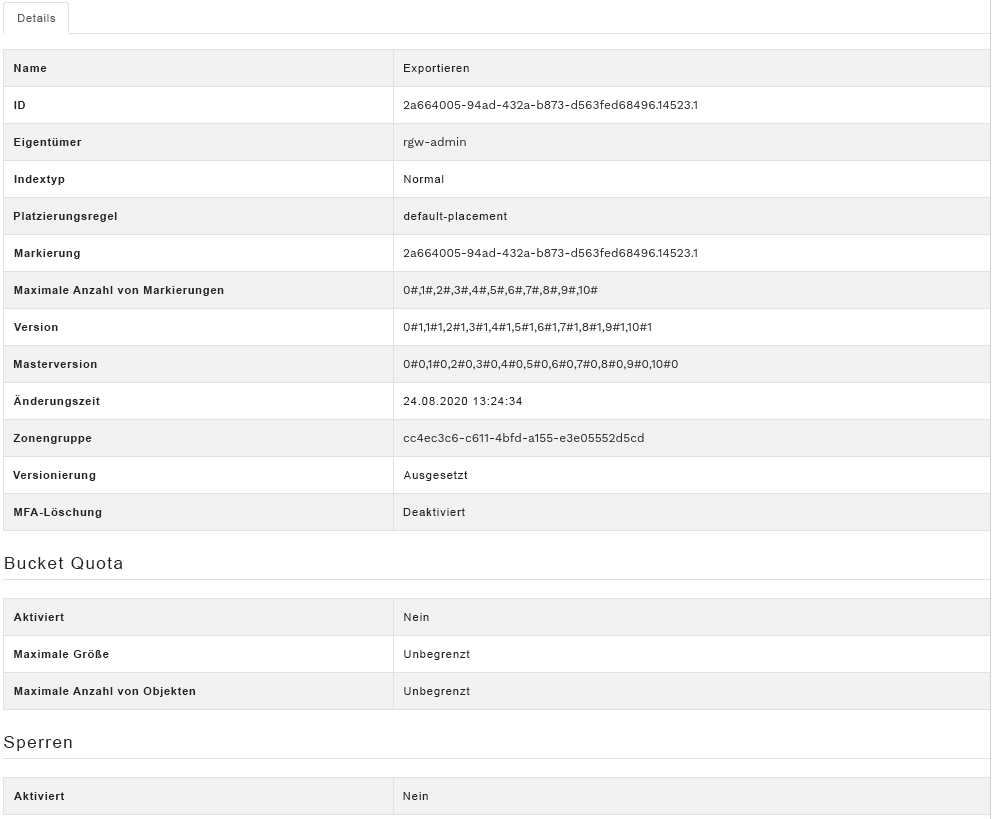

- 9.4 Gateway Bucket-Details

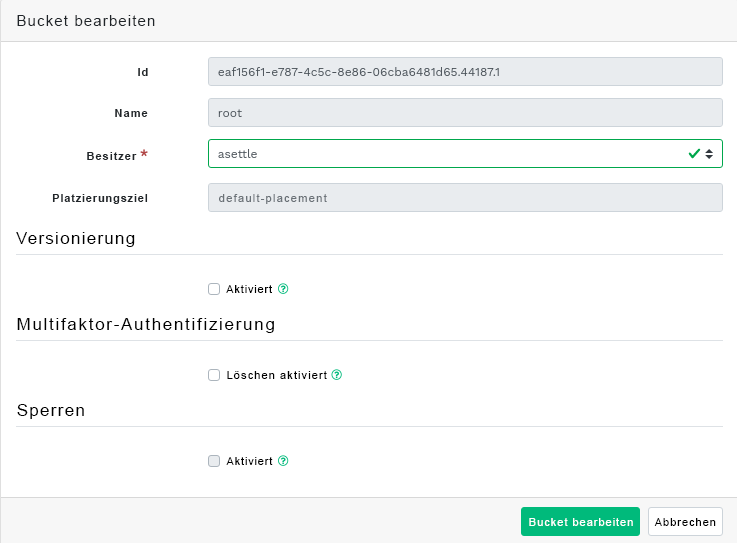

- 9.5 Bearbeiten der Bucket-Details

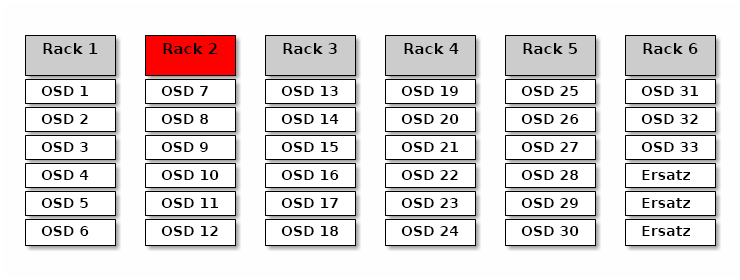

- 12.1 Ceph-Cluster

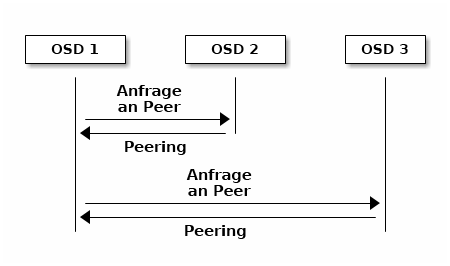

- 12.2 Peering-Schema

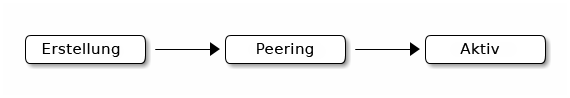

- 12.3 Statusangaben für Platzierungsgruppen

- 17.1 OSDs mit gemischten Geräteklassen

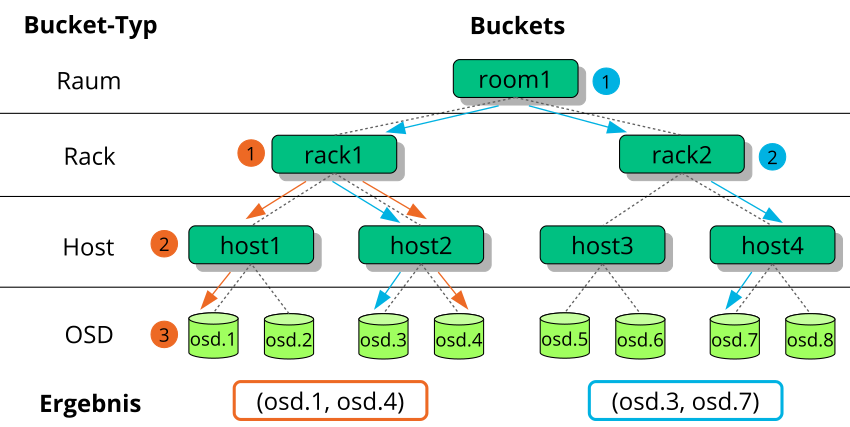

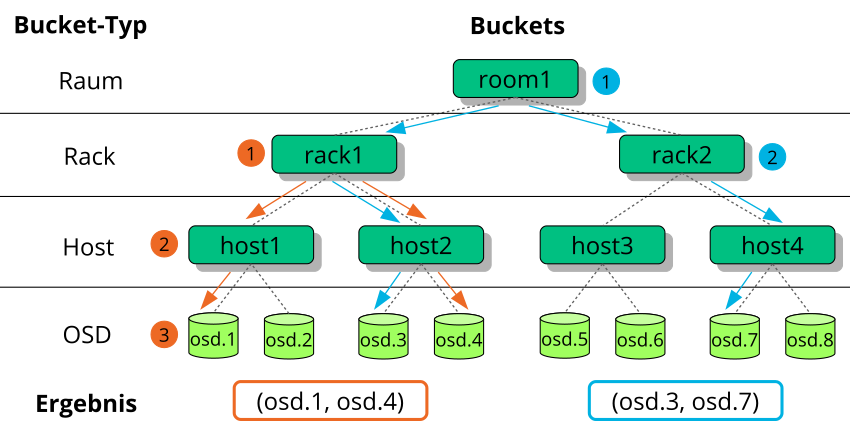

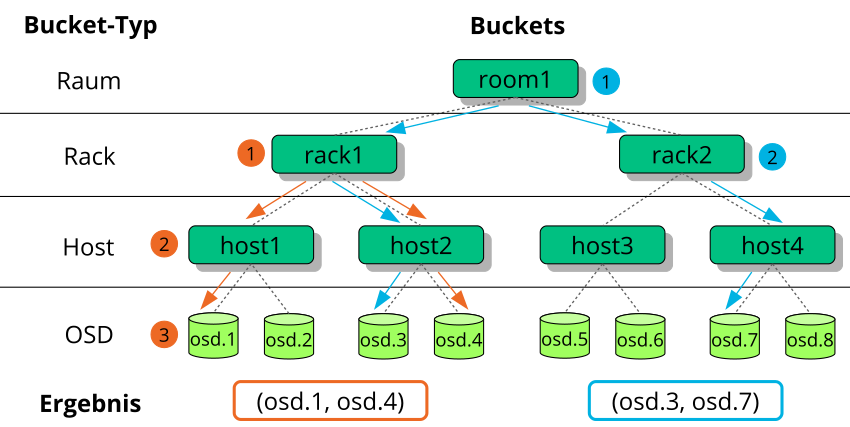

- 17.2 Beispielbaum

- 17.3 Methoden für den Austausch von Knoten

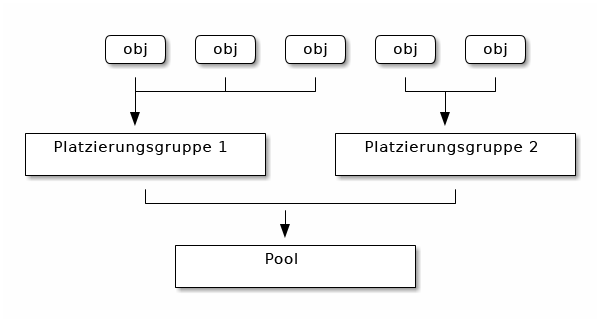

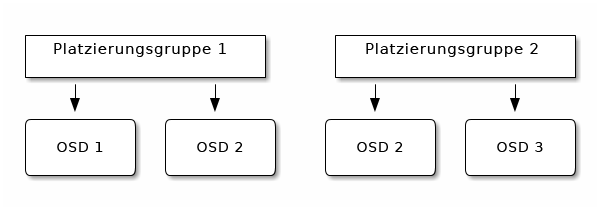

- 17.4 Platzierungsgruppen in einem Pool

- 17.5 Platzierungsgruppen und OSDs

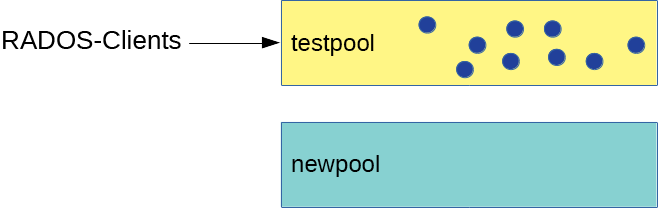

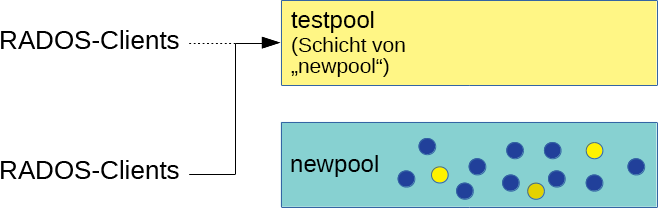

- 18.1 Pools vor der Migration

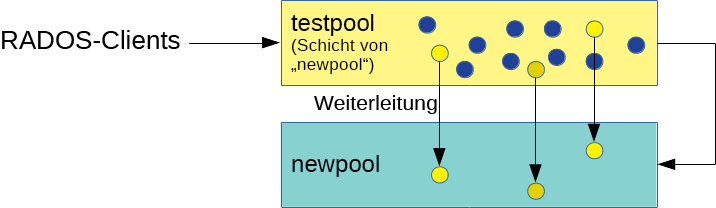

- 18.2 Einrichtung der Cache-Ebene

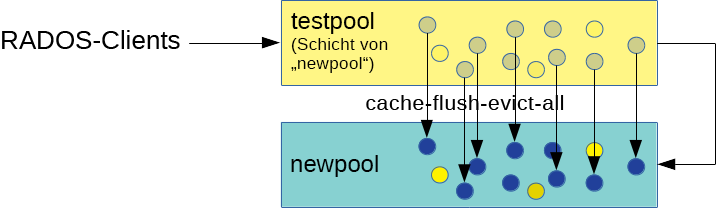

- 18.3 Leeren von Daten

- 18.4 Festlegen der Überlagerung

- 18.5 Migration abgeschlossen

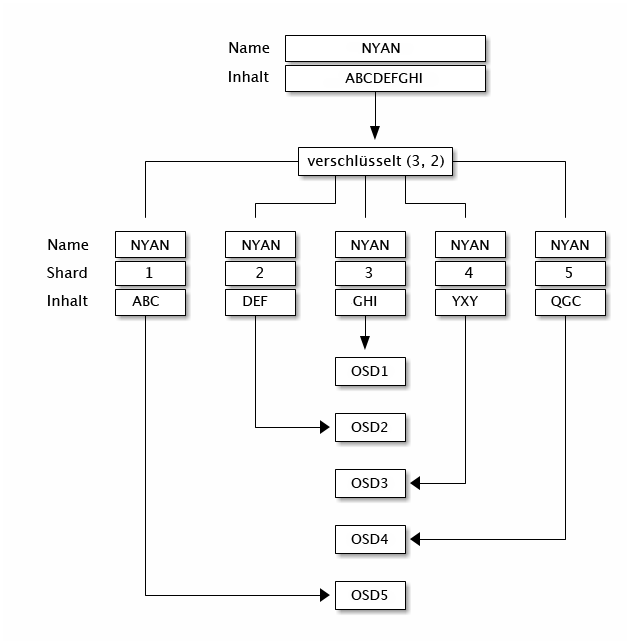

- 20.1 RADOS-Protokoll

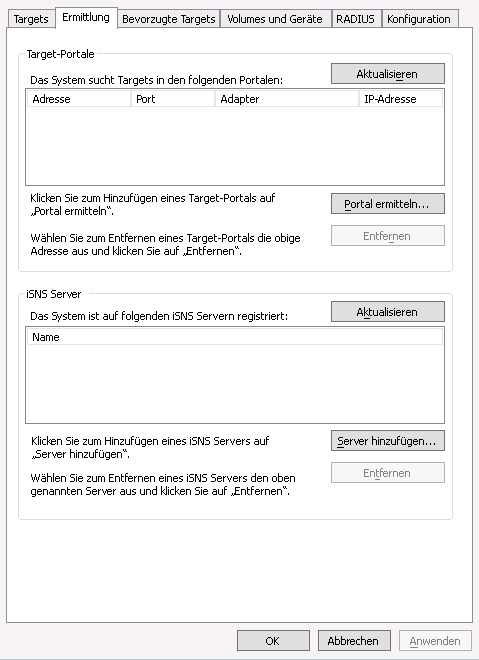

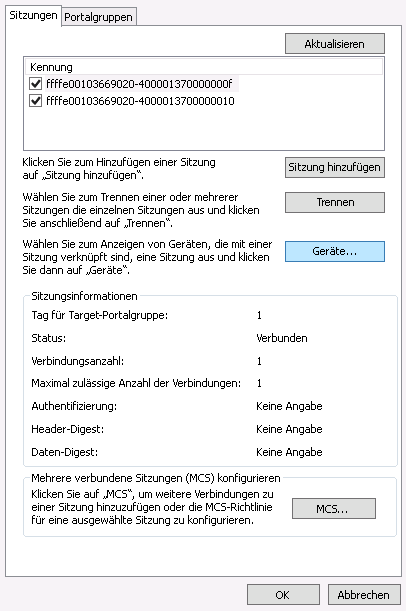

- 22.1 Eigenschaften des iSCSI-Initiators

- 22.2 Zielportal ermitteln

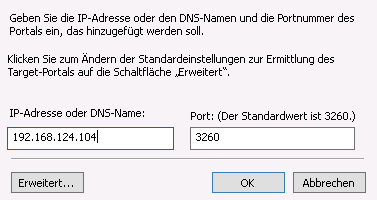

- 22.3 Zielportale

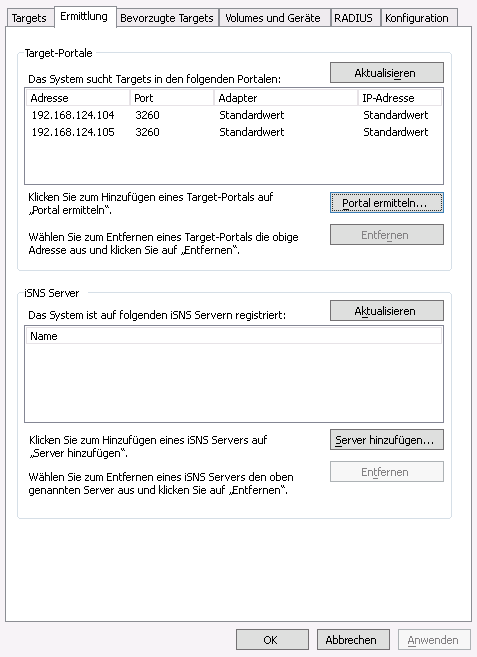

- 22.4 Zielgruppen

- 22.5 Eigenschaften des iSCSI-Ziels

- 22.6 Gerätedetails

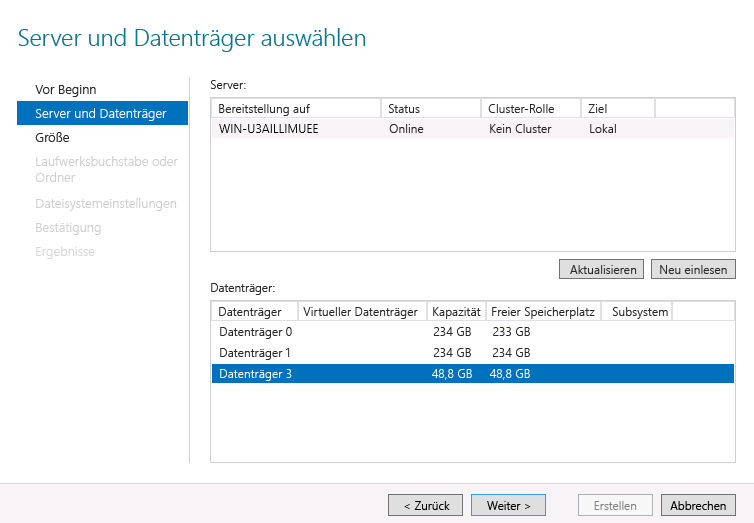

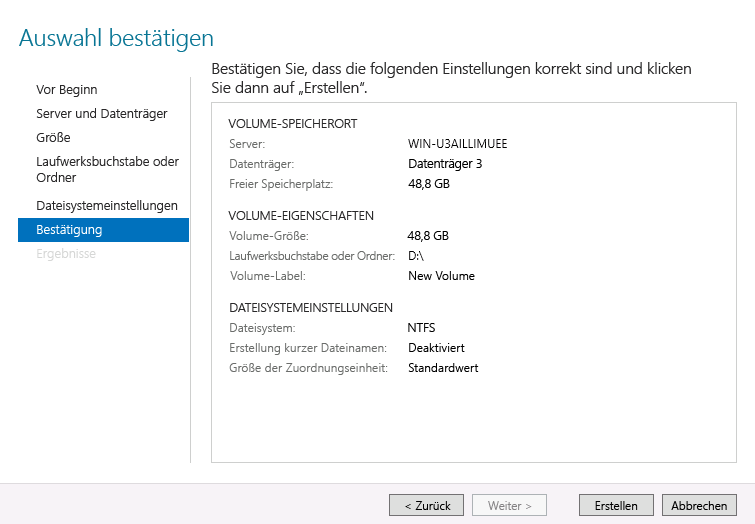

- 22.7 Assistent für neue Volumes

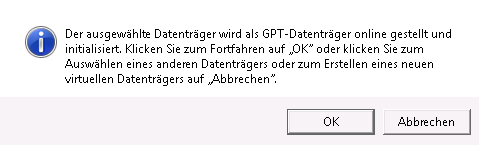

- 22.8 Eingabeaufforderung für Offline-Datenträger

- 22.9 Volume-Auswahl bestätigen

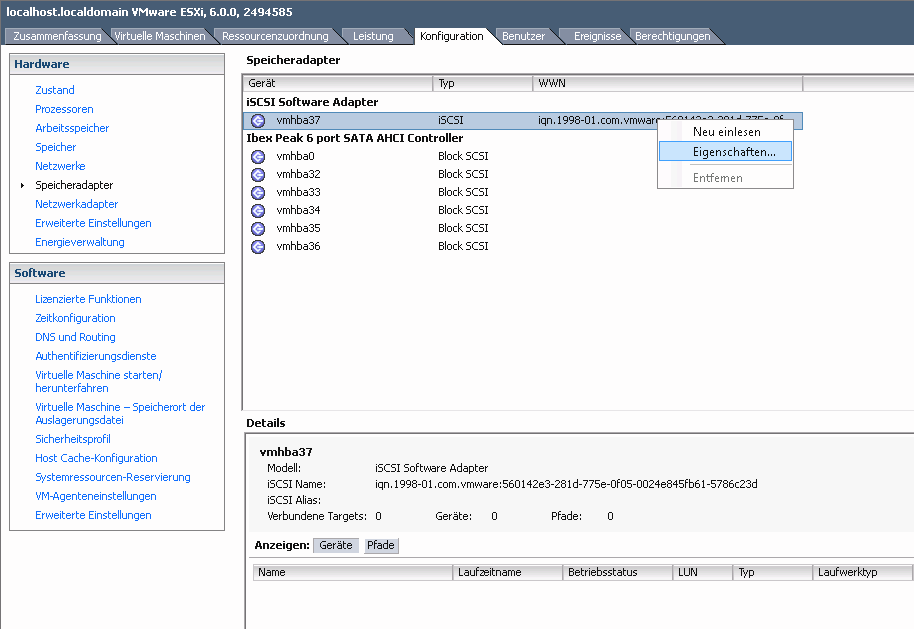

- 22.10 Eigenschaften des iSCSI-Initiators

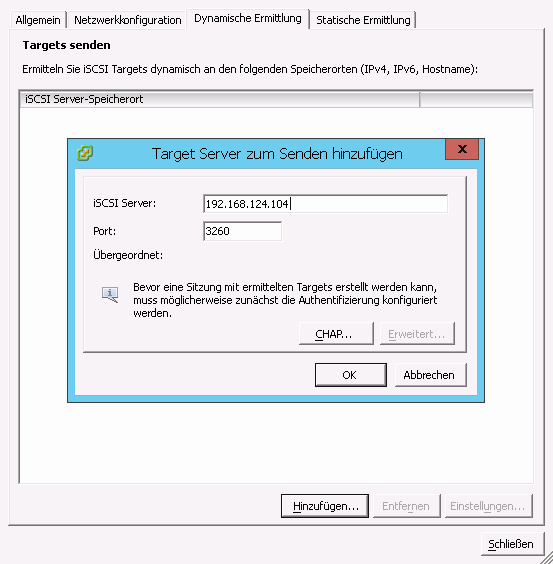

- 22.11 Zielserver hinzufügen

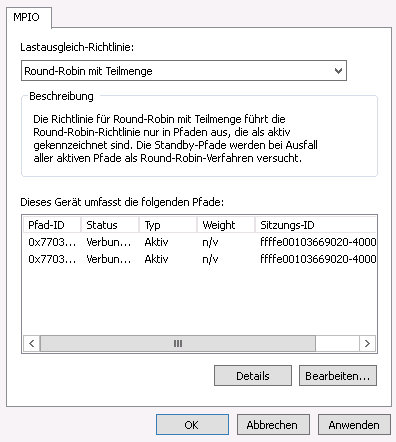

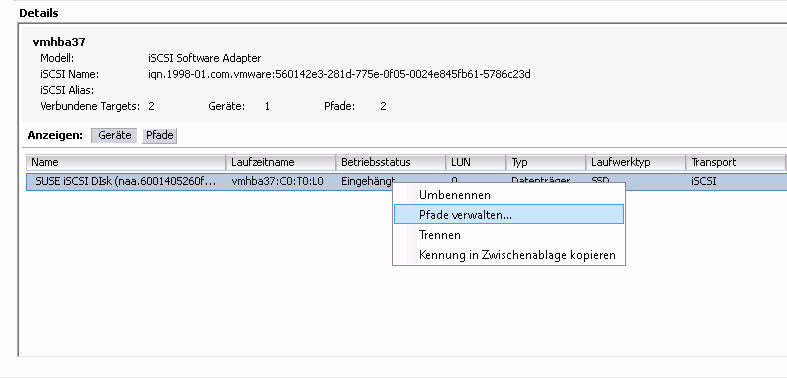

- 22.12 Multipfadgeräte verwalten

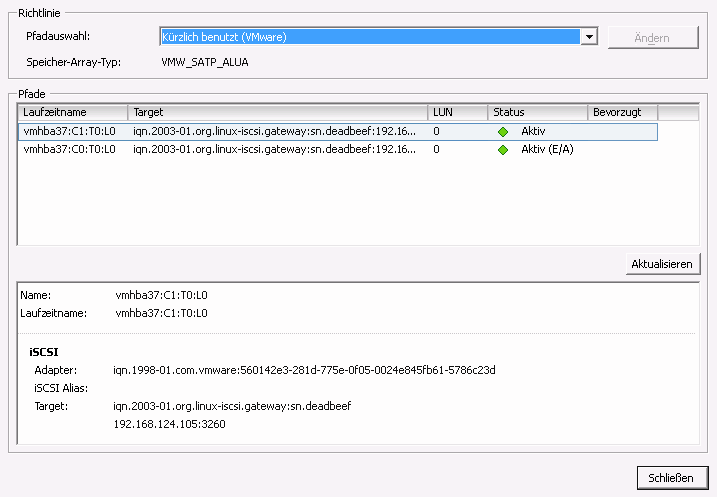

- 22.13 Auflistung der Pfade für Multipfad

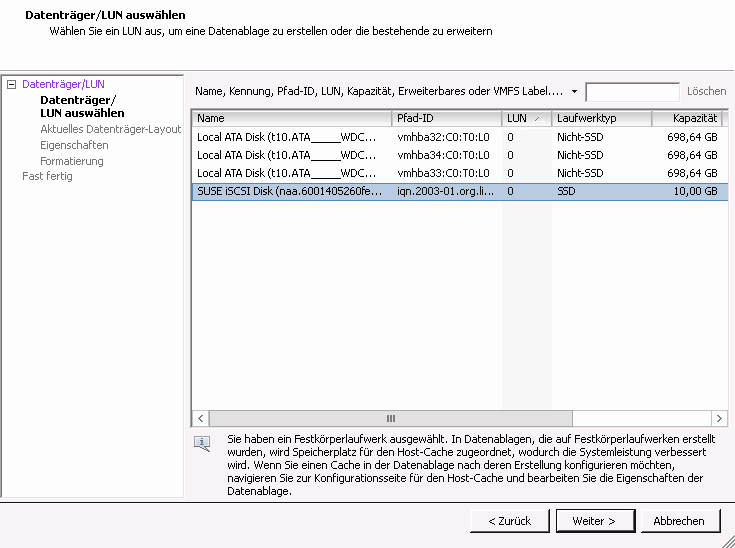

- 22.14 Dialogfeld „Speicher hinzufügen“

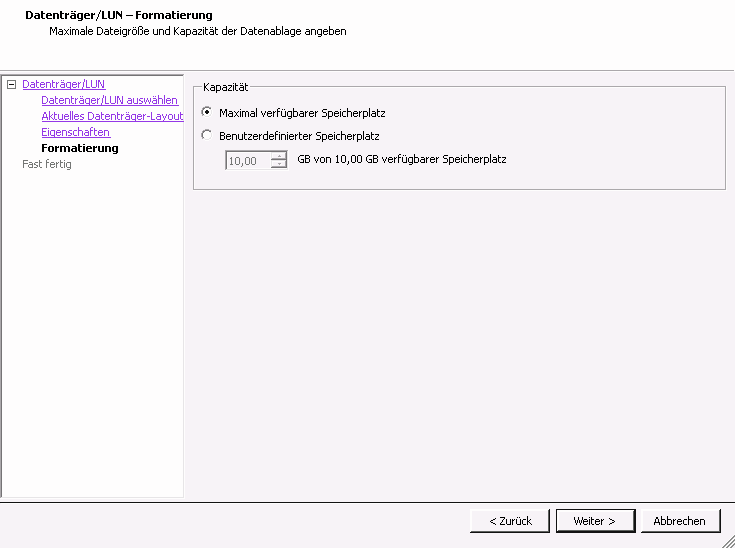

- 22.15 Benutzerdefinierte Speicherplatzeinstellung

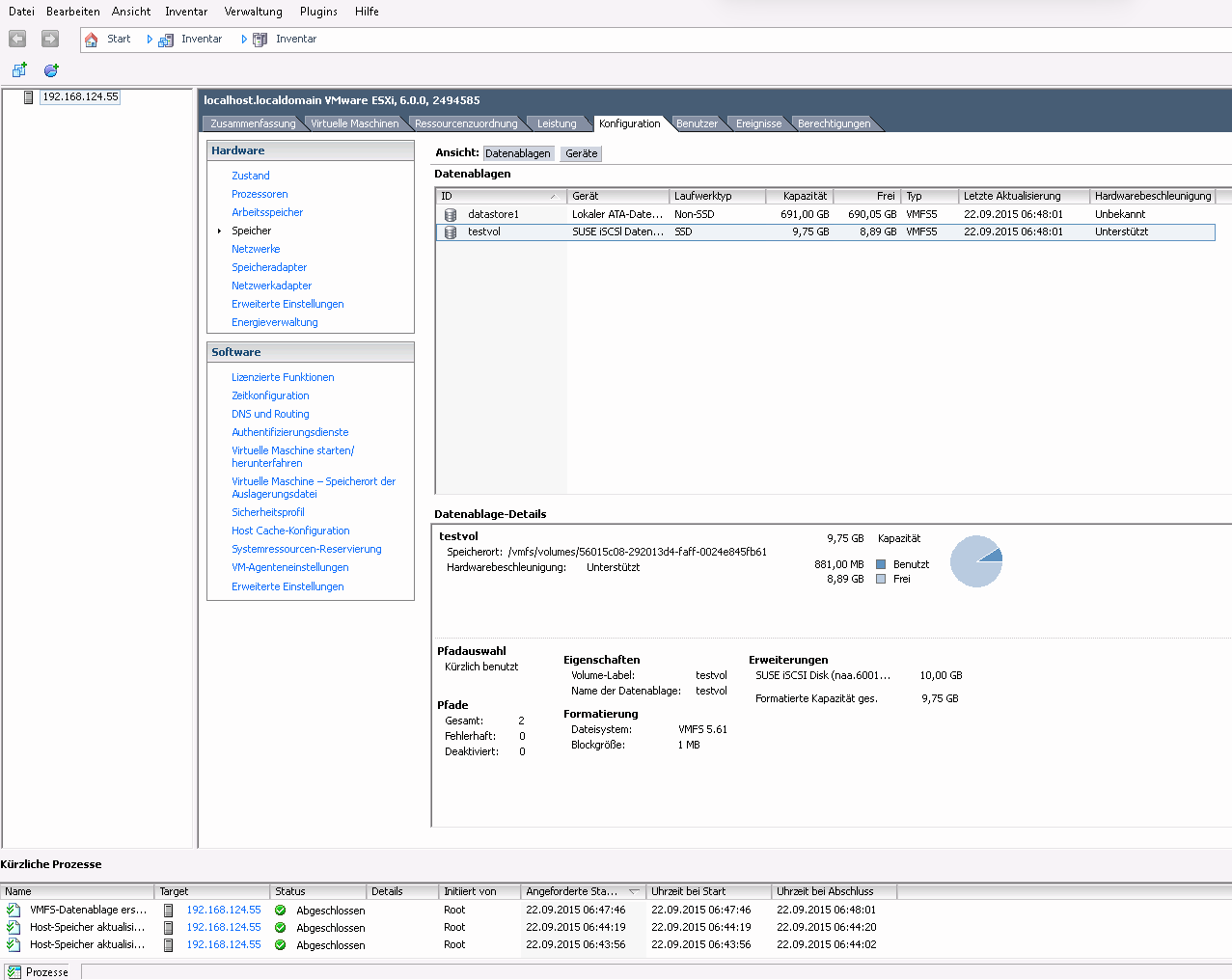

- 22.16 Überblick zur iSCSI-Datenablage

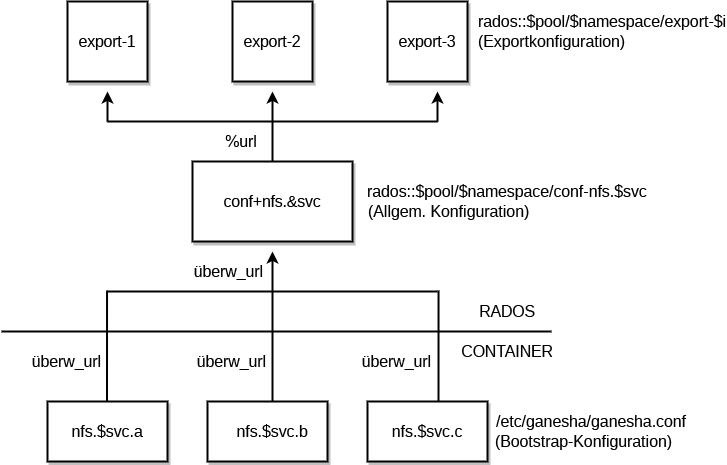

- 25.1 NFS-Ganesha-Struktur

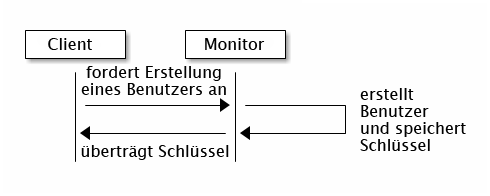

- 30.1 Einfache

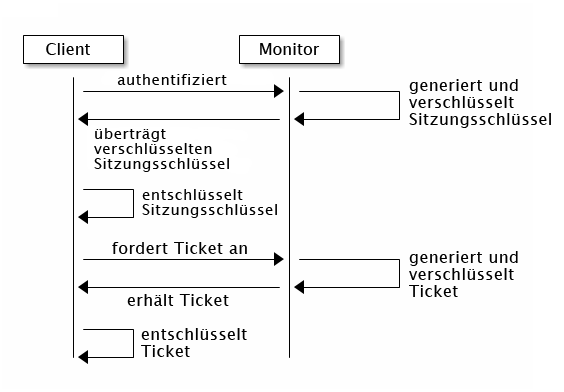

cephx-Authentifizierung - 30.2 Authentifizierung mit

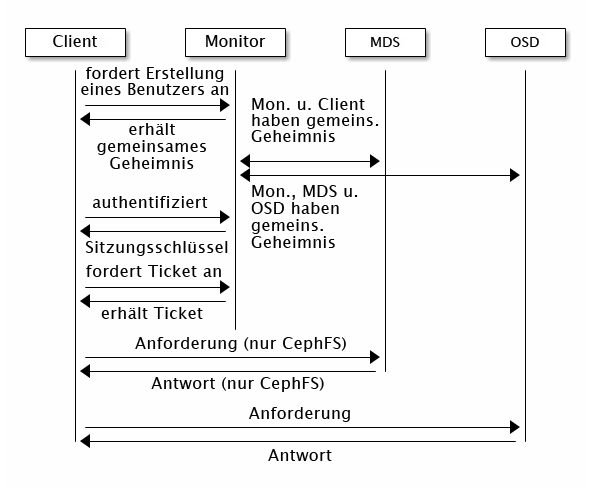

cephx - 30.3 Authentifizierung mit

cephx– MDS und OSD

- 12.1 Auffinden eines Objekts

- 13.1 Abstimmung nach Datenträgergröße

- 13.2 Einfache Einrichtung

- 13.3 Erweiterte Einrichtung

- 13.4 Erweiterte Einrichtung mit nicht einheitlichen Knoten

- 13.5 Experteneinrichtung

- 13.6 Komplexe (und unwahrscheinliche) Einrichtung

- 17.1

crushtool --reclassify-root - 17.2

crushtool --reclassify-bucket - 21.1 Trivial-Konfiguration

- 21.2 Nicht-Trivial-Konfiguration

- 28.1 Beispiel einer Beast-Konfiguration

- 28.2 CivetWeb-Beispielkonfiguration in

/etc/ceph/ceph.conf

Copyright © 2020–2023 SUSE LLC und Mitwirkende. Alle Rechte vorbehalten.

Sofern nicht anders angegeben, ist dieses Dokument unter Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0) lizenziert: https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Die SUSE-Marken finden Sie unter http://www.suse.com/company/legal/. Die Rechte für alle Marken von Drittanbietern liegen bei den jeweiligen Eigentümern. Markensymbole (®, ™ usw.) kennzeichnen Marken von SUSE und ihren Tochtergesellschaften. Sternchen (*) kennzeichnen Marken von Drittanbietern.

Alle Informationen in diesem Buch wurden mit größter Sorgfalt zusammengestellt. Auch hierdurch kann jedoch keine hundertprozentige Richtigkeit gewährleistet werden. Weder SUSE LLC, ihre Tochtergesellschaften, die Autoren noch die Übersetzer können für mögliche Fehler und deren Folgen haftbar gemacht werden.

Informationen über dieses Handbuch #

Dieses Handbuch konzentriert sich auf Routineaufgaben, die Sie als Administrator erledigen müssen, nachdem der grundlegende Ceph-Cluster bereitgestellt wurde (Vorgänge ab Tag 2). Außerdem werden alle unterstützten Möglichkeiten zum Zugriff auf die in einem Ceph-Cluster gespeicherten Daten beschrieben.

SUSE Enterprise Storage 7 ist eine Erweiterung zu SUSE Linux Enterprise Server 15 SP2. Es kombiniert die Funktion des Ceph(http://ceph.com/)-Speicherobjekts mit der Unternehmenstechnik und dem Support von SUSE. Mit SUSE Enterprise Storage 7 stellen IT-Organisationen eine dezentrale Speicherarchitektur bereit, die eine Reihe von Anwendungsfällen auf kommerziellen Hardwareplattformen unterstützt.

1 Verfügbare Dokumentation #

Die Dokumentation für unsere Produkte steht unter https://documentation.suse.com bereit. Hier finden Sie außerdem die neuesten Aktualisierungen und können die Dokumentation durchsuchen oder in verschiedenen Formaten herunterladen. Die neuesten Aktualisierungen der Dokumentation finden Sie in der englischen Sprachversion.

Darüber hinaus befindet sich die Dokumentation auf dem installierten System im Verzeichnis /usr/share/doc/manual. Sie ist enthalten in einem RPM-Paket namens

ses-manual_LANG_CODE. Installieren Sie es, wenn es nicht bereits auf Ihrem System vorhanden ist. Beispiel:

root # zypper install ses-manual_enDie folgende Dokumentation ist für dieses Produkt verfügbar:

- Implementierungsleitfaden

Diese Anleitung konzentriert sich auf die Bereitstellung eines grundlegenden Ceph-Clusters und auf die Bereitstellung zusätzlicher Services. Außerdem werden die Schritte für ein Upgrade auf SUSE Enterprise Storage 7 von der vorherigen Produktversion beschrieben.

- Betriebs- und Verwaltungshandbuch

Dieses Handbuch konzentriert sich auf Routineaufgaben, die Sie als Administrator erledigen müssen, nachdem der grundlegende Ceph-Cluster bereitgestellt wurde (Vorgänge ab Tag 2). Außerdem werden alle unterstützten Möglichkeiten zum Zugriff auf die in einem Ceph-Cluster gespeicherten Daten beschrieben.

- Security Hardening Guide (Sicherheitshandbuch)

Diese Anleitung konzentriert sich darauf, wie Sie die Sicherheit Ihres Clusters gewährleisten können.

- Troubleshooting Guide (Handbuch zur Fehlersuche)

In diesem Leitfaden werden verschiedene häufige Probleme bei der Ausführung von SUSE Enterprise Storage 7 und andere Fragen zu relevanten Komponenten wie Ceph oder Object Gateway behandelt.

- SUSE Enterprise Storage for Windows Guide (Handbuch zu SUSE Enterprise Storage für Windows)

In diesem Handbuch wird die Integration, Installation und Konfiguration von Microsoft-Windows-Umgebungen und SUSE Enterprise Storage mithilfe des Windows-Treibers beschrieben.

2 Feedback #

Wir freuen uns über Rückmeldungen und Beiträge zu dieser Dokumentation. Hierfür gibt es mehrere Kanäle:

- Serviceanforderungen und Support

Informationen zu Services und Support-Optionen, die für Ihr Produkt verfügbar sind, finden Sie unter http://www.suse.com/support/.

Zum Öffnen einer Service-Anforderung benötigen Sie ein SUSE-Abonnement, das beim SUSE Customer Center registriert ist. Gehen Sie zu https://scc.suse.com/support/requests, melden Sie sich an und klicken Sie auf .

- Fehlerberichte

Melden Sie Probleme mit der Dokumentation unter https://bugzilla.suse.com/. Zum Melden von Problemen ist ein Bugzilla-Konto erforderlich.

Zur Vereinfachung dieses Vorgangs können Sie die Links (Fehler in der Dokumentation melden) neben den Überschriften in der HTML-Version dieses Dokuments verwenden. Dadurch werden das richtige Produkt und die Kategorie in Bugzilla vorab ausgewählt und ein Link zum aktuellen Abschnitt hinzugefügt. Sie können somit sofort mit der Eingabe Ihres Berichts beginnen.

- Beiträge

Verwenden Sie für einen Beitrag zu dieser Dokumentation die Links (Quelle bearbeiten) neben den Überschriften in der HTML-Version dieses Dokuments. Sie führen Sie zum Quellcode auf GitHub, wo Sie eine Pull-Anforderung öffnen können. Für Beiträge ist ein GitHub-Konto erforderlich.

Weitere Informationen zur Dokumentationsumgebung für diese Dokumentation finden Sie in der README des Repositorys unter https://github.com/SUSE/doc-ses.

Alternativ können Sie E-Mails mit Fehlerberichten und Feedback zur Dokumentation an <doc-team@suse.com> senden. Geben Sie den Titel der Dokumentation, die Produktversion und das Datum der Veröffentlichung der Dokumentation an. Geben Sie zudem die entsprechende Abschnittsnummer und den Titel (oder die URL) an und fügen Sie eine kurze Beschreibung des Problems hinzu.

3 Konventionen in der Dokumentation #

In der vorliegenden Dokumentation werden die folgenden Hinweise und typografischen Konventionen verwendet:

/etc/passwd: Verzeichnis- und DateinamenPLATZHALTER: Ersetzen Sie PLATZHALTER durch den tatsächlichen Wert.

PFAD: Eine Umgebungsvariablels,--help: Kommandos, Optionen und ParameterBenutzer: Der Name eines Benutzers oder einer Gruppename_des_pakets: Der Name eines Softwarepakets

Alt, Alt–F1: Eine zu drückende Taste bzw. Tastenkombination. Tasten werden wie auf einer Tastatur in Großbuchstaben dargestellt.

, › : Menüelemente, Schaltflächen

AMD/Intel Dieser Absatz ist nur für die Intel 64/AMD64-Architekturen von Bedeutung. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.

IBM Z, POWER Dieser Absatz ist nur für die Architekturen

IBM ZundPOWERrelevant. Die Pfeile kennzeichnen den Anfang und das Ende des Textblocks.Kapitel 1, „Beispielkapitel“: Ein Querverweis auf ein anderes Kapitel in diesem Handbuch.

Kommandos, die mit

root-Privilegien ausgeführt werden müssen. Diesen Kommandos kann zur Ausführung als nicht privilegierter Benutzer auch häufig das Präfixsudovorangestellt sein.root #commandtux >sudocommandKommandos, die von Benutzern ohne Privilegien ausgeführt werden können.

tux >commandHinweise

Warnung: WarnhinweisWichtige Informationen, die Sie kennen müssen, bevor Sie fortfahren. Warnt vor Sicherheitsrisiken, potenziellen Datenverlusten, Beschädigung der Hardware oder physischen Gefahren.

Wichtig: Wichtiger HinweisWichtige Informationen, die Sie beachten sollten, bevor Sie den Vorgang fortsetzen.

Anmerkung: AnmerkungErgänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Tipp: TippHilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

Kompaktinfos

Ergänzende Informationen, beispielsweise zu unterschiedlichen Softwareversionen.

Hilfreiche Informationen, etwa als Richtlinie oder praktische Empfehlung.

4 Produktlebenszyklus und Support #

Verschiedene SUSE-Produkte haben unterschiedliche Produktlebenszyklen. Die genauen Lebenszyklusdaten für SUSE Enterprise Storage finden Sie unter https://www.suse.com/lifecycle/.

4.1 SUSE-Support – Definitionen #

Informationen zu unserer Support-Richtlinie und die entsprechenden Optionen finden Sie unter https://www.suse.com/support/policy.html und https://www.suse.com/support/programs/long-term-service-pack-support.html.

4.2 Erläuterung zum Support für SUSE Enterprise Storage #

Sie benötigen ein entsprechendes Abonnement bei SUSE, um Support zu erhalten. Gehen Sie zur Anzeige der für Sie verfügbaren spezifischen Support-Angebote zu https://www.suse.com/support/ und wählen Sie das betreffende Produkt aus.

Die Support-Stufen sind folgendermaßen definiert:

- L1

Problemermittlung: Technischer Support mit Informationen zur Kompatibilität, Nutzungs-Support, kontinuierliche Wartung, Informationssammlung und einfache Problembehandlung anhand der verfügbaren Dokumentation.

- L2

Problemisolierung: Technischer Support zur Datenanalyse, Reproduktion von Kundenproblemen, Isolierung von Problembereichen und Lösung für Probleme, die in Stufe 1 nicht gelöst wurden, sowie Vorbereitung für Stufe 3.

- L3

Problembehebung: Technischer Support zur Lösung von Problemen durch technische Maßnahmen zur Behebung von Produktfehlern, die durch den Support der Stufe 2 erkannt wurden.

Vertragskunden und Partner erhalten SUSE Enterprise Storage mit L3-Support für alle Pakete, ausgenommen:

Technologievorschauen

Audio, Grafik, Schriftarten und Artwork

Pakete, für die ein zusätzlicher Kundenvertrag erforderlich ist

Einige Pakete, die im Lieferumfang von Modul Workstation Extension enthalten sind, erhalten nur L2-Support.

Pakete mit dem Namensende -devel (die Header-Dateien und ähnliche Entwicklerressourcen enthalten) werden nur zusammen mit den entsprechenden Hauptpaketen unterstützt.

SUSE unterstützt nur die Nutzung von Originalpaketen, also unveränderten und nicht kompilierten Paketen.

4.3 Technologievorschauen #

Mit Technologievorschauen sind Pakete, Stacks oder Funktionen gemeint, die SUSE bereitstellt, um einen kurzen Einblick in bevorstehende Innovationen zu geben. Durch Technologievorschauen haben Sie die Möglichkeit, neue Technologien in Ihrer Umgebung zu testen. Über Ihr Feedback würden wir uns sehr freuen. Wenn Sie eine Technologievorschau testen, kontaktieren Sie bitte Ihre Ansprechpartner bei SUSE und teilen Sie ihnen Ihre Erfahrungen und Anwendungsfälle mit. Ihr Input ist für zukünftige Entwicklungen sehr hilfreich.

Technologievorschauen haben jedoch folgende Nachteile:

Technologievorschauen befinden sich noch in Entwicklung. Daher sind die Funktionen möglicherweise unvollständig oder auf andere Weise nicht für die Produktionsnutzung geeignet.

Technologievorschauen werden nicht unterstützt.

Technologievorschauen sind möglicherweise nur für bestimmte Hardwarearchitekturen verfügbar.

Details und Funktionen von Technologievorschauen sind Änderungen unterworfen. Upgrades auf Folgeversionen sind demnach nicht möglich und erfordern eine Neuinstallation.

Technologievorschauen können jederzeit aus einem Produkt entfernt werden. SUSE ist nicht verpflichtet, eine unterstützte Version dieser Technologie in der Zukunft bereitzustellen, zum Beispiel, wenn SUSE erkennt, dass eine Vorschau den Kunden- oder Marktanforderungen oder den Unternehmensstandards nicht entspricht.

Eine Übersicht der Technologievorschauen, die im Lieferumfang Ihres Produkts enthalten sind, finden Sie in den Versionshinweisen unter https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.

5 Mitwirkende bei Ceph #

Das Ceph-Projekt und dessen Dokumentation ist das Ergebnis der Arbeit von Hunderten von Mitwirkenden und Organisationen. Weitere Einzelheiten finden Sie in https://ceph.com/contributors/.

6 Kommandos und Kommandozeilen in diesem Handbuch #

Als Ceph-Cluster-Administrator können Sie das Cluster-Verhalten mit bestimmten Kommandos konfigurieren und anpassen. Hierzu benötigen Sie verschiedene Arten von Kommandos:

6.1 Salt-spezifische Kommandos #

Mit diesen Kommandos können Sie Ceph-Cluster-Knoten bereitstellen, Kommandos auf mehreren (oder allen) Cluster-Knoten gleichzeitig ausführen oder auch Cluster-Knoten hinzufügen oder entfernen. Die am häufigsten verwendeten Kommandos sind ceph-salt und ceph-salt config. Salt-Kommandos müssen auf dem Salt-Master-Knoten als root ausgeführt werden. Diese Kommandos werden in der folgenden Kommandozeile eingegeben:

root@master # Beispiel:

root@master # ceph-salt config ls6.2 Ceph-spezifische Kommandos #

Hierbei handelt es sich um Kommandos auf niedrigerer Ebene, mit denen alle Aspekte des Clusters und seiner Gateways auf der Kommandozeile konfiguriert und feinabgestimmt werden, zum Beispiel ceph, cephadm, rbd oder radosgw-admin.

Zum Ausführen von Ceph-spezifischen Kommandos benötigen Sie den Lesezugriff auf einen Ceph-Schlüssel. Die Capabilities des Schlüssels definieren dann Ihre Rechte in der Ceph-Umgebung. Sie können die Ceph-Kommandos als root (oder über sudo) ausführen und den uneingeschränkten Standard-Schlüsselbund „ceph.client.admin.key“ verwenden.

Als sicherere und empfohlene Alternative erstellen Sie je einen stärker eingeschränkten, individuellen Schlüssel für die einzelnen verwaltungsberechtigten Benutzer, den Sie dann in einem Verzeichnis ablegen, in dem die Benutzer ihn lesen können, beispielsweise:

~/.ceph/ceph.client.USERNAME.keyring

Sollen ein benutzerdefinierter verwaltungsberechtigter Benutzer und Schlüsselbund verwendet werden, müssen Sie den Benutzernamen und den Pfad des Schlüssels bei jeder Ausführung des Kommandos ceph mit den Optionen -n client angeben.USER_NAME und --keyring PATH/TO/KEYRING angeben.

Um dies zu vermeiden, nehmen Sie diese Optionen in die Variable CEPH_ARGS in den ~/.bashrc-Dateien der einzelnen Benutzer auf.

Ceph-spezifische Kommandos können auf jedem Cluster-Knoten ausgeführt werden. Es wird jedoch empfohlen, sie ausschließlich auf dem Admin-Knoten auszuführen. In dieser Dokumentation werden die Kommandos mit dem Benutzer cephuser ausgeführt. Die Kommandozeile lautet daher:

cephuser@adm > Beispiel:

cephuser@adm > ceph auth listWenn Sie laut Dokumentation ein Kommando für einen Cluster-Knoten mit einer bestimmten Rolle ausführen sollen, ist dies an der Bezeichnung der Kommandozeile ersichtlich. Beispiel:

cephuser@mon > 6.2.1 Ausführen von ceph-volume #

Ab SUSE Enterprise Storage 7 werden Ceph-Services containerisiert ausgeführt. Wenn Sie ceph-volume auf einem OSD-Knoten ausführen müssen, müssen Sie ihm das Kommando cephadm voranstellen. Beispiel:

cephuser@adm > cephadm ceph-volume simple scan6.3 Allgemeine Linux-Kommandos #

Linux-Kommandos, die nicht Ceph-spezifisch sind, wie zum Beispiel mount, cat oder openssl, werden entweder mit der Kommandozeile cephuser@adm > oder root # eingeführt. Dies hängt davon ab, welche Rechte für das entsprechende Kommando erforderlich sind.

6.4 Zusätzliche Informationen #

Weitere Informationen zur Ceph-Schlüsselverwaltung finden Sie in Abschnitt 30.2, „Schlüsselverwaltungsbereiche“.

Teil I Ceph Dashboard #

- 1 Infos zum Ceph Dashboard

Das Ceph Dashboard ist eine integrierte webbasierte Verwaltungs- und Überwachungsanwendung von Ceph, mit der verschiedene Aspekte und Objekte des Clusters verwaltet werden. Das Dashboard wird automatisch aktiviert, nachdem der Basis-Cluster bereitgestellt wurde. Weitere Informationen hierzu finden S…

- 2 Dashboard-Webbenutzeroberfläche

Öffnen Sie zum Anmelden bei Ceph Dashboard die zugehörige URL (unter Angabe der Portnummer). Führen Sie zum Abrufen der Adresse folgendes Kommando aus:

- 3 Verwalten von Ceph-Dashboard-Benutzern und -Rollen

Die Dashboard-Benutzerverwaltung mit Ceph-Kommandos wurde bereits in Kapitel 11, Verwalten von Benutzern und Rollen über die Kommandozeile vorgestellt.

- 4 Anzeigen von Cluster-internen Elementen

Über den Menüpunkt können Sie detaillierte Informationen über Ceph-Clusterhosts, Inventar, Ceph Monitors, Services, OSDs, Konfiguration, CRUSH-Zuordnung, Ceph Manager, Protokolle und Überwachungsdateien anzeigen.

- 5 Verwalten von Pools

Weitere allgemeine Informationen zu Ceph Pools finden Sie in Kapitel 18, Verwalten von Speicher-Pools. Spezifische Informationen zu Pools mit Löschcodierung finden Sie in Kapitel 19, Erasure Coded Pools.

- 6 Verwalten von RADOS-Blockgeräten

Klicken Sie zum Auflisten aller verfügbaren RADOS-Blockgeräte (RBDs) im Hauptmenü auf › .

- 7 Verwalten von NFS Ganesha

Weitere Informationen zu NFS Ganesha finden Sie in Kapitel 25, NFS Ganesha.

- 8 Verwalten von CephFS

Weitere Informationen zu CephFS finden Sie in Kapitel 23, Cluster-Dateisystem.

- 9 Verwalten des Object Gateways

Bevor Sie beginnen, wird möglicherweise die folgende Meldung angezeigt, wenn Sie versuchen, auf das Object-Gateway-Frontend im Ceph Dashboard zuzugreifen:

- 10 Manuelle Konfiguration

In diesem Abschnitt erhalten Sie erweiterte Informationen für Benutzer, die die Dashboard-Einstellungen manuell über die Kommandozeile konfigurieren möchten.

- 11 Verwalten von Benutzern und Rollen über die Kommandozeile

In diesem Abschnitt wird die Verwaltung von Benutzerkonten erläutert, die im Ceph Dashboard verwendet werden. Hier erhalten Sie Hilfestellung für die Erstellung oder Bearbeitung von Benutzerkonten sowie für die Festlegung der richtigen Benutzerrollen und Berechtigungen.

1 Infos zum Ceph Dashboard #

Das Ceph Dashboard ist eine integrierte webbasierte Verwaltungs- und Überwachungsanwendung von Ceph, mit der verschiedene Aspekte und Objekte des Clusters verwaltet werden. Das Dashboard wird automatisch aktiviert, nachdem der Basis-Cluster bereitgestellt wurde. Weitere Informationen hierzu finden Sie im Book “Implementierungsleitfaden”, Chapter 5 “Bereitstellung mit cephadm”, Section 5.3 “Bereitstellen des Ceph-Clusters”.

Mit dem Ceph Dashboard für SUSE Enterprise Storage 7 wurden weitere webbasierte Verwaltungsfunktionen hinzugefügt. Sie vereinfachen die Verwaltung von Ceph, einschließlich der Überwachung und Anwendungsadministration für den Ceph Manager. Sie müssen Ihren Ceph-Cluster nicht mehr mit komplexen Ceph-spezifischen Kommandos verwalten und überwachen. Sie können entweder die intuitive Oberfläche des Ceph Dashboards nutzen oder die integrierte REST-API.

Das Ceph-Dashboard-Modul visualisiert Informationen und Statistiken zum Ceph-Cluster über einen von ceph-mgr gehosteten Webserver. Im Book “Implementierungsleitfaden”, Chapter 1 “SES und Ceph”, Section 1.2.3 “Ceph-Knoten und -Daemons” finden Sie weitere Details zum Ceph Manager.

2 Dashboard-Webbenutzeroberfläche #

2.1 Anmelden #

Öffnen Sie zum Anmelden bei Ceph Dashboard die zugehörige URL (unter Angabe der Portnummer). Führen Sie zum Abrufen der Adresse folgendes Kommando aus:

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",Das Kommando gibt die URL für den Standort des Ceph Dashboards zurück. Falls Sie Probleme mit diesem Kommando haben, finden Sie eine Lösung im Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”.

Melden Sie sich mit dem Berechtigungsnachweis an, den Sie während der Cluster-Bereitstellung erstellt haben (weitere Informationen finden Sie im Book “Implementierungsleitfaden”, Chapter 5 “Bereitstellung mit cephadm”, Section 5.3.2.9 “Konfigurieren des Berechtigungsnachweises für die Anmeldung am Ceph Dashboard”).

Wenn Sie nicht über das Standardkonto admin auf das Ceph Dashboard zugreifen möchten, erstellen Sie ein benutzerdefiniertes Benutzerkonto mit Administratorrechten. Weitere Informationen finden Sie in Kapitel 11, Verwalten von Benutzern und Rollen über die Kommandozeile.

Die Benutzeroberfläche des Dashboards ist grafisch in mehrere Blöcke unterteilt: Dienstprogramm-Menü oben rechts auf dem Bildschirm, Hauptmenü auf der linken Seite und Inhaltsbereich.

2.4 Inhaltsbereich #

Der Inhaltsbereich belegt den Hauptteil des Dashboard-Bildschirms. Die Dashboard-Startseite enthält zahlreiche nützliche Widgets, mit denen Sie sich rasch über den aktuellen Status des Clusters, die Kapazität und die Leistung informieren können.

2.5 Allgemeine Funktionen der Webbenutzeroberfläche #

Im Ceph Dashboard arbeiten Sie oft mit Listen, beispielsweise Listen von Pools, OSD-Knoten oder RBD-Geräten. Alle Listen werden standardmäßig automatisch alle fünf Sekunden aktualisiert. Mit den folgenden allgemeinen Widgets verwalten Sie diese Listen oder passen Sie an:

Mit ![]() lösen Sie eine manuelle Aktualisierung der Liste aus.

lösen Sie eine manuelle Aktualisierung der Liste aus.

Klicken Sie auf ![]() , um einzelne Tabellenspalten anzuzeigen oder

auszublenden.

, um einzelne Tabellenspalten anzuzeigen oder

auszublenden.

Klicken Sie auf ![]() und geben Sie ein (oder wählen Sie aus), wie viele

Zeilen auf einer einzelnen Seite angezeigt werden sollen.

und geben Sie ein (oder wählen Sie aus), wie viele

Zeilen auf einer einzelnen Seite angezeigt werden sollen.

Klicken Sie in das Feld  und filtern Sie die Zeilen, indem Sie die Zeichenkette

eingeben, nach der gesucht werden soll.

und filtern Sie die Zeilen, indem Sie die Zeichenkette

eingeben, nach der gesucht werden soll.

Ändern Sie mit  die aktuell angezeigte Seite, wenn die Liste mehrere

Seiten umfasst.

die aktuell angezeigte Seite, wenn die Liste mehrere

Seiten umfasst.

2.6 Dashboard-Widgets #

Die einzelnen Dashboard-Widgets enthalten spezielle Statusinformationen zu einem bestimmten Aspekt eines aktiven Ceph-Clusters. Einige Widgets sind aktive Links. Wenn Sie darauf klicken, werden Sie zu einer detaillierten Seite des jeweiligen Themas weitergeleitet.

Bei einigen grafischen Widgets werden zusätzliche Informationen angezeigt, wenn Sie mit der Maus darauf zeigen.

2.6.1 Status-Widgets #

-Widgets geben Ihnen einen kurzen Überblick über den aktuellen Status des Clusters.

Grundlegende Informationen zum Zustand des Clusters.

Gesamtanzahl der Cluster-Knoten.

Anzahl der aktiven Monitors und deren Quorum.

Gesamtanzahl der OSDs sowie Anzahl der als up und in gekennzeichneten OSDs.

Anzahl der aktiven und im Standby befindlichen Ceph Manager Daemons.

Anzahl der aktiven Object Gateways.

Anzahl der Metadatenserver.

Anzahl der konfigurierten iSCSI-Gateways.

2.6.2 Kapazitäts-Widgets #

-Widgets bieten kurze Informationen zur Speicherkapazität.

Verhältnis der belegten und verfügbaren Rohspeicherkapazität.

Anzahl der im Cluster gespeicherten Datenobjekte.

Diagramm der Platzierungsgruppe gemäß ihrem Status.

Anzahl der Pools im Cluster.

Durchschnittliche Anzahl der Platzierungsgruppen pro OSD.

2.6.3 Leistungs-Widgets #

-Widgets liefern grundlegende Leistungsdaten der Ceph-Clients.

Die Anzahl der Lese-/Schreibvorgänge des Clients pro Sekunde.

Die Datenmenge in Byte pro Sekunde, die zu und von Ceph-Clients übertragen wird.

Der pro Sekunde wiederhergestellte Datendurchsatz.

Zeigt den Scrubbing-Status (weitere Informationen finden Sie in Abschnitt 17.4.9, „Scrubbing einer Platzierungsgruppe“). Er lautet entweder

inaktiv,aktiviertoderaktiv.

3 Verwalten von Ceph-Dashboard-Benutzern und -Rollen #

Die Dashboard-Benutzerverwaltung mit Ceph-Kommandos wurde bereits in Kapitel 11, Verwalten von Benutzern und Rollen über die Kommandozeile vorgestellt.

In diesem Abschnitt erfahren Sie, wie Sie Benutzerkonten über die Dashboard-Webbenutzeroberfläche verwalten.

3.1 Auflisten von Benutzern #

Klicken Sie im Dienstprogramm-Menü auf ![]() und wählen Sie .

und wählen Sie .

Die Liste enthält den Benutzernamen, den vollständigen Namen und die E-Mail-Adresse jedes Benutzers sowie eine Liste der zugewiesenen Rollen. Zudem ist angegeben, ob die Rolle aktiviert ist und wann das Passwort abläuft.

3.2 Hinzufügen neuer Benutzer #

Klicken Sie zum Hinzufügen eines neuen Benutzers oben links in der Tabellenüberschrift auf . Geben Sie den Benutzernamen, das Passwort sowie optional den vollständigen Namen und eine E-Mail-Adresse ein.

Klicken Sie auf das kleine Stiftsymbol und weisen Sie dem Benutzer vordefinierte Rollen zu. Bestätigen Sie mit .

3.3 Bearbeiten von Benutzern #

Klicken Sie zum Bearbeiten der Details zu einem Benutzer auf dessen Tabellenzeile und wählen Sie aus. Bestätigen Sie mit .

3.4 Löschen von Benutzern #

Klicken Sie auf die Tabellenzeile des Benutzers, um die Auswahl zu markieren. Wählen Sie die Dropdown-Schaltfläche neben und dann in der Liste die Option aus, um das Benutzerkonto zu löschen. Aktivieren Sie das Kontrollkästchen und bestätigen Sie mit .

3.5 Auflisten der Benutzerrollen #

Klicken Sie im Dienstprogramm-Menü auf ![]() und wählen Sie .

Klicken Sie dann auf die Registerkarte .

und wählen Sie .

Klicken Sie dann auf die Registerkarte .

Die Liste enthält den Namen und die Beschreibung der einzelnen Rollen sowie einen Hinweis, ob die betreffende Rolle eine Systemrolle ist.

3.6 Hinzufügen benutzerdefinierter Rollen #

Klicken Sie zum Hinzufügen einer neuen benutzerdefinierten Rolle oben links in der Tabellenüberschrift auf . Geben Sie den und die ein und wählen Sie neben die entsprechenden Berechtigungen aus.

Wenn Sie benutzerdefinierte Rollen erstellen und den Ceph-Cluster später

mit dem Kommando ceph-salt purge entfernen möchten,

müssen Sie zunächst die benutzerdefinierten Rollen bereinigen. Weitere

Informationen finden Sie in Abschnitt 13.9, „Vollständiges Entfernen eines Ceph-Clusters“.

Wenn Sie das Kontrollkästchen vor dem Namen eines Themas aktivieren, aktivieren Sie damit alle Berechtigungen für dieses Thema. Wenn Sie das Kontrollkästchen aktivieren, aktivieren Sie damit alle Berechtigungen für sämtliche Themen.

Bestätigen Sie mit .

3.7 Bearbeiten benutzerdefinierter Rollen #

Klicken Sie auf die Tabellenzeile eines Benutzers. Wählen Sie oben links in der Tabellenüberschrift die Option aus, um die Beschreibung und die Berechtigungen der benutzerdefinierten Rolle zu bearbeiten. Bestätigen Sie mit .

3.8 Löschen benutzerdefinierter Rollen #

Klicken Sie auf die Tabellenzeile einer Rolle, um die Auswahl zu markieren. Wählen Sie die Dropdown-Schaltfläche neben und dann in der Liste die Option aus, um die Rolle zu löschen. Aktivieren Sie das Kontrollkästchen und bestätigen Sie mit .

4 Anzeigen von Cluster-internen Elementen #

Über den Menüpunkt können Sie detaillierte Informationen über Ceph-Clusterhosts, Inventar, Ceph Monitors, Services, OSDs, Konfiguration, CRUSH-Zuordnung, Ceph Manager, Protokolle und Überwachungsdateien anzeigen.

4.1 Anzeigen von Cluster-Knoten #

Mit › rufen Sie eine Liste der Cluster-Knoten ab.

Klicken Sie auf den Dropdown-Pfeil neben einem Knotennamen in der Spalte , um die Leistungsdetails des Knotens anzuzeigen.

Die Spalte enthält alle Daemons, die auf den einzelnen zugehörigen Knoten ausgeführt werden. Zum Abrufen der ausführlichen Konfiguration eines Daemons klicken Sie auf den Namen dieses Daemons.

4.2 Zugreifen auf das Clusterinventar #

Mit › rufen Sie eine Liste der Geräte ab. Die Liste enthält den Gerätepfad, den Typ, die Verfügbarkeit, den Hersteller, das Modell, die Größe und die OSDs.

Klicken Sie in der Spalte einen Knotennamen zur Auswahl an. Klicken Sie nach der Auswahl auf , um das Gerät zu identifizieren, auf dem der Host ausgeführt wird. Dadurch wird das Gerät angewiesen, die LEDs blinken zu lassen. Wählen Sie für die Dauer dieser Aktion zwischen 1, 2, 5, 10 und 15 Minuten. Klicken Sie auf .

4.3 Anzeigen von Ceph Monitors #

Mit

›

rufen Sie eine Liste der Cluster-Knoten mit aktiven Ceph-Monitoren ab. Das

Inhaltsfenster ist in zwei Ansichten unterteilt: Status

und In Quorum oder Nicht in Quorum.

Die Tabelle enthält allgemeine Statistiken zu aktiven Ceph Monitors, einschließlich der folgenden:

Cluster-ID

Monmap geändert

Monmap-Epoche

quorum con

quorum mon

erforderliche Verbindung

erforderliche Überwachung

Die Bereiche In Quorum und Nicht in

Quorum enthalten die Namen der einzelnen Monitore, die Rangnummer,

die öffentliche IP-Adresse und die Anzahl der offenen Sitzungen.

Zum Abrufen der Ceph Monitor-Konfiguration eines Knotens klicken Sie auf den Namen dieses Knotens in der Spalte .

4.4 Anzeigen von Services #

Klicken Sie auf

› ,

um Details zu jedem der verfügbaren Services anzuzeigen:

crash, Ceph Manager und Ceph Monitors. Die Liste enthält

den Namen des Container-Images, die ID des Container-Images, den Status der

Services, die ausgeführt werden, sowie die Größe und den Zeitpunkt der

letzten Aktualisierung.

Klicken Sie auf den Dropdown-Pfeil neben einem Servicenamen in der Spalte , um die Details des Daemons anzuzeigen. Die Detailliste enthält den Hostnamen, den Daemon-Typ, die Daemon-ID, die Container-ID, den Container-Image-Namen, die Container-Image-ID, die Versionsnummer, den Status und den Zeitpunkt der letzten Aktualisierung.

4.5 Anzeigen von Ceph OSDs #

Mit › rufen Sie eine Liste der Knoten mit aktiven OSD-Daemons ab. Die Liste enthält die Namen der einzelnen Knoten, die ID, den Status, die Geräteklasse, die Anzahl der Platzierungsgruppen, die Größe, die Auslastung, ein Diagramm der Lese-/Schreibvorgänge im Zeitverlauf sowie die Rate der Lese-/Schreibvorgänge pro Sekunde.

Wählen Sie im Dropdown-Menü der in der Tabellenüberschrift den Eintrag aus, um ein Popup-Fenster zu öffnen. Dieser enthält eine Liste von Flags, die für den gesamten Cluster gelten. Sie können einzelne Flags aktivieren oder deaktivieren und dies dann mit bestätigen.

Wählen Sie im Dropdown-Menü der in der Tabellenüberschrift den Eintrag aus, um ein Popup-Fenster zu öffnen. Dieser enthält eine Liste von OSD-Wiederherstellungsprioritäten, die für den gesamten Cluster gelten. Sie können das bevorzugte Prioritätsprofil aktivieren und die einzelnen Werte darunter anpassen. Bestätigen Sie mit .

Klicken Sie auf den Dropdown-Pfeil neben einem Knotennamen in der Spalte , um eine erweiterte Tabelle mit Details zu den Geräteeinstellungen und der Leistung anzuzeigen. Auf den verschiedenen Karteireitern finden Sie Listen der , , , sowie ein grafisches der Schreib- und Lesevorgänge und die .

Nach dem Klicken auf einen OSD-Knotennamen wird die Tabellenzeile hervorgehoben. Dies bedeutet, dass Sie nun eine Aufgabe auf dem Knoten ausführen können. Sie können eine der folgenden Aktionen ausführen: , , , , , , , , , , oder .

Klicken Sie auf den Abwärtspfeil oben links in der Tabellenüberschrift neben der Schaltfläche und wählen Sie die gewünschte Aufgabe aus.

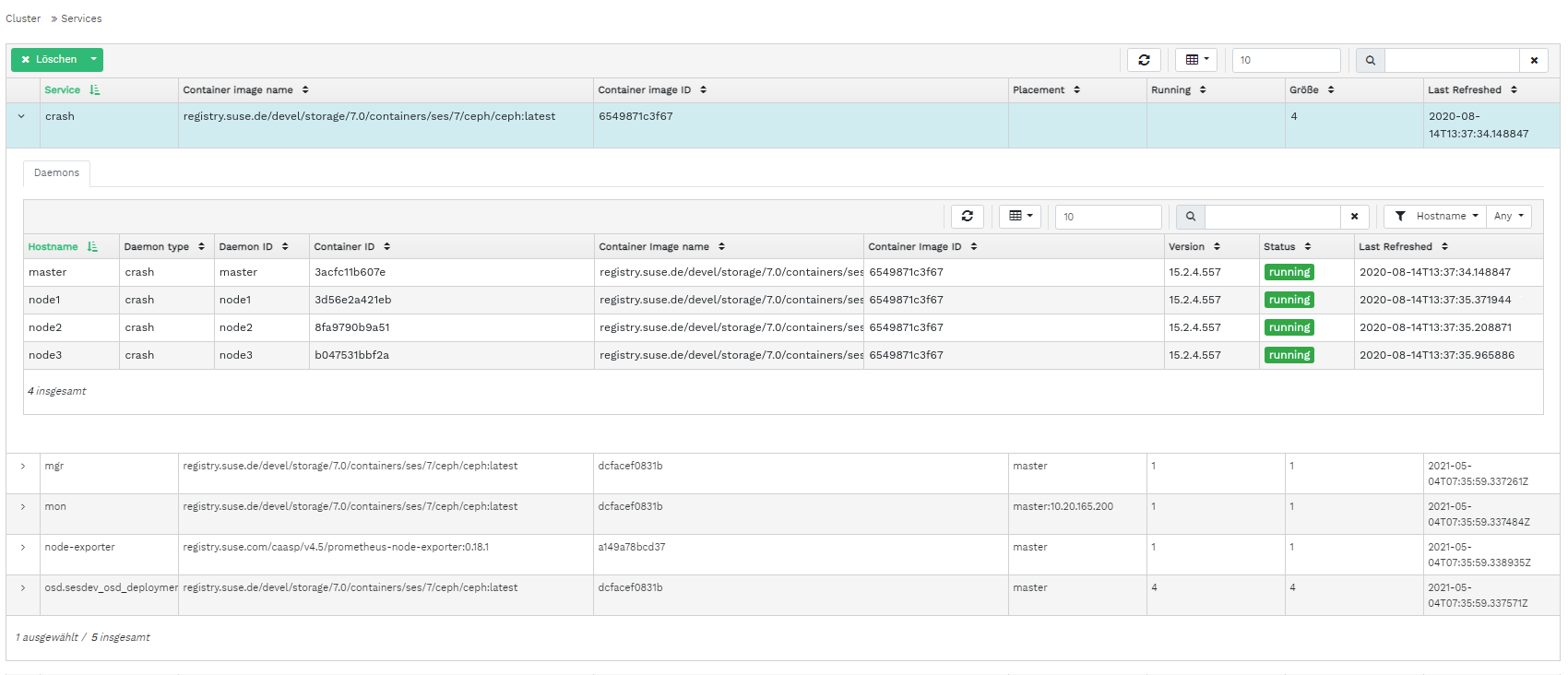

4.5.1 Hinzufügen von OSDs #

Führen Sie zum Hinzufügen neuer OSDs folgende Schritte aus:

Überprüfen Sie, ob einige Cluster-Knoten über Speichergeräte verfügen, deren Status

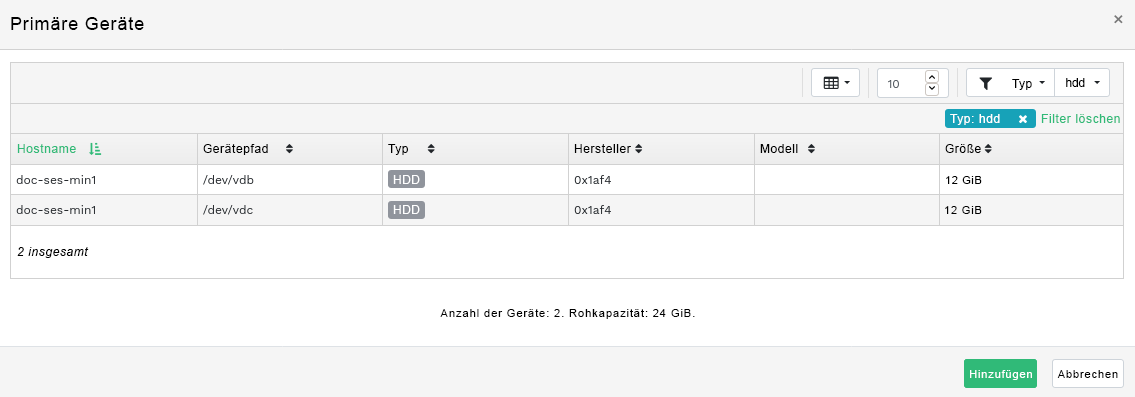

verfügbarlautet. Klicken Sie dann auf den Abwärtspfeil links oben in der Tabellenüberschrift und wählen Sie aus. Dadurch wird das Fenster geöffnet.Abbildung 4.9: OSDs erstellen #Klicken Sie zum Hinzufügen primärer Speichergeräte für OSDs auf . Bevor Sie Speichergeräte hinzufügen können, müssen Sie oben rechts in der Tabelle Filterkriterien angeben, z. B. . Bestätigen Sie Ihre Einstellung mit .

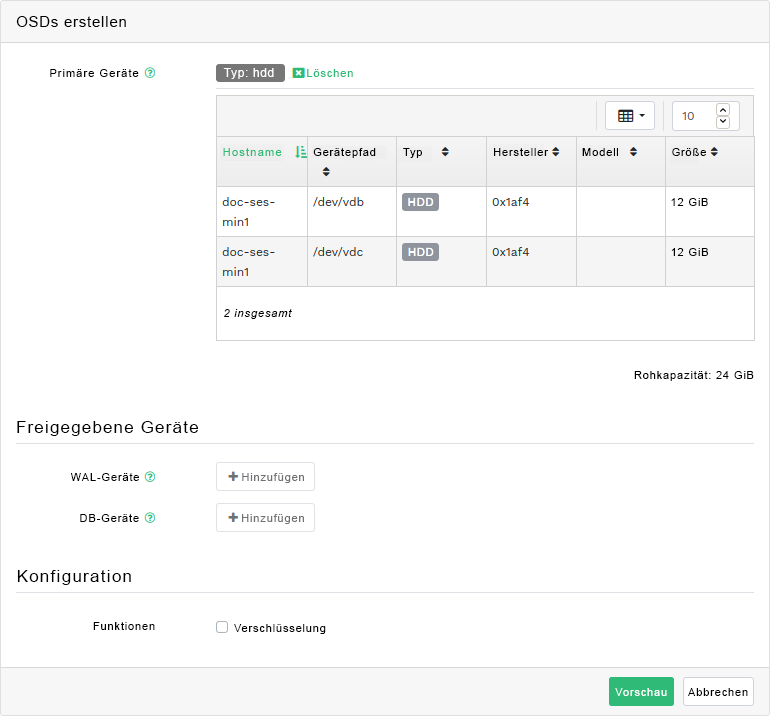

Abbildung 4.10: Hinzufügen von primären Geräten #Fügen Sie im aktualisierten Fenster optional freigegebene WAL- und BD-Geräte hinzu oder aktivieren Sie die Geräteverschlüsselung.

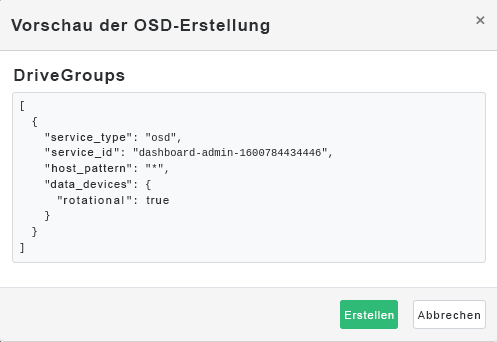

Abbildung 4.11: OSDs mit hinzugefügten primären Geräten erstellen #Klicken Sie auf , um die Vorschau der DriveGroups-Spezifikation für die zuvor hinzugefügten Geräte anzuzeigen. Bestätigen Sie mit .

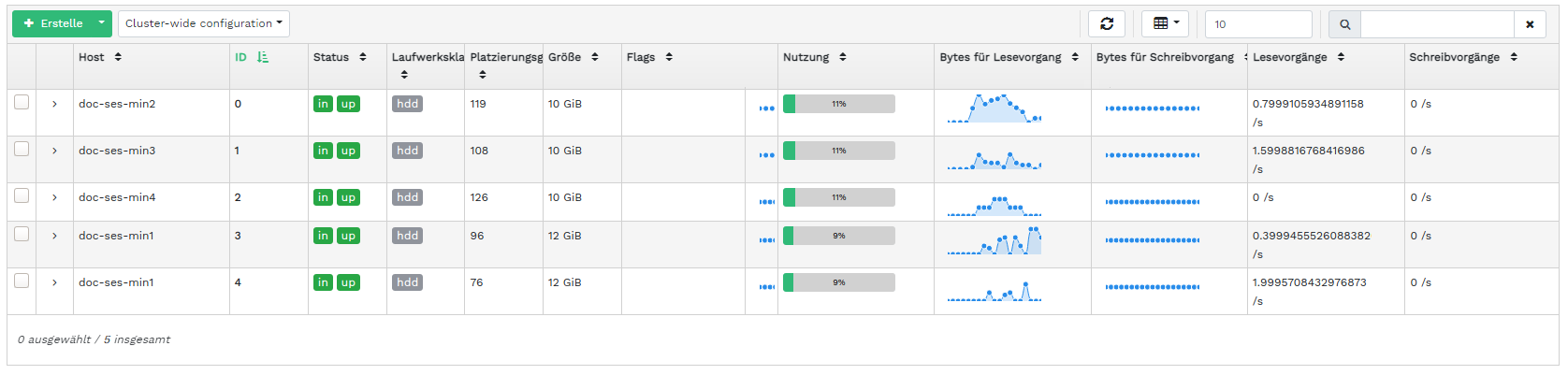

Abbildung 4.12: #Neue Geräte werden in die Liste der OSDs aufgenommen.

Abbildung 4.13: Neu hinzugefügte OSDs #AnmerkungEine Fortschrittsvisualisierung des OSD-Erstellungsprozesses ist nicht vorhanden. Es dauert einige Zeit, bis die OSDs tatsächlich erstellt sind. Die OSDs werden nach dem Bereitstellen in der Liste angezeigt. Wenn Sie den Bereitstellungsstatus überprüfen möchten, zeigen Sie die Protokolle an, indem Sie auf › klicken.

4.6 Anzeigen der Cluster-Konfiguration #

Mit › erhalten Sie eine umfassende Liste der Ceph-Cluster-Konfigurationsoptionen. Die Liste enthält den Namen der Option, eine Kurzbeschreibung und die aktuellen und Standardwerte sowie die Angabe, ob die Option bearbeitbar ist.

Klicken Sie auf den Dropdown-Pfeil neben einer Konfigurationsoption in der Spalte , um eine erweiterte Tabelle mit detaillierten Informationen über die Option anzuzeigen, z. B. den Wertetyp, die minimal und maximal zulässigen Werte, ob sie zur Laufzeit aktualisiert werden kann und vieles mehr.

Ist eine bestimmte Option hervorgehoben, können Sie ihre(n) Wert(e) mit der Schaltfläche oben links in der Tabellenüberschrift bearbeiten. Bestätigen Sie die Änderungen mit .

4.7 Anzeigen der CRUSH Map #

Mit › rufen Sie eine CRUSH-Zuordnung des Clusters ab. Weitere allgemeine Informationen zu CRUSH-Zuordnungen finden Sie in Abschnitt 17.5, „Umgang mit der CRUSH-Zuordnung“.

Wenn Sie auf den Root, die Knoten oder die einzelnen OSDs klicken, werden ausführlichere Informationen angezeigt, z. B. das Crush-Gewicht, die Tiefe im Zuordnungsbaum, die Geräteklasse des OSD und vieles mehr.

4.8 Anzeigen von Manager-Modulen #

Mit › rufen Sie eine Liste der verfügbaren Ceph-Manager-Module ab. Die Zeilen enthalten jeweils einen Modulnamen sowie einen Hinweis, ob das Modul derzeit aktiviert ist oder nicht.

Klicken Sie auf den Dropdown-Pfeil neben einem Modul in der Spalte , um in der nachfolgenden Tabelle eine erweiterte Tabelle mit detaillierten Einstellungen anzuzeigen. Zum Bearbeiten klicken Sie oben links in der Tabellenüberschrift auf die Schaltfläche . Bestätigen Sie die Änderungen mit .

Klicken Sie auf den Dropdown-Pfeil neben der Schaltfläche oben links in der Tabellenüberschrift, um ein Modul zu oder zu .

4.9 Anzeigen von Protokollen #

Mit › rufen Sie eine Liste der letzten Protokolleinträge des Clusters ab. Die Zeilen enthalten jeweils einen Zeitstempel, den Typ des Protokolleintrags sowie die protokollierte Meldung selbst.

Auf der Registerkarte finden Sie die Protokolleinträge des Revisions-Subsystems. Kommandos zum Aktivieren oder Deaktivieren der Revision finden Sie in Abschnitt 11.5, „Revision von API-Anforderungen“.

4.10 Anzeigen der Überwachung #

Klicken Sie auf › , um Details zu Prometheus-Warnungen zu verwalten und anzuzeigen.

Wenn Prometheus aktiv ist, können Sie in diesem Bereich detaillierte Informationen zu , oder anzeigen.

Wenn Sie Prometheus noch nicht bereitgestellt haben, werden ein Informationsbanner und ein Link zur entsprechenden Dokumentation angezeigt.

5 Verwalten von Pools #

Weitere allgemeine Informationen zu Ceph Pools finden Sie in Kapitel 18, Verwalten von Speicher-Pools. Spezifische Informationen zu Pools mit Löschcodierung finden Sie in Kapitel 19, Erasure Coded Pools.

Klicken Sie zum Auflisten aller verfügbaren Pools im Hauptmenü auf .

Die Liste enthält den Namen, den Typ, die zugehörige Anwendung, den Platzierungsgruppenstatus, die Reproduktionsgröße, die letzte Änderung, das Profil mit Löschcodierung, den CRUSH-Regelsatz, die Auslastung sowie die Lese-/Schreibstatistik der einzelnen Pools.

Klicken Sie auf den Dropdown-Pfeil neben einem Poolnamen in der Spalte , um eine erweiterte Tabelle mit detaillierten Informationen zum Pool anzuzeigen, wie zum Beispiel die allgemeinen Details, die Leistungsdetails und die Konfiguration.

5.1 Hinzufügen eines neuen Pools #

Klicken Sie zum Hinzufügen eines neuen Pools oben links in der Tabelle der Pools auf . Im Pool-Formular können Sie den Namen des Pools, den Typ, seine Anwendungen, den Komprimierungsmodus und die Quoten einschließlich der maximalen Größe in Byte und der maximalen Anzahl der Objekte eingeben. Im Pool-Formular wird automatisch die optimale Anzahl der Platzierungsgruppen für diesen Pool berechnet. Die Berechnung beruht auf der Anzahl der OSDs im Cluster und dem ausgewählten Pool-Typ mit den zugehörigen Einstellungen. Sobald die Anzahl der Platzierungsgruppen manuell festgelegt wird, wird sie durch eine berechnete Anzahl ersetzt. Bestätigen Sie mit .

5.2 Löschen von Pools #

Wählen Sie einen zu löschenden Pool in der Tabellenzeile aus. Klicken Sie auf den Dropdown-Pfeil neben der Schaltfläche und dann auf .

5.3 Bearbeiten der Optionen eines Pools #

Wählen Sie zum Bearbeiten der Optionen eines Pools den Pool in der Tabellenzeile aus und klicken Sie oben links in der Tabelle der Pools auf .

Sie können den Namen des Pools ändern, die Anzahl der Platzierungsgruppen erhöhen sowie die Liste der Pool-Anwendungen und die Komprimierungseinstellungen ändern. Bestätigen Sie mit .

6 Verwalten von RADOS-Blockgeräten #

Klicken Sie zum Auflisten aller verfügbaren RADOS-Blockgeräte (RBDs) im Hauptmenü auf › .

In der Liste werden kurze Informationen über das Gerät angezeigt, wie der Name des Geräts, der zugehörige Poolname, der Namespace, die Größe des Geräts, die Anzahl und Größe der Objekte auf dem Gerät, Details zur Bereitstellung der Details sowie das übergeordnete Gerät.

6.1 Anzeigen von Details zu RBDs #

Zum Abrufen ausführlicher Informationen zu einem Gerät klicken Sie auf dessen Zeile in der Tabelle:

6.2 Anzeigen der RBD-Konfiguration #

Zum Abrufen der ausführlichen Konfiguration eines Geräts klicken Sie auf dessen Zeile in der Tabelle und dann in der unteren Tabelle auf die Registerkarte :

6.3 Erstellen von RBDs #

Klicken Sie zum Hinzufügen eines neuen Geräts oben links in der Tabellenüberschrift auf und verfahren Sie im Bildschirm folgendermaßen:

Geben Sie den Namen des neuen Geräts ein. Informationen zu Benennungseinschränkungen finden Sie im Book “Implementierungsleitfaden”, Chapter 2 “Hardwareanforderungen und Empfehlungen”, Section 2.11 “Namensbegrenzungen”.

Wählen Sie den Pool mit der zugewiesenen

rbd-Anwendung aus, von dem aus das neue RBD-Gerät erstellt werden soll.Geben Sie die Größe des neuen Geräts an.

Legen Sie zusätzliche Optionen für das Gerät fest. Zum Abstimmen der Geräteparameter klicken Sie auf und geben Sie Werte für die Objektgröße, die Stripe-Einheit oder die Stripe-Anzahl ein. Sollen Grenzwerte für Quality of Service (QoS) festgelegt werden, klicken Sie auf und geben Sie die Werte ein.

Bestätigen Sie mit .

6.4 Löschen von RBDs #

Wählen Sie ein zu löschendes Gerät in der Tabellenzeile aus. Klicken Sie auf den Dropdown-Pfeil neben der Schaltfläche und dann auf . Bestätigen Sie den Löschvorgang mit .

Das Löschen eines RBDs kann nicht rückgängig gemacht werden. Wenn Sie stattdessen die Option wählen, können Sie das Gerät später wiederherstellen. Wählen Sie das Gerät hierzu auf der Registerkarte der Haupttabelle aus und klicken Sie oben links in der Tabellenüberschrift auf .

6.5 Erstellen von Snapshots von RADOS-Blockgeräten #

Wählen Sie zum Erstellen eines RBD-Snapshots das Gerät in der Tabellenzeile aus, und das Inhaltsfenster für die detaillierte Konfiguration erscheint. Wählen Sie den Karteireiter aus und klicken Sie oben links in der Tabellenüberschrift auf . Geben Sie den Namen des Snapshots ein und bestätigen Sie mit .

Wenn Sie einen Snapshot ausgewählt haben, können Sie weitere Aktionen für das Gerät durchführen, z. B. Umbenennen, Schützen, Klonen, Kopieren oder Löschen. Mit wird der Zustand des Geräts vom aktuellen Snapshot wiederhergestellt.

6.6 RBD-Spiegelung #

RBD-Images können asynchron zwischen zwei Ceph-Clustern gespiegelt werden. Mit dem Ceph Dashboard können Sie die Reproduktion von RBD-Images zwischen mindestens zwei Clustern konfigurieren. Diese Funktion ist in zwei Modi verfügbar:

- Journal-basiert

Bei diesem Modus wird die Funktion des RBD-Journaling-Images verwendet, um die absturzkonsistente Reproduktion zwischen Clustern sicherzustellen.

- Snapshot-basiert

Dieser Modus verwendet periodisch geplante oder manuell erstellte RBD-Image-Spiegel-Snapshots, um absturzsichere RBD-Images zwischen Clustern zu reproduzieren.

Die Spiegelung wird innerhalb von Peer-Clustern pro Pool konfiguriert. Sie kann für eine bestimmte Untergruppe von Images innerhalb des Pools konfiguriert werden oder so, dass alle Images innerhalb eines Pools automatisch gespiegelt werden, wenn nur die Journal-basierte Spiegelung verwendet wird.

Die Spiegelung wird mit dem Kommando rbd konfiguriert,

das standardmäßig in SUSE Enterprise Storage 7 installiert ist. Der

rbd-mirror-Daemon ist dafür

zuständig, Image-Aktualisierungen aus dem Remote-Peer-Cluster zu entnehmen

und sie auf das Image im lokalen Cluster anzuwenden. In

Abschnitt 6.6.2, „Konfigurieren des rbd-mirror-Daemons“ finden Sie weitere Informationen

zum Aktivieren des

rbd-mirror-Daemons.

Abhängig von den gewünschten Anforderungen an die Reproduktion kann die RBD-Spiegelung entweder für eine einseitige oder für eine zweiseitige Reproduktion konfiguriert werden:

- Einseitige Reproduktion

Wenn Daten nur von einem primären Cluster auf einen sekundären Cluster gespiegelt werden, läuft der

rbd-mirror-Daemon nur auf dem sekundären Cluster.- Zweiseitige Reproduktion

Wenn Daten von primären Images auf einem Cluster auf nicht primäre Images auf einem anderen Cluster gespiegelt werden (und umgekehrt), wird der

rbd-mirror-Daemon auf beiden Clustern ausgeführt.

Jede Instanz des rbd-mirror-Daemons

muss in der Lage sein, sich gleichzeitig mit dem lokalen und dem entfernten

Ceph-Cluster zu verbinden, zum Beispiel mit allen Monitor- und OSD-Hosts.

Außerdem muss das Netzwerk über eine ausreichende Bandbreite zwischen den

beiden Rechenzentren verfügen, um die Spiegelung des Workloads zu

bewältigen.

Allgemeine Informationen und Anweisungen für die RADOS-Block-Device-Spiegelung über die Kommandozeile finden Sie in Abschnitt 20.4, „RBD-Image-Spiegel“.

6.6.1 Konfigurieren von primären und sekundären Clustern #

Im primären Cluster wird der ursprüngliche Pool mit Images erstellt. Im sekundären Cluster werden der Pool oder die Images aus dem primären Cluster reproduziert.

Die Bezeichnungen primär und sekundär sind im Zusammenhang mit der Reproduktion relativ, da sie sich eher auf einzelne Pools als auf Cluster beziehen. Bei einer bidirektionalen Reproduktion kann ein Pool beispielsweise aus dem primären in den sekundären Cluster gespiegelt werden, während ein anderer Pool aus dem sekundären in den primären Cluster gespiegelt wird.

6.6.2 Konfigurieren des rbd-mirror-Daemons #

Die folgenden Verfahren zeigen, wie einfache Verwaltungsaufgaben zum

Konfigurieren der Spiegelung mit dem rbd-Kommando

ausgeführt werden. Die Spiegelung wird pro Pool in den Ceph-Clustern

konfiguriert.

Die Schritte der Pool-Konfiguration sollten auf beiden Peer-Clustern durchgeführt werden. Bei diesen Verfahren wird der Einfachheit halber angenommen, dass von einem einzelnen Host aus auf zwei Cluster (den „primären“ und den „sekundären“) zugegriffen werden kann.

Der rbd-mirror-Daemon führt die

eigentliche Cluster-Datenreproduktion durch.

Benennen Sie die Datei

ceph.confund die Schlüsselbunddatei um und kopieren Sie sie vom primären Host auf den sekundären Host:cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringGeben Sie zum Aktivieren der Spiegelung in einem Pool mit

rbddas Kommandomirror pool enable, den Poolnamen und den Spiegelungsmodus an:cephuser@adm >rbd mirror pool enable POOL_NAME MODEAnmerkungDer Spiegelungsmodus kann entweder

ImageoderPoollauten. Beispiel:cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageNavigieren Sie im Ceph Dashboard zu › . Die Tabelle links zeigt die aktiv ausgeführten

rbd-mirror-Daemons und ihren Zustand.Abbildung 6.6: Ausführen vonrbd-mirror-Daemons #

6.6.3 Deaktivieren der Spiegelung #

Geben Sie zum Deaktivieren der Spiegelung in einem Pool mit

rbd das Kommando mirror pool disable

und den Poolnamen an:

cephuser@adm > rbd mirror pool disable POOL_NAMEWenn die Spiegelung auf diese Weise in einem Pool deaktiviert wird, dann wird sie auch in anderen Images (im Pool) deaktiviert, für die eine Spiegelung explizit aktiviert wurde.

6.6.4 Bootstrapping von Peers #

Damit der rbd-mirror-Daemon seinen

Peer-Cluster erkennen kann, muss der Peer im Pool registriert und ein

Benutzerkonto erstellt werden. Dieser Vorgang kann mit

rbd und den Kommandos mirror pool peer

bootstrap create und mirror pool peer bootstrap

import automatisiert werden.

Geben Sie zum Erstellen eines neues Bootstrap-Tokens mit

rbd das Kommando mirror pool peer bootstrap

create, einen Pool-Namen sowie einen optionalen Namen für den

Standort zur Beschreibung des lokalen Clusters an:

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

Die Ausgabe von mirror pool peer bootstrap create ist

ein Token, das dem Kommando mirror pool peer bootstrap

import übergeben werden sollte, beispielsweise am primären

Cluster:

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \

joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

Geben Sie zum manuellen Importieren des von einem anderen Cluster

erstellten Bootstrap-Tokens mit dem Kommando rbd das

Kommando mirror pool peer bootstrap import, den

Poolnamen, einen Dateipfad zum erstellten Token (oder „-“, um von der

Standardeingabe zu lesen) sowie einen optionalen Standortnamen zur

Beschreibung des lokalen Clusters sowie eine Spiegelungsrichtung an

(standardmäßig rx-tx für eine bidirektionale Spiegelung,

kann aber auch auf rx-only für eine unidirektionale

Spiegelung festgelegt werden):

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathBeispielsweise am sekundären Cluster:

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW \ 1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1v \ bl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 Entfernen des Cluster-Peers #

Geben Sie zum Entfernen eines Ceph-Peer-Clusters für die Spiegelung mit dem

Kommando rbd das Kommando mirror pool peer

remove, den Poolnamen und die Peer-UUID (verfügbar über das

Kommando rbd mirror pool info) an:

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Konfigurieren der Pool-Reproduktion im Ceph Dashboard #

Der rbd-mirror-Daemon benötigt

Zugriff auf den primären Cluster, damit die RBD-Images gespiegelt werden

können. Stellen Sie sicher, dass Sie die Schritte in

Abschnitt 6.6.4, „Bootstrapping von Peers“ befolgt haben, bevor Sie

fortfahren.

Erstellen Sie sowohl auf dem primären als auch auf dem sekundären Cluster Pools mit demselben Namen und weisen Sie ihnen die Anwendung

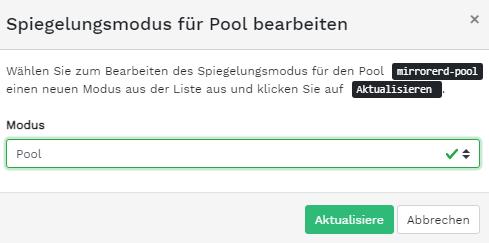

rbdzu. Weitere Informationen zum Erstellen eines neuen Pools finden Sie in Abschnitt 5.1, „Hinzufügen eines neuen Pools“.Abbildung 6.7: Erstellen eines Pools mit der RBD-Anwendung #Navigieren Sie im Dashboard des primären und des sekundären Clusters zu › . Klicken Sie in der Tabelle rechts auf den Namen des zu reproduzierenden Pools und dann auf und wählen Sie den Reproduktionsmodus aus. In diesem Beispiel wird der Pool-Reproduktionsmodus herangezogen, bei dem alle Images in einem bestimmten Pool reproduziert werden. Bestätigen Sie mit .

Abbildung 6.8: Konfigurieren des Reproduktionsmodus #Wichtig: Fehler oder Warnung im primären ClusterNach dem Aktualisieren des Reproduktionsmodus wird eine Fehler- oder Warnflagge in der entsprechenden rechten Spalte angezeigt. Der Grund hierfür ist, dass dem Pool bislang noch kein Peer-Benutzer für die Reproduktion zugewiesen wurde. Ignorieren Sie diese Flagge im primären Cluster, da der Peer-Benutzer ausschließlich im sekundären Cluster zugewiesen wird.

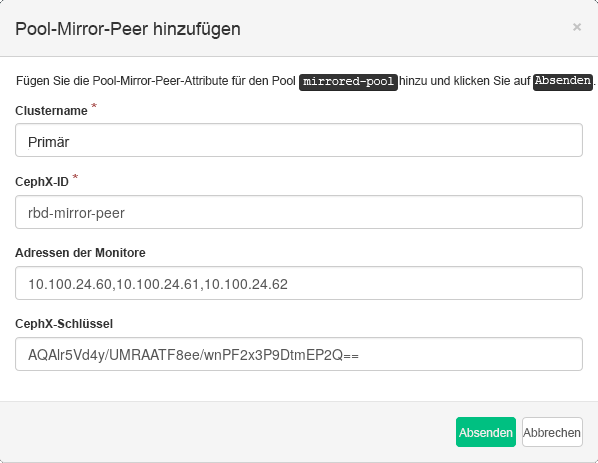

Navigieren Sie im Dashboard des sekundären Clusters zu › . Wählen Sie aus, um einen Pool-Spiegel-Peer hinzuzufügen. Geben Sie die Details für den primären Cluster an:

Abbildung 6.9: Hinzufügen des Peer-Berechtigungsnachweises #Eine willkürliche, eindeutige Zeichenkette, die den primären Cluster identifiziert, z. B. „primary“. Der Cluster-Name darf nicht mit dem tatsächlichen Namen des sekundären Clusters übereinstimmen.

Die Ceph-Benutzer-ID, die Sie als Spiegelungs-Peer erstellt haben. In diesem Beispiel lautet sie „rbd-mirror-peer“.

Kommagetrennte Liste von IP-Adressen der Ceph Monitor-Knoten des primären Clusters.

Schlüssel für die Peer-Benutzer-ID. Zum Abrufen führen Sie folgendes (Beispiel-)Kommando im primären Cluster aus:

cephuser@adm >ceph auth print_key pool-mirror-peer-name

Bestätigen Sie mit .

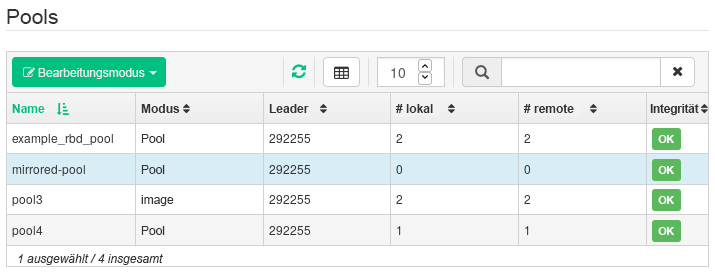

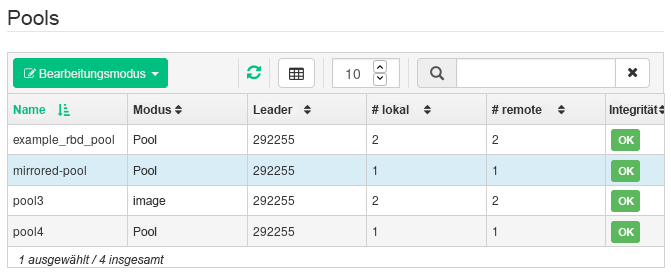

Abbildung 6.10: Liste der reproduzierten Pools #

6.6.7 Prüfen der Funktionsfähigkeit der RBD-Image-Reproduktion #

Wenn der rbd-mirror-Daemon

ausgeführt wird und die RBD-Image-Reproduktion im Ceph Dashboard

konfiguriert ist, können Sie prüfen, ob die Reproduktion tatsächlich

funktioniert:

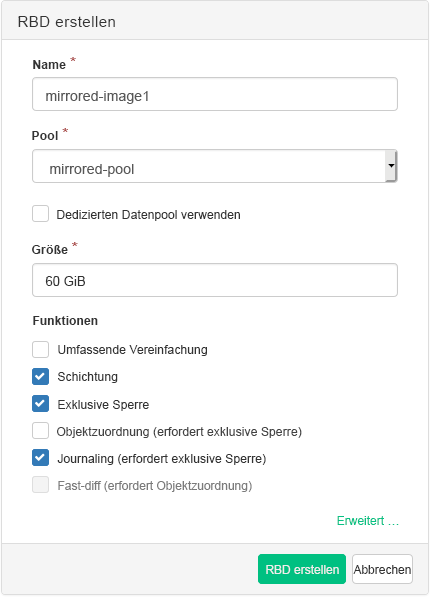

Erstellen Sie im Ceph Dashboard des primären Clusters ein RBD-Image und geben Sie den Pool, den Sie bereits für die Reproduktion erstellt haben, als dessen übergeordneten Pool an. Aktivieren Sie die Funktionen

Exklusive SperreundJournalingfür das Image. Weitere Informationen zum Erstellen von RBD-Images finden Sie in Abschnitt 6.3, „Erstellen von RBDs“.Abbildung 6.11: Neues RBD-Image #Sobald Sie das zu reproduzierende Image erstellt haben, öffnen Sie das Ceph Dashboard im sekundären Cluster und navigieren Sie zu › . Die Tabelle rechts zeigt die Veränderung in der Anzahl der -Images und die Anzahl der Images wird synchronisiert.

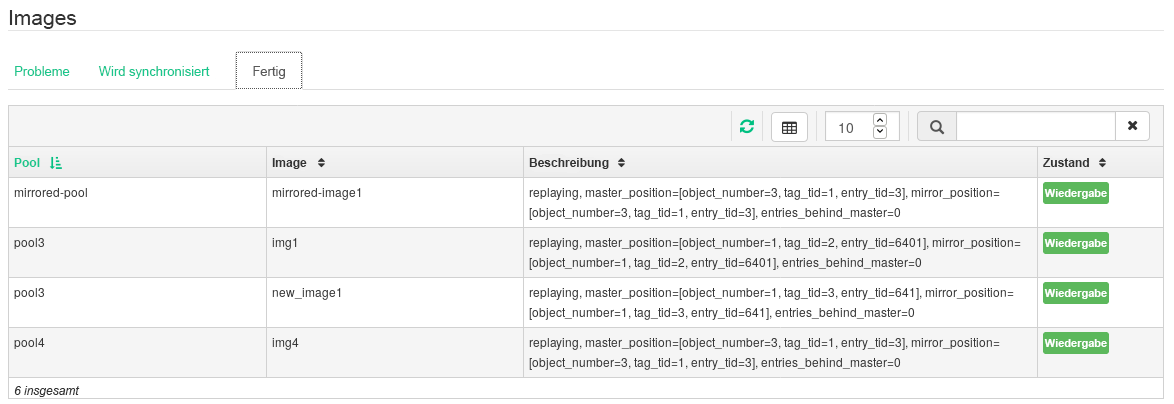

Abbildung 6.12: Synchronisiertes neues RBD-Image #Tipp: ReproduktionsprozessDie Tabelle unten auf der Seite zeigt den Reproduktionsstatus der RBD-Images. Auf der Registerkarte werden eventuelle Probleme angezeigt, die Registerkarte zeigt den Fortschritt der Image-Reproduktion und die Registerkarte enthält alle Images mit erfolgreicher Reproduktion.

Abbildung 6.13: Reproduktionsstatus der RBD-Images #Schreiben Sie im primären Cluster Daten in das RBD-Image. Navigieren Sie im Ceph Dashboard des sekundären Clusters zu › und prüfen Sie, ob die Größe des entsprechenden Images wächst, während die Daten im primären Cluster geschrieben werden.

6.7 Verwalten von iSCSI Gateways #

Weitere Informationen zu iSCSI-Gateways finden Sie in Kapitel 22, Ceph iSCSI Gateway.

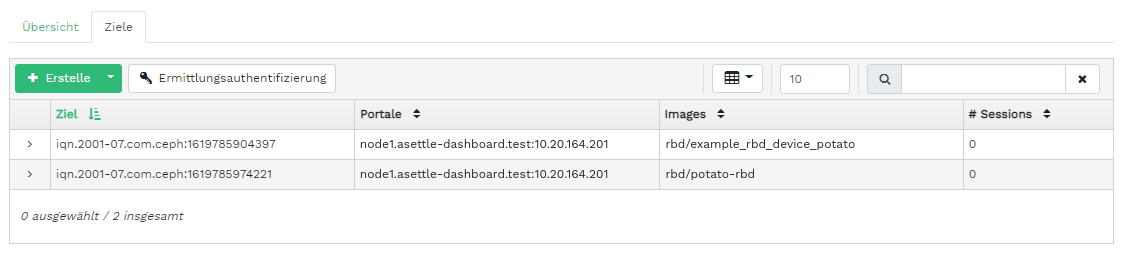

Klicken Sie zum Auflisten aller verfügbaren Gateways und zugeordneten Images im Hauptmenü auf › . Die Registerkarte mit einer Liste der derzeit konfigurierten iSCSI-Gateways und zugeordneten RBD-Images wird geöffnet.

Die Tabelle enthält den Status der einzelnen Gateways, die Anzahl der iSCSI-Ziele und die Anzahl der Sitzungen. Die Tabelle enthält den Namen der einzelnen zugeordneten Images, den Backstore-Typ des zugehörigen Pool-Namens und weitere statistische Daten.

Die Registerkarte enthält eine Liste der derzeit konfigurierten iSCSI-Ziele.

Klicken Sie zum Anzeigen detaillierterer Informationen über ein Ziel auf den Dropdown-Pfeil in der Tabellenzeile des Ziels. Eine Baumstruktur mit den Datenträgern, Portalen, Initiatoren und Gruppen wird geöffnet. Wenn Sie auf ein Element klicken, wird es erweitert und sein Inhalt wird angezeigt, optional mit einer zugehörigen Konfiguration in der Tabelle rechts.

6.7.1 Hinzufügen von iSCSI-Zielen #

Klicken Sie zum Hinzufügen eines neuen iSCSI-Ziels links oben in der Tabelle auf und geben Sie die erforderlichen Informationen ein.

Geben Sie die Zieladresse des neuen Gateways ein.

Klicken Sie auf und wählen Sie ein oder mehrere iSCSI-Portale aus der Liste aus.

Klicken Sie auf und wählen Sie ein oder mehrere RBD-Images für das Gateway aus.

Wenn Sie für den Zugriff auf das Gateway eine Authentifizierung verwenden müssen, aktivieren Sie das Kontrollkästchen und geben Sie den Berechtigungsnachweis ein. Weitere erweiterte Authentifizierungsoptionen finden Sie nach Aktivieren von (Gegenseitige Authentifizierung) und (Ermittlungsauthentifizierung).

Bestätigen Sie mit .

6.7.2 Bearbeiten von iSCSI-Zielen #

Zum Bearbeiten eines vorhandenen iSCSI-Ziels klicken Sie auf dessen Zeile in der Tabelle und dann oben links in der Tabelle auf .

Sie können dann das iSCSI-Ziel bearbeiten, Portale hinzufügen oder löschen und entsprechende RBD-Images hinzufügen oder löschen. Außerdem haben Sie die Möglichkeit, die Authentifizierungsoptionen für das Gateway anzupassen.

6.7.3 Löschen von iSCSI-Zielen #

Wählen Sie zum Löschen eines iSCSI-Ziels die Tabellenzeile aus, klicken Sie auf den Dropdown-Pfeil neben der Schaltfläche und wählen Sie aus. Aktivieren Sie und bestätigen Sie mit .

6.8 RBD-Quality-of-Service (QoS) #

Allgemeine Informationen und eine Beschreibung der RBD-QoS-Konfigurationsoptionen finden Sie in Abschnitt 20.6, „QoS-Einstellungen“.

Die QoS-Optionen können auf verschiedenen Ebenen konfiguriert werden.

global

für einzelne Pools

für einzelne Images

Die globale Konfiguration befindet sich an oberster Stelle in der Liste und wird für alle neu erstellten RBD-Images herangezogen, außerdem für alle Images, in denen diese Werte in der Pool- oder RBD-Image-Schicht nicht überschrieben werden. Ein global festgelegter Optionswert kann für einzelne Pools oder Images überschrieben werden. Die für einen Pool festgelegten Optionen werden für alle RBD-Images dieses Pools übernommen, sofern sie nicht von einer Konfigurationsoption in einem Image überschrieben werden. Die für ein Image festgelegten Optionen überschreiben die für einen Pool festgelegten Optionen sowie die global festgelegten Optionen.

Auf diese Weise können Sie globale Standardwerte definieren, für alle RBD-Images eines bestimmten Pools anpassen und dann die Poolkonfiguration für einzelne RBD-Images überschreiben.

6.8.1 Globale Konfiguration von Optionen #

Wählen Sie für die globale Konfiguration von RBD-Optionen im Hauptmenü › aus.

Wählen Sie zum Auflisten aller verfügbaren globalen Konfigurationsoptionen neben die Option aus dem Dropdown-Menü.

Filtern Sie im Suchfeld die Ergebnisse der Tabelle nach

rbd_qos. Damit wird eine Liste aller verfügbaren Konfigurationsoptionen für QoS angezeigt.Klicken Sie zum Ändern eines Werts auf dessen Tabellenzeile und wählen Sie dann oben links in der Tabelle aus. Das Dialogfeld enthält sechs Felder für die Eingabe von Werten. Die RBD-Konfigurationsoptionswerte müssen im Textfeld angegeben werden.

AnmerkungIm Gegensatz zu anderen Dialogfeldern können Sie den Wert in diesem Dialogfeld nicht in bequemen Einheiten angeben. Sie müssen ihn entweder in Byte oder in IOPS angeben, je nach bearbeiteter Option.

6.8.2 Konfigurieren von Optionen für einen neuen Pool #

Zum Erstellen eines neuen Pools und zum Konfigurieren von

RBD-Konfigurationsoptionen klicken Sie auf

› . Wählen Sie den Pooltyp

aus. Ergänzen Sie den Pool dann mit dem

Anwendungs-Tag rbd, damit Sie die RBD-QoS-Optionen

konfigurieren können.

Bei einem Pool mit Löschcodierung können keine RBD-QoS-Konfigurationsoptionen konfiguriert werden. Zum Konfigurieren der RBD-QoS-Optionen für Pools mit Löschcodierung müssen Sie den reproduzierten Metadaten-Pool eines RBD-Images bearbeiten. Die Konfiguration wird dann für den Daten-Pool mit Löschcodierung dieses Images übernommen.

6.8.3 Konfigurieren von Optionen für einen vorhandenen Pool #

Zum Konfigurieren von RBD-QoS-Optionen für einen vorhandenen Pool klicken Sie auf , dann auf die Tabellenzeile des Pools und dann oben links in der Tabelle auf .

Im Dialogfeld wird der Abschnitt angezeigt, gefolgt vom Abschnitt .

Wenn weder der Abschnitt noch der Abschnitt angezeigt wird, bearbeiten Sie entweder einen Pool mit Löschcodierung, bei dem keine RBD-Konfigurationsoptionen festgelegt werden können, oder der Pool ist nicht für die Verwendung durch RBD-Images konfiguriert. Im letzteren Fall weisen Sie dem Pool das Anwendungs-Tag zu; hiermit werden die entsprechenden Konfigurationsabschnitte angezeigt.

6.8.4 Konfigurationsoptionen #

Erweitern Sie die Konfigurationsoptionen mit . Eine Liste aller verfügbaren Optionen wird angezeigt. Die Einheiten der Konfigurationsoptionen werden bereits in den Textfeldern angezeigt. Bei Optionen mit Byte pro Sekunde (BPS) können Sie Abkürzungen wie „1M“ oder „5G“ eingeben. Diese werden automatisch in „1 MB/s“ bzw. „5 GB/s“ umgewandelt.

Mit der Schaltfläche zum Zurücksetzen rechts neben den einzelnen Textfeldern können Sie die für den Pool festgelegten Werte entfernen. Die Konfigurationswerte für global konfigurierte Optionen oder für RBD-Images werden hiermit nicht entfernt.

6.8.5 Erstellen von RBD-QoS-Optionen mit einem neuen RBD-Image #

Zum Erstellen eines RBD-Images und zum Festlegen von RBD-QoS-Optionen für dieses Image klicken Sie auf › und dann auf . Klicken Sie auf , um den Abschnitt mit der erweiterten Konfiguration zu maximieren. Öffnen Sie alle verfügbaren Konfigurationsoptionen mit .

6.8.6 Bearbeiten von RBD-QoS-Optionen für vorhandene Images #

Zum Bearbeiten von RBD-QoS-Optionen für ein vorhandenes Image wählen Sie › , klicken auf die Tabellenzeile des Pools und schließlich auf . Das Dialogfeld „Bearbeiten“ wird geöffnet. Klicken Sie auf , um den Abschnitt mit der erweiterten Konfiguration zu maximieren. Öffnen Sie alle verfügbaren Konfigurationsoptionen mit .

6.8.7 Ändern von Konfigurationsoptionen beim Kopieren oder Klonen von Images #

Wenn ein RBD-Image geklont oder kopiert wird, werden die für dieses Image festgelegten Werte standardmäßig ebenfalls kopiert. Sollen diese Werte beim Kopieren oder Klonen geändert werden, geben Sie die aktualisierten Konfigurationswerte im Dialogfeld zum Kopieren/Klonen ein, ebenso wie beim Erstellen oder Bearbeiten eines RBD-Images. Hiermit werden ausschließlich die Werte für das zu kopierende oder zu klonende RBD-Image festgelegt (oder zurückgesetzt). Dieser Vorgang verändert weder die Konfiguration des Quell-RBD-Images noch die globale Konfiguration.

Wenn Sie den Optionswert beim Kopieren/Klonen zurücksetzen, wird in diesem Image kein Wert für diese Option festgelegt. Dies bedeutet, dass ein Wert für diese Option herangezogen wird, der für den übergeordneten Pool festgelegt wurde, sofern der betreffende Wert im übergeordneten Pool konfiguriert ist. Ansonsten wird der globale Standardwert verwendet.

7 Verwalten von NFS Ganesha #

Weitere Informationen zu NFS Ganesha finden Sie in Kapitel 25, NFS Ganesha.

Klicken Sie zum Auflisten aller verfügbaren NFS-Exporte im Hauptmenü auf .

In der Liste werden das Verzeichnis, der Daemon-Hostname, der Typ des Speicher-Back-Ends und der Zugriffstyp der einzelnen Exporte angezeigt.

Zum Abrufen ausführlicher Informationen zu einem NFS-Export klicken Sie auf dessen Tabellenzeile.

7.1 Erstellen eines NFS-Exports #

Klicken Sie zum Hinzufügen eines neuen NFS-Exports links oben in der Tabelle der Exporte auf und geben Sie die erforderlichen Informationen ein.

Wählen Sie mindestens einen NFS Ganesha Daemon aus, der den Export ausführen soll.

Wählen Sie ein Speicher-Back-End aus.

WichtigZurzeit werden nur NFS-Exporte unterstützt, die mit CephFS gesichert sind.

Wählen Sie eine Benutzer-ID aus und legen Sie andere Back-End-spezifische Optionen fest.

Geben Sie den Verzeichnispfad für den NFS-Export ein. Das Verzeichnis wird erstellt, falls es am Server noch nicht vorhanden ist.

Legen Sie andere NFS-spezifische Optionen fest, z. B. die unterstützte NFS-Protokollversion, den Zugriffstyp, Squashing oder das Transportprotokoll.

Wenn sie den Zugriff ausschließlich auf bestimmte Clients beschränken müssen, klicken Sie auf und fügen Sie deren IP-Adressen zusammen mit dem Zugriffstyp und den Squashing-Optionen hinzu.

Bestätigen Sie mit .

7.2 Löschen von NFS-Exporten #

Um einen Export zu löschen, wählen Sie den Export in der Tabellenzeile aus und markieren Sie ihn. Klicken Sie auf den Dropdown-Pfeil neben der Schaltfläche und wählen Sie aus. Aktivieren Sie das Kontrollkästchen und bestätigen Sie mit .

7.3 Bearbeiten von NFS-Exporten #

Um einen vorhandenen Export zu bearbeiten, wählen und markieren Sie den Export in der Tabellenzeile und klicken Sie oben links in der Exporttabelle auf .

Sie können dann alle Details des NFS-Exports anpassen.

8 Verwalten von CephFS #

Weitere Informationen zu CephFS finden Sie in Kapitel 23, Cluster-Dateisystem.

8.1 Anzeigen des CephFS-Überblicks #

Mit im Hauptmenü rufen Sie einen Überblick der konfigurierten Dateisysteme ab. Die Haupttabelle zeigt den Namen und das Erstellungsdatum der einzelnen Dateisysteme und gibt an, ob ein Dateisystem aktiviert ist oder nicht.

Wenn Sie auf die Tabellenzeile eines Dateisystems klicken, erhalten Sie Details zu dessen Rang und den Pools, die in das Dateisystem eingefügt wurden.

Unten im Bildschirm werden Statistiken mit der Anzahl der zugehörigen MDS-Inodes und Client-Anfragen in Echtzeit angezeigt.

9 Verwalten des Object Gateways #

Bevor Sie beginnen, wird möglicherweise die folgende Meldung angezeigt, wenn Sie versuchen, auf das Object-Gateway-Frontend im Ceph Dashboard zuzugreifen:

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

Das liegt daran, dass das Object Gateway nicht automatisch von cephadm für das Ceph Dashboard konfiguriert wurde. Wenn diese Meldung angezeigt wird, folgen Sie den Anweisungen in Abschnitt 10.4, „Aktivieren des Verwaltungs-Frontends für das Object Gateway“, um das Object-Gateway-Frontend für das Ceph Dashboard manuell zu aktivieren.

Weitere allgemeine Informationen zum Object Gateway finden Sie in Kapitel 21, Ceph Object Gateway.

9.1 Abrufen von Object Gateways #

Zum Abrufen einer Liste der konfigurierten Object Gateways klicken Sie auf › . Die Liste enthält die ID des Gateways, den Hostnamen des Cluster-Knotens, auf dem der Gateway Daemon ausgeführt wird, sowie die Versionsnummer des Gateways.

Klicken Sie auf den Dropdown-Pfeil neben dem Namen des Gateways, um detaillierte Informationen über das Gateway anzuzeigen. Die Registerkarte enthält Details zu Lese-/Schreiboperationen und Cache-Statistiken.

9.2 Verwalten von Object-Gateway-Benutzern #

Mit › erhalten Sie eine Liste der vorhandenen Object-Gateway-Benutzer.

Klicken Sie auf den Dropdown-Pfeil neben dem Benutzernamen, um Details zum Benutzerkonto anzuzeigen, wie zum Beispiel die Statusinformationen oder die Details zum Benutzer und zu den Bucket-Quoten.

9.2.1 Hinzufügen eines neuen Gateway-Benutzers #

Klicken Sie zum Hinzufügen eines neuen Gateway-Benutzers oben links in der Tabellenüberschrift auf . Geben Sie den Berechtigungsnachweis, Details zum S3-Schlüssel und die Benutzer- und Bucket-Quote ein und bestätigen Sie mit .

9.2.2 Löschen von Gateway-Benutzern #

Wählen und markieren Sie einen Gateway-Benutzer, den Sie löschen möchten. Klicken Sie auf die Dropdown-Schaltfläche neben und wählen Sie in der Liste aus, um das Benutzerkonto zu löschen. Aktivieren Sie das Kontrollkästchen und bestätigen Sie mit .

9.2.3 Bearbeiten von Gateway-Benutzerdetails #

Um Gateway-Benutzerdetails zu ändern, wählen Sie den Benutzer aus und markieren Sie ihn. Klicken Sie oben links in der Tabellenüberschrift auf .

Bearbeiten Sie die grundlegenden oder die zusätzlichen Benutzerinformationen, z. B. die Befähigungen, Schlüssel, Unterbenutzer und Kontingente. Bestätigen Sie mit .

Die Registerkarte enthält eine schreibgeschützte Liste der Gateway-Benutzer mit ihren Zugriffsschlüsseln und den geheimen Schlüsseln. Zum Abrufen der Schlüssel klicken Sie auf einen Benutzernamen in der Liste und dann oben links in der Tabellenüberschrift auf . Mit dem „Augensymbol“ im Dialogfeld blenden Sie die Schlüssel ein, mit dem Zwischenablagensymbol kopieren Sie den entsprechenden Schlüssel in die Zwischenablage.

9.3 Verwalten der Object-Gateway-Buckets #

Object Gateway(OGW)-Buckets setzen den Funktionsumfang von OpenStack-Swift-Containern um. Object-Gateway-Buckets fungieren als Container zum Speichern von Datenobjekten.

Klicken Sie auf › , um eine Liste der Object-Gateway-Buckets anzuzeigen.

9.3.1 Hinzufügen eines neuen Buckets #

Klicken Sie zum Hinzufügen eines neuen Object-Gateway-Buckets oben links in der Tabellenüberschrift auf . Geben Sie den Namen des Buckets ein, wählen Sie den Inhaber aus und legen Sie das Platzierungsziel fest. Bestätigen Sie mit .

In dieser Phase können Sie durch Auswahl von eine Sperre aktivieren. Sie können dies jedoch auch noch nach der Erstellung konfigurieren. Weitere Informationen zu diesem Thema finden Sie in Abschnitt 9.3.3, „Bearbeiten des Buckets“.

9.3.2 Anzeigen der Bucket-Details #

Klicken Sie auf den Dropdown-Pfeil neben dem Bucket-Namen, um detaillierte Informationen zu einem Object-Gateway-Bucket anzuzeigen.

Unterhalb der Tabelle werden Details zu den Bucket-Quoteneinstellungen angezeigt.

9.3.3 Bearbeiten des Buckets #

Wählen und markieren Sie einen Bucket und klicken Sie dann oben links in der Tabellenüberschrift auf .

Sie können den Inhaber des Buckets aktualisieren oder die Versionierung, die Multi-Faktor-Authentifizierung oder die Sperre aktivieren. Bestätigen Sie alle Änderungen mit .

9.3.4 Löschen eines Buckets #

Wählen und markieren Sie den Object-Gateway-Bucket, den Sie löschen möchten. Klicken Sie auf die Dropdown-Schaltfläche neben und wählen Sie in der Liste aus, um den Bucket zu löschen. Aktivieren Sie das Kontrollkästchen und bestätigen Sie mit .

10 Manuelle Konfiguration #

In diesem Abschnitt erhalten Sie erweiterte Informationen für Benutzer, die die Dashboard-Einstellungen manuell über die Kommandozeile konfigurieren möchten.

10.1 Konfigurieren der TLS/SSL-Unterstützung #

Alle HTTP-Verbindungen zum Dashboard werden standardmäßig mit TLS/SSL gesichert. Für eine sichere Verbindung ist ein SSL-Zertifikat erforderlich. Sie können entweder ein eigensigniertes Zertifikat verwenden oder ein Zertifikat erzeugen und durch eine bekannte Zertifizierungsstelle (CA) signieren lassen.

Unter Umständen muss die SSL-Unterstützung deaktiviert werden. Dies ist beispielsweise der Fall, wenn das Dashboard hinter einem Proxy ausgeführt wird, der SSL nicht unterstützt.

Deaktivieren Sie SSL nur mit Bedacht, da die Benutzernamen und Passwörter damit unverschlüsselt an das Dashboard gesendet werden.

Mit folgendem Kommando deaktivieren Sie SSL:

cephuser@adm > ceph config set mgr mgr/dashboard/ssl falseDie Ceph-Manager-Prozesse müssen nach einer Änderung des SSL-Zertifikats und des Schlüssels manuell neu gestartet werden. Führen Sie hierzu entweder das folgende Kommando aus:

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAMEoder deaktivieren Sie das Dashboard-Modul und aktivieren Sie es wieder, wodurch auch der Manager sich selbst wieder neu erzeugt:

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 Erstellen von eigensignierten Zertifikaten #

Ein eigensigniertes Zertifikat für die sichere Kommunikation lässt sich schnell und einfach erstellen. So bringen Sie das Dashboard rasch in Gang.

Die meisten Webbrowser geben bei selbstsignierten Zertifikaten eine Fehlermeldung aus und fordern eine explizite Bestätigung, bevor eine sichere Verbindung zum Dashboard hergestellt wird.

Mit dem folgenden integrierten Kommando erzeugen und installieren Sie ein selbstsigniertes Zertifikat:

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 Verwenden von Zertifikaten, die von einer Zertifizierungsstelle signiert wurden #

Damit die Verbindung zum Dashboard ordnungsgemäß gesichert wird und Webbrowser-Fehlermeldungen zu selbstsignierten Zertifikaten unterbunden werden, wird empfohlen, ein Zertifikat zu verwenden, das von einer CA signiert ist.

Mit einem Kommando wie im folgenden Beispiel erzeugen Sie ein Zertifikat-Schlüsselpaar:

root # openssl req -new -nodes -x509 \

-subj "/O=IT/CN=ceph-mgr-dashboard" -days 3650 \

-keyout dashboard.key -out dashboard.crt -extensions v3_ca

Das obige Kommando gibt die Dateien dashboard.key und dashboard.crt aus. Sobald die Datei dashboard.crt von einer CA signiert wurde, aktivieren Sie es mit dem folgenden Kommando für alle Ceph-Manager-Instanzen:

cephuser@adm >ceph config-key set mgr/dashboard/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/key -i dashboard.key

Wenn Sie unterschiedliche Zertifikate für die einzelnen Ceph-Manager-Instanzen benötigen, bearbeiten Sie die Kommandos und geben Sie den Namen der Instanz wie folgt an. Ersetzen Sie NAME durch den Namen der Ceph-Manager-Instanz (in der Regel der zugehörige Hostname):

cephuser@adm >ceph config-key set mgr/dashboard/NAME/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/NAME/key -i dashboard.key

10.2 Ändern des Hostnamens und der Portnummer #

Ceph Dashboard bindet an eine bestimmte TCP/IP-Adresse und an einen bestimmten TCP-Port. Standardmäßig bindet der derzeit aktive Ceph Manager, auf dem das Dashboard gehostet wird, an den TCP-Port 8443 (oder 8080, wenn SSL deaktiviert ist).

Wenn auf den Hosts, auf denen Ceph Manager (und damit Ceph Dashboard) ausgeführt wird, eine Firewall aktiviert ist, müssen Sie möglicherweise die Konfiguration ändern, um den Zugriff auf diese Ports zu ermöglichen. Weitere Informationen zu den Firewall-Einstellungen für Ceph finden Sie im Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”.

Ceph Dashboard bindet standardmäßig an „::“, was allen verfügbaren IPv4- und IPv6-Adressen entspricht. Mit folgenden Kommandos können Sie die IP-Adresse und die Portnummer der Webanwendung ändern, sodass sie für alle Ceph-Manager-Instanzen gelten:

cephuser@adm >ceph config set mgr mgr/dashboard/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/server_port PORT_NUMBER

Auf jedem ceph-mgr-Daemon wird eine eigene Dashboard-Instanz gehostet; unter Umständen müssen diese Instanzen daher separat konfiguriert werden. Mit folgenden Kommandos ändern Sie die IP-Adresse und die Portnummer für eine bestimmte Manager-Instanz (ersetzen Sie NAME mit der ID der ceph-mgr-Instanz):

cephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_port PORT_NUMBER