- Acerca de esta guía

- I Ceph Dashboard

- 1 Acerca de Ceph Dashboard

- 2 Interfaz de usuario Web de la consola

- 3 Gestión de usuarios y funciones de Ceph Dashboard

- 4 Visualización de elementos internos del clúster

- 4.1 Visualización de nodos de clúster

- 4.2 Acceso al inventario del clúster

- 4.3 Visualización de monitores Ceph Monitor

- 4.4 Visualización de servicios

- 4.5 Visualización de los OSD de Ceph

- 4.6 Visualización de la configuración del clúster

- 4.7 Visualización del mapa de CRUSH

- 4.8 Visualización de módulos del gestor

- 4.9 Visualización de registros

- 4.10 Visualización de la supervisión

- 5 Gestión de repositorios

- 6 Gestión de dispositivos de bloques RADOS

- 7 Gestión de NFS Ganesha

- 8 Gestión de CephFS

- 9 Gestión de Object Gateway

- 10 Configuración manual

- 11 Gestión de usuarios y funciones en la línea de comandos

- II Operación del clúster

- 12 Determinación del estado del clúster

- 12.1 Comprobación del estado de un clúster

- 12.2 Comprobación del estado del clúster

- 12.3 Comprobación de las estadísticas de uso de un clúster

- 12.4 Comprobación del estado de los OSD

- 12.5 Comprobación de OSD llenos

- 12.6 Comprobación del estado del monitor

- 12.7 Comprobación del estado de los grupos de colocación

- 12.8 Capacidad de almacenamiento

- 12.9 Supervisión de los OSD y los grupos de colocación

- 13 Tareas operativas

- 13.1 Modificación de la configuración del clúster

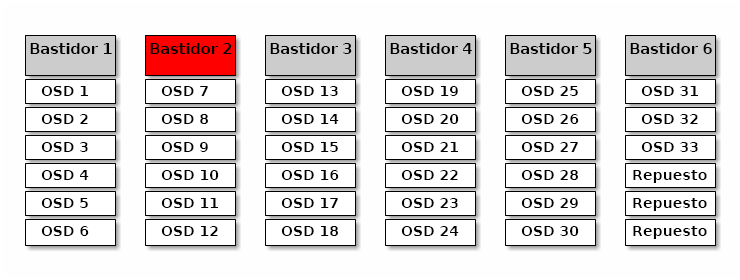

- 13.2 Adición de nodos

- 13.3 Eliminación de nodos

- 13.4 Gestión de OSD

- 13.5 Traslado del master de Salt a un nodo nuevo

- 13.6 Actualización de los nodos del clúster

- 13.7 Actualización de Ceph

- 13.8 Detención o reinicio del clúster

- 13.9 Eliminación de un clúster de Ceph completo

- 14 Funcionamiento de los servicios de Ceph

- 15 Copia de seguridad y recuperación

- 16 Supervisión y alertas

- 16.1 Configuración de imágenes personalizadas o locales

- 16.2 Actualización de los servicios de supervisión

- 16.3 Inhabilitación de la supervisión

- 16.4 Configuración de Grafana

- 16.5 Configuración del módulo de gestor de Prometheus

- 16.6 Modelo de seguridad de Prometheus

- 16.7 Receptor de alertas SNMP Alertmanager de Prometheus

- 12 Determinación del estado del clúster

- III Almacenamiento de datos en un clúster

- 17 Gestión de datos almacenados

- 18 Gestión de repositorios de almacenamiento

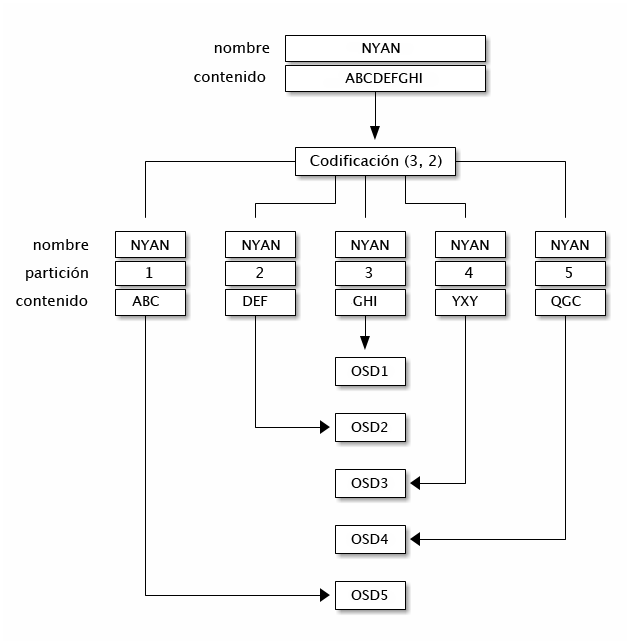

- 19 Repositorios codificados de borrado

- 20 Dispositivo de bloques RADOS

- 20.1 Comandos del dispositivo de bloques

- 20.2 Montaje y desmontaje

- 20.3 Instantáneas

- 20.4 Duplicados de imagen RBD

- 20.5 Ajustes de caché

- 20.6 Ajuste de QoS

- 20.7 Ajustes de lectura anticipada

- 20.8 Funciones avanzadas

- 20.9 Asignación del RBD utilizando clientes de kernel antiguos

- 20.10 Habilitación de dispositivos de bloques y Kubernetes

- IV Acceso a los datos del clúster

- 21 Ceph Object Gateway

- 21.1 Restricciones y limitaciones de denominación de Object Gateway

- 21.2 Distribución de Object Gateway

- 21.3 Funcionamiento del servicio de Object Gateway

- 21.4 Opciones de configuración

- 21.5 Gestión del acceso a Object Gateway

- 21.6 Procesadores frontales HTTP

- 21.7 Habilitación de HTTPS/SSL para pasarelas Object Gateway

- 21.8 Módulos de sincronización

- 21.9 Autenticación LDAP

- 21.10 Partición del índice de depósito

- 21.11 Integración con OpenStack Keystone

- 21.12 Colocación de repositorios y clases de almacenamiento

- 21.13 Pasarelas Object Gateway de varios sitios

- 22 Ceph iSCSI Gateway

- 23 Sistema de archivos en clúster

- 24 Exportación de datos de Ceph a través de Samba

- 25 NFS Ganesha

- 21 Ceph Object Gateway

- V Integración con herramientas de virtualización

- 26

libvirty Ceph - 27 Ceph como procesador final para la instancia de QEMU KVM

- 27.1 Instalación de

qemu-block-rbd - 27.2 Uso de QEMU

- 27.3 Creación de imágenes con QEMU

- 27.4 Cambio de tamaño de las imágenes con QEMU

- 27.5 Recuperación de información de la imagen con QEMU

- 27.6 Ejecución de QEMU con RBD

- 27.7 Habilitación de descartes y TRIM

- 27.8 Configuración de las opciones de caché de QEMU

- 27.1 Instalación de

- 26

- VI Configuración de un clúster

- A Actualizaciones de mantenimiento de Ceph basadas en versiones secundarias superiores de Octopus

- B Actualizaciones de la documentación

- Glosario

- 2.1 Pantalla de entrada a Ceph Dashboard

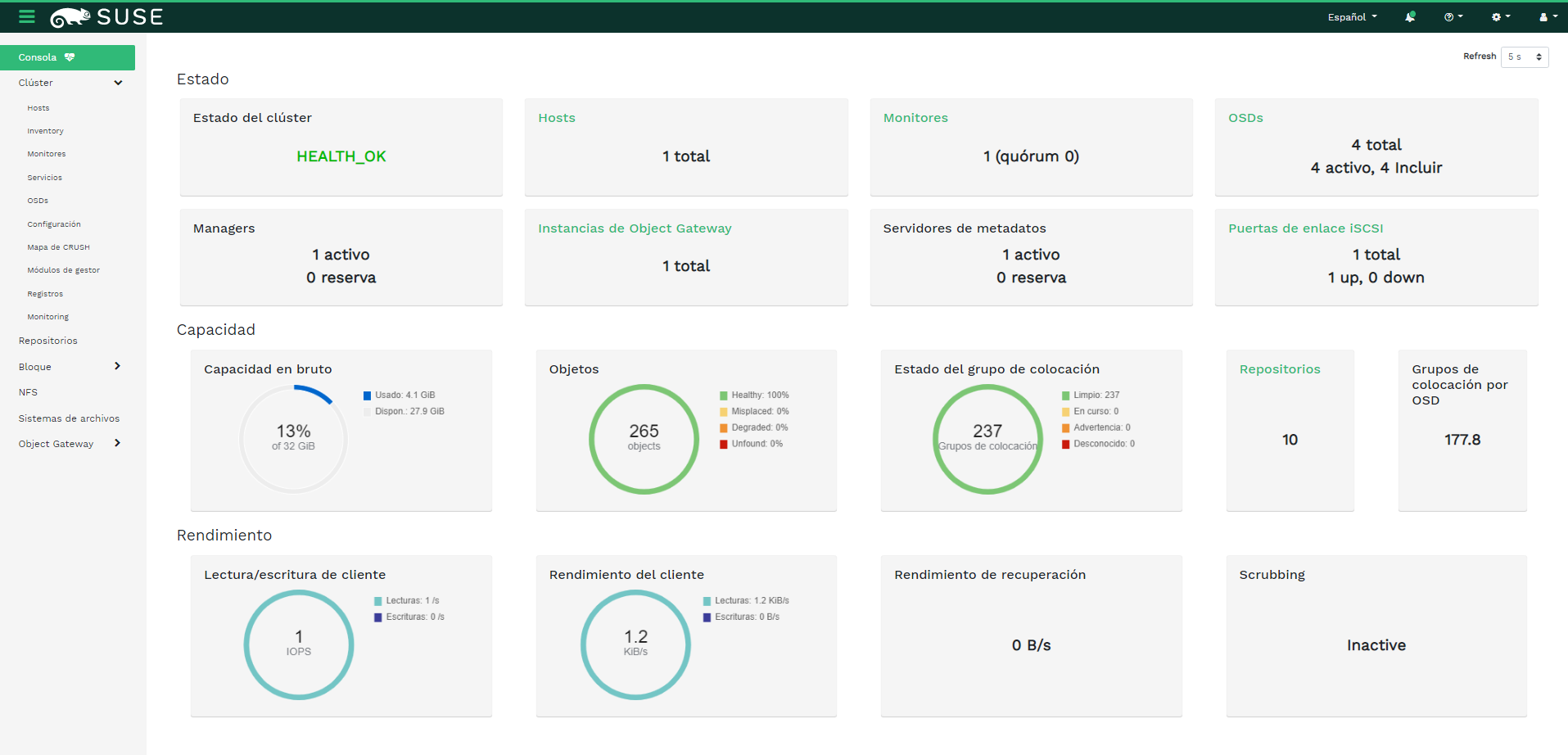

- 2.2 Página de inicio de Ceph Dashboard

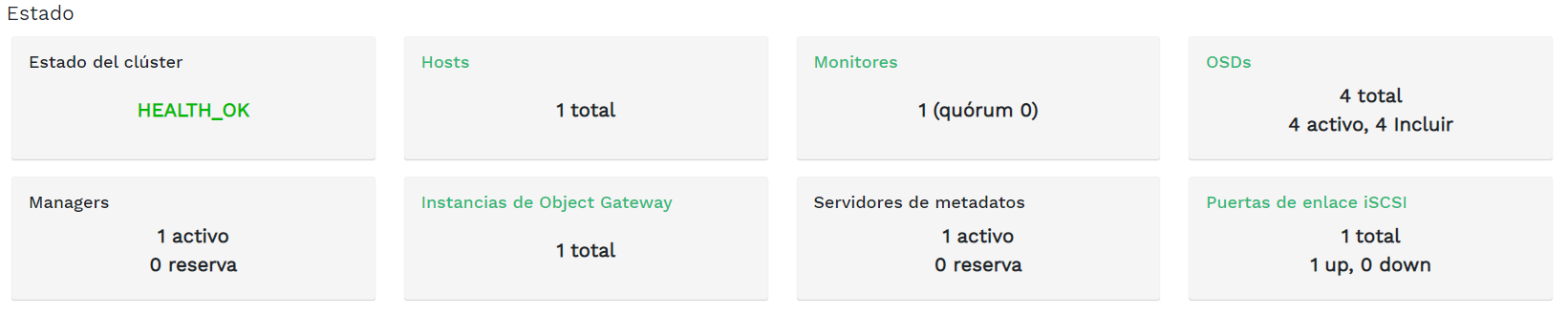

- 2.3 Widgets de Estado

- 2.4 Widgets de Capacidad

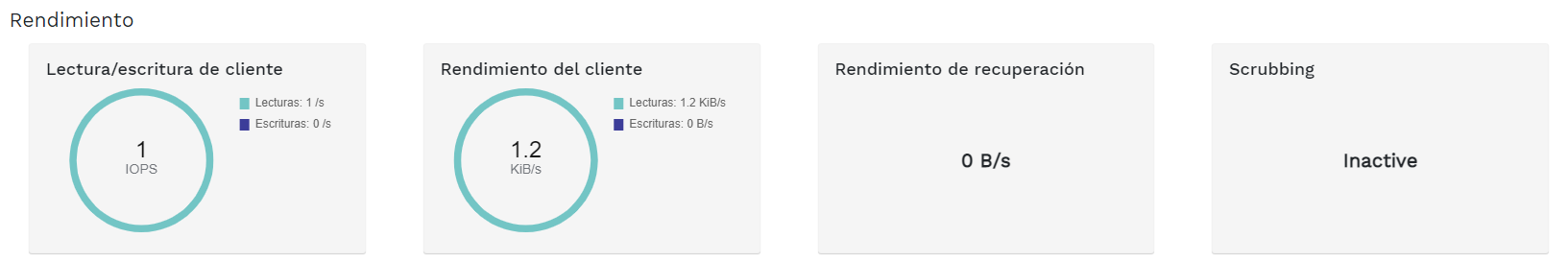

- 2.5 Widgets de Rendimiento

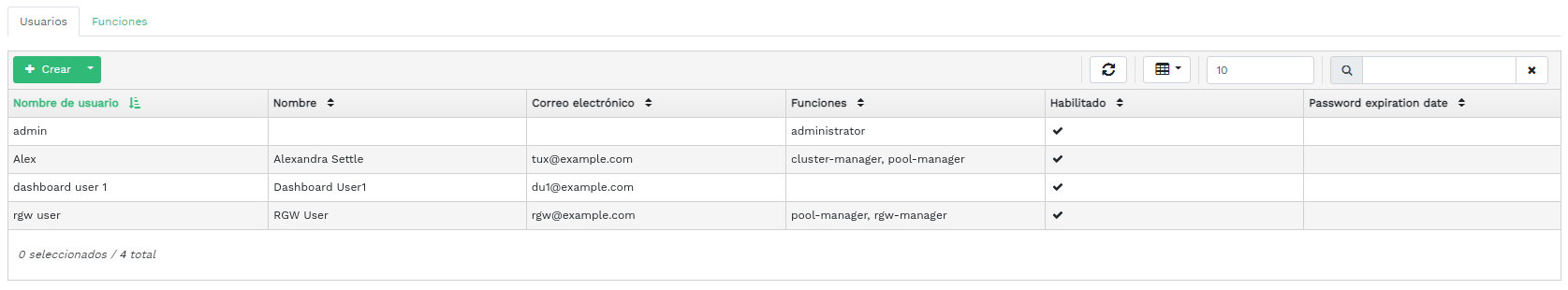

- 3.1 Gestión de usuarios

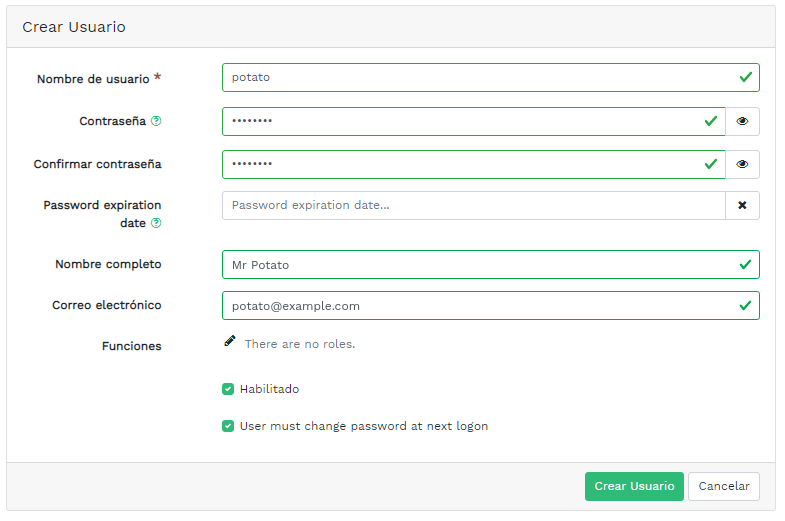

- 3.2 Adición de un usuario

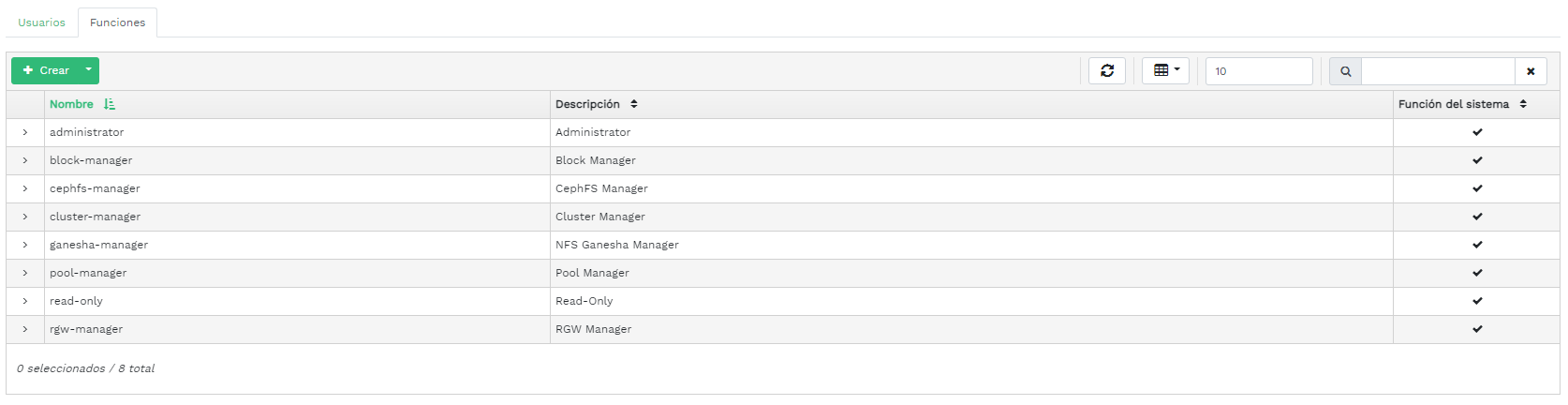

- 3.3 Funciones del usuario

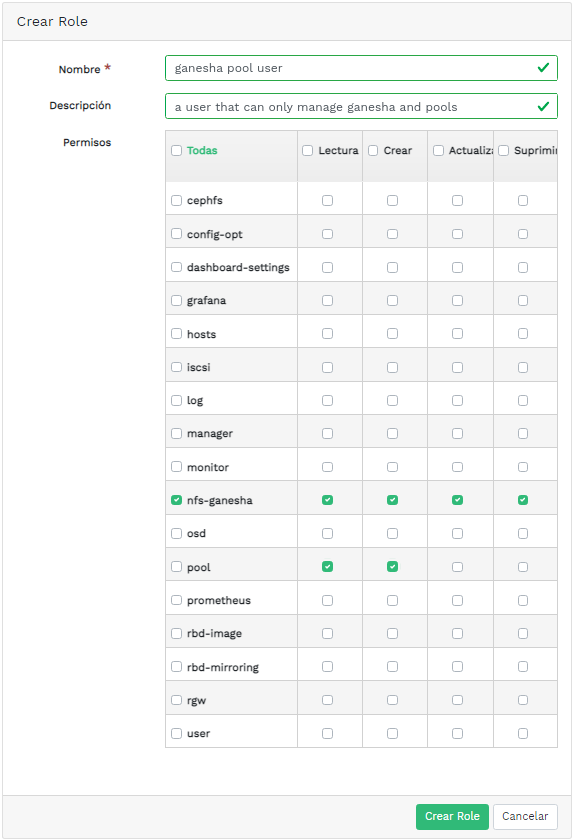

- 3.4 Adición de una función

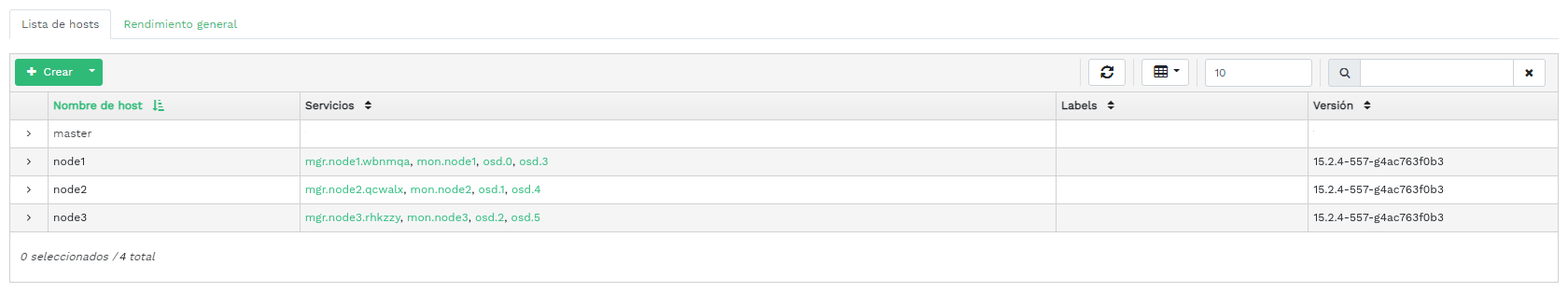

- 4.1 Hosts

- 4.2 Servicios

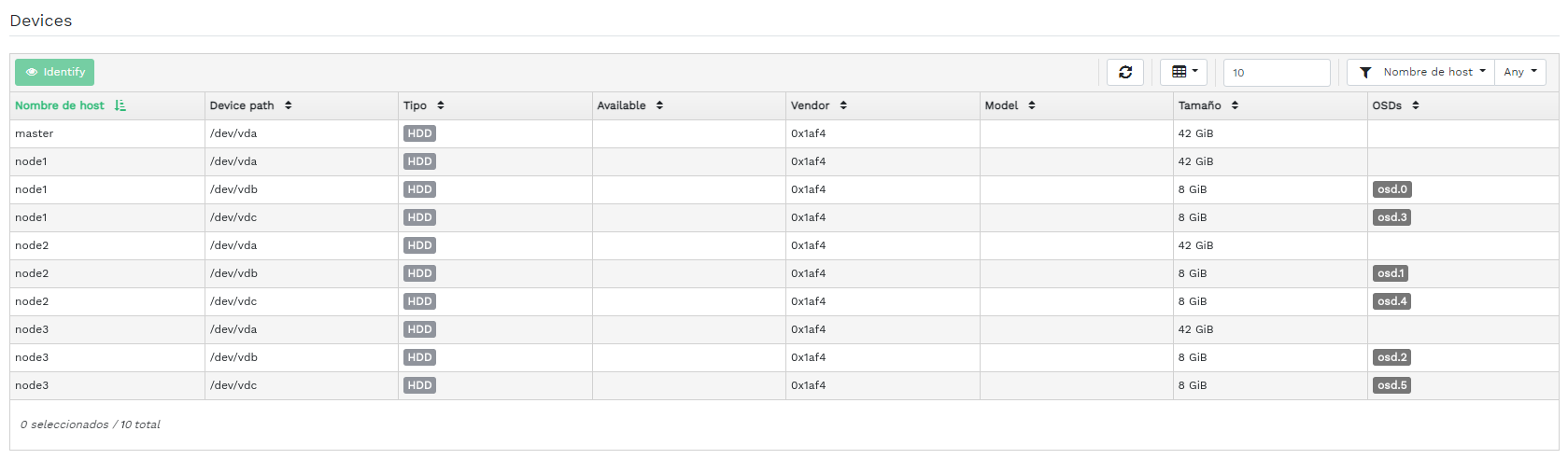

- 4.3 Monitores Ceph Monitor

- 4.4 Servicios

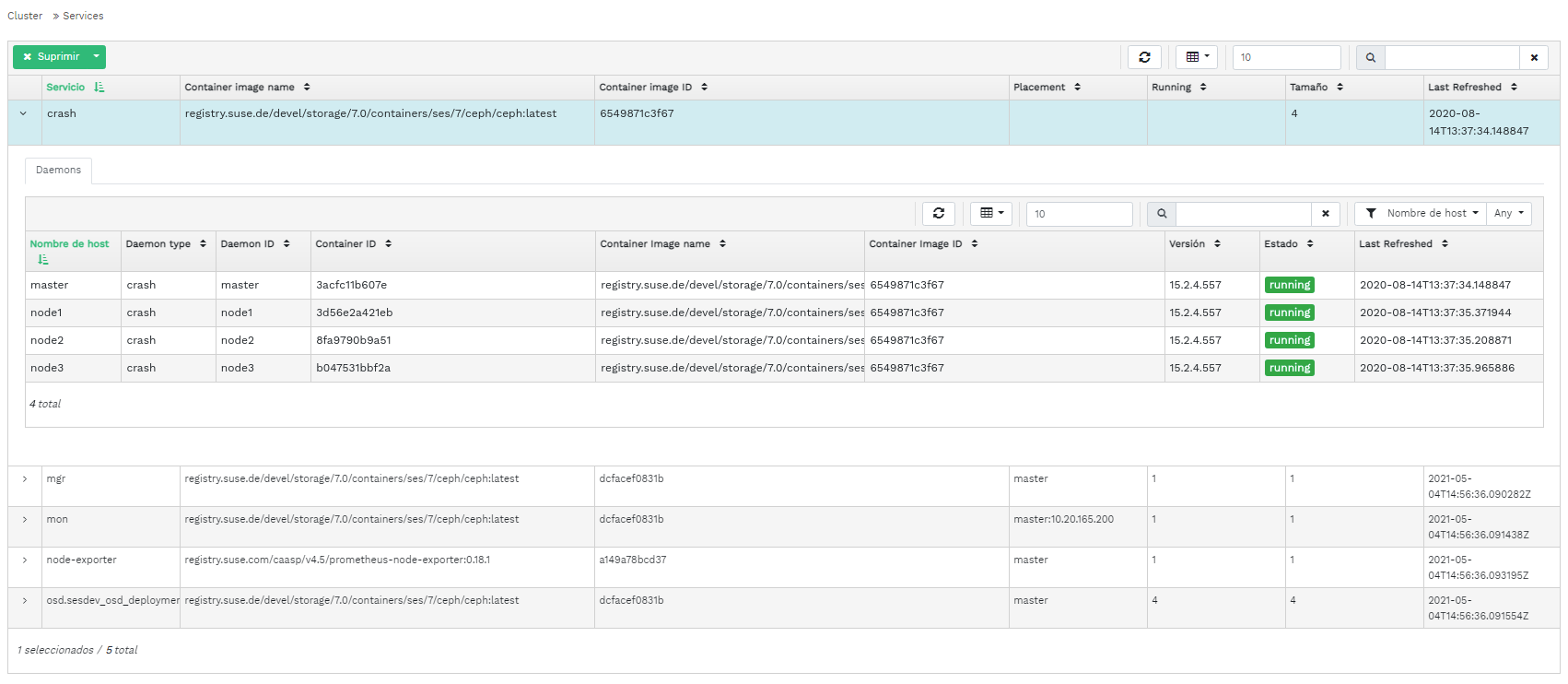

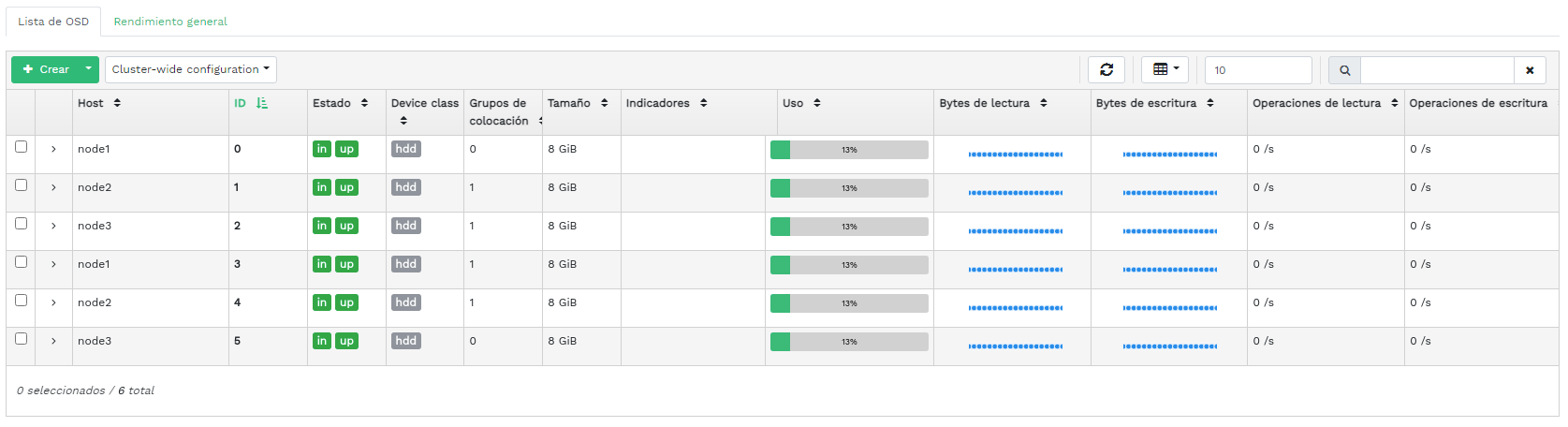

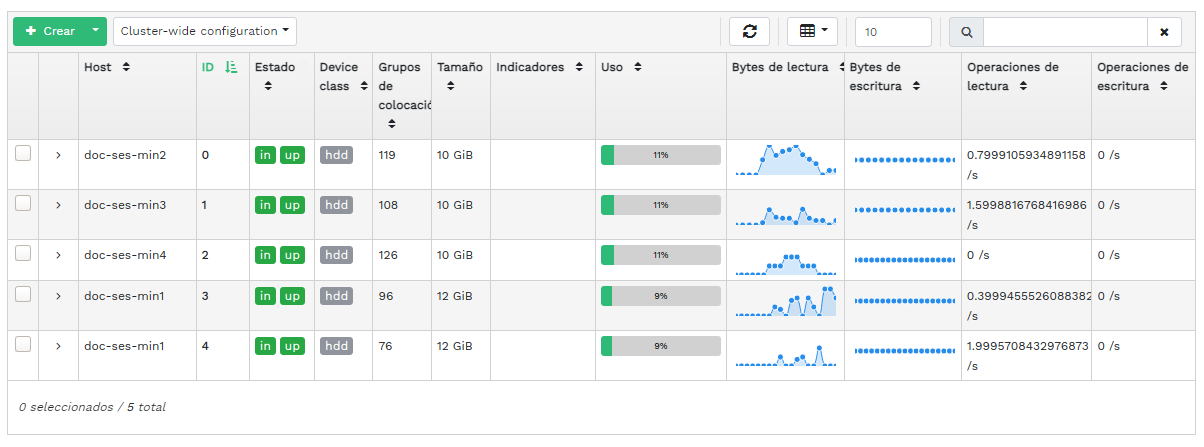

- 4.5 Daemons Ceph OSD

- 4.6 Indicadores de OSD

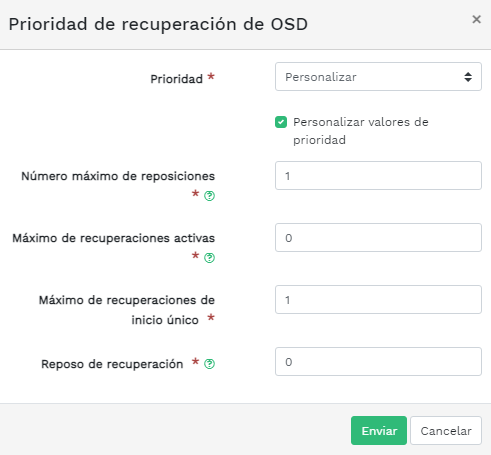

- 4.7 Prioridad de recuperación de OSD

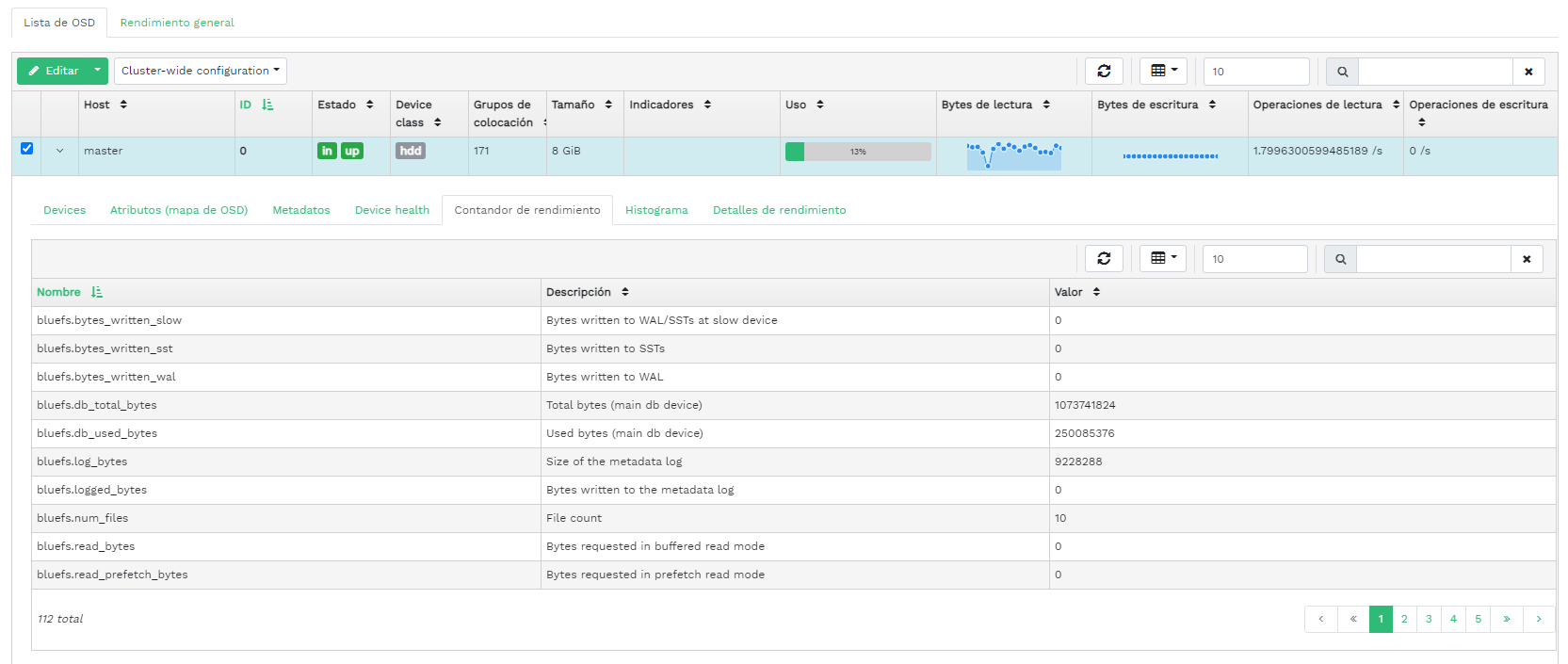

- 4.8 Detalles de OSD

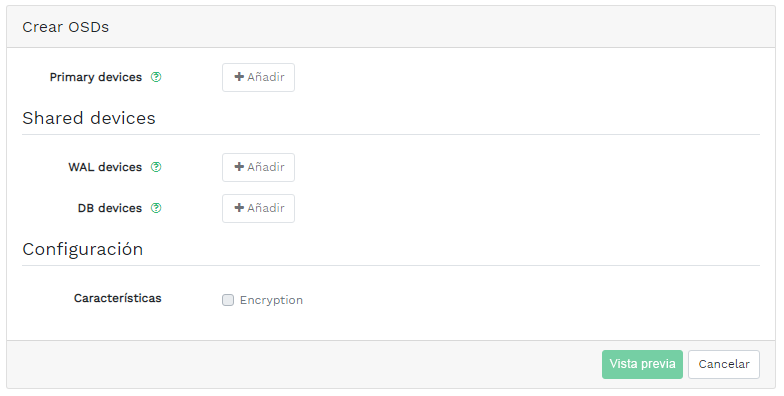

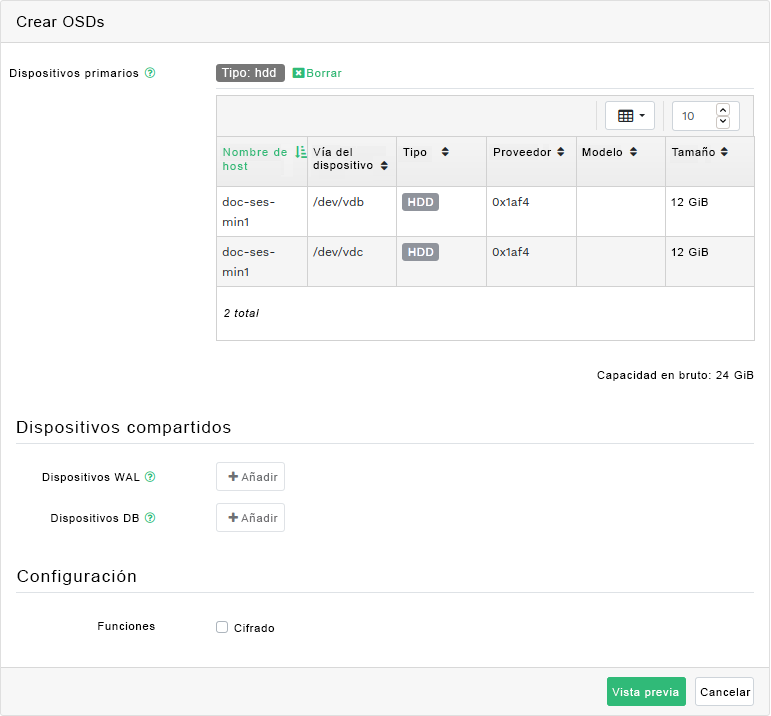

- 4.9 Crear OSDs

- 4.10 Adición de dispositivos primarios

- 4.11 Crear OSDs con dispositivos primarios añadidos

- 4.12

- 4.13 OSD recién añadidos

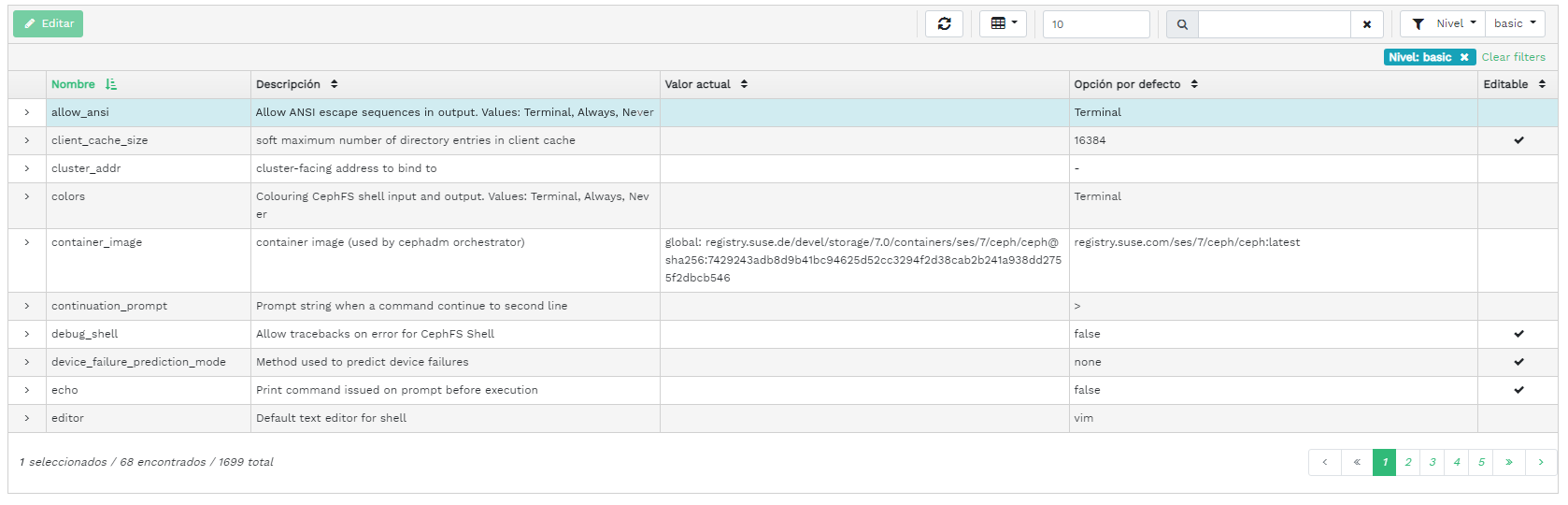

- 4.14 Configuración del clúster

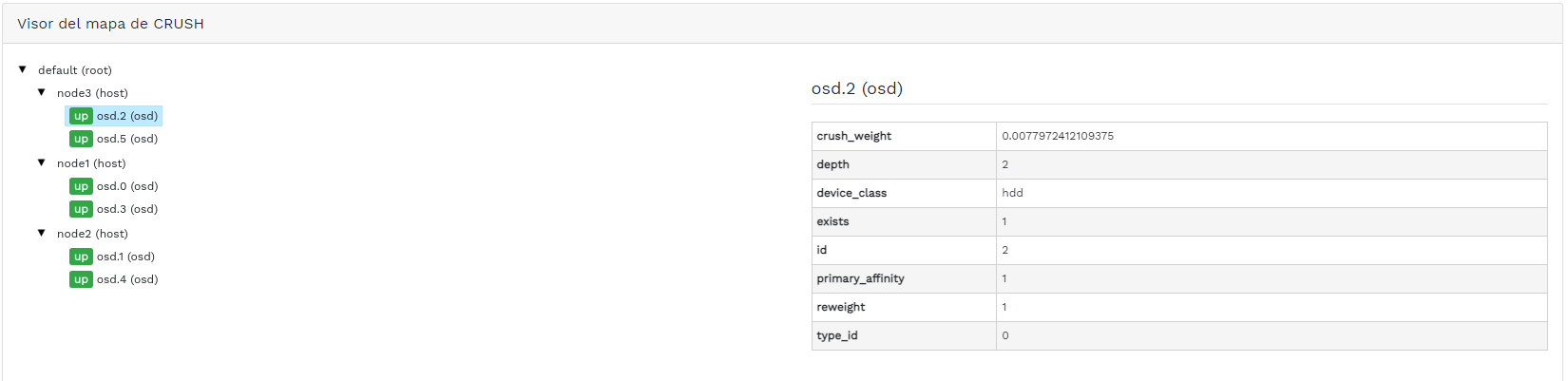

- 4.15 Mapa de CRUSH

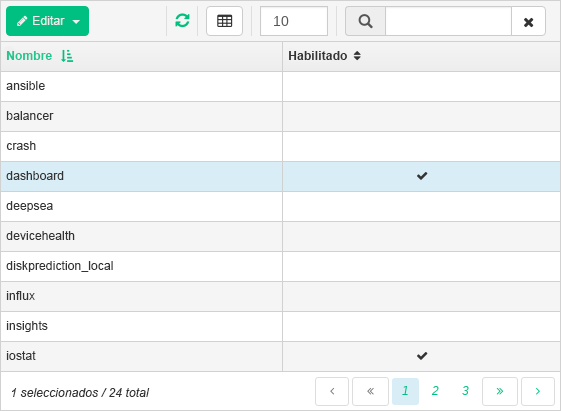

- 4.16 Módulos de gestor

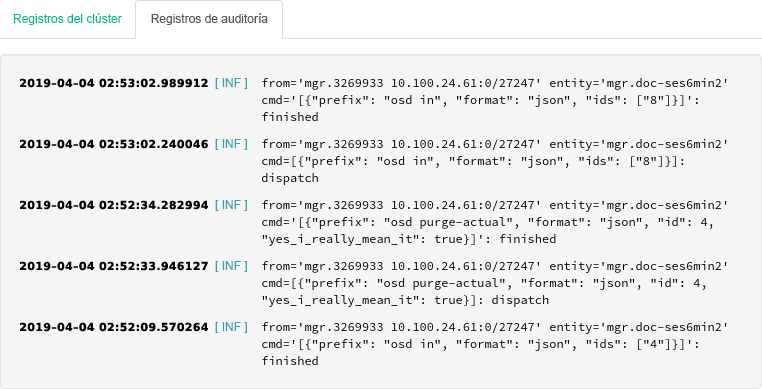

- 4.17 Registros

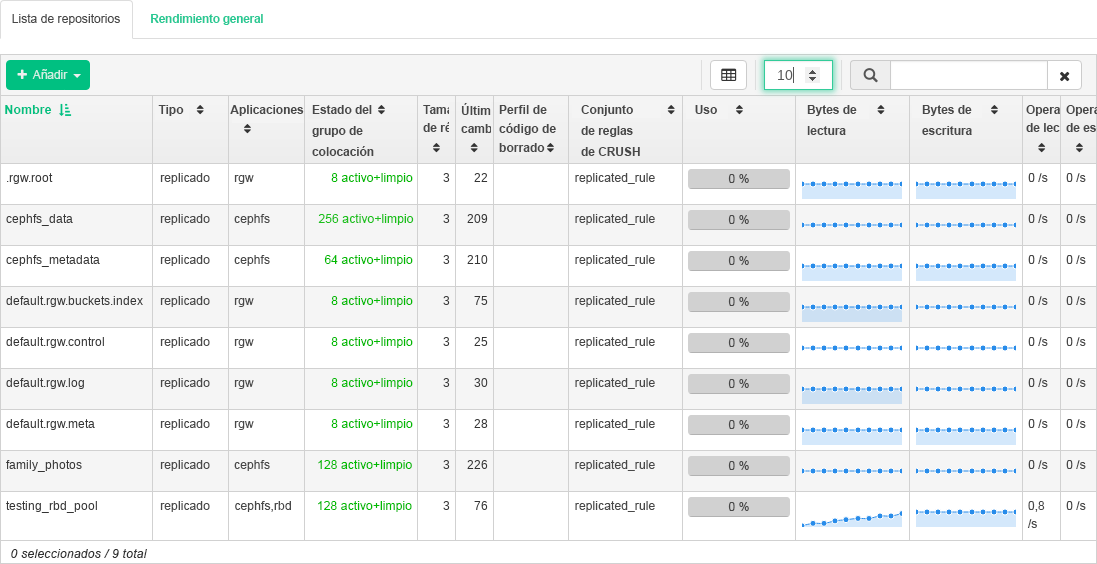

- 5.1 Lista de repositorios

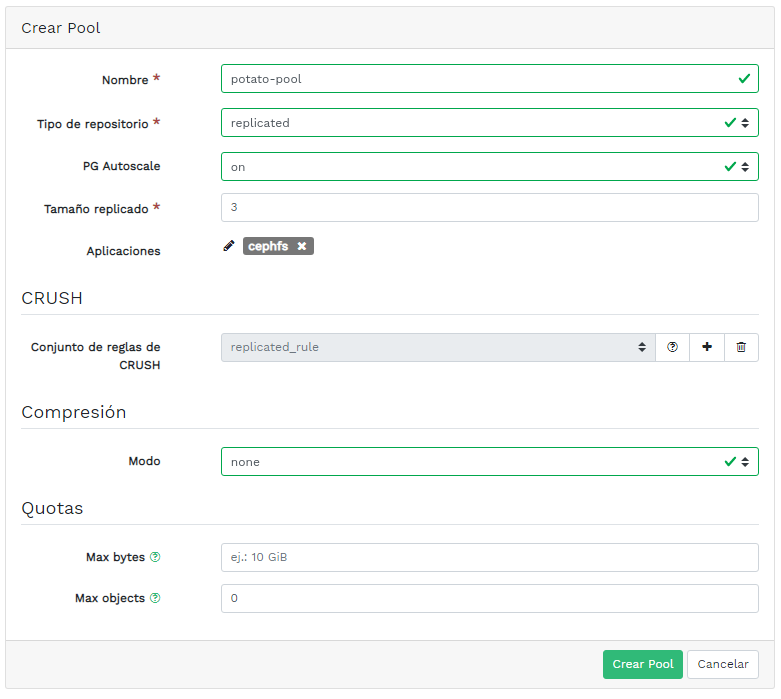

- 5.2 Adición de un repositorio nuevo

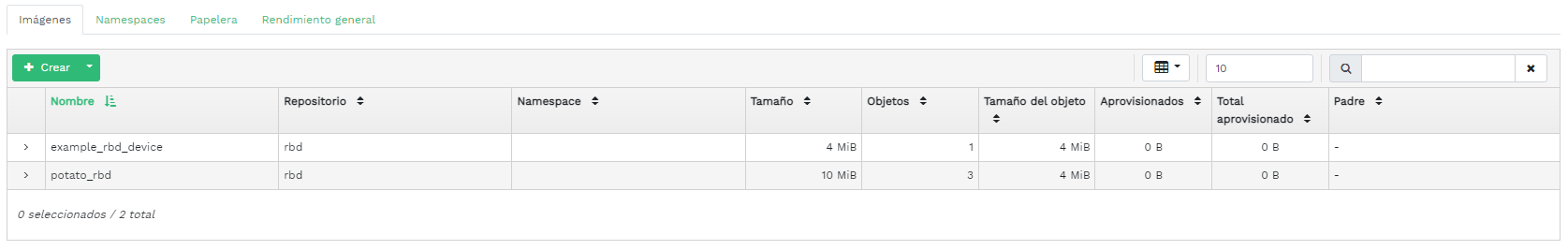

- 6.1 Lista de imágenes RBD

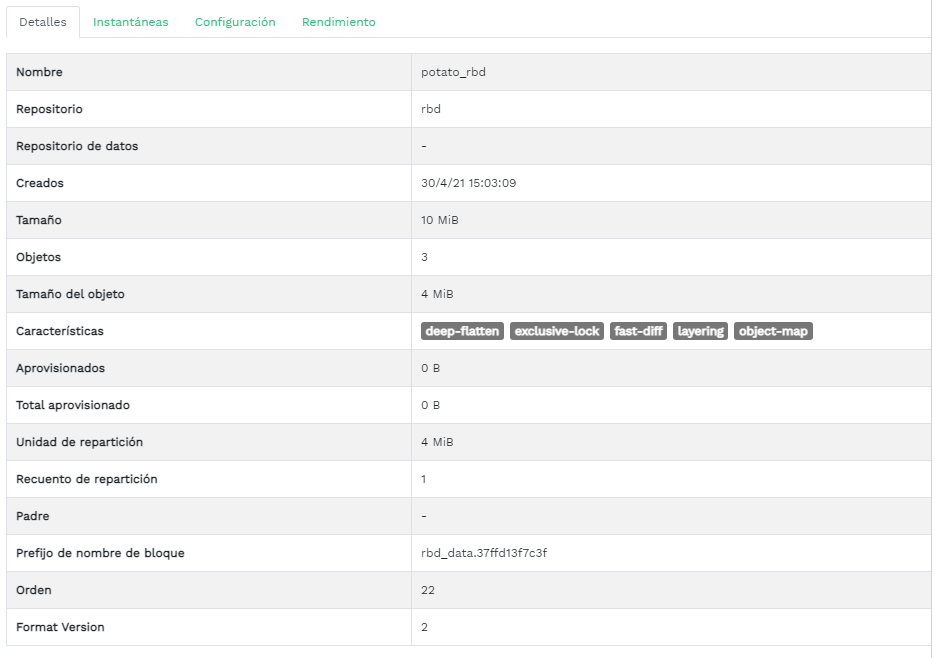

- 6.2 Detalles de RBD

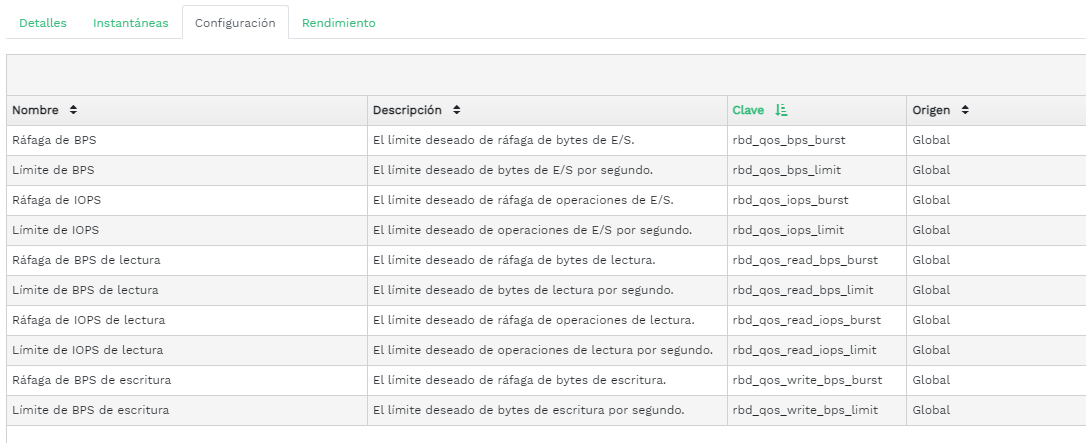

- 6.3 Configuración de RBD

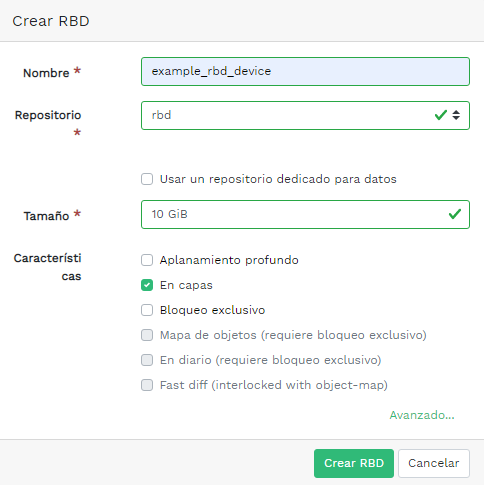

- 6.4 Adición de un RBD nuevo

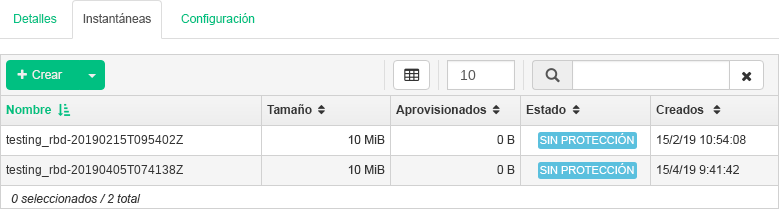

- 6.5 Instantáneas de RBD

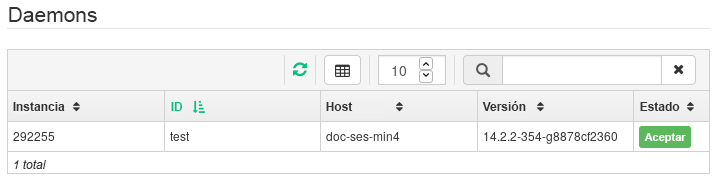

- 6.6 Ejecución de daemons

rbd-mirror - 6.7 Creación de un repositorio con la aplicación RBD

- 6.8 Configuración del modo de réplica

- 6.9 Adición de credenciales del par

- 6.10 Lista de repositorios replicados

- 6.11 Nueva imagen RBD

- 6.12 Nueva imagen RBD sincronizada

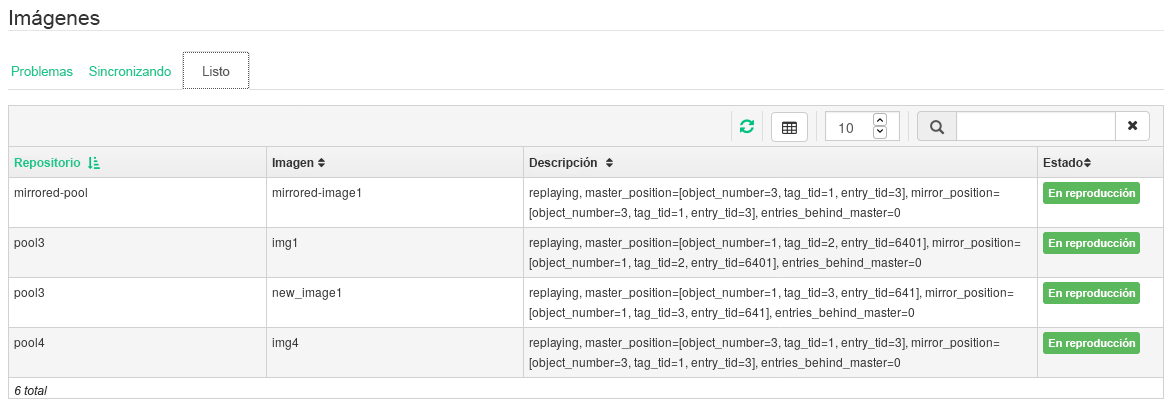

- 6.13 Estado de réplica de las imágenes RBD

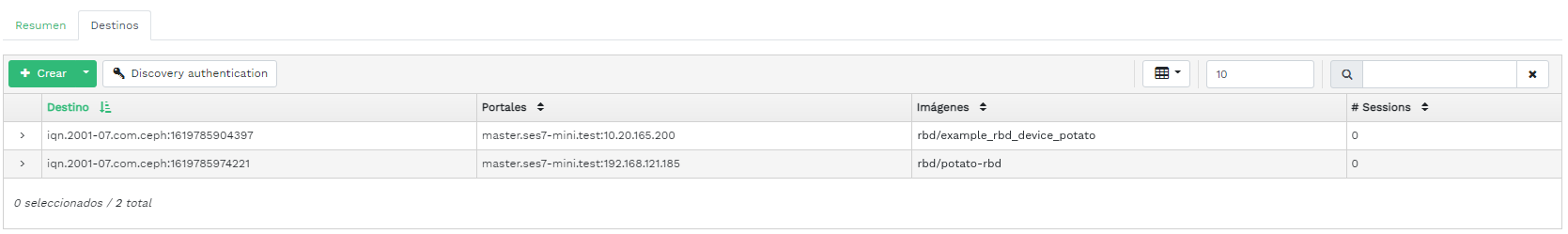

- 6.14 Lista de destinos iSCSI

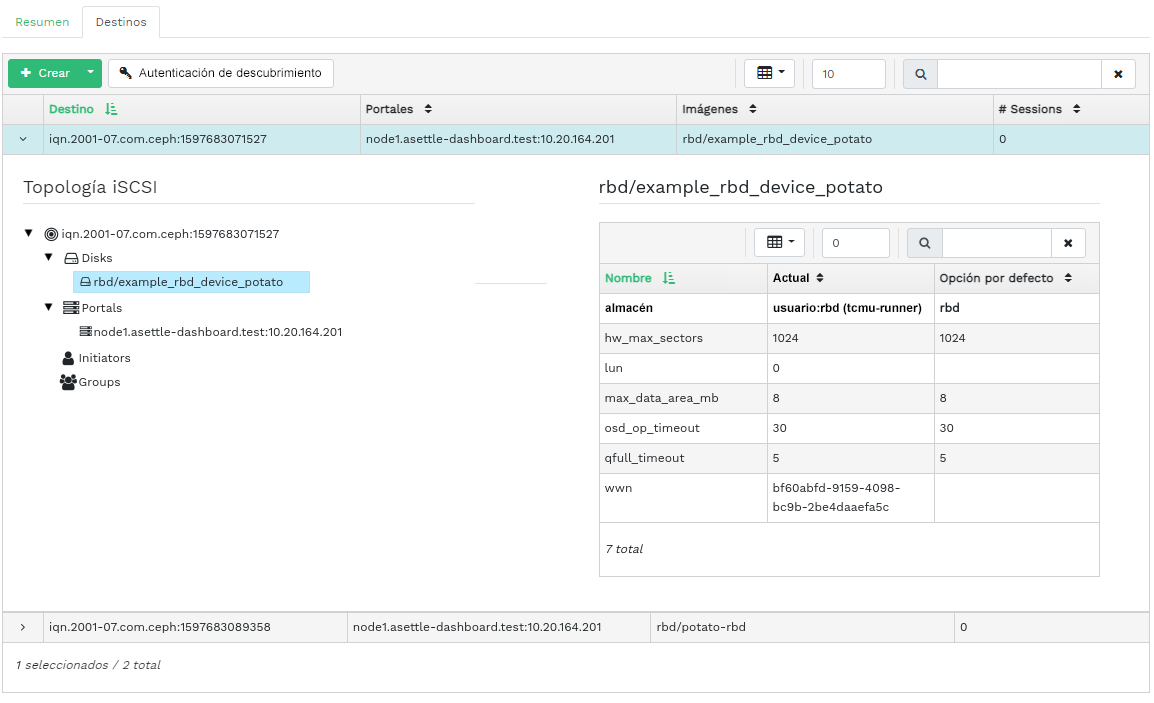

- 6.15 Detalles de destino iSCSI

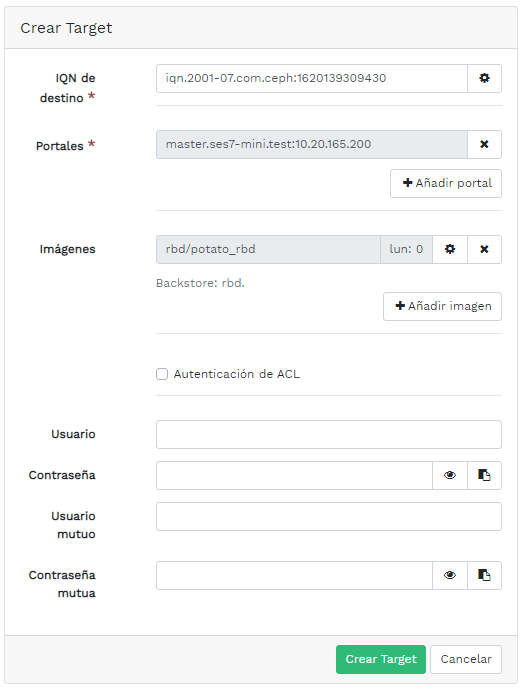

- 6.16 Adición de un destino nuevo

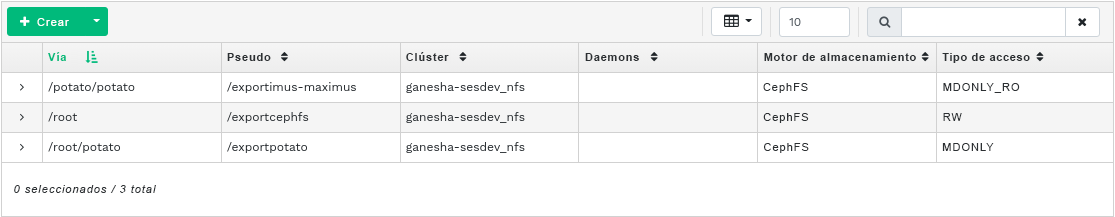

- 7.1 Lista de exportaciones NFS

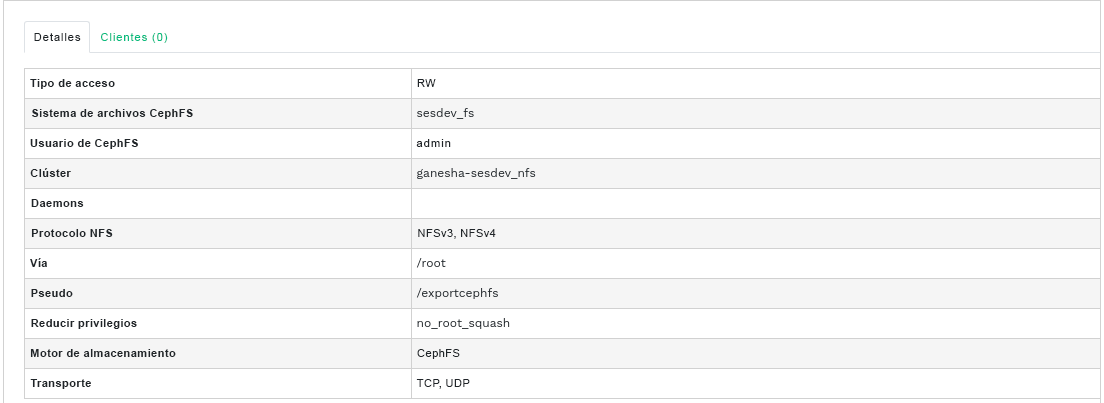

- 7.2 Detalles de la exportación NFS

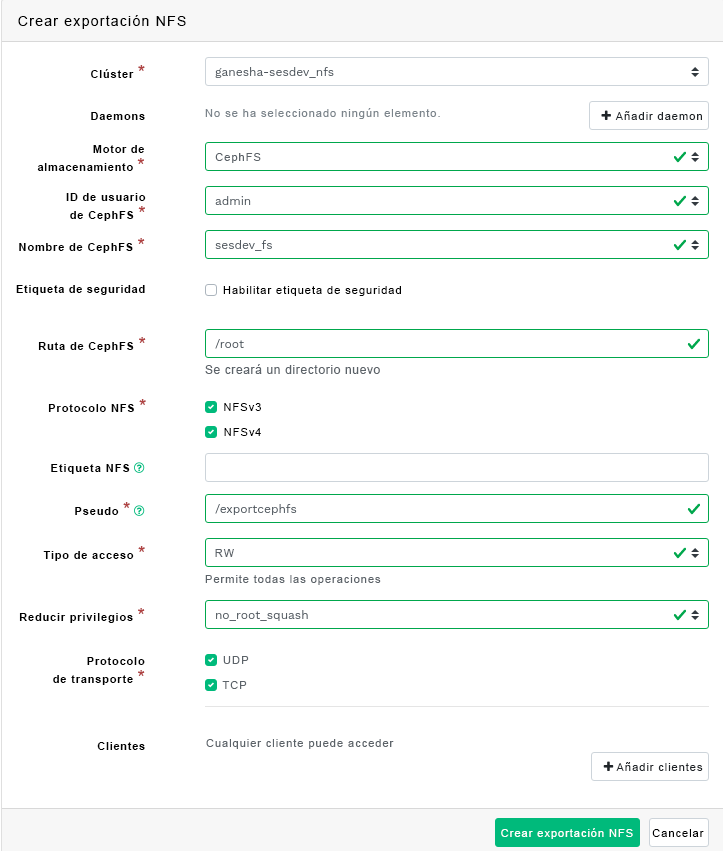

- 7.3 Adición de una exportación NFS nueva

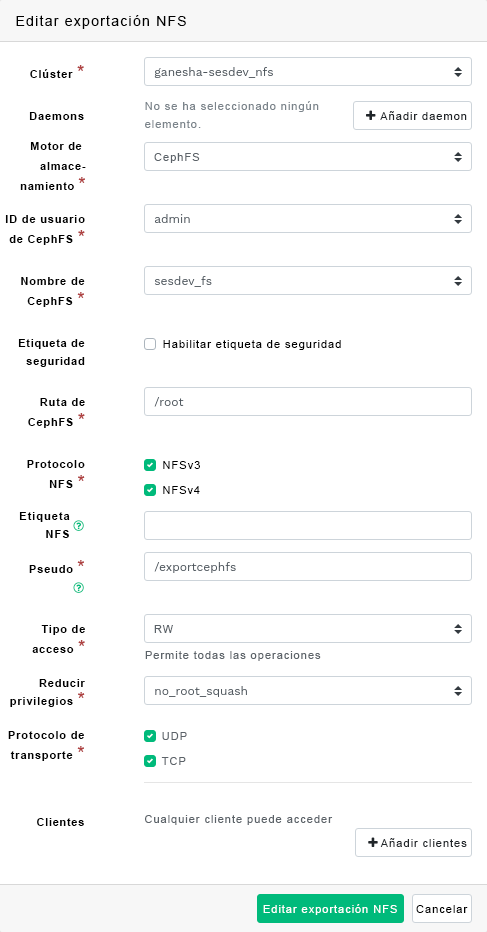

- 7.4 Edición de una exportación NFS

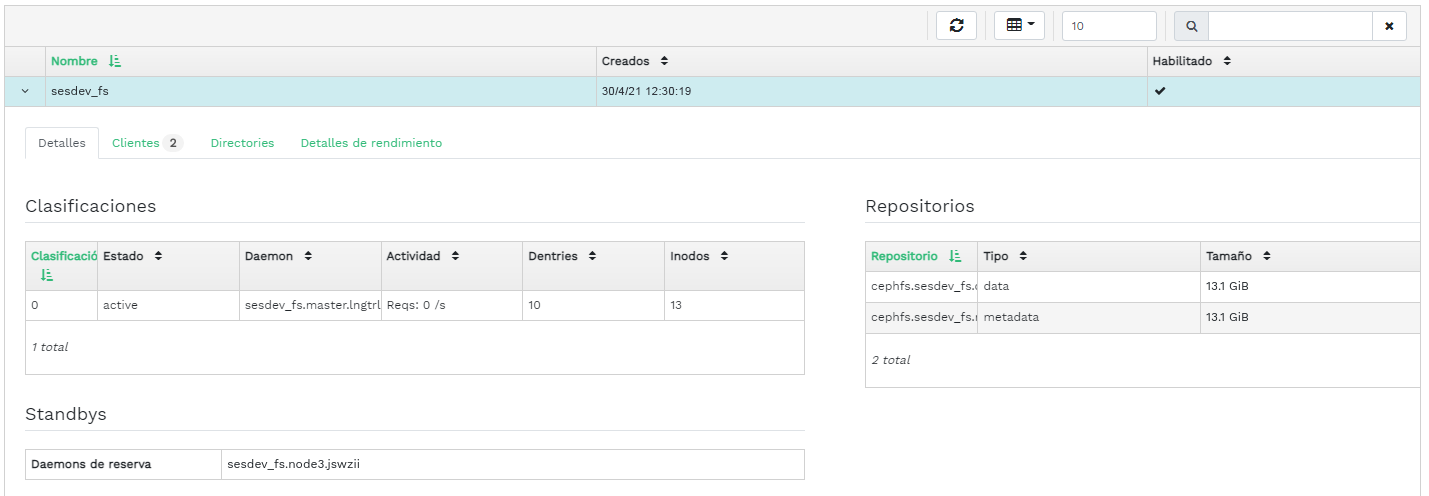

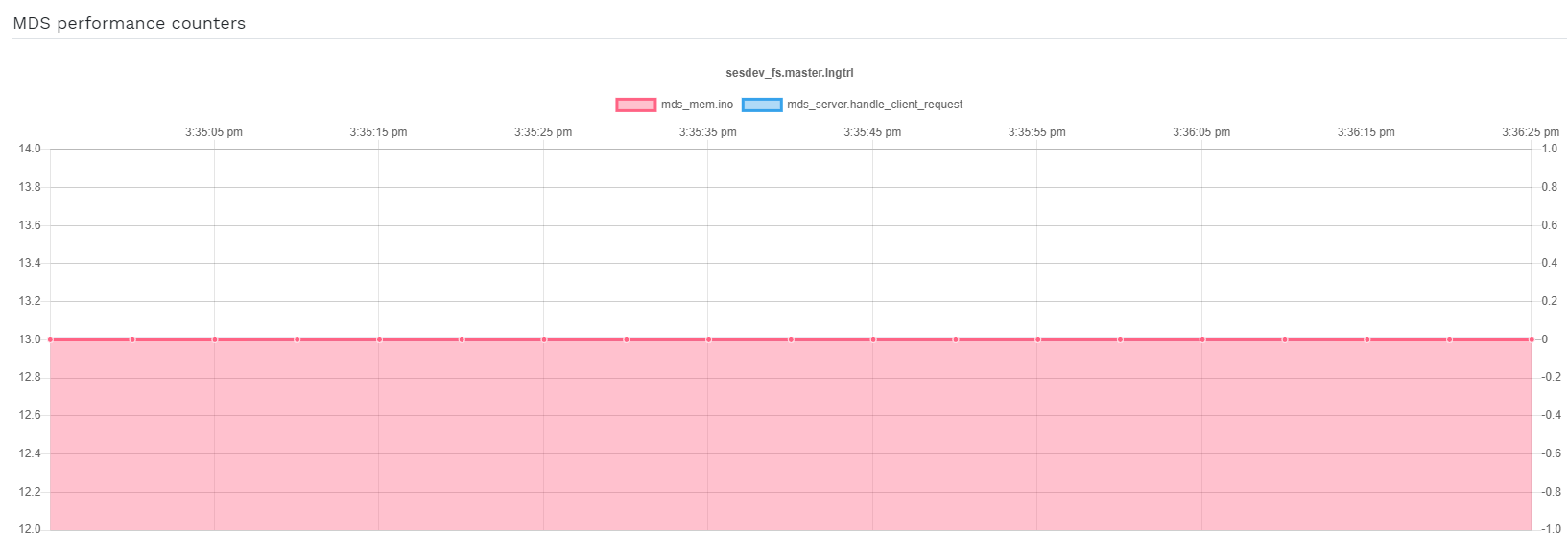

- 8.1 Detalles de CephFS

- 8.2 Detalles de CephFS

- 9.1 Detalles de la pasarela

- 9.2 Usuarios de pasarela

- 9.3 Adición de un nuevo usuario de pasarela

- 9.4 Detalles del depósito de pasarela

- 9.5 Edición de los detalles del depósito

- 12.1 Clúster de Ceph

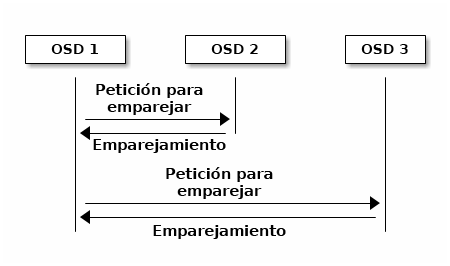

- 12.2 Esquema de emparejamiento

- 12.3 Estado de los grupos de colocación

- 17.1 OSDs con clases de dispositivos mixtos

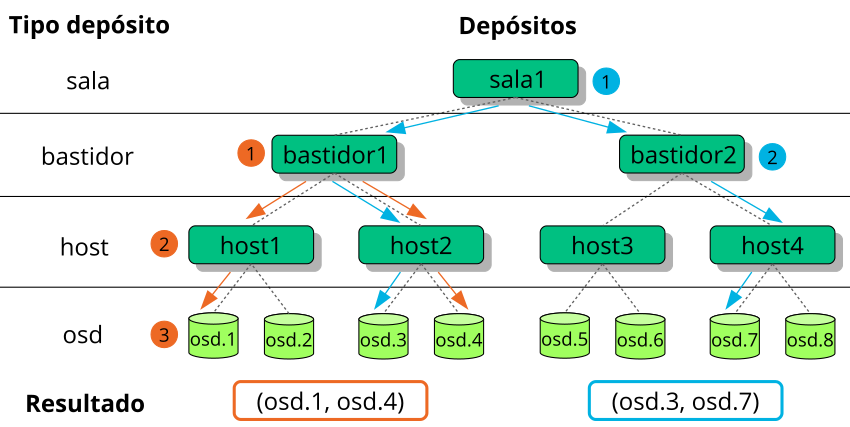

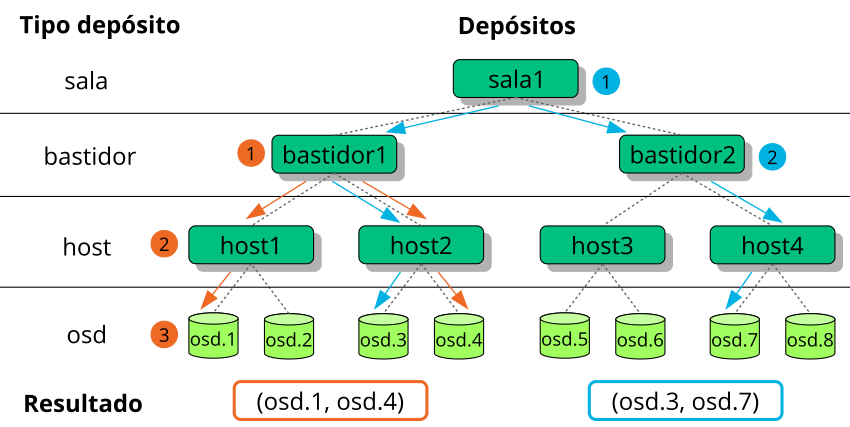

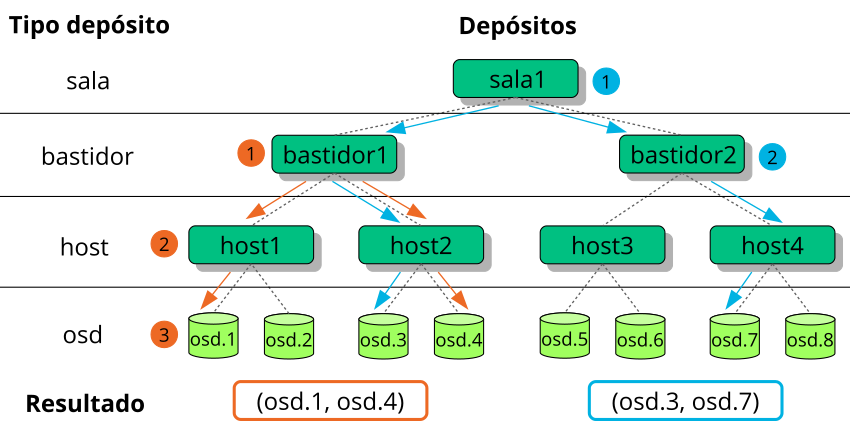

- 17.2 Árbol de ejemplo

- 17.3 Métodos de sustitución de nodos

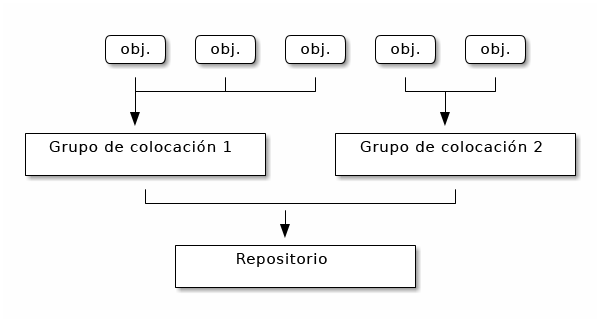

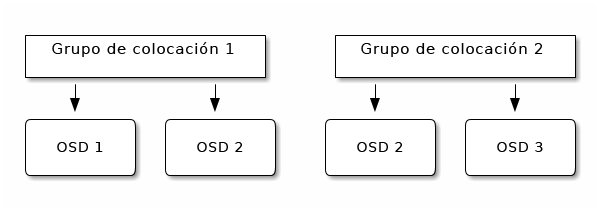

- 17.4 Grupos de colocación en un repositorio

- 17.5 Grupos de colocación y OSDs

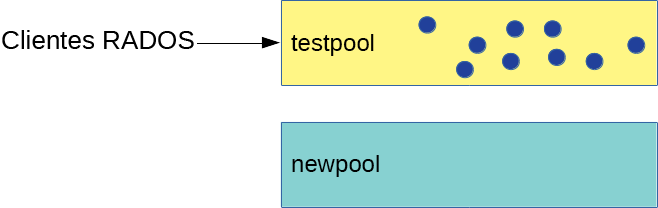

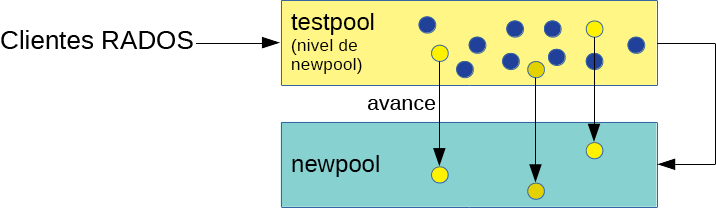

- 18.1 Repositorios antes de la migración

- 18.2 Configuración de los niveles de caché

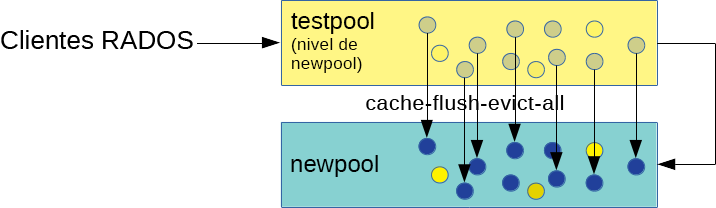

- 18.3 Limpieza de datos

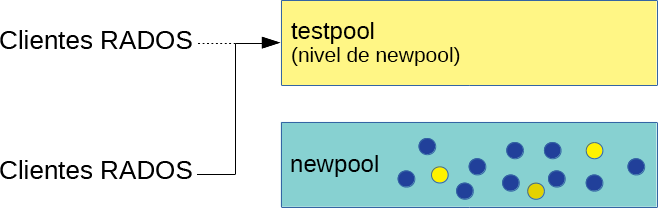

- 18.4 Configuración de la superposición

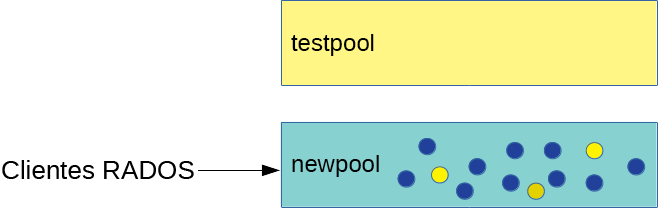

- 18.5 Migración completada

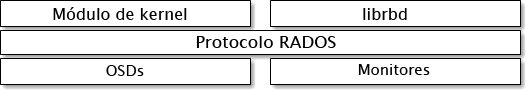

- 20.1 Protocolo RADOS

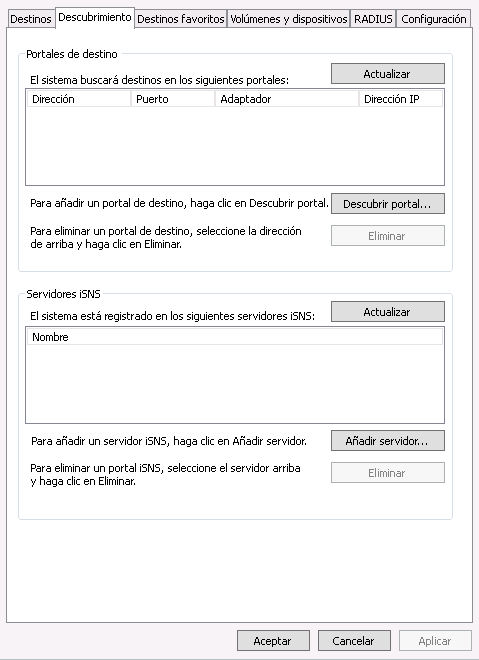

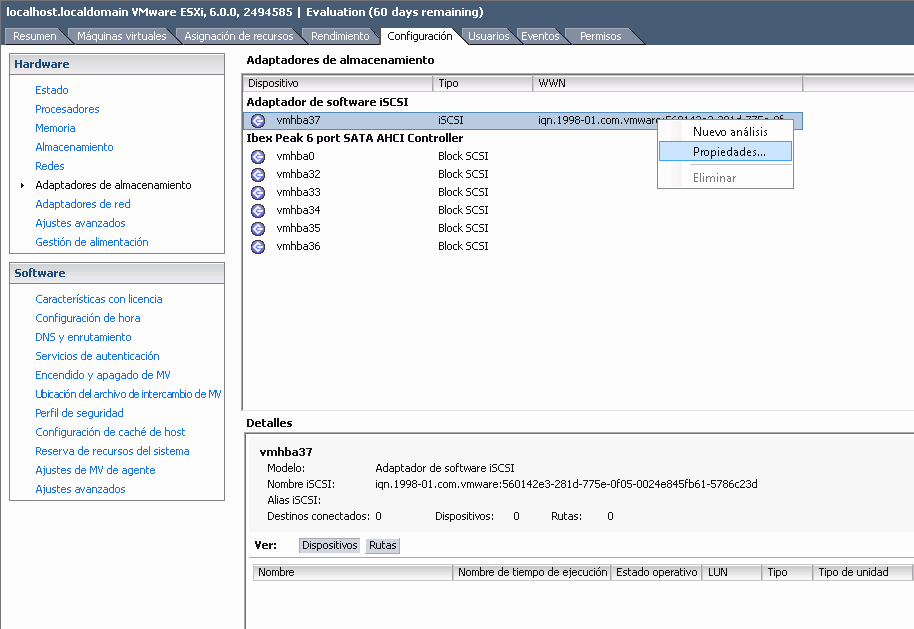

- 22.1 Propiedades del iniciador iSCSI

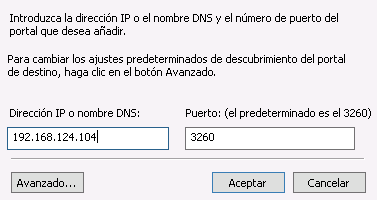

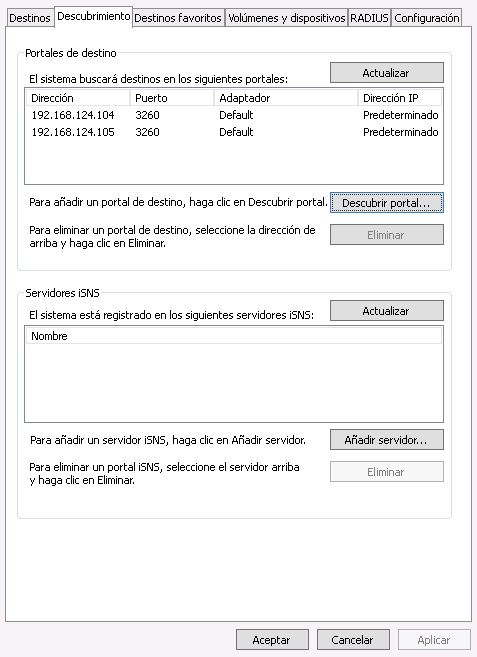

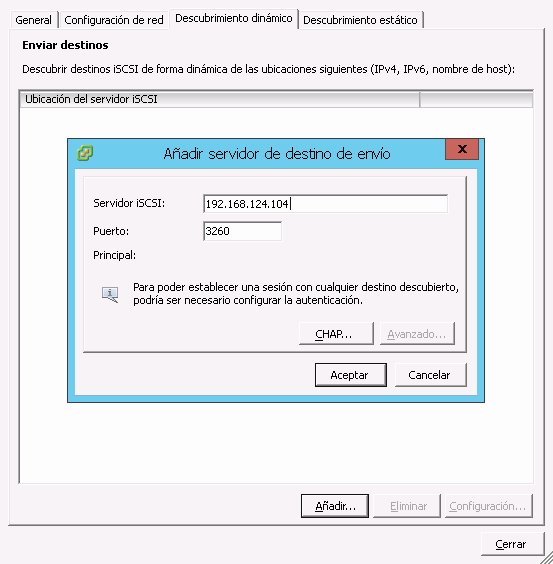

- 22.2 Descubrir portal de destino

- 22.3 Portales de destino

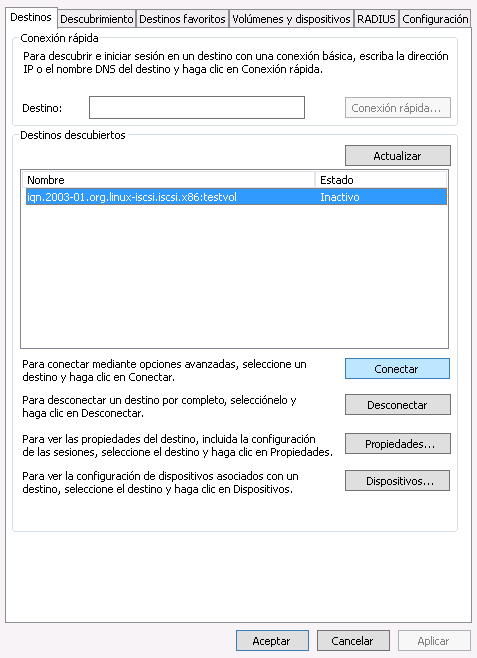

- 22.4 Destinos

- 22.5 Propiedades de destino iSCSI

- 22.6 Detalles del dispositivo

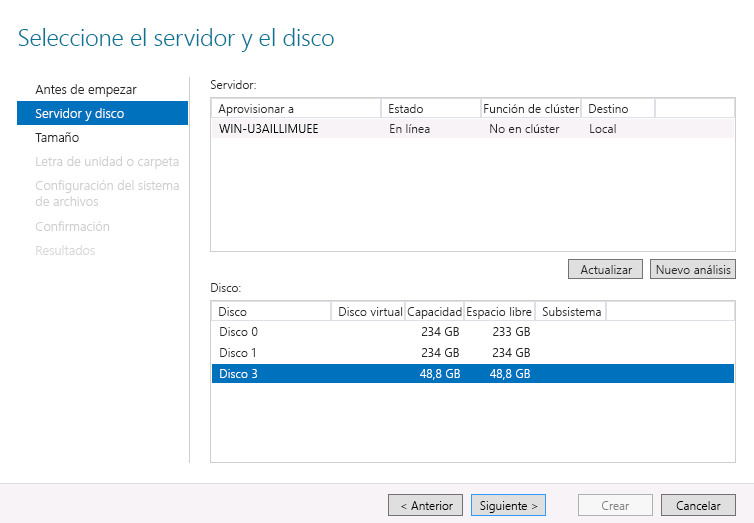

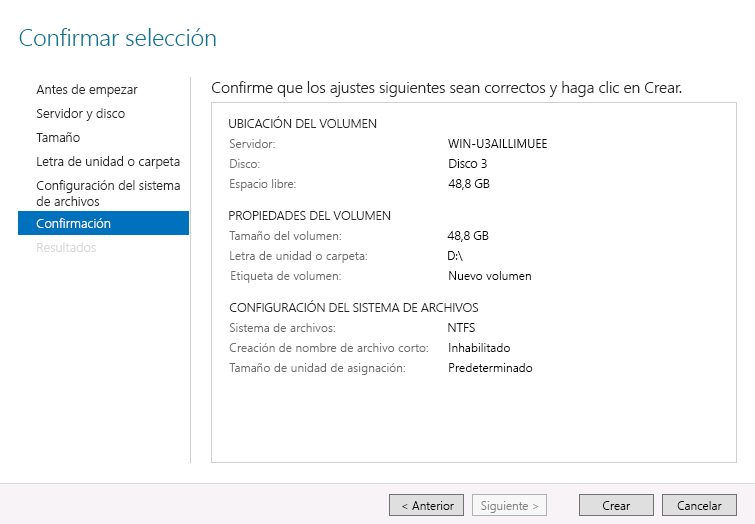

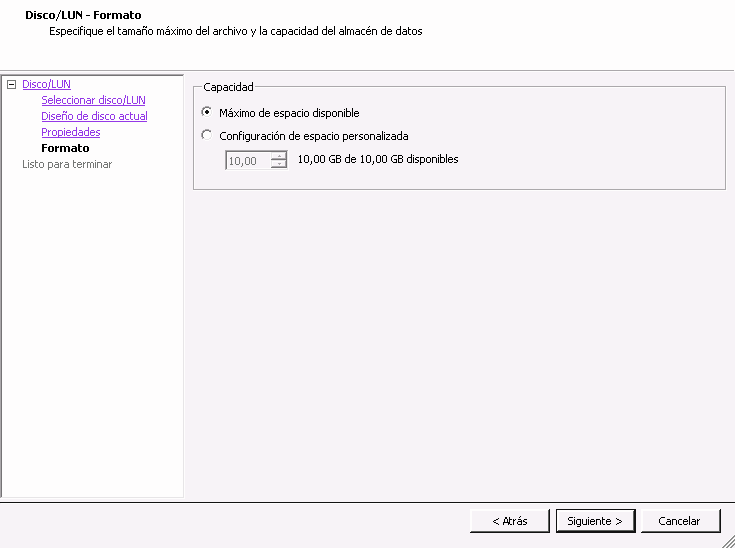

- 22.7 Nuevo asistente de volumen

- 22.8 Mensaje de disco sin conexión

- 22.9 Confirmación de las opciones del volumen

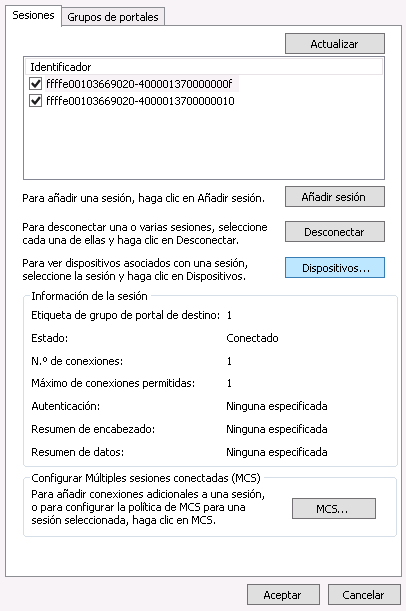

- 22.10 Propiedades del iniciador iSCSI

- 22.11 Adición de un servidor de destino

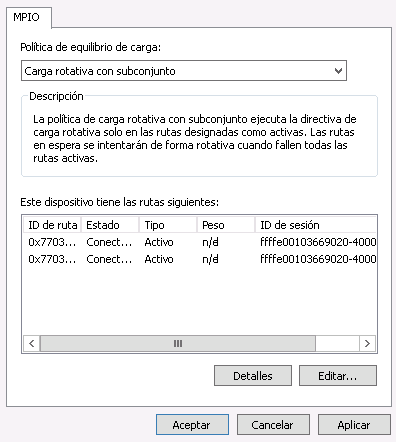

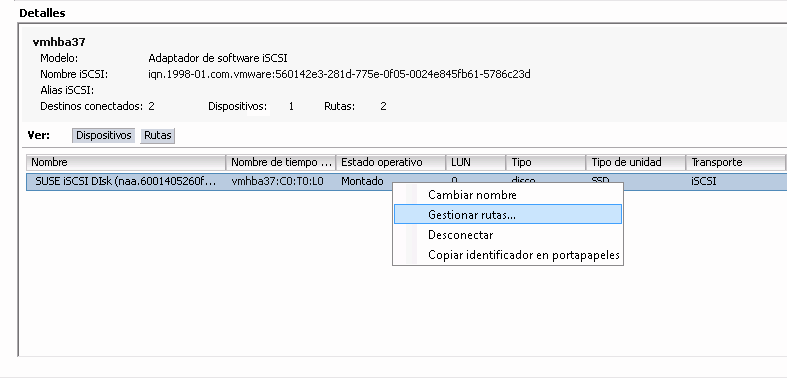

- 22.12 Gestión de dispositivos de múltiples rutas

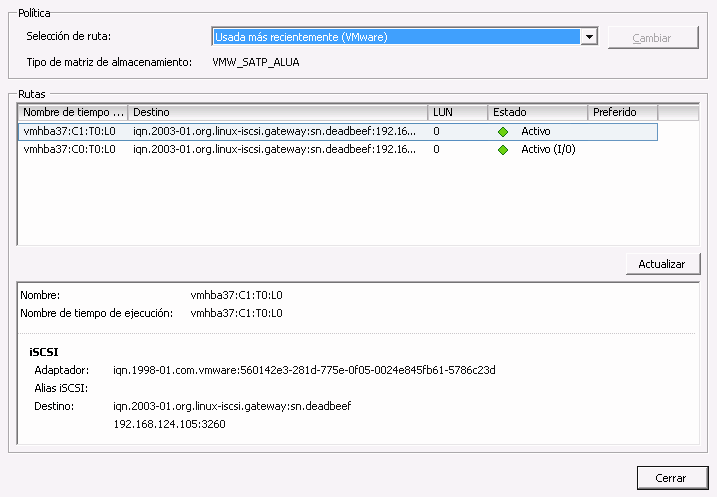

- 22.13 Lista de vías para múltiples rutas

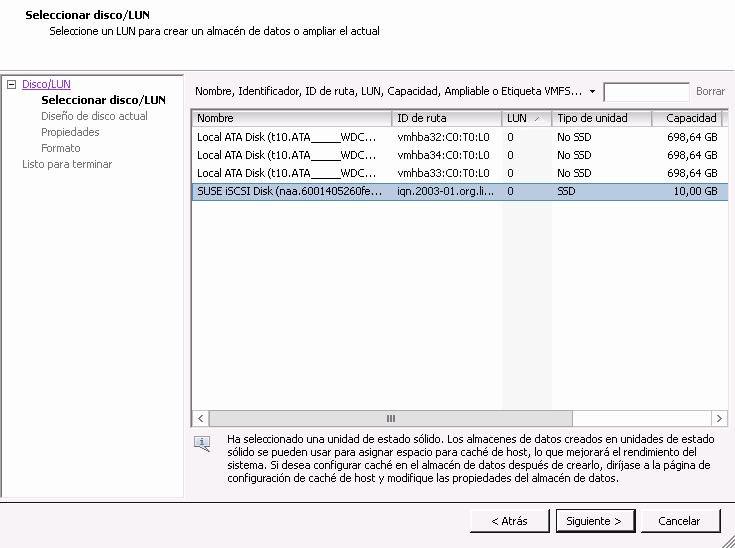

- 22.14 Recuadro de diálogo para añadir almacenamiento

- 22.15 Configuración de espacio personalizada

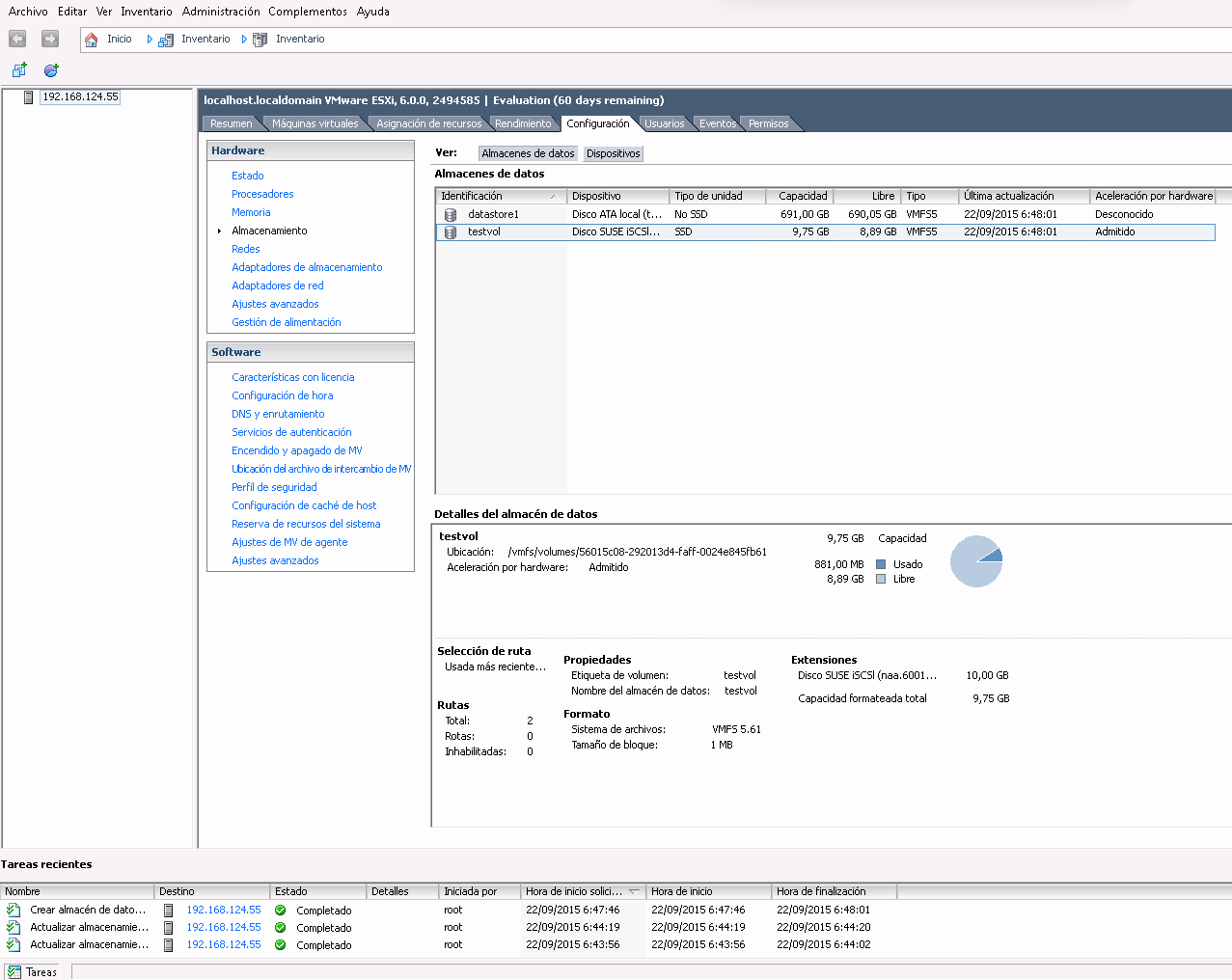

- 22.16 Resumen del almacén de datos iSCSI

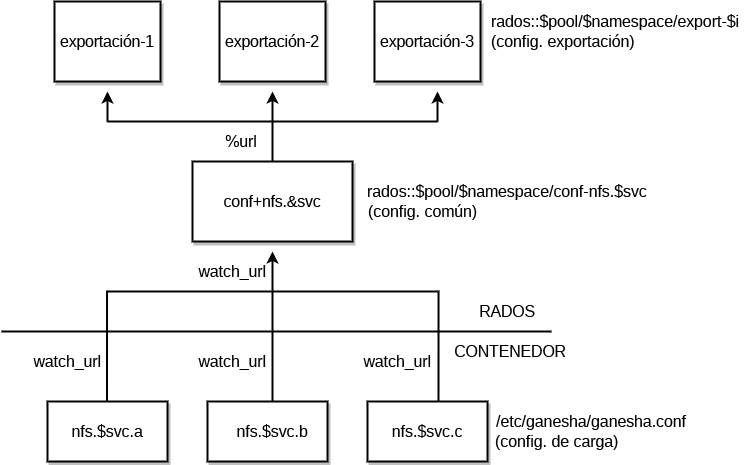

- 25.1 Estructura de NFS Ganesha

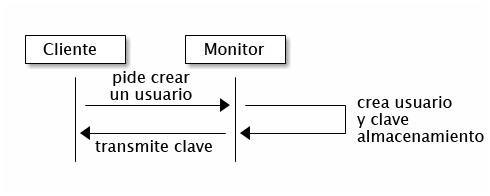

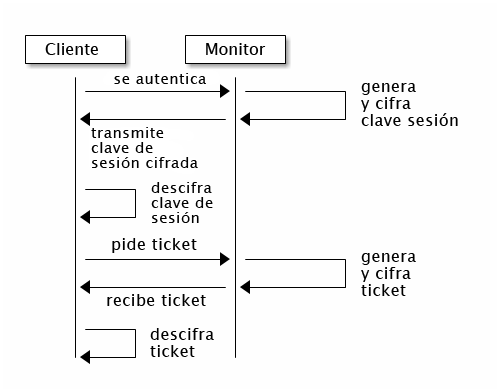

- 30.1 Autenticación básica con

cephx - 30.2 Autenticación con

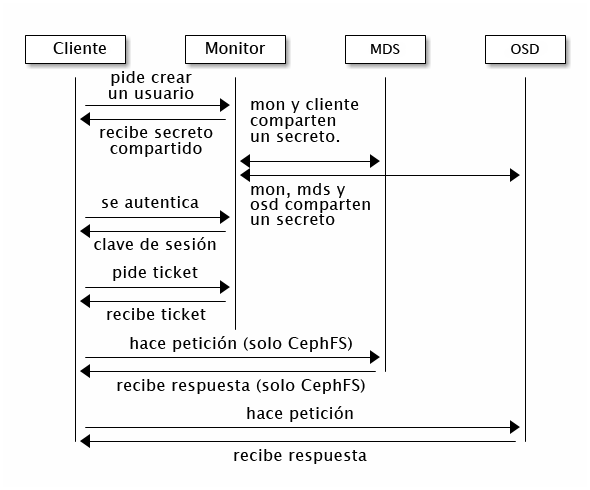

cephx - 30.3 Autenticación con

cephx: servidor de metadatos y OSD

- 12.1 Localización de un objeto

- 13.1 Filtrado por tamaño de disco

- 13.2 configuración sencilla

- 13.3 configuración avanzada

- 13.4 configuración avanzada con nodos no uniformes

- 13.5 configuración para expertos

- 13.6 configuración compleja (e improbable)

- 17.1

crushtool ‑‑reclassify‑root - 17.2

crushtool ‑‑reclassify‑bucket - 21.1 Configuración trivial

- 21.2 Configuración no trivial

- 28.1 Ejemplo de configuración de Beast

- 28.2 Ejemplo de configuración de Civetweb en

/etc/ceph/ceph.conf

Copyright © 2020–2023 SUSE LLC y colaboradores. Reservados todos los derechos.

Salvo que se indique lo contrario, este documento está sujeto a la licencia Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Para obtener información sobre las marcas comerciales de SUSE, consulte http://www.suse.com/company/legal/. Todas las marcas comerciales de otros fabricantes son propiedad de sus propietarios respectivos. Los símbolos de marca comercial (®,™ etc.) indican marcas comerciales de SUSE y sus afiliados. Los asteriscos (*) indican marcas comerciales de otros fabricantes.

Toda la información recogida en esta publicación se ha compilado prestando toda la atención posible al más mínimo detalle. Sin embargo, esto no garantiza una precisión total. Ni SUSE LLC, ni sus filiales, ni los autores o traductores serán responsables de los posibles errores o las consecuencias que de ellos pudieran derivarse.

Acerca de esta guía #

Esta guía se centra en las tareas rutinarias de las que usted, como administrador, debe ocuparse después de que se haya distribuido el clúster de Ceph básico (operaciones del día 2). También describe todas las formas admitidas para acceder a los datos almacenados en un clúster de Ceph.

SUSE Enterprise Storage 7 es una extensión para SUSE Linux Enterprise Server 15 SP2. Combina las funciones del proyecto de almacenamiento Ceph (http://ceph.com/) con la ingeniería empresarial y la asistencia de SUSE. SUSE Enterprise Storage 7 proporciona a las organizaciones de TI la capacidad de distribuir una arquitectura de almacenamiento distribuida que admite varios casos de uso mediante plataformas de hardware básicas.

1 Documentación disponible #

La documentación de nuestros productos está disponible en https://documentation.suse.com, donde también encontrará las actualizaciones más recientes y podrá explorar o descargar la documentación en diferentes formatos. Las últimas actualizaciones de la documentación se pueden encontrar en la versión en inglés.

Además, la documentación del producto también estará disponible en el sistema instalado, en la vía /usr/share/doc/manual. Se incluye en un paquete de RPM denominado

ses-manual_CÓDIGO_DE_IDIOMA. Instálelo si aún no está en el sistema, por ejemplo:

root # zypper install ses-manual_enLa documentación disponible para este producto es la siguiente:

- Guía de distribución

Esta guía se centra en la distribución de un clúster de Ceph básico y en cómo distribuir servicios adicionales. También se describen los pasos necesarios para actualizar a SUSE Enterprise Storage 7 desde la versión anterior del producto.

- Guía de administración y operaciones

Esta guía se centra en las tareas rutinarias de las que usted, como administrador, debe ocuparse después de que se haya distribuido el clúster de Ceph básico (operaciones del día 2). También describe todas las formas admitidas para acceder a los datos almacenados en un clúster de Ceph.

- Guía de protección de la seguridad

Esta guía se centra en cómo garantizar la seguridad del clúster.

- Guía de resolución de problemas

Esta guía describe varios problemas comunes al ejecutar SUSE Enterprise Storage 7 y otros problemas relacionados con los componentes relevantes, como Ceph u Object Gateway.

- Guía de SUSE Enterprise Storage para Windows

Esta guía describe la integración, instalación y configuración de entornos Microsoft Windows y SUSE Enterprise Storage mediante el controlador de Windows.

2 Proporcionar comentarios #

Agradecemos sus comentarios y contribuciones sobre esta documentación. Existen varios canales para enviarlos:

- Peticiones de servicio y asistencia técnica

Para obtener más información sobre los servicios y las opciones de asistencia técnica disponibles para el producto, consulte http://www.suse.com/support/.

Para abrir una petición de servicio, necesita una suscripción de SUSE registrada en el Centro de servicios al cliente de SUSE. Diríjase a https://scc.suse.com/support/requests, entre a la sesión y haga clic en (Crear nueva).

- Informes de errores

Puede informar sobre errores de la documentación en https://bugzilla.suse.com/. Para informar sobre errores, se requiere una cuenta de Bugzilla.

Para simplificar el proceso, puede utilizar los enlaces (Informar sobre errores de la documentación) que aparecen junto a los titulares de la versión HTML de este documento. De esta forma, se preseleccionan el producto y la categoría correctos en Bugzilla y se añade un enlace a la sección actual. Así, podrá empezar a escribir directamente el informe.

- Contribuciones

Para contribuir a esta documentación, utilice los enlaces (Editar origen) situados junto a los titulares de la versión HTML de este documento. Llevan al código fuente de GitHub, donde puede abrir una petición de extracción. Para contribuir, se requiere una cuenta de GitHub.

Para obtener más información sobre el entorno utilizado en esta documentación, consulte el archivo README (Léame) en https://github.com/SUSE/doc-ses.

- Correo

También puede informar sobre errores y enviar comentarios sobre la documentación a <doc-team@suse.com>. Por favor, incluya el título del documento, la versión del producto y la fecha de publicación de la documentación. También puede incluir el número de sección y título correspondientes (o proporcionar la URL), así como una descripción concisa del problema.

3 Convenciones de la documentación #

En este documento se utilizan los siguientes avisos y convenciones tipográficas:

/etc/passwd: nombres de directorio y nombres de archivos.ESPACIO RESERVADO: sustituya ESPACIO RESERVADO con el valor real.

VÍA: una variable de entorno.ls,‑‑help: comandos, opciones y parámetros.usuario: el nombre del usuario o grupo.nombre_de_paquete: el nombre de un paquete de software.

Alt, Alt–F1: tecla o combinación de teclas que pulsar. Las teclas se muestran en mayúsculas como en un teclado.

, › : elementos de menú, botones.

AMD/Intel Este párrafo solo es relevante para la arquitectura Intel 64/AMD64. Las flechas marcan el principio y el final del bloque de texto.

IBM Z, POWER Este párrafo solo es relevante para las arquitecturas

IBM ZyPOWER. Las flechas marcan el principio y el final del bloque de texto.Capítulo 1, “capítulo de ejemplo”: referencia cruzada a otro capítulo de esta guía.

Comandos que se deben ejecutar con privilegios de usuario

root. A menudo, también es posible añadir estos comandos como prefijos con el comandosudopara que un usuario sin privilegios los puedan ejecutar.root #commandtux >sudocommandComandos que pueden ejecutar los usuarios sin privilegios.

tux >commandNotificaciones

Aviso: aviso de advertenciaInformación vital que debe tener en cuenta antes de continuar. Advierte acerca de problemas de seguridad, pérdida de datos potenciales, daños del hardware o peligros físicos.

Importante: aviso importanteInformación importante que debe tener en cuenta antes de continuar.

Nota: aviso de notaInformación adicional, por ejemplo sobre las diferencias en las versiones de software.

Sugerencia: aviso de sugerenciaInformación útil, como una directriz o un consejo práctico.

Avisos compactos

Información adicional, por ejemplo sobre las diferencias en las versiones de software.

Información útil, como una directriz o un consejo práctico.

4 Ciclo de vida y asistencia del producto #

Los distintos productos de SUSE tienen distintos ciclos de vida. Para comprobar las fechas exactas del ciclo de vida de SUSE Enterprise Storage, consulte https://www.suse.com/lifecycle/.

4.1 Definiciones de asistencia técnica de SUSE #

Para obtener información sobre nuestra directiva de asistencia técnica y las opciones disponibles, consulte https://www.suse.com/support/policy.html y https://www.suse.com/support/programs/long-term-service-pack-support.html.

4.2 Declaración de asistencia técnica para SUSE Enterprise Storage #

Para recibir asistencia técnica, necesita disponer de una suscripción adecuada de SUSE. Para ver las ofertas de asistencia técnica específicas que tiene a su disposición, diríjase a https://www.suse.com/support/ y seleccione su producto.

Los niveles de asistencia se definen así:

- L1

Determinación de problemas; lo que significa que se ofrece asistencia técnica diseñada para proporcionar información de compatibilidad, asistencia sobre el uso, mantenimiento continuo, recopilación de información y resolución de problemas básicos con la documentación disponible.

- L2

Aislamiento de problemas; lo que significa que se ofrece asistencia técnica diseñada para analizar datos, reproducir los problemas del cliente, aislar el área del problema y proporcionar una resolución a los problemas que no se pueden resolver en el nivel 1 (L1) ni preparar para el nivel 3 (L3).

- L3

Resolución de problemas; lo que significa que se ofrece asistencia técnica diseñada para resolver los problemas mediante ingeniería y resolver los defectos que se han identificado en la asistencia de nivel 2 (L2).

En el caso de los clientes y socios con contrato, SUSE Enterprise Storage se suministra con asistencia L3 para todos los paquetes, excepto en los siguientes casos:

Tecnología en fase preliminar.

Sonido, gráficos, fuentes y material gráfico.

Paquetes que precisan de un contrato de clientes adicional.

Algunos paquetes incluidos como parte del módulo de extensión de estación de trabajo solo admiten asistencia L2.

Los paquetes con nombres que terminan en -devel (que contienen archivos de encabezado y recursos similares para desarrolladores) solo incluyen asistencia si van acompañados de sus paquetes principales.

SUSE solo admite el uso de paquetes originales. Es decir, paquetes que no hayan sido modificados ni recompilados.

4.3 Tecnología en fase preliminar #

Se considera como "tecnología en fase preliminar" cualquier paquete, pila o función proporcionada por SUSE para ofrecer un adelanto de las próximas innovaciones. Estos elementos se incluyen para ofrecer la oportunidad de probar nuevas tecnologías en su entorno. Le agradeceremos mucho sus comentarios. Si se dispone a probar una tecnología en fase preliminar, póngase en contacto con su representante de SUSE e infórmele de su experiencia y sus casos de uso. Sus comentarios nos resultarán útiles para desarrollar el producto.

Las tecnologías en fase preliminar tienen las limitaciones siguientes:

Están aún en proceso de desarrollo. En consecuencia, sus funciones pueden estar incompletas, ser inestables o no ser adecuadas de alguna otra forma para su uso en producción.

No se ofrece asistencia técnica para ellas.

Es posible que solo estén disponibles para arquitecturas de hardware específicas.

Sus detalles y funciones están sujetos a cambios. Como resultado, quizás no sea posible actualizar estas tecnologías en las versiones posteriores o que sea necesario realizar una instalación nueva.

Las tecnologías en fase preliminar se pueden eliminar de un producto en cualquier momento. SUSE no se compromete a facilitar una versión con asistencia técnica de dichas tecnologías en el futuro. Esto puede suceder, por ejemplo, si SUSE descubre que la tecnología en fase preliminar no cumple las necesidades del cliente o del mercado, o que no cumple con los estándares empresariales.

Para ver una descripción general de las tecnologías en fase preliminar incluidas con el producto, consulte la notas de la versión en https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.

5 Colaboradores de Ceph #

El proyecto Ceph y su documentación son el resultado del trabajo de cientos de colaboradores y organizaciones. Consulte https://ceph.com/contributors/ para obtener más información.

6 Comandos e indicadores de comandos utilizados en esta guía #

Como administrador de clústeres de Ceph, va a configurar y ajustar el comportamiento del clúster ejecutando comandos específicos. Necesitará varios tipos de comandos:

6.1 Comandos relacionados con Salt #

Estos comandos ayudan a distribuir los nodos de clúster de Ceph, a ejecutar comandos en varios nodos de clúster al mismo tiempo (o en todos ellos) o a ayudarle a añadir o quitar nodos de clúster. Los comandos más utilizados son ceph-salt y ceph-salt config. Los comandos de Salt se deben ejecutar en el nodo master de Salt como usuario root. Estos comandos se introducen con el siguiente símbolo del sistema:

root@master # Por ejemplo:

root@master # ceph-salt config ls6.2 Comandos relacionados con Ceph #

Se trata de comandos de nivel inferior para configurar y ajustar todos los aspectos del clúster y sus pasarelas en la línea de comandos, por ejemplo ceph, cephadm, rbd o radosgw-admin.

Para ejecutar comandos relacionados con Ceph, debe tener acceso de lectura a una clave de Ceph. Los privilegios que tiene en el entorno Ceph se definen en las capacidades de la clave. Una opción es ejecutar comandos de Ceph como usuario root (o mediante sudo) y utilizar el anillo de claves sin restricciones por defecto "ceph.client.admin.key".

La opción más segura y recomendada es crear una clave individual más restrictiva para cada usuario administrador y colocarla en un directorio donde los usuarios puedan leerla, por ejemplo:

~/.ceph/ceph.client.USERNAME.keyring

Para utilizar un usuario administrador y un anillo de claves personalizados, debe especificar el nombre de usuario y la vía a la clave cada vez que ejecute el comando ceph mediante las opciones -n client.NOMBRE_USUARIO y ‑‑keyring VÍA/A/ANILLO/DE/CLAVES.

Para evitarlo, incluya estas opciones en la variable CEPH_ARGS en los archivos ~/.bashrc de los usuarios individuales.

Aunque puede ejecutar comandos relacionados con Ceph en cualquier nodo de clúster, se recomienda hacerlo en el nodo de administración. Esta documentación utiliza al usuario cephuser para ejecutar los comandos, por lo tanto, se introducen con el siguiente símbolo del sistema:

cephuser@adm > Por ejemplo:

cephuser@adm > ceph auth listSi la documentación indica que ejecute un comando en un nodo de clúster con una función específica, el símbolo del sistema se encargará. Por ejemplo:

cephuser@mon > 6.2.1 Ejecución de ceph-volume #

A partir de SUSE Enterprise Storage 7, los servicios de Ceph se ejecutan en contenedores. Si necesita ejecutar ceph-volume en un nodo de OSD, debe anteponer el comando cephadm, por ejemplo:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandos generales de Linux #

Los comandos de Linux no relacionados con Ceph, como mount, cat o openssl se introducen con los símbolos del sistema cephuser@adm > o root #, dependiendo de los privilegios que requiera el comando relacionado.

6.4 Información adicional #

Para obtener más información sobre la gestión de claves de Ceph, consulte el Sección 30.2, “Áreas clave de gestión”.

Parte I Ceph Dashboard #

- 1 Acerca de Ceph Dashboard

Ceph Dashboard es una aplicación de supervisión y gestión de Ceph basada en Web que administra varios aspectos y objetos del clúster. La consola se habilita automáticamente después de distribuir el clúster básico en Book “Guía de distribución”, Chapter 5 “Distribución con cephadm”, Section 5.3 “Dist…

- 2 Interfaz de usuario Web de la consola

Para entrar a la sesión en Ceph Dashboard, abra su dirección URL en un navegador, incluido el número de puerto. Ejecute el comando siguiente para buscar la dirección:

- 3 Gestión de usuarios y funciones de Ceph Dashboard

En el Capítulo 11, Gestión de usuarios y funciones en la línea de comandos ya se describió la gestión de usuarios de la consola que se realiza mediante los comandos de Ceph en la línea de comandos.

- 4 Visualización de elementos internos del clúster

El elemento de menú permite ver información detallada acerca de los hosts del clúster de Ceph, el inventario, los monitores Ceph Monitor, los servicios, los OSD, la configuración, el mapa de CRUSH, Ceph Manager, los registros y los archivos de supervisión.

- 5 Gestión de repositorios

Para obtener información general sobre los repositorios de Ceph, consulte el Capítulo 18, Gestión de repositorios de almacenamiento. Para obtener información específica sobre los repositorios codificados de borrado, consulte el Capítulo 19, Repositorios codificados de borrado.

- 6 Gestión de dispositivos de bloques RADOS

Para mostrar todos los dispositivos de bloques RADOS (RBD) disponibles, haga clic en › en el menú principal.

- 7 Gestión de NFS Ganesha

Para obtener información general sobre NFS Ganesha, consulte el Capítulo 25, NFS Ganesha.

- 8 Gestión de CephFS

Para obtener información detallada sobre CephFS, consulte el Capítulo 23, Sistema de archivos en clúster

- 9 Gestión de Object Gateway

Antes de empezar, es posible que aparezca la siguiente notificación al intentar acceder al procesador frontal de Object Gateway en Ceph Dashboard:

- 10 Configuración manual

En esta sección se presenta información avanzada para los usuarios que prefieren configurar manualmente los valores de la consola en la línea de comandos.

- 11 Gestión de usuarios y funciones en la línea de comandos

En esta sección se describe cómo gestionar las cuentas de usuario utilizadas por la Ceph Dashboard. Sirve de ayuda para crear o modificar cuentas de usuario, así como para establecer las funciones y permisos de usuario adecuados.

1 Acerca de Ceph Dashboard #

Ceph Dashboard es una aplicación de supervisión y gestión de Ceph basada en Web que administra varios aspectos y objetos del clúster. La consola se habilita automáticamente después de distribuir el clúster básico en Book “Guía de distribución”, Chapter 5 “Distribución con cephadm”, Section 5.3 “Distribución del clúster de Ceph”.

En Ceph Dashboard para SUSE Enterprise Storage 7 se han añadido más funciones de gestión basadas en Web para facilitar la administración de Ceph, incluida la supervisión y la administración de aplicaciones en Ceph Manager. Ya no es necesario conocer comandos complejos relacionados con Ceph para gestionar y supervisar el clúster de Ceph. Puede utilizar la intuitiva interfaz de Ceph Dashboard o su API REST integrada.

El módulo Ceph Dashboard muestra información y estadísticas sobre el clúster de Ceph mediante un servidor Web alojado por ceph-mgr. Consulte Book “Guía de distribución”, Chapter 1 “SES y Ceph”, Section 1.2.3 “Nodos y daemons de Ceph” para obtener más información sobre Ceph Manager.

2 Interfaz de usuario Web de la consola #

2.1 Conexión #

Para entrar a la sesión en Ceph Dashboard, abra su dirección URL en un navegador, incluido el número de puerto. Ejecute el comando siguiente para buscar la dirección:

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",El comando devuelve la URL donde se encuentra Ceph Dashboard. Si tiene problemas con este comando, consulte el Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”.

Entre a la sesión con las credenciales que creó durante la distribución del clúster (consulte el Book “Guía de distribución”, Chapter 5 “Distribución con cephadm”, Section 5.3.2.9 “Configuración de las credenciales de entrada de Ceph Dashboard”).

Si no desea utilizar la cuenta admin por defecto para acceder a Ceph Dashboard, cree una cuenta de usuario personalizada con privilegios de administrador. Consulte el Capítulo 11, Gestión de usuarios y funciones en la línea de comandos para obtener más información.

La interfaz de usuario de la consola se divide en varios bloques: el menú de utilidades en la parte superior derecha de la pantalla, el menú principal en la parte izquierda y el panel de contenido principal.

2.4 Panel de contenido #

El panel de contenidos ocupa gran parte de la pantalla de la consola. La página de inicio de la consola muestra numerosos widgets útiles para informar brevemente sobre el estado actual del clúster, su capacidad y el rendimiento.

2.5 Características comunes de la interfaz del usuario Web #

En Ceph Dashboard se suele trabajar con listas; por ejemplo, listas de repositorios, nodos de OSD o dispositivos RBD. Todas las listas se actualizan automáticamente por defecto cada cinco segundos. Los widgets comunes siguientes ayudan a gestionar o a ajustar estas listas:

Haga clic en ![]() para activar una actualización manual de la lista.

para activar una actualización manual de la lista.

Haga clic en ![]() para mostrar u ocultar columnas individuales.

para mostrar u ocultar columnas individuales.

Haga clic en ![]() e introduzca o seleccione el número de filas que desea

mostrar en cada página.

e introduzca o seleccione el número de filas que desea

mostrar en cada página.

Haga clic dentro de  y filtre las filas escribiendo una cadena de búsqueda.

y filtre las filas escribiendo una cadena de búsqueda.

Use  para cambiar la página que se muestra si la lista se

extiende por varias páginas.

para cambiar la página que se muestra si la lista se

extiende por varias páginas.

2.6 Widgets de consola #

Cada widget de consola muestra información de estado específica relacionada con un aspecto específico de un clúster de Ceph en ejecución. Algunos widgets son enlaces activos y, después de hacer clic en ellos, le redirigirán a una página con detalles sobre el tema que representan.

Algunos widgets gráficos muestran más detalles al mover el ratón sobre ellos.

2.6.1 Widgets de Estado #

Los widgets de ofrecen una breve descripción general sobre el estado actual del clúster.

Presenta información básica sobre el estado del clúster.

Muestra el número total de nodos del clúster.

Muestra el número de monitores en ejecución y su quórum.

Muestra el número total de OSD, así como el número de OSD con los estados up e in.

Muestra el número de daemons de Ceph Manager activos y en espera.

Muestra el número de pasarelas Object Gateway en ejecución.

Muestra el número de servidores de metadatos.

Muestra el número de pasarelas iSCSI Gateway configuradas.

2.6.2 Widgets de Capacidad #

Los widgets de muestran información breve sobre la capacidad de almacenamiento.

Muestra la proporción de capacidad de almacenamiento en bruto utilizada y disponible.

Muestra el número de objetos de datos almacenados en el clúster.

Muestra un gráfico de los grupos de colocación según su estado.

Muestra el número de repositorios del clúster.

Muestra el promedio de grupos de colocación por OSD.

2.6.3 Widgets de Rendimiento #

Los widgets de muestran datos básicos de rendimiento de los clientes de Ceph.

La cantidad de operaciones de lectura y escritura de los clientes por segundo.

La cantidad de datos transferidos a y desde los clientes de Ceph en bytes por segundo.

El rendimiento de los datos recuperados por segundo.

Muestra el estado de depuración (consulte la Sección 17.4.9, “Depuración de un grupo de colocación”). Puede ser

inactivo,habilitadooactivo.

3 Gestión de usuarios y funciones de Ceph Dashboard #

En el Capítulo 11, Gestión de usuarios y funciones en la línea de comandos ya se describió la gestión de usuarios de la consola que se realiza mediante los comandos de Ceph en la línea de comandos.

En esta sección se describe cómo gestionar cuentas de usuario mediante la interfaz de usuario Web de la consola.

3.1 Listas de usuarios #

Haga clic en ![]() en el menú de utilidades y seleccione .

en el menú de utilidades y seleccione .

La lista contiene el nombre de usuario de cada usuario, el nombre completo, el correo electrónico, una lista de funciones asignadas, si la función está habilitada y la fecha de caducidad de la contraseña.

3.2 Adición de nuevos usuarios #

Haga clic en en la parte superior izquierda del encabezado de la tabla para añadir un nuevo usuario. Introduzca su nombre de usuario, contraseña y, opcionalmente, un nombre completo y un correo electrónico.

Haga clic en el icono de lápiz pequeño para asignar funciones predefinidas al usuario. Para confirmar, haga clic en .

3.3 Edición de usuarios #

Haga clic en la fila de un usuario para resaltarlo. Seleccione para modificar los detalles del usuario. Para confirmar, haga clic en

3.4 Supresión de usuarios #

Haga clic en la fila de de un usuario para resaltarlo. Seleccione el botón desplegable situado junto a y seleccione en la lista para suprimir la cuenta de usuario. Active la casilla de verificación y haga clic en para confirmar.

3.5 Listado de las funciones de usuario #

Haga clic en ![]() en el menú de utilidades y seleccione . A continuación, haga clic en la pestaña

.

en el menú de utilidades y seleccione . A continuación, haga clic en la pestaña

.

La lista contiene el nombre y la descripción de cada función e indica si se trata de una función del sistema.

3.6 Adición de funciones personalizadas #

Haga clic en en la parte superior izquierda del encabezado de la tabla para añadir una nueva función personalizada. Introduzca los datos correspondientes en y y, junto a seleccione los permisos adecuados.

Si crea funciones de usuario personalizadas y tiene previsto eliminar el

clúster de Ceph con el comando ceph-salt purge más

adelante, primero debe limpiar las funciones personalizadas. Más detalles

en la Sección 13.9, “Eliminación de un clúster de Ceph completo”

Al activar la casilla de verificación que precede al nombre del tema, se activan todos los permisos para ese tema. Al activar la casilla de verificación se activan todos los permisos para todos los temas.

Para confirmar, haga clic en .

3.7 Edición de funciones personalizadas #

Haga clic en la fila de un usuario para resaltarlo. Seleccione en la parte superior izquierda del encabezado de la tabla para editar una descripción y los permisos de la función personalizada. Para confirmar, haga clic en

3.8 Supresión de funciones personalizadas #

Haga clic en la fila de una función para resaltarla. Seleccione el botón desplegable situado junto a y seleccione en la lista para suprimir la función. Active la casilla de verificación y haga clic en para confirmar.

4 Visualización de elementos internos del clúster #

El elemento de menú permite ver información detallada acerca de los hosts del clúster de Ceph, el inventario, los monitores Ceph Monitor, los servicios, los OSD, la configuración, el mapa de CRUSH, Ceph Manager, los registros y los archivos de supervisión.

4.1 Visualización de nodos de clúster #

Haga clic en › para ver una lista de nodos de clúster.

Haga clic en la flecha desplegable situada junto al nombre de un nodo en la columna para ver los detalles de rendimiento del nodo.

La columna muestra todos los daemons que se ejecutan en cada nodo relacionado. Haga clic en un nombre de daemon para ver su configuración detallada.

4.2 Acceso al inventario del clúster #

Haga clic en › para ver una lista de dispositivos. La lista incluye la vía del dispositivo, el tipo, la disponibilidad, el proveedor, el modelo, el tamaño y los OSD.

Haga clic para seleccionar un nombre de nodo en la columna . Si está seleccionado, haga clic en para identificar el dispositivo en el que se ejecuta el host. Esto indica al dispositivo que haga parpadear sus LED. Seleccione la duración de esta acción, que puede ser 1, 2, 5, 10 o 15 minutos. Haga clic en

4.3 Visualización de monitores Ceph Monitor #

Haga clic en

›

para ver una lista de nodos de clúster con monitores de Ceph en ejecución.

El panel de contenido se divide en dos vistas: Estado y

En quórum o Sin quórum.

La tabla muestra estadísticas generales sobre los monitores Ceph Monitor en ejecución, incluido lo siguiente:

ID del clúster

Mapa de supervisión modificado

Época de mapa de supervisión

quórum de con

quórum de mon

con requerido

mon requerido

Los paneles Con quórum y Sin quórum

incluyen el nombre de cada monitor, el número de rango, la dirección IP

pública y el número de sesiones abiertas.

Haga clic en un nombre de nodo en la columna para ver la configuración relacionada de Ceph Monitor.

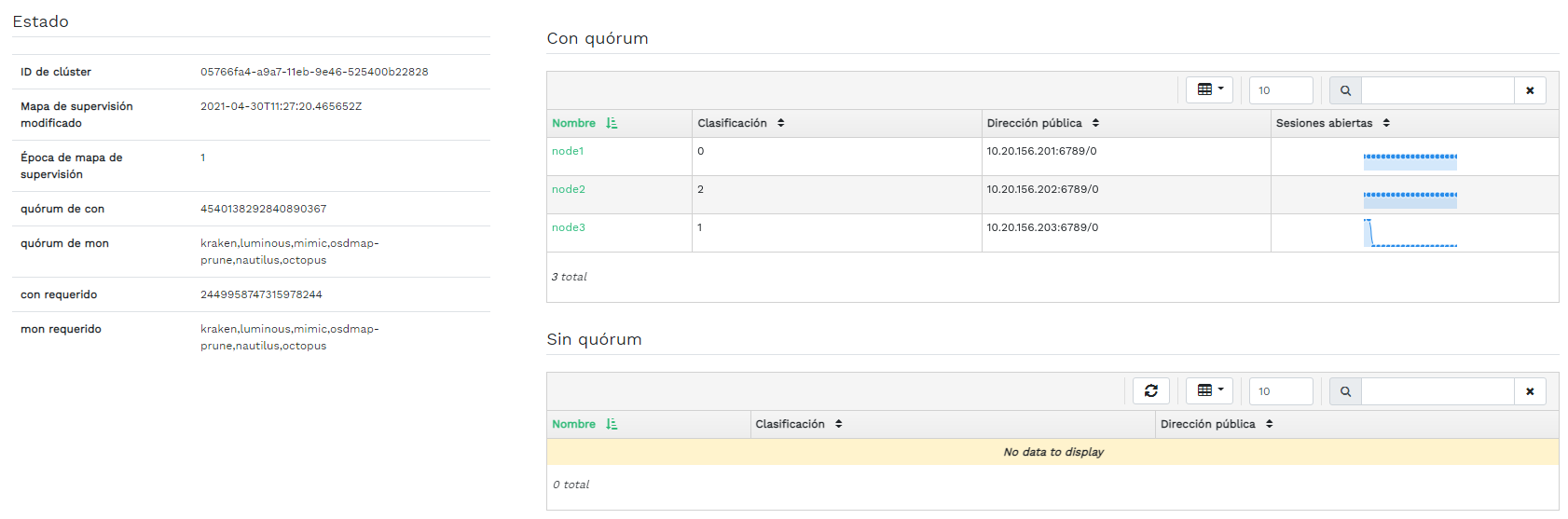

4.4 Visualización de servicios #

Haga clic en

›

para ver los detalles de cada uno de los servicios disponibles:

crash, Ceph Manager y monitores Ceph Monitor. La lista

incluye el nombre de la imagen del contenedor, el ID de la imagen del

contenedor, el estado de lo que se está ejecutando, el tamaño y cuándo se

actualizó por última vez.

Haga clic en la flecha desplegable situada junto al nombre de un servicio en la columna para ver los detalles del daemon. La lista de detalles incluye el nombre de host, el tipo de daemon, el ID de daemon, el ID de contenedor, el nombre de la imagen del contenedor, el ID de la imagen del contenedor, el número de versión, el estado y cuándo se actualizó por última vez.

4.5 Visualización de los OSD de Ceph #

Haga clic en › para ver una lista de nodos con daemons de OSD en ejecución. La lista incluye el nombre de cada nodo, el ID, su estado, la clase de dispositivo, el número de grupos de colocación, el tamaño, el uso, el gráfico de lecturas/escrituras en el tiempo y la tasa de operaciones de lectura/escritura por segundo.

Seleccione en el menú desplegable en el encabezado de la tabla para abrir una ventana emergente. En ella verá una lista de indicadores que se aplican a todo el clúster. Puede activar o desactivar indicadores individuales. Para confirmar, haga clic en

Seleccione en el menú desplegable en el encabezado de la tabla para abrir una ventana emergente. En ella verá una lista de prioridades de recuperación de OSD que se aplican a todo el clúster. Puede activar el perfil de prioridad preferido y después ajustar los valores individuales. Para confirmar, haga clic en

Haga clic en la flecha desplegable situada junto a un nombre de nodo en la columna para ver una tabla extendida con detalles sobre la configuración y el rendimiento del dispositivo. En las distintas pestañas, es posible ver listas de , , el , y un gráfico de lecturas y escrituras, así como

Cuando se hace clic en el nombre de un nodo de OSD, la fila de la tabla se resalta. Esto significa que ahora se puede realizar una tarea en el nodo. Puede realizar cualquiera de las siguientes acciones: o

Haga clic en la flecha hacia abajo situada en la parte superior izquierda del encabezado de la tabla, junto al botón y seleccione la tarea que desea realizar.

4.5.1 Adición de OSD #

Para añadir nuevos OSD, siga estos pasos:

Verifique que algunos nodos del clúster tengan dispositivos de almacenamiento cuyo estado sea

disponible.A continuación, haga clic en la flecha hacia abajo situada en la parte superior izquierda del encabezado de la tabla y seleccione Se abrirá la ventanaFigura 4.9: Crear OSDs #Para añadir dispositivos de almacenamiento primarios para los OSD, haga clic en Antes de poder añadir dispositivos de almacenamiento, debe especificar criterios de filtrado en la parte superior derecha de la tabla por ejemplo, . Para confirmar, haga clic en

Figura 4.10: Adición de dispositivos primarios #En la ventana actualizada, tiene la opción de añadir dispositivos WAL y BD compartidos, o bien de habilitar el cifrado de dispositivos.

Figura 4.11: Crear OSDs con dispositivos primarios añadidos #Haga clic en para ver la vista previa de la especificación DriveGroups para los dispositivos que ha añadido anteriormente. Para confirmar, haga clic en

Figura 4.12: #Los dispositivos nuevos se añadirán a la lista de OSD.

Figura 4.13: OSD recién añadidos #NotaNo es posible visualizar el progreso del proceso de creación de los OSD. Se tarda algún tiempo en crearlos. Los OSD aparecerán en la lista cuando se hayan distribuido. Si desea comprobar el estado de distribución, consulte los registros haciendo clic en › .

4.6 Visualización de la configuración del clúster #

Haga clic en › para ver una lista completa de las opciones de configuración del clúster de Ceph. La lista contiene el nombre de la opción, una descripción breve y sus valores actuales y por defecto. También se indica si la opción se puede editar.

Haga clic en la flecha desplegable situada junto a una opción de configuración en la columna para ver una tabla extendida con información detallada sobre la opción, como su tipo de valor, los valores mínimos y máximos permitidos, si se puede actualizar en el tiempo de ejecución y mucho más.

Después de resaltar una opción específica, puede editar sus valores haciendo clic en el botón en la parte superior izquierda del encabezado de la tabla. Para confirmar los cambios, haga clic en

4.7 Visualización del mapa de CRUSH #

Haga clic en › para ver un mapa de CRUSH del clúster. Para obtener información general sobre los mapas de CRUSH, consulte la Sección 17.5, “Manipulación del mapa de CRUSH”.

Haga clic en la raíz, los nodos o los OSD individuales para ver información más detallada, como el peso de CRUSH, la profundidad del árbol de mapa, la clase de dispositivo del OSD y mucho más.

4.8 Visualización de módulos del gestor #

Haga clic en › para ver una lista de los módulos de Ceph Manager disponibles. Cada línea está formada por nombre de módulo e información sobre si está habilitado actualmente.

Haga clic en la flecha desplegable situada junto a un módulo en la columna para ver una tabla extendida con detalles sobre la configuración en la tabla de abajo. Para editar los detalles, haciendo clic en en la parte superior izquierda del encabezado de la tabla. Para confirmar los cambios, haga clic en

Haga clic en la flecha desplegable situada junto al botón en la parte superior izquierda del encabezado de la tabla para o un módulo.

4.9 Visualización de registros #

Haga clic en › para ver una lista de las entradas de registro recientes del clúster. Cada línea está formada por una marca de tiempo, el tipo de la entrada de registro y el propio mensaje registrado.

Haga clic en la pestaña para ver las entradas de registro del subsistema de auditoría. Consulte en la Sección 11.5, “Auditoría de peticiones de API” los comandos necesarios para habilitar o inhabilitar la auditoría.

4.10 Visualización de la supervisión #

Haga clic en › para gestionar y ver los detalles de las alertas de Prometheus.

Si tiene Prometheus activo, en este panel de contenido puede ver información detallada sobre o

Si no ha distribuido Prometheus, aparecerá un anuncio con información y un enlace a la documentación pertinente.

5 Gestión de repositorios #

Para obtener información general sobre los repositorios de Ceph, consulte el Capítulo 18, Gestión de repositorios de almacenamiento. Para obtener información específica sobre los repositorios codificados de borrado, consulte el Capítulo 19, Repositorios codificados de borrado.

Para ver una lista de todos los repositorios disponibles, haga clic en en el menú principal.

La lista muestra el nombre y el tipo del repositorio, la aplicación relacionada, el estado del grupo de colocación, el tamaño de réplica, el último cambio, el perfil codificado de borrado, el conjunto de reglas de CRUSH y el uso y las estadísticas de lectura y escritura.

Haga clic en la flecha desplegable situada junto al nombre de un repositorio en la columna para ver una tabla extendida con información detallada sobre el repositorio, como los detalles generales, los detalles de rendimiento y la configuración.

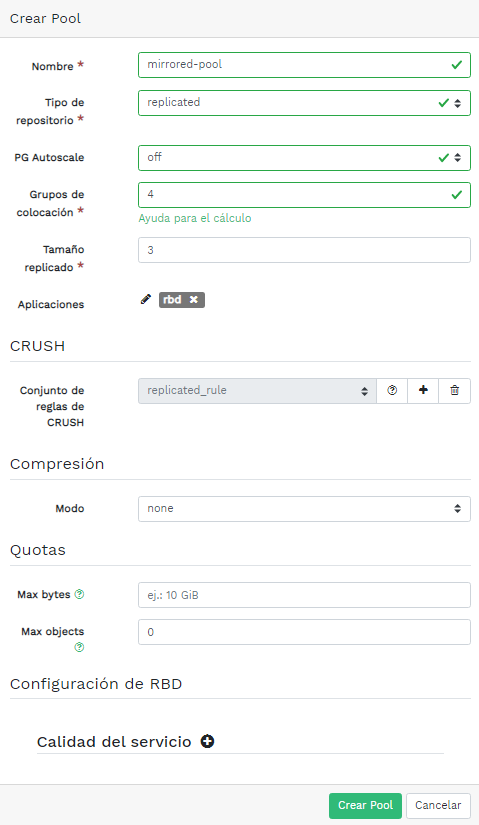

5.1 Adición de un repositorio nuevo #

Para añadir un repositorio nuevo , haga clic en en la parte superior izquierda de la tabla de repositorios. En el formulario del repositorio, puede introducir el nombre del repositorio, el tipo, sus aplicaciones, el modo de compresión y las cuotas, incluido el número máximo de bytes y el número máximo de objetos. El propio formulario calcula el número de grupos de colocación que mejor se adapta a este repositorio específico. El cálculo se basa en la cantidad de OSD del clúster y el tipo de repositorio seleccionado con su configuración específica. Si se define manualmente el número de grupos de colocación, el número calculado se sustituirá. Para confirmar, haga clic en

5.2 Supresión de repositorios #

Para suprimir un repositorio, selecciónelo en la fila de la tabla. Haga clic en la flecha desplegable situada junto al botón y haga clic en

5.3 Edición de las opciones de un repositorio #

Para editar las opciones de un repositorio, seleccione el repositorio en la fila de la tabla y haga clic en en la parte superior izquierda de la tabla.

Puede cambiar el nombre del repositorio, aumentar el número de grupos de colocación, cambiar la lista de aplicaciones del repositorio y la configuración de compresión. Para confirmar, haga clic en

6 Gestión de dispositivos de bloques RADOS #

Para mostrar todos los dispositivos de bloques RADOS (RBD) disponibles, haga clic en › en el menú principal.

La lista muestra información breve sobre el dispositivo, como el nombre del dispositivo, el nombre del repositorio relacionado, el espacio de nombres, el tamaño del dispositivo, el número y el tamaño de los objetos del dispositivo, detalles sobre la provisión de los detalles y el padre.

6.1 Visualización de detalles de los RBD #

Para ver información más detallada sobre un dispositivo, haga clic en su fila en la tabla:

6.2 Visualización de la configuración de RBD #

Para ver la configuración detallada de un dispositivo, haga clic en su fila en la tabla y, a continuación, en la pestaña de la tabla inferior:

6.3 Creación de RBD #

Para añadir un dispositivo nuevo, haga clic en en la parte superior izquierda del encabezado de la tabla y haga lo siguiente en la pantalla

Introduzca el nombre del dispositivo nuevo. Consulte el Book “Guía de distribución”, Chapter 2 “Requisitos y recomendaciones de hardware”, Section 2.11 “Limitaciones de nombres” para conocer las limitaciones a la hora de asignar un nombre.

Seleccione el repositorio con la aplicación

rbdasignada desde la que se creará el nuevo dispositivo RBD.Especifique el tamaño del nuevo dispositivo.

Especifique las opciones adicionales para el dispositivo. Para ajustar los parámetros del dispositivo, haga clic en e introduzca valores para el tamaño del objeto, la unidad de repartición o el recuento de repartición. Para especificar los límites de calidad de servicio (QoS), haga clic en e introdúzcalos.

Para confirmar, haga clic en

6.4 Supresión de RBD #

Para suprimir un dispositivo, selecciónelo en la fila de la tabla. Haga clic en la flecha desplegable situada junto al botón y haga clic en Para confirmar, haga clic en

Suprimir un RBD es una acción irreversible. Si en su lugar, usa la opción podrá restaurar el dispositivo más adelante seleccionándolo en la pestaña de la tabla principal y haciendo clic en en la parte superior izquierda del encabezado de la tabla.

6.5 Creación de instantáneas de dispositivos de bloques RADOS #

Para crear una instantánea de dispositivo de bloques RADOS, seleccione el dispositivo en la fila de la tabla y aparecerá el panel de contenido de configuración detallada. Seleccione la pestaña y haga clic en en la parte superior izquierda del encabezado de la tabla. Escriba el nombre de la instantánea y haga clic en para confirmar.

Después de seleccionar una instantánea, puede realizar acciones adicionales en el dispositivo, como cambiar su nombre, protegerlo, clonarlo, copiarlo o suprimirlo. La opción (Deshacer) restaura el estado del dispositivo de la instantánea actual.

6.6 Duplicación de un RBD #

Los dispositivos de bloques de imágenes RADOS se pueden duplicar de forma asincrónica entre dos clústeres de Ceph. Puede usar Ceph Dashboard para configurar la réplica de imágenes RBD entre dos o más clústeres. Esta capacidad está disponible en dos modos:

- Basada en registro

Este modo utiliza las imágenes RBD transaccionales para garantizar la réplica protegida contra bloqueos de un momento concreto entre los clústeres.

- Basada en instantáneas

Este modo utiliza instantáneas de duplicación de imágenes RBD creadas de forma programada periódicamente o manualmente para replicar imágenes de RBD protegidas contra bloqueos entre clústeres.

La duplicación se configura en cada repositorio dentro de clústeres conectores y se puede configurar en un subconjunto específico de imágenes dentro del repositorio o para que refleje automáticamente todas las imágenes de un repositorio si se usa únicamente la duplicación transaccional.

La duplicación se configura mediante el comando rbd, que

se instala por defecto en SUSE Enterprise Storage 7. El daemon

rbd-mirror es el responsable de la

extracción de actualizaciones de imágenes del clúster conector remoto y de

aplicarlos a la imagen en el clúster local. Consulte la

Sección 6.6.2, “Habilitación del daemon rbd-mirror” para obtener más información

sobre cómo habilitar el daemon

rbd-mirror.

Dependiendo de la necesidad de réplica, la duplicación del dispositivo de bloques RADOS se puede configurar para la réplica unidireccional o bidireccional:

- Réplica unidireccional

Cuando los datos solo se duplican desde un clúster primario a un clúster secundario, el daemon

rbd-mirrorse ejecuta solo en el clúster secundario.- Réplica bidireccional

Cuando los datos se duplican desde imágenes primarias de un clúster a imágenes no primarias de otro clúster (y viceversa), el daemon

rbd-mirrorse ejecuta en ambos clústeres.

Cada instancia del daemon

rbd-mirror debe poder conectarse a

los clústeres de Ceph locales y remotos simultáneamente; por ejemplo, a

todos los monitores y los hosts OSD. Además, la red debe tener suficiente

ancho de banda entre los dos centros de datos para poder gestionar la carga

de trabajo de duplicación.

Para obtener información general y el enfoque de la línea de comandos para duplicar un dispositivo de bloques RADOS, consulte la Sección 20.4, “Duplicados de imagen RBD”.

6.6.1 Configuración de clústeres primarios y secundarios #

El clúster primario es aquel donde se crea el repositorio original con imágenes. El clúster secundario es donde se replican el repositorio o las imágenes desde el clúster primario.

Los términos primario y secundario pueden ser relativos en el contexto de la réplica, ya que están más relacionados con los repositorios individuales que con los clústeres. Por ejemplo, en la réplica bidireccional, un repositorio se puede duplicar desde el clúster primario al secundario, mientras que otro repositorio se puede duplicar desde el clúster secundario al primario.

6.6.2 Habilitación del daemon rbd-mirror #

Los siguientes procedimientos demuestran cómo llevar a cabo las tareas

administrativas básicas para configurar la duplicación mediante el comando

rbd. La duplicación se configura de forma independiente

para cada repositorio dentro de los clústeres de Ceph.

Los pasos para configurar el repositorio deben realizarse en ambos clústeres conectores. Para simplificar los ejemplos, en estos procedimientos se presupone que hay dos clústeres, denominados "primario" y "secundario, a los que se puede acceder desde un único host.

El daemon rbd-mirror realiza la

réplica de los datos del clúster.

Cambie el nombre de

ceph.confy de los archivos de anillo de claves y cópielos del host primario al secundario:cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringPara habilitar la duplicación en un repositorio con

rbd, especifique el comandomirror pool enable, el nombre del repositorio y el modo de duplicación:cephuser@adm >rbd mirror pool enable POOL_NAME MODENotaEl modo de duplicación puede ser

imageopool. Por ejemplo:cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageEn Ceph Dashboard diríjase a › . La tabla de la izquierda muestra los daemons

rbd-mirrorque se ejecutan activamente y su estado.Figura 6.6: Ejecución de daemonsrbd-mirror#

6.6.3 Inhabilitación de la duplicación #

Para inhabilitar la duplicación en un repositorio con

rbd, especifique el comando mirror pool

disable y el nombre del repositorio:

cephuser@adm > rbd mirror pool disable POOL_NAMECuando se inhabilita la duplicación en un repositorio de esta forma, la duplicación también se inhabilitará en cualquier imagen (dentro del repositorio) para la que se haya habilitado la duplicación explícitamente.

6.6.4 Conectores de carga #

Para que rbd-mirror descubra su

clúster conector, este debe estar registrado en el repositorio y debe

crearse una cuenta de usuario. Este proceso se puede automatizar con

rbd mediante los comandos mirror pool peer

bootstrap create y mirror pool peer bootstrap

import.

Para crear manualmente un nuevo testigo de arranque con

rbd, especifique el comando mirror pool peer

bootstrap create, un nombre de repositorio y un nombre de sitio

opcional para describir el clúster local:

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

El resultado del comando mirror pool peer bootstrap

create será un testigo que se debe proporcionar al comando

mirror pool peer bootstrap import. Por ejemplo, en el

clúster primario:

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \

joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

Para importar manualmente el testigo de arranque creado por otro clúster

con el comando rbd, especifique el comando

mirror pool peer bootstrap import, el nombre del

repositorio, una vía de archivo al testigo creado (o "-" para leer desde la

entrada estándar), junto con un nombre de sitio opcional para describir el

clúster local y una dirección de duplicación (por defecto es

rx-tx para la duplicación bidireccional, pero también se

puede definir como rx-only para la duplicación

unidireccional):

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathPor ejemplo, en el clúster secundario:

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW \ 1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1v \ bl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 Eliminación de un clúster conector #

Para eliminar un clúster conector duplicado de Ceph con el comando

rbd, especifique el comando mirror pool peer

remove, el nombre del repositorio y el UUID del conector

(disponible mediante el comando rbd mirror pool info):

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Configuración de la réplica de repositorios en Ceph Dashboard #

El daemon rbd-mirror debe tener

acceso al clúster primario para poder duplicar imágenes RBD. Antes de

continuar, asegúrese de que ha seguido los pasos descritos en la

Sección 6.6.4, “Conectores de carga”.

Tanto en el clúster primario como en el secundario, cree repositorios con un nombre idéntico y asígneles la aplicación

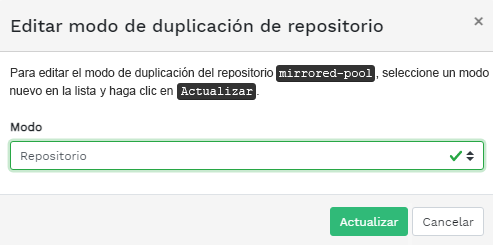

rbd. Consulte la Sección 5.1, “Adición de un repositorio nuevo” para obtener más información sobre cómo crear un repositorio.Figura 6.7: Creación de un repositorio con la aplicación RBD #Tanto en la consola primaria como en la secundaria del clúster, diríjase a › . En la tabla de la derecha, haga clic en el nombre del repositorio que desea replicar y, después de hacer clic en , seleccione el modo de réplica. En este ejemplo, trabajaremos con un modo de réplica de repositorio, lo que significa que se replicarán todas las imágenes de un repositorio determinado. Para confirmar, haga clic en

Figura 6.8: Configuración del modo de réplica #Importante: error o advertencia en el clúster primarioDespués de actualizar el modo de réplica, aparecerá un indicador de error o advertencia en la columna correspondiente de la derecha. Esto se debe a que el repositorio no tiene asignado todavía ningún usuario par para la réplica. Ignore este indicador para el clúster primario, ya que solo se asignará un usuario par al clúster secundario.

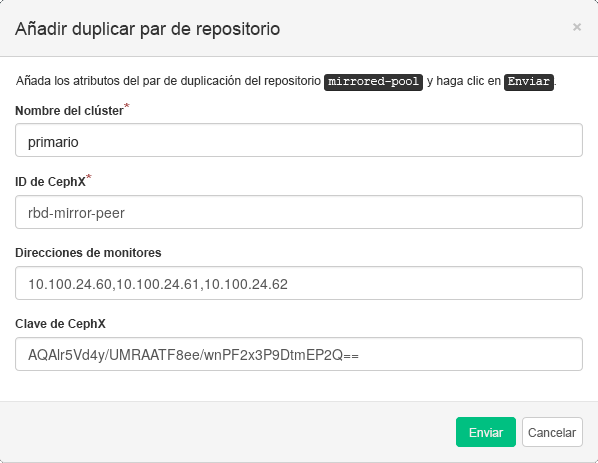

En la consola del clúster secundario, diríjase a › . Añada el par de duplicación del repositorio seleccionando . Proporcione los detalles del clúster primario:

Figura 6.9: Adición de credenciales del par #Se trata de una cadena arbitraria exclusiva que identifica al clúster primario; por ejemplo, "primario". El nombre del clúster debe ser distinto del nombre real del clúster secundario.

El ID de usuario de Ceph que creó como par de duplicación. En este ejemplo es "rbd-mirror-peer".

Lista separada por comas de direcciones IP o nombres de host de los nodos de Ceph Monitor del clúster principal.

La clave relacionada con el ID de usuario par. Puede recuperarla ejecutando el siguiente comando de ejemplo en el clúster primario:

cephuser@adm >ceph auth print_key pool-mirror-peer-name

Para confirmar, haga clic en

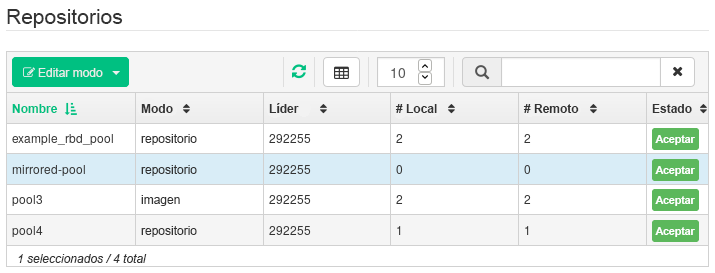

Figura 6.10: Lista de repositorios replicados #

6.6.7 Verificación del funcionamiento de la réplica de la imagen RBD #

Cuando el daemon rbd-mirror esté en

ejecución y la réplica de la imagen RBD esté configurada en Ceph Dashboard,

podrá verificar si la réplica realmente funciona:

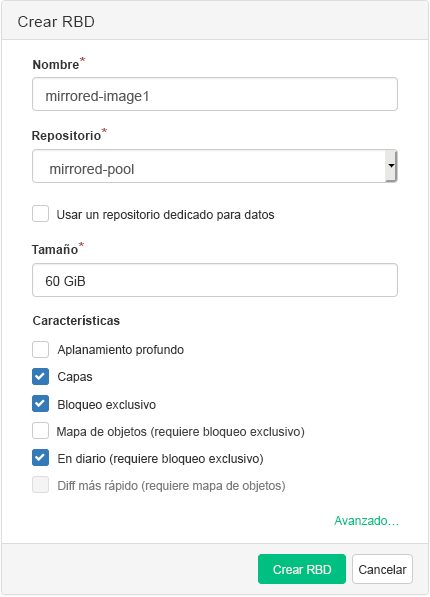

En Ceph Dashboard del clúster primario, cree una imagen RBD cuyo repositorio primario sea el repositorio que ya creó con fines de réplica. Habilite las funciones

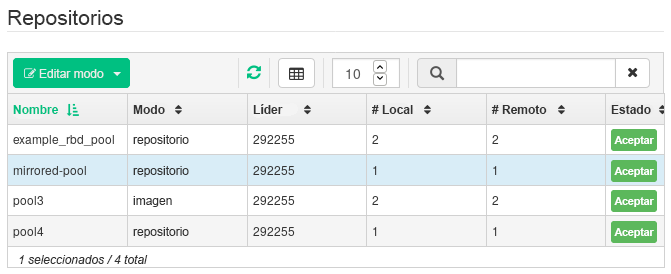

Bloqueo exclusivoyEn diariode la imagen. Consulte la Sección 6.3, “Creación de RBD” para obtener más información sobre cómo crear imágenes RBD.Figura 6.11: Nueva imagen RBD #Después de crear la imagen que desea replicar, abra la Ceph Dashboard del clúster secundario y diríjase a › . La tabla de la derecha reflejará el cambio en el número de imágenes de y sincronizará el número de imágenes de .

Figura 6.12: Nueva imagen RBD sincronizada #Sugerencia: progreso de la réplicaLa tabla de la parte inferior de la página muestra el estado de la réplica de las imágenes RBD. La pestaña incluye los problemas que se han podido producir, muestra el progreso de la réplica de la imagen y muestra todas las imágenes cuya réplica se ha realizado correctamente.

Figura 6.13: Estado de réplica de las imágenes RBD #En el clúster primario, escriba datos en la imagen RBD. En la Ceph Dashboard del clúster secundario, diríjase a › y supervise si el tamaño de la imagen correspondiente aumenta a medida que se escriben los datos en el clúster primario.

6.7 Gestión de pasarelas iSCSI Gateway #

Para obtener información general sobre las pasarelas iSCSI Gateway, consulte el Capítulo 22, Ceph iSCSI Gateway.

Para mostrar todas las pasarelas disponibles y las imágenes asignadas, haga clic en › en el menú principal. Se abre una pestaña que muestra las pasarelas iSCSI Gateway configuradas actualmente y las imágenes RBD asignadas.

La tabla muestra el estado de cada pasarela, el número de destinos iSCSI y el número de sesiones. La tabla muestra el nombre de cada imagen asignada, el nombre del repositorio relacionado, el tipo de almacén y otros detalles estadísticos.

La pestaña muestra los destinos iSCSI configurados actualmente.

Para ver información más detallada acerca de un destino, haga clic en la flecha desplegable de la fila de la tabla de destino. Se abre un esquema estructurado en forma de árbol con los discos, los portales, los iniciadores y los grupos incluidos. Haga clic en un elemento para expandirlo y ver su contenido detallado, opcionalmente con la configuración relacionada en la tabla de la derecha.

6.7.1 Adición de destinos iSCSI #

Para añadir un destino iSCSI nuevo, haga clic en en la parte superior izquierda de la tabla e introduzca la información necesaria.

Escriba la dirección de destino de la nueva pasarela.

Haga clic en y seleccione uno o varios portales iSCSI de la lista.

Haga clic en y seleccione una o varias imágenes RBD para la pasarela.

Si necesita utilizar autenticación para acceder a la pasarela, marque la casilla de verificación e introduzca las credenciales. Encontrará opciones de autenticación más avanzadas después de activar y .

Para confirmar, haga clic en

6.7.2 Edición de destinos iSCSI #

Para editar un destino iSCSI existente, haga clic en su fila en la tabla y haga clic en en la parte superior izquierda de la tabla.

A continuación, puede modificar el destino iSCSI, añadir o suprimir portales y añadir o suprimir imágenes RBD relacionadas. También puede ajustar la información de autenticación para la pasarela.

6.7.3 Supresión de destinos iSCSI #

Para suprimir un destino iSCSI, seleccione la fila de la tabla, haga clic en la flecha desplegable situada junto al botón y seleccione Active la casilla de verificación y haga clic en para confirmar.

6.8 Calidad del servicio (QoS) de un RBD #

Para obtener información general y una descripción de las opciones de configuración de QoS de un RDB, consulte la Sección 20.6, “Ajuste de QoS”.

Las opciones de QoS se pueden configurar en diferentes niveles.

Globalmente

En cada repositorio

En cada imagen

La configuración global se encuentra en la parte superior de la lista y se utiliza para todas las imágenes RBD recién creadas y para aquellas imágenes que no sustituyen estos valores en la capa del repositorio o de la imagen RBD. Un valor especificado globalmente se puede sustituir en cada repositorio o imagen. Las opciones especificadas en un repositorio se aplicarán a todas las imágenes RBD de ese repositorio a menos que se sustituyan por una opción de configuración definida en una imagen. Las opciones especificadas en una imagen sustituyen a las opciones especificadas en un repositorio y a las especificadas globalmente.

De esta manera, es posible definir valores por defecto globalmente, adaptarlos para todas las imágenes de RBD de un repositorio específico y sustituir la configuración del repositorio para imágenes RBD individuales.

6.8.1 Configuración global de opciones #

Para configurar las opciones del dispositivo de bloques RADOS de forma global, seleccione › en el menú principal.

Para mostrar todas las opciones de configuración global disponibles, junto a seleccione en el menú desplegable.

Los resultados de la tabla se pueden filtrar por

rbd_qosen el campo de búsqueda. Esto muestra todas las opciones de configuración disponibles para QoS.Para cambiar un valor, haga clic en la fila de la tabla y seleccione en la parte superior izquierda de la tabla. El recuadro de diálogo contiene seis campos diferentes para especificar valores. Los valores de la opción de configuración de RBD se deben indicar en el recuadro de texto .

NotaA diferencia de otros recuadros de diálogo, este no permite especificar el valor en unidades según convenga. Debe establecer estos valores en bytes o IOPS, dependiendo de la opción que esté editando.

6.8.2 Configuración de opciones en un nuevo repositorio #

Para crear un nuevo repositorio y configurar las opciones de configuración

de RBD en él, haga clic en › . Seleccione

como tipo de repositorio. A continuación,

deberá añadir la etiqueta de aplicación rbd al

repositorio para poder configurar las opciones de QoS de RBD.

No es posible configurar las opciones de configuración de QoS de RBD en un repositorio codificado de borrado. Para configurar las opciones de QoS de RBD para los repositorios codificados de borrado, debe editar el repositorio de metadatos replicados de una imagen RBD. A continuación, la configuración se aplicará al repositorio codificado de borrado de esa imagen.

6.8.3 Configuración de opciones en un repositorio existente #

Para configurar las opciones de QoS de RBD en un repositorio existente, haga clic en , haga clic en la fila del repositorio en la tabla y seleccione en la parte superior izquierda de la tabla.

Debería ver la sección en el recuadro de diálogo, seguida de una sección .

Si no ve las secciones ni , es probable que esté editando un repositorio codificado de borrado, que no se puede usar para establecer opciones de configuración de RBD, o bien que el repositorio no esté configurado para que las imágenes RBD lo puedan usar. En este último caso, asigne la etiqueta de aplicación al repositorio y aparecerán las secciones de configuración correspondientes.

6.8.4 Opciones de configuración #

Haga clic en el signo + de para abrir todas las opciones de configuración disponibles. Aparecerá una lista de todas las opciones disponibles. Las unidades de las opciones de configuración ya se muestran en los recuadros de texto. En el caso de las opciones de bytes por segundo (BPS), es posible utilizar accesos directos tales como "1M" o "5G". Se convertirán automáticamente a "1 MB/s" y "5 GB/s", respectivamente.

Al hacer clic en el botón de restablecimiento situado a la derecha de cada recuadro de texto, se eliminará cualquier valor establecido en el repositorio. Esta acción no elimina los valores de configuración de las opciones configuradas globalmente o en una imagen RBD.

6.8.5 Creación de opciones de QoS de RBD con una imagen RBD nueva #

Para crear una imagen RBD con las opciones de QoS de RBD establecidas en esa imagen, seleccione › y haga clic en . Haga clic en para expandir la sección de configuración avanzada. Haga clic en para abrir todas las opciones de configuración disponibles.

6.8.6 Edición de las opciones de QoS de RBD en imágenes existentes #

Para editar las opciones de QoS de RBD en una imagen existente, seleccione › , haga clic en la fila del repositorio en la tabla y, por último, haga clic en . Aparecerá el recuadro de diálogo de edición. Haga clic en para expandir la sección de configuración avanzada. Haga clic en para abrir todas las opciones de configuración disponibles.

6.8.7 Cambio de las opciones de configuración al copiar o clonar imágenes #

Si se clona o se copia una imagen RBD, los valores establecidos en esa imagen en particular también se copiarán por defecto. Si desea cambiarlos durante la copia o la clonación, puede hacerlo especificando los valores de configuración actualizados en el recuadro de diálogo correspondiente, del mismo modo que cuando se crear o se edita una imagen RBD. Al realizar esta acción, solo establecerá (o restablecerá) los valores de la imagen RBD que se va a copiar o clonar. Esta operación no cambia ni la configuración de la imagen RBD de origen ni la configuración global.

Si decide restablecer el valor de la opción durante la copia o clonación, no se establecerá ningún valor para esa opción en esa imagen. Eso significa que cualquier valor de esa opción especificada para el repositorio padre se usará si el repositorio padre tiene el valor configurado. De lo contrario, se usará el valor por defecto global.

7 Gestión de NFS Ganesha #

Para obtener información general sobre NFS Ganesha, consulte el Capítulo 25, NFS Ganesha.

Para mostrar todas las exportaciones NFS disponibles, haga clic en en el menú principal.

La lista muestra el directorio de cada exportación, el nombre de host del daemon, el tipo de procesador final de almacenamiento y el tipo de acceso.

Para ver información más detallada sobre una exportación NFS, haga clic en su fila en la tabla:

7.1 Creación de exportaciones NFS #

Para añadir una exportación NFS nueva, haga clic en en la parte superior izquierda de la tabla de exportaciones e introduzca la información necesaria.

Seleccione uno o más daemons NFS Ganesha que ejecutarán la exportación.

Seleccione un procesador final de almacenamiento.

ImportanteEn este momento, solo se admiten las exportaciones NFS respaldadas por CephFS.

Seleccione un ID de usuario y otras opciones relacionadas con el procesador final de almacenamiento.

Introduzca la vía de la exportación NFS. Si el directorio no existe en el servidor, se creará.

Especifique las demás opciones relacionadas con NFS, como la versión del protocolo NFS compatible, las opciones de Pseudo, el tipo de acceso, la opción de squash o el protocolo de transporte.

Si necesita limitar el acceso solo a determinados clientes, haga clic en y añada sus direcciones IP junto con el tipo de acceso y las opciones de squash.

Para confirmar, haga clic en

7.2 Supresión de exportaciones NFS #

Para suprimir una exportación, seleccione y resalte la exportación en la fila de la tabla. Haga clic en la flecha desplegable situada junto al botón y seleccione Active la casilla de verificación y haga clic en para confirmar.

7.3 Edición de exportaciones NFS #

Para editar una exportación existente, seleccione y resalte la exportación en la fila de la tabla y haga clic en en la parte superior izquierda de la tabla de exportaciones.

A continuación, puede ajustar todos los detalles de la exportación NFS.

8 Gestión de CephFS #

Para obtener información detallada sobre CephFS, consulte el Capítulo 23, Sistema de archivos en clúster

8.1 Visualización del resumen de CephFS #

Haga clic en en el menú principal para ver un resumen de los sistemas de archivos configurados. La tabla principal muestra el nombre de cada sistema de archivos, la fecha de creación y si está habilitado o no.

Al hacer clic en una fila de la tabla del sistema de archivos, se muestran detalles sobre su rango y los repositorios añadidos al sistema de archivos.

En la parte inferior de la pantalla, se muestran estadísticas con el número de inodos MDS relacionados y las peticiones del cliente, recopiladas en tiempo real.

9 Gestión de Object Gateway #

Antes de empezar, es posible que aparezca la siguiente notificación al intentar acceder al procesador frontal de Object Gateway en Ceph Dashboard:

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

Esto se debe a que cephadm no ha configurado automáticamente Object Gateway para Ceph Dashboard. Si se muestra esta notificación, siga las instrucciones de la Sección 10.4, “Habilitación del procesador frontal de gestión de Object Gateway” para habilitar manualmente el procesador frontal de Object Gateway para Ceph Dashboard.

Para obtener información general sobre Object Gateway, consulte el Capítulo 21, Ceph Object Gateway.

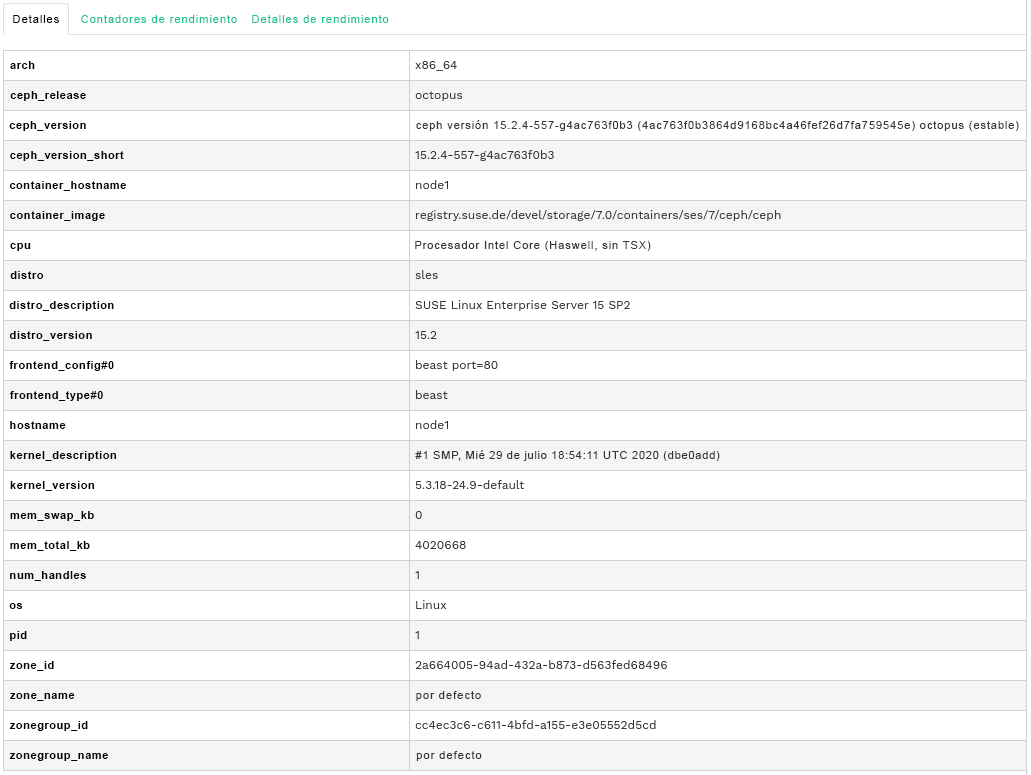

9.1 Visualización de pasarelas Object Gateway #

Para ver una lista de pasarelas Object Gateway configuradas, haga clic en › . La lista incluye el ID de la pasarela, el nombre de host del nodo del clúster donde se ejecuta el daemon de la pasarela y el número de versión de la pasarela.

Haga clic en la flecha desplegable situada junto al nombre de la pasarela para ver información detallada sobre ella. La pestaña muestra detalles sobre las operaciones de lectura y escritura y las estadísticas de caché.

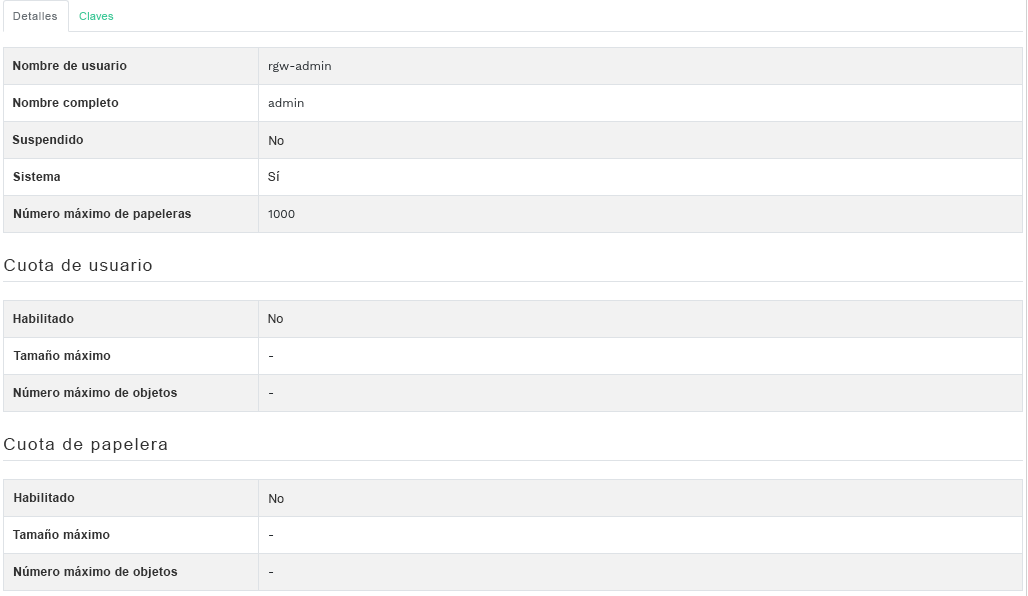

9.2 Gestión de usuarios de Object Gateway #

Haga clic en › para ver una lista de los usuarios existentes de Object Gateway.

Haga clic en la flecha desplegable situada junto al nombre de usuario para ver los detalles de la cuenta de usuario, como el estado o detalles de la cuota del usuario y del depósito.

9.2.1 Adición de un nuevo usuario de pasarela #

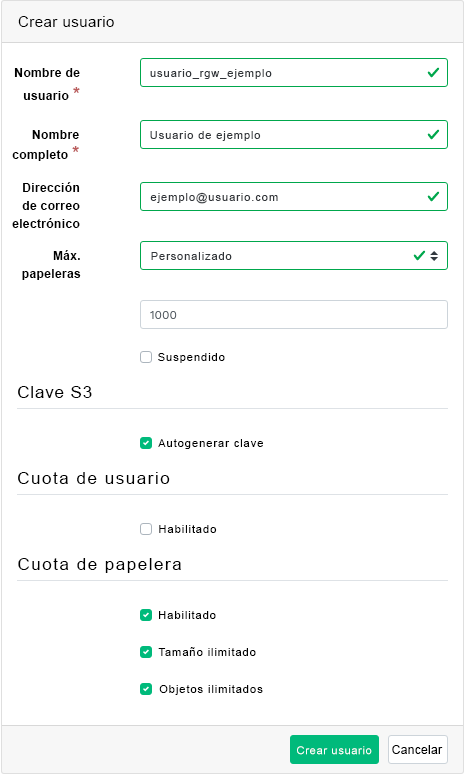

Para añadir un nuevo usuario de pasarela, haga clic en en la parte superior izquierda del encabezado de la tabla. Indique sus credenciales, los detalles sobre la clave S3 y las cuotas de usuario y depósito. A continuación, haga clic en para confirmar.

9.2.2 Supresión de usuarios de pasarela #

Para suprimir un usuario de pasarela, seleccione y resalte al usuario. Haga clic en el botón desplegable situado junto a y seleccione en la lista para suprimir la cuenta de usuario. Active la casilla de verificación y haga clic en para confirmar.

9.2.3 Edición de los detalles del usuario de pasarela #

Para cambiar los detalles del usuario de pasarela, seleccione y resalte al usuario. Haga clic en en la parte superior izquierda del encabezado de la tabla.

Puede modificar la información básica o adicional del usuario, como sus capacidades, las claves, los subusuarios y la información de cuota. Para confirmar, haga clic en

La pestaña incluye una lista de solo lectura de los usuarios de la pasarela y sus claves de acceso y secreta. Para ver las claves, haga clic en el nombre de un usuario en la lista y, a continuación, seleccione en la parte superior izquierda del encabezado de la tabla. En recuadro de diálogo , haga clic en el icono del "ojo" para mostrar las claves, o bien haga clic en el icono del portapapeles para copiar la clave relacionada en el portapapeles.

9.3 Gestión de depósitos de Object Gateway #

Los depósitos de Object Gateway (OGW) implementan la funcionalidad de los contenedores de OpenStack Swift. Los depósitos de Object Gateway sirven como contenedores para almacenar objetos de datos.

Haga clic en › para ver una lista de depósitos de Object Gateway.

9.3.1 Adición de un depósito nuevo #

Para añadir un depósito nuevo de Object Gateway, haga clic en en la parte superior izquierda del encabezado de la tabla. Introduzca el nombre del depósito, seleccione el propietario y defina el destino de colocación. Para confirmar, haga clic en

En esta fase también puede habilitar el bloqueo seleccionando ; sin embargo, se puede configurar después de la creación. Consulte la Sección 9.3.3, “Edición del depósito” para obtener más información.

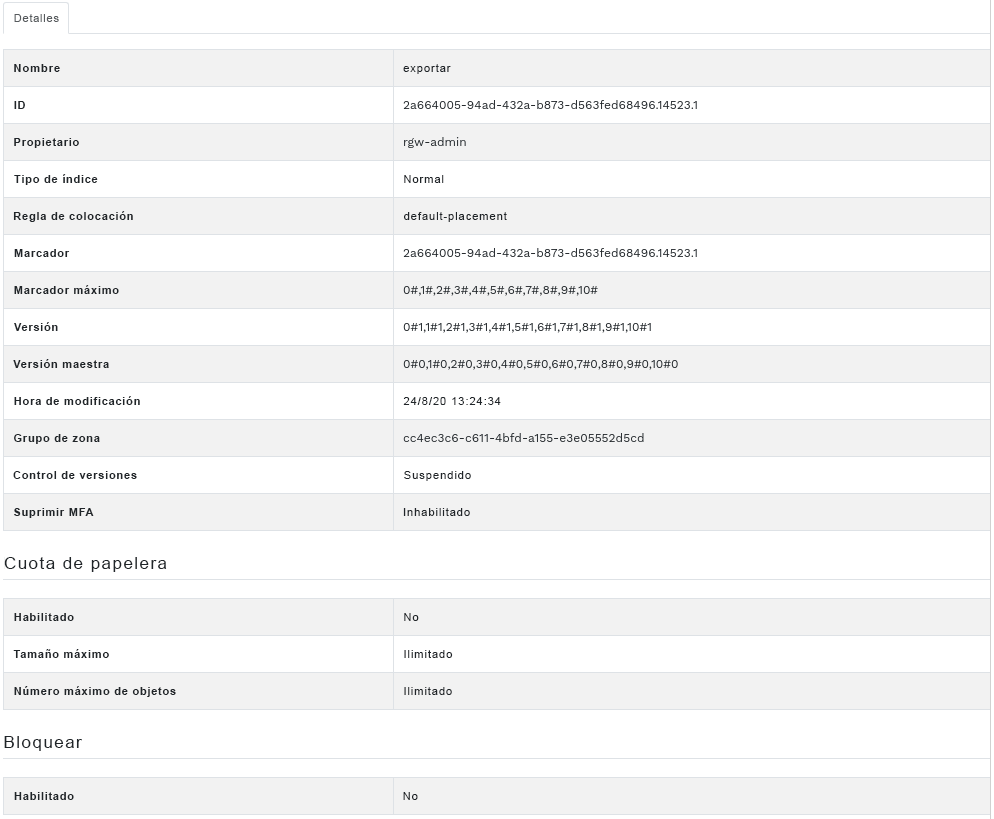

9.3.2 Visualización de detalles del depósito #

Para ver información detallada sobre un depósito de Object Gateway, haga clic en la flecha desplegable situada junto al nombre del depósito

Debajo de la tabla , puede encontrar detalles sobre la cuota de depósito y la configuración de bloqueo.

9.3.3 Edición del depósito #

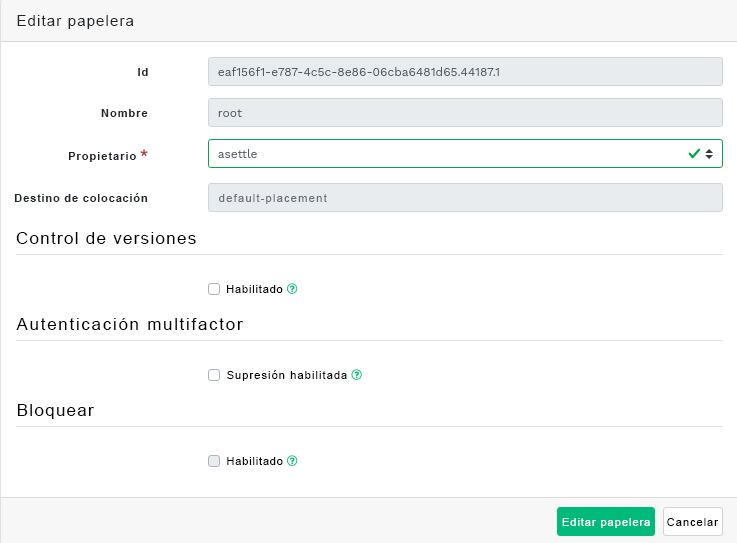

Seleccione y resalte un depósito y, a continuación, haga clic en en la parte superior izquierda del encabezado de la tabla.

Puede actualizar el propietario del depósito o habilitar el control de versiones, la autenticación multifactor o el bloqueo. Para confirmar los cambios, haga clic en

9.3.4 Supresión de un depósito #

Para suprimir un depósito de Object Gateway, selecciónelo y resáltelo. Haga clic en el botón desplegable situado junto a y seleccione en la lista para suprimir el depósito. Active la casilla de verificación y haga clic en para confirmar.

10 Configuración manual #

En esta sección se presenta información avanzada para los usuarios que prefieren configurar manualmente los valores de la consola en la línea de comandos.

10.1 Configuración de la compatibilidad con TLS/SSL #

Todas las conexiones HTTP a la consola están protegidas por defecto con TLS/SSL. Una conexión segura requiere un certificado SSL. Puede usar un certificado autofirmado o generar un certificado y hacer que una entidad de certificación (CA) conocida lo firme.

A veces puede ser necesario inhabilitar SSL por algún motivo. Por ejemplo, si la consola se ejecuta mediante un proxy que no admite SSL.

Tenga cuidado al inhabilitar SSL, ya que los nombres de usuario y las contraseñas se enviarán a la consola sin cifrar.

Para inhabilitar SSL, ejecute:

cephuser@adm > ceph config set mgr mgr/dashboard/ssl falseDebe reiniciar los procesos de Ceph Manager manualmente después de cambiar el certificado SSL y la clave. Puede hacerlo ejecutando:

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAMEo inhabilitando y volviendo a habilitar el módulo de consola, lo que también activa que el gestor se vuelva a reproducir a sí mismo:

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 Creación de certificados autofirmados #

Crear un certificado autofirmado para establecer comunicaciones seguras es sencillo. Es una manera rápida de conseguir poner en funcionamiento la consola.

La mayoría de los navegadores Web producen una advertencia sobre los certificados autofirmados y requerirán que se confirmen explícitamente antes de establecer una conexión segura con la consola.

Para generar e instalar un certificado autofirmado, utilice el siguiente comando integrado:

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 Uso de certificados firmados por una CA #

Para proteger correctamente la conexión a la consola y eliminar las advertencias de los navegadores Web sobre los certificados autofirmados, se recomienda usar un certificado firmado por una CA.