- Informazioni su questa guida

- I Ceph Dashboard

- 1 Informazioni sul Ceph Dashboard

- 2 Interfaccia utente Web del dashboard

- 3 Gestione degli utenti e dei ruoli del Ceph Dashboard

- 4 Visualizzazione dei componenti interni del cluster

- 4.1 Visualizzazione dei nodi del cluster

- 4.2 Accesso all'inventario del cluster

- 4.3 Visualizzazione dei Ceph Monitor

- 4.4 Visualizzazione dei servizi

- 4.5 Visualizzazione dei Ceph OSD

- 4.6 Visualizzazione della configurazione del cluster

- 4.7 Visualizzazione della mappa CRUSH del

- 4.8 Visualizzazione dei moduli Manager

- 4.9 Visualizzazione dei log

- 4.10 Visualizzazione del monitoraggio

- 5 Gestione dei pool

- 6 Gestione del dispositivo di blocco RADOS (RADOS Block Device, RBD)

- 6.1 Visualizzazione dei dettagli sugli RBD

- 6.2 Visualizzazione della configurazione dell'RBD

- 6.3 Creazione di RBD

- 6.4 Eliminazione di RBD

- 6.5 Creazione di snapshot del dispositivo di blocco RADOS (RADOS Block Device, RBD)

- 6.6 Copia speculare RBD

- 6.7 Gestione di iSCSI Gateway

- 6.8 Qualità di servizio (QoS) RBD

- 7 Gestione di NFS Ganesha

- 8 Gestione di CephFS

- 9 Gestione di Object Gateway

- 10 Configurazione manuale

- 11 Gestione di utenti e ruoli sulla riga di comando

- II Funzionamento del cluster

- 12 Determinazione dello stato del cluster

- 12.1 Verifica dello stato di un cluster

- 12.2 Verifica dell'integrità del cluster

- 12.3 Verifica delle statistiche sull'utilizzo di un cluster

- 12.4 Verifica dello stato degli OSD

- 12.5 Verifica degli OSD pieni

- 12.6 Verifica dello stato del monitor

- 12.7 Verifica degli stati dei gruppi di posizionamento

- 12.8 Capacità di memorizzazione

- 12.9 Monitoraggio di OSD e gruppi di posizionamento

- 13 Task operativi

- 13.1 Modifica della configurazione del cluster

- 13.2 Aggiunta di nodi

- 13.3 Rimozione di nodi

- 13.4 Gestione degli OSD

- 13.5 Trasferimento del Salt Master a un nuovo nodo

- 13.6 Aggiornamento dei nodi del cluster

- 13.7 Aggiornamento di Ceph

- 13.8 Interruzione o riavvio del cluster

- 13.9 Rimozione dell'intero cluster Ceph

- 14 Funzionamento dei servizi Ceph

- 15 Backup e ripristino

- 16 Monitoraggio e creazione di avvisi

- 16.1 Configurazione di immagini personalizzate o locali

- 16.2 Aggiornamento dei servizi di monitoraggio

- 16.3 Disabilitazione del monitoraggio

- 16.4 Configurazione di Grafana

- 16.5 Configurazione del modulo Manager di Prometheus

- 16.6 Modello di sicurezza di Prometheus

- 16.7 Webhook SNMP di Prometheus Alertmanager

- 12 Determinazione dello stato del cluster

- III Memorizzazione dei dati in un cluster

- 17 Gestione dei dati memorizzati

- 18 Gestione dei pool di memorizzazione

- 19 Pool con codice di cancellazione

- 20 Dispositivo di blocco RADOS (RADOS Block Device, RBD)

- 20.1 Comandi dei dispositivi di blocco

- 20.2 Montaggio e smontaggio

- 20.3 Snapshot

- 20.4 Copie speculari delle immagini RBD

- 20.5 Impostazioni della cache

- 20.6 Impostazioni QoS

- 20.7 Impostazioni di lettura in avanti

- 20.8 Funzioni avanzate

- 20.9 Mappatura di RBD tramite i client kernel meno recenti

- 20.10 Abilitazione dei dispositivi di blocco e di Kubernetes

- IV Accesso ai dati del cluster

- 21 Ceph Object Gateway

- 21.1 Restrizioni e limitazioni di denominazione di Object Gateway

- 21.2 Distribuzione di Object Gateway

- 21.3 Attivazione del servizio Object Gateway

- 21.4 Opzioni di configurazione

- 21.5 Gestione dell'accesso a Object Gateway

- 21.6 Front-end HTTP

- 21.7 Abilitazione di HTTPS/SSL per gli Object Gateway

- 21.8 Moduli di sincronizzazione

- 21.9 Autenticazione LDAP

- 21.10 Partizionamento dell'indice del compartimento

- 21.11 Integrazione di OpenStack Keystone

- 21.12 Posizionamento di pool e classi di storage

- 21.13 Object Gateway multisito

- 22 Ceph iSCSI Gateway

- 23 File system in cluster

- 24 Esportazione dei dati Ceph tramite Samba

- 25 NFS Ganesha

- 21 Ceph Object Gateway

- V Integrazione con gli strumenti di virtualizzazione

- 26

libvirte Ceph - 27 Ceph come back-end per l'istanza QEMU KVM

- 27.1 Installazione di

qemu-block-rbd - 27.2 Uso di QEMU

- 27.3 Creazione di immagini con QEMU

- 27.4 Ridimensionamento delle immagini con QEMU

- 27.5 Recupero delle informazioni sull'immagine con QEMU

- 27.6 Esecuzione di QEMU con RBD

- 27.7 Abilitazione dell'operazione di scarto e TRIM

- 27.8 Impostazione delle opzioni cache QEMU

- 27.1 Installazione di

- 26

- VI Configurazione di un cluster

- A Aggiornamenti alla manutenzione di Ceph basati sulle release intermedie upstream "Octopus"

- B Aggiornamenti della documentazione

- Glossario

- 2.1 Schermata di login del Ceph Dashboard

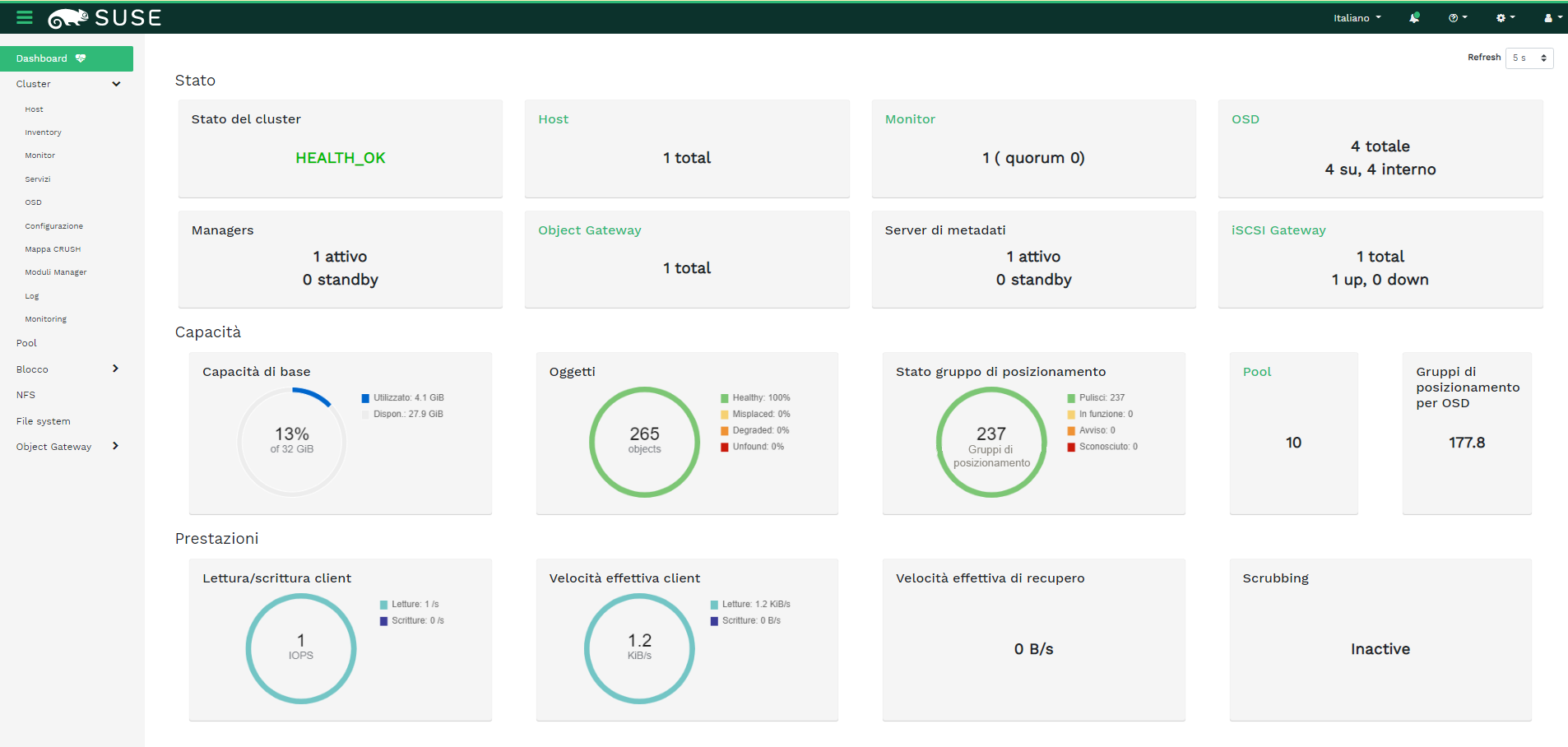

- 2.2 Home page del Ceph Dashboard

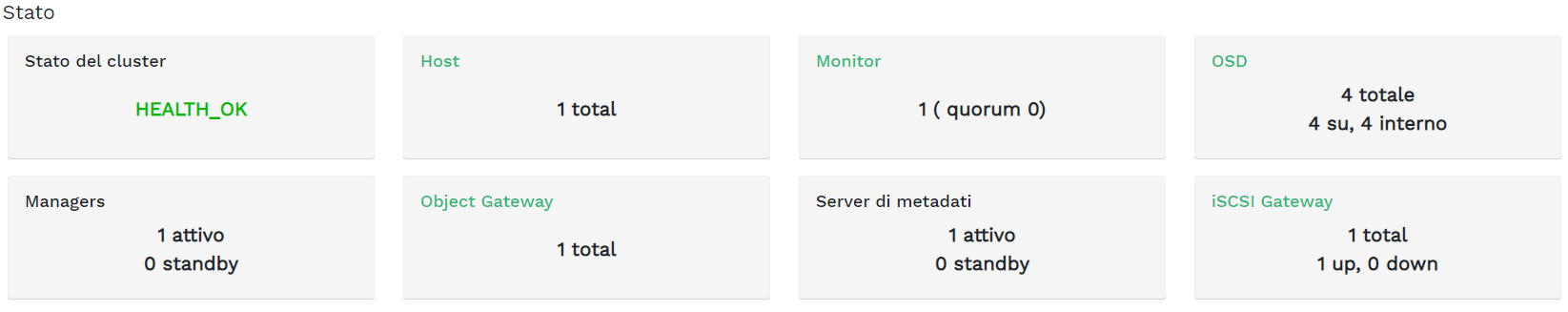

- 2.3 Widget Stato

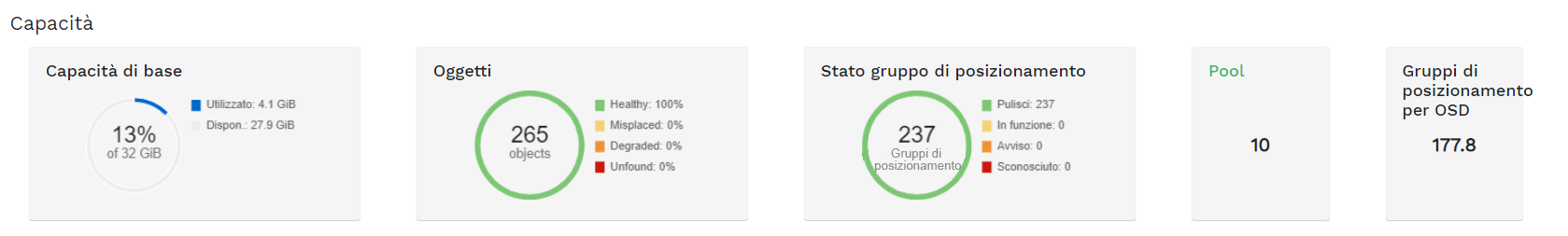

- 2.4 Widget Capacità

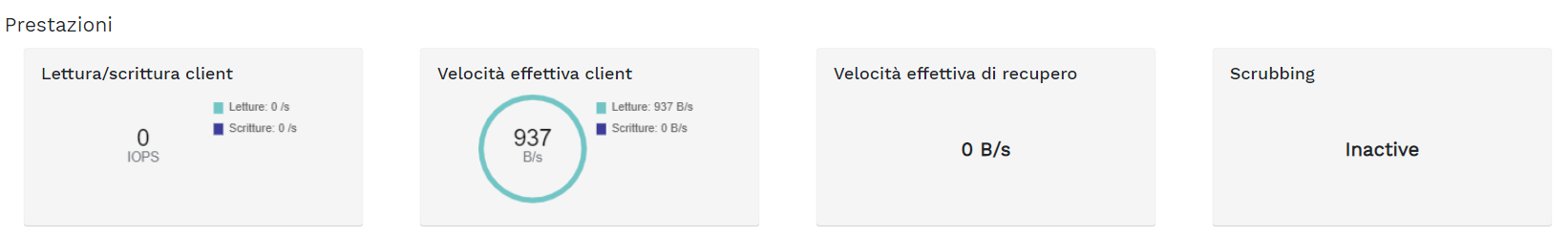

- 2.5 Widget prestazioni

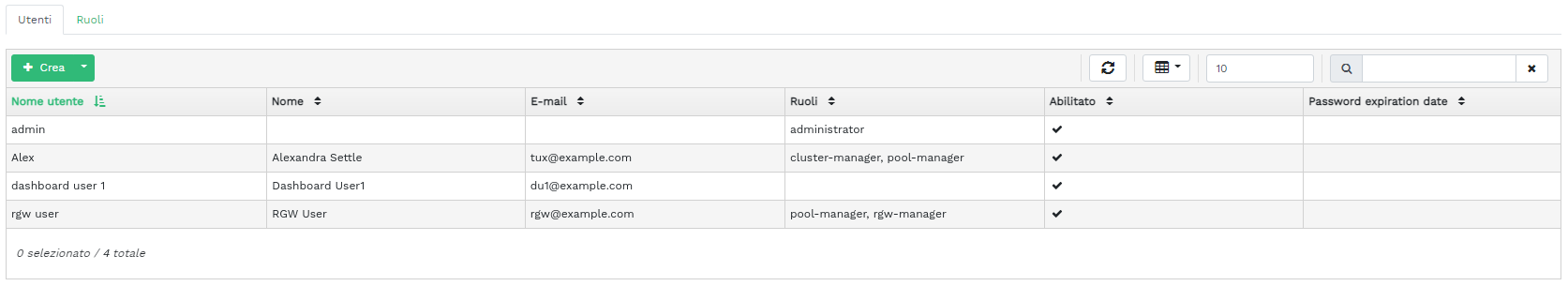

- 3.1 Gestione utenti

- 3.2 Aggiunta di un utente

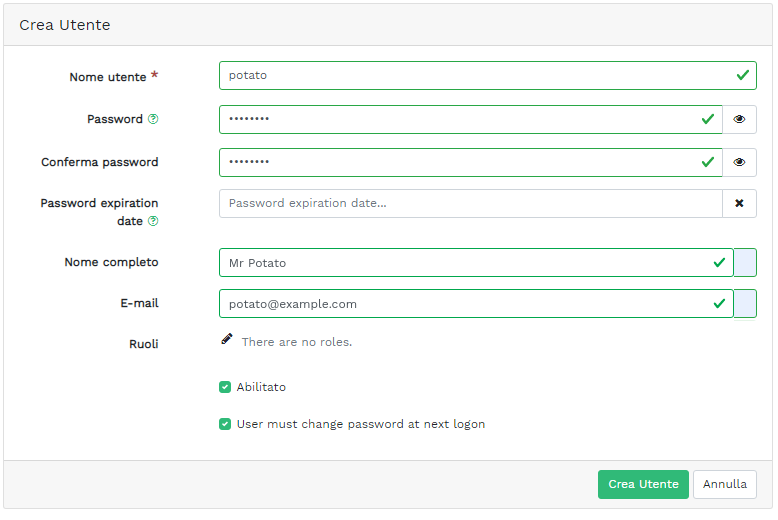

- 3.3 Ruoli dell'utente

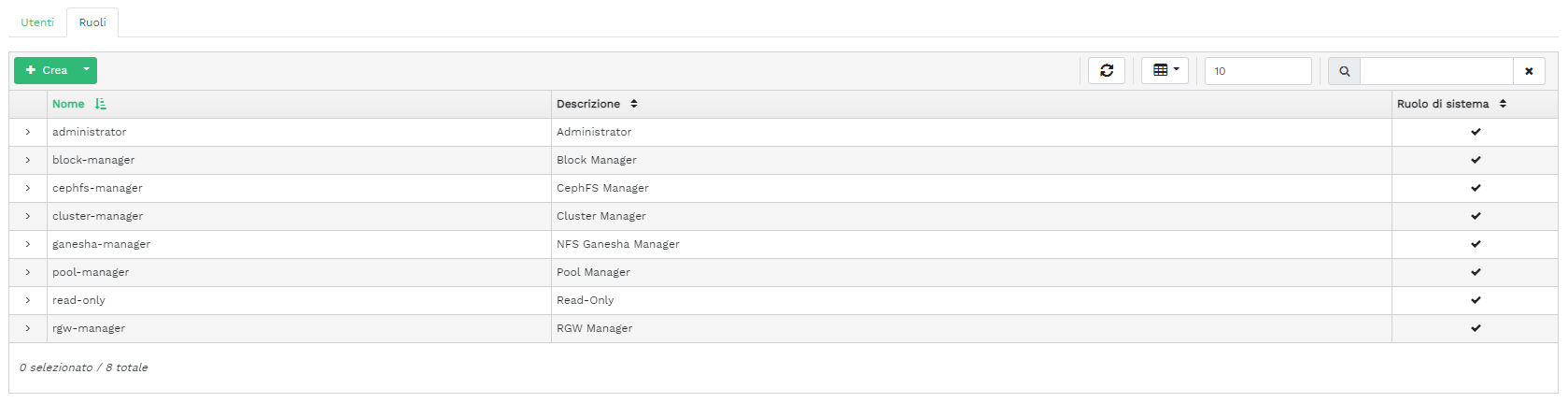

- 3.4 Aggiunta di un ruolo

- 4.1 Hosts

- 4.2 servizi

- 4.3 Ceph Monitor

- 4.4 servizi

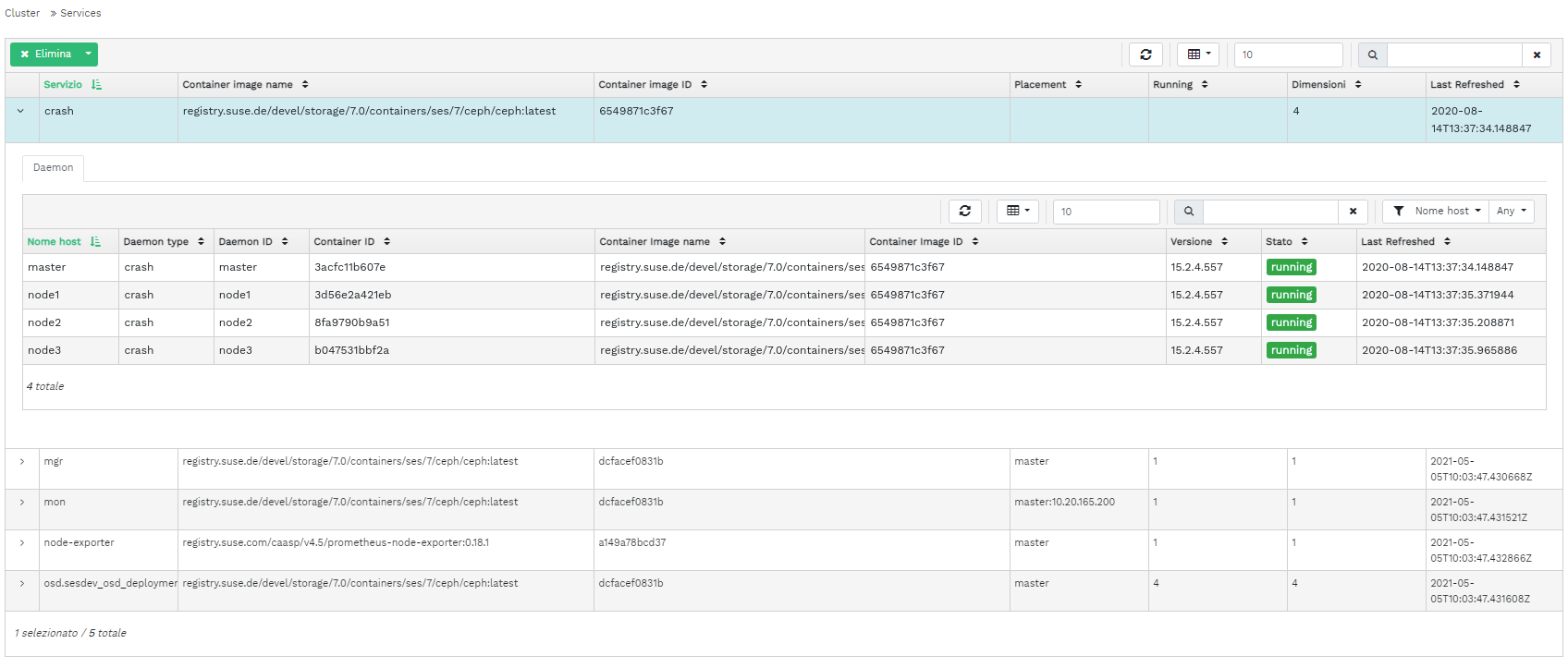

- 4.5 Ceph OSD

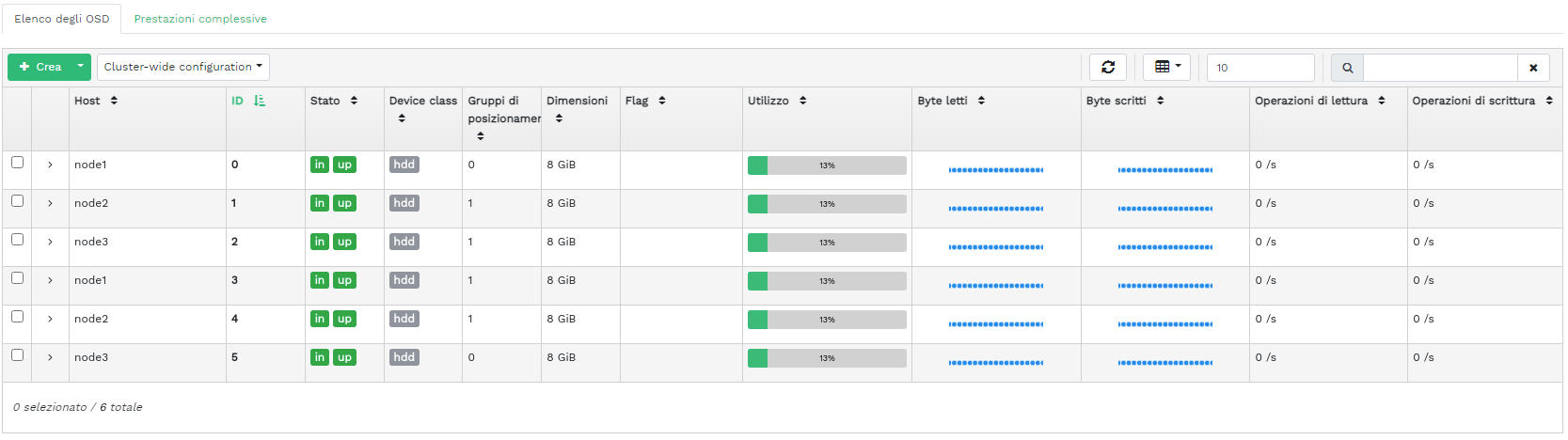

- 4.6 Flag OSD

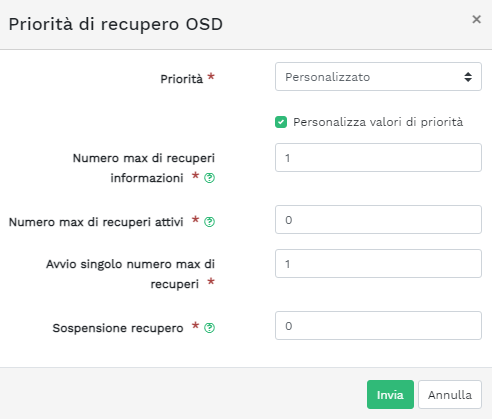

- 4.7 Priorità di recupero OSD

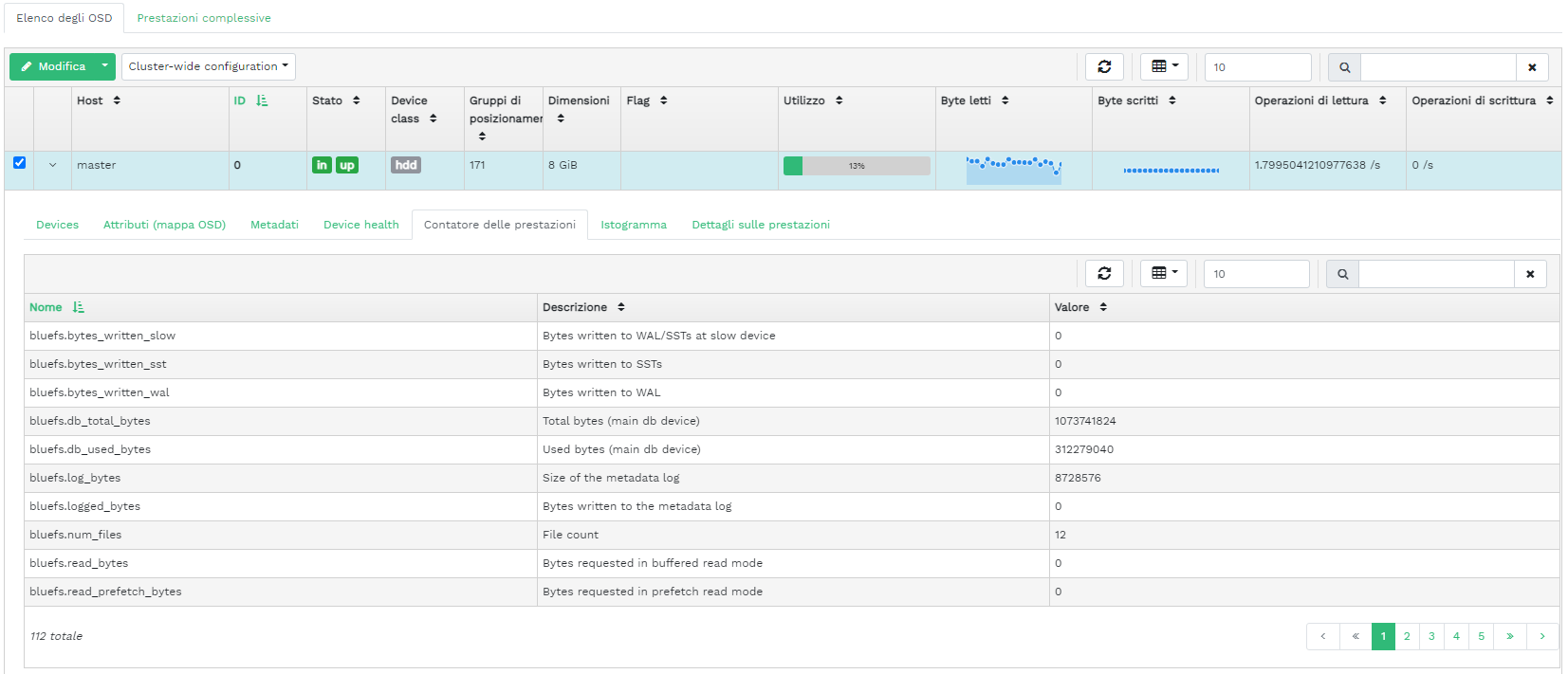

- 4.8 Dettagli OSD

- 4.9 Creazione di OSD

- 4.10 Aggiunta di dispositivi primari

- 4.11 Creazione di OSD con dispositivi primari aggiunti

- 4.12

- 4.13 OSD appena aggiunti

- 4.14 Configurazione del cluster

- 4.15 Mappa CRUSH

- 4.16 Moduli Manager

- 4.17 Log

- 5.1 Elenco di pool

- 5.2 Aggiunta di un nuovo pool

- 6.1 Elenco delle immagini RBD

- 6.2 Dettagli RBD

- 6.3 Configurazione RBD

- 6.4 Aggiunta di un nuovo RBD

- 6.5 Snapshot RBD

- 6.6 Esecuzione dei daemon

rbd-mirror - 6.7 Creazione di un pool con l'applicazione RBD

- 6.8 Configurazione della modalità di replica

- 6.9 Aggiunta delle credenziali del peer

- 6.10 Elenco dei pool replicati

- 6.11 Nuova immagine RBD

- 6.12 Nuova immagine RBD sincronizzata

- 6.13 Stato della replica delle immagini RBD

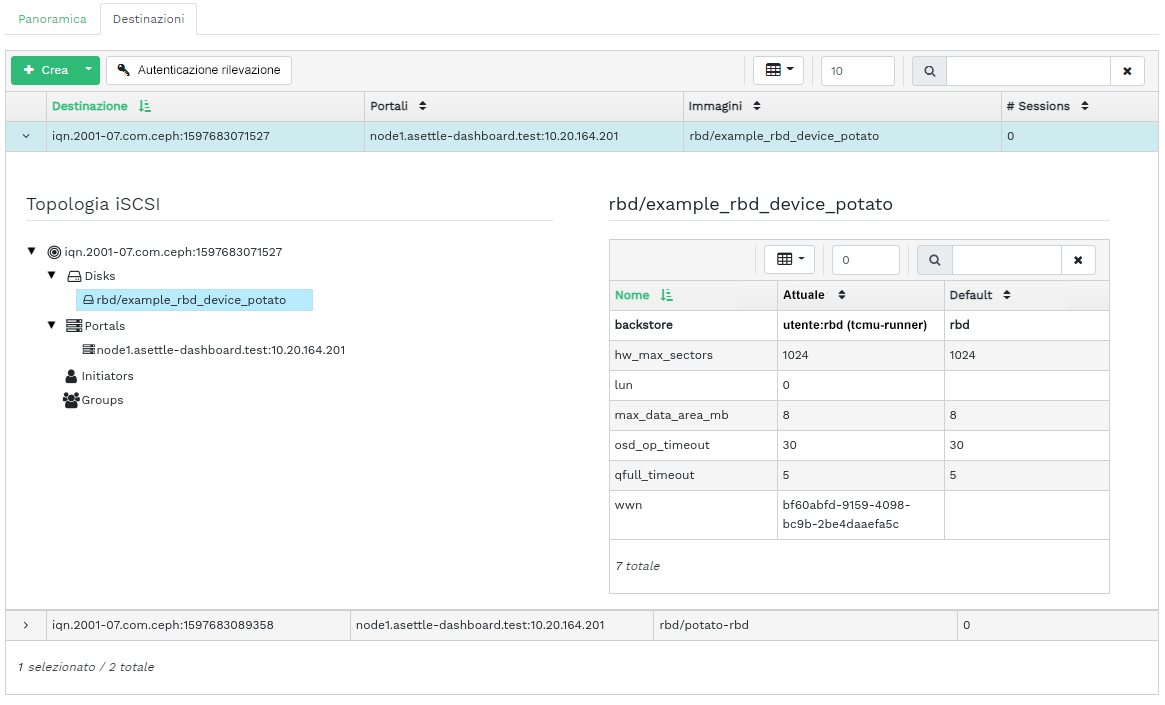

- 6.14 Elenco delle destinazioni iSCSI

- 6.15 Dettagli sulla destinazione iSCSI

- 6.16 Aggiunta di una nuova destinazione

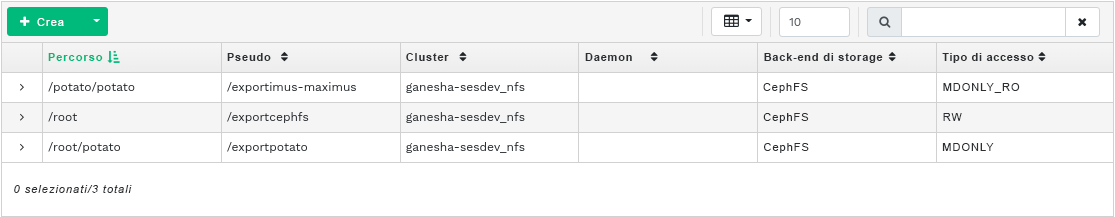

- 7.1 Elenco di esportazioni NFS

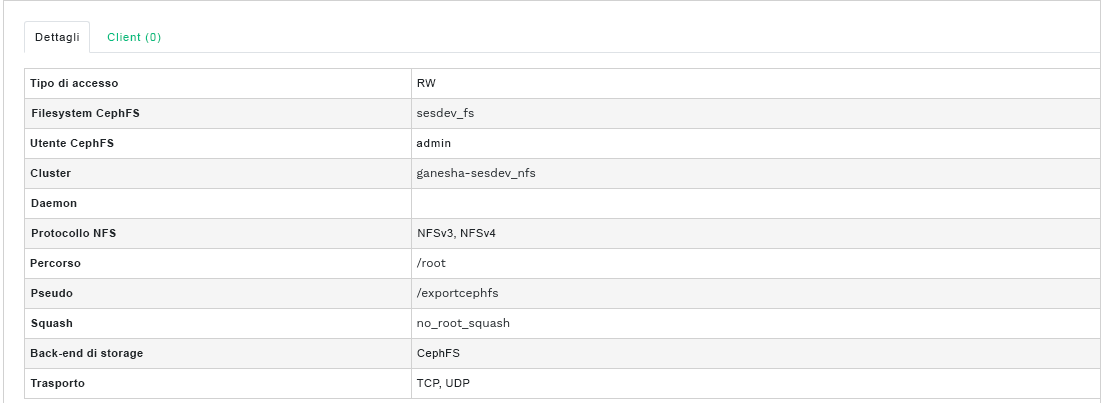

- 7.2 Dettagli esportazione NFS

- 7.3 Aggiunta di una nuova esportazione NFS

- 7.4 Modifica di un'esportazione NFS

- 8.1 Dettagli CephFS

- 8.2 Dettagli CephFS

- 9.1 Dettagli Gateway

- 9.2 Utenti Gateway

- 9.3 Aggiunta di un nuovo utente Gateway

- 9.4 Dettagli compartimento Gateway

- 9.5 Modifica dei dettagli del compartimento

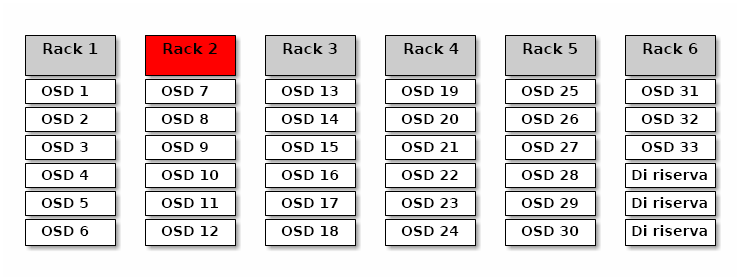

- 12.1 Cluster Ceph

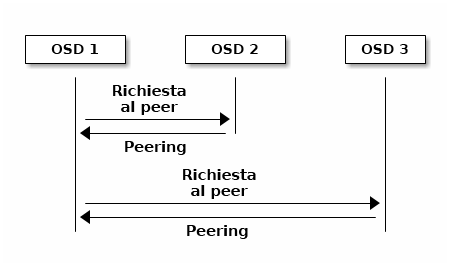

- 12.2 Schema di peering

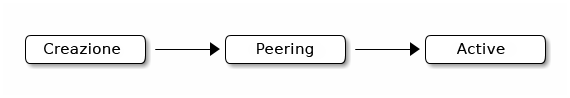

- 12.3 Stato dei gruppi di posizionamento

- 17.1 OSD con classi di dispositivi miste

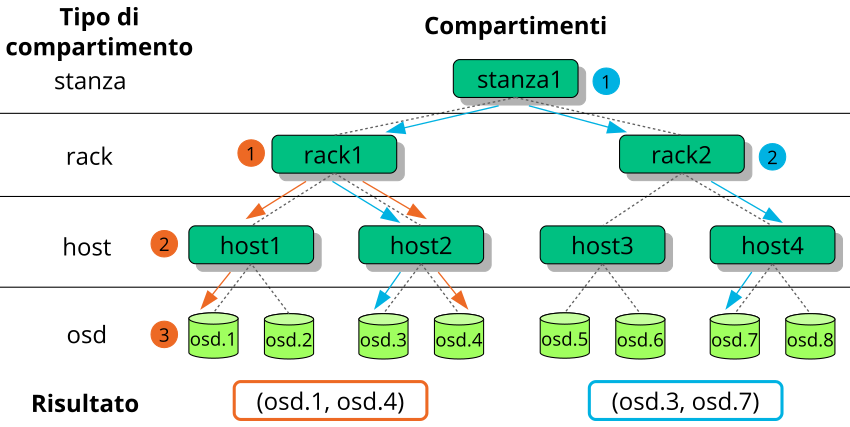

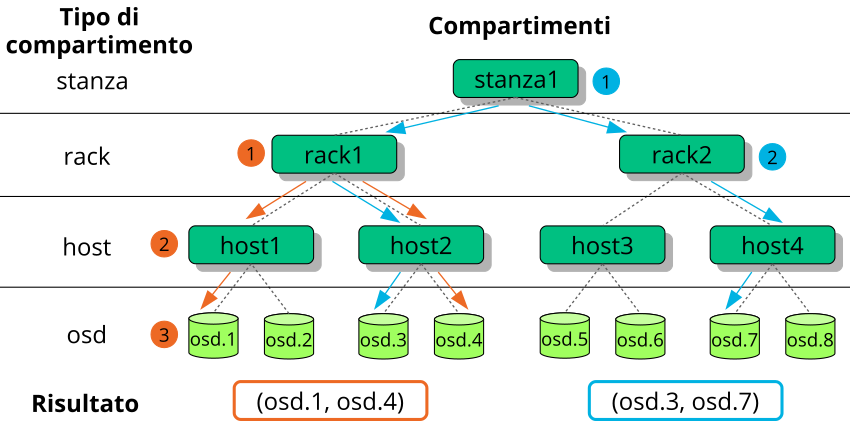

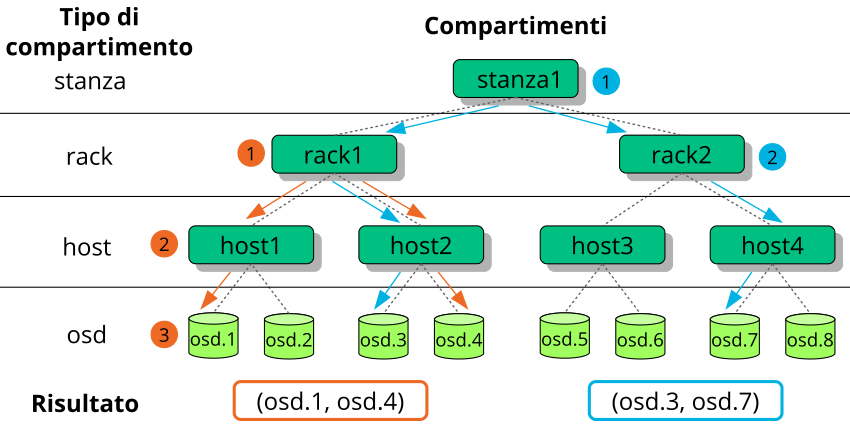

- 17.2 Albero di esempio

- 17.3 Metodi di sostituzione dei nodi

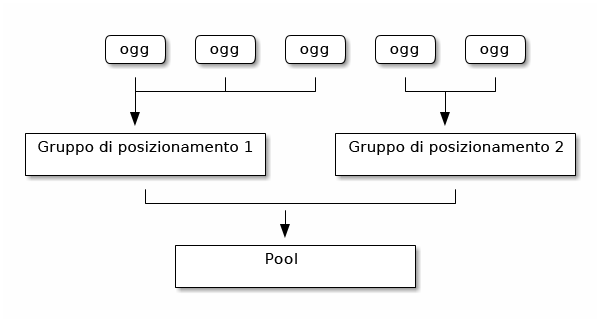

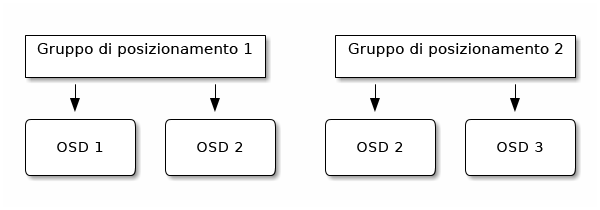

- 17.4 Gruppi di posizionamento in un pool

- 17.5 Gruppi di posizionamento e OSD

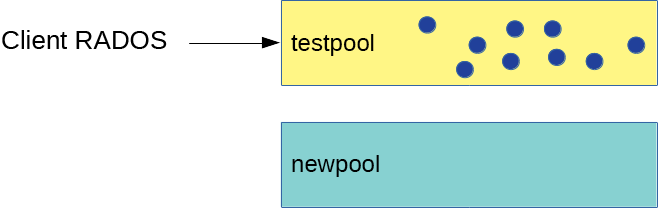

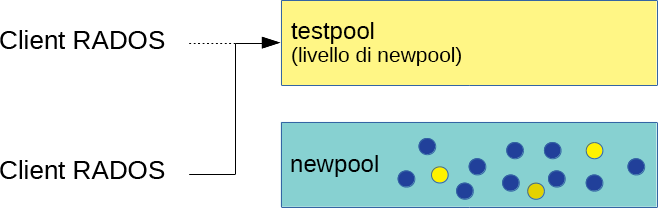

- 18.1 Pool prima della migrazione

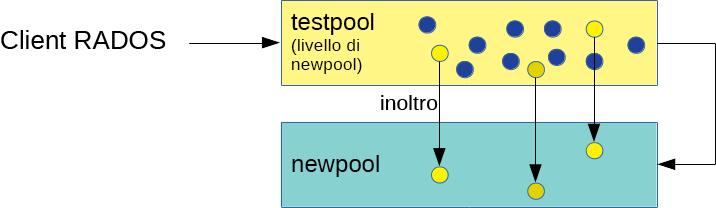

- 18.2 Configurazione del livello di cache

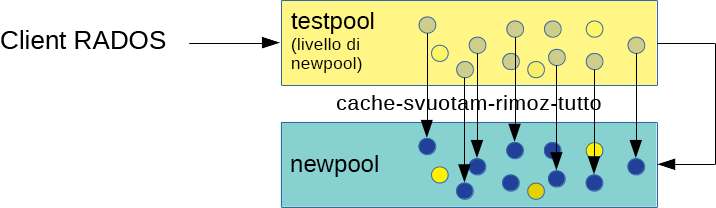

- 18.3 Svuotamento dei dati

- 18.4 Impostazione dell'overlay

- 18.5 Completamento della migrazione

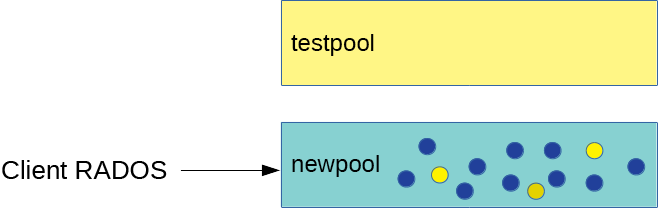

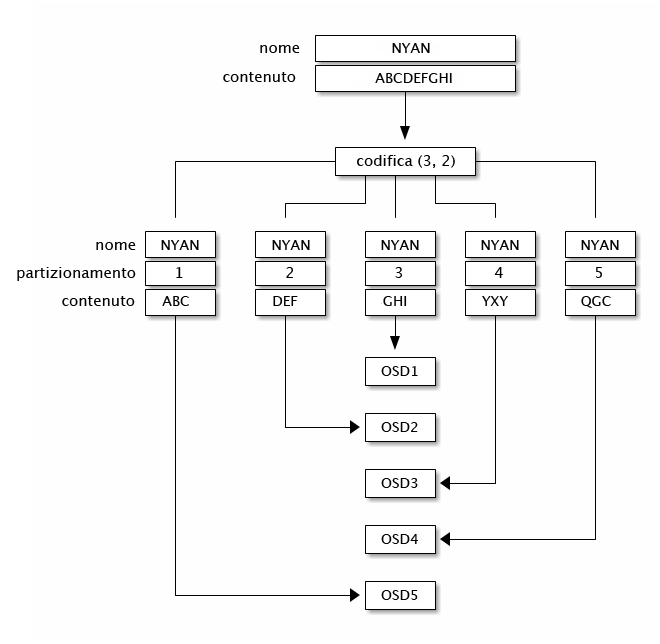

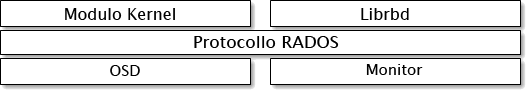

- 20.1 Protocollo RADOS

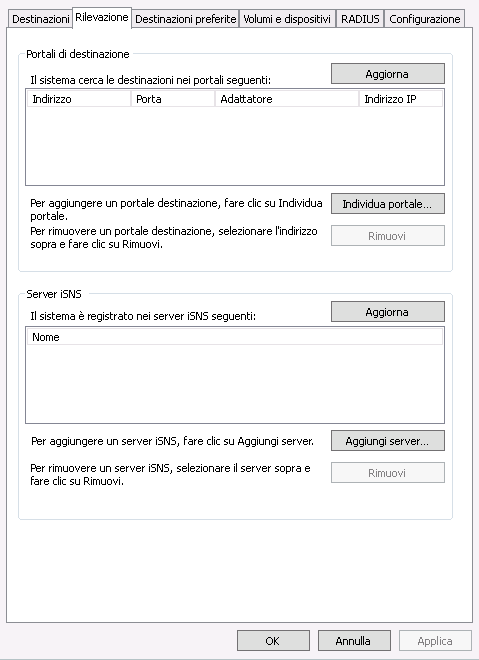

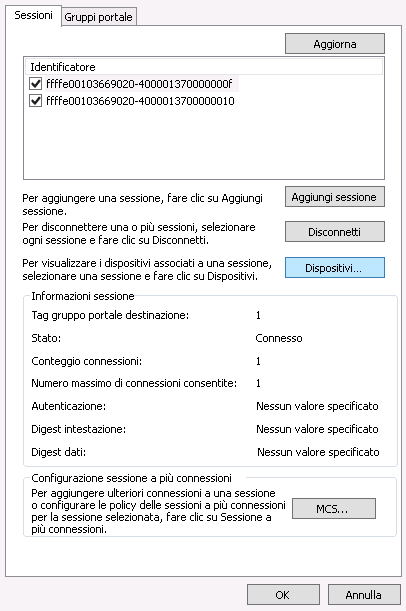

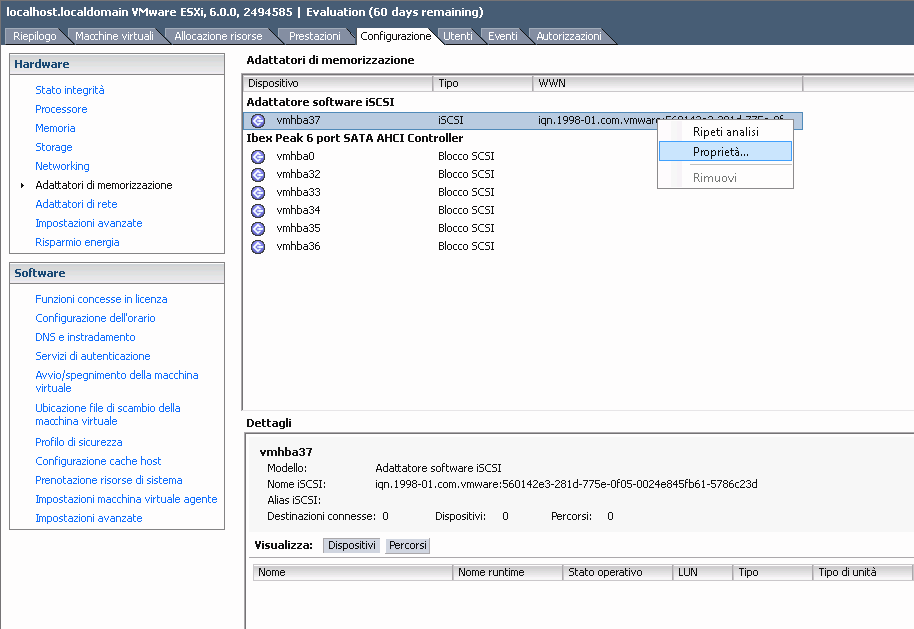

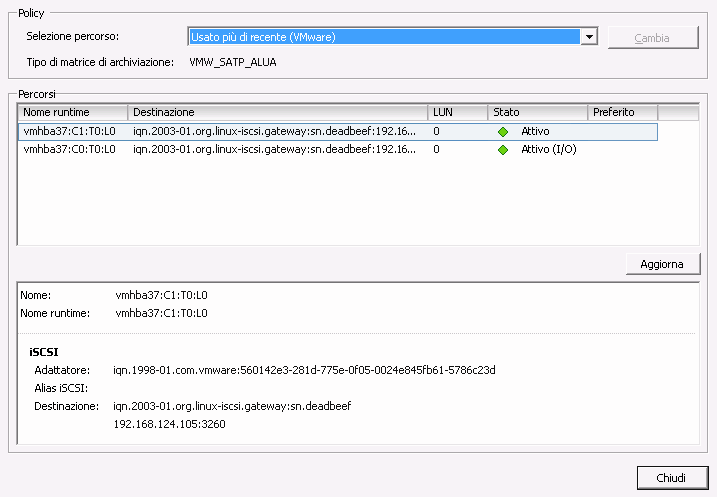

- 22.1 Proprietà iniziatore iSCSI

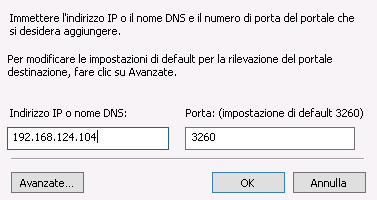

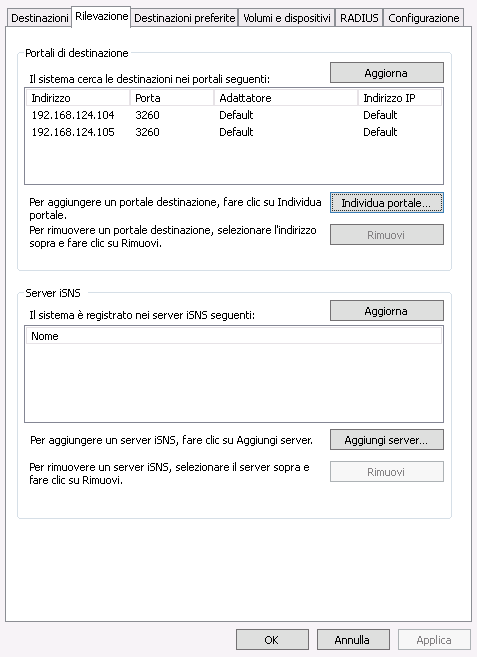

- 22.2 Rilevazione portale di destinazione

- 22.3 Portali di destinazione

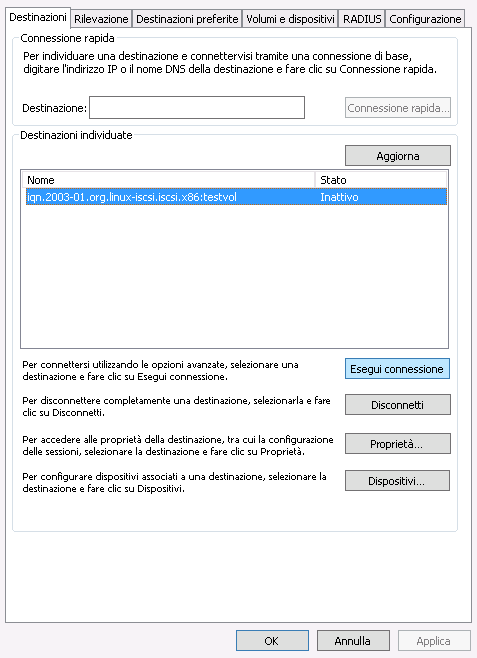

- 22.4 Destinazioni

- 22.5 Proprietà destinazione iSCSI

- 22.6 Dettagli dispositivo

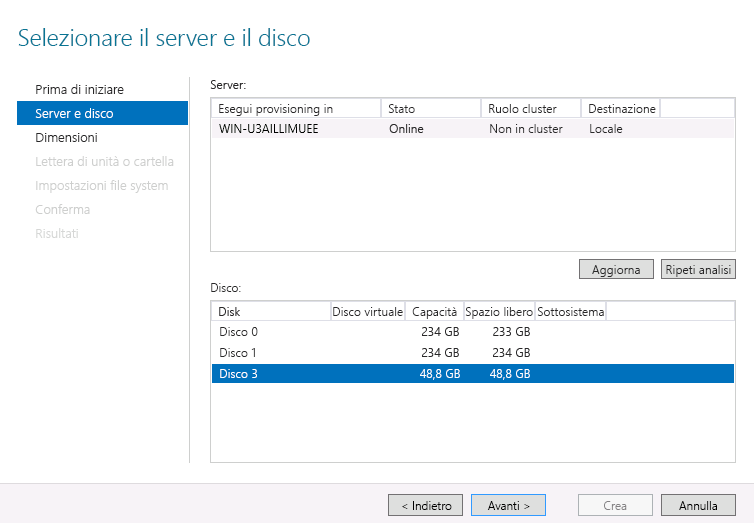

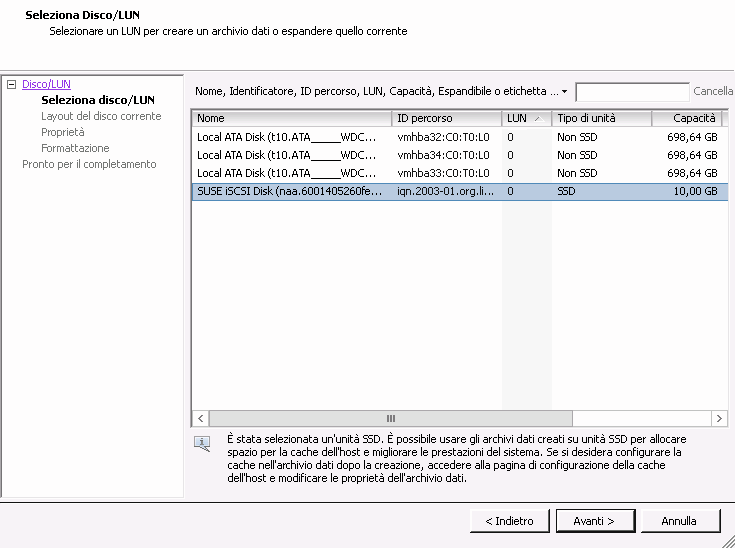

- 22.7 Procedura guidata per il nuovo volume

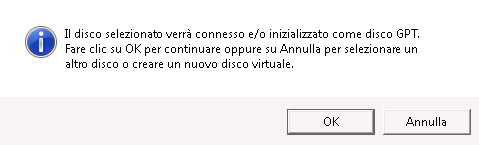

- 22.8 Prompt del disco offline

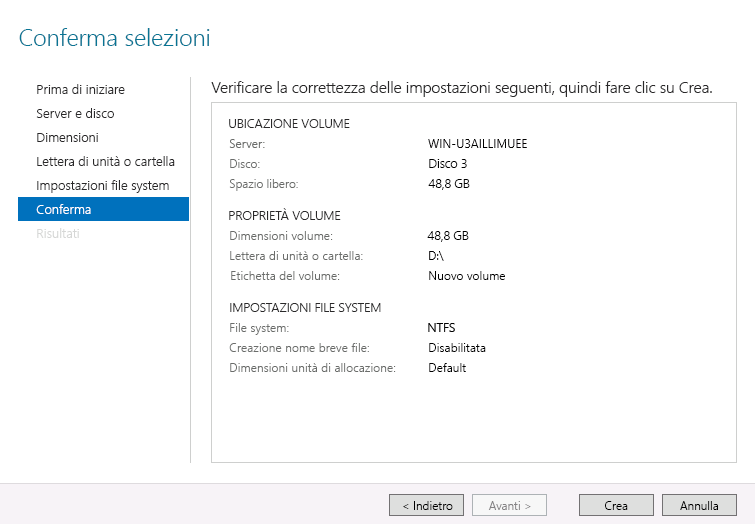

- 22.9 Conferma selezioni volume

- 22.10 Proprietà iniziatore iSCSI

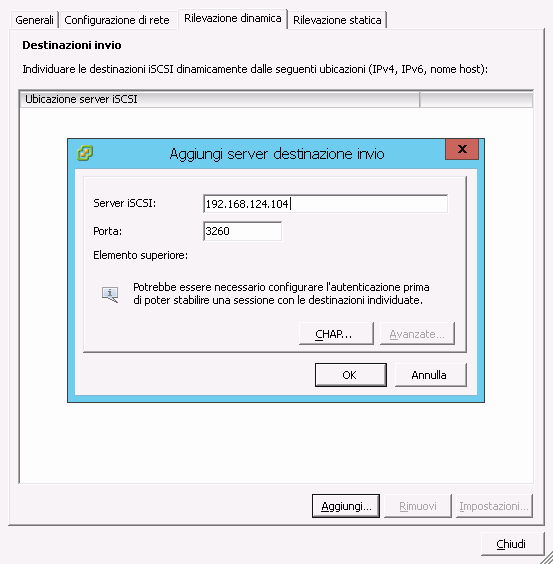

- 22.11 Aggiunta del server di destinazione

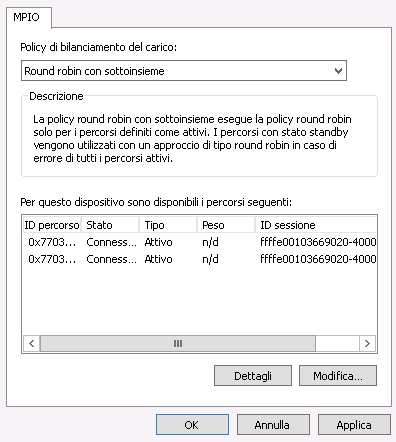

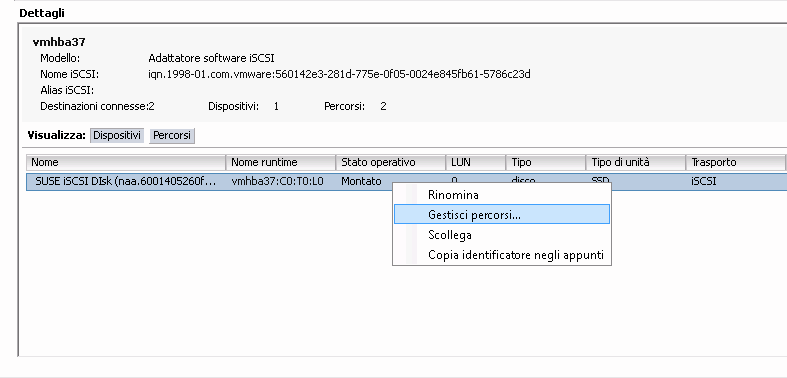

- 22.12 Gestione dei dispositivi multipath

- 22.13 Elenco dei percorsi per multipath

- 22.14 Finestra di dialogo Aggiungi memorizzazione

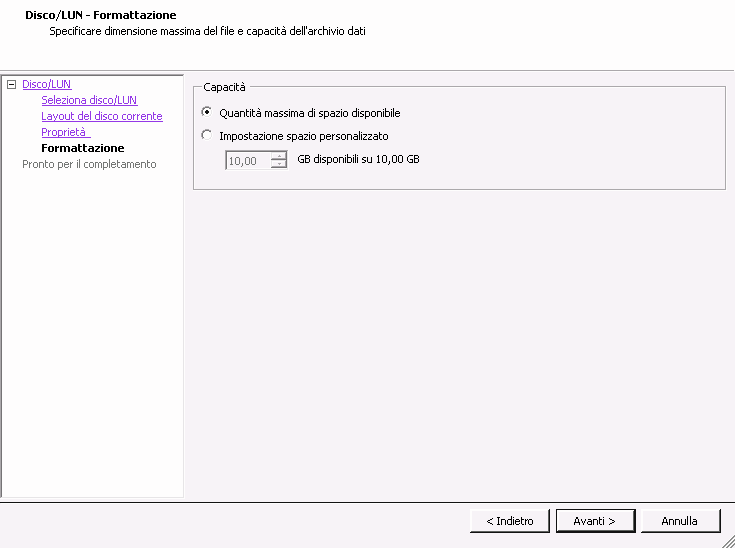

- 22.15 Impostazione spazio personalizzato

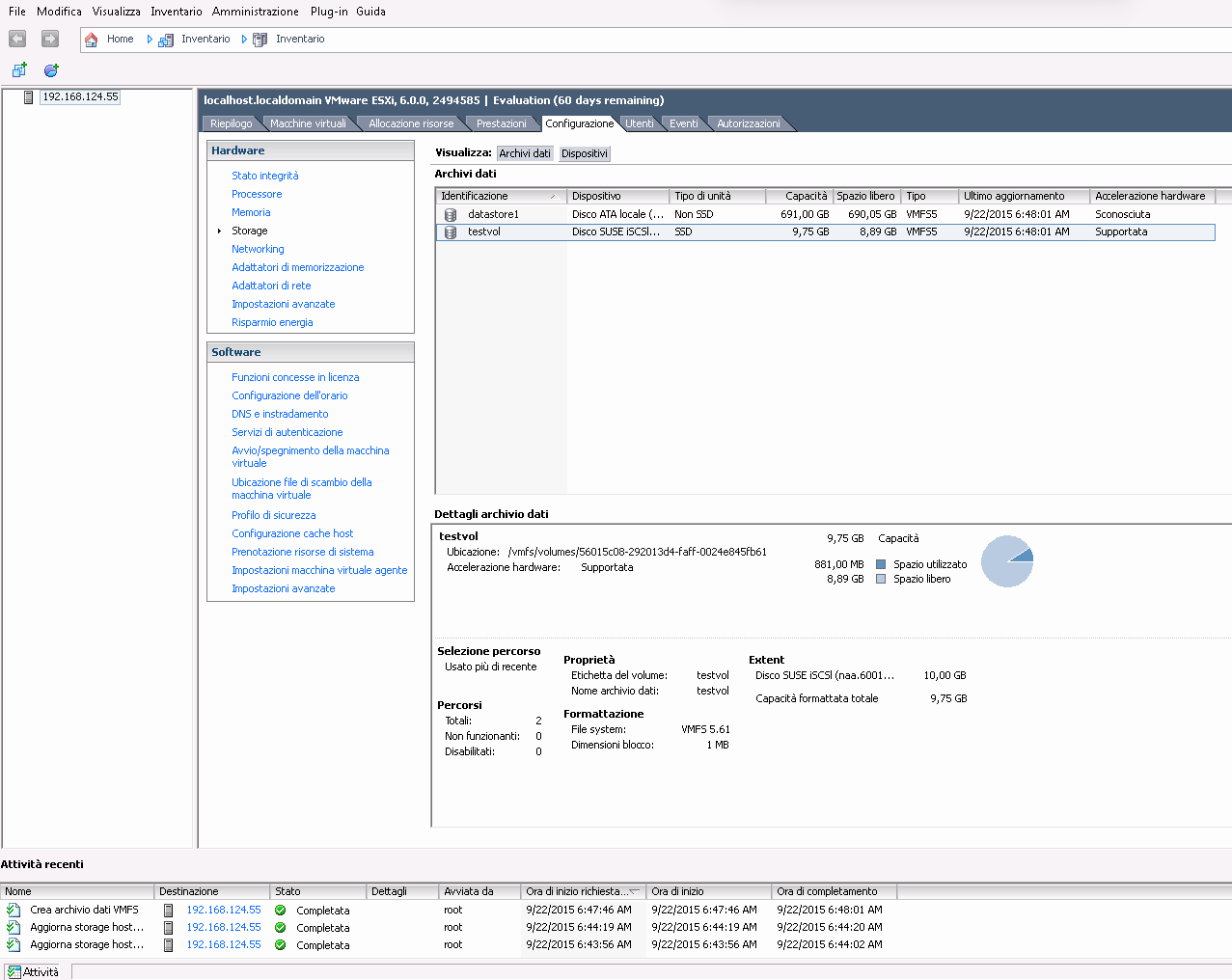

- 22.16 Panoramica dell'archivio dati iSCSI

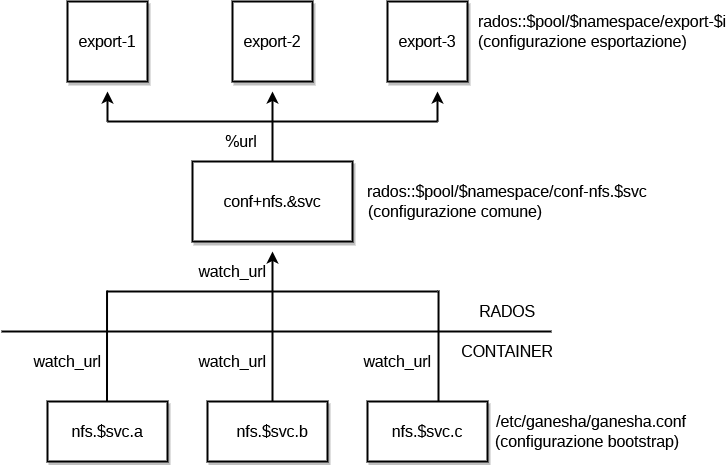

- 25.1 Struttura di NFS Ganesha

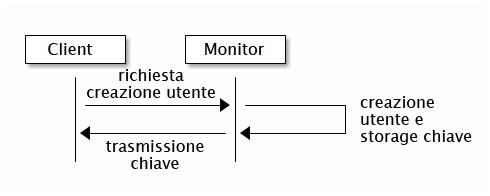

- 30.1 Autenticazione

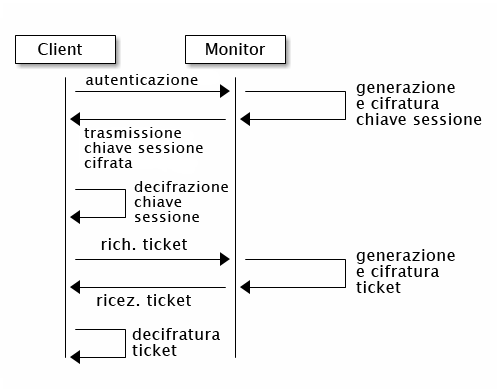

cephxdi base - 30.2 Autenticazione

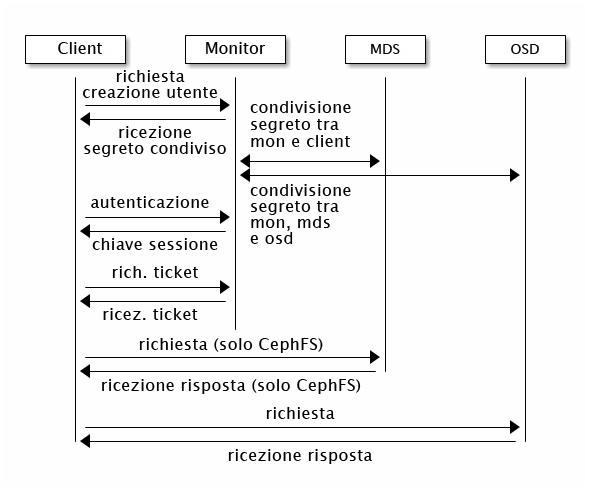

cephx - 30.3 Autenticazione

cephx- MDS e OSD

- 12.1 Individuazione di un oggetto

- 13.1 Corrispondenza in base alle dimensioni del disco

- 13.2 Configurazione semplice

- 13.3 Configurazione avanzata

- 13.4 Configurazione avanzata con nodi non uniformi

- 13.5 Configurazione esperta

- 13.6 Configurazione complessa (e improbabile)

- 17.1

crushtool --reclassify-root - 17.2

crushtool --reclassify-bucket - 21.1 Configurazione semplice

- 21.2 Configurazione complessa

- 28.1 Configurazione oggetto Beast di esempio

- 28.2 Configurazione Civetweb di esempio in

/etc/ceph/ceph.conf

Copyright © 2020–2023 SUSE LLC e collaboratori. Tutti i diritti riservati.

Tranne laddove diversamente specificato, il presente documento è fornito con licenza Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode

Per i marchi di fabbrica SUSE vedere http://www.suse.com/company/legal/. Tutti i marchi di fabbrica di terze parti appartengono ai rispettivi proprietari. I simboli di marchio di fabbrica (®, ™ e così via) indicano i marchi di fabbrica appartenenti a SUSE e alle rispettive affiliate. Gli asterischi (*) indicano i marchi di fabbrica di terze parti.

Tutte le informazioni presenti nella presente pubblicazione sono state compilate con la massima attenzione ai dettagli. Ciò, tuttavia, non garantisce una precisione assoluta. SUSE LLC, le rispettive affiliate, gli autori e i traduttori non potranno essere ritenuti responsabili di eventuali errori o delle relative conseguenze.

Informazioni su questa guida #

Questa guida è incentrata sui task di routine che gli amministratori devono completare in seguito alla distribuzione del cluster Ceph di base (operazioni giorno 2). Descrive inoltre tutti i metodi supportati per l'accesso ai dati memorizzati in un cluster Ceph.

SUSE Enterprise Storage 7 è un'estensione per SUSE Linux Enterprise Server 15 SP2 che combina le funzionalità del progetto di storage Ceph (http://ceph.com/) con il supporto e l'ingegneria aziendale di SUSE. SUSE Enterprise Storage 7 fornisce alle organizzazioni IT la possibilità di installare un'architettura di storage distribuita in grado di supportare numerosi casi di utilizzo mediante piattaforme hardware commodity.

1 Documentazione disponibile #

La documentazione relativa ai nostri prodotti è disponibile all'indirizzo https://documentation.suse.com, dove sono disponibili anche gli ultimi aggiornamenti ed è possibile sfogliare ed effettuare il download della documentazione in vari formati. Gli ultimi aggiornamenti della documentazione sono disponibili in lingua inglese.

Inoltre, la documentazione dei prodotti è disponibile nel sistema installato in /usr/share/doc/manual. È inclusa in un pacchetto RPM denominato

ses-manual_LANG_CODE. Installarlo se non è già presente nel sistema, ad esempio:

root # zypper install ses-manual_enPer questo prodotto è disponibile la seguente documentazione:

- Guida all'installazione

Questa guida è incentrata sulla distribuzione di un cluster Ceph di base e di servizi aggiuntivi. Illustra inoltre le procedure da completare per eseguire l'upgrade a SUSE Enterprise Storage 7 dalla versione precedente.

- Guida all'amministrazione e alle operazioni

Questa guida è incentrata sui task di routine che gli amministratori devono completare in seguito alla distribuzione del cluster Ceph di base (operazioni giorno 2). Descrive inoltre tutti i metodi supportati per l'accesso ai dati memorizzati in un cluster Ceph.

- Guida alla sicurezza avanzata

Questa guida descrive le procedure per verificare la protezione del cluster.

- Guida alla soluzione dei problemi

Questa guida descrive diversi problemi comuni correlati all'esecuzione di SUSE Enterprise Storage 7 e altri problemi relativi ai componenti pertinenti, come Ceph oppure Object Gateway.

- Guida di SUSE Enterprise Storage per Windows

Questa guida descrive le procedure di integrazione, installazione e configurazione degli ambienti Microsoft Windows e SUSE Enterprise Storage tramite il driver di Windows.

2 Invio di feedback #

Qualsiasi feedback e contributo alla presente documentazione è ben accetto. È possibile lasciare il proprio feedback tramite tanti canali diversi:

- Richieste di servizio e supporto

Per verificare i servizi e le opzioni di supporto disponibili per il proprio prodotto, visitare http://www.suse.com/support/.

Per aprire una richiesta di servizio, è necessario l'abbonamento al SUSE Customer Center. Andare a https://scc.suse.com/support/requests, eseguire il login e fare clic su .

- Segnalazioni di bug

Segnalare i problemi relativi alla documentazione all'indirizzo https://bugzilla.suse.com/. Per la segnalazione dei problemi, è necessario un account Bugzilla.

Per semplificare il processo, è possibile utilizzare i collegamenti per la , accanto ai titoli nella versione HTML del presente documento, che preselezionano la categoria e il prodotto corretti in Bugzilla e indirizzano alla sezione corrente. È possibile iniziare a digitare subito la segnalazione di bug.

- Contributi

Per contribuire alla presente documentazione, utilizzare i collegamenti , accanto ai titoli nella versione HTML del documento, che indirizzano al codice sorgente su GitHub, dove è possibile aprire una richiesta pull. Per inviare un contributo, è necessario un account GitHub.

Per ulteriori informazioni sull'ambiente di documentazione utilizzato, vedere il file README dell'archivio all'indirizzo https://github.com/SUSE/doc-ses.

- Posta

È inoltre possibile segnalare errori e inviare feedback sulla documentazione scrivendo all'indirizzo <doc-team@suse.com>. Includere il titolo del documento, la versione del prodotto e la data di pubblicazione del documento. Inoltre, includere il titolo e il numero della sezione pertinente (o specificare l'URL) e fornire una breve descrizione del problema.

3 Convenzioni utilizzate nella documentazione #

Nel presente documento vengono utilizzati gli avvisi e le convenzioni tipografiche illustrati di seguito:

/etc/passwd: nomi di directory e fileSEGNAPOSTO: sostituire SEGNAPOSTO con il valore effettivo

PATH: variabile di ambientels,--help: comandi, opzioni e parametriuser: nome dell'utente o del gruppopackage_name: nome di un pacchetto software

Alt, Alt–F1: tasto da premere o combinazione di tasti. I tasti sono visualizzati in maiuscolo come se fossero sulla tastiera.

, › (Salva con nome): voci di menu, pulsanti

AMD/Intel Questo paragrafo riguarda solo le architetture Intel 64/AMD64. Le frecce contrassegnano l'inizio e la fine del blocco di testo.

IBM Z, POWER Questo paragrafo si riferisce esclusivamente alle architetture

IBM ZePOWER. Le frecce contrassegnano l'inizio e la fine del blocco di testo.Capitolo 1, «Capitolo di esempio»: riferimento incrociato a un altro capitolo della presente guida.

Comandi che devono essere eseguiti con privilegi di

root. Per eseguire tali comandi come utente senza privilegi, è spesso possibile anteporvi il prefissosudo.root #commandtux >sudocommandComandi che possono essere eseguiti anche da utenti senza privilegi.

tux >commandAvvisi

Avvertimento: avvertenzaInformazioni essenziali che è indispensabile conoscere prima di procedere. Segnala problemi di sicurezza, potenziali perdite di dati, danni hardware o pericoli fisici.

Importante: avviso importanteInformazioni importanti che è consigliabile leggere prima di procedere.

Nota: notaInformazioni aggiuntive, che illustrano ad esempio le differenze tra le varie versioni del software.

Suggerimento: suggerimentoInformazioni utili, come linee guida o consigli pratici.

Avvisi compatti

Informazioni aggiuntive, che illustrano ad esempio le differenze tra le varie versioni del software.

Informazioni utili, come linee guida o consigli pratici.

4 Ciclo di vita del prodotto e supporto #

Prodotti SUSE diversi hanno cicli di vita diversi. Per verificare le date esatte del ciclo di vita di SUSE Enterprise Storage, visitare https://www.suse.com/lifecycle/.

4.1 Definizioni del supporto SUSE #

Agli indirizzi https://www.suse.com/support/policy.html e https://www.suse.com/support/programs/long-term-service-pack-support.html è possibile trovare informazioni sulle opzioni e la policy di supporto.

4.2 Informativa sul supporto per SUSE Enterprise Storage #

Per ricevere supporto, occorre una sottoscrizione idonea a SUSE. Per visualizzare le offerte di supporto specifiche disponibili, andare a https://www.suse.com/support/ e selezionare il prodotto in uso.

Di seguito sono riportate le definizioni dei livelli di supporto:

- L1

Individuazione del problema, ovvero supporto tecnico pensato per fornire informazioni di compatibilità, assistenza per l'utilizzo, operazioni di manutenzione, raccolta di informazioni e risoluzione dei problemi di base tramite la documentazione disponibile.

- L2

Isolamento del problema, ovvero supporto tecnico pensato per l'analisi dei dati, la riproduzione dei problemi dei clienti, l'isolamento dell'area del problema e la proposta di una risoluzione dei problemi non risolti al livello 1 o la loro preparazione per il livello 3.

- L3

Risoluzione del problema, ovvero supporto tecnico pensato per la risoluzione dei difetti del prodotto identificati al livello di supporto 2.

Per i clienti e i partner con contratto, SUSE Enterprise Storage è fornito con supporto L3 per tutti i pacchetti, a eccezione di quanto segue:

Anteprime della tecnologia

Suoni, grafiche, tipi di carattere e oggetti grafici

Pacchetti che richiedono un contratto con il cliente aggiuntivo

Alcuni pacchetti rilasciati come parte del modulo Workstation Extension dispongono soltanto del supporto L2.

I pacchetti il cui nome termina in -devel (contenenti file di intestazione e simili risorse per sviluppatori) sono supportati soltanto insieme ai relativi pacchetti principali.

SUSE supporterà soltanto l'utilizzo dei pacchetti originali. Vale a dire, i pacchetti non modificati e non ricompilati.

4.3 Anteprime della tecnologia #

Le anteprime della tecnologia sono pacchetti, stack o funzioni forniti da SUSE come anticipazioni sulle future innovazioni. Tramite le anteprime della tecnologia, i clienti hanno la possibilità di testare le nuove tecnologie all'interno del proprio ambiente. I feedback degli utenti sono bene accetti. Se si esegue il test di un'anteprima della tecnologia, contattare il proprio rappresentante SUSE per informarlo della propria esperienza utente e dei casi d'uso. I suggerimenti degli utenti sono molto utili per lo sviluppo futuro.

Le anteprime della tecnologia prevedono le limitazioni seguenti:

Le anteprime della tecnologia sono ancora in fase di sviluppo. Di conseguenza, potrebbero essere incomplete a livello di funzioni, instabili o in altri modi non adatte per l'utilizzo nell'ambiente di produzione.

Le anteprime della tecnologia non dispongono di alcun supporto.

Le anteprime della tecnologia potrebbero essere disponibili soltanto per architetture hardware specifiche.

I dettagli e le funzionalità delle anteprime della tecnologia sono soggetti a modifica. Di conseguenza, potrebbe non essere possibile eseguire l'upgrade alle successive release di un'anteprima della tecnologia e potrebbe essere necessario eseguire una nuova installazione.

È possibile rimuovere le anteprime della tecnologia da un prodotto in qualsiasi momento. SUSE non si impegna a fornire una versione supportata di tali tecnologie in futuro. Ad esempio, ciò potrebbe applicarsi nelle situazioni in cui SUSE rileva che un'anteprima non soddisfa le esigenze dei clienti o del mercato o che non è conforme agli standard aziendali.

Per una panoramica delle anteprime della tecnologia fornite con il prodotto, vedere le note di rilascio all'indirizzo https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.

5 Collaboratori di Ceph #

Il progetto Ceph e la relativa documentazione sono il risultato del lavoro di centinaia di collaboratori e organizzazioni. Per ulteriori dettagli, consultare la pagina all'indirizzo https://ceph.com/contributors/.

6 Comandi e prompt dei comandi utilizzati nella presente guida #

Gli amministratori del cluster Ceph si occupano della configurazione e della modifica del comportamento del cluster tramite l'esecuzione di comandi specifici. Saranno necessari diversi tipi di comandi:

6.1 Comandi correlati a Salt #

Questi comandi consentono di distribuire i nodi del cluster Ceph, di eseguire comandi contemporaneamente su più (o su tutti i) nodi del cluster e semplificano l'aggiunta o la rimozione dei nodi del cluster. I comandi utilizzati più di frequente sono ceph-salt e ceph-salt config. È necessario eseguire i comandi Salt sul nodo del Salt Master come root. Questi comandi sono introdotti dal prompt seguente:

root@master # Esempio:

root@master # ceph-salt config ls6.2 Comandi correlati a Ceph #

Si tratta di comandi di livello inferiore per la configurazione e l'ottimizzazione di tutti gli aspetti del cluster e dei relativi gateway sulla riga di comando, ad esempio ceph, cephadm, rbd o radosgw-admin.

Per eseguire i comandi correlati a Ceph, è necessario disporre dell'accesso in lettura a una chiave Ceph. Le capacità della chiave definiscono i privilegi dell'utente all'interno dell'ambiente Ceph. Un'opzione consiste nell'eseguire i comandi di Ceph come root (o tramite sudo) e utilizzare il portachiavi di default senza restrizioni "ceph.client.admin.key".

L'opzione consigliata e più sicura consiste nel creare una chiave individuale più restrittiva per ogni utente amministratore e inserirla in una directory in cui gli utenti possano leggerla, ad esempio:

~/.ceph/ceph.client.USERNAME.keyring

Per utilizzare un utente amministratore e un portachiavi personalizzati, è necessario specificare il nome utente e il percorso della chiave ogni volta che si esegue il comando ceph tramite le opzioni -n client.USER_NAME e --keyring PATH/TO/KEYRING.

Per evitarlo, includere queste opzioni nella variabile CEPH_ARGS nei file ~/.bashrc dei singoli utenti.

I comandi correlati a Ceph possono essere eseguiti su qualsiasi nodo del cluster, ma è consigliabile eseguirli sul nodo admin. In questa documentazione, l'utente cephuser esegue i comandi, pertanto questi vengono introdotti dal prompt seguente:

cephuser@adm > Esempio:

cephuser@adm > ceph auth listSe nella documentazione è indicato di eseguire un comando su un nodo del cluster con un ruolo specifico, questo verrà indirizzato dal prompt. Esempio:

cephuser@mon > 6.2.1 Esecuzione di ceph-volume #

A partire da SUSE Enterprise Storage 7, i servizi Ceph vengono eseguiti in container. Se è necessario eseguire ceph-volume su un nodo OSD, occorre anteporlo con il comando cephadm, ad esempio:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandi Linux generali #

I comandi Linux non correlati a Ceph, come mount, cat o openssl, sono introdotti con i prompt cephuser@adm > o root # , a seconda dei privilegi richiesti dal comando correlato.

6.4 Informazioni aggiuntive #

Per ulteriori informazioni sulla gestione della chiave Ceph, fare riferimento a Sezione 30.2, «Gestione delle chiavi».

Parte I Ceph Dashboard #

- 1 Informazioni sul Ceph Dashboard

Il Ceph Dashboard è un'applicazione di gestione e monitoraggio Ceph integrata e basata sul Web per l'amministrazione di diversi aspetti e oggetti del cluster. Il dashboard è abilitato automaticamente in seguito alla distribuzione del cluster di base come descritto nel Book “Guida alla distribuzione”…

- 2 Interfaccia utente Web del dashboard

Per eseguire il login al Ceph Dashboard, puntare il browser verso il relativo URL includendo il numero di porta. Eseguire il comando seguente per trovare l'indirizzo:

- 3 Gestione degli utenti e dei ruoli del Ceph Dashboard

La gestione degli utenti del dashboard tramite i comandi di Ceph sulla riga di comando è già stata illustrata nella Capitolo 11, Gestione di utenti e ruoli sulla riga di comando.

- 4 Visualizzazione dei componenti interni del cluster

La voce di menu consente di visualizzare informazioni dettagliate su host, inventario, Ceph Monitor, servizi, OSD, configurazione, mappa CRUSH, Ceph Manager, log e file di monitoraggio del cluster Ceph.

- 5 Gestione dei pool

Per informazioni generali sui pool Ceph, fare riferimento a Capitolo 18, Gestione dei pool di memorizzazione. Per informazioni specifiche sui pool con codice di cancellazione, fare riferimento al Capitolo 19, Pool con codice di cancellazione.

- 6 Gestione del dispositivo di blocco RADOS (RADOS Block Device, RBD)

Per visualizzare un elenco di tutti i dispositivi di blocco RADOS (RBD) disponibili, fare clic su › nel menu principale.

- 7 Gestione di NFS Ganesha

Per informazioni generali su NFS Ganesha, fare riferimento a Capitolo 25, NFS Ganesha.

- 8 Gestione di CephFS

Per informazioni dettagliate su CephFS, fare riferimento al Capitolo 23, File system in cluster.

- 9 Gestione di Object Gateway

Prima di iniziare, quando si tenta di accedere al front-end di Object Gateway sul Ceph Dashboard, potrebbe essere visualizzata la notifica seguente:

- 10 Configurazione manuale

Questa sezione fornisce informazioni avanzate per gli utenti che preferiscono configurare manualmente le impostazioni del dashboard nella riga di comando.

- 11 Gestione di utenti e ruoli sulla riga di comando

Questa sezione descrive come gestire gli account utente utilizzati dal Ceph Dashboard e fornisce informazioni sulla creazione o modifica degli account utente, nonché sull'impostazione dei ruoli dell'utente e delle autorizzazioni corretti.

1 Informazioni sul Ceph Dashboard #

Il Ceph Dashboard è un'applicazione di gestione e monitoraggio Ceph integrata e basata sul Web per l'amministrazione di diversi aspetti e oggetti del cluster. Il dashboard è abilitato automaticamente in seguito alla distribuzione del cluster di base come descritto nel Book “Guida alla distribuzione”, Chapter 5 “Distribuzione con cephadm”, Section 5.3 “Distribuzione del cluster Ceph”.

Il Ceph Dashboard di SUSE Enterprise Storage 7 dispone di ulteriori funzionalità di gestione basate sul Web per semplificare l'amministrazione di Ceph, incluse le attività di monitoraggio e amministrazione dell'applicazione sul Ceph Manager. Per gestire e monitorare il cluster Ceph, non è più necessario conoscere i complessi comandi di Ceph. È possibile utilizzare l'intuitiva interfaccia o l'API REST integrata del Ceph Dashboard.

Il modulo del Ceph Dashboard visualizza informazioni e statistiche sul cluster Ceph tramite un server Web ospitato da ceph-mgr. Vedere Book “Guida alla distribuzione”, Chapter 1 “SES e Ceph”, Section 1.2.3 “Daemon e nodi Ceph” per ulteriori dettagli su Ceph Manager.

2 Interfaccia utente Web del dashboard #

2.1 Login #

Per eseguire il login al Ceph Dashboard, puntare il browser verso il relativo URL includendo il numero di porta. Eseguire il comando seguente per trovare l'indirizzo:

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",Il comando restituisce l'URL su cui si trova il Ceph Dashboard. In caso di problemi con questo comando, vedere Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”.

Eseguire il login con le credenziali create durante la distribuzione del cluster (vedere Book “Guida alla distribuzione”, Chapter 5 “Distribuzione con cephadm”, Section 5.3.2.9 “Configurazione delle credenziali di login del Ceph Dashboard”).

Se non si desidera utilizzare l'account admin di default per accedere al Ceph Dashboard, creare un account utente personalizzato con privilegi di amministratore. Per ulteriori dettagli, fare riferimento alla Capitolo 11, Gestione di utenti e ruoli sulla riga di comando.

L'interfaccia utente del dashboard è graficamente suddivisa in più blocchi: il menu dell'utility in alto a destra sulla schermata, il menu principale a sinistra e il pannello dei contenuti principale.

2.4 Pannello dei contenuti #

Il pannello dei contenuti occupa la parte principale della schermata del dashboard. Nella home page del dashboard sono mostrati molti widget utili con informazioni sintetiche sullo stato corrente del cluster, sulla capacità e sulle prestazioni.

2.5 Funzioni dell'interfaccia utente Web comuni #

Spesso nel Ceph Dashboard si utilizzano elenchi: ad esempio, elenchi di pool, nodi OSD o dispositivi RBD. Tutti gli elenchi si aggiornano automaticamente per default ogni cinque secondi. I seguenti widget comuni consentono di gestire o regolare tali elenchi:

Fare clic su ![]() per attivare un aggiornamento manuale dell'elenco.

per attivare un aggiornamento manuale dell'elenco.

Fare clic su ![]() per visualizzare o nascondere colonne della tabella

individuali.

per visualizzare o nascondere colonne della tabella

individuali.

Fare clic su ![]() e immettere (o selezionare) il numero di righe da

visualizzare in un'unica pagina.

e immettere (o selezionare) il numero di righe da

visualizzare in un'unica pagina.

Fare clic all'interno di  e filtrare le righe digitando la stringa da ricercare.

e filtrare le righe digitando la stringa da ricercare.

Utilizzare  per modificare la pagina attualmente visualizzata se

l'elenco è distribuito su più pagine.

per modificare la pagina attualmente visualizzata se

l'elenco è distribuito su più pagine.

2.6 Widget del dashboard #

Ogni widget del dashboard mostra specifiche informazioni sullo stato relative a un determinato aspetto di un cluster Ceph in esecuzione. Alcuni widget sono collegamenti attivi che, dopo essere stati selezionati, reindirizzano l'utente a una pagina dettagliata dell'argomento a cui fanno riferimento.

Passando il mouse sopra alcuni widget grafici, è possibile visualizzare ulteriori dettagli.

2.6.1 Widget Stato #

I widget forniscono una breve panoramica sullo stato corrente del cluster.

Mostra le informazioni di base sullo stato del cluster.

Mostra il numero totale di nodi del cluster.

Mostra il numero di monitor in esecuzione e il relativo quorum.

Mostra il numero totale di OSD, oltre al numero di OSD negli stati up e in.

Mostra il numero di Ceph Manager Daemon attivi e in standby.

Mostra il numero di Object Gateway in esecuzione.

Mostra il numero di server di metadati.

Mostra il numero di iSCSI Gateway configurati.

2.6.2 Widget Capacità #

I widget mostrano brevi informazioni sulla capacità di storage.

Mostra il rapporto tra la capacità di storage nominale disponibile e quella utilizzata.

Mostra il numero di oggetti dati memorizzati nel cluster.

Visualizza un grafico dei gruppi di posizionamento in base al relativo stato.

Mostra il numero di pool nel cluster.

Mostra il numero medio di gruppi di posizionamento per OSD.

2.6.3 Widget Prestazioni #

I widget fanno riferimento ai dati di base sulle prestazioni dei client Ceph.

Numero di operazioni di lettura e scrittura dei client al secondo.

Quantità in byte al secondo di dati trasferiti ai e dai client Ceph.

Velocità effettiva dei dati recuperati al secondo.

Mostra lo stato della pulitura (vedere la Sezione 17.4.9, «Pulitura di un gruppo di posizionamento»). Lo stato può essere

inactive,enabledoactive(inattivo, abilitato o attivo).

3 Gestione degli utenti e dei ruoli del Ceph Dashboard #

La gestione degli utenti del dashboard tramite i comandi di Ceph sulla riga di comando è già stata illustrata nella Capitolo 11, Gestione di utenti e ruoli sulla riga di comando.

Questa sezione descrive come gestire gli account utente tramite l'interfaccia utente Web del dashboard.

3.1 Elenco degli utenti #

Fare clic su ![]() nel menu dell'utility e selezionare .

nel menu dell'utility e selezionare .

L'elenco contiene il nome utente, il nome completo, l'indirizzo e-mail, un elenco dei ruoli assegnati, le informazioni sullo stato di abilitazione del ruolo e la data di scadenza della password di ciascun utente.

3.2 Aggiunta di nuovi utenti #

Fare clic su in alto a sinistra nell'intestazione della tabella per aggiungere un nuovo utente. Immettere il nome utente e la password e facoltativamente il nome completo e l'e-mail.

Selezionare l'icona a forma di penna per assegnare i ruoli predefiniti all'utente. Confermare con .

3.3 Modifica di utenti #

Fare clic sulla riga di tabella corrispondente a un utente per evidenziarla. Selezionare per modificare i dettagli relativi all'utente. Confermare con .

3.4 Eliminazione di utenti #

Fare clic sulla riga di tabella corrispondente a un utente per evidenziarla. Selezionare il pulsante a discesa accanto a e selezionare dall'elenco per eliminare l'account utente. Attivare la casella di controllo e confermare con .

3.5 Elenco dei ruoli dell'utente #

Fare clic su ![]() nel menu dell'utility e selezionare . Quindi, fare clic sulla scheda .

nel menu dell'utility e selezionare . Quindi, fare clic sulla scheda .

L'elenco contiene il nome e la descrizione di ciascun ruolo e indica se si tratta di un ruolo di sistema.

3.6 Aggiunta di ruoli personalizzati #

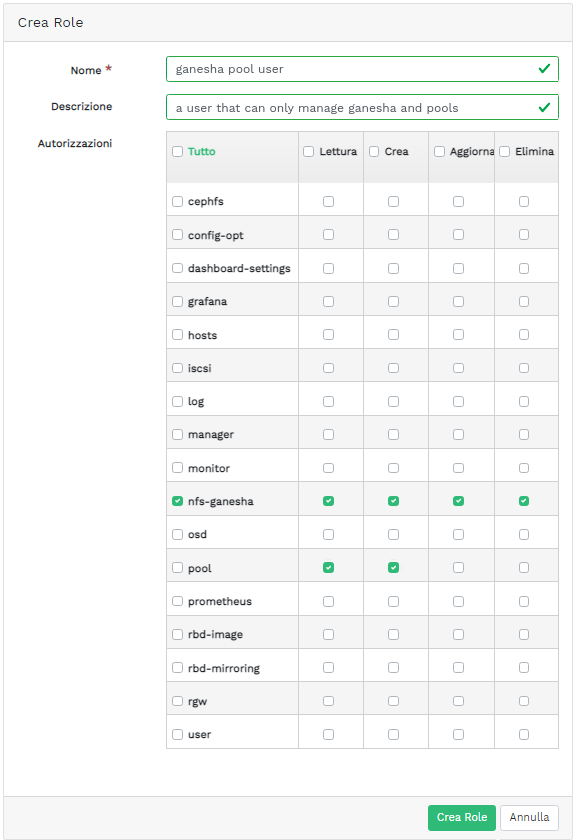

Fare clic su in alto a sinistra nell'intestazione della tabella per aggiungere un nuovo ruolo personalizzato. Immettere il e la e, accanto ad , selezionare le autorizzazioni appropriate.

Se si creano ruoli dell'utente personalizzati e si intende rimuovere il

cluster Ceph con il comando ceph-salt purge in un

secondo momento, è necessario innanzitutto eliminare definitivamente i

ruoli personalizzati. Ulteriori dettagli sono disponibili nella

Sezione 13.9, «Rimozione dell'intero cluster Ceph».

Tramite l'attivazione della casella di controllo accanto al nome dell'argomento, si attivano tutte le autorizzazioni correlate a quest'ultimo. Se si attiva la casella di controllo , si attivano tutte le autorizzazioni correlate a tutti gli argomenti.

Confermare con .

3.7 Modifica dei ruoli personalizzati #

Fare clic sulla riga di tabella corrispondente a un utente per evidenziarla. Selezionare in alto a sinistra nell'intestazione della tabella per modificare la descrizione e le autorizzazioni di un ruolo personalizzato. Confermare con .

3.8 Eliminazione dei ruoli personalizzati #

Fare clic sulla riga di tabella corrispondente a un ruolo per evidenziarla. Selezionare il pulsante a discesa accanto a e selezionare dall'elenco per eliminare il ruolo. Attivare la casella di controllo e confermare con .

4 Visualizzazione dei componenti interni del cluster #

La voce di menu consente di visualizzare informazioni dettagliate su host, inventario, Ceph Monitor, servizi, OSD, configurazione, mappa CRUSH, Ceph Manager, log e file di monitoraggio del cluster Ceph.

4.1 Visualizzazione dei nodi del cluster #

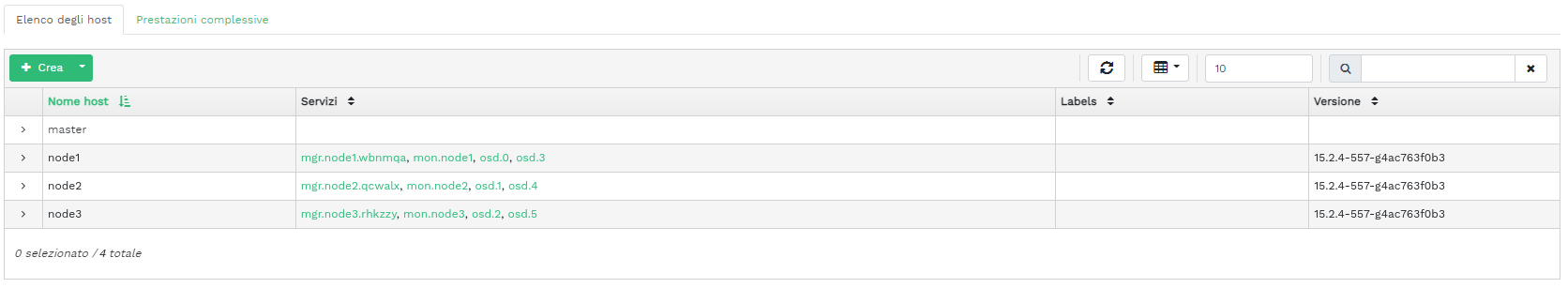

Fare clic su › per visualizzare un elenco dei nodi del cluster.

Fare clic sulla freccia a discesa accanto al nome di un nodo nella colonna per visualizzare i dettagli sulle prestazioni del nodo.

Nella colonna sono elencati tutti i daemon in esecuzione in ogni nodo correlato. Fare clic sul nome di un daemon per visualizzare la relativa configurazione dettagliata.

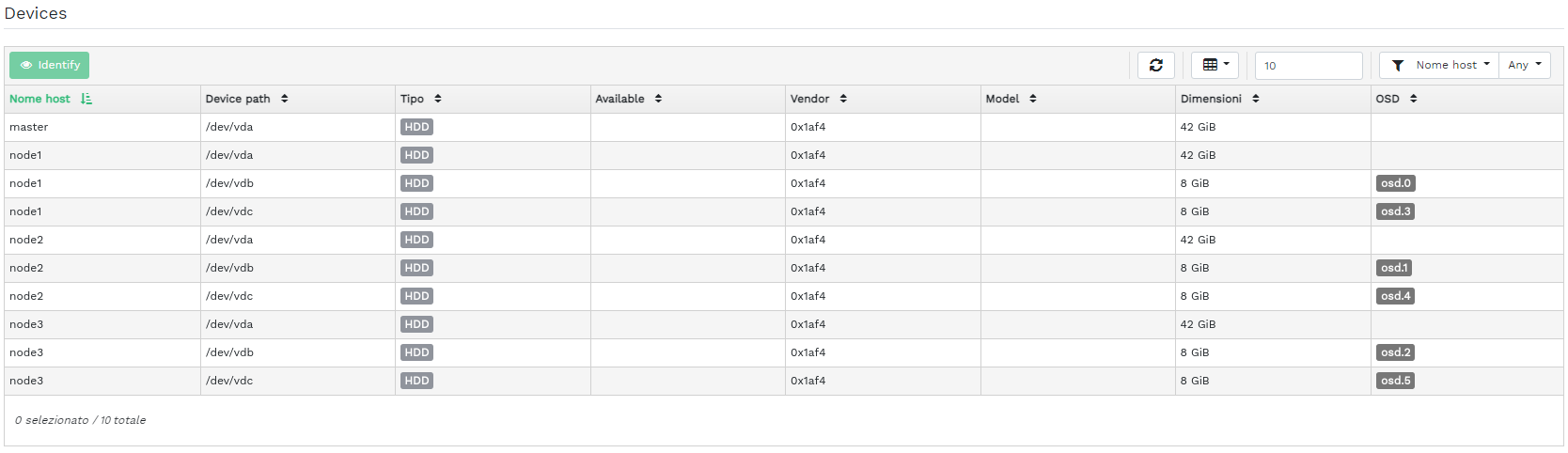

4.2 Accesso all'inventario del cluster #

Fare clic su › per visualizzare un elenco dei dispositivi. L'elenco riporta il percorso, il tipo, la disponibilità, il produttore, il modello, la dimensione e gli OSD del dispositivo.

Fare clic per selezionare il nome di un nodo nella colonna . Quindi, fare clic su per identificare il dispositivo su cui è in esecuzione l'host. Questa operazione invia al dispositivo l'istruzione di far lampeggiare i LED. Selezionare la durata di questa azione su 1, 2, 5, 10 o 15 minuti. Fare clic su .

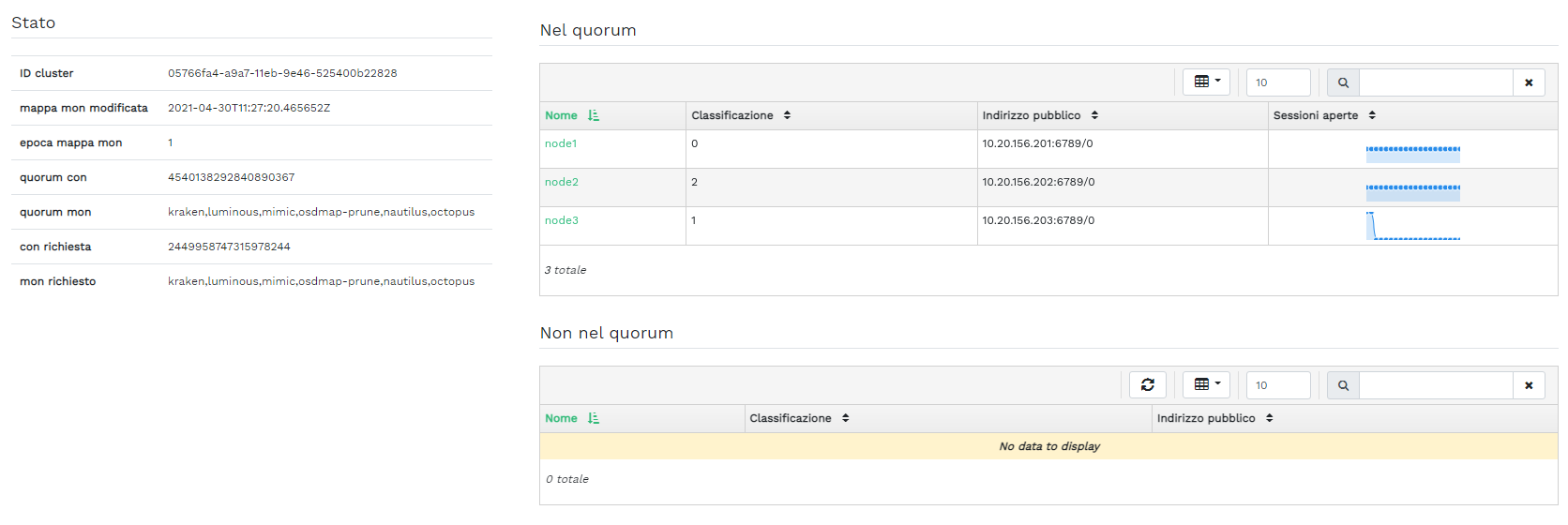

4.3 Visualizzazione dei Ceph Monitor #

Fare clic su

›

per visualizzare un elenco dei nodi del cluster con Ceph Monitor in

esecuzione. Il pannello dei contenuti è suddiviso in due viste:

Stato e Nel quorum o Non nel

quorum.

Nella tabella sono riportate le statistiche generali relative ai Ceph Monitor in esecuzione, inclusi:

ID cluster

monmap modified

monmap epoch

quorum con

quorum mon

required con

required mon

I pannelli Nel quorum e Non nel quorum

includono il nome, la classificazione, il numero, l'indirizzo IP pubblico e

il numero di sessioni aperte di ogni monitor.

Fare clic sul nome di un nodo nella colonna per visualizzare la configurazione del Ceph Monitor correlato.

4.4 Visualizzazione dei servizi #

Fare clic su

›

per visualizzare i dettagli su ciascuno dei servizi disponibili:

crash, Ceph Manager e Ceph Monitor. L'elenco include il

nome dell'immagine del container, l'ID dell'immagine del container, lo stato

degli elementi in esecuzione, la dimensione e l'ultimo aggiornamento.

Fare clic sulla freccia a discesa accanto al nome di un servizio nella colonna per visualizzare i dettagli sul daemon. Nell'elenco dei dettagli sono inclusi il nome host, il tipo di daemon, l'ID del daemon, l'ID del container, il nome dell'immagine del container, l'ID dell'immagine del container, il numero di versione, lo stato e l'ultimo aggiornamento.

4.5 Visualizzazione dei Ceph OSD #

Fare clic su › per visualizzare un elenco dei nodi con daemon OSD in esecuzione. Nell'elenco sono inclusi il nome, l'ID, lo stato, la classe del dispositivo, il numero di gruppi di posizionamento, le dimensioni, l'utilizzo, il grafico delle operazioni di lettura/scrittura nel tempo e la frequenza delle operazioni di lettura/scrittura al secondo di ogni nodo.

Selezionare dal menu a discesa nell'intestazione della tabella per aprire una finestra popup contenente un elenco dei flag che si applicano all'intero cluster. È possibile attivare o disattivare i singoli flag e confermare con .

Selezionare dal menu a discesa nell'intestazione della tabella per aprire una finestra popup contenente un elenco delle priorità di recupero OSD che si applicano all'intero cluster. È possibile attivare il profilo di priorità preferito e ottimizzare i singoli valori di seguito. Confermare con .

Fare clic sulla freccia a discesa accanto al nome di un nodo nella colonna per visualizzare una tabella estesa con i dettagli sulle impostazioni e le prestazioni del dispositivo. Sfogliando le diverse schede, è possibile visualizzare gli elenchi , , , , un delle operazioni di lettura e scrittura e .

Dopo aver fatto clic sul nome di un nodo OSD, la riga della tabella verrà evidenziata a indicare che è possibile eseguire task sul nodo. È possibile scegliere di eseguire una delle azioni seguenti: , , , , , , , , , , o .

Fare clic sulla freccia verso il basso in alto a sinistra nell'intestazione della tabella accanto al pulsante e selezionare il task che si desidera eseguire.

4.5.1 Aggiunta di OSD #

Per aggiungere nuovi OSD, seguire la procedura indicata di seguito:

Verificare che alcuni nodi del cluster dispongano di dispositivi di memorizzazione in stato

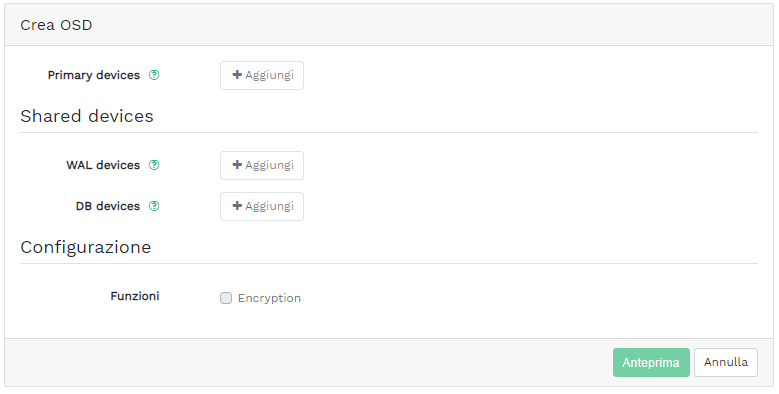

available(disponibile). Quindi, fare clic sulla freccia verso il basso in alto a sinistra nell'intestazione della tabella e selezionate . Si aprirà la finestra .Figura 4.9: Creazione di OSD #Per aggiungere dispositivi di memorizzazione primari per gli OSD, fare clic su . Prima che sia possibile aggiungere dispositivi di memorizzazione, è necessario specificare i criteri di filtro in alto a destra nella tabella , ad esempio . Confermare con .

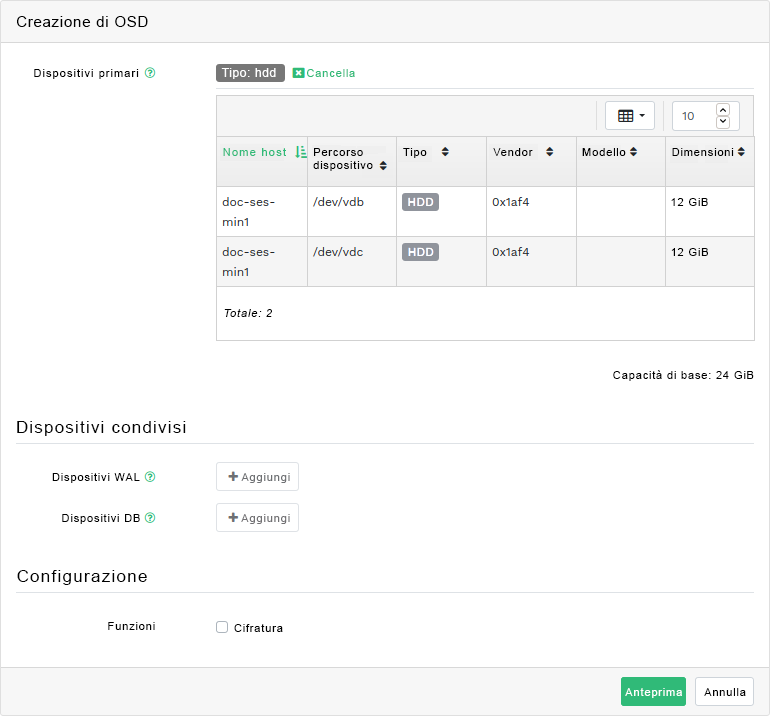

Figura 4.10: Aggiunta di dispositivi primari #Nella finestra aggiornata, è possibile aggiungere dispositivi WAL e DB condivisi o abilitare la cifratura dei dispositivi.

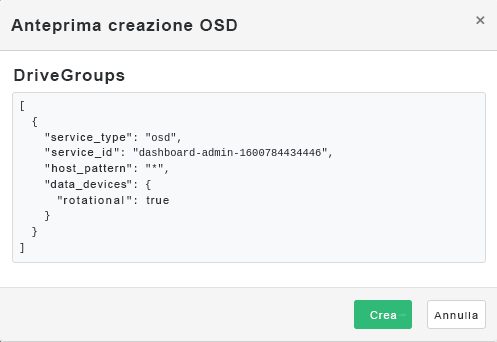

Figura 4.11: Creazione di OSD con dispositivi primari aggiunti #Fare clic su per visualizzare l'anteprima della specifica dei DriveGroups per i dispositivi aggiunti in precedenza. Confermare con il pulsante .

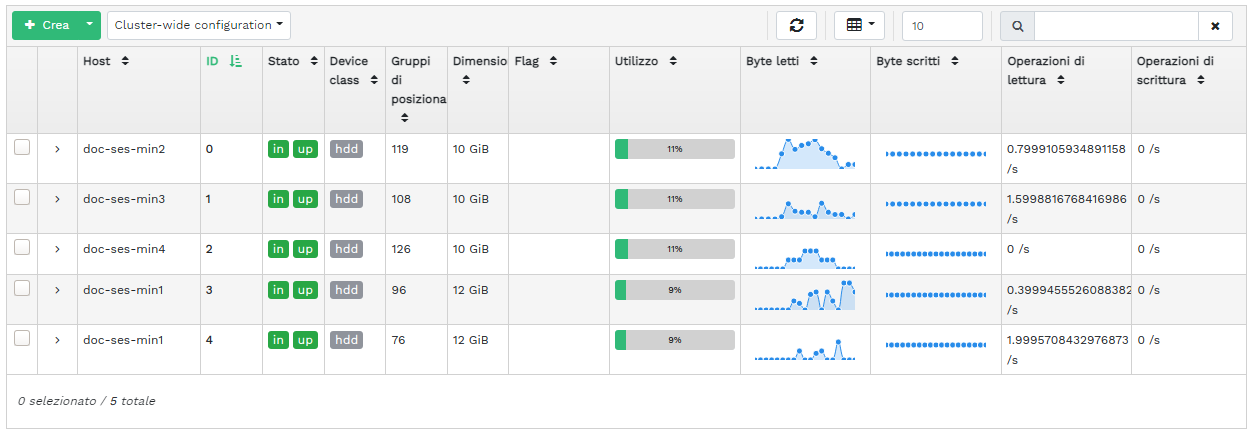

Figura 4.12: #I nuovi dispositivi verranno aggiunti all'elenco degli OSD.

Figura 4.13: OSD appena aggiunti #NotaLo stato di avanzamento del processo di creazione degli OSD non viene visualizzato. Per completare il processo, sono necessari diversi istanti. Gli OSD verranno visualizzati nell'elenco dopo essere stati distribuiti. Se si desidera controllare lo stato della distribuzione, aprire i log facendo clic su › .

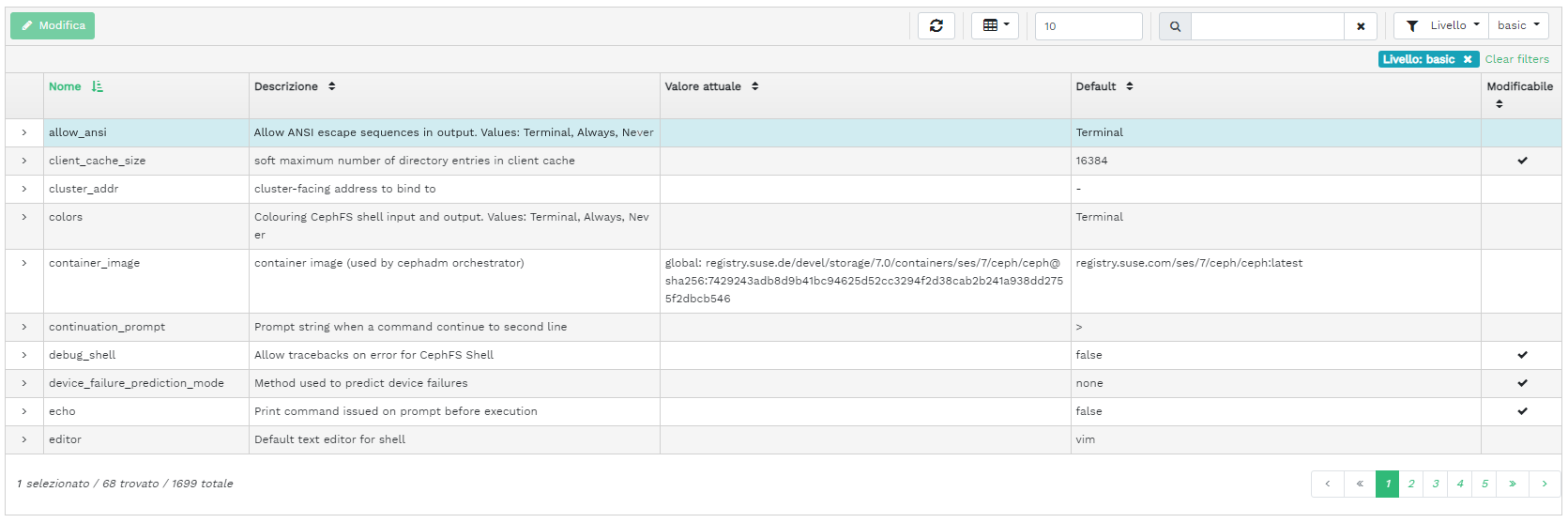

4.6 Visualizzazione della configurazione del cluster #

Fare clic su › per visualizzare un elenco completo delle opzioni di configurazione del cluster Ceph. L'elenco contiene il nome dell'opzione, la descrizione breve, i valori attuali e di default e se l'opzione è modificabile.

Fare clic sulla freccia a discesa accanto a un'opzione di configurazione nella colonna per visualizzare una tabella estesa con le informazioni dettagliate sull'opzione, come il tipo di valore, i valori minimo e massimo consentiti, se è possibile aggiornarla al runtime e molto altro.

Dopo aver evidenziato un'opzione specifica, è possibile modificarne i valori facendo clic sul pulsante in alto a sinistra nell'intestazione della tabella. Confermare le modifiche con .

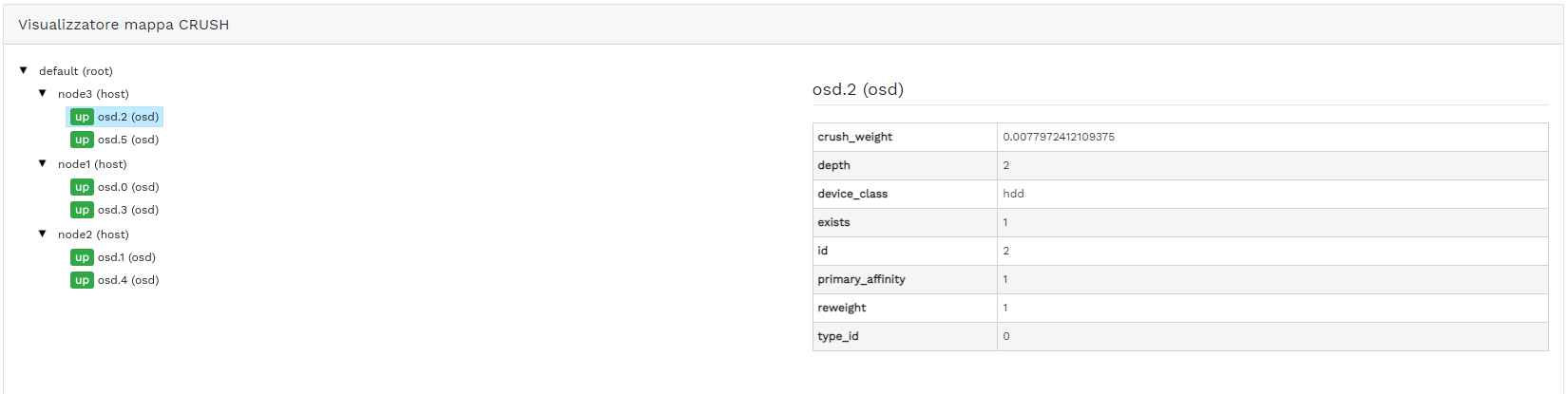

4.7 Visualizzazione della mappa CRUSH del #

Fare clic su › per visualizzare una mappa CRUSH del cluster. Per ulteriori informazioni generali sulle mappe CRUSH, fare riferimento alla Sezione 17.5, «Modifica della mappa CRUSH».

Fare clic sulla radice, sui nodi o sui singoli OSD per visualizzare altri dettagli, come il peso crush, la profondità nell'albero della mappa, la classe di dispositivi dell'OSD e molto altro.

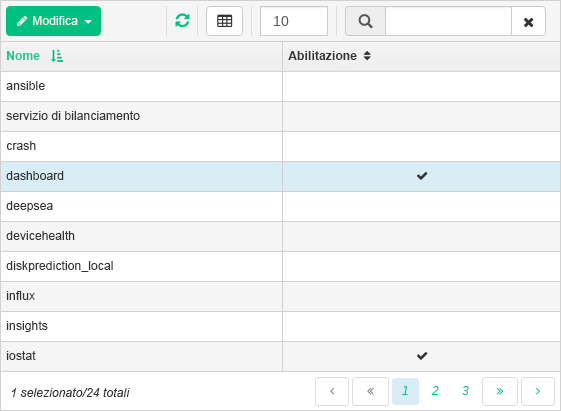

4.8 Visualizzazione dei moduli Manager #

Fare clic su › per visualizzare un elenco dei moduli Ceph Manager disponibili. Ogni riga contiene il nome del modulo e informazioni sul suo stato di abilitazione o disabilitazione.

Fare clic sulla freccia a discesa accanto a un modulo nella colonna per visualizzare una tabella estesa con le impostazioni dettagliate nella tabella di seguito. Modificarle facendo clic sul pulsante in alto a sinistra nell'intestazione della tabella. Confermare le modifiche con .

Fare clic sulla freccia a discesa accanto al pulsante in alto a sinistra nell'intestazione della tabella per o un modulo.

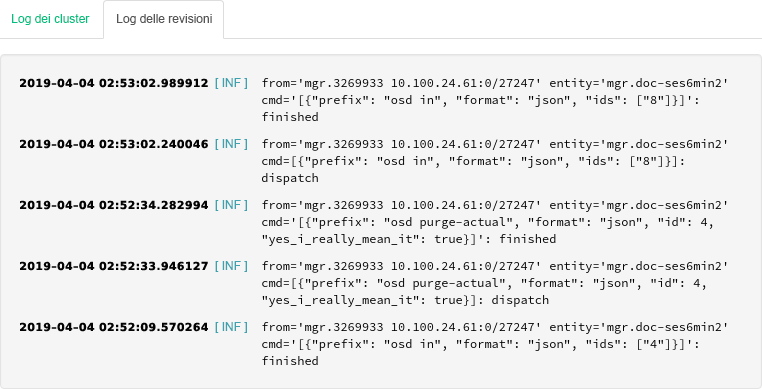

4.9 Visualizzazione dei log #

Fare clic su › per visualizzare un elenco delle voci di log recenti del cluster. Ogni riga contiene la registrazione dell'orario, il tipo di voce del log e il messaggio registrato.

Fare clic sulla scheda per visualizzare le voci di log del sottosistema di revisione. Fare riferimento alla Sezione 11.5, «Controllo delle richieste API» per i comandi di abilitazione o disabilitazione della revisione.

4.10 Visualizzazione del monitoraggio #

Fare clic su › per gestire e visualizzare i dettagli sugli avvisi di Prometheus.

Se Prometheus è attivo, nel relativo pannello dei contenuti è possibile visualizzare le informazioni dettagliate su , o .

Se Prometheus non è stato distribuito, verranno visualizzati un'intestazione di informazioni e un collegamento alla documentazione pertinente.

5 Gestione dei pool #

Per informazioni generali sui pool Ceph, fare riferimento a Capitolo 18, Gestione dei pool di memorizzazione. Per informazioni specifiche sui pool con codice di cancellazione, fare riferimento al Capitolo 19, Pool con codice di cancellazione.

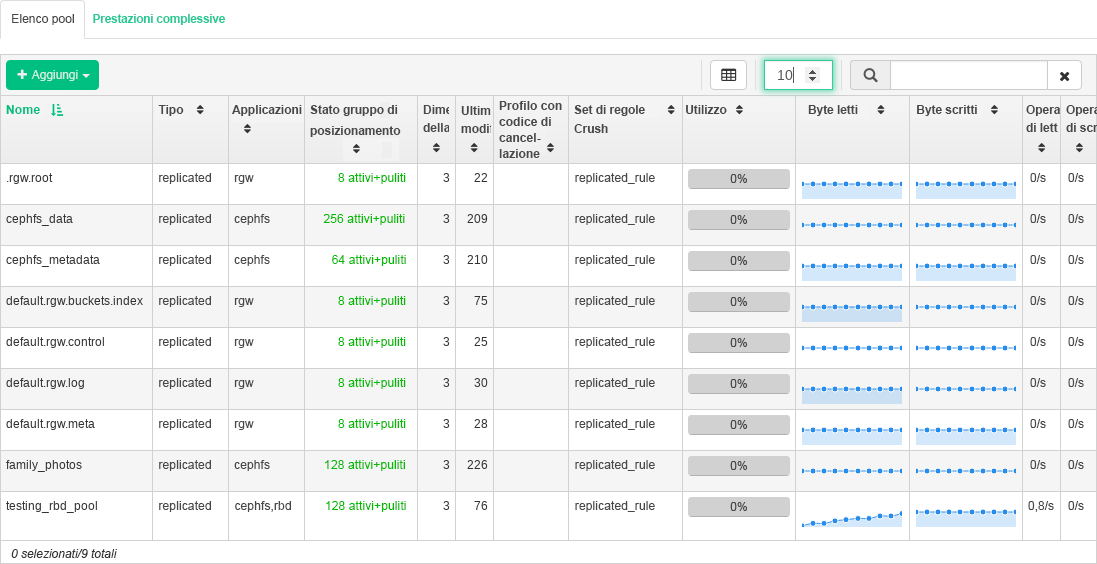

Per elencare tutti i pool disponibili, fare clic su nel menu principale.

Nell'elenco sono visualizzati il nome, il tipo, l'applicazione correlata, lo stato del gruppo di posizionamento, le dimensioni della replica, l'ultima modifica, il profilo con codice di cancellazione, il set di regole crush, l'utilizzo e le statistiche di lettura/scrittura relativi a ciascun pool.

Fare clic sulla freccia a discesa accanto a un nome del pool nella colonna per visualizzare una tabella estesa con informazioni dettagliate sul pool, come i dettagli generali, sulle prestazioni e la configurazione.

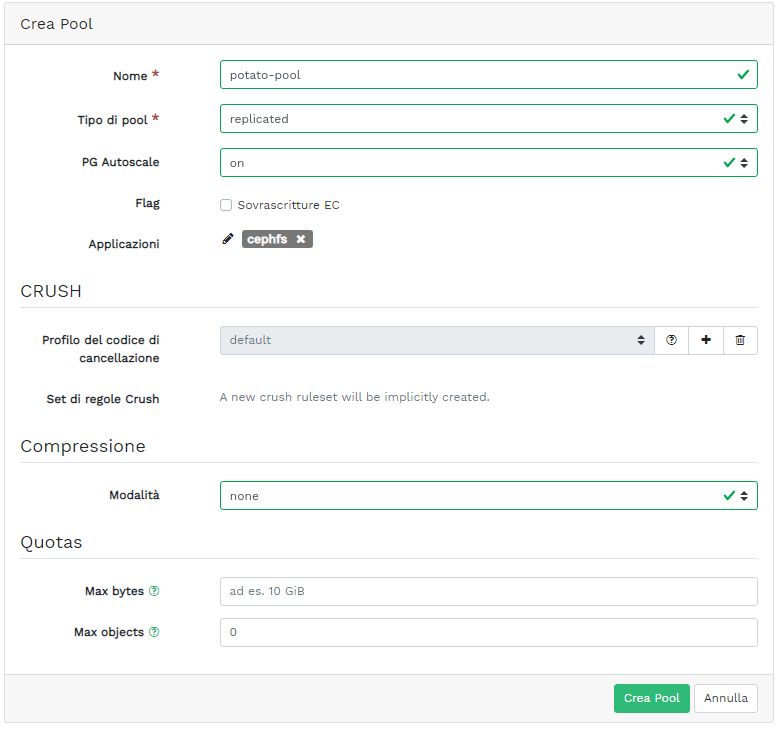

5.1 Aggiunta di un nuovo pool #

Per aggiungere un nuovo pool, fare clic su in alto a sinistra nella tabella dei pool. Nel modulo dei pool è possibile immettere il nome, il tipo, le applicazioni, la modalità di compressione e le quote relativi a un pool, incluso il numero massimo di byte e oggetti. Tale modulo calcola in anticipo il numero di gruppi di posizionamento più adatto per il pool specifico. Tale calcolo si basa sul numero di OSD nel cluster e sul tipo di pool selezionato con le relative impostazioni specifiche. Non appena viene impostato manualmente, il numero dei gruppi di posizionamento viene sostituito da un numero calcolato. Confermare con .

5.2 Eliminazione di pool #

Per eliminare un pool, selezionarlo nella riga della tabella. Fare clic sulla freccia a discesa accanto al pulsante e fare clic su .

5.3 Modifica delle opzioni di un pool #

Per modificare le opzioni di un pool, selezionare il pool nella riga della tabella e fare clic su in alto a sinistra nella tabella dei pool.

È possibile modificare il nome del pool, aumentare il numero di gruppi di posizionamento e modificare l'elenco delle applicazioni e delle impostazioni di compressione del pool. Confermare con .

6 Gestione del dispositivo di blocco RADOS (RADOS Block Device, RBD) #

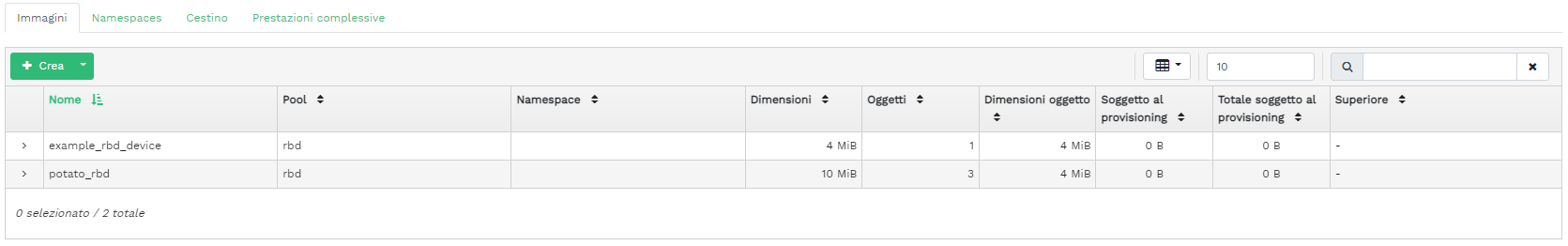

Per visualizzare un elenco di tutti i dispositivi di blocco RADOS (RBD) disponibili, fare clic su › nel menu principale.

L'elenco mostra brevi informazioni sul dispositivo come il nome, il nome pool correlato, lo spazio dei nomi, le dimensioni del dispositivo, il numero e la dimensione degli oggetti sul dispositivo, i dettagli sul provisioning e il dispositivo superiore.

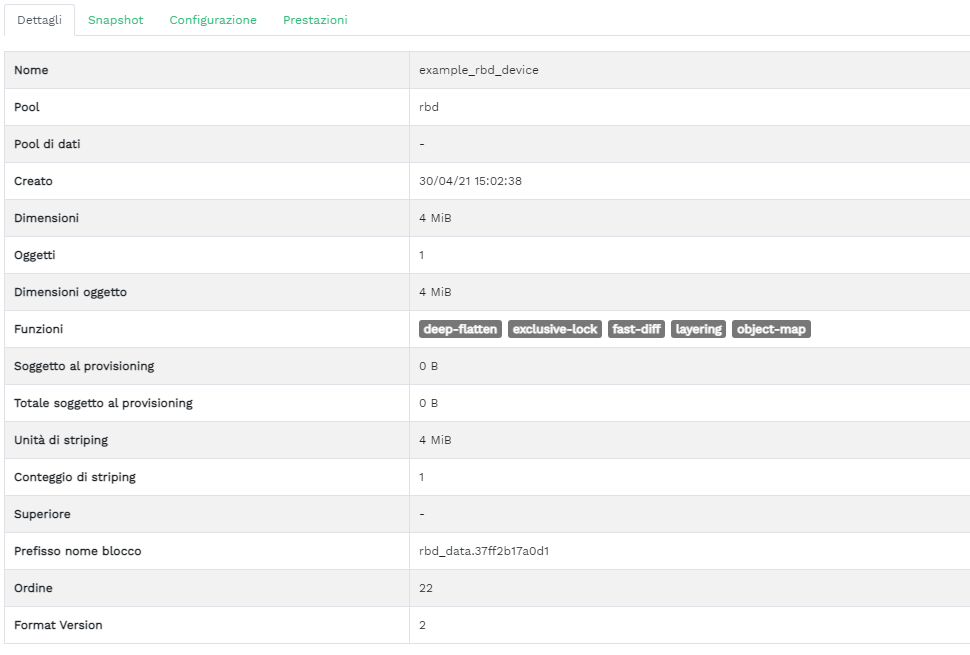

6.1 Visualizzazione dei dettagli sugli RBD #

Per visualizzare altri dettagli su un dispositivo, fare clic sulla relativa riga nella tabella:

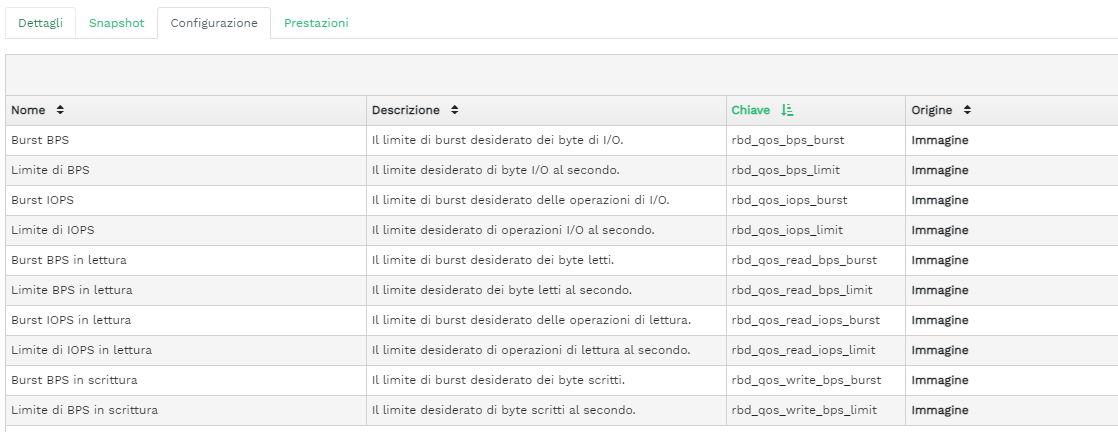

6.2 Visualizzazione della configurazione dell'RBD #

Per visualizzare la configurazione dettagliata di un dispositivo, fare clic sulla relativa riga nella tabella e sulla scheda nella tabella inferiore:

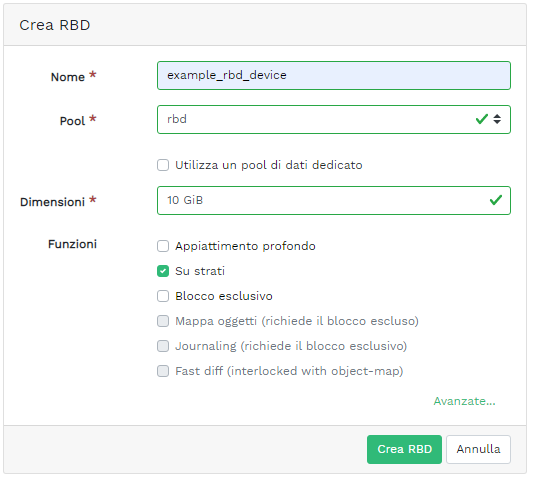

6.3 Creazione di RBD #

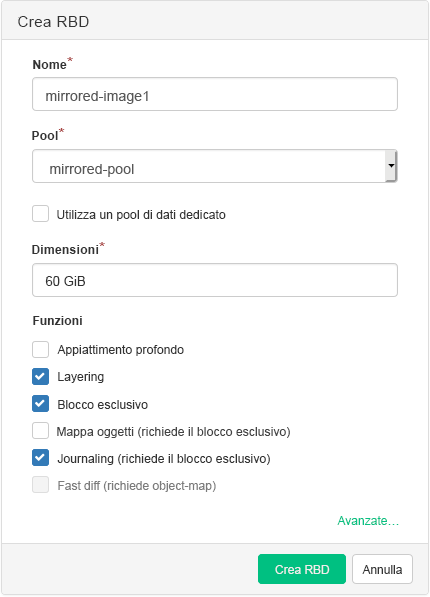

Per aggiungere un nuovo dispositivo, fare clic su in alto a sinistra nell'intestazione della tabella ed eseguire quanto riportato di seguito nella schermata :

Immettere il nome del nuovo dispositivo. Per le restrizioni di denominazione, fare riferimento a Book “Guida alla distribuzione”, Chapter 2 “Requisiti hardware e raccomandazioni”, Section 2.11 “Limitazioni di denominazione”.

Selezionare il pool con l'applicazione

rbdassegnata da cui verrà creato il nuovo dispositivo RBD.Specificare le dimensioni del nuovo dispositivo.

Specificare le opzioni aggiuntive per il dispositivo. Per ottimizzare i parametri del dispositivo, fare clic su e immettere i valori relativi alle dimensioni dell'oggetto, all'unità di striping o al numero di striping. Per immettere i limiti di qualità del servizio (QoS, Quality of Service), fare clic su .

Confermare con .

6.4 Eliminazione di RBD #

Per eliminare un dispositivo, selezionarlo nella riga della tabella. Fare clic sulla freccia a discesa accanto al pulsante e fare clic su . Confermare l'eliminazione con (Elimina RBD).

L'eliminazione di un RBD è un'azione irreversibile. Se invece si seleziona l'opzione , è possibile ripristinare il dispositivo in un secondo momento selezionandolo nella scheda della tabella principale e facendo clic su in alto a sinistra nell'intestazione della tabella.

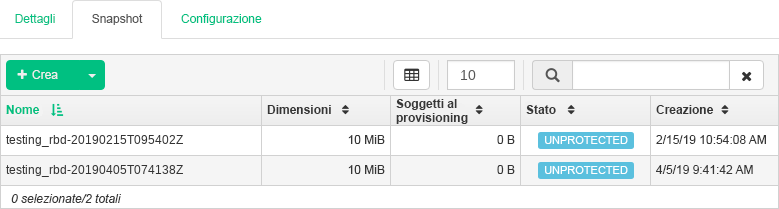

6.5 Creazione di snapshot del dispositivo di blocco RADOS (RADOS Block Device, RBD) #

Per creare uno snapshot del dispositivo di blocco RADOS (RADOS Block Device, RBD), selezionare il dispositivo nella riga della tabella per visualizzare il pannello dei contenuti relativo ai dettagli della configurazione. Selezionare la scheda e fare clic su in alto a sinistra nell'intestazione della tabella. Immettere il nome dello snapshot e confermare con .

Dopo aver selezionato una snapshot, è possibile eseguire ulteriori azioni sul dispositivo, ad esempio rinominarlo, proteggerlo, clonarlo, copiarlo o eliminarlo. L'opzione consente di ripristinare lo stato del dispositivo dallo snapshot attuale.

6.6 Copia speculare RBD #

È possibile eseguire la copia speculare delle immagini del dispositivo di blocco RADOS (RADOS Block Device, RBD) in modo asincrono tra due cluster Ceph. È possibile utilizzare il Ceph Dashboard per configurare la replica delle immagini RBD tra due o più cluster. Questa funzionalità è disponibile in due modalità:

- Basata sul journal

Questa modalità utilizza la funzione di journaling dell'immagine RBD per assicurare la replica temporizzata e con coerenza per arresto anomalo tra cluster.

- Basata su snapshot

Questa modalità utilizza snapshot di copia speculare dell'immagine RBD pianificati periodicamente o creati manualmente per eseguire la replica delle immagini RBD con coerenza per arresto anomalo tra cluster.

La copia speculare è configurata su ogni singolo pool all'interno dei cluster peer ed è possibile configurarla su un sottoinsieme specifico di immagini all'interno del pool o per fare in modo che esegua automaticamente la copia speculare di tutte le immagini del pool quando è in uso soltanto la modalità basata sul journal.

Per la configurazione della copia speculare si utilizza il comando

rbd, installato per default in SUSE Enterprise Storage 7.

Il daemon rbd-mirror è responsabile

del pull degli aggiornamenti delle immagini dal cluster peer remote e della

loro applicazione all'immagine nel cluster local. Vedere la

Sezione 6.6.2, «Abilitazione del daemon rbd-mirror» per maggiori informazioni

sull'abilitazione del daemon

rbd-mirror.

A seconda delle necessità di replica, è possibile configurare la copia speculare del dispositivo di blocco RADOS (RADOS Block Device, RBD) sulla replica a una o due vie:

- Replica a una via

Quando la copia speculare dei dati avviene soltanto da un cluster primario a uno secondario, il daemon

rbd-mirrorviene eseguito solo sul cluster secondario.- Replica a due vie

Quando la copia speculare dei dati avviene dalle immagini primarie su un cluster alle immagini non primarie su un altro cluster (e viceversa), il daemon

rbd-mirrorviene eseguito su entrambi i cluster.

Ogni istanza del daemon rbd-mirror

deve essere in grado di connettersi contemporaneamente al cluster Ceph

local e remote, ad esempio a tutti i monitor e agli host OSD. Inoltre, la

larghezza di banda della rete tra i due data center deve essere sufficiente

per gestire il workload della copia speculare.

Per informazioni generali e sull'approccio della riga di comando alla copia speculare del dispositivo di blocco RADOS, fare riferimento alla Sezione 20.4, «Copie speculari delle immagini RBD».

6.6.1 Configurazione dei cluster primario e secondario #

Nel cluster primario viene creato il pool originale con le immagini. Nel cluster secondario vengono replicati il pool o le immagini dal cluster primario.

I termini primario e secondario possono essere relativi nel contesto della replica, perché fanno riferimento più ai singoli pool che ai cluster. Ad esempio, nella replica bidirezionale, è possibile eseguire la copia speculare di un pool dal cluster primario a quello secondario mentre è in corso la copia speculare di un altro pool dal cluster secondario a quello primario.

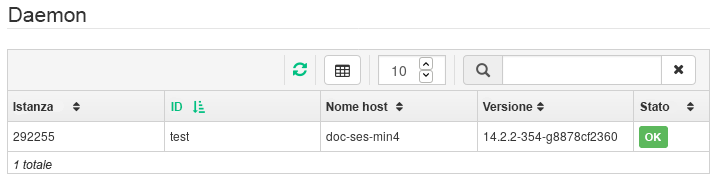

6.6.2 Abilitazione del daemon rbd-mirror #

Nelle procedure seguenti è illustrato come eseguire task amministrativi di

base per configurare la copia speculare tramite il comando

rbd. La copia speculare è configurata per ogni singolo

pool nei cluster Ceph.

I passaggi di configurazione del pool devono essere eseguiti su entrambi i cluster peer. Per maggior chiarezza, in queste procedure si presuppone che due cluster, denominati "primary" e "secondary", siano accessibili da un singolo host.

Il daemon rbd-mirror esegue la

replica effettiva dei dati del cluster.

Rinominare

ceph.confe i file di portachiavi e copiarli dall'host primario all'host secondario:cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringPer abilitare la copia speculare su un pool con

rbd, specificare il comandomirror pool enable, il nome del pool e la modalità di copia speculare:cephuser@adm >rbd mirror pool enable POOL_NAME MODENotaLa modalità di copia speculare può essere

imageopool. Esempio:cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageNel Ceph Dashboard, andare a › . Nella tabella a sinistra vengono mostrati i daemon

rbd-mirrorin esecuzione e il relativo stato.Figura 6.6: Esecuzione dei daemonrbd-mirror#

6.6.3 Disabilitazione della copia speculare #

Per disabilitare la copia speculare con rbd, specificare

il comando mirror pool disable e il nome del pool:

cephuser@adm > rbd mirror pool disable POOL_NAMEQuando si disabilita la copia speculare su un pool in questo modo, questa verrà disabilitata anche su qualsiasi immagine (nel pool) per la quale è stata abilitata esplicitamente la copia speculare.

6.6.4 Esecuzione del bootstrap dei peer #

Affinché rbd-mirror rilevi il

rispettivo cluster peer, è necessario registrare il peer nel pool e creare

un account utente. Questo processo può essere automatizzato con

rbd tramite i comandi mirror pool peer

bootstrap create e mirror pool peer bootstrap

import.

Per creare manualmente un nuovo token di bootstrap con

rbd, specificare il comando mirror pool peer

bootstrap create, il nome del pool e un nome del sito facoltativo

per la descrizione del cluster local:

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

L'output di mirror pool peer bootstrap create sarà un

token che dovrà essere fornito al comando mirror pool peer

bootstrap import. Ad esempio, sul cluster primario:

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1 \

vbl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

Per importare manualmente il token di bootstrap creato da un altro cluster

con il comando rbd, specificare il comando

mirror pool peer bootstrap import, il nome del pool, il

percorso del file al token creato (oppure "-" per leggere dall'input

standard), insieme al nome del sito facoltativo per la descrizione del

cluster local e a una direzione di copia speculare (l'impostazione di

default è rx-tx per la copia speculare bidirezionale, ma

è possibile configurare questa impostazione anche su

rx-only per la copia speculare unidirezionale):

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathAd esempio, sul cluster secondario:

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW \ 1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1v \ bl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 Rimozione di un peer del cluster #

Per rimuovere un cluster Ceph peer in copia speculare con il comando

rbd, specificare il comando mirror pool peer

remove, il nome del pool e l'UUID del peer (disponibile dal

comando rbd mirror pool info):

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Configurazione della replica del pool nel Ceph Dashboard #

Il daemon rbd-mirror deve disporre

dell'accesso al cluster primario per poter eseguire la copia speculare

delle immagini RBD. Assicurarsi di aver seguito la procedura descritta

nella Sezione 6.6.4, «Esecuzione del bootstrap dei peer» prima di continuare.

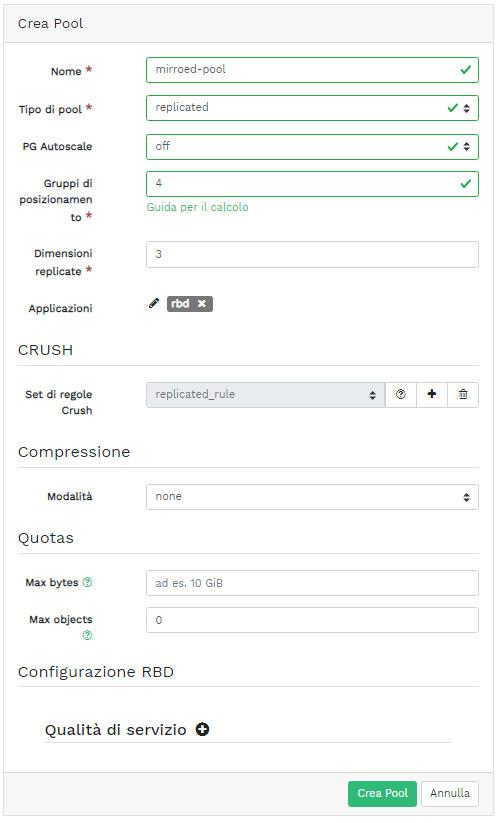

Nel cluster primario e secondario, creare pool con un nome identico e assegnarvi l'applicazione

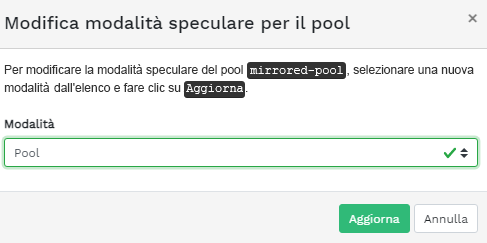

rbd. Per ulteriori dettagli sulla creazione di un nuovo pool, fare riferimento alla Sezione 5.1, «Aggiunta di un nuovo pool».Figura 6.7: Creazione di un pool con l'applicazione RBD #Nei dashboard del cluster primario e secondario, andare a › . Nella tabella a destra, fare clic sul nome del pool da replicare e, dopo aver fatto clic su , selezionare la modalità di replica. In questo esempio, verrà utilizzata la modalità di replica pool, che indica che verranno replicate tutte le immagini all'interno di un determinato pool. Confermare con .

Figura 6.8: Configurazione della modalità di replica #Importante: errore o avviso nel cluster primarioIn seguito all'aggiornamento della modalità di replica, verrà visualizzato un errore o un flag di avviso nella colonna destra corrispondente. Ciò si verifica perché al pool non è stato ancora assegnato nessun utente peer per la replica. Ignorare questo flag per il cluster primario poiché l'utente peer viene assegnato soltanto al cluster secondario.

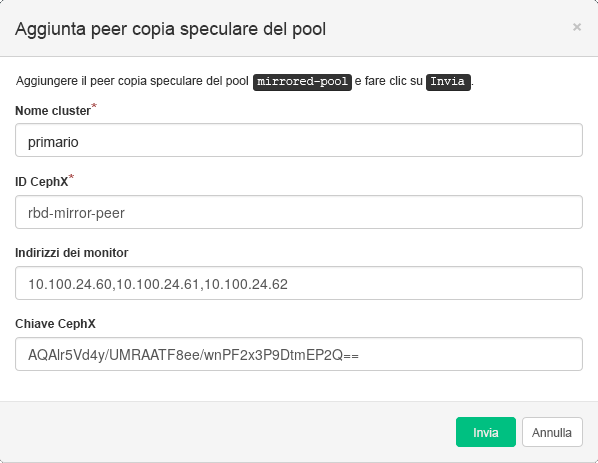

Nel dashboard del cluster secondario, andare a › . Aggiungere il peer di copia speculare del pool selezionando . Specificare i dettagli del cluster primario:

Figura 6.9: Aggiunta delle credenziali del peer #Stringa univoca arbitraria che identifica il cluster primario come "primary". Il nome del cluster deve essere diverso dal nome reale del cluster secondario.

ID utente Ceph creato come peer in copia speculare. In questo esempio è "rbd-mirror-peer".

Elenco separato da virgole degli indirizzi IP dei nodi Ceph Monitor del cluster primario.

Chiave correlata all'ID utente peer. È possibile recuperarla eseguendo sul cluster primario il comando di esempio seguente:

cephuser@adm >ceph auth print_key pool-mirror-peer-name

Confermare con .

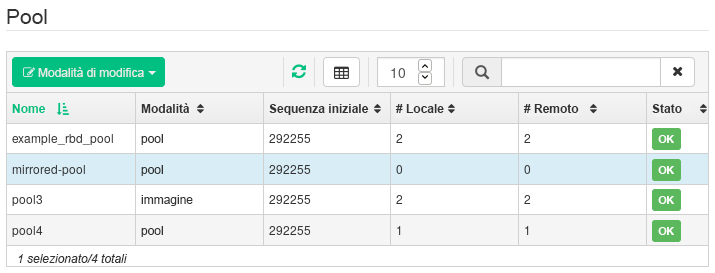

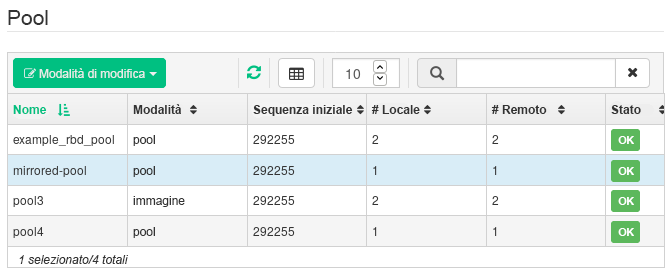

Figura 6.10: Elenco dei pool replicati #

6.6.7 Verifica del funzionamento della replica dell'immagine RBD #

Una volta che il daemon rbd-mirror

è in esecuzione e la replica dell'immagine RBD è configurata nel Ceph

Dashboard, è il momento di verificare il funzionamento della replica:

Nel Ceph Dashboard del cluster primario, creare un'immagine RBD per fare in modo che il relativo pool superiore sia quello già creato per scopi di replica. Abilitare le funzioni

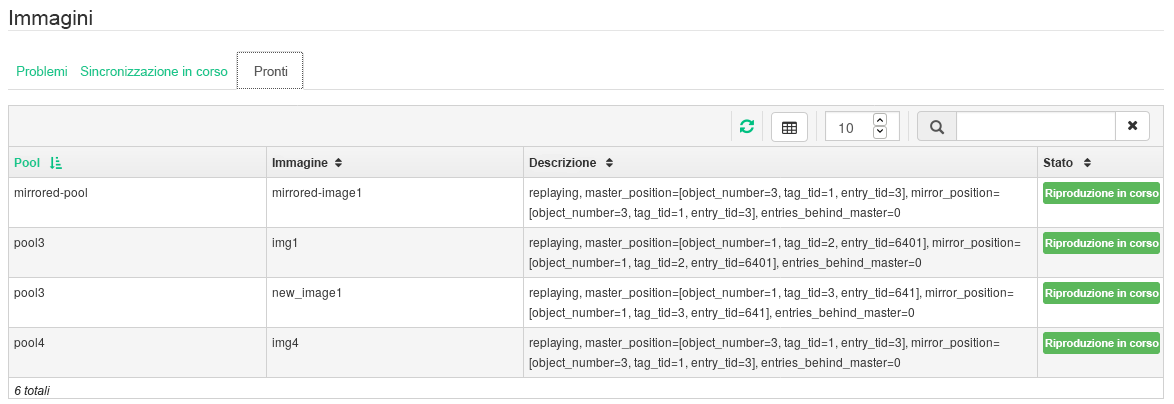

Blocco esclusivoeJournalingper l'immagine. Per i dettagli sulla creazione delle immagini RBD, fare riferimento alla Sezione 6.3, «Creazione di RBD».Figura 6.11: Nuova immagine RBD #Dopo aver creato l'immagine che si desidera replicare, aprire il Ceph Dashboard del cluster secondario e andare a › . La tabella a destra rifletterà la modifica del numero di immagini e sincronizzerà il numero di immagini .

Figura 6.12: Nuova immagine RBD sincronizzata #Suggerimento: avanzamento della replicaNella tabella in basso nella pagina viene mostrato lo stato della replica delle immagini RBD. La scheda include i possibili problemi, la scheda visualizza l'avanzamento della replica dell'immagine e la scheda elenca tutte le immagini di cui è riuscita la replica.

Figura 6.13: Stato della replica delle immagini RBD #Nel cluster primario, scrivere i dati nell'immagine RBD. Nel Ceph Dashboard del cluster secondario, andare a › e controllare se le dimensioni dell'immagine corrispondente aumentano via via che i dati vengono scritti nel cluster primario.

6.7 Gestione di iSCSI Gateway #

Per ulteriori informazioni generali sugli iSCSI Gateway, fare riferimento al Capitolo 22, Ceph iSCSI Gateway.

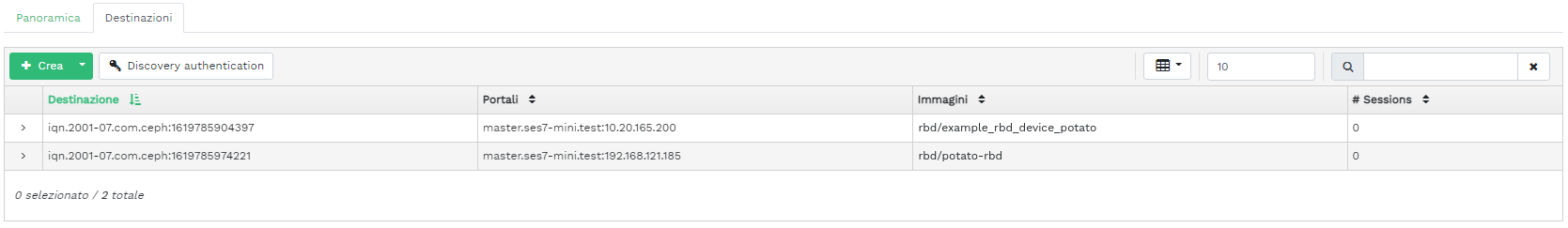

Per visualizzare un elenco di tutti i gateway e le immagini mappate disponibili, fare clic su › nel menu principale. Si apre la scheda , in cui vengono elencati gli iSCSI Gateway attualmente configurati e le immagini RBD mappate.

Nella tabella dei sono elencati lo stato, il numero di destinazioni iSCSI e il numero di sessioni di ogni gateway. Nella tabella sono elencati il nome, il nome del pool correlato, il tipo di backstore e altri dettagli statistici di ciascuna immagine mappata.

Nella scheda sono elencate le destinazioni iSCSI attualmente configurate.

Per visualizzare ulteriori informazioni dettagliate su una destinazione, fare clic sulla freccia a discesa nella riga della tabella delle destinazioni. Si apre uno schema con struttura ad albero in cui sono elencati i dischi, i portali, gli iniziatori e i gruppi. Fare clic su un elemento per espanderlo e visualizzare i relativi contenuti dettagliati, facoltativamente insieme alla configurazione correlata, nella tabella a destra.

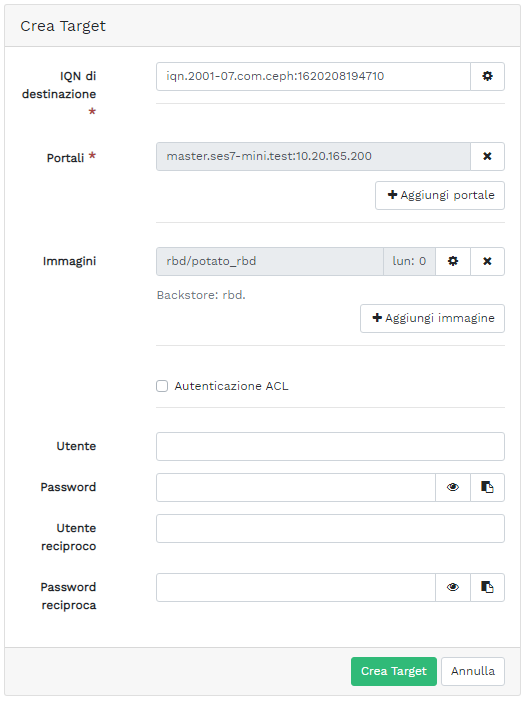

6.7.1 Aggiunta di destinazioni iSCSI #

Per aggiungere una nuova destinazione iSCSI, fare clic su in alto a sinistra nella tabella e immettere le informazioni richieste.

Immettere l'indirizzo di destinazione del nuovo gateway.

Fare clic su e selezionare uno o più portali iSCSI dall'elenco.

Fare clic su e selezionare una o più immagini RBD per il gateway.

Se è necessario utilizzare l'autenticazione per accedere al gateway, attivare la casella di controllo e immettere le credenziali. Ulteriori opzioni di autenticazione avanzata sono disponibili dopo l'attivazione di e .

Confermare con (Crea destinazione).

6.7.2 Modifica delle destinazioni iSCSI #

Per modificare una destinazione iSCSI esistente, fare clic sulla relativa riga nella tabella , quindi su in alto a sinistra nella tabella.

È quindi possibile modificare la destinazione iSCSI, aggiungere o eliminare portali e aggiungere o eliminare immagini RBD correlate. È inoltre possibile regolare le informazioni di autenticazione per il gateway.

6.7.3 Eliminazione delle destinazioni iSCSI #

Per eliminare una destinazione iSCSI, selezionare la riga della tabella e fare clic sulla freccia a discesa accanto al pulsante , quindi selezionare . Attivare la casella e confermare con .

6.8 Qualità di servizio (QoS) RBD #

Per ulteriori informazioni generali e per una descrizione delle opzioni di configurazione QoS RBD, fare riferimento alla Sezione 20.6, «Impostazioni QoS».

È possibile configurare le opzioni QoS a livelli diversi.

Globalmente

Per ogni singolo pool

Per ogni singola immagine

La configurazione globale si trova in cima all'elenco e verrà utilizzata per tutte le immagini RBD di nuova creazione e per quelle immagini che non ignorano tali valori sul livello di pool o di immagine RBD. Un valore di opzione specificato globalmente può essere ignorato per ogni singolo pool o per ogni singola immagine. Le opzioni specificate in un pool verranno applicate a tutte le immagini RBD di tale pool a meno che non siano sostituite da un'opzione di configurazione impostata in un'immagine. Le opzioni specificate in un'immagine sostituiranno quelle specificate globalmente e quelle specificate in un pool.

In questo modo, è possibile definire i valori di default globalmente, adattarli a tutte le immagini RBD di un pool specifico e sostituire la configurazione del pool per le singole immagini RBD.

6.8.1 Configurazione delle opzioni a livello globale #

Per configurare le opzioni del dispositivo di blocco RADOS (RADOS Block Device, RBD) a livello globale, selezionare › dal menu principale.

Per elencare tutte le opzioni di configurazione globale disponibili, accanto a , selezionare dal menu a discesa.

Filtrare i risultati della tabella applicando il filtro

rbd_qosnel campo di ricerca per visualizzare un elenco di tutte le opzioni di configurazione disponibili per QoS.Per modificare un valore, fare clic sulla relativa riga di tabella e selezionare in alto a sinistra nella tabella. La finestra di dialogo contiene sei campi diversi tramite cui è possibile specificare i valori. I valori dell'opzione di configurazione RBD sono obbligatori nella casella di testo

NotaA differenza di altre finestre di dialogo, questa non consente di specificare il valore nelle unità adeguate. È necessario impostare tali valori in byte o IOPS, a seconda dell'opzione che si sta modificando.

6.8.2 Configurazione delle opzioni in un nuovo pool #

Per creare un nuovo pool e configurarvi le opzioni di configurazione RBD,

fare clic su › . Selezionare

(replicato) come tipo di pool. Sarà quindi

necessario aggiungere il tag applicazione rbd al pool

per poter configurare le opzioni QoS RBD.

Non è possibile configurare le opzioni di configurazione QoS RBD sui pool con codice di cancellazione. A questo scopo, è necessario modificare il pool dei metadati replicato di un'immagine RBD. La configurazione verrà quindi applicata al pool di dati con codice di cancellazione di tale immagine.

6.8.3 Configurazione delle opzioni in un pool esistente #

Per configurare le opzioni QoS RBD in un pool esistente, fare clic su , quindi sulla riga di tabella corrispondente al pool e selezionare in alto a sinistra nella tabella.

Dovrebbe aprirsi la sezione nella finestra di dialogo, seguita dalla sezione .

Se le sezioni o non vengono visualizzate, è possibile che si stia modificando un pool con codice di cancellazione (erasure coded), il quale non può essere utilizzato per impostare le opzioni di configurazione RBD, o che il pool non sia configurato per l'utilizzo da parte delle immagini RBD. Nell'ultimo caso, assegnare il tag applicazione al pool per visualizzare le sezioni di configurazione corrispondenti.

6.8.4 Opzioni di configurazione #

Fare clic su per espandere le opzioni di configurazione. Verrà visualizzato un elenco di tutte le opzioni disponibili. Le unità delle opzioni di configurazione sono già visualizzate nelle caselle di testo. Se si seleziona l'opzione dei byte per secondo (BPS), è possibile utilizzare scorciatoie come "1M" o "5G". Tali valori verranno convertiti automaticamente in "1 MB/s" e "5 GB/s" rispettivamente.

Se si fa clic sul pulsante di reimpostazione a destra di ciascuna casella di testo, i valori impostati nel pool verranno rimossi. Questa azione non rimuove i valori di configurazione delle opzioni configurate a livello globale o in un'immagine RBD.

6.8.5 Creazione delle opzioni QoS RBD con una nuova immagine RBD #

Per creare un'immagine RBD con le opzioni QoS RBD impostate in quest'ultima, selezionare › e fare clic su . Fare clic su per espandere la sezione di configurazione avanzata. Fare clic su per aprire tutte le opzioni di configurazione disponibili.

6.8.6 Modifica delle opzioni QoS RBD sulle immagini esistenti #

Per modificare le opzioni QoS RBD in un'immagine esistente, selezionare › , fare clic sulla riga di tabella corrispondente al pool e quindi su . Verrà visualizzata la finestra di dialogo per la modifica. Fare clic su per espandere la sezione di configurazione avanzata. Fare clic su per aprire tutte le opzioni di configurazione disponibili.

6.8.7 Modifica delle opzioni di configurazione durante la copia o la clonazione delle immagini #

Se un'immagine RBD viene clonata o copiata, per default verranno copiati anche i valori impostati in tale immagine. Se si desidera modificarli durante la copia o la clonazione, specificare i valori di configurazione aggiornati nella finestra di dialogo di copia/clonazione seguendo gli stessi passaggi della procedura di creazione o modifica di un'immagine RBD. Questa operazione consente di impostare (o reimpostare) soltanto i valori dell'immagine RBD copiata o clonata e non influisce sulla configurazione dell'immagine RBD di origine o sulla configurazione globale.

Se si sceglie di reimpostare il valore di opzione durante la procedura di copia/clonazione, nell'immagine non verrà impostato alcun valore per tale opzione. Ciò vuol dire che verrà utilizzato il valore di tale opzione specificato per il pool superiore se in quest'ultimo è stato configurato tale valore. In caso contrario, verrà utilizzata l'impostazione di default globale.

7 Gestione di NFS Ganesha #

Per informazioni generali su NFS Ganesha, fare riferimento a Capitolo 25, NFS Ganesha.

Per elencare tutte le esportazioni NFS disponibili, fare clic su nel menu principale.

Nell'elenco sono visualizzati la directory, il nome host del daemon, il tipo di back-end di storage e il tipo di accesso di ciascuna esportazione.

Per visualizzare altri dettagli su un'esportazione NFS, fare clic sulla relativa riga di tabella.

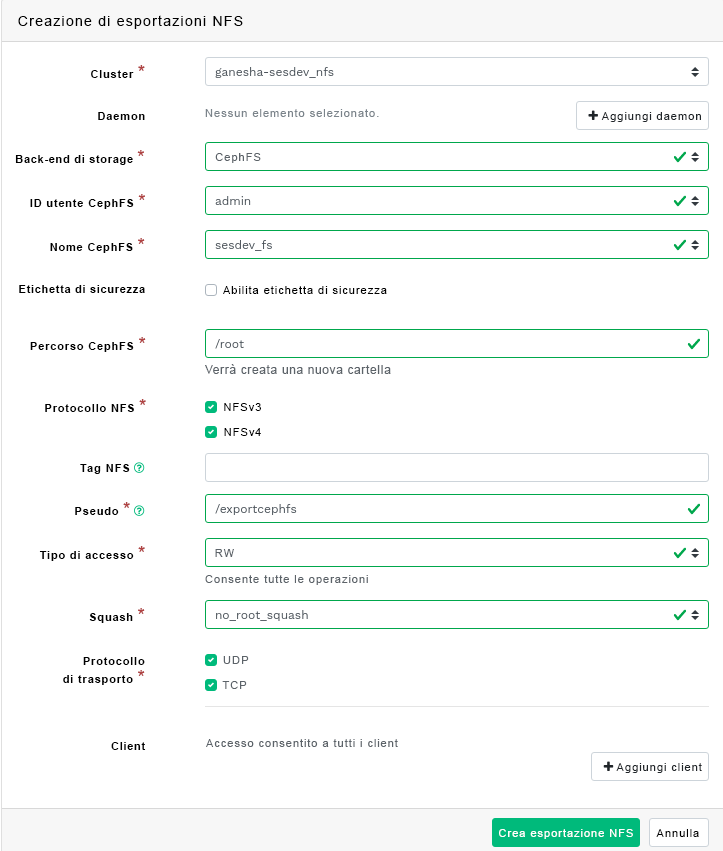

7.1 Creazione di esportazioni NFS #

Per aggiungere una nuova esportazione NFS, fare clic su in alto a sinistra nella tabella delle esportazioni e immettere le informazioni richieste.

Selezionare uno o più daemon NFS Ganesha che eseguiranno l'esportazione.

Selezionare un back-end di storage.

ImportanteAttualmente, sono supportate soltanto le esportazioni NFS supportate da CephFS.

Selezionare un ID utente e altre opzioni di back-end.

Immettere il percorso della directory per l'esportazione NFS. Se la directory non esiste sul server, questa verrà creata.

Specificare altre opzioni correlate a NFS, come la versione del protocollo NFS supportata, l'opzione pseudo, il tipo di accesso, il tipo di squash o il protocollo di trasporto.

Se è necessario limitare l'accesso solo a client specifici, fare clic su e aggiungere i rispettivi indirizzi IP insieme alle opzioni del tipo di accesso e di squashing.

Confermare con il pulsante .

7.2 Eliminazione di esportazioni NFS #

Per eliminare un'esportazione, selezionarla ed evidenziarla nella riga della tabella. Fare clic sulla freccia a discesa accanto al pulsante e selezionare . Attivare la casella di controllo e confermare con .

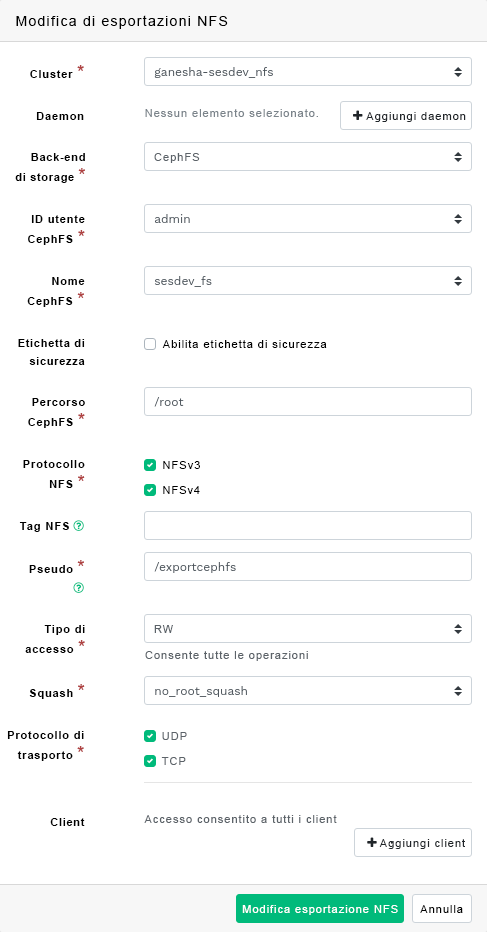

7.3 Modifica di esportazioni NFS #

Per modificare un'esportazione esistente, selezionare ed evidenziare l'esportazione nella riga della tabella e fare clic su in alto a sinistra nella tabella delle esportazioni.

Quindi, è possibile regolare tutti i dettagli dell'esportazione NFS.

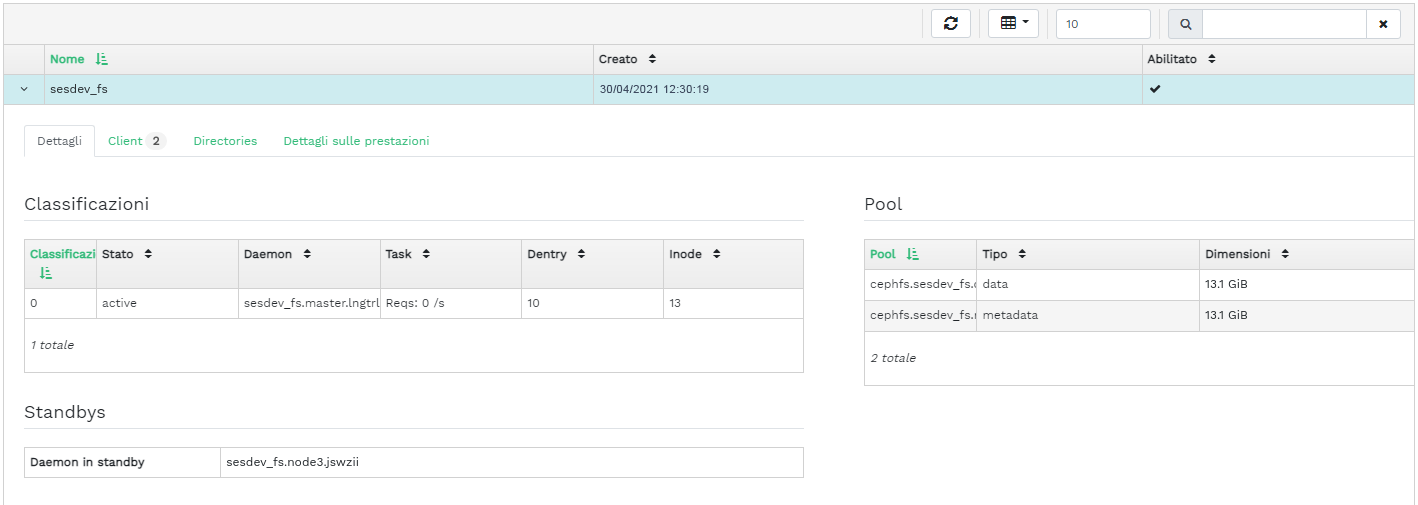

8 Gestione di CephFS #

Per informazioni dettagliate su CephFS, fare riferimento al Capitolo 23, File system in cluster.

8.1 Visualizzazione della panoramica su CephFS #

Fare clic su nel menu principale per visualizzare la panoramica dei file system configurati. Nella tabella principale viene mostrato il nome e la data di creazione di ciascun file system e informazioni sul relativo stato di abilitazione o disabilitazione.

Facendo clic sulla riga di tabella corrispondente a un file system, sarà possibile visualizzare i dettagli sulla classificazione e sui pool aggiunti a quest'ultimo.

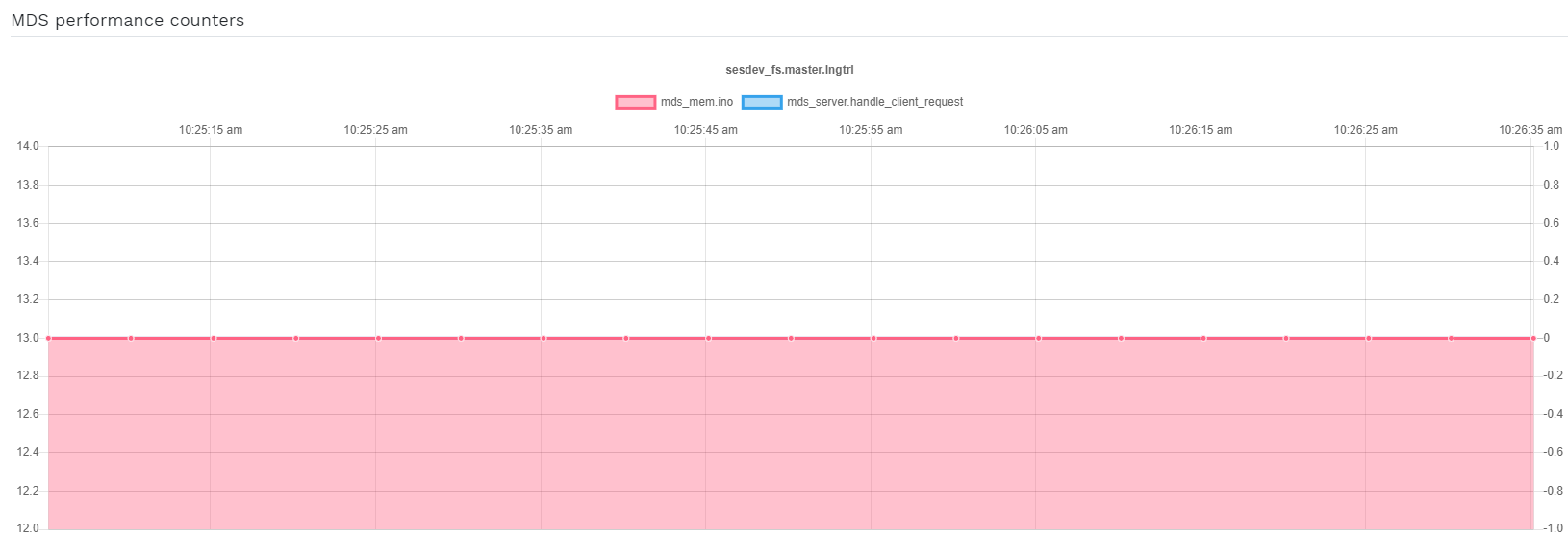

Nella parte inferiore della schermata, è possibile visualizzare le statistiche con il numero in tempo reale degli inode MDS e delle richieste client correlati.

9 Gestione di Object Gateway #

Prima di iniziare, quando si tenta di accedere al front-end di Object Gateway sul Ceph Dashboard, potrebbe essere visualizzata la notifica seguente:

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

Questa notifica viene visualizzata perché Object Gateway non è stato configurato automaticamente da cephadm per il Ceph Dashboard. Se viene visualizzata questa notifica, seguire le istruzioni descritte nella Sezione 10.4, «Abilitazione del front-end di gestione di Object Gateway» per abilitare manualmente il front-end di Object Gateway per il Ceph Dashboard.

Per ulteriori informazioni generali su Object Gateway, fare riferimento al Capitolo 21, Ceph Object Gateway.

9.1 Visualizzazione degli Object Gateway #

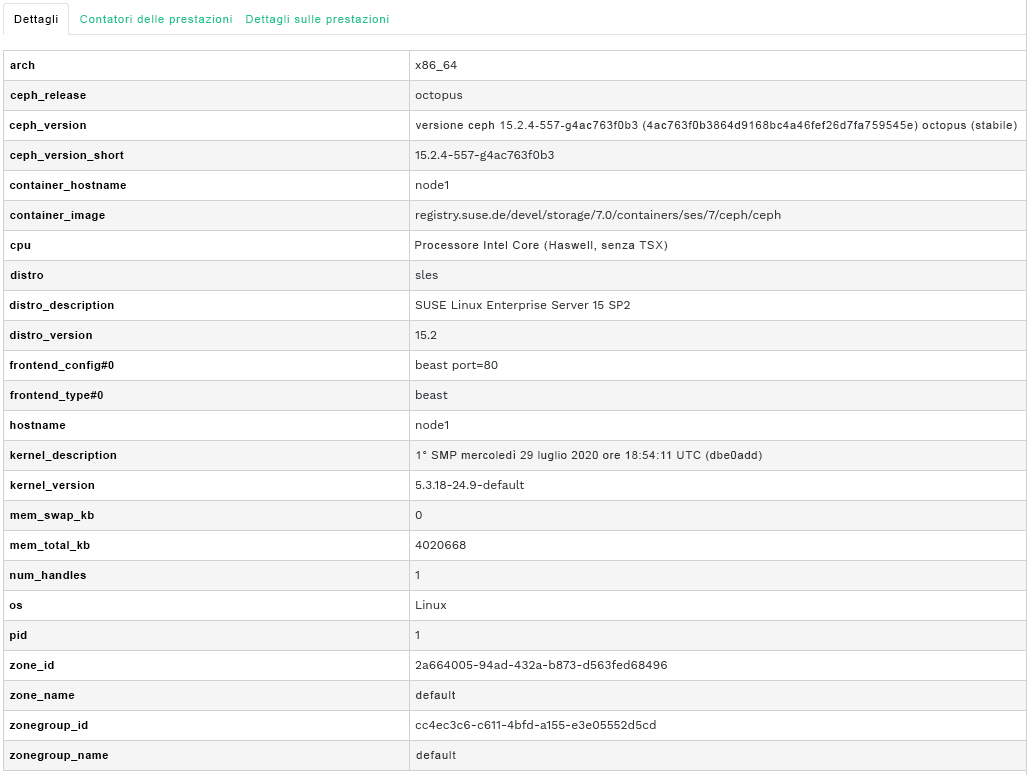

Fare clic su › per visualizzare un elenco degli Object Gateway configurati. L'elenco include l'ID del gateway, il nome host del nodo del cluster su cui è in esecuzione il daemon del gateway e il numero di versione del gateway.

Fare clic sulla freccia a discesa accanto al nome del gateway per visualizzare le relative informazioni dettagliate. Nella scheda vengono mostrati i dettagli delle operazioni di lettura/scrittura e le statistiche sulla cache.

9.2 Gestione degli utenti di Object Gateway #

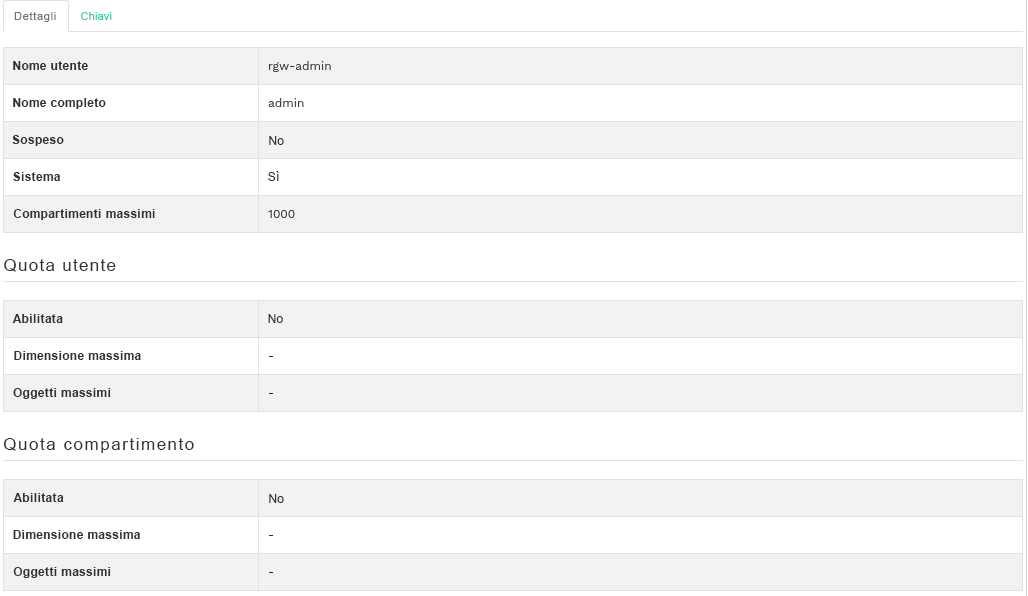

Fare clic su › per visualizzare un elenco degli utenti di Object Gateway esistenti.

Fare clic sulla freccia a discesa accanto al nome utente per visualizzare i dettagli sull'account utente, come le informazioni sullo stato o i dettagli sulla quota utenti o compartimenti.

9.2.1 Aggiunta di un nuovo utente Gateway #

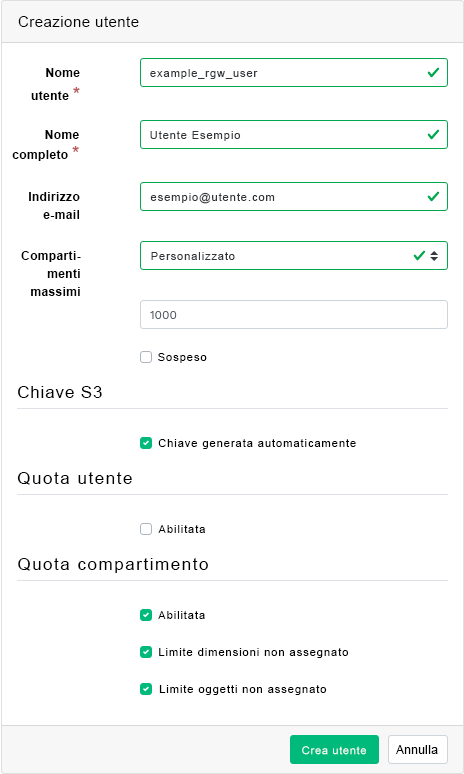

Per aggiungere un nuovo utente Gateway, fare clic su in alto a sinistra nell'intestazione della tabella. Inserire le credenziali, i dettagli della chiave S3 e delle quote utenti e compartimenti, quindi confermare con .

9.2.2 Eliminazione di utenti Gateway #

Per eliminare un utente Gateway, selezionarlo ed evidenziarlo. Fare clic sul pulsante a discesa accanto a e selezionare dall'elenco per eliminare l'account utente. Attivare la casella di controllo e confermare con .

9.2.3 Modifica dei dettagli di un utente Gateway #

Per modificare i dettagli di un utente Gateway, selezionare ed evidenziare tale utente. Fare clic su in alto a sinistra nell'intestazione della tabella.

Modificare le informazioni di base o aggiuntive dell'utente, come le informazioni su capacità, chiavi, sottoutenti e quota. Confermare con .

Nella scheda è incluso un elenco di sola lettura degli utenti Gateway e delle relative chiavi segrete e di accesso. Per visualizzare le chiavi, fare clic su un nome utente nell'elenco e selezionare in alto a sinistra nell'intestazione della tabella. Nella finestra di dialogo , fare clic sull'icona a forma di occhio per rendere visibili le chiavi oppure sull'icona degli appunti per copiare la chiave correlata negli appunti.

9.3 Gestione dei compartimenti Object Gateway #

I compartimenti Object Gateway (OGW) implementano la funzionalità dei container di OpenStack Swift e fungono da container per la memorizzazione degli oggetti dati.

Fare clic su › per visualizzare un elenco dei compartimenti Object Gateway.

9.3.1 Aggiunta di un nuovo compartimento #

Per aggiungere un nuovo compartimento Object Gateway, fare clic su in alto a sinistra nell'intestazione della tabella. Immettere il nome del compartimento, selezionare il proprietario e impostare la destinazione di posizionamento. Confermare con .

In questa fase è possibile inoltre abilitare il blocco selezionando ; a ogni modo, si tratta di un'impostazione che può essere configurata in seguito alla creazione. Consultare Sezione 9.3.3, «Modifica del compartimento» per maggiori informazioni.

9.3.2 Visualizzazione dei dettagli del compartimento #

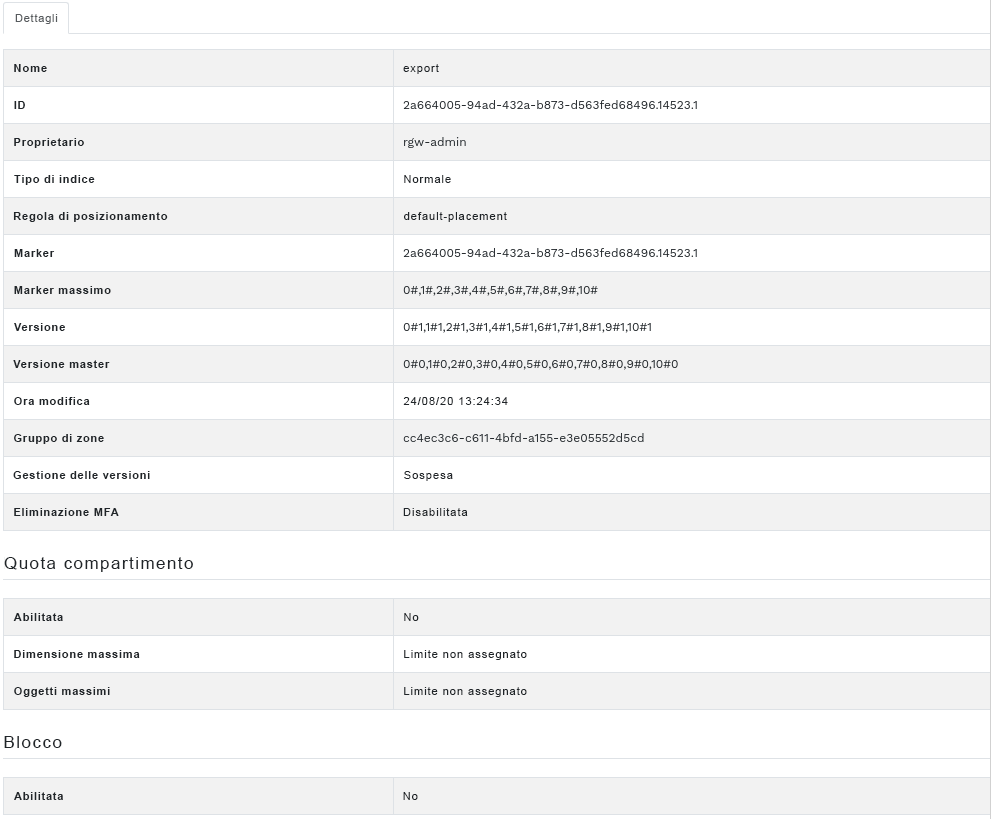

Per visualizzare informazioni dettagliate su un compartimento Object Gateway, fare clic sulla freccia a discesa accanto al nome del compartimento.

Sotto la tabella , è possibile trovare i dettagli delle impostazioni relative al blocco e alla quota compartimenti.

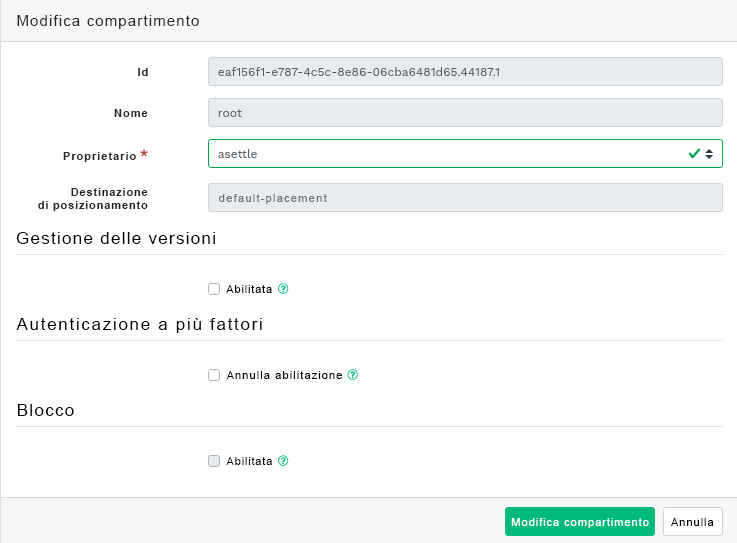

9.3.3 Modifica del compartimento #

Selezionare ed evidenziare un compartimento, quindi fare clic su in alto a sinistra nell'intestazione della tabella.

È possibile aggiornare il proprietario del compartimento o abilitare il controllo versioni, l'autenticazione a più fattori o il blocco. Confermare le modifiche con .

9.3.4 Eliminazione di un compartimento #

Per eliminare un compartimento Object Gateway, selezionarlo ed evidenziarlo. Fare clic sul pulsante a discesa accanto a e selezionare dall'elenco per eliminare il compartimento. Attivare la casella di controllo e confermare con .

10 Configurazione manuale #

Questa sezione fornisce informazioni avanzate per gli utenti che preferiscono configurare manualmente le impostazioni del dashboard nella riga di comando.

10.1 Configurazione del supporto TLS/SSL #

Per default, tutte le connessioni HTTP al dashboard sono protette da TLS/SSL. Per la connessione sicura è necessario un certificato SSL. È possibile utilizzare un certificato firmato da se stessi o generarne uno e farlo firmare da un'autorità di certificazione (CA) nota.

In alcune situazioni, potrebbe essere opportuno disabilitare il supporto SSL. Ad esempio, se il dashboard è in esecuzione dietro un proxy che non supporta SSL.

Prestare attenzione quando si disabilita SSL poiché i nomi utente e le password verranno inviati al dashboard senza cifratura.

Per disabilitare SSL eseguire:

cephuser@adm > ceph config set mgr mgr/dashboard/ssl falseIn seguito alla modifica del certificato e della chiave SSL, è necessario riavviare manualmente i processi di Ceph Manager. Per farlo, eseguire

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAMEo disabilitare e riabilitare il modulo del dashboard (questa azione comporta inoltre la rigenerazione del manager):

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 Creazione di certificati autofirmati #

La procedura di creazione di un certificato firmato da se stessi per la comunicazione sicura è semplice. In questo modo è possibile rendere operativo il dashboard più rapidamente.

La maggior parte dei browser Web creerà un complain relativo al certificato firmato da se stessi e richiederà una conferma esplicita prima di stabilire una connessione sicura al dashboard.

Per generare e installare un certificato firmato da se stessi, utilizzare il seguente comando integrato:

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 Utilizzo dei certificati firmati dall'autorità di certificazione #