- Sobre este guia

- I Ceph Dashboard

- 1 Sobre o Ceph Dashboard

- 2 Interface do usuário da Web do painel de controle

- 3 Gerenciar usuários e funções do Ceph Dashboard

- 4 Ver detalhes internos do cluster

- 4.1 Visualizando nós do cluster

- 4.2 Acessando o inventário do cluster

- 4.3 Visualizando Ceph Monitors

- 4.4 Exibindo serviços

- 4.5 Exibindo Ceph OSDs

- 4.6 Visualizando a configuração do cluster

- 4.7 Vendo o mapa CRUSH do

- 4.8 Visualizando módulos do gerenciador

- 4.9 Visualizando registros

- 4.10 Visualizando o monitoramento

- 5 Gerenciar pools

- 6 Gerenciar dispositivos de blocos RADOS

- 7 Gerenciar o NFS Ganesha

- 8 Gerenciar o CephFS

- 9 Gerenciar o Gateway de Objetos

- 10 Configuração manual

- 11 Gerenciar usuários e funções na linha de comando

- II Operação do cluster

- 12 Determinar o estado do cluster

- 12.1 Verificando o status de um cluster

- 12.2 Verificando a saúde do cluster

- 12.3 Verificando as estatísticas de uso de um cluster

- 12.4 Verificando o status do OSD

- 12.5 Verificando se há OSDs cheios

- 12.6 Verificando o status do monitor

- 12.7 Verificando estados de grupos de posicionamento

- 12.8 Capacidade de armazenamento

- 12.9 Monitorando OSDs e grupos de posicionamento

- 13 Tarefas operacionais

- 14 Operação de serviços do Ceph

- 15 Backup e restauração

- 16 Monitoramento e alerta

- 12 Determinar o estado do cluster

- III Armazenando dados em um cluster

- 17 Gerenciamento de dados armazenados

- 18 Gerenciar pools de armazenamento

- 19 Pools codificados para eliminação

- 20 Dispositivo de Blocos RADOS

- 20.1 Comandos do dispositivo de blocos

- 20.2 Montando e desmontando

- 20.3 Instantâneos

- 20.4 Espelhos de imagens RBD

- 20.5 Configurações de cache

- 20.6 Configurações de QdS

- 20.7 Configurações de leitura com ajuda

- 20.8 Recursos avançados

- 20.9 Mapeando o RBD por meio de clientes antigos do kernel

- 20.10 Habilitando dispositivos de blocos e Kubernetes

- IV Acessando os dados do cluster

- 21 Gateway de Objetos do Ceph

- 21.1 Restrições e limitações de nomeação do Gateway de Objetos

- 21.2 Implantando o Gateway de Objetos

- 21.3 Operando o serviço Gateway de Objetos

- 21.4 Opções de configuração

- 21.5 Gerenciando o acesso ao Gateway de Objetos

- 21.6 Front ends HTTP

- 21.7 Habilitar HTTPS/SSL para Gateways de Objetos

- 21.8 Módulos de sincronização

- 21.9 Autenticação LDAP

- 21.10 Fragmentação de índice do compartimento de memória

- 21.11 Integração do OpenStack Keystone

- 21.12 Posicionamento do pool e classes de armazenamento

- 21.13 Gateways de Objetos multissite

- 22 Ceph iSCSI Gateway

- 23 Sistema de arquivos em cluster

- 24 Exportar dados do Ceph por meio do Samba

- 25 NFS Ganesha

- 21 Gateway de Objetos do Ceph

- V Integração com ferramentas de virtualização

- VI Configurando um cluster

- A Atualizações de manutenção do Ceph baseadas nos point releases de upstream do “Octopus”

- B Atualizações da documentação

- Glossário

- 2.1 Tela de login do Ceph Dashboard

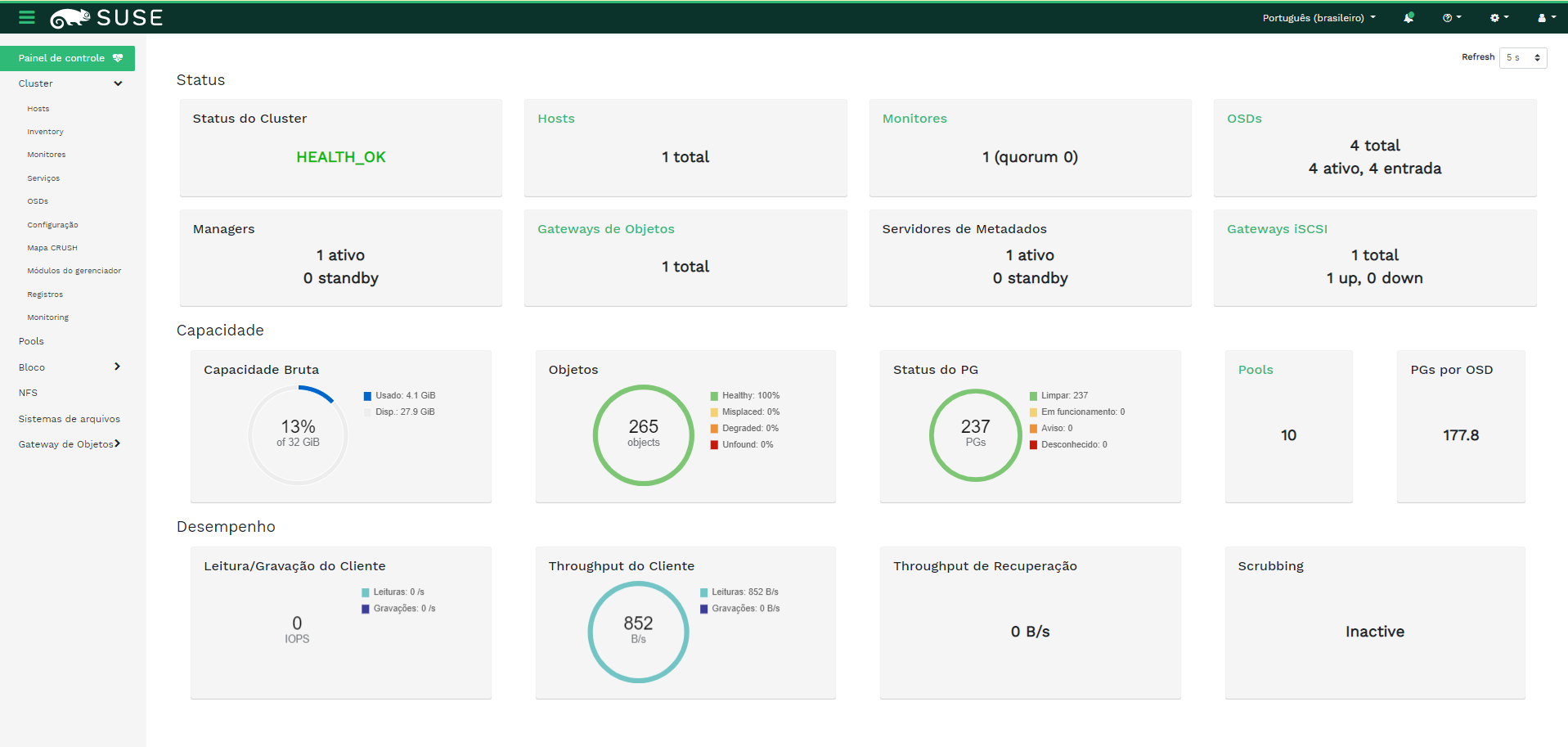

- 2.2 Home page do Ceph Dashboard

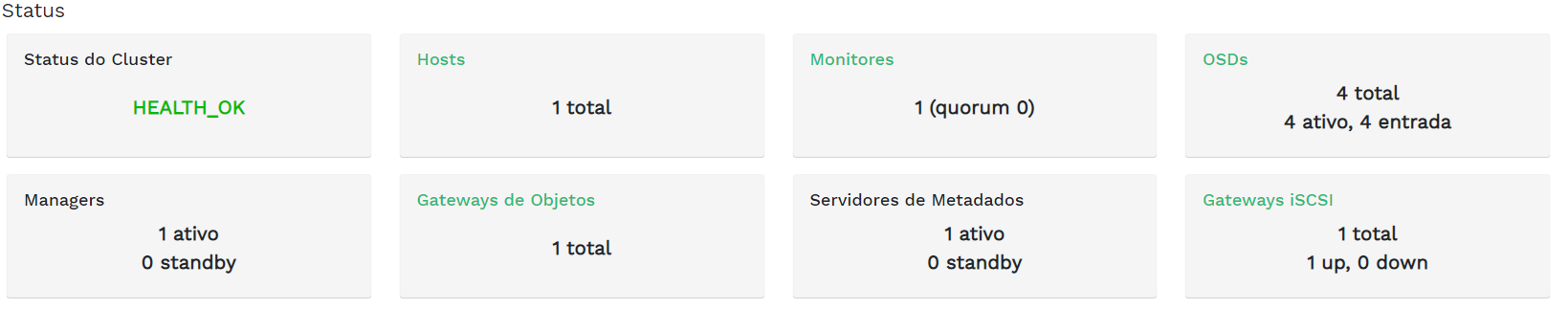

- 2.3 Widgets de status

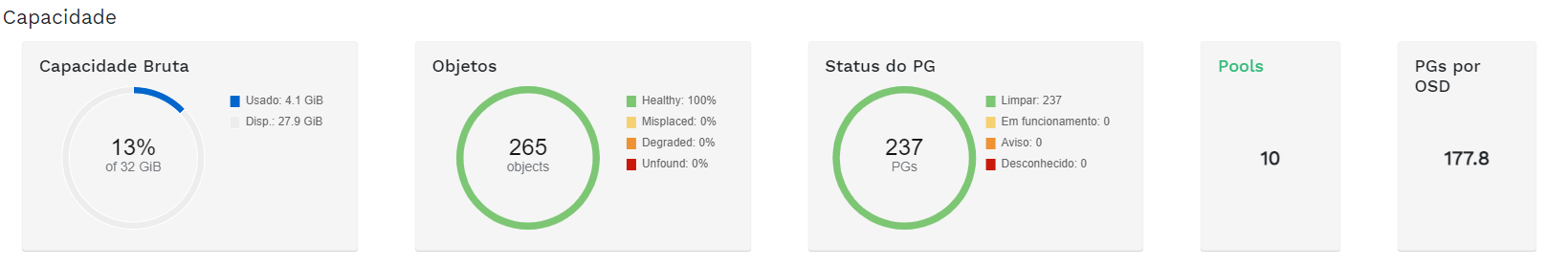

- 2.4 Widgets de capacidade

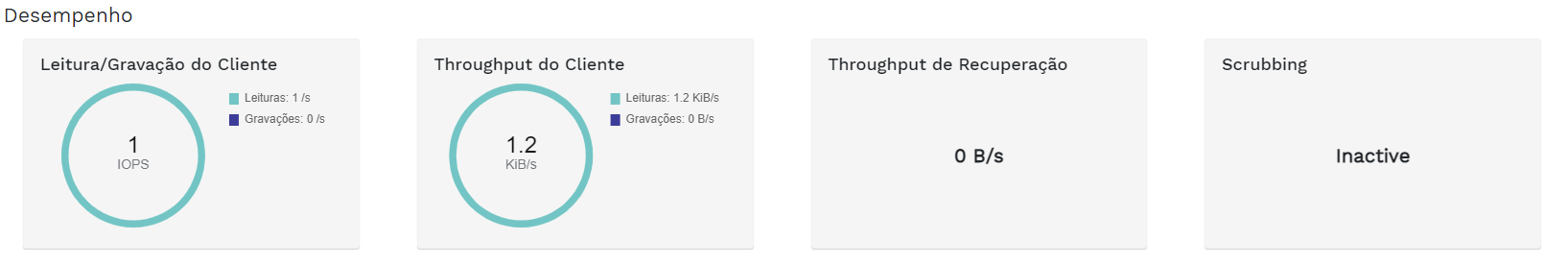

- 2.5 widgets de desempenho

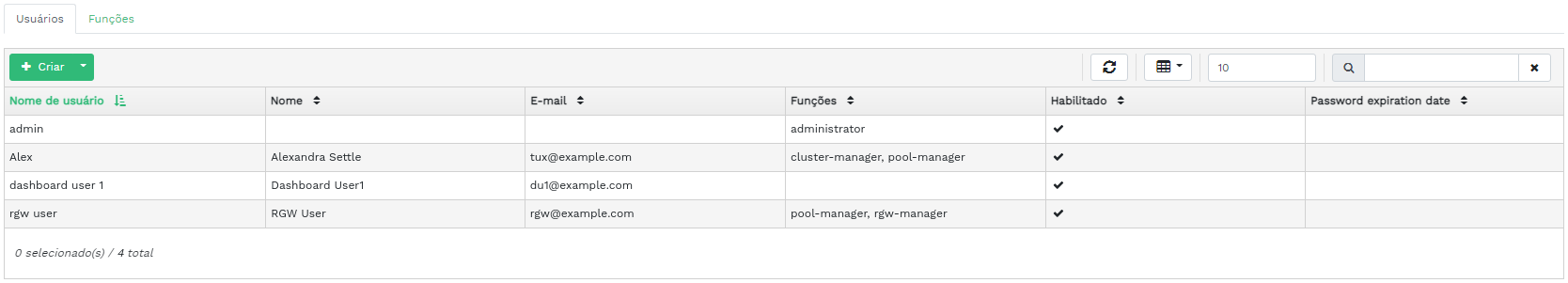

- 3.1 Gerenciamento de usuários

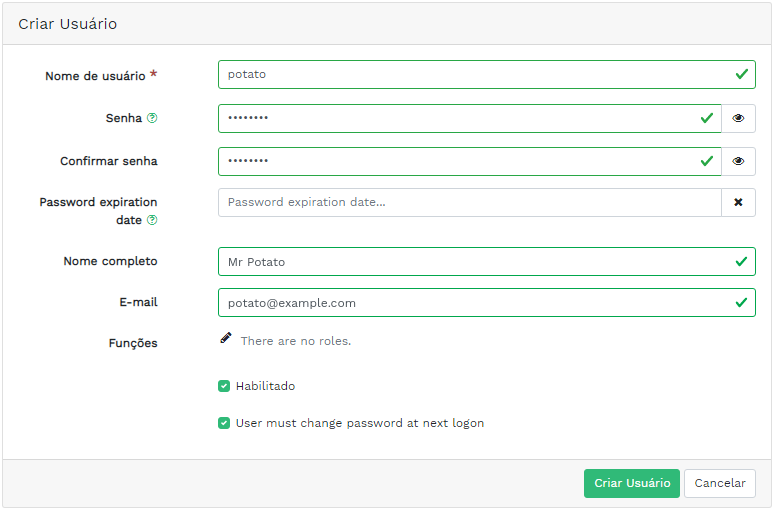

- 3.2 Adicionando um usuário

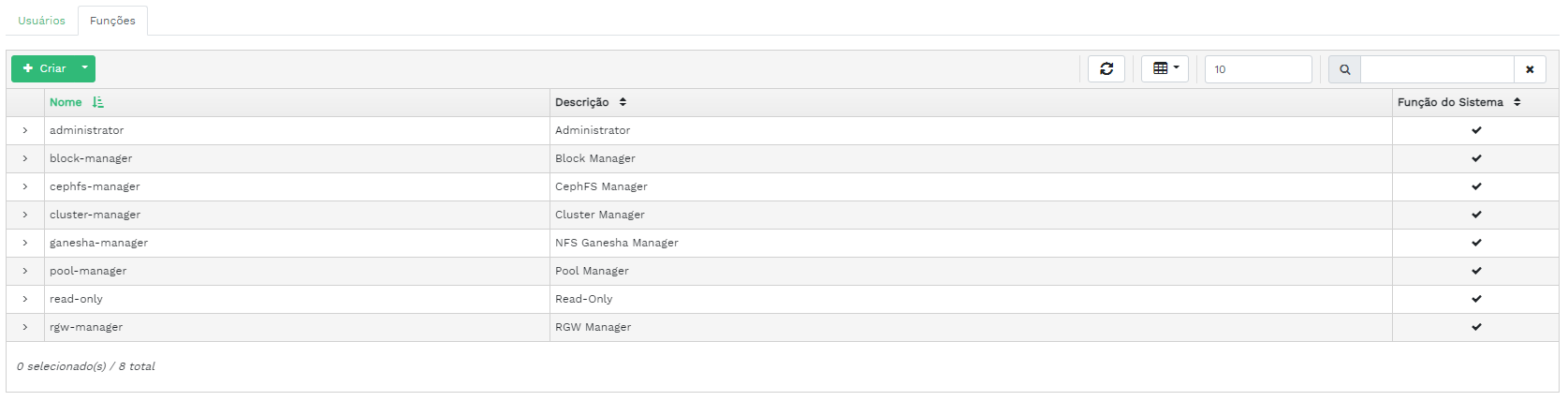

- 3.3 Funções de usuário

- 3.4 Adicionando uma função

- 4.1 Hosts

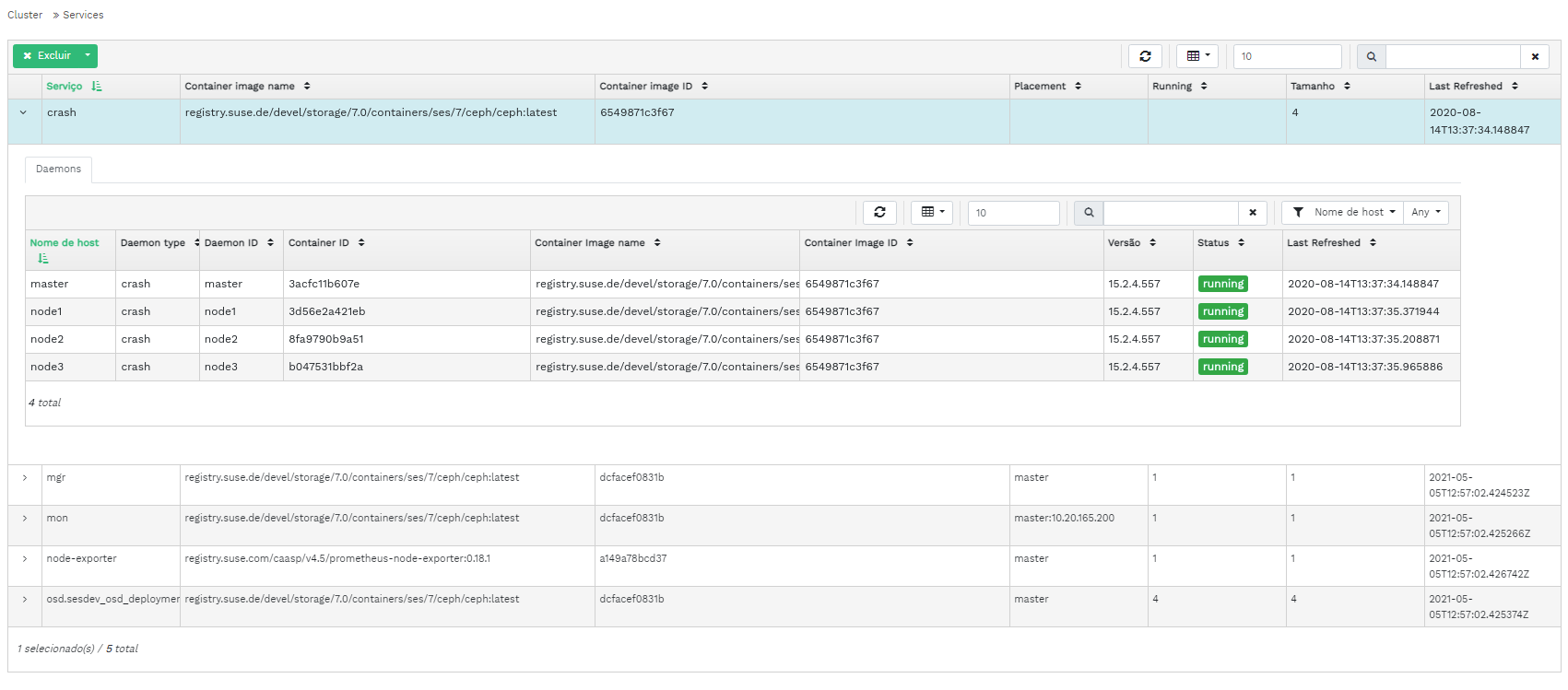

- 4.2 Serviços

- 4.3 Ceph Monitors

- 4.4 Serviços

- 4.5 Ceph OSDs

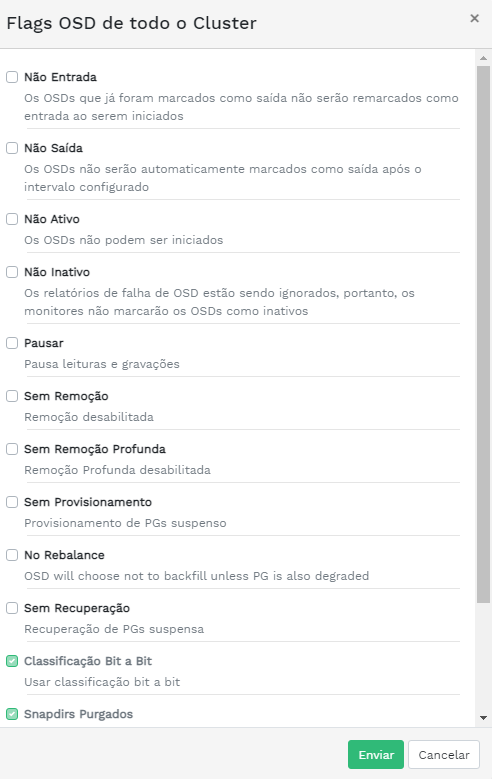

- 4.6 Flags OSD

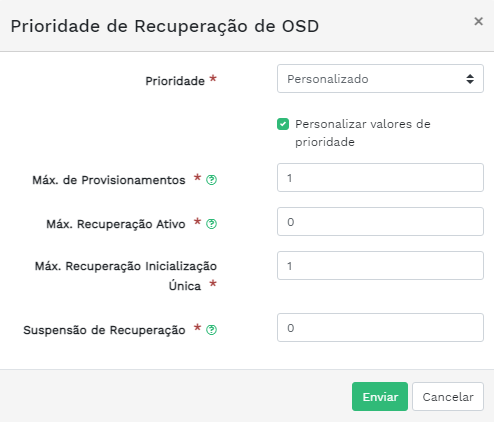

- 4.7 Prioridade de recuperação de OSD

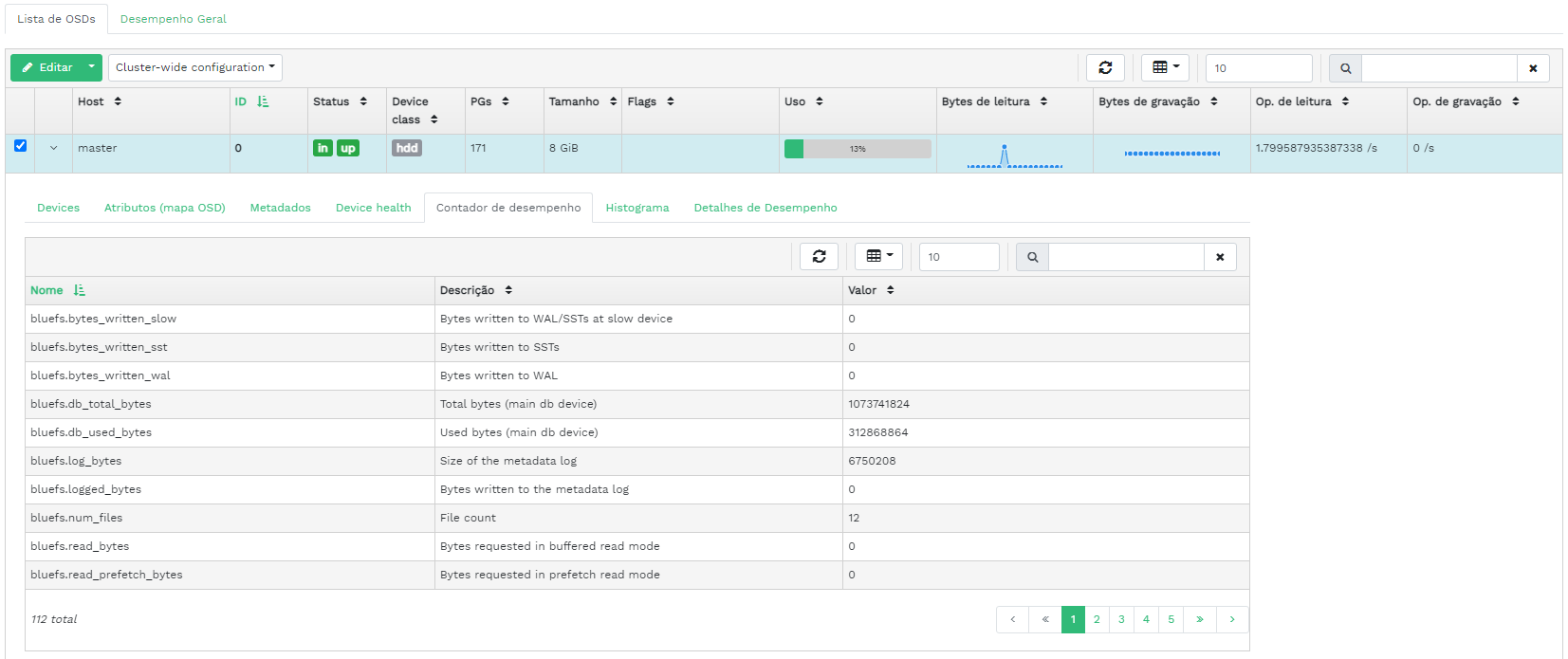

- 4.8 Detalhes do OSD

- 4.9 Criar OSDs

- 4.10 Adicionando dispositivos principais

- 4.11 Criar OSDs com dispositivos principais adicionados

- 4.12

- 4.13 OSDs recém-adicionados

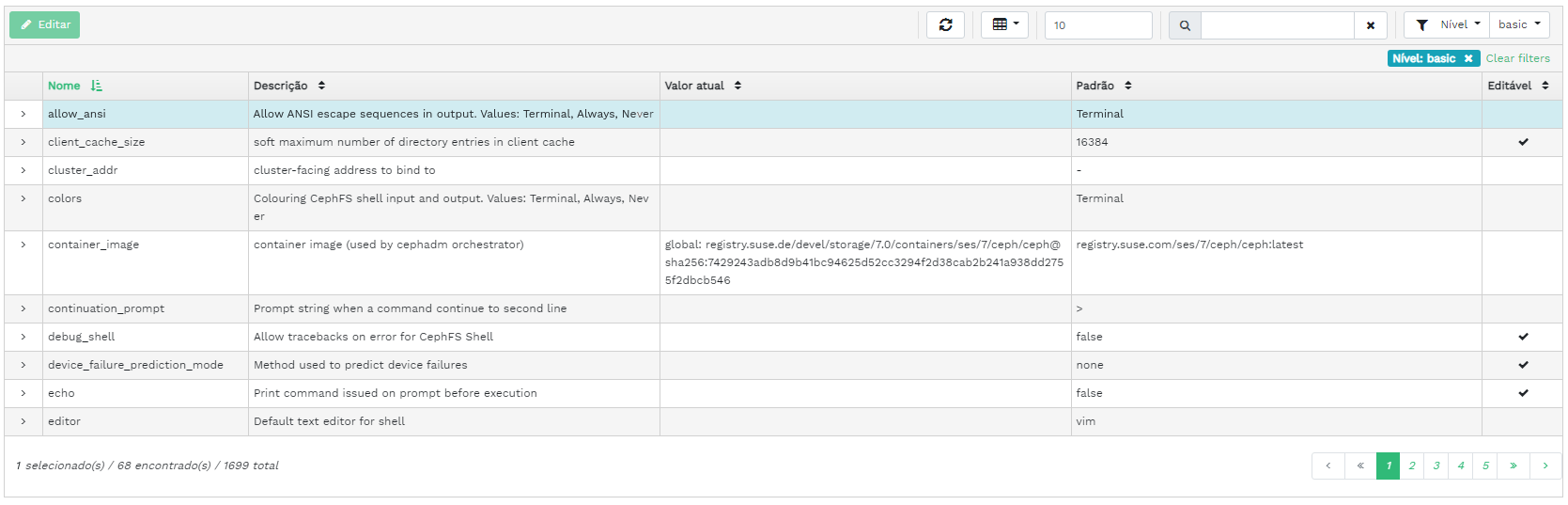

- 4.14 Configuração do cluster

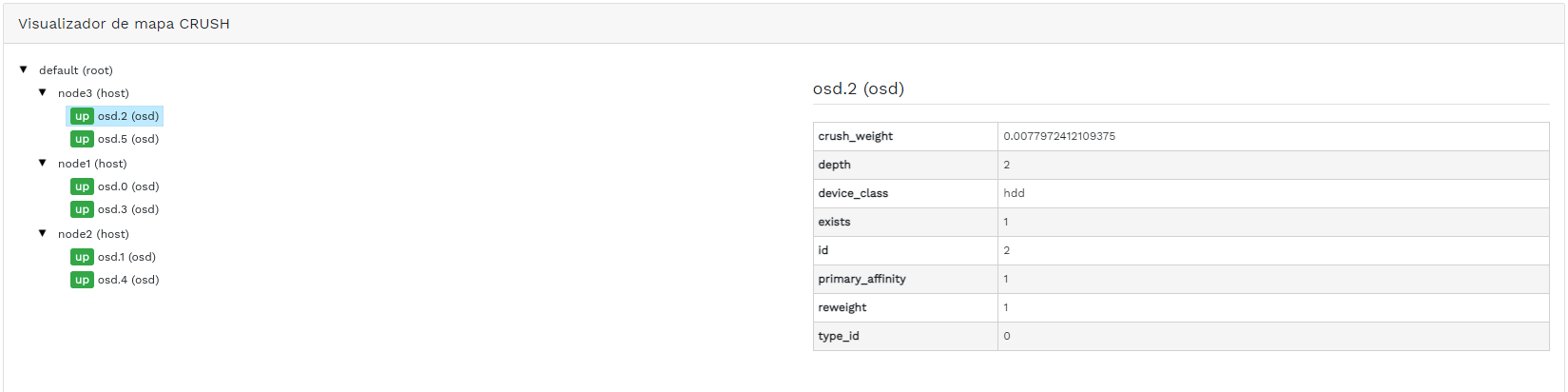

- 4.15 Mapa CRUSH

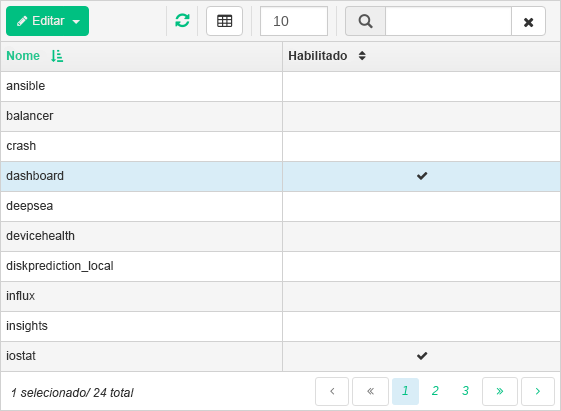

- 4.16 Módulos do gerenciador

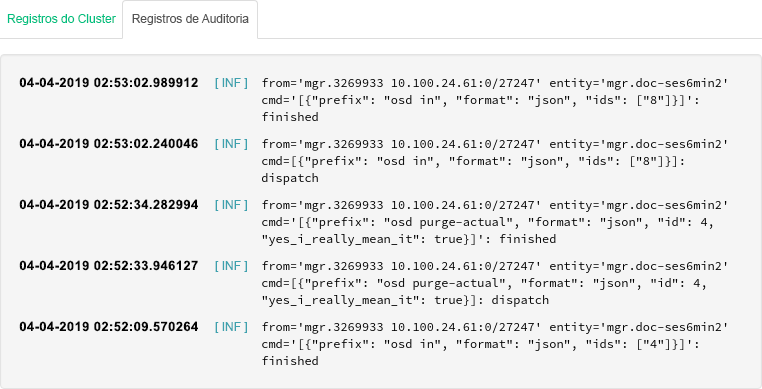

- 4.17 Registros

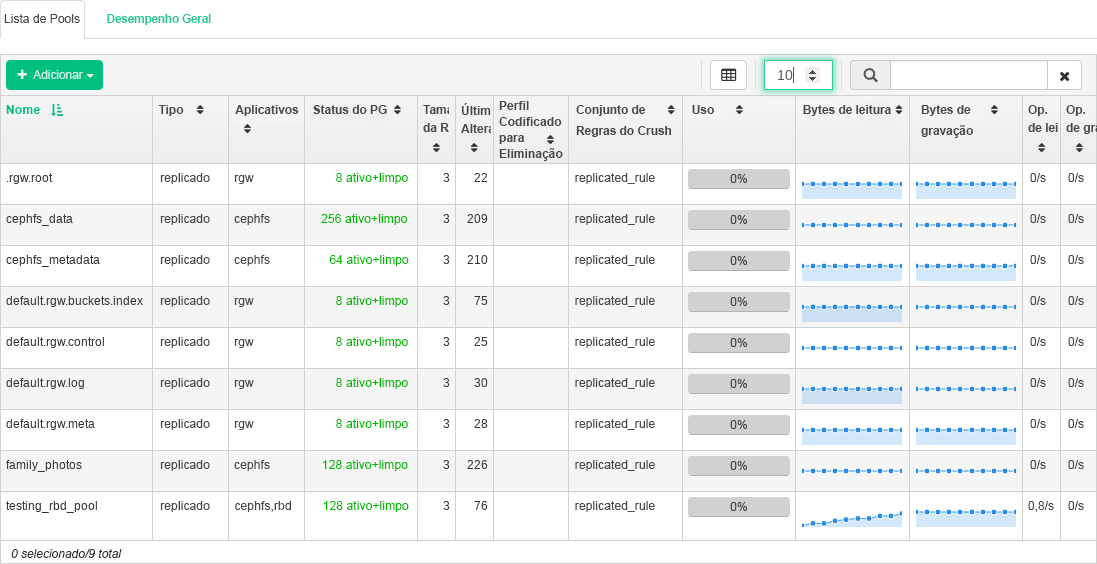

- 5.1 Lista de pools

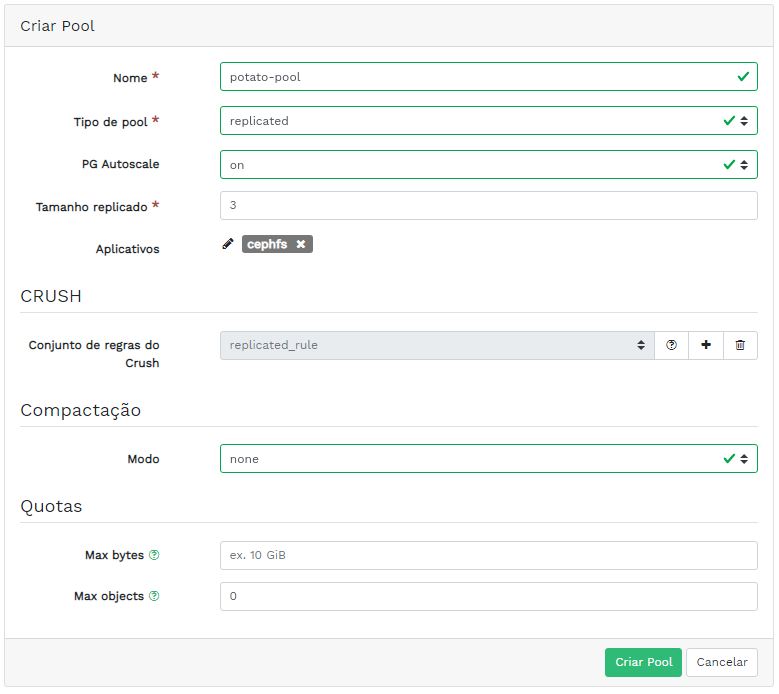

- 5.2 Adicionando um novo pool

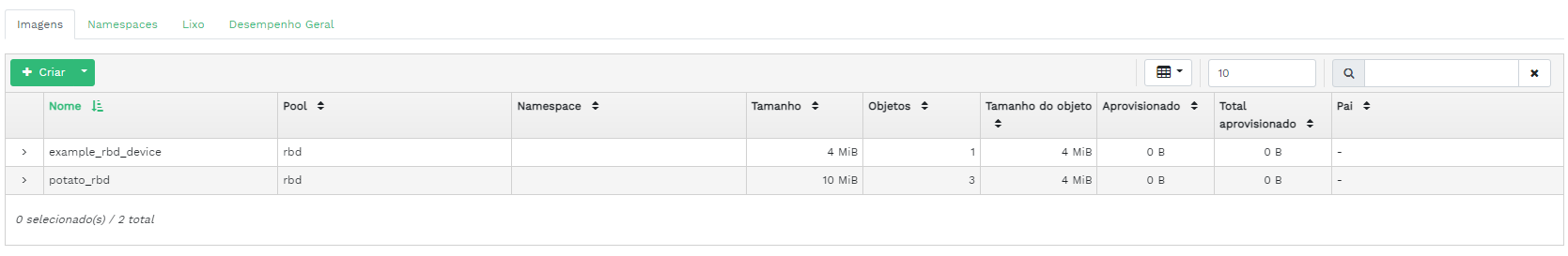

- 6.1 Lista de imagens RBD

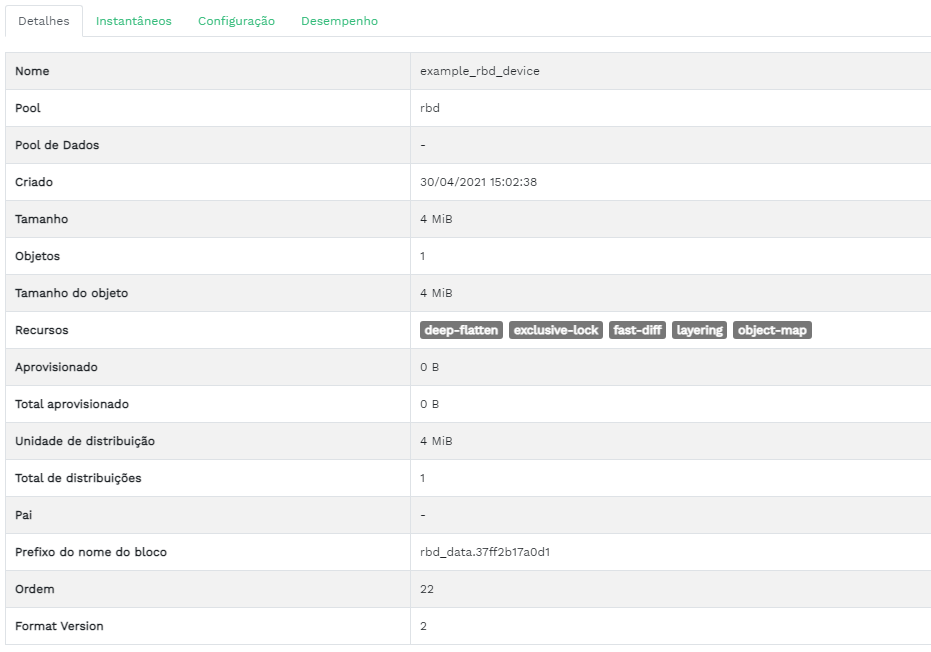

- 6.2 Detalhes do RBD

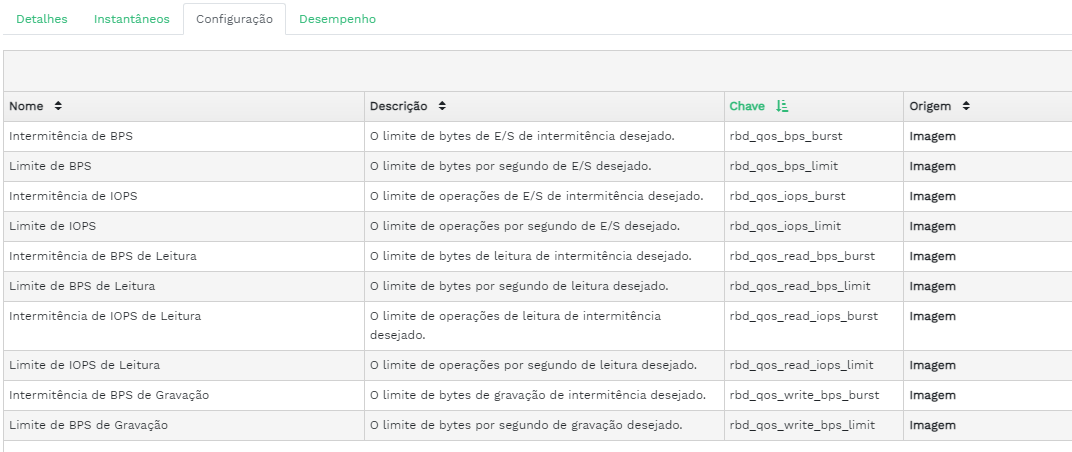

- 6.3 Configuração do RBD

- 6.4 Adicionando um novo RBD

- 6.5 Instantâneos do RBD

- 6.6 Executando daemons

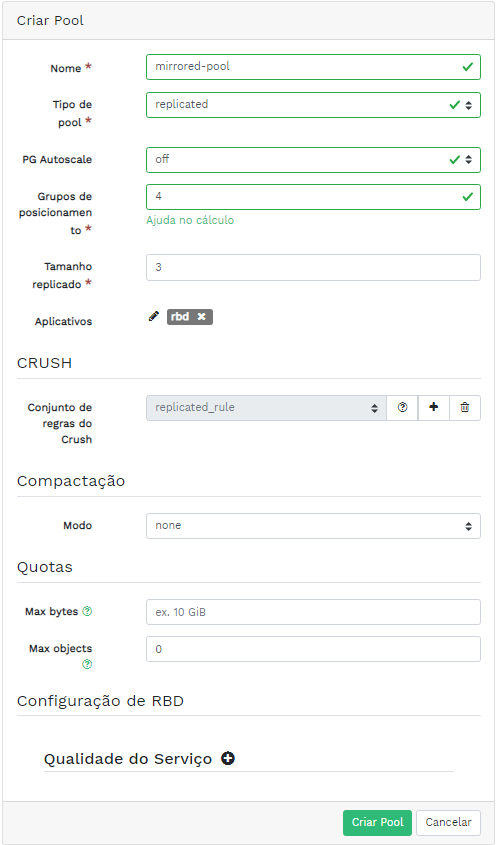

rbd-mirror - 6.7 Criando um pool com o aplicativo RBD

- 6.8 Configurando o modo de replicação

- 6.9 Adicionando credenciais do peer

- 6.10 Lista de pools replicados

- 6.11 Nova imagem RBD

- 6.12 Nova imagem RBD sincronizada

- 6.13 Status da replicação das imagens RBD

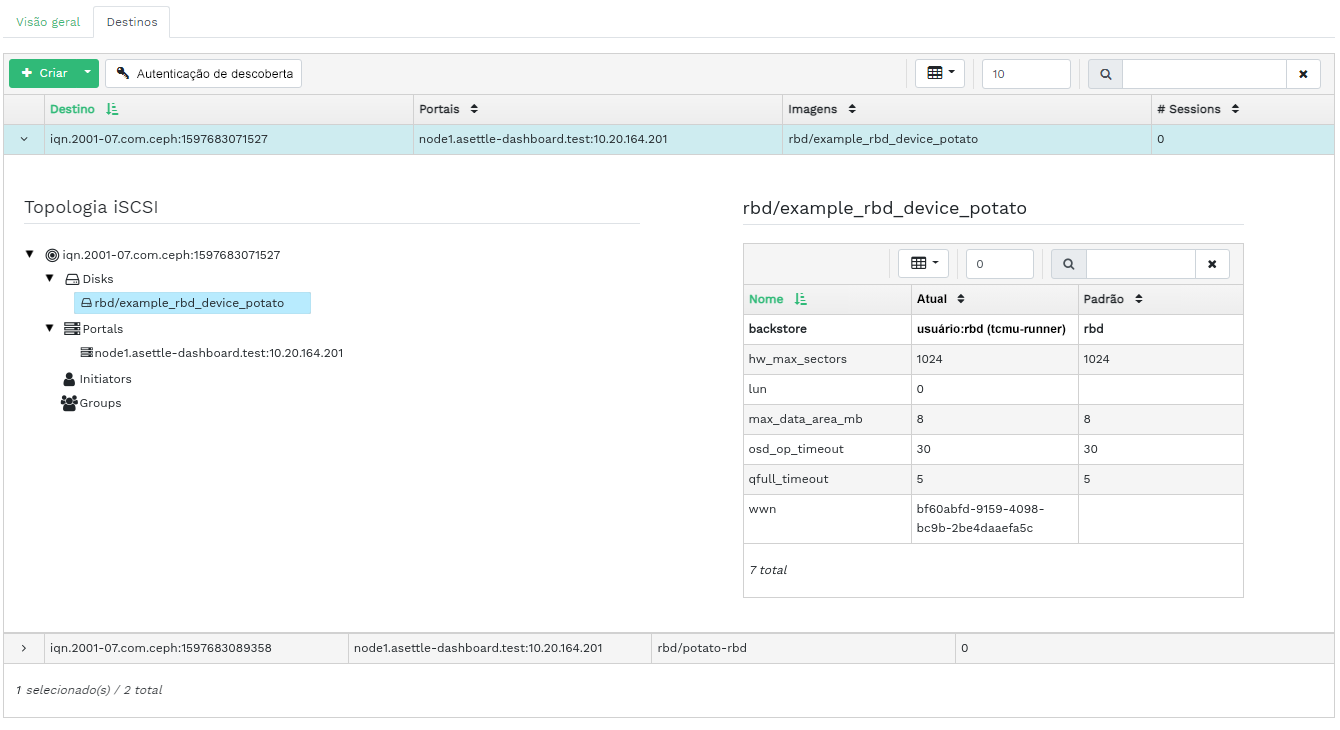

- 6.14 Lista de destinos iSCSI

- 6.15 Detalhes do destino iSCSI

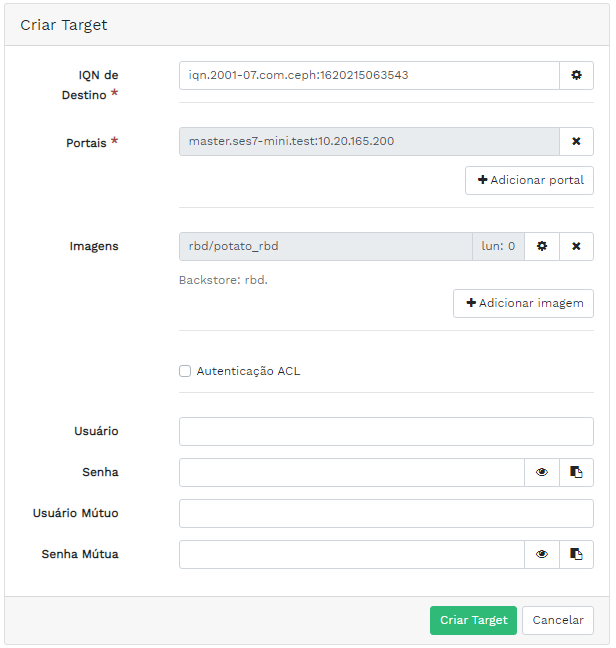

- 6.16 Adicionando um novo destino

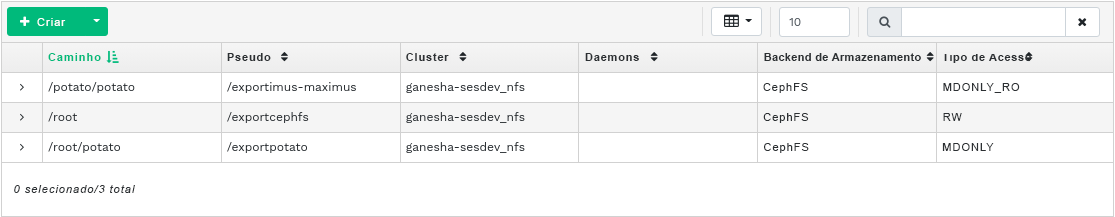

- 7.1 Lista de exportações do NFS

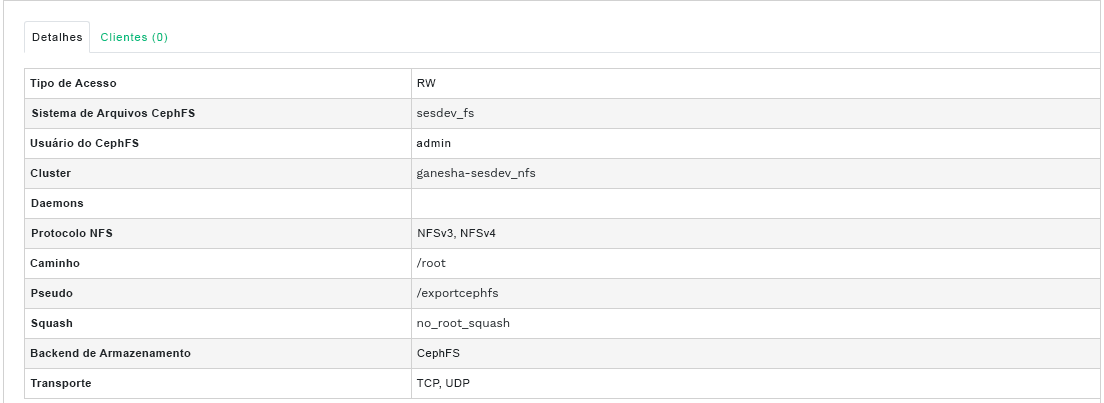

- 7.2 Detalhes da exportação do NFS

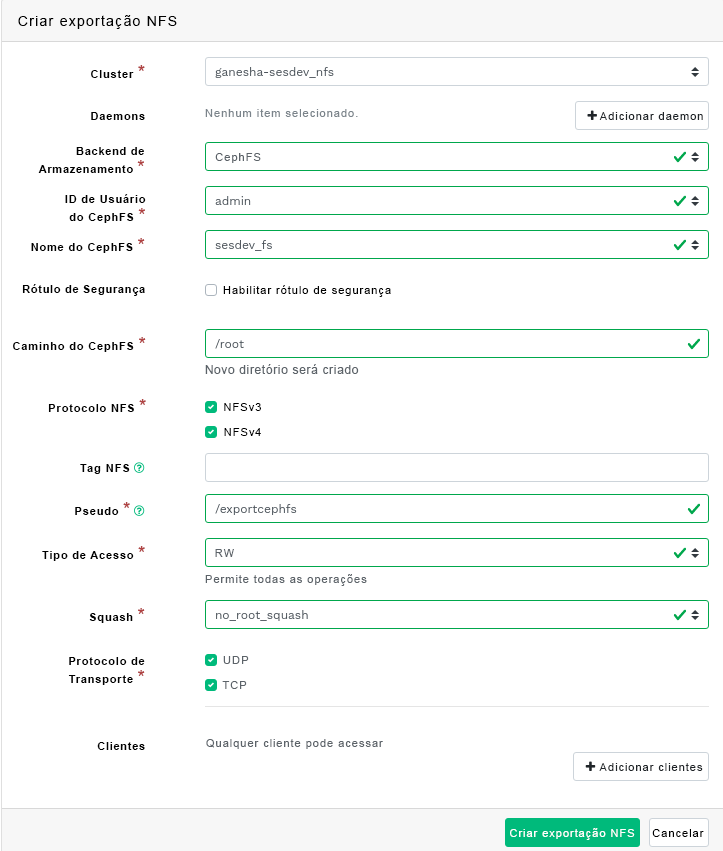

- 7.3 Adicionando uma nova exportação do NFS

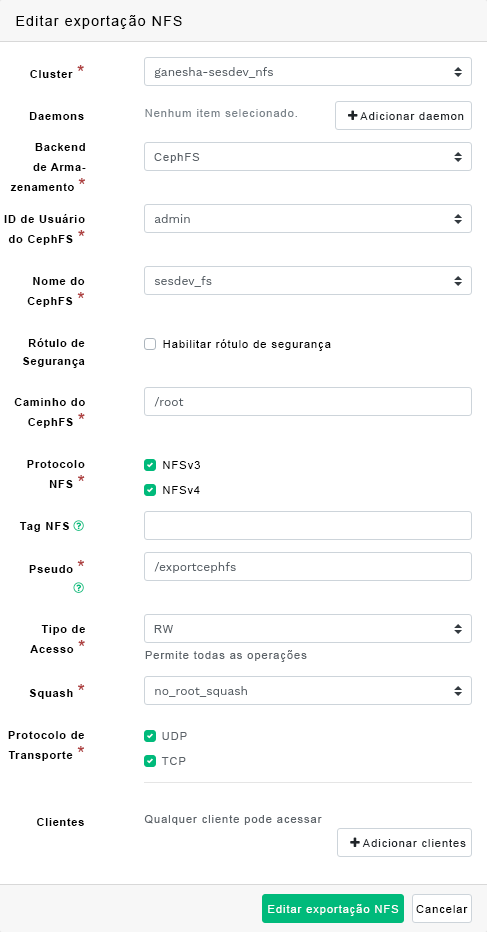

- 7.4 Editando uma exportação do NFS

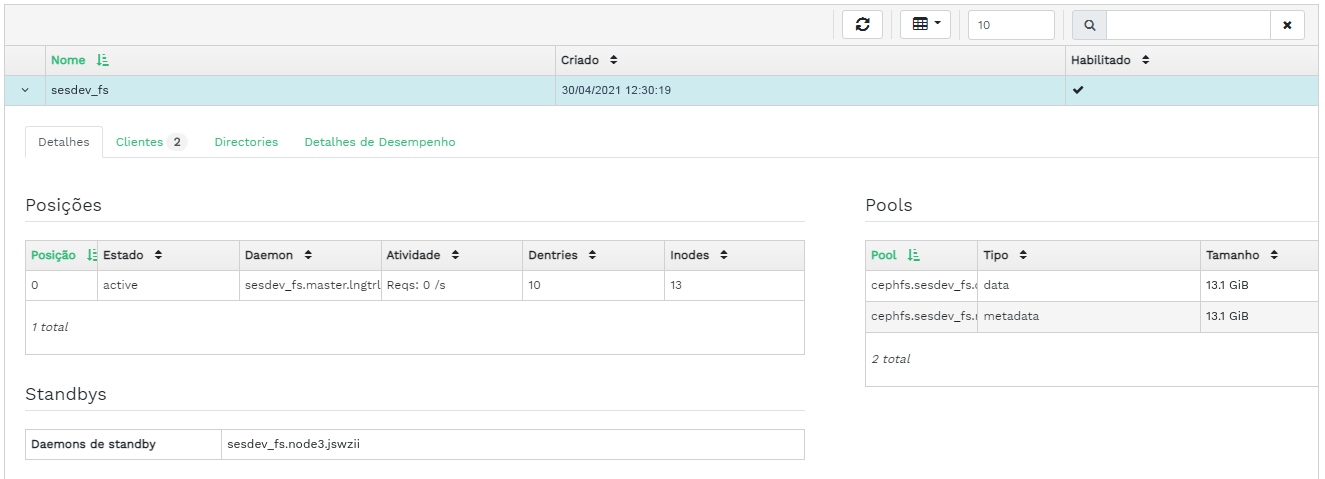

- 8.1 Detalhes do CephFS

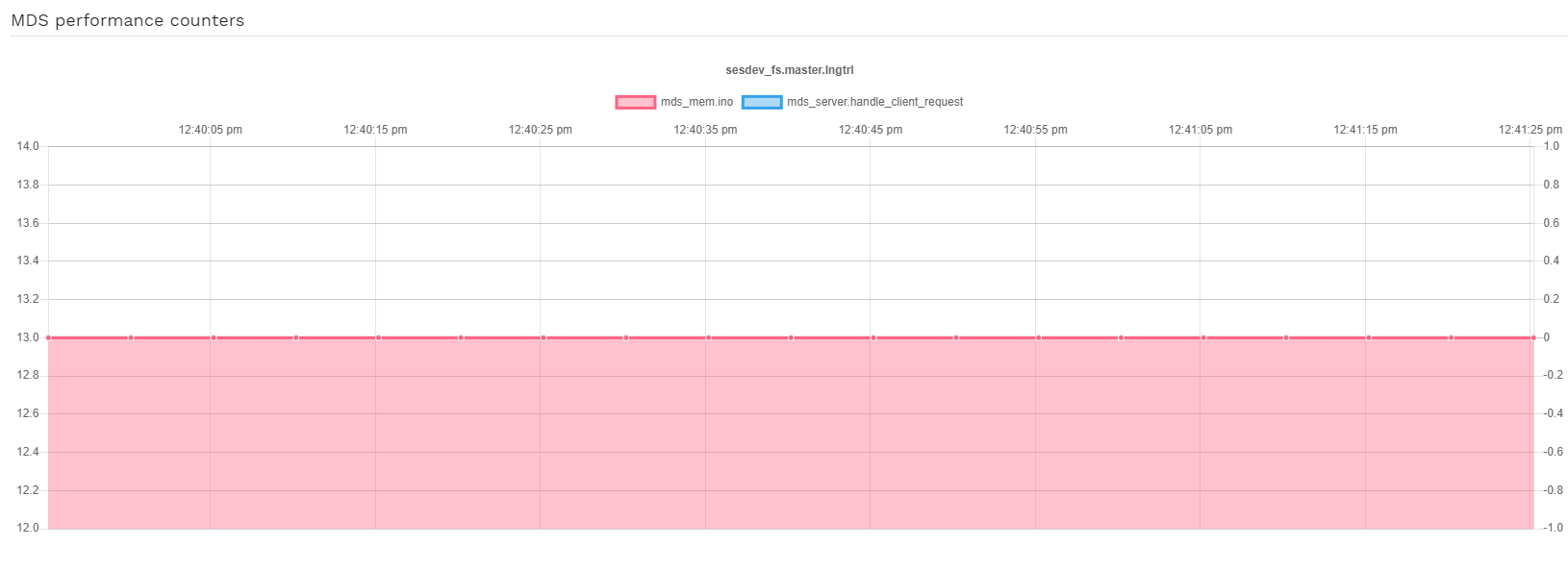

- 8.2 Detalhes do CephFS

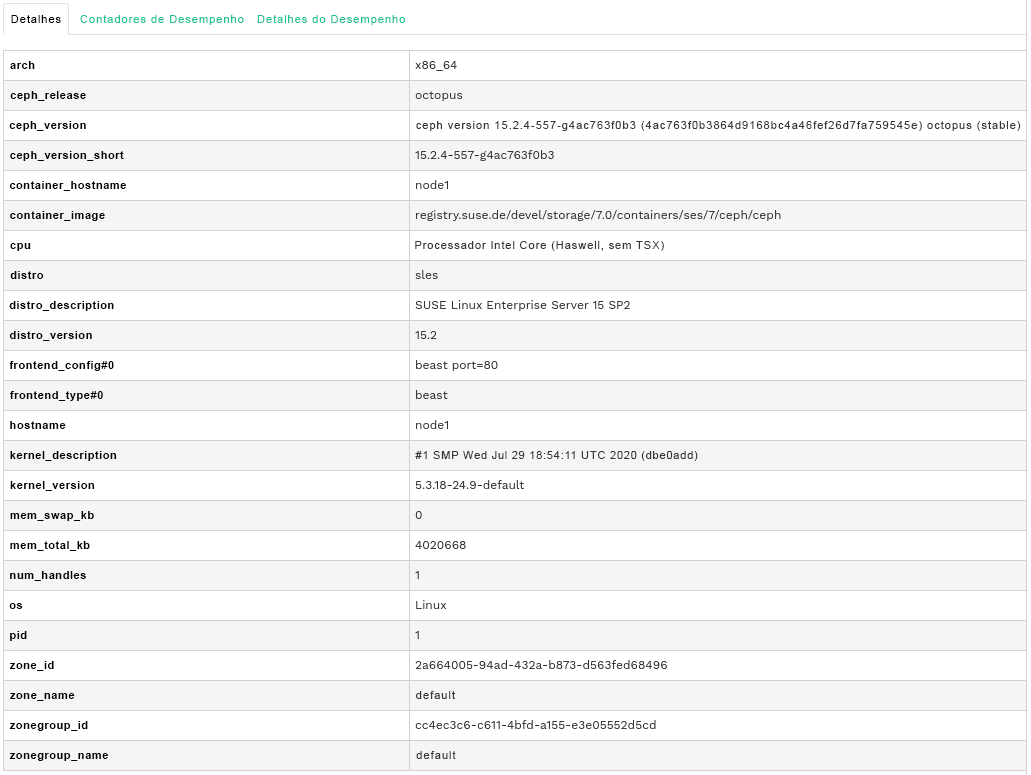

- 9.1 Detalhes do gateway

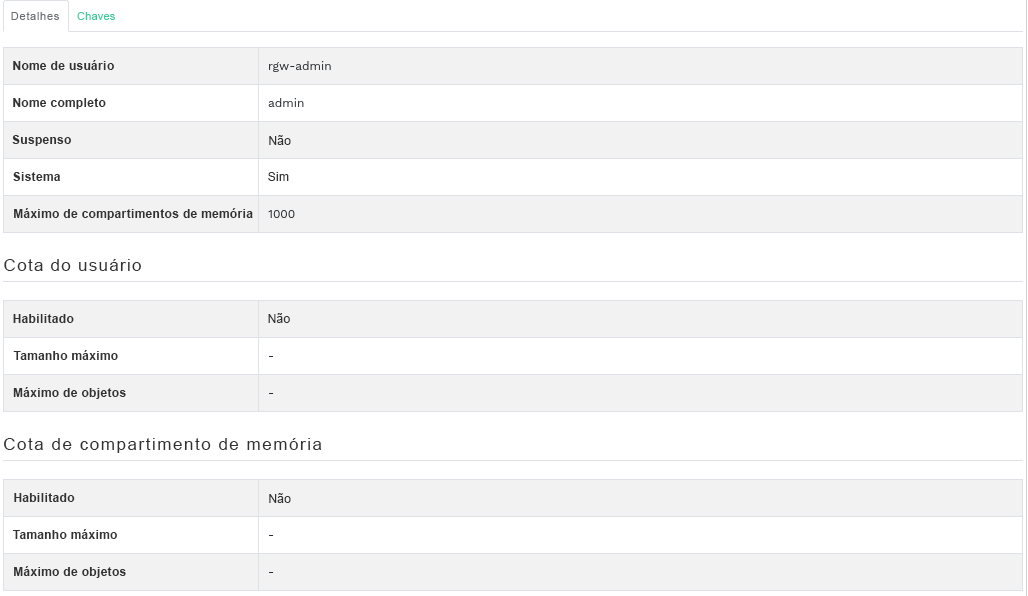

- 9.2 Usuários do gateway

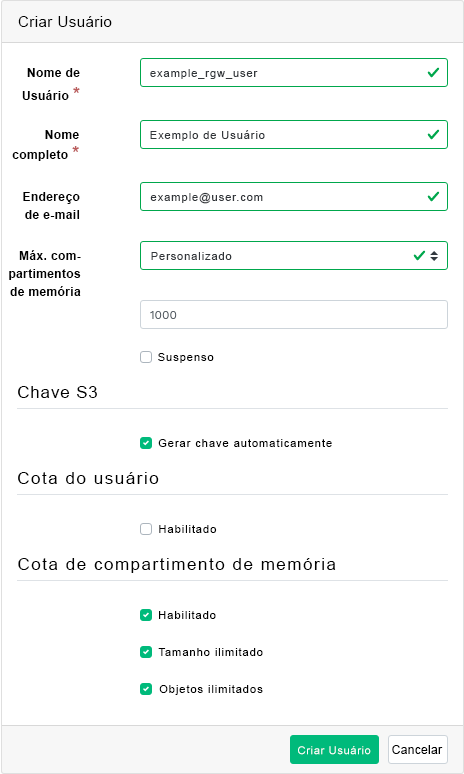

- 9.3 Adicionando um novo usuário do gateway

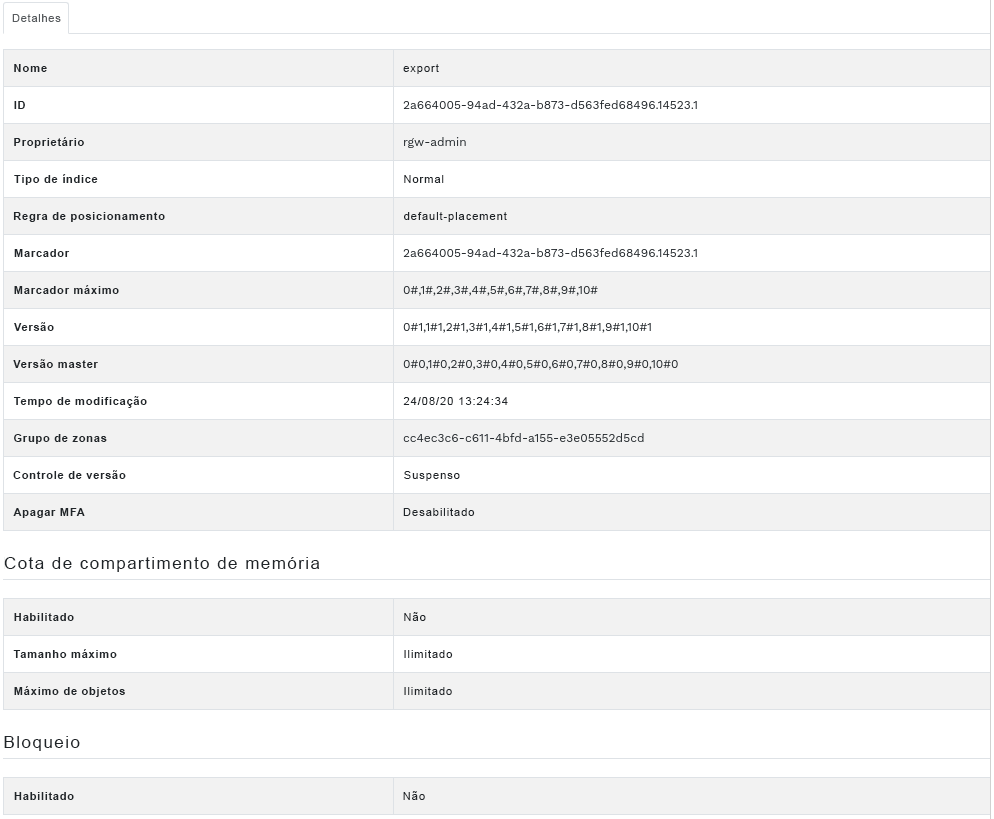

- 9.4 Detalhes do compartimento de memória do gateway

- 9.5 Editando os detalhes do compartimento de memória

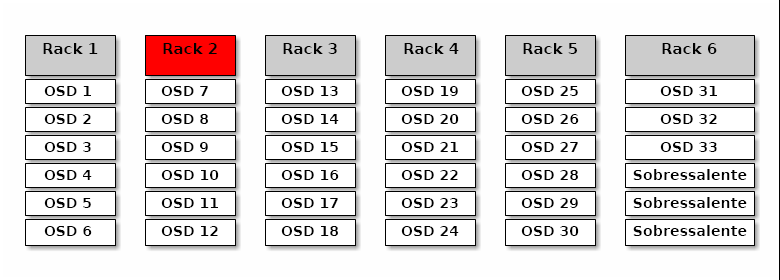

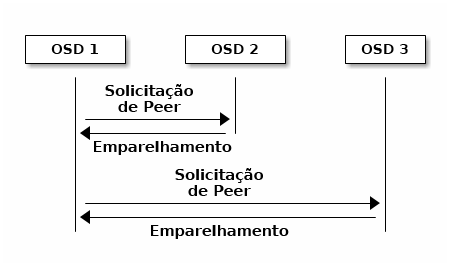

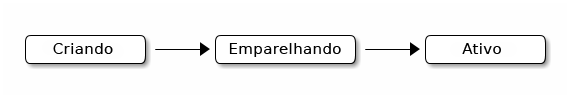

- 12.1 Cluster do Ceph

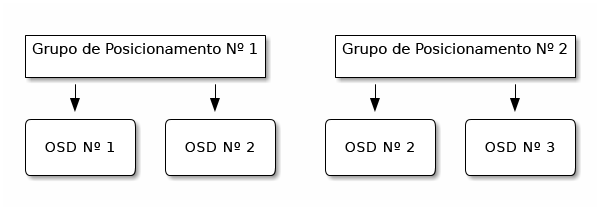

- 12.2 Esquema de emparelhamento

- 12.3 Status dos grupos de posicionamento

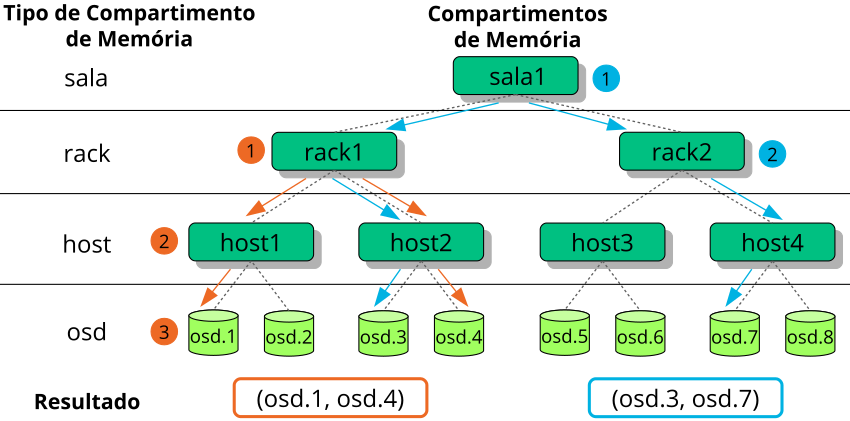

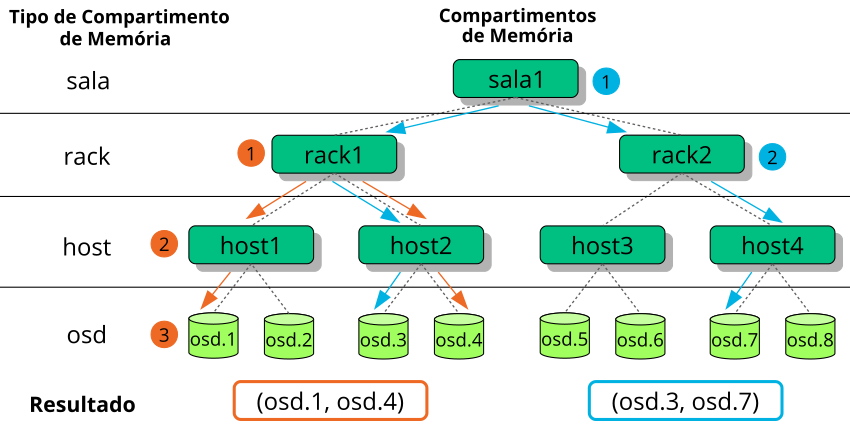

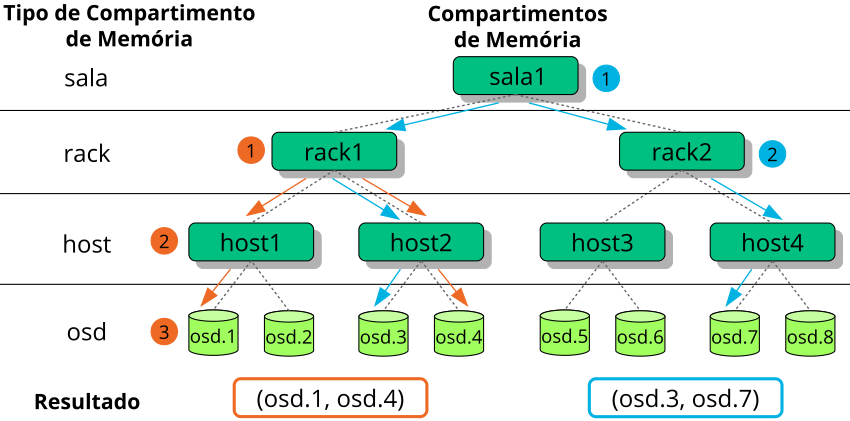

- 17.1 OSDs com classes de dispositivo combinadas

- 17.2 Exemplo de árvore

- 17.3 Métodos de substituição de nó

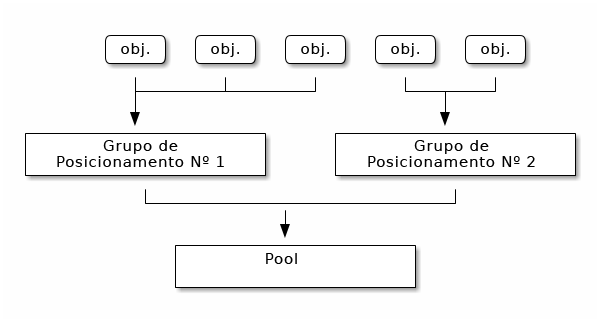

- 17.4 Grupos de posicionamento em um pool

- 17.5 Grupos de posicionamento e OSDs

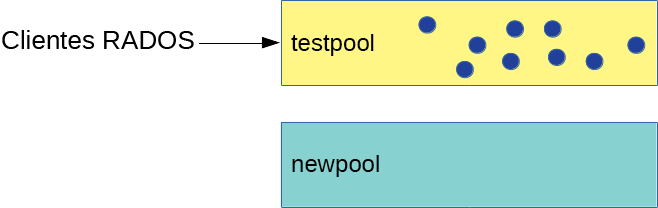

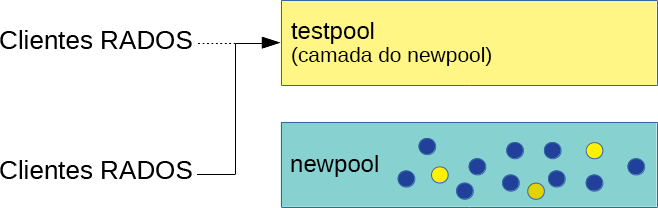

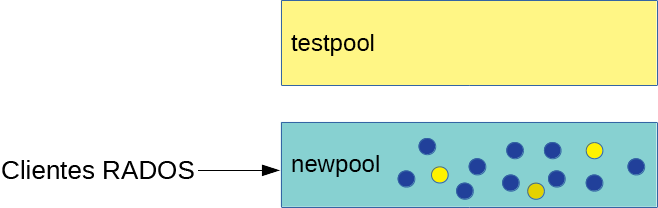

- 18.1 Pools antes da migração

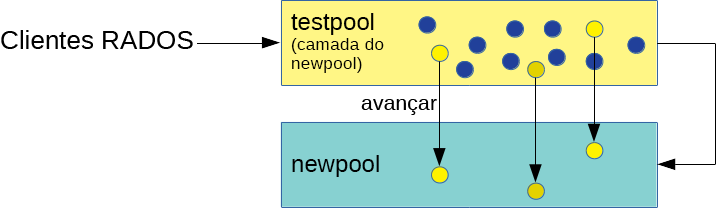

- 18.2 Configuração da camada de cache

- 18.3 Descarregando dados

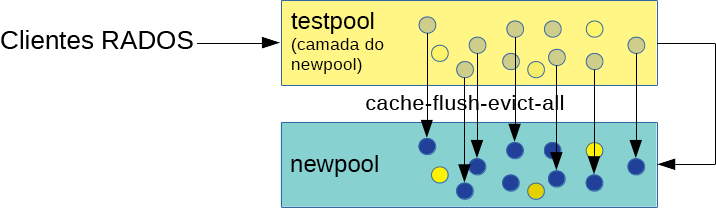

- 18.4 Definindo a sobreposição

- 18.5 Migração concluída

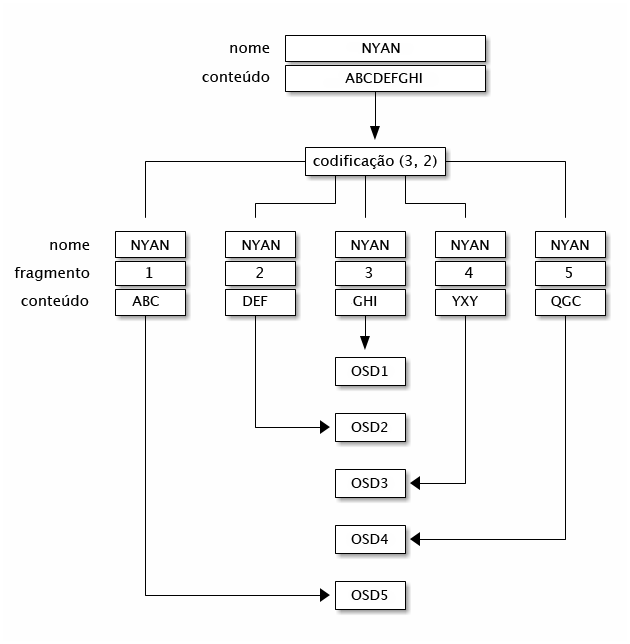

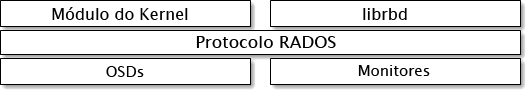

- 20.1 Protocolo RADOS

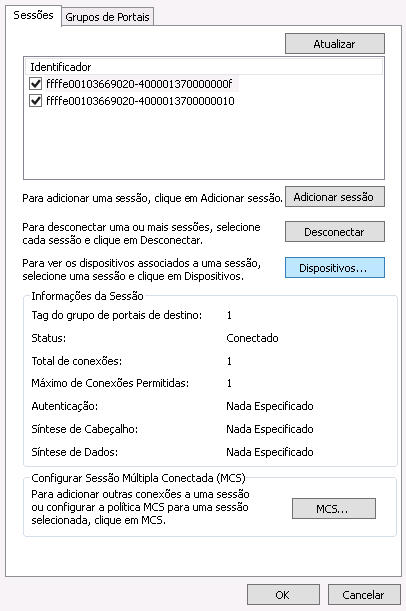

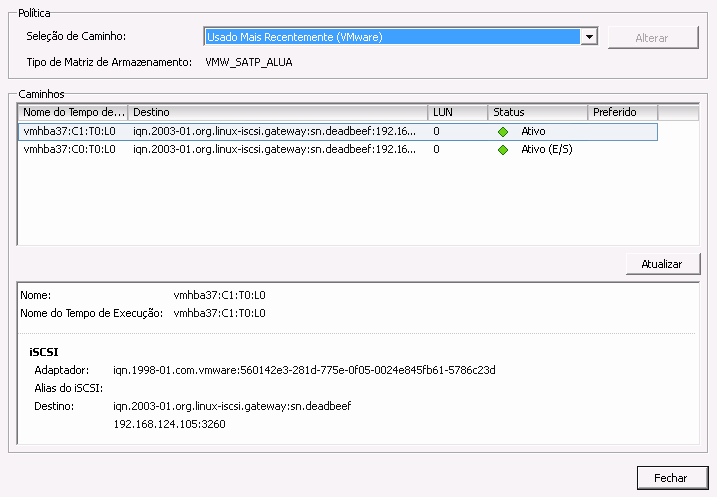

- 22.1 Propriedades do iniciador iSCSI

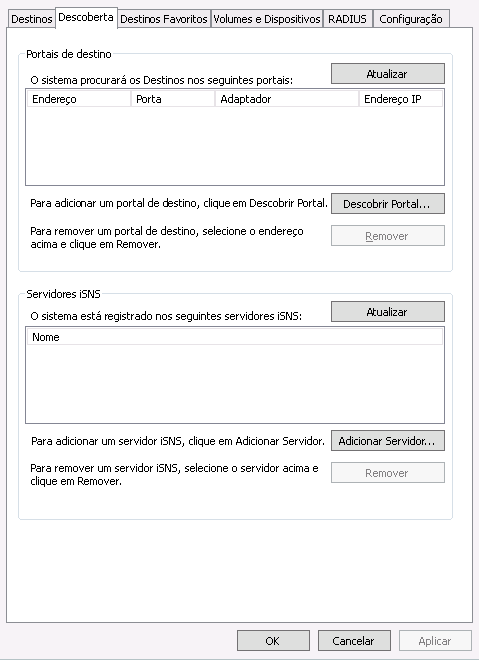

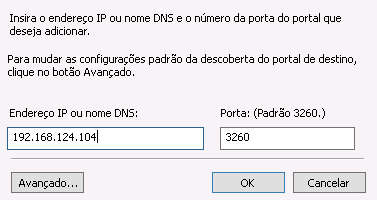

- 22.2 Portal de descoberta de destino

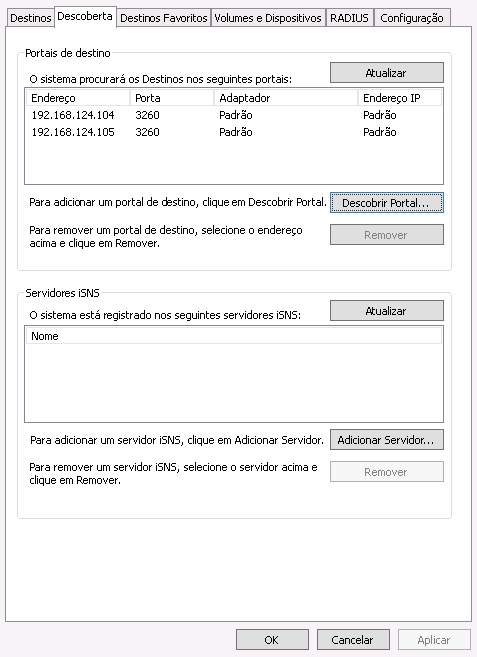

- 22.3 Portais de destino

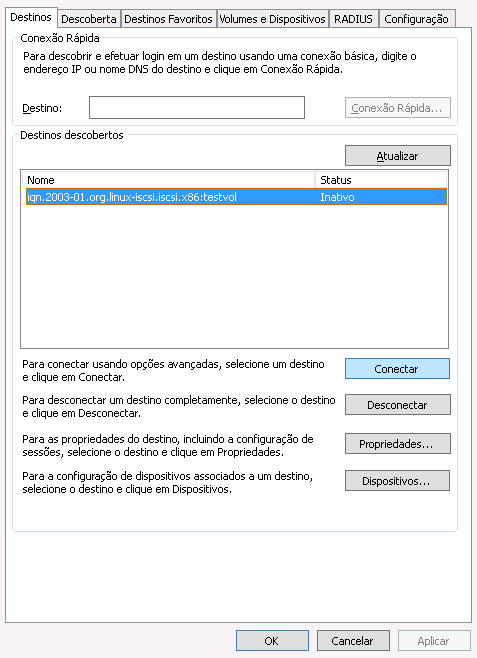

- 22.4 Destinos

- 22.5 Propriedades do destino iSCSI

- 22.6 Detalhes do dispositivo

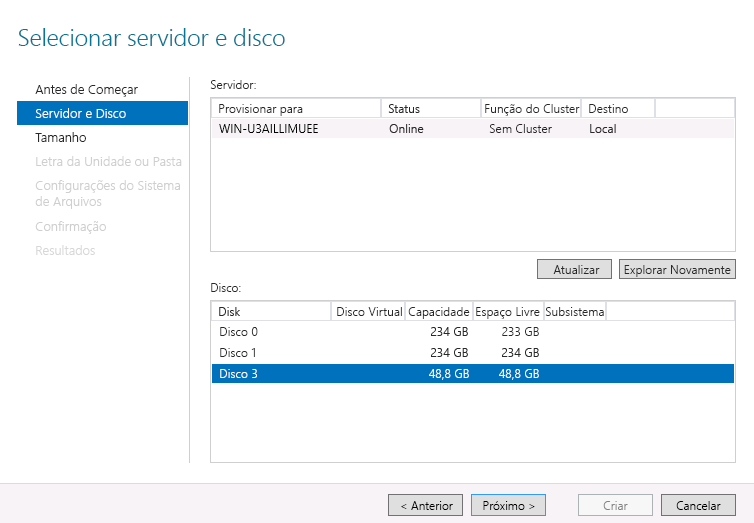

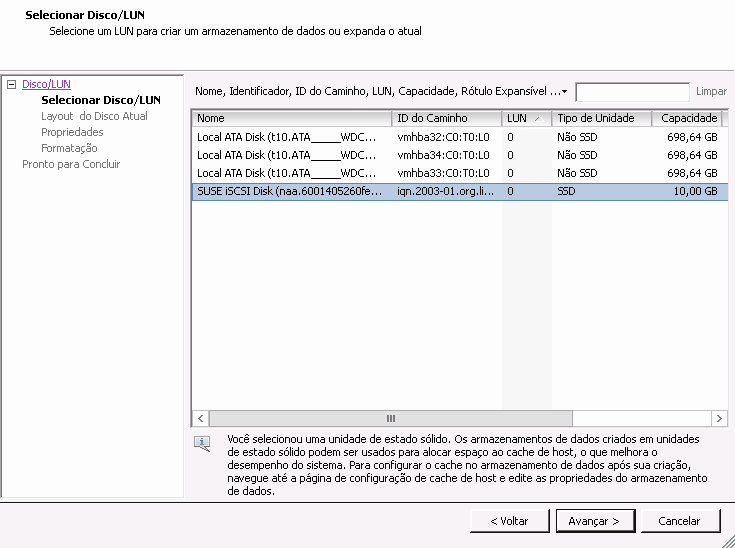

- 22.7 Assistente de novo volume

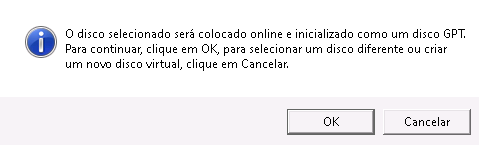

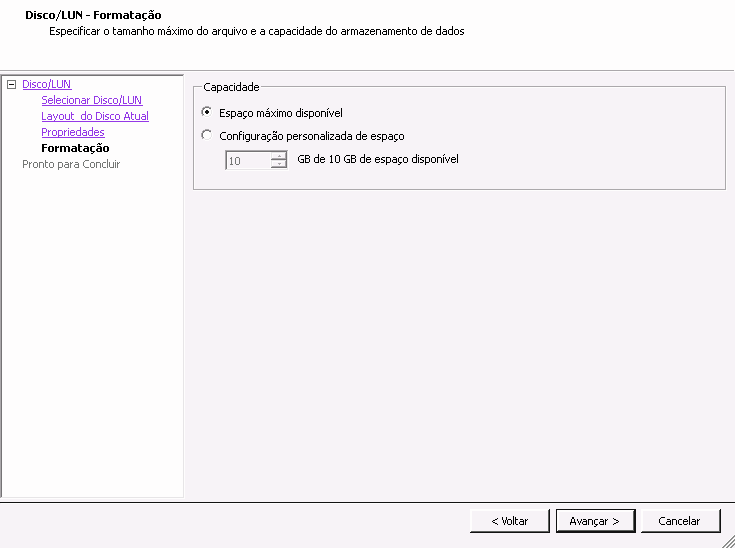

- 22.8 Prompt de disco offline

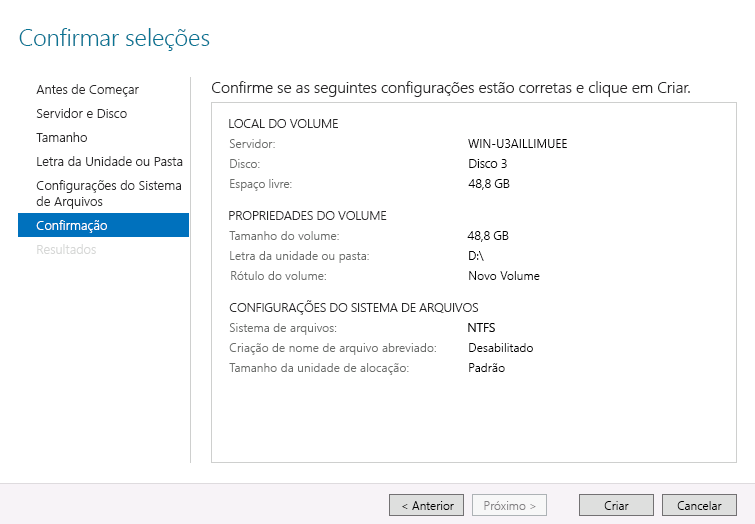

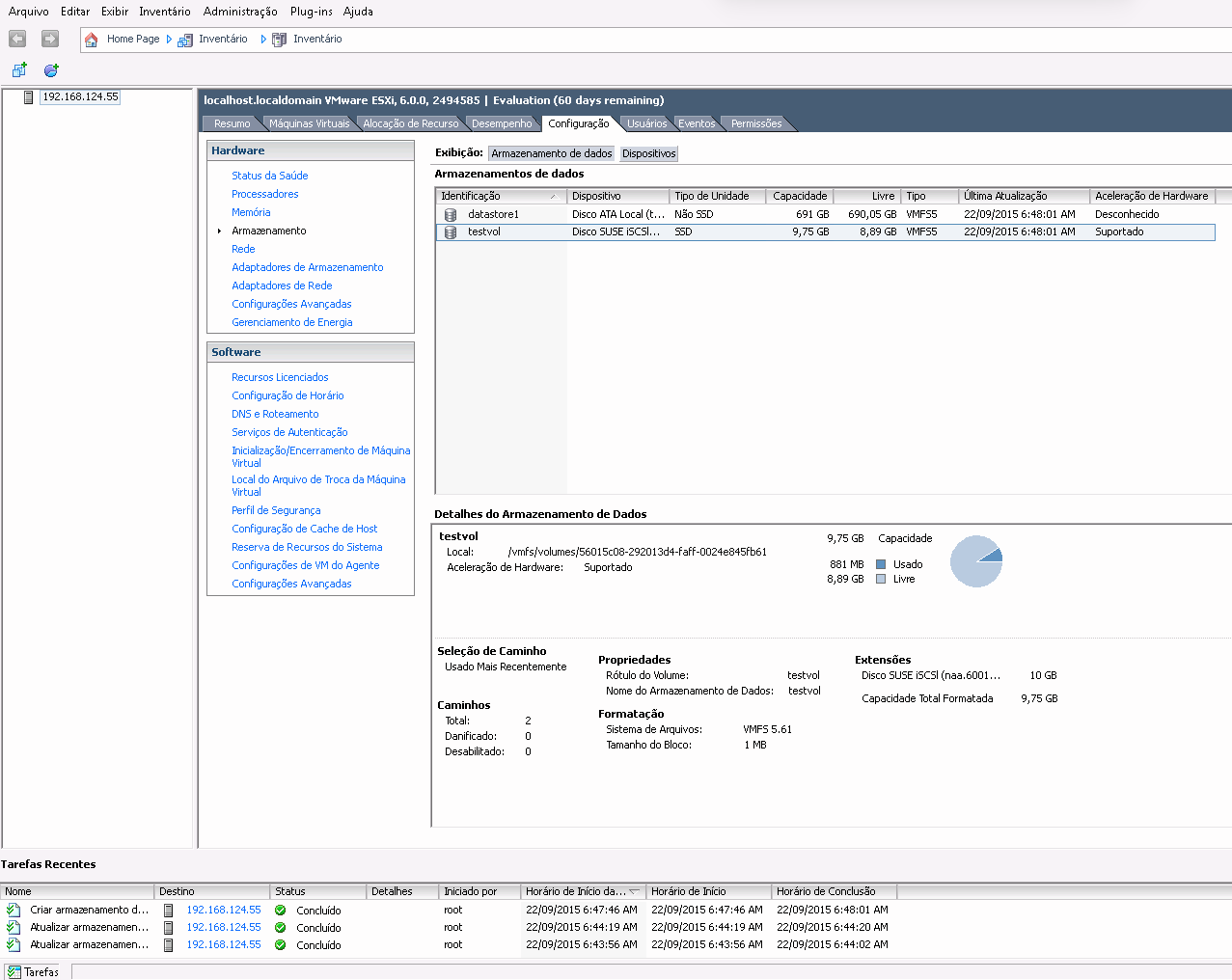

- 22.9 Confirmar seleções de volume

- 22.10 Propriedades do iniciador iSCSI

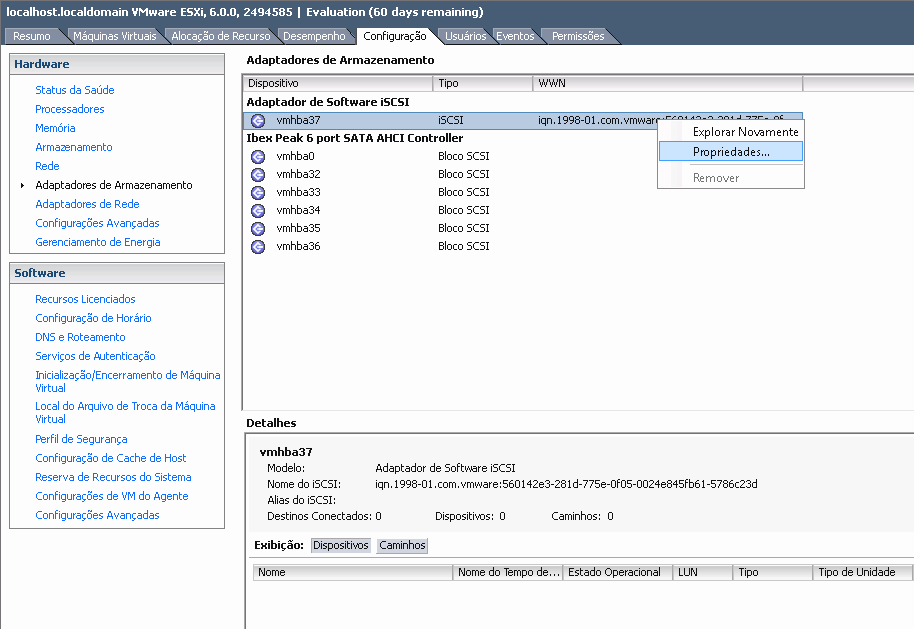

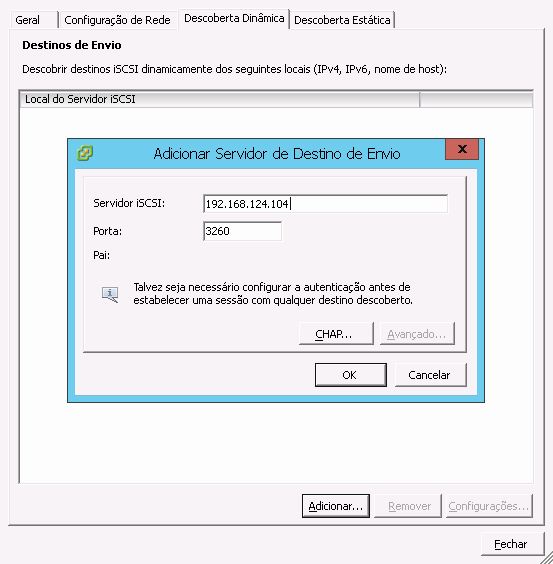

- 22.11 Adicionar servidor de destino

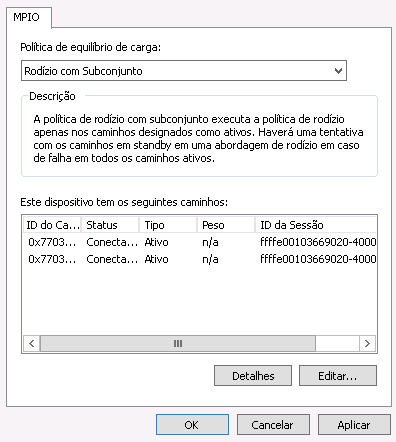

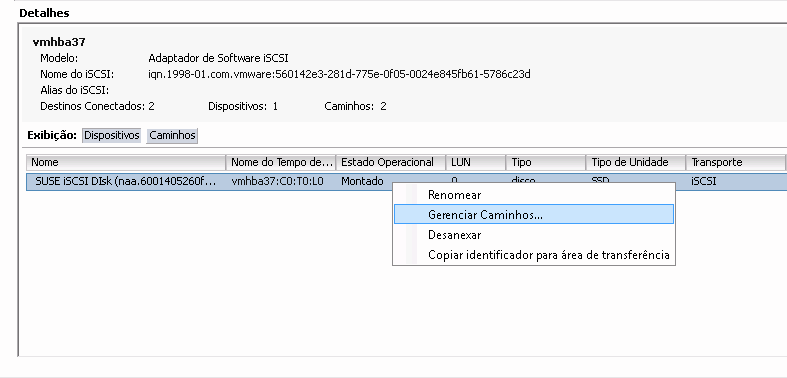

- 22.12 Gerenciar dispositivos de múltiplos caminhos

- 22.13 Listagem de caminhos para múltiplos caminhos

- 22.14 Caixa de diálogo de adição de armazenamento

- 22.15 Configuração personalizada de espaço

- 22.16 Visão geral do armazenamento de dados iSCSI

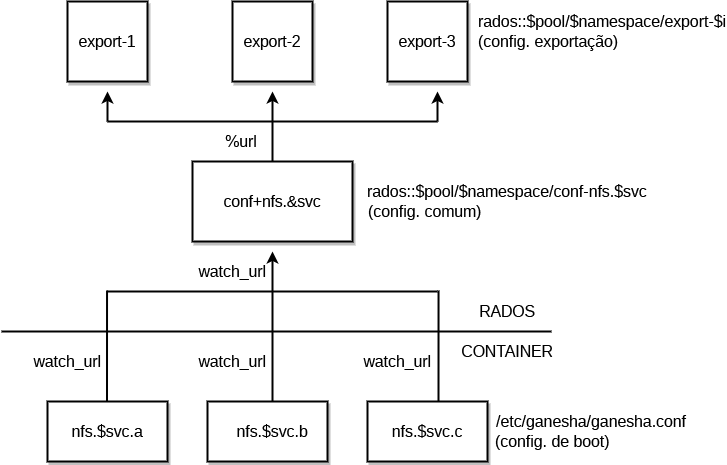

- 25.1 Estrutura do NFS Ganesha

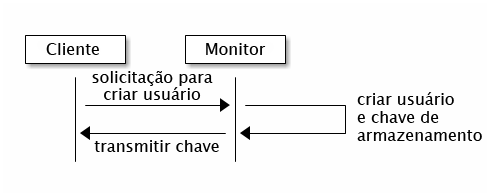

- 30.1 Autenticação básica do

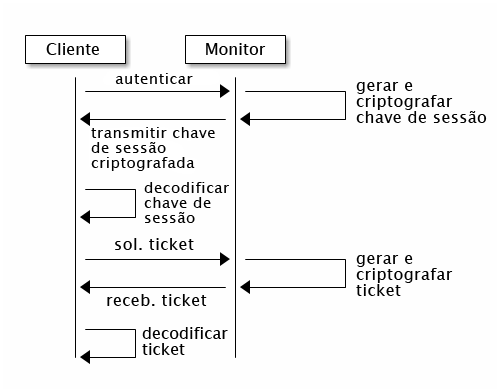

cephx - 30.2 Autenticação do

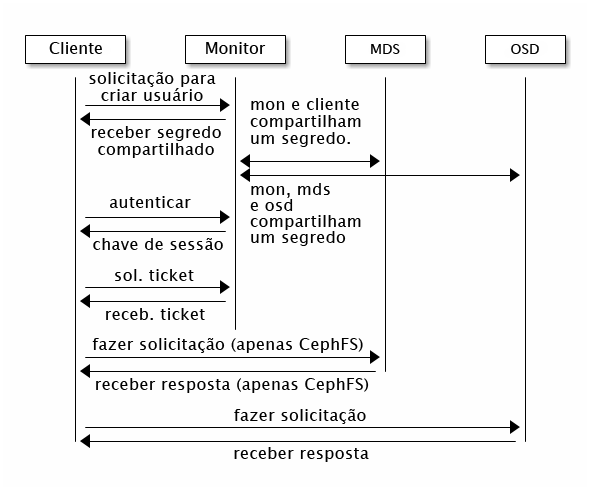

cephx - 30.3 Autenticação do

cephx: MDS e OSD

- 12.1 Localizando um objeto

- 13.1 Correspondendo por tamanho do disco

- 13.2 Configuração simples

- 13.3 Configuração avançada

- 13.4 Configuração avançada com nós não uniformes

- 13.5 Configuração técnica

- 13.6 Configuração complexa (e improvável)

- 17.1

crushtool --reclassify-root - 17.2

crushtool --reclassify-bucket - 21.1 Configuração comum

- 21.2 Configuração não comum

- 28.1 Exemplo de configuração do Beast

- 28.2 Exemplo de configuração do Civetweb em

/etc/ceph/ceph.conf

Copyright © 2020–2023 SUSE LLC e colaboradores. Todos os direitos reservados.

Exceto quando especificado de outra forma, este documento está licenciado nos termos da Creative Commons Attribution-ShareAlike 4.0 International (CC-BY-SA 4.0): https://creativecommons.org/licenses/by-sa/4.0/legalcode.

Para ver as marcas registradas da SUSE, visite http://www.suse.com/company/legal/. Todas as marcas registradas de terceiros pertencem aos seus respectivos proprietários. Os símbolos de marca registrada (®,™ etc.) representam marcas registradas da SUSE e suas afiliadas. Os asteriscos (*) indicam marcas registradas de terceiros.

Todas as informações deste manual foram compiladas com a maior atenção possível aos detalhes. Entretanto, isso não garante uma precisão absoluta. A SUSE LLC, suas afiliadas, os autores ou tradutores não serão responsáveis por possíveis erros nem pelas consequências resultantes de tais erros.

Sobre este guia #

O foco deste guia são as tarefas de rotina que você, como administrador, precisa realizar após a implantação do cluster básico do Ceph (operações do dia 2). Ele também descreve todos os meios possíveis para acessar os dados armazenados em um cluster do Ceph.

O SUSE Enterprise Storage 7 é uma extensão do SUSE Linux Enterprise Server 15 SP2. Ele combina os recursos do projeto de armazenamento do Ceph (http://ceph.com/) com a engenharia corporativa e o suporte da SUSE. O SUSE Enterprise Storage 7 oferece às organizações de TI o recurso para implantar uma arquitetura de armazenamento distribuído capaz de suportar inúmeros casos de uso por meio de plataformas de hardware convencional.

1 Documentação disponível #

A documentação para nossos produtos está disponível no site https://documentation.suse.com, onde você também pode encontrar as atualizações mais recentes e procurar ou fazer download da documentação em vários formatos. As atualizações mais recentes da documentação estão disponíveis em inglês.

Além disso, a documentação do produto está disponível no seu sistema instalado em /usr/share/doc/manual. Ela está incluída em um pacote RPM chamado

ses-manual_LANG_CODE. Instale esse pacote caso ainda não esteja em seu sistema, por exemplo:

root # zypper install ses-manual_enA seguinte documentação está disponível para este produto:

- Guia de Implantação

O foco deste guia é a implantação de um cluster básico do Ceph e de serviços adicionais. Ele também abrange as etapas de upgrade para o SUSE Enterprise Storage 7 a partir da versão anterior do produto.

- Guia de Administração e Operações

O foco deste guia são as tarefas de rotina que você, como administrador, precisa realizar após a implantação do cluster básico do Ceph (operações do dia 2). Ele também descreve todos os meios possíveis para acessar os dados armazenados em um cluster do Ceph.

- Guia de Reforço da Segurança

O foco deste guia é a garantia da segurança do cluster.

- Troubleshooting Guide (Guia de Solução de Problemas)

Este guia aborda os vários problemas comuns durante a execução do SUSE Enterprise Storage 7 e outras questões relacionadas a componentes relevantes, como o Ceph ou o Gateway de Objetos.

- Guia do SUSE Enterprise Storage para Windows

Este guia descreve a integração, a instalação e a configuração dos ambientes Microsoft Windows e SUSE Enterprise Storage que usam o Driver do Windows.

2 Inserindo comentários #

Ficamos satisfeitos com seus comentários e contribuições para esta documentação. E você pode contribuir por meio de vários canais:

- Solicitações de serviço e suporte

Para conhecer os serviços e as opções de suporte disponíveis para o seu produto, consulte http://www.suse.com/support/.

Para abrir uma solicitação de serviço, você precisa de uma assinatura do SUSE registrada no SUSE Customer Center. Vá para https://scc.suse.com/support/requests, efetue login e clique em .

- Relatórios de bugs

Relate os problemas com a documentação em https://bugzilla.suse.com/. A geração de relatórios de problemas requer uma conta do Bugzilla.

Para simplificar esse processo, você pode usar os links ao lado dos cabeçalhos na versão HTML deste documento. Isso pré-seleciona o produto e a categoria certos no Bugzilla e adiciona um link à seção atual. Você pode começar a digitar o relatório do bug imediatamente.

- Contribuições

Para contribuir com esta documentação, use os links ao lado dos cabeçalhos na versão HTML deste documento. Eles levarão você até o código-fonte no GitHub, onde é possível abrir uma solicitação pull. A contribuição requer uma conta do GitHub.

Para obter mais informações sobre o ambiente da documentação usado para este documento, consulte o README do repositório em https://github.com/SUSE/doc-ses.

É possível também relatar erros e enviar comentários sobre a documentação para <doc-team@suse.com>. Inclua o título do documento, a versão do produto e a data de publicação do documento. Mencione também o número e o título da seção relevante (ou inclua o URL) e insira uma breve descrição do problema.

3 Convenções da documentação #

Os seguintes avisos e convenções tipográficas são usados nesta documentação:

/etc/passwd: Nomes de diretório e arquivoPLACEHOLDER: Substitua PLACEHOLDER pelo valor real

PATH: Uma variável de ambientels,--help: Comandos, opções e parâmetrosuser: O nome do usuário ou grupopackage_name: O nome de um pacote de software

Alt, Alt–F1: Uma tecla para pressionar ou uma combinação de teclas. As teclas são mostradas em maiúsculas como no teclado.

, › : itens de menu, botões

AMD/Intel Este parágrafo apenas é relevante para as arquiteturas Intel 64/AMD64. As setas marcam o início e o fim do bloco de texto.

IBM Z, POWER Este parágrafo é relevante apenas para as arquiteturas

IBM ZePOWER. As setas marcam o início e o fim do bloco de texto.Capítulo 1, “Capítulo de exemplo”: Uma referência cruzada a outro capítulo deste guia.

Comandos que devem ser executados com privilégios

root. Geralmente, você também pode usar o comandosudocomo prefixo nesses comandos para executá-los como usuário não privilegiado.root #commandtux >sudocommandComandos que podem ser executados por usuários sem privilégios.

tux >commandAvisos

Atenção: Mensagem de avisoInformações vitais que você deve saber antes de continuar. Avisa sobre problemas de segurança, potencial perda de dados, danos no hardware ou perigos físicos.

Importante: aviso importanteInformações importantes que você deve saber antes de continuar.

Nota: NotaInformações adicionais, por exemplo, sobre diferenças nas versões do software.

Dica: Aviso de dicaInformações úteis, como uma diretriz ou informação prática.

Avisos compactos

Informações adicionais, por exemplo, sobre diferenças nas versões do software.

Informações úteis, como uma diretriz ou informação prática.

4 Ciclo de vida e suporte do produto #

Os diversos produtos da SUSE têm ciclos de vida diferentes. Para verificar as datas exatas do ciclo de vida do SUSE Enterprise Storage, consulte https://www.suse.com/lifecycle/.

4.1 Definições de suporte do SUSE #

Para obter informações sobre nossa política e opções de suporte, consulte https://www.suse.com/support/policy.html e https://www.suse.com/support/programs/long-term-service-pack-support.html.

4.2 Declaração de suporte do SUSE Enterprise Storage #

Para receber suporte, você precisa de uma inscrição apropriada na SUSE. Para ver as ofertas de suporte específicas que estão disponíveis para você, acesse https://www.suse.com/support/ e selecione seu produto.

Os níveis de suporte são definidos da seguinte forma:

- L1

Determinação do problema, que significa suporte técnico designado para fornecer informações de compatibilidade, suporte ao uso, manutenção contínua, coleta de informações e solução básica de problemas usando a documentação disponível.

- L2

Isolamento do problema, que significa suporte técnico designado para analisar os dados, reproduzir os problemas dos clientes, isolar a área problemática e resolver os problemas não resolvidos no Nível 1 ou preparar-se para o Nível 3.

- L3

Resolução do problema, que significa suporte técnico designado para resolver os problemas com a participação da engenharia para solucionar defeitos nos produtos que foram identificados pelo Suporte de Nível 2.

Para clientes e parceiros contratados, o SUSE Enterprise Storage é entregue com suporte L3 para todos os pacotes, com as seguintes exceções:

Prévias de tecnologia

Som, gráficos, fontes e arte

Pacotes que requerem um contrato de cliente adicional

Alguns pacotes enviados como parte do módulo Workstation Extension contam apenas com o suporte L2

Pacotes com nomes que terminam em -devel (com arquivos de cabeçalho e recursos de desenvolvedor semelhantes) apenas receberão suporte juntamente com os respectivos pacotes principais

A SUSE apenas oferecerá suporte ao uso dos pacotes originals. Isto é, pacotes que não foram modificados nem recompilados.

4.3 Prévias de tecnologia #

As Prévias de tecnologia são pacotes, pilhas ou recursos fornecidos pela SUSE como amostras de inovações futuras. As prévias de tecnologia foram incluídas para sua conveniência e para que você possa testar as novas tecnologias em seu ambiente. Agradecemos seus comentários! Se você testar uma prévia de tecnologia, contate seu representante SUSE e conte sobre sua experiência e seus casos de uso. Suas informações são úteis para o desenvolvimento futuro.

As prévias de tecnologia apresentam as seguintes limitações:

As prévias de tecnologia ainda estão em desenvolvimento. Portanto, elas podem ter funcionalidades incompletas, instáveis ou, de alguma outra maneira, inadequadas para uso em produção.

As prévias de tecnologia não contam com suporte.

As prévias de tecnologia talvez estejam disponíveis apenas para arquiteturas de hardware específicas.

Os detalhes e as funcionalidades das prévias de tecnologia estão sujeitos a mudanças. Consequentemente, o upgrade para as versões subsequentes de uma prévia de tecnologia pode ser impossível e exigir uma instalação nova.

As prévias de tecnologia podem ser removidas de um produto a qualquer momento. A SUSE não se compromete em oferecer uma versão com suporte desse tipo de tecnologia no futuro. Um exemplo de caso assim é se a SUSE descobrir que uma prévia não atende às necessidades do cliente ou do mercado ou não cumpre os padrões da empresa.

Para obter uma visão geral das prévias de tecnologia fornecidas com seu produto, consulte as notas de lançamento em https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7.

5 Colaboradores do Ceph #

O projeto do Ceph e a respectiva documentação são resultados do trabalho de centenas de colaboradores e organizações. Visite https://ceph.com/contributors/ para obter mais detalhes.

6 Comandos e prompts de comando usados neste guia #

Como administrador de cluster do Ceph, você configura e ajusta o comportamento do cluster executando comandos específicos. Há vários tipos de comandos que serão necessários:

6.1 Comandos relacionados ao Salt #

Esses comandos ajudam você a implantar nós do cluster do Ceph, executar comandos em vários (ou todos) nós do cluster ao mesmo tempo ou a adicionar ou remover nós do cluster. Os comandos usados com mais frequência são ceph-salt e ceph-salt config. Você precisa executar os comandos do Salt no nó do Master Salt como root. Esses comandos são introduzidos com o seguinte prompt:

root@master # Por exemplo:

root@master # ceph-salt config ls6.2 Comandos relacionados ao Ceph #

Esses são comandos de nível inferior para configurar e ajustar todos os aspectos do cluster e seus gateways na linha de comando, por exemplo, ceph, cephadm, rbd ou radosgw-admin.

Para executar os comandos relacionados ao Ceph, você precisa ter acesso de leitura a uma chave do Ceph. Os recursos da chave definem seus privilégios no ambiente do Ceph. Uma opção é executar os comandos do Ceph como root (ou por meio do sudo) e usar o chaveiro padrão irrestrito “ceph.client.admin.key”.

A opção mais segura e recomendada é criar uma chave individual mais restritiva para cada usuário administrador e colocá-la em um diretório onde os usuários possam lê-la, por exemplo:

~/.ceph/ceph.client.USERNAME.keyring

Para utilizar um usuário admin e um chaveiro personalizados, você precisa especificar o nome de usuário e o caminho para a chave toda vez que executar o comando ceph com as opções -n client.USER_NAME e --keyring PATH/TO/KEYRING.

Para evitar isso, inclua essas opções na variável CEPH_ARGS nos arquivos ~/.bashrc dos usuários individuais.

É possível executar os comandos relacionados ao Ceph em qualquer nó do cluster, mas a recomendação é executá-los no Nó de Admin. Esta documentação utiliza o usuário cephuser para executar os comandos, portanto, eles são introduzidos com o seguinte prompt:

cephuser@adm > Por exemplo:

cephuser@adm > ceph auth listSe a documentação orientar você a executar um comando em um nó do cluster com uma função específica, isso será processado pelo prompt. Por exemplo:

cephuser@mon > 6.2.1 Executando o ceph-volume #

A partir do SUSE Enterprise Storage 7, os serviços do Ceph são executados em containers. Se você precisar executar o ceph-volume em um nó OSD, anteceda-o com o comando cephadm, por exemplo:

cephuser@adm > cephadm ceph-volume simple scan6.3 Comandos gerais do Linux #

Os comandos do Linux não relacionados ao Ceph, como mount, cat ou openssl, são introduzidos com os prompts cephuser@adm > ou root #, dependendo dos privilégios exigidos pelo comando relacionado.

6.4 Informações adicionais #

Para obter mais informações sobre o gerenciamento de chaves do Ceph, consulte o Seção 30.2, “Gerenciamento de chave”.

Parte I Ceph Dashboard #

- 1 Sobre o Ceph Dashboard

O Ceph Dashboard é um aplicativo de monitoramento e gerenciamento do Ceph baseado na Web que administra vários aspectos e objetos do cluster. O painel de controle será habilitado automaticamente após a implantação do cluster básico descrita no Book “Guia de Implantação”, Chapter 5 “Implantação com c…

- 2 Interface do usuário da Web do painel de controle

Para efetuar login no Ceph Dashboard, aponte seu navegador para o URL dele, incluindo o número da porta. Execute o seguinte comando para encontrar o endereço:

- 3 Gerenciar usuários e funções do Ceph Dashboard

O gerenciamento de usuários do painel de controle realizado pelos comandos do Ceph na linha de comando já foi apresentado na Capítulo 11, Gerenciar usuários e funções na linha de comando.

- 4 Ver detalhes internos do cluster

O item de menu permite ver informações detalhadas sobre hosts de cluster do Ceph, inventário, Ceph Monitors, serviços, OSDs, configuração, Mapa CRUSH, Ceph Manager, registros e arquivos de monitoramento.

- 5 Gerenciar pools

Para obter mais informações gerais sobre os pools do Ceph, consulte o Capítulo 18, Gerenciar pools de armazenamento. Para obter informações específicas dos pools com código de eliminação, consulte o Capítulo 19, Pools codificados para eliminação.

- 6 Gerenciar dispositivos de blocos RADOS

Para listar todos os Dispositivos de Blocos RADOS (RBDs, RADOS Block Devices) disponíveis, clique em › no menu principal.

- 7 Gerenciar o NFS Ganesha

Para obter mais informações gerais sobre o NFS Ganesha, consulte o Capítulo 25, NFS Ganesha.

- 8 Gerenciar o CephFS

Para encontrar informações detalhadas sobre o CephFS, consulte o Capítulo 23, Sistema de arquivos em cluster.

- 9 Gerenciar o Gateway de Objetos

Antes de começar, talvez você veja a seguinte notificação ao tentar acessar o front end do Gateway de Objetos no Ceph Dashboard:

- 10 Configuração manual

Esta seção apresenta informações avançadas para usuários que preferem definir as configurações do painel de controle manualmente na linha de comando.

- 11 Gerenciar usuários e funções na linha de comando

Esta seção descreve como gerenciar contas de usuário usadas pelo Ceph Dashboard. Ela ajuda você a criar ou modificar as contas de usuário e definir as funções e permissões de usuário apropriadas.

1 Sobre o Ceph Dashboard #

O Ceph Dashboard é um aplicativo de monitoramento e gerenciamento do Ceph baseado na Web que administra vários aspectos e objetos do cluster. O painel de controle será habilitado automaticamente após a implantação do cluster básico descrita no Book “Guia de Implantação”, Chapter 5 “Implantação com cephadm”, Section 5.3 “Implantando o cluster do Ceph”.

O Ceph Dashboard para SUSE Enterprise Storage 7 adicionou mais recursos de gerenciamento baseados na Web para facilitar a administração do Ceph, incluindo o monitoramento e a administração de aplicativos no Ceph Manager. Você não precisa mais saber comandos complexos relacionados ao Ceph para gerenciar e monitorar o cluster do Ceph. Você pode usar a interface intuitiva da Ceph Dashboard ou a API REST incorporada.

O módulo Ceph Dashboard visualiza informações e estatísticas sobre o cluster do Ceph usando um servidor Web hospedado pelo ceph-mgr. Consulte o Book “Guia de Implantação”, Chapter 1 “SES e Ceph”, Section 1.2.3 “Nós e daemons do Ceph” para obter mais detalhes sobre o Ceph Manager.

2 Interface do usuário da Web do painel de controle #

2.1 Efetuando login #

Para efetuar login no Ceph Dashboard, aponte seu navegador para o URL dele, incluindo o número da porta. Execute o seguinte comando para encontrar o endereço:

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",O comando retorna o URL em que o Ceph Dashboard está localizado. Se você tiver problemas com esse comando, consulte o Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”.

Efetue login usando as credenciais que você criou durante a implantação do cluster (consulte o Book “Guia de Implantação”, Chapter 5 “Implantação com cephadm”, Section 5.3.2.9 “Configurando as credenciais de login do Ceph Dashboard”).

Se você não deseja usar a conta padrão admin para acessar o Ceph Dashboard, crie uma conta do usuário personalizada com privilégios de administrador. Consulte Capítulo 11, Gerenciar usuários e funções na linha de comando para obter mais detalhes.

A interface do usuário do painel de controle é dividida graficamente em vários blocos: o menu de utilitários na lateral superior direita da tela, o menu principal na lateral esquerda e o painel de conteúdo principal.

2.4 Painel de conteúdo #

O painel de conteúdo ocupa a parte principal da tela do painel de controle. A home page do painel de controle mostra muitos widgets úteis para informar você brevemente sobre as informações de status atual, capacidade e desempenho do cluster.

2.5 Recursos comuns da IU da Web #

No Ceph Dashboard, você costuma trabalhar com listas. Por exemplo, listas de pools, nós OSD ou dispositivos RBD. Todas as listas se atualizarão automaticamente por padrão a cada cinco segundos. Os seguintes widgets comuns ajudam você a gerenciar ou ajustar essas listas:

Clique em ![]() para acionar uma atualização manual da lista.

para acionar uma atualização manual da lista.

Clique em ![]() para exibir ou ocultar colunas individuais da tabela.

para exibir ou ocultar colunas individuais da tabela.

Clique em ![]() e insira (ou selecione) quantas linhas serão exibidas

em uma única página.

e insira (ou selecione) quantas linhas serão exibidas

em uma única página.

Clique em  e filtre as linhas digitando a string de pesquisa.

e filtre as linhas digitando a string de pesquisa.

Use  para mudar a página exibida no momento, se a lista

ocupar várias páginas.

para mudar a página exibida no momento, se a lista

ocupar várias páginas.

2.6 Widgets do painel de controle #

Cada widget do painel de controle mostra informações de status específicas relacionadas a um determinado aspecto de um cluster do Ceph em execução. Alguns widgets são links ativos e, depois de clicar neles, redirecionarão você para uma página detalhada relacionada do tópico que eles representam.

Alguns widgets gráficos mostram mais detalhes quando você move o cursor do mouse sobre eles.

2.6.1 Widgets de status #

Os widgets de apresentam uma breve visão geral do status atual do cluster.

Apresenta informações básicas sobre a saúde do cluster.

Mostra o número total de nós do cluster.

Mostra o número de monitores em execução e o quorum deles.

Mostra o número total de OSDs e o número de OSDs ativos e incluídos.

Mostra o número de daemons Ceph Manager ativos e em standby.

Mostra o número de Gateways de Objetos em execução.

Mostra o número de Servidores de Metadados.

Mostra o número de gateways iSCSI configurados.

2.6.2 Widgets de capacidade #

Os widgets de mostram informações resumidas sobre a capacidade de armazenamento.

Mostra a proporção de capacidade de armazenamento usado e bruto disponível.

Mostra o número de objetos de dados armazenados no cluster.

Exibe um gráfico dos grupos de posicionamento de acordo com o status deles.

Mostra o número de pools no cluster.

Mostra o número médio de grupos de posicionamento por OSD.

2.6.3 Widgets de desempenho #

Os widgets de referem-se aos dados básicos de desempenho dos clientes do Ceph.

A quantidade de operações de leitura e gravação dos clientes por segundo.

A quantidade de dados transferidos de e para os clientes do Ceph em bytes por segundo.

O throughput de dados recuperados por segundo.

Mostra o status da remoção (consulte a Seção 17.4.9, “Depurando um grupo de posicionamento”). Ele é

inativo,habilitadoouativo.

3 Gerenciar usuários e funções do Ceph Dashboard #

O gerenciamento de usuários do painel de controle realizado pelos comandos do Ceph na linha de comando já foi apresentado na Capítulo 11, Gerenciar usuários e funções na linha de comando.

Esta seção descreve como gerenciar as contas de usuário usando a interface do usuário da Web do painel de controle.

3.1 Listando usuários #

Clique em ![]() no menu de utilitários e selecione

.

no menu de utilitários e selecione

.

A lista contém o nome de usuário, o nome completo e o e-mail de cada usuário, uma lista de funções atribuídas, se a função está habilitada e a data de vencimento da senha.

3.2 Adicionando novos usuários #

Clique em na parte superior esquerda do cabeçalho da tabela para adicionar um novo usuário. Insira seu nome de usuário, senha e, opcionalmente, um nome completo e um e-mail.

Clique no ícone pequeno de caneta para atribuir funções predefinidas ao usuário. Clique em para confirmar.

3.3 Editando usuários #

Clique na linha da tabela de um usuário para realçar a seleção e escolha para editar os detalhes sobre o usuário. Clique em para confirmar.

3.4 Apagando usuários #

Clique na linha da tabela de um usuário para realçar a seleção, escolha o botão suspenso ao lado de e selecione na lista para apagar a conta do usuário. Ative a caixa de seleção e clique em para confirmar.

3.5 Listando funções de usuário #

Clique em ![]() no menu de utilitários e selecione

. Em seguida, clique na guia

.

no menu de utilitários e selecione

. Em seguida, clique na guia

.

A lista mostra o nome e a descrição de cada função e se é uma função do sistema.

3.6 Adicionando funções personalizadas #

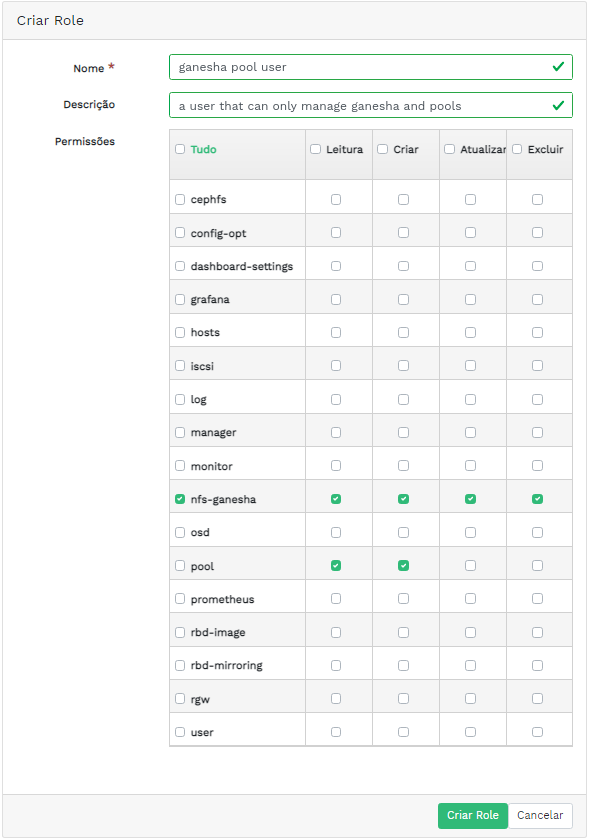

Clique em na parte superior esquerda do cabeçalho da tabela para adicionar uma nova função personalizada. Insira o e a e selecione as permissões apropriadas ao lado de .

Se você cria funções de usuário personalizadas e depois planeja remover o

cluster do Ceph com o comando ceph-salt purge, precisa

purgar primeiro as funções personalizadas. Encontre mais detalhes na

Seção 13.9, “Removendo um cluster inteiro do Ceph”.

Ao ativar a caixa de seleção que antecede o nome do tópico, você ativa todas as permissões para esse tópico. Ao ativar a caixa de seleção , você ativa todas as permissões para todos os tópicos.

Clique em para confirmar.

3.7 Editando funções personalizadas #

Clique na linha da tabela de um usuário para realçar a seleção e escolha na parte superior esquerda do cabeçalho da tabela para editar uma descrição e as permissões da função personalizada. Clique em para confirmar.

3.8 Apagando funções personalizadas #

Clique na linha da tabela de uma função para realçar a seleção, escolha o botão suspenso ao lado de e selecione na lista para apagar a função. Ative a caixa de seleção e clique em para confirmar.

4 Ver detalhes internos do cluster #

O item de menu permite ver informações detalhadas sobre hosts de cluster do Ceph, inventário, Ceph Monitors, serviços, OSDs, configuração, Mapa CRUSH, Ceph Manager, registros e arquivos de monitoramento.

4.1 Visualizando nós do cluster #

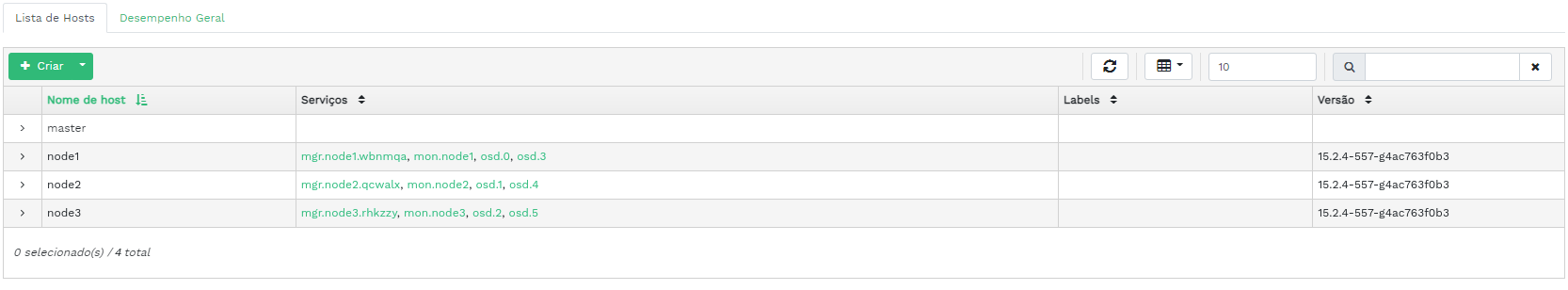

Clique em › para ver uma lista de nós do cluster.

Clique na seta suspensa ao lado do nome de um nó na coluna para ver os detalhes do desempenho do nó.

A coluna lista todos os daemons que estão em execução em cada nó relacionado. Clique no nome de um daemon para ver sua configuração detalhada.

4.2 Acessando o inventário do cluster #

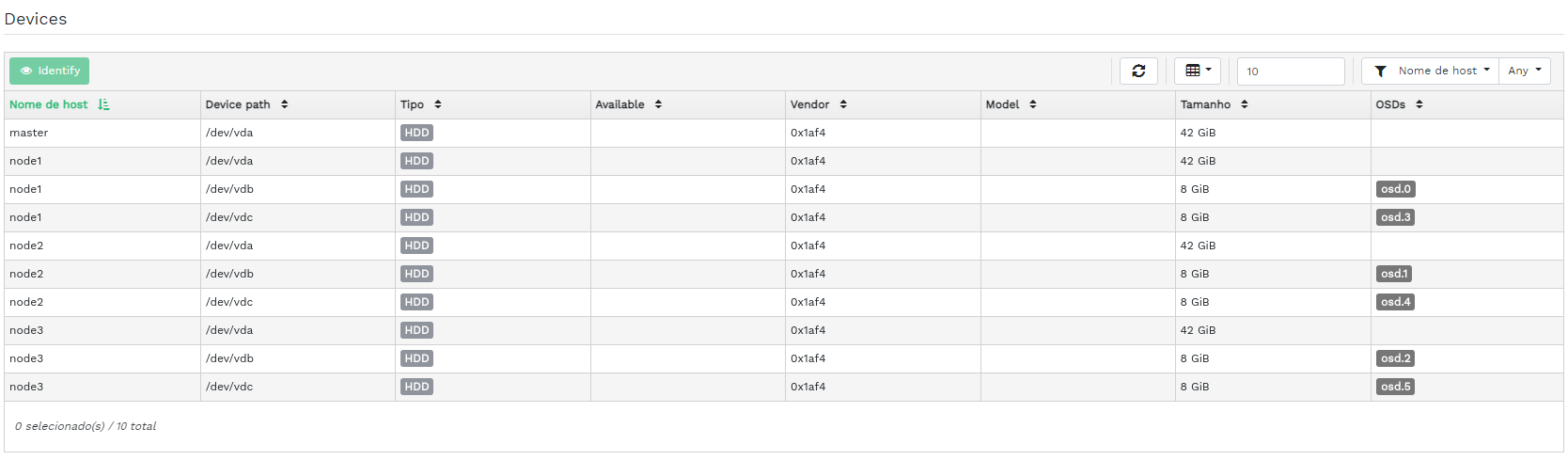

Clique em › para ver uma lista de dispositivos. A lista inclui o caminho, o tipo, a disponibilidade, o fornecedor, o modelo, o tamanho e os OSDs do dispositivo.

Clique para selecionar o nome de um nó na coluna . Quando selecionado, clique em para identificar o dispositivo no qual o host está sendo executado. Esse procedimento instrui o dispositivo a piscar os LEDs. Selecione a duração dessa ação entre 1, 2, 5, 10 ou 15 minutos. Clique em .

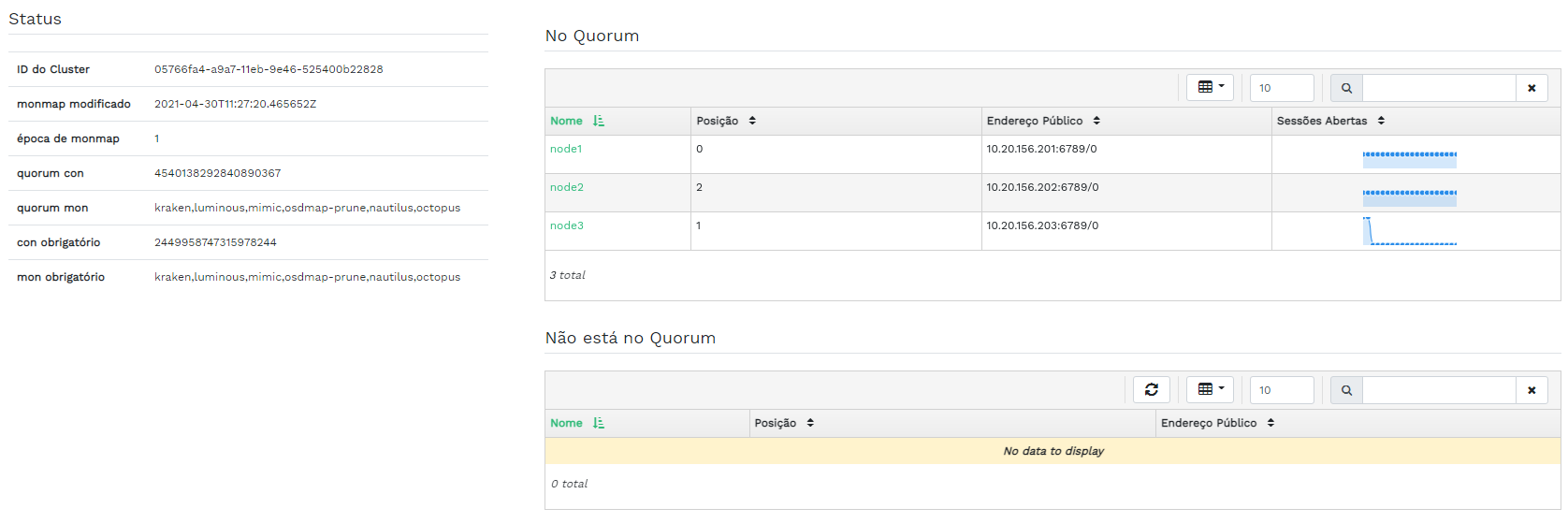

4.3 Visualizando Ceph Monitors #

Clique em

›

para ver uma lista de nós do cluster com monitores do Ceph em execução. O

painel de conteúdo é dividido em duas telas: Status e

No Quorum ou Não está no Quorum.

A tabela mostra as estatísticas gerais dos Ceph Monitors em execução, incluindo as seguintes:

ID do cluster

monmap modificado

época de monmap

quorum con

quorum mon

con obrigatório

mon obrigatório

Os painéis No Quorum e Não está no

Quorum incluem o nome, o número de classificação, o endereço IP

público e o número de sessões abertas de cada monitor.

Clique no nome de um nó na coluna para ver a configuração do Ceph Monitor relacionado.

4.4 Exibindo serviços #

Clique em

›

para ver os detalhes de cada um dos serviços disponíveis:

crash, Ceph Manager e Ceph Monitors. A lista inclui o

nome da imagem do container, o ID da imagem do container, o status do

elemento que está em execução, o tamanho e a data da última atualização.

Clique na seta suspensa ao lado do nome de um serviço na coluna para ver os detalhes do daemon. A lista de detalhes inclui nome de host, tipo de daemon, ID do daemon, ID do container, nome da imagem do container, ID da imagem do container, número da versão, status e data da última atualização.

4.5 Exibindo Ceph OSDs #

Clique em › para ver uma lista de nós com daemons OSD em execução. A lista inclui nome, ID, status, classe do dispositivo, número de grupos de posicionamento, tamanho, uso, cronograma de leituras/gravações e taxa de operações de leitura/gravação por segundo de cada nó.

Selecione no menu suspenso no cabeçalho da tabela para abrir uma janela popup. Ela mostra uma lista de flags que se aplicam a todo o cluster. É possível ativar ou desativar flags individuais e clicar em para confirmar.

Selecione no menu suspenso no cabeçalho da tabela para abrir uma janela popup. Ela mostra uma lista de prioridades de recuperação de OSD que se aplicam a todo o cluster. É possível ativar o perfil de prioridade preferencial e ajustar os valores individuais a seguir. Clique em para confirmar.

Clique na seta suspensa ao lado do nome de um nó na coluna para ver uma tabela estendida com os detalhes das configurações e do desempenho do dispositivo. Ao navegar pelas diversas guias, você pode ver listas de , , , , um gráfico das leituras e gravações e .

Depois que você clicar no nome de um nó OSD, a linha da tabela será realçada. Isso significa que agora você pode executar uma tarefa no nó. É possível executar qualquer uma das seguintes ações: , , , , , , , , , , ou .

Clique na seta para baixo na parte superior esquerda do cabeçalho da tabela ao lado do botão e selecione a tarefa que deseja executar.

4.5.1 Adicionando OSDs #

Para adicionar novos OSDs, siga estas etapas:

Verifique se alguns nós do cluster têm dispositivos de armazenamento com status

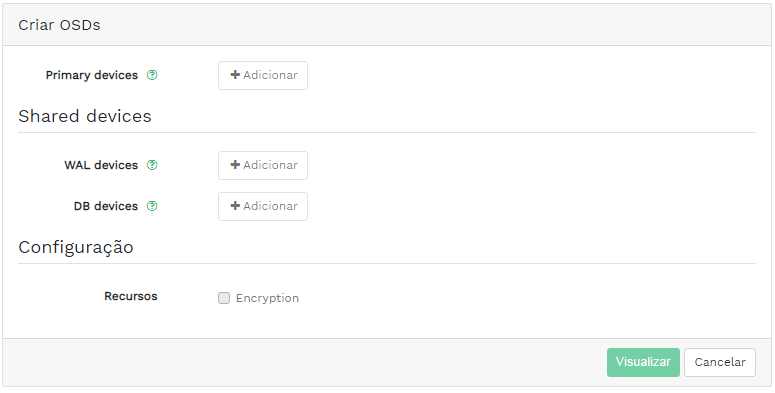

disponível. Em seguida, clique na seta para baixo na parte superior esquerda do cabeçalho da tabela e selecione . Isso abre a janela .Figura 4.9: Criar OSDs #Para adicionar dispositivos de armazenamento principais aos OSDs, clique em . Antes de adicionar dispositivos de armazenamento, você precisa especificar os critérios de filtragem na parte superior direita da tabela , por exemplo . Confirme com (Adicionar).

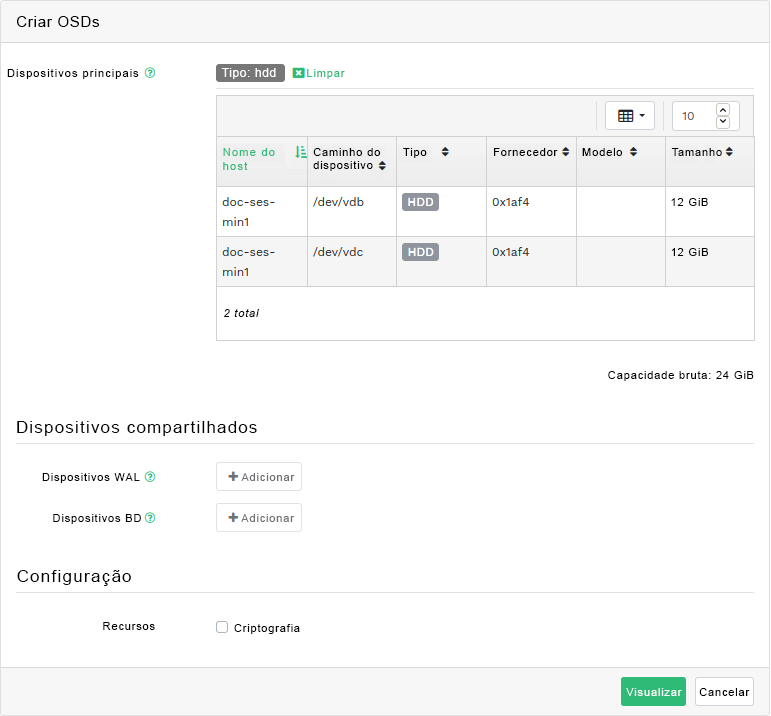

Figura 4.10: Adicionando dispositivos principais #Se preferir, na janela atualizada, adicione dispositivos WAL e BD compartilhados ou habilite a criptografia de dispositivo.

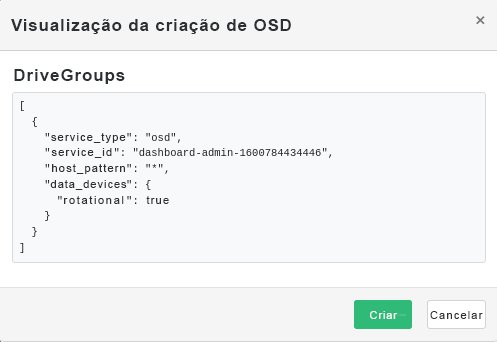

Figura 4.11: Criar OSDs com dispositivos principais adicionados #Clique em para ver a especificação DriveGroups dos dispositivos adicionados anteriormente. Clique em (Criar) para confirmar.

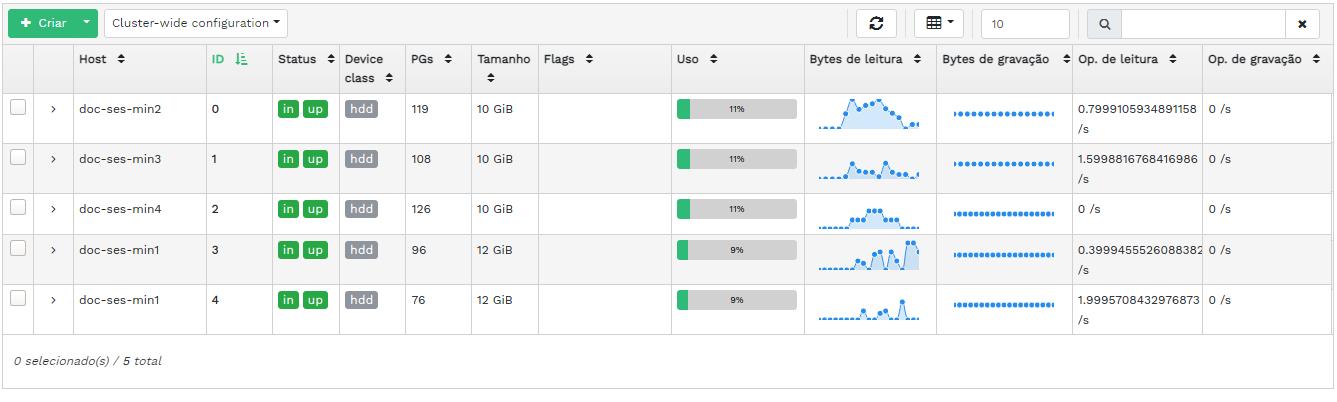

Figura 4.12: #Novos dispositivos serão adicionados à lista de OSDs.

Figura 4.13: OSDs recém-adicionados #NotaNão há visualização do andamento do processo de criação de OSDs. Leva um tempo para eles serem realmente criados. Os OSDs aparecerão na lista quando forem implantados. Para ver os registros e verificar o status da implantação, clique em › .

4.6 Visualizando a configuração do cluster #

Clique em › para ver uma lista completa de opções de configuração de cluster do Ceph. A lista contém o nome da opção, sua descrição resumida e seus valores atuais e padrão e indica se a opção é editável.

Clique na seta suspensa ao lado de uma opção de configuração na coluna para ver uma tabela estendida com informações detalhadas sobre a opção, como tipo de valor, valores mínimo e máximo permitidos, se é possível atualizá-la em tempo de execução etc.

Após realçar uma opção específica, você poderá editar o(s) valor(s) dela clicando no botão na parte superior esquerda do cabeçalho da tabela. Clique em para confirmar as mudanças.

4.7 Vendo o mapa CRUSH do #

Clique em › para ver um Mapa CRUSH do cluster. Para obter mais informações gerais sobre Mapas CRUSH, consulte a Seção 17.5, “Manipulação de mapa CRUSH”.

Clique em cada raiz, nó ou OSD para ver informações mais detalhadas, como peso do CRUSH, profundidade na árvore de mapa, classe de dispositivo do OSD e muitos mais.

4.8 Visualizando módulos do gerenciador #

Clique em › para ver uma lista dos módulos disponíveis do Ceph Manager. Cada linha consiste no nome do módulo e nas informações que indicam se ele está ou não habilitado no momento.

Clique na seta suspensa ao lado de um módulo na coluna para ver uma tabela estendida com as configurações detalhadas na tabela abaixo. Para editá-las, clique no botão na parte superior esquerda do cabeçalho da tabela. Clique em para confirmar as mudanças.

Clique na seta suspensa ao lado do botão na parte superior esquerda do cabeçalho da tabela para ou um módulo.

4.9 Visualizando registros #

Clique em › para ver uma lista das entradas de registro recentes do cluster. Cada linha consiste em uma marcação de horário, no tipo de entrada de registro e na própria mensagem registrada.

Clique na guia para ver as entradas de registro do subsistema de auditoria. Consulte a Seção 11.5, “Fazendo auditoria das solicitações de API” para ver os comandos que habilitam ou desabilitam a auditoria.

4.10 Visualizando o monitoramento #

Clique em › para gerenciar e ver detalhes sobre os alertas do Prometheus.

Se o Prometheus estiver ativo, você poderá ver informações detalhadas sobre , ou nesse painel de conteúdo.

Se você não tiver o Prometheus implantado, um banner de informações será exibido com um link para a documentação relevante.

5 Gerenciar pools #

Para obter mais informações gerais sobre os pools do Ceph, consulte o Capítulo 18, Gerenciar pools de armazenamento. Para obter informações específicas dos pools com código de eliminação, consulte o Capítulo 19, Pools codificados para eliminação.

Para listar todos os pools disponíveis, clique em no menu principal.

A lista mostra o nome, o tipo, o aplicativo relacionado, o status do grupo de posicionamento, o tamanho da réplica, a última mudança, o perfil codificado para eliminação, o conjunto de regras crush, o uso e as estatísticas de leitura/gravação de cada pool.

Clique na seta suspensa ao lado do nome de um pool na coluna para ver uma tabela estendida com informações detalhadas sobre o pool, como detalhes gerais e de desempenho e configuração.

5.1 Adicionando um novo pool #

Para adicionar um novo pool, clique em na parte superior esquerda da tabela de pools. No formulário do pool, você pode inserir o nome, o tipo, os aplicativos, o modo de compactação e as cotas do pool, incluindo o máximo de bytes e de objetos. O próprio formulário do pool pré-calcula o número de grupos de posicionamento mais adequado a esse pool específico. O cálculo é baseado na quantidade de OSDs no cluster e no tipo de pool selecionado com suas configurações específicas. Assim que um número de grupos de posicionamento for definido manualmente, ele será substituído por um número calculado. Clique em para confirmar.

5.2 Apagando pools #

Para apagar um pool, selecione-o na linha da tabela. Clique na seta suspensa ao lado do botão e clique em .

5.3 Editando as opções de um pool #

Para editar as opções de um pool, selecione-o na linha da tabela e clique em na parte superior esquerda da tabela de pools.

É possível mudar o nome do pool, aumentar o número de grupos de posicionamento, modificar a lista de aplicativos e as configurações de compactação do pool. Clique em para confirmar.

6 Gerenciar dispositivos de blocos RADOS #

Para listar todos os Dispositivos de Blocos RADOS (RBDs, RADOS Block Devices) disponíveis, clique em › no menu principal.

A lista mostra informações resumidas sobre o dispositivo, como nome do dispositivo, nome do pool relacionado, namespace, tamanho do dispositivo, número e tamanho dos objetos no dispositivo, dados sobre aprovisionamento dos detalhes e pai.

6.1 Visualizando detalhes sobre RBDs #

Para ver informações mais detalhadas sobre um dispositivo, clique na linha dele na tabela:

6.2 Visualizando a configuração do RBD #

Para ver a configuração detalhada de um dispositivo, clique na linha dele na tabela e, em seguida, na guia na tabela inferior:

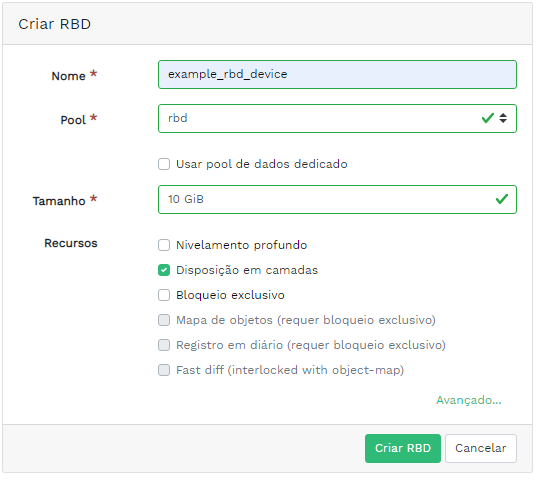

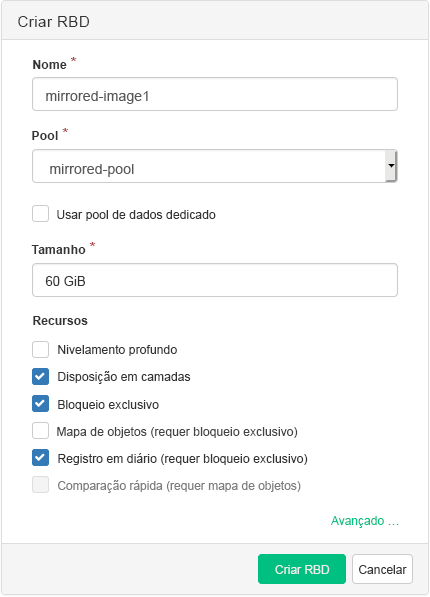

6.3 Criando RBDs #

Para adicionar um novo dispositivo, clique em na parte superior esquerda do cabeçalho da tabela e faça o seguinte na tela :

Insira o nome do novo dispositivo. Consulte o Book “Guia de Implantação”, Chapter 2 “Requisitos e recomendações de hardware”, Section 2.11 “Limitações de nome” para saber as limitações de nomeação.

Selecione o pool com o aplicativo

rbdatribuído que será usado como base para criação do novo dispositivo RBD.Especifique o tamanho do novo dispositivo.

Especifique outras opções para o dispositivo. Para ajustar os parâmetros do dispositivo, clique em e insira os valores para tamanho do objeto, unidade de distribuição ou total de distribuições. Para inserir limites de Qualidade do Serviço (QdS), clique em .

Clique em para confirmar.

6.4 Apagando RBDs #

Para apagar um dispositivo, selecione-o na linha da tabela. Clique na seta suspensa ao lado do botão e clique em . Clique em para confirmar a exclusão.

A exclusão de um RBD é uma ação irreversível. Em vez disso, se você , poderá restaurar o dispositivo posteriormente selecionando-o na guia da tabela principal e clicando em na parte superior esquerda do cabeçalho da tabela.

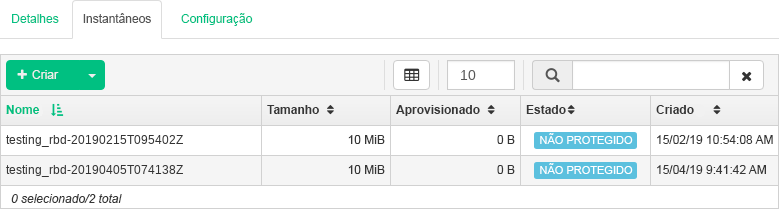

6.5 Criando instantâneos de dispositivo de blocos RADOS #

Para criar um instantâneo de Dispositivo de Blocos RADOS, selecione o dispositivo na linha da tabela, e o painel de conteúdo da configuração detalhada é exibido. Selecione a guia e clique em na parte superior esquerda do cabeçalho da tabela. Insira o nome do instantâneo e clique em para confirmar.

Após selecionar um instantâneo, você poderá executar outras ações no dispositivo, como renomear, proteger, clonar, copiar ou apagar. restaura o estado do dispositivo com base no instantâneo atual.

6.6 Espelhamento do RBD #

É possível espelhar as imagens de Dispositivo de Blocos RADOS de forma assíncrona entre dois clusters do Ceph. Você pode usar o Ceph Dashboard para configurar a replicação de imagens RBD entre dois ou mais clusters. Esse recurso está disponível em dois modos:

- Com base em diário

Esse modo usa o recurso de registro de imagens RBD em diário para garantir a replicação consistente com o ponto no tempo e a falha entre os clusters.

- Com base em instantâneo

Esse modo usa instantâneos de espelho de imagens RBD programados periodicamente ou criados manualmente para replicar imagens RBD consistentes com a falha entre os clusters.

O espelhamento é configurado por pool nos clusters de peer e pode ser configurado em um subconjunto específico de imagens no pool ou configurado para espelhar automaticamente todas as imagens em um pool ao usar apenas o espelhamento com base em diário.

O espelhamento é configurado usando o comando rbd que,

por padrão, está instalado no SUSE Enterprise Storage 7. O daemon

rbd-mirror é responsável por

capturar as atualizações da imagem do cluster de peer remoto e aplicá-las à

imagem no cluster local. Consulte a

Seção 6.6.2, “Habilitando o daemon rbd-mirror” para obter mais informações sobre

como habilitar o daemon rbd-mirror.

Dependendo da necessidade de replicação, o espelhamento de Dispositivo de Blocos RADOS pode ser configurado para replicação unidirecional ou bidirecional:

- Replicação unidirecional

Quando os dados são espelhados apenas de um cluster principal para um cluster secundário, o daemon

rbd-mirroré executado somente no cluster secundário.- Replicação bidirecional

Quando os dados são espelhados de imagens principais em um cluster para imagens não principais em outro cluster (e vice-versa), o daemon

rbd-mirroré executado nos dois clusters.

Cada instância do daemon rbd-mirror

deve ser capaz de se conectar aos clusters do Ceph local e remoto

simultaneamente, por exemplo, todos os hosts de monitor e OSD. Além disso,

a rede deve ter largura de banda suficiente entre os dois data centers para

processar a carga de trabalho de espelhamento.

Para obter informações gerais e a abordagem de linha de comando para espelhamento do Dispositivo de Blocos RADOS, consute a Seção 20.4, “Espelhos de imagens RBD”.

6.6.1 Configurando clusters principais e secundários #

O cluster principal é onde o pool original com as imagens é criado. O cluster secundário é onde o pool ou as imagens são replicados do cluster principal.

Os termos principal e secundário podem ser relativos no contexto de replicação porque estão mais relacionados aos pools individuais do que aos clusters. Por exemplo, na replicação de duas vias, é possível espelhar um pool do cluster principal para o secundário. É possível também espelhar outro pool do cluster secundário para o principal.

6.6.2 Habilitando o daemon rbd-mirror #

Os procedimentos a seguir demonstram como executar as tarefas

administrativas básicas para configurar o espelhamento usando o comando

rbd. O espelhamento é configurado por pool nos clusters

do Ceph.

As etapas de configuração do pool devem ser executadas nos dois clusters de peer. Estes procedimentos consideram a existência de dois clusters, chamados "principal" e "secundário", acessíveis de um único host, por motivos de clareza.

O daemon rbd-mirror executa a

replicação de dados do cluster real.

Renomeie os arquivos

ceph.confe de chaveiro e copie-os do host principal para o host secundário:cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyringPara habilitar o espelhamento em um pool com

rbd, especifiquemirror pool enable, o nome do pool e o modo de espelhamento:cephuser@adm >rbd mirror pool enable POOL_NAME MODENotaO modo de espelhamento pode ser

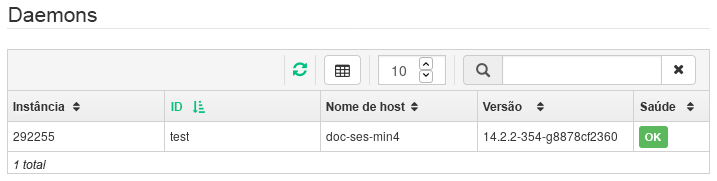

imageoupool. Por exemplo:cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool imageNo Ceph Dashboard, navegue até › . A tabela à esquerda mostra os daemons

rbd-mirrorem execução ativa e a saúde deles.Figura 6.6: Executando daemonsrbd-mirror#

6.6.3 Desabilitando o espelhamento #

Para desabilitar o espelhamento em um pool com rbd,

especifique o comando mirror pool disable e o nome do

pool:

cephuser@adm > rbd mirror pool disable POOL_NAMEQuando o espelhamento é desabilitado dessa maneira em um pool, ele também é desabilitado em todas as imagens (no pool) para as quais ele foi explicitamente habilitado.

6.6.4 Inicializando peers #

Para que rbd-mirror descubra seu

cluster de peer, o peer precisa ser registrado no pool, e uma conta do

usuário precisa ser criada. Esse processo pode ser automatizado com o

rbd e usando os comandos mirror pool peer

bootstrap create e mirror pool peer bootstrap

import.

Para criar manualmente um novo token de boot com o rbd,

especifique o comando mirror pool peer bootstrap create,

o nome de um pool, junto com o nome de um site opcional, para descrever o

cluster local:

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

A saída do mirror pool peer bootstrap create será um

token que deve ser inserido no comando mirror pool peer bootstrap

import. Por exemplo, no cluster principal:

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm \

1vbl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

Para importar manualmente o token de boot criado por outro cluster com o

comando rbd, especifique o comando mirror pool

peer bootstrap import, o nome do pool, um caminho de arquivo para

o token criado (ou '-' para ler a entrada padrão), juntamente com um nome

de site opcional para descrever o cluster local e uma direção de

espelhamento (o padrão é rx-tx para espelhamento

bidirecional, mas também pode ser definido como rx-only

para espelhamento unidirecional):

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-pathPor exemplo, no cluster secundário:

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW \ 1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1v \ bl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 Removendo o peer do cluster #

Para remover um cluster do Ceph de peer de espelhamento, com o comando

rbd, especifique o comando mirror pool peer

remove, o nome do pool e o UUID do peer (disponível ao executar o

comando rbd mirror pool info):

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 Configurando a replicação de pool no Ceph Dashboard #

O daemon rbd-mirror precisa ter

acesso ao cluster principal para poder espelhar imagens RBD. Verifique se

você seguiu as etapas na Seção 6.6.4, “Inicializando peers” antes

de continuar.

Em ambos os clusters principal e secundário, crie pools com nomes idênticos e atribua o aplicativo

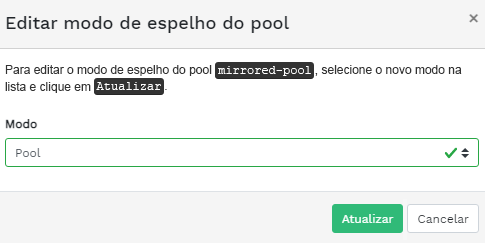

rbda eles. Consulte a Seção 5.1, “Adicionando um novo pool” para obter mais detalhes sobre a criação de um novo pool.Figura 6.7: Criando um pool com o aplicativo RBD #Em ambos os painéis de controle dos clusters principal e secundário, navegue até › . Na tabela à direita, clique no nome do pool que será replicado e, após clicar em , selecione o modo de replicação. Neste exemplo, trabalharemos com um modo de replicação de pool, o que significa que todas as imagens em um determinado pool serão replicadas. Clique em para confirmar.

Figura 6.8: Configurando o modo de replicação #Importante: erro ou aviso sobre o cluster principalApós a atualização do modo de replicação, um flag de erro ou aviso aparecerá na coluna direita correspondente. Isso acontece porque o pool ainda não tem um usuário peer atribuído para replicação. Ignore esse flag para o cluster principal já que atribuímos um usuário peer apenas ao cluster secundário.

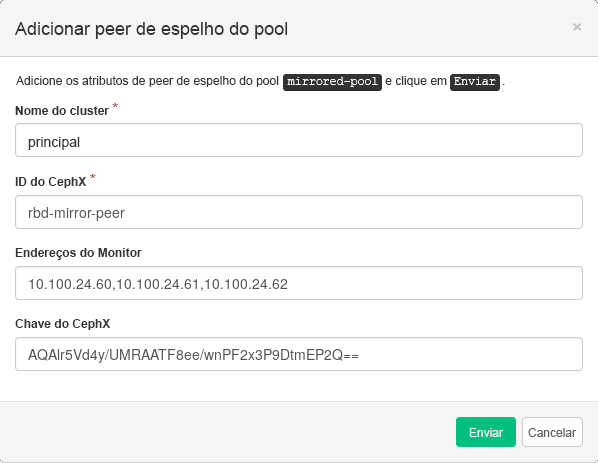

No Painel de Controle do cluster secundário, navegue até › . Adicione o peer do espelho do pool selecionando . Insira os detalhes do cluster principal:

Figura 6.9: Adicionando credenciais do peer #Uma string exclusiva arbitrária que identifica o cluster principal, como “primary”. O nome do cluster precisa ser diferente do nome do cluster secundário real.

O ID de usuário do Ceph que você criou como um peer de espelhamento. Neste exemplo, ele é o “rbd-mirror-peer”.

Lista de endereços IP separados por vírgula dos nós do Ceph Monitor do cluster principal.

A chave relacionada ao ID de usuário peer. Você pode recuperá-la executando o seguinte comando de exemplo no cluster principal:

cephuser@adm >ceph auth print_key pool-mirror-peer-name

Clique em para confirmar.

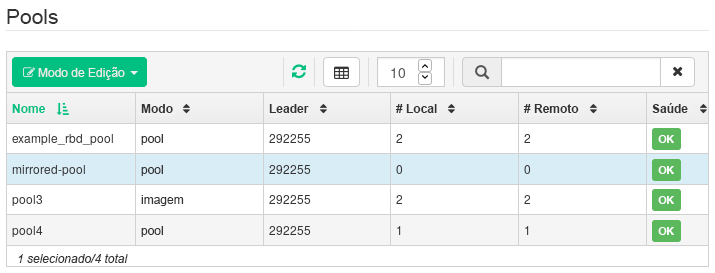

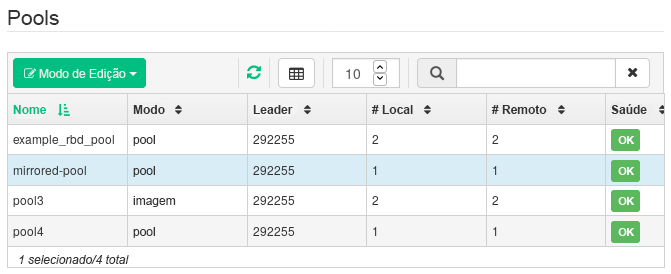

Figura 6.10: Lista de pools replicados #

6.6.7 Verificando se a replicação de imagens RBD funciona #

Quando o daemon rbd-mirror está em

execução e a replicação de imagens RBD foi configurada no Ceph Dashboard, é

hora de verificar se a replicação está realmente funcionando:

No Ceph Dashboard do cluster principal, crie uma imagem RBD de modo que seu pool pai seja o pool que você já criou para fins de replicação. Habilite os recursos

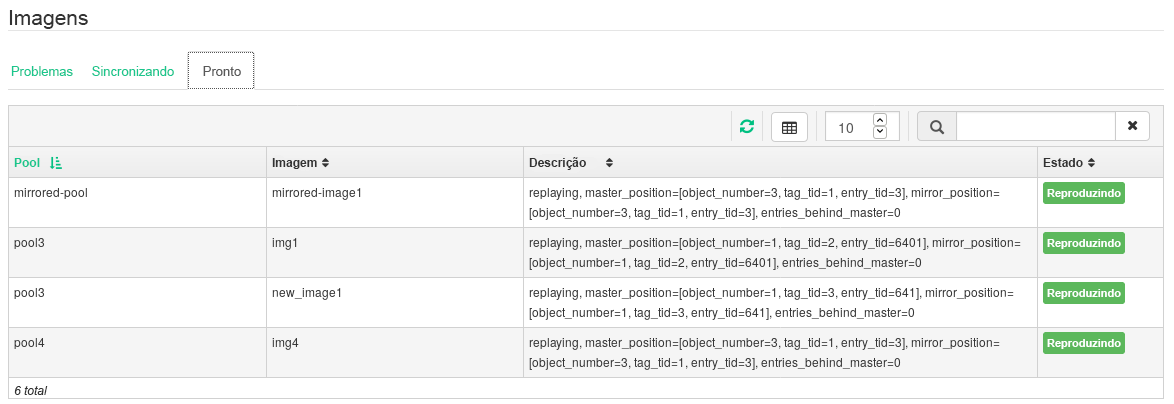

Bloqueio exclusivoeRegistro em diáriopara a imagem. Consulte a Seção 6.3, “Criando RBDs” para obter detalhes sobre como criar imagens RBD.Figura 6.11: Nova imagem RBD #Após criar a imagem que você deseja replicar, abra o Ceph Dashboard do cluster secundário e navegue até › . A tabela à direita refletirá a mudança no número de imagens de e sincronizará o número de imagens de .

Figura 6.12: Nova imagem RBD sincronizada #Dica: Andamento da replicaçãoA tabela na parte inferior da página mostra o status da replicação das imagens RBD. A guia inclui possíveis problemas, a guia exibe o andamento da replicação de imagens e a guia lista todas as imagens com replicação bem-sucedida.

Figura 6.13: Status da replicação das imagens RBD #No cluster principal, grave os dados na imagem RBD. No Ceph Dashboard do cluster secundário, navegue até › e monitore se o tamanho da imagem correspondente aumenta à medida que os dados no cluster principal são gravados.

6.7 Gerenciando iSCSI Gateways #

Para obter mais informações gerais sobre os Gateways iSCSI, consulte o Capítulo 22, Ceph iSCSI Gateway.

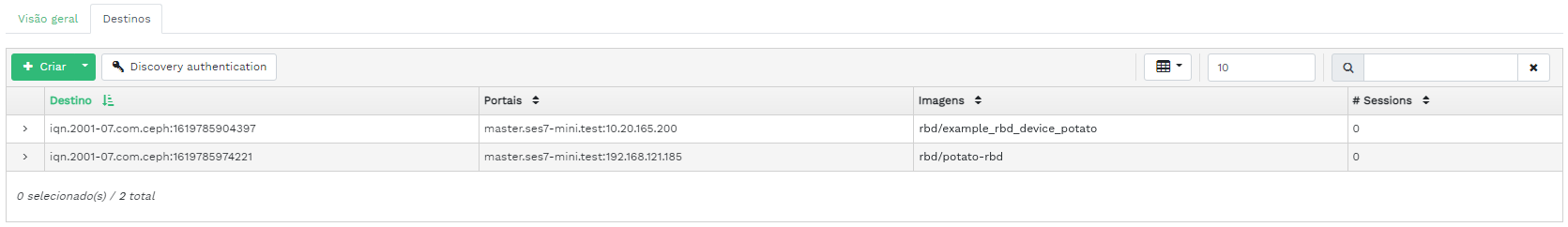

Para listar todos os gateways e imagens mapeadas disponíveis, clique em › no menu principal. A guia é aberta com a lista atual dos iSCSI Gateways configurados e das imagens RBD mapeadas.

A tabela lista o estado de cada gateway, o número de destinos iSCSI e a quantidade de sessões. A tabela lista o nome de cada imagem mapeada, o tipo de backstore do nome do pool relacionado e outros detalhes estatísticos.

A guia lista os destinos iSCSI configurados no momento.

Para ver informações mais detalhadas sobre um destino, clique na seta suspensa na linha da tabela de destinos. Um esquema estruturado em árvore é aberto com uma lista de discos, portais, iniciadores e grupos. Clique em um item para expandi-lo e ver seu conteúdo detalhado, opcionalmente com uma configuração relacionada na tabela à direita.

6.7.1 Adicionando destinos iSCSI #

Para adicionar um novo destino iSCSI, clique em na parte superior esquerda da tabela e insira as informações necessárias.

Digite o endereço de destino do novo gateway.

Clique em e selecione um ou vários portais iSCSI na lista.

Clique em e selecione uma ou várias imagens RBD para o gateway.

Se você precisa usar a autenticação para acessar o gateway, ative a caixa de seleção e insira as credenciais. Você poderá encontrar opções de autenticação mais avançadas após ativar e .

Clique em para confirmar.

6.7.2 Editando destinos iSCSI #

Para editar um destino iSCSI existente, clique na linha dele na tabela e clique em na parte superior esquerda da tabela.

Em seguida, você pode modificar o destino iSCSI, adicionar ou apagar portais e adicionar ou apagar imagens RBD relacionadas. Você também pode ajustar as informações de autenticação para o gateway.

6.7.3 Apagando destinos iSCSI #

Para apagar um destino iSCSI, selecione a linha da tabela e clique na seta suspensa ao lado do botão e selecione . Ative e clique em para confirmar.

6.8 Qualidade do Serviço (QdS) do RBD #

Para obter mais informações gerais e uma descrição das opções de configuração de QdS do RBD, consulte a Seção 20.6, “Configurações de QdS”.

É possível configurar as opções de QdS em diferentes níveis.

Globalmente

Por pool

Por imagem

A configuração global fica na parte superior da lista e será usada para todas as imagens RBD recém-criadas e para as imagens que não anulam esses valores no pool nem na camada da imagem RBD. Um valor de opção especificado globalmente pode ser anulado por pool ou por imagem. As opções especificadas em um pool serão aplicadas a todas as imagens RBD desse pool, exceto se forem anuladas por uma opção de configuração definida em uma imagem. As opções especificadas em uma imagem anularão as opções especificadas em um pool e globalmente.

Dessa forma, é possível definir padrões globalmente, adaptá-los a todas as imagens RBD de um pool específico e anular a configuração do pool para imagens RBD individuais.

6.8.1 Configurando opções globalmente #

Para configurar as opções do Dispositivo de Blocos RADOS globalmente, selecione › no menu principal.

Para listar todas as opções de configuração global disponíveis, ao lado de , escolha no menu suspenso.

Em seguida, filtre os resultados da tabela por

rbd_qosno campo de pesquisa. Esse procedimento lista todas as opções de configuração disponíveis para QdS.Para mudar um valor, clique na linha da tabela e selecione na parte superior esquerda da tabela. A caixa de diálogo inclui seus campos diferentes para especificar valores. Os valores da opção de configuração do RBD são obrigatórios na caixa de texto

NotaAo contrário das outras caixas de diálogo, esta não permite especificar o valor em unidades práticas. É necessário definir esses valores em bytes ou IOPS, dependendo da opção que você está editando.

6.8.2 Configurando opções em um novo pool #

Para criar um novo pool e definir opções de configuração do RBD nele,

clique em › . Selecione

como tipo de pool. Em seguida, você precisa

adicionar a tag do aplicativo rbd ao pool para poder

configurar as opções de QdS do RBD.

Não é possível definir opções de configuração de QdS do RBD em um pool codificado para eliminação. Para definir opções de QdS do RBD para pools codificados para eliminação, você precisa editar o pool replicado de metadados de uma imagem RBD. Na sequência, a configuração será aplicada ao pool de dados codificado para eliminação dessa imagem.

6.8.3 Configurando opções em pool existente #

Para definir opções de QdS do RBD em um pool existente, clique em , clique na linha do pool na tabela e selecione na parte superior esquerda da tabela.

Você deve ver a seção na caixa de diálogo, seguida de uma seção .

Se a seção ou não for exibida, provavelmente você estará editando um pool codificado para eliminação, que não pode ser usado para definir opções de configuração do RBD, ou o pool não foi configurado para uso por imagens RBD. Neste último caso, atribua a tag do aplicativo ao pool, e as seções de configuração correspondentes serão exibidas.

6.8.4 Opções de configuração #

Clique em para expandir as opções de configuração. Uma lista de todas as opções disponíveis será exibida. As unidades das opções de configuração já aparecem nas caixas de texto. No caso de qualqer opção de bytes por segundo (BPS, bytes per second), use atalhos como “1M” ou “5G”. Eles serão automaticamente convertidos em “1 MB/s” e “5 GB/s”, respectivamente.

Ao clicar no botão de redefinição à direita de cada caixa de texto, qualquer valor definido no pool será removido. Isso não remove os valores de configuração das opções definidas globalmente ou em uma imagem RBD.

6.8.5 Criando opções de QdS do RBD com uma nova imagem RBD #

Para criar uma imagem RBD com opções de QdS do RBD definidas nela, selecione › e clique em . Clique em para expandir a seção de configuração avançada. Clique em para abrir todas as opções de configuração disponíveis.

6.8.6 Editando opções de QdS do RBD em imagens existentes #

Para editar as opções de QdS do RBD em uma imagem existente, selecione › , clique na linha do pool na tabela e, por último, clique em . A caixa de diálogo de edição será exibida. Clique em para expandir a seção de configuração avançada. Clique em para abrir todas as opções de configuração disponíveis.

6.8.7 Mudando as opções de configuração ao copiar ou clonar imagens #

Se uma imagem RBD for clonada ou copiada, os valores definidos nela também serão copiados por padrão. Para mudá-los durante a cópia ou clonagem, você pode especificar os valores de configuração atualizados na caixa de diálogo de cópia/clonagem da mesma forma que na criação ou edição de uma imagem RBD. Esse procedimento apenas definirá (ou redefinirá) os valores para a imagem RBD que é copiada ou clonada. Essa operação não muda a configuração da imagem RBD de origem nem a configuração global.

Se você redefinir o valor da opção durante a cópia/clonagem, nenhum valor para essa opção será definido nessa imagem. Isso significa que qualquer valor dessa opção especificado para o pool pai será usado se o pool pai tiver o valor configurado. Do contrário, o padrão global será usado.

7 Gerenciar o NFS Ganesha #

Para obter mais informações gerais sobre o NFS Ganesha, consulte o Capítulo 25, NFS Ganesha.

Para listar todas as exportações NFS disponíveis, clique em no menu principal.

A lista mostra o diretório de cada exportação, o nome de host do daemon, o tipo de back end de armazenamento e o tipo de acesso.

Para ver informações mais detalhadas sobre uma exportação NFS, clique na linha dela na tabela.

7.1 Criando exportações do NFS #

Para adicionar uma nova exportação do NFS, clique em na parte superior esquerda da tabela de exportações e insira as informações necessárias.

Selecione um ou mais daemons NFS Ganesha que executarão a exportação.

Selecione um back end de armazenamento.

ImportanteNo momento, apenas as exportações do NFS com suporte do CephFS são permitidas.

Selecione um ID de usuário e outras opções relacionadas ao back end.

Digite o caminho do diretório para a exportação NFS. Se o diretório não existir no servidor, ele será criado.

Especifique outras opções relacionadas ao NFS, como versão do protocolo NFS suportada, pseudo, tipo de acesso, squash ou protocolo de transporte.

Se você precisa limitar o acesso apenas a determinados clientes, clique em e adicione os endereços IP deles juntamente com o tipo de acesso e as opções de squash.

Clique em para confirmar.

7.2 Apagando exportações do NFS #

Para apagar uma exportação, selecione-a e realce-a na linha da tabela. Clique na seta suspensa ao lado do botão e selecione . Ative a caixa de seleção e clique em para confirmar.

7.3 Editando exportações do NFS #

Para editar uma exportação existente, selecione-a e realce-a na linha da tabela e clique em na parte superior esquerda da tabela de exportações.

Em seguida, você pode ajustar todos os detalhes da exportação NFS.

8 Gerenciar o CephFS #

Para encontrar informações detalhadas sobre o CephFS, consulte o Capítulo 23, Sistema de arquivos em cluster.

8.1 Acessando a visão geral do CephFS #

Clique em no menu principal para acessar a visão geral dos sistemas de arquivos configurados. A tabela principal mostra o nome e a data de criação de cada sistema de arquivos, e se ele está ou não habilitado.

Ao clicar na linha de um sistema de arquivos na tabela, você revela detalhes sobre sua classificação e os pools adicionados a ele.

Na parte inferior da tela, você pode ver estatísticas que mostram o número de inodes MDS relacionados e solicitações de clientes, coletadas em tempo real.

9 Gerenciar o Gateway de Objetos #

Antes de começar, talvez você veja a seguinte notificação ao tentar acessar o front end do Gateway de Objetos no Ceph Dashboard:

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

Isso ocorre porque o Gateway de Objetos não foi configurado automaticamente pelo cephadm para o Ceph Dashboard. Se essa notificação aparecer, siga as instruções na Seção 10.4, “Habilitando o front end de gerenciamento do Gateway de Objetos” para habilitar manualmente o front end do Gateway de Objetos para o Ceph Dashboard.

Para obter mais informações gerais sobre o Gateway de Objetos, consulte o Capítulo 21, Gateway de Objetos do Ceph.

9.1 Vendo Gateways de Objetos #

Para ver uma lista de Gateways de Objetos configurados, clique em › . A lista inclui o ID do gateway, o nome de host do nó do cluster onde o daemon do gateway está sendo executado e o número da versão do gateway.

Clique na seta suspensa ao lado do nome do gateway para ver informações detalhadas sobre ele. A guia mostra detalhes sobre as operações de leitura/gravação e as estatísticas do cache.

9.2 Gerenciando usuários do Gateway de Objetos #

Clique em › para ver uma lista dos usuários existentes do Gateway de Objetos.

Clique na seta suspensa ao lado do nome do usuário para ver detalhes sobre a conta do usuário, como informações de status ou os detalhes de cota do usuário e do compartimento de memória.

9.2.1 Adicionando um novo usuário do gateway #

Para adicionar um novo usuário do gateway, clique em na parte superior esquerda do cabeçalho da tabela. Preencha as credenciais dele, os detalhes sobre a chave S3 e as cotas do usuário e do compartimento de memória e clique em para confirmar.

9.2.2 Apagando usuários do gateway #

Para apagar um usuário do gateway, selecione-o e realce-o. Clique no botão suspenso ao lado de e selecione na lista para apagar a conta do usuário. Ative a caixa de seleção e clique em para confirmar.

9.2.3 Editando detalhes do usuário do gateway #

Para mudar os detalhes do usuário do gateway, selecione-o e realce-o. Clique em na parte superior esquerda do cabeçalho da tabela.

Modifique as informações básicas ou adicionais do usuário, como informações de recursos, chaves, subusuários e cotas. Clique em para confirmar.

A guia inclui uma lista apenas leitura de usuários do gateway e suas chaves de acesso e secretas. Para ver as chaves, clique em um nome de usuário na lista e selecione na parte superior esquerda do cabeçalho da tabela. Na caixa de diálogo , clique no ícone de “olho” para exibir as chaves ou clique no ícone da área de transferência para copiar a chave relacionada para a área de transferência.

9.3 Gerenciando compartimentos de memória do Gateway de Objetos #

Os compartimentos de memória do Gateway de Objetos (OGW) implementam a funcionalidade dos containers OpenStack Swift. Os compartimentos de memória do Gateway de Objetos servem como containers para armazenar objetos de dados.

Clique em › para ver uma lista de compartimentos de memória do Gateway de Objetos.

9.3.1 Adicionando um novo compartimento de memória #

Para adicionar um novo compartimento de memória do Gateway de Objetos, clique em na parte superior esquerda do cabeçalho da tabela. Insira o nome do compartimento de memória, selecione o proprietário e defina o destino de posicionamento. Clique em para confirmar.

Nesta fase, você também pode habilitar o bloqueio selecionando ; no entanto, esse recurso poderá ser configurado após a criação. Consulte a Seção 9.3.3, “Editando o compartimento de memória” para obter mais informações.

9.3.2 Visualizando detalhes do compartimento de memória #

Para ver informações detalhadas sobre um compartimento de memória do Gateway de Objetos, clique na seta suspensa ao lado do nome do compartimento de memória.

Abaixo da tabela , você encontra detalhes sobre as configurações de cota e bloqueio de compartimento de memória.

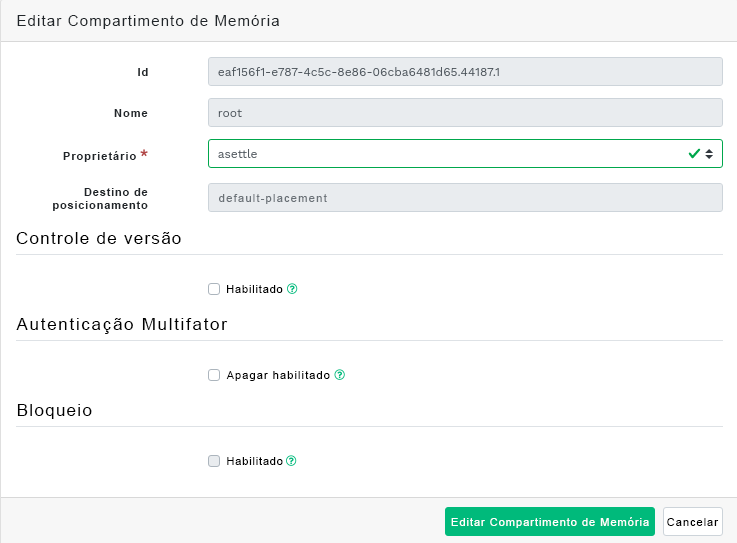

9.3.3 Editando o compartimento de memória #

Selecione e realce um compartimento de memória e clique em na parte superior esquerda do cabeçalho da tabela.

Você pode atualizar o proprietário do compartimento de memória ou habilitar o controle de versão, a autenticação multifator ou o bloqueio. Clique em para confirmar qualquer mudança.

9.3.4 Apagando um compartimento de memória #

Selecione e realce um compartimento de memória para apagá-lo do Gateway de Objetos. Clique no botão suspenso ao lado de e selecione na lista para apagar o compartimento de memória. Ative a caixa de seleção e clique em para confirmar.

10 Configuração manual #

Esta seção apresenta informações avançadas para usuários que preferem definir as configurações do painel de controle manualmente na linha de comando.

10.1 Configurando o suporte a TLS/SSL #

Por padrão, todas as conexões HTTP com o painel de controle são protegidas com TLS/SSL. Uma conexão segura requer um certificado SSL. Você pode usar um certificado autoassinado ou gerar um certificado assinado por uma autoridade de certificação (CA, certificate authority) reconhecida.

Talvez você tenha algum motivo específico para desabilitar o suporte a SSL. Por exemplo, se o painel de controle for executado por meio de um proxy que não suporta SSL.

Tenha cuidado ao desabilitar o SSL, já que os nomes de usuário e as senhas serão enviados ao painel de controle não criptografados.

Para desabilitar o SSL, execute:

cephuser@adm > ceph config set mgr mgr/dashboard/ssl falseVocê precisará reiniciar os processos do Ceph Manager manualmente após mudar o certificado SSL e a chave. Para fazer isso, é possível executar

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAMEou desabilitar e habilitar novamente o módulo do painel de controle, o que também aciona o gerenciador para se reativar:

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 Criando certificados autoassinados #

A criação de um certificado autoassinado para uma comunicação segura é simples. Dessa forma, você pode fazer com que o painel de controle seja executado rapidamente.

A maioria dos browsers da Web reclamará de um certificado autoassinado e exigirá a confirmação explícita antes de estabelecer uma conexão segura com o painel de controle.

Para gerar e instalar um certificado autoassinado, use o seguinte comando incorporado:

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 Usando certificados assinados por CA #

Para proteger apropriadamente a conexão com o painel de controel e eliminar as reclamações do browser da Web por causa de um certificado autoassinado, recomendamos o uso de um certificado assinado por uma CA.

Você pode gerar um par de chaves do certificado com um comando semelhante ao seguinte:

root # openssl req -new -nodes -x509 \

-subj "/O=IT/CN=ceph-mgr-dashboard" -days 3650 \

-keyout dashboard.key -out dashboard.crt -extensions v3_ca

O comando acima resulta nos arquivos dashboard.key e dashboard.crt. Após receber o arquivo dashboard.crt assinado por uma CA, habilite-o para todas as instâncias do Ceph Manager executando os seguintes comandos:

cephuser@adm >ceph config-key set mgr/dashboard/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/key -i dashboard.key

Se você precisar de certificados diferentes para cada instância do Ceph Manager, modifique os comandos e inclua o nome da instância da seguinte maneira. Substitua NAME pelo nome da instância do Ceph Manager (normalmente, o nome de host relacionado):

cephuser@adm >ceph config-key set mgr/dashboard/NAME/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/NAME/key -i dashboard.key

10.2 Mudando nome de host e número de porta #

O Ceph Dashboard está vinculado a um endereço TCP/IP e uma porta TCP específicos. Por padrão, o Ceph Manager ativo no momento e que hospeda o painel de controle está vinculado à porta TCP 8443 (ou 8080 quando o SSL está desabilitado).

Se um firewall estiver habilitado nos hosts que executam o Ceph Manager (e, portanto, o Ceph Dashboard), talvez seja necessário mudar a configuração para habilitar o acesso a essas portas. Para obter mais informações sobre as configurações de firewall do Ceph, consulte o Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”.

Por padrão, o Ceph Dashboard está vinculado a "::", que corresponde a todos os endereços IPv4 e IPv6 disponíveis. Você pode mudar o endereço IP e o número da porta do aplicativo Web para que eles se apliquem a todas as instâncias do Ceph Manager usando os seguintes comandos:

cephuser@adm >ceph config set mgr mgr/dashboard/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/server_port PORT_NUMBER

Como cada daemon ceph-mgr hospeda sua própria instância do painel de controle, talvez seja necessário configurá-los separadamente. Mude o endereço IP e o número da porta para uma instância específica do gerenciador usando os seguintes comandos (substitua NAME pelo ID da instância do ceph-mgr):

cephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_port PORT_NUMBER

O comando ceph mgr services exibe todos os endpoints que estão configurados. Procure a chave dashboard para obter o URL de acesso ao painel de controle.

10.3 Ajustando nomes de usuário e senhas #

Se você não deseja usar a conta de administrador padrão, crie uma conta de usuário diferente e associe-a a pelo menos uma função. Oferecemos um conjunto de funções de sistema predefinidas que você pode usar. Para obter mais detalhes, consulte a Capítulo 11, Gerenciar usuários e funções na linha de comando.

Para criar um usuário com privilégios de administrador, use o seguinte comando:

cephuser@adm > ceph dashboard ac-user-create USER_NAME PASSWORD administrator10.4 Habilitando o front end de gerenciamento do Gateway de Objetos #

Para usar a funcionalidade de gerenciamento do Gateway de Objetos do painel de controle, você precisa fornecer as credenciais de login de um usuário com o flag system habilitado:

Se você não tem um usuário com o flag

system, crie-o:cephuser@adm >radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --systemAnote as chaves access_key e secret_key na saída do comando.

Você também pode obter as credenciais de um usuário existente usando o comando

radosgw-admin:cephuser@adm >radosgw-admin user info --uid=USER_IDInsira as credenciais recebidas no painel de controle:

cephuser@adm >ceph dashboard set-rgw-api-access-key ACCESS_KEYcephuser@adm >ceph dashboard set-rgw-api-secret-key SECRET_KEY

Por padrão, o firewall está habilitado no SUSE Linux Enterprise Server 15 SP2. Para obter informações sobre configuração de firewall, consulte o Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”.

Há vários pontos a serem considerados:

O nome de host e o número da porta do Gateway de Objetos são determinados automaticamente.

Se várias zonas forem usadas, ele determinará automaticamente o host no grupo de zonas master e na zona master. Isso é o suficiente para a maioria das configurações. No entanto, em algumas circunstâncias, talvez você queira definir o nome de host e a porta manualmente:

cephuser@adm >ceph dashboard set-rgw-api-host HOSTcephuser@adm >ceph dashboard set-rgw-api-port PORTVeja a seguir outras configurações que você pode precisar:

cephuser@adm >ceph dashboard set-rgw-api-scheme SCHEME # http or httpscephuser@adm >ceph dashboard set-rgw-api-admin-resource ADMIN_RESOURCEcephuser@adm >ceph dashboard set-rgw-api-user-id USER_IDSe você usa um certificado autoassinado (Seção 10.1, “Configurando o suporte a TLS/SSL”) na configuração do Gateway de Objetos, desabilite a verificação de certificado no painel de controle para evitar conexões recusadas por causa de certificados assinados por uma CA desconhecida ou que não correspondem ao nome de host:

cephuser@adm >ceph dashboard set-rgw-api-ssl-verify FalseSe o Gateway de Objetos levar muito tempo para processar as solicitações, e se a execução do painel de controle apresentar tempo de espera, o valor do tempo de espera poderá ser ajustado (o padrão é 45 segundos):

cephuser@adm >ceph dashboard set-rest-requests-timeout SECONDS

10.5 Habilitando o gerenciamento de iSCSI #

O Ceph Dashboard gerencia destinos iSCSI usando a API REST fornecida pelo serviço rbd-target-api do gateway Ceph iSCSI. Verifique se ela está instalada e habilitada nos gateways iSCSI.

A funcionalidade de gerenciamento de iSCSI do Ceph Dashboard depende da versão 3 mais recente do projeto ceph-iscsi. Verifique se o seu sistema operacional tem a versão correta; do contrário, o Ceph Dashboard não habilitará os recursos de gerenciamento.

Se a API REST do ceph-iscsi estiver configurada no modo HTTPS e usar um certificado autoassinado, configure o painel de controle para evitar a verificação do certificado SSL ao acessar a API do ceph-iscsi.

Desabilite a verificação do SSL da API:

cephuser@adm > ceph dashboard set-iscsi-api-ssl-verification falseDefina os gateways iSCSI disponíveis: