- 关于本指南

- I Ceph Dashboard

- II 集群操作

- III 在集群中存储数据

- IV 访问集群数据

- V 与虚拟化工具集成

- VI 配置集群

- A 基于上游“Octopus”小版本的 Ceph 维护更新

- B 文档更新

- 词汇表

- 2.1 Ceph Dashboard 登录屏幕

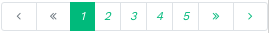

- 2.2 Ceph Dashboard 首页

- 2.3 状态控件

- 2.4 容量控件

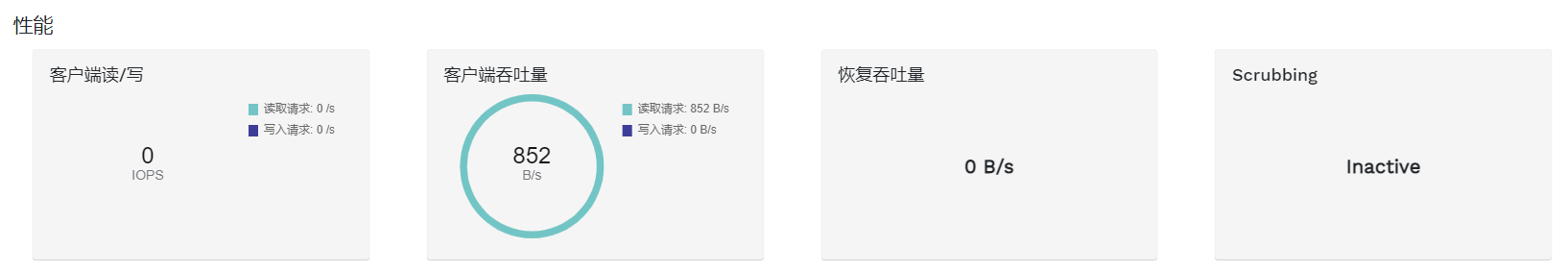

- 2.5 性能控件

- 3.1 用户管理

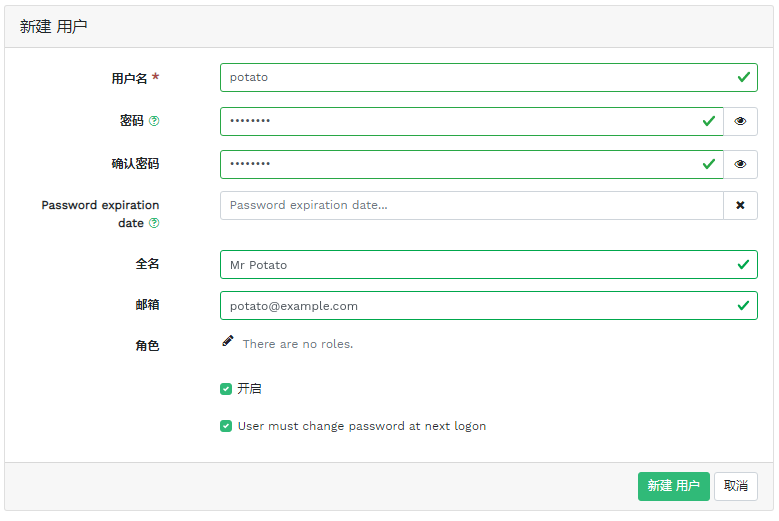

- 3.2 添加用户

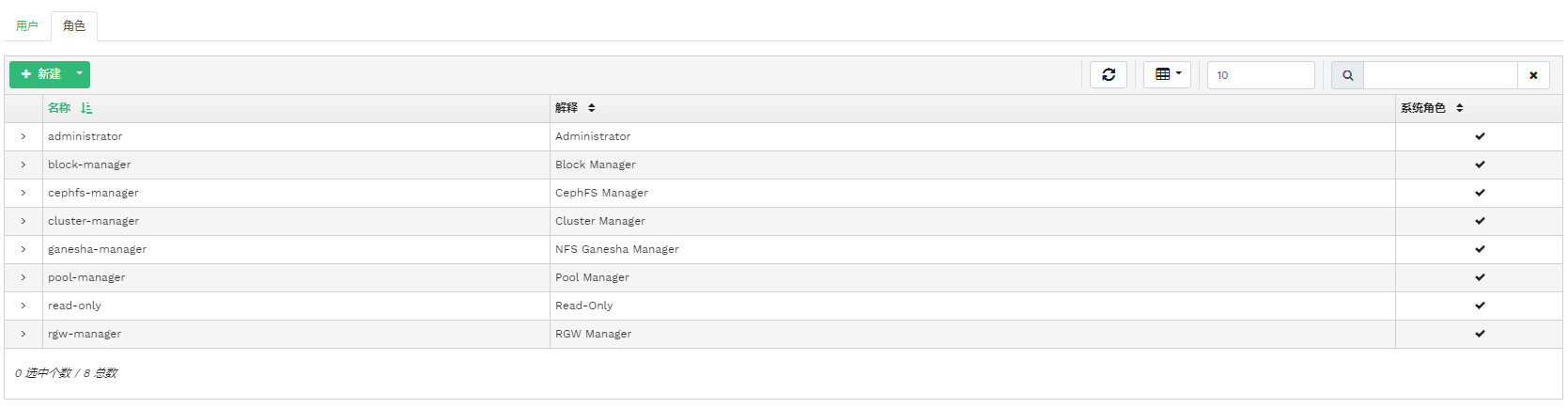

- 3.3 用户角色

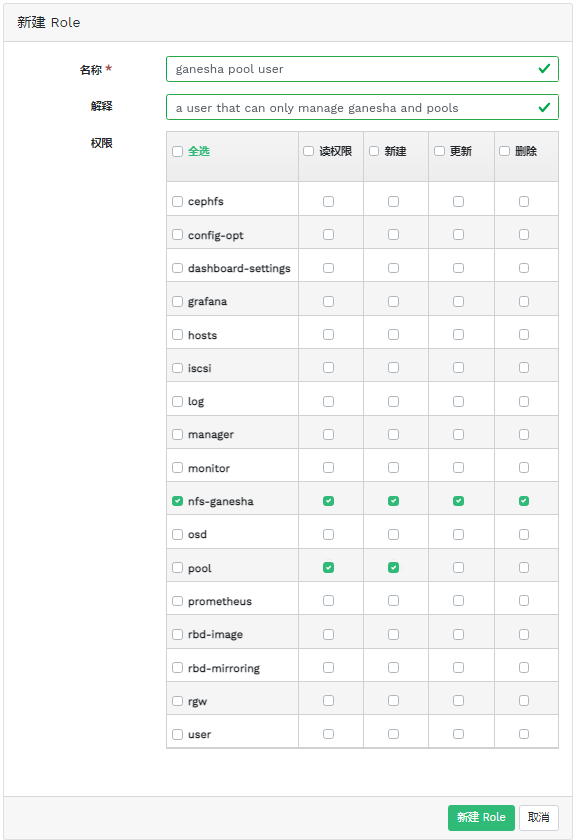

- 3.4 添加角色

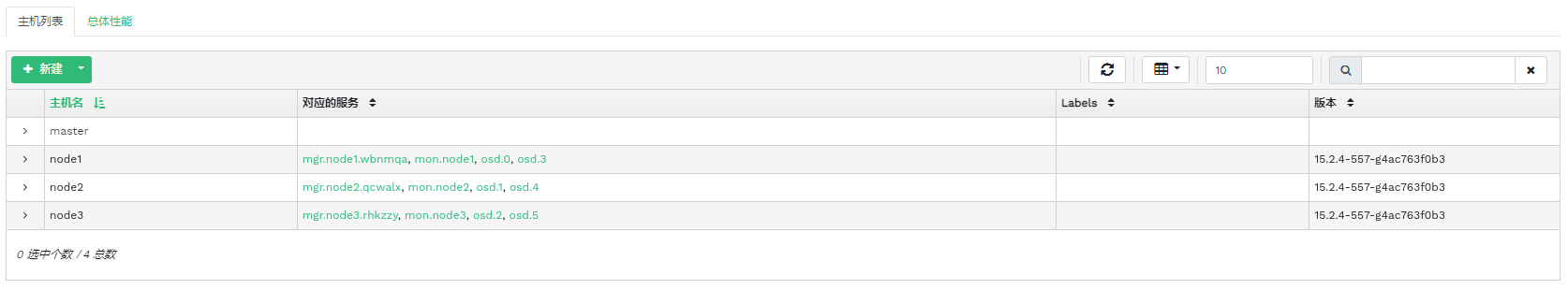

- 4.1 主机

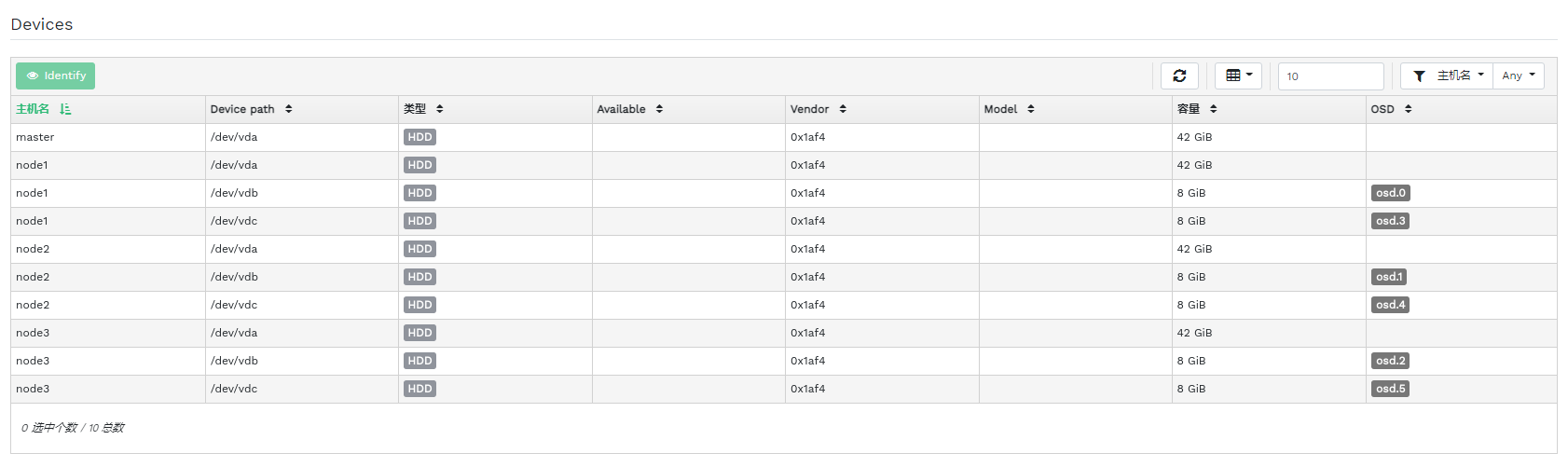

- 4.2 服务

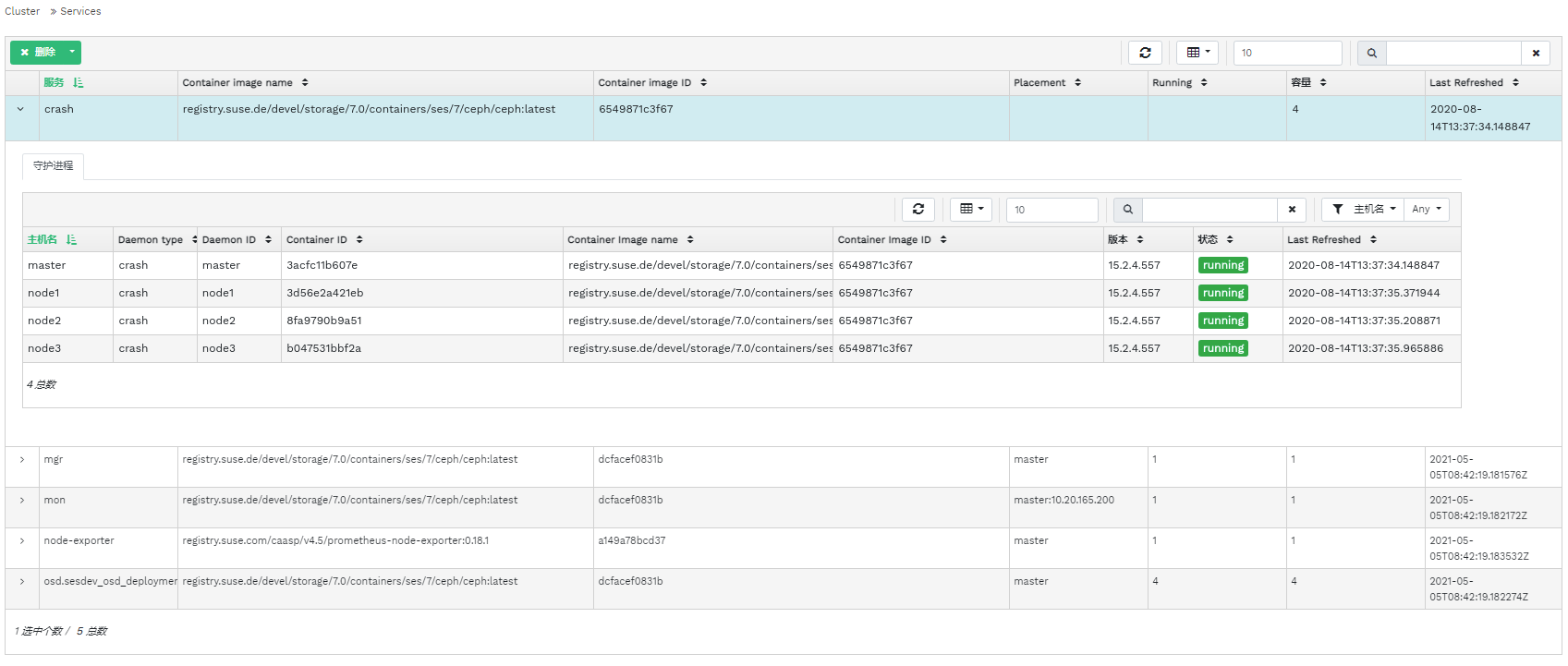

- 4.3 Ceph Monitor

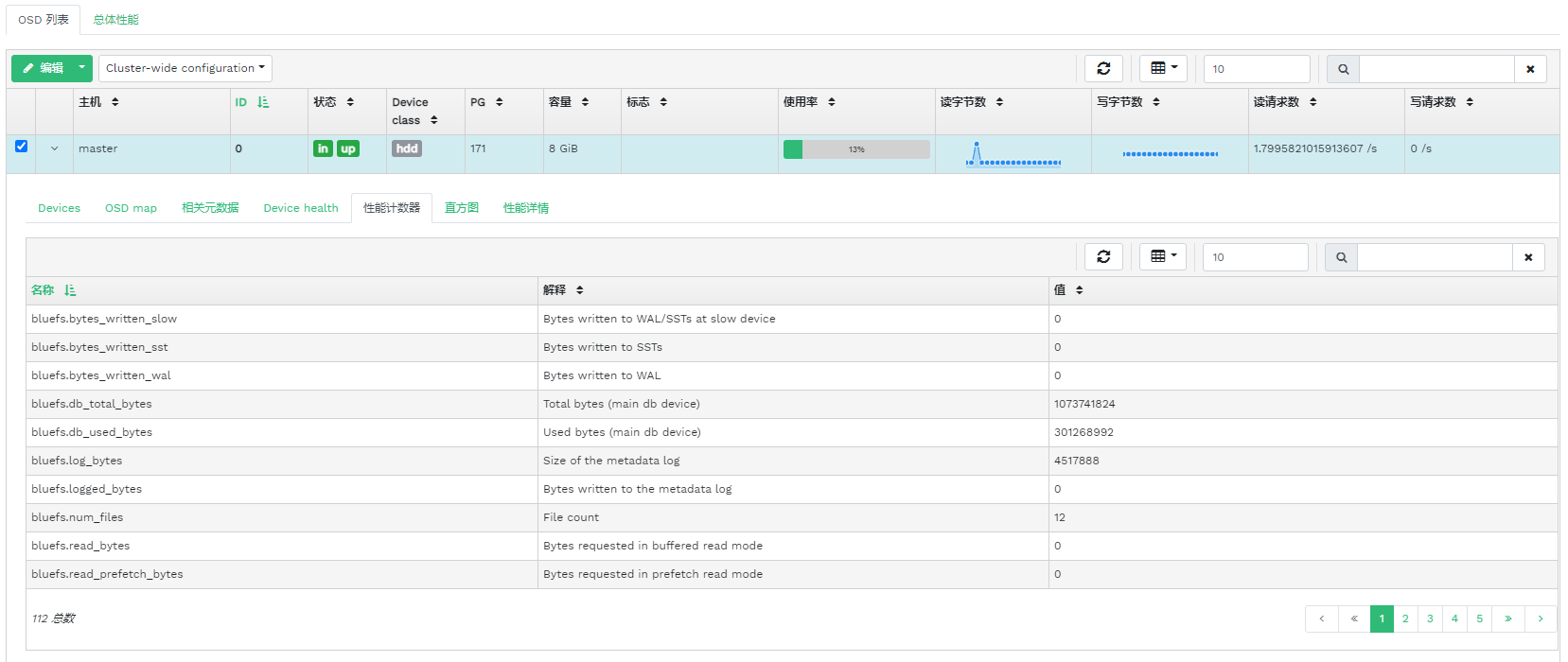

- 4.4 服务

- 4.5 Ceph OSD

- 4.6 OSD 标志

- 4.7 OSD 恢复优先级

- 4.8 OSD 详细信息

- 4.9 创建 OSD

- 4.10 添加主设备

- 4.11 创建添加了主设备的 OSD

- 4.12

- 4.13 新添加的 OSD

- 4.14 集群配置

- 4.15 CRUSH 索引

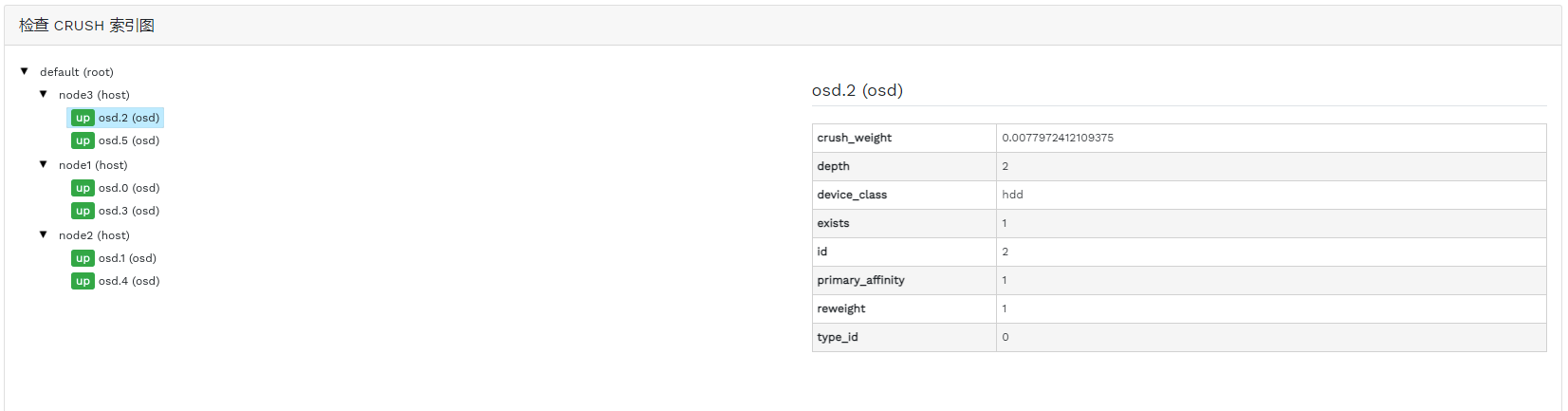

- 4.16 Manager 模块

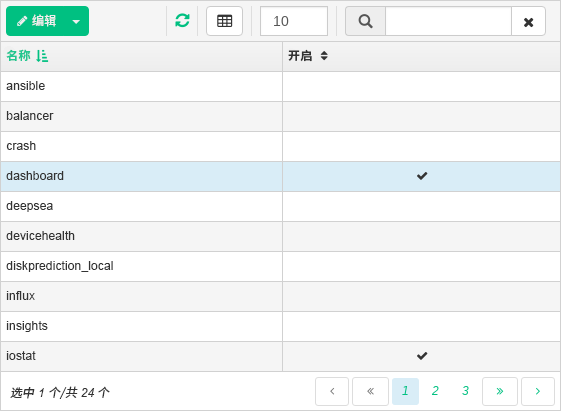

- 4.17 日志

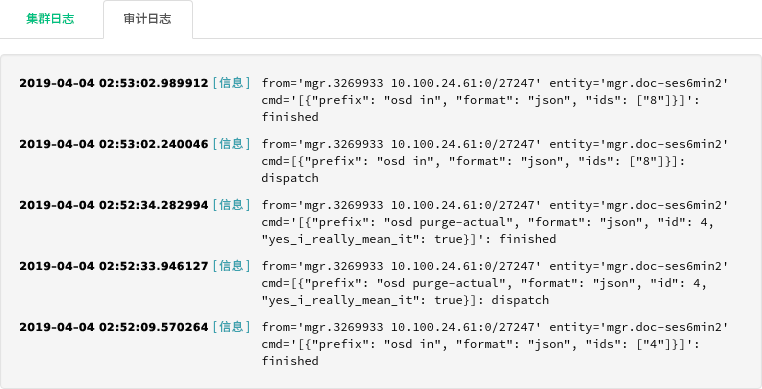

- 5.1 存储池列表

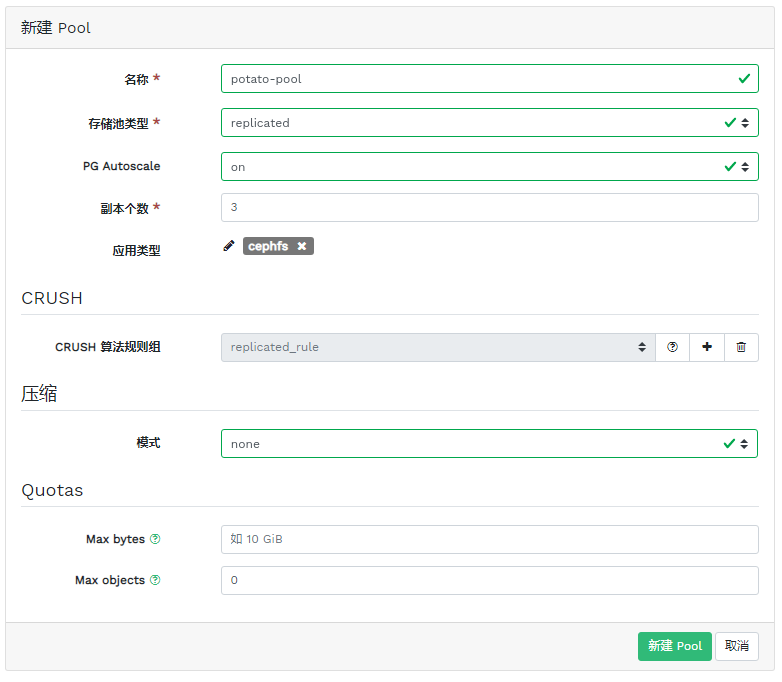

- 5.2 添加新存储池

- 6.1 RBD 映像列表

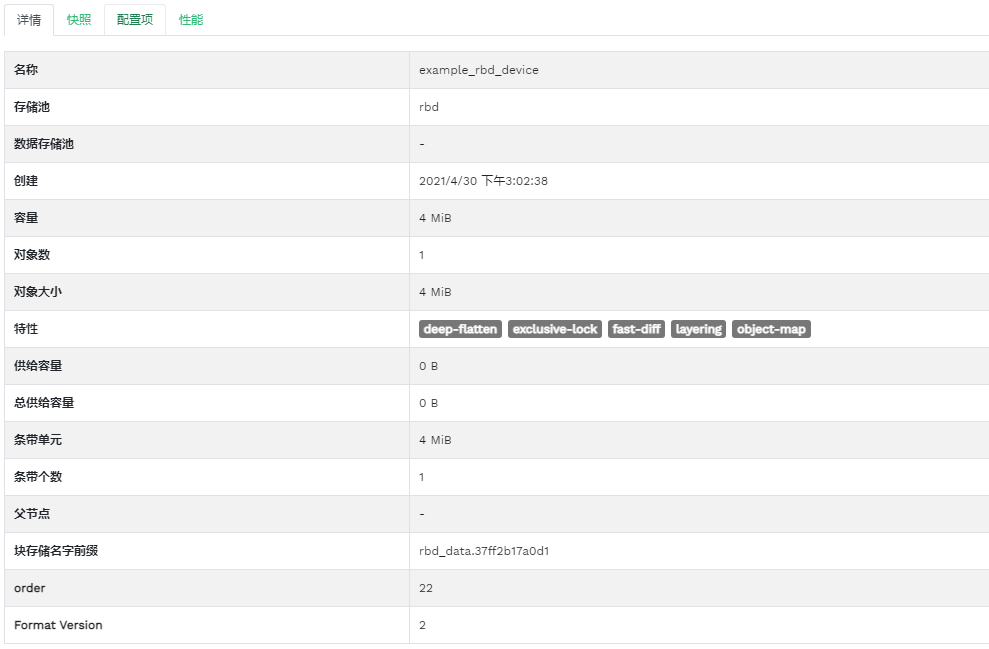

- 6.2 RBD 详细信息

- 6.3 RBD 配置

- 6.4 添加新的 RBD

- 6.5 RBD 快照

- 6.6 正在运行的

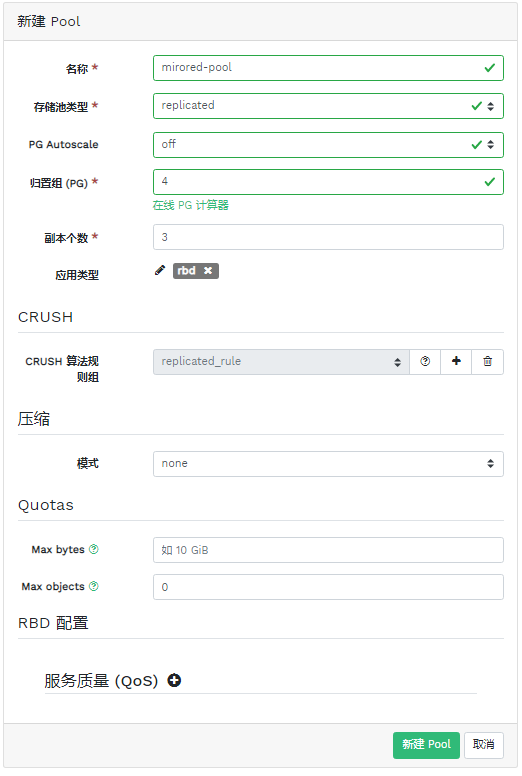

rbd-mirror守护进程 - 6.7 创建具有 RBD 应用的存储池

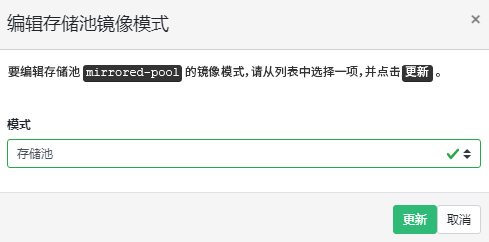

- 6.8 配置复制模式

- 6.9 添加对等身份凭证

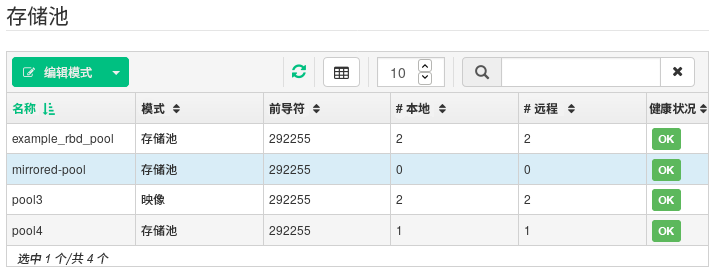

- 6.10 副本存储池列表

- 6.11 新 RBD 映像

- 6.12 同步的新 RBD 映像

- 6.13 RBD 映像的复制状态

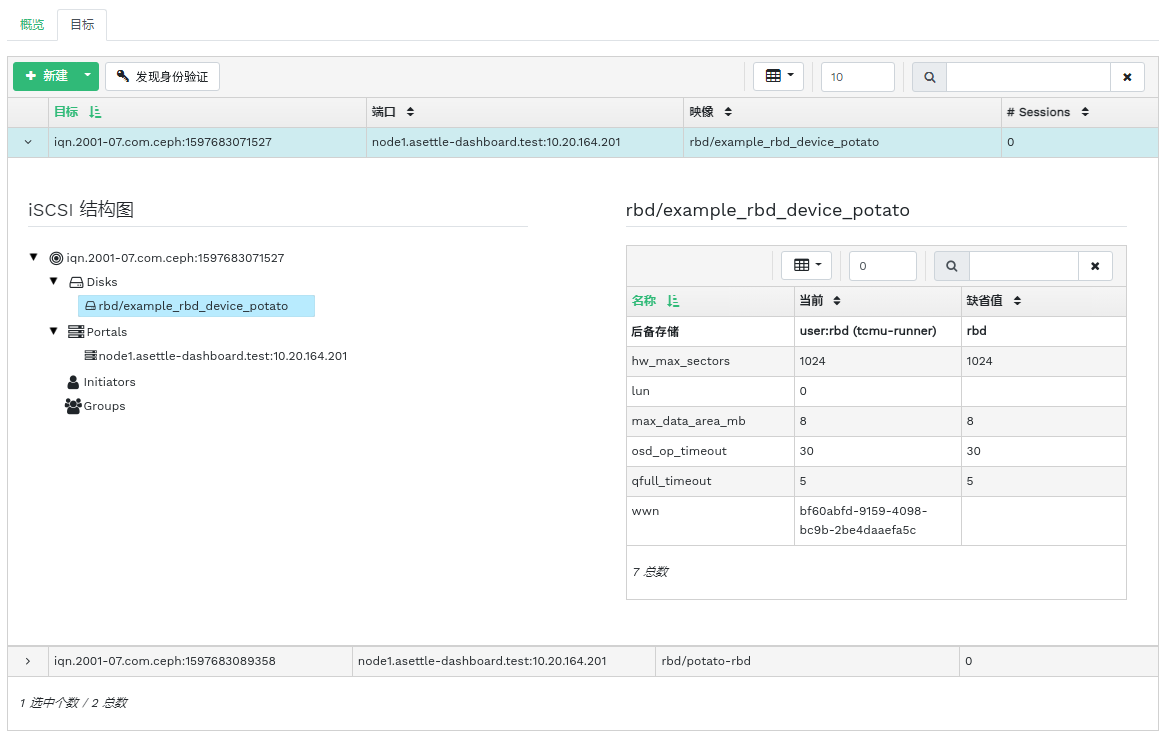

- 6.14 iSCSI 目标列表

- 6.15 iSCSI 目标详细信息

- 6.16 添加新目标

- 7.1 NFS 导出项列表

- 7.2 NFS 导出项详细信息

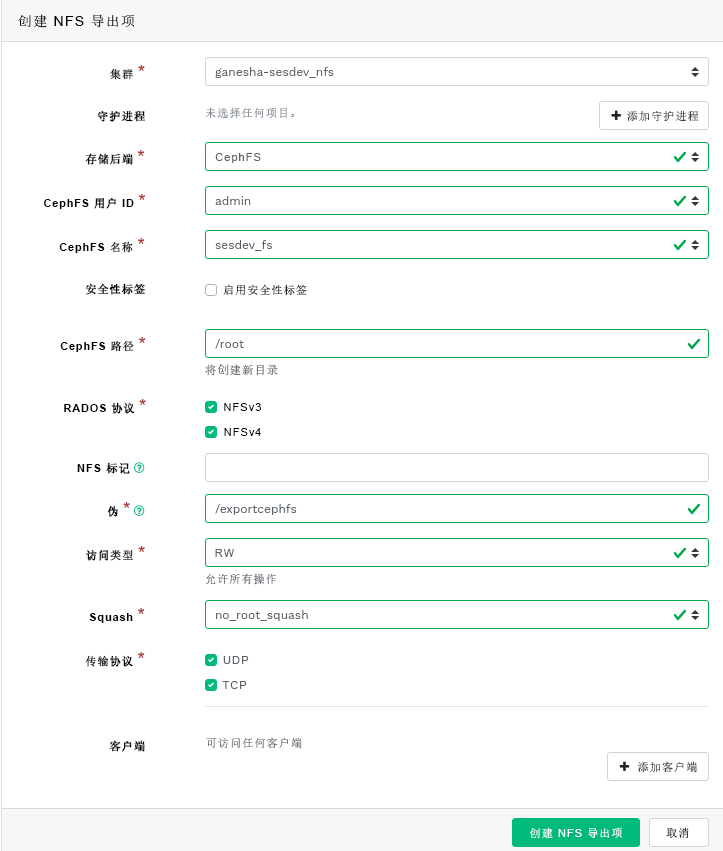

- 7.3 添加新的 NFS 导出项

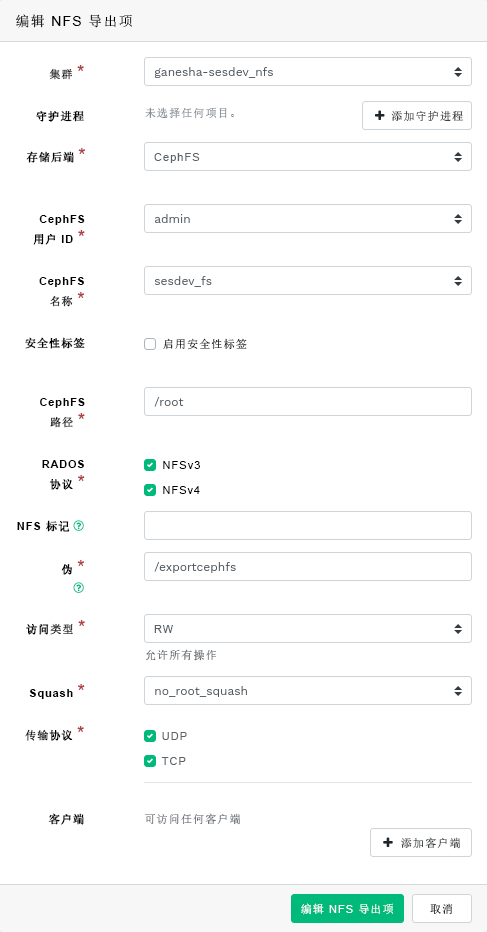

- 7.4 编辑 NFS 导出项

- 8.1 CephFS 详细信息

- 8.2 CephFS 详细信息

- 9.1 网关的详细信息

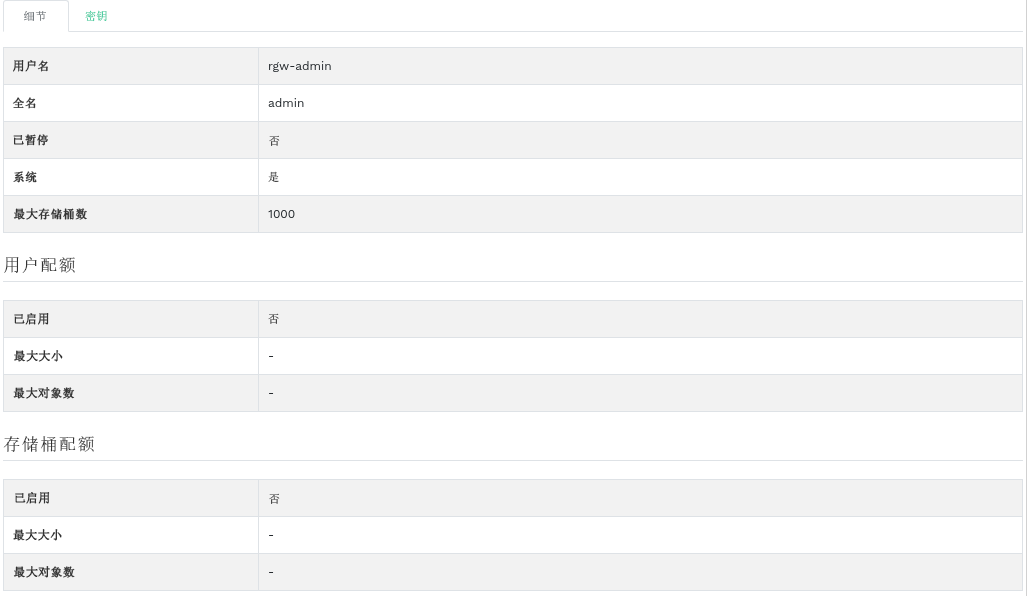

- 9.2 网关用户

- 9.3 添加新网关用户

- 9.4 网关存储桶详细信息

- 9.5 编辑存储桶详细信息

- 12.1 Ceph 集群

- 12.2 互联纲要

- 12.3 归置组状态

- 17.1 具有混合设备类型的 OSD

- 17.2 示例树

- 17.3 节点替换方法

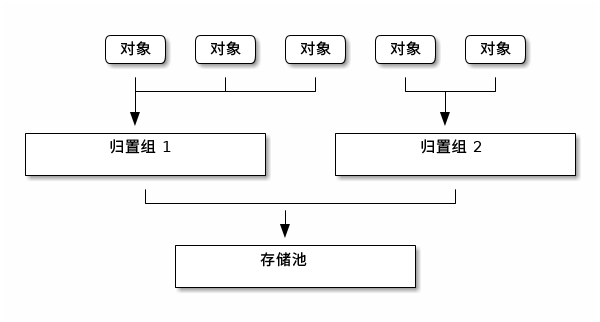

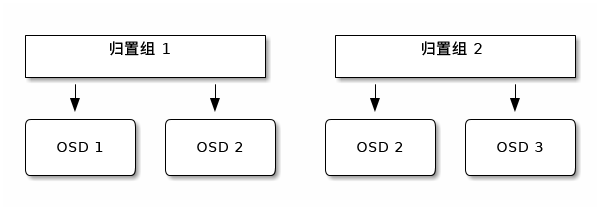

- 17.4 存储池中的归置组

- 17.5 归置组和 OSD

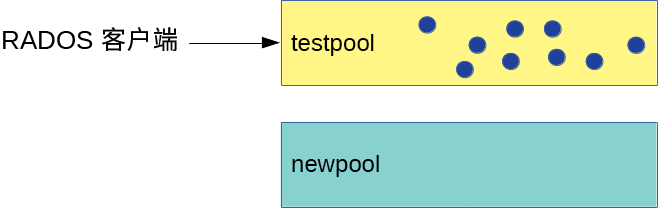

- 18.1 迁移前的存储池

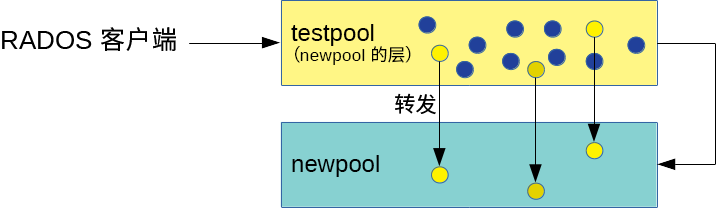

- 18.2 缓存层设置

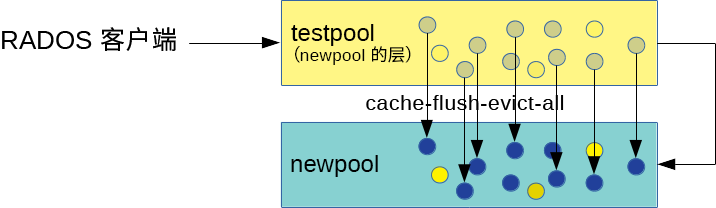

- 18.3 数据刷新

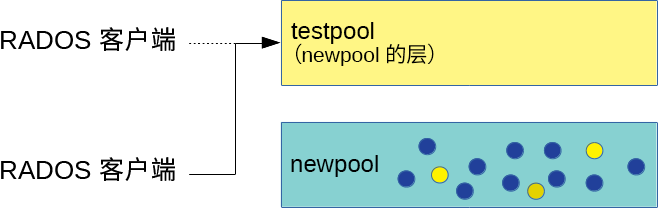

- 18.4 设置覆盖层

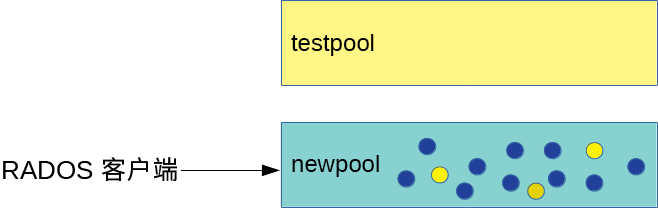

- 18.5 迁移完成

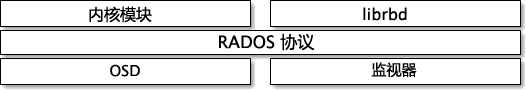

- 20.1 RADOS 协议

- 22.1 iSCSI 发起程序属性

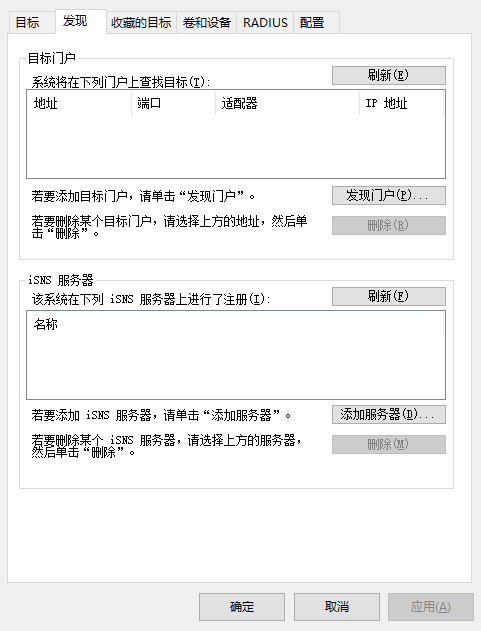

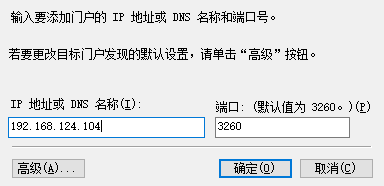

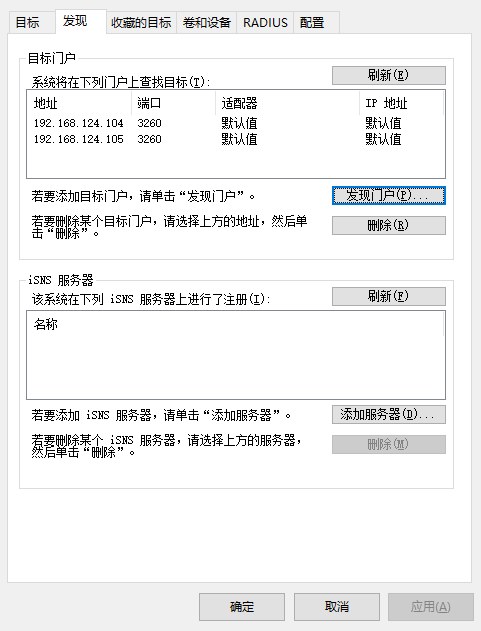

- 22.2 发现目标门户

- 22.3 目标门户

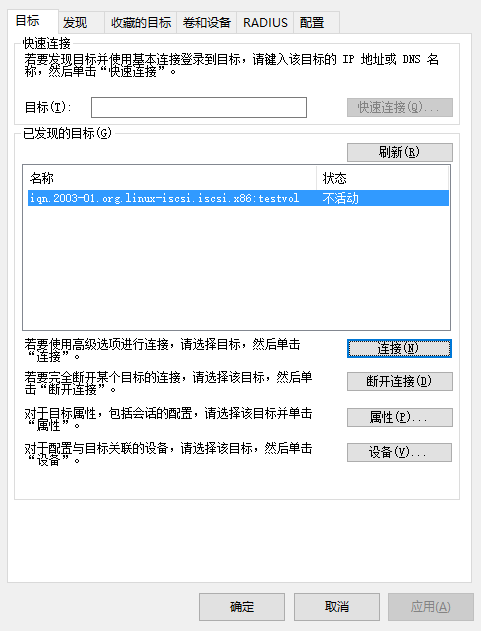

- 22.4 目标

- 22.5 iSCSI 目标属性

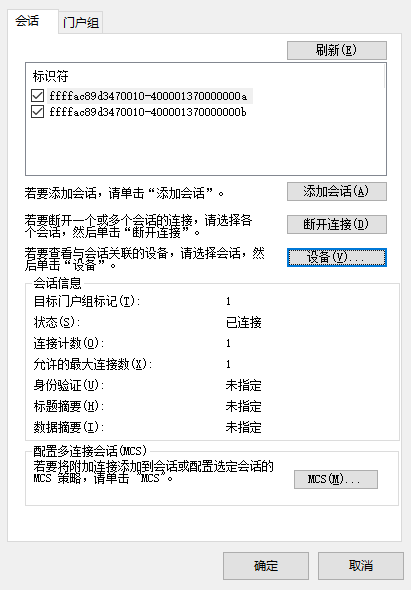

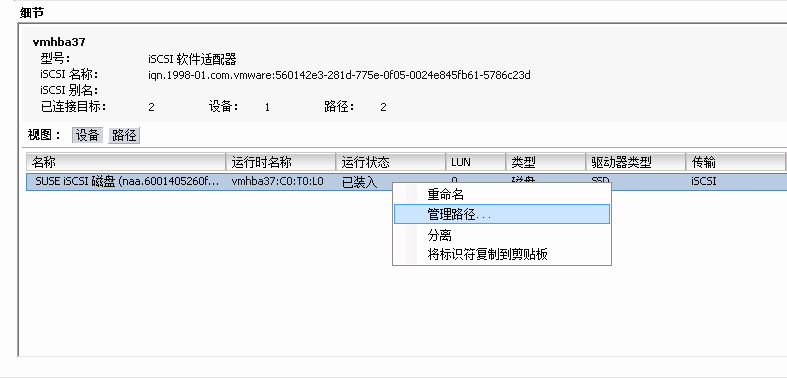

- 22.6 设备详细信息

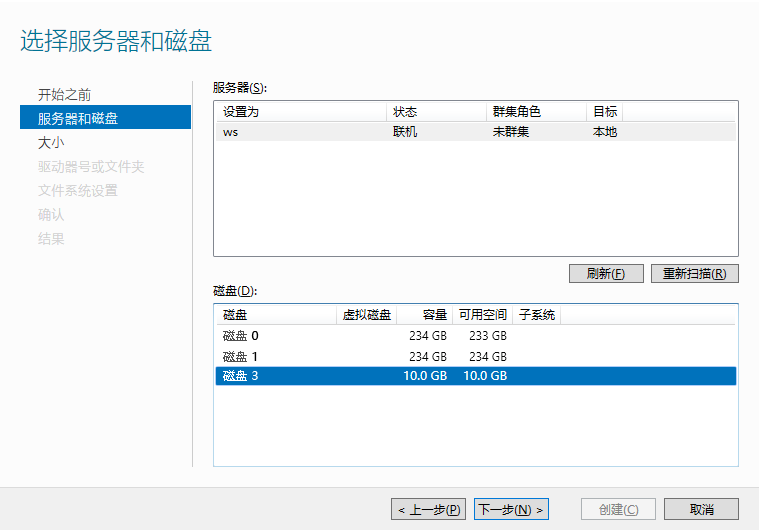

- 22.7 新建卷向导

- 22.8 脱机磁盘提示

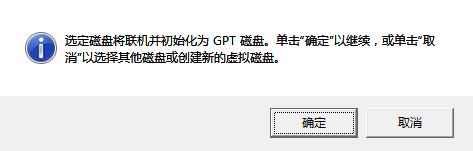

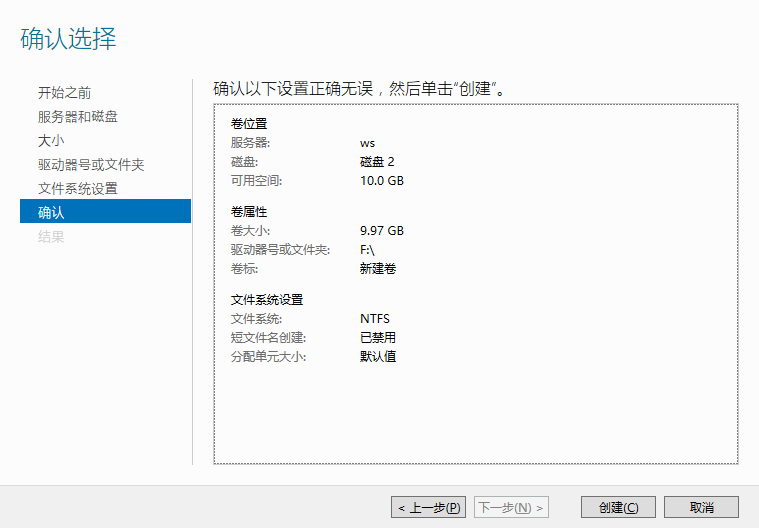

- 22.9 确认选择的卷设置

- 22.10 iSCSI 发起程序属性

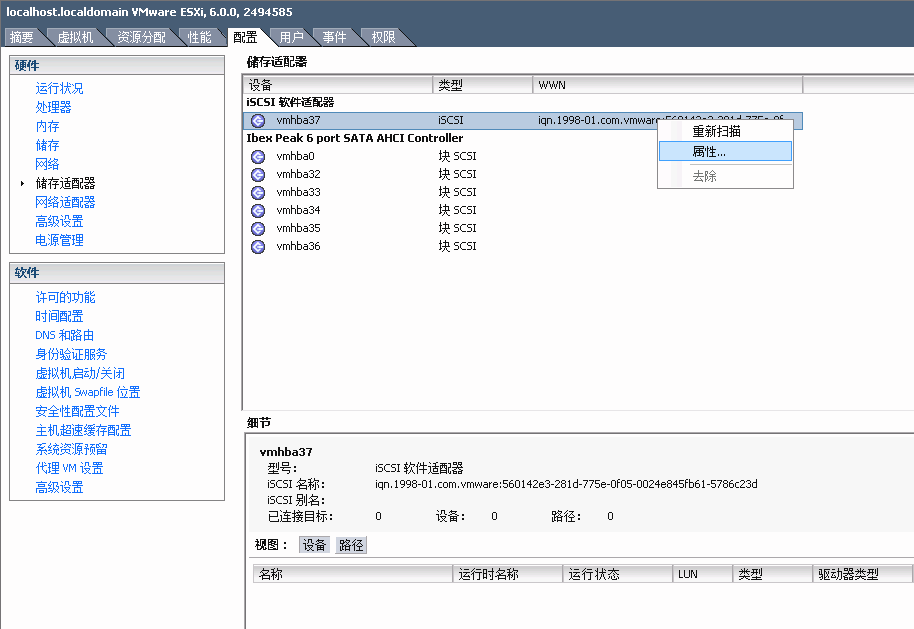

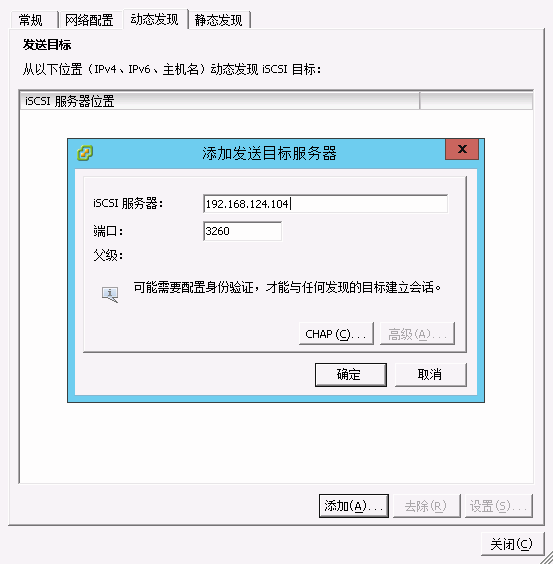

- 22.11 添加目标服务器

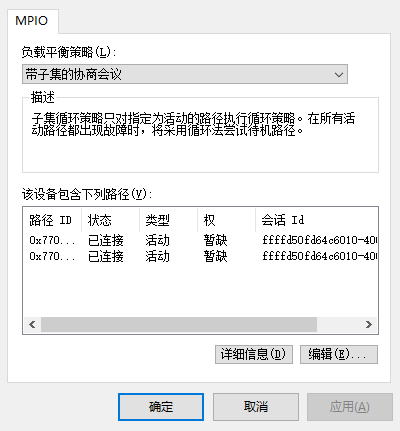

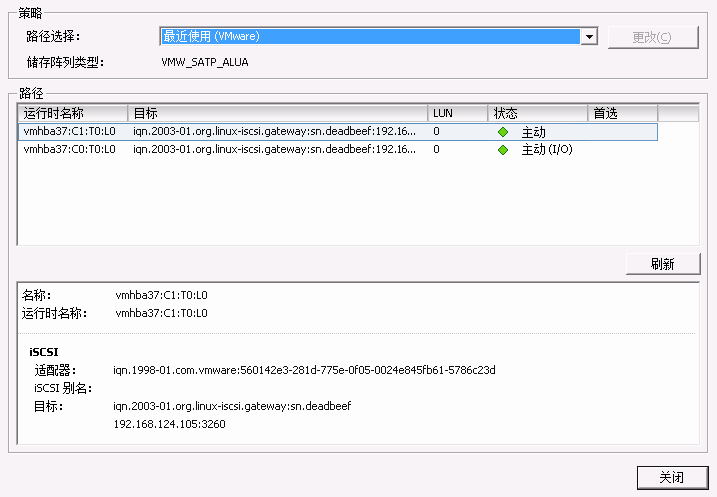

- 22.12 管理多路径设备

- 22.13 多路径的路径列表

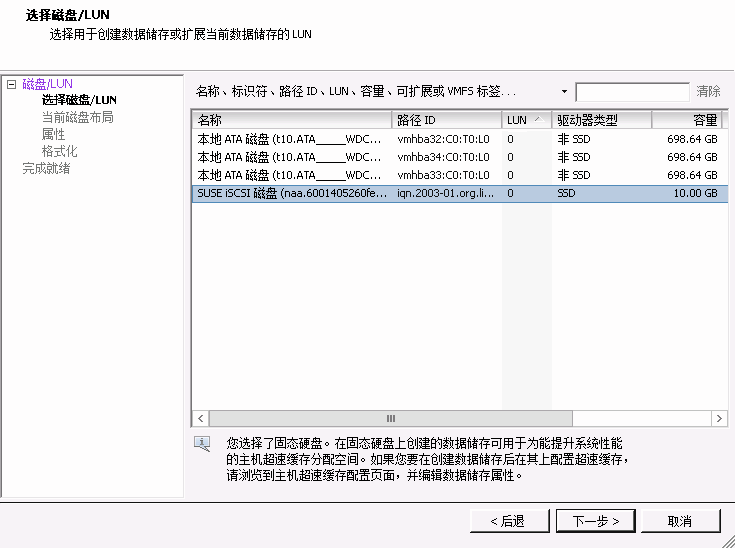

- 22.14 “添加储存”对话框

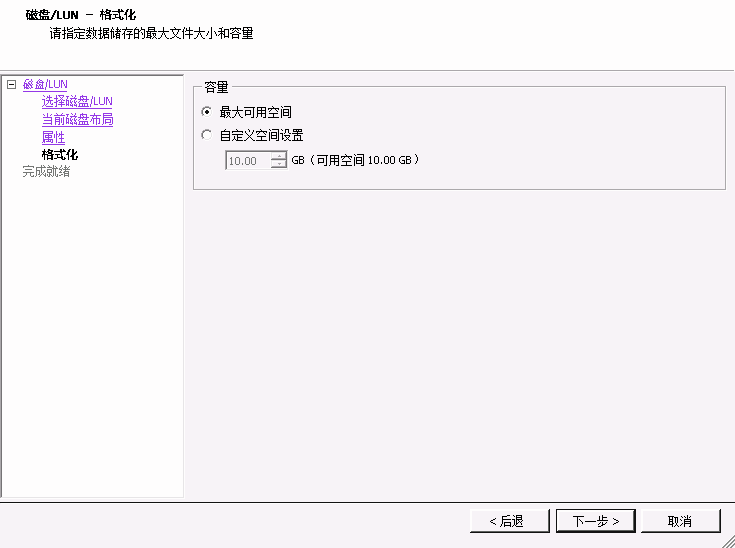

- 22.15 自定义空间设置

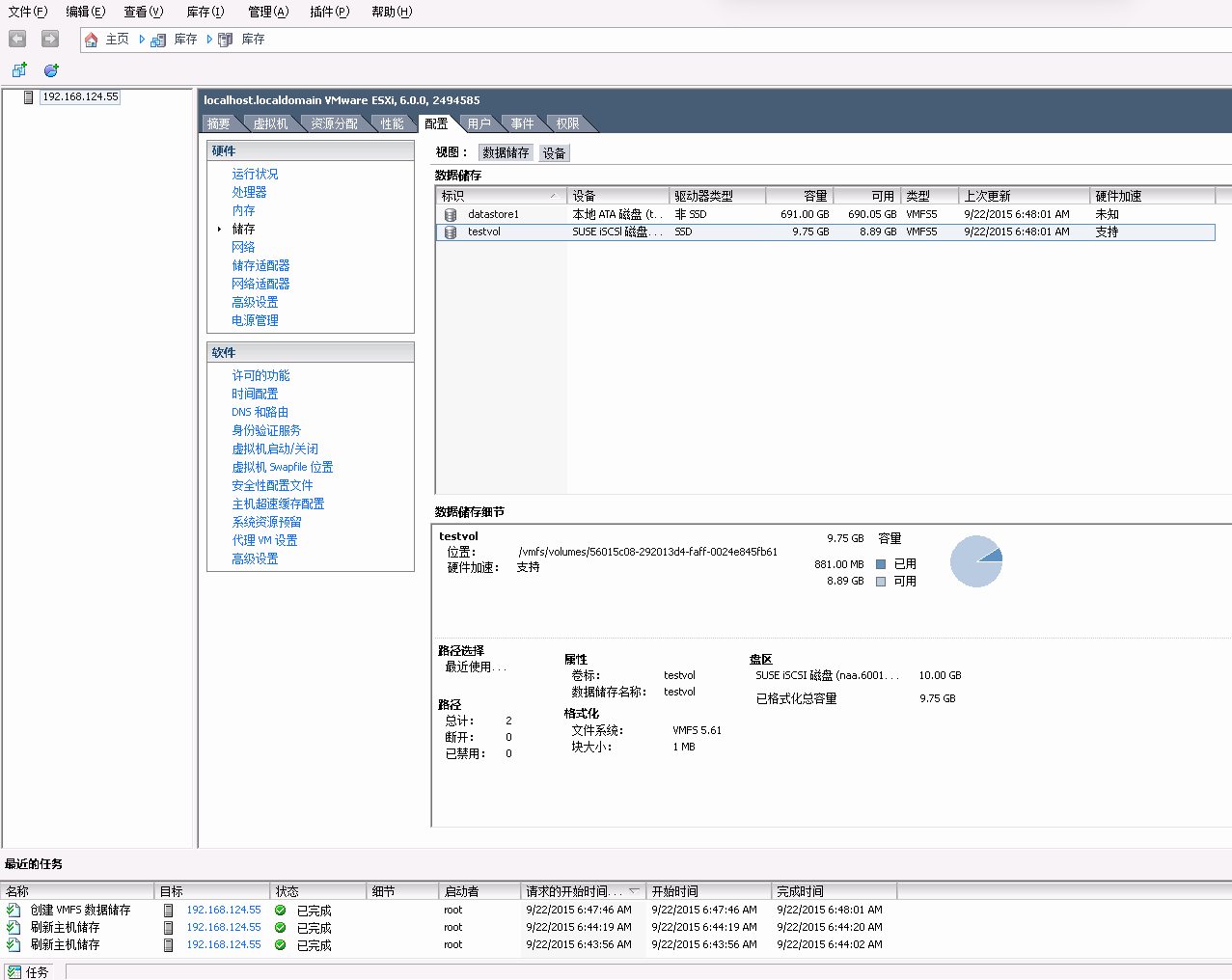

- 22.16 iSCSI 数据存储概述

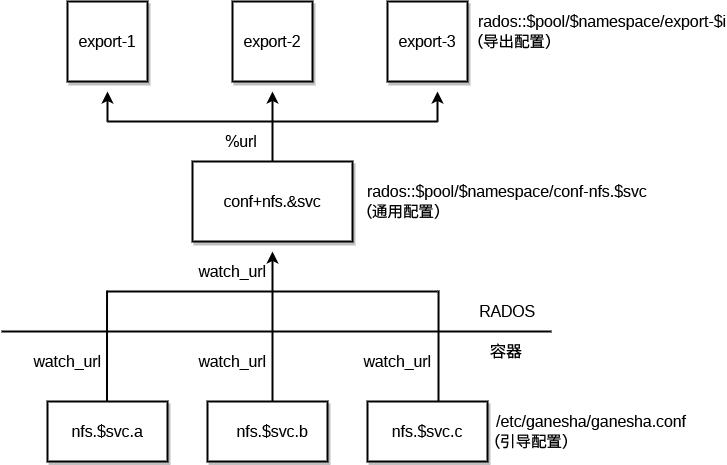

- 25.1 NFS Ganesha 结构

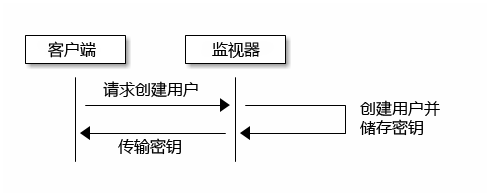

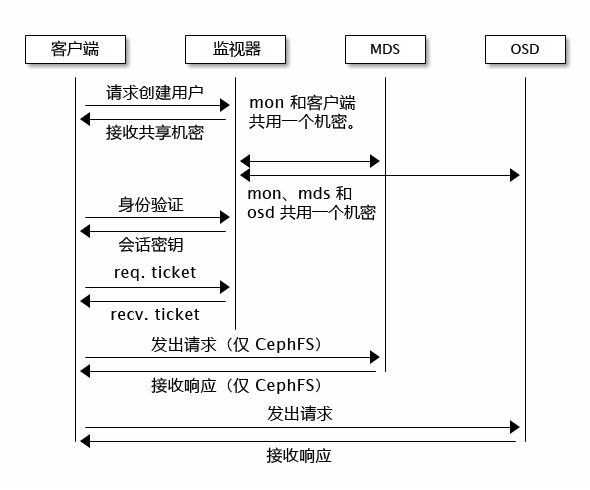

- 30.1

cephx基本身份验证 - 30.2

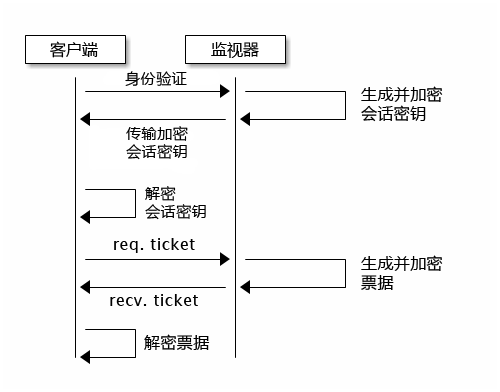

cephx身份验证 - 30.3

cephx身份验证 - MDS 和 OSD

版权所有 © 2020–2025 SUSE LLC 和贡献者。保留所有权利。

除非另有说明,否则本文档根据知识共享署名-相同方式共享 4.0 国际 (Creative Commons Attribution-ShareAlike 4.0 International, CC-BY-SA 4.0) 获得许可:https://creativecommons.org/licenses/by-sa/4.0/legalcode。

有关 SUSE 商标,请参见 http://www.suse.com/company/legal/。所有第三方商标均是其各自所有者的财产。商标符号(®、™ 等)代表 SUSE 及其关联公司的商标。星号 (*) 代表第三方商标。

本指南力求涵盖所有细节,但这不能确保本指南准确无误。SUSE LLC 及其关联公司、作者和译者对于可能出现的错误或由此造成的后果皆不承担责任。

关于本指南 #

本指南重点介绍在部署基本 Ceph 集群(第 2 天操作)之后,作为管理员需要处理的例行任务。此外,还介绍了访问 Ceph 集群中所存储数据的所有支持方法。

SUSE Enterprise Storage 7 是 SUSE Linux Enterprise Server 15 SP2 的一个扩展。它融合了 Ceph (http://ceph.com/) 存储项目的功能与 SUSE 的企业工程和支持。SUSE Enterprise Storage 7 为 IT 组织提供了部署分布式存储体系结构的能力,该体系结构可支持使用市售硬件平台的许多用例。

1 可用文档 #

我们的产品文档可从 https://documentation.suse.com 获取,您也可以在此处找到最新更新,以及浏览或下载各种格式的文档。最新的文档更新以英语版本提供。

此外,您安装的系统的 /usr/share/doc/manual 下会提供产品文档。该文档包含在名为

ses-manual_LANG_CODE的 RPM 包中。如果系统上尚未安装该包,请进行安装,例如:

root # zypper install ses-manual_en针对本产品提供的文档如下:

- 部署指南

本指南重点介绍如何部署基本 Ceph 集群以及如何部署其他服务。此外,还介绍了从先前的产品版本升级到 SUSE Enterprise Storage 7 的步骤。

- 管理和操作指南

本指南重点介绍在部署基本 Ceph 集群(第 2 天操作)之后,作为管理员需要处理的例行任务。此外,还介绍了访问 Ceph 集群中所存储数据的所有支持方法。

- 安全强化指南

本指南重点介绍如何确保集群的安全。

- 查错指南

本指南将带您了解运行 SUSE Enterprise Storage 7 时的各种常见问题以及与 Ceph 或对象网关等相关组件有关的其他问题。

- SUSE Enterprise Storage for Windows 指南

本指南介绍如何使用 Windows 驱动程序集成、安装和配置 Microsoft Windows 环境和 SUSE Enterprise Storage。

2 提供反馈 #

欢迎您对此文档提供反馈和贡献。反馈渠道包括:

- 服务请求和支持

有关产品可用的服务和支持选项,请参见 http://www.suse.com/support/。

要创建服务请求,需在 SUSE Customer Center 注册一个 SUSE 订阅。请转到 https://scc.suse.com/support/requests 并登录,然后单击。

- Bug 报告

在 https://bugzilla.suse.com/ 中报告文档问题。报告问题需要 Bugzilla 帐户。

要简化此过程,可以使用本文档 HTML 版本中的标题旁边的 链接。这样,就会在 Bugzilla 中预先选择正确的产品和类别,并添加当前章节的链接。然后,您便可以立即开始键入 Bug 报告。

- 贡献

要帮助改进本文档,请使用本文档 HTML 版本中的标题旁边的链接。这些链接会将您转到 GitHub 上的源代码,在其中可以创建拉取请求。参与贡献需要 GitHub 帐户。

有关本文档使用的文档环境的详细信息,请参见储存库的 README(网址:https://github.com/SUSE/doc-ses)。

- 邮件

您也可以将有关本文档中的错误以及相关反馈发送至:<doc-team@suse.com>。请在其中包含文档标题、产品版本和文档发布日期。此外,请包含相关的章节号和标题(或者提供 URL),并提供问题的简要说明。

3 文档约定 #

本文档中使用了以下通知和排版约定:

/etc/passwd:目录名称和文件名PLACEHOLDER:将会使用实际的值替换 PLACEHOLDER

PATH:环境变量ls、--help:命令、选项和参数user:用户或组的名称package_name:软件包的名称

Alt、Alt–F1:按键或组合键。按键以大写字母显示,与键盘上的一样。

、 › :菜单项,按钮

AMD/Intel 本段仅与 Intel 64/AMD64 体系结构有关。箭头标记文本块的开始位置和结束位置。

IBM Z, POWER 本段内容仅与

IBM Z和POWER体系结构相关。箭头标记文本块的开始位置和结束位置。第 1 章“示例章节”:到本指南中另一章节的交叉引用。

必须使用

root特权运行的命令。您往往还可以在这些命令前加上sudo命令,以非特权用户身份来运行它们。root #commandtux >sudocommand可以由非特权用户运行的命令。

tux >command注意

警告:警报通知在继续操作之前,您必须了解的不可或缺的信息。向您指出有关安全问题、潜在数据丢失、硬件损害或物理危害的警告。

重要:重要通知在继续操作之前,您必须了解的重要信息。

注意:注意通知额外信息,例如有关软件版本差异的信息。

提示:提示通知有用信息,例如指导方针或实用性建议。

精简通知

额外信息,例如有关软件版本差异的信息。

有用信息,例如指导方针或实用性建议。

4 产品生命周期和支持 #

不同的 SUSE 产品有不同的产品生命周期。要查看 SUSE Enterprise Storage 的确切生命周期日期,请参见 https://www.suse.com/lifecycle/。

4.1 SUSE 支持定义 #

有关我们的支持政策和选项的信息,请参见 https://www.suse.com/support/policy.html 和 https://www.suse.com/support/programs/long-term-service-pack-support.html。

4.2 SUSE Enterprise Storage 支持声明 #

要获得支持,您需要一个适当的 SUSE 订阅。要查看为您提供的具体支持服务,请转到 https://www.suse.com/support/ 并选择您的产品。

支持级别的定义如下:

- L1

问题判定,该技术支持级别旨在提供兼容性信息、使用支持、持续维护、信息收集,以及使用可用文档进行基本查错。

- L2

问题隔离,该技术支持级别旨在分析数据、重现客户问题、隔离问题领域,并针对级别 1 不能解决的问题提供解决方法,或作为级别 3 的准备级别。

- L3

问题解决,该技术支持级别旨在借助工程方法解决级别 2 支持所确定的产品缺陷。

对于签约的客户与合作伙伴,SUSE Enterprise Storage 将为除以下包外的其他所有包提供 L3 支持:

技术预览

声音、图形、字体和作品

需要额外客户合同的包

模块 Workstation Extension 随附的某些包仅享受 L2 支持。

名称以 -devel 结尾的包(包含头文件和类似的开发人员资源)只能同其主包一起接受支持。

SUSE 仅支持使用原始包,即,未发生更改且未重新编译的包。

4.3 技术预览 #

技术预览是 SUSE 提供的旨在让用户大致体验未来创新的各种包、堆栈或功能。随附这些技术预览只是为了提供方便,让您有机会在自己的环境中测试新的技术。非常希望您能提供反馈!如果您测试了技术预览,请联系 SUSE 代表,将您的体验和用例告知他们。您的反馈对于我们的未来开发非常有帮助。

技术预览存在以下限制:

技术预览仍处于开发阶段。因此,它们的功能可能不完备、不稳定,或者在其他方面不适合用于生产。

技术预览不受支持。

技术预览可能仅适用于特定的硬件体系结构。

技术预览的细节和功能可能随时会发生变化。因此,可能无法升级到技术预览的后续版本,而只能进行全新安装。

可随时从产品中删除技术预览。SUSE 不承诺未来将提供此类技术的受支持版本。例如,如果 SUSE 发现某个预览不符合客户或市场的需求,或者不符合企业标准,就可能会删除该预览。

有关产品随附的技术预览的概述,请参见 https://www.suse.com/releasenotes/x86_64/SUSE-Enterprise-Storage/7 上的发行说明。

5 Ceph 贡献者 #

Ceph 项目及其文档是数百个贡献者和组织辛勤工作的成果。有关详细信息,请参见 https://ceph.com/contributors/。

6 本指南中使用的命令和命令提示符 #

作为 Ceph 集群管理员,您需要通过运行特定命令来配置和调整集群行为。您将需要运行以下几种类型的命令:

6.1 与 Salt 相关的命令 #

这些命令可帮助您部署 Ceph 集群节点、同时在数个(或所有)集群节点上运行命令,或在您添加或删除集群节点时为您提供协助。最常用的命令是 ceph-salt 和 ceph-salt config。您需要以 root 身份在 Salt Master 节点上运行 Salt 命令。通过以下提示符来引入这些命令:

root@master # 例如:

root@master # ceph-salt config ls6.2 与 Ceph 相关的命令 #

这些是较低级别的命令,用于在命令行上配置和微调集群及其网关的所有方面,例如 ceph、cephadm、rbd 或 radosgw-admin。

要运行与 Ceph 相关的命令,您需要拥有 Ceph 密钥的读取访问权限,而密钥的用户权限则定义您在 Ceph 环境内的权限。一种方案是以 root 身份(或通过 sudo)运行 Ceph 命令,并使用不受限的默认密钥环“ceph.client.admin.key”。

建议您使用更安全的方案,即为每个管理员用户创建限制性更高的单独密钥,并将其存放在用户可读取的目录中,例如:

~/.ceph/ceph.client.USERNAME.keyring

要使用自定义管理员用户和密钥环,每次运行 ceph 命令(使用 -n client.USER_NAME 和 --keyring PATH/TO/KEYRING 选项)时,都需要指定该密钥的用户名和路径。

为避免出现此情况,请将这些选项包含在各个用户的 ~/.bashrc 文件中的 CEPH_ARGS 变量中。

虽然您可以在任何集群节点上运行与 Ceph 相关的命令,但建议您在管理节点上运行这些命令。本文档使用 cephuser 用户来运行命令,因此通过以下提示符来引入命令:

cephuser@adm > 例如:

cephuser@adm > ceph auth list如果文档指示您在集群节点上以特定角色来运行命令,应通过该提示符来寻址。例如:

cephuser@mon > 6.2.1 运行 ceph-volume #

从 SUSE Enterprise Storage 7 开始,Ceph 服务以容器化方式运行。如果您需要在 OSD 节点上运行 ceph-volume,则需要在其前面追加 cephadm 命令,例如:

cephuser@adm > cephadm ceph-volume simple scan6.3 一般的 Linux 命令 #

与 Ceph 无关的 Linux 命令(例如 mount、cat 或 openssl)可通过 cephuser@adm > 或 root # 提示符来引入,具体取决于相关命令所需的特权。

6.4 附加信息 #

有关 Ceph 密钥管理的详细信息,请参见第 30.2 节 “主要管理”。

第 I 部分 Ceph Dashboard #

- 1 关于 Ceph Dashboard

Ceph Dashboard 是一个内置的基于 Web 的 Ceph 管理和监控应用,负责管理集群的各个方面和对象。在Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3 “部署 Ceph 集群”中部署基本集群后,将自动启用该仪表盘。

- 2 仪表盘的 Web 用户界面

要登录 Ceph Dashboard,请将浏览器指向其 URL,包括端口号。运行以下命令可查找地址:

- 3 管理 Ceph Dashboard 用户和角色

有关在命令行上通过 Ceph 命令执行仪表盘用户管理的说明,请参见第 11 章 “在命令行上管理用户和角色”。

- 4 查看集群内部

您可以通过菜单项查看有关 Ceph 集群主机、库存、Ceph Monitor、服务、OSD、配置、CRUSH 索引、Ceph Manager、日志和监控文件的详细信息。

- 5 管理存储池

有关 Ceph 存储池的更多一般信息,请参见第 18 章 “管理存储池”。有关纠删码存储池特定的信息,请参见第 19 章 “纠删码存储池”。

- 6 管理 RADOS 块设备

要列出所有可用的 RADOS 块设备 (RBD),请点击主菜单中的 › 。

- 7 管理 NFS Ganesha

有关 NFS Ganesha 的更多一般信息,请参见第 25 章 “NFS Ganesha”。

- 8 管理 CephFS

要查看有关 CephFS 的详细信息,请参见第 23 章 “群集式文件系统”。

- 9 管理对象网关

开始之前,在尝试访问 Ceph Dashboard 上的对象网关前端时,您可能会收到以下通知:

- 10 手动配置

本节为更喜欢在命令行上手动配置仪表盘设置的用户提供了较深入的信息。

- 11 在命令行上管理用户和角色

本节说明如何管理 Ceph Dashboard 使用的用户帐户。该工具可帮助您创建或修改用户帐户,以及设置正确的用户角色和权限。

1 关于 Ceph Dashboard #

Ceph Dashboard 是一个内置的基于 Web 的 Ceph 管理和监控应用,负责管理集群的各个方面和对象。在Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3 “部署 Ceph 集群”中部署基本集群后,将自动启用该仪表盘。

Ceph Dashboard for SUSE Enterprise Storage 7 添加了更多基于 Web 的管理功能(包括对 Ceph Manager 的监控和应用管理),让 Ceph 管理变得更轻松。现在,您不必了解复杂的 Ceph 相关命令,便可轻松管理和监控您的 Ceph 集群。您可以使用 Ceph Dashboard 的直观界面,也可以使用其内置 REST API。

Ceph Dashboard 模块使用 ceph-mgr 托管的 Web 服务器直观呈现有关 Ceph 集群的信息和统计数据。有关 Ceph Manager 的更多详细信息,请参见Book “部署指南”, Chapter 1 “SES 和 Ceph”, Section 1.2.3 “Ceph 节点和守护进程”。

2 仪表盘的 Web 用户界面 #

2.1 登录 #

要登录 Ceph Dashboard,请将浏览器指向其 URL,包括端口号。运行以下命令可查找地址:

cephuser@adm > ceph mgr services | grep dashboard

"dashboard": "https://host:port/",该命令将返回 Ceph Dashboard 所在的 URL。如果您有与此命令相关的问题,请参见Book “Troubleshooting Guide”, Chapter 10 “Troubleshooting the Ceph Dashboard”, Section 10.1 “Locating the Ceph Dashboard”。

使用您在集群部署期间创建的身份凭证登录(参见Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.2.9 “配置 Ceph Dashboard 登录身份凭证”)。

如果您不想使用默认的 admin 帐户访问 Ceph Dashboard,请创建拥有管理员权限的自定义用户帐户。有关更多详细信息,请参见第 11 章 “在命令行上管理用户和角色”。

仪表盘用户界面以图形方式分为几个区块:屏幕右上方的实用程序菜单,左侧的主菜单以及主要的内容窗格。

2.4 内容窗格 #

内容窗格占据仪表盘屏幕的主要部分。仪表盘首页上显示了很多有用的控件,为您提供集群当前状态、容量及性能的概要信息。

2.5 常用 Web UI 功能 #

在 Ceph Dashboard 中,您经常会用到列表 — 例如,存储池列表、OSD 节点列表或 RBD 设备列表。所有列表默认每五秒会自动刷新一次。下列常用控件可帮助您管理或调整这些列表:

2.6 仪表盘控件 #

每个仪表盘控件显示与运行中 Ceph 集群特定方面相关的特定状态信息。有些控件是活跃链接,点击它们会将您重定向到其所代表主题的相关详细页面。

有些图形控件会在您将鼠标移到其上时显示更多详细信息。

2.6.1 状态控件 #

控件为您提供有关集群当前状态的简要概览。

显示有关集群健康状况的基本信息。

显示集群节点的总数。

显示运行中 Monitor 数量及其仲裁。

显示 OSD 的总数及处于 up 和 in 状态的 OSD 数量。

显示处于活跃和待机状态的 Ceph Manager 守护进程的数量。

显示运行中对象网关的数量。

显示元数据服务器的数量。

显示配置的 iSCSI 网关的数量。

2.6.2 容量控件 #

控件显示有关存储容量的简要信息。

显示已用与可用基本存储容量的比例。

显示集群中存储的数据对象数量。

显示按照状态分组的归置组图表。

显示集群中存储池的数量。

显示每个 OSD 的平均归置组数量。

2.6.3 性能控件 #

控件提供 Ceph 客户端的基本性能数据。

每秒客户端读写操作次数。

每秒与 Ceph 客户端之间传输的数据量(以字节为单位)。

每秒恢复的数据吞吐量。

显示洗刷(参见第 17.4.9 节 “洗刷归置组”)状态。其状态可以是

inactive、enabled或active。

3 管理 Ceph Dashboard 用户和角色 #

有关在命令行上通过 Ceph 命令执行仪表盘用户管理的说明,请参见第 11 章 “在命令行上管理用户和角色”。

本节说明如何使用仪表盘 Web 用户界面来管理用户帐户。

3.1 列出用户 #

该列表包含每个用户的用户名、全名、电子邮件、已指定角色的列表、角色是否启用以及密码超期日期。

3.2 添加新用户 #

点击表标题左上方的可添加新用户。输入其用户名、密码、全名(可选)和电子邮件。

点击铅笔小图标可为用户指定预定义角色。点击进行确认。

3.3 编辑用户 #

点击表中某个用户对应的行以高亮显示选择。选择,即可编辑该用户的详细信息。点击进行确认。

3.4 删除用户 #

点击表中某个用户对应的行以高亮显示选择。选择旁的下拉按钮,然后从列表中选择,即可删除用户帐户。激活复选框,然后点击进行确认。

3.5 列出用户角色 #

该列表包含每个角色的名称、描述及其是否属于系统角色。

3.6 添加自定义角色 #

点击表标题左上方的可添加新的自定义角色。输入和,然后在旁选择适当的权限。

如果您创建了自定义用户角色,并打算以后使用 ceph-salt purge 命令删除 Ceph

集群,则需要先清除自定义角色。有关详细信息,请参见第 13.9 节 “删除整个 Ceph 集群”。

通过激活主题名称前的复选框,您可以激活针对该主题的所有权限。通过激活复选框,您可以激活针对所有主题的所有权限。

点击进行确认。

3.7 编辑自定义角色 #

点击表中某个自定义角色对应的行以高亮显示选择。选择表标题左上方的,即可编辑自定义角色的描述和权限。点击进行确认。

3.8 删除自定义角色 #

点击表中某个角色对应的行以高亮显示选择,选择旁的下拉按钮,然后从列表中选择,即可删除角色。激活复选框,然后点击进行确认。

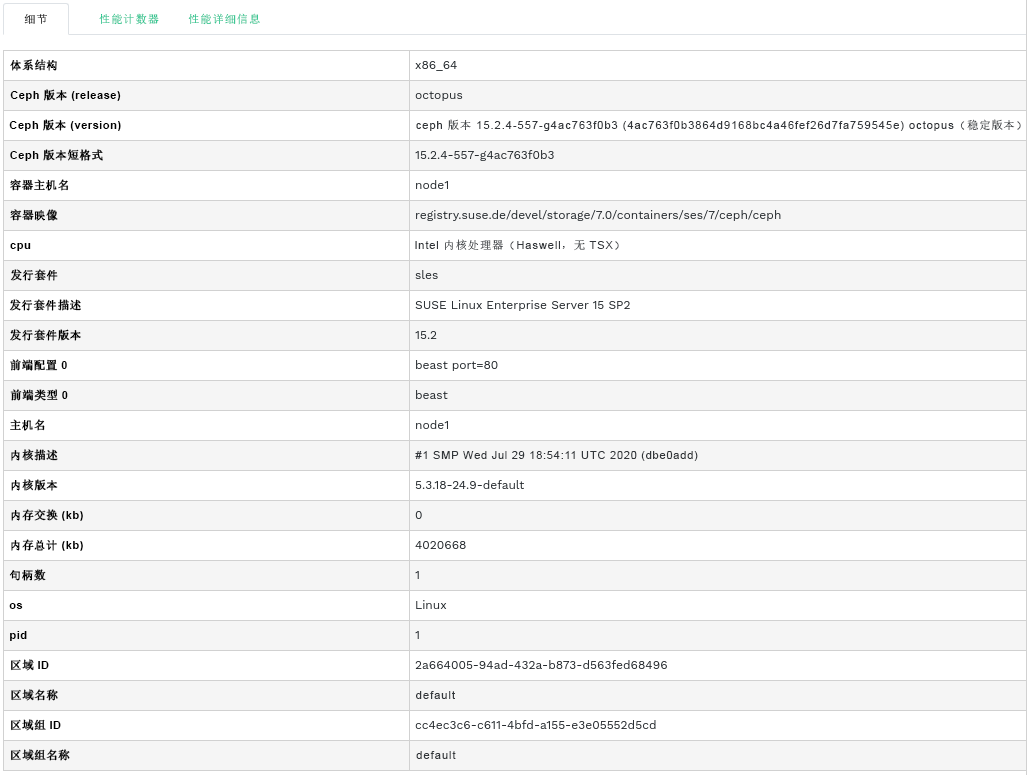

4 查看集群内部 #

您可以通过菜单项查看有关 Ceph 集群主机、库存、Ceph Monitor、服务、OSD、配置、CRUSH 索引、Ceph Manager、日志和监控文件的详细信息。

4.1 查看集群节点 #

点击 › 可查看集群节点列表。

点击列中某个节点名称旁的下拉箭头可查看节点的性能详细信息。

列中会列出每个相关节点上正在运行的所有守护进程。点击守护进程名称可查看其详细配置。

4.2 访问集群库存 #

点击 › 可查看设备列表。该列表包含设备路径、类型、可用性、供应商、型号、大小和 OSD。

点击以在列中选择节点名称。选择后,点击以标识正在运行主机的设备。这会让相应设备上的 LED 闪烁。选择此操作的时长(介于 1、2、5、10 或 15 分钟之间)。点击。

4.3 查看 Ceph Monitor #

点击 ›

可查看具有正在运行的 Ceph Monitor

的集群节点列表。内容窗格分为两个视图:状态和仲裁成员或非仲裁成员。

表显示有关运行中 Ceph Monitor 的一般统计数据,包括以下项目:

集群 ID

monmap 修改时间

monmap 版本编号

仲裁 con

仲裁 mon

所需 con

所需 mon

仲裁成员和非仲裁成员窗格包含每个 Monitor 的名称、排位号、公用 IP

地址和活动会话数。

点击列中的节点名称可查看相关的 Ceph Monitor 配置。

4.4 显示服务 #

点击 › 可查看每个可用服务的详细信息:crash、Ceph

Manager 和 Ceph Monitor。该列表包含容器映像名称、容器映像 ID、正在运行项目的状态、大小以及上次刷新时间。

点击列中某个服务名称旁的下拉箭头可查看守护进程的详细信息。详细信息列表包含主机名、守护进程类型、守护进程 ID、容器 ID、容器映像名称、容器映像 ID、版本号、状态以及上次刷新时间。

4.5 显示 Ceph OSD #

点击 › 可查看具有正在运行的 OSD 守护进程的节点列表。该列表包含每个节点的名称、ID、状态、设备类型、归置组数量、大小、使用率、不同时间的读/写图表和每秒读/写操作次数。

从表标题中的下拉菜单中选择,可打开一个弹出窗口。此窗口包含适用于整个集群的标志列表。您可以激活或停用单个标志,然后点击进行确认。

从表标题中的下拉菜单中选择,可打开一个弹出窗口。此窗口包含适用于整个集群的 OSD 恢复优先级列表。您可以激活首选的优先级配置,并对下面的各个值进行微调。点击进行确认。

点击列中某个节点名称旁的下拉箭头可查看扩展表,其中包含有关设备设置和性能的详细信息。您可以在数个选项卡之间切换,查看、、、各列表、读写操作次数的图形,以及。

点击某个 OSD 节点名称后,将高亮显示表中的对应行。这意味着现在您可以在该节点上执行任务。您可以选择执行以下任何操作:、、、、、、、、、、或。

点击表标题左上方按钮旁的向下箭头,然后选择要执行的任务。

4.5.1 添加 OSD #

要添加新的 OSD,请执行以下步骤:

确认某些集群节点的存储设备的状态为

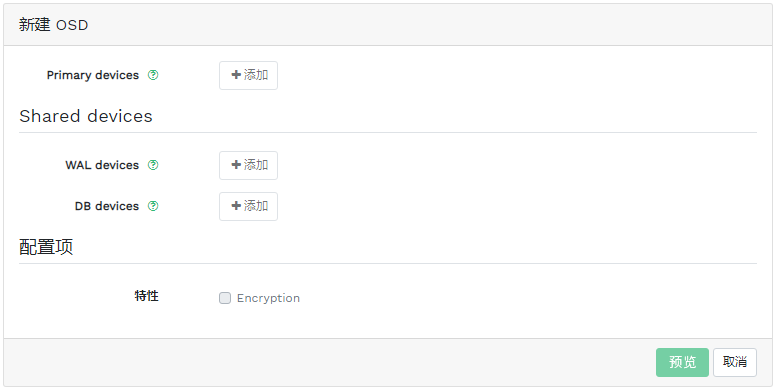

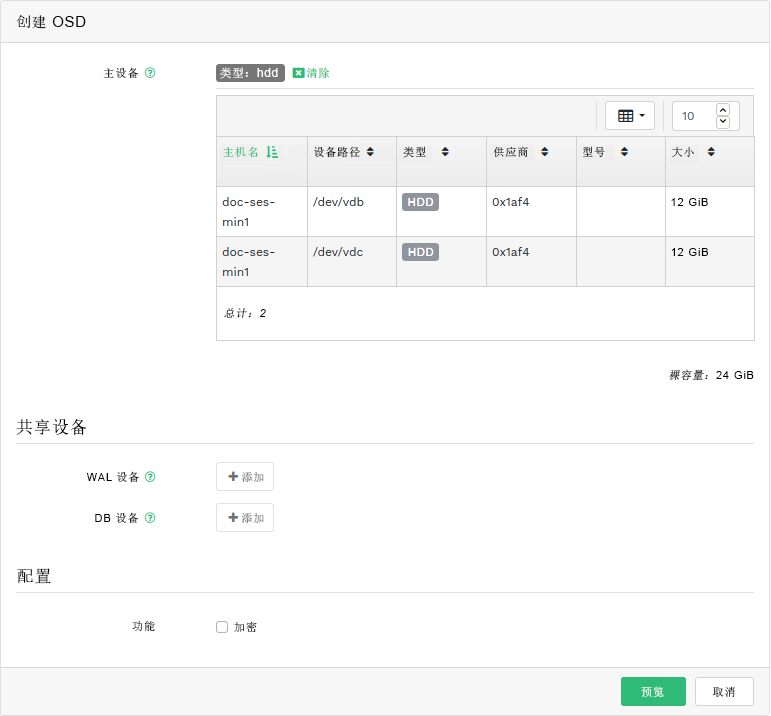

可用。然后点击表标题左上方的向下箭头并选择。此操作将打开 窗口。图 4.9︰ 创建 OSD #要为 OSD 添加主存储设备,请点击。在添加存储设备之前,需要在表的右上方指定过滤准则,例如 。单击进行确认。

图 4.10︰ 添加主设备 #在更新的 窗口中,可以选择添加共享的 WAL 和 BD 设备,或者启用设备加密。

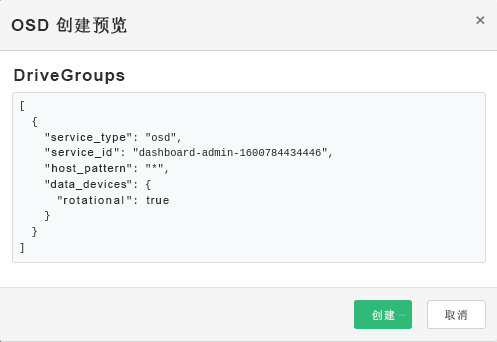

图 4.11︰ 创建添加了主设备的 OSD #点击可查看您之前所添加设备的 DriveGroups 规范预览。单击以确认。

图 4.12︰ #新设备将被添加到 OSD 列表中。

图 4.13︰ 新添加的 OSD #注意OSD 创建过程中无法查看进度。实际创建好 OSD 需要一些时间。部署 OSD 后,它们将显示在列表中。如果您要检查部署状态,请点击 › 查看相关日志。

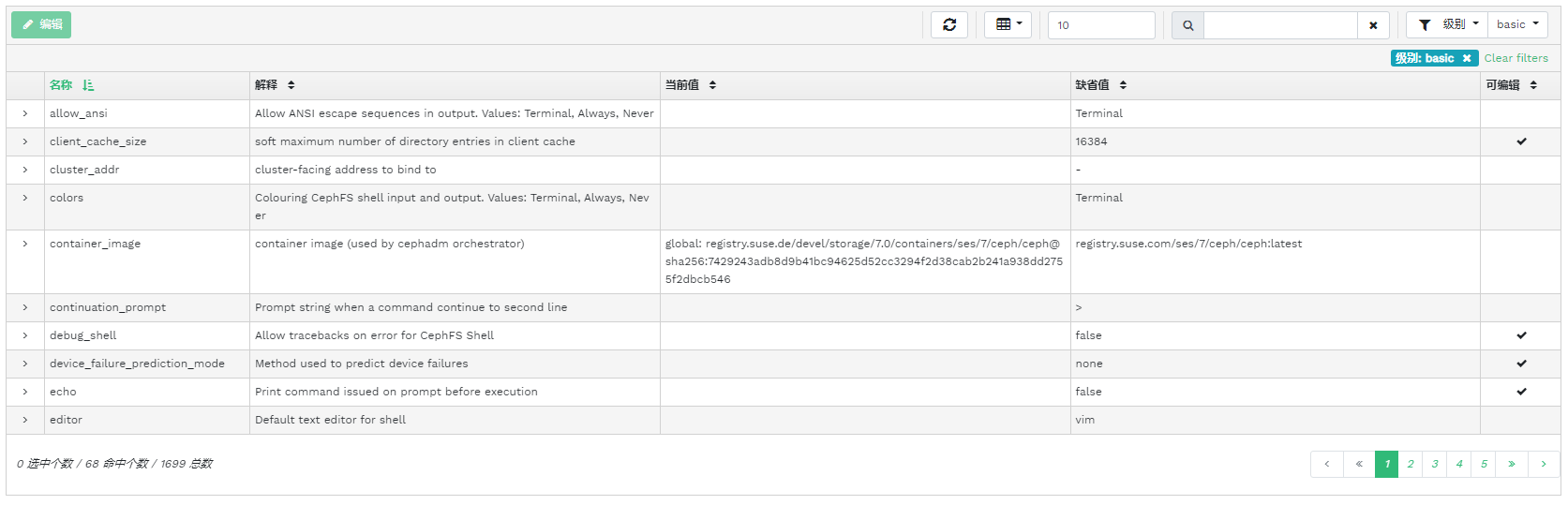

4.6 查看集群配置 #

点击 › 可查看 Ceph 集群配置选项的完整列表。该列表包含选项的名称、其简短描述、当前值和默认值以及选项是否可编辑。

点击列中某个配置选项旁的下拉箭头可查看扩展表,其中包含有关该选项的详细信息,例如其值类型、允许的最小值和最大值、是否可以在运行时更新等。

高亮显示特定选项后,您可以通过点击表标题左上方的按钮来编辑它的值。点击确认更改。

4.7 查看 CRUSH 索引 #

点击 › 可查看集群的 CRUSH 索引。有关 CRUSH 索引的更多一般信息,请参见第 17.5 节 “CRUSH 索引操作”。

点击根、节点或单个 OSD 可查看更多详细信息,例如 CRUSH 权重、索引树的深度、OSD 的设备类型等等。

4.8 查看 Manager 模块 #

点击 › 可查看可用 Ceph Manager 扩展模块的列表。每行包含扩展模块名称以及该扩展模块当前启用与否的信息。

点击列中某个模块旁的下拉箭头,可在下面的表中查看包含详细设置的扩展表。点击表标题左上方的按钮可进行编辑。点击确认更改。

点击表标题左上方按钮旁的下拉箭头可或模块。

4.9 查看日志 #

点击 › 可查看集群最近日志项的列表。每行包含一个时戳、日志项的类型及自身所记录的讯息。

点击选项卡可查看审计子系统的日志项。有关启用或禁用审计的命令,请参见第 11.5 节 “审计 API 请求”。

4.10 查看监控 #

点击 › 可管理和查看有关 Prometheus 告警的详细信息。

如果您启用了 Prometheus,则在此内容窗格中,您可以查看有关、或的详细信息。

如果您未部署 Prometheus,则会显示一个信息标题以及转到相关文档的链接。

5 管理存储池 #

要列出所有可用的存储池,请点击主菜单中的。

该列表显示每个存储池的名称、类型、相关应用、归置组状态、副本个数、上次更改时间、纠删码配置、crush 规则集、使用率以及读/写统计数据。

点击列中某个存储池名称旁的下拉箭头可查看扩展表,其中包含有关存储池的详细信息,例如一般详细信息、性能详细信息和配置。

5.1 添加新存储池 #

要添加新存储池,请点击存储池表左上方的。在存储池表单中,您可以输入存储池的名称、类型、其应用、压缩模式和配额(包括字节数上限和对象数量上限)。存储池表单会自行预先计算最适合此特定存储池的归置组数量。计算以集群中的 OSD 数量和选定存储池类型及其特定设置为依据。如果手动设置了归置组数量,计算出的数量会替换设置的数量。点击进行确认。

5.2 删除存储池 #

要删除存储池,请选择并高亮显示表中该存储池对应的行。点击按钮旁的下拉箭头,然后点击。

5.3 编辑存储池的选项 #

要编辑存储池选项,请选择表中该存储池对应的行,然后点击存储池表左上方的。

您可以更改存储池的名称、增加归置组的数量、更改存储池的应用列表和压缩设置。点击进行确认。

6 管理 RADOS 块设备 #

要列出所有可用的 RADOS 块设备 (RBD),请点击主菜单中的 › 。

该列表显示有关设备的简要信息,例如设备名称、相关存储池名称、名称空间、设备大小、设备上的对象数量和大小、有关详细信息供应的详细信息以及父项。

6.1 查看有关 RBD 的详细信息 #

要查看某个设备的更多详细信息,请点击表中对应的行:

6.2 查看 RBD 的配置 #

要查看某个设备的详细配置,请点击表中对应的行,然后点击下方表中的选项卡:

6.3 创建 RBD #

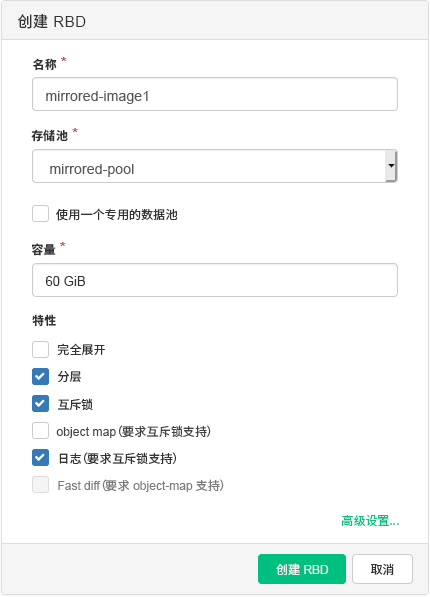

要添加新设备,请点击表标题左上方的,然后在 屏幕上执行以下操作:

输入新设备的名称。有关命名限制,请参见Book “部署指南”, Chapter 2 “硬件要求和建议”, Section 2.11 “名称限制”。

选择要在其中创建新 RBD 设备且指定了

rbd应用的存储池。指定新设备的大小。

为设备指定其他选项。要微调设备参数,请点击,然后输入对象大小、条带单元或条带个数的值。要输入服务质量 (QoS) 限制,请点击,然后输入限制。

点击 进行确认。

6.4 删除 RBD #

要删除设备,请选择表中该设备对应的行。点击按钮旁的下拉箭头,然后点击。点击 确认删除。

删除 RBD 的操作无法撤消。如果您选择将设备,那么稍后还可以将其恢复,只需在主表的选项卡上选择该设备,然后点击表标题左上方的。

6.5 创建 RADOS 块设备快照 #

要创建 RADOS 块设备快照,请选择表中该设备对应的行,将会显示详细的配置内容窗格。选择选项卡,然后点击表标题左上方的。输入快照的名称,然后点击进行确认。

选择快照后,您可以在设备上执行其他操作,例如重命名、保护、克隆、复制或删除。可根据当前快照恢复设备的状态。

6.6 RBD 镜像 #

RADOS 块设备映像可以在两个 Ceph 集群之间异步镜像。您可以使用 Ceph Dashboard 在两个或更多集群之间配置 RBD 映像复制。此功能有两种模式:

- 基于日志

此模式使用 RBD 日志映像功能来确保集群之间的复制在时间点和崩溃时保持一致。

- 基于快照

此模式使用定期安排或手动创建的 RBD 映像镜像快照,以在集群之间复制崩溃时保持一致的 RBD 映像。

镜像是基于对等集群中的每个存储池进行配置的,可以对存储池中的特定映像子集进行配置,也可以配置为在仅使用基于日志的镜像时自动镜像存储池中的所有映像。

镜像是使用 rbd 命令配置的,默认情况下,SUSE Enterprise Storage 7

中会安装该应用。rbd-mirror

守护进程负责从远程对等集群提取映像更新,并将它们应用于本地集群中的映像。有关启用

rbd-mirror

守护进程的详细信息,请参见第 6.6.2 节 “启用 rbd-mirror 守护进程”。

根据复制需求,RBD 块设备镜像可以配置为单向或双向复制:

- 单向复制

当数据仅会从主集群镜像到次集群时,

rbd-mirror守护进程仅在次集群上运行。- 双向复制

当数据从一个集群上的主映像镜像到另一个集群上的非主映像(反之亦然)时,

rbd-mirror守护进程将在两个集群上运行。

rbd-mirror 守护进程的每个实例都必须能够同时连接到本地和远程

Ceph 集群,例如所有 Monitor 和 OSD 主机。此外,网络必须在两个数据中心之间有足够的带宽来处理镜像工作负载。

6.6.1 配置主集群和次集群 #

主集群是用于创建包含映像的原始存储池的集群。次集群是用于从主集群复制存储池或映像的集群。

在复制上下文中,主与次这两个术语有可能是相对的,因为相较于集群来说,它们与单个存储池更为相关。例如,在双向复制中,可将一个存储池从主集群镜像到次集群,与此同时,也可以将另一个存储池从次集群镜像到主集群。

6.6.2 启用 rbd-mirror 守护进程 #

以下过程说明如何使用 rbd 命令来执行配置镜像的基本管理任务。镜像在 Ceph 集群中逐池进行配置。

两个对等集群上都应执行存储池配置步骤。为清楚起见,这些过程假设名为“primary”和“secondary”的两个集群可从单台主机访问。

rbd-mirror 守护进程负责执行实际的集群数据复制。

重命名

ceph.conf和密钥环文件,并将其从主要主机复制到次要主机:cephuser@secondary >cp /etc/ceph/ceph.conf /etc/ceph/primary.confcephuser@secondary >cp /etc/ceph/ceph.admin.client.keyring \ /etc/ceph/primary.client.admin.keyringcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.conf \ /etc/ceph/secondary.confcephuser@secondary >scp PRIMARY_HOST:/etc/ceph/ceph.client.admin.keyring \ /etc/ceph/secondary.client.admin.keyring要使用

rbd针对存储池启用镜像,请指定mirror pool enable、存储池名称和镜像模式:cephuser@adm >rbd mirror pool enable POOL_NAME MODE注意镜像模式可以是

image或pool。例如:cephuser@secondary >rbd --cluster primary mirror pool enable image-pool imagecephuser@secondary >rbd --cluster secondary mirror pool enable image-pool image在 Ceph Dashboard 上,导航到 › 。表的左侧会显示处于活跃状态的运行中

rbd-mirror守护进程及其健康状况。图 6.6︰ 正在运行的rbd-mirror守护进程 #

6.6.3 禁用镜像 #

要使用 rbd 针对存储池禁用镜像,请指定 mirror pool

disable 命令和存储池名称:

cephuser@adm > rbd mirror pool disable POOL_NAME使用这种方法对存储池禁用镜像时,还会对已为其明确启用镜像的所有映像(该存储池中)禁用镜像。

6.6.4 引导对等 #

为了使 rbd-mirror

发现其对等集群,需要将对等注册到存储池,并需要创建用户帐户。此过程可以使用 rbd 通过

mirror pool peer bootstrap create 和 mirror pool

peer bootstrap import 命令自动完成。

要使用 rbd 手动创建新的引导令牌,请指定 mirror pool peer

bootstrap create 命令、存储池名称以及描述本地集群的可选站点名称:

cephuser@adm > rbd mirror pool peer bootstrap create [--site-name local-site-name] pool-name

mirror pool peer bootstrap create 的输出将是应提供给

mirror pool peer bootstrap import 命令的令牌。例如,在主集群上:

cephuser@adm > rbd --cluster primary mirror pool peer bootstrap create --site-name primary

image-pool eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkL \

W1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1vbl9ob3N0I \

joiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ==

要使用 rbd 命令手动导入另一个集群创建的引导令牌,请指定 mirror pool peer

bootstrap import

命令、存储池名称、所创建令牌的文件路径(或设为“-”以从标准输入读取),以及描述本地集群的可选站点名称和镜像方向(默认设为

rx-tx 以进行双向镜像,但也可设为 rx-only 以进行单向镜像):

cephuser@adm > rbd mirror pool peer bootstrap import [--site-name local-site-name] \

[--direction rx-only or rx-tx] pool-name token-path例如,在次集群上:

cephuser@adm >cat >>EOF < token eyJmc2lkIjoiOWY1MjgyZGItYjg5OS00NTk2LTgwOTgtMzIwYzFmYzM5NmYzIiwiY2xpZW50X2lkIjoicmJkLW \ 1pcnJvci1wZWVyIiwia2V5IjoiQVFBUnczOWQwdkhvQmhBQVlMM1I4RmR5dHNJQU50bkFTZ0lOTVE9PSIsIm1v \ bl9ob3N0IjoiW3YyOjE5Mi4xNjguMS4zOjY4MjAsdjE6MTkyLjE2OC4xLjM6NjgyMV0ifQ== EOFcephuser@adm >rbd --cluster secondary mirror pool peer bootstrap import --site-name secondary image-pool token

6.6.5 删除集群对等 #

要使用 rbd 命令删除镜像对等 Ceph 集群,请指定 mirror pool peer

remove 命令、存储池名称和对等 UUID(可通过 rbd mirror pool

info 命令获得):

cephuser@adm > rbd mirror pool peer remove pool-name peer-uuid6.6.6 在 Ceph Dashboard 中配置存储池复制 #

rbd-mirror 守护进程需要拥有主集群的访问权限,才能镜像

RBD 映像。继续之前,请确保已按照第 6.6.4 节 “引导对等”中的步骤操作。

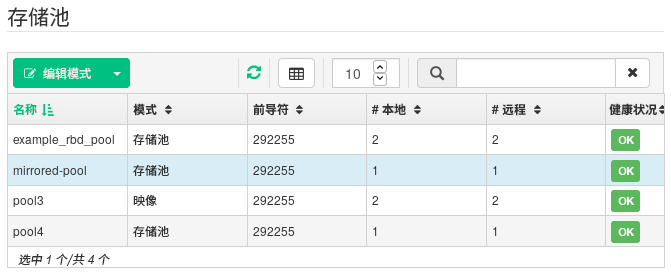

在主和次两个集群上,创建名称相同的存储池并为其指定

rbd应用。有关创建新存储池的更多详细信息,请参见第 5.1 节 “添加新存储池”。图 6.7︰ 创建具有 RBD 应用的存储池 #在主和次两个集群的仪表盘上,导航到 › 。在表右侧点击要复制的存储池的名称,然后点击,并选择复制模式。在此示例中,我们将使用存储池复制模式,也就是说将复制给定存储池中的所有映像。点击进行确认。

图 6.8︰ 配置复制模式 #重要:主集群上的错误或警报更新复制模式后,右侧相应的列中会显示错误或警告标志。这是因为尚未为存储池指定用于复制的同伴用户。对于主集群,请省略此标志,因为我们只需为次集群指定同伴用户。

在次集群的仪表盘上,导航到 › 。通过选择添加存储池镜像对等。提供主集群的详细信息:

图 6.9︰ 添加对等身份凭证 #用于识别主集群的任意唯一字符串,如“primary”。该集群名称不得与实际环境中次集群的名称相同。

您创建作为镜像同伴的 Ceph 用户 ID。此示例中为“rbd-mirror-peer”。

主集群 Ceph Monitor 节点的 IP 地址的逗号分隔列表。

与同伴用户 ID 相关的密钥。您可以通过在主集群上运行以下示例命令来获得该密钥:

cephuser@adm >ceph auth print_key pool-mirror-peer-name

点击进行确认。

图 6.10︰ 副本存储池列表 #

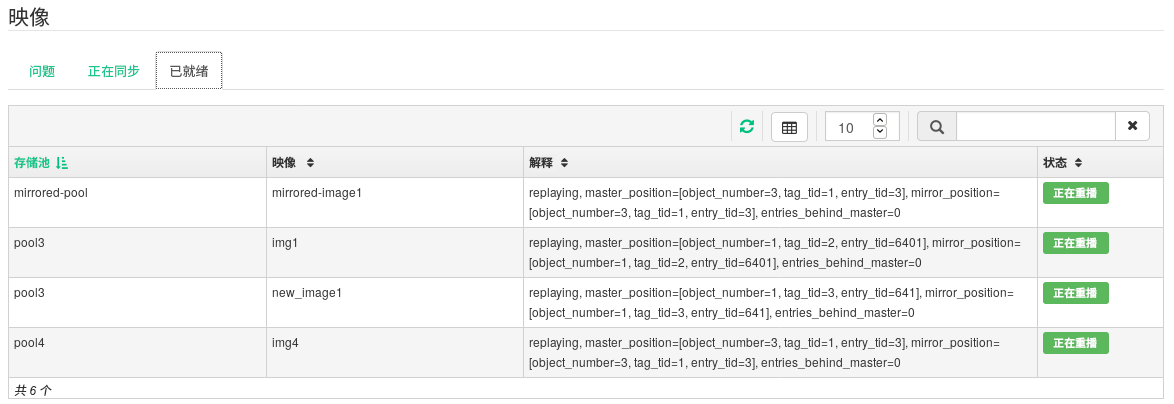

6.6.7 确认 RBD 映像复制是否有效 #

如果 rbd-mirror 守护进程正在运行,在 Ceph

Dashboard 上配置 RBD 映像复制后,就需要确认复制实际上是否有效:

在主集群的 Ceph Dashboard 上创建 RBD 映像,将您已创建用于复制目的的存储池设为其父存储池。为映像启用

互斥锁和日志特性。有关如何创建 RBD 映像的详细信息,请参见第 6.3 节 “创建 RBD”。图 6.11︰ 新 RBD 映像 #创建要复制的映像后,打开次集群的 Ceph Dashboard,并导航到 › 。右侧的表将在 所示数量的映像中反映该变化,并会同步 所示数量的映像。

图 6.12︰ 同步的新 RBD 映像 #在主集群上,将数据写入 RBD 映像。在次集群的 Ceph Dashboard 上,导航到 › ,监视相应映像大小的增长是否与主集群上写入的数据一致。

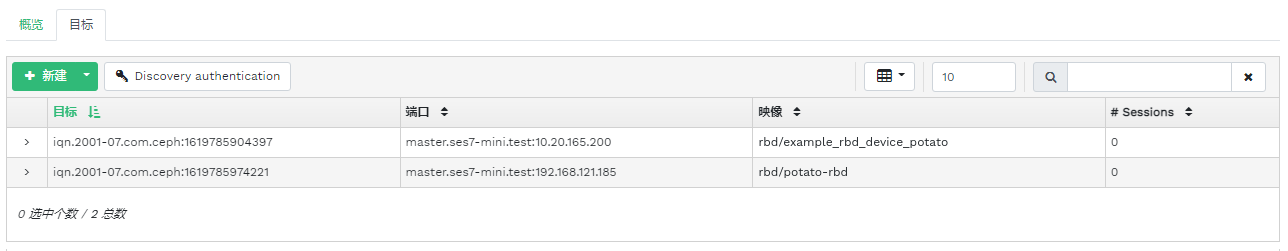

6.7 管理 iSCSI 网关 #

要列出所有可用网关和映射的映像,请点击主菜单中的 › 。选项卡即会打开,列出当前配置的 iSCSI 网关和映射的 RBD 映像。

表列出每个网关的状态、iSCSI 目标数量及会话数量。表列出每个映射的映像的名称、相关存储池名称、后备存储类型及其他统计数据详细信息。

选项卡列出当前配置的 iSCSI 目标。

要查看有关目标的更多详细信息,请点击表中该目标对应行上的下拉箭头。一个树状结构纲要即会打开,列出磁盘、端口、发起程序和组。点击某一项可将其展开并查看详细内容,右侧的表中也可能会显示其相关配置。

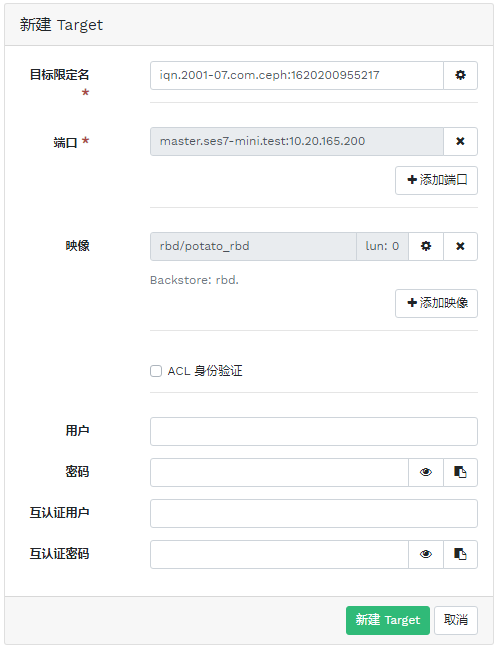

6.7.1 添加 iSCSI 目标 #

要添加新的 iSCSI 目标,请点击表左上方的,并输入所需信息。

输入新网关的目标地址。

点击并从列表中选择一个或多个 iSCSI 门户。

点击并为网关选择一个或多个 RBD 映像。

如果您需要使用身份验证才能访问网关,请激活 复选框并输入身份凭证。选中和之后,您可看到更多高级身份验证选项。

点击进行确认。

6.7.2 编辑 iSCSI 目标 #

要编辑某个现有 iSCSI 目标,请点击表中对应的行,然后点击表左上方的。

然后,您便可以修改 iSCSI 目标、添加或删除端口,以及添加或删除相关 RBD 映像。您还可以调整网关的身份验证信息。

6.7.3 删除 iSCSI 目标 #

要删除 iSCSI 目标,请选择表中对应的行并点击按钮旁的下拉箭头,然后选择。激活,然后点击进行确认。

6.8 RBD 服务质量 (QoS) #

QoS 选项可在不同级别配置。

全局

基于每个存储池

基于每个映像

全局配置位于列表顶部,将用于所有新创建的 RBD 映像,以及不会覆盖存储池或 RBD 映像层级相应值的映像。全局指定的选项值可能会被基于每个存储池或映像设置的值覆盖。针对某个存储池指定的选项将应用到该存储池的所有 RBD 映像,除非被针对某个映像设置的配置选项所覆盖。对映像指定的选项将覆盖对存储池指定的选项以及全局指定的选项。

因此可以如此操作:全局定义默认值,对默认值进行调整以适合特定存储池的所有 RBD 映像,然后覆盖单个 RBD 映像的存储池配置。

6.8.1 全局配置选项 #

要全局配置 RADOS 块设备选项,请从主菜单中选择 › 。

要列出所有可用的全局配置选项,请在旁从下拉菜单中选择。

在搜索字段中过滤

rbd_qos,以过滤表的结果。QoS 的所有可用配置选项即会列出。要更改某个值,请点击表中对应的行,然后选择表左上方的。对话框包含 6 个不同的字段供您指定值。在 文本框中,RBD 配置选项值是必填的。

注意此对话框与其他对话框不同,不允许您使用方便的单位指定值。您只能使用字节或 IOPS 单位设置这些值,具体取决于您要编辑的选项。

6.8.2 针对新存储池配置选项 #

要创建新存储池并对其配置 RBD 配置选项,请点击 › 。选择作为存储池类型。然后,您需要为存储池添加

rbd 应用标记,这样才能配置 RBD QoS 选项。

对于纠删码存储池是无法配置 RBD QoS 配置选项的。要为纠删码存储池配置 RBD QoS 选项,您需要编辑 RBD 映像的副本元数据池。该配置随后将应用于该映像的纠删码数据池。

6.8.3 针对现有存储池配置选项 #

要对某个现有存储池配置 RBD QoS 选项,请点击,然后点击表中该存储池对应的行,并选择表左上方的。

对话框中应该就会显示 部分,下面是 部分。

如果 和 部分均未显示,则可能是因为您正在编辑无法用于设置 RBD 配置选项的纠删码池,或该存储池未配置为供 RBD 映像使用。在下一个案例中,将为存储池指定 应用标记,相应的配置部分将会显示。

6.8.4 配置选项 #

点击 展开配置选项。所有可用选项的列表即会显示。文本框中已显示配置选项的单位。对于任何每秒字节数 (BPS) 选项,您可以选择使用“1M”或“5G”之类的缩写。系统会自动将其转换为对应的“1 MB/s”和“5 GB/s”。

点击每个文本框右侧的重设置按钮,将删除对该存储池设置的所有值。此操作不会删除全局配置或对 RBD 映像配置的选项的配置值。

6.8.5 使用新 RBD 映像创建 RBD QoS 选项 #

要创建 RBD 映像并对该映像设置 RBD QoS 选项,请选择 › ,然后点击。点击 可展开高级配置部分。点击 可打开所有可用配置选项。

6.8.6 编辑现有映像的 RBD QoS 选项 #

要编辑现有映像的 RBD QoS 选项,请选择 › ,然后点击表中该存储池对应的行,最后点击。编辑对话框随即显示。点击 可展开高级配置部分。点击 可打开所有可用配置选项。

6.8.7 在复制或克隆映像时更改配置选项 #

如果克隆或复制了 RBD 映像,对该特定映像设置的值默认也将被复制。如果您想在复制或克隆期间更改这些值,可通过在复制/克隆对话框中指定更新的配置值来进行更改,此过程与创建或编辑 RBD 映像时的方式相同。执行此操作只能设置(或重设置)所复制或克隆的 RBD 映像的值,无法更改来源 RBD 映像配置,也无法更改全局配置。

如果您选择在复制/克隆时重设置选项值,系统将不会对该映像设置该选项的值。这意味着系统将使用为父存储池指定的该选项的任何值(如果为父存储池配置了相应值)。如果没有为父存储池配置相应值,则将使用全局默认值。

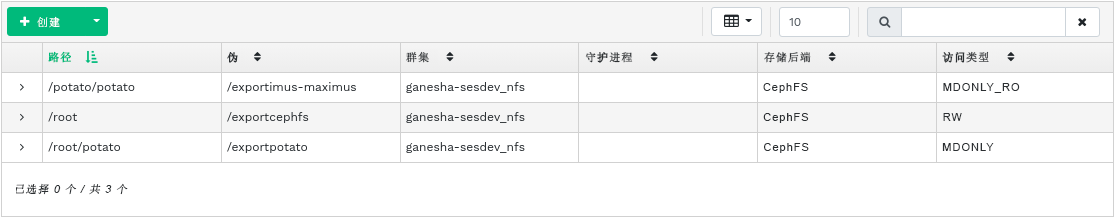

7 管理 NFS Ganesha #

要列出所有可用的 NFS 导出项,请点击主菜单中的 。

该列表会显示每个导出项的目录、守护进程主机名、存储后端类型以及访问类型。

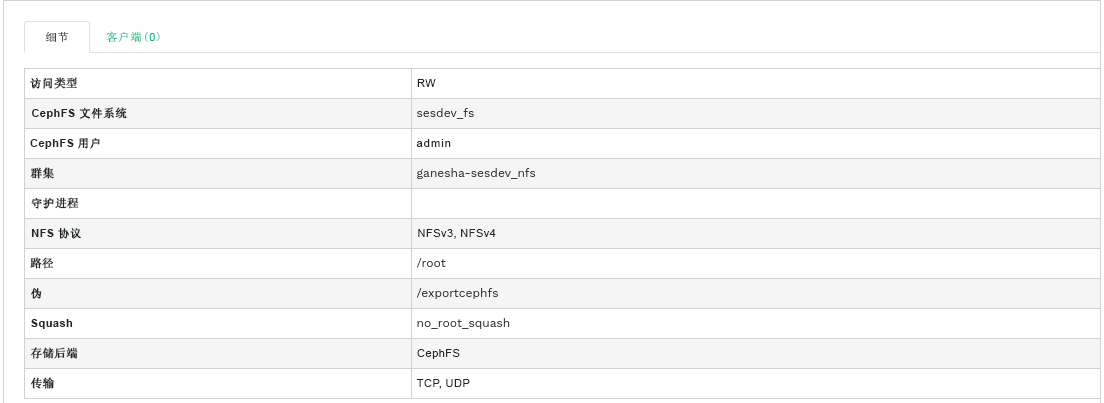

要查看某个 NFS 导出项的更多详细信息,请点击表中对应的行。

7.1 创建 NFS 导出项 #

要添加新的 NFS 导出项,请点击导出项表格左上方的并输入所需的信息。

选择一个或多个将运行导出项的 NFS Ganesha 守护进程。

选择存储后端。

重要目前,仅支持由 CephFS 提供支持的 NFS 导出项。

选择用户 ID 及其他后端相关选项。

输入 NFS 导出项的目录路径。如果该目录在服务器上不存在,系统将创建该目录。

指定其他 NFS 相关选项,例如支持的 NFS 协议版本、伪、访问类型、匿名访问或传输协议。

如果您需要设置限制,仅允许特定的客户端访问,请点击并添加它们的 IP 地址以及访问类型和匿名访问选项。

点击进行确认。

7.2 删除 NFS 导出项 #

要删除导出项,请选择并高亮显示表中该导出项对应的行。点击按钮旁的下拉箭头,然后选择。激活复选框,然后点击进行确认。

7.3 编辑 NFS 导出项 #

要编辑现有导出项,请选择并高亮显示表中该导出项对应的行,然后点击导出项表格左上方的。

然后,您便可以调整 NFS 导出项的所有详细信息。

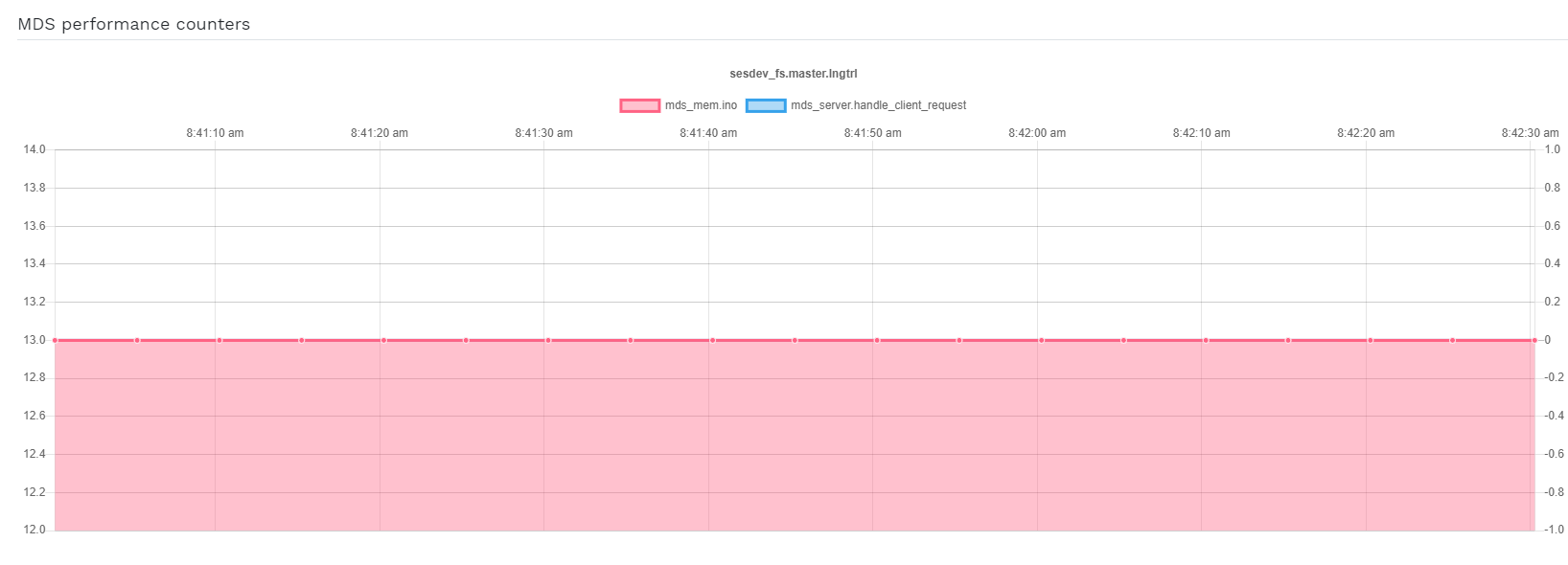

8 管理 CephFS #

8.1 查看 CephFS 概览 #

在主菜单中点击可查看配置的文件系统的概览。主表会显示每个文件系统的名称、创建日期,以及文件系统是否启用。

点击表中某个文件系统对应的行,可查看其排位以及添加到其中的存储池的详细信息。

您可在屏幕底部查看实时收集的相关 MDS Inode 及客户端请求数量统计数字。

9 管理对象网关 #

开始之前,在尝试访问 Ceph Dashboard 上的对象网关前端时,您可能会收到以下通知:

Information No RGW credentials found, please consult the documentation on how to enable RGW for the dashboard. Please consult the documentation on how to configure and enable the Object Gateway management functionality.

这是因为 cephadm 没有为 Ceph Dashboard 自动配置对象网关。如果您收到此通知,请按照第 10.4 节 “启用对象网关管理前端”中的说明手动启用 Ceph Dashboard 的对象网关前端。

9.1 查看对象网关 #

要查看配置的对象网关列表,请点击 › 。该列表包含网关的 ID、运行网关守护进程的集群节点的主机名以及网关的版本号。

点击网关名称旁的下拉箭头可查看有关该网关的详细信息。选项卡显示有关读/写操作及缓存统计数据的详细信息。

9.2 管理对象网关用户 #

点击 › 可查看现有对象网关用户的列表。

点击用户名旁的下拉箭头可查看有关用户帐户的详细信息,例如状态信息或用户和存储桶配额详细信息。

9.2.1 添加新网关用户 #

要添加新网关用户,请点击表标题左上方的。填写其身份凭证、有关 S3 密钥及用户和存储桶配额的详细信息,然后点击进行确认。

9.2.2 删除网关用户 #

要删除网关用户,请选择并高亮显示该用户。点击旁的下拉按钮,然后从列表中选择,即可删除用户帐户。激活复选框,然后点击进行确认。

9.2.3 编辑网关用户详细信息 #

要更改网关用户详细信息,请选择并高亮显示该用户。点击表标题左上方的。

修改基本或附加用户信息,例如其用户权限、密钥、子用户和配额信息。点击进行确认。

选项卡包含只读的网关用户列表以及这些用户的访问密钥和秘密密钥。要查看这些密钥,请点击列表中的用户名,然后选择表标题左上方的。在 对话框中,点击眼睛图标可显示密钥,点击剪贴板图标可将相关密钥复制到剪贴板。

9.3 管理对象网关存储桶 #

对象网关 (OGW) 存储桶实现了 OpenStack Swift 容器的功能。对象网关存储桶可充当存储数据对象的容器。

点击 › 可查看对象网关存储桶列表。

9.3.1 添加新的存储桶 #

要添加新的对象网关存储桶,请点击表标题左上方的。输入存储桶的名称,选择所有者,并设置归置目标。点击进行确认。

9.3.2 查看存储桶详细信息 #

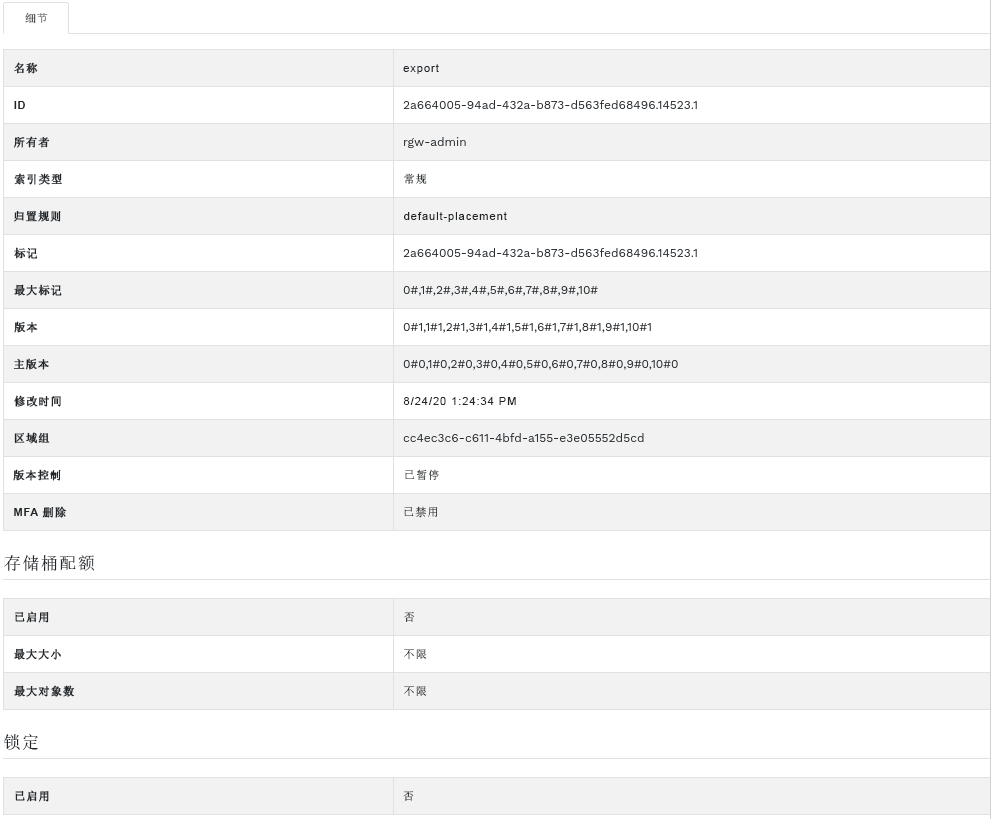

要查看有关对象网关存储桶的详细信息,请点击存储桶名称旁的下拉箭头。

您可以在表下方查看有关存储桶配额和锁定设置的详细信息。

9.3.3 编辑存储桶 #

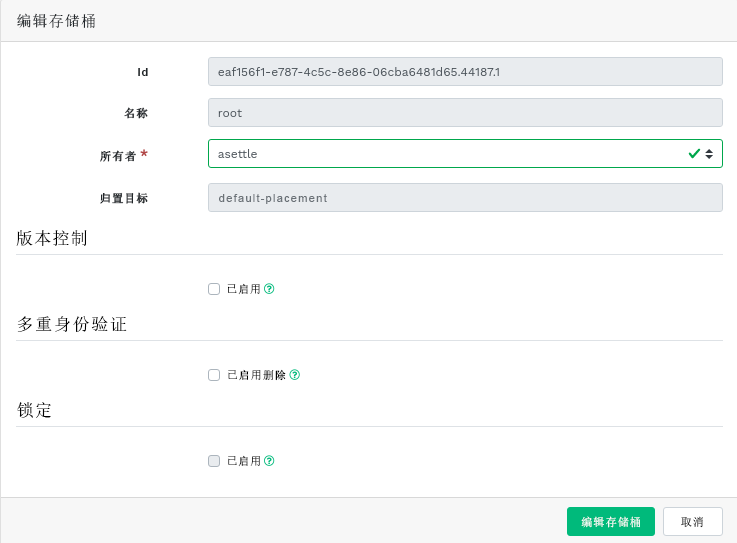

选择并高亮显示存储桶,然后点击表标题左上方的。

您可以更新存储桶的所有者,或者启用版本控制、多重身份验证或锁定功能。点击确认任何更改。

9.3.4 删除存储桶 #

要删除对象网关存储桶,请选择并高亮显示该存储桶。点击旁的下拉按钮,然后从列表中选择,即可删除存储桶。激活复选框,然后点击进行确认。

10 手动配置 #

本节为更喜欢在命令行上手动配置仪表盘设置的用户提供了较深入的信息。

10.1 配置 TLS/SSL 支持 #

所有连至仪表盘的 HTTP 连接默认都使用 TLS/SSL 来保障安全。安全连接需要 SSL 证书。您可以使用自我签名证书,也可以生成证书并让知名证书颁发机构 (CA) 对其签名。

您可能会出于某种原因需要禁用 SSL 支持。例如,如果仪表盘是在不支持 SSL 的代理之后运行。

禁用 SSL 要慎重,因为禁用 SSL 后,用户名和密码将以未加密的形式发送到仪表盘。

要禁用 SSL,请运行以下命令:

cephuser@adm > ceph config set mgr mgr/dashboard/ssl false更改 SSL 证书和密钥后,您需要手动重启动 Ceph Manager 进程。您可以通过运行以下命令

cephuser@adm > ceph mgr fail ACTIVE-MANAGER-NAME或禁用后再重新启用仪表盘扩展模块的方式来执行此操作,如此还会触发 Manager 的自我重新生成:

cephuser@adm >ceph mgr module disable dashboardcephuser@adm >ceph mgr module enable dashboard

10.1.1 创建自我签名证书 #

为了安全通讯而创建自我签名证书的过程非常简单。采用这种方式可迅速让仪表盘运行起来。

大多数 Web 浏览器都将对自我签名证书发起控诉,并需要在建立与仪表盘的安全连接前进行明确确认。

要生成并安装自我签名证书,请使用以下内置命令:

cephuser@adm > ceph dashboard create-self-signed-cert10.1.2 使用 CA 签名的证书 #

为了正确保障连至仪表盘的连接安全,以及消除 Web 浏览器对自我签名证书的控诉,我们建议使用 CA 签名的证书。

您可以使用如下命令生成证书密钥对:

root # openssl req -new -nodes -x509 \

-subj "/O=IT/CN=ceph-mgr-dashboard" -days 3650 \

-keyout dashboard.key -out dashboard.crt -extensions v3_ca

以上命令会输出 dashboard.key 和 dashboard.crt 文件。获得 CA 签名的 dashboard.crt 文件后,请运行以下命令为所有 Ceph Manager 实例启用该证书:

cephuser@adm >ceph config-key set mgr/dashboard/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/key -i dashboard.key

如果您需要为每个 Ceph Manager 实例使用不同的证书,请按如下所示修改命令,在其中指定实例的名称。将 NAME 替换为 Ceph Manager 实例的名称(通常是相关的主机名):

cephuser@adm >ceph config-key set mgr/dashboard/NAME/crt -i dashboard.crtcephuser@adm >ceph config-key set mgr/dashboard/NAME/key -i dashboard.key

10.2 更改主机名和端口号 #

Ceph Dashboard 与特定 TCP/IP 地址和 TCP 端口绑定。默认情况下,托管仪表盘的当前活跃 Ceph Manager 会与 TCP 端口 8443 绑定(如果禁用 SSL,则与 8080 端口绑定)。

如果在运行 Ceph Manager(以及 Ceph Dashboard)的主机上启用了防火墙,则您可能需要更改配置以启用对这些端口的访问。有关 Ceph 防火墙设置的详细信息,请参见Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”。

Ceph Dashboard 默认与“::”绑定,该符号表示所有可用的 IPv4 和 IPv6 地址。您可以使用以下命令更改 Web 应用的 IP 地址和端口号,以使它们适用于所有 Ceph Manager 实例:

cephuser@adm >ceph config set mgr mgr/dashboard/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/server_port PORT_NUMBER

因为每个 ceph-mgr 守护进程都托管着各自的仪表盘实例,您可能需要分别配置每个 Ceph Manager 实例。使用以下命令(将 NAME 替换为 ceph-mgr 实例的 ID)更改特定 Manager 实例的 IP 地址和端口号:

cephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESScephuser@adm >ceph config set mgr mgr/dashboard/NAME/server_port PORT_NUMBER

ceph mgr services 命令会显示当前配置的所有端点。查找 dashboard 键可获取用于访问仪表盘的 URL。

10.3 调整用户名和密码 #

如果您不想使用默认管理员帐户,可创建其他用户帐户并将其与至少一个角色相关联。我们提供了一组预定义的系统角色供您使用。有关详细信息,请参见第 11 章 “在命令行上管理用户和角色”。

要创建具有管理员权限的用户,请使用以下命令:

cephuser@adm > ceph dashboard ac-user-create USER_NAME PASSWORD administrator10.4 启用对象网关管理前端 #

要使用仪表盘的对象网关管理功能,您需要提供启用了 system 标志的用户的登录身份凭证:

如果您没有带

system标志的用户,请创建一个:cephuser@adm >radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --system记下命令输出中的 access_key 和 secret_key 密钥。

您还可以使用

radosgw-admin命令来获取现有用户的身份凭证:cephuser@adm >radosgw-admin user info --uid=USER_ID向仪表盘提供收到的身份凭证:

cephuser@adm >ceph dashboard set-rgw-api-access-key ACCESS_KEYcephuser@adm >ceph dashboard set-rgw-api-secret-key SECRET_KEY

默认情况下,SUSE Linux Enterprise Server 15 SP2 中会启用防火墙。有关防火墙配置的详细信息,请参见Book “Troubleshooting Guide”, Chapter 13 “Hints and tips”, Section 13.7 “Firewall settings for Ceph”。

请注意以下几点事项:

对象网关的主机名和端口号是自动确定的。

如果使用多个区域,对象网关会自动确定主区域组和主区域内的主机。此方式足以满足大部分设置的需求,但在某些情况下,您可能需要手动设置主机名和端口:

cephuser@adm >ceph dashboard set-rgw-api-host HOSTcephuser@adm >ceph dashboard set-rgw-api-port PORT下面是您可能需要进行的额外设置:

cephuser@adm >ceph dashboard set-rgw-api-scheme SCHEME # http or httpscephuser@adm >ceph dashboard set-rgw-api-admin-resource ADMIN_RESOURCEcephuser@adm >ceph dashboard set-rgw-api-user-id USER_ID如果您在对象网关设置中使用的是自我签名证书(第 10.1 节 “配置 TLS/SSL 支持”),请在仪表盘中禁用证书验证,以免发生因证书是由未知 CA 签名或与主机名不符而导致连接被拒。

cephuser@adm >ceph dashboard set-rgw-api-ssl-verify False如果对象网关处理请求所花的时间过长,导致仪表盘超时,则可调整超时值(默认为 45 秒):

cephuser@adm >ceph dashboard set-rest-requests-timeout SECONDS

10.5 启用 iSCSI 管理 #

Ceph Dashboard 使用 Ceph iSCSI 网关的 rbd-target-api 服务所提供的 REST API 管理 iSCSI 目标。确保已在 iSCSI 网关上安装并启用它。

Ceph Dashboard 的 iSCSI 管理功能取决于 ceph-iscsi 项目的最新版本 3。请确保您的操作系统提供了正确的版本,否则 Ceph Dashboard 将无法启用管理功能。

如果 ceph-iscsi REST API 以 HTTPS 模式配置并使用自我签名证书,请配置仪表盘以避免在访问 ceph-iscsi API 时发生 SSL 证书验证。

禁用 API SSL 验证:

cephuser@adm > ceph dashboard set-iscsi-api-ssl-verification false定义可用的 iSCSI 网关:

cephuser@adm >ceph dashboard iscsi-gateway-listcephuser@adm >ceph dashboard iscsi-gateway-add scheme://username:password@host[:port]cephuser@adm >ceph dashboard iscsi-gateway-rm gateway_name

10.6 启用单点登录 #

单点登录 (SSO) 是一种允许用户以单个 ID 和密码同时登录多个应用的访问控制方法。

Ceph Dashboard 支持通过 SAML 2.0 协议对用户进行外部身份验证。由于授权仍由仪表盘执行,因此您需要先创建用户帐户并将其与所需角色相关联。不过,身份验证过程可由现有身份提供者 (IdP) 执行。

要配置单点登录,请使用以下命令:

cephuser@adm > ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL \

IDP_METADATA IDP_USERNAME_ATTRIBUTE \

IDP_ENTITY_ID SP_X_509_CERT \

SP_PRIVATE_KEY参数:

- CEPH_DASHBOARD_BASE_URL

可用于访问 Ceph Dashboard 的基本 URL(例如“https://cephdashboard.local”)。

- IDP_METADATA

IdP 元数据 XML 的 URL、文件路径或内容(例如“https://myidp/metadata”)。

- IDP_USERNAME_ATTRIBUTE

可选。将用于从身份验证响应中获取用户名的属性。默认为“uid”。

- IDP_ENTITY_ID

可选。当 IdP 元数据上存在多个实体 ID 时,请使用该参数。

- SP_X_509_CERT / SP_PRIVATE_KEY

可选。Ceph Dashboard(服务提供程序)进行签名和加密时将使用的证书的文件路径或内容。

SAML 请求的发出者值将采用以下格式:

CEPH_DASHBOARD_BASE_URL/auth/saml2/metadata

要显示当前 SAML 2.0 配置,请运行以下命令:

cephuser@adm > ceph dashboard sso show saml2要禁用单点登录,请运行以下命令:

cephuser@adm > ceph dashboard sso disable要检查是否启用了 SSO,请运行以下命令:

cephuser@adm > ceph dashboard sso status要启用 SSO,请运行以下命令:

cephuser@adm > ceph dashboard sso enable saml211 在命令行上管理用户和角色 #

本节说明如何管理 Ceph Dashboard 使用的用户帐户。该工具可帮助您创建或修改用户帐户,以及设置正确的用户角色和权限。

11.1 管理密码策略 #

默认情况下会启用密码策略功能,包括以下检查:

密码长度是否超过 N 个字符?

旧密码和新密码是否相同?

可以完全打开或关闭密码策略功能:

cephuser@adm > ceph dashboard set-pwd-policy-enabled true|false可以打开或关闭以下各项检查:

cephuser@adm >ceph dashboard set-pwd-policy-check-length-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-oldpwd-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-username-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-exclusion-list-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-complexity-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-sequential-chars-enabled true|falsecephuser@adm >ceph dashboard set-pwd-policy-check-repetitive-chars-enabled true|false

此外,可使用以下选项配置密码策略行为。

最短密码长度(默认值为 8):

cephuser@adm >ceph dashboard set-pwd-policy-min-length N最小密码复杂性(默认值为 10):

cephuser@adm >ceph dashboard set-pwd-policy-min-complexity N密码复杂性是通过对密码中的每个字符进行分类来计算的。

密码中不允许使用的逗号分隔的单词列表:

cephuser@adm >ceph dashboard set-pwd-policy-exclusion-list word[,...]

11.2 管理用户帐户 #

Ceph Dashboard 支持管理多个用户帐户。每个用户帐户包含用户名、密码(使用 bcrypt 以加密形式存储)、可选名称和可选电子邮件地址。

用户帐户存储在 Ceph Manager 的配置数据库中,并在所有 Ceph Manager 实例之间全局共享。

使用以下命令可管理用户帐户:

- 显示现有用户:

cephuser@adm >ceph dashboard ac-user-show [USERNAME]- 创建新用户:

cephuser@adm >ceph dashboard ac-user-create USERNAME [PASSWORD] [ROLENAME] [NAME] [EMAIL]- 删除用户:

cephuser@adm >ceph dashboard ac-user-delete USERNAME- 更改用户密码:

cephuser@adm >ceph dashboard ac-user-set-password USERNAME PASSWORD- 修改用户名和电子邮件:

cephuser@adm >ceph dashboard ac-user-set-info USERNAME NAME EMAIL- 禁用用户

cephuser@adm >ceph dashboard ac-user-disable USERNAME- 启用用户

cephuser@adm >ceph dashboard ac-user-enable USERNAME

11.3 用户角色和权限 #

本节说明您可为用户角色指定的安全作用范围、如何管理用户角色,以及如何为用户帐户指定角色。

11.3.1 定义安全作用范围 #

用户帐户与一组角色相关联,这些角色定义了该用户可以访问仪表盘的哪些部分。仪表盘的各个部分均会划分在某个安全作用范围内。安全作用范围已预先定义且固定不变。当前可用的安全作用范围如下:

- hosts

包含与菜单项相关的所有特性。

- config-opt

包含与 Ceph 配置选项管理相关的所有特性。

- pool

包含与存储池管理相关的所有特性。

- osd

包含与 Ceph OSD 管理相关的所有特性。

- monitor

包含与 Ceph Monitor 管理相关的所有特性。

- rbd-image

包含与 RADOS 块设备映像管理相关的所有特性。

- rbd-mirroring

包含与 RADOS 块设备镜像管理相关的所有特性。

- iscsi

包含与 iSCSI 管理相关的所有特性。

- rgw

包含与对象网关管理相关的所有特性。

- cephfs

包含与 CephFS 管理相关的所有特性。

- manager

包含与 Ceph Manager 管理相关的所有特性。

- log

包含与 Ceph 日志管理相关的所有特性。

- grafana

包含与 Grafana 代理相关的所有特性。

- prometheus

包含与 Prometheus 告警管理相关的所有特性。

- dashboard-settings

允许更改仪表盘设置。

11.3.2 指定用户角色 #

角色指定了一个安全作用范围与一组权限之间的一组映射。权限分为四种类型:“read”、“create”、“update”和“delete”。

下面的示例指定了一个角色,具有该角色的用户拥有与存储池管理相关的特性的“read”和“create”权限,以及与 RBD 映像管理相关的特性的全部权限:

{

'role': 'my_new_role',

'description': 'My new role',

'scopes_permissions': {

'pool': ['read', 'create'],

'rbd-image': ['read', 'create', 'update', 'delete']

}

}仪表盘提供了一组预定义角色,我们称之为系统角色。全新安装 Ceph Dashboard 后即可使用这些角色:

- administrator

提供针对所有安全作用范围的全部权限。

- read-only

提供针对仪表盘设置以外的其他所有安全作用范围的读取权限。

- block-manager

提供针对“rbd-image”、“rbd-mirroring”和“iscsi”作用范围的全部权限。

- rgw-manager

提供针对“rgw”作用范围的全部权限。

- cluster-manager

提供针对“hosts”、“osd”、“monitor”、“manager”和“config-opt”作用范围的全部权限。

- pool-manager

提供针对“pool”作用范围的全部权限。

- cephfs-manager

提供针对“cephfs”作用范围的全部权限。

11.3.2.1 管理自定义角色 #

您可以使用以下命令创建新用户角色:

- 创建新角色:

cephuser@adm >ceph dashboard ac-role-create ROLENAME [DESCRIPTION]- 删除角色:

cephuser@adm >ceph dashboard ac-role-delete ROLENAME- 为角色添加作用范围权限:

cephuser@adm >ceph dashboard ac-role-add-scope-perms ROLENAME SCOPENAME PERMISSION [PERMISSION...]- 从角色中删除作用范围权限:

cephuser@adm >ceph dashboard ac-role-del-perms ROLENAME SCOPENAME

11.3.2.2 为用户帐户指定角色 #

使用以下命令可为用户指定角色:

- 设置用户角色:

cephuser@adm >ceph dashboard ac-user-set-roles USERNAME ROLENAME [ROLENAME ...]- 为用户添加其他角色:

cephuser@adm >ceph dashboard ac-user-add-roles USERNAME ROLENAME [ROLENAME ...]- 删除用户的角色:

cephuser@adm >ceph dashboard ac-user-del-roles USERNAME ROLENAME [ROLENAME ...]

如果您创建了自定义用户角色,并打算以后使用 ceph.purge 运行程序删除 Ceph 集群,则需要先清除自定义角色。有关详细信息,请参见第 13.9 节 “删除整个 Ceph 集群”。

11.3.2.3 示例:创建用户和自定义角色 #

本节说明创建具有以下权限的用户帐户的过程:可管理 RBD 映像、查看和创建 Ceph 存储池,并拥有针对任何其他安全作用范围的只读访问权限。

创建名为

tux的新用户:cephuser@adm >ceph dashboard ac-user-create tux PASSWORD创建角色并指定作用范围权限:

cephuser@adm >ceph dashboard ac-role-create rbd/pool-managercephuser@adm >ceph dashboard ac-role-add-scope-perms rbd/pool-manager \ rbd-image read create update deletecephuser@adm >ceph dashboard ac-role-add-scope-perms rbd/pool-manager pool read create将角色与

tux用户相关联:cephuser@adm >ceph dashboard ac-user-set-roles tux rbd/pool-manager read-only

11.4 代理配置 #

如果您要建立固定 URL 以访问 Ceph Dashboard,或者不允许直接连接到 Manager 节点,可以设置一个代理将传入请求转发到当前活动的 ceph-mgr 实例。

11.4.1 使用反向代理访问仪表盘 #

如果您要通过反向代理配置访问仪表盘,则可能需要使用 URL 前缀来访问。要让仪表盘使用包含您前缀的超链接,您可以设置 url_prefix 设置:

cephuser@adm > ceph config set mgr mgr/dashboard/url_prefix URL_PREFIX

然后,您便可通过网址 http://HOST_NAME:PORT_NUMBER/URL_PREFIX/ 来访问仪表盘。

11.4.2 禁用重定向 #

如果 Ceph Dashboard 位于 HAProxy 等负载平衡代理之后,请禁用重定向行为,以防止出现将内部(无法解析的)URL 发布到前端客户端的情况。使用以下命令可让仪表盘以 HTTP 错误(默认为500)响应,而不是重定向到活动仪表盘:

cephuser@adm > ceph config set mgr mgr/dashboard/standby_behaviour "error"要将设置重置为默认的重定向行为,请使用以下命令:

cephuser@adm > ceph config set mgr mgr/dashboard/standby_behaviour "redirect"11.4.3 配置错误状态码 #

如果禁用了重定向行为,则应自定义待机仪表盘的 HTTP 状态码。为此,请运行以下命令:

cephuser@adm > ceph config set mgr mgr/dashboard/standby_error_status_code 50311.4.4 HAProxy 示例配置 #

以下示例配置适用于使用 HAProxy 的 TLS/SSL 传递。

该配置适用于以下情况:如果仪表盘发生故障转移,前端客户端可能会收到 HTTP 重定向 (303) 响应,并将重定向到无法解析的主机。

两次 HAProxy 健康状况检查期间发生故障转移时,会发生此情况。在这种情况下,之前处于活动状态的仪表盘节点现在将以 303 进行响应,从而指向新活动节点。为避免出现该情况,您应该考虑禁用待机节点上的重定向行为。

defaults

log global

option log-health-checks

timeout connect 5s

timeout client 50s

timeout server 450s

frontend dashboard_front

mode http

bind *:80

option httplog

redirect scheme https code 301 if !{ ssl_fc }

frontend dashboard_front_ssl

mode tcp

bind *:443

option tcplog

default_backend dashboard_back_ssl

backend dashboard_back_ssl

mode tcp

option httpchk GET /

http-check expect status 200

server x HOST:PORT ssl check verify none

server y HOST:PORT ssl check verify none

server z HOST:PORT ssl check verify none11.5 审计 API 请求 #

Ceph Dashboard 的 REST API 可在 Ceph 审计日志中记录 PUT、POST 和 DELETE 请求。记录功能默认处于禁用状态,但您可使用以下命令将其启用:

cephuser@adm > ceph dashboard set-audit-api-enabled true如果记录功能处于启用状态,将会记录每个请求的以下参数:

- from

请求的来源,例如“https://[::1]:44410”。

- path

REST API 路径,例如

/api/auth。- method

“PUT”、“POST”或“DELETE”。

- user

用户的名称(或“None”)。

示例日志项如下所示:

2019-02-06 10:33:01.302514 mgr.x [INF] [DASHBOARD] \

from='https://[::ffff:127.0.0.1]:37022' path='/api/rgw/user/exu' method='PUT' \

user='admin' params='{"max_buckets": "1000", "display_name": "Example User", "uid": "exu", "suspended": "0", "email": "user@example.com"}'请求有效负载(自变量及其值的列表)的记录功能默认处于启用状态。您可以按照如下方式禁用该功能:

cephuser@adm > ceph dashboard set-audit-api-log-payload false11.6 在 Ceph Dashboard 中配置 NFS Ganesha #

Ceph Dashboard 可以管理使用 CephFS 或对象网关作为其后备存储的 NFS Ganesha 导出项。该仪表盘用于管理存储在 CephFS 集群上的 RADOS 对象中的 NFS Ganesha 配置文件。NFS Ganesha 必须将其部分配置存储在 Ceph 集群中。

运行以下命令以配置 NFS Ganesha 配置对象的位置:

cephuser@adm > ceph dashboard set-ganesha-clusters-rados-pool-namespace pool_name[/namespace]现在您便可以使用 Ceph Dashboard 管理 NFS Ganesha 导出项。

11.6.1 配置多个 NFS Ganesha 集群 #

Ceph Dashboard 支持管理属于不同 NFS Ganesha 集群的 NFS Ganesha 导出项。建议每个 NFS Ganesha 集群将其配置对象存储在不同的 RADOS 存储池/名称空间中,以便相互隔离各自配置。

使用以下命令可指定每个 NFS Ganesha 集群的配置位置:

cephuser@adm > ceph dashboard set-ganesha-clusters-rados-pool-namespace cluster_id:pool_name[/namespace](,cluster_id:pool_name[/namespace])*cluster_id 是唯一标识 NFS Ganesha 集群的任意字符串。

使用多个 NFS Ganesha 集群配置 Ceph Dashboard 时,Web UI 会自动让您选择导出项的所属集群。

11.7 调试插件 #

Ceph Dashboard 插件扩展了仪表盘的功能。调试插件允许根据调试模式来自定义仪表盘的行为。可以使用以下命令启用、禁用或检查调试插件:

cephuser@adm >ceph dashboard debug status Debug: 'disabled'cephuser@adm >ceph dashboard debug enable Debug: 'enabled'cephuser@adm >dashboard debug disable Debug: 'disabled'

默认情况下,它处于禁用状态。这是适用于生产部署的推荐设置。如果需要,可以启用调试模式,而无需重启动。

第 II 部分 集群操作 #

- 12 确定集群状态

当集群正在运行时,您可以使用

ceph工具来监视它。要确定集群状态,通常需要检查 Ceph OSD、Ceph Monitor、归置组和元数据服务器的状态。- 13 操作任务

要修改现有 Ceph 集群的配置,请执行以下步骤:

- 14 Ceph 服务的操作

您可以在守护进程、节点或集群级别操作 Ceph 服务。根据您需要的方法,使用 cephadm 或

systemctl命令。- 15 备份和恢复

本章说明您应当备份 Ceph 集群的哪些部分才能恢复集群功能。

- 16 监控和告警

在 SUSE Enterprise Storage 7 中,cephadm 会部署一个监控和告警堆栈。用户需要在 YAML 配置文件中定义要使用 cephadm 部署的服务(例如 Prometheus、告警管理器和 Grafana),也可以使用 CLI 来部署这些服务。当部署多个相同类型的服务时,会部署高可用性设置。但 Node Exporter 不适用于此规则。

12 确定集群状态 #

当集群正在运行时,您可以使用 ceph 工具来监视它。要确定集群状态,通常需要检查 Ceph OSD、Ceph

Monitor、归置组和元数据服务器的状态。

要以交互模式运行 ceph 工具,请不带任何自变量在命令行中键入

ceph。如果要在一行中输入多条 ceph

命令,则使用交互模式较为方便。例如:

cephuser@adm > ceph

ceph> health

ceph> status

ceph> quorum_status

ceph> mon stat12.1 检查集群的状态 #

您可以使用 ceph status 或 ceph -s 了解集群的即时状态:

cephuser@adm > ceph -s

cluster:

id: b4b30c6e-9681-11ea-ac39-525400d7702d

health: HEALTH_OK

services:

mon: 5 daemons, quorum ses-min1,ses-master,ses-min2,ses-min4,ses-min3 (age 2m)

mgr: ses-min1.gpijpm(active, since 3d), standbys: ses-min2.oopvyh

mds: my_cephfs:1 {0=my_cephfs.ses-min1.oterul=up:active}

osd: 3 osds: 3 up (since 3d), 3 in (since 11d)

rgw: 2 daemons active (myrealm.myzone.ses-min1.kwwazo, myrealm.myzone.ses-min2.jngabw)

task status:

scrub status:

mds.my_cephfs.ses-min1.oterul: idle

data:

pools: 7 pools, 169 pgs

objects: 250 objects, 10 KiB

usage: 3.1 GiB used, 27 GiB / 30 GiB avail

pgs: 169 active+clean输出内容提供了以下信息:

集群 ID

集群健康状况状态

Monitor 索引版本号和 Monitor 仲裁的状态

OSD 索引版本号和 OSD 的状态

Ceph Manager 的状态

对象网关的状态

归置组索引版本

归置组和存储池数量

理论上存储的数据量和存储的对象数量

所存储数据的总量。

used 值反映实际使用的原始存储量。xxx GB / xxx GB

值表示集群的可用容量(两者中较小的数字),以及集群的整体存储容量。理论数量反映在复制、克隆所存储数据或创建其快照前这些数据的大小。因此,实际存储的数据量通常会超出理论上的存储量,因为

Ceph 会创建数据的副本,可能还会将存储容量用于克隆和创建快照。

显示即时状态信息的其他命令如下:

ceph pg statceph osd pool statsceph dfceph df detail

要实时更新信息,请在 watch 命令中以自变量的方式使用以上任意命令(包括 ceph

-s):

root # watch -n 10 'ceph -s'如果您看累了,请按 Ctrl–C。

12.2 检查集群健康状况 #

在启动集群后到开始读取和/或写入数据期间,检查集群的健康状况:

cephuser@adm > ceph health

HEALTH_WARN 10 pgs degraded; 100 pgs stuck unclean; 1 mons down, quorum 0,2 \

node-1,node-2,node-3如果之前为您的配置或密钥环指定了非默认位置,则此时可以指定它们的位置:

cephuser@adm > ceph -c /path/to/conf -k /path/to/keyring healthCeph 集群会返回下列健康状况代码之一:

- OSD_DOWN

一个或多个 OSD 标记为已停机。OSD 守护进程可能已停止,或同伴 OSD 可能无法通过网络连接 OSD。常见原因包括守护进程已停止或已崩溃、主机已停机或网络中断。

校验主机是否运行良好,守护进程是否已启动,并且网络是否正常工作。如果守护进程已崩溃,守护进程日志文件 (

/var/log/ceph/ceph-osd.*) 可能会包含调试信息。- OSD_crush type_DOWN,例如 OSD_HOST_DOWN

特定 CRUSH 子树中的所有 OSD 均标记为已停机,例如主机上的所有 OSD。

- OSD_ORPHAN

在 CRUSH 索引层次结构中引用了 OSD,但它不存在。可使用以下命令从 CRUSH 层次结构中删除 OSD:

cephuser@adm >ceph osd crush rm osd.ID- OSD_OUT_OF_ORDER_FULL

以下项的使用率阈值未按升序排列:backfillfull(默认值为 0.90)、nearfull(默认值为 0.85)、full(默认值为 0.95)、failsafe_full。特别是,我们需要 backfillfull < nearfull,nearfull < full 且 full < failsafe_full。

要读取最新的值,请运行以下命令:

cephuser@adm >ceph health detail HEALTH_ERR 1 full osd(s); 1 backfillfull osd(s); 1 nearfull osd(s) osd.3 is full at 97% osd.4 is backfill full at 91% osd.2 is near full at 87%可以使用以下命令调整阈值:

cephuser@adm >ceph osd set-backfillfull-ratio ratiocephuser@adm >ceph osd set-nearfull-ratio ratiocephuser@adm >ceph osd set-full-ratio ratio- OSD_FULL

一个或多个 OSD 超出了 full 阈值,阻止集群处理写入操作。可使用以下命令检查各存储池的用量:

cephuser@adm >ceph df可使用以下命令查看当前定义的 full 比例:

cephuser@adm >ceph osd dump | grep full_ratio恢复写入可用性的临时解决方法是稍稍提高 full 阈值:

cephuser@adm >ceph osd set-full-ratio ratio请通过部署更多 OSD 将新的存储添加到集群,或者删除现有数据来腾出空间。

- OSD_BACKFILLFULL

一个或多个 OSD 超出了 backfillfull 阈值,因而不允许将数据重新平衡到此设备。这是一条预警,意味着重新平衡可能无法完成,并且集群将满。可使用以下命令检查各存储池的用量:

cephuser@adm >ceph df- OSD_NEARFULL

一个或多个 OSD 超出了 nearfull 阈值。这是一条预警,意味着集群将满。可使用以下命令检查各存储池的用量:

cephuser@adm >ceph df- OSDMAP_FLAGS

已设置一个或多个所需的集群标志。可使用以下命令设置或清除这些标志(full 除外):

cephuser@adm >ceph osd set flagcephuser@adm >ceph osd unset flag这些标志包括:

- full

集群标记为已满,无法处理写入操作。

- pauserd、pausewr

已暂停读取或写入。

- noup

不允许 OSD 启动。

- nodown

将会忽略 OSD 故障报告,如此 Monitor 便不会将 OSD 标记为 down。

- noin

先前标记为 out 的 OSD 在启动时将不会重新标记为 in。

- noout

停机的 OSD 在配置间隔过后将不会自动标记为 out。

- nobackfill、norecover、norebalance

恢复或数据重新平衡进程已暂停。

- noscrub、nodeep_scrub

洗刷进程已禁用(请参见第 17.6 节 “洗刷归置组”)。

- notieragent

缓存分层活动已暂停。

- OSD_FLAGS

一个或多个 OSD 设置了所需的每 OSD 标志。这些标志包括:

- noup

不允许 OSD 启动。

- nodown

将会忽略此 OSD 的故障报告。

- noin

如果此 OSD 先前在发生故障后自动标记为 out,当它启动时将不会标记为 in。

- noout

如果此 OSD 已停机,则在配置的间隔过后,它将不会自动标记为 out。

可使用以下命令来设置和清除每 OSD 标志:

cephuser@adm >ceph osd add-flag osd-IDcephuser@adm >ceph osd rm-flag osd-ID- OLD_CRUSH_TUNABLES

CRUSH 索引目前使用的设置很旧,应予以更新。

mon_crush_min_required_version配置选项可确定使用时不会触发此健康状况警告的最旧可调变量(即能够连接到集群的最旧客户端版本)。- OLD_CRUSH_STRAW_CALC_VERSION

CRUSH 索引目前使用较旧的非最佳方法来计算 straw 存储桶的中间权重值。应该更新 CRUSH 索引以使用较新的方法 (

straw_calc_version=1)。- CACHE_POOL_NO_HIT_SET

一个或多个缓存池未配置命中集来跟踪用量,这使分层代理无法识别要从缓存中刷新和赶出的冷对象。可使用以下命令对快速缓存池配置命中集:

cephuser@adm >ceph osd pool set poolname hit_set_type typecephuser@adm >ceph osd pool set poolname hit_set_period period-in-secondscephuser@adm >ceph osd pool set poolname hit_set_count number-of-hitsetscephuser@adm >ceph osd pool set poolname hit_set_fpp target-false-positive-rate- OSD_NO_SORTBITWISE

未在运行早于 Luminous 12 版本的 OSD,但是尚未设置

sortbitwise标志。您需要先设置sortbitwise标志,Luminous 12 或更新版本的 OSD 才能启动:cephuser@adm >ceph osd set sortbitwise- POOL_FULL

一个或多个存储池已达到其配额,不再允许写入。可使用以下命令设置存储池配额和用量:

cephuser@adm >ceph df detail您可以使用以下命令提高存储池配额

cephuser@adm >ceph osd pool set-quota poolname max_objects num-objectscephuser@adm >ceph osd pool set-quota poolname max_bytes num-bytes或者删除一些现有数据以减少用量。

- PG_AVAILABILITY

数据可用性下降,这意味着集群无法处理针对集群中某些数据的潜在读取或写入请求。具体而言,一个或多个 PG 处于不允许处理 I/O 请求的状态。有问题的 PG 状态包括正在互联、过时、不完整和不工作(如果这些状况不迅速解决)。运行以下命令可获得有关哪些 PG 受影响的详细信息:

cephuser@adm >ceph health detail大多数情况下,出现此情形的根本原因在于一个或多个 OSD 当前已停机。可使用以下命令查询特定的有问题 PG 的状态:

cephuser@adm >ceph tell pgid query- PG_DEGRADED

某些数据的数据冗余降低,这意味着集群没有所需数量的副本用于所有数据(对于副本存储池)或纠删码分段(对于纠删码存储池)。具体而言,一个或多个 PG 设置了 degraded 或 undersized 标志(集群中没有该归置组的足够实例),或者有一段时间未设置 clean 标志。运行以下命令可获得有关哪些 PG 受影响的详细信息:

cephuser@adm >ceph health detail大多数情况下,出现此情形的根本原因在于一个或多个 OSD 当前已停机。可使用以下命令查询特定的有问题 PG 的状态:

cephuser@adm >ceph tell pgid query- PG_DEGRADED_FULL

由于集群中的可用空间不足,某些数据的数据冗余可能已降低或面临风险。具体而言,一个或多个 PG 设置了 backfill_toofull 或 recovery_tooful 标志,这意味着集群无法迁移或恢复数据,原因是一个或多个 OSD 高于 backfillfull 阈值。

- PG_DAMAGED

数据洗刷(请参见第 17.6 节 “洗刷归置组”)进程发现集群中存在某些数据一致性问题。具体而言,一个或多个 PG 设置了 inconsistent 或 snaptrim_error 标志(表示某个较早的洗刷操作发现问题),或者设置了 repair 标志(表示当前正在修复此类不一致问题)。

- OSD_SCRUB_ERRORS

最近的 OSD 洗刷操作发现了不一致问题。

- CACHE_POOL_NEAR_FULL

缓存层池将满。在此环境中,“满”由缓存池的 target_max_bytes 和 target_max_objects 属性确定。池达到目标阈值时,如果正在从缓存刷新并赶出数据,写入池的请求可能会被阻止,出现常会导致延迟很高且性能变差的状态。可使用以下命令调整缓存池目标大小:

cephuser@adm >ceph osd pool set cache-pool-name target_max_bytes bytescephuser@adm >ceph osd pool set cache-pool-name target_max_objects objects正常的快速缓存清理和逐出活动还可能因基础层可用性或性能下降或者集群的整体负载较高而受到限制。

- TOO_FEW_PGS

使用中的 PG 数量低于每个 OSD 的 PG 数的可配置阈值

mon_pg_warn_min_per_osd。这可能导致集群中各 OSD 间的数据分布和平衡未达到最佳,以致降低整体性能。- TOO_MANY_PGS

使用中的 PG 数量高于每个 OSD 的 PG 数的可配置阈值

mon_pg_warn_max_per_osd。这可能导致 OSD 守护进程的内存用量较高,集群状态更改(例如 OSD 重启动、添加或删除)之后互联速度降低,并且 Ceph Manager 和 Ceph Monitor 上的负载较高。虽然不能减少现有存储池的

pg_num值,但可以减少pgp_num值。这样可有效地在同组 OSD 上并置一些 PG,从而减轻上述的一些负面影响。可使用以下命令调整pgp_num值:cephuser@adm >ceph osd pool set pool pgp_num value- SMALLER_PGP_NUM

一个或多个存储池的

pgp_num值小于pg_num。这通常表示 PG 计数有所提高,但未同时提升归置行为。使用以下命令设置pgp_num,使其与触发数据迁移的pg_num相匹配,通常便可解决此问题:cephuser@adm >ceph osd pool set pool pgp_num pg_num_value- MANY_OBJECTS_PER_PG

一个或多个存储池的每 PG 平均对象数大大高于集群的整体平均值。该特定阈值通过

mon_pg_warn_max_object_skew配置值控制。这通常表示包含集群中大部分数据的存储池具有的 PG 太少,以及/或者不包含这么多数据的其他存储池具有的 PG 太多。可通过调整 Monitor 上的mon_pg_warn_max_object_skew配置选项提高阈值,来消除该健康状况警告。- POOL_APP_NOT_ENABLED

存在包含一个或多个对象但尚未标记为供特定应用使用的存储池。将存储池标记为供某个应用使用即可消除此警告。例如,如果存储池由 RBD 使用:

cephuser@adm >rbd pool init pool_name如果存储池正由自定义应用“foo”使用,您还可以使用低级别命令标记它:

cephuser@adm >ceph osd pool application enable foo- POOL_FULL

一个或多个存储池已达到(或几乎要达到)其配额。触发此错误状况的阈值通过

mon_pool_quota_crit_threshold配置选项控制。可使用以下命令上调、下调(或删除)存储池配额:cephuser@adm >ceph osd pool set-quota pool max_bytes bytescephuser@adm >ceph osd pool set-quota pool max_objects objects将配额值设置为 0 将禁用配额。

- POOL_NEAR_FULL

一个或多个存储池接近其配额。触发此警告状况的阈值通过

mon_pool_quota_warn_threshold配置选项控制。可使用以下命令上调、下调(或删除)存储池配额:cephuser@adm >ceph osd osd pool set-quota pool max_bytes bytescephuser@adm >ceph osd osd pool set-quota pool max_objects objects将配额值设置为 0 将禁用配额。

- OBJECT_MISPLACED

集群中的一个或多个对象未存储在集群希望存储的节点上。这表示集群最近的某项更改导致的数据迁移尚未完成。误放的数据本质上不属于危险状况。数据一致性方面永远不会有风险,仅当所需位置放置了对象所需份数的新副本之后,系统才会删除对象的旧副本。

- OBJECT_UNFOUND

找不到集群中的一个或多个对象。具体而言,OSD 知道对象的新副本或更新副本应该存在,但在当前启用的 OSD 上却找不到该版对象的副本。系统将阻止对“未找到”对象的读取或写入请求。从理论上讲,可以将具有未找到对象最近副本的已停用 OSD 重新启用。可通过负责处理未找到对象的 PG 的互联状态识别候选 OSD:

cephuser@adm >ceph tell pgid query- REQUEST_SLOW

正花费很长的时间处理一个或多个 OSD 请求。这可能表示负载极重、存储设备速度缓慢或有软件错误。可以从 OSD 主机执行以下命令来查询有问题的 OSD 上的请求队列:

cephuser@adm >ceph daemon osd.id ops可以查看近期最慢的请求摘要:

cephuser@adm >ceph daemon osd.id dump_historic_ops可使用以下命令查找 OSD 的位置:

cephuser@adm >ceph osd find osd.id- REQUEST_STUCK

一个或多个 OSD 请求已被阻止一段相当长的时间,例如 4096 秒。这表示集群已有很长一段时间处于非健康状况(例如,没有足够的运行中 OSD 或非活跃 PG),或者 OSD 存在某种内部问题。

- PG_NOT_SCRUBBED

最近未洗刷(请参见第 17.6 节 “洗刷归置组”)一个或多个 PG。通常每

mon_scrub_interval秒洗刷一次 PG,当mon_warn_not_scrubbed这类间隔已过但未进行洗刷时,就会触发此警告。如果 PG 未标记为清理,系统将不会洗刷它们。如果 PG 放置错误或已降级,就会出现这种情况(请参见上文中的 PG_AVAILABILITY 和 PG_DEGRADED)。您可以使用以下命令手动对标记为清理的 PG 启动洗刷:cephuser@adm >ceph pg scrub pgid- PG_NOT_DEEP_SCRUBBED

最近未深层洗刷(请参见第 17.6 节 “洗刷归置组”)一个或多个 PG。通常每

osd_deep_scrub_interval秒洗刷一次 PG,当mon_warn_not_deep_scrubbed秒已过但未进行洗刷时,就会触发此警告。如果 PG 未标记为清理,系统将不会(深层)洗刷它们。如果 PG 放置错误或已降级,就会出现这种情况(请参见上文中的 PG_AVAILABILITY 和 PG_DEGRADED)。您可以使用以下命令手动对标记为清理的 PG 启动洗刷:cephuser@adm >ceph pg deep-scrub pgid

如果之前为您的配置或密钥环指定了非默认位置,则此时可以指定它们的位置:

root # ceph -c /path/to/conf -k /path/to/keyring health12.3 检查集群的使用率统计数据 #

要查看集群的数据使用率以及数据在多个存储池之间的分布,请使用 ceph df 命令。要获取更多详细信息,请使用

ceph df detail。

cephuser@adm > ceph df

--- RAW STORAGE ---

CLASS SIZE AVAIL USED RAW USED %RAW USED

hdd 30 GiB 27 GiB 121 MiB 3.1 GiB 10.40

TOTAL 30 GiB 27 GiB 121 MiB 3.1 GiB 10.40

--- POOLS ---

POOL ID STORED OBJECTS USED %USED MAX AVAIL

device_health_metrics 1 0 B 0 0 B 0 8.5 GiB

cephfs.my_cephfs.meta 2 1.0 MiB 22 4.5 MiB 0.02 8.5 GiB

cephfs.my_cephfs.data 3 0 B 0 0 B 0 8.5 GiB

.rgw.root 4 1.9 KiB 13 2.2 MiB 0 8.5 GiB

myzone.rgw.log 5 3.4 KiB 207 6 MiB 0.02 8.5 GiB

myzone.rgw.control 6 0 B 8 0 B 0 8.5 GiB

myzone.rgw.meta 7 0 B 0 0 B 0 8.5 GiB

输出中的 RAW STORAGE 段落提供集群用于数据的存储空间容量概览。

CLASS:设备的存储类别。有关设备类型的更多详细信息,请参见第 17.1.1 节 “设备类型”。SIZE:集群的整体存储容量。AVAIL:集群中可以使用的可用空间容量。USED:单纯为块设备中保存的数据对象分配的空间(所有 OSD 上的累计空间)。RAW USED:“USED”空间与块设备上为实现 Ceph 而分配/预留的空间(例如 BlueStore 的 BlueFS 部分)之和。% RAW USED:已用的原始存储量百分比。将此数字与full ratio和near full ratio搭配使用,可确保您不会用完集群的容量。有关其他详细信息,请参见第 12.8 节 “储存容量”。注意:集群填充程度当原始存储填满级别接近 100% 时,您需要向集群添加新存储空间。较高的用量可能导致单个 OSD 填满,集群健康状况出现问题。

使用命令

ceph osd df tree可列出所有 OSD 的填充程度。

输出内容的 POOLS

段落提供了存储池列表和每个存储池的理论用量。此段落的输出不反映副本、克隆数据或快照。例如,如果您存储含 1MB

数据的对象,理论用量将是 1MB,但是根据副本、克隆数据或快照数量,实际用量可能是 2MB 或更多。

POOL:存储池的名称。ID:存储池 ID。STORED:用户存储的数据量。OBJECTS:每个存储池的理论已存储对象数。USED:所有 OSD 节点单纯为数据分配的空间容量,以 kB 为单位。%USED:每个存储池的理论已用存储百分比。MAX AVAIL:给定存储池中的最大可用空间。

POOLS 段落中的数字是理论上的。它们不包括副本、快照或克隆数量。因此,USED 与

%USED 数量之和不会加总到输出内容 RAW STORAGE 段落中的

RAW USED 和 %RAW USED 数量中。

12.4 检查 OSD 状态 #

可通过执行以下命令来检查 OSD,以确保它们已启动且正在运行:

cephuser@adm > ceph osd stat或

cephuser@adm > ceph osd dump还可以根据 OSD 在 CRUSH 索引中的位置查看 OSD。

ceph osd tree 将列显 CRUSH 树及主机、它的 OSD、OSD 是否已启动及其权重:

cephuser@adm > ceph osd tree

ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 3 0.02939 root default

-3 3 0.00980 rack mainrack

-2 3 0.00980 host osd-host

0 1 0.00980 osd.0 up 1.00000 1.00000

1 1 0.00980 osd.1 up 1.00000 1.00000

2 1 0.00980 osd.2 up 1.00000 1.0000012.5 检查填满的 OSD #

Ceph 可阻止您向填满的 OSD 写入数据,以防丢失数据。在正常运行的集群中,当集群接近其填满比例时,您会收到警告。mon osd

full ratio 默认设为容量的 0.95 (95%),达到该比例后,集群会阻止客户端写入数据。mon osd

nearfull ratio 默认设为容量的 0.85 (85%),达到该比例时,集群会生成健康状况警告。

可通过 ceph health 命令报告填满的 OSD 节点:

cephuser@adm > ceph health

HEALTH_WARN 1 nearfull osds

osd.2 is near full at 85%或

cephuser@adm > ceph health

HEALTH_ERR 1 nearfull osds, 1 full osds

osd.2 is near full at 85%

osd.3 is full at 97%处理填满的集群的最佳方法是添加新的 OSD 主机/磁盘,以便让集群将数据重新分布到新的可用存储空间。

OSD 变满(即用完 100% 的磁盘空间)之后,往往会迅速崩溃而不发出警告。管理 OSD 节点时需记住下面几点提示。

每个 OSD 的磁盘空间(通常装入在

/var/lib/ceph/osd/osd-{1,2..}下)需放置在专用的底层磁盘或分区上。检查 Ceph 配置文件,确保 Ceph 不会将其日志文件存储在专供 OSD 使用的磁盘/分区上。

确保没有其他进程写入专供 OSD 使用的磁盘/分区。

12.6 检查 Monitor 状态 #

启动集群后,请在第一次读取和/或写入数据之前检查 Ceph Monitor 的仲裁状态。如果集群已在处理请求,请定期检查 Ceph Monitor 的状态,确保其正在运行。

要显示 Monitor 索引,请执行以下命令:

cephuser@adm > ceph mon stat或

cephuser@adm > ceph mon dump要检查 Monitor 集群的仲裁状态,请执行以下命令:

cephuser@adm > ceph quorum_statusCeph 将返回仲裁状态。例如,由三个 Monitor 组成的 Ceph 集群可能返回以下内容:

{ "election_epoch": 10,

"quorum": [

0,

1,

2],

"monmap": { "epoch": 1,

"fsid": "444b489c-4f16-4b75-83f0-cb8097468898",

"modified": "2011-12-12 13:28:27.505520",

"created": "2011-12-12 13:28:27.505520",

"mons": [

{ "rank": 0,

"name": "a",

"addr": "192.168.1.10:6789\/0"},

{ "rank": 1,

"name": "b",

"addr": "192.168.1.11:6789\/0"},

{ "rank": 2,

"name": "c",

"addr": "192.168.1.12:6789\/0"}

]

}

}12.7 检查归置组状态 #

归置组会将对象映射到 OSD。监视归置组时,您希望它们处于 active 和

clean 状态。有关详细内容,请参见第 12.9 节 “监控 OSD 和归置组”。

12.8 储存容量 #

作为防止数据丢失的安全措施,当 Ceph 存储集群接近其容量上限时,Ceph 将阻止您向 Ceph OSD 写入或从中读取数据。因此,让生产集群接近其填满比例不是一种好的做法,因为这样会牺牲高可用性。默认的填满比例设置为 0.95,即容量的 95%。对于所含 OSD 数量较少的测试集群而言,如此设置是非常激进的。

在监视集群时,请注意与 nearfull 比例有关的警告。出现该警告表示,如果一个或多个 OSD 发生故障,某些

OSD 的故障可能会导致服务暂时中断。请考虑添加更多 OSD 以增加存储容量。

测试集群的一种常见情境是系统管理员从 Ceph 存储集群中删除 Ceph OSD,等待集群重新达到平衡。然后再删除另一个 Ceph

OSD,以此类推,直到集群最终达到填满比例并锁死。我们建议即使使用测试集群时也进行一定的容量规划。通过规划,您可以预估维持高可用性所需的备用容量。从理论上讲,您需要规划能够应对一系列

Ceph OSD 发生故障的情况的方案,使集群无需立即替换这些 Ceph OSD 也可恢复到 active +

clean 状态。您可以运行 active + degraded

状态的集群,但这不适合正常运行状况。

下图展示了一个包含 33 个 Ceph 节点的简化 Ceph 存储集群,其中每个主机有一个 Ceph OSD,每个 Ceph OSD 从 3 TB

驱动器读取以及向其中写入数据。此示例集群实际的容量上限为 99 TB。mon osd full ratio 选项设置为

0.95。如果集群的剩余容量降至 5 TB,集群将不允许客户端读取和写入数据。因此,存储集群的运行容量为 95 TB,而不是 99 TB。

在这样的集群中,有一个或两个 OSD 发生故障属于正常现象。一种不常发生但合乎常理的情况是机柜的路由器或电源发生故障,导致多个 OSD(例如 OSD

7-12)同时停用。在这种情况下,您仍然应该设法使集群保持正常运行并达到 active + clean

状态,即使这意味着需要立即添加一些主机及额外的

OSD。如果容量使用率过高,您可能不会丢失数据。但是,如果集群的容量使用率超过填满比例,您虽然解决了故障域内发生的中断问题,却可能会损失数据可用性。因此,我们建议至少进行大致的容量规划。

针对您的集群确定以下两个数值:

OSD 的数量。

集群的总容量。

如果您将集群的总容量除以集群中的 OSD 数量,将得到集群内单个 OSD 的平均容量。将该数值与您预期正常运行期间将同时发生故障的 OSD 数量(一个相对较小的数值)相乘。最后,将集群容量与填满比例相乘得到运行容量上限。然后,减去您预期将发生故障的 OSD 中的数据量,即可得到一个合理的填满比例。使用更高的 OSD 故障数(一整个机柜的 OSD)重复上述过程,即可得到一个合理的接近填满比例数值。

以下设置仅在创建集群时才会应用,随后会存储在 OSD 索引中:

[global] mon osd full ratio = .80 mon osd backfillfull ratio = .75 mon osd nearfull ratio = .70

仅在创建集群时才会应用这些设置。此后,需要使用 ceph osd set-nearfull-ratio 和

ceph osd set-full-ratio 命令在 OSD 索引中更改这些设置。

- mon osd full ratio

在将 OSD 视为

满之前使用的磁盘空间百分比。默认值为 0.95- mon osd backfillfull ratio

在将 OSD 视为过

满而无法回填之前使用的磁盘空间百分比。默认值为 0.90- mon osd nearfull ratio

在将 OSD 视为

将满之前使用的磁盘空间百分比。默认值为 0.85

如果某些 OSD 将满,但其他 OSD 的容量充足,则表示将满 OSD 的

CRUSH 权重可能有问题。

12.9 监控 OSD 和归置组 #

高可用性和高可靠性要求采用容错方法来管理硬件和软件问题。Ceph 没有单一故障点,可以在“已降级”模式下处理数据请求。Ceph 的数据归置引入了一个间接层,以确保数据不会与特定 OSD 地址直接绑定。这表示跟踪系统故障原因需要找到属于问题根源的归置组和底层 OSD。

如果集群的某个部分发生故障,集群可能会阻止您访问特定对象,但这并不意味着您无法访问其他对象。遇到故障时,请执行相关步骤来监视 OSD 和归置组。然后开始进行查错。

Ceph 一般情况下会进行自我修复。但如果问题仍然存在,监视 OSD 和归置组将有助于您找到问题所在。

12.9.1 监视 OSD #

OSD 可能处于在集群内(“in”)状态,也可能处于在集群外(“out”)状态。同时,它也可能处于启用并运行(“up”)或停用且未运行(“down”)状态。如果某个 OSD 处于“up”状态,则它可能在集群内(您可以读取和写入数据),也可能在集群外。如果该 OSD 之前在集群内,最近已移出集群,则 Ceph 会将归置组迁移到其他 OSD。如果某个 OSD 在集群外,CRUSH 将不会为其指定归置组。如果某个 OSD 处于“down”状态,则它应该也处于“out”状态。

如果某个 OSD 处于“down”和“in”状态,则表示存在问题,并且集群将处于不健康状态。

如果您执行 ceph health、ceph -s 或

ceph -w 等命令,可能会注意到集群并非始终回显 HEALTH

OK。对于 OSD,您应当预期集群在以下情况下不会回显 HEALTH

OK:

您尚未启动集群(它不会响应)。

您已启动或重启动集群,但它尚未准备就绪,因为系统正在创建归置组,并且 OSD 正在互联。

您已添加或删除某个 OSD。

您已修改集群索引。

监视 OSD 的一个重要目的是确保当集群已启用且在运行时,集群中的所有 OSD 也已启用且在运行。要确定是否所有 OSD 都在运行,请执行以下命令:

root # ceph osd stat

x osds: y up, z in; epoch: eNNNN

结果应显示 OSD 总数 (x)、处于“up”状态的 OSD 数量 (y)、处于“in”状态的 OSD 数量 (z),以及索引版本号

(eNNNN)。如果在集群内(“in”)的 OSD数量大于处于“up”状态的 OSD 数量,请执行以下命令确定未在运行的

ceph-osd 守护进程:

root # ceph osd tree

#ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 2.00000 pool openstack

-3 2.00000 rack dell-2950-rack-A

-2 2.00000 host dell-2950-A1

0 ssd 1.00000 osd.0 up 1.00000 1.00000

1 ssd 1.00000 osd.1 down 1.00000 1.00000例如,如果 ID 为 1 的 OSD 处于停用状态,请将其启动:

cephuser@osd > sudo systemctl start ceph-CLUSTER_ID@osd.0.service有关与已停止或不会重启动的 OSD 相关的问题,请参见Book “Troubleshooting Guide”, Chapter 4 “Troubleshooting OSDs”, Section 4.3 “OSDs not running”。

12.9.2 指定归置组集 #

CRUSH 向 OSD 指定归置组时,会查看存储池的副本数量,然后再为 OSD 指定归置组,以便将每个归置组副本都指定给不同的

OSD。例如,如果存储池需要三个归置组副本,CRUSH 可能会将这三个副本分别指定给

osd.1、osd.2 和

osd.3。CRUSH 实际上会寻找一种伪随机归置方法,这种方法会将您在 CRUSH

索引中设置的故障域纳入考量,因此在大型集群中,您很少会看到归置组被指定给最邻近的 OSD 的情况。我们将应包含特定归置组的副本的 OSD

集称为在任集。在某些情况下,在任集中的 OSD

会处于停用状态,或者无法处理要访问归置组中对象的请求。当以下其中一种情况发生时,可能会出现这些情况:

您添加或删除了某个 OSD。CRUSH 随后会将归置组重新指定给其他 OSD,因而更改了在任集的组成部分,导致系统通过“回填”过程迁移数据。

某个 OSD 之前处于“down”状态、之前进行了重启动,而现在正在恢复。

在任集中的某个 OSD 处于“down”状态,或者无法处理请求,并且另一个 OSD 已暂代其职。

Ceph 使用启用集来处理客户端请求,启用集是实际处理请求的 OSD 集。在大多数情况下,启用集和在任集几乎完全相同。当两者不同时,可能表示 Ceph 正在迁移数据、某个 OSD 正在恢复,或者集群存在问题(例如,在此类情况下,Ceph 通常会回显

HEALTH WARN状态及“stuck stale”讯息)。

要检索归置组列表,请运行以下命令:

cephuser@adm > ceph pg dump要查看哪些 OSD 在给定归置组的在任集或启用集内,请运行以下命令:

cephuser@adm > ceph pg map PG_NUM

osdmap eNNN pg RAW_PG_NUM (PG_NUM) -> up [0,1,2] acting [0,1,2]结果应该会显示 OSD 索引版本号 (eNNN)、归置组数量 (PG_NUM)、启用集(“up”)中的 OSD,以及在任集(“acting”)中的 OSD:

如果启用集与在任集不一致,则可能表示集群正在自我重新平衡,或者集群可能存在问题。

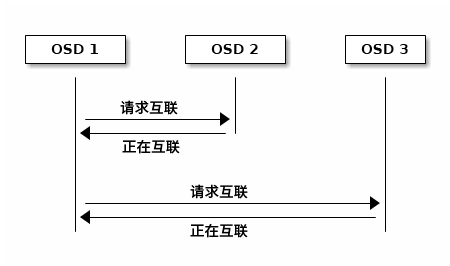

12.9.3 正在互联 #

归置组必须处于 active 及 clean

状态,您才能将数据写入其中。为了让 Ceph 确定某个归置组的当前状态,该归置组的主

OSD(在任集中的第一个 OSD)会与第二个和第三个 OSD

建立互联,以便就归置组的当前状态达成一致(假设存储池包含三个归置组副本)。

12.9.4 监控归置组状态 #

如果您执行 ceph health、ceph -s 或

ceph -w 等命令,可能会注意到集群并非始终回显 HEALTH OK

讯息。检查 OSD 是否正在运行之后,还应检查归置组状态。

在一些与归置组互联相关的情况下,集群预期将不会回显 HEALTH

OK:

您已创建存储池,并且归置组尚未互联。

归置组正在恢复。

您已向集群添加了 OSD,或已从集群中删除了 OSD。

您已修改 CRUSH 索引,并且您的归置组正在迁移。

在不同的归置组副本中存在数据不一致的情况。

Ceph 正在洗刷归置组的副本。

Ceph 的存储容量不足,无法完成回填操作。

如果上述其中一种情况导致 Ceph 回显 HEALTH

WARN,请不要惊慌。集群在许多情况下都会自行恢复。在有些情况下,您可能需要采取措施。监视归置组的一个重要目的是确保当集群已启用并运行时,所有归置组都处于“active”状态并且最好处于“clean”状态。要查看所有归置组的状态,请运行以下命令:

cephuser@adm > ceph pg stat

x pgs: y active+clean; z bytes data, aa MB used, bb GB / cc GB avail结果应该会显示归置组总数 (x)、处于特定状态(例如“active+clean”)的归置组数量 (y),以及存储的数据量 (z)。

除了归置组状态以外,Ceph 还会回显使用的存储容量 (aa)、剩余的存储容量 (bb),以及归置组的总存储容量。在以下情况下,这些数值可能非常重要:

已达到

near full ratio或full ratio。由于您的 CRUSH 配置中存在错误,您的数据未在集群中分布。

归置组 ID 由存储池编号(并非存储池名称)加一个句点 (.)和归置组 ID(一个十六进制数)组成。您可以在 ceph osd

lspools 的输出中查看存储池编号及其名称。例如,默认存储池 rbd 与存储池编号 0

对应。完全限定的归置组 ID 的格式如下:

POOL_NUM.PG_ID

通常显示如下:

0.1f

要检索归置组列表,请运行以下命令:

cephuser@adm > ceph pg dump您还可以将输出内容设置为 JSON 格式,并将其保存到文件中:

cephuser@adm > ceph pg dump -o FILE_NAME --format=json要查询特定归置组,请运行以下命令:

cephuser@adm > ceph pg POOL_NUM.PG_ID query以下列表详细说明了常见的归置组状态。

- CREATING(正在创建)

当您创建存储池时,Ceph 会创建您指定数量的归置组。Ceph 会在创建一个或多个归置组时回显“creating”。创建归置组之后,属于归置组在任集的各 OSD 将会互联。完成互联过程时,归置组状态应该为“active+clean”,这表示 Ceph 客户端可以开始向归置组写入数据。

图 12.3︰ 归置组状态 #- PEERING(正在互联)

当 Ceph 在对归置组执行互联操作时,会在存储归置组副本的各 OSD 之间就该归置组中的对象和元数据的状态达成一致。当 Ceph 完成互联过程时,便表示存储归置组的各 OSD 之间就归置组的当前状态达成一致。不过,完成互联过程并不表示每个副本都有最新的内容。

注意:权威历史在在任集的所有 OSD 都持续进行写入操作之前,Ceph 将不会向客户端确认写入操作。这样做可确保在上次成功完成互联操作之后,至少有一个在任集成员将拥有每个确认的写入操作的记录。

通过准确记录每个确认的写入操作,Ceph 可以构建并扩展一个新的权威归置组历史,即一个完整且完全有序的在任集,如果执行该在任集,会将 OSD 的归置组副本更新到最新状态。

- ACTIVE(活动)

当 Ceph 完成互联过程时,归置组可能会变为

active状态。active状态表示通常可在主归置组和副本中使用归置组中的数据进行读取和写入操作。- CLEAN(正常)

如果归置组处于

clean状态,则表示主 OSD 和副本 OSD 已成功互联,并且该归置组没有流浪副本。Ceph 已将归置组中的所有对象复制正确的次数。- DEGRADED(已降级)

当客户端将对象写入主 OSD 时,该主 OSD 负责将副本写入副本 OSD。主 OSD 将对象写入存储空间之后,归置组将保持“degraded”状态,直到主 OSD 收到了副本 OSD 发送的 Ceph 已成功创建副本对象的确认讯息。

归置组有可能处于“active+degraded”状态,这是因为即使 OSD 尚未存储所有对象,它也可能处于“active”状态。如果某个 OSD 变成停用状态,Ceph 会将指定给该 OSD 的每个归置组都标记为“degraded”。当该 OSD 恢复启用状态后,各 OSD 必须再次互联。不过,如果某个已降级归置组处于“active”状态,客户端仍然可以将新对象写入该归置组。

如果某个 OSD 处于“down”状态,并且持续保持“degraded”状况,Ceph 可能会将该停用的 OSD 标记为“out”(表示移出集群),并将停用(“down”)的 OSD 的数据重新映射到另一个 OSD。从将 OSD 标记为“down”到将其标记为“out”相隔的时间通过

mon osd down out interval选项控制,该选项默认设置为 600 秒。归置组也可能处于“degraded”状态,当 Ceph 找不到应在归置组中的一个或多个对象时便会发生此情况。虽然您无法读取未找到的对象或向其写入数据,却仍然可以访问“degraded”状态的归置组中的所有其他对象。

- RECOVERING(正在恢复)

Ceph 设计用于在发生硬件和软件问题时进行大规模容错。当 OSD 变成“down”状态时,其内容可能落后于归置组中其他副本的当前状态。当 OSD 恢复“up”状态时,必须更新归置组的内容以反映最新状态。在此期间,OSD 可能会显现出“recovering”状态。

恢复并非总是无足轻重的,因为硬件故障可能会导致多个 OSD 发生级联故障。例如,一个机架或机柜的网络交换机可能会发生故障,这可能会导致一些主机的 OSD 落后于集群的当前状态。解决故障之后,必须恢复每个 OSD。

Ceph 提供了一些设置,用来平衡新服务请求与恢复数据对象并将归置组恢复到最新状态的需求之间的资源争用。

osd recovery delay start设置允许 OSD 在启动恢复过程之前重启动、重新互联,甚至处理一些重放请求。osd recovery thread timeout用于设置线程超时,因为有可能会有多个 OSD 交错发生故障、重启动以及重新互联。osd recovery max active设置用于限制 OSD 将同时处理的恢复请求数,以防止 OSD 无法处理请求。osd recovery max chunk设置用于限制恢复的数据块大小,以防出现网络拥塞。- BACK FILLING(正在回填)

当新 OSD 加入集群时,CRUSH 会将集群中 OSD 的归置组重新指定给新添加的 OSD。强制新 OSD 立即接受重新指定的归置组可能会使新 OSD 过载。向 OSD 回填归置组可让此过程在后台开始。回填完成后,新 OSD 将在准备就绪时开始处理请求。

在执行回填操作期间,系统可能会显示以下其中一种状态:“backfill_wait”表示回填操作待处理,但尚未执行;“backfill”表示正在进行回填操作;“backfill_too_full”表示已请求进行回填操作,但由于存储容量不足而无法完成。如果某个归置组无法回填,则可能会被视为“incomplete”。

Ceph 提供了一些设置来管理与向某个 OSD(尤其是新 OSD)重新指定归置组有关的负载。默认情况下,

osd max backfills将向或从一个 OSD 同时进行的最大回填数设置为 10。backfill full ratio允许 OSD 在接近其填满比例(默认为 90%)时拒绝回填请求,并使用ceph osd set-backfillfull-ratio命令进行更改。如果某个 OSD 拒绝回填请求,osd backfill retry interval可让 OSD 重试请求(默认在 10 秒后)。OSD 还可以设置osd backfill scan min和osd backfill scan max,以管理扫描间隔(默认值分别为 64 和 512)。- REMAPPED(已重新映射)

当用于处理归置组的在任集发生变化时,数据会从旧在任集迁移到新在任集。新主 OSD 可能需要一段时间才能处理请求。因此,新主 OSD 可能会要求旧主 OSD 继续处理请求,直到归置组迁移完成。数据迁移完成时,映射将使用新在任集的主 OSD。

- STALE(过时)

尽管 Ceph 使用检测信号来确保主机和守护进程正在运行,但

ceph-osd守护进程也可能会卡住,无法及时报告统计数据(例如,当发生暂时的网络故障时)。默认情况下,OSD 守护进程每半秒钟 (0.5) 报告一次其归置组、引导及故障统计数据,这个频率高于检测信号阈值。如果某个归置组在任集的主 OSD 未能向 Monitor 报告,或者其他 OSD 已将该主 OSD 报告为“down”,则 Monitor 会将该归置组标记为“stale”。当您启动集群后,集群常常会在互联过程完成之前显示为“stale”状态。集群运行一段时间之后,如果归置组显示为“stale”状态,则表示这些归置组的主 OSD 处于停用状态,或者未向 Monitor 报告归置组统计数据。

12.9.5 查找对象位置 #

要在 Ceph 对象存储中存储对象数据,Ceph 客户端需要设置对象名称并指定相关的存储池。Ceph 客户端会检索最新的集群索引,并且 CRUSH 算法会计算如何将对象映射到归置组,然后计算如何以动态方式将该归置组指定给 OSD。要查找对象位置,您只需知道对象名称和存储池名称。例如:

cephuser@adm > ceph osd map POOL_NAME OBJECT_NAME [NAMESPACE]

作为示范,我们来创建一个对象。在命令行上使用 rados put

命令指定对象名称“test-object-1”、包含一些对象数据的示例文件“testfile.txt”的路径,以及存储池名称“data”。

cephuser@adm > rados put test-object-1 testfile.txt --pool=data要确认 Ceph 对象存储是否已存储对象,请运行以下命令:

cephuser@adm > rados -p data ls现在,我们来确定对象位置。Ceph 将会输出对象的位置:

cephuser@adm > ceph osd map data test-object-1

osdmap e537 pool 'data' (0) object 'test-object-1' -> pg 0.d1743484 \

(0.4) -> up ([1,0], p0) acting ([1,0], p0)

要移除示例对象,只需使用 rados rm 命令将其删除:

cephuser@adm > rados rm test-object-1 --pool=data13 操作任务 #

13.1 修改集群配置 #

要修改现有 Ceph 集群的配置,请执行以下步骤:

将集群的当前配置导出到文件:

cephuser@adm >ceph orch ls --export --format yaml > cluster.yaml编辑包含配置的文件并更新相关行。可在Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.4 “部署服务和网关”和第 13.4.3 节 “使用 DriveGroups 规范添加 OSD。”中找到规范示例。

应用新配置:

cephuser@adm >ceph orch apply -i cluster.yaml

13.2 添加节点 #

要向 Ceph 集群添加新节点,请执行以下步骤:

在新主机上安装 SUSE Linux Enterprise Server 和 SUSE Enterprise Storage。有关更多信息,请参考Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.1 “安装和配置 SUSE Linux Enterprise Server”。

将主机配置为已存在 Salt Master 的 Salt Minion。有关更多信息,请参考Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.2 “部署 Salt”。

将新主机添加到

ceph-salt并让 cephadm 能识别它,例如:root@master #ceph-salt config /ceph_cluster/minions add ses-min5.example.comroot@master #ceph-salt config /ceph_cluster/roles/cephadm add ses-min5.example.com有关更多信息,请参考Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.2.2 “添加 Salt Minion”。

确认节点是否已添加到

ceph-salt:root@master #ceph-salt config /ceph_cluster/minions ls o- minions ................................................. [Minions: 5] [...] o- ses-min5.example.com .................................... [no roles]将配置应用于新集群主机:

root@master #ceph-salt apply ses-min5.example.com确认新添加的主机现在是否属于 cephadm 环境:

cephuser@adm >ceph orch host ls HOST ADDR LABELS STATUS [...] ses-min5.example.com ses-min5.example.com

13.3 删除节点 #

要从集群中删除节点,请执行以下操作:

对于除

node-exporter和crash之外的所有 Ceph 服务类型,请从集群归置规范文件(例如cluster.yml)中删除节点的主机名。有关更多详细信息,请参见Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.4.2 “服务和归置规范”。例如,如果您要删除名为ses-min2的主机,请从所有placement:部分中删除所有出现的- ses-min2:更新

service_type: rgw service_id: EXAMPLE_NFS placement: hosts: - ses-min2 - ses-min3

更改为

service_type: rgw service_id: EXAMPLE_NFS placement: hosts: - ses-min3

将您的更改应用于配置文件:

cephuser@adm >ceph orch apply -i rgw-example.yaml从 cephadm 的环境中删除节点:

cephuser@adm >ceph orch host rm ses-min2如果节点正在运行

crash.osd.1和crash.osd.2服务,请通过在主机上运行以下命令将其删除:root@minion >cephadm rm-daemon --fsid CLUSTER_ID --name SERVICE_NAME例如:

root@minion >cephadm rm-daemon --fsid b4b30c6e... --name crash.osd.1root@minion >cephadm rm-daemon --fsid b4b30c6e... --name crash.osd.2从您要删除的 Minion 中删除所有角色:

cephuser@adm >ceph-salt config /ceph_cluster/roles/tuned/throughput remove ses-min2cephuser@adm >ceph-salt config /ceph_cluster/roles/tuned/latency remove ses-min2cephuser@adm >ceph-salt config /ceph_cluster/roles/cephadm remove ses-min2cephuser@adm >ceph-salt config /ceph_cluster/roles/admin remove ses-min2如果您要删除的 Minion 是引导 Minion,则还需要删除引导角色:

cephuser@adm >ceph-salt config /ceph_cluster/roles/bootstrap reset删除单个主机上的所有 OSD 后,从 CRUSH 索引中删除该主机:

cephuser@adm >ceph osd crush remove bucket-name注意存储桶名称应该与主机名相同。

现在您便可以从集群中删除 Minion:

cephuser@adm >ceph-salt config /ceph_cluster/minions remove ses-min2

如果发生故障,并且您尝试删除的 Minion 处于永久断电状态,则需要从 Salt Master 中删除节点:

root@master # salt-key -d minion_id

然后,手动将节点从 pillar_root/ceph-salt.sls 中删除。它通常位于 /srv/pillar/ceph-salt.sls 中。

13.4 OSD 管理 #

本节介绍如何在 Ceph 集群中添加、擦除或删除 OSD。

13.4.1 列出磁盘设备 #

要识别所有集群节点上已使用和未使用的磁盘设备,请通过运行以下命令列出这些设备:

cephuser@adm > ceph orch device ls

HOST PATH TYPE SIZE DEVICE AVAIL REJECT REASONS

ses-master /dev/vda hdd 42.0G False locked

ses-min1 /dev/vda hdd 42.0G False locked

ses-min1 /dev/vdb hdd 8192M 387836 False locked, LVM detected, Insufficient space (<5GB) on vgs

ses-min2 /dev/vdc hdd 8192M 450575 True13.4.2 擦除磁盘设备 #

要重新使用磁盘设备,需要先将其擦除(或清除):

ceph orch device zap HOST_NAME DISK_DEVICE

例如:

cephuser@adm > ceph orch device zap ses-min2 /dev/vdc

如果您之前在未设置 unmanaged 标志的情况下使用 DriveGroups 或 --all-available-devices 选项部署 OSD,cephadm 将在您擦除这些 OSD 后再自动部署它们。

13.4.3 使用 DriveGroups 规范添加 OSD。 #

DriveGroups 用于指定 Ceph 集群中 OSD 的布局。它们在单个 YAML 文件中定义。在本节中,我们将使用 drive_groups.yml 作为示例。

管理员应手动指定一组相关的 OSD(部署在 HDD 和 SDD 组合上的混合 OSD)或一组使用相同部署选项的 OSD(例如,对象存储、加密选项相同的各独立 OSD)。为了避免明确列出设备,DriveGroups 会使用与 ceph-volume 库存报告中的几个所选字段对应的过滤项列表。cephadm 将提供一些代码,用于将这些 DriveGroups 转换为供用户检查的实际设备列表。

将 OSD 规范应用于集群的命令是:

cephuser@adm >ceph orch apply osd -idrive_groups.yml

要查看操作预览并测试您的应用,可以将 --dry-run 选项与 ceph orch apply osd 命令一起使用。例如:

cephuser@adm >ceph orch apply osd -idrive_groups.yml--dry-run ... +---------+------+------+----------+----+-----+ |SERVICE |NAME |HOST |DATA |DB |WAL | +---------+------+------+----------+----+-----+ |osd |test |mgr0 |/dev/sda |- |- | |osd |test |mgr0 |/dev/sdb |- |- | +---------+------+------+----------+----+-----+

如果 --dry-run 输出符合您的预期,则只需重新运行命令而无需使用 --dry-run 选项。

13.4.3.1 非受管 OSD #

将符合 DriveGroups 规范的所有可用正常磁盘设备添加到集群后,它们将自动用作 OSD。此行为称为受管模式。

要禁用受管模式,请将 unmanaged: true 行添加到相关规范,例如:

service_type: osd service_id: example_drvgrp_name placement: hosts: - ses-min2 - ses-min3 encrypted: true unmanaged: true

13.4.3.2 DriveGroups 规范 #

下面是 DriveGroups 规范文件的示例:

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: drive_spec: DEVICE_SPECIFICATION db_devices: drive_spec: DEVICE_SPECIFICATION wal_devices: drive_spec: DEVICE_SPECIFICATION block_wal_size: '5G' # (optional, unit suffixes permitted) block_db_size: '5G' # (optional, unit suffixes permitted) encrypted: true # 'True' or 'False' (defaults to 'False')

之前在 DeepSea 中名为“加密”的选项已被重命名为“已加密”。在 SUSE Enterprise Storage 7 中应用 DriveGroups 时,请确保在服务规范中使用此新术语,否则 ceph orch apply 操作将失败。

13.4.3.3 匹配磁盘设备 #

您可以使用以下过滤器描述规格:

按磁盘型号:

model: DISK_MODEL_STRING

按磁盘供应商:

vendor: DISK_VENDOR_STRING

提示始终以小写形式输入 DISK_VENDOR_STRING。

要获取有关磁盘型号和供应商的详细信息,请检查以下命令的输出:

cephuser@adm >ceph orch device ls HOST PATH TYPE SIZE DEVICE_ID MODEL VENDOR ses-min1 /dev/sdb ssd 29.8G SATA_SSD_AF34075704240015 SATA SSD ATA ses-min2 /dev/sda ssd 223G Micron_5200_MTFDDAK240TDN Micron_5200_MTFD ATA [...]磁盘是否为旋转硬盘。SSD 和 NVMe 驱动器不属于旋转硬盘。

rotational: 0

部署将所有可用驱动器都用于 OSD 的节点:

data_devices: all: true

还可通过限制匹配磁盘的数量来过滤:

limit: 10

13.4.3.4 按大小过滤设备 #

您可以按磁盘设备大小对其过滤,可以按确切大小也可以按大小范围来过滤。size: 参数接受使用下列格式的自变量:

'10G' - 包括大小为该值的磁盘。

'10G:40G' - 包括大小在该范围内的磁盘。

':10G' - 包括大小小于或等于 10 GB 的磁盘。

'40G:' - 包括大小等于或大于 40 GB 的磁盘。

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: size: '40TB:' db_devices: size: ':2TB'

如果使用“:”分隔符,您需要用引号括住大小,否则“:”符号将被解释为新的配置哈希。

您可以指定以兆字节 (M) 或太字节 (T) 为单位的大小,而不能指定以千兆字节 (G) 为单位的大小。

13.4.3.5 DriveGroups 示例 #

本节包含其他 OSD 设置的示例。

下面的示例说明了使用相同设置的两个节点:

20 个 HDD

供应商:Intel

型号:SSD-123-foo

大小:4 TB

2 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

对应的 drive_groups.yml 文件如下所示:

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: model: SSD-123-foo db_devices: model: MC-55-44-XZ

这样的配置简单有效。但问题是管理员将来可能要添加来自不同供应商的磁盘,而这样的磁盘不在可添加范围内。您可以通过减少针对驱动器核心属性的过滤器来予以改进。

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: rotational: 1 db_devices: rotational: 0

在上面的示例中,我们强制将所有旋转设备声明为“data devices”,所有非旋转设备将被用作“shared devices”(wal、db)。

如果您知道大小超过 2 TB 的驱动器将始终充当较慢的数据设备,则可以按大小过滤:

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: size: '2TB:' db_devices: size: ':2TB'

下面的示例说明了两种不同的设置:20 个 HDD 将共享 2 个 SSD,而 10 个 SSD 将共享 2 个 NVMe。

20 个 HDD

供应商:Intel

型号:SSD-123-foo

大小:4 TB

12 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

2 个 NVMe

供应商:Samsung

型号:NVME-QQQQ-987

大小:256 GB

这样的设置可使用如下两个布局定义:

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: rotational: 0 db_devices: model: MC-55-44-XZ

service_type: osd service_id: example_drvgrp_name2 placement: host_pattern: '*' data_devices: model: MC-55-44-XZ db_devices: vendor: samsung size: 256GB

上述示例假设所有节点的驱动器都相同,但情况并非总是如此:

节点 1-5:

20 个 HDD

供应商:Intel

型号:SSD-123-foo

大小:4 TB

2 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

节点 6-10:

5 个 NVMe

供应商:Intel

型号:SSD-123-foo

大小:4 TB

20 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

您可以在布局中使用“target”键来定位特定节点。Salt 定位标记可让事情变得简单:

service_type: osd service_id: example_drvgrp_one2five placement: host_pattern: 'node[1-5]' data_devices: rotational: 1 db_devices: rotational: 0

后接

service_type: osd service_id: example_drvgrp_rest placement: host_pattern: 'node[6-10]' data_devices: model: MC-55-44-XZ db_devices: model: SSD-123-foo

上述所有案例都假设 WAL 和 DB 使用相同设备,但也有可能会在专用设备上部署 WAL:

20 个 HDD

供应商:Intel

型号:SSD-123-foo

大小:4 TB

2 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

2 个 NVMe

供应商:Samsung

型号:NVME-QQQQ-987

大小:256 GB

service_type: osd service_id: example_drvgrp_name placement: host_pattern: '*' data_devices: model: MC-55-44-XZ db_devices: model: SSD-123-foo wal_devices: model: NVME-QQQQ-987

在以下设置中,我们尝试定义:

由 1 个 NVMe 支持 20 个 HDD

由 1 个 SSD (db) 和 1 个 NVMe (wal) 支持 2 个 HDD

由 1 个 NVMe 支持 8 个 SSD

2 个独立 SSD(加密)

1 个 HDD 作为备用,不应部署

共使用如下数量的驱动器:

23 个 HDD

供应商:Intel

型号:SSD-123-foo

大小:4 TB

10 个 SSD

供应商:Micron

型号:MC-55-44-ZX

大小:512 GB

1 个 NVMe

供应商:Samsung

型号:NVME-QQQQ-987

大小:256 GB

DriveGroups 定义如下所示:

service_type: osd service_id: example_drvgrp_hdd_nvme placement: host_pattern: '*' data_devices: rotational: 0 db_devices: model: NVME-QQQQ-987

service_type: osd service_id: example_drvgrp_hdd_ssd_nvme placement: host_pattern: '*' data_devices: rotational: 0 db_devices: model: MC-55-44-XZ wal_devices: model: NVME-QQQQ-987

service_type: osd service_id: example_drvgrp_ssd_nvme placement: host_pattern: '*' data_devices: model: SSD-123-foo db_devices: model: NVME-QQQQ-987

service_type: osd service_id: example_drvgrp_standalone_encrypted placement: host_pattern: '*' data_devices: model: SSD-123-foo encrypted: True

在文件的整个分析过程中,将始终保留一个 HDD。

13.4.4 删除 OSD #

在从集群中删除 OSD 节点之前,请确认该集群中的可用磁盘空间是否比您要删除的 OSD 磁盘大。请注意,删除 OSD 会导致整个集群进行重新平衡。

通过获取其 ID 来识别要删除的 OSD:

cephuser@adm >ceph orch ps --daemon_type osd NAME HOST STATUS REFRESHED AGE VERSION osd.0 target-ses-090 running (3h) 7m ago 3h 15.2.7.689 ... osd.1 target-ses-090 running (3h) 7m ago 3h 15.2.7.689 ... osd.2 target-ses-090 running (3h) 7m ago 3h 15.2.7.689 ... osd.3 target-ses-090 running (3h) 7m ago 3h 15.2.7.689 ...从集群中删除一个或多个 OSD:

cephuser@adm >ceph orch osd rm OSD1_ID OSD2_ID ...例如:

cephuser@adm >ceph orch osd rm 1 2您可以查询删除操作的状态:

cephuser@adm >ceph orch osd rm status OSD_ID HOST STATE PG_COUNT REPLACE FORCE STARTED_AT 2 cephadm-dev done, waiting for purge 0 True False 2020-07-17 13:01:43.147684 3 cephadm-dev draining 17 False True 2020-07-17 13:01:45.162158 4 cephadm-dev started 42 False True 2020-07-17 13:01:45.162158

13.4.4.1 停止 OSD 删除 #

安排 OSD 删除后,您可以视需要停止删除。以下命令将重置 OSD 的初始状态并将其从队列中删除:

cephuser@adm > ceph orch osd rm stop OSD_SERVICE_ID13.4.5 替换 OSD #

要在保留其 ID 的情况下替换 OSD,请运行:

cephuser@adm > ceph orch osd rm OSD_SERVICE_ID --replace例如:

cephuser@adm > ceph orch osd rm 4 --replace

替换 OSD 与删除 OSD 基本相同(有关更多详细信息,请参见第 13.4.4 节 “删除 OSD”),只不过 OSD 不是从 CRUSH 层次结构中永久删除,而是被指定了一个 destroyed 标志。

destroyed 标志用于确定将在下一次 OSD 部署期间重复使用的 OSD ID。新添加的符合 DriveGroups 规范的磁盘(有关更多详细信息,请参见第 13.4.3 节 “使用 DriveGroups 规范添加 OSD。”)将被指定其所替换磁盘的 OSD ID。

追加 --dry-run 选项不会执行实际替换,而会预览通常会发生的步骤。

13.5 将 Salt Master 移至新节点 #

如果需要用新 Salt Master 主机替换 Salt Master 主机,请执行以下步骤:

导出集群配置并备份导出的 JSON 文件。有关详细信息,请参见Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.2.15 “导出集群配置”。

如果旧的 Salt Master 也是集群中的唯一管理节点,则需要将

/etc/ceph/ceph.client.admin.keyring和/etc/ceph/ceph.conf手动移至新的 Salt Master。停止并禁用旧的 Salt Master 节点上的 Salt Master

systemd服务:root@master #systemctl stop salt-master.serviceroot@master #systemctl disable salt-master.service如果旧的 Salt Master 节点不再位于集群中,还要停止并禁用 Salt Minion

systemd服务:root@master #systemctl stop salt-minion.serviceroot@master #systemctl disable salt-minion.service警告如果旧的 Salt Master 节点上有任何正在运行的 Ceph 守护进程(MON、MGR、OSD、MDS、网关、监控),请不要停止或禁用

salt-minion.service。按照Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.1 “安装和配置 SUSE Linux Enterprise Server”中所述的过程在新的 Salt Master 上安装 SUSE Linux Enterprise Server 15 SP2。

提示:转换 Salt Minion为便于将 Salt Minion 转换为新的 Salt Master,请从每个 Salt Minion 中删除原来的 Salt Master 的公共密钥:

root@minion >rm /etc/salt/pki/minion/minion_master.pubroot@minion >systemctl restart salt-minion.service在新的 Salt Master 上安装 salt-master 包和 salt-minion 包(如适用)。

在新的 Salt Master 节点上安装

ceph-salt:root@master #zypper install ceph-saltroot@master #systemctl restart salt-master.serviceroot@master #salt '*' saltutil.sync_all重要确保在继续之前运行所有三个命令。这些命令是幂等的;是否重复并不重要。

在集群中包含新的 Salt Master,如Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.1 “安装

ceph-salt”、Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.2.2 “添加 Salt Minion”和Book “部署指南”, Chapter 5 “使用 cephadm 进行部署”, Section 5.3.2.4 “指定管理节点”中所述。导入备份的集群配置并应用该配置:

root@master #ceph-salt import CLUSTER_CONFIG.jsonroot@master #ceph-salt apply重要导入之前,请在导出的

CLUSTER_CONFIG.json文件中重命名 Salt Master 的minion id。

13.6 更新集群节点 #

定期应用滚动更新,以使 Ceph 集群节点保持最新。

13.6.1 软件储存库 #

使用最新的软件包增补集群之前,请确认集群的所有节点均可访问相关的储存库。有关所需储存库的完整列表,请参见Book “部署指南”, Chapter 7 “从先前的版本升级”, Section 7.1.5.1 “软件储存库”。

13.6.2 储存库暂存 #

如果您使用向集群节点提供软件储存库的暂存工具(例如 SUSE Manager、储存库管理工具或 RMT),请确认 SUSE Linux Enterprise Server 和 SUSE Enterprise Storage 的“Updates”储存库的阶段都是在同一时刻创建的。

强烈建议您使用暂存工具来应用增补程序级别为 frozen 或 staged 的增补程序。这样可确保加入集群的新节点具有与已在集群中运行的节点相同的增补程序级别。通过这种方法,您无需向集群的所有节点都应用最新增补程序,新节点也能加入集群。

13.6.3 Ceph 服务停机时间 #