- Documentación de SUSE Edge 3.3.1

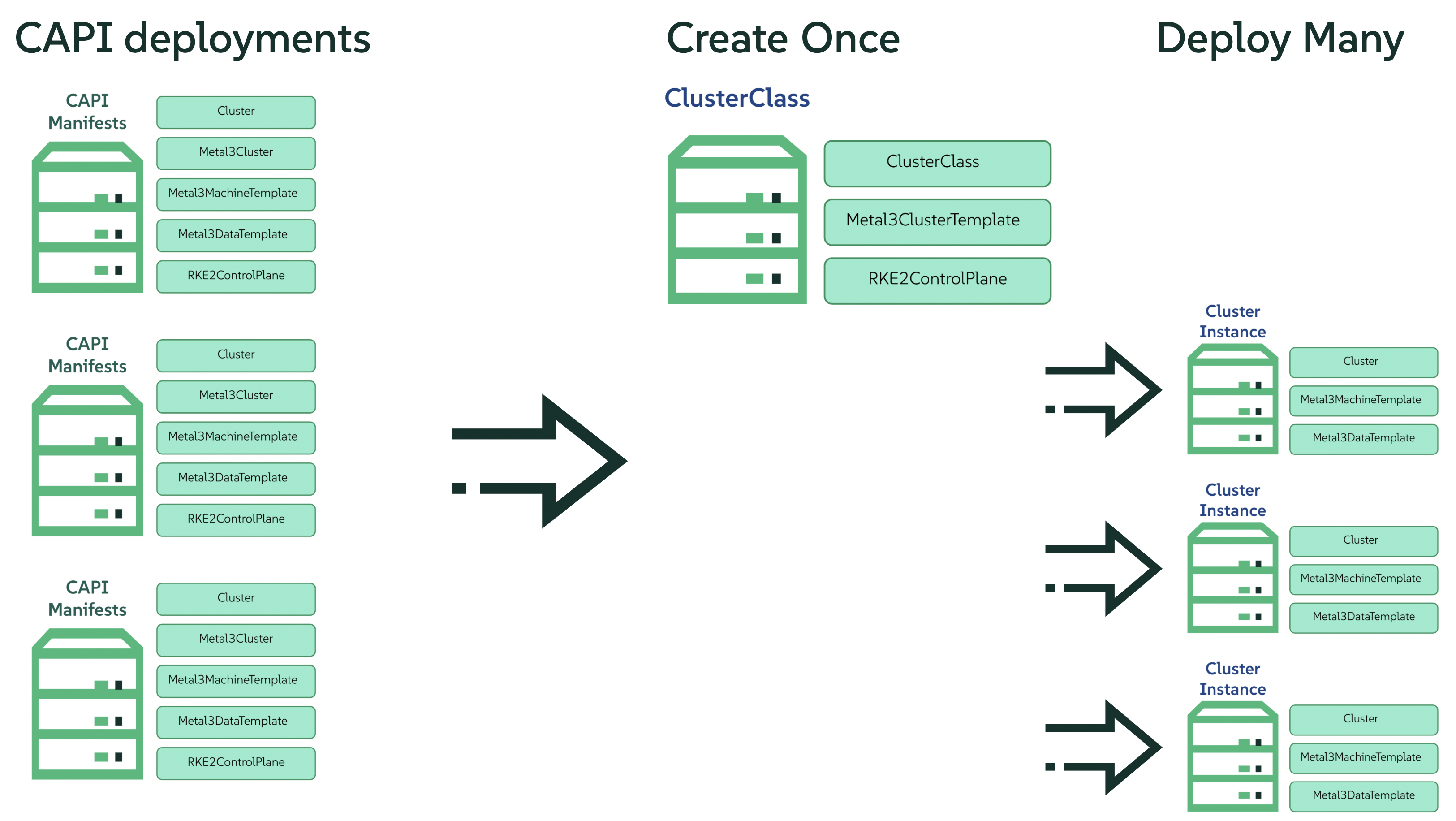

- I Guías de inicio rápido

- 1 Despliegues automatizados de BMC con Metal3

- 2 Incorporación de hosts remotos con Elemental

- 2.1 Arquitectura general

- 2.2 Recursos necesarios

- 2.3 Creación del clúster de arranque

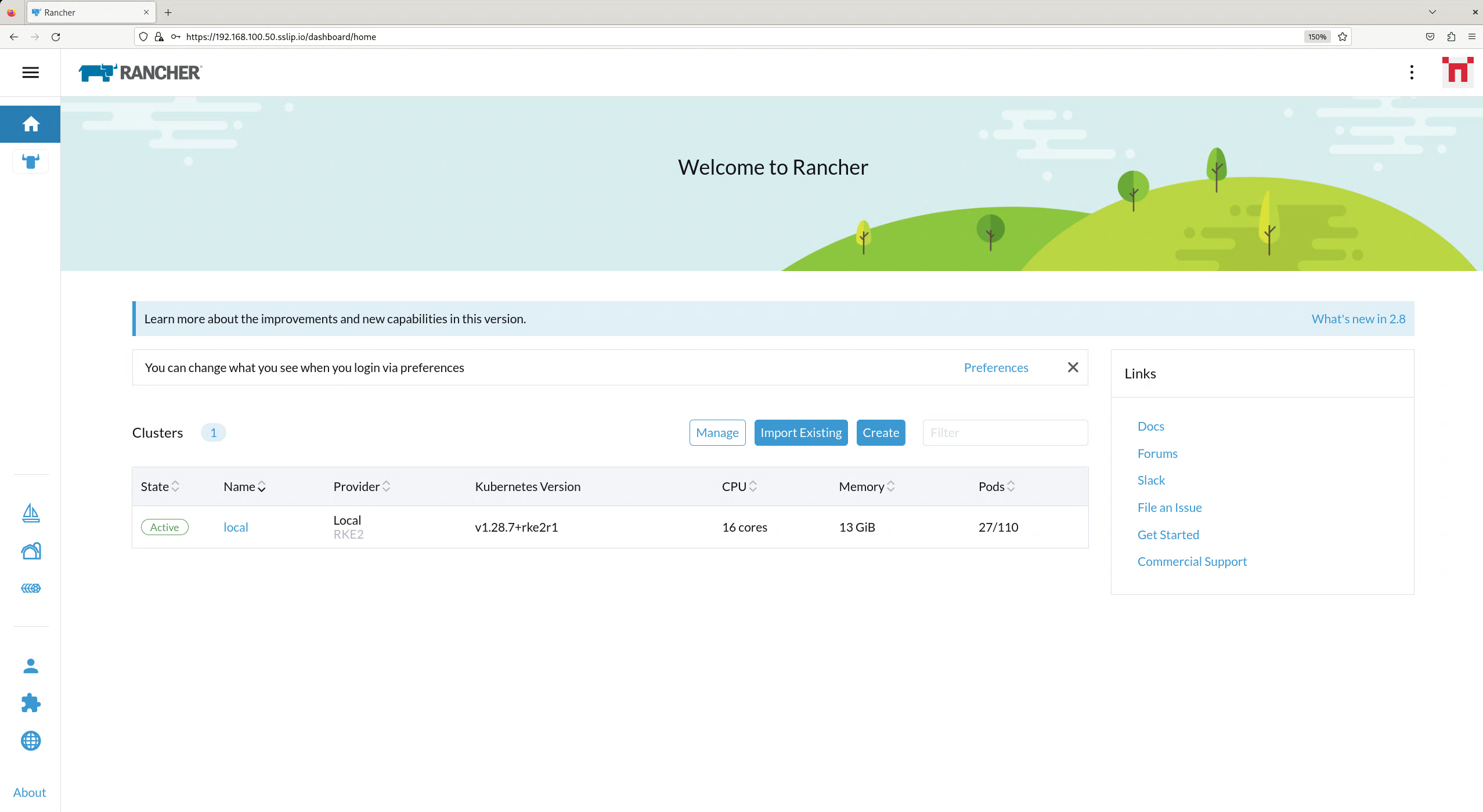

- 2.4 Instalar Rancher

- 2.5 Instalación de Elemental

- 2.6 Configuración de Elemental

- 2.7 Creación de la imagen

- 2.8 Arranque de los nodos descendentes

- 2.9 Creación de clústeres descendentes

- 2.10 Restablecimiento del nodo (opcional)

- 2.11 Pasos siguientes

- 3 Clústeres independientes con Edge Image Builder

- 4 SUSE Multi-Linux Manager

- II Componentes

- 5 Rancher

- 6 Extensiones de panel de control de Rancher

- 7 Rancher Turtles

- 8 Fleet

- 9 SUSE Linux Micro

- 10 Metal3

- 11 Edge Image Builder

- 12 Conexiones de red de Edge

- 13 Elemental

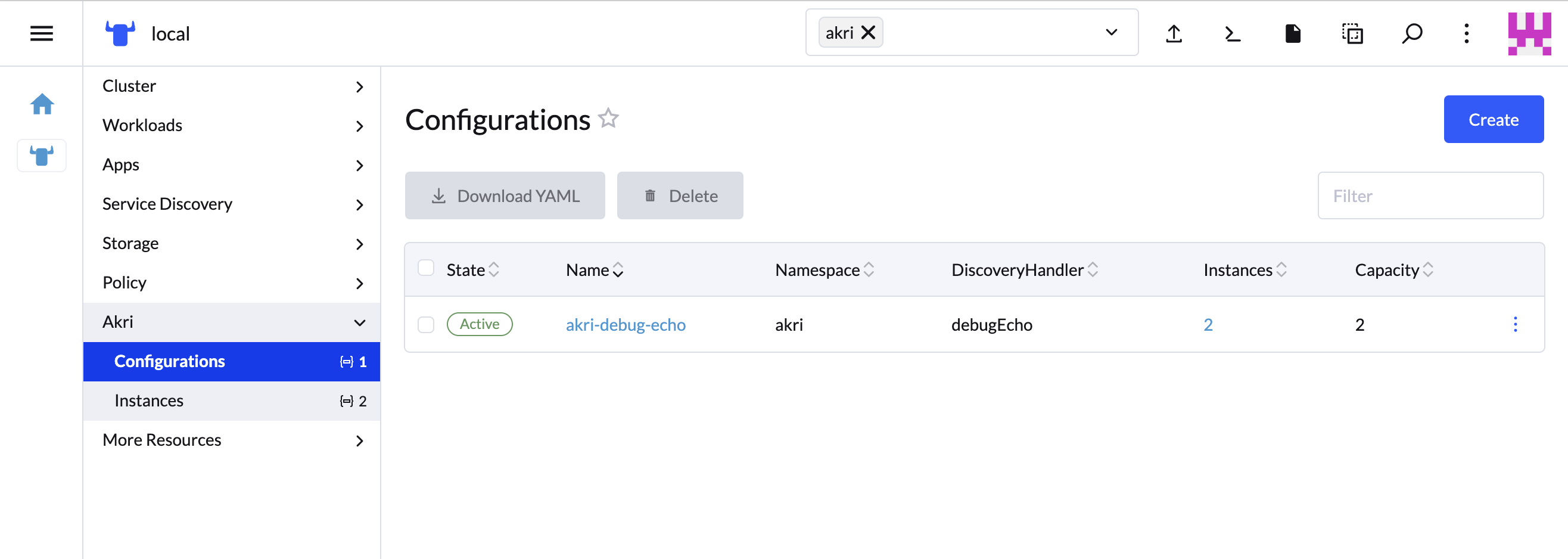

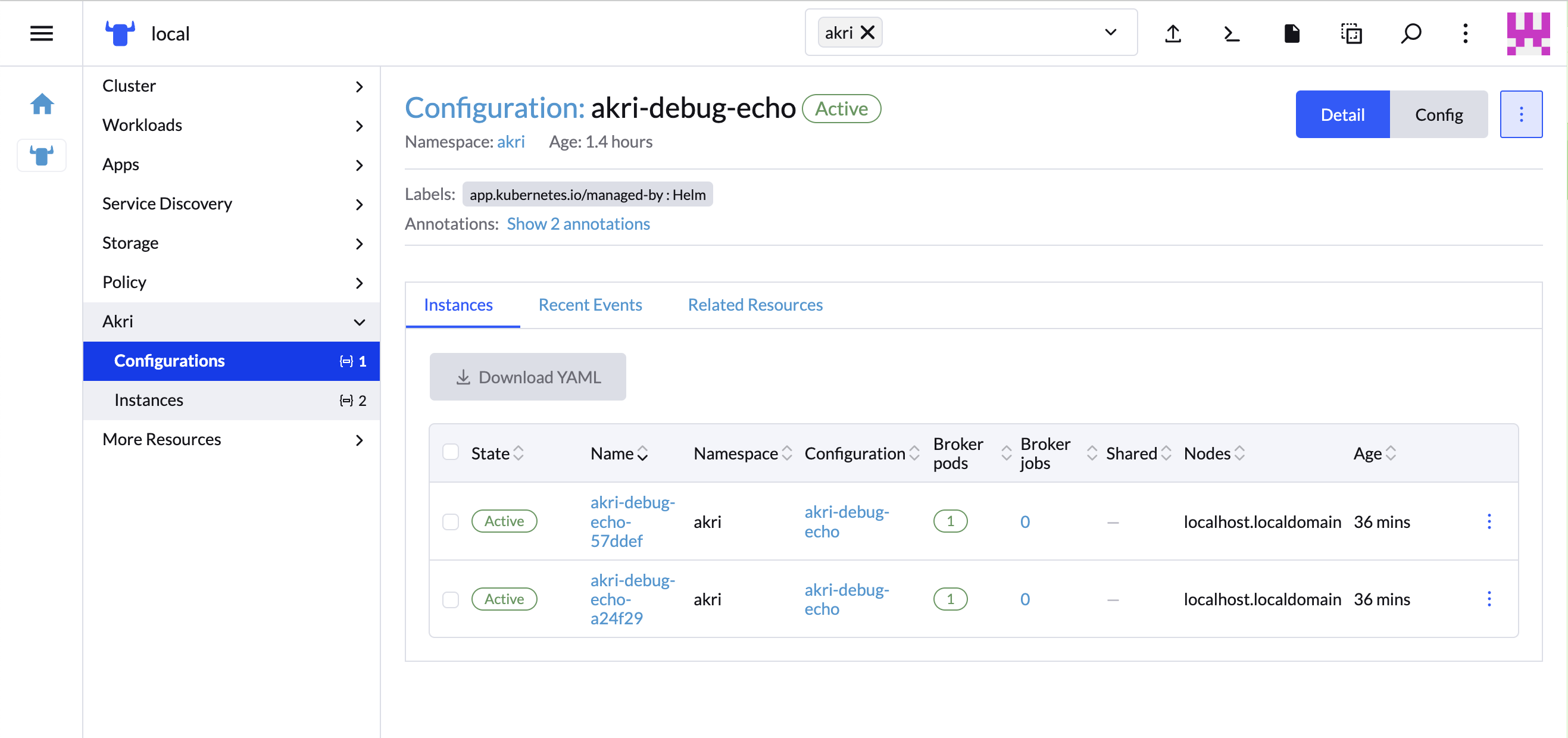

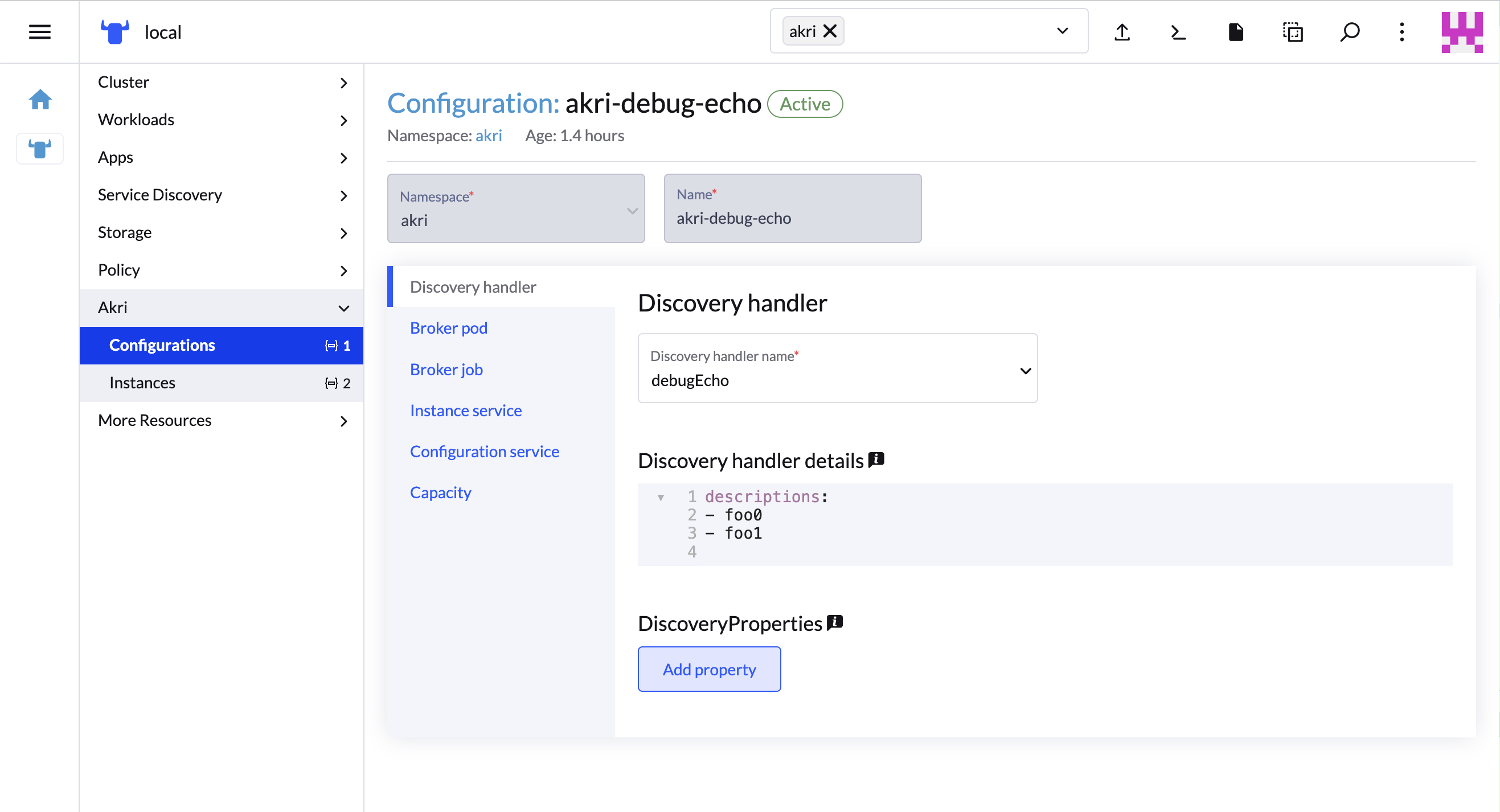

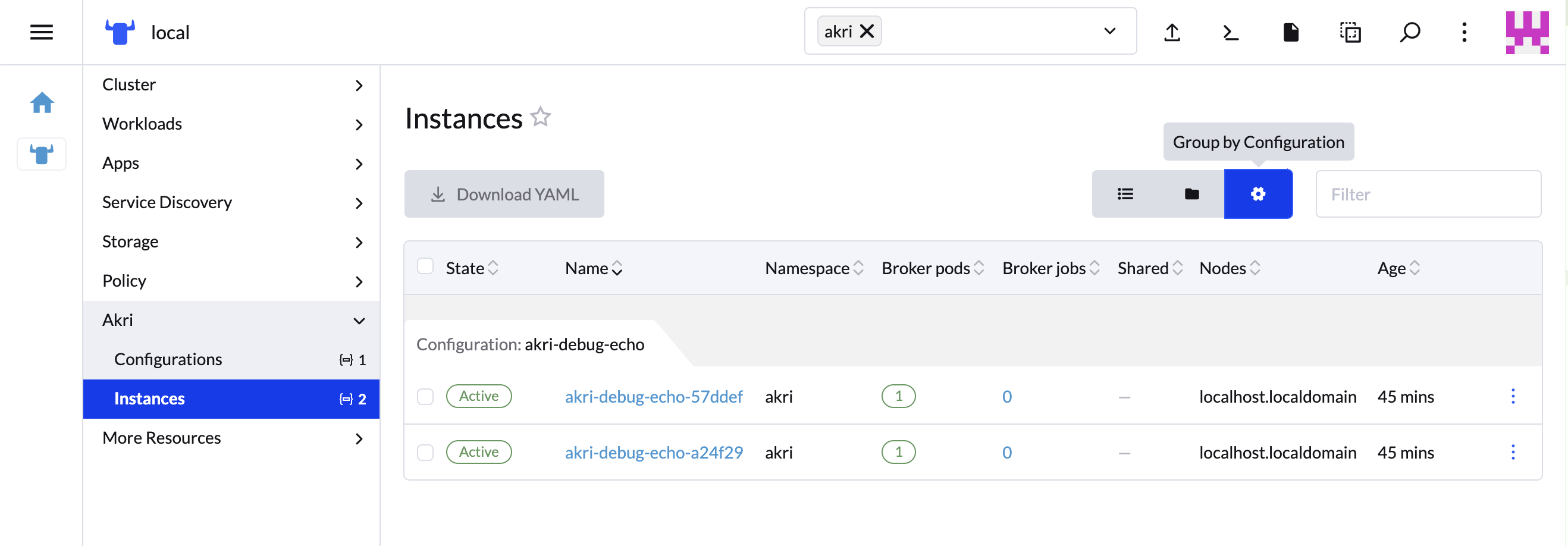

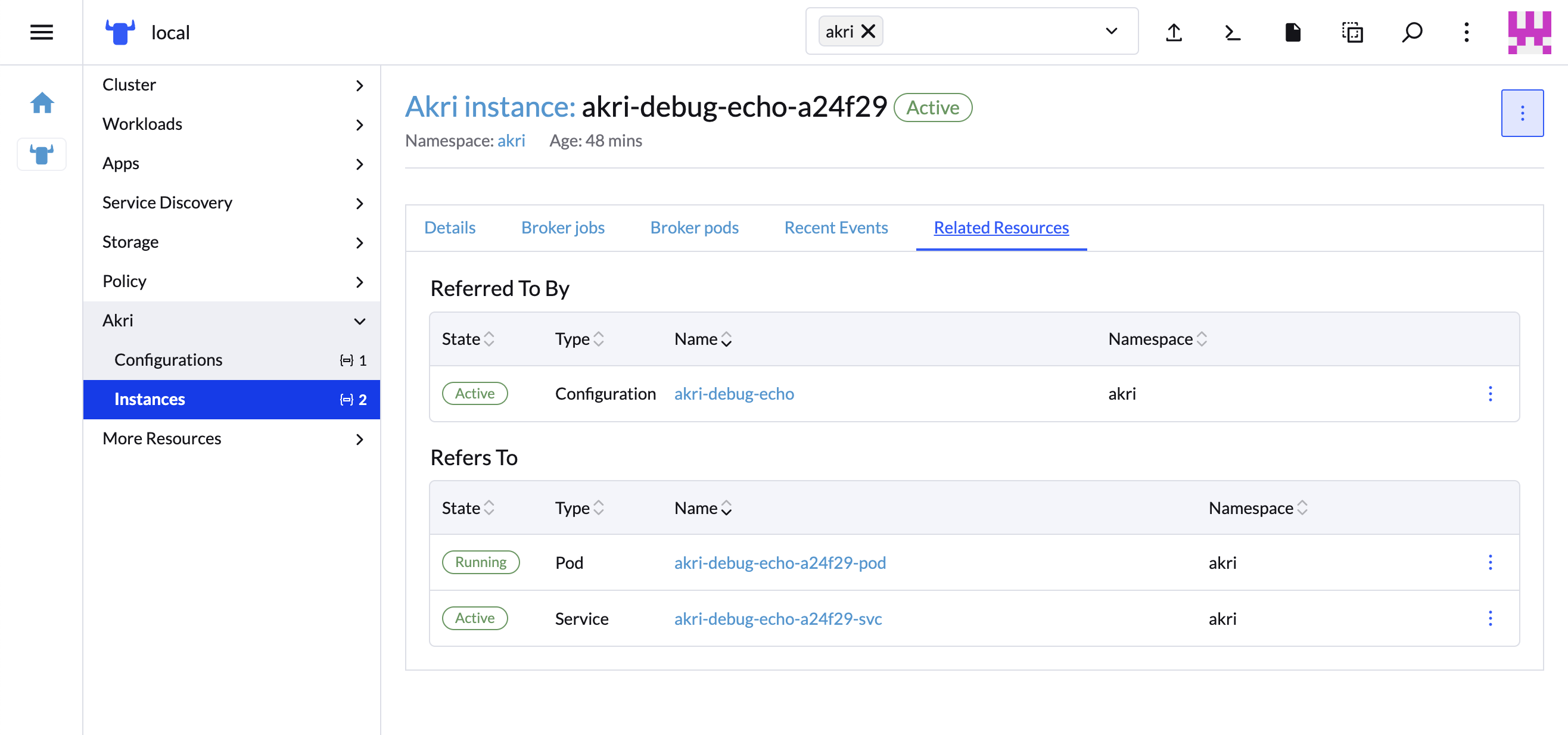

- 14 Akri

- 15 K3s

- 16 RKE2

- 17 SUSE Storage

- 18 SUSE Security

- 19 MetalLB

- 20 Endpoint Copier Operator

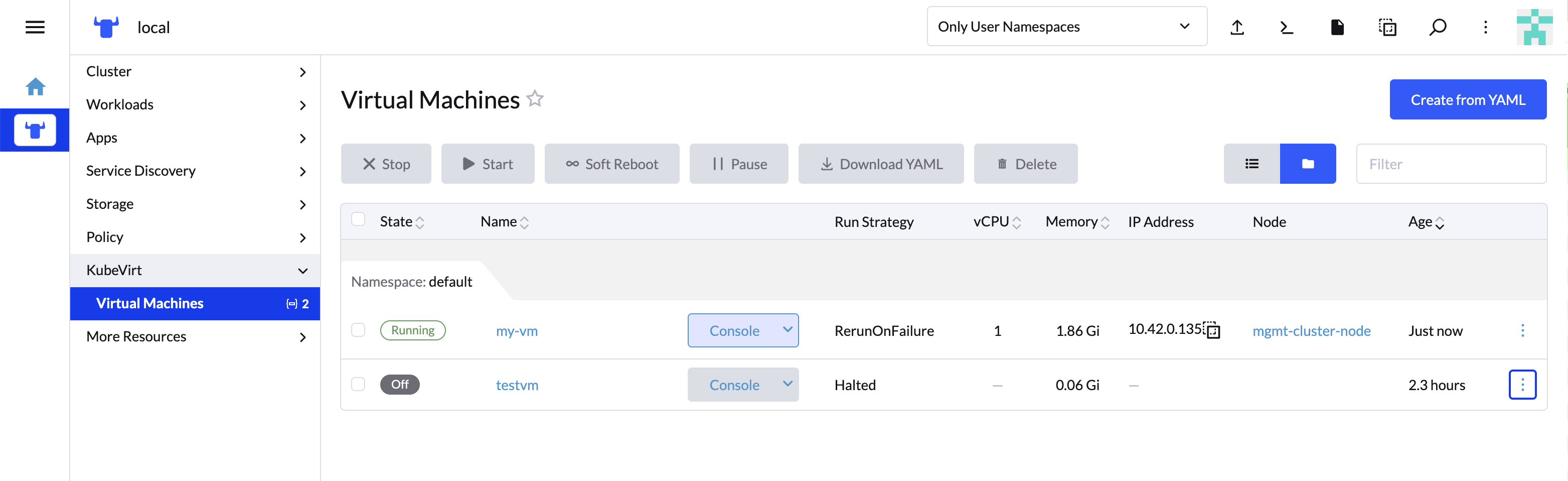

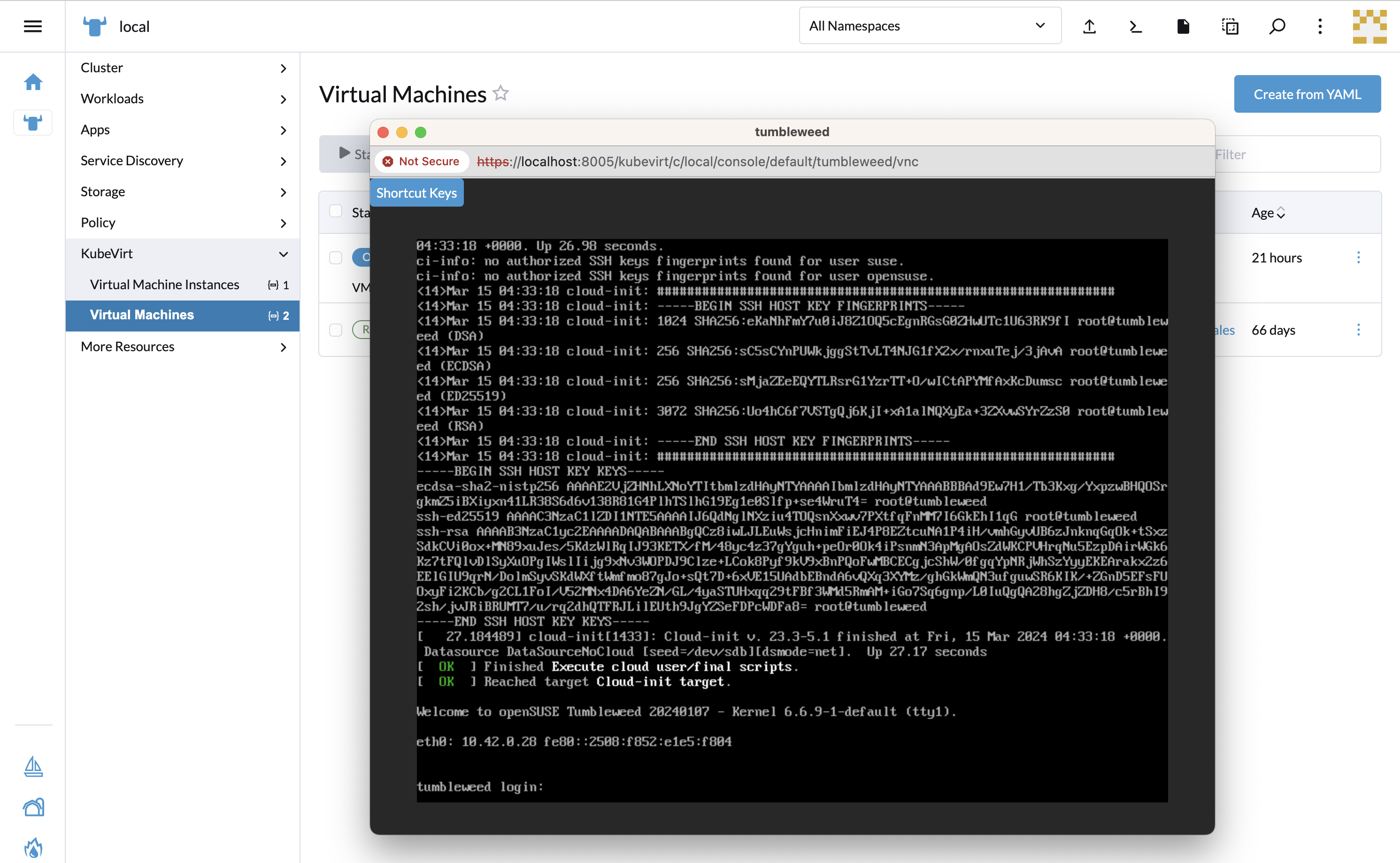

- 21 Edge Virtualization

- 21.1 Descripción general de KubeVirt

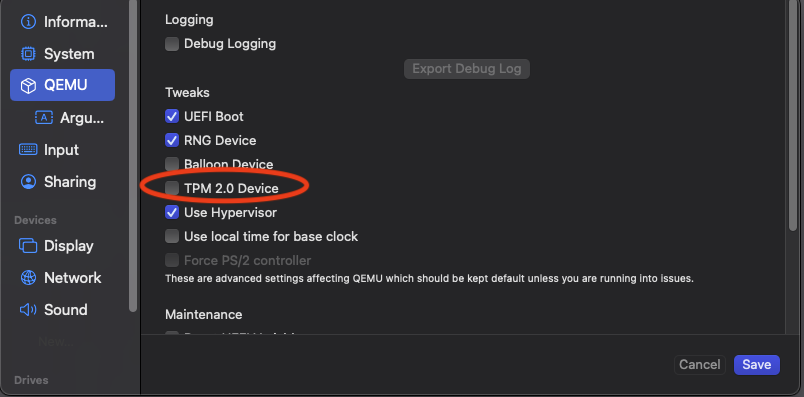

- 21.2 Requisitos previos

- 21.3 Instalación manual de Edge Virtualization

- 21.4 Despliegue de máquinas virtuales

- 21.5 Uso de virtctl

- 21.6 Conexión de redes sencilla con Ingress

- 21.7 Uso de la extensión de interfaz de usuario de Rancher

- 21.8 Instalación con Edge Image Builder

- 22 System Upgrade Controller

- 23 Upgrade Controller

- 23.1 ¿Cómo se usa Upgrade Controller en SUSE Edge?

- 23.2 Diferencias entre Upgrade Controller y System Upgrade Controller

- 23.3 Instalación de Upgrade Controller

- 23.4 ¿Cómo funciona Upgrade Controller?

- 23.5 Extensiones de la API de Kubernetes

- 23.6 Seguimiento del proceso de actualización

- 23.7 Limitaciones conocidas

- 24 SUSE Multi-Linux Manager

- III Guías prácticas

- IV Consejos y trucos

- V Integración de productos de otros fabricantes

- VI Operaciones de día 2

- VII Documentación del producto

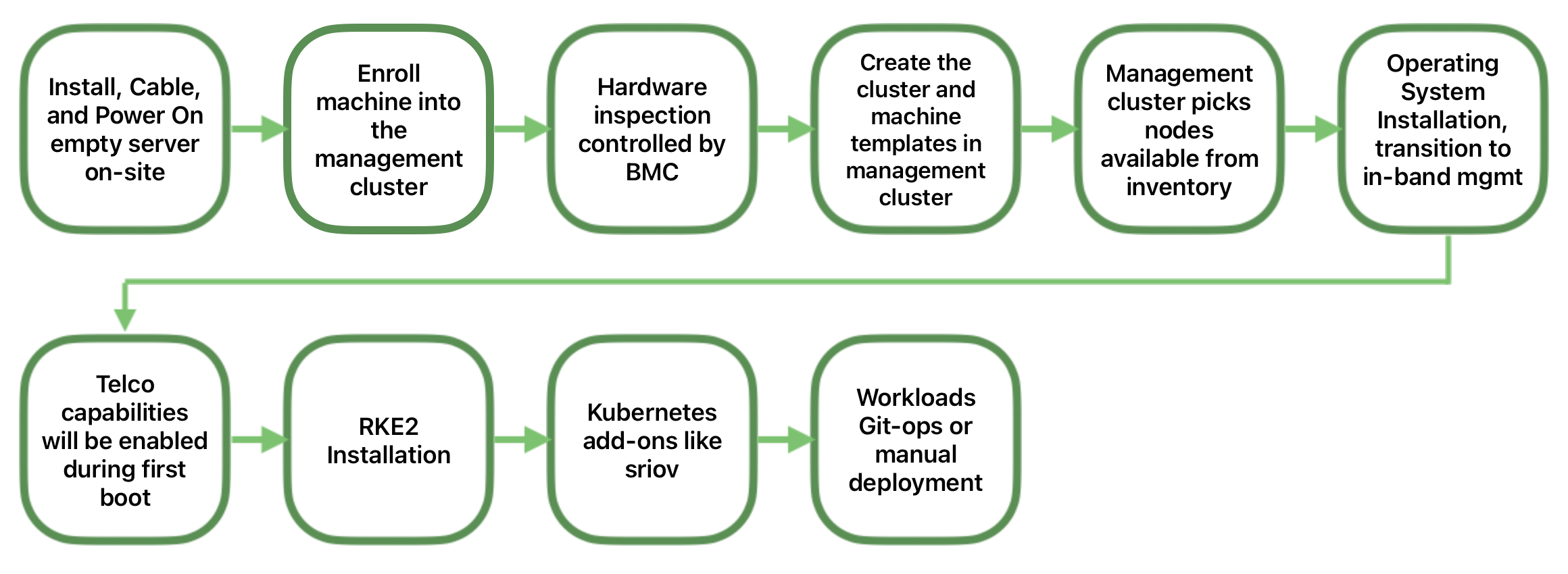

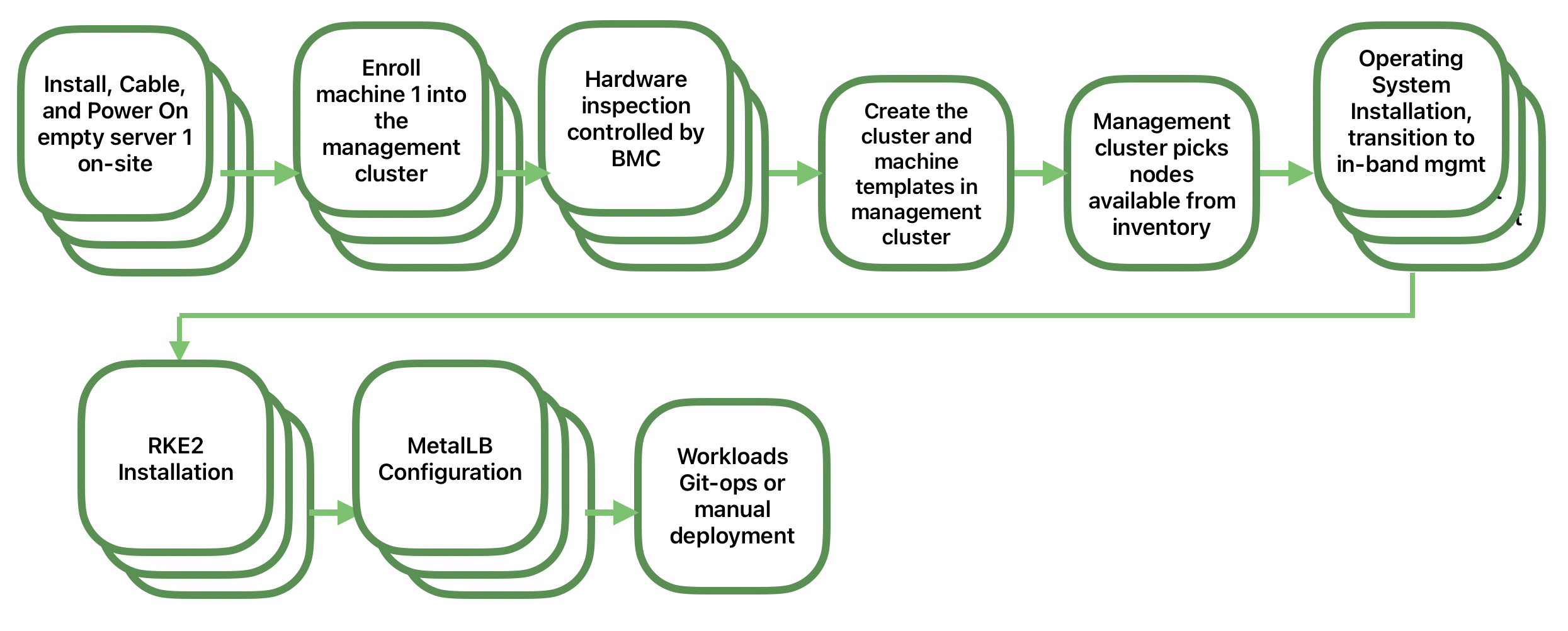

- 37 SUSE Edge for Telco

- 38 Concepto y arquitectura

- 39 Requisitos y supuestos

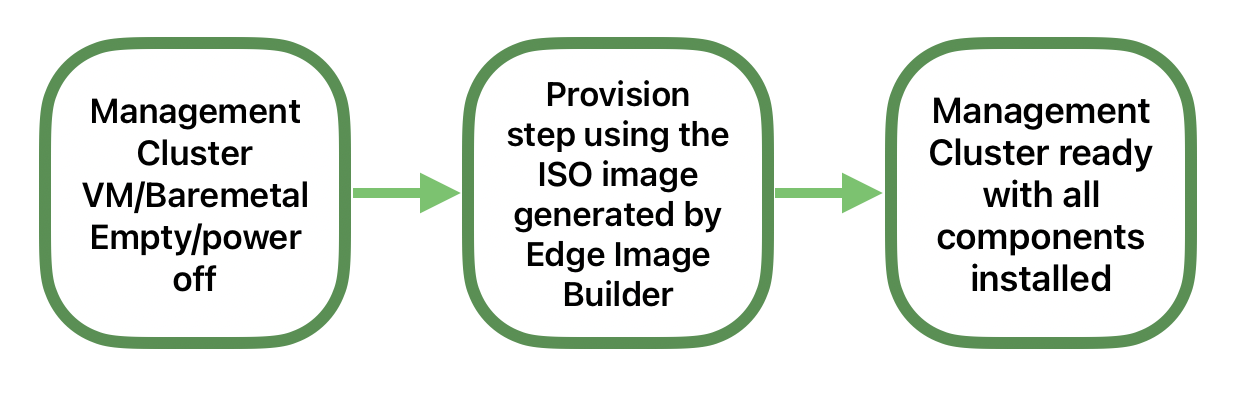

- 40 Configuración del clúster de gestión

- 41 Configuración de funciones de telecomunicaciones

- 41.1 Imagen del kernel en tiempo real

- 41.2 Argumentos del kernel para baja latencia y alto rendimiento

- 41.3 Fijación de CPU mediante Tuned y argumentos del kernel

- 41.4 Configuración de la CNI

- 41.5 SR-IOV

- 41.6 DPDK

- 41.7 Aceleración vRAN (

Intel ACC100/ACC200) - 41.8 Páginas enormes

- 41.9 Fijación de CPU en Kubernetes

- 41.10 Programación compatible con NUMA

- 41.11 MetalLB

- 41.12 Configuración del registro privado

- 41.13 Protocolo de tiempo de precisión (PTP)

- 42 Aprovisionamiento de red dirigida totalmente automatizado

- 42.1 Introducción

- 42.2 Preparación de la imagen del clúster descendente para entornos conectados

- 42.3 Preparación de la imagen del clúster descendente para entornos aislados

- 42.4 Aprovisionamiento de clústeres descendentes con aprovisionamiento de red dirigida (nodo único)

- 42.5 Aprovisionamiento de clústeres descendentes con aprovisionamiento de red dirigida (varios nodos)

- 42.6 Configuración de red avanzada

- 42.7 Funciones para telecomunicaciones (DPDK, SR-IOV, aislamiento de CPU, páginas enormes, NUMA, etc.)

- 42.8 Registro privado

- 42.9 Aprovisionamiento de clústeres descendentes en entornos aislados

- 43 Acciones del ciclo de vida

- VIII Solución de problemas

- 44 Principios generales para resolver problemas

- 45 Resolución de problemas de Kiwi

- 46 Resolución de problemas de Edge Image Builder (EIB)

- 47 Resolución de problemas de redes periféricas (NMC)

- 48 Resolución de problemas en escenarios "phone home"

- 49 Resolución de problemas de aprovisionamiento de red dirigida

- 50 Resolución de problemas de otros componentes

- 51 Recopilación de diagnóstico para la asistencia

- IX Apéndice

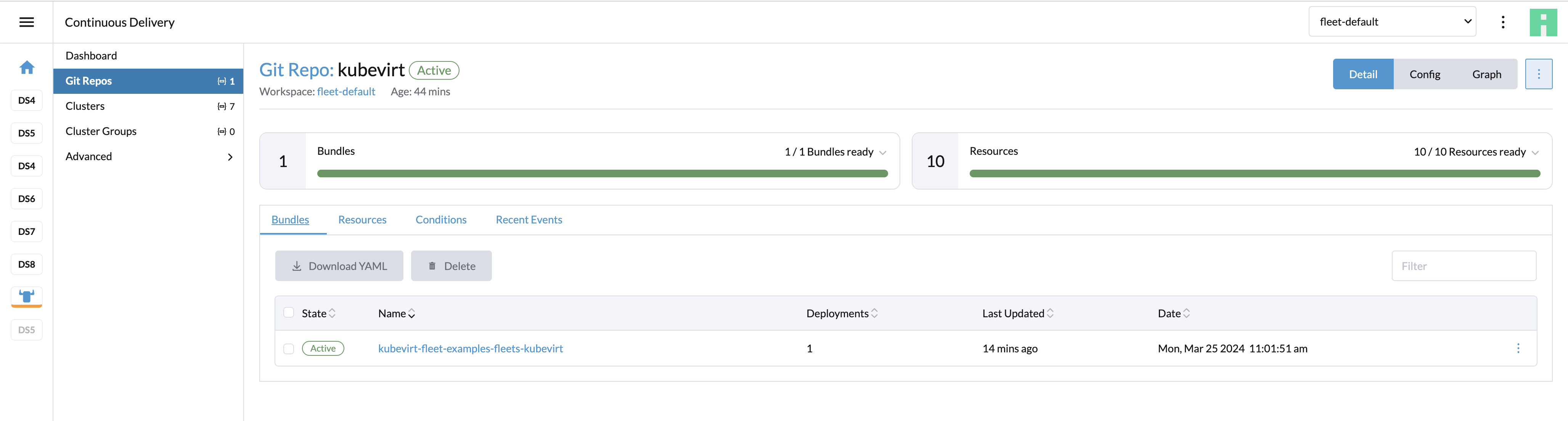

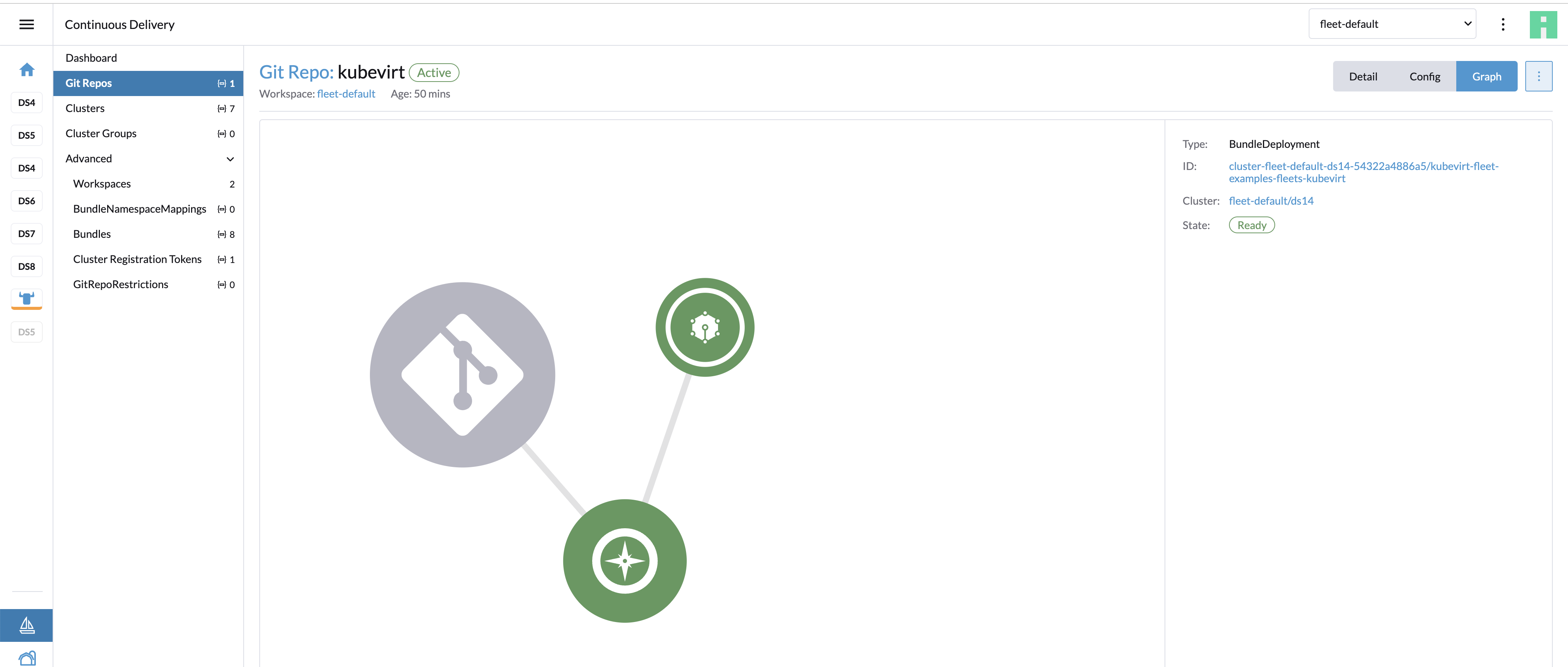

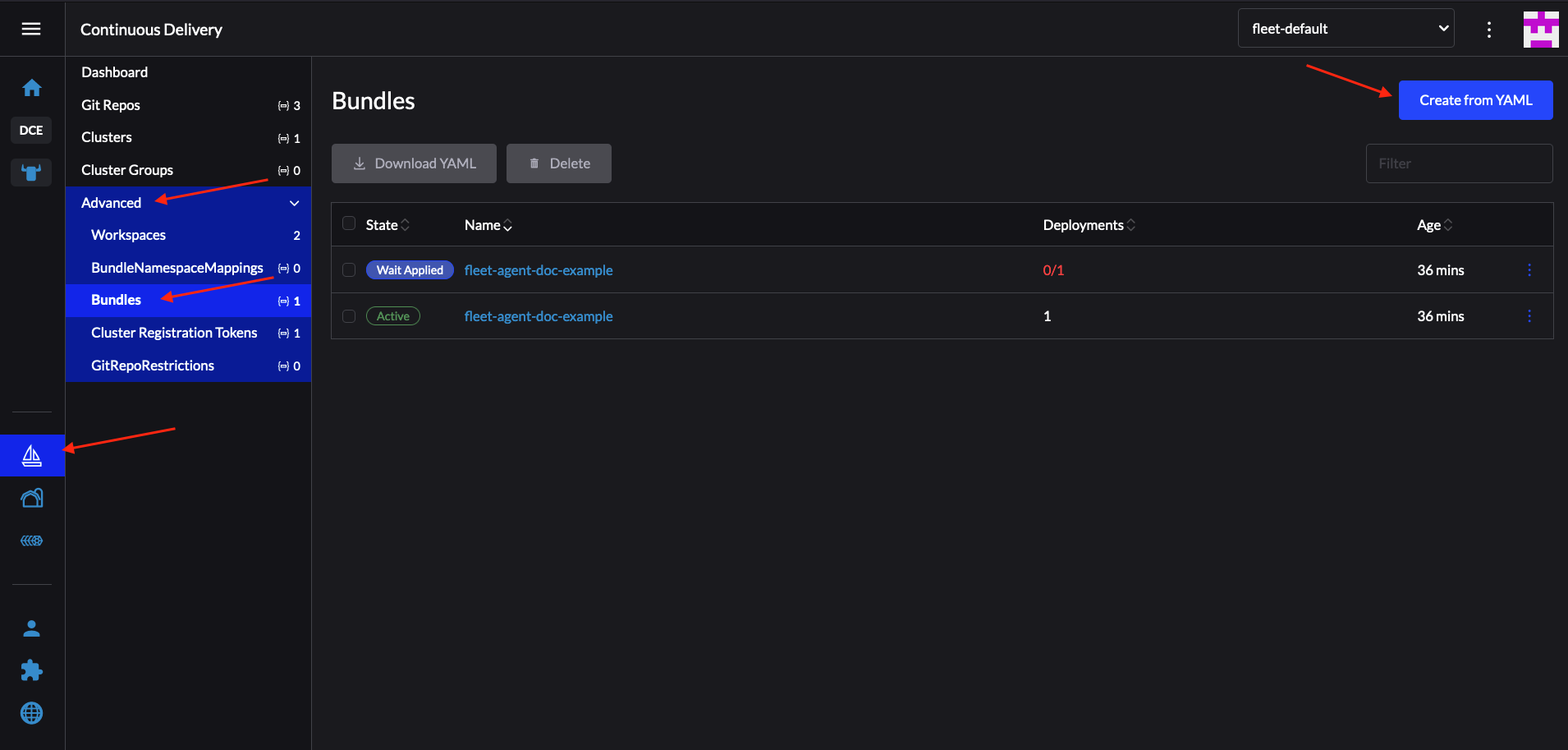

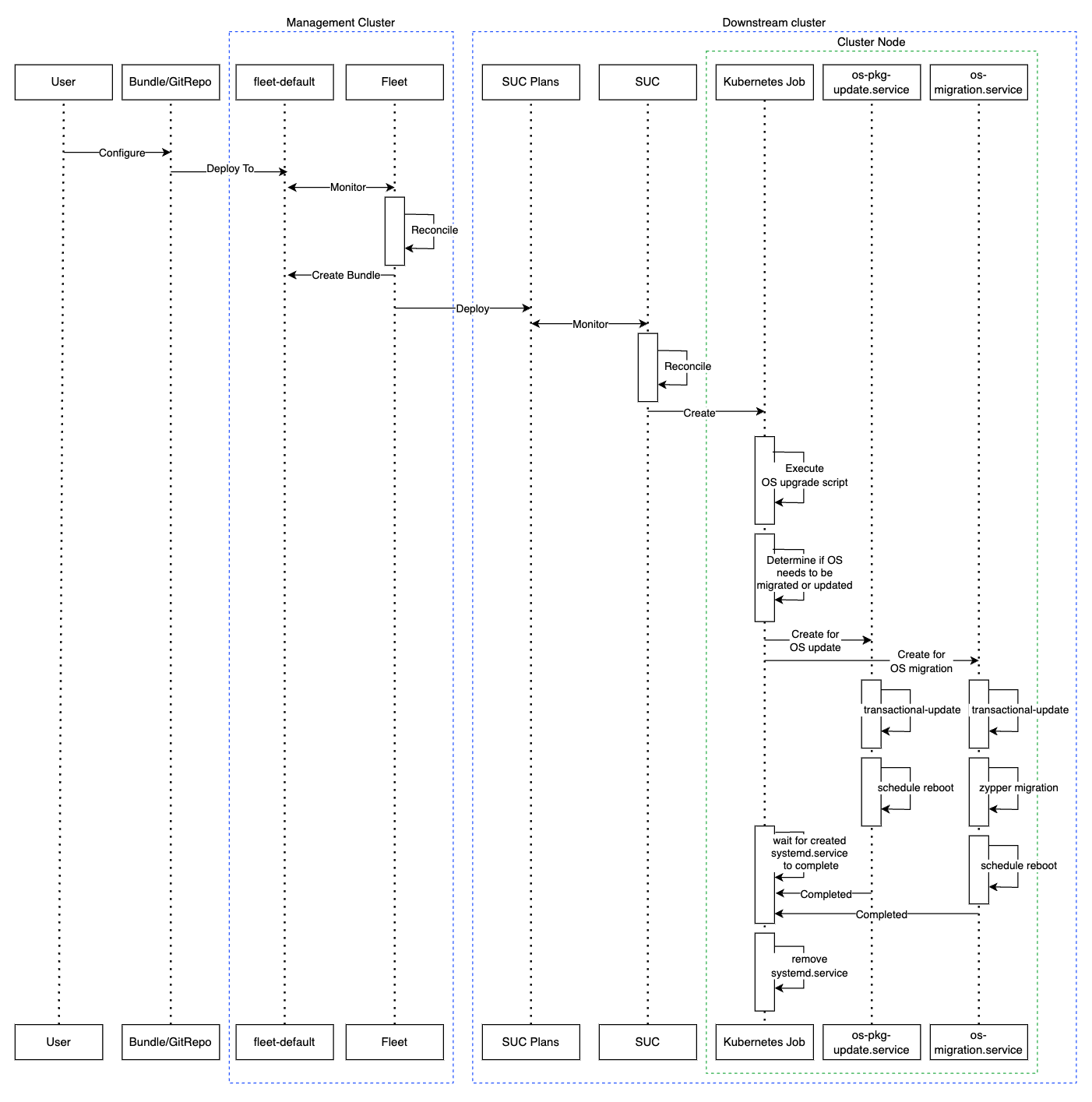

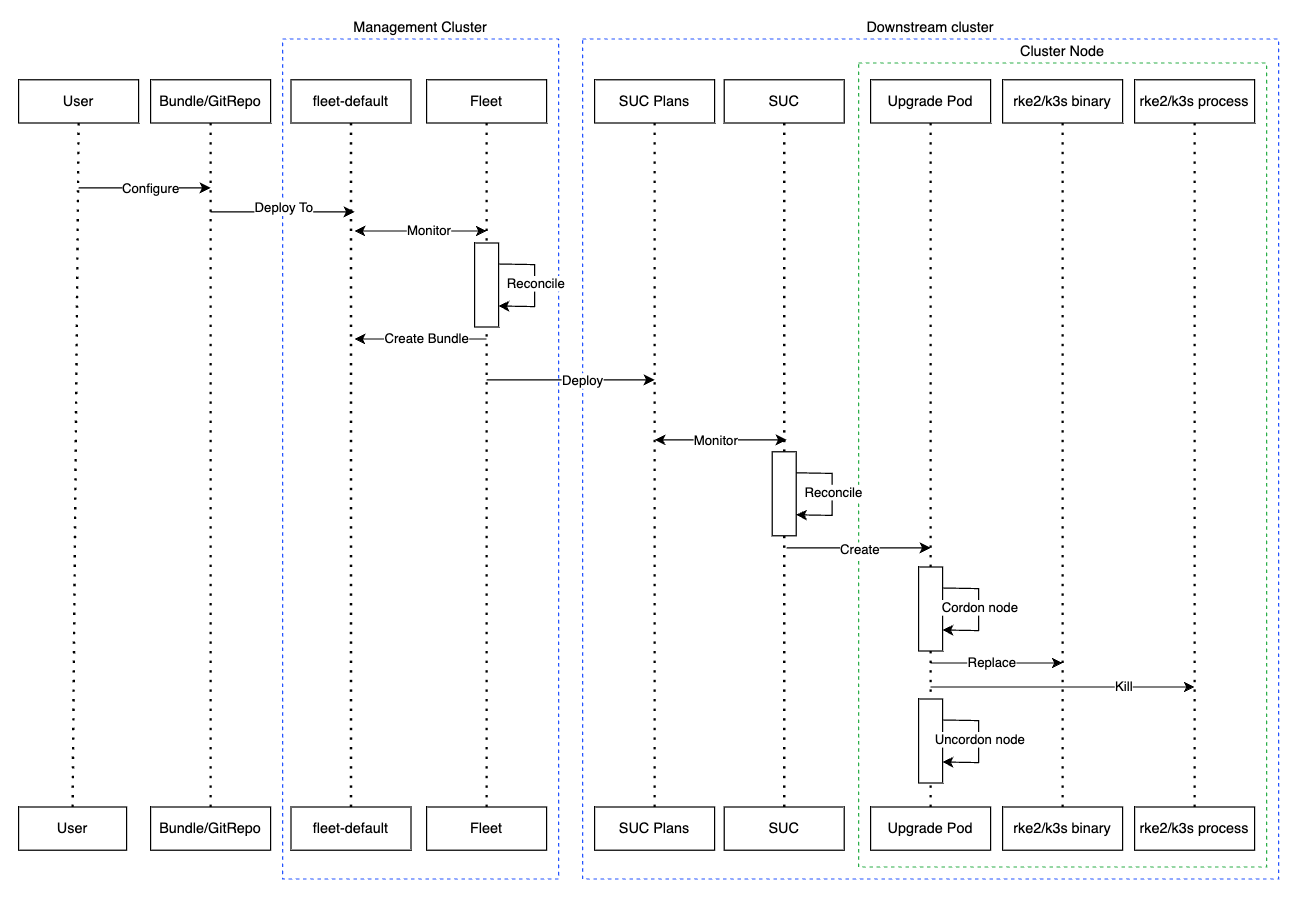

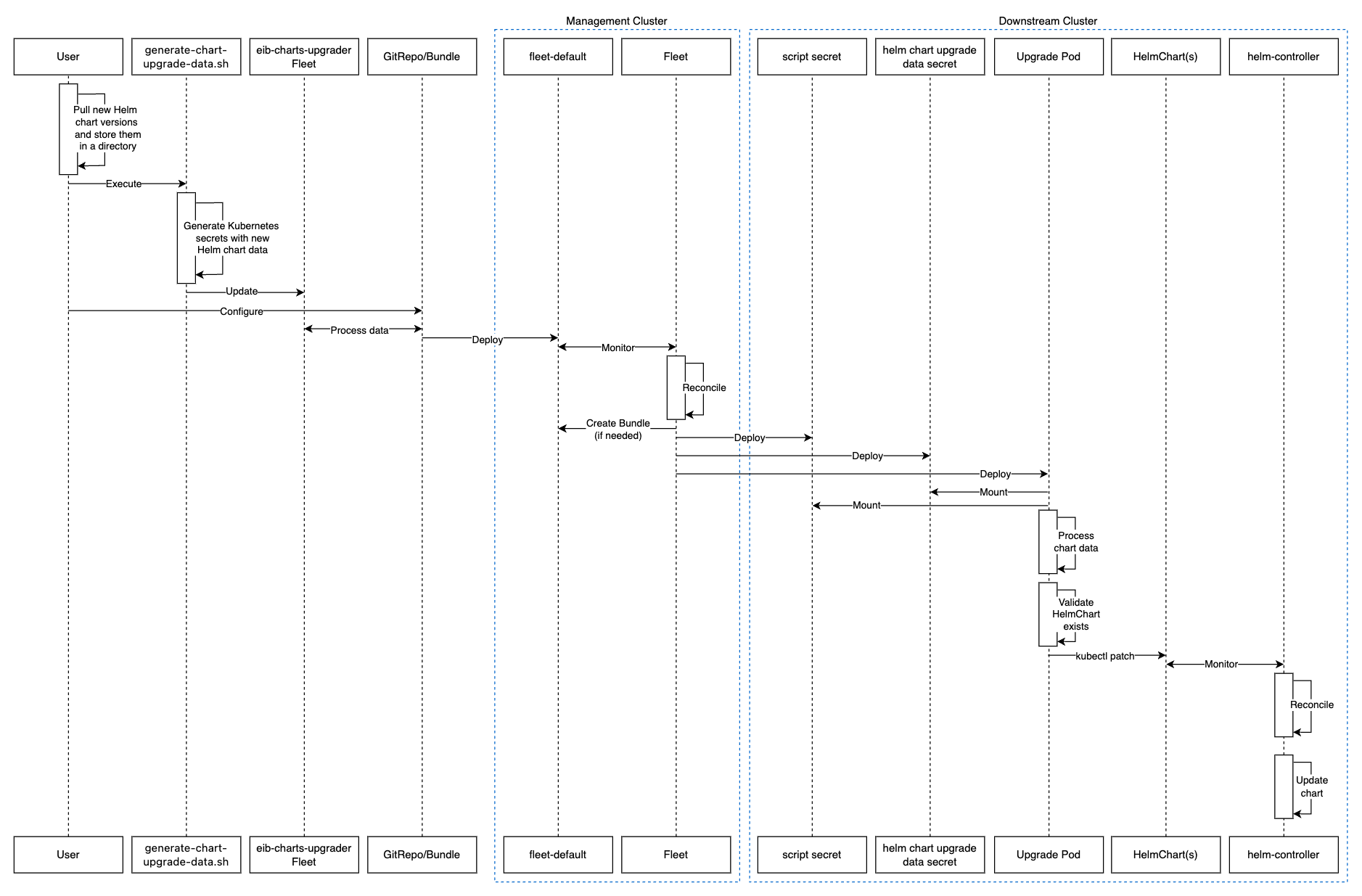

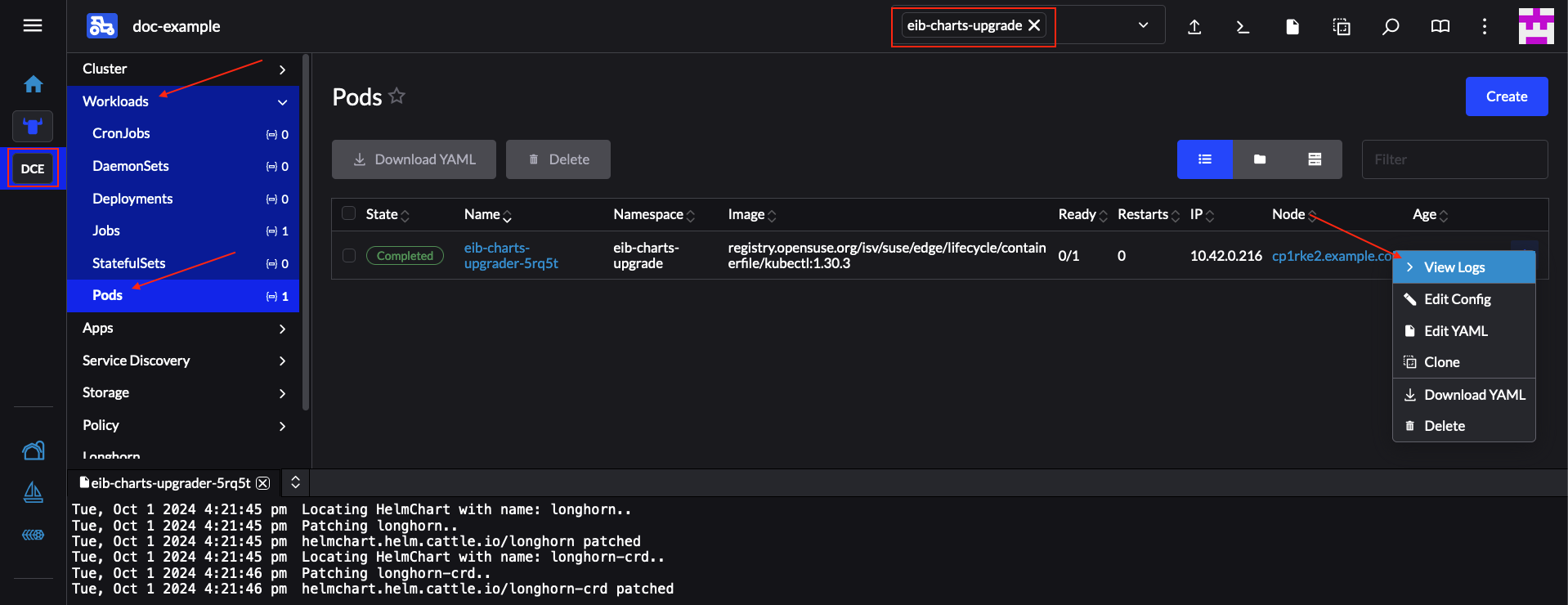

- 35.1 Despliegue del Bundle mediante la interfaz de Rancher

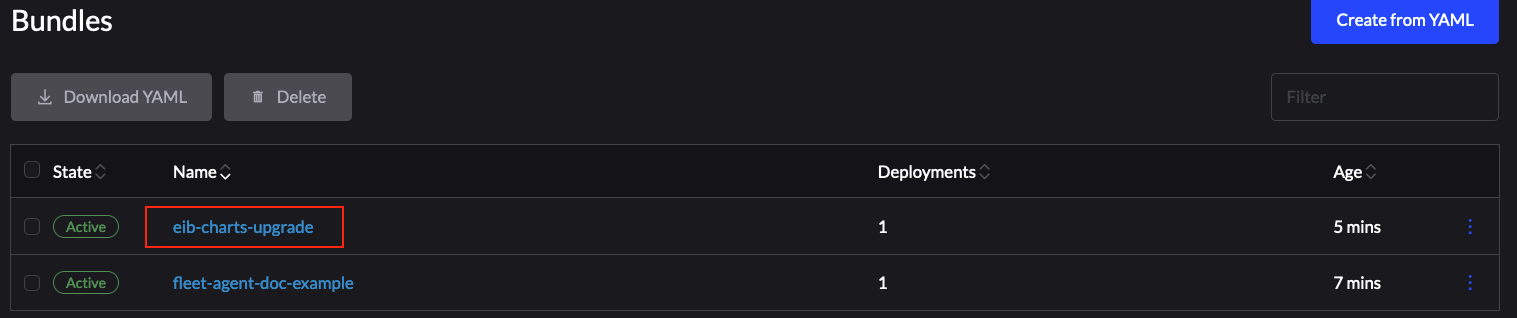

- 35.2 Bundle desplegado correctamente

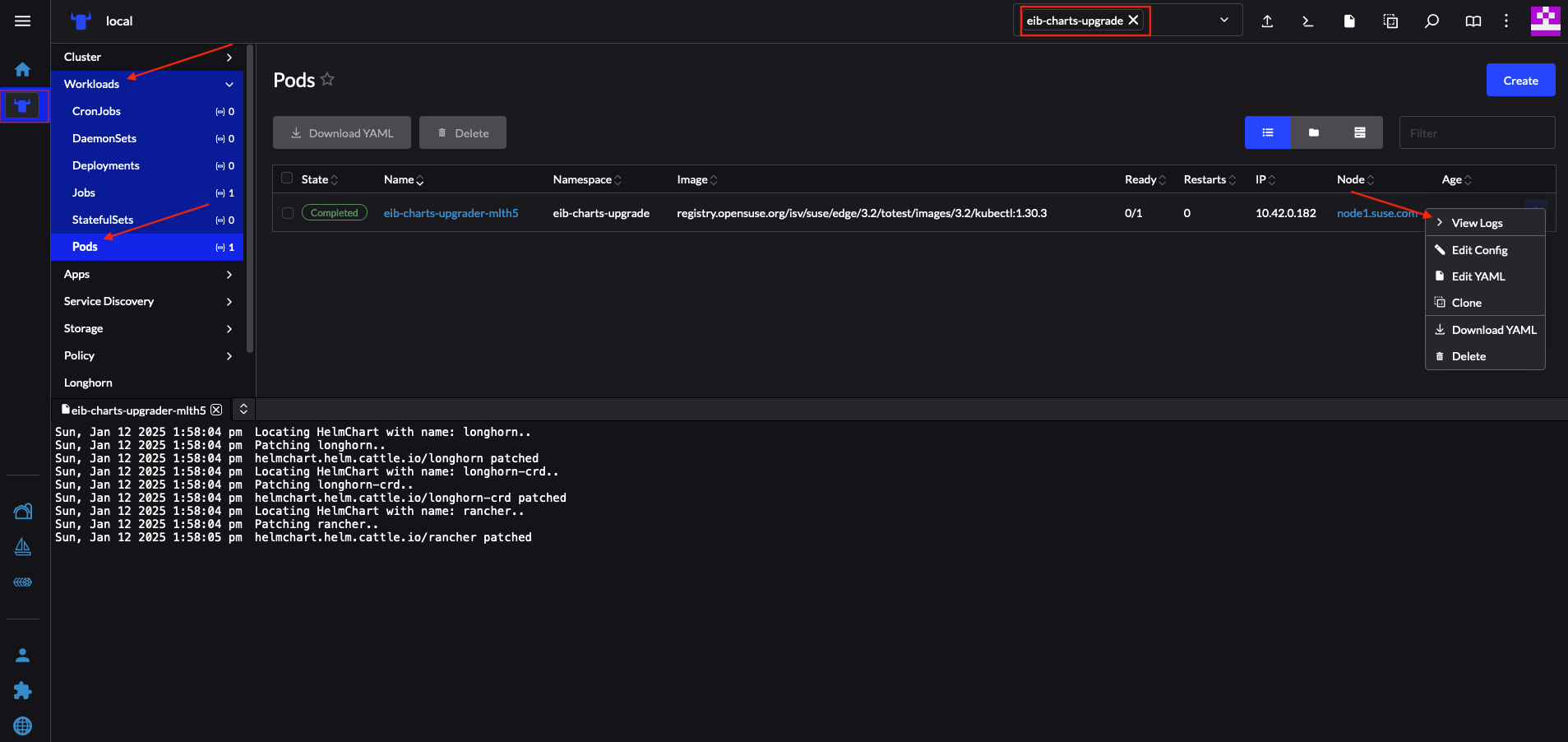

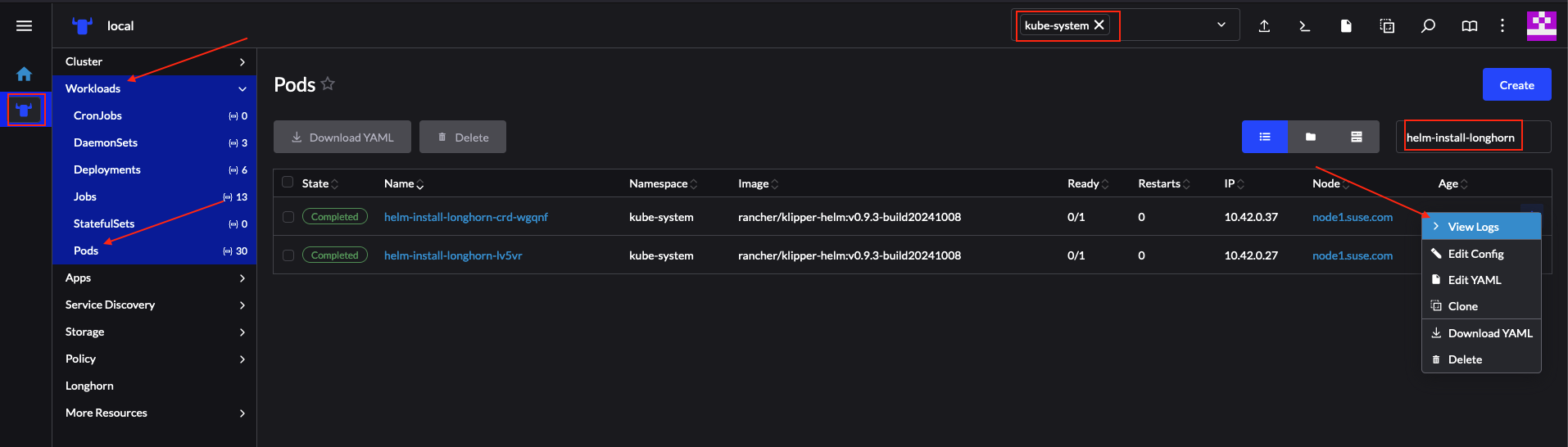

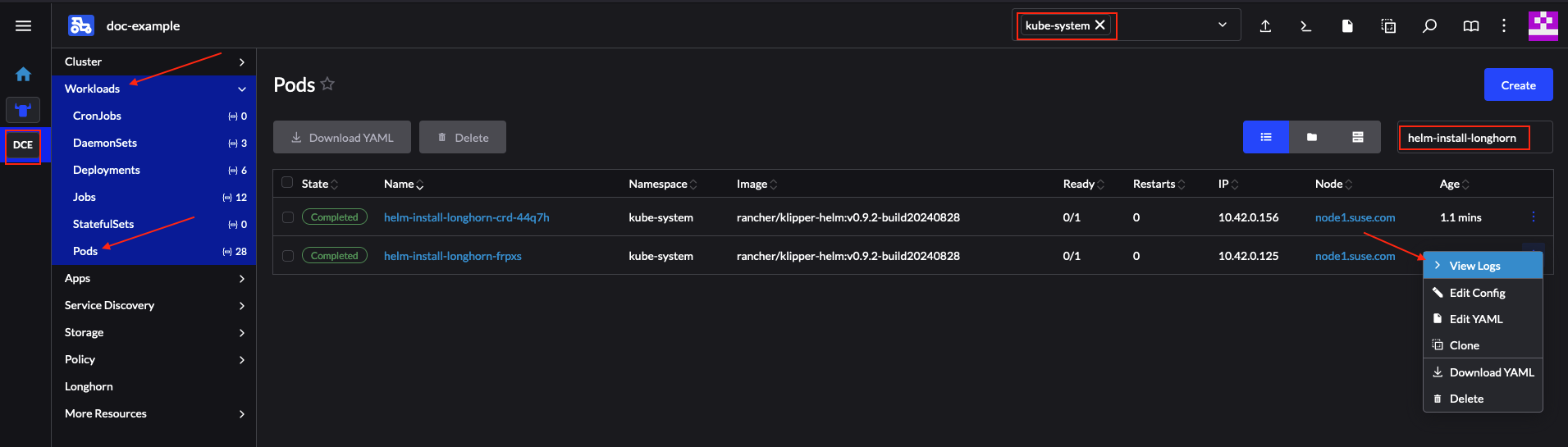

- 35.3 Registros de chart de Longhorn actualizado correctamente

- 36.1 Despliegue del Bundle mediante la interfaz de Rancher

- 36.2 Bundle desplegado correctamente

- 36.3 Registros de chart de Longhorn actualizado correctamente

Documentación de SUSE Edge 3.3.1 #

Le damos la bienvenida a la documentación de SUSE Edge. Aquí, encontrará una descripción general de la arquitectura, guías de inicio rápido, diseños validados, orientación sobre el uso de los componentes, integraciones de terceros y prácticas recomendadas para gestionar su infraestructura y sus cargas de trabajo de edge computing.

1 ¿Qué es SUSE Edge? #

SUSE Edge es una solución integral, diseñada específicamente, estrechamente integrada y validada de forma exhaustiva para abordar los retos únicos que plantea el despliegue de infraestructura y aplicaciones nativas de la nube en el perímetro. Su objetivo principal es proporcionar una plataforma propia, pero altamente flexible, escalable y segura, que abarque desde la creación de imágenes de distribución inicial, el aprovisionamiento y la incorporación de nodos, el despliegue de aplicaciones, la observabilidad y las operaciones completas del ciclo de vida. La plataforma se basa por completo en el mejor software de código abierto, en consonancia con nuestros más de 30 años de historia proporcionando plataformas SUSE Linux seguras, estables y certificadas, y en nuestra experiencia en la gestión de Kubernetes altamente escalable y rica en funciones con nuestra cartera de productos Rancher. SUSE Edge se basa en estas capacidades para ofrecer funcionalidades que pueden aplicarse a numerosos segmentos de mercado, incluyendo el comercio minorista, la medicina, el transporte, la logística, las telecomunicaciones, la fabricación inteligente y el IoT industrial.

2 Filosofía de diseño #

La solución se ha diseñado partiendo de la idea de que no existe una plataforma periférica única "válida para todo", debido a la gran variedad de requisitos y expectativas de los clientes. Los despliegues periféricos nos obligan a evolucionar para resolver continuamente problemas difíciles, como la escalabilidad masiva, la disponibilidad limitada de la red, las restricciones de espacio físico, las nuevas amenazas de seguridad y vectores de ataque, las variaciones en la arquitectura del hardware y los recursos del sistema, la necesidad de implantar e interactuar con infraestructuras y aplicaciones heredadas, y las soluciones de los clientes que tienen una vida útil prolongada. Dado que para muchos de estos retos es preciso pensar más allá de las fórmulas habituales, por ejemplo, en el despliegue de infraestructura y aplicaciones dentro de centros de datos o en la nube pública, tenemos que examinar el diseño con mucho más detalle y replantearnos muchas ideas que no hay que dar por hechas.

Por ejemplo, valoramos el minimalismo, la modularidad y la facilidad de uso. El minimalismo es importante para los entornos periféricos, ya que cuanto más complejo es un sistema, más probable es que tenga problemas. Cuando se analizan cientos de ubicaciones, y hasta cientos de miles, los sistemas complejos fallan de formas complejas. La modularidad de nuestra solución permite una mayor elección por parte del usuario, al tiempo que elimina la complejidad innecesaria en la plataforma. También debemos aportar facilidad de uso. Los seres humanos pueden cometer errores al repetir un proceso miles de veces, por lo que la plataforma debe garantizar que cualquier error potencial sea recuperable, eliminando la necesidad de visitas de técnicos in situ, pero también procurando que se consiga coherencia y estandarización.

3 Arquitectura general #

La arquitectura general del sistema SUSE Edge se divide en dos categorías principales: clústeres de "gestión" y clústeres "descendentes". El clúster de gestión se encarga de la gestión remota de uno o varios clústeres descendentes, aunque se entiende que, en determinadas circunstancias, los clústeres descendentes deben funcionar sin gestión remota; por ejemplo, en situaciones en las que un sitio periférico no tenga conectividad externa y deba funcionar de forma aislada. En SUSE Edge, los componentes técnicos que se utilizan para el funcionamiento de los clústeres de gestión y descendentes son en gran medida comunes, aunque se pueden diferenciar tanto en las especificaciones del sistema como en las aplicaciones que residen en ellos; es decir, el clúster de gestión ejecutaría aplicaciones que permitan la gestión de sistemas y las operaciones del ciclo de vida, mientras que los clústeres descendentes cumplirían los requisitos para dar servicio a las aplicaciones de los usuarios.

3.1 Componentes usados en SUSE Edge #

SUSE Edge está formado por componentes de SUSE y de Rancher, junto con funciones y componentes adicionales creados por el equipo de Edge para permitirnos abordar las limitaciones y complejidades que requiere la edge computing. En el diagrama simplificado siguiente se explican los componentes usados tanto en los clústeres de gestión como en los clústeres descendentes. Sin ser una lista exhaustiva, muestra la arquitectura general:

3.1.1 Clúster de gestión #

Gestión: esta es la parte centralizada de SUSE Edge que se usa para gestionar el aprovisionamiento y el ciclo de vida de los clústeres descendentes. El clúster de gestión suele incluir los componentes siguientes:

Gestión de varios clústeres con Rancher Prime (Capítulo 5, Rancher), que incluye un panel de control común para incorporar clústeres descendentes y para la gestión continua del ciclo de vida de la infraestructura y las aplicaciones, además de proporcionar un aislamiento completo de los inquilinos e integraciones de

IDP(proveedores de identidad), un amplio mercado de integraciones y extensiones de terceros, y una API independiente del proveedor.Gestión de sistemas Linux con SUSE Multi-Linux Manager, que permite la gestión automatizada de parches y configuraciones de Linux del sistema operativo Linux subyacente (*SUSE Linux Micro, Capítulo 9, SUSE Linux Micro) que se ejecuta en los clústeres descendentes. Tenga en cuenta que aunque este componente está en contenedores, actualmente debe ejecutarse en un sistema independiente del resto de los componentes de gestión, por lo que se etiqueta como "Gestión de Linux" en el diagrama anterior.

Un controlador dedicado de gestión del ciclo de vida (Capítulo 23, Upgrade Controller) que se encarga de la actualización de los componentes del clúster de gestión a una versión determinada de SUSE Edge.

Incorporación remota del sistema a Rancher Prime con Elemental (Capítulo 13, Elemental), lo que permite la vinculación posterior de los nodos periféricos conectados a los clústeres de Kubernetes deseados y el despliegue de aplicaciones, por ejemplo, a través de GitOps.

Compatibilidad opcional completa del ciclo de vida y la gestión física (bare metal) con los proveedores de infraestructura Metal3 (Capítulo 10, Metal3), MetalLB (Capítulo 19, MetalLB) y

CAPI(Cluster API), lo que permite el aprovisionamiento completo de extremo a extremo de sistemas físicos con capacidades de gestión remota.Un motor GitOps opcional llamado Fleet (Capítulo 8, Fleet) para gestionar el aprovisionamiento y el ciclo de vida de los clústeres descendentes y las aplicaciones que residen en ellos.

El clúster de gestión tiene SUSE Linux Micro (Capítulo 9, SUSE Linux Micro) como sistema operativo base y RKE2 (Capítulo 16, RKE2) como distribución de Kubernetes que aporta compatibilidad con las aplicaciones del clúster de gestión.

3.1.2 Clústeres descendentes #

Descendentes: esta es la parte distribuida de SUSE Edge que se utiliza para ejecutar las cargas de trabajo del usuario en el perímetro; es decir, el software que se ejecuta en la propia ubicación perimetral y que, normalmente, se compone de los siguientes componentes:

Una selección de distribuciones de Kubernetes, con distribuciones seguras y ligeras como K3s (Capítulo 15, K3s) y RKE2 (Capítulo 16, RKE2) (

RKE2está reforzada, certificada y optimizada para su uso en el sector público y en industrias reguladas).SUSE Security (Capítulo 18, SUSE Security) para habilitar funciones de seguridad como el análisis de vulnerabilidades de imágenes, la inspección profunda de paquetes y la protección en tiempo real contra amenazas y vulnerabilidades.

Software de almacenamiento en bloques con SUSE Storage (Capítulo 17, SUSE Storage) que permite un sistema de almacenamiento en bloques ligero, persistente, resistente y escalable.

Un sistema operativo Linux ligero, optimizado para contenedores y reforzado con SUSE Linux Micro (Capítulo 9, SUSE Linux Micro), que proporciona un sistema operativo inmutable y altamente resiliente para ejecutar contenedores y máquinas virtuales en el perímetro. SUSE Linux Micro está disponible para las arquitecturas AArch64 y AMD64/Intel 64, y también admite

kernel en tiempo realpara aplicaciones sensibles a la latencia (por ejemplo, para usos en telecomunicaciones).Para los clústeres conectados (los que tienen conectividad con el clúster de gestión), se despliegan dos agentes: Rancher System Agent, para gestionar la conectividad con Rancher Prime, y venv-salt-minion, para recibir instrucciones de SUSE Multi-Linux Manager y aplicar las actualizaciones de software de Linux. Estos agentes no son necesarios para la gestión de clústeres desconectados.

3.2 Conectividad #

La imagen anterior ofrece una descripción general de la arquitectura de los clústeres descendentes conectados y sus conexiones con el clúster de gestión. El clúster de gestión se puede desplegar en una amplia variedad de plataformas de infraestructura subyacentes, tanto en instalaciones locales como en la nube, dependiendo de la disponibilidad de red entre los clústeres descendentes y el clúster de gestión de destino. El único requisito para que funcione es que sea posible acceder a las API y las URL de redirección a través de la red que conecta los nodos del clúster descendente con la infraestructura de gestión.

Es importante entender que existen mecanismos distintos en los que se establece esta conectividad en relación con el mecanismo de despliegue del clúster descendente. Esto se explica con mucho más detalle en la siguiente sección. Como descripción general: existen tres mecanismos principales para que los clústeres descendentes conectados se establezcan como un clúster "gestionado":

Los clústeres descendentes se despliegan inicialmente en modo "desconectado" (por ejemplo, mediante Edge Image Builder, Capítulo 11, Edge Image Builder) y, a continuación, se importan al clúster de gestión si la conectividad lo permite.

Los clústeres descendentes se configuran para utilizar el mecanismo de incorporación integrado (por ejemplo, a través de Elemental (Capítulo 13, Elemental)) y se registran automáticamente en el clúster de gestión en el primer arranque, lo que permite la vinculación posterior de la configuración del clúster.

Los clústeres descendentes se han aprovisionado con capacidades de gestión bare metal (CAPI + Metal3) y se importan automáticamente en el clúster de gestión después de que este se haya desplegado y configurado (a través del operador Rancher Turtles).

Se recomienda desplegar varios clústeres de gestión para adaptarse a la escala de los despliegues de gran tamaño, optimizar el ancho de banda y la latencia en entornos geográficamente dispersos, y minimizar las interrupciones en caso de una caída del servicio o una actualización del clúster de gestión. Encontrará los límites actuales de escalabilidad del clúster de gestión y los requisitos del sistema aquí.

4 Patrones de despliegue perimetrales comunes #

Debido a la variedad de entornos operativos y requisitos de ciclo de vida existentes, hemos implantado compatibilidad para una serie de patrones de despliegue que se ajustan de manera general a los sectores del mercado y los casos de uso en los que funciona SUSE Edge. Hemos creado una guía de inicio rápido para cada uno de estos patrones a fin de que pueda familiarizarse con la plataforma SUSE Edge en función de sus necesidades. A continuación, se describen los tres patrones de despliegue que admitimos actualmente, con un enlace a la página de inicio rápido correspondiente.

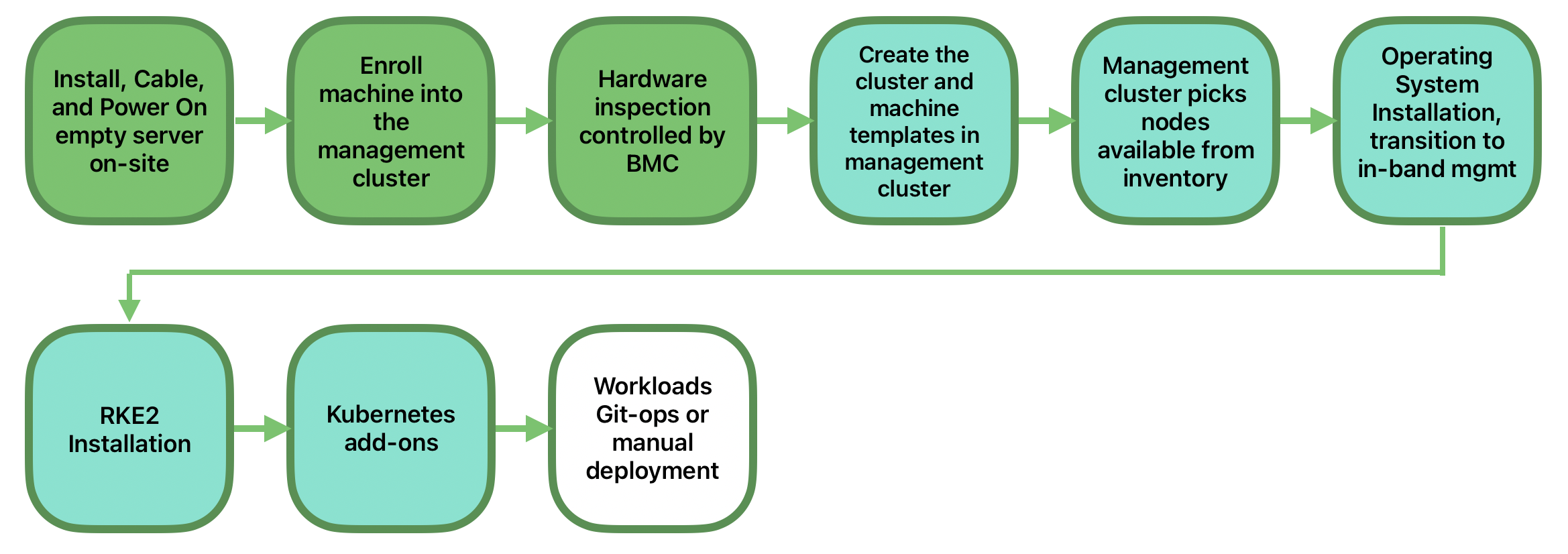

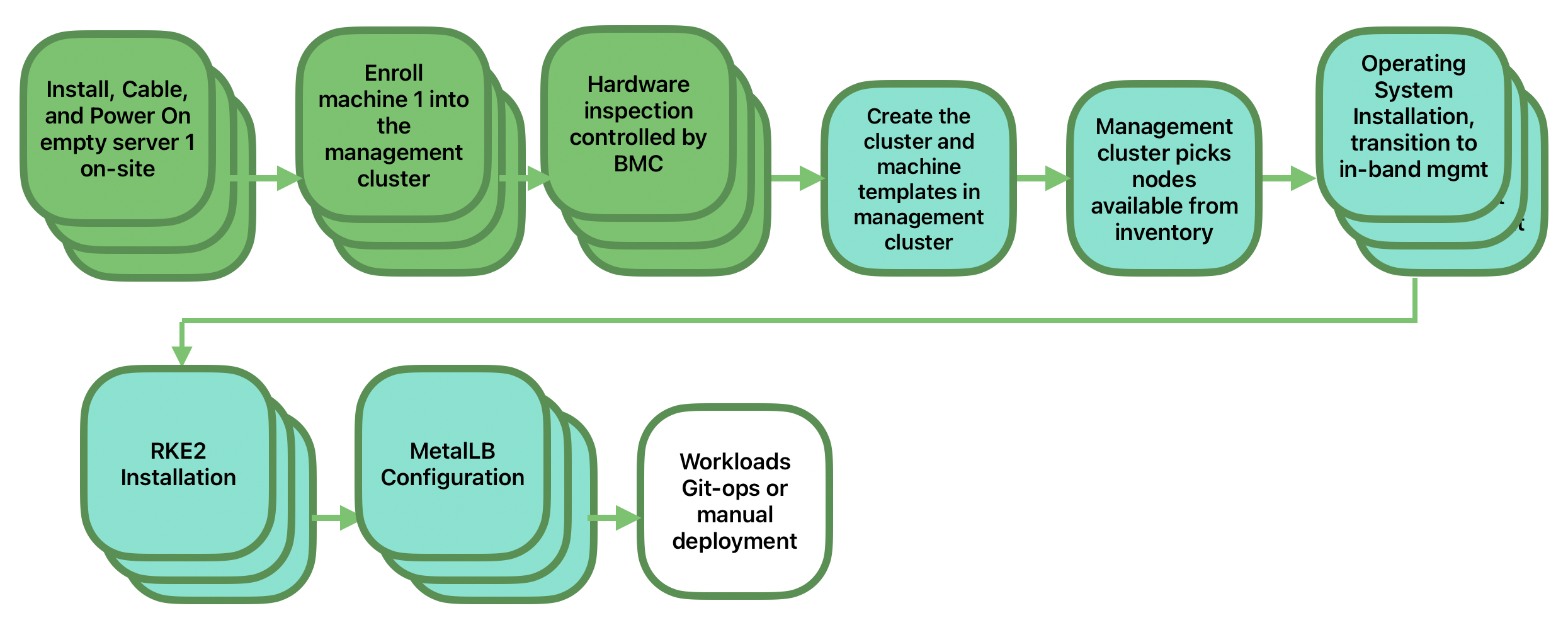

4.1 Aprovisionamiento de red dirigida #

En el aprovisionamiento de red dirigida se conocen los detalles del hardware en el que se desea realizar el despliegue y se tiene acceso directo a la interfaz de gestión fuera de banda para orquestar y automatizar todo el proceso de aprovisionamiento. En este caso, nuestros clientes esperan una solución que permita aprovisionar los sitios periféricos de forma totalmente automatizada desde una ubicación centralizada, lo que va mucho más allá de la simple creación de una imagen de arranque al minimizar las operaciones manuales en la ubicación periférica; basta con montar, alimentar y conectar las redes necesarias al hardware físico y el proceso de automatización enciende el equipo mediante la gestión fuera de banda (por ejemplo, a través de la API Redfish) y se encarga del aprovisionamiento, la incorporación y la implantación de la infraestructura sin intervención del usuario. La clave para que este modelo funcione es que los administradores conozcan los sistemas y que sepan qué hardware hay en cada ubicación y que el despliegue se gestionará de forma centralizada.

Esta solución es la más robusta, ya que interactúa directamente con la interfaz de gestión del hardware, trabaja con hardware conocido y tiene menos restricciones en cuanto a la disponibilidad de la red. En cuanto a la funcionalidad, esta solución utiliza ampliamente Cluster API y Metal3 para el aprovisionamiento automatizado, desde bare metal, pasando por el sistema operativo y Kubernetes hasta las aplicaciones en capas; y ofrece la posibilidad de vincularse al resto de las capacidades comunes de gestión del ciclo de vida de SUSE Edge tras el despliegue. La guía de inicio rápido para esta solución se puede encontrar en el Capítulo 1, Despliegues automatizados de BMC con Metal3.

4.2 Aprovisionamiento de red "phone home" #

A veces, se trabaja en un entorno en el que el clúster de gestión central no puede gestionar el hardware directamente (por ejemplo, si la red remota está protegida por un cortafuegos o no hay una interfaz de gestión fuera de banda, algo habitual en el hardware de tipo "PC" que suele encontrarse en el perímetro). En este caso, proporcionamos herramientas para aprovisionar de forma remota los clústeres y sus cargas de trabajo sin necesidad de saber dónde se envía el hardware cuando se arranca. Este sistema es en el que la mayoría de la gente piensa al hablar de la edge computing: son los miles de sistemas algo desconocidos que se arrancan en ubicaciones periféricas y se comunican de forma segura con la central, validando quiénes son y recibiendo instrucciones sobre lo que deben hacer. Aquí se espera un aprovisionamiento y una gestión del ciclo de vida con muy poca intervención del usuario, aparte de la creación previa de imágenes del equipo en fábrica o de simplemente conectar una imagen de arranque, por ejemplo, a través de USB, y encender el sistema. Los principales retos en este modelo son cómo abordar la escala, la coherencia, la seguridad y el ciclo de vida de estos dispositivos en el mundo real.

Esta solución ofrece una gran flexibilidad y coherencia en la forma en que se aprovisionan e incorporan los sistemas, independientemente de su ubicación, tipo o especificaciones, o de cuándo se encienden por primera vez. SUSE Edge permite una flexibilidad y personalización totales del sistema a través de Edge Image Builder y aprovecha las capacidades de registro que ofrece Elemental para la incorporación de nodos y el aprovisionamiento de Kubernetes, junto con SUSE Multi-Linux Manager para la aplicación de parches al sistema operativo. La guía de inicio rápido de esta solución se puede encontrar en el Capítulo 2, Incorporación de hosts remotos con Elemental.

4.3 Aprovisionamiento basado en imágenes #

Para los clientes que necesitan operar en entornos independientes, aislados o con limitaciones de red, SUSE Edge ofrece una solución que permite generar medios de instalación totalmente personalizados con todos los artefactos de despliegue necesarios para habilitar clústeres de Kubernetes de alta disponibilidad en el perímetro, tanto de un solo nodo como de múltiples nodos, incluyendo cualquier carga de trabajo o los componentes adicionales en capas que se requieran. Todo ello sin necesidad de conectividad de red con el mundo exterior y sin la intervención de una plataforma de gestión centralizada. La experiencia del usuario se asemeja mucho a la solución "phone home", en la que se proporcionan medios de instalación a los sistemas de destino, pero la solución se "arranca in situ". En este escenario, es posible conectar los clústeres resultantes a Rancher para su gestión continua (es decir, pasar de un modo de funcionamiento "desconectado" a "conectado" sin necesidad de realizar una reconfiguración o un redespliegue importantes), o bien seguir funcionando de forma aislada. Tenga en cuenta que, en ambos casos, se puede aplicar el mismo mecanismo unificado para automatizar las operaciones del ciclo de vida.

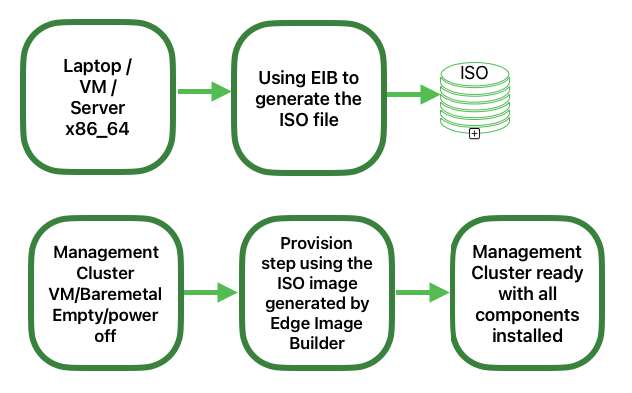

Además, esta solución se puede utilizar para crear rápidamente clústeres de gestión que puedan alojar la infraestructura centralizada que admite tanto el modelo de "aprovisionamiento de red dirigida" como el de "aprovisionamiento de red 'phone home'", ya que puede ser la forma más rápida y sencilla de aprovisionar todo tipo de infraestructura periférica. Esta solución utiliza en gran medida las capacidades de SUSE Edge Image Builder para crear medios de instalación totalmente personalizados y desatendidos. La guía de inicio rápido se puede encontrar en el Capítulo 3, Clústeres independientes con Edge Image Builder.

5 Validación de la pila SUSE Edge #

Todas las versiones de SUSE Edge tienen componentes estrechamente integrados y minuciosamente validados que se lanzan unidos. Como parte de los esfuerzos de integración continua y validación de la pila, que no solo prueban la integración entre componentes, sino que también garantizan que el sistema funcione según lo esperado en escenarios de fallo forzado, el equipo de SUSE Edge publica todas las pruebas realizadas y sus resultados. Estos, junto con todos los parámetros de entrada, se pueden encontrar en ci.edge.suse.com.

6 Lista completa de componentes #

Esta es la lista completa de componentes, junto con un enlace a una descripción general de cada uno de ellos y cómo se utilizan en SUSE Edge:

Rancher (Capítulo 5, Rancher)

Extensiones de panel de control de Rancher (Capítulo 6, Extensiones de panel de control de Rancher)

Rancher Turtles (Capítulo 7, Rancher Turtles)

SUSE Multi-Linux Manager

Fleet (Capítulo 8, Fleet)

SUSE Linux Micro (Capítulo 9, SUSE Linux Micro)

Metal³ (Capítulo 10, Metal3)

Edge Image Builder (Capítulo 11, Edge Image Builder)

NetworkManager Configurator (Capítulo 12, Conexiones de red de Edge)

Elemental (Capítulo 13, Elemental)

Akri (Capítulo 14, Akri)

K3s (Capítulo 15, K3s)

RKE2 (Capítulo 16, RKE2)

SUSE Storage (Capítulo 17, SUSE Storage)

SUSE Security (Capítulo 18, SUSE Security)

MetalLB (Capítulo 19, MetalLB)

KubeVirt (Capítulo 21, Edge Virtualization)

System Upgrade Controller (Capítulo 22, System Upgrade Controller)

Upgrade Controller (Capítulo 23, Upgrade Controller)

Parte I Guías de inicio rápido #

Aquí están las guías de inicio rápido

- 1 Despliegues automatizados de BMC con Metal3

Metal3 es un projecto de la CNCF que proporciona capacidades de gestión de infraestructura bare metal para Kubernetes.

- 2 Incorporación de hosts remotos con Elemental

En esta sección se explica la solución de aprovisionamiento de red "phone home" (el comando que se usa, traducido como "llamar a casa") como parte de SUSE Edge. En ella se utiliza Elemental para ayudar con la incorporación de nodos. Elemental es una pila de software que permite el registro remoto de…

- 3 Clústeres independientes con Edge Image Builder

Edge Image Builder (EIB) es una herramienta que agiliza el proceso de generación de imágenes de disco personalizadas y listas para arrancar (CRB) para equipos de arranque, incluso en entornos totalmente aislados. EIB se utiliza para crear imágenes de despliegue para su uso en las tres huellas de des…

- 4 SUSE Multi-Linux Manager

SUSE Multi-Linux Manager está incluido en SUSE Edge y proporciona automatización y control con el fin de mantener el sistema operativo subyacente SUSE Linux Micro constantemente actualizado en todos los nodos de su despliegue periférico.

1 Despliegues automatizados de BMC con Metal3 #

Metal3 es un projecto de la CNCF que proporciona capacidades de gestión de infraestructura bare metal para Kubernetes.

Metal3 ofrece recursos nativos de Kubernetes para gestionar el ciclo de vida de los servidores bare metal que admiten la gestión a través de protocolos fuera de banda, como Redfish.

También cuenta con un soporte maduro para Cluster API (CAPI) que permite la gestión de recursos de infraestructura a través de múltiples proveedores de infraestructura mediante API ampliamente adoptadas y neutrales con respecto a los proveedores.

1.1 Por qué usar este método #

Este método es útil para situaciones en las que el hardware de destino admite la gestión fuera de banda y se desea un flujo de gestión de la infraestructura totalmente automatizado.

Se configura un clúster de gestión para proporcionar API declarativas que permitan la gestión del inventario y el estado de los servidores bare metal del clúster descendente, incluida la inspección, limpieza y aprovisionamiento/desaprovisionamiento automatizados.

1.2 Arquitectura general #

1.3 Requisitos previos #

Existen algunas restricciones específicas relacionadas con el hardware y la red del servidor del clúster descendente:

Clúster de gestión

Debe tener conectividad de red con la API de gestión/BMC del servidor de destino

Debe tener conectividad de red con la red del plano de control del servidor de destino

Para clústeres de gestión de varios nodos, se requiere una dirección IP reservada adicional

Hosts que se van a controlar

Deben admitir la gestión fuera de banda mediante interfaces Redfish, iDRAC o iLO

Deben admitir el despliegue mediante medios virtuales (actualmente no se admite PXE)

Deben tener conectividad de red con el clúster de gestión para acceder a las API de aprovisionamiento de Metal3

Se requieren algunas herramientas, que se pueden instalar en el clúster de gestión o en un host que pueda acceder a él.

Un entorno de ejecución de contenedores como Podman o Rancher Desktop

El archivo de imagen de sistema operativo

SL-Micro.x86_64-6.1-Base-GM.raw se debe descargar del

Centro de servicios al cliente de

SUSE o de la página de descargas de

SUSE.

1.3.1 Configuración del clúster de gestión #

Los pasos básicos para instalar un clúster de gestión y usar Metal3 son:

Instalar un clúster de gestión RKE2

Instalar Rancher

Instalar un proveedor de almacenamiento (opcional)

Instalar las dependencias de Metal3

Instalar las dependencias de CAPI mediante Rancher Turtles

Crear una imagen del sistema operativo SLEMicro para los hosts del clúster descendente

Registrar los CR de BareMetalHost para definir el inventario de bare metal

Crear un clúster descendente definiendo los recursos de CAPI

En esta guía se entiende que ya existe un clúster RKE2 y que se ha instalado Rancher (incluido cert-manager), por ejemplo, utilizando Edge Image Builder (Capítulo 11, Edge Image Builder).

Estos pasos también se pueden automatizar por completo, como se describe en la documentación sobre el clúster de gestión (Capítulo 40, Configuración del clúster de gestión).

1.3.2 Instalación de las dependencias de Metal3 #

Si aún no se ha hecho como parte de la instalación de Rancher, se debe instalar y ejecutar cert-manager.

Se debe instalar un proveedor de almacenamiento persistente. Se recomienda

SUSE Storage, pero también se puede utilizar

local-pathprovisioner para entornos de

desarrollo/PoC. Las instrucciones siguientes dan por sentado que se ha marcado

una StorageClass como predeterminada; de lo contrario, se requiere

una configuración adicional para el chart de

Metal3.

Se requiere una IP adicional, gestionada por MetalLB para proporcionar un punto final coherente para los servicios de gestión de Metal3. Esta IP debe formar parte de la subred del plano de control y estar reservada para la configuración estática (no debe formar parte de ningún grupo DHCP).

Si el clúster de gestión es un solo nodo, no es necesario contar con una IP fleetnte adicional gestionada mediante MetalLB. Consulte la Sección 1.6.1, “Configuración de un solo nodo”.

Primero, se instala MetalLB:

helm install \ metallb oci://registry.suse.com/edge/charts/metallb \ --namespace metallb-system \ --create-namespaceLuego, se definen

IPAddressPoolyL2Advertisementcon la IP reservada, definida comoSTATIC_IRONIC_IPa continuación:export STATIC_IRONIC_IP=<STATIC_IRONIC_IP> cat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: ironic-ip-pool namespace: metallb-system spec: addresses: - ${STATIC_IRONIC_IP}/32 serviceAllocation: priority: 100 serviceSelectors: - matchExpressions: - {key: app.kubernetes.io/name, operator: In, values: [metal3-ironic]} EOFcat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: ironic-ip-pool-l2-adv namespace: metallb-system spec: ipAddressPools: - ironic-ip-pool EOFYa se puede instalar Metal3:

helm install \ metal3 oci://registry.suse.com/edge/charts/metal3 \ --namespace metal3-system \ --create-namespace \ --set global.ironicIP="$STATIC_IRONIC_IP"El contenedor de inicio puede tardar unos dos minutos en ejecutarse en este despliegue, así que asegúrese de que todos los pods estén funcionando antes de continuar:

kubectl get pods -n metal3-system NAME READY STATUS RESTARTS AGE baremetal-operator-controller-manager-85756794b-fz98d 2/2 Running 0 15m metal3-metal3-ironic-677bc5c8cc-55shd 4/4 Running 0 15m metal3-metal3-mariadb-7c7d6fdbd8-64c7l 1/1 Running 0 15m

No continúe con los siguientes pasos hasta que todos los pods del espacio de

nombres metal3-system estén en ejecución.

1.3.3 Instalación de las dependencias de Cluster API #

Las dependencias de Cluster API se gestionan mediante el chart de Helm de Rancher Turtles:

cat > values.yaml <<EOF

rancherTurtles:

features:

embedded-capi:

disabled: true

rancher-webhook:

cleanup: true

EOF

helm install \

rancher-turtles oci://registry.suse.com/edge/charts/rancher-turtles \

--namespace rancher-turtles-system \

--create-namespace \

-f values.yamlDespués de un tiempo, los pods del controlador deberían estar ejecutándose

en los espacios de nombres capi-system,

capm3-system, rke2-bootstrap-system y

rke2-control-plane-system.

1.3.4 Preparación de la imagen del clúster descendente #

Kiwi (Capítulo 28, Creación de imágenes actualizadas de SUSE Linux Micro con Kiwi) y Edge Image Builder (Capítulo 11, Edge Image Builder) se usan para preparar una imagen base de SLEMicro modificada que se aprovisiona en los hosts de clústeres descendentes.

En esta guía, se trata la configuración mínima necesaria para desplegar el clúster descendente.

1.3.4.1 Configuración de la imagen #

Como primer paso necesario para crear clústeres, cree una imagen nueva siguiendo las instrucciones del Capítulo 28, Creación de imágenes actualizadas de SUSE Linux Micro con Kiwi.

Al ejecutar Edge Image Builder, se monta un directorio desde el host, por lo que es necesario crear una estructura de directorios para almacenar los archivos de configuración usados para definir la imagen de destino.

downstream-cluster-config.yamles el archivo de definición de la imagen. Consulte el Capítulo 3, Clústeres independientes con Edge Image Builder para obtener más detalles.La imagen base, cuando se descarga, está comprimida con

xz, por lo que debe descomprimirse conunxzy copiarse/moverse a la carpetabase-images.La carpeta

networkes opcional. Para obtener más información, consulte la Sección 1.3.5.1.1, “Guion adicional para la configuración de la red estática”.El directorio custom/scripts contiene guiones que se ejecutan en el primer arranque; actualmente, se requiere un guion

01-fix-growfs.shpara cambiar el tamaño de la partición raíz del sistema operativo en el despliegue.

├── downstream-cluster-config.yaml

├── base-images/

│ └ SL-Micro.x86_64-6.1-Base-GM.raw

├── network/

| └ configure-network.sh

└── custom/

└ scripts/

└ 01-fix-growfs.sh1.3.4.1.1 Archivo de definición de la imagen del clúster descendente #

El archivo downstream-cluster-config.yaml es el principal

archivo de configuración para la imagen del clúster descendente. A

continuación, se muestra un ejemplo mínimo de despliegue mediante

Metal3:

apiVersion: 1.2

image:

imageType: raw

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-GM.raw

outputImageName: SLE-Micro-eib-output.raw

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

kernelArgs:

- ignition.platform.id=openstack

- net.ifnames=1

systemd:

disable:

- rebootmgr

- transactional-update.timer

- transactional-update-cleanup.timer

users:

- username: root

encryptedPassword: $ROOT_PASSWORD

sshKeys:

- $USERKEY1

packages:

packageList:

- jq

sccRegistrationCode: $SCC_REGISTRATION_CODEDonde $SCC_REGISTRATION_CODE es el código de registro

copiado del Centro de servicios al

cliente de SUSE y la lista de paquetes contiene

jq, que es obligatorio.

$ROOT_PASSWORD es la contraseña cifrada del usuario root,

que puede ser útil para pruebas y depuración. Se puede generar con el

comando openssl passwd -6 PASSWORD.

En entornos de producción, se recomienda usar las claves SSH que se pueden

añadir al bloque de usuarios sustituyendo $USERKEY1 por

las claves SSH reales.

net.ifnames=1 permite los nombres

predecibles para las interfaces de red

Esto coincide con la configuración predeterminada para el chart de

Metal3, pero el ajuste debe coincidir con el

valor de predictableNicNames configurado en el chart.

Tenga en cuenta también que

ignition.platform.id=openstack es obligatorio. Sin este

argumento, la configuración de SUSE Linux Micro a través de Ignition fallará

en el flujo automatizado de Metal3.

La sección time es opcional, pero se recomienda

encarecidamente configurarla para evitar posibles problemas con los

certificados y la desviación del reloj. Los valores proporcionados en este

ejemplo son solo ilustrativos. Ajústelos según sus requisitos específicos.

1.3.4.1.2 Guion Growfs #

Actualmente, se requiere un guion personalizado

(custom/scripts/01-fix-growfs.sh) para ampliar el sistema

de archivos y que coincida con el tamaño del disco en el primer arranque

después del aprovisionamiento. El guion 01-fix-growfs.sh

contiene la siguiente información:

#!/bin/bash

growfs() {

mnt="$1"

dev="$(findmnt --fstab --target ${mnt} --evaluate --real --output SOURCE --noheadings)"

# /dev/sda3 -> /dev/sda, /dev/nvme0n1p3 -> /dev/nvme0n1

parent_dev="/dev/$(lsblk --nodeps -rno PKNAME "${dev}")"

# Last number in the device name: /dev/nvme0n1p42 -> 42

partnum="$(echo "${dev}" | sed 's/^.*[^0-9]\([0-9]\+\)$/\1/')"

ret=0

growpart "$parent_dev" "$partnum" || ret=$?

[ $ret -eq 0 ] || [ $ret -eq 1 ] || exit 1

/usr/lib/systemd/systemd-growfs "$mnt"

}

growfs /Use el mismo método para añadir sus propios guiones personalizados que se ejecuten durante el proceso de aprovisionamiento. Para obtener más información, consulte el Capítulo 3, Clústeres independientes con Edge Image Builder.

1.3.4.2 Creación de la imagen #

Cuando se haya preparado la estructura de directorios siguiendo las secciones anteriores, ejecute el siguiente comando para crear la imagen:

podman run --rm --privileged -it -v $PWD:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file downstream-cluster-config.yamlEsto crea el archivo de imagen de salida denominado

SLE-Micro-eib-output.raw, basado en la definición

descrita anteriormente.

La imagen resultante debe estar disponible a través de un servidor web, ya

sea el contenedor del servidor multimedia habilitado mediante el chart de

Metal3 (Nota) o algún otro servidor al que

se pueda acceder localmente. En los ejemplos siguientes, nos referimos a

este servidor como imagecache.local:8080.

Al desplegar imágenes de EIB en clústeres descendentes, también es necesario

incluir la suma sha256 de la imagen en el objeto

Metal3MachineTemplate. Se puede generar de la siguiente

manera:

sha256sum <image_file> > <image_file>.sha256

# On this example:

sha256sum SLE-Micro-eib-output.raw > SLE-Micro-eib-output.raw.sha2561.3.5 Adición del inventario de BareMetalHost #

El registro de servidores bare metal para el despliegue automatizado requiere la creación de dos recursos: un secreto que almacena las credenciales de acceso a BMC y un recurso BareMetalHost de Metal3 que define la conexión de BMC y otros detalles:

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-credentials

type: Opaque

data:

username: YWRtaW4=

password: cGFzc3dvcmQ=

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

online: true

bootMACAddress: "00:f3:65:8a:a3:b0"

bmc:

address: redfish-virtualmedia://192.168.125.1:8000/redfish/v1/Systems/68bd0fb6-d124-4d17-a904-cdf33efe83ab

disableCertificateVerification: true

credentialsName: controlplane-0-credentialsTenga en cuenta lo siguiente:

El nombre de usuario y la contraseña del secreto deben estar cifrados en base64. No deben incluir saltos de línea al final (por ejemplo, use

echo -n, no soloecho)La etiqueta

cluster-rolese puede establecer ahora o más adelante, durante la creación del clúster. En el ejemplo siguiente, se esperacontrol-planeoworkerbootMACAddressdebe ser una dirección MAC válida que coincida con la NIC de plano de control del hostLa dirección

bmces la conexión a la API de gestión de BMC. Se admiten las siguientes:redfish-virtualmedia://<DIRECCIÓN IP>/redfish/v1/Systems/<ID DEL SISTEMA>: medio virtual Redfish, por ejemplo, SuperMicroidrac-virtualmedia://<DIRECCIÓN IP>/redfish/v1/Systems/System.Embedded.1: iDRAC de Dell

Consulte la documentación original de la API para obtener más información sobre la API de BareMetalHost

1.3.5.1 Configuración de IP estáticas #

El ejemplo anterior de BareMetalHost presupone que DHCP proporciona la configuración de red del plano de control, pero para situaciones en las que se necesite una configuración manual, como en el caso de las IP estáticas, es posible proporcionar una configuración adicional, como se describe a continuación.

1.3.5.1.1 Guion adicional para la configuración de la red estática #

Al crear la imagen base con Edge Image Builder, en la carpeta de

network, cree el archivo

configure-network.sh siguiente.

Esto consume datos de la unidad de configuración en el primer arranque y configura la red del host usando la herramienta NM Configurator.

#!/bin/bash

set -eux

# Attempt to statically configure a NIC in the case where we find a network_data.json

# In a configuration drive

CONFIG_DRIVE=$(blkid --label config-2 || true)

if [ -z "${CONFIG_DRIVE}" ]; then

echo "No config-2 device found, skipping network configuration"

exit 0

fi

mount -o ro $CONFIG_DRIVE /mnt

NETWORK_DATA_FILE="/mnt/openstack/latest/network_data.json"

if [ ! -f "${NETWORK_DATA_FILE}" ]; then

umount /mnt

echo "No network_data.json found, skipping network configuration"

exit 0

fi

DESIRED_HOSTNAME=$(cat /mnt/openstack/latest/meta_data.json | tr ',{}' '\n' | grep '\"metal3-name\"' | sed 's/.*\"metal3-name\": \"\(.*\)\"/\1/')

echo "${DESIRED_HOSTNAME}" > /etc/hostname

mkdir -p /tmp/nmc/{desired,generated}

cp ${NETWORK_DATA_FILE} /tmp/nmc/desired/_all.yaml

umount /mnt

./nmc generate --config-dir /tmp/nmc/desired --output-dir /tmp/nmc/generated

./nmc apply --config-dir /tmp/nmc/generated1.3.5.1.2 Secreto adicional con configuración de red de host #

Se puede definir un secreto adicional que contenga datos en el formato nmstate compatible con NM Configurator (Capítulo 12, Conexiones de red de Edge) para cada host.

A continuación, se hace referencia al secreto en el recurso

BareMetalHost mediante el campo de especificación

preprovisioningNetworkDataName.

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-networkdata

type: Opaque

stringData:

networkData: |

interfaces:

- name: enp1s0

type: ethernet

state: up

mac-address: "00:f3:65:8a:a3:b0"

ipv4:

address:

- ip: 192.168.125.200

prefix-length: 24

enabled: true

dhcp: false

dns-resolver:

config:

server:

- 192.168.125.1

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.125.1

next-hop-interface: enp1s0

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

preprovisioningNetworkDataName: controlplane-0-networkdata

# Remaining content as in previous exampleEn algunas circunstancias, la dirección MAC puede omitirse. Consulte la Sección 12.5.8, “Configuraciones unificadas de nodos” para obtener más detalles.

1.3.5.2 Preparación de BareMetalHost #

Después de crear el recurso BareMetalHost y los secretos asociados como se ha descrito, se activa un flujo de trabajo de preparación del host:

Se arranca una imagen ramdisk mediante la conexión de un dispositivo virtual al BMC del host de destino

El ramdisk inspecciona los detalles del hardware y prepara el host para el aprovisionamiento (por ejemplo, limpiando los discos de datos anteriores)

Una vez completado este proceso, se actualizan los detalles del hardware en el campo

status.hardwarede BareMetalHost y se pueden verificar

Este proceso puede tardar varios minutos, pero una vez completado, debería

ver que el estado de BareMetalHost pasa a ser available

(disponible):

% kubectl get baremetalhost

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available true 9m44s

worker-0 available true 9m44s1.3.6 Creación de clústeres descendentes #

Ahora creamos recursos de Cluster API que definen el clúster descendente y recursos del equipo que provocarán que se aprovisionen los recursos de BareMetalHost y, a continuación, se arranquen para formar un clúster RKE2.

1.3.7 Despliegue del plano de control #

Para desplegar el plano de control, se define un manifiesto YAML similar al que se muestra a continuación, que contiene los siguientes recursos:

El recurso Cluster define el nombre del clúster, las redes y el tipo de proveedor de plano de control/infraestructura (en este caso, RKE2/Metal3)

Metal3Cluster define el punto final del plano de control (IP del host para un solo nodo, punto final LoadBalancer para varios nodos; en este ejemplo se supone que hay un solo nodo)

RKE2ControlPlane define la versión de RKE2 y cualquier configuración adicional necesaria durante el arranque del clúster

Metal3MachineTemplate define la imagen del sistema operativo que se aplicará a los recursos BareMetalHost, y hostSelector define qué recursos BareMetalHost se consumirán

Metal3DataTemplate define los metadatos adicionales que se pasarán a BareMetalHost (tenga en cuenta que networkData no es compatible actualmente con Edge)

Para simplificar, en este ejemplo se entiende que hay un plano de control de

un solo nodo en el que BareMetalHost se ha configurado con la IP

192.168.125.200. Para ejemplos más avanzados de varios

nodos, consulte el Capítulo 42, Aprovisionamiento de red dirigida totalmente automatizado.

apiVersion: cluster.x-k8s.io/v1beta1

kind: Cluster

metadata:

name: sample-cluster

namespace: default

spec:

clusterNetwork:

pods:

cidrBlocks:

- 192.168.0.0/18

services:

cidrBlocks:

- 10.96.0.0/12

controlPlaneRef:

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

name: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

name: sample-cluster

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

metadata:

name: sample-cluster

namespace: default

spec:

controlPlaneEndpoint:

host: 192.168.125.200

port: 6443

noCloudProvider: true

---

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

metadata:

name: sample-cluster

namespace: default

spec:

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-controlplane

replicas: 1

version: v1.32.4+rke2r1

rolloutStrategy:

type: "RollingUpdate"

rollingUpdate:

maxSurge: 0

agentConfig:

format: ignition

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-controlplane

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-controlplane-template

hostSelector:

matchLabels:

cluster-role: control-plane

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-controlplane-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machineUna vez adaptado a su entorno, puede aplicar el ejemplo mediante

kubectl y, a continuación, supervisar el estado del

clúster mediante clusterctl.

% kubectl apply -f rke2-control-plane.yaml

# Wait for the cluster to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 22m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 27m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 22m

│ └─Machine/sample-cluster-chflc True 23m1.3.8 Despliegue de trabajadores/computación #

De forma similar al despliegue del plano de control, se define un manifiesto YAML que contiene los siguientes recursos:

MachineDeployment define el número de réplicas (hosts) y el proveedor de arranque/infraestructura (en este caso, RKE2/Metal3)

RKE2ConfigTemplate describe la versión de RKE2 y la configuración de arranque inicial para el arranque del host del agente

Metal3MachineTemplate define la imagen del sistema operativo que se aplicará a los recursos BareMetalHost, y el selector de host define qué recursos BareMetalHost se consumirán

Metal3DataTemplate define los metadatos adicionales que se pasarán a BareMetalHost (tenga en cuenta que

networkDatano es compatible actualmente)

apiVersion: cluster.x-k8s.io/v1beta1

kind: MachineDeployment

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

name: sample-cluster

namespace: default

spec:

clusterName: sample-cluster

replicas: 1

selector:

matchLabels:

cluster.x-k8s.io/cluster-name: sample-cluster

template:

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

spec:

bootstrap:

configRef:

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

name: sample-cluster-workers

clusterName: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-workers

nodeDrainTimeout: 0s

version: v1.32.4+rke2r1

---

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

agentConfig:

format: ignition

version: v1.32.4+rke2r1

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-workers-template

hostSelector:

matchLabels:

cluster-role: worker

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-workers-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machineUna vez copiado y adaptado el ejemplo anterior a su entorno, se puede

aplicar mediante kubectl y, a continuación, se puede

supervisar el estado del clúster con clusterctl.

% kubectl apply -f rke2-agent.yaml

# Wait for the worker nodes to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 25m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 30m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 25m

│ └─Machine/sample-cluster-chflc True 27m

└─Workers

└─MachineDeployment/sample-cluster True 22m

└─Machine/sample-cluster-56df5b4499-zfljj True 23m1.3.9 Desaprovisionamiento del clúster #

El clúster descendente se puede desaprovisionar eliminando los recursos aplicados en los pasos anteriores:

% kubectl delete -f rke2-agent.yaml

% kubectl delete -f rke2-control-plane.yamlEsto activa el desaprovisionamiento de los recursos BareMetalHost, lo que puede tardar varios minutos, tras lo cual deberían volver a estar disponibles:

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 deprovisioning sample-cluster-controlplane-vlrt6 false 10m

worker-0 deprovisioning sample-cluster-workers-785x5 false 10m

...

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available false 15m

worker-0 available false 15m1.4 Problemas conocidos #

El controlador de gestión de direcciones IP actualmente no se admite, ya que aún no es compatible con nuestras herramientas de configuración de red y la cadena de herramientas de primer arranque en SLEMicro.

Del mismo modo, los recursos IPAM y los campos networkData de Metal3DataTemplate no son compatibles actualmente.

Actualmente, solo se admite el despliegue mediante redfish-virtualmedia.

1.5 Cambios previstos #

Habilitar la compatibilidad con los recursos y la configuración de IPAM a través de los campos networkData.

1.6 Recursos adicionales #

La documentación de SUSE Edge for Telco (Capítulo 37, SUSE Edge for Telco) tiene ejemplos de uso más avanzados de Metal3 para casos de uso relacionados con las telecomunicaciones.

1.6.1 Configuración de un solo nodo #

En entornos de prueba/PoC en los que el clúster de gestión es de un solo nodo, no se necesita una IP fleetnte adicional gestionada a través de MetalLB.

En este modo, el punto final para las API del clúster de gestión es la IP

del clúster de gestión, por lo que debe reservarse cuando se utiliza DHCP o

debe configurarse de forma estática para garantizar que la IP del clúster de

gestión no cambie, lo que se denomina

<MANAGEMENT_CLUSTER_IP> abajo.

Para habilitar este escenario, los valores necesarios del chart de Metal3 son los siguientes:

global:

ironicIP: <MANAGEMENT_CLUSTER_IP>

metal3-ironic:

service:

type: NodePort1.6.2 Inhabilitación de TLS para la conexión ISO de medios virtuales #

Algunos proveedores de servidores verifican la conexión SSL al conectar imágenes ISO de medios virtuales al BMC, lo que puede causar un problema porque los certificados generados para el despliegue de Metal3 son autofirmados. Para solucionar este problema, es posible desactivar TLS solo para la conexión del disco de medios virtuales con los valores del chart de Metal3 de la siguiente manera:

global:

enable_vmedia_tls: falseUna solución alternativa es configurar los BMC con el certificado de la CA;

en este caso, puede leer los certificados del clúster utilizando

kubectl:

kubectl get secret -n metal3-system ironic-vmedia-cert -o yamlA continuación, el certificado se puede configurar en el panel de control

del BMC del servidor, aunque ese proceso es específico de cada proveedor (y

no es posible para todos los proveedores, en cuyo caso puede ser necesario

el indicador enable_vmedia_tls).

1.6.3 Configuración de almacenamiento #

Para entornos de prueba/PoC en los que el clúster de gestión es de un solo nodo, no se requiere almacenamiento persistente, pero para casos de uso en producción se recomienda instalar SUSE Storage (Longhorn) en el clúster de gestión para que las imágenes relacionadas con Metal3 puedan conservarse durante el reinicio/reprogramación de un pod.

Para habilitar este almacenamiento persistente, los valores necesarios del chart de Metal3 son los siguientes:

metal3-ironic:

persistence:

ironic:

size: "5Gi"La documentación sobre el clúster de gestión en SUSE Edge for Telco (Capítulo 40, Configuración del clúster de gestión) contiene más detalles sobre cómo configurar un clúster de gestión con almacenamiento persistente.

2 Incorporación de hosts remotos con Elemental #

En esta sección se explica la solución de aprovisionamiento de red "phone home" (el comando que se usa, traducido como "llamar a casa") como parte de SUSE Edge. En ella se utiliza Elemental para ayudar con la incorporación de nodos. Elemental es una pila de software que permite el registro remoto de hosts y la gestión centralizada y totalmente nativa en la nube del sistema operativo con Kubernetes. En la pila de SUSE Edge se utiliza la función de registro de Elemental para permitir la incorporación remota de hosts en Rancher, de modo que los hosts puedan integrarse en una plataforma de gestión centralizada y, desde allí, desplegar y gestionar clústeres de Kubernetes junto con componentes en capas, aplicaciones y su ciclo de vida, todo desde un lugar común.

Este enfoque puede ser útil en situaciones en las que los dispositivos que se desean controlar no se encuentren en la misma red que el clúster de gestión o no dispongan de un controlador de gestión fuera de banda integrado que permita un control más directo, y en los que se están arrancando muchos sistemas "desconocidos" diferentes en el perímetro y es necesario incorporarlos y gestionarlos de forma segura a gran escala. Este es un escenario común para usos en el comercio minorista, el IoT industrial u otros espacios en los que se tiene poco control sobre la red en la que se instalan los dispositivos.

2.1 Arquitectura general #

2.2 Recursos necesarios #

A continuación se describen los requisitos mínimos del sistema y del entorno para la ejecución:

Un host para el clúster de gestión centralizada (el que aloja Rancher y Elemental):

Mínimo de 8 GB de RAM y 20 GB de espacio en disco para desarrollo o pruebas (consulte este documento para el uso en producción)

Un nodo de destino que se va a aprovisionar, es decir, el dispositivo periférico (se puede utilizar una máquina virtual para fines de demostración o pruebas)

Mínimo de 4 GB de RAM, CPU de 2 núcleos y 20 GB de disco

Un nombre de host resoluble para el clúster de gestión o una dirección IP estática para utilizar con un servicio como sslip.io

Un host para crear el medio de instalación a través de Edge Image Builder

Una unidad flash USB desde la que arrancar (si se utiliza hardware físico)

Una copia descargada de la última imagen ISO de autoinstalación de SUSE Linux Micro 6.1, que se encuentra aquí

Los datos existentes en los equipos de destino se sobrescribirán como parte del proceso, por lo que debe asegurarse de realizar una copia de seguridad de todos los datos almacenados en dispositivos USB y discos conectados a los nodos de despliegue de destino.

En esta guía se utiliza un droplet de Digital Ocean para alojar el clúster ascendente y un NUC Intel como dispositivo descendente. Para crear el medio de instalación, se utiliza SUSE Linux Enterprise Server.

2.3 Creación del clúster de arranque #

Para empezar, cree un clúster capaz de alojar Rancher y Elemental. Este clúster debe ser enrutable desde la red a la que están conectados los nodos descendentes.

2.3.1 Creación del clúster de Kubernetes #

Si utiliza un hiperescalador (como Azure, AWS o Google Cloud), la forma más sencilla de configurar un clúster es utilizando sus herramientas integradas. Para que esta guía sea más concisa, no se detalla el proceso de cada una de estas opciones.

Si va a realizar la instalación en un servidor físico u otro servicio de alojamiento en el que también deba proporcionar la distribución de Kubernetes, le recomendamos que utilice RKE2.

2.3.2 Configuración de DNS #

Antes de continuar, debe configurar el acceso a su clúster. Como ocurre con la configuración del propio clúster, la forma de configurar el servidor DNS variará en función del lugar donde esté alojado.

Si no desea ocuparse de la configuración de los registros DNS (por ejemplo,

si se trata solo de un servidor de prueba efímero), puede utilizar un

servicio como sslip.io en su

lugar. Con este servicio, puede resolver cualquier dirección IP con

<dirección>.sslip.io.

2.4 Instalar Rancher #

Para instalar Rancher, necesitas acceder a la API de Kubernetes del clúster que acabas de crear. Esto varía en función de la distribución de Kubernetes que se utilice.

Para RKE2, el archivo kubeconfig se habrá escrito en

/etc/rancher/rke2/rke2.yaml. Guarde este archivo como

~/.kube/config en su sistema local. Es posible que tenga

que editar el archivo para incluir la dirección IP o el nombre de host

externos correctos.

Instale Rancher fácilmente con los comandos que encontrará en la documentación de Rancher:

Instale cert-manager:

helm repo add jetstack https://charts.jetstack.io

helm repo update

helm install cert-manager jetstack/cert-manager \

--namespace cert-manager \

--create-namespace \

--set crds.enabled=trueDespués, instale Rancher:

helm repo add rancher-prime https://charts.rancher.com/server-charts/prime

helm repo update

helm install rancher rancher-prime/rancher \

--namespace cattle-system \

--create-namespace \

--set hostname=<DNS or sslip from above> \

--set replicas=1 \

--set bootstrapPassword=<PASSWORD_FOR_RANCHER_ADMIN> \

--version 2.11.2Si se trata de un sistema de producción, use cert-manager para configurar un certificado real (como uno de Let’s Encrypt).

Busque el nombre de host que ha configurado e inicie sesión en Rancher con

la contraseña que ha utilizado en bootstrapPassword. Se

le guiará a través de un breve proceso de configuración.

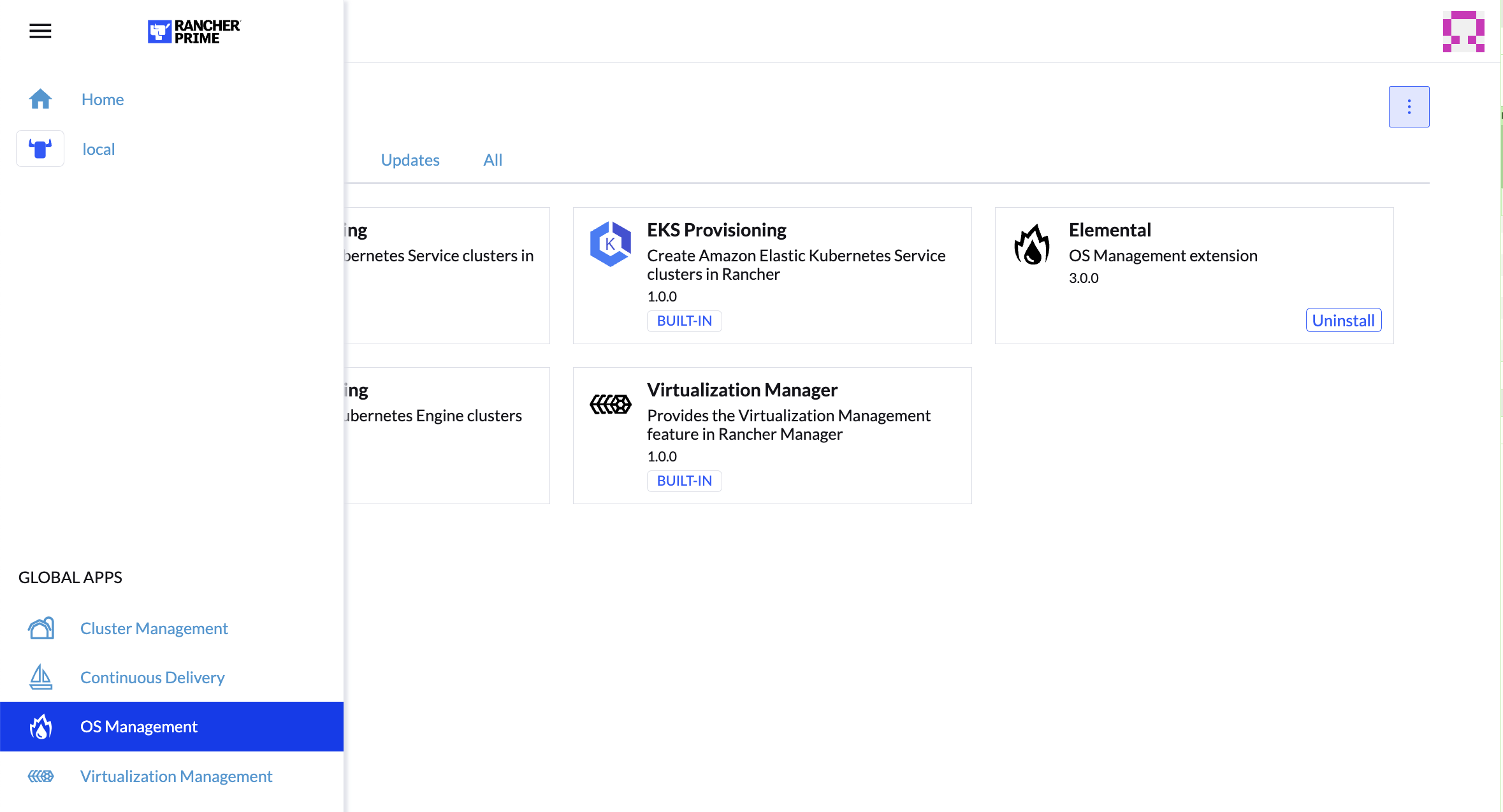

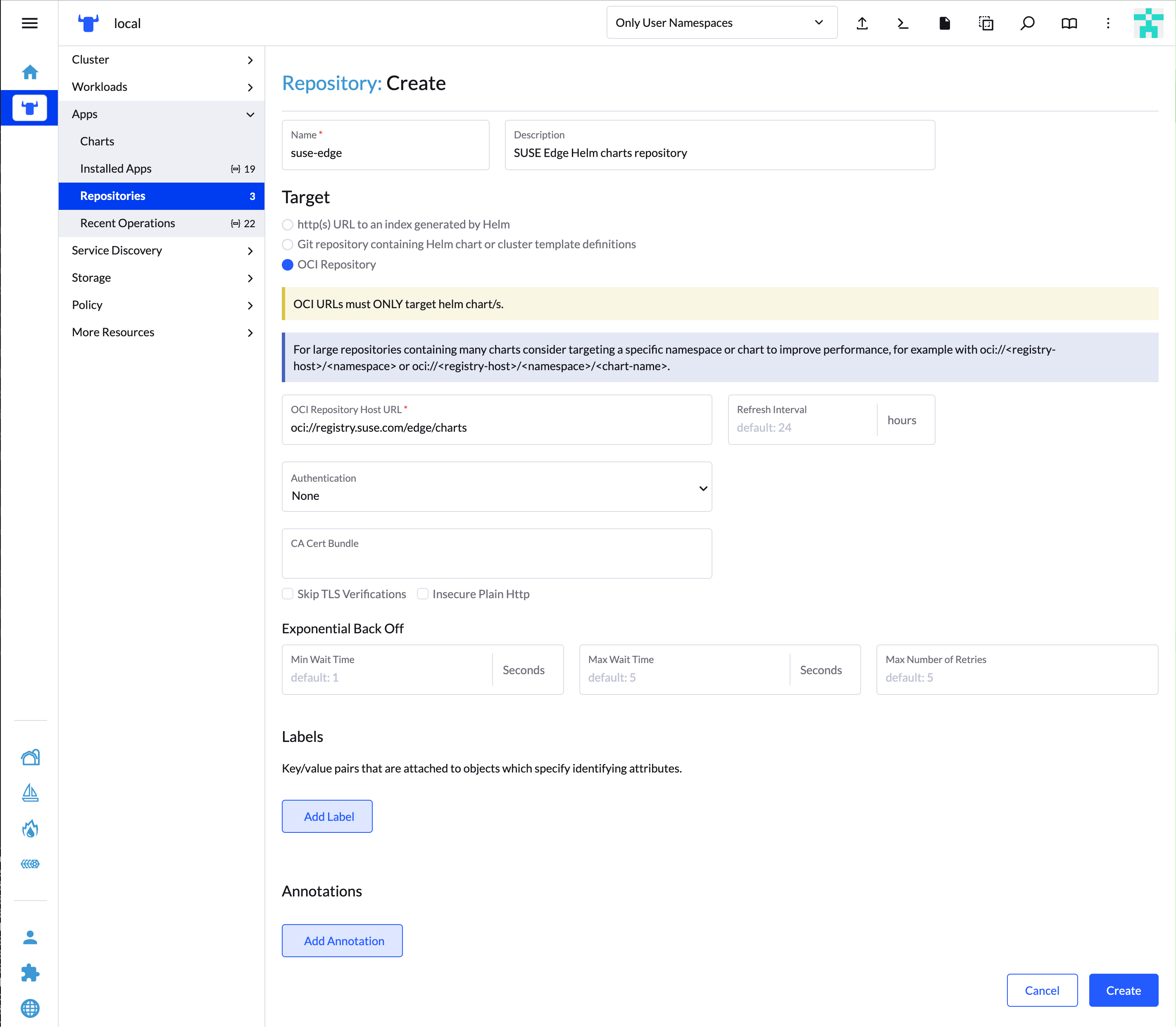

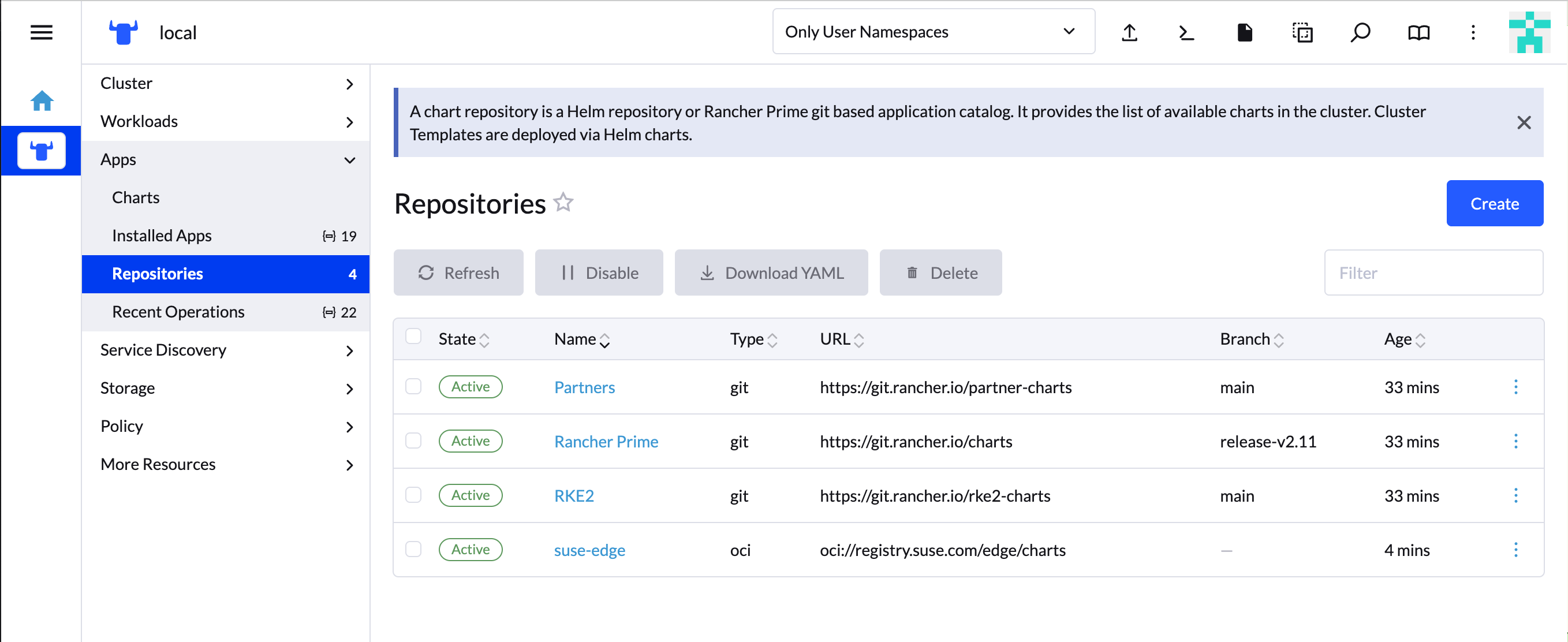

2.5 Instalación de Elemental #

Una vez instalado Rancher, ya puede instalar el operador de Elemental y las CRD necesarias. El chart de Helm para Elemental se publica como un artefacto OCI, por lo que la instalación es un poco más sencilla que la de otros charts. Se puede instalar desde la misma shell que se utilizó para instalar Rancher o en el navegador desde la shell de Rancher.

helm install --create-namespace -n cattle-elemental-system \

elemental-operator-crds \

oci://registry.suse.com/rancher/elemental-operator-crds-chart \

--version 1.6.8

helm install -n cattle-elemental-system \

elemental-operator \

oci://registry.suse.com/rancher/elemental-operator-chart \

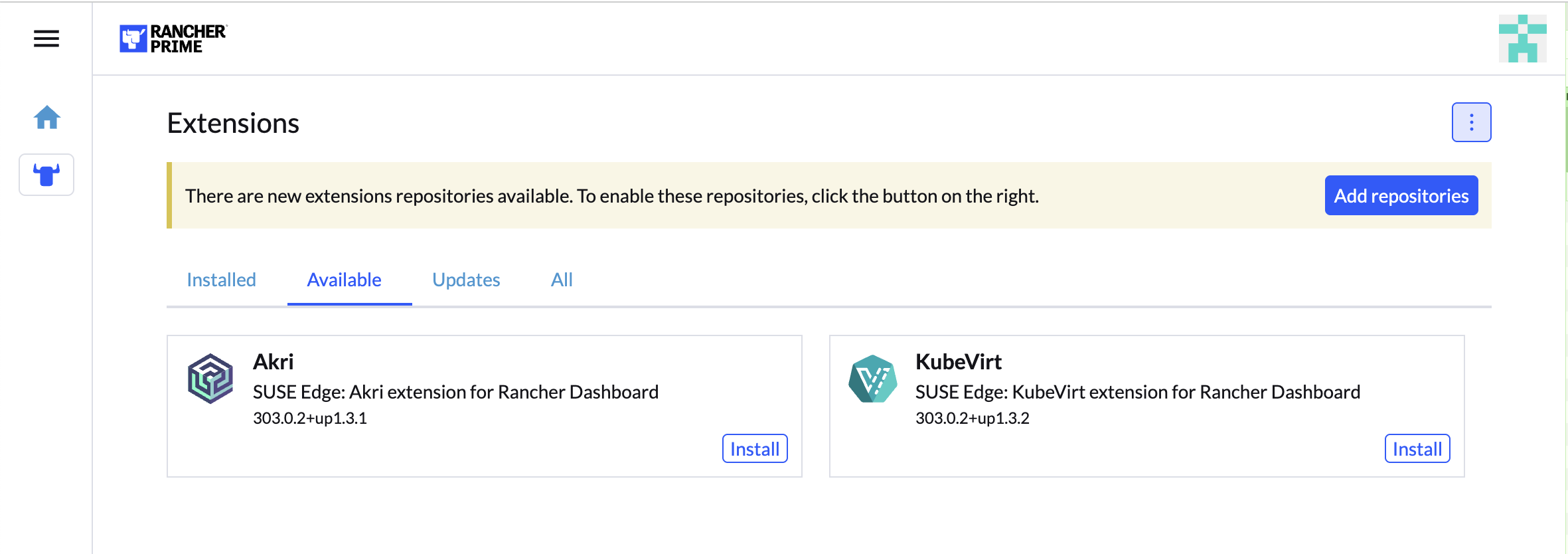

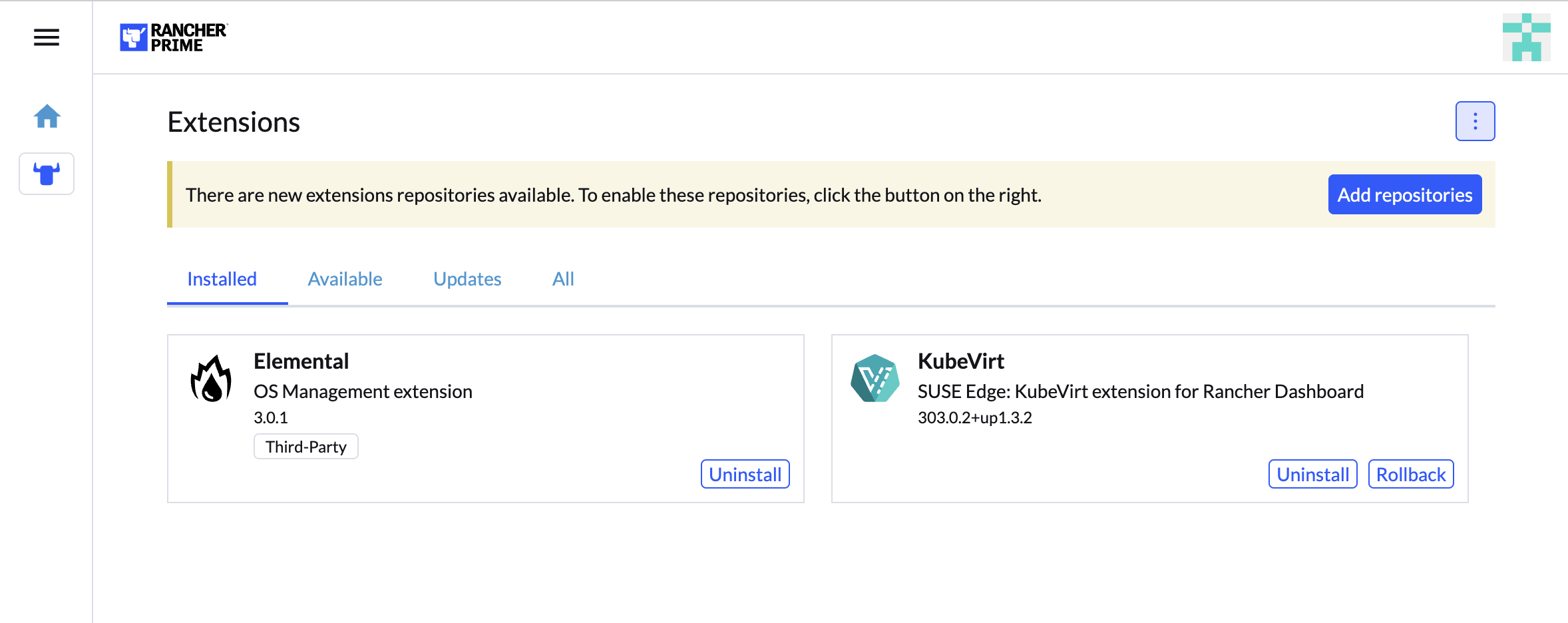

--version 1.6.82.5.1 (Opcional) Instale la extensión de interfaz de usuario de Elemental #

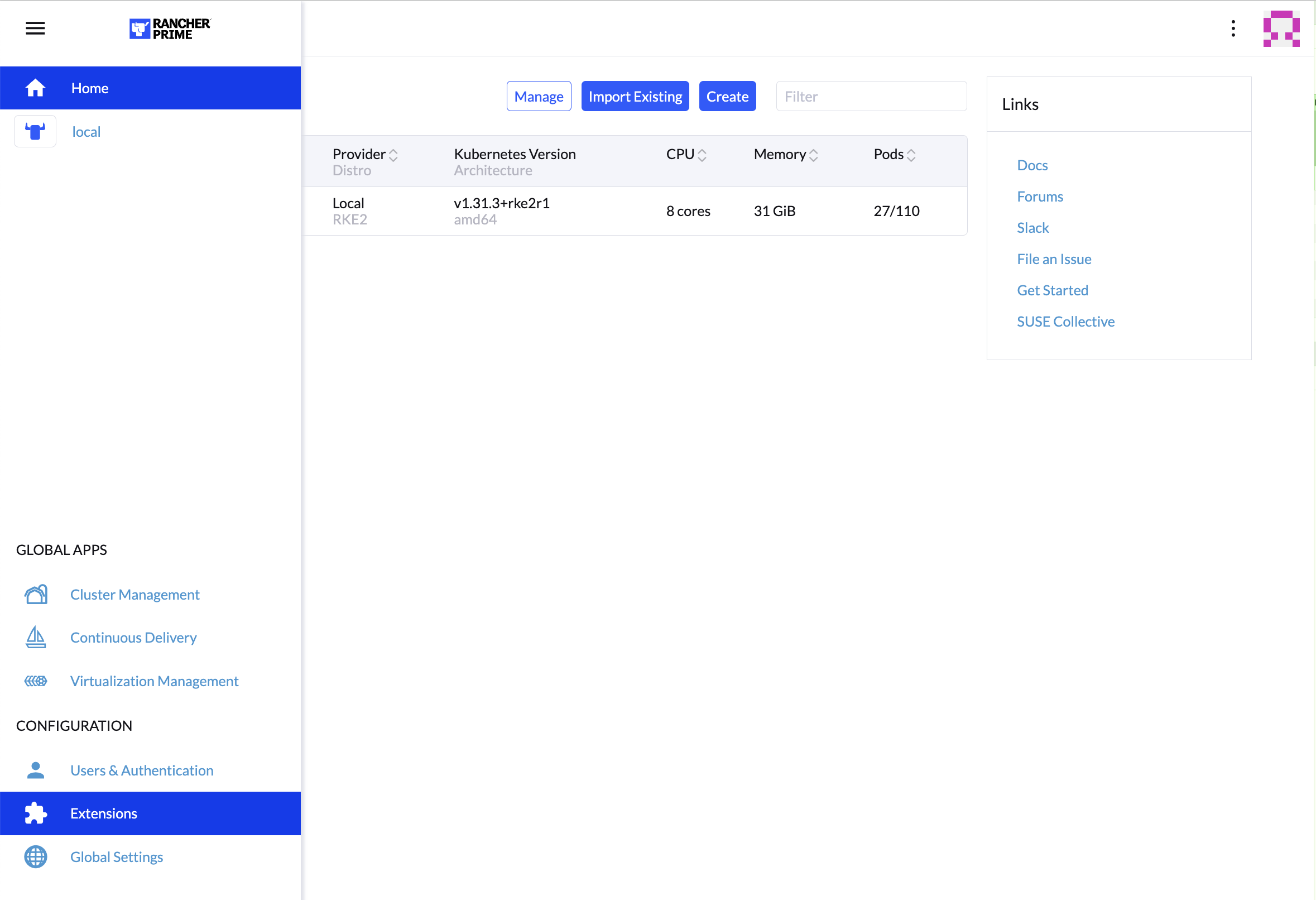

Para usar la interfaz de usuario de Elemental, inicie sesión en su instancia de Rancher y haga clic en el menú de tres líneas de la parte superior izquierda:

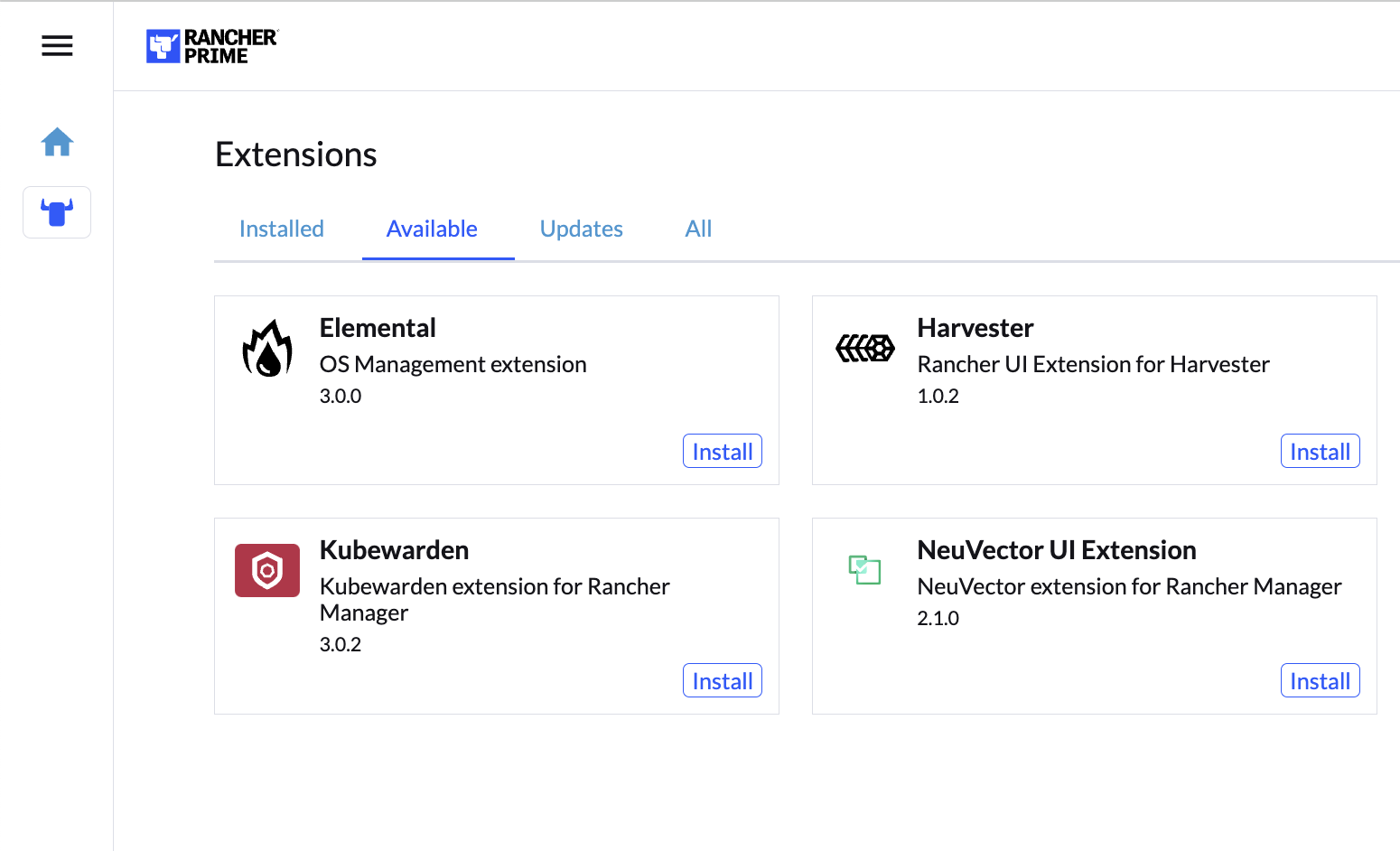

En la pestaña "Available" (Disponible) de esta página, haga clic en "Install" (Instalar) en la tarjeta de Elemental:

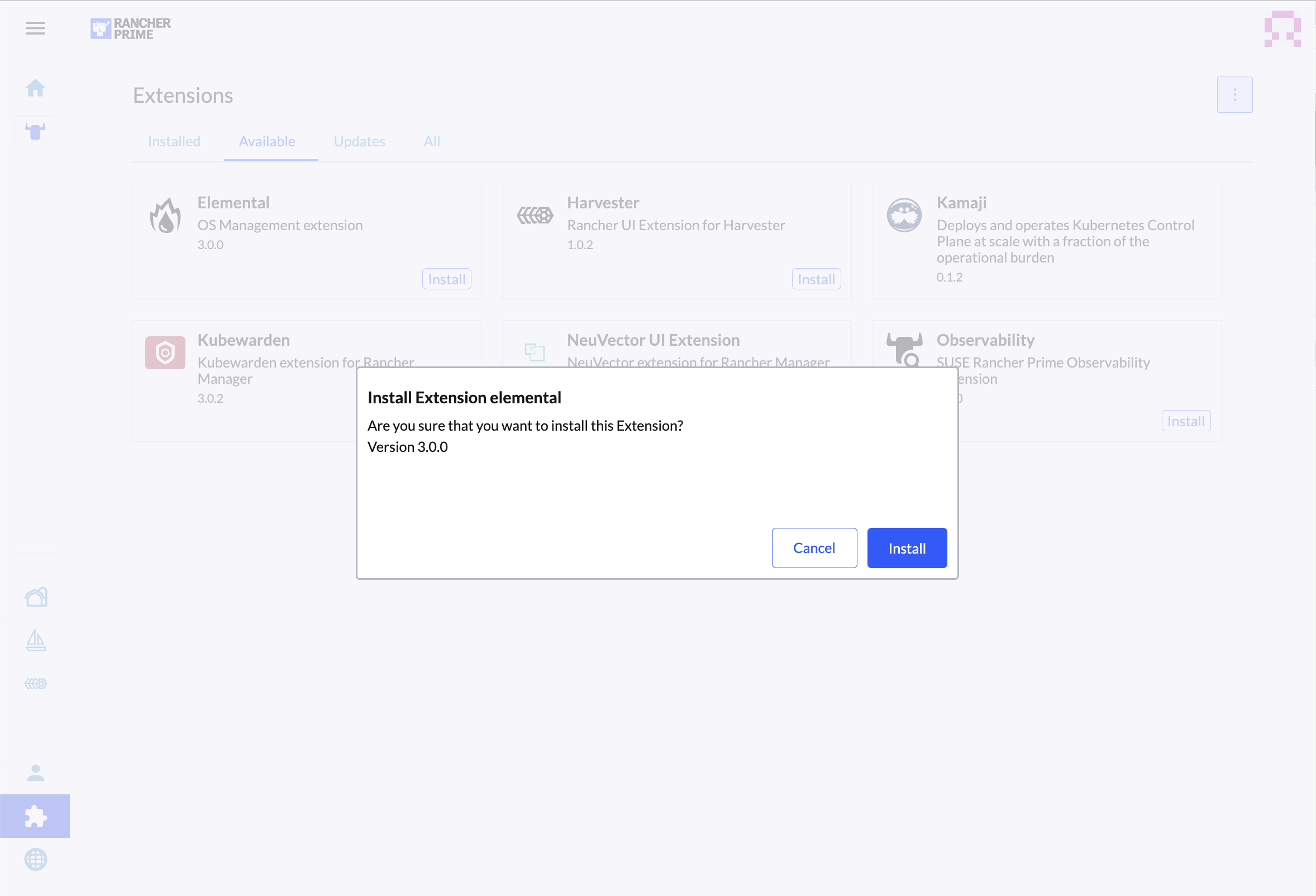

Confirme que desea instalar la extensión:

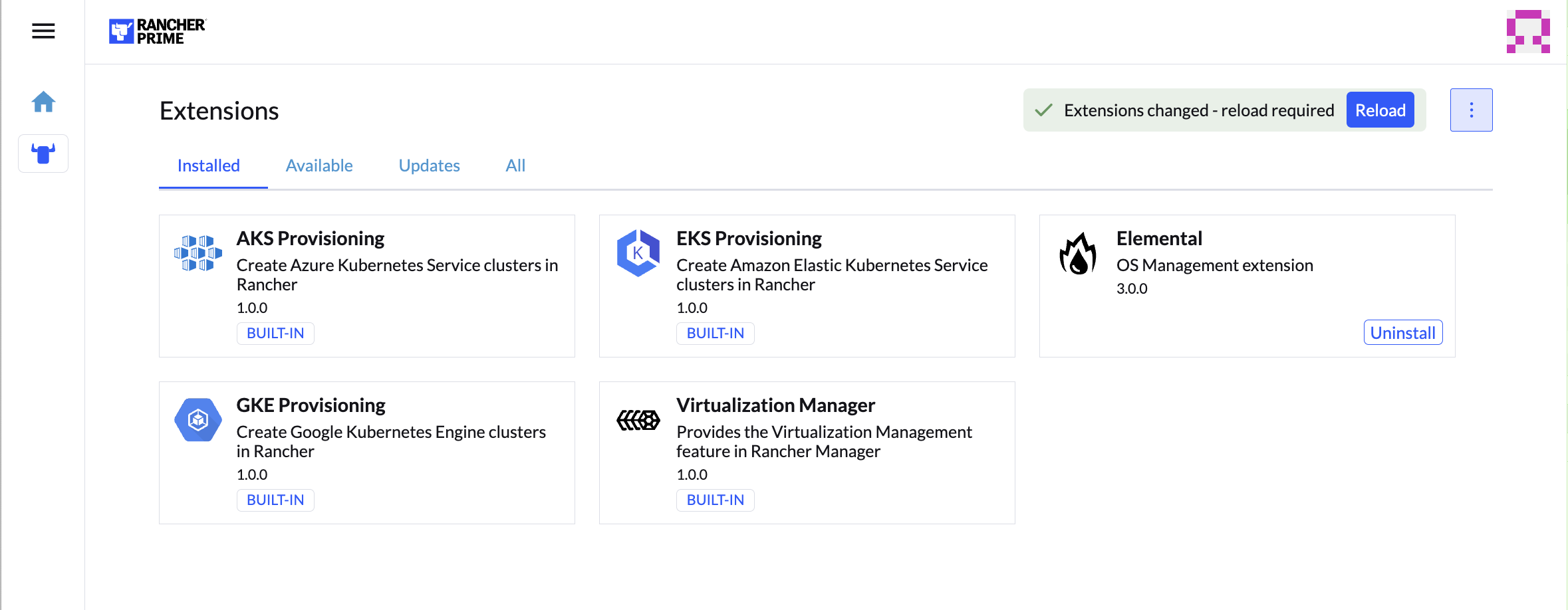

Cuando se instale, se le pedirá que vuelva a cargar la página.

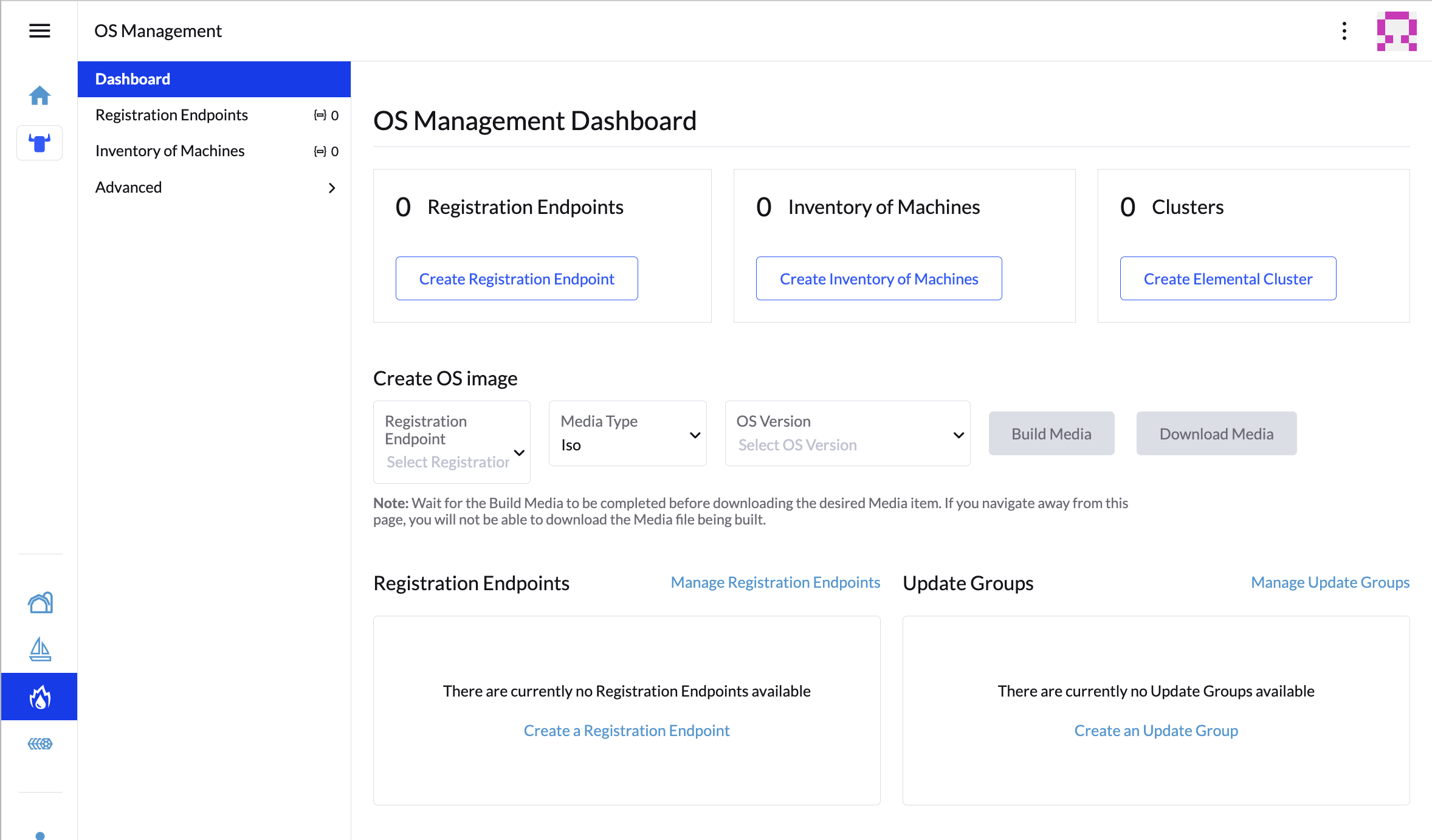

Tras el reinicio, podrá acceder a la extensión de Elemental a través de la aplicación global "OS Management" (Gestión del sistema operativo).

2.6 Configuración de Elemental #

Por sencillez, se recomienda configurar la variable $ELEM

con la vía completa donde desea que se encuentre el directorio de

configuración:

export ELEM=$HOME/elemental

mkdir -p $ELEMPara permitir que las máquinas se registren en Elemental, se necesita crear

un objeto MachineRegistration en el espacio de nombres

fleet-default.

Vamos a crear una versión básica de este objeto:

cat << EOF > $ELEM/registration.yaml

apiVersion: elemental.cattle.io/v1beta1

kind: MachineRegistration

metadata:

name: ele-quickstart-nodes

namespace: fleet-default

spec:

machineName: "\${System Information/Manufacturer}-\${System Information/UUID}"

machineInventoryLabels:

manufacturer: "\${System Information/Manufacturer}"

productName: "\${System Information/Product Name}"

EOF

kubectl apply -f $ELEM/registration.yamlEl comando cat escapa cada $ con una

barra invertida (\) para que Bash no las utilice como

plantilla. Elimine las barras invertidas si va a realizar una copia

manualmente.

Una vez creado el objeto, busque y anote el punto final que se le asigna:

REGISURL=$(kubectl get machineregistration ele-quickstart-nodes -n fleet-default -o jsonpath='{.status.registrationURL}')Alternativamente, puede hacerlo desde la interfaz de usuario.

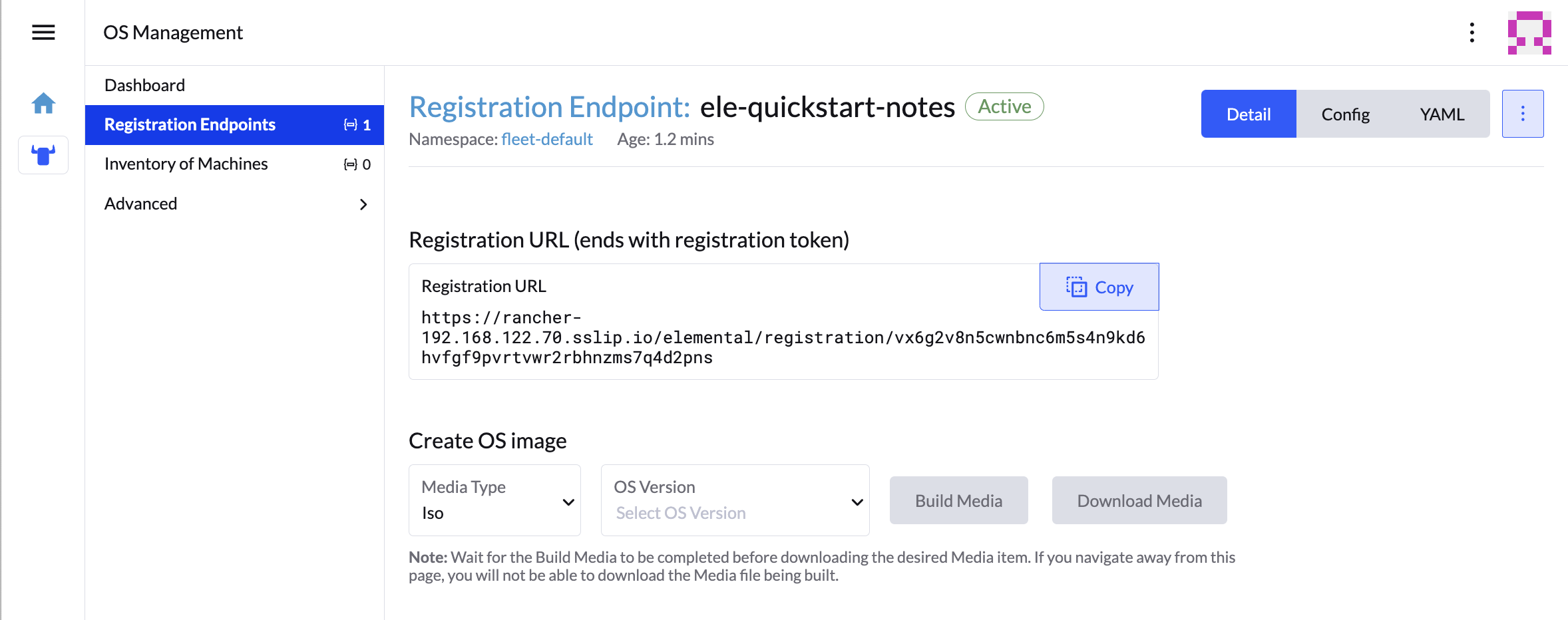

- Extensión de interfaz de usuario

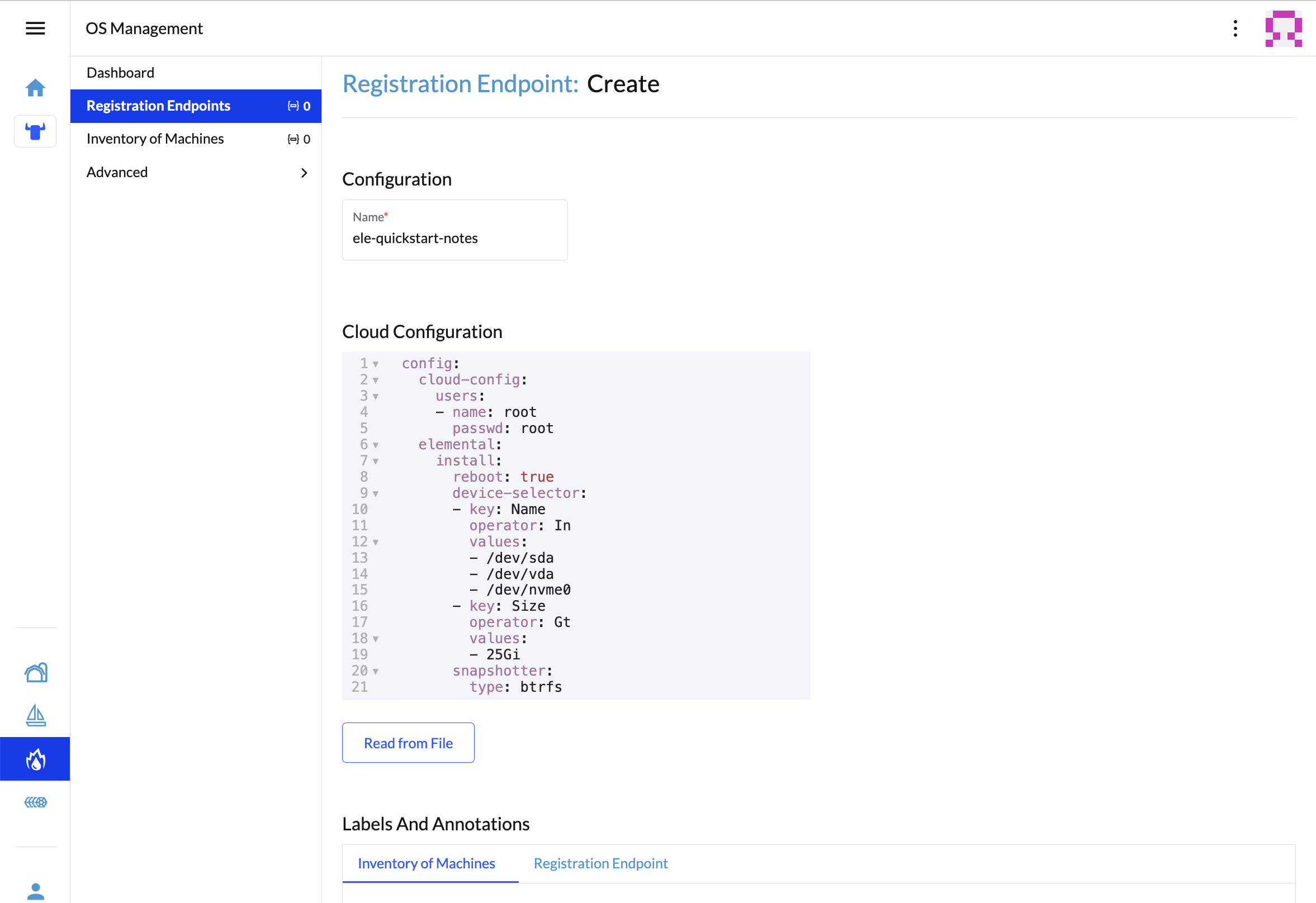

Desde la extensión de gestión del sistema operativo, haga clic en "Create Registration Endpoint" (Crear punto final de registro):

Asigne un nombre a esta configuración.

NotaPuede ignorar el campo "Cloud Configuration" (Configuración de la nube) porque estos datos se sobrescriben con los del paso siguiente con Edge Image Builder.

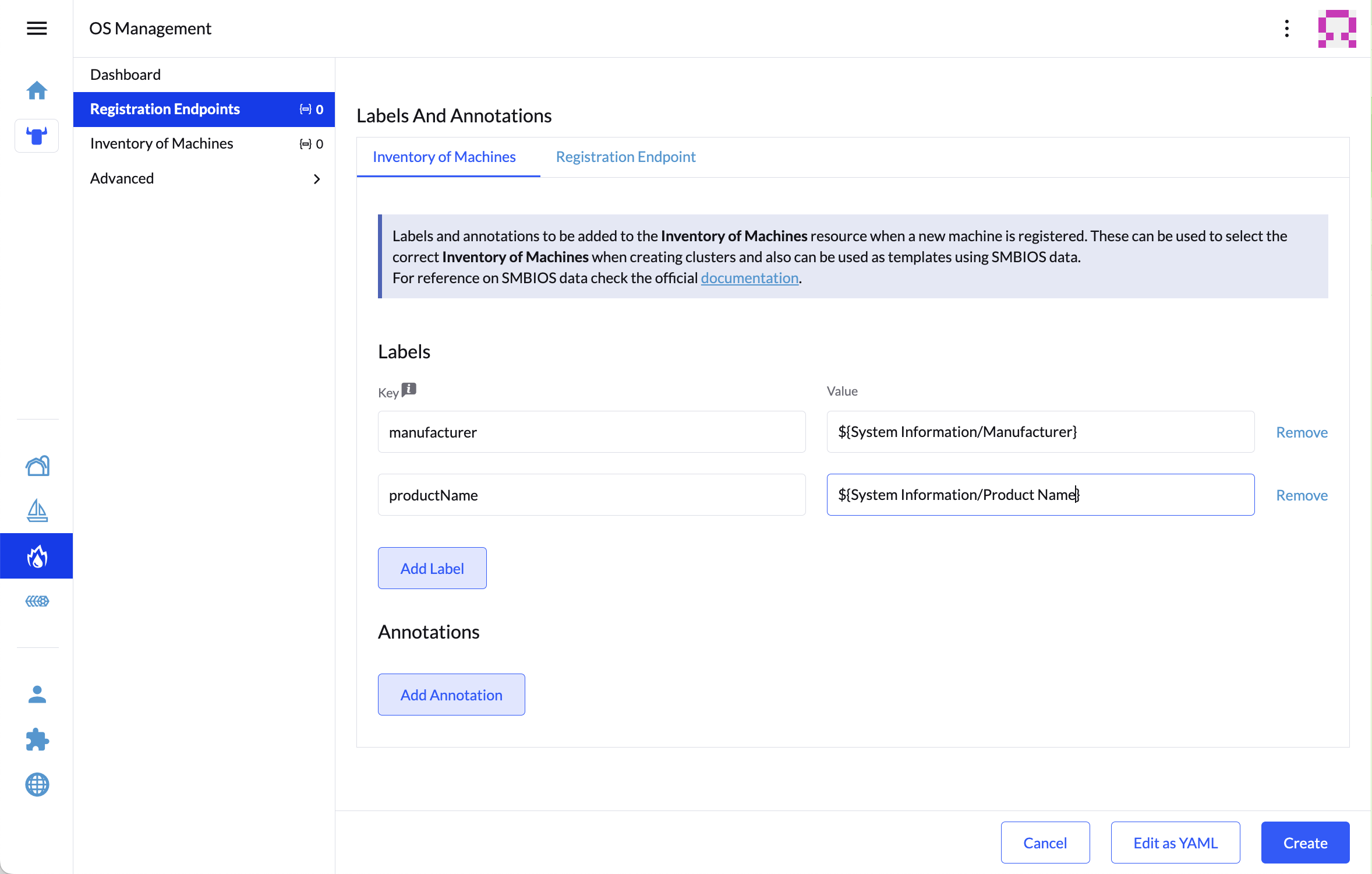

A continuación, desplácese hacia abajo y haga clic en "Add Label" (Añadir etiqueta) para cada etiqueta que desee que aparezca en el recurso que se crea cuando se registra un equipo. Esto resulta útil para distinguir cada equipo.

Haga clic en "Create" (Crear) para guardar la configuración.

Una vez creado el registro, debería ver la URL de registro en la lista y puede hacer clic en "Copy" (Copiar) para copiar la dirección:

SugerenciaSi ha salido de esa pantalla, puede hacer clic en "Registration Endpoints" (Puntos finales de registro) en el menú de la izquierda y, a continuación, hacer clic en el nombre del punto final que acaba de crear.

Esta URL se usa en el paso siguiente.

2.7 Creación de la imagen #

Aunque la versión actual de Elemental permite crear sus propios medios de instalación, en SUSE Edge 3.3.1 se hace con Kiwi y Edge Image Builder, por lo que el sistema resultante se crea con SUSE Linux Micro como sistema operativo base.

Para obtener más información sobre Kiwi, siga el proceso de creación de imágenes de Kiwi (Capítulo 28, Creación de imágenes actualizadas de SUSE Linux Micro con Kiwi) para crear imágenes nuevas en primer lugar. En el caso de Edge Image Builder, consulte la guía de introducción a Edge Image Builder (Capítulo 3, Clústeres independientes con Edge Image Builder) y la documentación de los componentes (Capítulo 11, Edge Image Builder).

Desde un sistema Linux con Podman instalado, cree los directorios y coloque la imagen base que está creando Kiwi:

mkdir -p $ELEM/eib_quickstart/base-images

cp /path/to/{micro-base-image-iso} $ELEM/eib_quickstart/base-images/

mkdir -p $ELEM/eib_quickstart/elementalcurl $REGISURL -o $ELEM/eib_quickstart/elemental/elemental_config.yamlcat << EOF > $ELEM/eib_quickstart/eib-config.yaml

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso

outputImageName: elemental-image.iso

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

isoConfiguration:

installDevice: /dev/vda

users:

- username: root

encryptedPassword: \$6\$jHugJNNd3HElGsUZ\$eodjVe4te5ps44SVcWshdfWizrP.xAyd71CVEXazBJ/.v799/WRCBXxfYmunlBO2yp1hm/zb4r8EmnrrNCF.P/

packages:

sccRegistrationCode: XXX

EOFLa sección

timees opcional, pero se recomienda encarecidamente configurarla para evitar posibles problemas con los certificados y la desviación del reloj. Los valores proporcionados en este ejemplo son solo ilustrativos. Ajústelos según sus requisitos específicos.La contraseña sin cifrar es

eib.Se necesita el código

sccRegistrationCodepara descargar e instalar los paquetes RPM necesarios de las fuentes oficiales (alternativamente, los RPMelemental-registeryelemental-system-agentse pueden cargar de forma manual y local).El comando

catescapa cada$con una barra invertida (\) para que Bash no las utilice como plantilla. Elimine las barras invertidas si va a realizar una copia manualmente.El dispositivo de instalación se borrará durante la instalación.

podman run --privileged --rm -it -v $ELEM/eib_quickstart/:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file eib-config.yamlSi está arrancando un dispositivo físico, es necesario grabar la imagen en una unidad flash USB. Puede hacerlo con:

sudo dd if=/eib_quickstart/elemental-image.iso of=/dev/<PATH_TO_DISK_DEVICE> status=progress2.8 Arranque de los nodos descendentes #

Ahora que se ha creado el medio de instalación, se pueden arrancar los nodos descendentes con él.

Para cada sistema que desee controlar con Elemental, añada el medio de instalación y arranque el dispositivo. Tras la instalación, se reiniciará y se registrará automáticamente.

Si utiliza la extensión de la interfaz de usuario, debería ver su nodo aparecer en "Inventory of Machines" (Inventario de equipos).

No retire el medio de instalación hasta que haya visto el mensaje de inicio de sesión; durante el primer arranque, se sigue accediendo a los archivos desde la memoria USB.

2.9 Creación de clústeres descendentes #

Para aprovisionar un clúster nuevo con Elemental, debe crear dos objetos.

- Linux

- Extensión de interfaz de usuario

El primero es MachineInventorySelectorTemplate. Este

objeto permite especificar una asignación entre los clústeres y los equipos

del inventario.

Cree un selector que coincida con cualquier equipo del inventario con una etiqueta:

cat << EOF > $ELEM/selector.yaml apiVersion: elemental.cattle.io/v1beta1 kind: MachineInventorySelectorTemplate metadata: name: location-123-selector namespace: fleet-default spec: template: spec: selector: matchLabels: locationID: '123' EOFAplique el recurso al clúster:

kubectl apply -f $ELEM/selector.yamlObtenga el nombre del equipo máquina y añada la etiqueta correspondiente:

MACHINENAME=$(kubectl get MachineInventory -n fleet-default | awk 'NR>1 {print $1}') kubectl label MachineInventory -n fleet-default \ $MACHINENAME locationID=123Cree un recurso de clúster K3s simple de un solo nodo y aplíquelo al clúster:

cat << EOF > $ELEM/cluster.yaml apiVersion: provisioning.cattle.io/v1 kind: Cluster metadata: name: location-123 namespace: fleet-default spec: kubernetesVersion: v1.32.4+k3s1 rkeConfig: machinePools: - name: pool1 quantity: 1 etcdRole: true controlPlaneRole: true workerRole: true machineConfigRef: kind: MachineInventorySelectorTemplate name: location-123-selector apiVersion: elemental.cattle.io/v1beta1 EOF kubectl apply -f $ELEM/cluster.yaml

Después de crear estos objetos, debería ver cómo se inicia un nuevo clúster de Kubernetes que usa el nuevo nodo que acaba de instalar.

2.10 Restablecimiento del nodo (opcional) #

SUSE Rancher Elemental permite realizar un "restablecimiento de nodo", que se puede activar opcionalmente cuando se elimina todo un clúster de Rancher o un solo nodo de un clúster, o cuando se elimina manualmente un nodo del inventario de equipos. Esto resulta útil cuando se desean restablecer y limpiar los recursos huérfanos y se quiere volver a incorporar automáticamente el nodo limpiado al inventario de equipos para que pueda reutilizarse. Esta función no está habilitada de forma predeterminada, por lo que no se limpiará cualquier sistema que se elimine (es decir, los datos no se eliminarán y los recursos del clúster de Kubernetes seguirán funcionando en los clústeres descendentes) y será necesaria una intervención manual para borrar los datos y volver a registrar el equipo en Rancher a través de Elemental.

Si desea que esta funcionalidad esté habilitada de forma predeterminada,

debe asegurarse de que esté explícitamente habilitada en

MachineRegistration añadiendo

config.elemental.reset.enabled: true, por ejemplo:

config:

elemental:

registration:

auth: tpm

reset:

enabled: trueA continuación, todos los sistemas registrados con este registro

MachineRegistration recibirán automáticamente la

anotación elemental.cattle.io/resettable: “true” en su

configuración. Si desea hacerlo manualmente en nodos individuales, por

ejemplo, porque tiene un MachineInventory que no tiene

esa anotación o porque ya ha desplegado nodos, puede modificar

MachineInventory y añadir la configuración

resettable. Por ejemplo:

apiVersion: elemental.cattle.io/v1beta1

kind: MachineInventory

metadata:

annotations:

elemental.cattle.io/os.unmanaged: 'true'

elemental.cattle.io/resettable: 'true'En SUSE Edge 3.1, el operador de Elemental coloca un marcador en el sistema

operativo que activará automáticamente el proceso de limpieza, detendrá

todos los servicios de Kubernetes, eliminará todos los datos persistentes,

desinstalará todos los servicios de Kubernetes, limpiará cualquier

directorio restante de Kubernetes/Rancher y forzará un nuevo registro en

Rancher a través de la configuración original de

MachineRegistration de Elemental. Esto ocurre

automáticamente, sin necesidad de intervención manual. El guion que se

ejecuta se encuentra en

/opt/edge/elemental_node_cleanup.sh y se activa a través

de systemd.path al colocar el marcador, por lo que su

ejecución es inmediata.

El uso de la función resettable presupone que el

comportamiento deseado al eliminar un nodo/clúster de Rancher es borrar los

datos y forzar un nuevo registro. En esta situación, la pérdida de datos

está garantizada, por lo que solo debe utilizarla si está seguro de que

desea que se realice un restablecimiento automático.

2.11 Pasos siguientes #

Se recomienda estudiar los siguientes recursos después de utilizar esta guía:

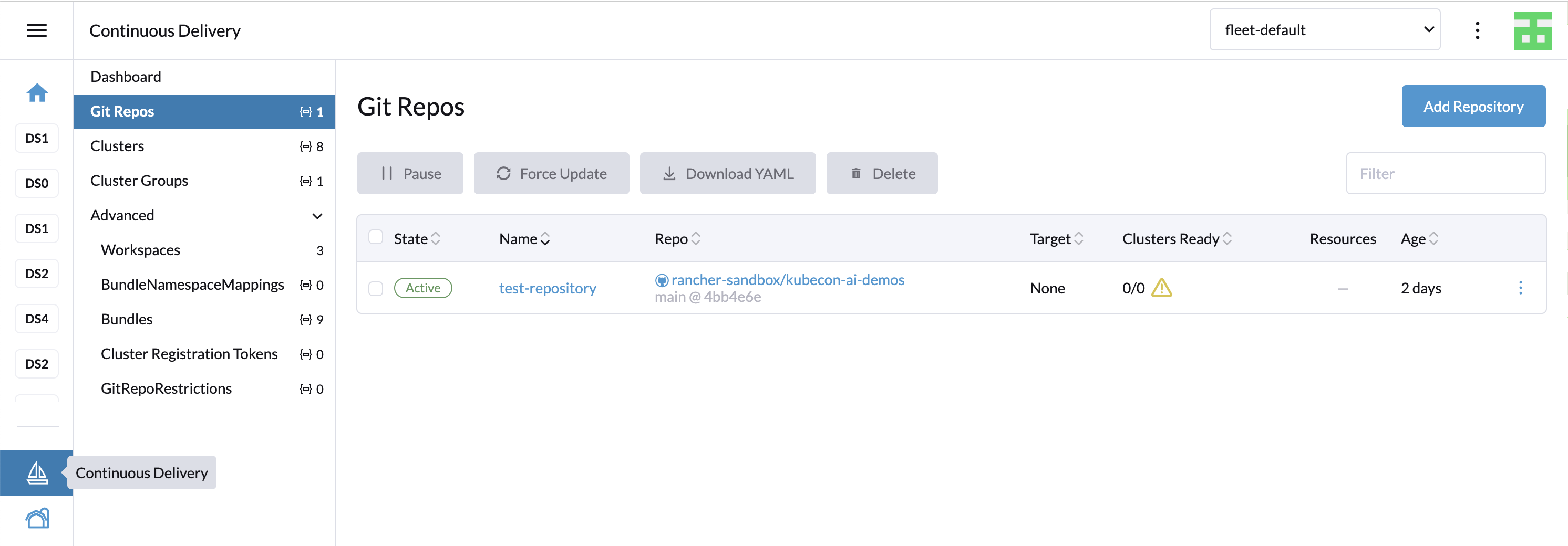

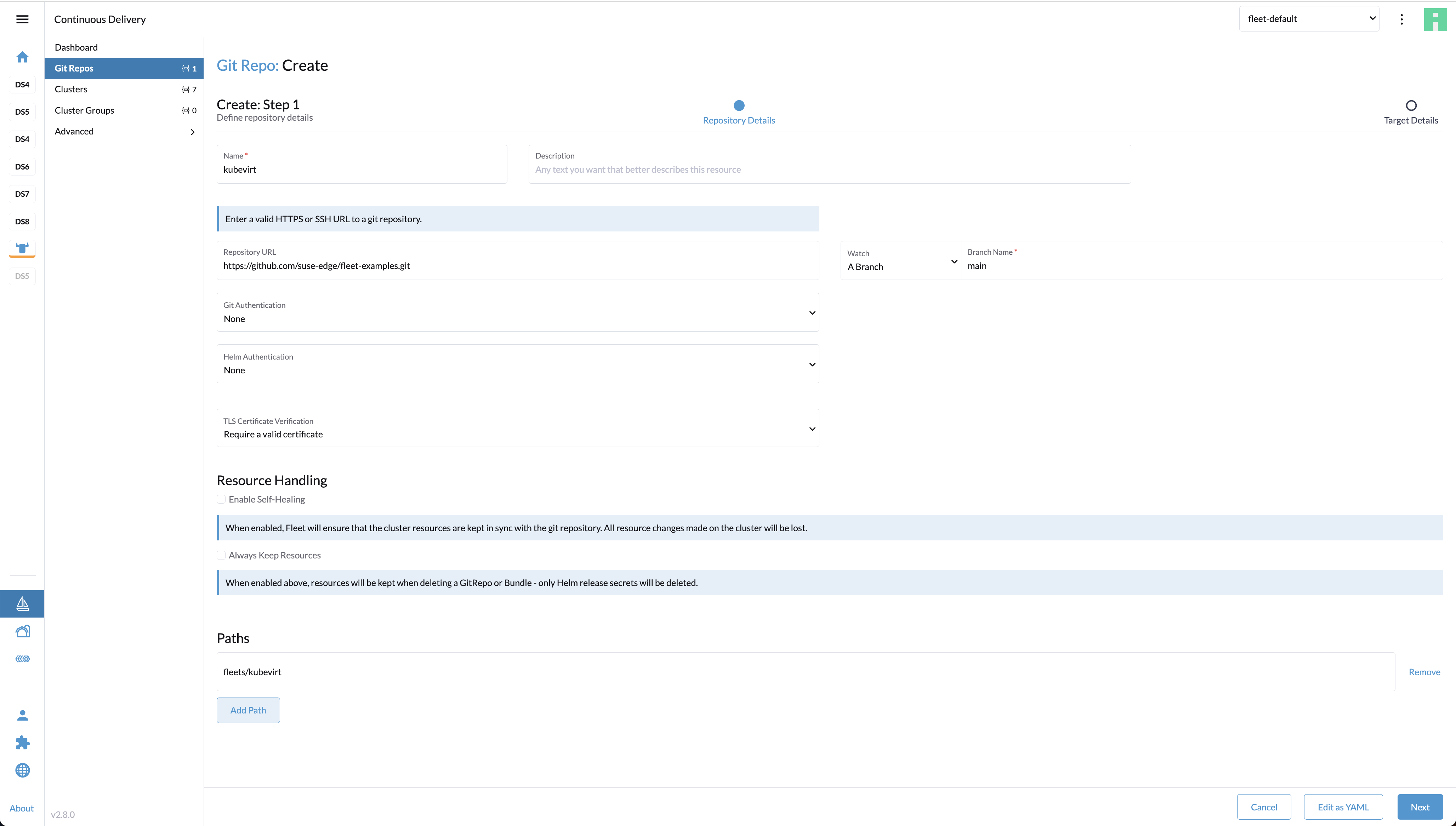

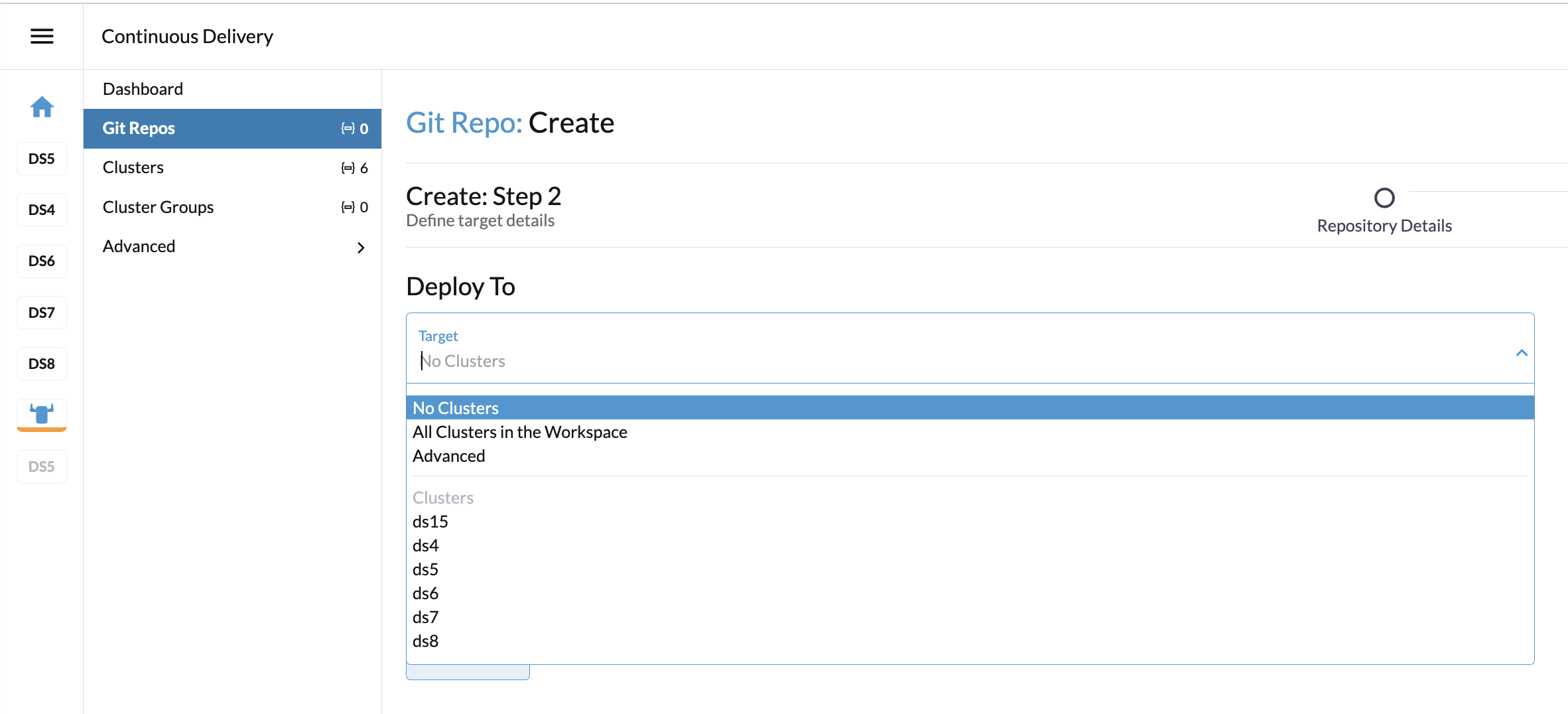

Automatización de extremo a extremo en el Capítulo 8, Fleet

Opciones de configuración de red adicionales en el Capítulo 12, Conexiones de red de Edge

3 Clústeres independientes con Edge Image Builder #

Edge Image Builder (EIB) es una herramienta que agiliza el proceso de generación de imágenes de disco personalizadas y listas para arrancar (CRB) para equipos de arranque, incluso en entornos totalmente aislados. EIB se utiliza para crear imágenes de despliegue para su uso en las tres huellas de despliegue de SUSE Edge, ya que es lo suficientemente flexible como para ofrecer las personalizaciones más pequeñas, como añadir un usuario o configurar la zona horaria, a través de una imagen configurada de forma integral que establece, por ejemplo, configuraciones de red complejas, despliega clústeres de Kubernetes de varios nodos, despliega cargas de trabajo de clientes y se registra en la plataforma de gestión centralizada a través de Rancher/Elemental y SUSE Multi-Linux Manager. EIB se ejecuta como una imagen de contenedor, lo que lo hace increíblemente portátil entre plataformas y garantiza que todas las dependencias necesarias sean autónomas, con un impacto mínimo en los paquetes instalados del sistema que se utiliza para operar la herramienta.

En escenarios de varios nodos, EIB despliega automáticamente MetalLB y Endpoint Copier Operator para que los hosts aprovisionados con la misma imagen compilada se unan automáticamente a un clúster de Kubernetes.

Para obtener más información, lea la introducción de Edge Image Builder (Capítulo 11, Edge Image Builder).

Edge Image Builder 1.2.1 admite la personalización de imágenes de SUSE Linux Micro 6.1. En versiones anteriores, como SUSE Linux Enterprise Micro 5.5 o 6.0, no se admite.

3.1 Requisitos previos #

Un equipo host AMD64/Intel 64 (físico o virtual) en el que se ejecute SLES 15 SP6.

El motor de contenedores Podman

Una imagen ISO de autoinstalación de SUSE Linux Micro 6.1 creada mediante el procedimiento Kiwi Builder (Capítulo 28, Creación de imágenes actualizadas de SUSE Linux Micro con Kiwi)

Para fines no relacionados con la producción, se puede utilizar openSUSE Leap 15.6 u openSUSE Tumbleweed como equipo host de creación. Otros sistemas operativos pueden funcionar, siempre que se disponga de un entorno de ejecución de contenedores compatible.

3.1.1 Obtención de la imagen de EIB #

La imagen del contenedor de EIB está disponible públicamente y se puede descargar desde el registro de SUSE Edge ejecutando el siguiente comando en el host de creación de imágenes:

podman pull registry.suse.com/edge/3.3/edge-image-builder:1.2.13.2 Creación del directorio de configuración de imágenes #

Dado que EIB se ejecuta dentro de un contenedor, es necesario montar un directorio de configuración desde el host, lo que le permite especificar la configuración deseada. Así, durante el proceso de creación, EIB tiene acceso a cualquier archivo de entrada y artefactos de apoyo necesarios. Este directorio debe tener una estructura específica. Vamos a crearlo suponiendo que este directorio existirá en su directorio de inicio y se llamará "eib":

export CONFIG_DIR=$HOME/eib