- Documentação do SUSE Edge 3.3.1

- I Guias de início rápido

- II Componentes

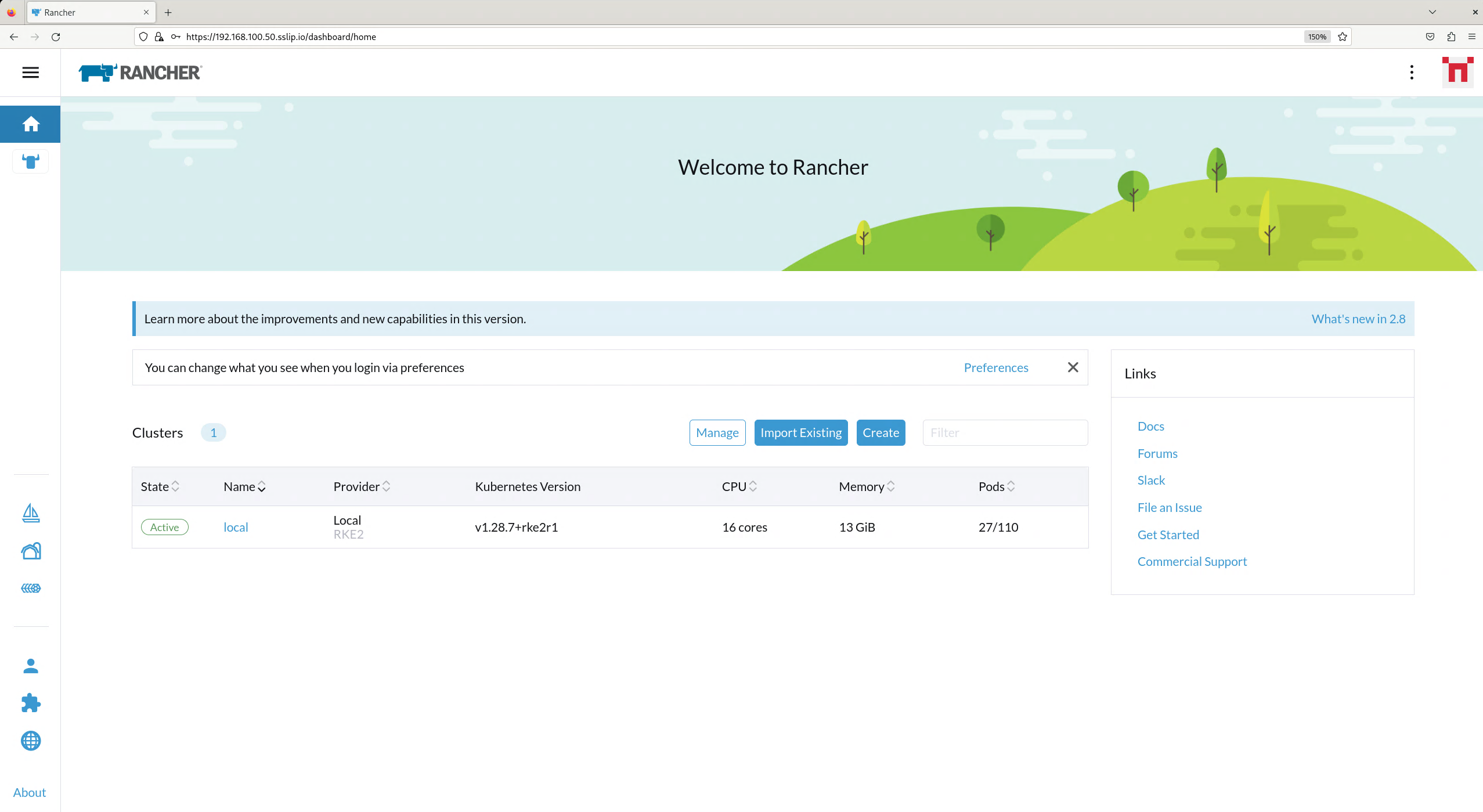

- 5 Rancher

- 6 Extensões do Rancher Dashboard

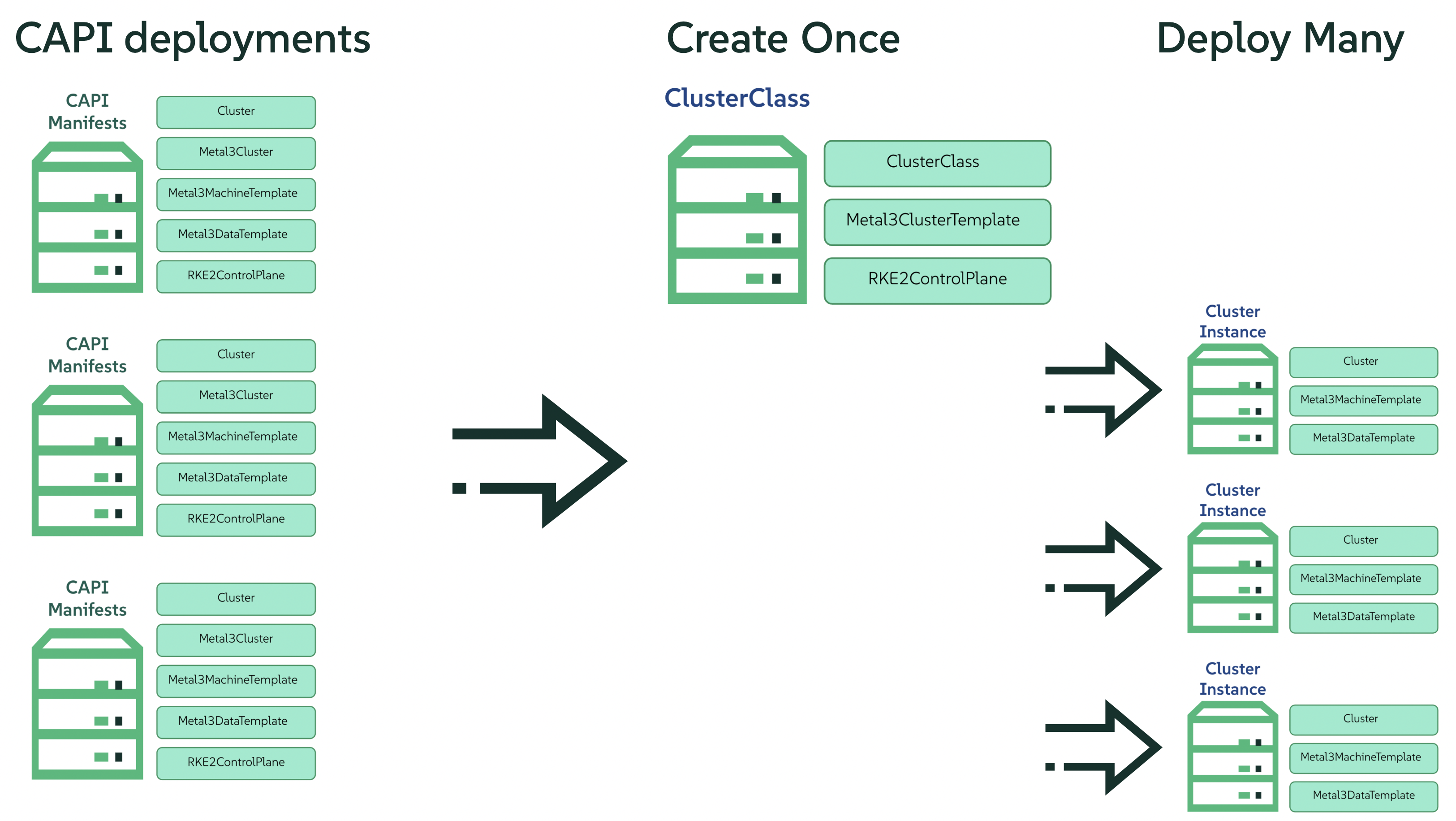

- 7 Rancher Turtles

- 8 Fleet

- 9 SUSE Linux Micro

- 10 Metal3

- 11 Edge Image Builder

- 12 Rede de borda

- 13 Elemental

- 14 Akri

- 15 K3s

- 16 RKE2

- 17 SUSE Storage

- 18 SUSE Security

- 19 MetalLB

- 20 Endpoint Copier Operator

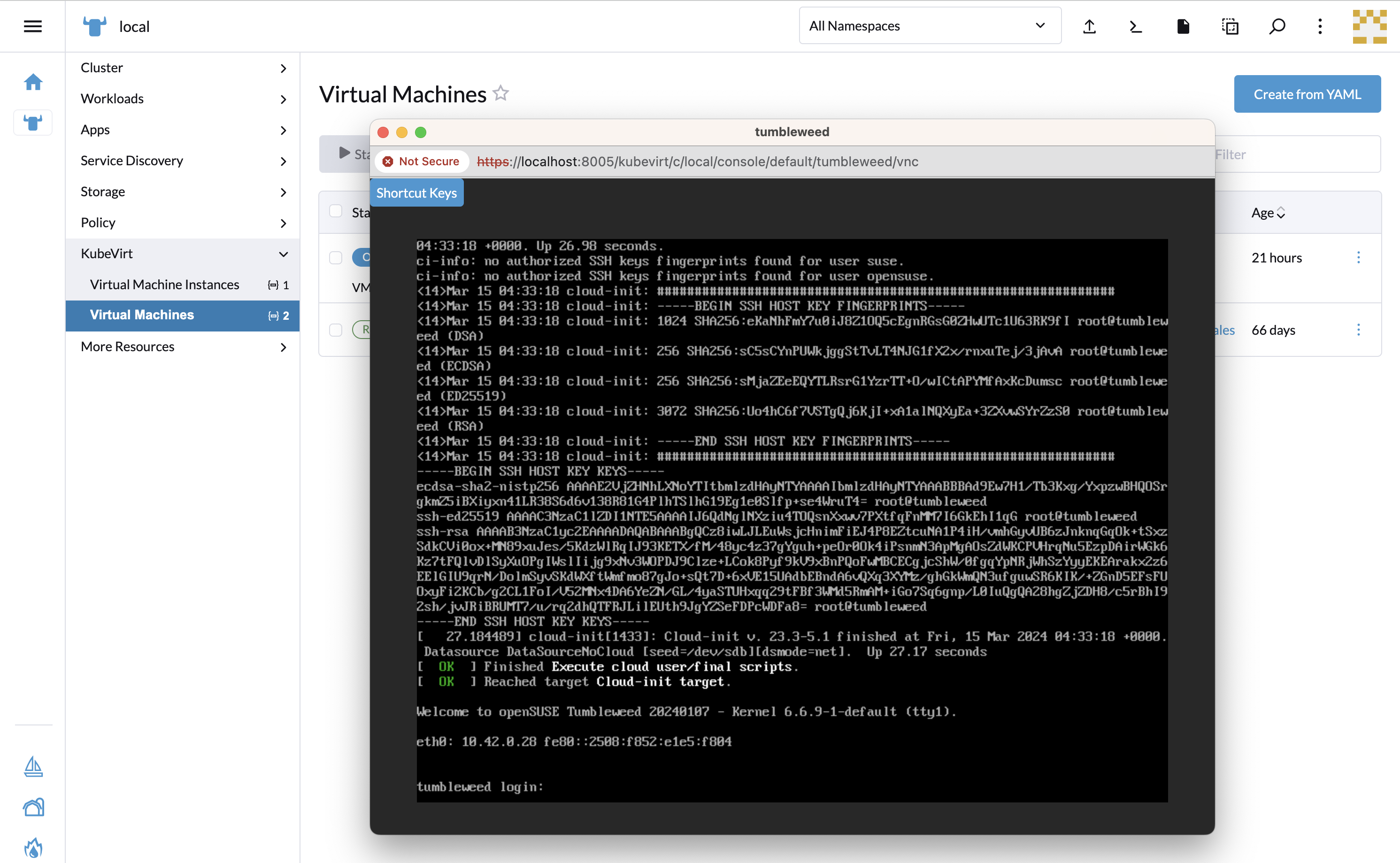

- 21 Edge Virtualization

- 22 System Upgrade Controller

- 23 Controller de upgrade

- 23.1 Como o SUSE Edge usa o Controller de upgrade?

- 23.2 Comparação entre Controller de upgrade e System Upgrade Controller

- 23.3 Instalando o Controller de upgrade

- 23.4 Como funciona o Controller de upgrade?

- 23.5 Extensões de API Kubernetes

- 23.6 Acompanhando o processo de upgrade

- 23.7 Limitações conhecidas

- 24 SUSE Multi-Linux Manager

- III Guias de procedimentos

- IV Dicas e truques

- V Integração de terceiros

- VI Operações de dia 2

- VII Documentação do produto

- 37 SUSE Edge for Telco

- 38 Conceito e arquitetura

- 39 Requisitos e suposições

- 40 Configurando o cluster de gerenciamento

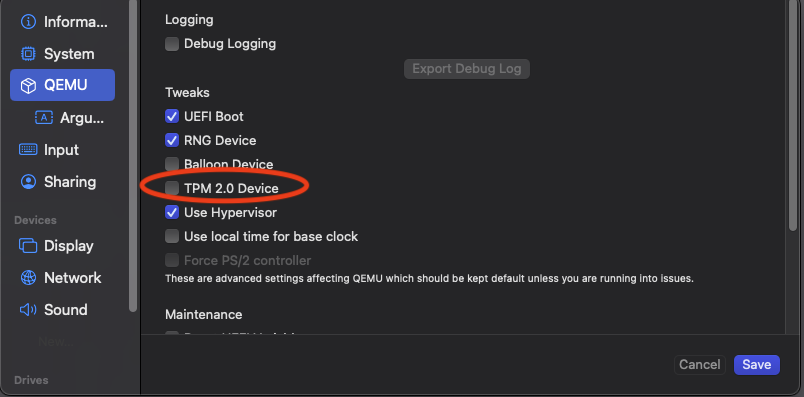

- 41 Configuração dos recursos de telecomunicações

- 41.1 Imagem do kernel para tempo real

- 41.2 Argumentos do kernel para baixa latência e alto desempenho

- 41.3 Fixação de CPU via TuneD e argumentos do kernel

- 41.4 Configuração da CNI

- 41.5 SR-IOV

- 41.6 DPDK

- 41.7 Aceleração vRAN (

Intel ACC100/ACC200) - 41.8 HugePages

- 41.9 Fixação da CPU em Kubernetes

- 41.10 Programação com reconhecimento de NUMA

- 41.11 MetalLB

- 41.12 Configuração do registro particular

- 41.13 Precision Time Protocol

- 42 Provisionamento de rede direcionado totalmente automatizado

- 42.1 Introdução

- 42.2 Preparar uma imagem de cluster downstream para cenários conectados

- 42.3 Preparar uma imagem de cluster downstream para cenários air-gapped

- 42.4 Provisionamento de cluster downstream com provisionamento de rede direcionado (nó único)

- 42.5 Provisionamento de cluster downstream com provisionamento de rede direcionado (vários nós)

- 42.6 Configuração avançada de rede

- 42.7 Recursos de telecomunicações (DPDK, SR-IOV, isolamento de CPU, HugePages, NUMA etc.)

- 42.8 Registro particular

- 42.9 Provisionamento de cluster downstream em cenários air-gapped

- 43 Ações de ciclo de vida

- VIII Solução de problemas

- 44 Princípios gerais da solução de problemas

- 45 Solução de problemas do Kiwi

- 46 Solucionando problemas no Edge Image Builder (EIB)

- 47 Solução de problemas da rede de borda (NMC)

- 48 Solucionando problemas em cenários "phone home"

- 49 Solução de problemas de provisionamento de rede direcionado

- 50 Solução de problemas de outros componentes

- 51 Coletando diagnósticos para o suporte

- IX Apêndice

Documentação do SUSE Edge 3.3.1 #

Boas-vindas à documentação do SUSE Edge. Você vai encontrar uma visão geral de alto nível da arquitetura, guias de início rápido, designs validados, orientação de como usar os componentes, integrações de terceiros e melhores práticas de gerenciamento da infraestrutura e das cargas de trabalho de computação de borda.

1 O que é o SUSE Edge? #

O SUSE Edge é uma solução completa, amplamente validada, de estreita integração e desenvolvida com um propósito específico para resolver os desafios exclusivos da implantação da infraestrutura e dos aplicativos nativos de nuvem na borda. Ele tem como objetivo principal oferecer uma plataforma persistente, porém bastante flexível, altamente escalável e segura que abrange a criação de imagem da implantação inicial, o provisionamento e a integração de nós, a implantação de aplicativos, a observabilidade e as operações do ciclo de vida completo. A plataforma foi criada do zero, com base no melhor software de código aberto, e condiz com os nossos mais de 30 anos de história como provedores de plataformas SUSE Linux seguras, estáveis e certificadas e com a nossa experiência em oferecer gerenciamento Kubernetes altamente escalável e repleto de recursos com o nosso portfólio Rancher. O SUSE Edge é fundamentado nesses recursos para entregar funcionalidades que atendem a inúmeros segmentos de mercado, como varejo, medicina, transporte, logística, telecomunicações, manufatura inteligente e IoT industrial.

2 Filosofia do design #

A solução foi criada com a ideia de que não existe uma plataforma de borda do tipo "tamanho único" porque os requisitos e as expectativas dos clientes variam de maneira significativa. As implantações de borda nos levam a resolver (e sempre aprimorar) alguns dos problemas mais desafiadores, como escalabilidade massiva, disponibilidade de rede restrita, limitações de espaço físico, novas ameaças à segurança e vetores de ataque, variações na arquitetura de hardware e nos recursos de sistema, a necessidade de implantar e estabelecer interface com infraestruturas e aplicativos legados e soluções de clientes com durações estendidas. Como muitos desses desafios são diferentes das mentalidades tradicionais, por exemplo, a implantação de infraestrutura e aplicativos em centros de dados ou na nuvem pública, precisamos analisar o design de modo muito mais detalhado e repensar várias hipóteses que antes eram comuns.

Por exemplo, consideramos importante o minimalismo, a modularidade e a facilidade das operações. O minimalismo é essencial nos ambientes de borda, já que as chances de um sistema falhar aumentam de acordo com a sua complexidade. Quando há centenas, ou até centenas de milhares de locais, os sistemas complexos vão apresentar falhas igualmente complexas. A modularidade em nossa solução oferece mais opções aos usuários e elimina a complexidade desnecessária da plataforma implantada. Precisamos também levar em consideração a facilidade das operações. As pessoas tendem a cometer erros quando repetem um processo milhares de vezes, portanto, a plataforma deve garantir que possíveis erros sejam recuperáveis, acabando com a necessidade de visitas técnicas, mas também buscar a consistência e a padronização.

3 Arquitetura de alto nível #

A arquitetura de alto nível do SUSE Edge está dividida em duas categorias principais, os chamados clusters de "gerenciamento" e "downstream". O cluster de gerenciamento é responsável pelo gerenciamento remoto de um ou mais clusters downstream, apesar de ser reconhecido que, em determinadas situações, os clusters downstream precisam operar sem gerenciamento remoto, por exemplo, quando um site de borda não tem conectividade externa e precisa operar de maneira independente. No SUSE Edge, os componentes técnicos usados na operação de ambos os clusters de gerenciamento e downstream são muito comuns, embora possam apresentar diferenças referentes a especificações de sistema e aos aplicativos nos quais residem, ou seja, o cluster de gerenciamento executa aplicativos que possibilitam as operações de ciclo de vida e gerenciamento de sistemas, enquanto os clusters downstream atendem aos requisitos para executar os aplicativos de usuário.

3.1 Componentes usados no SUSE Edge #

O SUSE Edge é composto de componentes existentes tanto do SUSE quanto do Rancher, junto com outros recursos e componentes desenvolvidos pela equipe do Edge, para enfrentarmos as restrições e as complexidades previstas na computação de borda. Veja abaixo uma explicação dos componentes usados nos clusters de gerenciamento e downstream, com um diagrama simplificado de alto nível (observe que não se trata de uma lista completa):

3.1.1 Cluster de gerenciamento #

Gerenciamento: trata-se da parte centralizada do SUSE Edge usada para gerenciar o provisionamento e o ciclo de vida dos clusters downstream conectados. Normalmente, o cluster de gerenciamento inclui os seguintes componentes:

Gerenciamento multicluster com o Rancher Prime (Capítulo 5, Rancher), que oferece um dashboard comum para integração de clusters downstream e gerenciamento do ciclo de vida contínuo da infraestrutura e dos aplicativos, além do isolamento total de locatários e das integrações de

IDP(provedor de identidade), um amplo mercado de integrações e extensões de terceiros e uma API independente de fornecedor.Gerenciamento de sistemas Linux com o SUSE Multi-Linux Manager, que permite o gerenciamento automatizado de patches e configurações do sistema operacional Linux subjacente (*SUSE Linux Micro (Capítulo 9, SUSE Linux Micro)) executado nos clusters downstream. Quando esse componente está conteinerizado, observe que ele precisa ser executado em um sistema separado dos outros componentes de gerenciamento, devidamente identificado no diagrama acima como "Linux Management".

Um controlador dedicado de gerenciamento do ciclo de vida (Capítulo 23, Controller de upgrade) encarregado dos upgrades dos componentes do cluster de gerenciamento para uma determinada versão do SUSE Edge.

Integração remota do sistema ao Rancher Prime com Elemental (Capítulo 13, Elemental), que permite a vinculação posterior dos nós de borda conectados aos clusters Kubernetes e a implantação de aplicativos, por exemplo, pelo GitOps.

Suporte opcional completo ao ciclo de vida e gerenciamento bare metal com os provedores de infraestrutura Metal3 (Capítulo 10, Metal3), MetalLB (Capítulo 19, MetalLB) e

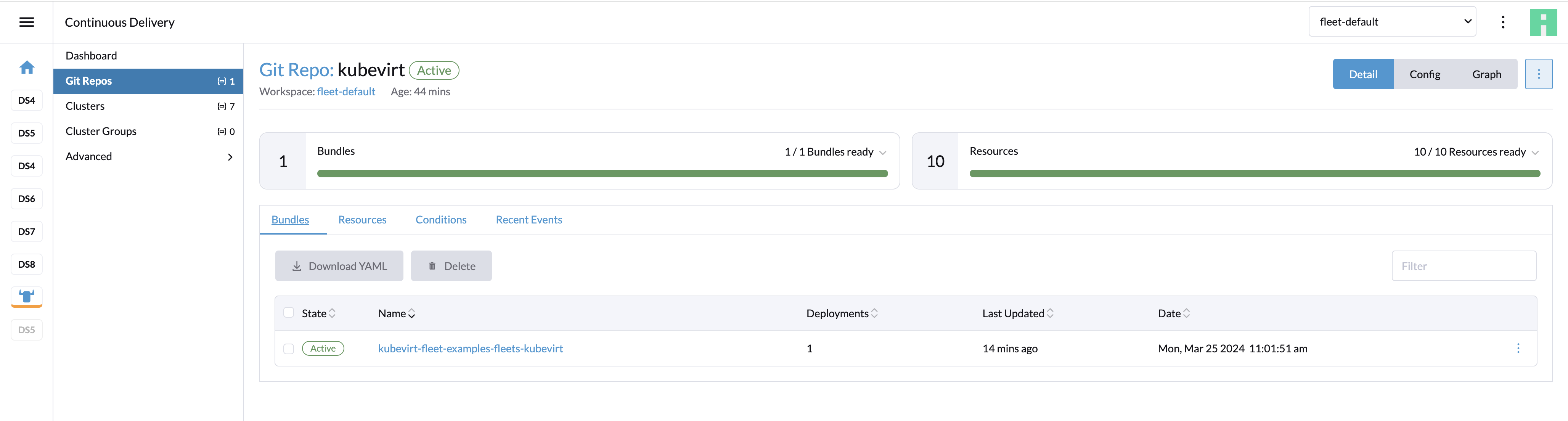

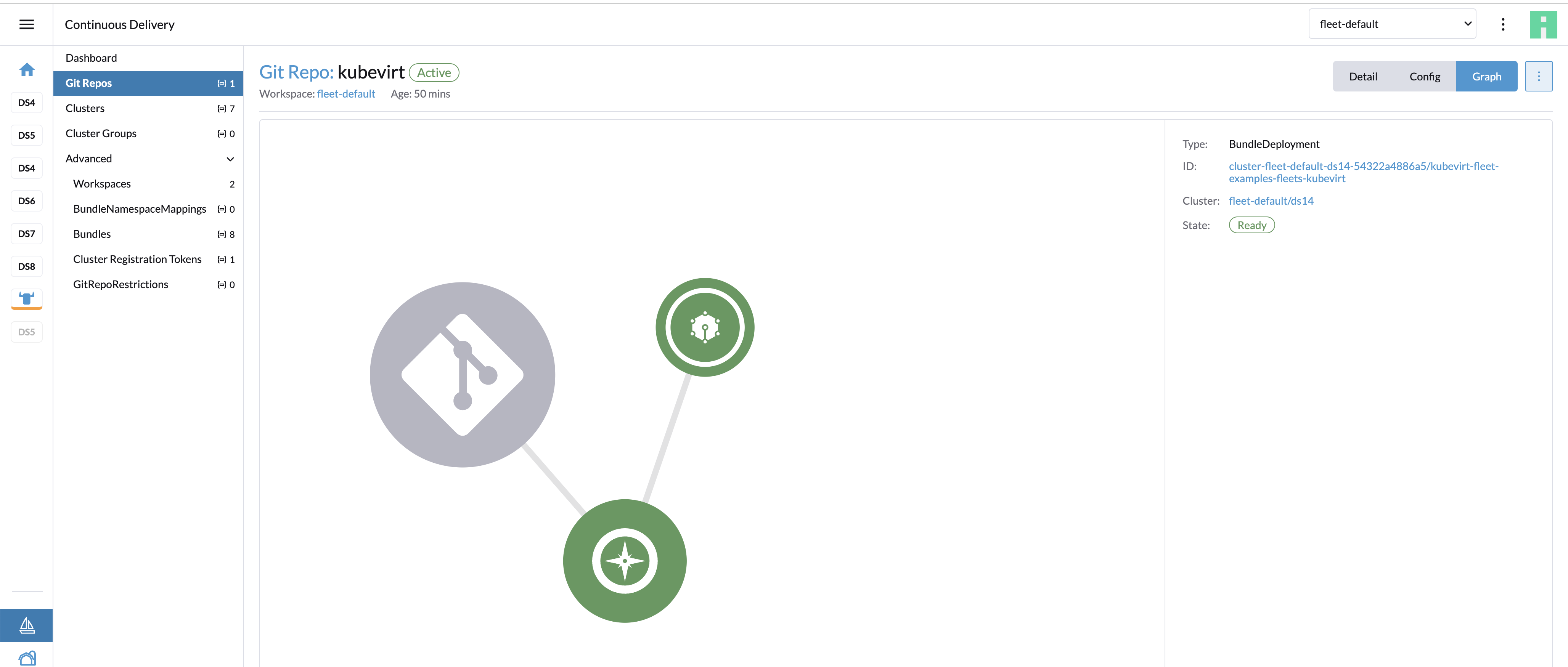

CAPI(Cluster API), que permite o provisionamento total, de ponta a ponta, dos sistemas bare metal com recursos de gerenciamento remoto.Um mecanismo opcional do GitOps chamado Fleet (Capítulo 8, Fleet) que gerencia o provisionamento e o ciclo de vida dos clusters downstream e dos aplicativos que residem neles.

O cluster de gerenciamento conta com o SUSE Linux Micro (Capítulo 9, SUSE Linux Micro) como o alicerce do sistema operacional de base e com o RKE2 (Capítulo 16, RKE2) como a distribuição Kubernetes que oferece suporte aos aplicativos do cluster de gerenciamento.

3.1.2 Clusters downstream #

Downstream: trata-se da parte distribuída do SUSE Edge usada para executar as cargas de trabalho dos usuários no Edge, ou seja, o software que é executado no próprio local de borda, e que normalmente inclui os seguintes componentes:

Uma seleção de distribuições Kubernetes, com distribuições seguras e leves como K3s (Capítulo 15, K3s) e RKE2 (Capítulo 16, RKE2) (

RKE2é protegido, certificado e otimizado para uso em órgãos governamentais e setores regulamentados).SUSE Security (Capítulo 18, SUSE Security) para habilitar recursos de segurança, como verificação de vulnerabilidade de imagens, inspeção detalhada de pacotes e proteção contra ameaças e vulnerabilidades em tempo real.

Armazenamento de software em blocos com o SUSE Storage (Capítulo 17, SUSE Storage), que possibilita o armazenamento em blocos leve, persistente, resiliente e escalável.

Um sistema operacional Linux leve, otimizado para contêiner e protegido com o SUSE Linux Micro (Capítulo 9, SUSE Linux Micro), que oferece um sistema operacional imutável e altamente resiliente para execução de contêineres e máquinas virtuais na borda. O SUSE Linux Micro está disponível para as arquiteturas AArch64 e AMD64/Intel 64 e também suporta o

kernel Real-Timepara aplicativos sensíveis à latência (por exemplo, os casos de uso de telecomunicações).Para os clusters conectados (ou seja, os que têm conectividade com o cluster de gerenciamento), dois agentes são implantados: Agente do sistema Rancher, para gerenciar a conectividade com o Rancher Prime, e venv-salt-minion, para receber as instruções do SUSE Multi-Linux Manager e aplicar as atualizações de software Linux. Eles não são obrigatórios para o gerenciamento de clusters desconectados.

3.2 Conectividade #

A imagem acima apresenta uma visão geral de alto nível da arquitetura dos clusters downstream conectados e sua relação com o cluster de gerenciamento. É possível implantar o cluster de gerenciamento em uma ampla variedade de plataformas de infraestrutura subjacentes, em instalações tanto no local quanto na nuvem, dependendo da disponibilidade de rede entre os clusters downstream e o cluster de gerenciamento de destino. O único requisito para que isso funcione é que a API e o URL de callback estejam acessíveis pela rede que conecta os nós do cluster downstream à infraestrutura de gerenciamento.

É importante reconhecer que existem mecanismos em que a conectividade é estabelecida e que são diferentes do mecanismo de implantação do cluster downstream. Há uma explicação mais detalhada sobre isso na próxima seção; mas, para um entendimento geral, há três mecanismos principais para estabelecer os clusters downstream conectados como um cluster "gerenciado":

Os clusters downstream são implantados primeiro no modo "desconectado" (por exemplo, pelo Edge Image Builder (Capítulo 11, Edge Image Builder)) e depois são importados para o cluster de gerenciamento se ou quando a conectividade permite.

Os clusters downstream são configurados para usar o mecanismo de integração incorporado (por exemplo, pelo Elemental (Capítulo 13, Elemental)) e são automaticamente registrados no cluster de gerenciamento na primeira inicialização, o que permite a vinculação posterior da configuração do cluster.

Os clusters downstream foram provisionados com os recursos de gerenciamento bare metal (CAPI + Metal3) e são automaticamente importados para o cluster de gerenciamento após a implantação e configuração do cluster (pelo operador Rancher Turtles).

É recomendada a implementação de vários clusters de gerenciamento para acomodar a grande escala de implantações, otimizar os ambientes geograficamente dispersos conforme as expectativas de largura de banda e de latência e minimizar as interrupções em caso de paradas ou upgrades do cluster de gerenciamento. Você encontra os limites de escalabilidade dos clusters de gerenciamento e os requisitos do sistema atuais aqui.

4 Padrões de implantação de borda comuns #

Devido à variedade de ambientes operacionais e requisitos de ciclo de vida, implementamos o suporte a alguns padrões de implantação que se adaptam de maneira flexível aos segmentos de mercado e casos de uso em que o SUSE Edge atua. Documentamos um guia de início rápido para cada um desses padrões de implantação para ajudar você a se familiarizar com a plataforma SUSE Edge de acordo com as suas necessidades. Os três padrões de implantação com suporte atualmente estão descritos a seguir, com um link para a respectiva página do guia de início rápido.

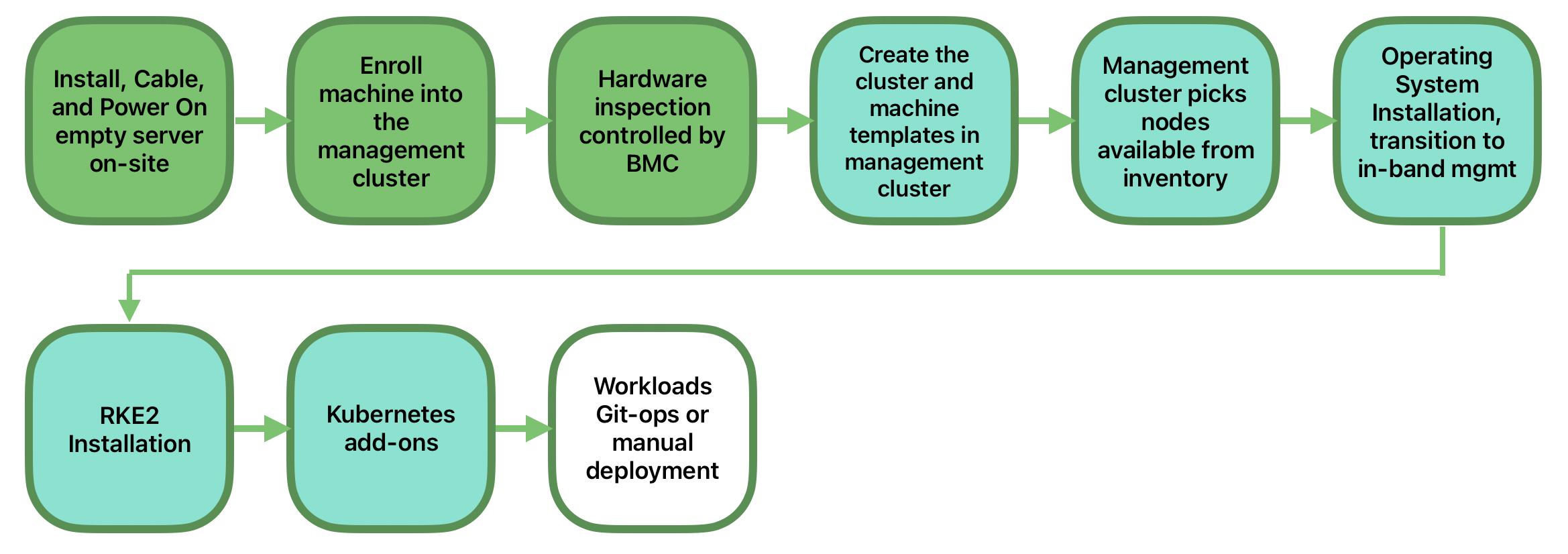

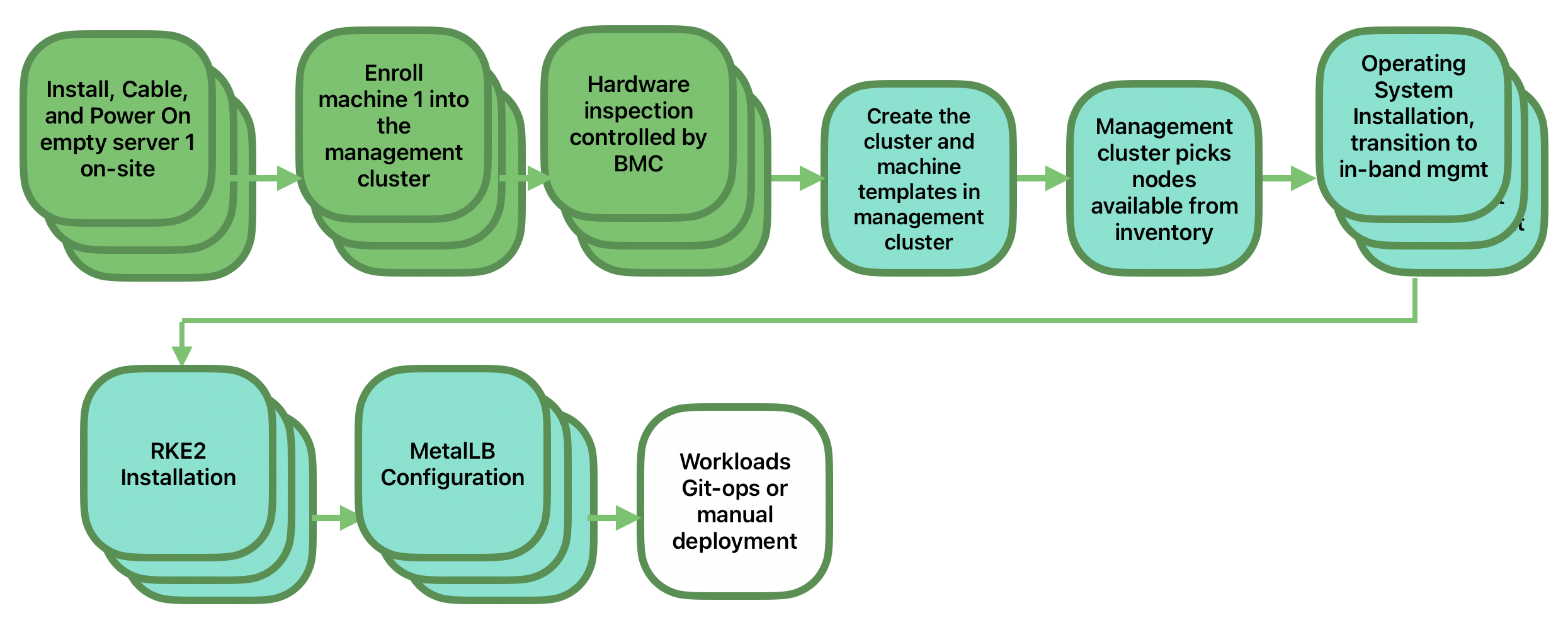

4.1 Provisionamento de rede direcionado #

O provisionamento de rede direcionado é por onde você fica sabendo dos detalhes do hardware em que deseja implantar e tem acesso direto à interface de gerenciamento fora da banda para orquestrar e automatizar todo o processo de provisionamento. Nesse cenário, nossos clientes esperam uma solução capaz de provisionar sites de borda completamente automatizados de um local centralizado, indo muito além da criação de uma imagem de inicialização, minimizando as operações manuais no local de borda: basta montar, ligar e conectar as redes necessárias ao hardware físico, e o processo de automação liga a máquina por meio do gerenciamento fora da banda (por exemplo, pela API Redfish) e cuida do provisionamento, da integração e da implantação da infraestrutura sem intervenção do usuário. A chave para que esse processo funcione é que os administradores conheçam os sistemas e saibam qual hardware está em que local, e que a implantação seja realizada centralmente.

Esta solução é a mais robusta, já que você interage diretamente com a interface de gerenciamento do hardware, trabalha com um hardware conhecido e tem menos restrições de disponibilidade de rede. Quanto às funcionalidades, a solução usa amplamente a Cluster API e o Metal3 para o provisionamento automatizado, de bare metal a sistema operacional, Kubernetes e aplicativos em camadas, e oferece a opção de se vincular aos demais recursos de gerenciamento do ciclo de vida comuns de pós-implantação do SUSE Edge. O início rápido da solução está disponível em Capítulo 1, Implantações automatizadas de BMC com Metal3.

4.2 Provisionamento de rede "phone home" #

Pode acontecer de você trabalhar em um ambiente onde o cluster de gerenciamento central não pode gerenciar o hardware diretamente (por exemplo, a rede remota é protegida por firewall ou não há uma interface de gerenciamento fora da banda; o que é comum em hardware do tipo "PC" mais encontrado na borda). Nesse cenário, oferecemos ferramentas para provisão remota de clusters e suas cargas de trabalho sem a necessidade de saber para onde o hardware é enviado quando é iniciado. É isto que a maioria das pessoas pensa sobre computação de borda: são milhares, ou dezenas de milhares, de sistemas um tanto desconhecidos que são iniciados nos locais de borda e se comunicam de maneira segura com a central ("phone home"), validando suas identidades e recebendo as instruções do que devem fazer. Nesse caso, nossos requisitos são o provisionamento e o gerenciamento do ciclo de vida com muito pouca intervenção do usuário, além de pré-criar a imagem da máquina de fábrica ou simplesmente anexar uma imagem de inicialização, por exemplo, por USB, e ligar o sistema. O principal desafio nesse caso é abordar a escala, a consistência, a segurança e o ciclo de vida desses dispositivos no mundo real.

Esta solução oferece um ótimo nível de flexibilidade e consistência no modo como os sistemas são provisionados e integrados, seja qual for seu local, tipo ou especificação ou quando são ligados pela primeira vez. O SUSE Edge oferece total flexibilidade e personalização do sistema pelo Edge Image Builder, além de aproveitar a oferta de recursos de registro Elemental do Rancher para integração de nós e provisionamento do Kubernetes, junto com o SUSE Multi-Linux Manager para aplicação de patches no sistema operacional. O início rápido da solução está disponível no Capítulo 2, Integração remota de host com o Elemental.

4.3 Provisionamento com base na imagem #

Para os clientes que precisam trabalhar em ambientes independentes, air-gapped ou com limitações de rede, o SUSE Edge oferece uma solução que permite gerar mídias de instalação totalmente personalizadas com todos os artefatos de implantação necessários para habilitar clusters Kubernetes de alta disponibilidade na borda, tanto de um quanto de vários nós, incluindo qualquer carga de trabalho ou componentes adicionais em camadas que sejam necessários. Tudo isso sem precisar de conectividade de rede com ambientes externos e sem a intervenção de uma plataforma de gerenciamento centralizada. A experiência do usuário é muito parecida com a solução "phone home", no que se refere à mídia de instalação fornecida aos sistemas de destino, mas a solução é "iniciada no local". Nesse cenário, é possível conectar os clusters resultantes ao Rancher para gerenciamento contínuo (ou seja, passar do modo de operação "desconectado" para "conectado" sem precisar de reconfiguração ou reimplantação significativa) ou continuar a operação de forma isolada. Observe que, em ambos os casos, é possível usar o mesmo mecanismo consistente para automatizar as operações de ciclo de vida.

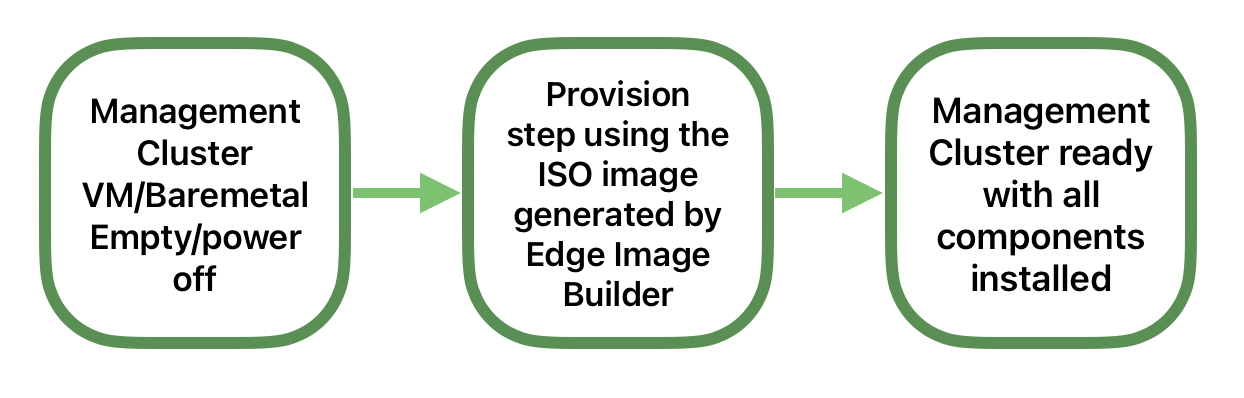

Além disso, é possível usar a solução para criar rapidamente clusters de gerenciamento que podem hospedar a infraestrutura centralizada que sustenta os modelos de provisionamento de rede tanto "direcionado" quanto "phone home", já que pode ser a forma mais rápida e simples de provisionar todos os tipos de infraestrutura de borda. Essa solução faz uso intensivo dos recursos do SUSE Edge Image Builder para criar mídias de instalação totalmente personalizadas e autônomas. O início rápido está disponível no Capítulo 3, Clusters independentes com o Edge Image Builder.

5 Validação da pilha do SUSE Edge #

Todas as versões do SUSE Edge têm componentes estreitamente integrados e validados na íntegra que são lançados juntos. Como parte do trabalho constante de integração e validação de pilha que testa a integração entre os componentes e garante que o desempenho do sistema atenda às expectativas em cenários de falha forçada, a equipe do SUSE Edge publica todas as execuções e os resultados dos testes. Os resultados e todos os parâmetros de entrada estão disponíveis em ci.edge.suse.com.

6 Lista completa de componentes #

A lista completa de componentes, com um link para a descrição de alto nível de cada um e como são usados no SUSE Edge, está disponível abaixo:

Rancher (Capítulo 5, Rancher)

Extensões do Rancher Dashboard (Capítulo 6, Extensões do Rancher Dashboard)

Rancher Turtles (Capítulo 7, Rancher Turtles)

SUSE Multi-Linux Manager

Fleet (Capítulo 8, Fleet)

SUSE Linux Micro (Capítulo 9, SUSE Linux Micro)

Metal³ (Capítulo 10, Metal3)

Edge Image Builder (Capítulo 11, Edge Image Builder)

NetworkManager Configurator (Capítulo 12, Rede de borda)

Elemental (Capítulo 13, Elemental)

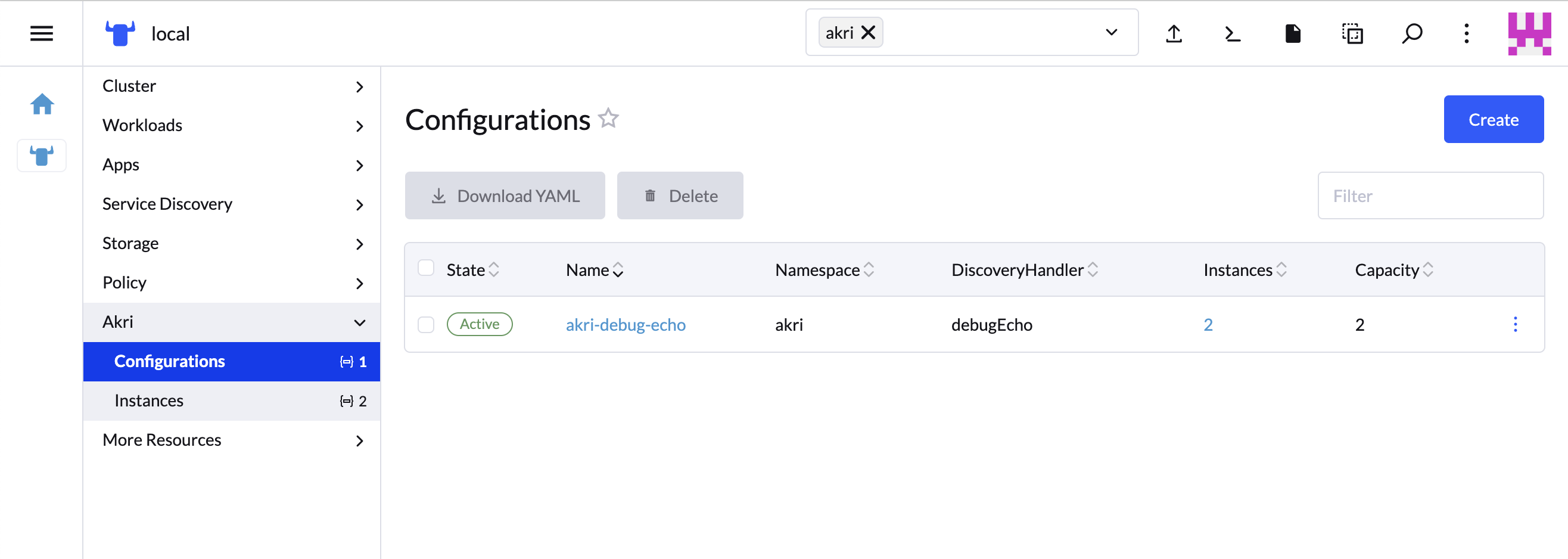

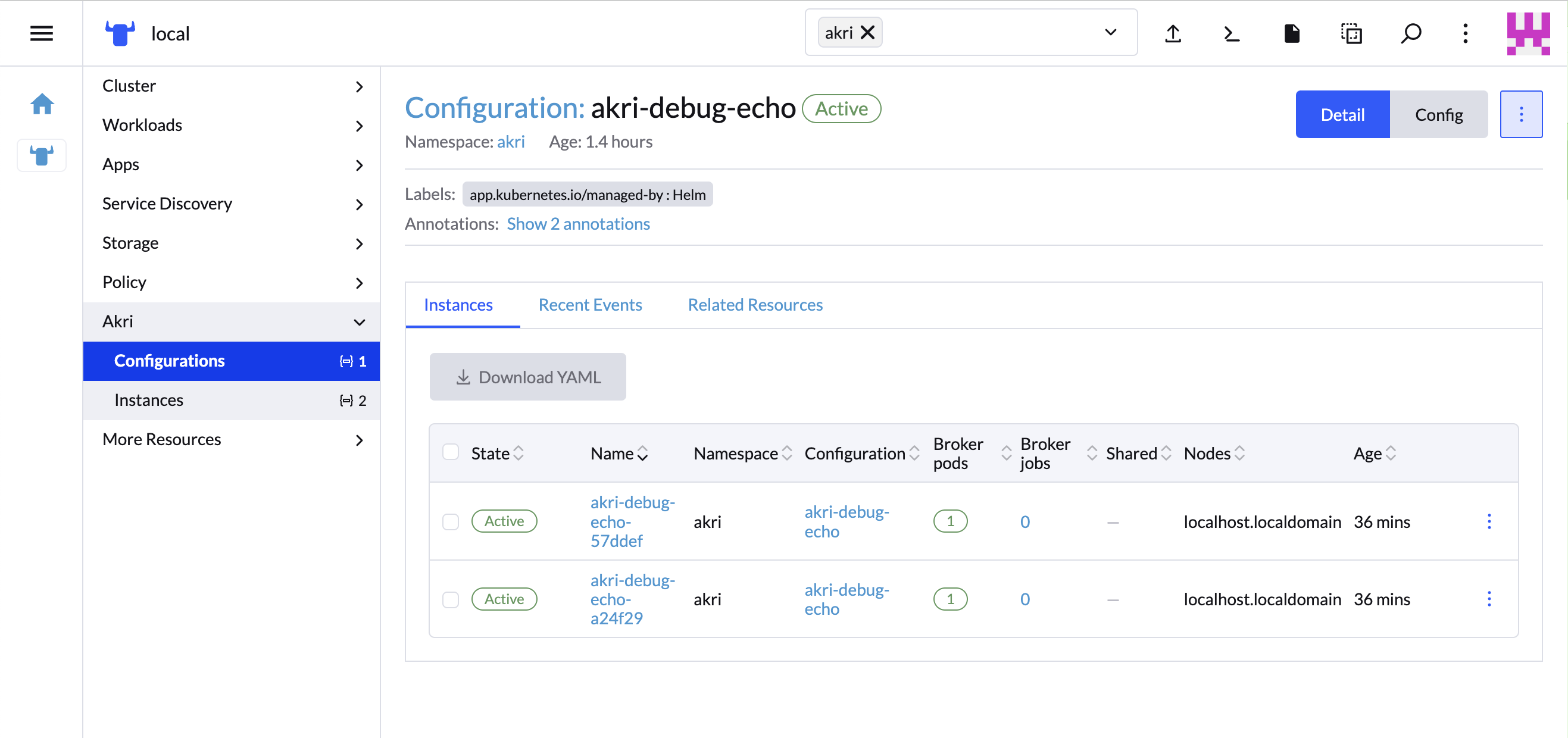

Akri (Capítulo 14, Akri)

K3s (Capítulo 15, K3s)

RKE2 (Capítulo 16, RKE2)

SUSE Storage (Capítulo 17, SUSE Storage)

SUSE Security (Capítulo 18, SUSE Security)

MetalLB (Capítulo 19, MetalLB)

KubeVirt (Capítulo 21, Edge Virtualization)

System Upgrade Controller (Capítulo 22, System Upgrade Controller)

Controller de upgrade (Capítulo 23, Controller de upgrade)

Parte I Guias de início rápido #

Estes são os guias de início rápido

- 1 Implantações automatizadas de BMC com Metal3

Metal3 é um projeto da CNCF que oferece recursos de gerenciamento de infraestrutura bare metal para Kubernetes.

- 2 Integração remota de host com o Elemental

Esta seção apresenta a solução de "provisionamento de rede 'phone home'" como parte do SUSE Edge, em que usamos o Elemental para auxiliar na integração de nós. O Elemental é uma pilha de software que permite o registro remoto de hosts e o gerenciamento de sistema operacional nativo de nuvem e totalm…

- 3 Clusters independentes com o Edge Image Builder

O Edge Image Builder (EIB) é uma ferramenta que simplifica o processo de geração de imagens de disco personalizadas e prontas para inicialização (CRB) para inicializar máquinas, mesmo em cenários totalmente air-gapped. O EIB é usado para criar imagens de implantação para uso em todas as três áreas d…

- 4 SUSE Multi-Linux Manager

O SUSE Multi-Linux Manager está incluído no SUSE Edge para oferecer a automação e o controle que mantêm o sistema operacional SUSE Linux Micro subjacente sempre atualizado em todos os nós da implantação de borda.

1 Implantações automatizadas de BMC com Metal3 #

Metal3 é um projeto da CNCF que oferece recursos de gerenciamento de infraestrutura bare metal para Kubernetes.

O Metal3 inclui recursos nativos do Kubernetes para gerenciar o ciclo de vida de servidores bare metal que suportam gerenciamento com protocolos fora da banda, como o Redfish.

Ele também conta com suporte a Cluster API (CAPI), que permite gerenciar os recursos da infraestrutura de vários provedores por meio de APIs amplamente adotadas e independentes de fornecedor.

1.1 Por que usar este método #

Este método é útil em cenários com hardware de destino que permite o gerenciamento fora da banda e quando se deseja um fluxo de gerenciamento de infraestrutura automatizado.

O cluster de gerenciamento é configurado para oferecer APIs declarativas que permitem o gerenciamento de inventário e de estado dos servidores bare metal do cluster downstream, incluindo inspeção automatizada, limpeza e provisionamento/desprovisionamento.

1.2 Arquitetura de alto nível #

1.3 Pré-requisitos #

Há algumas restrições específicas relacionadas ao hardware e à rede de servidor do cluster downstream:

Cluster de gerenciamento

É preciso ter conectividade de rede com a API de gerenciamento/BMC do servidor de destino

É preciso ter conectividade com a rede do plano de controle do servidor de destino

Para clusters de gerenciamento de vários nós, é necessário um endereço IP reservado adicional

Hosts para serem controlados

É preciso ter suporte a gerenciamento fora da banda pelas interfaces do Redfish, iDRAC ou iLO

É preciso ter suporte à implantação por mídia virtual (não há suporte a PXE no momento)

É preciso ter conectividade de rede com o cluster de gerenciamento para acessar as APIs de provisionamento do Metal3

Algumas ferramentas são necessárias e podem ser instaladas no cluster de gerenciamento ou em um host que possa acessá-lo.

Um tempo de execução do contêiner, como Podman ou Rancher Desktop

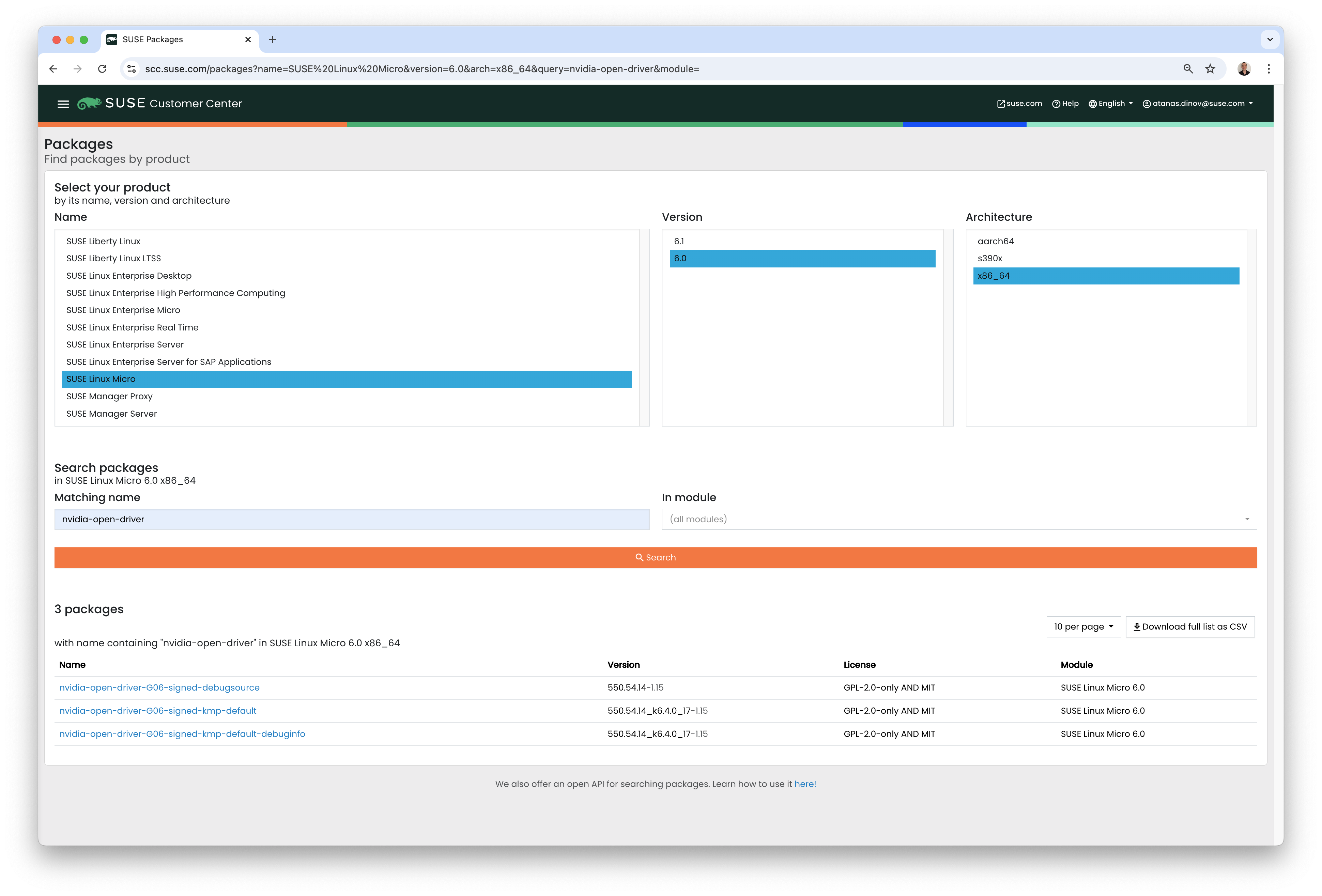

Faça download do arquivo de imagem de sistema operacional

SL-Micro.x86_64-6.1-Base-GM.raw pelo SUSE Customer Center ou pela página de download da

SUSE.

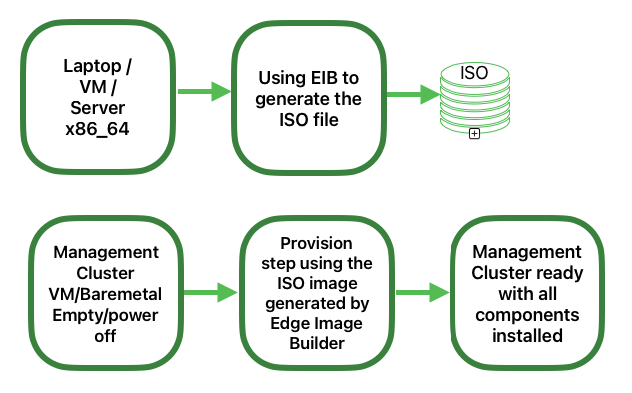

1.3.1 Configurar o cluster de gerenciamento #

As etapas básicas de instalação de um cluster de gerenciamento e uso do Metal3 são:

Instalar um cluster de gerenciamento RKE2

Instalar o Rancher

Instalar um provedor de armazenamento (opcional)

Instalar as dependências do Metal3

Instalar as dependências da CAPI pelo Rancher Turtles

Criar uma imagem do sistema operacional SLEMicro para hosts do cluster downstream

Registrar CRs de BareMetalHost para definir o inventário de bare metal

Criar um cluster downstream definindo recursos da CAPI

Este guia considera que já existe um cluster RKE2 e que o Rancher (incluindo o cert-manager) foi instalado, por exemplo, usando o Edge Image Builder (Capítulo 11, Edge Image Builder).

Estas etapas também podem ser totalmente automatizadas conforme descrito na documentação do cluster de gerenciamento (Capítulo 40, Configurando o cluster de gerenciamento).

1.3.2 Instalando as dependências do Metal3 #

O cert-manager deve ser instalado e executado caso não tenha sido junto com a instalação do Rancher.

É necessário instalar um provedor de armazenamento persistente. O SUSE

Storage é recomendado, mas também é possível usar o

local-path-provisioner em ambientes de

desenvolvimento/PoC. A instrução abaixo considera que StorageClass foi marcada

como padrão; do contrário, será necessária uma configuração adicional

para o gráfico do Metal3.

Um IP adicional é necessário, que pode ser gerenciado por MetalLB para fornecer um endpoint consistente aos serviços de gerenciamento do Metal3. Esse IP deve fazer parte da sub-rede do plano de controle e ser reservado para configuração estática (e não fazer parte de um pool DHCP).

Se o cluster de gerenciamento é um nó único, é possível evitar o requisito de IP flutuante adicional gerenciado por MetalLB. Consulte a Seção 1.6.1, “Configuração de nó único”.

Vamos instalar primeiro o MetalLB:

helm install \ metallb oci://registry.suse.com/edge/charts/metallb \ --namespace metallb-system \ --create-namespaceNa sequência, definimos um

IPAddressPooleL2Advertisementusando o IP reservado, especificado abaixo comoSTATIC_IRONIC_IP:export STATIC_IRONIC_IP=<STATIC_IRONIC_IP> cat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: ironic-ip-pool namespace: metallb-system spec: addresses: - ${STATIC_IRONIC_IP}/32 serviceAllocation: priority: 100 serviceSelectors: - matchExpressions: - {key: app.kubernetes.io/name, operator: In, values: [metal3-ironic]} EOFcat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: ironic-ip-pool-l2-adv namespace: metallb-system spec: ipAddressPools: - ironic-ip-pool EOFAgora é possível instalar o Metal3:

helm install \ metal3 oci://registry.suse.com/edge/charts/metal3 \ --namespace metal3-system \ --create-namespace \ --set global.ironicIP="$STATIC_IRONIC_IP"A execução do contêiner init pode levar cerca de dois minutos nesta implantação, portanto, garanta que todos os pods estejam em execução antes de continuar:

kubectl get pods -n metal3-system NAME READY STATUS RESTARTS AGE baremetal-operator-controller-manager-85756794b-fz98d 2/2 Running 0 15m metal3-metal3-ironic-677bc5c8cc-55shd 4/4 Running 0 15m metal3-metal3-mariadb-7c7d6fdbd8-64c7l 1/1 Running 0 15m

Não avance para as etapas seguintes até que todos os pods no namespace

metal3-system estejam em execução.

1.3.3 Instalando as dependências de API do cluster #

As dependências de API do cluster são gerenciadas pelo gráfico Helm do Rancher Turtles:

cat > values.yaml <<EOF

rancherTurtles:

features:

embedded-capi:

disabled: true

rancher-webhook:

cleanup: true

EOF

helm install \

rancher-turtles oci://registry.suse.com/edge/charts/rancher-turtles \

--namespace rancher-turtles-system \

--create-namespace \

-f values.yamlApós algum tempo, os pods do controlador deverão estar em execução nos

namespaces capi-system, capm3-system,

rke2-bootstrap-system e

rke2-control-plane-system.

1.3.4 Preparar a imagem do cluster downstream #

O Kiwi (Capítulo 28, Criando imagens atualizadas do SUSE Linux Micro com o Kiwi) e o Edge Image Builder (Capítulo 11, Edge Image Builder) são usados para preparar a imagem base do SLEMicro modificado que foi provisionado nos hosts do cluster downstream.

Neste guia, abordamos a configuração mínima necessária para implantar o cluster downstream.

1.3.4.1 Configuração da imagem #

Primeiro siga o Capítulo 28, Criando imagens atualizadas do SUSE Linux Micro com o Kiwi para gerar uma imagem nova como a primeira etapa necessária para criar clusters.

Ao executar o Edge Image Builder, um diretório é montado com base no host, portanto, é necessário criar uma estrutura de diretórios para armazenar os arquivos de configuração usados para definir a imagem de destino.

downstream-cluster-config.yamlé o arquivo de definição da imagem. Consulte o Capítulo 3, Clusters independentes com o Edge Image Builder para obter mais detalhes.Quando o download da imagem base é feito, ela é compactada com

xz, que deve ser descompactada comunxze copiada/movida para a pastabase-images.A pasta

networké opcional. Consulte a Seção 1.3.5.1.1, “Script adicional para configuração de rede estática” para obter mais detalhes.O diretório custom/scripts contém scripts que são executados na primeira inicialização. Atualmente, um script

01-fix-growfs.shé necessário para redimensionar a partição raiz do sistema operacional na implantação.

├── downstream-cluster-config.yaml

├── base-images/

│ └ SL-Micro.x86_64-6.1-Base-GM.raw

├── network/

| └ configure-network.sh

└── custom/

└ scripts/

└ 01-fix-growfs.sh1.3.4.1.1 Arquivo de definição da imagem do cluster downstream #

O downstream-cluster-config.yaml é o arquivo de

configuração principal para a imagem do cluster downstream. Veja a seguir um

exemplo mínimo de implantação por meio do Metal3:

apiVersion: 1.2

image:

imageType: raw

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-GM.raw

outputImageName: SLE-Micro-eib-output.raw

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

kernelArgs:

- ignition.platform.id=openstack

- net.ifnames=1

systemd:

disable:

- rebootmgr

- transactional-update.timer

- transactional-update-cleanup.timer

users:

- username: root

encryptedPassword: $ROOT_PASSWORD

sshKeys:

- $USERKEY1

packages:

packageList:

- jq

sccRegistrationCode: $SCC_REGISTRATION_CODEEm que $SCC_REGISTRATION_CODE é o código de registro

copiado do SUSE Customer

Center, e a lista de pacotes contém o jq, que é

obrigatório.

$ROOT_PASSWORD é a senha criptografada do usuário root,

que pode ser útil para teste/depuração. É possível gerá-la com o comando

openssl passwd -6 PASSWORD.

Para os ambientes de produção, a recomendação é usar as chaves SSH que podem

ser adicionadas ao bloco de usuários substituindo a

$USERKEY1 pelas chaves SSH reais.

O net.ifnames=1 habilita a Nomenclatura

de interface de rede previsível.

Isso corresponde à configuração padrão do gráfico do

Metal3, mas a configuração deve corresponder ao

valor predictableNicNames do gráfico.

Veja também que o ignition.platform.id=openstack é

obrigatório. Sem esse argumento, a configuração do SUSE Linux Micro pelo

ignition vai falhar no fluxo automatizado do

Metal3.

A seção time é opcional, mas sua configuração é altamente

recomendada para evitar possíveis problemas com certificados e divergência

de relógio. O valor usado neste exemplo é somente para fins

ilustrativos. Ajuste-o de acordo com seus requisitos específicos.

1.3.4.1.2 Script growfs #

Atualmente, é necessário um script personalizado

(custom/scripts/01-fix-growfs.sh) para expandir o sistema

de arquivos de acordo com o tamanho do disco na primeira inicialização após

o provisionamento. O script 01-fix-growfs.sh contém as

seguintes informações:

#!/bin/bash

growfs() {

mnt="$1"

dev="$(findmnt --fstab --target ${mnt} --evaluate --real --output SOURCE --noheadings)"

# /dev/sda3 -> /dev/sda, /dev/nvme0n1p3 -> /dev/nvme0n1

parent_dev="/dev/$(lsblk --nodeps -rno PKNAME "${dev}")"

# Last number in the device name: /dev/nvme0n1p42 -> 42

partnum="$(echo "${dev}" | sed 's/^.*[^0-9]\([0-9]\+\)$/\1/')"

ret=0

growpart "$parent_dev" "$partnum" || ret=$?

[ $ret -eq 0 ] || [ $ret -eq 1 ] || exit 1

/usr/lib/systemd/systemd-growfs "$mnt"

}

growfs /Adicione seus próprios scripts personalizados para execução durante o processo de provisionamento usando a mesma abordagem. Para obter mais informações, consulte o Capítulo 3, Clusters independentes com o Edge Image Builder.

1.3.4.2 Criação de imagem #

Depois que a estrutura de diretórios for preparada de acordo com as seções anteriores, execute o seguinte comando para criar a imagem:

podman run --rm --privileged -it -v $PWD:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file downstream-cluster-config.yamlEle cria o arquivo de imagem de saída chamado

SLE-Micro-eib-output.raw, com base na definição descrita

acima.

Depois disso, a imagem de saída deverá estar disponível em um servidor web,

ou o contêiner de servidor de mídia habilitado pelo gráfico do Metal3 (Nota) ou um outro servidor acessível

localmente. Nos exemplos a seguir, chamamos esse servidor de

imagecache.local:8080.

Na implantação de imagens EIB em clusters downstream, é necessário também

incluir a soma sha256 da imagem no objeto

Metal3MachineTemplate. É possível gerá-la com este

comando:

sha256sum <image_file> > <image_file>.sha256

# On this example:

sha256sum SLE-Micro-eib-output.raw > SLE-Micro-eib-output.raw.sha2561.3.5 Adicionando o inventário de BareMetalHost #

Para registrar servidores bare metal para implantação automatizada, é necessário criar dois recursos: um segredo com as credenciais de acesso ao BMC e um recurso BareMetalHost do Metal3 com a definição da conexão com o BMC e outros detalhes:

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-credentials

type: Opaque

data:

username: YWRtaW4=

password: cGFzc3dvcmQ=

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

online: true

bootMACAddress: "00:f3:65:8a:a3:b0"

bmc:

address: redfish-virtualmedia://192.168.125.1:8000/redfish/v1/Systems/68bd0fb6-d124-4d17-a904-cdf33efe83ab

disableCertificateVerification: true

credentialsName: controlplane-0-credentialsObserve o seguinte:

O nome de usuário/senha do segredo deve ser codificado com base64. Observe que ele não deve incluir novas linhas à direita (por exemplo, usar

echo -n, não apenasecho!)É possível definir o rótulo

cluster-roleagora ou mais tarde, durante a criação do cluster. No exemplo abaixo, esperamoscontrol-planeouworkerbootMACAddressdeve ser um MAC válido correspondente à NIC de plano de controle do hostO endereço

bmcé a conexão com a API de gerenciamento de BMC. As seguintes opções são suportadas:redfish-virtualmedia://<ENDEREÇO IP>/redfish/v1/Systems/<ID DO SISTEMA>: mídia virtual Redfish, por exemplo, SuperMicroidrac-virtualmedia://<ENDEREÇO IP>/redfish/v1/Systems/System.Embedded.1: iDRAC da Dell

Consulte os documentos da API upstream para obter mais detalhes sobre a API BareMetalHost

1.3.5.1 Configurando IPs estáticos #

O exemplo do BareMetalHost acima considera que o DHCP configura a rede do plano de controle, mas nos cenários em que a configuração manual é necessária, como no caso dos IPs estáticos, é possível definir uma configuração adicional, conforme descrito abaixo.

1.3.5.1.1 Script adicional para configuração de rede estática #

Ao criar a imagem base com o Edge Image Builder, na pasta

network, crie o arquivo

configure-network.sh a seguir.

Esse procedimento consome os dados da unidade de configuração na primeira inicialização e configura a rede do host usando a ferramenta NM Configurator.

#!/bin/bash

set -eux

# Attempt to statically configure a NIC in the case where we find a network_data.json

# In a configuration drive

CONFIG_DRIVE=$(blkid --label config-2 || true)

if [ -z "${CONFIG_DRIVE}" ]; then

echo "No config-2 device found, skipping network configuration"

exit 0

fi

mount -o ro $CONFIG_DRIVE /mnt

NETWORK_DATA_FILE="/mnt/openstack/latest/network_data.json"

if [ ! -f "${NETWORK_DATA_FILE}" ]; then

umount /mnt

echo "No network_data.json found, skipping network configuration"

exit 0

fi

DESIRED_HOSTNAME=$(cat /mnt/openstack/latest/meta_data.json | tr ',{}' '\n' | grep '\"metal3-name\"' | sed 's/.*\"metal3-name\": \"\(.*\)\"/\1/')

echo "${DESIRED_HOSTNAME}" > /etc/hostname

mkdir -p /tmp/nmc/{desired,generated}

cp ${NETWORK_DATA_FILE} /tmp/nmc/desired/_all.yaml

umount /mnt

./nmc generate --config-dir /tmp/nmc/desired --output-dir /tmp/nmc/generated

./nmc apply --config-dir /tmp/nmc/generated1.3.5.1.2 Segredo adicional com a configuração de rede do host #

É possível definir um segredo adicional com os dados no formato nmstate suportado pela ferramenta NM Configurator (Capítulo 12, Rede de borda) para cada host.

Depois disso, o segredo será referenciado no recurso

BareMetalHost pelo campo de especificação

preprovisioningNetworkDataName.

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-networkdata

type: Opaque

stringData:

networkData: |

interfaces:

- name: enp1s0

type: ethernet

state: up

mac-address: "00:f3:65:8a:a3:b0"

ipv4:

address:

- ip: 192.168.125.200

prefix-length: 24

enabled: true

dhcp: false

dns-resolver:

config:

server:

- 192.168.125.1

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.125.1

next-hop-interface: enp1s0

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

preprovisioningNetworkDataName: controlplane-0-networkdata

# Remaining content as in previous exampleEm algumas situações, é possível omitir o endereço MAC. Consulte a Seção 12.5.8, “Configurações unificadas de nós” para obter mais detalhes.

1.3.5.2 Preparação do BareMetalHost #

Depois de criar o recurso BareMetalHost e os segredos associados conforme descrito acima, será acionado um fluxo de trabalho de preparação do host:

Uma imagem de disco RAM será iniciada depois de conectar a mídia virtual ao BMC do host de destino

O disco RAM inspeciona os detalhes do hardware e prepara o host para provisionamento (por exemplo, limpando os discos de dados anteriores)

Ao término desse processo, os detalhes do hardware no campo

status.hardwaredo BareMetalHost serão atualizados e poderão ser verificados

Esse processo pode levar bastante tempo, mas quando for concluído, você verá

que o estado do BareMetalHost deve mudar para available:

% kubectl get baremetalhost

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available true 9m44s

worker-0 available true 9m44s1.3.6 Criando clusters downstream #

Agora criamos os recursos de Cluster API que definem o cluster downstream e os recursos de Machine que provisionam e, depois, iniciam os recursos do BareMetalHost para formar um cluster RKE2.

1.3.7 Implantação do plano de controle #

Para implantar o plano de controle, definimos um manifesto YAML semelhante ao mostrado abaixo, que contém os seguintes recursos:

O recurso Cluster define o nome do cluster, as redes e o tipo de provedor de plano de controle/infraestrutura (neste caso, RKE2/Metal3)

Metal3Cluster define o endpoint do plano de controle (IP do host para nó único, endpoint LoadBalancer para vários nós; neste exemplo, foi considerado o nó único)

RKE2ControlPlane define a versão RKE2 e a configuração adicional necessária durante a inicialização do cluster

Metal3MachineTemplate define a imagem do sistema operacional que será aplicada aos recursos do BareMetalHost, e hostSelector define quais BareMetalHosts serão consumidos

Metal3DataTemplate define o metaData adicional que será passado para o BareMetalHost (veja que o networkData não é suportado na solução Edge)

Para simplificar, este exemplo considera um plano de controle de nó único em

que o BareMetalHost está configurado com o IP

192.168.125.200. Para ver exemplos mais avançados de

vários nós, consulte o Capítulo 42, Provisionamento de rede direcionado totalmente automatizado.

apiVersion: cluster.x-k8s.io/v1beta1

kind: Cluster

metadata:

name: sample-cluster

namespace: default

spec:

clusterNetwork:

pods:

cidrBlocks:

- 192.168.0.0/18

services:

cidrBlocks:

- 10.96.0.0/12

controlPlaneRef:

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

name: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

name: sample-cluster

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

metadata:

name: sample-cluster

namespace: default

spec:

controlPlaneEndpoint:

host: 192.168.125.200

port: 6443

noCloudProvider: true

---

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

metadata:

name: sample-cluster

namespace: default

spec:

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-controlplane

replicas: 1

version: v1.32.4+rke2r1

rolloutStrategy:

type: "RollingUpdate"

rollingUpdate:

maxSurge: 0

agentConfig:

format: ignition

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-controlplane

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-controlplane-template

hostSelector:

matchLabels:

cluster-role: control-plane

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-controlplane-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machineDepois de adaptado ao seu ambiente, aplique o exemplo usando o

kubectl e monitore o status do cluster por meio do

clusterctl.

% kubectl apply -f rke2-control-plane.yaml

# Wait for the cluster to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 22m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 27m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 22m

│ └─Machine/sample-cluster-chflc True 23m1.3.8 Implantação de worker/computação #

De maneira semelhante à implantação do plano de controle, definimos um manifesto YAML que contém os seguintes recursos:

MachineDeployment define o número de réplicas (hosts) e o provedor de inicialização/infraestrutura (neste caso, RKE2/Metal3)

RKE2ConfigTemplate descreve a versão RKE2 e a configuração da primeira inicialização para inicializar o host do agente

Metal3MachineTemplate define a imagem do sistema operacional que será aplicada aos recursos do BareMetalHost, e o seletor de host define quais BareMetalHosts serão consumidos

Metal3DataTemplate define os metadados adicionais que serão passados para o BareMetalHost (veja que o

networkDatanão é suportado atualmente)

apiVersion: cluster.x-k8s.io/v1beta1

kind: MachineDeployment

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

name: sample-cluster

namespace: default

spec:

clusterName: sample-cluster

replicas: 1

selector:

matchLabels:

cluster.x-k8s.io/cluster-name: sample-cluster

template:

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

spec:

bootstrap:

configRef:

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

name: sample-cluster-workers

clusterName: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-workers

nodeDrainTimeout: 0s

version: v1.32.4+rke2r1

---

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

agentConfig:

format: ignition

version: v1.32.4+rke2r1

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-workers-template

hostSelector:

matchLabels:

cluster-role: worker

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-workers-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machineQuando o exemplo acima for copiado e adaptado ao seu ambiente, ele poderá

ser aplicado usando o kubectl e, depois, o status do

cluster poderá ser monitorado com o clusterctl

% kubectl apply -f rke2-agent.yaml

# Wait for the worker nodes to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 25m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 30m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 25m

│ └─Machine/sample-cluster-chflc True 27m

└─Workers

└─MachineDeployment/sample-cluster True 22m

└─Machine/sample-cluster-56df5b4499-zfljj True 23m1.3.9 Desprovisionamento do cluster #

É possível desprovisionar o cluster downstream excluindo os recursos que foram aplicados nas etapas de criação acima:

% kubectl delete -f rke2-agent.yaml

% kubectl delete -f rke2-control-plane.yamlEsse procedimento aciona o desprovisionamento dos recursos do BareMetalHost, o que pode levar bastante tempo. Depois disso, eles deverão voltar para o estado disponível:

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 deprovisioning sample-cluster-controlplane-vlrt6 false 10m

worker-0 deprovisioning sample-cluster-workers-785x5 false 10m

...

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available false 15m

worker-0 available false 15m1.4 Problemas conhecidos #

O controlador de gerenciamento de endereços IP upstream não é suportado no momento porque ainda não é compatível com a nossa seleção de ferramentas de configuração de rede e conjunto de ferramentas de primeira inicialização no SLEMicro.

De modo semelhante, os recursos IPAM e os campos networkData de Metal3DataTemplate não são suportados no momento.

Apenas há suporte para implantação por redfish-virtualmedia.

1.5 Alterações planejadas #

Habilitar suporte de recursos e configuração do IPAM pelos campos networkData

1.6 Recursos adicionais #

A documentação do SUSE Edge for Telco (Capítulo 37, SUSE Edge for Telco) tem exemplos de uso mais avançado do Metal3 para casos de uso de telecomunicações.

1.6.1 Configuração de nó único #

Para ambientes de teste/PoC em que o cluster de gerenciamento é um nó único, é possível evitar o requisito de IP flutuante adicional gerenciado por MetalLB.

Nesse modo, o endpoint para as APIs do cluster de gerenciamento é o IP do

cluster de gerenciamento, portanto, ele deve ser reservado ao usar DHCP ou

configurado estaticamente para garantir que não seja alterado. Mencionado

abaixo como <MANAGEMENT_CLUSTER_IP>.

Para possibilitar esse cenário, os valores do gráfico do Metal3 necessários são estes:

global:

ironicIP: <MANAGEMENT_CLUSTER_IP>

metal3-ironic:

service:

type: NodePort1.6.2 Desabilitando TLS para anexo de ISO de mídia virtual #

Alguns fornecedores de servidor verificam a conexão SSL ao anexar imagens ISO de mídia virtual ao BMC, o que pode causar um problema porque os certificados gerados para a implantação do Metal3 são autoassinados. Para solucionar esse problema, desabilite o TLS apenas para anexo de disco de mídia virtual com os valores do gráfico do Metal3 a seguir:

global:

enable_vmedia_tls: falseUma solução alternativa é configurar os BMCs com o certificado de CA. Nesse

caso, você pode ler os certificados do cluster usando o

kubectl:

kubectl get secret -n metal3-system ironic-vmedia-cert -o yamlDepois disso, o certificado poderá ser configurado no console de BMC do

servidor, embora o processo para isso seja específico do fornecedor (e pode

não ser possível para todos os fornecedores e, consequentemente, exigir o

uso do sinalizador enable_vmedia_tls).

1.6.3 Configuração do armazenamento #

Para ambientes de teste/PoC em que o cluster de gerenciamento é um nó único, não há necessidade de armazenamento persistente; mas em casos de uso de produção, a recomendação é instalar o SUSE Storage (Longhorn) no cluster de gerenciamento para que as imagens relacionadas ao Metal3 persistam durante a reinicialização/reprogramação de um pod.

Para habilitar o armazenamento persistente, os valores do gráfico do Metal3 necessários são estes:

metal3-ironic:

persistence:

ironic:

size: "5Gi"A documentação para cluster de gerenciamento do SUSE Edge for Telco (Capítulo 40, Configurando o cluster de gerenciamento) tem mais detalhes sobre como configurar um cluster de gerenciamento com armazenamento persistente.

2 Integração remota de host com o Elemental #

Esta seção apresenta a solução de "provisionamento de rede 'phone home'" como parte do SUSE Edge, em que usamos o Elemental para auxiliar na integração de nós. O Elemental é uma pilha de software que permite o registro remoto de hosts e o gerenciamento de sistema operacional nativo de nuvem e totalmente centralizado com o Kubernetes. Na pilha do SUSE Edge, usamos o recurso de registro do Elemental para fazer a integração remota de hosts no Rancher, o que permite integrar os hosts a uma plataforma de gerenciamento centralizada e, nela, implantar e gerenciar os clusters Kubernetes junto com os componentes em camadas, os aplicativos e o ciclo de vida deles, tudo de um único local.

Essa abordagem pode ser útil em cenários em que os dispositivos que você deseja controlar não estão na mesma rede que o cluster de gerenciamento, ou não têm uma integração por controlador de gerenciamento fora da banda que permita um controle mais direto, e quando você inicializa vários sistemas "desconhecidos" na borda e precisa integrá-los e gerenciá-los com segurança e em escala. Esse cenário é comum nos casos de uso de varejo, IoT industrial ou em outros ambientes de baixo controle da rede em que os dispositivos são instalados.

2.1 Arquitetura de alto nível #

2.2 Recursos necessários #

Veja a seguir uma descrição dos requisitos mínimos de sistema e de ambiente para execução por meio desta inicilização rápida:

Um host para o cluster de gerenciamento centralizado (o mesmo que hospeda o Rancher e o Elemental):

Espaço em disco mínimo de 8 GB RAM e 20 GB para desenvolvimento ou teste (consulte aqui para uso em produção)

O provisionamento de um nó de destino, ou seja, o dispositivo de borda (é possível usar uma máquina virtual para fins de demonstração ou teste)

Mínimo de 4GB de RAM, 2 núcleos de CPU e disco de 20 GB

Um nome de host "resolvable" para o cluster de gerenciamento ou um endereço IP estático para usar com um serviço do tipo sslip.io

Um host para montar a mídia de instalação usando o Edge Image Builder

Uma unidade flash USB de origem para inicialização (em caso de hardware físico)

Uma cópia baixada da imagem ISO mais recente do SelfInstall do SUSE Linux Micro 6.1 disponível aqui.

Os dados existentes nas máquinas de destino serão substituídos como parte do processo. Faça um backup dos dados em dispositivos de armazenamento USB e discos conectados aos nós de implantação de destino.

Este guia foi criado com um droplet da DigitalOcean para hospedar o cluster upstream e com um Intel NUC como dispositivo downstream. Para montar a mídia de instalação, o SUSE Linux Enterprise Server foi usado.

2.3 Criar o cluster de inicialização #

Para começar, crie um cluster capaz de hospedar o Rancher e o Elemental. Esse cluster precisa ser roteável na rede à qual os nós downstream estão conectados.

2.3.1 Criar o cluster Kubernetes #

Se você usa um hiperescalador (como Azure, AWS ou Google Cloud), a maneira mais fácil de configurar um cluster é usar as ferramentas incorporadas dele. Para manter este guia conciso, não detalhamos o processo de cada uma dessas opções.

Se você está instalando em um serviço de hospedagem bare metal, ou algum outro, e precisa também providenciar a própria distribuição Kubernetes, recomendamos usar o RKE2.

2.3.2 Configurar o DNS #

Antes de continuar, você precisa configurar o acesso ao cluster. Assim como na configuração do próprio cluster, a configuração do DNS será diferente dependendo do local onde ele está hospedado.

Se você não deseja configurar registros DNS (por exemplo, quando se trata

apenas de um servidor de teste efêmero), uma alternativa é usar um serviço

como o sslip.io. Com ele, você

resolve qualquer endereço IP com

<endereço>.sslip.io.

2.4 Instalar o Rancher #

Para instalar o Rancher, você precisa acessar a API Kubernetes do cluster que acabou de criar. Esse procedimento muda dependendo da distribuição Kubernetes que é usada.

Para o RKE2, o arquivo kubeconfig será gravado em

/etc/rancher/rke2/rke2.yaml. Salve-o como

~/.kube/config no sistema local. Talvez você tenha que

editar o arquivo para incluir o endereço IP ou o nome de host roteável

externamente correto.

Instale o Rancher facilmente com os comandos apresentados na documentação do Rancher:

Instale o cert-manager:

helm repo add jetstack https://charts.jetstack.io

helm repo update

helm install cert-manager jetstack/cert-manager \

--namespace cert-manager \

--create-namespace \

--set crds.enabled=trueEm seguida, instale o próprio Rancher:

helm repo add rancher-prime https://charts.rancher.com/server-charts/prime

helm repo update

helm install rancher rancher-prime/rancher \

--namespace cattle-system \

--create-namespace \

--set hostname=<DNS or sslip from above> \

--set replicas=1 \

--set bootstrapPassword=<PASSWORD_FOR_RANCHER_ADMIN> \

--version 2.11.2Se a finalidade do sistema é de produção, use o cert-manager para configurar um certificado real (como aquele da Let’s Encrypt).

Procure o nome de host que você configurou e faça login no Rancher com a

bootstrapPassword usada. Você será guiado por um curto

processo de configuração.

2.5 Instalar o Elemental #

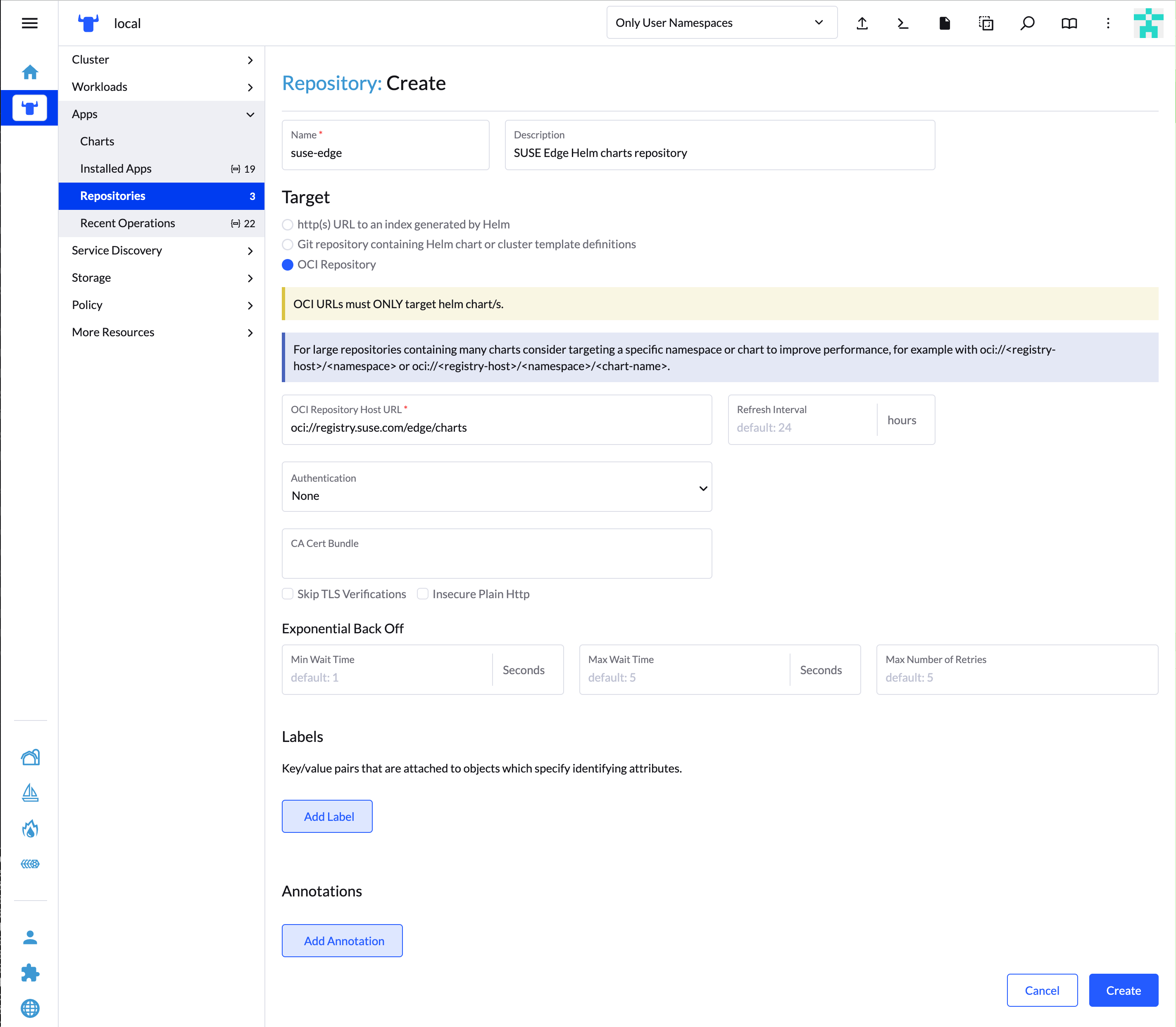

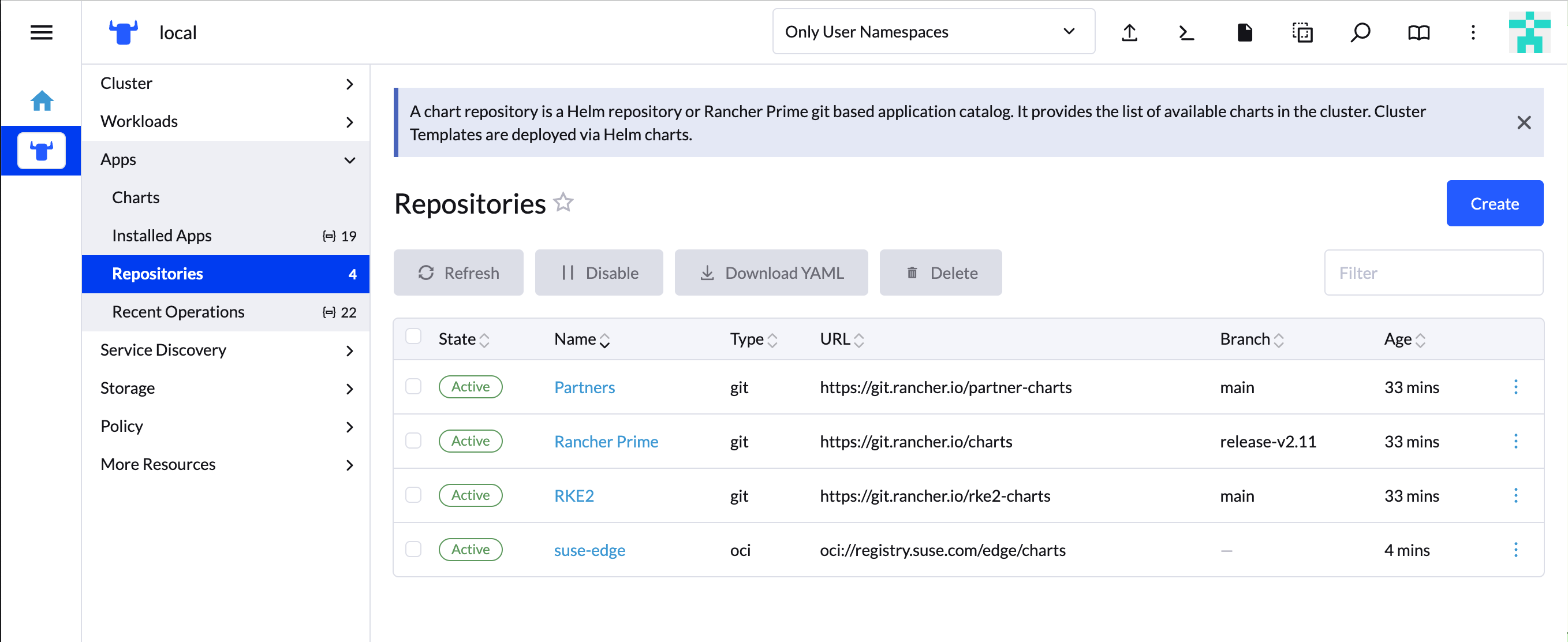

Com o Rancher instalado, agora você pode instalar o operador Elemental e as CRDs necessárias. O gráfico Helm do Elemental foi publicado como um artefato OCI, portanto, a instalação é um pouco mais simples do que a dos outros gráficos. É possível instalá-lo do mesmo shell usado para instalar o Rancher ou no navegador dentro do shell do Rancher.

helm install --create-namespace -n cattle-elemental-system \

elemental-operator-crds \

oci://registry.suse.com/rancher/elemental-operator-crds-chart \

--version 1.6.8

helm install -n cattle-elemental-system \

elemental-operator \

oci://registry.suse.com/rancher/elemental-operator-chart \

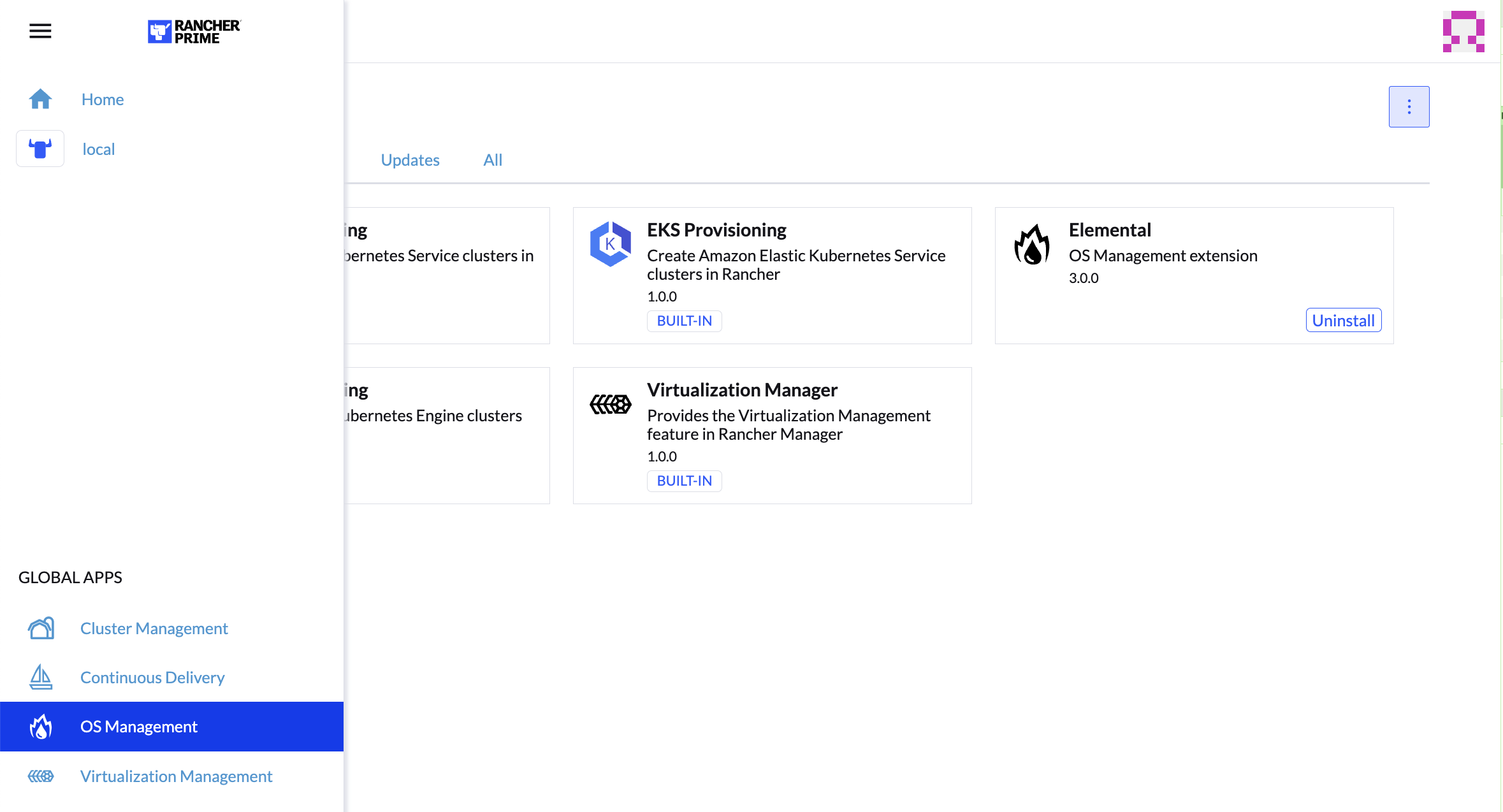

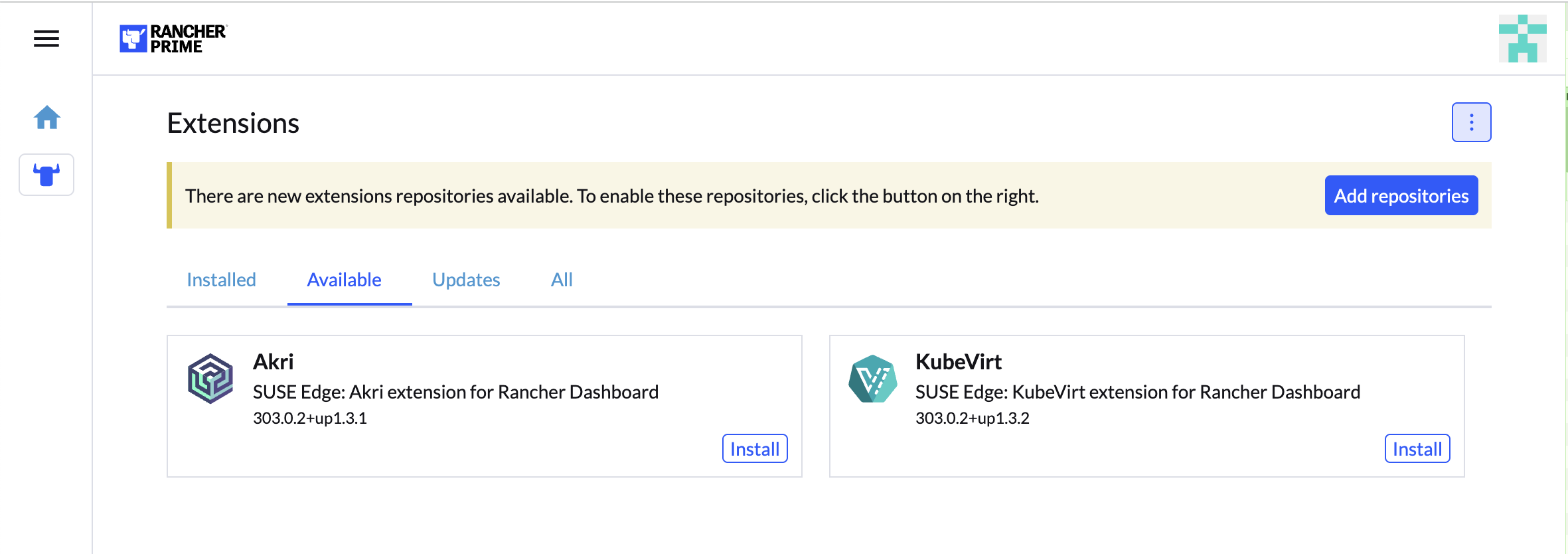

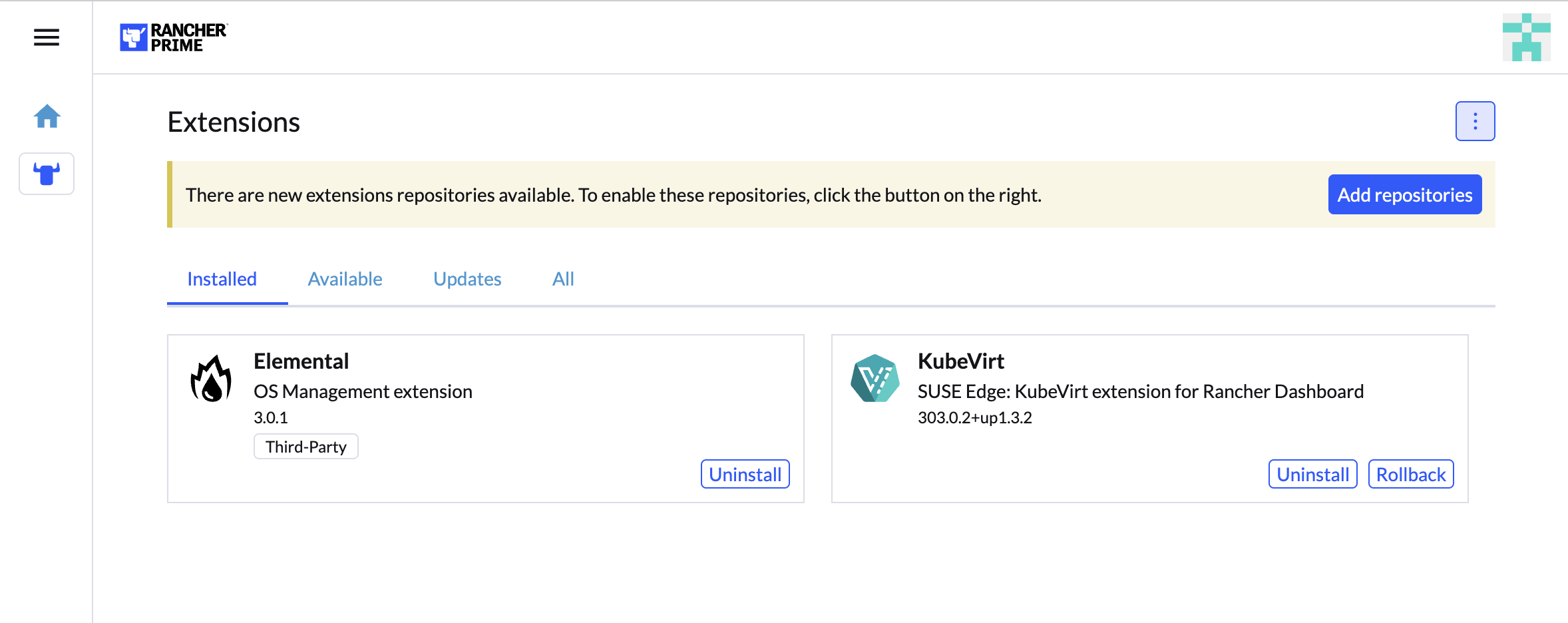

--version 1.6.82.5.1 Instalar a extensão de IU do Elemental (opcional) #

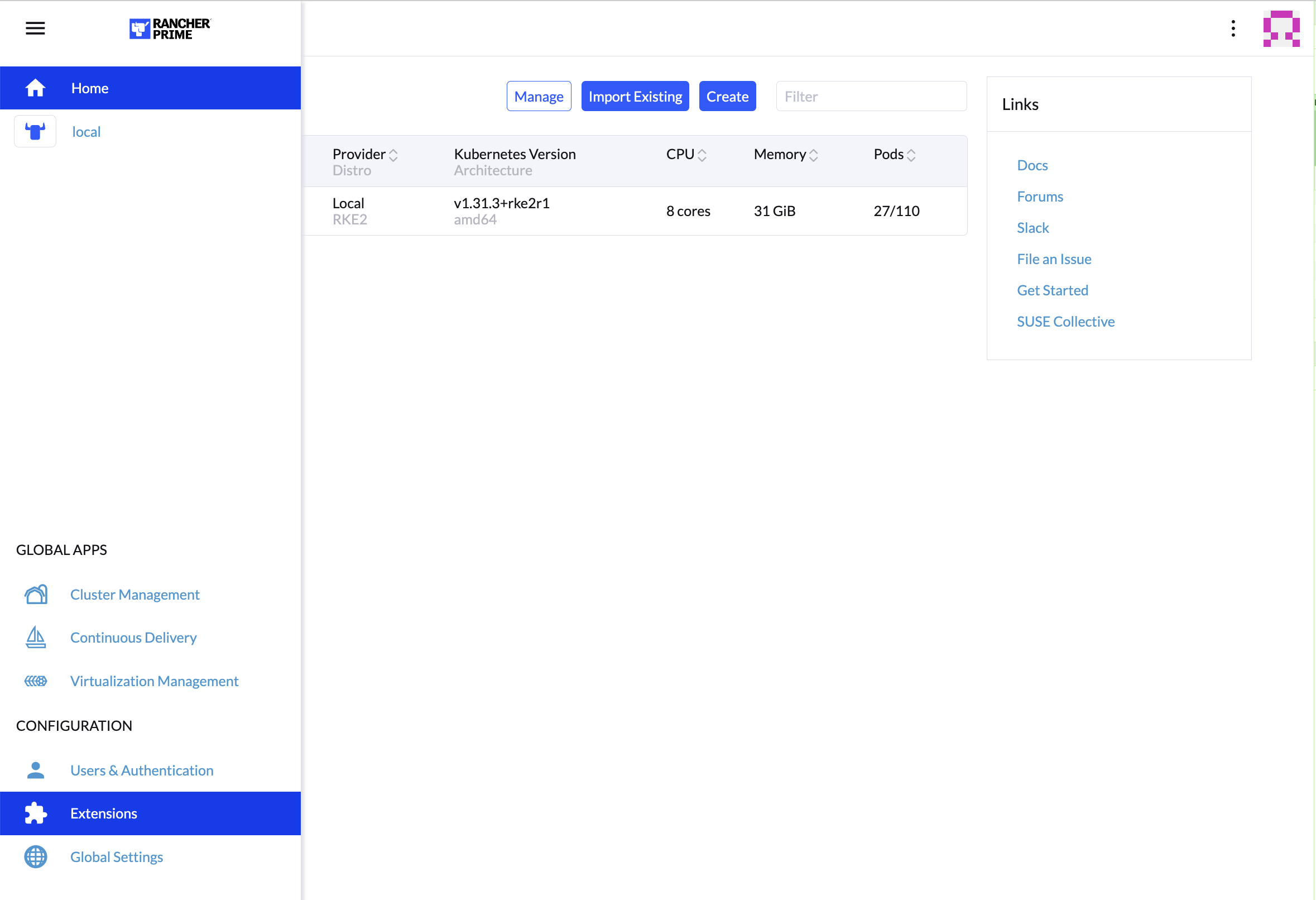

Para usar a IU do Elemental, faça login na instância do Rancher e clique no menu de três linhas na parte superior esquerda:

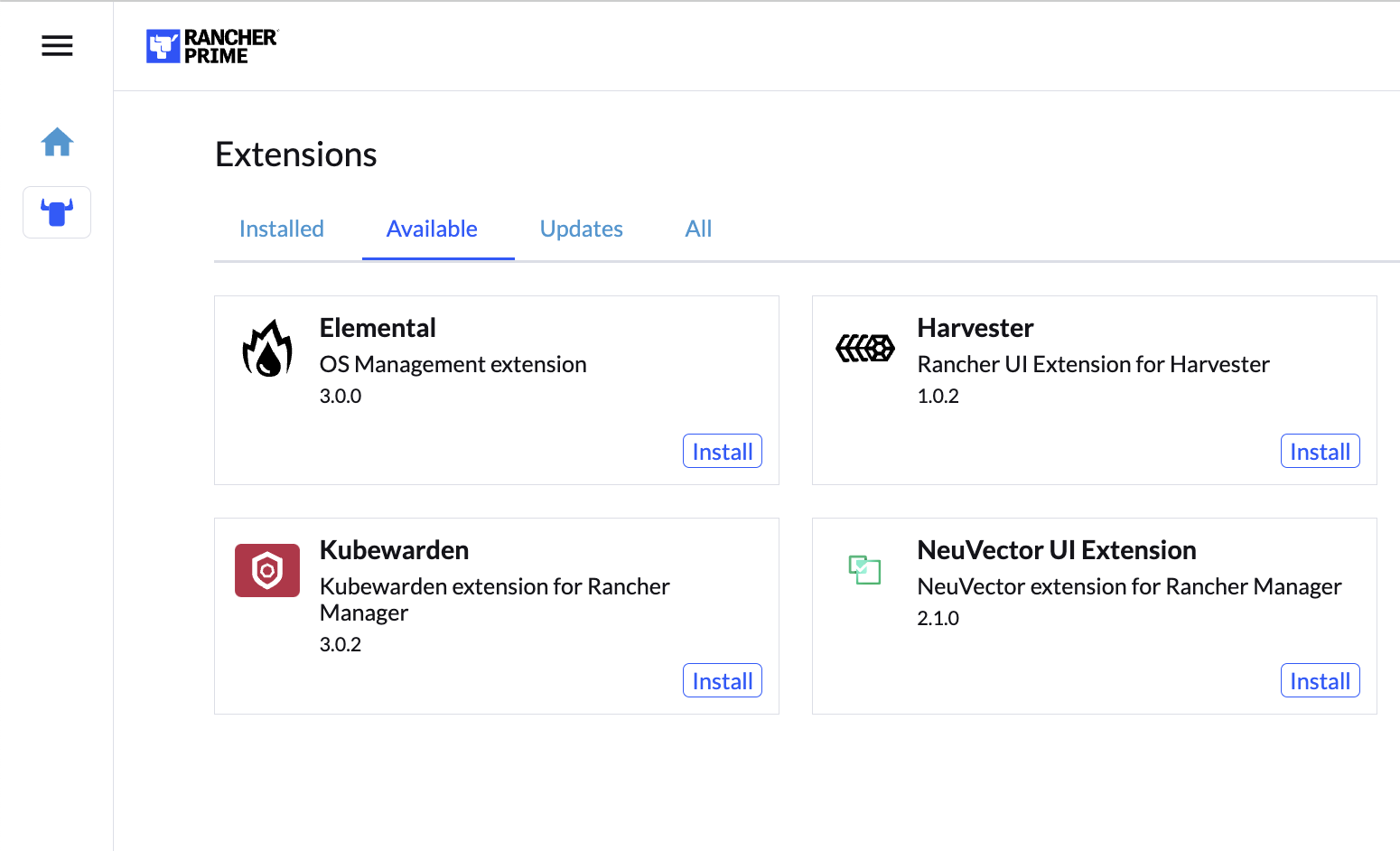

Na guia "Available" (Disponível) nesta página, clique em "Install" (Instalar) no cartão Elemental:

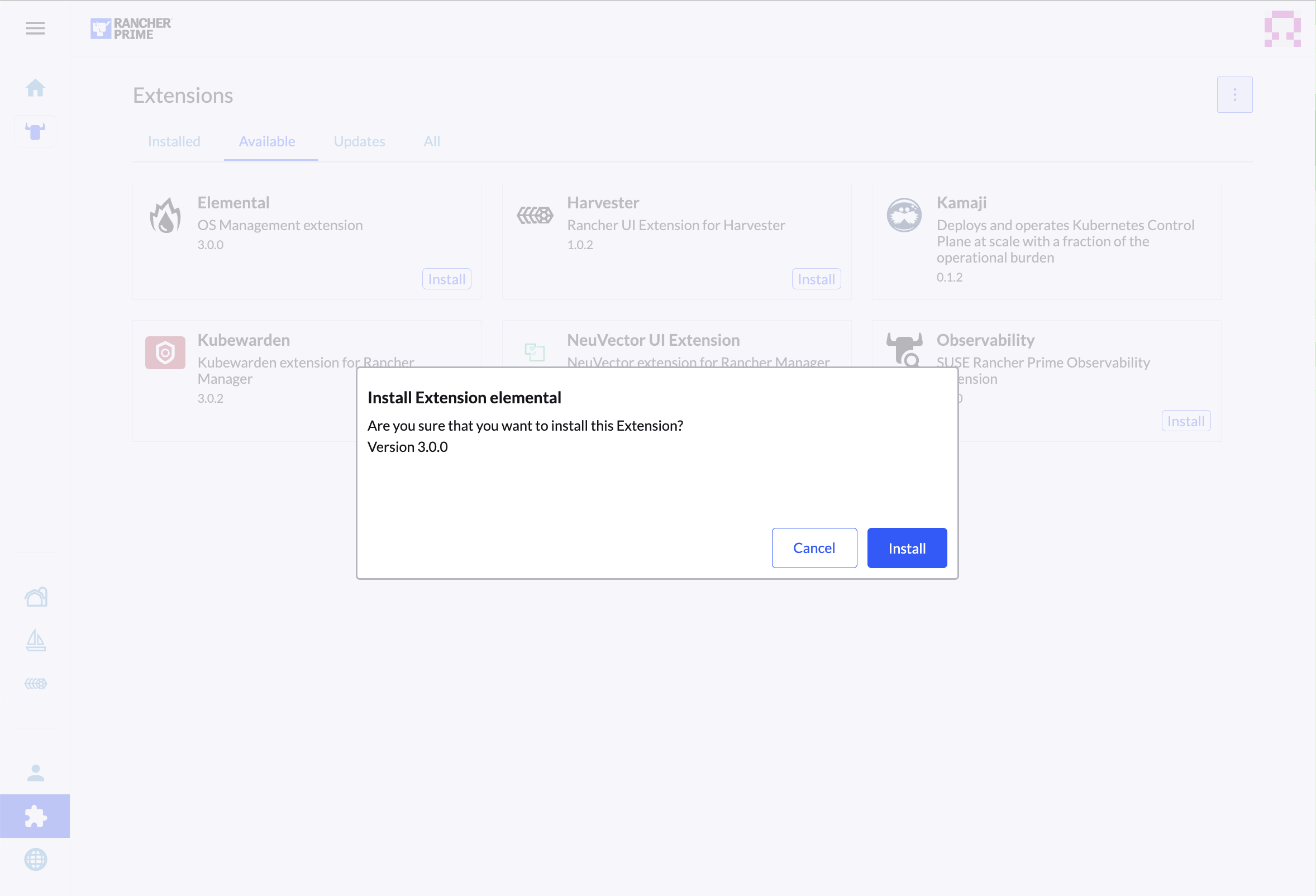

Confirme que você deseja instalar a extensão:

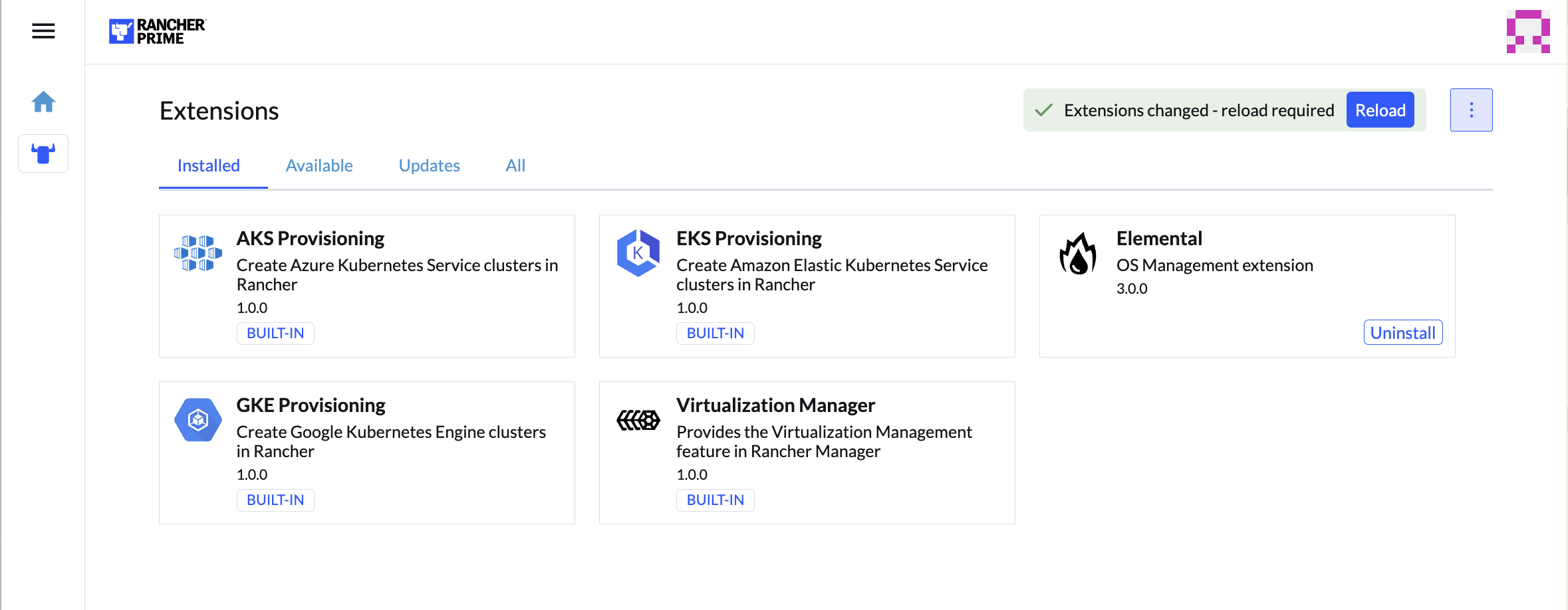

Após a instalação, será solicitado que você recarregue a página.

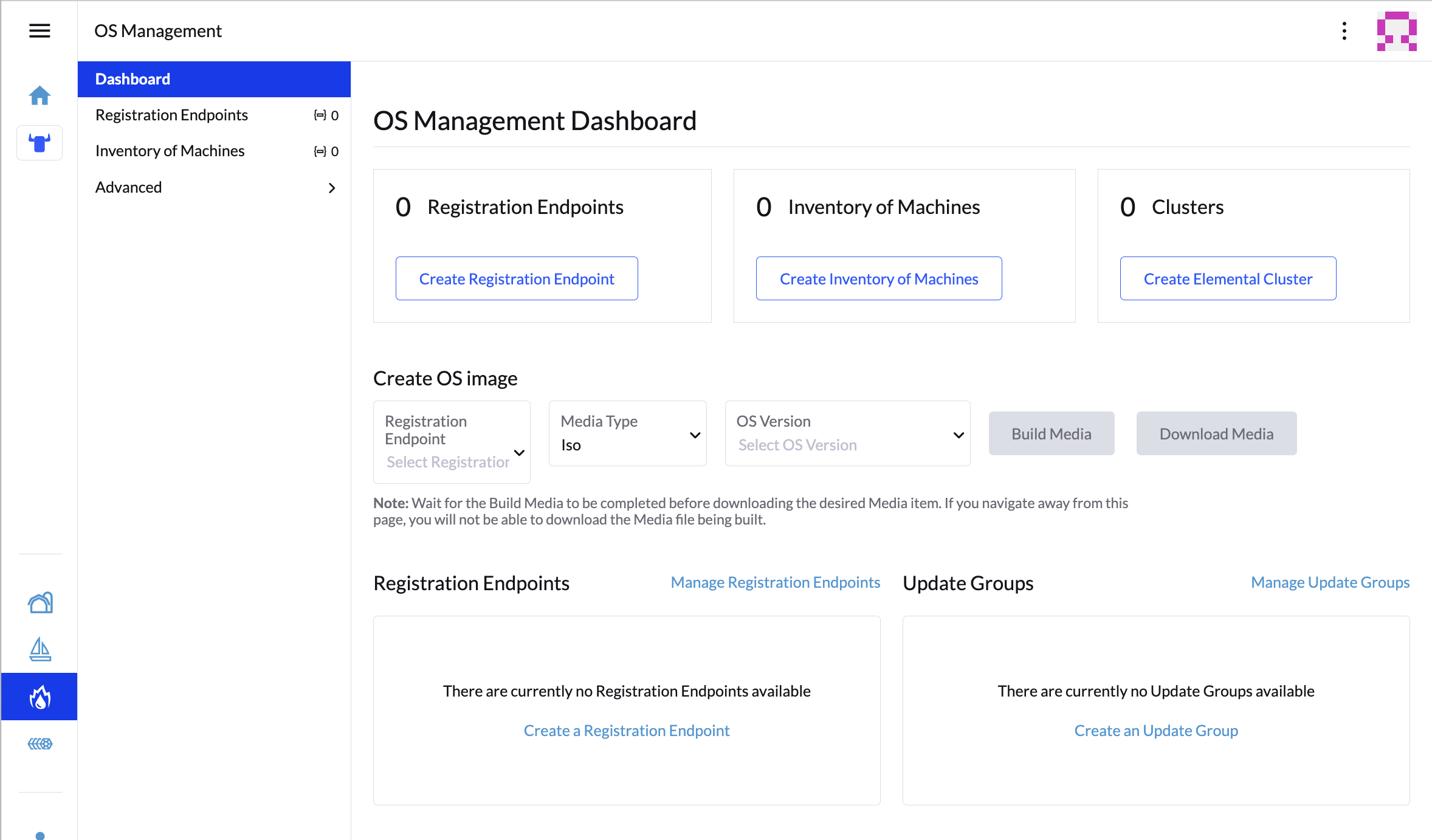

Após o recarregamento, acesse a extensão do Elemental pelo app global "OS Management".

2.6 Configurar o Elemental #

Para simplificar, recomendamos definir a variável $ELEM

como o caminho completo do local desejado para o diretório de configuração:

export ELEM=$HOME/elemental

mkdir -p $ELEMPara que as máquinas sejam registradas no Elemental, precisamos criar um

objeto MachineRegistration no namespace

fleet-default.

Vamos criar uma versão básica desse objeto:

cat << EOF > $ELEM/registration.yaml

apiVersion: elemental.cattle.io/v1beta1

kind: MachineRegistration

metadata:

name: ele-quickstart-nodes

namespace: fleet-default

spec:

machineName: "\${System Information/Manufacturer}-\${System Information/UUID}"

machineInventoryLabels:

manufacturer: "\${System Information/Manufacturer}"

productName: "\${System Information/Product Name}"

EOF

kubectl apply -f $ELEM/registration.yamlO comando cat insere um caractere de escape de barra

(\) para cada $ para que o Bash não os

utilize como gabarito. Remova as barras se estiver copiando manualmente.

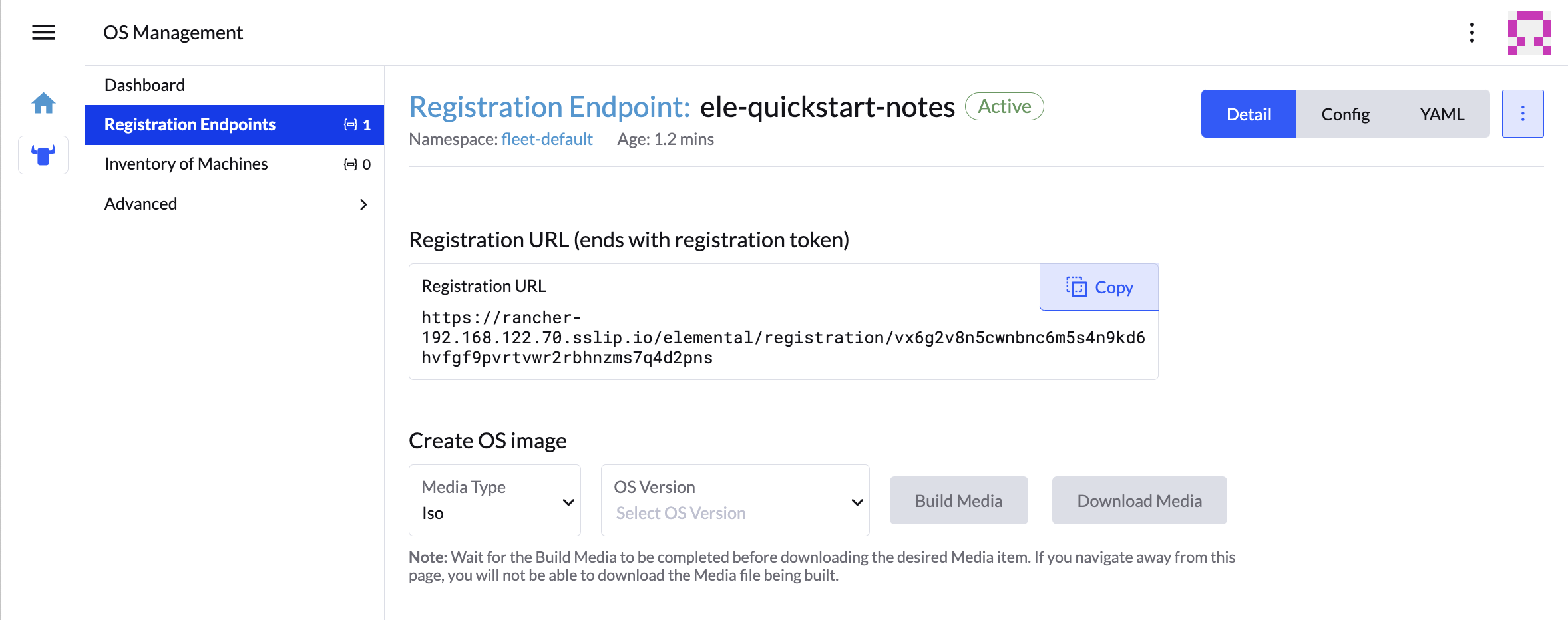

Depois que o objeto é criado, encontre e observe o endpoint que foi atribuído:

REGISURL=$(kubectl get machineregistration ele-quickstart-nodes -n fleet-default -o jsonpath='{.status.registrationURL}')Você também pode fazer isso pela IU.

- Extensão de IU

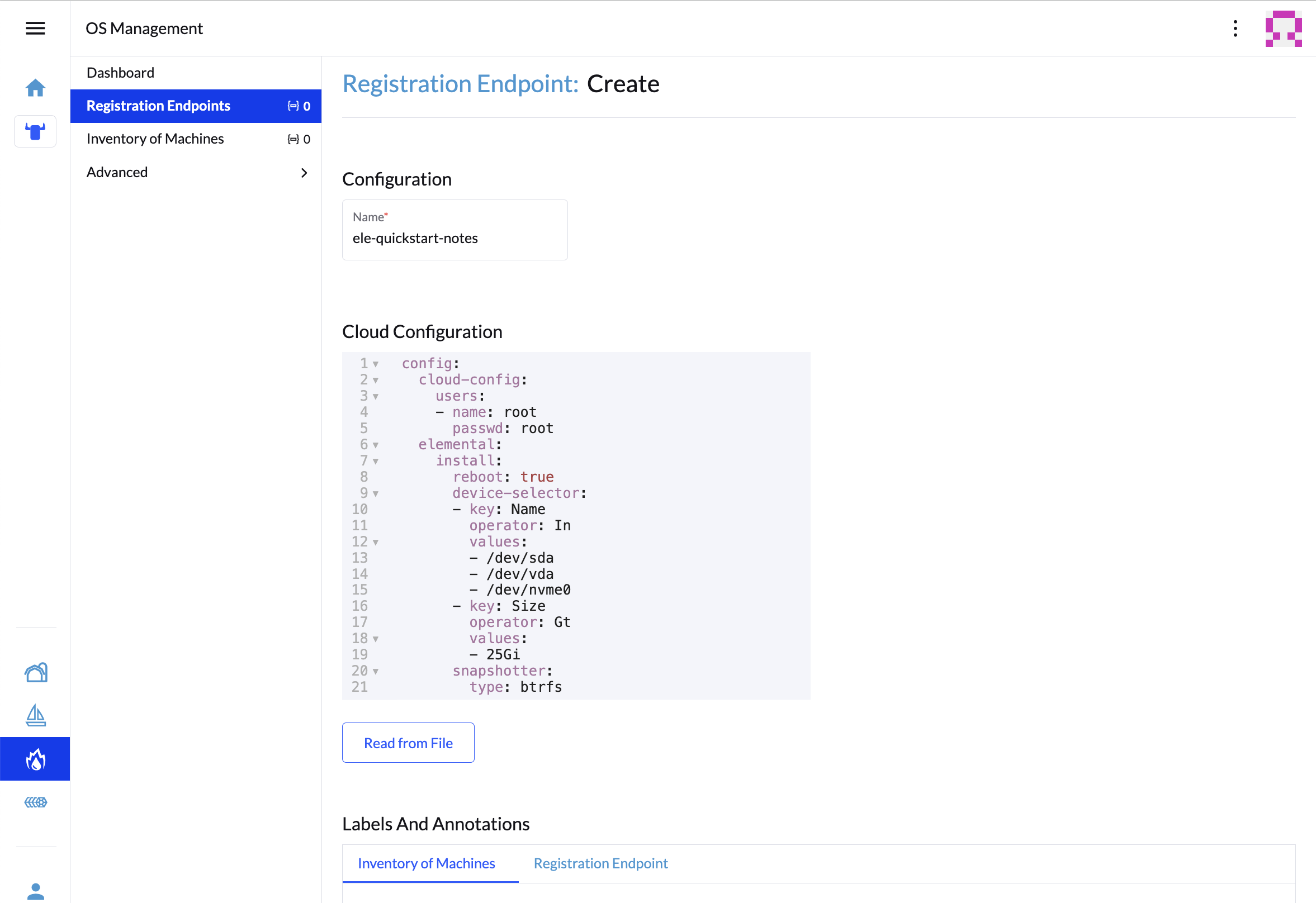

Na extensão OS Management, clique em "Create Registration Endpoint" (Criar endpoint de registro):

Dê um nome para esta configuração.

NotaVocê pode ignorar o campo Cloud Configuration (Configuração de nuvem) já que os dados nele serão substituídos ao executar as etapas a seguir com o Edge Image Builder.

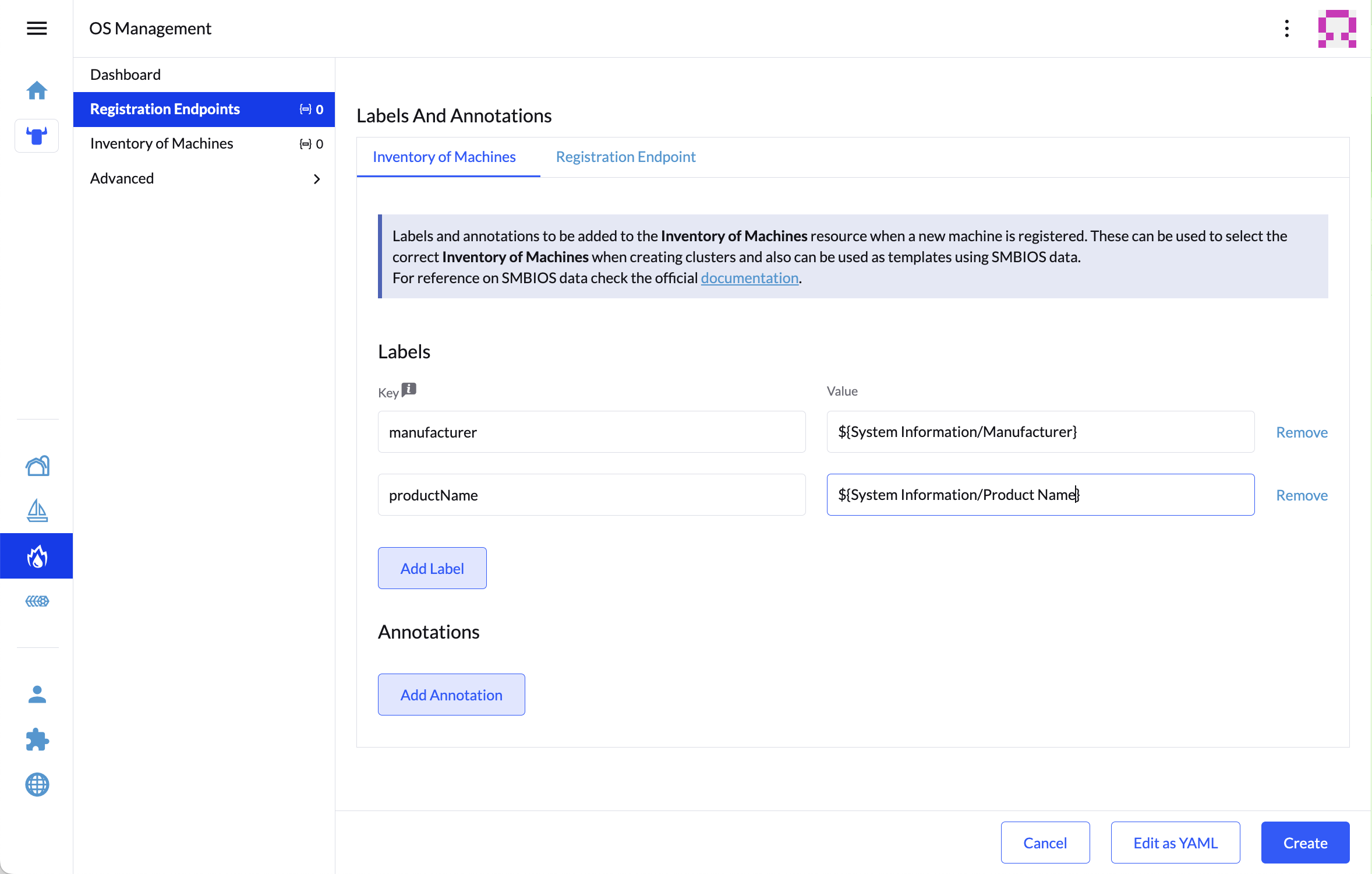

Em seguida, role para baixo e clique em "Add Label" (Adicionar rótulo) para cada rótulo que deseja incluir no recurso criado quando a máquina é registrada. Isso é útil para distinguir as máquinas.

Clique em "Create" (Criar) para salvar a configuração.

Após a criação do registro, você deverá ver o URL dele listado e poderá clicar em "Copy" (Copiar) para copiar o endereço:

DicaSe você clicou fora dessa tela, pode clicar em "Registration Endpoints" (Endpoints de registro) no menu esquerdo e, depois, no nome do endpoint que acabou de criar.

Esse URL será usado na próxima etapa.

2.7 Criar a imagem #

A versão atual do Elemental conta com um método para criar a própria mídia de instalação. No SUSE Edge 3.3.1, fazemos isso com o Kiwi e o Edge Image Builder, portanto, o sistema resultante é desenvolvido com o SUSE Linux Micro como o sistema operacional de base.

Para saber mais detalhes sobre o Kiwi, siga o processo do construtor de imagens do Kiwi (Capítulo 28, Criando imagens atualizadas do SUSE Linux Micro com o Kiwi) para primeiro criar novas imagens e, para o Edge Image Builder, consulte o Guia de Introdução do Edge Image Builder (Capítulo 3, Clusters independentes com o Edge Image Builder) e também a documentação do componente (Capítulo 11, Edge Image Builder).

Em um sistema Linux com o Podman instalado, crie os diretórios e insira a imagem base criada pelo Kiwi:

mkdir -p $ELEM/eib_quickstart/base-images

cp /path/to/{micro-base-image-iso} $ELEM/eib_quickstart/base-images/

mkdir -p $ELEM/eib_quickstart/elementalcurl $REGISURL -o $ELEM/eib_quickstart/elemental/elemental_config.yamlcat << EOF > $ELEM/eib_quickstart/eib-config.yaml

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso

outputImageName: elemental-image.iso

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

isoConfiguration:

installDevice: /dev/vda

users:

- username: root

encryptedPassword: \$6\$jHugJNNd3HElGsUZ\$eodjVe4te5ps44SVcWshdfWizrP.xAyd71CVEXazBJ/.v799/WRCBXxfYmunlBO2yp1hm/zb4r8EmnrrNCF.P/

packages:

sccRegistrationCode: XXX

EOFA seção

timeé opcional, mas sua configuração é altamente recomendada para evitar possíveis problemas com certificados e divergência de relógio. O valor usado neste exemplo é somente para fins ilustrativos. Ajuste-o de acordo com seus requisitos específicos.A senha não codificada é

eib.O

sccRegistrationCodeé necessário para fazer download e instalar os RPMs exigidos das fontes oficiais (se preferir, faça sideload manual dos RPMselemental-registere oelemental-system-agent).O comando

catinsere um caractere de escape de barra (\) para cada$para que o Bash não os utilize como gabarito. Remova as barras se estiver copiando manualmente.O dispositivo de instalação será apagado durante a instalação.

podman run --privileged --rm -it -v $ELEM/eib_quickstart/:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file eib-config.yamlSe você está inicializando um dispositivo físico, precisa gravar a imagem em uma unidade flash USB, o que pode ser feito com o comando:

sudo dd if=/eib_quickstart/elemental-image.iso of=/dev/<PATH_TO_DISK_DEVICE> status=progress2.8 Inicializar os nós downstream #

Agora que já criamos a mídia de instalação, podemos inicializar os nós downstream com ela.

Para cada um dos sistemas que você quer controlar usando o Elemental, adicione a mídia de instalação e inicialize o dispositivo. Após a instalação, ele será reinicializado e se registrará.

Se você usa a extensão de IU, deve ver o nó listado em "Inventory of Machines" (Inventário de máquinas).

Não remova o meio de instalação antes de ver o prompt de login. Durante a primeira inicialização, os arquivos ainda são acessados no dispositivo USB.

2.9 Criar clusters downstream #

Precisamos criar dois objetos ao provisionar um novo cluster usando o Elemental.

- Linux

- Extensão de IU

O primeiro é o MachineInventorySelectorTemplate. Esse

objeto permite especificar um mapeamento entre os clusters e as máquinas no

inventário.

Crie um seletor que corresponda qualquer máquina no inventário com um rótulo:

cat << EOF > $ELEM/selector.yaml apiVersion: elemental.cattle.io/v1beta1 kind: MachineInventorySelectorTemplate metadata: name: location-123-selector namespace: fleet-default spec: template: spec: selector: matchLabels: locationID: '123' EOFAplique o recurso ao cluster:

kubectl apply -f $ELEM/selector.yamlObtenha o nome da máquina e adicione o rótulo correspondente:

MACHINENAME=$(kubectl get MachineInventory -n fleet-default | awk 'NR>1 {print $1}') kubectl label MachineInventory -n fleet-default \ $MACHINENAME locationID=123Crie um recurso de cluster K3s simples de nó único e aplique-o ao cluster:

cat << EOF > $ELEM/cluster.yaml apiVersion: provisioning.cattle.io/v1 kind: Cluster metadata: name: location-123 namespace: fleet-default spec: kubernetesVersion: v1.32.4+k3s1 rkeConfig: machinePools: - name: pool1 quantity: 1 etcdRole: true controlPlaneRole: true workerRole: true machineConfigRef: kind: MachineInventorySelectorTemplate name: location-123-selector apiVersion: elemental.cattle.io/v1beta1 EOF kubectl apply -f $ELEM/cluster.yaml

Após a criação dos objetos, você deverá ver um novo cluster Kubernetes dar arranque (partida) usando o nó com o qual você acabou de instalar.

2.10 Redefinição de nó (opcional) #

O SUSE Rancher Elemental permite executar uma "redefinição de nó", que pode ser acionada quando um cluster inteiro é excluído do Rancher, um único nó é excluído do cluster ou um nó é excluído manualmente do inventário de máquinas. Esse recurso é útil para redefinir e limpar recursos órfãos e recuperar automaticamente o nó limpo no inventário de máquinas para que possa ser reutilizado. Isso não está habilitado por padrão e, portanto, um sistema que foi removido não será limpo (ou seja, os dados não serão removidos, e os recursos do cluster Kubernetes continuarão operando nos clusters downstream), será necessária uma intervenção manual para limpar os dados e registrar a máquina novamente no Rancher pelo Elemental.

Para habilitar essa funcionalidade por padrão, você precisa garantir que o

MachineRegistration a habilite explicitamente adicionando

config.elemental.reset.enabled: true, por exemplo:

config:

elemental:

registration:

auth: tpm

reset:

enabled: trueNa sequência, todos os sistemas registrados com esse

MachineRegistration receberão automaticamente a anotação

elemental.cattle.io/resettable: 'true' na respectiva

configuração. Para fazer isso manualmente em nós individuais, por exemplo,

porque obteve um MachineInventory existente que não tem

essa anotação ou já implantou os nós, você pode modificar o

MachineInventory e adicionar a configuração

resettable, por exemplo:

apiVersion: elemental.cattle.io/v1beta1

kind: MachineInventory

metadata:

annotations:

elemental.cattle.io/os.unmanaged: 'true'

elemental.cattle.io/resettable: 'true'No SUSE Edge 3.1, o operador Elemental insere um marcador no sistema

operacional que aciona o processo de limpeza automaticamente; ele interrompe

todos os serviços do Kubernetes, remove todos os dados persistentes,

desinstala todos os serviços do Kubernetes, limpa os diretórios restantes do

Kubernetes/Rancher e força o novo registro no Rancher por meio da

configuração original MachineRegistration do

Elemental. Isso é feito automaticamente, não há necessidade de intervenção

manual. O script chamado está disponível em

/opt/edge/elemental_node_cleanup.sh e é acionado pelo

systemd.path depois de inserir o marcador, portanto, sua

execução é imediata.

Com o uso do resettable, a funcionalidade assume que o

comportamento desejado ao remover um nó/cluster do Rancher é limpar os dados

e forçar um novo registro. A perda de dados é certa nessa situação,

portanto, use essa funcionalidade apenas se tiver certeza de que deseja

executar a redefinição automática.

2.11 Próximas etapas #

Veja alguns recursos recomendados para pesquisa depois de usar este guia:

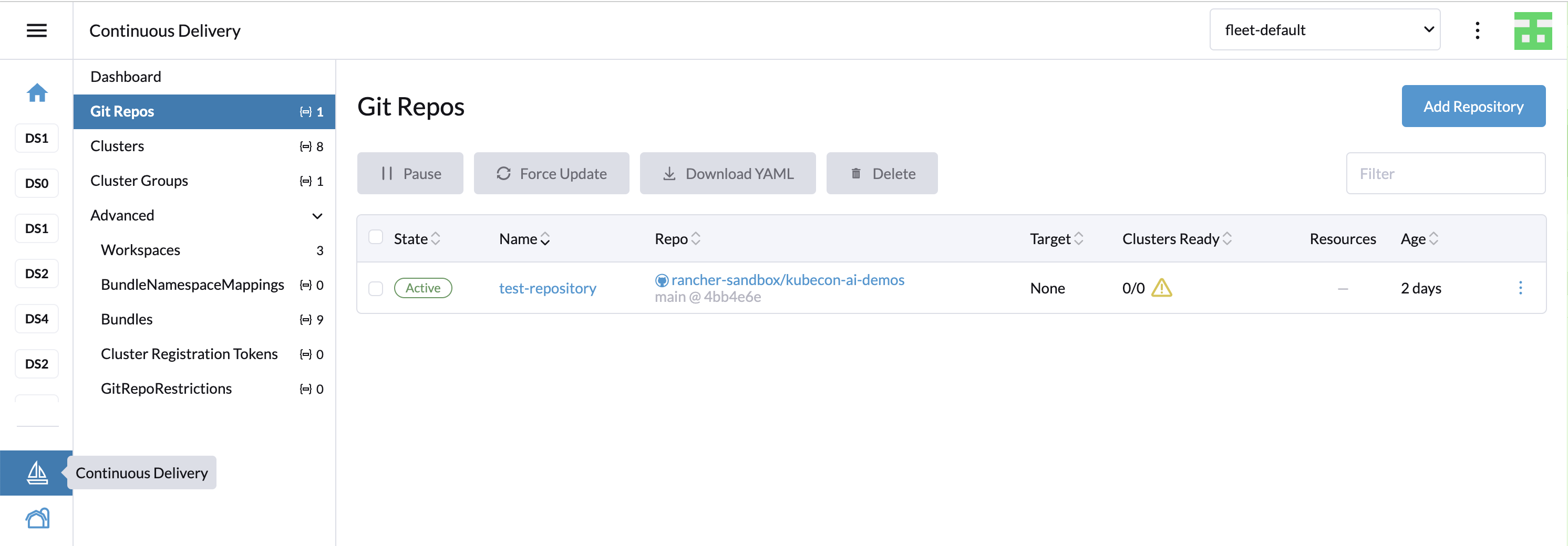

Automação de ponta a ponta no Capítulo 8, Fleet

Mais opções de configuração de rede no Capítulo 12, Rede de borda

3 Clusters independentes com o Edge Image Builder #

O Edge Image Builder (EIB) é uma ferramenta que simplifica o processo de geração de imagens de disco personalizadas e prontas para inicialização (CRB) para inicializar máquinas, mesmo em cenários totalmente air-gapped. O EIB é usado para criar imagens de implantação para uso em todas as três áreas de implantação do SUSE Edge, já que é flexível o suficiente para oferecer desde as menores personalizações, como adicionar um usuário ou definir o fuso horário, até uma imagem amplamente configurada que comporta, por exemplo, configurações de redes complexas, implantações de clusters Kubernetes de vários nós, implantações de cargas de trabalho de clientes e registros na plataforma de gerenciamento centralizado pelo Rancher/Elemental e SUSE Multi-Linux Manager. O EIB é executado como uma imagem de contêiner, o que o torna incrivelmente portátil entre as plataformas e garante que todas as dependências necessárias sejam autossuficientes, exercendo um impacto muito mínimo sobre os pacotes instalados do sistema usado para operar a ferramenta.

Nos cenários de vários nós, o EIB implanta automaticamente o MetalLB e o Endpoint Copier Operator para que os hosts provisionados que usam a mesma imagem criada ingressem em um cluster Kubernetes de maneira automática.

Para obter mais informações, leia a introdução do Edge Image Builder (Capítulo 11, Edge Image Builder).

O Edge Image Builder 1.2.1 suporta a personalização de imagens no SUSE Linux Micro 6.1. As versões mais antigas, como o SUSE Linux Enterprise Micro 5.5 ou 6.0, não são compatíveis.

3.1 Pré-requisitos #

Uma máquina host de build AMD64/Intel 64 (física ou virtual) com o SLES 15 SP6.

O mecanismo de contêiner Podman

Uma imagem ISO SelfInstall do SUSE Linux Micro 6.1 criada pelo procedimento do construtor Kiwi (Capítulo 28, Criando imagens atualizadas do SUSE Linux Micro com o Kiwi)

Para fins que não sejam de produção, é possível usar o openSUSE Leap 15.6 ou o openSUSE Tumbleweed como máquina host de build. Outros sistemas operacionais podem funcionar, desde que um tempo de execução do contêiner compatível esteja disponível.

3.1.1 Obtendo a imagem do EIB #

A imagem de contêiner do EIB é publicamente disponível e pode ser baixada do registro do SUSE Edge executando o seguinte comando no host de build da imagem:

podman pull registry.suse.com/edge/3.3/edge-image-builder:1.2.13.2 Criando o diretório de configuração de imagem #

Como o EIB é executado dentro de um contêiner, precisamos montar um diretório de configuração do host, o que permite especificar a configuração desejada e, durante o processo de criação, o EIB tem o acesso aos arquivos de entrada necessários e artefatos auxiliares. Esse diretório deve seguir uma estrutura específica. Vamos criá-lo imaginando que ele existe em seu diretório pessoal com o nome "eib":

export CONFIG_DIR=$HOME/eib

mkdir -p $CONFIG_DIR/base-imagesNa etapa anterior, criamos um diretório "base-images" que hospedará a imagem de entrada do SUSE Linux Micro 6.1. Vamos garantir que a imagem seja copiada para o diretório de configuração:

cp /path/to/SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso $CONFIG_DIR/base-images/slemicro.isoDurante a execução do EIB, a imagem base original não é modificada. Uma versão nova e personalizada é criada com a configuração desejada na raiz do diretório de configuração do EIB.

Neste momento, o diretório de configuração deve ter a seguinte aparência:

└── base-images/

└── slemicro.iso3.3 Criando o arquivo de definição de imagem #

O arquivo de definição descreve grande parte das opções configuráveis disponíveis no Edge Image Builder. Um exemplo completo das opções é apresentado aqui, e recomendamos que você leia o guia de imagens de criação upstream para ver exemplos mais detalhados do que vamos executar a seguir. Vamos começar com um arquivo de definição bem básico para a nossa imagem de sistema operacional:

cat << EOF > $CONFIG_DIR/iso-definition.yaml

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

EOFEssa definição especifica que estamos gerando uma imagem de saída para um

sistema baseado em AMD64/Intel 64. A imagem que será usada como base para

modificação posterior é uma imagem iso chamada

slemicro.iso, que esperamos que esteja no local

$CONFIG_DIR/base-images/slemicro.iso. Ela também descreve

que, depois que o EIB terminar de modificar a imagem, a imagem de saída se

chamará eib-image.iso e, por padrão, residirá em

$CONFIG_DIR.

Agora a estrutura do nosso diretório deve ter esta aparência:

├── iso-definition.yaml

└── base-images/

└── slemicro.isoNas seções a seguir, vamos analisar alguns exemplos de operações comuns:

3.3.1 Configurando usuários do sistema operacional #

O EIB permite pré-configurar usuários com informações de login, como senhas

ou chaves SSH, incluindo a definição de uma senha de root fixa. Como parte

deste exemplo, vamos corrigir a senha de root, e o primeiro passo é usar o

OpenSSL para criar uma senha criptografada unidirecional:

openssl passwd -6 SecurePasswordA saída será semelhante a esta:

$6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1Em seguida, podemos adicionar uma seção chamada

operatingSystem ao arquivo de definição com uma matriz

users dentro dela. O arquivo resultante terá esta

aparência:

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1É possível também adicionar outros usuários, criar diretórios pessoais, definir IDs de usuário, adicionar autenticação por chave SSH e modificar informações de grupo. Consulte o guia de criação de imagens upstream para ver mais exemplos.

3.3.2 Configurando o horário do sistema operacional #

A seção time é opcional, mas sua configuração é altamente

recomendada para evitar possíveis problemas com certificados e divergência

do relógio. O EIB configura o chronyd e o /etc/localtime

dependendo desses parâmetros.

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2O

timezoneespecifica o fuso horário no formato "região/localidade" (por exemplo, "Europa/Londres"). É possível ver a lista completa executando o comandotimedatectl list-timezonesno sistema Linux.ntp: define atributos relacionados à configuração do NTP (usando o chronyd).

forceWait: solicita que o chronyd tente sincronizar as fontes de horário antes de iniciar outros serviços, com um tempo limite de 180 segundos.

pools: especifica uma lista de pools que o chronyd usará como fontes de dados (usando o

iburstpara melhorar o tempo gasto na sincronização inicial).servers: especifica uma lista de servidores que o chronyd usará como fontes de dados (usando o

iburstpara melhorar o tempo gasto na sincronização inicial).

Os valores apresentados neste exemplo são apenas para fins ilustrativos. Ajuste-os de acordo com seus requisitos específicos.