- SUSE Edge 3.3.1 文档

- I 快速入门

- II 组件

- III 操作指南

- IV 提示和技巧

- V 第三方集成

- VI Day 2 操作

- VII 产品文档

- VIII 查错

- IX 附录

SUSE Edge 3.3.1 文档 #

欢迎阅读 SUSE Edge 文档,在这里可以找到总体体系结构概述、快速入门指南、经过验证的设计、组件用法指南、第三方集成,以及有关管理边缘计算基础架构和工作负载的最佳实践。

1 什么是 SUSE Edge? #

SUSE Edge 是有针对性的、紧密集成且经过全面验证的端到端解决方案,用于解决在边缘处部署基础架构和云原生应用程序时存在的独特挑战。其核心作用是提供一个有主见但高度灵活、高度可缩放且安全的平台,涵盖初始部署映像的构建、节点置备和初始配置、应用程序部署、可观测性和完整生命周期操作。该平台从一开始就构建于同类最佳的开源软件基础之上,传承了我们 30 年来提供安全、稳定且经认证的 SUSE Linux 平台的历史,继续通过 Rancher 产品组合提供高度可缩放且功能丰富的 Kubernetes 管理。SUSE Edge 基于这些功能构建,可以提供满足众多细分市场需求的功能,包括零售、医疗、交通、物流、电信、智能制造和工业物联网 (IoT)。

2 设计理念 #

该解决方案的设计考虑到了客户的需求和期望千差万别,因此不存在“以一应百”的边缘平台。边缘部署促使我们解决并不断设想出一些极具挑战性的问题,包括大规模可伸缩性、网络受限情况下的可用性、物理空间限制、新的安全威胁和攻击途径、硬件体系结构和系统资源的差异、部署旧式基础架构和应用程序并与之连接的要求,以及使用寿命较长的客户解决方案。由于其中的许多挑战与传统思维方式不同(例如在数据中心或公有云中部署基础架构和应用程序),我们必须更周密地审视设计,并反复思考许多常见假设条件。

例如,我们发现极简主义、模块化和易操作性具有重要价值。极简主义对于边缘环境非常重要,因为系统越复杂,就越容易出现故障。在分析数百乃至数十万个位置后,我们发现复杂的系统会出现纷繁复杂的故障。解决方案中的模块化允许用户做出更多选择,同时消除部署的平台中不必要的复杂性。我们还需要在这些方面与易操作性之间取得平衡。人类用户在重复某个流程数千次后可能会出现失误,因此平台应确保任何潜在失误都可恢复,从而消除技术人员亲临现场解决问题的需要,同时尽力实现一致性和标准化。

3 总体体系结构 #

SUSE Edge 的总体系统体系结构分为两个核心类别,即“管理”群集和“下游”群集。管理群集负责一个或多个下游群集的远程管理。不过,在某些情况下,下游群集需要在没有远程管理的情况下运行,例如在边缘站点没有外部连接并且需要独立运行的情况下。在SUSE Edge 中,用于管理群集和下游群集运维的技术组件在很大程度上是相同的,只是在系统规范和系统使用的应用程序方面可能有所不同:管理群集运行能够实现系统管理和生命周期操作的应用程序,而下游群集则是满足各项要求以支持用户应用程序的运行。

3.1 SUSE Edge 中使用的组件 #

SUSE Edge 由现有的 SUSE 和 Rancher 组件以及 Edge 团队构建的其他功能和组件组成,能帮助我们解决边缘计算中存在的限制和复杂性。以下是对管理群集和下游群集中所用组件的说明,并附有总体体系结构概要图(请注意,其中并未列举出所有组件):

3.1.1 管理群集 #

管理:SUSE Edge 的中心部分,用于管理所连下游群集的置备和生命周期。管理群集通常包括以下组件:

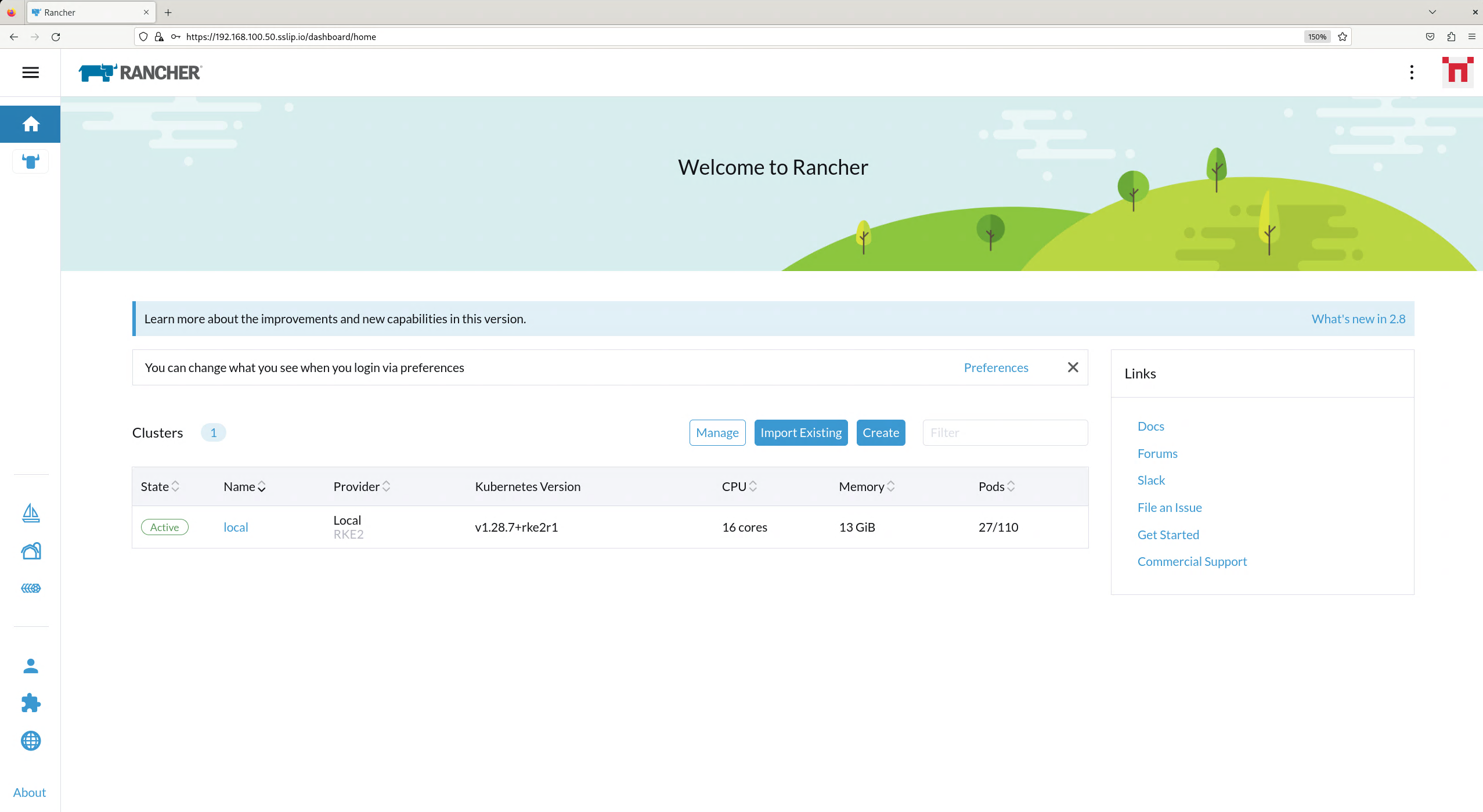

通过 Rancher Prime(第 5 章 “Rancher”)实现的多群集管理,为下游群集的初始配置以及基础架构和应用程序的持续生命周期管理提供了一个通用仪表板,还提供了全面的租户隔离和

IDP(身份提供程序)集成、第三方集成和扩展的巨大市场,以及不限供应商的 API。通过 SUSE Multi-Linux Manager 实现的 Linux 系统管理,支持对下游群集上运行的底层 Linux 操作系统 *SUSE Linux Micro(第 9 章 “SUSE Linux Micro”)执行自动化的 Linux 补丁和配置管理。请注意,虽然此组件已容器化,但它目前需要在与其他管理组件分离的单独系统上运行,因此在上图中标记为“Linux 管理”。

专用生命周期管理控制器(第 23 章 “升级控制器”),用于处理将管理群集组件升级到指定 SUSE Edge 版本的相关事务。

借助 Elemental(第 13 章 “Elemental”)实现的远程系统接入 Rancher Prime,支持将连接的边缘节点与所需的 Kubernetes 群集和应用程序部署进行后期绑定(例如通过 GitOps)。

可选的完整裸机生命周期与管理支持,通过 Metal3(第 10 章 “Metal3”)、MetalLB(第 19 章 “MetalLB”)和

CAPI(Cluster API) 基础架构提供程序实现,支持对具有远程管理功能的裸机系统执行完整的端到端置备。名为 Fleet(第 8 章 “Fleet”)的可选 GitOps 引擎,用于管理下游群集和其上安装的应用程序的置备和生命周期。

支撑管理群集本身的是作为基础操作系统的 SUSE Linux Micro(第 9 章 “SUSE Linux Micro”),以及作为支持管理群集应用程序的 Kubernetes 发行版的 RKE2(第 16 章 “RKE2”)。

3.1.2 下游群集 #

下游:SUSE Edge 的分布式组件,用于在边缘运行用户工作负载,即边缘位置运行的软件,通常由以下组件组成:

多种可供选择的 Kubernetes 发行版,包含 K3s(第 15 章 “K3s”)和 RKE2(第 16 章 “RKE2”)等安全的轻量级发行版(

RKE2已针对政府用途和受监管行业进行强化、认证和优化)。SUSE Security(第 18 章 “SUSE Security”),提供映像漏洞扫描、深度数据包检测、实时威胁和漏洞防护等安全功能。

借助 SUSE Storage(第 17 章 “SUSE Storage”)实现的软件块存储,提供轻量级、持久化、弹性佳且可扩缩的块存储服务。

轻量级、容器优化且经过强化的 Linux 操作系统 SUSE Linux Micro(第 9 章 “SUSE Linux Micro”),为在边缘运行容器和虚拟机提供了一个不可变且高弹性的操作系统。SUSE Linux Micro 适用于 AArch64 和 AMD64/Intel 64 两种体系结构,还支持

实时内核,可满足对延迟敏感的应用需求(如电信领域的使用场景)。对于连接的群集(即与管理群集连接的群集),会部署两个代理。一个是 Rancher System Agent,用于管理与 Rancher Prime 的连接;另一个是 venv-salt-minion,用于接收 SUSE Multi-Linux Manager 的指令,以执行 Linux 软件更新。这些代理对于离线群集的管理而言并非必需组件。

3.2 连接 #

上图提供了连接的下游群集及其与管理群集的连接的总体体系结构概览。管理群集可以部署在各种底层基础架构平台上,包括本地和云平台,具体取决于下游群集和目标管理群集之间的网络连接情况。这项功能的唯一要求是 API 和回调 URL 可以通过连接下游群集节点和管理基础架构的网络进行访问。

必须注意,建立这种连接的机制不同于下游群集部署的机制。下一节将对此进行更深入的介绍,不过先建立一个基本概念,连接的下游群集成为“受管理”群集主要有三种机制:

下游群集先以“断开连接”的方式部署(例如通过 Edge Image Builder(第 11 章 “Edge Image Builder”)),然后在连接允许的情况下导入管理群集。

下游群集会被配置为使用内置的初始配置机制(例如通过 Elemental(第 13 章 “Elemental”)),并且它们在首次引导时会自动注册到管理群集,以允许群集配置的后期绑定。

下游群集已置备裸机管理功能 (CAPI + Metal3),群集一旦部署和配置(通过 Rancher Turtles 操作器),它们就会自动导入管理群集。

4 常见的 Edge 部署模式 #

由于操作环境和生命周期要求各不相同,我们已针对一些不同的部署模式实施了支持,这些模式与 SUSE Edge 适用的细分市场和使用场景大体一致。我们为其中的每种部署模式编写了一份快速入门指南,以帮助您根据自己的需求熟悉 SUSE Edge 平台。下面介绍了我们目前支持的三种部署模式,并附有相关快速入门页面的链接。

4.1 定向网络置备 #

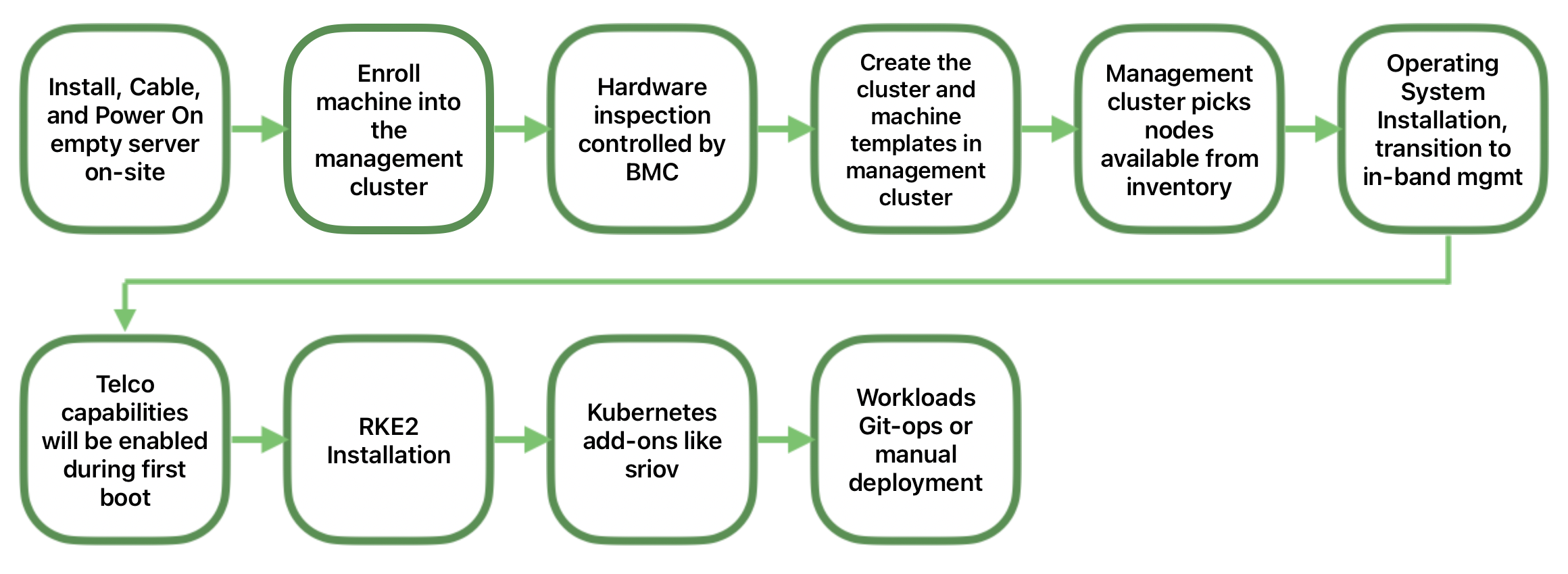

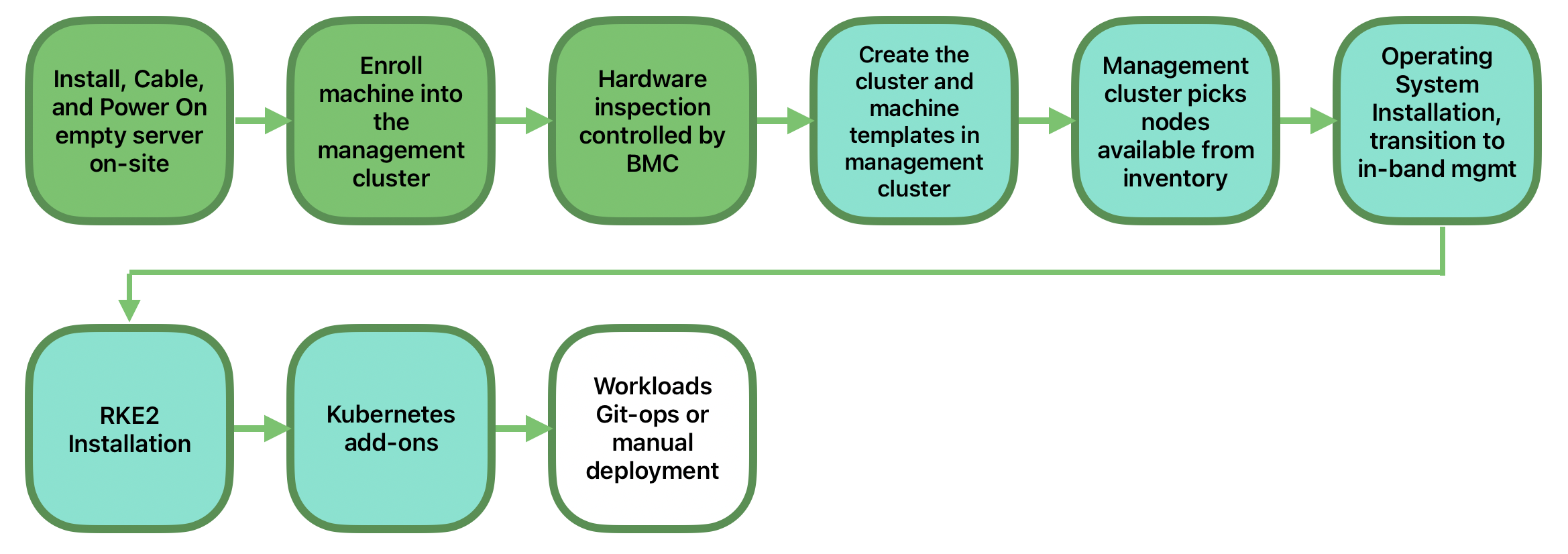

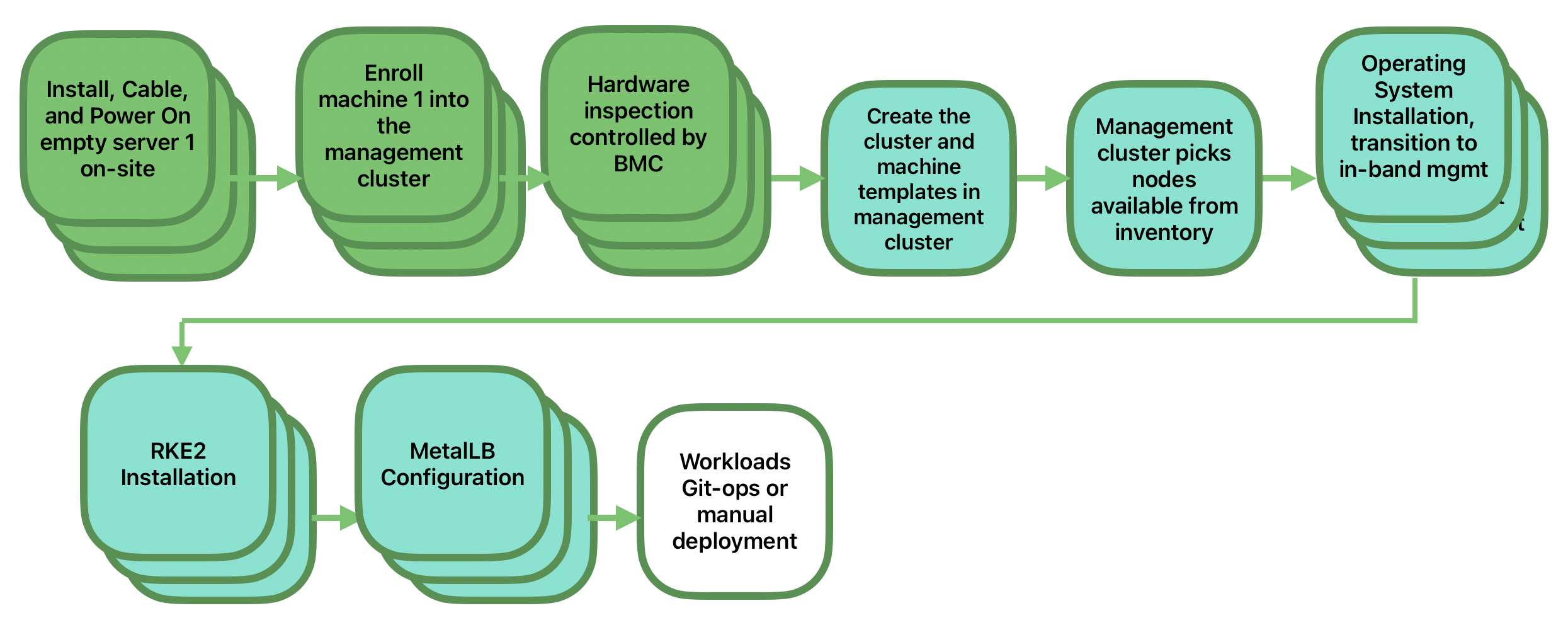

定向网络置备适用于您知道要部署到的硬件的细节,并可以直接访问带外管理界面来编排和自动化整个置备过程的情况。在这种情况下,客户预期解决方案能够从一个中心位置全自动地置备边缘站点,并可以最大限度地减少边缘位置的手动操作,也就是说,解决方案的作用远不止是创建引导映像;您只需将物理硬件装入机架、通电并为其连接所需的网络,自动化过程就会通过带外管理(例如通过 Redfish API)启动计算机并处理基础架构的置备、初始配置和部署,全程无需用户的干预。做到这一点的关键在于管理员了解系统;他们知道哪个硬件在哪个位置,并且部署预期可以得到集中处理。

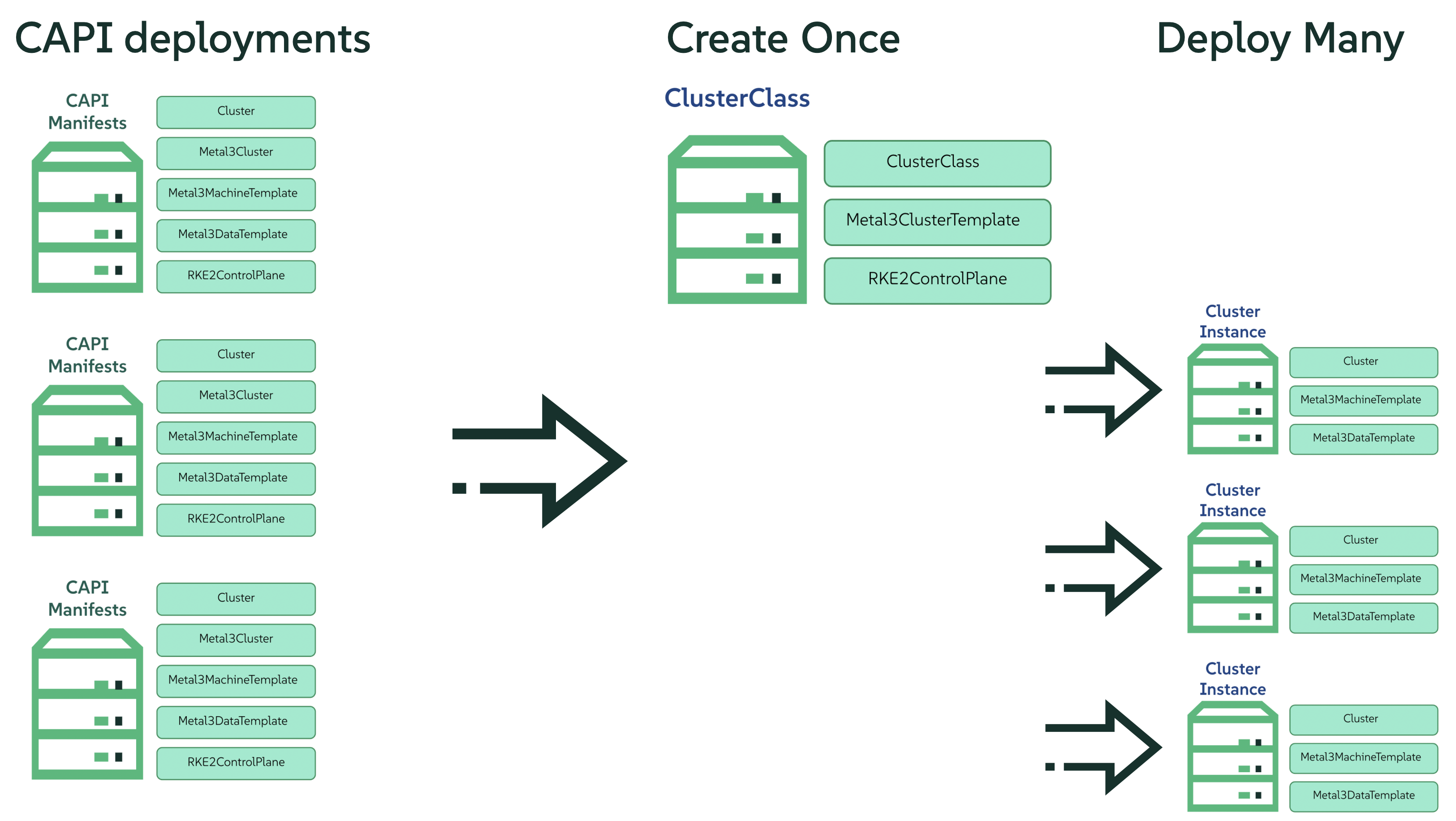

此解决方案最为稳健,因为您可以直接与硬件的管理界面交互和处理已知硬件,并且很少会遇到网络可用性方面的限制。在功能上,此解决方案广泛使用 Cluster API 和 Metal3 来自动完成从裸机到操作系统、Kubernetes 和分层应用程序的置备,并能够在部署后与 SUSE Edge 的其他常规生命周期管理功能相衔接。此解决方案的快速入门可在第 1 章 “使用 Metal3 实现 BMC 自动化部署”中找到。

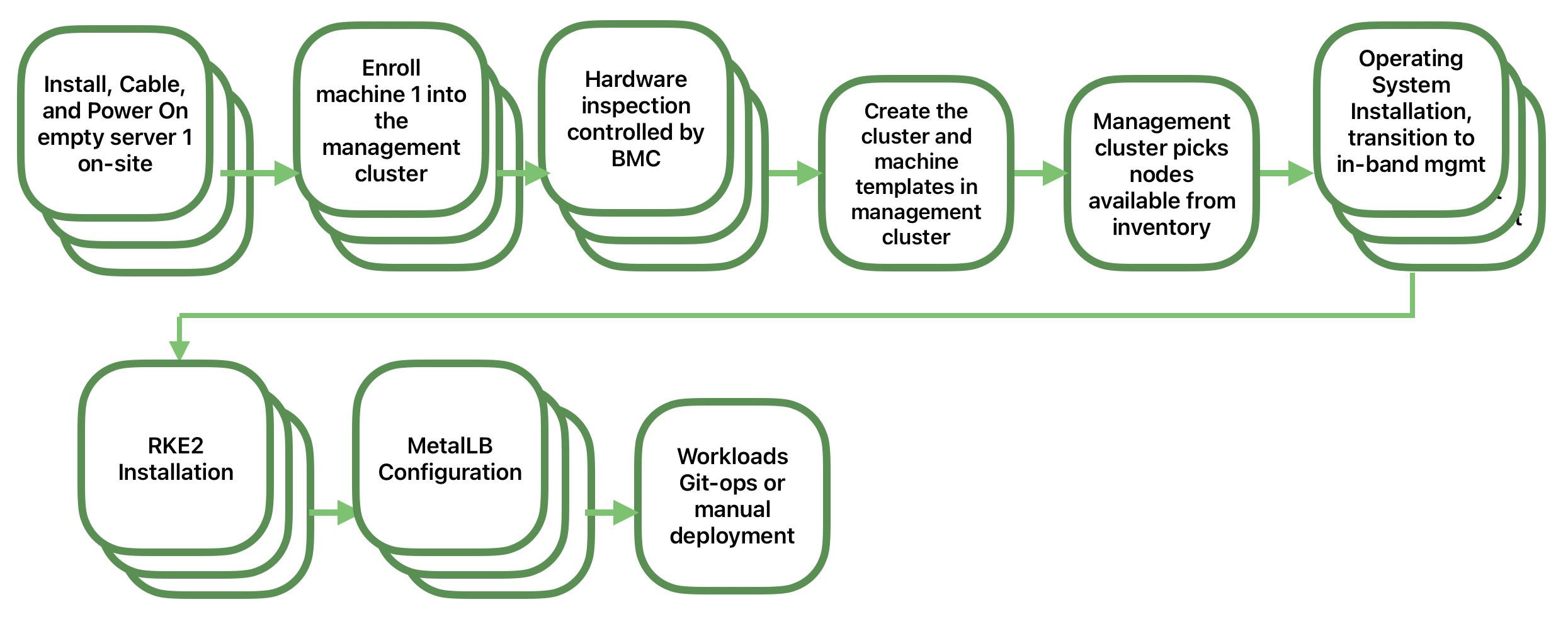

4.2 “自主回连”网络置备 #

有时,在您的操作环境中,中心管理群集无法直接管理硬件(例如,您的远程网络位于防火墙后面,或者没有带外管理界面;这种情况在边缘处经常使用的“PC”型硬件中很常见)。对于这种情况,我们提供了相应的工具来远程置备群集及其工作负载,而无需知道硬件在引导时位于何处。这就是大多数人对边缘计算的看法;有成千上万种不太常见的系统在边缘位置引导、安全地自主回连、验证它们的身份,并接收有关要执行哪种操作的指令。为此,我们希望除了出厂前预先构建计算机映像,或者简单挂接引导映像(例如通过 USB)来打开系统外,置备和生命周期管理工作几乎不需要用户干预即可完成。在此方面存在的主要挑战是如何解决这些设备在各种环境下的缩放性、一致性、安全性和生命周期管理问题。

此解决方案在系统置备和初始配置方式上提供了高度的灵活性和一致性,不受系统位置、类型或规格以及首次开机时间的影响。在 SUSE Edge 中,可以通过 Edge Image Builder 十分灵活地对系统进行自定义,同时可以利用 Rancher Elemental 提供的注册功能来初始配置节点和置备 Kubernetes,并利用 SUSE Multi-Linux 来修补操作系统。此解决方案的快速入门可在第 2 章 “使用 Elemental 进行远程主机接入”中找到。

4.3 基于映像的置备 #

对于需要在独立、隔离或网络受限的环境中操作的客户,SUSE Edge 提供了一种解决方案供客户生成完全自定义的安装媒体,其中包含所有必要的部署制品,用于在边缘启用单节点和多节点高可用性 Kubernetes 群集,包括任何所需的工作负载或其他分层组件。全程无需与外界建立任何网络连接,且无需集中式管理平台的干预。用户体验与“自主回连”解决方案非常相似,安装媒体同样会提供给目标系统,但该解决方案会“就地引导”。在这种情况下,可将创建的群集挂接到 Rancher 进行持续管理(即从“断开连接”转换为“已连接”操作模式,无需经过大范围的重新配置或重新部署),或者群集可以继续独立运行。请注意,在这两种情况下,都可以采用相同的一致性机制来自动执行生命周期操作。

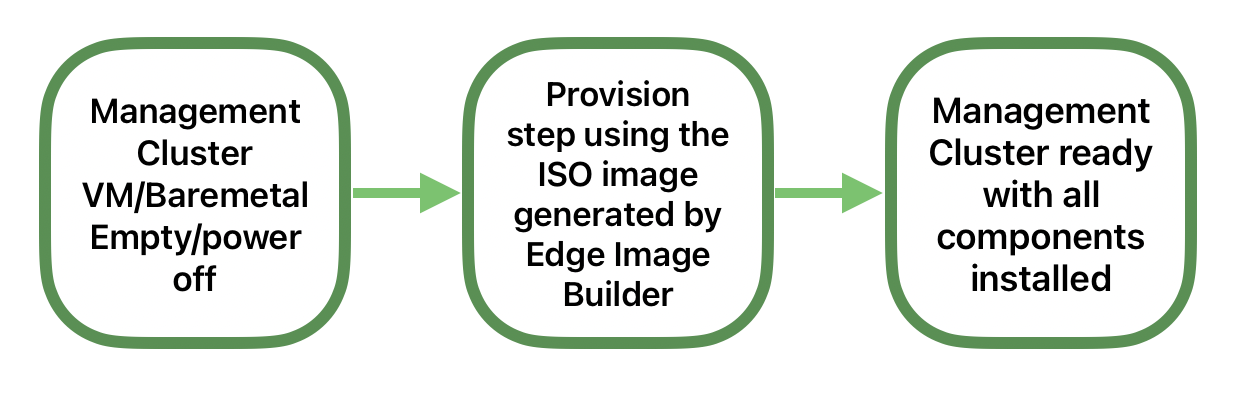

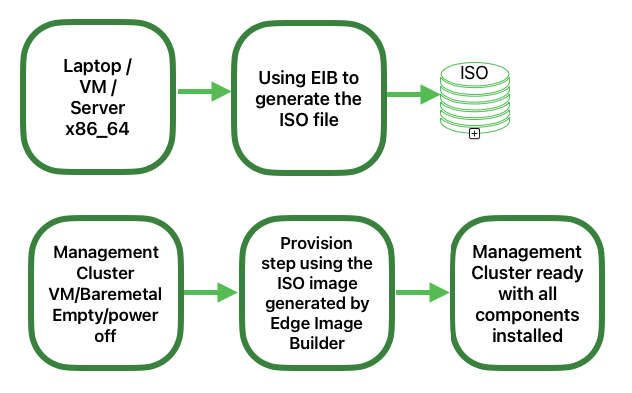

此外,使用此解决方案可以快速创建管理群集,这些管理群集可以托管同时支持“定向网络置备”和“自主回连网络置备”模型的集中式基础架构,因为它可能是置备各种 Edge 基础架构最快速、最简单的方式。此解决方案充分利用 SUSE Edge Image Builder 的功能,生成完全自定义的无人照管安装媒体;快速入门可在第 3 章 “使用 Edge Image Builder 配置独立群集”中找到。

5 SUSE Edge 堆栈验证 #

所有 SUSE Edge 版本均由紧密集成且经过全面验证的组件组成,这些组件作为一个整体进行版本控制。SUSE Edge 团队在集成和堆栈验证方面不断努力,不仅测试了组件之间的集成,还确保系统在因外界因素影响而发生故障的情况下仍能按预期运行。所有测试运行和结果均已向公众发布,结果和所有输入参数都可以在 ci.edge.suse.com 上找到。

6 完整组件列表 #

以下是组件的完整列表,以及对每种组件的概要说明及其在 SUSE Edge 中用法的相关链接:

Rancher(第 5 章 “Rancher”)

Rancher 仪表板扩展(第 6 章 “Rancher 仪表板扩展”)

Rancher Turtles(第 7 章 “Rancher Turtles”)

SUSE Multi-Linux Manager

Fleet(第 8 章 “Fleet”)

SUSE Linux Micro(第 9 章 “SUSE Linux Micro”)

Metal³(第 10 章 “Metal3”)

Edge Image Builder(第 11 章 “Edge Image Builder”)

NetworkManager Configurator(第 12 章 “边缘网络”)

Elemental(第 13 章 “Elemental”)

Akri(第 14 章 “Akri”)

K3s(第 15 章 “K3s”)

RKE2(第 16 章 “RKE2”)

SUSE Storage(第 17 章 “SUSE Storage”)

SUSE Security(第 18 章 “SUSE Security”)

MetalLB(第 19 章 “MetalLB”)

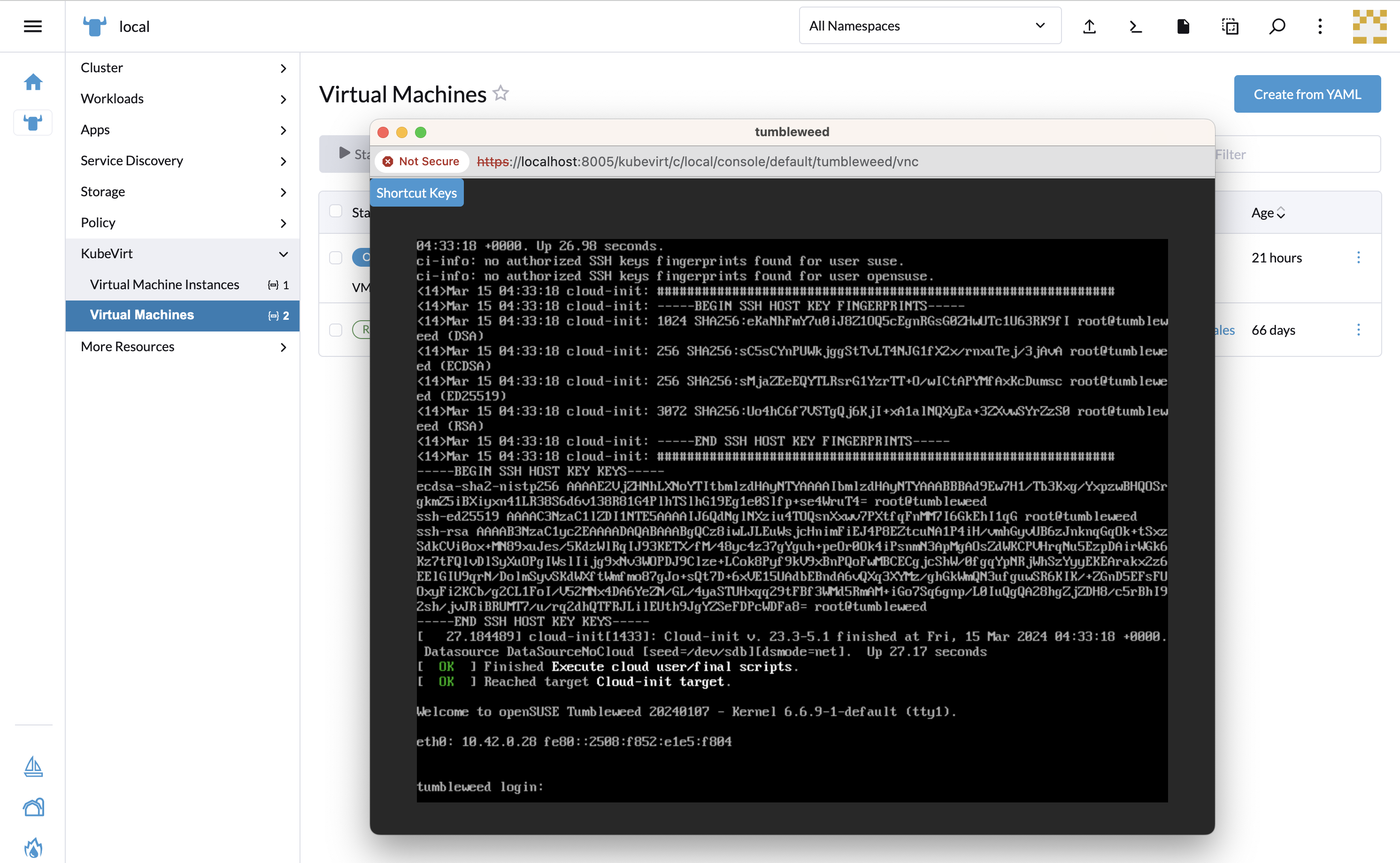

KubeVirt(第 21 章 “Edge Virtualization”)

系统升级控制器(第 22 章 “系统升级控制器”)

升级控制器(第 23 章 “升级控制器”)

第 I 部分 快速入门 #

从这里快速入门

- 1 使用 Metal3 实现 BMC 自动化部署

Metal3 是一个 CNCF 项目,它为 Kubernetes 提供裸机基础架构管理功能。

- 2 使用 Elemental 进行远程主机接入

本章介绍 SUSE Edge 中的“自主回连网络置备”解决方案。我们将使用 Elemental 来协助完成节点接入。Elemental 是一个软件堆栈,可用于注册远程主机和通过 Kubernetes 实现集中式云原生操作系统全面管理。在 SUSE Edge 堆栈中,我们将使用 Elemental 的注册功能将远程主机接入 Rancher,以便将主机集成到集中式管理平台,然后从该平台部署和管理 Kubernetes 群集以及分层组件、应用程序及其生命周期,所有这些操作都在一个中心位置完成。

- 3 使用 Edge Image Builder 配置独立群集

Edge Image Builder (EIB) 工具可以简化为引导计算机生成随时可引导 (CRB) 的自定义磁盘映像的过程,即使在完全隔离场景中也能做到这一点。EIB 用于创建所有三个 SUSE Edge 部署空间中使用的部署映像,因为它足够灵活,可以提供最简单的自定义过程,例如通过提供全面配置的映像来添加用户或设置时区。例如,该映像可以设置复杂的网络配置、部署多节点 Kubernetes 群集、部署客户工作负载,并通过 Rancher/Elemental 和 SUSE Multi-Linux Manager 注册到集中式管理平台。EIB 以容器映像的形式运行,因此具有极高的跨平台可移植性,…

- 4 SUSE Multi-Linux Manager

SUSE Edge 中包含 SUSE Multi-Linux Manager,其作用是提供自动化与控制能力,确保边缘部署的所有节点上作为底层操作系统的 SUSE Linux Micro 始终保持最新状态。

1 使用 Metal3 实现 BMC 自动化部署 #

Metal3 是一个 CNCF 项目,它为 Kubernetes 提供裸机基础架构管理功能。

Metal3 提供 Kubernetes 原生资源来管理裸机服务器的生命周期,支持通过 Redfish 等带外协议进行管理。

它还为 Cluster API (CAPI) 提供成熟的支持,允许通过广泛采用的不限供应商的 API 来管理跨多个基础架构提供商的基础架构资源。

1.1 为何使用此方法 #

此方法非常适合用于目标硬件支持带外管理,并且需要全自动化基础架构管理流程的场景。

管理群集配置为提供声明性 API 来对下游群集裸机服务器进行清单和状态管理,包括自动检查、清理和置备/取消置备。

1.2 总体体系结构 #

1.3 先决条件 #

下游群集服务器硬件和网络相关的限制具体如下所述:

管理群集

必须与目标服务器管理/BMC API 建立网络连接

必须与目标服务器控制平面网络建立网络连接

对于多节点管理群集,需要配置额外的预留 IP 地址

要控制的主机

必须支持通过 Redfish、iDRAC 或 iLO 接口进行带外管理

必须支持通过虚拟媒体进行部署(目前不支持 PXE)

必须与管理群集建立网络连接,以便能够访问 Metal3 置备 API

需要安装一些工具,可以安装在管理群集上,也可以安装在能够访问管理群集的主机上。

Podman 或 Rancher Desktop 等容器运行时

SL-Micro.x86_64-6.1-Base-GM.raw 操作系统映像文件必须从 SUSE Customer Center 或 SUSE 下载页面下载。

1.3.1 设置管理群集 #

安装管理群集和使用 Metal3 的基本步骤如下:

安装 RKE2 管理群集

安装 Rancher

安装存储服务提供程序(可选)

安装 Metal3 依赖项

通过 Rancher Turtles 安装 CAPI 依赖项

为下游群集主机构建 SLEMicro 操作系统映像

注册 BareMetalHost CR 以定义裸机清单

通过定义 CAPI 资源创建下游群集

本指南假设已安装现有的 RKE2 群集和 Rancher(包括 cert-manager),例如已使用 Edge Image Builder 安装(第 11 章 “Edge Image Builder”)。

1.3.2 安装 Metal3 依赖项 #

必须安装并运行 cert-manager(如果在安装 Rancher 的过程中未安装)。

必须安装持久性存储提供程序。建议使用 SUSE Storage,但对于开发/PoC 环境,也可以使用

local-path-provisioner。以下说明假设已将 StorageClass 标记为默认值,否则需要对

Metal3 chart 进行额外的配置。

需要提供一个额外的 IP,该 IP 由 MetalLB 管理,用于为 Metal3 管理服务提供一致的端点。此 IP 必须是控制平面子网的一部分,并且为静态配置预留(不是任何 DHCP 池的一部分)。

首先,我们需要安装 MetalLB:

helm install \ metallb oci://registry.suse.com/edge/charts/metallb \ --namespace metallb-system \ --create-namespace然后使用预留 IP 来定义

IPAddressPool和L2Advertisement(如下方的STATIC_IRONIC_IP所定义):export STATIC_IRONIC_IP=<STATIC_IRONIC_IP> cat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: ironic-ip-pool namespace: metallb-system spec: addresses: - ${STATIC_IRONIC_IP}/32 serviceAllocation: priority: 100 serviceSelectors: - matchExpressions: - {key: app.kubernetes.io/name, operator: In, values: [metal3-ironic]} EOFcat <<-EOF | kubectl apply -f - apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: ironic-ip-pool-l2-adv namespace: metallb-system spec: ipAddressPools: - ironic-ip-pool EOF现在可以安装 Metal3:

helm install \ metal3 oci://registry.suse.com/edge/charts/metal3 \ --namespace metal3-system \ --create-namespace \ --set global.ironicIP="$STATIC_IRONIC_IP"大约要经过两分钟,init 容器才会在此部署中运行,因此请确保所有 Pod 都已运行再继续操作:

kubectl get pods -n metal3-system NAME READY STATUS RESTARTS AGE baremetal-operator-controller-manager-85756794b-fz98d 2/2 Running 0 15m metal3-metal3-ironic-677bc5c8cc-55shd 4/4 Running 0 15m metal3-metal3-mariadb-7c7d6fdbd8-64c7l 1/1 Running 0 15m

请在 metal3-system 名称空间中的所有 Pod 都已运行后再继续执行以下步骤。

1.3.3 安装 Cluster API 依赖项 #

Cluster API 依赖项通过 Rancher Turtles Helm chart 管理:

cat > values.yaml <<EOF

rancherTurtles:

features:

embedded-capi:

disabled: true

rancher-webhook:

cleanup: true

EOF

helm install \

rancher-turtles oci://registry.suse.com/edge/charts/rancher-turtles \

--namespace rancher-turtles-system \

--create-namespace \

-f values.yaml一段时间后,控制器 Pod 应会在

capi-system、capm3-system、rke2-bootstrap-system

和 rke2-control-plane-system 名称空间中运行。

1.3.4 准备下游群集映像 #

Kiwi(第 28 章 “使用 Kiwi 构建更新的 SUSE Linux Micro 映像”)和 Edge Image Builder(第 11 章 “Edge Image Builder”)用于准备将在下游群集主机上置备的经过修改的 SLEMicro 基础映像。

本指南介绍部署下游群集所需的最低限度配置。

1.3.4.1 映像配置 #

运行 Edge Image Builder 时,将从主机挂载一个目录,因此需要创建一个目录结构来存储用于定义目标映像的配置文件。

downstream-cluster-config.yaml是映像定义文件,有关详细信息,请参见第 3 章 “使用 Edge Image Builder 配置独立群集”。下载的基础映像已经过

xz压缩,必须使用unxz将其解压缩,并将其复制/移动到base-images文件夹中。network文件夹是可选的,有关详细信息,请参见第 1.3.5.1.1 节 “用于静态网络配置的附加脚本”。custom/scripts 目录包含首次引导时运行的脚本;目前需要使用

01-fix-growfs.sh脚本来调整部署中的操作系统根分区的大小

├── downstream-cluster-config.yaml

├── base-images/

│ └ SL-Micro.x86_64-6.1-Base-GM.raw

├── network/

| └ configure-network.sh

└── custom/

└ scripts/

└ 01-fix-growfs.sh1.3.4.1.1 下游群集映像定义文件 #

downstream-cluster-config.yaml 文件是下游群集映像的主配置文件。下面是通过

Metal3 进行部署的极简示例:

apiVersion: 1.2

image:

imageType: raw

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-GM.raw

outputImageName: SLE-Micro-eib-output.raw

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

kernelArgs:

- ignition.platform.id=openstack

- net.ifnames=1

systemd:

disable:

- rebootmgr

- transactional-update.timer

- transactional-update-cleanup.timer

users:

- username: root

encryptedPassword: $ROOT_PASSWORD

sshKeys:

- $USERKEY1

packages:

packageList:

- jq

sccRegistrationCode: $SCC_REGISTRATION_CODE其中 $SCC_REGISTRATION_CODE 是从 SUSE Customer Center

中复制的注册代码,并且软件包列表包含必需的 jq。

$ROOT_PASSWORD 是 root 用户的已加密口令,可用于测试/调试目的。可以使用

openssl passwd-6 PASSWORD 命令生成此口令

对于生产环境,建议使用可添加到 users 块的 SSH 密钥(需将 $USERKEY1 替换为实际 SSH

密钥)。

net.ifnames=1 会启用可预测网络接口命名

这与 Metal3 chart 的默认配置相匹配,但设置必须与配置的 chart

predictableNicNames 值相匹配。

另请注意,ignition.platform.id=openstack 是必需的,如果不指定此参数,在

Metal3 自动化流程中通过 ignition 进行 SUSE Linux Micro

配置将会失败。

虽然 time

部分是可选的,但强烈建议配置该部分,以免出现证书和时钟偏差方面的潜在问题。本示例中提供的值仅作说明之用,请根据您的具体要求相应调整。

1.3.4.1.2 Growfs 脚本 #

目前,在置备后首次引导时,需要使用一个自定义脚本

(custom/scripts/01-fix-growfs.sh)

来增大文件系统,使之与磁盘大小匹配。01-fix-growfs.sh 脚本包含以下信息:

#!/bin/bash

growfs() {

mnt="$1"

dev="$(findmnt --fstab --target ${mnt} --evaluate --real --output SOURCE --noheadings)"

# /dev/sda3 -> /dev/sda, /dev/nvme0n1p3 -> /dev/nvme0n1

parent_dev="/dev/$(lsblk --nodeps -rno PKNAME "${dev}")"

# Last number in the device name: /dev/nvme0n1p42 -> 42

partnum="$(echo "${dev}" | sed 's/^.*[^0-9]\([0-9]\+\)$/\1/')"

ret=0

growpart "$parent_dev" "$partnum" || ret=$?

[ $ret -eq 0 ] || [ $ret -eq 1 ] || exit 1

/usr/lib/systemd/systemd-growfs "$mnt"

}

growfs /1.3.4.2 映像创建 #

按照前面的章节准备好目录结构后,运行以下命令来构建映像:

podman run --rm --privileged -it -v $PWD:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file downstream-cluster-config.yaml这会根据上述定义创建名为 SLE-Micro-eib-output.raw 的输出映像文件。

然后必须通过 Web 服务器提供输出映像,该服务器可以是通过 Metal3 chart 启用的媒体服务器容器(注意),也可以是其他某个本地可访问的服务器。在下面的示例中,此服务器是

imagecache.local:8080

将 EIB 映像部署到下游群集时,还需要在 Metal3MachineTemplate 对象中包含该映像的

sha256 校验和。可通过以下方式生成该校验和:

sha256sum <image_file> > <image_file>.sha256

# On this example:

sha256sum SLE-Micro-eib-output.raw > SLE-Micro-eib-output.raw.sha2561.3.5 添加 BareMetalHost 清单 #

注册自动部署的裸机服务器需要创建两个资源:一个用于存储 BMC 访问身份凭证的机密,以及一个用于定义 BMC 连接和其他细节的 Metal3 BareMetalHost 资源:

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-credentials

type: Opaque

data:

username: YWRtaW4=

password: cGFzc3dvcmQ=

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

online: true

bootMACAddress: "00:f3:65:8a:a3:b0"

bmc:

address: redfish-virtualmedia://192.168.125.1:8000/redfish/v1/Systems/68bd0fb6-d124-4d17-a904-cdf33efe83ab

disableCertificateVerification: true

credentialsName: controlplane-0-credentials请注意以下几点:

机密用户名/口令必须采用 base64 编码。请注意,此值不能包含任何尾部换行符(例如,应使用

echo-n,而不是简单地使用echo!)可以现在设置

cluster-role标签,也可以稍后在创建群集时设置。在以下示例中,应该设置control-plane或workerbootMACAddress必须是与主机的控制平面 NIC 匹配的有效 MACbmc地址用于连接 BMC 管理 API,支持以下类型:redfish-virtualmedia://<IP 地址>/redfish/v1/Systems/<系统 ID>:Redfish 虚拟媒体,例如 SuperMicroidrac-virtualmedia://<IP 地址>/redfish/v1/Systems/System.Embedded.1:Dell iDRAC

有关 BareMetalHost API 的详细信息,请参见上游 API 文档

1.3.5.1 配置静态 IP #

上面的 BareMetalHost 示例假设 DHCP 提供控制平面网络配置,但对于需要手动配置(例如静态 IP)的情况,可以提供附加配置,如下所述。

1.3.5.1.1 用于静态网络配置的附加脚本 #

使用 Edge Image Builder 创建基础映像时,请在 network 文件夹中创建以下

configure-network.sh 文件。

这会在首次引导时使用配置驱动器数据,并使用 NM Configurator 工具来配置主机网络。

#!/bin/bash

set -eux

# Attempt to statically configure a NIC in the case where we find a network_data.json

# In a configuration drive

CONFIG_DRIVE=$(blkid --label config-2 || true)

if [ -z "${CONFIG_DRIVE}" ]; then

echo "No config-2 device found, skipping network configuration"

exit 0

fi

mount -o ro $CONFIG_DRIVE /mnt

NETWORK_DATA_FILE="/mnt/openstack/latest/network_data.json"

if [ ! -f "${NETWORK_DATA_FILE}" ]; then

umount /mnt

echo "No network_data.json found, skipping network configuration"

exit 0

fi

DESIRED_HOSTNAME=$(cat /mnt/openstack/latest/meta_data.json | tr ',{}' '\n' | grep '\"metal3-name\"' | sed 's/.*\"metal3-name\": \"\(.*\)\"/\1/')

echo "${DESIRED_HOSTNAME}" > /etc/hostname

mkdir -p /tmp/nmc/{desired,generated}

cp ${NETWORK_DATA_FILE} /tmp/nmc/desired/_all.yaml

umount /mnt

./nmc generate --config-dir /tmp/nmc/desired --output-dir /tmp/nmc/generated

./nmc apply --config-dir /tmp/nmc/generated1.3.5.1.2 包含主机网络配置的附加机密 #

可为每个主机定义一个附加机密,其中包含采用 NM Configurator(第 12 章 “边缘网络”)所支持的 nmstate 格式的数据。

然后通过 preprovisioningNetworkDataName 规范字段在

BareMetalHost 资源中引用该机密。

apiVersion: v1

kind: Secret

metadata:

name: controlplane-0-networkdata

type: Opaque

stringData:

networkData: |

interfaces:

- name: enp1s0

type: ethernet

state: up

mac-address: "00:f3:65:8a:a3:b0"

ipv4:

address:

- ip: 192.168.125.200

prefix-length: 24

enabled: true

dhcp: false

dns-resolver:

config:

server:

- 192.168.125.1

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.125.1

next-hop-interface: enp1s0

---

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: controlplane-0

labels:

cluster-role: control-plane

spec:

preprovisioningNetworkDataName: controlplane-0-networkdata

# Remaining content as in previous example1.3.5.2 BareMetalHost 准备 #

按照上述步骤创建 BareMetalHost 资源和关联的机密后,将触发主机准备工作流程:

通过将虚拟媒体挂接到目标主机 BMC,引导内存盘映像

内存盘会检查硬件细节,并为主机做好置备准备(例如,清理磁盘中的旧数据)

完成此过程后,BareMetalHost

status.hardware字段中的硬件细节将会更新并可供验证

此过程可能需要几分钟时间,但完成后,您应该会看到 BareMetalHost 状态变为 available:

% kubectl get baremetalhost

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available true 9m44s

worker-0 available true 9m44s1.3.6 创建下游群集 #

现在创建用于定义下游群集的 Cluster API 资源,以及创建计算机资源,后者会导致置备 BareMetalHost 资源,然后引导这些资源以形成 RKE2 群集。

1.3.7 控制平面部署 #

为了部署控制平面,我们需要定义一个如下所示的 yaml 清单,其中包含以下资源:

群集资源定义群集名称、网络和控制平面/基础架构提供程序的类型(在本例中为 RKE2/Metal3)

Metal3Cluster 定义控制平面端点(单节点群集的主机 IP,多节点群集的负载平衡器端点,本示例假设使用单节点群集)

RKE2ControlPlane 定义 RKE2 版本,以及群集引导期间所需的任何其他配置

Metal3MachineTemplate 定义要应用于 BareMetalHost 资源的操作系统映像,hostSelector 定义要使用的 BareMetalHost

Metal3DataTemplate 定义要传递给 BareMetalHost 的其他元数据(请注意,Edge 解决方案目前不支持 networkData)

apiVersion: cluster.x-k8s.io/v1beta1

kind: Cluster

metadata:

name: sample-cluster

namespace: default

spec:

clusterNetwork:

pods:

cidrBlocks:

- 192.168.0.0/18

services:

cidrBlocks:

- 10.96.0.0/12

controlPlaneRef:

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

name: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

name: sample-cluster

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3Cluster

metadata:

name: sample-cluster

namespace: default

spec:

controlPlaneEndpoint:

host: 192.168.125.200

port: 6443

noCloudProvider: true

---

apiVersion: controlplane.cluster.x-k8s.io/v1beta1

kind: RKE2ControlPlane

metadata:

name: sample-cluster

namespace: default

spec:

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-controlplane

replicas: 1

version: v1.32.4+rke2r1

rolloutStrategy:

type: "RollingUpdate"

rollingUpdate:

maxSurge: 0

agentConfig:

format: ignition

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-controlplane

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-controlplane-template

hostSelector:

matchLabels:

cluster-role: control-plane

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-controlplane-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machine根据您的环境对该示例清单进行调整后,便可通过 kubectl 应用该清单,然后通过

clusterctl 监控群集状态。

% kubectl apply -f rke2-control-plane.yaml

# Wait for the cluster to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 22m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 27m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 22m

│ └─Machine/sample-cluster-chflc True 23m1.3.8 工作/计算节点部署 #

与部署控制平面时一样,我们需要定义一个 YAML 清单,其中包含以下资源:

MachineDeployment 定义复本(主机)数量和引导/基础架构提供程序(在本例中为 RKE2/Metal3)

RKE2ConfigTemplate 描述代理主机引导的 RKE2 版本和首次引导配置

Metal3MachineTemplate 定义要应用于 BareMetalHost 资源的操作系统映像,主机选择器定义要使用的 BareMetalHost

Metal3DataTemplate 定义要传递给 BareMetalHost 的其他元数据(请注意,目前不支持

networkData)

apiVersion: cluster.x-k8s.io/v1beta1

kind: MachineDeployment

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

name: sample-cluster

namespace: default

spec:

clusterName: sample-cluster

replicas: 1

selector:

matchLabels:

cluster.x-k8s.io/cluster-name: sample-cluster

template:

metadata:

labels:

cluster.x-k8s.io/cluster-name: sample-cluster

spec:

bootstrap:

configRef:

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

name: sample-cluster-workers

clusterName: sample-cluster

infrastructureRef:

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

name: sample-cluster-workers

nodeDrainTimeout: 0s

version: v1.32.4+rke2r1

---

apiVersion: bootstrap.cluster.x-k8s.io/v1alpha1

kind: RKE2ConfigTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

agentConfig:

format: ignition

version: v1.32.4+rke2r1

kubelet:

extraArgs:

- provider-id=metal3://BAREMETALHOST_UUID

additionalUserData:

config: |

variant: fcos

version: 1.4.0

systemd:

units:

- name: rke2-preinstall.service

enabled: true

contents: |

[Unit]

Description=rke2-preinstall

Wants=network-online.target

Before=rke2-install.service

ConditionPathExists=!/run/cluster-api/bootstrap-success.complete

[Service]

Type=oneshot

User=root

ExecStartPre=/bin/sh -c "mount -L config-2 /mnt"

ExecStart=/bin/sh -c "sed -i \"s/BAREMETALHOST_UUID/$(jq -r .uuid /mnt/openstack/latest/meta_data.json)/\" /etc/rancher/rke2/config.yaml"

ExecStart=/bin/sh -c "echo \"node-name: $(jq -r .name /mnt/openstack/latest/meta_data.json)\" >> /etc/rancher/rke2/config.yaml"

ExecStartPost=/bin/sh -c "umount /mnt"

[Install]

WantedBy=multi-user.target

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3MachineTemplate

metadata:

name: sample-cluster-workers

namespace: default

spec:

template:

spec:

dataTemplate:

name: sample-cluster-workers-template

hostSelector:

matchLabels:

cluster-role: worker

image:

checksum: http://imagecache.local:8080/SLE-Micro-eib-output.raw.sha256

checksumType: sha256

format: raw

url: http://imagecache.local:8080/SLE-Micro-eib-output.raw

---

apiVersion: infrastructure.cluster.x-k8s.io/v1beta1

kind: Metal3DataTemplate

metadata:

name: sample-cluster-workers-template

namespace: default

spec:

clusterName: sample-cluster

metaData:

objectNames:

- key: name

object: machine

- key: local-hostname

object: machine

- key: local_hostname

object: machine复制以上示例并根据您的环境进行修改后,可以通过 kubectl 应用该示例,然后使用

clusterctl 监控群集状态

% kubectl apply -f rke2-agent.yaml

# Wait for the worker nodes to be provisioned

% clusterctl describe cluster sample-cluster

NAME READY SEVERITY REASON SINCE MESSAGE

Cluster/sample-cluster True 25m

├─ClusterInfrastructure - Metal3Cluster/sample-cluster True 30m

├─ControlPlane - RKE2ControlPlane/sample-cluster True 25m

│ └─Machine/sample-cluster-chflc True 27m

└─Workers

└─MachineDeployment/sample-cluster True 22m

└─Machine/sample-cluster-56df5b4499-zfljj True 23m1.3.9 群集取消置备 #

可以通过删除上述创建步骤中应用的资源来取消置备下游群集:

% kubectl delete -f rke2-agent.yaml

% kubectl delete -f rke2-control-plane.yaml这会触发 BareMetalHost 资源的取消置备,此过程可能需要几分钟,之后,这些资源将再次处于可用状态:

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 deprovisioning sample-cluster-controlplane-vlrt6 false 10m

worker-0 deprovisioning sample-cluster-workers-785x5 false 10m

...

% kubectl get bmh

NAME STATE CONSUMER ONLINE ERROR AGE

controlplane-0 available false 15m

worker-0 available false 15m1.4 已知问题 #

目前不支持上游 IP 地址管理控制器,因为它与我们在 SLEMicro 中选择的网络配置工具和首次引导工具链尚不兼容。

此外,也不支持相关的 IPAM 资源和 Metal3DataTemplate networkData 字段。

目前仅支持通过 redfish-virtualmedia 进行部署。

1.5 计划的更改 #

通过 networkData 字段启用 IPAM 资源和配置支持

1.6 其他资源 #

SUSE Edge for Telco 文档(第 37 章 “SUSE Edge for Telco”)提供了 Metal3 在电信领域使用场景中更高级的用法示例。

1.6.1 单节点配置 #

对于管理群集仅包含单个节点的测试/PoC 环境,可能不需要通过 MetalLB 管理额外的浮动 IP。

在此模式下,管理群集 API 的端点是管理群集的 IP,因此在使用 DHCP 时应预留该 IP,或者配置静态 IP,以确保管理群集 IP 不会变化 -

在下面显示为 MANAGEMENT_CLUSTER_IP。

为了实现此方案,必须如下所示指定 Metal3 chart 值:

global:

ironicIP: <MANAGEMENT_CLUSTER_IP>

metal3-ironic:

service:

type: NodePort1.6.2 对虚拟媒体 ISO 挂接禁用 TLS #

某些服务器供应商在将虚拟媒体 ISO 映像挂接到 BMC 时会验证 SSL 连接,这可能会导致出现问题,因为针对 Metal3 部署生成的证书是自我签名证书。要解决此问题,可以使用如下所示的 Metal3 chart 值仅对虚拟媒体磁盘挂接禁用 TLS:

global:

enable_vmedia_tls: false另一种解决方法是使用 CA 证书配置 BMC - 在这种情况下,可以使用 kubectl 从群集读取证书:

kubectl get secret -n metal3-system ironic-vmedia-cert -o yaml然后可以在服务器 BMC 控制台上配置证书,不过,配置过程因供应商而异(并且不一定适用于所有供应商,如果不适用,可能需要指定

enable_vmedia_tls 标志)。

1.6.3 存储配置 #

在管理群集仅包含一个节点的测试/PoC 环境中,不需要持久性存储机制;但对于生产环境,建议在管理群集上安装 SUSE Storage (Longhorn),以便与 Metal3 相关的映像在 Pod 重启或重新调度时能够保持持久性。

为了实现此持久性存储机制,必须如下所示指定 Metal3 chart 值:

metal3-ironic:

persistence:

ironic:

size: "5Gi"SUSE Edge for Telco 管理群集文档(第 40 章 “设置管理群集”)提供了更多有关如何为管理群集配置持久性存储机制的信息。

2 使用 Elemental 进行远程主机接入 #

本章介绍 SUSE Edge 中的“自主回连网络置备”解决方案。我们将使用 Elemental 来协助完成节点接入。Elemental 是一个软件堆栈,可用于注册远程主机和通过 Kubernetes 实现集中式云原生操作系统全面管理。在 SUSE Edge 堆栈中,我们将使用 Elemental 的注册功能将远程主机接入 Rancher,以便将主机集成到集中式管理平台,然后从该平台部署和管理 Kubernetes 群集以及分层组件、应用程序及其生命周期,所有这些操作都在一个中心位置完成。

此方法在以下情况下可能很有用:您要控制的设备与管理群集不在同一网络中,或没有带外管理控制器接入功能可以进行更直接的控制;您要在边缘处引导许多不同的“未知”系统,并且需要安全地大规模接入和管理这些系统。这种情况在以下领域的使用场景中很常见:零售、工业物联网,或几乎无法通过设备要安装到的网络进行控制的其他领域。

2.1 总体体系结构 #

2.2 所需资源 #

下面说明了学习本快速入门所要满足的最低系统和环境要求:

在初始配置过程中会重写目标计算机上的现有数据,因此请务必备份挂接到目标部署节点的所有 USB 存储设备和磁盘上的所有数据。

本指南是使用托管上游群集的 Digital Ocean droplet 以及用作下游设备的 Intel NUC 制作的。为了构建安装媒体,我们使用了 SUSE Linux Enterprise Server。

2.3 构建引导群集 #

首先创建一个能够托管 Rancher 和 Elemental 的群集。必须可以从下游节点所连接到的网络路由此群集。

2.3.1 创建 Kubernetes 群集 #

如果您使用的是超大规模云(例如 Azure、AWS 或 Google Cloud),那么,设置群集的最简单方法是使用这些云的内置工具。为简洁起见,本指南不会详细介绍使用每种选项的操作过程。

如果您要安装到裸机或其他宿主服务,同时需要提供 Kubernetes 发行版本身,我们建议您使用 RKE2。

2.3.2 设置 DNS #

在继续之前,需要设置群集访问权限。与群集本身的设置一样,DNS 的配置方式因群集的托管位置而异。

如果您不想处理 DNS 记录的设置(例如,这只是一个临时使用的测试服务器),可以改用 sslip.io 之类的服务。通过此服务,可以使用

<address>.sslip.io 解析任何 IP 地址。

2.4 安装 Rancher #

要安装 Rancher,需要访问刚刚创建的群集的 Kubernetes API。具体方式因使用的 Kubernetes 发行版而异。

对于 RKE2,kubeconfig 文件会写入

/etc/rancher/rke2/rke2.yaml。将此文件作为

~/.kube/config 保存在本地系统上。可能需要编辑该文件,以包含正确的外部可路由 IP 地址或主机名。

使用 Rancher 文档中所述的命令轻松安装 Rancher:

安装 cert-manager:

helm repo add jetstack https://charts.jetstack.io

helm repo update

helm install cert-manager jetstack/cert-manager \

--namespace cert-manager \

--create-namespace \

--set crds.enabled=true然后安装 Rancher 本身:

helm repo add rancher-prime https://charts.rancher.com/server-charts/prime

helm repo update

helm install rancher rancher-prime/rancher \

--namespace cattle-system \

--create-namespace \

--set hostname=<DNS or sslip from above> \

--set replicas=1 \

--set bootstrapPassword=<PASSWORD_FOR_RANCHER_ADMIN> \

--version 2.11.2如果目标系统是生产系统,请使用 cert-manager 配置实际证书(例如 Let's Encrypt 提供的证书)。

浏览到您设置的主机名,然后使用您的 bootstrapPassword 登录到

Rancher。系统将指导您完成一个简短的设置过程。

2.5 安装 Elemental #

安装 Rancher 后,接下来可以安装 Elemental Operator 和所需的 CRD。Elemental 的 Helm chart 作为 OCI 制品发布,因此其安装过程比其他 chart 略简单一些。可以通过您用来安装 Rancher 的同一外壳安装 Helm chart,也可以在浏览器中通过 Rancher 的外壳安装。

helm install --create-namespace -n cattle-elemental-system \

elemental-operator-crds \

oci://registry.suse.com/rancher/elemental-operator-crds-chart \

--version 1.6.8

helm install -n cattle-elemental-system \

elemental-operator \

oci://registry.suse.com/rancher/elemental-operator-chart \

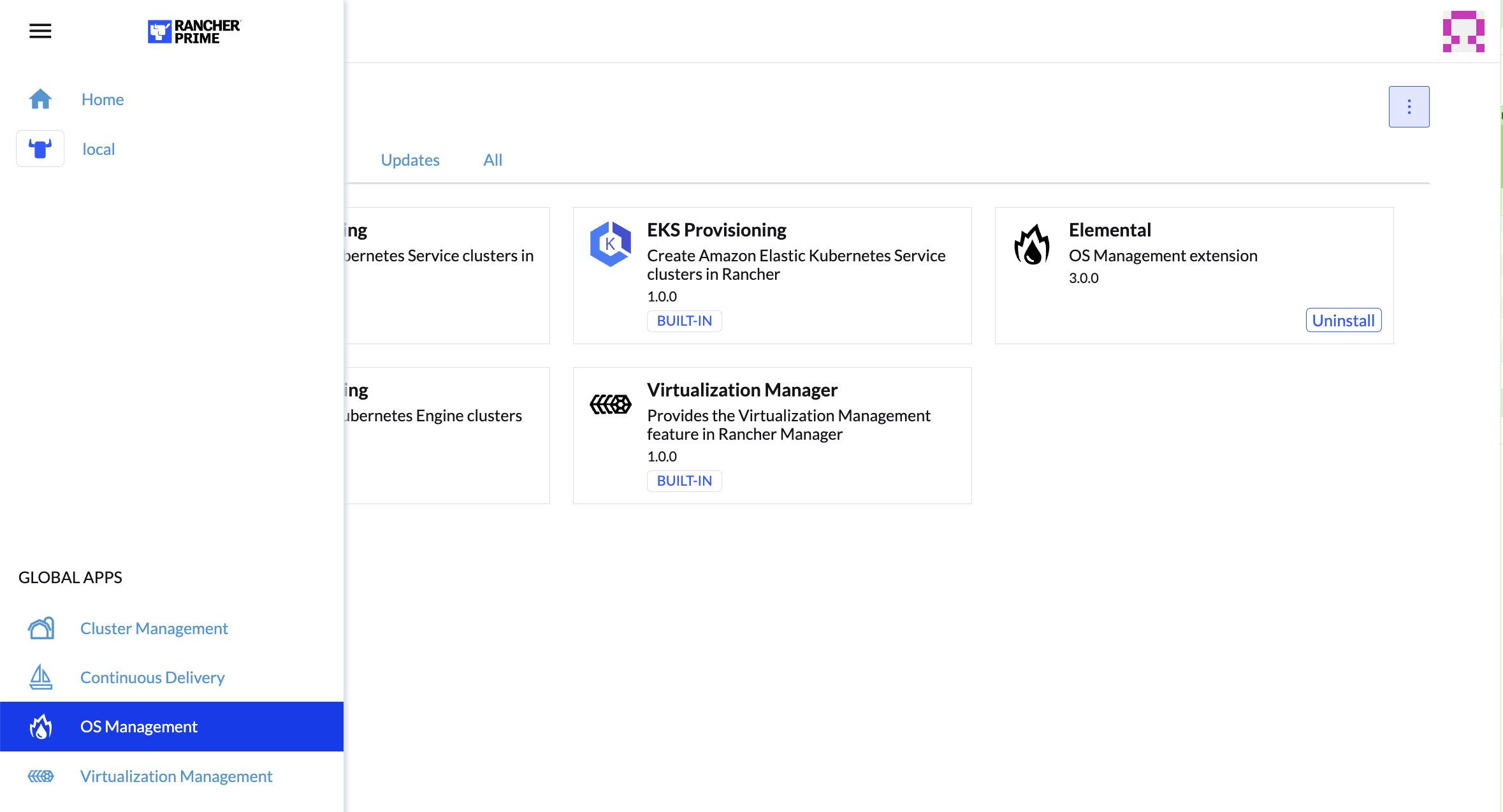

--version 1.6.82.5.1 (可选)安装 Elemental UI 扩展 #

2.6 配置 Elemental #

为方便起见,我们建议将变量 $ELEM 设置为配置目录所在的完整路径:

export ELEM=$HOME/elemental

mkdir -p $ELEM为了能够将计算机注册到 Elemental,我们需要在 fleet-default 名称空间中创建

MachineRegistration 对象。

我们来创建该对象的基本版本:

cat << EOF > $ELEM/registration.yaml

apiVersion: elemental.cattle.io/v1beta1

kind: MachineRegistration

metadata:

name: ele-quickstart-nodes

namespace: fleet-default

spec:

machineName: "\${System Information/Manufacturer}-\${System Information/UUID}"

machineInventoryLabels:

manufacturer: "\${System Information/Manufacturer}"

productName: "\${System Information/Product Name}"

EOF

kubectl apply -f $ELEM/registration.yamlcat 命令使用反斜杠 (\) 将每个

$ 符号转义,以免 Bash 将其模板化。如果手动复制命令,请去除反斜杠。

创建该对象后,找到并记下分配的端点:

REGISURL=$(kubectl get machineregistration ele-quickstart-nodes -n fleet-default -o jsonpath='{.status.registrationURL}')或者,可以在 UI 中执行此操作。

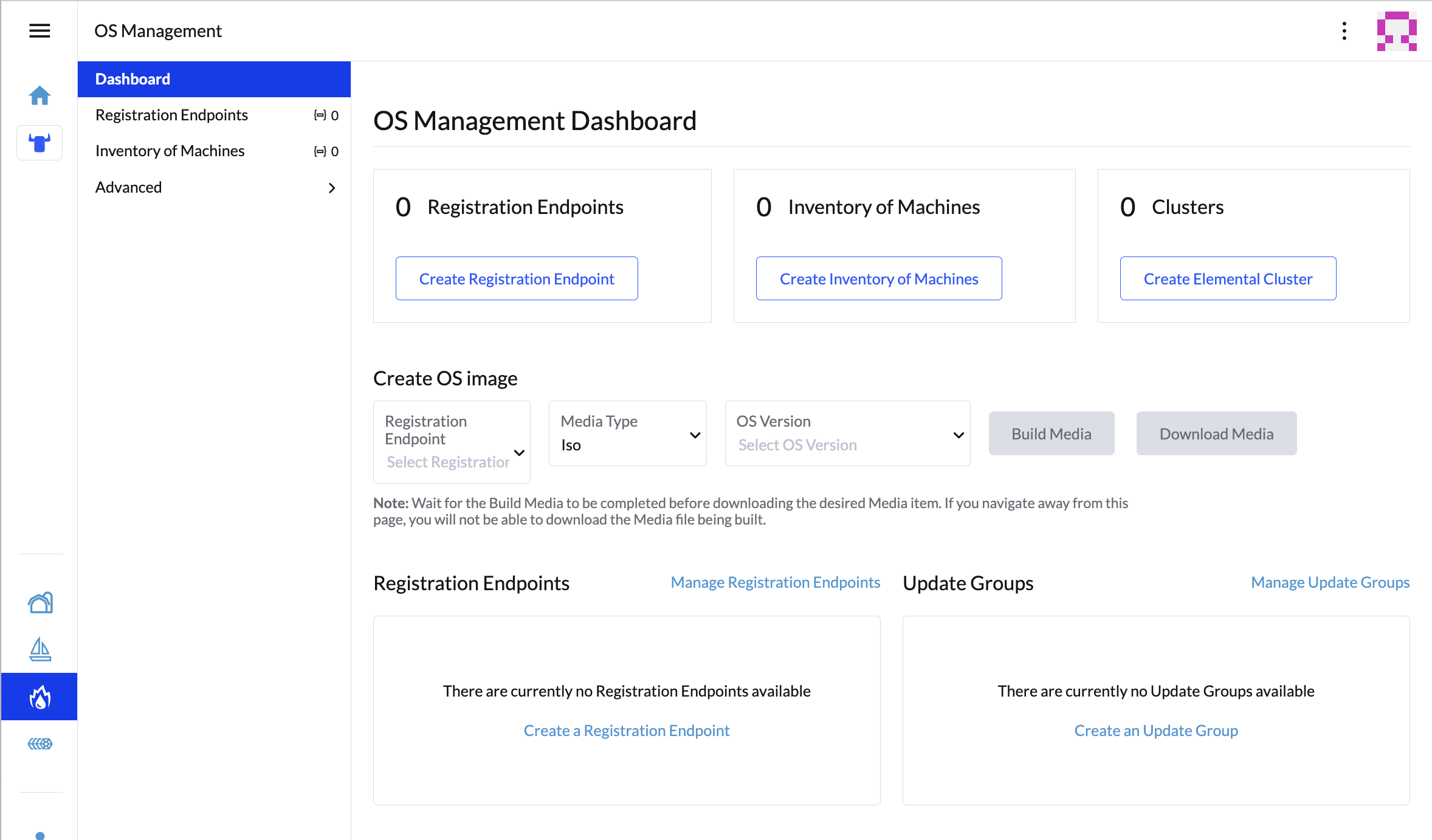

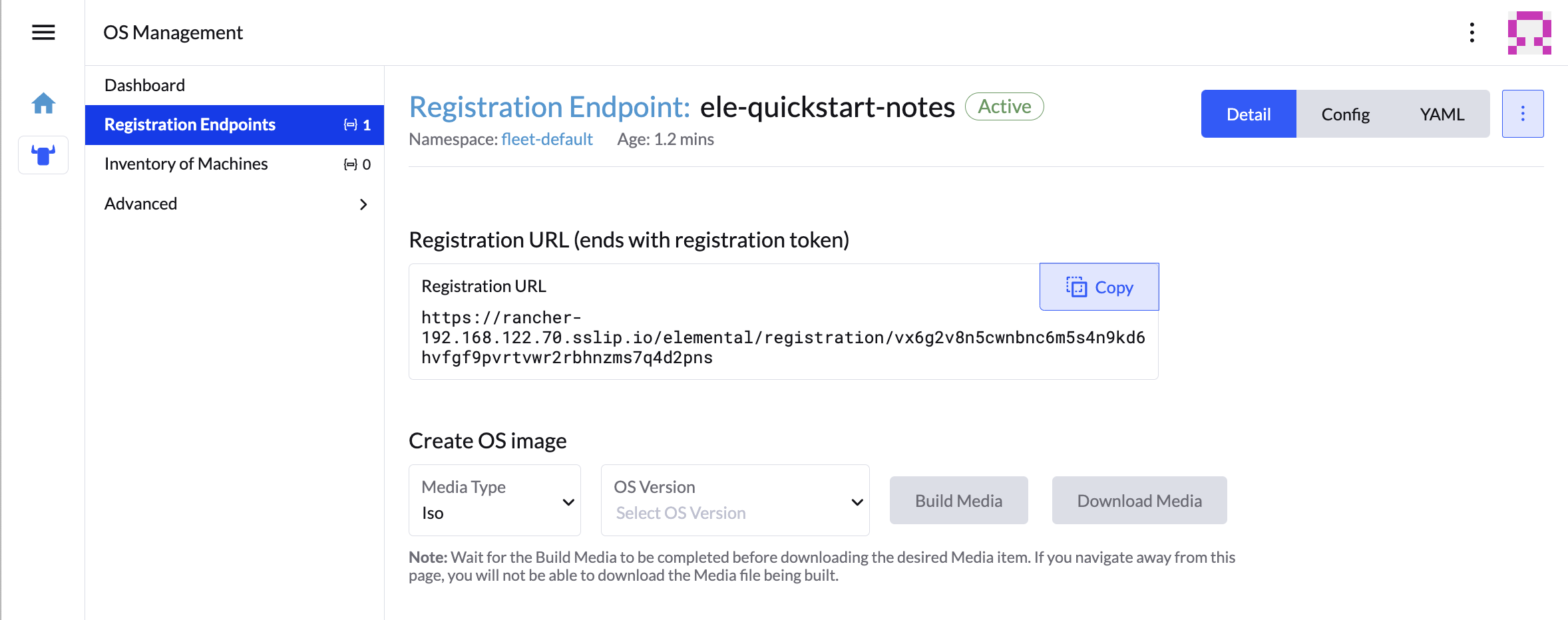

- UI 扩展

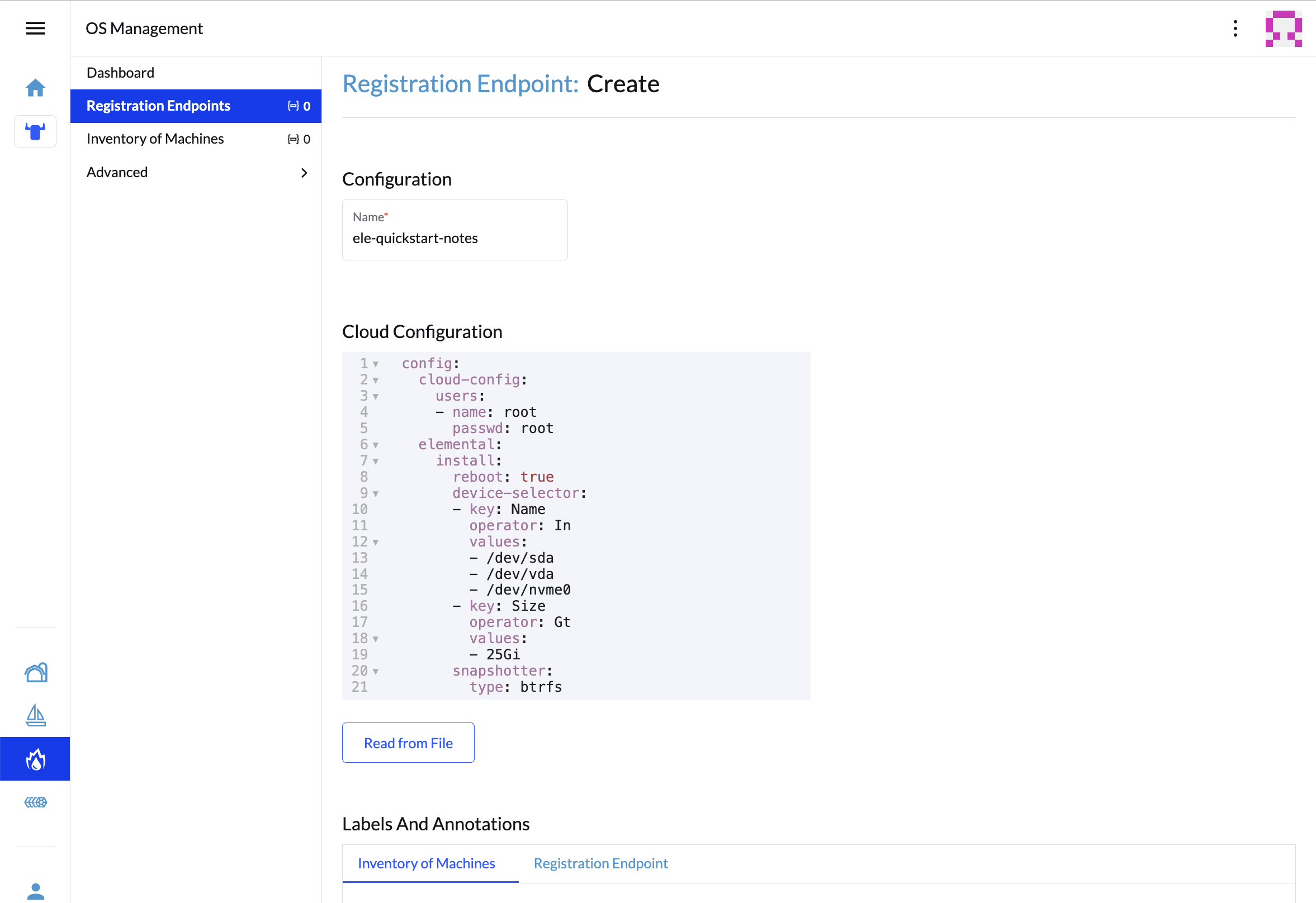

在“OS Management”(操作系统管理)扩展中,单击“Create Registration Endpoint”(创建注册端点):

为此配置命名。

注意您可以忽略“Cloud Configuration”(云配置)字段,因为此处的数据将被 Edge Image Builder 中的后续步骤覆盖。

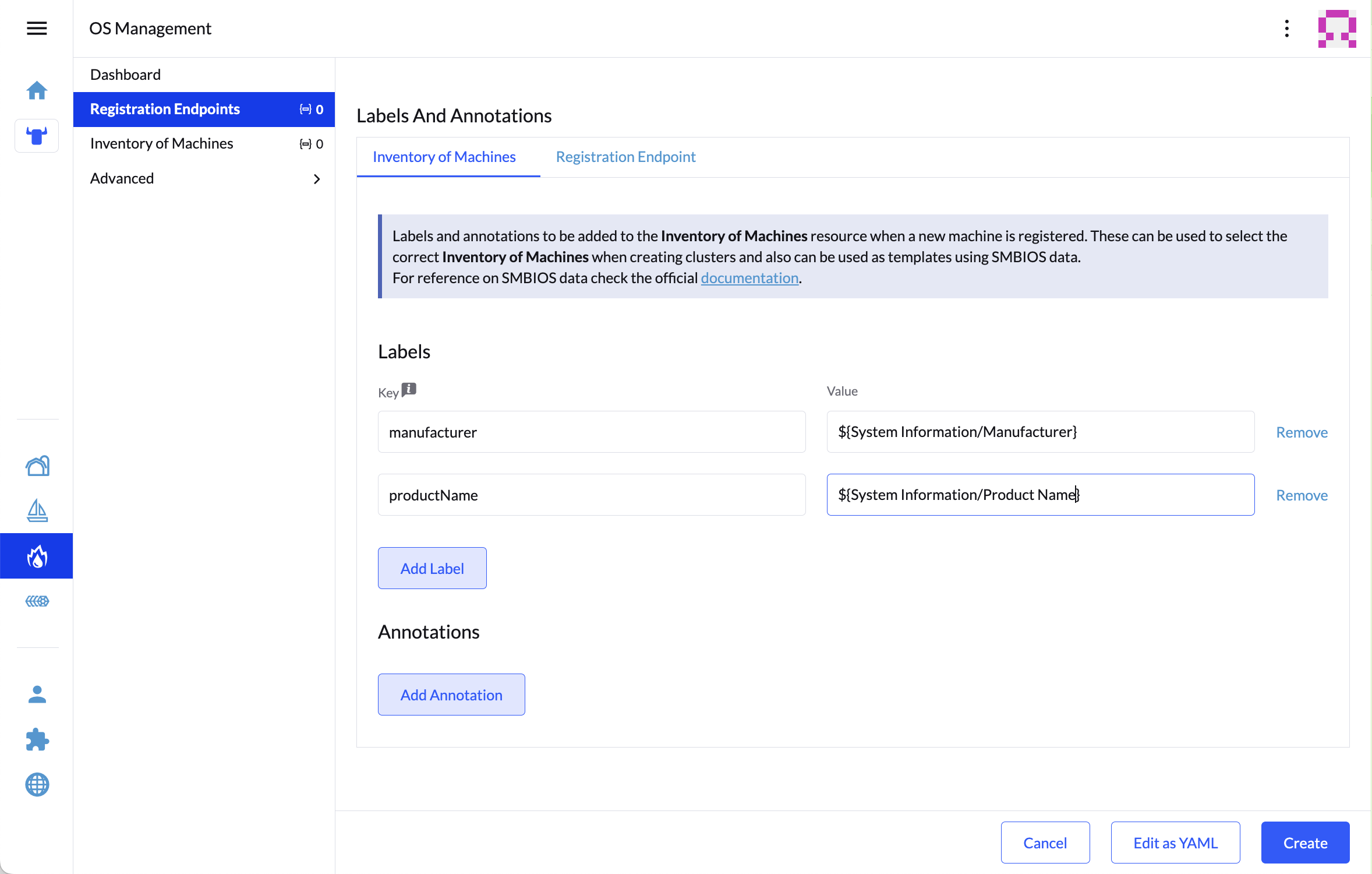

接下来,向下滚动并单击“Add Label”(添加标签),为注册计算机时创建的每个资源添加标签。标签可用于区分计算机。

单击“Create”(创建)以保存配置。

创建注册后,您应该就会看到列出的注册 URL,此时可以单击“Copy”(复制)来复制该网址:

提示如果您退出了该屏幕,可以单击左侧菜单中的“Registration Endpoints”(注册端点),然后单击刚刚创建的端点的名称。

此 URL 将在下一步骤中使用。

2.7 构建映像 #

虽然当前版本的 Elemental 提供了构建其自身安装媒体的方法,但在 SUSE Edge 3.3.1 中,我们改用 Kiwi 和 Edge Image Builder 来构建安装媒体,因此最终的系统将使用 SUSE Linux Micro 作为基础操作系统。

有关使用 Kiwi 的详细信息,请先按照 Kiwi 映像构建器流程(第 28 章 “使用 Kiwi 构建更新的 SUSE Linux Micro 映像”)构建全新映像;如要使用 Edge Image Builder,请参见 Edge Image Builder 入门指南(第 3 章 “使用 Edge Image Builder 配置独立群集”)和组件文档(第 11 章 “Edge Image Builder”)。

在安装了 Podman 的 Linux 系统中,创建相应目录并将 Kiwi 所构建的基础映像存放到其中:

mkdir -p $ELEM/eib_quickstart/base-images

cp /path/to/{micro-base-image-iso} $ELEM/eib_quickstart/base-images/

mkdir -p $ELEM/eib_quickstart/elementalcurl $REGISURL -o $ELEM/eib_quickstart/elemental/elemental_config.yamlcat << EOF > $ELEM/eib_quickstart/eib-config.yaml

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso

outputImageName: elemental-image.iso

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2

isoConfiguration:

installDevice: /dev/vda

users:

- username: root

encryptedPassword: \$6\$jHugJNNd3HElGsUZ\$eodjVe4te5ps44SVcWshdfWizrP.xAyd71CVEXazBJ/.v799/WRCBXxfYmunlBO2yp1hm/zb4r8EmnrrNCF.P/

packages:

sccRegistrationCode: XXX

EOF虽然

time部分是可选的,但强烈建议配置该部分,以免出现证书和时钟偏差方面的潜在问题。本示例中提供的值仅作说明之用,请根据您的具体要求相应调整。未编码的口令是

eib。要从官方来源下载和安装必要的 RPM,则需要配置

sccRegistrationCode(或者,也可以手动侧载elemental-register和elemental-system-agent)cat命令使用反斜杠 (\) 将每个$符号转义,以免 Bash 将其模板化。如果手动复制命令,请去除反斜杠。安装期间将会擦除安装设备。

podman run --privileged --rm -it -v $ELEM/eib_quickstart/:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file eib-config.yaml如果要引导物理设备,我们需要将映像刻录到 USB 闪存盘中。为此请使用以下命令:

sudo dd if=/eib_quickstart/elemental-image.iso of=/dev/<PATH_TO_DISK_DEVICE> status=progress2.8 引导下游节点 #

现在我们已创建安装媒体,接下来可以用它来引导下游节点。

对于您要使用 Elemental 控制的每个系统,请添加安装媒体并引导设备。安装后,系统会重引导并自行注册。

如果您正在使用 UI 扩展,则应会看到您的节点出现在“Inventory of Machines”(计算机清单)中。

在出现登录提示之前,请勿移除安装媒体;在首次引导期间,仍需访问 USB 记忆棒上的文件。

2.9 创建下游群集 #

使用 Elemental 置备新群集时,需要创建两个对象。

- Linux

- UI 扩展

第一个对象是

MachineInventorySelectorTemplate。此对象用于指定群集与清单中计算机之间的映射。

创建一个选择器,用于根据标签匹配清单中的任何计算机:

cat << EOF > $ELEM/selector.yaml apiVersion: elemental.cattle.io/v1beta1 kind: MachineInventorySelectorTemplate metadata: name: location-123-selector namespace: fleet-default spec: template: spec: selector: matchLabels: locationID: '123' EOF将资源应用于群集:

kubectl apply -f $ELEM/selector.yaml获取计算机名称并添加匹配标签:

MACHINENAME=$(kubectl get MachineInventory -n fleet-default | awk 'NR>1 {print $1}') kubectl label MachineInventory -n fleet-default \ $MACHINENAME locationID=123创建简单的单节点 K3s 群集资源,并将其应用于群集:

cat << EOF > $ELEM/cluster.yaml apiVersion: provisioning.cattle.io/v1 kind: Cluster metadata: name: location-123 namespace: fleet-default spec: kubernetesVersion: v1.32.4+k3s1 rkeConfig: machinePools: - name: pool1 quantity: 1 etcdRole: true controlPlaneRole: true workerRole: true machineConfigRef: kind: MachineInventorySelectorTemplate name: location-123-selector apiVersion: elemental.cattle.io/v1beta1 EOF kubectl apply -f $ELEM/cluster.yaml

创建这些对象后,您应会看到一个新的 Kubernetes 群集使用刚刚安装的新节点运行。

2.10 节点重置(可选) #

SUSE Rancher Elemental 支持执行“节点重置”,从 Rancher 中删除整个群集、从群集中删除单个节点或者从计算机清单中手动删除某个节点时,可以选择性地触发该操作。当您想要重置和清理任何孤立资源,并希望自动将清理的节点放回计算机清单以便重复使用时,此功能非常有用。默认未启用此功能,因此不会清理任何已去除的系统(即,不会去除数据,任何 Kubernetes 群集资源将继续在下游群集上运行),并且需要手动干预才能擦除数据,并通过 Elemental 将计算机重新注册到 Rancher。

如果您希望默认启用此功能,则需要通过添加 config.elemental.reset.enabled:

true,来确保 MachineRegistration 明确启用此功能,例如:

config:

elemental:

registration:

auth: tpm

reset:

enabled: true然后,所有使用此 MachineRegistration 注册的系统将自动在其配置中收到

elemental.cattle.io/resettable: 'true'

注解。如果您希望在各个节点上手动执行此操作(例如,您的现有 MachineInventory

没有此注解,或者您已部署节点),可以修改 MachineInventory 并添加

resettable 配置,例如:

apiVersion: elemental.cattle.io/v1beta1

kind: MachineInventory

metadata:

annotations:

elemental.cattle.io/os.unmanaged: 'true'

elemental.cattle.io/resettable: 'true'在 SUSE Edge 3.1 中,Elemental Operator 会在操作系统上设置一个标记,该标记将自动触发清理过程;它会停止所有

Kubernetes 服务、去除所有持久性数据、卸装所有 Kubernetes 服务、清理所有剩余 Kubernetes/Rancher

目录,并通过原始 Elemental MachineRegistration 配置强制重新注册到

Rancher。此过程会自动发生,无需任何手动干预。调用的脚本存放在

/opt/edge/elemental_node_cleanup.sh 中。一旦设置了标记,脚本便会通过

systemd.path 触发,因此会立即执行。

使用 resettable 功能的假设条件是,预期在从 Rancher

去除节点/群集时执行的行为是擦除数据并强制重新注册。在这种情况下,必然会丢失数据,因此,请仅在您确定要执行自动重置时才使用此功能。

2.11 后续步骤 #

下面是使用本指南后建议阅读的一些资源:

第 8 章 “Fleet”中的端到端自动化

第 12 章 “边缘网络”中的其他网络配置选项

3 使用 Edge Image Builder 配置独立群集 #

Edge Image Builder (EIB) 工具可以简化为引导计算机生成随时可引导 (CRB) 的自定义磁盘映像的过程,即使在完全隔离场景中也能做到这一点。EIB 用于创建所有三个 SUSE Edge 部署空间中使用的部署映像,因为它足够灵活,可以提供最简单的自定义过程,例如通过提供全面配置的映像来添加用户或设置时区。例如,该映像可以设置复杂的网络配置、部署多节点 Kubernetes 群集、部署客户工作负载,并通过 Rancher/Elemental 和 SUSE Multi-Linux Manager 注册到集中式管理平台。EIB 以容器映像的形式运行,因此具有极高的跨平台可移植性,可确保所有必需的依赖项都是独立的,对系统中所安装用于操作该工具的软件包的影响极小。

对于多节点场景,EIB 会自动部署 MetalLB 和 Endpoint Copier Operator,以便让使用构建的同一映像置备的主机自动加入 Kubernetes 群集。

有关详细信息,请阅读 Edge Image Builder 简介(第 11 章 “Edge Image Builder”)。

Edge Image Builder 1.2.1 支持自定义 SUSE Linux Micro 6.1 映像,但不支持 SUSE Linux Enterprise Micro 5.5 或 6.0 等旧版本。

3.1 先决条件 #

运行 SLES 15 SP6 的 AMD64/Intel 64 构建主机(物理机或虚拟机)。

Podman 容器引擎

通过 Kiwi 构建器过程(第 28 章 “使用 Kiwi 构建更新的 SUSE Linux Micro 映像”)创建的 SUSE Linux Micro 6.1 自安装 ISO 映像

对于非生产用途,可将 openSUSE Leap 15.6 或 openSUSE Tumbleweed 用作构建主机。其他操作系统也可能正常运行,前提是存在兼容的容器运行时。

3.1.1 获取 EIB 映像 #

EIB 容器映像已公开提供,可以通过在映像构建主机上运行以下命令从 SUSE Edge 注册表下载:

podman pull registry.suse.com/edge/3.3/edge-image-builder:1.2.13.2 创建映像配置目录 #

由于 EIB 在容器中运行,我们需要从主机挂载一个配置目录,以便能够指定所需的配置,并使 EIB 能够在构建过程中访问任何所需的输入文件和支持制品。此目录必须遵循特定的结构。我们在主目录中创建此目录,并将其命名为“eib”:

export CONFIG_DIR=$HOME/eib

mkdir -p $CONFIG_DIR/base-images在上一步骤中,我们创建了“base-images”目录,用于托管 SUSE Linux Micro 6.1 输入映像,现在我们确保将该映像复制到配置目录:

cp /path/to/SL-Micro.x86_64-6.1-Base-SelfInstall-GM.install.iso $CONFIG_DIR/base-images/slemicro.iso在 EIB 运行过程中,不会修改原始基础映像;在 EIB 配置目录的根目录中,会使用所需的配置创建新的自定义版本。

此时,配置目录应如下所示:

└── base-images/

└── slemicro.iso3.3 创建映像定义文件 #

定义文件描述 Edge Image Builder 支持的大多数可配置选项,可以在此处找到选项的完整示例。建议您查看上游构建映像指南,其中提供了比下文所述更详细的示例。首先,我们需要为操作系统映像创建一个非常简单的定义文件:

cat << EOF > $CONFIG_DIR/iso-definition.yaml

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

EOF此定义指定我们要为基于 AMD64/Intel 64 的系统生成输出映像。用作基础需要进一步修改的映像是名为

slemicro.iso 的 iso 映像,应该位于

$CONFIG_DIR/base-images/slemicro.iso。此定义还概述了在 EIB

修改完映像后,输出映像将命名为 eib-image.iso,默认情况下,该输出映像驻留在

$CONFIG_DIR 中。

现在,我们的目录结构应如下所示:

├── iso-definition.yaml

└── base-images/

└── slemicro.iso下面的章节将介绍几个常见操作的示例:

3.3.1 配置操作系统用户 #

EIB 允许您为用户预先配置登录信息(例如口令或 SSH 密钥),包括设置固定的 root 口令。在此示例中,我们将修复 root 口令,而第一步是使用

OpenSSL 创建一次性的已加密口令:

openssl passwd -6 SecurePassword此命令将输出如下所示的内容:

$6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1然后,我们可以在定义文件中添加一个名为 operatingSystem 的部分,其中包含

users 数组。最终的文件应如下所示:

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC13.3.2 配置操作系统时间 #

虽然 time 部分是可选的,但强烈建议配置该部分,以免出现证书和时钟偏差方面的潜在问题。EIB

将根据此处的参数配置 chronyd 和 /etc/localtime。

operatingSystem:

time:

timezone: Europe/London

ntp:

forceWait: true

pools:

- 2.suse.pool.ntp.org

servers:

- 10.0.0.1

- 10.0.0.2timezone以“区域/地点”格式指定时区(例如“欧洲/伦敦”)。在 Linux 系统上运行timedatectl list-timezones命令即可查看完整列表。ntp:定义与(使用 chronyd)配置 NTP 相关的属性:

forceWait:要求 chronyd 在启动其他服务前尝试同步时间源,超时时间为 180 秒。

pools:指定 chronyd 将用作数据源的池列表(使用

iburst缩短初始同步耗时)。servers:指定 chronyd 将用作数据源的服务器列表(使用

iburst缩短初始同步耗时)。

本示例中提供的值仅作说明之用,请根据您的具体要求相应调整。

3.3.3 添加证书 #

certificates

目录中存储的扩展名为“.pem”或“.crt”的证书文件将安装在节点系统范围的证书存储区内:

.

├── definition.yaml

└── certificates

├── my-ca.pem

└── my-ca.crt3.3.4 配置 RPM 软件包 #

EIB 的主要功能之一是提供相关机制来向映像添加更多软件包,以便在安装完成时,系统能够立即利用已安装的软件包。EIB 允许用户指定以下信息:

映像定义中按名称列出的软件包

要从中搜索这些软件包的网络储存库

SUSE Customer Center (SCC) 身份凭证,用于在官方 SUSE 储存库中搜索列出的软件包

通过

$CONFIG_DIR/rpms目录侧载网络储存库中不存在的自定义 RPM通过同一目录 (

$CONFIG_DIR/rpms/gpg-keys) 指定 GPG 密钥,以便可以验证第三方软件包

然后,EIB 将在映像构建时运行软件包解析过程,将基础映像用作输入,并尝试提取和安装所有提供的软件包(通过列表指定或在本地提供)。EIB 将所有软件包(包括所有依赖项)下载到输出映像中存在的储存库,并指示系统在首次引导过程中安装这些软件包。在映像构建期间执行此过程可确保在首次引导期间成功将软件包安装在所需平台(例如边缘节点)上。这对于需要将其他软件包嵌入映像,而非在运行时通过网络提取的环境(例如隔离环境或网络受限环境)而言,同样具有优势。

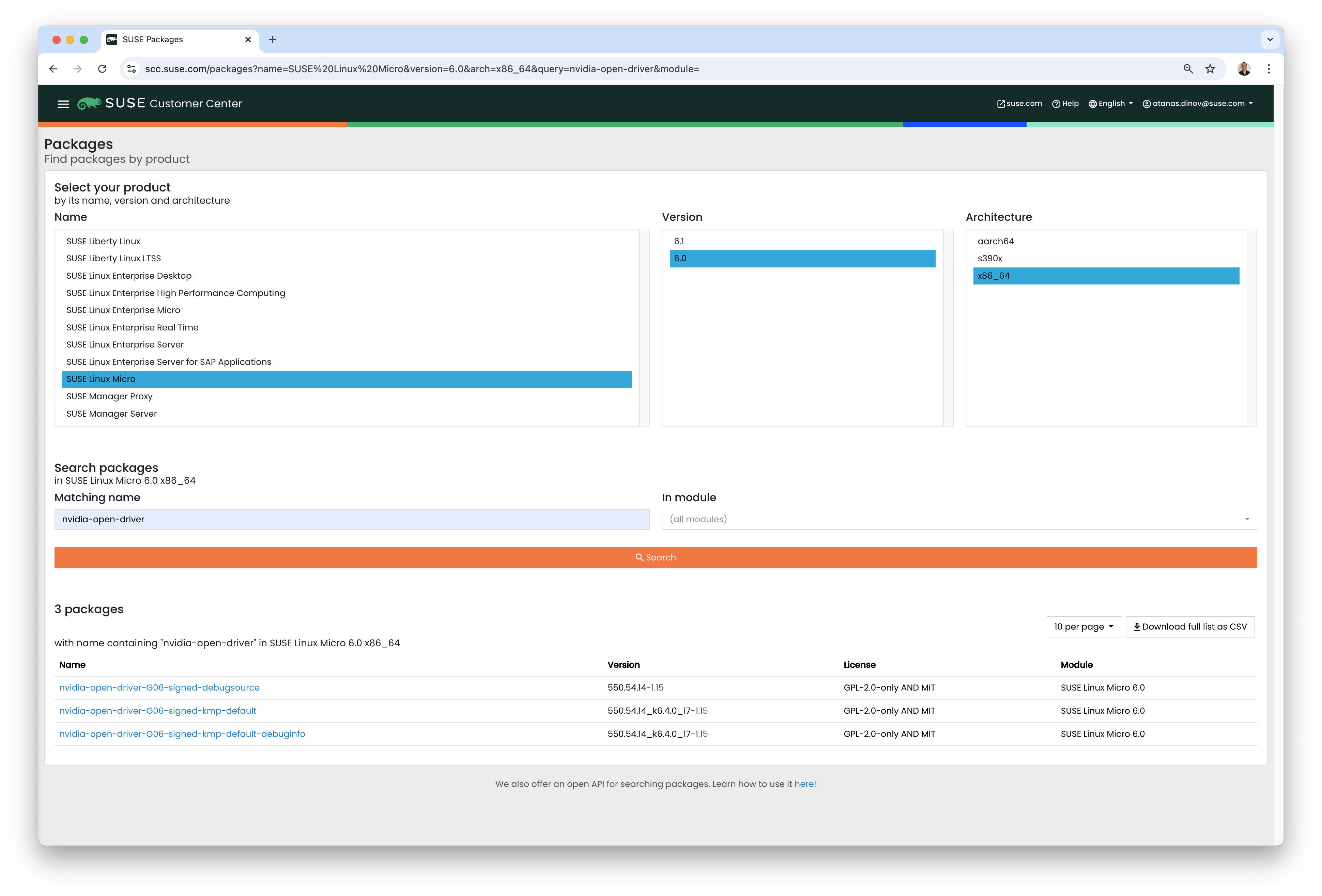

我们通过一个简单的示例来演示这一点:我们将安装由第三方供应商提供支持的 NVIDIA 储存库中的

nvidia-container-toolkit RPM 软件包:

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64最终的定义文件如下所示:

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64上面是一个简单的示例,但为了完整性,请在运行映像生成过程之前先下载 NVIDIA 软件包签名密钥:

$ mkdir -p $CONFIG_DIR/rpms/gpg-keys

$ curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey > $CONFIG_DIR/rpms/gpg-keys/nvidia.gpg通过此方法添加其他 RPM 的目的是添加受支持的第三方组件或用户提供(和维护)的软件包;请不要使用此机制来添加通常不受 SUSE Linux Micro 支持的软件包。如果使用此机制从 openSUSE 储存库(不受支持)添加组件,包括来自更新版本或服务包的组件,可能会导致配置不受支持 - 尤其是当依赖项解析导致操作系统核心部分被替换时,即便最终系统看似能正常运行,也可能存在问题。如有不确定之处,请联系 SUSE 代表,以协助确定您所需配置的可支持性。

3.3.5 配置 Kubernetes 群集和用户工作负载 #

EIB 的另一个特点是,可以使用它来自动部署可“就地引导”(即不需要任何形式的集中式管理基础架构来进行协调)的单节点和多节点高可用性 Kubernetes 群集。这种方式的主要应用场景是隔离式部署或网络受限环境,但即便在可完全无限制访问网络的情况下,它也可用于快速引导独立群集。

使用此方法不仅可以部署自定义操作系统,还可以指定 Kubernetes 配置、通过 Helm chart 指定任何其他分层组件,以及通过提供的 Kubernetes 清单指定任何用户工作负载。不过,使用此方法的设计原则是,默认假设用户希望实现隔离式部署,因此映像定义中指定的任何项目都将纳入映像中,其中包括用户提供的工作负载,在此过程中,EIB 会确保将定义文件所需的所有已识别镜像复制到本地,并由最终部署的系统中嵌入的映像注册表提供服务。

在下一个示例中,我们将采用现有的映像定义并指定 Kubernetes 配置(在本示例中,未列出系统及其角色,因此默认假设使用单节点群集),这会指示 EIB 置备单节点 RKE2 Kubernetes 群集。为了展示用户提供的工作负载(通过清单)和分层组件(通过 Helm)部署的自动化过程,我们将通过 SUSE Edge Helm chart 安装 KubeVirt,并通过 Kubernetes 清单安装 NGINX。需要追加到现有映像定义的附加配置如下:

kubernetes:

version: v1.32.4+rke2r1

manifests:

urls:

- https://k8s.io/examples/application/nginx-app.yaml

helm:

charts:

- name: kubevirt

version: 303.0.0+up0.5.0

repositoryName: suse-edge

repositories:

- name: suse-edge

url: oci://registry.suse.com/edge/charts最终的完整定义文件现在应如下所示:

apiVersion: 1.2

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

encryptedPassword: $6$G392FCbxVgnLaFw1$Ujt00mdpJ3tDHxEg1snBU3GjujQf6f8kvopu7jiCBIhRbRvMmKUqwcmXAKggaSSKeUUOEtCP3ZUoZQY7zTXnC1

packages:

packageList:

- nvidia-container-toolkit

additionalRepos:

- url: https://nvidia.github.io/libnvidia-container/stable/rpm/x86_64

kubernetes:

version: v1.32.4+k3s1

manifests:

urls:

- https://k8s.io/examples/application/nginx-app.yaml

helm:

charts:

- name: kubevirt

version: 303.0.0+up0.5.0

repositoryName: suse-edge

repositories:

- name: suse-edge

url: oci://registry.suse.com/edge/charts3.3.6 配置网络 #

在本快速入门的最后一个示例中,我们来配置在使用 EIB 生成的映像置备系统时启动的网络。请务必知道,除非提供网络配置,否则默认模式是在引导时对所有发现的接口使用 DHCP。但这并非在所有情况下都是理想配置,尤其是在 DHCP 不可用而需要提供静态配置时,或者需要设置更复杂的网络结构(例如绑定、LACP 和 VLAN)时,又或者需要覆盖某些参数(例如主机名、DNS 服务器和路由)时。

EIB 能够提供每个节点的配置(其中的相关系统由其 MAC 地址唯一标识),或者为每台计算机提供相同配置的覆盖值,这在系统 MAC

地址未知时更有用。EIB 使用一个称为 Network Manager Configurator(简称为

nmc)的附加工具,这是 SUSE Edge 团队构建的工具,用于基于 nmstate.io

声明式网络纲要应用自定义网络配置,在引导时识别其正在引导的节点,并在任何服务启动之前应用所需的网络配置。

我们现在通过在所需 network

目录中特定于节点的文件中(基于所需主机名)描述期望的网络状态,为使用单一接口的系统应用静态网络配置:

mkdir $CONFIG_DIR/network

cat << EOF > $CONFIG_DIR/network/host1.local.yaml

routes:

config:

- destination: 0.0.0.0/0

metric: 100

next-hop-address: 192.168.122.1

next-hop-interface: eth0

table-id: 254

- destination: 192.168.122.0/24

metric: 100

next-hop-address:

next-hop-interface: eth0

table-id: 254

dns-resolver:

config:

server:

- 192.168.122.1

- 8.8.8.8

interfaces:

- name: eth0

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E7

ipv4:

address:

- ip: 192.168.122.50

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

EOF上述示例是针对默认 192.168.122.0/24

子网设置的,假设测试在虚拟机上执行,请根据您的环境进行调整,不要忘记设置 MAC 地址。由于可以使用同一映像来置备多个节点,EIB(通过

nmc)配置的网络取决于它是否能够根据节点 MAC 地址唯一标识节点,因此在引导期间

nmc 将向每台计算机应用正确的网络配置。这意味着,您需要知道所要安装到的系统的 MAC

地址。或者,默认行为是依赖 DHCP,但您可以利用 configure-network.sh

钩子将通用配置应用于所有节点 - 有关详细信息,请参见网络指南(第 12 章 “边缘网络”)。

最终的文件结构应如下所示:

├── iso-definition.yaml

├── base-images/

│ └── slemicro.iso

└── network/

└── host1.local.yaml我们刚刚创建的网络配置将被分析,必要的 NetworkManager 连接文件将自动生成并插入到 EIB 要创建的新安装映像中。这些文件将在主机置备期间应用,从而生成完整的网络配置。

3.4 构建映像 #

获得基础映像和可供 EIB 使用的映像定义后,接下来我们需要构建映像。为此,只需使用 podman

结合“build”命令调用 EIB 容器,并指定定义文件:

podman run --rm -it --privileged -v $CONFIG_DIR:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file iso-definition.yaml该命令应输出如下所示的内容:

Setting up Podman API listener...

Downloading file: dl-manifest-1.yaml 100% (498/498 B, 9.5 MB/s)

Pulling selected Helm charts... 100% (1/1, 43 it/min)

Generating image customization components...

Identifier ................... [SUCCESS]

Custom Files ................. [SKIPPED]

Time ......................... [SKIPPED]

Network ...................... [SUCCESS]

Groups ....................... [SKIPPED]

Users ........................ [SUCCESS]

Proxy ........................ [SKIPPED]

Resolving package dependencies...

Rpm .......................... [SUCCESS]

Os Files ..................... [SKIPPED]

Systemd ...................... [SKIPPED]

Fips ......................... [SKIPPED]

Elemental .................... [SKIPPED]

Suma ......................... [SKIPPED]

Populating Embedded Artifact Registry... 100% (3/3, 10 it/min)

Embedded Artifact Registry ... [SUCCESS]

Keymap ....................... [SUCCESS]

Configuring Kubernetes component...

The Kubernetes CNI is not explicitly set, defaulting to 'cilium'.

Downloading file: rke2_installer.sh

Downloading file: rke2-images-core.linux-amd64.tar.zst 100% (657/657 MB, 48 MB/s)

Downloading file: rke2-images-cilium.linux-amd64.tar.zst 100% (368/368 MB, 48 MB/s)

Downloading file: rke2.linux-amd64.tar.gz 100% (35/35 MB, 50 MB/s)

Downloading file: sha256sum-amd64.txt 100% (4.3/4.3 kB, 6.2 MB/s)

Kubernetes ................... [SUCCESS]

Certificates ................. [SKIPPED]

Cleanup ...................... [SKIPPED]

Building ISO image...

Kernel Params ................ [SKIPPED]

Build complete, the image can be found at: eib-image.iso构建的 ISO 映像存储在 $CONFIG_DIR/eib-image.iso 中:

├── iso-definition.yaml

├── eib-image.iso

├── _build

│ └── cache/

│ └── ...

│ └── build-<timestamp>/

│ └── ...

├── base-images/

│ └── slemicro.iso

└── network/

└── host1.local.yaml每次构建时都会在 $CONFIG_DIR/_build/

中创建一个带时间戳的文件夹,其中包含构建日志、构建期间使用的制品以及 combustion 和

artefacts 目录,这两个目录包含添加到 CRB 映像的所有脚本和制品。

此目录的内容如下所示:

├── build-<timestamp>/

│ │── combustion/

│ │ ├── 05-configure-network.sh

│ │ ├── 10-rpm-install.sh

│ │ ├── 12-keymap-setup.sh

│ │ ├── 13b-add-users.sh

│ │ ├── 20-k8s-install.sh

│ │ ├── 26-embedded-registry.sh

│ │ ├── 48-message.sh

│ │ ├── network/

│ │ │ ├── host1.local/

│ │ │ │ └── eth0.nmconnection

│ │ │ └── host_config.yaml

│ │ ├── nmc

│ │ └── script

│ │── artefacts/

│ │ │── registry/

│ │ │ ├── hauler

│ │ │ ├── nginx:<version>-registry.tar.zst

│ │ │ ├── rancher_kubectl:<version>-registry.tar.zst

│ │ │ └── registry.suse.com_suse_sles_15.6_virt-operator:<version>-registry.tar.zst

│ │ │── rpms/

│ │ │ └── rpm-repo

│ │ │ ├── addrepo0

│ │ │ │ ├── nvidia-container-toolkit-<version>.rpm

│ │ │ │ ├── nvidia-container-toolkit-base-<version>.rpm

│ │ │ │ ├── libnvidia-container1-<version>.rpm

│ │ │ │ └── libnvidia-container-tools-<version>.rpm

│ │ │ ├── repodata

│ │ │ │ ├── ...

│ │ │ └── zypper-success

│ │ └── kubernetes/

│ │ ├── rke2_installer.sh

│ │ ├── registries.yaml

│ │ ├── server.yaml

│ │ ├── images/

│ │ │ ├── rke2-images-cilium.linux-amd64.tar.zst

│ │ │ └── rke2-images-core.linux-amd64.tar.zst

│ │ ├── install/

│ │ │ ├── rke2.linux-amd64.tar.gz

│ │ │ └── sha256sum-amd64.txt

│ │ └── manifests/

│ │ ├── dl-manifest-1.yaml

│ │ └── kubevirt.yaml

│ ├── createrepo.log

│ ├── eib-build.log

│ ├── embedded-registry.log

│ ├── helm

│ │ └── kubevirt

│ │ └── kubevirt-0.4.0.tgz

│ ├── helm-pull.log

│ ├── helm-template.log

│ ├── iso-build.log

│ ├── iso-build.sh

│ ├── iso-extract

│ │ └── ...

│ ├── iso-extract.log

│ ├── iso-extract.sh

│ ├── modify-raw-image.sh

│ ├── network-config.log

│ ├── podman-image-build.log

│ ├── podman-system-service.log

│ ├── prepare-resolver-base-tarball-image.log

│ ├── prepare-resolver-base-tarball-image.sh

│ ├── raw-build.log

│ ├── raw-extract

│ │ └── ...

│ └── resolver-image-build

│ └──...

└── cache

└── ...如果构建失败,会先在 eib-build.log 中记录相关信息。该日志会指出哪个组件构建失败,方便您进行调试。

此时,您应该有了一个随时可用的映像,它可以:

部署 SUSE Linux Micro 6.1

配置 root 口令

安装

nvidia-container-toolkit软件包配置嵌入的容器注册表以在本地处理内容

安装单节点 RKE2

配置静态网络

安装 KubeVirt

部署用户提供的清单

3.5 调试映像构建过程 #

如果映像构建过程失败,请参见上游调试指南。

3.6 测试新构建的映像 #

有关如何测试新构建的 CRB 映像的说明,请参见上游映像测试指南。

4 SUSE Multi-Linux Manager #

SUSE Edge 中包含 SUSE Multi-Linux Manager,其作用是提供自动化与控制能力,确保边缘部署的所有节点上作为底层操作系统的 SUSE Linux Micro 始终保持最新状态。

本快速入门指南旨在帮助您尽快熟悉 SUSE Multi-Linux Manager,目标是为您的边缘节点提供操作系统更新。本快速入门指南不会涉及诸如调整存储容量、创建和管理用于过渡的额外软件通道,或是针对大规模部署场景管理用户、系统组及组织等主题。对于生产用途,我们强烈建议您熟悉内容全面的 SUSE Multi-Linux Manager 文档。

要使 SUSE Edge 能够有效使用 SUSE Multi-Linux Manager,需执行以下步骤:

部署并配置 SUSE Multi-Linux Manager 服务器。

同步 SUSE Linux Micro 软件包储存库。

创建系统组。

创建激活密钥。

使用 Edge Image Builder 准备用于 SUSE Multi-Linux Manager 注册的安装媒体。

4.1 部署 SUSE Multi-Linux Manager 服务器 #

如果您的实例已在运行最新版 SUSE Multi-Linux Manager 5.0,则可以跳过此步骤。

您可以在专用物理服务器、自有硬件上的虚拟机或云中运行 SUSE Multi-Linux Manager 服务器。针对受支持的公有云,我们提供了预配置的 SUSE Multi-Linux 服务器虚拟机映像。

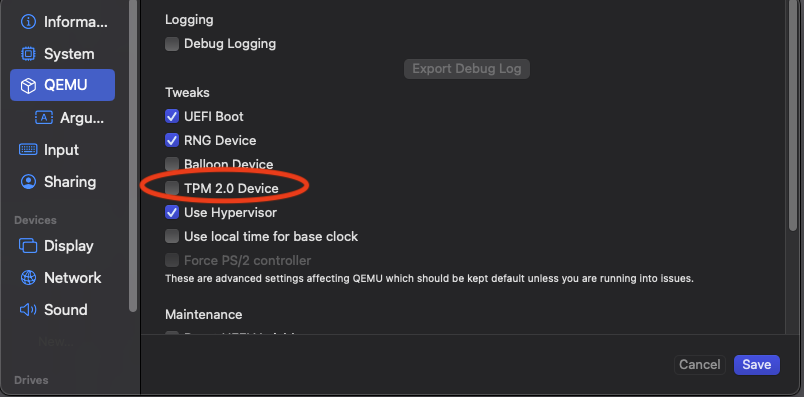

在本快速入门中,我们使用的是适用于 AMD64/Intel 64 的“qcow2”映像

SUSE-Manager-Server.x86_64-5.0.2-Qcow-2024.12.qcow2,您可以在

https://www.suse.com/download/suse-manager/

或 SUSE Customer Center 中找到该映像。此映像可在 KVM

等超级管理程序上作为虚拟机运行。请务必检查我们是否提供了该映像的最新版本,并在执行全新安装时使用最新版本。

您也可以在其他任何受支持的硬件体系结构上安装 SUSE Multi-Linux Manager 服务器。在这种情况下,请选择与您的硬件体系结构相匹配的映像。

下载映像后,请创建一台至少满足以下最低硬件规格的虚拟机:

16 GB RAM

4 个物理或虚拟核心

一个至少 100 GB 的额外块设备

使用 qcow2 映像时,无需安装操作系统。您可以直接将该映像挂接为根分区。

您需要设置网络,以便您的边缘节点日后能够通过包含完全限定域名(简称“FQDN”)的主机名访问 SUSE Multi-Linux Manager 服务器!

首次引导 SUSE Multi-Linux Manager 时,需要执行一些初始配置:

选择键盘布局

接受许可协议

选择您所在的时区

输入操作系统的 root 口令

后续步骤需要以“root”用户身份执行:

下一步需要用到两个注册代码,可在 SUSE Customer Center 中找到相应注册代码:

SLE Micro 5.5 的注册代码

SUSE Multi-Linux Manager 扩展的注册代码

注册 SUSE Linux Micro:

transactional-update register -r <REGCODE> -e <your_email>注册 SUSE Multi-Linux Manager:

transactional-update register -p SUSE-Manager-Server/5.0/x86_64 -r <REGCODE>产品字符串取决于您的硬件体系结构!例如,如果您在 64 位 Arm 系统上使用 SUSE Multi-Linux Manager,则该字符串为“SUSE-Manager-Server/5.0/aarch64”。

重引导

更新系统:

transactional-update除非未发生任何更改,否则请重引导系统以应用更新。

SUSE Multi-Linux Manager 通过由 Podman 管理的容器提供。mgradm

命令会为您处理设置和配置工作。

请务必为您的 SUSE Multi-Linux Manager 服务器配置包含完全限定域名(简称“FQDN”)的主机名,并确保您要管理的边缘节点能够在网络中正确解析该主机名!

在安装和配置 SUSE Multi-Linux Manager

服务器容器之前,您需要准备好之前添加的额外块设备。为此,您需要知道虚拟机为该设备分配的名称。例如,如果块设备为

/dev/vdb,则可使用以下命令将其配置为供 SUSE Multi-Linux Manager 使用:

mgr-storage-server /dev/vdb部署 SUSE Multi-Linux Manager:

mgradm install podman <FQDN>提供 CA 证书的口令。该口令应与您的登录口令不同。通常情况下,您之后无需输入此口令,但应将其记录下来。

提供“admin”用户的口令。这是登录 SUSE Multi-Linux Manager 的初始用户。您之后可以创建具有完整权限或受限权限的其他用户。

4.2 配置 SUSE Multi-Linux Manager #

部署完成后,您可以使用之前提供的主机名登录 SUSE Multi-Linux Manager Web 用户界面。初始用户为“admin”,请使用上一步设置的口令登录。

下一步需要您的组织身份凭证,这些凭证可在 SUSE Customer Center 中您所在组织的“用户”选项卡的第二个子选项卡中找到。通过这些身份凭证,SUSE Multi-Linux Manager 能够同步您已订阅的所有产品。

选择 › 。

在组织身份凭证选项卡中,使用您在 SUSE Customer Center

中找到的用户名和口令创建新身份凭证。

前往下一个选项卡 SUSE 产品。您需要等待与 SUSE Customer Center 的首次数据同步完成。

列表加载完毕后,使用过滤器仅显示“Micro 6”。选中与边缘节点运行的硬件体系结构(x86_64 或

aarch64)对应的 SUSE Linux Micro 6.1 复选框。

单击添加产品。此操作将会添加 SUSE Linux Micro 的主软件包储存库(即“通道”),并会自动添加

SUSE Manager 客户端工具的通道作为子通道。

首次同步可能需要一段时间才能完成,具体时长取决于您的互联网连接情况。您可以在此期间开始执行后续步骤:

在“系统”>“系统组”下,至少创建一个组,以便系统在初始配置时自动加入该组。组是对系统进行分类的重要方式,通过组可以一次性对整组系统应用配置或操作。其概念类似于

Kubernetes 中的标签。

单击 + 创建组

提供一个简短名称(例如“边缘节点”)和详细说明。

在“系统”>“激活密钥”下,至少创建一个激活密钥。激活密钥可视为一种配置文件,为系统进行 SUSE

Multi-Linux Manager

初始配置时会自动应用该配置。如果您希望特定边缘节点加入不同的组或使用不同的配置,可以为它们创建单独的激活密钥,之后在 Edge Image

Builder 中使用这些密钥来创建自定义安装媒体。

激活密钥的一个典型高级使用场景是:将测试群集分配到包含最新更新的软件通道,而生产群集则分配到仅会获取已在测试群集中验证过的那些最新更新的软件通道。

单击 + 创建密钥

输入简短说明(例如“边缘节点”),并提供一个唯一名称来标识该密钥(例如,对于硬件体系结构为 AMD64/Intel 64 的边缘节点,可命名为“edge-x86_64”)。密钥前面会自动添加一个数字,默认组织的前缀始终为“1”;如果在 SUSE Multi-Linux Manager 中创建其他组织并为其创建密钥,前缀数字可能会不同。

如果尚未创建任何克隆的软件通道,可将“基础通道”的设置保留为“SUSE Manager Default”,这会自动为边缘节点分配正确的 SUSE 更新储存库。

在“子通道”中,针对激活密钥适用的硬件体系结构,选择“包括建议项”滑块,这会添加“SUSE-Manager-Tools-For-SL-Micro-6.1”通道。

在“组”选项卡中,添加之前创建的组。所有使用该激活密钥进行初始配置的节点都将自动添加到该组中。

4.3 使用 Edge Image Builder 创建自定义安装映像 #

要使用 Edge Image Builder,您只需要拥有一个可通过 Podman 启动基于 Linux 的容器的环境。

在极简实验设置中,我们实际上可以使用运行 SUSE Multi-Linux Manager 服务器的同一台虚拟机。请确保该虚拟机有充足的磁盘空间!但不建议在生产环境中采用这种设置。有关我们已测试过与 Edge Image Builder 兼容的主机操作系统,请参见第 3.1 节 “先决条件”。

以 root 身份登录 SUSE Multi-Linux Manager 服务器主机。

提取 Edge Image Builder 容器:

podman pull registry.suse.com/edge/3.3/edge-image-builder:1.2.1创建目录 /opt/eib 及其子目录 base-images:

mkdir -p /opt/eib/base-images在本快速入门中,我们使用的是 SUSE Linux Micro 映像的“自安装”版本。该映像之后可写入物理 USB 闪存盘,用于在物理服务器上安装系统。如果服务器支持通过 BMC(基板管理控制器)远程挂接安装 ISO,也可采用这种方式。此外,该映像还可与大多数虚拟化工具结合使用。

如果需要将映像直接预加载到物理节点,或直接从虚拟机 (VM) 启动,也可使用“原始”版本的映像。

您可以在 SUSE Customer Center 或 https://www.suse.com/download/sle-micro/ 上找到这些映像。

将映像

SL-Micro.x86_64-6.1-Default-SelfInstall-GM.install.iso

下载或复制到 base-images 目录,并将其命名为“slemicro.iso”。

在基于 Arm 的构建主机上构建 AArch64 映像属于 SUSE Edge 3.3.1 的技术预览功能。该功能很可能可以正常运行,但目前尚未提供支持。如果您想尝试该功能,则需要在 64 位 Arm 计算机上运行 Podman,并且需要将所有示例和代码段中的“x86_64”替换为“aarch64”。

在 /opt/eib 中,创建一个名为

iso-definition.yaml 的文件。这是用于 Edge Image Builder 的构建定义文件。

下面的简单示例将会安装 SL Micro 6.1、设置 root 口令和键盘映射、启动 Cockpit 图形界面,并将节点注册到 SUSE Multi-Linux Manager:

apiVersion: 1.0

image:

imageType: iso

arch: x86_64

baseImage: slemicro.iso

outputImageName: eib-image.iso

operatingSystem:

users:

- username: root

createHomeDir: true

encryptedPassword: $6$aaBTHyqDRUMY1HAp$pmBY7.qLtoVlCGj32XR/Ogei4cngc3f4OX7fwBD/gw7HWyuNBOKYbBWnJ4pvrYwH2WUtJLKMbinVtBhMDHQIY0

keymap: de

systemd:

enable:

- cockpit.socket

packages:

noGPGCheck: true

suma:

host: ${fully qualified hostname of your SUSE Multi-Linux Manager Server}

activationKey: 1-edge-x86_64Edge Image Builder 还可以配置网络、在节点上自动安装 Kubernetes,甚至通过 Helm chart 部署应用程序。如需更详尽的示例,请参见第 3 章 “使用 Edge Image Builder 配置独立群集”。

对于 baseImage,请指定要使用的 base-images 目录中

ISO 的实际名称。

在此示例中,root 口令为“root”。请参见第 3.3.1 节 “配置操作系统用户”了解如何为要使用的安全口令创建口令哈希。

将键盘映射设置为安装系统后所需的实际键盘布局。

如前文所述, SUSE Multi-Linux Manager 主机需要一个完全限定的主机名,且在边缘节点引导至的网络中能够解析该主机名。

activationKey 的值应与您在 SUSE Multi-Linux Manager 中创建的密钥一致。

要构建在安装后能自动将边缘节点注册到 SUSE Multi-Linux Manager 的安装映像,您还需要准备两个制品:

用于安装 SUSE Multi-Linux Manager 管理代理的 Salt 受控端软件包

SUSE Multi-Linux Manager 服务器的 CA 证书

4.3.1 下载 venv-salt-minion 软件包 #

在 /opt/eib 中创建子目录 rpms。

从 SUSE Multi-Linux Manager 服务器将 venv-salt-minion

软件包下载到该目录。可以通过 Web UI 获取(在“软件”>“通道列表”中找到该软件包,并从

SUSE-Manager-Tools … 通道下载),或者使用 curl 等工具从 SUSE Multi-Linux Manager

的“引导储存库”下载:

curl -O http://${HOSTNAME_OF_SUSE_MANAGER}/pub/repositories/slmicro/6/1/bootstrap/x86_64/venv-salt-minion-3006.0-3.1.x86_64.rpm如果已有更新的版本发布,实际软件包名称可能会有所不同。如果有多个软件包可供选择,请始终选择最新版本。

4.4 下载 SUSE Multi-Linux Manager CA 证书 #

在 /opt/eib 中创建子目录 certificates

从 SUSE Multi-Linux Manager 将 CA 证书下载到该目录:

curl -O http://${HOSTNAME_OF_SUSE_MANAGER}/pub/RHN-ORG-TRUSTED-SSL-CERT必须将证书重命名为 RHN-ORG-TRUSTED-SSL-CERT.crt。这样,Edge Image

Builder 将在安装过程中确保在边缘节点上安装并激活该证书。

现在,您可以运行 Edge Image Builder:

cd /opt/eib

podman run --rm -it --privileged -v /opt/eib:/eib \

registry.suse.com/edge/3.3/edge-image-builder:1.2.1 \

build --definition-file iso-definition.yaml如果您为 YAML 定义文件使用了不同的名称,或者想使用其他版本的 Edge Image Builder,则需要相应地调整命令。

构建完成后,您可在 /opt/eib 目录中找到名为

eib-image.iso 的安装 ISO。

第 II 部分 组件 #

Edge 的组件列表

- 5 Rancher

请参见 https://ranchermanager.docs.rancher.com/v2.11 上的 Rancher 文档。

- 6 Rancher 仪表板扩展

用户、开发人员、合作伙伴及客户可以使用扩展来扩展和增强 Rancher UI。SUSE Edge 提供 KubeVirt 和 Akri 仪表板扩展。

- 7 Rancher Turtles

请参见 Rancher Turtles 文档,网址为:https://documentation.suse.com/cloudnative/cluster-api/

- 8 Fleet

Fleet 是一个容器管理和部署引擎,旨在让用户更好地控制本地群集,并通过 GitOps 进行持续监控。Fleet 不仅注重缩放能力,而且还为用户提供很高的控制度和可见性,以准确监控群集上安装的组件。

- 9 SUSE Linux Micro

- 10 Metal3

Metal3 是一个 CNCF 项目,它为 Kubernetes 提供裸机基础架构管理功能。

- 11 Edge Image Builder

请参见官方储存库。

- 12 边缘网络

本章介绍 SUSE Edge 解决方案中的网络配置方法。我们将展示如何以声明方式在 SUSE Linux Micro 上配置 NetworkManager,并说明如何集成相关的工具。

- 13 Elemental

Elemental 是一个软件堆栈,可用于通过 Kubernetes 实现集中式云原生操作系统全面管理。Elemental 堆栈由驻留在 Rancher 本身或边缘节点上的许多组件构成。核心组件包括:

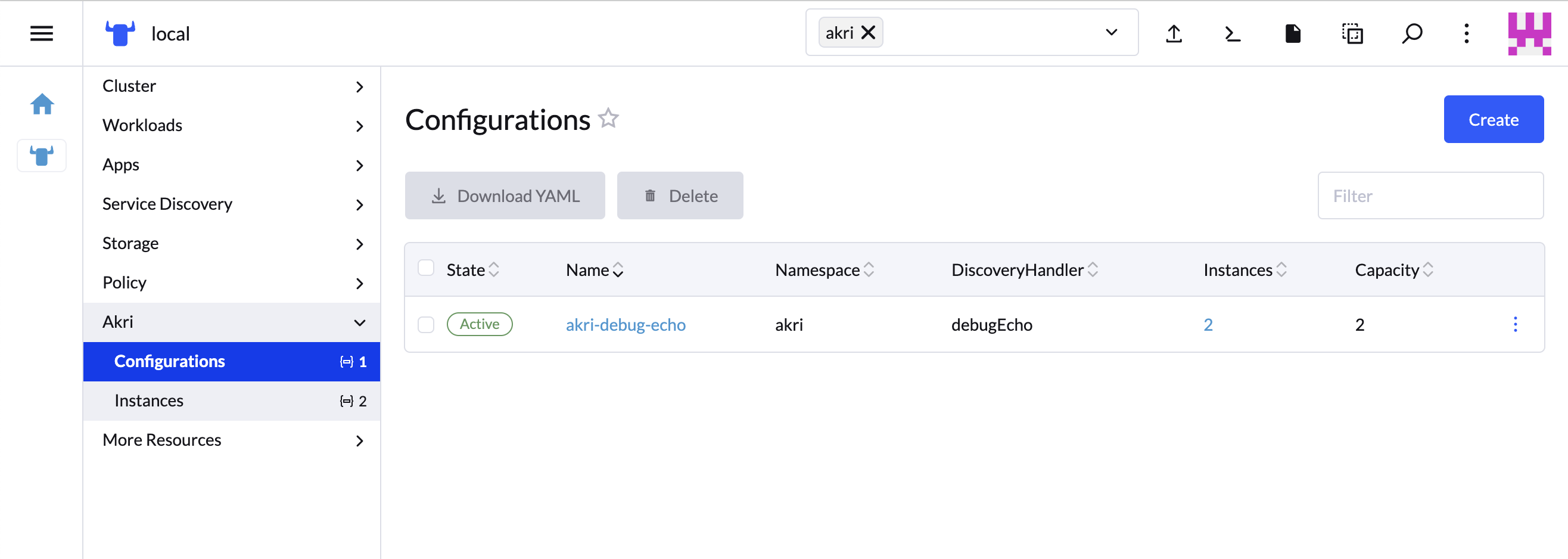

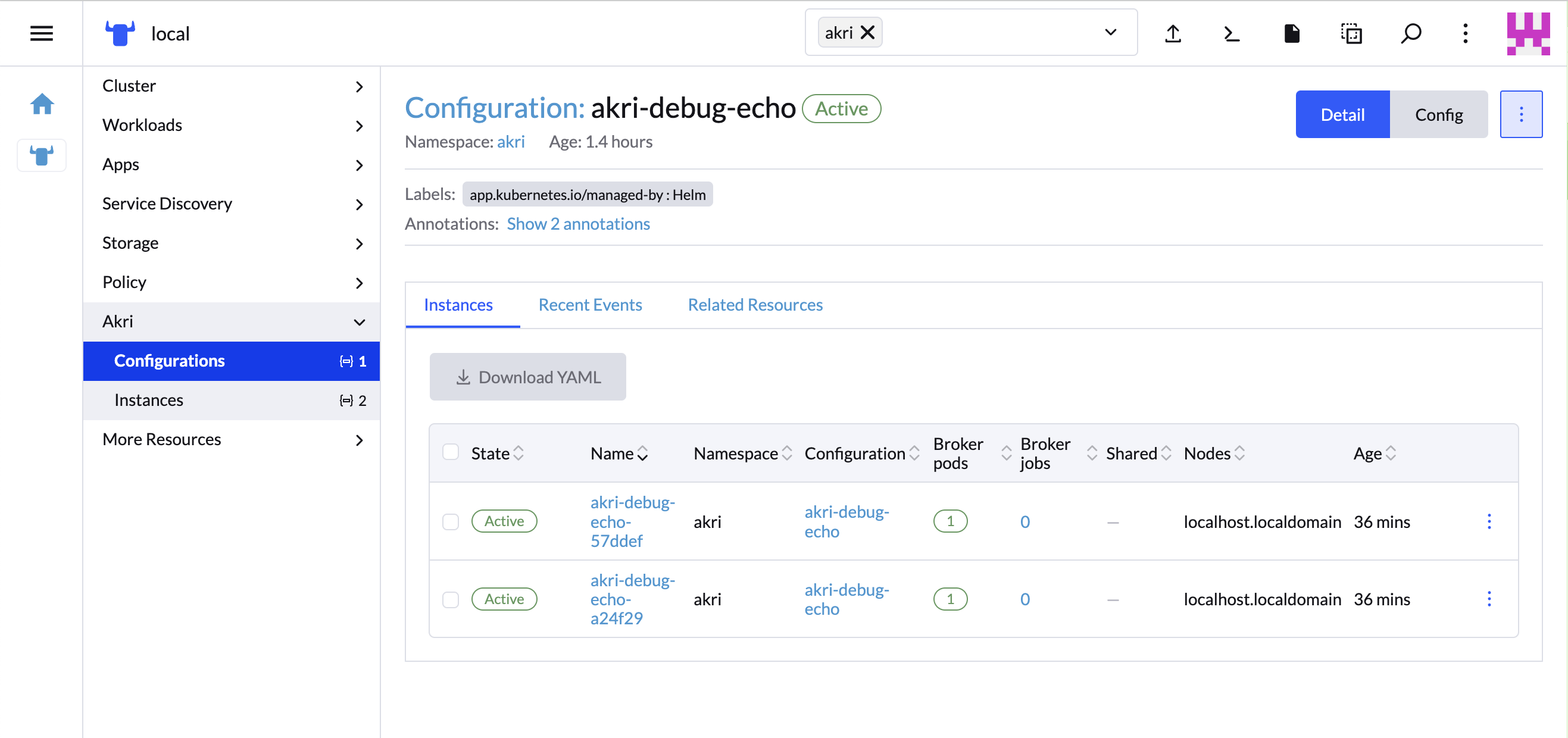

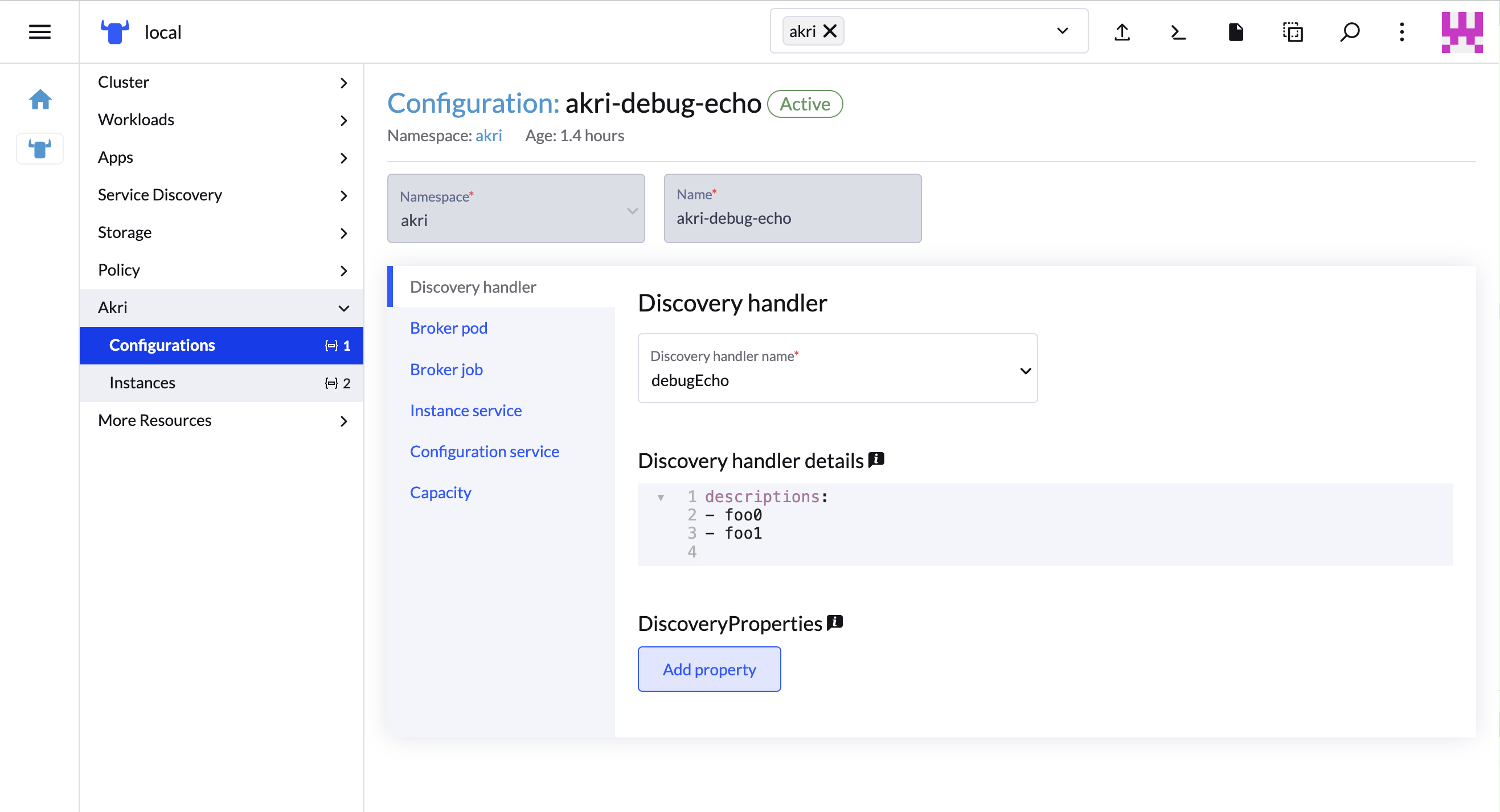

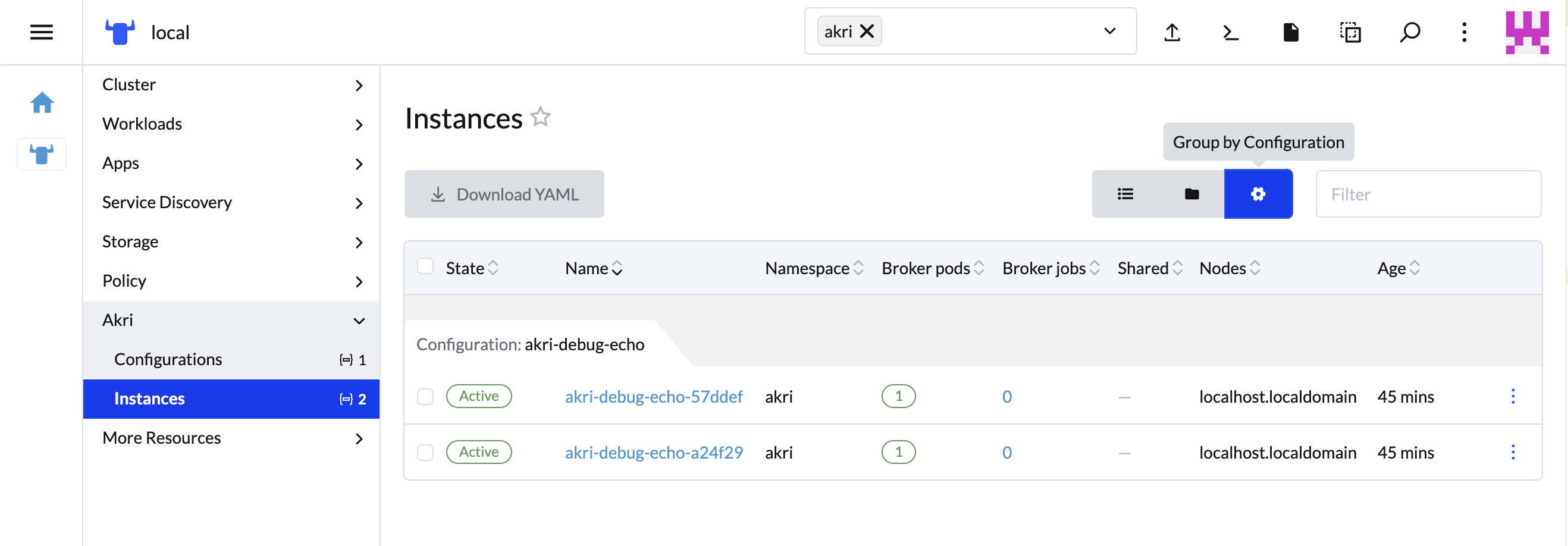

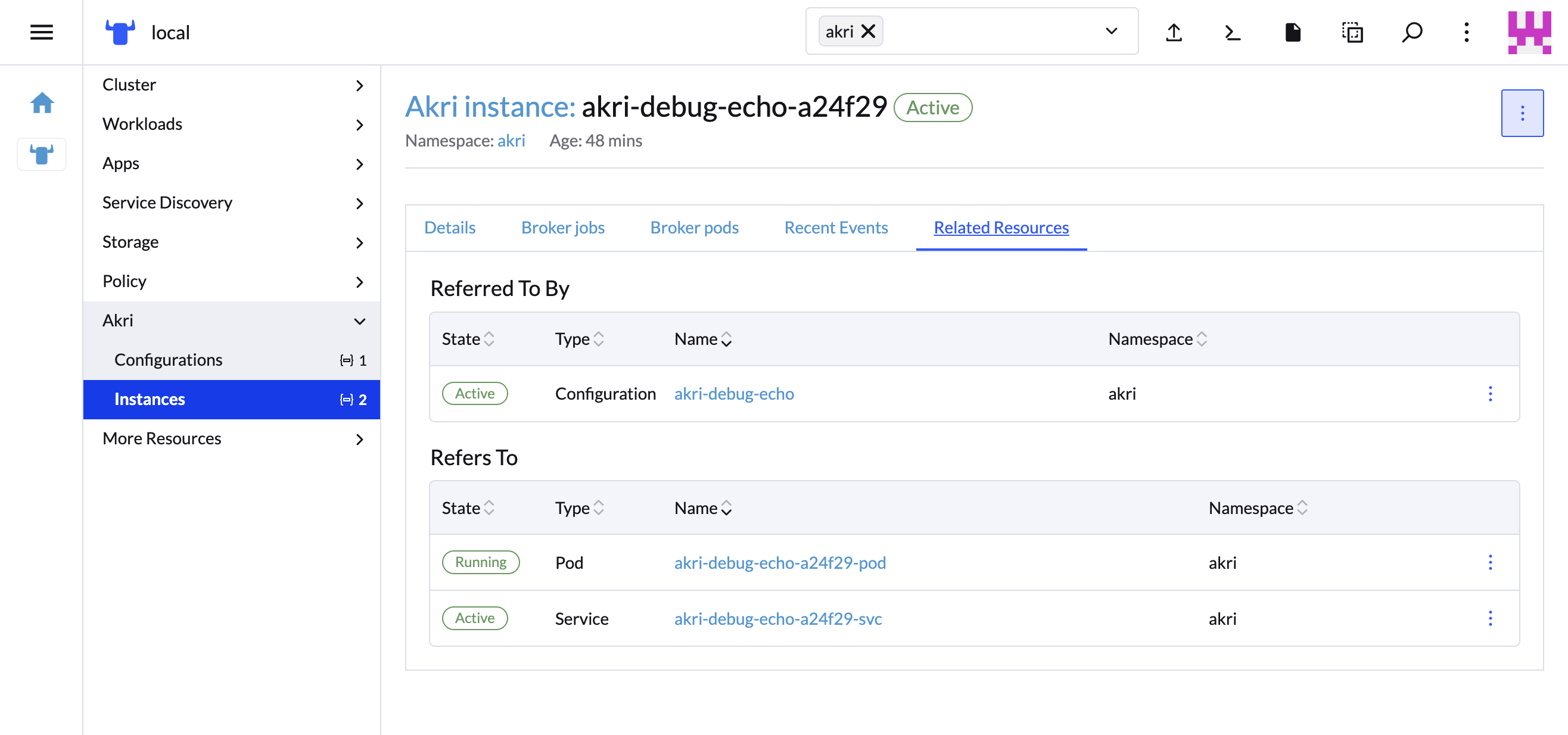

- 14 Akri

Akri 是一个 CNCF 沙箱项目,旨在发现叶设备并将其呈现为 Kubernetes 原生资源。它还允许为每个发现的设备调度一个 Pod 或作业。设备可以在节点本地,也可以联网,并可以使用多种协议。

- 15 K3s

K3s 是经过认证的高可用性 Kubernetes 发行版,专为无人照管、资源受限的远程位置或物联网设备内的生产工作负载而设计。

- 16 RKE2

请参见 RKE2 官方文档。

- 17 SUSE Storage

SUSE Storage 是一款可靠、易用的轻量级分布式块存储系统,专为 Kubernetes 设计。它是基于 Longhorn 的一款产品,而 Longhorn 是一个开源项目,最初由 Rancher Labs 开发,目前在 CNCF 旗下孵化。

- 18 SUSE Security

SUSE Security 是适用于 Kubernetes 的安全解决方案,它在统一的软件包中提供 L7 网络安全性、运行时安全性、供应链安全性与合规性检查。

- 19 MetalLB

请参见 MetalLB 官方文档。

- 20 Endpoint Copier Operator

Endpoint Copier Operator 是一个 Kubernetes 操作器,其用途是创建 Kubernetes 服务和端点的副本,并将它们保持同步。

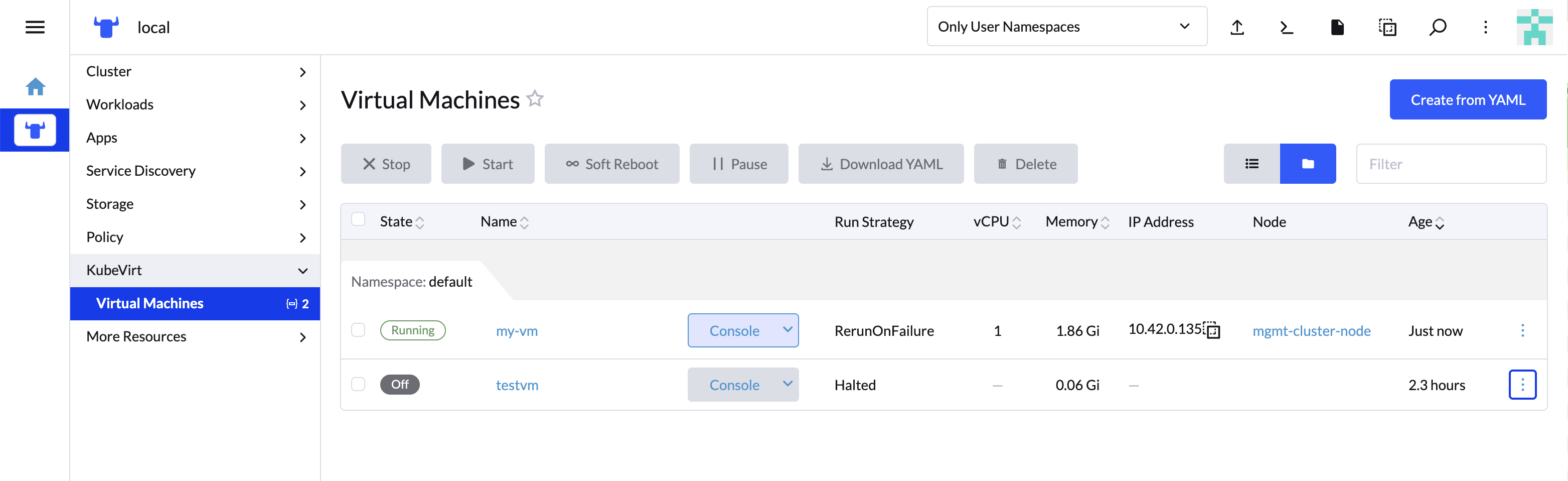

- 21 Edge Virtualization

本节介绍如何使用 Edge Virtualization 在边缘节点上运行虚拟机。Edge Virtualization 为轻量级虚拟化使用场景而设计,这些使用场景预期会使用一个通用工作流程来部署和管理虚拟化和容器化的应用程序。

- 22 系统升级控制器

请参见系统升级控制器文档。

- 23 升级控制器

Kubernetes 控制器可以执行以下 SUSE Edge 平台组件的升级:

- 24 SUSE Multi-Linux Manager

SUSE Edge 中包含 SUSE Multi-Linux Manager,其作用是提供自动化与控制能力,确保边缘部署的所有节点上作为底层操作系统的 SUSE Linux Micro 始终保持最新状态。

5 Rancher #

请参见 https://ranchermanager.docs.rancher.com/v2.11 上的 Rancher 文档。

Rancher 是一个功能强大的开源 Kubernetes 管理平台,可以简化跨多个环境的 Kubernetes 群集的部署、操作和监控。无论您是在本地、云中还是边缘管理群集,Rancher 都能提供统一且集中的平台来满足您的所有 Kubernetes 需求。

5.1 Rancher 的主要功能 #

多群集管理:Rancher 的直观界面让您可以从任何位置(公有云、专用数据中心和边缘位置)管理 Kubernetes 群集。

安全性与合规性:Rancher 在您的 Kubernetes 环境中实施安全策略、基于角色的访问控制 (RBAC) 与合规性标准。

简化的群集操作:Rancher 可自动执行群集置备、升级和查错,并为各种规模的团队简化 Kubernetes 操作。

集中式应用程序目录:Rancher 应用程序目录提供多种 Helm chart 和 Kubernetes 操作器,使容器化应用程序的部署和管理变得简单。

持续交付:Rancher 支持 GitOps 和 CI/CD 管道,可以自动化和简化应用程序交付过程。

5.2 Rancher 在 SUSE Edge 中的使用 #

Rancher 为 SUSE Edge 堆栈提供多项核心功能:

5.2.1 集中式 Kubernetes 管理 #

在采用大量分布式群集的典型边缘部署中,Rancher 充当中心控制平面来管理这些 Kubernetes 群集。它提供统一的界面用于置备、升级、监控和查错、简化操作并确保一致性。

5.2.2 简化的群集部署 #

Rancher 简化了轻量级 SUSE Linux Micro 操作系统上的 Kubernetes 群集创建,并通过稳健的 Kubernetes 功能简化了边缘基础架构的部署。

5.2.3 应用程序部署和管理 #

集成的 Rancher 应用程序目录可以简化跨 SUSE Edge 群集的容器化应用程序的部署和管理,实现无缝的边缘工作负载部署。

5.2.4 安全性和策略实施 #

Rancher 提供基于策略的治理工具、基于角色的访问控制 (RBAC),以及与外部身份验证提供程序的集成。这有助于 SUSE Edge 部署保持安全且合规,在分布式环境中,这一点至关重要。

5.3 最佳实践 #

5.3.1 GitOps #

Rancher 包含内置组件 Fleet。使用 Fleet 可以通过 git 中存储的代码管理群集配置和应用程序部署。

5.3.2 可观测性 #

Rancher 包含 Prometheus 和 Grafana 等内置监控和日志记录工具,可提供群集健康状况和性能的综合深入信息。

5.4 使用 Edge Image Builder 进行安装 #

SUSE Edge 使用第 11 章 “Edge Image Builder”来自定义基础 SUSE Linux Micro 操作系统映像。请按照第 27.6 节 “Rancher 安装”中所述,在 EIB 置备的 Kubernetes 群集上进行 Rancher 隔离式安装。

5.5 其他资源 #

6 Rancher 仪表板扩展 #

用户、开发人员、合作伙伴及客户可以使用扩展来扩展和增强 Rancher UI。SUSE Edge 提供 KubeVirt 和 Akri 仪表板扩展。

有关 Rancher 仪表板扩展的一般信息,请参见 Rancher

文档。

6.1 安装 #

所有 SUSE Edge 3.3.1 组件(包括仪表板扩展)均作为 OCI 制品分发。要安装 SUSE Edge 扩展,可以使用 Rancher Dashboard UI、Helm 或 Fleet:

6.1.1 通过 Rancher 仪表板 UI 安装 #

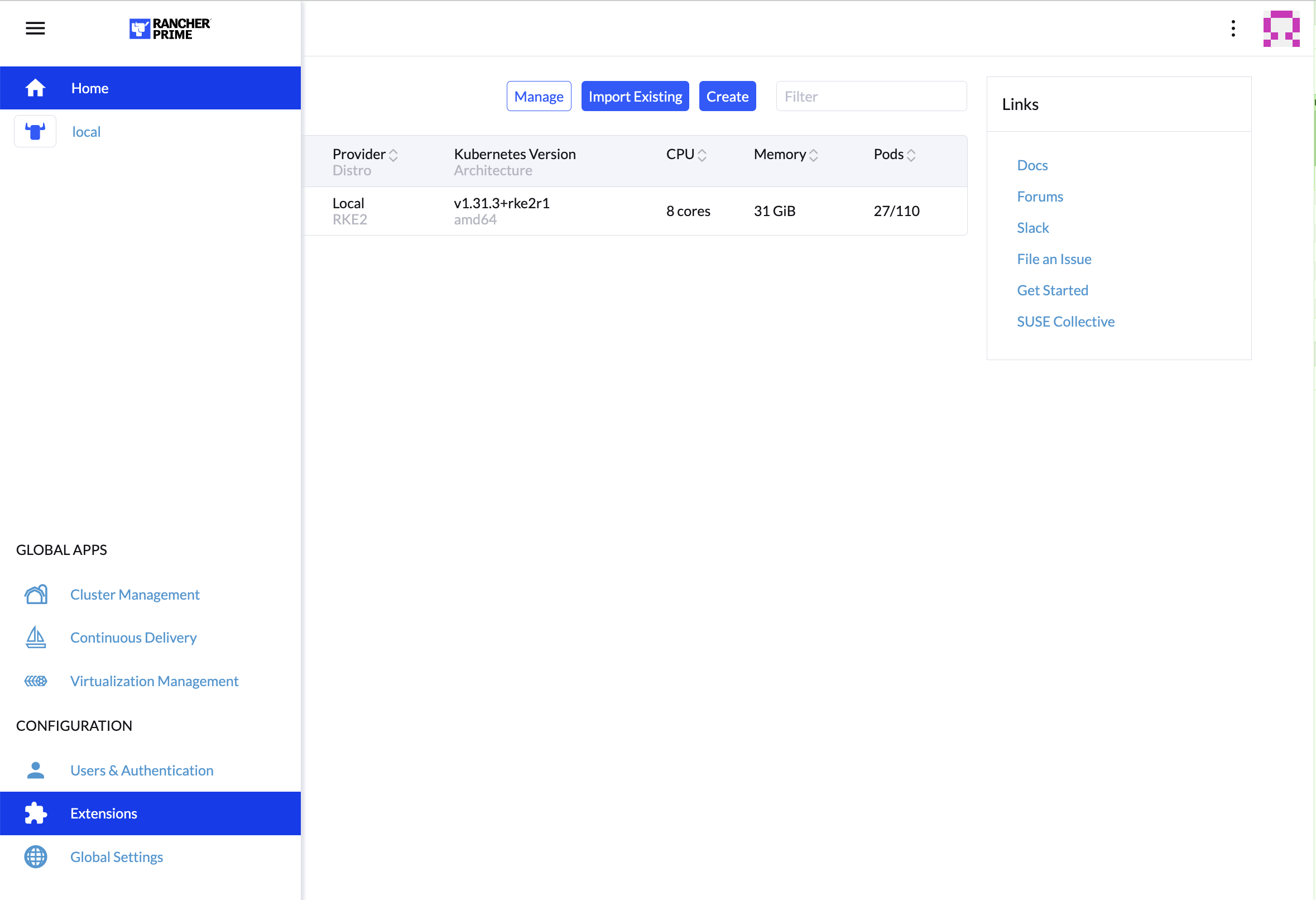

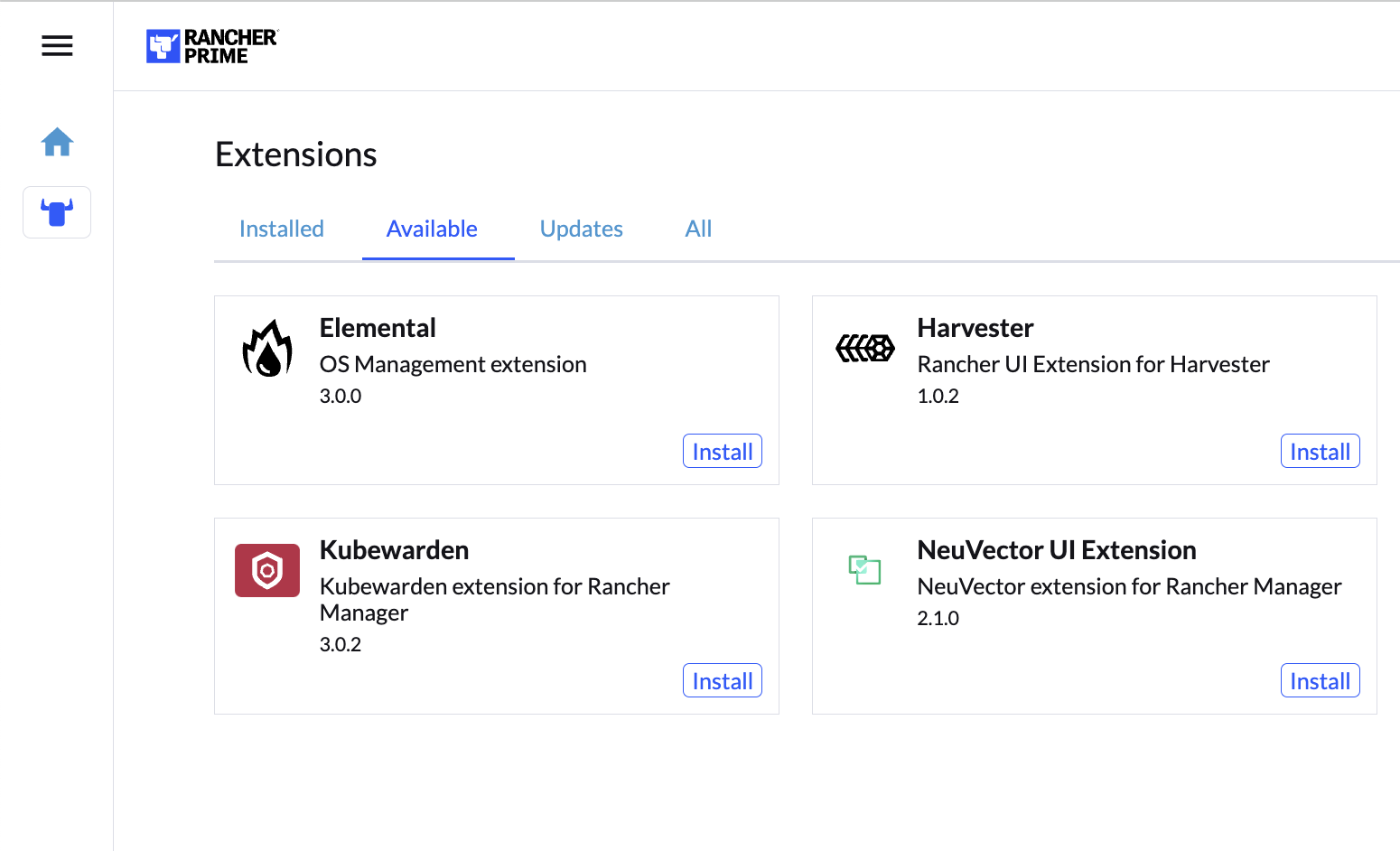

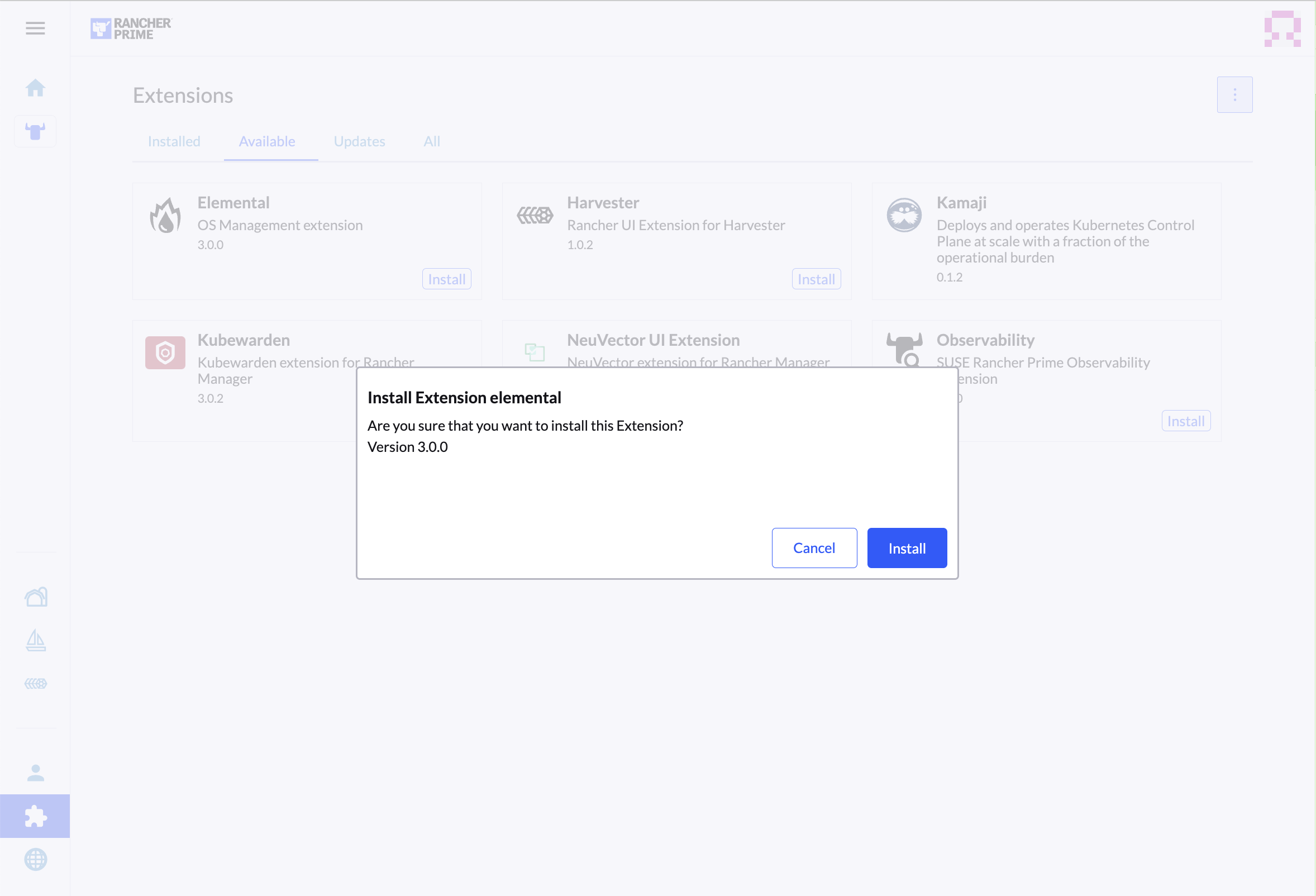

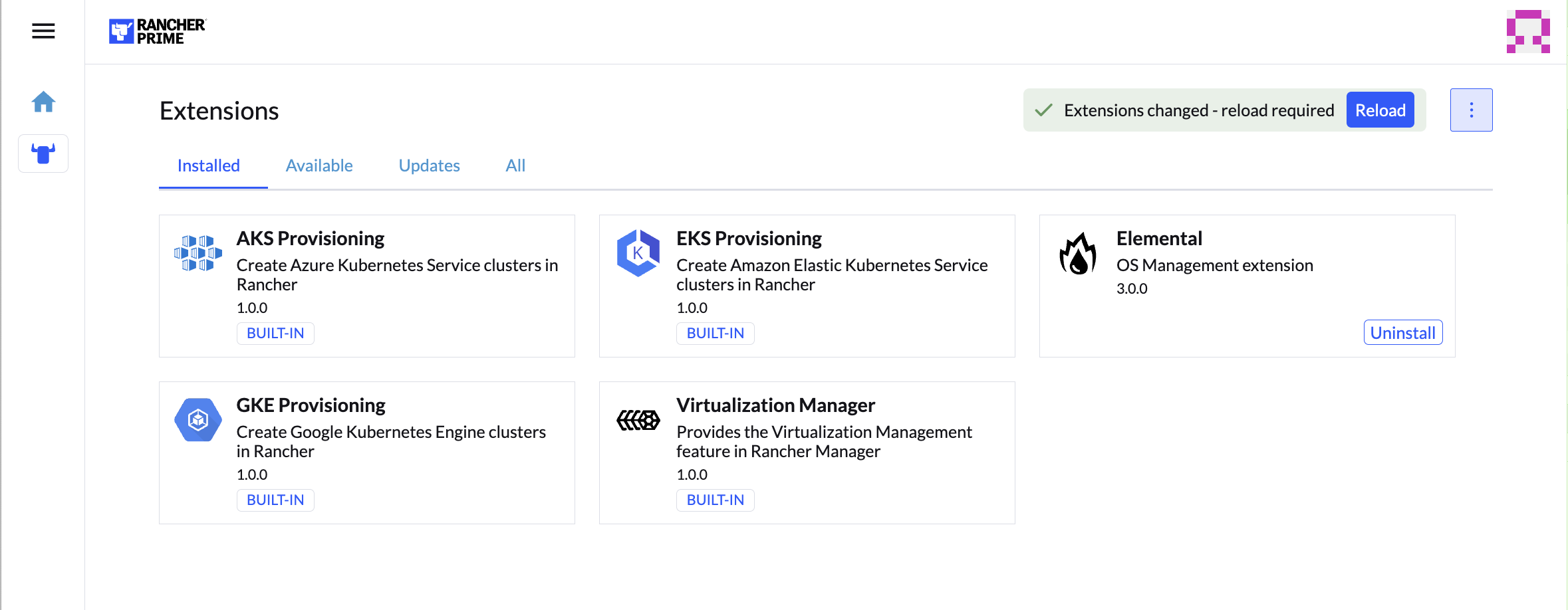

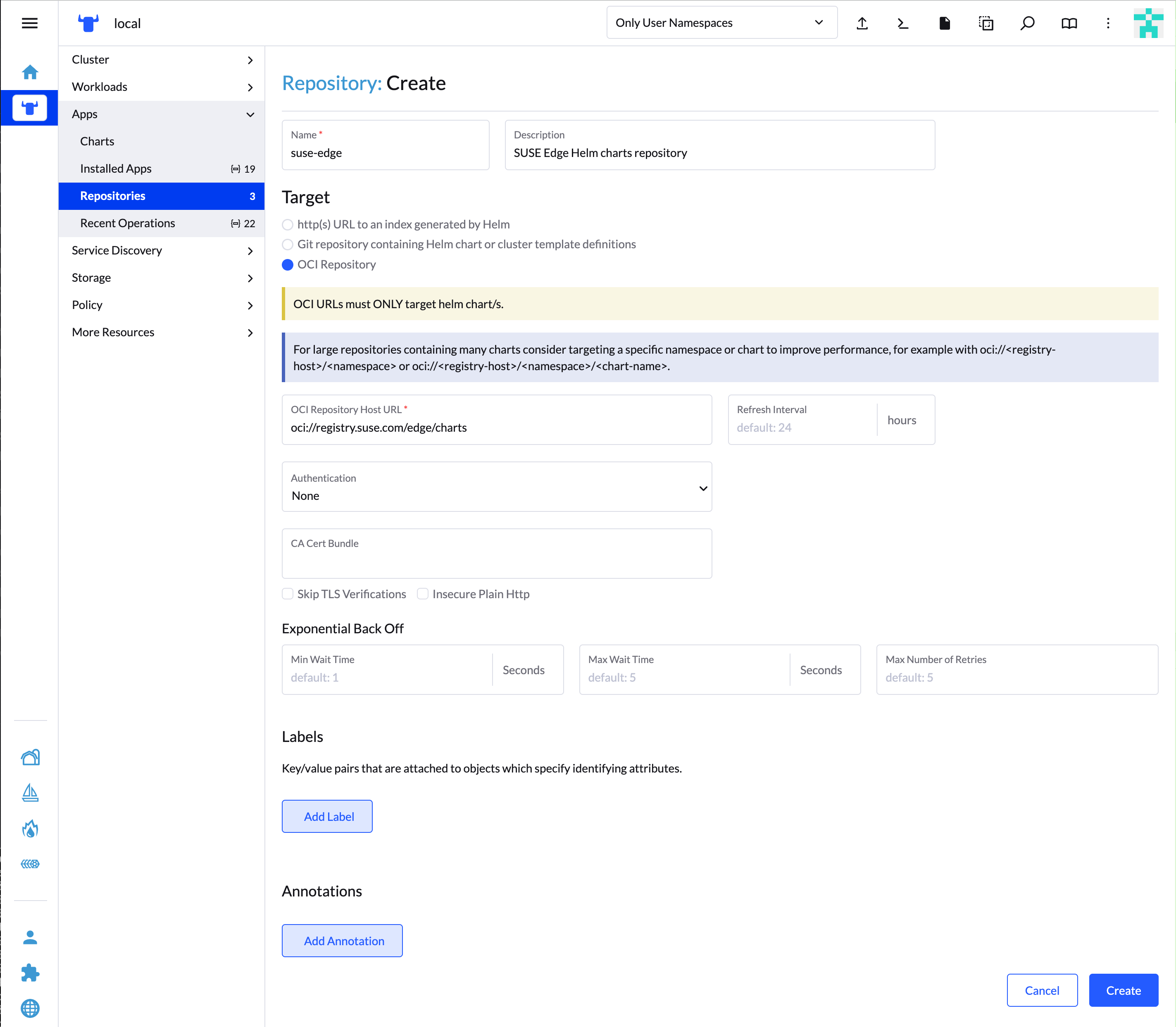

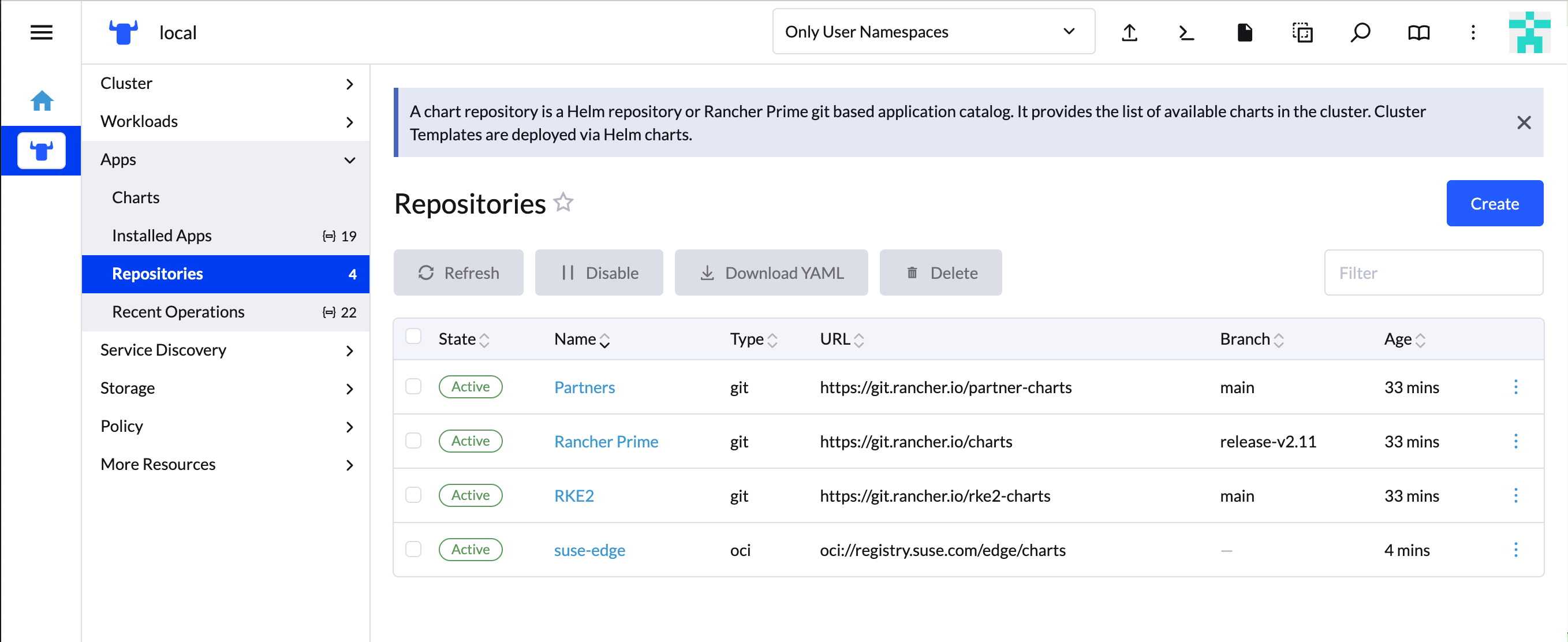

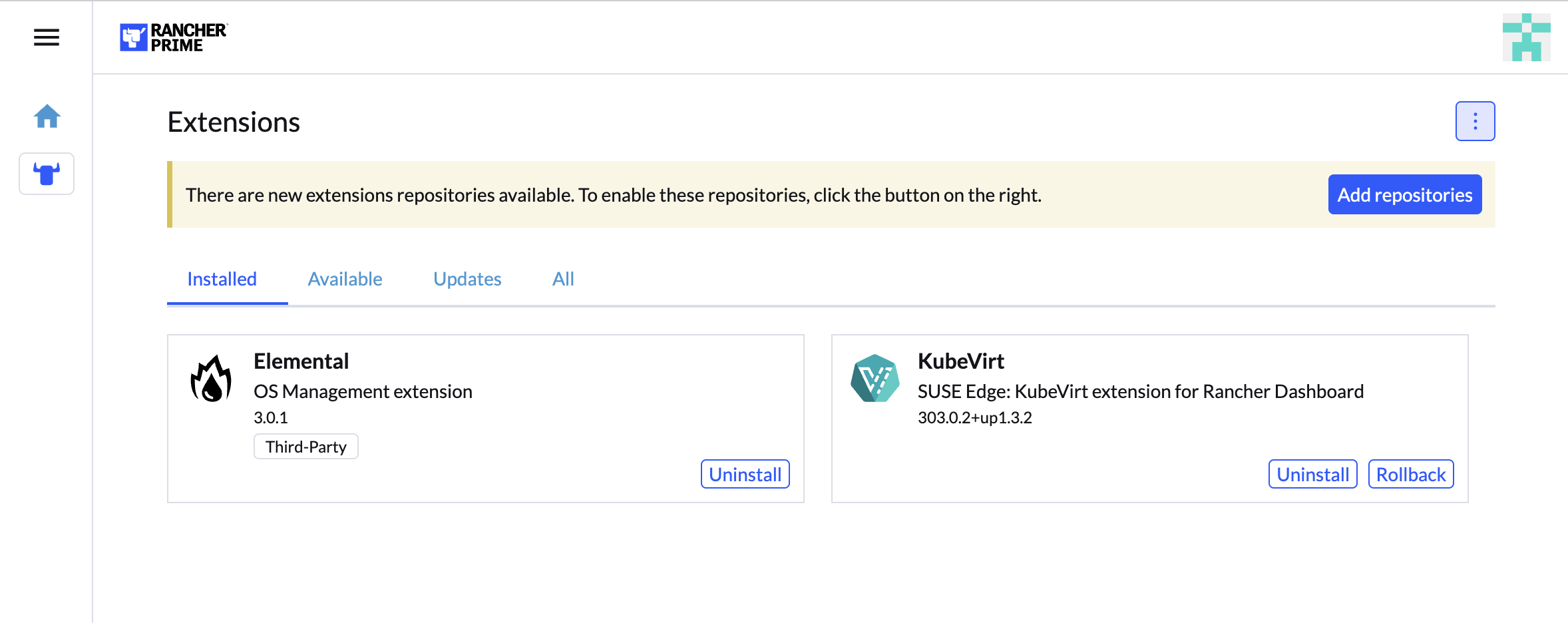

单击导航侧边栏 Configuration(配置)部分的 Extensions(扩展)。

在“Extensions”(扩展)页面上,单击右上角的三点菜单,然后选择 Manage Repositories(管理储存库)。

每个扩展都通过各自的 OCI 制品分发,可通过 SUSE Edge Helm chart 储存库获取。

在 Repositories(储存库)页面上,单击

Create(创建)。在表单中指定储存库名称和 URL,然后单击

Create(创建)。SUSE Edge Helm chart 储存库 URL:

oci://registry.suse.com/edge/charts您会看到扩展储存库已添加到列表中,并处于

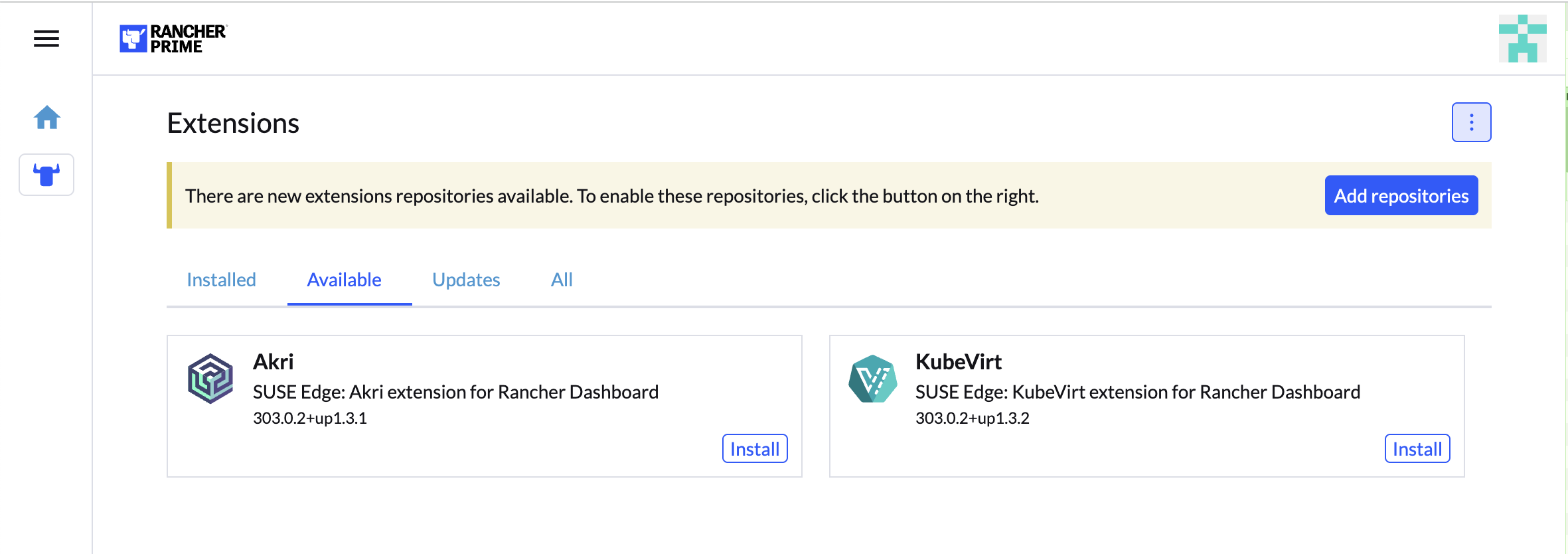

Active(活动)状态。导航回导航侧边栏 Configuration(配置)部分的 Extensions(扩展)。

在 Available(可用)选项卡中,可以看到可供安装的扩展。

在扩展卡片上单击

Install(安装)并确认安装。安装扩展后,Rancher UI 会提示重新加载页面,如

安装扩展 Rancher 文档页面所述。

6.1.2 使用 Helm 进行安装 #

# KubeVirt extension

helm install kubevirt-dashboard-extension oci://registry.suse.com/edge/charts/kubevirt-dashboard-extension --version 303.0.2+up1.3.2 --namespace cattle-ui-plugin-system

# Akri extension

helm install akri-dashboard-extension oci://registry.suse.com/edge/charts/akri-dashboard-extension --version 303.0.2+up1.3.1 --namespace cattle-ui-plugin-system扩展需安装在 cattle-ui-plugin-system 名称空间中。

安装扩展后,需要重新加载 Rancher 仪表板 UI。

6.1.3 使用 Fleet 进行安装 #

使用 Fleet 安装仪表板扩展需要定义一个 gitRepo 资源,该资源指向包含自定义

fleet.yaml 捆绑包配置文件的 Git 储存库。

# KubeVirt extension fleet.yaml

defaultNamespace: cattle-ui-plugin-system

helm:

releaseName: kubevirt-dashboard-extension

chart: oci://registry.suse.com/edge/charts/kubevirt-dashboard-extension

version: "303.0.2+up1.3.2"# Akri extension fleet.yaml

defaultNamespace: cattle-ui-plugin-system

helm:

releaseName: akri-dashboard-extension

chart: oci://registry.suse.com/edge/charts/akri-dashboard-extension

version: "303.0.2+up1.3.1"必须指定 releaseName 属性,而且它需要与扩展名称匹配,才能正确安装扩展。

cat <<- EOF | kubectl apply -f -

apiVersion: fleet.cattle.io/v1alpha1

metadata:

name: edge-dashboard-extensions

namespace: fleet-local

spec:

repo: https://github.com/suse-edge/fleet-examples.git

branch: main

paths:

- fleets/kubevirt-dashboard-extension/

- fleets/akri-dashboard-extension/

EOF有关详细信息,请参见第 8 章 “Fleet”和 fleet-examples

储存库。

安装扩展后,它们将列在 Installed(已安装)选项卡下的 Extensions(扩展)部分中。由于它们不是通过 Apps/Marketplace

安装的,因此带有 Third-Party(第三方)标签。

6.2 KubeVirt 仪表板扩展 #

KubeVirt 扩展为 Rancher 仪表板 UI 提供基本虚拟机管理。第 21.7.2 节 “使用 KubeVirt Rancher 仪表板扩展”中介绍了其功能。

6.3 Akri 仪表板扩展 #

Akri 是一个 Kubernetes 资源接口,让您可以轻松地将异构叶设备(例如 IP 摄像头和 USB 设备)公开为 Kubernetes 群集中的资源,同时还支持公开 GPU 和 FPGA 等嵌入式硬件资源。Akri 会持续检测有权访问这些设备的节点,并根据这些节点调度工作负载。

Akri 仪表板扩展允许您使用 Rancher 仪表板用户界面来管理和监控叶设备,并在发现这些设备后运行工作负载。

第 14.5 节 “Akri Rancher 仪表板扩展”中详细介绍了扩展功能。

7 Rancher Turtles #

请参见 Rancher Turtles 文档,网址为:https://documentation.suse.com/cloudnative/cluster-api/

Rancher Turtles 是一个 Kubernetes 操作器,它提供 Rancher Manager 与 Cluster API (CAPI) 之间的集成,旨在为 Rancher 添加全面的 CAPI 支持

7.1 Rancher Turtles 的主要功能 #

通过在 CAPI 置备的群集中安装 Rancher 群集代理,自动将 CAPI 群集导入 Rancher。

通过 CAPI 操作器安装并配置 CAPI 控制器依赖项。

7.2 Rancher Turtles 在 SUSE Edge 中的使用 #

SUSE Edge 堆栈提供了一个 Helm 封装 chart,该 chart 可使用特定配置安装 Rancher Turtles,以启用:

核心 CAPI 控制器组件

RKE2 控制平面和引导提供程序组件

Metal3(第 10 章 “Metal3”)基础架构提供程序组件

仅支持通过封装 chart 安装的默认提供程序 - 目前不支持替代的控制平面、引导和基础架构提供程序作为 SUSE Edge 堆栈的一部分。

7.3 安装 Rancher Turtles #

可按照 Metal3 快速入门(第 1 章 “使用 Metal3 实现 BMC 自动化部署”)指南或管理群集(第 40 章 “设置管理群集”)文档所述安装 Rancher Turtles。

7.4 其他资源 #

8 Fleet #

Fleet 是一个容器管理和部署引擎,旨在让用户更好地控制本地群集,并通过 GitOps 进行持续监控。Fleet 不仅注重缩放能力,而且还为用户提供很高的控制度和可见性,以准确监控群集上安装的组件。

Fleet 可以管理通过原始 Kubernetes YAML、Helm chart、Kustomize 的 Git 软件包或这三者的任意组合完成的部署。无论来源是什么,所有资源都会动态转换为 Helm chart,并使用 Helm 作为引擎在群集中部署所有资源。因此,用户可以获享很高的群集控制度、一致性和可审计性。

有关 Fleet 工作原理的信息,请参见 Fleet Architecture。

8.1 使用 Helm 安装 Fleet #

Fleet 已内置于 Rancher 中,但您也可以使用 Helm 将 Fleet 安装为任何 Kubernetes 群集上的独立应用程序。

8.2 使用 Rancher 中的 Fleet #

Rancher 使用 Fleet 在受管群集中部署应用程序。Fleet 的持续交付功能引入了大规模 GitOps,旨在管理在大量群集上运行的应用程序。

Fleet 作为 Rancher 的集成部分优势显著:使用 Rancher 管理的群集会在安装/导入过程中自动由 Fleet 代理部署,并且之后群集立即便能由 Fleet 管理。

8.3 在 Rancher UI 中访问 Fleet #

Rancher 中预安装了 Fleet,可通过 Rancher UI 中的 Continuous Delivery(持续交付)选项进行管理。

“Continuous Delivery”(持续交付)部分包括以下项目:

8.3.1 Dashboard(仪表板) #

所有工作空间中所有 GitOps 储存库的概览页面。仅显示包含储存库的工作空间。

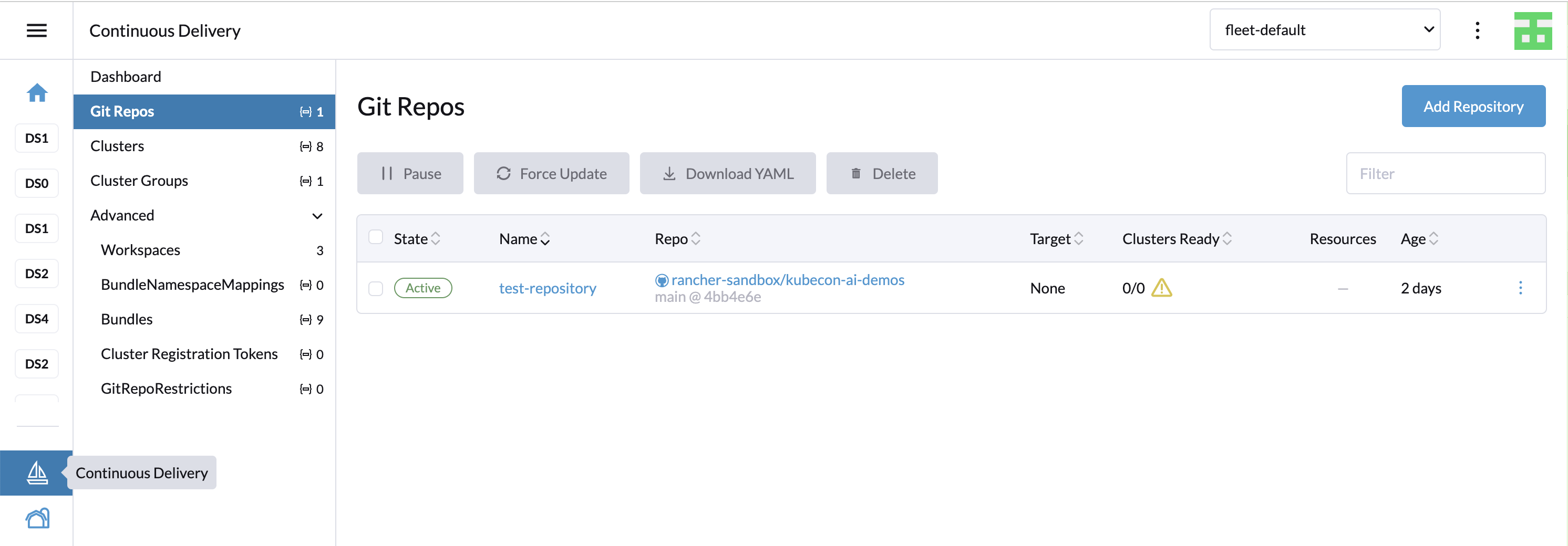

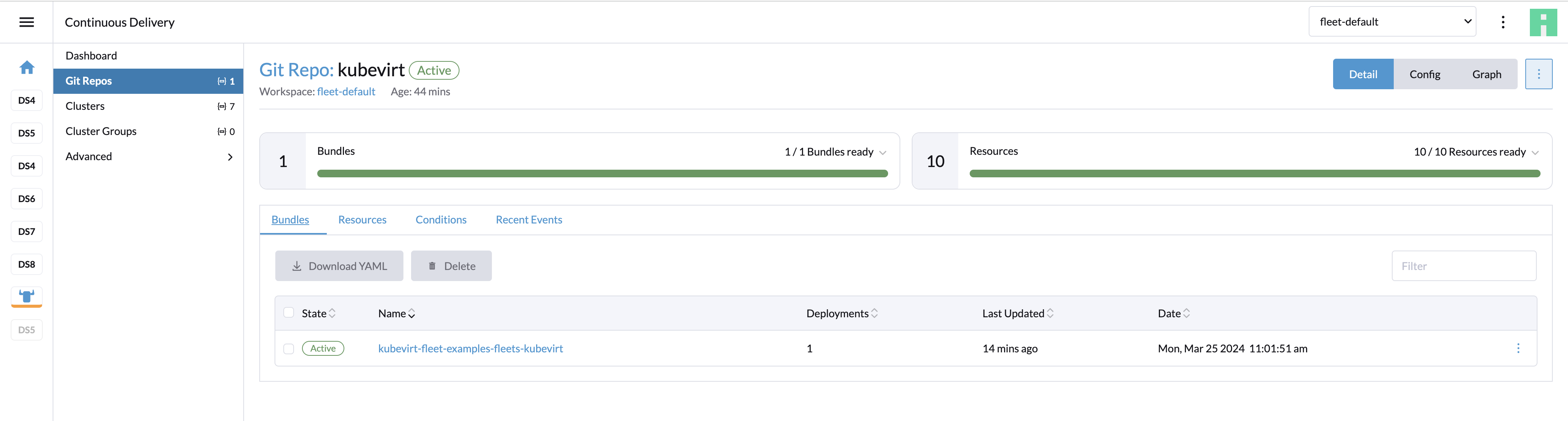

8.3.2 Git repos(Git 储存库) #

所选工作空间中的 GitOps 储存库列表。使用页面顶部的下拉列表选择活动工作空间。

8.3.3 Clusters(群集) #

受管群集列表。默认情况下,Rancher 管理的所有群集都会添加到 fleet-default

工作空间。fleet-local

工作空间包含本地(管理)群集。在此处可以暂停或强制更新群集,或者将群集移动到另一个工作空间。可以通过编辑群集来更新用于群集分组的标签和注解。

8.3.4 Cluster groups(群集组) #

在此部分,可以使用选择器对工作空间内的群集进行自定义分组。

8.3.5 Advanced(高级) #

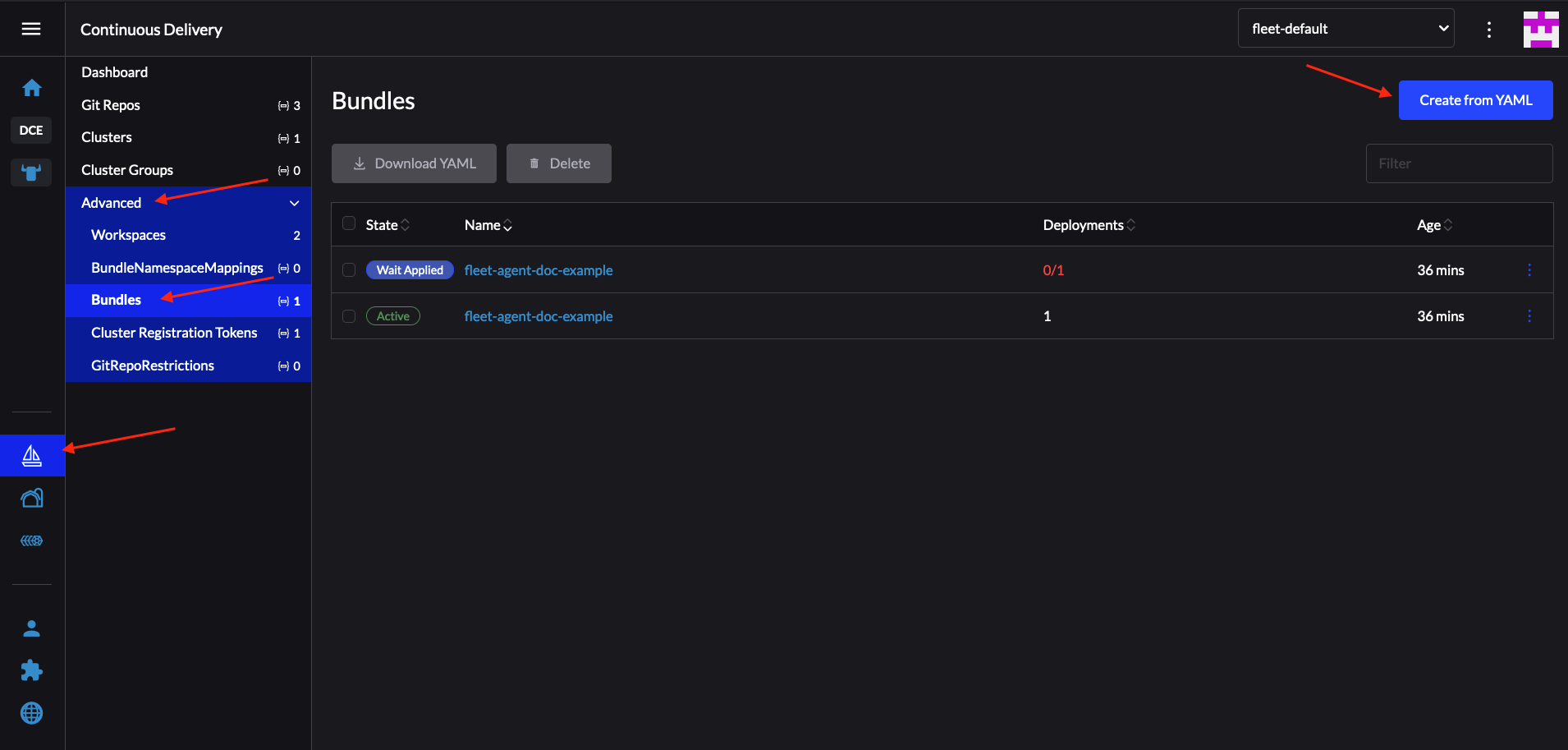

在“Advanced”(高级)部分可以管理工作空间和其他相关 Fleet 资源。

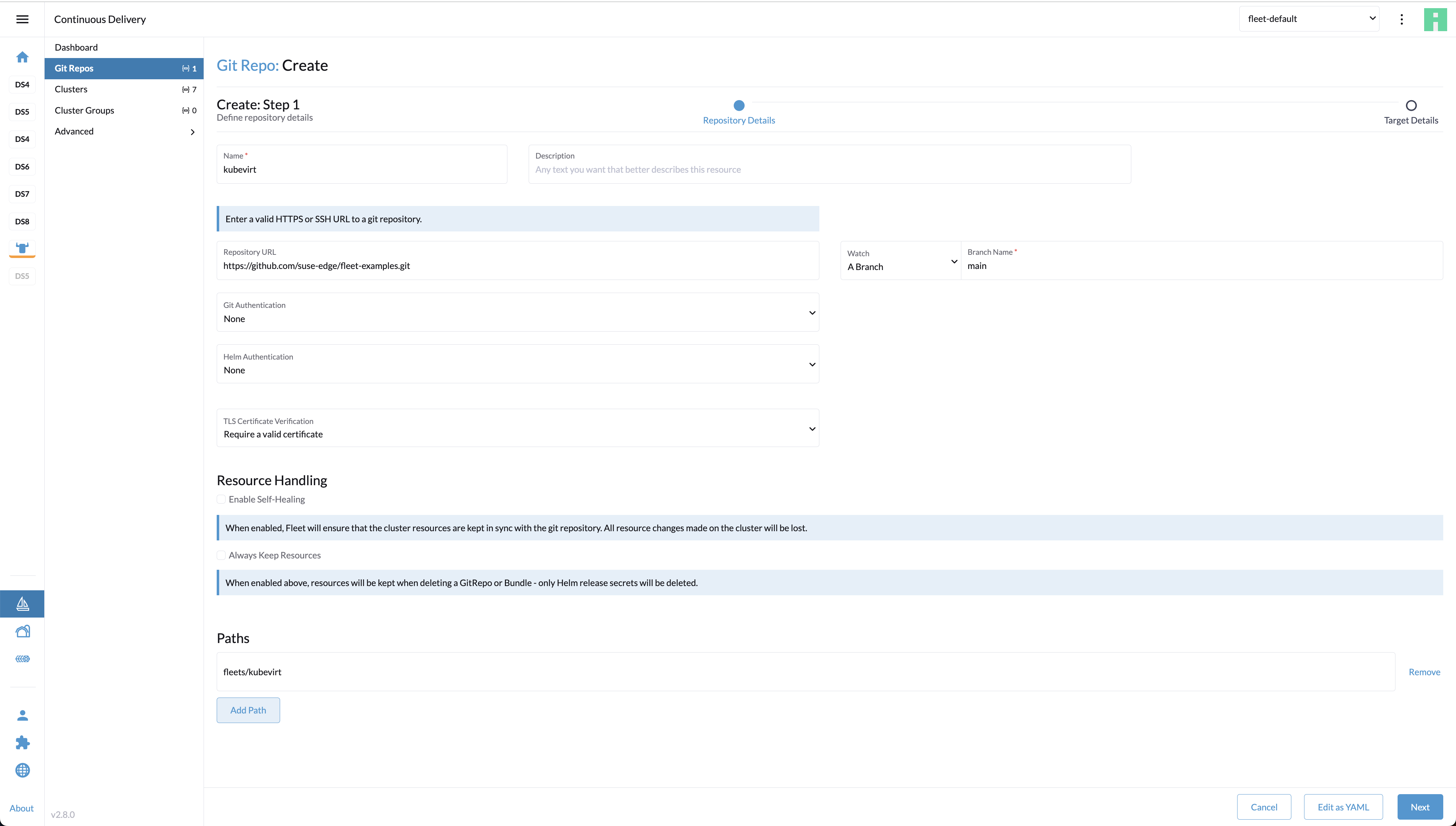

8.4 使用 Rancher 仪表板通过 Rancher 和 Fleet 安装 KubeVirt 的示例 #

创建包含

fleet.yaml文件的 Git 储存库:defaultNamespace: kubevirt helm: chart: "oci://registry.suse.com/edge/charts/kubevirt" version: "303.0.0+up0.5.0" # kubevirt namespace is created by kubevirt as well, we need to take ownership of it takeOwnership: true在 Rancher 仪表板中,导航到 ☰ > Continuous Delivery(持续交付)> Git repos(Git 储存库),然后单击

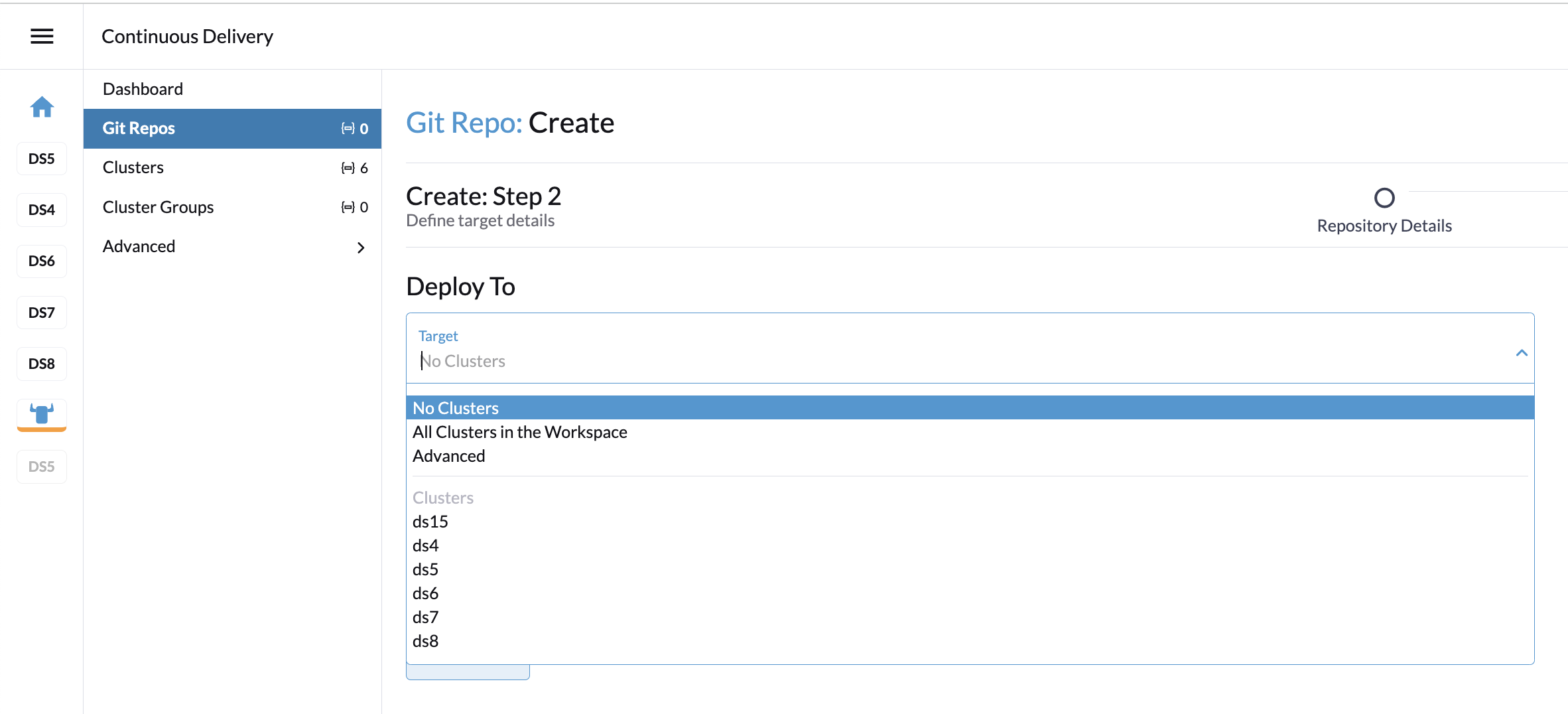

Add Repository(添加储存库)。储存库创建向导将指导您完成 Git 储存库创建步骤。提供名称、储存库 URL(引用上一步骤中创建的 Git 储存库),并选择适当的分支或修订版。对于较复杂的储存库,请指定路径以便在单个储存库中使用多个目录。

单击

Next(下一步)。在下一步骤中,可以定义工作负载的部署位置。在群集选择方面,可以使用多个基本选项:可以不选择任何群集、选择所有群集,或者直接选择特定的受管群集或群集组(如果已定义)。“Advanced”(高级)选项允许通过 YAML 直接编辑选择器。

单击

Create(创建)。系统即会创建储存库。从现在起,工作负载将在与储存库定义匹配的群集上安装并保持同步。

8.5 调试和查错 #

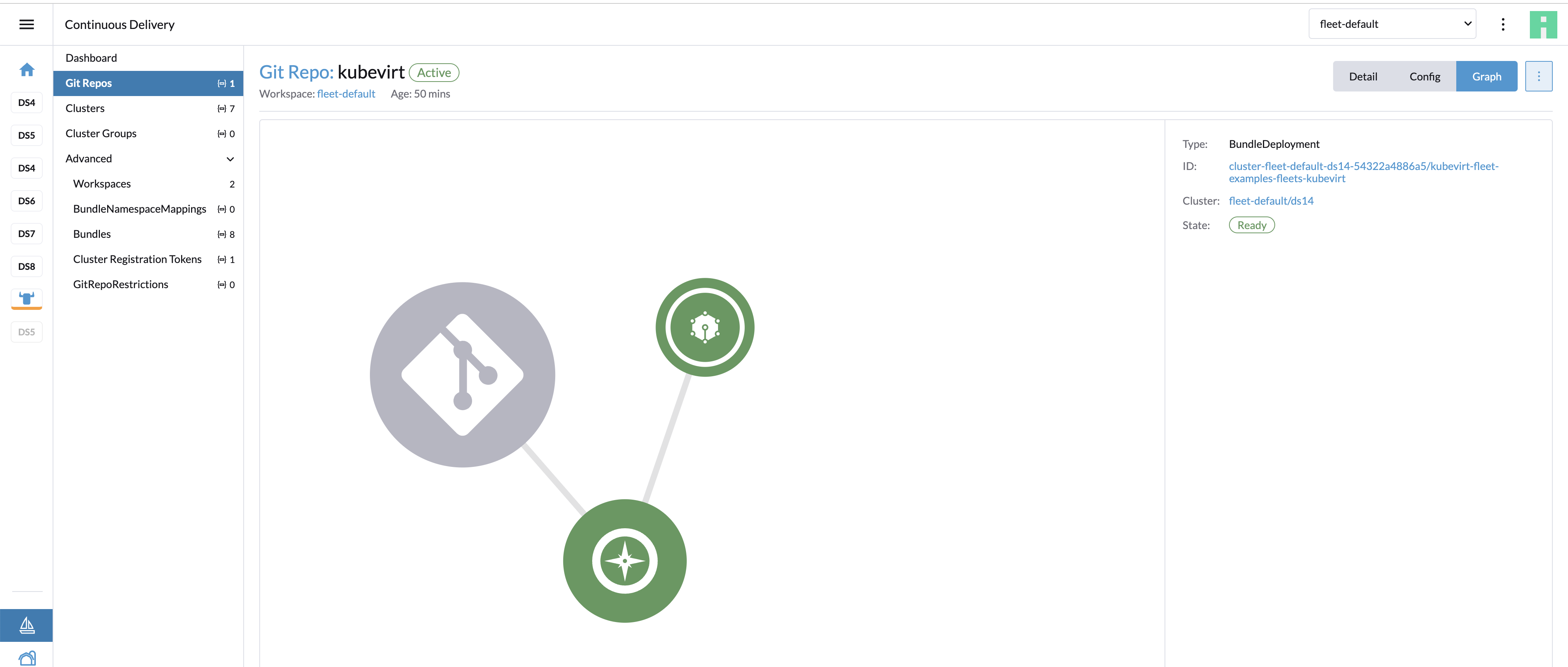

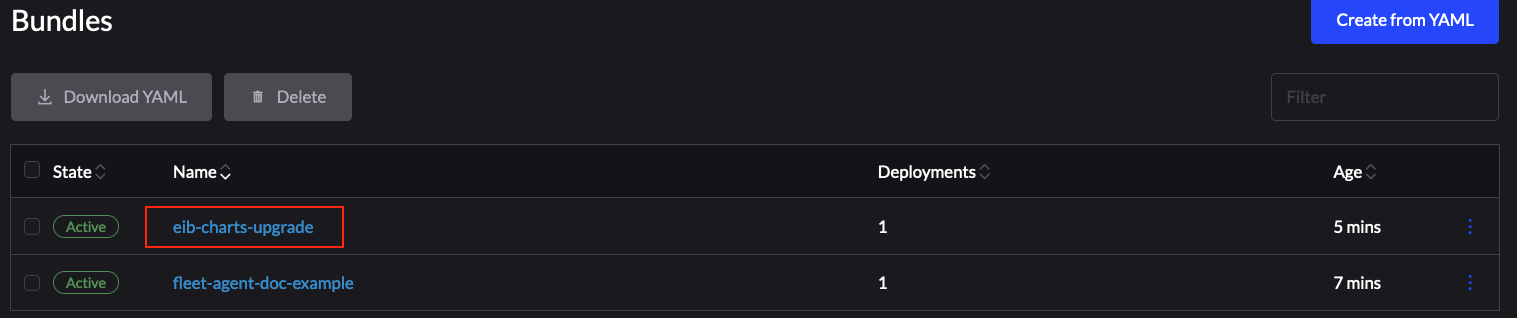

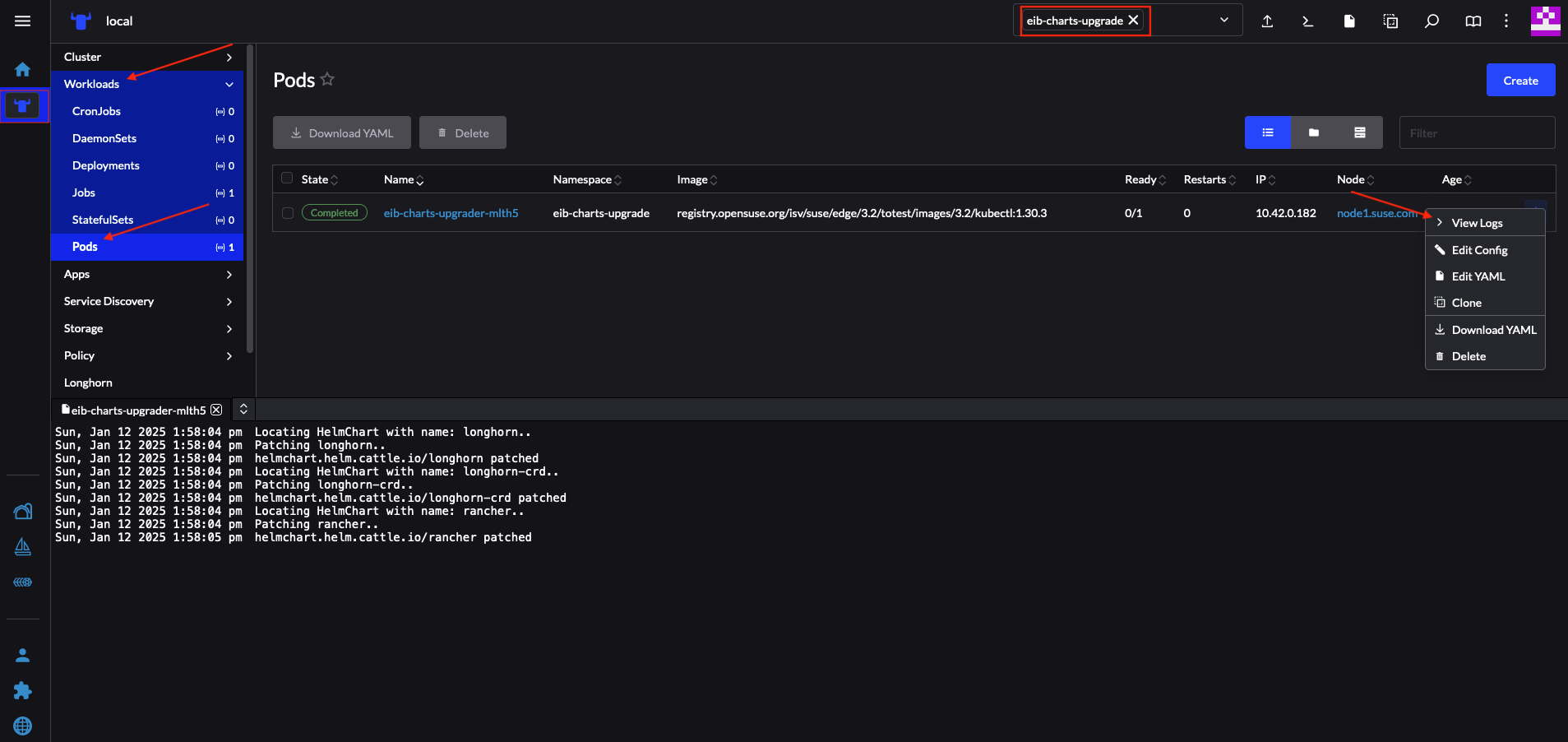

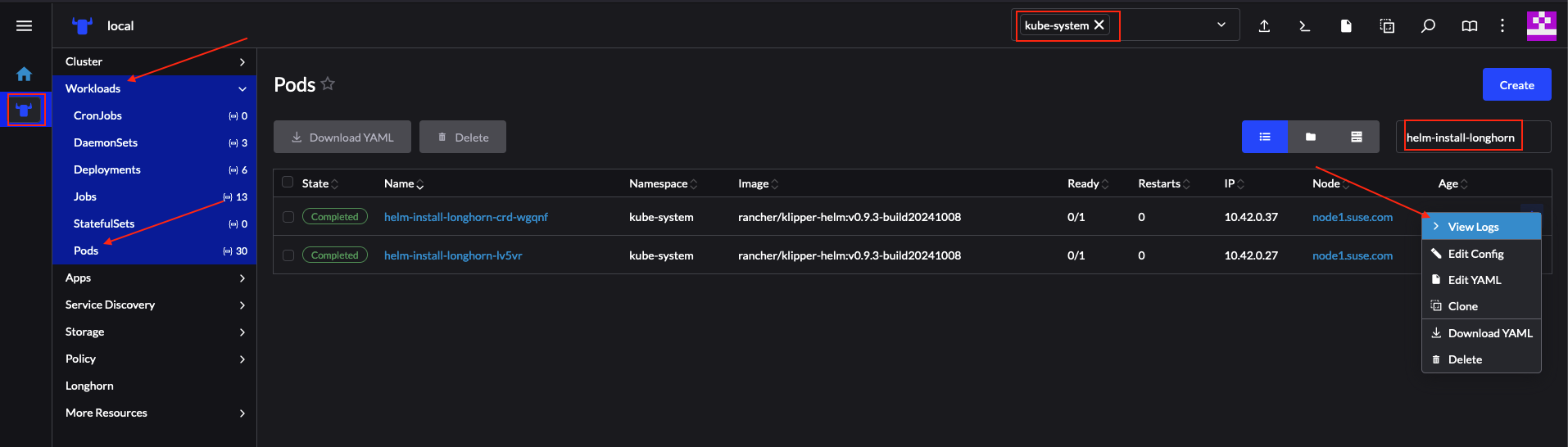

“Advanced”(高级)导航部分提供了低层级 Fleet 资源的概览。捆绑包是一个内部资源,用于编排 Git 中的资源。扫描 Git 储存库时,会生成一个或多个捆绑包。

要查找与特定储存库相关的捆绑包,请转到 Git 储存库细节页面,并单击 Bundles(捆绑包)选项卡。

对于每个群集,捆绑包将应用于创建的 BundleDeployment 资源。要查看 BundleDeployment 细节,请单击 Git

储存库细节页面右上角的 Graph(图表)按钮。系统随即会加载 Repo(储存库)> Bundles(捆绑包)> BundleDeployment

图表。在图表中单击相应 BundleDeployment 可查看其细节,单击 ID 可查看

BundleDeployment YAML。

有关 Fleet 查错提示的更多信息,请参见此处。

8.6 Fleet 示例 #

Edge 团队维护的一个储存库包含了有关使用 Fleet 安装 Edge 项目的示例。

Fleet 项目包含 fleet-examples 储存库,其中涵盖了 Git 储存库结构的所有使用场景。

9 SUSE Linux Micro #

SUSE Linux Micro 是一个安全的轻量级边缘操作系统。它将 SUSE Linux Enterprise 强化组件与开发人员需要的各种功能融入一套不可变的新式操作系统,从而形成一个可靠的基础架构平台,不仅具有同类最佳的合规性,而且易于使用。

9.1 SUSE Edge 如何使用 SUSE Linux Micro? #

我们使用 SUSE Linux Micro 作为平台堆栈的基础操作系统。它为我们提供了安全、稳定且精简的构建基础。

SUSE Linux Micro 的独特之处在于它使用了文件系统 (Btrfs) 快照,一旦在升级期间出错,我们就可以轻松回滚。这样,在出现问题时,即使无法进行物理访问,也可以对整个平台安全地进行远程升级。

9.2 最佳实践 #

9.2.1 安装媒体 #

SUSE Edge 使用 Edge Image Builder(第 11 章 “Edge Image Builder”)来预配置 SUSE Linux Micro 自安装映像。

9.2.2 本地管理 #

SUSE Linux Micro 附带 Cockpit,让您可以通过 Web 应用程序对主机进行本地管理。

此服务默认已禁用,但可以通过启用 systemd 服务 cockpit.socket 来启动。

9.3 已知问题 #

SUSE Linux Micro 目前不提供桌面环境,但我们正在开发容器化解决方案。

10 Metal3 #

Metal3 是一个 CNCF 项目,它为 Kubernetes 提供裸机基础架构管理功能。

Metal3 提供 Kubernetes 原生资源来管理裸机服务器的生命周期,支持通过 Redfish 等带外协议进行管理。

它还为 Cluster API (CAPI) 提供成熟的支持,允许通过广泛采用的不限供应商的 API 来管理跨多个基础架构提供商的基础架构资源。

10.1 SUSE Edge 如何使用 Metal3? #

此方法非常适合用于目标硬件支持带外管理,并且需要全自动化基础架构管理流程的场景。

此方法提供声明性 API 来对裸机服务器进行清单和状态管理,包括自动检查、清理和置备/取消置备。

10.2 已知问题 #

上游 IP 地址管理控制器目前不受支持,因为它与我们选择的网络配置工具尚不兼容。

相关的 IPAM 资源和 Metal3DataTemplate networkData 字段也不受支持。

目前仅支持通过 redfish-virtualmedia 进行部署。

11 Edge Image Builder #

请参见官方储存库。

Edge Image Builder (EIB) 工具可以简化为引导计算机生成自定义的随时可引导 (CRB) 磁盘映像的过程。使用一个这样的映像就能实现整个 SUSE 软件堆栈的端到端部署。

虽然 EIB 能够为所有置备场景创建 CRB 映像,但 EIB 在网络受限或完全隔离的隔离式部署中展现出极大价值。

11.1 SUSE Edge 如何使用 Edge Image Builder? #

SUSE Edge 使用 EIB 来简化和快速配置适用于多种场景的自定义 SUSE Linux Micro 映像。这些场景包括为虚拟机和裸机引导部署,具体如下:

K3s/RKE2 Kubernetes 的完全隔离式部署(单节点和多节点)

完全隔离式 Helm chart和 Kubernetes 清单部署

通过 Elemental API 注册到 Rancher

Metal3

自定义网络(例如静态 IP、主机名、VLAN、绑定等)

自定义操作系统配置(例如用户、组、口令、SSH 密钥、代理、NTP、自定义 SSL 证书等)

主机级和侧载 RPM 软件包的隔离式安装(包括依赖项解析)

注册到 SUSE Multi-Linux Manager 以进行操作系统管理

嵌入式容器映像

内核命令行参数

引导时启用/禁用的 Systemd 单元

用于任何手动任务的自定义脚本和文件

11.2 入门 #

有关 Edge Image Builder 用法和测试的综合文档可在此处找到。

另外请参见第 3 章 “使用 Edge Image Builder 配置独立群集”,其中介绍了一种基本部署场景。

当您熟悉此工具后,可在我们的 Tips and tricks 网页中查找一些更有用的信息。

11.3 已知问题 #

EIB 通过模板化 Helm chart 并分析模板中的所有映像来隔离 Helm chart。如果 Helm chart 未将其所有映像保留在模板中,而是侧载映像,则 EIB 将无法自动隔离这些映像。可通过手动将任何未检测到的映像添加到定义文件的

embeddedArtifactRegistry部分,来解决此问题。

12 边缘网络 #

本章介绍 SUSE Edge 解决方案中的网络配置方法。我们将展示如何以声明方式在 SUSE Linux Micro 上配置 NetworkManager,并说明如何集成相关的工具。

12.1 NetworkManager 概述 #

NetworkManager 是用于管理主网络连接和其他连接接口的工具。

NetworkManager 将网络配置存储为包含期望状态的连接文件。这些连接以文件的形式存储在

/etc/NetworkManager/system-connections/ 目录中。

有关 NetworkManager 的详细信息,请参见 SUSE Linux Micro 文档。

12.2 nmstate 概述 #

nmstate 是广泛采用的库(附带 CLI 工具),它提供一个声明性 API,可用于通过预定义的纲要进行网络配置。

有关 nmstate 的详细信息,请参见上游文档。

12.3 NetworkManager Configurator (nmc) 概述 #

SUSE Edge 中提供的网络自定义选项通过一个称为 NetworkManager Configurator(简称为 nmc)的 CLI 工具实现。此工具利用 nmstate 库提供的功能,因此完全能够配置静态 IP 地址、DNS 服务器、VLAN、绑定、网桥等。我们可以使用此工具根据预定义的期望状态生成网络配置,并自动将这些配置应用于许多不同的节点。

有关 NetworkManager Configurator (nmc) 的详细信息,请参见上游储存库。

12.4 SUSE Edge 如何使用 NetworkManager Configurator? #

SUSE Edge 利用 nmc 在各种不同的置备模型中进行网络自定义:

定向网络置备场景中的自定义网络配置(第 1 章 “使用 Metal3 实现 BMC 自动化部署”)

基于映像的置备场景中的声明性静态配置(第 3 章 “使用 Edge Image Builder 配置独立群集”)

12.5 使用 Edge Image Builder 进行配置 #

Edge Image Builder (EIB) 是可用于通过单个操作系统映像配置多个主机的工具。本节将介绍如何使用声明式方法来描述期望的网络状态,如何将这些状态转换为相应的 NetworkManager 连接,然后在置备过程中应用这些连接。

12.5.1 先决条件 #

如果您要学习本指南,事先需要做好以下准备:

一台运行 SLES 15 SP6 或 openSUSE Leap 15.6 的 AMD64/Intel 64 物理主机(或虚拟机)

一个可用的容器运行时(例如 Podman)

SUSE Linux Micro 6.1 原始映像,可在此处获取

12.5.2 获取 Edge Image Builder 容器映像 #

EIB 容器映像已公开提供,可以通过运行以下命令从 SUSE Edge 注册表下载:

podman pull registry.suse.com/edge/3.3/edge-image-builder:1.2.112.5.3 创建映像配置目录 #

我们来开始创建配置目录:

export CONFIG_DIR=$HOME/eib

mkdir -p $CONFIG_DIR/base-images确保下载的基础映像已移动到配置目录:

mv /path/to/downloads/SL-Micro.x86_64-6.1-Base-GM.raw $CONFIG_DIR/base-images/注意EIB 永远不会修改基础映像输入。它会创建一个包含所需修改内容的新映像。

此时,配置目录应如下所示:

└── base-images/

└── SL-Micro.x86_64-6.1-Base-GM.raw12.5.4 创建映像定义文件 #

定义文件描述了 Edge Image Builder 支持的大多数可配置选项。

首先,我们为操作系统映像创建一个非常简单的定义文件:

cat << EOF > $CONFIG_DIR/definition.yaml

apiVersion: 1.2

image:

arch: x86_64

imageType: raw

baseImage: SL-Micro.x86_64-6.1-Base-GM.raw

outputImageName: modified-image.raw

operatingSystem:

users:

- username: root

encryptedPassword: $6$jHugJNNd3HElGsUZ$eodjVe4te5ps44SVcWshdfWizrP.xAyd71CVEXazBJ/.v799/WRCBXxfYmunlBO2yp1hm/zb4r8EmnrrNCF.P/

EOF必须包含 image

部分,它指定输入映像、输入映像的体系结构和类型,以及输出映像的名称。operatingSystem

是可选部分,其中包含的配置允许用户通过 root/eib 用户名/口令登录到置备的系统。

注意您可以运行

openssl passwd -6 <password>来使用自己的已加密口令。

此时,配置目录应如下所示:

├── definition.yaml

└── base-images/

└── SL-Micro.x86_64-6.1-Base-GM.raw12.5.5 定义网络配置 #

期望的网络配置不是我们刚刚创建的映像定义文件的一部分。现在我们在特殊的 network/

目录下填充这些配置。我们来创建该目录:

mkdir -p $CONFIG_DIR/network如前所述,NetworkManager Configurator (nmc) 工具要求提供预定义纲要形式的输入。您可以参见上游 NMState 示例文档,了解如何设置各种不同的网络选项。

本指南将介绍如何在三个不同的节点上配置网络:

使用两个以太网接口的节点

使用网络绑定的节点

使用网桥的节点

不建议在生产构建中使用完全不同的网络设置,尤其是在配置 Kubernetes 群集时。网络配置通常应在节点之间或至少在给定群集内的角色之间保持同质。本指南包含的各种不同选项仅供参考。

注意以下示例采用 IP 地址范围为

192.168.122.1/24的默认libvirt网络。如果您的环境与此不同,请相应地进行调整。

我们来为第一个节点(名为 node1.suse.com)创建期望的状态:

cat << EOF > $CONFIG_DIR/network/node1.suse.com.yaml

routes:

config:

- destination: 0.0.0.0/0

metric: 100

next-hop-address: 192.168.122.1

next-hop-interface: eth0

table-id: 254

- destination: 192.168.122.0/24

metric: 100

next-hop-address:

next-hop-interface: eth0

table-id: 254

dns-resolver:

config:

server:

- 192.168.122.1

- 8.8.8.8

interfaces:

- name: eth0

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E1

ipv4:

address:

- ip: 192.168.122.50

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

- name: eth3

type: ethernet

state: down

mac-address: 34:8A:B1:4B:16:E2

ipv4:

address:

- ip: 192.168.122.55

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

EOF在此示例中,我们将定义两个以太网接口(eth0 和 eth3)的期望状态、其请求 IP 地址、路由和 DNS 解析。

必须确保列出了所有以太网接口的 MAC 地址。这些地址在置备过程中用作节点的标识符,用于确定要应用哪些配置。这就是我们使用单个 ISO 或 RAW 映像配置多个节点的方式。

接下来对第二个节点(名为 node2.suse.com)进行操作,该节点使用网络绑定:

cat << EOF > $CONFIG_DIR/network/node2.suse.com.yaml

routes:

config:

- destination: 0.0.0.0/0

metric: 100

next-hop-address: 192.168.122.1

next-hop-interface: bond99

table-id: 254

- destination: 192.168.122.0/24

metric: 100

next-hop-address:

next-hop-interface: bond99

table-id: 254

dns-resolver:

config:

server:

- 192.168.122.1

- 8.8.8.8

interfaces:

- name: bond99

type: bond

state: up

ipv4:

address:

- ip: 192.168.122.60

prefix-length: 24

enabled: true

link-aggregation:

mode: balance-rr

options:

miimon: '140'

port:

- eth0

- eth1

- name: eth0

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E3

ipv4:

enabled: false

ipv6:

enabled: false

- name: eth1

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E4

ipv4:

enabled: false

ipv6:

enabled: false

EOF在此示例中,我们将定义两个未启用 IP 寻址的以太网接口(eth0 和 eth1)的期望状态,以及采用轮替策略的绑定及其用于转发网络流量的相应地址。

最后,我们将创建第三个(也是最后一个)期望状态文件,该文件利用网桥,我们将其命名为 node3.suse.com:

cat << EOF > $CONFIG_DIR/network/node3.suse.com.yaml

routes:

config:

- destination: 0.0.0.0/0

metric: 100

next-hop-address: 192.168.122.1

next-hop-interface: linux-br0

table-id: 254

- destination: 192.168.122.0/24

metric: 100

next-hop-address:

next-hop-interface: linux-br0

table-id: 254

dns-resolver:

config:

server:

- 192.168.122.1

- 8.8.8.8

interfaces:

- name: eth0

type: ethernet

state: up

mac-address: 34:8A:B1:4B:16:E5

ipv4:

enabled: false

ipv6:

enabled: false

- name: linux-br0

type: linux-bridge

state: up

ipv4:

address:

- ip: 192.168.122.70

prefix-length: 24

dhcp: false

enabled: true

bridge:

options:

group-forward-mask: 0

mac-ageing-time: 300

multicast-snooping: true

stp:

enabled: true

forward-delay: 15

hello-time: 2

max-age: 20

priority: 32768

port:

- name: eth0

stp-hairpin-mode: false

stp-path-cost: 100

stp-priority: 32

EOF此时,配置目录应如下所示:

├── definition.yaml

├── network/

│ │── node1.suse.com.yaml

│ │── node2.suse.com.yaml

│ └── node3.suse.com.yaml

└── base-images/

└── SL-Micro.x86_64-6.1-Base-GM.raw注意

network/目录下的文件名是特意设定的,它们与置备过程中将要设置的主机名相对应。

12.5.6 构建操作系统映像 #

完成所有必要配置后,接下来我们只需运行以下命令来构建映像:

podman run --rm -it -v $CONFIG_DIR:/eib registry.suse.com/edge/3.3/edge-image-builder:1.2.1 build --definition-file definition.yaml输出应如下所示:

Generating image customization components...

Identifier ................... [SUCCESS]

Custom Files ................. [SKIPPED]

Time ......................... [SKIPPED]

Network ...................... [SUCCESS]

Groups ....................... [SKIPPED]

Users ........................ [SUCCESS]

Proxy ........................ [SKIPPED]

Rpm .......................... [SKIPPED]