19 OCFS2 #

OCFS 2 (Oracle Cluster File System 2)は、Linux 2.6以降のカーネルに完全に統合されている汎用ジャーナリングファイルシステムです。Oracle Cluster File System 2を利用すれば、アプリケーションバイナリファイル、データファイル、およびデータベースを、共有ストレージ中のデバイスに保管することができます。このファイルシステムには、クラスタ中のすべてのノードが同時に読み書きすることができます。ユーザスペース管理デーモンは、クローンリソースを介して管理され、HAスタック(特に、CorosyncおよびDLM (Distributed Lock Manager))との統合を実現します。

19.1 特長と利点 #

OCFS2は、たとえば、次のストレージソリューションに使用できます。

一般のアプリケーションとワークロード。

クラスタ中のXENイメージ。Xen仮想マシンと仮想サーバは、クラスタサーバによってマウントされたOCFS2ボリュームに保存できます。これによって、サーバ間でXen仮想マシンを素早く容易に移植できます。

LAMP (Linux、Apache、MySQL、およびPHP | Perl | Python)スタック。

OCF2は、高パフォーマンスでシンメトリックなパラレルクラスタファイルシステムとして、次の機能をサポートします。

アプリケーションのファイルを、クラスタ内のすべてのノードで使用できます。ユーザは、クラスタ中のOracle Cluster File System 2ボリュームに1回インストールするだけで構いません。

すべてのノードが、標準ファイルシステムインタフェースを介して、同時並行的に、ストレージに直接読み書きできるので、クラスタ全体に渡わたって実行されるアプリケーションの管理が容易になります。

ファイルアクセスがDLMを介して調整されます。ほとんどの場合、DLMによる制御は適切に機能しますが、アプリケーションの設計によっては、アプリケーションとDLMがファイルアクセスの調整で競合すると、スケーラビリティが制限されることがあります。

すべてのバックエンドストレージで、ストレージのバックアップ機能を利用することができます。共有アプリケーションファイルのイメージを簡単に作成することができるため、災害発生時でも素早くデータを復元することができます。

Oracle Cluster File System 2には、次の機能も用意されています。

メタデータのキャッシュ処理。

メタデータのジャーナル処理。

ノード間にまたがるファイルデータの整合性。

最大4KBのマルチブロックサイズ、最大1MBのクラスタサイズ、4PB(ペタバイト)の最大ボリュームサイズをサポートします。

32台までのクラスタノードをサポート。

データベースのパフォーマンスを向上する非同期、直接I/Oのサポート。

OCFS2は、SUSE Linux Enterprise High Availability Extensionによって提供される、pcmk (Pacemaker)スタックと併用する場合にのみ、SUSEによってサポートされます。o2cbスタックと組み合わせた場合、SUSEはOCFS2をサポートしません。

19.2 OCFS2のパッケージと管理ユーティリティ #

SUSE® Linux Enterprise Server 15 SP4上のHigh Availability Extensionには、OCFS2カーネルモジュール(ocfs2)が自動的にインストールされます。OCFS2を使用するには、ocfs2-toolsと、ご使用のカーネルに適合するocfs2-kmp-*パッケージが、クラスタの各ノードにインストールされていることを確認してください。

ocfs2-toolsパッケージには、次に示すOCFS2ボリュームの管理ユーティリティがあります。構文については、各マニュアルページを参照してください。

|

OCFS2ユーティリティ |

説明 |

|---|---|

|

debugfs.ocfs2 |

デバッグのために、OCFSファイルシステムの状態を調査します。 |

|

fsck.ocfs2 |

ファイルシステムにエラーがないかをチェックし、必要に応じてエラーを修復します。 |

|

mkfs.ocfs2 |

デバイス上にOCFS2ファイルシステムを作成します。通常は、共有物理/論理ディスク上のパーティションに作成します。 |

|

mounted.ocfs2 |

クラスタシステム上のすべてのOCFS2ボリュームを検出、表示します。OCFS2デバイスをマウントしているシステム上のすべてのノードを検出、表示するか、またはすべてのOCFS2デバイスを表示します。 |

|

tunefs.ocfs2 |

ボリュームラベル、ノードスロット数、すべてのノードスロットのジャーナルサイズ、およびボリュームサイズなど、OCFS2ファイルのシステムパラメータを変更します。 |

19.3 OCFS2サービスとSTONITHリソースの設定 #

OCFS2ボリュームを作成する前に、DLMおよびSTONITHリソースをクラスタ内のサービスとして設定する必要があります。

次の手順では、crmシェルを使用してクラスタリソースを設定します。19.6項 「Hawk2でのOCFS2リソースの設定」で説明されているように、リソースの設定にはHawk2を使用することもできます。

フェンシングデバイスを設定する必要があります。STONITHなしでは、設定内に配置されたメカニズム(external/sbdなど)は失敗します。

シェルを起動し、

rootまたは同等のものとしてログインします。手順11.3「SBDデバイスの初期化」で説明されるとおり、SBDパーティションを作成します。

crmconfigureを実行します。external/sdbをフェンシングデバイスとして設定し、/dev/sdb2を共有ストレージ上のハートビートとフェンシング専用のパーティションにします。crm(live)configure#primitivesbd_stonith stonith:external/sbd \ params pcmk_delay_max=30 meta target-role="Started"showで変更内容をレビューします。すべて正しければ、

commitで変更を送信し、quitでcrmライブ設定を終了します。

DLMに対するリソースグループの設定の詳細については、手順18.1「DLMのベースグループの設定」を参照してください。

19.4 OCFS2ボリュームの作成 #

19.3項 「OCFS2サービスとSTONITHリソースの設定」で説明されているように、DLMクラスタリソースを設定したら、システムがOCFS2を使用できるように設定し、OCFs2ボリュームを作成します。

一般に、アプリケーションファイルとデータファイルは、異なるOCFS2ボリュームに保存することを推奨します。アプリケーションボリュームとデータボリュームのマウント要件が異なる場合は、必ず、異なるボリュームに保存します。

作業を始める前に、OCFS2ボリュームに使用するブロックデバイスを準備します。デバイスは空き領域のままにしてください。

次に、手順19.2「OCFS2ボリュームを作成し、フォーマットする」で説明されているように、mkfs.ocfs2で、OCFS2ボリュームを作成し、フォーマットします。そのコマンドの重要なパラメータは、表19.2「重要なOCFS2パラメータ」に一覧されています。詳細情報とコマンド構文については、mkfs.ocfs2のマニュアルページを参照してください。

|

OCFS2パラメータ |

説明と推奨設定 |

|---|---|

|

ボリュームラベル( |

異なるノードへのマウント時に、正しく識別できるように、一意のわかりやすいボリューム名を指定します。ラベルを変更するには、 |

|

クラスタサイズ( |

クラスタサイズは、ファイルに割り当てられる、データ保管領域の最小単位です。使用できるオプションと推奨事項については、 |

|

ノードスロット数( |

同時にボリュームをマウントできる最大ノード数を指定します。各ノードについて、OCFS2はジャーナルなどの個別のシステムファイルを作成します。ボリュームにアクセスするノードに、リトルエンディアン形式のノード(AMD64/Intel 64など)とビッグエンディアン形式のノード(S/390xなど)が混在しても構いません。

ノード固有のファイルは、ローカルファイルと呼ばれます。ローカルファイルには、ノードスロット番号が付加されます。たとえば、

各ボリュームを同時にマウントすると予期されるノード数に従って、各ボリュームの作成時に、そのボリュームの最大ノードスロット数を設定します。

|

|

ブロックサイズ( |

ファイルシステムがアドレス可能な領域の最小単位を指定します。ブロックサイズは、ボリュームの作成時に指定します。使用できるオプションと推奨事項については、 |

|

特定機能のオン/オフ( |

カンマで区切った機能フラグリストを指定できます。

使用できるすべてのフラグの概要については、 |

|

事前定義機能( |

事前定義されたファイルシステム機能セットから選択できます。使用できるオプションについては、 |

mkfs.ocfs2によるボリュームの作成およびフォーマット時に機能を指定しない場合は、backup-super、sparse、inline-data、unwritten、metaecc、indexed-dirs、およびxattrの各機能がデフォルトで有効になります。

クラスタノードの1つだけで、次の手順を実行します。

端末ウィンドウを開いて、

rootとしてログインします。クラスタがオンラインであることをコマンド

crm statusで確認します。mkfs.ocfs2ユーティリティを使用して、ボリュームを作成およびフォーマットします。このコマンドの指定形式については、mkfs.ocfs2マニュアルページを参照してください。たとえば、最大32台のクラスタノードをサポートする新しいOCFS2ファイルシステムを

/dev/sdb1上に作成するには、次のコマンドを使用します。root #mkfs.ocfs2 -N 32 /dev/sdb1

19.5 OCFS2ボリュームのマウント #

OCFS2ボリュームは、手動でマウントするか、クラスタマネージャでマウントできます(手順19.4「クラスタリソースマネージャでOCFS2ボリュームをマウントする」参照)。

端末ウィンドウを開いて、

rootとしてログインします。クラスタがオンラインであることをコマンド

crm statusで確認します。コマンドラインから、

mountコマンドを使ってボリュームをマウントします。

OCFS2ボリュームは、完全に機能するクラスタスタックがなくても、単一ノードにマウントできます。たとえば、バックアップからデータにすばやくアクセスできます。これを行うには、-o noclusterオプションを指定してmountコマンドを使用します。

このマウント方法では、クラスタ全体の保護は行われません。ファイルシステムの損傷を防ぐため、ファイルシステムが1つのノードにのみマウントされていることを確認する必要があります。

High AvailabilityソフトウェアでOCFS2ボリュームをマウントするには、クラスタ内でocfs2ファイルシステムのリソースを設定します。次の手順では、crmシェルを使用してクラスタリソースを設定します。19.6項 「Hawk2でのOCFS2リソースの設定」で説明されているように、リソースの設定にはHawk2を使用することもできます。

シェルを起動し、

rootまたは同等のものとしてログインします。crmconfigureを実行します。OCFS2ファイルシステムをクラスタ内のすべてのノードにマウントするように、Pacemakerを設定します。

crm(live)configure#primitiveocfs2-1 ocf:heartbeat:Filesystem \ params device="/dev/sdb1" directory="/mnt/shared" fstype="ocfs2" \ op monitor interval="20" timeout="40" \ op start timeout="60" op stop timeout="60" \ meta target-role="Started"ocfs2-1プリミティブを手順18.1「DLMのベースグループの設定」で作成したg-storageグループに追加します。crm(live)configure#modgroupg-storage add ocfs2-1addサブコマンドは、デフォルトで新しいグループメンバーを追加します。ベースグループの内部コロケーションおよび順序付けによって、Pacemakerは、すでに実行しているdlmリソースも持つノード上でocfs2-1リソースのみ起動します。showで変更内容をレビューします。すべて正しければ、

commitで変更を送信し、quitでcrmライブ設定を終了します。

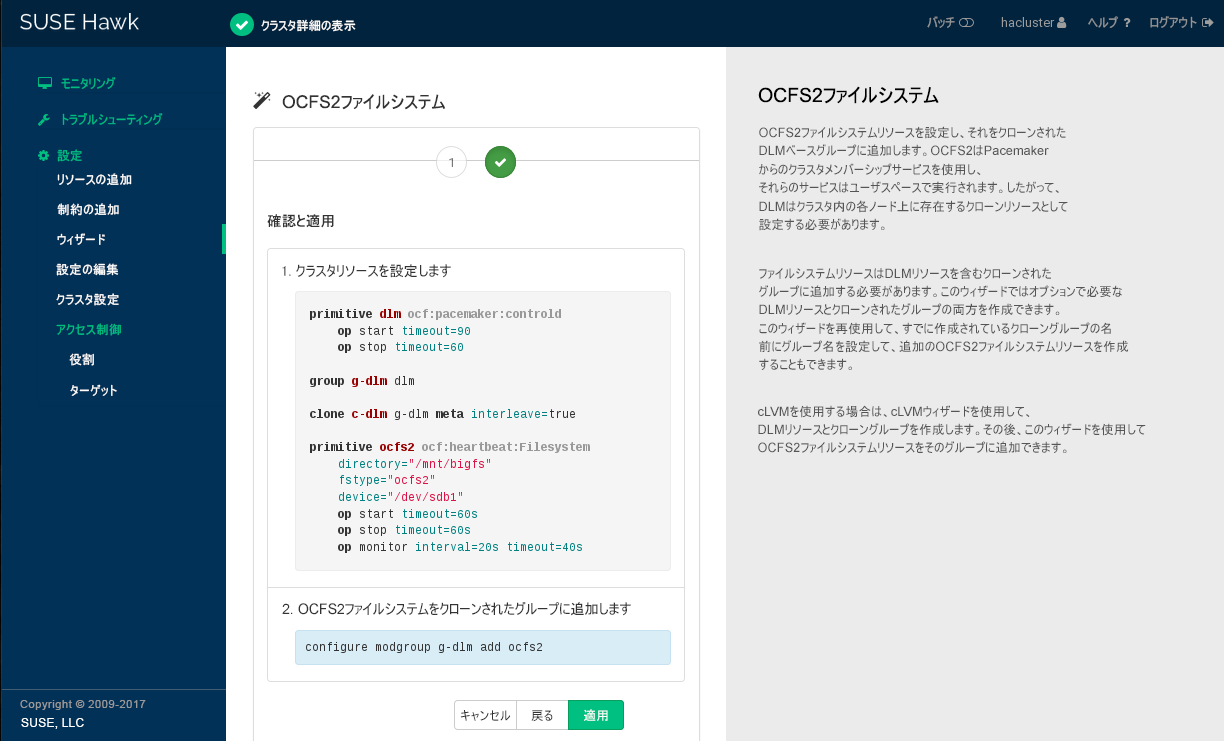

19.6 Hawk2でのOCFS2リソースの設定 #

crmシェルを使用して、DLM、およびOCFS2のファイルシステムリソースを手動で設定する代わりに、Hawk2ののOCFS2テンプレートを使用することもできます。

のOCFS2テンプレートには、STONITHリソースの設定が含まれません。ウィザードを使用する場合でも、手順19.1「STONITHリソースの設定」で説明されているように、共有ストレージ上でSBDパーティションを作成し、STONITHリソースを設定する必要があります。

また、HawkのOCFS2テンプレートを使用すると、手順18.1「DLMのベースグループの設定」および手順19.4「クラスタリソースマネージャでOCFS2ボリュームをマウントする」で説明されている手動設定とは若干異なるリソース設定になります。

Hawk2にログインします。

https://HAWKSERVER:7630/

左のナビゲーションバーで、を選択します。

カテゴリを展開して、

OCFS2 File Systemを選択します。画面の指示に従います。オプションについての情報が必要な場合には、オプションをクリックすると、Hawk2は簡単なヘルプテキストを表示します。最後の設定手順が完了したら、を選択して、入力した値を検証します。

CIBに適用する設定スニペットやその他の必要な変更がウィザードに表示されます。

適用予定の変更を確認します。すべてが希望どおりの場合は、変更を適用します。

画面上のメッセージが、アクションに成功したかどうかを示します。

19.7 OCFS2ファイルシステム上でクォータを使用する #

OCFS2ファイルシステム上でクォータを使用するには、適切なクォータ機能またはオプションを使用して、ファイルシステムを作成し、マウントします。オプションはursquota (個々のユーザのためのクォータ)またはgrpquota (グループのためのクォータ)です。これらの機能は後ほど、tunefs.ocfs2を使用して、マウントされていないファイルシステムで有効にすることもできます。

ファイルシステムで適切なクォータ機能が有効にされている場合、ファイルシステムは、そのメタデータで、各ユーザ(または)グループが使用しているスペースの量とファイルの数を追跡します。OCFS2はクォータ情報をファイルシステムの内部メタデータとして扱うので、quotacheck(8)プログラムを実行する必要はありません。すべての機能はfsck.ocf2、およびファイルシステムドライバ自体に組み込まれています。

各ユーザまたはグループに課せられている制限の強制を有効にするには、他のファイルシステムでの場合と同様に、quotaon(8)を実行します。

パフォーマンス上の理由で、各クラスタノードはクォータの計算をローカルに行い、この情報を、10秒ごとに共通の中央ストレージに同期するようになっています。この間隔は、tunefs.ocfs2と、usrquota-sync-intervalおよびgrpquota-sync-intervalオプションで調整することができます。クォータ情報は必ずしも常に正確というわけではないので、複数のクラスタノードを並列に運用している場合、ユーザまたはグループがクォータ制限をいくらか超えることもあります。

19.8 詳細の参照先 #

OCFS2の詳細については、次のリンクを参照してください。

- https://ocfs2.wiki.kernel.org/

OCFS2プロジェクトホームページ。

- http://oss.oracle.com/projects/ocfs2/

Oracleサイトにある以前のOCFS2プロジェクトのホームページ

- http://oss.oracle.com/projects/ocfs2/documentation

プロジェクトの以前のドキュメントホームページ。